Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

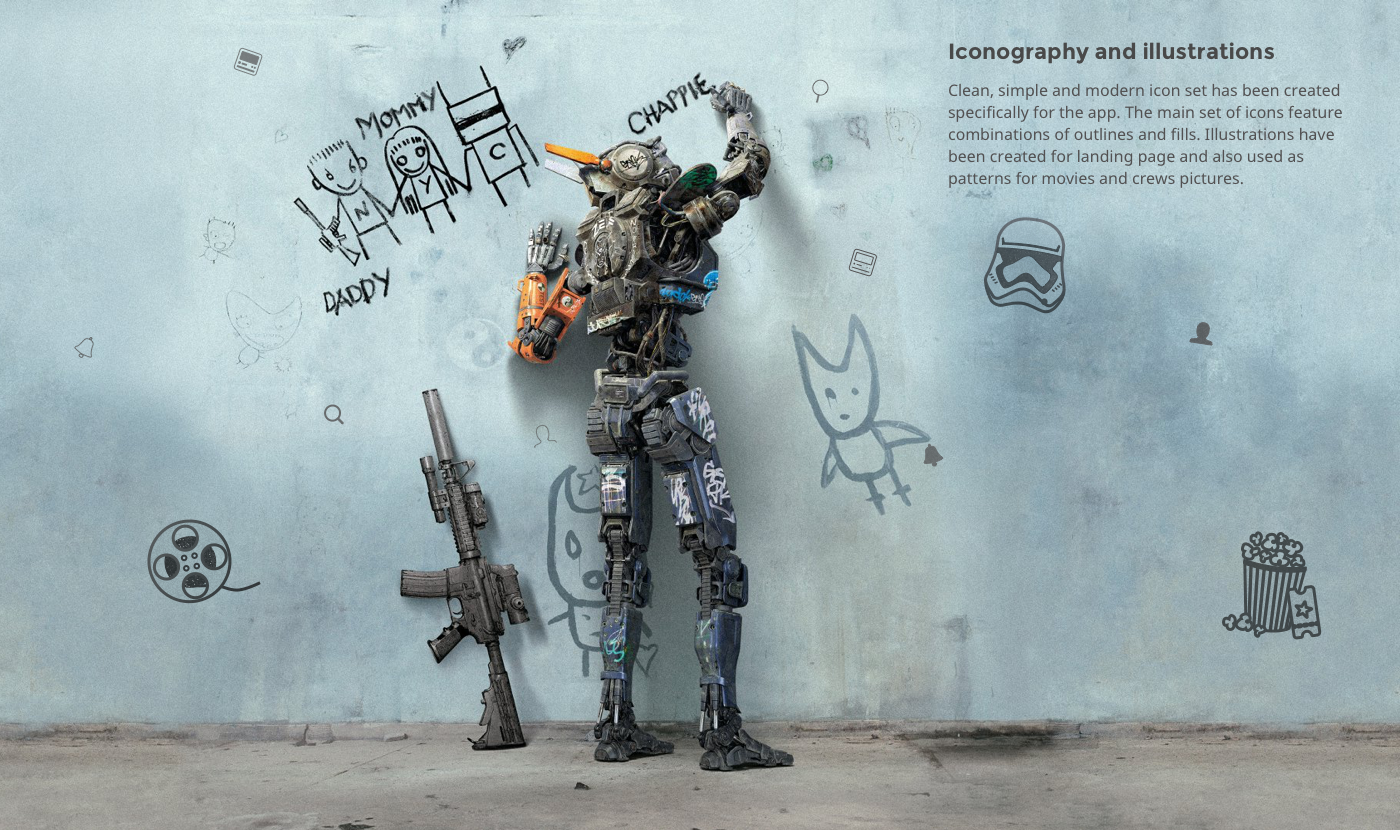

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Перевод] Математический детектив: поиск положительных целых решений уравнения |

«Я экспериментировал с задачами кубического представления в стиле предыдущей работы Эндрю и Ричарда Гая. Численные результаты были потрясающими…» (комментарий на MathOverflow)Вот так ушедший на покой математик Аллан Маклауд наткнулся на это уравнение несколько лет назад. И оно действительно очень интересно. Честно говоря, это одно из лучших диофантовых уравнений, которое я когда-либо видел, но видел я их не очень много.

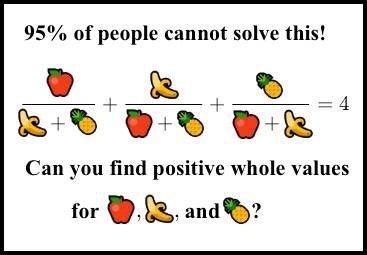

Я нашёл его, когда оно начало распространяться как выцепляющая в сети нердов картинка-псевдомем, придуманная чьим-то безжалостным умом (Сридхар, это был ты?). Я не понял сразу, что это такое. Картинка выглядела так:

«95% людей не решат эту загадку. Сможете найти положительные целочисленные значения?»

Вы наверно уже видели похожие картинки-мемы. Это всегда чистейший мусор, кликбэйты: «95% выпускников МТИ не решат её!». «Она» — это какая-нибудь глупая или плохо сформулированная задачка, или же тривиальная разминка для мозга.

Но эта картинка совсем другая. Этот мем — умная или злобная шутка. Примерно у 99,999995% людей нет ни малейших шансов её решить, в том числе и у доброй части математиков из ведущих университетов, не занимающихся теорией чисел. Да, она решаема, но при этом по-настоящему сложна. (Кстати, её не придумал Сридхар, точнее, не он полностью. См. историю в этом комментарии).

Вы можете подумать, что если ничего другое не помогает, то можно просто заставить компьютер решать её. Очень просто написать компьютерную программу для поиска решений этого кажущегося простым уравнения. Разумеется, компьютер рано или поздно найдёт их, если они существуют. Большая ошибка. Здесь метод простого перебора компьютером будет бесполезен.

Не знаю, удастся ли уместить полное решение в статью, если не принять, что все уже знают всё необходимое об эллиптических кривых. Я могу привести здесь только краткий обзор. Основной справочный источник — это чудесная, относительно недавняя работа Бремнера и Маклауда под названием «An unusual cubic representation problem» («Необычная проблема кубического представления»), опубликованная в 2014 году в Annales Mathematicae et Informaticae.

Итак, приступим.

Мы ищем положительные целочисленные решения уравнения

(я заменил обозначения переменных теми, которые используются в работе).

Первое, что нужно сделать, исследуя любое уравнение — попробовать поместить его в нужный контекст. Надо задать вопрос: что это за уравнение? Так, нас просят найти целочисленные решения, то есть это задача теории чисел. В текущей формулировке в уравнении используются рациональные функции (многочлены, делящиеся на другие многочлены), но очевидно, что мы можем домножить на общее кратное знаменателей, чтобы подчистить уравнение и получить только многочлены, то есть привести его к виду диофантова уравнения. Требование «положительности» довольно необычно, и, как мы увидим, усложняет всё.

Итак, сколько же у нас тут переменных? Вопрос кажется глупым: очевидно, что три, а именно , и . Но не торопитесь. Опытный исследователь теории чисел мгновенно заметит, что уравнение однородное. Это значит, что если является одним из решений уравнения, то решением является и . Понимаете, почему? Умножив каждую переменную на какую-нибудь постоянную ( — это просто пример), мы ничего не изменим, потому что константа в каждой из частей сокращается.

Это значит, что уравнение только притворяется трёхмерным. На самом деле оно двухмерно. В геометрическом представлении у нас есть поверхность (одно уравнение с тремя переменными в общем случае задаёт двухмерную поверхность. В целом, уравнений с переменными задают -мерное многообразие, где ). Но эта поверхность на самом деле ограничена линией, колеблющейся и проходящей через начало координат. Получившуюся поверхность можно понять, разобравшись в том, как она рассекает единичную плоскость. Это проективная кривая.

Проще всего объянить это сведение можно так: мы можем разделить решения, какими бы они ни были, на те, при которых , и те, при которых . В первом случае у нас остаётся всего две переменные, и , а во втором мы просто можем разделить на и получить решение при . Поэтому мы можем просто искать рациональные решения в и для случая , умножать их на общий делитель и получать целочисленное решение в , и . В сущности, целочисленные решения однородных уравнений соответствуют рациональным решениям неоднородной версии, которая на одну размерность меньше.

Продолжим: какова степень нашего уравнения? Степень уравнения — это максимальная степень, любого появляющаяся в уравнении одночлена, где «одночлен» — это произведение нескольких переменных, чья «степень» является количеством перемножаемых одночленов. Например, будет одночленом степени .

Поведение диофантовых уравнений сильно зависит от их степени. В целом:

- Со степенью всё просто.

- Степень полностью проанализирована и может быть решена довольно элементарными способами.

- Степень — это обширный океан глубокой теории и миллион нерешённых проблем.

- Степень и выше… Очень, очень сложны.

Мы имеем степень . Почему? Мы просто умножаем на делители:

Даже без раскрывания скобок можно увидеть, что степень равна : мы никогда не перемножаем более трёх переменных за раз. У нас получатся части типа , и , но никогда не будет чего-то больше трёх множителей. Если провести преобразования, то уравнение будет иметь вид

Вы можете возразить, что умножение на делители невозможно, если какие-то из них оказываются равны . Это верно — действительно, наше новое уравнение имеет несколько решений, не соответствующих исходному уравнению. Но на самом деле это хорошо. Версия с многочленами добавляет к оригиналу несколько «заплаток» и с ним становится проще работать. Нам просто нужно будет проверять, не исчезают ли исходные делители при каждом конкретном решении.

На самом деле уравнение с многочленами легко решить, например, , , . Это хорошо: у нас есть рациональное решение (рациональная точка). Это значит, что наше кубическое уравнение (степень = 3) на самом деле является эллиптической кривой.

Когда обнаруживаешь, что уравнение представляет собой эллиптическую кривую, то а) радуешься и б) отчаиваешься, потому что предстоит ещё много чего изучить. Это уравнение — прекрасный пример того, как мощную теорию эллиптических кривых можно применить к нахождению безумно сложно определяемых решений.

Первое, что обычно делают эллиптической кривой — приводят её в вейерштрассову форму. Это уравнение, которое выглядит как

а иногда как

(это называется развёрнутой вейерштрассовой формой. Она необязательна, но иногда более удобна).

Обычно любую эллиптическую кривую можно привести к такому виду (если вы только не работаете над полями с малыми характеристиками, но здесь нам не нужно о них волноваться). Объяснять способ поиска правильного преобразования было бы слишком долго, поэтому просто знайте, что это абсолютно механический процесс (критически важно в нём то, чтобы была хотя бы одна рациональная точка, которая у нас есть). Существуют разные пакеты вычислительной алгебры, которые сделают всё за вас.

Но даже если вы не знаете. как найти преобразование, проверить его очень просто, по крайней мере, это выполняется чисто механически. Необходимое преобразование в нашем случае задаётся страшно выглядящими формулами

Я знаю, что они похожи на неизвестно откуда взявшуюся магию вуду, но поверьте, это не так. Получив эти преобразования, с помощью монотонных, но довольно простых алгебраических расчётов мы покажем, что

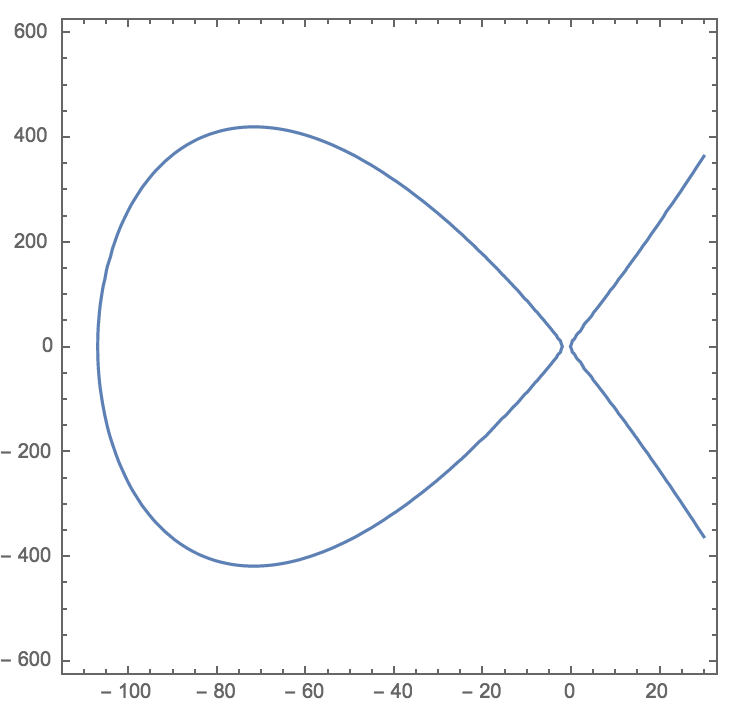

Это уравнение, хоть и выглядит совсем по-другому, на самом деле является достоверной моделью исходного. Графически оно выглядит так — типичная эллиптическая кривая с двумя вещественными частями:

«Рыбий хвост» справа растёт «в бесконечность и дальше». Овальная фигура слева является замкнутой и оказывается для нас довольно интересной.

Имея любое решение этого уравнения, мы можем восстановить необходимые значения , , с помощью уравнений

(Помните, что триплет нужно воспринимать проективно – какие бы значения вы ни получили с помощью этих уравнений, их всегда можно умножить на любую константу).

Два показанных нами отображения, из , , в , и наоборот, показывают, что эти два уравнения «одинаковы» с точки зрения теории чисел: рациональные решения одного дают рациональные решения другого. Технически это называется бирациональной эквивалентностью, а она является фундаментальным понятием алгебраической геометрии. Как мы уже заметили, могут существовать точки-исключения, которые не отображаются правильно. Это случаи, когда , или оказываются равны . Это привычная расплата в случае бирациональной эквивалентности, и она не должна вызывать никаких волнений.

Давайте рассмотрим пример.

На эллиптической кривой (2) есть хорошая рациональная точка:

, . Возможно, её не так просто найти, но очень просто проверить: просто вставьте эти значения и вы увидите, что две половины одинаковы (я выбирал эту точку не случайным образом, но пока это неважно). Можно просто проверить, какие значения , , она нам даёт. Мы получаем , , , и поскольку мы можем умножить на общий делитель, то результаты преобразуются в , , .

И в самом деле,

как можно с лёгкостью убедиться. Это простое решение нашего исходного уравнения в целых числах, но, увы, не в положительных целых. Это решение непросто вывести вручную, но и несложно получить без всей этой рассматриваемой здесь махины, приложив немного терпения. Самая сложность заключается в положительных решениях.

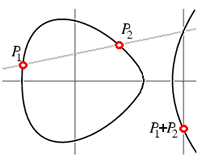

Теперь, получив рациональную точку на эллиптической кривой, например, на нашей кривой (2), можно начать генерировать другие с помощью техники хорд и касательных, рассмотренной в предыдущей статье на Quora.

Для начала прибавим нашу точку к ней самой, найдя касательную к кривой в точке и определив, где она снова встречается с кривой. Результат будет немного пугающим:

и снова эта новая точка соответствует значениям , , , являющимся решением исходного уравнения

Это решение определённо непросто найти вручную, но оно всё ещё под силу компьютеру. Однако оно по-прежнему неположительно.

Не пугаясь неудач, мы продолжаем вычислять , что можно определить соединением прямой линией и и нахождением третьей точки пересечения с кривой. И снова мы вычисляем , , , и снова результат неположителен. То же самое будет и с , и с , и так далее… пока мы не наткнёмся на .

9P=(-66202368404229585264842409883878874707453676645038225/13514400292716288512070907945002943352692578000406921,

58800835157308083307376751727347181330085672850296730351871748713307988700611210/1571068668597978434556364707291896268838086945430031322196754390420280407346469)Его определённо непросто найти, но с помощью нашей машинерии нам достаточно повторить девять раз простую геометрическую процедуру. Соответствующие значения , , потрясающи:

a=154476802108746166441951315019919837485664325669565431700026634898253202035277999,

b=36875131794129999827197811565225474825492979968971970996283137471637224634055579,

c=4373612677928697257861252602371390152816537558161613618621437993378423467772036Это 80-разрядные числа! Вы никак не смогли бы найти 80-разрядные числа на компьютере с помощью простого перебора. Выглядит невероятным, но вставив эти огромные числа в простое выражение , мы действительно получим ровно .

Фактически, они являются наименьшими решениями задачи. Если мы продолжим прибавлять к самой себе точку , то при этом просто будут расти делители. Непросто это доказать, потому что всегда есть вероятность сокращения, но теория высот для эллиптической кривой позволяет нам показать, что эти астрономические числа на самом деле являются простейшим решением уравнения.

Вернёмся к теории. Эллиптическая кривая над рациональными значениями имеет ранг, который является количеством точек, необходимых, чтобы использовать для метод хорд и касательных и быть уверенным, что мы рано или поздно найдём все рациональные точки на кривой. Наша эллиптическая кривая (2) имеет ранг 1. Это значит, что у неё есть бесконечное количество рациональных точек, но все они получаются из единственной, которая является ничем иным, как нашей точкой . Алгоритмы вычисления ранга и нахождения такого генератора далеки от тривиальных, но SageMath (теперь имеющий название CoCalc) выполняет их меньше чем за секунду всего в нескольких строках кода. Мой код можно посмотреть здесь. Он воспроизводит всё решение с нуля, но, конечно же, использует встроенные методы Sage для работы с эллиптическими кривыми.

В нашем случае точка лежит на овальной части кривой, как и точки для любого положительного целого . Они «кружатся» по овалу и постепенно довольно равномерно по нему распределяются. Это очень удачно, потому что только небольшая часть этого овала даёт положительные решения в отношении , , : это выделенная жирным часть графика ниже, взятого из работы Бремнера и Маклауда.

Точки , , и так далее, не лежат на выделенной части, а — лежит, именно так мы и получили наши 80-разрядные положительные решения.

Бремнер и Маклауд изучили, что происходит, если мы заменяем чем-то другим. Если вы думаете, что решения будут большими, то подождите, пока не увидите, какими окажутся решения при результате . Вместо 80 разрядов нам понадобится 398 605 460 разрядов. Да, это только количество разрядов решения. Если заменить результат на , то решение будет содержать триллионы разрядов. Триллионы. Для этого невинно выглядящего уравнения:

Поразительный пример того, как диофантовы уравнения с небольшими коэффициентами могут иметь огромные решения. Это внушает не просто трепет, а ощущение бездонности. Отрицательное решение десятой проблемы Гильберта означает, что рост решений при увеличении коэффициентов — это невычислимая функция, потому что если бы она была вычисляемой, то у нас был бы простой алгоритм решения диофантовых уравнений, а его не существует (ни простого, ни сложного). Соответствие 80-разрядные числа, числа из сотен миллионов разрядов и триллионы разрядов даёт нам небольшое представление о первых, небольших шагах этой чудовищной невычислимой функции. Немного измените числа в уравнении, и решения запросто превзойдут всё, что может вместиться в нашу жалкую, крошечную Вселенную.

Вот такое удивительно хитрое небольшое уравнение.

Благодарю пользователя MrShoor, приславшего мне ссылку на эту интересную статью.

|

Метки: author PatientZero математика занимательные задачки диофантовы уравнения |

Несколько слов о тестировании сложных аппаратных комплексов |

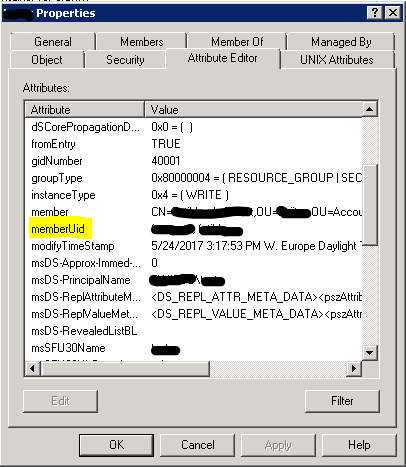

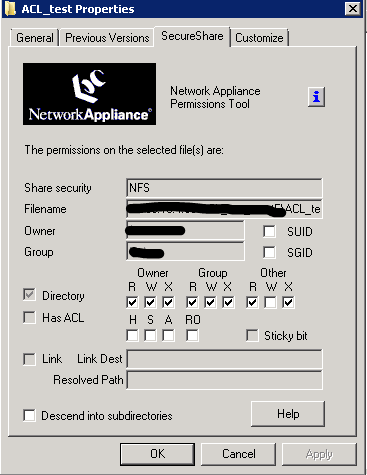

Предварительная подготовка

— Everyone please observe the fasten seat belt and no smoking signs have been turned on. Sit back and enjoy your ride.

Итак, по порядку.

Тестирование осуществляется на всех стадиях жизни аппаратуры. Тестирование бывает первоначальное (bringup), компонентное, функциональное, нагрузочное, производственное, и даже тестирование на заказчиках.

Еще на стадии разработки аппаратуры инженер думает о том, как он будет оживлять свое детище. Платы обсыпаются контрольными точками, отладочными коннекторами, перемычками, посадочными местами для запасных компонентов и прочим подобным. Совокупность возможностей для тестирования, заложенных в аппаратуру, называется DFT (Design for Testability). Плата, выпущенная в DFT фазе, может содержать в два раза больше компонентов, чем плата, вышедшая в тираж. Естественно, следуя принципу «работает – не трогай», потом ее никто не переделывает, и конечный потребитель недоуменно рассматривает пустующие посадочные места на материнской плате из магазина, придумывая различные конспирологические теории по поводу их предназначения.

Итак, нам произвели наш борд – что делать дальше? Ну конечно же – воткнуть в розетку и выпустить из него весь белый дым.

— Everybody falls the first time.

Фотка из интернета, у нас жжёных плат не нашлось, но каюсь – иногда так и делается. На моей памяти есть давняя история, когда любопытный системный архитектор сидел и подбирал наугад в какие разъёмы нужно воткнуть фазу, нейтраль и землю (ну вот не было у него времени заглянуть в схему), а рядом сидел разработчик и ловил бледного.

Но обычно всё происходит по-другому. Первая фаза тестирования – bringup (в народе «оживляш»).

Оживление Рождение

— Wake up, Neo...

Для bringup обычно изготавливается 3—5 образцов (в расчете на то, что как минимум два будут уничтожены в бреду дебага). Если в составе устройства есть дорогие чипы — на один из образцов они не устанавливаются. Фаб может предложить вам сэкономить на золоте — НИ В КОЕМ СЛУЧАЕ НЕ СОГЛАШАЙТЕСЬ (ну просто паять придется много и часто).

Плата без чипа — это первый кандидат на убой. На ней проверяются последовательность включения питания, сбросы, номиналы напряжений и прочее подобное. Потом такая плата является донором органов и/или полигоном для проверки всяческих гипотез. Также перед тем как что-то включать, нужно обязательно:

- прозвонить землю-питание, там частенько есть КЗ;

- визуально осмотреть плату – там запросто бывает перепутана полярность конденсаторов, чипы стоят вверх ногами, присутствует стружка, с лёгкостью можно найти пассивные компоненты, которые оторвали;

- отдельно изучить – а не поставили ли вам на плату компоненты, которые вы просили не ставить (лайфхак: не делайте черную маску на первых сэмплах – на ней не видно установлены или нет чип-резисторы).

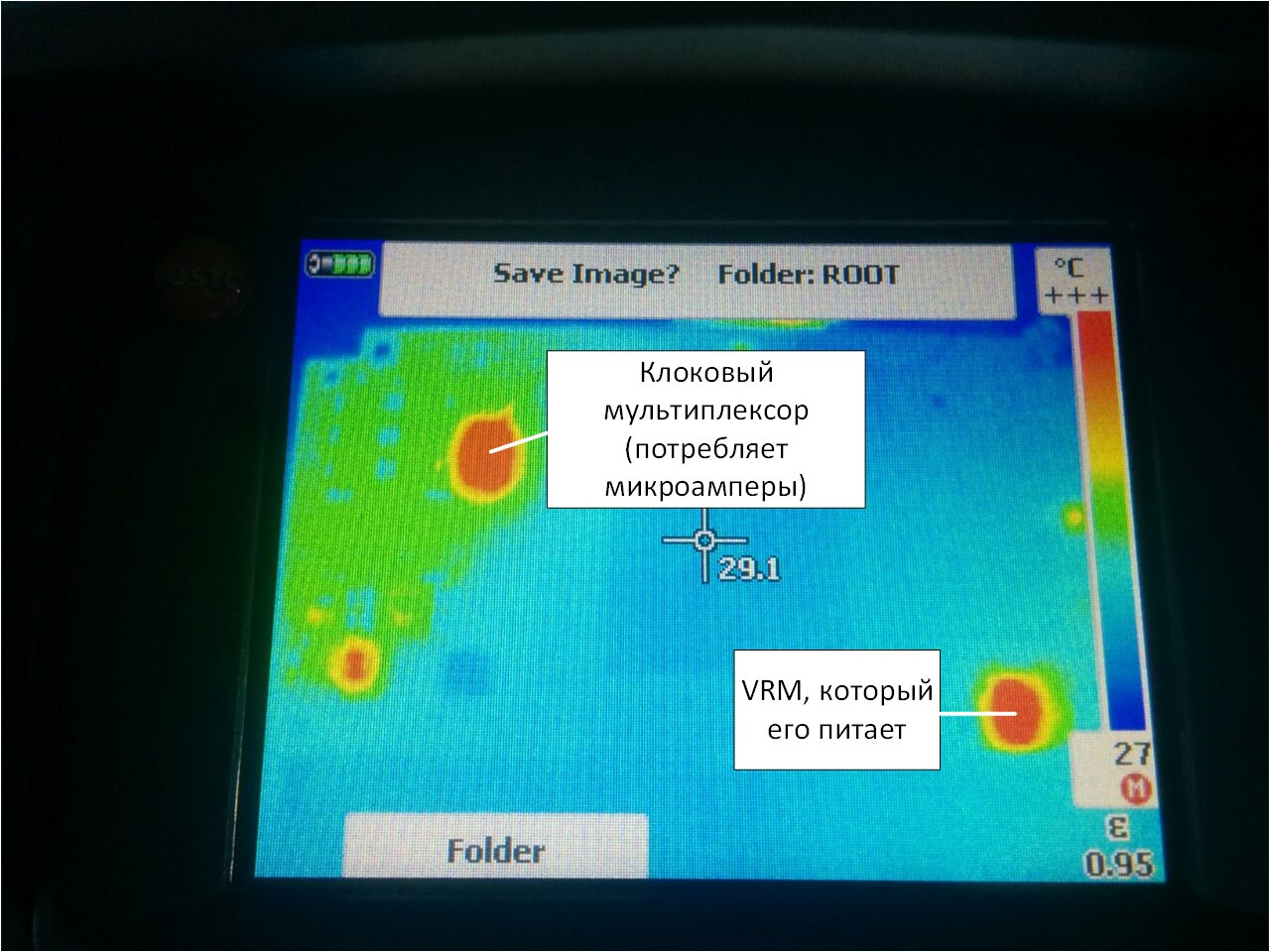

Наигрались с первой жертвой – идем пускать дым из боевой платы. При этом необходимо запастись пилотом с кнопкой отрубания питания и тепловизором. Пилот надо поставить под ногу, на случай если по рукам будет бить 220 В (ну или просто руки будут заняты), а в тепловизор можно увидеть КЗ.

Но вообще при самом первом включении обычно можно не бояться — оно скорее всего не включится, так как вы наверняка забыли перепаять компоненты, у которых в дизайне перепутаны ноги:

И еще припаять немножко проводов:

Термоклей — наше все, лучший друг разработчика, почти как скотч в обычной жизни.

Сразу после Дремеля:

И молотка, которым приходится забивать бонки в плату, — не всегда выходит аккуратно.

Иногда приходится делать пациенту рентген или томографию. Выглядит это так:

Отсканировать плёнку, оказывается, не очень просто. Сняли телефоном на просвет напротив окна.

Конкретно на этом снимке не видно ничего — не вглядывайтесь. Но вообще на рентгене можно увидеть непропай, трещины и прочее подобное.

Отдельно стоит сказать про bringup материнских плат, потому что делается он по-другому. DFT сэмплов матерей обычно заказывается много – порядка 20 штук. Стоит это дорого, поэтому тут своя стратегия.

Берутся разработчики и отправляются на фабрику. Собирается порядка 5 плат и конвейер останавливается. Далее у разработчиков есть порядка 30 минут, чтобы плату включить (для x86-систем критерий успеха — загрузить BIOS). Если всем повезло — собираются остальные образцы. Если нет — производство отменяется, а разработчики едут домой думать. Деньги затраченные на PCB — потеряны, зато компоненты ждут на складе следующей попытки.

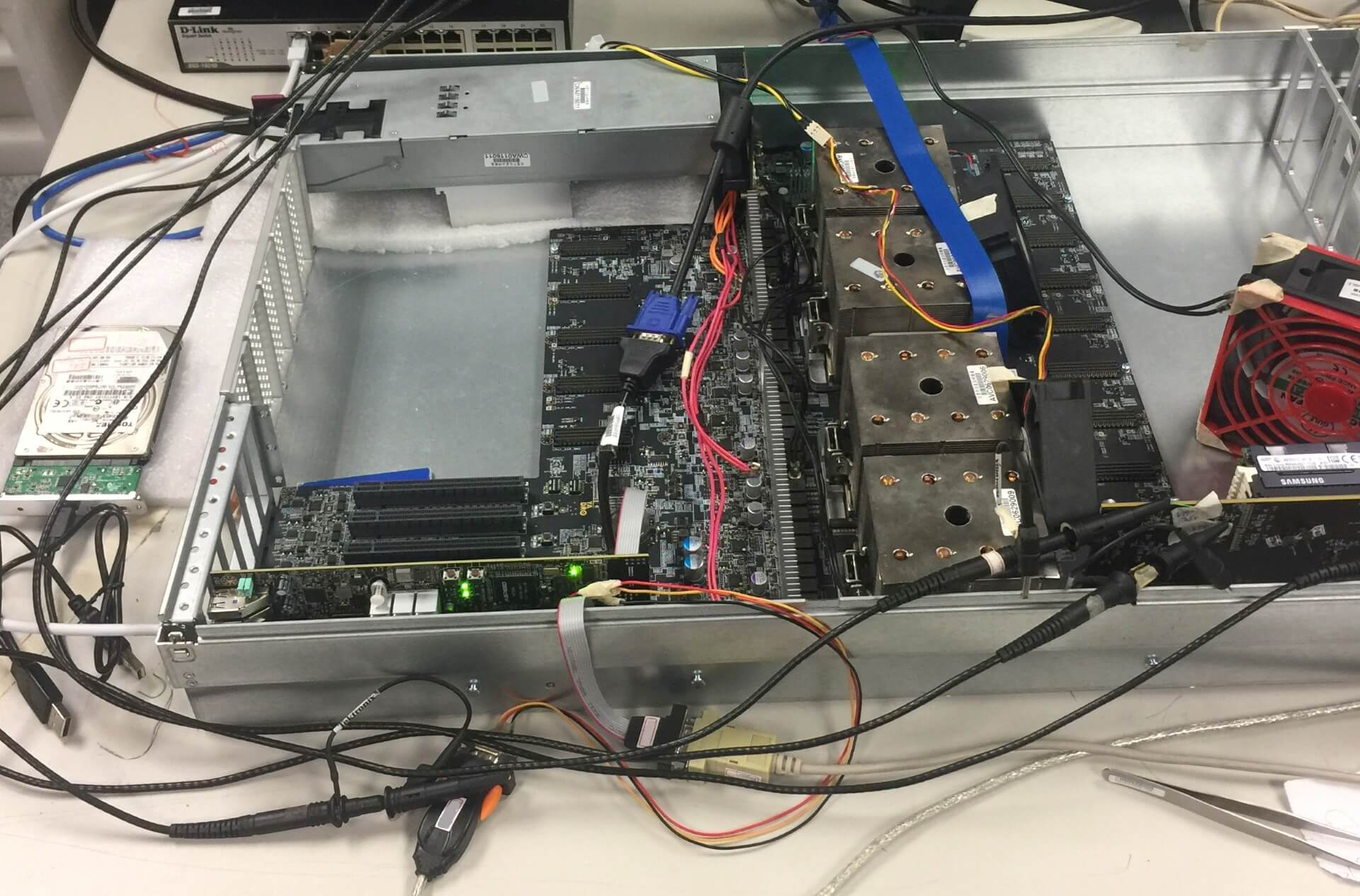

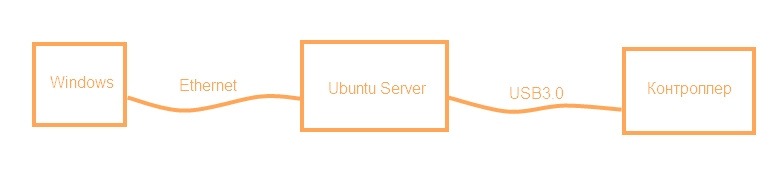

Хорошо — мы запустили нашу плату, и даже запустили другие, которые должны работать вместе с ней. Что дальше? Собираем стенд.

И тут вы, наверное, ожидаете увидеть такое?

Это все показуха для замминистров. Настоящий стенд должен быть собран из палок и желудей, и выглядит так:

— I didn't say it would be easy, Neo. I just said it would be the truth.

(стакан для противовеса, фломастер — чтоб радиатор внатяг сидел — оно там проводом примотано)

Или так:

В лабораторию набивается вот такая орда:

И все начинают наперегонки зашивать свои прошивки, программки, и тыкать везде осциллографом.

Иногда процессе то и дело раздается вежливая просьба «Дорогой коллега, пожалуйста, уберите паяльник от моей руки — уж очень горячо» или «Будьте так добры — больше не включайте источник питания, когда я привинчиваю плату к шасси».

Питерский офис очень на нас влияет. Как гласит наш веб-сайт:

В нашем конкретном случае основная цель проверки совместной работы нескольких устройств — узнать, работает ли PCI Express, соответствует ли он стандарту. Просто без всего остального в принципе можно жить. Обычно функционал, закладываемый в железку, избыточен. Тонны GPIO выводов, I2C/SPI шин, термодатчиков, ледов и прочего, как правило, остаются невостребованными, так как их отладку откладывают на последний момент, который никогда не наступает.

Естественно, у нас нет на каждый случай жизни измерительной аппаратуры за несколько миллионов рублей — это для слабаков. Нам на помощь спешит тестовое ПО от производителей компонентов. Практически все современные чипы с высокоскоростными интерфейсами имеют внутри цифровой осциллограф. К нему полагается специализированное ПО, позволяющее считать его показания. Запускаем и смотрим глазковые диаграммы. Видим такое:

Иногда видим опасный прищур:

А иногда ловим кальмаров:

Кальмары — самые опасные. Это нелинейные искажения, и встроенные эквалайзеры с таким бороться особо не умеют. Кальмары означают, что где-то в канале связи есть что-то очень плохое — слишком длинное переходное отверстие, существенный перепад импеданса, попадание какой-то неравномерности в 1/4 или 1/2 длины волны каких-то гармоник в полезной полосе и прочее подобное.

Кто-то, возможно, заметит, что кальмар немного похож на то, что делает с принятым сигналом DFE в эквалайзере приемника PCIe. Но в данном случае это таки кальмар, а не результат работы DFE (просто результат работы DFE используемое нами ПО отображать не умеет).

Отдельно надо сказать про тестовый софт, который тоже бывает крайне коварным. Например для снимания глазковых диаграмм мы используем две версии одной и той же программы — одна версия рисует картинки, но не пишет значения раскрыва глаза, вторая — наоборот.

Ну и да — если вы планируете снимать глаза по интерфейсу I2C — забудьте, это будет очень очень очень медленно. Только in-band. Проблема в том, что для съема in-band у Вашего устройства должен быть рабочий PCIe линк с компьютером, где работает тестовое ПО, что весьма проблематично когда Ваша железка не устанавливается в стандартный PCIe слот. И что самое забавное — у Вас уже должен быть хоть как-то работающий линк на том канале, который вы отлаживаете, причем именно в том режиме (gen2/3) в котором вам нужно (ибо в разных режимах разные глаза и по разному работают эквалайзеры). Нет

Про то, как выкручиваться с PCIe — я ранее написал отдельную статью.

Вообще, при разработке сервера, конечно, очень важна поддержка со стороны производителей используемых компонентов, поскольку сегодня сложность даже относительно простых чипов такова, что без использования встроенных в них тестовых вещей полноценно проверить и отладить систему вряд ли получится. Тактовые генераторы, регуляторы напряжений, сетевые контроллеры, коммутаторы PCI Express, редрайверы – все это имеет встроенные средства для настройки, диагностики, и нуждается в определенном наборе программ и кабелей для подключения для полноценной настройки и тестирования, без использования которых разработка становится просто невозможной.

В процессе проведения проверок иногда выясняется, что где-то что-то идет не так. И тогда начинается увлекательный процесс локализации ошибки, чтобы ее можно было исправить в следующей ревизии. И хорошо если это «не так» стабильно повторяется – тогда выяснить, что именно является причиной ошибки, как правило, не составляет труда. Но иногда все гораздо хуже. Например, на некоторых экземплярах плат при длительном прогоне тестов возникают одиночные некорректируемые ошибки на шине (которых быть не должно совсем). И вот здесь зачастую уже приходится применять метод «пристального взгляда» — то есть просто сидеть, гипотетически глядя на схему предполагать, что именно может быть причиной, пробовать эту гипотетическую причину устранить в схеме, и тестами уже проверить – угадали мы или нет.

Мы с подобным сталкивались несколько лет назад, когда тесты NVIDIA (да, многие производители предоставляют специфические наборы тестов, которые позволяют проверить вещи, недоступные программным путем при использовании стандартных утилит) давали редкие одиночные ошибки при длительных (сутки и более) прогонах на некоторых экземплярах плат. Тогда все дело оказалось в неудачной трассировке референсного клока (100 MHz) — хотя прежде чем мы к этому пришли, проверено было много всего, начиная от качества питания и заканчивая глазковыми диаграммами по всем линиям.

И кстати, это хорошо. Самый большой кошмар разработчика — когда все работает сразу. Это значит только одно — где-то закопана мина, которая сработает после отгрузки 100500 единиц оборудования заказчику. Дело в том, что в процессе поиска причины какой-то глобальной проблемы осуществляется проверка нескольких гипотез и как правило выявляется множество мелких неисправностей, никак с возникшей проблемой не связанных. Нет большой проблемы — не найдёте маленьких. Их за вас найдут ваши заказчики.

Проверка по списку

— All I do is what he tells me to do.

После завершения компонентных тестов начинается функциональное тестирование – проверка работоспособности комплекса в целом и корректной работы всех заложенных функций. Обычно этим занимается QA. Простор для творчества здесь, конечно, весьма обширный, но в целом основной упор делается на корректную работу системы при проигрывании стандартных сценариев использования. Здесь обнаруженные ошибки могут уже иметь как аппаратную, так и программную природу, поэтому в первую очередь важно выяснить, что именно вызвало ошибку. Зачастую первые предположения могут быть обманчивыми, то есть явно аппаратная на первый взгляд проблема может быть вызвана некорректной работой встроенного ПО. Значительную часть в функциональном тестировании занимает проверка того, как система отрабатывает разнообразные ошибки, которые могут возникать в процессе работы. Современные отладочные средства позволяют осуществлять искусственную инжекцию ошибок в стандартные интерфейсы процессоров, потому что на уровне железа многие из них создать специально достаточно проблематично (ну не отрывать же на лету чипы памяти или замыкать линии шины PCI Express).

А… я же не сказал, что функциональное тестирование не означает собранную готовую к бою систему. Тут тоже бывает не все гладко. В какой-то момент оказалось что у нас нет в запасе OcuLink кабелей нужной длины, и у сервера появились кишки.

И почему-то вот в такой вот конфигурации при нагрузочном тесте все начало перегреваться. До сих гадаем — почему. Кабели грелись, наверное.

А два арбуза в каждой руке унести сможешь?

— You're faster than this. Don't think you are, know you are…

В какой-то момент параллельно с функциональным тестированием начинается тестирование нагрузочное — важно убедиться, что сервер продолжает корректно функционировать в предельных режимах работы. Причем нагрузочные тесты проводятся как применительно к отдельным подсистемам (диски, память, процессоры, ввод-вывод), так и на всей системе в целом. Как правило локализованные тесты позволяют сильнее нагрузить один конкретный модуль, чем это можно сделать при максимальной нагрузке на всю систему.

Кроме того, здесь помогают отладочные средства от производителя аппаратной платформы (например, Hardware Tests Executive от IBM). Таким образом можно загнать процессор в совсем предельные режимы, принципиально недостижимые при работе реальных приложений. Основные проблемы, выявляемые при нагрузочном тестировании – перегрев, нестабильность питания или перегрузка по максимальному току, ошибки при активной работе с интерфейсами ввода-вывода.

Также на помощь приходят бенчмарки. Потому что когда реальные значение бенчмарков сильно отличаются от прогнозируемых — значит что-то пошло не так. Хороший повод пойти потыкать плату палочкой.

На стадии тестирования мы используем в основном микробенчмарки:

Для процессоров это обычно однопоточные нагрузки, типа spec2006 (сейчас уже speccpu2017), parsec, но вообще их огромное количество от сборки ядра linux и компрессии (lzma, gzip), до перемножения матриц и вычисления быстрого преобразования Фурье (fftw).

Для памяти много лет ничего не меняется: STREAM, RAMspeed SMP, lmbench.

Для дисков: fio, iozone.

При успешном прохождении всех функциональных и нагрузочных тестов остаются еще ряд вещей, требующих проверки – стабильность работы во всем диапазоне температур, стойкость к вибрации, проверка совместимости с определенным набором стандартных компонентов (память, диски, PCI Express контроллеры).

P.S.: После того как мы на функциональных тестах первой ревизии сервера все проверили и обрадовались, у нас в лаборатории внезапно обвалилось три сервера. Мы начали проверять питание и на линии 1.2В (питание шины PCIe процессоров) увидели вот такое:

Акцентирую ваше внимание — одна клетка 500mV. Номинал 1.2В. Резистором ошиблись в цепи компенсации одного из VRM. Вот с таким вот питанием были успешно пройдены все нагрузочные тесты, бенчмарки, прожарки и прочее подобное, и дизайн радостно поехал на вторую ревизию.

Так что, когда на Вашем уютном домашнем компьютере именитого бренда внезапно появляется экран смерти — не стоит думать, что это непременно «глючит винда».

|

Метки: author asmolenskiy тестирование it-систем блог компании yadro тестирование ошибки правда жизни аппаратное обеспечение |

Model-View-Intent и индикатор загрузки/обновления |

Добрый день! Многие Android-приложения загружают данные с сервера и в это время показывают индикатор загрузки, а после этого позволяют обновить данные. В приложении может быть с десяток экранов, практически на каждом из них нужно:

- при переходе на экран показывать индикатор загрузки (

ProgressBar) в то время, как данные грузятся с сервера; - в случае ошибки загрузки показать сообщение об ошибке и кнопку "Повторить загрузку";

- в случае успешной загрузки дать пользователю возможность обновлять данные (

SwipeRefreshLayout); - если при обновлении данных произошла ошибка, показать соответствующее сообщение (

Snackbar).

При разработке приложений я использую архитектуру MVI (Model-View-Intent) в реализации Mosby, подробнее о которой можно почитать на Хабре или найти оригинальную статью о MVI на сайте разработчика mosby. В этой статье я собираюсь рассказать о создании базовых классов, которые позволили бы отделить описанную выше логику загрузки/обновления от остальных действий с данными.

Первое, с чего мы начнем создание базовых классов, это создание ViewState, который играет ключевую роль в MVI. ViewState содержит данные о текущем состоянии View (которым может быть активити, фрагмент или ViewGroup). С учетом того, каким может быть состояние экрана, относительно загрузки и обновления, ViewState выглядит следующим образом:

// Здесь и далее LR используется для сокращения Load-Refresh.

data class LRViewState>(

val loading: Boolean,

val loadingError: Throwable?,

val canRefresh: Boolean,

val refreshing: Boolean,

val refreshingError: Throwable?,

val model: M

) Первые два поля содержат информацию о текущем состоянии загрузки (происходит ли сейчас загрузка и не произошла ли ошибка). Следующие три поля содержат информацию об обновлении данных (может ли пользователь обновить данные и происходит ли обновление в данный момент и не произошла ли ошибка). Последнее поле представляет собой модель, которую подразумевается показывать на экране после того, как она будет загружена.

В LRViewState модель реализует интерфейс InitialModelHolder, о котором я сейчас расскажу.

Не все данные, которые будут отображены на экране или будут еще как-то использоваться в пределах экрана, должны быть загружены с сервера. К примеру, имеется модель, которая состоит из списка людей, который загружается с сервера, и нескольких переменных, которые определяют порядок сортировки или фильтрацию людей в списке. Пользователь может менять параметры сортировки и поиска еще до того, как список будет загружен с сервера. В этом случае список — это исходная (initial) часть модели, которая грузится долго и на время загрузки которой необходимо показывать ProgressBar. Именно для того, чтобы выделить, какая часть модели является исходной используется интерфейс InitialModelHolder.

interface InitialModelHolder {

fun changeInitialModel(i: I): InitialModelHolder

} Здесь параметр I показывает какой будет исходная часть модели, а метод changeInitialModel(i: I), который должен реализовать класс-модель, позволяет создать новый объект модели, в котором ее исходная (initial) часть заменена на ту, что передана в метод в качестве параметра i.

То, зачем нужно менять какую-то часть модели на другую, становится понятно, если вспомнить одно из главных преимуществ MVI — State Reducer (подробнее тут). State Reducer позволяет применять к уже имеющемуся объекту ViewState частичные изменения (Partial Changes) и тем самым создавать новый экземпляр ViewState. В дальнейшем метод changeInitialModel(i: I) будет использоваться в State Reducer для того, чтобы создать новый экземпляр ViewState с загруженными данными.

Теперь настало время поговорить о частичных изменениях (Partial Change). Частичное изменение содержит в себе информацию о том, что именно нужно изменить в ViewState. Все частичные изменения реализуют интерфейс PartialChange. Этот интерфейс не является частью Mosby и создан для того, чтобы все частичные изменения (те, которые касаются загрузки/обновления и те, что не касаются) имели общий "корень".

Частичные изменения удобно объединять в sealed классы. Далее Вы можете видеть частичные изменения, которые можно применить к LRViewState.

sealed class LRPartialChange : PartialChange {

object LoadingStarted : LRPartialChange() // загрузка началась

data class LoadingError(val t: Throwable) : LRPartialChange() // загрузка завершилась с ошибкой

object RefreshStarted : LRPartialChange() // обновление началось

data class RefreshError(val t: Throwable) : LRPartialChange() // обновление завершилось с ошибкой

// загрузка или обновления завершились успешно

data class InitialModelLoaded(val i: I) : LRPartialChange()

} Следующим шагом является создание базового интерфейса для View.

interface LRView> : MvpView {

fun load(): Observable

fun retry(): Observable

fun refresh(): Observable

fun render(vs: LRViewState)

} Здесь параметр K является ключем, который поможет презентеру определить какие именно данные нужно загрузить. В качестве ключа может выступать, например, ID сущности. Параметр M определяет тип модели (тип поля model в LRViewState). Первые три метода являются интентами (в понятиях MVI) и служат для передачи событий от View к Presenter. Реализация метода render будет отображать ViewState.

Теперь, когда у нас есть LRViewState и интерфейс LRView, можно создавать LRPresenter. Рассмотрим его по частям.

abstract class LRPresenter, V : LRView>

: MviBasePresenter>() {

protected abstract fun initialModelSingle(key: K): Single

open protected val reloadIntent: Observable = Observable.never()

protected val loadIntent: Observable = intent { it.load() }

protected val retryIntent: Observable = intent { it.retry() }

protected val refreshIntent: Observable = intent { it.refresh() }

...

...

} Параметры LRPresenter это:

Kключ, по которому загружается исходная часть модели;Iтип исходной части модели;Mтип модели;VтипView, с которой работает данныйPresenter.

Реализация метода initialModelSingle должна возвращать io.reactivex.Single для загрузки исходной части модели по переданному ключу. Поле reloadIntent может быть переопределено классами-наследниками и используется для повторной загрузки исходной части модели (например, после определенных действий пользователя). Последующие три поля создают интенты для приема событий от View.

Далее в LRPresenter идет метод для создания io.reactivex.Observable, который будет передавать частичные изменения, связанные с загрузкой или обновлением. В дальнейшем будет показано, как классы-наследники могут использовать этот метод.

protected fun loadRefreshPartialChanges(): Observable = Observable.merge(

Observable

.merge(

Observable.combineLatest(

loadIntent,

reloadIntent.startWith(Any()),

BiFunction { k, _ -> k }

),

retryIntent

)

.switchMap {

initialModelSingle(it)

.toObservable()

.map { LRPartialChange.InitialModelLoaded(it) }

.onErrorReturn { LRPartialChange.LoadingError(it) }

.startWith(LRPartialChange.LoadingStarted)

},

refreshIntent

.switchMap {

initialModelSingle(it)

.toObservable()

.map { LRPartialChange.InitialModelLoaded(it) }

.onErrorReturn { LRPartialChange.RefreshError(it) }

.startWith(LRPartialChange.RefreshStarted)

}

) И последняя часть LRPresenter это State Reducer, который применяет к ViewState частичные изменения, связанные с загрузкой или обновлением (эти частичные изменения были переданы из Observable, созданном в методе loadRefreshPartialChanges).

@CallSuper

open protected fun stateReducer(viewState: LRViewState, change: PartialChange): LRViewState {

if (change !is LRPartialChange) throw Exception()

return when (change) {

LRPartialChange.LoadingStarted -> viewState.copy(

loading = true,

loadingError = null,

canRefresh = false

)

is LRPartialChange.LoadingError -> viewState.copy(

loading = false,

loadingError = change.t

)

LRPartialChange.RefreshStarted -> viewState.copy(

refreshing = true,

refreshingError = null

)

is LRPartialChange.RefreshError -> viewState.copy(

refreshing = false,

refreshingError = change.t

)

is LRPartialChange.InitialModelLoaded<*> -> {

@Suppress("UNCHECKED_CAST")

viewState.copy(

loading = false,

loadingError = null,

model = viewState.model.changeInitialModel(change.i as I) as M,

canRefresh = true,

refreshing = false

)

}

}

} Теперь осталось создать базовый фрагмент или активити, который будет реализовывать LRView. В своих приложениях я придерживаюсь подхода SingleActivityApplication, поэтому создадим LRFragment.

Для отображения индикаторов загрузки и обновления, а также для получения событий о необходимости повторения загрузки и обновления был создан интерфейс LoadRefreshPanel, которому LRFragment будет делегировать отображение ViewState и который будет фасадом событий. Таким образом фрагменты-наследники не обязаны будут иметь SwipeRefreshLayout и кнопку "Повторить загрузку".

interface LoadRefreshPanel {

fun retryClicks(): Observable

fun refreshes(): Observable

fun render(vs: LRViewState<*>)

} В демо-приложении был создан класс LRPanelImpl, который представляет собой SwipeRefreshLayout с вложенным в него ViewAnimator. ViewAnimator позволяет отображать либо ProgressBar, либо панель ошибки, либо модель.

С учетом LoadRefreshPanel LRFragment будет выглядеть следующим образом:

abstract class LRFragment, V : LRView, P : MviBasePresenter>> : MviFragment(), LRView {

protected abstract val key: K

protected abstract fun viewForSnackbar(): View

protected abstract fun loadRefreshPanel(): LoadRefreshPanel

override fun load(): Observable = Observable.just(key)

override fun retry(): Observable = loadRefreshPanel().retryClicks().map { key }

override fun refresh(): Observable = loadRefreshPanel().refreshes().map { key }

@CallSuper

override fun render(vs: LRViewState) {

loadRefreshPanel().render(vs)

if (vs.refreshingError != null) {

Snackbar.make(viewForSnackbar(), R.string.refreshing_error_text, Snackbar.LENGTH_SHORT)

.show()

}

}

} Как видно из приведенного кода, загрузка начинается сразу же после присоединения презентера, а все остальное делегируется LoadRefreshPanel.

Теперь создание экрана, на котором необходимо реализовать логику загрузки/обновления становится несложной задачей. Для примера рассмотрим экран с подробностями о человеке (гонщике, в нашем случае).

Класс сущности — тривиальный.

data class Driver(

val id: Long,

val name: String,

val team: String,

val birthYear: Int

)Класс модели для экрана с подробностями состоит из одной сущности:

data class DriverDetailsModel(

val driver: Driver

) : InitialModelHolder {

override fun changeInitialModel(i: Driver) = copy(driver = i)

} Класс презентера для экрана с подробностями:

class DriverDetailsPresenter : LRPresenter() {

override fun initialModelSingle(key: Long): Single = Single

.just(DriversSource.DRIVERS)

.map { it.single { it.id == key } }

.delay(1, TimeUnit.SECONDS)

.flatMap {

if (System.currentTimeMillis() % 2 == 0L) Single.just(it)

else Single.error(Exception())

}

override fun bindIntents() {

val initialViewState = LRViewState(false, null, false, false, null,

DriverDetailsModel(Driver(-1, "", "", -1))

)

val observable = loadRefreshPartialChanges()

.scan(initialViewState, this::stateReducer)

.observeOn(AndroidSchedulers.mainThread())

subscribeViewState(observable, DriverDetailsView::render)

}

} Метод initialModelSingle создает Single для загрузки сущности по переданному id (примерно каждый 2-й раз выдается ошибка, чтобы показать как выглядит UI ошибки). В методе bindIntents используется метод loadRefreshPartialChanges из LRPresenter для создания Observable, передающего частичные изменения.

Перейдем к созданию фрагмента с подробностями.

class DriverDetailsFragment

: LRFragment(),

DriverDetailsView {

override val key by lazy { arguments.getLong(driverIdKey) }

override fun loadRefreshPanel() = object : LoadRefreshPanel {

override fun retryClicks(): Observable = RxView.clicks(retry_Button)

override fun refreshes(): Observable = Observable.never()

override fun render(vs: LRViewState<*>) {

retry_panel.visibility = if (vs.loadingError != null) View.VISIBLE else View.GONE

if (vs.loading) {

name_TextView.text = "...."

team_TextView.text = "...."

birthYear_TextView.text = "...."

}

}

}

override fun render(vs: LRViewState) {

super.render(vs)

if (!vs.loading && vs.loadingError == null) {

name_TextView.text = vs.model.driver.name

team_TextView.text = vs.model.driver.team

birthYear_TextView.text = vs.model.driver.birthYear.toString()

}

}

...

...

} В данном примере ключ хранится в аргументах фрагмента. Отображение модели происходит в методе render(vs: LRViewState фрагмента. Также создается реализация интерфейса LoadRefreshPanel, которая отвечает за отображение загрузки. В приведенном примере на время загрузки не используется ProgressBar, а вместо этого поля с данными отображают точки, что символизирует загрузку; retry_panel появляется в случае ошибки, а обновление не предусмотрено (Observable.never()).

Демо-приложение, которое использует описанные классы, можно найти на GitHib.

Спасибо за внимание!

|

|

Разрушители легенд — Gentoo Linux |

Дочка Убунту прибежала к Дебиану и, весело смеясь, поцеловала его в лоб: "С днём рождения, папа!". Затем она окинула радостным взглядом сидящих за столом гостей и спросила своим звонким голосом:

— Папа, а где Gentoo, разве он ещё не пришёл?

— Нет, он ещё только собирается.

Среди прочих Linux дистрибутивов Gentoo выделяется тем, что его окружает множество мифов, светлой и темной окраски. Я его использую более 10 лет в качестве домашней и офисной рабочей станции и хочу с вами разоблачить несколько мифов и создать парочку новых.

Также хотелось бы рассказать о достоинствах и недостатках дистрибутива, дабы помочь сомневающимся и беженцам с systemd принять верное решение. Пользуясь случаем также хочу здесь разместить несколько полезных советов, которые помогут избежать многочасовых поисков в интернетах и повторной компиляции монструозных пакетов.

Миф №1 — прирост производительности

Gentoo Linux дает прирост производительности за счет того, что все программы компилируются под конкретное пользовательское железо. На этапе зарождения и становления дистрибутива этот тезис звучал с лютой настойчивостью.

Это на самом деле не совсем миф, но вы скорее всего не заметите прироста производительности, если не ставите целью доказать это статистически, вооружившись Phoronix Test Suite или чем-то подобным. Возможно исключение для FireFox, собранного с профилированием, USE="pgo".

На чем основан этот миф? Действительно узкий круг вычислительных программ можно ускорить при компиляции под определенную платформу, задавая компилятору включение инструкций SIMD, AESNI, или AVX. Бинарные дистрибутивы из-за чрезмерной заботы о совместимости со старой архитектурой базой зачастую приносят подобные оптимизации в жертву. Вернее будет сказать, что так было раньше, а сейчас это не играет большой роли.

Определенно, не за это адепты ценят Gentoo.

Миф №2 — обновления съедают много времени

Технически это верно, таки да, иногда программы обновляются долго, но обходные пути очень хорошо проторены, что и делает этот тезис мифом. Вот мои рекордсмены.

(5:515)$ sudo qlop -t libreoffice firefox qtwebengine

libreoffice: 15028 seconds average for 20 merges

firefox: 3127 seconds average for 32 merges

qtwebengine: 8884 seconds average for 5 mergesВо-первых никто не мешает долгоиграющие обновления запускать ночью. Во-вторых в любой момент задание emerge и компиляцию исходников можно поставить на паузу (Ctrl+Z), возобновив позже в фоновом режиме (bg) или явно (fg). В-третьих можно задать автоматическое обновление через небольной скрипт, например такой.

# Part 1

layman -S

emerge --sync

eix-update

# Part 2

emerge -avuND --with-bdeps=y --complete-graph=y --backtrack=30 --keep-going --verbose-conflicts --exclude "gentoo-sources firefox libreoffice chromium glibc perl python gcc" world

smart-live-rebuild -- -av --with-bdeps=y --complete-graph=y

emerge -av --exclude "gentoo-sources firefox libreoffice chromium glibc perl python gcc" @preserved-rebuild

eclean distfilesМиф №3 — в Gentoo самые свежие версии программ

Конечно, если сравнивать с Debian Linux, то в целом это так, однако и тут бывают исключения. Тот же Debian раньше стал использовать Grub 2 в стабильной ветке и Perl какое-то время был более новой версии, нежели в Gentoo. Если же сравнивать стабильные ветки менее консервативных дистрибутивов с таковыми в Gentoo, то результат может быть каким угодно. Все зависит от кучи обстоятельств, насколько данный пакет обеспечен мейнтейнером и волонтерами. Например QEMU обновляется почти одновременно со стабильной веткой Github, а MATE — застрял в Gentoo на версии 1.12.2 из-за того, что у него мало разработчиков.

(5:499)$ eix -ce qemu;eix -ce mate

[I] app-emulation/qemu (2.9.0-r2@19.05.2017): QEMU + Kernel-based Virtual Machine userland tools

[N] mate-base/mate (1.12-r1): Meta ebuild for MATE, a traditional desktop environment+1 — необычайная гибкость настроек

Поговорим теперь немного о достоинствах Gentoo Linux. Гибкость и возможность настроить очень многие аспекты ОС под себя это то, чем блещет дистрибутив. Вот всего лишь несколько таких примеров.

SystemdилиOpenRC, решайте сами.Pulseaudioставить или нет, думайте.- Включить поддержку

dri3вmesaиXorgили оставитьdri2? - Собрать незамутненную 64-битную ОС без 32-х битных библиотек совместимости или не стоит

упарыватьсянарываться? - Какие кодеки включить в

ffmpeg,mpv,vlc? - Как насчет альтернативного пакетного менеджера, если штатные

emergeиportageвас не устраивают?

+2 — скользящие релизы

Для меня это одно из основных преимуществ дистрибутива. Из-за того, что вы невнимательно читали RSS ленту вашего дистрибутива вы не окажетесь в ситуации, когда вам на голову свалился новый инит, файловая система или принцип работы сетевых интерфейсов.

Все важные изменения изменения доносят до пользователей заблаговременно через механизм рассылки новостей. Прочитать последние актуальные новости дистрибутива можно командой eselect news read.

(5:501)$ sudo eselect news read

No news is good news.+3 — хорошая документация

Это действительно так. Установку ОС значительно облегчает подробнейшее руководство, но есть также крайне полезные вики и форум.

Туда же входят упомянутые рассылки новостей и сообщения elog в специальных файлах /var/log/portage/elog.

± emerge и portage

Основная система управления пакетами portage и штатное средство управления пакетами emerge являются очень мощным и функциональным в руках опытного и внимательного к докам пользователя. Именно благодаря системе portage возможны тонкие и гибкие настройки операционной систему и пользовательского ПО (см. выше в +1). Даже беглое описание возможностей emerge/portage заслуживает отдельного поста, поэтому ограничусь общим описанием.

- Установка и обновление программ позволяет указать нужные и ненужные опции, которые соответственно будут включены в них или исключены из них во время сборки. Это задается

USEфлагами, которые транслируются в--enable-<опция>и--disable-<опция>инструкции.configureскрипта установки из исходников. - Удаление программ тупо их удаляет, не заботясь о зависимостях. Так что будьте осторожны с тем, что вы собираетесь удалить. Если удалить

pythonилиgcc, придется затем скачивать бинарные пакеты, так как emerge впадет в ступор и будет не в состоянии собрать программу из исходников. - Поиск в базе данных пакетов, список файлов в пакете, определение пакета по заданному файлу, зависимости данного пакета, история операций emerge и прочие полезности.

- Настройка производится правкой текстовых файлов, что не удивительно. С другой стороны таких файлов несколько и надо знать, что за что отвечает.

- Обсчет зависимостей, парсинг древа портов происходит довольно медленно и это зачастую нервирует. Стандартная проверка обновлений может занять 2 минуты прежде чем выдать результат на экран.

- Иногда случаются блокировки, конфликты между пакетами в момент обновления. В большинстве случаев такие ситуации устраняются за пару минут, если пользователь сносно знает матчасть. Однако в крайне редких случаях можно встрять надолго и распутывать зависимости по часу, а то и более.

Из-за чего могут возникать такие ситуации? По самым разным причинам, изменения в лицензировании продукта, необходимость замаскировать, или наоборот размаскировать пакет, изредка ляпы разработчиков. Тут наблюдается обратная зависимость от частоты обновлений, поэтому рекомендуется регулярно и по возможности часто обновлять систему, чтобы накопленная энтропия в древе портов не порождала цепной реакции.

-1 — начальная установка занимает много времени

Полная ерунда, вот установка с помощью однострочника.

wget goo.gl/5Y2Gj -O install.sh && sh install.shА если серьезно, то действительно весь процесс займет времени намного больше, чем при установки бинарных дистрибутивов, таких как Дебиан, или Убунту. Однако трудности более чем преодолимы, ввиду следующих обстоятельств.

- Качественная документация, о чем говорилось выше.

- SystemRescueCd — дистрибутив, созданный с целью восстановления работоспособности системы после аварии, основан на Gentoo. SystemRescueCd очень полезен в качестве установщика, позже на заключительном этапе вам пригодится образ ядра загрузочного LiveCD образа, если возникнут трудности с настройкой и сборкой ядра.

- Средство автоматизированной сборки ядра

gentoolkitпозволяет безболезненно пройти самый запутанный и неформализуемый процесс конфигурации и сборки ядра. Другие утилиты из набораportage-utils,eix,eselectи другие позволят хорошо ориентироваться в порядке и зависимостях установленных пакетов и избежать состояний блокировки.

Маленькие хитрости

Если по каким-то причинам компиляция пакета прервалась (выключился свет, завис компьютер и т. д.), но технически может быть возобновлена, можно продолжить процесс с этого самого места. Это особенно ценно для LibreOffice, Chromium или qt-webengine, которые собираются не один час.

ebuild /usr/portage/cate-gory/prog/prog-x.y.z.ebuild compileebuild /usr/portage/cate-gory/prog/prog-x.y.z.ebuild installebuild /usr/portage/cate-gory/prog/prog-x.y.z.ebuild qmerge

Смонтируйте /var/tmp/portage и /usr/portage на SSD, а если у вас немерено оперативной памяти, то можно и на tmpfs, это даст заметный прирост скорости работы emerge.

Можно сделать бинарный бэкапы системных пакетов на всякий пожарный случай.

quickpkg --include-config y <установленная программа>Использованные материалы и полезные ссылки

|

Метки: author temujin системное администрирование настройка linux it- инфраструктура *nix gentoo linux мифы и реальность |

[Из песочницы] Как повысить шансы при поиске работы и получить максимум приглашений на перспективные собеседования при минимуме времени |

Резюме в открытом доступе

Разместите свое резюме (как минимум одно) в открытом доступе. Так о Вашем резюме узнают компании, которые ищут сотрудников без размещенной вакансии. Работодатели могут не размещать вакансии по разным причинам: ищут замену еще работающему сотруднику и не хотят, чтобы он узнал, или не хотят, чтобы о вакансии узнали конкуренты, или нет аккаунта, или организация просто предпочитает самостоятельный поиск, так как при размещении получает большое количество нецелевых откликов, которые нужно обрабатывать.

Старайтесь обновлять резюме почаще, как минимум ежедневно (в том числе по выходным), предпочтительно утром, так как по моим наблюдениям это дает самое большое количество просмотров, вероятно, рекрутеры предпочитают начинать рабочий день с поиска. В настоящее время это можно делать одной кнопкой как на основном сайте, так и на мобильной версии для всех своих резюме на одной странице.

Если не хотите, чтобы вас могли легко идентифицировать (например, на текущем месте работы), то в настройках отметьте компанию, у которой не должны быть доступа к вашему резюме. Проверьте разные названия и юридические лица компании, так как существует вероятность, что у вашего работодателя несколько аккаунтов. Тем не менее, это не дает 100% гарантии, что ваш текущий работодатель не увидит, что вы ищете работу, поэтому вы можете использовать дополнительно другие варианты: не используйте вашу фамилию, вместо названия компания обозначьте сферу деятельности, например, компания входит в ТОП-10 телеком, или производство детской одежды, или интернет-агентство.

Отклики на вакансии

Настройте автопоиски по разным вариантам названия вакансий. Откликайтесь несколько раз на одну вакансию, если не получаете ответа (приглашения или отказа). Только между откликами делайте паузу в несколько дней или неделю. А на самые интересные для вас вакансии откликайтесь с таким же названием, как указано в описании вакансии, возможно, для этого вам придется создать отдельное резюме, но это можно сделать за пару минут, и, возможно, это же резюме пригодится для других интересных вакансий.

Приведу небольшое пояснение, почему по большому количеству откликов может быть низкое количество просмотров резюме. Дело в том, что из-за большого количества нецелевых откликов многие рекрутеры не просматривают все резюме, они видят отклики в виде списка, в котором отображается минимум информации о кандидате, и на основе краткой информации принимают решение, просматривать ли более подробную информацию.

В этом же кратком списке можно открыть сопроводительное письмо, поэтому сопроводительные письма нужны. Чтобы оно было нешаблонным, можно взять несколько основных требований из вакансии и указать, что соответствуете. Например: опыт работы менеджером по продажам в телеком, свободное знание английского языка, опыт продаж крупным брендовым клиентам. Или в сопроводительном письме можно обобщить свой опыт и указать достижения: 5 лет работы менеджером по продажам, 5 раз становился лучшим продавцом месяца за последний год и пр. Не буду советовать делать резюме специально под отдельную вакансию, как это часто рекомендуют в большом количестве статей на данную тему, но призываю для особенно интересных вам вакансий вносить изменения в шаблон сопроводительного письма, которые покажут, что вы внимательно ознакомились с требованиями вакансии и соответствуете им. Этим вы облегчите задачу HR-специалисту и повысите ваши шансы на собеседование.

Постарайтесь быть на связи по телефону, так как ряд рекрутеров предпочитают начинать контакт со звонка, и в случае недозвона, особенно после нескольких попыток, не попытаются связаться с вами другим способом.

Дополнительные каналы

Если есть особенно интересные вакансии, а все вышеперечисленные меры не дали результата, то попробуйте найти эту вакансию на сайте компании, или в ее официальных представительствах в социальных сетях или каналах в мессенджерах, и отправить свое резюме. Также сайты и соцсети можно использовать для поиска контактов HR-службы или ее сотрудников и попробовать связаться напрямую с ними. Если на личные сообщения все же не получаете ответа, то можно написать открыто в комментариях, что ждете ответа на свое резюме (если не скрываете факт поиска работы). Если и в этом случае не получаете ответа, то можете написать руководителям соответствующих подразделений. Только не делайте все это одновременно, это может вызвать негатив у рекрутеров, что точно не улучшит ваши шансы.

Если ищете работу в открытую, то можно указать это в своих профилях в соцсетях. Тогда там нужно разместить свое резюме (или мини-резюме с должностями, периодами работы и названиями компаний в которых работали) и кратко описать, какую работу ищете.

Указание желаемого дохода

Можно указать в тех случаях, если ваши зарплатные ожидания находятся в среднерыночном диапазоне (с учетом вашего опыта и навыков), а вы не хотите получать приглашения на собеседования в компании, где заплата будет ниже. Но учтите, что в данном случае этот параметр может также являться отсекающим фактором.

Зарплатные ожидания ниже рыночного уровня могут отпугнуть серьезные компании и вызвать интерес со стороны нестабильных и сомнительных организаций, поэтому не рекомендую их указывать, если есть достаточно времени на поиск работы. Но можно использовать для срочных случаев.

Указание дохода выше рыночного уровня допустимо для руководителей и специалистов высокого уровня, которые могут себе позволить искать работу несколько месяцев, так как это является очень сильным отсекающим фактором.

Прохождение тестов и выполнение тестовых заданий

Иногда тест или небольшое задание являются необходимыми для отклика на интересующую вас вакансию. Если это занимает немного времени и не требует большого усилия от вас, то рекомендую его выполнить, так как это часто используется, чтобы снизить количество нецелевых откликов на вакансию.

Если тест является для вас сложным или нужно много времени, то оцените, насколько интересна вам вакансия, стоит ли тратить время.

Если же речь идет о тестовом задании, которое не имеет стандартных решений, а требует индивидуального подхода, то, как правило, для его выполнения желательно сначала встретиться с представителями компании, чтобы лучше понять, чего именно от вас ожидают. Но если вакансия действительная интересная и компания серьезная, то, возможно, есть смысл сделать тестовое задание, так как, по моему опыту, процент кандидатов, которые действительно ответственно подходят к выполнению тестовых заданий, довольно низкий, что дает вам хороший шанс выделиться на общем фоне.

Надеюсь, что этот материал будет полезным и поможет в поиске работы, но не забывайте, что есть индивидуальные особенности и разные обстоятельства, поэтому, применяя вышеуказанные рекомендации относитесь к ним, как к возможным, но не исчерпывающим вариантам действий, и оценивайте их эффективность именно на своем примере.

Буду рада, если поделитесь полученным опытом.

|

Метки: author Alina_Alexandrovna управление персоналом карьера в it-индустрии поиск работы hr- процесс собеседования |

12 полезных сайтов для творческих коллективов |

|

Метки: author Logomachine читальный зал блог компании логомашина логомашина команда полезные ресурсы совет подборка |

[Перевод] Как Discord масштабировал Elixir на 5 млн одновременных пользователей |

Прошло два года. Сейчас у нас пять миллионов одновременных пользователей, а через систему проходят миллионы событий в секунду. Хотя мы абсолютно не сожалеем о выборе архитектуры, пришлось проделать массу исследований и экспериментов, чтобы добиться такого результата. Elixir — это новая экосистема, а экосистеме Erlang не хватает информации о её использовании в продакшне (хотя Erlang in Anger — это нечто). По итогу всего пути, пытаясь приспособить Elixir для работы в Discord, мы извлекли некоторые уроки и создали ряд библиотек.

Веерное развёртывание сообщений

Хотя у Discord много функций, в основном всё сводится к pub/sub. Пользователи подключаются к WebSocket и раскручивают сессию (GenServer), которая затем устанавливает соединение с удалёнными узлами Erlang, где работают guild-процессы (тоже GenServer'ы). Если что-то публикуется в guild (внутреннее именование “Discord Server”), оно разворачивается веером на каждую подключенную сессию.

Когда пользователь выходит в онлайн, он подключается к guild'у, а тот публикует статус присутствия во все остальные подключенные сессии. Есть и много другой логики, но вот упрощённый пример:

def handle_call({:publish, message}, _from, %{sessions: sessions}=state) do

Enum.each(sessions, &send(&1.pid, message))

{:reply, :ok, state}

endЭто был нормальный подход, когда мы изначально создали Discord для групп из 25 или менее пользователей. Однако нам повезло столкнуться с «хорошими проблемами» роста, когда люди начали использовать Discord в больших группах. В итоге мы пришли к тому, что на многих серверах Discord вроде /r/Overwatch присутствует до 30 000 пользователей одновременно. В пиковые часы мы наблюдали, что эти процессы не справляются с очередями сообщений. В определённый момент пришлось вручную вмешаться и отключить функции генерации сообщений, чтобы помочь справиться с нагрузкой. Нужно было разобраться с проблемой до того, как она приобретёт масштабный характер.

Мы начали с бенчмарков для самых нагруженных путей в рамках процессов guild и вскоре выявили очевидную причину неприятностей. Обмен сообщениями между процессами Erlang оказался не таким эффективным, как нам казалось, а единица работы Erlang для шедулинга процессов тоже обходилась весьма дорого. Мы обнаружили, что время одного вызова

send/2 может варьироваться от 30 мкс до 70 мкс из-за дешедулинга процесса вызова Erlang. Это означало, что в пиковые часы публикация одного события с большого guild'а может занять от 900 мс до 2,1 с! Процессы Erlang полностью однопоточные, и единственным вариантом параллелизации представлялись шарды. Такое мероприятие потребовало бы немалых сил, и мы знали, что найдётся лучший вариант.Нужно было как-то распределить работу по рассылке сообщений. Поскольку процессы spawn в Erlang обходятся дёшево, нашей первой идеей было просто спаунить новый процесс для обработки каждого публикуемого сообщения. Однако все публикации могли происходить в разное время, а клиенты Discord зависят от линеаризуемости событий. К тому же, такое решение нельзя хорошо масштабировать, потому что у сервиса guild становилось всё больше работы.

Вдохновлённые постом в блоге о повышении производительности в передаче сообщений между нодами, мы создали Manifold. Manifold распределяет работу по рассылке сообщений между удалёнными нодами с идентификаторами PID (идентификатор процессов в Erlang). Это гарантирует, что процессы рассылки будут вызывать

send/2 максимум столько раз, сколько вовлечено удалённых нодов. Manifold делает это, сначала группируя PID'ы по их удалённым нодам, а затем отправляя их в «разделитель» Manifold.Partitioner на каждой из этих нод. Затем разделитель последовательно хеширует PID'ы, используя :erlang.phash2/2, группирует их по количеству ядер и отправляет на дочерние воркеры. В конце концов, воркеры рассылают сообщения в реальные процессы. Это гарантирует, что разделитель не перегружен и продолжает обеспечивать линеаризуемость, как send/2. Такое решение стало эффективной заменой send/2:Manifold.send([self(), self()], :hello)Замечательным побочным эффектом Manifold стало то, что нам удалось не только распределить нагрузку CPU веерных сообщений, но и снизить сетевой трафик между нодами:

Снижение сетевого трафика на одну ноду Guild

Manifold лежит на GitHub, так что пробуйте.

Общие данные быстрого доступа

Discord — распределённая система, которая применяет консистентное хеширование. Использование этого метода потребовало создания кольцевой структуры данных, которую можно использовать для поиска ноды конкретного объекта. Мы хотели, чтобы система работала быстро, поэтому выбрали замечательную библиотеку Криса Муса, подключив её через порт Erlang C (процесс, отвечающий за интерфейс с кодом C). Она отлично работала, но по мере масштабирования Discord мы начали замечать проблемы во время всплесков с переподключением пользователей. Процесс Erlang, отвечающий за управление кольцом, начинал настолько загружаться работой, что не мог справиться с запросами к кольцу, и вся система не справлялась с нагрузкой. Решение на первый взгляд выглядело очевидным: запустить множество процессов с данными кольца для лучшего использования всех ядер машины, чтобы обработать все запросы. Но это слишком важная задача. Есть ли лучший вариант?

Давайте посмотрим на составляющие.

- Пользователь может быть в любом количестве guild'ов, но средний показатель 5.

- Ответственная за сессии виртуальная машина Erlang VM может поддерживать до 500 000 сессий.

- При подключении сессии ей нужно найти удалённую ноду для каждого guild'а, который ей интересен.

- Время коммуникации с другим процессом Erlang, используя request/reply, составляет около 12 мкс.

Если сессионный сервер сбоил и перезагружался, уходило около 30 секунд просто на поиски в кольце. Это даже не считая дешедулинга со стороны Erlang одного процесса, вовлечённого работу других процессов кольца. Можем ли мы полностью устранить эти издержки?

При работе с Elixir, если нужно ускорить доступ к данным, первым делом принято использовать ETS. Это быстрый, изменяемый словарь на C; обратной стороной медали является то, что данные копируются туда и считываются оттуда. Мы не могли просто перевести наше кольцо на ETS, потому что использовали порт C для управления кольцом, так что мы переписали код на чистом Elixir. Как только это было закончено, у нас появился процесс, который владел кольцом и непрерывно копировал его в ETS, так что другие процессы могли считывать данные напрямую из ETS. Это заметно подняло производительность, но операции чтения ETS занимали около 7 мкс и мы по-прежнему тратили 17,5 секунд на операции поиска значений в кольце. Структура данных кольца на самом деле довольно большая, и копирование её в ETS и считывание оттуда занимало основную часть времени. Мы были разочарованы; на любом другом языке программирования можно было просто сделать общее значение для безопасного чтения. Должен быть какой-то способ сделать это на Erlang!

После некоторого исследования мы нашли модуль mochiglobal, который использует функцию виртуальной машины: если Erlang встречает функцию, которая постоянно возвращает одни и те же данные, он помещает эти данные в доступную только для чтения кучу с общим доступом, к которой имеют доступ процессы. Копирование не требуется. mochiglobal использует это, создавая модуль Erlang с одной функцией и компилируя его. Поскольку данные никуда не копируются, расходы на поиск уменьшились до 0,3 мкс, что снизило общее время до 750 мс! Впрочем, полной халявы не бывает; само создание модуля со структурой данных такого размера в рантайме может занимать до секунды. Хорошая новость в том, что мы редко меняем кольцо, так что готовы заплатить такую цену.

Мы решили портировать mochiglobal на Elixir и добавить некоторую функциональность, чтобы избежать атомизации. Наша версия называется FastGlobal.

Ограниченный параллелизм

После решения важной проблемы с производительностью поиска ноды, мы заметили, что процессы, ответственные за обработку поиска

guild_pid в нодах guild стали давать задний ход. Медленный поиск нод раньше защищал их. Новая проблема заключалась в том, что около 5 000 000 сессионных процессов пытались давить на десять из этих процессов (по одному на каждой ноде guild). Здесь ускорение обработки не решало проблему; фундаментальной причиной было то, что обращения сессионных процессов к этому реестру guild'ов вываливались в таймаут и оставляли запрос в очереди к реестру. После некоторого времени запрос повторялся, но постоянно накапливаемые запросы переходили в неустранимое состояние. Получая сообщения из других сервисов, сессии блокировали бы эти запросы до тех пор, пока они не уйдут в таймаут, что приводило к раздуванию очереди сообщений и, в итоге, к OOM всей Erlang VM, результатом чего становятся каскадные перебои в обслуживании.Нужно было сделать сессионные процессы умнее; в идеале, они не должны даже пытаться делать эти вызовы к реестру guild'ов, если неудачный исход неизбежен. Мы не хотели использовать автоматический выключатель, чтобы не возникла ситуация, когда всплеск таймаутов приводит к временному состоянию, когда не делается вообще никаких попыток. Мы знали, как реализовать такое на других языках, но как сделать это на Elixir?

В большинстве других языков мы могли бы использовать атомарный счётчик для отслеживания исходящих запросов и раннего оповещения, если их количество слишком велико, эффективно реализуя семафор. Erlang VM построена на координации между процессами, но мы не хотели слишком загружать процесс, ответственный за эту координацию. После некоторых исследований мы наткнулись на

:ets.update_counter/4, который выполняет атомарные операции с обусловленных приращением на числе, которое находится в ключе ETS. Поскольку нужна была хорошая параллелизация, можно было запустить ETS в режиме write_concurrency, но по-прежнему считывать значение, поскольку :ets.update_counter/4 возвращает результат. Это дало нам фундаментальную основу для создания библиотеки Semaphore. Её исключительно легко использовать, и она очень хорошо работает с высокой пропускной способностью:semaphore_name = :my_sempahore

semaphore_max = 10

case Semaphore.call(semaphore_name, semaphore_max, fn -> :ok end) do

:ok ->

IO.puts "success"

{:error, :max} ->

IO.puts "too many callers"

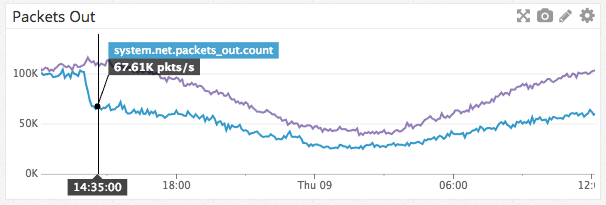

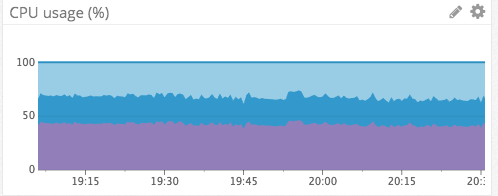

endЭта библиотека способствовала защите нашей инфраструктуры на Elixir. Не далее как на прошлой неделе случилась ситуация, похожая на вышеупомянутые каскадные перебои в обслуживании, но в этот раз никаких перебоев не было. Наши сервисы присутствия засбоили по другой причине, но сессионные сервисы даже не шелохнулись, а сервисы присутствия смогли восстановиться через несколько минут после перезагрузки:

Работа сервисов присутствия

Использование CPU сессионными сервисами за тот же период

Можете найти нашу библиотеку Semaphore на GitHub.

Заключение

Выбор и работа с Erlang и Elixir оказались отличным опытом. Если бы нас заставили вернуться и начать заново, мы определённо выбрали бы тот же путь. Надеемся, что рассказ о нашем опыте и инструментах будет полезен другим разработчикам Elixir и Erlang, а мы надеемся продолжить рассказывать о своей работе, решении проблем и получении опыта по ходу этой работы.

|

|

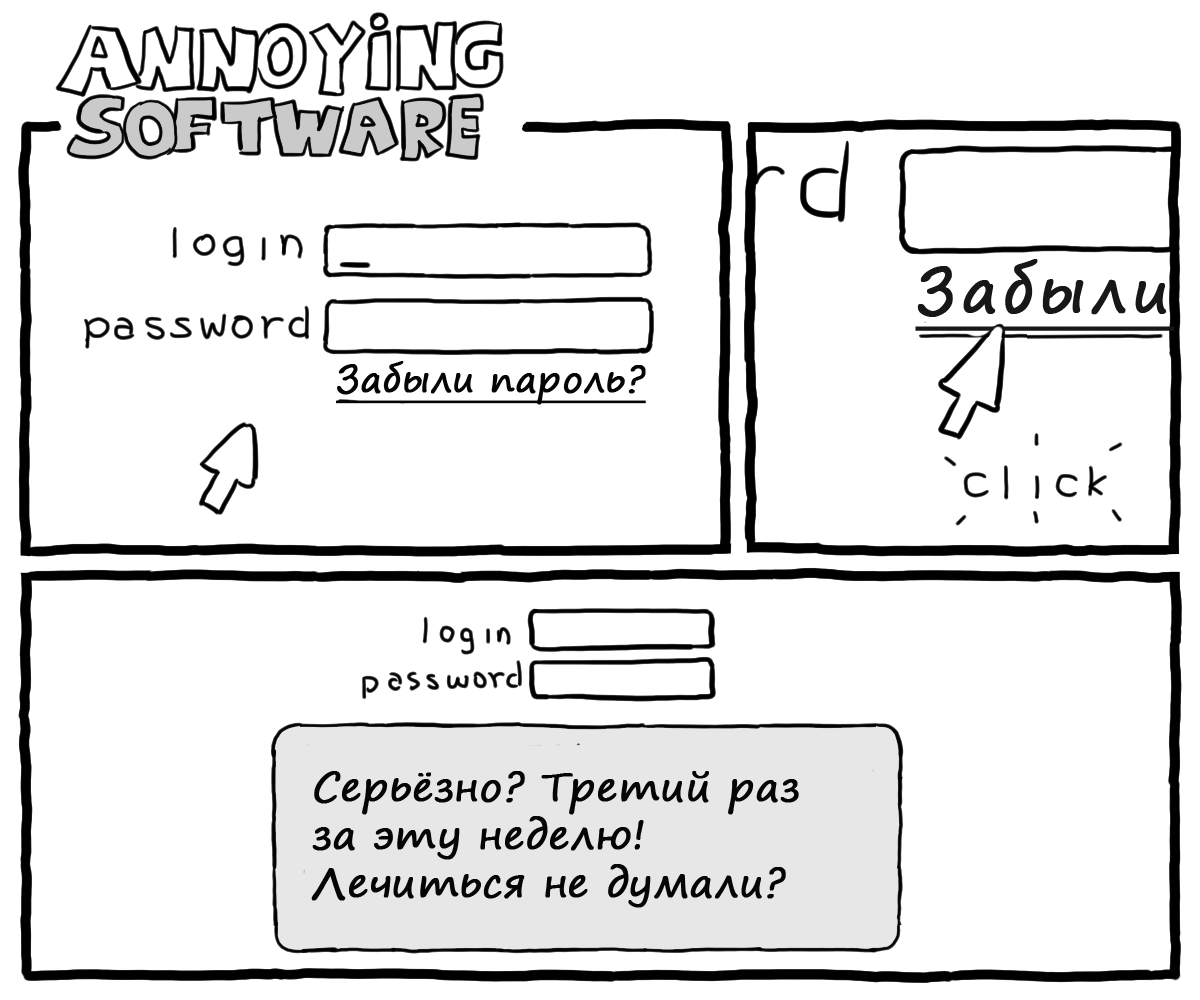

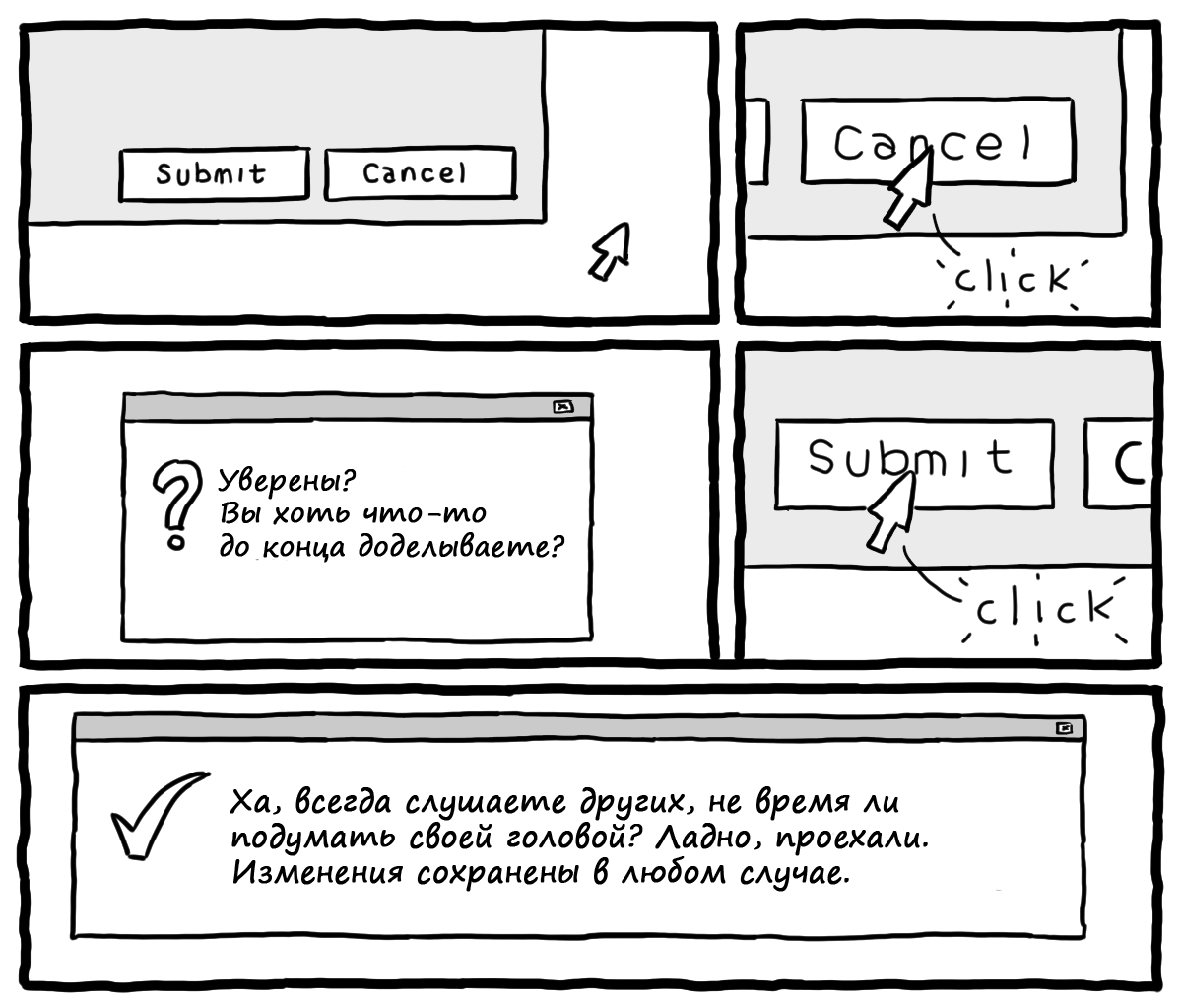

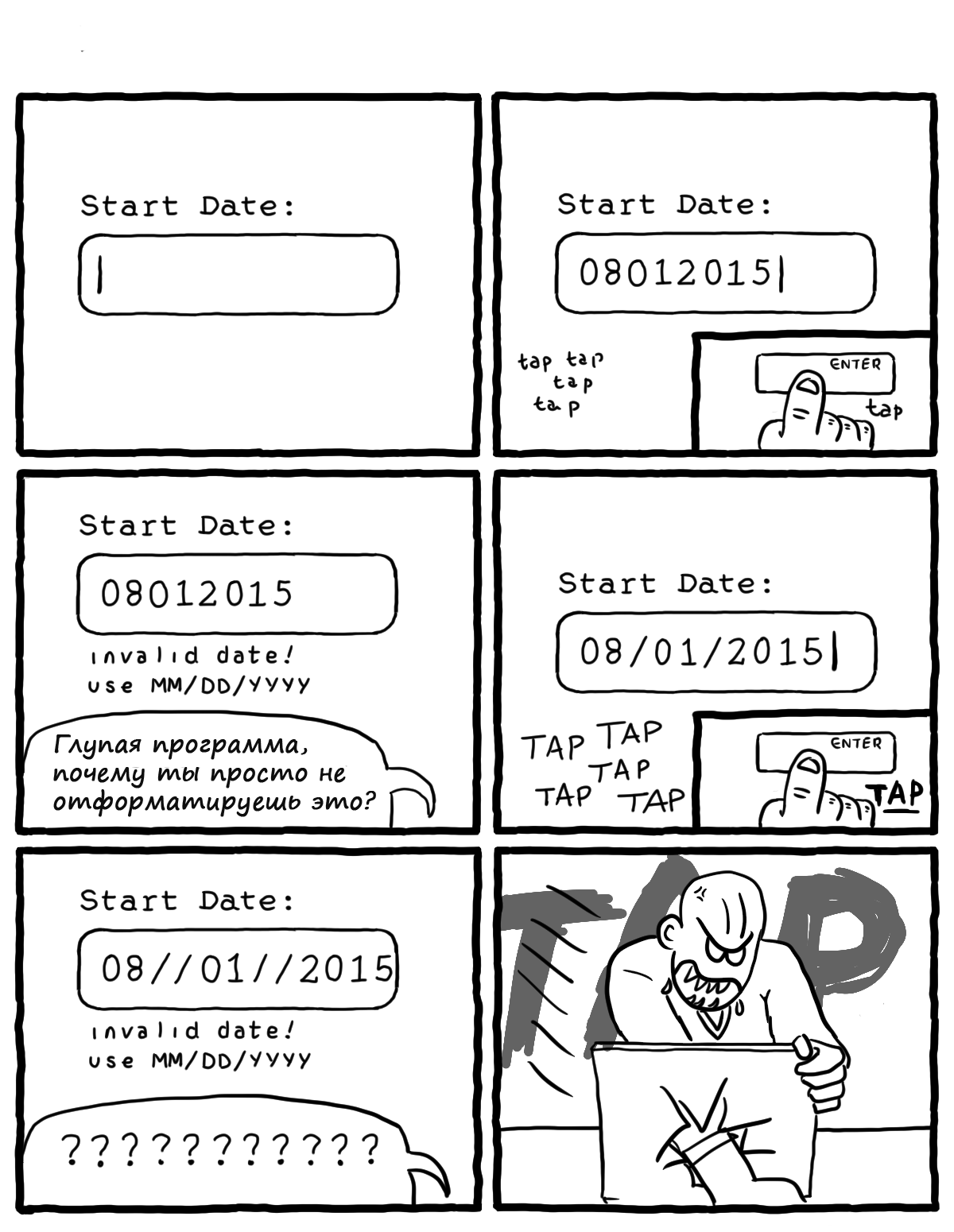

Комиксы Даниэля Стори (часть 2) |

Уровни программиста

О языке Brainfuck, протоколе Telnet и утилите nmap.

Эскалация проблемы

Ссылки на nixCraft и OMG! Ubuntu!

Большие данные

Big data на Википедии

Современное зло

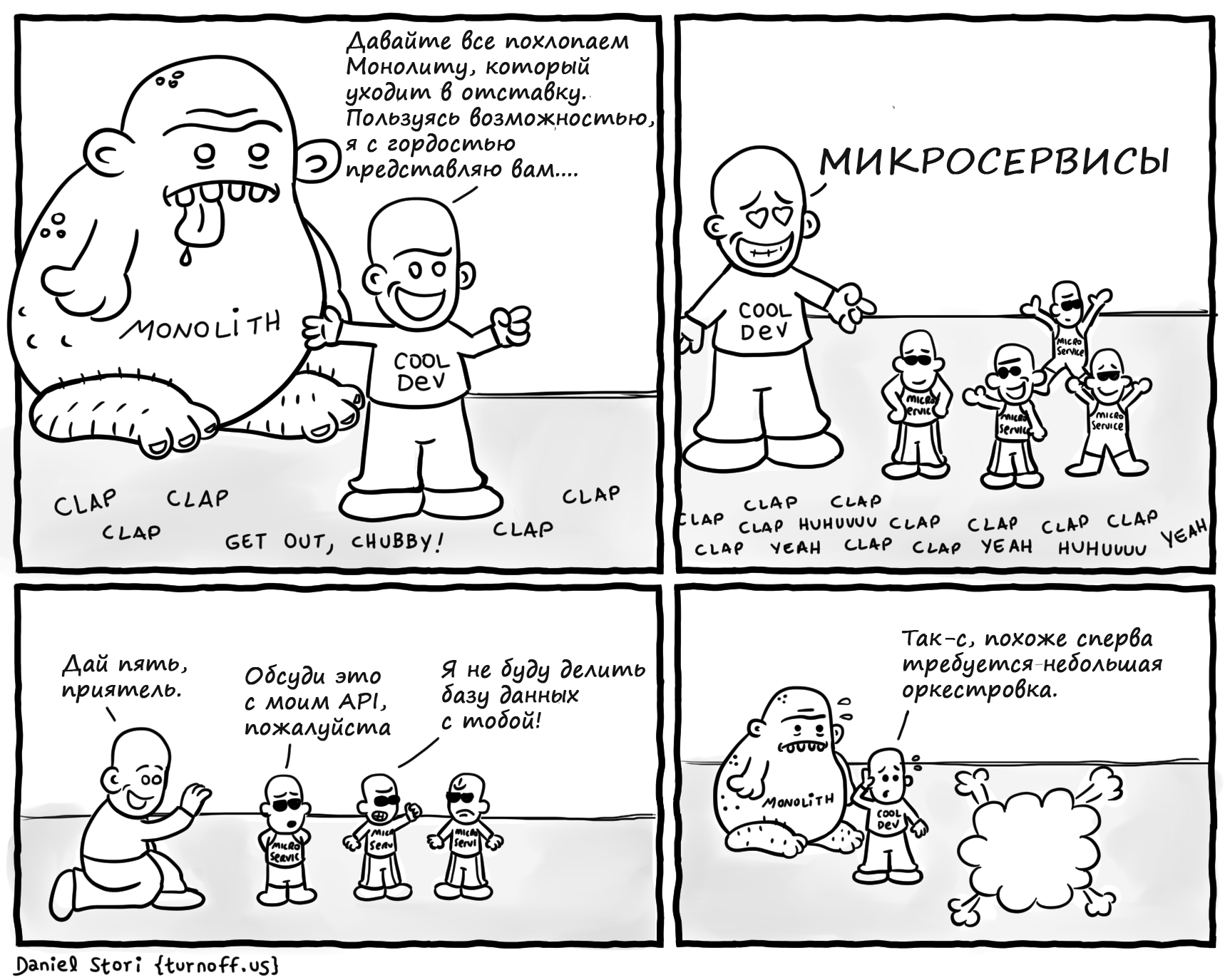

Вы готовы к переходу на микросервисы?

Потребовалось время. Интересная статья на Хабре.

Протоколы

TCP и UDP

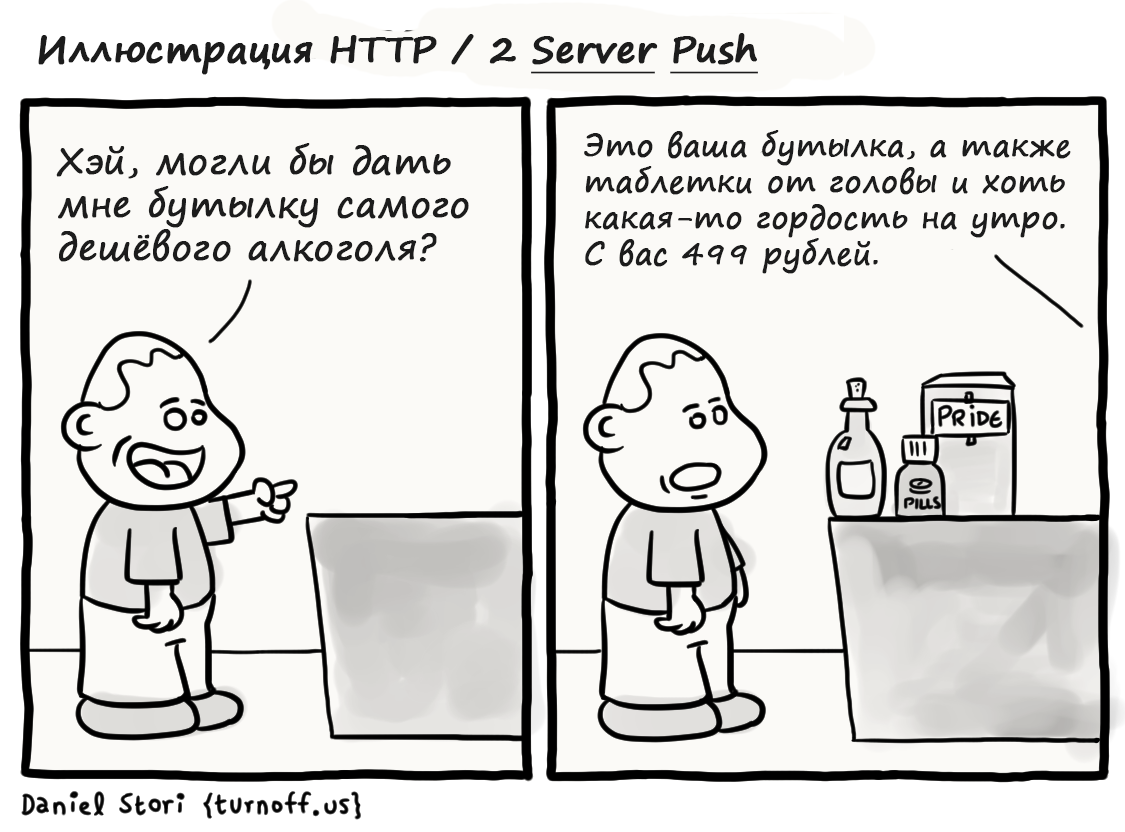

Вольная трактовка

HTTP / 2 Server Push на Википедии.

Ресторан Agile

Методология Agile и Каскадная (Waterfall) модель

Обычное утро

Дэдлайны, которые уже мертвы

О ТАРДИС

Надеемся, вам понравилась эта подборка. На этом пока всё, и мы отправляемся размышлять о следующей части или как лучше скажут сами комиксы

Это Дюк

|

Метки: author Cloud4Y читальный зал учебный процесс в it блог компании cloud4y комиксы юмор монолит cloud программисты шутят микросервисы java |

Как workflow разработки влияет на декомпозицию задач |

Одним из самых важных факторов, влияющих на скорость разработки и успех запуска проекта, является правильная декомпозиция идеи продакт-менеджера в задачи для непосредственно программирования. Как правильно это делать? Взять сценарий работы новой фичи от продакта и сразу начать кодить? Сначала написать приёмочные тесты, а потом – код, который будет обеспечивать их прохождение? А, может, переложить всё на плечи разработчиков – и пусть они в ходе скрам-покера сами решают?

Давайте подумаем и обозначим проблемы, которые могут возникнуть в процессе разделения задач, и способы их решения. В этом посте будут рассмотрены основные принципы декомпозиции задач при работе в команде. Меня зовут Илья Агеев, я – глава QA в Badoo. Сегодня расскажу, как workflow влияет на декомпозицию, насколько отличаются тестирование и выкладка задач, которые появляются в результате декомпозиции, и каких правил стоит придерживаться, чтобы процесс разработки проходил гладко для всех участников.

Почему это важно?

Необходимо помнить о том, что процесс разработки – это не только непосредственно сеанс написания кода. Когда мы говорим о разработке, я призываю смотреть на весь процесс целиком, начиная от постановки задачи и заканчивая стабильной работой фичи у наших пользователей. Если не брать в расчёт все этапы, которые предшествуют кодированию и следуют за ним, то очень легко можно попасть в ситуацию, когда все что-то делают, выполняют свои KPI, получают бонусы, а результат получается плачевный. Бизнес загибается, конкуренты «душат», но при этом все – молодцы.

Почему так происходит? Всё просто: человеческая психология заставляет людей смотреть на ситуации с точки зрения собственного комфорта. Разработчику не всегда хочется думать о том, что будет с кодом после его написания. Решил задачу – и хорошо. Его крайне редко это интересует (именно поэтому мы, айтишники, и работаем в этой отрасли – наша мотивация в основном держится на интересности задач), ведь в отношениях с людьми столько неопределённости. Гораздо более комфортно многие разработчики чувствуют себя, сидя за компьютером и сосредоточившись на решении своей собственной интересной задачи – блокчейнах с нейросетями – им совсем не хочется отвлекаться и думать о каких-то продакт-менеджерах, дедлайнах, пользователях, которые потом будут использовать их гениальное произведение (а то ещё и критиковать начнут!).

Это не плохо и не хорошо – мы ценим разработчиков именно за вдумчивое и грамотное решение технических задач. Но узкий взгляд на проблемы часто останавливает развитие. И речь о развитии не только конкретных людей, но и компании в целом. Ведь рост компании и совершенствование корпоративной культуры возможны только с ростом каждого сотрудника. Поэтому нам важно иногда вылезать из «кокона» и заставлять себя смотреть на проблемы шире, чтобы этот рост стимулировать.

И, разумеется, если такой важный этап, как декомпозиция, поручить человеку, который смотрит на всё исключительно с точки зрения собственного удобства, есть реальный риск огрести кучу проблем на последующих этапах: при слиянии результатов его работы с результатами других, при code review, при тестировании, выкладке в продакшн, и т. д.

Таким образом, определяя для себя, как правильно разбить ту или иную задачу, прикидывая, с чего следует начать и куда в итоге прийти, важно учитывать как можно больше факторов, а не смотреть на проблему только «со своей колокольни». Иногда для того чтобы всё работало быстрее и эффективнее на следующих этапах, приходится делать что-то сложнее и медленнее на том этапе, за который отвечаете вы.

Хороший пример – написание юнит-тестов. Зачем мне тратить своё драгоценное время на написание тестов, если у нас есть тестировщики, которые потом и так всё протестируют? А затем, что юнит-тесты необходимы не только для облегчения процесса кодинга – они нужны также и на последующих этапах. И нужны как воздух: с ними процесс интеграции и проверки регрессии ускоряется в десятки, сотни раз, на них базируется пирамида автоматизации. И это даже если не брать в расчёт ускорение вашей собственной работы: ведь «потрогав» код в каком-то месте, вам самому нужно убедиться в том, что вы ненароком что-нибудь не сломали. И один из самых быстрых способов это сделать – прогнать юнит-тесты.

Workflow

Многие команды, чтобы как-то формализовать отношения между участниками процесса, договариваются о правилах работы в коллективе: согласовывают стандарты кодирования, общий workflow в системе контроля версий, устанавливают расписание релизов и т. д.

Стоит ли говорить, что если изначально договориться о процессе, не принимая во внимание весь жизненный цикл фичи, то можно получить замедление и «грабли» в будущем? Особенно если учесть рост проекта и компании. О преждевременной оптимизации не забываем, но если есть процесс, который хорошо работает на разных масштабах, то почему бы его не использовать изначально?

Говоря о workflow разработки, многие, кто использует Git, сразу вспоминают (всуе) о некоем «стандартном git-flow», считая его идеальным, правильным, и часто внедряют его у себя. Даже на конференциях, где я выступал, рассказывая про workflow в Badoo, меня несколько раз спрашивали: «Зачем вы изобрели своё, почему не используете стандартный git-flow?» Давайте разбираться.

Во-первых, обычно, говоря про этот флоу, имеют в виду вот эту картинку. Я взял её из статьи Vincent Driessen “A successful Git branching model”, в которой описывается схема, довольно успешно работавшая на нескольких его проектах (было это в далёком 2010 году).

Сегодня некоторые крупные игроки на рынке хостинга кода вообще предлагают свой флоу, критикуя «стандартный git-flow» и описывая его недостатки; дают свои схемы, рекомендации, приёмы.