Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Сколько стоит перевести Хабр? |

|

Метки: author Schvepsss машинное обучение блог компании microsoft microsoft smartcat машинный перевод хабрахабр |

Как участие в профессиональных ИТ-сообществах влияет на карьеру |

Мы знаем, что для ИТ-рекрутеров крайне важно закрыть вакансию в кратчайшие сроки наименее затратным способом. Для этого у рекрутеров есть множество инструментов и методик: как для непосредственного поиска нужного специалиста, так и для предварительной оценки его профессиональных качеств. Они смотрят на опыт работы кандидата, на указанные им навыки, на отзывы со стороны коллег. В том числе смотрят и на его активность в профессиональных ИТ-сообществах.

Поэтому, месяц назад мы ввели на «Моём круге» рейтинги участия в ИТ-сообществах. Теперь каждый соискатель может показать на своём профиле, какой вклад он внёс и какие награды получил на «Хабре» и «Тостере», на StackOverflow и GitHub.

Но какую именно роль профессиональные ИТ-сообщества играют в жизни разработчиков и в их карьере? Насколько для работодателя важна информация об участии соискателя в этих сообществах? Какие сообщества более важны, а какие менее? Можно ли всё это как-то посчитать, измерить и оценить?

Мы провели опрос среди пользователей «Моего круга» по этой теме, собрали ответы тысячи респондентов и перевели их в наглядные диаграммы. На наш взгляд, получилась очень любопытная и убедительная картинка.

Портрет аудитории опроса

Посмотрим, кто принимал участие в опросе. В принципе, мы видим всё то же распределение по специализациям и типам компаний, что в наших предыдущих опросах. В этот раз мы решили еще уточнить позицию/квалификацию по общепринятой среди разработчиков классификации. И в очередной раз убедились, что на «Моём круге» сеньоры и лиды составляют значительную часть сообщества (44%).

Участие в ИТ-сообществах

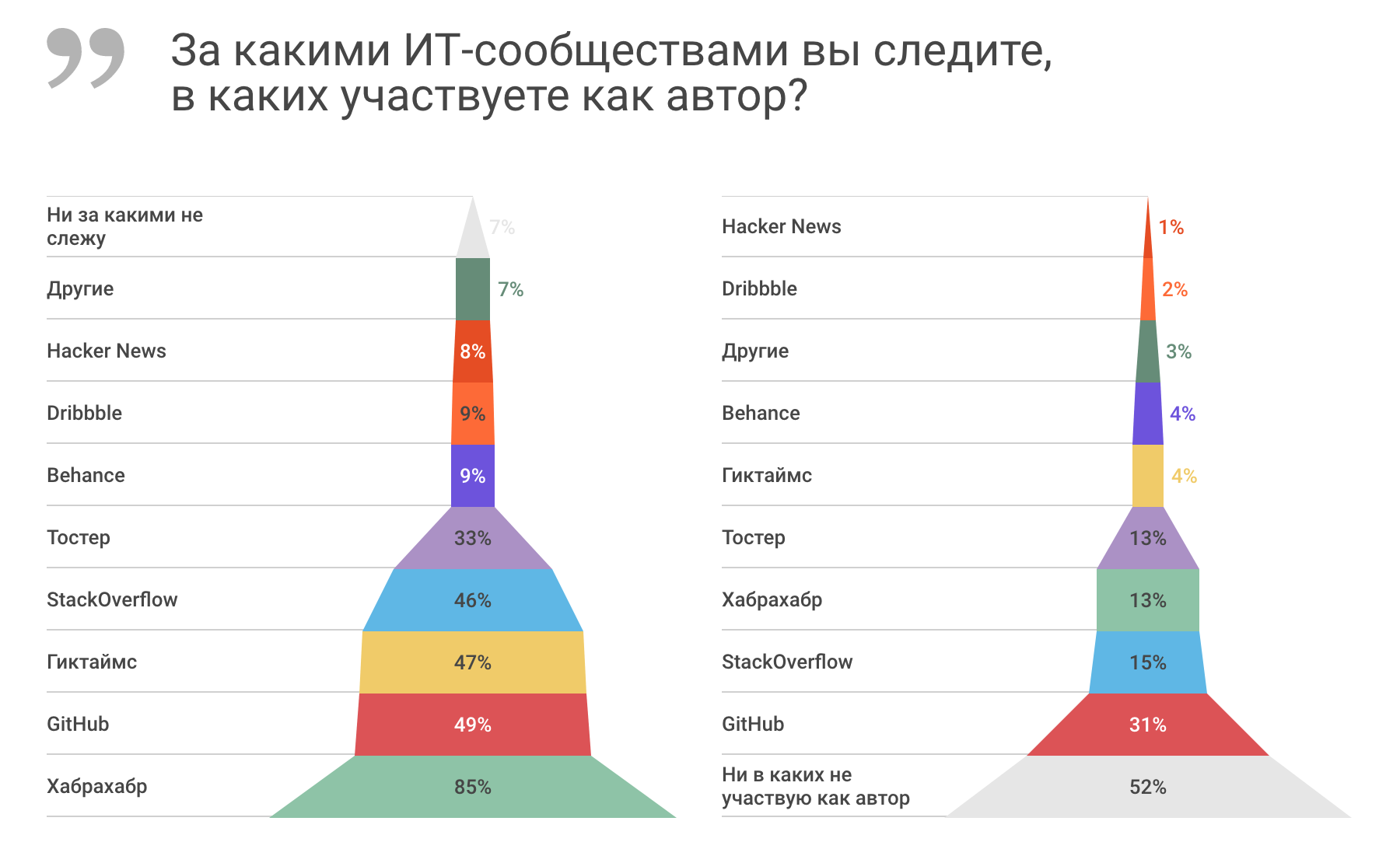

Подавляющее большинство опрошенных следит за «Хабрахабром» (85%), почти каждый второй следит также за «Гиктаймсом», GitHub и StackOverflow, каждый третий следит за «Тостером». Половина опрошенных никак не участвует в этих сообществах в качестве авторов. Почти каждый третий вносит свой вклад в GitHub, каждый седьмой — в StackOverflow, каждый восьмой — в «Хабрахабр» и «Тостер».

Среди других сообществ называли по большей части профильные группы в соцсетях, мессенджерах и на форумах, упоминали медиум, а также такие сообщества как Open Data Science, Web Standards и Reddit и другие.

Большинство (60-75%) участвует в ИТ-сообществах для личного развития: следят за трендами, поддерживают свои навыки, учатся. Меньше (20-40%) участвуют ради конкретной практической пользы: для развития своих проектов и расширения контактов, хорошего портфолио и карьеры. И ещё меньше (10-20%) участвуют ради помощи другим: обучают или развивают чужие проекты.

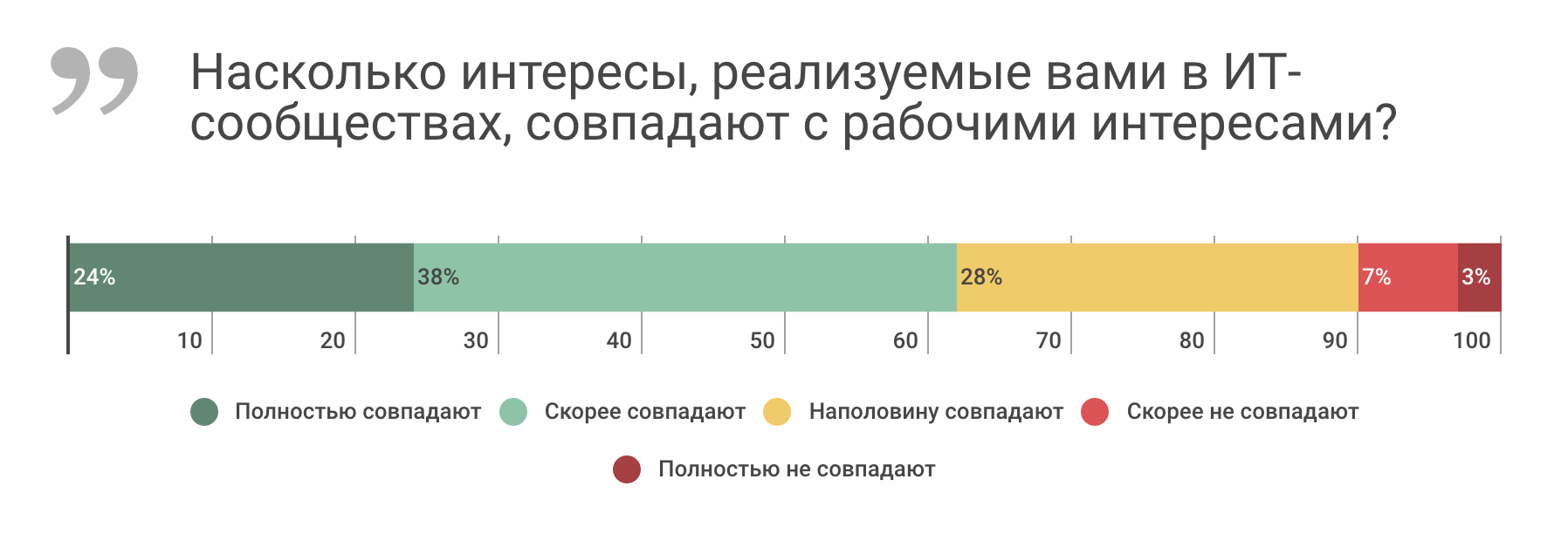

Разработчики регулярно спорят, нужно ли на работе афишировать своё участие в профессиональных ИТ-сообществах, ведь это не является прямым исполнением своих обязанностей. Но выясняется, что для большинства, двух специалистов из трёх, интерес участия в сообществах совпадает с текущим рабочим интересом, одно другому помогает и одно вытекает из другого.

Тем не менее, для одного из трёх эти интересы совпадают только наполовину или вовсе не совпадают. Думаем, для такой динамичной отрасли как ИТ, где каждый год появляются новые технологии и специализации, специалисты вынуждены заниматься не только своими текущими обязанностями, но и смотреть более широко, на смежные или новые области.

Взгляд на ИТ-сообщества со стороны соискателя

Двум специалистам из трёх, важно, чтобы потенциальный работодатель знал об их участии в ИТ-сообществах. Одному из трёх это безразлично. Что любопытно, если мы спрашиваем о том же самом, но по отношению к текущему работодателю, то уже только каждому второму это важно, а каждому второму — безразлично.

То есть участие в ИТ-сообществах чуть более важно для создания новых рабочих связей, чем для поддержания уже существующих.

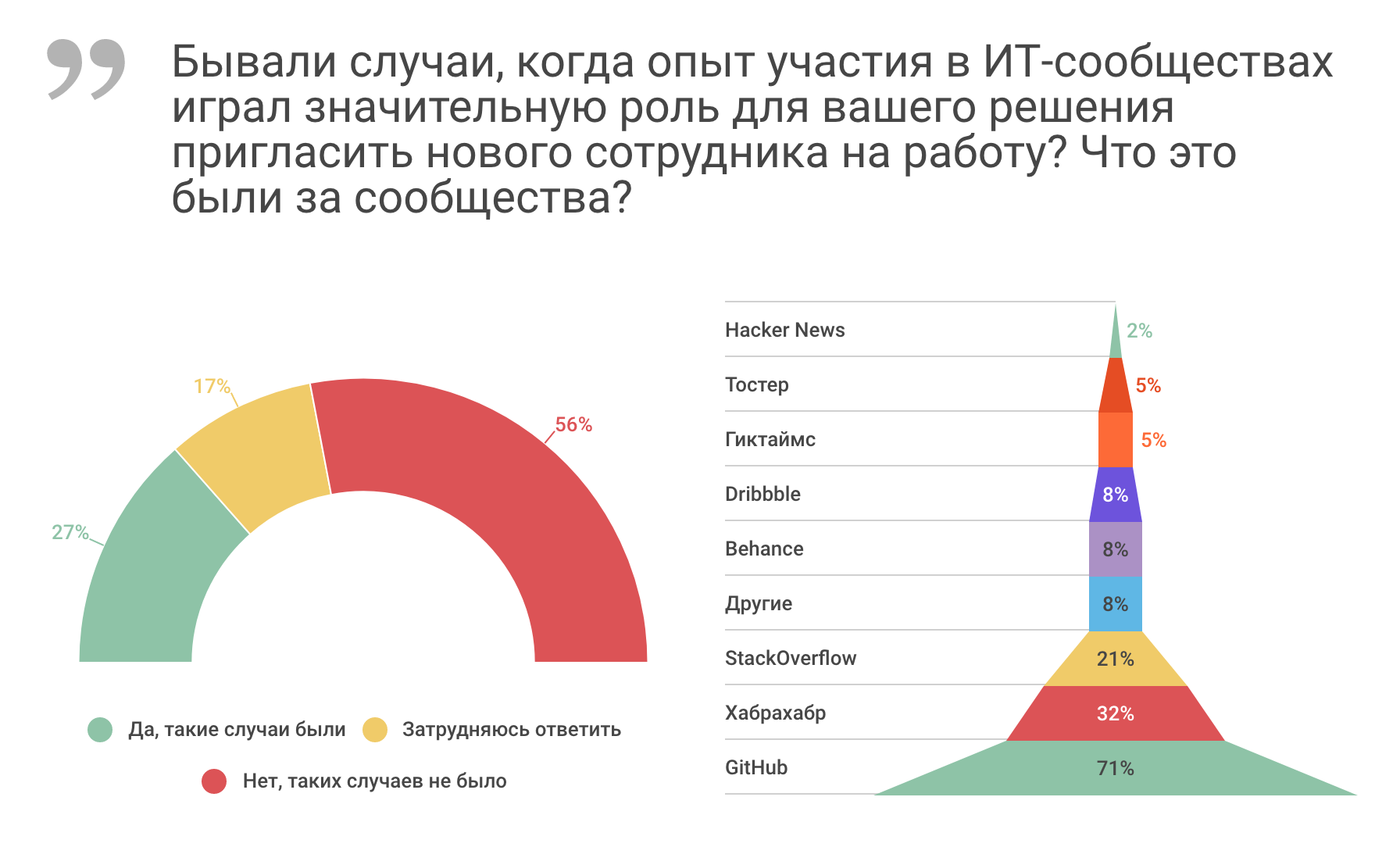

А теперь, одна из самых, на наш взгляд, любопытных частей опроса. Узнаем, насколько часто ИТ-сообщества на практике значительно влияют на карьеру специалиста. Оказывается, у каждого пятого в его карьере такие случаи были!

Самое влиятельное в этом смысле сообщество — GitHub. В половине случаев именно это сообщество оказывает решающую роль в получении новой работы. В трети случаев такую роль играет «Хабрахабр». В каждом седьмом случае — StackOverflow.

Среди других сообществ, оказывающих прямое влияние на карьеру, указали различные тематические форумы и митапы.

Взгляд на ИТ-сообщества со стороны работодателя

Половина опрошенных принимает участие в оценке потенциальных кандидатов. То есть если даже не принимают самостоятельных решений о найме, так или иначе оказывают влияние на тех, кто такие решения принимает. Примерно каждый второй при этом интересуется участием кандидатов в ИТ-сообществах.

Трое из четырёх работодателей интересуются участием кандидата в GitHub (75% интересуются). Каждый второй интересуется участием в «Хабрахабре» (48%). Чуть меньше интересуются участием в StackOverflow (39%). Каждый десятый — участием в «Тостере», «Гиктаймсе», Behance, Dribbble.

У каждого четвёртого работодателя были случаи, когда участие кандидата в ИТ-сообществе играло значительную роль в принятии решения о приглашении его на работу.

Самое влиятельное в этом смысле сообщество — опять же GitHub. Почти в трёх случаях из четырёх это сообщество оказывает решающую роль в приглашении кандидата на вакансию. В трети случаев такую роль играет «Хабрахабр». В каждом пятом случае — StackOverflow.

Выводы

Мы и раньше знали, что участие в ИТ-сообществах играет большую роль в профессиональном развитии и карьере специалиста. Но благодаря данному опросу смогли уточнить это знание и получить количественные представления.

Во-первых, мы уточнили, что каждый второй из тех, кто оценивает потенциальных кандидатов, обращает внимание на их участии в ИТ-сообществах. А каждый четвёртый из них отмечает случаи, когда эта информация играла значительную роль в принятии решения о найме.

Во-вторых, мы выяснили, что GitHub является самым влиятельным сообществом в сфере найма: почти трое из четырёх работодателей обращают внимание и принимают решения о найме по участию кандидата в этом сообществе. Второе место принадлежит «Хабрахабру»: каждый второй смотрит на него, каждый третий по нему принимает решение о найме. Третье место принадлежит StackOverflow: каждый третий смотрит, каждый пятый принимает ключевые решения.

|

|

В разрезе: новостной агрегатор на Android с бэкендом. Библиотека обхода интернет-сайтов на Java (crawler4j) |

Неотъемлемой частью системы сбора новостей является робот для обхода сайтов (crawler, круалер, «паук»). В его функции входит отслеживание изменений на указанных сайтах и внесение новых данных в базу данных (БД) системы.

Полностью готового и подходящего решения не было – в связи с этим потребовалось выбрать из имеющихся проектов что-то, что удовлетворяло бы следующим критериям:

- простота настройки;

- возможность настройки для обхода нескольких сайтов;

- нетребовательность к ресурсам;

- отсутствие дополнительных инфраструктурных вещей (координаторов работы, БД для «паука», дополнительных сервисов и т.д.).

Выбранным решением был достаточно популярный робот для обхода сайтов — crawler4j. Он, конечно тянет за собой массу библиотек для анализа полученного контента, однако это не сказывается на скорости его работы или потребляемых ресурсах. В качестве БД ссылок использует Berkley DB, создаваемому в настраиваемом каталоге для каждого анализируемого сайта.

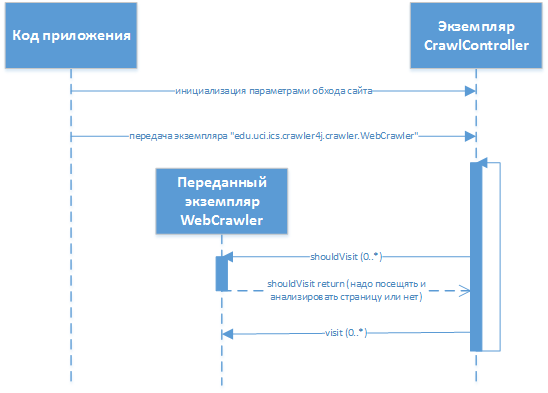

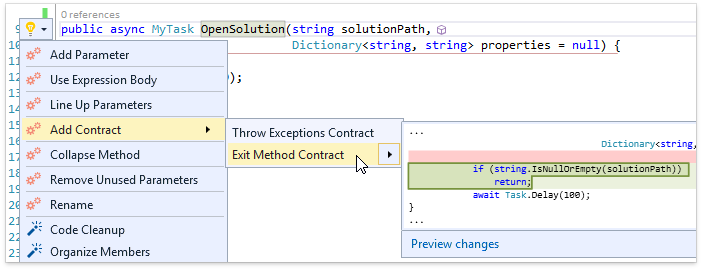

В качестве способа кастомизации разработчиком был выбран гибрид поведенческиих шаблонов «Стратегия» (право на принятие решение о том какие ссылки и разделы сайта анализировать приходится принимать клиенту) и «Наблюдатель» (при обходе сайта данные о странице (адрес, формат, содержание, мета данные) передаются клиенту, который волен сам принимать решать, как с ними поступать).

Фактически для разработчика «паук» выглядит как библиотека, которая подключается к проекту и в которую передаются необходимые реализации интерфейсов для кастомизации поведения. Разработчиком расширяется библиотечный класс

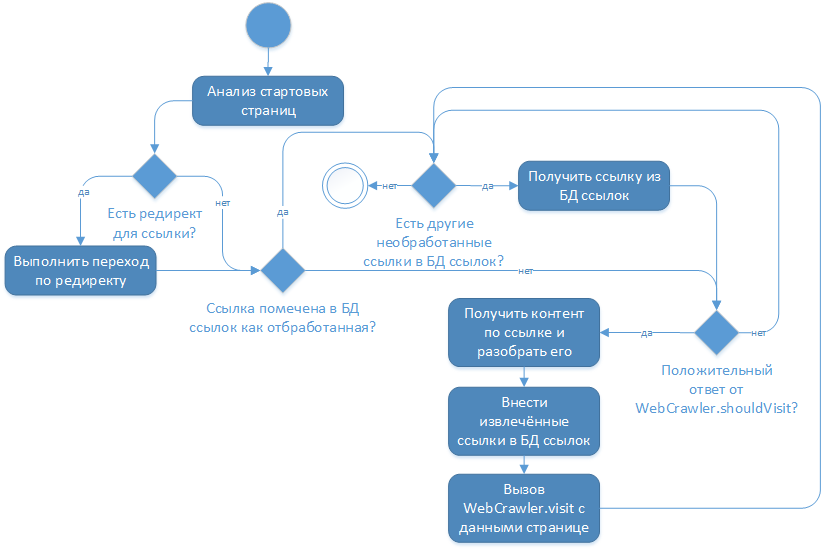

«edu.uci.ics.crawler4j.crawler.WebCrawler» (с методами «shouldVisit» и «visit»), который в последующем передаётся в библиотеку. Взаимодействие в процессе работы выглядит примерно таким образом:

, где

edu.uci.ics.crawler4j.crawler.CrawlController — основной класс библиотеки, через который осуществляется взаимодействие (настройка обхода, передача управляющего кода, получение информации о статусе, запуск/остановка).Реализацией парсинга сайтов ранее не приходилось заниматься – поэтому сразу же пришлось столкнуться с серией проблем и в процессе их устранения потребовалось сделать несколько решений по реализации и способам обработки полученных данных обхода:

- код анализа полученного контента и реализация шаблона «Стратегия» вынесен в виде отдельного проекта, версионность которого идёт отдельно от версий самого «паука»;

- фактический код анализа полученного контента и анализа ссылок реализован на groovy, что позволяет изменить логику работы без перезапуска пауков (активирована опция

«recompileGroovySource»в«org.codehaus.groovy.control.CompilerConfiguration») (при этом соответствующий код реализации«edu.uci.ics.crawler4j.crawler.WebCrawler»фактически содержит в себе лишь интерпретатор groovy, который обрабатывает в себе переданные данные); - извлечение данных с каждой встреченной страницы в «пауке» осуществляется не полное – убираются комментарии, «шапка» и «подвал», т.е. то что бессмысленно тратит 50% объёма каждой страницы – всё остальное сохраняется в базе MongoDB для последующего анализа (это позволяет перезапустить анализ страниц без повторного обхода сайтов);

- ключевые поля для каждой новости («дата», «заголовок», «тема», «автор» и т.д.) извлекаются уже из базы данных на MongoDB, при этом контролируется их заполненность – при достижении определённого количества ошибок – отправляется уведомление о необходимости корректировки скриптов (верный признак изменения структуры сайта).

Изменение в коде библиотеки

Основной проблемой для меня было некоторое архитектурное решение разработчика cralwer4j о том, что страницы сайта не меняются, т.е. логика его работы такова:

Изучив исходные тексты библиотеки я понял, что никакими настройками данную логику не изменить и было принято решение о создании fork основного проекта. В указанном ответвлении перед действием «Внести извлечённые ссылки в БД ссылок» осуществляется дополнительная проверка на необходимость внесения ссылок в БД ссылок: стартовые страницы сайта никогда не заносятся в эту БД и как результат — при их попадании в основной цикл обработки они получаются повторно и повторно разбираются, выдавая при этом ссылки на свежие новости.

Однако подобная доработка требовала изменения работы с библиотекой, при которой запуск основных методов должен осуществляться на периодической основе, что было легко реализовано с помощью библиотеки quartz. При отсутствии свежих новостей на стартовых страницах метод завершал свою работу через пару секунд (получив стартовые, проанализировав их и получив уже пройдённые ссылки) или записывал в БД свежие новости.

Спасибо за внимание!

|

Метки: author fedor_malyshkin проектирование и рефакторинг java crawler4j |

Разворачиваем Emercoin testnet и получаем много бесплатных монет |

Допустим, вы решили создать проект активно использующий блокчейн. Для хранения данных о товарах и их производителях, для учета транспортных средств и т.п. Будет разумно работу всех узлов на всех стадиях и не по одному разу. Встает проблема: записи в блокчейне не бесплатны, а если тестов много, то это может влететь в копеечку.

Специально для таких случаев существует режим “test mode”, когда монеты можно добывать центральным процессором любого маломощного ПК, но при этом они обладают всеми немонетарными свойствами “больших” монет EMC. Тестовые монеты можно пересылать на тестовые же адреса, создавать сколько угодно блокчейн-записей NVS, а кошельки в этом режиме объединять в testnet.

Сделать это очень просто:

Для начала надо скачать и установить последний кошелек Emercoin

Затем открыть emercoin.conf* и прописать:

testnet=1

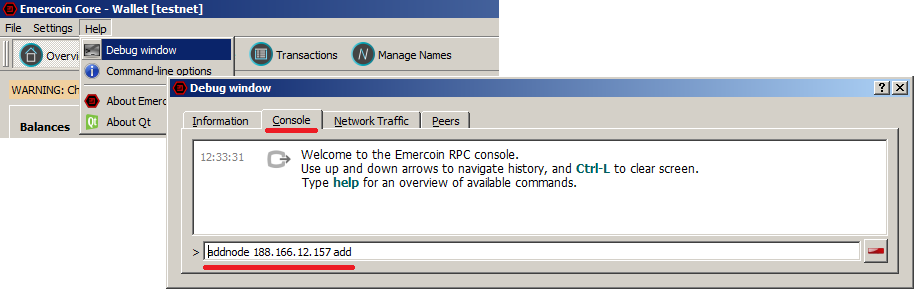

Запустить кошелек и немного подождать. Клиент найдет тестовый сервер-сид и синхронизирует в течении минут блокчейн. Если клиент долго не может найти сида, заходим в консоль и указываем сид мануально:

addnode 188.166.12.157 add

Ну и теперь самое сладкое, добываем монеты, как в старом добром 2009 году — процессором!

Опять заходим в консоль и вводим:

setgenerate true X (где X — число процессорных ядер, выделенных под майнинг. Если ничего не указывать, будут задействованы все доступные ядра)

PoW сложность сети настолько низкая, что через несколько минут кошелек закрывает блок и получает тестовые монеты. Их числа будет достаточно для проведения большинства экспериментов. Если же вам захочется еще, можно оставить кошелек в режиме майнинга на ночь или дольше, пока не образуется радующая глаз сумма.

Выключить режим генерации можно командой:

setgenerate false

Он так же отключается, если закрыть клиент кошелька.

Кстати, через 1 день, полученные PoW-майнингом монеты будут сами генерировать новые монеты с помощью механизма PoS.

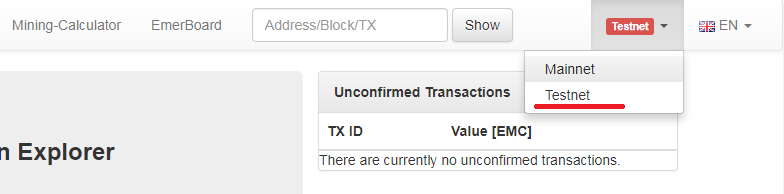

Для удобства отслеживания записей мы так-же развернули блокчейн эксплорер для публичного тестнета — testnet.emercoin.mintr.org он имеет тот-же функционал, что и для “большого Эмера”, между ними можно удобно переключаться.

Если по какой-то причине вас не устраивает публичный тестнет. Вы можете создать собственный — приватный.

Как это сделать?

Для начала Вы должны создать изолированную от Интернета локальную сеть, в которой будете производить эксперименты. Изоляция нужна, чтобы Ваш testnet не присоединился к публичному.

Далее, в этой тестовой сети установить как минимум два кошелька с активированной опцией testnet=1, как было указано выше.

После этого, на каждом узле Вашего локального тестнета, в консоли запустите команды “addnode”, как было указано в примере выше. В качестве IP-адресов укажите IP-адреса других компьютеров, где запущены узлы Вашего локального тестнета.

Например предположим, что Вы установили тестнет-кошельки на Ваших локальных машинах 192.168.1.10 и 192.168.1.11. Тогда в консоли кошелька на машине 192.168.1.10 введите “addnode 192.168.1.11 add”, а соответственно в консоли кошелька на машине 192.168.1.11 введите “addnode 192.168.1.10 add”.

Можно эти параметры внести в файл emercoin.conf. Таким образом, скажем на машине 192.168.1.10 он будет выглядеть так:

setgenerate=true 1

addnode=192.168.1.11

testnet=1

*Файл emercoin.conf находится в директории, где расположен блокчейн:

Linux/FreeBSD: $HOME/.emercoin

Windows: C:\Users\%User%\AppData\Roaming\EmerCoin

Если файла не существует — создайте его. При создании нового файла в Windows будьте внимательны — отключите “сокрытие расширений” в file explorer-е, чтобы не создать файл emercoin.conf.txt вместо emercoin.conf (Windows такое любит).

|

Метки: author EShumilov тестирование it-систем отладка анализ и проектирование систем блог компании emercoin мануалы блокчейн тестирование эмеркоин криптовалюты |

Colibri-ui — наше решение по автоматизации тестирования мобильного приложения |

То, как мы в Альфа-Лаборатории решали проблему поиска баланса между скоростью, бюджетом и качеством, мы и рассмотрим сегодня на примере Альфа-Мобайла. Забегая вперед, ВНИМАНИЕ, СПОЙЛЕР!!! наше решение доступно на github: библиотека colibri-ui и шаблон colibri-ui-template для быстрого старта.

В написании статьи принимали активное участие Павел pvivanov и Лилия Lidiyatullina

Что случилось?

В далёком 2013 нас даже не посещали мысли об автоматизации тестирования, поскольку процесс регрессионного тестирования занимал один день одного тестировщика на обе ОС (iOS/Android).

Однако с активным ростом приложения, добавлением в него новых услуг и сервисов затраты на ручное тестирование стали также расти высокими темпами.

Прибавьте сюда увеличение количества команд (с одной до шести), которые постоянно производят новые фичи — и регрессионное тестирование станет тромбом ваших процессов, который рискует оторваться и поставить под угрозу производство.

В какой-то момент мы пришли к тому, что на момент подготовки приложения к релизу все шесть команд “простаивают”, пока все шесть тестировщиков не покладая рук “регрессят” релиз-кандидат. Во временном эквиваленте продолжительность регрессионного тестирования выросла до 8 рабочих дней (шести человек!).

Не добавляет мотивации такое положение дел и самим тестировщикам. В определенный момент у нас даже появилась шутка “На регресс как на праздник!”

Что делать?

Проблему нужно было как-то решать, и у нас было два пути “пристроить баблишко”:

- вывод новых людей в ряды тестировщиков;

- автоматизация тестирования с целью отказа от ручного тестирования.

По этическим и экономическим соображениям мы выбрали второй вариант, всё-таки затраты на автоматизацию, как ни крути, гораздо более выгодное вложение.

Движение в выбранном направлении решили начать с пилотного проекта автоматизации тестирования мобильных приложений. По его результатам мы сформировали требования к будущему инструменту:

- Инструмент для автоматизации тестирования должен быть с максимально низким порогом входа в разработку для начала его использования.

Речь о минимизации написания кода, избавлении от написания сложных локаторов и т.д., поскольку основными пользователями инструмента являются тестировщики из продуктовых команд, которые могут не иметь опыта автоматизации. - Сценарии тестов должны быть понятны пользователям, не связанным с разработкой;

- Решение должно быть кроссплатформенным и работать сразу на двух платформах — Android и iOS;

- Должна быть сформирована ферма с подключенным набором мобильных устройств;

- Решение должно быть масштабируемым на другие мобильные приложения банка.

На основании полученных требований предстояло выбрать инструмент автоматизации.

В рамках пилотного проекта мы рассмотрели:

- Robotium

- Espresso

- UI Recorder

- Keep it Functional

- Calabash

- Appium

Требование к кроссплатформенности решения сузило выбор до последней пары из списка. Окончательный же выбор был сделан в пользу Appium по причине более активного сообщества, участвующего в разработке и поддержке.

Снижаем порог входа в разработку

Автоматизация какого-либо процесса на нижнем уровне — это скрипты и код. Однако далеко не каждый может разбираться в инструментах разработки или даже писать что-то самостоятельно. Именно поэтому мы решили максимально упростить этот момент, используя BDD-методологию на проектах.

Наш фреймворк разделен на несколько уровней абстракции, где верхний уровень пишется на популярном языке написания тестов Gherkin, а нижний уровень пишется разработчиками на языке программирования Java. Для написания сценариев был выбран JBehave.

Итак, как же выглядит наше решение со стороны пользователя?

Then загружена страница "Главный экран"

When скролл внутри "Основной список" до "Платежи и переводы"

When выполнено нажатие на "Платежи и переводы"

Then загружена страница "Платежи и переводы"

When скролл внутри "Список платежей и переводов" до "Мобильная связь"

When выполнено нажатие на "Мобильная связь"В этом примере описан процесс перехода с главного экрана на экран оплаты мобильной связи. Возможно, кто-то возразит, что с точки зрения бизнес-процесса ему неважно, каким путем он попадет на нужный экран, и он будет прав. Действительно, ничто не мешает нам перейти в нужный раздел, заменив последние пять строчек предыдущего сценария на одну, например, вот так:

When перейти в раздел "Мобильная связь"Однако такие шаги будут менее атомарными и их сложнее будет переиспользовать сразу на двух платформах, iOS и Android. Ведь когда мы хотим снизить порог входа в разработку, нужно максимально переиспользовать текущие шаги, иначе тестировщику все время будут нужны новые и как следствие — их реализация. А здесь, как мы помним, не всегда у тестировщика есть нужные навыки разработки.

Описываем экраны

Если со сценарием все предельно ясно, он читаем «с листа» и описывает наши действия, то как же указать локаторы, при этом стараясь явно их не использовать?

Один из способов достижения задачи по снижению порога входа — это упростить написание сложных локаторов и спрятать все в проект поглубже. Так родились две фабрики, которые позволяют по описанию создать локатор и использовать его для поиска. К сожалению, не всегда можно обойтись без написания локаторов, в редких случаях его приходится писать. Для таких ситуаций мы оставили возможность найти элемент по XPath.

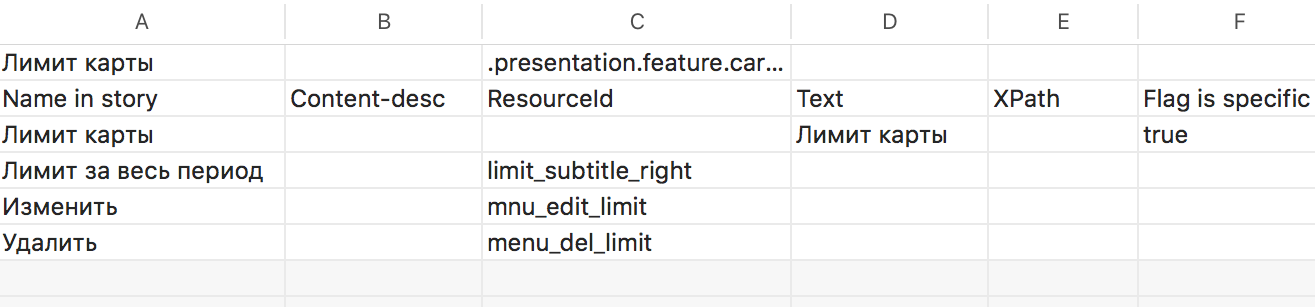

Описание элементов на экране у нас может состоять из четырех компонент. Все четыре компоненты никогда не используются, но две вполне могут использоваться, например, в случае, когда надо сначала скроллить до элемента, а затем нажать на него.

Составные части описания страницы как набора элементов:

- Content description — по этому идентификатору можно найти элементы на Android;

- ResourceId / AccessabilityIdeitificator — уникальный идентификатор. Иногда разработчики приложений не ставят идентификаторы, но это самый желанный элемент, который мы можем найти в разметке приложения для Android / iOS соответственно;

- Text — видимый текст, например, на кнопке, на которую можем нажать;

- XPath — обычный XPath по xml-разметке. Используется в случаях, когда предыдущими тремя способами однозначно описать элемент не получилось.

Имя элемента (Name in story) мы будем использовать в сценарии, по нему будем вытаскивать Content description / ResourceId / AccessabilityIdeitificator / Text / XPath.

Все описания мы собираем в .csv файлы, где в табличном виде можно удобно их править. С одной стороны, это обычный PageObject, а с другой — нашим тестировщикам не приходится править локаторы в коде.

Кажется, что куда уже проще! Описали экран, написали сценарий, запустили автотесты, но поговорим немного про нетривиальные задачи и посмотрим на наш фреймворк colibri-ui изнутри.

Настраиваем окружение

При работе с Appium всегда необходимо указывать, с каким мобильным устройством мы хотим работать. В нашем решении необходимо передать в проект udid устройства (уникальный идентификатор) и его название. Название также будет упоминаться в логах, если что-то пойдет не так. Отметим, что с помощью udid наш проект будет работать с нужным мобильным устройством, ведь их у нас целая ферма и все они подключены к одному Mac.

В настоящее время описания мобильных устройств хранятся в виде набора папок, в каждой из которых содержатся файлы настроек типа .property и json-объект. В файле типа .property указаны udid и имя устройства, json-объект содержит описание настроек ноды для работы в режиме кластера (см. шаблон colibri-ui-template).

Небольшой оффтоп, или как получить udid подключенных устройств!

Для Android мы выполняем в консоли «adb devices», для iOS — " instruments -s devices | grep -v (Simulator|$(id -un))" и получаем список подключенных девайсов. В случае с Android в списке будут как реальные устройства, так и эмуляторы, а для iOS мы фильтруем только реальные устройства. Если кому-то необходимо получить только эмуляторы, необходима другая фильтрация «instruments -s devices | grep Simulator».

В планах перенести этот набор папок в БД или в другое хранилище, либо получать список динамически, выполняя в процессе формирования окружения вышеуказанные команды. В настоящее время у нас нет потребности в таком улучшении.

Дополнительно отметим, что для работы вышеуказанных команд на вашем Mac должны быть установлены ADB Driver и Xcode соответственно. При работе с эмуляторами также не забываем выкачать их образы.

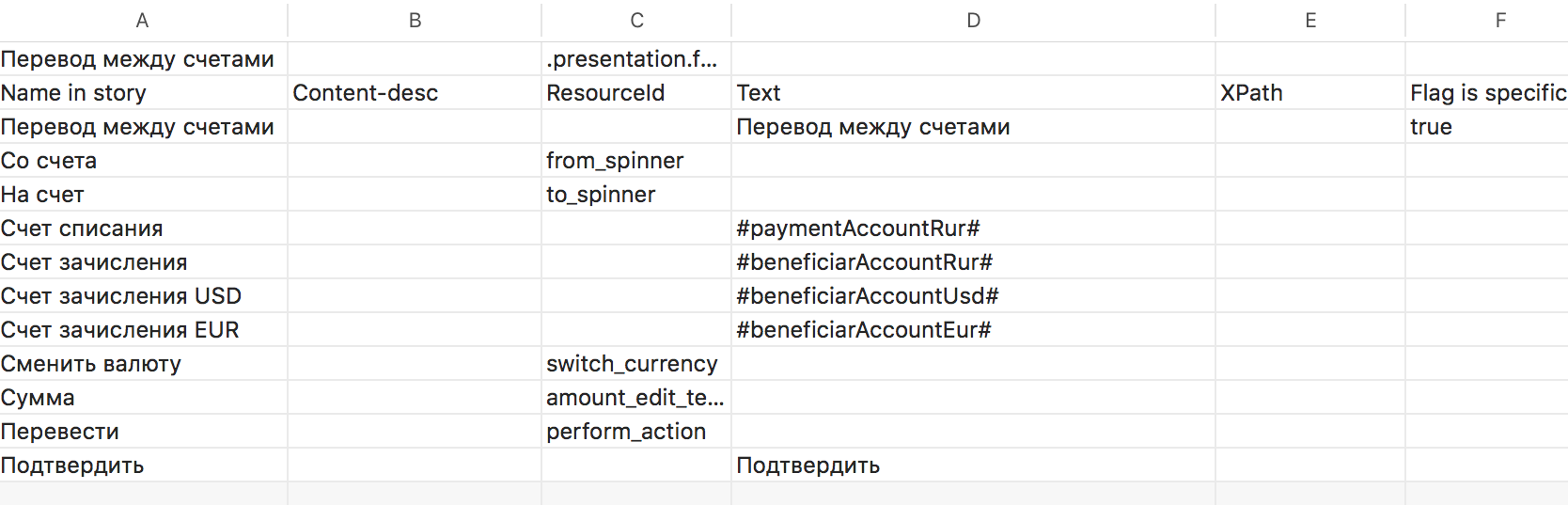

Описываем пользователя

К настоящему моменту мы учли все, что необходимо для запуска проекта в самом простом режиме. У нас есть сценарии, описания экранов и описания устройств. Однако в приложениях, которые тестируем мы, этого недостаточно. В наших приложениях необходимо авторизоваться каким-то пользователем на тестовый стенд и использовать его учетные данные, такие как: номер телефона, логин, пароль, номера счетов и т.д.

Файлы с учетными данными пользователей также лежат в проекте отдельной папкой. В перспективе, так же как и с устройствами, перенести их в БД или централизованное хранилище.

В сценариях и описаниях страниц мы используем маркеры вида #userName#, по которым получаем значение property из файла пользователя и заменяем эти маркеры в процессе прогона.

Таким образом, у нас может гоняться один и тот же набор сценариев на разных пользователях, в том числе одновременно.

Вот так это выглядит в описании страницы:

Вот так это выглятит в файле user.property:

paymentAccountRur=··0278

beneficiarAccountRur=··0163

beneficiarAccountUsd=··0889

beneficiarAccountEur=··0038Обязательно должны быть указаны ключи и значения.

Формируем Uber-шаги и некоторые побочные эффекты

Мы начали разработку с описания довольно мелких шагов, например, ввести текст или нажать на что-то. Со временем мы поняли, что писать сценарии мелкими шагами, либо писать сложные шаги, например, вернуться на главный экран, без дублирования кода мы не можем. Так начались поиски решения для переиспользования мелких шагов в более крупные.

Первой попыткой было добавить в проект guiсe, для организации DI, но его внедрение несло с собой переработку почти всего ядра проекта. А поскольку в зависимостях, прямо в appium-java-client, уже есть Spring, для нас решение стало очевидным и следующим нашим шагом было внедрение Spring.

При внедрении Sping в наш проект объем изменений был минимальный. В самой глубине проекта изменилась только фабрика шагов JBeHave и пара строчек в подключении Allure report. Почти все классы были объявлены компонентами и убрано большинство зависимостей.

Эффектом от внедрения стали не только шаги-конструкторы, в которых мы можем переиспользовать более мелкие действия, но и возможность вынести общие решения в библиотеку (ссылка на гитхаб была в самом начале). Для нас это актуально, т.к этим решением мы пользуемся на нескольких мобильных проектах.

Ну и самый необычный эффект в том, что мы можем написать тесты на тесты. Как бы смешно и неуклюже это ни звучало, но от качества инструмента тоже многое зависит, поэтому его тоже надо поддерживать и развивать. На текущий момент работы по покрытию еще идут. С внесением изменений в ядро проекта мы будем расширять тестовое покрытие внутри библиотеки.

Запускаем проект

Как уже говорилось, мы запускаем наш проект на определенном наборе устройств параллельно.

Пример запуска проекта из консоли:

./gradlew --info clean test --tests "*AndroidStories*" -Dorg.gradle.project.platform=Nexus6p_android6 -Dorg.gradle.project.user=6056789 -Dorg.gradle.project.testType=smokeNewReg -Dorg.gradle.project.buildVersion=9.0.0.7,developmentИз примера видно, что тесты запускаются для Android (--tests "*AndroidStories*"). Также в качестве параметров передаются:

Устройство, на котором будет запущен прогон тестов, Nexus6p_android6. Не забываем описывать устройство в проекте, об этом мы писали выше. Вот так это сделано у нас.

Файл device.properties содержит:

UDID=ENU14008659

deviceName=Nexus6pФайл test_node.json содержит данные для запуска ноды.

Тестовый пользователь 6056789, данные которого мы будем использовать. На проекте есть целый набор тестовых пользователей, которых мы используем для прогона наших тестов. Пользователь должен быть обязательно описан в user.properties.

Вид тестирования smokeNewReg, в нашем фреймворке реализована логика выбора тестовых сценариев по меткам Meta. В каждом сценарии в блоке Meta есть набор меток.

Meta:

@regressCycle

@smokeCycleВ файле testCycle.properties содержатся ключи и значения к меткам.

smoke=+smokeCycle,+oldRegistration,-skip

smokeNewReg=+smokeCycle,+newRegistrationCardNumber,-skip

smokeNewAccountReg=+smokeCycle,+newRegistrationAccountNumber,-skip

regress=+regressCycle,+oldRegistration,-skip

regressNewReg=+regressCycle,+newRegistrationCardNumber,-skipТаким образом, благодаря наличию Meta Matcher в JBehave, мы можем формировать набор тестовых сценариев на конкретный цикл тестирования.

Номер сборки, которую мы выкачиваем из централизованного хранилища, и ветку, из которой будет выкачана сборка. В нашем случае в файле environmentAndroid.properties лежит ссылка с подстановочными символами, которая формируется исходя из параметров, которые в свою очередь передаются на вход из консоли.

remoteFilePathReleaseAndDevelopment=http://mobile/android/mobile-%2$s/%1$s/mobile-%2$s-%1$s.apkТеперь, зная, как запустить проект из консоли, можно запросто интегрировать проект в Jenkins. На наших проектах есть такая интеграция, и тестировщику достаточно просто сформировать job в Jenkins для прогона автотестов.

Сейчас также сформирована ферма с мобильными устройствами. Это Mac Pro, к которому подключены порядка десяти мобильных устройств.

Формируем отчет

В нашем проекте отчет формируется с помощью allure report. Поэтому после того как тесты отработали, достаточно выполнить “allure generate directory-with-results”

В отчете мы можем увидеть статусы по каждому сценарию. Если начать открывать сценарии в отчете, то там можно найти шаги, по которым проходил тест, почти до вызова каждого метода. В случае если что-то развалилось, в шаге с ошибкой внутри будет находиться скриншот экрана.

Ранее скриншоты были в каждом шаге, но мы посчитали, что это бессмысленно, и скрин делается только на развалившихся сценариях. К тому же с ростом количества автоматизированных сценариев отчет начинает занимать все больше места.

Результат, который мы получили

Подведем итог по задачам, которые мы перед собой ставили.

- Нам удалось сделать инструмент для автоматизации тестирования с довольно низким порогом входа в разработку. В среднем, как показала практика, тестировщику достаточно две недели для того, чтобы уверенно начать писать и запускать автотесты. Наибольшие трудности у тестировщиков связаны с окружением по настройке appium.

- Сценарии тестов понятны всем членам команды, это особенно важно, когда на вашем проекте применяется BDD-методология.

- Наш фреймворк может работать одновременно с двумя платформами — iOS и Android.

- В текущий момент мы сформировали ферму из десяти мобильных устройств и Mac Pro. Проект интегрирован с Jenkins, и любой тестировщик может запустить автотесты в параллели на всех десяти устройствах.

- Наше решение масштабируемое и уже несколько мобильных проектов активно работают с нашим фреймворком и запускают автотесты.

В качестве бонуса:

- На одном из мобильных проектов за счет автоматизации мы полностью избавили функциональных тестировщиков от тестирования front-а на обратную совместимость с backend-ом. После внедрения автоматизации время тестирования в данном случае сократилось в 8 раз (с 8 часов до 1 часа).

- Новые автотесты пишутся тестировщиками в спринте вместе с разработкой новой функциональности в мобильных приложениях;

- Часть регрессионного тестирования уже автоматизирована, как следствие — мы сократили время на регресс с 8 дней до 1 дня. Это позволило нам релизиться чаще, а тестировщики перестали выпадать из команд на период регрессионного тестирования. Ну и просто стали чуточку счастливее :)

Результаты оправдали наши ожидания и подтвердили правильность решения пойти в автоматизацию.

Мы продолжаем развивать наше решение, которое доступно на github: библиотека colibri-ui и шаблон colibri-ui-template для быстрого старта. Дальше только больше!

Если вы хотите стать одним из тестировщиков Альфа-Лаборатории (или не только тестировщиком) — у нас есть открытые вакансии.

|

|

8 каких-то странных мифов про HR-технологии |

И начнем с простого примера — насколько проще стало коммуницировать после появления интернета? или созваниваться благодаря мобильным телефонам? Почему-то такого рода технологии не способствовали впаданию в панику.

Технологии сокращают время работы.

Оказывается, это не совсем правда.

По статистике Glassdoor, процесс найма сотрудника в 2016 году составлял 23 дня по сравнению с 10 днями в 2013 году (только в Великобритании количество дней, которые затрачиваются на найм, увеличилось с двух до четырёх недель). Это значит, что стали тратить существенно больше времени на скрининг (множество тестирований от употребления запрещенных веществ до проверки реальных навыков и бэкграунда) — компании стараются получить как можно больше нужной информации о кандидате, чтобы убедиться в том, подходит он или нет. В том числе, чтобы потом не облажаться и не потерять сотрудника через месяц, и не оправдать ожиданий человека.

Это значит, что технологии позволяют ускорить выполнение некоторых задач и детальнее подойти к процессу отбора. Инструменты создают для вас более подробную картину рекрутмента — чтобы вы ничего не упустили из виду. Так что технологии, которые вжух-вжух и всё за вас сделали — это неправда.

Технологии не влияют на количество сотрудников (утешительное!?).

Влияют, но сказать “заменяют”, нельзя.

Для некоторых компаний использование технологий становится просто жизненной необходимостью. И переход, конечно, связан с отказом от монотонной работы, которую выполняют сотрудники.

На митапах и встречах мы часто рассказываем о том, как приходим в компании с готовым решением. Например. Вот в компании «N» 10 девушек регулярно перепечатывают данные в таблицы. Только этим занимаются 24/7. И, скажем, у нас есть решение для подобных ситуаций (ну мы про автоматизацию же!). После этого возникают вопросы, мол, а как же так? Ведь пропадают рабочие места!

Пусть это не звучит очень цинично. Да, места пропадают, но зато у кого-то появится возможность выполнять какую-то более интересную работу, а не заниматься рутинными задачами снова и снова. Так всегда было: не везде же у нас всё ещё ручной труд и ручная работа, верно? В данном случае никакой дополнительной ценности в этом нет и быть не может.

А вот очевидный плюс HR-технологий в том, что можно отдавать дурацкие задачи в руки ботов / платформ / систем, но при этом открывать новые (нужные) позиции с задачами, которые будут под силу только человеку. И это может уравновешивать ситуацию: отдавая рутину машине, можно находить иные сферы развития компании и передавать их человеку, туда, где креативный подход к делу.

Работа HR’а сводится к нулю — “нас точно заменят!”.

Нет, это неправда.

Кадровики ушли в прошлое, но крутые специалисты в сфере остались, да ведь? Теперь работа с кадрами не заканчивается никогда: поиск, вовлечение, адаптация, обучение, развитие талантов, а потом ещё обучение и работа с брендом!

Согласно целому комплексу исследований вероятность того, что роботы заменят работу HR-менеджеров составляет 0,55%. Так что бояться нечего.

И как вас вообще может беспокоить появление ботов? Да, рекрутмент будет меняться и в отношении точечных позиций подход будет всё более детальным, в отношении массовых — будет появляться больше возможности совершать действия сразу с большим количеством кандидатов при минимальном участии человека.

Да, мы ждём, что конкуренция за талантливых специалистов тоже будет возрастать. Так что знаний потребуется намного больше: знать, что происходит на рынке, чего ждут кандидаты, как удерживать сотрудников, чем мотивировать их завтра, а чем — сегодня. HR-департаменту предстоит соединить в себе множество функций, стать принципиальным для бизнеса направлением. Стать маркетологами, научиться считать ROI и владеть аналитикой, понимать, как искать особенных специалистов, будь то разработчик, администратор в офисе или ещё один бухгалтер. Технологии приходят на помощь именно в этот момент, позволяя выполнять обязанности и контролировать эффективность в одной платформе (или нескольких, если необходимо).

Искусственный интеллект переворачивают рекрутмент с ног на голову.

Ну, скорее разговоры о нём.

Хабрахабр, конечно, не лучшее место для размышления об ИИ, но мы попробуем.

Что такое ИИ? Это научное направление (подчеркнуть “наука” несколько раз), основанное на моделировании человеческой деятельности, которую традиционно считают интеллектуальной. ИИ — это история про то, что машина может что-то творить. Это то, что раньше считалось прерогативой человека. Существует несколько «примеров» того, как уже влияет ИИ на рекрутинг и какие технологические продукты создаются сейчас на рынке (Mya, Textio, Pymetrics и так далее). Почему у нас возникают сомнения относительно того, что ИИ реально присутствует в большинстве проектах (которые заявляют о том, что они “really use AI”)?

— «Искусственный интеллект» — отличное словосочетание в первую очередь для продвижения продукта. Но суть в том, что это вставленное “ИИ” может никак не влиять на удобство и инновационность сервиса. Что само по себе как-то странно, согласитесь!

— Загадочность! Она прям окружает все стартапы, которые заявляют об использовании искусственного интеллекта. Все сервисы для рекрутмента, которые сейчас позиционируют себя как AI’шные, содержат в себе некоторые элементы, например, помогающие при осуществлении поиска или анализе потребностей человека, навыков. Ни один из них не рассказывает открыто и в подробностях о том, как технология работает и как реально соотносится с понятием AI.

Так что будем следить за развитием событий и реальными признаками AI в рекрутменте. Что-то разглядите — дайте нам знать.

Технологии небезопасны — за нами и так все следят, а тут ещё это!

Нет, это безопасно.

Окей, то есть доверить свои отпечатки пальцев Apple вы готовы, а перейти со старой системы, установленной на компьютере — нет? Удивительно! Мы все давно пользуемся картами, оплачиваем покупки смартфоном, и делимся подробностями личной жизни в социальных сетях. Почему же вас так пугают облачные системы? Всегда интересуйтесь у создателей платформ, которыми вы пользуетесь, где хранятся ваши священные данные, в какой стране и насколько хорошо они защищены. Сейчас всё довольно строго со 152 ФЗ, так что всем сервисам приходится подстраиваться. А если нет, то и ответа вам никакого адекватного не дадут.

Автоматизация — это сплошные волшебные кнопки!

И снова нет.

ОП! И инструмент сам ищет кандидатов.

ОП! Бренд работодателя просто сверкает от привлекательности.

Это так не работает. Автоматизация — это возможность передать машине (окей, системе) те задачи, которые вы делаете вручную и тратите время. Автоматизация — это отказ от рутинных функций в пользу интеллектуального труда. Так что если вы никогда не искали кандидатов в мессенджерах, и никогда вам это было не надо — зачем вам бот в Telegram? Сто раз взвесить такое решение надо.

Это вообще такая головная боль — стараться поспевать за всеми появляющимися digital-решениями не анализируя необходимость их использования. И не понимая, зачем вам нужен, скажем, видео-суперпупер-бот, новый сайт с огроменной анимацией про карьеру с блогом, автопоиск кандидатов в Instagram или что-то ещё. «Потому что у компании „Z“ уже есть!» — плохой ответ.

Знания и адекватная реакция на вопрос «зачем?» — в первую очередь, а найти решение любой задаче после вдумчивого анализа будет уже не сложно.

Адаптация к новому инструменту — болезненный процесс с потерей денег.

Нет.

Здесь есть два обычно пугающих момента: «очень долго согласовывать» и «сложно использовать». Так что разберемся.

С некоторыми компаниями согласование — это вопрос пары писем. И вот они уже пользуются системой и штурмуют рынок кандидатов. Отлаженные процессы внутри компании = успех при внедрении систем. Но это всё, конечно, зависит от клиента. Иногда согласование требует времени и всё же в итоге — лучше один раз договориться и затем просто продлевать подписку, видеть, как система растет и развивается и радоваться этому. Это вопрос, который нужно решить один раз.

И ко второму сомнительному мифу: да, мы знаем, что некоторые компании только сейчас переходят вообще с «папок на компьютере» к специальным системам для работы. Но при условии, что один инструмент позволяет сократить расходы на закрытие вакансии (вспомним кейс с перебиванием информации из таблиц), а также позволяет повысить эффективность работы команды с конкретными задачами, можно потратить время на обучение, на разбор функций и прочее. Вновь — это стоит потраченных усилий и точно не является оправданием при хранении данных в Google Docs. И помните, что любая система создаётся для пользователя: чтобы вы могли быстрее обучиться, вникнуть и начать работать. Прямо как при адаптации нового сотрудника ;)

Как не таргетируй и не ищи, лучший источник поиска — работный сайт.

Нет, потому что это не идеальный источник (как и любой другой)!

Технологии одновременно дали возможность находить индивидуальный подход к каждому кандидату, и позволили обращаться к сотням и тысячам потенциально заинтересованных.

Именно поэтому теперь так важно уметь таргетировать свой посыл, искать кандидатов с совершенно конкретными характеристиками. Понимать портрет своей аудитории. Автоматизированная работа с целым комплексом источников позволяет вам постоянно подстраиваться под изменение интересов аудитории, наблюдать за активностью, точечно формулировать запросы к своим кандидатам.

Мы провели эксперимент с одной компанией — предложили им не пользоваться работным сайтом две недели, публиковать вакансии на других ресурсах. Так вот. Количество откликнувшихся не изменилось. “Качество” кандидатов стало выше. И это логично, ведь когда вы ищете источники привлечения кандидатов под конкретные вакансии, вы находите площадки с учетом специфики позиции. Это работает лишь с частью вакансий, но всё же — работает. А значит позволяет сократить расстояние из точки А в точку Б: от вас до кандидата с конкретным опытом и навыками.

Так что аналитический подход вместе с правильной платформой позволяет нам разрушить даже миф о том, что только один тип источника приносит реальный результат.

Готовность использовать новые инструменты и учиться ставить конкретные цели и задачи в рамках бизнеса — это тоже область HR-технологий, которую предстоит осваивать и осваивать.

|

Метки: author blog_potok управление персоналом crm- системы блог компании potok ats рекрутмент hr автоматизация искусственный интеллект |

WiFiBeat: Обнаруживаем подозрительный трафик в беспроводной сети |

В данной статье мы поговорим о WiFiBeat, агенте, который может отправлять 802.11 фреймы в Elasticsearch, где мы можем их анализировать, строить графики и обнаруживать атаки. Вся эта система строится полностью на бесплатном ПО.

Введение

Официальный сайт утилиты — https://www.wlanpros.com/resources/wifi-beat/

GirHub — https://github.com/WiFiBeat/WiFiBeat

WiFiBeat позволяет работать с Wi-Fi адаптером в режиме монитора, создавать из фреймов JSON объекты и отправлять в базу данных аналитического движка Elasticsearch. Кроме этого, WiFiBeat может читать фреймы из PCAP файла.

Анализ собранной информации происходит в другом бесплатном продукте от Elastic — визуализаторе Kibana.

WiFiBeat официально стабильно работает на Ubuntu 16.04, но, конечно, его можно запустить и на других дистрибутивах, однако могут возникнуть трудности с зависимостями и несоответствием версий библиотек, под которые писалась утилита. Мы будем использовать 64-битную Ubuntu 16.04, к которой подключен USB Wi-Fi адаптер TP-LINK TL-WN722N в режиме монитора, для запуска WiFiBeat.

Elasticsearch и Kibana будут развернуты на 64-битной Debian 9.

Установка WiFiBeat

Процесс установки детально описан на GitHub.

Устанавливаем libtins

wget https://github.com/mfontanini/libtins/archive/v3.5.tar.gz

tar -zxf v3.5.tar.gz

cd libtins-3.5

apt-get install libpcap-dev libssl-dev build-essential libboost-all-dev

mkdir build

cd build

cmake ../ -DLIBTINS_ENABLE_CXX11=1

make

make install

ldconfigУстанавливаем недостающие пакеты в систему

apt-get install libyaml-cpp-dev libpoco-dev rapidjson-dev libtsan0 libboost-all-dev libb64-dev libwireshark-data build-essential libnl-3-dev libnl-genl-3-dev libnl-idiag-3-devУстанавливаем Codelite для сборки WiFiBeat

apt-get install codelite codelite-plugins

Запускаем codelite и создаем новый workspace

Тип C++

Запоминаем директорию

Когда workspace создан, переходим в директорию и скачиваем WiFiBeat и библиотеки с GitHub.

cd /root/WiFiBeat

git clone https://github.com/WiFiBeat/WiFiBeat

git clone https://github.com/WiFiBeat/elasticbeat-cpp

git clone https://github.com/WiFiBeat/simplejson-cppДобавляем все 3 проекта в наш workspace в codelite

В итоге должно получиться следующее

После двойного клика на wifibeat в списке проектов, он должен выделиться

Правым кликом на wifibeat выбираем Build

Выбираем компилятор, если не был выбран, и снова Build

Если все зависимости установлены в системе и Вы все сделали правильно до этого, то в завершении процесса компиляции Вы увидите сообщение об отсутствии ошибок.

====0 errors, 2 warnings, total time: 00:01:13 seconds====

Настройка

Процесс установки Elasticsearch и Kibana не будет рассматриваться в данной статье. На эту тему есть достаточно материалов в сети. Предполагаем, что они работают на машине 192.168.1.30, а WiFiBeat на машине 192.168.1.31. Elasticsearch слушает HTTP порт 9200 и не требует аутентификации.

К машине 192.168.1.31 я подключил Wi-Fi адаптер и перевел его в режим монитора.

В системе он отображается как mon0.

Из каталога с WiFiBeat копируем конфигурационный файл в etc и редактируем

cp wifibeat.yml /etc

vi /etc/wifibeat.ymlЭтот файл хорошо документирован, коротко пройдемся по основным опциям.

Я собираюсь анализировать трафик одной сети, работающей на пятом канале диапазона 2.4 ГГц.

Поэтому в настройках интерфейсов оставляю одну запись. Есть возможность анализировать сразу несколько каналов и для каждого задать время прослушивания.

wifibeat.interfaces.devices:

mon0: [5]Удаляю все из раздела Output file

В разделе с PCAP-фильтрами я задам следующее

wifibeat.interfaces.filters:

mon0: type mgtЗдесь указываются фильтры как в Wireshark, и в данном случае я указываю, что меня интересуют только Management фреймы 802.11. К ним относятся:

- Authentication frame

- Deauthentication frame

- Association request frame

- Association response frame

- Reassociation request frame

- Reassociation response frame

- Disassociation frame

- Beacon frame

- Probe request frame

- Probe response frame

- Request to Send (RTS) frame

- Clear to Send (CTS) frame

- Acknowledgement (ACK) frame

В разделах Local file и Decryption я все закомментировал, ключи шифрования в моем примере мне не понадобятся и читать из PCAP файла я так же не буду.

В разделе Queues ничего менять не буду и в разделе Outputs задам адрес и порт Elasticsearch.

output.elasticsearch:

enabled: true

protocol: "http"

# Array of hosts to connect to.

hosts: [ "192.168.1.30:9200" ]Сохраняем и переходим в каталог с WiFiBeat и подкаталог Debug. Здесь должен находиться скомпилированный исполняемый файл wifibeat.

Запуск

Запускаем Elasticsearch и Kibana на машине 192.168.1.30. Убеждаемся, что прослушивается порт 9200 (Elasticsearch) и Kibana (5601).

На машине 192.168.1.31 проверяем, что мы не допустили ошибок в конфигурации

./wifibeat -d

Вы должны увидеть парсинг конфигурационного файла. Если есть ошибки, то wifibeat сообщит о проблеме. Если все хорошо, то запускаем

./wifibeat -f

Ключ -f позволяет запустить wifibeat не в режиме демона. Для нас это пока удобнее.

Теперь если вы откроете Kibana и проверите индексы, то должны увидеть, что появился новый индекс wifibeat*

Настроим Kibana. Переходим в Management, Index Patterns

Создаем новый шаблон

Отмечаем его как основной

Теперь импортируем Dashboard-ы и Визализации, которые идут в комплекте с WiFiBeat

Выбираем файл kibana.json из каталога WiFiBeat/kibana

Если импорт прошел успешно, можно перейти на вкладку Dashboard и найти там WLAN

Если не использовать фильтры в wifibeat.yml он будет выглядеть так

С фильтрами (в нашем случае), мы не будем видеть данных по Control Frames и Data Frames.

Помимо дэшбордов у нас появились новые визуализации

В заключении

Далее при помощи еще одного компонента пакета Elasitc — X-Pack можно настроить действия при обнаружении, скажем всплеска фреймов деаутентификации, что может означать DoS атаку или попытку заполучить хэндшейк для брутфорса. Таким образом можно собрать систему обнаружения атак на беспроводную сеть.

|

Метки: author antgorka информационная безопасность блог компании pentestit elasticsearch kibana wifi 802.11 |

[Перевод] Load Average в Linux: разгадка тайны |

Средние значения нагрузки (Load averages) — это критически важная для индустрии метрика. Многие компании тратят миллионы долларов, автоматически масштабируя облачные инстансы на основании этой и ряда других метрик. Но на Linux она окутана некой тайной. Отслеживание средней нагрузки на Linux — это задача, работающая в непрерываемом состоянии сна (uninterruptible sleep state). Почему? Я никогда не встречал объяснений. В этой статье я хочу разгадать эту тайну, и создать референс по средним значениям нагрузки для всех, кто пытается их интерпретировать.

Средние значения нагрузки в Linux — это «средние значения нагрузки системы», показывающие потребность в исполняемых потоках (задачах) в виде усреднённого количества исполняемых и ожидающих потоков. Это мера нагрузки, которая может превышать обрабатываемую системой в данный момент. Большинство инструментов показывает три средних значения: для 1, 5 и 15 минут:

$ uptime

16:48:24 up 4:11, 1 user, load average: 25.25, 23.40, 23.46

top - 16:48:42 up 4:12, 1 user, load average: 25.25, 23.14, 23.37

$ cat /proc/loadavg

25.72 23.19 23.35 42/3411 43603Некоторые интерпретации:

- Если значения равны 0.0, то система в состоянии простоя.

- Если среднее значение для 1 минуты выше, чем для 5 или 15, то нагрузка растёт.

- Если среднее значение для 1 минуты ниже, чем для 5 или 15, то нагрузка снижается.

- Если значения нагрузки выше, чем количество процессоров, то у вас могут быть проблемы с производительностью (в зависимости от ситуации).

По этому набору из трёх значений вы можете оценить динамику нагрузки, что безусловно полезно. Также эти метрики полезны, когда требуется какая-то одна оценка потребности в ресурсах, например, для автоматического масштабирования облачных сервисов. Но чтобы разобраться с ними подробнее, нужно обратиться и к другим метрикам. Само по себе значение в диапазоне 23—25 ничего не значит, но обретает смысл, если известно количество процессоров, и если речь идёт о нагрузке, относящейся к процессору.

Вместо того, чтобы заниматься отладкой средних значений нагрузки, я обычно переключаюсь на другие метрики. Об этом мы поговорим ближе к концу статьи, в главе «Более подходящие метрики».

История

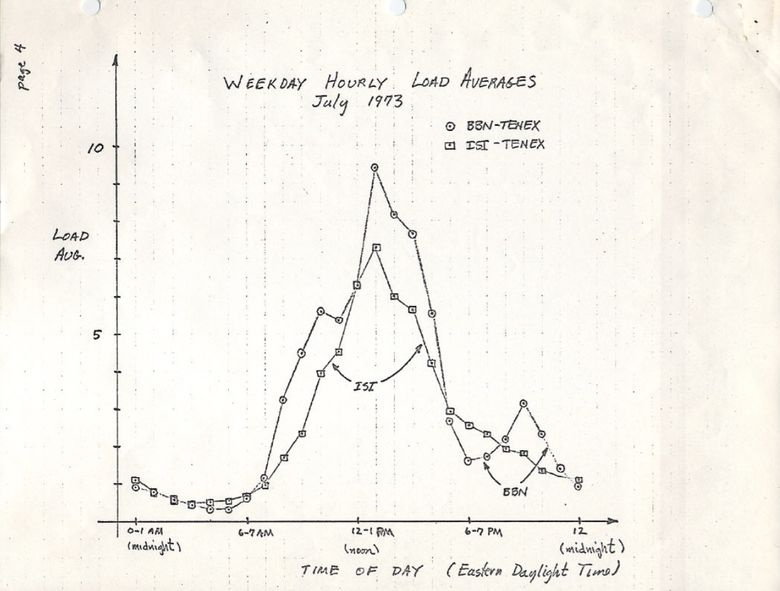

Изначально средние значения нагрузки показывают только потребность в ресурсах процессора: количество выполняемых и ожидающих выполнения процессов. В RFC 546 есть хорошее описание под названием "TENEX Load Averages", август 1973:

[1] Средняя нагрузка TENEX — это мера потребности в ресурсах CPU. Это среднее количество исполняемых процессов в течение определённого времени. Например, если часовая средняя нагрузка равна 10, то это означает (для однопроцессорной системы), что в любой момент времени в течение этого часа 1 процесс выполняется, а 9 готовы к выполнению (то есть не блокированы для ввода/вывода) и ждут, когда процессор освободится.

Версия на ietf.org ведёт на PDF-скан графика, нарисованного вручную в июле 1973, демонстрирующего, что эта метрика используется десятилетиями:

source: https://tools.ietf.org/html/rfc546

Сегодня можно найти в сети исходный код старых операционных систем. Вот фрагмент из TENEX (начало 1970's) SCHED.MAC, на макроассемблере DEC:

NRJAVS==3 ;NUMBER OF LOAD AVERAGES WE MAINTAIN

GS RJAV,NRJAVS ;EXPONENTIAL AVERAGES OF NUMBER OF ACTIVE PROCESSES

[...]

;UPDATE RUNNABLE JOB AVERAGES

DORJAV: MOVEI 2,^D5000

MOVEM 2,RJATIM ;SET TIME OF NEXT UPDATE

MOVE 4,RJTSUM ;CURRENT INTEGRAL OF NBPROC+NGPROC

SUBM 4,RJAVS1 ;DIFFERENCE FROM LAST UPDATE

EXCH 4,RJAVS1

FSC 4,233 ;FLOAT IT

FDVR 4,[5000.0] ;AVERAGE OVER LAST 5000 MS

[...]

;TABLE OF EXP(-T/C) FOR T = 5 SEC.

EXPFF: EXP 0.920043902 ;C = 1 MIN

EXP 0.983471344 ;C = 5 MIN

EXP 0.994459811 ;C = 15 MINА вот фрагмент из современной Linux (include/linux/sched/loadavg.h):

#define EXP_1 1884 /* 1/exp(5sec/1min) as fixed-point */

#define EXP_5 2014 /* 1/exp(5sec/5min) */

#define EXP_15 2037 /* 1/exp(5sec/15min) */В Linux тоже жёстко прописаны константы на 1, 5 и 15 минут.

Аналогичные метрики были и в более старых системах, включая Multics, которая содержала экспоненциальное среднее значение очереди планируемых заданий (exponential scheduling queue average).

Три числа

Три числа — это средние значения нагрузки для 1, 5 и 15 минут. Вот только они на самом деле не средние, и не для 1, 5 и 15 минут. Как видно из вышеприведённого кода, 1, 5 и 15 — это константы, используемые в уравнении, которое вычисляет экспоненциально затухающие изменяющиеся суммы пятисекундного среднего значения (exponentially-damped moving sums of a five second average). Так что средние нагрузки для 1, 5 и 15 минут отражают нагрузку вовсе не для указанных временных промежутков.

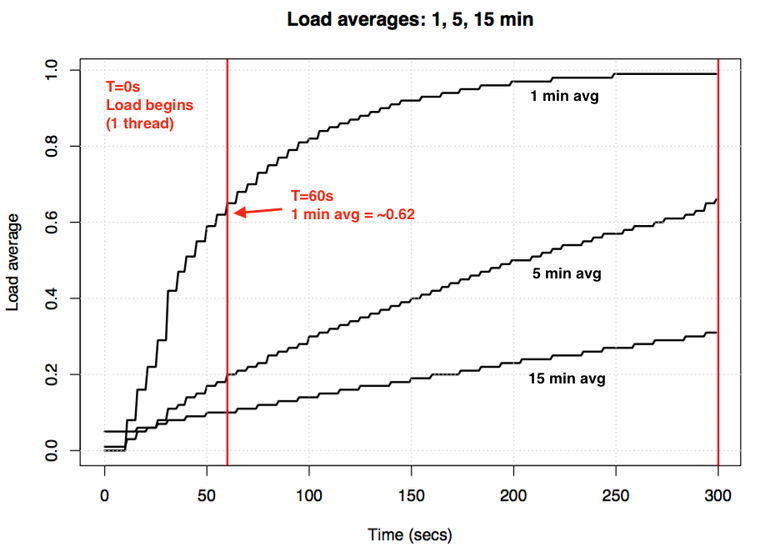

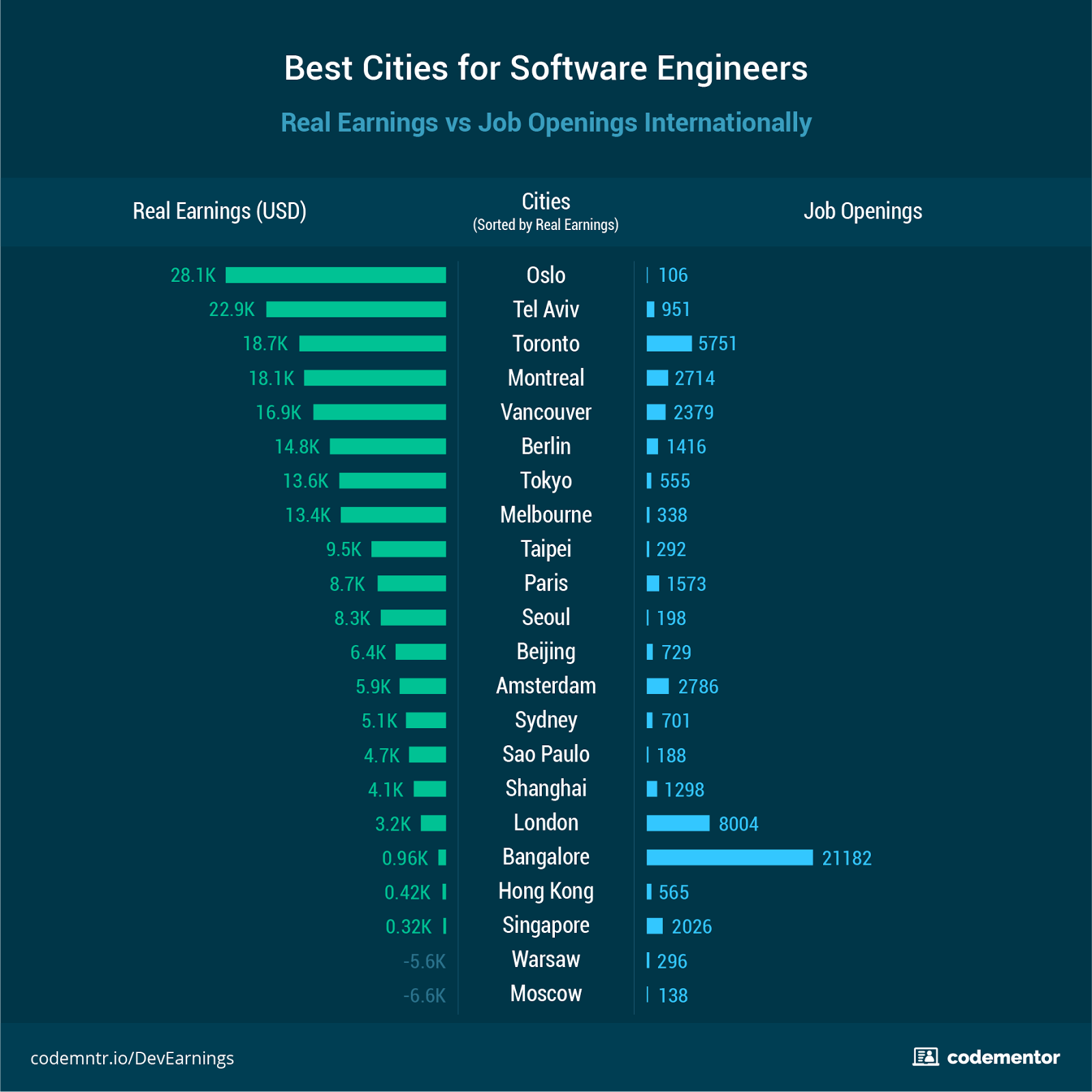

Если взять простаивающую систему, а затем подать в неё однопоточную нагрузку, привязанную к процессору (один поток в цикле), то каким будет одноминутное среднее значение нагрузки спустя 60 секунд? Если бы это было просто среднее, то мы получили бы 1,0. Вот график эксперимента:

Визуализация эксперимента по экспоненциальному затуханию среднего значения нагрузки.

Так называемое «одноминутное среднее значение» достигает примерно 0,62 на отметке в одну минуту. Доктор Нил Гюнтер подробнее описал этот и другие эксперименты в статье How It Works, также есть немало связанных с Linux комментариев на loadavg.c.

Непрерываемые задачи Linux

Когда в Linux впервые появились средние значения нагрузки, они отражали только потребность в ресурсах процессора, как и в других ОС. Но позднее они претерпели изменения, в них включили не только выполняемые задачи, но и те, что находятся в непрерываемом состоянии (TASK_UNINTERRUPTIBLE или nr_uninterruptible). Это состояние используется ветвями кода, которые хотят избежать прерывания по сигналам, в том числе задачами, блокированными дисковым вводом/выводом, и некоторыми блокировками. Вы могли уже сталкиваться с этим состоянием: оно отображается как состояние "D" в выходных данных ps и top. На странице ps(1) его называют «uninterruptible sleep (usually IO)».

Внедрение непрерываемого состояния означает, что в Linux средние значения нагрузок могут увеличиваться из-за дисковой (или NFS) нагрузки ввода/вывода, а не только ресурсов процессора. Всех, кто знаком с другими ОС и их средними нагрузками на процессор, включение этого состояния поначалу сильно смущает.

Зачем? Зачем это было сделано в Linux?

Существует несметное количество статей по средним нагрузкам, многие из которых упоминают про nr_uninterruptible в Linux. Но я не видел ни одного объяснения, или хотя бы серьёзного предположения, почему начали учитывать это состояние. Лично я предположил бы, что оно должно отражать более общие потребности в ресурсах, а не только применительно к процессору.

В поисках древнего патча для Linux

Легко понять, почему в Linux что-то меняется: просматриваешь историю git-коммитов для нужного файла и читаешь описания изменений. Я просмотрел историю на loadavg.c, но изменение, добавляющее неизменяемое состояние, датировано более ранним числом, чем файл, содержащий код из более раннего файла. Я проверил другой файл, но это ничего не дало: код «скакал» по разным файлам. Надеясь на удачу, я задампил git log -p по всему Github-репозиторию Linux, содержащему 4 Гб текста, и начал читать с конца, отыскивая место, где впервые появился этот код. Это мне тоже не помогло. Самое старое изменение в репозитории датировано 2005-м, когда Линус импортировал Linux 2.6.12-rc2, а искомое изменение было внесено ещё раньше.

Есть старинные репозитории Linux (1 и 2), но и в них отсутствует описание этого изменения. Стараясь найти хотя бы дату его внедрения, я изучил архив на kernel.org и обнаружил, что оно было в 0.99.15, а в 0.99.13 ещё не было. Однако версия 0.99.14 отсутствовала. Мне удалось её отыскать и подтвердить, что искомое изменение появилось в Linux 0.99.14, в ноябре 1993. Я надеялся, что мне поможет описание этого релиза, но и здесь я не нашёл объяснения:

«Изменения в последнем официальном релизе (p13) слишком многочисленны, чтобы их перечислять (или даже вспомнить)...» — Линус

Он упомянул лишь основные изменения, не связанные со средним значением нагрузки.

По дате мне удалось найти архивы почтовой рассылки kernel и конкретный патч, но более старое письмо было датировано аж июнем 1995:

«Во время работы над системой, позволяющей эффективнее масштабировать почтовые архивы, я случайно уничтожил текущие архивы (ай-ой)».

Я начал ощущать себя проклятым. К счастью мне удалось обнаружить старые архивы почтовой рассылки linux-devel, вытащенные из серверного бэкапа, зачастую хранящиеся как архивы дайджестов. Я просмотрел более 6000 дайджестов, содержащих свыше 98 000 писем, из которых 30 000 относились к 1993 году. Но ничего не нашёл. Казалось, исходное описание патча потеряно навеки, и ответа на вопрос «зачем» мы уже не получим.

Происхождение непрерываемости

Но вдруг на сайте oldlinux.org в архивированном файле почтового ящика за 1993 я нашёл это:

From: Matthias Urlichs <urlichs@smurf.sub.org>

Subject: Load average broken ?

Date: Fri, 29 Oct 1993 11:37:23 +0200

Ядро считает только "исполняемые" процессы при вычислении среднего значения нагрузки. Мне это не нравится. Проблема в том, что процессы, которые подкачиваются или ожидают в "быстром", то есть непрерываемом, вводе/выводе, тоже потребляют ресурсы.

Это нелогично, что средняя нагрузка снижается, когда вы заменяете диск с быстрой подкачкой на диск с медленной подкачкой…

В любом случае, следующий патч сделает среднее значение нагрузки более соответствующим субъективной скорости системы. И что ещё важнее, нагрузка всё ещё будет равна нулю, когда никто ничего не делает. ;-)

--- kernel/sched.c.orig Fri Oct 29 10:31:11 1993

+++ kernel/sched.c Fri Oct 29 10:32:51 1993

@@ -414,7 +414,9 @@

unsigned long nr = 0;

for(p = &LAST_TASK; p > &FIRST_TASK; --p)

- if (*p && (*p)->state == TASK_RUNNING)

+ if (*p && ((*p)->state == TASK_RUNNING) ||

+ (*p)->state == TASK_UNINTERRUPTIBLE) ||

+ (*p)->state == TASK_SWAPPING))

nr += FIXED_1;

return nr;

}

--

Matthias Urlichs \ XLink-POP N|rnberg | EMail: urlichs@smurf.sub.org

Schleiermacherstra_e 12 \ Unix+Linux+Mac | Phone: ...please use email.

90491 N|rnberg (Germany) \ Consulting+Networking+Programming+etc'ing 42Было просто невероятно прочитать о размышлениях 24-летней давности, ставших причиной этого изменения. Письмо подтвердило, что изменение в метрике должно было учитывать потребности и в других ресурсах системы, а не только процессора. Linux перешла от «средней нагрузки на процессор» к чему-то вроде «средней нагрузки на систему».

Упомянутый пример с диском с более медленной подкачкой не лишён смысла: снижая производительность системы, потребность в ресурсах (исполняемые и ждущие очереди процессы) должна расти. Однако средние значения нагрузки снижались, потому что они учитывали только состояния выполнения процессора (CPU running states), но не состояния подкачки (swapping states). Маттиас вполне справедливо считал это нелогичным, и потому исправил.

Непрерываемость сегодня

Но разве средние значения нагрузки в Linux иногда не поднимаются слишком высоко, что уже нельзя объяснить дисковым вводом/выводом? Да, это так, хотя я предполагаю, что это следствие новой ветви кода, использующей TASK_UNINTERRUPTIBLE, не существовавшего в 1993-м. В Linux 0.99.14 было 13 ветвей кода, которые напрямую использовали TASK_UNINTERRUPTIBLE или TASK_SWAPPING (состояние подкачки позднее убрали из Linux). Сегодня в Linux 4.12 почти 400 ветвей, использующих TASK_UNINTERRUPTIBLE, включая некоторые примитивы блокировки. Вероятно, что одна из этих ветвей не должна учитываться в среднем значении нагрузки. Я проверю, так ли это, когда снова увижу, что значение слишком высокое, и посмотрю, можно ли это исправить.

Я написал Маттиасу и спросил, что он думает 24 года спустя о своём изменении среднего значения нагрузки. Он ответил через час:

«Суть «средней нагрузки» — предоставить численную оценку занятости системы с точки зрения человека. TASK_UNINTERRUPTIBLE означает (означало?), что процесс ожидает чего-то вроде чтения с диска, что влияет на нагрузку системы. Система, сильно зависящая от диска, может быть очень тормозной, но при этом среднее значение TASK_RUNNING будет в районе 0,1, что совершенно бесполезно».

Так что Маттиас до сих пор уверен в правильности этого шага, как минимум относительно того, для чего предназначался TASK_UNINTERRUPTIBLE.

Но сегодня TASK_UNINTERRUPTIBLE соответствует большему количеству вещей. Нужно ли нам менять средние значения нагрузки, чтобы они отражали потребности в ресурсах только процессора и диска? Peter Zijstra уже прислал мне хорошую идею: учитывать в средней нагрузке task_struct->in_iowait вместо TASK_UNINTERRUPTIBLE, потому что это точнее соответствует вводу/выводу диска. Однако это поднимает другой вопрос: чего мы хотим на самом деле? Хотим ли мы измерять потребности в системных ресурсах в виде потоков выполнения, или нам нужны физические ресурсы? Если первое, то нужно учитывать непрерываемые блокировки, потому что эти потоки потребляют ресурсы системы. Они не находятся в состоянии простоя. Так что среднее значение нагрузки в Linux, вероятно, уже работает как нужно.

Чтобы лучше разобраться с непрерываемыми ветвями кода, я хотел бы измерить их в действии. Потом можно оценить разные примеры, измерить затраченное время и понять, есть ли в этом смысл.

Измерение непрерываемых задач

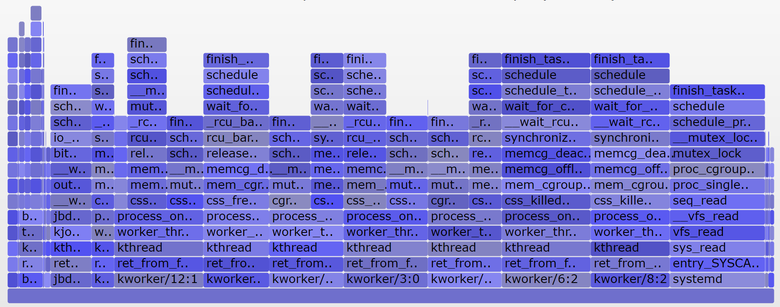

Вот внепроцессорный (off-CPU) флейм-график с production-сервера, охватывающий 60 секунд и показывающий только стеки ядра, на котором я оставил только состояние TASK_UNINTERRUPTIBLE (SVG).

График отражает много примеров непрерываемых ветвей кода:

Если вы не знакомы с флейм-графиками: можете покликать по блокам, изучить целиком стеки, отображающиеся как колонки из блоков. Размер оси Х пропорционален времени, потраченному на блокирование вне процессора, а порядок сортировки (слева направо) не имеет значения. Для внепроцессорных стеков выбран голубой цвет (для внутрипроцессорных стеков я использую тёплые цвета), а вариации насыщенности обозначают разные фреймы.

Я сгенерировал график с помощью своего инструмента offcputime из bcc (для работы ему нужны eBPF-возможности Linux 4.8+), а также приложения для создания флейм-графиков:

# ./bcc/tools/offcputime.py -K --state 2 -f 60 > out.stacks

# awk '{ print $1, $2 / 1000 }' out.stacks | ./FlameGraph/flamegraph.pl --color=io --countname=ms > out.offcpu.svgb>Для изменения выходных данных с микросекунда на миллисекунды я использую awk. Offcputime "--state 2" соответствует TASK_UNINTERRUPTIBLE (см. sched.h), это опция, которую я добавил ради этой статьи. Впервые это сделал Джозеф Бачик с его инструментом kernelscope, который тоже использует bcc и флейм-графики. В своих примерах я показываю лишь стеки ядра, но offcputime.py поддерживает и пользовательские стеки.

Что касается вышеприведённого графика: он отображает только 926 мс из 60 секунд, проведённые в состоянии непрерываемого сна. Это добавляет к нашим средним значениям нагрузки всего 0,015. Это время, потраченное некоторыми cgroup-ветвями, но на этом сервере не выполняется много дисковых операций ввода/вывода.

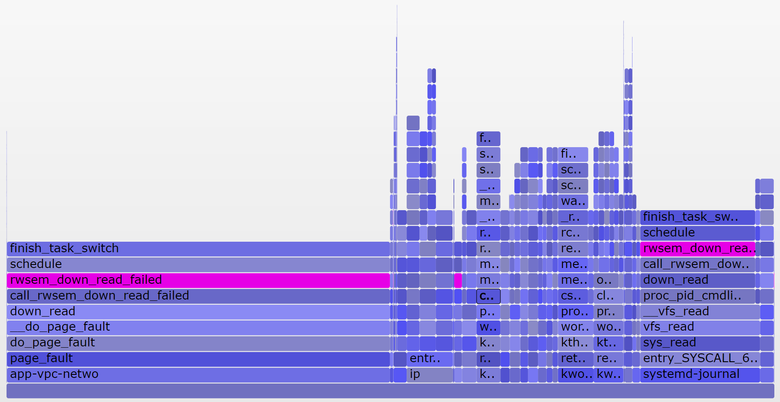

А вот более интересный график, охватывающий только 10 секунд (SVG):

Более широкая башня справа относится к блокируемому systemd-journal в proc_pid_cmdline_read() (чтение /proc/PID/cmdline), что добавляет к среднему значению нагрузки 0,07. Слева более широкая башня page fault, тоже заканчивающаяся на rwsem_down_read_failed() (добавляет к средней нагрузке 0,23). Я окрасил эти функции пурпурным цветом с помощью поисковой фичи в моём инструменте. Вот фрагмент кода из rwsem_down_read_failed():

/* wait to be given the lock */

while (true) {

set_task_state(tsk, TASK_UNINTERRUPTIBLE);

if (!waiter.task)

break;

schedule();

}Это код получения блокировки, использующий TASK_UNINTERRUPTIBLE. В Linux есть прерываемые и непрерываемые версии функций получения мьютексов (mutex acquire functions) (например, mutex_lock() и mutex_lock_interruptible(), down() и down_interruptible() для семафоров). Прерываемые версии позволяют прерывать задачи по сигналу, а затем будить для продолжения обработки прежде, чем будет получена блокировка. Время, потраченное на сон в непрерываемой блокировке, обычно мало добавляет к среднему значению нагрузки, и в данном случае прибавка достигает 0,3. Если бы было гораздо больше, то стоило бы выяснить, можно ли уменьшить конфликты при блокировках (например, я начинаю копаться в systemd-journal и proc_pid_cmdline_read()!), чтобы улучшить производительность и снизить среднее значение нагрузки.

Имеет ли смысл учитывать эти ветви кода в средней нагрузке? Я бы сказал, да. Эти потоки остановлены посреди выполнения и заблокированы. Они не простаивают. Им требуются ресурсы, хотя бы и программные, а не аппаратные.

Анализируем средние значения нагрузки в Linux

Можно ли полностью разложить на компоненты среднее значение нагрузки? Вот пример: на простаивающей 8-процессорной системе я запустил tar для архивирования нескольких незакэшированных файлов. Приложение потратило несколько минут, по большей части оно было блокировано операциями чтения с диска. Вот статистика, из трёх разных окон терминала:

terma$ pidstat -p `pgrep -x tar` 60

Linux 4.9.0-rc5-virtual (bgregg-xenial-bpf-i-0b7296777a2585be1) 08/01/2017 _x86_64_ (8 CPU)

10:15:51 PM UID PID %usr %system %guest %CPU CPU Command

10:16:51 PM 0 18468 2.85 29.77 0.00 32.62 3 tar

termb$ iostat -x 60

[...]

avg-cpu: %user %nice %system %iowait %steal %idle

0.54 0.00 4.03 8.24 0.09 87.10

Device: rrqm/s wrqm/s r/s w/s rkB/s wkB/s avgrq-sz avgqu-sz await r_await w_await svctm %util

xvdap1 0.00 0.05 30.83 0.18 638.33 0.93 41.22 0.06 1.84 1.83 3.64 0.39 1.21

xvdb 958.18 1333.83 2045.30 499.38 60965.27 63721.67 98.00 3.97 1.56 0.31 6.67 0.24 60.47

xvdc 957.63 1333.78 2054.55 499.38 61018.87 63722.13 97.69 4.21 1.65 0.33 7.08 0.24 61.65

md0 0.00 0.00 4383.73 1991.63 121984.13 127443.80 78.25 0.00 0.00 0.00 0.00 0.00 0.00

termc$ uptime

22:15:50 up 154 days, 23:20, 5 users, load average: 1.25, 1.19, 1.05

[...]

termc$ uptime

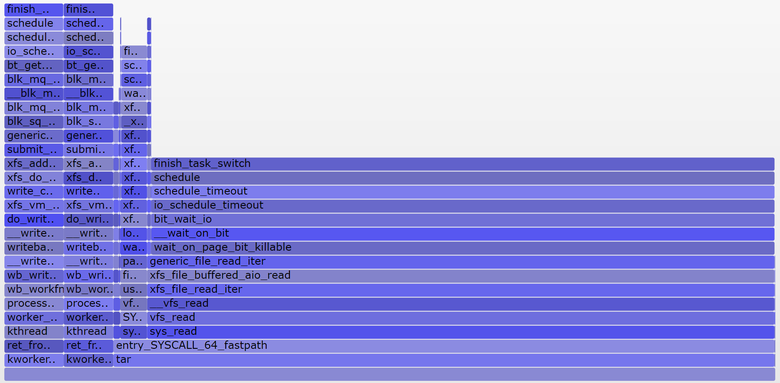

22:17:14 up 154 days, 23:21, 5 users, load average: 1.19, 1.17, 1.06Я также построил внепроцессорный флейм-график исключительно для непрерываемого состояния (SVG):

Средняя нагрузка в последнюю минуту составила 1,19. Давайте разложим на составляющие:

- 0,33 — процессорное время tar (pidstat)

- 0,67 — непрерываемые чтения с диска, предположительно (на графике 0,69, полагаю, что для него сбор данных начался чуть позже и охватывает немного другой временной диапазон)

- 0,04 — прочие потребители процессора (пользователь mpstat + система, минус потребление процессора tar'ом из pidstat)

- 0,11 — непрерываемый дисковый ввод/вывод воркеров ядра, сбросы на диск (на графике две башни слева)

В сумме получается 1,15. Не хватает ещё 0,04. Частично сюда могут входить округления и ошибки измерения сдвигов интервала, но по в основном это может быть из-за того, что средняя нагрузка представляет собой экспоненциально затухающую изменяющуюся сумму, в то время как другие используемые метрики (pidstat, iostat) являются обычными средними. До 1,19 одноминутная средняя нагрузка равнялась 1,25, значит что-то из перечисленного всё ещё тянет метрику вверх. Насколько? Согласно моим ранним графикам, на одноминутной отметке 62 % метрики приходилось на текущую минуту, а остальное — на предыдущую. Так что 0,62 x 1,15 + 0,38 x 1,25 = 1,18. Достаточно близко к полученному 1,19.

В этой системе работу выполняет один поток (tar), плюс ещё немного времени тратится потоками воркеров ядра, так что отчёт Linux о средней нагрузке на уровне 1,19 выглядит обоснованно. Если бы я измерял «среднюю нагрузку на процессор», то мне показали бы только 0,37 (расчётное значение из mpstat), что корректно только для процессорных ресурсов, но не учитывает тот факт, что нужно обрабатывать более одного потока.

Надеюсь, этот пример показал вам, что эти числа берутся не с потолка (процессор + непререрываемые), и вы можете сами разложить их на составляющие.

Смысл средних значений нагрузки в Linux

Я вырос на операционных системах, в которых средние значения нагрузок относились только к процессору, так что Linux-вариант всегда меня напрягал. Возможно, настоящая проблема заключается в том, что термин «средняя нагрузка» так же неоднозначен, как «ввод-вывод». Какой именно ввод/вывод? Диска? Файловой системы? Сети?.. Аналогично, средние нагрузки чего? Процессора? Системы? Эти уточнения помогли мне понять:

- В Linux средние нагрузки — это (или пытаются быть) «средние значения нагрузки на систему», систему в целом. Они измеряют количество выполняемых потоков и ожидающих своей очереди (процессор, диск, непрерываемые блокировки). Иными словами, эта метрика отражает количество потоков, которые не простаивают полностью. Преимущество: учитывается потребность в разных ресурсах.

- В других ОС средние нагрузки — это «средние значения нагрузки на процессор». Они измеряют количество потоков, выполняемых и готовых к выполнению в процессоре. Преимущество: проще в понимании и обосновании (только для процессоров).

Есть и другой возможный тип метрики: «средние значения нагрузки на физические ресурсы», куда входит нагрузка только на физические ресурсы (процессор и диск).

Возможно, когда-нибудь мы начнём учитывать в Linux и другие нагрузки, и позволим пользователям выбирать, что они хотят видеть: средние нагрузки на процессор, на диск, на сеть и так далее. Или вообще использовать всё вместе.

Что такое «хорошие» или «плохие» средние нагрузки?

Некоторые люди вычислили пороговые значения для своих систем и рабочих нагрузок: они знают, что когда метрика превышает значение Х, то задержка приложения вырастает и клиенты начинают жаловаться. Но никаких конкретных правил здесь нет.

Применительно к средней нагрузке на процессор кто-то может делить значения на количество процессоров и затем утверждать, что если соотношение больше 1,0, то могут возникнуть проблемы с производительностью. Это довольно неоднозначно, поскольку долгосрочное среднее значение (как минимум одноминутное) может скрывать в себе разные вариации. Одна система с соотношением 1,5 может прекрасно работать, а другая с тем же соотношением в течение минуты может работать быстро, но в целом производительность у неё низкая.

Однажды я администрировал двухпроцессорный почтовый сервер, который в течение дня работал со средней процессорной нагрузкой в диапазоне от 11 до 16 (соотношение между 5,5 и 8). Задержка была приемлемой, никто не жаловался. Но это экстремальный пример: большинство систем будут проседать при нагрузке/соотношении в районе 2.

Применительно к средним значениям нагрузки в Linux: они ещё более неоднозначны, поскольку учитывают разные типы ресурсов, так что не получится просто поделить на количество процессоров. Они полезны для относительного сравнения: если вы знаете, что система хороша работает при значении в 20, а сейчас 40, то пришло время посмотреть на другие метрики, чтобы понять, что происходит.

Более подходящие метрики

Рост средних нагрузок в Linux означает повышение потребности в ресурсах (процессоры, диски, некоторые блокировки), но вы не уверены, в каких. Чтобы пролить на это свет, можно использовать другие метрики. Например, для процессора:

- использование каждого процессора (per-CPU utilization): например, используя

mpstat -P ALL 1. - использование процессора для каждого процесса (per-process CPU utilization): например,

top, pidstat 1и так далее. - задержка очереди выполнения (диспетчера) для каждого потока (per-thread run queue (scheduler) latency): например, в /proc/PID/schedstats, delaystats, perf sched

- задержка очереди выполнения процессора (CPU run queue latency): например, в

/proc/schedstat,perf sched, моём инструменте runqlat bcc. - длина очереди выполнения процессора (CPU run queue length): например, используя vmstat 1 и колонку 'r', или мой инструмент

runqlen bcc.

Первые две — метрики использования, последние три — метрики насыщения (saturation metrics). Метрики использования полезны для оценки рабочей нагрузки, а метрик насыщения — для идентификации проблем с производительностью. Лучшая метрика насыщения для процессора — измерение задержки очереди выполнения (или диспетчера): это время, проведённое задачей/потоком в состоянии готовности к выполнению, но вынужденным ждать своей очереди. Это позволяет вычислить тяжесть проблем с производительностью. Например, какая часть времени тратится потоком на задержки диспетчера. А измерение длины очереди позволяет предположить лишь наличие проблемы, а её серьёзность оценить сложнее.

В Linux 4.6 функция schedstats (sysctl kernel.sched_schedstats) стала настраиваться ядром, и по умолчанию выключена. Подсчёт задержек (delay accounting) отражает ту же метрику задержки диспетчера из cpustat, и я предложил добавить её также в htop, чтобы людям было проще ею пользоваться. Проще, чем, к примеру, собирать метрику длительности ожидания (задержка диспетчера) из недокументированных выходных данных /proc/sched_debug:

$ awk 'NF > 7 { if ($1 == "task") { if (h == 0) { print; h=1 } } else { print } }' /proc/sched_debug

task PID tree-key switches prio wait-time sum-exec sum-sleep

systemd 1 5028.684564 306666 120 43.133899 48840.448980 2106893.162610 0 0 /init.scope

ksoftirqd/0 3 99071232057.573051 1109494 120 5.682347 21846.967164 2096704.183312 0 0 /

kworker/0:0H 5 99062732253.878471 9 100 0.014976 0.037737 0.000000 0 0 /

migration/0 9 0.000000 1995690 0 0.000000 25020.580993 0.000000 0 0 /

lru-add-drain 10 28.548203 2 100 0.000000 0.002620 0.000000 0 0 /

watchdog/0 11 0.000000 3368570 0 0.000000 23989.957382 0.000000 0 0 /

cpuhp/0 12 1216.569504 6 120 0.000000 0.010958 0.000000 0 0 /

xenbus 58 72026342.961752 343 120 0.000000 1.471102 0.000000 0 0 /

khungtaskd 59 99071124375.968195 111514 120 0.048912 5708.875023 2054143.190593 0 0 /

[...]

dockerd 16014 247832.821522 2020884 120 95.016057 131987.990617 2298828.078531 0 0 /system.slice/docker.service

dockerd 16015 106611.777737 2961407 120 0.000000 160704.014444 0.000000 0 0 /system.slice/docker.service

dockerd 16024 101.600644 16 120 0.000000 0.915798 0.000000 0 0 /system.slice/

[...]Помимо процессорных метрик, можете анализировать метрики использования и насыщения для дисковых устройств. Я анализирую их в методе USE, у меня есть Linux-чеклист.

Хотя существуют более явные метрики, это не означает, что средние значения нагрузки бесполезны. Они успешно используются в политиках масштабирования облачных микросервисов наряду с другими метриками. Это помогает микросервисам реагировать на увеличение разных типов нагрузки, на процессор или диски. Благодаря таким политикам безопаснее ошибиться при масштабировании (теряем деньги), чем вообще не масштабироваться (теряем клиентов), так что желательно учитывать больше сигналов. Если масштабироваться слишком сильно, то на следующий день можно будет найти причину.

Одна из причин, по которой я продолжаю использовать средние нагрузки, — это их историческая информация. Если меня просят проверить низкопроизводительные инстансы в облаке, я логинюсь и выясняю, что одноминутное среднее значение нагрузки гораздо ниже пятнадцатиминутного, то это важное свидетельство того, что я слишком поздно заметил проблему с производительностью. Но на просмотр этих метрик я трачу лишь несколько секунд, а потом перехожу к другим.

Заключение

В 1993 году Linux-инженер обнаружил нелогичную работу средних значений нагрузки, и с помощью трёхстрочного патча навсегда изменил их с «со средних нагрузок на процессор» на «средние нагрузки на систему». С тех пор учитываются задачи в непрерываемом состоянии, так что средние нагрузки отражают потребность не только в процессорных, но и в дисковых ресурсах. Обновлённые метрики подсчитывают количество работающих и ожидающих работы процессов (ожидающих освобождения процессора, дисков и снятия непрерываемых блокировок). Они выводятся в виде трёх экспоненциально затухающих изменяющихся сумм, в уравнениях которых используются константы в 1, 5 и 15 минут. Эти три значения позволяют видеть динамику нагрузки, а самое большое из них может использоваться для относительного сравнения с ними самими.

С тех пор в ядре Linux всё активнее использовалось непрерываемое состояние, и сегодня оно включает в себя примитивы непрерываемой блокировки. Если считать среднее значение нагрузки мерой потребности в ресурсах в виде выполняемых и ожидающих потоков (а не просто потоков, которым нужны аппаратные ресурсы), то эта метрика уже работает так, как нам нужно.