Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Перевод] Продвинутые перечисления с Ruby |

В программировании, у нас есть много способов делать выборку и обработку коллекции за единицу времени, путем добавления в цепочку дополнительной функции трансформации на каждом шаге. И каждый шаг, может как потреблять целиком всю коллекцию перед тем как передать результаты обработки следующем шагу, или он может обрабатывать коллекцию «лениво», передавая один или более элементов коллекции через все шаги преобразований.

Как работают перечисления в Ruby

В этом посте, я дам Вам краткий обзор о том, что делают блоки (block) и yield'ы. Блоки в Ruby, в которых мы заинтересованы, является кусками кода, определенными внутри методов или proc/lambda. Вы можете думать о yield, как о текущем блоке кода, куда вставляется другой блок кода откуда-то еще. Позвольте мне продемонстрировать.

def my_printer

puts "Hello World!"

end

def thrice

3.times do

yield

end

end

thrice &method(:my_printer)

# Hello World!

# Hello World!

# Hello World!

thrice { puts "Ruby" }

# Ruby

# Ruby

# Ruby

Методы принимают две формы блоков для команды yield: proc'ы или блоки. Метод method трансформирует определение метода в proc, который затем может быть передан внутрь как блок, как в примере my_printer выше.

Выше на том месте, где написана команда yield, равнозначно, как если бы код передающийся как блок, был бы на месте yield. Так что в первом случае представьте вызов yield, замененным на puts «Hello World!» и второй yield замененным на puts «Ruby».

yield может также работать как простой перечислитель. Вы можете передать любое значение внутрь как параметр к block/proc добавляя их после yield.

def simple_enum

yield 4

yield 3

yield 2

yield 1

yield 0

end

simple_enum do |value|

puts value

end

# 4

# 3

# 2

# 1

# 0

Требования к минимальному перечислителю

Стандартный способ создания перечислителя в Ruby это — each, выдает/йилдит (yields) значения. С учетом этого, вы можете объявить метод each на любом Ruby объекте и получить все преимущества более чем 50 методов для обработки и исполнения коллекций от модуля Enumerable. Просто добавьте include Enumerable внутрь объекта, который имеет валидный метод each, и вы можете полностью использовать все эти методы (имеется в виду методы модуля Enumerable).

Перечислители не ограничены простым коллекциями типа Array (массивы), они могут работать с любыми коллекциями, которые имеют в себе объявленный метод each (и обычно будет иметь модуль Enumerable в своих «прародителях/предках»).

Array.ancestors

# => [Array, Enumerable, Object, Kernel, BasicObject]

Hash.ancestors

# => [Hash, Enumerable, Object, Kernel, BasicObject]

Hash.method_defined? :each

# => true

require "set"

Set.ancestors

# => [Set, Enumerable, Object, Kernel, BasicObject]

«Ленивые» и не «ленивые» перечислители

«Ленивые» перечислители, обычно рассматриваются как лучший способ обработки коллекций, т.к. они позволяет вам обойти пошагово бесконечную последовательность, так далеко как вам необходимо.

Представьте линию сборки, где люди собирают пиццу, где каждый человек ответственен только за один шаг в готовке/трансформации пиццы. Первый человек бросает тесто правильной формы, следующий добавляет соус, следующий сыр, по человеку на каждую добавку (колбаски, перец, помидоры), еще один кладет все в печь, и последний человек доставляет готовую пиццу до Вас. В этом примере, «ленивая» версия сборки на Ruby — это иметь любое количество заказов на пиццу, но все оставшиеся будут ждать пока первая пицца пройдет через все стадии/шаги обработки, прежде чем продолжить делать следующую пиццу.

Если вы не используете «ленивый» перечислитель, тогда каждый шаг/стадия могла бы ждать пока на всей коллекции не отработает один шаг за единицу времени. Для примера, если у Вас есть 20 заказов на пиццу, человек, который бросает тесто должен будет сделать их 20 перед тем как к кому-то из них смогут добавить соус, следующим человеком на линии. И каждый шаг в очереди ожидает в похожей манере. Теперь, чем больше коллекцию Вам необходимо обработать, тем более смехотворным кажется заставлять ждать оставшихся сборочную линию.

Более жизненный пример: обработка списка писем, которую необходимо отправить всем пользователям. Если в коде ошибка и весь список обрабатывается не «лениво», тогда вполне вероятно, что никто не получит имейлы. В случае «ленивого» исполнения, потенциально, вы бы отправили письма большинству пользователей, перед тем как, скажем некорректный почтовый адрес вызвал бы проблему/ошибку. Если запись об отправке содержит статус успешности отправки, то проще отследить на какой записи (где) произошла ошибка.

Создание «ленивого» перечислителя в Ruby также просто как вызов lazy на объекте с включенным в него модулем Enumerable или вызов to_enum.lazy на объекте, с объявленным внутри него методом each.

class Thing

def each

yield "winning"

yield "not winning"

end

end

a = Thing.new.to_enum.lazy

Thing.include Enumerable

b = Thing.new.lazy

a.next

# => "winning"

b.next

# => "winning"

Вызов to_enum возвращает объект, который является как Enumerator так и Enumerable, и который будут иметь доступ ко всем их методам.

Важно обратить внимание, какие методы перечислителя будут «потреблять» всю коллекцию за раз, а какие будет «потреблять» (выполнять) её — «лениво». Для примера, метод partition потребляет всю коллекцию за раз, так что она не приемлема для бесконечных коллекций. Лучший выбор для ленивого выполнения, могли бы быть такие методы как chunk или select.

x = (0..Flot::INFINITY)

y = x.chunk(&:even?)

# => #:each>>

y.next

# => [true, [0]]

y.next

# => [false, [1]]

y.next

#=> [true, [2]]

z = x.lazy.select(&:even?)

# => #:select>

z.next

# => 0

z.next

# => 2

z.next

# => 4

В случае использования select с бесконечным коллекциями, вы должны в начале вызывать метод lazy от предотвращения потребления всей коллекции целиком методом select, И принудительного завершения программы из-за бесконечного её выполнения.

Создание «ленивого» перечислителя

В Ruby есть класс Enumerator::Lazy, который позволяет писать Вам собственные методы перечислителя как take в Ruby.

(0..Float::INFINITY).take(2)

# => [0, 1]

Для наглядного примера, мы реализуем FizzBuzz, который можно запустить на любом числе и который позволит получать бесконечные FizzBuzz результаты.

def divisible_by?(num)

->input{ (input % num).zero? }

end

def fizzbuzz_from(value)

Enumerator::Lazy.new(value..Float::INFINITY) do |yielder, val|

yielder << case val

when divisible_by?(15)

"FizzBuzz"

when divisible_by?(3)

"Fizz"

when divisible_by?(5)

"Buzz"

else

val

end

end end

x = fizzbuzz_from(7)

# => #

9.times { puts x.next }

# 7

# 8

# Fizz

# Buzz

# 11

# Fizz

# 13

# 14

# FizzBuzz

С помощью Enumerator::Lazy, неважно, что вы подаете на yielder — будет значение возвращаемое на каждом шаге в последовательности. Перечислитель следит за текущим прогрессом, когда вы используете next. Но когда вы вызываете each после нескольких вызовов next, он начнет с самого начала коллекции.

Параметр, который вы передаете в Enumerator::Lazy.new — это коллекция через который мы пройдем перечислителем. Если вы написали этот метод для Enumerable или совместимого объекта, вы можете просто передать self как параметр. val будет единственным значением, производимым в единицу времени методом коллекции each, а yielder будет единственным точкой входа для любого блока кода, который вы хотите передать, как если бы это было с each.

Продвинутое использование перечислителя

Когда обрабатываете коллекцию данных, рекомендуется в первую очередь выставить ограничивающие фильтры, и тогда обработка кодом ваших данных займет гораздо меньше времени. Если вы получаете данные для обработки из базы данных, выставьте ограничивающие фильтры на внутреннем языке базы данных, если это возможно, перед тем как передать данные дальше в Ruby. Так будет намного эффективнее.

require "prime"

x = (0..34).lazy.select(&Prime.method(:prime?))

x.next

# => 2

x.next

# => 3

x.next

# => 5

x.next

# => 7

x.next

# => 11

После метода select выше, вы можете добавить другие методы к обработке данных. Эти методы будут иметь дело только с ограниченным набором данных внутри простых чисел, а не со всеми простыми числами.

Группировка

Один прекрасный способ обработки данных для разбиения их на колонки — это использовать group_by, чтобы сконвертировать результат в ассоциативный массив групп. После этого, просто вытяните результаты, как если бы вы были заинтересованы во всех результатах.

[0,1,2,3,4,5,6,7,8].group_by.with_index {|_,index| index % 3 }.values

# => [[0, 3, 6], [1, 4, 7], [2, 5, 8]]

Если вы выведете результаты на веб-страницу, то данные выстроятся в следующем порядке:

0 3 6

1 4 7

2 5 8

Вызов group_by выше передает и значение, и индекс внутрь блока. Мы используем нижнее подчеркивание для значения из массива, чтобы обозначить, что мы не заинтересованы в этом значении, а только в индексе. Что в результате мы получим, так это ассоциативный массив с ключами 0, 1 и 2 указывающими на каждую группу значений, которую мы сгруппировали. Так как мы не должны беспокоиться о ключах, мы вызываем values на этом ассоциативном массиве, чтобы получить массив массивов и далее отобразить как нам надо.

Если мы бы захотели упорядочить полученные результаты слева направо в виде колонок, мы бы могли сделать следующее:

threes = (0..2).cycle

[0,1,2,3,4,5,6,7,8].slice_when { threes.next == 2 }.to_a

# => [[0, 1, 2], [3, 4, 5], [6, 7, 8]]

Перечислитель threes просто проходит бесконечно от 0 до 2, в «ленивой» манере. В итоге мы получим следующий вывод:

0 1 2

3 4 5

6 7 8

В Ruby также есть метод transpose, который переворачивает результаты выше от одного вида к другому.

x = [[0, 1, 2], [3, 4, 5], [6, 7, 8]]

x = x.transpose

# => [[0, 3, 6], [1, 4, 7], [2, 5, 8]]

x = x.transpose

# => [[0, 1, 2], [3, 4, 5], [6, 7, 8]]

«Сворачивание»

Давайте посмотрим на способы компоновки коллекций в результат. В других языках, это обычно делается через метод fold. В Ruby это долго делалось при помощи reduce и inject. Более свежее решение, и предпочтительный способ делать это с помощью each_with_object. Основная идея — это обработка одной коллекции в другую, выступающей как результат.

Суммирование целых чисел также просто как:

[1,2,3].reduce(:+)

# => 6

[1,2,3].inject(:+)

# => 6

class AddStore

def add(num)

@value = @value.to_i + num

end

def inspect

@value

end

end

[1,2,3].each_with_object(AddStore.new) {|val, memo| memo.add(val) }

# => 6

# As of Ruby 2.4

[1,2,3].sum

# => 6

each_with_object обычно требует объект, который может быть обновлен. Вы не можете изменить целочисленный объект из самого себя, вот почему для это тривиального примера мы создали объект AddStore.

Эти методы могут быть лучше продемонстрированы в работе, если брать данные из одной коллекции и класть их в другую коллекцию. Заметьте, что inject и reduce это одни и те же псевдонимы методов в Ruby и должны возвращать такое значение в конце блока, для того чтобы бы на основе него продолжать строить перечислитель.

each_with_object не нуждается чтобы бы последний кусок блока возвращал элемент, на котором он будет дальше строить перечислитель.

collection = [:a, 2, :p, :p, 6, 7, :l, :e]

collection.reduce("") { |memo, value|

memo << value.to_s if value.is_a? Symbol

memo # Note the return value needs to be the object/collection we're building

}

# => "apple"

collection.each_with_object("") { |value, memo|

memo << value.to_s if value.is_a? Symbol

}

# => "apple"

Структуры

Объект структуры в Ruby, также являются перечисляемым объектами, который можно использовать для создания удобных объектов, чтобы описать в них методы.

class Pair < Struct.new(:first, :second)

def same?; inject(:eql?) end

def add; inject(:+) end

def subtract; inject(:-) end

def multiply; inject(:*) end

def divide; inject(:/) end

def swap!

members.zip(entries.reverse) {|a,b| self[a] = b}

end

end

x = Pair.new(23, 42)

x.same?

# => false

x.first

# => 23

x.swap!

x.first

# => 42

x.multiply

# => 966

Структуры обычно не используются для больших коллекций, а больше используются как полезные дата-объекты, как способ организовать данные вместе, что в свою очередь поощряет прозрачное применение данных, нежели «заросли» данных.

Заросли данных — это когда две или более переменных всегда используются в группе, но при этом они бы не имели никакого смысла если бы использовались по отдельности. Эта группа переменных должна быть сгруппирована в объект/класс.

Так что, структуры в Ruby это обычно маленькие коллекции данных, но при этом ничто не говорит о том, что эти данные сами по себе могли бы представлять совсем другую коллекцию данных. В таком случае, структура может быть способом реализации трансформаций над этим же коллекциями данных, что наиболее вероятно, вы бы сделали то же самое написав свой собственный класс.

Подытожим

Ruby довольно чудесный язык с легкостью позволяющий работать, а также манипулировать коллекциями данных. Изучение каждой частички того, что предлагают Ruby, позволит Вам писать более элегантный код, а также тестировать и оптимизировать код для лучшей производительности.

Если производительность важна, тогда измерьте производительность отдельных реализаций и убедитесь, что установили фильтры и ограничения/лимиты в процесс обработки, как раннее, если конечно на то, есть возможность. Рассмотрите ограничение ваших входных данных в маленькие куски, используя метод readline на файлах, нежели read или readlines или используйте LIMIT number в SQL.

«Ленивая» итерация может оказать огромную помощь в разделение задач на различные потоки или фоновые задания обработки. Концепция «ленивых» итераций на самом деле не имеет недостатков, так что вы можете выбирать их для потребления любой коллекции в любом месте. Она предлагает гибкость, и некоторые языки, как Rust с итераторами, взяли за стандарт быть «лениво» реализованными (implemented lazily).

Возможности бесконечны, когда мы сталкиваемся с тем как манипулировать и управлять данными. И это забавный процесс, изучить и создать каждый способ манипулирования наборами данных в программировании. Ruby имеет хорошо документированные примеры для каждого из своих enumerable методов, так что он помогает учиться на основе них. Я поддерживаю Вас экспериментировать и открывать многие новые вещи, которые помогут сделать процесс программирования более приятным и приносящим удовольствие.

|

Метки: author houk ruby on rails ruby перечисления enumerators enumerations lambdas blocks перечислители |

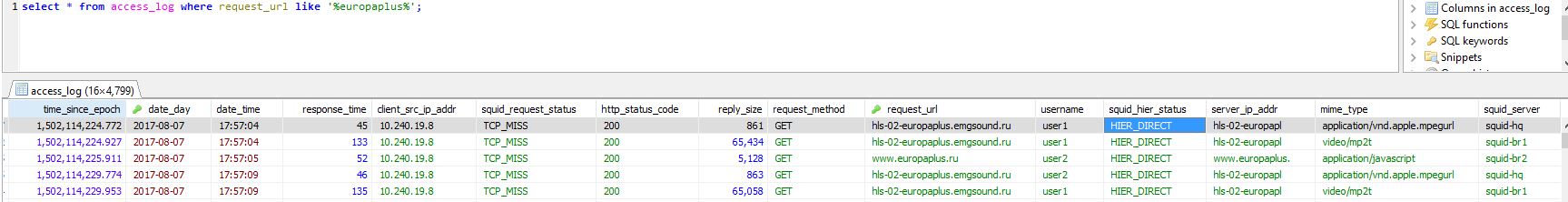

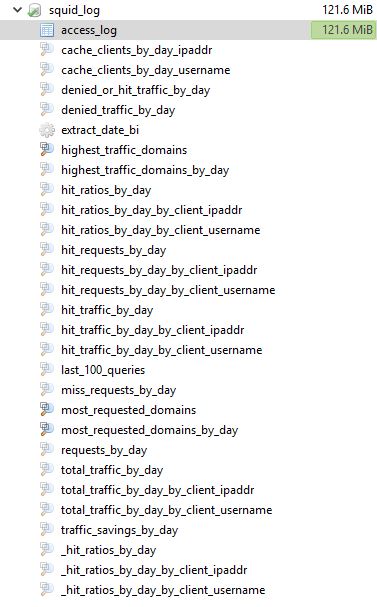

[Из песочницы] Централизованное хранилище логов для Squid Proxy или как мы логи в базу заворачивали |

Привет %username%,

Сегодня я хотел бы рассказать про достаточно тривиальную задачу сбора логов с децентрализованных Squid proxy серверов и подводные камни с которыми мы столкнулись.

Что имеем:

- Squid-hq

- Squid-br1

- Squid-br2

- Squid-br3

- Squid-br4

- Squid-db

Как видно из списка, в наличии 5 серверов squid proxy в разных удаленых офисах, и 1 база данных для сбора логов. Все OS CentOS 7.3, squid proxy от 3.3.8 до 3.5.26, Squid-db — с установленной mariadb 5.6

Из того что удалось найти это перловые скрипты и схема, собственно их и берем за основу:

- Ставим зависимости на сервера squid proxy:

yum install perl perl-Readonly* perl-URI perl-YAML perl-DBI perl-Carp perl-DBD-mysql

- После чего раскладываем по местам скрипты и конфиг для подключения к базе:

cp log_mysql_daemon.pl /usr/libexec/squid/log_mysql_daemon.pl

Даем права:

chmod +x /usr/libexec/squid/log_mysql_daemon.pl

chown squid:squid /usr/libexec/squid/log_mysql_daemon.pl

- Далее создаем конфиг файл для подключения скрипта к базе:

vi /etc/squid/log_mysql_daemon.conf

host: ""

database: "squid_log"

table: "access_log"

user: "squid"

pass: ""

- Создаем базу, импортируем схему и создаем юзера:

mysql -p

create database squid_log;

CREATE USER 'squid'@'%' IDENTIFIED BY '';

GRANT ALL PRIVILEGES ON squid_log.* TO 'squid'@'';

GRANT ALL PRIVILEGES ON squid_log.* TO 'squid'@'';

GRANT ALL PRIVILEGES ON squid_log.* TO 'squid'@'';

GRANT ALL PRIVILEGES ON squid_log.* TO 'squid'@'';

GRANT ALL PRIVILEGES ON squid_log.* TO 'squid'@'';

exit

cat log_mysql_daemon-table.sql log_mysql_daemon-views.sql | mysql -p squid_log

-

Переходим на сторонузлаsquid proxy конфига

Добавляем конфигурацию для демона

vi /etc/squid/squid.conf

acl dontLog http_status 403 407

logformat squid_mysql %ts.%03tu %6tr %>a %Ss %03Hs %access_log /var/log/squid/access.log squid

access_log daemon:/etc/squid/log_mysql_daemon.conf squid_mysql !dontLog

logfile_daemon /usr/libexec/squid/log_mysql_daemon.pl

Разбираем:

acl dontLog http_status 403 407 — опциональная строка, убирает ошибки из лога идущих в базу данных связаные с эрор кодами 403, 407. База будет расти в геометрической последовательности, а для репортинга не будет нести никакой ценности

logformat squid_mysql %ts.%03tu %6tr %>a %Ss %03Hs %b> — задаем формат логу, одно из важных условий для множественных squid серверов последнее значение с названием сервера с которого приходят логи. В оригинальных скриптах функционал отсутствует поэтому подкручиваем эту строку и сам скрипт следующим образом:

в /usr/libexec/squid/log_mysql_daemon.pl в настройку колонок добавляем squid-server

# fields that we should have in the database table

# this list depends on the log format configuration

my @required_fields = qw(

id

time_since_epoch

response_time

client_src_ip_addr

squid_request_status

http_status_code

reply_size

request_method

request_url

username

squid_hier_status

server_ip_addr

mime_type

squid_server

);

access_log /var/log/squid/access.log squid — Оставляем локальные логи для отладок и случаев проблем с базой, у них включен ротейшен поэтому лишним не будет

access_log daemon:/etc/squid/log_mysql_daemon.conf squid_mysql !dontLog — собственно сама строка к конфигурации демона. Обратите внимание что !dontLog отменяет логирование 403,407 только для базы данных, так что в случае отладки можно легко использовать локальные логи

logfile_daemon /usr/libexec/squid/log_mysql_daemon.pl — путь к перловому демону

- Перечитываем конфиги squid proxy

squid reconfigure

squid -k reconfigure

и получаем желаемый результат:

Доступные таблицы и вьюшки:

Заключение:

Как видно, данные теперь находятся централизованно в базе данных и легко доступны для обработки. Далее планируем написать фронтэнд для фильтрации и экспорта данных (репортинга). В целом статья написана и собрана из разных источников, к сожалению нигде не смог найти все вместе, поэтому считаю целесообразым оставить это здесь.

Было ли бы вам интересно почитать продолжения цикла статей про Squid Proxy?

|

Метки: author iRandom хранение данных системное администрирование настройка linux администрирование баз данных *nix squid3 proxy db perl system administration |

И снова Huawei Cloud Fabric: что такое SDN-архитектура и с чем её едят |

Не так давно мы рассказывали об интеграции SDN-решения Huawei Cloud Fabric с платформой VMware vSphere и рассуждали о выгодах, которые эта самая интеграция несёт.

В этот раз хотелось бы уделить больше внимания программно-определяемым сетям (SDN), преимуществам для бизнеса, которые можно извлечь из их использования, и непосредственно SDN-решению для ЦОД Cloud Fabric от Huawei.

Отрасль диктует свои правила

Бизнес все активнее использует виртуализацию и облачные технологии для повышения эффективности, совершенствования процессов и получения конкурентных преимуществ.

Корпоративные центры обработки данных эволюционируют в направлении облачных сред на основе виртуализации, которая стала для бизнеса банальной необходимостью, а не каким-то «ноу-хау».

Логическая цепочка довольно проста:

1. Виртуализация вычислительных ресурсов и ресурсов хранения в сочетании с автоматизацией управления и оркестрации сделали возможной виртуализацию рабочей нагрузки;

2. В свою очередь, виртуализация рабочей нагрузки позволяет менеджерам IT-систем и разработчикам приложений быстро создавать новые экземпляры сервисов и приложений в центре обработки данных.

Повышение пропускной способности при соединении независимых рабочих нагрузок и любых связанных сервисов через сеть до последнего времени было одной из основных «точек роста», однако возросшие темпы развития виртуализированных ресурсов для вычислений и хранения данных диктуют новые правила игры.

Приход программно-определяемых сетей инициировал появление более гибких систем определения и конфигурации сетевых путей и экстернализации плоскости сетевого контроля от индивидуальных устройств. Данная «выносимая во вне» плоскость управления, определяющая логическую топологию сети, теперь представляет вид сети «крупным планом» и обеспечивает гибкую оптимизацию сети на основе критериев, адаптированных к операционным аспектам среды.

С точки зрения внешней интеграции этот SDN-контроллер более предпочтителен благодря программным интерфейсам, которые позволяют системам работать совместно и согласованно с другими компонентами центра обработки данных.

Huawei отвечает

Cloud Fabric — SDN-решение Huawei для центров обработки данных — предлагает компаниям удобную в использовании и чрезвычайно открытую SDN-архитектуру, которая может масштабироваться в ту или иную сторону для работы со средой ЦОД любого размера, при этом обеспечивая гибкость интеграции и инфраструктуры, необходимую для быстрого развертывания новых приложений и сервисов.

Интеллектуальный центр системы – Agile Controller. Он обеспечивает централизованные, высокоустойчивые и интеллектуальные возможности управляющей плоскости для сетевой структуры ЦОД, построенной на коммутационной платформе CloudEngine от Huawei.

Agile Controller от Huawei для ЦОД разработан как полностью открытое решение, обеспечивающие эффективную интеграцию с популярными промышленными решениями сторонних разработчиков через открытый и стандартизованный программный интерфейс (API).

Какие же ключевые преимущества влечёт за собой правильное применение программного сетевого подхода к инфраструктуре центров обработки данных в целом, и SDN-решения Cloud Fabric в частности?

И самое главное — какое влияние эти преимущества могут оказать на бизнес?

Внутренние процессы

В первую очередь, появление программно-определяемых сетей принесло ощутимое улучшение IT-процессов в центрах обработки данных, зависящих от изменений в сети или её переконфигурации для развертывания комплексных сервисов или приложений

Раньше планирование сети, проектирование новых экземпляров приложений и их подготовка к изменениям, необходимым для поддержки, проводилось либо вручную, либо средствами грубой автоматизации. Но благодаря развитию SDN стали доступны новые уровни интегрированной автоматизации, подготовки и управления возможностями оркестрации сети, которые включают платформы виртуализации вычислений и хранения данных.

Выигрыш в затратах времени и ресурсов, необходимых для подготовки сетевых элементов и компонентов для новых приложений, варьируется от пятикратного до тридцатикратного.

Кроме того, интеграция SDN со всеми остальными ресурсами ЦОД образует фундамент для создания подлинно частных облачных платформ самообслуживания, позволяя конечным пользователям самостоятельно запрашивать и самостоятельно обеспечивать облачные сервисы в рамках своей корпорации. Снижение объема ручных процессов приводит к сокращению операционной перегрузки, ускорению вывода на рынок новых приложений и сервисов, а также снижению стоимости развертывания.

Помимо этого, улучшенный операционный контроль, который предоставляет SDN-решение Huawei Cloud Fabric (благодаря широкому сбору телеметрии в масштабах всей сети в сочетании с анализом больших данных), обеспечивает более качественный уровень автоматизации в ресурсоемких задачах по эксплуатации и техническому обслуживанию.

Широкомасштабное, высокоуровневое и вместе с тем весьма подробное видение и интеллектуальный анализ состояния сети посредством Agile Controller позволяет выявлять, изолировать и устранять последствия ошибок и сбоев быстрее и эффективнее. Непосредственное увеличение времени работы без сбоев снижает негативные последствия для бизнеса и сокращает потребность в людских ресурсах.

Эффективность использования ресурсов

Улучшения в IT-процессах ЦОД обеспечивают естественный прирост эффективности организации в целом.

1. Помимо роста операционной эффективности SDN позволяет сети самостоятельно обеспечивать внутренний баланс и вносить корректировки для оптимизации потоков трафика через инфраструктуру.

При этом возможность самооптимизации распространяется не только на локальную сеть ЦОД, но и затрагивает межсетевое взаимодействие центра обработки данных (DCI) при использовании SDN-архитектуры Huawei.

2. Кроме объединения корпоративных облачных ресурсов, распределенных по различным географическим объектам, грамотно оптимизированное DCI обеспечивает гораздо более высокий коэффициент использования доступных ресурсов, увеличивая его с 30% в среднем до 90%.

Как показала виртуализация серверов, повышение эффективности использования ресурсов напрямую сокращает эксплуатационные расходы и при этом значительно увеличивает жизненный цикл ресурсов ЦОД.

Повышение конкурентоспособности

Скорость и гибкость, привнесенные в корпоративные ЦОД с использованием SDN-решения Huawei, создают среду, которая сдвигает технический фокус с механизмов доставки сервисов и приложений на сами сервисы и приложения, и, следовательно, сокращает время вывода новых приложений на рынок. Эти приложения или сервисы могут быть как внутренними, которые способствуют совершенствованию процессов, улучшающих опыт конечного заказчика, так и обращенными вовне, которые обогащают взаимодействие и отношения с заказчиком. Смещение фокуса с процессов на возможности позволяет платформам быстро и инновационно развивать пользовательский опыт, давая толчок общей конкурентоспособности вне зависимости от отрасли.

Открытые решения

По своей открытости и интеграционным возможностям SDN-решение Huawei является передовым в отрасли. Что это значит для бизнеса?

Подлинно открытое SDN-решение не только предоставляет пользователю базовую интеграцию на уровне интерфейса посредством стандартных API, но и предоставляет взаимозаменяемые ключевые компоненты в архитектуре решения, при этом по-прежнему обеспечивая высокий уровень функциональности и надежности.

Это выходит за рамки простой реализации стандартизованных интерфейсов — речь идет о формировании партнерской экосистемы испытанных и сертифицированных решений от различных производителей, которые могут быть настроены под уникальные требования в любом окружении. Предоставляя для различных сетевых компонентов, таких как контроллер SDN-сети или облачная платформа оркестрации, возможность подключения на основе стандартных и открытых технологий, открытое решение обеспечивает не только адаптивность под конкретные требования, но и серьезный задел на будущее для развития всей системы.

В итоге

По мере того, как технические преимущества SDN становятся все более очевидны, возрастает важность понимания того, как это развитие сетевых технологий может непосредственно способствовать достижению бизнес-целей.

Несмотря на то, что многие из перечисленных здесь преимуществ характерны для технологии SDN в целом и присущи большинству SDN-решений, два важных отличия решения Huawei для ЦОД выделяют его среди прочих:

1. Параметры комплексного унифицированного SDN-решения Huawei Cloud Fabric обеспечивают единообразные интеграционные возможности SDN как для локальной сети ЦОД, так и для межсетевых взаимодействий (DCI) и в сетевых системах хранения данных (SAN).

2. Широкая взаимозаменяемость и открытый характер как архитектуры в целом, так и подхода к каждому компоненту решения в частности, обеспечивают максимальные интеграционные возможности, гибкость и жизненный цикл инфраструктуры в контексте обширной экосистемы и отраслевого партнерства.

По мере того, как на рынке появляется много поставщиков SDN, декларирующих аналогичные преимущества, Huawei может предложить глобальное покрытие, высокий уровень удобства использования, корпоративную поддержку и партнерство, обширные инвестиции в исследования и открытый подход в масштабах всей отрасли.

В связи со всем выше сказанным нам критически важен ваш пользовательский опыт взаимодействия с Huawei Cloud Fabric, и мы просим вас активнее с нами им делиться.

|

Метки: author Huawei_Russia сетевые технологии серверное администрирование облачные вычисления виртуализация it- инфраструктура sdn- архитектура huawei |

[Перевод] Криптовалюта Dash приглашает… взломать свой блокчейн |

Цифровая валюта Dash голосованием сообщества через Систему самофинансирования одобрила найм краудсорсинговой команды тестеров Bugcrowd для выявления уязвимостей в открытом коде своего программного обеспечения. Тысячи независимых исследователей Bugcrowd будут работать над выявлением потенциальных уязвимостей, которые Bugcrowd будет сортировать, проявлять, а затем предоставлять команде Dash Core для исправления.

Сначала процесс будет вестись в закрытом режиме — доступ будет только у специалистов по приглашению, а затем это трансформируется в публичную программу, когда следующий релиз Dash Эволюция будет готов к запуску.

“Наша цель – стать более безопасной и защищённой платёжной сетью”, – говорит Джим Бёрш, создатель бюджетных предложений «Dashincubator» и «Bugcrowd». “Речь идёт о деньгах – цифровом эквиваленте реальных наличных средств. Значительные суммы цифровых денег порождают мощный стимул для воров активизироваться в глобальном масштабе.

Этот проект Dash похож на создание банковского хранилища с последующим приглашением «грабителей элитных банков» для участия в проектировании его защиты, чтобы он впоследствии не мог быть ограблен другими преступниками.”

“Поскольку криптовалюта Dash развивается динамично и привлекает к себе всё больше внимания, то выявление и своевременное устранение уязвимостей становится абсолютно необходимо”, – говорит генеральный директор DAO «Dash Core» Райан Тейлор. “Программы поиска багов – это свежий взгляд на код, и он гарантирует, что “белые” хакеры помогут выявить любые недостатки в нашей системе безопасности. Предоставление сильных стимулов для привлечения опытных программистов является одним из многих инструментов, которыми мы располагаем, чтобы обеспечить максимальную надёжность кодовой базы Dash.”

В Bugcrowd сейчас участвуют уже более 60.000 различных исследователей. В среднем за две недели своей работы они обнаруживают около пяти критических уязвимостей, 70 уникальных уязвимостей и 200 глобальных уязвимостей.

“В настоящее время наблюдается огромный дефицит специалистов по кибербезопасности”, – говорит генеральный директор Bugcrowd Кейси Эллис. “Сопоставьте это с расширяющейся набором векторов атак, и вы поймёте, почему компании оказываются в невыгодном с точки зрения безопасности положении.”

“Мы накопили солидный ресурс профессиональных исследователей и многолетний опыт управления очень сложными программами. Мы живём в эпоху цифровых преобразований, а криптовалюта – это следующий этап в этой эволюции. Учитывая глобализацию и распределение рабочей силы, разумно предположить, что спрос на криптовалюты будет расти.”

Райан Тейлор из команды Dash Core уверен, что этот проект поможет улучшить продукт, который в настоящее время находится в разработке.

“Наш знаковый предстоящий релиз – Dash Эволюция – нацелен на то, чтобы полностью переосмыслить функционирование цифровой валюты, и он будет доступен для альфа-тестирования уже в Декабре 2017. Он демонстрирует, как оптимизация пользовательского опыта требует значительных изменений в базовых технологиях. Чем больше улучшений Dash вносит в оригинальный код Биткойна, на котором Dash базируется, тем ближе мы становимся к тому, что наш продукт будет соответствовать самым высоким стандартам. Поскольку цифровые валюты содержат в себе большую ценность и облегчают денежные переводы, крайне важно принять все возможные меры, чтобы быть абсолютно уверенными в том, что выявлены все, даже незначительные ошибки программного обеспечения.”

“Независимо от своего размера, организации, пытающиеся самостоятельно выявлять уязвимости в своём ПО, быстро понимают, что это очень сложная задача”», – говорит г-н Эллис. «Определение проблемных областей, определение уровней доступа, создание программы управления выявлением уязвимостей и даже определение сроков устранения проблем в рамках этой программы – всё это требует времени и ресурсов как при запуске программы, так и на постоянной основе по мере её развития. Выбрав Bugcrowd для управления поиском багов, команда Dash отделила свою работу от этого процесса, так что всё, что они увидят, – это результаты.”

|

Метки: author zapp управление сообществом управление проектами развитие стартапа венчурные инвестиции бизнес-модели dash криптовалюта блокчейн взлом |

За глобальные переменные замолвите слово? |

Мне, как и многим другим, в университете, рассказали про то, что глобальные переменные использовать плохо. Конечно, я пытался задавать вопрос: "Почему?", на который получил пространное объяснение про плохо структурированный код. Ответ я не понял до конца, но инстинкт самосохранения мне подсказал, что надо делать как говорят. Только спустя много лет, я нашел в статье E. M. Clarke Programming Language Constructs for Which It Is Impossible To Obtain Good Hoare Axiom Systems теорему, которая, на мой взгляд, проясняет ситуацию с глобальными переменными.

Итак, собственно, теорема Clarke:

It is impossible to obtain a system of Hoare axioms H which is sound and

complete in the sense of Cook for a programming language which allows:

(I) procedures as parameters of procedure calls,

(II) recursion,

(III) static scope,

(IV) global variables,

(V) internal procedures.

небольшие пояснения по тексту:

- Логика Хоара — исчисление, которое было введено Чарльзом Хоаром, для доказательства корректности программ в статье "An Axiomatic Basis For Computer Programming". Небольшое введение на Хабре можно прочитать здесь.

- доказуемость и полнота в смысле Кука — имеется ввиду статья "Soundness and Completeness of an Axiom System for Program Verification"

Попробую объяснить смысл простым языком, без глубокого погружения в терминологию.

Если использовать все пять перечисленных конструкций языка программирования, то можно

- столкнуться с задачей, которую, в принципе, нельзя запрограммировать, используя все пять этих конструкций;

- или написать программу, убедиться в работоспособности которой будет проблематично.

При этом, в той же статье показано, что если изменить/отказаться от одного из предложенных пунктов, то система аксиом существует.

Если перебрать все пять пунктов, то окажется, что наименее ценное, от чего можно отказаться — глобальные переменные.

Другими словами, глобальные переменные — это не зло, а жертва, которую пришлось принести, чтобы избежать проблем с отладкой, верификацией программ, возможностью реализации задачи.

|

Метки: author etyumentcev программирование математика hoare logic global variables soundness completness clarke |

Сайты интернет-магазинов и промышленных компаний наиболее уязвимы для хакерских атак |

Более половины современных сайтов содержат критически опасные уязвимости, которые позволяют злоумышленникам проводить различные атаки, включая отказ в обслуживании и кражу персональных данных. Такие выводы содержатся в исследовании компании Positive Technologies на основе работ по анализу защищенности веб-приложений за 2016 год.

Как следует из отчета, практически все исследованные веб-приложения (94%) позволяют осуществлять атаки на пользователей, и неудивительно - половина уязвимостей, вошедших в десятку самых распространенных, используются именно для таких атак. Доступ к персональным данным был получен в 20% приложений, обрабатывающих такие данные (включая сайты банков и государственных организаций).

Больше всего веб-приложений с уязвимостями высокого уровня риска найдено среди сайтов телекоммуникационных компаний (74%). Если же оценивать уровень защищенности в зависимости от возможных последствий, то хуже всего ситуация в промышленности (43% сайтов отличаются крайне низкой степенью защищенности) и в электронной коммерции (34%).

Исследователи отмечают, что уязвимости публичных сайтов по-прежнему являются популярным способом проникновения во внутреннюю инфраструктуру компании: каждое четвертое веб-приложение позволяет проводить такие атаки. Кроме того, четверть веб-приложений содержат уязвимости, позволяющие стороннему злоумышленнику получить доступ к базам данных.

Еще одно важное наблюдение - веб-приложения, находящиеся в процессе эксплуатации, оказались более уязвимыми, чем тестовые: критически опасные уязвимости выявлены в 55% продуктивных систем и в 50% тестовых систем. Это свидетельствует о том, что необходимо проводить анализ защищенности не только в процессе разработки, но и после внедрения в эксплуатацию. Для защиты уже эксплуатируемых приложений рекомендуется использовать межсетевые экраны уровня приложений (web application firewalls).

В исследовании также представлено сравнение эффективности различных методов анализа защищенности приложений («белый ящик» против «черного ящика») и приведены примеры выявления уязвимостей автоматизированным анализатором кода PT Application Inspector. Анализ исходного кода показывает намного более высокие результаты, чем исследование защищенности без доступа к коду приложения. Кроме того, тестирование исходного кода в процессе разработки позволяет значительно повысить защищенность конечного приложения. Для анализа исходного кода на различных стадиях разработки целесообразно применять автоматизированные средства, поскольку это позволяет выявить максимальное число ошибок в кратчайшее время.

Полная версия исследования: blog.ptsecurity.ru/2017/08/web-attacks.html

|

Метки: author ptsecurity информационная безопасность блог компании positive technologies исследование статистика уязвимости |

[Из песочницы] ML Boot Camp V, история решения на 3 место |

Знакомство с машинным обучением для меня началось с ML Boot Camp III где-то в феврале 2017 года и какое-то подобие представления что с такими задачами делать начинает складываться у меня только сейчас. Многое из сделанного в 5 контесте — результат в первую очередь изучения собрания статей на kaggle и обсуждений и примеров кода оттуда же. Ниже — слегка переработанный отчет о том, что пришлось сделать, чтобы занять 3 место.

Данные задачи

Датасет сформирован из 100.000 реальных клинических анализов. Даны возраст, рост, вес, пол, артериальное давление верхнее и нижнее, холестерин и глюкоза в крови.

Дополнительно есть «субъективные» данные — что пациенты сами о себе сообщили, отвечая на вопросы о курении, потреблении алкоголя и физической активности. Эта часть данных была еще и подпорчена организаторами, так что никаких особых надежд с ними у меня связано не было.

Исходные данные содержали заведомо нереальные значения — были люди с ростом 50 см в 30+ лет, с давлением вроде 16020, с отрицательными давлениями давлений. Объяснялось это ошибками при ручном вводе данных анализов.

Инструменты

Задача решалась на python с использованием стандартных для такого случая библиотек:

- pandas – чтение-запись и обработка табличных данных (на самом деле много чего еще, но в данном случае остальное не понадобилось);

- NumPy – операции над массивами чисел;

- scikit-learn – набор инструментов для машинного обучения, включая базовые алгоритмы МО, разбиение данных, валидацию;

- XGBoost – одна из наиболее ходовых реализаций градиентного бустинга;

- LightGBM – альтернатива XGBoost;

- TensorFlow + Keras — библиотека для обучения и использования нейронных сетей и обертка к ней;

- Hyperopt – библиотека для оптимизации функций в заданном пространстве аргументов;

Csv vs pickle

Для хранения данных при долгих расчетах сначала использовал csv пока не понадобилось сохранять вместе более сложные структуры чем отдельные таблицы. Очень хорошо проявил себя модуль pickle — все нужные данные сохраняются или читаются в 2 строки кода. Позже сохранять стал в сжатые файлы:

with gzip.open('../run/local/pred_1.pickle.gz', 'wb') as f:

pickle.dump((x, y), f)

Репозиторий

Весь код, относящийся к соревнованию лежит на github. В репозитории в old/ спрятаны старые скрипты, реальной пользы от которых не было, и оставленные только потому, что результаты их работы также отправлялись на проверку. Из-за ошибок в коде промежуточные результаты их выполнения позже оказались непригодны для использования, так что на итоговые решения никакого влияния эта часть кода не оказала.

Первые 2 недели

Первые 2 недели чистил данные, подставлял их в оставшиеся от прошлых соревнований модели и все это без особого успеха. Для каждого нового сабмита весь код из одного из существующих скриптов копировался целиком в новый и там уже редактировался. Результат – на исходе второй недели сказать с ходу что делает какой-то из последних скриптов и какие функции в нем реально используются, а какие просто занимают место, уже не мог. Код был громоздкий, трудночитаемый и мог проработать несколько часов и упасть не сохранив вообще ничего полезного.

Вторые 2 недели

Когда через 2 недели после начала копировать старые скрипты и немного их менять стало слишком сложно — пришлось начать полную переделку всего кода. Он был разбит на общие части — базовые классы и конкретные их реализации.

Общая идея новой организации кода — конвейер: данные -> признаки -> модели 1 уровня -> модели 2 уровня. Каждый этап реализует отдельный файл скрипта, который при запуске проделывает все положенные вычисления, сохраняет их, промежуточные результаты и свои данные. Скрипт для каждого следующего этапа импортирует код предыдущих этапов и получает данные для обработки от их методов. Идея за всем этим — чтобы можно было запустить скрипт для одной из финальных моделей, тот запустил скрипты для моделей уровнем ниже, те вызвали нужные им генераторы признаков, которые в свою очередь запустили нужный вариант очистки данных. Задача каждого скрипта — проверить существует ли файл, куда он должен сохранять свои результаты и если нет — выполнить необходимые расчеты и сохранить данные.

За всем этим был план сделать решение для организации моделей и данных в расчете на будущее использование, попутно отладив его на подходящей задаче. Собственно это решение и было важнейшим результатом контеста, которое сейчас плавно перерастает в небольшую библиотеку для облегчения жизни при участии в последующих соревнованиях такого рода.

Общий план

Изначально было запланировано 2 уровня моделей и надо было заготовить как можно больше различных моделей на 1й уровень. Способ этого добиться подготовить как можно больше по-разному обработанных данных, на которых будут обучены однотипные модели. Но готовить данные — дело долгое. Хоть работа с данными и является залогом успеха (достаточное количество добавленных осмысленных признаков позволяет обойтись простейшими моделями), но времени требует больше чем хотелось бы. Альтернатива — решение грубой силой, то есть относительно умеренная обработка данных и максимальное машинное время на вычисления.

Самое простое при таком подходе — обработать данные несколькими способами, придумать несколько наборов дополнительных признаков и использовать их комбинации. Получится куцый вариант Random subspace method, отличающийся от полноценного тем, что он совсем не random и признаки выбираются сразу группами. Так при небольшом количестве дополнительных признаков можно получить сотни вариантов обработанных данных (собственно количество способов чистки * (2 ^ количество групп признаков)). Предполагалось, что такой подход даст достаточно разные решения простых моделей, использующих разные подмножества признаков, чтобы каждое из них улучшало качество моделей 2 уровня.

Подготовка данных

То, что исходные данные были грязными надо было как-то учитывать. Основные подходы — или выкидывать все заведомо невозможные значения или пытаться как-то восстановить исходные данные. Так как источник таких искажений оставался неизвестен почти до конца — пришлось готовить данные несколькими способами, после чего обучать на них разные модели.

Каждый из вариантов обработки данных реализован классом, при обращении возвращающим полный датасет с соответствующими изменениями. Так как обработка данных на этом этапе по времени проходит достаточно быстро — промежуточные результаты сохранялись только для относительно долгого варианта (2) — восстановления субъективных признаков с помощью xgboost. Остальные данные генерировались по запросу.

Варианты обработки:

- Исходные данные в которых испорченные значения субъективной части теста заменены на 0.0001, чтобы привести их к числовому виду, но отличать от нетронутых.

- Испорченные субъективные признаки заменены: потребление алкоголя — 0, активность — 1. Далее по остальным колонкам данных было «восстановлено» курение.

- В данных с восстановленными субъективными признаками почищены экстремальные значения давлений.

- В данных с восстановленными субъективными признаками (из п.2) почищены экстремальные значения давлений, веса и роста.

- В данных только с очищенными давлениями (из п.3) дополнительно почищены вес, рост, давления.

- Данные с очищенными давлениями дополнительно преобразованы — любое отдельное неправдоподобное значение роста, веса или давления заменены на NaN.

Признаки

Из обработанных данных генерировались дополнительные признаки. Осмысленных из них было совсем немного — индекс массы тела, ожидаемые значения давления в зависимости от пола, веса и возраста по какой-то старой формуле и т.п. Гораздо больше дополнительных колонок с данными было получено автоматически достаточно простыми способами.

Дополнительные признаки генерировались из разных вариантов обработанных данных, но часто одним и тем же способом. Так как часть признаков могла требовать слишком много времени на повторный расчет их значений — колонки признаков сохранялись отдельно. Вычисление признаков в скриптах было реализовано аналогично очистке данных — в каждом скрипте определялся метод, возвращающий дополнительные колонки признаков.

Группы дополнительных признаков:

- Простейшие осмысленные признаки — ИМТ, пульсовое давление, усредненные значения давлений вида для разных значений x. Также взяты приближенные формулы вычисления давлений по возрасту/весу и для каждого пациента вычислены ожидаемые давления (формулы вида ). Вычислено на основе необработанных значений.

- То же, что в п.1, но дополнительно на основе имеющихся давлений сделана попытка восстановить вес пациента. Для каждого из предсказанных таким образом признаков добавлена разница с «реальным» значением. Вычислено на основе необработанных значение.

- Текстовое представление колонок необработанных данных, разбитое посимвольно — сначала с выравниванием слева, потом справа. Символы заменены их числовыми значениями (ord()). Где строка была слишком короткая и на все колонки не хватило — ставилось -1.

- То же, что в п.3, но полученные колонки бинарно закодированы (one-hot encoding).

- Данные из п.4, но пропущенные через PCA – тяжкое наследие недавно прошедшего на kaggle соревнования от mercedes, где модели с этим шаманством неплохо выглядели на паблике и печально на привате.

- Для всех колонок необработанных исходных данных кроме возраста рассчитаны средние значения целевой колонки. Для этого сначала значения давлений, роста и веса поделил на 10 и округлил, получив из них таким образом категориальные признаки. Далее разбил данные на 10 фолдов и для каждого из них по 9 другим фолдам посчитал для каждой категории взвешенное среднее значение целевой колонки (болен-не болен). Там, где среднее вычислить было не из чего, проставил просто глобальное среднее.

- То же что в п.6, но средние вычислялись еще и для признаков из п.2.

- То же что в п.7, но в качестве исходных данных взяты очищенные по варианту №5.

- То же что в п.7, но в качестве исходных данных взяты очищенные по варианту №3.

- Необработанные данные кластеризованы методом k-means, количества кластеров выбраны произвольно — 2, 5, 10, 15, 25. Номер кластера для каждого из таких случаев — бинарно закодирован.

- То же что в п.10, но использовались данные, очищенные по варианту №3.

Модели

Так как модели могут работать очень долго (десятки часов), падать с ошибками или прерываться специально — необходимо сохранять не только окончательные результаты, но и промежуточные данные. Для этого каждой модели задается базовое имя. Далее из имени модели и имени назначенного данным получается имя файла, где эти данные будут лежать. Все сохранение-загрузка идут через базовые методы модели, что и обеспечивает единообразное хранение промежуточных данных. В планах на будущее — держать данные не в файлах, а в какой-нибудь базе. Недостаток использованной реализации — можно забыть обновить имя при копировании модели и получить неопределенное состояние для данных исходной модели и ее копии.

Если у модели сохранены результаты ее вычислений — при обращении остается только их прочитать и вернуть вызывающей стороне. Если есть только промежуточные результаты — их тоже не приходится повторно считать. Это сильно экономит время, особенно когда речь идет о вычислениях на несколько часов.

Основное разделение сохраняемых моделями данных — по времени жизни этих данных. Для каждой такой группы данных предусмотрен свой базовый путь для сохранения. Всего таких 3 группы:

- Временные, которые не будут использованы при следующих запусках, например лучшие веса нейросетей для отдельных фолдов;

- Данные модели, которые при следующих запусках понадобятся — почти все остальное;

- Глобально полезные данные, которые могут пригодиться нескольким моделям, например дополнительные признаки;

Интерфейс у всех моделей общий и позволяет не только запускать их отдельно как обычные скрипты, но и грузить как модули python. Если некоторой модели нужны результаты работы других моделей — она их грузит и выполняет. Как результат — описание каждой из моделей 2 уровня удалось свести к списку имен моделей, чьи результаты надо объединить, и признаку необходимости отбора признаков жадным алгоритмом.

Среди моделей были основанные на нейросетях, которые на выходе могли дать очень уверенные 0 или 1 или очень близкие к крайним значения. Так как в случае ошибки подобная самоуверенность штрафуется logloss-ом очень сильно — значения всех моделей при сохранении обрезались так, чтобы до 0 или 1 оставалось не менее 1e-5. Проще всего оказалось добавить np.clip(z, 1e-5, 1-1e-5) и забыть об этом. В результате обрезались данные всех моделей, но большинство и так давали результаты в диапазоне примерно 0.1-0.93.

hyperopt

Для подгонки параметров моделей пришлось задействовать hyperopt (подробности). Результаты улучшались, но при этом долгое время для особенно медленных моделей я выставлял количество попыток порядка 20. И дня за 2 до конца в статье нашел упоминание hyperopt bootstrapping — по умолчанию первые 20 запусков моделей производится со случайными параметрами, что можно увидеть в исходниках. Пришлось срочно пересчитывать часть моделей.

Модели 1 уровня

В общий код моделей 1 уровня попал выбор входных данных для каждой модели — обязательно один вариант очистки исходных данных и 0 или более групп признаков. Сборка данных и признаков в общий датасет реализована в общем для моделей коде. Это сократило код отдельных моделей до задания конкретных исходных данных и дополнительных признаков.

Сделать общий код для оптимизации не хватило времени, так что отдельные базовые модели 1 уровня по-прежнему сильно копируют друг друга. Всего их получилось 2 разновидности:

- нейросети (keras)

- деревья (XGBoost, LightGBM, rf, et)

Главное отличие использовавшихся моделей на основе нейросетей — отсутствие подгонки гиперпараметров. Для остальных моделей использовался hyperopt.

Нейросети

Сколько-нибудь серьезного подбора параметров нейросетей не делал, так что и результаты их были хуже чем у бустинга. Позже в чате видел упоминание устройства сети наподобие 64-64 с активацией leaky relu и дропаутом на 1-5 нейронов в каждом слое, которая давала относительно приличный результат.

У себя нейронные сети использовал примерно следующего вида:

- вход;

- несколько сотен нейронов (обычно 256);

- какая-нибудь нелинейность, дропаут (где был — брал значения порядка 0.7, потому что считал, что слишком много параметров и сеть переобучается); если при обучении модель расходилась в nan-ы — добавлял batch normalization — подробности здесь или здесь;

- сотня-другая нейронов (64-128);

- нелинейность;

- десяток-другой нейронов (16);

- нелинейность;

- 1 выходной нейрон с классической сигмоидой на выходе.

Подобное устройство перекочевало из предыдущих соревнований почти без изменений. По отдельности нейросети проявляли себя не очень, но были оставлены, чтобы их результаты использовать при расчете моделей 2 уровня.

Выбор функций активации для внутренних слоев очень простой — из доступного набора исключил все варианты сигмоиды (из-за близких к 0 градиентов у границ значений), «чистый» ReLU (из-за того, что нейрон, начавший выдавать на выходе 0, из обучения выпадает) и брал что-то из оставшихся. Изначально это было Parametric Relu, в последних моделях начал брать Scaled Exponential Linear Units. Каких-либо значимых различий от такой замены заметить не удалось.

Как и для других моделей, данные для нейросетей бились на фолды с помощью KFold из sklearn. Для обучения на каждом разбиении приходилось строить модель заново, так как я слишком поздно узнал как можно переинициализировать веса в слоях сети без ее пересоздания.

Сети обучались до тех пор, пока улучшалось качество предсказаний на части данных, выделенных для валидации. При этом сохранялись веса для сети каждый раз, когда результат на валидации улучшался. Для этого стандартные callback-и keras – на сохранение состояния сети с лучшими результатами на валидации, на раннее прекращение обучения если за заданное количество проходов по обучающей выборке результаты валидации не улучшались и на уменьшение learning rate если результаты не улучшались несколько проходов.

Получалось, что если обучение сети заходило в тупик (локальный минимум) и результаты не улучшались за несколько проходов по данным — уменьшался learning rate и если это не помогало — еще через сколько-то ходов обучение останавливалось. После обучения загружалось наилучшее состояние весов сети за все время обучения.

При этом я достаточно поздно заметил проблему, возникающую при попытке несколько раз использовать один и тот же набор экземпляров callback-ов при обучении нескольких сетей. В этом случае состояние callback-ов при начале обучения новой сети не сбрасывается автоматически в начальное. Как результат learning rate для каждой новой сети снижался все больше и больше, а лучшие результаты не сохранялись, если они не были лучшими чем вообще все ранее полученные на всех сетях, где использовались те же callback-и.

Модели, основанные на деревьях

Использовалось 2 варианта «древесных» моделей — основанные на bagging random forest и extra trees и 2 реализации градиентного бустинга — XGBoost и LightGBM. Оба варианта случайного леса плохо проявили себя и на кросс-валидации и на паблике, так что остались просто из-за того, что на них пришлось потратить много машинного времени и была надежда, что они пригодятся при объединении результатов моделей. LightGBM и XGBoost проявили себя гораздо лучше и большая часть предсказаний на первом уровне была получена от них.

Каждая из «древесных» моделей после подгонки параметров рассчитывалась для нескольких (обычно — 3) исходных состояний генератора случайных чисел. Все такие результаты сохранялись отдельно для использования моделями 2 уровня. Предсказания же моделей 1 уровня получалось из результата для последнего использованного состояния ГСЧ.

В LightGBM и XGBoost предусмотрена возможность останавливать обучение, если качество обучения не улучшается на валидации за заданное число итераций. За счет этого можно было просто разрешить им обучаться 10000 шагов и останавливаться когда результаты на валидации перестанут улучшаться. В результате при подборе параметров таких моделей количество деревьев подбирать не было необходимости. Для random forest и extra trees от sklearn такой возможности нет, так что пришлось переложить подбор количества деревьев на hyperopt, который, похоже, за недостаточное количество попыток с задачей полностью не справился. Можно было обучать их по одному шагу, каждый раз проверяя качество на валидации самому, но помешала лень.

Несколько сидов

Результат работы отдельных моделей сильно зависит от состояния генератора случайных чисел. Для избавления от такой зависимости для моделей 1 уровня рассчитывались результаты обучения с несколькими сидами. При этом для каждого сида результаты сохранялись отдельно. При этом после окончания конкурса выяснилось, что в качестве результата, сохраняемого отдельной моделью 1 уровня, использовался результат для последнего из сидов. Результаты для остальных все же сохранялись и использовались моделями 2 уровня.

Модели 2 уровня

За счет того, что каждая из моделей 1 уровня давала от 1 до 4 предсказаний, на 2 уровне данные содержали до 190 колонок. Исходные данные и признаки туда не попали — только уже предсказанные вероятности. Каждая из моделей 2 уровня объединяла некоторое подмножество из моделей 1 уровня (некоторые использовали еще результаты ранних моделей 2 уровня).

Все модели 2 уровня устроены примерно одинаково — загрузка по имени модулей моделей, получение результатов их работы, опциональный выбор какие колонки из загруженных использовать и подгонка параметров регрессии для объединения предсказаний.

Что не сработало — попытка добавить еще уровень и объединить предсказания всех моделей 2 уровня. Результат такого объединения на паблике оказался настолько плохим, что делать вторую попытку я даже не думал.

При выборе части предсказаний, комбинация которых давала бы наилучший результат, использовался «жадный» алгоритм — выбиралась одна лучшая колонка из доступных, после чего в цикле к ранее выбранным колонкам по одной добавлялись колонки из числа оставшихся. Добавление колонок продолжалось пока оно улучшало результаты модели 2 уровня на валидации. При этом для экономии времени в качестве модели для отбора использовался BayesianRidge, результаты которого уступали только Ridge с хорошо подогнанными параметрами. В результате такого отбора обычно оставалось порядка 20 колонок с данными.

Для итогового подсчета изначально прогонялся выбор через hyperopt всех доступных регрессоров, но более-менее прилично себя проявили только BayesianRidge и Ridge из sklearn, так что в итоге код выродился до определения насколько хорошо комбинирует модели BayesianRidge и попыток улучшить этот результат подгонкой параметров Ridge.

Валидация

Изначально валидировался на разбиении на 10 фолдов. При этом некоторые модели начали показывать cv под 0.534-0.535 при результатах на паблике за 0.543-0.544, а то и хуже. Ближе к концу конкурса, чтобы сблизить результаты при валидации и на паблике я пробовал увеличить разбиение до 30 фолдов. Выбор числа 30 основан на возможностях процессора — выбирал максимальное значение при котором вычисления одной модели требовали менее 10 часов.

При этом все равно часть моделей валидировались на уровне 0.535-0.536, что на фоне результатов на паблике порядка 0.543 на паблике вызывало сомнения в адекватности схемы валидации. Дня за 3 до окончания соревнования к разбиению на 30 фолдов пришлось добавить 30 случайных разбиений на 0.7 и 0.3 от тренировочных данных. Выбор именно 30 — та же причина что и для cv — возможности процессора. Все разбиения были зафиксированы по random_state. После этого лучший результат на валидации был порядка 0.537.

Это тоже было далеко от желаемого, но до конца оставалось несколько дней, которых хватало только чтобы дождаться пока досчитаются последние модели, так что пришлось на этом остановиться. В итоге выбирал 2 сабмита с результатами лучше 0.543 на паблике и 0.538 на валидации. Как выяснилось позже, из 12 таких сабмитов 7 давали 3 место, так что оставалось просто не промахнуться.

|

Метки: author ifilonov машинное обучение ml boot camp |

Очень легкая система мониторинга с Телеграмом и Консулом |

|

Метки: author LeshiyUrban программирование go docker docker-compose consul telegram |

Асинхронный дешифратор |

Итак, об асинхронном дешифраторе. После размышлений я пришел к выводу, что единственный вменяемый путь синтеза асинхронного дешифратора это поэтапное удвоение разрядности адреса с помощью схемы надстройки над двумя дешифраторами вдвое меньшей разрядности. Доказать что альтернативного пути нет я не берусь. Но могу утверждать что альтернативный путь (если он есть) куда более затратен по количеству добавляемых новых сигналов.

Ввиду изложенного, речь в этой статье пойдет о двухразрядном дешифраторе. Как удвоить разрядность асинхронного дешифратора, тема следующей статьи.

Итак, опишем исходное поведение двухразрядного асинхронного дешифратора. Как ни странно, это не сложно сделать на языке STG, и дело тут даже не в маленькой разрядности.

Входные сигналы:

d — сигнал — команда на операцию дешифрации адреса;

r1, r2 — сигналы разрядов регистра адреса.

Выходные сигналы:

q1 — переключается если r1=1 и r2=1;

q2 — переключается если r1=1 и r2=0;

q3 — переключается если r1=0 и r2=1;

q4 — переключается если r1=0 и r2=0.

Поэтапно выполнение операции дешифрации выглядит следующим образом:

0. Когда сигнал d равен 0, внешняя управляющая схема (ВУС) произвольным образом переключает сигналы r1 и r2. Схема дешифратора (СД) не отслеживает изменения сигналов r1 и r2.

1. ВУС вырабатывает сигнал d+, команду на операцию дешифрации. К этому моменту ВУС устанавливает сигналы r1 и r2 в какое-то конкретное значение. ВУС обеспечивает, что до окончания операции дешифрации сигналы r1 и r2 менять свое значение не будут.

2. В зависимости от значения сигналов r1 и r2, СД вырабатывает один из сигналов: либо q1+, либо q2+, либо q3+, либо q4+.

3. ВУС вырабатывает сигнал d-.

4. СД вырабатывает один из сигналов в соответствии с пунктом 2: либо q1-, либо q2-, либо q3-, либо q4-. Этот сигнал является сигналом окончания операции дешифрации. После этого ВУС снова может изменять сигналы r1 и r2 произвольным образом.

Немного рассуждений о том как была синтезирована схема двухразрядного асинхронного дешифратора. По сути она представляет из себя два, происходящих параллельно, «выбора по уровню» (для каждого из сигналов r1 и r2). Подробнее о «выборе по уровню» можно прочитать здесь. Затем альтернативные ветви в двух параллельных процессах попарно синхронизируются. В результате получаются четыре альтернативные ветви. В приведенном графе скорректированного итогового поведения видны только четыре альтернативные ветви. Но это дань языку STG. Описывать на нем реально происходящие процессы крайне не удобно. Все вышеуказанные «выборы по уровню» и «синхронизации альтернативных ветвей» зашифрованы в данном поведении.

Можно добавить что синтезированное поведение не результат каких-то озарений. Это результат целенаправленного применения методологии, обзорно представленной здесь. Для каждого нового сигнала существует логическое обоснование его добавления.

В результате по представленному графу итогового поведения можно получить логические функции для каждого сигнала:

; ; ; ;

; ; ; ;

; ; ; ;

; ; ; ;

; ; ; ;

; ; ; ;

; ; ; ;

; ; ; ;

; ; ; ;

; ; ; ;

; ; ; ;

; ; ; .

Как видно, все уравнения помещаются в базис 2И-НЕ, 2ИЛИ-НЕ.

А вот собственно и сама SI схема двухразрядного асинхронного дешифратора.

У меня нет возможности проверить схему в реальном воплощении. Но если кто-то этим заинтересуется, я буду это только приветствовать. Чтобы произвести начальную установку, надо входной сигнал d установить в 0. Внутренние сигналы m1, m2, m3, m4 надо установить в 1. Чтобы не выходить из двухвходового базиса, сделать это можно следующим образом для каждого из элементов m1, m2, m3, m4.

Элемент слева преобразуется в подсхему справа. Входные сигналы r1, r2 можно установить произвольным образом.

|

Метки: author ajrec fpga асинхронные схемы асинхронный дешифратор |

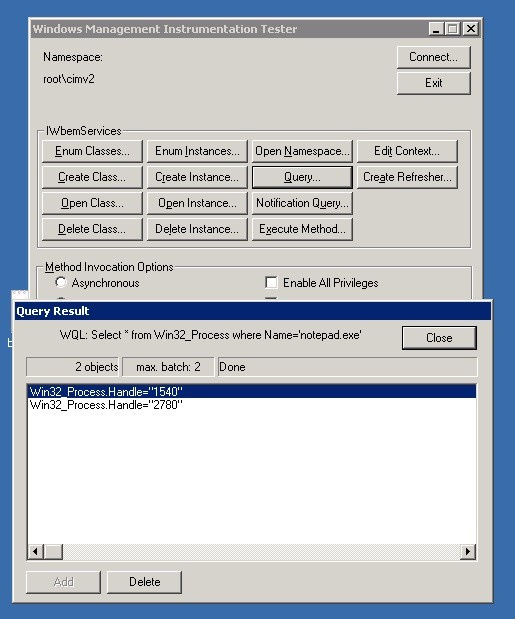

[Перевод - recovery mode ] Применение PowerShell для ИТ-безопасности. Часть I: отслеживание событий |

Во времена, когда я писал серию статей о тестах на проникновение, чтобы помочь человечеству в борьбе с хакерами, мне попалась информация о некоторых интересных командлетах и техниках PowerShell. Я сделал выдающееся открытие: PowerShell является самостоятельным средством защиты. Похоже, самое время начать новую серию публикаций о PowerShell.

В этих публикациях мы будем придерживаться мнения, что, хотя PowerShell не заменит специальные платформы безопасности (сотрудники Varonis могут вздохнуть с облегчением), это средство поможет ИТ-специалистам отслеживать угрозы и принимать другие меры для обеспечения безопасности. Кроме того, ИТ-отдел начнет ценить чудеса специализированных платформ безопасности, таких как наше решение Metadata Framework. PowerShell может выполнять интересные задачи по обеспечению безопасности в малых масштабах, но это средство не обладает характеристиками для работы со всей инфраструктурой.

Важное событие

Для начала рассмотрим использование PowerShell в качестве инструмента мониторинга системы для отслеживания файлов, процессов и действий пользователей.

Перед тем как начать проклинать меня, позвольте сказать, что я прекрасно знаю, что любой командный язык операционной системы можно использовать для отслеживания событий на системном уровне. Любой младший системный администратор может настроить, к примеру, скрипт оболочки Linux для опроса каталога, чтобы узнать, был ли обновлен файл, или для получения списка запущенных процессов, чтобы найти среди них нестандартные.

Сейчас речь не об этом.

Вместо этого PowerShell предоставляет непосредственное событийно-управляемое отслеживание на основе доступа операционной системы к изменениям нижнего уровня. Это равнозначно получению всплывающих уведомлений о последних событиях на новостном сайте вместо необходимости обновлять страницу вручную.

При этом PowerShell не будет работать без остановки, загружая циклы процессора. Скрипт активируется, когда происходит событие (изменение файла или вход в систему нового пользователя). Такое отслеживание безопасности гораздо эффективнее опросов методом подбора.

Ниже я объясню, как это делается.

Каждый, кто, как и я, изучал операционные системы, знает, что есть граница между процессами на уровне пользователя и процессами на уровне системы.

Операционная система (неважно, Linux или Windows) обрабатывает действия устройства на нижнем уровне, от чтения диска до получения пакетов, и скрывает это от рядовых приложений, запущенных на ПК.

Таким образом, если запустить любимое приложение для обработки текстов и просмотреть первую страницу документа, вся операция будет выглядеть, как плавное и синхронное действие. Однако в действительности происходят всевозможные события (поиск на диске, чтение дисковых блоков, отправка символов на экран и т. д.), которые намеренно скрыты от нас. За это можно благодарить Билла Гейтса.

Раньше только суровые системные инженеры знали об обработке событий на нижнем уровне. Теперь программисты PowerShell могут с удовольствием поделиться этой информацией.

Инструментальный язык ОС

Рассмотрим инструментарий управления Windows (WMI), который является попыткой Microsoft обеспечить последовательный просмотр объектов операционной системы.

Служба WMI, которой всего несколько лет, является частью крупной системы управления предприятием через Интернет (WBEM), предназначенной для стандартизации сведений, полученных от маршрутизаторов, переключателей, массивов хранения данных, а также операционных систем.

Как же выглядит и работает WMI?

Для наших целей инструментарий представляет собой язык запросов, как SQL, но вместо доступа к столбцам баз данных он дает комплексную информацию об операционной системе в виде иерархии

классов WMI. Разумеется, язык запросов называется WQL.В Windows имеется служебная программа WBEMTest, с помощью которой можно взаимодействовать с WQL. На изображении ниже показан запрос объекта

Win32_Process, содержащий информацию о текущем запущенном процессе.

Тренировочная работа с WQL в WBEMTest

Фактически это программный эквивалент монитора задач Windows. Впечатляет, не так ли? Если хотите узнать больше о WQL, загрузите превосходную электронную книгу Рави Чаганти (Ravi Chaganti), посвященную этой теме.

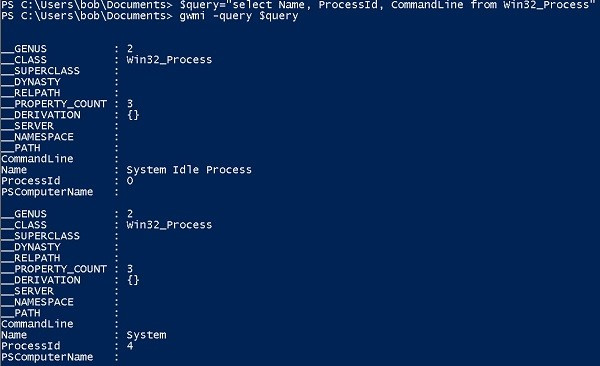

PowerShell и командлет Register-WmiEvent

Но это еще не все. От тренировочных заданий в WBEMTest можно перейти к запросам непосредственно в PowerShell.

Для этого подойдет командлет PowerShell

Get-WMIObject. Он позволяет отправлять запрос WQL непосредственно в виде параметра.На изображении ниже показаны первые несколько результатов запуска

select Name, ProcessId, CommandLine from Win32_Process в тестовой среде AWS.

gwmi — это Get-WmiObject в PowerShell

Результат немного ненадежен, так как есть некоторые скрытые свойства, имеющие отношение к основному классу регистрации данных. Кроме того, этот командлет выдает внушительный список в консоли.

Для улучшения работы с Win32_Process я переместил результат запроса в

Out-GridView — командлет PowerShell, который форматирует данные в аккуратную таблицу на основе графического интерфейса.

Неплохо для строки кода PowerShell. Но служба WMI способна на большее, чем просто запрашивать объекты ОС.

Как я упоминал ранее, она дает доступ к соответствующим событиям этих объектов. В WMI эти события ориентировочно разделены на три типа: создание, изменение и удаление.

До выхода PowerShell 2.0 доступ к этим событиям приходилось получать запутанным способом: создавая множество различных объектов, после чего происходило синхронное зависание, так что это не была настоящая асинхронная обработка событий. Чтобы узнать подробности, прочитайте публикацию MS Technet.

Теперь командлет

Register-WmiEvent в PowerShell 2.0 позволяет реагировать на события в более приемлемой манере. Иными словами, когда происходит событие, срабатывает вызов, который можно зарегистрировать.Вернемся к моей вымышленной (и уже знаменитой) компании Acme, чья ИТ-инфраструктура работает в среде AWS.

Системный администратор (назовем его Бобом) время от времени замечает, что место на сервере Salsa заканчивается. Он подозревает, что генеральный директор Acme Тед Блоутли загружает большие файлы, такие как аудиозаписи, в один из каталогов Боба, а затем перемещает на свой сервер Taco.

Боб хочет устроить западню: необходимо, чтобы при создании большого файла в основном каталоге в его консоли появлялось уведомление.

Чтобы сделать это, ему нужно работать с классом

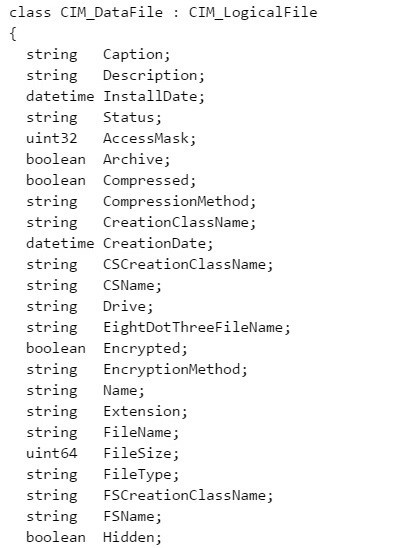

CIM_DataFile. Вместо получения доступа к процессам, как мы делали ранее, Боб использует этот класс для соединения с метаданными основного файла.

В PowerShell можно получить непосредственный доступ к объекту CIM_DataFile

В качестве Боба я создал следующий скрипт

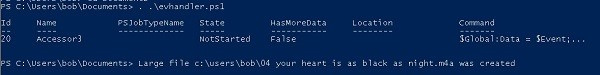

Register-WmiEvent, который будет отправлять уведомления в консоль при создании большого файла в основном каталоге.Register-WmiEvent -Query "SELECT * FROM __InstanceModificationEvent WITHIN 5 WHERE TargetInstance isa 'CIM_DataFile' and TargetInstance.FileSize > 2000000 and TargetInstance.Path = '\\Users\\bob\' and targetInstance.Drive = 'C:' "-sourceIdentifier "Accessor3" -Action { Write-Host "Large file" $EventArgs.NewEvent.TargetInstance.Name "was created”}Запуск этого скрипта непосредственно в консоли Salsa активирует команду Register-WmiEvent в фоновом режиме, назначая ей номер задания. Дальнейшее взаимодействие происходит только при возникновении события.

В следующей публикации я расскажу об этом подробнее. Фактически я использую WQL для запроса из каталога \Users\bob любого объекта

CIM_DataFile, превышающего 2 млн байтов. При создании файла, соответствующего условиям, появится уведомление, для которого активируется InstanceModificationEvent.В любом случае, играя роль Боба, я запустил скрипт из командной строки PowerShell, а затем, как и Тед из нашей истории, я скопировал большой файл MP4 в каталог Боба. Результат вы можете увидеть ниже.

Теперь мы знаем, что Тед — фанат Мелоди Гардо. Кто бы мог подумать!

В публикации были продемонстрированы некоторые удивительные возможности использования средства PowerShell в качестве инструмента для обнаружения угроз и небольшого анализа поведения.

Мы продолжим изучать эти аспекты в следующих статьях.

|

Метки: author Alexandra_Varonis хранение данных системное администрирование powershell блог компании varonis systems varonis информационная безопасность |

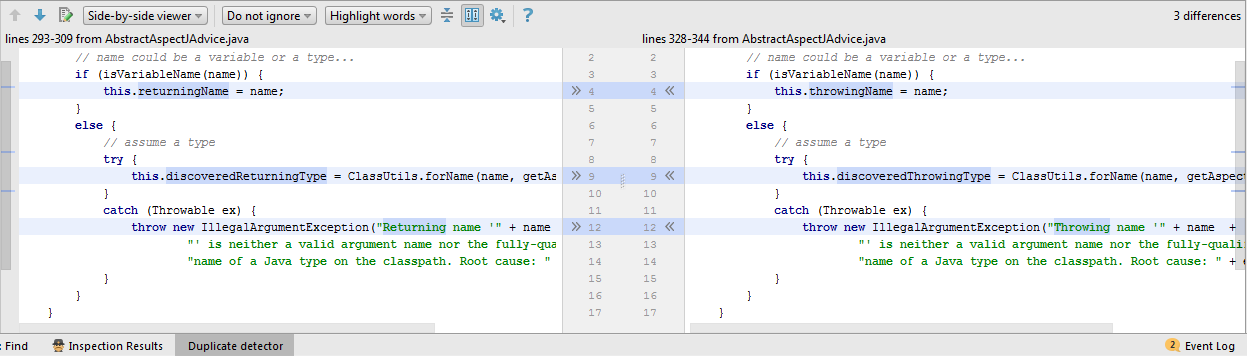

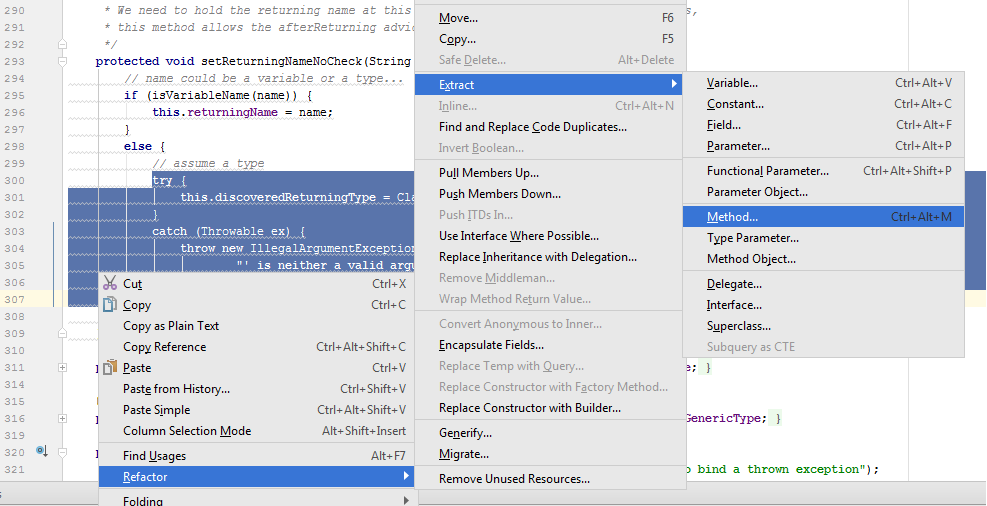

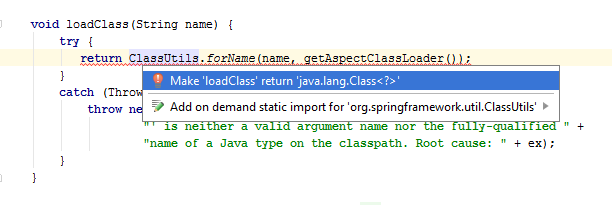

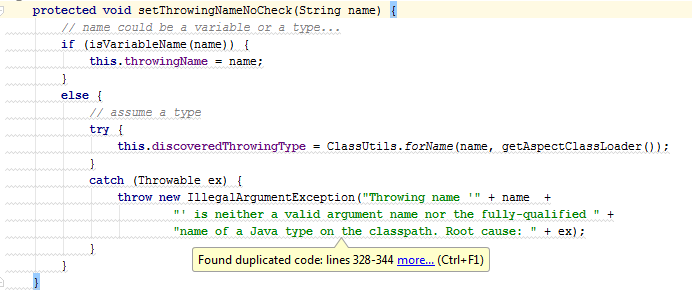

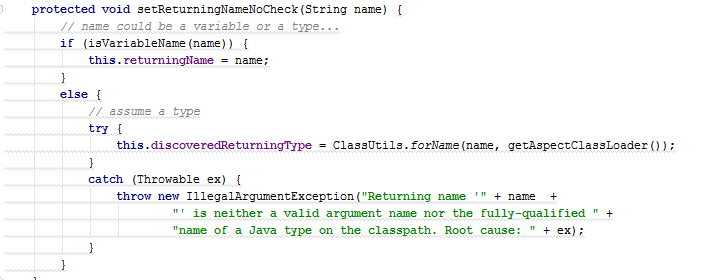

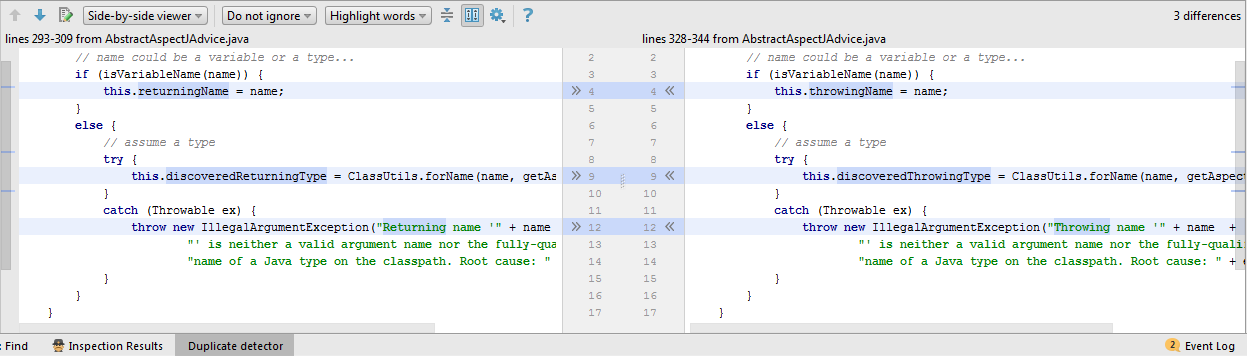

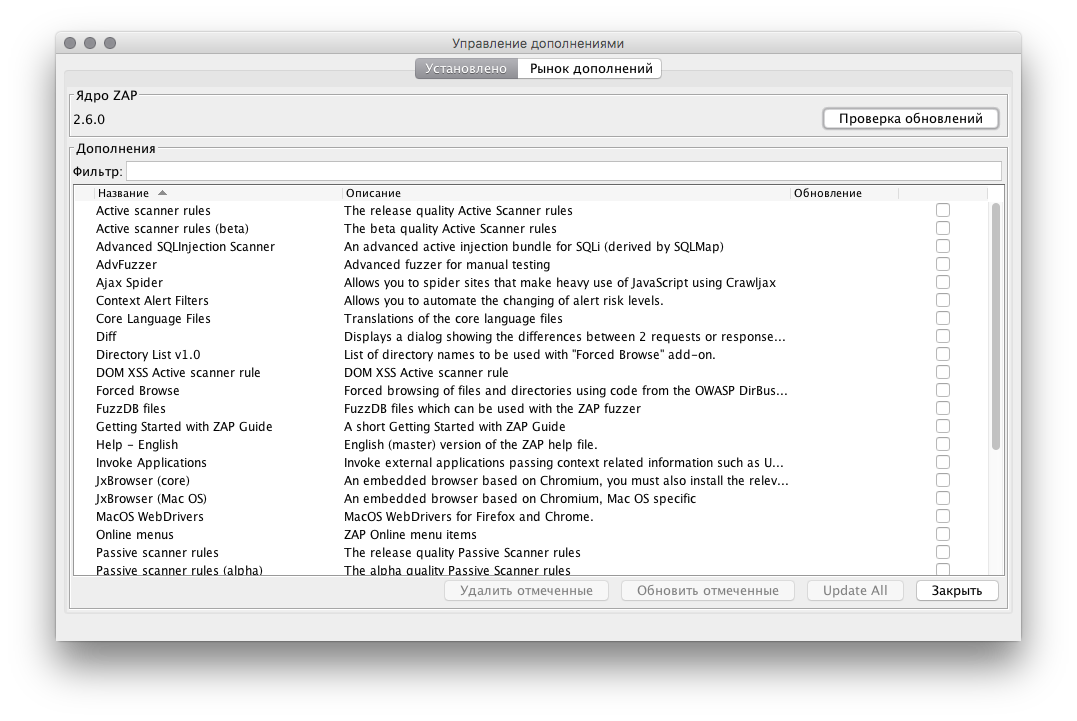

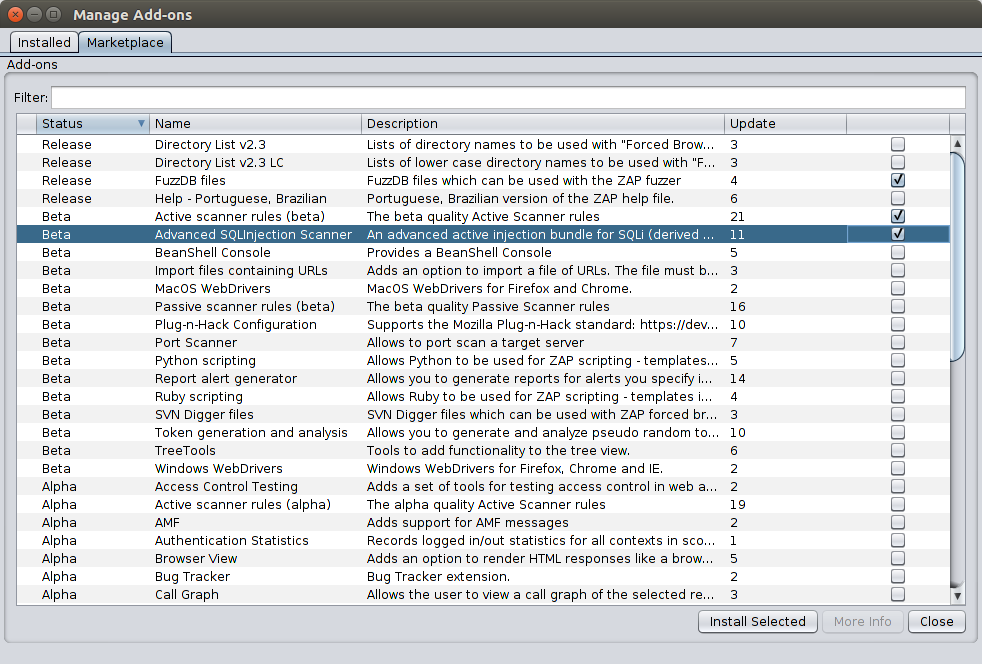

[Из песочницы] Атака клонов. Как бороться с дублированием кода? |

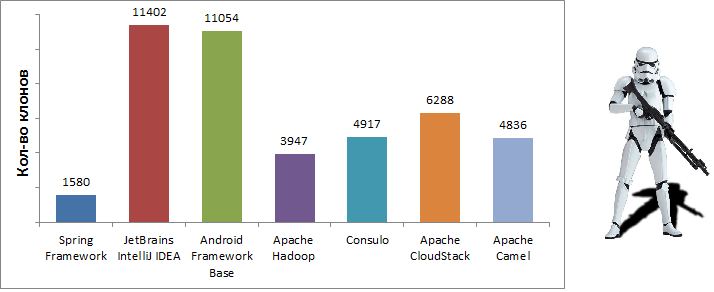

Несмотря на то, что проблемы, связанные с дублированием кода, упоминаются довольно часто, актуальность этих проблем из года в год остается почти неизменной. Во многих популярных проектах количество клонов измеряется сотнями или даже тысячами.

В рамках данной статьи мне бы хотелось напомнить, что такое программные клоны, какие они влекут за собой проблемы и как с ними можно бороться. В статье приводятся примеры рефакторинга реальных клонов из популярного фреймворка Spring. В качестве инструментов используются Java 8, IDE IntelliJ IDEA 2017.1 и плагин Duplicate Detector 1.1.

Откуда берутся клоны?

По сути, клоны — это просто схожие фрагменты исходного кода. В основном они появляются при копировании, даже не смотря на то, что копирование является общеизвестно плохой практикой. Конечно, это не единственная возможная причина появления клонов, существуют и другие, более объективные. Например, сам язык программирования может быть недостаточно выразительным, или у разработчика может не быть возможностей для соответствующего изменения исходного кода.

Можно выделить следующие основные причины возникновения клонов:

- Умышленное копирование фрагментов программы

- Многократное использование сложного API

- Повторная реализация существующей функциональности

- Слабая выразительность используемого языка

- Недостаток прав для модификации исходного кода

Нужно ли бороться с клонами?

С одной стороны, дублированный код обладает рядом очевидных недостатков. Такой код труднее изменять и развивать, из-за дубликатов увеличивается размер проекта и усложняется его понимание. Кроме того, при копировании также возникают риски распространения ошибок из исходных фрагментов.

С другой стороны, удаление дубликатов также может привести к ошибкам, особенно, если для этого необходимо вносить существенные изменения в текст программы. Однако главным аргументом против удаления клонов является то, что такое удаление часто приводит к увеличению числа зависимостей. Довольно интересно про это написано в статье "Redundancy vs dependencies: which is worse?".

С моей точки зрения, клоны являются признаком не очень качественного исходного кода и, соответственно, влекут за собой те же проблемы. К сожалению, их не всегда можно эффективно удалить, да и не всегда именно они являются настоящей проблемой. В некоторых случаях они могут указывать на неудачный выбор архитектуры или на чрезмерную захламленность функции.

В конечном счете, удалять клоны или нет — зависит от конкретной ситуации. Однако, в любом случае, дублированный код — это всегда повод задуматься.

Инструменты для поиска клонов

Существует довольно много инструментов для поиска клонов: PMD, CCFinder, Deckard, CloneDR, Duplicate finder (maven plugin), и многие другие.

К сожалению, в основном эти инструменты не интегрированы со средой разработки. Отсутствие интеграции значительно затрудняет навигацию и рефакторинг клонов. При этом, инструментов, встроенных в среду разработки, оказывается не так много. Например, в случае IntelliJ IDEA выбор стоит только между стандартными инспекциями и двумя плагинами (PMD и Duplicate Detector).

Данная статья преследует две цели. С одной стороны, с ее помощью мне бы хотелось внести свой скромный вклад в борьбу с дублированием исходного кода. С другой стороны, я бы хотел познакомить читателя с плагином Duplicate Detector, разработчиком которого я и являюсь. На данный момент, по сравнению со стандартными инспекциями, этот плагин обнаруживает в 3-4 раза больше клонов, предоставляет более удобный интерфейс и доступен для некоммерческой версии IntelliJ IDEA.

Основные возможности плагина Duplicate Detector:

- Анализ кода на лету (во время редактирования)

- Анализ проектов промышленного масштаба (с миллионами строк кода)

- Удобная навигация и сравнение дубликатов

- Поддержка языков Java и Kotlin

- Для работы с legacy кодом

- Для удобного code review