Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Для чего используется SBC на границе сетей |

Растущая заинтересованность в виртуализации приложений и сетевой функциональности только добавляет вопросов типа «возможно ли развернуть SBC в виртуальной среде и не проиграть в функциональности».

Как видно из названия, SBC (Session Border Controller, пограничный контроллер сессий) – это оборудование (или ПО), устанавливаемое на границе сетей и что-то контролирующее.

Контроль, который обеспечивает SBC, в первую очередь касается именно голосового трафика (сигнального и медийного), объемы которого растут в силу перехода от TDM к IP, набирающего обороты день ото дня. Сразу отметим, что этот тип оборудования ничего общего не имеет с файерволами и системами безопасности, работающими на уровне IP в обычных сетях СПД. Скорее наоборот, он дополняет и покрывает те участки, где даже самый продвинутый файервол ничего проконтролировать и тем более защитить не сможет.

Для начала и с целью упрощения понимания задач, которые решает SBC, я хотел бы напомнить читателям, что в теме пакетного голоса информация об IP адресах конечных элементов, участвующих в установлении соединения, находится в нескольких (разных) местах сигнального сообщения. Т.е. это не только IP адрес на третьем уровне, но и на более высоких уровнях, да и не в одном месте, и не только в заголовках пакетов и сообщений. Из этого следует, что оборудование, контролирующее голосовой тип трафика, должно знать, понимать и анализировать всю специфику передачи пакетного голоса на всех уровнях, начиная с третьего (IP).

Приступим к рассмотрению основных функциональных задач SBC. После каждой озвученной задачи буду давать короткое пояснение.

1. Скрытие внутренней топологии вашей сети от внешнего мира.

Под внутренней топологией понимается любая информация о сетевых настройках (IP адреса), устройствах и версиях ПО, пути прохождения голосового трафика, использовании трансляции адресов (NAT) и пр. Чтобы исключить вопросы и удивление, которое обычно испытывает руководство верхнего уровня операторов и корпоративных заказчиков, перефразирую так: да, такую деликатную информацию о вашей внутренней сетевой инфраструктуре, частично или полностью, достаточно легко можно получить путем простого анализа голосового трафика с помощью бесплатных анализаторов трафика. Это совсем не шутка. Такая информация по крупицам легко собирается из разных полей и заголовков сообщений сигнального и медийного голосового трафика. Часть специалистов инженерных служб заказчика на этом этапе успешно парируют: наши сетевые устройства (CPE, роутеры и тд и тп) используют функциональность ALG (Application Layer Gateway), которая помогает нам с этими проблемами. Отчасти это так, но только в совсем мизерной части. Чтобы завершить обсуждение различных ALG, которые исходя из моего многолетнего опыта работы в области пакетного голоса, зачастую только добавляют проблем в нормальной передаче трафика, приведу простую таблицу сравнения ALG и SBC.

Видно, что SBC производит полный анализ всех пакетов информации на любом уровне и должен уметь обрабатывать голосовой трафик так, чтобы исключить передачу деликатной информации наружу по любым стыкам.

Теперь поедем дальше, обсуждая только SBC и вычеркнув из рассмотрения всяческие ALG.

2. Разделение доверенных (внутренних) и недоверенных (внешних) сетей по различным физическим сетевым интерфейсам (разделение сетей на физическом уровне)

Защита передачи информации – это не только настройка различных фильтров, аксесс листов и других правил обработки и анализа трафика. В большинстве случаев применения рекомендуется физическое разделение внутренней и внешней сети путем разнесения стыков по разным физическим интерфейсам. Зачастую количество таких интерфейсов превышает два и определяется в зависимости от схемы включения. Как правило, имеет смысл как минимум говорить о разделении по разным физическим интерфейсам внутреннего и внешнего трафика, а также трафика управления.

3. Защита сетей

Скрытие топологии – это только один из многих аспектов, о которых приходится говорить во время обсуждения темы защиты голосовых сетей. В большинстве случаев, если не всегда, вопрос организации правильной стратегии защиты наталкивается на стандартную дилемму – защитить сеть и при этом не навредить сервису/бизнесу. Зажать в строгие правила обработки и анализа можно любой трафик, главное при этом обеспечить разумную и корректную работу всех сервисов и не дать повода абоненту/заказчику уйти к вашему конкуренту, который более грамотно настроил свою сеть и обеспечил возможность пользоваться расширенным набором сервисов. Я упоминаю здесь об этом потому, что на практике сплошь и рядом встречаются администраторы сетей, которые такой баланс не соблюдают либо в силу недостаточности знаний, либо по причине отсутствия достаточного внимания этому вопросу. Да и надо честно признать, что профессиональных специалистов в области передачи голоса не так много.

Обозначу основные моменты, на которые стоит обратить внимание при решении вопросов защиты.

a) Защита от взлома

Это самое первое, что приходит в голову при обсуждении вопросов защиты. Перечислю от простого к сложному несколько моментов, которые применяются сплошь и рядом при взломах.

- Банальное сканирование используемых портов, причем специализированными сканерами голосовых приложений и решений;

- проверка ответов вашего оборудования на стандартные сигнальные сообщения с целью выяснения деталей о вашей сети (даже минимальных данных достаточно, чтобы определить следующий шаг по взлому);

- определение некоторых типов сервисов (например, переадресации);

- подборы SIP логинов и паролей;

- сканирование сетевого трафика и анализ пакетов;

- попытки звонков от имени зарегистрированных/незарегистрированных абонентов;

- спуфинг (маскировка под легитимного абонента);

- подмена доверенных пакетов и попытка вклиниться в установленную легитимную сессию.

Наверное, достаточно для понимания серьезности проблемы. Любой нормальный SBC должен знать и уметь бороться с вышеперечисленным и не только с этим. А без детального анализа именно голосового трафика такая борьба бессмысленна. Надо понимать, что и администратор сети должен знать, как правильно настроить SBC для корректной работы. Для этого, кроме знаний, должны быть все возможности на SBC для настройки массы различных критериев, например, количество неуспешных попыток регистрации, обнаружение подозрительного трафика (не только вышеуказанные пункты, но например, анализ длины SIP сообщений) и много всего другого.

b) DoS/DDoS VoIP атаки

Задосить незащищенное голосовое оборудование можно легко, нужно только желание. И поверьте, есть масса способов сделать это, даже если применяется супер-пупер дата-файерволл. И снова проблема в том, что никакое СПД-шное оборудование не защитит, например, от безумного количества регистраций, посланных от имени корректного и легитимного абонента. Или от неимоверного количества попыток установления вызова на легитимного абонента. А все дело в том, что любой файерволл ОБЯЗАН пропусть весь этот трафик без ограничений, потому что он предназначается абсолютно легимному абоненту, а значит, должен быть обработан.

Вот только малая часть критериев, которые можно анализировать: количество попыток регистрации в секунду, превышение установленного количества посылаемых диалогов в секунду, одновременных установленных вызовов в секунду или попыток установления вызовов в секунду. Или вот, например, менее очевидные вещи: полоса, занимаемая конкретным абонентом (считать и ограничивать полосу по количеству одновременных разговоров давно уже перестало быть правильным, особенно с появлением адаптивных кодеков, способных менять занимаемую полосу в процессе разговора, без пересогласования медийной информации).

c) Некорректные голосовые пакеты

Под посылкой некорректных голосовых пакетов можно понимать несколько разных неприятных моментов, например:

— отправка длинного пакета и сигнального сообщения;

— формирование длинных полей и значений заголовков сигнальных сообщений;

— попытки вклиниться (и впоследствии перенаправить трафик не туда, куда нужно) в установленную сигнальную сессию, подменяя пакеты от легитимного абонента сторонними, но тоже легитимными пакетами;

— отправка сигнальных сообщений в измененном порядке

Думаю, не нужно пояснять, что все эти и некоторые другие неприятности могут дорого стоить, поскольку способны привести к неустойчивой, некорректной работе голосового сервиса, или к потере работоспособности вовсе.

d) Некорректные, но ничего не нарушающие сообщения SIP

Повторюсь, обычным файерволом такие пакеты и сообщения должны быть свободно пропущены, поскольку могут направляться на правильные разрешенные адреса, могут адресоваться легитимным абонентам. Однако могут причинить вред и неудобства оператору, потому что могут повлиять на работоспособность сервиса.

e) Звонки для незарегистрированных абонентов

Из вышесказанного становится понятно, что путем банального подбора и при разрешенных звонках на незарегистрированных пользователей организовать «слив» трафика за счет оператора становится не просто, а совсем просто. Комичность ситуации в том, что существует достаточно много решений, претендующих на серьезность и позволяющих делать такие вещи. Трагичность ситуации в том, что многие используют такие «решения» у себя, подвергая себя крайнему риску.

f) Возможность задавать произвольные правила анализа и проверки (классификация трафика)

Нормальный SBC должен уметь и позволять настраивать не только шаблонные часто использующиеся правила анализа трафика, но и любые разумные «хотелки/проверялки». В качестве примера, немного утрируя, приведу такое «идиотское» правило проверки: если входящий INVITE содержит более двух заголовков Via, а третий заголовок Via содержит IP адрес вида 172.х.х.100, и при этом поле From в части user part имеет набор букв XYZ, то разрешить (или запретить) обработку такого трафика. Надеюсь, понятно, что такая возможность добавляет гибкости при использовании SBC.

g) Динамические черные/белые списки и access листы

Достаточно стандартная функциональность. SBC должен уметь анализировать трафик и «автоматически» определять его легитимность. Любой подозрительный трафик, не удовлетворяющий заданным критериям, блокируется. В идеале должна поддерживаться защита по настраиваемым критериям, например, количество неуспешных попыток регистрации, количество попыток регистрации в секунду, превышение установленного количества посылаемых пакетов в секунду, обнаружение подозрительного трафика (например, длина SIP сообщений, попытки подделки SIP сообщений и вклинивания в установленную ранее активную SIP сессию)

h) Статические черные/белые списки и access листы

Ну а как же без этого? Пример: вы обнаружили злокачественный трафик, имеющий характерные признаки и причиняющий вред вашей сети. Например потому, что ваш администратор «забыл» или не подумал сконфигурировать и задать поведение SBC для какого-то сценария. Для быстрой блокировки просто закрываете поток зла, сразу весь, возможно и с частью полезного трафика. А потом начинаете думать и создавать то самое правило, которого не хватало.

Наверняка можно привести еще много примеров и задач, связанных с темой защиты. Мы рассмотрели самые основные. Для большинства ситуаций описанных возможностей SBC должно хватить.

4. Манипуляция с SIP заголовками, манипуляция с SDP

Способность модифицировать проходящие через SBC сообщения важны. В качестве самого простого примера, описывающего необходимость, вспомним о том, что уже обсудили выше – скрытие внутренней топологии сети. Модификация сигнальных сообщений на уровне SDP позволяет убрать из заголовков информацию, которую не нужно светить наружу. Другой пример – необходимость добавить или изменить информацию в сигнальных сообщениях, от которой зависит работоспособность сервиса. Вспомните, что в SIP бывают такие услуги, которые технически могут работать с использованием различных методов. И на ответной стороне вашего SIP транка метод может отличаться от того, какой применяется на вашей сети. Поэтому модификация необходимых полей позволяет обеспечивать работоспособность одинаковых сервисов, которые работают по-разному.

В добавление к вышесказанному остается сказать, что функциональность модифицировать сигнальные сообщения относится не только к заголовкам и содержимому SIP сообщений, то также и к SDP-части этих сообщений. Это важно, поскольку от SDP напрямую зависит корректность согласования и работоспособность передачи медийного трафика.

5. Нормализация SIP

Разные SIP клиенты, число которых бесконечно велико, могут иметь свои особенности работы. Зачастую эти особенности заключаются в том, что при работе этих клиентов используются нестандартные или некорректно сформированные заголовки и параметры SIP сообщений. Нормализация SIP сообщений при прохождении через SBC подразумевает приведение основных и обязательных SIP-заголовков к стандартному виду. Это означает стабилизацию работы при использовании разных SIP клиентов.

6. Обеспечение работы абонентов за NAT (NAT Traversal)

Эта тема заслуживает отдельного внимания. Во-первых, потому что использование и распространенность услуг так называемых виртуальных АТС значительно выросло. Во-вторых, в подавляющем большинстве случаев предоставление голосовых сервисов розничным абонентам (физлицам) происходит по схеме с регистрацией абонентов в ядре голосовой сети. Под ядром понимается оборудование, предоставляющее голосовые сервисы (софтсвитчи, SIP сервера, IMS и прочее). Регистрация SIP-клиентов в таких схемах включения в подавляющем большинстве случаев производится с устройств (роутеры, CPE, wifi точки доступа и пр), или из-за устройств, на которых включена функция трансляции адресов, потому что SIP-клиент имеет приватные немаршрутизируемые адреса типа 192.168.х.х и другие. Таким образом, NAT в таких схемах нельзя назвать методом, упрощающим предоставление голосового сервиса. Потому что трансляция адресов происходит на IP уровне, оставляя неизмененными адреса на более высоких уровнях. И согласование и прохождение SIP сигнализации от конечного SIP клиента до ядра сети в таких случаях подвержено трудностям. А кроме сигнального трафика есть еще и медийный. А IP адреса медийного трафика как раз передаются там, где никакой NAT их не заменит, да и не всякий ALG это умеет. Это приведет к тому, что медиа-трафик может быть направлен на немаршрутизируемые адреса. Последствия очевидны и крайне нежелательны – односторонняя слышимость как минимум, не говоря о других, менее очевидных особенностях и последствиях работы NAT. Поэтому способность SBC решать такие проблемы крайне важна. И важно, чтобы эти проблемы в идеале решались автоматически, не требуя индивидуального подхода в настройках к каждому конкретному подключению SIP абонента.

7. Совместимость с любыми сторонними решениями

Выше уже об этом упоминалось. Подключения и интерконнект с внешними сетями прогнозировано имеет дело с согласованием сигнализации SIP. Ну хотя бы потому, что несмотря на то, что SIP называют стандартом, свободную интерпретацию документов RFC разными производителями никто законодательно не отменял. Ну и вспомним, что самих «разновидностей» SIP RFC насчитывается сейчас более восьмидесяти. Теперь наверняка станет понятнее, что понимается под совместимостью. Совместить и возможность выполнить сопряжение оборудования разных производителей зачастую становится трудновыполнимой или невозможной задачей. Справиться с такими задачами могут далеко не все SBC, а только самые продвинутые.

8. Взаимодействие с сетями, имеющими стык с SS7 (поддержка SIP-I/SIP-T)

Тоже важная тема. Особенно сейчас, когда становится все более доступной возможность организации прямых межоператорских стыков с использованием SIP. Да и при подключении корпоративных клиентов тема тоже остается весьма актуальной, поскольку требуется конвертация SIP-I в обычный SIP.

Здесь речь идет о способности обрабатывать SIP трафик, в котором в SDP части передается контекст сигнализации ОКС-7, который может существенно повлиять на корректность отработки некоторых сервисов, например трансферов/форвардов, или даже прохождению базового вызова на границе двух операторов. Чтобы корректно решать эти проблемы, требуется возможность модификации некоторых полей в SDP части при прохождении транзитного вызова, или корректная конвертация SIP-I в обычный SIP. И это уже абсолютно точно функциональность профессиональных SBC, особенно если вспомнить количество различных вариантов и стандартов сигнализации ISUP. А как раз о ней и идет речь, когда мы говорим о передаче контекста ОКС-7 через SIP.

9. SIPREC для стыка с внешними система записи трафика

Тут вроде как все просто. Бывают задачи, когда требуется запись разговоров. Сразу оговоримся, что это не СОРМ (хотя иногда может применяться как workaround для СОРМ). Это запись разговоров. И речь тут о стыке со специализированными системами и решениями, которые такую задачу выполняют. Выполняется она посредством протокола Session Recording Protocol (SIPREC). Детали можно найти здесь.

Эта тема важна для части бизнес-задач. Сложность в том, что в задачах записи сессий существуют уникальные требования, которые не решены в существующих спецификациях протокола SIP. Речь идет о некоторых технических особенностях реализации решений, а также о вопросах безопасности и сохранения личных данных. Кроме этого, есть требование извещать абонента о том, что его разговор записывается. Для решения всех этих вопросов и был разработан SIPREC. Реализован далеко не у всех.

10. Разделение типов трафика по различным интерфейсам

Немного писал уже об этом. Сформулируем по-другому. Вариантов внедрения может быть много. Разделение внешнего и внутреннего трафика по различным физическим интерфейсам – это только часть. Порой нужно чтобы разный тип трафика был разделен по разным физическим интерфейсам. Например, сигнализация на одном, медиа на другом, управление на третьем. А может, нужно комбинировать. В общем, вариантов много. Полная поддержка добавляет гибкости.

11. Обеспечение взаимодействия IPv4 <-> IPv6

Тут все вроде бы просто, особых комментариев не требуется. Внедрения IPv6 уже есть, чем дальше, тем больше. Раз уж SBC стоит на границе голосовых сетей, то это его прямая обязанность – выполнять конвертацию.

12. Транскодинг

Тема большая и на самом деле очень важная. От этой функциональности зависит многое. В большинстве случаев под транскодингом понимается исключительно конвертация одного голосового кодека в другой. Однако это только верхняя часть айсберга. Под водой скрыто существенно больше. Если говорить про виртуальные решения, то при обсуждении вопросов транскодинга нужно параллельно обсуждать и производительность аппаратных серверов.

a) Конвертация TCP <-> UDP, TCP <-> TLS, UDP <-> TLS, динамическое изменение протокола транспортного уровня.

SIP поддерживает не только UDP. Существуют и другие варианты. На стыке сетей сплошь и рядом встает задача такой конвертации. И конечно же удобно, если это выполняется не только в фиксированной конфигурации, которая чаще всего встречается при подключении SIP транка, а и динамически. Ну представьте хотя бы абонентов, которые регистрируются на вашей голосовой платформе. Одни используют UDP, другие – TCP или вообще TLS. Как вы заранее поймете, как поступать с конкретным абонентом? Конечно лучше выполнять эту задачу динамически.

b) Конвертация RTP <-> SRTP

Тут тоже понятно и достаточно часто встречается. Конвертация RTP в SRTP и наоборот нужна несомненно.

c) Конвертация T.38 <-> G.711

Классика жанра. Давно и долго кричат все про смерть факсимильной связи. Но это далеко от реалий. Этот вид связи как использовался, так и продолжает использоваться. Конечно, современные системы уже в большинстве случаев экономят бумагу и отправляют факс на электронную почту в виде файла. Но от этого механизм передачи факса не меняется. Два самых распространенных формата передачи несовместимы друг с другом и требуется преобразование, если два абонента посылают факс друг другу, используя разные методы.

d) DTMF транскодинг (RFC2833 <-> inband <-> SIP INFO)

Тоже классическая проблема. Сигналы DTMF могут передаваться по-разному. Это зависит от настроек и возможностей/функциональности конкретного абонентского оборудования и голосового решения, предоставляющего конечный сервис. Но факт, что DTMF должен дойти из конца в конец. А что на пути и какой метод используется, это больной вопрос. Конвертация между различными методами крайне важна.

e) Транскодинг кодеков

Современный мир телекома движется вперед очень быстро. Ну вот пример некоторых типов кодеков, которые достаточно часто встречаются в последнее время:

G.723; G.729; G.728; NETCODER; GSM-FR; GSM-EFR; AMR; EVRC-QCELP; G.727; ILBC; EVRC-B; AMR-WB; G.722; EG.711; MS_RTA; SILK; SPEEX; OPUS.

На межоператорском стыке вопрос транскодирования в основном ограничивается транскодингом G.711 и G.729, хотя бывают и более экзотические случаи. Но при подключении корпоративных заказчиков или небольших операторов зачастую возникает задача совсем нетривильная, связанная с использованием так называемых «тяжелых» кодеков, применяющихся в специфических услугах и сервисах. Использование современных веб-сервисов или некоторых мобильных приложений также предполагает использование кодеков, отличных от общепринятых.

f) Ptime транскодирование.

Его правильнее было бы назвать по-другому, поскольку собственно транскодинга тут и как такового нет. Есть изменение времени пакетизации в рамках одного и того же кодека. Ответ на вопрос «зачем» очень прост – экономия полосы в канале. Для некоторых применений это очень важная задача и решается таким способом, позволяя экономить полосу и вычислительные мощности оборудования.

13. Поддержка REST

Многим это не нужно и они даже не заморачиваются на эту тему. Однако поддержка REST API позволяет гибко и очень просто решать многие и многие задачи. Интеграция со сторонними решениями, управление и безболезненная переконфигурация системы проводится очень быстро и не вызывает сложностей. В технологии NFV (Network Function Virtualization) протокол REST используется подавляющим большинством оркестраторов для целей контроля и управления NVF-элементов (Network Virtual Function element).

14. WebRTC и поддержка так называемых web-кодеков (например, OPUS)

WebRTC – также отдельная тема, позволяющая добавлять оператору много новых современных услуг и захватывать те ниши, на которые ранее и даже мысли не приходило обращать внимание. В основе своей WebRTC — это бесплатная open-project технология выполнения звонков, видео, чатов, передачи файлов в интернет без установки дополнительного оборудования или программного обеспечения (типа flash плейра, плагинов и пр.), напрямую из браузера персонального компьютера, с помощью Javascript API. Привлекательность и применимость очевидна. Техническая реализация требует использования WebRTC шлюза, поскольку применяется тут вовсе не SIP. WebRTC шлюз сам по себе это возможность терминации WebRTC трафика и конвертация его из WebSocket (заменяющего HTTP), в обычный SIP. Да и передача медиа трафика требует проксирования медиа, поскольку два абонента за симметричным NAT не смогут поговорить друг с другом. Но такой шлюз не выполняет задачи по обеспечению безопасности такой конвертации, а также не решает задачи защиты от DoS/DDoS атак, применение разных полиси, Call Admission Control, accoutnting, биллинг, траблешутинг, диагностику и многое другое. Поэтому такая задача ложится на плечи SBC. Т.е. сам по себе SBC должен иметь встроенную функциональность WebRTC шлюза. Ну и поддержка OPUS, поскольку этот кодек основной для применения в WebRTC. Конечно, не забудем и G.711, он также специфицирован для применения. Но на практике не применяется, поскольку не дает никакого качества в открытом интернете, слишком восприимчив к потерям пакетов и другим параметрам, определяющим качество голоса.

15. Маршрутизация SIP трафика на основе IP адресов, А и Б номеров, времени суток, доступности оборудования, стоимости минуты трафика и т.д. и т.п

О необходимости выполнять гибкую маршрутизацию на SBC можно говорить долго. Она нужна, и чем гибче возможности, тем больше выгоды для оператора, особенно для тех, кто использует I-SBC для пиринга. Для A-SBC задача гибкой маршрутизации также важна, особенно в случае предоставления услуг виртуальной АТС.

16. Возможность перемаршрутизации трафика на основе ответа оконечного оборудования

Эту задачу выделил отдельно, для I-SBC при пиринге она критически важна.

17. QoS для приоритезации трафика на определенном IP направлении или для определенного пользователя/клиента

Функциональность тоже, на мой взгляд, не требует детального описания и обсуждения. Подключаемые клиенты и операторы вправе заботиться о качестве и часто просят его обеспечить. А некоторые, так вообще требуют отчетов по качеству передаваемого трафика. В итоге побеждает тот, у кого качество выше.

В идеале, конечно, выигрывает тот, чей SBC умеет сохранять статистику о качестве любого звонка, которые он обработал. Это такие параметры как джиттер, потери пакетов, задержки, эхо, MOS, причины завершения вызова, инициатор завершения вызова, и многое другое. Иными словами, SBC одновременно выступает в качестве пробника трафика на сети.

18. Call Admission Control, ограничения по количеству сессий, полосы пропускания, др. параметрам

Ну а эта функциональность очень часто граничит с задачей экономии денег. Ну потому что нужно и важно контролировать ресурсы своего решения, практически грамотно и рационально ограничивая вашего заказчика или абонента от «поглощения» всех или большей части доступных ресурсов, ограничивая и контролируя нагрузку на ядро сети (SIP сервер, софтсвитч и т.д.)

19. Балансировка трафика (load balancing)

Функциональность важна, когда сложность сети позволяет организовывать и выстраивать гибкие схемы отработки услуг и трафика. Причем работает в обе стороны. У кого-то есть, например, резервные каналы и их использование приветствуется для организации не только отказоустойчивых схем, но и для распределения нагрузки на сеть или распределения сервисов по элеменам ядра сети.

20. Сбор и хранение CDR

Тоже все понятно. SBC, поскольку стоит на границе сети, может применяться в том числе и как точка биллинга или стыка с биллинговой системой. Тут важно понимать, что наиболее предпочтительным является текстовый формат CDR записей.

21. Возможность обеспечения одновременной обработки трафика для режимов access (доступ с регистрацией для услуг типа виртуальной АТС) и peering (обеспечение стыка по SIP транкам)

Часто можно встретить такое ограничение, когда SBC может работать только в каком-то одном режиме. Или только пиринг, или только на доступе. Иногда применение только одного из режимов на самом деле обусловлено схемой и задачей применения SBC. Но возможность работы только в одном режиме накладывает существенные ограничения на планирование и работу сервисов на сети, вынуждая покупать второе устройство для реализации полной схемы для одновременного использования SIP транков и абонентского трафика с регистрацией абонентов на SIP сервере. Поэтому возможность работать одновременно в двух режимах важно.

Раз уж в самом начале статьи упомянут тренд на виртуализацию, давайте сразу говорить и о том, что все описанное в статье, касается и виртуальных решений в том числе. Таким образом вопрос о возможности виртуальных SBC заменять специальные аппаратные комплекcы должен отпасть сам собой. Конечно, в этом вопросе есть тонкие моменты, я планирую по этому поводу отдельную статью.

|

Метки: author AUDC-SP разработка систем связи информационная безопасность asterisk sbc voip виртуализация приложений голосовая связь безопасность пакетная передача |

Когда IP-адресов будет хватать всем? |

Недавно у абонентов МТС Центрального федерального округа появилась возможность опробовать выход в интернет с использованием IPv6. За одну сессию по этому протоколу абоненту выдается адресация сразу в двух стандартах: IPv4 и IPv6. Такой режим называется Dual-Stack. Для того, чтобы ваше устройство работало с IPv6, необходимо подключить бесплатную услугу «Доступ к IPv6», а также произвести некоторые настройки на абонентском терминале. В этом посте подробнее о новой услуге расскажет наш специалист Олег Ермаков, его ник на Хабрхаб — eov. Передаем ему слово.

Всем привет! Мой рассказ будет состоять из двух частей. Первая описывает пользовательские настройки и способы контроля, что все у вас идет по плану. Вторая — уже дает краткий экскурс в технологию: как это сделано на сети сотового оператора в поле «3GPP-access». Сегмент «non-3GPP» затрагиваться не будет. Это тема для отдельной статьи.

Часть I

В результате перехода на новый протокол абонент имеет следующее:

1. Сервисы, которые работают с IPv6 адресацией, будут получать и передавать трафик БЕЗ использования NAT. Не знаю, все ли сталкивались с тем, что на поисковый запрос в Google иногда требуется ввести Captcha-код, или Google вообще отказывает в поиске. Причина в том, что Google считает, что с одного public IP идет слишком много запросов, и это воспринимается им как роботизированный опрос.

2. Абонент получит public IPv6 адрес, и на него будет доступен «входящий» трафик из интернета. Сейчас же из-за применения NAT сделать это не просто.

3. Абонент, который «раздает» интернет, получит возможность на каждое устройство, которое находится за «раздающим», иметь свой IPv6 адрес. Предлагаю обсудить плюсы и минусы этого в комментариях…

Не скрою, что от перехода на IPv6 выигрываем и мы (оператор): чем больше абонентов перейдет на IPv6, тем меньше потребуется IPv4 адресов для NAT/PAT трансляций. Уверен, что 99% абонентов не задумывается о том, что в итоге финансовые затраты на закупку дополнительного пространства IPv4 понесут именно они.

Предвижу вопрос: «Когда данная услуга станет доступна абонентам всей страны»? Отвечаю. Мы работаем над этим и постараемся запустить на большей части сети доступ до конца лета этого года.

На нашем сайте есть инструкция настройки, там расписаны общие положения. Дополнительно хочу пояснить несколько моментов:

1. Пока Dual-Stack работает только на устройствах с ОС Android, Windows и на некоторых роутерах. В ближайшее время IPv6 можно будет включить и на мобильных устройствах Apple. Однако, для обеспечения работоспособности с устройствами на iOS нам нужно пройти ряд дополнительных тестов. Прошу отнестись к этому с пониманием и набраться терпения. Пока получить IPv6 на устройствах Apple можно путем подключения к «мобильной точке доступа» с работающей услугой IPv6 через Wi-Fi.

2. На текущем этапе услуга ориентирована в первую очередь на продвинутых пользователей, которые понимают, что и зачем делают. Вы приобщаетесь к высоким технологиям, а мы изучаем ваш клиентский опыт, что на данном этапе крайне важно. Мы рассчитываем получить отзыв пользователей, доработать и усовершенствовать услугу. В дальнейшем мы планируем упростить подключение и отказаться от «услуги» как таковой и сделать функционал IPv6 доступным в настройках телефонов по умолчанию «из коробки». В идеале переход на IPv6 в мобильных сетях МТС планируется бесшовным.

3. В настройках подключения в ОБЯЗАТЕЛЬНОМ порядке нужно указать APN internet.mts.ru и тип протокола IPv4v6 (это ВАЖНО). Основным признаком верного указания APN является то, что абоненту выдается IPv4 адрес из диапазона 10.0.0.0/8 RFC1918, а не из диапазона 100.64.0.0/10 RFC6598. Если же в настройках телефона выбран протокол IPv4 или IPv6, то сеть выдаст ровно то, что и запрошено (IPv4 ИЛИ IPv6). В первом случае все будет работать по IPv4, а во втором — бОльшая часть интернет-ресурсов станет недоступна просто потому, что далеко не все перешли на IPv6. Если все сделано правильно, то будет выдано два адреса IPv4 и IPv6 (Dual-Stack). Мы пока намеренно не планируем распространять решение на «неверные настройки» (с неверным APN). Поступая таким образом, мы исходим из принципа «не навреди».

4. Для доступа к интернет-ресурсам в IPv6-адресации необходимо, чтобы и система DNS работала как положено. Для абонентских сессий с IPv4v6 выдается и IPv6 DNS сервер. Наличие IPv6 DNS серверов не обязательно, потому что и IPv4 сервера успешно резолвят AAAA записи. При подключении к сети мы выдаем оба сервера исключительно для того, чтобы все было «по фэншую».

5. Обратите особое внимание на то, что абоненту выдается public IPv6 адрес (на самом деле блок адресов /64), который доступен из сети интернет! Не стоит пренебрегать элементарными мерами безопасности. Крайне желательно установить антивирус и Firewall.

Таким образом, абоненты имеют IPv4 и IPv6 адрес. Резолвинг интернет-ресурсов осуществляется и по IPv4, и по IPv6. Дело за приложениями. По нашему опыту, браузер Google Chrome в первую очередь использует протокол IPv6 для ресурсов, которые имеют возможность работать по IPv6. Например, такие популярные ресурсы как Yandex и Google уже давно работают по IPv6.

Для проверки можно использовать ресурс test-ipv6.com. Если все настроено верно, то тест покажет оценку 10 из 10.

Если это не так, то нужно убедиться в том, что выключены оптимизаторы трафика в настройках браузера.

Часть II

Здесь мы углубимся в профессиональную область. Те, кто предпочтет ограничиться прикладной частью повествования, прошу комментировать или писать в личку свои вопросы. Сразу скажу, что не смогу помочь всем, но готов рассмотреть особо интересные случаи. Спасибо за понимание.

IPv6 как таковой появился в 1998 году и описан в RFC2460, поддержка IPv6 в мобильных сетях появилась в рекомендациях 3GPP Rel99 (2000 г). Широкого распространения технология не получила. Вероятно, тогда мало кто в мире знал, что такое IPv6, а недостатка в IPv4 адресах не предвиделось. Спустя 10 лет острой необходимости так и не возникло, поэтому мы проводили внутреннее тестирование, но внедрять не стали.

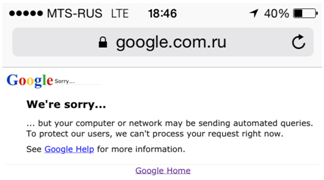

Начиная с 3GPP Rel8 для сетей LTE возникает эпоха Dual-Stack. Преимущества — налицо. Dual-Stack делает ненужными такие технологии как NAT64 и DNS64, при сохранении «обратной совместимости» с сетями на IPv4, по сути, делая плавный переход между технологиями.

Стало лучше, и это уже можно было использовать. К сожалению, при установлении соединения сеть поднимает два PDP контекста и неэффективно использует ресурсы сети.

Дальнейшее развитие Dual-Stack получило в 3GPP Rel9. В нем появилась поддержка для сетей 2G/3G и в нем же появилась возможность выдавать IPv4 и IPv6 адрес в рамках одного PDP контекста (bearer-а). Именно эта технология и применяется на сети МТС.

Если заглянуть чуть глубже, можно сказать, что 3GPP Rel10 описывает технологию DHCPv6 Prefix Delegation (DHCPv6-PD). Сейчас необходимость ее использования в мобильной сети неочевидна. Если есть конкретные предложения — пишите в комментариях или в личку.

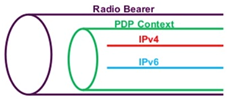

Для того чтобы технология заработала, была включена поддержка необходимого функционала на сетевых элементах HLR/HSS, SGSN/MME, GGSN/PGW, PCRF, OCS, CDR-коллектор, ну и, конечно, на транспортной сети.

HLR/HSS

Подключение услуги приводит к тому, что в HLR и в HSS меняется тип протокола в настройках APN-а с IPv4 на IPv4v6 (или both). В спецификации TS 29.272 (Rel9) дословно говорится следующее:

The PDN-Type AVP is of type Enumerated and indicates the address type of PDN. The following values are defined:

IPv4 (0)

This value shall be used to indicate that the PDN can be accessed only in

IPv4 mode.

IPv6 (1)

This value shall be used to indicate that the PDN can be accessed only in IPv6 mode.

IPv4v6 (2)

This value shall be used to indicate that the PDN can be accessed both in IPv4 mode, in IPv6 mode, and also from UEs supporting dualstack IPv4v6.

IPv4_OR_IPv6 (3)

This value shall be used to indicate that the PDN can be accessed either in IPv4 mode, or in IPv6 mode, but not from UEs supporting dualstack IPv4v6. It should be noted that this value will never be used as a requested PDN Type from the UE, since UEs will only use one of their supported PDN Types, i.e., IPv4 only, IPv6 only or IPv4v6 (dualstack). This value is only used as part of the APN subscription context, as an authorization mechanism between HSS and MME.

Как Вы уже догадались, мы используем опцию 2.

SGSN/MME

Настройка этих устройств для поддержки IPv6 несложная, она, по сути, ограничивается активацией соответствующей лицензии и включением поддержки dual-address-pdp для сервисов SGSN и MME, а также в настройках RNC, подключенных к SGSN.

PGW/GGSN

Уже не все так просто. Модернизации подвергаются:

— интерфейсы в сторону транспортной сети (поднимается address-family ipv6), и прописывается IP маршрутизация;

— прописываются ip-pool, из которых абонентам выдаются адреса;

— активируется поддержка IPv6 на APN;

— прописывается IPv6 DNS, который будет выдаваться абоненту при подключении.

PCRF/OCS

Обмен PGW c PCRF и OCS производится по протоколу Diameter (интерфейсы Gx и Gy соответственно). Особенность активации IPv6 только в том, что в этом сигнальном обмене появляется AVP Framed-IPv6-Prefix и добавляется еще одна AVP PDP-Address c IPv6 адресом. Соответственно, PCRF и OCS должны их принимать и учитывать (сохранять).

CDR-коллектор

Ожидаемо, что изменился формат CDR записей. Абонентский IPv4 адрес переместился в новое поле servedPDPPDNAddressExt, а IPv6 адрес будет записываться в servedPDPPDNAddress (это поле изначально поддерживало и IPv4 и IPv6).

servedIMSI 25001**********

p-GWAddress 213.87.x.x

chargingID 15934348563

servingNodeAddress 213.87.x.x

accessPointNameNI internet.mts.ru

pdpPDNType IPV4+IPV6

servedPDPPDNAddress 2a00:1fa0:800::5c:7ef:201

servedPDPPDNAddressExt 10.21.12.11

servinggNodePLMNIdentifier 250, 01

servedIMEISV 35915***********

rATType eUTRAN

mSTimeZone +03:00,

Транспортная сеть

Поднимается address-family ipv6 и прописывается маршрутизация.

В заключение я хочу задать вам вопрос.

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

|

Метки: author info_habr тестирование it-систем блог компании мтс мтс ipv6 pv4v6 dualstack |

Разбор доклада Артёма Гавриченкова о масштабировании TLS |

Слайды можно найти тут.

Disclaimer: про сертификаты и TLS только разбираемое выступление, а не сама статья.

Сюжет

Всегда приятно смотреть, как докладчик находит в какой-то общеупотребительной вещи подводные камни, которые вас, да-да, вот именно вас, запросто могут больно задеть. Это благодатные темы, заходят они обычно на ура. При этом человеку, который глубоко занимается тем, чем обычные люди просто пользуются, всегда есть чем шокировать публику.

Постановка задачи

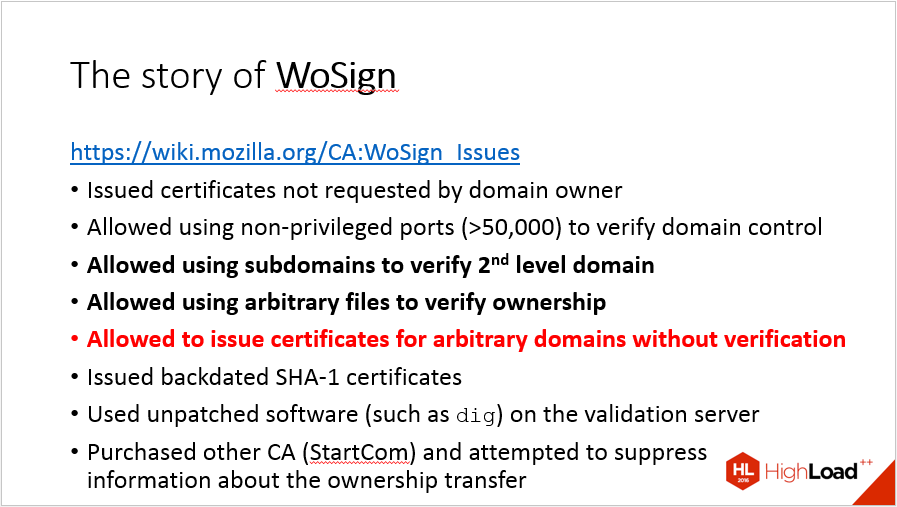

Основная часть рассказа (та, из которой уже непосредственно можно делать выводы и извлекать рекомендации) начинается в районе 9:40. Мне кажется, что к этому времени зрителю всё ещё не вполне понятно, о чём конкретно в докладе пойдёт речь, и это проблема. Cрывы покровов про то, кому принадлежат центры сертификации и почему им до сих пор «доверяют», начинаются примерно там же историей про WoSign. После этого сюжет уже не отпускает, а вот вводную часть я предложил бы сократить.

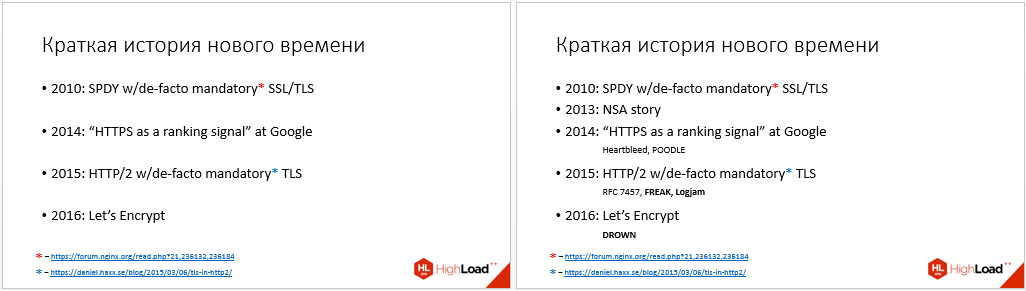

В самом деле, в начале доклада изложена новейшая история шифрования, упомянуты влияние на ранжирование Гугла, статистика Mozilla и Let's Encrypt, обнаруженные уязвимости на уровне протоколов, а также есть критика в адрес OpenSSL и GNU TLS. Объединяющая идея — технологический долг, а его главная составляющая — недостаток базовой информации у пользователей, о чём вам и расскажет… Это выглядит не вполне логично: редко случается, чтобы просветительскую деятельность связывали с возвратом технологического долга.

Привести зрителей к теме ликбеза можно было иначе, в частности, после упоминания Гугла и заботы о пользователях можно сразу перейти к «допустим, вы в первый раз задумались о том, чтобы внедрить шифрование, какие же задачи вам предстоит решить?»

Многие элементы информации, упомянутые во введении, терять жалко, но они естественно переносятся в другие секции. В частности, про Let's Encrypt, рост числа тех, кто им пользуется и краудфандинговую кампанию можно отлично рассказать в конце пункта «у кого купить сертификат».

Примеры

Примеры — одна из тех вещей, которые делают этот доклад интересным и достаточно простым для восприятия. Хочу отметить, что тут Артём всё делает отлично, и призвать читателей брать с него, да, пример.

Обратите внимание, что истории конкретны и содержат детали. У каждой ошибки, как известно, есть имя, фамилия и отчество, и в докладе они по возможности приведены. GlobalSign в октябре 2016 года проводил технические работы по перекроссировке корневых и промежуточных сертификатов и случайно отозвал все свои промежуточные сертификаты — здесь довольно много деталей, и это хорошо. Конкретные детали, даже если они не принципиальны для понимания сути, придают рассказу убедительности. Если подробности не отнимают много времени, не надо раздумывать, включать их в рассказ или нет. Включать, однозначно.

Если пример масштабен (в случае с GlobalSign проблема коснулась таких сервисов, как Wikipedia, Dropbox, Spotify), это придаёт ему веса.

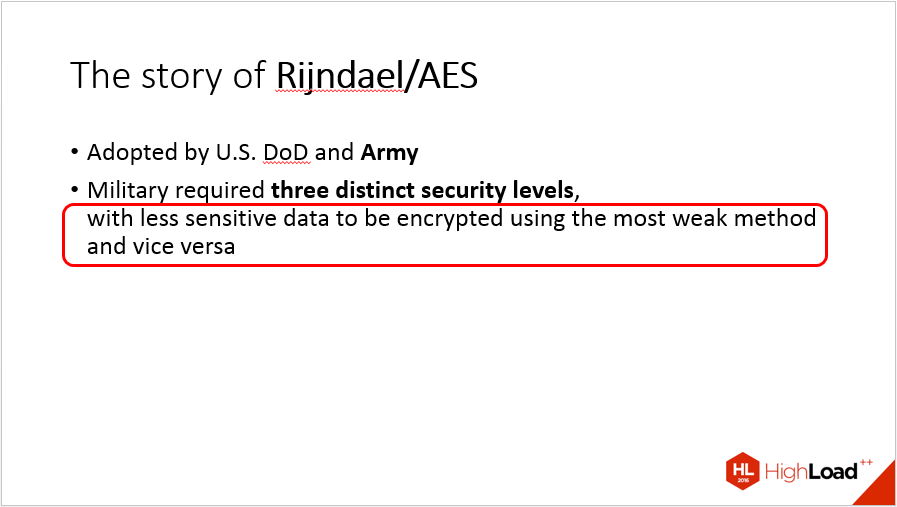

Парадоксальность примеров (когда первая мысль — WTF?) делает всё выступление более запоминающимся. В нашем случае истории про WoSign и про AES 128 / 256, пожалуй, укладываются в это определение. Последняя история ещё отлично ложится на стереотип о том, что «военные все тупые», который, независимо от реального положения дел, довольно крепко сидит в головах у многих из нас.

Поведение докладчика

Только не подумайте запятая что я читаю по бумажке

Имеет смысл прокомментировать листы с заметками, которые Артём держит в руках. Была пара отзывов от зрителей, которым это не понравилось, но я считаю, что тут всё хорошо. Многие люди с таким же успехом делают себе заметки докладчика в PowerPoint, Keynote или что у вас там. Кому-то удобнее бумажный носитель, некоторые люди до сих пор книжки читают бумажные. Важно лишь то, что докладчик должен обращаться к аудитории, а не к своим заметкам. Залипать в экране-суфлёре ничем не лучше, чем залипать в своих бумажках, зрители это замечают одинаково легко. Артём почти всё время смотрит в зал и говорит со зрителями, так что, на мой взгляд, распечатки докладу не вредят.

Слайды

Самодостаточность

Я исхожу из убеждения, что слайды — лишь сопроводительный материал, который помогает показывать то, что зрителям нужно именно увидеть, а также помогает не сбиться с мысли, если рассказ сложный. У Артёма явно прослеживается (подробнее об этом ниже) попытка сделать слайды самодостаточными, т.е. такими, которые можно просмотреть и получить примерно ту же информацию, что и от посещения живого выступления.

Я не могу рекомендовать этот подход. Он увеличивает количество текста на слайдах, при этом текст похож на то, что спикер говорит. Многие зрители при этом невольно тратят очень много энергии на то, чтобы сличить текст слайдов с речью и понять, насколько они совпадают. В случае, как у нас, англоязычных слайдов и русской устной речи неоправданный расход батарейки в голове зрителя может быть при этом очень высок.

Рассмотрим несколько примеров того, что можно безболезненно сократить (список не исчерпывающий).

Слайд 26:

У WoSign грехов на три расстрела. Возможно, некоторые из них для сокращения объёма стоит опустить. Кроме того, я бы вынес ссылку на CA:WoSign_issues в заголовок слайда. Это применимо не только здесь, но и на некоторых других слайдах: если у нас есть только один буллет первого уровня, а под ним россыпь подпунктов, то лучше этот буллет вынести в заголовок.

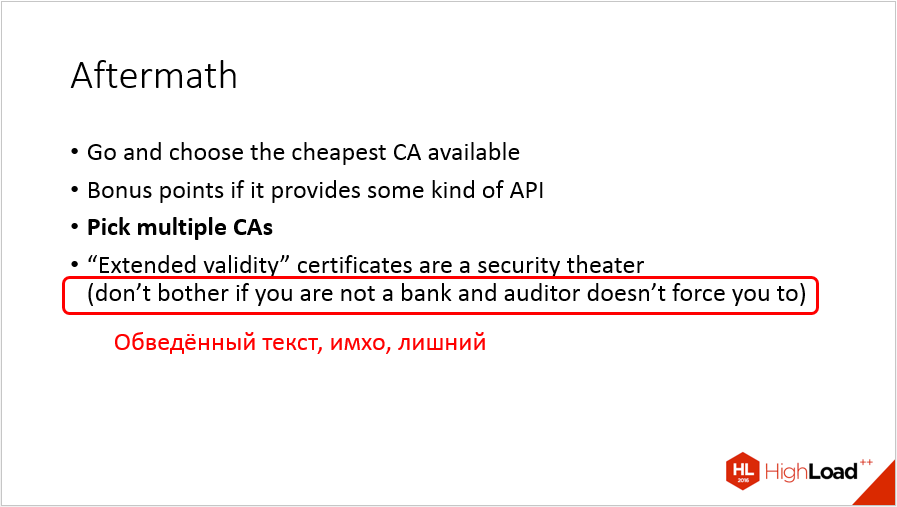

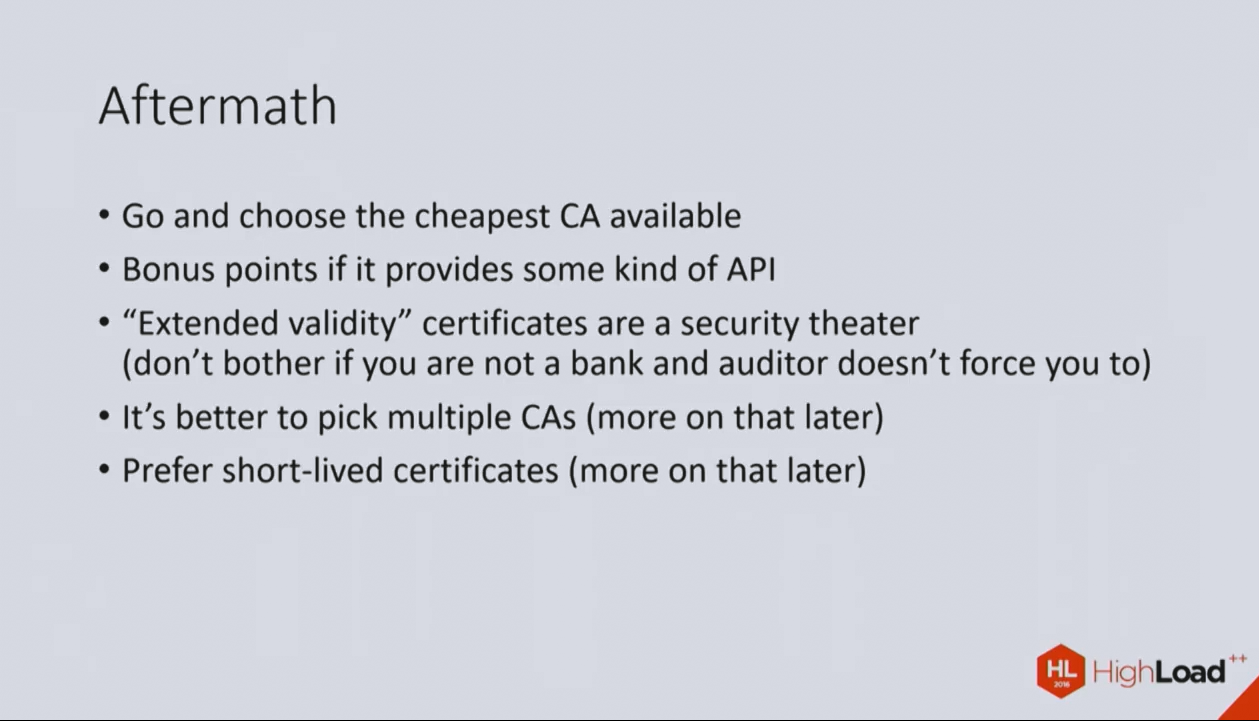

Слайд 33:

Про банки точно достаточно сказать голосом.

Кстати, слайды 33-34 на видео отличаются от опубликованных на сайте конференции. Это нормально, но я хочу привлечь внимание к слайду 34 из ролика (появляется на 18:05):

Здесь, кроме банков, есть ещё и два экземпляра «more on that later», которые на слайде совершенно не нужны.

Слайд 59:

Здесь та же проблема с дублированием на слайде текста, который стоит оставить только в голосе.

В целом доклад Артёма таков, что его трудно сопроводить графическими материалами. Нет ощущения, что в каких-то местах на слайды просятся диаграммы, схемы и картинки. В такой ситуации я бы предложил сосредоточить внимание людей на речи докладчика, а текст на экране сокращать.

Последовательный показ и сохранение контекста

В условиях, когда слайды в основном текстовые и текста много, довольно сильно спасает последовательный показ элементов на слайдах и максимальное сохранение контекста рассказа неизменным. Я убеждён, что достраивание существующей картины маленькими шагами экономит зрителям силы, делает восприятие проще. В рассматриваемом докладе этот приём применяется часто и успешно. Например, посмотрим на вступительные десять слайдов (первые ~8 минут). Для дальнейшего важно сравнить второй и десятый (если вы открыли слайды по ссылке, то пробегитесь и по тем, что между ними):

Во-первых, второй и пятый слайд совпадают. То есть на третьем и четвёртом докладчик показал нам графики, важные для антуража, а затем возвращает нас ровно в то место, из которого нужно продолжать рассказ. Многие докладчики боятся в точности повторить слайд, который они уже один раз показывали. Так вот, на всякий случай скажу, что ничего страшного в этом нет.

Во-вторых, далее последовательно появляются элементы, дополняющие рассказ «с другой стороны». Показать весь десятый слайд сразу нельзя: появятся спойлеры, пропадёт контраст между событиями. В других местах Артём также показывает буллеты последовательно, и так гораздо легче следить за происходящим и понимать, в каком месте рассказа мы в данный момент находимся.

Регулярные разборы

Если вы хотите получить обратную связь по своему выступлению, то я с радостью вам её предоставлю.

- Ссылка на видеозапись выступления.

- Ссылка на слайды.

- Заявка от автора. Без согласия самого докладчика ничего разбирать не будем.

Всё это нужно отправить хабраюзеру p0b0rchy, то есть мне. Обещаю, что отзыв будет конструктивным и вежливым, а также осветит и положительные моменты, а не только то, что надо улучшать.

|

Метки: author p0b0rchy криптография блог компании jug.ru group презентация разбор сертификаты безопасности tls |

ИТ на стадионе «Открытие Арена». Когда адреналина в проекте не меньше, чем во время матча |

Игра навылет

Стадион «Открытие Арена» – нечто среднее между торговым центром, гостиницей и аэропортом. Он рассчитан на 45 тысяч болельщиков. Это сравнимо со средней пропускной способностью аэропорта Пулково в сутки. Чтобы попасть на стадион, эти 45 тысяч человек должны пройти через турникеты, оборудованные билетно-пропускной системой. Билетно-пропускная система работает через ЛВС. Сбои ЛВС или самой билетно-пропускной системы означают давку у турникетов и прочие неприятности.

Гости на стадионе бывают четырех типов: фанаты, более спокойные любители футбола (так называемая категория «Публика»), VIP и СМИ. Журналистам нужен Wi-Fi и проводной доступ в интернет. Им важно как можно быстрее отправить репортаж в редакцию, так что в случае малейших проблем с интернетом они сразу же устраивают скандал.

Места для СМИ

В подтрибунном пространстве есть рестораны и торговые павильоны, работа которых завязана на кассовые терминалы. Еще там висят телевизоры, на которые можно транслировать рекламу или картинку с поля, – это очень удобно, можно стоять в очереди за хот-догом и смотреть футбол. Если телевизор ломается, компания, с которой заключен договор на трансляцию рекламы по этому телевизору, вправе выкатить стадиону неустойку. Кассовые терминалы тоже работают по ЛВС, и хуже всего, если во время матча перестанут проходить банковские транзакции. Страшно представить, что могут устроить 45 тысяч человек в замкнутом пространстве, если их не покормить вовремя.

В VIP-зоне за дополнительную плату можно снять скай-бокс – отдельное помещение с видом на поле, баром, официантами и собственной ложей на трибуне. Там тоже работает Wi-Fi и висят телевизоры. Аренда скай-бокса стоит дорого, поэтому и здесь любые проблемы с Wi-Fi и телевизорами однозначно обернутся претензиями в адрес стадиона.

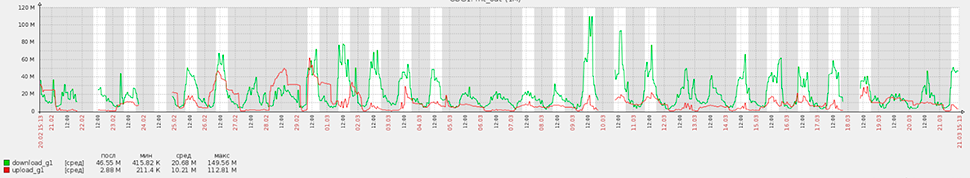

Статистика потребления интернет-трафика на стадионе «Открытие Арена» за месяц. Наиболее активные потребители — СМИ и офис футбольного клуба «Спартак».

Таким образом на каждый матч может прийти 45 тысяч человек, стадион за них отвечает и прилагает титанические усилия, чтобы все прошло гладко. Это огромный стресс и ответственность для всех, кто трудится на стадионе, в том числе для айтишников. Когда в следующий раз будете болеть за любимую команду, подумайте об этом.

Космос как предчувствие

В январе 2012 года стадион пригласил нас поучаствовать в конкурсе на СКС, ЛВС, АТС, серверную инфраструктуру, систему коллективного приема телевидения (СКПТ) и систему видеорекламы (Digital Signage). Туда же входил Wi-Fi, но этой теме мы посвятим отдельный пост. Чтобы победить в конкурсе, надо было выполнить два простых условия: предложить наиболее оптимальное по цене решение и доказать, что оно будет безотказно работать во время мероприятия.

Так выглядел стадион в декабре 2012 года, когда мы начали проектирование

В качестве исходных данных было техническое задание на три листа и куча проектной документации разной степени вменяемости. ЛВС и Wi-Fi были спроектированы на Cisco.

Запомнилось, что коммутатор Cisco Catalyst 6509 шел в спецификации без интерфейсных плат, трансиверов, лицензий, блоков питания и SMARTNETов. Cisco для этого проекта подходил, но не давал преимуществ в цене, так что решили заменить его на аналог от Huawei.

Результат получился дешевле и не уступал Cisco в надежности эксплуатации. Конечно, аналог от Huawei мог немножко покапризничать в ходе пуско-наладки и уступал Cisco в ассортименте доступных руководств по администрированию. Так и получилось, но в угоду оптимизации капитальных затрат с этим пришлось смириться.

Начали думать, как без ущерба для надежности сэкономить на серверах, СХД и оборудовании бесперебойного питания. Нам позвонили из российского представительства Huawei и предложили рассмотреть линейку ИБП UPS2000 с двойным преобразованием, X86-серверы Huawei Tecal и СХД OceanStor. В 2012 году для России это было совершенно незнакомое оборудование, особенно когда речь шла о UPS2000.

Так получилось решение с эксклюзивным железом, в котором ЛВС, Wi-Fi, серверы, СХД и даже ИБП были от одного вендора. В 2012 году ни с каким другим вендором осуществить эту идею было нельзя (сейчас из известных вендоров можно еще на HPE и DELL, но на DELL – вообще экзотика).

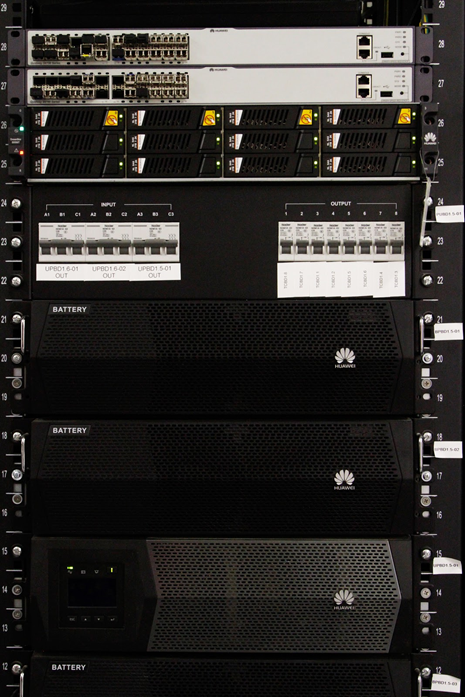

В двух дальних стойках — ИБП Huawei 2000 для серверных помещений. Фактически это три ИБП мощностью 15КВА каждый. Суммарная мощность составляет 45КВА. Oceanstor 5500С — слева.

Вопрос о надежности решили следующим образом. Поскольку опыта эксплуатации предлагаемого оборудования Huawei в России не было, ЛАНИТ пришлось поставить на кон свою 25-летнюю репутацию.

По условиям контракта, если в течение 5 лет с момента ввода в эксплуатацию заказчика не устраивает надежность того, что мы предлагаем, мы забираем оборудование себе, ставим что-то другое и платим за это самостоятельно.

В принципе, с Huawei можно было зайти еще дальше — взять АТС eSpace, Digital Signage vSpace, и сделать на Huawei вообще все, кроме лотков и СКС. Но не сложилось. vSpace не подошло по функционалу (об этом – чуть ниже), а по АТС выбор в итоге пал на Ааstra (бывшая Ericsson, ныне Mitel Networks). Заказчик хотел использовать базовые станции IP DECT по всему стадиону, потому нужно было заложить в проект станцию со встроенной поддержкой этого функционала. Наиболее дешевой из рассматриваемых и соответствующих требованиям оказалась Aastra.

Телевизоры и ревность

Стадион – очень ответственный объект, и если вы думаете, что закладывать туда оборудование без опыта эксплуатации в России – большой риск, вы правы. Но давайте поговорим об IPTV/Digital Signage.

Несмотря на внешнее сходство, это совершенно разные по функционалу системы, и на стадионе «Открытие Арена» у меня от них до сих пор ощущение, как от езды на американских горках. Это потому, что по ходу проекта постоянно менялось и количество ТВ-панелей, и чуть ли ни каждый телевизор хотя бы раз перекочевал из системы IPTV в Digital Signage или обратно. Поэтому решили спроектировать обе системы на одной платформе.

Заказчику идея понравилась. Еще ему хотелось с помощью такой системы управлять всеми телевизорами удаленно, обеспечить возможность наложения на ТВ-поток текстовой бегущей строки, поддержку Adobe Flash, пользовательский портал для контента Video-on-Demand и много чего еще. Таким требованиям из известных нам решений соответствовали: Cisco Stadium Vision (Cisco Systems, США), Tripleplay (Tripleplay Services, Великобритания) и C-nario (YCD Multimedia, США/Израиль). Для всех троих стадион обещал стать первым проектом подобного масштаба в России.

Начали сравнивать архитектуру решений. Первым с дистанции сошел C-nario. У него фантастический функционал, но в качестве приставок Set-top-box, при помощи которой система подключается к телевизору, предлагались x86-неттопы на базе Windows, что вызывало вопросы к надежности. Еще система на C-nario получилась самой дорогой.

Stadium Vision оказался дешевле C-nario, использовал проприетарные приставки set-top-box с логотипом Cisco на лицевой панели, и это было плюсом, так как в теории они более надежны, чем неттопы на Windows. Однако Cisco немножко ревновала нас к Huawei и всячески намекала на то, что если ЛВС будет не на Cisco, то работать должно, но вендор ничего не гарантирует (до сих пор интересно, почему).

У Tripleplay была принципиально другая архитектура. Англичане гарантировали совместимость с ЛВС любого вендора, а в качестве приставок set-top-box использовали изделия производства компании Amino, которые, в принципе, можно было свободно приобрести в России и использовать не только с Tripleplay. При наличии достаточного количества лицензий любую приставку можно было перевести из режима IPTV в Digital Signage парой кликов мышкой в панели администрирования.

Все это настраивало на более позитивный лад и выглядело бы совсем шикарно, если бы не то, как в Tripleplay предлагалось решать задачу удаленного управления ТВ-панелями.

В принципе, Tripleplay мог управлять ТВ-панелями либо через HDMI (но без гарантии совместимости с конкретной моделью телевизора), либо по RS232, но через переходник USB-RS232 из-за отсутствия порта RS232 у приставки Amino. Нам не подходили оба варианта, поскольку переходников не хотелось, а заказчик утвердил спецификацию ТВ-панелей чуть ли не перед самой закупкой. В результате заказчик выбрал Tripleplay и решил организовать удаленное управление ТВ-панелями на отдельном решении в виде контроллера AMX, который взаимодействовал с телевизорами по ЛВС.

Архитектура IPTV/Digital Signage получилась вот такая:

Реакция на мороз

На дворе январь 2013 года. На стадионе четыре сектора, по проекту подтрибунное пространство отапливается только в одном из них – западном. Однако даже оно не отапливалось. В этом пришлось убедиться в ходе прокладки лотков и кабельной инфраструктуры.

Вот так мы ходили к будущему стадиону зимой 2013 года. Коллеги рассказывали, что видели зайцев, которые прибегали с Тушинского поля.

Минус тридцать градусов, люди висят под потолком и тянут лотковую трассу, которая в конце концов упирается в лоток электриков или венткороб. Это потому, что представители смежных монтажных организаций, чтобы согреться, пустились прокладывать свои трассы не по проекту. В результате все стали друг другу мешать. На каждом участке собирался консилиум инженерно-технических работников заказчика и смежных монтажных организаций. Консилиум долго ругался, но потом решал, кто где будет прокладывать коммуникации. На следующем участке все повторялось. Подобная организация работ потребовала от нас проектного офиса на площадке и десанта в виде одного-двух проектировщиков. Каждый день они ходили на эти совещания и отрисовывали фактическую прокладку лотков.

Обстановка нашего проектного офиса на строительной площадке. Фотографировали летом.

С подобной спецификой организации работ приходится сталкиваться очень часто. Со временем ты привыкаешь и перестаешь понимать людей, которые тратят кучу времени на сводные планы прокладки инженерных сетей, BIM-модели, разводку коммуникаций в 3D и прочие вещи, которые совершенно бесполезны на объектах, где постоянно переделываются чертежи, меняются подрядчики, постоянно не хватает времени, и каждую неделю ты делаешь новый план-график.

Кабель мы начали прокладывать, только когда потеплело. Все равно хорошо, что мы заложили в проект кабели, которые рассчитаны на монтаж и эксплуатацию при морозе -40 градусов. Прокладка лотковых трасс по мосткам кровли стадиона оказалась не менее волнительной, так как там очень тесно, скользко и дует сильный ветер с Москвы-реки. Всего за 1 год было проложено 20 километров магистрального кабеля и 300 километров кабеля «витая пара».

Ходовые мостки кровли до начала монтажа слаботочных систем. Монтажники ежедневно проводили на них по 8-10 часов рабочего времени.

Компромисс

Когда закончились строительные работы в серверных помещениях и мы начали монтаж ИБП, всплыла одна пикантная конструктивная особенность UPS2000. В составе изделия шел распределительный щиток с автоматами, который включался между ИБП и блоками распределения питания (PDU) в стойках. Если сравнить номиналы этих автоматов, паспортные токи PDU, и номиналы автоматов вводного распределительного щитка серверного помещения, все это не соответствовало требованиям, прописанным в Правилах устройства электроустановок (они же «библия электриков», или просто ПУЭ). Мы написали об этом в Huawei, они ответили, что хотят посмотреть на все своими глазами. Так у меня состоялись самые странные деловые переговоры за всю мою карьеру.

Вот этот распределительный щиток шел в комплекте с UPS2000.

В серверной появился наш аккаунт-менеджер и три китайца. Мне их не представили, но было видно, что это не инженеры технической поддержки. Самый главный из них носил серый пиджак в клетку и был примерно полтора метра ростом. Два других носили черные пиджаки и были несколько выше главного, чего явно стеснялись. Шумел перфоратор. Воздух был мутным от строительной пыли, и мы стояли возле стоек с ИБП, потому что сесть было некуда. Мой рост – метр восемьдесят. Когда китаец в сером пиджаке говорил со мной, он смотрел на меня снизу вверх и все равно выглядел представительно. Его речь представляла собой смесь китайского и английского языка. Он искренне не понимал, в чем проблема. Я говорил о ПУЭ, принципах селективности автоматов, которые обязаны соблюдать все, кто находится в пределах границ Российской Федерации, но выражение его лица по-прежнему не менялось. Все, что он мне отвечал, тонуло в рокоте перфоратора. Когда перфоратор стих, китаец перешел на русский: «Мы можем поменять решение, но тогда мы за него не отвечаем». «По нашим законам вы и так за него не отвечаете, а отвечаю я как главный инженер проекта», – возразил я. В итоге мы договорились, что вендор приведет решение в соответствие с требованиями ПУЭ.

На самом деле практически все зарубежные вендоры, с которыми мы имеем дело, не всегда посвящены в тонкости российских ГОСТов и СНИПов. В некоторых случаях это грозит полной заменой технического решения. Хорошо, когда вендор это понимает и идет на конструктивный диалог без лишних препирательств и бюрократии.

Ведется монтаж оборудования

Грязные танцы

Чем меньше оставалось времени до окончания проекта, тем ярче становились трудовые подвиги строителей. Бригады маляров и штукатуров все чаще орудовали перфораторами в помещениях с работающими и сосущими пыль коммутаторами. Нависла угроза массового выхода из строя оборудования ЛВС и ЦОД по явно не гарантийной причине. Из положения пытались выйти продувкой «железа» баллонами со сжатым воздухом и даже заклеиванием интерфейсных портов оборудования.

Один из коммутаторов во время пуско-наладки. Порты бесхитростно заклеены малярным скотчем. Если приглядеться, виден слой строительной пыли на верхней панели устройства.

Борьба по SIP

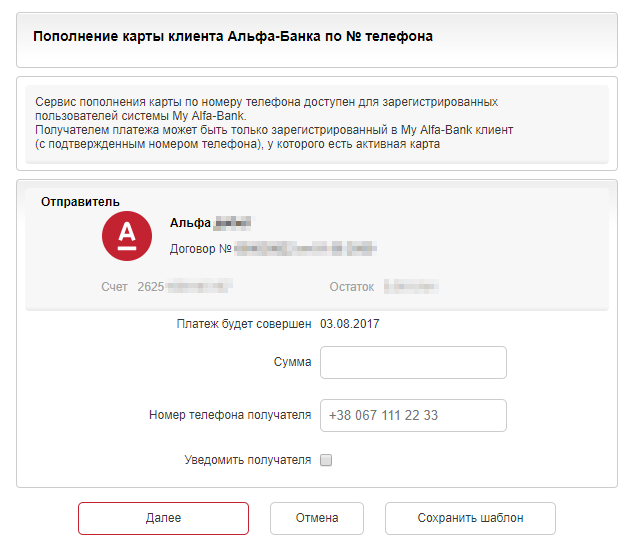

Тем временем заказчик принял решение подключить АТС не по E1, как было в проекте, а по SIP, для чего потребовались пограничные контроллеры сессий. Через месяц после принятия решения на стадион были доставлены два маршрутизатора Huawei AR2240 с платами обработки голоса.

После запуска данные устройства категорически отказались дружить по SIP с Aastra. Смена прошивки не помогла, и мы написали обращение в сервисную поддержку (TAC) Huawei. Сначала инженеры Huawei подключались к AR2240 удаленно, а когда и это не помогло, начались паломничества специалистов вендора непосредственно на объект с целью припадания к консолям маршрутизаторов и тонкой настройки параметров SIP, общее количество которых превышало 100 шт. Все закончилось патчем для ОС AR2240, который был разработан персонально для нашего проекта. После патча SIP заработал, но не так, как хотелось бы. Особенно запомнился баг, из-за которого при звонках с Aastra на номера с автосекретарем (DISA) связь рвалась через 30 секунд. Проблема решилась очередным патчем ПО маршрутизатора.

Про серверы Tecal особо вспомнить нечего – обычные серверы X86. Работали стабильно, к качеству сборки нареканий нет. Заодно познакомились с аналогом iLO у HPE для мониторинга и удаленного администрирования сервера — у Huawei Tecal это называется iMana, и оно вполне неплохо работает.

Две СХД Oceanstor S5500T тоже заработали без особых проблем, в них разве что расстроило тогдашнее отсутствие поддержки кластеризации вроде HP Peer Persistence или NetApp MetroCluster, но нам оно и не пригодилось. В настоящее время Oceanstor кластеризацию поддерживает, технология называется HyperMetro. Про нее есть статья на Хабре вот тут.

Футбол на расстоянии

Под занавес строительства у «Спартака» был запланирован выездной матч. Матч должны были показывать по телевизору в прямом эфире. Заказчик загорелся идеей вывести картинку этой трансляции на видеотабло стадиона, звук – на систему звукоусиления и пригласить на трибуны болельщиков. ТВ-сигнал в прямом эфире предлагалось брать с нашей СКПТ Tripleplay. К этому времени мы почти закончили пуско-наладку.

Видеотабло стадиона «Открытие Арена» во время церемонии открытия. Вполне подходит для просмотра телепередач.

Встала задача интеграции СКПТ, за которую отвечали мы, с системой видеотабло, за которую отвечал один подрядчик, и системой звукоусиления, за которую отвечал другой. Решили интегрировать не напрямую, а через Media Control Room стадиона, за который отвечал еще один подрядчик.

Media Control Room – центральная аппаратная мультимедийных систем стадиона. В ней формируется контент, который выдается на все средства отображения стадиона.

Нужно было как-то снять сигнал с IP-телевидения, подать его на матричный коммутатор Media Control Room’а, отмасштабировать и разделить на видео- и звуковую составляющую. Затем видео отправлялось на контроллеры табло, а звук — на микшерный пульт системы звукоусиления. При этом видео и звук не должны отставать друг от друга.

В итоге мы приобрели еще две приставки Amino A140, зарегистрировали их в системе Tripleplay и вывели на них ТВ-канал, по которому должны были транслировать матч. HDMI-интерфейс приставок через конвертеры HDMI-SDI включили в матричный коммутатор Media Control Room’а. И все заработало.

Было очень здорово сидеть на трибуне стадиона и смотреть матч по видеотабло площадью 172 кв.м.

Настоящее продолженное

Сейчас мы выполняем пуско-наладку оборудования Huawei для одного из наших заказчиков. Представьте себе, заказчику показался неудобным формат вывода одной из команд в консоли межсетевого экрана Huawei NGFW. Мы обратились в Huawei, и вендор выпустил персональный патч для Huawei NGFW заказчика, который меняет формат вывода консольной команды. Это продолжение гибкой политики Huawei, которая помогла нам построить успешный проект на новом для российского рынка оборудовании.

Проект строительства ИТ-инфраструктуры на стадионе «Открытие Арена» занял у нас 2 года. Было проложено 4500 портов СКС, сделана СКПТ на 180 ТВ-панелей, введены в эксплуатацию две СХД на 50ТБ каждая, четыре двухсокетных Rack-mount сервера для платформы виртуализации, 87 точек Wi-Fi, АТС на 250 абонентов и 36 базовых станций DECT.

Стадион стал одним из первых объектов в России, где были применены СХД Huawei Oceanstor, ИБП UPS2000, серверы Tecal и СКПТ/Digital Signage на базе решения Tripleplay. Сегодня ЛАНИТ занимается сервисной поддержкой этих решений. Это опорные решения. За время эксплуатации они успели обрасти другими ИТ-сервисами, в том числе депозитной клубной картой, которую можно использовать как для прохода на стадион, так и для оплаты покупок/дополнительных услуг на территории спорткомплекса.

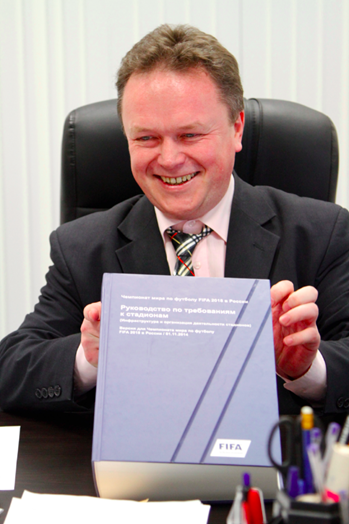

Ведется активное дооснащение стадиона для приема матчей FIFA в 2018 году. Оно затрагивает и ИТ-инфраструктуру. Причем довольно серьезно, поскольку в 2011 году, когда мы вели проектирование, стадион «Открытие Арена» не планировал участвовать в этом мероприятии.

В руках ИТ-директора стадиона «Открытие Арена» Игоря Шестунова талмуд требований FIFA к стадионам (порядка 900 страниц)

Проект получился довольно успешным. В 2014 году компания Huawei обявила его «Проектом года», а написанный ее инженерами патч вошел в состав следующей версии ОС Huawei AR2240. О надежности оборудования Huawei заказчик также отзывается позитивно, в том числе об UPS2000. Нам так и не представилась возможность оценить работу сервисного центра Huawei по доставке нового оборудования взамен того, что мы обеспыливали, так как за все время эксплуатации ни одно устройство Huawei не вышло из строя.

Нет нареканий и к решению IPTV/Digital Signage от Tripleplay. Положительные рекомендации от ИТ-службы стадиона «Открытие Арена» позволили нам предложить похожее решение для реконструкции стадиона «Лужники», которая закончилась в мае 2017 года.

Приятно, что англичане также учли опыт стадиона «Открытие Арена» и за три года значительно улучшили и без того неплохую систему, в том числе в части архитектуры. На «Лужниках» приставки set-top-box уже не нужны, вместо них используются плееры MagicInfo, встроенные в ТВ-панели Samsung. Удаленное управление ТВ-панелями работает по ЛВС без внешнего контроллера и осуществляется через WEB-интерфейс администратора системы. Мы обязательно расскажем о Tripleplay в одном из наших следующих постов.

Этот проект научил нас не бояться предлагать заказчику новые решения, если они ему действительно подходят, и если вендор, который их производит, готов тебя поддерживать. Все, что мы предложили стадиону и внедрили в 2012-2014 годах, в 2017 году востребовано и работает. Пожалуй, это главный показатель успешности и эффективности данного проекта.

|

Метки: author Raccooon системное администрирование сетевые технологии it- инфраструктура блог компании гк ланит интернет связь |

Что может и чего не может нейросеть: пятиминутный гид для новичков |

Если термины «катастрофическая забывчивость» и «регуляризация весов» вам пока ни о чем не говорят, читайте дальше: попробуем разобраться во всем по порядку.

/ Фотография Jun / CC-SA

/ Фотография Jun / CC-SAЗа что мы любим нейросети

Основное преимущество нейронных сетей перед другими методами машинного обучения состоит в том, что они могут распознавать более глубокие, иногда неожиданные закономерности в данных. В процессе обучения нейроны способны реагировать на полученную информацию в соответствии с принципами генерализации, тем самым решая поставленную перед ними задачу.

К областям, где сети находят практическое применение уже сейчас, можно отнести медицину (например, очистка показаний приборов от шумов, анализ эффективности проведённого лечения), интернет (ассоциативный поиск информации), экономику (прогнозирование курсов валют, автоматический трейдинг), игры (например, го) и другие. Нейросети могут использоваться практически для чего угодно в силу своей универсальности. Однако волшебной таблеткой они не являются, и чтобы они начали функционировать должным образом, требуется проделать много предварительной работы.

Обучение нейросетей 101

Одним из ключевых элементов нейронной сети является способность обучаться. Нейронная сеть — это адаптивная система, умеющая изменять свою внутреннюю структуру на базе поступающей информации. Обычно такой эффект достигается с помощью корректировки значений весов.

Связи между нейронами на соседних слоях нейросети — это числа, описывающие значимость сигнала между двумя нейронами. Если обученная нейронная сеть верно реагирует на входную информацию, то настраивать веса нет необходимости, а в противном случае с помощью какого-либо алгоритма обучения нужно изменить веса, улучшив результат.

Как правило, это делают с помощью метода обратного распространения ошибки: для каждого из обучающих примеров веса корректируются так, чтобы уменьшить ошибку. Считается, что при правильно подобранной архитектуре и достаточном наборе обучающих данных сеть рано или поздно обучится.

Существует несколько принципиально отличающихся подходов к обучению, в привязке к поставленной задаче. Первый — обучение с учителем. В этом случае входные данные представляют собой пары: объект и его характеристику. Такой подход применяется, например, в распознавании изображений: обучение проводится по размеченной базе из картинок и расставленных вручную меток того, что на них нарисовано.

Самой известной из таких баз является ImageNet. При такой постановке задачи обучение мало чем отличается от, например, распознавания эмоций, которым занимается Neurodata Lab. Сети демонстрируются примеры, она делает предположение, и, в зависимости от его правильности, корректируются веса. Процесс повторяется до тех пор, пока точность не увеличивается до искомых величин.

Второй вариант — обучение без учителя. Типичными задачами для него считаются кластеризация и некоторые постановки задачи поиска аномалий. При таком раскладе истинные метки обучающих данных нам недоступны, но есть необходимость в поиске закономерностей. Иногда схожий подход применяют для предобучения сети в задаче обучения с учителем. Идея состоит в том, чтобы начальным приближением для весов было не случайное решение, а уже умеющее находить закономерности в данных.

Ну и третий вариант — обучение с подкреплением — стратегия, построенная на наблюдениях. Представьте себе мышь, бегущую по лабиринту. Если она повернет налево, то получит кусочек сыра, а если направо — удар током. Со временем мышь учится поворачивать только налево. Нейронная сеть действует точно так же, подстраивая веса, если итоговый результат — «болезненный». Обучение с подкреплением активно применяется в робототехнике: «ударился ли робот в стену или остался невредим?». Все задачи, имеющие отношение к играм, в том числе самая известная из них — AlphaGo, основаны именно на обучении с подкреплением.

Переобучение: в чем проблема и как ее решить

Главная проблема нейросетей — переобучение. Оно заключается в том, что сеть «запоминает» ответы вместо того, чтобы улавливать закономерности в данных. Наука поспособствовала появлению на свет нескольких методов борьбы с переобучением: сюда относятся, например, регуляризация, нормализация батчей, наращивание данных и другие. Иногда переобученная модель характеризуется большими абсолютными значениями весов.

Механизм этого явления примерно такой: исходные данные нередко сильно многомерны (одна точка из обучающей выборки изображается большим набором чисел), и вероятность того, что наугад взятая точка окажется неотличимой от выброса, будет тем больше, чем больше размерность. Вместо того, чтобы «вписывать» новую точку в имеющуюся модель, корректируя веса, нейросеть как будто придумывает сама себе исключение: эту точку мы классифицируем по одним правилам, а другие — по другим. И таких точек обычно много.

Очевидный способ борьбы с такого рода переобучением – регуляризация весов. Она состоит либо в искусственном ограничении на значения весов, либо в добавлении штрафа в меру ошибки на этапе обучения. Такой подход не решает проблему полностью, но чаще всего улучшает результат.

Второй способ основан на ограничении выходного сигнала, а не значений весов, — речь о нормализации батчей. На этапе обучения данные подаются нейросети пачками — батчами. Выходные значения для них могут быть какими угодно, и тем их абсолютные значения больше, чем выше значения весов. Если из каждого из них мы вычтем какое-то одно значение и поделим результат на другое, одинаково для всего батча, то мы сохраним качественные соотношения (максимальное, например, все равно останется максимальным), но выход будет более удобным для обработки его следующим слоем.

Третий подход работает не всегда. Как уже говорилось, переобученная нейросеть воспринимает многие точки как аномальные, которые хочется обрабатывать отдельно. Идея состоит в наращивании обучающей выборки, чтобы точки были как будто той же природы, что и исходная выборка, но сгенерированы искусственно. Однако тут сразу рождается большое число сопутствующих проблем: подбор параметров для наращивания выборки, критическое увеличение времени обучения и прочие.

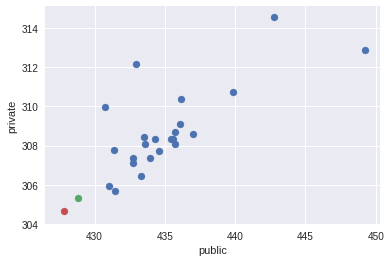

Эффект от удаления аномального значения из тренировочного свода данных (источник)

В обособленную проблему выделяется поиск настоящих аномалий в обучающей выборке. Иногда это даже рассматривают как отдельную задачу. Изображение выше демонстрирует эффект исключения аномального значения из набора. В случае нейронных сетей ситуация будет аналогичной. Правда, поиск и исключение таких значений — нетривиальная задача. Для этого применяются специальные техники — подробнее о них вы можете прочитать по ссылкам (здесь и здесь).

Одна сеть – одна задача или «проблема катастрофической забывчивости»

Работа в динамически изменяющихся средах (например, в финансовых) сложна для нейронных сетей. Даже если вам удалось успешно натренировать сеть, нет гарантий, что она не перестанет работать в будущем. Финансовые рынки постоянно трансформируются, поэтому то, что работало вчера, может с тем же успехом «сломаться» сегодня.

Здесь исследователям или приходится тестировать разнообразные архитектуры сетей и выбирать из них лучшую, или использовать динамические нейронные сети. Последние «следят» за изменениями среды и подстраивают свою архитектуру в соответствии с ними. Одним из используемых в этом случае алгоритмов является метод MSO (multi-swarm optimization).

Более того, нейросети обладают определенной особенностью, которую называют катастрофической забывчивостью (catastrophic forgetting). Она сводится к тому, что нейросеть нельзя последовательно обучить нескольким задачам — на каждой новой обучающей выборке все веса нейронов будут переписаны, и прошлый опыт будет «забыт».

Безусловно, ученые трудятся над решением и этой проблемы. Разработчики из DeepMind недавно предложили способ борьбы с катастрофической забывчивостью, который заключается в том, что наиболее важные веса в нейронной сети при выполнении некой задачи А искусственно делаются более устойчивыми к изменению в процессе обучения на задаче Б.

Новый подход получил название Elastic Weight Consolidation (упругое закрепление весов) из-за аналогии с упругой пружинкой. Технически он реализуется следующим образом: каждому весу в нейронной сети присваивается параметр F, который определяет его значимость только в рамках определенной задачи. Чем больше F для конкретного нейрона, тем сложнее будет изменить его вес при обучении новой задаче. Это позволяет сети «запоминать» ключевые навыки. Технология уступила «узкоспециализированным» сетям в отдельных задачах, но показала себя с лучшей стороны по сумме всех этапов.

Армированный черный ящик

Еще одна сложность работы с нейронными сетями состоит в том, что ИНС фактически являются черными ящиками. Строго говоря, кроме результата, из нейросети не вытащишь ничего, даже статистические данные. При этом сложно понять, как сеть принимает решения. Единственный пример, где это не так — сверточные нейронные сети в задачах распознавания. В этом случае некоторые промежуточные слои имеют смысл карт признаков (одна связь показывает то, встретился ли какой-то простой шаблон в исходной картинке), поэтому возбуждение различных нейронов можно отследить.

Разумеется, указанный нюанс делает достаточно сложным использование нейронных сетей в приложениях, когда ошибки критичны. Например, менеджеры фондов не могут понять, как нейронная сеть принимает решения. Это приводит к тому, что невозможно корректно оценить риски торговых стратегий. Аналогично банки, прибегающие к нейронным сетям для моделирования кредитных рисков, не смогут сказать, почему этот самый клиент имеет сейчас именно такой кредитный рейтинг.

Поэтому разработчики нейросетей ищут способы обойти это ограничение. Например, работа ведется над так называемыми алгоритмами изъятия правил (rule-extraction algorithms), чтобы повысить прозрачность архитектур. Эти алгоритмы извлекают информацию из нейросетей либо в виде математических выражений и символьной логики, либо в виде деревьев решений.

Нейронные сети — это лишь инструмент

Само собой, искусственные нейронные сети активно помогают осваивать новые технологии и развивать существующие. Сегодня на пике популярности находится программирование беспилотных автомобилей, в которых нейросети в режиме реального времени анализируют окружающую обстановку. IBM Watson из года в год открывает для себя всё новые прикладные области, включая медицину. В Google существует целое подразделение, которое занимается непосредственно искусственным интеллектом.

Вместе с тем порой нейронная есть — не лучший способ решить задачу. Например, сети «отстают» по таким направлениям, как создание изображений высокого разрешения, генерация человеческой речи и глубокий анализ видеопотоков. Работа с символами и рекурсивными структурами также даётся нейросистемам нелегко. Верно это и для вопросно-ответных систем.

Изначально идея нейронных сетей заключалась в копировании и даже воссоздании механизмов функционирования мозга. Однако человечеству по-прежнему нужно разрешить проблему скорости работы нейронных сетей, разработать новые алгоритмы логического вывода. Существующие алгоритмы по меньшей мере в 10 раз уступают возможностям мозга, что неудовлетворительно во многих ситуациях.