Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

«Как это работает»: Классификация ЦОД Tier |

/ фото Arthur Caranta CC

/ фото Arthur Caranta CCКлассификация Uptime Institute

У клиентов операторов дата-центров всегда были определенные ожидания и требования к предоставляемой инфраструктуре. В основном речь шла о надежности и безопасности — самых значимых показателях при выборе центра обработки данных. Вехой в становлении стандартизации стало объединение в 1989 году единомышленников в группу Uninterruptible Uptime Users Group (UUUG). По словам Эдварда Рафтера (Edward Rafter), инженера, проектировавшего ЦОДы на раннем этапе развития индустрии в США, это событие ознаменовало собой поворотный момент в обмене опытом и стало первым толчком к оценке инфраструктуры дата-центров.

В 1993 году организация Uptime Institute с помощью ассоциации компаний, ответственных за обслуживание наиболее важных ЦОДов в Америке, создала базу по обмену опытом. На ее основе начали вырабатываться способы оценки эффективности центров обработки данных. Были проанализированы аспекты, которые влияют на принятие бизнес-решений: около 30 факторов работоспособности дата-центров, относящихся к расположению, воздействию на окружающую среду и качеству обслуживания и 16 подсистем технического характера. На последних и было сосредоточено внимание Uptime Institute при разработке классификации. Она была оформлена в 1990-х в качестве стандартизованной методологии.

Uptime Institute обладает правами на сертификацию ЦОДов в соответствии с Tier-системой при проектировании, строительстве и эксплуатации инфраструктуры во всем мире. Дата-центры в России разрабатываются в соответствии с требованиями стандарта TIA-942 Ассоциации изготовителей оборудования для передачи данных (TIA) Института американских национальных стандартов. Требования TIA охватывают сферы строительства, электроснабжения, охлаждения, контроля безопасности, резервирования, ремонтопригодности и ввода в эксплуатацию.

Uptime Institute и внутренние ГОСТы используются в России как дополнения к стандартам TIA. Важно, что TIA-942, представленный в 2005 году, в свою очередь, основывается на стандарте Uptime Institute. Более того, между Uptime Institute и TIA достигнуто соглашение, в результате которого Ассоциация отказалась от использования в своей методологии термина Tier. Теперь он всецело связан с деятельностью Uptime Institute.

Если говорить о различиях двух подходов, стоит отметить, что система Uptime Institute не стремится обеспечивать жесткую техническую спецификацию того, как следует проектировать и строить ЦОДы. Стандарт TIA, напротив, диктует конкретные требования по ресурсам и доступности для каждого уровня. В отличие от Uptime Institute, TIA не имеет полномочий для проведения официальной процедуры оценки дата-центров. Также нет группы оценщиков, следящей за соблюдением стандартов. Однако конкретные требования к каждому уровню находятся в открытом доступе и не предусмотрено никакой платы за их использование. В противоположность этому Uptime Institute проводит платную сертификацию ЦОДов.

Известны четыре уровня стандарта Uptime Institute:

- Tier I — базовая инфраструктура без резервирования;

- Tier II — инфраструктура с резервными мощностями;

- Tier III — инфраструктура, поддерживающая параллельный ремонт;

- Tier IV — отказоустойчивая инфраструктура.

Каждый следующий уровень сертификации включает в себя требования для всех предыдущих уровней.

Дата-центр первого уровня предоставляет выделенную инфраструктуру для поддержки IT-систем за пределами офиса, источник бесперебойного питания для фильтрации скачков напряжения и обработки кратковременных отключений, специальное охлаждающее оборудование, которое продолжает функционировать и по завершении рабочего дня, генератор для защиты систем от продолжительных отключений электроэнергии.

ЦОДы второго уровня включают в себя резервные возможности для критически важных компонентов в целях обеспечения ремонта и повышенной защиты IT-процессов от сбоев. Резервируемые системы включают в себя оборудование для питания и охлаждения, такие как источники бесперебойного питания, чиллеры или насосы, а также генераторы.

Центр обработки данных Tier III не требует прекращения работы оборудования для замены «железа» и обслуживания. К компонентам добавляется резервный канал питания и охлаждения так, чтобы каждый элемент, необходимый для поддержки IT-системы, можно было отключить, и это не сказалось на работе.

ЦОДы Tier IV в дополнение ко всем особенностям предыдущего уровня характеризуются повышенной (еще большей, чем у Tier III) отказоустойчивостью, то есть сбои отдельных элементов или перебои резервного канала не сказываются на IT-операциях.

Принято считать, что ожидаемый уровень безотказной работы дата-центра Tier I составляет 99,671% (1729 минут годового простоя); Tier 2 — 99,741% (1361 минут годового простоя); Tier III — 99,982% (95 минут годового простоя); Tier IV — 99,995% (26 минут годового простоя).

Зачем нужна классификация ЦОДов?

Uptime Institute принимает заявки операторов дата-центров на независимую оценку инфраструктуры. Это добровольная процедура, к которой прибегают не все компании. При этом, исходя из базовой идеи классификации, прозрачность в вопросе выбора ЦОДа — благо для клиентов. Поэтому, начиная с 2015 года, Uptime Institute принялся стимулировать операторов к прохождению сертификации.

Организация объявила о новом параметре оценки дата-центров — энергоэффективности. Предлагаются два уровня соответствия: «одобренный» и «активированный». Результат оценки, по мнению Uptime Institute, свидетельствует о передовом опыте компании в отрасли. Подтвержденная энергоэффективность дата-центра выступает дополнительным аргументом для выбора клиентами.

В целом классификация важна для клиента, так как она выступает гарантией соответствия ожиданиям конечного результата в вопросе безотказной работы и производительности. Джо Хертвик (Joe Hertvik), глава консалтинговой компании Hertvik Business Services, определяет несколько сценариев использования рейтинговой системы:

- Оценка рисков при передаче инфраструктуры облачному провайдеру.

- Настройка дата-центра с целью обеспечения его соответствия конкретным бизнес-потребностям.

- Предоставление сертификата клиентам в качестве дополнительного преимущества.

- Выбор уровня доступности сети при оценке рисков.

Набор подсистем, на которых Uptime Institute концентрирует свое внимание, говорит о том, что оценка инфраструктуры позволяет взвешенно принимать решения при выборе дата-центров и формировать адекватные ожидания.

Какой Tier выбрать?

Существует распространенное заблуждение: уровень качества услуг дата-центров возрастает с каждым Tier. На самом деле, классификация ЦОДов не нацелена на то, чтобы определить лучший тип дата-центров. Каждый Tier предназначен для удовлетворения разнообразных бизнес-потребностей и требований к производительности. Различным предприятиям нужна различная инфраструктура, и для большинства организаций хостинг в центре Tier IV попросту неэффективен.

В 2013 году портал Data Center Dynamics опросил группу экспертов, чтобы выяснить, стоит ли переплачивать за переход на более высокий Tier. Раул Шеуол (Rahul Shewale), консультант в Capgemini, и доктор Карлос Гарсия де ла Ночеда (Dr Carlos Garcia de la Noceda) сошлись во мнении, что ЦОД Tier III может обладать более надежной инфраструктурой и быть более эффективным с экономической точки зрения, чем Tier IV. А Уильям Энгл (William Angle), директор CS Technology, участвовавший в создании первого в мире объекта Tier IV, полагает, что почти 60% всех сбоев происходит из-за людей, а не из-за инфраструктуры — поэтому не всегда есть смысл обращаться к максимальным конфигурациям.

Сотрудники Uptime Institute же сообщают, что расходы на инфраструктуру ЦОДов и операционные сложности возрастают от уровня к уровню, и владельцам следует выбирать Tier, который лучше соответствует потребностям конкретного бизнеса.

«Tier IV не всегда «лучше» решения Tier II. Инфраструктура центра обработки данных должна соответствовать коммерческому применению, иначе компании могут вложить чрезмерно большой капитал или взять на себя слишком большой риск», — говорится на сайте организации.

Если вспомнить последние новости, можно заметить, что стремление Бангладеша и Fujitsu к ЦОДам Tier IV объясняется климатическими и сейсмическими обстановками, но не лучшими характеристиками этих дата-центров в сравнении с другими. Строительство мега-ЦОДа власти Бангладеш анонсировали еще в 2014 году, и тогда же появилась информация о выборе под эти цели района, подверженного землетрясениям.

Представители Uptime Insitute заявили, что риски землетрясения не учитываются при сертификации Tier, однако, по словам Гэри Вонга (Gary Wong) из телекоммуникационной компании Instor Solutions, метод сейсмической изоляции учитывается Uptime Insitute для присуждения Tier IV в сейсмически опасных районах. Что касается обновления статуса дата-центров Fujitsu в Австралии, оно было вызвано отключением из-за удара молнии в 2015 году, рассказал исполнительный директор Fujitsu в Австралии и Новой Зеландии Майк Фостер (Mike Foster).

На практике получается, что возможностей дата-центров Tier I и Tier II обычно достаточно для предприятий, которые могут справиться со случайным простоем сервера в нерабочее время. Для компаний, чей бизнес функционирует в режиме 24 часа в сутки по всему миру, или для компаний, где любой простой отрицательно скажется на операционной деятельности, инвестиции в Tier III или Tier IV могут себя оправдать.

Иначе говоря, Tier I подойдет для малых предприятий, в которых IT-инфраструктура лишь расширяет внутренние бизнес-процессы и не является основным инструментом. Tier II будет достаточным для малых предприятий, чьи IT-запросы в основном ограничены традиционными рабочими часами и позволяют отключать систему в нерабочее время. Крупные предприятия с обязательствами по круглосуточному обслуживанию клиентов и автоматизации бизнес-процессов, работающие в сферах, где качество сервиса является конкурентным преимуществом, могут выбирать между Tier III и Tier IV. При этом защита от простоев в случае с Tier III является достаточной в большинстве ситуаций.

Например, мы в «ИТ-ГРАД» выбрали для размещения части своей распределенной инфраструктуры ЦОД SDN, который является дата-центром уровня Tier III. Этого достаточно, чтобы предоставлять востребованные IT-услуги, начиная от co-location и заканчивая арендой IaaS-облака, сертифицированного в соответствии с требованиями стандарта PCI DSS.

Для обеспечения должной надежности в SDN используются такие решения, как динамические источники бесперебойного питания, собственная распределительная подстанция, модульная структура, охлаждение силами установки KyotoCooling B.V. на основе роторного теплообмена. Безопасность дата-центра обеспечивается многоуровневой защитой с несколькими периметрами.

Поддержка температурно-влажностного режима в SDN

Таким образом, в дискуссии о лучшем Tier не существует универсального ответа — Tier IV не является «серебряной пулей» и подходит лишь ограниченному типу организаций. Таким образом, при выборе уровня дата-центра компании в первую очередь необходимо исходить из целей, которые она собирается решать и финансовых возможностей — все зависит от области задач конкретной компании.

P.S. Еще несколько материалов по теме из Первого блога о корпоративном IaaS:

- IaaS и виртуальный дата-центр против VPS и VDS

- Виртуальный дата-центр: уровни виртуализации

- VMware Cloud Foundation: развертывание программного ЦОД и гибридного облака

- SAP HANA и программно-определяемый ЦОД: практический кейс

|

Метки: author it_man it- стандарты блог компании ит-град ит-град tier дата-центр |

Smart IDReader SDK — добавляем распознавание в Android приложения |

Привет, Хабр! В одной из прошлых наших статей изучался вопрос встраивания ядра распознавания Smart IDReader в iOS приложения. Пришло время обсудить эту же проблему, но для ОС Android. Ввиду большого количества версий системы и широкого парка устройств это будет посложнее, чем для iOS, но всё же вполне решаемая задача. Disclaimer – приведённая ниже информация не является истинной в последней инстанции, если вы знаете как упростить процесс встраивания/работы с камерой или сделать по другому – добро пожаловать в комментарии!

Привет, Хабр! В одной из прошлых наших статей изучался вопрос встраивания ядра распознавания Smart IDReader в iOS приложения. Пришло время обсудить эту же проблему, но для ОС Android. Ввиду большого количества версий системы и широкого парка устройств это будет посложнее, чем для iOS, но всё же вполне решаемая задача. Disclaimer – приведённая ниже информация не является истинной в последней инстанции, если вы знаете как упростить процесс встраивания/работы с камерой или сделать по другому – добро пожаловать в комментарии!

Допустим, мы хотим добавить функционал распознавания документов в своё приложение и для этого у нас есть Smart IDReader SDK, который состоит из следующих частей:

bin– сборка библиотеки ядраlibjniSmartIdEngine.soдля 32х битной архитектуры ARMv7bin-64– сборка библиотеки ядраlibjniSmartIdEngine.soдля 64х битной архитектуры ARMv8bin-x86– сборка библиотеки ядраlibjniSmartIdEngine.soдля 32х битной архитектуры x86bindings– JNI обёрткаjniSmartIdEngineJar.jarнад библиотекойlibjniSmartIdEngine.sodata– файлы конфигурации ядраdoc– документация к SDK

Некоторые комментарии по содержанию SDK.

Наличие трех сборок библиотеки под разные платформы – плата за большое разнообразие устройств на ОС Android (сборку для MIPS не делаем по причине отсутствия устройств данной архитектуры). Сборки для ARMv7 и ARMv8 являются основными, версия для x86 обычно используется нашими клиентами для конкретных устройств на базе мобильных процессоров Intel.

Обёртка JNI (Java Native Interface) jniSmartIdEngineJar.jar требуется для вызова C++ кода из Java приложений. Сборка обёртки у нас автоматизирована с помощью инструментария SWIG (simplified wrapper and interface generator).

Итак, как говорят французы, revenons `a nos moutons! У нас есть SDK и нужно с минимальными усилиями встроить его в проект и начать использовать. Для этого потребуются следующие шаги:

- Добавление необходимых файлов к проекту

- Подготовка данных и инициализация движка

- Подключение камеры к приложению

- Передача данных и получение результата

Для того чтобы каждый мог поиграться с библиотекой мы подготовили и выложили исходный код Smart IDReader Demo for Android на Github. Проект сделан для Android Studio и демонстрирует пример работы с камерой и ядром на основе простого приложения.

Добавление необходимых файлов к проекту

Рассмотрим данный процесс на примере проекта приложения под Android Studio, для пользователей других IDE процесс не особо отличается. По умолчанию в каждом проекте Android Studio создает папку libs, из которой сборщик Gradle забирает и добавляется к проекту JAR файлы. Именно туда скопируем JNI обёртку jniSmartIdEngineJar.jar. Для добавления библиотек ядра существует несколько способов, проще всего это сделать с помощью JAR архива. Создаем в папке libs архив с именем native-libs.jar (это важно!) и внутри архива подпапки lib/armeabi-v7a и lib/arm64-v8a и помещаем туда соответствующие версии библиотек (для x86 библиотеки подпапка будет lib/x86).

В этом случае ОС Android после установки приложения автоматически развернёт нужную версию библиотеки для данного устройства. Сопутствующие файлы конфигурации движка добавляем в папку assets проекта, если данная папка отсутствует, то её можно создать вручную или с помощью команды File|New|Folder|Assets Folder. Как видим, добавить файлы к проекту очень просто и занимает совсем немного времени.

Подготовка данных и инициализация движка

Итак, мы добавили необходимые файлы к приложению и даже успешно его собрали. Руки так и тянутся попробовать новый функционал в деле, но для этого нужно ещё немного поработать :-) А именно сделать следующее:

- Развернуть файлы конфигурации ядра из assets

- Загрузить библиотеку и инициализировать движок

Чтобы библиотека могла получить доступ к файлам конфигурации необходимо перенести их из assets в рабочую папку приложения. Достаточно сделать это один раз при запуске и затем обновлять только при выходе новой версии. Проще всего такую проверку сделать, основываясь на версии кода приложения, и если она изменилась то обновить файлы.

// текущая версия кода приложения

int version_code = BuildConfig.VERSION_CODE;

SharedPreferences sPref = PreferenceManager.getDefaultSharedPreferences(this);

// версия кода из настроек

int version_current = sPref.getInt("version_code", -1);

// если версии отличаются нужно обновить данные

need_copy_assets = version_code != version_current;

// обновляем версию кода в настройках

SharedPreferences.Editor ed = sPref.edit();

ed.putInt("version_code", version_code);

ed.commit();

…

if (need_copy_assets == true)

copyAssets();Сама процедура копирования не сложна и заключается в получении данных из файлов, находящихся в assets приложения, и записи эти данных в файлы рабочего каталога. Пример кода функции, осуществляющей такое копирование, можно посмотреть в примере на Github.

Осталось только загрузить библиотеку и инициализировать ядро. Вся процедура занимает определённое время, поэтому разумно выполнять её в отдельном потоке, чтобы не затормаживать основной GUI поток. Пример инициализации на основе AsyncTask

private static RecognitionEngine engine;

private static SessionSettings sessionSettings;

private static RecognitionSession session;

...

сlass InitCore extends AsyncTask {

@Override

protected Void doInBackground(Void... unused) {

if (need_copy_assets)

copyAssets();

// конфигурирование ядра

configureEngine();

return null;

}

@Override

protected void onPostExecute(Void aVoid) {

super.onPostExecute(aVoid);

if(is_configured)

{

// устанавливаем ограничения на распознаваемые документы (например, rus.passport.* означает подмножество документов российского паспорта)

sessionSettings.AddEnabledDocumentTypes(document_mask);

// получаем полные наименования распознаваемых документов

StringVector document_types = sessionSettings.GetEnabledDocumentTypes();

...

}

}

}

…

private void configureEngine() {

try {

// загрузка библиотеки ядра

System.loadLibrary("jniSmartIdEngine");

// путь к файлу настроек ядра

String bundle_path = getFilesDir().getAbsolutePath() + File.separator + bundle_name;

// инициализация ядра

engine = new RecognitionEngine(bundle_path);

// инициализация настроек сессии

sessionSettings = engine.CreateSessionSettings();

is_configured = true;

} catch (RuntimeException e) {

...

}

catch(UnsatisfiedLinkError e) {

...

}

}Подключение камеры к приложению

Если ваше приложение уже использует камеру, то можете спокойно пропустить этот раздел и перейти к следующему. Для оставшихся рассмотрим вопрос использования камеры для работы с видео потоком для распознавания документов посредством Smart IDReader. Сразу оговоримся, что мы используем класс Camera, а не Camera2, хотя он и объявлен как deprecated начиная с версии API 21 (Android 5.0). Это осознанно сделано по следующим причинам:

- Класс Camera значительно проще в использовании и содержит необходимый функционал

- Поддержка старых устройств на Android 2.3.x и 4.x.x до сих пор актуальна

- Класс Camera до сих пор отлично поддерживается, тогда как в начале запуска Android 5.0 у многих производителей были проблемы с реализацией Camera2

Чтобы добавить поддержку камеры в приложение нужно прописать в манифест следующие строки:

Хорошим тоном является запрос разрешения на использование камеры, реализованные в Android 6.x и выше. К тому же пользователи этих систем всегда могут отобрать разрешения у приложения в настройках, так что проверку все равно проводить нужно.

// если необходимо - запрашиваем разрешение

if( needPermission(Manifest.permission.CAMERA) == true )

requestPermission(Manifest.permission.CAMERA, REQUEST_CAMERA);

…

public boolean needPermission(String permission) {

// проверка разрешения

int result = ContextCompat.checkSelfPermission(this, permission);

return result != PackageManager.PERMISSION_GRANTED;

}

public void requestPermission(String permission, int request_code)

{

// запрос на разрешение работы с камерой

ActivityCompat.requestPermissions(this, new String[]{permission}, request_code);

}

@Override

public void onRequestPermissionsResult(int requestCode, String permissions[], int[] grantResults)

{

switch (requestCode) {

case REQUEST_CAMERA: {

// запрос на разрешение работы с камерой

boolean is_granted = false;

for(int grantResult : grantResults)

{

if(grantResult == PackageManager.PERMISSION_GRANTED) // разрешение получено

is_granted = true;

}

if (is_granted == true)

{

camera = Camera.open(); // открываем камеру

....

}

else

toast("Enable CAMERA permission in Settings");

}

default:

super.onRequestPermissionsResult(requestCode, permissions, grantResults);

}

}Важной частью работы с камерой является установка её параметров, а именно режима фокусировки и разрешения предпросмотра. Из-за большого разнообразия устройств и характеристик их камер этому вопросу следует уделить особое внимание. Если камера не поддерживает возможности фокусировки, то приходится работать с фиксированным фокусом или направленным на бесконечность. В таком случае особо ничего сделать нельзя, получаем изображения с камеры as is. А если нам повезло и фокусировка доступна, то проверяем, поддерживаются ли режимы FOCUS_MODE_CONTINUOUS_PICTURE или FOCUS_MODE_CONTINUOUS_VIDEO, что означает постоянный процесс фокусировки на объектах съемки в процессе работы. Если эти режимы поддерживаются, то выставляем их в параметрах. Если же нет, то можно сделать следующий финт – запустить таймер и самим вызывать функцию фокусировки у камеры с заданной периодичностью.

Camera.Parameters params = camera.getParameters();

// список поддерживаемых режимов фокусировки

List focus_modes = params.getSupportedFocusModes();

String focus_mode = Camera.Parameters.FOCUS_MODE_AUTO;

boolean isAutoFocus = focus_modes.contains(focus_mode);

if (isAutoFocus) {

if (focus_modes.contains(Camera.Parameters.FOCUS_MODE_CONTINUOUS_PICTURE))

focus_mode = Camera.Parameters.FOCUS_MODE_CONTINUOUS_PICTURE;

else if (focus_modes.contains(Camera.Parameters.FOCUS_MODE_CONTINUOUS_VIDEO))

focus_mode = Camera.Parameters.FOCUS_MODE_CONTINUOUS_VIDEO;

} else {

// если нет автофокуса то берём первый возможный режим фокусировки

focus_mode = focus_modes.get(0);

}

// установка режима фокусировки

params.setFocusMode(focus_mode);

// запуск автофокуса по таймеру если нет постоянного режима фокусировки

if (focus_mode == Camera.Parameters.FOCUS_MODE_AUTO)

{

timer = new Timer();

timer.schedule(new Focus(), timer_delay, timer_period);

}

…

// таймер периодической фокусировки

private class Focus extends TimerTask {

public void run() {

focusing();

}

}

public void focusing() {

try{

Camera.Parameters cparams = camera.getParameters();

// если поддерживается хотя бы одна зона для фокусировки

if( cparams.getMaxNumFocusAreas() > 0)

{

camera.cancelAutoFocus();

cparams.setFocusMode(Camera.Parameters.FOCUS_MODE_AUTO);

camera.setParameters(cparams);

}

}catch(RuntimeException e)

{

...

}

} Установка разрешения предпросмотра достаточно проста, основные требования чтобы соотношения сторон preview камеры соответствовали сторонам области отображения для отсутствия искажений при просмотре, и желательно чтобы разрешение было как можно выше, так как от него зависит качество распознавания документа. В нашем примере приложение отображает preview на весь экран, поэтому выбираем максимальное разрешение, соответствующее соотношениям сторон экрана.

DisplayMetrics metrics = new DisplayMetrics();

getWindowManager().getDefaultDisplay().getMetrics(metrics);

// соотношение сторон экрана

float best_ratio = (float)metrics.heightPixels / (float)metrics.widthPixels;

List sizes = params.getSupportedPreviewSizes();

Camera.Size preview_size = sizes.get(0);

// допустимое отклонение от оптимального соотношения при выборе

final float tolerance = 0.1f;

float preview_ratio_diff = Math.abs( (float) preview_size.width / (float) preview_size.height - best_ratio);

// выбираем оптимальное разрешение preview камеры по соотношению сторон экрана

for (int i = 1; i < sizes.size() ; i++)

{

Camera.Size tmp_size = sizes.get(i);

float tmp_ratio_diff = Math.abs( (float) tmp_size.width / (float) tmp_size.height - best_ratio);

if( Math.abs(tmp_ratio_diff - preview_ratio_diff) < tolerance && tmp_size.width > preview_size.width || tmp_ratio_diff < preview_ratio_diff)

{

preview_size = tmp_size;

preview_ratio_diff = tmp_ratio_diff;

}

}

// установка размера preview в настройках камеры

params.setPreviewSize(preview_size.width, preview_size.height);Осталось совсем немного – установить ориентацию камеры и отображение preview на поверхность Activity. По умолчанию углу 0 градусов соответствует альбомная ориентация устройства, при поворотах экрана её нужно соответственно менять. Тут можно еще вспомнить добрым словом Nexus 5X от Google, матрица которого установлена в устройстве вверх ногами и для которого нужна отдельная проверка на ориентацию.

private boolean is_nexus_5x = Build.MODEL.contains("Nexus 5X");

SurfaceView surface = (SurfaceView) findViewById(R.id.preview);

...

// портретная ориентация

camera.setDisplayOrientation(!is_nexus_5x ? 90: 270);

// отображение preview на поверхность приложения

camera.setPreviewDisplay(surface.getHolder());

// начало процесса preview

camera.startPreview();Передача данных и получение результата

Итак, камера подключена и работает, осталось самое интересное – задействовать ядро и получить результат. Запускаем процесс распознавания, начав новую сессию и установив callback для получения кадров с камеры в режиме preview.

void start_session()

{

if (is_configured == true && camera_ready == true) {

// установка параметров сессии, например тайм-аут

sessionSettings.SetOption("common.sessionTimeout", "5.0");

// создании сессии распознавания

session = engine.SpawnSession(sessionSettings);

try {

session_working = true;

// семафоры готовности кадра к обработке и ожидания кадра

frame_waiting = new Semaphore(1, true);

frame_ready = new Semaphore(0, true);

// запуск потока распознавания в отдельном AsyncTask

new EngineTask().execute();

} catch (RuntimeException e) {

...

}

// установка callback для получения изображений с камеры

camera.setPreviewCallback(this);

}

}Функция onPreviewFrame() получает текущее изображение с камеры в виде массива байт формата YUV NV21. Так как она может вызываться только в основном потоке, чтобы его не замедлять вызовы ядра для обработки изображения помещаются в отдельный поток с помощью AsyncTask, синхронизация процесса происходит с помощью семафоров. После получения изображения с камеры даём сигнал рабочему потоку начать его обработку, по окончании — сигнал на получение нового изображения.

// текущее изображение

private static volatile byte[] data;

...

@Override

public void onPreviewFrame(byte[] data_, Camera camera)

{

if(frame_waiting.tryAcquire() && session_working)

{

data = data_;

// семафор готовности изображения к обработке

frame_ready.release();

}

}

…

class EngineTask extends AsyncTask

{

@Override

protected Void doInBackground(Void... unused) {

while (true) {

try {

frame_ready.acquire(); // ждем новый кадр

if(session_working == false) // остановка если сессия завершена

break;

Camera.Size size = camera.getParameters().getPreviewSize();

// передаём кадр в ядро и получаем результат

RecognitionResult result = session.ProcessYUVSnapshot(data, size.width, size.height, !is_nexus_5x ? ImageOrientation.Portrait : ImageOrientation.InvertedPortrait);

...

// семафор ожидания нового кадра

frame_waiting.release();

}catch(RuntimeException e)

{

... }

catch(InterruptedException e)

{

...

}

}

return null;

}После обработки каждого изображения ядро возвращает текущий результат распознавания. Он включает в себя найденные зоны документа, текстовые поля со значениями и флагами уверенности, а также графические поля, такие как фотографии или подписи. Если данные распознаны корректно или произошел тайм-аут, то устанавливается флаг IsTerminal, сигнализирующий о завершении процесса. Для промежуточных результатов можно производить отрисовку найденных зон и полей, показывать текущий прогресс по качеству распознавания и многое другое, все зависит от вашей фантазии.

void show_result(RecognitionResult result)

{

// получаем распознанные поля с документа

StringVector texts = result.GetStringFieldNames();

// получаем изображения с документа, такие как фотография, подпись и так далее

StringVector images = result.GetImageFieldNames();

for (int i = 0; i < texts.size(); i++) // текстовые поля документа

{

StringField field = result.GetStringField(texts.get(i));

String value = field.GetUtf8Value(); // данные поля

boolean is_accepted = field.IsAccepted(); .. статус поля

...

}

for (int i = 0; i < images.size(); i++) // графические поля документа

{

ImageField field = result.GetImageField(images.get(i));

Bitmap image = getBitmap(field.GetValue()); // получаем Bitmap

...

}

...

}После этого нам остается только остановить процесс получения изображений с камеры и прекратить процесс распознавания.

void stop_session()

{

session_working = false;

data = null;

frame_waiting.release();

frame_ready.release();

camera.setPreviewCallback(null); // останавливаем процесс получения изображений с камеры

...

}Заключение

Как можно убедиться на нашем примере, процесс подключения Smart IDReader SDK к Android приложениям и работа с камерой не являются чем-то сложным, достаточно всего лишь следовать некоторым правилам. Целый ряд наших заказчиков успешно применяют наши технологии в своих мобильных приложениях, причем сам процесс добавления нового функционала занимает весьма небольшой время. Надеемся, с помощью данной статьи и вы смогли убедиться в этом!

P.S. Чтобы посмотреть, как Smart IDReader выглядит в нашем исполнении после встраивания, вы можете скачать бесплатные полные версии приложений из App Store и Google Play.

|

|

[Перевод] Непрерывная интеграция: CircleCI vs Travis CI vs Jenkins |

Под катом вы найдете перевод статьи ознакомительного характера, в которой сравниваются три системы непрерывной интеграции: CircleCI, Travis CI и Jenkins.

Определение и назначение CI

Непрерывная интеграция (CI, Continuous Integration) — это практика разработки программного обеспечения, при которой изменения кода с высокой частотой интегрируются в общий репозиторий и проверяются с помощью автоматической сборки.

Непрерывная интеграция нацелена на ускорение и облегчение процесса выявления проблем, возникающих в процессе разработки программного обеспечения. При регулярной интеграции изменений единовременный объем проверок уменьшается. В результате на отладку тратится меньше времени, которое можно перераспределить на добавление новых функций. Также возможно добавить проверку стиля кода, цикломатической сложности (чем ниже сложность, тем легче тестировать) и другие виды контроля. Это упрощает рецензирование кода (code review), экономит время и улучшает качество кода.

Как это работает

- Разработчики проверяют код локально на своих компьютерах.

- Затем изменения отправляются в общий репозиторий.

- Репозиторий отправляет запрос (webhook) системе CI.

- CI-сервер запускает задание (тесты, покрытие, проверку синтаксиса и т. д.).

- CI-сервер сохраняет артефакты и выпускает релиз для тестирования.

- В случае возникновения ошибок сборки или тестирования CI-сервер оповещает команду.

- Команда исправляет проблему.

CircleCI vs Travis CI vs Jenkins

Надеюсь, теперь процесс непрерывной интеграции в общих чертах нам понятен, и мы можем перейти к сравнению нескольких популярных в настоящее время CI-платформ, у каждой из которых есть свои преимущества и недостатки. Давайте начнем с CircleCI.

CircleCI

Функции:

- CircleCI — это облачная система, для которой не нужно настраивать отдельный сервер и которую не придется администрировать. Однако существует и локальная версия, которую вы можете развернуть в частном облаке.

- Даже для коммерческого использования существует бесплатная версия.

- С помощью REST API можно получить доступ к проектам, сборкам и артефактам. Результатом сборки является артефакт или группа артефактов. Артефактом могут быть скомпилированное приложение или исполняемые файлы (например, APK для Android) или метаданные (например, информация об удачно завершившемся тестировании).

- CircleCI кэширует сторонние зависимости, что позволяет избежать постоянной установки необходимых окружений.

- Существует возможность подключения к контейнеру по SSH. Это может потребоваться, если возникнут какие-то проблемы.

- CircleCI — полностью готовое решение, требующее минимальной настройки.

CircleCI совместима с:

- Python, Node.js, Ruby, Java, Go и т. д.;

- Ubuntu (12.04, 14.04), Mac OS X (платные аккаунты);

- Github, Bitbucket;

- AWS, Azure, Heroku, Docker, выделенный сервер;

- Jira, HipChat, Slack.

Достоинства CircleCI:

- легкое и быстрое начало работы;

- бесплатная версия для коммерческого использования;

- небольшие и легко читаемые файлы конфигурации в формате YAML;

- отсутствие необходимости в выделенном сервере CircleCI.

Недостатки CircleCI:

- CircleCI в бесплатной версии поддерживает только Ubuntu 12.04 и 14.04. Для использования MacOS придется заплатить;

- несмотря на то что CircleCI может работать с любыми языками программирования, из коробки поддерживаются только Go (Golang), Haskell, Java, PHP, Python, Ruby/Rails, Scala;

- при желании подстроить систему под себя в некоторых случаях могут возникнуть проблемы, и тогда для достижения цели понадобится стороннее программное обеспечение.

Также, несмотря на то что у облачных систем есть несомненные преимущества, нужно быть готовым к тому, что в любой момент необходимая вам функция может быть убрана, и вы ничего с этим поделать не сможете.

Travis CI

Travis CI и CircleCI очень похожи

Обе системы:

- используют файлы конфигурации в формате YAML;

- развернуты в облаке;

- поддерживают Docker для запуска тестов.

Что есть в TravisCI и нет в CircleCI?

- Запуск тестов одновременно под Linux и Mac OS X.

- Поддержка большего количества языков «из коробки»:

Android, C, C#, C++, Clojure, Crystal, D, Dart, Erlang, Elixir, F#, Go, Groovy, Haskell, Haxe, Java, JavaScript (with Node.js), Julia, Objective-C, Perl, Perl6, PHP, Python, R, Ruby, Rust, Scala, Smalltalk, Visual Basic. - Поддержка build matrix.

Build matrix

language: python

python:

- "2.7"

- "3.4"

- "3.5"

env:

- DJANGO='django>=1.8,<1.9'

- DJANGO='django>=1.9,<1.10'

- DJANGO='django>=1.10,<1.11'

- DJANGO='https://github.com/django/django/archive/master.tar.gz'

matrix:

allow_failures:

- env: DJANGO='https://github.com/django/django/archive/master.tar.gz'Build matrix — это инструмент, который дает возможность выполнять тесты, используя разные версии языков и пакетов. Он обладает богатыми возможностями по настройке. Например, при неудачных сборках в некоторых окружениях система может выдать предупреждение, но сборка целиком не будет считаться неудачной (это удобно при использовании dev-версий пакетов).

TOX

Если вы предпочитаете какую-либо другую CI-платформу, то Build Matrix можно создать с помощью Tox.

[tox]

envlist = py{27,34,35}-django{18,19,110,master}

[testenv]

deps =

py{27,34,35}: -rrequirements/test.txt

django18: Django>=1.8,<1.9

django19: Django>=1.9,<1.10

django110: Django>=1.10,<1.11

djangomaster: https://github.com/django/django/archive/master.tar.gz

commands = ./runtests.py

[testenv:py27-djangomaster]

ignore_outcome = TrueTox — это универсальный консольный инструмент по управлению пакетами и их тестированию в virtualenv. Его можно установить с помощью pip install tox или easy_install tox.

Достоинства Travis CI:

- build matrix «из коробки»;

- быстрый старт;

- небольшие и легко читаемые файлы конфигурации в формате YAML;

- бесплатная версия для opensource-проектов;

- отсутствие необходимости в выделенном сервере.

Недостатки Travis CI:

- по сравнению с CircleCI цены выше, нет бесплатной версии для коммерческого использования;

- ограниченные возможности по настройке (для некоторых вещей может потребоваться сторонний софт).

Jenkins

Возможности:

- Jenkins — это автономное приложение на Java, которое может работать под Windows, Mac OS X и другими unix-подобными операционными системами.

- В Update Center можно найти сотни плагинов, поэтому Jenkins интегрируется практически с любым инструментом, относящимся к непрерывной интеграции и непрерывной поставке (continuous delivery).

- Возможности Jenkins могут быть практически неограниченно расширены благодаря системе подключения плагинов.

- Предусмотрены различные режимы: Freestyle project, Pipeline, External Job, Multi-configuration project, Folder, GitHub Organization, Multibranch Pipeline.

- Jenkins Pipeline — это набор плагинов, поддерживающих создание и интеграцию в Jenkins цепочек непрерывной поставки. Pipeline предоставляет расширяемый набор инструментов по моделированию цепочек поставки типа "as code" различной степени сложности с помощью Pipeline DSL.

- Позволяет запускать сборки с различными условиями.

- Jenkins может работать с Libvirt, Kubernetes, Docker и др.

- Используя REST API, можно контролировать количество получаемых данных, получать/обновлять config.xml, удалять задания (job), получать все сборки, получать/обновлять описание задания, выполнять сборку, включать/отключать задания.

Достоинства Jenkins:

- цена (он бесплатен);

- возможности по настройке;

- система плагинов;

- полный контроль над системой.

Недостатки Jenkins:

- требуется выделенный сервер (или несколько серверов), что влечет за собой дополнительные расходы на сам сервер, DevOps и т. д.;

- на настройку необходимо время.

Заключение

Какую систему CI выбрать? Это зависит от ваших потребностей и планируемого способа использования этого инструмента.

CircleCI хорошо подходит для небольших проектов, где основная задача — запустить непрерывную интеграцию как можно быстрее.

Travis CI рекомендуется в первую очередь для open-source проектов, которые необходимо тестировать в различных окружениях.

Jenkins я бы посоветовал для больших проектов, при работе над которыми потребуется серьезная настройка системы (в случае Jenkins выполняется с помощью плагинов). В Jenkins можно изменить практически что угодно, но на это потребуется время. Если вы хотите побыстрее запустить CI-цепочку, Jenkins может не подойти.

Ссылки:

|

Метки: author olemskoi devops блог компании southbridge circleci travis jenkins continuous integration continuous delivery |

Расширяем экосистему Skyeng, открыв API словаря — первые участники конкурса |

Месяц назад мы открыли API нашего словаря, предложили всем желающим использовать его в своих приложениях и сервисах и даже объявили конкурс среди разработчиков. За прошедшее время мы получили 18 конкурсных заявок, среди них несколько готовых решений. Сегодня мы решили в своем блоге дать авторам четырех из них возможность рассказать о своем продукте (а мы прокомментируем).

Если вы пропустили пост о нашей экосистеме, где был объявлен конкурс – вот ссылка. На тот момент у нас еще не были готовы условия конкурса — вот и они. Призовой фонд нашего конкурса составляет 200 тысяч рублей — деньги для разработчика нового приложения или сервиса не бывают лишними!

Ну а теперь — к знакомству с первыми участниками.

Евгений Криулин – Lenny English Bot

Lenny — это чатбот, который помогает пользователям пополнять их словарный запас по 10 слов в день. ЦА — это люди, которые изучают английский прямо сейчас или изучали его ранее. Большой словарный запас нужен для того, чтобы хорошо говорить, легко читать, понимать других и просто думать.

Lenny — это чатбот, который помогает пользователям пополнять их словарный запас по 10 слов в день. ЦА — это люди, которые изучают английский прямо сейчас или изучали его ранее. Большой словарный запас нужен для того, чтобы хорошо говорить, легко читать, понимать других и просто думать.

Чтобы слова не забывались, их нужно регулярно «освежать» в памяти. Далеко ходить мы не стали и построили алгоритм повторения на основе кривой забывания Эббингауза. На деле это значит, что пользователь повторяет слова через 30 минут, 1 день, 1 неделю, 1 месяц и 1 год. Таким образом слова закрепляются долговременной памяти. А в нужный момент их можно оттуда достать и применить.

Теперь о контенте. Перед началом конкурса у нас уже была база из 10 000 слов. И когда Skyeng предоставляет возможность сделать базу еще лучше, ей надо пользоваться. Мы так и сделали, получив и сохранив в отдельные файлы все необходимое.

А именно:

import requests

import time

from content import dictionary

def skyeng_word(word):

url = "http://dictionary.skyeng.ru/api/public/v1/words/search?_format=json&search={}".format(word)

response = requests.get(url)

try:

ids = response.json()[0]['meanings'][0]['id']

return skyeng_meaning(ids)

except:

return None

def skyeng_meaning(ids):

url = "http://dictionary.skyeng.ru/api/public/v1/meanings?_format=json&ids={}".format(ids)

response = requests.get(url)

return response.json()[0]['examples'][0]['text']

def get_example(word):

example = skyeng_word(word)

if example is not None:

return example

else:

return '!!! {} !!!'.format(word)

def add_example():

i = 1

while i <= 10000:

time.sleep(1)

example = get_example(dictionary[i]['word'])

with open('examples.py', 'a') as file:

file.write("{}: \"{}\"\n".format(i, example))

print(i)

i += 1

if __name__ == '__main__':

add_example()import requests

import time

from content import dictionary

def skyeng_word(word):

url = "http://dictionary.skyeng.ru/api/public/v1/words/search?_format=json&search={}".format(word)

response = requests.get(url)

try:

ids = response.json()[0]['meanings'][0]['id']

return skyeng_meaning(ids)

except:

return None

def skyeng_meaning(ids):

url = "http://dictionary.skyeng.ru/api/public/v1/meanings?_format=json&ids={}".format(ids)

response = requests.get(url)

return response.json()[0]['definition']['text']

def get_definition(word):

definition = skyeng_word(word)

if definition is not None:

return definition

else:

return '!!! {} !!!'.format(word)

def add_definition():

i = 1

while i <= 10000:

time.sleep(1)

definition = get_definition(dictionary[i]['word'])

with open('definitions.py', 'a') as file:

file.write("{}: \"{}\"\n".format(i, definition))

print(i)

i += 1

if __name__ == '__main__':

add_definition()import requests

import time

from content import dictionary

def skyeng_word(word):

url = "http://dictionary.skyeng.ru/api/public/v1/words/search?_format=json&search={}".format(word)

response = requests.get(url)

try:

voice_url = "http:{}".format(response.json()[0]['meanings'][0]['soundUrl'])

return requests.get(voice_url)

except:

return None

def get_voice():

i = 1

while i <= 10000:

time.sleep(1)

voice = skyeng_word(dictionary[i]['word'])

file_name = '{}.ogg'.format(i)

if voice is not None:

with open(file_name, 'wb') as file:

file.write(bytes(voice.content))

print(i)

i += 1

if __name__ == '__main__':

get_voice()Далее мы просто обновили текущую базу всем сохраненным.

Думаю, не стоит объяснять, почему мы сохранили контент у себя вместо того, чтобы каждый раз обращаться к API. Такой способ быстрее. А чем быстрее работает бот, тем довольнее пользователи.

Закончить свой дебют на Хабре хотелось бы афоризмом. Он отражает философию нашей небольшой команды — «Words can inspire and words can destroy. They are important to learn».

Благодарим школу Skyeng за возможность сделать продукт лучше. Спасибо всем, удачи!

Skyeng: Нам очень нравится бот LennyEnglishBot, он минималистичный и ненавязчивый, а работает на трех платформах – Telegram, Facebook и Viber. Для тех, кто не хочет или не может ставить лишнее приложение в телефон – самое оно, порог вхождения минимальный. В нашей экосистеме такой продукт очень был нужен.

Проблема, однако, в том, что этот бот не до конца интегрирован в нашу экосистему. Автор загнал туда фиксированный набор из 10 тысяч слов и подтянул к этому набору наши определения. Нет возможности тренировать произвольные слова и, главное для нас, нет возможности тренировать слова, взятые на изучение в Vimbox. Надеемся, что в будущих версиях бота все это будет учтено, потому что, повторимся, он нам очень-очень нравится.

Наиль Галиаскаров — readore.io

readore — это коллекция книг, синхронизированных с аудио-дорожкой. Каждой книге присвоен уровень сложности, что позволяет легко подобрать литературу для своего уровня владения языком. При чтении можно мгновенно переводить незнакомые слова и добавлять в список слов для запоминания. Начиная с этого момента во всех книгах это слово будет выделено, а в течение дня мы будем отправлять ему уведомление "слово-перевод".

Приложение было реализовано еще до конкурса, когда для изучения испанского я купил Маркеса в бумажном переплете. Тогда и пришла идея изучать иностранный язык с любимыми книгами.

С помощью API SkyEng наше приложение теперь снова будет работать в Украине (до этого мы использовали Яндекс.Словарь), я как раз искал бесплатную альтернативу. Ну и теперь по многочисленным просьбам пользователей, readore может похвастаться offline-словарем.

Skyeng: Нам это приложение понравилось. Симпатичное, похоже на Bookmate. В некоторых книжках есть встроенная озвучка. Встроен словарь и переводчик, можно отмечать слова на изучение. И самое приятное, что в ближайшее время у учеников нашей школы появится возможность добавлять слова на изучение в нашем мобильном приложении Words.

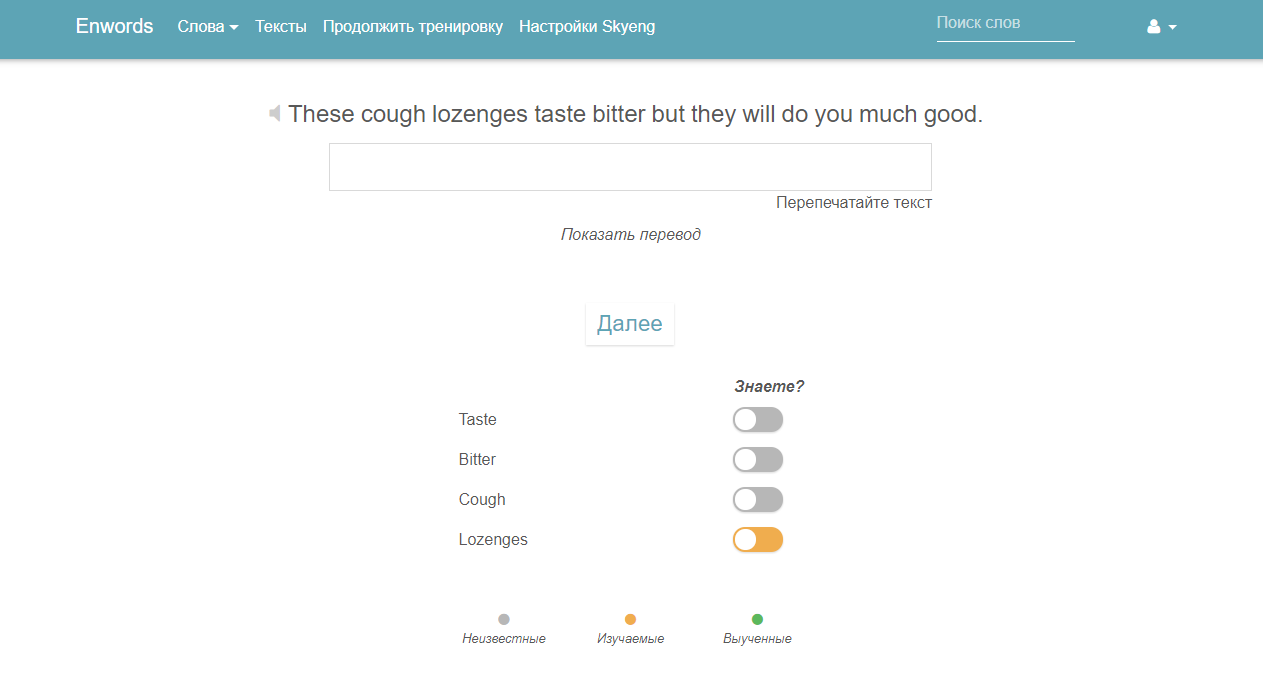

Дмитрий Садовников — Enwords

Изучаю английский уже года три, до этого мечтал смотреть фильмы и читать литературу в оригинале. Мечта сбылась, но запоминание новых слов дается с трудом, постоянно попадаются слова, которые я не знаю.

Прочитал когда-то статью на geektimes, из которой узнал про сайт tatoeba.org. Выгрузил оттуда список предложений, распарсил и выбрал самые часто встречающиеся слова, а дальше решил не ограничиваться только английским языком. В итоге была создана своя база, состоящая из 3.5 миллионов предложений, 500 тысяч слов на 30 языках, включая даже эсперанто. Создал web-приложение, в котором можно добавлять слова для изучения и отмечать выученные. Запоминание слов происходит при повторении их в небольших фразах.

Есть режим тренировок, где фразу нужно полностью перепечатать (заодно можно тренировать слепую печать). Можно загрузить текст для изучения, обычно использую тексты из уроков A.J. Hoge, он парсится, на выходе получается список слов, отсортированный по частоте встречаемости в этом тексте. Приложение не подойдет совсем новичкам в иностранных языках, грамматических уроков здесь нет.

Недавно подключил Skyeng API в связке с jQuery плагином qtip, теперь по клику на английское слово отправляется ajax запрос в Skyeng, и появляется перевод слова с озвучкой. Я давно хотел подключить такой функционал, руки не доходили, но со Skyeng это заняло буквально час. В ближайшее время позволю своим пользователям изучать слова, которые они добавили в учетной записи Skyeng, надеюсь это повысит конверсию.

Проект opensource, полностью бесплатный, если будет много пользователей, придется вводить платные функции, сервера нужно оплачивать, но основа все равно будет доступна для всех.

Написан на Ruby on Rails, любой желающий может предлагать свои идеи по функционалу, дизайну, маркетингу, вообще от product manager’а я бы не отказался.

Skyeng: Enwords предоставляет возможность самостоятельно составлять списки слов для изучения, это функционал, который активно просят пользователи нашего приложения Words. Однако текстовый парсер, в отличие от нашего Wordset Generator, не умеет сортировать слова по уровню сложности, поэтому на выходе получается очень большой список, начинающийся с артиклей, местоимений и заведомо всем известных слов; таким образом, надо потратить время на извлечение нужной для изучения лексики. Важная фишка Enwords – открытый исходный код.

UPD: новая важная фишка — возможность добавлять слова из своего аккаунта в Skyeng, достаточно указать e-mail в поле "Настройки Skyeng". Отлично!

Дмитрий Лапаев – Больше Слов

Идея приложения следующая: создать онлайн переводчик слов (фраз) с сохранением вариантов перевода (оффлайн) для детального изучения полученных значений. Т.е. подразумевается "бессистемное" расширение словарного запаса.

Идея приложения следующая: создать онлайн переводчик слов (фраз) с сохранением вариантов перевода (оффлайн) для детального изучения полученных значений. Т.е. подразумевается "бессистемное" расширение словарного запаса.

API Skyeng в настоящий момент используется в виде реализации запроса (метод "search": dictionary.skyeng.ru/api/public/v1/words/search). Порадовало то, что работает без авторизации, а результаты предоставляются как для русских, так и английских слов. Из структуры результатов запроса возникла простая реализация приложения в виде двух фрагментов: «список полученных (по запросу) слов» и «отображение значений (вариантов перевода)». Полученные значения отображаются в виде «визуальных карточек» с возможностью загрузки аудио-файлов для воспроизведения транскрипции. Результаты поискового запроса сохраняются в БД приложения (состоит из двух связанных таблиц, используется ORM Lite), аудио-файлы и изображения хранятся в директории приложения.

Каждому слову (результаты запроса) назначается одна из категорий:

1) "Для изучения",

2) "Изученное",

3) "Избранное",

4) "Просмотренное" (назначается при выборе слова для просмотра значений перевода);

при перемещении в "Изученное" формируется тестовое задание: выбрать верный из пяти предложенных вариантов перевода, случайная выборка из таблицы "значения" при совпадении поля "часть речи" (Part of speech).

Skyeng: «Больше Слов» — по сути упрощенный аналог нашего приложения Words. Хотя он не очень вписывается в нашу экосистему, мы рады его существованию: мы за разнообразие и возможность выбора.

Конкурс Skeyng продолжается, мы надеемся увидеть еще больше интересных разработок, использующих наш API. Если у вас есть идея или готовое приложение — заполните заявку.

Ну а если вы хотите разрабатывать приложения внутри Skyeng — у нас, как всегда, есть интересные вакансии.

|

Метки: author Ontaelio разработка мобильных приложений разработка веб-сайтов api блог компании skyeng экосистема конкурс идея для стартапа ридер словарь переводчик |

«Ультимативный» блокчейн-дайджест: полезные материалы на Хабре и другие источники по теме |

Сегодня мы решили подготовить тематическую подборку для тех, кто хотел бы разобраться в устройстве блокчейн-технологии, но и не забыли более «продвинутых» пользователей.

/ изображение Ron Mader CC

/ изображение Ron Mader CCДля начинающих

«C чем это едят»: что такое блокчейн

Компания BitFury принимает участие в развитии блокчейна с 2011 года. Здесь мы рассказываем об истории данной технологии, даем простое объяснение принципов работы и знакомим с основными составляющими. Этот материал стоит использовать в качестве отправной точки и рекомендовать к прочтению всем, кто хотел бы понять, что такое блокчейн.

Что такое эксклюзивные блокчейны

Простыми словами об особенностях эксклюзивных блокчейнов, их задачах, сферах применения и возможностях. В этом материале мы постарались привести как можно больше примеров и дать полезные ссылки на первоисточники. Кроме того, здесь вы найдете подраздел, посвященный фреймворкам для эксклюзивных блокчейнов.

Объяснение блокчейна для веб-разработчиков

Хабражитель Ratix подготовил перевод материала «The Blockchain Explained to Web Developers, Part 1: The Theory» за авторством Франсуа Занинотто (Francois Zaninotto). Это очередная попытка разобраться в теме с помощью самостоятельного перевода первоисточника. В этой статье вы найдете базовое определение блокчейна, краткий рассказ о криптовалютах, майнинге, блоках и контрактах.

Кто нужен блокчейн-проектам, где их искать и сколько платят специалистам

Крупнейшие международные организации начинают активное внедрение в свою деятельность технологии построения цепочки блоков транзакций. Здесь вы сможете увидеть экспертное мнение о том, какие специалисты нужны прямо сейчас, кто в них заинтересован и какие вам потребуются знания для работы с блокчейном.

Кладбище блокчейн-проектов

Это — сборник 43 инцидентов, негативно отразившихся на тех или иных криптовалютах. Беглый анализ основных причин произошедшего говорит, что основные проблемы связаны с применением методов социальной инженерии, перехватом аккаунтов облачного хранилища данных и базовых уязвимостей на уровне приложений.

Для любителей

Как майнить с помощью бумаги и ручки

mark_ablov подготовил перевод занимательной заметки Кена Ширриффа (Ken Shirriff), которую тот написал еще в 2014 году. Этот материал будет интересен тем, кто хотел бы перейти от слов к практике и разобраться в сути технологии. Помимо времени на решение задачи Кен предполагает и свое энергопотребление, хотя затраты на бумагу и ручки он исключил из общего обоснования экономической эффективности процесса.

Как масштабировать биткойн-блокчейн

Здесь мы разбираемся с тем, как устранить самый большой недостаток биткойн-блокчейна. Из этой статьи вы узнаете о тех решениях, которые предлагает мировое сообщество, и о том, какое из них станет частью биткойн-сети. Для тех, кто уже успел немного погрузиться в тему: речь пойдет о Segregated Witness и Lightning Network.

Как работать с метаданными блокчейна

Пошаговый анализ того, что можно сделать на уровне метаданных. От биткоин-адреса до Transaction ID и возможных параметров метаданных, их передачи и необходимых для этого ресурсов.

Как запустить надстройку над биткойн-блокчейном

Здесь мы приводим чуть более детальный разбор того, что из себя представляет Lightning Network. Плюс рассказываем о том, как можно настроить двунаправленный платежный канал, немного о работе в сети, трехстороннем обмене и маршрутизации в Lightning Network.

«Алгоритмы консенсуса»: Подтверждение доли и доказательство работы

Распределенный и децентрализованный характер архитектуры блокчейна ставит перед сообществом задачу распределенного консенсуса. В этой статье мы начинаем со структуры блокчейн-сетей, говорим о консенсусе и «доказательстве работы». Помимо этого — приводим альтернативы для PoW. Этот материал мы рекомендуем «продвинутым пользователям».

«Криптография в блокчейнах»: о хеш-функциях и цифровых подписях

Разбираемся с тем, что лежит в основе блокчейна. Здесь вы сможете узнать, что дает защиту от коллизий, познакомиться с «эффектом лавины» и найти «живые» примеры, которые наглядно иллюстрируют рассматриваемые понятия. В этом нам помогли Алиса и Боб, активные пользователи биткойна.

Различия, плюсы и минусы: публичные и приватные блокчейны

Крупнейшие банковские структуры и другие организации активно изучают возможности построения собственных приватных блокчейнов. Мы решили разобраться с соответствующей терминологией и характерными особенностями публичных и приватных блокчейнов.

Обзор децентрализованных технологий. Часть 1 и Часть 2

Александр Стрелов pokupo написал серию обзорных материалов и постарался коротко осветить самые интересные проекты из области блокчейна. Его основная задача заключалась в том, чтобы начать рассказывать о революционной технологии, которая открывает новые возможности для построения принципиально иных систем и программных продуктов.

Погружение в блокчейн: Быстрые и безопасные транзакции

Корпоративный блог Microsoft повествует о проектах, разработанных на основе технологии блокчейн. В этом материале вы найдете краткий анализ проблем, которые решает новая технология, и практический туториал на тему выполнения задачи по развёртыванию, в том числе и распределенного варианта, сети блокчейн. Продолжение цикла статей — здесь.

200 строк на блокчейн

Лаури Хартикка (Lauri Hartikka) поможет разобраться с реализацией простейшего блокчейна на самописном примере, который он назвал NaiveChain. Сам проект написан на Javascript, а в материале Лаури рассказывает о его основных составляющих и архитектуре. Дополнительно для интересующихся: репозиторий на GitHub.

Кейсы

Как с помощью блокчейна защитить свои данные

Компания Acronis рассказывает в своем корпоративном блоге о том, каким образом новую технологию возможно применить в сфере обеспечения безопасности данных. Здесь кратко рассмотрена техническая сторона задачи и поставлены юридические вопросы, которые влияют на применение подобных решений на территории России.

Иное применение блокчейнов: Смарт-контракты

В одном их материалов блога Bitfury Group на Хабрахабре мы решили разобраться с тем, что из себя представляют смарт-контракты. Здесь мы кратко затронули примеры платформ для смарт-контрактов (Rootstock) и поговорили о будущем и практическом применении умных контрактов.

Разработки Университета ИТМО: Управление дронами на блокчейне

Университет ИТМО рассказывает об одном из точечных экспериментов своего сообщества. Сфера применения — управление беспилотниками. Платформа — Ethereum.

Блокчейн для управления городом: властям Дубая поможет IBM

Правительство Дубая планирует запустить управление инфраструктурой города на базе блокчейна уже в следующем году. Создаваемая платформа будет открытой и для других регионов. В своем корпоративном блоге на Хабре компания IBM (партнер проекта) подчеркивает, что возможности новой технологии должны и будут применяться не только в сфере финансовых услуг.

Регистрация прав на землю с помощью блокчейна

Bitfury Group поможет правительству Грузии вести регистрацию прав собственности на земельные участки с помощью технологии блокчейн. Об этом кейсе мы рассказывали в своем англоязычном блоге на Medium.

Электронное правительство на основе блокчейн-технологий

Еще один кейс применения блокчейна вне финансового сектора — сотрудничество Bitfury Group и правительства Украины. Первый этап программы — интеграция технологии в платформу электронного правительства. Первоначальные области для внедрения: реестры, социальный сектор, сферы здравоохранения и энергетики. По мере завершения пилотного проекта программа охватит все сферы правительственной компетенции, включая информационную безопасность.

ТОП 10 ошибок при создании блокчейн-проектов от Gartner Inc

Владимир>Menaskop подготовил перевод материала, который предлагает взглянуть не только на технологическую, но и на управленческую составляющую блокчейн-проектов. Оригинал — в блоге Gartner на английском.

Блокчейн для ИИ

Трент МакКонахи (Trent McConaghy) поделился со своей аудиторией видением того, каким образом блокчейн может повлиять на развитие ИИ. Трент рассмотрел этот вопрос с точки зрения «стратегии голубого океана» и проанализировал возможности для работы с большими данными.

Для чего подойдет блокчейн

Блог Digital Chains на Medium представляет аудитории интересный англоязычный материал на тему практического применеия блокчейна. Здесь вы сможете найти 30 use-кейсов с примерами уже существующих проектов: от сервиса для доставки товаров и до методов управления медицинской историей пациентов.

Что может блокчейн

Журнал Эксперт заинтересовался возможностями блокчейна и привел собственный разбор проблем и решений в таких сферах как регистрация прав на собственность, заключение контрактов, гарантирование свободы информации и ряда других. Получился великолепный аналитический материал, который мы рекомендуем к прочтению.

Где и как применять блокчейн

Майк Голдин (Mike Goldin), разработчик блокчейн-решений, записал тематический подкаст на тему возможностей новой технологии и проблем, которые приходится решать. Здесь вы сможете найти текстовый транскрипт выпуска.

17 use-кейсов для блончейна

Еще одна англоязычная подборка с огромным количеством примеров уже запущенных проектов (в среднем по 3-4 примера на каждый use-кейс). Данный материал подойдет тем, кто только начинает разбираться в теме.

27 отраслей для применения блокчейна

CB Insights, одна из наиболее авторитетных аналитических компаний, публикует свою подборку сфер применения блокчейна. Этот материал дополняет предыдущие новыми примерами реализованных проектов.

Другие тематические сборники:

- BitFury Group Research Whitepapers: 1 и 2

- Список из 101 лидера блокчейн-индустрии

- Авторский список источников по теме

- Еще один «ультимативный» список источников

- Обсуждение по теме в разделе Show HN

- Великолепная подборка источников на Github

|

Метки: author alinatestova программирование блог компании bitfury group bitfury мегаподборка блокчейн blockchain |

QML: как легко получать футболки в конкурсах mail.ru по машинному обучению |

|

Метки: author quantum программирование машинное обучение python mlbootcamp |

Нагрузочное тестирование Web-систем. Продолжаем подготовку |

Предлагаю рассмотреть следующие элементы конфигурации сценария, которые могут повлиять на производительность вашего теста.

Хочу описать почему использование реальных методов HTTP важнее, чем его «быстрые» аналоги. Затронем необходимость использования проверок получаемых данных и выстраивание регулярных выражений для получения значений.

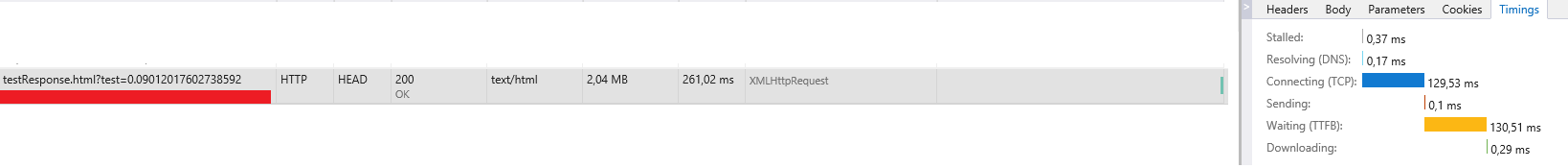

Получение ответов с реальным размером данных

По-моему, мнению как минимум в финальном тестировании Web-системы необходимо использовать те запросы, которые отправляет браузер. Если это был GET запрос, то мы должны симулировать только его и не подменять его например на HEAD. Основная разница между данными методами в том, что GET получает содержимое ответа, а HEAD нет. Казалось бы зачем мне получать не нужные данные например от картинок, css, шрифтов, но как показывает практика они не менее важны.

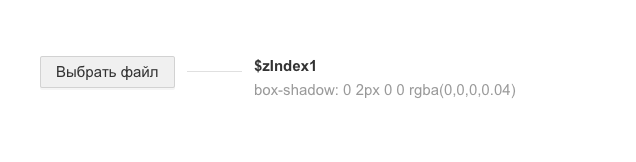

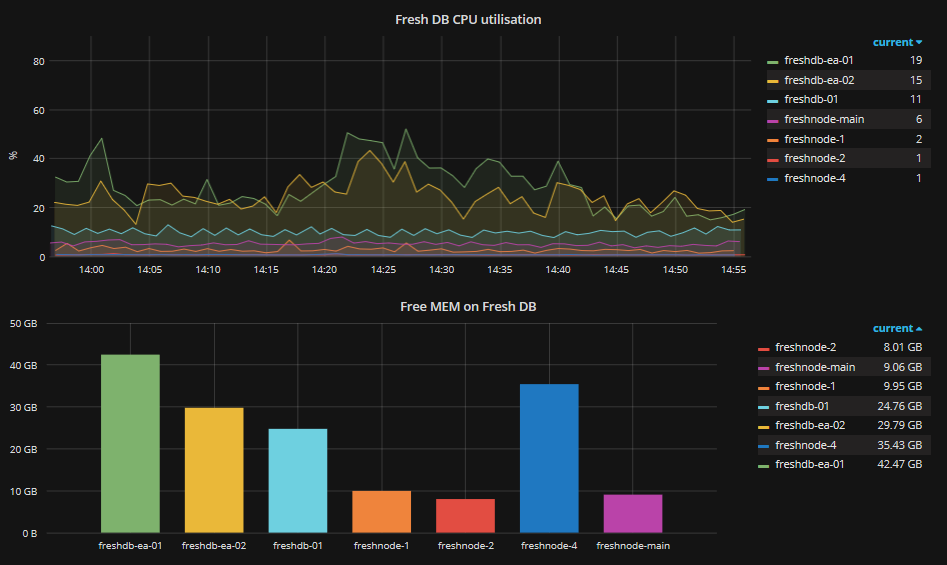

Сравним два типа запросов для одного и того же тестового ресурса

HEAD

GET

На картинках видно, что GET запрос выполняется во много раз дольше, чем HEAD. А следовательно сервер дольше отдавал данные на данный запрос и не мог обслуживать следующие. При одном пользователе эта разница не кажется существенной, но при использовании 1 000 виртуальных пользователей сервер будет тратить времени больше не обработку каждого из них.

Например, наш Web-сервер настроен таким образом, что может обрабатывать только 100 одновременных подключений. В результате мы увидим, что первые 100 подключаться и будут работать как минимум 3 секунды. При этом все остальные 900 будут ждать возможности подключения. Как только кто-то из первой сотни закончит, то отдаст ресурсы следующему. То есть тысячный пользователь в нашем пример сможет начать работать с указанным запросом только примерно через 27 секунд. Если бы мы использовали HEAD метод, то тысячный пользователь получил бы доступ к системе уже через 2 секунды. (данные расчёты крайне грубые)

В результате мы видим, как использование «правильного» метода для обращения к серверу показывает реальную на него нагрузку.

Использованный на картинках является полностью синтетических для отображения большей наглядности по времени выполнения запросов. У вас может не быть столь больших запросов. Но даже при ответе в 100 — 200 Килобайт и использовании 5 000 пользователей мы можем наблюдать значительные замедления в работе Web-сервера.

Проверка получаемых данных

Многие скажут, что проверка получаемых данных это не нагрузочное тестирование, а функциональное, и вы будете от части правы. На практике же получаются ситуации, когда функциональная часть Web-системы начинает не корректно работать именно под большой нагрузкой. Например web-приложение может не правильно обрабатывать входящие данные при большой нагрузке.

Я сталкивался с ситуациями когда web-система сообщала об успешности выполнения запроса, отправляя ответ 200 ОК. Но тело запроса было пустым, после глубокого изучения системы удалось выяснить, что это запланированный ответ. То есть успешность выполнения запроса можно было только определить по наличию содержимого в ответе.

Получается, что единственным вариантом проверки правильности работы системы под высокой нагрузкой является контроль получаемых данных, а не только статус получения ответа.

Сегодня, при интенсивном развитии технологий динамической работы с web-системами (AJAX, WebSocket, Flash, Java и др.), мы можем на один и тот же запрос получать различное содержимое. И необходимо быть уверенным, что текст ответа является правильным.

Построение «правильных» регулярных выражений

Во многих утилитах для выполнения нагрузочного тестирования, что бы проверить правильность получаемых данных необходимо использовать регулярные выражения. Все мы знаем что это такое, но что же такое «правильные» регулярные выражения. Это выражение, которое затрачивает как можно меньше времени на поиск исходного значения.

В сети интернет очень много примеров и статей на тему низкой производительности тех или иных регулярных выражений или движков, на которых они используются. В них рассказывается, что такое ленивые, жадные и сверх жадные квантификаторы. Почему и когда надо использовать группировки и чередования. Как выполнять конкретизацию для увеличения скорости работы движка регулярных выражений. Я думаю, кому это важно и интересно, смогут найти информацию.

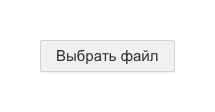

Я же хочу продемонстрировать почему надо их выстраивать правильно. Возьмем некую последовтельность запросов, которые при записи имели некие задержки.

На картинке задержки обозначены зелеными стрелками.

При выполнении сценария, утилита должна симулировать задержки между запросами тем самым гарантируя «реальную» нагрузку пользователя.

Из предыдущего абазаца мы выяснили, что надо выполнять контроль получаемых данных. Делаем мы это с помощью регулярных выражений. В результате для части запросов мы составим выражения и начинаем проверку.

Выполняемые проверки должны тратить время на поиск данных. В результате мы получим примерно следующее

Красными стрелками показано какое-то время, которое будет затрачено на работу регулярных выражений.

В результате мы видим, что общее время выполнения сценария уже немного отклонилось о того, как если бы это делал один пользователь. Если же учесть, что каждый виртуальный пользователь должен делать такую проверку, а у нас на одном компьютере запущено 1 000 таких, то время на их обработку увеличится в несколько раз. Каждый виртуальный пользователь будет захватывать ресурсы операционной системы для проведения вычислений. Следовательно, пока ресурсы заняты одними пользователями, другие не могут получить к ним доступ.

Чем точнее у нас регулярное выражение, тем меньше времени тратится на его обработку, а мы получаем более реальную нагрузку на систему при большом количестве виртуальных пользователей

Конечно для многих использование регулярных выражений, а тем более их «правильного» варианта не требуется. Но если вы хотите приблизить свой тест к более реальным условиям выполнения виртуальными пользователями, то необходимо не забывать про скорость работы сервисных функций.

Заключение

Мы рассмотрели три возможных варианта, которые могут влиять на искажение результатов нагрузочного тестирования. Конечно не все из описанных ситуаций повлияют на такие параметры как время соединения с сервером, время ответа сервера и другие получаемые вами характеристики.

Но в большинстве случаев нас интересует сколько реальных пользователей выполняют тот или иной сценарий, с какой скоростью нам будет отвечать сервер, и какое время каждый из пользователей потратит на выполнение данного сценария. А вот на эти параметры могут поялиять расмотренные пункты.

Время ответа сервера на запрос у вас может составлять и несколько миллисекунд. При большем объеме получаемых данных и обработке их, время выполнения всего сценария может затянуться на несколько минут, что порой не приемлемо для заказчиков такого теста.

|

Метки: author Nick-Monk тестирование веб-сервисов высокая производительность нагрузочное тестирование web- сайт |

Бесплатные, линейные иконки для вашего сайта или приложения |

Привет, Мир! На dribbble.com я нашел сет из 77 бесплатных иконок, которые мне очень понравились. Чтобы выразить свое спасибо автору, я запустил страницу на GitHub pages, для быстрого и удобного использования. Что именно получилось, читайте под катом.

Читать дальше ->

|

Метки: author nikitamarcius0 разработка веб-сайтов css awesomeicons fontawesomeicons linear icons линейные иконки иконки шрифтов бесплатные иконки |

[Из песочницы] Электронная демократия или как собрать и обработать данные по голосованию (и явке) за реновацию в Москве |

Да и после заявлений типа:

Что касается популярности этих сервисов, то центры госуслуг «Мои документы» привлекли чуть больше половины всех проголосовавших, незначительно уступив порталу «Активный гражданин»как-то возникают лёгкие сомнения. Так что — приступим к сбору информации! А потом будем её анализировать. Для этого нам понадобится какой-нибудь язык (скажем, питон), какая-нибудь бд (скажем, sqlite) и какой-нибудь веб-скраппер, благо для питона их множество. Сразу говорю, в конце дам ссылку на получившуюся базу данных, можно сделать с ней что угодно.

Заходим на сайт мэрии, крутим колёсико. Надо собрать данные с 4543 домов. Кликам по случайному дому, по районным спискам, и смотрим, в каком формате вообще данные есть.

Судя по всему, у каждого дома есть некий id, который мы и видим в url:

https://www.mos.ru/otvet-stroitelstvo/itogi-golosovaniya-zhitelej-po-proektu-programmy-renovacii/?u=121Следовательно, для того, чтобы обработать все дома, нам нужно где-то достать список всех айдишников и перебрать их, забирая с каждой странички нужную информацию, а именно — количество голосов за, количество голосов против, количество голосов всего (ведь есть и «неопределившиеся» голоса, когда у одной квартиры половина голосует за, а половина — против) и было ли общедомовое собрание (зачем? а вдруг пригодится).

Где достать список айдишников? Как мы уже видели выше, в районных списках нет ссылок на указанные дома, это просто текстовый список адресов и всё. А жаль, было бы удобно. Похоже, здесь придётся заниматься перебором. Но для начала всё-таки сделаем функцию, собирающую данные с каждого конкретного айдишника.

Для начала сделаем гет-запрос на какой-нибудь дом, и посмотрим на получившийся ответ, чтобы понять, что нам вообще оттуда скраппить.

import requests

r = requests.get('https://www.mos.ru/otvet-stroitelstvo/itogi-golosovaniya-zhitelej-po-proektu-programmy-renovacii/?u=121')

print(r.text)С удивлением обнаруживаем, что в ответе никаких данных по голосованию нет, нам отдаётся какой-то шаблон страницы. Посмотрим глазами, как происходит загрузка результатов. И действительно — сначала у нас в браузере страница с незаполненными полями, а через некоторое время в них появляются данные. Возьмём браузер с подходящими средствами «для разработчика», например, мозиллу, и посмотрим, что же там, собственно, происходит.

Ага! Мы обнаружили запрос браузера к некоему апи, причём айдишник совпадает с айдишником дома, который мы смотрим.

Иными словами, гет-запрос на www.mos.ru/altmosprx/api/1/renovation/house_result/121 безо всяких параметров даёт нам в ответ JSON такого вида:

{

"execTime": 0.044450044631958,

"errorMessage": "",

"result": {

"table": "Код квартиры Идентификатор голоса Решение Дата Выбор квартиры 0G6O4 bf659227e8e3

5f9403659209

За

За

18.05

18.05

За

0G6O5 3f12be5cea77

За

15.05

За

... 0G6V1 5acd126a410ea1a842e67066ea68fa8f

За

24.05

За

",

"total": {

"und": 0,

"za": 100,

"protocol_res": 0,

"protiv": 0,

"gorod_mark": 0,

"protocol_date": null,

"house_status": 1,

"gorod": 0

},

"und_table": "Код квартиры Идентификатор голоса Решение Дата Выбор квартиры

",

"address": "Авиационная улица, дом 63, корпус 2"

},

"request_id": "empty_requestid",

"errorCode": 0

}Отлично, тут нам даже не понадобится ничего скрапать, все данные и так есть сразу из апи. Всего-то нужно — посчитать количество apartment-id (всего голосов), взять готовые данные о проценте голосов за, об общедомовом собрании.

Но всё-таки, в каком диапазоне айдишников мы будем смотреть? Всего домов должно быть 4543. Даём апи 0 — есть такой дом. Даём -1 — ошибка, ну и на том спасибо. Нижнюю границу определили. Даём 10000 — есть такой дом. Ладно, их явно больше 4543. Попробуем определить верхнюю границу приблизительно, посмотрев какой-нибудь дом из недавно присоединённых территорий… Возвращаемся к карте, лезем куда-нибудь в «Новую Москву» подальше от «старой», о: поселение Кокошкино, дачный посёлок Кокошкино, улица Труда, дом 2, id: 440931. Ну, как минимум полмиллиона их у нас есть.

Перебирать полмиллиона ссылок в обычном loop'е — идея не самая лучшая, поэтому воспользуемся модулем concurrent.futures. Можно, конечно, было бы использовать что-нибудь вроде asyncio, но у нас не настолько масштабная задача и можно обойтись «малой кровью». Всё очень просто. Смотрим, что отдаёт апи при заведомо правильном номере дома, при заведомо неправильном, и делаем функцию для чекинга этого всего. Потом крутим это всё в цикле с паралелльными запросами, т.к. айдишников нужно обработать довольно много. Потом оформляем результат и записываем его. В целом получается примерно такой код:

import requests

from concurrent.futures import ProcessPoolExecutor

import concurrent.futures

def check(url):

#try тут нужен, потому что гет-реквест, не смотря на таймаут, иногда плохо себя ведёт

#мы же не хотим в конце перебора миллиона страничек получить краш с ошибкой

try:

r = requests.get('https://www.mos.ru/altmosprx/api/1/renovation/house_result/' + str(url) + '/', timeout=10)

print(url)

r.encoding = 'utf-8'

if '400: Bad Request' not in r.text:

return str(url)

except:

#ошибок будет немного, но лучше эти номера потом пробить ещё раз, для этого пишем и их

woops = str(url) + ' failed'

return woops

results = []

with ProcessPoolExecutor(max_workers=6) as executor:

future_results = {executor.submit(check, url): url for url in range(0, 1000000)}

#если нужны конкретные номера, то просто берём их из списка: url in somelist

for future in concurrent.futures.as_completed(future_results):

results.append(future.result())

results[:] = [item for item in results if item or item == 0]

#check возвращает None, если дома нет, убираем; а вот ноль нам нужен, не забудем о нём

with open('/home/deb/mosres.txt', 'w') as f:

for item in results:

f.write('{}\n'.format(item))Запускаем и идём по своим делам — это надолго даже с 6 worker'ами. Забегая вперёд, скажу, что обработав миллион, получил где-то на 70 домов меньше, чем было в результатах, так что пришлось крутить эту волынку до 10 миллионов. Это долго, оставил работать и ушёл на работу.

Конечно, можно было бы поднять количество параллельных запросов, но мы же пользуемся чужим айпи, нужно вести себя вежливо (а то вдруг забанят).

В общем, у нас есть список всех айдишников домов, теперь надо их обработать, забрать всю имеющуюся информацию и т.п. В текстовый файл такой массив засовывать не с руки — обрабатывать будет неудобно. Воспользуемся sqlite3.

Создадим бд. Все поля очевидны, разве что дом и дополнительные элементы типа корпуса, строения и т.п. разнесём — на всякий случай, если захотим, например, смотреть тенденции у рядом стоящих домов.

import sqlite3

schema = "CREATE TABLE `houses` (\

`id` INTEGER PRIMARY KEY,\

`street` TEXT NOT NULL ,\

`house_nbr` TEXT NOT NULL,\

`house_additional` TEXT,\

`total_votes` INTEGER,\

`total_za` INTEGER,\

`meeting` INTEGER DEFAULT '0',\

`flats` INTEGER\

);"

conn = sqlite3.connect('renovation.db')

cur = conn.cursor()

db = cur.execute(schema)

conn.commit()

conn.close()