Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Время чудес, или Тормоза для конца света |

Когда говорят «конец света», значит, хотят продать кукурузные хлопья,

а вот если говорят «без паники», тут уж дело серьезнее.

Стивен Кинг. «Буря столетия»

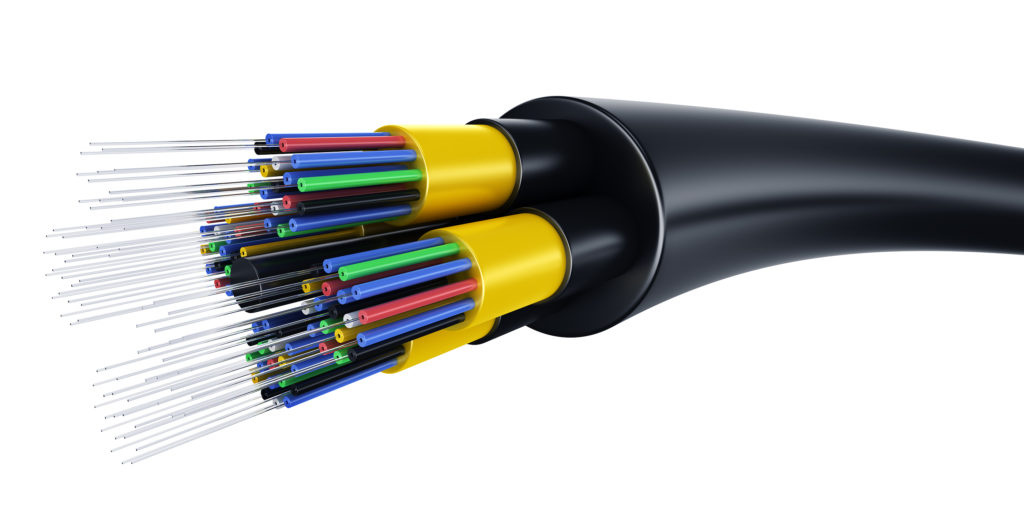

Говорят, что наиболее оптимистичные пессимисты верят в счастливый конец света. Применительно к телекому эта мысль имеет второе дно. Все учебные пособия по телекоммуникациям сходятся в одном: когда взамен медных линий стали применяться волоконно-оптические линии связи (ВОЛС) вкупе с лазерами, для отрасли наступило долгожданное и практически вечное счастье, по крайней мере в части обеспечения высокой пропускной способности для почти мгновенной (буквально со скоростью света) доставки множества информационных потоков. Так в отрасли началось время чудес. Да будет свет!

Однако сегодня пропускная способность оптических транспортных сетей стремительно приближается к своему пределу. Дальнейшее ее наращивание потребует организации новой инфраструктуры ВОЛС и – новых инвестиций. Об этом и предлагаем поговорить ниже.

Наперегонки к пределам

Меж тем природа регулярно напоминает нам, что ничего вечного в ней нет. И «пределы беспредельности» оптического транспорта также не за горами, хотя дату «конца света» в ВОЛС удавалось не единожды отодвигать.

Конечно, такую простую неприятность, как отключение электричества, связисты научились преодолевать в первую очередь. Следующая неприятность, а именно непрерывное сокращение безрегенерационного (без промежуточных оптических регенераторов) промежутка на магистральных ВОЛС по мере увеличения скорости передачи, грозила было серьезными проблемами всей отрасли. Спасение пришло в лице когерентных систем класса N x 100 Гбит/с. Системы плотного спектрального волнового уплотнения (DWDM) позволили справиться с этой убийственной для отраслевого бизнеса неприятностью, обеспечив безрегенерационную дальность порядка 5–6 тыс. км в наземных линиях связи и более 10 тыс. км – в подводных (в зависимости от применяемых схем модуляции и кодирования – QPSK, QAM и пр.).

Ныне на очереди – физические пределы пропускной способности оптического волокна вкупе с ростом в них задержек распространения сигнала. И это на фоне текущего и грядущего роста информационных потоков, вызванного развитием интернета вещей и сетей мобильной связи пятого поколения (5G). Стоит напомнить, что сети 5G должны будут иметь не только сверхвысокие скорости передачи информации (до 1 Гбит/с и выше), но и чрезвычайно малые задержки передачи сигнала (порядка 1 мс и менее). Наиболее сильное влияние на суммарное значение задержки оптического сигнала в системе передачи оказывает длина оптоволокна. С учетом того, что в современном мире практически не осталось транспортных и магистральных сетей, организованных не на базе ВОЛС, получение сверхмалых задержек, если речь идет о чем-либо протяженном за границы стран, регионов и даже городов, становится невозможным.

Прежде всего, повышение эффективности ВОЛС с помощью DWDM значительно увеличивает задержки непосредственно в элементах сети DWDM, где сигнал подвергается различным преобразованиям. Также в канальном слое DWDM большое внимание с необходимостью уделяется дисперсионным характеристикам оптической линии, заставляя прибегать к компенсаторам дисперсии, которые в своем нынешнем исполнении вносят дополнительную задержку. К счастью, использование когерентных систем класса N x 100 Гбит/с позволило от компенсаторов дисперсии отказаться. Это существенно улучшило качество оптического тракта и снизило потери в нем, что благотворно сказалось на предельных дистанциях передачи сигнала. Вместе с тем вопреки утвердившемуся мнению, скорость распространения оптического сигнала в оптоволокне существенно ниже скорости распространения электрических сигналов в медных линиях связи и радиосигналов в атмосфере*.

Собственно, поэтому МСЭ-T и разработал рекомендации по допустимым уровням задержки. В большинстве случаев она не должна превышать 150 мс в одну сторону, что вполне приемлемо, например, для VoIP. Задержки от 150 до 400 мс также могут быть приемлемыми, если принимать в расчет и экономические характеристики (в первую очередь стоимость разговора).

Таким образом, с точки зрения минимальных задержек современные ВОЛС не могут считаться чем-то особенным, что существенно повлияет на физическую и логическую топологии оптических транспортных сетей будущего. Уже сегодня динамика роста наземных и подводных кабельных сетей различается – в силу разницы в стоимости права прохода и строительства, а также вносимых задержек сигнала.

«Смерть волокна»?

Приход в отрасль связи таких глобальных «возмутителей спокойствия», как Google и Facebook, создал дополнительный стимул для развития инфраструктуры оптических систем передачи континентального и межконтинентального классов, обладающих предельной пропускной способностью «на вырост», с учетом очень высоких темпов роста интернет-трафика вообще и доли видеотрафика в нем в частности. Поэтому отраслевая литература пестрит победными реляциями о запуске новых линий, очередных рекордах пропускной способности, создании международных консорциумов для прокладки новых трансокеанских подводных кабельных систем и т.п.

Стремительная динамика ИКТ-отрасли заставила также говорить и о «смерти волокна», поскольку стало понятно, что недалек тот день, когда развитие связи на базе ВОЛС упрется в физические пределы пропускной способности оптических линий. А это означает, что на уже проложенных ВОЛС нельзя будет сделать ничего нового, кроме как уплотнить их по максимуму, и следует прокладывать новые кабели, что весьма недешево. Всяческие технологические улучшения сделали сегодня «обычной» возможность создавать системы связи, позволяющие передать поток 100 Гбит/с и даже 400 Гбит/с (4 х 100 Гбит/с) по одной оптической несущей («лямбде»). Однако далее дело застопорилось, поскольку эмпирический предел спектральной эффективности для подобных оптических систем составляет примерно 5 бит/с/Гц и он уже практически достигнут, вследствие чего одно оптическое волокно имеет предельную пропускную способность порядка 25–50 ТБод в зависимости от задействованных оптических диапазонов. Впрочем, практический предел символьной скорости передачи по одному оптическому волокну, определяемый физическими характеристиками используемого материала, сейчас равняется 12–25 ТБод в зависимости от типа модуляции и пр.

С появлением систем 100 Гбит/с с когерентным приемом была достигнута почти предельная эффективность использования независимых параметров светового излучения (фазы и поляризации), и усложнение модуляции неизбежно приведет к существенному падению дальности передачи**. То есть снова встает проблема безрегенерационной дальности. Впрочем, новых успехов в системах DWDM можно добиться уплотнением каналов, расширением спектрального диапазона (т.е. подбором других оптопрозрачных материалов), более изощренными методами модуляции и детектирования (называемыми пробабилистическими), а также применением «фотонных кристаллов», многосердцевидных волокон и пр. Нетрудно видеть, что большинство этих решений сопряжено с организацией новой инфраструктуры ВОЛС и соответственно с новыми инвестициями. Разве что помудрить еще со способами модуляции.

Таким образом, в скором времени во всей отрасли дальней связи начнутся серьезные перемены, обусловленные исчерпанием ресурса проложенных кабельных линий. Этот «ползучий» процесс исчерпания емкости наследованной оптической инфраструктуры вкупе с падением тарифов и маржинальности магистрального бизнеса в целом может в ближайшие годы создать новую интригу в развитии этого сегмента и запустить «качели» «спрос – предложение». Ожидаемый результат – интенсификация работ по уплотнению уже существующего оптического волокна и строительству новых оптических линков всех классов.

Так что, господа, без паники!

*Салифов И. Расчет и сравнение сред передачи современных магистральных сетей связи по критерию латентности (задержки). T-Comm № 4 2009 с. 42.

**Трещиков В., Наний О., Леонов А. особенности разработки DWDM-систем высокой емкости. T-Comm № 9 2014 с. 83.

Авторы публикации:

Александр ГОЛЫШКО, системный аналитик ГК «Техносерв»

Виталий ШУБ, заместитель генерального директора, бизнес-направление «Телеком», IPG Photonics Russia (НТО «ИРЭ-Полюс»)

|

Метки: author TS_Telecom стандарты связи сжатие данных сетевые технологии блог компании техносерв волс линии связи кабельные линии оптическое волокно |

Что такое DevOps: подход, который может изменить всё |

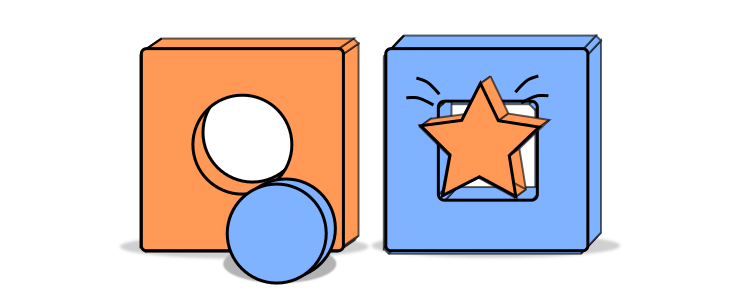

DevOps это не профессия, а культура, философия, метод — набор практик, объединяющий вместе разработчиков программного обеспечения, тестировщиков и людей, отвечающих за его обслуживание. Отсюда название — акроним от “development” и “operations”. Основная цель — уменьшение разрыва между работой всех IT- подразделений компании, оптимизация ответственности за задачи «на стыке» разработки и эксплуатации, повышение производительности, снижение количества ошибок, и, как следствие, удовлетворение потребностей бизнеса и клиента.

Стандартный процесс делится на 5 этапов:

• анализ требований к проекту;

• проектирование;

• реализация;

• тестирование продукта;

• внедрение и поддержка.

При этом взаимодействие, как правило, осуществляется в лучшем случае между соседними. Таким образом, если после выпуска ПО в нём обнаруживаются ошибки, в первую очередь рассматриваются вопросы к железу и системным администраторам, потом к тестировщикам, и лишь потом дело доходит до разработчиков и планировщиков. Когда у вас один релиз в год — ничего страшного, но в современных компаниях производительность достигает десятков выпусков в день. Найти быстрое решение или хотя бы виновника в такой ситуации почти невозможно. Остается только два решения:

забивать штат десятками и сотнями сисадминов и промежуточных работников, которые бы успевали отслеживать каждый релиз, что крайне сомнительно, или же минимизировать ошибки, изменив подход к делопроизводству в целом.

DevOps — современное решение данной проблемы. Он меняет указанный подход на циклический и, в тоже время, сквозной. В таком производственном процессе все этапы взаимосвязаны, требуют четкой организации и контроля. То есть разработчики, помимо основной деятельности, должны участвовать в деплое, системщики — в разработке, тестировщики — в настройке и т.д. Реализация методологии DevOps — задача сложная и кропотливая, реализуемая, как при помощи инструментов, так и специалистов. В этом, кстати, ее главное отличие от Agile, где достаточно лишь изменить образ мышления, организацию труда, не обязательно внедряя дополнительный персонал или программные системы.

До России практика внедрения DevOps начала доходить около 5 лет назад, поэтому потребность в DevOps — инженерах неуклонно растет, конкуренция пока еще низкая, а спрос на специалистов еще не сформировался и так же находится на стадии постоянного роста.

Ещё один плюс изучения DevOps — отсутствие фундаментальной подготовки кадров. Несмотря на привлекательность методологии, многие специалисты — бывшие разработчики, желающие расширить фронт работ. Но куда чаще в DevOps идут системщики, которым мало работы с кодом в shell и bash. В целом, для того, чтобы овладеть этой методологией, не надо иметь серьезного бэкграунда. Достаточно иметь опыт работы на одной из степеней жизни ПО и знать хотя бы в теории смежные дисциплины.

Практической стороне вопроса как раз и посвящен наш курс. Программа разбита на 5 логических уровней. На первом акцентируем внимание на базовых вещах DevOps — чаты, системы контроля версий и задач, визуализация рабочего процесса, облачные сервисы, безопасное удалённое подключение. В общем, всё то, без чего сложно представить современное коллективное программирование. Из продуктов познакомимся поближе с Google Cloud Platform, Packer, Slack, HipChat, Rocketchat и конечно же Git.

После того, как заложим основы разработки и администрирования, переходим на второй уровень, где обсудим настройки и конфигурирование инфраструктуры. На примере утилиты Terraform научимся создавать, изменять и присваивать версии компонентам нашей системы и поработаем с remote backends. Кроме того, на первых двух уровнях рассмотрим модель BSA (Base-Service-App): от базового уровня до применения конфигурацией при помощи Ansible.

На третьем уровне начнём работу с Docker — системой для автоматизации и развёртывания приложений, в частности с Dockerfile,

Hub, Compose. Здесь же рассмотрим понятия непрерывной интеграции и автоматизированного конвейера поставки, немного затронем тестирование контейнеров. Тем самым уже на этом этапе мы заложим правильную организацию выпуска ПО согласно методологии DevOps.

Уровень четвёртый посвящен такой важной процедуре в жизни каждого изделия, как мониторинг с последующим выявлением и записью ошибок. Для этого сначала определимся, что надо отслеживать, рассмотрим наиболее популярные системы мониторинга, алертинга и логирования. Разумеется, на практике узнаем, как их установить, настроить и поработаем с ними.

На последнем пятом уровне, дойдём до вершины DevOps-мастерства — оркестрированию и стратегии деплоя и масштабирования. Для этого нам потребуются Docker Swarm, Service Discovery, Kubernetes и Gitlab CI.

В нашем курсе мы постарались максимально цельно продемонстрировать именно практику организации производства ПО согласно DevOps, ведь именно здесь, возникает наибольшее количество вопросов. Поэтому если вы заинтересовались этой темой и хотите на практике познакомиться с “правильным” циклом разработки и деплоя ПО, самое время приобщиться к культуре DevOps — добро пожаловать на наш курс.

До старта курса осталось меньше месяца!

|

Метки: author Dmitry21 тестирование веб-сервисов программирование блог компании отус отус otus devops linux администрирование тестирование |

[Перевод] Система перемотки времени в стиле Prince of Persia |

В этом туториале мы создадим простую игру, в которой игрок может перематывать назад действия. Делать мы её будем в Unity, но можно адаптировать систему и под другие движки. В первой части мы рассмотрим основы этой функции, а во второй напишем её костяк и сделаем его более универсальным.

Во-первых, давайте посмотрим на игры, в которых используется такая система. Мы изучим различные варианты применения этой техники, а затем создадим небольшую игру с функцией перемотки.

Демонстрация основных возможностей

Вам потребуется последняя версия Unity и опыт работы с движком. Исходный код будет выложен в открытый доступ, чтобы вы могли сравнить с ним свои результаты.

Готовы? Поехали!

Как эта система используется в других играх?

Prince of Persia: The Sands of Time стала одной из первых игр со встроенной в геймплей механикой перемотки времени. Когда игрок умирает, он может не только перезапустить игру, но и перемотать её на несколько секунд назад, на момент, когда персонаж ещё жив, и сразу же попробовать снова.

Prince of Persia: The Forgotten Sands. Трилогия Sands Of Time превосходно интегрировала перемотку времени в свой геймплей. Благодаря этому игрок не прерывается на быструю загрузку и остаётся погружённым в игру.

Эта механика интегрирована не только в геймплей, но и в повествование и саму вселенную игры, и упоминается на протяжении всего сюжета.

Похожая система используется в таких играх как Braid, в которой гейплей тоже тесно связан с перемоткой времени. Героиня игры Overwatch Трейсер имеет способность, которая возвращает её на то место, где она была несколько секунд назад, то есть перематывает назад её время, даже в многопользовательской игре. В серии гоночных игр GRID тоже присутствует механика снепшотов: во время гонки у игрока есть небольшой запас перемоток, которые можно использовать, когда машина попадает в серьёзную аварию. Это избавляет игроков от раздражения, возникающего при авариях в конце гонки.

При серьёзном столкновении в GRID вы имеете возможность перемотать игру на момент до аварии

Другие примеры использования

Но эту систему можно использовать не только как замену быстрого сохранения. Ещё один способ использования — реализация «призраков» в гоночных играх и асинхронном многопользовательском режиме.

Реплеи

Это ещё один интересный способ использования функции. Он используется в таких играх как SUPERHOT, в серии Worms и в большинстве спортивных игр.

Спортивные реплеи работают почти так же, как показывают по телевидению: процесс игры показывается повторно, иногда под другим углом. Для этого в играх записывается не видео, а действия пользователя, благодаря чем можно проигрывать реплеи под разными углами и ракурсами. В играх Worms реплеи подаются с юмором: показываются мгновенные повторы очень смешных или эффективных убийств.

SUPERHOT тоже записывает движения. После прохождения уровня показывается реплей всего игрового процесса, который умещается всего в несколько секунд.

Забавны реплеи в Super Meat Boy. Пройдя уровень, игрок видит все предыдущие попытки, наложенные друг на друга.

Реплей в конце уровня Super Meat Boy. Все предыдущие попытки записываются, а затем воспроизводятся одновременно.

Призраки в гонках на время

Гонка с призраком — это техника, при которой игрок ездит по пустой трассе, стараясь показать наилучшее время. Но в то же время он соперничает с призраком — полупрозрачной машиной, в точности повторяющей путь лучшей предыдущей попытки игрока. С ней невозможно столкнуться, то есть игрок может сконцентрироваться на достижении наилучшего времени.

Чтобы не ездить в одиночку, можно состязаться с самим собой, что делает гонки на время интереснее. Эта функция используется в большинстве гоночных игр, от серии Need for Speed до Diddy Kong Racing.

Гонка с призраком в Trackmania Nations. Это «серебряная» сложность, она означает, что игрок получит серебряную медаль, если обгонит призрака. Заметьте, что модели машин пересекаются, то есть призрак не материален и его можно проехать насквозь.

Призраки в многопользовательских режимах

Ещё один способ использования функции — призраки в многопользовательском асинхронном режиме. В этой редко используемой функции многопользовательские матчи выполняются записью данных одного игрока, которые отправляются другому игроку, который затем соревнуется с первым. Данные применяются так же, как в гонках с призраком, только соревнование происходит с другим игроком.

Такой тип соревнований используется в играх Trackmania, где можно гонять на разных сложностях. Такие записанные гонщики становятся противниками, которых нужно победить, чтобы получить награду.

Монтаж съёмки

В некоторых играх перемотка может быть просто забавным инструментом. В Team Fortress 2 есть встроенный редактор реплеев, в котором можно создавать собственные ролики.

Редактор реплеев в Team Fortress 2. Записанный бой можно просмотреть с любой точки зрения, а не только из глаз игрока.

После включения функции можно записывать и просматривать предыдущие матчи. Очень важно, что записывается всё, а не только то, что видит игрок. Это значит, что можно перемещаться по записанному игровому миру, видеть, где все находятся и управлять временем.

Как это реализовать

Для тестирования этой системы нам нужна простая игра. Давайте создадим её!

Игрок

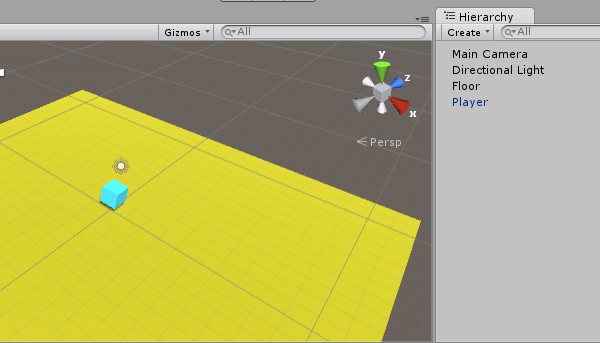

Создайте в сцене куб, это будет персонаж игрока. Затем создайте новый скрипт C# под названием

Player.cs и добавьте в функцию Update() следующее:void Update()

{

transform.Translate (Vector3.forward * 3.0f * Time.deltaTime * Input.GetAxis ("Vertical"));

transform.Rotate (Vector3.up * 200.0f * Time.deltaTime * Input.GetAxis ("Horizontal"));

}Так мы сможем управлять персонажем с помощью стрелок. Прикрепите скрипт к кубу. Теперь после нажатия на Play вы сможете передвигаться. Измените угол камеры, чтобы она смотрела на куб сверху. Наконец, создайте плоскость пола и назначьте каждому объекту свой материал, чтобы мы не двигались в пустоте. Должно получиться что-то подобное:

Попробуйте управлять кубом с помощью WSAD и клавиш со стрелками

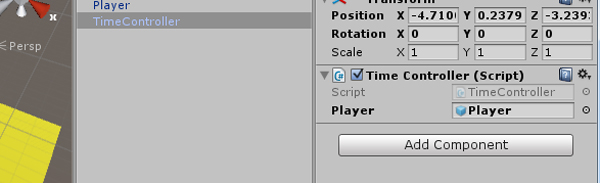

TimeController

Теперь создадим новый скрипт C#

TimeController.cs и добавлим его к новому пустому GameObject. Он будет управлять записью и перемоткой игры.Чтобы это сработало, мы запишем движение персонажа игрока. После нажатия кнопки перемотки мы будем изменять координаты персонажа. Для начала создадим переменную, хранящую персонажа:

public GameObject player;Назначим объект игрока в получившийся слот TimeController, чтобы он мог иметь доступ к игроку и его данным.

Затем нужно создать массив для хранения данных игрока:

public ArrayList playerPositions;

void Start()

{

playerPositions = new ArrayList();

}Теперь нам нужно непрерывно записывать положение игрока. У нас будет сохранённое положение игрока в последнем кадре, позиция в которой находился игрок 6 кадров назад и позиция, где был игрок 8 секунд назад (или любое назначенное вами время записи). Когда мы нажмём клавишу воспроизведения, то будем возвращаться обратно по массиву положений и назначать их кадр за кадром, в результате создав функцию перемотки времени.

Для начала давайте сохраним данные:

void FixedUpdate()

{

playerPositions.Add (player.transform.position);

}В функции

FixedUpdate() мы записываем данные. Используется FixedUpdate(), потому что она выполняется с постоянной частотой 50 циклов в секунду (или любое выбранное значение), что позволяет нам записывать данные с фиксированным интервалом. Функция Update() же выполняется с той частотой, которую обеспечить процессор, что усложнило бы нам работу.Этот код будет каждый кадр сохранять в массив положение игрока. Теперь нам нужно применить его!

Мы добавим проверку нажатия кнопки перемотки. Для этого нам необходимо булева переменная:

public bool isReversing = false;И проверка в функции

Update():void Update()

{

if(Input.GetKey(KeyCode.Space))

{

isReversing = true;

}

else

{

isReversing = false;

}

}Чтобы игра выполнялась в обратную сторону, нам нужно применить данные вместо записи. Новый код записи и применения положения игрока должен выглядеть так:

void FixedUpdate()

{

if(!isReversing)

{

playerPositions.Add (player.transform.position);

}

else

{

player.transform.position = (Vector3) playerPositions[playerPositions.Count - 1];

playerPositions.RemoveAt(playerPositions.Count - 1);

}

}А весь скрипт

TimeController будет выглядеть следующим образом:using UnityEngine;

using System.Collections;

public class TimeController: MonoBehaviour

{

public GameObject player;

public ArrayList playerPositions;

public bool isReversing = false;

void Start()

{

playerPositions = new ArrayList();

}

void Update()

{

if(Input.GetKey(KeyCode.Space))

{

isReversing = true;

}

else

{

isReversing = false;

}

}

void FixedUpdate()

{

if(!isReversing)

{

playerPositions.Add (player.transform.position);

}

else

{

player.transform.position = (Vector3) playerPositions[playerPositions.Count - 1];

playerPositions.RemoveAt(playerPositions.Count - 1);

}

}

}Кроме того, не забудьте добавить в класс

player проверку того, выполняется ли в TimeController перемотка, чтобы выполнять движение только если оно не воспроизводится. В противном случае поведение может стать странным:using UnityEngine;

using System.Collections;

public class Player: MonoBehaviour

{

private TimeController timeController;

void Start()

{

timeController = FindObjectOfType(typeof(TimeController)) as TimeController;

}

void Update()

{

if(!timeController.isReversing)

{

transform.Translate (Vector3.forward * 3.0f * Time.deltaTime * Input.GetAxis ("Vertical"));

transform.Rotate (Vector3.up * 200.0f * Time.deltaTime * Input.GetAxis ("Horizontal"));

}

}

}

Эти новые строки будут при запуске автоматически находить в сцене объект

TimeController и проверять его в процессе выполнения. Мы можем управлять персонажем только тогда, когда перемотка не выполняется.Теперь мы можем перемещаться по миру и перематывать движение назад клавишей «пробел». Можете скачать пакет по ссылке в конце статьи и открыть TimeRewindingFunctionality01, чтобы проверить работу!

Но постойте, почему наш простой игрок-кубик продолжает смотреть в последнем направлении, в котором мы его оставили? Потому что мы не догадались записывать поворот объекта!

Для этого нам нужен ещё один создаваемый в начале массив, чтобы сохранять и применять данные.

using UnityEngine;

using System.Collections;

public class TimeController: MonoBehaviour

{

public GameObject player;

public ArrayList playerPositions;

public ArrayList playerRotations;

public bool isReversing = false;

void Start()

{

playerPositions = new ArrayList();

playerRotations = new ArrayList();

}

void Update()

{

if(Input.GetKey(KeyCode.Space))

{

isReversing = true;

}

else

{

isReversing = false;

}

}

void FixedUpdate()

{

if(!isReversing)

{

playerPositions.Add (player.transform.position);

playerRotations.Add (player.transform.localEulerAngles);

}

else

{

player.transform.position = (Vector3) playerPositions[playerPositions.Count - 1];

playerPositions.RemoveAt(playerPositions.Count - 1);

player.transform.localEulerAngles = (Vector3) playerRotations[playerRotations.Count - 1];

playerRotations.RemoveAt(playerRotations.Count - 1);

}

}

}Попробуйте запустить! TimeRewindingFunctionality02 — это усовершенствованная версия. Теперь наш игрок-куб может двигаться назад во времени и будет выглядеть точно так, как выглядел в соответствующий момент.

Заключение

Мы создали простой прототип игры с уже вполне рабочей системой перемотки времени, но она ещё далека от совершенства. Далее мы сделаем её гораздо более стабильной и универсальной, а также добавим интересные эффекты.

Вот что нам ещё предстоит сделать:

- Записывать только каждый 12-й кадр и интерполировать состояния между записанными кадрами, чтобы объём данных не был слишком огромным

- Записывать только последние 75 положений и поворотов игрока, чтобы массив не стал слишком громоздким и игра не вылетала

Кроме того, мы подумаем, как расширить эту систему, чтобы она действовала не только для игрока:

- Как записывать не только одного игрока

- Добавим эффект, сообщающий о перемотке (типа размытия VHS-сигнала)

- Используем для хранения положения и поворота игрока собственный класс, а не массивы

Архив проекта Unity

Итак, мы создали простую игру, в которой можно перематывать время до предыдущей точки. Теперь мы можем усовершенствовать эту функцию и сделать её использование гораздо интереснее.

Запись меньшего объёма данных и интерполяция

На данный момент мы записываем положения и повороты игрока 50 раз в секунду. Такой объём данных быстро станет неподъёмным, и это будет особенно заметно в более сложных играх, а также на слабых мобильных устройствах.

Вместо этого мы можем выполнять запись только 4 раза в секунду и интерполировать положение и поворот между этими ключевыми кадрами. Таким образом мы сэкономим 92% производительности, а результаты будут на вид неотличимы от записей с 50 кадрами в секунду, потому что они воспроизводятся за доли секунды.

Начнём с записи ключевых кадров через каждые x кадров. Для этого нам сначала нужны новые переменные:

public int keyframe = 5;

private int frameCounter = 0;Переменная

keyframe — это кадр в методе FixedUpdate, в который мы будем записывать данные игрока. В настоящий момент ей присвоено значение 5, то есть данные будут записываться на каждом пятом цикле выполнения метода FixedUpdate. Поскольку FixedUpdate выполняется 50 раз в секунду, то за секунду будет записываться 10 кадров. Переменная frameCounter будет использоваться как счётчик кадров до следующего ключевого кадра.Теперь изменим блок записи в функции

FixedUpdate, чтобы он выглядел вот так:if(!isReversing)

{

if(frameCounter < keyframe)

{

frameCounter += 1;

}

else

{

frameCounter = 0;

playerPositions.Add (player.transform.position);

playerRotations.Add (player.transform.localEulerAngles);

}

}Если вы попробуете запустить игру сейчас, то увидите, что теперь перемотка занимает гораздо меньше времени. Так получилось, потому что мы записываем меньше данных, но воспроизводим их на обычной скорости. Нужно это исправить.

Для начала нам нужна ещё одна переменная

frameCounter, чтобы не записывать данные, а воспроизводить их.private int reverseCounter = 0;Исправим код, восстанавливающий положение игрока, чтобы использовать его так же, как мы записываем данные. Функция

FixedUpdate должна выглядеть так:void FixedUpdate()

{

if(!isReversing)

{

if(frameCounter < keyframe)

{

frameCounter += 1;

}

else

{

frameCounter = 0;

playerPositions.Add (player.transform.position);

playerRotations.Add (player.transform.localEulerAngles);

}

}

else

{

if(reverseCounter > 0)

{

reverseCounter -= 1;

}

else

{

player.transform.position = (Vector3) playerPositions[playerPositions.Count - 1];

playerPositions.RemoveAt(playerPositions.Count - 1);

player.transform.localEulerAngles = (Vector3) playerRotations[playerRotations.Count - 1];

playerRotations.RemoveAt(playerRotations.Count - 1);

reverseCounter = keyframe;

}

}

}Теперь при перемотке времени игрок будет перескакивать к предыдущим положениям в реальном времени!

Но мы хотели не совсем этого. Нам нужно интерполировать положения между этими ключевыми кадрами, что будет немного сложнее. Во-первых, нам потребуются четыре переменные:

private Vector3 currentPosition;

private Vector3 previousPosition;

private Vector3 currentRotation;

private Vector3 previousRotation;Они будут хранить текущие данные игрока и один записанный ключевой кадр до текущих данных, чтобы мы могли выполнять интерполяцию между ними.

Затем нам понадобится эта функция:

void RestorePositions()

{

int lastIndex = keyframes.Count - 1;

int secondToLastIndex = keyframes.Count - 2;

if(secondToLastIndex >= 0)

{

currentPosition = (Vector3) playerPositions[lastIndex];

previousPosition = (Vector3) playerPositions[secondToLastIndex];

playerPositions.RemoveAt(lastIndex);

currentRotation = (Vector3) playerRotations[lastIndex];

previousRotation = (Vector3) playerRotations[secondToLastIndex];

playerRotations.RemoveAt(lastIndex);

}

}Она присваивает соответствующую информацию переменным положения и поворота, между которыми мы будем выполнять интерполяцию. Мы будем делать это в отдельной функции, потому что мы вызываем её для двух разных точек.

Блок восстановления данных будет выглядеть так:

if(reverseCounter > 0)

{

reverseCounter -= 1;

}

else

{

reverseCounter = keyframe;

RestorePositions();

}

if(firstRun)

{

firstRun = false;

RestorePositions();

}

float interpolation = (float) reverseCounter / (float) keyframe;

player.transform.position = Vector3.Lerp(previousPosition, currentPosition, interpolation);

player.transform.localEulerAngles = Vector3.Lerp(previousRotation, currentRotation, interpolation);Мы вызываем функцию для получения последнего и предпоследнего набора данных из массивов через заданный интервал ключевых кадров (в нашем случае это 5), но нам также нужно вызывать её в первом цикле, когда выполняется восстановление. Поэтому нам нужен этот блок:

if(firstRun)

{

firstRun = false;

RestorePositions();

}Чтобы он работал, нам также понадобится переменная

firstRun:private bool firstRun = true;И для сброса при отпускании клавиши «пробел»:

if(Input.GetKey(KeyCode.Space))

{

isReversing = true;

}

else

{

isReversing = false;

firstRun = true;

}Вот как работает интерполяция: вместо того, чтобы просто использовать последний сохранённый ключевой кадр, эта система получает последний и предпоследний кадры, после чего интерполирует данные между ними. Количество интерполяции зависит от текущего расстояния между кадрами.

Интерполяция выполняется функцией Lerp, которой мы передаём текущее и предыдущее положение (или поворот). Затем вычисляется коэффициент интерполяции, который может иметь значения от 0 до 1. Затем игрок помещается между двумя сохранёнными точками, например, в 40% на пути к последнему ключевому кадру.

Если замедлить движение и воспроизводить его покадрово, то можно на самом деле увидеть, как персонаж движется между этими ключевыми кадрами, но в процессе игры это незаметно.

Таким образом мы значительно снизили сложность схемы перемотки времени и сделали её гораздо более стабильной.

Запись только фиксированного количества кадров

Сильно уменьшив количество сохраняемых кадров, теперь мы можем сделать так, чтобы система не сохраняла слишком много данных.

Сейчас это просто куча записанных в массив данных, не рассчитанная на долговременное использование. С ростом массива он становится всё более громоздким и доступ занимает больше времени, а вся система оказывается нестабильной.

Чтобы исправить это, мы можем добавить код, проверяющий, не разросся ли массив больше определённого размера. Если мы будем знать, сколько кадров в секунду мы сохраняем, то можем определить, сколько секунд перематываемого времени нужно хранить, чтобы это не мешало игре и не увеличивало её сложность. В довольно сложной Prince of Persia время перемотки ограничено примерно 15 секундами, а в более технически простой игре Braid перемотка может быть бесконечной.

if(playerPositions.Count > 128)

{

playerPositions.RemoveAt(0);

playerRotations.RemoveAt(0);

}Когда массив превзойдёт определённый размер, мы будем удалять его первый элемент. Поэтому он всегда будет хранить столько данных, сколько может перемотать игрок, и не будет мешать эффективности. Вставим этот код в функцию

FixedUpdate после кода записи и воспроизведения.Использование собственного класса для хранения данных игрока

Пока мы записываем положение и поворот игрока в два отдельных массива. Хотя это и работает, нам нужно постоянно помнить, что мы записываем и считываем данных из двух мест одновременно, что может привести к проблемам в будущем. Однако мы можем создать отдельный класс для хранения всех этих данных, а в перспективе — и других (если это будет необходимо для проекта).

Код собственного класса, который будет использоваться как контейнер для данных, выглядит следующим образом:

public class Keyframe

{

public Vector3 position;

public Vector3 rotation;

public Keyframe(Vector3 position, Vector3 rotation)

{

this.position = position;

this.rotation = rotation;

}

}Можно добавить его в файл TimeController.cs file перед началом объявления классов. Он создаёт контейнер для сохранения положения и поворота игрока. Конструктор позволяет создать его напрямую со всех необходимой информацией.

Остальную часть алгоритма нужно адаптировать под работу с новой системой. В методе Start необходимо инициализировать массив:

keyframes = new ArrayList();И вместо:

playerPositions.Add (player.transform.position);

playerRotations.Add (player.transform.localEulerAngles);мы можем сохранять непосредственно в объект Keyframe:

keyframes.Add(new Keyframe(player.transform.position, player.transform.localEulerAngles));Здесь мы добавляем положение и поворот игрока в один объект, который затем добавляется в единый массив, что значительно снижает сложность алгоритма.

Добавление эффекта размывания, обозначающего включенную перемотку

Нам очень нужен какой-нибудь признак, сообщающий о том, что выполняется перемотка времени. Пока об этом знаем только мы, а игрока такое поведение может сбить с толку. В подобных ситуациях неплохо добавлять разные сигналы, сообщающие игроку о выполняемой перемотке, как визуальные (например, небольшое размывание экрана), так и звуковые (замедление и воспроизведение музыки в обратном порядке).

Давайте сделаем что-то в стиле Prince of Persia добавив немного размывания.

Перемотка времени в Prince of Persia: The Forgotten Sands

Unity позволяет наслаивать один на другой несколько эффектов камеры, и поэкспериментировав, вы можете подобрать идеально подходящий к вашему проекту.

Для использования базовых эффектов их сначала нужно импортировать. Для этого зайдём в Assets > Import Package > Effects и импортируем всё, что нам предлагают.

Визуальные эффекты можно применять непосредственно к камере. Перейдите в Components > Image Effects и добавьте эффекты Blur и Bloom. Их сочетание создаёт хороший эффект, к которому мы стремимся.

Это базовые настройки. Можете настроить их в соответствии со своим проектом.

Если попробовать запустить игру сейчас, то она будет использовать эффект постоянно.

Теперь нам нужно научиться включать и отключать его. Для этого необходимо импортировать в

TimeController эффекты изображения. Добавляем их в самое начало:using UnityStandardAssets.ImageEffects;Чтобы получить доступ к камере из

TimeController, добавим эту переменную:private Camera camera;И присвоим ей значение в функции

Start:camera = Camera.main;Затем добавим этот код для включения эффектов при перемотке времени:

void Update()

{

if(Input.GetKey(KeyCode.Space))

{

isReversing = true;

camera.GetComponent().enabled = true;

camera.GetComponent().enabled = true;

}

else

{

isReversing = false;

firstRun = true;

camera.GetComponent().enabled = false;

camera.GetComponent().enabled = false;

}

} При нажатии клавиши «пробел» теперь вы не только будете перематывать время в сцене, но и активируете эффект перемотки камеры, сообщая игроку о происходящем.

Весь код

TimeController должен выглядеть следующим образом:using UnityEngine;

using System.Collections;

using UnityStandardAssets.ImageEffects;

public class Keyframe

{

public Vector3 position;

public Vector3 rotation;

public Keyframe(Vector3 position, Vector3 rotation)

{

this.position = position;

this.rotation = rotation;

}

}

public class TimeController: MonoBehaviour

{

public GameObject player;

public ArrayList keyframes;

public bool isReversing = false;

public int keyframe = 5;

private int frameCounter = 0;

private int reverseCounter = 0;

private Vector3 currentPosition;

private Vector3 previousPosition;

private Vector3 currentRotation;

private Vector3 previousRotation;

private Camera camera;

private bool firstRun = true;

void Start()

{

keyframes = new ArrayList();

camera = Camera.main;

}

void Update()

{

if(Input.GetKey(KeyCode.Space))

{

isReversing = true;

camera.GetComponent().enabled = true;

camera.GetComponent().enabled = true;

}

else

{

isReversing = false;

firstRun = true;

camera.GetComponent().enabled = false;

camera.GetComponent().enabled = false;

}

}

void FixedUpdate()

{

if(!isReversing)

{

if(frameCounter < keyframe)

{

frameCounter += 1;

}

else

{

frameCounter = 0;

keyframes.Add(new Keyframe(player.transform.position, player.transform.localEulerAngles));

}

}

else

{

if(reverseCounter > 0)

{

reverseCounter -= 1;

}

else

{

reverseCounter = keyframe;

RestorePositions();

}

if(firstRun)

{

firstRun = false;

RestorePositions();

}

float interpolation = (float) reverseCounter / (float) keyframe;

player.transform.position = Vector3.Lerp(previousPosition, currentPosition, interpolation);

player.transform.localEulerAngles = Vector3.Lerp(previousRotation, currentRotation, interpolation);

}

if(keyframes.Count > 128)

{

keyframes.RemoveAt(0);

}

}

void RestorePositions()

{

int lastIndex = keyframes.Count - 1;

int secondToLastIndex = keyframes.Count - 2;

if(secondToLastIndex >= 0)

{

currentPosition = (keyframes[lastIndex] as Keyframe).position;

previousPosition = (keyframes[secondToLastIndex] as Keyframe).position;

currentRotation = (keyframes[lastIndex] as Keyframe).rotation;

previousRotation = (keyframes[secondToLastIndex] as Keyframe).rotation;

keyframes.RemoveAt(lastIndex);

}

}

} Скачайте пакет с проектом и попробуйте поэкспериментировать с ним.

Подводим итог

Наша игра с перемоткой времени стала гораздо лучше. Алгоритм значительно усовершенствован, потребляет на 90% меньше вычислительной мощности и при этом намного стабильнее. Мы добавили интересный эффект, сообщающий игроку о том, что выполняется перемотка времени.

Настало время сделать на его основе настоящую игру!

|

Метки: author PatientZero разработка игр unity3d c# time rewind перемотка времени prince of persia |

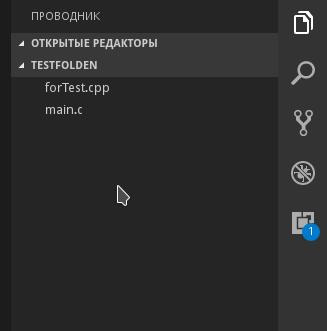

С/С++ на Linux в Visual Studio Code для начинающих |

Передаю слово автору.

Относительно недавно я переехал на Linux. Разрабатывать на Windows, конечно, удобнее и приятнее, но и здесь я нашел эффективный способ легко и быстро отлаживать код на С/С++, не прибегая к таким методам как «printf-стайл отладки» и так далее.

Итак приступим. Писать в

sublime (или gedit/kate/emacs), а запускать в терминале — так себе решение, ошибку при работе с динамическим распределением памяти вряд ли найдёшь с первого раза. А если проект трудоёмкий? У меня есть более удобное решение. Да и ещё поддержка Git в редакторе, одни плюсы.Сегодня мы поговорим про Visual Studio Code.

Установка

Ubuntu/Debian

- Качаем версию пакета VS Code с расширением .deb

- Переходим в папку, куда скачался пакет (cd ~/Загрузки или cd ~/Downloads)

- Пишем, где (имя пакета).deb — название файла, который вы только что скачали:

sudo dpkg -i (имя пакета).deb sudo apt-get install -f

OpenSUSE/SLE Based distrs

- Установим репозиторий:

sudo rpm --import https://packages.microsoft.com/keys/microsoft.asc sudo sh -c 'echo -e "[code]\nname=Visual Studio Code\nbaseurl=https://packages.microsoft.com/yumrepos/VScode\nenabled=1\ntype=rpm-md\ngpgcheck=1\ngpgkey=https://packages.microsoft.com/keys/microsoft.asc" > /etc/zypp/repos.d/VScode.repo' - Обновим пакеты и установим VS Code:

sudo zypper refresh sudo zypper install code

Расширения для С/С++

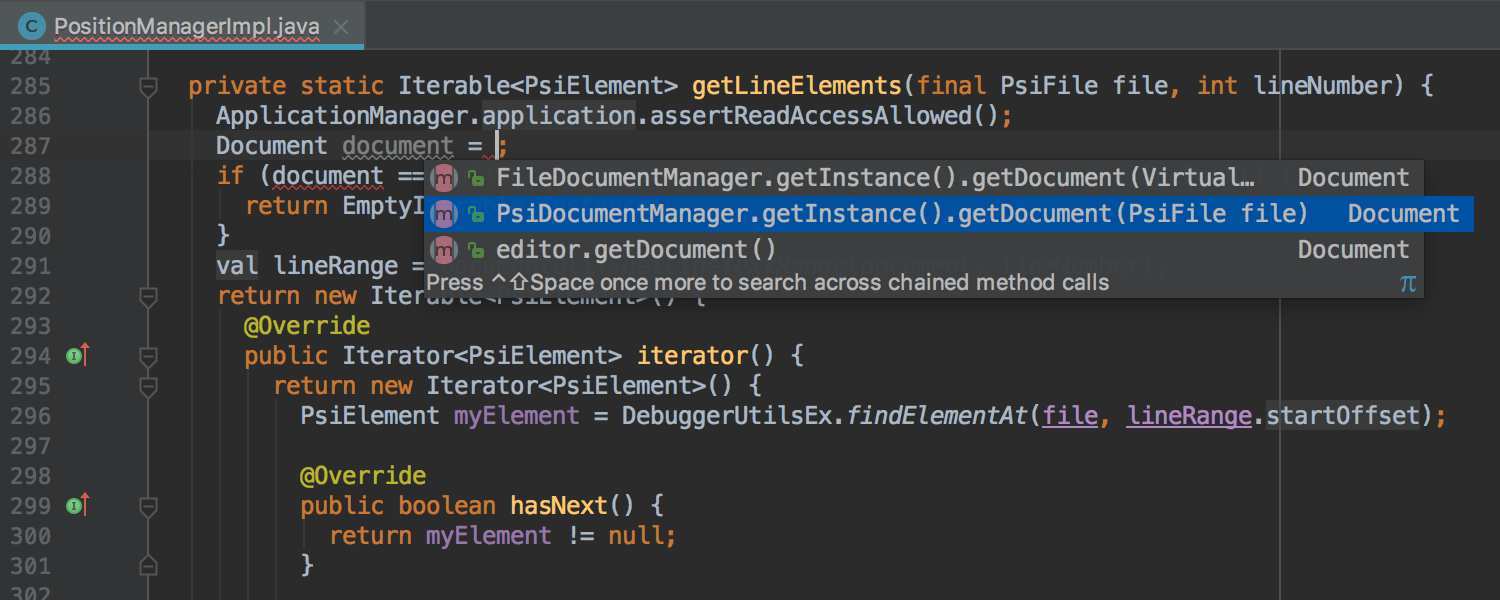

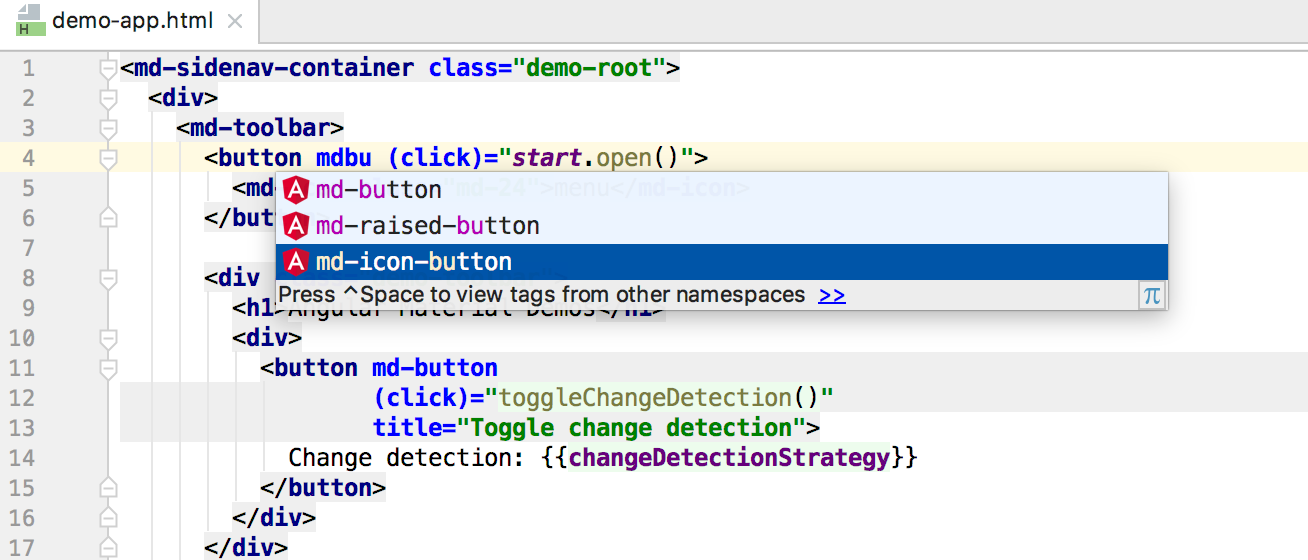

Чтобы VS Code полностью сопровождал нас при работе с файлами С/С++, нужно установить расширение «cpptools». Также полезным будет поставить один из наборов сниппетов.

Настоятельно рекомендую включить автосохранение редактируемых файлов, это поможет нам в дальнейшем.

Идём дальше. Открываем любую папку (новую или нет, неважно).

У меня в этой папке уже есть пара файлов для работы с C/C++. Вы можете скопировать одну из своих наработок сюда или создать новый файл.

Осталось всего ничего. Настроить компиляцию в одну клавишу и научиться отлаживать без

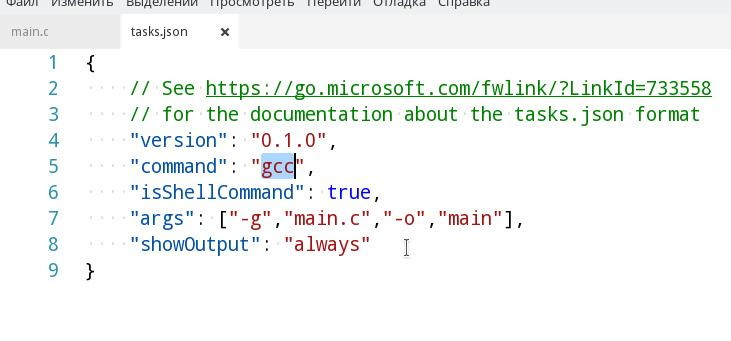

printf.Шаг 1. Открываем файл .c/.cpp, который (обязательно) лежит в вашей папке.

Шаг 2. Нажимаем Ctrl+Shift+B. VS Code вам мягко намекнет, что он не знает как собирать ваш проект.

Шаг 3. Поэтому дальше настраиваем задачу сборки: выбираем «Настроить задачу сборки» -> «Others».

Шаг 4. Прописываем конфигурацию в соответствии с образцом. По сути мы пишем скрипт для консоли, так что всем кто имел дело с ней будет понятно дальнейшее. Прошу заметить, что для сборки исходников в системе должен стоять сам компилятор (gcc или другой, отличаться будет только значение поля

command). Поэтому для компиляции .cpp, понадобится в поле command указать g++ или c++, а для .c gcc.Шаг 5. В

args прописываем аргументы, которые будут переданы на вход вашему компилятору. Напоминаю, что порядок должен быть примерно таким: -g, <имя файла>.Внимание: Если в вашей программе используется несколько файлов с исходным кодом, то укажите их в разных аргументах через запятую. Также обязательным является ключ

-g(а лучше даже -g3). Иначе вы не сможете отладить программу.Если в проекте для сборки вы используете

makefile, то в поле command введите make, а в качестве аргумента передайте директиву для сборки.

Шаг 6. Далее возвращаемся обратно к нашему исходнику. И нажимаем F5 и выбираем C++.

Шаг 7. Осталось только написать путь к файлу программы. По умолчанию это

${workspaceRoot}/a.out, но я в своем файле сборки указал флаг -o и переименовал файл скомпилированной программы, поэтому у меня путь до программы: ${workspaceRoot}/main.

Шаг 8. Всё, больше нам не нужно ничего для начала использования всех благ VS Code. Переходим к основному проекту.

Отладка

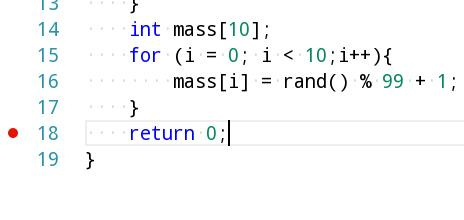

Для начала скомпилируем программу (нет, нет, убери терминал, теперь это делается по нажатию Ctrl+Shift+B).

Как вы видите в проводнике появился

main, значит все в порядке и сборка прошла без ошибок. У меня не слишком большая программа, но выполняется она моментально. Одним словом, провал чистой воды, потому что отладка идет в отдельном терминале, который закрывается после того, как программа дошла в main() до "return 0;".

Пришло время для брейкпоинтов. Выберем строчку с

"return 0;" и нажимаем F9.

Строчка, помеченная красной точкой слева — место, где остановится программа, при выполнении.

Далее нажимаем F5.

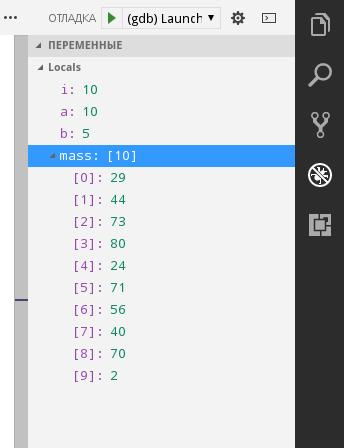

Как я и сказал, программа остановила выполнение. Обратите внимание на окно с локальными переменными.

Удобненько. Также при остановке можно наводить мышкой на переменные и структуры в коде и смотреть их значения.

Также, если на каком-то этапе выполнения вам нужно посмотреть пошаговое выполнение той или иной операции, например в цикле, то поставьте брейкпоинт перед ней и нажмите F10 для выполнения текущей строчки без захода в подпрограмму и F11 с заходом.

Также есть случаи, когда считать выражение очень муторно вручную, но для отладки вам нужно знать, например, значение суммы трех элементов массива, или значение большого логического выражения. Для этого существуют контрольные значения. Все это и многое другое могут показать вам Контрольные значения (или «watch»).

Важно:

- Для каждой папки вам нужно отдельно настроить файлы сборки и путь к программе.

- VS Code не решит ваших проблем, но поможет быстрее с ними разобраться. Причем в разы.

- После каждого изменения программы, ее нужно компилировать заново, нажимая Ctrl+Shift+B.

Полезные шорткаты можно посмотреть здесь.

Об авторе

Максимилиан Спиридонов — разработчик C#, студент МАИ, Microsoft Student Partner. В профессиональную разработку на .NET пришёл ещё в школе. Около года работал с реальными проектами на WPF(MVVM)+C#, MySQL, более 4-х лет разрабатывал на C#. Основная сфера интересов сейчас — это мобильная разработка на Xamarin. Также, по воле случая в сфере интересов оказались С/С++ и Linux.

|

Метки: author Schvepsss разработка под linux visual studio c++ блог компании microsoft microsoft с++ linux visual studio code |

Сказ о проектном менеджере в банке и как он решил проблемы с удаленным подрядчиком |

А потом с подрядчиками что-то случилось. Толи они поменяли менеджера, толи разработчиков перекинули на другой проект и оставили ему джунов, толи еще что-то. Процессы стали выполняться медленнее, сроки продалбыватся, качество стало хуже. Стал думать менеджер, что же случилось и как бы ему решить свою проблему? Пошел он к старому приятелю своему, у которого компания занимается ИТ аутсорсингом. Рассказал он о проблеме своей. И приятель вспомнил, что недавно он писал документ для своей команды, где расписал о том, как коммуницировать с заказчиком, чтобы это было эффективно и качество не страдало. Поделился он документом с менеджером. А менеджер прочитал его и с минимальными правками отправил письмо подрядчику.

Коллеги, здравствуйте

Не знаю как вам, но мне кажется, что мы сейчас рассинхронизированы и нынешнее положение вещей это только усугубляет. В перспективе это обязательно скажется на качестве задач, сроках которые будут увеличиваться. В свою очередь вы будете не довольны тем, что нами оплачено одно время, а вы затратили на задачи совсем другое. В итоге всё это может привести к нашему расставанию, что не выгодно для наших компаний.

Чтобы избежать все вышеизложенное, я подготовил небольшой список принципов и правил нашего с вами взаимодействия.

- Встать на сторону заказчика. Это значит, что нужно одевать на себя шапку заказчика и будучи в его шкуре представить мотивы его требований и задач. Мотивы могут быть очевидные, а могут быть и скрытые. Если чувствуете, что в задаче нет дополнительной информации для полного понимания – надо о ней спрашивать и фиксировать в исходном документе о задаче, который размещен на гугл диске. Все должно быть прозрачно ясно.

- для пээмов: если в процессе получения задачи или юзер стори вы чувствуете спорные моменты или что-то упускаете, то постарайтесь получить всю информацию, чтобы быть с заказчиком on the same page. Заказчик может говорить одно, подразумевать другое, а ожидать третье.

- для остальных: для ребят разработчиков/дизайнеров тоже полезно перед началом работы над задачей представить себя заказчиком и понять его мотивы. Это такой простой и недолгий мысленный эксперимент и он поможет вам глубоко и ясно понять задачу. Если же вы получили задачу и она, в принципе, понятна, но вы не видите общей картины и не чувствуете как она в целом повлияет на процесс – обязательно сообщите об этом пээму.

- Честность, уважение и сдержанность.

- честность: своевременно говорите о проблемах и о отставаниях, чтобы заказчик на своей стороне успел мобилизоваться. От ошибок никто не застрахован, но их замалчивание расценивается как не профессионализм.

- уважение: заказчик может быть со своими тараканами в голове, может иногда тупить. Но раз уж он работает с вами, это что-то значит.

- сдержанность: старайтесь сдерживать свои эмоции в общении и в переписке.

- Коммуникация! Коммуникация! Коммуникация! (хотелось бы сразу заметить, что под коммуникацией ни в коем разе не подозревается пустая болтовня и бездумные переговоры). Ниже приведу выдержки из книги Remote, так как мы с вами работаем удаленно:

- Почаще рассказывайте клиенту, что сделано по проекту. Это лучший способ избавить его от вполне естественной тревоги. Послушайте, он же платит вам приличные деньги, и некоторое беспокойство, которое он ощущает с момента расставания с авансом, вполне понятно. Так что показывайте ему то, за что он платит. Когда клиенты регулярно видят результаты ваших усилий, они гораздо лучше себя чувствуют. Но для того чтобы избежать постоянных созвонов, НУЖНО четко и структурированно вести работу над задачами в нашем инструменте – Трак:

- Задача должна быть оформлена полностью по шаблону (что нужно сделать, как это сделать, критерии готовности и прочее)

- У задачи должны быть проставлены все пункты (milestone, планируемый срок исполнения, компоненты, номер релиза, дата и прочее)

- У задачи должен быть виден прогресс, то есть если разработчик проставил задачу в статус inProgress и работает над ней, то я ожидаю увидеть, что он по ней сделал в течении дня (это минимум 2 комментария к задаче в день, которые понятно раскроют суть сделанного)

- Будьте подчеркнуто доступны для общения. Поскольку у нас нет возможности встречаться лично, лучше вовремя перезванивать, отвечать на электронную почту, отзываться в мессенджерах и так далее. Это азы деловой этики, и их важность десятикратно усиливается в случае удаленной работы. Если вы работаете удаленно, клиенты более подозрительно относятся к оставшимся без ответа звонкам и «потерянной» почте. Будьте на связи, это в ваших интересах. Для того чтобы плыть в одном русле теперь каждый день у нас с вами в 9:30 будет видеоконференция (это будет стенд-ап не больше чем на 10 минут, чтобы сверить часы, услышать проблемы и понять куда движемся). Присутствие всей команды обязательно.

- Подключайте заказчика к работе, пусть он видит весь процесс. Пусть чувствует, что это и его проект тоже. Да, вас наняли из-за вашего опыта, но и у него опыта хватает. Показывайте полусырой, еле двигающийся прототип или сервис, лучше на начальном этапе понять что не так и потратить меньше ресурсов и сил на переделку. Я как заказчик понимаю, что такое прототип и на какие вещи не стоит обращать внимание, здесь важно базовое понимание работы, а детали это детали.

В результате дела пошли хорошо. И причем команда девелоперов была довольна этим регламентом больше, чем сам автор письма. Без четких правил и дисциплины любой процесс взаимодействия разваливается. Хорошо бы эти правила командам разработчиков иметь внутри себя и придерживаться их, а не ждать пока это сделает кастомер.

|

Метки: author Gen1us2k управление разработкой управление проектами управление персоналом управление людьми управление проектами и командой |

Книга «Python. Уроки» |

Добрый день, коллеги!

Добрый день, коллеги!Я являюсь одним из авторов блога devpractice.ru. В конце апреля 2017 года нами была написана завершающая статья из цикла «Уроки по языку Python», всего их получилось 15 штук. Спустя какое-то время, у нас появилась идея объединить весь накопленный материал. Так появилось первое издание книги «Python. Уроки». Эту книгу мы решили распространять бесплатно и предлагаем вам ознакомиться с ней.

Скачать «Python. Уроки» вы можете непосредственно с сайта. В книге основной акцент сделан на обучение базовым вещам (установка и запуск программ, типы данных, условные операторы и циклы, структуры данных, функции, исключения), темы, связанные с ООП, итераторами и генераторами даны в ознакомительном объеме.

Краткое содержание книги:

Урок 1. Установка

Урок 2. Запуск программ на Python

Урок 3. Типы и модель данных

Урок 4. Арифметические операции

Урок 5. Условные операторы и циклы

Урок 6. Работа с IPython и Jupyter Notebook

Урок 7. Работа со списками (list)

Урок 8. Кортежи (tuple)

Урок 9. Словари (dict)

Урок 10. Функции в Python

Урок 11. Работа с исключениями

Урок 12. Ввод-вывод данных. Работа с файлами

Урок 13. Модули и пакеты

Урок 14. Классы и объекты

Урок 15. Итераторы и генераторы

Будем рады любой обратной связи!

|

Метки: author marat_ab python уроки python |

Как я был обманут, связавшись с дизайнером Ramin Nasibov (Berlin, Germany) |

Считаю необходимым поделиться с читателями как меня надули. Возможно это поможет другим избежать подобных ошибок. Большое количество лайков и последователей в соц.сетях не гарантирует вас от обмана. Обман может быть не только в невыполнении оплаченных работ, но и в получении в качестве результата не оригинальных изображений.

12 июня через Twitter я получил сообщение с предложением о сотрудничестве:

Are looking for a freelance designer and social media manager? Professional Branding and Social Media Design. Porfolio: nasibov.me If you have any questions please email me: ramin@nasibov.me

Я нуждался в обновлении изображений на моем сайте vialatm.com. Познакомившись с его представительством в соц. сетях, я обратился с вопросом о стоимости работ. Практически сразу я получил предложение обсудить все в Skype митинге. Через 30 минут мы провели переговоры в Skype. Оказалось что дизайнер свободно говорит на русском. Мы пришли к соглашению, что в течении недели он подготовит оригинальные изображения для моего сайта. Он запросил оплату в размере 50% от общей стоимости работ. Я предлагал провести оплату через PayPal, но он настоял на оплате через Payoneer.

Через два часа я получил запрос на оплату работ и сразу произвел оплату:

После этого общаться с ним стало весьма проблематично. То он не отвечал потому, что был далеко от компьютера, то он не появлялся на оговоренных Skype митингах из-за проблем с интернетом.

22 июня, в связи с отсутствием каких-либо результатов и неудачных попыток связаться и пообщаться с ним, я попросил его вернуть авансовый платеж.

23 июня, не получив никаких ответов, я предупредил его что буду пытаться разрешить возникшую ситуацию по другим каналам.

Полное молчание. Я был вынужден приобрести дизайн сайта в другой компании и купить изображения на iStock.

25 июня я направил жалобу в платежную систему Payoneer. И вот после этого он объявился. Через Skype от него было получено сообщение:

Hello Andrey. As a result of the action of the group by the scammer and the burglars, I lost access to my own social networks, mail and Skype. Unfortunately you had to communicate with scammers on my behalf. As a result, not only you, but also other users were deceived. The criminals professionally mimicked my content in social networks and in contacting clients requested advances. At the moment, with the help of a lawyer and right services, I was able to return access to my social networks and Skype. After gaining access back I was shocked by the correspondence and the number of cheated people. At the moment, I draft an application to the relevant authorities and contact the deceived customers. Since the fraudsters in a certain way managed to get money, I have to work for clients for free and without any fees. I’m really sorry Andrey. Are you interested in receiving your order?

Вкратце суть его в том, что его акаунтами завладели мошенники, общался я с мошенниками, с помощью адвокатов он вернул доступ к своим социальным сетям и прочая чушь!:

Все это время, в Twitter он публиковал свои новые работы, а в Facebook делился фотографиями (кошки, кресла, ...). А я все свои последние сообщения ему дублировал по эл. почте, в Twitter и Skype.

28 июня он предложил в течении 1-2 дней выполнить работы.

Но я отказался и потребовал возвращения денег (в течении двух недель после оплаты я даже никакого эскиза не получил, и он откликнулся только после моего обращения в Payoneer).

После этого он окончательно исчез.

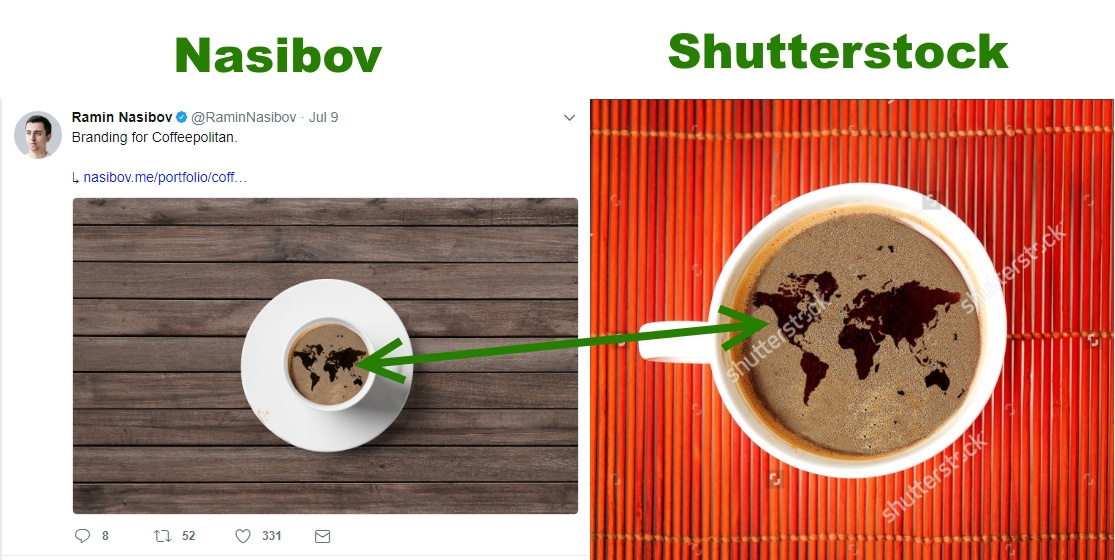

Я еще раз решил взглянуть на работы этого дизайнера и мое внимание привлекло публикация в Twitter — работы для компании «Coffeepolitan» https://twitter.com/RaminNasibov Никакого труда не составило найти подобную картинку с картой мира на кофе на сайте — Shutterstoc

Чашка и деревянный фон на картинках отличаются (но чашек и фона из деревяшек найти вообще труда не составляет), а вот картинки карты мира на кофе совпадают до мелочей.

Очень интересно какое изображение является оригиналом, а какое копией?

Между прочим этот дизайнер имеет два сайта http://nasibov.me/ и http://pixelin.me/ с impressum

Выводы из всего этого — договоры на работы должны сопровождаться четкими юридическими документами. В них должны быть предусмотрены санкции не только за срыв сроков, но и ответстсвенность за получение изображений, к которым могут быть предявлены права третьих лиц.

|

Метки: author Euler2012 блог компании euler2012.com дизайн жулики и воры |

Доработки шаблонизатора DoT.js |

Так случилось и с DoT.js. Поначалу заброшенный авторами примерно на год в 2013-м, он получил их внимание ненадолго, поднявшись с версии 1.0.1 до 1.1.1, и снова был заброшен (или стабилизирован, смотря как рассуждать). В связи с этим ещё в 2013 году понадобилось (делать клон DoT.js), а теперь — и апгрейдить его.

Он — такой же быстрый, как и встроенный

_.template() в Underscore/Lodash, но с улучшенным синтаксисом, при котором необходимость писать JS в шаблонах встречается нечасто, а в Underscor-овском — нужна всегда. Этим скобкам со скриптами даже придумали специальный термин: javascript encapulated sections (JES), и от них, в основном, избавились.Что получаем дополнительно?

1. Структура шаблонизатора была переработана (в 2013-м, ссылка оттуда), чтобы лучше читалась и уменьшилось число декодирований функций;

2. Тесты показали, что быстродействие в среднем не изменилось (колебания -3% — +10% в зависимости от параметров);

3. Добавлена команда работы по структуре, аналогично работе по массиву;

4. 4-й параметр — фильтр элементов структуры или массива;

5. Кое-где замедления вследствие обхода багов скомпенсированы оптимизацией кода и регекспов;

6. Глобальное имя «doT» способно меняться на другое в настройках (у оригинала — нет);

7. Наведён порядок в нумерации версий и версионировании глобальных функций encodeHTML() — инстансов, принятых здесь для оптимизации.

Для справки по нумерации версий

В npm копия версии 1.1.1 один-в-один в package.json названа как 1.1.2, но в файле — остался номер 1.1.1; в ветке 2.0 в репо — то же самое с необновлением номера 1.1.1 и есть всего 1 отличие в

var rw = unescape(...). В общем, всё сделано для неразберихи. Поэтому считаем, что самая новая версия — 1.1.1, в которой учтём отличие из ветки 2.0. Ветка 2.0 своего звания не заслуживает.По случаю, удобно сделать документацию (есть от авторов), с инструментом для её проверки. (Что в Сети нашлось читабельного — ссылки внизу.) Если кратко:

• он сохранил «исконный» синтаксис Underscore

_.template(), в котором внутри скобок "{{ ... }}" можем писать любой JS-код, включая незакрытые фигурные и операторные скобки, а снаружи скобок — HTML-фрагменты текста.• скобки переопределить можно, переопределив в настройках все регекспы с ними (обычно не нужно);

• имя старшего элемента структуры

'it' тоже переопределить можно, как и 4 логических настройки поведения;• поддерживается AMD, commonJS и просто глобальное имя его (

'doT');• кроме базового универсального синтаксиса, имеет ряд команд, подобных стилю Mustache/Handelbars;

• как и они, и

_.template(), имеет 2 этапа шаблонизации (каррирования параметров) — в функцию и затем в HTML (или другой) код;• не заточен строго под HTML, но привязан к JS, поэтому его сфера — браузеры и NodeJS;

• не намного больше по объёму, чем исходный код

_.template() — 3.4 К в сжатом не зипованном виде.(Для экспериментов с кодом нового или старого шаблонизатора можно воспользоваться старым примером в http://jsfiddle.net/6KU9Y/2/ (но далее есть js-фиддл лучше). Построена и в репозитории удобная страница тестирования 2 движков на общем шаблоне и данных — в

test/index.html. По умолчанию она сравнивает одинаковость результатов в развёрнутой и минифицированной версиях файлов. И второй движок может работать лишь с клоном, т.к. у него возможно глобальное имя, отличное от 'doT'. Вместо минифицированной можно поставить клон, а на первом месте, например, оригинальный DoT.js 1.1.1 и смотреть различия в парсинге.)

В файле второго движка нужно перед открытием страницы установить имя

globalName:'doTmin'.Впрочем, и в онлайне то же самое несложно: https://jsfiddle.net/spmbt/v3yvpbsu/22/embedded/#Result или с фреймами и редактированием кода, у кого большие экраны: https://jsfiddle.net/spmbt/v3yvpbsu/22/. Файлы подключать не надо, лишь копипастить содержимое 2 версий DoT.js, а во второй, удобнее это делать в клоне — подправить имя

doT на doTmin (даже если не minimized). По умолчанию выставлены DoT.js 1.1.1 оригинал и DoT12.js 1.2.1 — клон.Бенчмарк (3-я кнопка) устроен по короткому промежутку времени, поэтому зависит от параллельных процессов, и о скорости синхронных алгоритмов можно судить при усреденении по большому числу измерений (среднее накапливается и позволяет немного судить о скоростях). Встроенный в проект бенчмарк есть, но он сложный, через Ноду, а делает то же самое (по группе тестовых файлов).

В страницу тестов встроены чекбокс автообновления и перехват ошибок, что позволяет проводить тесты по той версии, которая останется исправной. Так, легко сравнить скорости команд

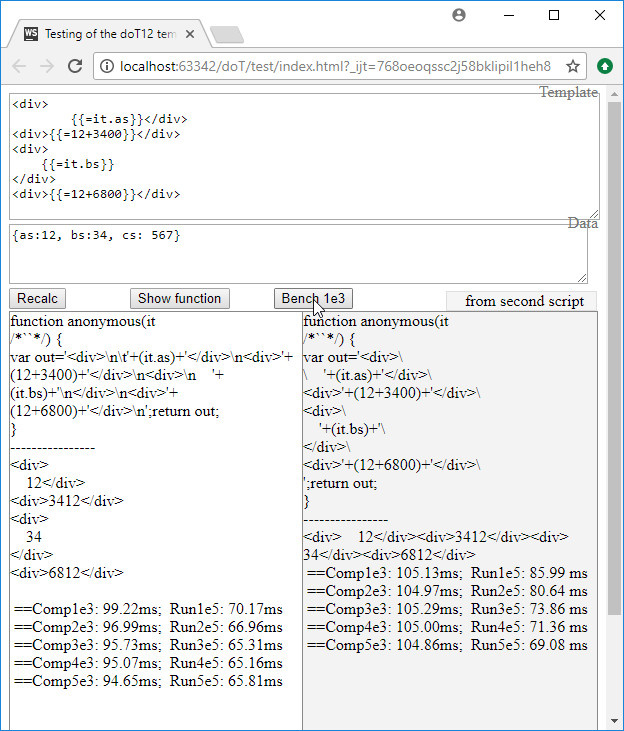

'~' и '@' по массиву. Вторая тоже работать может, но значительно медленнее — на 10-15% (проверяется кнопкой «Bench»). Это связано с необходимостью использовать более медленный цикл for-in во втором случае. Тем не менее, без for-in для структур не обойтись, чтобы не иметь необходимости подготовки массивов из структур для оригинальной версии, не имеющей команды '@'.Сразу традиционно заметим, что 2-е вычисление (расчёт по компилированному шаблону) идёт в сотню раз быстрее (для коротких выражений), чем полная компиляция каждый раз (1-е число, по в 100 раз меньшему числу измерений). На скриншоте "

Comp1e3: 99.22ms" означает: «1000 полных компиляций проведены за время 99.22ms». "Run5e5: 69.08 ms" в 5-й строчке означает: «50 тысяч быстрых генераций HTML по шаблону проведены за усреднённое время 69.08ms на каждые 10 тысяч генераций».Добавлен спадающий список примеров, из которого можно извлечь типичные примеры применения команд DoT.js и протестировать их в 2 версиях скрипта. Изменения примеров временно сохраняются и к ним можно вернуться, повторно выбрав прежний пункт примера, если страница браузера не была перезагружена.

О командах — подробнее

В начале пункта в кавычках будет приведено имя, которым в коде

DoT12.js названо регулярное выражение, отвечающее за данную функцию (команду) шаблонизации.Команда "valEncEval"

Один регексп под этим именем объединяет 3 прежних команды, имеющие сходный синтаксис.

{{ часть выражения и операторов JS }}{{= выражение JS }}"

" в значении выражения, если будет выложен в страницу браузера, будет вести себя не как текст, а как тег — приведёт к переносу строки по правилам HTML.{{! выражение JS }}&...;) символы превращаются в текст;Команда "conditional"

{{? if-выражение }} then-шаблон {{?}}{{? if-выражение }} then-шаблон {{?? [if-else-выражение]}} [if-]else-шаблон {{?}}Выражение — любое, содержащее глобальные переменные или структуру с именем

'it', в которую передаётся параметр при шаблонизации.if-else легко получить, инвертируя if-выражение. Синтаксис не стали усложнять, видимо, ради скорости.

Команда "use"

{{# выражение, выдающее строку }}{{# ...}} можно внести в шаблон текст другого шаблона через переменную. Но задумана команда была для более простых и конкретных дел, в паре с командой «define».Команда "define"

Появилась с версии 1.0. Поначалу решалось не в тексте шаблонов, а в списке параметров после настроек (3-й параметр в doT.template(шаблон, настройки, параметры)).

Формат определения переменной для «use»-команд в команде «define»:

{{## def.defin1 :что_угодно_до_скобки#}}

или {{## def.defin1 =что_угодно_до_скобки#}} - имеет другой смысл (функция)Переменные могут быть с точками и $, в них определяется любая строка. Есть ряд хитростей.

Точки в имени (стиль кого-то копировали).

Если первые 4 символа — 'def.', они удаляются.

Если через двоеточие — записываются пары def[code] = {arg: param, text: v};

Через равенство определяется функция 'def' (удобно посмотреть на тестовой странице в списке примеров).

Можно в одном месте определить макрос, чтобы 2 и более раз использовать. Как все макросы — сомнительно с точки зрения качества кода. Если понадобятся макросы — это значит — понадобилось перед кем-то выгородиться, уменьшив размер текстов грязным способом, потому что вовремя не продумано, как правильно с точки зрения проекта его уменьшить. И на хранение переменных тратятся ресурсы скрипта.

Некоторый плюс есть в том, что разделяются окружения и места работы скрипта, как с парой команд use-useParams.

И есть семантическая разница в том, что скрипты выполняются на лету, в момент связывания шаблона с данными, а define и use — на шаг раньше, при связывании функции шаблона с шаблоном. Одним словом — это макросы.

Команда "defineParams"

{{##foo="bar"#}}Команда "useParams"

Использование ранее определённых параметров.{{#def.foo}}{{ операторы JS }}Команда "iterate"

Объединение 2 команд с разными скоростями и возможностями.

While-шаблон

{{~...}} — это пробежка по массиву циклом while. (Выбирали, очевидно, из всего и выбрали самое быстрое на тот момент в браузерах.) Работает быстрее на 10-15%, чем её альтернатива {{@...}} на for-in-шаблоне, которая может пробегать по массиву или по струкутуре. 4-й параметр — фильтрация элементов по выражению. В оригинальной версии поддерживается только массив и без фильтрации. Не устраивает — всегда есть "{{ ... }}" (писать удобно, читать — нет, как Perl или машинный код).{{~ it : value : index : filter-expression }} while-шаблон {{~}}, где

it — слово 'it' (или другое), означающее первый аргумент, или глобальное имя массива, или выражение, возвращающее массив; value — любое имя, например, 'v' или 'value' без кавычек, которое будет использоваться в for-шаблоне на месте подставляемого значения элемента массива, например, в выражении {{= value+1}}; index — аналогично, любое имя, определяющее индекс элемента массива.Да, параметры указаны «навыворот» (сначала value, потом index), но так сложилось у них, менять не будем и здесь, и в следующей похожей команде. Логика в том, что последний (и вообще последние)

index можно опускать, если не нужен в шаблоне, вместе с двоеточием.Опускать можно в клоне и другие параметры, оставляя двоеточия. В оригинале — нельзя: хотя бы букву, но писать надо. Первый параметр по умолчанию — 'it' (а точнее —

templateSettings.varname), у остальных тоже есть умолчания, но они очень технические, незапоминаемые.В сумме, всё сделано так, чтобы и компиляция, и исполнение шаблонов были максимально быстрыми, без лишних действий и красивостей. Скорее всего, можно ещё что-нибудь улучшить, а некоторые улучшения исполнения ухудшат время компиляции, поэтому во всём — разумный баланс.

{{@ it : value : index : expression }} for-in-шаблон {{@}}Пробежка по структуре, по первому её уровню. Выполняется в браузере медленнее (% на 10-15), чем в массиве, нужно учитывать особенности порядка выдачи ключей-чисел и остальных ключей (числа идут вначале, потом все остальные ключи, кроме старых версий IE типа 8-й и ниже, Оперы и старых Fx того же прошлого времени. Где числа шли в общем ряду с другими.). Причём, порядок ни один стандарт не гарантирует, но он есть. Использовать его или проверять, или полагаться на массивы — дело разработчика. Самые авторитетные скажут, что доверять на 100% нельзя и будут правы. Такая же история и в Python, и в JSON.

В то же время, использования порядка, в котором пришёл JSON или была определена структура, сокращает объём кода процедур. 4-м параметром добавлено выражение — условие фильтра. Если false — элемент не выводится. (Если нет условия, сохраняется паразитное условие

"if(1)"? это — плата за баланс.)Примеры сокращений параметров

{{@::i}} for-in-шаблон {{@}}Пример:

{{@::i}} {{=it[i]}} {{@}}{{@:v}} {{=v}} {{@}}Вместо шаблонов — можно использовать массивы в

"@"-командах. Но наоборот, в "~"-командах (в массивах) — структуры — нельзя, ради совместимости с оригиналом.… Через лет 7 всё это пропадёт и умрёт под грузом новых великолепных фреймворков, где вопросы по-своему и по-другому будут решены. forEach, filter, reduce, JSX — убийцы шаблонов уже на пороге и одной ногой каждый по эту сторону двери. А управлять разметками экрана сможет даже шимпанзе. А пока — спешите поковыряться в костылях, пока они окончательно не стали историй, как К155ЛА3.

Что там за настройки и зачем нужны

varname: 'it',Эта настройка — довольно понятная. В выражениях шаблонов применяется имя вместо arguments[0] (первого параметра промежуточной скомпилированной функции). arguments[0] далеко не всегда применишь из-за вложенных функций, а имя — почти всегда, если нет конфликтов. Вот если есть конфликты — имя можно сменить, причём, не только прямо в коде библиотечного шаблонизатора, что моветон, но и во 2-м параметре

doT.template(), в локальных настройках текущей команды. (Есть ещё способ «статической» смены настроек, добравшись к ним по window.doT.templateSettings.)Есть и другие специфические имена у этого шаблонизатора, которые могут вызвать конфликты. Их легко увидеть на странице тестов, нажав кнопку «Show function» на странице тестирования

test/index.html. Это имена: out, arr1, arr2, ..., ll (две малые L), v, i (при проходе по массивам. Они экранируют такие же внешние имена. Но it — на особом счету, без неё — никуда, поэтому вынесена в настройки.strip: true,Выкидывание лишних пробелов, табов и переносов строк. Если форматирование выходного текста не важно, используем true. Функция и шаблон будут короче, а скорость компиляции, как ни покажется странным, чуть ниже (1-2%); исполнение — по скорости неотличимо. Т.е. для ускорения компиляции нужно ставить

strip: false.append: true,Стиль добавления кусочков HTML-кода и данных в переменную out — суммированием в цепочке или операторами присваивания. Последнее удлиняет текст функции, поэтому, если особо не нужно — выбираем true. (Видимо, когда-то это было вопросом — что выбрать и что быстрее работает.)

log: true,Не используется. Или забыли удалить, или нужно где-то в соседних скриптах типа NodeJS — express.

selfcontained: false,Здесь скрывается небольшая история оптимизации. Функция

doT.template(...) может быть подготовлена в одном общем окружении (_globals) и тут же исполнена как doT.template(...)(...), а может — отдельно (прийти по ajax или из файла). В последнем случае нужно true (удлиняет функцию doT.template(...)), а обычно, в первом случае — false. Тогда не приходится в ней генерировать лишнего, а подсчитанное сохраняется в _globals._encodeHTML, генерируемой из _globals.doT.encodeHTMLSource(), но не всегда, а лишь при наличии команд {{! выражение}} в шаблонах.Другими словами,

selfcontained = true — значит, что функцию шаблона doT.template() будут использовать отдельно от doT.js, поэтому она должна содержать в себе всё для выполнения шаблонизации. Всё — это значит лишь особый случай кодирования HTML-символов командами {{!}}. Если они есть, в функцию нужно включить определение функции кодирования — строку doT.encHtmlStr при её создании (так сделано в клоне 1.2.1, а в оригинале функция encodeHTMLSource преобразуется в строку).В версии 1.1.1 оригинала есть недоработка — алгоритм всегда «засовывает» код функции в шаблон, без сжатия, даже если

selfcontained = false, это пришлось исправить. Ещё эта функция занимается связыванием параметра doNotSkipEncoded постоянно, хотя это нужно только при создании функции шаблона.Затем, в оригинальном движке есть проблема конфликта версий, потому что они используют глобальный объект (window, globals) для оптимизации использования функции кодирования HTML. Её решили в клоне 1.2.1 тем, что глобальное имя функции кодирования выбрали зависящим от имени движка и версии. Получилось примерно так:

var encHt = '_'+dS.globalName + doT.version.replace(/\./g,'').

...

encHtmlStr:'var encodeHTML=typeof '+ encHt +'!="undefined"?'+ encHt +':function(c){return((c||"")+"").replace('

+ (dS.doNotSkipEncoded ?'/[&<>"'\\/]/g':'/&(?!#?\\w+;)|[<>"'/]/g')

+',function(s){return{"&":"&","<":"<",">":">",'"':""","'":"'","/":"/"}[s]||s})};'Получаем строку для вставки в функцию шаблона, но если

selfcontained = false и есть {{! выражение}}, то ограничиваемся выполнением её в глобальном объекте, чтобы из него использовать encodeHTML().doNotSkipEncoded: false,Аргумент

doT.encodeHTMLSource(). Работает для функций {{! выражение}} — выдачи безопасного (без исполняемых тегов) HTML-кода. Если они есть в любом шаблоне окружения, первый раз определяется функция _globals._encodeHTML генерации безопасных символов для экономии повторных её вызовов. Сделано для решения таких багов: github.com/olado/doT/issues/106. Если true, то не кодируются все коды вида "&....;", и главный результат — некодирование амперсенда в '&' в таких выражениях.Заключение

Для скорости компиляции, очевидно нужны такие параметры, которые требуют меньше действий: по возможности,

selfcontained = true. Остальные части doT оптимизированы хорошо, выбраны в среднем самые быстрые решения. Скорость версий зависит от конкретного вида шаблонов, поэтому утверждение о скорости может быть лишь усреднённым по кругу задач.В целом, клон компилирует шаблон в функцию несколько медленнее из-за увеличенного объёма анализа кода, который нужно делать для решения некоторых багов. Например, удлинена функция unescape(). Если из неё убрать 2 последних replace, скорость увеличится на 3% (Chrome v.61 Canary), но будут некоторые баги.

Если же не обращать внимание на единицы процентов, то шаблонизатор doT.js — один из наиболее быстрых и, в то же время, компактный. ES6 и даже новые методы массивов не использует — написан не в ту эпоху. Это даёт плюс в том, что поддерживается всеми браузерами (должен работать и в IE8). В ie11 протестирован. На тестовой странице test.index.html

performance.now() полифиллится.• Гитхаб DoT12.js (клон оригинала), DoT.js.

• JSFiddle для экспериментов с шаблонизатором (код 2013 года) и шаблонами (изначально внесён клон Dot; в других соседних номерах фиддлов читатели могли оставить результаты своих экспериментов, которые они могут документировать и оставить ссылку в комментарии; проверить работу своей версии без сохранения — нажать кнопку «Run»).

• Статья по клону DoT.js 2013 года с тестами производительности.

• Сравнение версий, тесты и накопительные бенчмарки для DoT — DoT12: https://jsfiddle.net/spmbt/v3yvpbsu/22/embedded/#Result• Сравнение версий, тесты и накопительные бенчмарки для DoT — DoT12: https://jsfiddle.net/spmbt/v3yvpbsu/22/embedded/#Result или с фреймами и редактированием кода: https://jsfiddle.net/spmbt/v3yvpbsu/22/

* Closure Compiler — сжимает немного лучше в Advanced mode, чем Uglify;

* Using doT.js (хорошая подборка примеров, 2012)

* Using doT.js Способы записать цепочки if-else;

* Документация с песочницами, от авторов, подробно, с поясняющими примерами по ссылкам.

|

Метки: author spmbt node.js javascript html dot.js шаблонизаторы handlebars mustache |

Стоимость хранения данных: «игра с нулевой суммой» |

/ Flickr / William Hook / CC

/ Flickr / William Hook / CCВ антагонистической игре есть два игрока, выигрыши которых противоположны. Ситуация с погоней за снижением стоимости жестких дисков очень похожа на такую игру.