Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Перевод] AWS DeepLearning AMI — почему (и как) его стоит использовать |

Иногда хорошие вещи приходят бесплатно ...

Что такое AMI?

Для тех из вас, кто не знает, что такое AMI, позвольте мне процитировать официальную документацию по этому вопросу:

Amazon Machine Image (AMI) предоставляет данные, необходимые для запуска экземпляра виртуального сервера в облаке. Вы настраиваете AMI при запуске экземпляра, и вы можете запустить столько экземпляров из AMI, сколько вам нужно. Вы также можете запускать экземпляры виртуальных машин из множества различных AMI, сколько вам нужно.

Этого должно быть достаточно, чтобы понять остальную часть статьи, однако я бы посоветовал потратить некоторое время на официальную документацию об AMI.

Глубокое обучение или глубинное (англ. Deep learning) — набор алгоритмов машинного обучения, которые пытаются моделировать высокоуровневые абстракции в данных, используя архитектуры, состоящие из множества нелинейных преобразований

Глубокое обучение является частью более широкого семейства методов машинного обучения, которые подбирают представление данных. Наблюдение (например, изображение) может быть представлено многими способами, такими как вектор интенсивности значений на пиксель, или (в более абстрактной форме) как множество примитивов, областей определенной формы, и т. д.

С другой стороны есть и мнения, что глубокое обучение — не что иное, как модное слово или ребрендинг для нейронных сетей. Wiki.

Что такое AWS DeepLearning AMI (а.к.а. DLAMI) и почему его нужно использовать?

Обучение (тренировку) нейронных сетей можно делать 2-мя путями: с использование CPU или с использованием GPU. Думаю ни для кого не секрет что обучение с помощью GPU показывает лучшие результаты, с точки зрения скорости(а как следствие и затрат), чем обучение с помощью CPU, поэтому все современные системы машинного обучения поддерживают GPU. Однако, чтобы использовать все преимущества GPU мало просто иметь этот самый GPU, вам необходимо еще "по приседать":

- Получить сам GPU.

- Настроить его драйвера.

- Найти библиотеки, которые могут использовать все возможности именно вашего GPU. Библиотеки должны быть совместимы с драйверами и оборудованием из 1 и 2.

- Вам необходимо иметь нейронную сеть, которая была скомпилирована с библиотеками, которые были найдены ранее.

Так что же нужно сделать что бы решить все эти 4 незадачи? Есть 2 варианта:

- Загрузить исходный код сети и библиотеку для работы с GPU, а затем соберите все самостоятельно в нужной конфигурации(в реальности это еще сложнее сделать чем звучит).

- Найти сборку фреймворка с поддержкой GPU, затем установить все необходимое и надеется что оно взлетит.

Оба случая имеют разные плюсы и минусы, однако есть один большой минус для этих вариантов — оба требуют от пользователя некоторых технических знаний. Это основная причина, по которой не так много людей, как хотелось бы, тренируют нейронные сети на GPU.

Как DLAMI может решить эту проблему? Да легко, дело в том, что DLAMI, это первое бесплатное решение, включающее все, что необходимо прямо из коробки:

- Драйвера для новейшего графического процессора от Nvidia;

- Последние библиотеки CUDA и CuDNN;

- Предварительно собранные фреймворки с поддержкой GPU (и собранные с теми версиями CUDA и CuDNN которые доступны в AMI).

Аль, к слову, список фреймворков, которые работают из коробки:

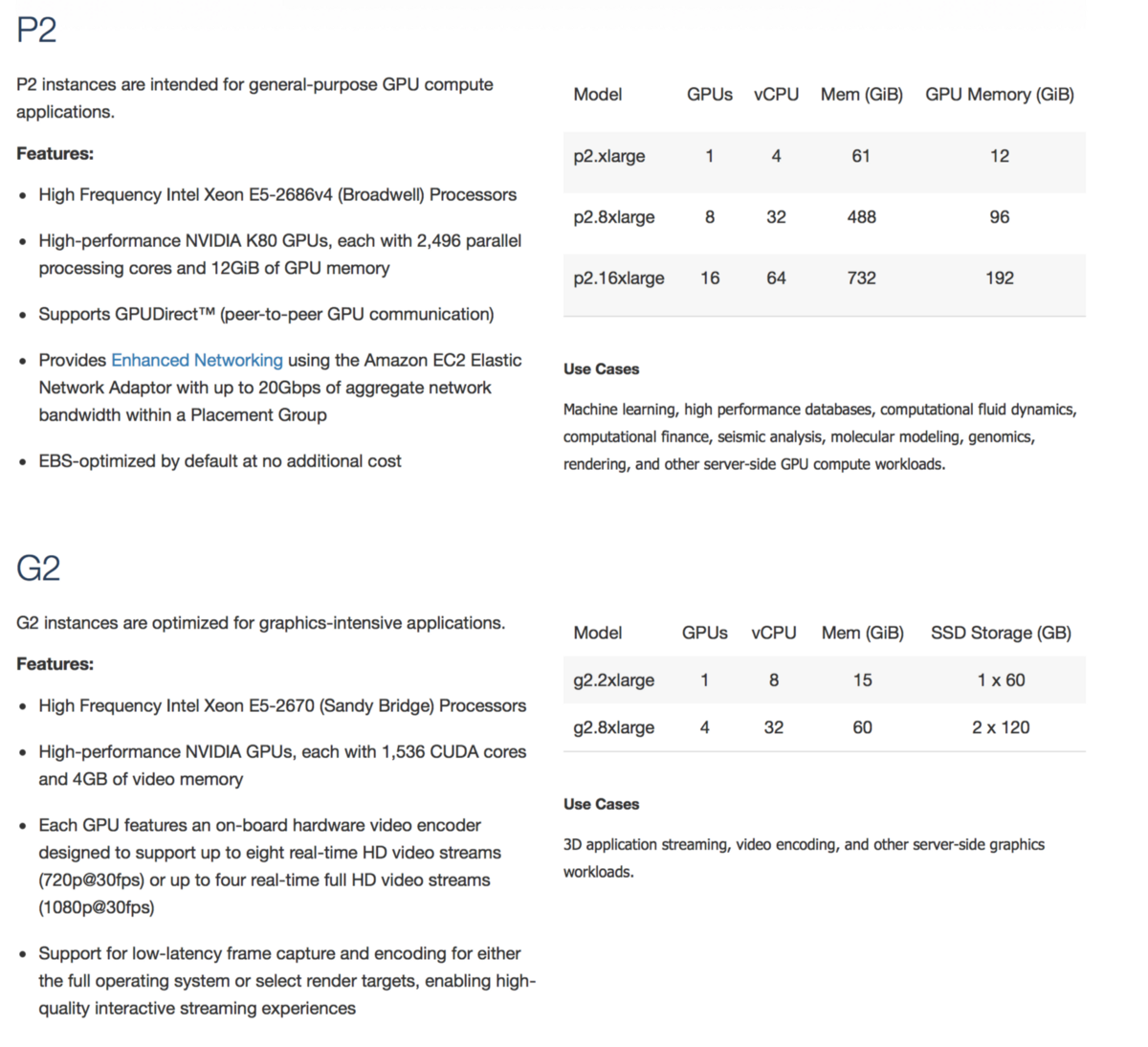

DLAMI можно использовать с GPU-совместимым машинами на AWS, например P2 или G2:

Можете, кстати, попробовать поиграться со свеже выпущенными G3

Надеюсь, теперь у нас есть ответ на вопрос: почему и кому нужно использовать DLAMI. Теперь давайте обсудим ответ на следующий вопрос ...

Как именно можно создать машину с DLAMI?

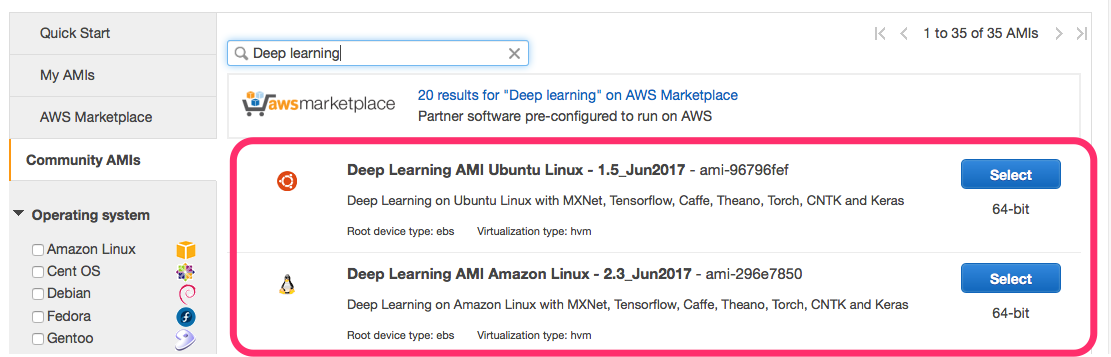

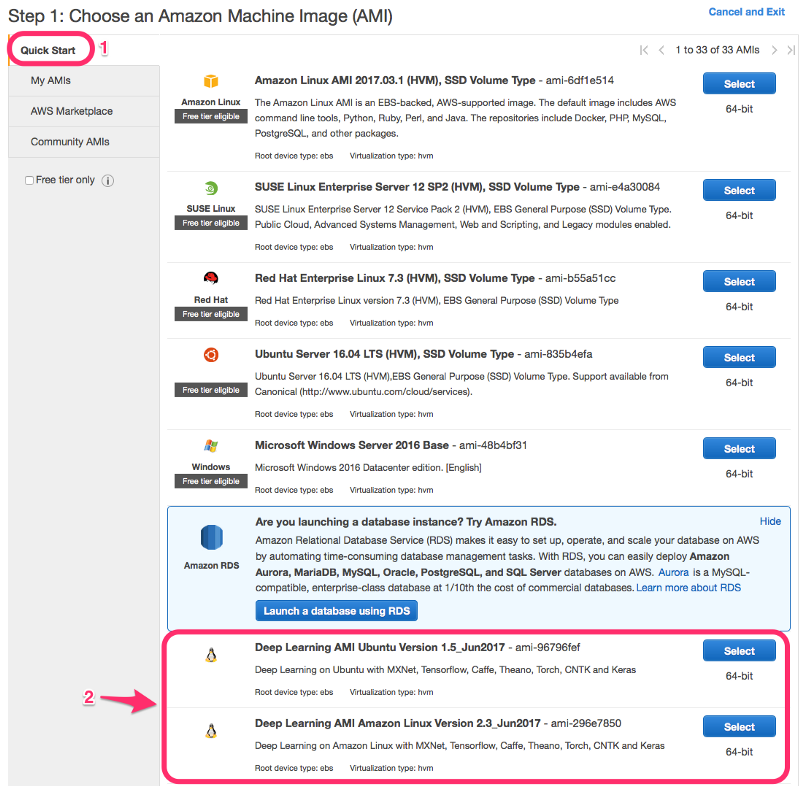

Для этого сначала нужно выбрать, какой вариант DLAMI более предпочтителен:

- на базе Ubuntu (может использоваться с любыми пакетами Ubuntu).

- на базе Amazon Linux (включает все программы AWS, такие как awscli, из коробки).

Если с типом DLAMI определились то перейдем с способам создания машин на базе DLAMI:

- С помощью AWS EC2 Marketplace:

- С помощью консоли EC2.

Консоль EC2 фактически предоставляет два способа ее создания, обычное создание:

И ускоренное создание консоли EC2, применяя конфигурацию по умолчанию:

Проблемы с обновлениями

Существует одна оговорка, которую необходимо обсудить. Поскольку все фреймворки построены с нуля, вы не можете просто так взять и обновить их до последней версии, есть риск получить версию фреймворка, которая не собрана с поддержкой GPU (или не совместима с версией CUDA). Так что обновляйте пакеты на свой страх и риск!

Согласен, это затрудняет переход на новые версии фреймворков, поскольку вам нужно перейти на новый AMI, а не просто обновить пакет. В свою очередь переход на новую AMI может быть болезненным. Поэтому имейте это в виду, создавая новый экземпляр виртуальной машины, я бы посоветовал вам создать отдельную EBS для хранения ваших данных, которую вы можете легко отмонтировать и использовать с новым экземпляром виртуальной машины с обновленной версией AMI. Ну или храните данные в репозитории.

На практике я обнаружил, что это не такая уж большая проблема для машин которые используется не продолжительно в исследовательских целях. Плюс DLAMI, обычно, включает в себя достаточно свежие версии фреймворков.

|

Метки: author b0noII машинное обучение amazon web services aws mxnet deep learning aws ec2 dlami |

IBM и ВВС США разрабатывают нейроморфный суперкомпьютер нового поколения |

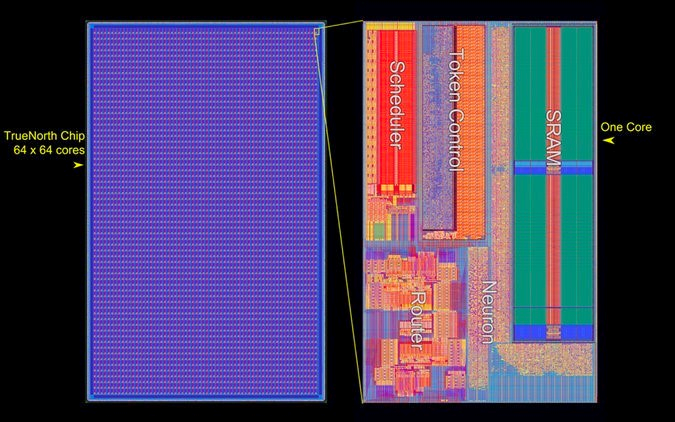

Еще в 2014 году компания IBM представила чип нового типа, который предназначен для реализации нейронных сетей. Тогда разработчики рассказывали о том, что чип содержит 1 миллион нейронов и 256 миллионов синапсов, что, с некоторыми оговорками, похоже на архитектуру неокортекса. Такой процессор можно использовать для решения задач, где требуется высокая и сверхвысокая производительность. Например, с его помощью можно классифицировать объекты в видеопотоке (это уже делается) в режиме реального времени.

Несколько позже Ливерморская национальная лаборатория (LLNL) объявила о создании производительного компьютера, принцип работы которого схож с принципом работы мозга человека. Система включает 16 миллионов нейронов и 4 млрд синапсов. В компьютере, который был разработан лабораторией, всего 16 TrueNorth чипов, а сама система получила название IBM Neuromorphic System. Для чего такие системы могут использоваться?

«Нейроморфные вычисления открывают весьма впечатляющие новые возможности, и, в целом, эта сфера соответствует нашему видению будущего высокопроизводительных компьютерных систем», — говорит Джим Брейс (Jim Brase), один из руководителей проекта. «Потенциальные возможности нейроморфных вычислений и машинный интеллект помогут изменить то, как мы проводим научные исследования», — продолжает он. По мнению специалистов, на основе таких чипов можно создавать системы на порядок более производительные, чем самые мощные компьютеры современности.

Корпорация IBM старается совершенствовать новую технологию. Сейчас она участвует в совместном проекте с ВВС США. Партнеры собираются создать новый суперкомпьютер, который будет включать 64 миллиона нейронов и 16 миллиардов синапсов. При этом потреблять он будет всего 10 Вт энергии, то есть его можно будет подключить к обычной энергосети.

По мнению разработчиков, новый компьютер (его название TrueNorth Neurosynaptic System) позволит работать с несколькими источниками данных одновременно (видео, изображения, аудио и текст). Сейчас один нейроморфный процессор состоит из 5,4 млн транзисторов, составляющих ядра, всего их 4096. Ядра, в свою очередь создают массив из 1 млн цифровых нейронов, которые взаимодействуют друг с другом посредством 256 миллионов электрических синапсов.

Зачем все это военным? Дело в том, что ВВС США, а именно Air Force Research Lab (AFRL), использует возможности процессора для идентификации военных и гражданских транспортных средств при радиолокации с воздуха. Военные утверждают, что чип работает не хуже, чем мощный военный компьютер. Но энергии при этом потребляется в двадцать раз меньше. В дальнейшем, с увеличением производительности чипов, эффективность работы систем будет гораздо выше.

Чип TrueNorth изготовлен по 28 нм техпроцессу. Он содержит 5,4 миллиарда транзисторов и представляет собой нейроморфную систему со следующими характеристиками:

• один миллион эмулируемых «нейронов»

• 256 миллионов эмулируемых связей между нейронами — «синапсов»

• около 400 мегабит SRAM памяти (приблизительно 50 мегабайт)

Но не только военные интересуются такими процессорами. Корпорация Samsung ранее создала на основе TrueNorth систему машинного зрения. Ее принцип работы отличается от принципа работы обычных камер. И эта система обеспечивает обработку видеопотока со скоростью в 2 тысячи кадров в секунду и выше. У самых современных камер этот показатель не превышает 120 fps.

Но все это — лишь начальный этап. Ведь такие процессоры позволяют создавать самообучающиеся системы, которые максимально близко могут приблизиться к архитектуре мозга человека. Сейчас возможности TrueNorth изучают (и расширяют их) более 40 научно-исследовательских организаций, включая самые известные.

|

Метки: author ibm машинное обучение высокая производительность блог компании ibm нейромфорный компьютер компьютеры |

Security Week 28: а Petya сложно открывался, в Android закрыли баг чипсета Broadcomm, Copycat заразил 14 млн девайсов |

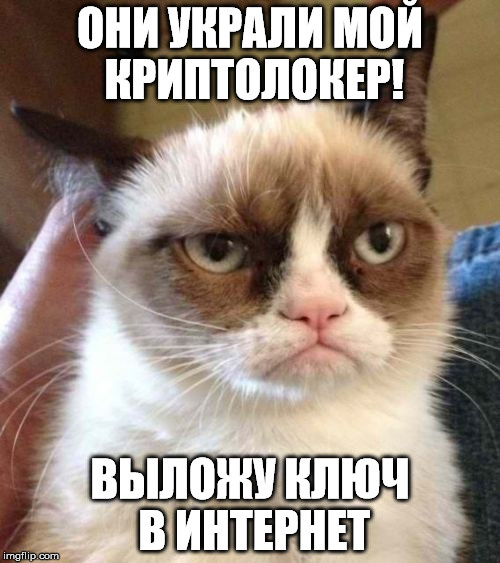

Прошлогодний троянец-криптолокер Petya, конечно, многое умеет – ломает MBR и шифрует MFT, но сделаться столь же знаменитым как его эпигоны, у него не вышло. Но вся эта история с клонами – уничтожителями данных, видимо, настолько расстроила Януса, автора первенца, что тот взял и выложил закрытый ключ от него.

Прошлогодний троянец-криптолокер Petya, конечно, многое умеет – ломает MBR и шифрует MFT, но сделаться столь же знаменитым как его эпигоны, у него не вышло. Но вся эта история с клонами – уничтожителями данных, видимо, настолько расстроила Януса, автора первенца, что тот взял и выложил закрытый ключ от него.Однако опубликовал не просто так «нате, владейте!», а решил подойти к процессу творчески и поиграть с «белыми шляпами», запаролив архив и оставив в своем твиттере ссылку на него с подсказкой в виде цитаты из фильма «Золотой глаз». Авось, хотя бы так заметят и запомнят. Автор, видимо, фанат бондианы – отсюда и его никнейм, и название файла с ключом (Natalya), и имена троянцев Petya и Misha. Быстрее всех загадку отгадали в Malwarebytes и выложили содержимое файла:

Congratulations!

Here is our secp192k1 privkey:

38dd46801ce61883433048d6d8c6ab8be18654a2695b4723

We used ECIES (with AES-256-ECB) Scheme to encrypt the decryption password into the "Personal Code" which is BASE58 encoded.

Исследователь из «Лаборатории Касперского» Антон Иванов тут же проверил – ключ оказался правильным. Ранее Петю уже ломали исследователи, что вынудило Януса пофиксить ошибку в новых версиях троянца, но теперь жертвы всех настоящих Петь могут свободно заполучить свои файлы обратно.

Это не первый случай публикации ключа от криптолокера – например, что-то такое произошло год назад с TeslaCrypt. Сейчас Янус просто закрыл свой проект, заодно перекрыв кислород подражателям, зарабатывающим на слегка модифицированном Petya. Увы, жертвам exPetr/non-Petya эта благотворительность никак не поможет.

Google закрыл баг Broadpwn в Android

Новость. Бытует мнение, что подцепить инфекцию на смартфон непросто – надо свалять конкретного дурака: согласиться на загрузку неведомого файла типа adobe_flash_update_mamoi_klyanus_bez_virusov.apk, разрешить установку недоверенных программ и наконец, самому лично все инсталлировать. Однако ж есть и на мобильных осях прямая и явная угроза – RCE-баги, которые регулярно находят и закрывают. На этот раз исследователь из Exodus Intelligence анонсировал доклад на Black HAT USA 2017 об особо неприятном баге CVE-2017-9417, связанном с WiFi-чипами BCM43xx производства Broadcomm. Назвали его Broadpwn, что как бы должно свидетельствовать об уровне опасности. И он позволяет запускать произвольный код в контексте ядра, причем атака проводится удаленно. Кроме того интересно, что продемонстрированный эксплойт успешно обходит DEP и ASLR.

Полного списка уязвимых моделей смартфонов нет, но автор эксплойта заявляет, что баг имеется во всех флагманах Samsung, во многих моделях LG и HTC, а также в нескольких iPhone. Кстати, о возможности эксплуатации Broadpwn под iOS пока вообще ничего неизвестно, и Apple молчит об этом баге, как сами знаете кто. Как Apple.

Помимо Broadpwn в cвежее обновление Google попали патчи еще для 11 критических дыр, в том числе для RCE-бага CVE-2017-0540, который позволяет через специально созданный файл запускать код в контексте привилегированного процесса. Присутствует эта “черная дыра” в Android 5.0.2, 5.1.1, 6.0, 6.0.1, 7.0, 7.1.1 и 7.1.2. Патчи получат владельцы Nexus и Pixel, остальные – как повезет. В общем, то самое чувство, когда Google при очередном апдейте устраняет сразу несколько RCE-уязвимостей, но ты понимаешь, что на твой смартфон, выпущенный год назад, патча не будет никогда.

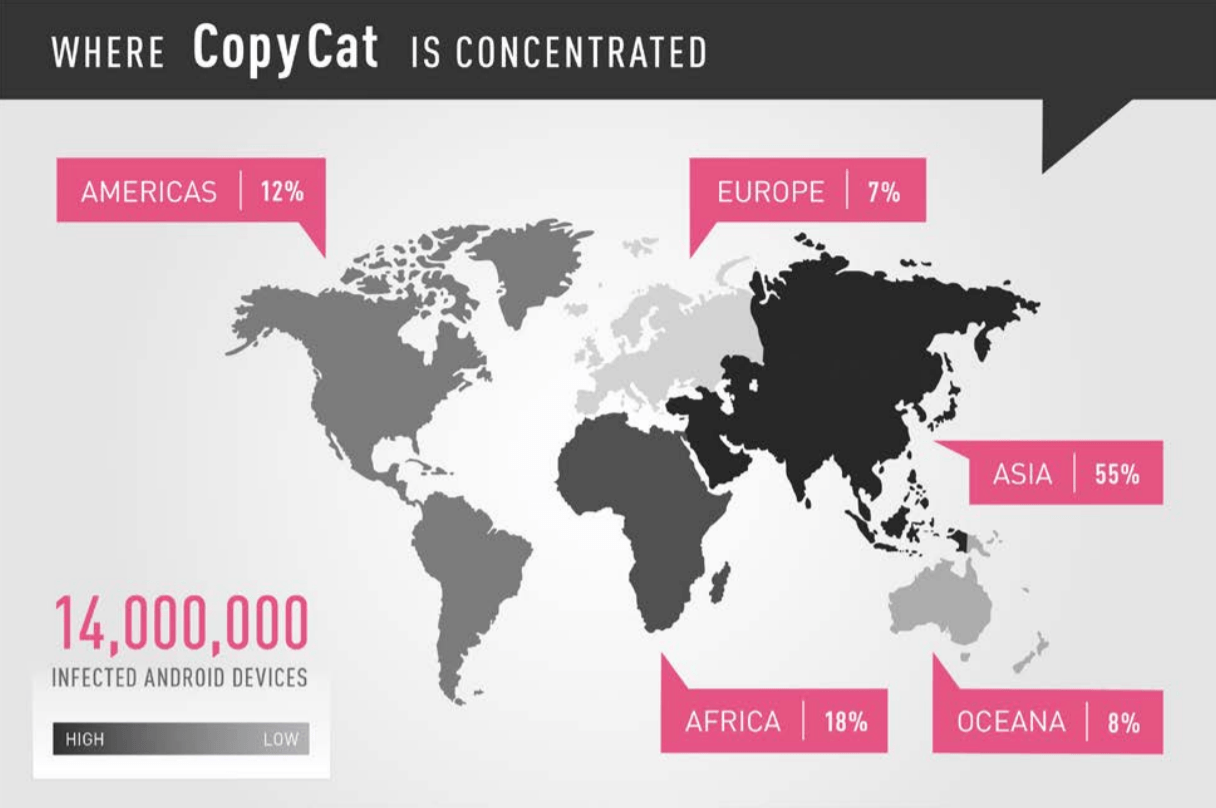

Помимо Broadpwn в cвежее обновление Google попали патчи еще для 11 критических дыр, в том числе для RCE-бага CVE-2017-0540, который позволяет через специально созданный файл запускать код в контексте привилегированного процесса. Присутствует эта “черная дыра” в Android 5.0.2, 5.1.1, 6.0, 6.0.1, 7.0, 7.1.1 и 7.1.2. Патчи получат владельцы Nexus и Pixel, остальные – как повезет. В общем, то самое чувство, когда Google при очередном апдейте устраняет сразу несколько RCE-уязвимостей, но ты понимаешь, что на твой смартфон, выпущенный год назад, патча не будет никогда.Троянец Copycat заразил 14 млн Android-устройств

Новость. И снова о мобильной гигиене. Вот вы, допустим, свято чтите нормы информационной безопасности на мобильных устройствах, не ходите на своем смартфоне куда попало и ставите только известные приложения с миллионами скачиваний. И все же такая пакость, как Copycat, у вас каким-то образом оказалась, и показывает вам тонны рекламных поп-апов. Это невыдуманная история, около 14 миллионов Android-девайсов оказались в таком положении, из них на 8 млн еще и удалить троянца не так-то легко, так как он получил права рута.

Троянец распространяется не только традиционными методами, такими как вредоносные лендинги и спам. Его внедряют в популярные приложения и выкладывают в сторонние магазины приложений, которые так популярны в Азии, – соответственно, большая часть заражений зафиксирована именно в этом регионе.

После установки CopyCat достает пачку отмычек-эксплойтов и пытается получить root-права в системе, после чего радостно внедряет свою библиотеку в процесс демона-лаунчера Zygote. Далее он подменяет параметр реферрера установки (install_referrer) так, чтобы получать деньги, что вкладывает издатель приложения в продвижение. Также он умеет подменяет демонстрируемую пользователю рекламу, и способен устанавливать сторонние приложения, то есть выступает как гарантированный канал распространения чего угодно, что закажут.

Древности

«Attention-629»

Опасный нерезидентный вирус, записывается в .COM-файлы текущего каталога. Крайне примитивен. 800-й «потомок» вируса при старте должен сообщить: «Attention! I’m virus», однако содержит такое количество ошибок, что вряд ли доживет до такого почтенного возраста.

Цитата по книге «Компьютерные вирусы в MS-DOS» Евгения Касперского. 1992 год. Страницa 60.

Disclaimer: Данная колонка отражает лишь частное мнение ее автора. Оно может совпадать с позицией компании «Лаборатория Касперского», а может и не совпадать. Тут уж как повезет.

|

Метки: author Kaspersky_Lab информационная безопасность блог компании «лаборатория касперского» klsw petya expetr android google copycat broadpwn |

[Перевод] Реверс-инжиниринг одной строчки JavaScript |

Тема: Можешь развернуть и объяснить мне эту одну строчку кода?

Текст:Считай меня тупым, но… я не понимаю её и буду благодарен, если растолкуешь подробно. Это трассировщик лучей в 128 символах. Мне кажется, он восхитительный.

Эта строчка JavaScript отрисует анимацию, которая показана на изображении под катом. В браузере она запускается здесь. Скрипт написан автором www.p01.org, где вы можете найти эту и много других классных демок.

Вызов принят!

Reverse Engineering One Line of JavaScript : https://t.co/QsTzYBvWbu cc @akras14

— Binni Shah (@binitamshah) July 13, 2017

Часть I. Извлекаем читаемый код

Первым делом я оставил HTML в HTML, код JavaScript перенёс в файл

code.js, а p закавычил в id="p".index.html

Я заметил, что там переменная

k — просто константа, так что убрал её из строчки и переименовал в delay.code.js

var delay = 64;

var draw = "for(n+=7,i=delay,P='p.\\n';i-=1/delay;P+=P[i%2?(i%2*j-j+n/delay^j)&1:2])j=delay/i;p.innerHTML=P";

var n = setInterval(draw, delay);Далее,

var draw был просто строкой, которая исполнялась как функция eval с периодичностью setInterval, поскольку setInterval может принимать и функции, и строки. Я перенёс var draw в явную функцию, но сохранил изначальную строку для справки на всякий случай.Ещё я заметил, что элемент

p в действительности ссылался на элемент DOM с идентификатором p, объявленным в HTML, который я недавно закавычил. Оказывается, на элементы в JavaScript можно ссылаться по их идентификатору, если id состоит только из букв и цифр. Я добавил document.getElementById("p"), чтобы сделать код понятнее.var delay = 64;

var p = document.getElementById("p"); // < --------------

// var draw = "for(n+=7,i=delay,P='p.\\n';i-=1/delay;P+=P[i%2?(i%2*j-j+n/delay^j)&1:2])j=delay/i;p.innerHTML=P";

var draw = function() {

for (n += 7, i = delay, P = 'p.\n'; i -= 1 / delay; P += P[i % 2 ? (i % 2 * j - j + n / delay ^ j) & 1 : 2]) {

j = delay / i; p.innerHTML = P;

}

};

var n = setInterval(draw, delay);Затем я объявил переменные

i, p и j и перенёс их в начало функции.var delay = 64;

var p = document.getElementById("p");

// var draw = "for(n+=7,i=delay,P='p.\\n';i-=1/delay;P+=P[i%2?(i%2*j-j+n/delay^j)&1:2])j=delay/i;p.innerHTML=P";

var draw = function() {

var i = delay; // < ---------------

var P ='p.\n';

var j;

for (n += 7; i > 0 ;P += P[i % 2 ? (i % 2 * j - j + n / delay ^ j) & 1 : 2]) {

j = delay / i; p.innerHTML = P;

i -= 1 / delay;

}

};

var n = setInterval(draw, delay);Я разложил цикл

for и преобразовал его в цикл while. Из трёх частей прежнего for осталась только одна часть CHECK_EVERY_LOOP, а всё остальное (RUNS_ONCE_ON_INIT; DO_EVERY_LOOP) перенёс за пределы цикла.var delay = 64;

var p = document.getElementById("p");

// var draw = "for(n+=7,i=delay,P='p.\\n';i-=1/delay;P+=P[i%2?(i%2*j-j+n/delay^j)&1:2])j=delay/i;p.innerHTML=P";

var draw = function() {

var i = delay;

var P ='p.\n';

var j;

n += 7;

while (i > 0) { // <----------------------

//Update HTML

p.innerHTML = P;

j = delay / i;

i -= 1 / delay;

P += P[i % 2 ? (i % 2 * j - j + n / delay ^ j) & 1 : 2];

}

};

var n = setInterval(draw, delay);Здесь я развернул троичный оператор

( condition ? do if true : do if false) in P += P[i % 2 ? (i % 2 * j - j + n / delay ^ j) & 1 : 2];.i%2 проверяет, является переменная i чётной или нечётной. Если она четная, то просто возвращает 2. Если нечётная, то возвращает «магическое» значение magic (i % 2 * j - j + n / delay ^ j) & 1; (подробнее об этом чуть позже).Это значение (индекс) используется для сдвига строки P, так что назовём

index и превратим строку в P += P[index];.var delay = 64;

var p = document.getElementById("p");

// var draw = "for(n+=7,i=delay,P='p.\\n';i-=1/delay;P+=P[i%2?(i%2*j-j+n/delay^j)&1:2])j=delay/i;p.innerHTML=P";

var draw = function() {

var i = delay;

var P ='p.\n';

var j;

n += 7;

while (i > 0) {

//Update HTML

p.innerHTML = P;

j = delay / i;

i -= 1 / delay;

let index;

let iIsOdd = (i % 2 != 0); // <---------------

if (iIsOdd) { // <---------------

index = (i % 2 * j - j + n / delay ^ j) & 1;

} else {

index = 2;

}

P += P[index];

}

};

var n = setInterval(draw, delay);Я разложил

& 1 из значения index = (i % 2 * j - j + n / delay ^ j) & 1 в ещё один оператор if.Здесь хитрый способ проверки на чётность результата в круглых скобках, когда для чётного значения возвращается 0, а для нечётного — 1.

& — это побитовый оператор AND. Он работает так:- 1 & 1 = 1

- 0 & 1 = 0

Следовательно,

something & 1 преобразует "something" в двоичное представление, а также добивает перед единицей необходимое количество нулей, чтобы соответствовать размеру "something", и возвращает просто результат AND последнего бита. Например, 5 в двоичном формате равняется 101, так что если мы применим на ней логическую операцию AND с единицей, то получится следующее: 101

AND 001

001Другими словами, пятёрка — нечётное число, а результатом 5 AND 1 (5 & 1) будет 1. В консоли JavaScript легко проверить соблюдение этой логики.

0 & 1 // 0 - even return 0

1 & 1 // 1 - odd return 1

2 & 1 // 0 - even return 0

3 & 1 // 1 - odd return 1

4 & 1 // 0 - even return 0

5 & 1 // 1 - odd return 1Обратите внимание, что я также переименовал остальную часть

index в magic, так что код с развёрнутым &1 будет выглядеть следующим образом:var delay = 64;

var p = document.getElementById("p");

// var draw = "for(n+=7,i=delay,P='p.\\n';i-=1/delay;P+=P[i%2?(i%2*j-j+n/delay^j)&1:2])j=delay/i;p.innerHTML=P";

var draw = function() {

var i = delay;

var P ='p.\n';

var j;

n += 7;

while (i > 0) {

//Update HTML

p.innerHTML = P;

j = delay / i;

i -= 1 / delay;

let index;

let iIsOdd = (i % 2 != 0);

if (iIsOdd) {

let magic = (i % 2 * j - j + n / delay ^ j);

let magicIsOdd = (magic % 2 != 0); // &1 < --------------------------

if (magicIsOdd) { // &1 <--------------------------

index = 1;

} else {

index = 0;

}

} else {

index = 2;

}

P += P[index];

}

};

var n = setInterval(draw, delay);Далее я развернул

P += P[index]; в оператор switch. К этому моменту стало понятно, что index может принимать только одно из трёх значений — 0, 1 или 2. Также понятно, что переменная P всегда инициализируется со значениями var P ='p.\n';, где 0 указывает на p, 1 указывает на ., а 2 указывает на \n — символ новой строкиvar delay = 64;

var p = document.getElementById("p");

// var draw = "for(n+=7,i=delay,P='p.\\n';i-=1/delay;P+=P[i%2?(i%2*j-j+n/delay^j)&1:2])j=delay/i;p.innerHTML=P";

var draw = function() {

var i = delay;

var P ='p.\n';

var j;

n += 7;

while (i > 0) {

//Update HTML

p.innerHTML = P;

j = delay / i;

i -= 1 / delay;

let index;

let iIsOdd = (i % 2 != 0);

if (iIsOdd) {

let magic = (i % 2 * j - j + n / delay ^ j);

let magicIsOdd = (magic % 2 != 0); // &1

if (magicIsOdd) { // &1

index = 1;

} else {

index = 0;

}

} else {

index = 2;

}

switch (index) { // P += P[index]; <-----------------------

case 0:

P += "p"; // aka P[0]

break;

case 1:

P += "."; // aka P[1]

break;

case 2:

P += "\n"; // aka P[2]

}

}

};

var n = setInterval(draw, delay);Я разобрался с оператором

var n = setInterval(draw, delay);. Метод setInterval возвращает целые числа, начиная с единицы, увеличивая значение при каждом вызове. Это целое число может использоваться для clearInterval (то есть для отмены). В нашем случае setInterval вызывается всего один раз, а переменная n просто установилась в значение 1.Я также переименовал

delay в DELAY для напоминания, что это всего лишь константа.И последнее, но не менее важное, я поместил круглые скобки в

i % 2 * j - j + n / DELAY ^ j для указания, что у ^ (побитового XOR) меньший приоритет, чем у операторов %, *, -, + и /. Другими словами, сначала выполнятся все вышеупомянутые вычисления, а уже потом ^. То есть получается (i % 2 * j - j + n / DELAY) ^ j).Уточнение: Мне указали, что я ошибочно поместил

p.innerHTML = P; //Update HTML в цикл, так что я убрал его оттуда.const DELAY = 64; // approximately 15 frames per second 15 frames per second * 64 seconds = 960 frames

var n = 1;

var p = document.getElementById("p");

// var draw = "for(n+=7,i=delay,P='p.\\n';i-=1/delay;P+=P[i%2?(i%2*j-j+n/delay^j)&1:2])j=delay/i;p.innerHTML=P";

/**

* Draws a picture

* 128 chars by 32 chars = total 4096 chars

*/

var draw = function() {

var i = DELAY; // 64

var P ='p.\n'; // First line, reference for chars to use

var j;

n += 7;

while (i > 0) {

j = DELAY / i;

i -= 1 / DELAY;

let index;

let iIsOdd = (i % 2 != 0);

if (iIsOdd) {

let magic = ((i % 2 * j - j + n / DELAY) ^ j); // < ------------------

let magicIsOdd = (magic % 2 != 0); // &1

if (magicIsOdd) { // &1

index = 1;

} else {

index = 0;

}

} else {

index = 2;

}

switch (index) { // P += P[index];

case 0:

P += "p"; // aka P[0]

break;

case 1:

P += "."; // aka P[1]

break;

case 2:

P += "\n"; // aka P[2]

}

}

//Update HTML

p.innerHTML = P;

};

setInterval(draw, 64);Окончательный результат выполнения можно увидеть здесь.

Часть 2. Понимание кода

Так что здесь происходит? Давайте разберёмся.

Изначально значение

i установлено на 64 посредством var i = DELAY;, а затем каждый цикл оно уменьшается на 1/64 (0,015625) через i -= 1 / DELAY;. Цикл продолжается, пока i больше нуля (код while (i > 0) {). Поскольку за каждый проход i уменьшается на 1/64, то требуется 64 цикла, прежде чем оно уменьшится на единицу (64/64 = 1). В целом уменьшение i произойдёт 64x64 = 4096 раз, чтобы уменьшиться до нуля.Изображение состоит из 32 строк, со 128 символами в каждой. Очень удобно, что 64 x 64 = 32 x128 = 4096. Значение

i может быть чётным (не нечётным let iIsOdd = (i % 2 != 0);), если i является строго чётным числом. Такое произойдёт 32 раза, когда оно равняется 64, 62, 60 и т. д. Эти 32 раза index примет значение 2 index = 2;, а к строке добавится символ новой строки: P += "\n"; // aka P[2]. Остальные 127 символов в строке примут значения p или ..Но когда устанавливать

p, а когда .?Ну, для начала нам точно известно, что следует установить

. при нечётном значении let magic = ((i % 2 * j - j + n / DELAY) ^ j);, или установить p, если «магия» чётная.var P ='p.\n';

...

if (magicIsOdd) { // &1

index = 1; // second char in P - .

} else {

index = 0; // first char in P - p

}Но когда

magic чётное, а когда нечётное? Это вопрос на миллион долларов. Перед тем как перейти к нему, давайте определим ещё кое-что.Если убрать

+ n/DELAY из let magic = ((i % 2 * j - j + n / DELAY) ^ j);, то получится статическая картинка, на которой вообще ничего не двигается:

Теперь посмотрим на

magic без + n/DELAY. Как получилась эта красивая картинка?(i % 2 * j - j) ^ j Обратите внимание, что получается в каждом цикле:

j = DELAY / i;

i -= 1 / DELAY;Другими словами, мы может выразить

j через конечное i как j = DELAY/ (i + 1/DELAY). Но поскольку 1/DELAY слишком малое число, то для этого примера можно отбросить + 1/DELAY и упростить выражение до j = DELAY/i = 64/i.В таком случае мы можем переписать

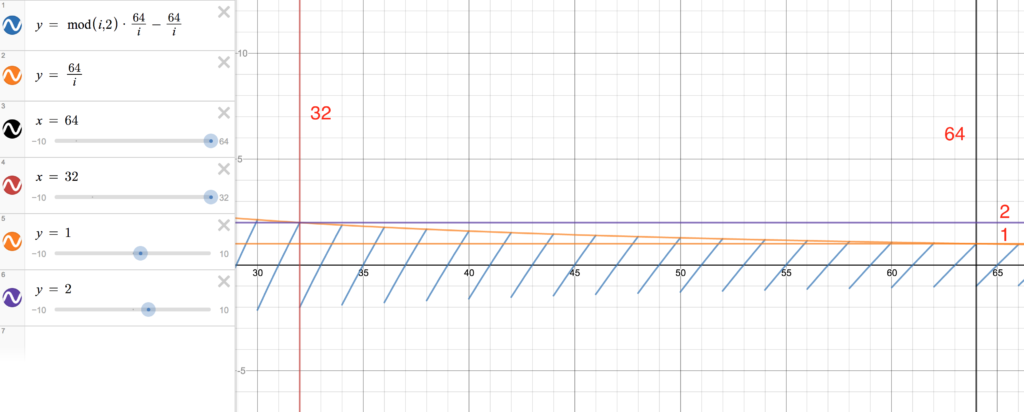

(i % 2 * j - j) ^ j как i % 2 * 64/i - 64/i) ^ 64/i.Используем онлайновый графический калькулятор для отрисовки графиков некоторых из этих функций.

Прежде всего, отрисуем

i%2.Выходит симпатичный график со значениями y от 0 до 2.

Если отрисовать

64/i, то получим такой график:

Если отрисовать всю левую сторону выражения, то получится график, который выглядит как сочетание двух предыдущих.

В конце концов, если мы отрисуем две функции рядом друг с другом, то увидим следующее.

О чём говорят эти графики?

Давайте припомним вопрос, на который мы пытаемся ответить, то есть каким образом получилась такая красивая статическая картинка:

Мы знаем, что если «магия»

(i % 2 * j - j) ^ j принимает чётное значение, то нужно добавить p, а для нечётного числа нужно добавить ..Увеличим первые 16 строк нашего графика, где

i имеет значения от 64 до 32.

Побитовый XOR в JavaScript отбросит все значения справа от запятой, так что это равнозначно применению метода

Math.floor, который округляет число в меньшую сторону.Он вернёт 0, если оба бита равны 1 или оба равны 0.

Наша

j начинается с единицы и медленно продвигается к двойке, останавливаясь прямо около неё, так что можем считать её всегда единицей при округлении в меньшую сторону (Math.floor(1.9999) === 1), и нам нужна ещё одна единица с левой стороны, чтобы получить в результате ноль и дать нам p.Другими словами, каждая зелёная диагональ представляет собой один ряд в нашем графике. Поскольку для первых 16 рядов значение j всегда больше 1, но меньше 2, то мы можем получить нечётное значение только в том случае, если левая сторона выражения

(i % 2 * j - j) ^ j, она же i % 2 * i/64 — i/64, то есть зелёная диагональ, тоже будет выше 1 или ниже -1.Вот некоторые результаты из консоли JavaScript, чтобы посмотреть результаты вычислений: 0 или -2 означают, что результат чётный, а 1 соответствует нечётному числу.

1 ^ 1 // 0 - even p

1.1 ^ 1.1 // 0 - even p

0.9 ^ 1 // 1 - odd .

0 ^ 1 // 1 - odd .

-1 ^ 1 // -2 - even p

-1.1 ^ 1.1 // -2 - even pЕсли посмотреть на наш график, то там самая правая диагональная линия едва выходит выше 1 и ниже -1 (мало чётных чисел — мало символов

p). Следующая выходит чуть дальше за эти границы, третья — ещё чуть дальше и т. д. Линия номер 16 едва удерживается в границах между 2 и -2. После линии 16 мы видим, что наш статический график меняет свой характер.

После 16-й строки значение

j пересекает лимит 2, так что меняется ожидаемый результат. Теперь мы получим чётное число, если зелёная диагональная линия выше 2 или ниже -2, или внутри рамок 1 и -1, но не соприкасается с ними. Вот почему мы видим на картинке две или больше групп символов p начиная с 17-й строки.Если присмотреться к нескольким самым нижним линиям в анимированной картинке, то вы заметите, что они не следуют одному и тому же шаблону из-за большой флуктуации графика.

Теперь вернёмся к

+ n/DELAY. В коде мы видим, что значение n начинается с 8 (1 от setInteval и плюс 7 на каждый вызов метода). Затем оно увеличивается на 7 при каждом срабатывании setInteval. После достижения значения 64 график изменяется следующим образом.

Обратите внимание, что

j по-прежнему находится около единицы, но теперь левая половина красной диагонали в пределах примерно 62-63 находится примерно около нуля, а правая половина в пределах примерно 63-64 — около единицы. Поскольку наши символы появляются в убывающем порядке от 64 к 62, то можно ожидать, что правая половина диагонали в районе 63-64 (1 ^ 1 = 0 // even) добавит кучку символов p, а левая половина диагонали в районе 62-63 (1 ^ 0 = 1 // odd) добавит кучку точек. Всё это будет нарастать слева направо, как обычный текст.Рендеринг HTML для такого условия выглядит следующим образом (вы можете жёстко вбить значение

n в редакторе CodePen и посмотреть). Это совпадает с нашими ожиданиями.

К этому моменту количество символов

p выросло до постоянной величины. Например, в первом ряду половина всех значений всегда будут чётными. Теперь символы p и . будут только меняться местами.Для примера, когда

n увеличивается на 7 на следующем вызове setInterval, график немного изменится.

Обратите внимание, что диагональ для первого ряда (около отметки 64) сдвинулась примерно на один маленький квадратик вверх. Поскольку четыре больших квадратов представляют собой 128 символов, в одном большом квадрате будет 32 символа, а в одном маленьком квадрате 32/5 = 6,4 сивола (примерно). Если посмотрим на рендеринг HTML, то там первый ряд действительно сдвинулся вправо на 7 символов.

И один последний пример. Вот что происходит, если вызвать setInterval ещё семь раз, а

n будет равняться 64+9x7.

Для первого ряда

j по-прежнему равняется 1. Теперь верхняя половина красной диагонали около отметки 64 примерно упирается в два, а нижний конец около единицы. Это переворачивает картинку в другую сторону, поскольку теперь 1^2 = 3 // odd - . и 1 ^ 1 = 0 //even - p. Так что можно ожидать кучу точек, за которыми пойдут символы p.Выглядеть это будет так.

График бесконечно зациклен.

Надеюсь, наша работа имеет какой-то смысл. Вряд ли я когда-нибудь смог бы самостоятельно придумать нечто подобное, но было интересно разобраться в этом коде.

|

Метки: author m1rko реверс-инжиниринг ненормальное программирование занимательные задачки визуализация данных javascript обратная разработка минимализм демо |

Цикл стартапа: как (в общем) работает венчурное инвестирование |

|

Метки: author Roman_Yankovskiy законодательство и it-бизнес венчурные инвестиции бизнес-модели цикл стартапа книга стартапы; финансирование; инвесторы |

Чемпионы мира — о спортивном программировании |

DataArt давно дружит с командой ИТМО по спортивному программированию и помогает ей. Этим летом в гости в наш петербургский центр разработки пришли Илья Збань, Иван Белоногов и Владимир Смыкалов. Чемпионы мира 2017 года рассказали о том, как именно программисты соревнуются между собой, о тренировочных сборах, любимых задачах и сильнейших соперниках.

Олимпиада по программированию

Главное соревнование программистов — международная студенческая олимпиада под эгидой ACM (ACM-ICPC, или просто ICPC) — проходит с 1970-х, а в виде, близком к сегодняшнему, оформилась в 1989 году. Олимпиада предназначена для студентов и аспирантов, за редким исключением к соревнованиям не допускают программистов старше 24-х лет. К тому же, испытывать силы в финале можно только дважды, а в региональных отборах разрешается участвовать всего пять раз. На ранних этапах, проходящих по всему миру, соревнуются тысячи команд. Около сотни лучших доходят до финала.

Основные правила

Команды состоят из трех человек, при этом в распоряжении каждой команды — только один компьютер. Перед началом соревнования всем выдаются конверты с задачами алгоритмического или математического характера — от восьми до 13 штук — которые нужно решить за пять часов. Решение задачи — программа, считывающая текстовый запрос и выдающая текстовый ответ. Для проверки решение прогоняется примерно на сотне тестов, заранее подготовленных жюри, — верным оно признается, только если ответ получается правильным в каждом из тестов.

Правила ICPC очень доходчиво изложены в ролике, выпущенном к чемпионату Урала по программированию — одному из первичных этапов отбора на Олимпиаду. Они едины для всех регионов и с 2013 года остались без изменений.

Языки и среда

В финале 2017 года можно было использовать языки Java, C++ и Python. Впрочем, понятно, что Python в принципе не очень быстрый — жюри не гарантировало, что на нем можно будет сдать задачу. Однако оно давало гарантии, что у них есть решения, написанные на этих языках, которые проходят все тесты.

На разных соревнованиях набор языков может быть различным. Например, на онлайн-платформе Codeforces допускается около 20 языков: от C++ и Java до Haskell и Perl.

Большинство команд в финалах пишет на C++, поскольку на первый план выходит скорость. В качестве среды разработки многие команды используют VIM (в нем, например, работали Иван и Илья) или Gina (в ней работал Владимир). Те, кто все же пишет на Java, как правило пользуются средой вроде Eclipse, поскольку писать на Java без автокомплита гораздо сложнее.

В ближайшее время можно ждать изменений, поскольку финалы теперь будет спонсировать JetBrains (20 лет до конца мая 2017 года спонсором ICPC был IBM). Это значит, что на них появится и продукция спонсора: IDEA для Java и CLion для С++. Возможно, после этого команды начнут широко пользоваться отладчиками, хотя пока чаще справляются без них.

Эволюция задач

В начале 2000-х преобладали задачи на перебор с небольшими ограничениями, сейчас стало больше задач на структуры данных. При этом в мире есть несколько достаточно обособленных школ спортивного программирования: если в Польше любят идейные, часто математические, задачи, в Китае предпочитают сложные технические, где приходится писать много кода, — например, считать комбинаторику.

Цель всегда — придумать и реализовать решение, которое работает быстро. Любую задачу можно хоть как-то решить, например, написав программу, которая просто переберет все возможные варианты. Но в последние годы задачи, предполагающие написание переборов, практически не встречаются.

Существуют ограничения по времени и памяти, однако на практике проблемы с тем, что решение использует слишком много памяти, возникают нечасто. Ограничение по времени на каждый тест обычно от одной до трех секунд в зависимости от задачи — это тоже указывается в условии.

Примеры задач

Задачи бывают разными: на графы, строки, геометрию и т. д. Допустим, рассчитать кратчайший путь между городами на карте. Или построить максимально длинную взлетно-посадочную полосу на острове, представленном в виде невыпуклого многоугольника. Задачей может быть сравнение текстов — поиск наибольшей общей подстроки для пары строк.

Еще один формат — интерактивные задачи, где вам предлагают поиграть в какую-нибудь игру с системой, написанной жюри. В одном из полуфиналов нужно было написать программу, способную в 90 % случаев выигрывать у предложенного алгоритма в крестики-нолики. Задачи с прошлых финалов, включая последний, можно посмотреть здесь.

Процесс решения

В основном участники команд разбирают листы с условиями в зависимости от личных предпочтений: кто-то больше любит задачи на строки, кто-то — на геометрию. В целом индивидуальная работа здесь преобладает над командной.

Первым делом нужно придумать алгоритм решения одной из задач. Иногда автор решения обсуждает его с командой, чтобы убедиться — решение получается математически правильным. После этого автор садится писать код — двое других участников в это время продолжают думать над решениями остальных задач. Когда код написан, его можно проверить на тестовых примерах, которые обычно прилагаются к условию, и отправлять в систему для оценки. Поскольку компьютерное время ограничено (напомним, что компьютер у участников всего один), на соревнованиях всегда присутствует принтер: если решение не работает, кто-то — обычно его автор — ищет ошибки, распечатав код на бумаге.

Особенности кода

С одной стороны, люди, занимающиеся спортивным программированием, умеют писать код быстро и четко, причем в стрессовых условиях. С другой стороны, их нередко критикуют за то, что этот код содержит непонятные переменные и трудно читается. В коде, который пишется на соревнованиях, действительно нет длинных понятных названий переменных — ведь его не придется поддерживать через год. Впрочем, на высоком уровне эта проблема так остро не стоит, поскольку код все же должен быть понятен товарищам по команде.

Еще одна особенность спортивного программирования в том, что тестовой системой никак не оценивается освобождение памяти — решение работает всего несколько секунд.

Алгоритмы

Мы знаем довольно много алгоритмов, используем разные структуры данных: дерево отрезков, дерево Фенвика, декартово дерево и т. д. Иногда сбалансированное дерево поиска приходится писать самостоятельно, параллельно модифицировав его так, чтобы оно считало информацию, определенную условием задачи. Например, в языке С++ есть структура множества, которая умеет поддерживать множество чисел и, например, находить следующее. Задача же может требовать найти не следующее число, а сумму всех чисел, меньших или равных заданному. Стандартными структурами реализовать это не получится.

Приносить какие-то фрагменты коды с собой нельзя, но на чемпионате мира разрешается пользоваться так называемым team reference — распечатанным на бумаге набором алгоритмов. Хотя многое мы умеем писать с ходу, в этом году немало времени потратили на его подготовку — тестировали более сложные алгоритмы. Но в итоге записями не воспользовались вообще.

Объем кода напрямую не влияет на итоговую оценку, другое дело, что 1000 строк написать за отведенное время сложно. А придумав красивое лаконичное решение, можно уложиться всего в 10–15 минут. Именно под поиск таких изящных путей и заточены большинство условий: средний объем решения — 100-200 строк кода, хотя в некоторых случаях он может доходить до 300. В обычной жизни 300 строк не так уж много, но здесь у тебя есть всего пять часов на решение всех задач. Писать нужно быстро, а если в трех сотнях строк будет допущена ошибка — задача не пройдет, значит, все время на ее решение будет попросту потеряно. К тому же, чем длиннее код, тем труднее найти ошибку в распечатанной версии.

Другие турниры и тренировки

Денежные призы далеко не основная мотивация участников турниров. На фото: Иван Белоногов и Илья Збань — призеры VK Cup 2015 (источник — страница Ивана Белоногова). В 2017-м призером VK Cup стал третий участник чемпионской команды ИТМО Владимир Смыкалов.

Мы постоянно участвуем в индивидуальных турнирах — их проводится очень много. Например, соревнования на российском сайте Codeforces регулярно собирают по несколько тысяч человек, из которых россиян обычно около 20 %. Стандартный тур здесь состоит из пяти алгоритмических задач, которые нужно решить за два часа. Самое главное в сложившемся вокруг этого ресурса сообществе — личный рейтинг, рассчитанный по системе Эло, как в шахматах. Успешно выступая на турнирах, программисты получают очки — их определенное количество автоматически меняет цвет ника. Те, у кого ники красные, получают не только просьбы о помощи, но и предложения от работодателей. А главное, как любые спортсмены-чемпионы, пользуются всеобщим уважением — для многих участников «красный ник» сам по себе служит достаточным стимулом для борьбы.

Круче красных ников, только красные ники с первой черной буквой. 13 июля в двадцатке лучших на Codeforces было восемь россиян, по двое украинцев, поляков и китайцев и по одному представителю Швейцарии, Австралии, Кореи, США, Тайваня и Беларуси. При этом белорусский программист сейчас возглавляет рейтинг, хотя в принципе перестановки в таблице происходят постоянно.

Крупные соревнования проводят Mail.ru, Яндекс, Facebook, Google и другие компании. Например, в первом раунде текущего турнира Google Code Jam участвовало 20 тысяч человек. Тысяча лучших получили фирменные футболки, 25 — поедут на финал, который в этом году пройдет в Дублине.

Помимо Google Code Jam, Google проводил еще один турнир — Hash Code, финал которого в проходил в головном офисе компании. Участникам, в частности, выдавались планы зданий, которые нужно было максимально покрыть сетью Wi-Fi-точек, используя как можно меньше роутеров и проводов. Оптимального решения у такой задачи не существует, но решить ее лучше других, конечно, возможно.

Одним из зданий, в котором организаторы Google Hash Code предлагали расставить роутеры, была парижская Гранд-Опера.

Отдельный вид соревнований представляет AI Cup, где нужно написать программу искусственного интеллекта, способную играть против оригинальной программы, предоставленной организаторами в виде библиотеки. Игры создают специально для турниров, т. е. поиграть в них руками в принципе нельзя. Но сценарии подбирают так, чтобы писать для них стратегии было интересно.

В этом году игра была похожа на современные MOBA: решение должно было управлять командой из пяти волшебников, обеспечив между ними обмен командами с помощью кодовых слов.

Подобные соревнования постоянно проходят на французском сайте CodinGame. И приятно, что в турнирах AI мы добиваемся неплохих результатов, занимая места в первых двух двадцатках при полном отсутствии тренировок. Все-таки в спортивном программировании главный навык — сесть, подумать и написать код.

Платформа Topcoder иногда проводит марафонские соревнования, которые могут продолжаться несколько недель. Есть несколько турниров, например, Deadline24 или Challenge24, финальная часть которых длится сутки. Отбираются на них, решая обычные алгоритмические задачи, а в финале здесь нужно создавать стратегии для управления игрой. На этом турнире самым эффективным нам показалось писать код первые 12 часов, а исправлением ошибок заниматься после перерыва на сон.

Онлайн-платформы позволяют поддерживать себя в форме, иначе навык решения задач теряется очень быстро. Но интересны они, конечно, не только как тренировка. Соревнования всегда драйв и эмоции, которых без них может остро не хватать.

Тренировки

Почти все наши тренировки длятся по пять часов, как и самые главные соревнования. Обычно мы просто решаем задачи с одного из прошедших турниров. Новые алгоритмы мы практически не учим, поскольку знаем их достаточно много. В конце концов, от нас ждут не знания сложных структур данных, а способности быстро придумать решение. Поэтому и специальные книги нам не очень помогают. Гораздо эффективнее читать отдельные статьи или слушать лекции по конкретным темам в интернете.

Несколько раз в год проходят сборы, на которые собираются команды из разных стран. В частности, в Петрозаводск в этом году приезжали сильные поляки, а в МФТИ в Долгопрудном — программисты из Китая и Австралии. На сборах мы полторы недели разбираем новые, специально подготовленные задачи, в том числе, привезенные другими командами.

Совмещать спортивное программирование с учебой было сложно в первые два года — на третьем и четвертом курсах стало легче, поскольку занятий в университете стало меньше. В принципе в это время многие студенты уже начинают работать. У нас времени на полноценную работу пока нет, хотя предложения после турниров мы, конечно, получаем.

Соперники

Самые сильные команды стабильно собирают вузы из России, Польши, Китая, Кореи и Японии. Временами удачные составы подбираются у одного из западно-европейских или американских университетов, но в целом там спортивным программированием явно интересуются меньше. Восточная Европа и Азия доминируют и в индивидуальных турнирах, например, на Codeforces. По количеству участников на многих соревнованиях первой постоянно оказывается Индия, однако чаще всего результаты их представители показывают не самые высокие. Хотя в решении проблем дизайна индийцы как раз сильны — это проявляется на cпециальных турнирах на Topcoder.

Школьная сборная США сезона 2017/18. Успеха в спортивном программировании в Америке в основном достигают молодые люди с азиатскими корнями.

Самыми загадочными соперникам кажутся программисты из Северной Кореи, которые в условиях ограниченного доступа к интернету все-таки тренируются и часто выступают довольно прилично. Правда, в этом году на финал в США они не приехали, а на Codeforces у них сложилась репутация читеров. В частности, северо-корейских участников онлайн-турниров обвиняли, что с одного аккаунта код пишут явно разные люди. А это строго запрещено правилами.

В этом году в десятку лучших на международной Олимпиаде вошла всего одна команда из Западной Европы — студенты Королевского технологического института из Стокгольма.

Успехи России выглядят вполне объяснимыми, поскольку здесь — и очень сильная математическая школа, и сложившаяся тусовка олимпиадников, готовая помочь начинающим. В России, помимо ИТМО, очень сильные команды представляют СПбГУ (чемпионы прошлого года), МГУ, московский Физтех, вузы Екатеринбурга и Саратова, хотя время от времени хорошие составы удается собрать и другим университетам.

На фото еще одна команда ИТМО: Артем Васильев и Бориса Минаев и Геннадий Короткевич — чемпионы мира 2015 года. Кубки Международной олимпиады по программированию не переходящие — теперь в ИТМО хранится уже семь.

|

Метки: author DataArt спортивное программирование алгоритмы c++ блог компании dataart icpc acm icpc итмо олимпиадное программирование |

[Перевод] Scala коллекции: секреты и трюки |

Представляю вашему вниманию перевод статьи Павла Фатина Scala Collections Tips and Tricks. Павел работает в JetBrains и занимается разработкой Scala плагина для IntelliJ IDEA. Далее, повествование идет от лица автора.

В этой статье вы найдете упрощения и оптимизации, характерные для повседневного использования API Scala коллекций.

Некоторые советы основаны на тонкостях реализации библиотеки коллекций, однако большинство рецептов — это разумные преобразования, которые на практике часто упускаются из виду.

Этот список вдохновлен моими попытками разработать практичные инспекции для Scala коллекций, для Scala плагина IntelliJ. Сейчас мы внедряем эти инспекции, так что, используя Scala плагин в IDEA, вы автоматически выигрываете от статического анализа кода.

Тем не менее, эти рецепты ценны сами по себе. Они могут помочь вам углубить понимание стандартной библиотеки коллекций Scala и сделать ваш код быстрее и выразительнее.

Обновление:

Если вы испытываете тягу к приключениям,

вы можете узнать, как помочь в развитии IntelliJ плагина для Scala и попробовать свои силы в реализации, подобрав подходящую инспекцию.

Содержание:

1. Легенда

2. Композиция

3. Побочные эффекты

4. Последовательности (Sequences)

4.1. Создание

4.2. Длина

4.3. Равенство

4.4. Индексация

4.5. Существование

4.6. Фильтрация

4.7. Сортировка

4.8. Свертка

4.9. Сопоставление

4.10. Перерабатываем

5. Множества (Sets)

6. Option-ы

6.1. Значение

6.2. Null

6.3. Обработка

6.4. Перерабатываем

7. Таблицы

8. ДополнениеВсе примеры кода доступны в репозитории на GitHub.

1. Легенда

Чтобы сделать примеры кода понятней, я использовал следующие обозначения:

seq— экземпляр основанной наSeqколлекции, вродеSeq(1, 2, 3)set— экземплярSet, напримерSet(1, 2, 3)array— массив, такой какArray(1, 2, 3)option— экземплярOption, например,Some(1)map— экземплярMap, подобныйMap(1 -> "foo", 2 -> "bar")???— произвольное выражениеp— предикат функции типаT => Boolean, например_ > 2n— целочисленное значениеi— целочисленный индексf,g— простые функции,A => Bx,y— некоторые произвольные значенияz— начальное или значение по умолчаниюP— паттерн

2. Композиция

Помните, вопреки тому, что рецепты изолированы и самодостаточны, их можно скомпоновать для последующего постепенного превращения в более продвинутые выражения:

seq.filter(_ == x).headOption != None

// от seq.filter(p).headOption к seq.find(p)

seq.find(_ == x) != None

// от option != None к option.isDefined

seq.find(_ == x).isDefined

// от seq.find(p).isDefined к seq.exists(p)

seq.exists(_ == x)

// от seq.exists(_ == x) к seq.contains(x)

seq.contains(x)Так, мы можем полагаться на "заменяющую модель применения рецептов" (аналогично SICP), и использовать ее для упрощения сложных выражений.

3. Побочные эффекты

"Побочный эффект" (Side effect) это основное понятие, которое стоит рассмотреть перед тем, как мы перечислим основные преобразования.

По сути, побочный эффект — любое действие, которое наблюдается за пределами функции или выражения помимо возврата значения, например:

- операция ввода-вывода,

- модификация переменной (доступной за пределами области видимости),

- изменение состояния объекта (наблюдаемое вне области видимости),

- возбуждение исключения (которое также не обрабатывается внутри области видимости).

О функциях или выражениях, содержащих любое из вышеперечисленных действий, говорят, что они имеют побочные эффекты, в противном случае их называют «чистыми».

Почему побочные эффекты так важны? Потому что с ними порядок исполнения имеет значение. Например, два «чистых» выражения, (связанных с соответствующими значениями):

val x = 1 + 2

val y = 2 + 3Так как они не содержат побочных эффектов (т.е. эффектов, наблюдаемых вне выражений), мы можем вычислить эти выражения в произвольном порядке — сначала x, а затем y или сначала y, а затем x — это не повлияет на корректность полученных результатов (мы можем даже закешировать результирующие значения, если того захотим). Теперь рассмотрим следующую модификацию:

val x = { print("foo"); 1 + 2 }

val y = { print("bar"); 2 + 3 }А это уже другая история — мы не можем изменить порядок выполнения, потому что в нашем терминале будет напечатано "barfoo" вместо "foobar" (и это явно не то, чего хотелось).

Так, присутствие побочных эффектов сокращает число возможных преобразований (как упрощений, так и оптимизаций), которые мы можем применить к коду.

Схожие рассуждения применимы и к родственным коллекциям, выражениям. Представим, что где-то за пределами области видимости у нас есть некий builder:

seq.filter(x => { builder.append(x); x > 3 }).headOptionВ принципе, вызов seq.filter(p).headOption упрощается до seq.find(p), впрочем, наличие побочного эффекта не дает нам это сделать:

seq.find( x => {builder.append(x); x > 3 })Хотя эти выражения и эквивалентны с позиции конечного значения, они не эквивалентны касательно побочных эффектов. Первое выражение добавит все элементы, а последнее отбросит все элементы, как только найдет первое совпадающее с предикатом значение. Поэтому такое упрощение сделать нельзя.

Что можно сделать для того, чтобы автоматическое упрощение стало возможным? Ответ — это золотое правило, которого следует придерживаться по отношению ко всем побочным эффектам в нашем коде (включая тот, где коллекций нет в принципе):

- Избегать побочных эффектов, когда это возможно.

- В противном случае изолировать побочные эффекты от чистого кода.

Поэтому нам нужно либо избавиться от builderа (вместе с его API, в котором есть побочные эффекты), либо отделить вызов builderа от чистого выражения. Предположим, что этот builder является неким сторонним объектом, изжить который мы не можем, так что нам остается лишь изолировать вызов:

seq.foreach(builder.append)

seq.filter(_ > 3).headOptionТеперь мы можем благополучно выполнить преобразование:

seq.foreach(builder.append)

seq.find(x > 3)Чисто и красиво! Изоляция побочных эффектов сделала возможным автоматическое преобразование. Дополнительная выгода еще и в том, что из-за присутствия четкого разделения, человеку легче понять получившийся код.

Наименее очевидным и при этом наиболее важным преимуществом изоляции побочных эффектов будет улучшение надежности нашего кода вне зависимости от других возможных оптимизаций. Касательно примера: первоначальное выражение может порождать различные побочные эффекты, зависящие от текущей реализации Seq. Для Vector, например, оно добавит все элементы, для Stream оно пропустит все элементы после первого удачного сопоставления с предикатом (потому что стримы «ленивы» — элементы вычисляются только тогда, когда это необходимо). Отделение побочных эффектов позволяет нам избежать этих неопределенностей.

4. Последовательности (Sequences)

Хотя советы в этом разделе и относятся к наследникам Seq, некоторые преобразования допустимы и для других типов коллекций (и не коллекций), например: Set, Option, Map и даже Iterator (потому что все они предоставляют похожие интерфейсы с монадическими методами).

4.1 Создание

Явно создавайте пустые коллекции

// До

Seq[T]()

// После

Seq.empty[T]Некоторые неизменяемые (immutable) классы коллекций имеют синглтон-реализацию метода empty. Однако, далеко не все фабричные методы проверяют длину созданных коллекций. Так что, обозначив пустоту на этапе компиляции, вы можете сохранить либо место в куче (путем переиспользования экземпляра), либо такты процессора (которые могли бы быть потрачены на проверки размерности во время выполнения).

Также применимо к: Set, Option, Map, Iterator.

4.2 Длины

Для массивов используйте length вместо size

// До

array.size

// После

array.lengthХотя size и length по существу синонимы, в Scala 2.11 вызовы Array.size по-прежнему выполняются через неявное преобразование (implicit conversion), таким образом создавая промежуточные объекты-обертки для каждого вызова метода. Если вы, конечно, не включите эскейп анализ для JVM, временные объекты станут обузой для сборщика мусора и ухудшат производительность кода (особенно внутри циклов).

Не отрицайте isEmpty

// До

!seq.isEmpty

!seq.nonEmpty

// После

seq.nonEmpty

seq.isEmptyПростые свойства содержат меньше визуального шума, чем составные выражения.

Также применимо к: Set, Option, Map, Iterator.

Не вычисляйте длину при проверке на пустоту.

// До

seq.length > 0

seq.length != 0

seq.length == 0

// После

seq.nonEmpty

seq.nonEmpty

seq.isEmptyС одной стороны, простое свойство воспринимается гораздо легче, чем составное выражение. С другой стороны, наследникам LinearSeq (таким как List) может потребоваться O(n) времени на вычисление длины списка (вместо O(1) для IndexedSeq), таким образом мы можем ускорить наш код, избегая вычисления длины, когда нам, вобщем-то, это значение не очень-то и нужно.

Имейте также в виду, что вызов .length для бесконечных стримов может никогда не закончиться, поэтому всегда проверяйте стрим на пустоту явно.

Также применимо к: Set, Map.

Во время сравнения не вычисляйте полный размер коллекции

// До

seq.length > n

seq.length < n

seq.length == n

seq.length != n

// После

seq.lengthCompare(n) > 0

seq.lengthCompare(n) < 0

seq.lengthCompare(n) == 0

seq.lengthCompare(n) != 0Поскольку расчет размера коллекции может быть достаточно «дорогим» вычислением для некоторых типов коллекций, мы можем сократить время сравнения с O(length) до O(length min n) для наследников LinearSeq (которые могут быть спрятаны под Seq-подобными значениями). Кроме того, такой подход незаменим, когда имеем дело с бесконечными стримами.

Не используйте exists для проверки на пустоту

// До

seq.exists(_ => true)

seq.exists(const(true))

// После

seq.nonEmptyРазумеется, такой трюк будет совсем излишним.

Также применимо к: Set, Option, Map, Iterator.

4.3 Равенство

Не полагайтесь на == для сравнения содержимого массивов

// До

array1 == array2

// После

array1.sameElements(array2)Проверка на равенство всегда будет выдавать false для различных экземпляров массивов.

Также применимо к: Iterator.

Не проверяйте на равенство коллекции различных категорий

// До

seq == set

// После

seq.toSet == setПроверки на равенство могут быть использованы для сравнения коллекций и различных категорий (например List и Set).

Прошу вас дважды подумать о смысле данной проверки (касательно примера выше — как рассматривать дубликаты в последовательности).

Не используйте sameElements для сравнения обыкновенных коллекций

// До

seq1.sameElements(seq2)

// После

seq1 == seq2Проверка равенства — это способ, которым следует сравнивать коллекции одной и той же категории. В теории это может улучшить производительность из-за наличия возможных низлежащих проверок экземпляра (eq, обычно намного быстрее).

Не используйте corresponds явно

// До

seq1.corresponds(seq2)(_ == _)

// После

seq1 == seq2У нас уже есть встроенный метод, который делает тоже самое. Оба выражения принимают во внимание порядок элементов. И мы опять-таки сможем выиграть пользу от повышения производительности.

4.4 Индексация

Не получайте первый элемент по индексу

// До

seq(0)

// После

seq.headДля некоторых классов коллекций обновленный подход может быть немного быстрее (ознакомьтесь с кодом List.apply, например). К тому же, доступ к свойству намного проще (как синтаксически, так и семантически), чем вызов метода с аргументом.

Не получайте последний элемент по индексу

// До

seq(seq.length - 1)

// После

seq.lastПоследнее выражение будет понятней и позволит избежать ненужного вычисления длины коллекции (а для линейных последовательностей это может занять немало времени). Более того, некоторые классы коллекций могут извлекать последний элемент более эффективно в сравнении с доступом по индексу.

Не проверяйте нахождение индекса в границах коллекции явно

// До

if (i < seq.length) Some(seq(i)) else None

// После

seq.lift(i)Семантически второе выражение эквивалентно, однако более выразительно

Не эмулируйте headOption

// До

if (seq.nonEmpty) Some(seq.head) else None

seq.lift(0)

// После

seq.headOptionУпрощенное выражение более лаконично.

Не эмулируйте lastOption

// До

if (seq.nonEmpty) Some(seq.last) else None

seq.lift(seq.length - 1)

// После

seq.lastOptionПоследнее выражение короче (и потенциально быстрее).

Будьте осторожны с типами аргументов для indexOf и lastIndexOf

// До

Seq(1, 2, 3).indexOf("1") // скомпилируется

Seq(1, 2, 3).lastIndexOf("2") // скомпилируется

// После

Seq(1, 2, 3).indexOf(1)

Seq(1, 2, 3).lastIndexOf(2)Из-за особенностей работы вариантности, методы indexOf и lastIndexOf принимают аргументы типа Any. На практике это может приводить к труднонаходимым багам, которые невозможно обнаружить на этапе компиляции. Вот где будут к месту вспомогательные инспекции вашей IDE.

Не создавайте диапазон индексов последовательности вручную

// До

Range(0, seq.length)

// После

seq.indicesУ нас есть встроенный метод, который возвращает диапазон из всех индексов последовательности.

Не используйте zip для связывания коллекции с индексами вручную

// До

seq.zip(seq.indices)

// После

seq.zipWithIndexВо-первых, последнее выражение короче. Кроме того, мы можем ожидать некоторый прирост производительности, из-за того, что мы избегаем скрытого вычисления размера коллекции (что в случае линейных последовательностей может обойтись недешево).

Дополнительное преимущество последнего выражения в том, что оно хорошо работает с потенциально бесконечными коллекциями (например Stream).

Используйте экземпляр IndexedSeq как объект-функцию:

// До (seq: IndexedSeq[T])

Seq(1, 2, 3).map(seq(_))

// После

Seq(1, 2, 3).map(seq)Поскольку экземпляр IndexedSeq[T] также является Function1[Int, T], вы можете использовать его как таковой.

4.5 Существование

Не используйте предикат сравнения для проверки наличия элемента

// До

seq.exists(_ == x)

// После

seq.contains(x)Второе выражение семантически эквивалентно, при этом более выразительно. Когда эти выражения применяются к Set, производительность может разительно отличаться, потому что поиск у множеств стремится к O(1) (из-за внутреннего индексирования, не использующегося при вызове exists).

Также применимо к: Set, Option, Iterator.

Будьте осторожны с типом аргумента contains

// До

Seq(1, 2, 3).contains("1") // компилируется

// После

Seq(1, 2, 3).contains(1)Так же как методы indexOf и lastIndexOf, contains принимает аргументы типа Any, что может привести к труднонаходимым багам, которые не обнаруживаются на этапе компиляции. Будьте с ними осторожны.

Не используйте предикат неравенства для проверки отсутствия элемента

// До

seq.forall(_ != x)

// После

!seq.contains(x)И снова последнее выражение чище и, вероятно, быстрее (особенно для множеств).

Также применимо к: Set, Option, Iterator.

Не считайте вхождения для проверки существования

// До

seq.count(p) > 0

seq.count(p) != 0

seq.count(p) == 0

// После

seq.exists(p)

seq.exists(p)

!seq.exists(p)Очевидно, когда нам нужно знать, находится ли соответствующий условию элемент в коллекции, подсчет количества удовлетворяющих элементов будет излишним. Упрощенное выражение выглядит чище и работает быстрее.

- Предикат

pдолжен быть чистой функцией. - Также применимо к:

Set,Map,Iterator.

Не прибегайте к фильтрации для проверки существования

// До

seq.filter(p).nonEmpty

seq.filter(p).isEmpty

// После

seq.exists(p)

!seq.exists(p)Вызов filter создает промежуточную коллекцию, которая занимает место в куче и нагружает GC. К тому же, предшествующие выражения находят все вхождения, в то время как требуется найти только первое (что может замедлить код в зависимости от возможного содержимого коллекции). Потенциальный выигрыш в производительности менее значим для ленивых коллекций (таких как Stream и, в особенности, Iterator).

- Предикат

pдолжен быть чистой функцией. - Также применимо к:

Set,Option,Map,Iterator.

Не прибегайте к поиску, чтобы проверить существование

// До

seq.find(p).isDefined

seq.find(p).isEmpty

// После

seq.exists(p)

!seq.exists(p)Поиск определенно лучше фильтрации, однако и это далеко не предел (по крайней мере, с точки зрения ясности).

Также применимо к: Set, Option, Map, Iterator.

4.6 Фильтрация

Не отрицайте предикат filter

// До

seq.filter(!p)

// После

seq.filterNot(p)Последнее выражение синтактически проще (при том, что семантически они эквивалентны).

Также применимо к: Set, Option, Map, Iterator.

Не фильтруйте, чтобы посчитать

// До

seq.filter(p).length

// После

seq.count(p)Вызов filter создает промежуточную (и не очень-то нужную) коллекцию, которая будет занимать место в куче и нагружать GC.

Также применимо к: Set, Option, Map, Iterator.

Не используйте фильтрацию для того, чтобы найти первое вхождение

// До

seq.filter(p).headOption

// После

seq.find(p)Конечно, если seq не является ленивой коллекцией (как, например, Stream), фильтрация найдет все вхождения (и создаст временную коллекцию) при том, что требовался только первый элемент.

Также применимо к: Set, Option, Map, Iterator.

4.7 Сортировка

Не сортируйте по свойству вручную

// До

seq.sortWith(_.property < _.property)

// После

seq.sortBy(_.property)Для этого у нас есть свой метод, более ясный и выразительный.

Не сортируйте по тождеству вручную

// До

seq.sortBy(identity)

seq.sortWith(_ < _)

// После

seq.sortedИ для этого тоже есть метод.

Выполняйте обратную сортировку в один шаг

// До

seq.sorted.reverse

seq.sortBy(_.property).reverse

seq.sortWith(f(_, _)).reverse

// После

seq.sorted(Ordering[T].reverse)

seq.sortBy(_.property)(Ordering[T].reverse)

seq.sortWith(!f(_, _))Таким образом, мы можем избежать создания промежуточной коллекции и исключить дополнительные преобразования (чтобы сберечь место в куче и циклы процессора).

Не используйте сортировку для нахождения минимального элемента

// До

seq.sorted.head

seq.sortBy(_.property).head

// После

seq.min

seq.minBy(_.property)Последний подход более выразителен. Кроме того, из-за того что не создается дополнительная коллекция, работать он будет быстрее.

Не используйте сортировку для нахождения максимального элемента

// До

seq.sorted.last

seq.sortBy(_.property).last

// После

seq.max

seq.maxBy(_.property)Объяснение совпадает с предыдущим советом.

4.8 Свертка

Не вычисляйте сумму вручную

// До

seq.reduce(_ + _)

seq.fold(z)(_ + _)

// После

seq.sum

seq.sum + zПреимущества этого подхода — ясность и выразительность.

- Другие возможные методы:

reduceLeft,reduceRight,foldLeft,foldRight. - Второе преобразование может быть заменено первым, если

zравняется0. - Также применимо к:

Set,Iterator.

Не вычисляйте произведение вручную

// До

seq.reduce(_ * _)

seq.fold(z)(_ * _)

// После

seq.product

seq.product * zПричины те же, что и в предыдущем случае.

- Второе преобразование может быть заменено первым, если

zравняется1. - Также применимо к:

Set,Iterator.

Не ищите минимальный элемент вручную

// До

seq.reduce(_ min _)

seq.fold(z)(_ min _)

// После

seq.min

z min seq.minОбоснование такое же, как и в предыдущем случае.

Также применимо к: Set, Iterator.

Не выполняйте поиск максимального элемента вручную

// До

seq.reduce(_ max _)

seq.fold(z)(_ max _)

// После

seq.max

z max seq.maxВсе как и в предыдущем случае.

Также применимо к: Set, Iterator.

Не эмулируйте forall

// До

seq.foldLeft(true)((x, y) => x && p(y))

!seq.map(p).contains(false)

// После

seq.forall(p)Цель упрощения — ясность и выразительность.

- Предикат

pдолжен быть чистой функцией. - Также применимо к:

Set,Option(для второй строки),Iterator.

Не эмулируйте exists

// До

seq.foldLeft(false)((x, y) => x || p(y))

seq.map(p).contains(true)

// После

seq.exists(p)При всей ясности и выразительности, последнее выражение может работать быстрее (оно останавливает последующую обработку элементов, как только найдет первый подходящий элемент), что может работать для бесконечных последовательностей.

- Предикат

pдолжен быть чистой функцией. - Также применимо к:

Set,Option(для второй строки),Iterator.

Не эмулируйте map

// До

seq.foldLeft(Seq.empty)((acc, x) => acc :+ f(x))

seq.foldRight(Seq.empty)((x, acc) => f(x) +: acc)

// После

seq.map(f)Это «классическая» в функциональном программировании реализация отображения (map) через свертку. Бесспорно, она поучительна, но нужды ее использовать нет. Для этого у нас есть встроенный и выразительный метод (который еще и быстрее, так как в своей реализации использует простой цикл while).

Также применимо к: Set, Option, Iterator.

Не эмулируйте filter

// До

seq.foldLeft(Seq.empty)((acc, x) => if (p(x)) acc :+ x else acc)

seq.foldRight(Seq.empty)((x, acc) => if (p(x)) x +: acc else acc)

// После

seq.filter(p)Причины те же, что и в предыдущем случае.

Также применимо к: Set, Option, Iterator.

Не эмулируйте reverse

// До

seq.foldLeft(Seq.empty)((acc, x) => x +: acc)

seq.foldRight(Seq.empty)((x, acc) => acc :+ x)

// После

seq.reverseИ опять-таки встроенный метод быстрее и чище.

Также применимо к: Set, Option, Iterator.

4.9 Сопоставление

Вот несколько обособленных советов, посвященных сопоставлению с образцом в Scala и частичным функциям.

Используйте частичные функции вместо функций с паттерн-матчингом

// До

seq.map {

_ match {

case P => ??? // x N

}

}

// После

seq.map {

case P => ??? // x N

}Обновленное выражение дает сходный результат и выглядит при этом проще.

Описанные выше преобразования можно применить к любым функциям, а не только к аргументам функции map. Этот совет относится не только к коллекциям. Однако, в виду вездесущести функций высшего порядка в API стандартной библиотеки коллекций Scala, он будет весьма кстати.

Конвертируйте flatMap с частичной функцией collect

// До

seq.flatMap {

case P => Seq(???) // x N

case _ => Seq.empty

}

// После

seq.collect {

case P => ??? // x N

}Обновленное выражение дает аналогичный результат и выглядит намного проще.

Также применимо к: Set, Option, Map, Iterator.

Преобразовать match к collect, когда результатом является коллекция

// До

v match {

case P => Seq(???) // x N

case _ => Seq.empty

}

// После

Seq(v) collect {

case P => ??? // x N

}Учитывая, что все case-операторы создают коллекции, можно упростить выражение, заменив match на вызов collect. Так мы создаем коллекцию всего один раз, опустив при этом явные ветки case для дефолтных случаев.

Лично я обычно использую этот трюк с Option, а не с последовательностями как таковыми.

Также применимо к: Set, Option, Iterator.

Не эмулируйте collectFirst

// До

seq.collect{case P => ???}.headOption

// После

seq.collectFirst{case P => ???}Для такого случая у нас есть особый метод, который работает быстрее для неленивых коллекций.

- Частичная функция должна быть чистой.

- Также применимо к:

Set,Map,Iterator.

4.10 Перерабатываем

Соединяем последовательные вызовы filter

// До

seq.filter(p1).filter(p2)

// После

seq.filter(x => p1(x) && p2(x))Так мы можем избежать создания промежуточной коллекции (после первого вызова filter), чем облегчим участь сборщика мусора.

Мы так же можем использовать обобщенный подход, который полагается на представления (смотрите ниже), получив: seq.view.filter(p1).filter(p2).force.

- Предикаты

p1иp2должны быть чистыми функциями. - Также применимо к:

Set,Option,Map,Iterator.

Соединяем последовательные вызовы map

// До

seq.map(f).map(g)

// После

seq.map(f.andThen(g))Как и в предыдущем случае, мы сразу создаем конечную коллекцию без создания промежуточной.

Мы так же можем применить обобщенный подход, который полагается на view (смотрите ниже), получив: seq.view.map(f).map(g).force.

- Функции

fиgдолжны быть чистыми. - Также применимо к:

Set,Option,Map,Iterator.

Сортируйте после фильтрации

// До

seq.sorted.filter(p)

// После

seq.filter(p).sortedСортировка — процедура затратная. Поэтому нет нужды сортировать элементы, которые на следующем шаге могут быть отфильтрованы.

- Подобное применимо ко всем возможным методам сортировки, таким как

sortWithиsortBy. - Предикат

pдолжен быть чистой функцией.

Не переворачивайте коллекцию явно перед вызовом map

// До

seq.reverse.map(f)

// После

seq.reverseMap(f)Первое выражение создает промежуточную (перевернутую) коллекцию перед преобразованием элементов, что иногда бывает достаточно разумно (например для List). В других случаях, что будет более эффективно, можно сразу выполнить требуемые преобразования, не создавая промежуточную коллекцию.

Не переворачивайте коллекцию явно для получения обратного итератора

// До

seq.reverse.iterator

// После

seq.reverseIteratorК тому же последнее выражение проще и может быть более эффективным.

Не конвертируйте коллекцию Set для нахождения отдельных элементов

// До

seq.toSet.toSeq

// После

seq.distinctНет нужды создавать временное множество (во всяком случае явно), чтобы найти отдельные элементы.

Не эмулируйте slice

// До

seq.drop(x).take(y)

// После

seq.slice(x, x + y)Для линейных последовательностей, ничего кроме ясно выраженных мыслей и намерений мы не получим. Однако, в случае с индексированными последовательностями мы можем ожидать потенциальный прирост производительности.

Также применимо к: Set, Map, Iterator.

Не эмулируйте splitAt

// До

val seq1 = seq.take(n)

val seq2 = seq.drop(n)

// После

val (seq1, seq2) = seq.splitAt(n)Для линейных последовательностей (как для List, так и для Stream), упрощенные выражения будут выполняться быстрее из-за того, что результаты вычисляются за один проход.

Также применимо к: Set, Map.

Не эмулируйте span

// До

val seq1 = seq.takeWhile(p)

val seq2 = seq.dropWhile(p)

// После

val (seq1, seq2) = seq.span(p)А так мы можем пройти последовательность и проверить предикат не два, а всего один раз.

- Предикат

pне должен иметь побочных эффектов. - Также применимо к:

Set,Map,Iterator.

Не эмулируйте partition

// До

val seq1 = seq.filter(p)

val seq2 = seq.filterNot(p)

// После

val (seq1, seq2) = seq.partition(p)Опять-таки, преимуществом будет вычисление в один проход

- Предикат

pне должен иметь побочных эффектов. - Также применимо к:

Set,Map,Iterator.

Не эмулируйте takeRight

// До

seq.reverse.take(n).reverse

// После

seq.takeRight(n)Последнее выражение более выразительно и потенциально более эффективно (как для индексированных, так и для линейных последовательностей).

Не эмулируйте flatten

// До (seq: Seq[Seq[T]])

seq.reduce(_ ++ _)

seq.fold(Seq.empty)(_ ++ _)

seq.flatMap(identity)

// После

seq.flattenНет необходимости делать это вручную: у нас уже есть встроенный метод.

Также применимо к: Set, Option, Iterator.

Не эмулируйте flatMap

// До (f: A => Seq[B])

seq.map(f).flatten

// После

seq.flatMap(f)Опять-таки незачем писать велосипед. Улучшится не только выразительность, дополнительная коллекция создаваться тоже не будет.

Также применимо к: Set, Option, Iterator.

Не используйте map если результат игнорируется

// До

seq.map(???) // результат игнорируется

// После

seq.foreach(???)Когда вам нужны именно побочные эффекты, оправданий вызову map нет. Такой вызов вводит в заблуждение, при том еще и менее эффективен.

Также применимо к: Set, Option, Map, Iterator.

Не используйте unzip для извлечения единственного элемента

// До (seq: Seq[(A, B]])

seq.unzip._1

// После

seq.map(_._1)Незачем создавать дополнительные коллекции, когда требуется всего-навсего один элемент.

- Другой возможный метод:

unzip3. - Также применимо к:

Set,Option,Map,Iterator.

Не создавайте временные коллекции

Этот рецепт разбит на три части (в зависимости от конечного результата преобразования).

1) Преобразование сокращает коллекцию до единственного значения.

// До

seq.map(f).flatMap(g).filter(p).reduce(???)

// После