Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Из песочницы] Как я создал систему установки принтеров на работе |

Здравствуй, уважаемый %user%. Сегодня я расскажу о том, как я написал пользовательскую систему для обеспечения возможности пользователям самим устанавливать требуемые для них принтеры. Немного расскажу о месте где я работаю, чтобы было понятно зачем я это сделал. Заранее скажу, что о существовании компонента роли в Windows Server 2012 R2, которая даёт возможность установить принтер с браузера я знал. Но мне хотелось изобрести свой велосипед, да и ограничения здесь будут наверное в фантазии. Кому стало интересно добро пожаловать под кат. Для не терпеливых сразу скажу, что скриншоты в конце статьи.

Немного о работе

Работаю я в хелпдеске в некой большой организации, которая имеет много филиалов. Имеется более тысячи сотрудников работающие перед компьютерами. Можно догадаться, что есть большой зоопарк сетевых принтеров, есть отдельные работники отвечающие за работоспособность принтеров. Установку принтеров компьютерам осуществляем мы – хелпдеск. Очень часто сотрудники разных отделов переходят из одного рабочего места в другое, приходят или увольняются, или вообще меняют должность и профессию и так далее. Куча всего интересного. Соответственно из-за этого очень часто поступают звонки к нам в хелпдеск о просьбе установить им принтер. Понимаете, попросить пользователя, сказать IP адрес принтера, это все равно что попросить обезьяну сварить суп. Приведу пример диалога (реальный случай):

Я- Да. Правильно. Вы туда попали

U- Помогите мне пожалуйста установить принтер на мой компьютер

Я-Хорошо, скажите мне пожалуйста имя вашего компьютера.

U-Имя моего компьютера comp-01 (имя вымышленное)

Я-Какой принтер вам поставить? (Подключаясь к компьютеру)

U- HP LaserJet 600, он находится в %place%

Я – расположение принтера мне ничего не дает (и правда поменяют его другим принтером так как первый испортился, или поменяют его место). Хорошо, можете ли вы мне сказать ip адрес этого принтера?

U- ….

Пауза на конце трубки. Я аж услышал, как зашевелился у пользователя мозг, пошла кровь из ушей и наконец он спросил

U- Простите что? Айми? Что вам сказать? Айми адрес?

Я – Айпи, айпи адрес.

U- Айпи? А что это такое? Как можно на него посмотреть?

Я –Ладно скажите кроме вас кто-то еще этим принтером пользуется?

U-Ну им пользуется %another_user%

Я-Пожалуйста попросите у него имя компьютера и получите разрешение чтобы я на секундочку к нему подключился

U- Ок, сейчас (и слышу приглушенный голос того как он спрашивает у %another_user% имя компьютера и разрешение на подключение)

Я-…..(думая про себя: айми айми айми, елки палки какую рифму на айми можно придумать)

U-Алё

Я- Да, я вас слушаю

U- Имя компьютера comp-02, можете подключаться

Я- Попросите %another_user% показать мне принтер, которым он постоянно пользуется (подключаюсь к компьютеру)

U- Ок, сейчас (опять приглушенный голос)…… — Вот этот

Я- Ок, хорошо, я понял всё не буду вас задерживать на линии сейчас сам всё поставлю и настрою

U- Хорошо, спасибо. Однако вы мне не сказали, что такое айми.

Я- Наверное, вы имели в виду айпи. Ну сложно будет объяснить сейчас, так как звонков многовато, но в общем это адрес устройства в сети.

Вы слышали когда-нибудь как ломается мозг у гуманитария? Я услышал этот звук, знаете такой глухой звук с брызгами большого количество информации с содержанием одной лишь только «воды».

U – ....(долгая пауза)… Ясно. Я отойду по делам а вы поставьте принтер

Я- Да, хорошо, до свидания

А теперь представьте, что каждый третий звонящий в хелпдеск, с просьбой установить принтер в таком же состоянии. Как быть? Данного рода диалоги очень сильно утомляют, да и объяснить юзверю как напечатать конфигурацию устройства, чтобы посмотреть на IP принтера, это что-то сверхтяжелое. Значит нужна какая-то автоматизация. А что если собрать централизованно все принтеры на один отдельный принтер сервер, написать некий простой веб-сайт с дружелюбным интерфейсом. Пару кликов и принтер установился. Вызов принят.

Все не так и сложно как кажется

Попросил системных администраторов выделить отдельный сервер на Windows Server 2012 R2.

На принтер сервере

- Установил роль Printer Sever

- Создал папку scripts$, чтобы хранить скрипты установки принтеров

- Установил XAMPP

- Добавил apache и mysql как службу в автозагрузку, чтобы в случае перезагрузки сервера, веб-сайт не грохнулся

С принтерами:

- Наклеил на все принтеры до которых руки доходят наклейки с их номерами и установил их на принтер сервер. Порядковый номер — это некий идентификатор для принтера. Где бы он не находился юзверь всегда сможет найти его по порядковому номеру. К примеру: «HP LaserJet 600 Printer #id %filial%», где %filial% — имя филиала, #id уникальный порядковый номер принтера. Распечатывается бумажка с порядковым номером и клеится на принтер. Знать пользователю даже имя принтера не обязательно. Совпал номер с тем что на сайте – значит он и есть.

- Договорился с менеджерами филиалов, попросил выделить кого-то знающего в филиале чтобы собрали и отправили мне имена, ip адреса принтеров и наклеили их номера порядковые. Добавил все принтеры по одному на принтер сервер.

Начинаем программировать

Веб-сайт построен на PHP написанием самописного MVC движка, с помощью использования только редактора Notepad++, Google и браузера (да – только по хардкору). Знаниями по какому-то фреймворку не обладаю, изучать лень, использовать javascript фреймворки в 2к17?, да и не слишком ли много для принтеров?

Поставим цель, что нам нужно от этой системы:

- Максимально простая и наглядная для пользователя

- Возможность создания учетных записей администраторов

- Возможность добавлять\удалять принтеры администраторам

- Возможность добавлять\удалять филиалы администраторам

- Наличие какой-либо справочной информации для пользователя

- Смена языка

- Возможность устанавливать принтеры не одним, а несколькими методами (скриптами)

Определим структуру проекта:

- App

- Configs

- Controllers

- Locale

- Views

- Uploads

В корневой папке создадим файл index.php добавим код:

В папке configs создадим файл database.php:

Зайдем в браузере в phpmyadmin, создадим базу данных printer с использованием кодировки utf8_general_ci. Создадим 3 таблицы с именами branches, printers, users.

Структура branches:

| Имя | Тип | Дополнительно |

|---|---|---|

| Id | int(6) | AUTO_INCREMENT, PRIMARY, UNIQUE |

| branch_name | varchar(255) | |

| image | varchar(255) |

Структура printers:

| Имя | Тип | Дополнительно |

|---|---|---|

| Id | int(6) | AUTO_INCREMENT, PRIMARY, UNIQUE |

| Name | varchar(255) | |

| branchid | int(6) | По умолчанию значение: 1 |

| description | text | |

| ipaddress | varchar(255) | |

| image | varchar(255) | |

| File1 | varchar(255) | |

| File2 | varchar(255) | |

| File3 | varchar(255) |

Структура users:

| Имя | Тип | Дополнительно |

|---|---|---|

| Id | int(6) | AUTO_INCREMENT, PRIMARY, UNIQUE |

| Login | varchar(128) | |

| Token | varchar(128) | |

| password | varchar(128) | |

| lang | varchar(10) | |

| logindate | varchar(255) |

Как видно из таблиц branchid определяет к какому филиалу относится принтер (получив значение его id).

Создадим запись с id равной 1, именем филиала «none» и image значением «none». Эта запись нужна для того чтобы задавать принтеру не установленный филиал. Первая запись захардкожена и не отображается в списках филиалов, как и для юзверей так и в админке. Её удалить нельзя.

Класс Database я нашел в просторах интернета. В нем имеется функция для подключения к нашей базе данных, с использования значений для подключения от файла database.php находящийся в папке configs и функция для осуществления запросов к БД.

Класс Info используется для получения, изменения, удаления данных из БД. Именно с использованием этого класса осуществляются все операции в системе.

Одним из важных классов является класс Controller.php. Как видно из названия этот класс является контроллером, который принимает GET и POST запросы в __construct($get, $post) из index.php. Получив определенный запрос он собирает куски страницы во едино соответственно требуемому запросу и выполняет требуемые функции из Info.php.

Класс Views является классом, который загружает куски страницы. Каждая страница имеет свое название соответствующее php файлу в папке Views. Так к примеру, чтобы отобразить главную страницу, следует написать:

$views = new Views;

$views->addView('header', 'header.php');

$views->addView('menu', 'menu.php');

$views->addView('dashboard', 'dashboard.php');

$views->addView('footer', 'footer.php');

В этом же классе определяется текущий язык пользователя, загружается локализация из ini файла и создается переменная $lang, которая уже используется в самом куске страницы. Пример кода главной страницы (dashboard.php):

В папке views так же есть файлы css, javascript. За основу CSS стилей я использовал Bootstrap.

Класс Lang определяет текущий язык пользователя. Сперва он пытается получить куки «cookie_lang». Если не обнаруживает его, то ставит по умолчанию русский язык. Функция getLangArray() загружает нужный ini файл и возвращает массив вида «ключ» — > «значение». Именно эта функция используется в классе views.

Что мы получили

Пользователь заходит на главную страницу. Там описание того куда он попал и кнопка, которая открывает список всех филиалов. После того как пользователь выберет филиал, откроется список принтеров. Принтеры отображаются в виде сетки, где их фотографии и их названия. Пользователь выбирает принтер, открывается страница с выбранным принтером, где есть большая кнопка «Установить» (также там информация о принтере, его IP адрес). При нажатии на эту кнопку скачивается bat файл, который в свою очередь открывает vbs скрипт, расшаренный в папке scripts$ на принтер сервере. Проблема в том что если закачивать файл vbs, то вместо того чтобы скачать его, браузер открывает этот файл у себя в новой вкладке. Поэтому пришлось так извращаться. Vbs файлы на шаре папке тоже рассортированы вместе со своим bat файлом по папкам. К примеру, ниже приведена структура папки:

Printer#id

- Printer#id.bat

- Printer#id.vbs

Где #id порядковый номер принтера.

При добавлении нового принтера через админку, заполняются требуемые поля и выбирается нужный bat файл из шары. Файл установки, фотография принтера загружается в папку uploads. В админке сделано так, что мы можем закачать до трех разных файлов установки. Сколько файлов закачано столько и кнопок «Установить». В данном случае обошлось без альтернативных методов установки принтеров. VBS скрипта оказалось достаточно.

VBS script

Vbs скрипт устанавливающий принтер выглядел таким образом:

printerName = "\\prnserver01\HP LaserJet 600 printer1 branch1"

Set WshNetwork = CreateObject("WScript.Network")

WshNetwork.AddWindowsPrinterConnection printerName

WSHNetwork.SetDefaultPrinter printerName

Данный скрипт выполняется в невидимом режиме, какое-то время отображается окно командной строки, затем он исчезает. Данный скрипт обладает минусом того, что не понятно, что происходит. Поэтому подумав немного поменял его в такой вид:

'Задаем путь принтера

printerName = "\\prnserver01\HP LaserJet 600 printer1"

'Создаем окно Internet Explorer

Set objExplorer = CreateObject("InternetExplorer.Application")

'Задаем настройки окна - длину, ширину, позицию на экране

objExplorer.Navigate "about:blank"

objExplorer.ToolBar = 0

objExplorer.StatusBar = 0

objExplorer.Left = 500

objExplorer.Top = 250

objExplorer.Width = 550

objExplorer.Height = 170

objExplorer.Visible = 1

'Задаем заголовок

objExplorer.Document.Title = "Ustanovka printera"

'Задаем html код страницы, со своим крутым дизайном

objExplorer.Document.Body.InnerHTML = " Ustanovka printera: 0% " & printerName & "

"

'Ждем 500 миллисекунд, находим на странице объект с id progress и меняем его значение. Психологический фактор для юзверя, толку от этого 0

Wscript.Sleep 500

objExplorer.document.getElementById("progress").innerText = " Ustanovka printera: 10%"

'Создаем объект для установки принтера, устанавливаем принтер и ставим его по умолчанию. Скрипт не продолжит выполнятся пока принтер не установится или выйдет ошибка

Set WshNetwork = CreateObject("WScript.Network")

WshNetwork.AddWindowsPrinterConnection printerName

WSHNetwork.SetDefaultPrinter printerName

'Психологический фактор на 200 миллисекунд, хотя принтер уже установился или вышла ошибка

Wscript.Sleep 200

objExplorer.document.getElementById("progress").innerText = " Ustanovka printera: 20%"

'Ещё один психологический фактор на 200 миллисекунд

Wscript.Sleep 200

objExplorer.document.getElementById("progress").innerText = " Ustanovka printera: 40%"

'Ещё один, это же такой кайф когда проценты быстро идут

Wscript.Sleep 200

objExplorer.document.getElementById("progress").innerText = " Ustanovka printera: 60%"

'В этом моменте можно уже откинуться

Wscript.Sleep 200

objExplorer.document.getElementById("progress").innerText = " Ustanovka printera: 80%"

'О свершилось чудо, наконец!

Wscript.Sleep 100

objExplorer.document.getElementById("progress").innerText = " Printer ustanovlen!"

'Получим на 3 секунды еще кайфа от того, что установили принтер и прощаемся

Wscript.Sleep 3000

objExplorer.Quit

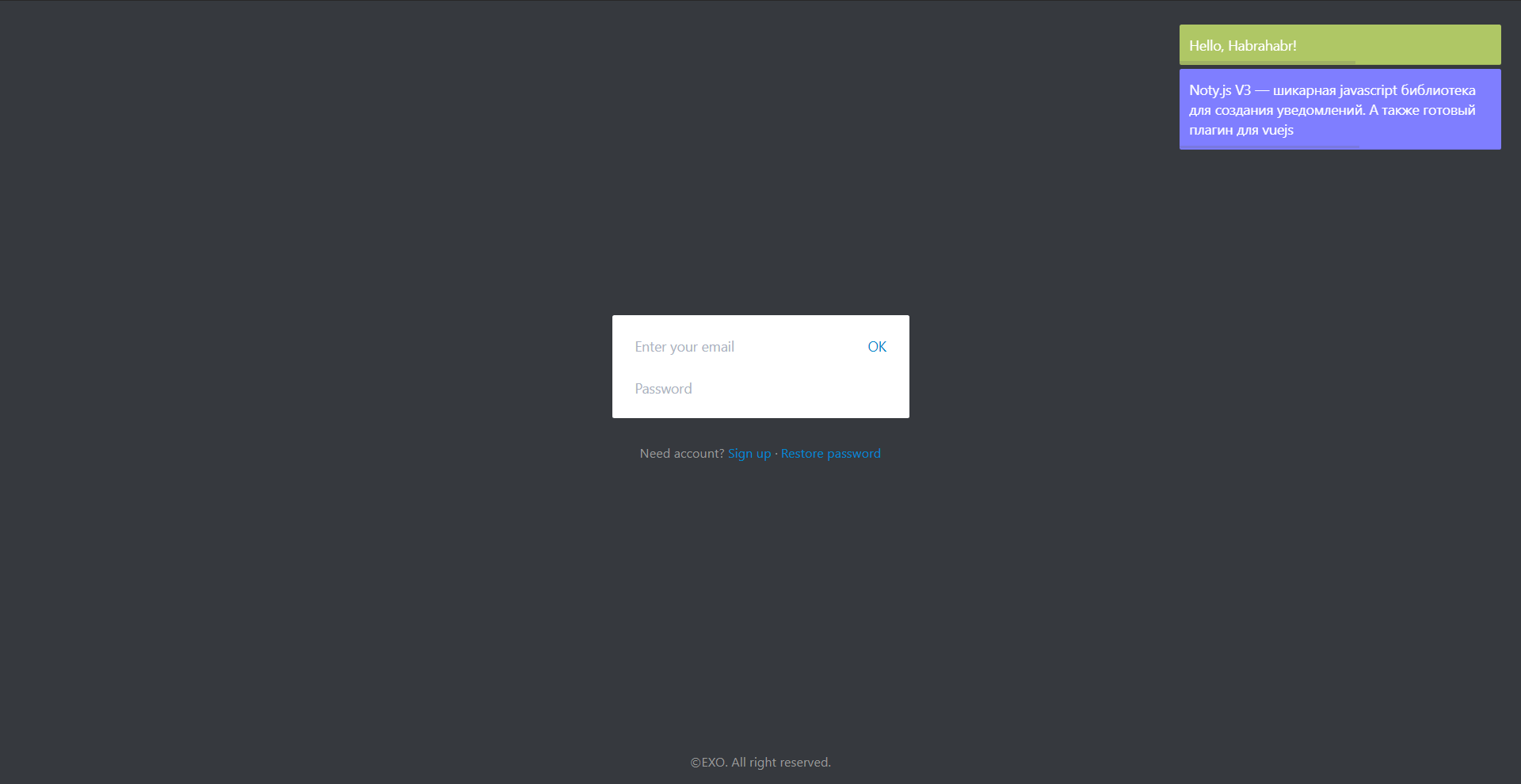

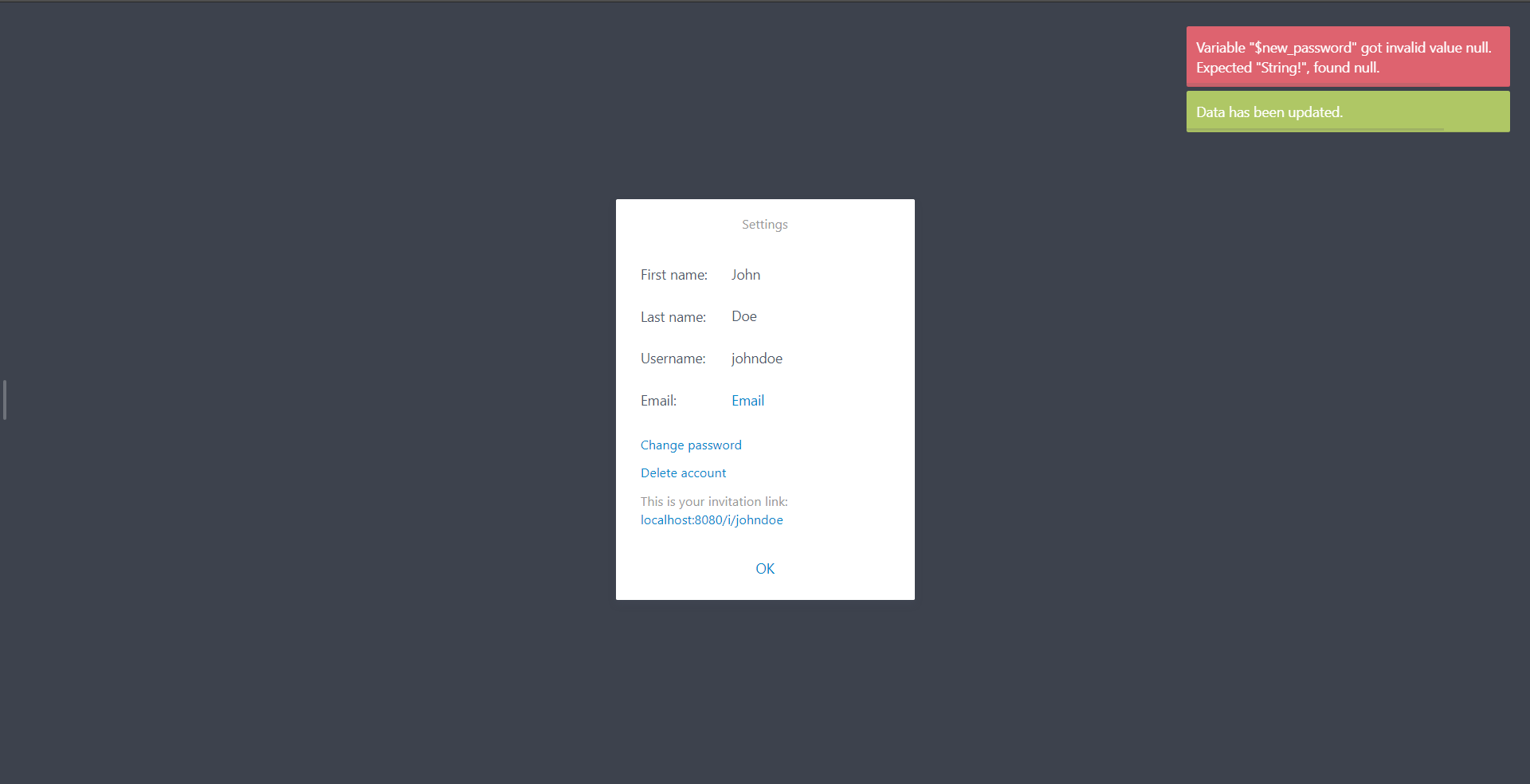

Скриншоты

Исходный код всего этого выложил на github

Теперь звонков по поводу установки принтеров стало намного меньше.

Спасибо за внимание!

|

Метки: author AkshinM разработка веб-сайтов php html css printer setup system программирование |

Нейротеатр: технологии Университета ИТМО помогают создавать «искусство новых медиа» |

/ Фотография Университета ИТМО

/ Фотография Университета ИТМОПроект NEU-theatre

Нейротеатр — это, по сути, сплав искусства и технологий. На Geek Picnic этот жанр был представлен выступлением танцоров, использовавших нейроинтерфейсы. Они считывали эмоции артистов и передавали их внутреннее состояние с помощью музыки, света, цвета, проекции и ритма.

Танцоры на выступлении работали с так называемым синестетическим шаром — он позволял «отобразить» эмоции исполнителя. Кроме того, его можно было использовать, чтобы менять звуковое сопровождение перфоманса.

/ Фотография Университета ИТМО

Весь этот хайп вокруг нейроинтерфейсов хорош тем, что люди вспоминают о том, что у них есть мозг. И что его возможности стоит использовать и развивать более активно

– Юрий Дидевич, медиахудожник, один из создателей NEU-theatre

По сути, нейротеатр — это пример того, как наш мозг становится центром особого направления в искусстве. Оказывается, наши эмоции могут творить аудиовизуальную реальность, благодаря которой артист становится еще ближе к зрителю. Это уже даже не иммерсивный спектакль, когда можно оказаться участником представления — такой формат позволяет лучше понять, что творится у артиста в голове, — буквально.

Кто создавал

Создатели проекта NEU-theatre: российский медиахудожник, музыкант, лектор Института Art&Science Университета ИТМО Юрий Дидевич, Высшая школа светового дизайна Университета ИТМО и танцевальный коллектив Stage DFT.

Юрий Дидевич много лет занимается вопросами интеграции компьютерных технологий и искусства. В 2014 году его спектакль «Нейроинтегрум» был поставлен на Новой сцене Александринского театра в Санкт-Петербурге. Нейротеатр NEU-theatre — еще один проект Юрия, объединяющий искусство и ИТ.

/ Фотография Университета ИТМО

Высшая школа светового дизайна Университета ИТМО — это и образовательный, и экспериментально-практический проект, объединяющий обучение, науку и искусство. В Высшей школе светового дизайна проводятся исследования городской среды, работает проектная лаборатория, направление Light & Art занимается созданием световых инсталляций и световым сопровождением фестивалей. Кроме того, там можно получить образование по профилю «Световой дизайн» — в школе открыты магистратура и аспирантура, курсы повышения квалификации и летняя школа.

Такое сочетание науки и искусства организаторы нейротеатра считают максимально перспективным:

Было бы здорово, чтобы ученые, в том числе, российские, перестали относиться к искусству как к чему-то ущербному. Это очень хорошее сочетание — ученого и его научного подхода и художников, людей, воспринимающих мир несколько иначе. Это может привести к очень интересным результатам

– Юрий Дидевич

Как это работает

На первый взгляд может показаться, что нейротеатр — это просто мультимедийный перфоманс с музыкой, светом, цветом и танцорами. На самом деле артисты, занятые в представлении, действительно передают аудитории свое состояние — нейроинтерфейс анализирует их мозговую активность и «выдает» определенную аудиовизуальную картинку.

/ Фотография Университета ИТМО

Программа анализа мозговой активности — разработка авторов NEU-theatre (проект практически полностью основывается на собственных разработках его создателей). В основе такого анализа лежит изучение биоэлектрогенеза и работа по фиксации и расшифровке нервных импульсов, которые генерирует мозг человека.

При таком подходе в равной степени важными становятся и искусство, и технология (ПО), и конкретный инструментарий — интерфейсы, с которыми работают художники и артисты. Кстати, Юрий Дидевич отметил, что он и его коллеги ожидают появления более доступных устройств и интерфейсов для фиксации и распознавания эмоций — спроектированных специально для артистов.

Принцип работы нейротеатрального инструментария и вообще нейротеатра не нов — первые попытки зафиксировать состояние человека на сцене появились еще в начале ХХ века (тогда для этого использовались даже гальванометры). Впоследствии интерес к этому жанру то угасал, но снова возвращался — не в последнюю очередь благодаря новостям о достижениях ученых. Можно сказать, что сейчас нейротеатр переживает свое второе рождение — и дает артистам уже совершенно новые технологические возможности.

О чем еще мы рассказываем на Хабре:

- Как складывается карьера после Университета ИТМО

- Как Университет ИТМО помогает организаторам Кубка конфедераций и ЧМ-2018

- Как семантические технологии улучшают онлайн-образование

- Скорочтение: работает или нет? Часть 1, Часть 2, Часть 3

|

Метки: author itmo визуализация данных блог компании университет итмо университет итмо neu-theatre |

[Из песочницы] WPF и Box2D. Как я делал физику c WPF |

Доброго времени хабр. Я большой фанат физики в играх, работал с некоторыми интересными физическими движками но сегодня я расскажу о Box2D. Он максимально прост и понятен и отлично подходит для двумерной физики. Я заметил что в интернете очень мало туториалов по Box2D на C#, их почти нет. Меня неоднократно просили написать статейку по этому поводу. Чтож, время пришло. Будет много кода, букв и немного комментариев. Для вывода графики используется WPF и элемент Viewport3D. Кому интересно, добро пожаловать подкат.

Box2D — компьютерная программа, свободный открытый физический движок. Box2D является физическим движком реального времени и предназначен для работы с двумерными физическими объектами. Движок разработан Эрином Катто (англ. Erin Catto), написан на языке программирования C++ и распространяется на условиях лицензии zlib.

Движок используется в двумерных компьютерных играх, среди которых Angry Birds, Limbo, Crayon Physics Deluxe, Rolando, Fantastic Contraption, Incredibots, Transformice, Happy Wheels, Color Infection, Shovel Knight, King of Thieves.

Скачать можно по ссылке Box2D.dll

WPF и Viewport3D

Для отрисовки мира я решил по определенным причинам взять WPF, кончно отрисовывать можно на чем угодно, хоть на обычном Grphics и PictureBox, но это не желательно т.к. Graphics выводит графику через ЦП и будет отнимать много процессорного времени.

Напишем небольшое окружение для работы с графикой. В дефолтное окно проекта добавим следующий XAML:

ClipToBounds — говорит то что невидимые грани будут отсекаться, хотя здесь это не пригодится т.к. будет 2D проекция, я все равно это включу.

После устанавливается перспективная камера. FarPlaneDistance — максимальное расстояние которое захватывает камера, NearPlaneDistance — минимальное расстояние, и дальше позиция, куда смотрит камера и как она смотрит. Дальше мы создаем элемент Model3DGroup в который мы будем кидать геометрию через его имя «models», и добавляем в него 3 освещения.

Ну вот, с XAML разобрались, теперь можно начать писать класс для создания геометрии:

public class MyModel3D

{

public Vector3D Position { get; set; } // Позиция квадрата

public Size Size { get; set; } // Размер квадрата

private TranslateTransform3D translateTransform; // Матрица перемещения

private RotateTransform3D rotationTransform; // Матрица вращения

public MyModel3D(Model3DGroup models, double x, double y, double z, string path, Size size, float axis_x = 0, double angle = 0, float axis_y = 0, float axis_z = 1)

{

this.Size = size;

this.Position = new Vector3D(x, y, z);

MeshGeometry3D mesh = new MeshGeometry3D();

// Проставляем вершины квадрату

mesh.Positions = new Point3DCollection(new List

{

new Point3D(-size.Width/2, -size.Height/2, 0),

new Point3D(size.Width/2, -size.Height/2, 0),

new Point3D(size.Width/2, size.Height/2, 0),

new Point3D(-size.Width/2, size.Height/2, 0)

});

// Указываем индексы для квадрата

mesh.TriangleIndices = new Int32Collection(new List { 0, 1, 2, 0, 2, 3 });

mesh.TextureCoordinates = new PointCollection();

// Устанавливаем текстурные координаты чтоб потом могли натянуть текстуру

mesh.TextureCoordinates.Add(new Point(0, 1));

mesh.TextureCoordinates.Add(new Point(1, 1));

mesh.TextureCoordinates.Add(new Point(1, 0));

mesh.TextureCoordinates.Add(new Point(0, 0));

// Натягиваем текстуру

ImageBrush brush = new ImageBrush(new BitmapImage(new Uri(path)));

Material material = new DiffuseMaterial(brush);

GeometryModel3D geometryModel = new GeometryModel3D(mesh, material);

models.Children.Add(geometryModel);

translateTransform = new TranslateTransform3D(x, y, z);

rotationTransform = new RotateTransform3D(new AxisAngleRotation3D(new Vector3D(axis_x, axis_y, axis_z), angle), 0.5, 0.5, 0.5);

Transform3DGroup tgroup = new Transform3DGroup();

tgroup.Children.Add(translateTransform);

tgroup.Children.Add(rotationTransform);

geometryModel.Transform = tgroup;

}

// Утсанавливает позицию объекта

public void SetPosition(Vector3D v3)

{

translateTransform.OffsetX = v3.X;

translateTransform.OffsetY = v3.Y;

translateTransform.OffsetZ = v3.Z;

}

public Vector3D GetPosition()

{

return new Vector3D(translateTransform.OffsetX, translateTransform.OffsetY, translateTransform.OffsetZ);

}

// Поворачивает объект

public void Rotation(Vector3D axis, double angle, double centerX = 0.5, double centerY = 0.5, double centerZ = 0.5)

{

rotationTransform.CenterX = translateTransform.OffsetX;

rotationTransform.CenterY = translateTransform.OffsetY;

rotationTransform.CenterZ = translateTransform.OffsetZ;

rotationTransform.Rotation = new AxisAngleRotation3D(axis, angle);

}

public Size GetSize()

{

return Size;

}

}

Этот класс создает квадрат и отрисовывает на нем текстуру. Думаю по названиям методов понятно какой метод за что отвечает. Для рисования геометрических фигур я буду использовать текстуру и накладывать ее на квадрат с альфа каналом.

Box2D — Hello world

Начнем с самого основного, с создания мира. Мир в Box2D имеет определенные параметры, это границы(квадрат) в которых обрабатываются физические тела.

В параметрах мира так же есть вектор гравитации и возможность объектов «засыпать» если их инерция равно нулю, это хорошо подходит для экономии ресурсов процессора. Пораметров конечно больше, но нам пока нужны только эти. Создадим класс Physics и добавим следующий конструктор:

public class Physics

{

private World world;

public Physics(float x, float y, float w, float h, float g_x, float g_y, bool doSleep)

{

AABB aabb = new AABB();

aabb.LowerBound.Set(x, y); // Указываем левый верхний угол начала границ

aabb.UpperBound.Set(w, h); // Указываем нижний правый угол конца границ

Vec2 g = new Vec2(g_x, g_y); // Устанавливаеи вектор гравитации

world = new World(aabb, g, doSleep); // Создаем мир

}

}

Дальше необходимо написать методы для добавления различных физических тел, я добавлю 3 метода создающих круг и квадрат и многоугольник. Сразу добавляю в класс Physics две константы:

private const string PATH_CIRCLE = @"Assets\circle.png"; // Изображение круга

private const string PATH_RECT = @"Assets\rect.png"; // Изображение квадрата

Описываю метод для создания квадратного тела:

public MyModel3D AddBox(float x, float y, float w, float h, float density, float friction, float restetution)

{

// Создается наша графическая модель

MyModel3D model = new MyModel3D(models, x, -y, 0, PATH_RECT, new System.Windows.Size(w, h));

// Необходим для установи позиции, поворота, различных состояний и т.д. Советую поюзать свойства этих объектов

BodyDef bDef = new BodyDef();

bDef.Position.Set(x, y);

bDef.Angle = 0;

// Наш полигон который описывает вершины

PolygonDef pDef = new PolygonDef();

pDef.Restitution = restetution;

pDef.Friction = friction;

pDef.Density = density;

pDef.SetAsBox(w / 2, h / 2);

// Создание самого тела

Body body = world.CreateBody(bDef);

body.CreateShape(pDef);

body.SetMassFromShapes();

body.SetUserData(model); // Это отличная функция, она на вход принемает объекты типа object, я ее использовал для того чтобы запихнуть и хранить в ней нашу графическую модель, и в методе step ее доставать и обновлять

return model;

}

И для создания круглого тела:

public MyModel3D AddCircle(float x, float y, float radius, float angle, float density,

float friction, float restetution)

{

MyModel3D model = new MyModel3D(models, x, -y, 0, PATH_CIRCLE, new System.Windows.Size(radius * 2, radius * 2));

BodyDef bDef = new BodyDef();

bDef.Position.Set(x, y);

bDef.Angle = angle;

CircleDef pDef = new CircleDef();

pDef.Restitution = restetution;

pDef.Friction = friction;

pDef.Density = density;

pDef.Radius = radius;

Body body = world.CreateBody(bDef);

body.CreateShape(pDef);

body.SetMassFromShapes();

body.SetUserData(model);

return model;

}

Я тут этого делать не буду, но можно создавать многоугольники примерно таким способом:

public MyModel3D AddVert(float x, float y, Vec2[] vert, float angle, float density,

float friction, float restetution)

{

MyModel3D model = new MyModel3D(models, x, y, 0, Environment.CurrentDirectory + "\\" + PATH_RECT, new System.Windows.Size(w, h)); // Данный метод нужно заменить на рисование многоугольников

BodyDef bDef = new BodyDef();

bDef.Position.Set(x, y);

bDef.Angle = angle;

PolygonDef pDef = new PolygonDef();

pDef.Restitution = restetution;

pDef.Friction = friction;

pDef.Density = density;

pDef.SetAsBox(model.Size.Width / 2, model.Size.Height / 2);

pDef.Vertices = vert;

Body body = world.CreateBody(bDef);

body.CreateShape(pDef);

body.SetMassFromShapes();

body.SetUserData(model);

return info;

}

Очень важно рисовать выпуклые многоугольники чтоб коллизии обрабатывались корректно.

Тут все достаточно просто если вы знаете английский. Дальше нужно создать метод для обработки логики:

public void Step(float dt, int iterat)

{

// Параметры этого метода управляют временем мира и точностью обработки коллизий тел

world.Step(dt / 1000.0f, iterat, iterat);

for (Body list = world.GetBodyList(); list != null; list = list.GetNext())

{

if (list.GetUserData() != null)

{

System.Windows.Media.Media3D.Vector3D position = new System.Windows.Media.Media3D.Vector3D(

list.GetPosition().X, list.GetPosition().Y, 0);

float angle = list.GetAngle() * 180.0f / (float)System.Math.PI; // Выполняем конвертацию из градусов в радианы

MyModel3D model = (MyModel3D)list.GetUserData();

model.SetPosition(position); // Перемещаем нашу графическую модель по x,y

model.Rotation(new System.Windows.Media.Media3D.Vector3D(0, 0, 1), angle); // Вращаем по координате x

}

}

}

Помните тот model в методах AddCircle и AddBox который мы запихивали в body.SetUserDate()? Так вот, тут мы его достаем MyModel3D model = (MyModel3D)list.GetUserData(); и вертим как говорит нам Box2D.

Теперь это все можно затестить, вот мой код в дефолтном классе окна:

public partial class MainWindow : Window

{

private Game.Physics px;

public MainWindow()

{

InitializeComponent();

px = new Game.Physics(-1000, -1000, 1000, 1000, 0, -0.005f, false);

px.SetModelsGroup(models);

px.AddBox(0.6f, -2, 1, 1, 0, 0.3f, 0.2f);

px.AddBox(0, 0, 1, 1, 0.5f, 0.3f, 0.2f);

this.LayoutUpdated += MainWindow_LayoutUpdated;

}

private void MainWindow_LayoutUpdated(object sender, EventArgs e)

{

px.Step(1.0f, 20); // тут по хорошему нужно вычислять дельту времени, но лень :)

this.InvalidateArrange();

}

}

Да, я забыл упомянуть о том что я добавил в класс Physics метод px.SetModelsGroup(); для удобства передачи ссылки на объект Model3DGroup. Если вы используете какой нибудь другой графический движок, то вы можете обойтись и без этого.

Вы наверное заметили что значения координат кубиков слишком маленькие, ведь мы привыкли работать с пикселем. Это связано с тем что в Box2D все метрики расчитываются в метрах, по этому если вы хотите чтобы все расчитывалось в пикселях, вам нужно пиксели делить на 30. На пример bDef.SetPosition(x / 30.0f, y / 30.0f); и все будет гуд.

Уже с этими знаниями можно успешно написать простенькую игру, но есть у Box2D еще несколько фишек, на пример отслеживание столконовений. На пример что бы знать что пуля попала по персонажу, или для моделирования разного грунта и т.д. Создадим класс Solver:

public class Solver : ContactListener

{

public delegate void EventSolver(MyModel3D body1, MyModel3D body2);

public event EventSolver OnAdd;

public event EventSolver OnPersist;

public event EventSolver OnResult;

public event EventSolver OnRemove;

public override void Add(ContactPoint point)

{

base.Add(point);

OnAdd?.Invoke((MyModel3D)point.Shape1.GetBody().GetUserData(), (MyModel3D)point.Shape2.GetBody().GetUserData());

}

public override void Persist(ContactPoint point)

{

base.Persist(point);

OnPersist?.Invoke((MyModel3D)point.Shape1.GetBody().GetUserData(), (MyModel3D)point.Shape2.GetBody().GetUserData());

}

public override void Result(ContactResult point)

{

base.Result(point);

OnResult?.Invoke((MyModel3D)point.Shape1.GetBody().GetUserData(), (MyModel3D)point.Shape2.GetBody().GetUserData());

}

public override void Remove(ContactPoint point)

{

base.Remove(point);

OnRemove?.Invoke((MyModel3D)point.Shape1.GetBody().GetUserData(), (MyModel3D)point.Shape2.GetBody().GetUserData());

}

}

Прошу заметить что мы наследуем класс от ContactListener. Используется в Box2D для отслеживания коллизий. Дальше мы просто передадим объект этого класса объекту world в классе Physics, для этого напишем функцию:

public void SetSolver(ContactListener listener)

{

world.SetContactListener(listener);

}

Создадим объект и передадим его:

Game.Solver solver = new Game.Solver();

px.SetSolver(solver);

В классе Solver есть несколько колбэков которые вызываются по очереди в соответствии с названиями, повесим один на прослушивание:

solver.OnAdd += (model1, model2) =>

{

// Произошло столкновение тел model1 и model2

};

Так же вы можите прикрутить к классу MyModel3D свойство типа string name, задавать ему значение и уже в коллбэке OnAdd проверять конкретно какое тело с каким телом столкнулось.

Так же Box2D позволяет делать связи между телами. Они могут быть разных типов, рассмотрим пару:

public Joint AddJoint(Body b1, Body b2, float x, float y)

{

RevoluteJointDef jd = new RevoluteJointDef();

jd.Initialize(b1, b2, new Vec2(x, y));

Joint joint = world.CreateJoint(jd);

return joint;

}

Это простое жесткое соединение тела b1 и b2 в точке x, y. Вы можете посмотреть свойства у класса RevoluteJointDef. Там можно сделать так чтобы объект вращался, подходит для создания машины, или мельницы. Идем дальше:

public Joint AddDistanceJoint(Body b1, Body b2, float x1, float y1, float x2, float y2,

bool collideConnected = true, float hz = 1f)

{

DistanceJointDef jd = new DistanceJointDef();

jd.Initialize(b1, b2, new Vec2(x1, y1), new Vec2(x2, y2));

jd.CollideConnected = collideConnected;

jd.FrequencyHz = hz;

Joint joint = world.CreateJoint(jd);

return joint;

}

Это более интересная связь, она эмитирует пружину, значение hz — напряженность пружины. С таким соединением хорошо делать подвеску для машины, или катапульту.

Заключение

Это далеко не все что может Box2D. Что самое классное в этом движке, так это то что он бесплатный и на него есть порт под любую платформу, и синтаксис практически не отличается. Кстати я пробовал его использовать в Xamarin на 4.1.1 андроиде, сборщик мусора постоянно тормозил приложения из-за того что Box2D плодил много мусора. Говорят начиная с пятого андроида благодоря ART все не так плохо, хотя я не проверял.

Ссылка на проект GitHub: github.com/Winster332/Habrahabr

Порт на dotnet core: github.com/Winster332/box2d-dotnet-core-1.0

|

Метки: author Win332 разработка игр программирование c# .net wpf box2d |

Код высших достижений |

Спортивное программирование объединяет турниры самого разного уровня — от школьных и студенческих олимпиад до финалов чемпионата мира. Крупнейшие международные компании организовывают свои контесты и выступают спонсорами авторитетных соревнований вроде ACM-ICPC. В нашей команде работают четыре чемпиона мира по программированию, и уже в четвёртый раз мы совместно с Codeforces проводим VK Cup — собственный турнир ВКонтакте.

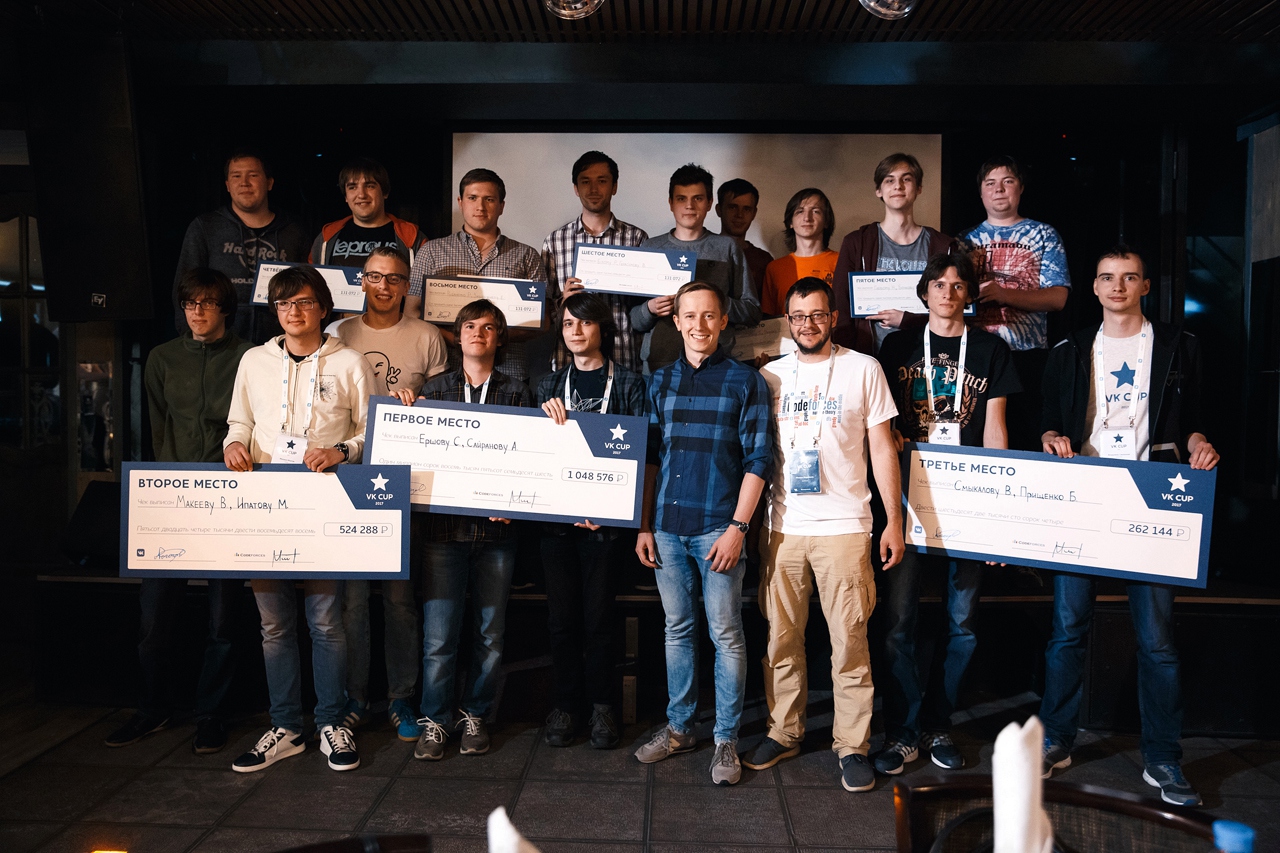

Управляющий директор ВКонтакте Андрей Рогозов, основатель Codeforces Михаил Мирзаянов с победителями и призёрами VK Cup 2017

Откуда берутся чемпионы?

Часто всё начинается ещё со школы: олимпиады по информатике, студенческие соревнования, а потом и этапы международных чемпионатов. Спортивное программирование требует, в первую очередь, много и изобретательно думать, а не действовать по какому-то стандартному шаблону. Несмотря на это, умение решать олимпиадные задачи тоже нужно тренировать. Сборы, лекции, прорешивание бесконечных наборов задач — всё это в чём-то напоминает подготовку обычных атлетов.

Если Вы уже избрали другой профессиональный путь, не стоит огорчаться. Заглянуть в мир спортивного программирования можно и более простым способом.

На платформе Codeforces любой желающий может попробовать свои силы в решении задач разного уровня сложности. За каждую решенную в рамках рейтинговых раундов задачу участник получает баллы. На основании этих баллов участники раундов ранжируются и получают рейтинг. После окончания раунда можно прочитать разбор решения, если не удалось найти его самостоятельно. Подборка задач за годы существования проекта скопилась впечатляющая, смотрите сами.

Уверен, что соревнования по программированию — увлекательный и эффективный способ научиться кодить, разобраться в структурах данных и выработать алгоритмическое мышление. Пробуйте участвовать, раунды на Codeforces открыты для всех и проходят каждую неделю. Наша цель — предложить интересные задачи для каждого участника!

Михаил Мирзаянов, основатель Codeforces

Турниры и задачи

Регламент проведения турниров может различаться в деталях, но общие принципы сохраняются. Обычно участникам отводится строго ограниченное время, сами задачи могут быть ранжированы по «стоимости» в зависимости от уровня сложности, а решения оцениваются с помощью набора готовых тестов. Самый популярный язык спортивного программирования — C++, хотя бывают и исключения. Например, на одном из раундов VK Cup 2017 нужно было решить каждую задачу на отдельном языке.

Соревнования могут быть личными и командными, с ограничениями по возрасту участников и без. У турнира может быть определённая тематика — например, AI, стратегии для биржи или классические алгоритмы. Поставленная задача может заключаться во взломе удалённого сервера или в создании нейросети для хороших результатов на синтетическом датасете.

Создание задач — отдельное искусство, которое требует от автора не меньшей подготовки, чем у самого участника. Победители прошлых лет часто принимают участие в написании задач для нового турнира. У хорошей задачи есть характерные свойства:

- Её можно решить.

- Её можно решить в отведённое время.

- Для проверки решения можно создать набор тестов, на которых правильное решение будет работать, а неправильное — выдавать ошибку (или не укладываться в ограничения по времени выполнения и объёму памяти).

- Она интересная. Олимпиадные задачи не решаются «в лоб», и даже если за условиями проглядывает какой-то фундаментальный алгоритм, придётся как следует подумать, чтобы понять, как именно его здесь применить.

Хотя опытные участники соревнований видели уже тысячи разных задач и редко запоминают их в деталях, авторы стараются добавить живое описание проблемы. В архиве Codeforces попадаются задачи про пылкий поток любви, «фибоначчиеватость» и хипстера Васю. Как такое пропустить?

После победы

Победителей престижных соревнований хотят заполучить к себе в штат самые известные IT-компании. Случается, что предложение о работе ждёт участника ещё до подведения итогов контеста.

Это неудивительно. Помимо очевидного (такие люди — умные), опыт в спортивном программировании во многих случаях даст преимущество разработчику. Он не боится сложностей, потому что привык постоянно иметь дело с нетривиальными задачами. Он умеет быстро принимать решения в непростых ситуациях и эффективно использовать все имеющиеся ресурсы.

Конечно, не во всех отраслях индустрии навыки такого разработчика будут использованы по максимуму. Отличное знание фундаментальных алгоритмов и умение выбирать эффективные структуры данных позволяют привлекать лучших из лучших к разработке высоконагруженных сложных систем, где они могут проявить себя в полной мере.

Это относится и к нам — почти все С-разработчики ВКонтакте принимали участие в соревнованиях. Мы используем самописные базы данных, созданные талантливыми программистами, которые не раз побеждали в самых престижных чемпионатах, включая ACM-ICPC.

Чемпионы ACM-ICPC 2014 — Егор Суворов, Дмитрий Егоров, Павел Кунявский. Тренер Андрей Лопатин. Двое участников этой команды сейчас работают ВКонтакте.

VK Cup

ВКонтакте всегда поддерживал это направление: мы спонсировали обучение олимпиадному программированию в СПбГУ, помогали организовывать Летнюю компьютерную школу, сделали свой вклад в создание Codeforces. Следующим закономерным шагом стала организация собственного турнира.

История VK Cup началась в 2012 году с первого личного состязания. Сейчас кубок проходит в формате турнира для команд из двух человек. Возраст участников ограничен — не младше 14 и не старше 23 лет.

Финал VK Cup 2017 в штабе ВКонтакте

С марта по июль участники решали задачи отборочных раундов. Из 2736 команд, принявших участие в квалификации, до финала дошли лишь 20 лучших. Финал чемпионата традиционно проводится в штабе ВКонтакте, Доме Зингера на Невском проспекте. Об итогах VK Cup 2017 мы рассказали в этой статье.

Хочу участвовать!

Мы будем ждать Вас на VK Cup 2018. И призываем попробовать свои силы в других открытых турнирах:

Facebook Hacker Cup

Google Code Jam

AtCoder

IPSC

Topcoder Open

deadline24

SnackDown

Russian Code Cup

Яндекс.Алгоритм

|

Метки: author dmitryegorov спортивное программирование блог компании вконтакте вконтакте vk cup acm icpc |

Yubikey 4 — покупка, доставка и получение |

Часть 2: Покупка и доставка Yubikey 4

Итак, определившись с выбором ключа для 2FA, я начал поиски продавца для покупки Yubikey 4.

Первым делом был обследован русскоязычный сегмент интернета. Оказалось, что существуют две организации, которые вроде бы занимаются реализацией продукции Yubico.

В первую очередь — это сайт www.yubico.ru. В настоящее время он не работает. (Хинт — работает прямая ссылка на файл в формате PDF «yubikey_manual.pdf» — на русском языке, кому нужно). Но в тот момент, когда я делал анализ и выбор продавца ключа, этот сайт ещё функционировал. Тем не менее, даже тогда я обратил внимание на странную вещь — на сайте для продажи не были представлены современные устройства — например, интересный мне ключ Yubikey 4. Также в описании к существующим продуктам были указаны старые версии ПО. Более того, сайт, предлагающий продукт, обеспечивающий цифровую безопасность, был на простом http. И ещё более того. Когда я поинтересовался в почтовой переписке о возможности купить ключ, ответ мне пришёл с почтового домена mail.ru.

Можно было сделать предположение, что новых устройств продавец не предлагает. Предположение оказалось верным, сайт работу по факту прекратил.

Вторая организация, которая предлагала продажу Yubikey была ещё более странной. Она называется >the_kernel. Интернет магазина я не нашёл, предлагалось отправить заявку через форму на сайте. С одной стороны, цены указаны такие же как и у производителя, но отсутствие возможности сделать заказ, оплатить и ждать доставку меня немного удивило. Для XXI века это — мягко говоря — странность. Специально для тех, кто не любит ходить по ссылкам, живёт в первопрестольной и хочет иметь Yubikey, даю контактную информацию с сайта. Возможно, данные ещё актуальны. Вот они:

121357, г. Москва, ул. Верейская, д. 29, стр. 33, офис D216.2 (БЦ Верейская Плаза 3) Тел. +7 499 648-8848 Email info [dot] ru [at] thekernel [dot] com Web www.thekernel.ru

Вот здесь, на Тостере также есть небольшая ветка по вопросам приобретения устройств Yubico.

Один из участников обсуждения (@Driwars) упомянул о том, что таможня не пропустила до адресата купленный на Амазоне ключ. Имейте это ввиду.

Так, в РФ ситуация с продажей в розницу ключей Yubikey более менее ясна. Что же может предложить нам западный (для кого-то — восточный) рынок?

Как правило, наиболее низкую цену может предложить сам производитель, поэтому будет разумно поискать возможность покупки товара напрямую у Yubico. Однако, учитывая стоимость доставки, которая может составлять существенную величину в общей стоимости товара, имеет смысл посмотреть и у других игроков рынка, например — Амазон.

Приступим.

Вопрос — занимается ли компания Yubico непосредственно продажами устройств? Ответ — да, занимается. Открывая заглавную страницу сайта www.yubico.com мы видим вверху кнопку «BUY NOW», и при нажатии на неё переходим сразу к возможности купить товар. Это уже хорошо! Кроме того, обращаем внимание на то, что при покупке есть возможность оформить дисконт — для пользователей GitHub и для учащихся. Насколько можно видеть, скидка одинаковая и составляет 20%, а это уже весьма и весьма неплохо!

Переходим к процедуре оплаты, но перед этим смотрим на доставку (Shipping). И тут — раз — и видим такую фразу:

*no shipping to: Afghanistan, North Korea, Iran, Russia, Sudan, Syria

Вот это да! Как неожиданно! Россия между Ираном и Суданом, в приятном соседстве с Северной Кореей и Сирией… Для контраста можете полистать список стран, где можно приобрести и получить устройство с доставкой от Yubico.

Так, какие же могут быть варианты? Для России — на оффсайте указан >the_kernel. Можете попробовать связаться с представителями этой ТНК.

А что с Амазоном? Давайте посмотрим поближе.

Находим в поиске Yubikey, меняем справа в поле «Ship to» страну на Russian Federation и видим в поле описания товара и доставки следующее:

This item does not ship to Russian Federation.

Вот так.

Что же делать, если вам всё же хотелось иметь для тестирования либо функционального применения устройство Yubikey?

Вариантов может быть несколько:

1. Если вы имеете возможность по работе или по личной инициативе бывать за границей, едете туда и покупаете там. Либо предварительно оплатив товар и доставку, либо в отпуске, либо через друзей и знакомых.

2. Попросите ваших живущих за границей друзей/родных/коллег/знакомых купить устройство и выслать вам. Условия согласуйте сами.

3. Воспользоваться услугами пересыльщиков. Типа Шопотама и Бандерольки. Полагаю, противозаконного в этом ничего нет.

4. Бартер. Скажем, с индусами. Вы им — код, они вам — ключ.

5. Something else. Insert your own point.

Что до меня? Как я покупал ключ? Я воспользовался пунктом 3, посчитав предварительно все расходы. Итого, в реализации получилось вот так:

стоимость самого ключа Yubikey4: $40

скидка: -$8

доставка на адрес в USA: $5

налог: $2.88

итого — на выходе с Yubico: $39.88

Услуги пересылки: $5.78 (и я считаю это весьма гуманной стоимостью)

Итого, в сумме получается $45.66, что по текущему курсу составляет 2 735,52 рубля.

Успехов!

P.S. Есть новое в линейке продуктов. Появился ключ с интерфейсом USB-C.

|

Метки: author ElderMan криптография информационная безопасность github yubico yubikey 2fa amazon well shaped nails |

Вышел Upsource 2017.2 с поддержкой внешних инспекций кода, Python, NPM и многим другим |

У нас отличные новости — вышел Upsource 2017.2! В этом релизе мы добавили ряд наиболее часто запрашиваемых возможностей, и, как обычно, улучшили уже имеющуюся функциональность.

Давайте посмотрим, что попало в этот релиз.

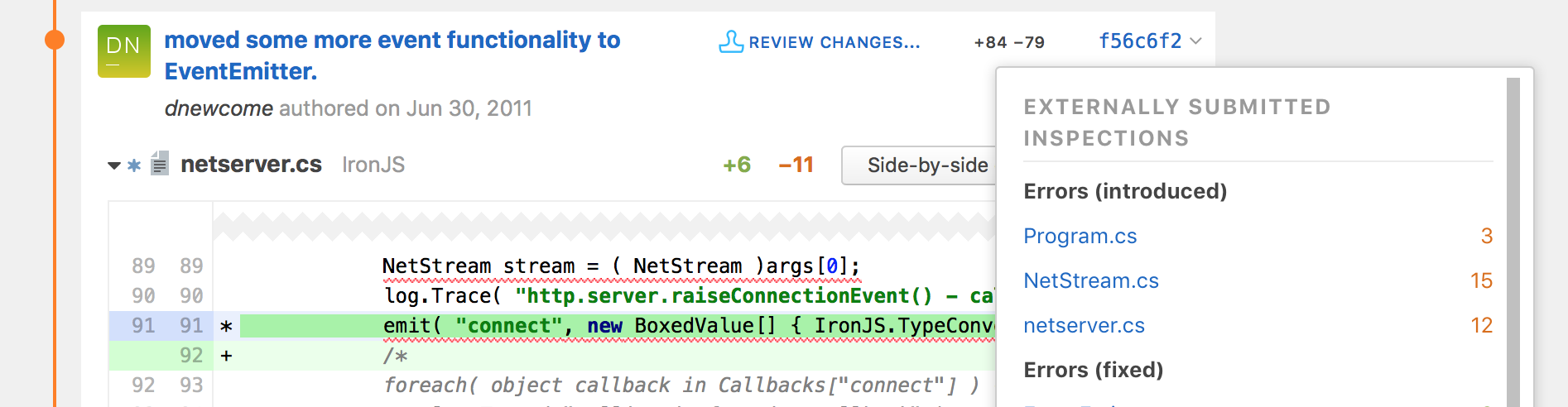

Поддержка внешних инспекций кода

Если Вы используете встроенные в TeamCity инспекции кода на базе ReSharper или IntelliJ IDEA, или пользуетесь инспекциями SonarQube, теперь Вы сможете извлечь из них дополнительную пользу. Upsource 2017.2 умеет показывать результаты такого анализа в своем UI, наряду с результатами встроенных инспекций. Рецензирование кода становится немного проще, если сразу видно, какие новые потенциальные проблемы привнесло именно это изменение.

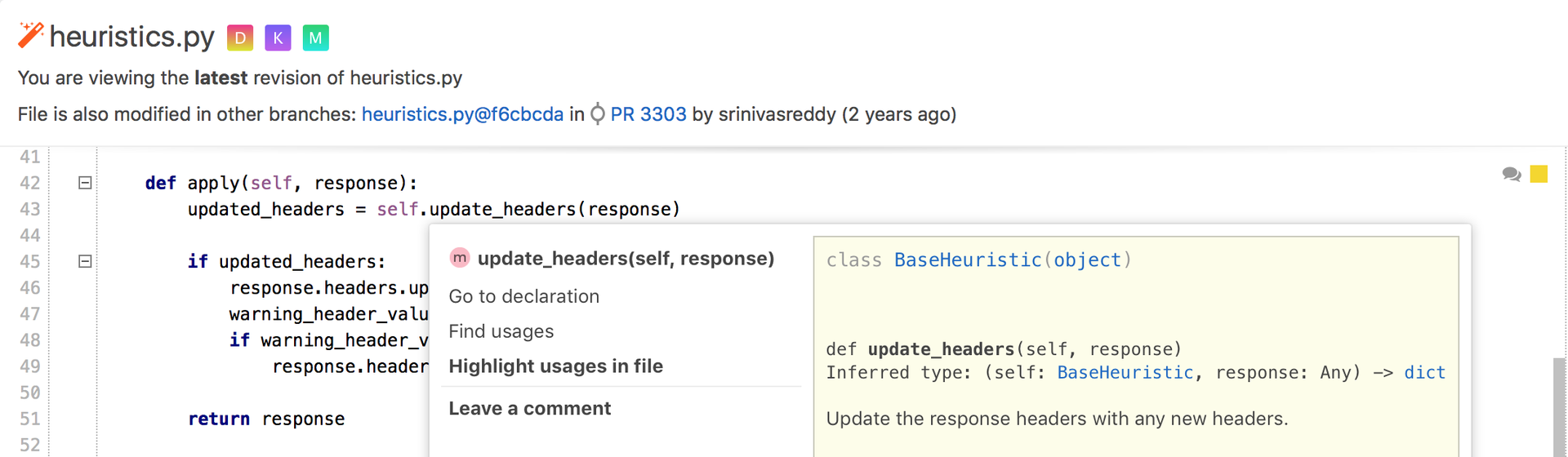

Поддержка Python

Навигация по коду и статический анализ, аналогичные тем, что уже имеются для Java, JavaScript, PHP и Kotlin, стали доступны и для Python проектов. Эта функциональность помогает лучше понять изменения в проекте и разобраться в том, какие потенциальные проблемы могли прокрасться в эти изменения, или как можно еще улучшить качество кода.

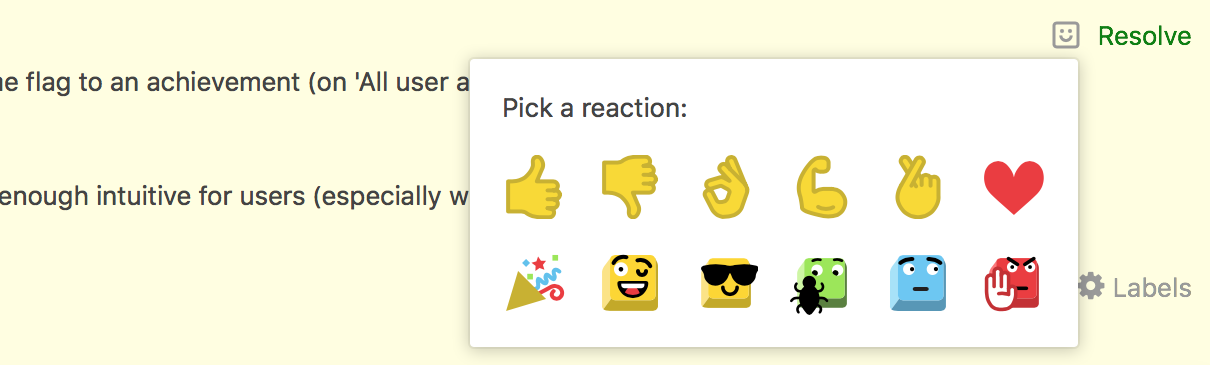

Реакции

Довольно часто дискуссии приходят к тому, что в развернутом ответе необходимости нет, а отреагировать на комментарий все-таки как-то нужно. Для того, чтобы Вы могли сэкономить время себе и другим в таких ситуациях, мы добавили небольшой набор реакций.

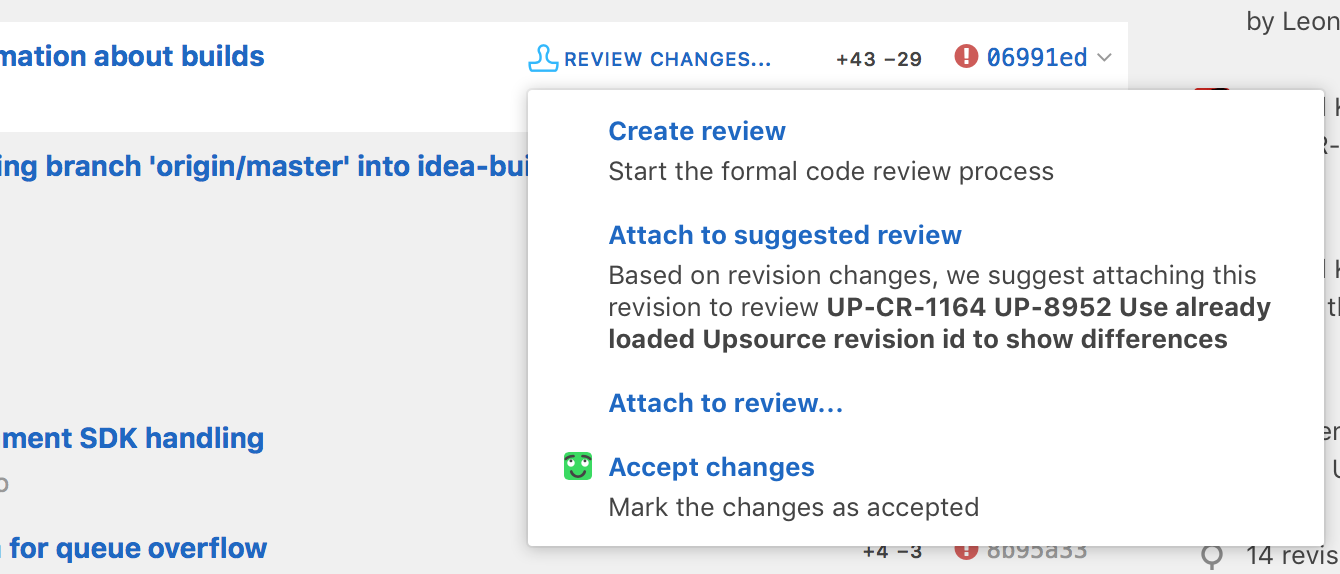

Поддержка GitLab

Мы рады сообщить, что теперь Вы можете создавать code review для GitLab merge requests в Upsource.

Поддержка NPM

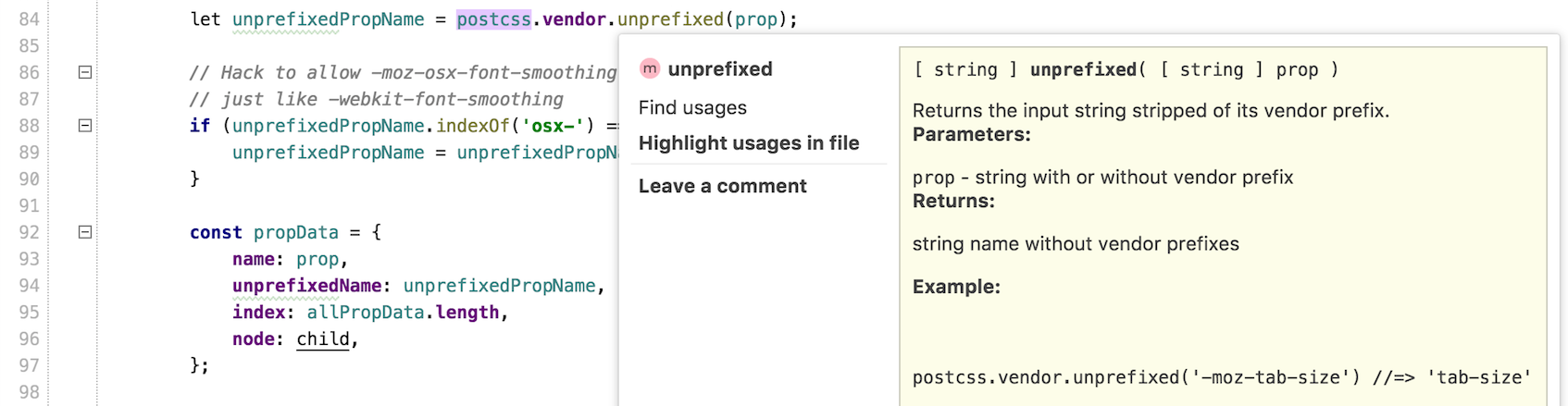

Мы улучшили «Go to declaration» и «Find usages» для JavaScript кода. Теперь Upsource устанавливает зависимости, перечисленные в package.json.

Подсказка при создании Code Review

Используя статистический анализ, Upsource теперь способен подсказать, к какому code review относится новое изменение.

Немного игровых элементов

Чтобы разнообразить рутину и сделать ознакомление с продуктом чуть более занимательным, мы добавили систему ачивок. На данном этапе, их набор ограничен, но это только начало!

И многое другое

Про остальные новые возможности Upsource Вы можете узнать на странице продукта.

Скачать продукт можно отсюда; ознакомиться с ценами — здесь, а следить за самыми последними новостями можно, подписавшись на Twitter-аккаунт Upsource.

|

Метки: author kafooster python javascript java блог компании jetbrains release code review php kotlin code analysis jetbrains code quality tools .net resharper |

Почему руководство не принимает agile и что вы можете с этим сделать |

Почему руководство не принимает agile и что вы можете с этим сделать

Первый в моей практике переход в agile имел полную поддержку высшего руководства компании. Топ менеджмент обеспечил финансирование всех необходимых тренингов, инструментов и консалтинга.

Руководители провели встречи со всеми сотрудниками компании, на которых разъяснили новый подход к работе и то, как изменятся документирование, разработка и структура команд. Правда была одна странная штука: проектные планы, управление портфелем и бюджетирование должны были остаться прежними, не говоря уже про HR и финансы. С тех пор я слышал эту историю много раз, разница была только в деталях — что именно должно было остаться неизменным. При этом все (за исключением может быть пары executives)) согласно кивали.

Наши топы часто тратят уйму времени и денег на agile, но при этом дискредитируют инициативы, которые продвигают. Это не просто частая проблема; это практически всеобщая проблема, а всеобщие проблемы склонны иметь системные причины.

Я приведу пять самых распространенных причин, почему топы не получают agile — и что с этим делать.

Enterprise Agile: Поторопитесь ускориться быстрее

1. Руководство рассматривает agile как активности исключительно командного уровня

Рассмотрим ситуацию: Обычная agile «трансформация» начинается с организации персонала в Scrum команды. Это сокращает время передачи требований в разработку, кода из разработки в тестирование, но никак не решает вопросов внешних зависимостей команды от ИТ, эксплуатации или HR.

Как недавно отметил Mike Cottmeyer pointed out на конференции Agile & Beyond — внешние зависимости разрушают устойчивую производительность команды (velocity).

А когда производительность команды неустойчива, невозможно сказать, когда проект будет завершен.

Cottmeyer отмечал, что именно в этот момент у agile-коучей начинаются проблемы при попытке уговорить руководителей «начать доверять командам». Доверие к командам это прекрасно, но у руководства возникают вопросы, на которые нет ответов. Например: «Когда мы можем открыть новый проект? На что направить маркетинговый бюджет и когда? Сколько заложить в бюджет, чтобы сделать следующую штуку?»

Cottmeyer говорит о том, что внешние зависимости команды это ключевое препятствие. Он рекомендует компаниям, которые стоят на пути адаптации или «внедрения Agile» убирать зависимости, искать обходные пути, пересматривать любые соглашения об уровне сервиса (SLA), чтобы сделать функциональные команды более предсказуемыми. Scrum и XP не предназначены для решения проблем взаимозависимости команд, а я вижу эти проблемы в любой организации с тремя и более командами.

Почти всегда настоящее узкое горло — это взаимозависимости команд. И именно с ним agile методики командного уровня не помогут, а руководители окажутся без желанных результатов и продолжат задавать неудобные вопросы.

2. Руководство не получает обучения необходимого уровня

Недавно мои коллеги проводили двухдневный тренинг для высшего руководства очень прибыльной компании. Тренинг назывался «Agile for Executives», но выяснилось, что это скорее тренинг по Scrum — речь шла о спринтах, историях и самоорганизованных командах. После тренинга у руководства появилось много идей о том, как «те ребята» должны «делать» программы, но оно не получило никаких реальных инструментов управления зависимостями или понимания, что делать с портфелем и бюджетами.

Большая часть руководства слишком занята, чтобы пойти на двухдневный тренинг. Обучение Scrum им в любом случае бесполезно. Как впрочем не сильно помогут и все книги про разработку программного обеспечения, которые обычно читают команды. Сайты о том, как требуется меняться руководству, полны многозначительных советов типа «исследуйте и адаптируйте» или «учитесь быстро», но эти советы никак не говорят руководству о том, как им в реальности управлять проектами в больших организациях.

Eric Willeke, советник по корпоративной гибкости в CA Technologies утверждает, что большинство agile-коучей уровня команды и программы никогда не принимали решения на том уровне, который является повседневным для руководства. И тот факт, что у них нет этого совершенно необходимого опыта означает, что они не готовы обеспечить обучение, которое требуется руководству.

3. Водопадная модель скрывает неэффективность от руководства

Когда водопад был обычной практикой, организации пытались вести две дюжины инициатив, когда-то меньше, когда-то больше. Примерно первые восемь были высокоприритетными, следующе восемь среднеприоритетными и оставшиеся восемь низкоприоритетными. Даты в плане появлялись на основании прошлого опыта и принятых обязательствах, а PMO создавал виртуальные команды, чтобы сделать обещанное.

Хорошая штука в таком подходе в том, что если что-то затягивается, то команда может легко переключиться и сфокусироваться на чем-то, что помечено как высокоприоритетное. Это позволяет избежать печальных последствий закона Брукса (добавление людей на последних стадиях проекта удлиняет его), потому что просто увеличивает время работы или процент участия уже задействованных участников проекта — да-да, вы не добавляете «больше» людей.

В результате некоторые компании, использующие водопад, сумели избежать части проблем от задержанных проектов.

Конечно то, что было помечено как низкоприоритетное, делается крайне долго, если вообще делается, но мы же знаем, что они и были низкоприоритетными. Организация получает то. что было заявлено как необходимое, примерно в запланированное время. И конечно, все известные типы скрытой неэффективности водопада здесь присутствуют: все происходит долго, и полно необдуманных решений, взаимозависимостей и переделок. Но для управления это не так значимо, потому что проекты завершаются.

Завершенный проект — это довольно приличный клапан сброса давления, который организация теряет, когда переходит в agile разработку и ограничивает количество задач в работе. Почему? Потому что, когда команды выделены на один проект, не остается того процента времени, который можно отжать у них, нет способа подшаманить, чтобы компенсировать потери. Таким образом у менеджмента становится на один рычаг меньше для выруливания в сторону дедлайна.

Конечно, всегда сложно держаться курса, но некоторые организации научились скрывать это с помощью водопада. Менеджеры, которые нуждаются в этом, обнаружат, что инструмент, доступный в водопаде, исчезает в agile разработке. Если организация заблокирована многочисленными взаимозависимостями команд и производительность команд нестабильна, результат будет по-прежнему запаздывать.

Для руководства в таких компаниях все выглядит так, как будто все стало только хуже, когда они перешли на agile.

4. Ведущие руководители слишком сосредоточены на каком-то одном аспекте

DevOps невероятно привлекательная и популярная по многим причинам штука. Высшее руководство реально хочет DevOps, но некоторые верят, что DevOps можно купить и «установить». Если вы обзавелись современным средством контроля версий и добавили немного непрерывной интеграции, автоматизированного тестирования и выкладку одной кнопкой, вы волшебным образом сократили путь от запроса до реализации с месяцев до минут.

Все это может быть правдой, есть реально мощные инструменты, но организация получает значительно больше, воспитывая в себе эффективность, а не приобретая инструменты. Когда ScotiaBank проводил agile эксперимент, они обнаружили семь уровней согласования для внесения изменения в продуктивную среду. Консалтинговая компания, которая запускала процесс, просто наняла больше людей, которые занимались согласованиями параллельно разработке. Это давало свои плоды, а еще пополняло счета консалтинговой компании. Dave Dame и Aaron Sampson, которые работали на этом проекте, придерживались другой тактики: изменить процесс так, чтобы контроль соответствовал рискам (теперь уже сниженным).

В то же время вы не сможете снижать риски, если единственная вещь, которая интересует руководство, — это статус запуска непрерывной поставки, и единственное препятствие, которое они видят, это «Doker-изация серверной фермы».

Полная agile-трансформация будет включать изменения организационной структуры, процессов развития и построения технических компетенций, культуры, управления продуктами, закупок, практик контрактованная и, да, даже HR. Фокусировка на одной из этих областей или даже на нескольких из них может привести к созданию чего-то типа трубопровода с кучей засоров, колен и букетом других проблем.

5. Множество конфликтующих целей на уровне руководителей

Agile подход применяется не ради самого себя, а для получения желаемого результата. CA Technologies’ Willeke спешит отметить, что «гибкость без цели лишена смысла». Внедрение agile, по его мнению, должно быть неразрывно связано с бизнес результатом — сокращением time to market, снижением издержек, лучшим клиентским сервисом, лучшим соответствием продукта потребностям заказчика и более высоким качеством. Но если цели или «зачем» недостаточно ясны, то «что» и «как» будут перепутаны. Это самое «что» может в конце концов оказаться совсем не тем, что руководство думало себе получить.

Выделить единственную цель для движения в agile может быть крайне сложно и, на самом деле, не нужно: в конце концов, руководству были обещаны все указанные выше преимущества (смотри пункт 1). Но всякое может быть.

Как это починить

Если что-то сломано, возможно, еще не поздно это исправить. Помните только, что исправить сломанное намного сложнее, чем предотвратить поломку. В крупных организациях все обсуждения будут сводиться к описанным выше ошибкам. И если вы нашли у себя эти корневые причины (нестабильная производительность, отсутствие времени на тренинги для руководства, утверждения типа «раньше такого не было», чрезмерное внимание только к одному аспекту agile разработки и т.д.) — это явный показатель того, что на уровне руководства есть явное непонимание того, что же такое agile и как туда попасть.

И вы не сможете исправить это, болтая у кулера про то, как руководство «не покупает». И посмотрите правде в глаза: просто поправлять людей на встречах — это прекрасный путь в никуда.

Напротив, найдите самую неприятную корневую проблему и займитесь ей. Если это тренинги, сделайте их информативными. Если проблема в выравнивании понимания, задавайте уточняющие вопросы для того, чтобы выявить противоречия. Если действующий водопад прячет проблемы и вызывает вопросы к agile, поднимите исторические данные и решите проблему предсказуемости.

Подумайте о проблемах руководства, не воспринимая «они не покупают» как ограничение. Не пытайтесь их переспорить. Найдите пути расширения собственных возможностей.

|

Метки: author vkalenov agile перевод matthew heusser enterprise agility executives |

Как мы упоролись и откалибровали кофе-машину на спектрофотометре |

Однажды, посреди рабочего дня мы внезапно осознали, что мы больше не можем так жить. Душа требовала совершить что-то бессмысленное и беспощадное во имя науки. И мы решили откалибровать кофе-машину. Нормальные люди тыкают в дефолтную кнопку и пьют все, что вытечет из кофеварки. Чуть более продвинутые для этого открывают инструкцию и тщательно ей следуют. Может быть еще читают рекомендации обжарщика, если конечно это не прогорклые noname зерна, которые пару лет лежали на безымянном складе. Нас к нормальным можно отнести с большой натяжкой, поэтому мы решили идти своим путем. Короче говоря, под легкой кофеиновой интоксикацией от седьмой чашки эспрессо мы решили задействовать весь возможный арсенал лаборатории, чтобы получить эталонный напиток.

Добро пожаловать в мир безумия, ультрацентрифуг, спектрофотометрии кофе в специальных планшетах и небольшого количества python, pandas и seaborn, чтобы визуализировать все это безобразие.

Правильная экстракция

Для начала, надо понять, что мы хотим получить. Основной смысл правильной настройки кофеварки в том, чтобы получить сбалансированный профиль экстракции. При этом не меньше половины успеха зависит от правильного зерна, которое было обжарено с соблюдением всех деталей термопрофиля. У хреновых обжарщиков зерна могут быть неравномерной обжарки или с другими дефектами. Но даже идеальный кофе можно превратить в жуткое пойло, если неправильно его приготовить.

Оптимальная температура для классического способа приготовления кофе — 90-95°С. При этом количество зерен должно быть примерно 10-20 г/ 100 мл воды. Также надо учитывать, что процесс экстракции идет неравномерно, от более легких и летучих к менее растворимым компонентам. Вся беда заключается в том, что при выходе за оптимальные значения температуры воды, степени компрессии кофейной таблетки (для эспрессо), степени помола, соотношения кофе к воде или времени мы можем не успеть «вытащить» из зерна все, что нам нужно. Или наоборот захватить чрезмерное количество тяжелых фракций, испортив вкус и баланс напитка. В частности, при гипер-экстракции в чашку попадает избыточное количество хлорогеновых кислот, которые заставляют кофе чрезмерно горчить и сдвигают баланс вкуса в кислую сторону. При недостаточной экстракции будет что-то водянистое и печальное на вкус.

Хининовая и гидроксикоричные кислоты, структурная основа хлорогеновых кислот

Подготовка эксперимента

В автоматической кофе-машине нам доступны для регулировки только два параметра: помол и компрессия. Степень помола определяется механическим вращением регулятора, который устанавливает зазор между жерновами. Компрессия свежесмолотой кофейной таблетки предустановлена и имеет 5 условных уровней сжатия. Наша задача состоит в подборе оптимальных параметров, при которых концентрация и баланс растворенных веществ будут давать идеальный вкус.

Сам кофе для тестирования нам прислали для бесчеловечных экспериментов из Торрефакто, за что им огромное спасибо. Две основные категории: B и C (темная и светлая обжарка в их классификации).

Гондурас Сан-Маркос (источник)

Темная обжарка. Мы как-то уже перешли на среднюю, но для сравнения этот сорт очень достойный вариант. Особенно хорош с молоком, но для наших задач мы будем готовить из него эспрессо. Вкус довольно простой, без тонких нюансов, но очень насыщенный.

Бразилия Ипанема Дульче (источник)

Просто офигительный ароматный сорт, с очень сбалансированным вкусом и сладкой фруктовой кислинкой. Само зерно содержит большое количество углеводов, что и придает легкую сладость.

Для каждого сорта и каждого из пяти уровней сжатия кофейной таблетки выбирается по 8 чашек образцов. Заодно сотрудники лаборатории плюются или радуются полученному результату. Вслепую, естественно. Выбирают оптимальные по вкусу образцы, чтобы потом сравнить с объективными показателями аппаратного исследования.

Глубокая заморозка

Нам себя стало жалко и мы не стали пить 80 чашек кофе за один день. Поэтому образцы маркировались и забрасывались в морозилку. Милая такая морозильная камера, с температурой около -90 градусов. Жрет 4 киловатта, но в итоге внутри даже углекислый газ выпадает в виде снежка на стенках. Идеальный вариант.

Когда все образцы готовы, достаем их из морозильной камеры и кладем в орбитальный шейкер. Да мне тоже нравится, как это звучит. Почти как орбитальный планетарный лазер, но это просто шейкер. Ждем полной разморозки образцов и заодно все хорошо все перемешиваем.

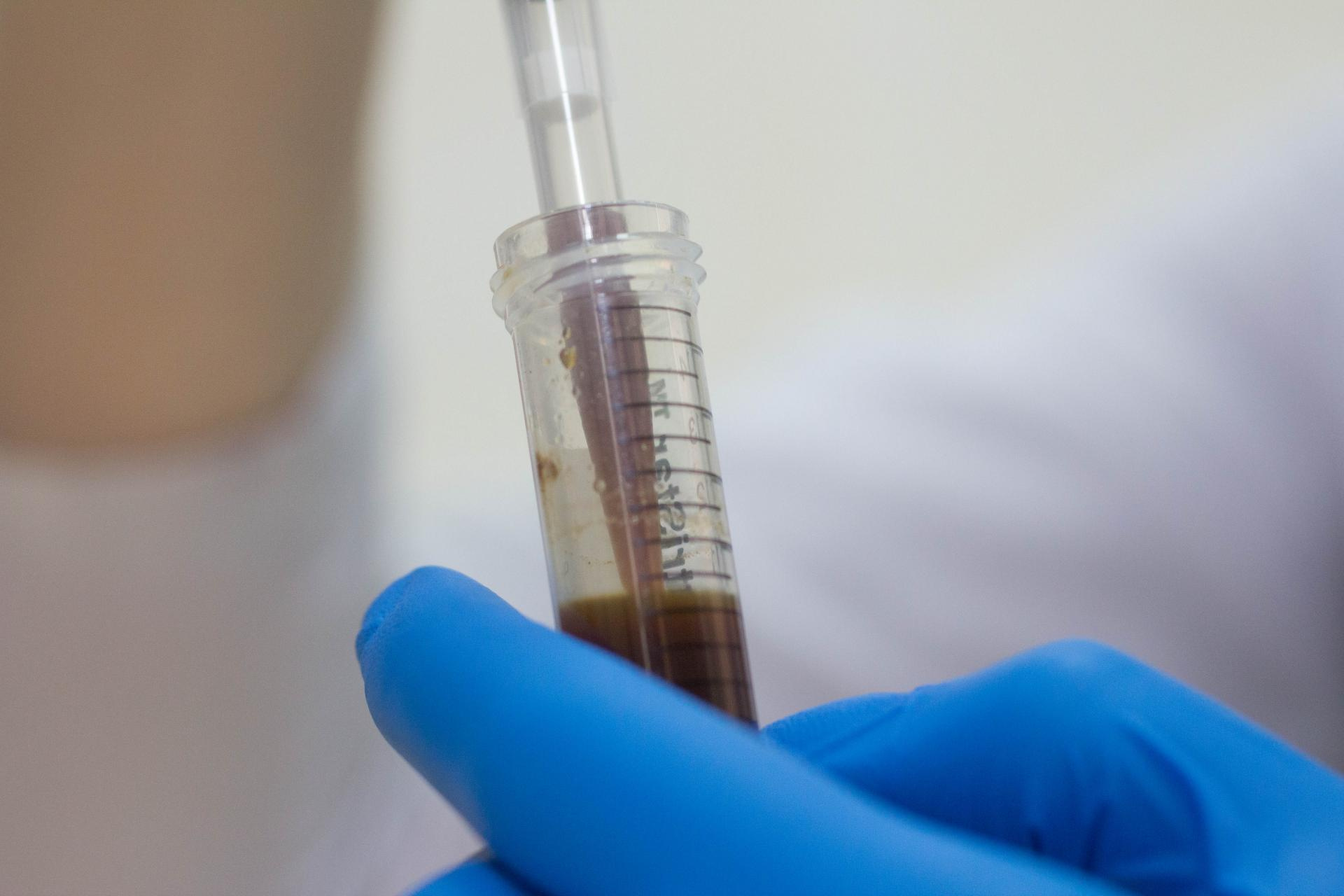

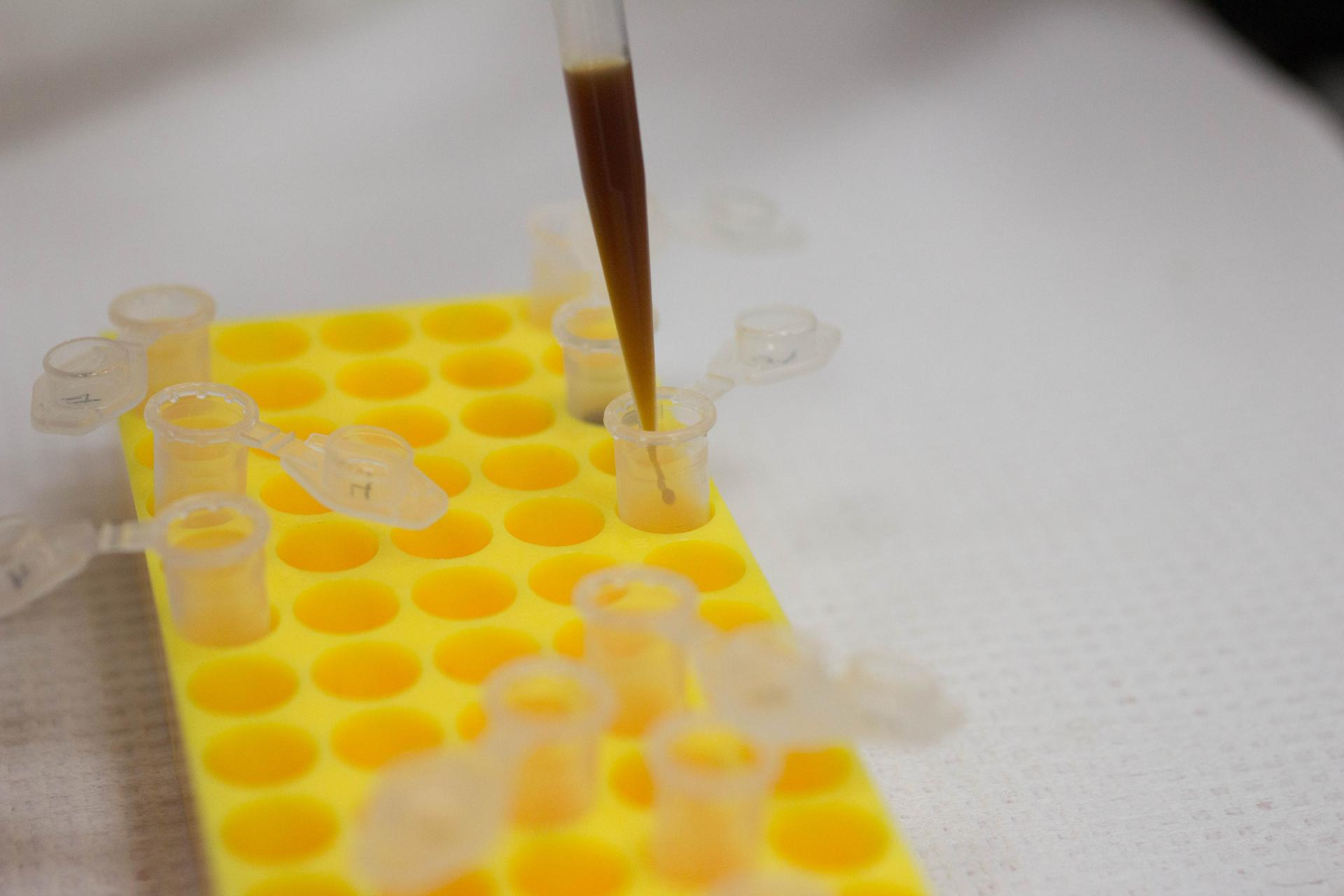

Разливаем по пробиркам и центрифугируем

Для начала надо очень глубокомысленно осмотреть образцы. Без этого чуда не произойдет)

Из больших пробирок забираем микропипеткой кофе и разливаем по маленьким пробиркам для центрифугирования. Каждую пробирку маркируем номером и вносим в отдельный журнал, чтобы потом не перепутать образцы.

Пробирки расставляем в центрифуге строго симметрично для соблюдения баланса. На больших скоростях вращения это критично. После центрифугирования мы получим чистый водный раствор того, что экстрагировалось из кофе, а все микрочастицы, прошедшие через фильтр кофемашины останутся в виде осадка.

Спектрофотометрия

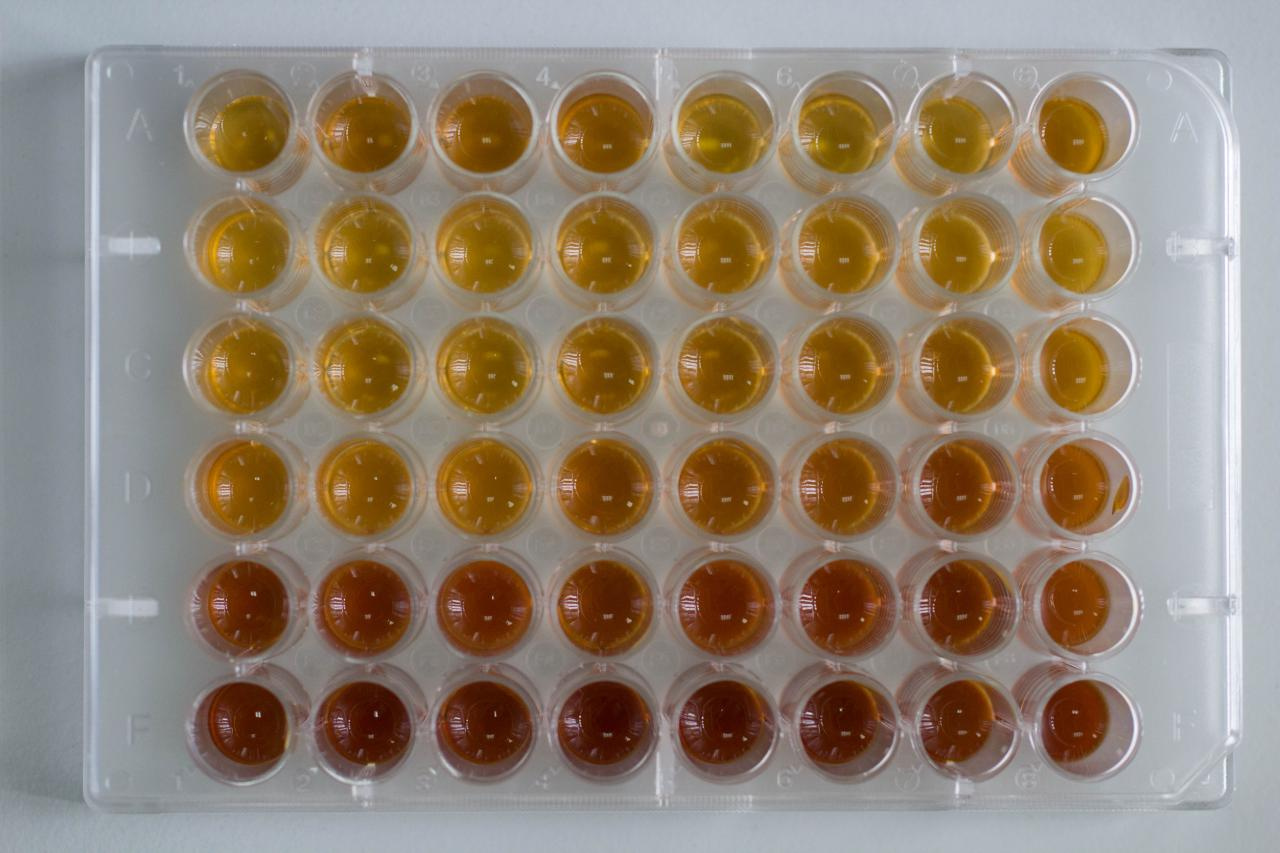

Снова берем микропипетку и разливаем точные дозы образцов по отдельным лункам специального 48-луночного планшета.

В результате образцы красиво распределяются по оттенкам. Сверху вниз идет увеличение степени сжатия и полноты экстракции.

Планшеты загружаются в спектрофотометр FilterMax от Molecular Devices. Там целая куча режимов исследования образца, различные варианты фильтров, лазерных источников излучения и тому подобного. Мы долго думали, что бы такого странного имело смысл измерить на кофе и решили, что измерять ту же флюоресценцию в ультрафиолете довольно бессмысленно. Решили оценить степень поглощения лазерного излучения на длине волны 450 нм. Эта длина волны синего лазера. В принципе, вполне логично. Насыщенный раствор кофе имеет красноватый оттенок и должен хорошо поглощать синюю часть спектра.

В результате мы получили таблицы поглощения для всех наших образцов. Однако было бы неплохо все это наглядно визуализировать. Так как я чаще всего в работе использую python и pandas с seaborn, то и данные мы сохраним в наиболее удобном для загрузки в pandas виде.

medium,level 1,21.31

medium,level 1,20.57

medium,level 1,24.49

medium,level 1,26.95

medium,level 1,20.49

medium,level 1,20.06

medium,level 1,21.22

medium,level 1,23.32

medium,level 2,28.09

medium,level 2,28.27

medium,level 2,23.13

medium,level 2,25.72

medium,level 2,26.75

medium,level 2,26.05

medium,level 2,26.92

medium,level 2,25.92

medium,level 3,32.88

medium,level 3,32.23

medium,level 3,33.13

medium,level 3,28.72

medium,level 3,28.82

medium,level 3,31.49

medium,level 3,32.31

medium,level 3,33.81

medium,level 4,38.68

medium,level 4,40.54

medium,level 4,39.34

medium,level 4,43.3

medium,level 4,41.48

medium,level 4,42.26

medium,level 4,42.73

medium,level 4,42.35

medium,level 5,57.62

medium,level 5,70.62

medium,level 5,70.74

medium,level 5,57.94

medium,level 5,77.62

medium,level 5,76.64

medium,level 5,69.12

medium,level 5,66.39

dark,level 1,27.54

dark,level 1,26.8

dark,level 1,30.72

dark,level 1,33.18

dark,level 1,26.72

dark,level 1,26.29

dark,level 1,27.45

dark,level 1,29.55

dark,level 2,34.32

dark,level 2,34.5

dark,level 2,29.36

dark,level 2,31.95

dark,level 2,32.98

dark,level 2,32.28

dark,level 2,33.15

dark,level 2,32.15

dark,level 3,39.11

dark,level 3,38.46

dark,level 3,39.36

dark,level 3,34.95

dark,level 3,35.05

dark,level 3,37.72

dark,level 3,38.54

dark,level 3,40.04

dark,level 4,44.91

dark,level 4,46.77

dark,level 4,45.57

dark,level 4,49.53

dark,level 4,47.71

dark,level 4,48.49

dark,level 4,48.96

dark,level 4,48.58

dark,level 5,63.85

dark,level 5,76.85

dark,level 5,76.97

dark,level 5,64.17

dark,level 5,83.85

dark,level 5,82.87

dark,level 5,75.35

dark,level 5,72.62

Рисуем графики с python, pandas и seaborn

Для построения графика вначале импортируем наш csv в виде pandas dataframe. После этого с помощью замечательной библиотеки seaborn и функции barplot построим график, сгруппированный по степени обжарки. Для большей контрастности используем палитру «Paired», она очень хороша при сравнении разных групп. Кстати, как вы помните, мы ранжировали образцы по вкусовым качествам. Дегустаторы кофе из нас так себе, но на удивление конценсус был достигнут. Оптимальный вкус у напитка был в том случае, когда степень поглощения на длине 450 нм была в районе 32%. Отрисуем соответствующую линию на графике с помощью plt.axhline.

import matplotlib.pyplot as plt

import pandas as pd

import seaborn as sns

df = pd.read_csv("data.csv")

sns.set()

sns.set_style("whitegrid")

sns.set_context("talk")

ax = sns.barplot(x="Compression", y="Absorbance", hue="Roast", data=df, palette="Paired")

ax.set(ylim=(0, 100), xlabel='Compression level', ylabel='Absorbance at 450 nm, %')

plt.axhline(32, alpha=0.4, color='black', linestyle='dashed', label='Optimal concentration')

plt.legend(loc='upper left')

plt.savefig("plot.png", dpi=300)

plt.show()

На графике четко видно, что оптимальная степень сжатия для кофе темной обжарки вторая, а для средней — третья. Помимо этого восхитительного вывода из нашего эксперимента мы видим, что при максимальном сжатии увеличивается разброс в концентрации растворенных веществ между отдельными чашками эспрессо. То ли машина не обеспечивает повторяемость, то ли при такой компрессии начинают значительно влиять такие факторы как длина случайно пробитого канала в кофейной таблетке, по которому протекает горячая вода.

Чтобы сделать окончательно красиво, построим график отклонения нашего параметра от оптимума. Для этого из колонки Absorbance в нашем dataframe вычтем 32 (наш оптимум).

# Subtract optimal value

df['Absorbance'] = df['Absorbance'] - 32

import matplotlib.pyplot as plt

import pandas as pd

import seaborn as sns

df = pd.read_csv("data.csv")

# Subtract optimal value

df['Absorbance'] = df['Absorbance'] - 32

sns.set()

sns.set_style("whitegrid")

sns.set_context("talk")

ax = sns.barplot(x="Compression", y="Absorbance", hue="Roast", data=df, palette="Paired")

ax.set(xlabel='Compression level', ylabel='Deviation from optimal concentration')

plt.legend(loc='upper left')

plt.savefig("plot_diverging.png", dpi=300)

plt.show()

Как-то так, бессмысленно и беспощадно, можно получить чашку идеального эспрессо)

P.S. Если смогу найти время, то будет еще пост про скоростную ультразвуковую экстракцию ледяного кофе. Образцы есть, будем творить странное дальше.

|

Метки: author Meklon ненормальное программирование визуализация данных python кофе мы можем в любой момент бросить |

Рано закапывать Java |

Много было сказано про «красоту» кода на Java, но на мой взгляд, главное — не инструмент, а умение им пользоваться. Под катом попытка написать декларативный DSL для вёрстки под Android даже не изобретая новый язык программирования!

Вёрстка на Java всегда ассоциировалась у меня с болью.

float dp = getResources().getDisplayMetrics().density;

FrameLayout root = new FrameLayout(this);

root.setBackgroundColor(RED);

root.setLayoutParams(

new ViewGroup.LayoutParams(

MATCH_PARENT,

(int)(100f*dp)));

FrameLayout child = new FrameLayout(this);

child.setBackgroundColor(GREEN);

FrameLayout.LayoutParams childParams =

new FrameLayout.LayoutParams(

(int)(50f*dp),

(int)(50f*dp));

childParams.gravity = CENTER;

child.setLayoutParams(childParams);

root.addView(child);Результат:

И дело даже не в том, что код выглядит страшно (а он страшный как чёрт). Основная проблема в том, что в нём невозможно не ошибиться. Я 3 раза перезаливал сюда этот код, в первый и второй разы наивно полагая, что смогу всё правильно написать сразу, и тщательно перепроверив всё лишь в третий. Скажете, что дело в моей невнимательности и будете правы, но если даже в такой простой вёрстке можно накосячить, то что уж говорить про что-то более сложное?

Но почему с вёрсткой на Java всё так грустно? На мой взгляд основная причина — возможность верстать в xml и отсутствие инструмента для вёрстки на Java.

Минусы xml

Для меня их 3.

Первый — оверхед.

Зачем тратить ресурсы и без того не очень мощных устройств на Android на такие операции, как inflate и findViewById? На оптимизацию этих операций было потрачено много времени и сил, но они от этого не стали бесплатными.

Второй — громоздкость.

Удручает необходимость дублировать тэги, писать перед каждым атрибутом «android:», а после вырабатывать частиную слепоту чтобы читать этот код.

Третий — ограниченность языка.

Допустим, я хочу сделать подпись к автару больше самого аватара на 10dp.

Но этого сделать нельзя потому что xml не поддерживает выражения.

Почему не Anko?

Anko — это DSL, с помощью которого можно декларативно описывать разметку на Kotlin.

frameLayout {

backgroundColor = RED

frameLayout {

backgroundColor = GREEN

}.lparams(dip(50), dip(50)) {

gravity = CENTER

}

}.lparams(matchParent, dip(100))Получаем все возможности полноценного языка программирования, лучшую производительность и даже не мучаемся с вёрсткой интерфейса на Java!

Всё прекрасно, но, на мой взгляд, неприлично тянуть за собой целый рантайм языка при разработке библиотек. 500 кб — не так много для конечного приложения, но для библиотеки — явно перебор.

JAnko

Как оказалось, возможностей Java хватает чтобы верстать декларативно.

new frameLayout(this) {{

new lparams(this) {{

width = MATCH_PARENT;

height = dip(100);

}}._();

backgroundColor = RED;

new frameLayout(this) {{

new lparams(this) {{

width = dip(50);

height = dip(50);

gravity = CENTER;

}}._();

backgroundColor = GREEN;

}}._();

}}._();Язык поддерживает блоки кода без названия. Они выполняются перед конструктором класса сразу после конструктора класса-родителя.

class A {

// block

{

// some code

}

}Именно эту возможность Java я использовал чтобы не писать название переменной, в которой лежит виджет для изменения каждого его свойства.

Пример с аватаркой и подписью.

new imageView(this) {{

new lparams(this) {{

width = dimen(R.dimen.avatarSide);

height = dimen(R.dimen.avatarSide);

}}._();

}}._();

new textView(this) {{

new lparams(this) {{

width = dimen(R.dimen.avatarSide) + dip(10);

height = WRAP_CONTENT;

}}._();

}}._();Выглядит немного странно.

Похоже на человека в монокле и оператор на scala. Но для proof of concept — вполне достаточно.

Итоги

0). На Kotlin код выглядит вот так:

object : frameLayout(this) {

init {

object : lparams(this) {

init {

width = MATCH_PARENT

height = dip(100f)

}

}.`_`()

backgroundColor = RED

object : frameLayout(this) {

init {

object : lparams(this) {

init {

width = dip(50f)

height = dip(50f)

gravity = CENTER

}

}.`_`()

backgroundColor = GREEN

}

}.`_`()

}

}.`_`()1). Вес aar составляет 12кб

2). Idea не сбивает форматирование

3). Коду на Java иногда можно придать неожиданный для Java вид

Репозиторий с библиотекой и примерами: github.com/a-dminator/janko

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

|

Метки: author adev_one разработка под android java android пятничный пост |

Bare words в JavaScript |

И там была такая штука как bare words, которая показывалась на примере Ruby.

«Голые слова» (barewords) — это слова без кавычек, которые вы можете использовать в качестве строк.

В JavaScript их, вроде как и нет, поэтому я попробовал их в него пропихнуть, что в целом получилось.

Получился вот такой код:

with(bareWords) {

alert(Иван + Ургант)

console.log(We, can, use, bare, words)

}

А реализовано это было вот так:

try {

let self = this

window.bareWords = new Proxy({}, {

has: function(target, name) {

return !(name in self)

},

get: function(target, name) {

return name

},

})

} catch(e) {

console.error('Your browser doesn't support bare words.')

}

При попытке получить свойство из this, из-за происков with, запрос идет в прокси, где мы и возвращаем строковое значение вместо злобной ошибки о отсутствии переменной.

Спасибо за внимание.

Если что, вот ссылочка на Github

|

Метки: author mitinsvyat javascript wat |

[Перевод] Создание движка для блога с помощью Phoenix и Elixir / Часть 10. Тестирование каналов |

От переводчика: «Elixir и Phoenix — прекрасный пример того, куда движется современная веб-разработка. Уже сейчас эти инструменты предоставляют качественный доступ к технологиям реального времени для веб-приложений. Сайты с повышенной интерактивностью, многопользовательские браузерные игры, микросервисы — те направления, в которых данные технологии сослужат хорошую службу. Далее представлен перевод серии из 11 статей, подробно описывающих аспекты разработки на фреймворке Феникс казалось бы такой тривиальной вещи, как блоговый движок. Но не спешите кукситься, будет действительно интересно, особенно если статьи побудят вас обратить внимание на Эликсир либо стать его последователями.»

В этой части мы научимся тестировать каналы.

На чём мы остановились

В конце прошлой части мы доделали классную систему «живых» комментариев для блога. Но к ужасу, на тесты не хватило времени! Займёмся ими сегодня. Этот пост будет понятным и коротким, в отличие от чересчур длинного предыдущего.

Прибираем хлам

Прежде, чем перейти к тестам, нам нужно подтянуть несколько мест. Во-первых, давайте включим