Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Let’s Encrypt: раздаем видео по HTTPS в один клик |

Что такое Let's Encrypt знает, наверное, каждый читатель Хабрахабра, ведь опубликовано уже более 100 статей на эту тему. Большая часть из них, это инструкции по установке и настройке: какой пакет установить, какие строчки конфига поправить, какой скрипт разместить в crontab, как завести это очередном веб-сервере и автоматизировать для docker и прочих модных технологий.

В нашем продукте — Flussonic, мы сделали, пожалуй, самый простой способ настройки Let's Encrypt, не требующий правки конфигов, просто нажатием кнопки «Сделай мне HTTPS».

Справка

Для тех кто первый раз слышит про «Let's Encrypt», небольшая справка:

Let's Encrypt — центр сертификации предоставляющий в автоматическом режиме бесплатные криптографические сертификаты для TLS шифрования (HTTPS) со сроком на 90 дней. Проект создан для того, чтобы HTTPS стал доступнее для интернет-проектов, чтобы максимально упросить процесс получения, настройки и сделать его абсолютно бесплатным, без ущерба безопасности.

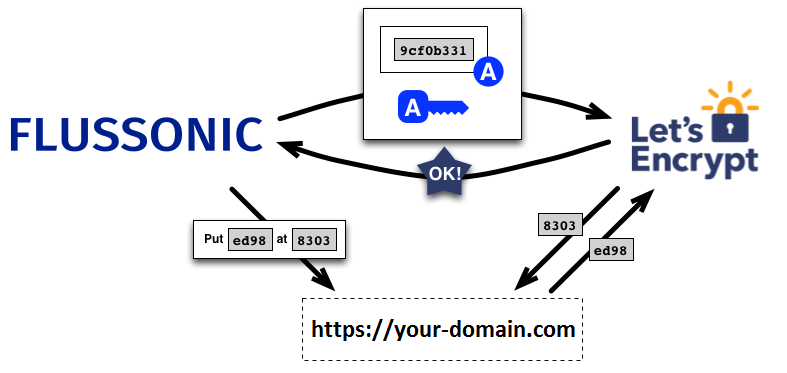

Выдача и продление сертификата происходоит в автоматическом режиме по протоколу Automated Certificate Management Environment (ACME). В этом протоколе к веб-серверу, запросившему сертификат, производится серия запросов, для подтверждения факта владения доменом.

В большинстве linux дистрибутивов есть пакет, позволяющий за 30 секунд получить сертификат в удобном формате для популярных веб-серверов (nginx, apache2). Опытные системные администраторы без проблем смогут настроить любой софт с TLS шифрованием для использования этого сертификата. А для настройки автоматического обновления нужно добавить одну строчку в crontab.

На данный момент, Let's Encrypt выдали уже более 100 миллионов сертификатов. Сервис невероятно популярен и рекомендуется к использованию.

Let's Encrypt и Flussonic

Как-то неприлично аудитории Хабра объяснять зачем нужен HTTPS, когда речь идет о передаче видео, в том числе с камер видеонаблюдения. Пользователи становятся более грамотными, обращают внимание на наличие безопасного соединения, когда речь идет о заполнении форм, и уж тем более, для них важно, чтобы видео с камеры наблюдения доставлялось безопасно. А если речь идет про корпоративное использование, то это просто обязательно.

Мы добавили поддержку Let's Encrypt во Flussonic уже давно, а недавно прокачали его, чтобы сам следил за сроком жизни. А сейчас я покажу вам, как наши клиенты настраивают HTTPS, это невероятно просто.

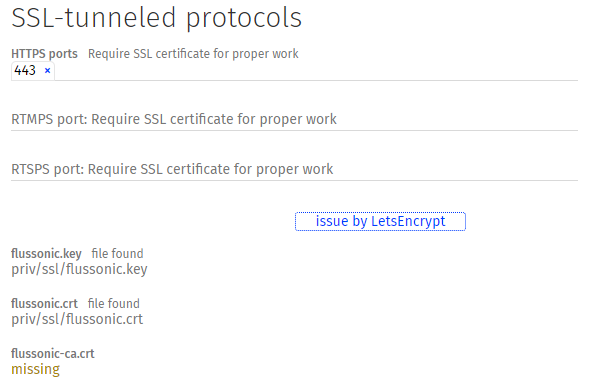

Предполагается, что клиент уже имеет доменное имя, настроил DNS соответсвующим образом. Открывает веб-интерфейс Flussonic и переходит во вкладку «Config» и указывает порт для HTTPS:

После ввода номера порта, в интерфейсе появляется кнопка «Issue by LetsEncrypt», нажав на которую происходит общение по ACME. Вводить имя домена не требуется, Flussonic получает его из адресной строки браузера. Это решение экономит несколько секунд времени, исключает ошибку при наборе, что в целом упрощает жизнь нашим клиентам.

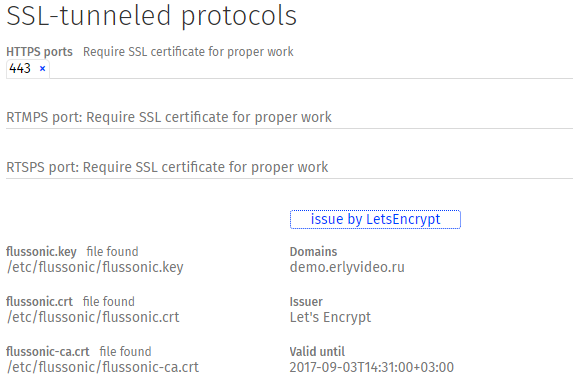

На скриншоте выше результат нажания на кнопку: отображаются параметры полученного сертификата, центр сертификации и срок действия. Остается только нажать на кнопку «сохранить» и все, перезагрузка сервиса не потребуется, а Flussonic будет сам продлевать сертификат.

Итоги

Как я и написал в самом начале: пожалуй, у нас самая простая реализация настройки Let's Encrypt: никакого дополнительного софта и ввода настроек с клавиатуры.

Доставляйте видео по безопасному соединению — это просто, бесплатно и очень востребовано сегодня. Мы сделали все, чтобы вы могли сосредоточиться на своем сервисе, а не конфигурации софта.

|

|

Настройка среды разработки: кружок рукоделия (Часть 1) |

Привет, дорогой читатель!

Сегодня я хочу поделиться своим опытом настройки персонального окружения для работы с различными PHP-based проектами. В данной статье описывается опыт ручной настройки окружения.

Данная статья написана

Автоматизацию процесса развертывания среды я напишу в одной из следующих статей.

Статья будет очень длинной с уклоном в техническую сторону. Прошу под «кат».

Предыстория

Прежде чем начать, хочу поделиться небольшой историей о том, как все начиналось.

Долгое время, процесс разработки велся в основном на одном проекте, с упором на долгосрочные перспективы (работы было много: на 1 год вперед). И так было от компании к компании. Так что мне не составляло особого труда добавить пару «конфигов» и перезагрузить сервера на локальной машине, чтобы добавить новый проект. При смене компании я просто настраивал все с нуля подстраиваясь под проект.

В конце 2016 года мне пришлось перейти с одного проекта на другой в связи с чередой очень неприятных событий. Перейдя на новый проект с толкнулся с тем, что архитектура проекта была построена так, что нужно одновременно поддерживать минимум 5 сервисов, работающих в связке. Так же мне все еще приходится время от времени поддерживать предыдущие проекты. Да и, не забывать об R&D проектах, Open Source проектах, “халтурке”, семье и детях.

Такое стечение обстоятельств повлияло на дальнейшую историю моей среды разработки и все что с этим связано.

Цель: гибкая среда разработки для PHP-based проектов

И так. Мне нужно получить рабочее окружение, позволяющее вести разработку, отладку и исследования во множественных PHP-based проектах с привязкой к инфраструктуре компании.

Примечание: дальнейшее описание относится к двум проектам, которые сейчас находятся в моей зоне ответственности: Warface Hub — то, что от него осталось, и CryEngine Hub — результат молниеносной реализации, “удачной” архитектуры и “правильного” планирования.

Таким образом я получил следующее

- Windows 10 — Host с VMWare или VitrualBox

- Ubuntu — Guest c:

- Samba — для работы с файлами проектов

- Bind9 — локальный DNS сервер

- Nginx, PHP FPM, MySQL и все остальное

- Другие виртуальные машины

Ресурсы

В крупных компаниях очень часто используют решения от компании Microsoft для обеспечения работы внутренней связи между сотрудниками (Outlook, Lync, AD) и еще кучи «самописных» приложений. Так как лень мне не позволяет искать и настраивать клиенты под Linux или использовать Wine, то я успешно начал использовать “гибрид” двух OS и виртуализацию:

- Windows 10 (Host OS)

- Ubuntu 16.04 (Guest OS — VM)

- SSD — максимально быстрый. При данной реализации очень важно иметь быстрый диск.

- 16Gb ram — Чем больше, тем лучше. Мне приходится выделять до 12Gb для всех гостевых OS, так как приходится решать cross-browser проблемы, которые на эмуляторах не воспроизводятся.

Установка серверов, приложений и компонентов.

На этом этапе устанавливаем все (Guest OS), что может нам понадобится для того чтобы поднять простой стек из Nginx, PHP и MySQL, а также все остальное, что может пригодится в проектах (NPM, Yarn, Composer). Не забываем про нашу среду разработки и добавляем туда Samba и Bind9.

$ sudo add-apt-repository ppa:ondrej/php

$ sudo apt-get install php5.6 php7.0 php7.1 php7.1-fpm

$ sudo apt-get install php-bcmath php-curl php-dev php-fpm php-gd php-intl php-json php-mbstring php-mcrypt php-mysql php-readline php-soap php-sqlite3 php-tidy php-xml php-zip php-codecoverage php-codesniffer php-common php-geoip php-igbinary php-imagick php-memcache php-memcached php-redis php-ssh2 php-xdebug php-xhrpof

$ sudo apt-get install php5.6-bcmath php5.6-curl php5.6-dev php5.6-fpm php5.6-gd php5.6-intl php5.6-json php5.6-mbstring php5.6-mcrypt php5.6-mysql php5.6-opcache php5.6-readline php5.6-soap php5.6-sqlite3 php5.6-tidy php5.6-xml php5.6-zip

$ sudo apt-get install php7.0-bcmath php7.0-curl php7.0-dev php7.0-fpm php7.0-gd php7.0-intl php7.0-json php7.0-mbstring php7.0-mcrypt php7.0-mysql php7.0-opcache php7.0-readline php7.0-soap php7.0-sqlite3 php7.0-tidy php7.0-xml php7.0-zip

$ sudo apt-get install php7.1-opcache

$ sudo apt-get install memcached redis-server redis-tools nginx mysql-server-5.7 mysql-client-5.7 composer npm curl nodejs nodejs-legacy ruby-full

$ curl -sS https://dl.yarnpkg.com/debian/pubkey.gpg | sudo apt-key add -

$ echo "deb https://dl.yarnpkg.com/debian/ stable main" | sudo tee /etc/apt/sources.list.d/yarn.list

$ sudo apt-get update && sudo apt-get install yarn

$ sudo gem update --system

$ sudo gem install compass

$ composer global require hirak/prestissimo

$ sudo npm install -g grunt-cli

$ sudo apt-get install bind9 samba

Samba-сервер

Первое, к чему я потянулся — Samba-сервер, который настроил для того, чтобы моя IDE могла работать непосредственно с файловой системой гостевой OS.

Первое, к чему я потянулся — Samba-сервер, который настроил для того, чтобы моя IDE могла работать непосредственно с файловой системой гостевой OS. Все мои проекты будут находится по пути /var/www/{project-name}.

Так же в процессе настройки гостевой ОС я принудительно настроил DHCP сервер так, чтобы у нее был статический IP и пряталось все за NAT: 172.16.126.130.

[global]

workgroup = WORKGROUP

server string = %h server (Samba, Ubuntu)

dns proxy = no

# few changes to speed up smbd

strict allocate = Yes

read raw = Yes

write raw = Yes

strict locking = No

socket options = TCP_NODELAY IPTOS_LOWDELAY SO_RCVBUF=131072 SO_SNDBUF=131072

min receivefile size = 16384

use sendfile = true

aio read size = 16384

aio write size = 16384

max log size = 1000

syslog only = no

syslog = 0

server role = standalone server

usershare allow guests = yes

[www]

path = /var/www

available = yes

valid users = oxcom

read only = no

browsable = yes

public = yes

writable = yes

executable = yes

Чтобы IDE могла работать с этим ресурсом я монтирую эту Netbios папку как удаленный локальный диск.

@echo off

@title Local UBUNTU Network Drive

net use q: \\172.16.126.130\www {user-password} /USER:oxcom

Unmount local drive

@echo off

@title Local UBUNTU Network Drive

net use q: /delete

Почему я стал использовать Samba, а не Shared Folders?

На то время, когда я этим вопросом задался получалось так, что Shared Folders являлись монтируемой директорией, а NGINX не хотел их использовать как root директорию проекта. Второй причиной стало то, что время от времени у меня Shared Folders отваливались без видимой на то причины и без возможности быстро все восстановить. А также нет возможности работать с симлинками, которые необходимы для некоторых пакетов npm и не только.

Есть ли какие-то проблемы с IDE?

Да и разные, но SSD спасает:

- иногда индексирование проектов происходит долго

- при быстром изменении большого количества файлов (merge, rebase, смена бранча) не сразу подхватываются изменения. Смотрю в сторону rsync.

- Если отключить диск раньше, чем закрыть IDE, то, при закрытии проекта, IDE зависнет

- Если отвалится сеть, то проект скорее всего нужно будет открыть еще раз

DNS-сервер

Дорогой читатель может представить насколько трудно в большой компании запросить небольшие изменения в настройках сети. И даже если вы успешно пройдете первый этап объяснения для чего вам это нужно, то второй этап (реализация) может затянуться на очень большой срок, что проще все сделать самому.

Дорогой читатель может представить насколько трудно в большой компании запросить небольшие изменения в настройках сети. И даже если вы успешно пройдете первый этап объяснения для чего вам это нужно, то второй этап (реализация) может затянуться на очень большой срок, что проще все сделать самому.Так как я очень ленивый, то через какое-то время мне надоело добавлять в hosts файл записи вида:

172.16.126.130 project1.lo

172.16.126.130 project2.lo

Было решено, что нужен локальный DNS-сервер, который можно настроить быстрее, чем я смогу выпить бутылку немецкого крепкого пива. После чего был послан запрос в лигу лени. Результат не заставил себя долго ждать: BIND9

Настройка очень проста: описываем конфигурации прямого и обратного пула доменов, а также не забываем их подключить:

;

; BIND data file for local loopback interface

;

$TTL 604800

@ IN SOA lo. root.lo. (

0000119 ; Serial

604800 ; Refresh

86400 ; Retry

2419200 ; Expire

604800 ) ; Negative Cache TTL

;

@ IN NS lo.

@ IN A 172.16.126.130

@ IN AAAA ::1

* IN CNAME @

;

; BIND data file for local loopback interface

;

$TTL 604800

;

; BIND reverse data file for local loopback interface

;

$TTL 604800

@ IN SOA ns.lo. root.lo. (

0000112 ; Serial

604800 ; Refresh

86400 ; Retry

2419200 ; Expire

604800 ) ; Negative Cache TTL

;

@ IN NS lo.

zone "lo" {

type master;

file "/etc/bind/db.lo";

check-names ignore;

allow-query { any; };

allow-transfer { any; };

};

zone "126.16.172.in-addr.arpa" {

type master;

file "/etc/bind/db.126.16.172";

allow-query { any; };

allow-transfer { any; };

};

options {

directory "/var/cache/bind";

forwarders {

8.8.8.8;

8.8.4.4;

};

recursion yes;

listen-on { any; };

auth-nxdomain no; # conform to RFC1035

listen-on-v6 { any; };

};

Сервер настроен. Теперь, для полной радости осталось решить еще несколько задач:

- заставить Host систему использовать наш DNS-сервер для домена .lo. По-этому меняем на Host машине нужно параметры виртуальной сети так, чтобы первым был наш DNS-сервер, и чистим DNS-кеш.

- заставить Guest систему тоже использовать наш DNS-сервер. Тут проще: редактируем сетевой интерфейс и прописываем туда наш DNS-сервер

Результат не заставляет себя ждать:

; <<>> DiG 9.10.3-P4-Ubuntu <<>> example.lo

;; global options: +cmd

;; Got answer:

;; ->>HEADER<<- opcode: QUERY, status: NOERROR, id: 32204

;; flags: qr aa rd ra; QUERY: 1, ANSWER: 2, AUTHORITY: 1, ADDITIONAL: 2

;; OPT PSEUDOSECTION:

; EDNS: version: 0, flags:; udp: 4096

;; QUESTION SECTION:

;example.lo. IN A

;; ANSWER SECTION:

example.lo. 604800 IN CNAME lo.

lo. 604800 IN A 172.16.171.130

;; AUTHORITY SECTION:

lo. 604800 IN NS lo.

;; ADDITIONAL SECTION:

lo. 604800 IN AAAA ::1

;; Query time: 0 msec

;; SERVER: 172.16.171.130#53(172.16.171.130)

;; WHEN: Mon Jul 17 11:09:52 CEST 2017

;; MSG SIZE rcvd: 111

Pinging lo [172.16.171.130] with 32 bytes of data:

Reply from 172.16.171.130: bytes=32 time<1ms TTL=64

Reply from 172.16.171.130: bytes=32 time<1ms TTL=64

Вот только «nslookup example.lo» не работает. Почему — не знаю, но любой браузер на Host машине будет нормально ходить на соответствующий сервер.

PHP-FPM и Pools

Вроде все работает. Теперь необходимо приступить к настройке PHP для каждого из проектов.

Вроде все работает. Теперь необходимо приступить к настройке PHP для каждого из проектов.Работая над последними проектами у меня получилось так, что один проект может состоять из различных сервисов или собирать в себе многие другие проекты. По-этому у меня получилась следующая структура:

- warface.com

- cryengine.com

- shop.cryengine.com

- forum.cryengine.com

В процессе работы приходится использовать API вызовы между проектами и было бы очень хорошо уметь «дебажить» это все с помощью XDebug и любимой IDE. При попытках использовать один PHP Pool я сталкивался со следующими проблемами:

- при отладке на одном домене с общей сессией PHP-FPM блокирует исполнение остальных запросов с такой же сессий (как смог так и описал :)). Таким образом останавливаясь на где-то на cryengine.com я не смогу работать с forum.cryengine.com, пока не завершится предыдущий запрос.

- неудобно проводить отладку двух проектов одновременно с разными ключами XDebug. Да-да, я стараюсь максимально избегать изменения настроек среды из PHP

И так. Чтобы это решить, я создал свой PHP Pool по шаблону для каждого проекта под каждую версию PHP. И подключаю их 'include=/etc/php/7.0/fpm/pool.d/*.d/*.conf'

; Start a new pool

; the variable $pool can we used in any directive and will be replaced by the

; pool name ('www' here)

[{project-name}-{project-subname}]

user = www-data

group = www-data

listen = /run/php/php7.0-$pool-fpm.sock

listen.owner = www-data

listen.group = www-data

pm = dynamic

pm.max_children = 20

pm.start_servers = 5

pm.min_spare_servers = 3

pm.max_spare_servers = 7

php_admin_value[xdebug.idekey] = key-$pool

Выглядит это примерно так:

cryengine.d/www.conf

cryengine.d/shop.conf

cryengine.d/forum.conf

warface.d/www.conf

www.conf

php5.6-cryengine-www-fpm.sock

php5.6-cryengine-shop-fpm.sock

php5.6-cryengine-forum-fpm.sock

php5.6-warface-www-fpm.sock

php5.6-fpm.sock

php7.0-cryengine-www-fpm.sock

php7.0-cryengine-shop-fpm.sock

php7.0-cryengine-forum-fpm.sock

php7.0-warface-www-fpm.sock

php7.0-fpm.sockТеперь каждый проект имеет свой PHP Pool и проставленным xdebug.idekey, что позволяет проводить непрерывную отладку между несколькими проектами (не забывайте настроить php.ini)

NGINX

Настройка сервера довольно проста. Для каждого проекта создается отдельный файл конфигурации в 'sites-available', который описывает конфигурацию vhost. В конфигурации мы подключаем соответствующие файлы конфигурации для каждого проекта.

Настройка сервера довольно проста. Для каждого проекта создается отдельный файл конфигурации в 'sites-available', который описывает конфигурацию vhost. В конфигурации мы подключаем соответствующие файлы конфигурации для каждого проекта.Основываясь на указанной выше архитектуре я реализовал вот такую структуру:

cryengine.d/

- www.conf

- forum.conf

- shop.conf

- ssl.conf

warface.d/

- www.conf

- ssl.conf

sites-available/

- www.cryengine.conf

- forum.cryengine.conf

- shop.cryengine.conf

- www.warface.conf

nginx.conf

server {

listen 443 ssl http2;

server_name {project-subname}.{project-name}.lo;

root /var/www/{project-subname}.{project-name}.com/wwwroot;

index index.php;

error_log /var/www/{project-subname}.{project-name}.com/log/nginx.error.log error;

access_log /var/www/{project-subname}.{project-name}.com/log/nginx.access.log;

# configuration related to sub-project

include {project-name}.d/www.conf;

# global configuration for projects

include {project-name}.d/ssl.conf;

}Таким образом в /etc/nginx/{project-name}.d/ хранятся все конфигурации, которые относятся к проекту, а также сопутствующим под проектам. Каждый проект имеет свой PHP Pool пока каждую версию PHP, что позволяет быстро переключаться между версиями и только для одного проекта.

Итоги

Спасибо, что дочитали до конца. Я искренне надеюсь, что ручной труд еще не вымер, ибо разработчик должен уметь настроить среду сам и без автоматизации.

В итоге я получил гибрид между двумя ОС, который позволяет полностью использовать все внутренние сервисы компании, а также вести разработку и отладку в среде, максимально приближенной к LIVE.

Я понимаю, что это не идеальное решение, но это один из способов, как можно за короткий промежуток времени подготовить среду разработки.

Минусы:

- Долгая индексация в IDE

- При переустановке/переносе виртуальной машины нужно изменять конфигурацию для Bind9 и скрипт подключения диска

- Это все не автоматизировано

Плюсы:

- рабочую среду можно переносить с машина на машину

- разработчик остается в Windows окружении и есть возможность использовать MS сервисы, которые установлены в компании.

- разработчик работает с Linux окружением, которое может быть легко настроено как LIVE среда.

|

Метки: author OxCom разработка веб-сайтов php virtual machine development environment |

[Из песочницы] Применение преобразования Фурье для создания гитарного тюнера на Android. Часть 1 |

В основе спектрального анализа звуковых данных лежит алгоритм, который носит название преобразование Фурье. При раскладывании исходного звукового сигнала на частотные составляющие, отдельные частоты называются гармониками. Основная гармоника определяет высоту звучания, а второстепенные гармоники определяют его тембр. Есть достаточно много мобильных приложений, которые используют преобразование Фурье для того, чтобы отобразить весь спектр частот (гармоник). Так же, есть мобильные приложения, которые служат для настройки гитар. Они работают по принципу: основная гармоника находится по самому высокому значению амплитуды в спектре. Такое утверждение не совсем верно, потому что основная гармоника определяется самой наименьшей из всех кратных этой гармонике, либо шагом между гармониками. Возникает необходимость найти способ, который позволит отобразить значение основной гармоники в спектре звукового сигнала.

В первой части статьи мы рассмотрим принцип работы дискретного преобразование Фурье, а также возможность записывать звуковые данные с Android устройства с помощью класса AudioRecord.

ДПФ, БПФ. Библиотека JTransforms.

Звуковые данные, записанные в виде импульсно-кодовой модуляции (PCM), показывают амплитуду звуковой волны в конкретный момент времени. В 19-м веке Жан Батист Фурье доказал, что любой периодический сигнал можно представить, как сумму бесконечного ряда простых синусоидальных сигналов. Из чего следует, что наш исходный звуковой сигнал, можно представить в виде суммы, упорядоченных по частоте, простых синусоидальных сигналов с собственными амплитудами. Тем самым перейти от одной зависимости (амплитуда-время) к другой (амплитуда-частота). Такое преобразование называется преобразованием Фурье.

Для вычисления преобразования Фурье на компьютерах ввели понятие дискретное преобразование Фурье (ДПФ), которое требует в качестве входа дискретную функцию.

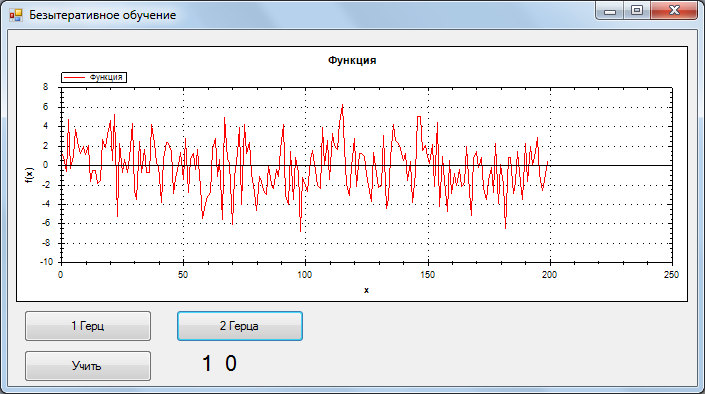

Рассмотрим принцип работы дискретного преобразования Фурье в среде программирования Java. Для начала, опишем некоторую функцию, которая будет представлять сумму двух гармоник (косинусов) с частотами 100 Гц и 880 Гц соответственно.

private double someFun(int index, int sampleRate) {

final int amplitudeOfFirstHarmonic = 15;

final int amplitudeOfSecondHarmonic = 1;

final int frequencyOfFirstHarmonic = 100;

final int frequencyOfSecondHarmonic = 880;

return amplitudeOfFirstHarmonic * Math.cos((frequencyOfFirstHarmonic * 2 * Math.PI * index ) / sampleRate)

+ amplitudeOfSecondHarmonic *Math.cos((frequencyOfSecondHarmonic * 2 * Math.PI * index) / sampleRate);

}В качестве частоты дискретизации возьмём значение 8000 Гц и заполним массив из 8000 элементов данными, вызывая функцию someFunc() в цикле

final int sampleRate = 8000;

final int someFuncSize = 8000;

double[] someFunc = new double[someFuncSize];

for (int i = 0; i < someFunc.length; i++) {

someFunc[i] = someFun(i, sampleRate);

}В результате чего, получим массив значений, который определяет дискретное представление нашей функции. Для визуального представления полученных данных, выведем, полученные значения, из массива в файл .csv и построим график в программе Excel

Как видно из диаграммы, гармоника с частотой 100 Гц имеет амплитуду 15, значение которой и было указано в константе amplitudeOfFirstHarmonic. Поверх первой гармоники с частотой 100 Гц и амплитудой 15, рисуется вторая гармоника с частотой 880 Гц и амплитудой равной единице.

По такому же принципу создадим две базисные функции косинуса и синуса. Только теперь, мы будем передавать значение частоты в параметры методов наших базисных функций

private double cos(int index, int frequency, int sampleRate) {

return Math.cos((2 * Math.PI * frequency * index) / sampleRate);

}

private double sin(int index, int frequency, int sampleRate) {

return Math.sin((2 * Math.PI * frequency * index) / sampleRate);

}Теперь, определим метод, который будет выполнять дискретное преобразование Фурье. В качестве параметров метода, передадим массив значений исходной дискретной функции, состоящей из суммы простых косинусов, и частоту дискретизации этой функции.

private double[] dft(double[] frame, int sampleRate) {

final int resultSize = sampleRate / 2;

double[] result = new double[resultSize * 2];

for (int i = 0; i < result.length / 2; i++) {

int frequency = i;

for (int j = 0; j < frame.length; j++) {

result[2*i] +=frame[j] * cos(j, frequency, sampleRate);

result[2*i + 1] +=frame[j] * sin(j, frequency, sampleRate);

}

result[2*i] =result[2*i] / resultSize;

result[2*i + 1] = result[2*i + 1] / resultSize;

}

return result;

}После выполнения преобразования Фурье, полученные значения, определяют проекции всех векторов, упорядоченных по частоте, на оси косинусов и синусов. Для того, чтобы найти длину такого вектора, необходимо применить теорему Пифагора .

double[] result;

long start = System.currentTimeMillis();

result = dft(someFunc, sampleRate);

long finish = System.currentTimeMillis();

long timeConsumedMillis = finish - start;

System.out.println("Time's dft: " + timeConsumedMillis);

double[] amplitude = new double[sampleRate/2];

for (int i = 0; i < result.length / 2; i++) {

amplitude[i] = Math.sqrt(result[2*i]*result[2*i] + result[2*i+1]*result[2*i+1]);

System.out.println(i + ": " + "Projection on cos: " + result[2*i] + " Projection on sin: " + result[2*i + 1]

+ " amplitude: "+ amplitude[i] + "\n");

}В результате выполнения кода из предыдущего листинга, мы получили представление нашей дискретной функции someFunc() в виде набора значений амплитуд, которые упорядочены по частоте, от нуля до половины частоты дискретизации.

Таким образом, для гармоник с частотами 100 Гц и 880 Гц, значения амплитуд, будут соответствовать тем значениям, которые были указаны в константах amplitudeOfFirstHarmonic и amplitudeOfSecondHarmonic метода someFunc(). А для остальных гармоник, которых остаётся ровно 3998, значения амплитуд будут приближены к нулю, потому что, остальные гармоники не были определены в исходной дискретной функции someFunc(), которая передавалась на дискретное преобразование Фурье.

Выведем значения амплитуд, полученных после преобразования Фурье функции someFunc(), в файл .csv и построим график в программе Excel. В результате преобразования Фурье, мы получили спектр исходного сигнала

Алгоритм дискретного преобразования Фурье на компьютере выполняется за время , что является слишком медленным процессом. Для быстрых вычислений дискретного преобразования Фурье, придумали быстрое преобразование Фурье (БПФ). Алгоритм БПФ, производит вычисления, используя рекурсивный подход, благодаря которому, время выполнения алгоритма уменьшается до . Существует готовая реализация алгоритма БПФ в среде программирования Java, которая представлена в виде библиотеки JTransforms.

Запись данных с микрофона. AudioRecord

За получения звуковых данных в формате PCM с мобильного устройства на платформе Android отвечает класс AudioRecord.

Для создания экземпляра класса AudioRecord, в конструкторе класса AudioRecord, необходимо указать такие параметры как:

- audioSource — источник, откуда ведётся запись.

- sampleRateInHz — частота дискретизации в Герцах.

- channelConfig — тип аудио канала.

- audioFormat — формат кодирования данных.

- minBufferSize — минимальный размер буфера.

После создания экземпляра класса AudioRecord, необходимо вызвать метод startReading(), который начнёт запись с мобильного устройства. Записанные звуковые данные будут храниться во внутреннем буфере класса AudioRecord в размере порции, указанной в параметре minBufferSize при создании экземпляра класса. Из внутреннего буфера класса AudioRecord, необходимо периодически забирать записанные данные с помощью вызова метода read() класса AudioRecord.

Для примера, запишем звуковые данные с мобильного устройства, а затем выведем, эти данные, в текстовый файл .csv и построим график полученных звуковых данных, используя программу Excel

При создании экземпляра класса AudioRecord, используем частоту дискретизации равной 8000 Гц и размер буфера равный 1024.

Если эта часть статьи была интересна, то во второй части статьи мы займёмся созданием гитарного тюнера на Android.

|

Метки: author ByArt разработка мобильных приложений алгоритмы java бпф дпф гармоника тюнер для гитары андроид преобразование фурье звуковая волна частота дискретизации |

[Перевод] CSS — это не чёрная магия |

Однако, по мере того, как вы будете совершенствоваться в деле веб-разработки, легкомысленное отношение к CSS останется в прошлом. Столкнувшись с чем-то неописуемо странным, вы поймёте, что попросту не представляете, как именно CSS работает, что делается в его недрах. Что-то похожее было и у меня. Первые пару лет после учёбы я занималась JavaScript-разработкой полного цикла, эпизодически касаясь CSS. Я всегда считала, что мой хлеб — это JavaScript, ему я отдавала всё своё время.

Например, участвовала в дискуссиях на JavaScript Jabber. В последний год я решила сосредоточиться на фронтенде и только тогда поняла, что не в состоянии, например, отлаживать таблицы стилей так же, как JS-код.

Про CSS часто шутят, но немногие отнеслись к нему достаточно серьёзно и попытались его понять. Кто, столкнувшись с проблемой, осмысленно занимался поиском ошибок, учитывая то, как CSS обрабатывают браузеры? Вместо этого мы хватаем код из первого попавшегося ответа на Stack Overflow, не брезгуем разного рода хаками, или просто игнорируем проблемы.

Как результат — слишком часто разработчики попросту разводят руками, когда браузер творит со стилями непонятные вещи. Тут впору подумать, что CSS сродни чёрной магии. Однако, любому программисту известно, что компьютер — это машина для разбора и выполнения написанных человеком команд, и CSS, в этом плане, ничем не отличается от любимого нами JS. А если так — CSS вполне можно узнать и пользоваться им осмысленно и продуктивно.

Знание внутренних механизмов работы CSS пригодится в разных ситуациях. Например — при серьёзной отладке и оптимизации производительности веб-страниц. Часто, когда говорят и пишут про CSS, делают упор на решение распространённых проблем. Мне же хочется рассказать о том, как всё это работает.

DOM и CSSOM

Для начала, важно понимать, что в браузерах, помимо прочих подсистем, имеется JavaScript-движок и движок рендеринга. Нас, в данном случае, интересует последний. Например, мы обсудим детали, которые относятся к WebKit (Safari), Blink (Chrome), Gecko (Firefox), и Trident/EdgeHTML (IE/Edge).

Браузер, в ходе вывода веб-страницы на экран, выполняет определённую последовательность действий, ведущую к построению объектной модели документ (DOM, Document Object Model), и объектной модели таблицы стилей (CSSOM, CSS Object Model). Эту последовательность действий, упрощённо, можно представить в следующем виде:

- Преобразование: чтение байтов HTML- и CSS-кода с диска или загрузка их из сети.

- Токенизация: разбивка потока входных данных на фрагменты (например: начальные теги, конечные теги, имена атрибутов, значения атрибутов), удаление ненужных символов, таких, как пробелы и переводы строк.

- Лексирование: этот шаг похож на токенизацию, но здесь осуществляется определение типа каждого токена (например: этот токен — число, тот — строковой литерал, ещё один — оператор равенства).

- Синтаксический анализ: здесь система принимает поток токенов после лексирования, интерпретирует их, используя специфическую грамматику, и превращает этот поток в абстрактное синтаксическое дерево.

После того, как будут созданы подобные древовидные структуры для CSS и HTML, движок рендеринга формирует, основываясь на них, то, что называется деревом рендеринга. Это — часть процесса создания макета документа.

Дерево рендеринга — это модель визуального представления документа, которая позволяет вывести графические элементы документа в правильном порядке. Конструирование дерева рендеринга производится по такому алгоритму:

- Начиная с корня дерева DOM обойти все видимые узлы.

- Пропустить невидимые узлы.

- Для каждого видимого узла найти соответствующие ему правила в CSSOM и применить их.

- Сгенерировать видимые узлы с содержимым и вычисленными для них стилями.

- И, наконец, сформировать дерево рендеринга, которое включает в себя, для всех видимых на экране элементов страницы, и их содержимое, и информацию о стилях.

CSSOM может оказать сильнейшее влияние на дерево рендеринга, но не на дерево DOM.

Рендеринг

После того, как дерево рендеринга и макет страницы созданы, браузер может приступить к выводу элементов на экран. Вот как выглядит этот процесс.

- Создание макета страницы. Этот этап включает в себя вычисление размеров элемента и его позиции на экране. Родительские элементы могут воздействовать на дочерние элементы. Иногда и дочерние элементы могут воздействовать на родительские.

- Отрисовка. В ходе этого этапа производится преобразование дерева рендеринга в изображения, которые являются основой того, что будет выведено на экран. Сюда входит вывод текстов, цветов, изображений, границ, теней. Отрисовка обычно выполняется на нескольких слоях, при этом, если JavaScript-код страницы воздействует на DOM, страница может быть перерисована несколько раз.

- Сведение слоёв. На данном этапе производится объединение слоёв и формирование итогового изображения, которое и будет видимо на экране. При этом, так как элементы страницы могут быть выведены на разных слоях, слои нужно свести в правильном порядке.

Время отрисовки страницы зависит от особенностей дерева рендеринга. Кроме того, чем больше будет ширина и высота элемента — тем дольше будет и время отрисовки.

Добавление различных эффектов способно увеличить время отрисовки страницы. Вывод графических представлений элементов производится в соответствии с контекстом наложения, в том порядке, в котором они расположены относительно друг друга. Сначала выводятся те элементы, которые расположены ниже, потом — те, которые расположены выше. Позже, говоря о свойстве

z-index, мы остановимся на этом подробнее. Для тех, кто хорошо воспринимает визуальную информацию, вот отличная демонстрация процесса формирования графического представления страницы.Говоря о выводе графического представления страниц в браузерах, часто упоминают и аппаратное ускорение графики. В подобных случаях обычно имеют в виду ускорение сведения слоёв. Речь идёт об использовании ресурсов видеокарты для подготовки к выводу содержимого веб-страниц.

Сведение слоёв с использованием аппаратного ускорения позволяет значительно увеличить скорость рендеринга в сравнении с традиционным подходом, при котором используется лишь процессор. В связи со всем этим нельзя не вспомнить о CSS-свойстве

will-change, умелое использование которого позволяет ускорить вывод страниц. Например, при использовании CSS-трансформаций, свойство will-change позволяет подсказать браузеру, что элемент DOM будет трансформирован в ближайшем будущем. Выглядит это как will-change: transform. Это позволяет передать GPU некоторые операции по отрисовке и сведению слоёв, что способно значительно повысить производительность страниц, содержащих много анимированных элементов. Улучшить производительность с помощью will-change можно, воспользовавшись конструкциями will-change: scroll-position, will-change: contents, will-change: opacity, will-change: left, top.Важно понимать, что некоторые свойства способны вызвать изменение макета страницы, в то время как изменение других — лишь её перерисовку. Конечно, с точки зрения производительности лучше, если вы можете обойтись лишь перерисовыванием страницы при неизменном макете.

Например, изменение цвета элемента оставит макет неизменным, приведя лишь к перерисовыванию элемента. А вот изменение позиции элемента приведёт и к изменению макета, и к перерисовке самого элемента, его дочерних элементов, и, возможно, смежных элементов. Добавление узла DOM так же приведёт к пересчёту макета и к перерисовыванию страницы. Серьёзные изменения, такие, как увеличение размера шрифта HTML-элемента, приводят к изменению макета и перерисовыванию всего дерева рендеринга.

Если вы похожи на меня, то вы, вероятно, лучше знакомы с DOM, чем с CSSOM, поэтому давайте уделим CSSOM некоторое внимание. Важно отметить, что по умолчанию CSS рассматривается как ресурс, блокирующий рендеринг. Это означает, что браузер не будет выполнять рендеринг до полной готовности CSSOM.

Кроме того, надо понимать, что между DOM и CSSOM нет полного соответствия. Различия этих структур обусловлены наличием в DOM невидимых элементов, скриптов, мета-тегов, тегов со служебной информацией, не выводимой на экран, и так далее. Всё это при построении CSSOM не учитывается, так как не влияет на графическое представление страницы.

Ещё одно различие между DOM и CSSOM заключается в том, что при анализе CSS используется контекстно-независимая грамматика. Другими словами, в движке рендеринга нет кода, который доводил бы CSS до некоего приемлемого вида, как это делается при разборе HTML для создания DOM.

При анализе символов, формирующих HTML-элементы, браузер вынужден принимать во внимание окружающие символы, ему нужно большее, нежели только спецификация языка, так как какие-то элементы в разметке могут отсутствовать, однако, движку, во что бы то ни стало, надо вывести страницу. Отсюда и необходимость в более сложных алгоритмах обработки данных.

Заканчивая разговор о рендеринге, кратко рассмотрим путь веб-страницы от набора байтов, хранящихся на сервере, до структур данных, на основе которых формируется её графическое представление.

Браузер выполняет HTTP-запрос, запрашивая у сервера страницу. Веб-сервер отправляет ответ. Браузер конвертирует данные, полученные от сервера, в токены, которые затем преобразуется в узлы деревьев DOM и CSSOM. После того, как эти деревья готовы, строится дерево рендеринга, на основе которого формируется макет страницы, производится послойная отрисовка элементов и сведение слоёв. В результате получается веб-страница, которую мы видим на экране.

Специфичность селекторов

Теперь, когда в том, как работает браузер, мы немного разобрались, взглянем на несколько наиболее распространённых моментов, в которых путаются разработчики. Для начала поговорим о специфичности селекторов.

Очень упрощённо, специфичность селекторов означает применение каскадных CSS-правил в правильном порядке. Однако есть много способов выбрать тег с использованием CSS-селектора и браузеру нужен способ принятия решения о том, какой стиль надо назначить конкретному тегу. Браузеры принимают подобные решения, вычисляя значение специфичности для каждого селектора.

Расчёт показателей специфичности селекторов сбивает с толку многих JavaScript-разработчиков, поэтому давайте остановимся на этом подробнее. Мы будем использовать следующий пример. Имеется тег

div с классом container. В этот тег вложен ещё один div, id которого — main. Внутри main имеется тег p, в котором содержится тег a.

Сейчас, не подглядывая в ответ, попытайтесь проанализировать нижеприведённый CSS и сказать, какого цвета будет текст ссылки в теге

a.#main a {

color: green;

}

p a {

color: yellow;

}

.container #main a {

color: pink;

}

div #main p a {

color: orange;

}

a {

color: red;

}Может, красного цвета? Или зелёного? Нет. Ссылка будет розового цвета со значением специфичности 1,1,1. Вот остальные результаты:

div #main p a: 1,0,3#main a: 1,0,1p a: 2a: 1

Для нахождения этих чисел нужно произвести следующие вычисления:

- Первое число: количество селекторов ID.

- Второе число: количество селекторов класса, селекторов атрибутов (например:

[type="text"],[rel="nofollow"]) и псевдоклассов (:hover, :visited).

- Третье число: количество селекторов типа и псевдоэлементов (

::before, ::after)

Например, взглянем на такой селектор:

#header .navbar li a:visitedЗначение специфичности для него будет 1,2,2. Тут имеется один ID, один класс, один псевдокласс, и два селектора типа элемента (

li и a). Это значение можно прочитать и так, как будто в нём нет запятых, вместо 1,2,2 — 122. Запятые тут имеются только для того, чтобы подчеркнуть, что перед нами не десятичное число из трёх цифр, а три числа. Это особенно важно для теоретически возможных результатов вроде 0,1,13. Если переписать это в виде 0113, неясно будет, как вернуть его в исходное состояние.Позиционирование элементов

Теперь мне хотелось бы поговорить о позиционировании. Позиционирование элементов и создание макета страницы, как мы уже видели, идут рука об руку.

Построение макета — рекурсивный процесс, который может быть вызван для всего дерева рендеринга как результат глобального изменения стилей, или только для части дерева, когда изменения коснуться лишь некоторых элементов, которые надо будет перерисовать. Вот одно интересное наблюдение, которое можно сделать, обратившись к дереву рендеринга и представив, что в нём используется абсолютное позиционирование. При таком подходе объекты, из которых строится макет страницы, размещаются в дереве рендеринга не в тех же местах, что и в дереве DOM.

Часто меня спрашивают о преимуществах и недостатках использования flexbox и float. Конечно, flexbox — это, с точки зрения юзабилити, очень хорошо, будучи применённым к одному и тому же элементу, макет с flexbox рендерится примерно 3.5 мс, в то время как рендеринг макет с float может занять около 14 мс. Таким образом, для учёта мелких, но важных деталей, JS-разработчикам имеет смысл поддерживать свои знания в области CSS в таком же хорошем состоянии, как и знания в области JavaScript.

Свойство z-index

И, наконец, мне хотелось бы поговорить о свойстве

z-index. На первый взгляд кажется, что говорить тут особо не о чем. Каждый элемент в HTML-документе может быть либо перед другими, либо позади них. Кроме того, это работает только для позиционированных элементов. Если установить свойство z-index для элемента, позиционирование которого явно не задано, это ничего не изменит.Ключ к поиску и устранению проблем, связанных с

z-index, заключается в понимании идеи контекстов наложения. Поиск неполадок всегда начинается с корневого элемента контекста наложения. Контекст наложения — это концепция расположения HTML-элементов в трёхмерном пространстве, в частности — вдоль оси Z, относительно пользователя, находящегося перед монитором. Другими словами — это группа элементов с общим родителем, которые вместе перемещаются по оси Z либо ближе к пользователю, либо дальше от него.Каждый контекст наложения имеет один HTML-элемент в качестве корневого элемента. Когда свойства позиционирования и

z-index не используются, правила взаимодействия элементов просты. Порядок наложения элементов соответствует порядку их появления в HTML.Однако, можно создавать новые контексты наложения с помощью свойств, отличающихся от

z-index, и вот тут уже всё становится сложнее. Среди них — свойство opacity, когда это значение меньше единицы, filter, когда значение этого свойства отличается от none, и mix-blend-mode, значение которого не normal. Эти свойства, на самом деле, создают новые контексты наложения. На всякий случай хочется напомнить, что режим наложения (blend mode) позволяет задать то, как пиксели на некоем слое взаимодействуют с видимыми пикселями на слоях, расположенных ниже этого слоя.Свойство

transform тоже вызывает создание нового контекста наложения в тех случаях, когда оно отличается от none. Например, scale(1) и translate3d(0,0,0). Опять же, как напоминание, свойство scale используется для изменения размера элемента, а translate3d позволяет задействовать GPU для CSS-переходов, повышая качество анимации.Итоги

Если для вас этот материал стал первым шагом к серьёзному освоению CSS, надеемся, вы уже очень скоро научитесь решать проблемы со стилями самостоятельно. А здесь можно найти список дополнительных материалов, которые помогут вам углубить и расширить ваши знания.

Уважаемые читатели! Если вы хорошо знаете CSS, расскажите пожалуйста о том, как вы с ним разобрались. Поделитесь опытом. Уверены, многим это пригодится.

|

Метки: author ru_vds разработка веб-сайтов css блог компании ruvds.com веб-разработка |

Машинное обучение и поиск темной материи: соревнование от ЦЕРНа и Яндекса |

|

Метки: author nau4no программирование машинное обучение python big data блог компании яндекс kaggle data science physics |

[Перевод] Как создать виртуальную машину в Google Таблицах |

Недавно я заметил, что в Google Документах есть достаточно полнофункциональная система скриптов под названием Apps Script. Она позволяет вам писать на JavaScript некоторые довольно полезные вещи:

- Запускать код в ответ на такие события, как открытие документов или изменение ячеек

- Создавать пользовательские функции таблиц для формул в Google Таблицах

- Использовать такие сервисы, как Google Переводчик для перевода текста или Gmail для отправки электронной почты

- Добавлять новые элементы меню в интерфейс Google Документов с помощью своих пользовательских функций

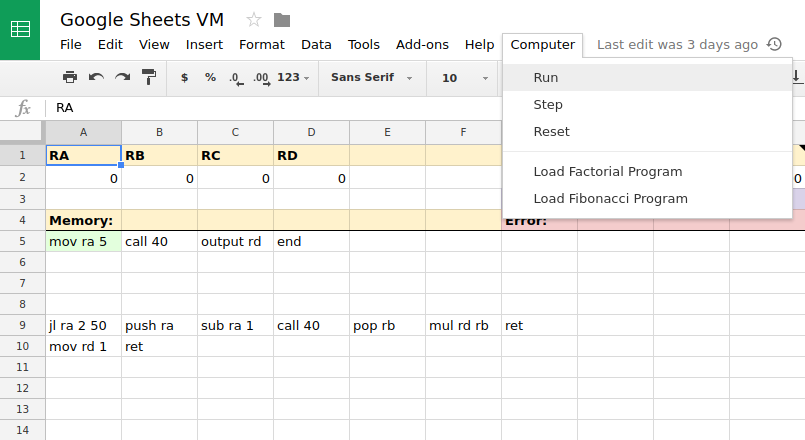

Естественно, по этой причине мне пришлось создать что-нибудь интересное. Вот, смотрите: виртуальная машина в Google Таблицах, генерирующая числа Фибоначчи!

Как она работает

У ВМ есть область памяти в 100 ячеек, пронумерованных от 0 до 99. Каждая ячейка может содержать команду или целое значение.

Также существует стек, который начинается в нижней части области памяти и растет вверх.

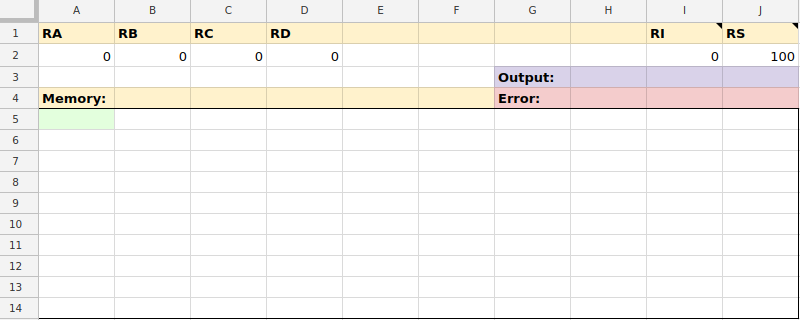

Вот так выглядит лист ВМ, когда он пуст:

Обратите внимание на следующее:

- RA, RB, RC и RD — это регистры общего назначения.

- RI — это указатель на команду. Он указывает на следующую команду, которая должна быть выполнена в области памяти, которая подсвечивается зеленым цветом.

- RS — это указатель на стек. Он указывает на ячейку памяти в верхней части стека. Она подсвечивается синим цветом.

- Вывод (Output) отображает вывод программы.

- Ошибка (Error) отображает любые ошибки, возникающие при анализе или выполнении команды.

- Память (Memory) — это область из 100 ячеек памяти.

Чтобы запустить команду, Apps Script проверяет значение RI в фоновом режиме, чтобы понять, какая команда должна выполняться следующей. Она считывает команду в ячейке, на которую указывает RI, и анализирует ее.

Существуют команды для перемещения данных между памятью и регистрами, управления стеком или выполнения условных команд.

После выполнения команды значение RI увеличивается, чтобы указывать на следующую ячейку в памяти.

Использование

Существует специальное меню под названием «Компьютер» (Computer) с некоторыми функциями, которые используются для управления ВМ:

- Запуск (Run) запускает текущую программу до ее окончания или обнаружения ошибки.

- Шаг (Step) запускает одну команду, а затем приостанавливается.

- Сброс (Reset) очищает все регистры и поле вывода, тем самым подготавливая программу к повторному запуску.

- Загрузка факториальной программы (Load Factorial Program) загружает факториальный пример из другой таблицы.

- Загрузка программы Фибоначчи (Load Fibonacci Program) загружает пример Фибоначчи с другого листа.

Команды

Существует несколько реализованных команд:

Общие

- mov dst src копирует значение из src в dst.

Математические

- add dst src прибавляет dst к src и сохраняет результат в dst.

- sub dst src вычитает src из dst и сохраняет результат в dst.

- mul dst src умножает dst на src и сохраняет результат в dst.

Операции со стеком

- push src загружает src в стек.

- pop dst извлекает значение из верхушки стека и сохраняет его в dst.

Переходы и условные команды

- jmp target переходит к команде в ячейке, на которую ссылается target.

- jl cmp1 cmp2 target сравнивает cmp1 с cmp2. Если cmp1 меньше, чем cmp2, выполнение переходит к target.

Функции

- call target — это вызов функции. Он загружает текущий указатель на команду в стек, чтобы он мог быть возвращен позже, а затем переходит к target.

- ret возвращает функцию. Он извлекает значение из стека и переходит к нему.

Прочее

- output src записывает src в Вывод (Output): раздел интерфейса.

- end завершает программу.

Способы адресации

Операнды в приведенных выше командах могут принимать несколько форм:

Immediates — это литеральные значения, встроенные в команду. Примеры: 7 и123. Например, чтобы скопировать значение 7 в регистр ra:

mov ra 7Registers ссылаются на регистры по имени. Примеры: ra, rb, rc. Чтобы скопировать значение из rc в rb:

mov rb rcMemory ссылается на значение внутри ячейки области памяти. Примеры: $0, $10, $99. Чтобы скопировать значение из ra в первую ячейку памяти:

mov $0 raЧтобы скопировать значение из последней ячейки памяти в rd:

mov rd $99Indirect ссылается на значение, на которое указывает ячейка памяти. Примеры: @15, @50. Поэтому, если ячейка памяти 10 содержит значение 20, а ячейка памяти 20 содержит значение 30, вы можете скопировать значение 30 в ra следующим образом:

mov ra @10Он проверяет ячейку памяти 10, чтобы найти значение 20. Затем он обращается к ячейке памяти 20, чтобы найти значение 30, и копирует это значение в ra.

Рекурсия

Вы можете использовать стек и команды call и ret для выполнения рекурсивных вызовов. Вот пример, который использует рекурсию для генерации факториала числа 5:

Код, начинающийся с jl ra 2 50, является функцией, которая принимает вводное значение в ra и возвращает результат в rd. Она вызывает себя рекурсивно для вычисления факториала значения в ra.

Как получить копию

Если вы хотите поиграться с ней самостоятельно, то можете сделать ее копию здесь.

Вы можете увидеть код Apps Script, выбрав «Инструменты» (Tools), а затем «Редактор скриптов» (Script Editor).

|

Метки: author PayOnline программирование javascript google app engine блог компании payonline google docs числа фибоначчиб payonline |

[recovery mode] Unity на Linux? Да без проблем |

Думаю долго мучает эта идея многих из нас: А не перейти ка мне полностью на Linux? Так было и со мной. Много дней раздумий, много за и против.

Все кто открыл эту статью, не раз сталкивались с этим родом ОС, но мало кто оставался на ней надолго. Тоже происходило и со мной. Очень часто. В один день я решился. Поставил Mint 18, так как по мне, самый удобный, настроил драйвера и пошло поехало.

Думал как ставить Unity так, чтобы не через Wine. И о чудо. Unity уже давно ведут ветку Linux пакетов, готовых к установке. Есть у них как и .sh скрипт, так и готовый .deb пакет(ссылки внизу).

Каждая выпускаемая версия Unity собирается и для нашей OC. Есть косяки иногда, но они малозаметны и, в принципе, для комфортной разработки есть всё что нужно и всё хорошо работает.

И так. Unity ставится просто и легко

- С помощью готового .deb пакета через менеджер

- Или через терминал

sudo sh /path/to/*.sh

Дальше начинается неразбериха. Думаю вы знаете, что Unity использует свой компилятор. Ему нежен .Net версии 3.5.

Я пробовал для работы Rider от JB(на окнах всё хорошо, в Ubuntu,Mint ругается на отсутствие .Net 3.5), VSCode(тоже самое и ещё чуть чуть) и новый MonoDevelop, который поставляется через flatpack. Но с ним оказалась куча проблем, главной из которых является неполное, а с моей стороны даже некорректное чтение файловой системы. Лезет не в те разделы, не видя при этом то, что надо. В итоге нарушается линковка и вы вряд ли захотите каждый раз мучаться с настройкой библиотек. Поэтому я пришёл к простому решению — поставить Mono из стандартных репозиториев через apt. Приступим.

Советую сделать перед началом всего

sudo apt-get updateОбновились.

Дальше ставится Mono версии 5.9.6\

sudo apt-get install monodevelopИ так. Нам нужна сама программа. Мы её получили. Указываем на неё в Unity.

В Unity идём Edit->Preferences->External Tools->External Script Editor выбираем пункт monodevelop

Запускаем. Всё хорошо. Но линковщик ругается: чувак, а где .Net 3.5? И многие тут стопорятся. У mono есть так называемые mono-reference-assemblies. Нам то оно и нужно

sudo apt-get install mono-reference-assemblies-3.5В итоге: Unity замечательно дружит с Linux, не создавая проблем при разработке. Так же всё ПО, которое было у меня на Windows, я смог заменить аналогами на Linux Mint.

У меня стоит третья снизу

|

Метки: author DenisVladimirovich тестирование игр разработка под linux разработка игр linux unity3d linux game programming bash c# |

Дорога к С++20 |

Сегодня завершилась летняя встреча комитета ISO WG21 C++, проходившая в Торонто с 10 по 15 июля. Вскоре нас наверняка ждёт подробный отчёт от РГ21, а сегодня уважаемой публике предлагается пост-«разогрев» с обсуждением самого интересного.

Сегодня завершилась летняя встреча комитета ISO WG21 C++, проходившая в Торонто с 10 по 15 июля. Вскоре нас наверняка ждёт подробный отчёт от РГ21, а сегодня уважаемой публике предлагается пост-«разогрев» с обсуждением самого интересного.Итоги встречи следующие: стандарт С++17 завершен и будет опубликован на следующем собрании в ноябре этого года; стандарт С++20 уже обзавелся первыми серьезными фичами — концептами (concepts), явными обобщёнными лямбда-функциями (explicit generic lambdas) — и это только начало.

Возможности нового стандарта С++17 обсуждались уже не раз, про нововведения писали на Хабре, проводили доклады на конференциях, поэтому снова их приводить здесь я не буду. Не секрет, что ключевой особенностью этого выпуска С++ стал перенос самых «вкусных» возможностей в неопределенное будущее. Что ж, теперь можно с уверенностью сказать, что многие долгожданные «фичи» переехали именно в С++20. Взятый курс на расширение stdlib никуда не делся, поэтому от C++20 можно ожидать гораздо большего и богатого набора функций. Как обычно, заранее прошу прощения за любые неточности.

Черновик стандарта С++20

Концепты

Многострадальные Concepts, когда-то не вошедшие в C++11, потом переделанные в виде нового предложения Concepts-Lite, наконец-то становятся частью стандарта.

По поводу краткого синтаксиса для концептов (terse syntax) комитету договориться пока не удалось; однако, обсуждение будет продолжаться в рамках С++20.

_VA_OPT_

#define LOG(msg, ...) printf(msg __VA_OPT__(,) __VA_ARGS__)

LOG("hello world") // => printf("hello world")

LOG("hello world", ) // => printf("hello world")

LOG("hello %d", n) // => printf("hello %d", n)Явные обобщённые лямбда-функции (Explicit generic lambdas) [pdf]

[] (T t) { /* ... */ } Лямбда-функции были добавлены в язык в стандарте C++11, требовавшие указания конкретного типа; стандарт C++14 в свою очередь позволил объявлять параметры лямбда-функций со спецификатором типа auto:

[](auto x) { /* ... */ }Теперь взаимодействовать с типами параметра (или параметров) станет проще — при определении лямбда-функций можно будет использовать привычный синтаксис шаблона функций:

[](T x) { /* ... */ }

[](T* p) { /* ... */ }

[](T (&a)[N]) { /* ... */ }

shared_ptr для массивов [pdf]

shared_ptr p = make_shared(1024);Тема поднималась неоднократно — например, здесь1.

Определение порядка байтов

Больше нет нужды прибегать к хитрым приёмам — на самом деле, компилятор и так всегда знал ответ, просто теперь он им сможет поделиться:

enum class endian

{

little = __ORDER_LITTLE_ENDIAN__,

big = __ORDER_BIG_ENDIAN__,

native = __BYTE_ORDER__

};Улучшенная дедукция аргумента шаблона

vector v{vector{1, 2}};

// Выведет vector вместо vector> TS (Technical Specifications)

Перечисленные ниже TS отныне являются частью С++17 (уже обсуждались в прошлые разы):

- Filesystem v1 [pdf] — порт boost::filesystem,

- Parallelism v1 [pdf] — благодаря этому TS, большая часть библиотеки algorithm отныне будет доступна в «параллельной» версии,

- Library Fundamentals v1 [pdf] — расширение стандартной библиотеки: std::string_view, std::optional, std::any, system_error.

Помимо этого, комитет опубликовал следующие технические спецификации, для которых компиляторы уже могут делать экспериментальные реализации (и они наверняка здесь обсуждались ранее):

- Coroutines v1 — вокруг сопрограмм было много обсуждений

- Ranges v1 — проскочили вслед за концептами, и, будем надеяться, попадут в С++20

- Networking v1 — имеет все шансы попасть в C++20; библиотека для работы с сокетами, в основе которой лежит boost::asio.

Далее рассматриваются TS, работа над которыми все ещё продолжается.

Некоторые из них — но, определенно, не все — войдут в состав С++20.

Модули (Modules) [pdf]

Модули по-прежнему находятся в разработке, однако, в их жизни случилось серьезное событие — стал доступен ранний черновик TS Модулей. В его публичной версии за прошедшее время ничего не изменилось (не считая пары мелких деталей) — т.е. модули по-прежнему основываются на дизайне Microsoft и не экспортируют макросы. По этому вопросу хотелось бы услышать мнение членов комитета, поскольку есть подозрения, что это не окончательное решение.

Concurrency v1 [pdf]

Опубликован, и уже на следующей встрече будет частично принят в С++20. Содержит улучшения, которые сделают futures неблокирующими (в отличие от std::async), а также latches, барьеры и atomic smart pointers. Не вошел в С++17 по причине того, что был поздно опубликован и не получилось собрать достаточно практического опыта.

Непосредственно имплементация была вдохновлена MS Visual Studio, HPX и just::thread. Перед встречей были опасения, что новые предложения P0676 и P0701 могут отодвинуть принятие TS на неопределенный срок.

Transactional Memory v1 [pdf]

Опубликован, однако по этому TS еще совсем недавно у его же авторов оставались вопросы по части того, насколько быстрыми могут быть атомики и shared_ptr вне транзакций, если они должны с транзакцией взаимодействовать. Остается ждать разъяснений по поводу того, изменилось ли что-либо с прошлого раза.

Library Fundamentals v2

Опубликован. Нечто вспомогательное, потребуется для С++20.

Executors v1 [pdf]

В разработке. Должен войти в С++20, т.к. на него завязаны несколько других TS библиотек, связанных с гетерогенными вычислениями.

Reflection v1 [pdf]

В разработке. Есть все шансы попадания в С++20, ибо ему будет посвящена одна из грядущих встреч.

В основе TS лежат интроспекция кода и (с недавних пор) материализация (reification). По мнению комитета, TS пригодится в метапрограммировании, ставшему популярным благодаря Boost::Hana и аналогичных библиотек — а также для гетерогенных контейнеров.

Concurrency v2

В разработке на ранней стадии. Библиотека concurrent data structures, сoncurrent queues, lock-free алгоритмов и структур данных; включает в себя Hazard pointers (указатели опасности), RCU (безопасное освобождение памяти для lock-free контейнеров), atomic views. Вероятность попадания в С++20 крайне мала, т.к. находится еще на ранней стадии — при этом комитет осознает востребованность этого функционала и он, по словам автора, в самой активной разработке.

Parallelism v2

В разработке. Оказывается, за время разработки Parallelism v1 сделали не только Parallel STL для CPU, но и для GPU. Parallelism v2 —

Library Fundamentals v3

В разработке.

Contracts v1

В разработке. Будет либо TS, либо включение в стандарт С++20. Вкратце: улучшенная версия assert, которая позволяет проводить проверку пре- и пост- условий (т.е. инварианты). По мнению комитета, библиотека поможет С++ стать более безопасным языком, чтобы разработчики ПО для медицины, автомобилей, авиации и кибер-безопасности спали спокойней.

Numerics [pdf]

В разработке на ранней стадии. Кое-что из продвинутой арифметики наверняка войдет в С++20: decimal floating point, bounded types (например, fixed point types), unbounded types, multiprecision arithmetic. Должно пригодиться в работе в работе игровым разработчикам (которые, впрочем, привыкли сами писать то, что им требуется).

2D Graphics v1

На ранней стадии.

По мелочи

Идёт работа над добавлением новых функций к std::string — starts_with, ends_with.

Стоит заметить, что причиной появления сразу нескольких будущих TS стали распределенные и гетерогенные вычисления. Участники комитета понимают, что вот уже долгое время CUDA/OpenMP/OpenCL обгоняет нативный C++. В данный момент, все функции вроде std::invoke, std::async, параллельные алгоритмы и пр. предполагают, что std::thread используется исключительно на CPU; и даже несмотря на то, что черновик Executors TS содержит подвижки на этом фронте в виде включения в него новых фич, этого будет недостаточно, и работы предстоит еще очень много.

Уже продолжительное время эксперты из Google, NVidia, Codeplay и NASDAQ принимают участие в работе над черновиками грядущих TS, чтобы определить направление развития С++, и приоритеты будущего языка вам известны: Concurrency, Parallelism, Transactional Memory, и Networking.

Время покажет, что из обещанного действительно войдет в C++20, и насколько оправдаются наши надежды.

Литература

Michael Wong — What's in C++20 and the C++17 final score card

Обсуждение

2017 Toronto ISO C++ Committee Discussion Thread (Concepts in C++20; Coroutines, Ranges and Networking TSes published)

C++17: The Language Features — Nicolai Josuttis

|

Метки: author HotWaterMusic программирование it- стандарты c++ c++20 iso |

Разработка скриптов-обёрток с помощью инструмента Sparrow |

Доброе время суток! В данном посте я хочу рассказать как с помощью инструмента Sparrow лёгко и просто писать собственные обёртки к существующим скриптам и утилитам, а так же зачем вам это может понадобиться.

Очень часто мы имеем дело с различными скриптами, которые нам приходится запускать для разных задач и на разных серверах. Эти скрипты могут быть написанными нами самими же или устанавливаться как часть пакетов программного обеспечения. Так или иначе очень часто задача сводится к тому, что нужно просто запустить некий скрипт с набором параметров:

script Основной трудностью здесь может быть, то что аргументы скрипта могут быть достаточно развесистыми и сложными, и при этом, в зависимости от контекста задачи, ещё и разными. Это порождает ряд неудобств, конечно не таких критичных, но тем не менее о которых хочется упомянуть:

Приходится каждый раз вспоминать ( или искать в history ) аргументы передаваемые на вход скрипту, если запускаешь скрипт вручную.

- Если прописываешь запуск скрипта в крон, то, в случае с большим количеством аргументов, записи получаются сложные, и, как следствие, тяжело читаемые и редактируемые, легко ошибиться при очередной правке вручную.

Итак, здесь нас могут выручить скрипты-обёртки, которые будут инкапсулировать все, что связанно с логикой подготовки входных параметров для заданной скрипта, а затем запускать данный скрипт с данными параметрами.

Вместо того, что бы писать свои скрипты-обёртки можно воспользоваться инструментом Sparrow, и я покажу сейчас как легко и просто это можно сделать.

Установка Sparrow

Sparrow — это CPAN модуль, поэтому ставим его соответственно:

$ cpanm Sparrow Выбор скрипта, для которого будем писать обёртку

Так как это обучающая статья — выберу любой скрипт, в чисто ознакомительных целях, в реальной жизни, это будет скрипт или скрипты, которые вы используете в своей работе. Пусть это будет утилита speedtest-cli, предназначенная для тестирования скорости интернета на вашем локальном узле. Судя по документации, у скрипта достаточное большоеи количество настроек, задаваемых через аргументы командной строки — как раз тот самый случай, когда обёртка может быть уместна. Представим себе что мы хотим запускать данный скрипт по крону и отсылать отчёты что бы анализировать доступность интернета в течение определённого периода времени. Пердположим на интересуют два варианта вызова скрипта:

sppedtest-cli --no-download # не выполнять тест скачивания и

speedtest-cli --no-upload # не выполнять тест закачивания И в обоих случаях мы хотим всегда добавлять опцию

--bytes # выводить информацию в отчёте в байтах, а не в битах Также, допустим что в первом случае мы хотим указать тайм-аут ожидания при http запросах:

--timeout 10 # http тайм-аут Хорошо, таким образом у нас есть два отдельных запуска скрипта speedtest-cli с различными параметрами.

Написание скрипта-обёртки в виде Sparrow плагина

Создаём скрипт-историю:

$ nano story.bash

speedtest-cli $(args_cli)В данном случае всю работу делает предопределённая в Sparrow bash функция args_cli, котороя прозрачно передаст на вход скрипта speedtest-cli все входные параметры.

Определяем загрузчик утилиты speedtest-cli. Sparrow умеет ставить зависимости для скриптов, поддерживая ряд пакетных менеджеров, определённых для различных языков программирования, в том числе для Python. Утилита speedtest-cli ставится как pip модуль, так что просто определим файл зависимостей в стиле установщика pip:

$ nano requirements.txt

speedtest-cli==1.0.6Хорошо, идём дальше осталось определить файл с мета данными плагина и собственно загрузить его в репозиторий Sparrow плагинов:

$ nano sparrow.json

{

"name" : "speedtest-cli",

"description" : "Simple wrapper for speedtest-cli from https://github.com/sivel/speedtest-cli",

"version" : "0.0.1",

"url" : "https://github.com/melezhik/sparrow-plugins/tree/master/speedtest-cli",

"category": "utilities",

"python_version" : 2,

"sparrow_version": "0.2.45"

}Формат файла мета данных для Sparrow плагина подробно описан в документации по Sparrow, здесь мы его разбирать не будем, нам важно лишь то, что плагин называется аналогично скрипту, для которого он предоставляет обёртку.

Теперь у нас все готово, что бы загрузить плагин в репозитарий:

$ sparrow plg upload # запускаем из дериктории где лежат файлы плагинаНастройка Sparrow задач для запуска скрипта-обёртки

Здесь собственно начинается самое интересное. Это то, как мы будем использовать созданный нами плагин для запуска утилиты speedtest-cli, описанной ранее.

Допустим, мы хотим запускать данную утилиту на другом сервере. Не трудно догадаться, что сначала нам необходимо установить соответсвующий Sparrow плагин:

$ sparrow plg install speedtest-cliЕсли все пройдёт успешно мы получим установленный Sparrow плагин и собственно саму утилиту speedtest-cli вместе со всеми Python зависимостями.

Сделаем простую поверку, что плагин работает:

$ sparrow plg run speedtest-cli -- --helpЕсли все хорошо, то мы получим help от утилиты speedtest-cli.

Что бы связать запускаемый плагин с определёнными параметрами создадим задачи. Вспоминаем, что нам требуется запускать speedtest-cli с разными аргументами.

$ sparrow project create monitoring # создадим проект - это контейнер для задач

$ sparrow task add monitoring nettest-download speedtest-cli

$ sparrow task add monitoring nettest-upload speedtest-cli Последними двумя командами мы создали задачи для разных запусков утилиты speedtest-cli, теперь настроим их:

$ sparrow task ini monitoring/nettest-download

---

args:

- timeout: 10

-

- bytes

- no-upload $ sparrow task ini monitoring/nettest-upload

---

args:

-

- bytes

- no-downloadТеперь нам просто отсатется запустить наши задачи:

$ sparrow task run monitoring/nettest-upload

$ sparrow task run monitoring/nettest-uploadНаши обёртки готовы и работают как надо.

Заключение

Sparrow позволяет легко и просто писать обёртки для практически любых консольных утилит. Это избавляет от необходимости писать отдельные скрипты для запуска одной и той же утилиты с различными параметрами, для этого есть простой и мощный инструмент Sparrow задач. Sparrow плагины переносимы практически на любой Linux сервер, где установлен Perl. Также настройка скриптов в стиле Sparrow подразумевает генерацию входных данных в форматах YAML и JSON, что сильно упрощает запуск подобных скриптов из любых современных языков программирования и делает их автоматизацию более простой. Для примера можно посмотреть проект Sparrowdo, который позволяет настраивать и запускать Sparrow задачи удалённо по ssh.

Ссылки по теме

- код плагина speedtest-cli — https://github.com/melezhik/sparrow-plugins/tree/master/speedtest-cli

- страница плагина в репозитории SparrowHub — https://sparrowhub.org/info/speedtest-cli

- документация по Outthentic — фреймворка по разработке скриптов, который используется при написании Sparrow плагинов — https://github.com/melezhik/outthentic

- документация по Sparrow — менеджере сценариев — https://github.com/melezhik/sparrow

С уважением, Алексей Мележик, автор Sparrow

|

Метки: author alexey_melezhik разработка под linux perl perl6 devops (*nix) автоматизация python |

Метод BFGS или один из самых эффективных методов оптимизации. Пример реализации на Python |

|

Метки: author FUNNYDMAN программирование машинное обучение математика алгоритмы python оптимизация bfgs |

А был ли взлом «Госуслуг»? Расследование расследования от ИБ Яндекса |

В первых сообщениях об угрозе говорилось о внедрении на страницы сайта фрагментов с iframe, подгружающих данные с не менее 15 сомнительных доменов. Наши аналитики достаточно быстро приступили к изучению кода страниц сайта, чтобы защитить пользователей Яндекс.Браузера при помощи существующего у нас механизма предотвращающего подобные угрозы. О самом механизме расскажем чуть ниже, но главное здесь в другом – найденные фрагменты кода были нам хорошо знакомы.

Если вы хорошо знакомы с разработкой расширений для популярных браузеров, то знаете, что у авторов существует не так много способов для заработка на собственных творениях. Платные расширения почти не встречаются, и в результате большинство попыток заработать строится вокруг того, что они просто внедряют рекламу в код посещаемых пользователями страниц. Для этого существуют целые партнерские программы, которые предлагают авторам расширений встроить код, который их расширения должны внедрять во все посещаемые пользователем страницы. Обычно встроенный фрагмент занимается тем, что показывает дополнительную, часто не очень качественную рекламу, но, вообще говоря, технологически позволяет осуществить и что-то более опасное. На gosuslugi.ru присутствовали фрагменты кода, которые в подобных расширениях могут использоваться для сбора статистики или показа рекламы.

Такие фрагменты попадают в код страницы на стороне клиента, если у него установлено расширение. И здесь напрашивается вопрос: «как же тогда этот код оказался на стороне сервера?» И у нас есть гипотеза.

Мы считаем, что появление данного кода на страницах gosuslugi.ru не связано со взломом, целенаправленной атакой. Более вероятно, что у администратора, который редактировал содержимое этих страниц, было установлено подобное расширение. Оно внедрило посторонний код в документ, когда он загружался на сторону клиента, а на сервере он появился уже после того, как сотрудник сохранил свои изменения. В пользу этой версии говорит еще один факт. Мы внимательно мониторили все найденные фрагменты, и ни один из них так и не начал подгружать какой-либо контент – авторы кода вряд ли предполагали, что получат доступ к пользователям портала государственных услуг. Но это не означает, что угрозы не было — они могли начать делать это в любой момент, как только поняли, на страницах какого сайта оказался их код.

А теперь про механизм защиты. У порядка процента пользователей Яндекса возникает аналогичная проблема с посторонним контентом в посещаемых страницах. И это очень много. Поэтому мы давно и активно боремся с подобной угрозой. Прежде всего, мы защищаем пользователей Яндекс.Браузера с помощью механизма, который препятствует подгрузке данных с выявленных сомнительных адресов. Информация о новых угрозах оперативно попадает в базу SafeBrowsing, которая доступна Браузеру, Поиску и другим нашим сервисам при помощи специального API. Это позволяет нам быстро пресекать распространение эпидемий без необходимости выпускать обновление для самого приложения.

К счастью, в случае с Госуслугами пользователи Яндекс.Браузера по большей части уже были защищены: 15 найденных фрагментов из 16 уже были внесены в базу SafeBrowsing еще до ситуации с сайтом в рамках обычного процесса поиска угроз.

И еще кое-что. Иметь щит на стороне клиента хорошо, но и о защите на стороне сервиса тоже не стоит забывать. Мы рекомендуем всем крупным сервисам, работающим с приватными данными пользователей, внедрять поддержку Content Security Policy. Это позволит заблокировать подгрузку стороннего контента и защитить ваших пользователей. Сервисы Яндекса уже давно используют CSP для предотвращения загрузки постороннего кода.

|

|

[Из песочницы] Рекомендации по безопасности при работе с Docker |

Docker ускоряет разработку и циклы развертывания и тем самым позволяет выдавать готовый код в невероятно короткие сроки. Но у этой медали есть и обратная сторона — безопасность. Стоит знать о ряде вещей, на безопасность которых влияет Docker, и именно о них пойдет речь в этой статье. Мы рассмотрим 5 типовых ситуаций, в которых образы, развернутые на Docker, становятся источником новых проблем с безопасностью, которые вы могли и не учитывать. Также мы рассмотрим крутые инструменты для решения этих проблем и дадим совет, которым вы можете воспользоваться, чтобы удостовериться, что все люки задраены при деплое.

1. Достоверность образа

Начнем с проблемы, которая является, пожалуй, неотъемлемой частью самой природы Docker — достоверность образа.

Если вы хоть когда-нибудь пользовались Docker, то вам должно быть известно, что с его помощью вы можете разместить контейнеры практически на любом образе — как на образе из официального списка поддерживаемых репозиториев, таких как NGINX, Redis, Ubuntu, или Alpine Linux, так и на любом другом.

В результате у нас есть огромный выбор.

Если один контейнер не решает всех ваших задач, вы можете заменить его на другой. Но разве такой подход самый безопасный?

Если вы со мной не согласны, давайте рассмотрим этот вопрос с другой стороны.

Когда вы разрабатываете приложение, менеджер пакетов позволяет с легкостью использовать чужой код, но стоит ли использовать чей попало код в разработке? Или к любому коду, который вы не анализировали, следует относиться со здоровым уровнем подозрительности? Если безопасность хоть что-то для вас значит, то я бы на вашем месте всегда тщательно проверял код, прежде чем интегрировать его в свое приложение.

Я прав?

Ну и с таким же подозрением надо относиться к Docker-контейнерам.

Если вы не знаете автора кода, как вы можете быть уверены в том, что выбранный вами контейнер не содержит бинарников другого вредоносного кода?

Верно, никакой уверенности тут быть не может.

При таких условиях я могу дать три совета.

Используйте приватные или доверенные репозитории (trusted repositories)

Во-первых, можно использовать приватные или проверенные репозитории, вроде доверенных репозиториев Docker Hub.

В официальных репозиториях можно найти следующие образы:

- Операционные системы (Ubuntu, например)

- Языки программирования (PHP и Ruby)

- Сервера (MySQL, PostgreSQL и Redis)

Что выделяет Docker Hub из других репозиториев, помимо прочего, — это то, что образы всегда сканирует и просматривает Docker’s Security Scanning Service.

Если вы не слышали об этом сервисе, то вот цитата из его документации:

Docker Cloud и Docker Hub могут сканировать образы в приватных репозиториях, чтобы убедиться, что в них нет известных уязвимостей. После этого они отправляют отчет о результатах сканирования по каждому тэгу образа.

В итоге, если вы используете официальные репозитории, вы будете знать, что контейнеры безопасны и не содержат вредоносный код.

Опция доступна для всех платных тарифов. На бесплатном тарифе она тоже есть, но с ограничением по времени. Если вы уже на платном тарифе, то вы можете воспользоваться функцией сканирования, чтобы проверить, насколько безопасны ваши кастомные контейнеры и нет ли в них уязвимостей, о которых вы не знаете.

Таким образом, вы можете создать приватный репозиторий и использовать его внутри вашей организации.

Используйте Docker Content Trust

Еще один инструмент, которым стоит воспользоваться — Docker Content Trust.

Это новая функция, доступная в Docker Engine 1.8. Она позволяет верифицировать владельца образа.

Цитата из статьи о новом релизе, автор Diogo M'onica, ведущий специалист по безопасности Docker:

Прежде чем автор публикует образ в удаленном реестре, Docker Engine подписывает этот образ приватным ключом автора. Когда вы загружаете к себе этот образ, Docker Engine использует публичный ключ для верификации, что этот образ именно тот, который выложил его автор, что это не подделка и что на нем есть все последние обновления.

Подведем итог. Сервис защищает вас от подделок, атак повторного воспроизведения и компрометирования ваших ключей. Очень сильно рекомендую ознакомиться с этой статьей и с официальной документацией.

Docker Bench Security

Еще один инструмент, которым я недавно пользовался — это Docker Bench Security. Это большая подборка рекомендаций по развертыванию контейнеров в продакшене.

Инструмент основывается на рекомендациях из the CIS Docker 1.13 Benchmark, и применяется в 6 областях:

- Конфигурация хоста.

- Конфигурация демона Docker.

- Файлы конфигурации демона Docker.

- Образы контейнеров и build файлы.

- Runtime контейнера.

- Операции Docker security.

Чтобы его установить, клонируйте репозиторий при помощи

git clone git@github.com:docker/docker-bench-security.gitПотом введите cd docker-bench-secutity и запустите такую команду: