Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Wi-Fi в метро: архитектура сети и подземные камни |

Всего за пару лет поездка москвича в метро перестала быть ежедневной рутиной. Если раньше единственным развлечением в подземке были чтение книг, прессы и MP3-плеер, то теперь к ним добавились онлайн-шоппинг, просмотр сериалов, деловая переписка, даже знакомства в Tinder и квесты. А все благодаря появлению в метро бесплатной сети Wi-Fi. Порядка 80% москвичей регулярно подключаются к сети MT_FREE в метро, не задумываясь, как это работает и чьими силами это сделано. Бытует мнение, что Wi-Fi в метро “провел” сам метрополитен, но это не совсем верно. Беспроводная сеть — это проект “МаксимаТелеком”. Для компании это был первый опыт строительства высокоскоростной сети Wi-Fi с уникальными в мировой практике инженерными и техническими решениями. В этом посте мы расскажем, как организована сеть Wi-Fi в метро Москвы.

На самом деле у нас две сети...

Радиосеть внутри вагонов

Вы входите в вагон, видите стикер с названием сети или уже по привычке включаете Wi-Fi на своем телефоне. В это же время устройство подключается к сети с SSID MT_FREE. Она организована высокоплотными точками доступа, которые находятся в каждом вагоне, работают в двух диапазонах 2,4 ГГц и 5 ГГц и поддерживают стандарты 802.11a/b/g/n. Управляет ими контроллер в головном вагоне. В составе таких вагонов два, а значит, и контроллера тоже два. Все оборудование в подвижном составе, в том числе и между вагонами, соединяют кабели — витая пара.

Радиосеть поезд-тоннель

После прохождения внутренней поездной сети данные передаются на стационарную сетевую инфраструктуру с использованием радиоканала поезд-тоннель. Он устанавливается между базовой станцией, находящейся в каждом головном вагоне, и базовыми станциями, расположенными вдоль пути следования подвижного состава в тоннеле, а также на открытых участках путей. Расположение базовых станций вдоль путей таково, что поезд движется в сплошном радиополе. Благодаря этому перерывы в связи минимальны. Базовые станции на поезде размещаются так же, как и контроллеры точек доступа на каждом головном вагоне, при этом во время движения состава активна только одна из станций. Радиоканал работает в том же частотном диапазоне, что и Wi-Fi – 5 ГГц, но использует проприетарный протокол передачи данных. В отличие от оборудования внутри поезда, оборудование радиоканала поезд-тоннель можно увидеть снаружи подвижного состава и в тоннелях/на открытых участках путей.

Разрешенный частотный спектр 5150 – 5350 МГц разбит на пять непересекающихся каналов по 40 МГц каждый. На каждой линии используются все пять каналов, обычно в последовательности 1-3-5-2-4, чтобы максимально избежать влияния помех при работе соседних устройств в одном частотном диапазоне.

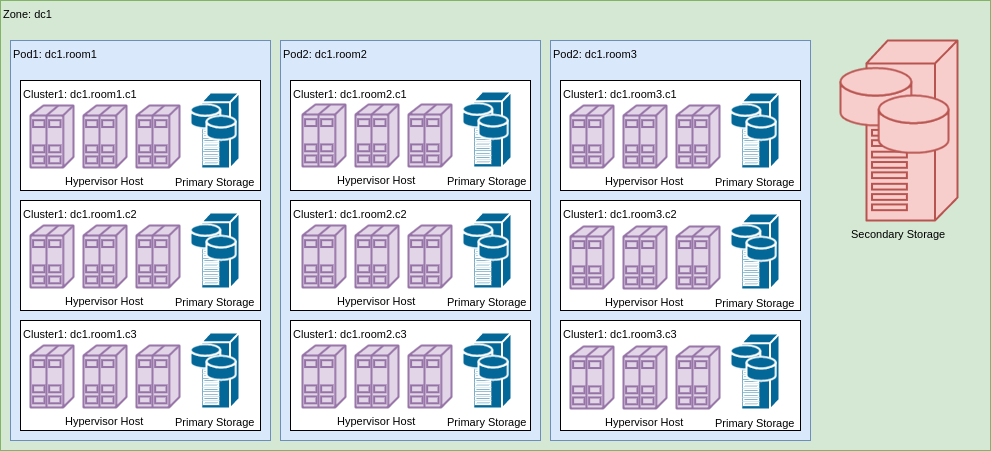

Сетевая архитектура

Каждая базовая станция на пути следования поезда подключена к расположенным в служебных помещениях метрополитена коммутационным узлам с помощью выделенной волоконно-оптической сети. Бесперебойное электроснабжение базовых станций также организовано с помощью оборудования, установленного в этих коммутационных узлах.

Архитектура стационарной сети передачи данных не отличается от типовой архитектуры операторов связи. Это “двойная звезда” с географическим резервированием каналов связи и ключевого оборудования. В сети есть несколько каналов связи с магистральными операторами связи, общей пропускной способностью более 60 Гбит/с.

Базовые станции подключаются в коммутаторы с использованием WDM-технологии для экономии волокон (то есть по одному волокну на разных длинах волн одновременно происходит прием и передача данных). Коммутаторы доступа имеют по два аплинка с георезервированием (кабели ВОЛС физически расположены в разных тоннелях) в коммутаторы агрегации по 1 Гбит/с каждый. Те, в свою очередь, подключены по георезервированным линиям связи в коммутаторы ядра, но уже интерфейсами 10 Гбит/с.

Хьюстон, у нас проблемы...

Технологические сложности

Для работы в метрополитене нужно оборудование:

- выдерживающее тяжелые условия эксплуатации в тоннеле (взвешенная металлическая пыль и машинное масло) и на подвижном составе (резкие перепады температур и вибрация);

- удовлетворяющее требованиям метрополитена (использовать негорючие материалы, соответствовать требованиям по электромагнитной совместимости, работать от нестандартных источников питания);

- имеющее необходимую для работы сети функциональность.

В метрополитене в подвижном составе используется постоянный ток с номинальным напряжением 80В. Однако в зависимости от состояния аккумуляторных батарей и количества разрывов в контактном рельсе реальное напряжение “скачет” от 30В до 150В.

Найти приемлемый по цене блок питания с такими параметрами нам не удалось, а стоимость подходящих вариантов делала проект нецелесообразным.

Здесь нас очень выручила компания из Новосибирска «Сибконтакт». Под наши требования коллеги изготовили блок питания, который мы успешно протестировали и в дальнейшем использовали во всех составах. Устройства оказались очень надежными, стоили недорого, а производить необходимое количество поставщик успевал за несколько недель, а не месяцев, как это происходит обычно.

Также мы столкнулись с нестандартным электропитанием в тоннеле — двухфазной сетью с напряжением 127В. Запитать оборудование, работающее от однофазной сети 220В от нее невозможно, и мы протягивали новые кабели от собственных источников питания, установленных в технических помещениях станций. Это повысило надежность сети, поскольку мы применили источники бесперебойного питания и автоматы ввода резерва.

Большие трудности вызвало и многообразие типов поездов. Это повлияло на работу по проектированию размещения оборудования локальных сетей составов — она была колоссальной. Во-вторых, при строительстве выяснилось, что почти все составы, даже одной серии и года выпуска – разные. Это связано с тем, что их постоянно модернизировали и устанавливали дополнительное оборудование. Такие работы проводились отдельно по каждому составу, а мы каждый раз оснащали поезд уникальным образом.

Серьезные вопросы возникли при радиопланировании сети. Они были связаны как с разнообразием материалов, из которых выполнены тоннели, так и с нехваткой исходной информации по их конструкции, геометрии, а также ответвлениям и препятствиям.

Мы сами полностью обследовали все тоннели — в московском метро их более 330 км, а в двухпутном исчислении более 660 км. Мы применяли определенные метрики и правила размещения базовых станций, а уже после установки и запуска оборудования в ходе эксплуатации проводили измерения радиопокрытия и уточняли оптимальные точки размещения оборудования. Некоторые базовые станции нам пришлось перенести уже после установки.

Эти трудности заставили нас вместе с коллегами из нижегородской компании «Радио Гигабит» провести научно-исследовательские работы и разработать уникальную методику радиопланирования в тоннелях, которая базируется на симуляции (математическом моделировании) канального и системного уровня транспортной радиосети в тоннелях и на открытых участках. В новых проектах мы уже не гадаем, а точно знаем, как именно расставлять оборудование для получения заданных характеристики канала.

Архитектурные сложности

Основное оборудование, формирующее радиоканал между составом и тоннелем располагается в “голове” (помним, что их две), при этом вагоны при заезде в депо в подвижных составах постоянно меняются. Сеть работает в постоянном движении, в результате которого все время меняются сетевые порты и физические устройства, через которые идет трафик одних и тех же сессий из одного состава. В связи с этим мы решали целый ряд архитектурных проблем:

- полностью автоматическая настройка сети состава при замене или изменении порядка вагонов

- распределение внутривагонных точек доступа между двумя контроллерами W-Fi в поезде

- корректное получение пользователями и оборудованием в составе IP-адресов

- “выход” трафика пользователя через правильную базовую станцию, активную в данный момент времени

- перескакивание MAC-адресов с одного порта стационарного коммутатора на другой при движении поезда (в стационарной сети такое не происходит или случается крайне редко), требующее постоянного “переобучения” сетевых портов на MAC-уровне

Отдельную проблему представлял мониторинг нашей сети. Обычные системы мониторинга сетевого оборудования неспособны отличить ситуацию, при которой состав уходит из зоны радиопокрытия от поломки оборудования состава. Это приводит к большому количеству ложных срабатываний системы предупреждений о неисправностях. Кроме того, единицей мониторинга и технического обслуживания является именно поезд (поскольку всегда надо понимать, где находится в данный момент та или иная единица оборудования и как она соединена с другими элементами сети), а на практике составы в метро — сущность динамическая, состав вагонов в которой может меняться ежедневно, а то и по два раза в день. Мы создали собственные средства мониторинга, которые автоматически детектируют появление поезда в зоне покрытия, “обходят” его, определяя состав и порядок следования вагонов и установленного в них оборудования и представляют операторам центра управления сетью данные уже в разрезе фактически действующих на линии поездов.

Это ключевые технические задачи, которые «МаксимаТелеком» решала при планировании и создании сети. Причем процесс этот продолжается до сих пор, поскольку нагрузки на сеть растут и появляются новые станции метро. Многие уроки, полученные в ходе московского проекта, мы применили при строительстве сети Wi-Fi в метро Петербурга, благодаря этому её удалось сделать гораздо более производительной и быстрой. Но об этом мы расскажем в следующих постах.

|

Метки: author SKarasev сетевые технологии беспроводные технологии блог компании maximatelecom wi-fi метро mt_free сеть максимателеком |

Как Яндекс создавал курс по C++, или Почему нам всё пришлось переписать |

Недавно Физтех, Яндекс и ШАД запустили ещё один курс на платформе Coursera — «Основы разработки на C++: белый пояс». Он посвящён знакомству с С++. Я расскажу, для кого этот курс, как мы его готовили, что получилось в итоге и каковы наши дальнейшие планы.

Как всё началось, было выброшено и началось снова

Онлайн-специализацию из пяти курсов по С++ мы задумали прошлым летом. Сначала сочиняли программу потихоньку, потом активнее, и в октябре начали снимать видео.

Мы успели снять почти половину первого курса, но тут Илья, лидер команды преподавателей, посмотрел доклад Кейт Грегори о типичных ошибках обучения C++ и понял, что мы допустили большинство из них. 30 ноября Илья написал в общий чатик:

Ребята! У меня плохие новости. Я осознал, что наш первый курс — ***** :(

Тут нужно заметить, что мы с самого начала решили делать курсы, которые, во-первых, рассказывали бы про современный С++ и, во-вторых, были бы направлены на практику. Нет смысла пересказывать учебник или справочник — надо давать людям скилл, чтобы человек мог начать писать код после первых же уроков.

И всё-таки академическая привычка и склонность к дотошности оказались слишком сильны. В первоначальном варианте программы темы шли друг за другом, подчиняясь строгой логике. Все зависимости между ними были соблюдены, возможности С++ рассматривались глубоко и подробно. К сожалению, в результате стандартные контейнеры и алгоритмы впервые упоминались не раньше второго курса, потому что являются шаблонными конструкциями — а до середины второго курса, думали мы, слушатели ещё не будут знать шаблоны.

Наверное, всем понятно, в чём тут проблема. Чтобы пользоваться std::vector, совершенно не обязательно знать, как устроены шаблоны и даже что это такое.

Момент осознания был оглушительным: мы с самого начала знали, что курс должен быть практическим и давать скилл, а не справку — и всё равно совершили ошибку. Мы пали жертвой собственной экспертизы и стали углубляться во внутреннее устройство С++, вместо того чтобы рассказывать, как легко с его помощью можно решать практические задачи.

Стало понятно, что программу надо переписывать, а б'oльшую часть отснятых видео выбросить и снять заново. Это добавило команде преподавателей много работы и привычку всё время думать о практичности курса.

Что получилось

Пока получился первый курс. Предполагается, что в начале курса слушатель может увидеть язык С++ впервые в жизни (но при этом стоит представлять, что такое программирование в целом, и не бояться слов «переменная», «цикл», «список»), а в конце будет способен написать небольшое key-value хранилище с возможностью добавлять туда записи и запрашивать все значения по какому-нибудь известному ключу.

Чтобы человеку было комфортно решать такую задачу, надо рассказать ему про базовые конструкции языка, функции, несколько стандартных контейнеров и алгоритмов, структуры и классы, потоки ввода и вывода, исключения. Рассказывать стоит не слишком глубоко, но так, чтобы всем этим можно было воспользоваться. Ну и конечно, надо выдать побольше задач, чтобы после просмотра видео можно было сразу «потрогать» материал собственными руками.

Отзывы бета-тестеров и слушателей внушают оптимизм. Мы надеемся, что у нас получился хороший вводный курс, к тому же на русском языке, что должно серьёзно облегчить восприятие материала многими людьми.

Остальные плюсы описаны выше: ориентированность на практику, много задач, использование современных возможностей языка. Авторы курса — старшие разработчики Яндекса, которые знают С++ на глубоком уровне и готовы поделиться богатым опытом применения языка в боевых проектах. Поэтому и лекции, и задания учат наиболее эффективному, безопасному и простому программированию на С++.

В планах — более хардкорные курсы, от жёлтого до чёрного пояса. Их мы стараемся готовить так, чтобы даже сведущие в С++ люди могли с интересом послушать и, возможно, узнать что-то новое. А пока советуйте наш первый курс друзьям-новичкам, им понравится.

Что именно рассказываем

Курс длится пять недель. На каждой неделе с первой по четвёртую слушателю предстоит посмотреть 10-20 коротких видео и решить несколько задач. Фрагмент курса для каждой недели содержит как задачи и тесты, необходимые для получения сертификата, так и дополнительные необязательные задачи — для тех, кто хочет потренироваться побольше. Последняя неделя полностью посвящена решению финальной задачи.

Доступ к обязательным заданиям стоит около 1600 рублей, но студенты могут подать в Coursera заявку на финансовую помощь и получить доступ бесплатно. Все видео и необязательные задания — бесплатные по умолчанию.

Программа курса выглядит так:

Неделя 1

Обзор возможностей С++

Hello, worldКомпиляция, запуск, отладка

Обзор типов

Операции с простыми типами

Операции с контейнерами

Языковые конструкции

Установка EclipseОперации

Создание проекта в Eclipse

Отладка в Eclipse

ПрисваиваниеУсловные операторы и циклы

Арифметические

Логические

Неделя 2

Функции

СинтаксисКонтейнеры

Передача параметров по значению

ссылки как способ изменить переданный объект

const-ссылки как способ сэкономить на копировании

const защищает от случайного изменения переменной

std::vector

Std::map

Std::set

Взгляд в будущее: обход словаря с помощью structured bindings

Неделя 3

Алгоритмы и лямбды

min, max, sortВидимость и инициализация переменных

count, count_if, лямбды

современный аналог std::transform — for (auto& x: container)

ООП

Введение в структуры и классы

Неделя 4

ООП: примеры

Работа с текстовыми файлами и потоками

Перегрузка операторов

Встраивание пользовательских типов в контейнеры

Исключения

Неделя 5 — курсовой проект

antoshkka, который участвует в работе группы по стандартизации, помогал нам и с курсом: «Язык C++ красив, быстр, используется большинством крупных IT компаний, а специалисты по этому языку ценятся во всём мире. К несчастью, многие курсы и учебники по C++ на самом деле учебники по «С», а с такими знаниями вам придётся несладко. Поэтому мы подготовили курс по правильному C++, с классами и без утечек памяти. Если ты знаешь любой другой язык программирования и хочешь открыть для себя мир правильного C++, то наш курс для тебя».

|

|

Обобщённое копирование связных графов объектов в C# и нюансы их сериализации |

Классификация подходов к копированию

1) по обобщённости: рутинные и обобщённые

Рутинные подходы подразумевают имплементацию своей логики копирования для каждого конкретного класса, то есть создание ряда специальных служебных методов, отвечающих за копирование тех или иных сущностей. Методы эти зачастую содержат скучный и однообразный код в больших объёмах. Ручное написание таких методов утомительно и чревато ошибками. Однако автоматические генераторы кода облегчают эту задачу, хотя зачастую и накладывают свои ограничения на объекты и структуру графов. Преимущество данных методик в их высокой производительности при малом потреблении памяти. Обычно они применяются в protobuf-сериализаторах.

Обобщённые же подходы избавлены от необходимости написания дополнительной однотипной логики за счёт некоторого снижения производительности, а также применимы к объектам различных типов, отвечающим определённым требованиям.

2) по возможностям сериализации и десериализации: без поддержки, с точной и сверхточные поддержкой

Сериализация предполагает возможность сохранения информации о состояния графа объектов в строку либо массив байт, а десериализация — восстановления по данной информации графа с исходным состоянием, что, в свою очередь, позволяет использовать эти механизмы для глубинного копирования. Существует немало альтернативных реализаций сериализаторов для различных форматов, однако, даже будучи близкими по назначению, они очень различаются в нюансах. Но так или иначе их можно разделить на два класса: точные, что в определённых случаях вносят свои искажения в копию, и сверхточные, которые позволяют восстанавливать сложные графы без изменений.

Искажения чаще всего бывают следующего характера:

— нарушение ссылочной структуры графа

[причины: несколько ссылок на один объект, замкнутые циклические ссылки]

var person = new Person();

var role = new Role();

person.MainRole = role; // use the one 'role' instance before serialization

person.Roles.Add(role); // but possible two separated instances after graph deserializationvar person = new Person();

var role = new Role {Person = person};

person.Roles.Add(role); // may cause stack overflow exception— утрата информации о типах объектов

[причины: применяется ссылка на объект с типом базового класса]

// may cause exception on deserialization

[DataMember]public object SingleObject = new Person();

[DataMember]public object[] Array = new [] { new Person() };— искажение родственных примитивных типов

[причины: ограничения форматов сериализации]

[DataMember]public object SingleObject = 12345L;

// long may be deserialized like int, Guid like string

[DataMember]public object[] Array = new [] { 123, 123L, Guid.New(), Guid.New().ToString() };— потеря свойств при сериализации классов-коллекций

[причины: ограничения сериализаторов]

[CollectionDataContract]

public class CustomCollection: List

{

// property may be lost

[DataMember]public string Name { get; set; }

}— индивилуальные ограничения сериализаторов

[причины: например, многомерные массивы (object[,,,])]

// may cause exception on serialization

[DataMember]public int[,,] Multiarray = new {{{1,2,3}, {7,8,9}}};* перечисленные недостатки присущи даже стандартному DataContractJsonSerializer

Классификация обобщённых способов копирования

1) по охвату структуры графа: поверхностное и глубинное

Поверхностное и глубинное копирование принципиально различны. Пускай даны объекты А и Б, причём А содержит ссылку на Б (граф А=>Б). При поверхностном копировании объекта А будет создан объект А', который также будет ссылаться на Б, то есть в итоге получится два графа А=>Б и А'=>Б. У них будет общая часть Б, поэтому при изменении объекта Б в первом графе, автоматически его состояние будет мутировать и во втором. Объекты же А и А' останутся независимы. Но наибольший интерес представляют графы с замкнутыми (циклическими) ссылками. Пускай А ссылается на Б и Б ссылается на А (А<=>Б), при поверхностном копировании объекта А в А' получим весьма необычный граф А'=>Б<=>А, то есть в итоговый граф попал изначальный объект, который подвергался клонированию. Глубинное же копирование предполагает клонирования всех объектов, входящих в граф. Для нашего случая А<=>Б преобразуется в А'<=>Б', в итоге оба графа совершенно изолированы друг от друга. В некоторых случаях достаточно поверхностного копирования, но далеко не всегда.

2) по охвату состояния графа: полное и частичное

Что касается состояния, то при копировании его можно воспроизводить абсолютно полностью, то есть получать совершенно идентичный клон, либо частично, ограничиваясь лишь существенными для решения задачи данными, например, копировать только публичные члены или же те, что отмечены специальными атрибутами.

Обзор основных методик копирования

1) MemberwiseClone вкупе с рефлексией

Для осуществления поверхностного копирования [shallow copy] объекта в платформе .NET предусмотрен специальный защищённый [protected] метод MemberwiseClone у класса object, который создаёт полную копию объекта путём копирования всех его полей. Используя данный метод в комбинации с рефлексией можно реализовать рекурсивный алгоритм глубинного копирования [deep copy].

Плюсы:

— портабельный

— быстро работает

— не нуждается в публичных и дефолтных конструкторах для создания объекта

Минусы:

— нельзя сериализовать и десериализовать объекты

— копирует все поля подряд без возможности их фильтрации

using System.Collections.Generic;

using System.Runtime.CompilerServices;

namespace Art.Comparers

{

public class ReferenceComparer : IEqualityComparer

{

public static readonly ReferenceComparer Default = new ReferenceComparer();

public int GetHashCode(T obj) => RuntimeHelpers.GetHashCode(obj);

public bool Equals(T x, T y) => ReferenceEquals(x, y);

}

}

using System;

using System.Collections.Generic;

using System.Linq;

using System.Reflection;

using System.Text.RegularExpressions;

using Art.Comparers;

namespace Art

{

public static class Cloning

{

public static List LikeImmutableTypes = new List {typeof(string), typeof(Regex)};

public static T MemberwiseClone(this T origin, bool deepMode,

IEqualityComparer comparer = null) => deepMode

? (T) origin.GetDeepClone(new Dictionary(comparer ?? ReferenceComparer.Default))

: (T) MemberwiseCloneMethod.Invoke(origin, null);

private static readonly MethodInfo MemberwiseCloneMethod =

typeof(object).GetMethod("MemberwiseClone", BindingFlags.NonPublic | BindingFlags.Instance);

private static IEnumerable EnumerateFields(this Type type, BindingFlags bindingFlags) =>

type.BaseType?.EnumerateFields(bindingFlags)

.Concat(type.GetFields(bindingFlags | BindingFlags.DeclaredOnly)) ??

type.GetFields(bindingFlags);

private static bool IsLikeImmutable(this Type type) => type.IsValueType || LikeImmutableTypes.Contains(type);

private static object GetDeepClone(this object origin, IDictionary originToClone)

{

if (origin == null) return null;

var type = origin.GetType();

if (type.IsLikeImmutable()) return origin;

if (originToClone.TryGetValue(origin, out var clone)) return clone;

clone = MemberwiseCloneMethod.Invoke(origin, null);

originToClone.Add(origin, clone);

if (type.IsArray && !type.GetElementType().IsLikeImmutable())

{

var array = (Array) clone;

var indices = new int[array.Rank];

var dimensions = new int[array.Rank];

for (var i = 0; i < array.Rank; i++) dimensions[i] = array.GetLength(i);

for (var i = 0; i < array.Length; i++)

{

var t = i;

for (var j = indices.Length - 1; j >= 0; j--)

{

indices[j] = t % dimensions[j];

t /= dimensions[j];

}

var deepClone = array.GetValue(indices).GetDeepClone(originToClone);

array.SetValue(deepClone, indices);

}

}

var fields = type.EnumerateFields(BindingFlags.Instance | BindingFlags.NonPublic | BindingFlags.Public);

foreach (var field in fields.Where(f => !f.FieldType.IsLikeImmutable()))

{

var deepClone = field.GetValue(origin).GetDeepClone(originToClone);

field.SetValue(origin, deepClone);

}

return clone;

}

}

}

var person = new Person();

var role = new Role();

person.Roles.Add(role);

var deepClone = person.MemberwiseClone(true);* альтернативные, но немного неоптимальные реализации данной методики один и два

2) Сравнение функциональности некоторых современных библиотек сериализации

В плане функциональности хорошие надежды подаёт совсем новая библиотека Replication Framework, о которой не очень давно вышла обзорная публикация на Хабре. Хотя она предназначена для решения более широкого круга задач, одними из ключевых требований при её разработке были реализация глубинного копирования и сверхточной [де]сериализации сколь угодно сложных графов.

Лицензионная версия Replication Framework бесплатна для некоммерческого и учебного использования и предоставляется по запросу. Пробная триал-версия на nuget функциональна до сентября 2017 года.

Реализации методов глубинного копирования на C#

public static T GetDeepClone(this T obj)

{

using (var ms = new MemoryStream())

{

var formatter = new BinaryFormatter();

formatter.Serialize(ms, obj);

ms.Position = 0;

return (T) formatter.Deserialize(ms);

}

} public static T GetDeepClone(this T obj)

{

using (var ms = new MemoryStream())

{ // preserveObjectReferences==true to save valid reference structure of graph

var serializer = new DataContractSerializer(typeof(T), null, int.MaxValue, false, true, null);

serializer.WriteObject(ms, obj);

ms.Position = 0;

return (T) serializer.ReadObject(ms);

}

} public static T GetDeepClone(this T obj)

{

using (var ms = new MemoryStream())

{

var serializer = new DataContractJsonSerializer(typeof(T));

serializer.WriteObject(ms, obj);

ms.Position = 0;

return (T) serializer.ReadObject(ms);

}

} public static T GetDeepClone(this T obj)

{

var json = JsonConvert.SerializeObject(obj);

return JsonConvert.DeserializeObject(json);

} public static T GetShallowClone(this T obj) => obj.MemberwiseClone(false);

public static T GetDeepClone(this T obj) => obj.MemberwiseClone(true); public static T GetDeepClone(this T obj)

{

var snapshot = obj.CreateSnapshot();

return snapshot.ReplicateGraph();

} Всё!

|

|

[Перевод] Как я нашёл баг в процессорах Intel Skylake |

Инструкторы курсов «Введение в программирование» знают, что студенты находят любые причины для ошибок своих программ. Процедура сортировки отбраковала половину данных? «Это может быть вирус в Windows!» Двоичный поиск ни разу не сработал? «Компилятор Java сегодня странно себя ведёт!» Опытные программисты очень хорошо знают, что баг обычно в их собственном коде, иногда в сторонних библиотеках, очень редко в системных библиотеках, крайне редко в компиляторе и никогда — в процессоре. Я тоже так думал до недавнего времени. Пока не столкнулся с багом в процессорах Intel Skylake, когда занимался отладкой таинственных сбоев OCaml.

Инструкторы курсов «Введение в программирование» знают, что студенты находят любые причины для ошибок своих программ. Процедура сортировки отбраковала половину данных? «Это может быть вирус в Windows!» Двоичный поиск ни разу не сработал? «Компилятор Java сегодня странно себя ведёт!» Опытные программисты очень хорошо знают, что баг обычно в их собственном коде, иногда в сторонних библиотеках, очень редко в системных библиотеках, крайне редко в компиляторе и никогда — в процессоре. Я тоже так думал до недавнего времени. Пока не столкнулся с багом в процессорах Intel Skylake, когда занимался отладкой таинственных сбоев OCaml.Первое проявление

В конце апреля 2016 года вскоре после выпуска OCaml 4.03.0 один Очень Серьёзный Индустриальный Пользователь OCaml (ОСИП) обратился ко мне в частном порядке с плохими новостями: одно из нших приложений, написанное на OCaml и скомпилированное в OCaml 4.03.0, падало случайным образом. Не при каждом запуске, но иногда вылетал segfault, в разных местах кода. Более того, сбои наблюдались только на их самых новых компьютерах, которые работали на процессорах Intel Skylake (Skylake — это кодовое название последнего на тот момент поколения процессоров Intel. Сейчас последним поколением является Kaby Lake).

За последние 25 лет мне сообщали о многих багах OCaml, но это сообщение вызывало особенное беспокойство. Почему только процессоры Skylake? В конце концов, я даже не мог воспроизвести сбои в бинарниках ОСИПа на компьютерах в моей компании Inria, потому что все они работали на более старых процессорах Intel. Почему сбои не воспроизводятся? Однопоточное приложение ОСИПа делает сетевые и дисковые операции I/O, так что его выполнение должно быть строго детерминировано, и любой баг, который вызвал segfault, должен проявлять себя при каждом запуске в том же месте кода.

Моим первым предположением было то, что у ОСИПа глючит железо: плохая микросхема памяти? перегрев? По моему опыту, из-за таких неисправностей компьютер может нормально загружаться и работать в GUI, но падает под нагрузкой. Итак, я посоветовал ОСИПу запустить проверку памяти, снизить тактовую частоту процессора и отключить Hyper-Threading. Предположение насчёт HT появилось в связи с недавним сообщением о баге в Skylake с векторной арифметикой AVX, который проявлялся только при включенном HT (см. описание).

ОСИПу не понравились мои советы. Он возразил (логично), что они запускали другие требовательные к CPU и памяти задачи/тесты, но падают только программы, написанные на OCaml. Очевидно, они решили, что их железо в порядке, а баг в моей программе. Ну отлично. Я всё-таки уговорил их запустить тест памяти, который не выявил ошибок, но мою просьбу выключить HT они проигнорировали. (Очень плохо, потому что это сэкономило бы нам кучу времени).

Одновременно ОСИП провёл впечатляющее расследование с использованием разных версий OCaml, разных компиляторов C, которые используются для компиляции системы поддержки выполнения OCaml, и разных операционных систем. Вердикт был следующий. Глючит OCaml 4.03, включая ранние беты, но не 4.02.3. Из компиляторов глючит GCC, но не Clang. Из операционных систем — Linux и Windows, но не MacOS. Поскольку в MacOS используется Clang и там работает порт с Windows-версии на GCC, то причиной чётко назвали OCaml 4.03 и GCC.

Конечно, ОСИП рассуждал логично: мол, в системе поддержки выполнения OCaml 4.03 был фрагмент плохого кода С — с неопределённым поведением, как мы говорим в бизнесе — из-за которого GCC генерировал сбойный машинный код, поскольку компиляторам C позволено работать при наличии неопределённого поведения. Это не первый раз, когда GCC максимально некорректно обрабатывает неопределённое поведение. Например, см. эту уязвимость в безопасности или этот сломанный бенчмарк.

Такое объяснение казалось вполне правдоподобным, но оно не объясняло случайный характер сбоев. GCC генерирует причудливый код из-за неопределённого поведения, но это по-прежнему детерминистический код. Единственной причиной случайности, которую я смог придумать, могла быть Address Space Layout Randomization (ASLR) — функция ОС для рандомизации адресного пространства, которая изменяет абсолютные адреса в памяти при каждом запуске. Система поддержки выполнения OCaml кое-где использует абсолютные адреса, в том числе для индексации страниц памяти в хеш-таблицу. Но сбои оставались случайными даже после отключения ASLR, в частности, во время работы отладчика GDB.

Наступил май 2016 года, и пришла моя очередь замарать руки, когда ОСИП прислал тонкий намёк — дал доступ в шелл к своей знаменитой машине Skylake. Первым делом я собрал отладочную версию OCaml 4.03 (к которой позже планировал добавить больше отладочного инструментария) и собрал заново приложение ОСИПа с этой версией OCaml. К сожалению, эта отладочная версия не вызывала сбой. Вместо этого я начал работать с исполняемым файлом от ОСИПа, сначала интерактивно вручную под GDB (но это сводило меня с ума, потому что иногда приходилось ждать сбоя целый час), а затем с небольшим скриптом OCaml, который запускал программу 1000 раз и сохранял дампы памяти на каждом сбое.

Отладка системы поддержки выполнения OCaml — не самое весёлое занятие, но посмертная отладка из дампов памяти вообще ужасна. Анализ 30 дампов памяти показал ошибки segfault в семи разных местах, два места в OCaml GC, а ещё пять в приложении. Самым популярным местом с 50% сбоев была функция

mark_slice в сборщике мусора OCaml. Во всех случаях у OCaml была повреждена куча: в хорошо сформированной структуре данных находился плохой указатель, то есть указатель, который указывал не на первое поле блока Caml, а на заголовок или на середину блока Caml, или даже на недействительный адрес памяти (уже освобождённой). Все 15 сбоев mark_slice были вызваны указателем на два слова впереди блока размером 4.Все эти симптомы согласовались со знакомыми ошибками, вроде той, что компилятор

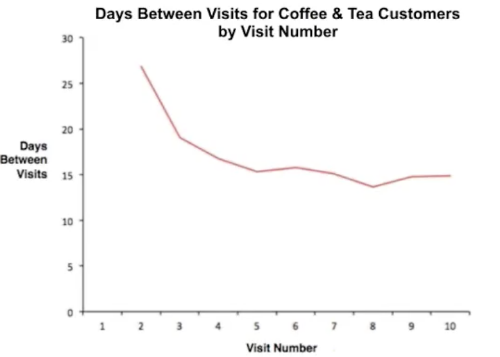

mark_slice забывал зарегистрировать объект памяти в сборщике мусора. Однако такие ошибки привели бы к воспроизводимым сбоям, которые зависят только от распределения памяти и действий сборщика мусора. Я совершенно не понимал, какой тип ошибки управления памятью OCaml мог вызвать случайные сбои!За неимением лучших идей, я опять прислушался к внутреннему голосу, который шептал: «аппаратный баг!». У меня было неясное ощущение, что сбои чаще случаются, если машина находится под большей нагрузкой, как будто это просто перегрев. Для проверки этой теории я изменил свой скрипт OCaml для параллельного запуска N копий программы ОСИПа. Для некоторых прогонов я также отключал уплотнитель памяти OCaml, что вызывало большее потреблением памяти и большую активность сборщика мусора. Результаты оказались не такими, как я ожидал, но всё равно поразительными:

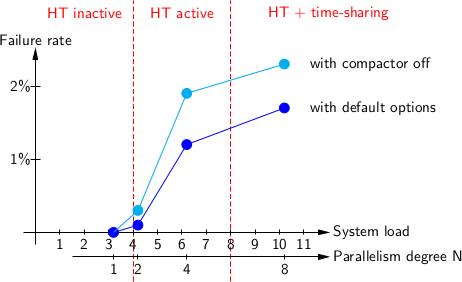

| N | Загрузка системы | С настройками по умолчанию | С отключенным уплотнителем |

|---|---|---|---|

| 1 | 3+epsilon | 0 сбоев | 0 сбоев |

| 2 | 4+epsilon | 1 сбой | 3 сбоя |

| 4 | 6+epsilon | 12 failures | 19 failures |

| 8 | 10+epsilon | 17 сбоев | 23 сбоя |

| 16 | 18+epsilon | 16 сбоев | />

Здесь показано количество сбоев на 1000 запусков тестовой программы. Видите скачок между и ? И плато между более высокими значениями ? Чтоб объяснить эти цифры, нужно более подробно рассказать о тестовой машине Skylake. У неё 4 физических ядра и 8 логических ядер, поскольку включен HT. Два ядра были заняты в фоне двумя долговременными тестами (не моими), но в остальном машина была свободна. Следовательно, загрузка системы равнялась , где — это количество тестов, запущенных параллельно.

Когда одновременно работает не более четырёх процессов, планировщик ОС поровну распределяет их между четырьмя ядрами машины и упорно старается не направлять два процесса на два логических ядра одного физического ядра, потому что это приведёт к недостаточному использованию других физических ядер. Такое происходит в случае с , а также большую часть времени в случае с . Если количество активных процессов превышает 4, то ОС начинает применять HT, назначая процессы двум логическим ядрам на одном и том же физическом ядре. Это случай . Только если все 8 логических ядер на машине заняты, ОС осуществляет традиционное разделение времени между процессами. В нашем эксперименте это случаи и .

Теперь стало видно, что сбои начинаются только при включении Hyper-Threading, точнее, тогда, когда программа OCaml работала рядом с другим потоком (логическим ядром) на том же физическом ядре процессора.

Я отправил ОСИПу результаты экспериментов, умоляя его принять мою теорию о том, что во всём виновата многопоточность. В этот раз он послушал и отключил HT на своей машине. После этого сбои полностью исчезли: двое суток непрерывного тестирования не выявили вообще ни одной проблемы.

Проблема решена? Да! Счастливый конец? Не совсем. Ни я, ни ОСИП не пытались сообщить о проблеме в Intel или кому-то ещё, потому что мы были удовлетворены тем, что можно компилировать OCaml c Clang, а ещё потому что ОСИП не хотел неприятной огласки в духе «продукты ОСИПа падают случайным образом!». Я же совсем устал от этой проблемы, да и не знал, как сообщать о таких вещах (в Intel нет публичного баг-трекера, как у обычных людей), а ещё я подозревал, что это баг конкретных машин ОСИПа (например, партия сбойных микросхем, которая случайно попала не в ту корзину на фабрике).

Второе проявление

2016-й год прошёл спокойно, больше никто не сообщал, что небо (sky, точнее, Skylake — каламбур) падает из-за OCaml 4.03, так что я с радостью забыл об этом маленьком эпизоде с ОСИПом (и продолжил сочинять ужасные каламбуры).

Затем, 6 января 2017 года Ангерран Декорн и Джорис Джованнанджели из Ahrefs (ещё один Очень Серьёзный Индустриальный Пользователь OCaml, член Консорциума Caml в придачу) сообщили о загадочных случайных сбоях с OCaml 4.03.0: это PR#7452 в баг-трекере Caml.

В их примере повторяемого сбоя сам компилятор ocamlopt.opt иногда падал или выдавал бессмысленный результат, когда компилировал большой исходный файл. Это не слишком удивительно, потому что ocamlopt.opt сам по себе является программой OCaml, скомпилированной компилятором ocamlopt.byte, но так было проще обсуждать и воспроизвести проблему.

Публично открытые комментарии к багу PR#7452 довольно хорошо показывают, что произошло дальше, а сотрудники Ahrefs подробно описали свою охоту за багом в этой статье. Так что я выделю только ключевые моменты этой истории.

- Через 12 часов после открытия тикета, когда в обсуждении было уже 19 комментариев, Ангерран Декорн сообщил, что «все машины, которые смогли воспроизвести баг, работают на процессорах семейства Intel Skylake».

- На следующий день я упомянул о случайных сбоях у ОСИПа и предложил отключить многопоточность (Hyper-Threading).

- Ещё через день Джорис Джованнанджели подтвердил, что баг не воспроизводится при отключенном Hyper-Threading.

- Параллельно Джорис обнаружил, что сбой происходит только если система поддержки выполнения OCaml собрана с параметром

gcc -O2, но неgcc -O1. Оглядываясь назад, это объясняет отсутствие сбоев с отладочной версией окружения OCaml и с OCaml 4.02, поскольку они обе по умолчанию собираются с параметромgcc -O1. - Я выхожу на сцену и публикую следующий комментарий:

Будет ли безумием предположить, что настройка

gcc -O2на окружении OCaml 4.03 выдаёт специфическую последовательность инструкций, которая вызывает аппаратный сбой (какие-то степпинги) в процессорах Skylake с Hyper-Threading? Возможно, это и безумие. С другой стороны, уже есть одна задокументированная аппаратная проблема с Hyper-Threading и Skylake (ссылка) - Марк Шинвелл связался с коллегами в Intel и сумел протолкнуть отчёт через отдел поддержки пользователей.

Затем ничего не происходило 5 месяцев, пока…

Открытие

26 мая 2017 года пользователь "ygrek" опубликовал ссылку на следующий журнал изменений из пакета с «микрокодом» от Debian:

* New upstream microcode datafile 20170511 [...]

* Likely fix nightmare-level Skylake erratum SKL150. Fortunately,

either this erratum is very-low-hitting, or gcc/clang/icc/msvc

won't usually issue the affected opcode pattern and it ends up

being rare.

SKL150 - Short loops using both the AH/BH/CH/DH registers and

the corresponding wide register *may* result in unpredictable

system behavior. Requires both logical processors of the same

core (i.e. sibling hyperthreads) to be active to trigger, as

well as a "complex set of micro-architectural conditions" Эррата SKL150 была задокументирована компанией Intel в апреле 2017 года и описана на странице 65 в Обновлении спецификаций семейства процессоров Intel 6-го поколения. Похожая эррата упоминается под номерами SKW144, SKX150, SKZ7 для разновидностей архитектуры Skylake и KBL095, KBW095 для более новой архитектуры Kaby Lake. Слова «полный кошмар» не упоминаются в документации Intel, но приблизительно описывают ситуацию.

Несмотря на довольно расплывчатое описание («сложный набор микроархитектурных условий», и не говорите!) эта эррата бьёт прямо в цель: включенный Hyper-Threading? Есть такое! Проявляется псевдослучайно? Есть! Не имеет отношения ни к плавающей запятой, ни к векторным инструкциям? Есть! К тому же, готово обновление микрокода, которое устраняет эту ошибку, оно мило упаковано в Debian и готово к загрузке в наши тестовые машины. Через несколько часов Джорис Джованнанджели подтвердил, что сбой исчез после обновления микрокода. Я запустил ещё больше тестов на своей новёхонькой рабочей станции с процессором Skylake (спасибо отделу снабжения Inria) и пришёл к тому же выводу, поскольку тест, который обваливался быстрее чем за 10 минут на старом микрокоде, проработал 2,5 суток без проблем на новом микрокоде.

Есть ещё одна причина считать, что SKL150 — виновник наших проблем. Дело в том, что проблемный код, описанный в этой эррате, как раз и генерирует GCC при компиляции системы поддержки выполнения OCaml. Например, в файле

byterun/major_gc.c для функции sweep_slice получается такой код C:hd = Hd_hp (hp);

/*...*/

Hd_hp (hp) = Whitehd_hd (hd);После макрорасширения это выглядит так:

hd = *hp;

/*...*/

*hp = hd & ~0x300;Clang компилирует этот код банальным способом, используя только регистры полной ширины:

movq (%rbx), %rax

[...]

andq $-769, %rax # imm = 0xFFFFFFFFFFFFFCFF

movq %rax, (%rbx)Однако GCC предпочитает использовать 8-битный регистр

%ah для работы с битами от 8 до 15 из полного регистра %rax, оставляя остальные биты без изменений:movq (%rdi), %rax

[...]

andb $252, %ah

movq %rax, (%rdi)Эти два кода функционально эквиваленты. Одной возможной причиной выбора GCC может быть то, что его код более компактный: 8-битная константа

$252 помещается в один байт кода, в то время как 32-битной, расширенной до 64 бит, константе $-769 нужно 4 байта. Во всяком случае, сгенерированный GCC код использует и %rax, и %ah и, в зависимости от уровня оптимизации и неудачного стечения обстоятельств, такой код может окончиться циклом, достаточно маленьким, чтобы вызвать баг SKL150.Так что, в итоге, это всё-таки аппаратный баг. Говорил же!

Эпилог

Intel выпустила обновления микрокода для процессоров Skylake и Kaby Lake, которые исправляют или обходят проблему. Debian опубликовала подробные инструкции для проверки, подвержен ли багу ваш процессор и как получить и применить обновления микрокода.

Публикация о баге и выпуск микрокода оказались очень своевременными, потому что у нескольких проектов на OCaml начали происходить таинственные сбои. Например, у Lwt, Coq и Coccinelle.

Об аппаратном баге написал ряд технических сайтов, например, Ars Technica, HotHardware, Tom's Hardware и Hacker's News [и GeekTimes — прим. пер.].

|

Метки: author m1rko тестирование it-систем отладка компиляторы assembler ocaml caml skylake hyper-threading |

Анонс Ruby Meetup #6 |

Традиционная встреча рубистов с докладами, общением и пиццей состоится 20 июля в офисе компании Rambler&Co!

1. Ruby on Rails в эпоху микросервисов – Станислав Герман, руководитель группы ruby разработки в Rambler&Co

Расскажу о некоторых фактах и персональном опыте перехода от монолитного приложения к микро сервисной архитектуре. Когда такой переход имеет смысл, какие подводные камни при переходе ожидать и как «Ruby on Rails» позволяет нам решить проблем с масштабированием монолита.

2. Overcommit: удобное описание и использование git хуков для повышения качества кода – Вольдэмар Дулецкий, Evrone

3. Парсинг пользовательского ввода с использованием PEG – Иван Лопатин

В своем докладе хочу рассказать о том что такое PEG парсеры, на примере библиотеки treetop.

Расскажу о том как описать грамматику PEG парсера. Чем они могут быть полезны и в каких случаях их стоит применять.

Разберем практический кейс использования PEG парсера на примере разбора пользовательского ввода.

4. Деплой длиною в год – Александр Кадыров, RCNTEC

Представьте себе начало: географически распределённый сервис с 18 серверами на борту и больше 3 тысяч корпоративных пользователей, которые в разное время должны иметь молниеносный ответ от сервера аутентификации через API или по протоколу RADIUS.

Сервис используется в бухгалтерии 1С, корпоративном портале на 1400 пользователей, интегрирован с линуксовым sudo и многими другими приложениями и сервисами. Любая недоступность сервиса аутентификации означает только одно — юзеры будут вас ненавидеть.

Необходимо зарелизиться таким образом, чтобы сервис не остановился ни на секунду, мог откатиться назад при любой ошибке и в любое время проводить проверку пользовательских данных. У нас это заняло полтора года.

В этом коротком докладе я расскажу о нашем опыте применения Ansible для управления платформой аутентификации, способной переваривать любые нагрузки, и почему вам надо дружить с админами или девопсами.

Лень готовить доклад?

У нас будет свободный микрофон для lightning talks — приходи с краткими тезисами, знакомься, обсуждай наболевшее. Регламент — 5 минут.

А кроме докладов, мы будем рады ответить на все вопросы о предстоящей конференции RailsClub

Мероприятие бесплатное, а регистрация обязательна – railsclub.timepad.ru/event/531200

С нас пицца и чай!

Начало в 19.00

Место: Варшавское шоссе, д. 9, стр. 1

Обязательно зарегистрируйтесь и возьмите с собой паспорт, чтобы вас пропустила охрана бизнес-центра!

Организаторы события: RailsClub, Evrone и MoscowRB

Гостеприимные хозяева: Rambler&Co – одна из крупнейших российских групп компаний, работающих в области медиа, технологий и электронной коммерции с аудиторией свыше 40 млн человек в месяц.

|

Метки: author SanDark7 разработка веб-сайтов ruby on rails ruby блог компании rambler co peg |

Анонс Moscow Spark #2 |

Как мы и обещали, наше мероприятие становится регулярным – 27 июля состоится Moscow Spark #2! Moscow Spark #1, организованный группой компаний Rambler&Co, собрал больше 200 участников, и мы надеемся, что жаркая погода, которая когда-нибудь установится в московском регионе, не помешает нам собрать столько же (и даже больше) участников в этот раз. Тем более, что мы нашли новых, интересных докладчиков.

1. Про аналитику и серебряные пули – Александр Подсобляев (Rambler&Co)

В своем докладе я расскажу о том, как мы перезапускали Рамблер/топ-100, доступных инструментах на рынке и о нашем опыте переезда с архитектуры батч-обсчета данных на обсчет данных в реальном времени. Расскажу об архитектуре двух решений и их компонентах. Кратко обсудим особенности обработки данных с помощью Python в Hive, фундаментальные проблемы хранения агрегатов, кратко рассмотрим преимущества и недостатки альтернативного подхода. Подробно разберем способ обработки меняющихся событий с помощью PySpark, способы работы с различными компонентами системы из PySpark, возникающие при этом проблемы и их решение. Плюс посмотрим на результаты, скорость работы новой системы и некоторые подводные камни.

2. Тензорные разложения для рекомендаций на Spark – Алексей Петров (Zvooq)

В Spark.ML для рекомендаций присутствует реализация алгоритма ALS, который достаточно хорошо себя показывает в большинстве реальных примеров. В докладе я хочу представить свою реализацию на Spark алгоритма iTALS, который является обобщением алгоритма матричных разложений ALS для тензоров. Такой алгоритм позволяет учитывать контекст в рекомендациях, делать их более точными и гибкими. В докладе будет рассказано о результатах сравнительного эксперимента ALS и iTALS.

3. Погружаемся в Catalyst – Павел Клеменков (Rambler&Co)

Dataset и Dataframe стали предпочтительными интерфейсами работы со Spark. Во многом благодаря активной разработке оптимизатора запросов Catalyst. В докладе мы рассмотрим мотивацию создания Spark.SQL и поймем, почему он так критически важен для работы PySpark. А так же подробно разберем как устроен Catalyst изнутри и как можно расширить его функциональность.

4. Динамическая аллокация ресурсов или как жить в условиях общежития? – Артём Пичугин (New Professions Lab)

При помощи динамической аллокации ресурсов в Spark можно добиться того, чтобы задача получала дополнительные ресурсы, если таковые имеются в свободном пуле. Таким образом, иногда, можно использовать всю мощь кластера и быстрее проводить вычисления. В докладе я расскажу, как динамическая аллокация ресурсов помогла сделать возможной работу 30-40 студентов в условиях приближающегося дедлайна по лабораторным работам и жить всем в счастье.

Мероприятие бесплатное, а регистрация обязательна – rambler-co-e-org.timepad.ru/event/533749

С нас пицца и чай!

Начало в 19.00

Место: Варшавское шоссе, д. 9, стр. 1, подъезд №5. Мансарда Rambler&Co

Обязательно зарегистрируйтесь и возьмите с собой паспорт, чтобы вас пропустила охрана бизнес-центра!

Приходите, будет интересно!

|

Метки: author SanDark7 машинное обучение scala python big data блог компании rambler co spark ml |

Использование утилит timeout & strace для мониторинга неактивности пользователя для разрыва соединения Shellinabox |

Недавно я занимался тем, что исследовал какие существуют решения для реализации web-ssh прокси-сервера. Суть задачи заключается в том, чтобы дать пользователям возможность соединяться с произвольным ssh-сервером посредством web-интерфейса. Обычно, решения web-ssh предназначены для соединения с сервером, на котором они развернуты, но в рамках моей задачи мне хотелось, чтобы пользователь мог указать IP, порт, имя и пароль пользователя (или ключ) и выполнить соединение с произвольным сервером. С ходу найти подобного решения мне не удалось.

Вообще-то, конечно, есть Guacamole, но для моей задачи использование этого приложения было слишком затратным как по ресурсам разработки, так и по функциям и их организации, поэтому от Guacamole я отказался.

Однако, для открытого пакета shellinabox я обнаружил решение на блоге на немецком языке, которое я и решил довести до нужного мне уровня. В итоге, получился симпатичный контейнер Docker, который можно найти как на GitHub так и на Dockerhub, который решает все необходимые задачи.

Но, статья не об этом, а о сопутствующем коде на Python, который мне пришлось написать. Дело в том, что мне не нравилось, что если пользователь открыл web ssh и куда-то ушел, то сессия будет висеть бесконечно, что на мой взгляд неприемлемо. Это ведет к следующим отрицательным последствиям:

- ресурсы прокси-сервера терминалов используются неэффективно, поскольку он вынужден обслуживать неиспользуемые сессии;

- открытое в браузере без присмотра окно с ssh навевает чувство тоски и уязвимости.

В общем, я решил, что хочу добиться того, чтобы shellinabox разрывал соединение в том случае, если пользователь несколько минут не пишет ничего на консоль (stdin) и на stdout не поступают данные.

Достаточно продолжительный поиск в Google показал мне, что цели можно добиться с использованием команды timeout и strace. Команда timeout оказалась для меня новой, ее назначение — обеспечить прерывание процесса по достижению некоторого таймаута в том случае, если он сам не завершился.

Команду strace я использую часто, однако, обычно применяю ее для того, чтобы отслеживать причину, по которой какая-то служба или команда не работает как ожидается. В рамках моего поиска на тему того, как осуществить мониторинг активности на каналах stdin, stdout процесса я обнаружил, что strace так же может это обеспечить:

strace -e write=1,2 -e trace=write -p В общем, данные команды были тем, что мне было необходимо для осуществления задуманного. Общая схема выглядит так:

- При открытии нового соединения shellinabox запускает python-скрипт;

- Python-скрипт запускает (fork) процесс-демон мониторинга активности процесса, который осуществляет мониторинг своего же PID;

- python-скрипт выполняет (exec) ssh (замена себя на ssh).

Для тех, кто хочет сразу посмотреть как же устроен весь скрипт, отправляю сюда. Для остальных далее по частям.

Кратко, код можно представить следующим образом.

monitor_daemon(inactivity_interval, identity_file)

...

...

os.execv("/usr/bin/ssh", ["/usr/bin/ssh"] + identity_args + ["-o", "StrictHostKeyChecking=no", "-o", "UserKnownHostsFile=/dev/null", "-p", str(peer_port), "%s@%s" % (peer_login, peer_ip)])Код простой и самоочевидный. Вся магия находится внутри функции monitor_daemon:

def monitor_daemon(inactivity_interval, identity_file):

orig_pid = os.getpid()

try:

pid = os.fork()

if pid > 0:

return

except OSError as e:

print("Fork #1 failed: %d (%s)" % (e.errno, e.strerror))

sys.exit(1)

os.chdir("/")

os.setsid()

os.umask(0)

try:

pid = os.fork()

if pid > 0:

sys.exit(0)

except OSError as e:

print("Fork #2 failed: %d (%s)" % (e.errno, e.strerror))

sys.exit(1)

if identity_file != "":

time.sleep(1)

os.unlink(identity_file)

try:

while True:

proc = subprocess.Popen('timeout %d strace -e write=1,2 -e trace=write -p %d' % (inactivity_interval, orig_pid), shell=True, stdout=subprocess.PIPE, stderr=subprocess.PIPE)

proc.poll()

counter = 0

for line in proc.stderr.readlines():

counter += 1

if(counter <= 3):

os.kill(orig_pid, signal.SIGKILL)

sys.exit(0)

except Exception as e:

pass

sys.exit(0)где нас более всего интересует часть:

while True:

proc = subprocess.Popen('timeout %d strace -e write=1,2 -e trace=write -p %d' % (inactivity_interval, orig_pid), shell=True, stdout=subprocess.PIPE, stderr=subprocess.PIPE)

proc.poll()

counter = 0

for line in proc.stderr.readlines():

counter += 1

if(counter <= 3):

os.kill(orig_pid, signal.SIGKILL)

sys.exit(0)в которой и происходит в цикле запуск мониторинга, который после заданного периода ожидания выполняет завершение процесса ssh, если требуется.

Вот собственно и все. Решение оказалось достаточно простым, но потребовало некоторое время на изучение доступных инструментов.

PS: Я не являюсь профессиональным python-разработчиком, код субоптимален.

PPS: Если у кого-то возникнет желание улучшить код, добро пожаловать в репозиторий, я с удовольствием приму PR-ы.

|

Метки: author ivankudryavtsev разработка под linux python linux strace ssh shellinabox |

[Перевод] Отжиг и вымораживание: две свежие идеи, как ускорить обучение глубоких сетей |

В этом посте изложены две недавно опубликованные идеи, как ускорить процесс обучения глубоких нейронных сетей при увеличении точности предсказания. Предложенные (разными авторами) способы ортогональны друг другу, и могут использоваться совместно и по отдельности. Предложенные здесь способы просты для понимания и реализации. Собственно, ссылки на оригиналы публикаций:

1. Ансамбль снимков: много моделей по цене одной

Обычные ансамбли моделей

Ансамбли — это группы моделей, используемых коллективно для получения предсказания. Идея проста: обучи несколько моделей с разными гиперпараметрами, и усредни их предсказания при тестировании. Эта методика дает заметный прирост в точности предсказания, большинство победителей соревнований по машинному обучению

Так в чем проблема?

Обучение N моделей потребует в N раз больше времени по сравнению с тренировкой одной модели.

Механика SGD

Стохастический градиентный спуск (SGD) — жадный алгоритм. Он перемещается в пространстве параметров в направлении наибольшего уклона. При этом, есть один ключевой параметр: скорость обучения. Если скорость обучения слишком высока, SGD игнорирует узкие лощины в рельефе гиперплоскости параметров (минимумы) и перескакивает через них как танк через окопы. С другой стороны, если скорость обучения мала, SGD проваливается в один из локальных минимумов и не может выбраться из него.

Однако, есть возможность вытащить SGD из локального минимума повысив скорость обучения.

Следим за руками...

Авторы статьи используют этот контролируемый параметр SGD для скатывания в локальный минимум и выхода оттуда. Разные локальные минимумы могут давать одинаковый процент ошибок при тестировании, но конкретные ошибки для каждого локального минимума будут разными!

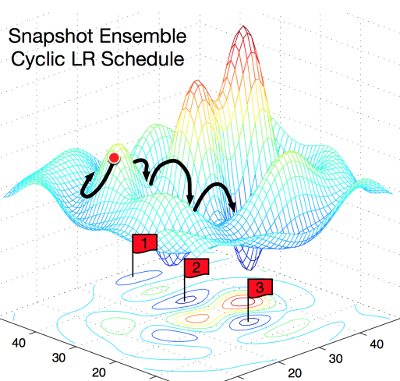

На этой картинке очень наглядно поясняется концепция. Слева показано, как работает обычный SGD, пытаясь найти локальный минимум. Справа: SGD проваливается в первый локальный минимум, делается снимок обученной модели, затем SGD выбирается из локального минимума и ищет следующий. Так вы получаете три локальных минимума с одинаковым процентом ошибок, но различающимися характеристиками ошибок.

Из чего состоит ансамбль?

Авторы эксплуатируют свойство локальных минимумов отражать различные «точки зрения» на предсказания модели. Каждый раз, когда SGD достигает локального минимума, сохраняют снимок модели, из которых при тестировании и составят ансамбль.

Циклический косинусный отжиг

Для автоматического принятия решения, когда погружаться в локальный минимум, и когда выходить из него, авторы используют функцию отжига скорости обучения:

Формула выглядит громоздко, но на самом деле довольно проста. Авторы используют монотонно убывающую функцию. Альфа — новое значение скорости обученя. Альфа-ноль — предыдущее значение. Т — общее число итераций, которое вы планируете использовать (размер батча Х число эпох). М — число снимков модели, которое хотите получить (размер ансамбля).

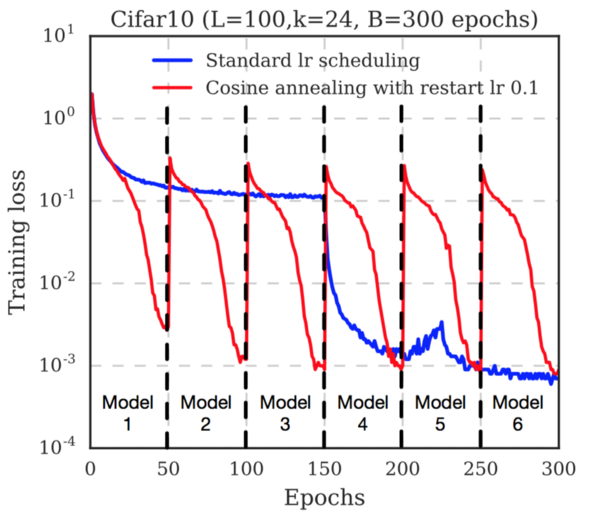

Обратите внимание, как быстро снижается функция потерь перед сохранением каждого снимка. Это потому, что скорость обучения непрерывно снижается. После сохранения снимка скорость обучения восстанавливают (авторы используют уровень 0.1). Это выводит траекторию градиентного спуска из локального минимума, и начинается поиск нового минимума.

Заключение

Авторы приводят результаты тестирования на нескольких датасетах (Cifar 10, Cifar 100, SVHN, Tiny IMageNet) и нескольких популярных архитектурах нейронных сетей (ResNet-110, Wide-ResNet-32, DenseNet-40, DenseNet-100). Во всех случаях ансамбль, обученный предложенным способом показал наименьший процент ошибок.

Таким образом, предложена полезная стратегия получения прироста точности без дополнительных вычислительных затрат при обучении моделей. О влиянии разных параметров, таких как Т и М на производительность, см. оригинал статьи.

2. Вымораживание: ускорение обучения путем последовательного замораживания слоёв

Авторы статьи продемонстрировали ускорение обучения путем замораживания слоёв без потери точности предсказания.

Что означает замораживание слоёв?

Замораживание слоя предотвращает изменение весовых коэффициентов слоя при обучении. Эта методика часто используется при обучении переносом (transfer learning), когда базовую модель, обученную на другом датасете, замораживают.

Как замораживание влияет на скорость модели?

Если вы не хотите изменять весовые коэффициенты слоя, обратный проход по этому слою можно полностью исключить. Это серьезно ускоряет процесс вычислений. Например, если половина слоев в вашей модели заморожена, для тренировки модели потребуется вдвое меньше вычислений.

С другой стороны, вам все-таки нужно обучить модель, так что если вы заморозите слои слишком рано, модель будет давать неточные предсказания.

В чем новизна?

Авторы показали способ, как замораживать слои один за другим как можно раньше, оптимизируя время обучения за счет исключения обратных проходов. В начале модель целиком обучаема, как обычно. После нескольких итераций первый слой модели замораживают, и продолжают обучать остальные слои. После еще нескольких итераций замораживают следующий слой, и так далее.

(Опять) отжиг скорости обучения

Авторы использовали отжиг скорости обучения. Важное отличие их подхода: скорость обучения изменяется от слоя к слою, а не для всей модели. Они использовали следующее выражение:

Здесь альфа — скорость обучения, t — номер итерации, i — номер слоя в модели.

Обратите внимание, поскольку первый слой модели будет заморожен первым, его тренировка продлится наименьшее количество циклов. Для компенсации этого авторы масштабировали начальный коэффициент обучения для каждого слоя:

В результате, авторы добились ускорения обучения на 20% за счет падения точности на 3%, либо ускорения на 15% без снижения точности предсказания.

Однако, предложенный метод не очень хорошо работает с моделями, в которых не используются пропуски слоёв (такими как VGG-16). В таких сетях ни ускорения, ни влияния на точность предсказания не обнаружено.

|

|

Тем временем Proxmox VE обновился до версии 5.0 |

Громкой эту новость не назвать, но парни, который год «пилящие» Proxmox VE, два дня назад выпустили новую версию своего детища — 5.0.

Громкой эту новость не назвать, но парни, который год «пилящие» Proxmox VE, два дня назад выпустили новую версию своего детища — 5.0.Нас, конечно, интересуют изменения — тянут ли они на новую major версию. На мой взгляд, вполне, а подробности, по традиции, под катом.

(Для тех, кому слова Proxmox VE не знакомы, приведу пару слов описания: «Proxmox Virtual Environment (Proxmox VE) — система виртуализации с открытым исходным кодом, основанная на Debian GNU/Linux. В качестве гипервизоров использует KVM и LXC. Управление виртуальными машинами и администрирование самого сервера производятся через веб-интерфейс либо через стандартный интерфейс командной строки Linux.»)

Официальный список изменений рассказывает довольно скупо:

- Сборка производится на пакетной базе Debian 9.0 «Stretch» (прошлая версия была основана на Debian 8.0 «Jessie»);

- Используется ядро Linux 4.10

- Используется QEMU 2.9

- LXC обновлен до 2.0.8;

- Реализована возможность асинхронной репликации хранилища между несколькими узлами кластера. Функция работает при использовании ZFS, и на сегодня помечена как «technology preview»;

- Обновлены шаблоны построения изолированных окружений LXC на базе Debian, Ubuntu, CentOS, Fedora, OpenSUSE, Arch Linux, Gentoo и Alpine;

- Новая/существенно улучшеная удалённая консоль noVNC;

- В состав включена реализация распределённой файловой системы Ceph 12.1.0 Luminous (также с пометкой «technology preview»), собранная сотрудниками Proxmox;

- Поддержка Live-миграции с использованием локального хранилища;

- Внесены улучшения в web-интерфейс: улучшены средства фильтрации и пакетного выполнения операций, обеспечен показ адресов USB и Host PCI;

- Улучшен установочный ISO-образ;

- Добавлены средства импорта виртуальных машин от других гипервизоров, включая

VMware и Hyper-V. - Улучшения документации, плюс множественные исправления ошибок в старых релизах.

Пару вещей опишу чуть подробнее, еще несколько изменений отлично видны в ролике от авторов Proxmox VE, который приведен в конце поста.

Репликация хранилища

Разговор идет об асинхронной репликации, когда раз в определенное время снапшот состояния хранилища отправляется на другое хранилище. Это уменьшает сетевой трафик, и позволяет предъявлять меньшие требования к оборудованию. Можно задать, что и как часто мы реплицируем, и иметь на другом хранилище «довольно свежую» копию данных с основного. Все зависит от задач, но во многих случаях для целей быстрого восстановления работоспособности даже такой подход — просто отличный вариант. Еще раз уточню, работает эта функция между хранилищами zfs.

Импорт ВМ из других гипервизоров

Такого рода импорт нужен не каждый день, но, уж когда нужен, требует довольно много времени на разбирательство с ним — похоже, сейчас процесс получится сокртить. Конечно, импорт — это и проблемы запуска гостя на базе нового гипервизора (разные гостевые ОС отнесутся по разному, скажем, к изменению списка оборудования), но сама функциональность актуальна. Предполагается, что импорт произойдет из самых популярных форматов (скажем, vmdk), но большинство гипервизоров умеют сегодня экспортировать машины в формат VMWare — после чего используем новую функцию утилиты qm (вызываемая как qm importdisk), и сражаемся уже с ОС в виртуалке.

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

|

Метки: author dmitry_ch хранение данных системное администрирование виртуализация proxmox proxmox ve proxmox 5 kvm lxc zfs ceph |

Виртуальный конвейер разработки сайтов и автоматизация |

Продолжаем серию материалов «Как сделать веб-студию эффективной и начать зарабатывать?» В предыдущем материале мы разобрали, как оптимизировать бизнес-процессы студии, связанные с докоментооборотом, который необходим для обеспечения контракта.

Как вы помните, документооборот не несет ценности клиенту в виде продукта за которым он к нам обращается. Именно поэтому все, что связано с «бумажной работой», мы постарались максимально оптимизировать. Если у вас это получилось или вы хотя бы сделали существенный шаг по направлению к этому, то вы большие молодцы. Как я говорил ранее, имено такие процессы, не несущие полезной нагрузки, часто невидимые для руководителя студии, несут основные потери времени и денег.

Сегодня поговорим о полезных процессах: непосредствено об организации разработки сайта. Я не планирую затрагивать CMS, дизайн, принципы верстки, языки программирования… Их оптимизацией займемся в последнюю очередь. Да и не расскажу я вам чего-то нового в этой области. А вот к концептуальному подходу организации производства стоит прислушаться. Это заложит основу для будущего масштабирования.

Напоминаю, что наша задача — бысто и качественно создать сайт, который будет решать задачу клиента. А задача сайта клиента простая — конвертировать посетителей в звонки или заявки. Дополнительной задачей ставим правильную индексацию сайта и попадание его в поисковые системы (как можно выше) без дополнительных вложений со стороны клиента. Это важный момент, своего рода изюминка на торте.

Клиент может говорить, что ему нужен сайт для имиджа, автоматизации, описания услуг, интеграции … короче, для всего. Соглашайтесь, но задачу нашу не забывайте. Нам нужно, чтобы телефон отдела продаж нашего клиента зазвонил, и как можно быстрей. Как только процесс пошел, значит можно выдохнуть и дальше спокойно работать. 20% усилий которые принесут 80% результата вы уже сделали. Именно на это нацелена работа будущего веб-завода в первую очередь. Все остальные работы не принесут вам прибыли и, скорее всего, клиенту. Подходите к дальнейшему расширению функционала максимально осторожно.

Далее много букв про организацию завода. Начинающим студиям читать в первую очередь. Делать с нуля гораздо проще, чем потом переделывать :)

Создаем технологичный завод по производству сайтов

Для повышения эффективности производства в середине XIX века был изобретен конвейер. Скорость движения конвейера напрямую влияет на скорость выпуска продукции. Регулируя скорость конвейера — можно получить востребованный продукт по конкурентной цене и требуемого качества. Снижаем скорость конвейера – повышаем глубину проработки продукта (заметьте, не качество), ускоряем конвейер – повышаем скорость выпуска продукта. В нашем случае, продукт – это сайт.

Виртуальный конвейер для цифрового продукта

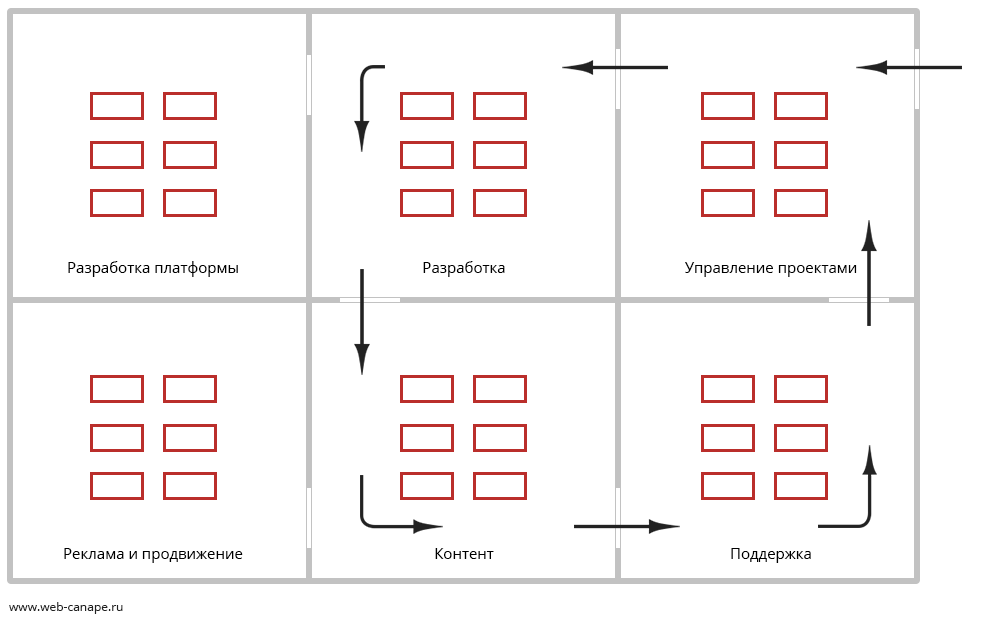

В WebCanape сейчас от начальной точки до конечной конвейер проезжает за 14 дней (по сути, это срок в договоре с клиентом). За два дня (раньше за один) выполняется одна из семи типовых групп операций: формирование задания на проект, производство (распараллеливаем на три линии — дизайн сайта, наполнение сайта, программирование), согласование, тестирование, запуск проекта, повторное тестирование, сдача проекта. Если команда небольшая, то часть этапов может быть вынесено на аутсорс, но срок этапа должен быть жестким. В ритмичности сила конвейера.

Для того чтобы конвейер двигался без остановок и задержек, исполнительный менеджер, который курирует проект на всех этапах, на первом этапе проводит сбор всех необходимых материалов. В основной перечень, без чего проект не может быть запущен в работу, входят: текстовые и графические материалы для первичного наполнения, элементы фирменного стиля, фотоматериалы, данные для заполнения каталогов продукции, доступы к домену и хостингу. Собрав все материалы, можно запускать конвейер и гарантировать его безостановочную работу, что в свою очередь гарантирует создание сайта в срок.

На каждом из этапов производственные ресурсы подобраны таким образом, чтобы конвейер мог обслужить в два раза больше заказов, чем поступает на входе. Это позволяет сглаживать неравномерность спроса и работать с проектами из буферных линий.

На буферную линию проект попадает, если он не может двигаться дальше по причине затягивания согласования с клиентом дизайна или наполнения. После согласования проект возвращается на основную линию и продолжает движение вперед. При этом календарные сроки проекта затягиваются, но договорные сроки (мы их считаем в нормо-днях) пролонгируются на время задержки в буферной зоне. Запомните эти два параметра, они нам понадобятся далее.

Естественно, что наличие проектов в буферной зоне — это пассивы на производстве. Чем их больше, тем большая степень неопределенности в системе. Это напрямую влияет на снижение общей эффективности производства и скорости оборота денег в системе. Количество таких проектов и их время простоя необходимо минимизировать. Это основная задача исполнительных менеджеров после запуска проекта в работу.

Где живет и как выглядит конвейер

Несмотря на то, что конвейер виртуальный, рабочие места (производственные узлы) в офисе, как на реальном предприятии, желательно выстроить в правильную производственную цепочку. Хоть заказ переходит от узла к узлу по виртуальным каналам, физическое расстояние между узлами и их взаимное расположение очень важны. Это позволяет лучше представлять и контролировать производственный процесс, оптимизировать коммуникации и рабочее время.

Рабочие места в офисе лучше располагать последовательно, в соответствии со схемой производства

Исполнительный менеджер контролирует движение проекта на конвейере с помощью CRM. В нашем случае, это доработанная CanapeCRM. В этой системе собирается вся статистика по этапам движения проекта, формируются уведомления для клиентов и прочее.

Как только проект поступает на конвейер, исполнительный менеджер, в соответствии с регламентом, разворачивает и настраивает базовую сборку, ставит задачи на производственные участки. Для задач мы используем redmine. Базовая сборка — это сайт с типовым набором программных модулей для выбраного типа сайта.

Для оперативного планирования загрузки участков используется информационное табло, на котором видно, сколько проектов на линии в текущий момент, в каком статусе и какие сроки выпуска. На табло используется понятный всем принцип светофора. Зеленый — проект укладывается в сроки, желтый — сроки близки к дедлайну, красный — проект опаздывает. Цвет проекта говорит о том, с каким приоритетом им нужно заняться.

На каждом производственном участке есть руководитель группы. Он занимается планированием, отвечает за качественное выполнение операций в соответствии с нормативами и регламентом, обеспечивает обучение и рост новичков. В общем, курирует бесперебойную работу своего отрезка конвейера. По завершению производства собирается статистика, и проект оценивается по четырем основным параметрам: сроки в календарных днях, сроки в нормо-днях, выполнение нормативы в нормо-часах и отзыв клиента. Это позволяет объективно определить успешность проекта. Об этом подробнее расскажу чуть позже в статье про мониторинг производства.

Особенности этапов производства сайтов на конвейре

Постановка в работу. Прежде чем проект пойдет в работу — менеджер формирует задание на разработку. Задание в нашем случае — это рабочий прототип сайта. По принципу «канапе» менеджер формирует модульный состав проекта. Каждый из модулей обладает рядом визуальных и функциональных состояний, правильно подбирая которые, мы получаем качественную заготовку для будущего сайта. Задача менеджера на данном этапе выбрать наиболее оптимальные проверенные варианты решений, которые подходят для конкретных задач клиента. Дальше с этими модулями будут работать дизайнеры, копирайтеры и программисты.

Дизайн и верстка. Графическая сетка типовых решений сайтов продумывается и тестируется отдельным подразделением. Примерно раз в квартал она обновляется, попадает в релиз базовой сборки и уже далее на конвейер. Основная работа дизайнера на конвейере – сделать дизайн в рамках стандартной сетки, подобранной менеджером для данного клиента на этапе постановки проекта в работу. Основной фокус в проработке промо-составляющей сайта, чтобы за несколько секунд заинтересовать посетителя и показать, что он попал туда, куда хотел. Дополнительно прорабатываются интерфейсные элементы (или модули) сайта, чтобы придать сайту свою стилистику и правильно расставить акценты.

Все графические элементы базовой сетки (в PSD) заранее сгруппированы в смарт-объекты (меню, шапка, авторизация и прочее), с которыми потом дизайнер работает. Это сделано для удобства и порядка. Вот тут два монитора дизайнеру очень пригодятся. В одном дизайнер работает со смарт-объектом, а во втором видит сайт целиком. Если все правильно подготовить, то на этом экономится куча времени и результат получается стандартно хорошим.

Дополнительно отмечу, что в рамках ограничений (время, стандартная сетка) часто получается результат лучше, чем при полете фантазии и отсутствии ограничений.

Наполнение. Сначала готовятся тексты. На этой фазе необходимо добиться, как минимум 97% уникальности. Это необходимо для дальнейшего успешного поискового продвижения. Для проверки используется программа ETXT.

При размещении текстов на сайт используются готовые в админке шаблоны оформления текстов, своего рода конструктор текстовых блоков. Это позволяет контент-менеджерам, не привлекая дизайнера и верстальщика, быстро сделать качественное наполнение сайта.

Дополнительно используются служебные шаблоны. Они необходимы больше для поисковых систем. Это фрагменты сайта, находящиеся в специальной микроразметке, которую видят только поисковые системы. С ее помощью поисковики понимают, где на сайте телефон, адрес, товары, отзывы и другие, что в свою очередь хорошо сказывается на результатах выдачи сайта в поисковых системах. О важности этого еще на этапе создания сайта – я уже говорил выше.

Разработка функционала. При необходимости разработки уникального функционала, не входящего в базовую сборку, проект идет на участок программирования. По нажатию кнопки, программист создает копию базовой площадки для ее доработки. Все изменения программного кода фиксируются через систему контроля версий. Это позволяет впоследствии (на этапе технической поддержки) видеть историю доработок проекта. Когда доработки готовы, копия площадки сливается с основной, и проект передается на тестирование.

Тестирование. Тестирование проходит в две итерации. На первом шаге тестировщики проверяют корректность работы сайта (правильная настройка параметров поисковой оптимизации, работу форм…). На втором шаге тестировщик смотрит общее состояние проекта на предмет соответствия критериям качества (внешний вид, наполнение, тексты уведомлений, работу нестандартного функционала и пр). Эти же две итерации выполняются после того, как проект выложен на хостинг и привязан домен.

Завершение проекта. На данном этапе решается много организационных задач. Получается вторая часть оплаты. Собирается вся статистика с производственных участков (время разработки в нормо-днях, фактических днях, в часах), чтобы сравнить собранные показатели с плановыми (это понадобится для корректировки премий менеджерского состава).

Запрашивается отзыв у клиента. Проект публикуется в портфолио, передается на гарантийную поддержку и в отдел продвижения.

Я перечислил основные этапы движения проекта. Только на этапе сдачи проекта более 30 пунктов, которые необходимо выполнить менеджеру. Чтобы все это не забыть, мы используем корпоративный свод регламентов и правил. Это такая толстая настольная книга менеджеров.

Вместо заключения

Что важно для клиента? Цена. Сроки. Качество. Что гарантирует конвейер?

- Автоматизация существенно снижает себестоимость производства — цена

- Лента конвейера точно прибудет к назначенной дате — сроки

- Все этапы будут пройдены, все регламенты будут выполнены — качество

Конечно, не все идеально в этом мире. И на конвейерах бывают сбои. Но, если стремиться к совершенству, можно добиваться неплохих результатов. Если есть вопросы, готовы на них ответить. В следующем выпуске расскажу про дополнительные особенности производства и этапы сдачи сайта клиенту.

Все предыдущие материалы доступны в базовой статье.

Команда WebCanape

|

Метки: author vasyay управление разработкой управление проектами бизнес-модели блог компании webcanape конвейер webcanape создание сайтов веб-студия бизнес студии |

5 свежих примеров разбора и улучшения дизайна простыми способами |

FotoFast: убираем обводку

FotoFast — небольшой фотосалон из Петербурга. Они обратились к нам, чтобы мы подсказали приемы, для улучшения для их логотипа. Прикидываем, что можно сделать:

Убираем тяжелую, черную обводку и подбираем контрастные цвета — белый и зеленый. Теперь необходимость в обводке отпала, цвета делают работу за нее. Мы бы предложили “FotoFast” использовать такой прием, как динамическая айдентика:

Так, могла бы выглядеть вывеска “FotoFast” днем и в ночное время:

Итог

Плюсы:

+ Логотип стал выглядеть современно, название компании легко читается

Минусы:

— Возможно слишком модно для фотостудии

Cloby: добавляем мягкости