Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Rich Notifications, utm-метки, webhook и другие нововведения PushAll |

За последние 5 месяцев произошло много изменений в PushAll. Много мелких изменений, правок ошибок и оптимизаций, но есть и крупные изменения, о которых мы опишем в статье. Каждый пункт выполнен в стиле how-to.

Rich Push Notifications.

Rich Notifications это уведомления с дополнительными элементами. Например стандартный набор состоит из иконки, заголовка и текста. Rich Notifications добавляет к этому набору кнопки и крупную картинку.

Мы очень долго тянули с этой «фичей», а зря. Демка в виде дополнения для хрома от 2014 года давно уже висит, и для Android, Rich Notifications были представлены еще в 2012 году. И только пол года назад они стали доступны для Web Push.

Мы сделали поддержку Rich Notifications для Chrome дополнения, Android приложения, Email (приходят уведомления с кнопками и большой картинкой) и для Web Push. Также такие уведомления доступны через историю уведомлений в любом браузере.

Это очень полезная функция. Например если у вас есть превью к вашей новости — вы можете его поместить на крупную картинку. Если ваше уведомление имеет ветвление — например вы обновили приложения сразу для iOS и Android и вы можете отправить одно уведомление с обоими ссылками. Также на основе этой механики можно делать опросы, или давать пользователю выбор, чтобы он мог отреагировать на уведомление. Например если у вас есть сервис для напоминаний то у уведомления могут быть 2 кнопки — отложить на час, и отменить, а по клику на само уведомление будут открываться подробности напоминания.

Нужно помнить, что на некоторых платформах, например iOS и Safari, такие кнопки не поддерживаются. Вы должны это предусмотреть это на вашей стороне, отображая подобный выбор по клику на уведомлении.

Такие уведомления можно отправить через ручную рассылку, используя кнопку «Дополнительные поля» и через API. Для этого нужно добавить в обычную структуру отправки любого уведомления поля bigimage и actions (внутри него массив кнопок с заголовком и ссылкой)

{

"bigimage":"https:\/\/urlimage",

"actions":[

{

"title":"test",

"url":"https:\/\/url1"

},

{

"title":"test2",

"url":"https:\/\/url2"

}

]

}UTM-метки

Для отслеживания конверсий на клики ранее приходилось добавлять utm-метки вручную. Теперь по-умолчанию на бесплатном тарифе добавляется utm-метка utm_source=pushall, на платном тарифе это поле можно отредактировать.

А еще мы оптимизировали работу настроек распределив их на 4 отдельные секции. Это куда удобнее, чем одна большая лента настроек.

WebHook

Нам часто писали, что хорошо было бы сделать альтернативу callback-ссылке. Теперь вы можете привязать свой webhook-адрес и получать в реальном времени данные о подписке или отписке от канала.

Если у вас небольшой личный канал, вы можете получать уведомления о подписке или отписке.

Самое важное — вы можете передать вашу строку, которую вы получите через webhook. Просто добавьте 'authstring'. Например pushall.ru/news?authstring=teststring. И вы получите teststring вместе с другими публичными данными пользователя в виде JSON в postdata. Передача authstring доступна бесплатно до конца недели, далее в платном тарифе. Также эта строка будет передаваться в callback уже совсем скоро.

Также для платных тарифов будет доступны расширенные Webhook-действия, например смена статуса индивидуальных уведомлений (unicast). Это позволит отправить уведомление и в случае, если статус не сменился в течении 10 минут (если оно не было доставлено), отправить через другой канал связи, например, смс-сообщение.

Другие нововведения

Мы поправили множество ошибок в работе сервиса. После урагана в Москве мы сделали канал-зеркало твиттера МЧС Теперь мы компенсируем комиссию яндекса при пополнении баланса, то есть сколько вы потратили за перевод, столько и придет на баланс.

На платном тарифе можно редактировать цвета канала (только не переборщите).

Мы перешли на Let's Encrypt и включили шифрование для Email-рассылок.

Тем временем отправлено около 100 миллионов уведомлений.

|

Метки: author BupycNet расширения для браузеров api блог компании pushall pushall push уведомления android webhook push notifications webpush |

[Перевод] Создание быстрых и более оптимизированных сайтов на WordPress |

Я собрал список плохих web-решений, а также рекомендаций о том, чего делать на вашем сайте не стоит. Список основывается на тысячах часов общения с клиентами, а также поддержки и устранения неполадок, с которыми я сталкиваюсь ежедневно. Что-то из предложенного будет достаточно примитивным, а какие-то вопросы будут более продвинутого уровня. Многое из описанного может отделять успешный сайт на WordPress от провального. Ведь, несмотря на то, что выбор правильного web-хостинга очень важен, вы должны уделять достаточно времени оптимизации сайта на WordPress, чтобы он был успешным.

Я часто замечаю, что опытные разработчики сосредотачиваются на том, что они хороши в создании тех или иных web-решений, что заставляет их пренебрегать или просто-напросто забывать про изучение и применение актуальных методов оптимизации. Вне зависимости от того, новичок вы в WordPress, или же опытный разработчик, следующие советы помогут вам создавать гораздо более быстрые и оптимизированные сайты на WordPress.

1. Смена хостинга — не всегда решение проблемы

2. Работающие сайты не предназначены для разработки

3. Не разработчик? - Не лезь в код

4. Не экономьте на темах и плагинах

5. Контролируйте AJAX-запросы

6. Будьте аккуратны при работе с рекламными сетями и внешними сервисами

7. Чрезмерная оптимизация может нанести вред производительности

8. Популярные проблемы с производительностью легко диагностировать

9. Изменение ядра WordPress, это плохо

10. Обеспечьте совместимость с PHP 7 и HHVM до переноса сайта

11. Крупные сайты должны заниматься оптимизацией баз данных

12. Действительно ли вам необходима универсальная тема?

13. Лог ошибок - ваш друг

14. Google здесь не просто так

15. 123456 больше не допускается

16. Скрипты не всегда должны загружаться по всему сайту

1. Смена хостинга — не всегда решение проблемы

Одна из самых важных вещей, которую люди должны осознавать, заключается в том, что смена web-хостинга не решит никаких проблем сама собой. Если ваш сайт на WordPress имеет проблемы с кодом или конфликтующие плагины, ваш сайт не исправится, где бы вы его не размещали.

Администрируемый хостинг предоставит вам столько поддержки и помощи, сколько сможет, но не будет заниматься отладкой кода или плагинов. Написание хорошего кода на PHP, создание и редактирование функционала плагинов и тем, правка интеграции, а также наполнение сайта содержимым - не зона ответственности web-хостинга. Этим может заняться опытный разработчик, который вникнет в работу сайта, изучит проблему и решит её.

2. Работающие сайты не предназначены для разработки

Я могу повторить это тысячу раз. Никогда не используйте работающие сайты для разработки! Сейчас почти все основные администрируемые хостинги WordPress имеют среды разработки и обкатки, и, безусловно, не без оснований. Использование этих решений спасает нас от аварийного падения рабочего сайта из-за неудачных попыток что-то протестировать.

Если вы не хотите использовать такие решения, вы можете воспользоваться локальной разработкой и тестированием, используя то, что некоторые называют LAMP или LEMP -стеком. Они предназначены для работы с Linux, Apache/Nginx, MySQL и PHP. А такие инструменты, как WAMP и MAMP упростят и ускорят сборку сервера для локальной разработки.

Все эти инструменты улучшались и развивались с течением времени, однако, в локальной разработке есть свои проблемы, например, среда, которая не очень точно имитирует ваш опубликованный сайт. Прежде всего, вам придется выяснить, как перенаправить ваши наработки с локальной машины на рабочий сайт так, чтобы не пришлось перезаписывать существующие данные, а сайт не упал. В зависимости от ваших настроек, этот процесс может стать отдельной проблемой. Отдельные сложности могут возникнуть с конфликтующими портами или ошибками из-за различий в версиях MySQL.

Чтобы избежать таких проблем, я рекомендую воспользоваться такими инструментами, как DesktopServer и Local, которые созданы исключительно для ускорения вашего рабочего процесса при локальной работе с WordPress. Они включают в себя упрощенные способы передачи данных рабочему сайту, а также имеют дополнительные функции, такие как работа с WP-CLI и встроенная поддержка режима мультисайтов. Поддержка мультисайтов сама по себе может быть бесценной, поскольку работа с большими локальными копиями WordPress иногда может быть довольно сложной.

Среды обкатки и локального тестирования могут помочь вам справиться с проблемами до того, как они сломают вам сайт.

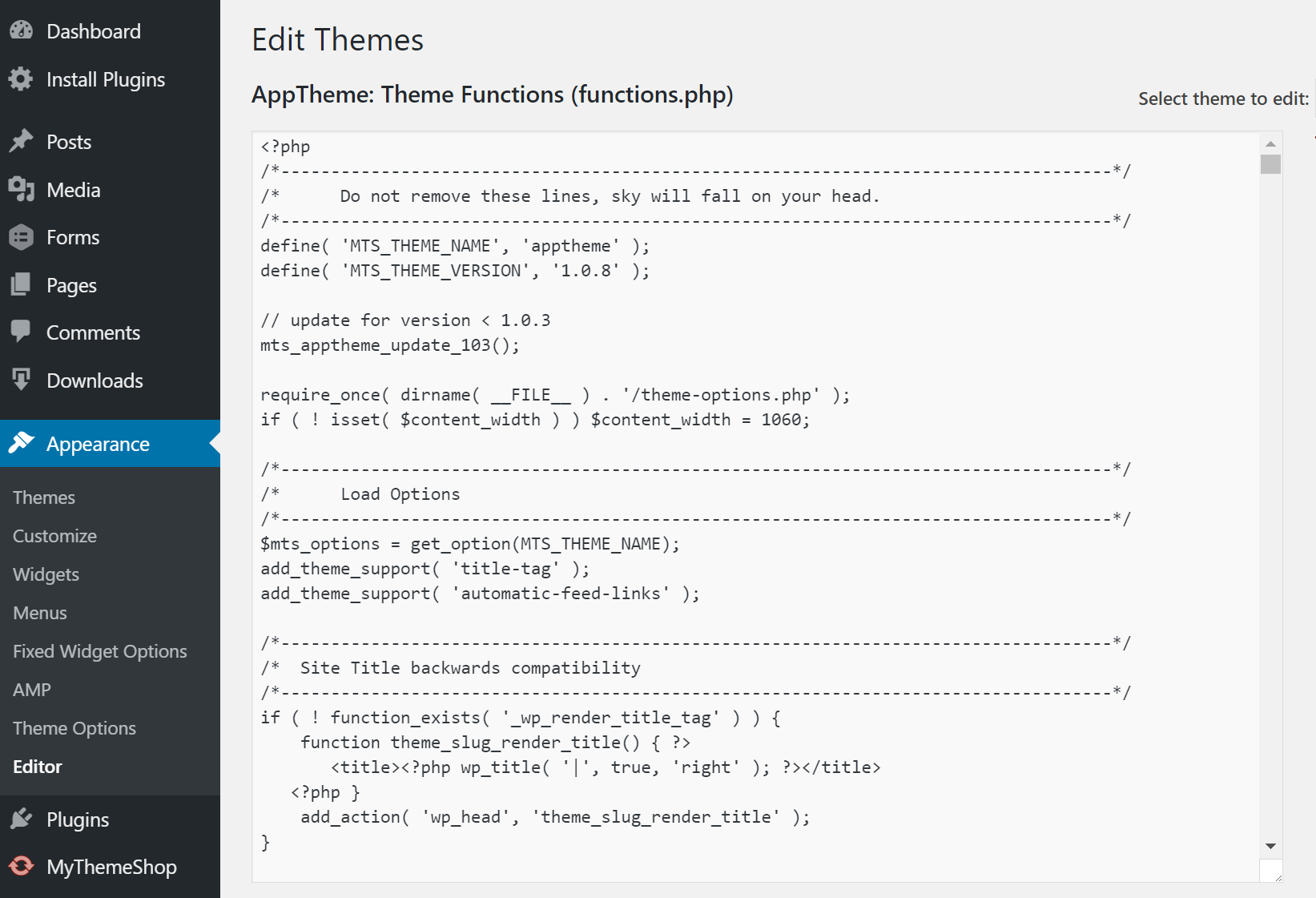

3. Не разработчик? - Не лезь в код

Люди, которые либо не знакомы с WordPress, либо не знают основ программирования, не должны редактировать файлы. Одна из самых распространенных причин, по которой сайты на WordPress падают, это то, что кто-то занимается редактированием PHP-файла прямо из редактора внешнего вида в панели управления. Кроме того, вы не должны редактировать работающий сайт, как уже было сказано ранее.

Рекомендация для администраторов: поместите следующий код в файл wp-config.php с заменой edit_themes, edit_plugins, и edit_files привелегий для всех пользователей. Это помешает пользователям уронить сайт посредством редактирования кода.

define('DISALLOW_FILE_EDIT', true);Также, отключите возможность редактирования файлов темы или установки плагинов для пользователей. Для этого поместите следующий код в файл wp-config.php.

define('DISALLOW_FILE_MODS', true);Учтите, вышеприведенные команды также отключат редактор файлов для тем и плагинов. Больше информации в WordPress Codex.

4. Не экономьте на темах и плагинах

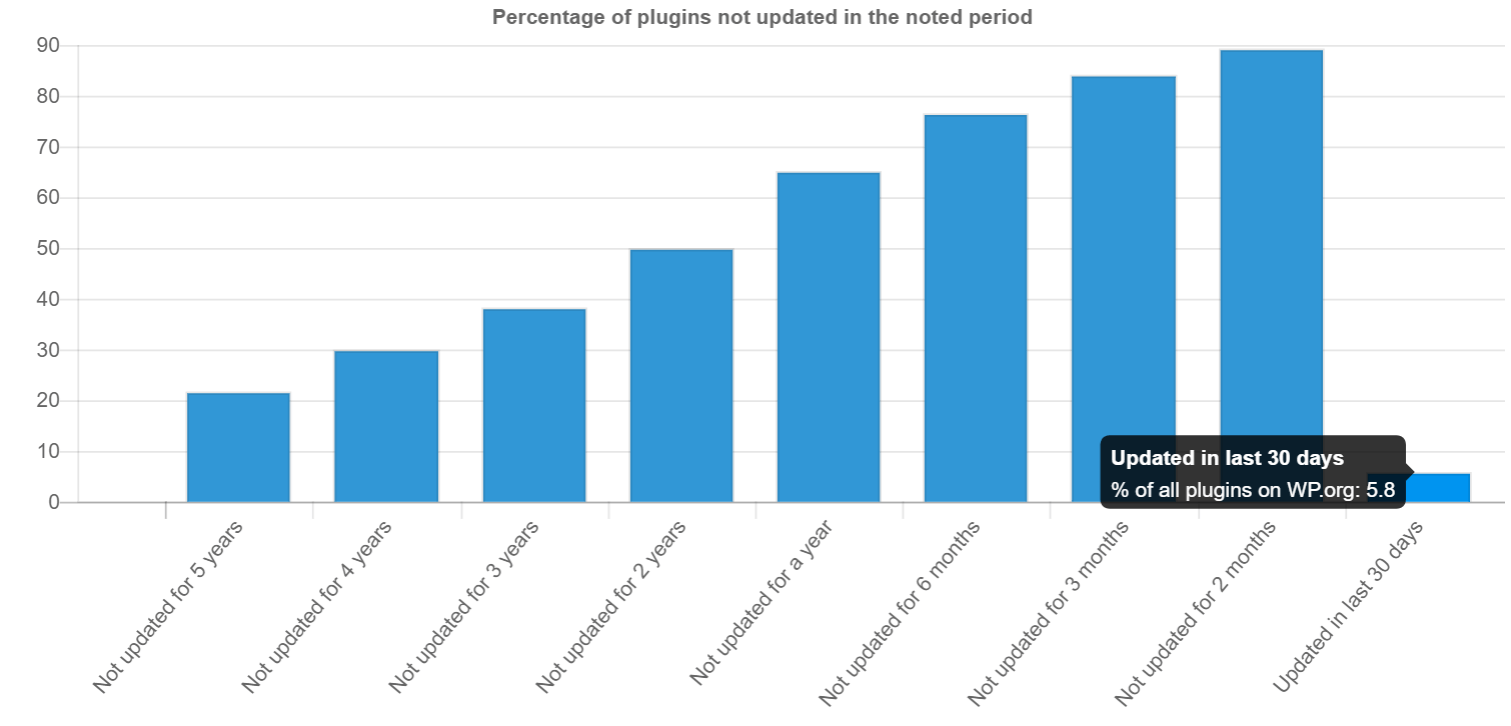

Понятно, что вы хотели бы сэкономить пару долларов, но не стоит делать это за счет тем и плагинов. WordPress должен быть основой вашего сайта, а темы и плагины - это клей, держащий функционал проекта вместе. Старайтесь придерживаться авторитетных разработчиков при выборе плагинов. Заранее изучите историю поддержки продукта разработчиком, просмотрите рейтинги и прочитайте отзывы. Такое исследование может стать сложнейшей задачей, с учетом более чем 50.000 плагинов в каталоге WordPress.

Очень часто устаревшие или некачественные темы и плагины подвержены внедрению вредоносов или занимаются установкой вредоносного контента и ссылок на ваш сайт. Согласно исследованиям WP Loop, почти половина из всех опубликованных плагинов, не обновлялась уже более двух лет. Это одновременно шокирует и пугает.

Еще один источник плагинов и тем, который стоит изучить - это сторонние каталоги, предлагающие премиальные решения по низкой цене. При выборе этого источника, вы не поддержите разработчика. Кроме того, вы полагаетесь на ненадежный источник обновлений, что тоже не очень хорошо.

Ожидание обновлений установленных плагинов - это огромная проблема для пользователей WordPress, которые покупают решения в сторонних каталогах, вроде ThemeForest. Многие разработчики тем встраивают в них дополнительные плагины, такие как Revolution Slider или Visual Composer. Дело тут в том, что при обнаружении уязвимостей во встроенном плагине, пользователю приходится ждать обновления от разработчика темы, хотя сам плагин мог быть исправлен буквально сразу же. Это делает многие сайты очень уязвимыми для хакеров.

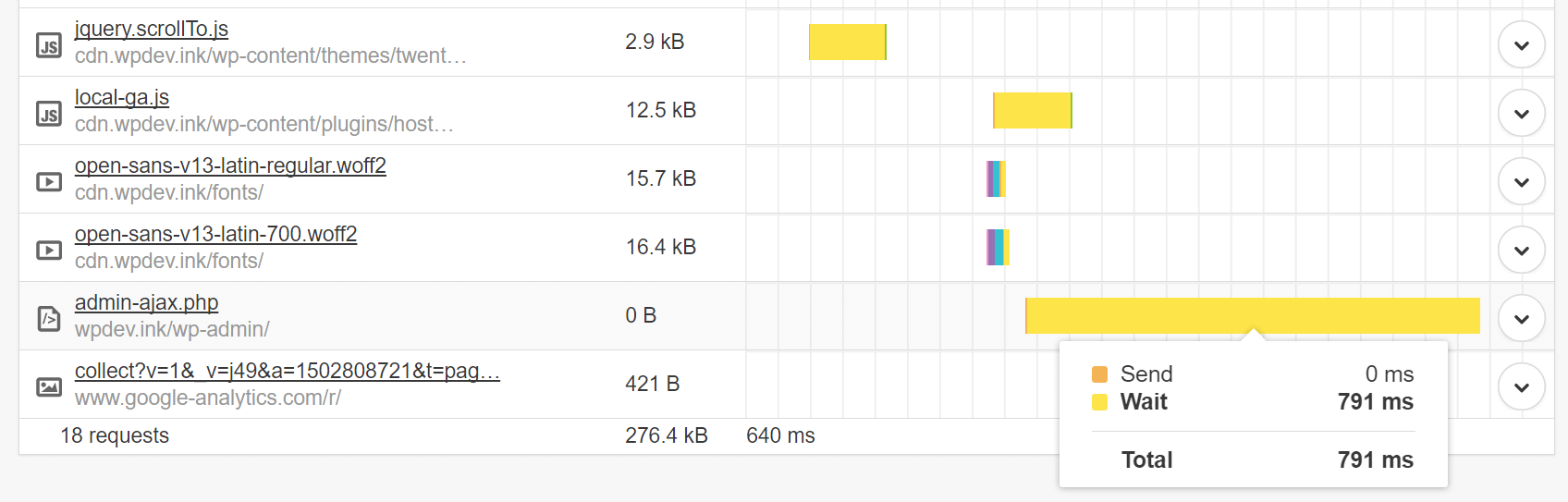

5. Контролируйте AJAX-запросы

Следите за тем, как используются AJAX-запросы на сайте, а также за плагинами, использующими AJAX. Например, API WordPress Heartbeat использует /wp-admin/admin-ajax.php для обращения к AJAX через браузер. Многие из этих обращений лишние. Особенно частое использование этого файла происходит при всплесках трафика и загрузке процессора. Это может существенно замедлить ваш сайт. Это чем-то похоже на запуск DDoS-атаки против себя самого.

Если есть сторонние плагины, использующие admin-ajax.php, убедитесь в том, что они взаимодействуют с ним правильно. Вы без труда можете отслеживать HTTP POST-запросы и, на основе имени, определять, каким плагином они вызваны. Например, тот, что обнаружил я, get_shares_count, оказался популярным плагином для взаимодействия с социальными сетями, который перегружал admin-ajax.php. На сайте с высоким трафиком, перегрузка выросла бы многократно.

Однако AJAX загружается только после загрузки самой страницы, так что, если вы видите соответствующие предупреждения в тесте скорости, не всегда проблема в AJAX.

6. Будьте аккуратны при работе с рекламными сетями и внешними сервисами

Большинство сайтов с высоким трафиком зарабатывают на рекламе, и отказ от сторонних поставщиков рекламных объявлений не представляется возможным. Тем не менее, важно, чтобы количество сторонних сервисов было минимальным - вы должны понимать, насколько сильно они нагружают ваш сайт.

Вот краткое сравнение того, как рекламные сети могут повлиять на ваш сайт на WordPress.

Параметры тестирования: на тестовый ресурс я добавил три объявления из Google AdSense, размером 300x250. На сайте установлена тема по умолчанию - Twenty Sixteen. Я замерил скорость загрузки до установке AdSense, и после.

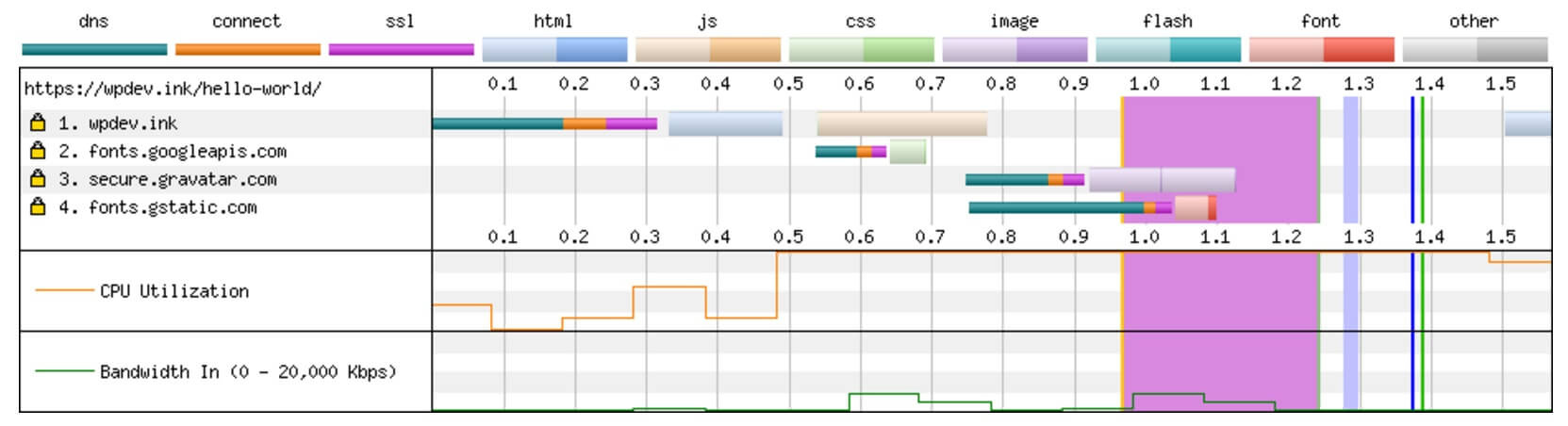

До AdSense (результаты тестирования)

- Первая загрузка: 1,372 с.

- Повторная загрузка: 1,013 с.

Разбивка содержимого по соединениям:

После AdSense (результаты тестирования)

- Первая загрузка: 4,103 с.

- Повторная загрузка: 3,712 с.

Разбивка содержимого по соединениям:

Просто установив 3 объявления Google AdSense, мы добавили 6 дополнительных подключений. Сайт на WordPress c рекламными объявлениями в 2,7 раза медленнее, чем без них. В основном это связано с дополнительным временем поиска DNS и использованием JavaScript на странице. Все это должно создать у вас картину происходящего на крупных сайтах, вставляющих 10 объявлений на одну страницу. Независимо от того, насколько быстрый хостинг вы используете, он не будет исправлять задержки от сторонних рекламных подключений.

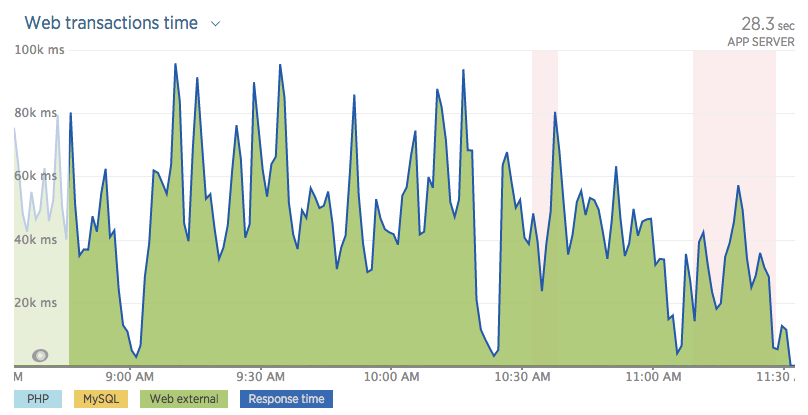

Ниже приведен еще один пример сайта с большим количеством внешних рекламных HTTP-запросов, что вызвало большую нагрузку на WordPress.

Было так много запросов, что сервер приложений вообще не загружался. Сайт был просто недоступен, пытаясь выполнить все внешние запросы.

Другим хорошим примером является сайт Huffington Post. Если вы проведете тест скорости загрузки, вы увидите огромное число HTTP-запросов к рекламным сетям. Быстрый тест показал скорость загрузки свыше 13 секунд!

- Первая загрузка: 15,908 с. | 221 HTTP-запрос

- Повторная загрузка: 13,957 с. | 66 HTTP-запросов

Но простое удаление рекламы маловероятно станет хорошим решением, ведь многие сайты большую часть дохода получают именно с нее. Придется заняться оптимизацией загрузки своих скриптов. Вы можете воспользоваться асинхронной загрузкой скриптов или отложить их загрузку, чтобы они не прерывали рендеринг ваших страниц. Когда дело доходит до производительности, всегда приходится балансировать между воспринимаемой и фактической производительностью.

Пример асинхронного JavaScript:

src="example.js" asyncПример отложенного JavaScript:

src="example.js" deferУ Патрика Секстона есть другой метод отсрочки JavaScript. WordPress версии 4.1 и выше, имеет фильтр, с помощью которого вы можете легко добавить атрибуты async или defer к своим скриптам.

Как правило, используя внешние службы, вы хотите кэшировать ответы. Зачем? Потому, что, если вы этого не сделаете, может возникнуть «проблема белого экрана смерти». Каждая внешняя служба, которую вы добавляете, должна быть из надежного и проверенного источника. В конце концов, если они упадут, это повлияет на весь ваш сайт или на ваши бизнес-операции.

7. Чрезмерная оптимизация может нанести вред производительности

В Интернете есть тысячи статей, дающих “советы” о том, как ускорить и оптимизировать сайт на WordPress. Но нет ничего хуже, чем когда пользователи чрезмерно оптимизируют свои сайты. Да, это происходит гораздо чаще, чем вы думаете. Владельцам сайтов WordPress часто кажется, что добавив чего-то, он удвоит скорость загрузки.

Ниже я перечислил несколько проблем, с которыми встречаюсь регулярно:

Попытка закэшировать кэш

В отличии от типичных VPS или обычных серверов, многие хостинги WordPress имеют собственное кеширование, которое выполняется на уровне сервера (например, Redis или Memcache). Многие провайдеры запрещают использование кэширующих плагинов, потому что их использование может вызвать все типы проблем, но чаще всего, 502 Bad Gateway. Попытка “закэшировать кэш”, как я это называю, никогда не является хорошей идеей.

Плагины, такие, как WP Rocket и Cache Enabler, великолепны, но они разрабатывались для серверов, которым необходима дополнительная помощь в ускорении вашего сайта. Рекомендую почитать подробнее о том, что касается кэширования объектов - популярной серверной формой кэширования, часто используемой сегодня.

2x CDN = 2x скорость загрузки, верно?

CDN действительно могут значительно уменьшить время загрузки контента в разных географических регионах, но только при грамотной настройке. Один из самых популярных сервисов - Cloudflare, технически является прокси-сервером, и немного отличается от обычного поставщика CDN, поскольку вы направляете к нему весь свой DNS, а не только содержимое сайта.

Обычно я вижу, как пользователи подключают Cloudflare, затем добавляют KeyCDN или MaxCDN вдобавок. Это часто происходит из-за того, что они читают чьи-то сообщения в блогах, где видят рекомендации попробовать новые сервисы. Они устанавливают новые сервисы, забывая про уже подключенные, и, хотя эта комбинация может работать при определенных сценариях, чаще всего, все заканчивается беспорядком. В большинстве случаев, стоит использовать либо Cloudflare, либо стороннего поставщика CDN, каждый из которых имеет свои преимущества и недостатки.

Огромное количество SEO-плагинов не обеспечивает более высокую позицию в поисковой выдаче

Вы хотите доминировать в поисковой выдаче, это понятно. Но ведь добавление 3 плагинов для SEO не поможет вам достичь этой цели. На самом деле, есть много проблем с совместимостью, возникающих при использовании All In One SEO, Yoast и других плагинов для SEO одновременно, например, вывод дублирующих метатегов. Установка дополнительных плагинов не гарантирует улучшение вашей поисковой оптимизации.

8. Популярные проблемы с производительностью легко диагностировать

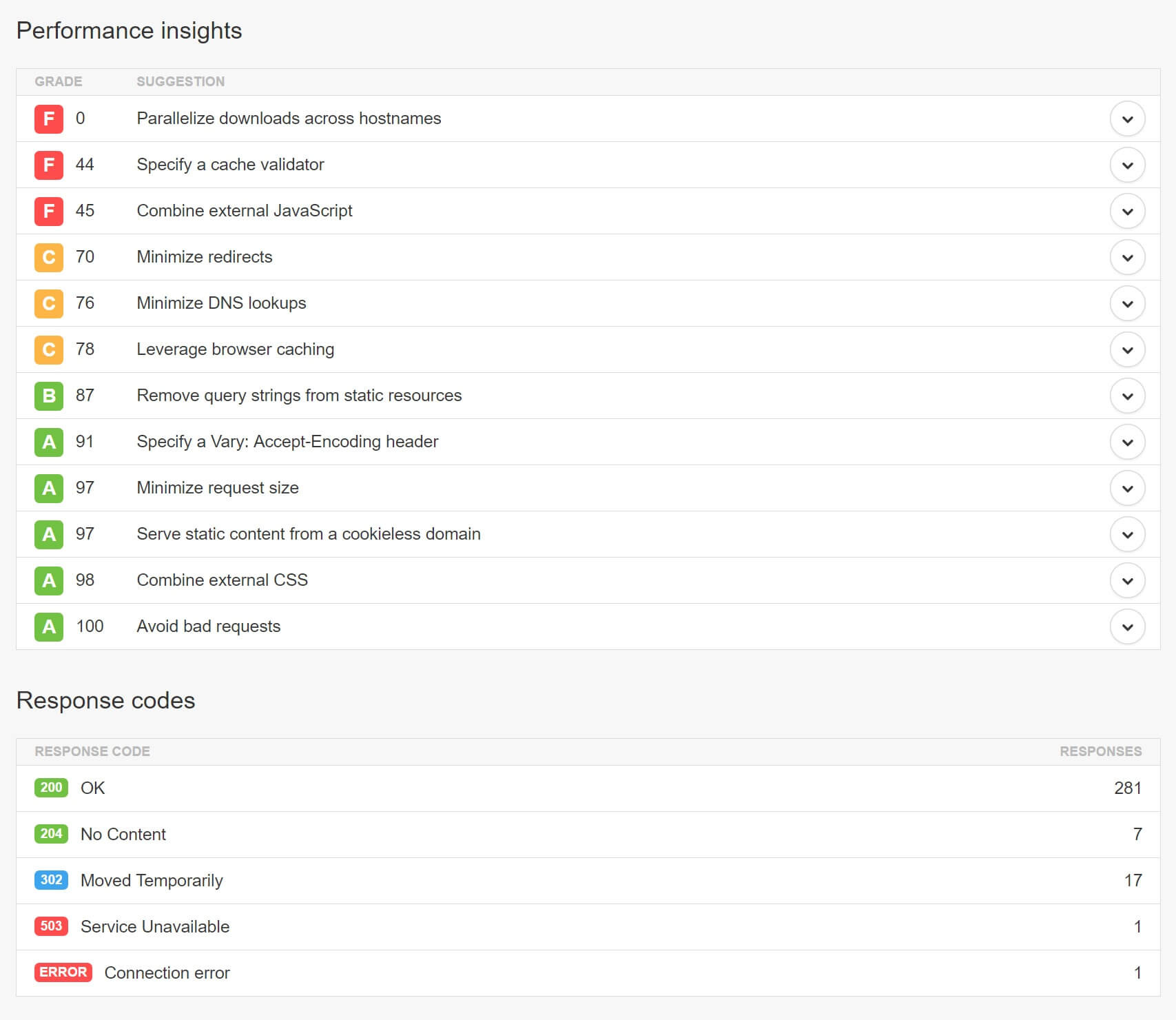

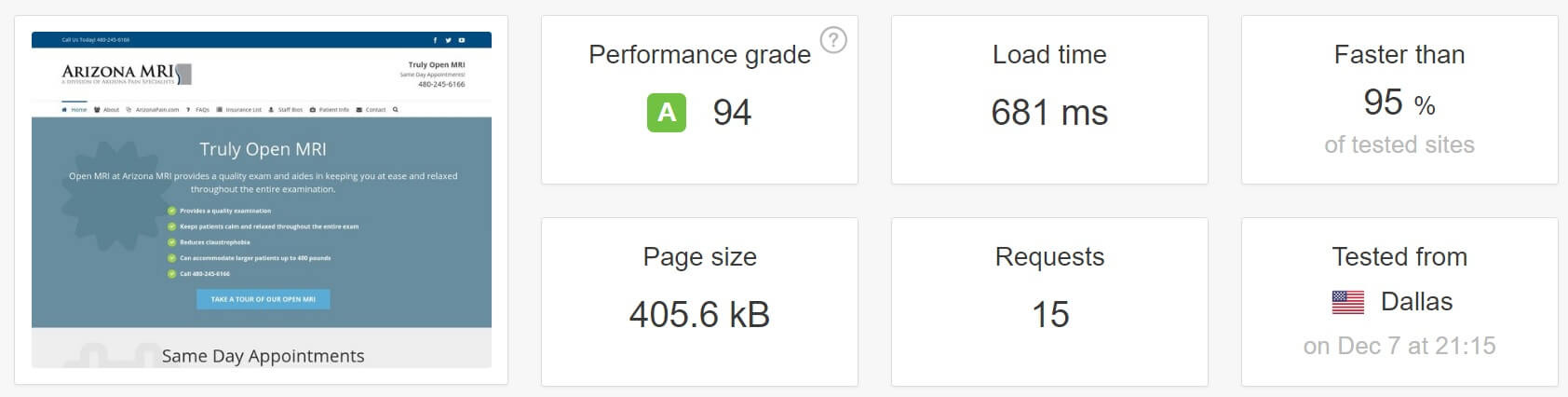

Даже если вы не являетесь продвинутым пользователем WordPress, общие проблемы с производительностью достаточно легко обнаруживать. Продвинутым пользователям я рекомендую пользоваться WebPageTest, поскольку он поддерживает последние протоколы HTTP/2. Для остальных подойдет Pingdom. Простой каскадный анализ покажет вам, есть ли у вас ненужные переадресации, отсутствующие файлы, избыток DNS-запросов или перегрузка сайта через сторонние скрипты или рекламные сети.

Взгляните на оценки производительности и коды ответов, и вы узнаете, с чего начать решение ошибок на вашем сайте.

9. Изменение ядра WordPress, это плохо

Возьмите за правило: внесение изменений в ядро WordPress, чтобы ваш код начал работать - это плохая идея. Особенно на работающем сайте. Такие манипуляции могут создать уязвимости на вашем сайте. А если вы не предусмотрели обновление изменений для новых версий ядра, ваши правки будут теряться с каждым новым обновлением WordPress. Лучше всего, если вы будете пользоваться встроенными инструментами и функциями WordPress, плагинами, дочерними темами и хуками.

10. Обеспечьте совместимость с PHP 7 и HHVM до переноса сайта

Известно, что PHP 7 и HHVM очень способствуют повышению производительности сайтов на WordPress. И конечно, всегда приятно использовать новейшее и самое лучшее. Но сначала стоит убедиться, что ваш сайт совместим с этими технологиями. Например, если вы обновляетесь с PHP 5.6 до PHP 7, вы должны протестировать все функции вашего сайта на WordPress в обкаточной среде или локально, чтобы убедиться, что проблем с совместимостью нет. Один устаревший, но очень важный для вас плагин, может не работать с PHP 7, что означает, что вам придется подождать его обновления, прежде чем переходить на более свежие технологические решения.

11. Крупные сайты должны заниматься оптимизацией баз данных

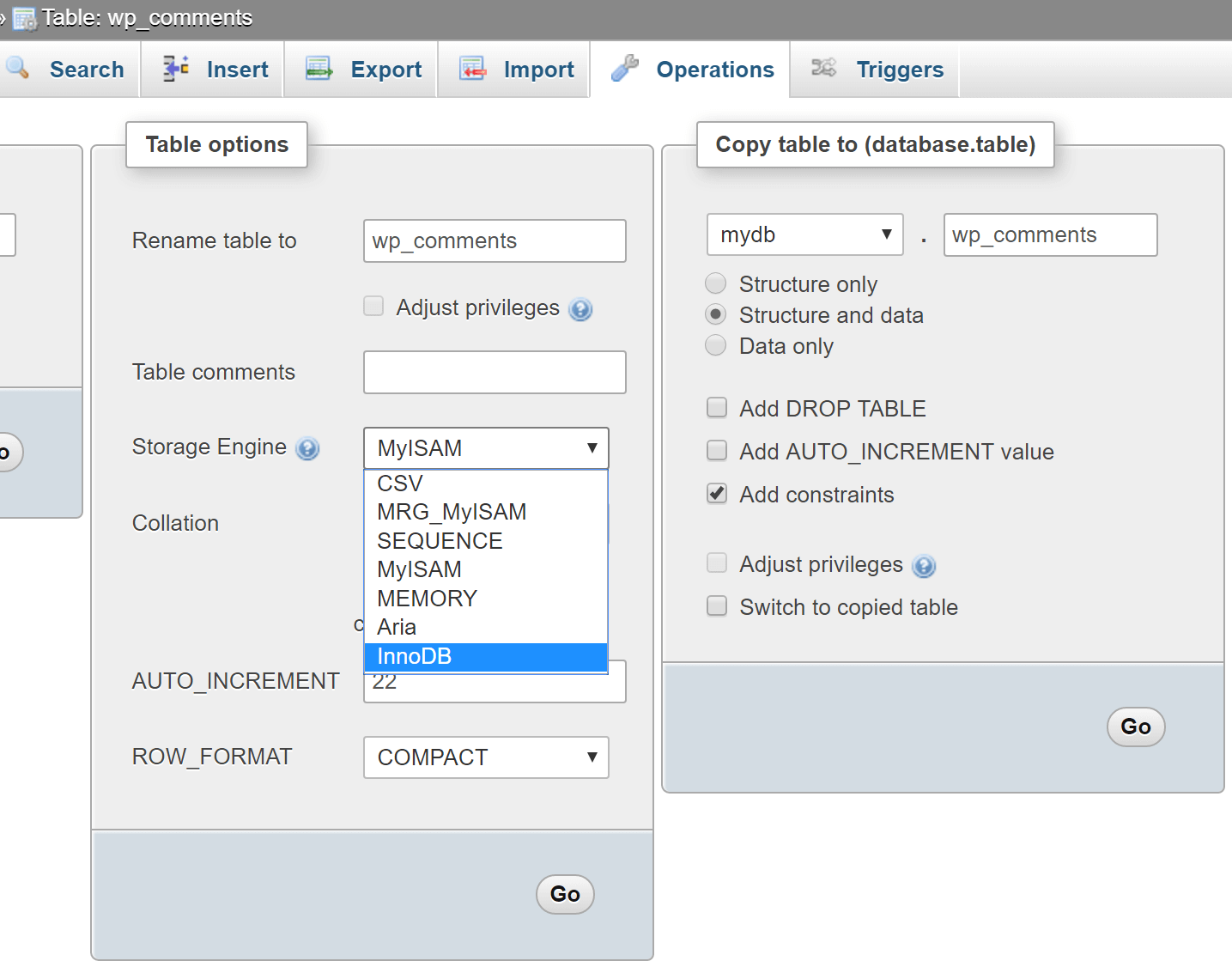

Один из самых простых способов замедлить работу большого сайта на WordPress - это не заниматься оптимизацией базы данных. Простые задачи, такие, как очистка следов старых версий WordPress или удаление неиспользуемых таблиц, могут защитить ваш сайт от замедления. Также, я заметил, что многие старые сайты все еще используют MyISAM в работе баз данных. InnoDB, на данный момент, является куда более быстрым и надежным решением.

Вы можете конвертировать свои таблицы всего в несколько простых действий. Для начала, убедитесь, что вы используете MySQL 5.6.4 или более новую, а также, что вы сделали резервную копию, в качестве меры предосторожности. В этом примере используется таблица wp_comments. Просто запустите команду ALTER, чтобы преобразовать для работы с InnoDB.

ALTER TABLE wp_comments ENGINE=InnoDB;Если же вы работаете с актуальной версией phpMyAdmin, вы можете открыть нужную таблицу, перейти во вкладку “Операции” и изменить механизм хранения там.

Еще один простой способ оптимизации - это отключение или ограничение количества хранимых исправлений в базе данных. Вы можете добавить в свой wp-config.php следующее, чтобы полностью их отключить.

define('WP_POST_REVISIONS', false );Или просто измените их количество, хранимое для каждого поста или страницы:

define('WP_POST_REVISIONS', 3);Мне попадалось множество сайтов с более чем 200 версий постов. Если у вашего хостинга нет внутренней оптимизации, настройки WordPress придется задавать вручную, ведь по умолчанию, он будет хранить неограниченное число исправлений.

Если на вашем сайте сохранено множество изменений, вы можете запустить этот сценарий в phpMyAdmin, чтобы их удалить:

DELETE FROM wp_posts WHERE post_type = "revision";Вы также можете воспользоваться плагином WP-Optimize для этих целей.

12. Действительно ли вам необходима универсальная тема?

Существует огромная проблема, которую я наблюдаю в сообществе WordPress. Люди покупают универсальные темы, а используют лишь 1% её функционала или и того меньше. Они смотрят на демо-страницы и видят красивые слайдеры и кастомизированные блоки, которые убеждают их в необходимости приобретения, однако, на самом деле, эти возможности могут никогда им не пригодиться. Можно купить более простую и менее функциональную тему, и тем самым, сэкономить и деньги и время, которое, в итоге, будет затрачено на ее оптимизацию, ведь простая тема будет быстрее прямо “из коробки”.

Я не хочу сказать, что все универсальные темы плохие. На самом деле, при грамотной настройке, они могут работать очень быстро - вот пример с темой Avada, которая загружается за 700 мс.

Однако для оптимизации существующей темы потребуется много знаний и времени. Для большинства пользователей WordPress, если они не используют и половину функционала темы, использование более простых тем - это выход. Не позволяйте красивым баннерам и причудливым слайдерам дурачить вас. Чаще всего, весь этот набор опций будет лишь замедлять ваш сайт.

13. Лог ошибок - ваш друг

Если вы знаете, как вести себя с файлами WordPress и файлом wp-config.php, журнал ошибок может сослужить вам хорошую службу. Регулярно проверяя его, вы спасете себя от всевозможных головных болей, а также глубже изучите работу WordPress. Мало кто из пользователей заглядывает в лог перед обращением за помощью к техподдержке хостинга. С помощью нескольких простых настроек в wp-config.php, вы сможете включить ведение журнала ошибок, который по умолчанию сохраняется в /wp-content/debug.log.

Включение логирования:

define( 'WP_DEBUG_LOG', true );Вывод логов на странице:

define( 'WP_DEBUG_DISPLAY', true );Подробнее в WP_DEBUG codex.

14. Google здесь не просто так

Не бойтесь искать ответы в Google. Интернет полон подсказок и решений. В течение пары минут, вы можете исправить большинство ваших проблем. Ответы на типичные вопросы, вроде “как изменить DNS в GoDaddy” или “как пользоваться sFTP”, легко могут быть найдены в Google.

В Интернете есть крупные ресурсы, посвященные работе с WordPress, такие, как StackExchange и WordPress Codex, не говоря уже о сотнях блогов с обучающими статьями.

Кроме того, у хорошего хостинга WordPress, вероятнее всего, есть собственная удобная база знаний, которая поможет пользователям находить ответы на вопросы, а хостингу - сократить время на поддержку пользователей в типовых случаях.

15. 123456 больше не допускается

SpashData собирает список наиболее часто используемых слитых паролей (более 2 млн.) каждый год. Неудивительно, что в 2015 году самым популярным паролем был “123456” - тот же, что и в 2014 году. Это довольно неприятно для хостингов, так как использование таких паролей держит сайты буквально в шаге от взлома. Одним из лучших решений является использование KeePass или его аналогов. Зашифрованный пароль в облаке всегда намного безопаснее, чем “123456”.

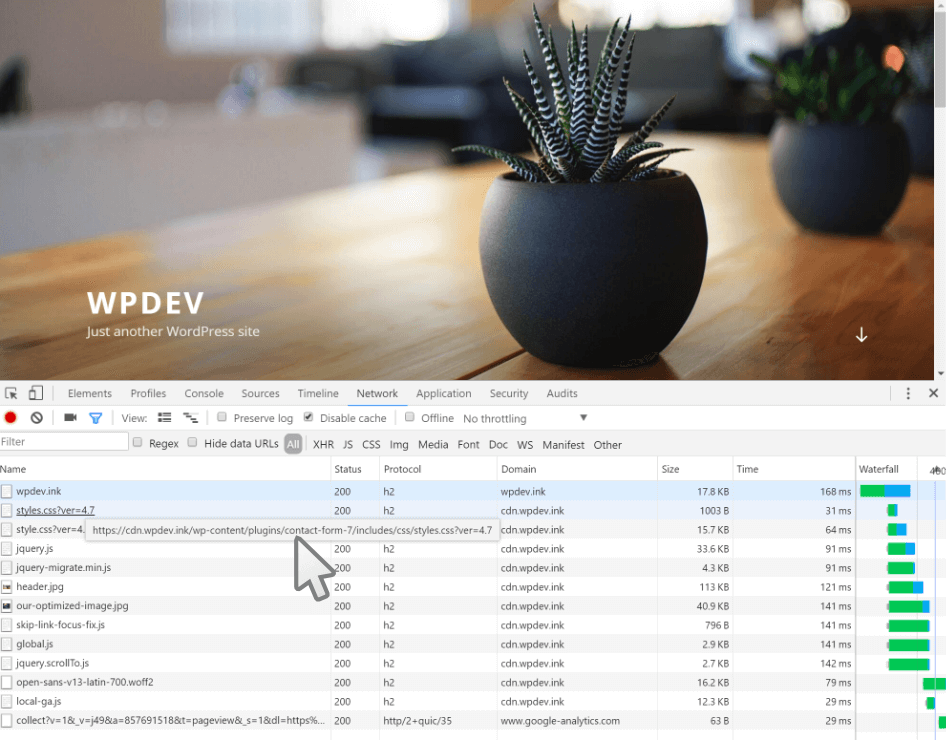

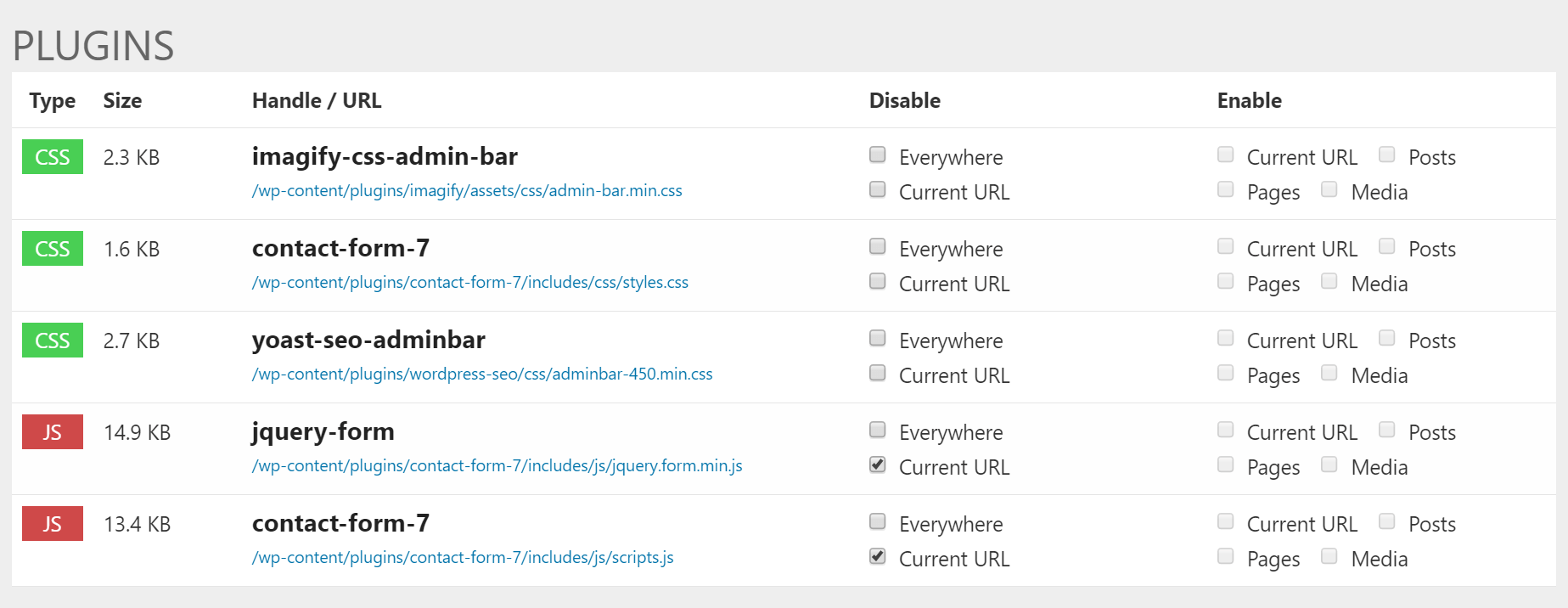

16. Скрипты не всегда должны загружаться по всему сайту

К сожалению, в отличии от статического веб-сайта, который контролируется вручную, сайт на WordPress находится во власти разработчиков тем и плагинов. И далеко не все разработчики заботятся о производительности своих решений. Существует огромное количество плагинов, которые загружают свои скрипты на все страницы сайта, хотя сам плагин применяется только на одной из них. Если учесть, что плагинов может быть несколько десятков, проблема множится, а сайт замедляется.

Один из таких примеров - популярный плагин Contact Form 7. Как показано ниже, он загружает файлы CSS и JavaScript на домашнюю страницу сайта, хотя там не используется ни одной контактной формы.

Есть несколько способов это исправить. Первый - использовать функцию wp_dequeue_script(), введенную в WordPress 3.1. Она позволяет удалять скрипты из очереди загрузки на вашем сайте. Вот пример использования этой функции с Contact Form 7. Разработчик Contact Form 7 также имеет документацию о том, как использовать JavaScript и CSS только там, где это необходимо.

Второй способ - использовать специальные плагины для WordPress, например, Gonzalez или Plugin Organizer. Ниже приведен пример использования Gonzalez на нашем сайте. Удобное окно настроек позволяет за пару щелчков мыши убрать JavaScript и CSS файлы плагина Contact Form 7 со всех страниц, кроме страницы контактов, тем самым, увеличив скорость загрузки остального сайта.

Заключение

Существуют причины, по которым WordPress используется на более чем 28% всех веб-сайтов. Это очень надежная, удобная и многофункциональная CMS. Каждый, от авторов домашних блогов до нескольких сотен компаний, полагается на него каждый день. Но так же, как с большинством платформ, если использовать WordPress неправильно или не заниматься его оптимизацией, работа с ним может быстро превратиться в головную боль.

|

Метки: author ScarletFlash отладка высокая производительность wordpress перевод оптимизация mysql css javascript хостинг производительность скорость загрузка страница |

[Из песочницы] Динамическая таблица поверх Google Maps |

Введение

Вам когда-нибудь нужно было отображать крупные массивы данных с привязкой к карте? Мне на работе понадобилось отображать заказы сгруппированные по широте и долготе. И не просто статической таблицей, а динамической, с разной детализацией для разного приближения карты.

К сожалению (или к счастью?), готовых решений я не нашёл. Google Карты позволяют накладывать маркеры и фигуры на карты, но эти способы представляют слишком мало информации. С Яндекс картами оказалось не лучше. Но Карты Гугл имеют механизм пользовательских наложений с HTML-содержанием. И для инкапсуляции этой работы с картами и наложениями я создал JavaScript библиотеку GMapsTable. Возможно, кому-нибудь она окажется интересной или полезной. Рабочий пример.

Чтобы не возникло путаницы, параметр zoom будем называть приближением карты, а scale — масштабом. Первый относится к Google Maps API, а второй к описываемой библиотеке.

Задача в целом

Итак, что у нас есть? Какой-нибудь источник данных (например, сервер с базой данных, обрабатывающий и посылающий данные в формате JSON) и веб-страничка с JavaScript, которая запрашивает данные и визуализирует их на Картах Гугл.

Данные имеют аккумулятивную природу (в моём случае каждой области можно поставить в соответствие: число заказов, клиентов и среднюю сумму). Поэтому данные могут и должны отображаться с разной детализацией для разных приближений.

Основное содержание HTML страницы для GMapsTable:

..в :

..в :

GMapsTable позволяет абстрагироваться от взаимодействия с GoogleMaps API. Вам нужно лишь предоставить подходящий объект с данными. Время перейти к JavaScript'y! Чтобы использовать GMapsTable, нужно получить объект DataContainer для Вашего div'a карты:

// Аргумент: ID div'а

// и словарь параметров GoogleMaps,

// это не обязательно

var container = new DataContainer("map", {

zoom: 9,

center: {lat: 55.7558, lng: 37.6173},

mapTypeId: 'roadmap'

});Затем нужно передать две функции:

container.dataLoader = function (scale, borders) {

... вызвать container.processData(some_data);

}

container.scaler = function (zoom) {

... return какое-нибудь число;

}Но что именно писать внутри функций?.. Для начала разберёмся, как работает GMapsTable.

Data для DataContainer

DataContainer занимается отображением Ваших данных и заботится о том, когда оно должно быть обновлено. В самом начале и когда изменяются приближение и границы "камеры", он пробует использовать сохранённые данные, а если их нет, то вызывает функцию dataLoader. Вам нужно сгенерировать объект с данными и передать его функции DataContainer.processData. Структура объекта должна быть такая:

data: {

minLat: float,

difLat: float,

minLon: float,

difLon: float,

scale: int,

table: [

[value, value, ...],

[value, value, ...],

...

],

tocache: boolean

}Значением (value) может быть число, строка или любой объект, если вы укажите собственную функцию форматирования ячейки таблицы. Масштаб (sale) это целое число, говорящее, на сколько частей должны делиться единицы широты и долготы. Параметр tocache указывает, должны ли данные для текущего масштаба быть сохранены и более не запрашиваться.

data: {

minLat: 55.0,

difLat: 2.0,

minLon: 37.0,

difLon: 1.0,

scale: 2,

table: [

[1, 3, 0, 1],

[0, 1, 2, 0]

],

tocache: true

}Здесь данные покрывают область от 55.0, 37.0 до 57.0, 38.0 и делят каждую единицу широты и долготы на 2 части (получается, одна клетка широты-долготы делится на 4 части). Также здесь указано, что для данного масштаба это полные данные, и они должны быть сохранены для использования в дальнейшем.

Перевод приближения в масштаб

Приближение (zoom) это параметр Google Maps API, целое число между 1 (карта мира) и 22 (улица). Запрашивать и хранить данные для каждой единицы приближения неудобно и нецелесообразно, поэтому GMapsTable переводит их в масштаб (scale) — число, указывающее, на сколько частей нужно делить единицу широты и долготы.

Сохранение данных

Чтобы отображение при изменении масштаба было моментальным, GMapsTable хранит наборы данных для некоторых (либо всех) масштабов. Например, у меня была база данных с координатами почти со всей России — около 42 тысяч ячеек для масштаба 10 (500 КБ, довольно легко хранится и обрабатывается у меня в десктопном браузере) и 17 миллионов для масштаба 200 (несколько МБ, вызывает значительные подвисания). Поэтому сервер оценивает число ячеек всех данных, и если их немного, отправляет данные из всей БД, иначе только для запрошенного региона. Получается такой алгоритм:

Границы (bounds) — это объект JavaScript с полями minlat, maxlat, minlon, maxlon — текущими границами Google Maps и хорошим отступом про запас.

В Вашей реализации dataLoader Вы можете смело игнорировать аргументы, если нет нужды использовать разную детализацию для разных масштабов или если Ваши данные не покрывают такой большой регион. Просто передайте данные и их границы по широте и долготе и scale, на сколько разбиваете единицы широты-долготы. Но для полноты картины я предлагаю такое поведение функции dataLoader (или сервера, к которому она обращается):

Список всех параметров

Вы можете указать такие параметры для DataContainer:

1) scaler(zoom) — переводит приближение из GoogleMaps в масштаб для GMapsTable. Оба целые числа.

2) dataLoader(scale, borders) — вызывается, когда нужны новые данные. Должен передать объект данных в DataContainer.processData(data).

Параметр borders это объект JavaScript с полями minlat, maxlat, minlon, maxlon — текущими границами Google Maps и хорошим отступом про запас.

3) tableBeforeInit(map, table, data) — вызывается перед тем, как таблица начинает заполняться ячейками. Аргумент map это объект Google Maps, table это HTML элемент таблицы, а data — предоставленный Вами объект данных для текущего масштаба.

4) cellFormatter(td, val) — вызывается для заполнения ячейки. td это HTML element, ячейка таблицы. val это данные из Вашего объекта данных.

5) boundsChangedListener(zoom) — вызывается, когда изменяются границы Google Maps.

6) minZoomLevel, maxZoomLevel — переменные для минимального и максимального приближения карты. Целые числа между 1 (карта мира) и 22 (улица).

Для успешной работы DataContainer необходимы только первые две функции.

Пример и исходники

Полный и хорошо прокомментированный пример использования: HTML-страничка и JS-код.

А также есть GMapsTable в GitHub.

|

Метки: author AivanF maps api javascript google maps визуализация данных |

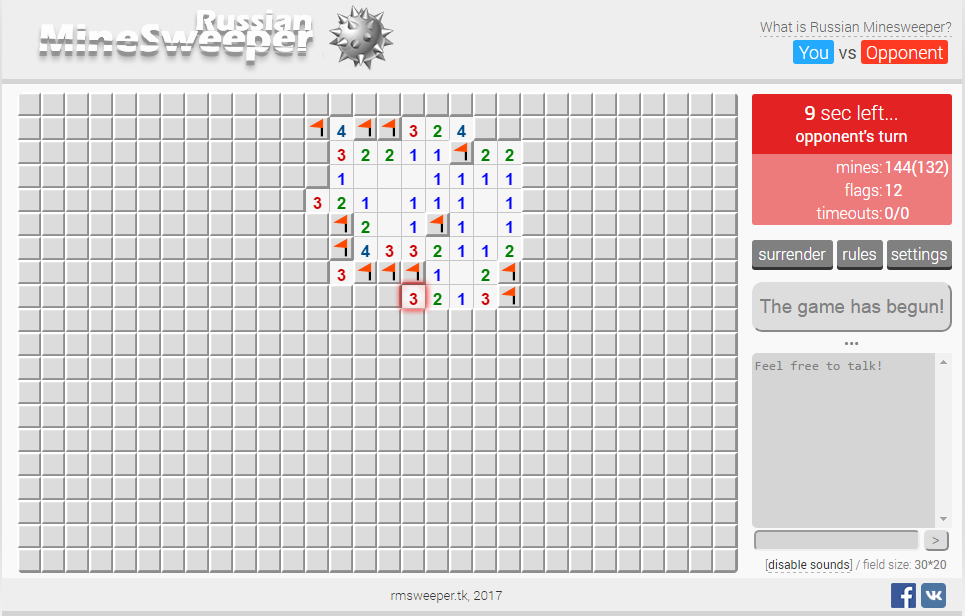

Russian Minesweeper — мультиплеерная версия игры «Сапёр» |

Здравствуйте, уважаемые читатели.

Искренне надеюсь, что среди читателей Хабра найдутся любители такой замечательной игры как «Сапёр».

Если верно помню, то впервые эта игра появилась на операционной системе Windows 3.1 ещё в далеком 1994-ом году. В то время эта игра позиционировалась как средство для обучения использованию компьютерной мыши и в целом графическому интерфейсу ОС. Выглядела она примерно так:

Игрок открывает ячейки, стараясь не открыть ячейку с миной. Открыв ячейку с миной, он проигрывает. Мины расставляются после первого хода, поэтому проиграть на первом же ходу невозможно. Если под открытой ячейкой мины нет, то в ней появляется число, показывающее, сколько ячеек, соседствующих с только что открытой, «заминировано» (в каждом варианте игры соседство определяется по-своему); используя эти числа, игрок пытается рассчитать расположение мин, однако иногда даже в середине и в конце игры некоторые ячейки всё же приходится открывать наугад. Если под соседними ячейками тоже нет мин, то открывается некоторая «не заминированная» область до ячеек, в которых есть цифры. «Заминированные» ячейки игрок может пометить, чтобы случайно не открыть их. Открыв все «не заминированные» ячейки, игрок выигрывает.

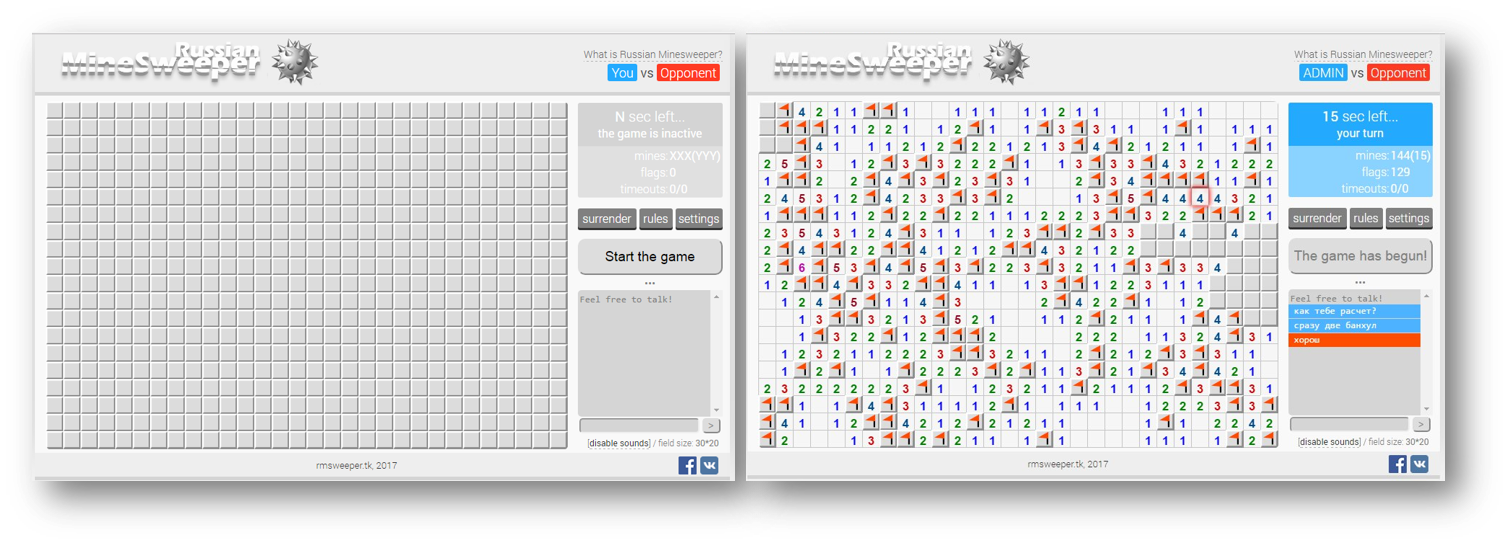

Однако, время идет, популярность сапера падает, и хочется внести новую жизнь и краски в эту игру. Именно так и родилась мультиплеерная версия игры, именованная как "Russian Minesweeper", которая представляет собой браузерную онлайн игру.

Заинтересовавшихся прошу под кат.

Характеристики игры

Разумеется, чтобы какое-то количество игроков смогли вместе играть в эту игру, правила придется каким-либо образом модернизировать и вообще видоизменять. Однако, главное правило — существенный принцип оставить как в оригинале.

Таким образом, собственно, и был разработан комплекс правил, чтобы позволить нескольким игрокам одновременно играть на одном и том же поле.

Основные правила игры следующие:

- Цель игры — первым пометить все мины флагами и открыть пустые клетки.

- У каждого игрока свои (локальные) флаги.

- У игроков одно и тоже (глобальное) поле с минами.

- Игроки ходят по очереди (однако, сейчас ведется разработка «параллельного» режима).

- Если игрок кликнет по мине, он проиграет, а его оппонент выиграет соответственно.

- Время на ход игрока ограничено (~25 сек.) — необходимо ходиться как можно быстрее.

- Если игрок пропустит ход три раза подряд, он проиграет, а его оппонент выиграет соответственно.

- Если игрок пропустит шесть ходов за все время игры, он проиграет, а его оппонент выиграет соответственно.

- Ничья невозможна. Один из игроков в любом случае выставит флаги корректным образом быстрее чем другой.

- Первый ход достается случайному игроку.

- Игрок может сдаться в любой момент игры.

Также был разработан ряд характеристик минного поля для игры:

- Подрыв при вскрытии первой клетки в начале игры невозможен.

- Мины равномерно распределены по игровому полю.

- Свойства «пустоты», открываемой при первом клике:

- Размер от A до B пустых клеток (0 мин вокруг).

- Пустота не должна представлять из себя линию открытых клеток только по одной из сторон ориентации.

- Процент минных клеток (тип регулятора — вещественный) и размер поля регулируются в настройках приложения.

Таким образом, при текущей конфигурации, при первом клике открывается «пустота» от 3 до 12 «нулевых» клеток, а поле размера 32x20.

Извиняюсь за огромное количество списков, однако, не могу не упомянуть, что игра помимо этого обладает следующим функционалом:

- Аккорд — открытие более одной клетки за ход. Это возможно в случае клика (ЛКМ) по цифре в клетке на игровом поле, а кол-во флагов вокруг смежных клеток равно искомой цифре.

- Чат — между игроками в режиме реального времени.

- Nickname в игре.

- Звуковое сопровождение в игре.

Технологии

Полный список технологий, используемых при разработке продукта, следующий:

- C# .NET + ASP .NET – основа для веб-сервера.

- HTML5 / CSS3 – для разработки интерфейса клиентской части.

- JavaScript – для динамической работы клиентской части.

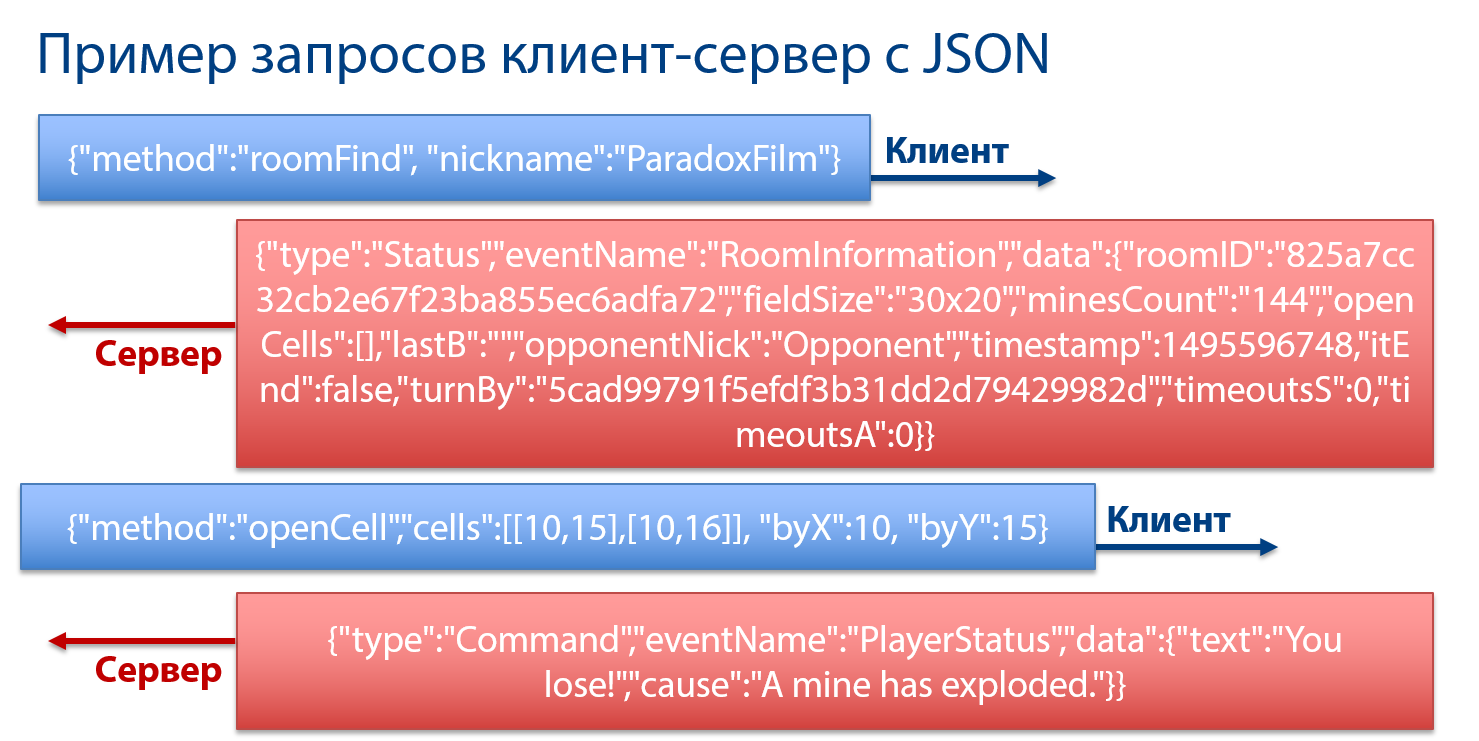

- JSON – для сериализации/десераилизации пакетов клиент-сервер.

- WebSocket – протокол используется как метод связи клиент-сервер.

- HTML Canvas — технология для отрисовки минного поля.

- jQuery – эффективное и быстрое взаимодействие между HTML и JS.

- JSON Newton – библиотека для удобной работы с JSON.

- Adobe Photoshop – для отрисовки графических элементов интерфейса.

- GitHub – как удобная площадка для контроля версий проекта.

- Microsoft Azure – для размещения веб-сервера в Интернете.

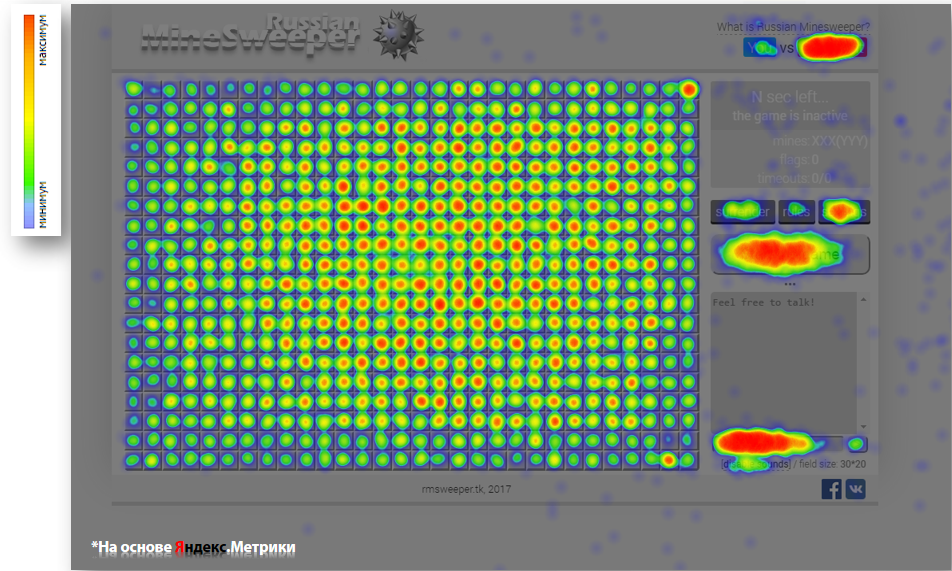

- Яндекс.Метрика – статистика и анализ поведения игроков.

- CloudFlare – в качестве CDN-прокси / SSL / Anti DDoS.

- Microsoft Visual Studio – в качестве основной среды разработки.

- Sublime Text – в качестве инструмента разработки под JavaScript.

- Microsoft IIS – для разворачивания ASP. NET

Самими проблемными местами в проекте было нижеследующее:

- Синхронизация игроков друг с другом

- Проблема: как быстро оповещать игроков об изменениях на поле?

Варианты: long polling; websockets; cyclic polling; etc - Решение: использовать WebSocket

- Проблема: как быстро оповещать игроков об изменениях на поле?

- Отрисовка минного поля и прочих элементов игры

- Проблема: какие инструменты будут наиболее оптимальны?

Варианты: HTML table/div; SVG; HTML5 Canvas; etc - Решение: HTML5 Canvas + JavaScript

- Проблема: какие инструменты будут наиболее оптимальны?

Интересные цифры

- 23 человека по меньшей мере принимали участие в тестировании.

- 183 298 клика сделано по полю во время тестирования.

- С 119-ой попытки минное поле было пройдено до конца.

- Поле размером 32x20 наиболее оптимально для игры (эмпирическое наблюдение).

- От 3 до 12 «нулевых» клеток лучше всего открывать при первом клике (эмпирическое наблюдение).

А также прикрепляю карту кликов от Яндекс.Метрики, по ней можно сделать ряд интересных умозаключений. Например очевидно, что основная область «битвы» это центр поля, а чат пользуется популярностью.

Планы на будущее

В будущем хочется доделать следующий функционал:

- Реализовать комнату на N игроков.

- Возможность создания «дружеской комнаты» и одиночного режима.

- Оптимизация приложения под мобильные устройства.

- Переход на более мощные сервера для реализации приложения в массы.

- Создание баг-трекера.

- Реализация удобной обратной связи с игроками.

- Более детальная статистика использования приложения.

Заключение

В заключение хочу сказать следующее — будьте, пожалуйста, аккуратнее с сервером игры :)

Он получен бесплатно по подписке от Microsoft Azure и его мощности крайне скромны.

Искренне уповаю на то, что после этой статьи мы с вами вместе сможем насладиться этой игрой.

Напоминаю, что она доступна по адресу https://rmsweeper.tk, а также есть сообщество во «ВКонтакте».

Спасибо за внимание,

с Вами был Петр.

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

|

Метки: author ParadoxFilm я пиарюсь swiper multiplayer сапер mineswiper мультиплеер asp.net c# websocket json |

Потенциально опасные алгоритмы |

|

Метки: author randall математика криптография информационная безопасность алгоритмы блог компании mail.ru group ошибки уравнение формулы разработка программирование |

Распределённые вычисления поверх Ceph RADOS и AsyncMessenger |

Асинхронная система сообщений существенно снижает накладные расходы сетевого уровня Ceph, а применение абстракций NetworkStack делает возможной реализацию различных протоколов стека (POSIX/ SPDK/ DPDK/ RDMA).

Программирование при помощи librados

Для достижения максимальной производительности и внутренней гибкости Ceph можно применять встроенные в библиотеку

librados вызовы функций, доступные для большинства языком программирования, например, для C, C++, Python, PHP и Java. С этой целью вы сначала устанавливаете инструменты разработки. Например, для Debian- дистрибутивов: $ sudo apt-get install build-essential$ sudo apt-get install librados-devЗатем в своём приложении вы:

- Выполняете необходимые подготовительные операции самого приложения (считывание параметров, подготовку справки об этом приложении и т.п.)

- Считываем файл настроек

ceph.confдля получения мониторов - Подключаемся к кластеру Ceph

- Открываем нужный пул RADOS

- Открываем образ для чтения/записи

- Выполняем необходимую операцию чтения/записи

- Закрываем соединение с пулом

- Закрываем соединение с кластером Ceph

(Пример приложения)

Порой приложение требует атомарности выполняемой операции, состоящей из нескольких действий, например, из записи собственно данных и их атрибутов. То есть, если в процессе выполнения атомарной (неделимой) последовательности действий происходит какое- либо прерывание или некий сбой, отвергаются все уже выполненные действия. Реальной записи или изменения не происходит. Долгое время разработчики Ceph не теряли надежды на поддержку атомарности за счёт средств btrfs, поскольку её реализация в рамках xfs приводит к снежному кому проблем, самой малой из которых является необходимость, как минимум, дублированной записи. В конце концов, начиная с выпуска Kraken для лежащее в основе OSD хранилища было принято решение по умолчанию отказываться от файлового хранения с применением POSIX файловых систем и применять упрощённую файловую систему BlueFS для хранения собственно данных и RocksDB для хранения метаданных и, возможно, отложенных записей (WAL, write-ahead log). Данное хранилище получило название

BlueStore (указывающая на Blочную природу хранилища, изначально имевшего незатейливое название NewStore). подробнее...

Теперь, имея в руках полноценную реализацию транзакций, не отягощённую избыточными накладными расходами, мы со спокойной совестью можем их использование в своих приложениях. Посмотрим как меняется скелет нашей программы:

- Выполняете необходимые подготовительные операции самого приложения (считывание параметров, подготовку справки об этом приложении и т.п.)

- Считываете файл настроек

ceph.confдля получения мониторов - Подключаетесь к кластеру Ceph

- Открываете нужный пул RADOS

- Инициализируем списки буферов обмена (по числу необходимых действий) и заполняем их данными

- Создаём транзакцию

- Последовательно записываем данные буферов обмена в транзакцию

- Фиксируем транзакцию

- Закрываем соединение с пулом

- Закрываем соединение с кластером Ceph

(Пример приложения)

Ещё одной достойной функциональностью

librados является организация приложений наблюдатель- уведомитель ( watch — notify). Работа наблюдателя организуется путём обратного вызова (callback). При создании наблюдателя через вызов соответствующей функции вы передаёте в таком вызове двумя параметрами ссылки на необходимые функции обратного вызова. Первая применяется для выполнения действия в случае получения уведомления, а вторая используется когда что-то пошло не так, в ней вы производите необходимые действия по отработке ошибок.

Например, таким образом вы создаёте моментальный снимок некоторого объекта. Клиент, которому требуется выполнить такой снимок, отправляет всем находящимся в ожидании для данного объекта клиентам (watcher) уведомления (выступая в качестве notifier), в котором он сообщает, что может сбросить свой кэш данного объекта и выполнить проверку на непротиворечивость данных.

(Пример приложения)

Распределённые вычисления при помощи классов RADOS Ceph

Библиотека

librados работает с объектами, хранящимися в распределённой системе хранения RADOS (Reliable Autonomic Distributed Object Store), в основе которого лежат демоны хранения объектов (OSD, Object Storage Daemon), каждый из которых обслуживает некое собственное хранилище (например, уже упоминавшееся BlueStore).Одним из примечательных свойств OSD является возможность локальной обработки хранимых в нём данных методами класса

RADOS. Это открывает широкие возможности революционного увеличения производительности распределённой обработки хранимых данных, поскольку избавляет вас от необходимости обмена самими данными для такой обработки.Например, вы можете вычислять хеш-значения и контрольные суммы данного объекта, осуществлять их проверку. Вы можете выполнять поиск в таких данных и их анализ, выставляя результаты, скажем, в метаданных самого объекта.

Одним из простейших способов такой разработки является применение языка сценариев Lua, который, начиная с выпуска Kraken встроен в класс

RADOS. Данный сценарий, как правило, в виде строк JSON (скажем, в программе с применением librados на Python) передаётся в имеющийся объект класса RADOS, где он и исполняется.Пример приложения изменения в объекте всех строчных букв на прописные. Отметим, что по умолчанию исполнение сценариев Lua в OSD отключено, для включения такой возможности необходимо внести приведённые в примере изменения в файлы настроек OSD.

К сожалению, в настоящее время функциональные возможности языка сценариев Lua достаточно ограничены. Для решения более сложных задач вам придётся скомпилировать исходный код Ceph со встроенным в него классом

RADOS, написанным, например, на C или C++. В Примере приложения вычисления MD5 объекта приводятся пошаговые инструкции построения такого решения, а также сопоставляются результаты времён его работы в сравнении с аналогичным приложением, исполняющимся на клиенте, находящимся не на узле OSD и вынужденном считывать данные с OSD и записывать в него результат расчёта. результат сравнения даёт преимущество в абсолютных затратах времени в два порядка.Поскольку данный метод обработки может приводить в случае ошибок к утрате данных и нарушению работы самого OSD, естественно, все применяемые методы должны быть тщательно проверены и иметь всеобъемлющие средства обработки ошибок.

Ceph Async Messenger

Дополнительные средства для распределённой обработки данных предоставляет имеющаяся в Ceph система асинхронного обмена сообщениями. Например, таким образом реализован механизм применения RDMA в реализации Mellanox.

Первоначально

AsyncMessenger, судя по всему, разрабатывался в качестве расширения epoll, призванного полностью вытеснить SimpleMessenger, являющийся первоначальной системой обмена сообщений и лежащей в основе сетевого протокола Ceph. Такая потребность вызвана тем фактом, что для каждой пары участников однорангового взаимодействия (peering) в SimpleMessenger создаются 4 потока (по два с каждой стороны). С ростом числа участников это приводит к экспоненциальному росту общего числа потоков (thread) в узлах участников. В настоящее время все три метода реализуют сетевой протокол Ceph, при этом применяя один общий рабочий пул.

В протоколе

AsyncMessenger участвуют сервер и клиент. Сервер выполняет инициализацию, привязывается к file descriptor (fd) и осуществляет ожидание уведомлений по нему (listen). В отличие от определённых POSIX методов select() и poll(), epoll предоставляет механизм обработки сообщений со сложностью O(1), в отличие от O(n) для SimpleMessenger, исключая перебор событий, не имеющих активных fd. AsyncMessenger применяет библиотеку libevent, предоставляемую средствами epoll. Обработка события осуществляется сервером по получению уведомления на fd, либо по тайм- ауту. Помимо этого сервер может добавлять ожидание fd, принимать соединения, добавлять приём fd и осуществлять взаимодействие.

Клиент инициирует установление соединения и устанавливает его для выполнения взаимодействия. Весь обмен сетевого уровня приложений обрабатывается машиной состояний

AsyncConnection. Статья Wei Jin акцентирует основные моменты данного типа взаимодействия.Дальнейшим развитием механизма

AsyncMessenger является развитие абстракции NetworkStack, которая позволяет осуществлять распределённую поддержку различных сетевых стеков (Posix/ DPDK/ RDMA), а также встроенной в BlueStore поддержки SPDK.Данный уровень абстракции реализует понятия

ServerSocket и ConnectedSocket, причём первый ожидает поступления запросов, а второй собственно и осуществляет чтение и запись всех данных. Основные моменты реализации приложений с применением данных абстракций приводятся в статье Стек асинхронной системы сообщений Ceph того же Wei Jin.

|

|

Комиксы Даниэля Стори |

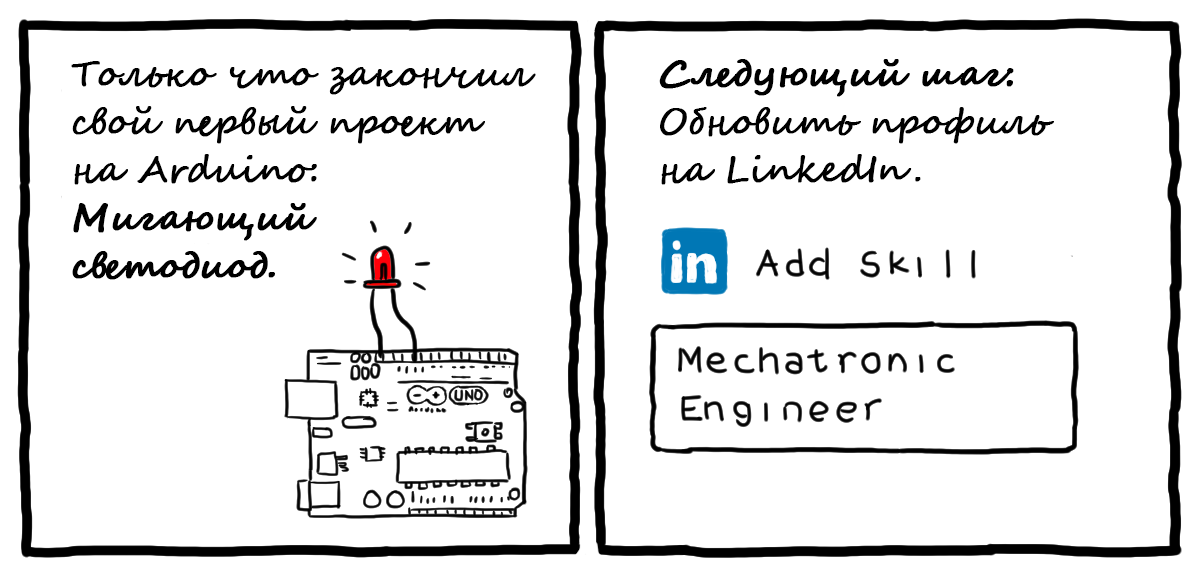

Arduino-проект

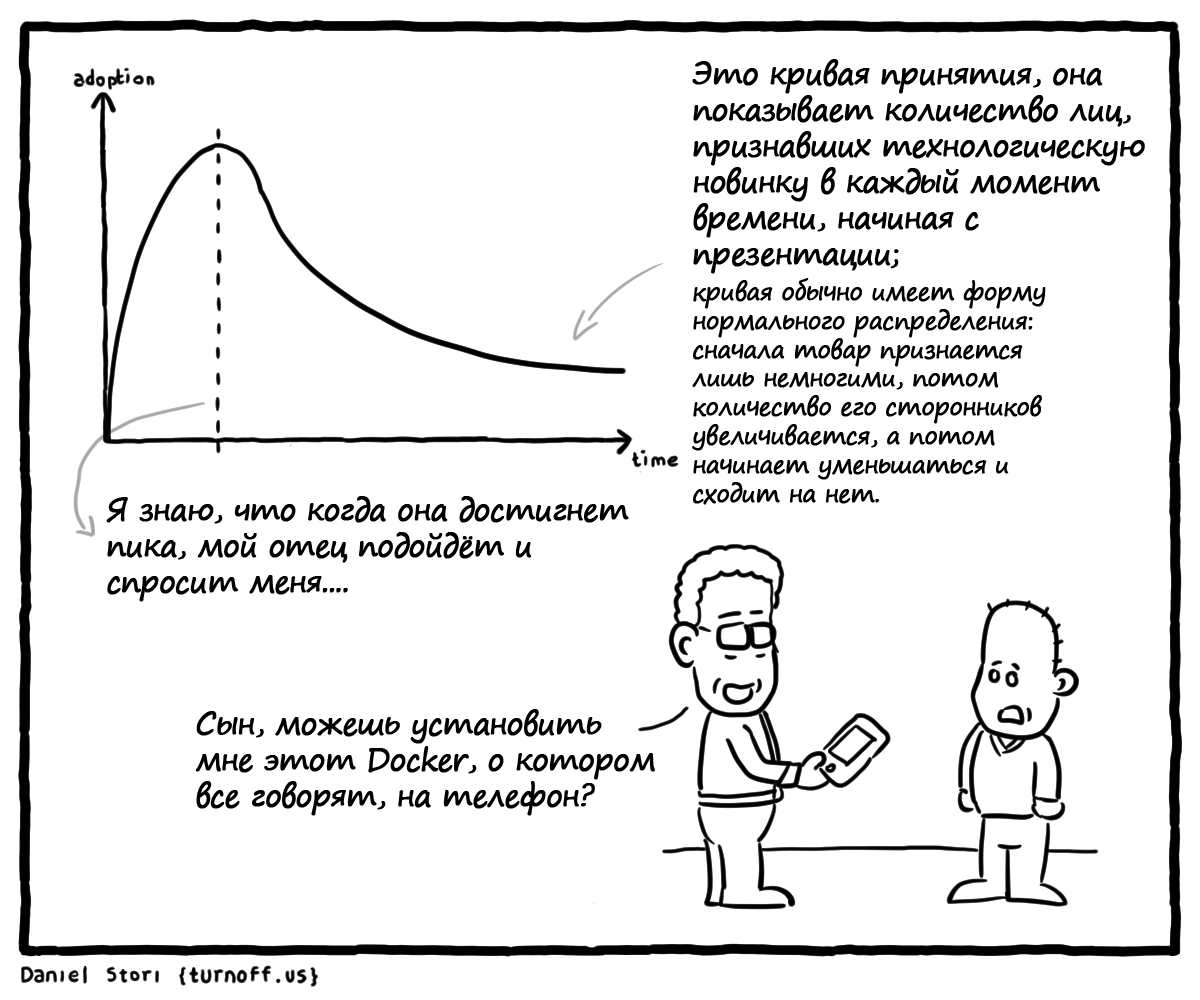

Хайп Detected

«Скоро все будут использовать Docker»

Миграция в Облако (иногда бывают сложности)

TCP-приятели

Если вы случайно зашли на Хабр: TCP (Wikipedia) и список наиболее часто используемых сокращений в IT

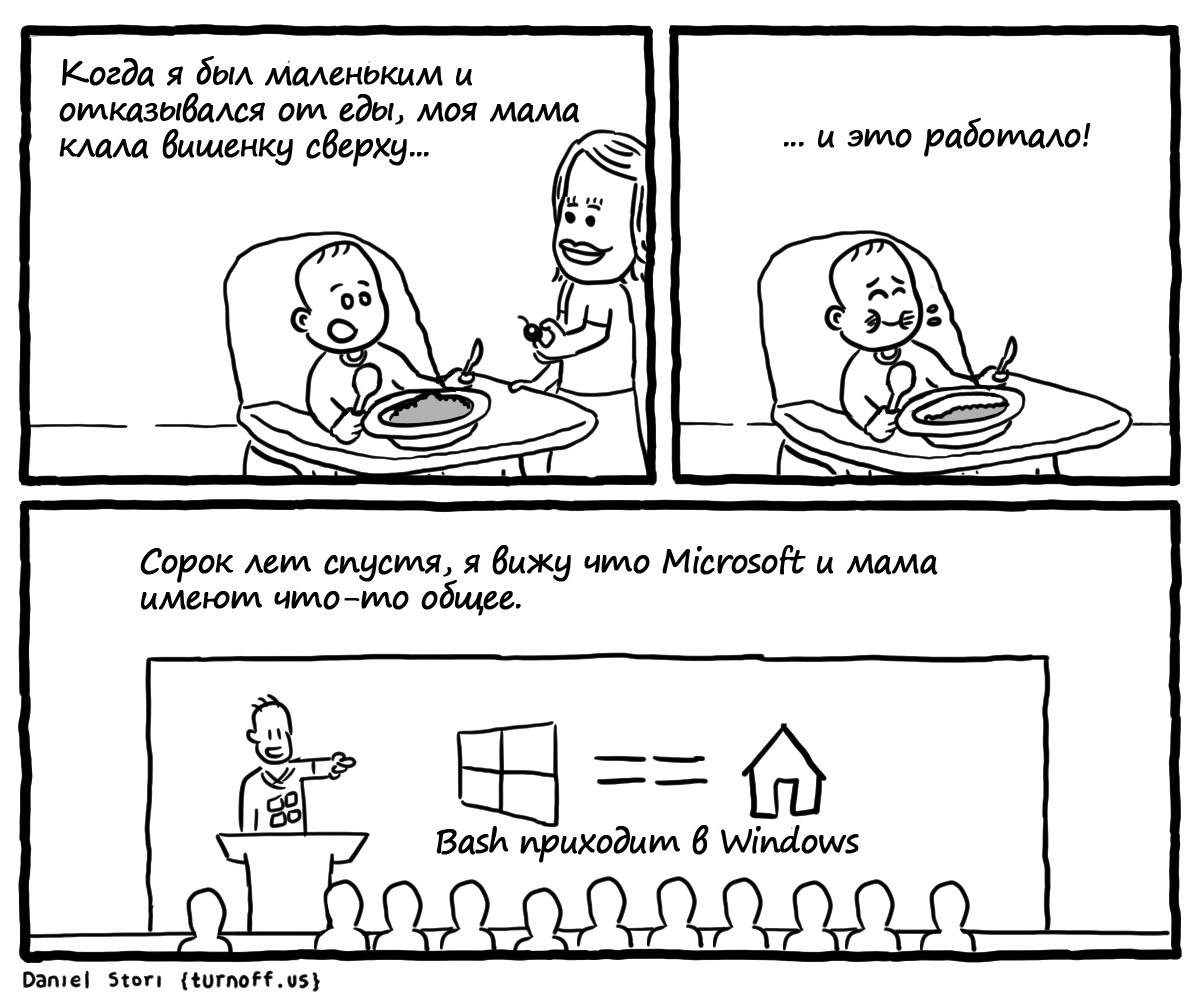

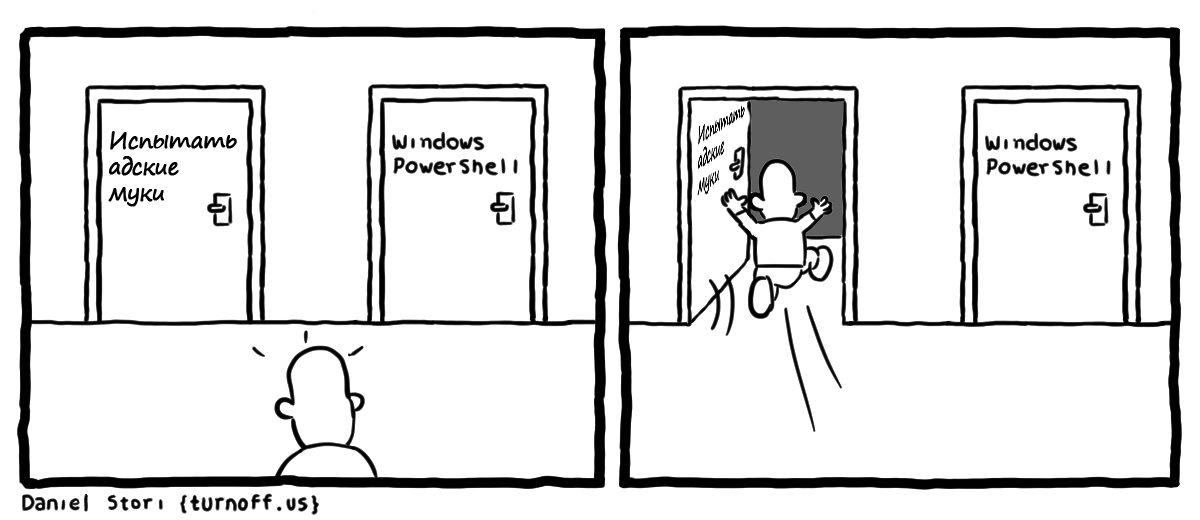

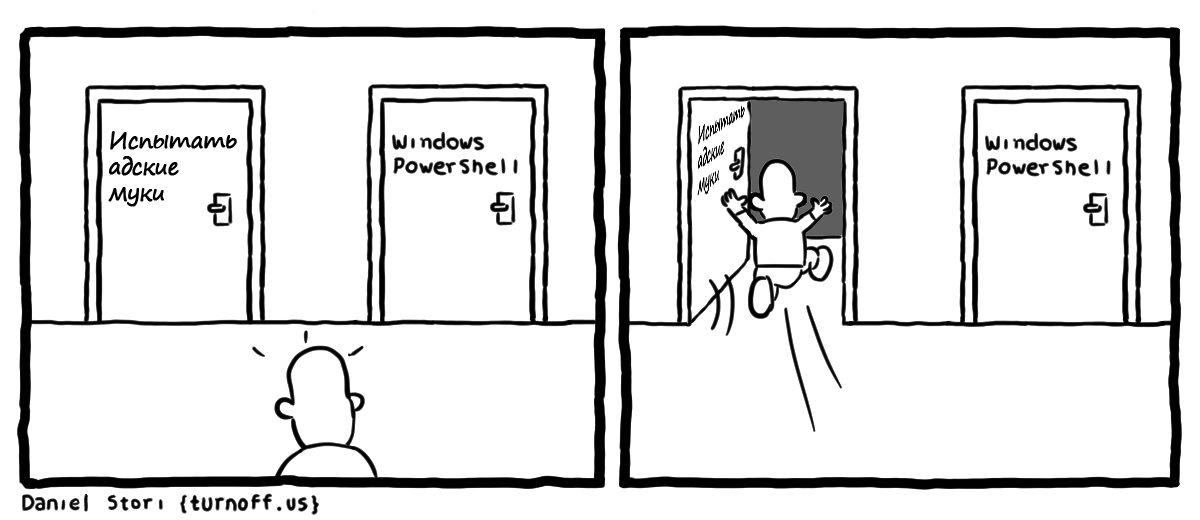

Bash на Windows

Я обожаю Windows PowerShell

Дом Линуса Торвальдса

Вы когда-нибудь задумывались над тем, как выглядит дом Линуса Торвальдса? Даниэль Стори приоткрывает нам «окно» в скромный образ жизни знаменитого создателя Linux.

Сказки о DOS

Если вы молоды, то, возможно, не знаете о Дискетах 5 1/4 и игре Test Drive

Тестирование программного обеспечения

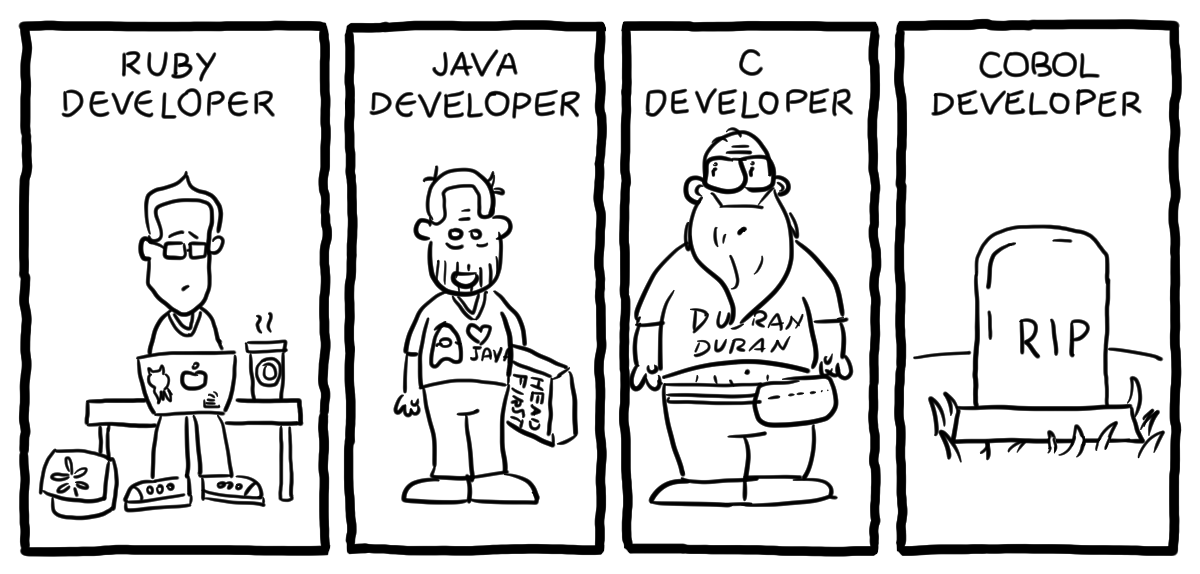

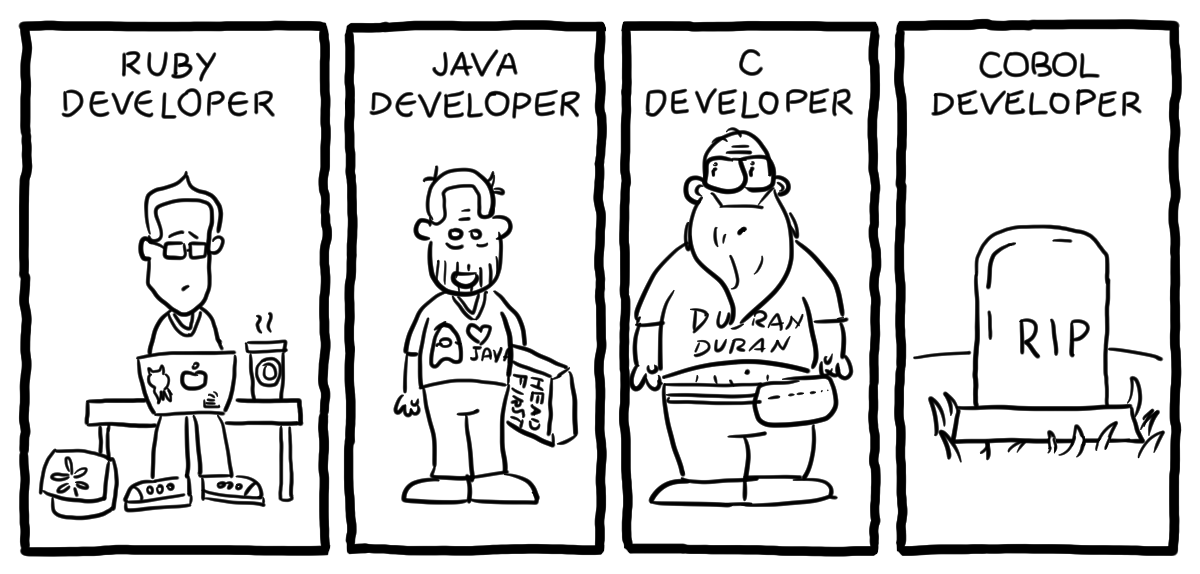

Продвинутые биологические виды

Разработчики

Автор немного сгущает краски, говоря о Cobol, но доля правды, конечно, присутствует.

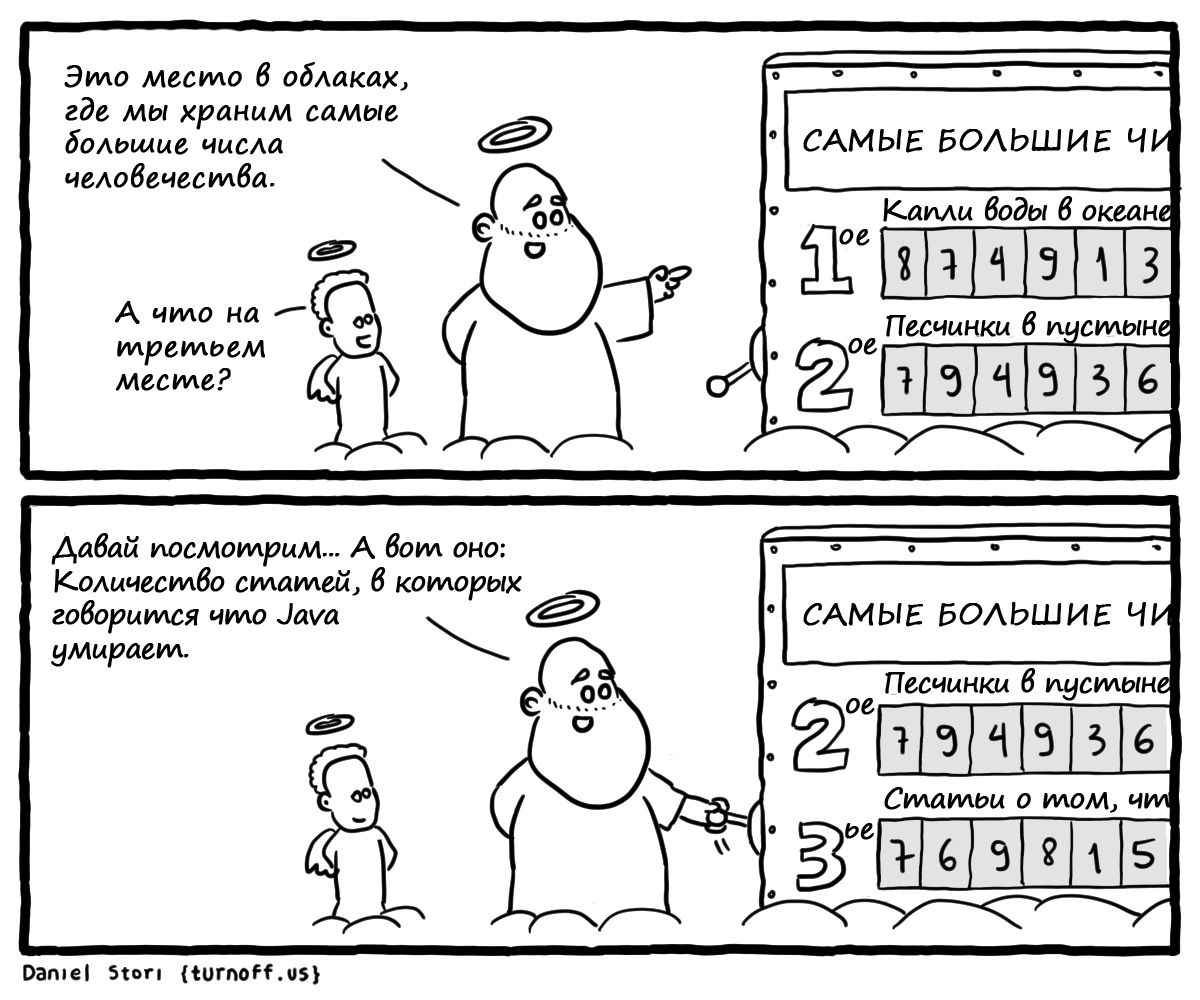

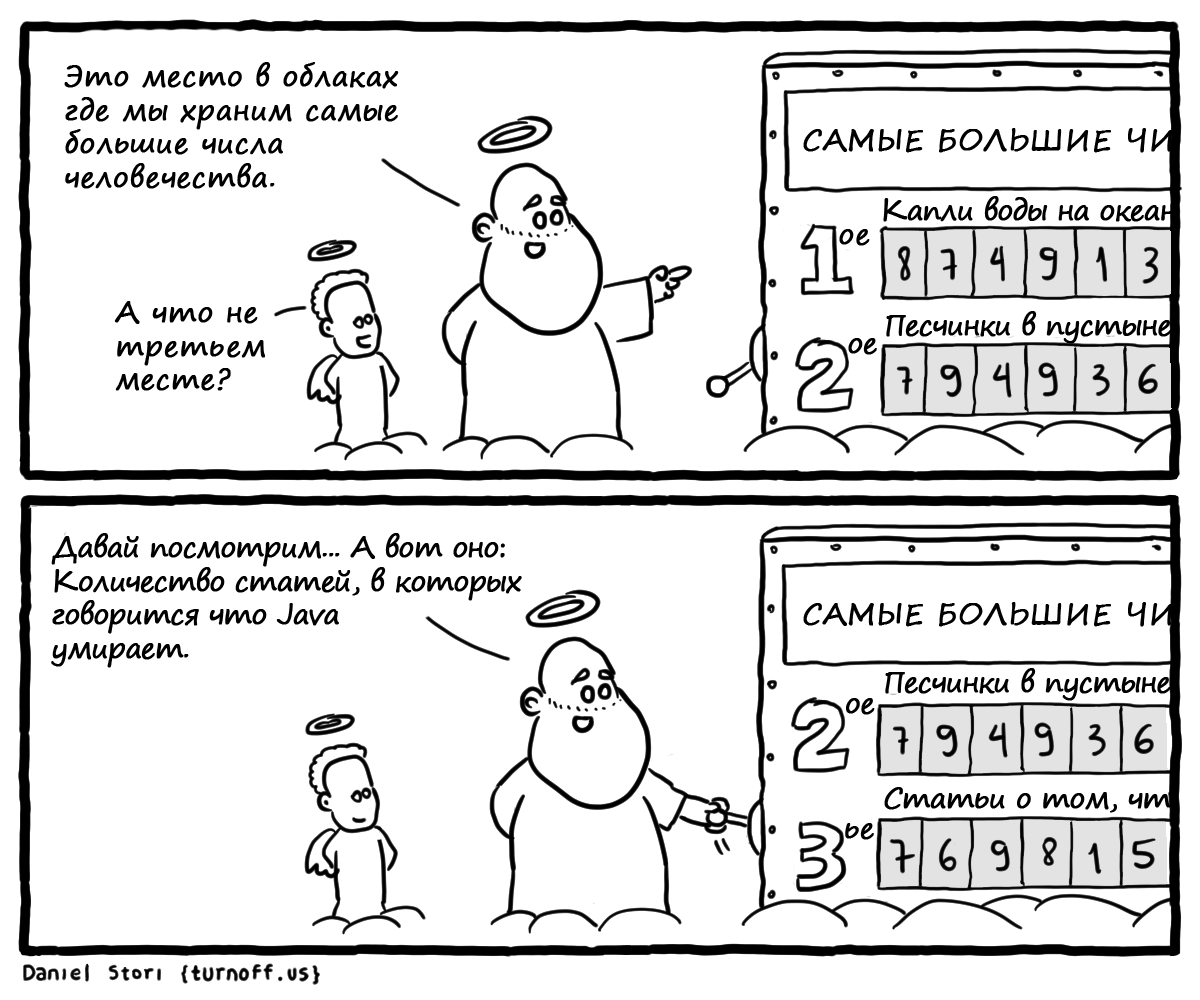

Большие числа

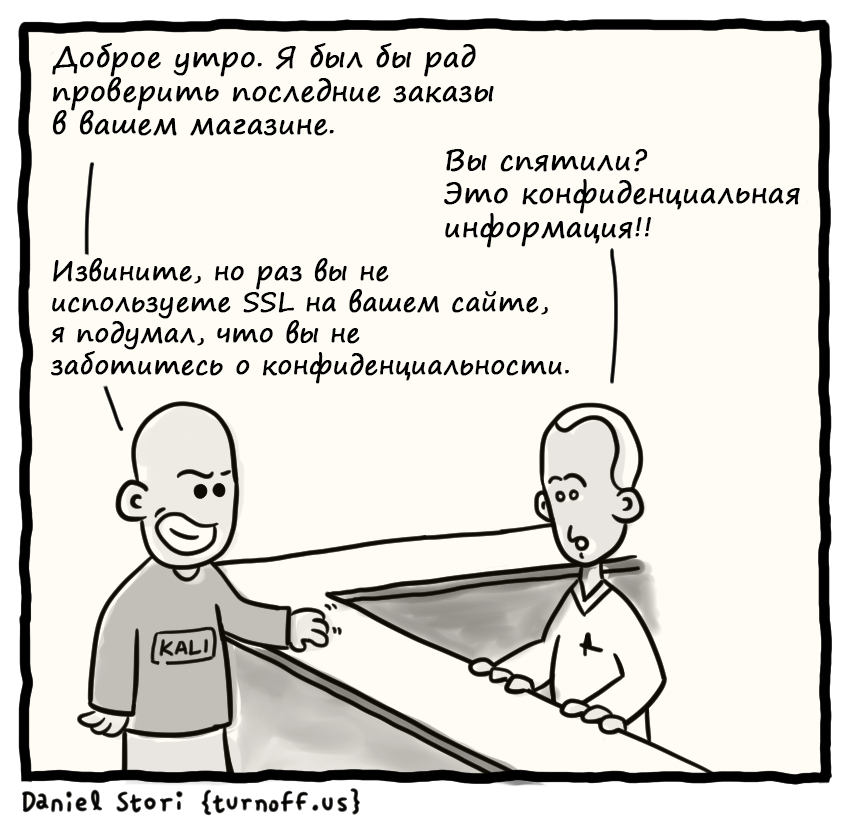

Ловкий трюк для менеджеров по продаже SSL-сертификатов

Если вы не используете SSL, вы не можете быть уверены, что любая конфиденциальная информация, передаваемая на вашем сайте, не будет использована хакерами. Немножко о Kali Linux

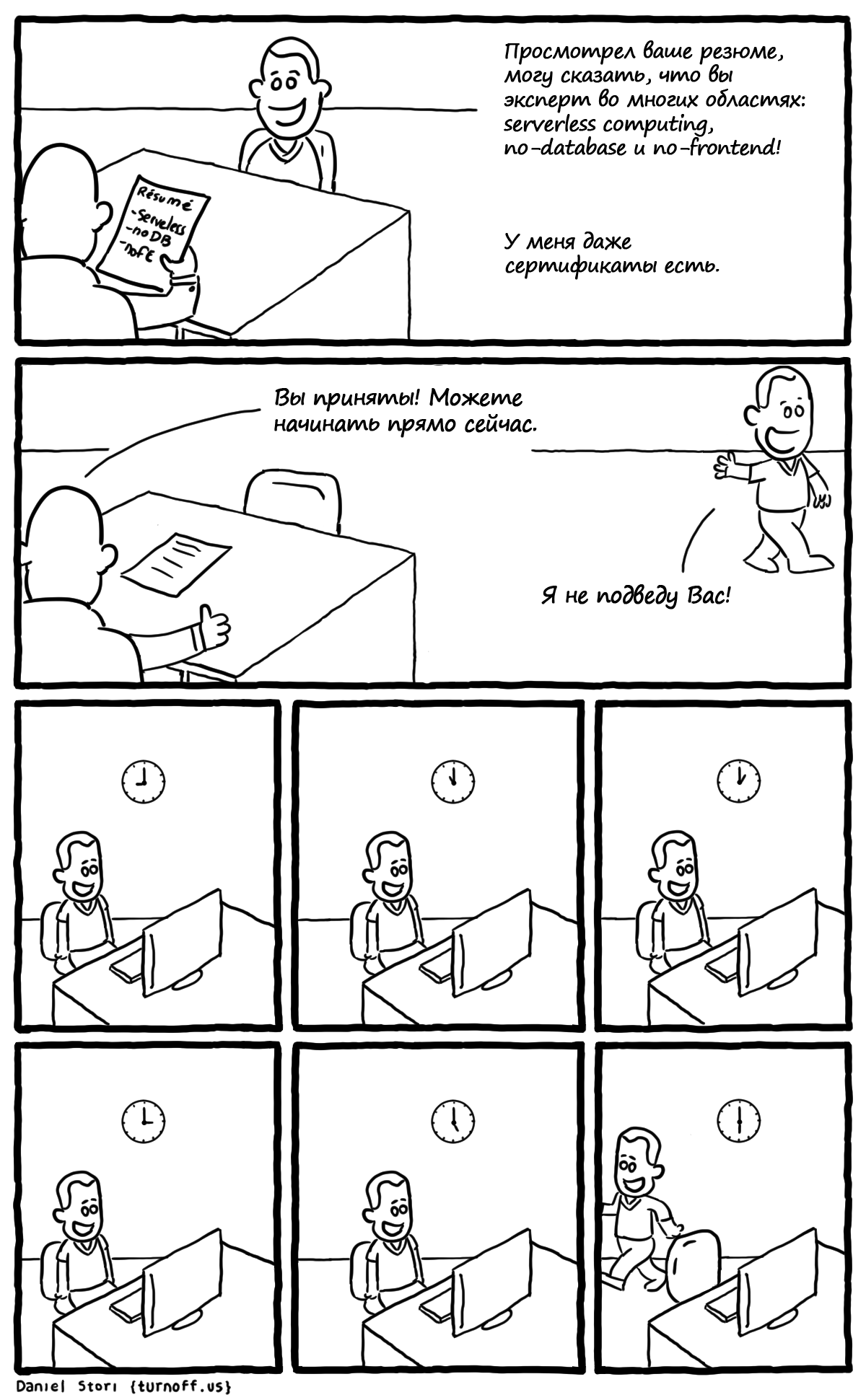

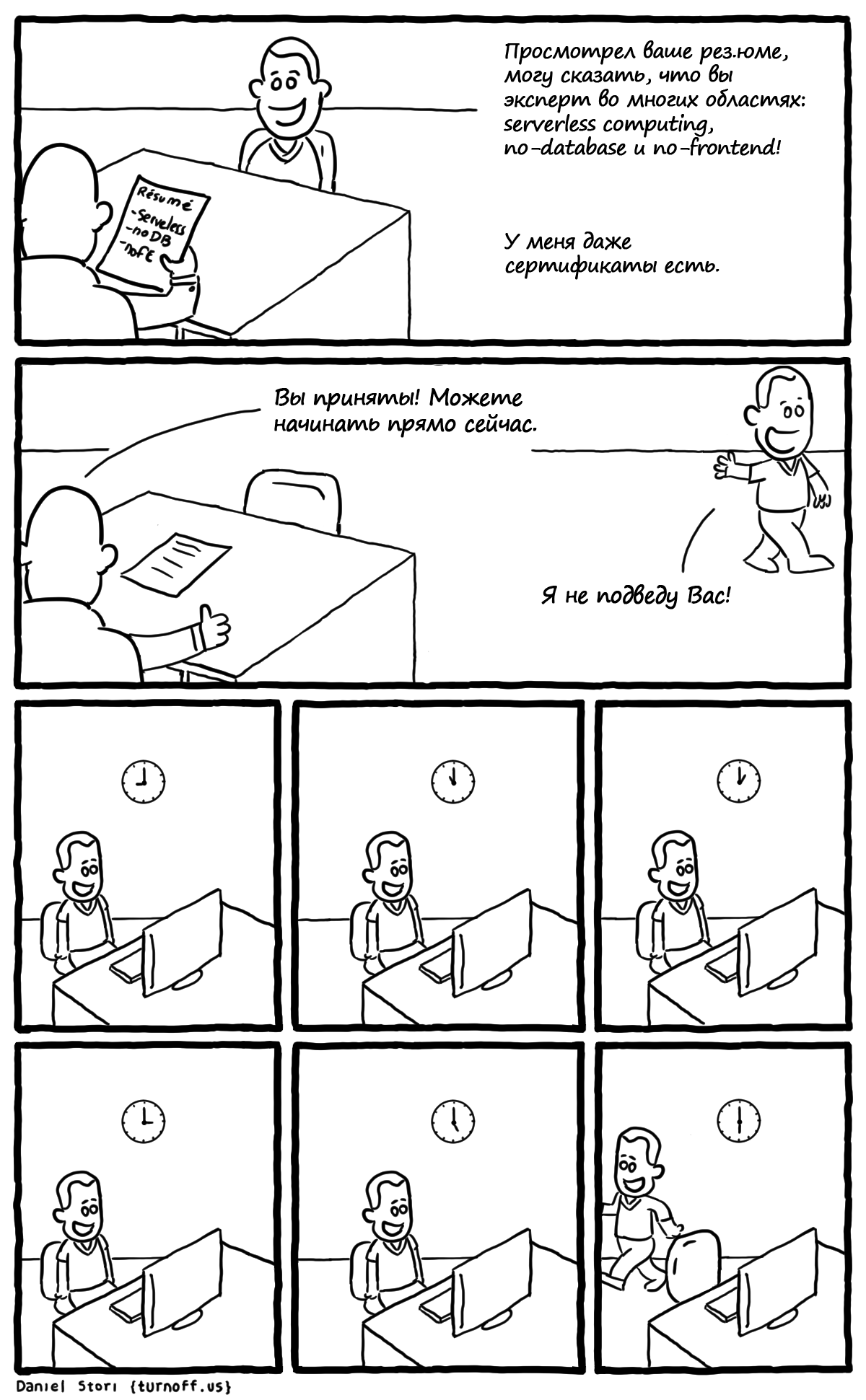

Codeless-разработчик или опережая тренды

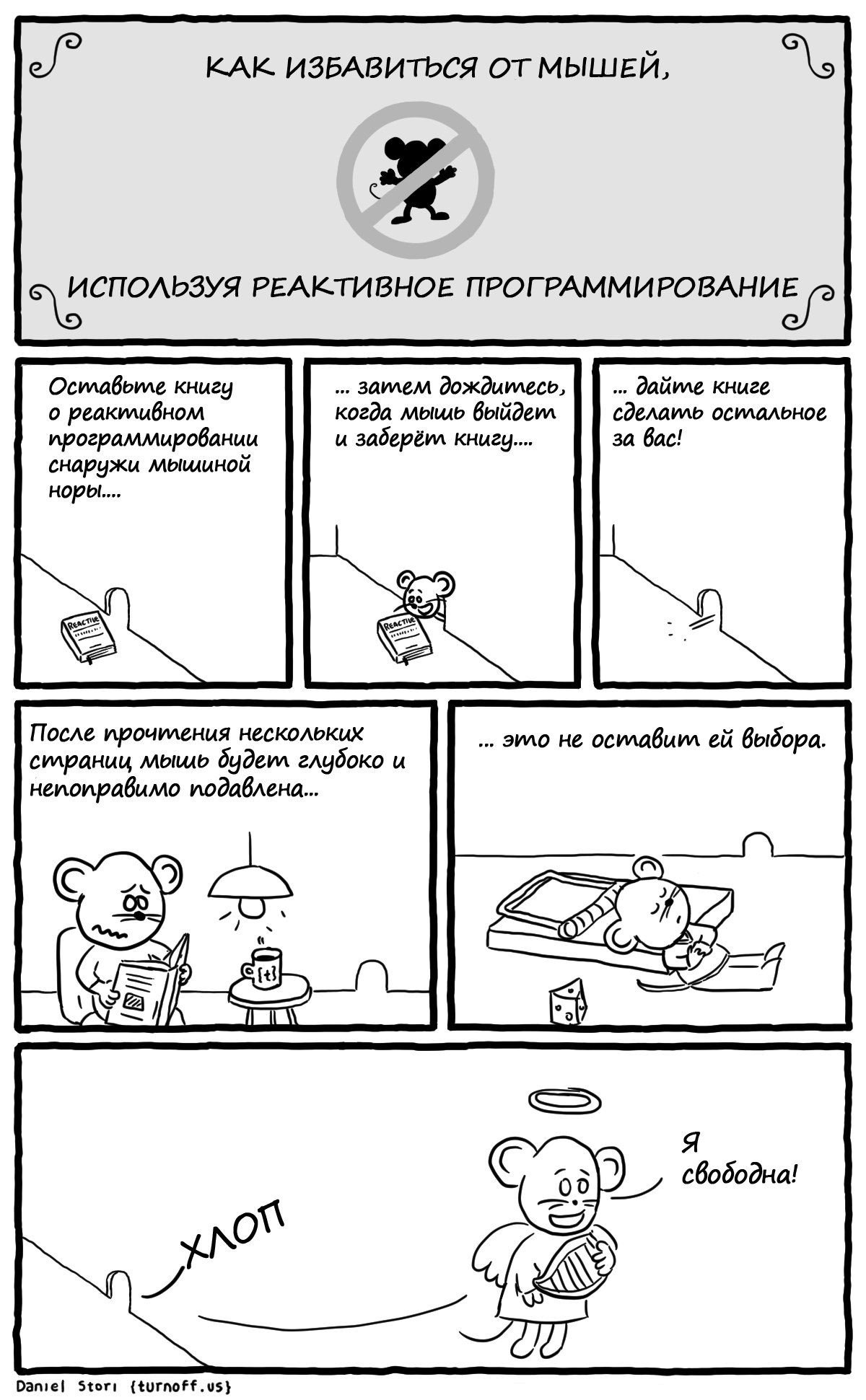

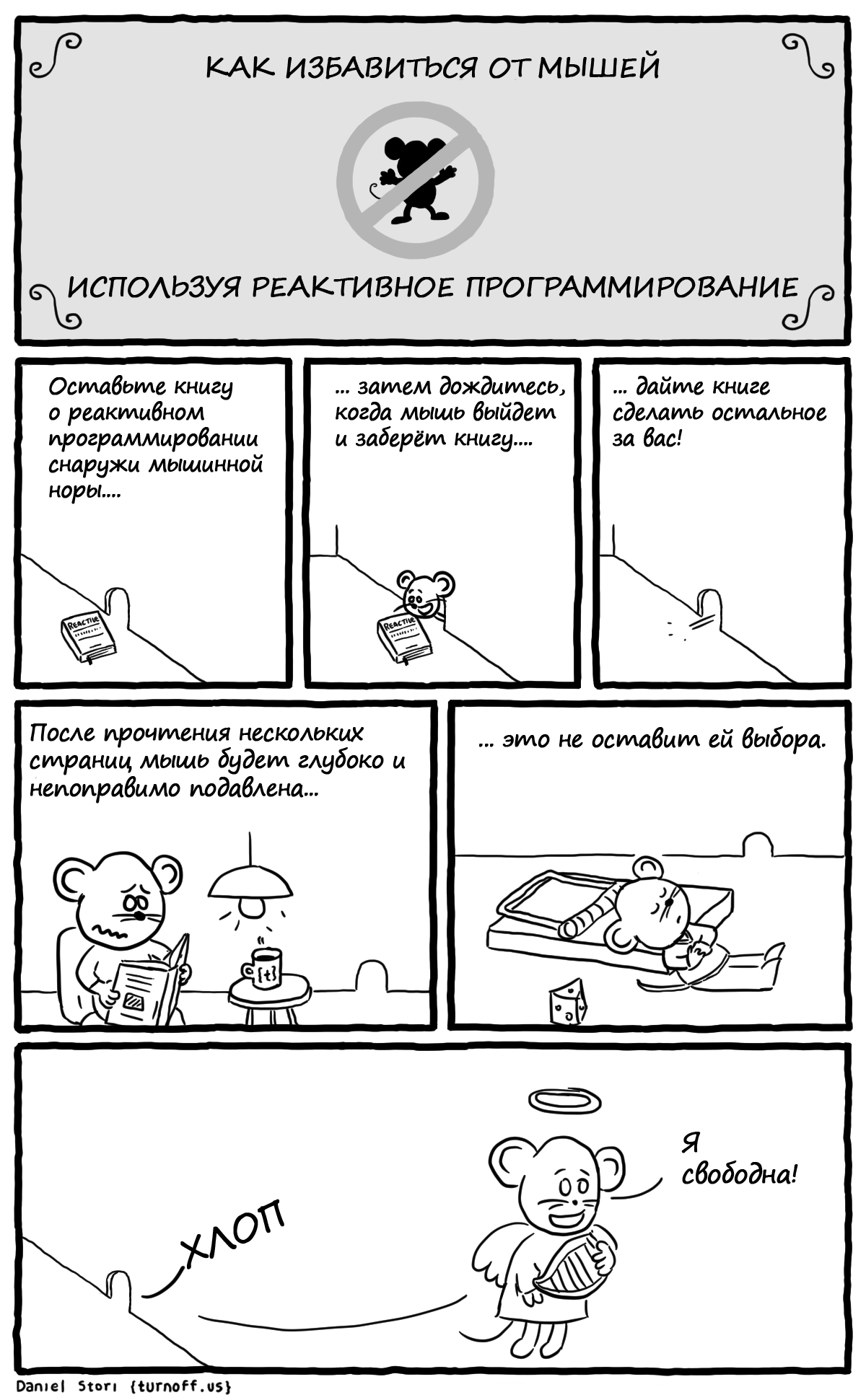

Реактивное программирование

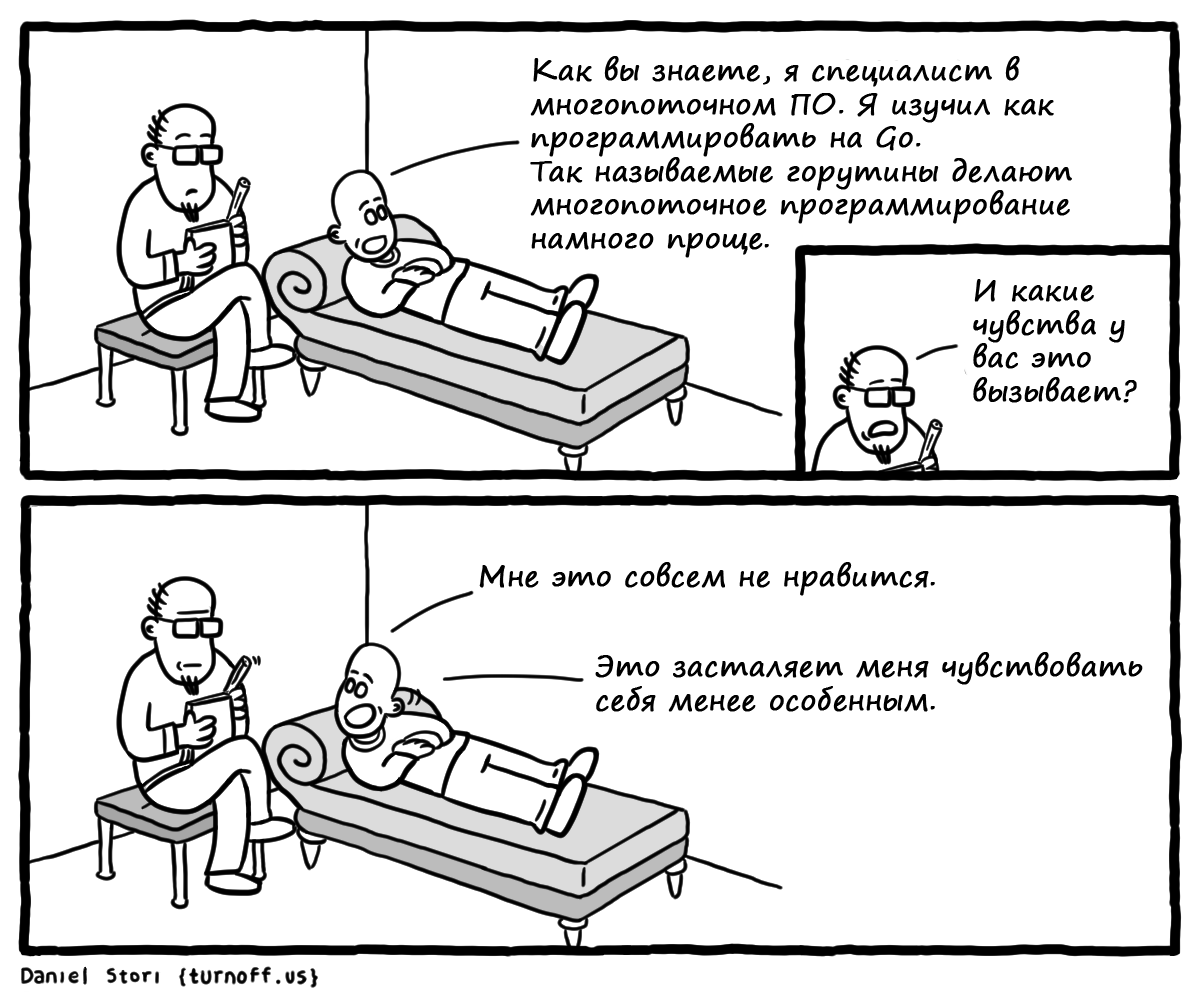

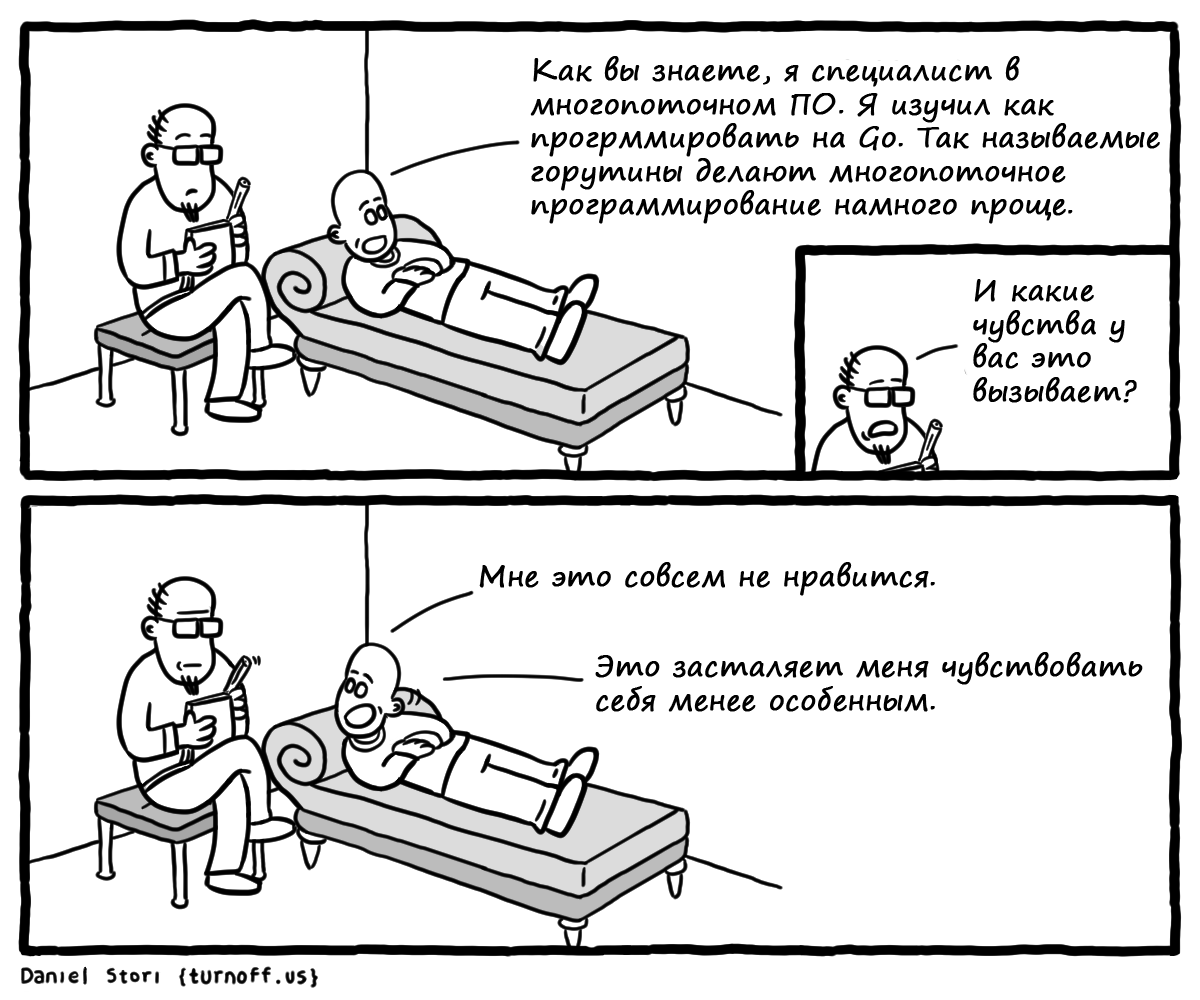

Когда навыки уже не такие ценные

Когда нанял «неправильного» архитектора

О LAMP

Когда не все понимают, чем ты занимаешься

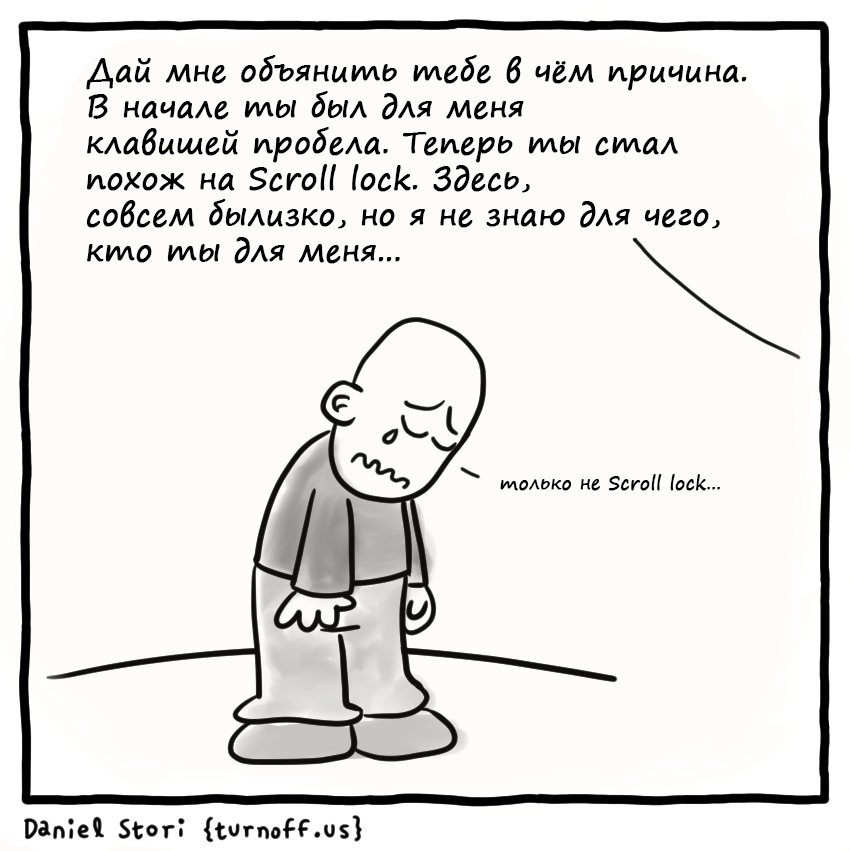

Как объяснить программисту, что вы расстаётесь и всё кончено

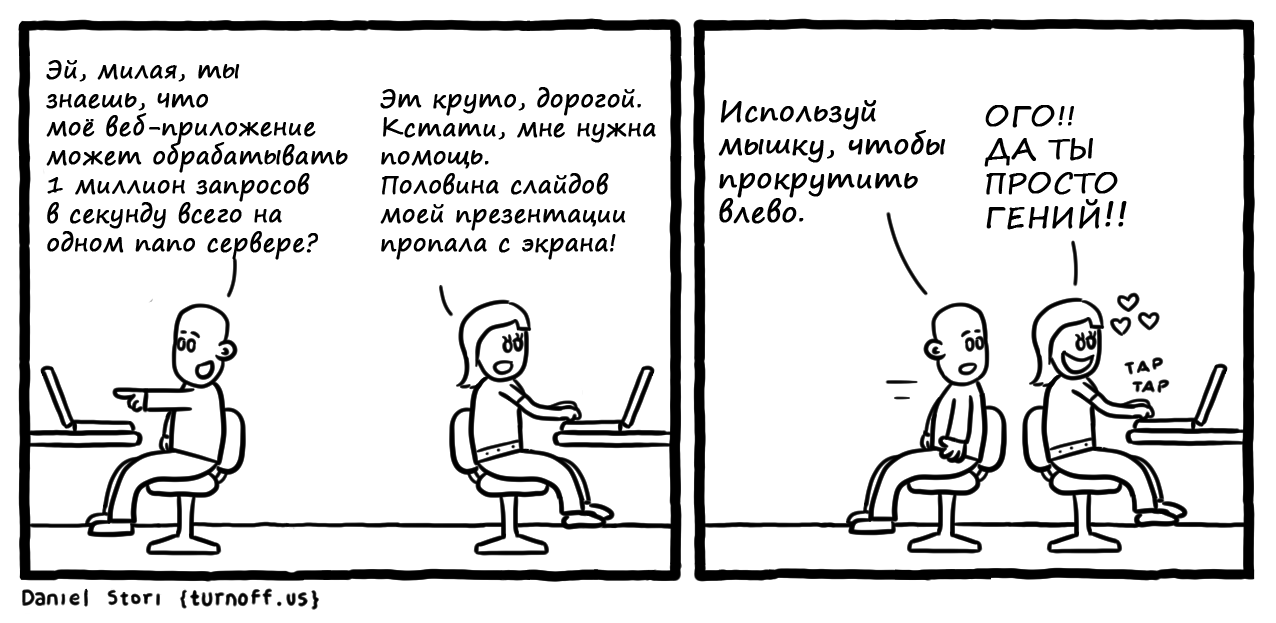

Как я встретил вашу маму

Как программист решает, что пора завести ребёнка

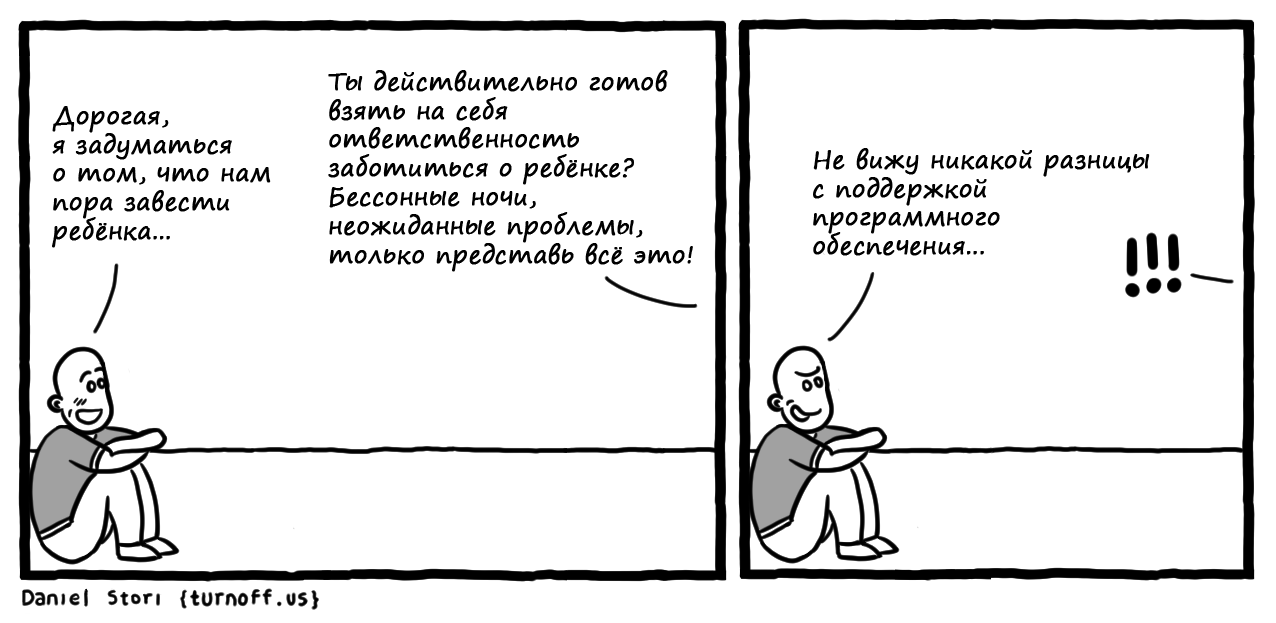

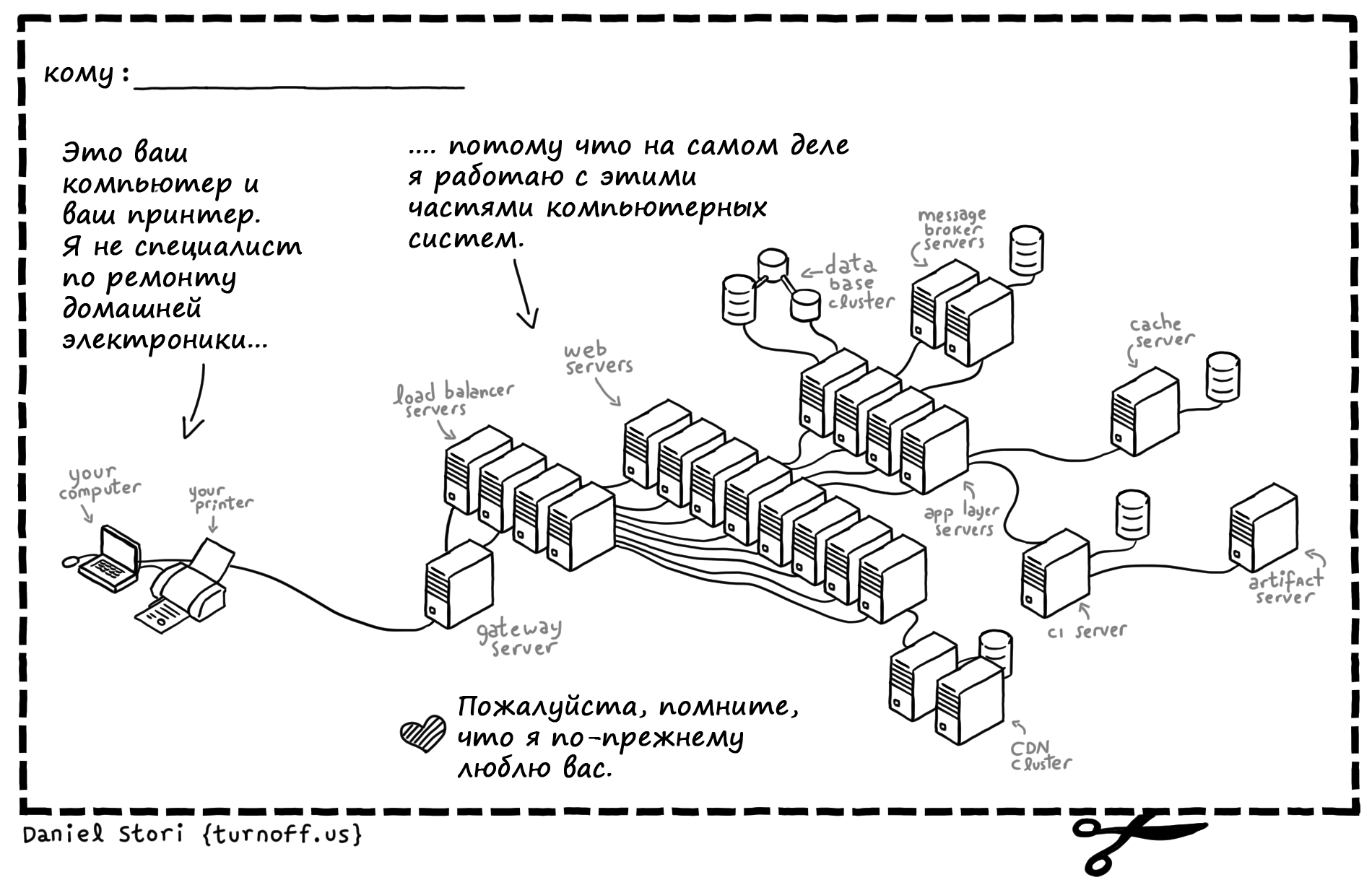

Как объяснить, что принтеры не твоя «стихия» или «посвящается моим родственникам...»

|

Метки: author Cloud4Y читальный зал блог компании cloud4y комиксы юмор bash linux cloud программисты шутят |

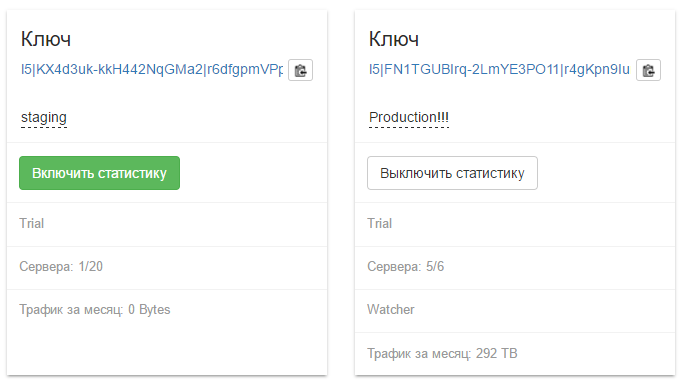

Сервис сбора статистики с Flussonic |

Много лет мы только продавали софт, теперь мы приготовили к запуску сервис по сбору статистики и предоставлению отчетов. У нас берут Flussonic, запускают его на своих серверах, абоненты смотрят видео с этих инстансов Flussonic и создаются записи о сессиях просмотра.

Эти сессии как раз сливаются в наш сервис и мы покажем отчеты, сделанные по ним, в личном кабинете.

Включается легко: в личном кабинете есть большая кнопка «Включить статистику». После нажатия через минуту Flussonic начнет отправлять нам сессии и они будут надежно сохраняться.

В данный момент мы дадим лишь самые базовые отчеты: распределение по странам, по браузерам (и прочим устройствам), по каналам. Можем дать как сырой список сессий, так и агрегировать похожие друг на друга:

За две недели закрытого тестирования, у нас пока что скромный миллиард записей, но мы уверены, что справимся и с объёмом в 100 раз больше: пока что мы можем очень быстро показать даже уникальные сессии, а это очень недешевый отчет. Конкретно на этом скриншоте я показал, как выглядит склеивание похожих сессий в уникальные, т.е. если с одного и того же адреса, с тем же самым User Agent пытались смотреть одно и то же в узкий промежуток времени, то скорее всего это одна сессия, просто плохо учтенная.

Немного деталей

Мы уже столкнулись с очень неприятной проблемой парсинга заголовка User Agent: ведь у нас много приставок (Set-Top-Box) и прочих подобных штук, а они в обычных базах браузеров отсутствуют.

Так же всплыла неожиданная проблема с MaxMind: нельзя просто так купить у них полную базу и показывать вам результаты поиска по ней, это требует специальную лицензию от 30.000$.

Но это всё так, решаемые проблемы и мы сейчас со всем этим работаем.

Отдельный момент с яваскриптовой мордой: это SPA React приложение, которое живет в отдельном микросервисе вместе с самим сервисом. Мы уже не первый компонент так делаем: яваскрипт, css живут и развиваются с самим бекендом сервиса и пользователю подключаются простой вставкой яваскрипта. Хитрости есть с авторизацией, потому что мы хотим не просто сообщать аккаунт, а заодно его права доступа, так что авторизационная сессия открывается при заходе пользователя в личный кабинет через межсерверное взаимодействие.

Планы

Планов на будущее у нас немало:

- сделать разделение в статистике на межсерверный трафик и трафик к клиентам

- помочь отловить тех, кто шарит аккаунт друзьям, а так же тех, кто занимается рестримингом

- добавить информацию о глубине просмотра архива и т.п.

Если кто-то хочет попробовать, пощупать, но ещё не запускал Flussonic, то мы с радостью дадим бесплатный триал.

И, кстати, важно: сбор статистики и отчеты мы собираемся делать бесплатно!

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

|

Метки: author erlyvideo визуализация данных reactjs erlang/otp блог компании эрливидео статистика flussonic сервис статистики |

Спикеры #ITsubbotnik – о том, как технологии изменят мир через пять лет |

Спикеры #ITsubbotnik – инженеры ЕРАМ, которые не могут не делиться своим опытом с окружающими. Они рассказывают не только об успехах, но и о том, на какие грабли наступали и как справлялись с проблемами.

А еще их доклады – всегда про будущее: говорят о новых подходах и инструментах, которые скоро, вероятно, для многих станут привычной повседневностью.

Кто-то любит прогнозировать, кто-то нет, а кто-то делает так, чтобы прогонозы сбывались или нет. Спикеры #ITsubbotnik рассказали, как то, что они делают сегодня, может изменить мир через пять лет.

Дома станут умнее и безопаснее

Сергей Чибирев, Android-разработчик. Тема доклада – «Умный дом своими руками».

«Если мы сегодня спросим первого встречного, что такое умный дом, скорее всего, получим ответ, что это дорого, и что это ненужная роскошь. Такие системы действительно недешевые, но не потому, что сложные, а из-за того, что лоббируются определенными производителями. Их продают как роскошь.

Где-то в 2005 году случился технический прорыв, который сделал умный дом доступным. Сейчас его можно сделать своими руками, не переплачивая, и на конференции мы рассказывали как.

Становится всё сложнее утаить, что такие системы – дешевые, и скоро эти технологии шагнут к нам в дома. Например, я вхожу в квартиру, открывается дверь, мне не нужен ключ: система опознала. Она приветствует меня голосовым сообщением и отвечает на мои голосовые команды, включает мою любимую музыку, зажигает свет. Она поддерживает нужную температуру и уровень влажности в доме. В общем, создаёт среду, в которой мне максимально комфортно. Такие технологии уже доступны. Пока люди относятся к ним, как к роскоши, но скоро привыкнут».

Андрей Ортяшов, Android-разработчик. Тема доклада – «Умный дом своими руками».

«Не люблю загадывать, но мне кажется, что интернет вещей будет стремительно развиваться из-за своей дешевизны и общедоступности. Вероятно, в каждом доме через пять лет будут «умные» элементы. Не во всех квартирах появятся, к примеру, системы открытия и закрытия занавесок, так как многим это покажется нерентабельным. Но какие-то элементарные вещи – отключить электропитание, выключить электрическую плиту, получить сигнал в связи с утечкой газа – будут появляться в домах. Часто в нашей стране происходят взрывы бытового газа из-за того, что утечку вовремя не зафиксировали. При этом системы, которые могут регистрировать такие случаи и оповещать жильцов, довольно дешевые и простые».

У людей появится больше свободного времени

Дмитрий Никитко, аналитик данных. Тема доклада – «Нейронные сети для извлечения структурированной информации из документов».

«Я рассказывал о том, как применять глубокие нейронные сети для извлечения структурированной информаци из документов с различным шаблоном. Например, у нас есть обычные чеки из магазина. Они отличаются друг от друга, но основной набор данных в них одинаковый, к примеру, везде есть общая сумма. Но в разных чеках она расположена в разных местах. Чтобы извлечь и структурировать эту информацию, мы использовали нейросети.

Я думаю, что в ближайшие пять лет стоит ждать появления высокопроизводительных процессоров для тренировки более сложных систем. Нейросети смогут освободить людей от рутинной работы. Появится больше времени, чтобы заниматься любимыми делами.

Те, кто работает в этой области, скептически относятся к заявлениям, что искусственный интеллект поработит нас, как показано в фильмах. Все зависит от того, какую функцию мы оптимизируем. Если говорить о людях как о нейросетях, они стремятся максимизировать свое удовольствие и избежать боли. Если тренировать нейросеть по похожему принципу и пытаться максимизировать вычислительные мощности, которые ей доступны, кто знает, что получится? Но я думаю, все будет хорошо».

Мы будем делать больше спонтанных покупок

Дмитрий Яцюк, DevOps-инженер. Тема доклада – «Готовое комплексное инфраструктурное решение для Hadoop Big data и AWS с Cloudera CDH 5.x».

«Решение, о котором я рассказывал, рассчитано на крупных клиентов в области ритейла. Что оно изменит через пять лет? Возможно, мы станем больше покупать: нам будут активнее предлагать, рекомендации станут точнее. Это происходит уже сейчас: мы заходим, например, на «Яндекс.Маркет» и покупаем то, о чем даже не задумывались. Чем больше данных анализируют специалисты, тем точнее становятся рекомендации: будь это еда или песня в социальной сети».

Карточки в поликлиниках перестанут пропадать

Сергей Черноляс, Java-разработчик. Тема доклада – «JPA for NoSQL».

«Организация баз данных, как реляционных, так и нереляционных, будет совершенствоваться, а автоматизация сильно повлияет на финансовый сектор, телеком, медицину и не только. Наример, в больницах, где медицинские карточки пока не заносят в электронные базы данных, начнут это делать, и они уже не потеряются».

Искусственный интеллект будет тестировать искусственный интеллект

Антон Шапин, инженер по автоматизированному тестированию. Тема доклада – «Visualization, storage and comparison results of performance testing by using Grafana and InfluxDB».

«Через пять лет изменится все: IT-мир меняется каждый месяц. В QA так или иначе возникнет проблема при работе с большими объемами данных и при проверке искусственного интеллекта. Многие компании идут в область разработки искусственного интеллекта и нейросетей. Как все это тестировать, к сожалению, пока не совсем понятно. Чтобы тестировать искусственный интеллект, нужен будет другой искусственный интеллект. Выработка этих методологий – большой вызов QA-сообществу.

Ручные тестировщики полностью не исчезнут, потому что машина – это машина, а кто создает тесты? Человек. Кроме того, есть области, которые очень дорого проверять в автоматическом режиме, куда нет смысла вкладывать большие деньги».

Роман Иовлев, инженер по автоматизированному тестированию. Тема доклада – «Java edge in test automation».

«Автоматизаторы пытаются упростить рутинную работу ручных тестировщиков, при этом работу самих автоматизаторов тоже можно улучшить. Я уверен, что в перспективе тестирование будет все больше использовать возможности искусственного интеллекта и функциональных бизнес-моделей и в меньшей степени будет связано с написанием кода. Появятся мощные библиотеки или инструменты, которые смогут сами решить, какие нужны сценарии, наборы данных и подходы к тестированию. А тестировщик будет лишь определять, что требуется от системы».

Компании смогут быстрее получать обратную связь о продуктах

Роман Димитренко, DevOps-инженер. Тема доклада – «Building PaaS with the HashiStack».

«Continuous integration и continuous delivery – это то, что движет сейчас любой бизнес и способствует быстрым изменениям. Если говорить о веб-сайтах, то время с принятия решения о добавлении новой функциональности на сайт до его реализации существенно сокращается. В полностью автоматизированной среде речь идет уже не о часах, а о минутах. Все станет быстрее, вмешательства оператора и ручной работы не потребуется.

При помощи продуктов, о которых я говорил, владельцы бизнеса смогут быстрее, чем сейчас, получать обратную связь: работает их продукт или нет, приносит он деньги компании или не приносит».

Станет доступен новый вид поиска в сети

Михаил Хлуднев, специалист в области search engines. Тема доклада — «Search LIKE %SQL%».

«Я рассказывал про поиск по подстроке. Это сложнее, чем обычный поиск по ключевым словам. По целому слову все умеют искать, а по его части нет: это очень долго. Я представил методику, как мгновенно находить огромные массивы документов по подстрокам. Что изменится через пять лет? Этот вид поиска будет доступен всем. Любая бабушка сможет сделать поиск по подстроке. Мне кажется, так справки из собеса искать очень удобно».

Хранить данные будет удобнее

Степан Ракитин, Java-разработчик. Тема доклада – «Создаем отказоустойчивые распределенные приложения вместе с Atomix».

«Сейчас есть очень мало баз данных, которые рассчитаны на большие данные и соответствуют принципу «strong consistency», при котором данные должны быть в единственно принятом состоянии среди всех узлов кластера. Я считаю, что в ближайшие годы будут активно развиваться системы хранения данных, гарантирующие отказоустойчивость. Данные будут находиться в актуальных состояниях на всех серверах».

Приложения станут более дешевыми и качественными

Рустам Кадыров, Java-разработчик. Тема доклада – «Как приструнить зоопарк из микросервисов».

«Что изменится через пять лет с помощью этой технологии? Обычные пользователи почувствуют, что онлайн-сервисы стали дешевле и качественнее. Они и сейчас доступны, но микросервисная архитектура позволяет удешевить инфраструктуру для их использования. То есть, если правильно все организовать, можно тратить меньше денег на поддержку инфраструктуры. За счет такой архитектуры можно сделать доставку новой функциональности быстрее, и время разработки приложения сократится.

Новые алгоритмы, нейронные сети и более эффективное использование технологий, которые уже есть, сделают работу сервисов быстрее и качественнее. Голосовые помощники и онлайн-переводчики станут умнее».

У облаков будет достойный конкурент

Андрей Филатов, DevOps-инженер. Тема доклада – «Ансамбль солёных поваров: сравниваем Ansible, SaltStack и Chef».

«В своем докладе я сравнивал три ведущие, по моему мнению, SCM-системы: Chef, Ansible и SaltStack. В скором времени, мне кажется, эксплуатация практически полностью будет автоматизирована. Профессия системного администратора, который управляет сервисами в ручном режиме, наверное, просто перестанет существовать. Останутся только те, кто использует системы управления конфигурацией в автоматическом режиме. А возможно, всех нас заменят нейронные сети, которые будут генерировать код и управлять инфраструктурой. Этого не случится в ближайшее время, но если говорить о дальней перспективе – вполне возможно.

Сейчас мои персональные фавориты – докер-контейнеры и управление инфраструктурой при помощи контейнеризации. Использование облачных сервисов и контейнеризации решает одни и те же задачи, но разными способами. Контейнеры, например, более производительны по справнению с облаками».

Понадобится больше нефункциональных тестировщиков

Сергей Мишанин, инженер по автоматизированному тестированию. Тема доклада – «Report Portal. Руководство для адептов Cucumber».

«Я уже 10 лет работаю в тестировании ПО, из которых 9 лет занимаюсь автоматизацией. Когда я только начал работать в этой сфере, автоматизация казалась инновационной. Прошло девять лет, и, казалось бы, она должна уже быть везде, но это пока не так. Мы успешно прошли стадию Agile, когда все быстро, динамично, нет времени и ресурсов на тестирование вручную. Потребность в таких тестировщиках будет уменьшаться. Востребованы будут аналитики, но тесты должны выполняться автоматически. Мне кажется, через пять лет автоматизация будет везде. Кроме того, если сейчас мы говорим об автоматизации тестирования, мы, как правило, имеем в виду функциональные тесты. Я думаю, что будет стремительно развиваться потребность в нефункциональном тестировании. Это производительность, секьюрити и не только. В наш мир приходит интернет вещей, и машинам придется еще больше общаться с машинами».

Денис Клыков, инженер по нагрузочному тестированию. Тема доклада – «Visualization, storage and comparison results of performance testing by using Grafana and InfluxDB».

«Я верю, что сферу нагрузочного тестирования ждет большое будущее. В последние пять лет стало больше проектов, где заказчики уделяют много внимания нефункциональным требованиям к ПО. Бизнес начинает понимать, что скорость и другие характеристики производительности IT-систем важны для увеличения прибыли и привлечения инвестиций. Если раньше услуги нагрузочного тестирования пользовались спросом только у финансовых, телекоммуникационных компаний и интернет-гигантов, сейчас они востребованы ритейлом, мультимедиа, нефтегазовым сектором. А значит, и специалисты по нагрузочному тестированию будут все больше нужны рынку».

|

Метки: author AliceMir исследования и прогнозы в it блог компании epam мероприятие будущее epam systems конференция информационные технологии |

Юмор для IT-специалистов |

Мы подумали, что если среда — это маленькая пятница, значит можно немножко расслабиться. Поэтому мы подготовили несколько юмористических комиксов от Даниэля Стори (Daniel Stori). Желаем приятного просмотра.

Arduino-проект

Хайп Detected

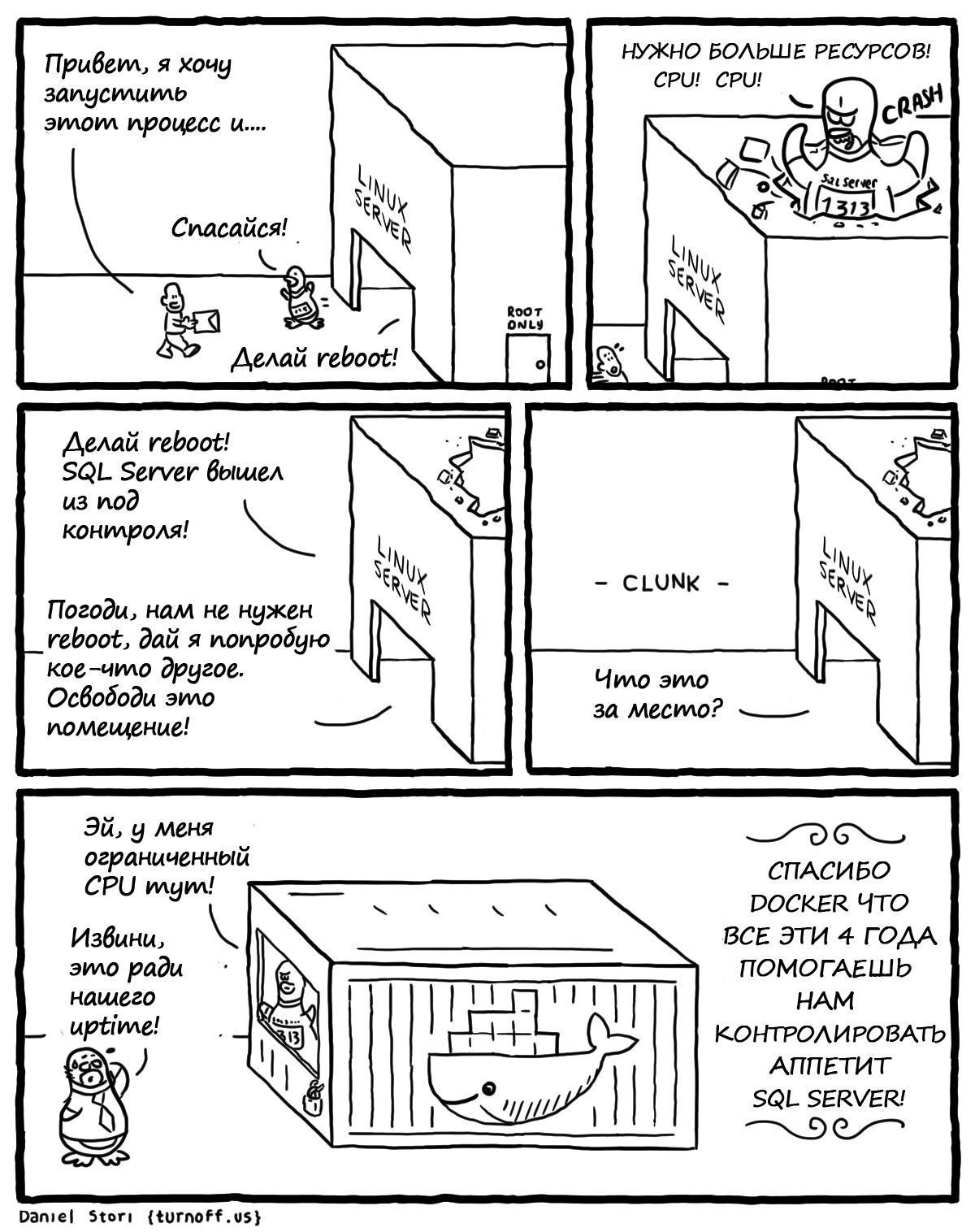

«Скоро все будут использовать Docker»

Миграция в Облако (иногда бывают сложности)

TCP-приятели

Если вы случайно зашли на Хабр: TCP (Wikipedia) и список наиболее часто используемых сокращений в IT

Bash на Windows

Я обожаю Windows PowerShell

SQL Server на Linux

Дом Линуса Торвальдса

Вы когда-нибудь задумывались над тем, как выглядит дом Линуса Торвальдса? Даниэль Стори приоткрывает нам «окно» в скромный образ жизни знаменитого создателя Linux.

Сказки о DOS

Если вы молоды, то, возможно, не знаете о Дискетах 5 1/4 и игре Test Drive

Тестирование программного обеспечения

Продвинутые биологические виды

Разработчики

Автор немного сгущает краски, говоря о Cobol, но доля правды, конечно, присутствует.

Большие числа

Ловкий трюк для менеджеров по продаже SSL-сертификатов

Если вы не используете SSL, вы не можете быть уверены, что любая конфиденциальная информация, передаваемая на вашем сайте, не будет использована хакерами. Немножко о Kali Linux

Codeless-разработчик или опережая тренды

Реактивное программирование

Когда навыки уже не такие ценные

Когда нанял «неправильного» архитектора

О LAMP

Как объяснить программисту, что вы расстаётесь и всё кончено

Как я встретил вашу маму

Как программист решает, что пора завести ребёнка

Как объяснить, что принтеры не твоя «стихия»

|

|

[Из песочницы] Современный CMake: 10 советов по улучшению скриптов сборки |

CMake — это система сборки для C/C++, которая с каждым годом становится всё популярнее. Он практически стал решением по умолчанию для новых проектов. Однако, множество примеров выполнения какой-либо задачи на CMake содержат архаичные, ненадёжные, раздутые действия. Мы выясним, как писать скрипты сборки на CMake лаконичнее.

Если вы хотите опробовать советы в деле, возьмите пример на github и исследуйте его по мере чтения статьи: https://github.com/sergey-shambir/modern-cmake-sample

Совет №1: указывайте высокую минимальную версию CMake

Совет не относится к тем, кто пишет публичные библиотеки, поскольку для них важна совместимость со старым окружением разработки. А если вы пишете проект с закрытым кодом либо узкоспециальное опенсорсное ПО, то можно потребовать от всех разработчиков поставить последнюю версию CMake. Без этого многие советы статьи работать не будут! На момент написания статьи мы имеем CMake 3.8.

cmake_minimum_required(VERSION 3.8 FATAL_ERROR)Совет №2: не вызывайте ни make, ни make install

Современный CMake умеет сам вызывать систему сборки. В документации CMake такой режим называется Build Tool Mode.

# Переходим из каталога myproj в myproj-build

mkdir ../myproj-build && cd ../myproj-build

# Конфигурируем для сборки из исходников в ../myproj

cmake -DCMAKE_BUILD_TYPE=Release ../myproj

# Запускаем сборку в текущем каталоге

cmake --build .

# Запускаем сборку, передаём ключ '-j4' низлежащей системе сборки.

cmake --build . -- -j4Если вы генерируете проект Visual Studio, вы также можете собрать его из командной строки, в том числе можно собрать конкретный проект в конкретной конфигурации:

cmake --build . \

--target myapp \

--config Release \

--clean-firstНа Linux не используйте make install, иначе вы засорите свою систему. Об этом есть отдельная статья Хочется взять и расстрелять, или ликбез о том, почему не стоит использовать make install

Совет №3: используйте несколько CMakeLists.txt

Вложенность CMakeLists.txt — это нормально. Если ваш проект разделён на 3 библиотеки, 3 набора тестов и 2 приложения, то почему бы не добавить CMakeLists.txt для каждого из них? Тогда вам потребуется создать ещё один центральный CMakeLists.txt, и в нём выполнить add_subdirectory. Так может выглядеть центральный CMakeLists:

cmake_minimum_required(VERSION 3.8 FATAL_ERROR)

project(opengl-samples)

# Лайфхак: объявленные в старшем CMakeLists функции

# будут видны в подпроектах, включённых через add_subdirectory

include(scripts/functions.cmake)

add_subdirectory(libs/libmath)

add_subdirectory(libs/libplatform)

add_subdirectory(libs/libshade)

# Инструкция enable_testing неявно объявляет опцию BUILD_TESTING,

# по умолчанию BUILD_TESTING=ON.

# Вызывайте `cmake -DBUILD_TESTING=OFF projectdir` из командной строки,

# если не хотите собирать тесты.

enable_testing()

if(BUILD_TESTING)

add_subdirectory(tests)

endif()

# ..остальные цели..Совет №4: не засоряйте глобальную область видимости

Не заводите глобальных переменных без крайней необходимости. Не используйте link_directories(), include_directories(), add_definitions(), add_compile_options() и другие подобные инструкции.

- Используйте target_link_libraries для добавления статических и динамических, внутренних и внешних библиотек, от которых зависит цель

- Используйте target_include_directories вместо include_directories для добавления путей поиска заголовков, от которых зависит цель

- Используйте target_compile_definitions вместо add_definitions для добавления макросов, с которыми собирается цель

- Используйте target_compile_options для добавления специфичных флагов компилятора, с которыми собирается цель

# Добавляем цель-библиотеку

add_library(mylibrary \

ColorDialog.h ColorDialog.cpp \

ColorPanel.h ColorPanel.cpp)

# ! Осторожно - непереносимый код !

# Добавляем к цели путь поиска заголовков /usr/include/wx-3.0

# Лучше использовать find_package для получения пути к заголовкам.

target_include_directories(mylibrary /usr/include/wx-3.0)Стоит заметить, чтоtarget_link_librariesможет добавить пути поиска заголовков библиотеки, если библиотека находится в вашем проекте и к ней были прикреплены пути поиска заголовков через конструкциюtarget_include_directories(libfoo PUBLIC ...).

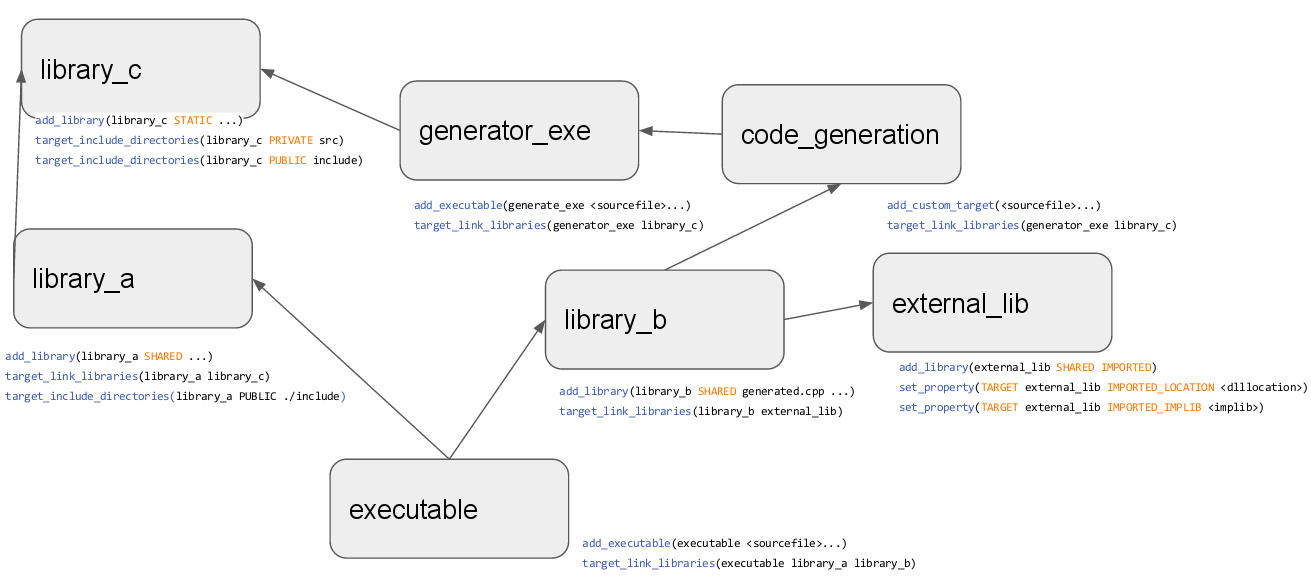

Есть пример схемы зависимостей, взятый из презентации Modern CMake / an Introduction за авторством Tobias Becker:

Совет №5: включите, наконец, C++17 или C++14!

В последние годы стандарт C++ обновляется часто: мы получили потрясающие изменения в C++11, C++14, C++17. Старайтесь по возможности отказаться от старых компиляторов. Например, для Linux ничто не мешает установить последнюю версию Clang и libc++ и начать собирать все проекты со статической компоновкой C++ runtime.

Лучший способ включить C++17 без игры с флагами компиляции — явно сказать CMake, что он вам нужен.

# Способ первый: затребовать от компилятора фичу cxx_std_17

target_compile_features(${TARGET} PUBLIC cxx_std_17)

# Способ второй: указать компилятору на стандарт

set_target_properties(${TARGET} PROPERTIES

CXX_STANDARD 17

CXX_STANDARD_REQUIRED YES

CXX_EXTENSIONS NO

)С помощью target_compile_features вы можете требовать не C++17 или C++14, а определённых фич со стороны компилятора. Полный список известных CMake фич компиляторов можно посмотреть в документации.

Совет №6: используйте функции

В CMake можно объявлять свои функциональные макросы и свои функции. Есть лишь одно различие между ними: переменные, установленные внутри функции, являются локальными.

Удобно писать функции, чтобы решать текущие проблемы кастомизации сборки либо упрощать добавление множества целей сборки. Пример ниже был написан для более корректного включения C++17 из-за того, что

- CMake 3.8 ещё не умеет передавать Visual Studio флаг

/std:c++latestдля включения C++17 - при использовании

std::experimental::filesystemв Clang/libc++ нужно указать компоновщику, что проект надо линковать сlibc++experimental.a, поскольку вlibc++.aмодуля filesystem пока ещё нет; также нужно линковать с pthread, поскольку реализация thread/mutex и т.п. опирается на pthread

# В текущей версии CMake не может включить режим C++17 в некоторых компиляторах.

# Функция использует обходной манёвр.

function(custom_enable_cxx17 TARGET)

# Включаем C++17 везде, где CMake может.

target_compile_features(${TARGET} PUBLIC cxx_std_17)

# Включаем режим C++latest в Visual Studio

if (CMAKE_CXX_COMPILER_ID STREQUAL "MSVC")

set_target_properties(${TARGET} PROPERTIES COMPILE_FLAGS "/std:c++latest")

# Включаем компоновку с libc++, libc++experimental и pthread для Clang

elseif (CMAKE_CXX_COMPILER_ID MATCHES "Clang")

set_target_properties(${TARGET} PROPERTIES COMPILE_FLAGS "-stdlib=libc++ -pthread")

target_link_libraries(${TARGET} c++experimental pthread)

endif()

endfunction(custom_enable_cxx17)Каждая функция — это по сути хак, созданный для переопределения языка CMake или его поведения. Для других разработчиков смысл этого хака неясен. Поэтому старайтесь к каждой инструкции в функции добавлять комментарий, объясняющий её цель и смысл.

В крупных открытых проектах, например в KDE, применение своих функций может быть дурным тоном. Вы можете рассмотреть иные варианты: писать скрипт сборки явно по принципу "Explicit is better then implicit", либо даже предложить добавить свою функцию в upstream проекта CMake.

Совет №7 (спорный): не перечисляйте исходные файлы по одному

Мой коллега разрабатывает вне работы маленький 3D движок для рендеринга сцены с моделями и анимациями через OpenGL, GLES, DirectX и Vulkan. Однажды мы с ним обсуждали этот проект, и оказалось, что для сборки под все платформы (Windows, Linux, Android) он использует Visual Studio! Он недоволен тем, что Microsoft редко обновляет Android NDK, но не хочет отказываться от сборки через MSBuild по одной простой причине.

Ему не хочется сопровождать список файлов для сборки в двух системах сборки.

Когда-то я вёл портирование игры с iOS на Android, и мы поддерживали две системы сборки с помощью скрипта, который читал проект XCode и автоматически дополнял список файлов в Android.mk. Если вы используете CMake, то вам даже скрипт не нужно писать.

В CMake есть функция aux_source_directory, но она имеет недостаток: заголовки не добавляются в список и не появляются в любом сгенерированном проекте для IDE.

- на выручку приходит

file(GLOB ...), сканирующий файлы по маске - чтобы не замусорить новыми переменными глобальную область видимости, создадим функцию

custom_add_executable_from_dir(name) - чтобы функция, размещённая в отдельном файле, использовала как точку отсчёта путь к текущему CMakeLists.txt, мы применим переменную

CMAKE_CURRENT_SOURCE_DIR

function(custom_add_executable_from_dir TARGET)

# Собираем файлы с текущего каталога