Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

ФСТЭК даёт «добро» |

Информационной безопасности в нынешнее неспокойное время уделяется особое внимание. Вопросы ИБ – важная часть задач, решаемых государственными учреждениями и организациями, коммерческими компаниями при разработке и эксплуатации информационных систем, баз персональных данных. В связи с этим, необходимо учитывать требования международного и российского законодательства к информационным системам, предназначенные для работы с подобной информацией.

С каждым годом ужесточаются требования отечественных регуляторов: Федеральной службы по техническому и экспортному контролю, Федеральной службы безопасности, Министерства обороны, Службы внешней разведки, Федеральной службы охраны, Министерства связи и массовых коммуникаций, Банка России. Каждый из них действует в своей сфере компетенции, описанной законодательством.

Если, например, ФСБ «отвечает» за криптографию, а ФСТЭК – «за всё остальное» (межсетевые экраны, антивирусы, системы предотвращения вторжений и т. п.).

Сертификация ФСТЭК

Почему сертификация ФСТЭК? Именно ФСТЭК России, помимо прочей деятельности, осуществляет следующие полномочия: «организует в соответствии с законодательством Российской Федерации проведение работ по оценке соответствия (включая работы по сертификации) средств противодействия техническим разведкам, технической защиты информации, обеспечения безопасности информационных технологий, применяемых для формирования государственных информационных ресурсов, а также объектов информатизации и ключевых систем информационной инфраструктуры».

Сертификация — форма осуществляемого органом по сертификации подтверждения соответствия объектов требованиям технических регламентов, положениям стандартов, сводов правил или условиям договоров. В данном случае речь идет о РОСС RU.0001.01БИОО – «Системе сертификации средств защиты информации по требованиям безопасности информации».

Существуют различные требования ФСТЭК по защите тех или иных видов конфиденциальной информации. По итогам процедуры подтверждения соответствия того или иного программного или программно-аппаратного средства требованиям по безопасности выдается сертификат. Или не выдается – зависит от результата.

Оценка соответствия применяется во многих областях, и ИБ — не исключение. В зарубежной практике существует стандарт ISO IEC 15408:2009, специально предназначенный для описания критериев оценки ИТ с точки зрения информационной безопасности. В России действуют свои системы сертификации средств защиты.

Безопасность ЦОД

К программному обеспечению, которое используется для построения ключевых систем информационной инфраструктуры, и к самим этим системам предъявляются особые требования. Кроме того, в ЦОД размещаются ценные информационные активы компаний и организаций, защита которых должна обеспечиваться на должном уровне и с учетом угроз информационной безопасности, требований законодательства России и регуляторов.

К ЦОД предъявляются требования 152-ФЗ «О персональных данных», 21-го, 17-го, 31-го приказов ФСТЭК России, требования ФСБ России по криптографической защите информации, требования Банка России, ФЗ-256 «О безопасности объектов топливно-энергетического комплекса». И это только основные требования.

Например, согласно 152-ФЗ «О персональных данных», системы обработки и хранения персональной информации россиян должны не только располагаться на территории нашего государства, но и соответствовать предъявляемым законодательством требованиям в области безопасности. Особенно это касается операторов коммерческих ЦОД, для которых сохранность и безопасность информации клиентов является одним из ключевых критериев оценки качества.

С момента вступления в силу 152-ФЗ обработка персональных данных, включенных в информационные системы, осуществляется в соответствии с данным законом, что предполагает исполнение операторами всех требований к используемому программному обеспечению.

Согласно федеральному закону 149-ФЗ, все программное обеспечение в государственных, правоохранительных, финансовых и других структурах, обрабатывающих служебную информацию, подлежит сертификации ФСТЭК. Закон разрешает таким организациям использовать только сертифицированное ПО.

Если в коммерческом, корпоративном или государственном ЦОД хранятся персональные данные, из требований законодательства в числе прочего вытекают также необходимые меры по их физической защите. Конкретный набор таких мер зависит от уровня конфиденциальности, установленного для обрабатываемых данных. Исходя из этого, выбирается класс защищенности ЦОД по нормам ФЗ и ФСТЭК и обеспечивается необходимая защита, в том числе и физическая. Наиболее сбалансированный способ обеспечить физическую безопасность ЦОД — реализовать многоуровневую защиту (с несколькими периметрами безопасности). Как и при эшелонированной обороне, прорыв одного уровня не будет означать прорыва системы безопасности.

Наряду с организационными мерами и документирование комплекс мер по защите персональных данных предполагает внедрение технических средств защиты. По сложившейся практике это круглосуточное присутствие в ЦОД и на его территории специально обученной вооруженной охраны, а также средства видеонаблюдения, охватывающие внешний периметр ЦОД и внутренние помещения.

На организации, владеющие персональными данными граждан, накладывается ответственность и за сохранность этих данных. Необходимые меры физической защиты прямо или косвенно следуют также из других стандартов и нормативов – международных и национальных, таких как TIA-942, Sarbanes-Oxley, SSAE 16/SAS 70 и др.

В отношении физической безопасности выделяют следующие требования: организация режима обеспечения безопасности помещений, контроль физического доступа к инфраструктуре, в том числе к помещениям и сооружениям, контроль вноса и выноса оборудования, включая машинные носители. Важное внимание уделяется несанкционированному доступу к информации. Правильное построение и документирование процедур контроля доступа позволяют соблюсти необходимые требования по обеспечению физической безопасности.

Какие же именно системы и средства аттестованы в нашем дата-центре?

Что аттестовано?

В ЦОД RUVDS аттестованы автоматизированные рабочие места сотрудников (антивирусная защита, защита от взлома информационной системы), средства вывода (принтер), контроль доступа в помещение, средства защиты от прослушивания. В частности, аттестат системы контроля и управления доступом (СКУД) гарантирует надёжность физической безопасности серверов ЦОД.

Все действия постоянно протоколируются, активность за рабочим местом проверяется на подозрительную и при необходимости, может быть заблокирована с оповещением ответственных лиц. Используется сертифицированное программное обеспечение, начиная с сертифицированной ФСТЭК ОС Windows и специализированного ПО для контроля доступа и фильтрации трафика до антивирусной защиты и гипервизора.

Таким образом, защищается рабочее пространство, которое имеет прямое отношение к данным клиентов. Это делается средствами ОС на рабочих станциях, баз данных, специализированными защитными и антивирусными продуктами, межсетевыми экранами, средствами контроля доступа (СКУД), резервного копирования и восстановления, уничтожения данных и контроля удаления информации.

Если клиент попросит вынести свою инфраструктуру на отдельную машину, можно полностью защитить и ее, к примеру, установить туда VipNet, SecretNet, какие-то специальные антивирусы. И при этом услуги, которые мы предоставляем, будут сертифицированы, а нашего заключения о проведенной работе по защите инфраструктуры клиента будет достаточно, чтобы тот мог отчитаться перед регулирующими органами.

Исключается этап аттестации ИТ-инфраструктуры заказчика, тем самым до 50% снижается объем требуемых трудозатрат и времени, значительно сокращается требуемый размер инвестиций, существенно облегчается процесс аттестации информационных систем.

Что касается персональных данных, то наши серверы физически находятся в Российской Федерации, RUVDS имеет также лицензии Федеральной службы по надзору в сфере связи, информационных технологий и массовых коммуникаций №137295 от 30.10.2015 («Телематические услуги связи») и №137296 от 30.10.2015 («Услуги связи по передаче данных, за исключением услуг связи по передаче данных для целей передачи голосовой информации»), так что по поводу исполнения данного федерального закона вы можете быть спокойны.

Для чего сертифицируют ЦОД

Получение подтверждающих документов говорит о надёжности провайдера и предлагаемых им услуг. Сертификация, в первую очередь, подтверждает ответственность компании перед всеми клиентами (не только теми, кто работает с конфиденциальной информацией). Сам процесс лицензирования по нормативам ФСТЭК является длительным и довольно затратным. Его просто не могут себе позволить небольшие участники рынка или участники, заинтересованные в сиюминутной выгоде от проекта.

Получение лицензии ФСТЭК — это инвестиции в стратегическое развитие компании. Лицензия ФСТЭК не только подтверждает компетентность компании для работы с персональными данными, но и дает возможность предлагать услуги компаниям, в том числе из государственного сектора, которые обязаны соблюдать требования по защите конфиденциальной информации, например, сами обладают лицензией ФСТЭК и передают нам как провайдеру услуг данные, которые подлежат защите по нормативам ФСТЭК.

Помимо серьезной защиты и резервирования на уровне дата-центра и сертификации ФСТЭК, RUVDS заключила соглашение о страховании персональных данных и корпоративной информации третьих лиц. Кроме общего страхования, RUVDS совместно с AIG планирует предложить своим клиентам уникальные условия индивидуального страхования их деятельности и данных на виртуальных серверах компании.

И, конечно, в нашем дата-центре ваши ресурсы будут защищены от DDoS-атак: анализ сетевого трафика производится в режиме 24/7, а защита позволяет стабильно выдерживать атаки мощностью до 1500 Гбит/сек. Аналитическая система фильтрует входящий на ваш адрес трафик, удаляет вредоносную информацию, передавая на вашу сторону только легитимный безопасный трафик.

|

Метки: author ru_vds хостинг сетевые технологии it- инфраструктура блог компании ruvds.com ruvds фстэк сертификация |

Дизайн интерфейса корпоративного инструмента BI для data mining |

Количество информации в мире растет в геометрической прогрессии, а тем временем человеческий мозг не способен эволюционировать с той же скоростью. Поэтому множество крупных компаний уже столкнулись с тем, что данные и отчеты в многостраничных и многоколоночных таблицах нужно не только собирать и хранить, пересылать и выгружать, но еще и регулярно анализировать и исследовать. Но что делать, если гигантские многоэкранные таблицы все больше запутывают и утомляют, нежели помогают исследовать и выявлять закономерности? Это значит, что на помощь должны прийти самые передовые технологии и, естественно, дизайн.

Что такое BI

Business intelligence (сокращенно BI) — это методы и инструменты для перевода необработанной информации в осмысленную, удобную форму. Эти данные используются для бизнес-анализа. Технологии BI обрабатывают большие объемы неструктурированных данных, чтобы найти стратегические возможности для бизнеса.

Бизнес-анализ как деятельность состоит из нескольких связанных между собой процессов:

- интеллектуальный анализ данных (data mining),

- аналитическую обработку в реальном времени (online analytical processing),

- получение информации из баз данных (querying),

- составление отчетов (reporting).

Цель BI — интерпретировать большое количество данных, заостряя внимание лишь на ключевых факторах эффективности, моделируя исход различных вариантов действий, отслеживая результаты принятия решений.

Причем, по гениальному определению Ханса Питера Луна, с которым я абсолютно согласен, “Важны не сами факты как таковые, а именно связи между ними”.

Зачем это нужно?

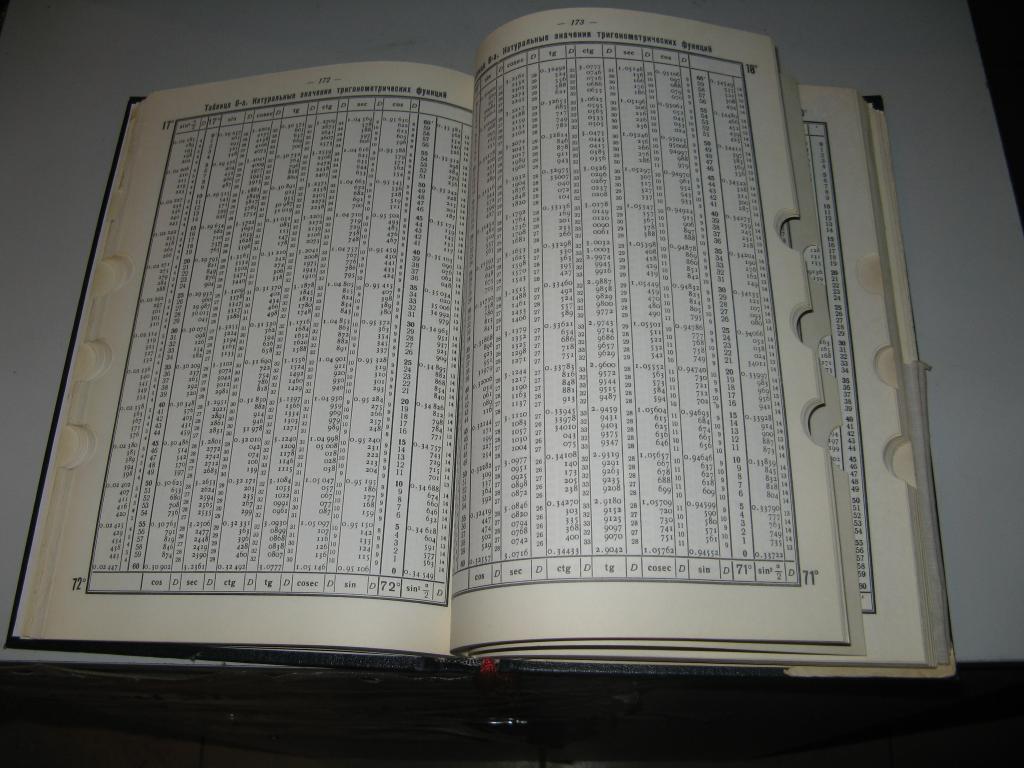

На самом деле по настоящему большие и сложные данные появились не вчера. Любой учебник по баллистике и морской навигации трехсотлетней давности способен точно также ввести в полный ступор любого современного неподготовленного обывателя.

Дело лишь в том, что ранее проблемой качественной визуализации и презентации имеющихся в наличии данных никто всерьез не озадачивался, ибо знание как таковое уже было привилегией для очень небольших групп людей. Сейчас это звучит странно, но большую часть своей истории человечество было убеждено, что любые существующие знания нужны очень узкой и специализированной группе людей:

- Астрономия и медицина только для шаманов (знахарей),

- Библия — только на латинском для горстки священников,

- грамота — только для одного на всю деревню писаря,

- иностранный язык — для одного на всю страну толмача и т.д…

Данные же категории людей знающих, в свою очередь, не жалели времени и сил для постижения любых объемов знаний в любых количествах, разумно полагая именно эту деятельность гарантией своего высокого социального статуса и сытного питания. Им не требовалась инфографика и качественная визуализация, дизайн бар-чартов и вращающихся в трехмерном пространстве “пирогов” (pie chart), так как им доставало времени, сил и усердия для посвящения всей своей жизни для ежедневного наблюдения за всем небольших существующим в тот момент в наличии объемом данных.

Концепция, что “знания нужны всем и сразу” еще относительно молода и не обрела еще 100% сторонников даже в современном мире, ведь даже в общедоступном сегодня интернете с каждым днем нарастают тенденции ограничений, запретов, усложнений, манипуляций недостоверной информацией.

Интересно, что именно инфографика сегодня вышла на свой пик востребованности — когда громадные данные уже кем-то структурируются, обрабатываются, перевариваются, обрезаются и подаются нужным автору образом, дабы как можно точнее подкрепить его изначальную идею — визуальной аргументацией.

Именно скорость восприятия заранее “разжеванных” для пользователя данных определяет сегодня общую эффективность, обучаемость и прибыльность любого сотрудника в любой компании. Причем потребность современного общества именно в мульти-экспертах, совмещающих неглубокие знания сразу в множестве смежных отраслей, добавляет острую необходимость помещения незнакомых данных сразу в нужный контекст, чтобы подавать любые колонки цифр сразу в нужном ракурсе, как можно сильнее расширяя перед пользователем весь горизонт происходящих событий.

Именно поэтому большинство современных чартов должно синтезировать в одном месте сразу несколько различных показателей: точечный показатель, накопление, скорость его роста по времени и возможную проекцию на будущее.

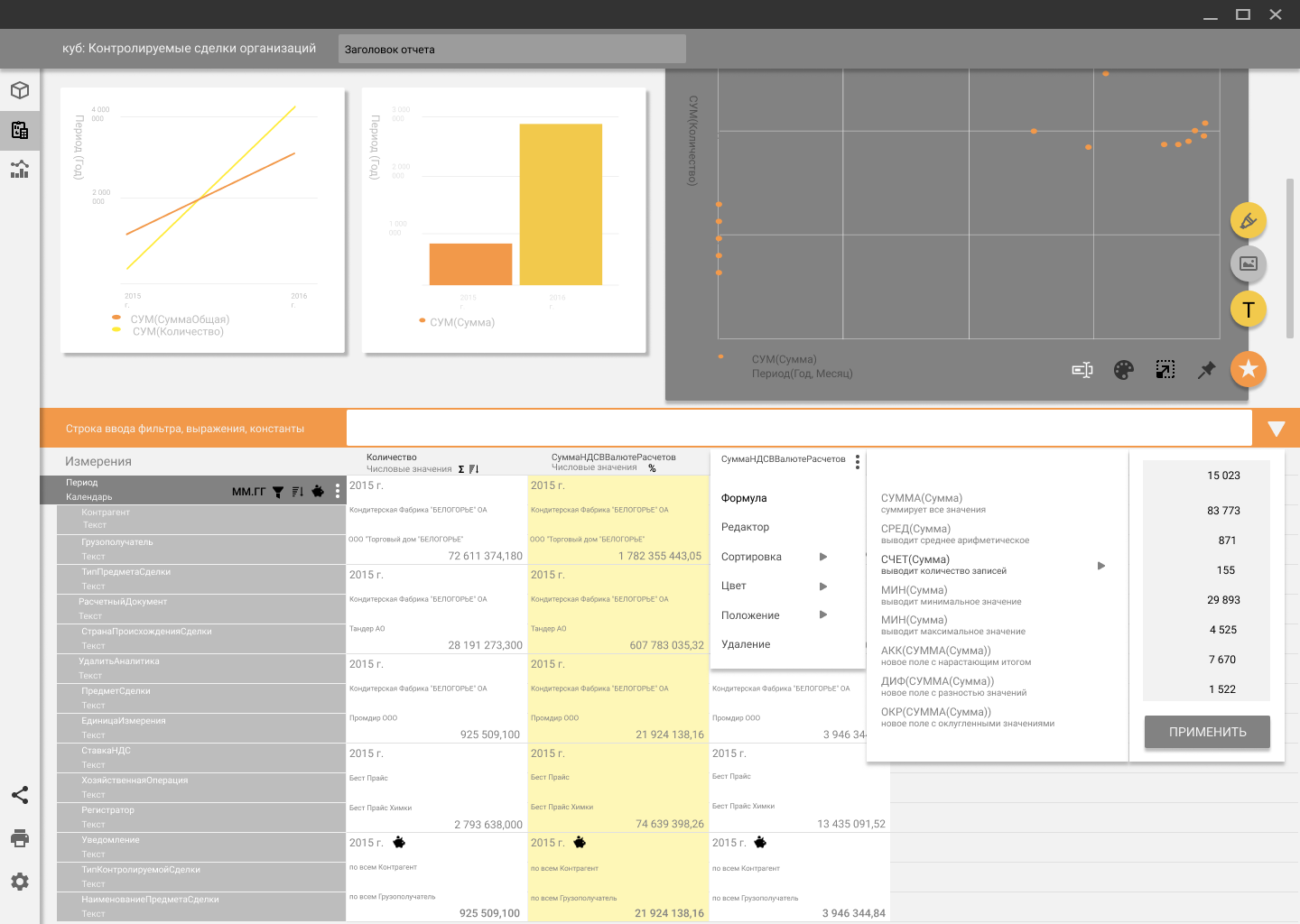

Но в тоже время при первичном бенчмаркинге быстро выяснилось, что именно “Таблица — королева данных”, так как наш типовой пользователь, глядя на самую качественную диаграмму, мгновенно хочет уточнить данные в таблице. Более того, настраивать сортировку, фильтрацию, задавать сложные выражения столбцам цифр ему также привычнее именно в табличном варианте. Спасибо за это десятилетиям доминирования картины мира от MS Excel.

Что мы имеем

Заточенность нашей будущей системы под конкретный формат данных конкретного предприятия позволило максимально упростить обработку данных из базы и качество формируемых OLAP-кубов. Кубы могли сливаться и позволять редактировать имеющиеся данные. Сама информация в кубах уже была четко разделена на Dimensions и Measures, и готовые технологии уже выявляли пустые или вырожденные наборы данных, чтобы скрывать их по умолчанию от пользователя.

Изучив огромное количество аналогов: MS Power BI, Dundas, Tableau, Qlik было с интересом обнаружено, что одну из самых простых для обучения и комфортных для работы систем разработала как раз отечественная компания “Полиматика”.

Даже в их бесплатном демо-доступе было заметно то количество продуманных и одновременно простых решений, которые нашли их специалисты. именно их подход и был взят за основу с желанием улучшить и углубить все доступные в свободном доступе наработки.

Три уровня качества дизайна

На мой взгляд, существует три пути для решения любой задачи, в которой дизайн любой современной системы занимает второе по мере убывания сложности место.

1 уровень — решение с помощью алгоритмов и полностью невидимый для стороннего наблюдателя интерфейс.

Такая система высшего уровня не спрашивает, не ждет разрешения и включения настройки от запутавшегося в паутине информации пользователя — а сама способна предложить ему нужные данные, выявить особо интересные кластеры, всплески, провести связи между совершенно независимыми (на первый взгляд) данными и выдать конечному пользователю готовый совет, план действий, путь движения к цели.

Идеально это решение не только тем, что минимально отвлекает простого человека от насущных дел своими просьбами ввести данные, затем указать, выбрать, кликнуть, дропнуть; но и тем, что способно самостоятельно находить и обрабатывать глубинную причину той или иной проблемы.

Лучшей аналогией такого подхода является предварительная профилактика заболеваний у человека с юного возраста, когда медицина предлагает заранее закаляться и чистить зубы, укреплять свое тело и дух, не дожидаясь выявления симптомов (возможно, уже сильно запущенной) болезни.

На этом уровне решения визуальный дизайн системе не нужен по определению, в то же время логические схемы, uml-диаграммы, декомпозиции процессов или просто Mindmap-ы занимают не одну сотню страниц в Техзадании.

Как вашему организму не важен дизайн того ведра, с помощью которого вы будете обливаться холодной водой каждое утро — но ему крайне важно четкое расписание утреннего графика, выверенная температура воды и набор мотивации для ежедневного совершения оздоровительного ритуала для четкое движения к цели.

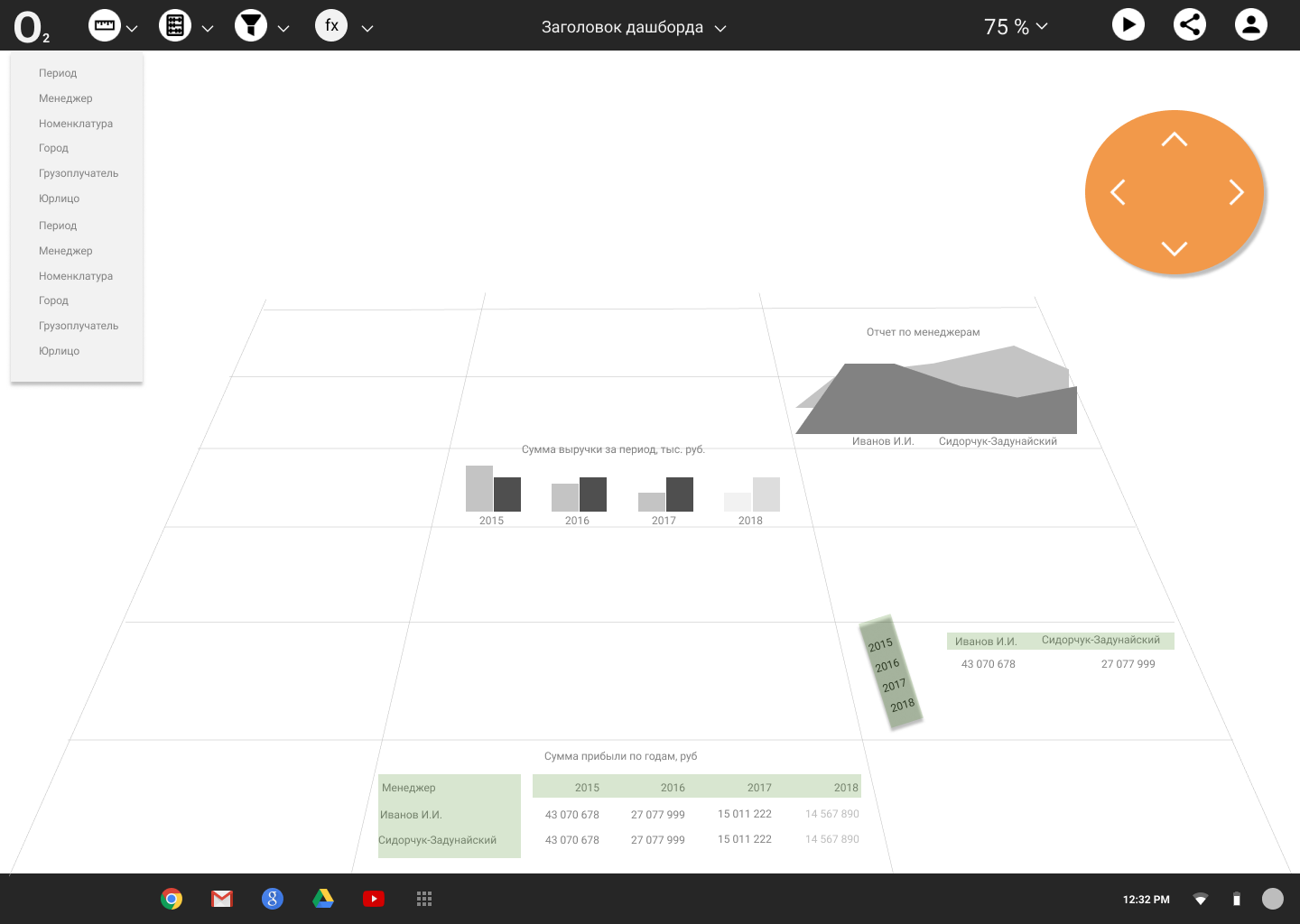

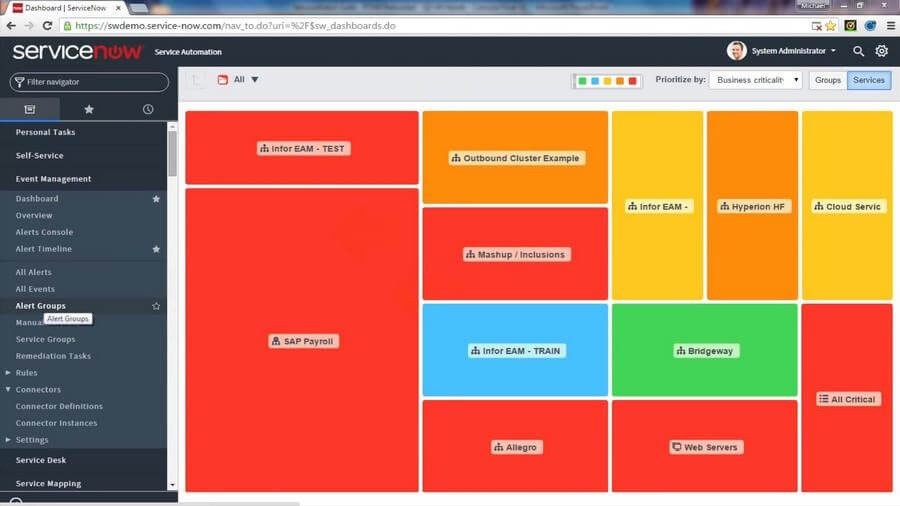

Очень круто, когда современная система способна хотя бы имитировать такую умную деятельность, заранее предполагая, какие отчеты и представления данных будут максимально востребованы пользователем. Это позволяет загружать экран с готового к визуальному восприятию дашборда, а не с “чистого листа”. Оптимальным приемом здесь является начальное распределение всех существующих фактов и сведений — по измерению времени. Так пользователь сразу вовлечен в процесс и заинтересован добавить новых измерений для более глубокого исследования, покрутить полученными данными или сразу перейти на визуализации.

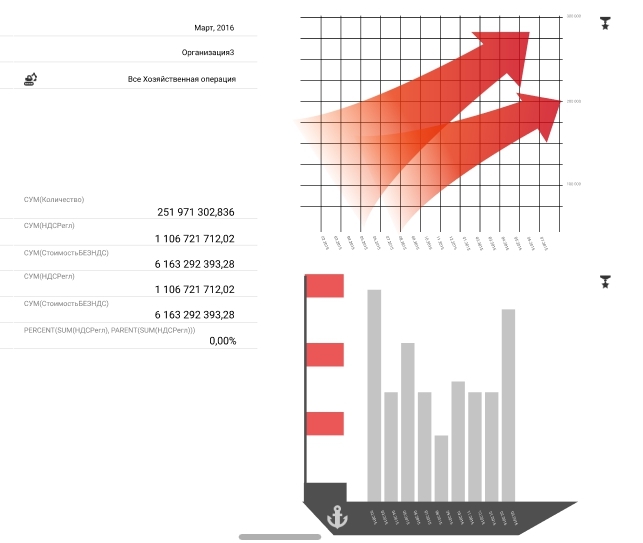

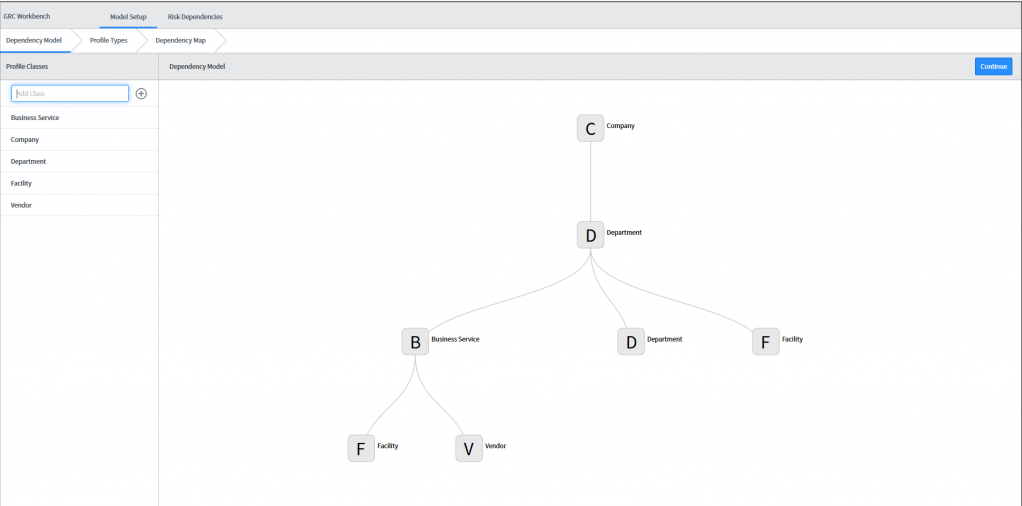

Именно так поступают в Яндекс.Метрике, эту же идею мгновенного формирования дашборда на основе существующих связей реализовали и у нас:

На втором уровне, когда зарождение проблемы было упущено и ее первопричины не очень ясны — и расположено 99% существующих инструментов дата дискавери, исследования и аналитики. Здесь на первый план выходит качество графического дизайна и удобной презентации данных.

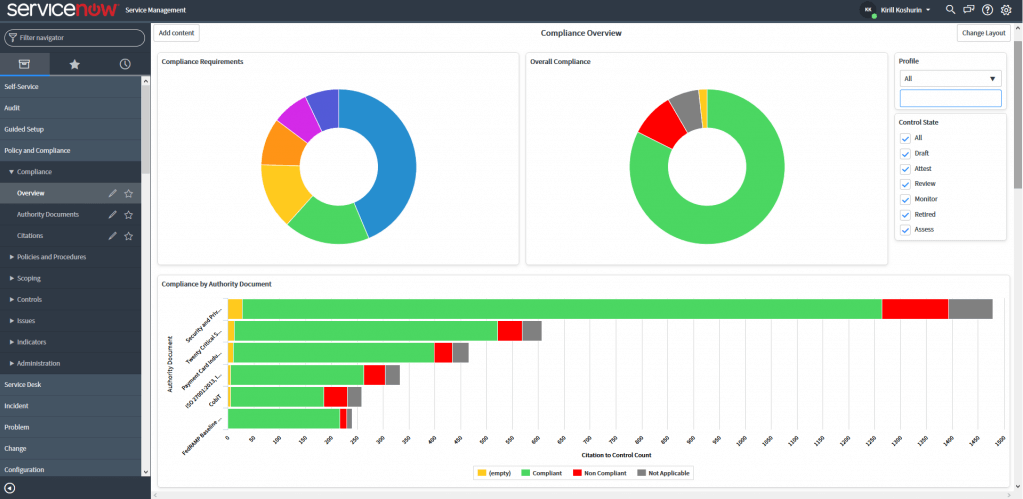

Аналог из медицины — это красиво упакованная таблетка в сладкой глазури, принимая которую, больной надеется с максимальным комфортом начать бороться с наиболее явно различимыми симптомами и последствиями вроде повышенной температуры. Хотя ведь сама по себе высокая температура — это не болезнь, а попытка организма самостоятельно и вполне адекватно отреагировать и воспротивиться на появление проблемы. Именно по этому же принципу организована работа современных BI систем, когда по не типичным проявлениям данных на дашборде можно сделать вывод, что живой организм вашего бизнеса, как может, сопротивляется возникшей откуда-то проблеме.

Именно здесь к качеству дизайна дашбордов таких следует применять любые измеримые характеристики, дополнительно с стандартным субъективным понятиям о красоте и визуальном вкусе.

Крайне важны будут также:

- скорость внесения изменений в наборы данных,

- удобство подготовки отчетов,

- количество действий для смены типа отображения или обновления данных,

- возможность создавать собственные шаблоны, библиотеки, наборы данных.

Третий и самый низкий уровень качества в моем понимании состоит из постоянных подсказок, оповещений, уведомлений, многоэкранных мастеров создания и длительного процесса onboarding. Здесь опять же качество дизайна не играет никакой роли, ибо смотреть пользователь будет в основном на текстовые рекомендации и стрелочки. Создавать подобный избыточно сложный интерфейс для системы работы с избыточно сложными данными — идея провальная априори. Да и медицинские примеры тут не совсем удачные: постоянные заговоры, наговоры и снятия порти вместо комплексного лечения.

Создание фундаментальных принципов будущей системы

1. Наглядность — данные видно всегда

С точки зрения UX, прятать сами данные хоть на несколько секунд под менюшками, настройками и модальными окнами так же плохо, как внезапно скрывать Корзину с готовым заказом и общей стоимостью как раз за секунду до совершения пользователем покупки в интернет-магазине. Также невозможно себе представить выпадающие меню в кабине пилота реактивного истребителя или машиниста электровоза, зато на рабочем экране разнообразных такая практика стала слишком уж навязчивой.

2. Непрерывность (бесшовность) — взаимодействую там же, где получаю результат

Вообще проблема разрыва данных от элементов их управления довольно нетривиальна и требовала от нас нескольких десятков попыток ее решения. Под разрывом здесь подразумевается необходимость управлять данными через особую интерфейсную панель, расположенную справа\слева или сверху\снизу от собственно самой таблицы.

Самым естественным с точки зрения эволюции у любого человека является принцип “беру то, что вижу”, когда колонки диаграммы или строки таблицы полностью интерактивны и готовы реагировать на любое желание пользователя не дожидаясь выдвижения особой контрольной панели где-либо в стороне. Это был, пожалуй, один из самых сложных для воплощения принципов.

3. Эмоциональность как основа быстрого восприятия

Мы пришли к пониманию, что выросший в абсолютно трехмерном мире человек должен будет потратить лишние милисекунды, чтобы перевести абстракцию чисел в окрашенную эмоциями и пониманием информацию, например:

здесь не просто так написано 32 456 рублей — это хороший выделенный цветом результат, это правильно, я молодец;

здесь не просто так написано 34% — это повод выделить цифру маркером, организовать собрание, устроить выговор и совершить давно планируемую перестановку в руководстве.

Без этих эмоциональных историй, генерируемых нашим сознанием, цифры остаются просто странными арабскими закорючками, информирующими об измерении тех или иных показателей.

Были даже попытки для придания эмоций в одномерный мир цифр и двумерный мир диаграмм добавить трехмерности:

- создания анимированных по оси времени прокручиваемых роликов,

- инструментарий для добавления на отчеты фотографий, картинок и видео,

- и даже возможности поворачивать любую таблицу на трехмерной панели в режиме онлайн хоть вверх ногами.

Смотришь прямо — видишь таблицу, чуть наклонил рабочую панель, как вдруг из цифр выросли цветные столбцы или линейные диаграммы, превращая набор таблиц — в визуально красивый дашбоард.

Тут мы попались на авторитет всемирного эксперта в области дизайна Эдварда Тафти, который постоянно призывает помещать числовые данные в контекст, дополняя их нужной атмосферой и формируя, по сути, дополненную реальность. К сожалению, трудозатраты на качественное помещение многомерных OLAP-кубов в трехмерный мир оказались бы просто запредельными, а полезный эффект не столь очевиден.

4. Антимобильность

При полевых исследованиях процесса работы с большими данными очень спорной показалась обязательность создания полноценного инструмента управления данными для мобильных интерфейсов.

Скорее всего, следует четко разделять сложные конструкторы, высоконагруженные настройками, опциями и продвинутыми возможностями (см. кабину пилота) — от места расслабленного путешественника в страну Больших Данных в бизнес-классе у окна.

Точно также, как потребителя голливудского блокбастера не пускают в режиссерское кресло, мы пришли к выводу, что для одного и того же пользователя потребуются две разные роли в системе:

оператора данными на ПК с продвинутым функционалом конструктора, формирующим необходимые кубы, сводные таблицы, а также итоговые дашборды,

зрителя на смартфоне, увлеченного конечным повествованием и искренне сопереживающего появляющимся перед ним перипетиям сюжета, представленного на дашборде\сториборде.

5. Ключевая роль таблицы

Очевидно, что важность и простоту табличного представления данных не стоит недооценивать. В то же время, собственные скромные исследования наглядно доказали, что людям довольно тяжело воспринимать таблицы уже из 4-5 колонок данных. Более того, выработалось внутреннее убеждение, что адекватно оценить информацию (сфокусироваться и увязать в последовательность из 3 и более умозаключений) обыватель способен лишь в том столбце, по которому данные в таблице (сколь угодно большого объема) были отсортированы.

При этом, уже сложная двойная сортировка внутри групп второго уровня воспринимается с проблемами, а сортировка внутри третьего уровня вложенности в таблицах — через некоторое время вызывает у исследуемых простейшие ошибки и путаницу в выводах.

Таким образом, получается парадокс, когда многомерные OLAP-кубы данных с 5-7 наборами сведений по 10-20 измерениям в идеале нужно адаптировать в целых ворох простейших таблиц с одним-двумя измерениями и парой наборов сведений, вырожденных в карточки.

Слишком хаотичный внешний вид такого решения с кипой из сотен карточек на экране, несмотря на неплохую технику слияния этих самых простейших таблиц “перетаскиванием”, накладыванием и обратным “разрывом” — не позволил в полной мере следовать по пути, найденном с помощью собственных же наблюдений.

Сами по себе карточные интерфейсы, безусловно, очень хороши, как и возможность отправить единственную карточку из таблицы с нужным показателем в любой мессенджер без выгрузки всего дашборда (а то и куба), но на самом деле для пользователя наличие именно этой небольшой фичи не станет определяющим фактором при выборе инструмента для data discovery.

Говоря начистоту, проблема выбора софта для исследования внутри компании вообще не возникала, поэтому новаторские интерфейсные идеи требовалось строго урезать до минимума.

6. Долой перетаскивания и промахи

Даже несмотря на модность и трендовость такой операции как drag&drop, на практике и в по-настоящему сложных системах от нее приходится периодически отказываться. Все дело в том, что перетаскивание “съедает” непростительно много времени и сил у юзера, заставляя его вместо типового клика:

- захватывать,

- тащить,

- целиться,

- отпускать,

- плеваться,

- снова брать и тащить уже точнее.

В моих исследованиях оказалось, что средний drag&drop небольшого поля с данными в таблицу\диаграмму\конструктор отнимает приблизительно две секунды времени. Иногда же эта утомительная операция отнимала и по полминуты, забирая у юзера концентрацию, калории и время от дальнейшего глубинного анализа полученных данных.

То же справедливо и для вложенных dropdown меню, в которых для совершения пары настроек зачастую необходимо дважды подряд открывать меню первого уровня, чтобы затем переходить в последующие подменю. Хуже всего, когда подобные меню настроек спроектированы таким образом, что вываливаются поверх данных, ради рассматриваяния которых, собственно, и затевался весь процесс.

Основные проблемы

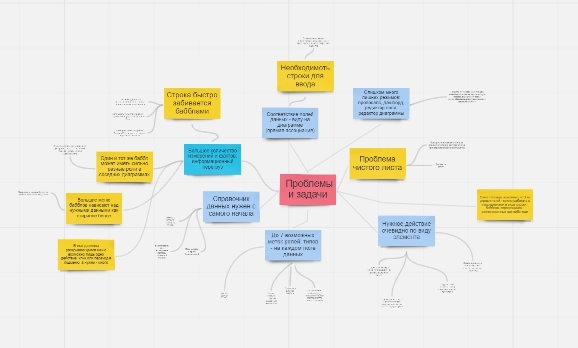

Так, шаг за шагом, при проектировании интерфейса удалось выделить несколько фундаментальных проблем:

а) Большие данные — действительно большие. У них много измерений, фактов, возможностей представления и до 7 одновременных настроек, которые постоянно создают визуальный перегруз для аналитика и не без скролла входят ни в горизонтальные строки, ни в вертикальные панели:

б) Постоянно перед глазами нужно держать справочник всех полей данных выбранного куба, что отнимает до четверти всего экрана;

в) Гайды Google material, адаптированные под управление соцсетями и контактами на небольшом смартфоне — категорически не подходят для сложной системы b2b;

г) Отсутствие прямой ассоциации между фактом и действием с ним. Сложность отображения связанных данных перекидыванием визуальных “мостиков” между ними;

д) Отсутствие ярко выраженного конверсионного действия, четкой итоговой цели, конца исследования. Каждые данные могут трансформироваться постоянно, пользователь может регулярно возвращаться к одному отчету и на его базе создавать все новые вариации и срезы данных;

е) Регулярная потребность в вводе с клавиатуры сложных выражений, фильтров, категорий для качественного анализа предварительно сформированных системой таблиц;

ж) Возможность задавать фильтры как ко всему отчету сразу, так и к каждой диаграмме по отдельности, не позволяя пользователю запутаться в сложных хитросплетениях фильтрации;

з) обязательный инструмент для выделения любой области внутри таблицы (лассо) с выносом данных в отдельную визуальную сущность (таблицу или диаграмму);

и) работа в едином окне без перезагрузки страниц и затемнения их модальными окнами.

Устарели ли хот-кеи?

Авиасимуляторы прошлого, схожие по сложности с интерфейсами сегодняшних аналитических программ, вовсю пользовались горячими клавишами. Поэтому, на каком-то этапе интересной идеей показалось перенести все сложности управления данными на клавиатуру.

Так, каждое поле данных могло иметь лишь индикаторы текущего состояния, а все сортировки, формулы, фильтры или смена оси осуществлялись бы с помощью сочетаний S, F, Z, X, Y, Tab с кнопкой Ctrl, после выделения нужного факта\измерения мышкой. Естественно, такой подход требовал бы довольно длительного обучения и адаптации пользователя (высокий порог входа), но зато мог бы заметно разгрузить визуальную часть интерфейса.

Точно также в какой-то момент показалось, что замена всех опций на тэги способна значительно разгрузить интерфейс. Но такая разгрузка была мнимой, облегчая экран — мы сильно усложняли жизнь оператору наших данных, заставляя его удерживать в голове правила написания громадного количества тэгов и кратких формул:

Также, к сожалению, из соображений предельной эффективности, не удалось продавить решение для написания полностью своей графической библиотеки для стилизации графических отчетов под нужды компании. Пришлось брать одну из существующих и лишать себя вот такой красоты:

Итоги всех мучений

Как вы можете видеть, было перепробовано большое количество концепций, каждая из которых имела право на существование, но не удовлетворяла в полной мере всем ключевым принципам, а также не решала всех существующих проблем, а то и порождала новые.

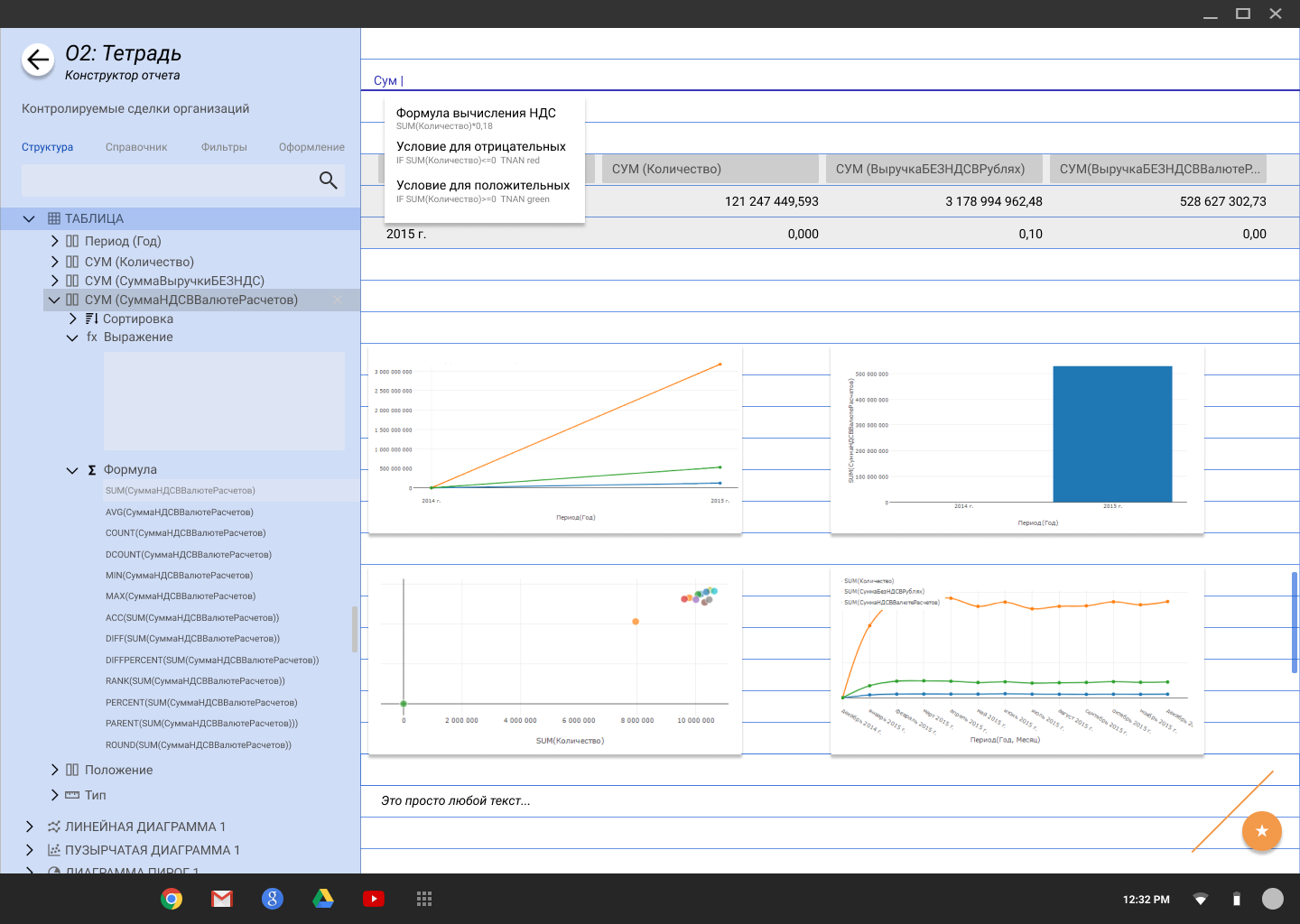

На текущем этапе мне кажется, что ближе всех к идеалу подходит решение, условно названное нами концепцией “Тетрадь”:

Оно эмоционально — порождает приятные воспоминания со школы, оно содержит тетрадную разлиновку, максимально подчеркивая важность талицы. Оно позволяет видеть данные всегда и перекрывает только при вводе нового значения в строку. Оно абсолютно антимобильно в виде конструктора, но позволяет просматривать с телефона сгенерированный в html дашборд по ссылке.

Каждая строка здесь интерактивна и позволяет начать ввод названия Измерения, Значения, Фильтра прямо в любом указанном месте. А качественный автокомплит подскажет и ускорит ввод.

Здесь отсутствуют любые перетаскивания, а все настройки логично структурированы в левом блока навигации и управления. Один и тот же экран на ПК является и конструктором таблицы, и итоговым дашбордом.

Слева всегда доступен справочник данных, а лассо (Ctrl+L) позволяет выделять из таблицы любую область.

Но последней проблемы здесь пока решить никак не удалось — сами данные и их настройки оказались предельно разорваны, и человеку постоянно приходится смотреть в правую часть экрана, совершая настройки слева.

Собственно, цель данной статьи и состоит в том, чтобы призвать на помощь многоуважаемых коллег, которые смогли бы добровольно и искренне помочь разрешить последнюю дилемму и добраться, наконец, до первого релиза.

|

Метки: author sanemerov интерфейсы веб-дизайн usability data mining data science business intelligence business analysis полиматика |

Сохранить данные и веру в человечество: большая миграция кластера ElasticSearch |

В этом материале я продолжаю делиться полевым опытом работы с системой сбора логов на базе Heka и ElasticSearch.

На этот раз рассказ пойдет про миграцию данных между двумя кластерами ElasticSearch 2.2 и 5.2.2, которая стоила немалых нервов лично мне. Как-никак, предстояло перевезти 24 миллиарда записей, не сломав уже работающую систему.

Прошлая статья закончилась на том, что система работает, логи поступают и складываются в кластер ElasticSearch, доступен их просмотр в реальном времени через Kibana. Но кластер изначально был собран со значительным запасом по памяти как раз на вырост.

Если обратиться к официальной документации ElasticSearch (далее просто ES), то в первую очередь вы увидите строгое предупреждение «Don't cross 32 gb». Превышение грозит проседанием производительности вплоть до моментов полной остановки, пока garbage collector выполняет пересборку в духе «stop the world». Рекомендация производителя по памяти на сервере: 32 ГБ под heap (xms/xmx) и еще 32 ГБ свободного места под кэш. Итого 64 ГБ физической памяти на одну дата-ноду.

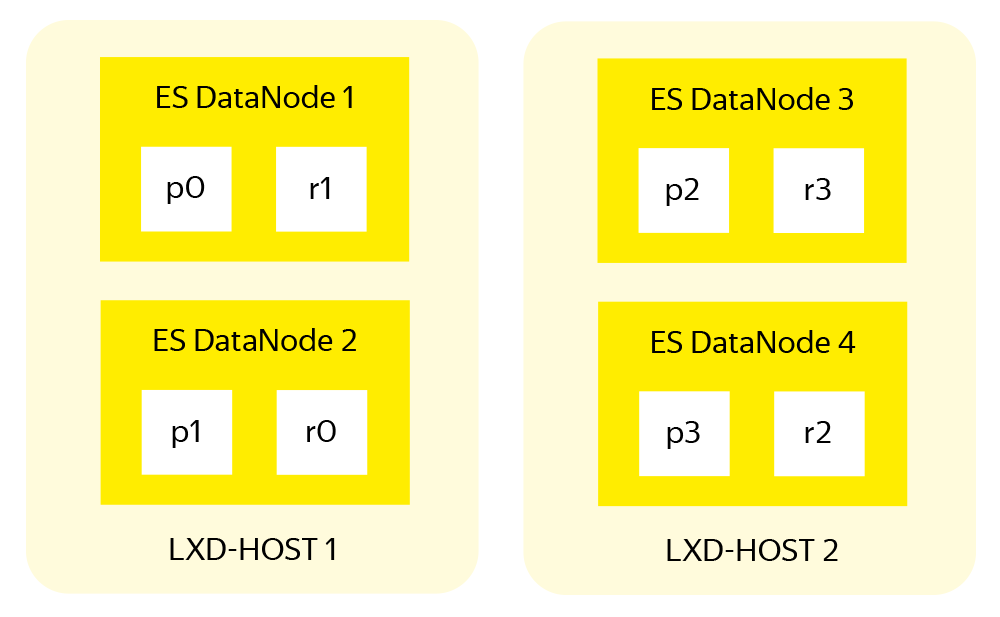

Но что делать, если памяти больше? Официальный ответ все в той же документации – ставить несколько экземпляров ES на один хост. Но мне такой подход показался не совсем правильным, так как штатных средств для этого не предусмотрено. Дублировать init-скрипты – это прошлый век, поэтому более интересной выглядела виртуализация кластера с размещением нод в LXD-контейнерах.

LXD (Linux Container Daemon) – так называемый «контейнерный легковизор». В отличии от «тяжелых» гипервизоров не содержит эмуляции аппаратуры, что позволяет сократить накладные расходы на виртуализацию. К тому же имеет продвинутый REST API, гибкую настройку используемых ресурсов, возможности переноса контейнеров между хостами и другие возможности, более характерные для классических систем виртуализации.

Вот такая вырисовывалась структура будущего кластера.

К началу работ под рукой было следующее железо:

Четыре работающих дата-ноды ES в составе старого кластера: Intel Xeon 2x E5-2640 v3; 512 ГБ ОЗУ, 3x16 ТБ RAID-10.

- Два новых пустых сервера аналогичной предыдущему пункту конфигурации.

По задумке, на каждом физическом сервере будет две дата-ноды ES, мастер-нода и клиентская нода. Кроме того, на сервере разместится контейнер-приёмник логов с установленными HAProxy и пулом Heka для обслуживания дата-нод этого физического сервера.

Подготовка нового кластера

В первую очередь нужно освободить одну из дата-нод – этот сервер сразу уходит в новый кластер. Нагрузка на оставшиеся три возрастет на 30%, но они справятся, что подтверждает статистика загрузки за последний месяц. Тем более это ненадолго. Далее привожу свою последовательность действий для штатного вывода дата-ноды из кластера.

Снимем с четвертой дата-ноды нагрузку, запретив размещение на ней новых индексов:

{

"transient": {

"cluster.routing.allocation.exclude._host": "log-data4"

}

}Теперь выключаем автоматическую ребалансировку кластера на время миграции, чтобы не создавать лишней нагрузки на оставшиеся дата-ноды:

{

"transient": {

"cluster.routing.rebalance.enable": "none"

}

}Собираем список индексов с освобождаемой дата-ноды, делим его на три равные части и запускаем перемещение шардов на оставшиеся дата-ноды следующим образом (по каждому индексу и шарду):

PUT _cluster/reroute

{

"commands" : [ {

"move" :

{

"index" : "service-log-2017.04.25", "shard" : 0,

"from_node" : "log-data4", "to_node" : "log-data1"

}

}

}Когда перенос завершится, выключаем освободившуюся ноду и не забываем вернуть ребалансировку обратно:

{

"transient": {

"cluster.routing.rebalance.enable": "all"

}

}Если позволяют сеть и нагрузка на кластер, то для ускорения процесса можно увеличить очередь одновременно перемещаемых шардов (по умолчанию это количество равно двум)

{

"transient": {

"cluster": {

"routing": {

"allocation": {

"cluster_concurrent_rebalance": "10"

}

}

}

}

}Пока старый кластер постепенно приходит в себя, собираем на трёх имеющихся серверах новый на базе ElasticSearch 5.2.2, с отдельными LXD-контейнерами под каждую ноду. Дело это простое и хорошо описанное в документации, поэтому опущу подробности. Если что – спрашивайте в комментариях, расскажу детально.

В ходе настройки нового кластера я распределил память следующим образом:

Мастер-ноды: 4 ГБ

Клиентские ноды: 8 ГБ

Дата-ноды: 32 ГБ

- XMS везде устанавливаем равным XMX.

Такое распределение родилось после осмысления документации, просмотра статистики работы старого кластера и применения здравого смысла.

Синхронизируем кластеры

Итак, у нас есть два кластера:

Старый – три дата-ноды, каждая на железном сервере.

- Новый, с шестью дата-нодами в LXD контейнерах, по две на сервер.

Первое, что делаем, – включаем зеркалирование трафика в оба кластера. На приемных пулах Heka (за подробным описанием отсылаю к предыдущей статье цикла) добавляем ещё одну секцию Output для каждого обрабатываемого сервиса:

[Service1Output_Mirror]

type = "ElasticSearchOutput"

message_matcher = "Logger == 'money-service1''"

server = "http://newcluster.receiver:9200"

encoder = "Service1Encoder"

use_buffering = trueПосле этого трафик пойдет параллельно в оба кластера. Учитывая, что мы храним индексы с оперативными логами компонент не более 21 дня, на этом можно было бы и остановиться. Через 21 день в кластерах будут одинаковые данные, а старый можно отключить и разобрать. Но долго и скучно столько ждать. Поэтому переходим к последнему и самому интересному этапу – миграции данных между кластерами.

Перенос индексов между кластерами

Так как официальной процедуры миграции данных между кластерами ES на момент выполнения проекта не существует, а изобретать «костыли» не хочется – используем Logstash. В отличии от Heka он умеет не только писать данные в ES, но и читать их оттуда.

Судя по комментариям к прошлой статье, у многих сформировалось мнение, что я почему-то не люблю Logstash. Но ведь каждый инструмент предназначен для своих задач, и для миграции между кластерами именно Logstash подошёл как нельзя лучше.

На время миграции полезно увеличить размер буфера памяти под индексы с 10% по умолчанию до 40%, которые выбраны по среднему количеству свободной памяти на работающих дата-нодах ES. Также нужно выключить обновление индексов на каждой дата-ноде, для чего добавляем в конфигурацию дата-нод следующие параметры:

memory.index_buffer_size: 40%

index.refresh_interval: -1По-умолчанию индекс обновляется каждую секунду и создает тем самым лишнюю нагрузку. Поэтому, пока в новый кластер никто из пользователей не смотрит, обновление можно отключить. Заодно я создал шаблон по умолчанию для нового кластера, который будет использоваться при формировании новых индексов:

{

"default": {

"order": 0,

"template": "*",

"settings": {

"index": {

"number_of_shards": "6",

"number_of_replicas": "0"

}

}

}

}С помощью шаблона выключаем на время миграции репликацию, тем самым снизив нагрузку на дисковую систему.

Для Logstash получилась следующая конфигурация:

input {

elasticsearch {

hosts => [ "localhost:9200" ]

index => "index_name"

size => 5000

docinfo => true

query => '{ "query": { "match_all": {} }, "sort": [ "@timestamp" ] }'}

}

output {

elasticsearch { hosts => [ "log-new-data1:9200" ]

index => "%{[@metadata][_index]}"

document_type => "%{[@metadata][_type]}"

document_id => "%{[@metadata][_id]}"}}

}В секции input описываем источник получения данных, указываем системе, что данные нужно забирать пачками (bulk) по 5000 записей, и выбираем все записи, отсортированные по timestamp.

В output нужно указать назначение для пересылки полученных данных. Обратите внимание на описания следующих полей, которые можно получить из старых индексов:

document_type – тип (mapping) документа, который лучше указать при переезде, чтобы имена создаваемых mappings в новом кластере совпадали с именами в старом – они используются в сохранённых запросах и дашбордах.

- document_id – внутренний идентификатор записи в индексе, который представляет собой уникальный 20-символьный хэш. С его явной передачей решаются две задачи: во-первых, облегчаем нагрузку на новый кластер не требуя генерировать id для каждой из миллиардов записей, и во-вторых, в случае прерывания процесса нет необходимости удалять недокачанный индекс, можно просто запустить процесс заново, и ES проигнорирует записи с совпадающим id.

Параметры запуска Logstash:

/usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/migrate.conf --pipeline.workers 8Ключевыми параметрами, влияющими на скорость миграции, являются размер пачек, которые Logstash будет отправлять в ES, и количество одновременно запускаемых процессов (pipeline.workers) для обработки. Строгих правил, которые определяли бы выбор этих значений, нет – они выбирались экспериментальным путем по следующей методике:

Выбираем небольшой индекс: для тестов использовался индекс с 1 млн многострочных (это важно) записей.

Запускаем миграцию этого индекса с помощью Logstash.

Смотрим на thread_pool на приёмной дата-ноде, обращая внимание на количество «rejected» записей. Рост этого значения однозначно говорит о том, что ES не успевает проиндексировать поступающие данные – тогда количество параллельных процессов Logstash стоит уменьшить.

- Если резкого роста «rejected» записей не происходит – увеличиваем количество bulk/workers и повторяем процесс.

После того как всё было подготовлено, составлены списки индексов на переезд, написаны конфигурации, а также разосланы предупреждения о предстоящих нагрузках в отделы сетевой инфраструктуры и мониторинга, я запустил процесс.

Чтобы не сидеть и не перезапускать процесс logstash, после завершения миграции очередного индекса я сделал с новым файлом конфигурации следующее:

Список индексов на переезд разделил на три примерно равные части.

В /etc/logstash/conf.d/migrate.conf оставил только статическую часть конфигурации:

input { elasticsearch { hosts => [ "localhost:9200" ] size => 5000 docinfo => true query => '{ "query": { "match_all": {} }, "sort": [ "@timestamp" ] }'} } output { elasticsearch { hosts => [ "log-new-data1:9200" ] index => "%{[@metadata][_index]}" document_type => "%{[@metadata][_type]}" document_id => "%{[@metadata][_id]}"}} }

Собрал скрипт, который читает имена индексов из файла и вызывает процесс logstash, динамически подставляя имя индекса и адрес ноды для миграции.

- Всего нужно запустить три экземпляра скрипта, по одному на каждый файл: indices.to.move.0.txt, indices.to.move.1.txt и indices.to.move.2.txt. После этого данные уходят в первую, третью и пятую дата-ноды.

Код одного из экземпляров скрипта:

cat /tmp/indices_to_move.0.txt | while read line

do

echo $line > /tmp/0.txt && /usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/migrate.conf --pipeline.workers 8 --config.string "input {elasticsearch { index => \"$line\" }} output { elasticsearch { hosts => [ \"log-new-data1:9200\" ] }}"

done;Для просмотра статуса миграции пришлось «на коленке» собрать ещё один скрипт, и запустить в отдельном процессе screen (через watch -d -n 60):

#!/bin/bash

regex=$(cat /tmp/?.txt)

regex="(($regex))"

regex=$(echo $regex | sed 's/ /)|(/g')

curl -s localhost:9200/_cat/indices?h=index,docs.count,docs.deleted,store.size | grep -P $regex |sort > /tmp/indices.local

curl -s log-new-data1:9200/_cat/indices?h=index,docs.count,docs.deleted,store.size | grep -P$regex | sort > /tmp/indices.remote

echo -e "index\t\t\tcount.source\tcount.dest\tremaining\tdeleted\tsource.gb\tdest.gb"

diff --side-by-side --suppress-common-lines /tmp/indices.local /tmp/indices.remote | awk '{print $1"\t"$2"\t"$7"\t"$2-$7"\t"$8"\t"$4"\t\t"$9}'Процесс миграции занял около недели. И честно скажу – спалось мне эту неделю неспокойно.

После переезда

После переноса индексов осталось сделать совсем немного. В одну прекрасную субботнюю ночь старый кластер был выключен и изменены записи в DNS. Поэтому все пришедшие на работу в понедельник увидели новый розово-голубой интерфейс пятой Kibana. Пока сотрудники привыкали к обновленной цветовой гамме и изучали новые возможности, я продолжил работу.

Из старого кластера взял еще один освободившийся сервер и поставил на него два контейнера с дата-нодами ES под кластер новый. Все остальное железо отправилось в резерв.

Итоговая структура получилась точно такой, какой планировалась на первой схеме:

Три мастер-ноды.

Две клиентские ноды.

Восемь дата-нод (по две на сервер).

- Четыре log-receiver (HAProxy + Heka Pools, по одному на каждый сервер).

Переводим кластер в production режим – возвращаем параметры буферов и интервалы обновления индексов:

memory.index_buffer_size: 10%

index.refresh_interval: 1sКворум кластера (учитывая три мастер-ноды) выставляем равным двум:

discovery.zen.minimum_master_nodes: 2Далее нужно вернуть значения шард, принимая во внимание, что дата-нод у нас уже восемь:

{

"default": {

"order": 0,

"template": "*",

"settings": {

"index": {

"number_of_shards": "8",

"number_of_replicas": "1"

}

}

}

}Наконец, выбираем удачный момент (все сотрудники разошлись по домам) и перезапускаем кластер.

Нашардить, но не смешивать

В этом разделе я хочу обратить особое внимание на снижение общей надёжности системы, которое возникает при размещении нескольких дата-нод ES в одном железном сервере, да и вообще при любой виртуализации.

С точки зрения ES кластера – всё хорошо: индекс разбит на шарды по количеству дата-нод, каждый шард имеет реплику, primary и replica шарды хранятся на разных нодах.

Система шардирования и репликации в ES повышают как скорость работы, так и надёжность хранения данных. Но эта система проектировалась с учётом размещения одной ноды ES на одном сервере, когда в случае проблем с оборудованием теряется лишь одна дата-нода ES. В случае с нашим кластером упадут две. Даже с учетом равного разделения индексов между всеми нодами и наличия реплики для каждого шарда, не исключена ситуация когда primary и replica одного и того же шарда оказываются на двух смежных дата-нодах одного физического сервера.

Поэтому разработчики ES предложили инструмент для управления размещением шард в пределах одного кластера – Shard Allocation Awareness (SAA). Этот инструмент позволяет при размещении шард оперировать не дата-нодами, а более глобальными структурами вроде серверов с LXD-контейнерами.

В настройки каждой дата-ноды нужно поместить ES атрибут, описывающий физический сервер, на котором она находится:

node.attr.rack_id: log-lxd-host-NТеперь нужно перезагрузить ноды для применения новых атрибутов, и добавить в конфигурацию кластера следующий код:

{

"persistent": {

"cluster": {

"routing": {

"allocation": {

"awareness": {

"attributes": "rack_id"

}

}

}

}

}

}Причем только в таком порядке, ведь после включения SAA кластер не будет размещать шарды на нодах без указанного атрибута.

Кстати, аналогичный механизм можно использовать для нескольких атрибутов. Например, если кластер расположен в нескольких дата-центрах и вы не хотите туда-сюда перемещать шарды между ними. В этом случае уже знакомые настройки будут выглядеть так:

node.attr.rack_id: log-lxd-hostN

node.attr.dc_id: datacentre_name{

"persistent": {

"cluster": {

"routing": {

"allocation": {

"awareness": {

"attributes": "rack_id, dc_id"

}

}

}

}

}

}Казалось бы, все в этом разделе очевидно. Но именно очевидное и вылетает из головы в первую очередь, так что отдельно проверьте – тогда после переезда не будет мучительно больно.

Следующая статья цикла будет посвящена двум моим самым любимым темам – мониторингу и тюнингу уже построенной системы. Обязательно пишите в комментариях, если что-то из уже написанного или запланированного особенно интересно и вызывает вопросы.

|

Метки: author adel-s системное администрирование серверная оптимизация it- инфраструктура devops блог компании яндекс.деньги elasticsearch kibana lxd логи |

Mониторинг Nginx Plus в Zabbix |

|

Метки: author StraNNicK nginx devops nginx plus zabbix |

Некоммерческий сертификат официального сайта Кубка конфедераций |

Открываем их официальный сайт confederationscup.net

И смотрим на сертификат. Выдан некоммерческой организацией Let's encrypt и срок действия сертификата с 10 мая по 8 августа 2017 года.

Информация о сертификате:

Является ли Кубок Конфедераций не коммерческой организацией, раз он получил такой сертификат, или программисты слишком торопились, что не смогли купить нормальный (платный) сертификат SSL?

|

|

[Перевод] 40 необычных вопросов, задаваемых на собеседовании в Apple |

А когда речь заходит о работе в магазинах Apple, соискателям задают много вопросов, которые в большинстве случаев связанны с сглаживанием конфликтов. Некоторые вопросы требуют решения хитрых математических задач, в то время как другие на первый взгляд кажутся простыми, но на деле это не так.

Собеседование на позицию Product Design Engineer:

Собеседование на позицию Software Engineer:

«У вас есть 100 монет, лежащих на столе. У каждой из них есть две стороны: «орел» и «решка». 10 монет «орлом» вверх и 90 «решкой» вверх. Вы не можете почувствовать, увидеть или как-то распознать, где какая сторона. Вам нужно поделить все монетки на две части так, чтобы в каждой из них было равное количество монеток, которые лежат «орлом» вверх»

«Было ли такое, что вы не соглашались с решением менеджера? Приведите конкретный пример и объясните, как вы решили вопрос. Каков итог спора и как человек, с которым вы спорили, описал бы вас сейчас»

«В приложении iTunes находится множество изображений, которые со временем устаревают. Какой способ вы бы использовали для того, чтобы избавиться от устаревших изображений?»

«Почему вы хотите присоединиться к компании «Apple» и что вы потеряете в своей нынешней работе, если мы наймем вас?»

«Опишите интересную проблему и как вы ее решили»

«Вы креативны? Расскажите о какой-нибудь свей креативной идее?»

Собеседование на позицию научного сотрудника:

Собеседование на позицию сотрудника розничного магазина Apple:

«Опишите не самый приятный опыт в вашей жизни»

Собеседование на позицию в команду поддержки Apple Genius:

Собеседование на позицию Lead Systems Engineer:

Собеседование на позицию Hardware Test Design Lead:

«Как бы вы спланировали поездку в Северную Корею для ваших коллег?»

Собеседование на позицию Hardware Engineer:

Собеседование на позицию менеджера глобальной сети снабжения:

Собеседование на позицию домашнего консультанта:

Собеседование на позицию Software QA Engineer:

«Перед вами три коробки, в одной из которых находятся только яблоки, во второй — только апельсины, в третьей — яблоки и апельсины. Все коробки помечены неправильно. Открыв только одну кробку и взяв только один фрукт, как можно сразу же правильно обозначить все коробки?»

«62 — 63 = 1; Измените только один элемент (цифру или операнда), чтобы утверждение стало правильным»

«Как бы вы протестировали тостер?»

Собеседование на позицию специалиста:

«Почему компания «Apple» изменила название с «Apple Computers Incorporated» на «Apple Inc.?»

«Когда вы посещаете Apple Store в качестве клиента, что вы замечаете в магазине? Как вы себя чувствуете, когда вы впервые входите?»

Собеседование на позицию Build Engineer:

Собеседование на позицию инженера-механика:

Собеседование на позицию Software Engineering Manager:

«Каковы ваши неудачи и чему они вас научили?»

Собеседование на позицию консультанта колл-центра:

«Звонит человек, у которого очень старый компьютер и он не работает. Что вы предложите?»

Собеседование на позицию Family Room Specialist:

Собеседование на позицию College At-Home Advisor:

Собеседование на позицию ведущего аналитика:

Собеседование на позицию Engineering Project Manager:

Собеседование на позицию Technical Lead:

Собеседование на позицию специалиста по оказанию услуг:

Собеседование на позицию специалиста по планированию спроса:

Собеседование на позицию специалиста по техническим вопросам:

Собеседование на позицию управляющего финансами:

|

Метки: author zarytskiy карьера в it-индустрии собеседование вопросы apple |

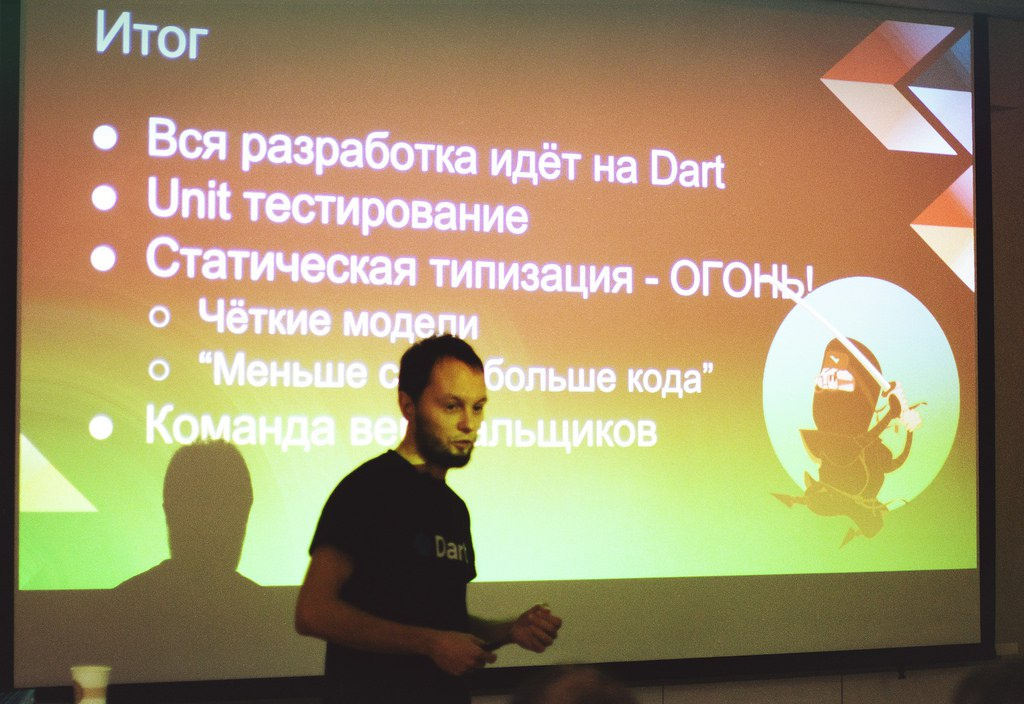

Два года с Dart: о том, как мы пишем на языке, который ежегодно «хоронят» (часть 1) |

«А он еще не умер?»,- спрашивают нас про Dart на каждой фронтенд-конференции. «А как Google поддерживает язык?», «как вы нанимаете разработчиков в команду?», «а почему не TypeScript, если вам нужна типизация?»

Мы решили объединить наиболее частые вопросы и задать их в интервью Игорю Демьянову, менеджеру по разработке Wrike.

Поговорим с ним о том, почему Wrike, с 2 млн строчками кода за спиной больше двух лет назад не побоялся перейти с JavaScript на Dart, как проходила миграция, как рос продукт и увеличивалась команда разработчиков, как развивается язык сегодня, несмотря на разговоры о его стагнации или даже смерти.

Игорь, продукту уже больше 10 лет, а что было до того момента, как вы начали использовать Dart для разработки фронтенда Wrike?

До Dart мы писали на ExtJS 3 и частично на ExtJS 4. Плюс у нас был небольшой самодельный фреймворк, который написал один из бывших сотрудников. Этот «велосипед» нам сейчас скорее мешает, и мы от него потихоньку избавляемся. На данный момент в проекте более 2,5 млн строк клиентского кода, новый функционал мы уже года два пишем на дарте и потихоньку избавляемся от легаси на ExtJS.

В какой момент и почему пришло понимание, что надо переставать писать на JS?

Оно пришло, когда Wrike начал активно расти. Когда у нас в команде было 11 человек — мы еще как-то могли использовать JavaScript, более-менее понимать, кто какой код пишет, помнить все нюансы старого кода. Но сейчас в команде фронтенда у нас около 50 человек, разработчики распределены более чем по 10 scrum-командам, и правило личных договоренностей уже не работает. Задач много, разработчиков много, кода много.

Много кода — это сколько?

На клиент мы в данный момент грузим около 10 мегабайт сжатого кода, раньше было 5 или 6. И раньше эта цифра выглядела страшно, сейчас и подавно. Но мы тут ничего не можем сделать -продукт активно растет функционально. Разумеется, мы стремимся, чтобы отдельные куски кода грузились по требованию, но в каких-то случаях приходится подгружать весь код сразу, чтобы весь функционал Wrike был доступен клиенту мгновенно.

Так а почему Dart?

Dart выгодно отличается от всего остального тем, что он может выкидывать неиспользуемые части кода, это и позволяет нам жить с таким огромным легаси. Когда проект большой и разработчиков много, очень сложно контролировать, что ты используешь, а что нет. Есть код, который лежит в кодовой базе — может быть, его просто кто-то забыл выкинуть из общей сборки — и он все еще живет с нами. И если бы мы использовали JS с его сборщиками, этот код точно приходил бы на клиент. А Dart позволяет оптимизировать и выпилить ненужный код. Плюс мы не зависим ни от каких стандартов JS, которые постоянно меняются и обновляются. Кода ты делаешь enterprise-продукт, очень сложно выбить у бизнеса время на перевод с одного стандарта на другой.

Выбрав Dart, мы пошли по пути медленной миграции: вначале переписали корную часть, затем — остальной функционал. Сейчас у нас уже грузится нового кода больше, чем старого. При этом продукт активно развивается и новые фичи приходится делать очень быстро.

С точки зрения команды, процесс тоже поменялся — разработчики меньше времени тратят на разбирательства, какие параметры куда передаются.

Да, сейчас примерно эти же возможности есть у Typescript или JS+Flow, но нам нравится Dart. У языка простой и понятный синтаксис, а главное — он позволяет нам концентрироваться на идеях, экономить время, которое бы мы тратили на рефакторинг или, скажем, на переход с ES5 на ES6, фреймворки и т.п.

Сейчас ведется какая-то разработка компонентов продукта на JS?

В отдельных исключительных случаях мы можем вносить изменения в легаси-код на JS, если видим какой-то critical bug. В остальных случаях пишется новый код на Dart — он либо заменяет старый код, либо добавляет новый функционал.

Какой фреймворк вы используете?

Примерно год назад мы перешли с Polymer на Angular2. Сейчас планируем переход на Angular3, а к концу года — на Angular4. Во многих компаниях бизнес в этом отношении довольно тяжело идет навстречу R'n'D — такие миграции сопровождаются долгими спорами и убеждениями. То, что мы используем самые новые инструменты — не только заслуга фронтенд-разработчиков, но и наших тестировщиков-автоматизаторов, которые хорошо помогают нам с регрессионными тестами и QA Manual. Когда мы переходили на Dart, то получили поддержку всех технических команд Wrike, поэтому этот переход нам дался относительно безболезненно. Так же и с Angular — прогнозируем, что переход между версиями затянется на 1-2 месяца, вряд ли больше.

Сейчас мало знают о языке Dart, но 2 года назад информации же вообще не было. Как вообще вам удалось по живому в работающем проекте все переделать? Трудно представить, что бизнес на это вообще пошел.

Я сам начал использовать Dart с версии 0.8, когда он был еще только в бете. На момент внедрения в Wrike Dart уже был официально зарелижен, появилась спецификация, стандарты и т.п., то есть мы были уверены, что принципиально в языке ничего не будет меняться. Мы знали, с каким языком будем иметь дело, все проанализировали и получили первые результаты, которыми смогли аргументированно доказать необходимость изменений. Главным доводом в пользу дарта был Tree Shaking — умение дарта выпиливать неиспользуемый код вплоть до методов. А это при нашем объеме legacy критично.

Почему не TypeScript?

Если бы мы, допустим, портировали Wrike на TypeScript, это было бы, наверное, «дешевле». С другой стороны, у нас столько кода, что портирование на TS, нам скорее всего ничего бы не дало — остался бы тот же объем подгружаемого легаси, только на TypeScript. Dart же заставляет нас писать лаконично и правильно, и не дает допустить простых ошибок в проектировании, это его плюс, но в этом, конечно, и его строгость.

Если вернуться к бизнесу, то да, здесь мы получили поддержку. Наш CEO Андрей Филев — сам в прошлом разработчик, и разговор с ним можно вести на одном языке. Плюс, репутация Google как разработчика языка о многом говорит. В конце концов, эти изменения были необходимы и самому бизнесу, чтобы максимально быстро разрабатывать и выпускать фичи, позволяющие нам оставаться одними из лидеров рынка. В общем, бизнес поддержал, и сейчас мы очень быстро движемся, а бизнес доволен нашей скоростью.

Но вот те 11 человек, которые писали на JS и вынуждены были переходить на Dart, наверно, не так радостно восприняли эту новость?

Ребята, которые поработали с каким-то другим языком, кроме JavaScript, очень легко переходили на Dart. Они, наоборот, были довольны, что дарт решает их проблемы с чужим кодом и упрощает коммуникацию. Конечно, были и те, кто знал только лишь один JavaScript, и, как и любой «старовер», в штыки воспринимал изменения.

Сейчас в JavaScript-мир довольно низкий порог вхождения, очень много в сообществе новичков, которые осваивают язык, но едва ли понимают, как проектируются большие продукты. У моего коллеги Евгения Гусева есть доклад на эту тему, который не так давно вызвал немалую полемику среди JS-разработчиков.

Любой язык можно рассматривать только в контексте его применения, поэтому тут споры и холивары бессмысленны. Например, JavaScript всем хорош для прототипирования — как бы вы ни написали код на JS, вы его скорее всего запустите. Нет понятия “плохой JavaScript” — либо он работает, как вам нужно, либо он работает не так, как вам нужно, и все.

С Dart сложнее. У вас, как в Java и как в .net, есть анализатор, который вам говорит: «Знаешь, дружок, как бы не так. Так нельзя делать. Нельзя создавать динамические классы и т.п.». То есть язык просто не позволит самому себе выстрелить в ногу, как бы вы ни хотели.

Если вы посмотрите, многие создатели Dart, работали с серьезными объекто-ориентированными языкам, V8 делали, даже кто-то из Java у них есть. Они подошли к проектированию языка с точки зрения больших приложений, поэтому Dart – это язык для средних, больших, и очень больших приложений. Он по дефолту предлагает одно, но самое эффективное решение, и оно идет «из коробки». Вы в один клик можете сделать отложенную загрузку/загрузку по требованию, язык сам будет «выпиливать», оптимизировать код – это те бонусы, которые нужны большим приложениям. На маленьких приложениях вы практически никакого заметного эффекта по сравнению с JS не увидите.

О том, как развивается язык, что нового в нем ждать в ближайший год, насколько охотно разработчики языка из Google участвуют в жизни сообщества и решают возникающие проблемы, читайте во второй части интервью примерно через неделю.

Мы будем благодарны за вопросы в комментариях и, если потребуется, напишем более подробные технические статьи о работе с Dart на их основе.

|

Метки: author Wriketeam разработка веб-сайтов программирование javascript dart блог компании wrike wrike wriketechclub dartium ddc angular2 angularjs |

«Когда с базами данных происходит критическая авария, это всегда случается несколько эпически» — Илья Космодемьянский |

На PG Day'17 Russia Илья проведет интенсивный учебный курс по PostgreSQL для системных администраторов и DevOps.

Во время беседы Илья поделился своим видением текущего места PostgreSQL на рынке современных баз данных, рассказал об основных отличиях российских технологических конференций от западных, и объяснил, для кого предзначен созданный им мастер-класс.

PG Day: Компания, которую ты основал, предоставляет поддержку для PostgreSQL. Почему именно PostgreSQL, а не MS SQL Server или ORACLE?

Илья: Поскольку мы начали заниматься Postgres-ом, до того как это стало модно, можно честно сказать, что это был осознанный выбор. Сейчас о Postgres-е не говорит только ленивый, а в те времена это была хорошая open source-ная база, но не более того.

Мне есть с чем сравнивать: я работал довольно много с Oracle-ом и немного — с MySQL. Oracle — это крутая база, но достаточно в SQL*Plus залогиниться, чтобы понять, что многие вещи там сделаны очень давно и они не очень удобны. При технологическом превосходстве Oracle, Postgres привлекал именно простотой использования, несмотря на то, что это полноценная база данных с серьезными возможностями.

С другой стороны, это open source, и ты строишь свой бизнес немного по другим законам, которые отличаются от поддержки коммерческого продукта. Ты зависишь от сообщества. Кому-то от этого становится не по себе, но при этом нет привязки к коммерческому производителю. Что ты будешь делать, если вдруг Oracle решит, что все его продукты должны поддерживать только сертифицированные партнеры?

Коммерческие базы данных — это кот в мешке, который постоянно меняется не по твоей воле, ты никак не можешь это контролировать и предвидеть. Open source в этом смысле намного приятней.

Поддержка открытого исходного кода — это довольно интересное направление. Сейчас на рынке коммерческих баз данных можно наблюдать примерно то же самое, что когда-то происходило на рынке операционных систем. Были очень дорогие коммерческие операционные системы (Novell Netware, HP UX, Solaris), которые были сильно переоценены и стоили очень больших денег. И сейчас, когда появились бесплатные десктопные операционные системы, а на серверах Linux сильно потеснил своих конкурентов, то же самое происходит с базами данных. Коммерческим производителям приходится что-то менять в своих подходах, в ценах на лицензии. Я не утверждаю, что Postgres захватит мир завтра, я бы даже опечалился, если бы это произошло, потому что “да здравствует конкуренция”. Но перспектив у него в этом смысле — огромное количество, и он меняет этот рынок у нас на глазах.

PG Day: На твой взгляд, PostgreSQL может заменить коммерческие СУБД по своим техническим возможностям?

Илья: Конкретно в такой формулировке — да, конечно, может и активно заменяет. Но это не значит, что PostgreSQL технологически круче чем Oracle. Далеко не всем проектам нужны какие-то супер-фичи, которыми обладает Oracle, такие как работа на голом железе без файловой системы. Это такие вещи которые присущи только Oracle — они супер высокотехнологичны, но требуют приобретения очень дорогих лицензий. Далеко не везде эта технологическая мощь нужна. Я много раз сталкивался с ситуацией, когда очень дорогая лицензия на Oracle покупается для небольшого проекта просто потому что в компании привыкли, что так можно делать. «У нас есть Oracle, мы не хотим иметь дело с дешевыми лицензиями, мы привыкли к хорошему Oracle EE”, при том что проект без проблем может работать на PostgreSQL.

PostgreSQL достаточно хорош для таких задач, он прекрасно с ним справляется, проще в эксплуатации, не требует затрат на лицензирование. Это очень широкий спектр ситуаций, когда Postgres действительно может замещать коммерческие СУБД. При этом задач, где Oracle лучше подходит технически, становится все меньше. В большинстве случаев цены на лицензии не оправдывают того технологического превосходства, которое Oracle имеет для этих проектов.

PG Day: CEO часто отрываются от каждодневной технической работы. Скажи, насколько ты близок к решению технических задач в компании?

Илья: Есть такая фраза: хочу сделать успешный стартап, нанять туда CEO и работать там программистом. Такие схемы, к сожалению, в реальной жизни не работают. Чтобы все это двигалось вперед, технические задачи приходится отодвигать на второй план. Другой вопрос, что мы занимаемся, прежде всего, техподдержкой и консалтингом — вся наша организация подчинена техническим вопросам. Невозможно построить лучшую в мире техническую поддержку баз данных PostgreSQL, не вникая в технические детали и задачи, которыми занимаются DBA, не участвуя в разборках происшествий с базами. Моя задача — организовывать взаимодействие людей, которые этим занимаются. Хоть я и не занимаюсь администрированием баз данных непосредственно, во все эти вопросы приходиться вникать, чтобы понять, что вообще происходит, в какую сторону нам нужно двигаться и так далее.

PG Day: Расскажи самый эпический случай из твоей практики, который хорошо бы проиллюстрировал надпись на твоем Twitter профиле — " Быть ДБА это также легко как ездить на велосипеде, только велосипед в огне, ты в огне, все в огне и ты в аду”?

Илья: Вряд ли найдется много DBA, будут радостно рассказывать самые эпические эпизоды в своей практике. Всякое случалось. Когда с базами данных происходит какая-то критическая авария, это всегда случается несколько эпически, хоть мы и стараемся везде соломки подстелить.

Звонят в два часа ночи, говорят что у нас все упало, ничего не работает, база данных накрылась, потому что у нее закончились transaction id и что-то было не так настроено. При этом все администраторы, которые должны были за ней следить в этот момент, в доску пьяны, на дворе два часа ночи, у звонящего кончается батарейка на телефоне, и надо что-то сделать. Такие случаи регулярно встречаются, поэтому фраза про велосипед — это наш девиз.

PG Day: Ты часто ездишь на конференции. Чем отличаются сообщества в России, Европе и Америке? Насколько сильно чувствуется наличие сообщества PostgreSQL на конференциях в России и за границей?

Илья: Это два больших отдельных вопроса. Многие конференции за границей — community-driven, их делают энтузиасты, ориентируясь на развитие community, а не непосредственный заработок (хотя было бы неправильно утверждать, что они совсем не преследуют такие цели).

Первое отличие, которое бросается в глаза — организаторы российских конференций рассчитывают заработать деньги. Билет на мероприятие стоит дороже, все происходит с оттенком шоу-бизнеса. В отличие от России, на западе люди меньше переживают о том, как сделать, чтобы спонсорам было интересно. Многие российские конференции не могут позволить себе очень интересную программу, потому что спонсорам будет скучно, ведь слушатели пойдут не к ним, а на интересный доклад. При этом российские конференции довольно качественно организованы: все отлажено как часы, тратится много денег, подготовкой занимаются профессионалы. Западные конференции часто нацелены на содержание, а не на форму.

Второе отличие: рынок у нас сильно меньше мирового по объективным причинам. Если ты участвуешь только в российских конференциях, очень просто возомнить себя самым умным. Поэтому я рекомендую выбираться на международные конференции — ты мгновенно понимаешь, какое количество людей намного умней тебя, намного быстрей соображает, у них есть чему поучиться. Очень полезно.

И еще один момент. В Северной Америке никто не воспринимает посещение конференции как способ развеяться, потусоваться со знакомыми. Большинство людей, слушатели и докладчики, рассматривает это как серьезное обучение и повышение квалификации. Приезжая на мероприятие, они выкладываются по полной. На американской конференции допустимо начать доклады и в девять утра — слушатели приходят туда работать, а не скрываться от офисной рутины.

PG Day: Чего ты ожидаешь от PG Day Russia? Требования к аудитории — какой минимум знаний должен быть, может, порекомендуешь что-то почитать?

Илья: Я ожидаю, что у нас получится сделать хорошее событие, причем посвященное не только Посгресу, но и базам данных в общем. Я всегда беспокоюсь за то, чтобы всем технарям, которые работают с базами данных, было интересно поучаствовать. Чтобы программа была высокого уровня, наполненная интересными техническими докладами.

У нас есть такая идея, что нельзя привозить только хороших иностранных спикеров и показывать, мол, «вот, ребята, смотрите как бывает». Нам нужно растить наше Российское сообщество изнутри. Мы зовем известных в мировом сообществе спикеров, чтобы они задавали планку. Приглашаем наших проверенных российских товарищей, которые могут много чего интересного рассказать, и всегда пытаемся найти новых докладчиков, которые раньше не выступали на широкой публике. Не самый простoй подход, но, тем не менее, в последние годы нам это удавалось.

В этот раз у нас еще более серьезная заявка: помимо основного ядра про PostgreSQL у нас планируется несколько дополнительных потоков. С потоком по MySQL и другим открытым базам данных нам очень помогает Percona, привлекает спикеров и аудиторию. Будет также поток по системному администрированию. Все мы знаем, что Postgres-овые админы и разработчики очень плотно погружены в эти темы, поэтому могут какие-то пограничные вещи тоже послушать.

И организуем два необычных потока. Сейчас много всяких переживаний: лучше ли Postgres чем Oracle? Когда Postgres наконец-то победит Oracle? Чтобы разобраться, мы решили сделать поток по коммерческим базам данных, предоставить возможность и “ораклистам” и “посгресистам” посмотреть на другие технологии. И еще у нас поток по computer science. Он включает в себя пограничные вещи между эксплуатацией баз данных и теми тенденциями, что происходят сейчас в этой науке. Ожиданий много, и главное мое беспокойство как организатора — чтобы всем было интересно и хорошо.

Требований к аудитории на самом деле никаких нет, мы рассчитываем, что каждый найдет себе интересную тему. Доклады у нас разноплановые: не только для профессионалов, которые уже все знают. Есть и для тех, кто считает свой уровень чуть ближе к среднему, и для новичков. Достаточно посмотреть на наши мастер-классы. Будет, например, очень интересный вводный курс по MS SQL Server-у и по анализу производительности Oracle. По Посгресу мой workshop будет вводный, а мастер-класс Алексея Лесовского — очень интенсивный, с расчетом на очень серьезную аудиторию. Каждый сможет найти себе по интересу и по уровню.

PG Day: К слову о твоем вводном курсе по PostgreSQL для системных администраторов и DevOps. Он всегда привлекает большое количество слушателей. Почему этот мастер-класс так популярен?

Илья: Ничего удивительного в этом нет. PostgreSQL набирает популярность, и людям зачастую проще послушать курс, суммирующий для них огромную документацию. Иначе придется долго читать и набирать опыт более болезненным способом.

Лично мне не очень нравится устройство нашей документации. Она устроена как reference-мануал, информация структурирована по разделам. Человеческое мышление так не работает. Людям хочется получить ответ, как решить более обширную задачу: установить PostgreSQL и начать с ним работать. Документация для этого не предназначена, ее надо читать целиком. Есть руководства в wiki, но они зачастую не актуальны. Поэтому такие курсы очень востребованы, поскольку основаны на практическом опыте, они ближе к практическим задачам администраторов.

Я всегда из стараюсь преподавать на основе того опыта, который имеют все DBA в нашей компании. Я смотрю, что происходит в разборе каких то инцидентов с клиентами, что меняется с выходом новых версий Postgres-а. Получается такое обобщение практического опыта нескольких очень крутых специалистов. Людям это нравится и приносит пользу, поэтому они приходят на обучение.

PG Day: Твои мастер-классы и доклады всегда очень детальны. Скажи, каким образом ты поддерживаешь актуальность технической информации?

Илья: Во-первых, я всегда слежу за коммитфестом и процессом разработки. Когда feature list уже более-менее “устаканился”, я проверяю, какие изменения произошли и как они работают. Это несложный процесс, который, естественно, не добавляет большого количества деталей.

Я советуюсь с коллегами DBA, которые каждый день работают “в поле”. Я слежу за нашей внутренней системой знаний и о том, что происходит в клиентской поддержке. Уже привычные к такому делу DBA знают материал моих слайдов и говорят: «так, слушай, вот этот слайд нужно обновить, тут уже все поменялось». Это кропотливый труд, много подготовительной работы, которую я один сделать никогда бы не осилил.

Моя роль заключается не в поиске технических деталей, а в их систематизации и изложении в методическом виде так, чтобы людям было проще воспринимать материал.

PG Day: Твои доклады доступны в Интернете. Так ли необходимо посещать мастер-класс, ведь можно просто скачать презентацию?

Илья: Презентации необходимы — люди любят их посмотреть и какую-то информацию для себя оттуда извлечь. Скажу честно, я не очень умею и люблю делать самодостаточные презентации. Я не понимаю, зачем тогда нужен доклад? Например, есть на слайде какая-то схема, как что-то устроено в PostgreSQL или в Linux, и эта схема требует моих пояснений. Если я вынесу эти пояснения на несколько соседних слайдов, будет не очень понятно что происходит. Появится много текста, презентация станет перегружена. Поэтому я обычно показываю и рассказываю на докладе голосом, с помощью указки или как-то иначе.

Когда речь идет о тренинге, я всегда являюсь сторонником работать в формате семинара. Можно прийти со своими проблемами (если они по теме этого мастер-класса), задать вопросы и получить на них ответы. Это способствует большей отдаче и большему эффекту.

PG Day: Специалистам какого профиля в первую очередь стоит посетить твой мастер-класс? Смогут ли слушатели с разным уровнем подготовки почерпнуть для себя что-то полезное?

Илья: Очень сложно рассчитывать на какую-то конкретную аудиторию, когда ты делаешь мастер-класс на конференции. В первую очередь, это админы и DBA, как начинающие, так и практикующие. Возможно, опытным специалистам, какие-то вещи вначале покажутся очевидными, поскольку я обычно стараюсь двигаться от простого материала к сложному. Но я всегда советую даже элементарный материал еще раз послушать, поскольку повторение способствует систематизации знаний.

Буквально две недели назад меня попросили послушать доклад по производительности PostgreSQL. Я послушал и вспомнил какие-то моменты, которые уже давно забыл. Мы обсуждали особенности swap’инга разных страниц из памяти в Linux, и я понял, что на этот момент не обращал внимания, а людям он далеко не всегда понятен. Поэтому я сам люблю послушать, чтобы навести порядок в голове, и другим советую.

Особенно рекомендую посетить мастер-класс людям, которые не занимаются профессиональным администрированием PostgreSQL и не планируют становиться крутыми DBA. Это материал будет особенно полезен для людей, которые занимаются DevOps, разрабатывают приложения. У них нет возможности иметь в штате квалифицированного DBA, и приходится самим разбираться со всем этим. Я попытаюсь дать полную инструкцию, что делать, куда смотреть. Пользуясь этими знаниями, слушатели смогут начать эффективно использовать PostgreSQL.

PG Day: Спасибо, Илья!

|

Метки: author rdruzyagin администрирование баз данных блог компании pg day'17 russia postgresql data egret postgresql consulting interview интервью |

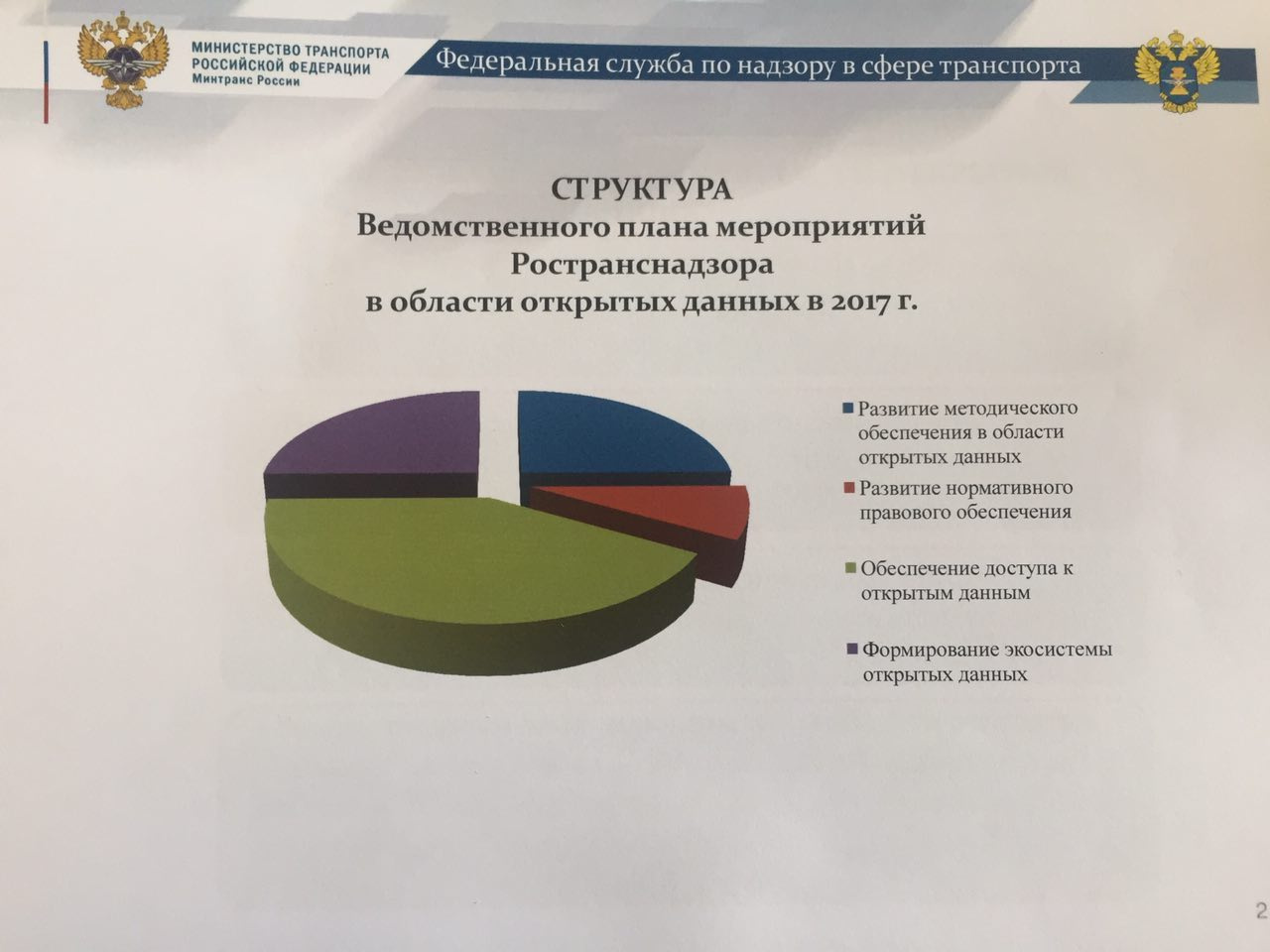

Совет по открытым данным: раскрытие транспортных данных |

Источник фото: сайт Открытого Правительства

24 мая прошло очередное заседание совета по открытым данным, повесткой которого стало раскрытие транспортных данных. По сравнению с предыдущими заседаниями, “ляпов” было меньше, дополнительное финансирование в размере полуторного бюджета ведомства никто в этот раз не запрашивал, а об эмоциональной оценке деятельности Росгидромета уже написано в официальном пресс-релизе на сайте Открытого Правительства. Остается только пройтись по пунктам повестки и рассказать об опубликованных и планируемых датасетах.