Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Тёмные паттерны — как зловредные интерфейсы пытаются атаковать и обманывать |

Вот это тоже:

И смущает меня здесь даже не заголовок пункта про отсутствие страховки, а по умолчанию выбранный первый пункт. При том, что при их основной логике сортировки по повышению цены первым должен идти немного другой — вообще бесплатный. Более того, меня смущает, что это предлагается как пакет, а не как отказ от страховки.

Теперь давайте посмотрим на менее очевидные вещи.

Вот замечательная девушка Оля прислала картинку из китайского ресторана в Петербурге:

Наверное, сложно назвать это dark pattern’ом, потому что нет элемента злонамеренности. Возможно, есть идиотизм, но милый и понятный. Никакого ущерба по несознанке.

Вот ещё вариант со страховкой:

Наверное, нет, это уже прямо пограничный случай — потому что галка «оформление страхового полиса» стоит, но полис не выбран. Как видите, если я не посмотрю, сгенерится ошибка, и мне придётся думать над формой. Ущерба по несознанке нет.

Идём дальше. Вот форма отписки Сендсея, внешнего сервиса-платформы рассылок. Примерно каждый тысячный нажимает на кнопку «выполнить» после того, как отпишется. Даркпаттерн, потому что можно было и переименовать кнопку. Хотя бы. Ну и радиокнопка здесь прото излишня.

Вот здесь мне не дают прочитать тариф — маленькое окно и английский:

Явный тёмный паттерн (от меня намеренно скрывают информацию), да? Нет, оказалось, что они осознали проблему и поправили в следующем релизе.

Вот это явный даркпаттерн Аэрофлот-Бонуса, чтобы получить услугу, нужно подписаться на другую:

Этим же часто грешат банки (особенно много трогательных историй про страховку кредита), но у них всё решается заявлением на бумаге. В частности, по SMS-банку, который иногда пытаются привязать к карте. Нельзя называть таким образом услуги. Есть норматив, но его исполнение обычно делают мучительным и максимально унижающим человеческое достоинство. Как возврат товара.

Вот ещё одно суровое место, где о психике пользователя заранее позаботились:

В этой форме откроется один набор адресов для выбора, если мне отопление, и другой набор — если мне электричество. Но, опять же, не похоже, что они скрывают адреса. Это не осознанное усложнение, а просто кривые руки.

А вот юридически-правильное и очень крутое обоснование:

Только вот юзеру от этого не лучше. Он видел «20 Гб» в заголовке без звёздочек, и что это 10 днём, а 10 ночью — не знал:

В реальном мире даркпаттерн:

Мелкий шрифт (он реально мелкий) под кассой пенсионеры не увидят. Более того, на объявлении ложь — в аптеке есть товары, которые подлежат возврату. Не подлежит возврату большая часть товаров. Или группы товаров, в т.ч. лекарственные средства. Но не всё сразу. Про это нет даже в звёздочке.

Вот ещё один пример «мягко навязанной» услуги:

Это в KFC в счёт в начале автоматические включается пожертвование. Если не сказать, что его надо выкинуть, они не уберут. Разумное предположение, что отказаться от пожертвования куда сложнее, не добавить его добровольно, парни, имхо, преступили некий этический порог.

Вот ещё похожий по ощущениям момент: Дропбокс открывает окно предупреждения про то, что место кончается:

Его хрен закроешь, видна только кнопка «Улучшить». На самом же деле при наведении курсора мыши крест появляется:

Похожий пример в приложениях — «Оставь отзыв» и кнопки «Оставить» и «Не сейчас». Без кнопки «Никогда». Ещё более мягкий пример — это как ведёт себя тот же деинсталлятор Акрониса. Он очень требовательный к вниманию пользователя, поэтому считает себя вправе показываться поверх всех окон в системе:

Но давайте посмотрим ещё на то, что может быть явным «тёмным паттерном». Вот это объявление ЦППК — оно или нет?

Проблема в том, что тут непонятно, что такое «залоговая стоимость» — складывается ощущение, что это цена карты. Непонятно, что она бесплатная. Нет пункта (3), где говорится о получении залога обратно. Поскольку ЦППК нет особого смысла снижать количество провождающих электрички, наверное, это просто кривые руки. Для них-то понятие «Залоговая стоимость» очевидно.

Вот риэлторы развешивают объявления рукописным шрифтом. То, что это печать, можно догадаться, увидев только выборку:

На мой взгляд, тёмный паттерн, но юридически не докопаешься. Какой хотят шрифт, такой и используют.

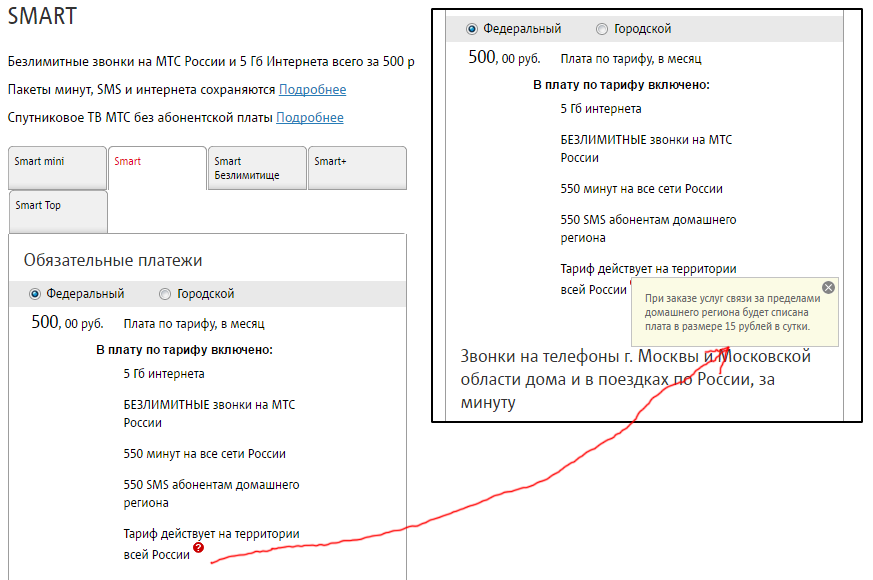

Вот ещё скрин:

Там экраном ниже примечательная вещь:

За «лучшее» и другие превосходные степени без доказательства больно бьёт антимонопольный комитет. Кстати, это яркий показатель того, что компания работает втёмную — обычно это первое, что пишут на вывеске или в рекламе. Моё просто исследование показало, что как минимум это не лучшая цена — либо не хватает существенных условий сделки вроде «*при доставке до 30 минут».

Итак, что имеем: тёмный паттерн — это злонамеренно искажённый интерфейс, когда привычный пользователю шаблон поведения используется для достижения непрямых целей, либо когда вероятный для существенной доли пользователей вариант поведения скрывается.

Очевидно, что под «злонамеренно» и «непрямыми целями» я понимаю не юридическое определение, а некое оптимальное для пользователей, причём исхожу из локальной этики. Один из сотовых операторов, к примеру, приводил исследование, что автопродление пакета интернета (платное) — это услуга, которую хотело бы подавляющее большинство пользователей. Ну не знаю, как по мне — надо спросить при подключении или после первого ручного продления, а не навязывать услугу.

Проверяем.

Терминал в сотовом салоне:

Явно плохой паттерн — надо было предупреждать про принтер до оплаты. Если бы мне нужна была эта квитанция, я бы хотел узнать до начала платежа, а не в конце.

Вот это, как это ни странно, не подпадает под определение:

Условия указаны, про то, что очки состоят из линз и оправы, знают почти все. Сомнительный момент, но, наверное, здравый смысл всё же подсказывает, в чём подвох. То есть он всё же обозначен.

Вот Трипэдвайзер достал меня своей просьбой зарегистрироваться. Если нажать «Пропустить» сверху (эту кнопку ещё надо найти) — будет вот такое окно:

Dark pattern не в том, что они сныкали кнопку и сделали её непохожей на кнопку, а в том, что после «пропустить» ты ждёшь главного меню. А вместо этого тебе дают модальное окно с двумя вариантами — «позже» и «вход». Оно само по себе нарушает привычный мне шаблон UX, плюс не имеет кнопки «никогда».

Ну и напоследок, задача, которая поставила меня в тупик:

Это Букинг предлагает подписаться на рассылку. Непонятно только, что это именно рассылка по письму в день.

Вот примерно так. И ещё очень рекомендую прочитать пост «Интерфейсы, предназначенные для обмана» в переводе JIghtuse. Только не забудьте, что переходя по этой ссылке, вы даёте согласие на установку браузера Амиго. Ну и мой пост про эксплуатацию этого всего в 2014-м в продуктовой рознице и не только. С тех пор, кстати, многое поменялось — появились пакеты молока по 850 и 800 мл.

Сразу уточню, что все суждения выше — мои личные ощущения, и, конечно, с ними можно спорить.

|

Метки: author Milfgard интерфейсы блог компании мосигра темные паттерны dark pattern шаблоны ux |

Разбираемся в джунглях программирования, или почему Маугли дружил с Python? |

Современный информационный мир — такие же джунгли. Базы данных, высотой до небес, свисающие с них компьютерные сети, аляпистые динамические веб-сайты, дикие конкуренты, которые готовы вас съесть живьём. И да, Python один из немногих языков программирования, дружба с которым сделает вас царём IT-джунглей. Изучить его на уровне Junior не так сложно, но как быть, если хочется большего? Если хочется легко ориентироваться в различных библиотеках, уметь решать сложные задачи при помощи Python, в конце концов, написать серьезный проект на Python, который потом не стыдно будет показать работодателю на собеседовании? Для тех, кто хочет новых высот, мы нашли персонального Каа — преподаватель курса серьезного изучения Python будет 5 месяцев делиться мудростью и знаниями со студентами новой группы, проверять домашнии задания, давать фитбеки, направлять и поддерживать, рассказывать о тонкостях языка, чтобы после окончания курса студент мог легко ориентироваться в дебрях программирования на уровне middle/senior специалиста, имел подтверждающие навыки проект и, в случае успешного обучения, имел реальные возможности трудоустройства в крупнейшие IT компании (они гарантируют лучшим студентам курса собеседования).

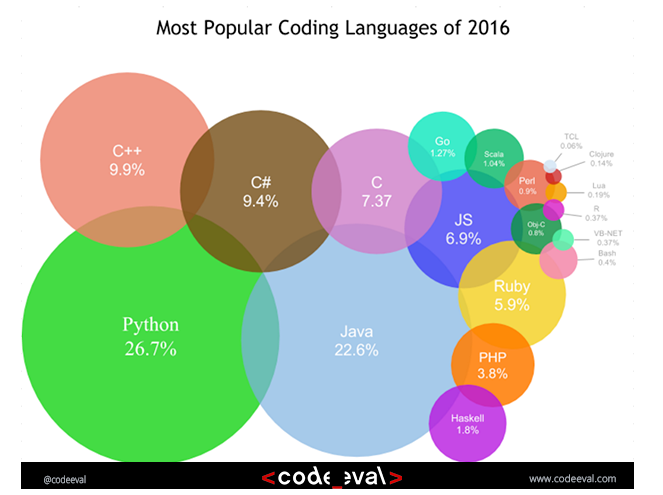

Почему для нового курса мы все-таки выбрали Python? Этому есть ряд причин.

Питон очень сильный

Средняя продолжительность жизни королевского питона 20-30 лет. Язык Python прожил уже 26 и чувствует себя великолепно. Всё это время он не лежал бездушно где-то на солнце, он рос, развивался, проникал во всевозможные сферы мира IT и не только. За это время он обзавёлся очень крутым фреймворком — Django, который входит в шестёрку самых популярных по версии Hotframeworks.com.

Python сегодня на полном серьёзе конкурирует с MATLAB, Scilab и GNU Octave в области математических вычислений и больших данных благодаря мощным библиотекам и модулям. Data Science — вообще самое актуальное направление сегодня для этого языка.

В играх, особенно онлайн-играх, Python также крайне хорош для связки больших потоков информации, графики и железа. Такие Game-проекты, как Battlefield, EVE Online, Mount & Blade, Sims 4, Civilization IV использует Python для различных нужд, от серверных элементов управления до внутренней логики игры.

Python позволяет создавать функциональный и динамический код, писать веб и десктопные приложения, БД, с параллельными вычислениями, сетями, серверами. Серьёзно — для Python нет невыполнимых задач, есть только те, где он не слишком подходит. Говорят, питоны не очень быстрые.

У питона куча друзей

Среди программистов у Python огромное количество поклонников, а если верить данным некоторых рейтингов, то это вообще самый “дружный” язык программирования в мире.

В больших и богатых компаниях питона тоже любят. В своих продуктах его используют Google, Facebook, Dropbox, Yahoo, NASA, IBM, Mozilla и многие другие. Куда проще перечислить крупные IT-компании, где по какой-то причине Python обходят стороной.

Вообще очень трудно представить современную жизнь без питона. Смотрите ли вы видео на YouTube, или играете в World of Tanks, или коллективно пишите код с использованием Mercurial, что-то параллельно подкачивая в BitTorrent — везде Python.

С питоном не пропадёшь

Разработчики со знанием Python становятся всё более заметной силой на рынке труда. Конкуренция в профессии серьёзная, но не запредельная, при этом спрос на таких специалистов устойчиво высокий. Достаточно просто взглянуть на статистику портала Indeed:

К слову, примерно такой же спрос на специалистов со знанием Javascript и лишь на 0,4 процента больше у Java. Статистику по востребованности в пределах России мы уже обозначали в одном из наших предыдущих текстов. Коротко: он не огромный, но заметный. По данным trud.com, в России программистов со знанием Python требуется больше, чем разработчиков для iOS и Android вместе взятых.

Дружба с питоном выгодна всем

Мало того, что на рынке труда существует устойчивый спрос на знатоков Python, так и ещё средний уровень зарплат уверенно входит в пятерку по всей IT-области по версии всё того же портала trud.com. Взгляните на выборку по всей России:

Требования по возрасту при этом предельно либеральные — основная масса вакансий охватывает людей от 22 до 45 лет и опытом работы менее 3 лет. Правда уровень минимальных знаний, которые требуются даже на должность джуниора, — приличный, поверхностным знанием языка и фреймворка Django отделаться не получится.

P.S. В “Книге джунглей” мудрый Каа давал юному Маугли советы о жизни, проецируя их на законы джунглей. В мире реальном вам ни к чему слушать змей. Гораздо лучше схватить Python за хвост и, размахивая им, нестись по джунглям программирования навстречу новым карьерным вершинам. И Python вас за это даже не укусит.

|

Метки: author Dmitry21 программирование python блог компании отус otus.ru otus обучение |

Поддержка исследователей в области Deep Learning |

Мы решили сделать небольшой вклад в развитие deep learning в России и выделить 3 виртуальных сервера с GPU тем, кто что-то делает в этой области. 2 виртуалки мы решили отдать нашим выпускникам, а 1 виртуалку дать в пользование кому-то «со стороны».

Условия следующие:

— мы даем вам на 2 недели доступ к виртуальному серверу с одним GPU Tesla M60 и всем необходимым окружением (Torch, TF, Keras, etc);

— по итогам 2 недель работы мы делаем вместе с вами пост в нашем блоге на Хабре, где вы делитесь своими результатами с сообществом;

— ваш проект должен быть обязательно связан с deep learning.

Свои заявки с описанием проекта присылайте на мою почту apichugin@newprolab.com до четверга, 15 июня, 23:59. В пятницу мы примем решение, чьи проекты больше заслуживают нашей скромной поддержки.

|

Метки: author a-pichugin обработка изображений машинное обучение data mining big data блог компании new professions lab deep learning gpu конкурс бесплатно без смс |

Советы начинающему скалисту (Часть 2) |

Часть 2. Обо всем и ни о чем

Сегодня мы обсудим ряд скалических идиом, которые не поместились в первую часть статьи. Мы рассмотрим вопросы интероперации языка с Java и, главное, неправильное использование объектно-ориентированных особенностей Scala.

Структура цикла

Длина выражений

В Scala практически все является выражением, и даже если что-то возвращает Unit, вы всегда можете получить на выходе ваш (). После длительного программирования на языках, где превалируют операторы (statements), у многих из нас (и я не являюсь исключением) возникает желание запихнуть все вычисления в одно выражение, составив из них длинный-предлинный паровозик. Следующий пример я нагло утащил из Effective Scala. Допустим, у нас есть последовательность кортежей:

val votes = Seq(("scala", 1),

("java", 4),

("scala", 10),

("scala", 1),

("python", 10))Мы можем лихо её обработать (разбить на группы, просуммировать внутри групп, упорядочить по убыванию) единственным выражением:

val orderedVotes = votes

.groupBy(_._1)

.map { case (which, counts) =>

(which, counts.foldLeft(0)(_ + _._2))

}.toSeq

.sortBy(_._2)

.reverseЭтот код прост, понятен, выразителен? Возможно — для съевшего собаку скалиста. Однако, если мы разобьём выражение на именованные составляющие, легче станет всем:

val votesByLang =

votes groupBy { case (lang, _) => lang }

val sumByLang =

votesByLang map { case (lang, counts) =>

val countsOnly = counts map { case (_, count) => count }

(lang, countsOnly.sum)

}

val orderedVotes = sumByLang.toSeq

.sortBy { case (_, count) => count }

.reverseНаверное, этот пример недостаточно нагляден — чего уж, я даже поленился его сам придумать. Но поверьте, мне попадались очень длинные конструкции, которые их авторы даже не удосуживались переносить на несколько строк.

Очень часто в Scala приходят через Spark, а уж используя Spark так и хочется сцепить побольше «вагончиков»-преобразований в длинный и выразительный «поезд». Читать такие выражения сложно, их нить повествования теряется достаточно быстро.

Сверхдлинные выражения и operator notation

Надеюсь, всем известно, что 2 + 2 в Scala является синтаксическим сахаром для выражения 2.+(2). Этот вид записи именуется операторной нотацией (operator notation). Благодаря ей в языке нет операторов как таковых, а есть лишь методы, пусть и с небуквенными именами, а сама она — мощный инструмент, позволяющий создавать выразительные DSL (собственно, для этого символьная нотация и была добавлена в язык). Вы можете сколь угодно долго записывать вызовы методов без точек и скобочек: object fun arg fun1 arg1. Это безумно круто, если вы хотите сделать читаемый DSL:

myList should have length 10Но, в большинстве случаев, операторная нотация в сочетании с длинными выражениями приносит сплошные неудобства: да, операции над коллекциями без скобок выглядят круче, вот только понять их можно только тогда, когда они разбиты на именованные составляющие.

«Поезда» и postfix notation

Постфиксные операторы, при определенных условиях, способны вскружить голову несчастному парсеру, поэтому в последних версиях Scala эти выражения нужно импортировать явно:

import language.postfixOpsСтарайтесь не использовать эту возможность языка и проектировать ваши DSL так, чтобы и вашим пользователям не приходилось ее использовать. Это довольно просто сделать.

Неинициализируемые значения

Scala поддерживает неинициализированные значения. Например, это может вам пригодиться при создании beans. Давайте посмотрим на следующий Java-класс:

class MyClass {

// По-умолчанию, любой наследник Object инциализируется в null.

// Примитивные типы инициализируются значениями по-умолчанию.

String uninitialized;

}Такого же поведения мы можем добиться и от Scala:

class {

// Синтаксис с нижним подчеркиванием говорит Scala, что

// данное поле не будет инциализировано.

var uninitialized: String = _

}Пожалуйста, не делайте этого бездумно. Инициализируйте значения везде, где можете. Используйте эту языковую конструкцию только если используемый вами фреймворк или библиотека яростно на этом настаивают. При неаккуратном использовании вы можете получить тонны NullPointerException. Однако знать об этой функции следует: однажды подобное знание сэкономит время. Если вы хотите отложить инициализацию, используйте ключевое слово lazy.

Никогда не используйте null

- Всегда инициализируйте значения.

- Оборачивайте

Nullable, которые могут прийти извне вOption. - Не возвращайте

null: используйтеOption,Either,Tryи др. - Видите предпосылки для появления null — быстрее исправляйте, пока ваши коллеги на радостях не завезли в проект специально предназначенный для борьбы с NPE язык.

Иногда встречаются ситуации, когда null-значения являются частью модели. Возможно, эта ситуация возникла ещё задолго до вашего прихода в команду, а уж тем более задолго до внедрения Scala. Как говорится: если пьянку нельзя предотвратить, ее следует возглавить. И в этом вам поможет паттерн, именуемый Null Object. Зачастую это всего-лишь еще один case-класс в ADT:

sealed trait User

case class Admin extends User

case class SuperUser extends User

case class NullUser extends UserЧто мы получаем? Null, пользователя и типобезопасность.

О перегрузках

Методы

В Scala существует возможность перегрузки конструкторов классов. И это — не лучший способ решить проблему. Скажу больше, это — не идиоматичный способ решения проблемы. Если говорить о практике, эта функция полезна, если вы используете Java-reflection и ваш Scala-код вызывается из Java или вам необходимо такое поведение (а почему бы в таком случае не сделать Builder)? В остальных случаях лучшая стратегия — создание объекта-компаньона и определение в нем нескольких методов apply.

Наиболее примечательны случаи перегрузки конструкторов из-за незнания о параметрах по-умолчанию (default parameters).

Совсем недавно, я стал свидетелем следующего безобразия:

// Все включено!

case class Monster (pos: Position, health: Int, weapon: Weapon) {

def this(pos: Position) = this(pos, 100, new Claws)

def this(pos: Position, weapon: Weapon) = this(pos, 100, weapon)

}Ларчик открывается проще:

case class Monster(

pos: Position,

health: Short = 100,

weapon: Weapon = new Claws

)Хотите наградить вашего монстра базукой? Да, не проблема:

val aMonster = Monster(Position(300, 300, 20), weapon = new Bazooka)Мы сделали мир лучше, монстра — миролюбивее, а заодно перестали перегружать все, что движется. Миролюбивее? Определенно. Ведь базука — это еще и музыкальный инструмент (Википедия об этом умалчивать не станет).

Сказанное относится не только к конструкторам: люди часто перегружают и обычные методы (там где этого можно было избежать).

Перегрузка операторов

Считается достаточно противоречивой фичей Scala. Когда я только-только погрузился в язык, перегрузка операторов использовалась повсюду, всеми и везде, где только можно. Сейчас эта фича стала менее популярна. Изначально перегрузка операторов была сделана, в первую очередь, для того, чтобы иметь возможность составлять DSL, как в Parboiled, или роутинг для akka-http.

Не перегружайте операторы без надобности, и если считаете, что эта надобность у вас есть, то все-равно не перегружайте.

А если перегружаете (вам нужен DSL или ваша библиотека делает нечто математическое (или трудновыразимое словами)), обязательно дублируйте оператор функцией с нормальным именем. И думайте о последствиях. Так, Благодаря scalaz оператор |@| (Applicative Builder) получил имя Maculay Culkin. А вот и фотография "виновника":

Безусловно, после того, как вы многократно перегрузите конструкторы, вам для довершения картины захочется налепить геттеров и сеттеров.

О геттерах и сеттерах

Scala предоставляет отличное взаимодействие с Java. Она также способна облегчить вам жизнь при дизайне так называемых Beans. Если вы не знакомы с Java или концепцией Beans, возможно, вам следует с ней ознакомиться.

Слышали ли вы о Project Lombok? В стандартной библиотеке Scala имеется схожий механизм. Он именуется BeanProperty. Все, что вам нужно, — создать bean и добавить аннотацию BeanProperty к каждому полю, для которого хотите создать getter или setter.

Для того чтобы получить имя видаisPropertyдля переменных булева типа, следует добавитьscala.beans.BooleanBeanPropertyв вашу область видимости.

Аннотацию @BeanProperty можно так же использовать и для полей класса:

import scala.beans.{BooleanBeanProperty, BeanProperty}

class MotherInLaw {

// По закону, она может сменить имя:

@BeanProperty var name = "Megaera"

// А эти ребята имеют свойство плодиться.

@BeanProperty var numberOfCatsSheHas = 0

// Но некоторые вещи неизменны.

@BooleanBeanProperty val jealous = true

}Для case class-ов тоже работает:

import scala.beans.BeanProperty

case class Dino(@BeanProperty name: String,

@BeanProperty var age: Int)Поиграем с нашим динозавром:

// Начнем с того, что он не так стар как вы думаете

val barney = Dino("Barney", 29)

barney.setAge(30)

barney.getAge

// res4: Int = 30

barney.getName

// res14: String = BarneyВ виду того, что мы не сделали name переменной, при попытке использовать сеттер, мы получим следующее:

barney.setName

:15: error: value setName is not a member of Dino

barney.setName Кстати о case-классах

Появление case-классов — это прорыв для JVM-платформы. В чем же их основное преимущество? Правильно, в их неизменяемости (immutability), а также наличию готовых equals, toString и hashCode. Однако, зачастую и в них можно встретить подобное:

// Внимание на var.

case class Person(var name: String, var age: Int)Иногда case-классы приходится-таки делать изменяемыми: например, если вы, имитируете beans, как в примере выше.

Но зачастую подобное случается тогда, когда глубокий джуниор не понимает, что такое имутабельность. С разработчиками уровнем повыше бывает не менее интересно, ведь они прекрасно осознают что делают:

case class Person (name: String, age: Int) {

def updatedAge(newAge: Int) = Person(name, newAge)

def updatedName(newName: String) = Person(newName, age)

}Однако про метод copy знают не все. Это норма. Подобное мне доводилось наблюдать не раз, чего уж там, в свое время я сам так хулиганил. Работает copy аналогично своему тезке, который определен для кортежей:

// Обновили возраст, получили новый инстанс.

person.copy(age = 32)О размерах case-классов

Иногда case-классы имеют свойство раздуваться до 15–20 полей. До появления Scala 2.11 этот процесс хоть как-то ограничивался 22 элементами. Но сейчас ваши руки развязаны:

case class AlphabetStat (

a: Int, b: Int,

c: Int, d: Int,

e: Int, f: Int,

g: Int, h: Int,

i: Int, j: Int,

k: Int, l: Int,

m: Int, n: Int,

o: Int, p: Int,

q: Int, r: Int,

s: Int, t: Int,

u: Int, v: Int,

w: Int, x: Int,

y: Int, z: Int

)Хорошо, я вам наврал: руки, конечно, стали свободнее, однако ограничения JVM никто не отменял.

Большие case-классы это плохо. Это очень плохо. Бывают ситуации, когда этому есть оправдание: предметная область, в которой вы работаете, не допускает агрегации, и структура представляется плоской; вы работаете с API, спроектированным глубокими идиотами, которые сидят на сильнодействующих транквилизаторах.

И знаете, чаще всего приходится иметь дело со вторым вариантом. Хочется, чтобы case-классы легко и непринужденно укладывались на API. И я вас пойму, если так.

Но я перечислил только уважительные оправдания монструозности ваших case-классов. Есть и наиболее очевидная: для того, чтобы обновить поле, глубоко запрятанного вглубь вложенных классов, приходится очень сильно помучиться. Каждый case-класс надо старательно разобрать, подменить значение и собрать. И от этого недуга есть средство: вы можете использовать линзы (lenses).

Почему линзы называются линзами? Потому что они способны сфокусироваться на главном. Вы фокусируете линзу на определенную часть структуры, и получаете ее, вместе с возможностью ее (структуру) обновить. Для начала объявим наши case-классы:

case class Address(street: String,

city: String,

postcode: String)

case class Person(name: String, age: Int, address: Address)А теперь заполним их данными:

val person = Person("Joe Grey", 37,

Address("Southover Street",

"Brighton", "BN2 9UA"))Создаем линзу для улицы (предположим что наш персонаж захотел переехать):

import shapeless._

val streetLens = lens[Person].address.streetЧитаем поле (прошу заметить что строковый тип будет выведен автоматически):

val street = streetLens.get(person)

// "Southover Street"Обновляем значение поля:

val person1 = streetLens.set(person)("Montpelier Road")

// person1.address.street == "Montpelier Road"Пример был нагло украден «из отсюда»

Аналогичную операцию вы можете совершить и над адресом. Как видите, это достаточно просто. К сожалению, а может быть и к счастью, Scala не имеет встроенных линз. Поэтому вам придется использовать стороннюю библиотеку. Я бы рекомендовал вам использовать shapeless. Собственно, приведенный выше пример, был написан с помощью этой весьма доступной для начинающего скалиста библиотеки.

Существует множество других реализаций линз, если хотите, вы можете

использовать scalaz, monocle. Последняя предоставляет более продвинутые механизмы использования оптики, и я бы рекомендовал ее к дальнейшему использованию.

К сожалению, для того, чтобы описать и объяснить механизм действия линз, может потребоваться отдельная статья, поэтому считаю, что вышеизложенной информации достаточно для того, чтобы начать собственное исследование оптических систем.

Переизобретение enum'ов

Берем опытного Java-разработчика и заставляем его писать на Scala. Не проходит и пары дней, как он отчаянно начинает искать enum'ы. Не находит их и расстраивается: в Scala нет ключевого слова enum или, хотя бы, enumeration. Далее есть два варианта событий: или он нагуглит идиоматичное решение, или начнет изобретать свои перечисления. Часто лень побеждает, и в результате мы видем вот это:

object Weekdays {

val MONDAY = 0

// догадайтесь что будет дальше...

}А дальше то что? А вот что:

if (weekday == Weekdays.Friday) {

stop(wearing, Tie)

}Что не так? В Scala есть идиоматичный способ создания перечислений, именуется он ADT (Algebraic Data Types), по-русски алгебраические типы данных. Используется, например в Haskell. Вот как он выглядит:

sealed trait TrafficLight

case object Green extends TrafficLight

case object Yellow extends TrafficLight

case object Red extends TrafficLight

case object Broken extends TrafficLightМногословно, самодельное перечисление, конечно, было короче. Зачем столько писать? Давайте объявим следующую функцию:

def tellWhatTheLightIs(tl: TrafficLight): Unit = tl match {

case Red => println("No cars go!")

case Green => println("Don't stop me now!")

case Yellow => println("Ooohhh you better stop!")

}И получим:

warning: match may not be exhaustive.

It would fail on the following input: Broken

def tellWhatTheLightIs(tl: TrafficLight): Unit = tl match {

^

tellWhatTheLightIs: (tl: TrafficLight)UnitМы получаем перечисление, свободное от привязки к каким либо константам, а также проверку на полноту сопоставления с образцом. И да, если вы используете «enum для бедных», как их обозвал один мой небезызвестный коллега, используйте сопоставление с образцом. Это наиболее идиоматичный способ. Стоит заметить, об этом упоминается в начале книги Programming in Scala. Не каждая птица долетит до середины Днепра, так же как и не каждый скалист прочтет Magnum Opus.

Неплохо про алгебраические типы данных рассказано, как ни странно, в Википедии. Касательно Scala, есть достаточно доступный пост и презентация, которая, возможно, покажется вам интересной.

Избегайте булевых аргументов в сигнатурах функций

Признайтесь, вы писали методы, которые в качестве аргумента принимают Boolean? В случае с Java ситуация вообще катастрофичная:

PrettyPrinter.print(text, 1, true)Что может означать 1? Доверимся интуиции и предположим что это количество копий. А за что отвечает true? Это может быть что угодно. Ладно, сдаюсь, схожу в исходники и посмотрю, что это.

В Scala вы можете использовать ADT:

def print(text: String, copies: Int, wrapWords: WordWrap)Даже если вам достался в наследство код, требующий логических аргументов, вы можете использовать параметры по умолчанию.

// К интам тоже применимо,

// а вдруг это не количество копий, а отступы?

PrettyPrinter.print(text, copies = 1, WordWrap.Enabled)Об итерации

Рекурсия лучше

Хвостовая рекурсия работает быстрее, чем большинство циклов. Если она, конечно, хвостовая. Для уверенности используйте аннотацию @tailrec. Ситуации бывают разными, не всегда рекурсивное решение оказывается простым доступным и понятным, тогда используйте while. В этом нет ничего зазорного. Более того, вся библиотека коллекций написана на простых циклах с предусловиями.

For comprehensions не для итерации (по индексам)

Главное, что вам следует знать про генераторы списков, или, как их еще Называют, «for comprehensions», — это то, что основное их предназначение — не в реализации циклов.

Более того, использование этой конструкции для итерации по индексам будет достаточно дорогостоящей процедурой. Цикл while или использование хвостовой рекурсии — намного дешевле. И нагляднее.

«For comprehension» представляет собой синтаксический сахар для методов map, flatMap и withFilter. Ключевое слово yield используется для последующей агрегации значений в результирующей структуре. Используя «for comprehension» вы, на самом деле, используете те же комбинаторы, просто в завуалированой форме. Используйте их напрямую:

// хорошо

1 to 10 foreach println

// плохо

for (i <- 1 to 10) println(i)Помимо того, что вы вызвали тот же код, вы еще и добавили некую переменную i, которой совершенно здесь не место. Если вам нужна скорость, используйте цикл while.

Об именах переменных

Занимательная история имен переменных в формате вопрос-ответ:

Вопрос: Откуда вообще взялись i, j, k в качестве параметров циклов?

Ответ: Из математики. А в программирование они попали благодаря фортрану, в котором тип переменной определяется ее именем: если первая буква имени начинается с I, J, K, L, M, или N, это автоматически означает, что переменная принадлежит к целочисленному типу. В противном случае, переменная будет считаться вещественной (можно использовать директиву IMPLICIT для того, чтобы изменить тип, устанавливаемый по умолчанию).

И этот кошмар живет с нами вот уже почти 60 лет. Если вы не перемножаете матрицы, то использованию i, j и k даже в Java нет оправдания. Используйте index, row, column — все что угодно. А вот если вы пишете на Scala, старайтесь вообще избегать итерации с переменными внутри for. От лукваого это.

Дополнением к этому разделу будет видео, в котором подробно рассказывается все, что вы хотели знать про генераторы списков.

О выражениях

Не используйте return

В Scala почти все является выражением. Исключение составляет return, который не следует использовать ни при каких обстоятельствах. Это не опциональное слово, как думают многие. Это конструкция которая меняет семантику программы. Подробнее об этом можете прочитать здесь

Не используйте метки

Представьте себе, в Scala есть метки. И я понятия не имею, зачем они туда были добавлены. До выхода Scala 2.8 по данному адресу располагалась еще и метка continue, позже она была устранена.

К счастью, метки не являются частью языка, а реализованы при помощи выбрасывания и отлова исключений (о том, что делать с исключениями, мы поговорим далее в этой статье).

В своей практике я не встречал еще ни единого случая, когда подобное поведение могло хоть как-то быть оправдано. Большая часть примеров, которые я нахожу в сети, притянуты за уши и высосаны из пальца. Нет, ну вы посмотрите:

Этот пример взят отсюда:

breakable {

for (i <- 1 to 10) {

println(i)

if (i > 4) break // выскочить из цикла.

}

}Об исключительных ситуациях

Это исключительная тема заслуживает большой и отдельной статьи. Возможно, даже серии статей. Рассказывать об этом можно долго. Во-первых, потому, что Scala поддерживает несколько принципиально разных подходов к обработке исключений. В зависимости от ситуации, вы можете выбрать тот, который подходит лучше всего.

В Scala нет checked exceptions. Так что если где-то у нас исключения и могут возникнуть — обязательно их обрабатывайте. И самое главное, не бросайтесь исключениями. Да, есть ситуации когда зеленые монстры вынуждают вас это делать. И более того, у зеленых монстров и их почитателей это вообще является нормой. Во всех остальных случаях — не бросайтесь исключениями. То, что в свое время Джоэл Спольски писал применительно к C++ и Java, к Scala применимо даже в большей степени. И в первую очередь именно из-за ее функциональной природы. Метки и goto недопустимы в функциональном программировании. Исключения ведут себя схожим образом. Бросив исключение, вы прерываете flow. Но, как уже было сказано выше, ситуации бывают разными, и если ваш фреймворк этого требует — Scala дает такую возможность.

Вместо того, чтобы возбуждать исключения, вы можете использовать Validation из scalaz, scala.util.Try, Either. Можно использовать и Option, если вам не жалко людей, которые будут поддерживать ваш код. И это будет все-равно лучше, чем бросаться исключениями.

Структурные типы

Просто не используйте их. Даже если ваши руки к ним тянутся, вам, скорее всего, они не нужны. Во-первых, структурные типы работают через рефлексию, что достаточно дорого с точки зрения производительности, во вторых — вы их не контролируете. Интересные мысли изложены на этот счет здесь.

? extends App

Знаете что не так с этим кодом:

object Main extends App {

Console.println("Hello World: " + (args mkString ", "))

}Конкретно с этим примером «все так». Все будет хорошо и прекрасно работать, пока вы не усложните код достаточно, чтобы встретиться с непредсказуемым поведением. И виной тому один трейт из стандартной библиотеки. Он называется DelayedInit. Прочитать о нем вы можете здесь. Трейт App, который вам предлагается расширить в большинстве руководств, расширяет трейт DelayedInit. Подробнее об App в документации.

It should be noted that this trait is implemented using the DelayedInit functionality, which means that fields of the object will not have been initialized before the main method has been executed.

По-русски:

Следует учесть, что данный трейт реализован с использованием функциональности DelayedInit, что означает то, что поля объекта не будут проинициализированны до выполнения метода main.

В будущем это обещают исправить:

Future versions of this trait will no longer extend DelayedInit.

Плохо ли использовать App? В сложных многопоточных приложениях я бы не стал этого делать. А если вы пишете «Hello world»? Почему бы нет. Я стараюсь лишний раз не связываться и использую традиционный метод main.

Коллекции

Очень часто в коде можно увидеть эмуляцию функций стандартной библиотеки Scala. Приведу простой пример:

tvs.filter(tv => tv.displaySize == 50.inches).headOptionТоже самое, только короче:

tvs.find(tv => tv.displaySize == 50.inches)Подобные «антипаттерны» не редкость:

list.size = 0 // плохо

list.isEmpty // ok

!list.empty // плохо

list.nonEmpty // ok

tvs.filter(tv => !tv.supportsSkype) // плохо

tvs.filterNot(tv => tv.supportsSkype) // okКонечно, если вы используете IntelliJ IDEA, она вам обязательно подскажет наиболее эффективную комбинацию методов. Scala IDE, насколько мне известно, так не умеет.

О неэффективном использовании библиотеки коллекций Scala можно рассказывать сколь угодно долго. И это уже очень не плохо сделал Павел Фатин в своей статье Scala collections Tips and Tricks, с которой я вам очень рекомендую ознакомиться. И да, старайтесь не вызывать элементы коллекций по индексам. Нехорошо это.

Список литературы

В заключении этой статьи я бы хотел порекомендовать материалы, которые я нахожу полезными для изучения.

Книги

Книга, которую должен прочесть каждый Scala-разработчик. К сожалению, терпения хватает не всем, однако она стоит затраченных усилий.

Официальная документация

Статьи

- Effective Scala, для которой существует и перевод на русский, хотя я, безусловно, советую вам ознакомиться с оригиналом.

- Scala Collections Tips and Tricks Павла Фатина.

- О том, чего лучше не делать в Scala, очень доступно изложено здесь.

- Scala Collections Tips and Tricks.

Видео

- Scala with style — доклад создателя языка о том, как идиоматично писать на Scala.

- Martin Odersky, Scala — the Simple Parts

- Daniel Spiewak, May Your Data Ever Be Coherent

- For: What is it good for? — выступление, посвященное подробному разбору «for comprehensions».

Благодарности

Автор хотел бы выразить свою признательность

- Владу Ледовских — за вычитку,

- Павлу Кретову (@firegurafiku) — за безуспешные попытки привести этот текст к литературной норме, а также за помощь с разделом о

typedefв первой части статьи, - Арсению Жижелеву (@primetalk) — за внесение многочисленных уточнений в изначальный текст,

- Семёну Попугаеву (@senia) — за найденные неточности.

Отдельное спасибо EDU-отделу DataArt и всем тем, кто, проходя наши курсы по Scala, подталкивал меня к написанию этой статьи. Спасибо вам, уважаемые читатели, за то, что дочитали (или хотя бы промотали) до конца.

|

Метки: author ppopoff функциональное программирование программирование scala начинающим начинающему чистый код стиль кодирования |

[Перевод] Декораторы в JavaScript |

|

Метки: author ru_vds javascript блог компании ruvds.com декоратор программирование |

LXC aka Linux Container: простота и надёжность |

Что такое LXC?

Аббревиатура расшифровывается просто Linux Container. Это контейнерная система виртуализации, которая действует в пределах операционной системы Linux. Что это значит? С LXC можно запустить несколько полностью изолированных и независимых друг от друга экземпляров ОС Linux на одном компьютере. Помимо этого есть возможность создать надежный кластер из нескольких десятков серверов, когда один и тот же экземляпр контейнера выполняется сразу на нескольких физических машинах и в случае выхода из строя одного сервера работа контейнера не приостанавливается ни на минуту. Так же данные контейнера находятся сразу на нескольких хранилищах, реализуется это различными методами (ceph ). Что позволяет помимо живой миграции контейнера между нодами кластера так же еще больше повысить надежность хранения данных, гибко увеличивать дисковую подсистему контейнера в пределах … ну пределы практически неограничены –настолько насколько хватит хранилища, а хранилища могут быть очень большие, например, в нашем случае мы сейчас строим хранилище в несколько петабайт информации.

Немного о механизмах виртуализации

В чем разница между виртуальными машинами и контейнерами? традиционные типы виртуализации, например, KVM тратят ресурсы сервера на обcлуживание самой виртуальной среды, в случае же контейнера до 95% мощности отдается непосредственно в контейнер и он работает по сути на уровне хостовой машины. Замеры производительности контейнеров мы приведем ниже в этой статье.

Сравнение LXC и KVM

| LXC | KVM |

|---|---|

| Изменение размера диска – в случае контейнера LXC увеличение или уменьшение диска происходит очень быстро практически на «лету» | Так как KVM это полноценно изолированный контейнер измение размера диска требует перезагрузки виртуальной машины, все как на физическом сервере |

| Расщирение RAM, ядер CPU, диска etc. Не требует перезагрузки, если требуется непрерывная работа виртуальной машины то выбор очевиден | При любых изменениях в параметрах VPS требуется перезагрузка |

| Быстрая перезагрузка контейнера | Как писали выше – KVM требует столько же времени на рестарт как и обычный сервер |

| Быстрая установка любого образа как операционной системы так и готовых шаблонов (OpenVPN, TorrenServer,OpenLDAP,MediaServer, OwnCloud у нас больше 100 различных шаблонов на все случаи жизни) | Возможность установки различных версий Windows и FreeBSD как из шаблонов так и из собственного ISO |

| Создание собственной внутренней сети между контейнерами | Создание собственной внутренней сети между контейнерами |

По сути, LXC и не является полноценной системой виртуализации. Виртуального аппаратного окружения как такового нет, зато создаётся безопасное изолированное пространство. LXC отличается высокой функциональностью, компактностью и гибкостью в отношении ресурсов, необыкновенной результативностью, простотой использования. С этим механизмом вы сможете создать дата-центр состоящий из нескольких контейнеров для различных целей. Как пример один контейнер мы настраиваем как роутер и firewall за ним распологаем в сегменте DMZ –web, почтовый и file сервера.

Создание контейнера на примере нашего хостинга

Итак приступим к заказу (ссылка на корзину) – выбираем имя хоста, пароль для root, параметры CPU, RAM и диска, далее переходим к выбору шаблона для контейнера и жмем «Далее», для тестов мы сделали промо-код HelloHabr, который позволит месяц тестировать совершенно бесплатно. Далее регистрируемся в билинге и если что-то пошло не так создаем запрос в сапорт. Заходим в клиентский кабинет выбираем свежесозданный контейнер и приступаем к тестам. Какие же возможности по доступу нам предлагают в личном кабинете – самое простое это noVNC консоль которая позволяет управлять контейнером непосредственно из браузера  , далее SPICE консоль — представляет собой систему отображения (рендеринга) удаленного дисплея, построенную для виртуальной среды, которая позволяет вам просматривать виртуальный «рабочий стол» вычислительной среды не только на машине, на которой он запущен, но и откуда угодно через Интернет(из wiki), так же в разделе Backup мы можем сделать как мгновенный снимок контейнера, так и полное резервное копирование виртуально машины, есть возможность выбрать как тип архива, так и вид копии.

, далее SPICE консоль — представляет собой систему отображения (рендеринга) удаленного дисплея, построенную для виртуальной среды, которая позволяет вам просматривать виртуальный «рабочий стол» вычислительной среды не только на машине, на которой он запущен, но и откуда угодно через Интернет(из wiki), так же в разделе Backup мы можем сделать как мгновенный снимок контейнера, так и полное резервное копирование виртуально машины, есть возможность выбрать как тип архива, так и вид копии.  Так же мы можем настроить задания для Backup которые будут выполнятся по определенному расписанию с оповещением на емейл.

Так же мы можем настроить задания для Backup которые будут выполнятся по определенному расписанию с оповещением на емейл.

Так же хотел бы отметить еще одну удобную опцию – настройка firewall непосрдественно из бразуера, что очень удобно для тех кто не владеет тонкими настройками firewall в Linux. Все очень удобно как для опытных администраторов, так и совсем начинающих.

Тестирование производительности

Я для тестов взял самую начальную конфигурацию и теперь хочу посмотреть насколько ее хватает для простых задач, тестировать производительность я буду с помощью пакета unixbench сначала добавим недостающие пакеты

apt-get install build-essential libx11-dev libgl1-mesa-dev libxext-devдалее скачиваем сам unixbench и приступаем к тестированию —

cd /tmp/

wget https://github.com/kdlucas/byte-unixbench/archive/master.zip

unzip master.zipи запускаем

./RunЖдем пока unixbench потестирует контейнер и любуемся результатом

BYTE UNIX Benchmarks (Version 5.1.3)

System: test: GNU/Linux

OS: GNU/Linux -- 4.4.59-1-pve -- #1 SMP PVE 4.4.59-87 (Tue, 25 Apr 2017 09:01:58 +0200)

Machine: x86_64 (unknown)

Language: en_US.utf8 (charmap="ANSI_X3.4-1968", collate="ANSI_X3.4-1968")

CPU 0: Intel(R) Xeon(R) CPU E5649 @ 2.53GHz (5076.7 bogomips)

Hyper-Threading, x86-64, MMX, Physical Address Ext, SYSENTER/SYSEXIT, SYSCALL/SYSRET, Intel virtualization

09:14:27 up 33 min, 2 users, load average: 0.23, 0.06, 0.06; runlevel Jun

------------------------------------------------------------------------

Benchmark Run: Tue Jun 13 2017 09:14:28 - 09:42:27

24 CPUs in system; running 1 parallel copy of tests

Dhrystone 2 using register variables 29175436.4 lps (10.0 s, 7 samples)

Double-Precision Whetstone 3707.9 MWIPS (8.9 s, 7 samples)

Execl Throughput 4656.0 lps (30.0 s, 2 samples)

File Copy 1024 bufsize 2000 maxblocks 874980.2 KBps (30.0 s, 2 samples)

File Copy 256 bufsize 500 maxblocks 243115.0 KBps (30.0 s, 2 samples)

File Copy 4096 bufsize 8000 maxblocks 1778945.2 KBps (30.0 s, 2 samples)

Pipe Throughput 1587733.6 lps (10.0 s, 7 samples)

Pipe-based Context Switching 273143.4 lps (10.0 s, 7 samples)

Process Creation 11873.0 lps (30.0 s, 2 samples)

Shell Scripts (1 concurrent) 5665.4 lpm (60.0 s, 2 samples)

Shell Scripts (8 concurrent) 1061.0 lpm (60.0 s, 2 samples)

System Call Overhead 1897076.6 lps (10.0 s, 7 samples)

System Benchmarks Index Values BASELINE RESULT INDEX

Dhrystone 2 using register variables 116700.0 29175436.4 2500.0

Double-Precision Whetstone 55.0 3707.9 674.2

Execl Throughput 43.0 4656.0 1082.8

File Copy 1024 bufsize 2000 maxblocks 3960.0 874980.2 2209.5

File Copy 256 bufsize 500 maxblocks 1655.0 243115.0 1469.0

File Copy 4096 bufsize 8000 maxblocks 5800.0 1778945.2 3067.1

Pipe Throughput 12440.0 1587733.6 1276.3

Pipe-based Context Switching 4000.0 273143.4 682.9

Process Creation 126.0 11873.0 942.3

Shell Scripts (1 concurrent) 42.4 5665.4 1336.2

Shell Scripts (8 concurrent) 6.0 1061.0 1768.3

System Call Overhead 15000.0 1897076.6 1264.7

========

System Benchmarks Index Score 1372.3

------------------------------------------------------------------------

Benchmark Run: Tue Jun 13 2017 09:42:27 - 10:10:50

24 CPUs in system; running 24 parallel copies of tests

Dhrystone 2 using register variables 28791897.2 lps (10.1 s, 7 samples)

Double-Precision Whetstone 3650.7 MWIPS (9.0 s, 7 samples)

Execl Throughput 4573.6 lps (29.9 s, 2 samples)

File Copy 1024 bufsize 2000 maxblocks 899496.3 KBps (30.0 s, 2 samples)

File Copy 256 bufsize 500 maxblocks 243438.3 KBps (30.0 s, 2 samples)

File Copy 4096 bufsize 8000 maxblocks 1960457.7 KBps (30.0 s, 2 samples)

Pipe Throughput 1588441.9 lps (10.1 s, 7 samples)

Pipe-based Context Switching 221247.7 lps (10.0 s, 7 samples)

Process Creation 10910.9 lps (30.0 s, 2 samples)

Shell Scripts (1 concurrent) 8683.0 lpm (60.1 s, 2 samples)

Shell Scripts (8 concurrent) 1088.9 lpm (60.8 s, 2 samples)

System Call Overhead 1899698.1 lps (10.1 s, 7 samples)

System Benchmarks Index Values BASELINE RESULT INDEX

Dhrystone 2 using register variables 116700.0 28791897.2 2467.2

Double-Precision Whetstone 55.0 3650.7 663.8

Execl Throughput 43.0 4573.6 1063.6

File Copy 1024 bufsize 2000 maxblocks 3960.0 899496.3 2271.5

File Copy 256 bufsize 500 maxblocks 1655.0 243438.3 1470.9

File Copy 4096 bufsize 8000 maxblocks 5800.0 1960457.7 3380.1

Pipe Throughput 12440.0 1588441.9 1276.9

Pipe-based Context Switching 4000.0 221247.7 553.1

Process Creation 126.0 10910.9 865.9

Shell Scripts (1 concurrent) 42.4 8683.0 2047.9

Shell Scripts (8 concurrent) 6.0 1088.9 1814.9

System Call Overhead 15000.0 1899698.1 1266.5

========

System Benchmarks Index Score 1399.9

Немного рекламы

Так же хотел бы напомнить про наши выделенные сервера с защитой от ДДОС атак

Сейчас вы можете заказать 2x Intel Xeon E5540 с 32Gb ECC DDR3 RAM с полной защитой и SSD диском на 240Gb всего за 3127 руб

Так же всегда в наличии Intel Core i7-7700 от 3769 руб

За дополнительными скидками велкам в личку

|

Метки: author ondys devops *nix блог компании контел хостинг |

ГИС и распределенные вычисления |

Я снова буду рассказывать о геоинформационных технологиях.

Этой статьей я начинаю серию о технологиях на стыке миров классических ГИС и все еще модного направления BigData. Я расскажу о ключевых особенностях применения распределенных вычислений к работе с геоданными, а также сделаю краткий обзор существующих инструментов.

Сегодня нас окружает огромное количество неструктурированных данных, которые до недавнего времени было немыслимо обработать. Примером таких данных могут служить, например, данные метеодатчиков, используемые для точного прогноза погоды. Более структурированные, но не менее массивные датасеты – это, например, спутниковые снимки (алгоритмам обработки снимков c помощью машинного обучения даже посвящен ряд статей у сообщества OpenDataScience). Набор снимков высокого разрешения, допустим, на всю Россию занимает несколько петабайт данных. Или история правок OpenStreetMap — это терабайт xml. Или данные лазерного сканирования. Наконец, данные с огромного количество датчиков, которыми обвешано множество техники – от дронов до тракторов (да, я про IoT). Более того, в цифровую эпоху мы сами создаем данные, многие из которых содержат в себе информацию о местоположении. Мобильная связь, приложения на смартфонах, кредитные карты – все это создает наш цифровой портрет в пространстве. Множества этих портретов создают поистине монструозные наборы неструктурированных данных.

На рисунке — визуализация треков OpenStreetMap с помощью GeoWave

Где стык ГИС и распределенных вычислений? Что такое «большие геоданные»? Какие инструменты помогут нам?

Здесь к месту упомянуть немного заезженный, но все еще не лишившийся смысла термин BigData, Большие Данные. Расшифровка этого термина зачастую зависит от личного мнения расшифровывающего, от того, какие инструменты и в какой сфере он использует. Часто BigData используется как всеохватывающий термин для описания технологий и алгоритмов для обработки больших массивов неструктурированных данных. Часто основная идея – это скорость обработки данных за счет использования алгоритмов распределенных вычислений.

Помимо скорости обработки и объема данных, существует еще аспект «сложности» данных. Как разделить сложные данные на части, «партиции» для параллельной обработки? Геоданные изначально относились к сложным данным, и с переходом к «большим геоданным» эта сложность возрастает практически экспоненциально. Соответственно, важной становится не просто обработка миллиардов записей, а миллиардов географических объектов, которые являются не просто точками, но линиями и полигонами. К тому же, зачастую требуется вычисление пространственных взаимоотношений.

Пространственное партицирование

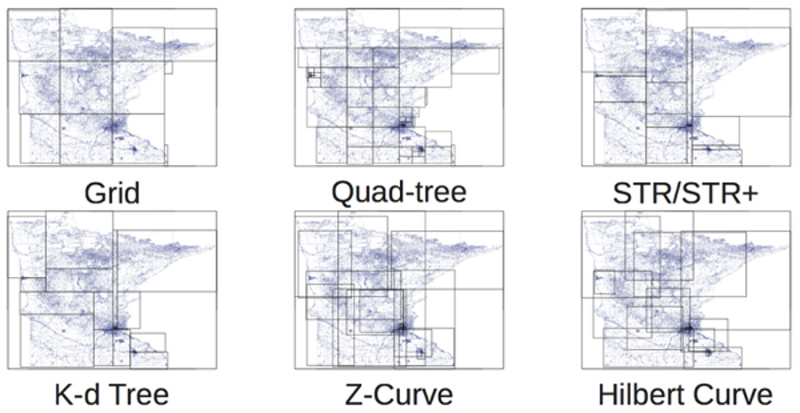

На помощь нам приходит пространственная индексация, и зачастую классические методы индексации здесь слабо применимы. Для индексации двумерного и трехмерного пространства существует немало подходов. Например, знакомые многим геодезические сети, деревья квадрантов, R-деревья:

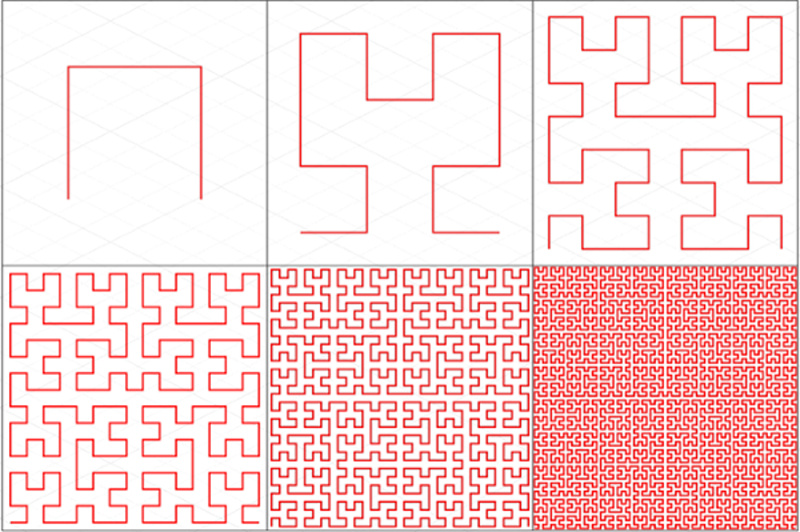

Одним из наиболее интересных методов является многообразие «заполняющих пространство кривых», Z-Curve и Gilbert Curve на рисунке выше. Первооткрывателем этих кривых был Джузеппе Пеано. Основная идея заключается в том, чтобы превратить многомерное пространство в одномерное с помощью кривой, которая фрактально заполняет собой все пространство. Вот, например, так кривая Гильберта заполняет собой плоскость:

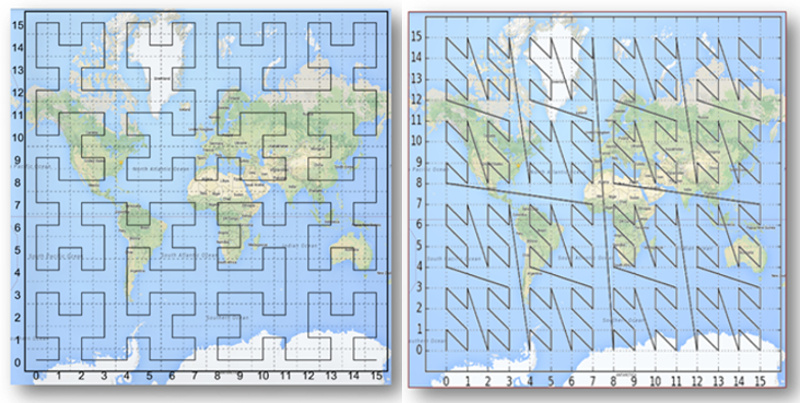

А вот так эти кривые выглядят на земной поверхности:

Взяв на вооружение эти индексы, мы можем, наконец, прийти к партицированию геоданных. Нужно ли нам заново изобретать методики? К счастью, нет! На помощь нам приходят уже существующие фреймворки. Их немало, каждый из них имеет свою применимость и свои сильные стороны. Ниже я расскажу о наиболее примечательных.

GeoJinni (в прошлом SpatialHadoop)

spatialhadoop.cs.umn.edu

GeoJinni (прежде называвшийся SpatialHadoop) – крайне интересное расширение для Hadoop, добавляющее геопространственные функции в различные слои и компоненты Hadoop для хранения, обработки и индексации больших геоданных. Если быть точным, то расширение затрагивает слои MapReduce и хранения, а также добавляет свой собственный операционный слой.

На самом нижнем уровне добавляется новый тип данных, позволяющий хранить и обрабатывать геоданные как ключ-значение. Также добавляются инструменты для загрузки и выгрузки различных форматов геоданных. В противовес классической структуре (точнее, ее отсутствию) хранилища Hadoop, GeoJinni создает два слоя индексного пространства, локальный и глобальный. Глобальный индекс позволяет партицировать данные по нодам кластера, локальный же отвечает за партиции на каждый ноде. Эта концепция позволяет использовать три типа индексов – Grid, R-tree и R+-tree. Все индексы строятся по запросу пользователя и размещаются непосредственно в HDFS.

GeoJinni устанавливается как расширение к уже существующему кластеру Hadoop, что не требует сборки кластера заново. Расширение может быть без проблем установлено в различных дистрибутивах Hadoop, например, Apache Hadoop, Cloudera или Hortonworks.

GeoMesa

www.geomesa.org

GeoMesa – это набор инструментов, созданный специально для распределенных обработки, анализа и визуализации больших пространственно-временных данных, в том числе и потоковых. Например, потоки данных датчиков IoT, данные соцсетей.

Основой для хранения массивных наборов данных являются распределенные колоночные типы хранение, такие как Accumulo, HBase, Google Bigtable. Это позволяет быстро обращаться к этим данным через запросы с использованием расстояний и площадей. Также GeoMesa позволяет обрабатывать данные практически в реальном времени через специальный слой для системы потоковых сообщений Apache Kafka.

Наконец, с помощью подключения к ГИС-серверу GeoServer GeoMesa предоставляет доступ к своим потоковым сервисам через OGC протоколы WFS и WMS, что дает большой простор для пространственно-временных анализа и визуализации, от карт до графиков.

GeoWave

locationtech.github.io/geowave

GeoWave в своей концепции задумывался как аналог PostGIS, пространственному расширению PostgreSQL, но для распределенного колоночного хранилища Accumulo. Этим хранилищем он долгое время и ограничивался, при этом оставаясь проектом с закрытым кодом. Лишь недавно код был передан в фонд Apache. И уже подключаются хранилище HBase и картографический движок Mapnik.

Предоставляет для Accumulo мультипространственные индексы, стандартные географические типы и операции, а также возможность обработки облаков точек PDAL. Обработка данных происходит через расширения для MapReduce, а визуализация через плагин к GeoServer.

Очень похож в своей концепции с GeoMesa, использует те же хранилища, но сосредоточен не на пространственно-временных выборках, а на визуализации многомерных массивов данных.

GeoTrellis

geotrellis.io

GeoTrellis отличается от своих собратьев. Он задумывался не как инструмент для работы с большими массивами геоданных, а как возможность утилизации распределенных вычислений для максимальной скорость обработки даже стандартных объемов геоданных. В первую очередь, речь идет об обработки растров, но за счет эффективной системы партицирований стало возможно выполнять и пространственные операции, и конвертацию данных. Основными инструментами разработки являются Scala и Akka, инструментом распределенной аналитики – Apache Spark.

Глобальная цель проекта – предоставление отзывчивого и богатого инструментария на уровне веб-приложения, что должно изменить пользовательский опыт в использовании систем распределенных вычислений. В конечном итоге, развитие экосистемы открытых геотехнологий, где GeoTrellis дополнит PostGIS, GeoServer и OpenLayers. Основными целями команда разработки ставит следующие:

- Создание масштабируемых высокопроизводительных веб-геосервисов

- Создание распределенных геосервисов для обработки «больших геоданных»

- Максимальная параллелизация процессов обработки данных

GeoTrellis – прекрасный фреймворк для разработчиков, предназначенный для создания отзывчивых и простых REST-сервисов для обращения к моделям геопроцессинга. Оптимизация и параллелизация производится самим фреймворком.

GIS Tools for Hadoop

esri.github.io/gis-tools-for-hadoop

Наборы инструментов от Esri хотя формально и являются открытыми, но их применение имеет смысл в первую очередь с продуктами Esri. По концепции очень схожи с GeoJinni.

Инструменты разделены на три уровня

- Esri Geometry API for Java. Библиотека для расширения Hadoop геопространственными абстракциями и операциями

- Spatial Framework for Hadoop. Расширение для использования геопространственных запросов в Hive Query Language

- Geoprocessing Tools for Hadoop. Непосредственно средства интеграции Hadoop и ArcGIS, позволяющие выполнять операции распределенного пространственного анализа в настольном и серверном приложениях.

Что дальше?

Геоданные всегда были где-то рядом с большими данными, и приход инструментов распределенных вычислений позволяет делать действительно интересные вещи, позволяя не только географам, но и аналитикам данных (или как их модно называть, Data Science), совершать новые открытия в области анализа данных. Мгновенные моделирование затоплений, создание линий горизонта, пространственная статистика, анализ населения, создание трехмерных моделей из облаков точек, анализ спутниковых снимков.

Следующие статьи я посвящу инструментам и сфере их применения.

Ваши комментарии могут помочь нам в проработке тем для следующих статей.

- О каком из фреймворков вы бы хотели прочитать первым?

- О каком применении распределенных вычислений вы бы хотели узнать подробнее?

|

Метки: author fall_out_bug геоинформационные сервисы big data блог компании техносерв гис распределенные вычисления |

FabricPool — технология экономии для All Flash хранилищ |

В этой статье я поговорю о репликации между СХД, SSD технологиях, All Flash хранилищах, куда движется рынок СХД, об объектных СХД, о технологии СХД FabricPool, видении DataFabric, снэпшотах и о новой прошивке ONTAP для СХД. СХД, СХД, СХД — это все системы, которые ставятся, у заказчика в ЦОД для построения классической инфраструктуры или частного облака, это заказчики, которые держат свой собственный ЦОД, свою систему хранения и основная часть их инфраструктуры работает на их собственном оборудовании. Какое вообще отношение эти хранилища, и все перечисленные темы, имеют к облаку и публичным провайдерам? Я расскажу об всех этих технологиях, которые, казалось бы, не имеют к публичным облачным провайдерам никакого отношения. Но по ходу рассказа станет понятно, как все они образуют тренд и помогают двигаться в сторону гибридного облака: Частное + Публичное и как NetApp поможет перенести часть данных заказчика, которые ранее всегда жили только у заказчика на его собственном оборудовании в публичное облако.

Я хочу, чтобы за технологиями вы увидели картину ближайшего будущего из которых оно, состоит. Не для того, чтобы вы увидели «какой же олень северный», будущее нужно видеть, чтобы понимать в какую сторону двигаться и развиваться.

SSD тренд

SSD накопители дешевеют, но пока по-прежнему дорогие. У кого есть в компах или ноутах SSD? Заметно ускорение работы, не так ли? Мы уже прошли несколько стадий развития NAND: SLC, MLC, теперь уже поколение TLC накопителей, с каждым новым витком развития стоимость технологии удешевляется. Множество потенциальных новых типов носителей обещают в будущем ещё больше ёмкость, ещё больше скорость и т.д. И возможно, когда-нибудь, технологии, где ячейки памяти не изнашиваются. SSD даже для ноутбука не дешевые, а что говорить о больших промышленных решениях All Flash Array? Как сделать, чтобы SSD удешевить в таких решениях? Ответ таков: использовать технологии дедупликации и компрессии данных, чтобы удешевить стоимость терабайта. У NetApp есть целый ряд технологий сжатия данных. Так к примеру базу данных SQL вполне было реально сжать в два раза, это я видел у одного нашего заказчика, при этом производительность была лучше, чем у других конкурентов на тесте и её включение/выключение не влияло на производительность. Это было в прошивке ONTAP 8.3.2, а сейчас уже вышла ONTAP 9.2 с агрегат инлайн дедупликацией. SSD это однозначно будущее СХД, все без исключения вендоры это признали. Некоторые вендоры отказались развивать экстремально дорогие High-End хранилищ и начали разрабатывать более дешевые и производительные AFA.

DataFabric

DataFabric это не одна технология, а целый набор технологий, видение, желание NetApp по движению в сторону объединения и интеграции всех своих продуктов тем как можно большим количеством способов и большей мобильности данных. К примеру:

- В новых версиях двух абсолютно разных систем и архитектур, таких как ONTAP и AltaVault, поддерживается репликация SnapMirror, которая ранее поддерживалась только между двумя FAS системами

- Поддержка репликации данных расположенных на СХД с аппаратной платформой NetApp E-Series и ОС SANtricity в облако для разворацивания там резервной площадки.

- Интеграция SolidFier и StorageGRID.

- StorageGRID и AltaVault

- ну и естественно возможность FAS <-> ONTAP Cloud / ONTAP Select репликации

Подробнее о DataFabric

StorageGRID объектное хранилище

StorageGRID это объектное хранилище для данных, которые достаточно редко изменяются: фото, видео, архивы, бэкапы. Что такое объектное хранилище подробнее можно почитать в статье.

Это софт, который может быть установлен у облачного провайдера и лицензируются для потерабайтно-помесячно: есть заказчик потребляющий ресурс и платящий за него — есть деньги, покупается лицензия; нет денег — не покупается.

Снэпшоты

Кто работал со снэпшотами VMware и Hyper-V на высоконагруженных виртуальных машинах? Плохо работают не так ли? Чем больше снэпшотов тем хуже работает виртуалка, тем дольше они удаляются и это удаление ещё сильнее убивает производительность этой машины. Для NetApp ONTAP, снэпшоты это сущий пустяк, никаких проблем производительности при создании или удалении. Множество интеграций с софтом резервного копирования типа Veeam или CommVault и т.д., позволяющих снимать консистентные снэпшоты. VMware vVol позволяют снимать hardware-assistant снэпшоты хранилищем гранулярно для каждой отдельной виртуальной машины, что устраняет проблемы вызванные снэпшотами гипервизоров. Такие не тормозящие снэпшоты выгодно использовать для резервного копирования и DR. Там, где есть возможность использовать hardware-assistant снэпшоты хранилища, не влияющие на производительность, везде стоит их использовать.

Новая версия ONTAP 9.2

Напомню, что ONTAP это прошивка 9.2, которая устанавливается или на аппаратную платформу FAS/AFF или доступна в виде софта (SDS) с виртуальной машиной у вас на сервере (ONTAP Select) или в публичном облаке (ONTAP Cloud). Пару месяцев назад вышла новая прошивка ONTAP, большинство текущих заказчиков уже сейчас может обновить систему до 9.2.

В своей предыдущей статье я расписал новый функционал доступный в прошивке 9.2.

Replication

Репликация для DR на FAS или ONTAP Select. Работает на базе снэпшотов между двумя нетапами. Так вот эта репликация с FabricPool позволяет экономить не только на основной площадке. Можно на резервную площадку поставить СХД с 10-20% пространства от основной, а все остальное опять таки смешать на холодный уровень.

Tiering или FabricPool

Первое что стоит сказать о FabricPool, что как и любая технология тиринга она призвана в первую очередь экономить ресурсы СХД, а это деньги заказчика. Если же бюджет не ограничен, то можно тупо купить All Flash систему и хранить на ней снэпшоты за 3 года плюс купить ещё одну такую же систему на резервный сайт, построить метрокластер и третью такую же на резервный бэкапный сайт. Но как правило денег на такую архитектуру нет, но интерес к SSD есть и деньги на объем для продуктива (или какой-то его важной части) всё же есть, а вот для бэкапов, снэпшотов и резервирований, уже нет. Здесь и приходит на помощь FabricPool.

FabricPool это технология, позволяющая объединить быстрое и медленное хранилище для создания гибридного пула (агрегата) состоящего из SSD и облака S3, на подобии как это работает в технологии кеширования FlashPool. Также как и в FlashPool, все данные сначала попадают на горячий уровень SSD уровень, а холодные данные потом смещаются на медленный и дешевый уровень, это позволяет экономить дорогостоящее место на SSD.

FabricPool это технология, реализована в рамках стратегии DataFabric, которая в свою очередь должна расширить интеграцию всех продуктов NetApp и расширить возможности мобильности данных.

Когда NetApp делает новую фичу, он не смотрит на других и не пытается добавить фичу «ради галочки». Вместо этого выпускается технология, которая действительно хорошо продуманная и будет востребована потребителями. Это касается и новой Tiering-фичи FabricPool. С ростом спроса на SSD увеличивается число инсталляций и интереса к этой технологии, поэтому NetApp выпустил функционал FabricPool позволяющий более рационально использовать дорогостоящие SSD накопители.

FabricPool это технология смещения холодных данных с SSD агрегата (AFF, FAS, ONTAP Cloud систем) на холодный объектный уровень — в облако Amazon S3 или на объектную СХД NetApp StorageGRID.

Внедрение FabricPool для перемещения данных на Object Storage будет состоять из двух стадий. В 9.2RC будет доступна возможность смещать только снэпшоты. А следующей стадией будет возможность смещения холодных данных из активной файловой системы вольюма на холодный уровень, доступно с версии 9.2GA. Пока с FabricPool не поддерживаются FlexFroup, MetroCluster, ONTAP Select, SnapLock и др.

FabricPool на FAS/AFF и третестороннее объектное хранилище холодных данных

Для использования функционала FabricPool на FAS/AFF системах с третесторонним объектным хранилищем Amazon S3 необходимо приобретать по-терабайтные лицензии, которые добавляются в ONTAP, добавление лицензии FabricPool сразу добавляет 10ТБ. Потом можно добавлять по терабайту.

FabricPool на FAS/AFF и StorageGRID

Для работы функционала FabricPool на системах хранения FAS/AFF, лицензия необходима только в случае использования Amazon S3. В случае NetApp StorageGRID лицензия для работы FabricPool не нужна.

FabricPool и ONTAP Cloud

Для систем ONTAP Cloud живущая в публичном облаке также нет потерабайтного лицензирования со стороны ONTAP Cloud для включения FabricPool — заказчик оплачивает только фактическое потребленное пространство холодного уровня в объектном хранилище S3 напрямую самому облачному провайдеру. На данный момент FabricPool поддерживается только в ONTAP Cloud для Amazon.

FabricPool и Disaster Recovery

Как и раньше, для построения DR площадки и передачи данных между двумя СХД ONTAP используется репликация SnapMirror. Очень часто для экономии финансов, на DR площадку покупался более простое и дешевое хранилище. Теперь же FabricPool позволяет немного по-другому подойти к этому вопросу. К примеру, если на основной площадке используется AFF система, то на резервную можно разместить такую же или похожую, но все же AFF систему. В All Flash хранилищах большую часть бюджета отъедают не контроллеры, а сами SSD накопители. Теперь с FabricPool можно установить на резервную площадку AFF систему, но только с 10%-20% полезного пространства от основного хранилища, так как холодные данные будут уходить на холодный объектный уровень. Позволяя таким образом экономить на дисках, но не ставить контроллеры, которые не тянули бы производительность. В случае если на горячем уровне нет места для новых горячих блоков, они будут читаться напрямую из холодного объектного хранилища.

Чем FabricPool может быть интересен облачным провайдерам?

СХД предоставляет высокоскоростной, но достаточно дорогой уровень хранения данных. Владельцев СХД NetApp FabricPool это способ экономить. А некоторые заказчики просто согласно законам своей страны не могут выносить все или часть своих данных за рубеж в Amazon S3. Для облачного провайдера FabricPool это новые заказчики и дополнительный сервис хранения данных.

Что необходимо облачному провайдеру

Технология FabricPool это технология Tiering позволяющая новым и существующим заказчикам смещать снэпшоты (бэкапы) и холодные данные продуктивных СХД использующий SSD (дорогой уровень) из их ЦОДов, в публичное облако на холодный (дешевый уровень). В публичном облаке необходимо развернуть софт NetApp StorageGrid (доступен в виде образов VMware, KVM и Docker). Для облачных провайдеров NetApp StorageGrid лицензируется потерабайтно помесячно, это очень удобно: пока есть заказчики этой услуги, облачный провайдер платит за лицензии, нет — не платит. Для владельцев СХД NetApp, которые будут использовать StorageGrid расположенный у облачного провайдера лицензию покупать не нужно.

Высчитать стоимость услуги хранения холодных данных FabricPool для провайдера

стоимость будет включать следующие основные затраты для провайдера:

- У софта StorageGrid есть системные требования (CPU, Memory), соответственно это затраты для провайдера

- Заказчик будет подключаться по IP к сервис провайдеру соответственно это или просто внешний белый IP адрес с пробросом порта https на StorageGrid внутри облака. Внешний белый IP и возможно FireWall стоят каких-то денег; Или это опять-таки белый IP для подключения по VPN, по которому заказчик будет перегонять холодные данные. Построить VPN тоже стоит денег; или это выделенный канал связи

- Дисковое пространство которое будет занято для разворачивания узлов StorageGrid — выделяется один раз, не меняется на протяжении всей жизни узла. Но количество узлов может со временем расти по мере нагрузки и роста занятого пространства. Минимальное число 5 узлов StorageGrid (могут быть виртуальными машинами): 3 узла (storage node) + 2 административных узла (Gateway node & Admin node).

- По-месячно — по-терабайтное лицензирования NetApp

- И собственно дисковое пространство занятое под хранение собственно данных от заказчиков.

Выводы

Технология FabricPool позволяет интегрировать ONTAP и объектные хранилища для холодных данных в рамках стратегии DataFabric. Для владельцев СХД, FabricPool позволяет более рационально использовать дорогостоящие ресурсы All Flash систем и SSD агрегатов, смещая неактивные холодные данные на дешевый уровень, что в свою очередь делает системы хранения NetApp All Flash более доступными по стоимости владения. Объектное хранилище легко масштабируется по мере роста и теоретически не имеет ограничений по пространству (текущий Soft Limit 70PB). Для облачных провайдеров FabricPool это способ привлечь новых заказчиков, которые ранее продуктивные данные хранили только на своём оборудовании.

|

|

LTS Webinar — Топ-5 интересных уязвимостей или как Вас могли взломать за последний год |

15 июня пройдёт онлайн-конференция со спикером Luxoft.

Тема — Топ-5 интересных уязвимостей или как Вас могли взломать за последний год.

Основные тезисы доклада:

1. Потребность в средствах обеспечения безопасности приложений и преимущества всестороннего процесса application security.

2. Безопасность приложений и тестирование на проникновение: фундаментальные отличия и внешние сходства.

3. Автоматический статический и динамический анализы.

4. Пределы автоматизации и улучшение автоматизации ручными проверками.

Спикер: Динар Гатауллин, эксперт по информационной безопасности.

Имеет высшее образование по направлению информационной безопасности и опыт работы 6+ лет. Интересуется как способами защиты, так и способами нападения на информационные системы (в рамках закона и в целях проактивной защиты). В настоящее время специализируются в области ручного тестирования защищенности комплексных веб-систем и мобильных приложений.

Конференция стартует 15 июня в 17:00 часов по московскому времени.

Для участия в конференции необходимо зарегистрироваться по ссылке career.luxoft.com/lts-luxoft-technology-series/ru

Участие – бесплатное.

Для того, чтобы принять участие в онлайн-конференции, достаточно иметь компьютер или мобильное устройство, подключённые к интернету. Никакого специального программного обеспечения устанавливать не нужно. Плагин платформы загрузится за несколько секунд.

|

Метки: author Evgenia_s5 информационная безопасность java блог компании luxoft безопасность веб-приложений тестирование application security |

Сервис будущего: возможности и риски |

|

Метки: author ceesaxp читальный зал финансы в it блог компании райффайзенбанк i/o 2017 google будущее уже здесь конференция raiffeisenbank |

Win32/Industroyer: новая угроза для промышленных систем управления |

Создателей Win32/Industroyer отличает высокая квалификация и глубокое понимание промышленных систем управления и протоколов связи в электроэнергетике. Маловероятно, чтобы кто-либо мог написать и протестировать подобное ПО без доступа к специализированному оборудованию, которое используется в целевой среде.

Авторы вредоносной программы реализовали поддержку четырех промышленных протоколов, описанных в следующих стандартах:

- IEC 60870-5-101 (IEC 101)

- IEC 60870-5-104 (IEC 104)

- IEC 61850

- OLE for Process Control Data Access (OPC DA)

В дополнение к этому авторы Industroyer разработали инструмент для выполнения DoS-атак (denial-of-service – отказ в обслуживании), нацеленных на определенные устройства релейной защиты, в частности, линейку Siemens SIPROTEC.

Возможности Win32/Industroyer впечатляют. Если сравнить его с инструментами, которые использовались в атаках на украинскую энергосистему в 2015 году и привели к массовым отключениям электроэнергии 23 декабря 2015 года (BlackEnergy, KillDisk и другие компоненты, включая легитимное ПО для удаленного доступа), можно утверждать, что за Industroyer стоит кибергруппа более высокого уровня. Авторы создали вредоносную программу, которая позволяет напрямую управлять выключателями и прерывателями цепи в сети электрических подстанций. По некоторым признакам мы предполагаем, что Industroyer может быть связан со сбоем энергоснабжения в Киеве в декабре 2016 года. Тем не менее, на момент написания отчета это не было подтверждено, и расследование продолжается. Вектор заражения пока не установлен.

Industroyer состоит из нескольких модулей, описание и анализ которых представлены в следующих разделах отчета. Прежде чем перейти к деталям, предлагаем упрощенную схему, которая показывает связь между компонентами вредоносной программы.

Рисунок 1. Упрощенная схема компонентов Win32/Industroyer.

Некоторые компоненты (включая стиратель данных) аналогичны по своей концепции инструментам, использовавшимся в атаках BlackEnergy на украинские энергокомпании в 2015 году. Тем не менее, мы не видим связи между прошлыми атаками и кодом нового вредоносного ПО.

Основной бэкдор

Главный компонент Industroyer – основной бэкдор – используется атакующими для управления остальными компонентами программы.

Как и положено бэкдору, этот компонент довольно прост. Он подключается к удаленному C&C-серверу через HTTPS и получает команды от атакующих. Все изученные образцы жестко запрограммированы на использование одного и того же адреса прокси, расположенного в локальной сети. Таким образом, бэкдор явно предназначен для работы в определенной организации. Также стоит упомянуть, что большинство C&C-серверов бэкдора используют Tor.

Возможно, наиболее интересная особенность бэкдора в том, что атакующие могут задать конкретный час, когда малварь будет активна. Например, можно модифицировать бэкдор таким образом, чтобы он обращался к C&C-серверу в нерабочее время. Это усложняет обнаружение, основанное только на проверке сетевого трафика. Тем не менее, все образцы, изученные до настоящего времени, работали круглосуточно.

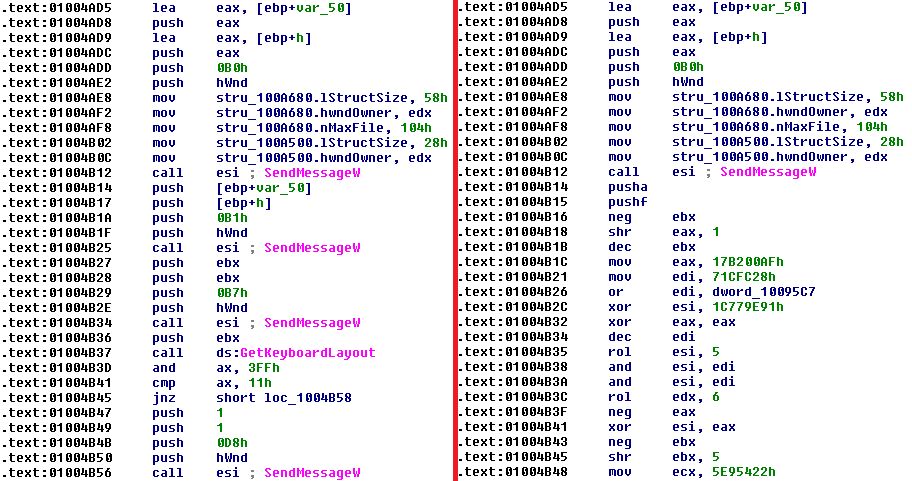

Рисунок 2. Декомпилированный код основного бэкдора с возможностью задать время.

После подключения к удаленному C&C-серверу основной бэкдор отправляет в POST-запрос следующие данные:

- строка GUID (глобально-уникальный идентификатор) для текущего профиля оборудования, полученная при помощи функции

GetCurrentHwProfile - версия вредоносного ПО – 1.1e

- жестко запрограммированный ID образца

- результат любой ранее полученной команды

Жестко запрограммированный ID используется атакующими в качестве идентификатора зараженной машины. Среди всех изученных образцов мы обнаружили следующие значения ID:

- DEF

- DEF-C

- DEF-WS

- DEF-EP

- DC-2-TEMP

- DC-2

- CES-McA-TEMP