Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Из песочницы] Сумасшедший искусственный интеллект |

Почему все хотят создать здравомыслящий искусственный интеллект? Что если пойти другим путём, и попробовать создать сумасшедший искусственный интеллект? Случалось ли у вас такое такое, когда какая нибудь навязчивая мысль не давала вам покоя весь день, то и дело всплывая в сознании? Или что вы не могли вспомнить слово, хотя оно крутилось у вас на языке? Или вы пытались что-то вспомнить, но у вас ничего не выходило? А спустя несколько дней, а то и недель, эта информация вдруг всплывала в сознании...

В связи с этим сделаем предположение, что на самом деле мы не управляем мысленным процессом на прямую, а лишь отправляем задания на обработку. Есть задания, ответы на которые находятся на поверхности в быстром доступе. И есть задания, ответы на которые мозг отложил куда-то по дальше.

Тогда ситуацию, в которой мы ни как не можем что-то вспомнить, можно объяснить тем, что мозг взял задание в обработку, не нашел ответа в быстром доступе, и положил это задание в очередь заданий с низким приоритетом. Обработка очереди заданий с низким приоритетом происходит в фоновом режиме, и не гарантирует выполнение задания. Или ситуацию, когда у нас то и дело в сознании всплывает какая-то мысль можно объяснить тем, что мозг и не переставал эту мысль крутить в цикле. И иногда эта мысль попадала в наш фокус.

За дело!

Словарь терминов

- Словарь — набор уникальных слов, полученных путём анализа какого-либо текста;

- Мыслеслово — слово из словаря;

- Мыслеобраз — образ возникший в воображении;

- Мыслечувство — реакции на внешние раздражители: свет, тепло, звук, и т.д.

- Мысль — набор из мыслеслова, мыслеобраза и мыслечувства.

- Мыслеассоциация — связь между мыслесловами, мыслеобразами и мыслечувствами, обладающая весом;

- Мыслефункция — принимает на вход мыслеслово, мыслеобраз и мыслечувство, и вызывает мыслефункцию;

- Мыслепредложение — цепочка из мыслеслов;

- Эфир — непрерывный поток из мыслепредложений;

Обучение ИИ

Наполнение словаря мыслесловами происходит путём анализа какого-либо текста (чем больше текста проанализировано, тем лучше). При анализе производятся следующие операции:

- берём первое слово из текста и добавляем его в словарь;

- связываем это слово с последующими двумя (возможны другие варианты) словами, проставляя вес для каждой новой связи (чем дальше от текущего слова находится последующее слово, тем меньше вес), тем самым мы получили мыслеассоциации;

- вес мыслеассоциации увеличивается каждый раз, когда в тексте повторно встречается сочетание слов;

Давайте пока разберем только мыслеслово, мыслепредложение, эфир и мыслефункцию, которая на вход получает одно мыслеслово. Суть работы мыслефункции в следующем: если мы подадим на вход мыслефункции мыслеслово "лук", то в процессе обработки мыслеслова мыслефункция отберёт из словаря все мыслеслова, которые имеют мыслеассоциации со словом "лук", например "зеленый", "репчатый", "оружие", "овощ", "тетива", "стрела" и т.д. Затем она вызывает саму себя, отправляя на вход мыслеслово вес мыслеассоциации которого наибольший.

Получается, что мыслефункция порождает целый ряд вызовов мыслефункций, отправляя на вход очередное мыслеслово, тем самым мы получили цепочку из мыслеслов, т.е. мыслепредложение.

Весь этот процесс идёт непрерывно, тем самым создавая эфир.

Построим цепочку из трёх мыслефункций: На вход первой мы подаем мыслеслово "лук". Она, в свою очередь, вызывает вторую мыслефункцию подавая ей на вход мыслеслово "репчатый". Вторая мыслефункция вызывает третью, отправляя ей на вход мыслеслово "овощ" и т.д.

Таким образом мы получаем цепочку из мыслефункций, и если взять все мыслеслова этой цепочки, то получим мыслепредложение: "лук репчатый овощ".

С учётом того, что в фокусе сознания человек может держать, по моим наблюдениям, только одну мысль (для этого был придуман простой эксперимент, в ходе которого необходимо перечислить алфавит, произнося после каждой буквы цифру, т.е.: А1 Б2 В3 и т.д.), а все остальные мысли представим как непрерывный поток(эфир), из которого мы иногда ловим в фокусе одну из цепочек мыслей (мыслепредложение).

Изменяя веса мыслеассоциаций мы можем влиять на ход мыслеслов в мыслепредложениях. Это можно сравнить с тем, когда вы читаете статью, и после прочтения ещё долго обдумываете мысль, которой автор с вами поделился. Или же вы посмотрели фильм, и затем рассказываете о нём друзьям. Другой пример когда изменяются веса у мыслеассоциаций, это момент встречи с знакомым человеком, который вам что-то обещал, но вы про это забыли, а теперь увидев его снова вспомнили.

Подытожим

Если у нас получится создать подобный эфир, то поток мыслепредложений в этом эфире будет похож на мысли сумасшедшего человека, который повторяет одно и тоже. Одной из основных задач, решение которой необходимо будет добиться, это создание наибольшей длинны мыслепредложений. Тогда "спрашивая" систему о чём либо, она нам будет отвечать этими мыслепредложениями.

|

Метки: author PWRMind машинное обучение ai ии искусственный интеллект |

SQL Server Integration Services (SSIS) для начинающих – часть 2 |

Часть 1 – habrahabr.ru/post/330618

В этой части изменим логику загрузки справочника Products:

- При помощи компонента «Union All» объединим два входящих потока в один;

- Для новых записей будем делать вставку, а для записей, которые уже были добавлены ранее будем делать обновление. Для разделения записей на добавляемые и обновляемые воспользуемся компонентом Lookup;

- Для обновления записей применим компонент «OLE DB Command».

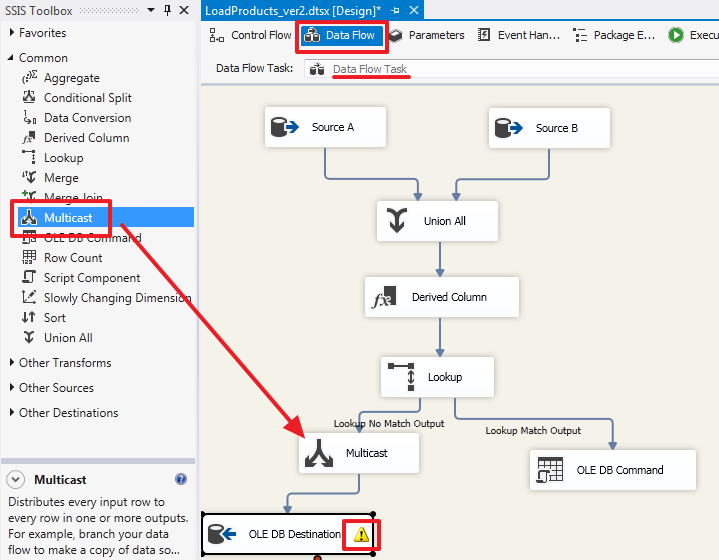

В завершении этой части рассмотрим компонент Multicast для того чтобы распараллелить выходящий набор.

Итого в этой части мы познакомимся с четырьмя новыми компонентами: Union All, Lookup, OLE DB Command и Multicast.

Дальше так же будет очень много картинок.

Продолжим знакомство с SSIS

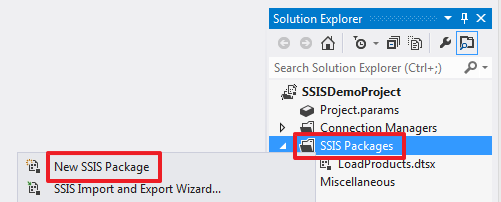

Создадим новый пакет:

И переименуем его в «LoadProducts_ver2.dtsx»:

В области «Control Flow» создадим «Data Flow Task»:

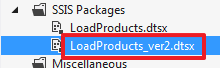

Двойным щелчком по элементу «Data Flow Task» зайдем в его область «Data Flow». Создадим два элемента «Source Assistant» для соединений SourceA и SourceB. Переименуем эти элементы в «Source A» и «Source B» соответственно:

«Source A» настроим следующим образом:

Текст запроса:

SELECT

ID SourceProductID,

Title,

Price

FROM ProductsВ целях демонстрации больших возможностей за раз, здесь я намеренно отпустил SourceID.

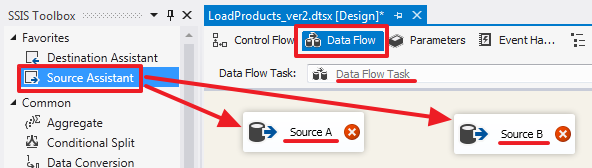

«Source B» настроим следующим образом:

Текст запроса:

SELECT

ID SourceProductID,

'B' SourceID,

Title,

Price

FROM ProductsВ результате набор A у нас будет иметь 3 колонки [SourceProductID, Title, Price], а набор B будет иметь 4 колонки [SourceProductID, SourceID, Title, Price].

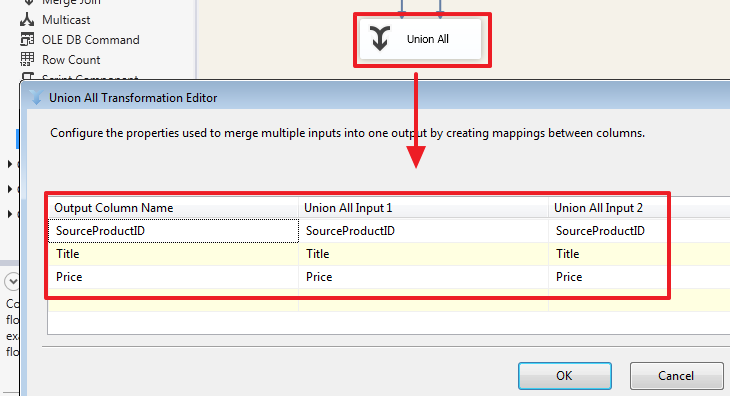

Воспользуемся элементом «Union All», чтобы объединить данные из 2-х наборов в один. Направим в него синие стрелки из «Source A» и «Source B»:

Каким образом делается сопоставление колонок двух входящих наборов, можно увидеть дважды щелкнув на элементе «Union All»:

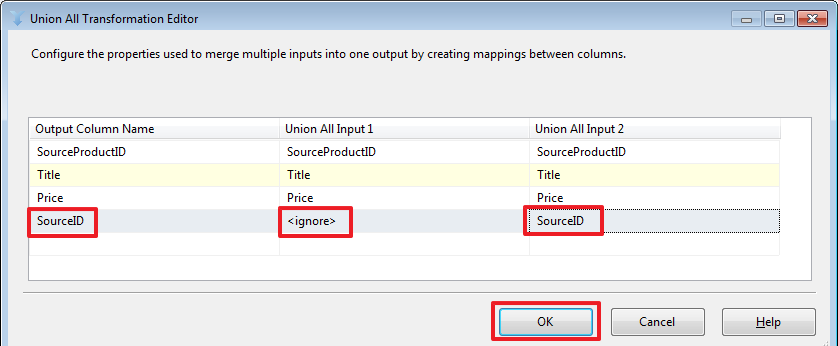

Как мы видим, здесь сделалось автоматическое сопоставление колонок имена которых совпадают. При необходимости мы можем сделать свое сопоставление, для примера добавим колонку SourceID из второго набора:

В данном случае значения SourceID набора «Source A» будут равны NULL.

Объединение двух наборов в данном случае делается на стороне SSIS. Здесь стоит обратить внимание на то, что базы источники и принимающая база могут располагаться на разных серверах/экземплярах SQL Server, по этой причине мы не всегда сможем так просто написать SQL запрос используя в нем таблицы из разных баз с применением SQL-операции UNION или JOIN (который можно было использовать вместо Lookup описанного ниже).

Для того чтобы заменить NULL значения на «A» воспользуемся компонентом «Derived Column» в который направим поток из «Union All»:

Двойным щелчком зайдем в редактор «Derived Column» и настроим его следующим образом:

Проделаем следующее (мышь в помощь):

- Укажем в «Derived Column» значение «Replace 'SourceID'» — это будет означать что мы на выходе заменяем старую колонку SourceID на новую;

- Перетащим в область «Expression» функцию REPLACENULL;

- Перетащим на место первого аргумента функции REPLACENULL колонку SourceID;

- В качестве второго аргумента пропишем константу «A».

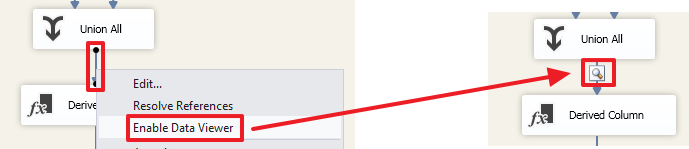

Для того чтобы понять, что произошло с данными после прохождения «Union All» сделайте «Enable Data Viewer» для стрелки, идущей от «Union All» к «Derived Column»:

Теперь при запуске пакета на выполнение вы сможете увидеть набор, который получился в результате:

Здесь видно, что на этом этапе (до Derived Column) в колонке SourceID для строк первого набора стоят значения NULL.

Для того чтобы определить была ли добавлена ранее запись в базу DemoSSIS_Target воспользуемся компонентом Lookup:

Дважды щелкнув по нему настроим данный элемент:

Здесь мы скажем, что те строки, для которых не найдено соответствие, мы будем перенаправлять в поток «no match output». В этом случае на выходе мы получим 2 набора «Lookup Match Output» и «Lookup No Match Output».

Например, если выставить значение «Ignore failure», то в строках, для которых не нашлось сопоставления в поле TargetID (см. ниже) будет записано значение NULL и все строки будут возвращены через один набор «Lookup Match Output».

«Full cache» говорит о том, что набор, который будет использоваться в качестве справочника одним SQL запросом (см.на следующей вкладке) будет полностью загружен в память и строки будут сопоставляться уже с кэша без повторных обращений к SQL Server.

Если же выбрать «Partial cache» или «No cache», то на вкладке Advanced можно будет прописать запрос с параметрами, который будет выполняться для сопоставления каждой строки входящего набора. Для интереса можно поиграться с этим свойством и через SQL Server Profiler посмотреть какие будут формироваться запросы при выполнении пакета.

На следующей вкладке нам нужно определить набор, который будет выступать в роли справочника:

Я прописал здесь запрос:

SELECT

SourceID,

SourceProductID,

ID TargetID

FROM Products

На следующей вкладке нужно указать по каким полям делается поиск строки в справочнике и какие колонки из справочника нужно добавить в выходной набор (если это нужно):

Для определение связи нужно при помощи мыши перетащить поле SourceProductID на SourceProductID и поле SourceID на SourceID.

Добавим компонент «Destination Assistant» для вставки записей с потока «Lookup No Match Output»:

Перетащим синюю стрелку с «Lookup» на «OLE DB Destination» и в диалоговом окне выберем поток «Lookup No Match Output»:

В итоге мы получим следующее:

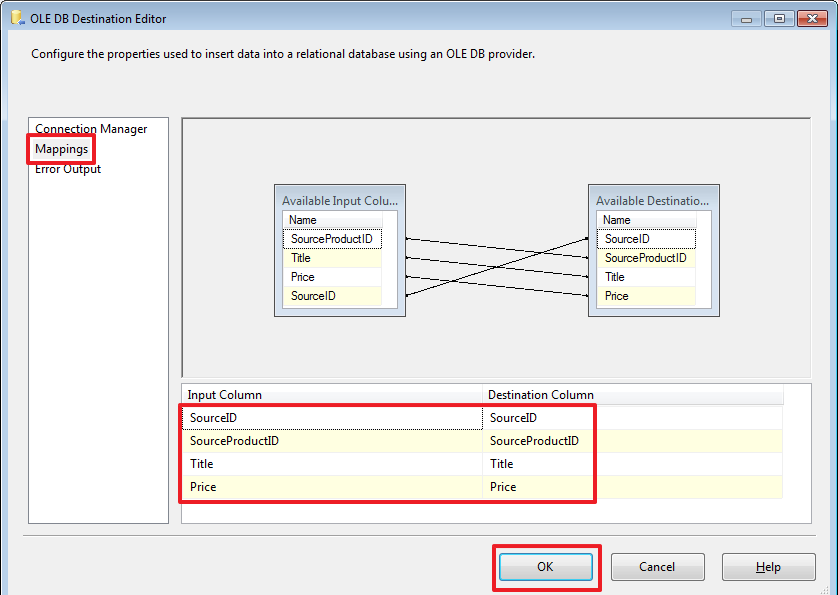

Дважды щелкнув по «OLE DB Destination» настроим его:

Обработку вставки новых записей мы сделали.

Теперь для обновления ранее вставленных записей воспользуемся компонентом «OLE DB Command» и перенесем на него синюю стрелку от Lookup:

В этот компонент автоматически будет направлен поток «Lookup Match Output», т.к. поток «Lookup No Match Output» мы уже выбрали ранее:

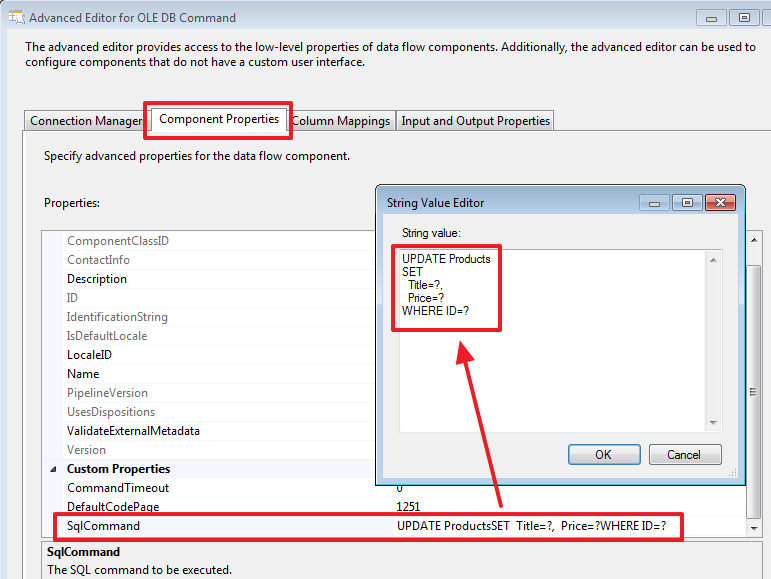

Дважды щелкнем на «OLE DB Command» и настроим его:

Пропишем следующий запрос на обновление:

UPDATE Products

SET

Title=?,

Price=?

WHERE ID=?

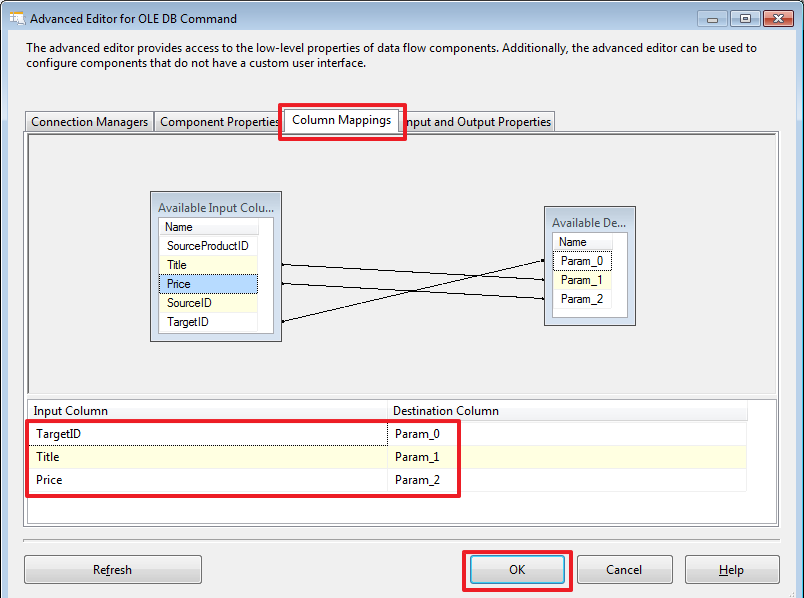

На следующей вкладке укажем каким образом будут задаваться параметры на основании данных строк входящего набора «Lookup Match Output»:

Через SSMS добавим новых продуктов в базу DemoSSIS_SourceB:

USE DemoSSIS_SourceB

GO

-- добавим новых товаров

SET IDENTITY_INSERT Products ON

INSERT Products(ID,Title,Price)VALUES

(6,N'Точилка',NULL),

(7,N'Ластик',NULL),

(8,N'Карандаш простой',NULL)

SET IDENTITY_INSERT Products OFF

GOДля того чтобы отследить как менялись данные, вы можете, перед запуском пакета на выполнение, в необходимых местах сделать «Enable Data Viewer»:

Запустим пакет на выполнение:

В итоге мы должны увидеть, что 3 строки было вставлено при помощи компонента «OLE DB Destination» и 10 строк обновлено при помощи компонента «OLE DB Command».

Запрос прописанный в «OLE DB Command» выполнился для каждой строки входящего набора, т.е. в данном примере 10 раз.

В «OLE DB Command» можно прописать более сложную логику на TSQL, например, сделать проверку, были ли изменены Title или Price, и делать обновление соответствующей строки только если какое-то из значений отличается.

Для наглядности добавим новую колонку в таблицу Products в базе DemoSSIS_Target:

USE DemoSSIS_Target

GO

ALTER TABLE Products ADD UpdatedOn datetime

GO

Давайте теперь пропишем следующую команду:

Текст команды:

DECLARE @TargetID int=?

DECLARE @Title nvarchar(50)=?

DECLARE @Price money=?

IF(EXISTS(

SELECT Title,Price

FROM Products

WHERE ID=@TargetID

EXCEPT

SELECT @Title,@Price

)

)

BEGIN

UPDATE Products

SET

Title=@Title,

Price=@Price,

UpdatedOn=GETDATE()

WHERE ID=@TargetID

ENDТак же можно было бы все это оформить в виде хранимой процедуры, а здесь прописать ее через вызов «EXEC ProcName ?,?,?». Здесь, думаю, кому как удобнее, мне порой удобнее, чтобы все было прописано в одном месте, т.е. в SSIS-проекте. Но если использовать процедуру, то тоже получаем свои удобства, в этом случае можно, было бы просто изменить процедуру и избежать переделки и повторного развертывания SSIS-проекта.

После чего переопределим привязку параметров согласно их очередности в тексте команды:

Сделаем в базе DemoSSIS_SourceA обновление:

USE DemoSSIS_SourceA

GO

UPDATE Products

SET

Price=30

WHERE ID=2 -- Корректор

И снова запустим проект на выполнение.

В результате после очередного запуска пакета на выполнение, UPDATE должен будет выполниться только 1 раз, только для этой записи.

После выполнения пакета проверим это при помощи запроса:

USE DemoSSIS_Target

GO

SELECT *

FROM Products

ORDER BY UpdatedOn DESC

В рамках данной части рассмотрим еще компонент «Multicast». Данный компонент позволяет получить из одного потока несколько. Это может быть полезно, когда одни и те же данные необходимо записать в два или более разных мест – т.е. входит один набор, а выходит столько его копий сколько нам нужно, и с каждой копией этого набора мы можем делать что захотим.

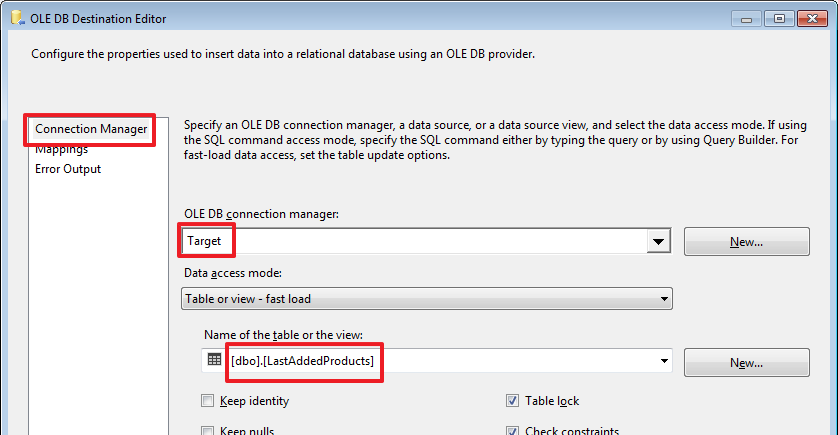

Для примера создадим в базе DemoSSIS_Target еще одну таблицу LastAddedProducts:

USE DemoSSIS_Target

GO

CREATE TABLE LastAddedProducts(

SourceID char(1) NOT NULL, -- используется для идентификации источника

SourceProductID int NOT NULL, -- ID в источнике

Title nvarchar(50) NOT NULL,

Price money,

CONSTRAINT PK_LastAddedProducts PRIMARY KEY(SourceID,SourceProductID),

CONSTRAINT CK_LastAddedProducts_SourceID CHECK(SourceID IN('A','B'))

)

GO

Для очистки этой таблицы добавим в область «Control Flow» компонент «Execute SQL Task» и пропишем в нем команду «TRUNCATE TABLE LastAddedProducts»:

Перейдем в область «Data Flow» компонента «Data Flow Task» и добавим компонент следующим образом:

Обратите внимание на желтый восклицательный знак – это произошло из-за того, что мы добавили колонку UpdatedOn и не привязали ее. Зайдем в элемент «OLE DB Destination», перейдем на вкладку Mappings оставим для колонки UpdatedOn в качестве входящего поля Ignore и нажмем OK:

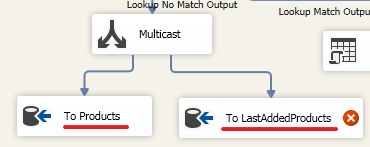

Создадим еще один элемент «OLE DB Destination» и перетащим на него вторую синюю стрелку от элемента Multicast:

Переименуем для наглядности:

Настроим «To LastAddedProducts»:

Удалим через SSMS три последние вставленные записи:

USE DemoSSIS_Target

GO

DELETE Products

WHERE SourceID='B'

AND SourceProductID>=6И запустим пакет на выполнение:

В итоге добавление произошло в 2 таблицы – Products и LastAddedProducts.

Заключение по второй части

В этой части мы рассмотрели каким образом можно делать синхронизацию небольших справочников. Здесь конечно не учитывается тот момент, что данные в источниках могут еще удаляться, но при необходимости вы сможете попробовать сделать это самостоятельно, т.к. при удалении иногда нужно учитывать дополнительные факторы, например, на удаляемую запись могут быть ссылки из других таблиц (в следующей части планируется это сделать).

Чтобы не нарушать ссылочную целостность, иногда запись в принимающей таблице удаляется логически, для этого, например, можно в эту таблицу добавить поле Deleted типа bit (флаг логического удаления) или DeletedOn типа datetime (дата/время логического удаления).

Порой на сервере, на котором располагается база Target делается вспомогательная промежуточная база (обычно ее называют Staging) и первым делом «сырые» данные из Source загружаются в нее. Так как теперь Target и Staging находятся на одном сервере, то вторым шагом мы можем легко написать SQL-запрос (например, используя SQL-конструкцию MERGE или запрос с применение конструкции JOIN), который оперирует с наборами обеих этих баз.

SSIS достаточно интересный инструмент, который на мой взгляд не помешает иметь в своем арсенале, так как в некоторых случаях он может сильно упростить процесс интеграции. Но конечно бывают ситуации, когда все взвесив, разумнее написать интеграцию прибегая к другим способам, например, использовать Linked Servers и писать процедуры на чистом TSQL или писать свою утилиту на каком-то другом языке программирования с применением всей мощи ООП и т.п.

Изучая материал проявляйте больше любопытства, например, щелкайте по вкладкам, которые я не показал, смотрите и анализируйте информацию на них, щелкайте по стрелкам, у них тоже есть свои свойства и настройки. Экспериментируйте, со всем что вам покажется интересным, не ленитесь делать свои небольшие тестовые примеры. Меняйте схему, так чтобы это приводило к исключениям, выбирайте более подходящие параметры у компонент пытаясь найти наиболее подходящий выход из сложившейся ситуации.

Спасибо за внимание! Удачи!

Продолжение следует…

|

Метки: author Leran2002 sql microsoft sql server ssis integration services sql server etl |

Дайджест интересных материалов для мобильного разработчика #206 (05-12 июня) |

|

Побеждаем Android Camera2 API с помощью RxJava2 (часть 1) |

|

12 часов в шкуре Android разработчика глазами JS разработчика |

|

Новый опрос Developer Economics 2017 |

Дайджест доступен и в виде рассылки. Подписаться вы можете тут.

iOS

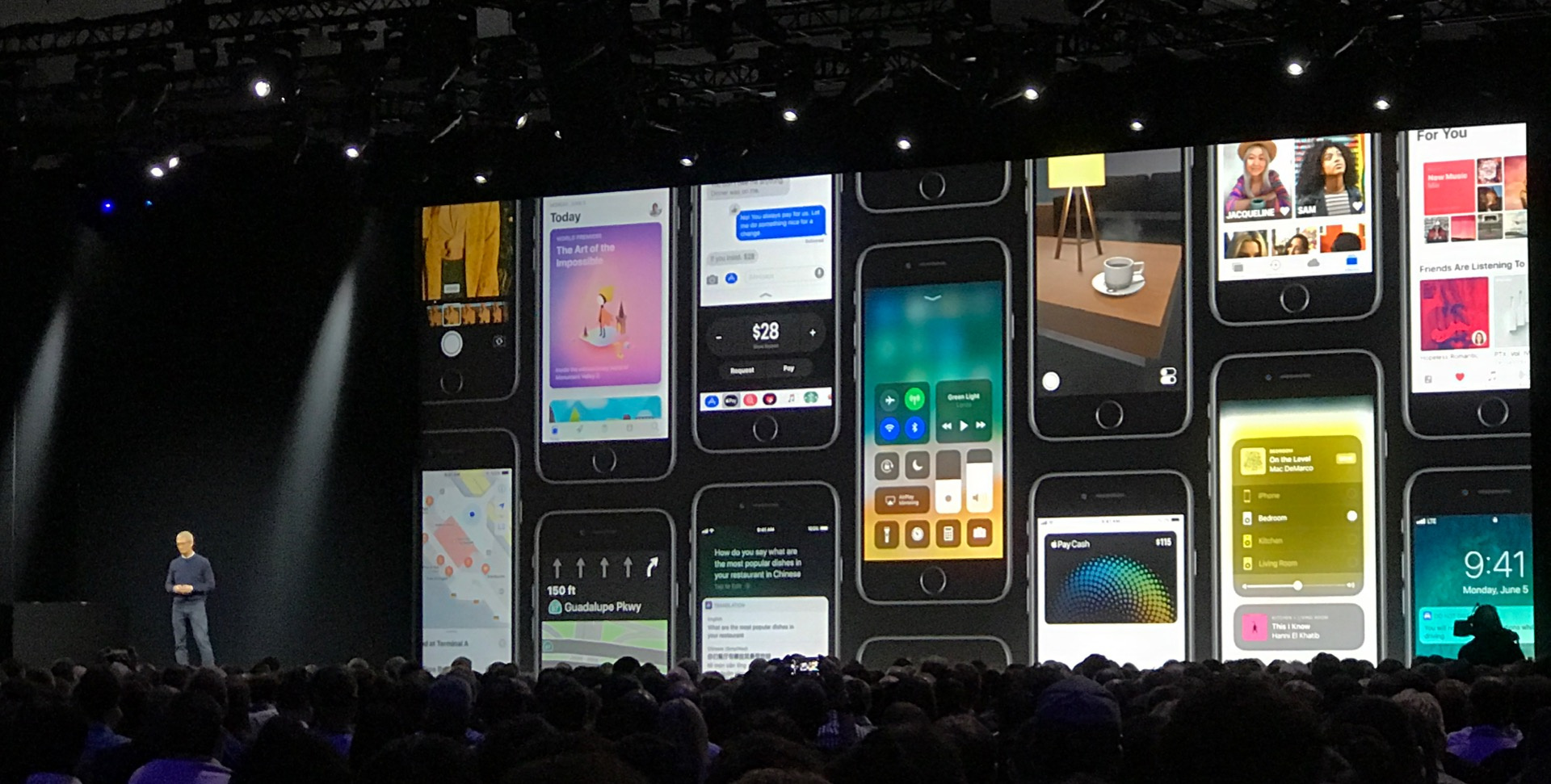

iOS- (+12) WWDC — на что Apple делает ставку в 2017 году?

- (+11) WWDC 2017. Пошумим немножечко

- (+7) Интеграция Cordova в нативный iOS проект

- (+5) iOS 11: каким станет видео в App Store и как это использовать

- Apple запретила бинарные опционы в App Store

- WWDC: Победители Apple Design Awards 2017

- WWDC: ARKit — самая большая платформа дополненной реальности

- WWDC: Core ML — машинное обучение в iOS

- WWDC: App Store радикально обновился

- WWDC: Apple представила Metal 2

- WWDC: watchOS 4

- WWDC: iOS 11

- WWDC: Как изменится страница приложения в новом App Store

- У Apple вышла первая серия “Планеты приложений”

- Российские разработчики и дизайнеры об основных анонсах WWDC 2017

- Изменения в App Store для iOS 11 с точки зрения ASO

Нативное машинное обучение и компьютерное зрение в iOS 11

Нативное машинное обучение и компьютерное зрение в iOS 11 iOS 11: Важные дополнения UIKit

iOS 11: Важные дополнения UIKit Дождь или снег при помощи CAEmitterLayer

Дождь или снег при помощи CAEmitterLayer Множественный выбор в Table View

Множественный выбор в Table View Уроки из 3 миллионов загрузок

Уроки из 3 миллионов загрузок Core ML и Vision: Руководство по Machine Learning в iOS 11

Core ML и Vision: Руководство по Machine Learning в iOS 11

Android

Android- (+33) Android-митап в офисе Badoo 17 июня

- (+23) Поездка на Google I/O: как, зачем и сколько стоит

- (+17) Разбираемся с новыми архитектурными компонентами в Android

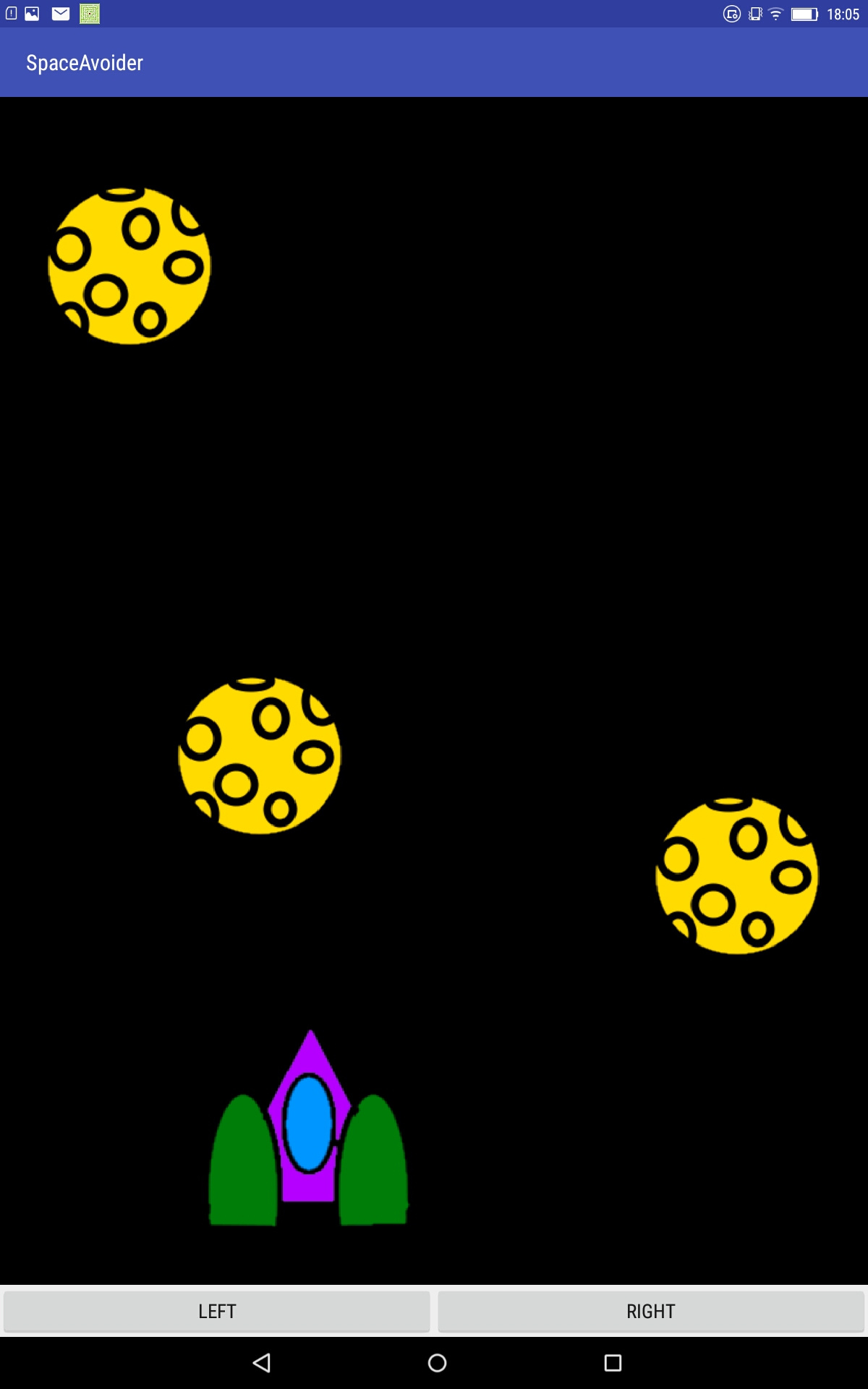

- (+13) Туториал: Создание простейшей 2D игры на андроид

- (+7) Поворот экрана во время выполнения долговременной операции

- I/O 2017 Recap: 15 июня в Москве

- Длину названия приложения в Google Play увеличили до 50 знаков

Android Dev Подкаст. Выпуск 35. Безопасность, фрагментация, новые тренды и старые проблемы

Android Dev Подкаст. Выпуск 35. Безопасность, фрагментация, новые тренды и старые проблемы Задачи по расписанию и умные работы в Android

Задачи по расписанию и умные работы в Android Как разместить файлы разметки в подпапки

Как разместить файлы разметки в подпапки Гильотинная анимация меню в Android

Гильотинная анимация меню в Android Топ-5 библиотек июня

Топ-5 библиотек июня Барьеры ConstraintLayout

Барьеры ConstraintLayout Учимся создавать Paint для Android

Учимся создавать Paint для Android Keddit: Учите Kotlin, разрабатывая приложение

Keddit: Учите Kotlin, разрабатывая приложение Как я сделал умный звонок с помощью Android Things

Как я сделал умный звонок с помощью Android Things Apdroid O API финализированы

Apdroid O API финализированы Как сделать свайп-кнопку

Как сделать свайп-кнопку Graywater для Android

Graywater для Android Адаптивные иконки и больше

Адаптивные иконки и больше Как ускорить медленные сборки Gradle

Как ускорить медленные сборки Gradle Aesthetic: движок для внедрения тем

Aesthetic: движок для внедрения тем

Karchitec: RSS ридер на компонентах Google

Karchitec: RSS ридер на компонентах Google

Windows

Windows Разработка

Разработка- (+12) Unity: система сохранения для любого проекта

- (+11) Firebase на I/O 2017: новые возможности

- (+11) Создание дизайн-экосистемы для десятков связанных ИТ-решений: слово дизайнерам

- (+10) Экосистема: больше участников — больше прибыль! Зачем Skyeng открывает API

- (+7) Must-Have 3: игровые интерфейсы и ассеты для дизайнера и художника

- Гид по разработке личности для бота

- 10 мобильных приложений с лучшим UI: Май 2017

- Какими должны быть инженеры будущего?

- Оповещения: трагедия цифровых общин

- ManoMotion выпускает SDK для отслеживания жестов рук

- Основы мобильной навигации

Аналитика, маркетинг и монетизация

Аналитика, маркетинг и монетизация- (+16) Интервью с Джошем Патриджем (Shazam) про маркетинг, бизнес, стратегию и новые продукты

- (+10) Видео: инди-разработчики о провалах, успехе и монетизации

- Что произойдет с App Store Intelligence без топ-гроссинга?

- Тенденции и перспективы mCommerce-приложений

- Важный нюанс в расчёте retention: как и зачем считать day 0 retention

- “Рынок мобильных приложений в России”: исследование Zorka.Mobi и Adjust

- Продвижение через YouTube-блогеров: как, где и за сколько

- Что работает лучше всего: AdColony исследовала рекламу установок приложений

Сколько следует тратить на мобильный маркетинг?

Сколько следует тратить на мобильный маркетинг? 21 метрика для измерения успеха

21 метрика для измерения успеха

Устройства, IoT, AI

Устройства, IoT, AI- (+32) Пеленгатор на дополненной реальности

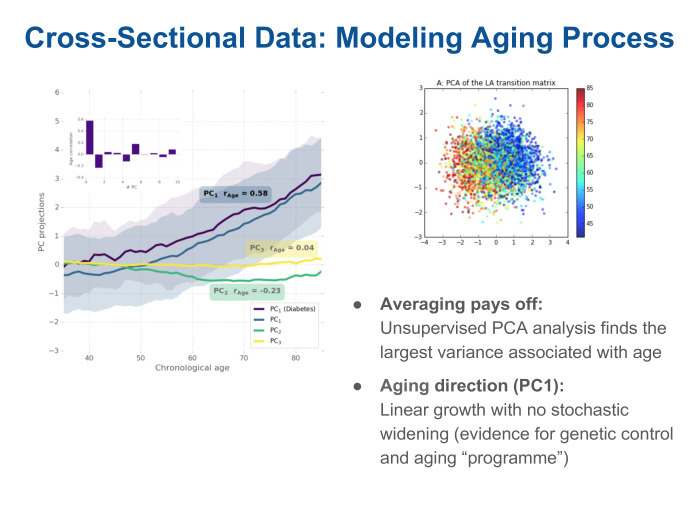

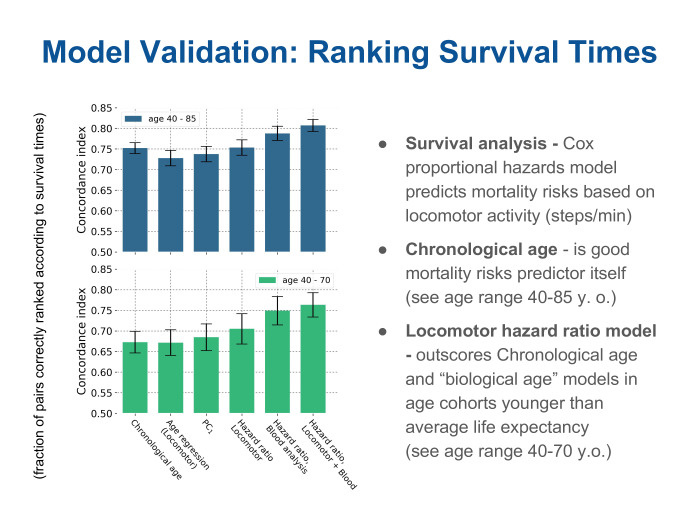

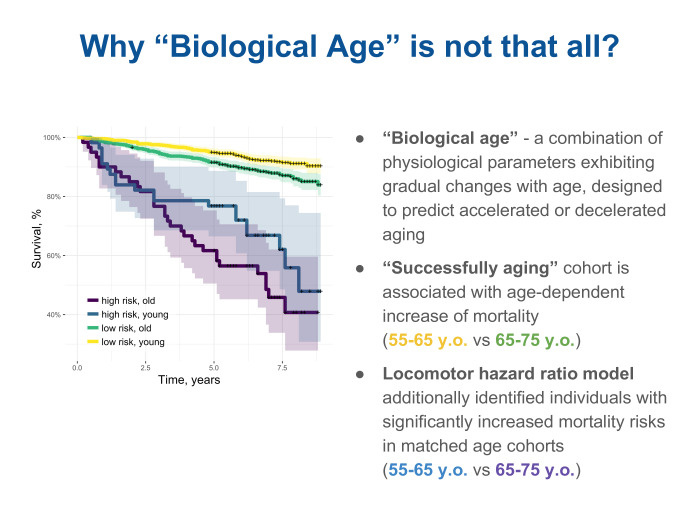

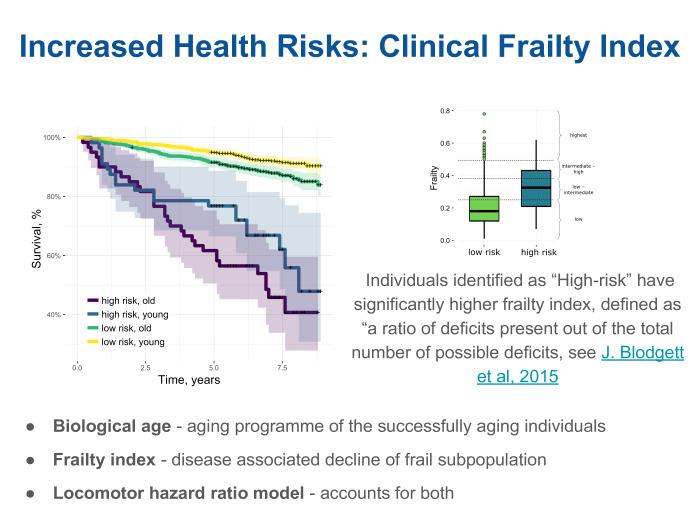

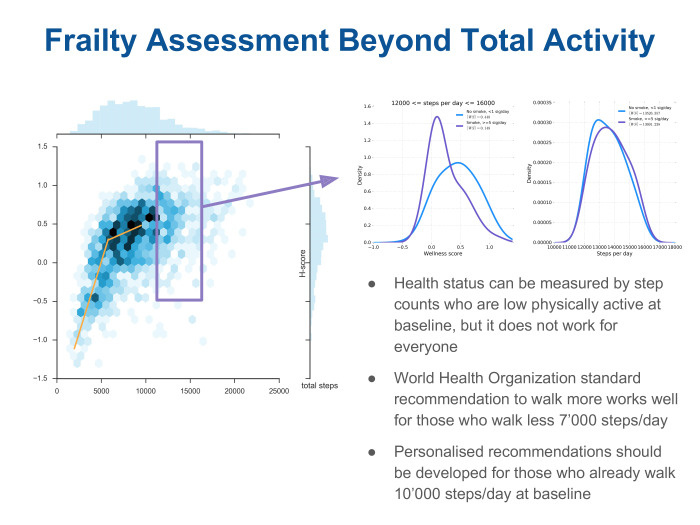

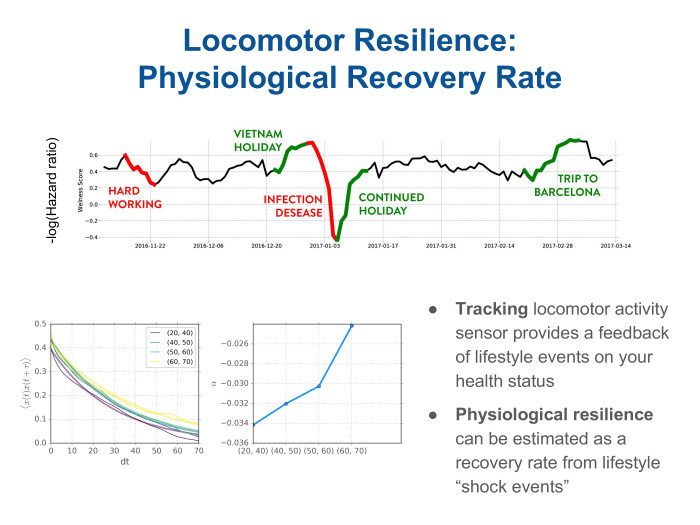

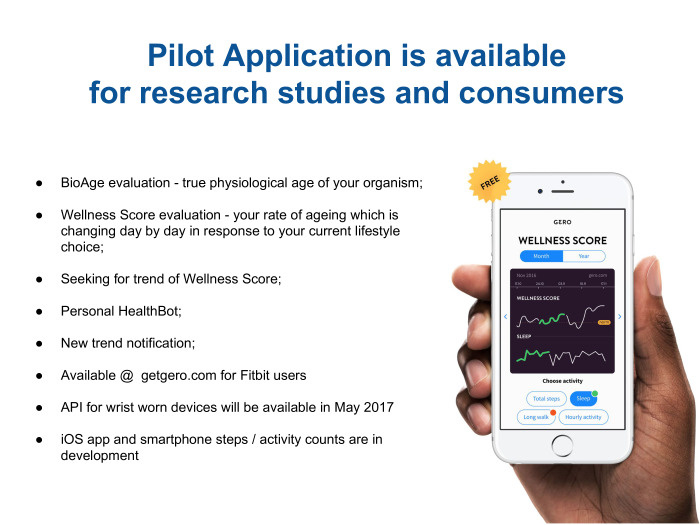

- (+31) Оценка параметров старения с помощью носимой электроники. Лекция в Яндексе

- (+29) Предотвращение негативных последствий при разработке систем искусственного интеллекта, превосходящих человеческий разум

- SoftBank покупает Boston Dynamics у Alphabet

- Дайджест интернета вещей: Май 2017

- Microsoft выпустила Cognitive Toolkit 2.0

- Intel прогнозирует новую «экономику пассажиров»

< Предыдущий дайджест. Если у вас есть другие интересные материалы или вы нашли ошибку — пришлите, пожалуйста, в почту.

|

|

[recovery mode] Готовим git reset правильно |

Предисловие

У плохо организованных разработчиков, типа меня, часто так бывает, что накомитишь всякого, а потом оказывается что не то и не туда, но git помнит всё и весь этот разгул анархии остаётся в истории.

Мне всегда казалось что это можно исправить, но сколько раз я не начинал искать ответа на этот вопрос — как в git удалить камиты — столько раз мне это не удавалось.

А всё потому что мои поиски приводили меня к rebase, а надо было искать reset.

На мой вкус вопрос недостаточно освещён и моя заметка призвана закрыть этот пробел.

Алгоритм

- git branch // смотрим где мы находимся — в какой ветке

- git status // проверяем что у нас актуальная версия

- git log // ищем камит к которому мы хотим откатиться

- sudo git reset --hard 7bcdf46b14b2dacc286b0ad469d5f9022d797f68 // указываем камит начиная с которого нам надо забыть наши изменения, при этом из локальной ветки все камиты с указанного будут забыты — удалены

- git push --force origin feature/draft // заливаем локальную ветку в оригинальную (ветку сервера) — из оригинальной ветки будут удалены все «лишние» камиты

- Победа !

Если есть более правильный способ, то прошу озвучить в коментах.

PS

На самом деле камиты из репозитория не удаляются, удаляется связь этих камитов с деревом изменений, таким образом эти камиты пропадают из ветки, но git помнит всё.

|

Метки: author SbWereWolf git admin |

Реформа SQL-ориентированного подхода в DAO |

Вводная

Мне часто в проектах приходится сталкиваться с фреймворками по работе с БД. Концептуально, эти фреймворки можно разбить на 2 больших класса:

- ORM-ориентированные

- SQL-ориентированные

Немного обзора

Прежде чем преступить, предлагаю вспомнить, совсем кратко, что есть. Кто в теме, смело пропускайте обзор.

И так, на сцене представители ORM-ориентированного подхода:Эти представители справляются со своей задачей по-разному. Последний, например, DSL-way, предлагает конструировать SQL запросы, используя, либо сгенерированные объекты по схеме Вашей БД, либо просто строки. Другие, требуют описывать соответствие между java-объектами и таблицами БД. Но не суть. Их все объединяет одна идея: максимально изолировать разработчика от написания SQL-запросов, предлагая взамен — ORM-мышление.

С другой стороны собрались представители SQL-ориентированного подхода:

- Spring Framework JDBC

- sql2o (очень понравился)

- JDBI

- RefOrms

Я знаю о существовании и третьего класса фреймворков: генераторы. Им тяжело отвоевать нишу, потому что такие решение как правило пишутся под конкретный проект и им трудно быть универсальными. Идея в них следующая: сгенерировать DAO-слой полностью, используя знания конкретного проекта, знание о БД и специфики бизнес требований. Встречался с такими решениями дважды. Очень не привычно, когда приходится дорабатывать генератор DAO-слоя, вместо написания SQL-запросов или меппинга.

Что не так?

Я умышленно не давал оценочных суждений тому или иному подходу, ORM vs SQL vs Генераторы. Каждый решает сам, в купе с имеющимися обстоятельствами, что выбирать. Но вот готов предложить определенную альтернативу как в стилистическом выражении так и в концептуальном для SQL-ориентированных. Но прежде скажу, что мне не нравится на уровне кода (производительность, debug и прочее — опускаю) в существующих решениях:

- Определенная многословность для достижения простых вещей

- Бойлерплейт, бойлерплейт, бойлерплейт… и еще раз бойлерплейт

- Отсутсвие точки в коде, где можно посмотреть sql-orm или orm-sql варианты

- В том или ином виде конструирование SQL-запроса по условиям фильтрации

- Многознание для использования API фреймворка — узнай про +100500 сущностей прежде, чем преступить кодить

Декларативный стиль

Каким? Думаю простым, таким, чтобы взял и начал кодить. Но, а если серьезно? Декларативным. Да, я сторонник декларативного стиля в таких вещах, нежели императивного. Что в java приходит на ум первым, если речь идет о декларативном подходе? Да всего 2 вещи: аннотации и интерфейсы. Если эти 2 субстанции скрестить и направить в русло SQL-ориентированного решения, то получим следующее:

public class Client {

private Long id;

private String name;

private ClientState state;

private Date regTime;

public Long getId() {

return id;

}

public void setId(Long id) {

this.id = id;

}

public String getName() {

return name;

}

public void setName(String name) {

this.name = name;

}

public ClientState getState() {

return state;

}

public void setState(ClientState state) {

this.state = state;

}

public Date getRegTime() {

return regTime;

}

public void setRegTime(Date regTime) {

this.regTime = regTime;

}

}

enum ClientState {

ACTIVE(1),

BLOCKED(2),

DELETED(3);

private int state;

ClientState(int state) {

this.state = state;

}

@TargetMethod

public int getState() {

return state;

}

@TargetMethod

public static ClientState getClientState(int state) {

return values()[state - 1]; // только для краткости

}

}public interface IClientDao {

@TargetQuery(query =

"SELECT id, name, state " +

" FROM clients " +

" WHERE id = ?", type = QT_SELECT)

Client findClient(long clientId);

}-- Таблица клиентов

CREATE TABLE clients (

id bigint NOT NULL,

name character varying(127) NOT NULL,

state int NULL,

reg_time timestamp NOT NULL,

CONSTRAINT pk_clients PRIMARY KEY (id)

);- А кто реализует контракт IClientDao и как получить доступ к реализации?

- А где описывается меппинг полей?

- А как насчет чего-то посложнее? А то эти примеры на 3 копейки уже надоели.

Просто Proxy

>>1. А кто реализует этот контракт и как получить доступ к реализации?

Контракт реализуется самим фреймворком с помощью инструмента java.lang.reflect.Proxy и реализовывать его самому для SQL целей не нужно. А получить доступ к реализации очень просто, с помощью… Да в прочим на примере показать легче:

IClientDao clientDao = com.reforms.orm.OrmDao.createDao(connection, IClientDao.class);

Client client = clientDao.findClient(1L);

Концепция

>>2. А где описывается меппинг полей?

Как и обещал выше, я затрону 2 вещи: стиль и концепцию. Чтобы ответить на второй вопрос, нужно рассказать о концепции. Посыл таков, что, чтобы предложить новое — нужен радикальный взгляд на решение. А как насчет SQL-92 парсера? Когда мне впервые пришла эта мысль, я откинул ее так далеко, что думал больше с ней не встречусь. Но как тогда сделать SQL-ориентированный фреймворк удобным? Пилить очередную надстройку? Или делать очередной хелпер к хелперу фреймворка? На мой взгляд, лучше ограничить поддерживаемый набор SQL конструкций — как неплохой компромисс, и взамен получить нечто удобное, на мой взгляд. Мэппинг осуществляется на основе дерева выражений, после парсинга SQL-запроса. В примере выше имена колонок соотносятся с именами полей ORM объекта один к одному. Разумеется, фреймворк поддерживает меппинг и более сложный, но о нем чуть позже.

Примеры

>> 3. А как насчет чего-то посложнее? А то эти примеры на 3 копейки уже надоели.

А есть ли смысл вообще заморачиваться с SQL-92 парсером, если фреймворк не будет уметь делать, чего-то посложнее? Но показать все в примерах без объема — не простая задача. Разумеется я покажу, правда буду опускать местами декларации таблиц в SQL и части java кода.

Одной из немногих вещей, которая мне никогда не нравилась в SQL-ориентированных решениях — это необходимость конструирования SQL-запросов. Например, когда определенные критерии фильтрации могут быть заданы, а могут быть и не заданы. И Вам наверняка знаком такой фрагмент кода, точнее его упрощенный вариант:

// где-то в DAO

private String makeRegTimeFilter(Date beginDate, Date endDate) {

StringBuilder filter = new StringBuilder();

if (beginDate != null) {

filter.append(" reg_time >= ?");

}

if (endDate != null) {

if (filter.length() != 0) {

filter.append(" AND");

}

filter.append(" reg_time < ?");

}

return filter.length() == 0 ? null : filter.toString();

}

public interface IClientDao {

@TargetQuery(query =

"SELECT id, name, state " +

" FROM clients " +

" WHERE regTime >= ::begin_date AND " +

" regTime < ::end_date", type = QT_SELECT)

List findClients(@TargetFilter("begin_date") Date beginDate,

@TargetFilter("end_date") Date endDate);

}

SELECT id, name, state FROM clients WHERE regTime < ?// Бойлерплейт get/set код вырезал. В своем файле.

public class ClientFilter {

private Date beginDate;

private Date endDate;

}

public interface IClientDao {

@TargetQuery(query =

"SELECT id, name, state " +

" FROM clients " +

" WHERE regTime >= ::begin_date AND " +

" regTime < ::end_date", type = QT_SELECT)

List findClients(@TargetFilter ClientFilter period);

}

Разумеется, фреймворк поддерживает и статические, обязательные к указанию фильтры. И синтаксис у них такой же, как в HQL или SpringTemplate — ': именованный параметр'.

Правда, со статическими фильтрами всегда связана одна проблема: 'Как реагировать на null параметр'? Быстрым ответом кажется сказать — 'Кидай исключение, не ошибешься'. Но всегда ли это нужно? Давайте перейдем к примеру, загрузки клиентов с определенным статусом и проверим это:

public interface IClientDao {

@TargetQuery(query =

"SELECT id, name, state " +

" FROM clients " +

" WHERE state = :state", type = QT_SELECT)

List findClients(@TargetFilter("state") ClientState state);

}

Про меппинг

Фильтры в запросах это конечно хорошо, но в java решениях большое внимание уделяется мэппингу результата работы SQL-запроса на ORM объекты и их связывание и связывание самих сущностей. Этого настолько много, посмотрите чего стоит одна спецификация JPA. Или посмотрите в своих проектах на перекладывания из ResultSet в объекты предметной области или установку значений в PreparedStatement. Громоздко, не правда ли? Я выбрал путь, может меннее надежный и менее изящный, но однозначно — простой. Зачем далеко ходить, когда можно устроить меппинг прям в SQL-запросе. Это ведь первое, что приходит в голову?

Давайте сразу к примерам. И вот задача, как мепить результат запроса, если все колонки таблицы отличаются от полей ORM класса, плюс ORM имеет вложенный объект?

public class Client {

private long clientId;

private String clientName;

private ClientState clientState;

private Address address;

private Date regTime;

// ниже как обычно...

}

enum ClientState {

ACTIVE(1),

BLOCKED(2),

DELETED(3);

private int state;

ClientState(int state) {

this.state = state;

}

@TargetMethod

public int getState() {

return state;

}

@TargetMethod

public static ClientState getClientState(int state) {

return values()[state - 1]; // для примера сойдет

}

}

public class Address {

private long addressId;

private String refCity;

private String refStreet;

}

public interface IClientDao {

@TargetQuery(query =

"SELECT cl.id AS client_id, " + // underscore_case -> camelCase преобразование

" cl.name AS clientName, " + // можно сразу в camelCase

" cl.state AS client_state, " + // any_type to enum преобразование автоматически поддерживается, если в enum имеется аннотация @TargetMethod

" cl.regDate AS t#regTime, " + // t# - это директива, что нам нужна и дата и время java.sql.Timestamp -> java.util.Date

" addr.addressId AS address.addressId, " + // обращение к вложенному объекту через точку, а как еще?

" addr.city AS address.refCity, " +

" addr.street AS address.refStreet " +

" FROM clients cl, addresses addr" +

" WHERE id = :client_id", // допускается указание именованного параметра для простого фильтра

type = QT_SELECT)

Client findClient(long clientId);

}

И последнее, немного бизнес логики

Идеальные дао, когда одна операция — один декларативный метод. И это конечно хорошо, но так бывает не всегда. В приложении часто нужно получить гибридную или составную сущность, когда часть данных формируется одним SQL-запросом, другая часть вторым SQL-запросом и т.д. Или сделать определенные склейки, проверки. Возможно это и не суть самого дао, но такие манипуляции как правило имеют место быть и их изолируют, но делают публичными, дабы вызывать из разных участков программы. Но что нам делать с интерфейсами, если все же приспичит засунуть бизнес логику в дао? Неожиданно для меня и к удивлению многих разработчиков в java8 появились дефолтные методы. Круто? Да я знаю, что новость протухла, ведь на дворе 2017 год, но не сыграть ли на этом? А что если скрестить декларативный стиль принятый за основу разработки DAO слоя и дефолтные методы для бизнес логики? А давайте посмортим, что из этого получится, если понадобиться добавить проверку ORM объекта на null и загрузить данные из другого DAO:

public interface IClientDao {

// этот метод уже видели

@TargetQuery(query =

"SELECT id, name, state " +

" FROM clients " +

" WHERE id = ?", type = QT_SELECT)

Client findClient(long clientId);

// получить дао внутри другого дао доступно из коробки

IAddressDao getAddressDao();

// метод с бизнес логикой

default Client findClientAndCheck(long clientId, long addressId) throws Exception {

Client client = findClient(clientId);

if (client == null) {

throw new Exception("Клиент с id '" + clientId + "' не найден");

}

// Здесь код может быть сколь угодно сложным, если нужно

IAddressDao addressDao = getAddressDao();

client.setAddress(addressDao.loadAddress(addressId));

return client;

}

}

Заключение

Не знаю дорогой читатель, удалось ли мне привнести чего-то нового, в этот заполненный мир SQL-фреймворков или нет, судить Вам. Но я попробовал и доволен тем, что попробовал. Жду с нетерпением критического взгляда на предложенный подход и идей, если таковые имеются. Решение доступно на гитхабе, ссылка на который уже указана в главе Немного обзора в списке SQL-ориентированных фреймворков последней строчкой. Всего хорошего.

|

Метки: author reforms программирование java reforms sql ориентированный интерфейсное программирование dao |

«Ближе к народу»: Как сделать IaaS доступнее |

/ Flickr / Dennis Skley / CC

Исследования различных аналитических компаний и экспертов только подкрепляют прогнозы роста значимости ЦОД. Например, Statista говорят об увеличении годового траффика дата-центров до 9,8 эксабайт в 2018 году. Такие нагрузки обостряют задачи эффективного использования ресурсов, повышения гибкости ИТ-инфраструктуры и своевременной реакции на запросы клиентов.

Решение можно найти гораздо быстрее и с меньшими затратами, если компания готова использовать те инструменты, которая она предлагает своим клиентам. Этот подход мы применяем в управлении собственным IaaS-провайдером — практически все наши сотрудники работают с имеющимся инструментарием услуг и знают на практике, что и как устроено.

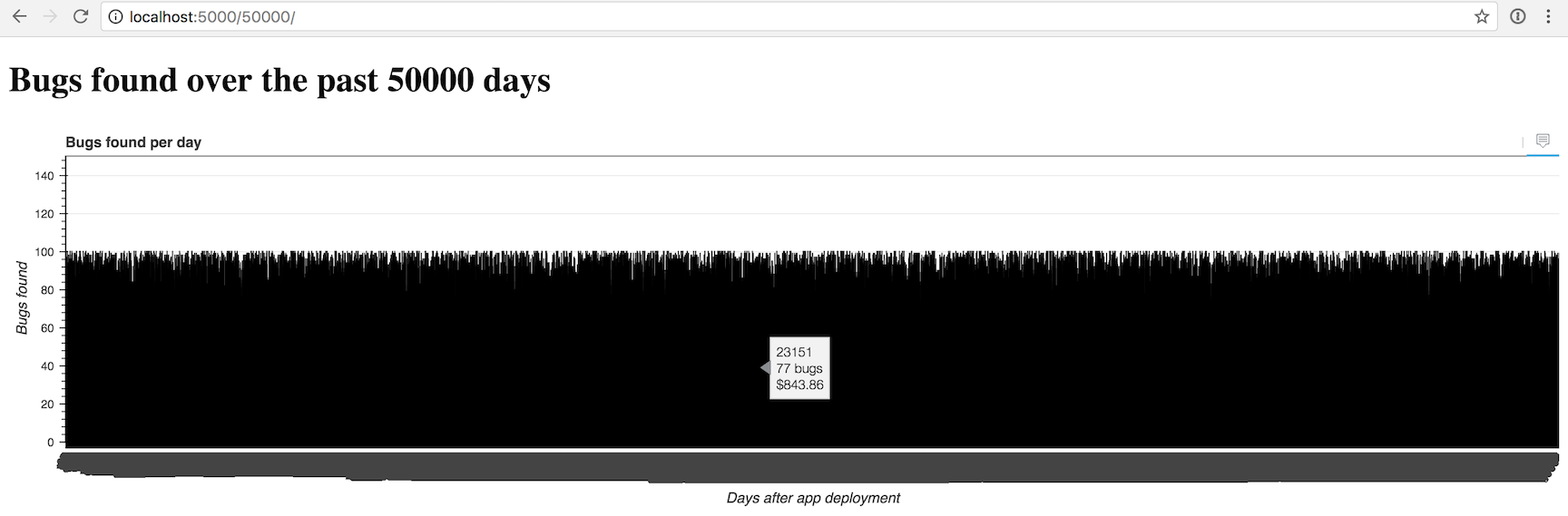

Обратная связь от команды позволяет здраво оценивать ситуацию и потребность в тех или иных возможностях, которые нужны для эффективной работы клиентов и компании в целом. Один из примеров — разработка и ввод системы мониторинга нагрузки на инфраструктуру наших клиентов. С помощью такого сервиса заказчик может в реальном времени оценить, за что он платит и отказаться от части неиспользуемых ресурсов.

Для реализации этой возможности от нас не потребовались какие-то сложные манипуляции. Что мы сделали: выбрали графическую библиотеку для вывода информации и настроили интеграцию vSphere c помощью .NET SDK для получения данных о нагрузке отдельных виртуальных машин. Все это — еще один шаг в сторону модели pay-as-you-go — оплаты только за потребленные ресурсы и ввода системы автоматического масштабирования при пиковых нагрузках.

Анализ рынка и мнений клиентов привели нас к пониманию необходимости ввода и других новшеств. Об этом мы уже неоднократно рассказывали, но позволим себе кратко остановиться на основных моментах:

- редизайн основных разделов сайта компании (и еще одно улучшение в дальнейшем)

- разработка специального калькулятора, который позволяет быстро оценить потенциальные затраты на содержание инфраструктуры и перейти к ее запуску

- настройка предустановленного ПО (панель управления и возможность отслеживания состояния лицензий) и инструментария для управления контентом (предустановленные CMS)

- автоматизация различных служебных задач (пример нашего DNS-менеджера)

Подобные проекты не требуют глобального пересмотра всего сервиса, многолетнего проектирования и разработки. Вместе с этим они помогают повысить уровень доступности наших сервисов для аудитории, которая достаточно далека от ИТ-специфики и не обладает профильными знаниями.

/ Flickr / Bruno Cordioli / CC

Физическое состояние инфраструктуры требует аналогичного внимания. Здесь нужно понимать не только сиюминутные задачи, но и общие тренды развития ИТ, которые будут формировать потребности клиентов.

Далее необходимо подумать о балансе производительности, востребованности ресурсов и поддерживающей экосистемы. Все это невозможно без переосмысления подходов к организации работы ЦОД, оптимизации рисков и повышения уровня доступности сервисов.

Здесь не помешает политика открытости. Следуя этому принципу, мы подготовили и опубликовали соответсвующие материалы о ЦОД, в которых размещено наше оборудование: SDN (Санкт-Петербург), Dataspace (Москва) и AHOST (Алма-Ата). Помимо этого мы привели базовые данные о производительности.

Можно сказать, что этот принцип является общепринятым практически для любого аспекта нашей деятельности. Если говорить о доступности нашей инфраструктуры, то здесь мы предоставляем реальные финансовые гарантии и открыто делимся нашим SLA. Плюс мы рассказываем о своем опыте устранения неисправностей и анализируем инциденты, которые произошли у западных коллег.

Помимо этого мы проводим фотоэкскурсии по нашему «облаку» прямо здесь в блоге на Хабре для того, чтобы вы могли как можно ближе познакомиться с реальным оборудованием. И даже даем рекомендации по выбору IaaS-провайдера для того, чтобы вы могли обратить внимание не только на уровень доступности, но и другие нюансы облачных услуг.

Еще больше наших материалов по теме:

- Как создать провайдера виртуальной инфраструктуры

- Как выбрать направление для развития ИТ-проекта

- Мифы об облачных технологиях: часть 1, часть 2 и часть 3

- Личный опыт: Как мы автоматизировали работу с DNS-записями в хостинг-панели

- Подборка материалов об облаках, дата-центрах и разработке сервисов

- Знакомство с IaaS-провайдером: о чем мы пишем на Хабре и в своем блоге

- Дайджест: работа IaaS-провайдера, SSL-сертификаты, ЦОД и наш «пятничный формат»

- «Мелочи, на которые мы обратили внимание»: кейс IaaS-провайдера

- «Теперь обязательно»: выдача SSL-сертификатов с учетом DNS-записи

- «Как это работает»: знакомство с SSL/TLS

|

Метки: author 1cloud управление e-commerce блог компании 1cloud.ru 1cloud iaas |

NNCP: лечение online- и цензуро- зависимости store-and-forward методом |

Кто виноват?

В рунете в последнее время поднято много дискуссий о страхе перед проектами законов, которые могут поставить вообще существование нашей части Интернета под вопросом. Интерпретация этих законопроектов может быть такой, что всё где используется шифрование будет вне закона, запрещено, а кому нужна сеть где невозможно не публично передать данные, приватно поговорить?

Представители власти говорят что нет речи о запрете, а всего-лишь о контроле: то есть, мол если они смогут читать, то никаких проблем — но мы то знаем что не бывает шифрования «прозрачного» для одних, но надёжного от других. Подобный «контроль» равносилен тому, что любое наше слово должно бы быть передано через посредника, прямое общение между двумя собеседниками недопустимо. Кроме того, наличие централизованного посредника опасно злоупотреблением цензурой и закрытием доступа к пластам информации. Плюс это колоссальный поток приватной информации о людях (каждый их клик будет зафиксирован) — то есть глобальная слежка со всеми отсюда вытекающими проблемами.

Все эти проблемы преподносятся в оппозиционном виде против власти, мол именно они виноваты в том, что мы, простые люди, можем лишиться такого чуда света, как Сеть сетей. Так ли всё плохо и так ли действительно нас, с нашими технологиями, «не любит» власть?

Всё не так плохо — всё гораздо хуже. Потому-что доступность информации, глобальная тотальная слежка и цензура уже давно стали де-фактом, без каких-либо принятых законопроектов. Вот только зачинщиками всего этого были и являются корпорации типа Google, Facebook, Microsoft и Apple.

Не секрет, что Web-технологии крайне сложны, громоздки и трудоёмки в разработке: попробуйте написать Web-броузер с нуля со всеми CSS-ами и JavaScript-ами с DOM-ом. Известно, что активно разрабатываемых броузеров по пальцам посчитать и их разработкой занимаются люди из этих корпораций. Поэтому любая разработка движется исключительно и логично в сторону потребностей корпораций.

Какой Web был раньше, с технологической точки зрения? У пользователей стоит специальная программа (старый добрый тёплый ламповый Web-броузер), которая по стандартизованному HTTP протоколу (говорящему какой документ, какой ресурс нужно получить), подключаясь к серверам, получает HTML (возможно плюс изображения) документ и отображает его. Это распределённая сеть хранения документов в которой один протокол. Мы по сети получаем готовые документы, которые можно сохранить на жёстком диске и читать без дальнейших подключений к серверам.

Как работает Web «корпораций»? У пользователя стоит специальная программа (до сих пор обзывающаяся Web-броузером), которая по транспортному протоколу (это HTTP, но который к гипертексту отношения уже никакого не имеет, который можно заменить какими угодно другими протоколами передачи файлов) получает программу, написанную на JavaScript (хотя сейчас это может быть какой-нибудь WebAssembly, являющийся обычным бинарным исполняемым кодом, аналогично .exe файлу), запускает её в виртуальной машине и эта программа по своему собственному протоколу (то есть правилам взаимодействия с сервером и форматом сообщений) начинает общение с сервером чтобы получить данные и их отобразить на экране. Сохранить отображённые данные, думая что это документ, вряд ли получится. Автоматизировать получение документов тоже не получится, потому-что каждый отдельный сайт это отдельная программа и свой протокол общения со своим форматом сообщений (структурой JSON запросов, например). Теперь это распределённая сеть приложений, скачиваемых на пользовательские компьютеры.

Безусловно, все эти программы являются закрытыми, так как код, как минимум, обфусцирован и не пригоден для чтения или правки людьми. Раньше мы один раз устанавливали себе программу реализующую один заданный протокол и поддерживающую, как минимум, один стандартизованный формат документов. Теперь, каждый раз, с каждым сайтом мы скачиваем очередную отличающуюся программу.

Что такое закрытая проприетарная программа? Это то, когда вы не управляете своим компьютером, когда вы не знаете что программа на нём собирается делать Не вы говорите своей машине что ей надо выполнять, а программа вам говорит что вам дозволено делать. Безусловно, всё это касается и любой другой проприетарной программы, не только автоматически скачанному JS-коду. Однако, существенная разница между установленным Microsoft Windows с каким-нибудь Microsoft Word на вашем компьютере и JS-кодом — вы их ставите один раз и если не замечаете ничего опасного или настораживающего в их работе, то просто не беспокоитесь и доверяете. Однако в Web мире вы, каждый раз заходя на сайт, можете получить новую версию программы и любой современный броузер вам этого даже не сообщит. Если раньше вы не замечали что сайт отсылает на сервер приватные данные, то, зайдя на него через пять минут, он может начать. Никто, без специальных плагинов и танцев с бубном, вам об этом не скажет и не предупредит что вы используете другую версию скачанной программы. Экосистема заточена на беспрекословное скачивание несвободных программ. Владельцы таких сайтов могут заставить выполнить на пользовательских компьютеров что им заблагорассудится буквально поменяв несколько файлов на свои серверах и новая версия программы автомагически будет исполнятся.

Может проблемы преувеличены, ведь это же не обычная .exe программа которая имеет доступ до огромного количества ресурсов компьютера, а программа запускающаяся, по идее, в изолированной виртуальной машине? К сожалению, размер и сложность кодовой базы современных броузеров так огромны, что даже просто сделать анализ их безопасности очень затратно, не говоря уж о том, что эта кодовая база меняется настолько быстро, что любой анализ на момент своего завершения будет не актуален. Сложность это главный враг любой системы безопасности. Сложные протоколы типа TLS доказали, что даже если сотни миллионов людей используют и разрабатывают под OpenSSL, который является свободной программой с открытым исходным кодом — там могут быть фатальные критические ошибки. Плюс все мы видели что атаки типа Row hammer можно произвести и из броузера. Кроме того, есть успешные атаки на кэш процессора нацеленные на узнавание ключа AES, выполняемые тоже из броузера. Виртуальная машина столь стремительно изменяющаяся и с такой сложностью не может быть безопасна по определению, ведь даже полная виртуализация в каком-нибудь Xen или KVM не помогает против некоторых атак. Да и какой смысл делать хорошее изолированное окружение, когда бизнес корпораций это наоборот сбор как можно большего количества данных?

Теперь давайте попробуем отключить JavaScript в нашем броузере и походим по самым разным современным сайтам. На сегодняшний день, какая-то часть ресурсов не будет работать совсем, однако на оставшихся 99% сайтов мы увидим, что куда-то подевалось огромное количество рекламы. Мы увидим, что от нас стало исходить на порядки меньшее количество запросов выдающих наши приватные данные посторонним сайтам/серверам — то есть слежка существенно сокращена, как минимум отсутствием контакта с многочисленными третьими лицами.

Всё это делается, как официально сообщается, ради рекламы, ради таргетированной рекламы, ради её улучшения и ради нас. Только улучшается всё это исключительно за счёт слежки за нами. Известный специалист по безопасности и криптограф Брюс Шнайер не раз подчёркивает что бизнес-модель Интернета это слежка за пользователями. Все эти корпорации живут за счёт того, что следят за пользователями (подчеркну что под слежкой подразумевается сбор данных о нём) и продают полученную информацию.

Кто-то может возразить: какая же это слежка за мной в магазине, если я вот пришёл в таком-то пальто и вот моё лицо видно — я сам выдал эту информацию. Действительно, IP адрес, TCP-порты, User-Agent своего броузера я сам присылаю и не могу не присылать — так уж устроен Web. Но если продавец начинает спрашивать как меня зовут, откуда я, ходить за мной по пятам — это уже запрос информации которая не нужна для совершения транзакции купли-продажи, это уже слежка. А ведь сайты корпораций именно этим и занимаются, уничтожая доступ к информации по стандартизованным протоколам (которые так мало о нас говорят) и форматам документов — если они заставят использовать своё ПО, то в нём то уж они вольны следить как заблагорассудится.

Опросите большинство людей кого конкретно по-настоящему задели блокировки Роскомнадзора и они потеряли доступность какой-то информации? Не считая громких кратковременных блокировок типа Github, максимум что люди скажут, так это потеря Рутрэкера. Однако, как и в случае с Pirate Bay, стоит понимать что это уже не прихоть властей и не политика, а власть корпораций типа Голливуда и подобных им. Их денежные состояния и влияние на власть стран достаточно весомы. Самим властям закрывать Рутрэкер или Pirate Bay не имеет смысла, так как, в основном, это дешёвые (с точки зрения инфраструктуры) развлечения отвлекающие людей от политики (потенциально создающей опасность для власти).

А вот потери тонн информации из-за того, что сайт перестал работать простыми HTTP+HTML методами, заставляя людей использовать его ПО, вынуждающее быть постоянно в online (если человек не будет в online, то как о нём собрать информацию?) — по моему, сказались и сказываются всё сильнее и сильнее. Отключите человека от Интернета и он не в состоянии вообще ничего сделать, ни даже прочитать почту или посмотреть свои фотографии или вспомнить о встрече, ведь всё это осталось в облаках.

Информация «попавшая» в соцсеть типа ВКонтакте — недоступна для индексирования сторонними роботами, часто недоступна для неавторизованных лиц. Мол, только если я разрешу скачивать закрытые проприетарные программы, зарегистрируюсь, предоставляя идентификационные данные своего «маячка» (сотового телефона), то только тогда я смогу увидеть пару абзацев текста про какой-нибудь очередной музыкальный концерт. Дикое количество Web-разработчиков просто разучились делать сайты иначе — без слежки и установки каждому пользователю своего ПО они ничего не покажут, ни бита информации полезной нагрузки. Потому-что корпорации обучают людей только такому неэтичному и неуважающему пользователей методу разработки. Чтобы увидеть хотя бы одно сообщение в Google Groups, надо скачать почти два мегабайта JS-программ — комментарии излишни.

Таким образом, тотальная слежка, недоступность информации, централизованная цензура — всё это уже произошло, всё это культивируется самими же разработчиками, обычными людьми. Соцсети «чисты»: мол, никто не заставляет в нас всё это размещать. Действительно, людьми крайне легко манипулировать и крайне легко умалчивать о том чего они лишаются, показывая только положительные стороны своих подходов. А ценность начинают понимать только с потерей.

Есть много людей которые используют практически только ВКонтакте и YouTube: каждое их действие уже отслеживается, вся их переписка (у них нет email, только учётная запись в ВК или Telegram) читается, вся поступающая информация тривиально цензурируется (сколько раз Facebook был замечен за манипуляцией людьми, путём цензуры данных?). И таких уже возможно большинство, однако никто насильно их не заставлял и выбор есть до сих пор. Для них у провайдеров уже есть специальные более дешёвые тарифные планы в которых доступ только до ряда сервисов. Когда масса этих людей станет совсем критической, то останутся только такие тарифные планы, так как какой смысл поддерживать провайдеру инфраструктуру обеспечивающие доступ ко всему Интернету, когда достаточно иметь пиринг с полдюжиной сетей корпораций и 99.99% пользователей довольны? Цены на полноценные тарифы будут повышаться (если останутся вообще) и это уже станет барьером для доступности Интернета.

Людей волнует что в TLS соединении будет принудительно выставлен CA сертификат как это например произошло в Казахстане, для того чтобы следить, прослушивать и цензуру устраивать? Но, при этом, этих же самых людей не волнует что другие стороны (сервисы корпораций) вообще устанавливают своё закрытое ПО и свои протоколы? Эти же самые люди, путём размещения информации только в соцсетях, как-раз поддерживают централизацию и гегемонию одной корпорации над всеми данными. Они уже давно самостоятельно роют себе Интернет-могилы, пытаясь свалить все беды на «дефолтного» крайнего.

К корпорациям с распростёртыми руками, а власть, которая делает куда менее катастрофичные вещи, хаять.

Что делать?

меньшинству людей которым действительно нужен Интернет, кому нужна возможность, грубо говоря, послать произвольные данные с одного произвольного компьютера на другой?

Если не нравятся сервисы корпораций или соцсети, то никто не заставляет их использовать и всегда можно сделать свой аналог (с блэкджеком и шлюхами, опционально). У каждого дома есть мощный компьютер, быстрая сеть и все возможности технической реализации. Движки для соцсетей типа Diaspora или GNU Social уже давно существуют.

Если не нравится как предоставляют данные, делая это с огромным порогом вхождения (свой протокол и формат), то хотя бы самостоятельно делать это подобающим удовлетворительным образом. Это относится к разработчикам.

Если у ресурса не хватает жёстких дисков, канала для обеспечения всех потребностей, то не забывать про кооперацию и предложить возможность зеркалирования ресурса. Вместо этого, к сожалению, многие переезжают в CDN-ы, такие как Cloudflare, который частенько запрещает вход из сети Tor, заставляя проходить унизительные деанонимизационные процедуры.

Если не нравится что всё большее количество провайдеров не даёт статические IP-адреса, вообще не даёт полноценных адресов, а только внутренний адрес за NAT-ом, то размещение ресурсов внутри overlay сетей типа Tor hidden service (.onion) или I2P (.i2p) может быть единственным способом подключиться к вам извне. Необходимо не забывать об участии в подобных сетях и жертвовать, зачастую неиспользуемые, ресурсы ваших компьютеров. Развивать и поддерживать не только low-latency сети, априори подверженные ряду атак из-за своей природы, но и сети типа Freenet и GNUnet. Чтобы не было как всегда: пока гром не грянет.

Если цензура, поддерживаемая корпорациями, действительно достигнет такого состояния, когда произвольные компьютеры не смогут обмениваться шифрованным трафиком между собой, то бишь, закроется Интернет и останется только whitelist удалённый доступ до дюжины сервисов, то можно сделать свою сеть.

Прокладывать оптоволокно или кабели вряд ли можно рассматривать, так как это стоит огромных денег (забудем про то, что это ещё и не разрешат). Но mesh-сети поверх беспроводных каналов связи реализовать можно и в спартанских домашних условиях. Вариантом может быть не обязательно создание полностью изолированной сети, а той, в которой хотя бы кто-то будет иметь доступ до работающего Интернета, являясь шлюзом. Проектов достаточно много чтобы было среди чего выбирать.

Но не забываем про желания корпораций о запрете изменения прошивок на WiFi-маршрутизаторах и не забываем что огромное количество WiFi модулей не работают без бинарных блобов. Подобный vendor-lockin не исключает жёсткий контроль над трафиком, как например, в современных проприетарных ОС невозможно установить программы не криптографически подписанные корпорациями (одобрившими запуск данного ПО). Сделать WiFi чип самостоятельно в домашних условиях очень дорого и не исключено что с рынка пропадут и те, на которых можно было бы сделать mesh-сеть. Речь не только про WiFi, но и любые другие беспроводные решения с толстым каналом связи. Любительские радиостанции можно сделать и в домашних условиях, но ёмкость их каналов плачевна, да и нельзя так просто взять и поднять такую станцию дома — нужны разрешения.

Mesh сеть возможно создать в теории, но на практике нужно большое количество достаточно географически распределённых людей чтобы создать нечто внушительного размера и имеющее практическую пользу, а не только академическую. Есть разные мнения, но лично мой опыт показывает что люди не особо стремятся сотрудничать и поэтому не приходится надеяться, что mesh-сеть, хотя бы, в Москве можно было бы создать. А людей нужно действительно много, потому-что WiFi (или другие доступные ёмкие радиорешения) работает на относительно коротких расстояниях.

Кроме того, mesh-сети и их протоколы хорошо заточены исключительно под real-time соединения. Они рассчитаны на то, чтобы можно было бы в реальном времени открывать сайты или удалённо использовать терминал. Если связанность в сети теряется, то это равносильно разрыву кабеля и, до восстановления, другой участок сети будет недоступен, приводя в негодность real-time low-delay программы. Необходимо ещё и обеспечивать хорошее резервирование каналов — что дорого и ресурсоёмко.

Более кардинальное решение это забыть о real-time сервисах и вспомнить что и без них жизнь вполне возможна. Так ли критично что ваше сообщение дойдёт не сиюсекундно, а возможно через несколько минут или часов? Электронная почта остаётся самым надёжным и распространённым методом общения и она не гарантирует никаких временных рамок по доставке: задержки в десятки минут штатны.

Для чтения большинства сайтов real-time не нужен в принципе. Сайт можно скачать, доступными во всех свободных ОС, программами типа GNU Wget и отправить зеркало сайта к себе. Существует и стандарт для хранения Web-данных: WARC (Web ARChive), используемый в Internet Archive. Один файл может содержать полностью весь Web-сайт. Такой же подход используется и в Freenet сети: сайты тоже помещаются в архив, чтобы не качать через сеть сотни блоков данных, которые наверняка были бы запрошены, а атомарно сразу же получить всё. Подчеркну: формат Web архивов уже стандартизован и десятки петабайт Internet Archive сделаны именно в нём. Ценные страницы стоит сохранить просто средствами Web-броузера на диске, ведь сегодня ссылка рабочая, а завтра уже запросто нет. Вы возможно усвоили информацию по ней, но дать своему товарищу уже не сможете. Это потерянная информация, особенно в условиях централизованных систем типа CDN и соцсетей.

Если отказаться от real-time и обязательного сиюминутного online режима работы, то не нужны даже mesh-сети, а достаточны гораздо менее требовательные store-and-forward (сохранить и отправить дальше) решения. Одной из таких сетей, существующей до сих пор, является FidoNet, который, до распространения дешёвого Интернета, был вполне себе распространённой (среди того самого меньшинства) глобальной сетью. Да, сообщения шли часами или целыми днями, но, поверьте, интересного общения в Фидо запросто было куда больше чем сейчас можно найти среди невероятного количества Интернет форумов и рассылок.

Node-to-Node CoPy

Я ничуть не призываю возродить FidoNet или UUCP (Unix-to-Unix CoPy), про использование которого я уже писал раньше!

Во-первых, все эти системы были созданы во времена, когда криптография фактически не была доступна для простых смертных и когда каналы связи навряд ли прослушивались и, если и прослушивались, то только целенаправленно, а не массово (чисто технически сейчас проще прослушивать всех, чем конкретно заданных лиц). Тогда ещё не было бизнеса основанного на слежке за людьми. Шифрования и сильной аутентификации они не предоставляли.

Во-вторых, тот же FidoNet, был создан для простых персональных компьютеров с DOS-ом, в отличии от UUCP бывшим де-факто методом связи между Unix-системами. Сейчас почти любая свободная ОС это Unix-like мир. Не многие захотят отказаться от привычного почтового клиента и привычных программ для общения с «внешним миром». FidoNet с UUCP это совершенно иные экосистемы.

В идеале, хотелось бы иметь нечто, что было бы как можно более прозрачно для email и передачи файлов. Вместе с этим и имело современную криптографическую безопасность. Этого можно достичь с UUCP, но прикручивая к нему дополнительные обёртки для шифрования и аутентификации. Кроме того, ни FidoNet ни UUCP не заточены из коробки на работу через сменные накопители информации. Да, в FidoNet можно скопировать исходящие пакеты на дискету и на целевом узле скопировать их назад, но это ручное действие, легко получающееся в виду простоты системы, но штатно не предусмотренное (нет команд «вот тебе дискета, я хочу пойти к Вовану», «вот я с дискетой от Вована, побывавшая и у Васька, действуй»).

Для удовлетворения этой хотелки и создан набор свободных (GNU GPLv3+) программ NNCP. Они заточены на то, чтобы, как можно с меньшими человеческими затратами, организовать современную небольшую store-and-forward сеть.

Рассмотрим как всем этим пользоваться на конкретных примерах.

Мы, Алиса (возьмём имена уж из мира криптографии) и Боб, установили себе NNCP и у нас куча nncp-* команд. Для начала создадим (командой nncp-cfgnew) свои собственные пары криптографических ключей:

alice% nncp-cfgnew | tee alice.yaml

self:

id: ZY3VTECZP3T5W6MTD627H472RELRHNBTFEWQCPEGAIRLTHFDZARQ

exchpub: F73FW5FKURRA6V5LOWXABWMHLSRPUO5YW42L2I2K7EDH7SWRDAWQ

exchprv: 3URFZQXMZQD6IMCSAZXFI4YFTSYZMKQKGIVJIY7MGHV3WKZXMQ7Q

signpub: D67UXCU3FJOZG7KVX5P23TEAMT5XUUUME24G7DSDCKRAKSBCGIVQ

signprv: TEXUCVA4T6PGWS73TKRLKF5GILPTPIU4OHCMEXJQYEUCYLZVR7KB7P2LRKNSUXMTPVK36X5NZSAGJ632KKGCNODPRZBRFIQFJARDEKY

noiseprv: 7AHI3X5KI7BE3J74BW4BSLFW5ZDEPASPTDLRI6XRTYSHEFZPGVAQ

noisepub: 56NKDPWRQ26XT5VZKCJBI5PZQBLMH4FAMYAYE5ZHQCQFCKTQ5NKA

neigh:

self:

id: ZY3VTECZP3T5W6MTD627H472RELRHNBTFEWQCPEGAIRLTHFDZARQ

exchpub: F73FW5FKURRA6V5LOWXABWMHLSRPUO5YW42L2I2K7EDH7SWRDAWQ

signpub: D67UXCU3FJOZG7KVX5P23TEAMT5XUUUME24G7DSDCKRAKSBCGIVQ

noisepub: 56NKDPWRQ26XT5VZKCJBI5PZQBLMH4FAMYAYE5ZHQCQFCKTQ5NKA

sendmail:

- /usr/sbin/sendmail

spool: /var/spool/nncp/alice

log: /var/spool/nncp/alice/log

NNCP создаёт исключительно Friend-to-Friend (F2F) сети, где каждый участник знает о соседях с которыми общается. Если Алисе надо контактировать с Бобом, то, предварительно, они обязаны обменяться своими публичными ключами и прописать их в конфигурационные файлы. Узлы обмениваются между собой, так называемыми, зашифрованными пакетами — неким аналогом OpenPGP. Каждый пакет явно адресован заданному участнику. Это не Peer-to-Peer (P2P), где любой может подключиться к любому и что-то отослать: это создаёт возможность Sybil атак, когда ноды злоумышленника могут вывести всю сеть из строя или, как минимум, следить за активностью участников в ней.

Простейший конфигурационный файл содержит следующие поля:

- self.id — идентификатор нашей ноды

- self.exchpub/self.exchprv и self.signpub/self.signprv — ключи используемые для создания зашифрованных пакетов

- self.noisepub/self.noiseprv — опциональные ключи используемые при общении узлов по TCP соединению

- neigh — содержит информацию обо всех известных участниках сети, «соседях». Всегда содержит запись self — в ней находятся ваши публичные данные и именно её можно смело раздавать людям, так как в ней только публичные части ключей

- spool — путь до spool-директории где находятся исходящие зашифрованные пакеты и необработанные входящие

- log — путь до журнала в котором сохраняются все выполняемые действия (отправленный файл/письмо, принятые, итд)

Боб генерирует свой файл. Обменивается с Алисой своим ключом и добавляет её в свой конфигурационный файл (Алиса делает то же самое):

alice% cat bob.yaml

self:

id: FG5U7XHVJ342GRR6LN4ZG6SMAU7RROBL6CSU5US42GQ75HEWM7AQ

exchpub: GQ5UPYX44T7YK5EJX7R73652J5J7UPOKCGLKYNLJTI4EBSNX4M2Q

exchprv: HXDO6IG275S7JNXFDRGX6ZSHHBBN4I7DQ3UGLOZKDY7LIBU65LPA

signpub: 654X6MKHHSVOK3KAQJBR6MG5U22JFLTPP4SXWDPCL6TLRANRJWQA

signprv: TT2F5TIWJIQYCXUBC2F2A5KKND5LDGIHDQ3P2P3HTZUNDVAH7QUPO6L7GFDTZKXFNVAIEQY7GDO2NNESVZXX6JL3BXRF7JVYQGYU3IA

noiseprv: NKMWTKQVUMS3M45R3XHGCZIWOWH2FOZF6SJJMZ3M7YYQZBYPMG7A

noisepub: M5V35L5HOFXH5FCRRV24ZDGBVVHMAT3S63AGPULND4FR2GIPPFJA

neigh:

self:

id: FG5U7XHVJ342GRR6LN4ZG6SMAU7RROBL6CSU5US42GQ75HEWM7AQ

exchpub: GQ5UPYX44T7YK5EJX7R73652J5J7UPOKCGLKYNLJTI4EBSNX4M2Q

signpub: 654X6MKHHSVOK3KAQJBR6MG5U22JFLTPP4SXWDPCL6TLRANRJWQA

noisepub: M5V35L5HOFXH5FCRRV24ZDGBVVHMAT3S63AGPULND4FR2GIPPFJA

sendmail:

- /usr/sbin/sendmail

alice:

id: ZY3VTECZP3T5W6MTD627H472RELRHNBTFEWQCPEGAIRLTHFDZARQ

exchpub: F73FW5FKURRA6V5LOWXABWMHLSRPUO5YW42L2I2K7EDH7SWRDAWQ

signpub: D67UXCU3FJOZG7KVX5P23TEAMT5XUUUME24G7DSDCKRAKSBCGIVQ

noisepub: 56NKDPWRQ26XT5VZKCJBI5PZQBLMH4FAMYAYE5ZHQCQFCKTQ5NKA

spool: /var/spool/nncp/bob

log: /var/spool/nncp/bob/log

Далее, Боб хочет послать файл Алисе:

bob% nncp-file -cfg bob.yaml ifmaps.tar.xz alice: 2017-06-11T15:33:20Z File ifmaps.tar.xz (350 KiB) transfer to alice:ifmaps.tar.xz: sent

и ещё и бэкап своей файловой системы, но делая через Unix-way конвейеры:

bob% export NNCPCFG=/path/to/bob.yaml bob% zfs send zroot@backup | xz -0 | nncp-file - alice:bobnode-$(date "+%Y%m%d").zfs.xz 2017-06-11T15:44:20Z File - (1.1 GiB) transfer to alice:bobnode-20170611.zfs.xz: sent

Затем он может посмотреть на то, чем загромождена его spool директория:

bob% nncp-stat

self

alice

nice: 196 | Rx: 0 B, 0 pkts | Tx: 1.1 GiB, 2 pkts

Каждый пакет, кроме информации об отправителе и получателе, содержит ещё и, так называемый, nice уровень. Это просто однобайтное число — приоритет. Почти все действия можно сопроводить ограничением на максимально допустимый уровень nice. Это аналог grade в UUCP. Используется для того, чтобы в первую очередь обрабатывать пакеты с более высоким приоритетом (меньшим значением nice), чтобы почтовые сообщения проходили не смотря на то, что в фоне пытается передаться фильм на DVD. По-умолчанию, для отправки файлов задаётся приоритет 196, который мы и видим. Rx это принятые пакеты, ещё не обработанные, а Tx это пакеты для передачи.

Пакеты зашифрованы и их целостность гарантированно проверяется. Пакеты также и аутентифицированы — достоверно известно от кого они. Почти во всех командах можно указать минимальный необходимый размер пакета — в них автоматически добавится мусор, дополняющий до нужного размера. При этом, настоящий размер полезной нагрузки скрыт от стороннего наблюдателя, зашифрован.

При передаче файлов можно указать опцию -chunked, указав ей размер кусочка на которые должен будет быть побит файл. Тут используется очень напоминающая BitTorrent схема: файл бьётся на части и добавляется meta-файл содержащий информацию о каждом кусочке, для гарантированного, с точки зрения целостности, восстановления файла. Это может быть полезно, если нужно скрыть размеры огромных файлов (как с трупом — одним куском его проблематично перетаскивать, а вот разделив на шесть частей, куда проще). Ещё полезно, когда нужно передать большие объёмы данных через накопители заведомо меньших размеров: тогда передача данных произведётся за несколько итераций.

Теперь это надо как-то передать Алисе. Один из способов — через накопитель данных, через копирование файлов на файловой системе.

Боб берёт USB flash накопитель, создаёт на нём файловую систему, запускает:

bob% nncp-xfer -mkdir /mnt/media 2017-06-11T18:23:28Z Packet transfer, sent to node alice (1.1 GiB) 2017-06-11T18:23:28Z Packet transfer, sent to node alice (350 KiB)

и получает там набор директорий со всеми исходящими пакетами для каждой известной ему ноды. Какие именно ноды «рассматривать» можно ограничить опцией -node. Опция -mkdir требуется только для первого запуска — если директории для соответствующих нод уже есть на накопителе, то они будут обработаны, а в противном случае ноды просто будут пропущены. Это удобно тем, что если флешка «ходит» только между некоторыми участниками «сети», то только пакеты для них и будут помещаться на накопитель, без необходимости постоянно указывать -node.

Вместо USB накопителя может выступать временная директория из которой будет создан ISO образ для записи на компакт-диск. Это может быть какой-то публичный FTP/NFS/SMB сервер, подмонтированный в /mnt/media директорию. Подобный NAS может быть размещён на работе или ещё где-то — лишь бы двое контактирующих участников хоть изредка но имели возможность подключиться к нему. Это может быть портативный PirateBox, по пути собирающий и раздающий NNCP пакеты. Это может USB dead drop, к которому время от времени, подключаются совершенно разные и незнакомые люди: если в целевой директории есть неизвестные ноды, то мы их игнорируем и можем только узнать о факте их существования и количестве передаваемых пакетов.

Все эти накопители и хранилища содержат только зашифрованные пакеты. Видно от кого и кому они предназначены, сколько, какого размера и приоритета. Но не более. Без приватных ключей нельзя узнать даже тип пакета (почтовое сообщение это, файл или транзитный пакет). NNCP не пытается быть анонимным.

Использование nncp-xfer не требует никаких приватных ключей: нужны только знания о соседях — их идентификаторы. Таким образом, можно отправляться в дорогу с spool директорией и минимальным конфигурационным файлом (без приватных ключей) подготовленным командой nncp-cfgmin, не боясь за компрометацию ключей. nncp-toss вызов, требующий приватных ключей, можно выполнить в любое другое удобное время. Однако, если всё же боязно за безопасность приватных ключей или даже конфигурационного файла, где все ваши соседи перечислены, то можно использовать утилиту nncp-cfgenc, позволяющую его зашифровать. В качестве ключа шифрования используется парольная фраза введённая с клавиатуры: в зашифрованном файле есть соль, пароль усиливается CPU и memory hard алгоритмом Balloon, поэтому, имея хорошую парольную фразу, можно особо не беспокоиться о компрометации (кроме паяльника).

Алисе достаточно выполнить команду чтобы скопировать предназначенные для неё файлы в свою spool директорию:

alice% nncp-xfer /mnt/media

2017-06-11T18:41:29Z Packet transfer, received from node bob (1.1 GiB)

2017-06-11T18:41:29Z Packet transfer, received from node bob (350 KiB)

alice% nncp-stat

self

bob

nice: 196 | Rx: 1.1 GiB, 2 pkts | Tx: 0 B, 0 pkts

Мы видим, что у неё появились необработанные (Rx) пакеты в spool директории. Однако, не всё так просто. У нас хоть и сеть друзей (F2F), доверяй, но проверяй. Вы должны явно разрешить заданной ноде отправлять вам файлы. Для этого Алиса должна добавить в раздел Боба конфигурационного файла указание куда помещать передаваемые от него файлы.

bob: id: FG5U7XHVJ342GRR6LN4ZG6SMAU7RROBL6CSU5US42GQ75HEWM7AQ exchpub: GQ5UPYX44T7YK5EJX7R73652J5J7UPOKCGLKYNLJTI4EBSNX4M2Q signpub: 654X6MKHHSVOK3KAQJBR6MG5U22JFLTPP4SXWDPCL6TLRANRJWQA noisepub: M5V35L5HOFXH5FCRRV24ZDGBVVHMAT3S63AGPULND4FR2GIPPFJA incoming: /home/alice/bob/incoming

После этого, нужно запустить обработку входящих зашифрованных пакетов командой nncp-toss (аналогично tosser-у в FidoNet):

alice% nncp-toss 2017-06-11T18:49:21Z Got file ifmaps.tar.xz (350 KiB) from bob 2017-06-11T18:50:34Z Got file bobnode-20170611.zfs.xz (1.1 GiB) from bob

Эта команда имеет опцию -cycle, позволяющая ей висеть в фоне и регулярно проверять и обрабатывать spool директорию.

Кроме отправки файлов, есть возможность и запроса на передачу файла. Для этого, необходимо в конфигурационном файле явно прописать freq (file request) запись для каждой ноды из какой директории можно запрашивать файлы:

bob: id: FG5U7XHVJ342GRR6LN4ZG6SMAU7RROBL6CSU5US42GQ75HEWM7AQ exchpub: GQ5UPYX44T7YK5EJX7R73652J5J7UPOKCGLKYNLJTI4EBSNX4M2Q signpub: 654X6MKHHSVOK3KAQJBR6MG5U22JFLTPP4SXWDPCL6TLRANRJWQA noisepub: M5V35L5HOFXH5FCRRV24ZDGBVVHMAT3S63AGPULND4FR2GIPPFJA incoming: /home/alice/nncp/bob/incoming freq: /home/alice/nncp/bob/pub

теперь Боб может сделать запрос на файл:

bob% nncp-freq alice:pulp_fiction.avi PulpFiction.avi 2017-06-11T18:55:32Z File request from alice:pulp_fiction.avi to pulp_fiction.avi: sent bob% nncp-xfer -node alice /mnt/media

а Алиса, после обработки входящих сообщений, автоматически ему отправит запрошенный файл:

alice% nncp-toss 2017-06-11T18:59:14Z File /home/alice/nncp/bob/pub/pulp_fiction.avi (650 MiB) transfer to bob:PulpFiction.avi: sent 2017-06-11T18:59:14Z Got file request pulp_fiction.avi to bob

Нет функционала по отправке списка файлов, но о нём всегда можно договориться пользователям, например, сохранив вывод ls -lR в ls-lR файле корневой директории.

Теперь, представим, что Алиса и Боб знают Еву (но эта Eve хорошая, не плохая криптографическая, ведь у нас же сеть друзей), однако Алиса не имеет прямого контакта с ней. Они живут в разных городах и только Боб курирует между ними время от времени. В NNCP поддерживаются транзитные пакеты, устроенные аналогично луковичному шифрованию в Tor: Алиса может создать зашифрованный пакет для Евы, и поместить его в ещё один зашифрованный пакет для Боба, с указанием, что его надо переслать Еве. Длина цепочки не ограничена и промежуточный участник знает только предыдущее и последующее звено цепи, не зная настоящего отправителя и получателя.

Указание транзитного пути задаётся записью via в ноде. Например Алиса хочет сказать что Ева доступна через Боба:

bob: id: FG5U7XHVJ342GRR6LN4ZG6SMAU7RROBL6CSU5US42GQ75HEWM7AQ exchpub: GQ5UPYX44T7YK5EJX7R73652J5J7UPOKCGLKYNLJTI4EBSNX4M2Q signpub: 654X6MKHHSVOK3KAQJBR6MG5U22JFLTPP4SXWDPCL6TLRANRJWQA noisepub: M5V35L5HOFXH5FCRRV24ZDGBVVHMAT3S63AGPULND4FR2GIPPFJA eve: self: id: URVEPJR5XMJBDHBDXFL3KCQTY3AT54SHE3KYUYPL263JBZ4XZK2A exchpub: QI7L34EUPXQNE6WLY5NDHENWADORKRMD5EWHZUVHQNE52CTCIEXQ signpub: KIRJIZMT3PZB5PNYUXJQXZYKLNG6FTXEJTKXXCKN3JCWGJNP7PTQ noisepub: RHNYP4J3AWLIFHG4XE7ETADT4UGHS47MWSAOBQCIQIBXM745FB6A via: [bob]

Как конкретно Ева контактирует с Бобом Алисе не известно и нет необходимости знать: как-то сообщения до неё должны дойти и Боб видит только факты отправки транзитного трафика. Исходящее сообщение до Евы у Боба создаётся автоматически nncp-toss-ом после обработки сообщения от Алисы.

Если речь идёт о хорошей безопасности, то для этого нужно использовать компьютеры с воздушным зазором (air-gapped) — не подключённые к сетям передачи данных, в идеале имеющих, например, только CD-ROM/RW. А «перед» ними находится компьютер в который втыкаются флешки или трафик от других нод: на нём можно убедиться что флешки не содержат ничего вредоносного, и, если он подключён к Интернету или другой сети, то уязвимости ОС не могут скомпрометировать air-gapped компьютер. На подобную ноду приходят только транзитные пакеты, которые породят исходящие сообщения для air-gapped компьютера записываемые на компакт-диск.

Если в конфигурационный файл добавить раздел:

notify:

file:

from: nncp@bobnode

to: bob+file@example.com

freq:

from: nncp@bobnode

to: bob+freq@example.com

то на почту bob+file@example.com будут отправляться уведомления о переданных файлах, а на bob+freq@example.com уведомления о запрошенных файлах.