Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[recovery mode] По щучьему велению… (язык программирования Pike) |

Краткие характеристики:

— интерпретируемый (не будете думать чем бы заняться во время компиляции);

— cинтаксис: основанный на С (с минимальными отличиями);

— лицензия — GNU GPL, GNU LGPL and MPL;

— объектно-ориентированный;

— со сборщиком мусора (которому кстати, можно подсказывать если очень надо);

— …

История

Язык появился еще 1994 году. Автор Fredrik H"ubinette. Предшественником считатся язык LPC (объектно-ориентированный язык на иснове языка C, созданный прежде всего для разработки игр — LPC Тут на самом деле интересная история — но копипастить вики не имеет смысла. Короче говоря, если бы не игры, не было бы языка.

Скажу сразу — с документацией не все в порядке. Далеко не все примеры (даже для новичков) будут работать (причем это может быть даже Hello world!).

Для начала работы можете запустить интерпретатор. Для этого можно просто набрать pike в консоли без параметров. И экспериментировать. Но мы так делать не будем. Давайте просто попишем (например, в блокноте).

Привет, мир!

Текст программы:

int main()

{

write("Hello world!\n");

return 0;

}

Сохраняем этот текст в hello.pike и запускаем в коммандной строке: pike hello.pike

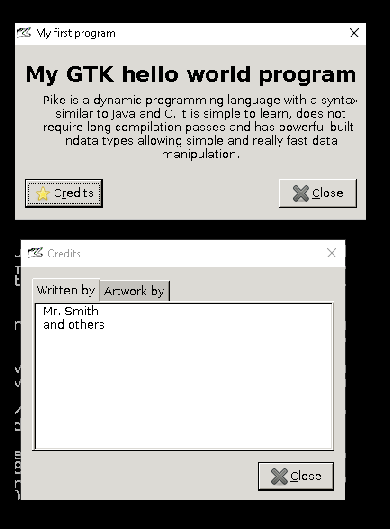

Теперь с окошечком:

int main()

{

GTK.setup_gtk();

object w = GTK.AboutDialog();

w.set_program_name("My GTK hello world program");

w.signal_connect("destroy", lambda(){exit(0);});

w.set_title("My first program");

w.set_comments("Pike is a dynamic programming language with a syntax similar to Java and C. "+

"It is simple to learn, does not require long compilation passes and has powerful built-in" +

"data types allowing simple and really fast data manipulation.");

array(string) arr1=({"Mr. Smith", "and others"});

array(string) arr2=({"Mrs. Smith", "and others"});

w.set_authors(arr1);

w.set_artists(arr2);

w.show_now();

return -1;

}

Как видим, работа идет через GTK. Возврат -1 из функкции main нужно для того чтобы программа сразу не прекратила работу, иначе окошечка не увидите. Выход и программы происходит по кнопке закрытия окна с помощью прикрепленной лямбда-функции lambda(){exit(0);}

В официальном туториале для этого применяют GTK.Alert(«Hello world!»), но однако у меня такое не заработало (версия 8.0) — видимо туториал устарел.

Структуры данных:

Синтаксис работы с основными структурами данных радует.

Массивы:

int main()

{

array(string) arr1 = ({ "red", "green", "white" });

write(arr1);

write("\n");

array(string) arr2 = ({ "red", "green", "yellow" });

write(arr2);

write("\n");

write(arr2 + arr1); //просто все элементы двух массивов

write("\n");

write(arr2 & arr1); //пересечение

write("\n");

write(arr2 | arr1); //объединение множеств

write("\n");

write(arr2 ^ arr1); //xor - т.е. только те элементы которые не являются общими

write("\n");

write(arr2 - arr1); //разность

write("\n");

return 0;

}

Результат:

redgreenwhite

redgreenyellow

redgreenyellowredgreenwhite

redgreen

redgreenyellowwhite

yellowwhite

yellow

Maps:

int main()

{

mapping map2 = (["red":4, "white":42, "blue": 88]);

mapping map1 = (["red":4, "green":8, "white":15]);

print_map(map2 + map1);

print_map(map2 - map1);

print_map(map2 & map1);

print_map(map2 | map1);

print_map(map2 ^ map1);

return 0;

}

void print_map(mapping m){

array(string) arr;

arr = indices(m);

foreach(arr, string key){

write(key + ":" + m[key] + " ");

write("\n");

}

Результат:

red:4 green:8 white:15 blue:88

blue:88

red:4 white:15

red:4 white:15 green:8 blue:88

green:8 blue:88

Есть еще так называемые multiset. По сути тоже что mapping, но без значений:

int main(){

multiset o = (< "", 1, 3.0, 1, "hi!" >);

print_multiset(o);

return 0;

}

void print_multiset(multiset m){

array(string) arr;

arr = indices(m);

foreach(arr, string key){

write(key + ":" + m[key] + " ");

};

write("\n");

}

Результат:

1:1 1:1 3.0:1 :1 hi!:1

Объекты

class car {

public string color;

public string mark;

private string driver;

void create(string c, string m, string d){

color = c;

mark = m;

driver = d;

}

string who(){

return mark + " " + color + "\n";

}

}

int main(){

car car1 = car("red", "vaz", "Mike");

write(car1.who());

car car2 = car("green", "mers", "Nik");

write(car2.who());

write(car2.mark);

return 0;

}

Результат:

vaz red

mers green

mers

Метод create играет роль конструктора. Есть и модификаторы доступа. Но будьте осторожны с модификатором static. Мало того что он означает совсем не то, что вы подумали — он еще и depricated.

Связь с Java

А теперь дернем код Java (а почему и нет если можем?):

int main()

{

float pi = Java.pkg.java.lang.Math.PI;

write("Pi = " + pi + "\n");

object syst = Java.pkg.java.lang.System;

write("time = " + syst.currentTimeMillis() + "\n");

object str = Java.pkg.java.lang.String("...Hello!...");

write((string)str.substring(3,str.length()-3) + "\n");

object map2 = Java.pkg.java.util.HashMap();

object key = Java.pkg.java.lang.String("oops");

object val = Java.pkg.java.lang.String("ha-ha");

map2.put(key, val);

write((string) map2.get("oops") + "\n");

object map = Java.JHashMap(([ "one":1, "two":2 ]));

write((string) map.get("two") + "\n");

return 0;

}

Как видно из примера, обращение к классам Java идет через Java.pkg. При печати надо не забывать приводить объекты Java к строке с помощью (string). Можно вызывать обычные методы Java. Как видно из примера, для HashMap есть даже специальная конструкция для облегчения работы (что, впрочем, неудивительно).

Работа с интернетом

Скачаем страничку с интернета и выведем в консоль:

int main()

{

Protocols.HTTP.Query web_page;

web_page = Protocols.HTTP.get_url("https://pike.lysator.liu.se/about/");

string page_contents = web_page->data();

write(page_contents);

return 0;

}

Щука помнит об СССР:

int main(){

Geography.Countries.Country c = Geography.Countries.USSR;

write(c.name + "\n");

return 0;

}

Заключение

Мое личное мнение — любопытный язык, но очень сырой. Или можно его рассматривать как язык, созданный под конкретный проект. Документация очень хромает. Но пусть растут все цветы.

Ссылки

-> Главная

-> Википедия (англ)

-> Статья об языке

-> github

-> Roxen (веб-сервер на Pike)

|

Метки: author nemavasi программирование pike java |

[recovery mode] Без правок. Как стать самым счастливым дизайнером на планете |

Три месяца назад я проектировал корпоративный сайт. Имея хороший опыт, я подошел к задаче серьезно: провел аудит отрасли, определил цели бизнеса, описал задачи пользователей и на основе всего этого создал приятный и удобный интерфейс. Но, несмотря на все старания, мой дизайн был отвергнут. Я получил длинный список правок, расстроился и, чтобы не написать чего лишнего, закрыл ноутбук и отправился на улицу.

Свежий столичный воздух подействовал, и я начал понимать, в чем дело. Дизайн был хорош, да и заказчик вполне адекватен. Проблема, с которой, как оказалось сталкиваются тысячи дизайнеров по всему миру, была в другом.

Ошибка дизайнера

На старте карьеры, получая список правок, я сразу же приступал к редактированию макетов, после чего отправлял их обратно. Итогом подобной коммуникации становились недоработанные интерфейсы и диалоги следующего содержания:

— Это полная херня!

— Но я же все сделал, как вы сказали!

— Ты дизайнер. Не я должен тебе говорить, что делать и как.

— :(

Прошло немало времени, прежде чем я понял, что подобные конфликты никак не связаны с качеством макетов и личностью клиента, ведь год за годом уровень моих работ повышался, появлялись новые заказчики, но подобные диалоги все еще возникали. Поняв, что дело в другом, я посмотрел на эту ситуацию со стороны и увидел то, что многие упускают при работе с клиентом.

Эффективные коммуникации

Примерно в тоже время я дочитывал отличную книгу «Сожги свое портфолио», автор которой утверждал, что нетворкинг и коммуникации влияют на успех не меньше, чем качество работ. Эти слова вместе с личным опытом заставили меня посмотреть на процесс работы с клиентом по-новому.

Поставив себя на место клиента, я кое-что понял. Он же ничего не понимает в дизайне, а лишь ждет wow-эффекта от нашей работы, но когда получает статические макеты, большая часть которых состоит из белого пространства, замирает в недоумении.

Чтобы избежать этого, я с самого начала объясняю заказчику, что суть работы дизайнера не в создании спецэффектов, а в решении проблем бизнеса. Второе, о чем важно упомянуть — каждое визуальное решение основано не на вкусовом предпочтении дизайнера, а на понимании целевой аудитории сервиса. Зафиксировав это вначале, клиент будет понимать, что дизайнеры — это не потомки великих художников, а, как минимум, люди, использующие факты и логику. Осознав это, заказчик будет оценивать вашу работу через призму проблем бизнеса, а не визуальных ожиданий.

После этого я перестал отправлять макеты по почте. Идеальный вариант — личная встреча или хотя бы звонок. У клиента обязательно возникнут вопросы, на которые вы должны аргументированно ответить, показав свою подготовленность. А если вас не будет рядом, то вместо аргументированных ответов, клиент сделает ошибочные выводы, которые уведут ваше общение в сторону мелких деталей, обсуждение которых может затянуться и отдалить вас от главной цели.

Не рекомендую отправлять ссылку на прототип в InVision, поскольку возможность оставлять комментарии в один клик принесет вам огромный список порой неадекватных вопросов и опять же уведет от главной задачи.

Отличный вариант — видео. Продемонстрируйте основной путь пользователя от захода на сервис до целевого результата. Клиент получит ожидаемый wow-эффект и сразу увидит, как ваше решение упрощает использование продукта.

Как отправить макеты по почте и не облажаться

Бывают случаи, когда все-таки приходится отправлять макеты по почте. В этом случае я могу посоветовать несколько вещей:

— Обязательно описывайте процесс вашей работы. Почему вы сделали так, а не по-другому. Почему эта кнопка должна находиться именно здесь, почему она красного цвета и так далее. Это покажет, что каждое ваше решение обосновано.

— Отправьте видео. Очень просто создать анимацию в Principle, посложнее во Framer и After Effects. Было время, я создавал презентацию проекта в Apple Keynote (проект приняли).

— Перед отправкой макетов ответьте на простые вопросы, которые помогут избежать банальных ошибок. Ясна ли главная цель пользователя на каждой странице? Останавливается ли взгляд на нужных элементах и в нужной последовательности? Соблюдена ли визуальная иерархия? Соответствует ли визуальный вес элементов их роли в интерфейсе? Нет ли орфографических или пунктуационных ошибок?

— Ну и, напоследок, перечитайте задание и сверьте его с решением.

Когда я начал использовать эти методы, мои работы стали чаще принимать без правок, вследствие чего возросла уверенность и удовлетворенность работой, что для дизайнера и есть счастье.

Еще одна вещь

Вспомните начало статьи. Клиент не доволен работой, а дизайнер считает упреки необоснованными. Почему такое происходит? Почему два профессионала своего дела конфликтуют? Быть может, потому что они попросту не понимают друг друга? Вполне может быть.

Клиент не понимает суть работы дизайнера, в то время, как дизайнер, получая странные вопросы, считает клиента неадекватным. В итоге два вроде бы разумных человека конфликтуют.

А ведь такие случаи происходят регулярно. Вспомните истории, когда многолетняя дружба рушится, расходятся пары, судятся партнеры по бизнесу, начинаются войны. Вспомните об этом, когда у вас не ладится разговор. Не важно с кем. Быть может вы, как заказчик с дизайнером, просто не понимаете друг друга. Просто не слышите. А ведь это так отделяет нас от того к чему мы так стремимся — счастью.

Отличной недели!

Илья

|

Метки: author iskros прототипирование интерфейсы дизайн мобильных приложений графический дизайн веб-дизайн дизайн нетворкинг проектирование карьера |

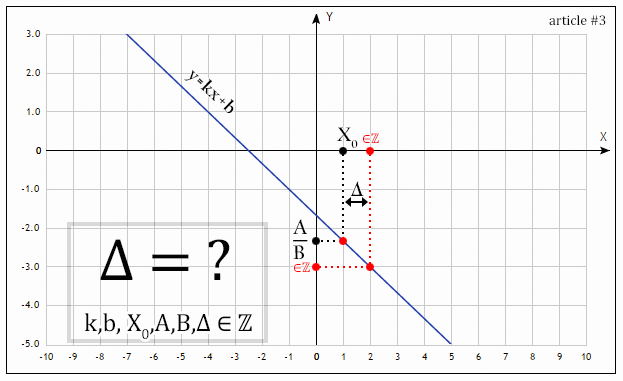

Решение линейных диофантовых уравнений с любым числом неизвестных |

Здравствуйте, уважаемые читатели!

Продолжаю серию дилетантских статей о математике.

Сегодня предлагаю поразмышлять над некоторой интересной математической задачкой.

А именно, давайте-ка для разминки решим следующее линейной уравнение:

«Чего сложного?» — спросите вы. Действительно, лишь одно уравнение и целых четыре неизвестных. Следовательно, три переменных есть свободные, а последняя зависит от оных. Так давайте выразим скорее! Например, через переменную , тогда множество решений следующее:

где — множество любых действительных чисел.

Что же, решение действительно оказалось слишком тривиальным. Тогда будем нашу задачу усложнять и делать её более интересной.

Вспомним про линейные уравнения с целыми коэффициентами и целыми корнями, которые, собственно, являются разновидностью диофантовых уравнений. Конкретно — наложим на наше уравнение соответствующие ограничение на целочисленность коэффициентов и корней. Коэффициенты при неизвестных у нас и так целые (), а вот сами неизвестные необходимо ограничить следующим:

где — множество целых чисел.

Теперь решение, полученное в начале статьи, «не проканает», так как мы рискуем получить как рациональное (дробное) число. Так как же решить это уравнение исключительно в целых числах?

Заинтересовавшихся решением данной задачи прошу под кат.

А мы с вами продолжаем. Попробуем произвести некоторые элементарные преобразования искомого уравнения:

Задача выглядит по-прежнему непонятной, в таких случаях математики обычно производят какую-нибудь замену. Давайте и мы с вами её бахнем:

Опа, мы с вами достигли интересного результата! Коэффициент при у нас сейчас равен единице, а это значит, что мы с вами можем выразить эту неизвестную через остальные неизвестные в этом уравнении без всяких делений (чем грешили в самом начале статьи). Сделаем это:

Обращу внимание, что это говорит нам о том, что какие бы не были (в рамках диофантовых уравнений), всё равно останется целым числом, и это прекрасно.

Вспоминая, что справедливо говорить, что . А подставив заместо полученный выше результат получим:

Тут мы также видим, что что какие бы не были , всё равно останется целым числом, и это по-прежнему прекрасно.

Тогда в голову приходит гениальная идея: так давайте же объявим как свободные переменные, а будем выражать через них! На самом деле, мы уже это сделали. Осталось только записать ответ в систему решений:

Теперь можно лицезреть, что в системе решений нигде нет деления, а это значит, что всегда решения будут целочисленными. Попробуем найти частное решение исходного уравнения, положив, к примеру, что :

Подставим в исходное уравнение:

Тождественно, круто! Давайте попробуем ещё разок на другом примере?

Тут мы видим отрицательный коэффициент, он может доставить нам изрядных проблем, так что давайте от греха избавимся от него заменой , тогда уравнение будет следующим:

Как мы помним, наша задача сделать такие преобразования, чтобы в нашем уравнении оказалась неизвестная с единичным коэффициентом при ней (чтобы затем выразить её через остальные без любого деления). Для этого мы должны снова что-нибудь взять «за скобку», самое быстрое — это брать числа которые самые близкие к единице:

Введем замену , тогда получим:

Вновь возьмем за скобку и наконец получим в уравнении неизвестную с единичным коэффициентом:

Введем замену , тогда:

Выразим отсюда нашу одинокую неизвестную :

Из этого следует, что какие бы мы не взяли, все равно останется целым числом. Тогда найдем из соотношения :

Аналогичным образом найдем из соотношения :

На этом наша система решений созрела — мы выразили абсолютно все неизвестные, не прибегая к делению, тем самым показывая, что решение точно будет целочисленным. Также не забываем, что , и нам надо ввести обратную замену. Тогда окончательная система решений следующая:

Таким образом, осталось ответить на вопрос — а любое ли подобное уравнение можно так решить? Ответ: нет, если уравнение в принципе нерешаемо. Такое возникает в тех случаях, если свободный член не делится нацело на НОД всех коэффициентов при неизвестных. Иными словами, имея уравнение:

Для его решения в целых числах необходимо выполнение следующего условия:

(где — наибольший общий делитель).

Резюмируя вышесказанное, выпишем алгоритм действий для решения линейных диофантовых уравнений с любым числом неизвестных:

- Проверяем, а решаемо ли уравнение вообще (вышеописанным свойством ). Если ответ положительный — переходим к следующему пункту.

- Для ускорения процесса поделим все коэффициенты (включая свободный член) на их .

- Избавляемся от отрицательных коэффициентов в уравнении заменой

- Проводим серию замен (разваливая некоторые члены уравнения на суммы и объединяя их в скобки) таким образом, чтобы в конце концов один из членов уравнения был с единичным коэффициентов, и мы смогли вывести его без какого либо деления. Объявляем все переменные,

через которые выражена оная, как свободные. - Выводим остальные переменные через вышевыведенную (выводим из всех наших замен), не забывая также про обратные замены.

- Объединяем все в единую систему решений.

В заключение стоит сказать, что также можно добавить ограничения на каждый член уравнения в виде неравенства на оного (тогда к системе решений добавляется система неравенств, в соответствии с которой нужно будет скорректировать ответ), а также добавить ещё чего-нибудь интересное.

С вами был Петр,

спасибо за внимание.

|

Метки: author ParadoxFilm математика диофантовы уравнения целые числа уравнение полином решение |

Redux: попытка избавиться от потребности думать во время запросов к API, часть 2 |

Мы хотим создать пакет, который позволит нам избавиться от постоянного создания однотипных reducer'ов и action creator'ов для каждой модели, получаемой по API.

Первая часть — вот эта вот статья. В ней мы создали конфиг для нашего будущего пакета и выяснили, что он должен содержать action creator, middleware и reducer. Приступим к разработке!

Action Creator

Начнем мы с самого простого — action creator'а. Тут наш вклад будет минимальным — нам нужно просто написать традиционный action creator для redux-api-middleware с учетом нашего конфига.

Для получения юзеров он должен выглядеть приблизительно так:

import {CALL_API} from 'redux-api-middleware';

const get = () => ({

[CALL_API]: {

endpoint: 'mysite.com/api/users',

method: 'GET',

types: ['USERS_GET', 'USERS_SUCCESS', 'USERS_FAILURE']

}

});В action можно добавить еще headers, credentials. Если запрос успешен, то мы получаем USERS_SUCCESS, и у него в action.payload лежат полученные по API данные. Если произошла ошибка, — получаем USERS_FAILURE, у которого в action.errors лежат ошибки. Все это подробно описано в документации.

В дальнейшем, для простоты рассуждений, будем считать, что данные в payload уже нормализованы. Нас интересует, как можно модернизировать наш creator для получения всех сущностей. Все довольно просто: для того, чтоб возвращать нужные сущности, передаем в creator название этой сущности:

import {CALL_API} from 'redux-api-middleware';

const initGet = (api) => (entity) => ({

[CALL_API]: {

endpoint: api[entity].endpoint, // endpoint мы будем брать из конфига

method: 'GET',

types: api[entity].types // и actions мы будем брать из конфига

}

});Еще необходимо добавить фильтрацию ответа сервера по GET-параметрам, чтоб мы могли ходить только за нужными данными и не тащить ничего лишнего. Я предпочитаю передавать GET-параметры в качестве словаря и сериализовать их отдельным методом objectToQuery:

import {CALL_API} from 'redux-api-middleware';

const initGet = (api) => (entity, params) => ({

[CALL_API]: {

endpoint: `${api[entity].endpoint}${objectToQuery(params)}`,

method: 'GET',

types: api[entity].types

}

});Инициализируем сам creator:

const get = initGet(config.api);Теперь, вызывая с нужными аргументами метод get, мы отправим запрос о необходимых данных. Теперь надо позаботиться о том, как полученные данные хранить — напишем reducer.

Reducer

Точнее, два. Один будет класть в store сущности, а другой — время их прихода. Хранить их в одном месте — плохая идея, ведь тогда мы будем смешивать чистые данные с локальным состоянием приложения на клиенте (ведь время прихода данных у каждого клиента свое).

Тут нам понадобятся те же successActionTypes и react-addons-update, который обеспечит иммутабельность store. Тут нам надо будет пройтись по каждой сущности из entities и сделать отдельный $merge, то есть, совместить ключи из defaultStore и receivedData.

const entitiesReducer = (entities = defaultStore, action) => {

if (action.type in successActionTypes) {

const processedData = {};

const receivedData = action.payload.entities || {};

for (let entity in receivedData) {

processedData[entity] = { $merge: receivedData[entity] };

}

return update(entities, processedData);

} else {

return entities;

}

};Аналогично для timestampReducer, но там мы будем устанавливать текущее время прибытия данных в store:

const now = Date.now();

for (let id in receivedData[entity]) {

entityData[id] = now;

}

processedData[entity] = { $merge: entityData };schema или lifetime, successActionTypes понадобятся нам при инициализации — аналогичный код мы писали в action creator'е.

Чтоб получить defaultState, сделаем так:

const defaultStore = {};

for (let key in schema) { // или lifetime, для второго reducer'а

defaultStore[key] = {};

}successActionTypes можно получить из конфига api:

const getSuccessActionTypes = (api) => {

let actionTypes = {};

for (let key in api) {

actionTypes[api[key].types[1]] = key;

}

return actionTypes;

};Это, конечно, задача простая, но один такой простой reducer сэкономит нам кучу времени на написании своего reducer'а для каждого типа данных.

Рутинная работа закончена — перейдем к основному компоненту нашего пакета, который и будет заботиться о том, чтоб ходить только за теми данными, которые реально нужны, и при этом не заставлять нас думать об этом.

Middleware

Напомню, что мы считаем, что к нам приходят сразу нормализованные данные. Тогда в middleware мы должны пройтись по всем данным, полученным в entities, и собрать список id отсутствующих связанных сущностей, и сделать запрос к API за этими данными.

const middleware = store => next => action => {

if (action.type in successActionTypes) { // Если это action, в котором пришли данные

const entity = successActionTypes[action.type]; // Определяем тип данных

const receivedEntities = action.payload.entities || {};; // Достаем пришедшие сущности

const absentEntities = resolve(entity, store.getState(), receivedEntities); // Находим отсутствующие

for (let key in absentEntities) {

const ids = absentEntities[key]; // Получаем список id отсутствующих

if (ids instanceof Array && ids.length > 0) { // Если список не пустой

store.dispatch(get(key, {id: ids})); // Отправляем action, который идет за этими и только этими данными

}

}

}

return next(action);

}successActionTypes, resolve и get нужно передавать middleware при инициализации.

Осталось только реализовать метод resolve, который будет определять, каких данных не хватает. Это, пожалуй, самая интересная и важная часть.

Для простоты мы будем считать, что в store.entities хранятся наши данные. Можно и это вынести как отдельный пункт конфига, и присоединять туда reducer, но на данном этапе это неважно.

Мы должны вернуть abcentEntities — словарь такого вида:

const absentEntities = {users: [1, 2, 3], posts: [107, 6, 54]};Где в списках хранятся id отсутствующих данных. Чтоб определить, каких данные отсутствуют, нам и пригодятся наши schema и lifetime из конфига.

Вообще, по foreign key может лежать и список id, а не один id — никто не отменял many-to-many и one-to-many relations. Это нам надо будет учесть, проверив тип данных по foreign key, и, если что, сходить за всеми из списка.

const resolve = (type, state, receivedEntities) => {

let absentEntities = {};

for (let key in schema[type]) { // проходим по всем foreign key полученных

const keyType = schema[typeName][key]; // Получаем тип foreign key

absentEntities[keyType] = []; // Инициализируем будущий список отсутствующих

for (let id in receivedEntities[type]) { // Проходим по всем полученным сущностям

// Проверка на список

let keyIdList = receivedEntities[type][id][key];

if (!(keyIdList instanceof Array)) {

keyIdList = [keyIdList];

}

for (let keyId of keyIdList) {

// Проверяем, есть ли id в store

const present = state.entities.hasOwnProperty(keyType) && state.entities[keyType].hasOwnProperty(keyId);

// Проверяем, есть ли он в receivedEntities

const received = receivedEntities.hasOwnProperty(keyType) && receivedEntities[keyType].hasOwnProperty(keyId);

// Проверяем, не просрочены ли данные?

const relevant = present && !!lifetime ? state.timestamp[keyType][keyId] + lifetime[keyType] > Date.now() : true;

// Если он получен в данном action, или лежит в store и актуален, класть его в absent нет смысла

if (!(received || (present && relevant))) {

absentEntities[keyType].push(keyId);

}

}

}

};Вот и все — немного головоломной логики и рассмотрения всех случаев, и наша функция готова. При инициализации надо не забыть передать в нее schema и lifetime из конфига.

Заключение

В целом, все уже работает, если мы примем такие допущения:

- Можно обойтись без тестирования.

- Никто и никогда не допустит ошибку в конфигах.

- Данные приходят в middleware уже нормализованными.

Все эти пункты (особенно первый!) необходимо тщательно проработать, и мы это сделаем в третьей части. Но это уже не так интересно, ведь почти весь код, выполняющий нашу цель, уже написан, поэтому для тех, кто захочет просто посмотреть и потестить самостоятельно, привожу ссылки:

|

Метки: author geoolekom разработка веб-сайтов reactjs javascript api es6 redux react |

Наивно. Супер. Рецензия на книгу Джина Желязны «Говори на языке диаграмм» |

Книга "Say It With Chart" (дословно «Скажи это с помощью диаграммы») написана более 30-ти лет назад (в 1985 году!), однако и сегодня пользуется интересом. Она переведена на главные мировые языки, переиздается вновь и вновь, бизнесмены, маркетологи, аналитики считают её настольной книгой и в 2017-м.

Книгу интересно читать, в ней много полезного, но это было ожидаемо. Неожиданностью стал недостаток информации о её авторе в сети (которому принадлежит еще несколько мировых бестселлеров). О Джине Желязны нет статьи в Википедии (ни на английском, ни на русском), на запросы типа «биография Дж. Желязны» или «кто такой Дж. Желязны» выдаются бесчисленные сайты с одним и тем же текстом — аннотацией к книге «Говори на языке диаграмм». А это, согласитесь, только усиливает интерес, поэтому рецензия будет состоять из двух частей: «О книге» и «Кто такой Джин Желязны?».

О книге

В книге показано, как эффективно передать информацию в визуальной форме с помощью различных диаграмм, графиков и схем. Автор именно «показывает», а не просто рассказывает. Книга читается легко и на одном дыхании, потому что 80% информации в ней — это изображения — рисунки, диаграммы всех видов, примеры «хорошо и плохо», графики и таблицы. И всего около 20% объема книги — это текст — правила, примеры из практики, советы, выводы. То есть слово «пособие» в названии использовано абсолютно оправданно.

Главная идея сформулирована в самом начале:

«Работа над любой презентацией начинается с определения того, что вы хотите сказать. И лишь потом — выбор формы диаграммы и рисунка».К этой мысли автор возвращает читателя на протяжении всей книги. Этим фактом объясняется успех книги: несмотря на то, что она написана очень давно и технологии визуализации данных шагнули далеко вперед, подход и способы остаются актуальными. Желязны признается:

«Не всегда было так, как сейчас. Я пришел в сферу визуальных коммуникаций в 1961 году до нашей эры. То есть до эры компьютеров, вычислительных и копировальных машин».В оригинале используется игра слов: «It wasn’t always like that. I entered the field of visual communications in the year 1961 B.C. That’s Before Computers, Before Calculators, Before Copiers». B.C. = Before Christ = до рождества Христова, то есть до н.э. Before Computers, Before Calculators, Before Copiers.

Поэтому идея о том, что в коммуникации необходимо отталкиваться от природных способностей, особенностей мышления и восприятия человека, не устаревает. «Широкое распространение компьютерных технологий привело к тому, что слайды пекутся как пирожки… Пресные и невкусные. Не сформулировав то, что вы хотите сказать, не беритесь за карандаш», — говорится в работе.

Пособие по визуальным коммуникациям состоит из 4-х частей: выбор диаграмм, использование диаграмм, концепции и метафоры в презентации (решения в поисках проблемы) и sayit.com (использование компьютерных технологий в представлении данных).

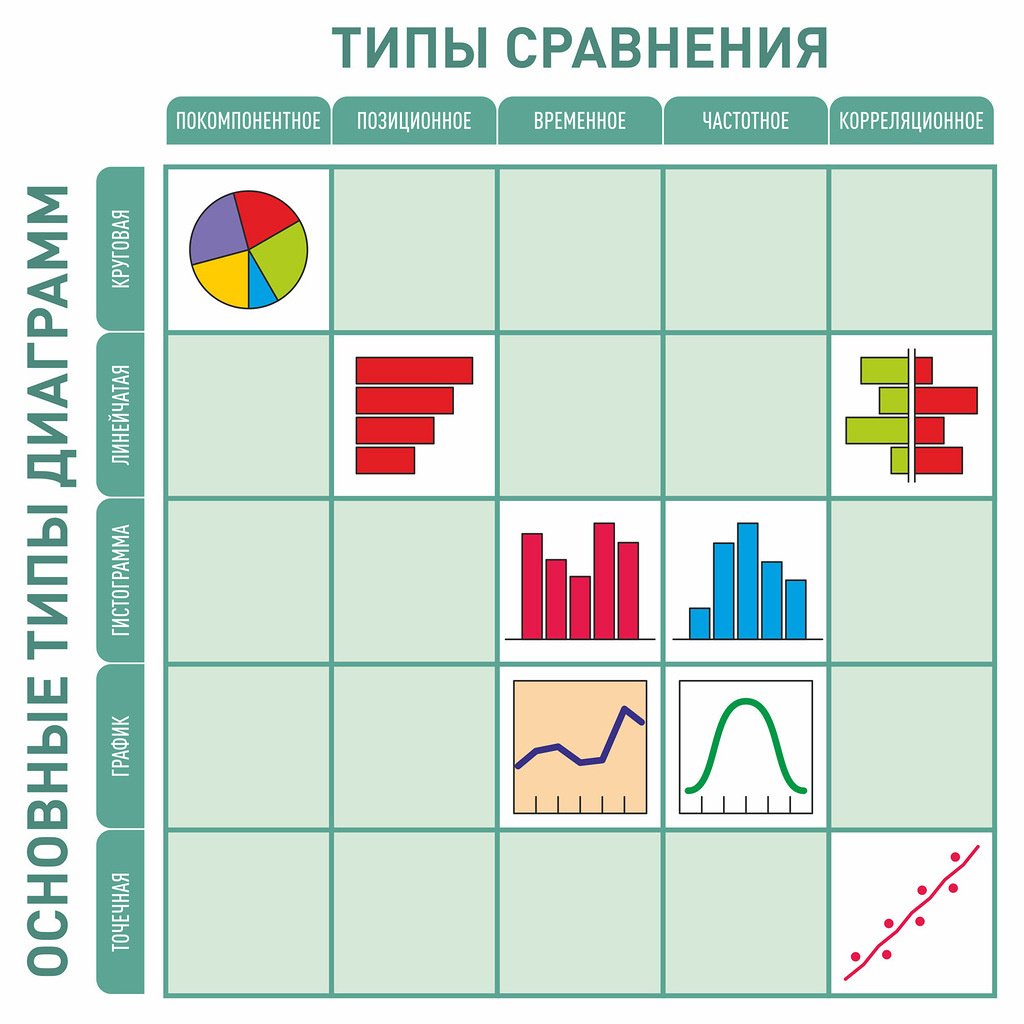

Часть I — описание процесса преобразования данных в диаграммы. Читателю предлагается пройти следующий путь:

- «отталкиваясь» от фактических данных сформулировать идею,

- затем определить тип сравнения (все идеи могут быть показаны с помощью 5-ти типов сравнений),

- исходя из типа сравнения, выбрать тип диаграммы.

Джин Желязны уточняет:

«Тип диаграммы определяют вовсе не данные (доллары или проценты) и не те или иные параметры (прибыль, рентабельность или зарплата), а ваша идея — то, что вы хотите в диаграмму вложить».

Формулировка того, что вы хотите сказать, должна быть краткой и четкой. Главный посыл — заголовок презентации или диаграммы — сравним с заголовком статьи в газете или журнале. Ошибочны заголовки диаграмм типа «Количество контрактов, заключенных с января по август» (констатируют факт, вывод нужно делать зрителям самостоятельно). Хороший заголовок должен указывать на суть изображения, например, «Количество контрактов выросло» (констатируют вывод).

Любая идея может быть передана с помощью одного из 5-ти типов сравнения, удобным инструментом является выбор нужной диаграммы по ключевым словам (по формулировке того, что необходимо донести до аудитории, зрителей).

В п. 1.3. первой части «Выбор диаграмм» подробно рассмотрены все 5 основных видов диаграмм: круговая, линейчатая, гистограмма, график и точечная; их варианты и примеры использования. Некоторые рекомендации сегодня кажутся «прописными истинами», хотя, возможно, именно в этой книге они и были прописаны впервые:

- Круговая диаграмма – самый непрактичный тип диаграмм.

- Помещать на круговой диаграмме не более 6-ти компонентов, в идеале – 5 самых важных, остальные сгруппировать в один сектор с названием «прочее».

- Самый главный сектор круговой диаграммы должен идти от линии 12-ти часов циферблата (сверху вправо), он должен быть самым контрастным.

- Не использовать на линейчатой диаграмме и гистограмме одновременно подписи на шкале и у столбца.

- На диаграммах использовать целые числа, избегая дробей.

- Координатная сетка не должна быть яркой. «Координатная сетка как линии футбольного поля; нужны, чтобы судьи могли выполнять свои функции, а не чтобы привлекать внимание зрителей».

Первую часть автор заканчивает тем, что

«диаграммы — это наглядные пособия, вспомогательные материалы, а отнюдь не замена письменному и устному слову. Используйте их умело, и они сослужат вам хорошую службу».

Для проверки того, готов ли читатель «умело использовать» описанное (правильно ли понята и усвоена информация), предлагается практикум. Несколько реальных задач для самостоятельного решения — нужно выбрать тип диаграммы, иллюстрирующей ту или иную идею, нарисовать на специально оставленных страницах и сравнить с правильными ответами.

Часть II посвящена использованию 5 типов диаграмм для передачи соответствующих идей. На 44 страницах автор последовательно комментирует и подробно разбирает 80 примеров диаграмм разного вида. Материал помогает углубиться в перечисленные в первой части типы визуализации данных. Автор приводит иллюстрации (примеры диаграмм), комментирует их, сравнивает с другими.

Продуктивной показалась мысль о том, что визуализацию идеи нужно протестировать во всех возможных вариантах и только после этого выбрать лучший. Желязны пишет:

«Необязательно хвататься за первую понравившуюся вам идею. Продолжайте искать, играйте с диаграммами и, в конце концов, вы найдете идеально подходящее визуальное решение».

По мнению автора, для проверки эффективности выбранного варианта диаграммы нужно убрать шкалы:

«Отсутствие шкал не должно мешать пониманию взаимосвязей. Убрав шкалы, вы можете с успехом проверить, наглядно ли составлены диаграммы, чётко ли они передают основную идею».

Среди описываемых во второй части диаграмм есть необычные, которые могут стать источником новых (или хорошо забытых старых) идей.

Часть III «Концепции и метафоры в презентации (Решения в поисках проблемы)» — 50 страниц рисунков, схем, моделей визуализации процессов, отношений, движения, взаимодействия с минимумом текста (заголовки и редкие, краткие пояснения). Все эти «визуальные решения проблем коммуникации» разделены на две группы: визуальные концепции (абстрактные фигуры) и визуальные метафоры (предметы окружающего мира). Это готовый набор изображений для использования в докладах, презентациях или статьях — достаточно наполнить нужную своим содержанием.

В части IV речь идет о том, «как разработать наглядные пособия для презентации на компьютере».

Полезными в компьютерной презентации Джин Желязны считает эффекты анимации, движения элементов, цветные фото, звуки, видео и ссылки. Главные плюсы (по сравнению с «доинтернетовскими» печатными материалами) — скорость создания графической работы и возможность внести изменения в считанные минуты (прямо на месте, где будет проходить презентация или по дороге к нему). Минусы — это технические сложности (необходим проектор, экран и др.) и «ощущение того, что выступающий пускает пыль в глаза, и его заботит больше форма, а не содержание информации».

Перечислены правила хорошей презентации (например, «чем крупнее, тем лучше»). Отдельный параграф рассуждений о цвете в презентации: «используйте цвет по назначению, а не для красоты»; назначения цвета — выделить нужные элементы, обозначить лейтмотив (один параметр на разных слайдах одним и тем же цветом), изобразить символически (использовать символическое значение цвета).

Для проверки эффективности презентации автор рекомендует перевести ее в черно-белый формат. Изображения и текст должны быть четкими, хорошо читаться даже издалека.

К сожалению, книга заканчивается неожиданно — заключения, выводов или итогов нет. На последней странице есть человек в плаще и шляпе со шпагой в руках. Этот рисунок — графическая «печать» автора, его опознавательный знак — напомнил мне подпись в «живых» письмах (на тетрадном листе), которые мы писали раньше. До нашей эры. Эры цифровых технологий.

Кто такой Джин Желязны?

Недосказанность книги заставила меня пойти за этим человеком со шпагой и сделать еще несколько открытий.

На его персональном сайте говорится, что он работает директором по визуальным коммуникациям в McKinsey & Company (консалтинговая фирма существует с 1926 года!), выступает с лекциями и тренингами в ведущих бизнес-школах Америки и Европы. Его книги: «Говори на языке диаграмм» (Say It With Charts), «Говори на языке презентаций» (Say It With Presentations), сейчас идет работа над «Говори на языке воображения» (Say It With Imagination).

Интересно противопоставление взглядов Дж. Желязны и Эдварда Тафти.

Желязны защищает PowerPoint и доказывает, что инструмент может быть очень полезным в визуальной коммуникации. Он пишет:

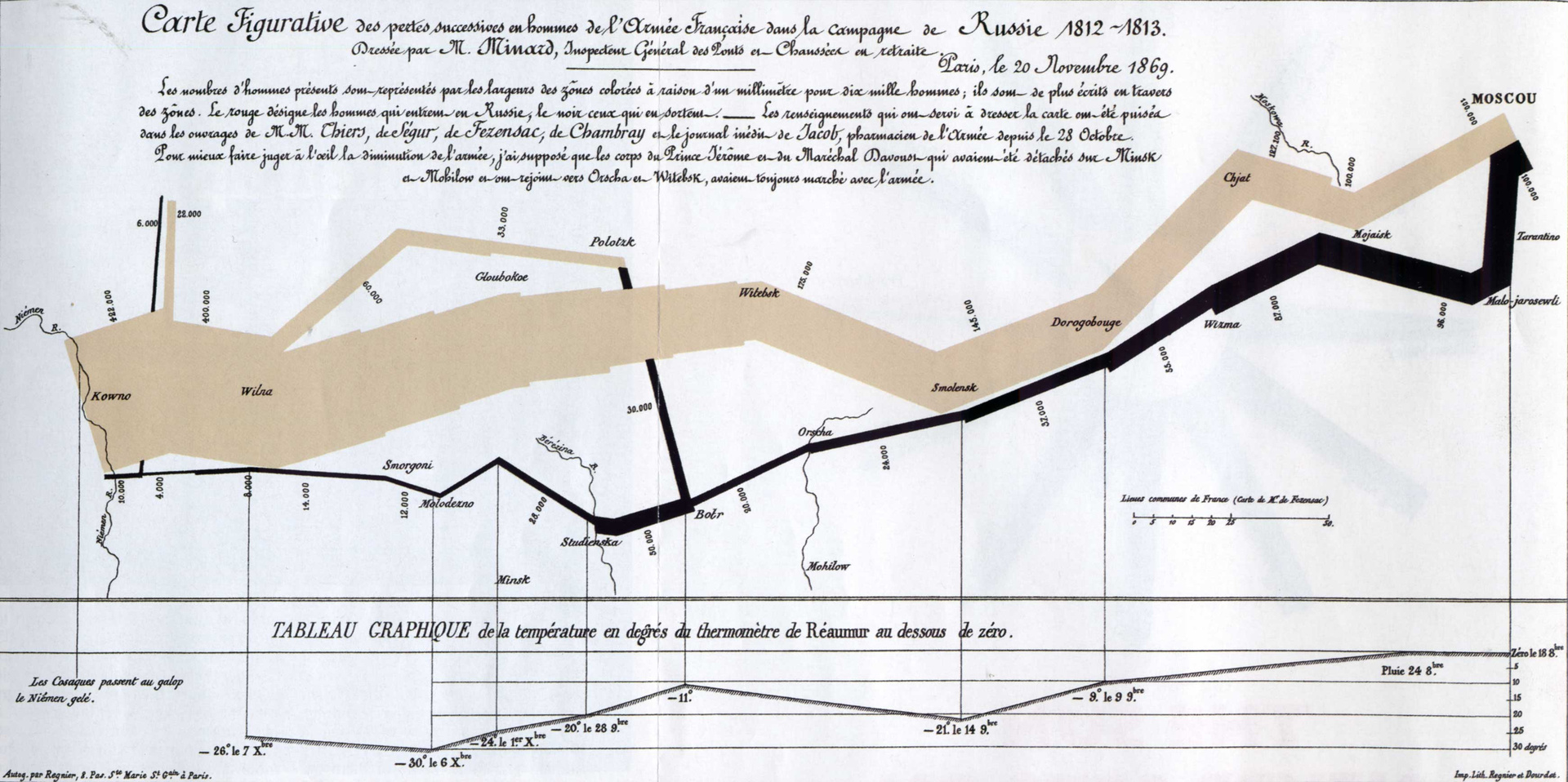

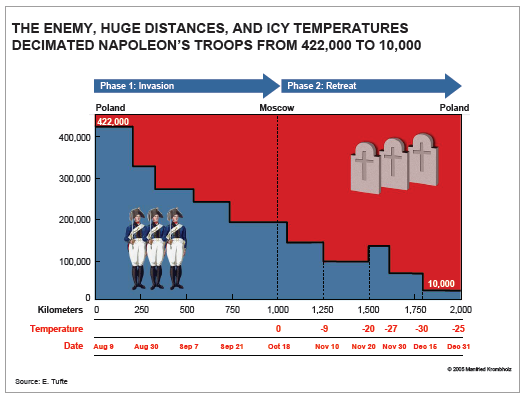

«Думаю, что все вы знаете о жарких спорах экспертов бизнес-коммуникации вокруг PowerPoint. Наверное, нет другого такого софта, вокруг которого было бы столько эмоций. Иногда даже кажется, что противники застрелят друг друга пунктами списков (bullet points — «пули пункты»). Громче всех, конечно, «выстрелы» критиков. Один из главных, профессор Университета Йеля Эдвард Тафти, утверждает, что PowerPoint провоцирует людей на создание пошлого, тривиального контента и сильно «засоряет» серьёзную коммуникацию. «Совещания должны фокусироваться на кратких письменных отчетах на бумаге, а не на тезисах или обрывочных пунктах списка, проецируемых на стену», — считает Тафти в своей работе «Когнитивный стиль PowerPoint».Далее Желязны доказывает пользу самой популярной программы для создания презентаций, приводя свой вариант визуализации карты похода Наполеона на Москву (Charles Joseph Minard (1781–1840)) — той самой карты, которую Тафти называет одним из лучших примеров информационной графики, — сделанные в PowerPoint.

Желязны не настаивает на исключительной пользе PowerPoint, но говорит, что качественный, доказательный инфодизайн можно сделать с помощью даже самых простых инструментов.

У него есть книга мемуаров «В одно мгновение» (In The Moment), в которой он делится эпизодами своей жизни.

Вступление к книге:

«Если бы вы были восьмилетним ребёнком и видели, что ваших друзей куда-то забирают нацисты, то вы бы подумали, что Париж — это плохое место пребывания в 1942 году. Если бы вы носили Звезду Давида, то так оно и было. Переход от измученной Европы к энергичной, трепещущей Америке также не всегда воспринимался легко. Школа в Бронксе (на уличный манер «Da Bronx»), колледж, служба в ВВС и, наконец, корпоративная Америка — мир крупного бизнеса. Большие шаги и отсутствие матери, которая могла бы вести тебя. Для начала Жанно стал Джином, автором этих сверкающих, разоблачающих, дерзких, тонких, мудрых, острых, терпимых, любопытных, гениальных, грустных и веселых, хитрых и прямолинейных эссе без границ. Джин, мы готовы развлекаться и удивляться всему тому, что ты должен сказать, и неизменно восхищаться твоими идеями».

Джин Желязны — визуал во всех сферах жизни и проявлениях. Кроме его знаменитых книг, подтверждением тому является его хобби — коллекционирование необычных наборов шахматных фигур. У него десятки шахматных наборов неожиданной формы.

В этом увлечении очевидна его любовь к геометрическим формам, восхищение линиями, наблюдательность и юмор — все то, что свойственно истинному художнику и творцу.

|

Метки: author meteor-city графический дизайн информационный дизайн презентация диаграммы визуализация рецензия на книгу джин желязны |

SQL Server Integration Services (SSIS) для начинающих – часть 1 |

SSIS – это инструмент, который позволяет в удобном виде реализовать интеграцию, т.е. реализовать процесс переноса данных из одного источника в другой. Этот процесс иногда называют ETL (от англ. Extract, Transform, Load – дословно «извлечение, преобразование, загрузка»).

Думаю, данный практический курс будет полезен тем, кто хочет изучить SSIS и не знает с чего начать. Здесь в режиме Step By Step мы начнем с самого начала, т.е. установки всего необходимого.

Дальше будет очень много картинок!

Необходимые инструменты для изучения SSIS

В данной статье SSIS будет рассматриваться на примере SQL Server 2014 Developer Edition. Службы Integration Services доступны в SQL Server 2014 начиная с редакции Standard.

Дополнительно необходимо будет скачать и установить инструмент разработчика SQL Server Data Tools (SSDT).

SSDT – это расширение для Visual Studio, которое позволит создавать проекты необходимого нам типа.

Для облегчения процесса установки, я воспользуюсь SSDT для Visual Studio 2012 (VS2012), его можно скачать по ссылке (файл «SSDTBI_VS2012_x86_ENU.exe»):

www.microsoft.com/en-US/download/details.aspx?id=36843

По описанию, данная версия SSDT поддерживает следующие версии SQL Server: SQL Server 2014, SQL Server 2012, SQL Server 2008 и 2008 R2.

Если на вашем компьютере не установлен VS данной версии, то установщик SSDT установит минимальную версию оболочки, которая позволит создавать проекты нужного нам типа.

Установка SQL Server и SSDT

Первым делом установим SQL Server со всеми необходимыми компонентами.

Я все устанавливал на чистую Windows 7 SP 1 (x64), ничего дополнительного кроме указанного ниже устанавливать не придется.

Т.к. курс предназначен для начинающих, то распишу весь процесс установки подробно.

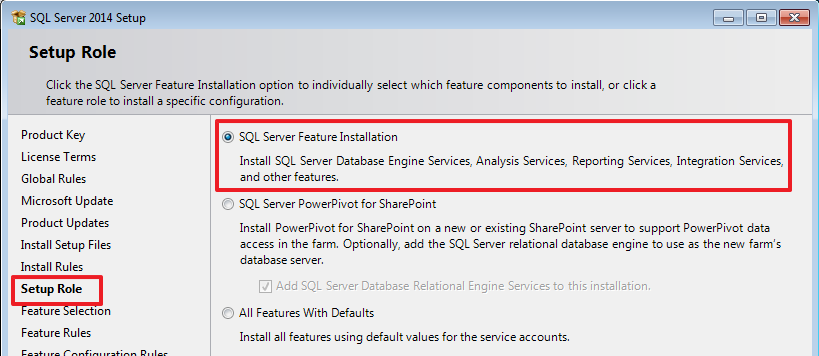

Запускаем установочный файл SQL Server 2014:

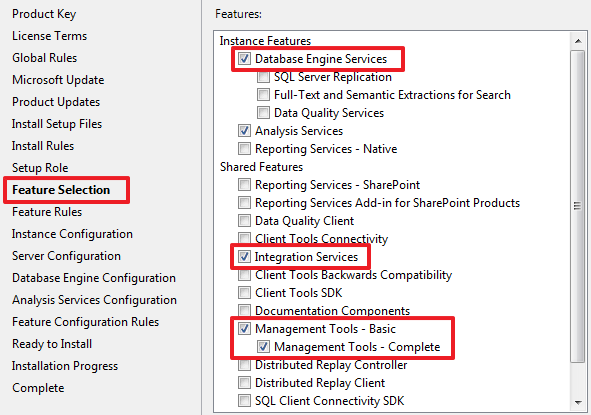

Для работы SSIS достаточно будет выбрать следующие компоненты:

Т.к. мне в дальнейшем понадобится Analysis Services (SSAS), то я отметил и его, если он вам не нужен вы можете не выбирать данный компонент.

У меня нет других установленных SQL Server, и я сделаю этот экземпляр используемым по умолчанию:

Сделаю, чтобы SQL Agent запускался автоматически:

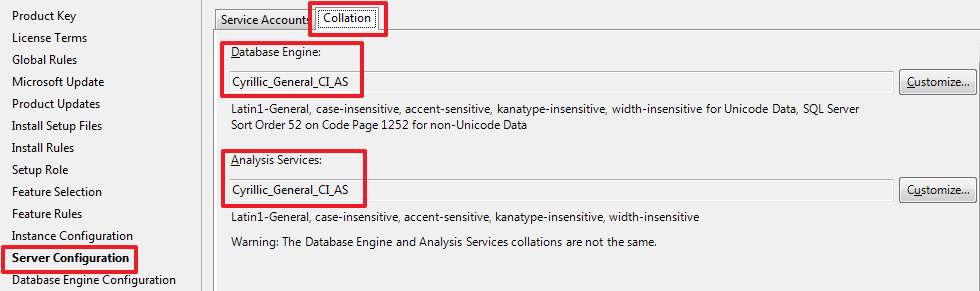

При необходимости можно изменить Collation, который будет использоваться по умолчанию:

Установлю смешанный режим аутентификации, указав свой пароль для пользователя sa:

Т.к. я еще выбрал Analysis Services, то делаю настройки для него:

Нажимая Next и Install запускаем установку SQL Server и его компонент.

Так как у меня на компьютере всего один диск, то все директории я оставил по умолчанию, при необходимости вы можете изменить их на более удобные.

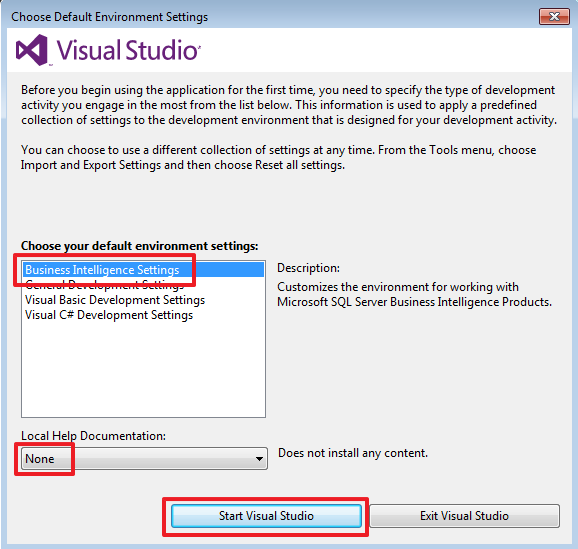

Следующим шагом установим SSDT – это расширение для Visual Studio, которое даст нам возможность создавать проекты SSIS. Установщик SSDT ставит минимальную версию оболочки VS, поэтому предварительно устанавливать VS отдельно нет надобности.

Запускаем «SSDTBI_VS2012_x86_ENU.exe», и добравшись до следующего шага выбираем следующий пункт:

Нажимая Next запускаем установку.

После завершения установки на всякий случай перезагружаем компьютер.

Это все, что нам понадобится для изучения SSIS.

Создание демонстрационных баз данных

Запустим SQL Server Management Studio (SSMS) и при помощи скрипта создадим 3 базы данных – первые две (DemoSSIS_SourceA и DemoSSIS_SourceB) будут выступать в роли источников данных, а третья (DemoSSIS_Target) в роли получателя данных:

-- первая БД выступающая в роли источника данных

CREATE DATABASE DemoSSIS_SourceA

GO

ALTER DATABASE DemoSSIS_SourceA SET RECOVERY SIMPLE

GO

-- вторая БД выступающая в роли источника данных

CREATE DATABASE DemoSSIS_SourceB

GO

ALTER DATABASE DemoSSIS_SourceB SET RECOVERY SIMPLE

GO

-- БД выступающая в роли получателя данных

CREATE DATABASE DemoSSIS_Target

GO

ALTER DATABASE DemoSSIS_Target SET RECOVERY SIMPLE

GO

В базах источниках создадим тестовые таблицы и наполним их тестовыми данными:

USE DemoSSIS_SourceA

GO

-- продукты из источника A

CREATE TABLE Products(

ID int NOT NULL IDENTITY,

Title nvarchar(50) NOT NULL,

Price money,

CONSTRAINT PK_Products PRIMARY KEY(ID)

)

GO

-- наполняем таблицу тестовыми данными

SET IDENTITY_INSERT Products ON

INSERT Products(ID,Title,Price)VALUES

(1,N'Клей',20),

(2,N'Корректор',NULL),

(3,N'Скотч',100),

(4,N'Стикеры',80),

(5,N'Скрепки',25)

SET IDENTITY_INSERT Products OFF

GO

USE DemoSSIS_SourceB

GO

-- продукты из источника B

CREATE TABLE Products(

ID int NOT NULL IDENTITY,

Title nvarchar(50) NOT NULL,

Price money,

CONSTRAINT PK_Products PRIMARY KEY(ID)

)

GO

-- наполняем таблицу тестовыми данными

SET IDENTITY_INSERT Products ON

INSERT Products(ID,Title,Price)VALUES

(1,N'Ножницы',200),

(2,N'Нож канцелярский',70),

(3,N'Дырокол',220),

(4,N'Степлер',150),

(5,N'Шариковая ручка',15)

SET IDENTITY_INSERT Products OFF

GO

Создадим таблицу в принимающей базе:

USE DemoSSIS_Target

GO

-- принимающая таблица

CREATE TABLE Products(

ID int NOT NULL IDENTITY,

Title nvarchar(50) NOT NULL,

Price money,

SourceID char(1) NOT NULL, -- используется для идентификации источника

SourceProductID int NOT NULL, -- ID в источнике

CONSTRAINT PK_Products PRIMARY KEY(ID),

CONSTRAINT UK_Products UNIQUE(SourceID,SourceProductID),

CONSTRAINT CK_Products_SourceID CHECK(SourceID IN('A','B'))

)

GO

Создание SSIS проекта

Запустим Visual Studio 2012 и выберем один из видов предлагаемой нам настройки среды, так здесь же я откажусь от локальной документации:

Создадим новый проект (File -> New -> Project…):

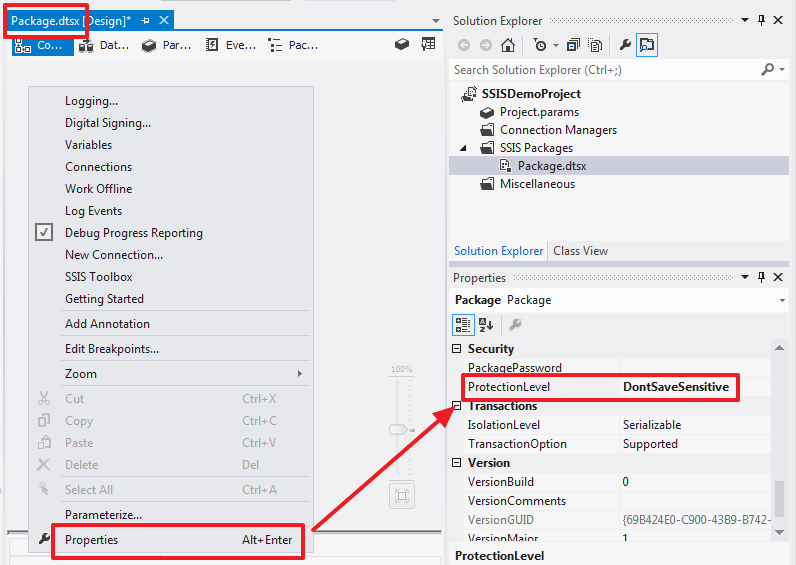

Для последующего облегчения развертывания зайдем в свойства проекта и изменим опцию ProtectionLevel на DontSaveSensitive:

То же самое сделаем в свойствах пакета, который создался по умолчанию:

Для всех новых пакетов данное свойство будет заполняться значением из свойства проекта.

Создадим соединения:

Заполняем параметры соединение с БД:

Боевые параметры соединения в дальнейшем можно будет настроить при создании задачи SQL Server Agent.

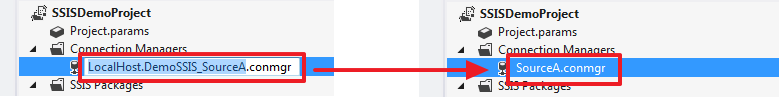

Для удобства я переименую название соединения на SourceA:

Таким же образом создадим и переименуем соединения для баз DemoSSIS_SourceB и DemoSSIS_Target:

Переименуем пакет, созданный по умолчанию, в «LoadProducts.dtsx»:

Сначала напишем простую логику, которая будет полностью очищать таблицу Products в базе DemoSSIS_Target и снова загружать в нее данные из двух баз данных DemoSSIS_SourceA и DemoSSIS_SourceB.

Для очистки воспользуемся компонентом «Execute SQL Task», который мы при помощи мыши создадим в области «Control Flow»:

Для наглядности можно переименовать название компонент. Зададим ему имя «Delete All Products From Target»:

Для этой цели используется свойство Name.

Дважды щелкнем на этом элементе и пропишем следующие свойства:

Т.к. TSQL команда «TRUNCATE TABLE Products» ничего не возвращает оставим свойства ResultSet равным None.

В дальнейшем мы рассмотрим, как пользоваться параметрами и каким образом можно воспользоваться результатом выполнения команды, записанной в SQLStatement, а пока попытаемся увидеть всю картину как это работает в целом.

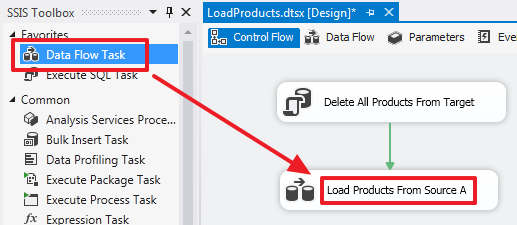

Теперь скинем в область «Control Flow» компонент «Data Flow Task» и переименуем его в «Load Products From Source A», а также протянем к этому компоненту зеленную стрелку от «Delete All Products From Target»:

Таким образом мы создали цепочку, которая будет выполняться последовательно.

Щелкнув дважды на «Load Products From Source A» мы попадаем в область «Data Flow» этого элемента.

Data Flow Task – это сложный компонент, который имеет свою область, в которой создаются вложенные элементы для работы с потоком данных.

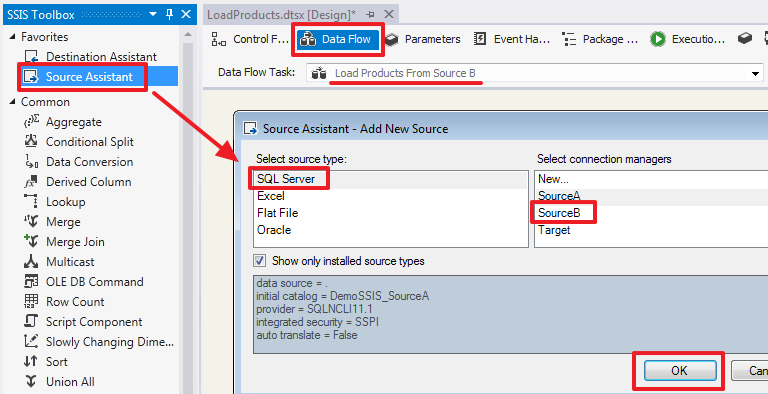

Скинем в эту область компонент «Source Assistant»:

Этот компонент отвечает за получение данных из источника. Дважды щелкнув по нему, мы сможем настроить его:

Пока воспользуемся режимом «Data access mode» равным «Table or view». Это приведет к получению всех строк из таблицы Products. Посмотреть данные можно нажав на «Preview…».

На закладке Columns мы можем выбрать только необходимые нам колонки и при необходимости переименовать их прописав новое имя в колонке «Output Columns»:

Для получателя нужна еще одна дополнительная колонка SourceID, добавим ее к выходному набору при помощи компонента «Derived Column», который переименуем в «Add SourceID», так же протянем синюю стрелку к данному элементу от «OLE DB Source»:

Дважды щелкнем по элементу «Add SourceID» и пропишем значение «A» в виде константы:

Здесь я воспользовался функцией преобразования типа (DT_STR,1,1251) для того чтобы превратить Unicode строку в ANSI.

Теперь создадим компонент «Destination Assistant»:

Направим в него поток от «Add SourceID»:

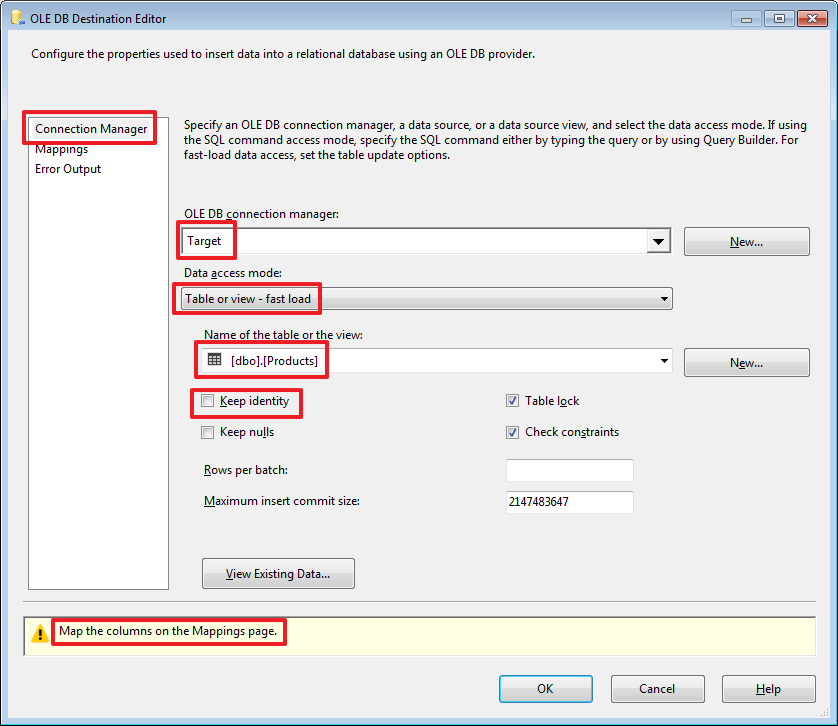

Дважды щелкнем по «OLE DB Destination» и произведем настройки:

Здесь мы показываем в какую таблицу будет записываться полученный набор.

«Keep identity» используется в случае если в принимающей таблице есть поле с флагом IDENTITY и мы хотим, чтобы значения в него тоже записывались из источника (это аналогично включению опции SET IDENTITY_INSERT Products ON).

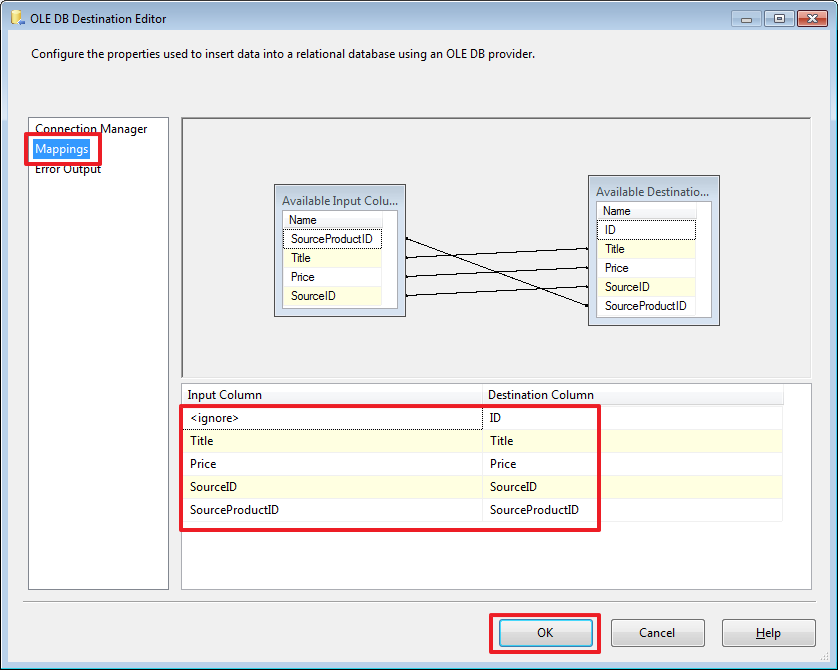

Перейдя на закладку Mappings осуществим привязку полей источника с полями получателя:

Так как у нас поля источника и приемника именуются одинаково, то привязка осуществилась автоматически.

Можем протестировать работу пакета и убедиться, что данные залились в таблицу Products базы DemoSSIS_Target.

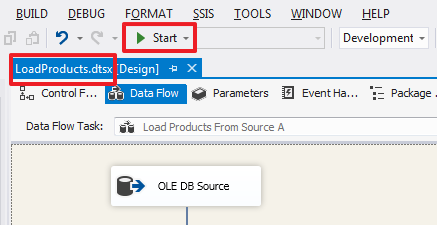

Запускаем пакет на выполнение из Visual Studio нажав Start или клавишу F5:

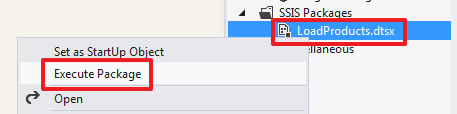

Так же пакет можно выполнить, воспользовавшись командой из контекстного меню:

При помощи «Set as StartUp Object» можно задать пакет, который будет запускаться по нажатию на Start (F5).

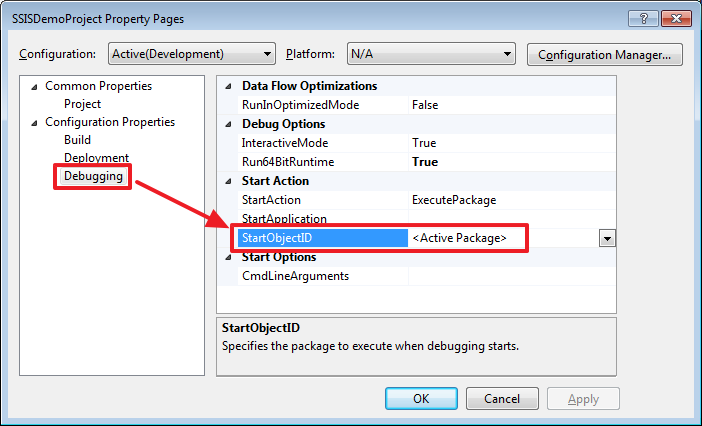

Какой пакет будет запускаться при нажатии на Start (F5) можно переопределить в свойствах проекта:

По умолчанию будет запускаться пакет открытый в текущий момент, об этом говорит значение StartObjectID равное

Запустив проект мы должны увидеть следующую картину:

Пакет выполнился без ошибок, о чем говорит зеленый значок и текст в нижней части.

В случае наличия ошибок их можно будет увидеть вкладке Progress.

Нажмем на ссылку «Package execution completed…» или на кнопку «Stop Debugging» расположенную на панели инструментов для остановки выполнения пакета.

Выполним запрос:

USE DemoSSIS_Target

GO

SELECT *

FROM Products

И убедимся, что данные были записаны в принимающую таблицу.

Перейдем в область «Control Flow» и создадим еще один компонент «Data Task Flow», который назовем «Load Products From Source B», протянем на него зеленную стрелку от «Load Products From Source A»:

Двойным щелчком зайдем в область «Data Flow» этого элемента и создадим «Source Assistant»:

Дважды щелкнув на этом элементе, настроим его по-другому:

Выберем режим «SQL command» и пропишем следующий запрос:

SELECT

ID SourceProductID,

'B' SourceID,

Title,

Price

FROM Products

Дальше сразу создадим компонент «Destination Assistant» и протянем на него синюю стрелку от «OLE DB Source»:

Двойным щелчком зайдем в редуктор этого элемента и настроим его:

Запустим проект на выполнение и убедимся, что данные с двух источников попали в таблицу в базе Target:

USE DemoSSIS_Target

GO

SELECT *

FROM Products

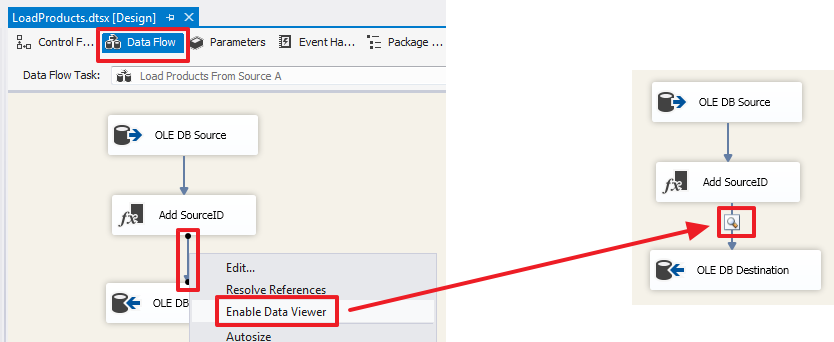

Дополнительно в контекстном меню стрелки можно активизировать «Data Viewer»:

Теперь при запуске пакета на выполнение в этой точке будет сделана остановка и нам будут показаны данные этого потока:

Для продолжения выполнения пакета нужно нажать на кнопку со стрелкой или просто закрыть окно просмотра данных.

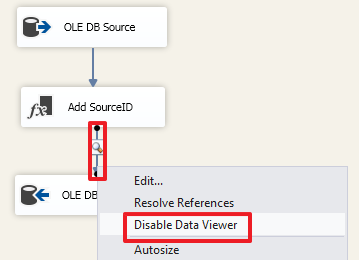

Для отключения этой функции в контекстном меню стрелки выбираем «Disable Date Viewer»:

Для первой части думаю этого будет достаточно.

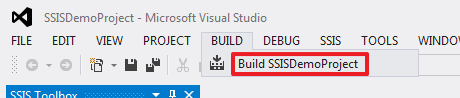

Создадим сборку:

В результате мы получим файл «C:\SSIS\SSISDemoProject\bin\Development\SSISDemoProject.ispac».

Рассмотрим каким образом делается развертывание этого проекта на SQL Server.

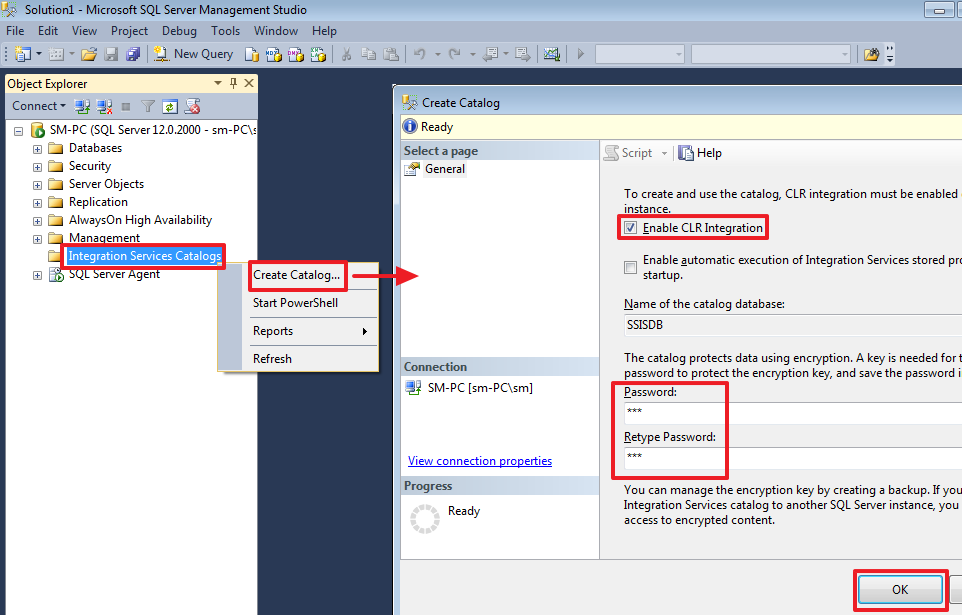

Развертывание SSIS

Все последующие действия будем делать в SSMS.

Создание каталога SSISDB:

Здесь вводим любой пароль.

Теперь создаем папку, в которой будет располагаться наш проект:

Разворачиваем сам проект:

В завершении мы должны увидеть следующую картину:

После обновления (F5) мы увидим наш проект:

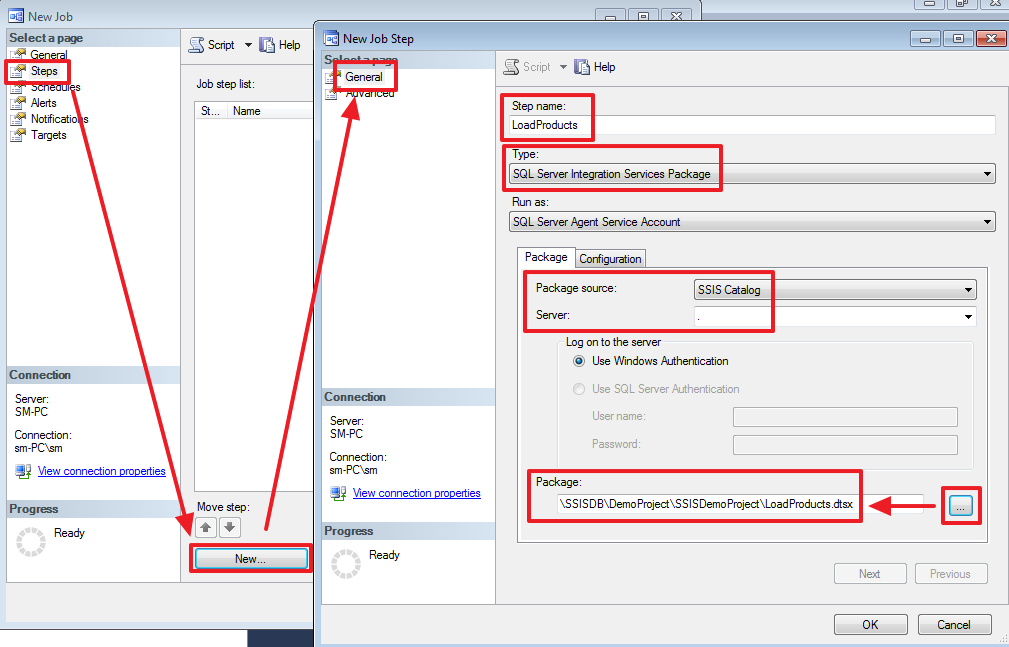

Создание задачи в SQL Server Agent

Создадим задачу в SQL Agent, для выполнения пакета по расписанию:

Создаем новый шаг:

На вкладке «Configuration -> Parameters» можно задать параметры пакета (их рассмотрим в следующих частях).

На вкладке «Configuration -> Connection Manager» мы можем изменить параметры подключения для каждого соединения, которое мы создали в проекте:

На закладке Advanced можно изменить логику, которая будет использоваться при успешном или неуспешном завершении шага:

Шаг создан:

Осталось создать расписание для данной задачи:

Расписание можно задать разнообразным образом. Думаю, здесь все должно быть интуитивно понятно:

Все, задача создана.

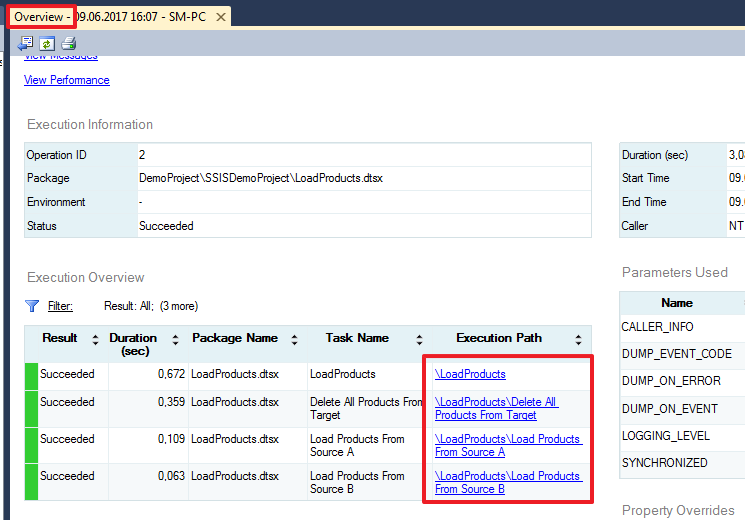

Делаем тестовый запуск:

Так как шаг у нас всего один, то задача запустится сразу, иначе нужно было бы указать с какого шага нужно начать выполнение.

Результат выполнения задачи можно увидеть в следующем журнале:

В данном журнале можно увидеть успешность завершения каждого шага, а также время выполнения и прочие параметры.

Более подробный отчет о выполнении пакета можно посмотреть при помощи следующего отчета:

Заключение по первой части

В этой части я постарался дать обзорную картину, чтобы у читателя сразу сложилась в голове полная картина как все это выглядит и работает.

Я постарался описать все как можно подробнее, для того, чтобы обучающийся смог самостоятельно установить все необходимые инструменты и проработать материал шаг за шагом на практике, т.к. при самостоятельном изучении иметь рабочую среду это очень важный аспект.

На мой взгляд SSIS очень удобный и интуитивно понятный инструмент и многое в нем можно понять разбираясь самостоятельно. Это я говорю исходя из своего опыта, так как мне самому по большей части пришлось разбираться с SSIS самостоятельно и здесь я делюсь с вами своим опытом в данной области.

Надеюсь данный материал поможет многим сделать первые шаги в изучении данного инструмента и в дальнейшем применить свои знания в работе.

Хороших выходных! Удачи!

Продолжение следует…

|

Метки: author Leran2002 sql microsoft sql server ssis integration services sql server etl |

Security Week 23: EternalBlue портировали на Win10, ЦРУ атакует с файлсерверов, маркетологи незаметно заразили весь мир |

Приключения EternalBlue продолжаются: теперь исследователи из RiskSense портировали его на Windows 10. На первый взгляд это деструктивное достижение, однако же, именно в этом состоит немалая часть работы исследователя-безопасника. Чтобы защититься от будущей угрозы, сначала надо эту угрозу создать и испытать, причем крайне желательно сделать это раньше «черных шляп».

Приключения EternalBlue продолжаются: теперь исследователи из RiskSense портировали его на Windows 10. На первый взгляд это деструктивное достижение, однако же, именно в этом состоит немалая часть работы исследователя-безопасника. Чтобы защититься от будущей угрозы, сначала надо эту угрозу создать и испытать, причем крайне желательно сделать это раньше «черных шляп». Ранее RiskSense разработали EternalBlue-модуль для Metasploit, который отличается от оригинала тем, что его гораздо хуже детектят IDS. Из него выкинули имплант DoublePulsar который слишком хорошо изучен и не особо умеет скрываться на машине, демаскируя атаку. Вместо него исследователи разработали собственный шеллкод, который способен загрузить нужную нагрузку напрямую.

Исходный EternalBlue, как и его модуль для Metasploit, работает лишь на Windows 7 и Windows XP, а также на Windows Server 2003/2008 R2. В своем отчете компания подробно анализирует все цепочку багов, используемых эксплойтом, и из документа видно, что к подобной атаке уязвимы все системы на базе ядра NT – однако выручают защитные технологии, часть из которых EternalBlue обходить умеет, часть – не очень.

Старший аналитик компании Шон Диллон высказался в духе, что атаки такого типа (heap spray) на ядро Windows – «почти чудо», настолько трудоемка их разработка, в отсутствие доступных исходников ОС. Поэтому такую же атаку для Linux разработать было бы проще.

Исследователи же создали версию, успешно атакующую Windows 10 x64 версии 1511 (Threshold 2), для чего понадобилось разработать новый способ обхода DEP. Особо отмечено, что на других версиях Win10 новый эксплойт не работает. Но принцип атаки понятен, понятна и его широкая применимость. Ждем волны WannaCry под Windows 10?

Опубликована документация на имплант ЦРУ для заражения сетей

Новость. Американское разведсообщество все больше «радует» мировое сообщество информационной безопасности. То ли АНБ соревнуется с ЦРУ в эдаком хитром пиаре, то ли в обеих организациях завелись последователи Сноудена – столь же идейные, но, все же, более осторожные.

В прошлый четверг на WikiLeaks появилась публикация о разработанном в ЦРУ импланте, превращающем файлсервер под Windows в точку распространения вредоносных программ по локальной сети. Инструмент, скромно названный Pandemic, подменяет запрашиваемые машинами с файлсервера файлы троянизированными версиями. Согласно документации, Pandemic 1.1 умеет подменять до 20 различных файлов объемом до 800 Мб.

Имплант действует предельно незаметно, не получая непосредственного доступа к файлу. Он устанавливает драйвер-фильтр операционной системы, который позволяет «на лету» модифицировать ввод-вывод с накопителей. Собственно, похожим образом действуют антивирусы, анализирующие файлы при запуске, и системы прозрачного шифрования файлов.

Очевидно, заражение машины-клиента происходит в том случае, если файл с сервера будет запущен, то есть в первую очередь опасны исполняемые файлы. Однако нельзя исключать применение Pandemic с эксплойтами, например, для Microsoft Office – в этом случае заражение будет распространяться и через документы.

Китайский зловред заразил 250 миллионов компьютеров по всему миру

Новость. Исследование. Пекинское маркетинговое агентство Rafotech продемонстрировало блестящий пример беспощадного китайского маркетинга. Не само – ему помогли ребята из CheckPoint, вскрывшие нехилую кампанию Fireball. Современный маркетинг не может без биг даты – клиента надо знать лучше, чем его мама. Поэтому бигдату нужно собирать, как можно быстрее и больше.

Новость. Исследование. Пекинское маркетинговое агентство Rafotech продемонстрировало блестящий пример беспощадного китайского маркетинга. Не само – ему помогли ребята из CheckPoint, вскрывшие нехилую кампанию Fireball. Современный маркетинг не может без биг даты – клиента надо знать лучше, чем его мама. Поэтому бигдату нужно собирать, как можно быстрее и больше.Rafotech придумала собирать ее с помощью троянца. Зловред Fireball заражает компьютер жертвы очень простыми методами – его устанавливают более-менее легитимные программы (так называемое crapware) самой Rafotech и ее коллег, также его можно получить в спаме. Казалось бы, не самые мощные каналы распространения, однако же, по данным CheckPoint, троянец инфицировал более 250 миллионов компьютеров по всему миру.

Первым делом Fireball заменяет установленный в браузере поисковик на поддельный, который перенаправляет запросы в Yahoo или Google но при этом прилежно собирает информацию для своих владельцев. Помимо этого Fireball умеет все, что может понадобиться честному китайскому маркетологу: запускать произвольный код, загружать и устанавливать из Интернета любой софт, манипулировать веб-траффиком пользователя так, чтобы генерировать просмотры рекламы. Технически Fireball продвинут не хуже своих более знаменитых ботнетов – он отлично умеет избегать обнаружения (что доказывает масштаб распространения), и имеет гибкую инфраструктуру управления и контроля.

На своем сайте Rafotech заявляет, что ею «охвачено более 300 миллионов пользователей». Ну, теперь мы знаем, что это похоже на правду. Таки охвачено. Однако тревожит, что речь не только об индивидуальных пользователях – в CheckPoint посчитали, что Fireball поражены 20% корпоративных систей в мире. Потенциально это дает боевым маркетологам поистине устрашающие возможности, и не только по показу рекламы.

Древности

«Find-1575»

Неопасный резидентный вирус. Записывается в COM- и EXE-файлы при их старте и при поиске файлов в каталогах (функции DOS FindFirst и FindNext FCB). При некоторых условиях по экрану начинает ползать «зеленая гусеница». Перехватывает int 1Ch, 21h

Цитата по книге «Компьютерные вирусы в MS-DOS» Евгения Касперского. 1992 год. Страницa 67.

Disclaimer: Данная колонка отражает лишь частное мнение ее автора. Оно может совпадать с позицией компании «Лаборатория Касперского», а может и не совпадать. Тут уж как повезет.

|

Метки: author Kaspersky_Lab информационная безопасность блог компании «лаборатория касперского» klsw eternalblue wikileaks fireball rafotech цру |

О новых интересных законах или «Тварь ли я дрожащая или всё-таки сообщество» |

Данный пост навеян недавними постами о запрете VPN, TOR и прочих «средств обхода блокировок» (тут и тут), о мессенджерах и вообще всё растущим интересом властьпридержащих к тотальному контролю над мнениями, умами и жизнями. Даже не столько постами навеян, сколько комментариями к ним.

Кто-то предлагает «заводить трактор», кто-то предлагает выходить на митинги, кто-то ничего не предлагает, а просто ругает власть, которая в очередной раз спокойненько всех нагнула (ещё нет, но, думаю, все согласятся, что все эти законы примут и будут новые, ещё интереснее).

Я ни в коем случае не осуждаю ни тех, кто собирается искать лучшей доли где-то в другом месте, ни тех, кто хочет выплеснуть ярость на улицы.

Я всего лишь предлагаю вспомнить что мы здесь, все собравшиеся — "сообщество IT-профессионалов". И все вышеуказанные проблемы растут из/затрагивают/используют нашу сферу. И мы можем хотя бы попытаться решать проблему внутри сообщества.

Ведь все эти запреты и грейт воллы внедряют не депутаты, а руки вполне себе определённых программистов, сисадминов, методистов, которые пишут ТЗ и прочих «тыжкомпьютерщиков». Которые работают, получают деньги, потом увольняются и идут работать куда-то в более солидные конторы на ещё более солидные зарплаты. Которые читают хабр и ГТ, пишут тут комменты и вполне себе чувствуют себя частью разгневанного сообщества. Как-то слабо себе представляю все эти запреты, если в структуре, которая всё это будет реализовывать, будет перманентная вакансия на соответствующие должности.

И одним из возможных решений или хотя бы попыткой решения было бы следующее:

Всех программистов, помогающих этой «содомии» «банить» — не брать на работу за то, что работал в соответствующих местах и помогал «насаждать». Составлять чёрные списки, распространять информацию и т.п.

Давайте хоть как-то попытаемся представлять из себя "сообщество профессионалов" — сплочённую организацию взрослых людей, понимающих, в отличие обезьян с гранатами и удостоверениями, куда может всё это завести не только сферу, но и страну.

Что мы можем сделать

- Образование — доносить со студенческой скамьи, что IT — это иногда большая ответственность. Что ты можешь или помогать ущемлять конституционные права населения вообще и сообщества в частности, или быть частью сообщества, но не играть за обе команды сразу. Те, кто имеет отношение к образованию, преподаватели ВУЗов и курсов, спикеры конференций и семинаров, рекрутеры, вербующие старшекурсников — это прежде всего ваша ответственность.

- Управление — принимать соответствующие решения, когда к вам на работу приходит устраиваться «коллаборационист». Это сфера ответственности управленцев и кадровиков.

- Информация — распространять соответствующую информацию, списки, резюме и т.п. Это работа сообщества в целом, тут каждый может помочь. Особенно те, кто имеет отношения к СМИ, имеет блоги, твиттеры, каналы, стримы и прочие орудия воздействия на широкие массы.

- Те специалисты, которые работают на условного врага — отказываться от исполнения идиотский указаний вплоть до увольнения. Со своей стороны сообщество должно оказывать поддержку тем, кто отказался работать против сообщества и общества в целом. В нашей сфере всегда есть нехватка специалистов и сообщество вполне может помочь с трудоустройством таким людям.

У IT есть огромное преимущество перед многими другими отраслями. У нас замкнутое и (сравнительно) не слишком уж многочисленное сообщество. И любые законы, которые принимаются для/против сообщества, реализуются руками членов сообщества. Если Равшан откажется строить шлагбаум для «Платона» (история с борьбой дальнобойщиков), на его место придёт Джамшут и ещё сотни тысяч других.

В IT всё гораздо более компактно. Напиши прямо тут, на Хабре, представители крупных компаний, что они не будут брать на работу людей, которые помогали создавать механизмы блокировок и прочих кар, присоединись к ним ещё несколько крупных и некрупных компаний — и об этом скоро узнают все представители сообщества. И будут принимать решение — пачкаться и работать всю жизнь в этой грязи за небольшую зарплату, или думать о будущем.

Кстати, крупные компании заинтересованы в этом как минимум не меньше, чем другие, потому что такие вещи зачастую или ограничивают их в чём-то, или выжимают с рынка (https://geektimes.ru/post/278362/), или просто заставляют оплачивать фантазии депутатов. Кроме крупных компаний, в этом также заинтересованы провайдеры, которые также часто платят из своего кармана за любые несуразицы (СОРМ).

Работа с возражениями

Дискриминация при приёме на работу запрещена.

Да, запрещена, и тем не менее в нашей стране работодатель — царь и бог в вопросах приёма на работу. Тем более, что никто не мешает отказать в трудоустройстве стандартными фразами — «вы нам не подошли», «мы вам перезвоним», «у нас уже есть кандидат, который пришёл раньше». Я уж не говорю о том, что «если ты плюнешь на коллектив — коллектив утрётся, но если коллектив плюнет на тебя, ты утонешь».

Да что мы можем? Мы же просто программисты… ничего не получится… злое правительство… вот если бы кто-то… досиделись… нет, мне ребёнка ещё из садика забирать...

Никакой гарантии, что данный подход сработает, нет. Но это будет хотя бы какое заявление о себе, изъявление своей воли, мнение, действие. А не просто сидеть и ждать. К тому же это не требует больших усилий, не нужно стоять на морозе, сидеть в КПЗ и т.п.

Ой не, лучше сесть на трактор/пойти на митинг

Одно другому совершенно не мешает и вполне может работать параллельно.

Я не в России, мне пофик

Это не вопрос России, это уже давно всемирная проблема. Где-то запрещают вообще всё, где-то запрещают что-то, где-то не запрещают ничего, а потом вдруг оказывается, что вся твоя многогранная натура вполне уместилась в досье (Сноуден гарантирует это). Там, где ещё ничего не запрещено, скорее всего скоро начнут, в России тоже совсем недавно всё было относительно спокойно. Хотя большинство пользователей Хабра живут в странах, где уже что-то запрещают.

Я за блокировки, они спасают меня от террористов, делают мой интернет чище, а мою кожу — нежной и шелковистой

Очень хотелось бы посмотреть, сколько террористов удалось наловить на нашей планете благодаря блокировкам и запретам в Интернете. Вообще, перефразируя известное изречение «если бы терроризма не было, его бы стоило выдумать» — прикрываться борьбой с терроризмом очень удобно, можно протащить любые законы, а несогласных объявить пособниками. Террористы давно и успешно обходят любые блокировки, а блокировки делают для управления толпой, ограничения доступа к «ненужной» информации и вычисления тех, кому такая информация интересна. А незащищённый, например, VPN'ом (который хотят запретить) трафик некоторые провайдеры разбавляют своей рекламой, собирают личные данные и проч. и проч. Более того, пока кто-то всерьёз верит в заблуждение, что блокировки способны защитить от терроризма, занижается уровень опасности («у нас блокировки, нам не страшно»), чем пользуются эти самые террористы. Ну и отличная цитата от Франклина, которая себя уже давно оправдала: "Те, кто готовы пожертвовать свободой ради безопасности, не достойны ни свободы, ни безопасности". Дайте им защищать вашу безопасность ценой вашей свободы и скоро вы станете просто бесправным домашним животным.

Убивают не пули, а люди. Программисты не виноваты, виноваты депутаты.

В сфере IT-технологий практически всегда есть нехватка кадров. Практически всегда можно найти себе работу, не конфликтующую с моральными принципами (если они есть). И делать вид, что программист в данном случае — это безвольная жертва, это, мягко говоря, не соответствует истине. Ну а уж если человек совсем никак

Хэппи энд Вместо послесловия

Поддерживать данную инициативу или нет — это личное дело каждого. Но ясно одно — уже назрело время сообществу IT-профессионалов становиться действительно сообществом, поднимать дискуссии, начинать диалог с властью, где-то даже не словом, а делом показывать несогласие, самостоятельно выражать своё мнение, которое у нас никто не хочет спрашивать. Привлекать в дискуссию специалистов из других областей — юристов, социологов, экономистов. То, с чем мы сейчас столкнулись — это большой гнойник. Это не просто очередной депутатский фортель, это комплексная проблема — проблема нарушения конституционных прав, проблема некомпетентности власти, проблема отсутствия диалога власти и экспертов, проблема экономических просчётов, проблема ущемления бизнеса всех размеров для реализации этих фантазий. В дальнейшем эти проблемы будут усугубляться проблемами оттока квалифицированных кадров (судя по шуму заведённых тракторов), а это уже — настоящая проблема информационной безопасности и удар по экономике.

|

Метки: author prohodil_mimo управление персоналом карьера в it-индустрии законодательство и it-бизнес vpn tor torrent it законодательство и ит |

[Из песочницы] Русскоязычная спецификация языка Java |

Начнем с того, что в языке Java существуют такие термины как operator, operation, operand и statement. В силу устоявшейся традиции, в русскоязычных переводах термин operator чаще всего переводится как «операция». Например, в первом томе Хорстмана читаем: «Операция / означает целочисленное деление». И это не единичный пример, а общепринятая практика. Хорошо, пусть в русскоязычных переводах объединены понятия operator и operation, хотя это и противоречит требованиям спецификации и словаря: «Operators are special symbols that perform specific operations on one, two, or three operands, and then return a result». Однако пойдем дальше.

Следующим устоявшимся штампом является применения термина «оператор» в качестве перевода понятия statement. И тут уже проблема посерьезнее: у нас переплетаются два совершенно разных понятия, и столь свободное толкование вызывает уже определенные разночтения и противоречия, касающиеся основ языка и потому, влияющих на его понимание в целом.

С точки зрения спецификации: «Statements are roughly equivalent to sentences in natural languages. A statement forms a complete unit of execution» и к ним относятся все наши «операторы» в т.ч. ветвления, циклов и пр. Хотя в спецификации они именуются как statements.

Теперь прочитав, например переводную литературу, вы уже будете несколько озадачены, обратившись к первоисточникам. Но и это еще не все. Обратимся, например к оператору (или все-таки инструкции?) switch:

switch (choice) {

case 1:

. . . .

break;

case 2:

. . . .

break;

case 3:

. . . .

break;

case 4:

. . . .

break;

default:

//неверный ввод

break;

}

Сможете ли вы дать определения используемым здесь понятиям: switch, choice, case n (отдельно для case и отдельно для n), default, break? Вот, например, как представляет себе это переводчик того же Хорстмана:

Выполнение начинается с метки ветви case, соответствующей значению 1 переменной choice, и продолжается до очередного оператора break или конца оператора switch.. Лично меня формулировка

соответствующей значению 1 переменной choiceвводит в ступор, хотя, конечно, догадаться можно. Но не это главное. Тут продемонстрирована устоявшаяся традиция перевода термина statement словом «оператор», вносящая некоторую сумятицу по отношению к его англоязычному собрату. Что же касается поставленного вопроса, то вот как его трактует спецификация:

switch — statement;

choice — expression;

case — switch label;

n — case constant;

break — statement;

-> Официальная спецификация языка

Теперь о традициях перевода. Судя по всему, сложились они на заре программирования в Советсвком Союзе, и в дальнейшем кочевали из языка в язык. Насколько известно мне, первая попытка русскоязычного переводя спецификации языка Java была сделана в 1999 году. Но, опять же насколько известно мне, напечатана не была. В ней, действительно, была отдана дань устоявшимся традициям, о которых было сказано выше. Однако, в 2015 году вышел, наконец, печатный перевод. И вот здесь-то, значение терминов оказалось пересмотренным, и на мой взгляд, более соответствует официальной англоязычной спецификации. Хотя, как мне кажется, там тоже есть к чему придраться. В этом издании operator имеет значение «оператор», statement — «инструкция», ну и т.д.

Очень хотелось бы узнать мнение специалистов, поскольку вопрос, на мой взгляд, является непраздным, поскольку касается основ языка, на которых строится его фундамент и правильное понимание. Кроме того, связанные с этим вопросы могут, например, встретиться на сертификационных экзаменах, которые как известно, стараются сдавать на языке оригинала, ну и просто в общении программистов, которые могут представлять себе по разному значения тех или иных терминов. А может быть существует и официальной русскоязычное издание спецификации языка Java? В любом случае, для его выхода накопилось достаточно разночтений. Ведь все вышесказанное касается только отдельных примеров, которых несомненно гораздо больше.

|

Метки: author vitaliy4us java |

Приглашаем на официальный мастер-класс по UE4 от Epic Games |

Во вторник, 13 июня, в Санкт-Петербруге, в Университете ИТМО пройдет мастер-класс по разработке игр на Unreal Engine 4, где экспертом выступит евангелист Epic Games — Шьорд де Йонг. Посетителям на выбор будет предложена одна из двух тем, которые Шьорд подготовил для выступления. В зале Шьорду будут помогать опытные разработчики на UE4.

Во вторник, 13 июня, в Санкт-Петербруге, в Университете ИТМО пройдет мастер-класс по разработке игр на Unreal Engine 4, где экспертом выступит евангелист Epic Games — Шьорд де Йонг. Посетителям на выбор будет предложена одна из двух тем, которые Шьорд подготовил для выступления. В зале Шьорду будут помогать опытные разработчики на UE4.Об эксперте

За спиной у Шьорда почти двадцать лет опыта работы в игровой индустрии. Он начинал с дизайна уровней, но со временем перешел и во многие области разработки игр, такие как гейм дизайн, рендеринг, скриптинг. Шьoрд специализируется исключительно на игровом движке Unreal Engine, с которым он работает с 1999 года и имеет весьма обширные знания о данной технологии. Он работал со всеми четырьмя поколениями движка и над семью выпущенными на нем AAA проектами, в числе которых игры серии Unreal Tournament, WarPath, Rekoil, Huxley. Шьорд является автором двух книг о разработке игр, проводит лекции и воркшопы в университетах по всему миру, а также возглавляет свою собственную студию разработки — Teotl Studios, которая в прошлом году выпустила успешный Survival Horror — The Solus Project.

Детали мероприятия:

Мастер класс проводится университетом ИТМО в рамках запуска и развития направления ITMO.GameDev, совместно с Epic Games и официальным сообществом разработчиков Unreal Engine 4. Это будет уже второе подобное мероприятие в Санкт-Петербруге. Напомним, что 8 апреля в Санкт-Петербурге состоялся первый официальный митап разработчиков UE4 при участии Sperasoft, Epic Games и официального сообщества разработчиков UE4, который собрал в одном месте более 120 человек.

Начало в 15:30. Длительность сессии — 4 часа, язык — английский. По желанию вы можете принести с собой ноутбук. Предпочтительная версия движка — 4.16 (или 4.15 с установленным плагином RenderDoc).

Место проведения:

г. Санкт-Петербург, ул. Ломоносова, д. 9, ауд. 1216/0 (актовый зал), Университет ИТМО.

Для участия в мероприятии необходимо зарегистрироваться.

|

|

Гейзенбаг 2.0: как прошла в Петербурге конференция по тестированию |

В Москве конференция Гейзенбаг уже проходила в декабре 2016-го, а теперь впервые добралась до Петербурга. Суть у Гейзенбаг 2017 Piter осталась прежней: «конференция о тестировании, но не только для тестировщиков». А изменились ли детали? Какие доклады были в этот раз? Правда ли, что Илари Хенрик Эгертер сбрил свою удивительную бороду? Ответы на все эти важнейшие вопросы — под катом.

Организационно всё было примерно как в предыдущий раз: один день, три трека, открывающий и закрывающий кейноуты. Зато разницу могли ощутить те, кто не присутствовал на конференции лично, а смотрел доступ к онлайн-трансляции. Обычно в перерывах между докладами, пока присутствующие на площадке общаются, расспрашивают спикеров в дискуссионных зонах и подходят к стендам спонсоров, онлайн-зрителям особо нечего делать. Но не в этом случае: пока на площадке кто-то увлечённо играл в футбол «багами», зрители трансляции могли посмотреть интервью со спикерами и включения из холла.

Первым выступающим был Илари Хенрик Эгертер, уже знакомый зрителям московского Гейзенбага, где у него тоже был открывающий кейноут. И тех, кто запомнил его по тому выступлению (уже доступному на YouTube), прямо с утра ждал шок: вместо запомнившейся всем эпической бородищи, на отращивание которой явно ушёл не один год, у Илари теперь гораздо более скромная борода.

А Илари говорят ненастоящий - бороды то нет. Ну почти нет :) @ilarihenrik, where is your beard?#heisenbug pic.twitter.com/YCWQET07Bk

— Maxim Shulga (@maxbeard12) June 4, 2017