Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Из песочницы] Язык программирования SPL — пример решения задачи |

Далее я сразу приведу пример программы и результат ее работы, а потом подробно разберем все шаг за шагом.

Текст программы:

text = #.readtext("hamlet.txt")

words = #.split(text, " ", ".", ",", ";", "'", "!", "?", "-", "(", ")", "[", "]", #.crlf, #.quot)

> i, 1..#.size(words)

>> words[i] = ""

key = #.lower(words[i])

dict[key] += 1

total += 1

<

#.sortval(dict)

#.reverse(dict)

#.output(total, " слов; ", #.size(dict), " уникальных слов")

> i, 1..10

key = dict[i]

#.output(i, " : ", key, " = ", dict[key])

<

Результат работы программы:

32885 слов; 4634 уникальных слов

1 : the = 1091

2 : and = 969

3 : to = 767

4 : of = 675

5 : i = 633

6 : a = 571

7 : you = 558

8 : my = 520

9 : in = 451

10 : it = 421Теперь разберем подробнее как это работает.

Первая строка:

text = #.readtext("hamlet.txt")считывает текст файла «hamlet.txt» в переменную «text».

Затем в строке:

words = #.split(text, " ", ".", ",", ";", "'", "!", "?", "-", "(", ")", "[", "]", #.crlf, #.quot)функция "#.split" делит текст «text» на отдельные слова с помощью указанных разделителей и сохраняет результат в массив «words». В списке разделителей также присутствуют системные константы "#.crlf" и "#.quot", которые обозначают символы CRLF (перевод строки) и кавычки ".

Далее идет цикл, который начинается командой ">". В первой строке цикла:

> i, 1..#.size(words)указано, что циклить он будет по переменной «i», которая меняется от 1 до количества слов в массиве «words», которое возвращает функция "#.size".

В следующей строке:

>> words[i] = ""стоит команда перехода на начало цикла ">>" при условии, что очередное слово «words[i]» — не пустое. Это для того, чтобы не учитывать пустые слова, которые получились при делении текста.

Затем в текстовой переменной «key» получаем очередное слово в нижнем регистре благодаря функции "#.lower":

key = #.lower(words[i])и следующая строка:

dict[key] += 1выполняет основную работу — в запись из словаря «dict» по ключу «key» прибавляется 1, таким образом подсчитывая количество каждого слова.

В строке:

total += 1подсчитывается общее количество слов, которые были учтены, и результат хранится в переменной «total».

Следующая строка:

<это конец цикла.

Теперь сортируем словарь «dict» по значению:

#.sortval(dict)Сортировка производится в порядке возрастания, поэтому в следующей строке:

#.reverse(dict)словарь реверсируется в обратный порядок, по убыванию.

В принципе, работа сделана, нужно напечатать результат. Следующая строка выдает немного статистики:

#.output(total, " слов; ", #.size(dict), " уникальных слов")где размер словаря «dict», возвращаемый функцией "#.size", дает нам количество уникальных слов.

Следующий цикл:

> i, 1..10выводит 10 наиболее часто употребляемых слов.

Эта строка:

key = dict[i]получает очередной ключ словаря, который и есть слово,

а следующая строка:

#.output(i, " : ", key, " = ", dict[key])печатает и это слово, и сколько раз оно встречается в тексте. Таким образом, обращение к словарю по числовому индексу возвращает нам ключ записи с этим порядковым индексом, а обращение к словарю по текстовому ключу возвращает нам значение записи, которым является число — сколько раз это слово встретилось в тексте.

Последняя команда:

<закрывает цикл.

Как видно из этого примера, SPL полностью автоматически определяет тип всех объектов — числовых и текстовых переменных, массивов, а также других объектов. При работе со словарем добавление новых записей производится автоматически.

Спасибо за внимание и успехов в программировании!

|

Метки: author Mr_Kibernetik программирование spl |

[Из песочницы] Клиент-сервер шаг — за — шагом, от однопоточного до многопоточного |

Цель публикации показать начинающим Java программистам все этапы создания многопоточного сервера. Для полного понимания данной темы основная информация содержится в комментариях моего кода и в выводимых в консоли сообщениях для лучшего понимания что именно происходит и в какой именно последовательности.

В начале будет рассмотрено создание элементарного клиент-сервера, для усвоения базовых знаний, на основе которых будет строиться многопоточная архитектура.

Понятия.

— Потоки: для того чтобы не перепутать что именно подразумевается под потоком я буду использовать существующий в профессиональной литературе синоним — нить, чтобы не путать Stream и Thread, всё таки более профессионально выражаться — нить, говоря про Thread.

— Сокеты(Sockets): данное понятие тоже не однозначно, поскольку в какой-то момент сервер выполняет — клиентские действия, а клиент — серверные. Поэтому я разделил понятие серверного сокета — (ServerSocket) и сокета (Socket) через который практически осуществляется общение, его будем называть сокет общения, чтобы было понятно о чём речь.

Кроме того сокетов общения создаётся по одному на каждом из обменивающихся данными приложении, поэтому сокет приложения которое имеет у себя объект - ServerSocket и первоначально открывает порт в ожидании подключения будем называть сокет общения на стороне сервера, а сокет который создаёт подключающееся к порту по известному адресу второе приложение будем называть сокетом общения на стороне клиента.Оглавление:

1) Однопоточный элементарный сервер.

2) Клиент.

3) Многопоточный сервер – сам по себе этот сервер не участвует в общении напрямую, а лишь является фабрикой однонитевых делигатов(делигированных для ведения диалога с клиентами серверов) для общения с вновь подключившимися клиентами, которые закрываются после окончания общения с клиентом.

4) Имитация множественного обращения клиентов к серверу.

Итак начнём с изучения структуры однопоточного сервер, который может принять только одного клиента для диалога. Код приводимый ниже необходимо запускать в своей IDE в этом идея всей статьи. Предлагаю все детали уяснить из подробно задокументированного кода ниже:

- 1) Однопоточный элементарный сервер.

import java.io.DataInputStream;

import java.io.DataOutputStream;

import java.io.IOException;

import java.net.ServerSocket;

import java.net.Socket;

public class TestAsServer {

/**

*

* @param args

* @throws InterruptedException

*/

public static void main(String[] args) throws InterruptedException {

// стартуем сервер на порту 3345

try (ServerSocket server= new ServerSocket(3345);){

// становимся в ожидание подключения к сокету под именем - "client" на серверной стороне

Socket client = server.accept();

// после хэндшейкинга сервер ассоциирует подключающегося клиента с этим сокетом-соединением

System.out.print("Connection accepted.");

// инициируем каналы для общения в сокете, для сервера

// канал чтения из сокета

DataInputStream in = new DataInputStream(client.getInputStream());

System.out.println("DataInputStream created");

// канал записи в сокет

DataOutputStream out = new DataOutputStream(client.getOutputStream());

System.out.println("DataOutputStream created");

// начинаем диалог с подключенным клиентом в цикле, пока сокет не закрыт

while(!client.isClosed()){

System.out.println("Server reading from channel");

// сервер ждёт в канале чтения (inputstream) получения данных клиента

String entry = in.readUTF();

// после получения данных считывает их

System.out.println("READ from client message - "+entry);

// и выводит в консоль

System.out.println("Server try writing to channel");

// инициализация проверки условия продолжения работы с клиентом по этому сокету по кодовому слову - quit

if(entry.equalsIgnoreCase("quit")){

System.out.println("Client initialize connections suicide ...");

out.writeUTF("Server reply - "+entry + " - OK");

Thread.sleep(3000);

break;

}

// если условие окончания работы не верно - продолжаем работу - отправляем эхо-ответ обратно клиенту

out.writeUTF("Server reply - "+entry + " - OK");

System.out.println("Server Wrote message to client.");

// освобождаем буфер сетевых сообщений (по умолчанию сообщение не сразу отправляется в сеть, а сначала накапливается в специальном буфере сообщений, размер которого определяется конкретными настройками в системе, а метод - flush() отправляет сообщение не дожидаясь наполнения буфера согласно настройкам системы

out.flush();

}

// если условие выхода - верно выключаем соединения

System.out.println("Client disconnected");

System.out.println("Closing connections & channels.");

// закрываем сначала каналы сокета !

in.close();

out.close();

// потом закрываем сам сокет общения на стороне сервера!

client.close();

// потом закрываем сокет сервера который создаёт сокеты общения

// хотя при многопоточном применении его закрывать не нужно

// для возможности поставить этот серверный сокет обратно в ожидание нового подключения

server.close();

System.out.println("Closing connections & channels - DONE.");

} catch (IOException e) {

e.printStackTrace();

}

}

}- 2) Клиент.

Сервер запущен и находится в блокирующем ожидании server.accept(); обращения к нему с запросом на подключение. Теперь можно подключаться клиенту, напишем код клиента и запустим его. Клиент работает когда пользователь вводит что-либо в его консоли (внимание! в данном случае сервер и клиент запускаются на одном компьютере с локальным адресом — localhost, поэтому при вводе строк, которые должен отправлять клиент не забудьте убедиться, что вы переключились в рабочую консоль клиента!). После ввода строки в консоль клиента и нажатия enter строка проверяется не ввёл ли клиент кодовое слово для окончания общения дальше отправляется серверу, где он читает её и то же проверяет на наличие кодового слова выхода. Оба и клиент и сервер получив кодовое слово закрывают ресурсы после предварительных приготовлений и завершают свою работу. Посмотрим как это выглядит в коде:

import java.io.BufferedReader;

import java.io.DataInputStream;

import java.io.DataOutputStream;

import java.io.IOException;

import java.io.InputStreamReader;

import java.net.Socket;

import java.net.UnknownHostException;

public class TestASClient {

/**

*

* @param args

* @throws InterruptedException

*/

public static void main(String[] args) throws InterruptedException {

// запускаем подключение сокета по известным координатам и нициализируем приём сообщений с консоли клиента

try(Socket socket = new Socket("localhost", 3345);

BufferedReader br =new BufferedReader(new InputStreamReader(System.in));

DataOutputStream oos = new DataOutputStream(socket.getOutputStream());

DataInputStream ois = new DataInputStream(socket.getInputStream()); )

{

System.out.println("Client connected to socket.");

System.out.println();

System.out.println("Client writing channel = oos & reading channel = ois initialized.");

// проверяем живой ли канал и работаем если тру

while(!socket.isOutputShutdown()){

// ждём консоли клиента на предмет появления в ней данных

if(br.ready()){

// данные появились - работаем

System.out.println("Client start writing in channel...");

Thread.sleep(1000);

String clientCommand = br.readLine();

// пишем данные с консоли в канал сокета для сервера

oos.writeUTF(clientCommand);

oos.flush();

System.out.println("Clien sent message " + clientCommand + " to server.");

Thread.sleep(1000);

// ждём чтобы сервер успел прочесть сообщение из сокета и ответить

// проверяем условие выхода из соединения

if(clientCommand.equalsIgnoreCase("quit")){

// если условие выхода достигнуто разъединяемся

System.out.println("Client kill connections");

Thread.sleep(2000);

// смотрим что нам ответил сервер на последок перед закрытием ресурсов

if(ois.available()!=0) {

System.out.println("reading...");

String in = ois.readUTF();

System.out.println(in);

}

// после предварительных приготовлений выходим из цикла записи чтения

break;

}

// если условие разъединения не достигнуто продолжаем работу

System.out.println("Client sent message & start waiting for data from server...");

Thread.sleep(2000);

// проверяем, что нам ответит сервер на сообщение(за предоставленное ему время в паузе он должен был успеть ответить)

if(ois.available()!=0) {

// если успел забираем ответ из канала сервера в сокете и сохраняем её в ois переменную, печатаем на свою клиентскую консоль

System.out.println("reading...");

String in = ois.readUTF();

System.out.println(in);

}

}

}

// на выходе из цикла общения закрываем свои ресурсы

System.out.println("Closing connections & channels on clentSide - DONE.");

} catch (UnknownHostException e) {

// TODO Auto-generated catch block

e.printStackTrace();

} catch (IOException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}

}- 3) Многопоточный сервер

А что если к серверу хочет подключиться ещё один клиент!? Ведь описанный выше сервер либо находится в ожидании подключения одного клиента, либо общается с ним до завершения соединения, что делать остальным клиентам? Для такого случая нужно создать фабрику которая будет создавать описанных выше серверов при подключении к сокету новых клиентов и не дожидаясь пока делигированный подсервер закончит диалог с клиентом откроет accept() в ожидании следующего клиента. Но чтобы на серверной машине хватило ресурсов для общения со множеством клиентов нужно ограничить количество возможных подключений. Фабрика будет выдавать немного модифицированный вариант предыдущего сервера(модификация будет касаться того что класс сервера для фабрики будет имплементировать интерфейс — Runnable? для возможности его использования в пуле нитей — ExecuteServices). Давайте создадим такую серверную фабрику и ознакомимся с подробным описанием её работы в коде:

- Фабрика:

import java.io.BufferedReader;

import java.io.IOException;

import java.io.InputStreamReader;

import java.net.ServerSocket;

import java.net.Socket;

import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;

/**

* @author mercenery

*

*/

public class MultiThreadServer {

static ExecutorService executeIt = Executors.newFixedThreadPool(2);

/**

* @param args

*/

public static void main(String[] args) {

// стартуем сервер на порту 3345 и инициализируем переменную для обработки консольных команд с самого сервера

try (ServerSocket server = new ServerSocket(3345);

BufferedReader br = new BufferedReader(new InputStreamReader(System.in))) {

System.out.println("Server socket created, command console reader for listen to server commands");

// стартуем цикл при условии что серверный сокет не закрыт

while (!server.isClosed()) {

// проверяем поступившие комманды из консоли сервера если такие

// были

if (br.ready()) {

System.out.println("Main Server found any messages in channel, let's look at them.");

// если команда - quit то инициализируем закрытие сервера и

// выход из цикла раздачии нитей монопоточных серверов

String serverCommand = br.readLine();

if (serverCommand.equalsIgnoreCase("quit")) {

System.out.println("Main Server initiate exiting...");

server.close();

break;

}

}

// если комманд от сервера нет то становимся в ожидание

// подключения к сокету общения под именем - "clientDialog" на

// серверной стороне

Socket client = server.accept();

// после получения запроса на подключение сервер создаёт сокет

// для общения с клиентом и отправляет его в отдельную нить

// в Runnable(при необходимости можно создать Callable)

// монопоточную нить = сервер - MonoThreadClientHandler и тот

// продолжает общение от лица сервера

executeIt.execute(new MonoThreadClientHandler(client));

System.out.print("Connection accepted.");

}

// закрытие пула нитей после завершения работы всех нитей

executeIt.shutdown();

} catch (IOException e) {

e.printStackTrace();

}

}

}- Модифицированный Runnable сервер для запуска из предыдущего кода:

import java.io.DataInputStream;

import java.io.DataOutputStream;

import java.io.IOException;

import java.net.Socket;

public class MonoThreadClientHandler implements Runnable {

private static Socket clientDialog;

public MonoThreadClientHandler(Socket client) {

MonoThreadClientHandler.clientDialog = client;

}

@Override

public void run() {

try {

// инициируем каналы общения в сокете, для сервера

// канал чтения из сокета

DataInputStream in = new DataInputStream(clientDialog.getInputStream());

System.out.println("DataInputStream created");

// канал записи в сокет

DataOutputStream out = new DataOutputStream(clientDialog.getOutputStream());

System.out.println("DataOutputStream created");

///////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////

// основная рабочая часть //

//////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////

// начинаем диалог с подключенным клиентом в цикле, пока сокет не

// закрыт клиентом

while (!clientDialog.isClosed()) {

System.out.println("Server reading from channel");

// серверная нить ждёт в канале чтения (inputstream) получения

// данных клиента после получения данных считывает их

String entry = in.readUTF();

// и выводит в консоль

System.out.println("READ from clientDialog message - " + entry);

// инициализация проверки условия продолжения работы с клиентом

// по этому сокету по кодовому слову - quit в любом регистре

if (entry.equalsIgnoreCase("quit")) {

// если кодовое слово получено то инициализируется закрытие

// серверной нити

System.out.println("Client initialize connections suicide ...");

out.writeUTF("Server reply - " + entry + " - OK");

Thread.sleep(3000);

break;

}

// если условие окончания работы не верно - продолжаем работу -

// отправляем эхо обратно клиенту

System.out.println("Server try writing to channel");

out.writeUTF("Server reply - " + entry + " - OK");

System.out.println("Server Wrote message to clientDialog.");

// освобождаем буфер сетевых сообщений

out.flush();

// возвращаемся в началло для считывания нового сообщения

}

///////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////

// основная рабочая часть //

//////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////

// если условие выхода - верно выключаем соединения

System.out.println("Client disconnected");

System.out.println("Closing connections & channels.");

// закрываем сначала каналы сокета !

in.close();

out.close();

// потом закрываем сокет общения с клиентом в нити моносервера

clientDialog.close();

System.out.println("Closing connections & channels - DONE.");

} catch (IOException e) {

e.printStackTrace();

} catch (InterruptedException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}

}Для имитации множественного обращения клиентов к серверу, создадим и запустим (после запуска серверной части) фабрику Runnable клиентов которые будут подключаться серверу и писать сообщения в цикле:

- 4) Имитация множественного обращения клиентов к серверу.

import java.io.IOException;

import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;

public class Main {

// private static ServerSocket server;

public static void main(String[] args) throws IOException, InterruptedException {

// запустим пул нитей в которых колличество возможных нитей ограничено -

// 10-ю.

ExecutorService exec = Executors.newFixedThreadPool(10);

int j = 0;

// стартуем цикл в котором с паузой в 10 милисекунд стартуем Runnable

// клиентов,

// которые пишут какое-то количество сообщений

while (j < 10) {

j++;

exec.execute(new TestRunnableClientTester());

Thread.sleep(10);

}

// закрываем фабрику

exec.shutdown();

}

}Как видно из предыдущего кода фабрика запускает — TestRunnableClientTester() клиентов, напишем для них код и после этого запустим саму фабрику, чтобы ей было кого исполнять в своём пуле:

import java.io.DataInputStream;

import java.io.DataOutputStream;

import java.io.IOException;

import java.net.Socket;

public class TestRunnableClientTester implements Runnable {

static Socket socket;

public TestRunnableClientTester() {

try {

// создаём сокет общения на стороне клиента в конструкторе объекта

socket = new Socket("localhost", 3345);

System.out.println("Client connected to socket");

Thread.sleep(2000);

} catch (Exception e) {

e.printStackTrace();

}

}

@Override

public void run() {

try (

// создаём объект для записи строк в созданный скокет, для

// чтения строк из сокета

// в try-with-resources стиле

DataOutputStream oos = new DataOutputStream(socket.getOutputStream());

DataInputStream ois = new DataInputStream(socket.getInputStream())) {

System.out.println("Client oos & ois initialized");

int i = 0;

// создаём рабочий цикл

while (i < 5) {

// пишем сообщение автогенерируемое циклом клиента в канал

// сокета для сервера

oos.writeUTF("clientCommand " + i);

// проталкиваем сообщение из буфера сетевых сообщений в канал

oos.flush();

// ждём чтобы сервер успел прочесть сообщение из сокета и

// ответить

Thread.sleep(10);

System.out.println("Client wrote & start waiting for data from server...");

// забираем ответ из канала сервера в сокете

// клиента и сохраняемеё в ois переменную, печатаем на

// консоль

System.out.println("reading...");

String in = ois.readUTF();

System.out.println(in);

i++;

Thread.sleep(5000);

}

} catch (IOException e) {

// TODO Auto-generated catch block

e.printStackTrace();

} catch (InterruptedException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}

}Запускайте, вносите изменения в код, только так на самом деле можно понять работу этой структуры.

P.S. В последнем примере клиенты и серверы работают в бесконечном цикле, так что после окончания тестирования кода не забудьте завершить их работу.

Спасибо за внимание.

|

Метки: author OlegMercenery java многопоточность на java клиент-сервер чат java |

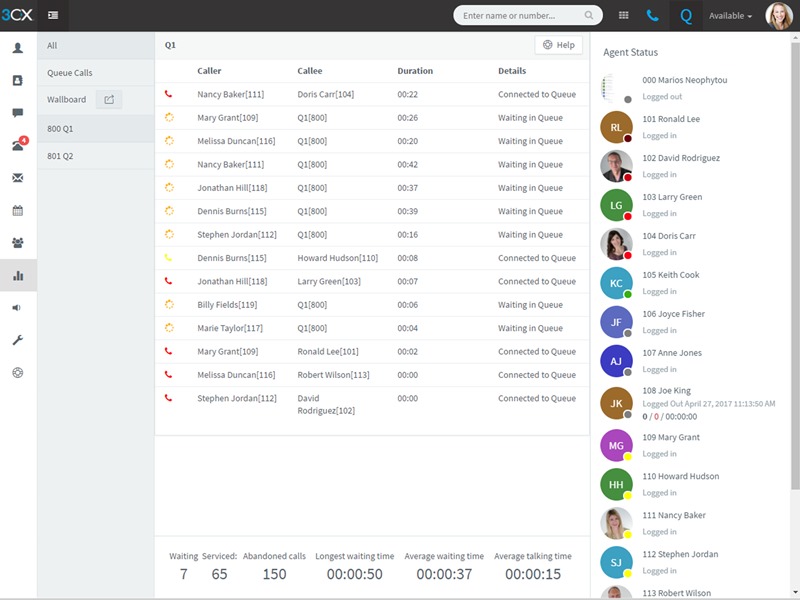

[recovery mode] Представляем 3CX Phone System V15.5 |

3CX v15.5 подчинена концепции “Deploy Anywhere”. Это значит, что она одинаково быстро и просто устанавливается на:

- Стандартных серверах Windows и Debian Linux. Система может быть установлена как ISO образ (Linux) и как серверное приложение (Windows и Linux).

- Мини ПК на платформе Intel, например, Intel NUC, Zotac, Shuttle и Gigabyte. Эти ПК доступны у локальных поставщиков, всегда есть на складе, и покрываются локальной гарантией. Благодаря массовому производству, они стоят значительно дешевле специализированных платформ для АТС. Установка также делается из ISO образа Debian.

- VPS серверах Debian, предоставляемых такими гигантами, как Google, Amazon, OVH, 1&1. Однако, вы всегда можете выбрать VPS хостинг нужной мощности и в вашем регионе.

- Автоматический сервис развертывания АТС 3CX из “файла ответов” с помощью сервиса PBX Express. За несколько минут вы получаете готовую к работе систему объединенных коммуникаций.

Интегрированные веб-конференции

Новый веб-клиент включает интерфейс моментального создания видеоконференций. Для этого не нужны никакие плагины и вообще какая-либо настройка. Достаточно нажать одну кнопку и пригласить участников по e-mail или просто “сбросив“ ссылку на подключение. Приглашенные участники подключаются через стандартный браузер, в котором формируется интерфейс клиента видеоконференций. 3CX – единственная система на рынке, предлагающая интегрированные бесплатные видеоконференции до 100 одновременных участников!

Визуальное управление вызовами на телефоне и смартфоне

Веб-клиент для управления IP телефонами теперь использует стандарт uaCSTA. Он позволяет надежно управлять связанным телефоном, независимо от физического расположения устройства, пользователя и АТС. Не важно, где расположена АТС – локально или в облаке – любые действия в новом веб-клиенте будут гарантированно отработаны на вашем телефоне, без веб-запросов и открытия дополнительных портов на сетевом экране. Если клиент 3CX установлен на смартфоне, веб-клиент без проблем сможет им управлять, даже если вы находитесь за пределами офиса.

Chrome расширение Click2Call

Обновленное расширение Chrome Click2Call позволяет оператору звонить одним кликом с любой веб-страницы, из большинства веб-CRM и Office365.

Другие возможности 15.5

- Интегрированный отельный модуль. Теперь он бесплатно включен в редакцию 3CX Pro и позволяет обмениваться служебной информацией с системами управления гостиничным хозяйством (PMS системами) по протоколу Fidelio и Mitel (и совместимыми). Подробнее о возможностях модуля можно узнать из документации.

- Поддержка Google Firebase PUSH. Новый стандарт доставки PUSH уведомлений, используемый в новых версиях Android, который пришел на замену Google Cloud Messaging. Новая инсталляция 3CX будет использовать предустановленный Firebase аккаунт, однако рекомендуется использовать собственный аккаунт, созданный по этой инструкции.

- Соответствие стандарту PCI (передача параметров кредитных карт). Если во время записи разговора клиент сообщает информацию о кредитной карте, запись разговора приостанавливается. При этом сохраняется единый файл записи этого разговора.

- Среда разработки голосовых приложений Call Flow Designer. Теперь она поставляется бесплатно, однако работа созданных приложений поддерживается только в редакции 3CX Pro. Подробнее о разработке приложений для 3CX, включая скрипты исходящего обзвона, можно узнать здесь.

Видеоролики о некоторых функциях веб-клиента

Загрузки и документация

- Руководство администратора

- Руководство пользователя

- Установка на Windows

- Установка на Linux

- Расширение Click2Call

- 3CX Session Border Controller

|

|

[Из песочницы] Делаем бота для дракончика в Google Chrome |

Давайте приступим к его созданию. Принцип действия бота таков, мы парсим цвет пикселя на определенном расстоянии от персонажа в цикле и проверяем, если цвет пикселя равен цвету кактуса, то прыгаем иначе ни чего не делаем.

Начнем с того, что найдем нужный пиксель. В моем случае этот пиксель находится на координатах «775x250». Нужный пиксель я беру на 1 выше самого высокого бугорка на дороге и на расстоянии от персонажа выведенного методом проб и ошибок. Также следует заметить, что у меня разрешение экрана 1920х1080 21.5" и если у вас другое, то скорее всего будет работать криво.

Создадим консольное приложение в VS.

Для начала объявим переменные для координат пикселя.

public static int x = 775;

public static int y = 250;

Затем подключим DLL для работы.

[DllImport("user32.dll")]

public static extern IntPtr GetDC(IntPtr hwnd);

[DllImport("user32.dll")]

public static extern int ReleaseDC(IntPtr hwnd, IntPtr hDC);

[DllImport("gdi32.dll")]

public static extern uint GetPixel(IntPtr hDC, int x, int y);

Далее все еще проще, добавляем код для самого обработчика

IntPtr hDC = GetDC(IntPtr.Zero);

while (true)

{

uint pixel = GetPixel(hDC, x, y);

if (pixel == 5460819)

{

SendKeys.SendWait("{UP}");

}

}

Код взят в бесконечный цикл.

if (pixel == 5460819)Данная строчка означает, что когда цвет пикселя равен цвету кактуса в кодировке Decimal, то происходит нажтие стрелки вверх.

SendKeys.SendWait("{UP}");Так же нужно подключить 2 ссылки.

using System.Diagnostics;

using System.Windows.Forms;На данный момент дракончик с легкостью преодолевает 500 игровых метров, а дальше его подстерегает неожиданность ввиде птиц и ночи. Для решения этих проблем я напишу следующую статью. Удачи!

using System;

using System.Collections.Generic;

using System.Linq;

using System.Runtime.InteropServices;

using System.Text;

using System.Threading.Tasks;

using System.Diagnostics;

using System.Windows.Forms;

namespace DragonChrome

{

class Program

{

#region VAR

public static int x = 775;

public static int y = 250;

#endregion

#region DLL

[DllImport("user32.dll")]

public static extern IntPtr GetDC(IntPtr hwnd);

[DllImport("user32.dll")]

public static extern int ReleaseDC(IntPtr hwnd, IntPtr hDC);

[DllImport("gdi32.dll")]

public static extern uint GetPixel(IntPtr hDC, int x, int y);

#endregion

static void Main(string[] args)

{

IntPtr hDC = GetDC(IntPtr.Zero);

while (true)

{

uint pixel = GetPixel(hDC, Convert.ToInt32(x), y);

if (pixel == 5460819)

{

SendKeys.SendWait("{UP}");

}

}

}

}

}|

|

[Из песочницы] Настройка Reverse Proxy Apache (Debian 8) с автоматической выдачей Let's Encrypt |

Решение было найдено: поднять Reverse Proxy на Apache и сделать так, чтобы работала автовыдача сертификатов Let's Encrypt. А после чего спокойно публиковать его на Firewall, при этом порты буду перенаправляться с http на https.

За основу берем что у нас стоит чистый Debian GNU/Linux 8 (jessie). Подробнее под катом.

Ну что-ж, поехали.

aptitude install -y build-essential

aptitude install -y libapache2-mod-proxy-html libxml2-dev

aptitude install -y apache2После чего активируем следующие модули:

a2enmod proxy

a2enmod proxy_http

a2enmod proxy_ajp

a2enmod rewrite

a2enmod deflate

a2enmod headers

a2enmod proxy_balancer

a2enmod proxy_html

a2enmod proxy_ftp

a2enmod proxy_connect

a2enmod sslи рестартуем Apache:

service apache2 restartТут нас поджидает первая неудача, Apach'у для правильной работы не хватает модуля mod_xml2enc, НО! в Jessie этот модуль не работает, нам последовательно нужно внести следующие команды:

aptitude install apache2-prefork-dev libxml2 libxml2-dev apache2-dev

mkdir ~/modbuild/ && cd ~/modbuild/

wget http://apache.webthing.com/svn/apache/filters/mod_xml2enc.c

wget http://apache.webthing.com/svn/apache/filters/mod_xml2enc.h

apxs2 -aic -I/usr/include/libxml2 ./mod_xml2enc.c

cd ~

rm -rfd ~/modbuild/

service apache2 restartПосле чего, все у нас хорошо, модуль стоит. Едем дальше )

Так как мы хотим опубликовать HTTPS сайт, до того момента пока мы не установим Let's Encrypt, нам нужно сделать самоподписанный сертификат для нашего сайта, вводим комманду:

mkdir /etc/apache2/ssl

cd /etc/apache2/ssl

openssl req -x509 -nodes -days 365 -newkey rsa:2048 -keyout server.key -out server.crtНам нужно создать файл конфигурации и назвать его понятным именем:

touch /etc/apache2/sites-available/sambi4.confИ задаем файлу примерно такое содержание:

ServerName sambi4.ru

Redirect permanent / https://sambi4.ru/ #отвечает за перенаправление на https

SSLEngine On

SSLProxyEngine On

ProxyRequests Off

ProxyPreserveHost On

ProxyVia full

SSLCertificateFile /etc/apache2/ssl/server.crt #указываем путь к нашему самоподписанному сертификату

SSLCertificateKeyFile /etc/apache2/ssl/server.key #указываем путь к нашему самоподписанному ключу сертификата

ProxyHTMLInterp On

ProxyHTMLExtended On

Order deny,allow

Allow from all

ProxyPass / https://192.168.199.78/ #IP адрес публикуемого ресурса.

ProxyPassReverse / https://192.168.199.78/ #IP адрес публикуемого ресурса.

ServerName sambi4.ru

ServerAdmin sambi4@sambi4.ru #считается хорошим тоном указывать email админа

DocumentRoot "/var/www/html" #эта строка нужна для того чтобы апач запустился, без нее он не сможет опубликовать ваш ресурс.

После завершения создания, не забываем включить наш сайт:

a2ensite /etc/apache2/sites-available/sambi4.confперезапускаем Apache:

service apache2 restartПосле всех проделанных процедур, мы имеем настроеный Reverse Proxy на Apache2, теперь можно приступить к настройке Let's Encrypt:

Из всех бесплатных сертификатов, жив остался только Let's Encrypt, но его особенность в том, что сертификат выдается сроком на 3 месяца.

Нам нужно поставить сертификат, и сделать автоматическую выдачу при завершении срока сертификации.

echo 'deb http://ftp.debian.org/debian jessie-backports main' | tee /etc/apt/sources.list.d/backports.listпосле:

aptitude updateну а теперь ставим сам Let's Encrypt:

aptitude install -y python-certbot-apache -t jessie-backportsДожидаемся процесса установки, и пробуем выпустить сертификат:

certbot --apacheИ вот тут нас поджидает неудача:

ERROR:letsencrypt_apache.configurator:No vhost exists with servername or alias of: sambi4.ru. No vhost was selected. Please specify servernames in the Apache config

Связано это с тем, что в репозитариях до сих пор старая версия (на момент написания 0.10.2), в которой наблюдаются ошибки. А именно ошибки в python-скриптах. Решение как обычно просто:

Качаем свежую версию certbot:

git clone https://github.com/certbot/certbot.gitПосле чего, идем по пути:

cd /usr/lib/python2.7/dist-packagesУдаляем папки (а лучше делаем бэкап):

acme

certbot

certbot_apache

И копируем файлы из нового релиза:

cp /root/certbot/certbot /usr/lib/python2.7/dist-packages/

cp /root/certbot/acme/acme/ /usr/lib/python2.7/dist-packages/

cp /root/certbot/certbot-apache/certbot_apache/ /usr/lib/python2.7/dist-packages/Теперь можно со спокойной душой запускать процесс выпуска сертификата:

certbot --apacheОтвечаем на вопросы и все!

Поздравляю, сертификат мы выпустили, теперь нужно добавить скрипт автопродления сертификата, т.к. Let's Encrypt выдает сертификаты сроком только на 90 дней (мы об этом помним).

Все просто. Нам в cron нужно добавить строчку:

30 2 * * 1 /usr/bin/certbot renew >> /var/log/le-renew.logТ.е. набираем:

crontab -eИ добавляем нашу строку (обязательно перейти на следующую срочку, иначе не сохранится)

И все, повторить бесконечное множество раз с Вашими другими ресурсами.

Удачи, админы!

|

Метки: author SAMbI4 apache *nix apache2 letsencrypt reverse proxy |

[Перевод] Советы по Postgres для Rails разработчиков |

В апреле на RailsConf в Фениксе мы обсудили огромное количество советов по использованию Postgres с Rails, и подумали, что будет полезно их записать и поделиться с более широкой аудиторией. Здесь вы найдете некоторые из них, касающиеся отладки и улучшения производительности базы данных вашего Rails приложения.

Управление долгими запросами с помощью таймаутов

Долгие запросы могут оказывать все виды негативных воздействий на вашу базу данных. Независимо от того, работают ли запросы часами или всего несколько секунд, они могут держать блокировки, переполнять WAL, или просто потреблять огромное количество системных ресурсов. C Postgres легче добиться большей стабильности с помощью установки таймаута на запросы. Удобно, что можно установить значение по умолчанию, например, 5 секунд, как показано в примере ниже, и тогда любой запрос, длящийся дольше 5 секунд будет убит:

production:

url:

variables:

statement_timeout: 5000Если вам требуется, чтобы запрос выполнялся дольше в пределах сессии, можно задать таймаут, действительный только для текущего соединения:

class MyAnalyticsJob < ActiveJob::Base

queue_as :analytics

def perform

ActiveRecord::Base.connection.execute “SET statement_timeout = 600000” # 10 минут

# ...

ensure

ActiveRecord::Base.connection.execute “SET statement_timeout = 5000” # 5 секунд

end

end

Поиск “плохих” запросов

Rails многое абстрагирует при взаимодействии с вашей базой данных. Это может быть как хорошо, так и плохо. Postgres сам позволяет отслеживать долгие запросы, но по мере роста вашего Rails приложения, этого может оказаться недостаточно. Чтобы узнать происхождение запроса, есть чрезвычайно удобный гем marginalia, который будет логировать, откуда именно пришел ваш запрос. Теперь, когда вы видите неправильный запрос, слишком медленный, или который просто можно убрать, вы точно знаете где в коде это поправить:

Account Load (0.3ms)

SELECT `accounts`.* FROM `accounts`

WHERE `accounts`.`queenbee_id` = 1234567890

LIMIT 1

/*application:BCX,controller:project_imports,action:show*/Внимание на комментарий — прим.пер.

Высокоуровневый обзор ситуации с запросами к базе

Часто требуется общая картина того, что происходит в вашей базе данных. pg_stat_statements — это расширение Postgres, которое часто предустановленно в облачных средах, таких как Citus Cloud. Оно позволяет видеть, какие запросы выполнялись с момента последнего сброса статистики и как они себя вели.

Например, чтобы увидеть 10 наиболее долго выполняющихся запросов и их среднее время, выполните следующее:

SELECT query, total_time / calls AS avg_time

FROM pg_stat_statements

ORDER BY total_time DESC

LIMIT 10;Если включить «track_io_timing» в сборщике статистики Postgres, то можно понять что является узким местом — процессор или ввод-вывод. Можно узнать больше о pg_stat_statements здесь (или в другой статье okmeter.io на хабре — прим.пер.).

Использование продвинутых фич

По умолчанию Rails использует файл «schema.rb» для хранения копии схемы базы данных, обычно используемой для инициализации базы данных перед запуском тестов. К сожалению, многие расширенные функции Postgres, такие как функциональные и частичные индексы, а также составные первичные ключи, не могут быть представлены в этом DSL.

Вместо этого имеет смысл перейти на генерируемый и используемый Rails файл «db/structure.sql», который можно сделать следующим образом:

# Use SQL instead of Active Record's schema dumper when creating the database.

# This is necessary if your schema can't be completely dumped by the schema dumper,

# like if you have constraints or database-specific column types

config.active_record.schema_format = :sqlВнутри используется формат Postgres «pg_dump», который иногда может быть чересчур подробным, но зато гарантирует получение полностью восстановленной структуры базы данных. Если вы столкнетесь с проблемой чрезмерно длинных diff-ов, можете взглянуть на activerecord-clean-db-structure.

Следите за тем, чтобы сложные транзакции не блокировали друг друга

Rails любит помещать всё в транзакции, особенно при использовании хуков «before_save» и многоуровневых связей между моделями. Существует одно важное предостережение, которое следует учитывать при транзакциях, которые могут создавать проблемы при масштабировании. Например, в такой транзакции:

BEGIN;

UPDATE organizations SET updated_at = ‘2017-04-27 11:31:03 -0700’ WHERE id = 123;

SELECT * FROM products WHERE store_id = 456;

--- еще всякие statement’ы тут

COMMIT; Первый оператор UPDATE будет удерживать блокировку на строку "organizations" с id "123", с самого начала и до COMMIT’а транзакции.

Представьте другой запрос к той же самой "organization", пришедший, например, от другого пользователя, и выполняющий аналогичную транзакцию. Как правило, чтобы выполниться, этому другому запросу придется ждать комита первой транзакции, что увеличит время ответа. Чтобы исправить это, можно переупорядочить транзакцию, чтобы UPDATE выполнялся ближе к концу, а также рассмотреть возможность сгруппировать обновления полей временных меток вне транзакции после выполнения основной работы.

Чтобы обнаруживать подобные проблемы зарание, вы можете установить «log_lock_waits = on» в PostgreSQL.

Контролируйте подключения к базе данных

Rails по умолчанию поддерживает пул подключений к базе данных. Когда приходит новый запрос, он берет одно соединение из пула и передает его в приложение. По мере масштабирования вашего Rails приложения это может привести к сотням открытых подключений к базе данных, хотя на самом деле только часть из них выполняет работу. Ключом к этому является использование менеджера соединений для уменьшения активных подключений к базе данных, например, такого как pgBouncer. Менеджер соединений будет открывать соединения, когда транзакции активны, и не пропускать простаивающие соединения, которые не выполняют никакой работы.

От переводчика — а еще вы можете использовать наш мониторинг, который отследит количество соединений к Постгресу и к pgBouncer и много всего другого и поможет предупредить и разрешить проблемные ситуации.

|

Метки: author tru_pablo ruby on rails postgresql блог компании okmeter.io active record postgres activerecord |

Самодельный эмулятор дисковода для Amiga |

Я долго думал, где разместить эту статью — здесь или на geektimes. С одной стороны, она касается разработки для микроконтроллеров, а с другой речь пойдёт о разработке устройства для очень старого компьютера, тема о которых находится на geektimes. Однако, на geektimes описываются сами устройства и программирование для них на их API, а здесь всё-таки, устройство собрано на почти современной элементной базе.

У некоторых дома сохранились компьютеры Amiga, кому-то такой компьютер могли просто отдать (как мне), а кто-то специально себе его купил. И иногда бывает так, что компьютер есть, но на нём нет винчестера (например, у меня на Amiga 500 его нет), а запустить что-то на нём хочется. Возиться с дискетами (которые можно записать на PC только с помощью специальных устройств) не вариант. Вот и выбирают люди эмуляторы дисководов. Сейчас их предлагается довольно много, но вот несколько лет назад таких устройств ещё почти не было. Насколько мне известно, первым эмулятор дисковода для Amiga сделал tnt23. Можно было, конечно, купить у него эмулятор, но хотелось всё-таки попробовать свои силы в создании собственного, тем более, что в попытке запустить этот компьютер я на тот момент уже создал простое устройство для записи дискет, и в целом формат дискеты проблемы не представлял. Описываемая статья была когда-то написана для журнала Dogma, но не попала в выпуск этого журнала потому, что про неё просто забыли. Однако, я знаю, здесь есть амижники и, думаю, им будет интересно прочесть, как можно сделать свой собственный эмулятор дисковода. Быть может, эта информация подтолкнёт кого-то к созданию своего устройства, гораздо более совершенного. Итак, начнём.

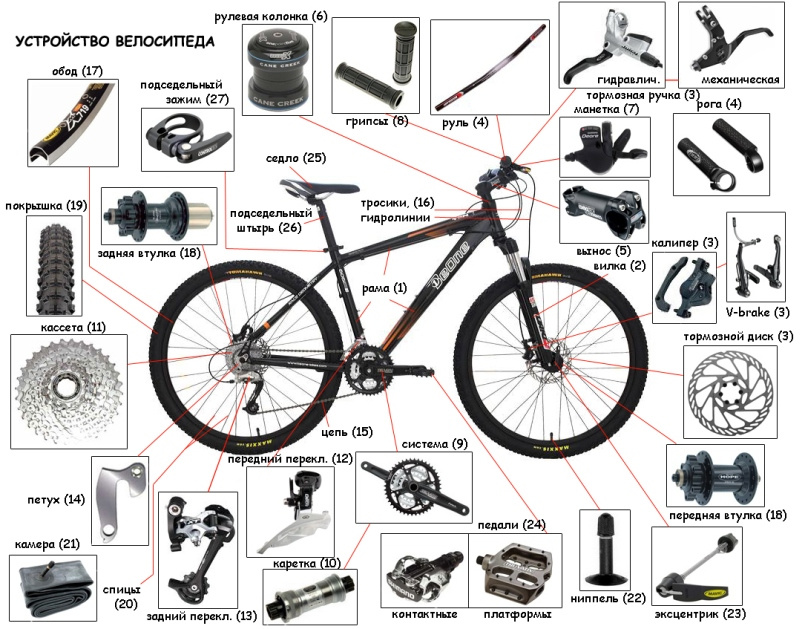

Описанный ниже эмулятор дисковода достаточно несложен сборке и не содержит дефицитных деталей. Проблема может возникнуть лишь с поиском 30 контактных модулей SIMM ёмкостью 1 МБ. Однако, такие модули были широко распространены и, скорее всего, их можно найти на радиорынках. На Юноне в СПб они точно были.

Список деталей для сборки:

Марка применяемых конденсаторов, диодов, резисторов, дросселя, кнопок и держателя SD-карты значения не имеет. Диоды требуются обязательно с падением напряжения на переходе не менее 0.5 В. Дисплей может быть с другими буквенными индексами.

Эмулятор подключается в разъём внешнего дисковода и позволяет воспроизводить выбранный образ дискеты. Образы дискет хранятся в корневом каталоге на SD-карте с файловой системой FAT16. Файлы создаются специальной программой-конвертером файлов ADF и представляют собой побайтные данные стандартной 80 дорожечной дискеты, закодированные с помощью MFM кодирования. Никаких заголовков такие файлы не содержат. Ввиду упрощения схемотехники эмулятор не имеет аппаратной возможности переводить линии дисковода в Z-состояние в зависимости от того выбран ли дисковод A или B. Это значит, что все дисководы Amiga требуется аппаратно отключить во время работы с эмулятором. Однако, возможность распознавать адрес дисковода теоретически предусмотрена программно – для этого требуется чтобы микроконтроллер опознавал адрес и переводил выходы в Z-состояние, если адрес не соответствует нужному. Линии для чтения адреса дисковода на схеме предусмотрены, но программно такая возможность не реализована.

Внешний вид эмулятора со стороны дисплея.

Схемотехнически эмулятор состоит из двух частей. Каждая из частей основана на микроконтроллере Atmega16. Микроконтроллер первой части занимается выводом информации на дисплей, обработкой кнопок, чтением информации с SD-карты с использованием аппаратного SPI, формированием части линий дисковода. Микроконтроллер второй части занимается регенерацией динамической памяти и формирует остальные сигналы линий дисковода. Обе части обмениваются информацией по шине SPI. Для контроллера D2 шина SPI для связи с D3 программная, а в D3 задействован аппаратный SPI.

Рассмотрим подробнее назначение элементов. Микросхема D1 обеспечивает питание SD-карты напряжением 3.3 В. Диоды VD1-VD6 понижают напряжение линий SPI c 5 до 3.3 В. Резисторы R1-R6 и R8-R9 притягивают линии к земле. RC-цепочки R7-C3 и R11-C5 формируют сигнал начального сброса микроконтроллеров. Элементы Z1, C1 и C2 обеспечивают генерацию 16 МГц на первом микроконтроллере (D2). Второй микроконтроллер (D3) работает в режиме внешней синхронизации от тактового генератора первого микроконтроллера. Резистор R10 управляет контрастностью изображения на дисплее. Элементы L1 и C4 обеспечивают фильтрацию напряжения источника питания.

Аппаратная часть эмулятора дисковода собирается на плате размерами 220x125 мм. Печать односторонняя, выполняется любым доступным методом, например, ЛУТ. На противоположной печати стороне платы необходимо поставить ряд перемычек проводом (отображены синими дорожками в прилагающемся файле печатной платы в формате Sprint Layout 4.0).

Программная часть эмулятора состоит из двух программ для микроконтроллеров. Программа для микроконтроллера D2 находится в папке MK1, а для микроконтроллера D3, соответственно, в папке MK2. После прошивки микроконтроллеров соответствующим HEX-файлом любым доступным способом (в том числе, для прошивки можно использовать схему “пять проводков в LPT-порт компьютера” совместно с программой программатора Uniprof), необходимо выставить FUSE-биты конфигурации контроллеров. С помощью этих битов необходимо в обоих контроллерах отключить JTAG, переключить D2 на тактирование от внешнего кварцевого резонатора 16 МГц, включить для D2 увеличенную амплитуду сигнала с осциллятора на выходе (бит CKOPT), а D3 переключить на тактирование от внешнего источника. Если ваш программатор не имеет собственного тактового генератора, контроллеры после этой операции будут недоступны для программирования. Чтобы они снова стали программируемыми потребуется подключить к XTAL1 контроллеров любой внешний генератор с частотой несколько сотен килогерц. Обязательно перед модификацией FUSE-битов считайте их с контроллера. Обратите внимание, что разные программаторы по-разному трактуют включенный и выключенный бит.

Эмулятор не требует наладки после сборки. Однако, возможно, не все модули SIMM 30 PIN будут корректно работать с ним. Для этой цели в меню эмулятора есть пункт “ТЕСТИРОВАНИЕ ПАМЯТИ”.

Для облегчения понимания работы программного обеспечения эмулятора необходимо знать следующее. На стандартной дискете Amiga хранит записанные данные по 80 дорожек с двух сторон. Каждая дорожка состоит из 11 секторов по 512 байт. Следовательно, полный объём данных дискеты 901120 байт. Именно такой объём имеют ADF-файлы образов дискет. Такой файл не содержит заголовков, а данные внутри просто перечисляются следующим образом: (дорожка 0, сторона 0), (дорожка 0, сторона 1), (дорожка 1, сторона 0), (дорожка 1, сторона 1)… (дорожка 79, сторона 0), (дорожка 79, сторона 1). Каждая дорожка — это запись 11 секторов по 512 байт начиная с 0 сектора. Для эмуляции дискеты такой файл в чистом виде не подходит. Дело в том, что ADF файл хранит только полезные данные безо всякой служебной информации и без модуляции. Рассмотрим, как осуществляется модуляция сигнала в компьютере Amiga.

Любой дисковод представляет из себя не более, чем аналог магнитофона. Он никак не кодирует записанные данные. Вы выбираете дорожку и модулируете ток (а, следовательно, и напряженность магнитного поля) через головку дисковода для записи информации. При воспроизведении в местах, где напряженность магнитного поля изменялась, дисковод считывает короткий импульс. Amiga использует при записи на дискеты модифицированную частотную модуляцию, так называемую MFM (Modified Frequency Modulation). При таком способе модуляции изменение тока через катушку зависит не только от значения записываемого бита, но и от значения предшествующих бит, как показано в таблице ниже. В графе “кодируется” R означает смену намагниченности (подачу импульса дисководу), а N — намагниченность не изменяется. В дальнейшем для записи MFM файла в бинарном формате примем R равным 1, а N равным 0. В MFM файл записываются уже на один бит данных два бита смены намагниченности. Таким образом, размер данных MFM файла по сравнению с ADF файлом будет удвоенный. Но просто преобразовать ADF в MFM нельзя. Amiga использует свой собственный формат записи на дискеты, который потребуется учесть.

Условимся номером трека называть номер дорожки на одной из сторон диска (т.е. номер трека изменяется от 0 до 79), а номером дорожки ((2*номер трека)+номер стороны диска). Номер дорожки изменяется от 0 до159, номер стороны диска изменяется от 0 до 1, номер сектора изменяется от 0 до 11.

В формате Amiga каждая дорожка содержит:

- Начальный зазор (128 байт MFM кода 0x00).

- Данные 11 секторов по 544 байта на сектор.

- Конечный зазор (704 байта MFM кода 0x00)

Каждый сектор содержит:

- Маркер начала сектора.

- Идентификатор сектора (4 байта: 0xFF, номер дорожки, номер сектора, смещение сектора. Смещение сектора вычисляется как 11 минус номер сектора на дорожке.)

- Метка сектора (16 байт 0x00).

- Контрольная сумма заголовка (4 байта).

- Контрольная сумма данных (4 байта).

- Данные сектора (512 байт).

Идентификатор и данные секторов закодированы перестановкой битов. Для идентификатора берутся 4 байта и переставляются биты. Сначала идут нечётные биты (нумерация битов, как обычно, с 0) – это составит 2 байта. Затем идут чётные биты – так же 2 байта. Таблица иллюстрирует вышесказанное. Верхняя строка – стандартный порядок битов (номера в ячейках), нижняя – результат перестановки.

Данные секторов группируются по 2 байта, и перестановка происходит внутри этой пары аналогичным образом:

Контрольная сумма представляет собой операцию исключающее ИЛИ (XOR) всех байт данных сектора или заголовка (с учётом перестановки битов!), сгруппированных по 2 байта. Сама контрольная сумма не подвергается перестановке битов. Хотя поле для контрольной суммы 4 байтное, сама контрольная сумма получится двухбайтная.

Помимо 544 байт данных, закодированных с помощью MFM кодирования, каждый сектор содержит специальный маркер начала данных. Маркер представляет собой комбинацию нулей и единиц, которую невозможно получить MFM-кодированием. Такой комбинацией является комбинация 01000100100010010100010010001001 перед записью которой записываются 4 байта с комбинацией 10101010. Первый байт комбинации 10101010 зависит от предыдущего выданного с помощью MFM кодирования бита. Если последний выданный бит сектора был 1, то этот байт будет равен 01000100, а если там был 0, то 10101010.

Учитывая всё вышеизложенное, дорожка дискеты в формате MFM выглядит так:

- Начальный зазор: 128 байт 00000000.

- Маркер начала данных сектора:

10101010 (этот байт зависит от последнего записанного бита и может быть 01000100)

10101010

10101010

10101010

01000100

10001001

01000100

10001001 - Данные сектора без маркера: 1080 байт на сектор.

- Повторить с шага 2 для всех 11 секторов.

- Конечный зазор: 704 байт 00000000.

Итого, каждая дорожка в MFM-кодировании занимает (1080+8)*11+128+704=12800 байт кода. Если теперь этот код выдать на линию данных с дисковода учитывая временную развёртку дорожки, то Amiga сможет прочесть данные этой дорожки.

Проблема состоит в том, что длительность импульсов данных составляет от 0.15 до 0.8 мкс. В данном эмуляторе выбрана длительность импульсов 0.5 мкс. Это означает, что на частоте работы контроллера 16 МГц у нас будет 32 такта на бит MFM кода. За эти 32 такта микроконтроллер D3 должен производить регенерацию динамической памяти, считывание байта MFM-кода, выдачу бита смены намагниченности на линии дисковода. Чтобы уложиться в 32 такта, эта часть программы написана на ассемблере и строго выровнена по тактам. Операции чтения байта и регенерации памяти разнесены во времени. Это значит, что пока выдаётся побитно байт MFM кодирования, на каждый бит имеется 32 такта и для каждого выдаваемого бита строго определено, какие именно операции мы в эти 32 такта выполняем. Например, при выдаче бита 0 мы можем установить строку динамической памяти (сигнал RAS). При выдаче бита 1 мы можем установить столбец динамической памяти (сигнал CAS). При выдаче бита 2 мы считываем следующий выдаваемый байт данных. И так далее. Таким образом выдаётся весь образ дискеты.

Собственно, вот и получился простейший эмулятор дисковода.

Видео работы эмулятора:

Архив с печатными платами, прошивками, схемами и программами.

|

Метки: author da-nie программирование микроконтроллеров assembler amiga avr эмулятор дисковода |

Интернет на магнитах 5 — Маяки и сообщения (личные, публичные и обновления) |

Я вспомнил что не рассказал важную часть для обеспечения возможности общения и обновления контента в P2P сетях.

Не все P2P сети имеют возможность отправки и приёма личных сообщений. Также не всегда сообщение можно оставить в оффлайн. Мы исправим этот недостаток используя три возможности P2P сетей: поиск файла, просмотр шары(списка опубликованных файлов) или комментарии к файлу.

Как это работает

Шаблон маяка создаётся однократно и используется для создания маяков для связи с автором.

Общий алгоритм получения

- Публикуется шаблон маяка.

- Формируется маяк.

- Поиск этого маяка и файла с хешем маяка в имени.

- Загрузка найденных файлов или просмотр шары источников маяка.

Общий алгоритм отправки такой

- Пишем сообщение.

- Шифруем открытым ключом адресата.

- Формируем маяк по шаблону адресата.

- Получаем хеш от маяка и вставляем в имя файла с сообщением.

- Публикуем маяк и файл с сообщением в p2p сетях.

Наше сообщение и маяк свободно могут копировать другие участники сети. Так как оно зашифровано они не смогут его прочитать но помогут его держать онлайн пока его не получит адресат.

Открытое сообщение от автора

- Публикуем шаблон маяка.

- Пишем сообщение и подписываем.

- Генерируем маяк.

- В имя файла сообщения вписываем хеш маяка.

- Публикуем маяк и файл с сообщением.

Шаблон маяка

Это файл из которого формируется маяк.

Шаблон маяка формирует тот кто желает получать сообщения (адресат) и публикует у себя в шаре либо комментарием с магнитом к другому маяку. Шаблон должен включать в себя

- Публичный ключ для шифрования сообщений предназначенных адресату

- Шаблон маяка — инструкции для формирования маяка

- Подпись — файл подписывается.

Инструкции шаблона должны позволить генерировать файлы с одинаковыми хешами(маяки) каждый час либо другой выбранный период времени.

Пример шаблона маяка

Файл: lighthouse_template_f43b4866b4f47e8e27bfafa56f4c4f2384a3135d.asc

-----BEGIN PGP SIGNED MESSAGE-----

Hash: SHA256

- -----BEGIN PGP PUBLIC KEY BLOCK-----

Version: GnuPG v2

mQENBFk6ZDMBCADE/yoNEOosw16n3P2ZSjH+quYlSbZePBudHnAlNZ/e4KSxEnXx

B/44vKJX98y0X6TjCk0TVrAfJQhOrwg9/X6IMkeii1Nzt+NhrygojuVmEJS0kHvi

QoJLrotBXdYWbUtfVE8zGS/qVmtFi6ns/ouV1yqLnRSA+dVfLNa/7k5glo+7TEDt

g/CkSQ5CKJowPnBYnCxF4aQQQi8ydDIMXIFVyuApPRHLNsqIeA4CFlpb2Xb3ksEN

/tse4zjBRgNS3nc6SLYfv6KKb8O6oHxWzz+mXlrvL4G1dszUE7Yg4FND9t9P+bMQ

d+7OqDgO00/eEBooTcOptuHXTLxftu3z9S2VABEBAAG0Iml2YW4zODYgPG1hZ25l

dEBpdmFuMzg2LmdpdGh1Yi5pbz6JAT8EEwEIACkFAlk6ZDMCGyMFCQEOQt0HCwkI

BwMCAQYVCAIJCgsEFgIDAQIeAQIXgAAKCRBvTE8jhKMTXUA7B/93TSAcSQW5Nvgw

CpgsJHTRbUsWT2heovl1CeME39H3iKxlNVMl2N5l5kFNUryLMo63ZXp5tm9C7UKx

o2X6+3TJg/Td+WxC2vhXyLeSWc6KkV98a7Sg6kgdBBDXA1x4TfLNT8dijYBqNNgU

OVJ3gOyOCXa7Is9gPYobtwFvTTzsKqfz3JkAZf54Y7EulLYo+esty2nDqIhyC+7Q

a5izjxhGME1gAWjPT4Yr/QytmL1D1WD8tmmVrvFtBwUo3iyZhf2TCVkkJ41mOAq+

Vr2tfZPnxUxSaLMU4cm0rUoZ79NK3FX70xJjy4IgQtj/NDuQwv1KgqSClxCKkpI/

BJSvjxzguQENBFk6ZDMBCAD6DTPWTkG7Zqqhz/5oaM4zFG9ncTtnVXiR0rRPzuyn

aXz1/Kn3odEEG4kyEQbHS/lLfnLsqAkSMjUHiBsC6R0h1bTqSDnHEhPqpuLm526N

6j+o5/oIC8ANlGH5fFGDMNXy5MrRuFGMv/tHDuSW56rb6Kh9jPoU+1HCAGpv4zd9

iXB/nOYHlLl3NZ4+883wd0BgIKslSpvOU8sTjqcEwcIFFHr8SBUM6x1nKSq1Ad+C

bEQPBA7EKdIeV/N5CZ9s6fnvUvc1bNMOO8YdJ4wCWfDSGWu7ZdPyj+Yh+9/R7EIW

bEAHX5v/IcAu1u0U53goehGvEu9K4lNjibYRu8hDU02fABEBAAGJASUEGAEIAA8F

Alk6ZDMCGwwFCQEOQt0ACgkQb0xPI4SjE11j5Af9EBukKcDSQfSFBgsRRxLzfk3l

B4Qa7Kb2JKPdf8p+rlC8n7b7nS1WnDsh/ADnRO1+njP4oHo4eV3P09ao9PNagM5k

YldAG2oAOj9RhVSMI4Jt+/Tf7NZixLPjMCakrGA47wQwC9bp+AmV/ST8I6/r2t3W

4uXDLUKzvZxpBUVqEG9x0olnQiBgMicyUlW1WmyMKiorVET6rSnCv3yv33lMRQRG

5txSw/z0jXhhK6ENn0mHMGeiBqGITTwjQM7uQTkw2GmNJfHpg+jThnJQran+cGDZ

tvKsoBc4BFnM4eTxZfeyYPquG2QWZ59kcqm4JRyJfHYKT+CIPQXmEmD4uyp5/Q==

=QxOi

- -----END PGP PUBLIC KEY BLOCK-----

yyyy - год полностью по UTC±0:00

mm - месяц по времени UTC±0:00 (дополняется нулём если меньше 10)

dd - день по времени UTC±0:00 (дополняется нулём если меньше 10)

hh - час в 24 часовом формате по времени UTC±0:00 (дополняется нулём если меньше 10)

Шаблон имени файла маяка (важно для сети BitTorrent):

lighthouse_yyyy-mm-ddThhZ_f43b4866b4f47e8e27bfafa56f4c4f2384a3135d.asc

Для формирования маяка добавьте в конце файла дату и время в формате:

yyyy-mm-ddThhZ

-----BEGIN PGP SIGNATURE-----

Version: GnuPG v2

iQEcBAEBCAAGBQJZOr9iAAoJEG9MTyOEoxNd8RIIALQUa9BuMgh+uET4wse7sBDG

19RvKbUq+9HCOaxL+Qfz+C5VO1XVIxC/Vi2iP1RVwBjkKtTANXdxcf9jR/S2ZHpL

0ohDsJ8O8EPf0sTEr5nvGE27KobEhvAb9TbxrOLuZlWtqWh09CvgyEZPVnnMa7v1

WL6xVln2BjZOkndn60ToqPcVUYQpwIEfHBz7S8WYdRFumN8sUCfJYaXGFElSLKiA

2Y+fTayhPIKcwBTzRuIU6fQWWCUA7egZ3JsWWiBP68parRcsDDOia3UiddFRr0jW

lmGrsOJiZ2Vq2xfXNqY+BfcSdT8AXnt9yUYCdaH2w2oI3uEXlw8eF8JyxO60w8k=

=FJOw

-----END PGP SIGNATURE-----

Маяк

Маяк формируется из шаблона маяка по инструкциям указанным в нём. Сначала идёт сам шаблон в неизменном виде а далее идут данные которые сформированы по инструкциям из шаблона.

Задача маяка в том чтоб один и тот же маяк(с одинаковым хешем) могли сформировать и отправитель и получатель и по хешу найти друг друга или посредника который хранит сообщение.

Пример маяка

Маяк на 09 июня 2017 года 18:33 Москвы будет выглядеть так.

Файл: lighthouse_2017-06-09T15Z_f43b4866b4f47e8e27bfafa56f4c4f2384a3135d.asc

-----BEGIN PGP SIGNED MESSAGE-----

Hash: SHA256

- -----BEGIN PGP PUBLIC KEY BLOCK-----

Version: GnuPG v2

mQENBFk6ZDMBCADE/yoNEOosw16n3P2ZSjH+quYlSbZePBudHnAlNZ/e4KSxEnXx

B/44vKJX98y0X6TjCk0TVrAfJQhOrwg9/X6IMkeii1Nzt+NhrygojuVmEJS0kHvi

QoJLrotBXdYWbUtfVE8zGS/qVmtFi6ns/ouV1yqLnRSA+dVfLNa/7k5glo+7TEDt

g/CkSQ5CKJowPnBYnCxF4aQQQi8ydDIMXIFVyuApPRHLNsqIeA4CFlpb2Xb3ksEN

/tse4zjBRgNS3nc6SLYfv6KKb8O6oHxWzz+mXlrvL4G1dszUE7Yg4FND9t9P+bMQ

d+7OqDgO00/eEBooTcOptuHXTLxftu3z9S2VABEBAAG0Iml2YW4zODYgPG1hZ25l

dEBpdmFuMzg2LmdpdGh1Yi5pbz6JAT8EEwEIACkFAlk6ZDMCGyMFCQEOQt0HCwkI

BwMCAQYVCAIJCgsEFgIDAQIeAQIXgAAKCRBvTE8jhKMTXUA7B/93TSAcSQW5Nvgw

CpgsJHTRbUsWT2heovl1CeME39H3iKxlNVMl2N5l5kFNUryLMo63ZXp5tm9C7UKx

o2X6+3TJg/Td+WxC2vhXyLeSWc6KkV98a7Sg6kgdBBDXA1x4TfLNT8dijYBqNNgU

OVJ3gOyOCXa7Is9gPYobtwFvTTzsKqfz3JkAZf54Y7EulLYo+esty2nDqIhyC+7Q

a5izjxhGME1gAWjPT4Yr/QytmL1D1WD8tmmVrvFtBwUo3iyZhf2TCVkkJ41mOAq+

Vr2tfZPnxUxSaLMU4cm0rUoZ79NK3FX70xJjy4IgQtj/NDuQwv1KgqSClxCKkpI/

BJSvjxzguQENBFk6ZDMBCAD6DTPWTkG7Zqqhz/5oaM4zFG9ncTtnVXiR0rRPzuyn

aXz1/Kn3odEEG4kyEQbHS/lLfnLsqAkSMjUHiBsC6R0h1bTqSDnHEhPqpuLm526N

6j+o5/oIC8ANlGH5fFGDMNXy5MrRuFGMv/tHDuSW56rb6Kh9jPoU+1HCAGpv4zd9

iXB/nOYHlLl3NZ4+883wd0BgIKslSpvOU8sTjqcEwcIFFHr8SBUM6x1nKSq1Ad+C

bEQPBA7EKdIeV/N5CZ9s6fnvUvc1bNMOO8YdJ4wCWfDSGWu7ZdPyj+Yh+9/R7EIW

bEAHX5v/IcAu1u0U53goehGvEu9K4lNjibYRu8hDU02fABEBAAGJASUEGAEIAA8F

Alk6ZDMCGwwFCQEOQt0ACgkQb0xPI4SjE11j5Af9EBukKcDSQfSFBgsRRxLzfk3l

B4Qa7Kb2JKPdf8p+rlC8n7b7nS1WnDsh/ADnRO1+njP4oHo4eV3P09ao9PNagM5k

YldAG2oAOj9RhVSMI4Jt+/Tf7NZixLPjMCakrGA47wQwC9bp+AmV/ST8I6/r2t3W

4uXDLUKzvZxpBUVqEG9x0olnQiBgMicyUlW1WmyMKiorVET6rSnCv3yv33lMRQRG

5txSw/z0jXhhK6ENn0mHMGeiBqGITTwjQM7uQTkw2GmNJfHpg+jThnJQran+cGDZ

tvKsoBc4BFnM4eTxZfeyYPquG2QWZ59kcqm4JRyJfHYKT+CIPQXmEmD4uyp5/Q==

=QxOi

- -----END PGP PUBLIC KEY BLOCK-----

yyyy - год полностью по UTC±0:00

mm - месяц по времени UTC±0:00 (дополняется нулём если меньше 10)

dd - день по времени UTC±0:00 (дополняется нулём если меньше 10)

hh - час в 24 часовом формате по времени UTC±0:00 (дополняется нулём если меньше 10)

Шаблон имени файла маяка (важно для сети BitTorrent):

lighthouse_yyyy-mm-ddThhZ_f43b4866b4f47e8e27bfafa56f4c4f2384a3135d.asc

Для формирования маяка добавьте в конце файла дату и время в формате:

yyyy-mm-ddThhZ

-----BEGIN PGP SIGNATURE-----

Version: GnuPG v2

iQEcBAEBCAAGBQJZOr9iAAoJEG9MTyOEoxNd8RIIALQUa9BuMgh+uET4wse7sBDG

19RvKbUq+9HCOaxL+Qfz+C5VO1XVIxC/Vi2iP1RVwBjkKtTANXdxcf9jR/S2ZHpL

0ohDsJ8O8EPf0sTEr5nvGE27KobEhvAb9TbxrOLuZlWtqWh09CvgyEZPVnnMa7v1

WL6xVln2BjZOkndn60ToqPcVUYQpwIEfHBz7S8WYdRFumN8sUCfJYaXGFElSLKiA

2Y+fTayhPIKcwBTzRuIU6fQWWCUA7egZ3JsWWiBP68parRcsDDOia3UiddFRr0jW

lmGrsOJiZ2Vq2xfXNqY+BfcSdT8AXnt9yUYCdaH2w2oI3uEXlw8eF8JyxO60w8k=

=FJOw

-----END PGP SIGNATURE-----

2017-06-09T15ZХеши этого маяка (urn:[название]:[хеш или мультихеш или CIDv1])

urn:sha1:mthkta2fsilqxpoox6vessac37674gl3

urn:tree:tiger:abrmyjcyckt7lccz5jjqebazmt3tkuordfetana

urn:btih:i7mif67cu6r2jkxw23qwyanlx7tqqtoy

urn:ed2k:7f9112c53d5ae16377d54c6bdc34d4f7

urn:sha256:ad300aeb8b4ab6db19b640883d19d0900841c25689ed97e0ec0490cd23a7bd71

urn:ipfs:zb2rhiJLDNbWfS1z6yKcTGzQcazmumkcttkXc4FFq3hfeGn8YСоответственно каждый час создаётся новый маяк.

В каждой P2P сети используется соответствующий ей хеш.

Поиск фалов по хешу маяка позволяет передать открытое сообщение в имени файла маяка. (Gnutella2, DirectConnect, Edonkey2000, IPFS)

Поиск используя хеш как часть имени файла позволит передать файл. Это может быть зашифрованное публичным ключём из маяка приватное сообщение. (Gnutella2, DirectConnect, Edonkey2000, IPFS)

Комментарии к файлу маяка также могут использоваться. В них может быть сообщение либо магнит на файл с сообщением приватным. (Gnutella2)

IPFS

Для сети IPFS необходимо найти источники маяка и получить связанные с источниками файлы/каталоги по публичным ключам источников. Далее в списке найти сам маяк или файл/каталог с хешем маяка в имени.

Получаем список пиров с маяком:

ipfs dht findprovs [мультихеш маяка]Результатом будут мультихеши публичных ключей пиров с маяком

Получаем мультихеш шары:

ipfs name resolve [мультихеш публичного ключа]Результат /ipfs/ путь с мультихешом связанного файла или каталога

Ищем маяк и файл с хешом маяка в имени:

ipfs refs -r --format=" " [мультихеш шары]| grep "[мультихеш маяка]" В результате получаем сообщения:

[мультихеш маяка] [Сообщение в имени файла маяка]

[мультихеш файла] [Имя файла которое содержит в себе мультихеш маяка]Во втором случае сообщением является содержимое файла. Его можно загрузить командой:

ipfs get [мультихеш файла]Edonkey2000, DirectConnect, Gnutella(1,2)

Эти сети позволяют поиск по хешу и по имени файла. Так что достаточно хеш использовать как имя либо искать сам маяк по хешу и смотреть шару источников.

Gnutella2

В этой сети возможно комментирование источниками файла. В таком случае достаточно искать маяк по хешу и смотреть комментарии к результатам. Или можно также искать используя хеш как часть имени файла.

BitTorrent

Пока не придумал. Возможность комментирования раздачи убрали из uTorrent.

Есть идея по генерации большого маяка и путём затирания частей формировать штрихкод из которого можно получить хеш нового сообщения.

Второй вариант создание множества маяков и тогда присутствие на раздаче будет 1 а отсутствие 0. Часть маяков будут кодировать хеш а другая часть контрольную сумму.

Заключение

Как то так.

Ссылки

CID (Content IDentifier)

multihash

Commands | IPFS Docs

Интернет на магнитах 1 — Магнит

Интернет на магнитах 2 — Гипертекст

Интернет на магнитах 3 — P2P Сайт и Форум

Интернет на магнитах 4 — Делим магнит на части

|

Метки: author ivan386 децентрализованные сети peer-to-peer lighthouse gnupg |

[Из песочницы] Дело было вечером. автомасштабируемый веб-сервис с балансировкой нагрузки на примере Bitrix в Google Cloud Platform |

На самом деле материал применим ко многим веб-проектам. Точнее это простенький гайд по построению отказоустойчивых и распределенных приложений на базе виртуальных машин Google Compute Engine, баз Google Cloud SQL и балансировщика нагрузки Google.

Уважаемые знатоки и профессионалы Bitrix, вариантов реализации данного решения очень много, тут приведен лишь один. Можно рассматривать и виртуальные машины, и контейнеры, и Google App Engine в виде облачной платформы. Плюсом ко всему будет возможность подключения хранилища Google Storage, которая была включена в движок уже достаточно давно. Вообще, буду рад обсудить возможность совместного пилота Bitrix на GCP, возможно именно ваш опыт будет описан в следующий раз, как применимый именно к Bitrix.

Приступим

Что такое Bitrix, мы объяснять долго не будем. Это профессиональная система управления веб-проектами и огромное количество корпоративных сайтов, интернет-магазинов, порталов и сообществ работают именно на нем.

Несмотря на объем текста с картинками, у меня вся процедура развертывания заняла около двух часов с учетом выловленных грабелек.

Начнем с создания базы данных

Меню -> Cloud SQL -> Создать экземпляр

Выбираем MySQL, «Дальше», «Создать базу второго поколения».

Указываем имя базы, местоположение, зону, размер машины, тип диска, объем хранилища, расписание резервного копирования, пароль root, время перерыва на тех. Обслуживание, добавляем сеть. Я для теста выбрал машину 1vCPU, 1,7Gb RAM и 200Гб обычного HDD хранилища, потом можем изменить. При создании базы, обращаем внимание на зону, в ней-же расположится виртуальная машина.

Разрешенную сеть для тестов можно поставить 0.0.0.0/0 (все) и подключаться напрямую. Но мы поступим правильно и сделаем по-человечески, не будем тут ничего указывать, безопасность важнее.

Далее нам потребуется настроить сервисный аккаунт. Сразу оговорюсь для чего он нужен. Если Вы подключаетесь к базе данных прямо по ее IP-адресу, то этот шаг можно пропустить. Аккаунт нам потребуется для безопасного подключения через прокси. Иначе, машина создастся с записью по умолчанию, которая не имеет доступа к другим службам.

Итак, открываем меню, переходим в IAM и администрирование -> Сервисные аккаунты -> Создать сервисный аккаунт. Название и ИД указываем на свой вкус, выбираем роль Cloud SQL -> Клиент Cloud SQL. OK, закончили.

С базой разобрались.

Создаем виртуальную машину

Жмем на «бутерброд» (Меню) -> Compute Engine -> Экземпляры ВМ -> Создать экземпляр.

Возьмем образ Debian 8 или любой другой, на вкус. Берем для старта простую машину: 1 ядро, 3,5Гб RAM.

Изменяем сервисный аккаунт машины на тот, который мы создали на предыдущем шаге (для связи с нашим Cloud SQL. Ставим галки «разрешить HTTP» и «разрешить HTTPS» в зависимости от планируемого протокола.

Далее нам нужно слегка автоматизировать нашу машину, точнее запускать на ней SQL-прокси. Для этого раскрываем параметры «Настройка параметров управления, диска, сети и SSH-ключей» и в разделе Автоматизация -> Сценарий запуска пишем:

sudo wget https://dl.google.com/cloudsql/cloud_sql_proxy.linux.amd64

sudo mv cloud_sql_proxy.linux.amd64 cloud_sql_proxy

sudo chmod +x cloud_sql_proxy

sudo ./cloud_sql_proxy -instances==tcp:3306 &— берем из свойств нашей базы данных, это «Название соединения с экземпляром». Статья по подключению через прокси

Почему так? На самом деле для запуска нужна только последняя строчка, все остальное достаточно выполнить один раз при настройке машины. Это пример, чтобы не разбивать на всю статью по кусочкам.

Далее важный момент. Идем на вкладку «Диски» и снимаем галку «Удалить загрузочный диск при удалении экземпляра». Да, мы будем удалять нашу машину после ее настройки.

С созданием машины закончили, нажимаем «создать» и ждем.

По завершении создания, подключаемся по SSH к нашей виртуалке и настраиваем ее. Про настройку самой машины под Bitrix я писать много не буду, материалов полно и на Хабре и в Интернете. Есть даже готовый скрипт “Веб окружение”, но я его не использовал по религиозным убеждениям. Мне было проще все запустить руками, чем разбираться в чужом бутерброде. Опишу только то, что делал я для запуска. Причем без какой-либо оптимизации и тюнинга, иначе меня могут завалить комментариями гуру оптимизации PHP, Zend, NGINX и прочего, без обид.

Для начала обновим:

sudo apt-get update

sudo apt-get upgradeMySQL-клиент:

sudo apt-get install mysql-clientApache:

sudo apt-get install apache2PHP:

sudo apt-get install php5 libapache2-mod-php5 php5-mysqlРестартуем Apache:

sudo systemctl restart apache2Далее нам для «пряморукого» подключения к базе данных потребуется Cloud SQL прокси. Скрипт его запуска мы писали при создании машины, он срабатывает при каждом ее запуске. Проверим работает-ли:

mysql -u root -p --host 127.0.0.1Вводим пароль рута от базы, наслаждаемся строчкой:

mysql>Если с первого раза не сработает, то проверяем стартовый скрипт машины и перезагружаем ее.

Разворачиваем Bitrix

Обычным wget загружаем прямо с сайта:

Wget https://www.1c-bitrix.ru/download/start_encode_php5.tar.gzСсылка указана для примера на стартовую версию. Далее распаковываем файлы в каталог веб-сервера, я оставил по-умолчанию.

С машиной вроде закаончили, переходим к списку виртуальных машин на Google Cloud и открываем нашу машину по HTTP (или HTTPS, если настроили):

В процессе установки указываем MySQL сервер 127.0.0.1, логин и пароль root от нашей базы Cloud SQL и далее идем по нужному нам пути в мастере до окончания установки. Когда все готово, можем проверить производительность конфигурации. Что у меня получилось:

Я, конечно, обратил внимание на производительность MySQL и по началу был удивлен. Но, как выяснилось позднее, это вполне адекватные данные, база в реальности выдает нормальную производительность, просто она у нас все-таки облачная.

Все работает, перейдем к следующему этапу.

Создадим масштабируемую группу машин и поставим ее за балансировщик нагрузки

Я сделаю это в одном регионе, в Европе. Но для понимания сервис все-таки возможно разнести и по регионам (например, если у нас есть партнеры в Азии). Принцип работы похож, только создавать нужно будет две группы в двух регионах и реплику базы там-же.

Для начала нужно создать образ диска. Удаляем нашу виртуальную машину. Да-да, именно удаляем. Тут важно вспомнить, сняли ли мы при ее создании галку «Удалить загрузочный диск при удалении экземпляра». Если забыли, то клонируем (при открытии машины кнопка сверху) и снимаем ее в параметрах. После удаления машины, нам будет доступен ее диск для создания образа.

Идем в раздел Compute Engine -> Образы, нажимаем “создать образ”. При создании ничего хитрого нет, указываем наш освободившийся диск и все готово.

Далее создаем шаблон наших будущим машин с Bitrix.

Идем в Compute Engine -> Шаблоны экземпляров. Создаем шаблон по аналогии с нашей виртуалкой, но уже из нашего образа.

Указываем:

- Имя

- Размер (нужный нам размер одной ВМ, далее они будут «размножаться»)

- Образ (в разделе «Пользовательские образы» указываем созданный ранее)

- Сервисный аккаунт (созданный нами ранее с правами «Клиент Cloud SQL»)

- Разрешаем трафик по настроенным протоколам HTTP/HTTPS

- Раскладываем «Настройка параметров управления, диска и SSH-ключей» и пишем сценарий запуска:

sudo ./cloud_sql_proxy -instances==tcp:3306 &Повторюсь, этот сценарий включался при создании машины, теперь достаточно только последней строчки. Шаблон настроен. Помним про то, что берем с свойствах нашей PaaS базы данных.

Создадим группу экземпляров:

Открываем Compute Engine -> Группы экземпляров -> Создать группу экземпляров.

Указываем:

- Имя,

- Зону (я указывал зону расположения базы),

- Шаблон (который мы только что создали),

- Включаем автомасштабирование,

- Основа для автомасштабирования — балансировщик

- Минимальное и максимальное количество экземпляров указываем как нам нужно

- Можем создать проверку состояния. Укажем путь HTTP и, если машина не ответит, то будет прибита и запустится другая.

Создали.

Балансировщик нагрузки

Жмем на «бутерброд» слева сверху, Сеть -> Балансировка нагрузки -> Создать балансировщик нагрузки.

Балансировка нагрузки HTTP/HTTPS -> Начать настройку.

Указываем:

- Назание, как нам удобно

- Конфигурация серверной ВМ -> Серверные службы и сегменты -> (раскладываем) Серверные службы -> Создать Серверную службу. Указываем группу экземпляров, которую создавали. Включаем нужный нам режим балансировки (я включал по частоте запросов), указываем значения показателей, Готово. Тут же указываем проверку состояния машин, которую мы создавали, или создаем новую. Можем включить CDN.

- Конфигурация интерфейсной ВМ. Это то, то будет смотреть во внешний мир из нашего решения. Указываем название, протокол HTTP/HTTPS, тип адреса (статика конечно же), подгружаем сертификат (если нужен).

Готово, создать. Работать начинает практически сразу, можно не ждать.

После создания балансировщика, открываем вкладку «интерфейсные ВМ» и видим его внешний адрес. По нему наш Bitrix и будет работать в Google Cloud Platform. Переходим по адресу, наслаждаемся. Этот адрес можем писать в DNS.

Напоследок пара тестов производительности и масштабирования

Сначала, что мы имеем:

- Cloud SQL база — 1vCPU, 1,7Gb RAM

- Группа виртуальных машин с масштабированием от одной до семи, каждая 1vCPU, 3,5Gb RAM (можете подобрать оптимальную для вашего проекта, я взял стандартные машины)

- Балансировщик нагрузки с одним внешним IP-адресом

Запуск дополнительных экземпляров машин я настроил сначала при 100 одновременных соединениях, чтобы показать как работает. Для боевого решения можете использовать собственные параметры. Тестирование проводилось в пробном периоде GCP с ограничением на количество ядер для всех машин всего в восемь штук, потому восьмое ядро заняла машина с которой непосредственно запускался тест.

Сначала получился такой график теста:

Стало понятно, что машины не успевают запускаться. Потому их минимальное количество было увеличено до двух, количество соединений на машину уменьшено до 50, а предельная нагрузка снижена до 80%. В итоге получилось:

В итоге все взлетело, автоматическое масштабирование заработало как надо.

Конечно много чего можно еще добавить к нашему решению. Например, тюнинг сервера под сам Битрикс, копирование и репликацию базы, отработку отказа и пр. Это тема уже для других материалов. Данная статья написана скорее не для того, чтобы показать возможность работы Bitrix и других веб- и мобильных проектов на Google Cloud. Это простенький гайд по построению отказоустойчивых и распределенных приложений на базе виртуальных машин с применением балансировщика нагрузки Google.

Чтобы организовать распределенное приложение, нам понадобится просто реплицировать базу в другой регион, создать еще одну группу виртуальных машин в другом регионе и включить машины в наш глобальный балансировщик. Google сам будет выбирать оптимальных маршрут и направлять пользователей к приложению в ближайшую локацию.

Чуть позже будет опубликована еще одна статья, как запустить Bitrix на Google App Engine. Думаю, что это будет уже интереснее.

В последнюю очередь коснемся стоимости сервисов:

- В минимальной конфигурации — 2 VM веб-сервера (1 vCore, 3,5 Gb RAM), 1 VM MySQL (1 vCore, 1,7 Gb RAM), load Balancer) ~100$/мес

- В максимальной конфигурации (7 VM веб-сервера, 1 VM MySQL, load Balancer) ~230$/мес

Цены естественно приблизительные, для конкретного боевого решения может потребоваться мощная БД, распределение по регионам и прочее. Тут все рассчитано для расположения в европейском ЦОДе без излишеств.

Кроме скромного прайса за впечатляющие ресурсы, радует еще и то, что Google Cloud Platform стала наконец то доступна и в России для безналичной оплаты организациям.

|

|