Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

«Самый большой конкурент — это те, кто делают все самостоятельно» — Петр Зайцев о создании и развитии компании Percona |

Мы поговорили с Петром об истории становления компании, ключевых ценностях, трудностях работы на современном технологическом рынке и стратегии развития компании, обсудили некоторые особенности подбора сотрудников в Percona — процесс, который Петр курирует лично.

На PG Day'17 Russia Петр впервые прочитает для русскоязычной аудитории свой авторский курс, посвященный архитектуре и оптимизации производительности InnoDB, а также проведет обзор доступных средств для эксплуатации MySQL 5.7 как документо-ориентированной базы данных.

PG Day: Пётр, расскажи о себе, кто ты и чем ты занимаешься?

Петр: Петр Зайцев – основатель и СЕО компании “Перкона” (Percona). Компания была основана более 10 лет назад. Мы предоставляем решения в сфере MySQL и MongoDB. Основной наш бизнес – это поддержка (support), удаленное администрирование (remote DBA) и управление (managed services), но мы также занимаемся консалтингом и тренингами.

PG Day: Как вы начали строить бизнес именно вокруг MySQL? Почему выбрали эту СУБД?

Петр: На самом деле, не было такого, что я сел и стал думать, на чем делать бизнес. До основания “Перконы” я работал в компании MySQL AB и, соответственно, я знал технологии, у меня были связи, знакомства с людьми в этой индустрии. И поэтому, когда появилась возможность и желание сделать что-то свое, выбор был вполне понятным и очевидным. В бизнесе нужно делать то, что умеешь, то, в чем ты видишь потенциальный успех. В момент основания “Перконы” у меня не было грандиозной идеи, что она станет компанией, в которой будет работать более 100 человек. Я думал, что позанимаюсь консалтингом пару лет, а потом, может, буду делать что-то другое. Но начало оказалось довольно успешным, всё пошло-поехало, и мы втянулись.

PG Day: Когда ты еще работал в MySQL AB, у тебя был технический бэкграунд, то есть ты пришел в менеджмент из технологий?

Петр: Да, верно. В MySQL я работал в чисто технической роли. Последний год я был entry-level менеджером. Но, в основном, это было техническое направление.

PG Day: Если бы ты принимал сейчас решение открыть бизнес по консалтингу, по каким критериям бы выбирал технологию, стек? Как изменилось бы твое решение относительно текущих реалий?

Петр: Здесь есть несколько критериев. Я считаю, что с MySQL мне очень сильно повезло по двум причинам. Во-первых, когда “Перкона” была основана, рынок MySQL очень быстро рос, не хватало специалистов, и многие компании, которые хотели внедрять эту технологию, были готовы платить очень много денег. Такие циклы повторяются и для других технологий. Например, Hadoop. Несколько лет назад, когда произошел взрывной рост Hadoop, у людей, которые понимали в этой технологии, были очень хорошие возможности, потому что спрос превышал предложение в разы. Сейчас я бы, конечно, смотрел на это направление. И второе, один из ключевых моментов успеха — важно делать то, что тебе нравится, то, к чему у тебя лежит душа. Если ты занимаешься тем, что тебе не нравится, просто ради денег, то вряд ли будет успех, в какой бы области ты ни работал.

PG Day: Весь ваш софт полностью бесплатный. Вы не делаете проеприетарное ПО, которое можно было бы продавать. Почему вы отказались от такой модели развития бизнеса, как продажа своих закрытых решений?

Петр: Рынок закрытого программного обеспечения или даже открытых исходников основной функциональности (open core) с некоторыми платными фичами значительно больше, чем рынок полностью открытого программного обеспечения, которым занимается “Перкона”. Тем не менее, на нем также есть очень много конкурирующих компаний. В этот рынок вкладывается очень много ресурсов, компании поднимают много денег — венчурные капиталы и т.д. У них совершенно другая бизнес-модель, которая нам не очень интересна.

Мы фокусируемся на рынке чистого, открытого программного обеспечения, которое нам позволяет серьезно отличаться от других вендоров. Особенно это важно на рынке MySQL, где мы не работаем с какой-либо совершенно новой технологией, не создаем ее с нуля.

Часто люди, говоря о рынке “Перконы”, сравнивают нас с кем-то вроде MongoDB, MySQL или MariaDB. На самом деле это не совсем правильно, потому что наша задача не создать платформу или технологию с нуля, а предоставлять услуги для лучшей открытой платформы в этой области. Если бы мы делали Percona Server с закрытыми “примочками”, то разница между нашим решением и, например, решениями Oracle, была бы очень мала. Это был бы тот же самый Oracle, но попроще, подешевле. Это не очень хороший мотиватор. Если удел Oracle – это закрытое программное обеспечение, которое делает пользователей зависимыми от поставщика (vendor lock-in), даже в случае с MySQL – это open core, то мы делаем Open Source, который помогает избежать этого. Очень понятная и простая разница.

PG Day: Как с того момента, как ваша компания была основана, развился рынок поддержки, консалтинга MySQL? Наверняка у “Перконы” стало больше конкурентов. Чем вы от них отличаетесь? Что позволяет вам оставаться конкурентоспособными и занимать высокие позиции на рынке?

Петр: Если говорить о MySQL, “Перкона” работает на нескольких рынках, которые имеют разных конкурентов. Если говорить о поддержке, то компании, которые являются нашими конкурентами – это только Oracle и MongoDB, две единственные компании, которые реально могут предоставлять полный цикл поддержки, включая исправление проблем, багов в программном обеспечении. MariaDB тоже была на рынке MySQL, но сейчас они выходят с него и фокусируются только на поддержке платформы MariaDB.

Мы уникальны тем, что являемся единственной компанией, которая поддерживает широкий спектр MySQL и MongoDB технологий, а не только свои решения. Например, если MySQL от Oracle поддерживает свой стек технологий для бэкапа, мониторинга и всего остального, то мы поддерживаем как наши технологии Percona Server, Percona XtraDB Cluster, так и MySQL от Oracle, вариант MySQL от MariaDB, а также облачные решения — такие, как Amazon RDS и Google Cloud SQL.

В области поддержки мы являемся единственным вендором, который покрывает и MySQL, и MongoDB одновременно, что многим достаточно интересно по двум причинам. Во-первых, когда происходит эволюция технологий, во многих компаниях образуется баланс между тем, сколько MySQL и сколько MongoDB они используют. Достаточно сложно работать с двумя вендорами, это негибко и неудобно. Если “взлетит” цена на услуги Oracle, вы скажете: «Слушайте, ребята. Мы у вас купили поддержку для 100 MySQL instances, но на самом деле мы будем использовать 50 экземпляров MySQL, а остальные будут MongoDB. Можем мы перевести лицензии?». Конечно, они скажут: «Не можете», — потому что они будут получать меньше денег. С нашей стороны, мы предоставляем поддержку, которая покрывает оба решения, а сколько чего клиент предполагает использовать, остается на его усмотрение.

Во-вторых, любой вендор, который работает только с одной технологией, заинтересован в том, чтобы эта технология использовалась как можно больше. Чем больше ты сможешь показать, что MySQL может использоваться, тем больше договоров на поддержку ты можешь получить. На текущем этапе, если есть выбор между этими двумя СУБД, у нас нет такой мотивации. Клиент может использовать MySQL или MongoDB — для нас это не имеет финансовой разницы. Это позволяет всей нашей команде предлагать более объективные решения, которые основаны на выгодах для клиента, и избегать конфликта интересов. Наверное, одна из наиболее важных вещей, которые легли в основу “Перконы”: мы стараемся концентрироваться на решении, которое действительно является оптимальным клиента, а не для нашего кошелька.

В сфере удаленного управления и администрирования конкуренты у нас уже другие: такие компании, как Pythian и Datavail. И также “облачные” компании, потому что владельцы многих бизнесов сейчас начинают думать: “Если я буду использовать Database as a Service, облачные решения от Amazon, Google Cloud SQL, то, может, мне DBA и не нужны будут?” Для многих компаний это не совсем так, но этот вариант конкуренции тоже является интересным кейсом для нас. Но если говорить в целом о наших сервисах, самый большой конкурент – это, наверное, те, кто делают все самостоятельно. Я это часто объясняю на примере рынка уборки в офисе. Кто здесь самый большой конкурент? Возможно, многие скажут: «А давайте мы сэкономим деньги, сами будем убирать и пылесосить!» Понятно, что это своего рода выбор. И такой выбор стоит перед людьми, которые решают, самим управлять своими базами данных или отдать их кому-то другому.

PG Day: Ты упомянул про сервис удаленного администрирования. Я так понимаю, это DBA-специалисты, которые работают как внешние подрядчики для компаний, оказывают услуги консалтинга. Можешь рассказать, как вы пришли к такому направлению, чем оно привлекательно сейчас?

Петр: Во-первых, мы предпочитаем об этом говорить не как о внешнем подряде, который часто ассоциируется с чем-то негативным. Мы чаще говорим о продолжении облачной модели и технологий типа “Х as a service”. Что у нас происходит с облаком? Люди поняли, что очень часто не имеет смысла нанимать и содержать полный штат специалистов, которые могут поставить серверы и подключить кабели. Для многих компаний это не слишком критичные решения, их можно отдать на аутсорс, чтобы компания могла сфокусироваться на своем основном бизнесе.

Для технологичных компаний это создание продукта. Для компаний в области розничных продаж это может быть маркетинг или логистика. И операции по обслуживанию баз данных часто сводятся просто к работе, которая должна быть сделана. Если ее пытаются сделать внутри компании, то она отнимает энергию. Мы в данном случае предлагаем людям передать все эти проблемы нам и сфокусироваться на разработке своего продукта.

В этом плане рынок Database as a Service нам даже помогает, потому что эти компании вкладывают много средств в маркетинг. Они стараются донести до клиентов мысль о том, что самим настраивать базы данных и управлять ими может быть невыгодно. Но они не идут до конца. Если посмотреть, например, на Amazon RDS, то это не тот сервис, с которым может работать менеджер. Кто-то должен решать, какие instances нужно развернуть, как “задизайнить” схему. Простая настройка бэкапа, мониторинга тоже требует наличия технических специалистов. И это как раз то, что мы можем предложить, потому что мы умеем становиться частью команды и сотрудничать непосредственно и с менеджментом, и с отделом разработки для того, чтобы полностью решить эти проблемы.

PG Day: Ты рассказывало диверсификации тех технологий, которые вы поддерживаете. В какой момент появилось решение взять на поддержку MongoDB? Это был осмысленный шаг, или так органически получилось?

Петр: С одной стороны, мы в начале разработки своей стратегии хотели добавить еще технологии. Я считаю очень важным, чтобы мы действительно могли представлять объективные решения клиентам. Есть такая пословица: if you have a hammer, everything looks like a nail — если у тебя есть один инструмент, которым ты умеешь работать, то тебе все кажется подходящим для этого инструмента, даже когда он не нужен. Появилась возможность на рынке MongoDB, и она очень хорошо подошла для нас: на этом рынке имеется спрос на альтернативных вендоров поддержки, отчасти потому что MongoDB как компания много работала над позиционированием себя как альтернативы MySQL.

Мы смогли приобрести компанию TokuTek, которая уже предоставляла услуги поддержки MongoDB и своего “форка” MongoDB, известного на рынке. Это позволило нам успешно выйти на новый рынок, не делать все с нуля. Не случись этого, нам потребовалось бы больше времени, чтобы начать заниматься чем-то кроме MySQL.

PG Day: Консалтинг – это бизнес, который основан на людях. Компания у вас распределенная, нет одного большого здания, в котором вы все сидите. Как вам удается справляться с большим количеством клиентов? Какие специалисты у вас работают?

Петр: У нас сейчас работает около 150 человек, 30 разных стран, 20 разных штатов США. В основном, люди работают из дома. В США, в Северной Каролине, у нас есть небольшой офис, там в среднем работает 5 человек в день. Он сделан так, чтобы там было удобно проводить встречи. К нам часто приезжают гости. Также у нас есть много маленьких офисов.

На мой взгляд, не совсем правильно ставить в один ряд бизнес в области поддержки и консалтинговый бизнес. Мы начинали как консалтинговая компания, и через несколько лет нам стало сложно развиваться. Компания росла, усложнялась её структура, увеличивались издержки, мы стали заниматься разработкой программного обеспечения — такого как Percona Server для MySQL. Консалтинг часто является достаточно непредсказуемым: бывают периоды, когда клиенты приходят один за другим, но иногда случается менее “урожайный” сезон, и тогда тебя куча консультантов, которым нечем заняться.

Поэтому мы перешли на бизнес-модель: поддержка и удаленное управление — это подписка с фиксированной стоимостью за месяц или год, что дает преимущество как нам, так и нашим клиентам. Для нас это предсказуемый доход, возможность планировать инвестиции и ресурсы. Но и для клиентов это тоже более предсказуемо по бюджетам, которые могут быть запланированы один раз. За последний год мы перешли на эту модель оказания услуг по подписке, и где-то 85% наших доходов — это именно поддержка и удаленное управление. И только 15% — это консалтинг и тренинг.

Теперь с точки зрения масштабирования. Наличие фиксированной подписки позволяет нам инвестировать в технологию для того, чтобы увеличивать нашу эффективность. Наиболее очевидно это с точки зрения удаленного управления. У многих компаний, которые тарифицируют оплату по часам, возникает конфликт интересов. Если ты внедряешь слишком много автоматизации клиентам, то от них требуется оплачивать меньше часов. Но, поскольку клиенты платят тебе за часы, может быть сложно найти деньги на то, чтобы вкладываться в инновацию с целью увеличить автоматизацию и повысить продуктивность. С нашей точки зрения, поскольку мы продаем результат за фиксированную цену, основной интерес – автоматизировать всё как можно больше, чтобы снизить человеческие затраты. Это позволяет нам серьёзно вкладываться в автоматизацию. Это полезно клиенту, потому что системы, которые хорошо автоматизированы, более стабильны. Компьютер делает меньше ошибок, чем люди. Особенно это касается больших систем и больших команд.

Я думаю, что значительная доля нашего успеха связана с этим. Это позволяет нам быть значительно более гибкими с точки зрения персонала. Допустим, ты продаешь какой-то биллинг клиенту, и у тебя в штате есть какой-то супер-разработчик, в пять раз более продуктивный, и поэтому ты бы хотел за него брать в три раза больше денег. На самом деле, бизнес-модель консалтинга так не работает. К большому разбросу в ценах корпоративные клиенты относятся негативно, хотя широко известен факт, что продуктивность в области разработки программного обеспечения между специалистами среднего и высокого класса может отличаться в десять раз. Поэтому, фокусируясь на нашей модели работы по подписке, мы можем позволить себе вкладываться в высокоэффективный персонал.

PG Day: Ты начал говорить про клиентов корпоративного уровня. Я думаю, не секрет, что у вас много очень крупных клиентов типа BBC, Airbnb, Cisco и так далее. Каковы основные сложности взаимодействия с клиентом такого уровня?

Петр: У крупных компаний более высокие требования к структуре и постоянству результата. Это было для меня одним из челленджей в трансформации “Перконы”. Когда мы начинали, мы работали со многими стартапами. Интересные, активные ребята, которые могли сказать «Слушайте, как классно: я “Перконе” задаю вопрос и получаю от них три разных мнения, которые имеют право на существование». Мы все понимаем, что в области технологий нет единственно правильного решения, как в задаче по математике. Обычно их несколько, и все вполне приемлемые: можно сделать так или эдак, и всё будет работать. Поначалу мы нанимали таких умных, независимых ребят и говорили: «Ребята, делайте, как хотите. Главное, чтобы это было разумно, и клиент был доволен».

Когда мы начали работать с enterprise-клиентами, ожидания стали меняться. Они хотят постоянства — как, например, в Starbucks, которые говорят: «Ребята, нам не нужен самый лучший кофе в мире, но мы хотим приходить, просить капучино, и пусть он всегда будет абсолютно одинаковый». Корпорации уделяют этому аспекту очень много внимания. Они хотят задавать один и тот же вопрос (что они часто делают, потому что у них много команд, которые сталкиваются с одними и теми же проблемами) и рассчитывать на получение одного и того же ответа. Если они получают каждый раз разный ответ, их это просто сводит с ума. И это требует совершенно другого подхода к организации команды. Это требует создания внутренних процессов, внутренних баз знаний и так далее, чтобы мы гарантировали, что если у нас спрашивают вот такую вещь, то ответ от “Перконы” всегда будет такой. Можно придумать еще 25 разных ответов, которые тоже будут правильными, но наш ответ такой. Для меня это было не очень понятно, потому что несколько ограничивает креативность. Но многие enterprise-клиенты требуют и ожидают именно этого.

PG Day: Как вы осуществляете подбор хороших специалистов? Компания распределённая, люди разбросаны по всему миру. По своему опыту знаю, собеседовать людей удаленно значительно сложнее, чем вживую.

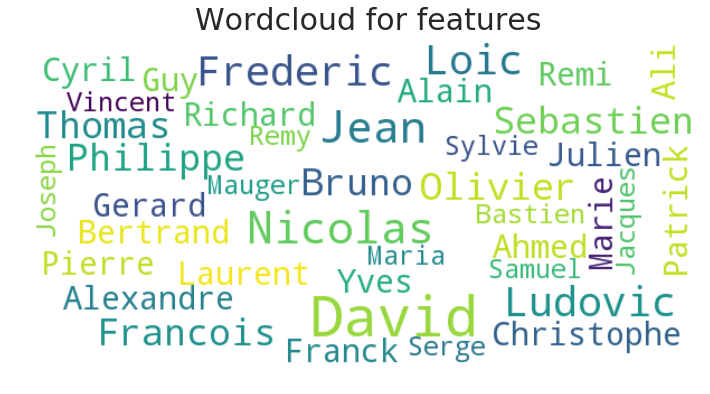

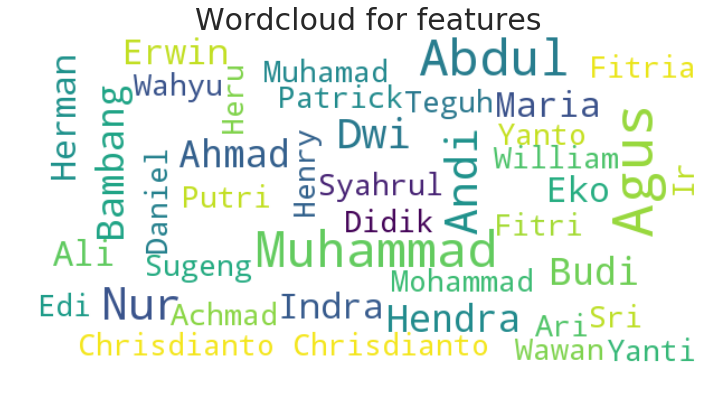

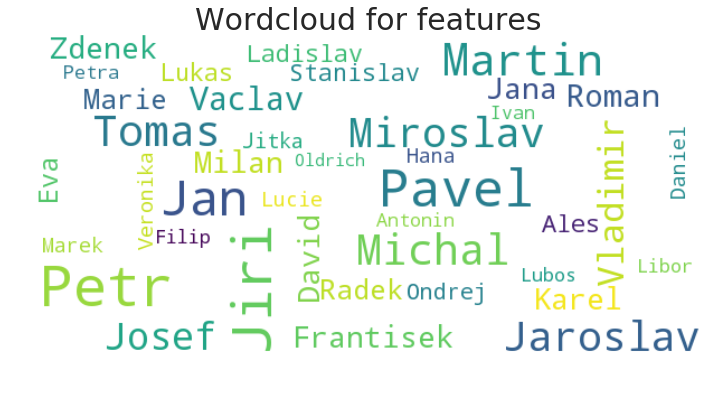

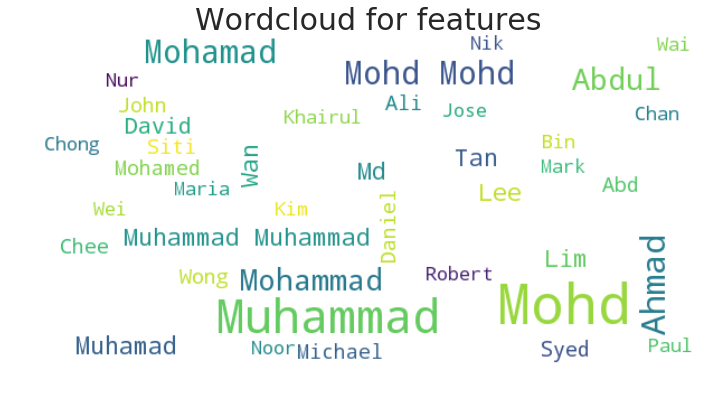

Петр: Да, я согласен, удалённый найм — вопрос сложный. Но у этой модели есть свои преимущества: если ты ищешь людей всему миру, то у тебя большой пул потенциальных кандидатов, не нужно ограничиваться рамками твоего города. В маленьких городках специалистов не хватает. Если ты находишься в Нью-Йорке или Сан-Франциско, специалисты есть, но за ними ведут охоту богатые компании. Есть еще аспекты, связанные с культурой. Представители некоторых культур на собеседовании будут отвечать, что они знают все. Другие люди более критичны к себе — в частности, русские. Очень часто слышишь: «Ну, я SQL не особенно хорошо знаю. Английский у меня плохой». Начинаешь говорить с человеком, а он и по-английски хорошо говорит, и MySQL совсем неплохо знает, просто у него очень высокие требования к себе.

Что еще интересно? Поскольку интервью проходит удаленно, мы проводим несколько собеседований с привлечением разных людей. Это у нас занимает больше времени, чем обычно, поскольку мы не приглашаем человека в офис. Понять с помощью устных вопросов, насколько человек хорош, сложно. Поэтому для многих позиций мы проводим тесты. У нас есть специальный тренажер: сломанная система, в которую нужно залогиниться и починить её. При этом один из наших сотрудников играет роль клиента, с которым можно общаться. Это позволяет проверить очевидные вещи, например, спросит ли кандидат: «А можно ваш сервер перезапустить?» Некоторые специалисты не понимают, что, работая с клиентами, эти моменты нужно уточнять. Им дали сервер “пофиксить”, и они считают, что теперь они могут все, что угодно: “положить” его на час, операционку переустановить. Мы смотрим не только на технические знания, но и на умение вежливо общаться, оценивать каковы потребности клиента, о чём его нужно информировать. Хороший сервис тоже важен.

В 95% случаев я провожу финальное интервью. Моя цель, прежде всего, ответить на вопросы человека. Я хочу, чтобы человек, который приходит к нам, имел возможность спросить меня, какие есть проблемы, чего следует опасаться, и уже потом, когда он решил ввязаться во все это, винить только себя в том, что он сделал такой выбор. Шутка, конечно. Я со своей стороны стараюсь убедиться, что эти люди соответствуют нашей компании, её культуре, имиджу. Таким образом, я тоже хочу взять ответственность за найм в том числе и на себя.

Расскажу об одном моем трюке. Я понимаю особенность технических позиций: у знаний очень небольшой период полураспада, образно выражаясь. Если сравнить то, что необходимо знать сейчас, и то, что требовалось знать 5 лет назад, выяснится, что появилось много нового, а половина старого багажа знаний уже не актуальна. Необходимо, чтобы человек мог быстро и эффективно учиться, поглощать новую информацию. В разговоре с кандидатами я нахожу что-то, о чём я имею большее представление, чем они. И, когда они начинают “плавать”, я говорю: «Отлично, ты же у компьютера сейчас. Давай я тебе дам пять минут, погугли, проведи исследование темы, а потом мы об этом поговорим снова!» Для меня это очень хороший показатель того, насколько толковым является человек. Специалисты, которые умеют быстро находить и усваивать информацию, обычно хорошо справляются со всеми обязанностями. У кого-то, возможно, и есть нужные нам сейчас знания, но информацию он усваивает очень медленно и плохо. Такой человек вряд ли сможет у нас работать.

PG Day: Как вы управляете рисками? DBA — это опасная профессия, человеку доверяются “живые” данные клиентов, всегда существует вероятность потерять что-то безвозвратно.

Петр: Риск, безусловно, есть. И кажется, если сотрудник находится где-то в другом месте, всё гораздо более страшно. Хотя, на самом деле, можно работать с человеком близко, а потом он учудит то, чего ты не ожидал. Поэтому я не считаю, что в данном случае риски существенно выше. Со своей стороны мы стараемся делать проверку рекомендаций, делаем background check человека: нет ли у него какого-то криминального прошлого, не наврал ли он, что учился в университете таком-то. Мы много людей нанимаем по личным рекомендациям. Могу сказать, что за 10 лет работы были разные случаи. С кем-то нам повезло, с кем-то не очень. Ошибки, конечно, люди допускали, но чтобы кто-то навредил из злого умысла — такого не было.

PG Day: В заключение, дай, пожалуйста, небольшой анонс мастер-класса, который ты будешь читать на PG Day’17.

Петр: Это хороший обучающий мастер-класс, в рамках которого мы поговорим об оптимизации и архитектуре InnoDB. Это подсистема хранения, storage engine, которая используется, наверное, в 99% инстансов MySQL по всему миру. Я читаю этот курс за границей на наших конференциях Percona Live более пяти лет, и всегда успешно. Каждый год я обновляю материал: появляются новые версии MySQL, какие-то новые возможности. Обычно с посещаемостью всё отлично, и я получаю хороший фидбек от людей. Им не надоедает. Мастер-класс выстроен как лекция, на очень детальном уровне рассматривающая наиболее важные аспекты InnoDB: как работает эта подсистема хранения, как устроены данные на физическом уровне, как работают транзакции, что происходит при разных операциях чтения, записи и так далее. Я считаю, что после прохождения обучения слушатели получат ясное представление о том, что для InnoDB хорошо, что плохо, почему база “тормозит” в каких-то ситуациях и что нужно делать, чтобы этого избежать.

PG Day: Кому в первую очередь может быть интересно участие в мастер-классе?

Петр: Больше всего этот мастер-класс интересен DBA и системным администраторам, которые работают с MySQL. Им нужно знать, как задействовать максимум возможностей MySQL. У слушателей будет много шансов задать вопросы, обсудить какие-то свои прикладные проблемы в разрезе изучаемого материала.

PG Day: Спасибо, Петр!

|

Метки: author rdruzyagin развитие стартапа карьера в it-индустрии бизнес-модели блог компании pg day'17 russia mysql percona interview интервью |

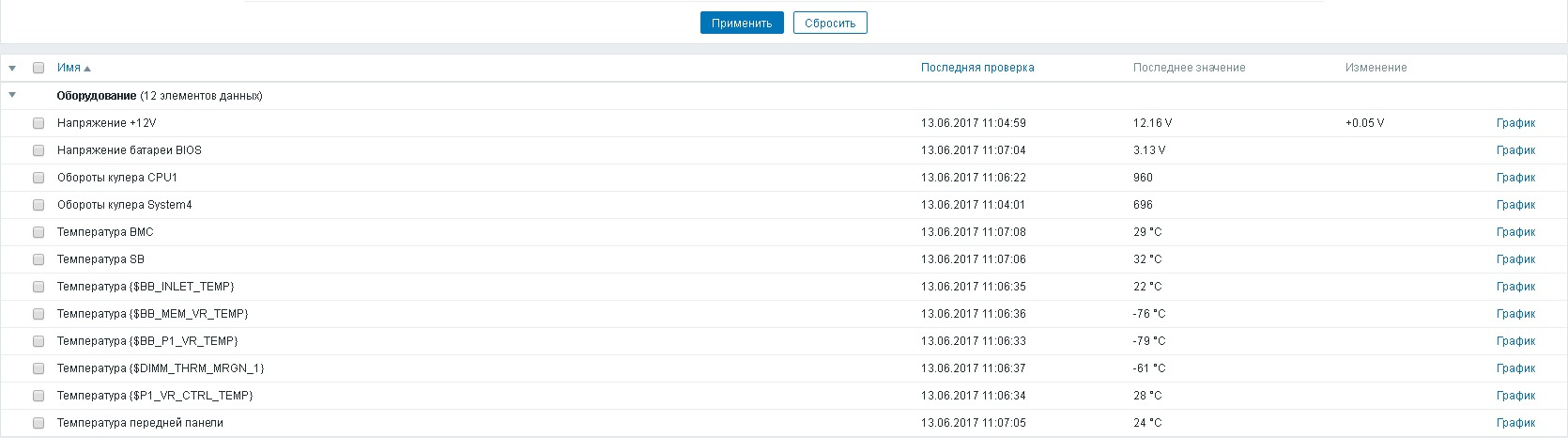

Zabbix: LLD-мониторинг IPMI датчиков |

Всем привет, меня зовут Андрей. И я люблю «железо». А еще люблю мониторинг. И наконец в моей жизни появился настоящий сервер с IPMI и прочими взрослыми технологиями. И я надеюсь, что появятся еще. Именно это сподвигает меня на поиск универсальных решений. Итак: LLD-обнаружение IPMI датчиков.

Что вы получите «из коробки»:

- Обнаружение датчиков температуры, напряжения, оборотов

- Триггеры, основанные на показаниях SDR

Суммарно понадобятся:

- Скрипт на Bash

- Шаблон

- Документация или Интернет для переименования элементов

Для начала уточню, что у вас должен быть подготовленный рабочий сервер Zabbix 3.2, настроенный узел IPMI.

Скрипт

Он выполняется на сервере как внешняя проверка, поэтому должен находиться в папке externalscripts, которая указана в конфигурации сервера. По умолчанию в Ubuntu это /usr/lib/zabbix/externalscripts. Не забывайте установить соответствующие права на выполнение этого скрипта.

Шаблон

Для каждого подключаемого узла необходимо указать 4 макроса, а именно: {$IPMIIP}, {$IPMIPRIV}, {$IPMIUSER}, {$IPMIPASS}. Значения их интуитивно понятны, кроме только что {$IPMIPRIV} — это роль пользователя (ADMIN, USER и т.д.). Вносить их нужно, так как в Заббиксе нет стандартных макросов на этот счет. Возможно, в будущем они появятся.

Особенность шаблона, как и в прошлой статье, состоит в двойном преобразовании макросов {${#X}}. Оно позволяет заменять имена сенсоров на читаемые. Согласитесь, приятнее выглядит «Напряжение батареи BIOS», а не «Напряжение BB_3.3V_VBAT».

Все что вам нужно сделать для этого — внести соответствующий макрос в список шаблона в виде:

{$CPU1_TEMPERATURE} = CPU1

В списке уже есть несколько преобразований для Intel S1200 и Asus RS300.

VR — Voltage Regulator

SSB — Server South Bridge

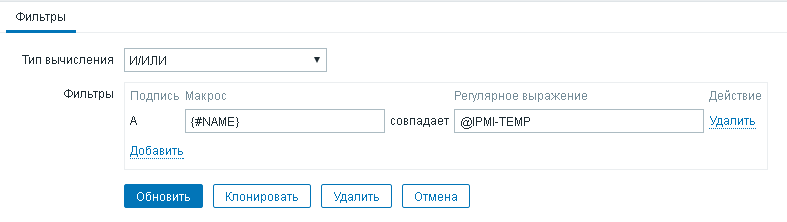

Немного о фильтрации

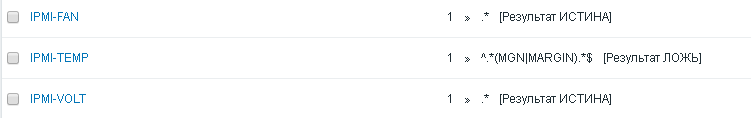

Не все датчики нужно считывать, это факт. К примеру, зачем мне суммарный запас (Agg Margin) по температуре? Для таких случаев для каждого обнаружения есть свой фильтр. Но увы, переключить его в режим «не совпадает» нельзя. Возможное решение — использовать глобальные регулярные выражения (Результат ЛОЖЬ). В фильтр же добавляется имя выражения с символом @.

Для каждого из обнаружений для себя я сделал: IPMI-FAN, IPMI-VOLT, IPMI-TEMP (в шаблон они не попадают).

Немного о триггерах

Значения для условий триггеров берутся из SDR, то есть из самого контроллера. Поля SDR содержат 6 колонок порогов: нижний опасный, нижний критичный, нижний некритичный, верхний некритичный, верхний критичный, верхний опасный. Если значение одного из полей отсутствует, то триггер не создается. ИМХО, самый логичный способ изменить триггер — изменить поля SDR устройства под свои нужды. Как это сделать — читайте инструкцию к вашему контроллеру или МП.

Итого

Свои zabbix-

|

Метки: author AcidVenom системное администрирование серверное администрирование zabbix мониторинг ipmi bash |

Полное погружение в виртуальную реальность: настоящее и будущее |

В статье мы поговорим о том, что представляют собой технологии для полного погружения в виртуальную реальность в настоящее время, про плюсы и минусы разных типов обратной тактильной связи и про будущее полного погружения.

Материал подготовлен на базе лекции Дениса Дыбского, которая проходила на конференции VR-Today в рамках нашей образовательной программы «Менеджмент игровых проектов» в ВШБИ. Видео и конспект под катом.

Составляющие полного погружения

- Первый и самый важный момент — это визуальная картинка. Все привыкли, что погружение в виртуальную реальность происходит с помощью шлемов виртуальной реальности. Как правило, HTC Vive, Oculus Rift, Gear VR, PS VR и прочих шлемов, которые сейчас есть на рынке.

- Второй важный момент — это звук. Без звука в виртуальную реальность невозможно погрузиться на данный момент, поскольку картинка должна полностью сочетаться со звуком. Для того, чтобы пользователь, находясь в виртуальной реальности, смог позиционировать себя в пространстве и знать, где он находится.

- Следующий, еще более важный момент — это тактильная связь или haptic. В западной терминологии он называется haptic feedback — “обратная тактильная связь”.

- Симуляция вкуса.

- Симуляция запаха.

- Положение человека в пространстве.

Это 6 составляющих, которые позволяют человеку полностью погрузиться в VR. Рассмотрим подробнее обратную тактильную связь (haptic). Это технология, позволяющая получать тактильную информацию через осязание. Это довольно сложная технология, на данный момент на рынке есть несколько вариаций ее реализации, которые позволяют по-разному передавать чувство прикосновения, ощущения и так далее.

Типы обратной тактильной связи:

- Первый из них — это силовая обратная связь. К примеру, в автосимуляторах с использованием руля чувствуется обратная тактильная отдача от него при столкновениях и так далее. Это и есть силовая обратная связь. Она позволяет почувствовать давление на руки (как правило) или на тело.

- Следующий и самый распространенный, самый изученный на данный момент тип обратной тактильной связи — это вибротактильный фидбек. Самый яркий пример — это вибрация смартфона. Она даёт нам знать, когда приходит сообщение или поступает звонок.

- Следующий тип довольно сложный и мало распространенный на данный момент на рынке, — это ультразвук. Он позволяет при помощи генерации звуков высокой частоты почувствовать форму и текстуру объекта. На данный момент на рынке есть пара решений, которые позволяют использовать эту технологию.

- Термальная обратная связь — еще один тип обратной связи. Он позволяет в виртуальной реальности почувствовать холод, тепло, переход от тепла к холоду и наоборот.

- Наверное, самый точный для передачи ощущений способ — это электростимуляция. К примеру, пояса для того, чтобы привести себя в форму, которые позиционируются как пояса для сжигания лишнего подкожного жира используют именно электростимуляцию. Это маленькие электрические импульсы, которые работают, как правило, на разной частоте, амплитуде и силе тока. В VR химическую реакцию довольно сложно сымитировать, но электростимуляцию очень легко воспроизвести. Можно настроить индивидуальный электрический сигнал под каждое ощущение и чувствовать прикосновение, попадание мяча в какую-либо часть тела или даже дождь.

Существующие проблемы

- Сейчас для погружения в виртуальную реальность стимулируется всего лишь 2 чувства из 5 — это зрение и слух.

- Еще бОльшая проблема, чем предыдущая — это наличие проводов в PC и консольных шлемах. Через шлем виртуальной реальности проходит большой объем данных, а для этого нужны провода. Для того, чтобы почувствовать себя полностью свободным в виртуальной реальности, нужно их убрать.

- Проблема взаимодействия с виртуальным миром. Как правило, для того, чтобы полноценно с ним взаимодействовать, нужны контроллеры. Сейчас в роли контроллеров у разных производителей выступают обычные контроллеры Vive, Oculus Touch и др. Но для того, чтобы полноценно взаимодействовать с объектами, иметь возможность дотронуться до них, повернуть, взять, почувствовать его текстуру, вес, нужны перчатки виртуальной реальности. Что в них должно входить: как минимум это система захвата движения для того, чтобы можно было отслеживать положение руки в пространстве, то, как двигаются пальцы, сжимаются ли они, как рука поворачивается относительно всего тела. Должна отслеживаться мелкая моторика. При прикосновении к виртуальному объекту должна быть обратная связь. К примеру, текстуру можно сделать с помощью электростимуляции. Если это какой-то большой объект, к примеру, человек натыкается на стену руками, то, естественно это можно сымитировать вибротактильным фидбеком.

- Из-за того, что на данном моменте на рынке присутствуют решения, которые в основном используют вибрацию либо силовой фидбек, это уменьшает качество взаимодействия в виртуальной среде, потому что они не позволяют максимально точно передать все ощущения.

- Еще один момент: в виртуальной реальности при полном погружении нужно имитировать ходьбу. Как это можно сделать? Первый способ — это телепортация. К примеру, это реализовано в HTC Vive, там с помощью контроллера можно телепортироваться в разные места в виртуальной среде. Второй — это непосредственно физическая ходьба по помещению. Но для того, чтобы полностью погрузиться, в зависимости от объема виртуального мира, в который вы погружаетесь, нужно маленькое либо большое помещение. Но для полноценного перемещения в максимально больших открытых мирах невозможно использовать только небольшое помещение. Поскольку нужно ходить во все стороны, это не очень удобно. Третий более-менее решающий эту проблему гаджет, это Tread Meal (сейчас есть несколько предложений на рынке), который позволяет прямо в нем двигаться, он поддерживает тело человека и не дает человеку уставать.

Исходя из вышесказанного можно сделать вывод, что на данный момент систем полного погружения в виртуальную реальность как таковых не существует. Эти системы пока можно назвать только системами частичного погружения. Возможно, кому-то покажется, что достаточно использовать только шлем, чтобы погрузиться в виртуальную реальность, но нет, это не правда.

Примеры систем, которые идут к тому, чтобы полностью погрузить человека в VR.

CAVE

Это проект, который был запущен в 1992 году. Он состоит как правило из огромных дисплеев по всей комнате. Это встроенные в стену колонки, направленный звук, система захвата движений и стереоскопические дисплеи.

The VOID

Парк развлечений VR, открывшийся несколько лет назад в Юте, США. Физические локации, по которым в нем можно ходить, полностью соответствуют виртуальным.

AlloSphere

10-метровая сфера со множеством стереоскопических дисплеев, встроенной системой захвата движения, звуком и так далее.

Teslasuit

Костюм для полного погружения в VR. Выглядит как обычный костюм, имеет в себе несколько систем.

- Система передачи ощущений, то есть, система обратной тактильной связи Haptic Feedback System. Она позволяет маскимально точно передавать ощущения VR. Можно почувствовать, как к тебе кто-то прикасается, даже если он находится за 1000 км от тебя.

- Система захвата движений. Позволяет пользователю отслеживать его положение в пространстве и перемещения по нему. На данный момент это инерционный трекинг, но сейчас разрабатывается гибридный мокап, в котором будет использоваться и оптический трекинг.

- Климат контроль. Позволяет чувствовать холод, тепло, снижение или увеличение температуры.

- Костюм полностью беспроводной.

- Для того, чтобы позволить сторонним разработчикам использовать костюм, был разработан собственный SDK.

- Перчатка с хаптиком.

- 5G и облако для процессинга (в планах). Сегодня все девайсы требуют мощного железа для того, чтобы полноценно запускать контент и не было никаких лагов. Костюм позволит весь процессинг перевести в облако. Это избавит пользователей от железа, уберет всю лишнюю периферию. Поскольку периферия очень сильно снижает мобильность в VR, облако должно быть довольно мощным, распределенным и еще много всяких нюансов. Поэтому его создание займет не менее 3-5 лет.

А теперь немного заглянем в будущее

Сейчас разрабатываются системы, которые позволят подключить компьютер напрямую к мозгу человека. Они разрабатываются уже достаточно давно. Ну, и самый обсуждаемый проект — Neuralink от Илона Маска. Это очень сложный проект, судя по тому, какой сейчас уровень технологий, это произойдет не ранее чем через 15-25 лет, а возможно и больше.

Костюм — более близкий по времени вариант. Костюм — это система, которая позволяет производить полный тренинг жизненных показателей человек. В планах у разработчиков стоит разработка умной одежды, в которую будут встроены различного рода датчики (температурные, замеряющие уровень кислорода в крови, влажность и другие датчики, позволяющие снимать жизненно важные показатели организма).

Параллельно с костюмом много разработок по перчаткам. Они позволяют взаимодействовать с объектами. Перчатки тоже напичканы сенсорами, которые работают на электростимуляции. В самой перчатке есть все те же системы контроля, которые есть в костюме.

Еще один важный момент — это симуляция веса в виртуальной реальности. Все хотят не просто почувствовать объект, потрогать его, ощутить его форму, но и почувствовать, сколько он весит. Это реально с помощью электростимуляции. Сейчас есть исследования, которые позволяют говорить о том, что при помощи электростимуляции можно очень точно имитировать вес предмета. Такая штука тоже будет своевременно или немного позже.

В ближайшее время мы выложим у нас в блоге на Habrahabr конспекты и записи всех остальных лекций с конференции по виртуальной реальности VR-Today. Подписывайтесь, чтобы получить уведомление по их выходу.

Осенью у нас начинается обучение на нашей образовательной программе «Менеджмент игровых проектов», приглашаем 28 июня на день открытых дверей!

|

Метки: author viacheslavnu разработка под ar и vr vr виртуальная реальность teslasuit костюм виртуальной реальности полное погружение тактильная связь haptic |

Пишем Guard |

Привет, хабр!

Есть несколько способов проверять аргументы на правильность. Например, для проверки на null можно использовать:

- if (!ReferenceEquals(arg, null)) throw…

- Code Contracts: Contract.Requires(!ReferenceEquals(arg, null))

- Guard.IsNotNull(arg, nameof(arg))

В статье я рассмотрю только третий вариант (все примеры кода — для C#, однако некоторые из них будут полезны и в Java).

Ошибка №1: не подготовились к проверкам аргументов и в теле метода

Чаще всего в проекте, для устранения копирования одинакового кода, кто-то создает статический класс, в котором можно проверить поле на null, больше нуля и т.д.

Однако в этом случае забывается, что одна и так же проверка может быть крайне полезна и для валидации аргументов (в этом случае дополнительным параметром передается имя аргумента), и для проверок внутри метода (в этом случае бросается другое исключение).

Итак, для начала лучше всего заранее договориться об именованиях обоих случаев. Например, Guard.IsNotNull для тела метода и Guard.ArgumentIsNotNull для аргументов

Ошибка №2: вызов string.format при каждой проверке

Сразу примеры ошибочного кода:

Guard.IsNotNull(connection, $"Unable to setup connection with host {host} and port {port}")

Guard.IsNotNull(connection, string.Format("Unable to setup connection with host {0} and port {1}", host, port)) // это просто развернутая строчка вышеОба примера выше генерят строку на каждую проверку (в теории, все Guard не бросают исключений на боевом сервере, то есть мы генерим немало строк просто для того, чтобы их потом съел сборщик мусора).

Исправленный вариант:

public static class Guard

{

public static void IsNotNull(object value, string format, params object[] formattingArgs) // тут мы сконструируем строку в самый последний момент, когда выделение небольшого куска памяти уже не будет ударять по производительности

}На самом деле вариант выше тоже плохой. В нем уже не создается строка, однако на каждый вызов метода создается новый массив formattingArgs. Конечно, для него выделяется меньше памяти, однако такие методы всё равно будут нагружать на сборщик мусора.

Самое обидное, что программа будет тормозить, однако простой профайлинг не подстветит проблему. У вас просто программа будет чаще останавливаться для очистки памяти (я исправил такую ошибку в одной из программ, сборка мусора стала занимать вместо прежних 15% всего лишь 5%).

Итак, поступаем так же, как сделано в string.Format: нагенерим побольше методов для разного числа аргументов.

public static class Guard

{

public static void IsNotNull(object value, string errorMessage)

public static void IsNotNull(object value, string errorMessageFormat, object arg1)

public static void IsNotNull(object value, string errorMessageFormat, object arg1, object arg2)

public static void IsNotNull(object value, string errorMessageFormat, object arg1, object arg2, object arg3)

}Итак, теперь массив выделяться не будет. Однако, мы автоматом получили новую проблему — Boxing.

Рассмотрим вызов метода: Guard.IsNotNull(connection, "Unable to setup connection with host {0} and port {1}", host, port). Переменная port имеет тип int (чаще всего по крайней мере). Получается, что для того, чтобы передать переменную по значению, .Net каждый раз будет создавать int в куче, чтобы передать его как object. Эта ситуация будет встречаться намного реже, но всё же будет.

И другая проблема — если изначальный проверяемый объект — это value type (например, мы проверяем на null в generic методе, который не имеет ограничений на тип).

Исправить это можно увеличением созданием Generic методов для проверок:

public static class Guard

{

public static void IsNotNull(TObject value, string errorMessage)

public static void IsNotNull(TObject value, string errorMessageFormat, TArg1 arg1)

public static void IsNotNull(TObject value, string errorMessageFormat, TArg1 arg1, TArg2 arg2)

public static void IsNotNull(TObject value, string errorMessageFormat, TArg1 arg1, TArg2 arg2, TArg3 arg3)

} Ошибка №3: отсутствие кодогенерации

Как видно выше, для того, чтобы удобно проверять значения на null нам надо:

- Создать два набора функций — для проверки аргументов и для проверок в теле метода

- В каждом наборе — создать кучу дубликатов, который будут содержать один и тот же код

Без кодогенерации относительно сложно добавлять новые функции, а уж тем более менять их.

Еще улучшения

Пункты ниже не ускорят вашу программу, а просто незначительно улучшат читаемость

ReSharper Annotations

Часто ReSharper ругается, что значение может быть null, хотя его вроде бы проверили с помощью Guard'а. В этом случае можно либо начать постепенно забивать на предупреждения в коде (что может быть чревато), либо объяснить проверяющим, что всё нормально. Полный список аттрибутов можно просмотреть здесь, однако вот полезные для нас:

- AssertionMethodAttribute и AssertionConditionAttribute — они вдвоем объяснят системе, что метод только проверяет аргумент, а заодно и распишут, что именно проверяют

- NoEnumerationAttribute — покажет, что если передать на вход IEnumerable, то по нему никто не будет итерироваться

- CollectionAccessAttribute — если вы вдруг решили проверить все аргументы коллекции (например, что их не больше пяти, и что они не null), то с помощью этого аттрибута можно сказать, что именно происходит с коллекцией (чтение, запись и т.д.)

- StringFormatMethodAttribute — объясняет, что один из параметров является строкой, которую потом будут использовать как формат. В этом случае её дополнительно проверят, что она может быть разобрана string.Format, что число аргументов соответствует ожиданиям и т.д. Я, кстати, еще не видел проекта, в котором была бы отключена эта проверка, и в котором после её включения не было бы ошибок, что string.Format просто не может выполниться

Записывать больше информации

В теории, число исключений из наших функций на боевых серверах должно быть наименьшим. А следовательно, любое их срабатывание должно нести в себе максимум информации: что же произошло на самом деле (ведь ситуация-то редкая). Как минимум, лучше всего включать в текст:

- Тип (а лучше — вызов ToString у него), который оказался некорректным.

- Если есть еще аргументы для сравнения — то информацию о них тоже

- Полный stacktrace (т.к. иначе он обрезается до места, где исключение было поймано)

Заключение

Надеюсь, эта статья поможет сравнительно просто улучшить проверки в вашем коде.

Немного ранее я реализовал все наработки в библиотеке (исходный код под MIT лицензией) — так что можете просто использовать её (или скопировать код к себе и т.д.)

|

|

Цена ошибки: кто и сколько платит за промахи программистов? |

Современные программисты живут в интересное время, когда программное обеспечение проникает буквально во все сферы жизни человека и начинает существовать в бесчисленном количестве устройств, плотно вошедших в наш обиход. Сейчас уже никого не удивишь программами в холодильниках, часах и кофе-машинах. Однако, параллельно с торжеством удобства растет и зависимость людей от умной техники. Неизбежное последствие: на первый план выходит надежность программного обеспечения. Сложно кого-то напугать взбесившейся кофеваркой, хотя и она может натворить много бед (литры кипящего кофе стекают по вашей белоснежной мраморной столешнице...). Но мысль о растущих требованиях к качеству ПО важна, поэтому поговорим об ошибках в коде, которые повлекли за собой существенные траты времени и денег.

Цель повествования — борьба с идеей, что к дефектам в программах можно относиться так же пренебрежительно, как и раньше. Теперь ошибки в программах — это не только неправильно нарисованный юнит в игре, сейчас от кода зависит сохранность имущества и здоровье людей. В этой статье я хочу привести несколько новых примеров необходимости трепетного отношения к коду.

Нельзя отрицать, что сложные программы все активнее входят в нашу жизнь: управляемая со смартфона бытовая техника, гаджеты, наделенные таким функционалом, о котором еще 10 лет назад не приходилось и мечтать и, конечно, более сложное ПО на заводах, в автомобилях и т.д. Любая программа создается человеком и, чем она умнее, тем опаснее ее сбой.

Поговорим о деньгах, потерянных из-за ошибок в программном обеспечении, и росте нашей зависимости от программного кода. Тема неоднократно обсуждаемая (в том числе моим коллегой — Андреем Карповым — "Большой Калькулятор выходит из-под контроля"), и каждый новый пример доказывает: качество кода — не то, чем можно пренебрегать.

Космос

Дорогой дефис

Спутник Mariner 1 в 1962 году должен был отправиться к Венере. Стартовав с мыса Канаверал, ракета практически сразу сильно отклонилась от курса, что создало серьезную угрозу падения на землю. Для предотвращения возможной катастрофы NASA было принято решение запустить систему самоуничтожения ракеты. Спустя 293 секунды с момента старта, Mariner 1 был ликвидирован.

Ревизионная комиссия провела расследование, в ходе которого было выявлено: причиной аварии послужила программная ошибка, из-за которой поступали неверные управляющие сигналы.

Программист неправильно перевел написанную формулу в компьютерный код, пропустив макрон или надчёркивание (что значит "n-ое сглаживание значения производной радиуса R по времени").

Программа даже незначительные изменения скорости воспринимала как весьма существенные и проводила корректировку курса (источник).

Цена "пропущенного дефиса" — 18 млн долларов (на тот момент).

Российский GPS, опустившийся на дно

Ярким примером того, как из-за программной ошибки могут быть потеряны миллионы, является относительно недавний случай. Казалось бы, в 21 веке есть все необходимое для написания надёжных программ, особенно, если речь идет о космической отрасли. Опытные специалисты с отличным образованием, хорошее финансирование, возможность использования лучших инструментов для проверки программного обеспечения. Все это не помогло. 5 декабря 2010 года ракета-носитель "Протон-М" с тремя спутниками "Глонасс-М" — российский аналог GPS, упала в Тихий океан.

Причину аварии, после завершения расследования, озвучил официальный представитель Генпрокуратуры РФ Александр Куренной: "Установлено, что причиной аварии стало применение неверной формулы, в результате чего масса заправленного в бак окислителя разгонного блока жидкого кислорода на 1582 кг превысила максимально допустимую величину, что повлекло выведение ракеты-носителя на незамкнутую орбиту и его падение в акваторию Тихого океана" (источник).

Интересный момент в этой истории — документ о необходимости корректировки формулы был, но его списали как исполненный. Руководство же не удосужилось проверить выполнение своих указаний. Все причастные к аварии лица были привлечены к уголовной ответственности и крупным штрафам. Но это не компенсирует потери, составившие 138 миллионов долларов.

Автомобили

Еще в 2009 году профессор информатики в Техническом университете Мюнхена, эксперт по программному обеспечению в автомобилях Манфред Бра, сказал: "Программное обеспечение автомобиля премиум-класса содержит около 100 миллионов строк кода" (источник). С того момента прошло уже восемь лет, и совсем не обязательно быть поклонником передачи Top Gear, чтобы заметить: современные автомобили — это настоящие интеллектуальные машины.

По заявлению все того же эксперта, стоимость программного обеспечения и электроники в автомобиле составляет порядка 40% от его цены на рынке. И это касается бензиновых моторов, что же говорить о гибридах и электрокарах, где это значение равно примерно 70%!

Когда электронная начинка становится сложнее механической, то возрастает ответственность разработчиков программного обеспечения. Баг в одной из ключевых систем, например, торможения, представляет гораздо большую опасность, чем порвавшийся тормозной шланг.

Садиться за руль современных комфортных и "умных" авто или ездить на олдскульных, но понятных машинах? Решать вам, я же предлагаю небольшую подборку багов в программном обеспечении автомобилей.

И снова Toyota

Японские автомобили Toyota имеют положительную репутацию, но периодически в СМИ попадает информация об отзыве некоторого количества машин. В нашем блоге уже есть статья о программной ошибке в Toyota — "Toyota: 81 514 нарушений в коде", но этот случай, к сожалению, не единичный.

В 2005 году было отозвано 160 тыс. гибридов Toyota Prius 2004 года выпуска и начала 2005. Проблема заключалась в том, что машина могла в любой момент остановиться и заглохнуть. На устранение бага было затрачено около 90 минут на одно транспортное средство или около 240 тыс. человеко-часов.

Chrysler и Volkswagen

В мае 2008 года Chrysler отозвал 24535 автомобилей Jeep Commanders 2006 года выпуска. Причина — программная ошибка в модуле управления автоматической трансмиссией. Сбой приводил к неконтролируемой остановке двигателя.

В июне того же года Volkswagen отзывает около 4000 Passat и 2500 Tiguans. Здесь ошибка в программном обеспечении оказывала воздействие на увеличение оборотов двигателя. Показания тахометра начинали ползти вверх при включенном кондиционере.

Стоит ли говорить о том, что процесс отзыва автомобилей связан с огромными финансовыми затратами. Но для таких крупных компаний-производителей гораздо страшнее не денежные потери, а упадок доверия потребителей. При огромной конкуренции на автомобильном рынке, одна такая оплошность может обернуться очень и очень негативными последствиями. Восстановление репутации надежного производителя — дело нелегкое.

Tesla

Выше речь шла об обычных автомобилях, причем не самых последних годов выпуска. Как видите, даже в них возможны программные ошибки, что уж говорить об активно популяризируемых экологически безопасных электрокарах.

Поговорим, конечно же, о Tesla Model S. 7 мая 2016 Джошуа Браун, прославившийся благодаря своим роликам на YouTube, посвященным восхвалениям электромобиля, попал в автокатастрофу. Он находился за рулем Tesla Model S. Будучи на 100% уверенным в интеллекте машины, он доверился автопилоту. Результат доверия трагичный — от полученных травм Джошуа скончался на месте.

Катастрофа получила широкую огласку. Началось расследование. Удалось установить, что, по всей видимости, Браун самостоятельно не следил за дорогой, а автопилот столкнулся с ситуацией, которая не нашла отражение в его программном коде. Перед Tesla Джошуа двигался грузовик с прицепом. Автомобиль планировал выполнить маневр — левый поворот, соответственно, требовалось сбавить скорость. Но Tesla, едущий позади, не начал тормозить, т.к. системы автопилота не распознали находящийся впереди объект.

Произошло это, скорее всего, из-за яркого солнца. Лучи отражались от прицепа и автопилот воспринял грузовик единым целым с небом. В официальном докладе это объяснялось следующим образом: "Системы автоматического торможения Теслы являются технологией избегания столкновения в редких случаях и не спроектированы для надежного выполнения во всех режимах аварии, включая столкновения в результате пересечения путей" (источник). Полный отчет об аварии находится в свободном доступе.

Иными словами, автопилот призван помогать водителю (более совершенный круиз-контроль, грубо говоря), а не заменять его функции. Конечно, репутацию Tesla такое оправдание не сильно спасло. Работы над совершенствованием программного обеспечения продолжились, но Tesla Model S с дорог отозваны не были.

Представители компании привели следующую дорожную статистику: "На каждые 90 млн. миль пройденного пути умирает один человек. В противоположность, люди проезжали 130 млн. миль на автопилоте Тесла перед тем, как была подтверждена первая смерть. Сейчас эта цифра поднялась до 200 млн." (источник)

С одной стороны, такая статистика свидетельствует о том, что электрокар безопаснее, но готовы ли вы доверить свою жизнь, жизнь пассажиров и других участников дорожного движения программе?

И это не риторический вопрос. Судя по новостям биржи, вопреки нашумевшей аварии, акции Tesla выросли на 50% с начала 2017 года. Способствуют этому два значимых фактора: популярность движений, выступающих за улучшение экологии в мире, и высокий личный рейтинг главы Tesla — Илона Маска.

Всеобщий масштаб — Беда 2038 года

Не могла не привести в завершении статьи этот пример. Подробно о Беде 2038 года вы можете прочитать в статье "2038: остался всего 21 год", я же остановлю внимание на одном важном моменте.

Оборудование для заводов: всевозможные станки, конвейеры; бытовая техника и другие сложные агрегаты, оснащенные специализированным программным обеспечением, имеют достаточно продолжительный срок службы. Вероятность того, что выпущенный в 2017 году станок будет функционировать и в 2038 очень и очень велика. Отсюда логично сделать вывод: проблема, когда 32-битные значения типа time_t больше не смогут корректно отображать даты, уже актуальна!

Если сейчас разработчики программного обеспечения не будут брать ее в расчет, то что же ждет программистов в 2038 году?! Есть все шансы на то, что ПО для встроенных систем устроит немало сюрпризов. Но, думаю, мы будем тому свидетелями.

Заключение

Возможно, приведенные в статье примеры покажутся слишком эпичными. Безусловно, широкую огласку получают только трагические случаи. Но я уверена, что в каждой компании, занимающейся разработкой программного обеспечения, есть история о том, как всего одна ошибка повлекла за собой множество проблем, пусть и в локальном масштабе.

Можно ли найти виновного? Иногда да, иногда — нет. Но смысл не в том, чтобы найти крайнего и каким-то образом покарать его. Идея в другом — программы усложняются, они все больше входят в нашу жизнь, а значит и требования к надежности кода растут. Увеличивается цена типовых ошибок, ответственность за качество кода тяжелой ношей ложится на плечи разработчиков.

Какой же выход? Модернизировать процесс разработки. Дать программистам помощников — специальные программы для выявления и устранения ошибок. Комплексное использование современных методик существенно снижает вероятность того, что баг в коде не будет обнаружен на этапе разработки.

Желаю вам не допускать промахов, а вашим проектам никогда не попасть в подборку, аналогичную той, что приведена в этой статье.

|

|

Операция “Миграция”: если ваша почта где-то там, а надо, чтобы была здесь |

Последние года два мой отдел плотно занимается проектами миграции корпоративных почт с зарубежных сервисов в MS Exchange базе инфраструктуры наших дата-центров. Из облачных сервисов типа Office 365, Gmail в основном мигрируют из-за ФЗ-242, так как хотят, чтобы почта жила на российской инфраструктуре. Это не единственная причина: часть компаний после миграции целиком передает нам почтовую систему на администрирование под жесткий SLA, что не всегда можно получить в массовых сервисах. Те, у кого почта раньше жила на железе и кто хочет расширяться, не связываясь с покупкой нового оборудования, также обращаются к нам, скромному российскому облачному провайдеру.

На 27 проектах миграции и 50 тыс. перенесенных ящиков бывало всякое. Сегодня хочу рассказать, что нужно учесть и продумать, если собрались переезжать.

Что хотите получить на выходе

Перед стартом проекта согласовываем с провайдером следующие моменты:

- функциональность, которую ожидаете получить от новой почтовой системы: объем трафика, календари, UM, общие папки и пр.

- доступность на этапе миграции и после. Готовы ли вы на простои? Если да, то в каком объеме и когда? На какую доступность рассчитываете после миграции, когда ваши пользователи будут работать с новой системой?

- какие бизнес-процессы завязаны на почтовую организацию: работа службы поддержки, маркетинговые рассылки и пр.

- с какими решениями нужно интегрировать (1C, Sharepoint, Skype и пр.). Был случай, когда ИТ-менеджер стартовал миграцию почты из Lotus в Exchange, и на полдороге выяснилось, что у них есть еще и корпоративный портал, завязанный на Lotus. Переезжать на новый портал они не планировали, поэтому свернули миграцию, а непредусмотрительного менеджера уволили.

- примерные сроки миграции. Даже если все правильно посчитать с учетом объемов данных, которые нужно перенести на новую площадку, обязательно всплывут непредвиденные технические ограничения: канал связи окажется медленнее, чем ожидалось, или обнаружатся лимиты на экспорт данных из исходной почтовой системы.

С последним мы столкнулись, когда перевозили клиента из Gmail. В процессе выяснилось, что за сутки можно экспортировать не более 1,5 ГБ данных. Даже если ящик был всего на 2 ГБ, то его приходилось экспортировать два дня – 1,5 ГБ, потом сутки ждем и докачиваем оставшиеся 500 ГБ. Перенос ящиков на 20 ГБ занимал почти два недели.

Пока все экспортировалось небольшими порциями, жизнь в компании не останавливалась и приходила новая почта, которую тоже нужно синхронизировать с новой площадкой. Проблему удалось решить с помощью утилиты Cloudiway: она вытягивала все содержимое ящиков с учетом суточного лимита, т.е. нам не приходилось вручную раз в сутки выкачивать разрешенные 1,5 ГБ. Затем вытягивала дельту писем, которые падали за то время, пока она тянула основной объем. Со временем дельта все уменьшалась и уменьшалась, и после того как все данные из исходного ящика были перенесены, мы переключали пользователя на работу с целевой почтовой системой.

Еще одна “черная дыра”, куда уходит куча проектного времени, – взаимодействие между участниками проекта. Особенно если их больше двух.

Клиент мигрировал с зарубежного хостинга, и цепочка взаимодействия выглядела следующим образом: мы общались с проект-менеджером заказчика, он передавал наши сообщения ИТ-департаменту, который взаимодействовал с зарубежным хостинг-провайдером Exchange. Как-то нам нужно было включить MPC-proxy (служба, обеспечивающая перемещение почтовых ящиков во время миграции) на зарубежной площадке, и это заняло две недели.

На старте всегда озвучивают очень оптимистичные сроки. Будьте реалистами и смело умножайте первоначальную оценку на два.

Аудит существующей инфраструктуры

Здесь все просто: нужно проанализировать исходную почтовую систему и понять, что у нее со следующими параметрами:

- входящий и исходящий объем SMTP-трафика;

- количество и суммарный объем почтовых ящиков;

- количество конечных пользователей;

- расположение клиентов: они могут подключаться изнутри сети и снаружи сети, с доменных или недоменных машин;

- протоколы клиентских подключений и версии клиентов (MacOS-клиент, Outlook Anywhere, POP3, IMAP, ActiveSync);

- текущая конфигурация почтовой системы:

— количество SMTP-доменов организации;

— количество групп рассылок;

— наличие ящиков большого размера (от 20 ГБ);

— наличие сервисных ящиков (для 1С, сканеров, рассылок);

— массовые рассылки.

На основе этой информации будем продумывать сайзинг и архитектуру новой почтовой системы.

В одном из проектов клиент забыл рассказать про то, что их маркетинг ежедневно рассылает миллионы писем. В результате новую систему посайзили без учета этой нагрузки. Когда ящик, с которого шли массовые рассылки, переехал на новую систему, то инфраструктура новой почтовой системы “прилегла”. Пришлось на ходу делать ресайзинг системы. Благо, все работало на виртуализации и быстро добавить ресурсы было несложно.

Архитектура почтовой системы

Выбор архитектуры MS Exchange будет зависеть от требований к доступности. Вариантов два:

Stand alone. Все почтовые ящики располагаются на одном сервере. Этот вариант – не про высокую доступность, зато про низкую стоимость. На уровне приложения резервирования нет. Если на других уровнях (например, виртуализация) резервирования тоже нет, то при сбое Exchange будет недоступен.

Такая архитектура подойдет, если у вас немного ящиков и вас устроит восстановление из бэкапа.

High Availability. Все роли почтовой системы дублируются. Серверы MailBox (на схеме – MBX) добавляются в группу высокой доступности (Database Availability Group, DAG). При отказе одного из серверов почтовые базы переедут на резервные. Конечный пользователь ничего не заметит. Эту схему можно реализовать и в рамках двух дата-центров. Тогда почтовой системе не будет страшен выход из строя целого ЦОДа.

Эта архитектура – для тех компаний, для которых неприемлем простой. Чаще всего это большие компании.

Схема HA.

Выбор антиспам/антивирус-решения

Из своего опыта скажу, что большие компании выбирают что-то типа Kaspersky Mail Security. Небольшие проекты обычно пользуются встроенными антивирус- и антиспам-решениями. Они могут быть не такими удобными или функциональными, как сторонние решения, но свою задачу они тоже хорошо выполняют. Никто особо не жаловался еще).

Сайзинг почтовой системы

Вопрос не стоит, если новая система – полный клон старой и мы ничего не планируем в ней менять. Для остальных случаев придется посчитать ресурсы. У MS есть инструмент (на самом деле просто excel-табличка с кучей параметров:)), с помощью которого можно просчитать объем ресурсов для инсталляции Exchange – Microsoft Exchange Sizing Calculator. Сразу скажу, что инструмент не интуитивный и потребует времени, чтобы разобраться, но это неплохой вариант, если за плечами нет опыта сайзинга подобных проектов.

При расчете не забываем делать поправку на то, что почтовая система будет бэкапиться, а значит скорость бэкапа будет в том числе зависеть от типа используемых дисков. Если планируете использовать антивирус, который будет проверять базу онлайн, то логичнее выбрать SAS-диски, но, конечно, выбор типа дисков должен базироваться на анализе реальной нагрузки на систему.

Так как миграция происходит не одномоментно, особенно для больших компаний, нужно предусмотреть возможность масштабирования инфраструктуры под почту (в одном проекте за время миграции численность пользователей успела вырасти в 2 раза – было 1000, стало 2000). Если под систему используются виртуальные ресурсы, то это сделать проще.

Способ миграции

Способ миграции определяют следующие моменты: размер почтовой системы, сроки, можете ли вы позволить себе простой и трудозатраты, на которые вы готовы пойти.

При сutover-миграции вся почтовая система переносится на новую площадку целиком за одну итерацию. Этот вариант можно рассматривать, если у вас небольшая почтовая система (до 500 ГБ) и вы согласны на простой от нескольких часов. Сама миграция будет быстрой: если удачно запланировать техокно, то можно переехать за выходные или даже быстрее, с минимальными неудобствами для бизнеса.

В сценарии сoexistence почтовая система постепенно переносится на новую площадку без простоя. При этом исходная и целевая почтовые системы какое-то время одновременно живут на двух площадках: часть пользователей уже работает в новой системе, а часть – в старой. Такая миграция подходит для любых объемов, но увеличиваются сроки, трудозатраты, стоимость, так как данные переносятся частями и увеличивается количество согласований и прочей бюрократии. Технически это более сложный вариант, нужна определенная квалификация админов.

План миграции, инструкции, регламенты

После того, как со всем определились, закрепляем порядок действий в плане миграции. В нем прописываем все технические детали миграции:

- архитектура исходной и конечной систем;

- техокна и длительность простоя;

- собственно порядок действий по миграции.

Если участников в проекте много, то прописываем процедуры административного взаимодействия и зоны ответственности. Не обязательно, чтобы это была официальная бумага с подписью и печатью на каждой странице. Можно просто в письме договориться о том, кто и за что отвечает, как строится взаимодействие с третьими сторонами (DNS-хостер, облачный провайдер) и пр.

Не забываем о конечных пользователях: предупреждаем их о дате переключения на новую почтовую систему, готовим инструкцию или целый FAQ по подключению к новой почтовой системе и что делать, если что-то не работает. Такой же алгоритм используем для техподдержки. Нет, это не формальность. Когда несколько сотен или даже тысяч сотрудников одновременно не будут знать, что делать, и начнут атаковать техподдержку, которая тоже будет не в курсе, будет не очень весело.

В одном из проектов миграции из Office 365 в Exchange была следующая ситуация. На исходной системе у пользователей была две учетки – для входа на компьютер (AD-учетка) и для входа в почту, в Office 365. После миграции должна была остаться одна учетная запись. Пользователей было около 600, поэтому важно было до них четко донести, какую из учетных записей использовать в новой системе.

На этом все. Задавайте вопросы в комментариях. И всем удачных переездов.

|

|

Как мы собрали 400 человек на конференцию с нулевым рекламным бюджетом |

Каждый год WebCanape организует большой фестиваль Tabtabus для айтишников и предпринимателей. В 2016 году мы поставили себе цель собрать с ночевкой в палатках 400+ человек на берегу красивого озера. Нижеописанный лайф-хак очень помог нам в этом.

В чем суть идеи?

Знаете, что происходит, когда пользователь социальной сети обновляет аватарку? Это событие моментально попадает в ленты друзей и имеет существенный вес в приоритете отображения. Идея очень проста. Нужно, что бы на время участники мероприятия (особенно спикеры или известные гости) поставили забрендированную аватарку под ваше мероприятие. Чем больше, тем лучше.

Нужно преодолеть порог насыщения, вовлекать все больше людей, чтобы они сами делали себе аватарки. Если все правильно организовано, в какой-то момент кажется, что весь facebook и Вконтакт идет на ваше мероприятие :) И вот тут небольшая автоматизация делает это возможным.

Автоматизируем сервис для народа

Мы упростили процесс, создав, простой инструмент, где любой желающий может создать скрипт генерации брендированной аватарки для своего мероприятия и разместить на сайте.

Сначала загружаются накладки, потом генерируется код скрипта для вставки на ваш сайт. Интегрируете сервис на свой сайт или просто даете клиентам прямую уникальную ссылку. После этого любой пользователь прямо на сайте вашего мероприятия может сгенерить себе аватарку.

Попробуйте воспользоваться сервисом аватарок >>

- Пример сгенерированного пользователем профиля: avatar.web-canape.ru/client?id=5

- Пример накладки в PSD yadi.sk/d/HoGOG2u-3HDBd7

Несколько рекомендаций на основе нашего опыта

- Рекомендуем давать пользователю выбор из вариантов шаблонов аватарки. Пусть он будет вовлечен в этот процесс. Чем больше времени он потратит на генерацию своей аватарки, тем больше шансов, что он ее разместит :)

- Не стоит перегружать аватарку графикой. В этом случае люди просто не будут ее размещать. С вашим шаблоном аватарка должна стать стильней, а не наоборот. Человек должен быть на первом плане, графика — дополнять и украшать.

- Попросите дизайнера сделать накладку. Это займет час его времени.

- Убедите спикеров поставить аватарку. Как это сделать? Просто попросите их об этом. Им же тоже важно привлечь на свое выступление заинтересованную публику. Хорошее мероприятие — это совместный труд выступающих и организаторов.

Если это поможет вам собрать аудиторию, просто расскажите нам об этом. Уже будет приятно. Всем полных залов и хороших ивентов! Да, и не забудьте заглянуть к нам на Табтабус :)

|

|

Как масштабировать биткойн-блокчейн |

Биткойн, как самый крупный, популярный и надежный блокчейн также не лишен таковых, однако сообщество их активно решает. Поэтому в рамках сегодняшнего поста мы затронем следующие вопросы:

- Какой самый большой недостаток биткойн-блокчейна?

- Какие решения предлагало мировое сообщество?

- Какое из них станет частью биткойн-сети?

/ изображение Susana Fernandez CC

/ изображение Susana Fernandez CCСегодня к блокчейну активно присматриваются банки, энергетические компании, участники рынка интернета вещей и государственные организации. Например, Bank of America и Microsoft начали совместную разработку финансовой блокчейн-платформы, а компания Chronicled запустила блокчейн-платформу для интернета вещей, которая создает безопасные и совместимые со множеством других систем цифровые идентификаторы. Однако окружение и условия, в которых работает биткойн, значительно отличаются от тех, какими они были в момент зарождения криптовалюты. Количество пользователей выросло до нескольких десятков миллионов человек (более 13 млн), что вызвало увеличение числа ежедневных транзакций (порядка 400 тыс.).

Количество ресурсов, которые приходится затрачивать на работу программного обеспечения и хранение реестра биткойна со списком проведенных транзакций довольно большое. Вся цепочка транзакций биткойн-блокчейна прослеживается, начиная с самой первой операции, проведенной 12 января 2009 года создателем биткойна Сатоши Накамото. На сегодняшний день размер биткойн-блокчейна составляет порядка 120 ГБ и продолжает расти.

Все эти особенности функционирования системы привели к возникновению проблемы масштабирования биткойна и ограничили его теоретический размер. Блокчейн является последовательностью блоков, каждый из которых представляет собой защищенный криптографическими алгоритмами набор транзакций. При этом Сатоши Накамото (примерно через год после создания биткойна) ограничил размер блока одним мегабайтом. Это было сделано с целью предотвращения вероятных DoS-атак злоумышленников, когда они создают большие (в теории неограниченные) блоки, чтобы парализовать сеть.

Однако такая мера безопасности оказала негативный эффект на пропускную способность сети в целом (в долгосрочной перспективе). На сегодняшний день биткойн может обработать порядка 7 транзакций в секунду (TPS). При этом фактическая нагрузки на сеть биткойна составляет 3,5 TPS. Для сравнения, показатель TPS в системе Visa равен 2 000 (в моменты пиковой активности — 50 000).

Ранние предложения по решению проблемы

Первые предложения по улучшению биткойна были представлены в 2015 году (BIP 100 и BIP 101) разработчиками ядра Джеффом Гарзиком (Jeff Garzik) и Гевином Андресеном (Gavin Andresen). Оба решения предлагали увеличить размер блока, однако являлись хардфорками, то есть не имели обратной совместимости. Это означало, что при их реализации старое программное обеспечение становилось несовместимым с новой сетью. В BIP 100 предлагалось настраивать размер блока по решению майнеров, а в BIP 101 — единовременно увеличить размер блока до 8 мегабайт.

На тот момент увеличение размеров блока являлось наиболее простым решением с технической точки зрения, однако ни одна из схем так и не была реализована. Отказ в реализации оказался связан больше с политическими (в рамках биткойн экосистемы) проблемами, чем с техническими. Наличие больших блоков могло привести к централизации биткойна, поскольку для их хранения и обработки потребовалось бы еще больше вычислительной мощности, а выделить такие объемы ресурсов смогут только крупные компании. Таким образом, возникло бы противоречие с главной идеей биткойн-блокчейна как криптовалюты, управляемой пользователями.

Segregated Witness

В конце 2015 года разработчик Питер Вюлле (Pieter Wuille) презентовал предложение под названием Segregated Witness, увеличивающее пропускную способность сети. Подход изменял не размеры блока, но способ хранения транзакций. Одним из преимуществ решения стала возможность его реализации через софтфорк (то есть обеспечив обратную совместимость). После выхода технического описания Segregated Witness, предлагаемые решения проблемы масштабируемости разделились на две группы: одни стремились увеличить размер блока, а другие — оставить блок без изменений, оптимизируя иные аспекты протокола. Достигнуть консенсуса по этому вопросу никак не удавалось. До недавнего времени.

20 мая ключевые игроки биткоин-индустрии все же смогли найти точки соприкосновения. Участники конференции Hong Kong Bitcoin Roundtable Consensus (в том числе компания BitFury) согласились поддержать несколько апгрейдов протокола биткойна. Один из них —это активация Segregated Witness по достижении уровня поддержки в 80% (мощности майнеров). Второй связан с увеличением размеров блока до 2 МБ. Это решение даже повлияло на стоимость биткойна. Интерес к криптовалюте и новые открывающиеся возможности по масштабированию блокчейна привели к тому, что цена за биткойн перевалила отметку в 2,5 тыс. долларов.

Можно сказать, что транзакции в биткойне состоят из двух компонентов. Первый компонент освобождает биткойны, заблокированные в предыдущих транзакциях, используя так называемые вводы. Вводы включают в себя скрипты (ScriptSigs); каждый такой скрипт содержит набор инструкций по открыванию биткойнов (например, цифровую подпись). Второй компонент транзакции содержит набор выводов (скрипты ScriptPubKeys), которые запирают освобожденные биткойны (или немного меньше). Каждый запирающий скрипт определяет условия, при которых соответствующие биткойны могут быть потрачены (например, при условии знания определенного закрытого ключа). Получается, что биткойны перемещаются от вводов к выводам транзакции и от одной транзакции к другой.

Запирание и отпирание биткойнов осуществляется отправителями транзакций, и транслируется по сети в форме пакетов информации. В выводах, запирающих биткойны, как правило, содержатся инструкции, смысл которых — убедиться, что пользователь знает нужный приватный ключ, соответствующий указанному публичному ключу.

Технология Segregated Witness видоизменяет эту цепочку взаимодействий. Вновь созданные выводы начинают использовать другой тип запирающего скрипта, который получил название «тратит кто угодно» (anyone can spend), поскольку не требует цифровых подписей, и на первый взгляд может быть потрачен кем угодно. Хитрость в том, что запирающий скрипт вида anyone can spend содержит специфическую последовательность байтов, которая привязывает к скрипту «настоящие» условия траты биткойнов.

Похожий прием используется в P2SH (Pay to Script Hash). Как и в случае SegWit, с P2SH биткойны по-прежнему запираются в сценарии, однако в выход транзакции добавляется не сам запирающий сценарий, а его хеш. Для того, чтобы потратить биткойны, запертые таким сценарием, нужно знать не только «настоящий» запирающий сценарий (как может показаться при первом прочтении scriptPubKey), но и отпирающий scriptSig для этого сценария (например, цифровую подпись).

Segregated Witness, по сути, выделяет scriptSig (подписи транзакций) в отдельную структуру данных — witness (доказательство). Таким образом, SegWit является аддоном, который полностью игнорируется старыми узлами, но признается новыми. И старые и новые узлы считают транзакции с SegWit корректными: первые видят скрипты «тратит кто угодно» и считают транзакцию корректной (хотя и странной с точки зрения семантики), а вторые — обращаются к подписи в witness. За счет этого технология позволяет устранить плавкость транзакций (tx malleability), сохранить дисковое пространство и оптимизировать скорость проверки подписей.

Есть, однако, небольшая сложность: если подписи не влияют на хеши транзакций, он уже не может являться доказательством того, что для транзакций, включенных в блок, существуют в природе корректные подписи. Чтобы обойти эту особенность, майнер пишет в определенное место блока хеш, зависящий от всех witness в транзакциях, который вычисляется аналогично хешу транзакций блока, то есть при помощи деревьев Меркла.

Еще одним достоинством SegWit может служить тот факт, что в нем сохраняются байты версий. Они предшествуют скрипту и обозначают его тип. Это дает возможность обозначать требования, необходимые для высвобождения биткойнов. Фактически это позволит запирать биткойны самыми разными способами. Реализовать потенциал этой функции смогут подписи Шнорра, которые более компактны и верифицируются быстрее нынешних ECDSA-подписей, а также более сложные типы мультисигнатурных транзакций и даже смарт-контракты, подобные Ethereum.

На практике запирающие сценарии в SegWit выглядят подобным образом (этот пример взят из реальной транзакции, только не в биткойне, а в другом очень похожем с технической точки зрения блокчейне — лайткойне; на нем SegWit уже активирован):

"scriptPubKey": {

"asm": "0 07389b37ea077e9431a2e64530649f8a61befa54",

"hex": "001407389b37ea077e9431a2e64530649f8a61befa54",

"type": "witness_v0_keyhash"

}Сценарий состоит из байта версии сценария (0), после которого идут 20 байтов, соответствующих обычному адресу в биткойн-сети (хешу публичного ключа). Если смотреть с точки зрения узла, ничего не знающего о SegWit, этот сценарий может быть потрачен кем угодно, например, пустым отпирающим сценарием scriptSig. В самом деле, scriptPubKey только добавляет данные в стек и никаких проверок данных, помещенных в стек сценарием scriptSig до этого, не производит.

Если же смотреть с точки зрения узла, знающего о SegWit, этот сценарий сигнализирует о том, что в поле witness тратящей транзакции должна содержаться цифровая подпись транзакции вместе с публичным ключом, хеш которого указан в сценарии. Поле scriptSig при этом должно быть пустым.

Как именно стоит проверять SegWit-сценарий, узел определяет на основе байта версии и длины следующего элемента scriptPubKey (в примере выше — 20). Пока в SegWit определены 2 типа сценариев: на основе публичного ключа (наш пример) и более сложный для произвольных проверок (например, мультисигнатур). Во втором случае в scriptPubKey записывается 32-байтовый хеш «настоящего» запирающего сценария. Во время траты средств, этот сценарий, вместе с подходящим отпирающим сценарием, должен быть предоставлен в поле witness. При этом хеш запирающего сценария должен совпадать со значением, указанным в scriptPubKey.

Lightning Network