Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Быстрое восстановление данных. Чем нам помогут LRC? |

В современном мире наблюдается экспоненциальный рост объемов данных. Перед вендорами СХД возникает целый ряд задач, связанных с колоссальными объемами информации. Среди них — защита пользовательских данных от потери и максимально быстрое восстановление данных в случае выхода из строя сервера или диска.

В нашей статье будет рассмотрена задача быстрой реконструкции. Казалось бы, оптимальным решением для защиты данных является репликация, однако объем служебной информации при этом сценарии составляет 100% и более. Выделить такой объем возможно не всегда. Следовательно, нужно искать компромисс между избыточностью и скоростью восстановления.

Широко известным подходом, обеспечивающим меньший объем служебной информации, являются коды с локальной четностью (LRC) и регенерирующие коды. Эти решения работают как для распределенных систем, так и для локальных дисковых массивов.

В этой статье мы рассмотрим особенности применения LRC-кодов для дисковых массивов и предложим сценарии ускоренного восстановления данных отказавшего диска.

Тестирование производительности мы проводили одновременно и для LRC, и для регенерирующих кодов, но о последних мы более подробно расскажем в одной из следующих статей.

Доступность данных

Технология RAID (Redundant Array of Independent Disks) применяется в системах хранения данных для обеспечения высокой скорости доступа к данным и отказоустойчивости. Высокая скорость достигается за счет распараллеливания процессов чтения и записи данных на диски, а отказоустойчивость — за счет применения помехоустойчивого кодирования.

С течением времени требования к объему и надежности систем хранения увеличивались. Это привело к появлению новых уровней RAID (RAID-1...6, RAID-50, RAID-60, RAID-5E и т.д.) и применению разных классов помехоустойчивых кодов, как MDS (Maximum distance separable — коды с максимальным кодовым расстоянием), так и не-MDS.

Мы рассмотрим, как влияет размещение данных при определенном способе кодирования на скорость восстановления отказавшего диска, и, как следствие, на доступность данных дискового массива.

Availability (доступность) — это вероятность того, что система будет доступна по запросу. Высокая доступность достигается, в частности, за счет кодирования, т.е. часть дискового пространства системы отводится не под пользовательские данные, а для хранения контрольных сумм. В случае отказа дисков системы утраченные данные могут быть восстановлены с помощью этих контрольных сумм — тем самым обеспечивается доступность данных. Как правило, availability рассчитывается по формуле:

MTTF — Mean Time To Failure (средняя наработка до отказа), MTTR — Mean Time To Repair (среднее время восстановления). Чем меньше время, необходимое для восстановления определенного компонента системы, в данном случае – диска или кластерного узла, тем выше доступность данных.

Скорость восстановления компонента зависит от:

- скорости записи восстановленных данных;

- скорости чтения;

- количества прочитанных данных, необходимых для восстановления;

- производительности алгоритма декодирования.

Каждый из вариантов организации хранения данных и расчета контрольных сумм имеет свои преимущества и недостатки. Например, коды Рида-Соломона (RS codes) обеспечивают высокую отказоустойчивость. RS-коды являются кодами с максимальным кодовым расстоянием (MDS) и представляются оптимальными с точки зрения избыточного места под хранение контрольных сумм. Недостаток RS-кодов состоит в том, что они достаточно сложны с точки зрения кодирования и требуют очень много чтений для восстановления отказа.

Среди других возможных решений — модифицированные Rotated RS-коды или WEAVER codes (разновидность XOR-кодов). Последние достаточно просты с точки зрения кодирования и требуют очень мало чтений для восстановления отказа. Однако при этом способе кодирования под контрольные суммы требуется выделить гораздо больший, чем при MDS-кодах, объем хранилища.

Хорошим решением указанных выше проблем стало появление LRC (Local Reconstruction Codes). В работе «Erasure Coding in Windows Azure Storage» проводится детальное описание этих кодов, которые, по сути, являются преобразованием RS-кодов в не-MDS. В этой же работе проводится сравнение LRC с другими кодами и показаны преимущества LRC. В данной статье мы рассмотрим, как влияет расположение блоков LRC-страйпов на скорость восстановления.

Проблемы использования LRC в RAID

Далее мы кратко опишем идеологию LRC, рассмотрим возникающие проблемы и возможные пути их решения. Рассмотрим последовательность блоков, хранящихся на дисках, образующих один страйп. В дальнейшем, если не указано иное, будем понимать страйп как множество блоков, находящихся на разных дисках и объединенных общей контрольной суммой.

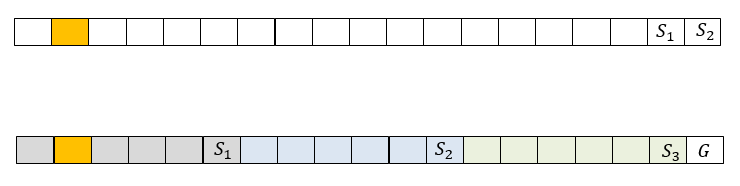

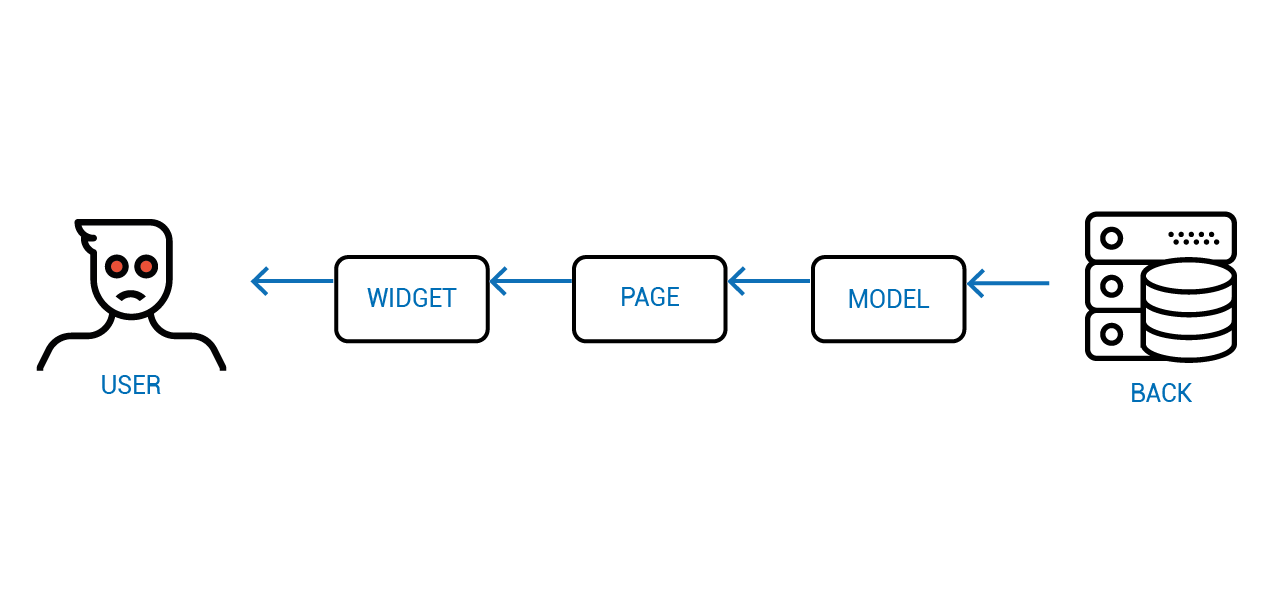

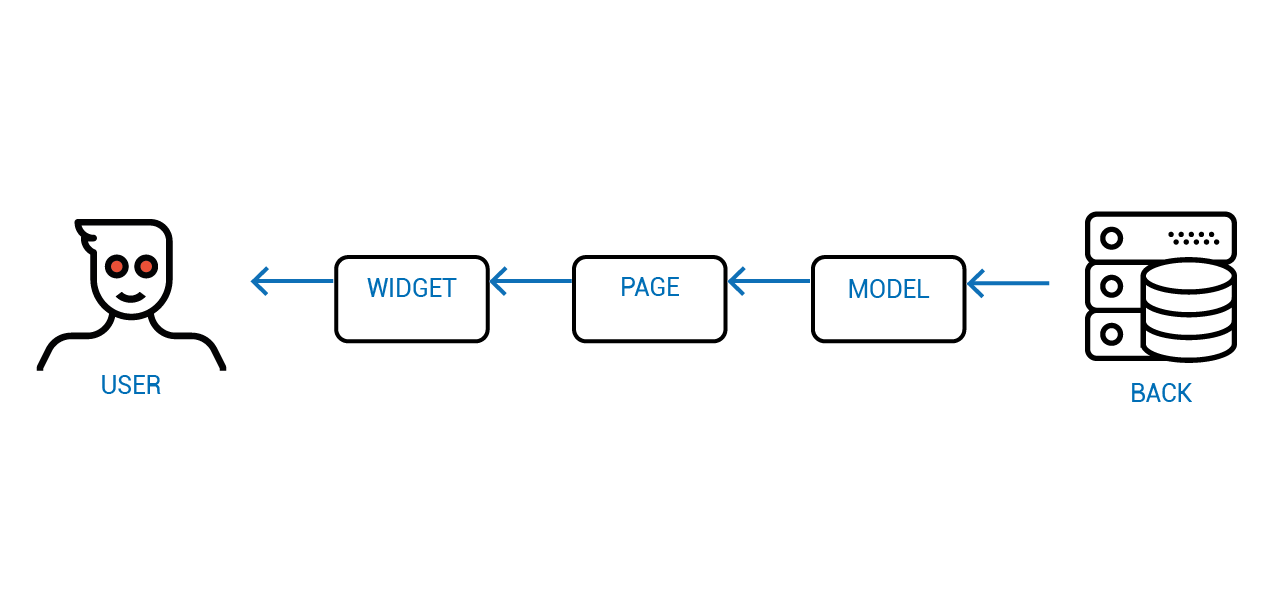

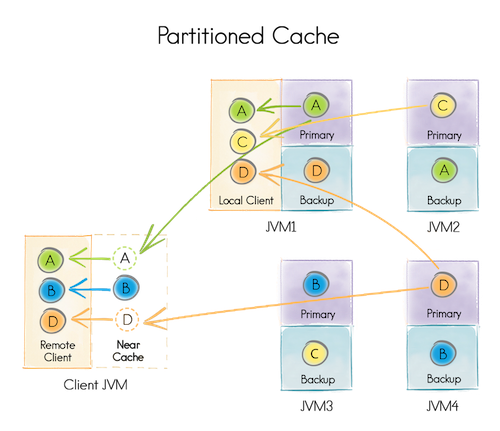

Если данные этого страйпа закодированы RS кодом, как это, например, делается в RAID-6 с двумя контрольными суммами, то кодовую информацию содержат два блока страйпа. На рис. 1 сверху представлен страйп из 19 блоков, среди которых 2 блока и — контрольные суммы. При отказе диска, содержащего, например, блок с номером 2, для восстановления этого блока необходимо будет прочитать 17 блоков из каждого страйпа (16 не отказавших и одну контрольную сумму).

Коды локальной реконструкции в данном случае потребуют разбиения страйпа на несколько локальных групп, для каждой из которых рассчитывается локальная контрольная сумма (local syndrome). Для всех блоков данных также рассчитывается глобальная контрольная сумма. На рис. 1 рассмотрен пример, в котором блоки разбиты на 3 локальные группы размером 5. Для каждой из них рассчитаны локальные контрольные суммы , а также рассчитана одна глобальная контрольная сумма G.

Рис. 1. Пример представления страйпа RAID6 и страйпа LRC

Локальные контрольные суммы вычисляются как XOR блоков данных, от которых они зависят. Глобальных контрольных сумм может быть несколько, они вычисляются как контрольные суммы RS кодов. В данном случае для восстановления блока с номером 2 необходимо прочитать 6 блоков. Это в 3 раза меньше по сравнению с предыдущим случаем, но на хранение контрольных сумм здесь потребуется больше места. Следует отметить, что в случае отказа 2 дисков одной группы, LRC легко преобразуется в классический RS при сложении (XOR) всех 3 локальных контрольных сумм.

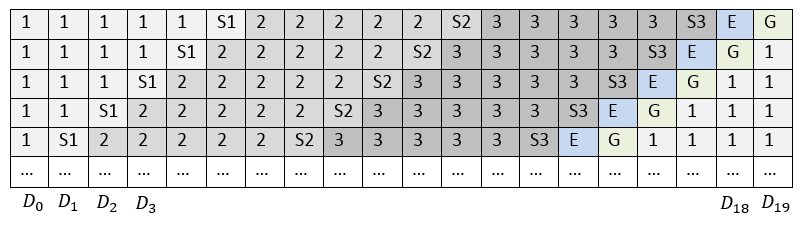

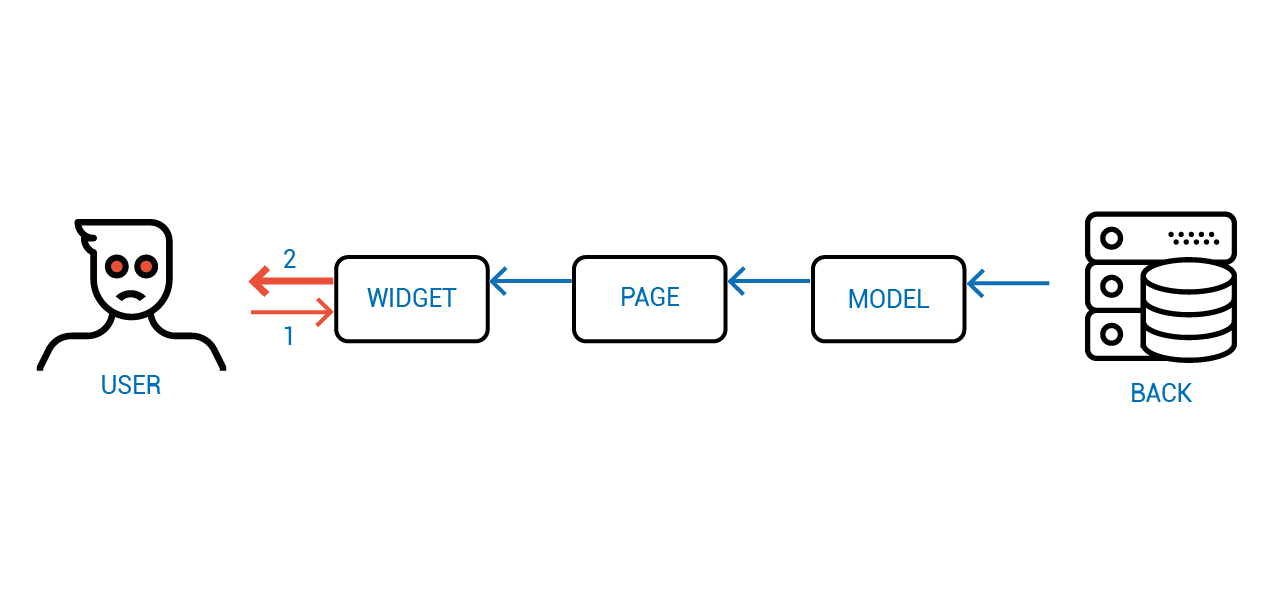

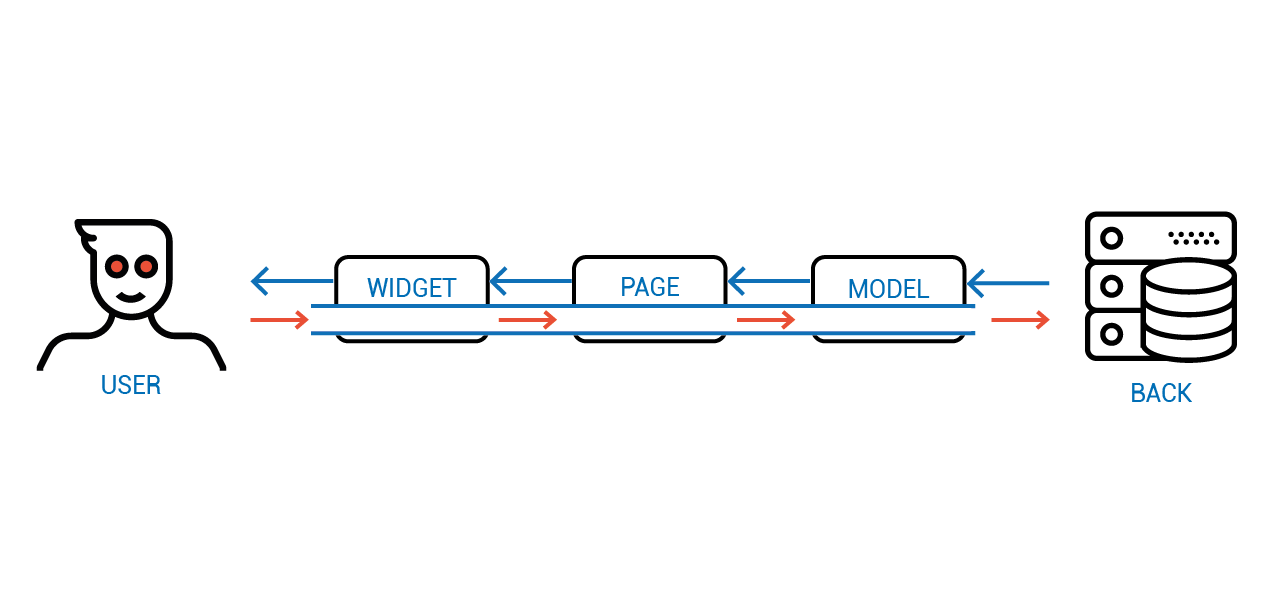

Использование LRC может отлично решить проблему количества чтений, необходимых для восстановления одного диска. Тем не менее, если все страйпы располагать на дисках или кластерных узлах одинаковым образом и не менять в них последовательность блоков, то получится, что при изменении данных в любом блоке локальной группы всегда будет пересчитываться локальная контрольная сумма этой группы и глобальная контрольная сумма страйпа. Таким образом, компоненты с контрольными суммами будут подвержены большим нагрузкам и износу. Следовательно, производительность такого массива будет ниже. Классически такая проблема в RAID решается циклическим сдвигом страйпов на дисках, см. рис. 2.

Чтобы при восстановлении данных скорость восстановления не ограничивалась скоростью записи на один компонент системы хранения, в каждый страйп может быть добавлен так называемый Empty Block (E), как это делается в RAID-5E и RAID-6E. Таким образом, восстановленные данные в каждом страйпе записываются на свой empty block, а значит, и на отдельный диск. Наличие empty block в страйпе необязательно. В дальнейших наших рассуждениях мы будем рассматривать страйпы с таким блоком для полноты картины.

Рис. 2. Расположение блоков страйпа со сдвигом

Таким образом, при использовании циклического сдвига и наличии empty block расположение страйпов по дискам примет вид как на рис. 2.

Использование LRC также накладывает незначительное ограничение по количеству дисков, на которых может быть расположен страйп. Так, если количество локальных групп равно , размер одной локальной группы равен , количество глобальных контрольных сумм равно и наличествует empty block, то общий размер страйпа будет равен . Если число дисков отличается от длины страйпа, то возможны два варианта:

- Создавать локальные группы разного размера. В таком случае некоторые локальные контрольные суммы будут чаще обновляться при изменении данных страйпа, что может привести к более медленной записи.

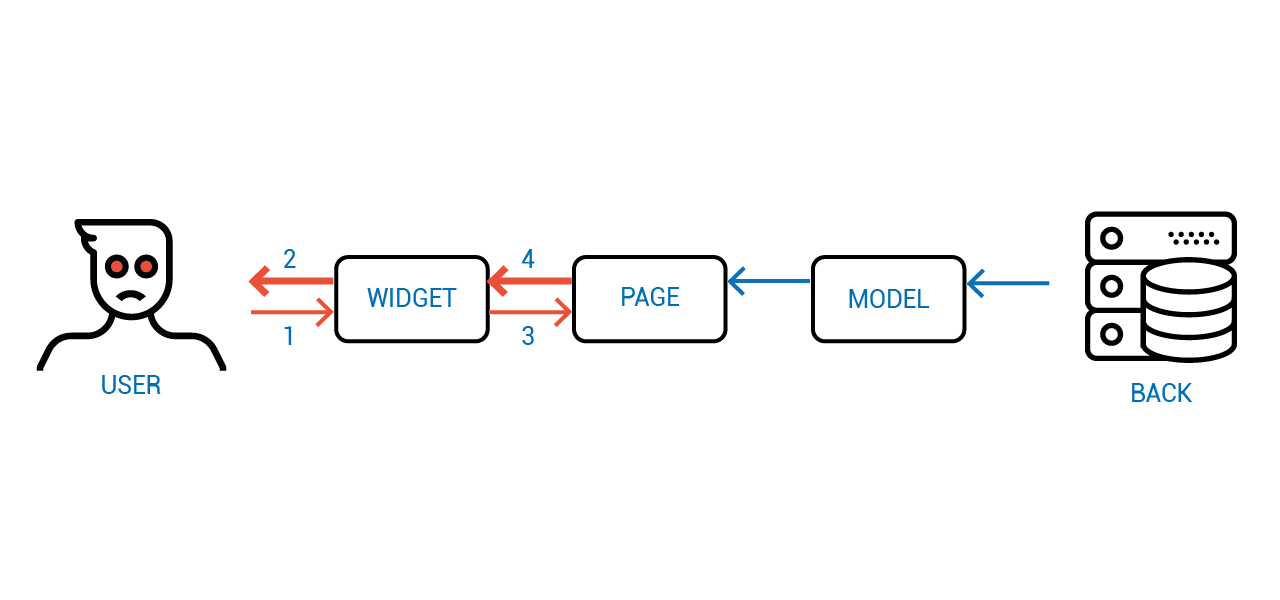

- Не размещать каждый страйп на все диски, а там, где заканчивается один страйп, сразу начинать второй, см. рис. 3. Такой подход приводит к тому, что все локальные группы могут быть одинакового размера, и циклическое смещение вносится автоматически сообразно расположению страйпов. Если длина страйпа совпадает с количеством дисков, то для каждого страйпа выполняется циклический сдвиг, как это делается для RAID-6.

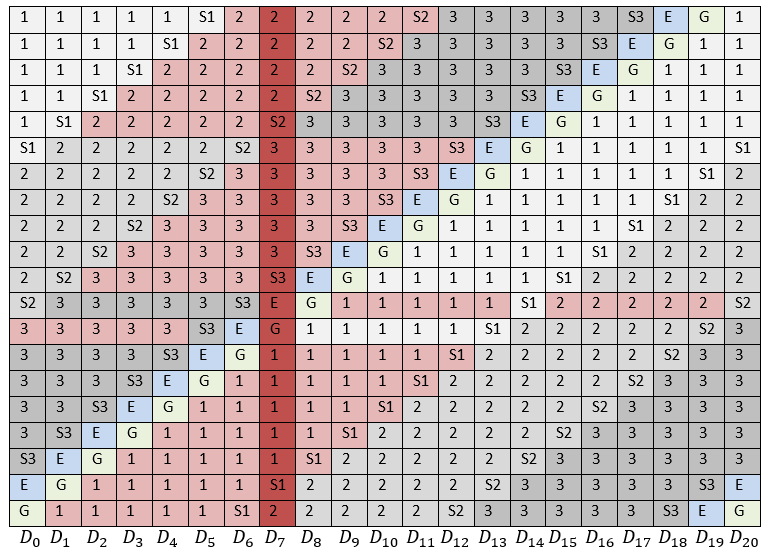

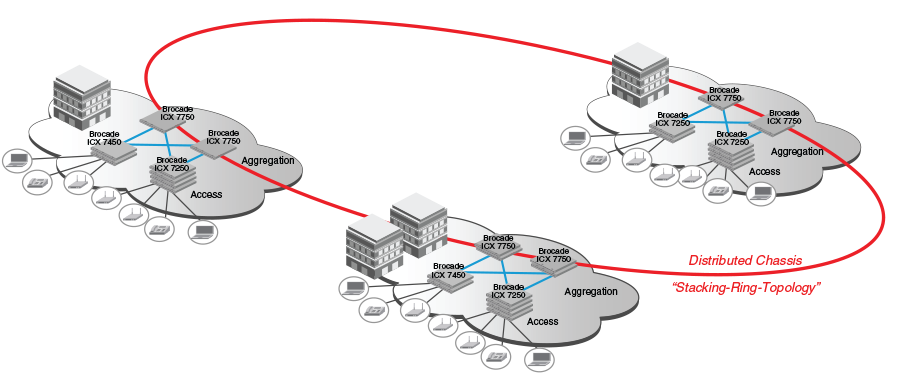

Рис. 3. Блоки, необходимые для восстановления одного отказавшего диска

На рис. 3 рассмотрен случай отказа одного диска — . Розовым цветом обозначены все блоки, которые необходимо прочитать, чтобы восстановить его.

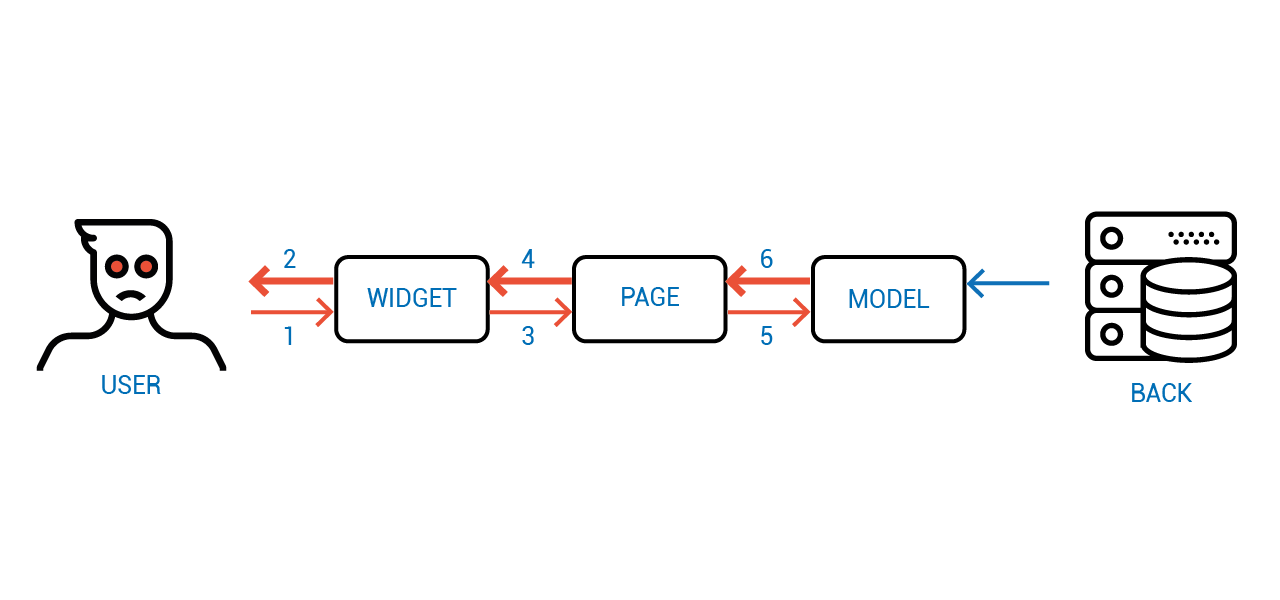

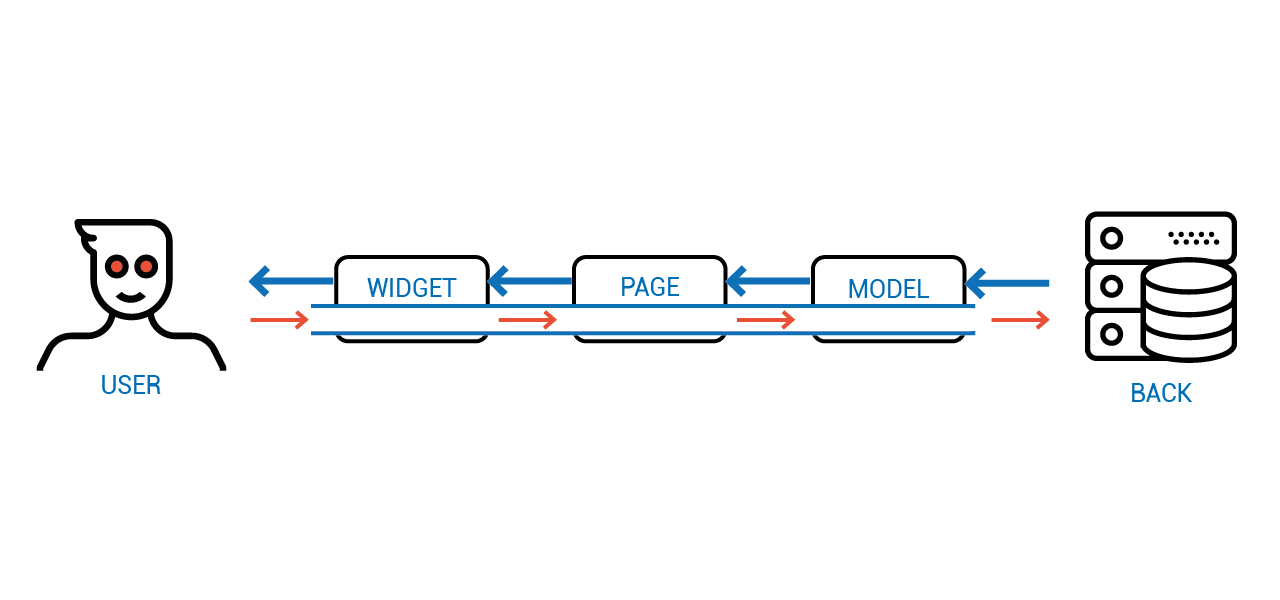

Рис. 4. Количество блоков, прочитанное с каждого диска для восстановления одного отказавшего диска

Всего потребовалось прочитать 105 блоков. Если бы вместо LRC использовался RAID-6, то необходимо было бы 340 прочитанных блоков. Чтобы понять, является ли такое расположение блоков оптимальным, посчитаем количество прочитанных с каждого диска блоков, см. рис. 4.

Можно заметить, что диски, располагающиеся ближе к отказавшему, будут гораздо больше нагружены по сравнению с остальными. Таким образом, при восстановлении данных в случае отказа именно эти наиболее загруженные диски станут узким местом. Однако, расположение блоков LRC-страйпа, когда сперва идут блоки первой локальной группы, затем второй, затем третьей, не является жестким ограничением. Таким образом, наша задача состоит в определении такого расположения блоков, при котором нагрузка на все диски в случае отказа была бы минимальной и равномерной.

Рандомизированные алгоритмы для дисков большого объема

Оставляя в стороне различные способы решения аналогичной проблемы для RAID-6, рассмотрим возможный сценарий в случае с LRC:

- Для каждого LRC-страйпа берем классическое расположение блоков (аналогично рис. 1). Используем номер выбранного страйпа в качестве инициализирующего значения (seed) для генератора случайных чисел. Для всех страйпов используется один и тот же генератор случайных чисел, но с разным seed.

- Используя инициированный генератор случайных чисел и исходное расположение блоков, получим случайное расположение блоков в текущем страйпе. В нашем случае был применен алгоритм Fisher–Yates shuffle.

- Такую процедуру выполняем для каждого страйпа.

При таком подходе каждый страйп будет иметь некоторую случайную структуру, которая однозначно определяется его номером. Поскольку в данной задаче не требуется криптографическая стойкость генератора случайных чисел, то мы можем использовать достаточно простой и быстрый его вариант. Таким образом возможно оценить математическое ожидание средней загрузки каждого диска в случае отказа.

Введем обозначения: — объем каждого диска в массиве, — размер одного блока страйпа, — длина одного страйпа, — количество дисков, — размер локальной группы. — количество локальных групп, — количество глобальных контрольных сумм. Тогда математическое ожидание средней загруженности каждого диска будет рассчитываться следующим образом:

Располагая такой оценкой и зная скорость чтения блоков с диска, можно сделать приблизительную оценку времени восстановления одного отказавшего диска.

Тестирование производительности

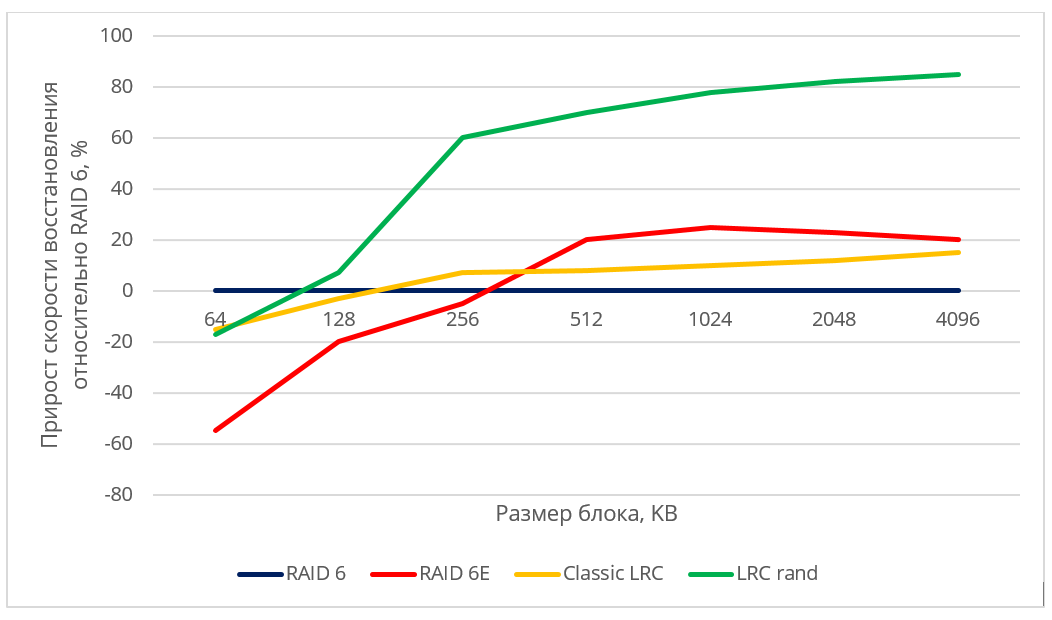

Для тестирования производительности мы создавали RAID из 22 дисков с различными схемами размещения. RAID-устройство создавалось при помощи модификации device-mapper, которая меняла адресацию блока данных по определенному алгоритму.

На RAID записывались данные, для которых выполнялся расчет контрольных сумм в целях последующего восстановления. Выбирался отказавший диск. Выполнялось восстановление данных либо на соответствующие empty blocks, либо на hot spare disk.

Мы сравнили следующие схемы:

- RAID-6 — классический RAID-6 с двумя контрольными суммами; восстановление данных на hot spare disk;

- RAID-6E — RAID6 c empty блоком в конце страйпа; восстановление данных на empty blocks соответствующих страйпов;

- Classic LRC+E — LRC-схема, в которой локальные группы идут последовательно и заканчиваются контрольной суммой (см рис. 3); восстановление на empty block;

- LRC rand — для генерации каждого LRC-страйпа, его номер используется в качестве ядра генератора случайных числе, восстановление данных на empty block.

Для тестирования использовались 22 диска со следующими характеристиками:

- MANUFACTURER: IBM

- PART NUMBER: ST973452SS-IBM

- CAPACITY: 73GB

- INTERFACE: SAS

- SPEED: 15K RPM

- SIZE FORM FACTOR: 2.5IN

При тестировании производительности большую роль играет размер блоков страйпа. Чтение с дисков при восстановлении данных ведется по возрастающим адресам (последовательно), но из-за декластеризации в случайных схемах расположения некоторые блоки пропускаются. Это значит, что при работе с блоками малого размера позиционирование магнитной головки диска будет производиться очень часто, что пагубно скажется на производительности.

Поскольку конкретные значения скорости восстановления данных могут зависеть от модели жестких дисков, производителя, RPM и др., мы представили полученные результаты в относительных величинах. На рис 5. продемонстрирован прирост производительности в рассматриваемых схемах (RAID6 c empty блоком, Classic LRC, LRC rand) в сравнении с классическим RAID-6.

Рис. 5. Относительная производительность различных алгоритмов размещения

При восстановлении данных на hot spare диск скорость восстановления ограничивалась скоростью записи на диск для всех схем, использующих hot spare. Можно заметить, что рандомизированная LRC-схема дает достаточно высокий прирост скорости восстановления по сравнению с неоптимальной схемой и RAID-6.

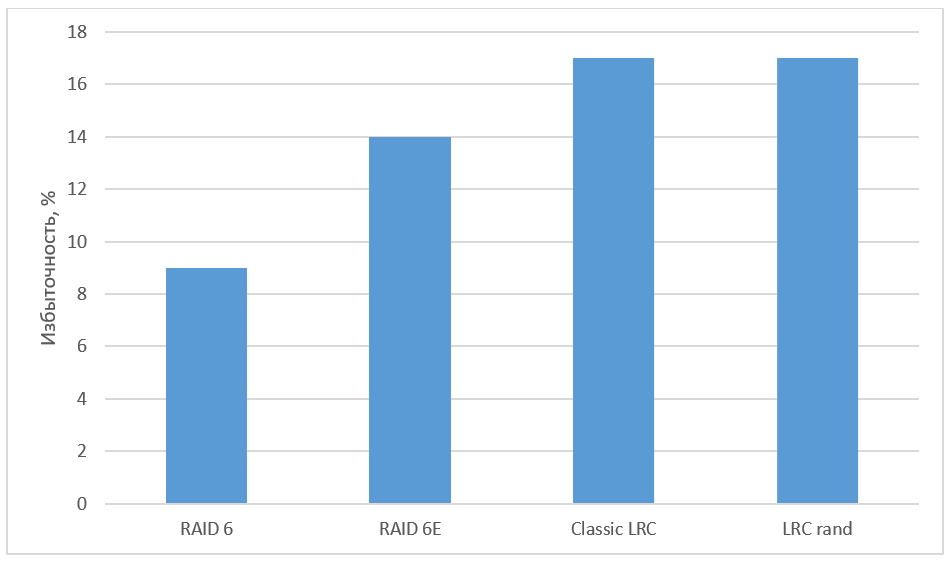

Рис. 6. Избыточность различных алгоритмов

Заключение

Мы привели возможные варианты расположения блоков, а также провели тестирование различных схем и увидели заметный прирост в скорости восстановления. Благодаря высокой масштабируемости LRC-кодов данный подход может использоваться также при построении массивов из большого количества дисков, с помощью увеличения количества локальных групп. Повышение надежности может достигаться за счет увеличения числа глобальных контрольных сумм.

Помехоустойчивое кодирование при помощи LRC способствует существенному снижению избыточности в хранилище по сравнению с репликацией. Схемы кодирования, отличающиеся от кодов Рида-Соломона, на практике чаще всего исследуются в контексте LRC. Xorbas — реализация LRC в HDFS — потребовала увеличения избыточности на 14% по сравнению с RS-кодированием. Скорость восстановления при этом увеличилась на 25-45%. Количество чтений и пересылок по сети также значительно сократилось. Для дальнейшего изучения оптимальных LRC советуем обратиться к работе «A Family of Optimal Locally Recoverable Codes» (Itzhak Tamo, Alexander Barg).

Использованные источники:

- Hafner, J. L., WEAVER Codes: Highly Fault Tolerant Erasure Codes for Storage Systems, FAST-2005: 4th Usenix Conference on File and Storage Technologies

- Khan, O., Burns, R., Plank, J. S., Pierce, W., Huang, C. Rethinking Erasure Codes for Cloud File Systems: Minimizing I/O for Recovery and Degraded Reads, FAST-2012: 10th Usenix Conference on File and Storage Technologies

- Huang, C., Simitci, H., Xu, Y., Ogus, A., Calder, B., Gopalan, P., Li, J., Yekhanin, S., Erasure Coding in Windows Azure Storage, USENIX Annual Technical Conference

- M. Sathiamoorthy, M. Asteris, D. Papailiopoulos, A. G. Dimakis, R. Vadali, S. Chen, and D. Borthakur. XORing Elephants: Novel Erasure Codes for Big Data. In Proceedings of the VLDB Endowment, volume 6, pages 325–336. VLDB Endowment, 2013.

- Itzhak Tamo, Alexander Barg. A Family of Optimal Locally Recoverable Codes. arXiv preprint arXiv: 1311.3284, 2013.

|

Метки: author raidixteam системное программирование математика алгоритмы блог компании raidix lrc xor восстановление данных raid6 доступность данных |

Как я участвовал в хакатоне Angular Attack, и что из этого вышло |

О том, что это и как начиналось

Вдохновением послужил прошлогодний пример Андрея, с которым мы работаем в одной команде.

Тем более, для того, чтобы вписаться в участие, не нужно ничего, кроме настроенного рабочего окружения… и готовности писать код в течение 48 часов на выходных без сна и отдыха.

Как правило, и с первым, и со вторым у хороших разработчиков проблем не бывает.

Условия хакатона элементарны. Все происходит удаленно. Старт – в полночь по Гринвичу в субботу, финиш – в полночь в понедельник, в команде от 1 до 4 человек, до старта эвента никакого электронного контента создавать нельзя (ни кода, ни ассетов), хотя рисовать на бумажке блок-схемы и придумывать алгоритмы – сколько угодно. Каждому участнику выдается приватный репозиторий на GitHub, в который он кладет код в процессе написания. Обязательное условие – на выходе должно быть web-приложение с использованием фреймворка Angular. Свободно распространяемый контент и библиотеки в своем приложении использовать можно с соблюдением условий лицензии (например, ссылка на автора). Все.

А вот чего бы этакого написать?

Где-то за пару недель до начала я начал задумываться над идеей. Мысли про будущее приложение возникали следующие:

- Оно должно быть простым в использовании – работ будет много, судьи – обычные люди, и, если человек за пару десятков секунд не поймет, как пользоваться приложением, он скорее всего не будет разбираться дальше.

- Оно должно быть несложным в разработке. Я собирался участвовать в одиночку, и идея должна быть такова, чтобы банально успеть ее реализовать за эти 48 часов. Поэтому всякие мысли про бэкенд и прочее отпали сразу – только single page app, только фронт, только чистый Angular.

- Оно должно быть не очень банальным – нужно, чтобы идея цепляла. Опять же – судьи оценивают не крутость кода, а работу и внешний вид. Поэтому можно написать игру “виселица” (как кстати, многие и сделали), но человек, сыграв в нее раз, больше никогда в игру не вернется (а одним из критериев оценки является так называемый Utility/Fun – насколько работа полезна, прикольна, и, в общем, вызывает желание пользоваться ей вновь и вновь).

Вообще, если придумать совершенно новую идею, отвечающую всем трем пунктам, то можно запросто стать миллионером. У меня в итоге не получилось – я решил остановиться на собственной реализации уже известной, старой-старой логической головоломки, которая работала еще под DOS, и в которую мы в студенчестве заигрывались с головой.

Суть ее относительно проста: есть поле из шести рядов по шесть клеток, в каждом ряду могут находиться картинки-элементы, объединенные каким-либо признаком, например, в первом ряду сверху – лица, во втором – знаки зодиака, в третьем — цифры – и так далее. В начале игры на доске загадана некоторая правильная комбинация положения всех элементов, неизвестная играющему, и цель игры – используя предложенный набор подсказок, определить правильную позицию для каждого элемента на доске.

При старте игры некоторые элементы уже могут быть открыты (например, буква L в нижнем ряду доски – это означает, что она точно находится именно здесь). В клетках же, где правильный элемент еще точно не определен, показываются оставшиеся возможные варианты. К примеру, в каждой из остальных клеток нижнего ряда, исходя из текущей позиции, все еще возможны варианты из букв H, O, M, E и S.

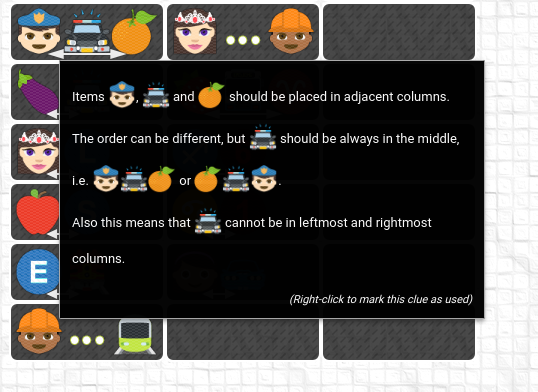

Далее, смотрим на подсказки. В самой игре можно навести на подсказку курсор мыши, и появится тултип с ее описанием (правда, на английском, но я верю, что для хабровцев это не проблема), здесь же просто упомяну, что каждая подсказка в нижнем ряду под игровой доской означает, что оба элемента, указанные на ней, должны находиться в одном столбце.

Если мы глянем, например, на седьмую подсказку слева, то увидим, что буква L должна быть в том же столбце, что и цифра 5. L у нас уже открыта – значит, уверенно открываем 5 над ней (левый клик). Теперь посмотрим на пятую слева подсказку (знак зодиака Овен в одном столбце с Е). Ни Овен, ни Е у нас пока не открыты, но открыта L, а это означает, что над ней Овна точно нет. Следовательно, мы можем убрать знак Овен из клетки над буквой L (правый клик).

Таким образом, применяя подсказки для открывания картинок, положение которых мы можем определить однозначно, и убирая элементы, которые точно не могут быть в соответствующих клетках, мы постепенно уменьшаем неопределенность, и в конце концов, приходим к единственно верному решению головоломки. Ну, или не приходим – пока навыки не отточены, с решением можно запросто зайти не туда, но в этом случае поможет хитрая кнопка Undo to Last Correct, которая откатывает позицию на последнюю верную, до ошибки, и решение головоломки можно продолжить с правильного места.

Понеслась!, или немного про алгоритмы

В пятницу вечером, перед началом эвента настроил окружение. В качестве языка выбрал Google Dart – тут сомнений не было: несмотря на то, что основным трендом в разработке под Angular является TypeScript, практически весь фронтенд в нашей компании сейчас пишется именно на Дарте, и я решил не изобретать велосипед. Также выполнил настройки git-а и хостинга – в этом году организаторы не предоставляли место для размещения работ, рассчитывая, что каждый из участников сам решит этот вопрос. У меня хостинг был, и это не вызвало проблем, но, возможно, кому-то о таких вещах стоит знать заранее.

В субботу, к старту хакатона в три ночи решил не вставать, проснулся где-то в шесть утра. Решил – сегодня пишу логику, завтра – UI. Если с логикой в день не укладываюсь – то завтра утром решаю, имеет ли смысл вообще продолжать.

А вот с этой самой логической частью, кстати, был довольно интересный челлендж.

Для головоломки надо было сгенерировать: 1) правильную позицию на доске, 2) позицию, которая изначально открыта, и, самое главное, 3) набор подсказок, которые позволяют перевести открытую позицию в правильную. Причем, набор подсказок должен быть в идеале необходимым и достаточным – задача должна решаться, и при этом, единственным способом.

С генерацией случайной правильной позиции и изначально рандомно открытых нескольких картинок проблем, естественно, не возникло, а вот как создать набор подсказок для конкретной позиции, придумалось не сразу. Пытаясь решить задачу в лоб, я попробовал добавлять случайные подсказки в набор до тех пор, пока они не позволяли открыть доску полностью (для этого потребовался метод, который с данным набором подсказок пытается решить позицию – и либо решает ее, либо рапортует, что этого сделать нельзя), но столкнулся с тем, что набор часто получался избыточным, и дело было даже не в дубликатах (их как раз можно было отследить) – случалась ситуация, когда некий поднабор подсказок полностью дублировался другим поднабором, при этом одинаковых элементов в них не было, а итогового сета все еще не хватало для полного открытия доски.

В итоге я решил поступить следующим образом: изначально создать заведомо избыточный набор подсказок, и попытаться решить им позицию. Если не вышло – пересоздаем набор, если же получилось – рекурсивно выкидываем по одной подсказке и снова пытаемся найти решение. В какой-то момент задача решаться перестанет, тогда мы берем минимальный сет подсказок, с которым решение было найдено, и объявляем его итоговым. Это сработало.

Были опасения, что все эти рекурсивные построения будут зверски тормозить (все вычисления происходят в браузере на клиенте, во время работы алгоритма мы пытаемся программно решить головоломку несколько сотен раз, а у процедуры решения своя рекурсия… и так далее), но, на удивление, после небольшой оптимизации, все заработало довольно шустро. На современных машинах позиция с подсказками строится практически мгновенно, на медленных и древних – около секунды).

Естественно, все заработало не с первого раза. Какие-то вещи я не сразу учел, что-то было настолько сложно проверяемо без UI, что пришлось написать пару юнит-тестов, которые, в свою очередь, тоже нашли пару ошибок, но факт – в субботу ближе к вечеру логическая часть игры у меня была, и можно было приступить к реализации графической части и взаимодействия с пользователем.

Графика? Все уже нарисовано до нас!

Для игровой доски требовались картинки, отвечающие условию: 6 наборов по 6 штук, каждый набор объединен определенным признаком. Сам бы я замучался их делать – к сожалению, именно в рисовании медведь оттоптал мне оба уха, руки, и все пальцы в придачу, включая те, которые на ногах. Но здесь выручил набор смайлов Emojione, которые с недавнего времени свободно входят в поставку Photoshop CC, на который у меня есть совершенно официальная подписка как часть плана Adobe для фотографов, так что условия лицензии соблюдены. Впрочем, без подписки, думаю, тоже все было бы в порядке: Emojione – свободно распространяемая библиотека.

Кстати, изображения, естественно, упаковал в спрайт использованием responsive backround sprites css — это позволило отображать картинки просто заданием класса для элементов, более того — при необходимости легко менять их размер. Про саму технологию написано уже немало — можно, например, почитать тут.

И да – несколько картинок все-таки пришлось нарисовать самому, включая стрелочки на подсказках, пару круглых кнопочек для help-страницы, бэкграунд для игрового поля, имитирующий лист бумаги в клеточку, и лого, которое показывается при загрузке игры. Впрочем, тут использовались стандартные текстуры и фигуры Photoshop, и с этим неразрешимых проблем не возникло.

Но если у вас в команде есть нормальный дизайнер – знайте, что вам уже невероятно повезло.

Штирлиц на грани провала

Воскресенье ушло на создание и вылизывание UI. Простейшая играбельная версия была готова где-то после полудня, но до комфортной игры было еще далеко – не было ни функциональности Undo, ни уведомлений о том, что позиция решена правильно/неправильно, ни уровней сложности. Первые две фичи были чисто техническими, а вот с последней, кстати, я поступил просто: сделал три уровня – легкий, средний и тяжелый, которые отличаются только количеством изначально открытых клеток. Для Easy это всегда 10, для Medium – 5, а вот на Hard – от нуля до двух. Да, в некоторых раскладах на харде изначально не открыто ни одной клетки. И более того – задача в этом случае тоже решается!

В какой-то момент я понял, что каждой подсказке обязательно нужен тултип, в котором будет подробно описано, что она из себя представляет, иначе судьям, незнакомым с игрой, будет крайне сложно понять, что означает весь этот пестрый набор картинок. Прошерстив в интернете имеющиеся библиотеки с компонентами для Angular Dart, остановился на Angular Material, в котором этот тултип имелся. Одна беда – библиотека была в бета-версии, которой в свою очередь, требовалась последняя бета Ангулара. Ну, где наша не пропадала – проапдейтил сборку со стабильного Angular 2.2.0 до беты 3.0.0, посмотрел, что вроде ничего не поломалось, и все работает как надо, обрадовался, и начал приделывать красивый тултип к подсказкам.

Заняло это примерно часа два, и вот что в итоге получилось:

Теперь небольшое отступление, для тех, кто не знаком с языком Dart. Код, написанный на нем, не может исполняться в обычном браузере напрямую, его обязательно нужно скомпилировать в Javascript специальной командой. Но для разработки Google выпускает специальную версию браузера Chromium – Dartium, который содержит встроенную виртуальную машину, способную выполнять чистый дартовский код. Понятное дело, что вся разработка идет в этом специальном браузере – так значительно быстрее, а компилируется итоговая версия только тогда, когда ее нужно куда-то выложить.

Так вот – тултипы заработали, подумалось – самое время выложить промежуточную версию на внешний хостинг. Скомпилировал, залил на удаленный сервер, попытался открыть в Chrome – и был крепко удивлен тем, что приложение падает с ошибкой где-то глубоко в недрах Angular. Стектрейс ни о чем не говорил. Два часа назад, когда я заливал предыдущую версию, еще без тултипов, она отлично работала. Нескомпилированный код, запущенный в Dartium, тоже работал без проблем. А вот собранный – нет.

И вот тут-то и стало ясно – переход на бету Angular, наверное, не такая хорошая идея, как показалось вначале – работоспособность-то ее никто не гарантирует. Внезапно осозналось, что и время как-то довольно быстро уже движется к вечеру второго дня, а тултипы придется переделывать с нуля, и потраченного впустую времени безумно жалко.

В качестве последней надежды около получаса читал профильные форумы – и на каком-то по счету внезапно обнаружил вопрос от участника с такой же, как у меня, проблемой. Более того, ему ответили – двадцать минут назад (!), посоветовав обновить сам Dart SDK на последнюю версию, вышедшую за несколько часов до этого.

Лихорадочно обновляю Dart на локальной машине, собираю пакет, выкладываю на сервер, проверяю – работает.

Выдыхаю – в этот раз просвистело мимо.

И серьезный урок – наверное, все учесть все-таки невозможно, но до старта хакатона надо по максимуму продумать, что, и как будет использоваться, какие библиотеки, совместимы ли они друг с другом, какие могут быть у всего этого подводные камни. Если бы я сразу понял, что тултипы есть только в бета-версиях Angular material, возможно, не стал бы рисковать и сразу знал, что нужно писать свой. Или поискал бы другую библиотеку.

На финишной прямой…

Остаток вечера ушел на создание help-странички. К тому времени глаза уже собрались в кучу, количество выпитого кофе за день измерялось десятками чашек, но очень хотелось, чтобы так называемый onboarding – процесс ознакомления пользователя с приложением – был настолько эффективным, насколько это возможно. С учетом ограниченного времени, затраченного на реализацию, получилось, наверное, не очень, но тем не менее, лучше, чем ничего – по крайней мере, пользователь видит, что о нем заботятся, и, прежде чем показать ему приложение, которое не всегда интуитивно понятно, пытаются объяснить, что его ожидает.

Уже ближе к ночи потратил пару часов на отлов орфографических и стилистических ошибок, после чего решил, что пытаться что-то улучшать дальше бессмысленно – голова к тому времени соображала очень туго, и вместо исправления косяков можно было запросто наплодить новые, собрал итоговую версию, выложил ее на хостинг, заполнил карточку работы и отправил ее на проверку.

В сумме весь процесс написания кода занял чуть больше тридцати часов (да, я все-таки иногда спал), плюс пара часов на графику. И в общем, вся разработка прошла довольно гладко, за исключением истории с бетой Angular, но все хорошо, что хорошо кончается – в следующий раз буду опытнее.

…и неожиданный результат

Процесс оценки и обсуждения работ длился неделю. Игра собрала не очень много фидбэка (свои оценки и мнения могли высказывать не только судьи, но и другие участники эвента), хотя этот самый фидбэк был в основном положительным, а оценки от именно судей – практически неизменно высокими. Но, если честно, сложно было представить, что в день объявления результатов я увижу свою игру на первом месте из сотни с лишним работ участников. Для меня это был, в первую очередь, именно интересный опыт программирования в таком формате – двое суток, идея, реализация, готовый конкурентоспособный продукт на выходе, хотя итоговая победа безусловно, была приятным бонусом.

И только моя супруга, два дня таскавшая мне кофе и еду к компьютеру, в этой победе изначально не сомневалась. Спасибо ей.

Рабочая версия игры находится здесь: http://sherlock.netmafia.ru/ (крайне рекомендуется разрешение монитора Full HD).

Репозиторий с исходным кодом — тут: https://github.com/izolenta/sherlock, возможно, кому-то будет интересно познакомиться с языком Google Dart.

Спасибо за прочтение – и удачи!

|

Метки: author stickytape разработка веб-сайтов программирование dart angularjs блог компании wrike angular2 angularattack хакатон front-end |

Интервью с Яковом Шуваевым про команду инженеров, мотивацию и собеседования |

Мы постараемся немного изменить ситуацию – предлагаем вашему вниманию интервью с руководителем одного из технических отделов ЛАНИТ Яковом Шуваевым. Отдел специализируется на реализации решений в области построения надежной и безопасной программной инфраструктуры информационных систем, сервисов, обеспечивающих производственный цикл разработки, а также на всем, что касается баз данных и информационной безопасности.

Яков, расскажите немного о себе и вкратце о своем отделе. Чем вы занимаетесь и над чем работаете сейчас?

Начну, наверное, с учебы. Я из РУДН. Учился на физмате на специальности «Прикладная математика и информатика». Первые три курса учеба занимала все время, на четвертом появилось немного свободы, и я решил, что пора взяться за работу. Шел 2006 год. Было три варианта. Основной план был сходить в те компании, о которых были реальные отзывы от моих друзей. Таких вариантов было два, и первым в списке оказался ЛАНИТ. Мой однокурсник, который учился на параллельном потоке какое-то время там уже работал. Он и организовал мне мое первое в жизни собеседование в ИТ-компании. На этом собеседовании меня встретили мой непосредственный будущий руководитель, руководитель группы разработки и вице-президент компании, который тогда вице-президентом не был, а был простым руководителем проектов – они сидели в одном боксе в опенспейсе. В то время я слабо представлял себе, какие бывают роли в ИТ-компаниях, поэтому пошел на ту же позицию, что и мой однокурсник – «Разработчик-стажер». К слову сказать, если бы тогда я хотел заниматься тем, чем занимаюсь сейчас, у меня бы это не вышло – на тот момент в структуре подразделения была пара специалистов по базам данных, а админов и инженеров по безопасности не было в принципе. После того, как руководитель группы разработки выяснил, что про GWT, JEE и сборщик мусора я мало, что знаю, а мой опыт программирования сводится к написанию лабораторных в вузе и игры судоку на C# для КПК, он передал меня моему будущему руководителю. Мне выдали лист А4 с задачами на логику. Как потом выяснилось, все, кого собеседовали в отдел разработки, прошли через эти задачи.

Интересный факт. Не все знают, но физмат РУДН плотно обосновался в ЛАНИТ. Только в одном подразделении, в котором работает Яков, трудятся еще 5 выпускников физмата РУДН.

Какие еще были варианты? Ты сказал, что было три.

Если бы я выбрал второй вариант, то сейчас я, возможно, работал бы в одной из приобретенных «Ростелекомом» компаний. Думаю, тоже неплохой вариант.

Третий вариант, запасной, заключался в том, чтобы разместить резюме на сайте с вакансиями, ждать обратной связи и забрасывать потенциальных работодателей письмами. К счастью, второй и третий вариант не пригодились.

Тогда

На одном из первых проектов мне поручили разворачивать систему у одного из заказчиков. Понравилось собирать из набора деталей работающую систему. Когда пришлось собирать кластер из серверов приложений, тогда еще BEA Weblogic, открылся «новый дивный мир».

Я выяснил, что для того, чтобы система заработала быстро, надежно и безопасно, одного кода не достаточно. Плюс, как показала практика, если код работает у разработчика – это еще не значит, что его можно просто так взять и запустить в кластере.

Дальше больше. Были новые проекты, на которых я уже полностью переключился с разработки на администрирование. Так в проектах подразделения, в котором я работал, появились Linux, SVN и сервер непрерывной сборки в его текущем виде. Единственное – меня смущало, что я долго не мог найти в интернете подходящего описания моей ИT-роли в проекте и команде. Это было немного шире, чем системное администрирование, термин DevOps появился только в 2008 году, а на аббревиатуру SRE я тогда не наткнулся. В итоге, долго ломал голову над тем, чем же на самом деле занимаюсь. Это напрягало.

С этими мыслями я написал своему руководителю, после чего он предложил эту активность назвать «ИТ-инфраструктурой», а соответственно мою роль на проектах как «специалист по ИТ-инфраструктуре». Жизнь обрела смысл и понеслась…

Да и как сейчас уже понимаю, инфраструктурой на тот момент я занимался лучше, чем писал код.

DevOps и SRE

В 2009 году стартовал проект по разработке одного из государственных порталов. Производственный процесс стал резко меняться в соответствии с потоком и масштабом новых задач: росла команда, росло число тестовых стендов. Стенды нужно было создавать, поддерживать в актуальном состоянии, нужно было готовиться к запуску системы в промышленную эксплуатацию. Меня одного на все активности стало не хватать, и мы начали расширять штат «инфраструктуровщиков». Как я уже говорил, на тот момент в штате были специалисты по БД Oracle, которых не совсем было понятно к какой административной единице отнести: то ли к разработке, то ли к администрированию. В итоге решили, что их буду курировать я.

На момент образования сектора в нем работало 5 человек, включая меня.

К 2016 году наше подразделение открыло дополнительные региональные офисы в Челябинске, Перми, Саратове и Ижевске. «Собачка немного подросла», и в 2016 году наша команда стала распределенной – свыше 30 человек. Встал вопрос о ее трансформации в более крупную административную единицу подразделения – отдел.

Во время подготовки к этому нужно было решить очень «сложный» вопрос – как назвать отдел. С одной стороны, команду давно знали по таким ключевым словам как «инфраструктура» и «базы данных». С другой стороны, область нашей деятельности с 2010 года значительно расширилась, да и слово «инфраструктура» у многих ассоциируется с железом, сетью, ЦОДами – всем тем, чем профессионально занималось и занимается другое подразделение ЛАНИТ.

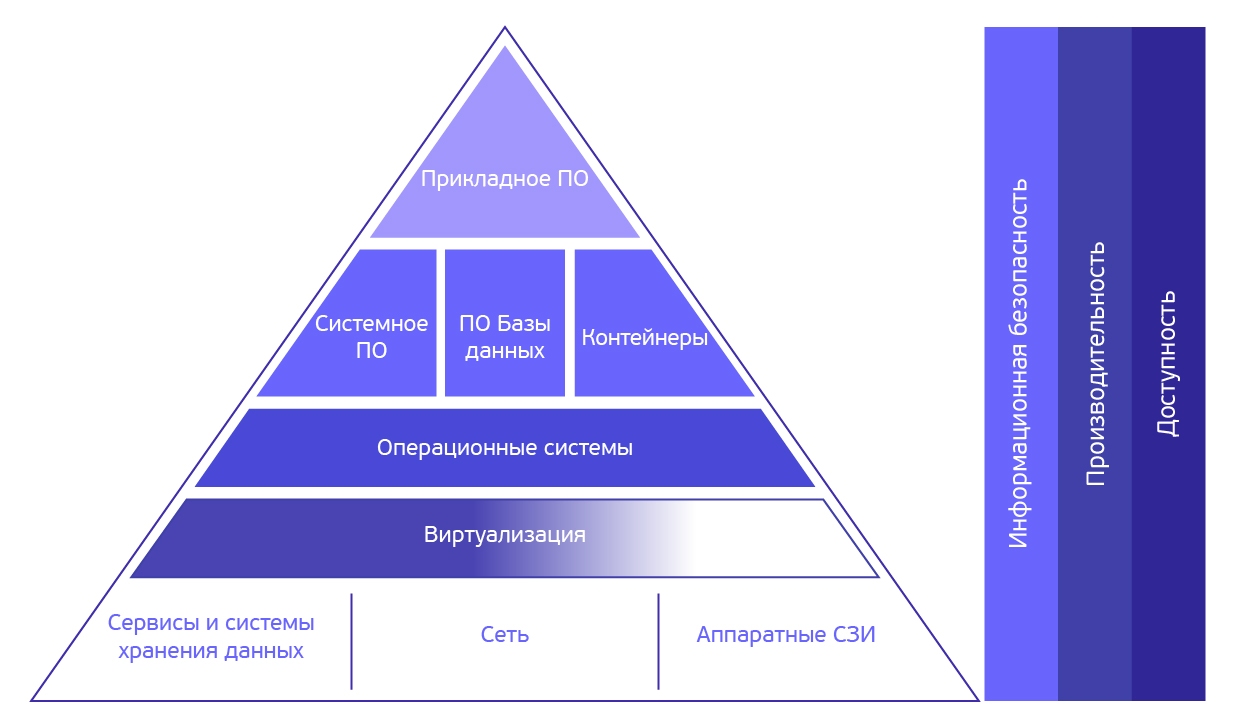

На собеседованиях, которые я провожу, рассказывая, чем занимается наш отдел, обычно рисую картинку в виде пирамиды, которая условно представляет уровни абстрактной информационной системы, начиная с железа, на котором все работает, и заканчивая прикладным ПО, которое разрабатывает наше подразделение. Верхний уровень «Прикладное ПО» – уровень, которым занимается отдел разработки. Здесь реализуется прикладная функциональность, которая нужна заказчику информационной системы.

Ниже – это уровни, которыми занимается наш отдел. Какие-то уровни пирамиды мы закрываем полностью, какие-то – частично. Под частичным закрытием я понимаю то, что сотрудники отдела как минимум должны понимать, что происходит и там, и там, чтобы решать основную задачу – сделать так, чтобы ПО работало быстро, надежно и безопасно.

Эти задачи можно решать, выстроив «инфраструктурный периметр» вокруг прикладного кода, но очевидно, что чаще всего это сделать невозможно, поэтому мы тесно взаимодействуем с командой разработки и командой, которая занимается железом, сетью и виртуализацией для достижения этих целей.

При этом нужно понимать, что «забора» с уровнем ПО в верхней части пирамиды и уровнем физики снизу нет. Как минимум, чтобы ответить на вопрос, нужно ли оптимизировать код, добавить железа или «докрутить» ОС, надо либо разбираться во всех этих уровнях, либо уметь правильно провести диагностику и сформулировать вопрос к тому, кто разбирается.

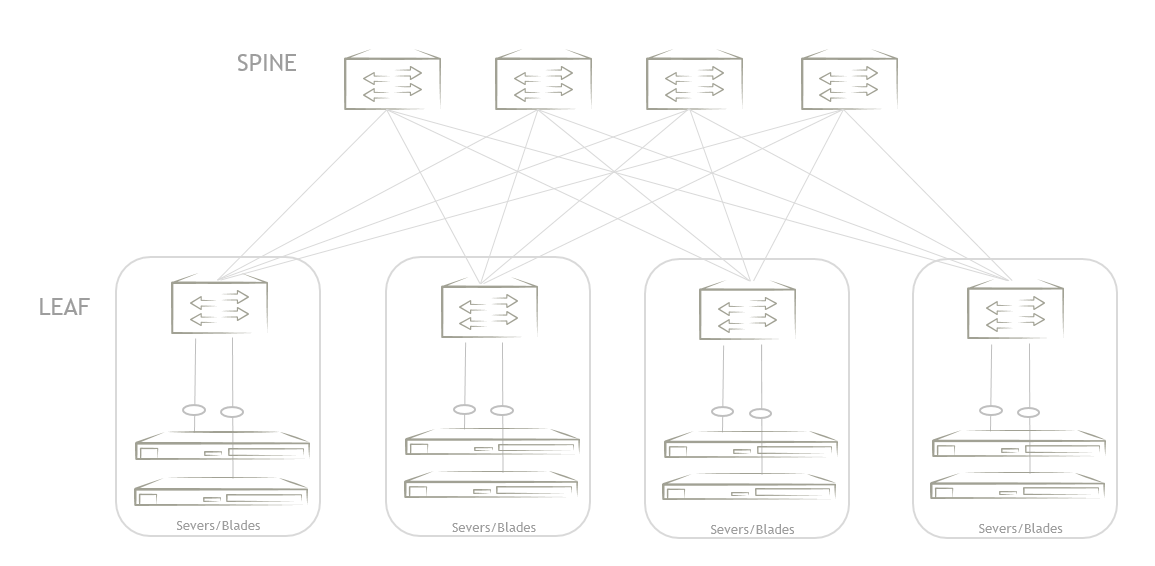

По структуре отдел делится на секторы. Первый сектор предоставляет услуги по эксплуатации информационных систем. Обычно это третий уровень поддержки, что означает, что команда в курсе того, что из себя представляет система, как она работает, какие задачи выполняет и принимает непосредственное участие в процессе разработки системы. Целями работы этой команды являются обеспечение надежной, быстрой и безопасной работы ППО в промышленной среде и обеспечение непрерывности процессов производства. Основные задачи, которые решает команда сектора, включают в себя: создание и настройку решений по автоматизации развертывания, инфраструктурный и бизнес-мониторинг, управление конфигурациями, управление облачными ресурсами, обеспечение надежности и все, что с этим связано. К 2017 году, в отличие от времени, когда все начиналось, прогрессивное человечество успело придумать термины, которыми можно максимально точно описать то, чем сейчас занимается сектор – это смесь элементов DevOps и SRE.

Базы

Чем еще занимался отдел?

Второе направление – это сервисы. Jira и Wiki система уже давно стали неотъемлемой частью производственного процесса практически любого проекта подразделения. Кроме того, на базе Jira, помимо проектных, автоматизируется много сервисов самого подразделения, начиная от заказа канцелярии и получения VPN-доступа для удаленной работы и заканчивая процессом приема на работу новых сотрудников.

Третье направление работы сектора – предоставление облачных вычислительных ресурсов и ресурсов по хранению данных проектным командам подразделения. Мы предоставляем услуги по организации аренды ресурсов у разных облачных провайдеров, таких как Amazon, Selectel, OnCloud и автоматизации подготовки тестовых окружений для проектов в облаках.

Второй сектор – это команда специалистов по базам данных. В начале своего пути команда специализировалась только на СУБД Oracle. Со временем ребята получили большой опыт работы с СУБД PostgreSQL, NoSQL БД RIAK и рядом продуктов, которые тем или иным образом связаны с базами данных. Например, тот же Delphix.

С расширением компетенций команды трансформировался и класс решаемых командой баз данных задач.

Новый класс задач потребовал использования новых инструментов?

Источник

Бывает по-разному. Иногда приходит задача, и ее надо срочно решить. Тут уже не важно, какими инструментами. Если оказывается, что в этот момент ты умеешь держать в руках только микроскоп, то и все задачи, включая “забивание гвоздей”, будешь решать микроскопом. Это, кстати, нормально, если заказчик хочет микроскоп, платит за микроскоп и за построенный с помощью микроскопа дом и в конце получает то, что хотел. Со стороны ситуация может выглядеть странно, но если заказчик доволен, то цель достигнута.

По очевидным причинам мы таких ситуаций стараемся не допускать. Чтобы решать задачи, делать проекты и не выглядеть при этом странно, важно до получения новой задачи или старта нового проекта быть в курсе того, что происходит вокруг тебя в отрасли. Знание широкого круга технологий и решений дает возможность объяснить заказчику, что микроскоп – это не лучшая в мире вещь, и предложить наиболее оптимальный для решения задачи вариант.

И как вы это делаете?

Стараемся быть в курсе :) Смотрим вебинары, ходим на конференции, организуем митапы. Если позволяют сроки, пытаемся на некоторых задачах использовать новые технологии, чтобы, когда придет время, иметь возможность предложить и их.

Безопасность и надежность

Понятно. Инфраструктура и базы данных – это все, чем вы занимаетесь или есть еще какие-то направления?

Есть. В 2015 году мы начали заниматься направлениями информационной безопасности и проектированием катастрофоустойчивых решений. Среди результатов можно отметить завершение проектирования схемы резервирования двух крупных государственных информационных систем. В одном проекте система резервируется на два дата-центра, во втором – на четыре.

Насколько мне известно, тот же Amazon позволяет это делать практически из «коробки». В чем сложность?

Amazon предоставляет такую возможность на уровне своей инфраструктуры или сервисов – смотря, чем вы пользуетесь. При этом, в зависимости от технологий, которые используются у вас на проекте, работать это будет хорошо только тогда, когда вы на уровне кода своей системы учитываете возможность «переезда» между дата-центрами. В противном случае результат будет мало предсказуемым. В нашем случае задача была придумать схему резервирования для уже много лет работающей системы, которая бы гарантировала заданные показатели RTO и RPO.

ОК. А что с безопасностью?

В любой стране есть законы и регламенты, которые требуют от определенного класса систем соответствовать некоторому набору требований. В России основными законами в этой области являются 149, 152 и 63 ФЗ и соответствующие им приказы различных ведомств. Так как в основном мы занимается государственными информационными системами, в которых могут обрабатываться персональные данные, а еще может использоваться электронно-цифровая подпись, то мы должны учесть требования всей этой нормативки. Из результатов могу отметить завершение работ по аттестации одной из информационных систем, которую разрабатывает наше подразделение, по требованиям ФСТЭК, мы провели сертификацию программного обеспечения, входящего в эту систему, и две оценки влияния по требованиям ФСБ.

Помимо обязательных по закону мероприятий, внутри подразделения мы проводим обучение коллег из других отделов, тестирования и разработки по вопросам информационной безопасности при производстве и эксплуатации систем.

И как в итоге звучит название отдела?

«Отдел инфраструктурных решений, сервисов и управления данными». Длинно, но отражает суть того, чем мы занимаемся.

Чем особенно гордишься за время работы?

Горжусь тем, что удалось собрать профессиональную команду, с которой можно решать задачи и которой я доверяю.

О мотивации

Как вы мотивируете сотрудников добиваться нужных результатов? И в чем секрет успешной команды, на ваш взгляд?

Специально никого не мотивирую. В своей работе я исхожу из двух принципов. Первый – при постановке задачи помимо описания того, что я жду в качестве результата, стараюсь обозначить контекст: зачем и кому нужен результат этой задачи. На своем опыте знаю, нет более странного состояния, когда пытаешься угадать, чего именно от тебя хотят и в каком виде, особенно, если задачу получаешь на вход не от того, кому нужен результат.

Второй – я исхожу из того, что у нас все люди взрослые, включая стажеров. Всем, кто к нам приходит, я говорю, что, если задача непонятна, не надо пытаться гадать и додумывать, нужно подойти и спросить – по лбу никто не ударит, зато это может всем сэкономить кучу времени.

По поводу секрета успешности. Этот вопрос лучше задать моему руководителю – директору подразделения :) Если бы он гипотетически ответил, что наш отдел является успешным, я бы, опять же, гипотетически, ответил на этот вопрос историей. К сожалению, я не знаю, кто автор, но она мне очень близка по духу. Звучит она примерно так:

«У одного руководителя берут интервью.

— Скажите, вот у вас все сотрудники постоянно посещают разные конференции, получают сертификаты, ходят на разные тренинги и митапы в офисы других компаний… Вы не боитесь, что они за ваш счет всему научатся и уйдут от вас?

— Я боюсь, что они ничему не научатся и останутся».

Про найм сотрудников

Существует ли, на ваш взгляд, кадровый голод в ЛАНИТ и в ИТ-сфере в целом? Какие специалисты нужны ЛАНИТ сегодня, чтобы решить поставленные перед компанией задачи? И что нужно сделать, чтобы молодежь оставалась работать в компании?

Хорошие вопросы. Сложности с наймом специалистов есть, но эта ситуация характерна для всего рынка – не только для ЛАНИТ. Так как проекты, над которыми работает наше подразделение, обычно не предполагают работу «отсюда и до обеда», список специалистов, которые нам подходят, сильно сужается.

Вариантов, как быть в такой ситуации, на мой взгляд, несколько.

Первый – классический. Можно искать нужных тебе людей, применяя классические HR-подходы, – долго, но результат на выходе всегда качественный. Многие могут со мной здесь поспорить, но я могу сказать о своем опыте. Наверное, мне везло с нашими HR-ами.

Можно еще искать людей в регионах, можно брать стажеров и прокачивать их под нужные вам задачи. Все три способа не сделают текущей команде хорошо прямо сейчас, но в перспективе решат задачу.

Второй – пиарить компанию на рынке, в соцсетях и привлекать тех, кто раньше даже и не задумывался о работе в ЛАНИТ. Про Яндекс, Avito, Mail.ru знают все, а что вы знаете про ЛАНИТ? Всегда задаю на собеседованиях этот вопрос.

И что отвечают?

Обычно, если приходят из интеграторов, то скорее всего что-то слышали, но не обязательно про проекты, которыми занималось именно наше подразделение. ЛАНИТ – это группа компаний, и каждая из них специализируется на чем-то. Кто-то космодромы строит, кто-то банкоматами занимается – разные направления есть. Остальные про нас либо не знают ничего, либо могут ответить что-то типа «Да, слышал… Это же вы госуслуги делаете?» :) И это при том, что ЛАНИТ который год входит в тройку крупнейших ИТ-компаний России, а проектами, которые реализовало только наше подразделение, пользуются по всей стране.

Главное — не зацикливаться на одном подходе и, к счастью, в этом плане мы активно движемся в нужном направлении. Проводим митапы, вышли на Хабр. Плюс сейчас набирает обороты стажерская программа, по которой мы ищем молодых ребят к себе для обучения и дальнейшего трудоустройства.

Стараемся быть в тренде.

Про удержание сотрудников

В тренде – это хорошо. А как дальше удерживать сотрудников?

Для начала, я бы хотел сказать, что никто никого силой не держит :) Для того, чтобы сотрудники не хотели уходить, должны быть созданы условия, с которыми было бы сложно расстаться. В первую очередь – это возможность заниматься любимым делом, далее – чтобы сотрудники чувствовали стабильность и перспективы роста в компании, третье – чтобы они могли развиваться на пользу себе и компании.

Чтобы этого достичь, во-первых, мне кажется важным, чтобы каждый сотрудник понимал, чем занимается и живет подразделение, в котором он работает. Если он этого не понимает, он не будет понимать, что и зачем он делает и частью чего он является.

Очевидно, что мы не стартап и не продуктовое подразделение, хотя у нас есть и свои программные продукты и внутренние стартапы. В первую очередь, мы – интегратор, который делает проекты. Большие и сложные проекты «под ключ». Что это означает на практике? Это значит, что мы реализуем полный производственный цикл создания информационных систем, начиная со сбора требований и заканчивая эксплуатацией и развитием уже функционирующих в продакшене систем. Сами проекты, над которыми мы работаем, социально значимые, важные для страны. Одно осознание от того, чем ты занимаешься и сколько людей пользуется результатом твоей работы, мотивирует очень сильно.

Во-вторых, каждый сотрудник должен понимать, какие возможности открывает для него работа в компании, какие у него есть варианты развития и возможности для этого.

В подразделении накоплен колоссальный опыт, который можно перенимать и развиваться с его помощью с бешеной скоростью. Уверен, существует не так много компаний и подразделений, которые могут поделиться теми знаниями и компетенциями, которыми обладают наши эксперты. Бери и учись!

С теорией понятно, а как на практике? Все прямо так и работает?

Ну… мы не идеальны, но стараемся идти в этом направлении. Большую часть этой теории можно тут же «пощупать» на практике. Динамика наших проектов такова, что, попав в круговорот выпуска очередного релиза какого-нибудь федерального «космолета» под конец года, можно за месяц получить опыта больше, чем в иной компании за год.

Источник

В начале такая скорость сбивает с толку. Иногда вообще сложно понять, что происходит. Но погрузившись в эту атмосферу, уже сложно отказаться от этого ритма, который мотивирует тебя держать руку на пульсе прогресса и постоянно развиваться.

Ну и, конечно же, в-третьих – собеседования.

О собеседованиях

Чтобы сотрудника удержать, надо сделать так, чтобы его не надо было удерживать. А для этого надо, чтобы в команду попадали люди, которые на 100% впишутся в коллектив и сразу вольются в общий поток. Понять, попадет этот сотрудник в поток или нет, за несколько часов собеседования – это та еще задача. Начиная общение с кандидатами, я всегда первым делом синхронизирую с ними терминологию. Все, кто к нам приходит, обычно, где-то до этого работали. У всех есть свое понимание тех или иных терминов: кто-то говорит, что он архитектор, кто-то рассказывает про то, что они делали высоконагруженные проекты, кто-то рассказывает, что у них в базах данных хранилось много данных и т.д. Прежде, чем строить диалог, нужно понять, что вы разговариваете на одном языке. Если вы смотрели фильм «Прибытие», то вот тут примерно такая же история.

В случае нашего подразделения один проект может состоять из десятков частей, причем каждая часть – как отдельный большой проект для иных компаний. Каждый такой проект делает отдельная команда, состоящая из менеджера, аналитика, тимлида разработки и т.д. Когда на первой встрече человек говорит о том, что он «участвовал в 100 проектах, поддерживал 1000 серверов и разворачивал более 9000 баз данных», то на первый взгляд кажется, что человека с таким опытом надо брать в команду, не глядя. Но, если начинать погружаться в детали, часто все становится не таким очевидным.

Еще одна важная вещь, которую я всегда спрашиваю у людей, которых собеседую, это то, чем бы они хотели заниматься в ИТ-компании, если бы у них был выбор при прочих равных? К чему лежит душа, если хотите? Так как у нас постоянно открыты вакансии на разные роли, мы, как правило, не фильтруем людей под вакансию, а смотрим людей и, если есть такая возможность, даем им выбор – на какую позицию им пойти. Для меня главное, чтобы человек, которого мы возьмем, не только делал работу хорошо, но и получал от этого удовольствие – тогда вероятность, что он уйдет, будет меньше.

О наставничестве

В-четвертых, чтобы люди могли прокачиваться, расти, обмениваться опытом и самовыражаться, нужно поддерживать постоянный процесс накопления этого опыта и передачи знаний. Такие возможности у нас тоже есть.

Корпоративной базой знаний в формате Wiki, наверное, сейчас никого уже не удивишь, но сказать о ней все-таки стоит. В нашей базе собрано множество страниц, созданных сотрудниками, с примерами решения технических задач и статьями на различные ИТ темы. Это не статьи формата Хабра или что-то такое. Это скорее заметки сотрудников разной степени детализации для своих же коллег, которые быстро помогают сориентироваться новичкам в том наборе технологий, которые мы используем, и быстрее погрузиться в проект или вспомнить что-то, что было уже давно.

О митапах

Для тех сотрудников, которым тесно в корпоративной Wiki, да и чего скрывать, для PR тоже, мы в прошлом году запустили цикл мероприятий #TechGuruDay, с Твиттером и каналом в Телеграм. Митапы проходят на площадке ЛАНИТ с живыми докладами по ИT-тематике. Наши сотрудники могут выступить в компании приглашенных внешних спикеров. Запустили в этом году блог на Хабре, в который могут писать все сотрудники. Кстати, пользуясь случаем, приглашаю всех, у кого есть интересная тема для митапа, пишите мне на сайте meetup.com – если тема будет как-то пересекаться с тем, что мы делаем, организуем совместный митап.

Поэтому, резюмируя, могу сказать, что причин не уходить от нас, как мне кажется, больше, чем уходить! Но, жизненные ситуации бывают разные, и от нас тоже уходят. В этих случаях мы обычно очень грустим, но продолжаем работать дальше. Особенно, зная, что ушедшие сотрудники грустят вместе с нами и очень часто через какое-то время возвращаются назад.

О планах на будущее

Есть у вас в планах запустить какие-то новые активности?

В этом году хочется провести больше митапов TechGuruDay, чем было в прошлом году, хочется рассказать что-нибудь интересное на какой-нибудь конференции.

Что можете пожелать своим коллегам?

Не стоять на одном месте, постоянно развиваться и двигать мир вперед!

Если прямо сейчас народ захочет попасть к тебе в команду, где им узнать про ваши «космолеты» и кто вам нужен?

Сейчас будет как последний слайд на какой-нибудь презентации с конференции с большой надписью «WE’RE HIRING».

Про «космолеты» можно задавать вопросы в комментариях. Если коротко, то ищем спецов по базам данных PostgreSQL и Oracle, инженеров со знанием ansible и python в команду DevOps/SRE, архитекторов и инженеров по безопасности. Причем, всех уровней. Ну, и, как у всех, у нас есть сайт с вакансиями, где все более подробно расписано.

|

Метки: author katjevl управление разработкой управление персоналом карьера в it-индустрии блог компании гк ланит работа в ит ланит инженерия devops интервью |

Новые продукты и сервисы на выставке Citrix Synergy |

Согласно недавнему исследованию Oxford Economic Research, руководители, которые поддержали виртуализацию рабочих мест и стратегию повышения мобильности бизнеса, превзошли своих коллег по целому ряду показателей, включая более высокую выручку и прибыль, низкие расходы, высокий коэффициент закрепления кадров и удовлетворенность заказчиков. Становится очевидно, что уже в ближайшем будущем для достижения успеха организациям нужно будет активно включаться в процесс цифрового преобразования как бизнес-процессов, так и ИТ-инфраструктуры и корпоративных политик. Сделать это без помощи сторонних специалистов – задача нетривиальная и сложная.

Компания Citrix предоставляет новые возможности для преодоления проблем, возникающих в процессе цифровой трансформации. Новые продукты и сервисы Citrix предоставляют расширенные функциональные возможности для пользователей в рамках унифицированной и защищенной цифровой рабочей среды. Новые мобильные, программно-определяемые сетевые и аналитические сервисы в рамках Citrix Cloud, передовые инструменты для документооборота и интеллектуальная инфраструктура информационной защиты, призваны упростить доступ и контроль за приложениями и данными, облегчить выполнение рабочих процессов и предоставить сотрудникам возможности гибкой работы в мобильном режиме.

Облачные среды

Агентство Gartner отмечает, что сегодня 40% своего бюджета компании тратят на облачные технологии (включая облачные сервисы). При этом 78% опрошенных компаний планируют увеличить эти расходы в 2017 г. Активное внедрение облачных технологий создает сложности для конечных пользователей, которые вынуждены применять несколько облачных сервисов, приложений и источников данных, не говоря уже о необходимости использования различных технологий доступа и нескольких наборов учетных данных. Теневые ИТ-ресурсы создают проблемы в виде использования несанкционированных приложений и инструментов, что усложняет обслуживание ИТ-комплекса и увеличивает риск нарушения информационной безопасности. Для поддержания производительности работы сотрудников Citrix представляет обновленную и защищенную цифровую рабочую среду , которая унифицирует доступ и управление мобильными приложениями, SaaS-, веб-, Windows-приложениями и документами, а также консолидирует доступ, контроль и рабочие процессы в одном решении. С помощью системы единой регистрации сотрудники имеют защищенный доступ к одинаковым функциональным возможностям на любом устройстве. В отличие от других решений, защищенная цифровая рабочая среда Citrix создана на основе контекстного подхода. Это единственное решение, которое включает функции совместной работы, управления правами на доступ к данным и бизнес-процессов. Непосредственно в защищенной цифровой рабочей среде пользователи могут создавать, редактировать и совместно работать с онлайн-документами Office 365.

Citrix ускорила разработку инноваций в области облачных технологий с выпуском новых сервисов и функциональных возможностей для расширения этой мощной модели предоставления рабочих сред. Эти сервисы включают XenApp Essentials и XenDesktop Essentials , рабочая нагрузка которых реализована в Microsoft Azure, но управляются они из Citrix Cloud. Дополнительные сервисы Citrix Cloud включают решение по управлению мобильными устройствами и приложениями XenMobile, а также NetScaler Gateway Service, что позволяет заказчикам быстро и просто создавать шлюз-в-облаке. Кроме того, Citrix Cloud предлагает интеграцию с Azure Active Directory, предлагая администраторам использовать возможности, предоставляемые Интернетом вещей и другими новыми сервисами, разработанными лабораторией Citrix.

Усиленная защита и расширенная аналитика

Согласно глобальному опросу, проведенному в 2017 г. институтом Понемон , 73% респондентов назвали управление данными, 76% – управление конфигурацией и 72% – управление приложениями в качестве основных условий для снижения рисков при создании новой ИТ-инфраструктуры в ближайшие 2 года. Увеличение и изменение периметра корпоративной безопасности создает потребность в более интеллектуальном подходе при управлении политиками информационной безопасности в рамках всего нового периметра. Для того чтобы помочь заказчикам эффективно защищать свои среды, Citrix Consulting Services представило Security Practice и Citrix Analytics, новое решение обеспечения безопасности и анализа поведения, которое расширяет функциональные возможности Citrix NetScaler Management and Analytics System (MAS) и предлагает новые функции обнаружения подозрительного поведения приложений в рамках продуктов Citrix (XenApp/XenDesktop, XenMobile, ShareFile, NetScaler) и проактивного устранения рисков.

Используя большой набор алгоритмов машинного обучения, Citrix Analytics соотносит и анализирует собранные из разных источников данные для обнаружения и изоляции рискованных действий пользователей. Эти рискованные действия пользователей объединяются для создания агрегированного профиля рисков. После обнаружения рискованных действий Citrix Analytics активирует широкий набор средств контроля политик для того, чтобы нейтрализовать угрозу. Такие средства контроля политик включают в себя многофакторную аутентификацию, запись сессий пользователя, установку жестких параметров доступа к данным, блокировку подозрительных приложений и даже карантин пользователей.

Хотя Citrix Analytics уделяет большое внимание вопросам безопасности, существуют другие направления, включая производительность и доступность, в которых Citrix Analytics предоставляет большие преимущества. Несколько аналитических модулей реализовано в ПО NetScaler MAS (Management and Analytics System). NetScaler MAS – это программный продукт, которые выполняет управление сетями и их анализ. NetScaler MAS предоставляет следующие функции:

- Централизованное управление для высокой эффективности работы: NetScaler MAS автоматизирует административные задачи, включая управление конфигурацией и сертификатами, для того, чтобы сэкономить время и исключить ошибки, связанные с человеческим фактором. NetScaler MAS также интегрируется с ПО для управления облачными средами и SDN.

- Контроль и анализ: NetScaler MAS использует данные сети для проактивного определения и устранения ошибок и обнаружения угроз безопасности.

- Управление жизненным циклом приложений: NetScaler MAS контролирует и управляет приложениями в рамках всей инфраструктуры доставки приложений

Более подробно о решениях, представленных в рамках выставки Citrix Synergy, читайте в моих следующих статьях.

|

Метки: author sergx71 сетевые технологии виртуализация it- инфраструктура citrix citrix synergy облачные технологии netscaler аналитика программно-определяемый |

[Из песочницы] Дополнение к анализу алгоритмов |

Эта статья продолжает вводные статьи об асимптотическом анализе сложности алгоритмов на Хабре. Здесь вы узнаете о smoothed анализе и об особенностях анализа алгоритмов во внешней памяти. Любознательных ждут ссылки на дополнительный материал, а в конце я съем полином.

Что нужно знать перед началом?

По долгу службы я собеседовал студентов для программ стажировки и обучающих курсов. Ни один из тех студентов не знал четкого определения «О»-большое. Поэтому я крайне советую обратиться за таким определением к математической литературе. Базовые сведения в популярной форме вы найдете в цикле статей «Введение в анализ сложности алгоритмов»

Smoothed analysis

Скорее всего, вы впервые слышите это словосочетание. Что неудивительно, т.к. Smoothed анализ появился по меркам математики недавно: в 2001 году. Разумеется это подразумевает, что идея не лежит на поверхности. Я буду считать, что вам уже известен анализ худшего случая, анализ среднего, а так же сравнительно бесполезный анализ лучшего случая: и того три очевидных варианта. Так вот smoothed analysis — четвертый вариант.

Прежде чем объяснить зачем он понадобился, проще сперва уточнить зачем придумали предыдущие три. Я знаю три ключевых ситуации, в которых асимптотический анализ выручает:

— Во время защиты диссертации по математике.

— Когда надо понять почему один алгоритм быстрее другого или потребляет меньше памяти.

— Когда надо предсказать рост времени работы или используемой памяти алгоритма в зависимости от роста размера входа.

Последний пункт справедлив с оговорками. Из-за того, что реальное железо устроено сложно, теоретическая оценка характера роста будет работать как оценка снизу для того, что вы увидите в эксперименте. Я сознательно опускаю расшифровку слова «сложно», т.к. она займет не мало времени. Поэтому я надеюсь, что читатель понимающе кивнет и не станет меня допрашивать.

Для наших целей важно уточнить, что асимптотическая оценка не говорит какой алгоритм работает быстрее, и уж тем более ничего не говорит о конкретной реализации. Асимптотика предсказывает общий вид функции роста, но не абсолютные значения. Алгоритмы быстрого умножения — хрестоматийный пример такой ситуации: метод Карацубы обгоняет наивный только после достижения длины в «несколько десятков знаков», а метод Шёнхаге — Штрассена обгоняет метод Карацубы при длине «от 10 000 до 40 000 десятичных знаков». Невозможно сделать подобные выводы без эксперимента, если смотреть только на асимптотику.

С другой стороны имея на руках результаты эксперимента нельзя сделать вывод, что подобная тенденция будет сохраняться всегда или что нам не повезло с входными данными. В этой ситуации и выручает асимптотический анализ, который помогает доказать, почему алгоритм сортировка Хоара быстрее пузырька. Другими словами одновременно необходимы как экспериментальные данные, так и теоретические результаты для полного понимания и душевного спокойствия.

Это объясняет наличие одной асимптотической оценки, но зачем остальные? Всё просто. Допустим у двух алгоритмов асимптотическая оценка худшего случая одинакова, а результаты экспериментов говорят об явных преимуществах одного над другим. В такой ситуации придется анализировать средний случай в поисках разницы, которая всё объяснит. Именно это происходит при сравнении сортировки Хоара и пузырька, у которых асимптотически одинаковый худший случай, но разный средний.

Smoothed оценка находится посередине между средним и худшим случаем. Она записывается так:

, где некоторая небольшая константа, множество возможных входных данных размера , функция возвращающая время (или память), которое алгоритм затратит на обработку конкретных данных, — математическое ожидание, а скобки разные для удобства.

Говоря простым языком smooth оценка означает, что не существует достаточно большого непрерывного куска данных, на которых алгоритм будет работать в среднем медленнее, чем . Таким образом smoothed оценка сильнее средней, но слабее худшей. Очевидно что варьируя можно смещать её от среднего к максимуму.

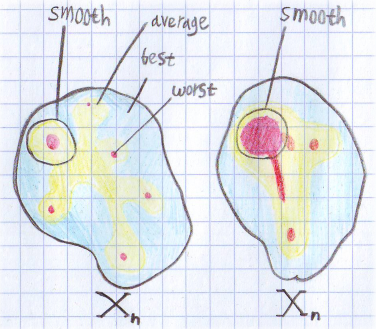

Поскольку определение не тривиально я нарисовал картинку для понимания:

Тут нарисовано распределение времени по множеству входных данных для некоторого n. Красные области — худший случай, желтые — средний, а голубые — лучший. Для левого множества средняя и smoothed оценка будут примерно одинаковыми. А вот для правого smoothed оценка будет ближе к худшему случаю. Для обоих множеств smoothed оценка точнее описывает поведение алгоритма. Если представить, что оба рисунка соответствуют одной и той же задаче, но разным алгоритмам, получается интересная ситуация. Оценка лучшего, худшего и среднего случая у них одинаковая. Но на практике левый алгоритм будет работать по ощущениям лучше, т.к. на правый намного проще устроить алгоритмическую атаку.

Тут нарисовано распределение времени по множеству входных данных для некоторого n. Красные области — худший случай, желтые — средний, а голубые — лучший. Для левого множества средняя и smoothed оценка будут примерно одинаковыми. А вот для правого smoothed оценка будет ближе к худшему случаю. Для обоих множеств smoothed оценка точнее описывает поведение алгоритма. Если представить, что оба рисунка соответствуют одной и той же задаче, но разным алгоритмам, получается интересная ситуация. Оценка лучшего, худшего и среднего случая у них одинаковая. Но на практике левый алгоритм будет работать по ощущениям лучше, т.к. на правый намного проще устроить алгоритмическую атаку. Подробнее об этом можно прочитать в статье «Smoothed Analysis of Algorithms». В ней применяют этот подход для анализа симплекс метода. По ссылкам можно найти и другие статьи.

Анализ алгоритмов во внешней памяти

Прежде чем говорить об алгоритмах во внешней памяти стоит подчеркнуть один момент, который обходят стороной. Теоретические оценки, о которых велась речь, формально выводятся не абы где, а в модели под названием «RAM машина». Это такая модель, в которой доступ к произвольному месту памяти происходит за одну элементарную операцию. Таким образом вы приравниваете вычислительные операции и операции с памятью, что упрощает анализ.

Внешняя память это диск, сеть или другое медленное устройство. Для анализа алгоритмов оперирующих с ними используют другую модель выполнения во внешней памяти. Если упрощать, то в этой модели у компьютера есть машинных слов внутренней памяти, все операции с которой, ничего не стоят, так же ничего не стоят вычислительные операции на CPU, а ещё есть внешняя память, с которой возможно работать только целыми блоками размера слов и каждая такая операция считается элементарной. Причем значительно больше . В этой модели говорят об IO сложности алгоритма.

Таким образом даже если решать на каждом блоке NP-полную задачу в памяти, это не повлияет на IO-сложность алгоритма. Но в такой формулировке это не большая проблема поскольку блок имеет фиксированную длину и мы просто говорим, что вот такая у нас элементарная операция. Однако модель будет не применима для алгоритма драматически уменьшающего число операций на CPU ценой увеличения операций с диском, так что в итоге это будет выгодно. Но даже в таком случае, нужно что бы этот размен был нетривиальным. Причем размен в обратную сторону укладывается в модель, поэтому добавление сжатия не вызывает сложностей. А замена медленного алгоритма сжатия на более быстрый, относится к тривиальному размену.

Второе отличие от RAM модели — формат операций. Оперировать можно только крупными непрерывными блоками. Это отражает работу с дисками на практике. Которая в свою очередь обусловлена тем, что у дисков разрыв между скоростью последовательных операций по сравнению с внутренней памятью меньше, чем аналогичный разрыв между операцией с произвольной ячейкой. Таким образом выгодно нивелировать время позиционирования. В модели мы просто говорим, что нам это удалось и времени позиционирования нет, но есть непрерывные блоки длины , достаточной что бы модель была корректной.

При анализе в этой модели будьте аккуратны с округлением, т.к. чтение одного машинного слова и машинных слов занимает одно и то же время. В общем случае чтение последовательных слов занимает операций, и при небольших вклад округления будет значительным, особенно если потом эта величина умножается на что-то.

Из-за особенностей модели задачи начинают решаться будто быстрее, т.к. вычислительные операции ничего не стоят. Например сортировка слиянием выполняется за , что намного быстрее чем могло бы быть. Но не стоит обманываться, при фиксированных и , все это дает лишь мультипликативную константу, которую легко съедает диск.

SSD и кэш

Есть две темы, которые нельзя обойти. Начнем с кэша. Логика примерно следующая: в целом отношения кэша и оперативной памяти похожи на отношения памяти и диска. Но есть один нюанс: у оперативной памяти нет лага на случайный доступ. Несмотря на то, что чтение из L1 кэша примерно в 200 раз медленнее, чем чтение из памяти, все таки основа модели в лаге на поиск. Существует альтернативная постановка вопроса: составить алгоритм так, что бы минимизировать число промахов кэша, но это тема для отдельного разговора.

SSD всего в 4 раз медленнее памяти на последовательное чтение, но в 1500 раз медленнее на случайное чтение. Именно по этому модель в целом справедлива для него, т.к. вы все равно будете хотеть нивелировать лаг на поиск.

Таким образом эта модель хоть и простая, но остается корректной в большом числе случаев. Подробнее об алгоритмах во внешней памяти с примерами анализа предлагаю ознакомиться в курсе Максима Бабенко из 5 лекций.

Бонус

Напоследок расскажу об интересном обозначении, применяемом при анализе NP-полных задач. Сам я узнал о таком обозначении в лекциях Александра Куликова «Алгоритмы для NP-трудных задач».

Неформально символ «О»-большое съедает всё кроме старшего члена, а у старшего члена съедает мультипликативную константу. Оказывается, существует символ , который съедает не просто мультипликативную константу, а целый полином. Т.е. , и . Так что если вам станет грустно из-за того, что ваша программа тормозит, можете утешать себя мыслью, что алгоритмически её IO-сложность .

|

Метки: author SharplEr математика асимптотика анализ алгоритмов |

Как «Пилот» модернизировал фискальный регистратор в ККТ Fujitsu |

Подробно о сути закона и его влиянии как на магазины, так и на обычных покупателей, группа компаний «Пилот» писала в своем блоге. Теперь наглядно продемонстрируем, как контрольно-кассовую технику (ККТ) требуется модернизировать согласно требованиям 54-ФЗ. Заинтересовавшихся прошу под кат.

Покажем это на примере контрольно-кассовой техники (ККТ) POSprint FP510-Ф. За основу в качестве печатающего устройства был взят производимый в Японии принтер FP510 от компании Fujitsu. К слову, это устройство доказало свою надежность — за 6 лет продаж «Пилотом» техники на базе этого печатающего устройства, практически не было случаев отказов: один раз специалисты компании зафиксировали отказ комплектующего (преобразователя питания на материнской плате принтера) и несколько раз был диагностирован контактный сбой шлейфа термоголовки, устранённый простым передёргиванием шлейфа.

Для появления на свет ККТ POSprint FP510-Ф требуется программная модернизация модели ККМ POSprint FP510K, заключающаяся в смене прошивки и замене электронной контрольной ленты защищенной (ЭКЛЗ) на фискальный накопитель (ФН) или подготовка с нуля, то есть из принтера.

Рассмотрим второй способ. Возьмём принтер Fujitsu FP510

Принтеры поступают от производителя без интерфейсной платы с заглушкой (брэкетом)

Извлекаем заглушку

Устанавливаем на неё фискальный модуль с предустановленным ПО

Устанавливаем на модуль фискальный накопитель

Помещаем сборку внутрь корпуса, фиксируем с помощью винта, наклеиваем гарантийные этикетки. С помощью специальной утилиты производим диагностику интерфейсов подключения, присваиваем заводской номер.

ККТ готова к использованию.

Казалось бы, все просто и ничего не мешает ритейлерам закупить необходимую для соответствия требованиям ФЗ-54 технику. Однако есть явная проблема: дефицит, либо брак фискальных накопителей. По договору с производителем предоплаченные ФН должны поступать заказчикам в течение 60 дней. По факту же этот срок значительно увеличивается. А это значит, что не все ритейлеры успеют поставить на учет свою ККТ – а по закону они должны это сделать до 1 июля 2017 года.

Если же говорить о том, кто использует в работе ККТ POSprint FP510-Ф, то это такие крупные сети, как «Атак», «Ашан», «Детский мир», «Иль Де Ботэ», «Летуаль», Bershka, Lefties, Massimo Dutti, Oysho, Pull&Bear, Stradivarius, Zara, Zara Home и др.

|

Метки: author NoWE it- инфраструктура блог компании fujitsu fujitsu принтер ккт эклз пилот |

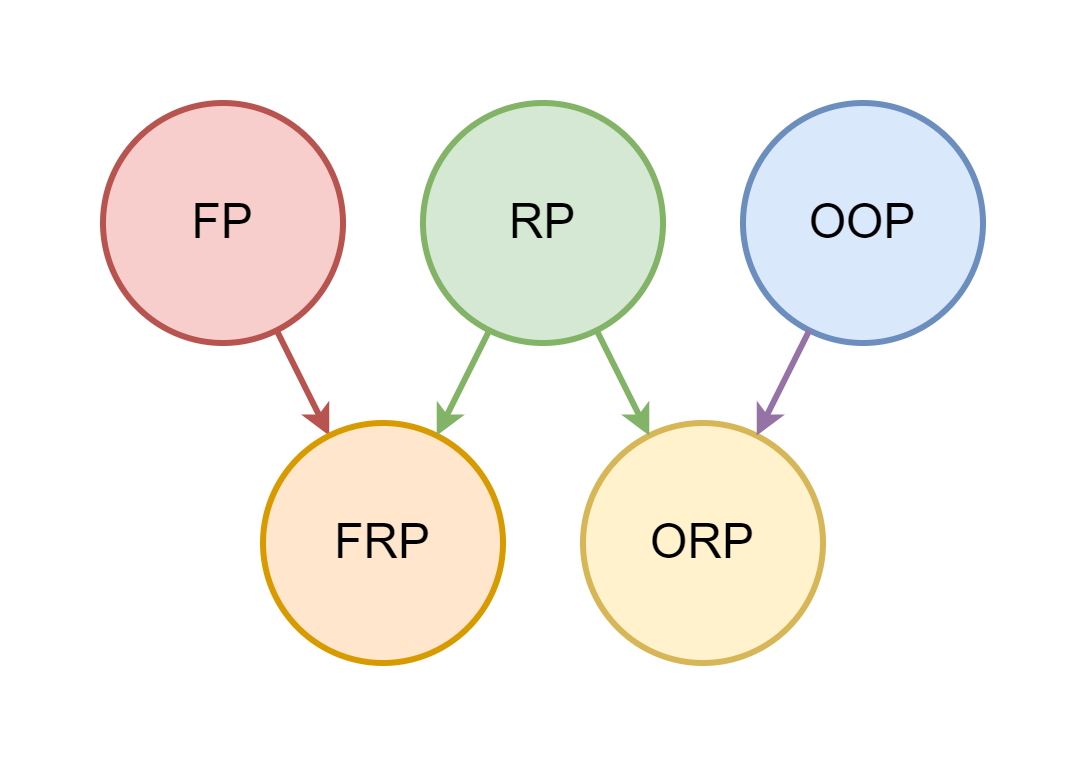

Объектное Реактивное Программирование |

Дмитрий Карловский из SAPRUN представляет… ммм...

Это — текстовая версия одноимённого выступления на FrontendConf'17. Вы можете читать её как статью, либо открыть в интерфейсе проведения презентаций.

| Надоело.. | Чем поможет ОРП? |

|---|---|

| … писать много, а делать мало? | Пиши мало, делай много! |

| … часами дебажить простую логику? | Реактивные правила обеспечат консистентность! |

| … асинхронщина? | Синхронный код тоже может быть неблокирующим! |

| … что всё по умолчанию тупит? | ОРП оптимизирует потоки данных автоматом! |

| … функциональные головоломки? | Объекты со свойствами — проще некуда! |

| … что приложение падает целиком? | Позволь упасть его части — само поднимется! |

| … жонглировать индикаторами ожидания? | Индикаторы ожидания пусть сами появляются, где надо! |

| … двустороннее связывание? | Двустороннее связывание нужно правильно готовить! |

| … пилить переиспользуемые компоненты? | Пусть компоненты будут переиспользуемыми по умолчанию! |

| … вечно догонять? | Вырывайся вперёд и лидируй! |

Рекламная пауза

Всем привет, меня зовут Дмитрий Карловский. Я — руководитель группы веб-разработки компании САПРАН. Компания наша является крупнейшим интегратором САП-а в России, но в последнее время мы активно смотрим в сторону разработки собственных программных продуктов.

$mol — реактивный до мозга костей

Один из них — кроссплатформенный open source веб фреймворк быстрого построения отзывчивых интерфейсов с говорящим названием "$mol". В нём мы по максимуму применяем возможности Объектного Реактивного Программирования, о которых я и расскажу далее...

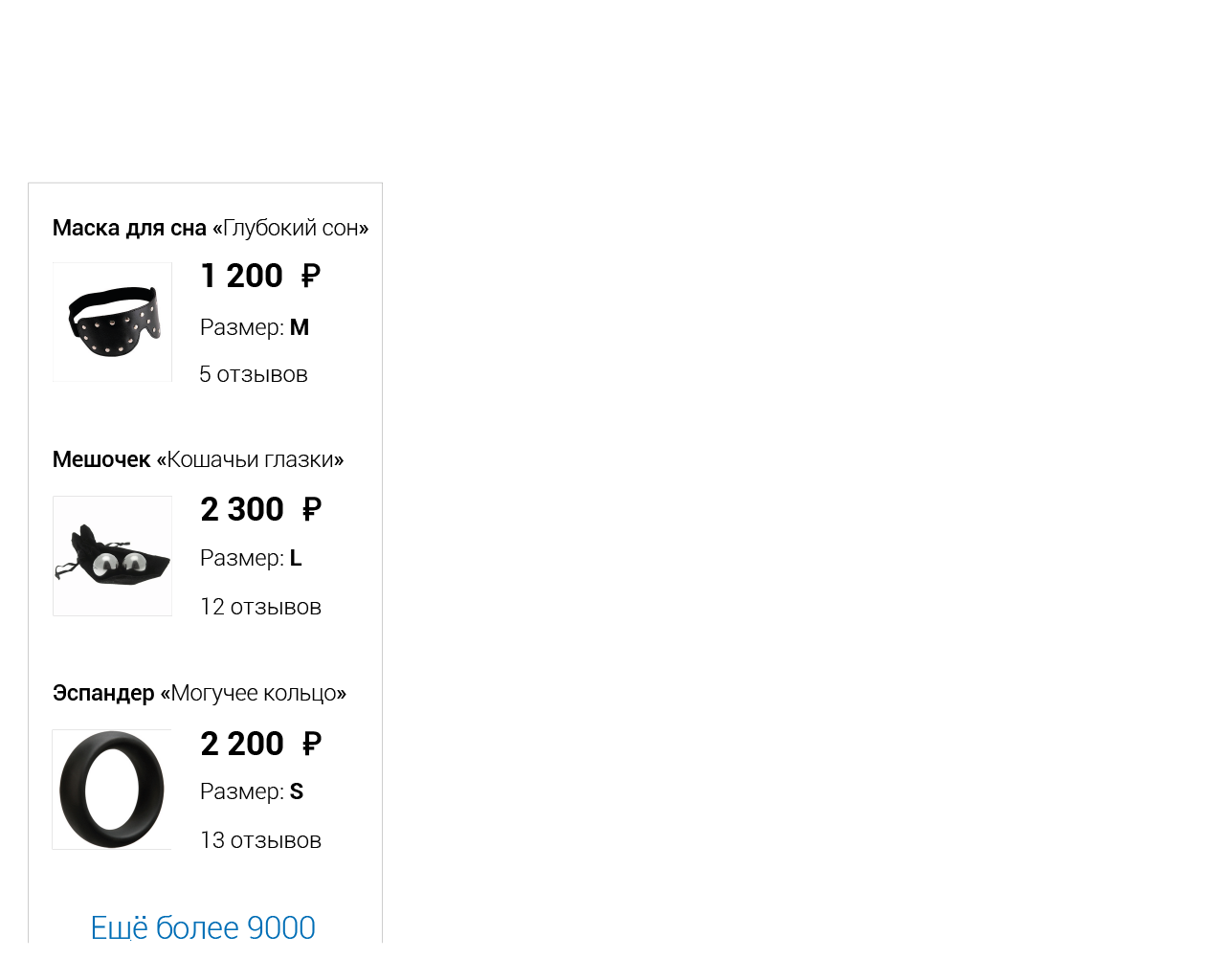

Что будем делать вечером? Попробуем завоевать ритейл!

Давайте представим, что мы решили открыть интернет-магазин по продаже игрушек. Причём сделать мы хотим всё не абы как, а стильно, модно, молодёжно, быстро, гибко и надёжно..

Каталог товаров

Игрушек у нас много, а начать продажи надо было ещё вчера. Поэтому мы хотим сделать всё как можно быстрее, но не про… теряв user experience.

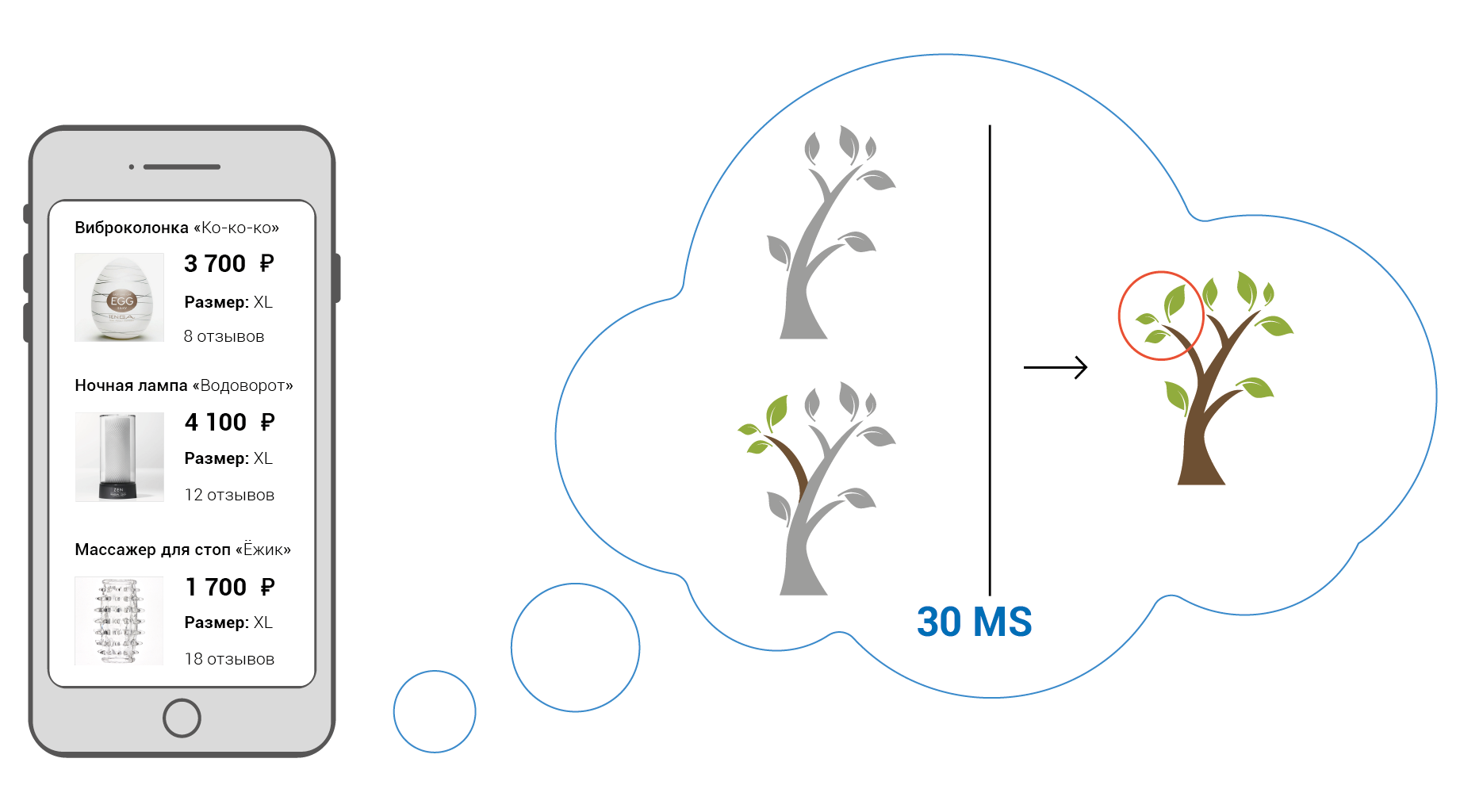

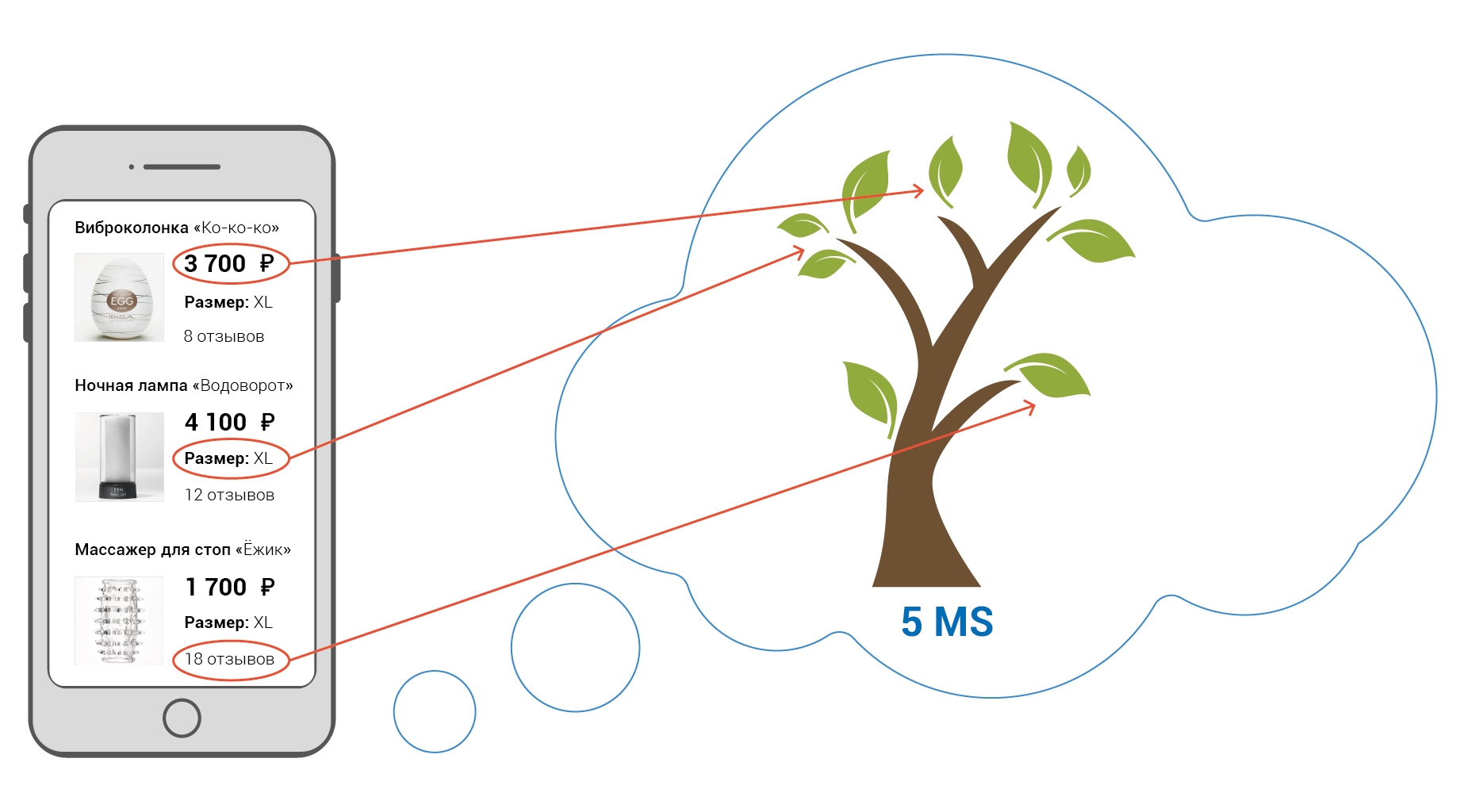

Мы можем загрузить основные данные всех игрушек на клиентское устройство и позволить пользователю просматривать каталог быстро, без сетевых задержек.

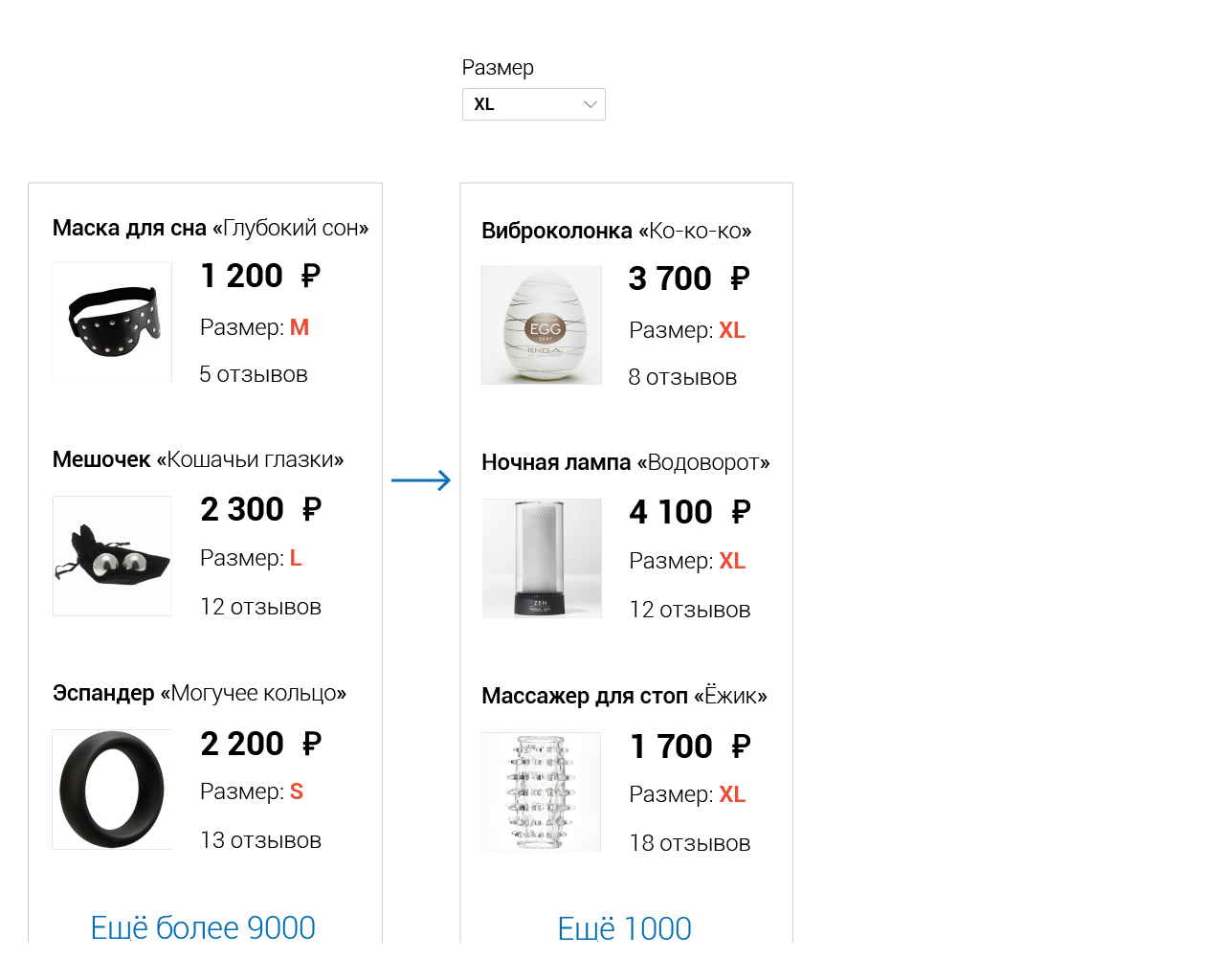

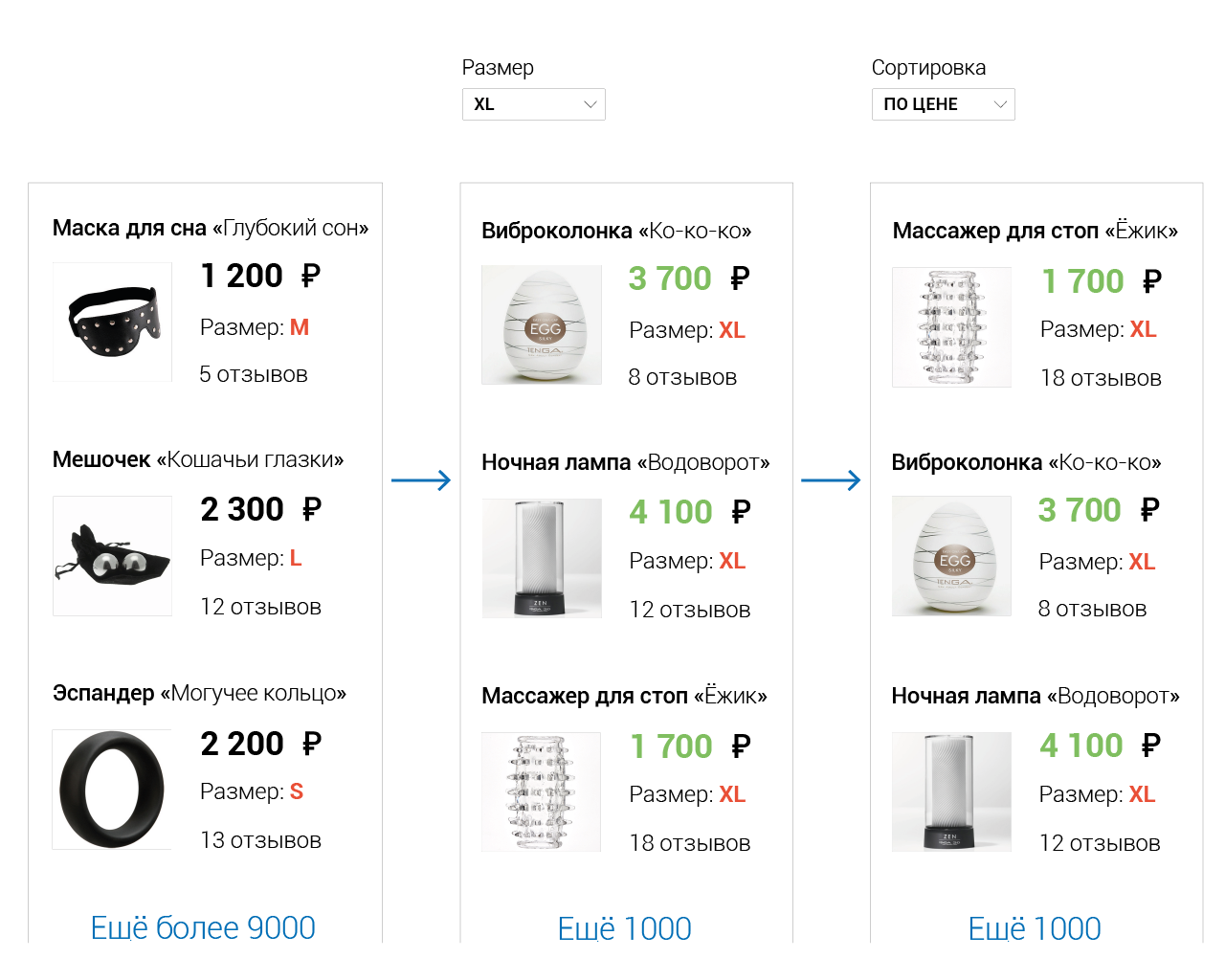

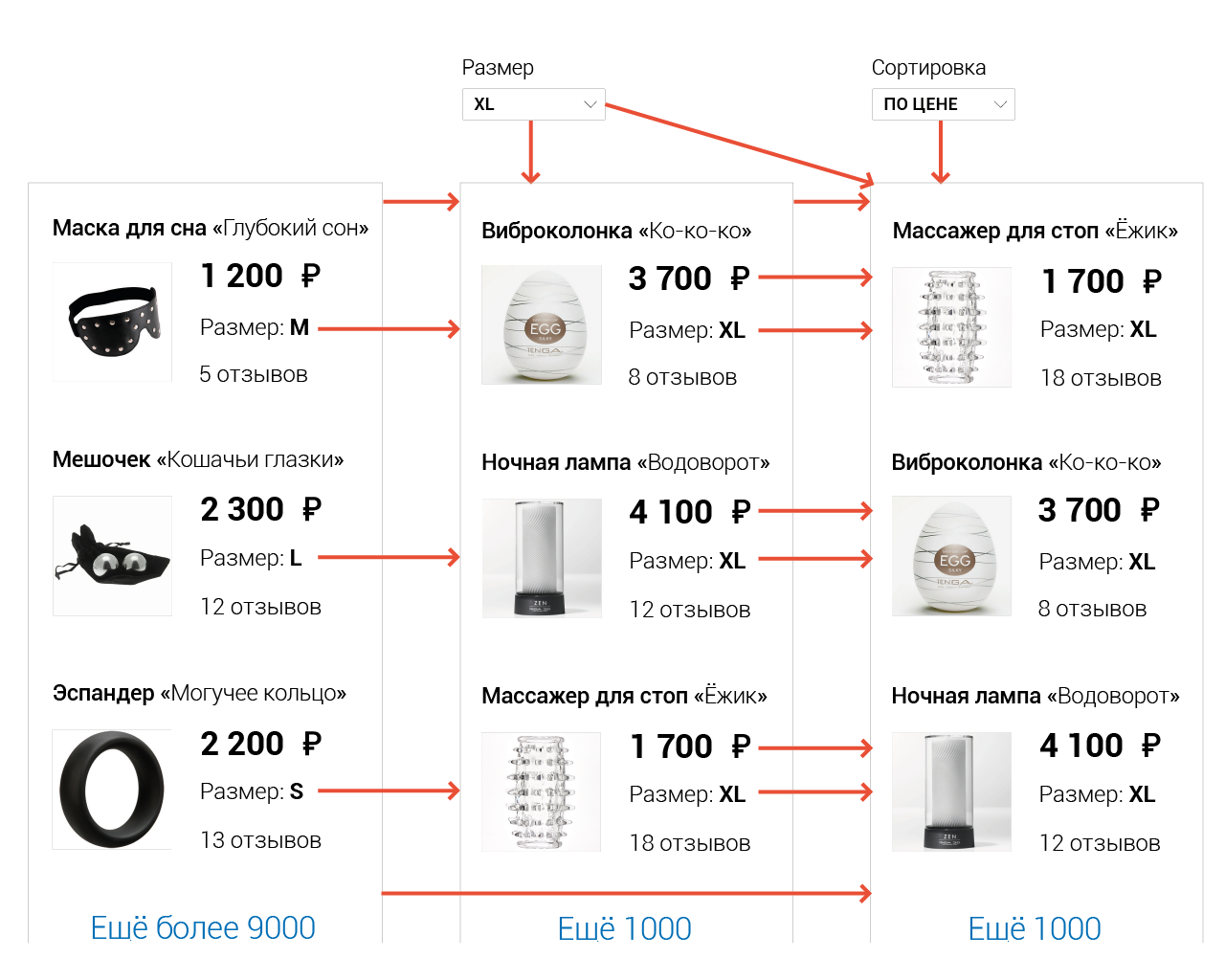

Фильтрация

Листать наш каталог, конечно, увлекательное занятие, но пользователь хотел бы ограничить выбор лишь теми игрушками, что особенно интересуют его в данный момент. Поэтому мы добавляем фильтрацию.

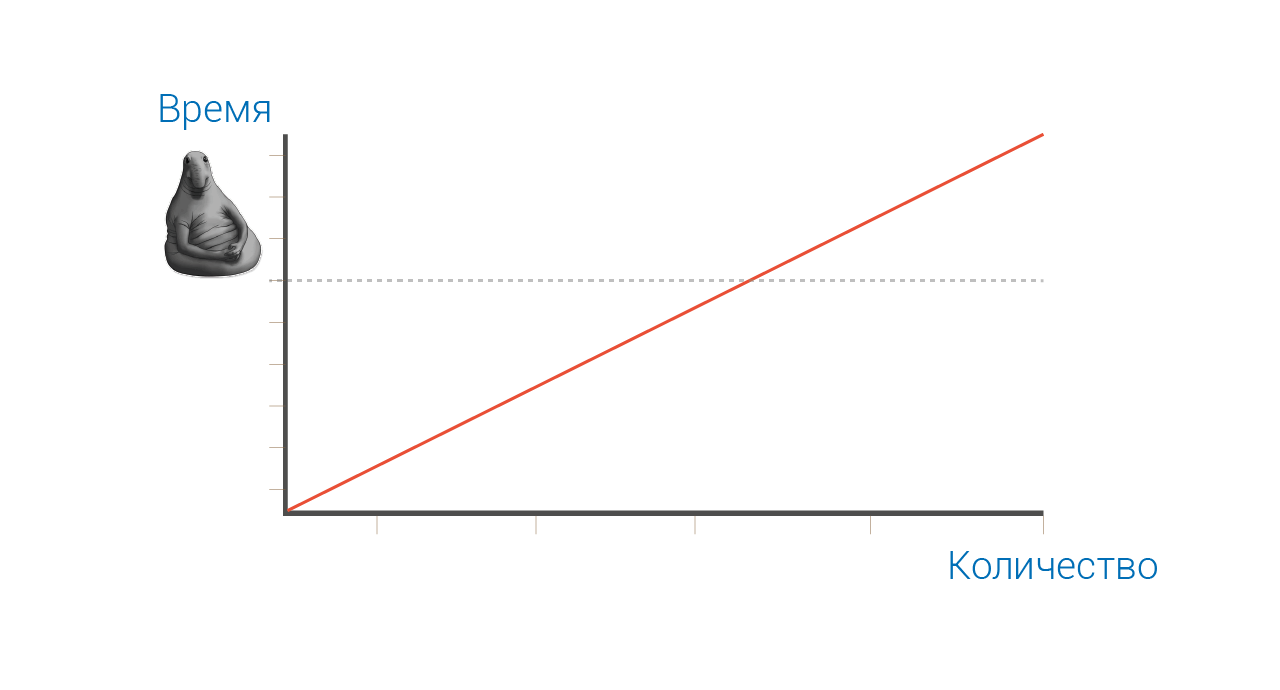

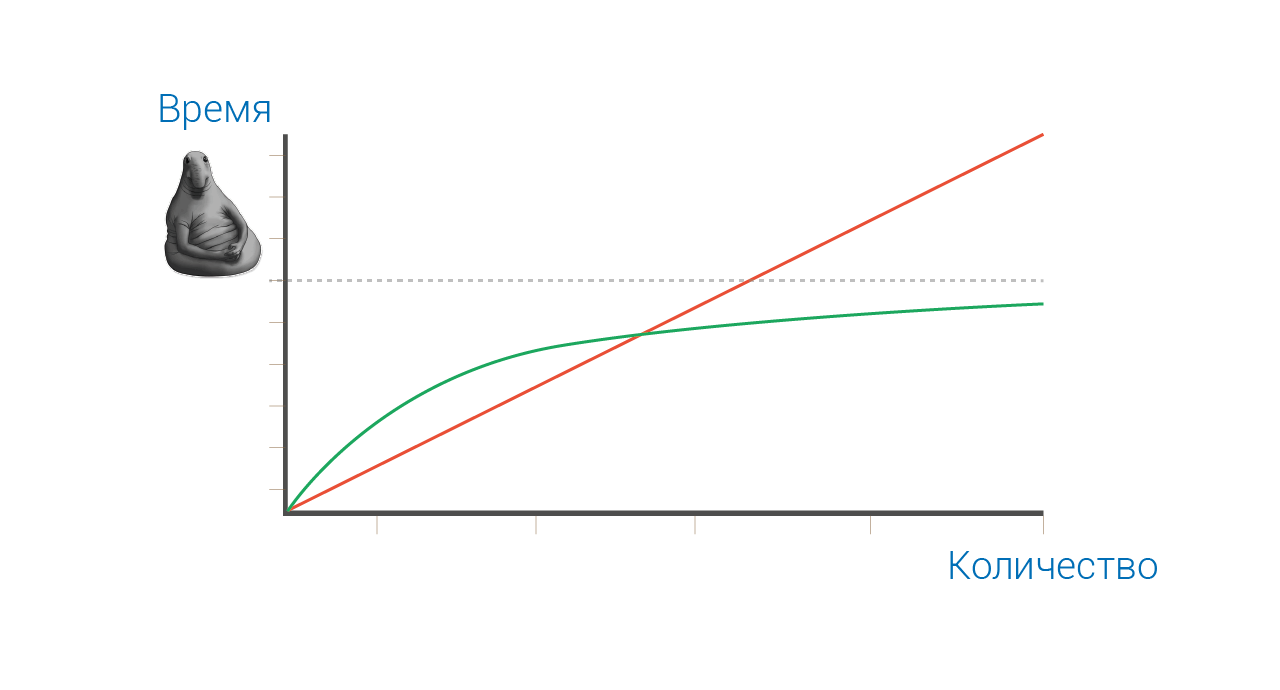

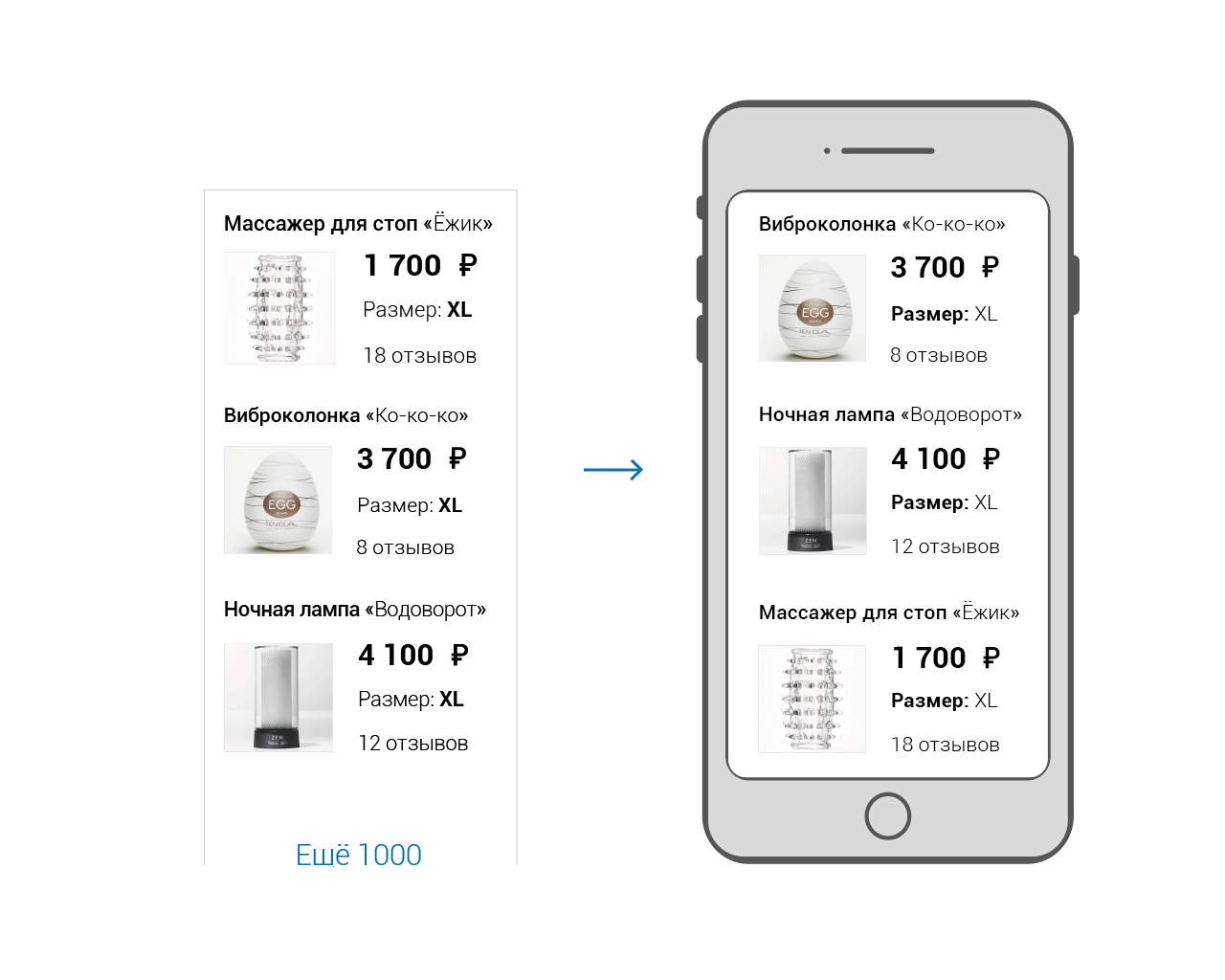

На больших объёмах данных сложный фильтр может накладываться продолжительное время, поэтому для обеспечения отзывчивости нам бы не хотелось, чтобы фильтрация повторялась лишний раз, когда в ней нет необходимости.