Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Перевод] Как принять закон или обработка данных в распределённых системах понятным языком |

|

|

Бесплатные билеты на In-Memory Computing Summit 2017 – Europe |

Возможно, вы знаете, что 20-21 июня в Амстердаме пройдет In-Memory Computing Summit 2017 – Europe. Все детали тут.

Мероприятие, ставшее уже традиционным в США, с этого года также будет ежегодно собирать экспертов из Европы и Азии на новой европейской площадке. На различных секциях конференции выступят представители компаний ING, Intel, Tata Consultancy Services, The Glue, Redis Labs, ScaleOut Software и WSO2.

У меня есть несколько бесплатных билетов, которыми я с удовольствием поделюсь с вами.

Напишите мне на почту mkuznetsov@gridgain.com или в личные сообщения на Хабре.

От вас — ФИО и название компании на английском языке, адрес электронной почты и мобильный телефон.

Приезжайте, будет круто!

|

Метки: author Sibarit машинное обучение java big data .net блог компании gridgain apache ignite gridgain distributed computing data grid compute grid imc |

10 правил организации эффективной клиентской поддержки |

Однако, описанные бизнес-процессы вашей компании ещё не означают, что ваша служба поддержки пользователей будет работать. Ее сотрудникам необходимо овладеть необходимым уровнем знаний и научиться массе приемов работы с пользователями. И, конечно, им необходимо дать в руки инструмент, с помощью которого они будут коммуницировать с пользователями.

Правила клиентской поддержки

Любая служба клиентской поддержки должна следовать правилам, которые были выбиты на камне слезами поколений их предшественников. Они на собственном опыте прочувствовали, как надо делать, а как не надо.

1. Клиент всегда прав!

Если люди выбирают ваш продукт или пользуются вашей услугой и платят при этом за нее деньги, то они вправе получить ответ на любой, даже самый дурацкий вопрос. Даже если клиент ошибается и его претензии не обоснованы, то это всего лишь значит, что вам необходимо объяснить ему его ошибку. Любое решение об отказе от «неадекватного клиента» должно принимать руководство компании и только после позитивного закрытия заявки.

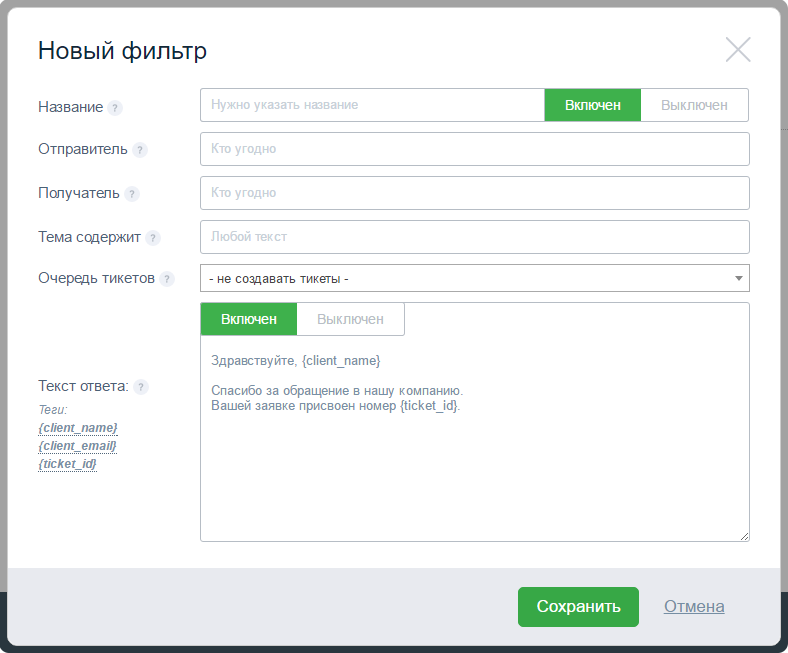

2. Всегда уведомляйте клиентов о получении заявки

Каким бы каналом связи вы не пользовались, у вас всегда должен быть настроен сервис-автоответчик, который будет автоматически отсылать сообщение о том, что заявка пользователя поступила в обработку. Таким образом ваш клиент будет знать, что ему скоро помогут.

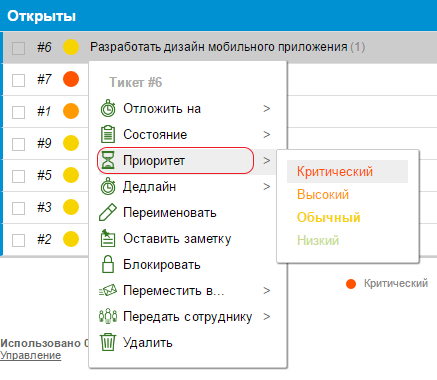

3. Научитесь определять срочность входящих задач

Безусловно, вы должны решать проблемы абсолютно любого клиента. Но всегда стоит понимать, что если клиент прямо сейчас теряет деньги из-за проблем на вашей стороне, но его заявку надо решать сразу же. А простой вопрос пользователя о том, можно ли вставить картинку с котиком в какой-то блок вашего сервиса, можно оставить на потом. Даже если заявка с котиком поступила раньше. И это приводит нас к следующим правилам.

4. Сообщайте клиенту о сроках решения его проблемы

Если вы сразу не можете выполнить заявку пользователя, или у вас появилось более срочное дело, то всегда сообщайте о сроках вашего ответа. Клиент будет знать, что над его проблемой работают, и скоро всё исправится.

5. Ответ в течение 24 часов

Вне зависимости от вашей загруженности или срочности заявки, она должна быть закрыта за 24 часа. Исключениями могут быть, пожалуй, лишь праздники, так как в наше время многие компании часто работают и в выходные дни.

6. И, конечно, сразу же сообщайте клиенту о решении проблемы

Не заставляйте его догадываться об этом или самим тратить время, пытаясь повторить действие, которое привело к ошибке. Ничего, кроме раздражения, это не вызывает.

7. Ответы на вопросы пользователей должны быть лаконичными и без лишних подробностей

Пользователям важно знать, что их проблемы решены, и получить информацию, как не допустить повторения ошибок. При этом старайтесь избегать официального стиля и всегда ищете точки соприкосновения. Добейтесь симпатии у вашего клиента и вы получите позитив в общении и отличный фидбек в виде отзывов и рекомендаций.

8. Ответы на заявки должны быть грамотными

Ничто так не портит имидж компании, как орфографическая ошибка в официальном письме. Тем более, если она смешная. Помните, что любая такая ситуация может привести к тому, что скриншот ошибки службы поддержки появится в социальных сетях.

9. Всегда завершайте общение

Клиент должен точно сказать, что его проблема решена, и у него нет к вам вопросов. Любая недосказанность будет трактоваться как ваша некомпетентность и негативно скажется на всей компании. Всегда благодарите клиентов за обращение и время, которые они на него тратят. Помните, что они приносят вам деньги так же, как ваш сервис или услуги помогают зарабатывать им.

10. Создавайте базу знаний

Большинство клиентов напишет в клиентскую поддержку только в крайнем случае. Они перероют весь ваш сайт в поисках ответа на свои вопросы и, не найдя их, будут писать раздраженные письма. Любое обращение клиентов и закрытые заявки следует анализировать, и если их повторение возможно — писать об этом инструкцию или краткую заметку в FAQ. Так вы сможете предвосхитить множество проблем и снять большую часть нагрузки с ваших сотрудников.

Эти правила могут показаться очевидными, но в реальной работе почти каждая компания, которая организует у себя службу клиентской поддержки, соблюдает их далеко не все. Что приводит к очень неприятным проблемам на ровном месте. Если же изначально утвердить подобную инструкцию для сотрудников и натренировать их постоянно сверяться с ней, чтобы дошло до автоматизма, то вы избежите множества ошибок.

Осталось только разобраться, каким инструментом клиентская поддержка будет пользоваться в своей работе. Это очень важно и тут есть множество вариантов. Большинство крупных компаний используют CRM сервисы с интегрированными модулями учёта заявок, в которые заносят все поступающие от пользователей обращения. Там же назначаются ответственные, все заявки обрабатываются, отслеживаются и закрываются.

Это очень удобно для контроля за сотрудниками службы клиентской поддержки, но достаточно сложно в интеграции в структуру компании. Внедрение CRM — многоступенчатый процесс, который включает в себя анализ потребностей компании, разработку и внедрение сервисов, а также тестирование и лицензирование. Также вам необходимо будет обучить всех сотрудников и организовать поддержку пользователей самого сервиса. И, конечно, такие системы достаточно дорого стоят на начальном этапе внедрения и требуют постоянного обслуживания.

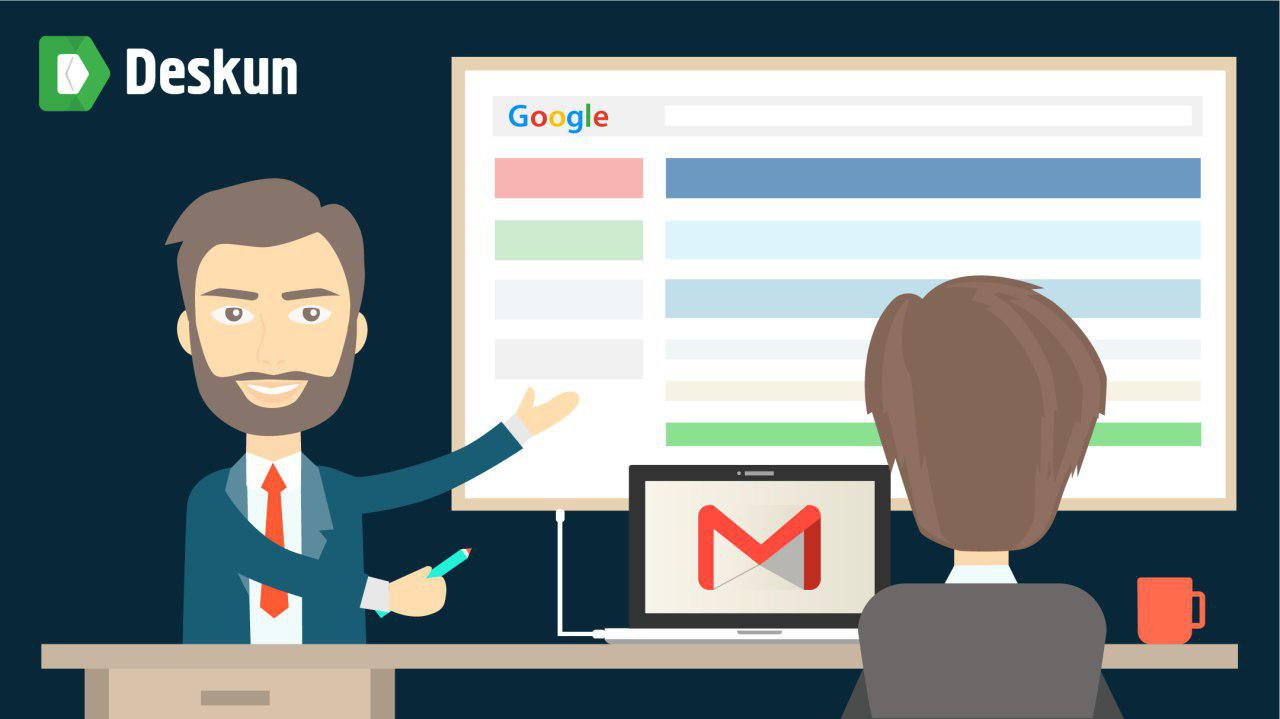

Большинство стартапов не могут себе позволить такие мощные системы, и поэтому им приходится использовать различные программы для ведения заявок. Или даже обращаться к самым простым веб-сервисам для управления проектами. Мы в Deskun решили не идти обычным путём и разработали свой инструмент для поддержки клиентов на основе почты Gmail. В итоге, получился сервис, который можно развернуть для работы всего за 5 минут. Обучение сотрудников проходит очень быстро, так как Deskun органично встраивается в уже всем знакомый интерфейс почтового сервиса.

|

|

Белый список Роскомнадзора: выводы и убытки |

Я изучил сей документ и вот несколько выводов, неутешительных, которыми хочу поделиться:

- Яндекс, Вконтакте, ivi, Телеграм — не полный перечень ресурсов, которые страдают из-за непродуманной системы блокировок. Конечно же, особо хочется выделить Wiki, т.к. с ней проблемы явно будут и не раз ещё. К слову, на vc и Роскомсвободе уже пошутили про *.google.* — и это вновь подтверждает данное опасение.

- Список очень длинный, но есть в нём одна явная закономерность: отсутствие закономерностей. Россия — не самая большая страна (если брать именно Рунет, а не площадь географии), но при этом домены государственных и муниципальных органов и учреждений настолько разные по формату — что диву даёшься: тут и распиаренные домены в зоне.рф. (например, неудобоваримое — http://мкра.рф/); и домены формата http://mcx-ra.ru/ (в Адыгее вообще любят загадочные домены, не правда ли?) или вот http://szn24.ru/. Догадаться с первого раза — что и о чём это, мягко скажем, сложно. Впрочем — об этом чуть ниже.

Ещё одна деталь, которая сразу же бросается в глаза, это домены с www и без онного: допустим — как на рисунке 1.

Рис. 1

Возможно, вам на секундочк у показалось, что детали, о которых сказано выше, — не существенные, но это не так: ибо дьявол и соль вопросов всегда в них, в нюансах.

Поясню.

Дело в том, что все три пункта доказывают следующее:

- Государству (ака публичной власти) много лет было фиолетово на то, как именно наполняется Рунет, как функционирует, а главное — как вообще он развивается с точки зрения взаимодействия самих властных структур и граждан. Появилась необходимость — стали «кпепать» сайты все: министерства, ведомства и прочие структуры организации чиновников. При этом бессистемность такого подхода в итоге привела к тому, что для обычных граждан до сих пор не ясно — точно это сайт государственный (муниципальный) или всё же скам. Не легче ли было ввести одну зону gov.ru и, скажем, region.ru или что-то в этом духе для всех? Есть ли случаи фишинга и других видов мошенничества в этом русле? Да. Но об этом — в следующий раз.

- Далее — из-за вот такого, сумбурного, подхода многие коммерческие сайты очень часто и очень много терпят убытков, сами того не замечая. Пример — ниже.

- Наконец, белые списки — это кладезь информации для тех, кто любит искать:

- аффилированные компании (с кем и почему — пояснять не буду);

- сайты, которые можно использовать как дорвеи с пониманием, что их не заблокируют точно;

- и много ещё для чего.

Но пока — об убытках.

Не так давно ко мне обратился Хаброжитель — nelsh. Вот его пост о том, как ТТК блокирует сайты, которые блокироваться не должны, — https://habrahabr.ru/post/328768/.

Из комментариев к этой публикации, а также переписки с nelsh пришёл к выводам, что незаконная и необоснованная блокировка происходит по следующим причинам:

- Неверная настройка ПО у провайдера

- Система «Ревизор», которая в принципе работать правильно на 100% не приучена (чтобы вы понимали, о чём я — почитайте вот этот пост: повторять его нет смысла).

- «Адекватных способов противодействия «атаке на DNS заблокированного интернет-ресурса» у Роскомнадзора нет»: РКН уже писал о том, что подход изменит, но воз — и ныне на одном колесе стоит всё там же.

Проблема описанная принадлежит именно ТТК (в частности, Иркутск, Дальний Восток, Краснодар, Ростов-на-Дону: или ещё, а также здесь, здесь, или вот здесь — в общем, надеюсь, что пруфов достаточно). Как это выглядит технически — можно посмотреть здесь.

Рис. 2

При этом, цитирую: «ТТК на магистральном уровне блочит рандомные не значащиеся в реестре IP (видно как раз потому, что детектят другие IP для заблоченных доменов, и кто-то троллит/или CDN). В итоге не открываются рандомные сайты. Из последних крупных, что были замечены — сайты Uniquiti, служебные домены EVE Online, Ingress — правда все они на CDN сидят. Недавно пара IP Github.com была заблочена, со всеми вытекающими — гитхаб тупо не открывался несколько часов, но это было не сильно массово… Блочится не у всех, кто ходит через ТТК, видимо зависит от особенностей стыка провайдера с ТТК».

Меня же, как юриста, очень беспокоит этот вопрос: ведь рано или поздно, с учётом того, как развивается Рунет, это может коснуться каждого. К тому же сейчас очень много предпосылок для «неправедной борьбы»:

- Китай выдавливает АКИТ и иже с ними, а значит — АКИТ всё больнее будет бить… нет, не по Китаю, а по ИП и ООО в Рунете.

- Сама по себе блокировка и её механизм — просто кладезь для злоупотреблений.

- Кроме того, более-менее крупные игроки (интернет-провайдеры, операторы сотовой связи и т.д.) рады стараться, дабы угодить и это, как видим, всё только портит.

Для объективности скажу, что есть случаи, когда блокировки, напротив, помогают бизнесу, пусть даже и косвенно.

Конечно, судиться с гос. органами — дело неблагодарное: долго, дорого, но заканчивается не как у Лебедева, а без «о». Но судится с провайдерами — можно и нужно. И не только судится, но и бороться всеми иными законными способами. Иначе всё это станет напоминать цирк шапито.

Безусловно, не последнюю роль в этом играет принятый 10 февраля 2017 года закон № 1102471-6 об изменениях в КоАП РФ в части установления ответственности операторов связи. Звучит она следующим образом (ст. 13.34 в смысле): “неисполнение оператором связи, оказывающим услуги по предоставлению доступа к информационно-телекоммуникационной сети «Интернет», «обязанности» по ограничению или возобновлению доступа к информации, доступ к которой должен быть ограничен или возобновлен на основании сведений, полученных от федерального органа исполнительной власти, осуществляющего функции по контролю и надзору в сфере связи, информационных технологий и массовых коммуникаций”.

Отмечу, что дела показательные по штрафам уже есть, например:

- Постановление от 20 апреля 2017 г. по делу № 5-206/2017

- Определение от 17 мая 2017 года

- Постановление от 19 мая 2017 г. N 06АП-2217/2017

Что можно и нужно использовать для защиты своих прав?

Во-первых, есть ст. 15 ГК РФ — возмещение убытков: реальный ущерб + упущенная выгода. Формула — простая, но на деле доказать реальный ущерб ещё можно (например, если ваши клиенты напишут Вам, что сайт был недоступен в такое-то время и вы докажите, что это было из-за ошибки провайдера/РКН), а вот упущенную выгоду — уже многим сложнее. Скажем, человек хотел купить телефон за 20 000 руб. Вы их потеряли. Кроме того, потеряли ещё закуп на 18 000 и возможную прибыль на 2000 на следующий. И да, если кто-то из юристов скажет вам обратное (что доказать это “проще пареной репы) — не верьте :). Кроме того, можно искать убытки:

- в случае, если переходы были по рекламной кампании;

- по партнёрским ссылкам;

- по другим платным источникам.

Во-вторых, стт. 152 ГК РФ — защита деловой репутации. Здесь с российскими судами всё ещё сложнее, чем со ст. 15 и ей сопутствующими. Но тем не менее, когда провайдер вас незаконно блокирует он тем самым распространяет информацию, что ваш сайт (ресурс в Интернете в принципе) внесён в “чёрный список” и тем самым потенциальные покупатели, а также покупатели постоянные дезинформируются, а в итоге сарафанное радио, особенно, если у вас проект местного разлива или регионального масштаба, может нанести вреда даже больше, чем просто само отсутствие покупок из-за псевдоблока. Чтобы вы понимали серьёзность сего — список с офсайта РКН по блокировкам:

- Детская порнография, наркотики, а также информация о суициде

- Информации экстремистского характера

- Информация порнографического характера (кроме детской порнографии)

- Клевета в сети «Интернет»

В-третьих, ст. 1 ГК РФ — не стоит о ней забывать никогда. Например, ещё в Постановлении Президиума ВАС РФ от 23 ноября 2010 г. № 6763/10 по делу N А53-6358/08 (Вестник ВАС РФ. 2011. N 3) было указано: «Произвольное вмешательство кого-либо в частные дела не допускается», кроме того, часто к этому обращаются и арбитражные суды (ходовой пример Решение АС Красноярского края от 03 ноября 2010 г. по делу N А33-12455/2010): «в содержании принципа недопустимости произвольного вмешательства кого-либо в частные дела ключевым является понятие частного дела как деятельности гражданина или юридического лица (как частного лица), основанной на частном интересе в сфере применения частного права». Это будет ещё сложнее, чем п. 1 и п. 2.

Другие нормы не указываю, т.к. рассматривать случаи нужно индивидуально (если есть — присылайте, рассмотрим вместе).

Для юристов, практикующих особенно, все три пункта — очевидны, но для большинства — априори проигрышны. Для предпринимателей — не очевидны, но ещё более проигрышны. Но всё же — моя жизненная позиция заключается в том, что свои интересы важно и нужно отстаивать: чем чаще и лучше будет это делать каждый, тем быстрее мы получим рабочую систему по итогу. Выбор — безусловно, за вами.

Я же со своей стороны продолжаю настаивать на том, что каждый закон, должен проходить длительную стадию обсуждения: будь-то онлайн-кассы, интернет-мессенджеры, электронные деньги, интернет-торговля или что-то ещё. Иначе, после быстрого принятия «сверху», мы имеем множество технических, организационных, правовых и иных дыр, которые не позволяют функционировать этим же законам нормально.

Опять же — кому-то эта истина покажется прописной, но, судя по последним веяниям, таковой она, к сожалению, не является.

Пока всё — во второй части попробую разобрать пример с ТТК и обещанные выше — отдельно и в другом ракурсе.

P.S. Мини-подборка материалов по незаконным блокировкам РКН и/или провайдерами:

- https://geektimes.ru/post/287714/ — EVE Online

- https://rublacklist.net/29059/ — о том, как с этим пробуют бороться

- Конечно же — самая лучшая подборка у тех, кто на этом специализируется: моё им личное спасибо за сей труд

- Отбойный материал формата “маразм крепчал”

- А это — не (совсем, но всё же по) теме, зато красивая статистика.

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

|

Метки: author Menaskop терминология it законодательство и it-бизнес роскомнадзор белый список роскомсвобода блокировка сайтов it- юрист |

[Из песочницы] Когда docker-compose не хватает |

О чем пойдет речь

Здесь периодически появляются посты, в которых авторы делятся своими подходами по использованию docker. Ну что же, вот вам еще один. Ниже я расскажу о нашем опыте использования docker-окружения, о неудобствах, с которыми мы столкнулись, как мы с ними боролись, и во что это вылилось. А также поделюсь небольшим, но столь полезным для нас, инструментом.

Как мы жили до этого

Для начала немного истории. Так сложилось, что по долгу службы, мы в той или иной степени разрабатываем и поддерживаем одновременно несколько проектов. Все они имеют разный возраст, требования и соответственно работают в разном окружении. В связи с этим при развертывании локальной копии возникали некоторые неудобства. Когда ты переключаешься на проект, с которым ранее не работал, приходится возиться с его настройкой, а также с настройкой рабочей среды. И если внутри команды это могло решиться довольно быстро, то с периодически подключаемыми внештатными разработчиками все сложнее. Было принято решение перенести разработку в docker-окружение. Здесь мы не стали ничего выдумывать, а пошли общепринятым путем. Каждый сервис поднимался в отдельном контейнере. Для связки использовали docker-compose.

Для параллельной работы над несколькими проектами требуется установка всех сервисов необходимых каждому из них. В первую очередь мы создали репозиторий, в котором располагался файл конфигурации для docker-compose, а также конфигурации требуемых для работы образов. Все довольно быстро заработало и на какое-то время это нас устроило. Как оказалось, в дальнейшем данный подход решал нашу проблему частично. По мере добавления проектов в новую экосистему этот репозиторий наполнялся файлами конфигураций и различными вспомогательными скриптами. Это привело к тому что при работе над одним единственным проектом разработчику приходилось либо тащить зависимости всех проектов, либо же править docker-compose.yml, отключая лишние сервисы. В первом случае приходилось ставить лишние контейнеры, что нам казалось не лучшим решением, а во втором нужно было знать какие контейнеры требуются для работы приложения. Хотелось иметь более гибкое решение, которое позволит устанавливать только необходимые компоненты, а также, если не исключит, то минимизирует ручную работу. И вот к чему мы пришли...

ddk

ddk (Docker Development Kit) — инструмент, призванный упростить настройку окружения и автоматизировать развертывание среды разработки для проектов, работающих в docker-окружении. Звучит, наверное, сильно. На деле же, ddk является некой оберткой над git и docker и предоставляет ряд дополнительных команд для удобного управления пакетами, файлами конфигураций и проектами. В некотором роде, это менеджер зависимостей окружения для проектов и сервисов docker-compose.

Изначально ddk — это набор python-скриптов, но конечный пользователь получает единственный исполняемый файл, с которым и работает. Теперь, помимо установки самого docker'а и docker-compose, разработчику необходимо проинициализоровать ddk, создав конфигурационный файл. Эта задача решается вызовом команды init.

cd /var/projects/ddk

ddk initПосле этого подключение к новому проекту выглядит следующим образом:

ddk project get my.project.ru

ddk compose --upТакже, при необходимости, перенаправляем новый домен на localhost.

echo 127.0.0.1 my.project.ddk >> /etc/hostsПервая команда клонирует проект и выполняет его инициализацию. Вторая генерирует конфигурацию для docker-compose и запускает необходимые сервисы. В процессе выполнения будут загружены все недостающие компоненты. По завершению сборки разработчик получает полностью рабочую локальную копию проекта, которая доступна по адресу my.project.ddk.

Немного о том, как это работает.

При использовании ddk рабочей считается та директория, в которой расположен конфигурационный файл, сгенерированный командой init. Сам же исполняемый файл может располагаться в любом удобном месте. Поиск конфигурации осуществляется, начиная с текущей директории, а затем ddk поднимается по дереву каталогов пока не обнаружит искомый файл или не достигнет корня файловой системы. Схожим образом работают git и docker-compose. После того, как файл конфигурации найден, ddk формирует некоторые каталоги для хранения пакетов и исходного кода проектов, разрешает и устанавливает зависимости. Установка компонентов осуществляется простым клонированием git-репозитория, адрес которого определяется путем конкатенации имени компонента и префикса из конфигурационного файла.

# "project-repo-prefix": ["git@github.com/vendor-name/"]

ddk project get my.project.ru

git clone git@github.com/vendor-name/my.project.ru.gitСамо собой, ddk не является простым шорткатом для git clone, и имеет дополнительные функциональные возможности, из-за которых он и задумывался. О том, как, зачем и почему — чуть ниже, а здесь добавлю лишь то, что в итоге сформируется директория, в которой будут собраны все проекты, а также необходимые для их работы конфигурационные файлы. Данная директория может быть без проблем перемещена в другой каталог или на другую машину.

ddk-пакеты

Первое чего хотелось добиться — сделать все окружение максимально модульным. Мы выделили описание каждого сервиса в отдельные конфигурационные файлы и вынесли их в самостоятельные репозитории. Коллега назвал их пакетами. Эти самые пакеты и легли в основу работы нашего инструмента. При сборке docker-compose.yml ddk проходит по всем требуемым пакетам и генерирует на их основе итоговый конфигурационный файл.

Как правило, нет необходимости устанавливать отдельные пакеты самостоятельно, так как при сборке автоматически подгружаются все недостающие компоненты. Тем не менее имеется возможность для их установки и обновления.

ddk package install package-name

ddk package updateТеперь о содержимом. В корне всегда находится конфигурационный файл ddk.json, в котором указываются имя контейнера и используемый docker-образ. Ниже приведен пример пакета с минимальной конфигурацией.

{

"container_name": "memcached.ddk",

"image": "memcached:latest"

}Как вы, наверное, заметили, фактически, это часть конфигурации из docker-compose.yml представленная в формате JSON. Такой подход дает возможность установить любые параметры, поддерживаемые docker-compose. Вот пример более сложного пакета, который использует отдельный Dockerfile и монтирует директории.

{

"build": "${PACKAGE_PATH}",

"container_name": "nginx.ddk",

"volumes": [

"${SHARE_PATH}/var/www:/var/www",

"${PACKAGE_PATH}/storage/etc/nginx/conf.d:/etc/nginx/conf.d:ro",

"${PACKAGE_PATH}/storage/etc/nginx/nginx.conf:/etc/nginx/nginx.conf:ro",

"${PACKAGE_PATH}/storage/var/log/nginx:/var/log/nginx"

]

}Листинг директории пакета:

storage/

etc/

nginx/

conf.d/

site.ddk.sample

nginx.conf

ddk.json

DockerfileКлючи, имеющие префикс "ddk-" используются для указания специальных директив. На данный момент единственным поддерживаемым ключом является "ddk-post-install", который хранит список команд, выполняющихся после установки и обновления пакета.

{

"ddk-post-install": [

"echo 'Done'"

]

}Один из вариантов использования данной опции приведен в разделе "Соглашения"

Проекты

Теперь рассмотрим, как использовать ddk на примере конкретного проекта. Для того, чтобы развернуть существующий проект достаточно вызвать команду get.

ddk project get project-idДанная команда клонирует проект в директорию share/var/www, после чего производится поиск конфигурационного файла (по умолчанию в корне проекта), и запускаются все необходимые команды из секции on-init. На этом этапе выполняется настройка индивидуальных параметров проекта (генерация .env, установка прав на файлы, конфигурация базы данных и т.п.).

Помимо команд для инициализации, файл ddk.json содержит список пакетов, от которых зависит работа проекта. Если какой-то из пакетов отсутствует, он будет автоматически установлен. Ниже приведен пример конфигурации проекта.

{

"packages": [

"mysql5.5",

"memcached",

"apache-php5.5"

],

"on-init": [

"${PROJECT_PATH}/init.sh ${PACKAGES_PATH} ${PROJECT_DIR}"

]

}Несмотря на то, что секция on-init позволяет передать несколько команд мы, как правило, указываем лишь одну. В примере выше вы можете видеть, что при инициализации проекта запустится скрипт развертывания, который и выполнит основную конфигурацию. Такой подход оказался удобнее, так как дает большую гибкость и позволяет добавить интерактив в процесс инициализации проекта.

При необходимости расширить конфигурацию какого-либо пакета, можно сделать это, указав его в виде объекта. Данный объект должен иметь атрибут name, содержащий название пакета. Все остальные атрибуты будут восприняты как конфигурация.

{

"packages": [

{

"name": "nginx",

"depends_on": [

"php-fpm7.1"

],

"environment": [

"SOME_VAR=Hello"

]

}

]

}Таким образом мы имеем возможность влиять на работу сервисов, не меняя оригинальную конфигурацию пакета.

Соглашения

В процессе работы в docker-окружении мы выработали несколько соглашений, которых и стараемся придерживаться.

Во-первых, при монтировании каких-либо файлов и директорий пакета либо проекта, их структура должна совпадать со структурой внутри контейнера. Т.е. package-name/storage соответствует корневой директории контейнера package-name. Директория share также соответствует корневой директории контейнеров. Именно поэтому все проекты располагаются в share/var/www. Данное правило прослеживается и в приведенных выше примерах.

Следующий пункт заключается в том, что при установке пакетов, в контейнерах которых предполагается модификация файловой системы, создается специальный пользователь, учетные данные которого соответствуют данным пользователя хост-системы. Другими словами, мы мапим логин, идентификатор пользователя и идентификатор группы с хост-системы в контейнер. В дальнейшем все команды в контейнере рекомендуется выполнять, используя эти данные. Такой подход позволяет избежать проблем с правами доступа при обращении к файлам вне контейнера. Если хотя бы один из проектов сконфигурирован подобным образом, будет создана директория share/home/, которая монтируется в контейнер и используется в качестве домашнего каталога. Ниже пример того, как мы это реализовали.

{

"container_name": "php71-fpm.ddk",

"command": "map-user.sh",

"env_file": [

"${PACKAGE_PATH}/env/user.env"

],

"ddk-post-install": [

"mkdir -p ${PACKAGE_PATH}/env",

"echo USER_NAME=`whoami` > ${PACKAGE_PATH}/env/user.env",

"echo USER_ID=`id -u` >> ${PACKAGE_PATH}/env/user.env",

"echo GROUP_ID=`id -g` >> ${PACKAGE_PATH}/env/user.env"

]

}Как вы видите, после установки пакета генерируется файл с данными пользователя. При старте контейнера скрипт map-user.sh проверяет и при необходимости создает учетную запись, используя полученные данные.

Щепотка магии

Последнее, что требуется сделать это запустить все необходимые сервисы, используя обычный docker-compose. Для генерации параметров запуска предназначена команда compose. При ее вызове, ddk проходит по всем активным проектам, собирает данные о пакетах и их параметрах, объединяет всю полученную информацию с конфигурациями самих пакетов и на основе этих данных генерирует итоговый docker-compose.yml. Данный файл и используется при запуске.

ddk compose

docker-compose up -dЕсли при формировании конфигурации указать соответствующую опцию, можно обойтись одной командой.

ddk compose --upHello, world

Желающие увидеть ddk в действии могут развернуть демо-проект.

Качаем последнюю сборку:

wget https://github.com/simbigo/ddk/raw/master/dist/ddk

chmod +x ddkНастраиваем будущий домен:

echo 127.0.0.1 hello.ddk >> /etc/hostsРазворачиваем проект:

./ddk init

./ddk project get hello

./ddk compose --upПосле успешной сборки всех образов, проект доступен по адресу http://hello.ddk

Заключение

Чего добились:

- Модульное окружение.

- Формирование конфигурации одной командой.

- Отсутствие многоразовой ручной работы.

- Минимальное время для включения разработчика в проект.

Над чем стоит поработать:

- В ddk практически отсутствует какая-либо обработка ошибок.

- Планировали реализовать корректную работу на MacOS, но на данный момент в нашей команде отсутствует маковод, и инструмент в этой системе не тестировался. Скорее всего, всплывут какие-то особенности, и потребуется доработка.

- Адреса репозиториев для пакетов и проектов передаются в качестве массива, но по факту работа ведется только с первым элементом. Необходимо реализовать корректную проверку существования репозитория и поиск по множеству адресов.

- Удаление лишних контейнеров.

- В скриптах инициализации довольно много повторяющегося кода. Может быть, имеет смысл вынести общие функции в ddk.

Для тех, у кого возникнет непреодолимое желание посмотреть, сделать лучше или просто покритиковать код, прилагаю ссылку на github. Будем рады, если инструмент окажется полезным еще кому-то, кроме нас.

|

Метки: author Simbigo разработка веб-сайтов программирование ddk docker docker-compose |

Polybius Bank: самое значительное событие года в мире криптовалют |

Мне кажется, что с ICO банка «Полибиус» сейчас повторяется та же история. Как бы претенциозно не звучал заголовок, я действительно считаю этот проект грандиозным шагом вперёд. Таким же значительным, какой в свое время сделал PayPal. И вот почему.

Несмотря на бурно растущую криптоэкономику, старый, классический финансовый мир смотрит в нашу сторону весьма консервативно и скептически. На это есть причины. Криптовалюты до сих пор не построили замкнутого цикла экономики и остро нуждаются в сопряжении с фиатной (обычной денежной) массой. Размер которой постоянно растет, но её движение по прежнему контролируют финансовые регуляторы и банки.

В воле финансовых мастодонтов старого, но всё ещё современного нам мира в один прекрасный момент взять и заблокировать расчётные счета любого криптопроекта. Последний, наиболее яркий пример — блокировка долларовых счетов биржи Bitfinex обслуживавшим её банком Wells Fargo.

Примерно за месяц до этих событий, этот же финансовый волюнтарист отказался проводить средства во все банки России, внеся их, если верить саппорту биржи, в персональный черный список. Просто потому что им так захотелось. Это можно объяснить мотивами политическими (санкции), но кому от этого станет легче?

Более мелкие и локальные события происходят регулярно в Польше, Англии, Австралии. Проблема носит глобальный характер. Неважно насколько значимый и крупный у вас проект — он может оказаться на грани катастрофы от удара в спину от любого «надёжного и уважаемого банка». А если чужим банкам нельзя верить, то надо построить свой!

И разумеется, это будет ой как не просто. Не с технической стороны, с этим как раз всё в порядке — и даже, пожалуй, лучше, чем у банков классических и “банков 2.0”. Главные усилия потребуются с юридической стороны.

Проект Polybius разрабатывали целый год команда из финансистов, банкиров, юристов и представителей европейских регуляторов. Это очень важно. Это крайне важно — найти полное юридическое обоснование, определить рамки существования, возможности первого настоящего криптовалютного банка. И такое решение было найдено.

А теперь о последствиях, и почему я считаю этот проект грандиозным. Как только набирающая обороты криптоэкономика получит настоящий банк, будут значительно снижены издержки на конвертации в фиат и обратно. Polybius станет неким шлюзом, хабом, готовым принять к себе всех, от мелких стартапов и обменников до крупных бирж и пулов.

Эпоха безумных процентов, которые сейчас съедают от 5–10% в каждую сторону, уйдет в прошлое. Объёмы обмена криптовалюта-фиат вырастут многократно, станут удобнее и будут понятные не только посвящённым, но и действительно многим. А Polybius, как первый, абсолютно легальный банк, работающий с криптомиром, получит на этом колоссальную прибыль. Он станет аналогом PayPal, только превзойдет его раза в четыре. И да, я не возражаю, чтобы вы запомнили этот твит.

Немного о технической стороне проекта

Я не буду утомлять вас пересказами white paper проекта и ряда других документов, просто кратко резюмирую своими словами.

Polybius Bank — банковская система нового измерения с использованием самых современных технологий, включая блокчейн и специализированный искусственный интеллект. Идея создания универсального современного банка для всех принадлежит компании HashCoins.

Одна из задач, которую ставили перед собой создатели проекта — уменьшение расходов на содержание банка за счёт использования самых современных технологий.

Финансовые сервисы Polybius будут полностью интегрированы с международными системами, чтобы предоставлять все необходимые услуги для международных расчётов по всему миру. Банк будет строиться на принципах открытости API и применения зарекомендовавших себя инноваций и сервисов в индустрии платежей и обработки данных. Это настоящая революция в сфере банковского дела.

Вклад Emercoin в развитие криптобанка

Блокчейн Emercoin будет очень плотно интегрирован в IT-структуру банка. На нём будет построен банковский документооборот. Основой станет технология блокчейна Emercoin NVS, которая позволяет позволяет записывать любую информацию в объёме до 20 килобайт. Эти записи обладают такими важными свойствами, как: уникальность, возможность передачи и однозначного установления её принадлежности.

В блокчейне Emercoin будут храниться все важные банковские документы, которые могут быть интересны общественности и иметь юридическую значимость. Европейские страны не запрещают использование блокчейна в финансовом институте при условии, что аудитор подтверждает его операционную безопасность.

Кроме этого, широко будут использованы технологии EmerSSL и EmerSSH. Первая из них поможет значительно повысить безопасность аккаунтов клиентов банка, а вторая решит вопрос безопасности и масштабирования инфраструктуры самого банка в планетарном масштабе.

ICO Polybius Bank

31 мая была запущена краудфандинговая ICO-кампания банка. Приобрести токены-акции Polybius, являющиеся смарт-контрактами, можно будет в течение до 5 июля.

Токен Polybius, он же доля в блокчейне Polybius, дает право на получение дивидендов в соответствии со своими долями. 20% ежегодной прибыли компании будет распределяться между всеми проданными по итогам ICO токенами.

Этот проект привлек уже более 11 тысяч инвесторов со всего мира. Минимальный план по сборам в $1,5 млн был пройден менее, чем за сутки после начала ICO. Всего за два первых дня было собрано $6 миллионов, гарантирующих становление Polybius как банка. На данный момент, спустя всего неделю после старта, проект уже собрал более половины из максимальной требуемой суммы в $25 млн, что однозначно обещает нам, что он состоится в полной или почти полной комплектации (DigiPass, блокчейн, большие данные, ИИ…)

Прибрести токены ещё можно, но главное сейчас не это. Главное, что, возможно, лет 20 спустя вы сможете рассказывать, что новый PayPal рождался прямо на ваших глазах.

|

Метки: author EShumilov финансы в it блог компании emercoin polybius блокчейн криптовалюты |

[recovery mode] Кто владеет Nimses? |

IT Юристы компании Lawboot Lawyers & Consultants провели небольшое исследование набирающий популярности стартап Nimses.

Исходя из данных на вебсайте стартапа, «Администрацией» {термин взят дословно из Terms of Use} мобильного приложения и сайта выступает компания под названием Nimses Inc.

Администрация — NIMSES INC, 1209 N ORANGE ST, WILMINGTON, DE 19801, USA, Tel (650) 288- 1989

Мы поискали эту компанию в официальном и публичном реестре Штата Делавер (США).

Место регистрации: США, Штат Делавер

Регистрационный номер: 6107207

Дата регистрации: 26 июля 2016 года

Тип компании: Корпорация

Регистратор: THE CORPORATION TRUST COMPANY

Адрес регистратора: WILMINGTON, CORPORATION TRUST CENTER 1209 ORANGE ST

Директор и собственник компании Nimses Inc пока не доступен в реестре, возможно потому что компания еще не подавала Annual Report.

Кому принадлежит торговая марка «Nimses»:

(не транслитерируем, чтоб не допустить ошибок)

Владелец: Myronivskyi Davyd Serhiiovych

Страна: Украина

Адрес: vul. Yaroslaviv val, bud. 28, kv. 8, m.Kyiv 01034

Заявка была подана: 25 ноября 2016 года

Результаты мы взяли с официального и общедоступного источника:

WIPO (world international property organisation).

Подробнее по ссылке по ссылке.

Кому принадлежит домен nimses.com:

Владелец домена скрыл свои данные и они не отображаются через «whois»

Выводы:

Мы не увидели в реестре реального собственника и директора компании, хотя очень интересно увидеть всех, кто находится «за кулисами» стартапа.

Фактом является то, что Myronivskyi Davyd Serhiiovych владеет торговой маркой Nimses.

Является ли он собственником компании пока остается загадкой…

Следите за новостями от IT юристов LAWBOOT на нашем телеграмм канале

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

|

Метки: author lawboot исследования и прогнозы в it nimses lawboot юристы для it юрист it lawyer it стартап оффшорные компании |

Дзен не позвонит |

На дворе 2017 год, а это значит, что я уже как полтора года занимаюсь мазохизмом.

Два года назад я был весел и жизнелюбив, сейчас не хочется ни шутить ни развлекаться. За два года redux сделал меня фаталистом. Моя уверенность в ужасном будущем так называемого “frontend” увеличивается с каждым днём. В конце концов, сбербанк сделал redux основой своего стека, а эти ребята хорошего не выберут. Шутка! Я уверен, там работают замечательные специалисты.

Прошлое

Когда то Ден Абрамов вдохновил тысячи специалистов простой фразой а-ля “Я получаю удовольствие от работы”, просто добавив

Зачем был создан redux? Для облегчения жизни разработчика? Для потребностей бизнеса? Нет! Для того, чтобы заработала горячая перезагрузка шаблонов react.

Между тем, в тот момент, абсолютно параллельно от Дена и не зная его работы, я занимался решением похожих проблем, но в другой экосистеме и это не требовало глобально стейта. Экосистема умерла, события не связаны, просто пришло её время…

Ден говорил о фрустрации, о том что он тратит слишком много времени на перезагрузку страницы, но сколько он подарил фрустрации миру после этого, интересно, задумывается ли он сколько человеко часов было и будет потрачено взамен?

Настоящие

Зачем мы тут и чем вообще занимаемся? Думаю каждый из нас рано или поздно задаётся этим вопрос. Очертя некие границы вопроса, я нашёл и ответ — создаю приложения для бизнеса, максимально быстро, просто, стабильно, поддерживаемо.

Как сказал кто-то (может я?): «Ценность инструмента, прямо пропорционально количеству работы, что он упрощает».

И давайте честно ответим на простой вопрос, верно ли это утверждение для redux и иже с ним?

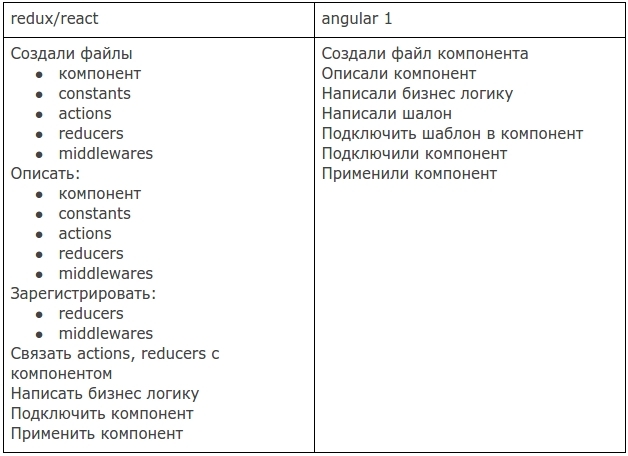

Для примера сравним создание равнозначных компонентов в 2х стеках: redux/react и angular 1 (что был актуален на то время).

19 против 7 и это ещё оставляя за скобками настройки store, selectors и тонну вопросов и изменений связанных с проблемами взросления стека.

И так почти во всех аспектах. Прошу поделиться в комментариях обратным опытом, если таковой имеется.

Вообще, я не хочу сказать что redux это что-то плохое, в конце то концов, не может же ошибаться целая индустрия? В своём роде redux сделал революцию, принёс functional programming в массы, так сказать. И даже не важно, хорошо это или плохо.

Да, кому-то и вправду нужна горячая перезагрузка бизнес логики. А где-то логику проще описать процедурно, а не объектно. Для чего-то нужен микроменеджмент состояния.

Но давайте посмотрим правде в глаза, большая часть из нас делает интерфейсы для управления данными: пользователь изменил, мы сохранили на сервере, максимум — как-то отреагировали. Сама по себе эта задача очень проста, с ней мы справлялись на ура ещё с jQuery, а через 5-10 лет нас всех заменят роботы, но пока нам нужно упростить и себе и им жизнь, уменьшить время и стоимость разработки. Загляните в свои reducers, не сводятся ли 95% всех манипуляций к CRUD, а оставшиеся 5% может быть и вовсе оседают в middlewares? Так нужен ли нам специальный reducer на каждый чих?

Возможно пора двигаться дальше, посмотреть как все эти проблемы решали до нас более зрелые стеки?

Будущее

Где-то в глубине моей души теплится надежда, что всё у нас будет хорошо.

Последнии несколько месяцев я занимаюсь исследованиями и поиском форм и методов. Самые ощутимый результат моих творческих экспериментов — www.npmjs.com/package/react-component-redux, хоть он и сильно отстаёт от хода мысли.

Это я не пиарюсь, и пробовать не призываю. Это попыткой представить, как должны выглядеть универсальные приложения. Уверен, у каждого второго из вас, есть что сказать по этому поводу, призываю, выскажитесь!

Главное что я для себя вынес на данный момент — мы должны начать называть вещи своими именами, а не играть в ролевые игры, например:

Компоненты контейнеры — просто компонентами;

Компоненты репрезентации — виджетами;

Store — база данных;

Selectors — ORM. И да, нам нужны не только getters но и setters;

Мы должны перестать подстраиваться под диктовку инструментов, должны сами решать, как нам делать нашу работу быстрее и качественнее, а следовательно и бизнес успешнее.

Должны перестать искать killer features с выросшей на 10% скоростью рендеринга. Нам нужен стандарт, но уже не “frontend”, а Универсального Приложения, работающего везде, от унитаза, до космического корабля?

P.S.

Интересное сравнение производительность из далёкого 2014:

jsperf.com/comparing-performance-of-functional-vs-imperative

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

|

Метки: author firstpasha reactjs javascript redux redux-sucks react |

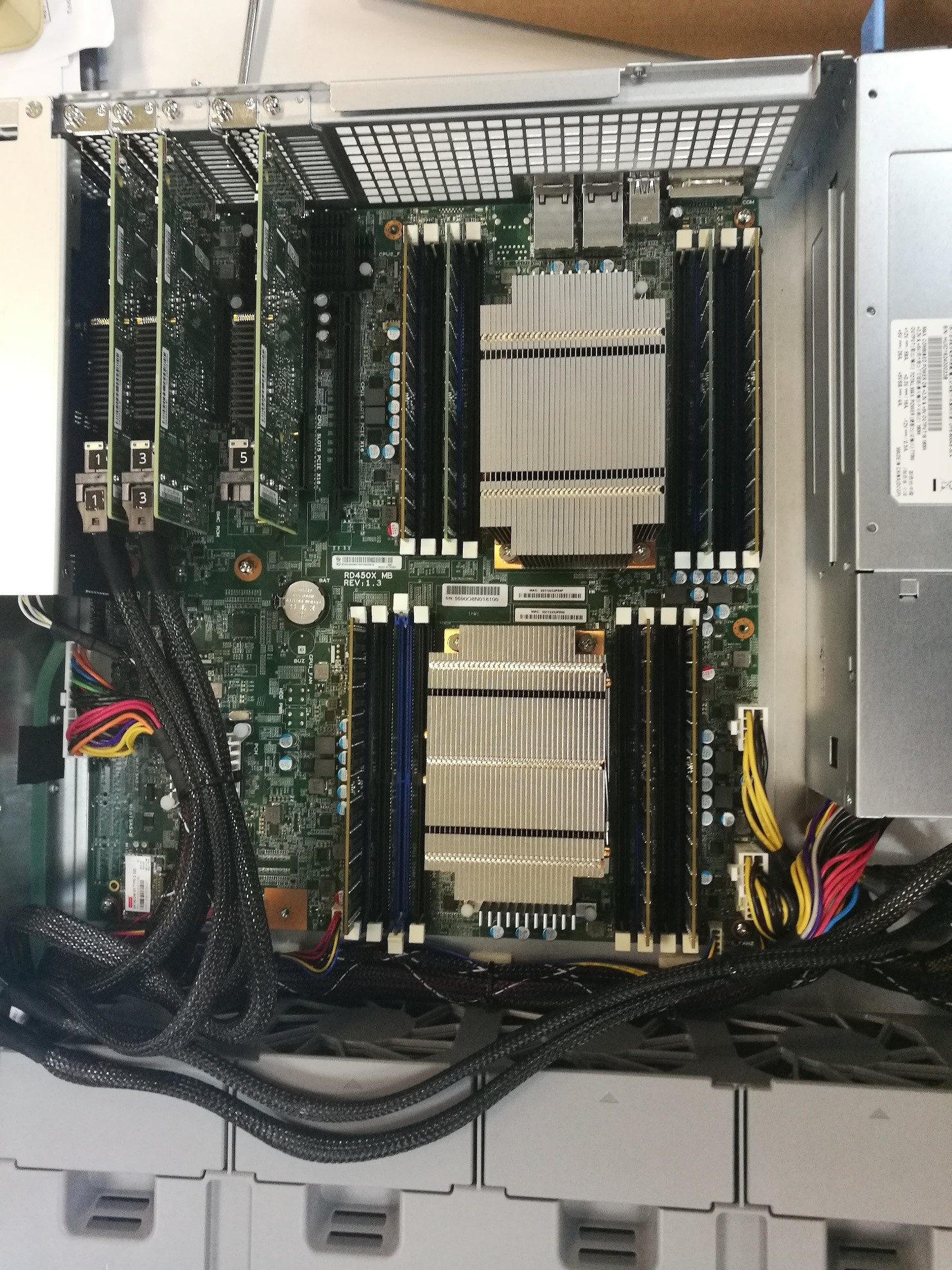

Дешевый full flash – выдумка или реальность? |

Причины появления флеш-систем (All Flash Array – AFA) достаточно просты — унифицированные гибридные массивы не справляются с огромной производительностью флеш-накопителей, а логика работы основывается на взаимодействии с классическими HDD, увеличивая время отклика системы и износ SSD. Основываясь на этом, можно выделить 3 основных отличия AFA:

- Повышенная производительность контроллеров, способная полностью «прокачать» используемые накопители.

- Оптимизированная архитектура, снижающая время отклика системы.

- Интеллектуальный функционал обработки и записи данных, снижающий износ накопителей.

Именно поэтому, когда коллеги предложили мне протестировать массив Synology FS3017, я очень удивился. Давайте вместе оценим его параметры и определимся, подходит ли он под категорию AFA.

Массив FS3017 имеет стандартное стоечное исполнение: в корпусе высотой 2U помещается 24 SFF накопителя, поддерживаются накопители различных производителей (Intel, OCZ, Seagate и т.д.), что характерно для всей продукции Synology. Но что удивило меня больше всего — так это поддержка классических HDD — это ставит под вопрос принадлежность FS3017 к сегменту AFA. Из положительного — поддерживаются накопители как enterprise-класса с SAS-интерфейсом, так и более бюджетные SATA-накопители.

В качестве процессора используются 2 x Intel Xeon E5-2620 (6-core, 2.4 GHz) v3, объём встроенной памяти составляет 64GB DDR4, и может быть расширен до внушительных 512 Gb.

В качестве сетевых интерфейсов в базовой конфигурации имеются 2 порта 10 GE с поддержкой технологии Link Aggregation, используемых как для управления массивом, так и для передачи данных. Дополнительно можно установить 2 PCI-E (x16 и x8) модуля: сетевой модуль расширения (1GbE / 10GbE / 25GbE / 40GbE) или SAS-модуль для подключения двух дополнительных дисковых полок (RX1217sas на 12 LFF-слота или RX2417sas на 48 SFF-слота).

В качестве операционной системы используется знакомый всем пользователям Synology DiskStation Manager (DSM) версии 6.1. Я ожидал, что для своего AFA Synology выпустит особую версию микрокода, но она соответствует DSM настольных и стоечных моделей. Так что же делает этот массив AFA? Как выяснилось – поддержка технологии RAID F1.

Согласно описанию производителя технология RAID F1 призвана снизить вероятность потери данных, связанной с выходом из строя всей RAID-группы целиком. Так как в отличие от HDD выход из строя SSD-накопителей обусловлен окончанием ресурса накопителя (износом ячеек), то, теоретически, возможна ситуация, когда все накопители одного рейда умрут одновременно. Во избежание такой ситуации был разработан RAID F1. Распределяя блоки данных между накопителями аналогично RAID 5, RAID F1 записывает блок с контрольными суммами дважды на 1 накопитель. Это приводит к тому, что его ресурс тратится быстрее, а значит вероятность выхода из строя всех дисков рейда уменьшается. После завершения ресурса и замены накопителя система автоматически выбирает наиболее изношенный накопитель, и начинает писать дублирующие блоки на него.

Несмотря на все заявления производителей, SSD до сих пор остаются дорогостоящими накопителями, и умышленно снижать их ресурс представляется не самым оправданным решением проблемы с точки зрения бизнеса. В то время как основные игроки AFA-рынка внедряют технологии балансировки и снижения объема записываемых данных для продления срока жизни ssd-накопителей, Synology пошли в противоположную сторону. Насколько оправдан и будет ли признан рынком такой подход покажет время.

В остальном массив FS отличается от линейки RS (стоечные массивы Synology) наличием более мощного процессора (Intel Xeon D Family), второго сокета и поддержки RAID F1. Унаследовал FS3017 и стандартные сценарии использования – список рекомендованных пакетов DSM состоит из сервера облачного хранилища, сервера заметок и видеорегистратора. Ни о какой оптимизации архитектуры и логики для использования ssd речи тут не идет, в пользу чего говорит и наличие функции SSD-кэша. Так как два из трех признаков AFA-систем не соблюдаются, остается проверить насколько массив может прокачивать наши ssd-накопители.

Систему для тестов мне предоставили с расширенной до 128 Gb памятью и 12-ю накопителями Intel SSD DC S3520 Series объемом 480 Gb. Достойные показатели производительности и доступная за счет использование SATA-интерфейса цена делают их наиболее интересными для тех, кто планирует собирать флеш-систему бюджетного класса. Я выделил 1 диск под горячую замену (поддерживается глобальная замена дисков со всех полок) и 11 дисков я объединил в RAID F1. На получившейся RAID-группе я создал iSCSI-том и презентовал его серверу под управлением Windows Server 2016. Спецификация сервера: 2*Intel Xeon E5-2695 V3 2.3 GHz 14-core, 128 Gb RAM, 2-port 10 GE Base-T. По техническим причинам мне пришлось использовать только один порт 10 GE Base-T, что явно сказалось на производительности массива.

Нагрузку я генерировал самой популярной на рынке программой синтетических тестов Iometer. Целью тестов была не производительность дисков, а самого массива, поэтому я решил использовать паттерн 4KiB 100% random.

Начать я решил с «идеальной» нагрузки в 100% read, чтоб проверить посмотреть на «красивую» цифру. FS3017 показал себя достойно, выдав 156k IOPS.

При этом утилизация дисков и вычислительных мощностей системы не достигала 90% — это говорит о том, что узким местом является канал передачи данных. Далее я перешел к «боевым» тестам. Профиль нагрузки я выбрал наиболее распространенный: 67% чтения, 33% записи. Нагрузку генерировало 25 Worker’ов (терминология Iometer) на 5 iSCSI target’ов.

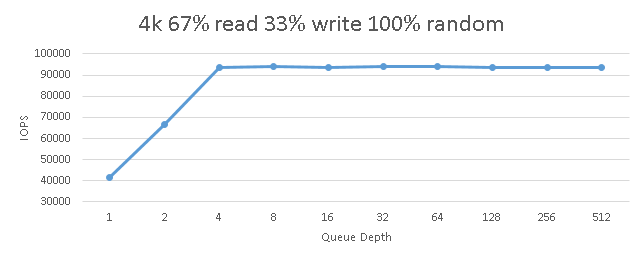

Исходя из личного опыта, указанная конфигурация AFA массива при подобном профиле нагрузки должна генерировать порядка 120-170k IOPS.После запуска цикличных тестов с повышением количества потоков я увидел следующую картину:

Как видно из графика, предел был достигнут уже при 4 потоках I/O на нагружаемый Worker и составлял ~94’000 IOPS. При этом нет дальнейшей деградации (которая всегда наступает при достижении «потолка» массива), следовательно, это значение ограничено пропускной способностью канала. Об этом говорят и показатели утилизации вычислительных ресурсов массива, не превышающие 15%.

Стоит отметить взрывной рост времени задержки при увеличении количества потоков:

При достижении 4 потоков на Worker (что суммарно дает нам 100 потоков на систему) задержка составляла ~1.06 ms, после чего началась резкая деградация в геометрической прогрессии.

В дальнейшем, я планирую подключить сервер двумя портами, чтобы увидеть сколько система может выжать максимума из этих дисков. Но даже достигнутые 94 k IOPS позволяют FS3017 по праву называться AFA-системой

Система FS3017 оставила после себя очень странное впечатление: учитывая достигнутые в тестах показатели производительности, она действительно может позиционироваться как AFA-решение, однако пониженная надежность (из-за отсутствия второго контроллера) и урезанный в сравнении с конкурентами функционал ставит крест на ее использовании в серьезных корпоративных задачах. А именно этот сектор на текущий день является основным и единственным пользователем AFA-систем.

Но несмотря на это, я уверен, что она обязательно найдет свой сегмент рынка. Одним из наиболее очевидных может являться разработка корпоративных приложений и БД со сложным рельефом. В этих задачах мы можем позволить себе положить тестовую копию базы или всю тестовую среду на очень быструю и относительно дешевую FS3017 для дальнейших оперативных задач, не подвергая бизнес угрозе потерять критичные данные.

|

|

[Перевод] Интеллектуальность — новый виток в развитии систем локализации |

Всякий, кто работал над проектами локализации ПО, знает, насколько это может быть сложно. Неважно, занимаетесь вы локализацией веб-сайта или приложения, — работы очень много: получение строк на перевод из программного кода (вручную); постоянные метания между разработчиками, руководителями проектов и переводчиками; проверка и перепроверка точности перевода; и наконец — все то же самое еще раз для другого языка (или другого проекта). Давайте будем честны: это медленные, трудоемкие и разрозненные процессы. Но так быть не должно.

Ключевое понятие в современных системах локализации — это «интеллектуальность», подход, который изменяет взгляд разработчиков приложений и веб-сайтов на процесс перевода. Интеллектуальная система локализации — это использование обмена данными, технологических инструментов, автоматизации, передового опыта и аналитических инструментов с целью избавиться от головной боли при переводе.

Компания Translationexchange написала о том, как выглядит перевод в такой системе, а мы в Alconost как ее вендор, предоставляющий услуги профессионального перевода, эту статью перевели.

В первую очередь — автоматизация процессов локализации

Основной процесс локализации должен быть полностью автоматизирован (да, это возможно!). Используемая система должна по мере работы сохранять фрагменты переведенных текстов, чтобы потом можно было использовать их в нескольких проектах перевода, в будущих итерациях и обновлениях. Разработчики часто заняты сразу несколькими проектами, поэтому организация повторяемого процесса — это и более короткие циклы перевода, и намного меньшее количество возможных ошибок (которые придется исправлять), и добавление новых языков уже не с нуля.

Умные лингвистические технологии

Правда, было бы здорово нанять команду профессиональных лингвистов, которые при необходимости мгновенно выбирали бы самый точный перевод — для каждого слова, предложения и понятия? Сегодня команда лингвистов уже не нужна — технология сделает тяжелую работу за вас. Современные системы контекстного перевода развились настолько, что могут увеличить точность перевода в десяток раз (избавив от необходимости догадываться о подразумеваемом контексте) и сделать так, чтобы любой перевод звучал естественно.

Использование переводов, сделанных другими

Работа над переводом в изолированной системе, отделенной от опыта других переводчиков и разработчиков, может требовать больших усилий. А ведь вполне возможно, что многие строки, над которыми вы работаете, уже переведены до вас и сохранены в базе данных сообщества. Достаточно получить доступ к хранилищу — и самые распространенные переводы будут к вашим услугам бесплатно. А это существенно экономит время.

Оперативное взаимодействие

Умная локализация требует усилий всей команды. Когда у разработчиков и руководителей проектов есть прямая оперативная связь с переводчиками, избыточные звенья устраняются, и работа над проектами идет легче и спокойнее. А интеллектуальные системы локализации — это центральная платформа совместной работы при получении исходных строк, их переводе и публикации.

Статистика и показатели хода локализации

Чтобы не упускать из виду важные данные, которые могут сэкономить время и силы в долгосрочной перспективе, необходимо отслеживать состояние и показатели работы над переводами. Для организации эффективного перевода необходимо иметь возможность отслеживать, насколько близок к завершению перевод мобильного или веб-приложения, искать узкие места в локализации, следить за скоростью выполнения переводов или даже оценивать каждого переводчика по эффективности сделанной им работы.

Интеллектуальная система локализации внесет существенную лепту в работу всей команды, занятой переводами. Научитесь использовать эти подходы — чем скорее, тем лучше, — и окажется, что локализация ПО может и не быть такой утомительной.

О переводчике

Перевод статьи выполнен в Alconost.

Alconost занимается локализацией приложений, игр и сайтов на 68 языков. Переводчики-носители языка, лингвистическое тестирование, облачная платформа с API, непрерывная локализация, менеджеры проектов 24/7, любые форматы строковых ресурсов, перевод технических текстов.

Мы также делаем рекламные и обучающие видеоролики — для сайтов, продающие, имиджевые, рекламные, обучающие, тизеры, эксплейнеры, трейлеры для Google Play и App Store.

Подробнее: https://alconost.com

|

Метки: author alconost управление проектами локализация продуктов gtd блог компании alconost alconost локализация автоматизация перевод переводчики |

История одного лендинга |

Здравствуйте, дорогие хабравчане! В этом посте я хочу рассказать о том, как и в какую цену я заказывал сайт у фрилансеров, в какие сроки я получил результат и что из этого сделал сам. Задача была создать “лендинг-магазин”: одностраничный сайт для двух товаров, с возможностью сразу же сделать заказ через полнофункциональную корзину.

Здравствуйте, дорогие хабравчане! В этом посте я хочу рассказать о том, как и в какую цену я заказывал сайт у фрилансеров, в какие сроки я получил результат и что из этого сделал сам. Задача была создать “лендинг-магазин”: одностраничный сайт для двух товаров, с возможностью сразу же сделать заказ через полнофункциональную корзину. Этот пост содержит совсем немного технических подробностей и рассказывает больше о рабочем процессе и взаимодействии с людьми.

Техническое задание

Будучи сам разработчиком, я прекрасно понимаю значимость технического задания и осознаю, что если что-то упустить, то оно не будет реализовано. Совсем небольшой процент исполнителей, обладающих значительным опытом и клиентоориентированным подходом, будет терпеливо подсказывать заказчику, как и что лучше сделать, если тот что-то не учел. Но именно к таким людям складывается наибольшее доверие, и к ним хочется приходить с новыми заказами.

Я постарался составить максимально подробное ТЗ, разместив всю информацию в виде макета с примерным расположением элементов и комментариями, по какой логике что должно работать. Но даже с таким, достаточно подробным, на мой взгляд, описанием и фактически готовым прототипом, люди умудрялись задавать вопросы, ответы на которые мне казались очевидными. Отсюда вывод — чем детальнее и доступнее вы “разжевываете” то, что хотите донести, чем больше вы формализуете и четко описываете то, каким должен быть результат, тем меньше вопросов получите. Если у вас в голове проскальзывает мысль, что “это итак понятно” — нет, и еще раз нет! Не ленитесь и опишите этот момент, сделайте сноску или пояснение.

Дизайн

Далее я разместил заказ на одном из популярных фриланс-сайтов. Я достаточно критически отношусь к визуальной составляющей сайтов, и приятный продуманный дизайн для меня играет большую роль.

Всего мне поступило 61 предложение, среди которых было даже “скопировать любой лендинг и поменять в нем любые элементы (фон, картинки, текст, контакты и тд) за 24 часа”. Все предложения можно условно разбить на несколько ценовых категорий (плюс-минус):

- От 1000 до 3000 — простовато, зачастую не очень профессионально, на мой вкус

- От 4000 до 8000 — вполне удобоваримое качество, но не всегда стабильное. Большие портфолио, и, думаю, большинство заказчиков останутся довольны результатом.

- От 9000 до 15000 — часто складывается впечатление слегка завышенной цены, но просматривая портфолио, все таки виден стабильный результат. Эта ценовая категория пользуется популярностью. В основном, лично мне не нравилась стилистика работ. А когда сомневаешься, в таких делах, риск не очень оправдан.

- Категория 20 и выше — часто зависит от эго дизайнера. Много талантливых художников работает в этой категории — такие сайты впечатляют, но для моей задачи это было лишним. Может быть дополнена проработанным прототипом, что создает впечатление подхода к работе “с головой” и хоть как-то оправдывает дороговизну.

Сначала мне понравилось портфолио дизайнера, который целился в последнюю категорию. Пообщавшись и немного поторговавшись, он сказал, “могу сделать без изысков”, вдвое снизив цену, но это меня и оттолкнуло. Я побоялся платить за “полуфабрикат” от дорогого дизайнера, который снизошел, чтобы что-то для меня, так и быть, сваять. Пусть лучше это будет полноценная работа с нормальной отдачей за те же деньги от кого-то еще.

Когда я уже был готов выбирать из того, что было, мне поступило очередное предложение из второй ценовой категории. На удивление, мне понравилось практически все портфолио и я сразу предложил дизайнеру сотрудничать. Со всеми моими пожеланиями мы договорились на 7000 руб.

Для оформления страницы требовалось качественное фото товара с разных ракурсов — этим озаботился я сам, о чем даже снял это видео. На второй день дизайнер прислал мне практически готовую работу, которая сразу же превзошла мои ожидания! Мы внесли некоторые незначительные правки, после чего была отрисована мобильная версия.

Верстка

Следующим шагом требовалось вдохнуть жизнь в макет. Вообще, я и сам люблю заниматься дизайном и верстать, но это не основное направление моей деятельности. И, если бы я не делегировал эту работу, то, возможно, и не закончил бы до сих пор.

Разместив заказ, я получил 20 предложений. Самым шокирующим было предложение за 19000 руб. На вопрос, что же я получу за такую цену, потенциальный подрядчик ответил: “Входит качественная верстка, чек-лист для проверки habrahabr.ru/post/114256/, описание логики работы корзины”.

Было несколько предложений за 1500-2000 руб, потом несколько за 6000 руб и еще парочка 10000+ руб.

Одно из предложений привлекло меня больше всего правильными уточняющими вопросами (я просил заранее предусмотреть картинки в разрешении x2, чтобы четко отображались на retina-дисплеях), и я предложил начать работу. Мы договорились на 3000 рублей. Первые результаты верстальщик предоставил уже через пару дней и сказал, что в связи с годовщиной свадьбы родителей слегка задерживается.

Через три дня он предоставил готовый результат. Я указал на несколько недочетов и высказал свои пожелания, после чего он пропал и появился только через неделю, посетовав на то, что приболел. Но большинство моих пожеланий были выполнены, и более того, сделано много того, что я изначально не просил — функционал корзины и даже серверную часть. Все это я собирался сделать сам. Осталось лишь одно не самое значительное пожелание, на что я указал и предложил обсудить удобный способ оплаты…

Далее в течение трех недель я периодически пытался узнать, как у него дела, и еще раз предложил рассчитаться, но безуспешно. Под конец третьей недели верстальщик появился, написал “Сегодня постараюсь доделать” и опять пропал… После этого, я плюнул, скачал пофайлово готовую верстку, переделал JavaScript так, как мне было удобнее, и сделал backend.

Дорогой верстальщик, если ты читаешь эту статью, пожалуйста, напиши, куда я мог бы перевести тебе оплату. Мне крайне неловко пользоваться результатом твоего труда бесплатно.

Backend

Серверную часть я сделал сам за 1.5 дня. В принципе, я мог бы и эту часть заказать, но, боюсь, трудозатраты на ТЗ с описанием нюансов и моим видением желаемого результата, в купе с пожеланиями по качеству кода, были бы сопоставимы с ресурсами, которые заняла у меня собственная работа.

Я использовал Slim Framework, подключив к нему несколько библиотек:

- Illuminate Database (он же Eloquent — компонент Laravel) — для работы с базой

- PHP dotenv — для конфигурации в разных окружениях

- recaptcha — чтобы защититься от спама

- PHPMailer — для отправки писем

Код хранится в репозитории на Bitbucket, а работает на обычном виртуальном хостинге.

Зачем это все?

Изначально я понимал, что сам проект вряд ли будет коммерчески успешен. Это обусловлено текущим положением дел в данной нише, но мне, в первую очередь, было интересно реализовать идею в жизнь, чтобы потом не корить себя за то, что я даже не попробовал этим заняться. Так что, с уверенностью могу сказать, что цели своей достиг, получив интересный опыт.

Если у вас есть идея, не откладывайте ее в долгий ящик, а пробуйте реализовать. Я еще год назад собирался приступить, но сделал это только сейчас. Старайтесь делегировать работу по-максимуму, чтобы заниматься именно проектом, а не нюансами реализации. Любую задумку можно воплотить в разумные сроки и суммы, даже если вы сильно загружены основной работой. А готовый результат всегда доставляет приятные эмоции!

|

Метки: author Treg разработка веб-сайтов php javascript лендинг дизайн верстка техническое задание фриланс |

[Из песочницы] Как создать язык программирования |

Как все началось

Дело было утром. Я захотел создать что-то на питоне, сложное, но посильное для меня. И тут я понял, что хочу создать язык программирования…

Как я создавал его...

Lexer

Куда же без него! Он требуется для «разделения» всего на токены. Если объяснить зачем он тогда представим: у нас есть код (CoffeScript).

a = true

if a

console.log('Hello, lexer')И лексер превращает этот код в это(сокращенная запись):

[IDENTIFIER:"a"]

[ASSIGN:"="]

[BOOLEAN:"true"]

[NEWLINE:"\n"]

[NEWLINE:"\n"]

[KEYWORD:"if"]

[IDENTIFIER:"a"]

[NEWLINE:"\n"]

[INDENT:" "]

[IDENTIFIER:"console"]

[DOT:"."]

[IDENTIFIER:"log"]

[ROUND_BRAKET_START:"("]

[STRING:"'Hello, lexer'"]

[ROUND_BRAKET_END:")"]

[NEWLINE:"\n"]

[OUTDENT:""]

[EOF:"EOF"]Но в моем случае я делаю все проще, т.к. это будет излишком трудности, а также язык программирования у меня простой. У меня все просто:

def lexer(code):

code = code.split(";") # Токенезация

code = code[0:-1] # Т.к. есть баг, что последний элемент пустой

return parse(code, number=0) # "Отсылаем" это все парсеруИ код (моего «ЯП»):

printf Test; exit;Он превратит в читабельное (!):

["printf Test", "exit"]Парсер

Самое сложное только начинается… Сделать токенезацию легко, а обработать это сложно. В теории мы должны проверять команду, потом ее аргументы. Кажется это легко, но нет! По началу все было примерно так:

number = 0

if code[number].startswith("printf"):

print(code[number][7:-0]

number += 1Но ничего не работало, точнее не печатало текст, потом я попробовал так:

number = 0

if code[number].startswith("printf"):

print(code[number][7:-1]

number += 1Но приходилось писать в конце любой символ. Потом я понял, что, если узнать длину строки и обрезать с 7-го символа по последний все должно работать.

number = 0

if code[number].startswith("printf"):

l = len(code[number])

print(code[number][7:l]

number += 1Вроде работает, но если выводить текст боле два и более раз то в начале идет лишний пробел… Но даже с помощью переменной проверяющей печатался ли раньше текст, ничего не работало правильно. После нескольких десятков минут и кружки кофе я придумал, что и как.

if code[number][7] == " ":

l = len(code[number])

print(code[number][8:l]

else:

l = len(code[number])

print(code[number][7:l]Но все равно ничего не работало :| и с таким лицом я пытался что-то сделать… Целый час. И спустя около полутора часа я сделал это!

l = len(code[number]) # Получаем длину

if code[number][6] == " ": # Если 6-ой символ это пробел

print(code[number][7:l]) # Печатаем все с 7-го символа

else: # Иначе

print(code[number][8:l]) #Потом полчаса шаманства и… Все работает на ура!

P.S.

- Не весь код с комментариями, т.к. он ориентирован на продвинутых программистов.

- Код в спойлере, т.к. он длинный и в «главный» текст статьи не входит.

- Прошу не ругаться насчет кода, мне 11 лет.

- Это моя первая статья на Хабре и вообще.

- Код в начале был взят из одной статьи на Хабре.

def parse(code, number=0):

try:

# Print function #

if code[number].startswith("printf") or code[number].startswith(" printf"):

# Get len

l = len(code[number])

# If text starts with space

if code[number][6] == " ":

print(code[number][7:l])

# Else

else:

print(code[number][8:l])

number += 1

parse(code, number)

# Input function #

if code[number].startswith("input") or code[number].startswith(" input"):

# Get len

l = len(code[number])

# If text starts with space

if code[number][6] == " ":

input(code[number][7:l])

# Else

else:

input(code[number][8:l])

number += 1

parse(code, number)

# Exit function #

elif code[number].startswith("exit") or code[number].startswith(" exit"):

input("\nPress \"Enter\" to exit.")

exit()

else:

cl = len(code[number])

command = code[number]

command = command[1:cl]

print("\n", "=" * 10)

print("Error!")

print("Undefined command " + '"' + command + '"' + ".")

print("=" * 10)

input("Press \"Enter\" to exit...")

exit()

except IndexError:

input("\n[!] Press \"Enter\" to exit.")

exit()

def lexer(code):

code = code.split(";")

code = code[0:-1]

return parse(code, number=0)

code = input()

lexer(code)|

Метки: author isisTance программирование python язык программирования |

Найти дизайнера: миссия (почти) выполнима |

В апреле в связи с большим объемом заказов у нашей команды возникла необходимость пополнить свои ряды двумя хорошими дизайнерами для работы в офисе с перспективой дальнейшего обучения и развития в нашей компании.

Изучив портфолио и возможности всех наших общих знакомых из этой области, находящихся в поиске работы, мы пришли к выводу, что необходимо воспользоваться сервисами, предлагающими размещение вакансий. Мы остановились на следующих ресурсах: Мой круг и HeadHunter.

Заполнив анкеты вакансий, мы стали получать огромное количество заявок. Изучая портфолио претендентов, нас смущали работы крупных онлайн ресурсов, которые они представили на behance. Поэтому, мы решили подготовить собственное тестовое задание для своих потенциальных дизайнеров. Конечно, мы хотели бы найти для своего коллектива человека интересного, креативного, имеющего свой индивидуальный творческий подход к выполнению любого задания и который бы с большим желанием стремился к дальнейшему росту и обучению.

Тестовое задание было достаточно простым, а именно нарисовать первые два экрана главной страницы по техническому заданию и брифу, более подробно можно посмотреть тут:

Подробнее о вакансии и тестовом задании

Все соискатели с удовольствием соглашались выполнить это задание и присылали свои результаты уже на следующий день. К сожалению, мы столкнулись с тем, что портфолио у большинства специалистов не соответствует их реальным навыкам. В выполнении этого несложного задания можно сразу увидеть подход и отношение человека к своей работе, его потенциал, его уровень и т.п.

Не хотелось бы никого обидеть, тут вопрос чисто профессиональный, я представлю, для примера, несколько полученных нами «работ»:

К сожалению, мы были очень разочарованы таким выполнением задания. Создавалось впечатление, что “специалисты” не владеют даже базовыми знаниями работы в photoshop/illustrator/sketch. Более того, работы были выполнены не по техническому заданию.

Уже через две недели поиска было понятно, что таким способом нам будет трудно и долго искать компетентного и талантливого специалиста. Поэтому, мы стали использовать более широкий творческий подход для поиска, чем и хотелось поделиться с читателем этой статьи.

Выставки. Мы решили принять участие в тематических выставках. Для этого, особенно интересной нам, показалась выставка Дизайна и рекламы – 2017 в Центральном Доме Художника, которая проходила с 11.04.2017 по 14.04.2017. Она привлекла нас своей обширной программой event, где большое место занимала наша тематика веб дизайна.

Нам удалось в короткие сроки договориться с руководителями этой выставки о коротком выступлении, где наша команда познакомила участников со всеми направлениями деятельности своей компании и более детально раскрыла наш процесс разработки дизайна для комплексных проектов. Также, в конце выступления, мы сделали короткое объявление о том, как нам важно найти специалиста для дальнейшего творческого сотрудничества и развития с нами. В этом объявлении мы сделали акцент на все положительные аспекты для потенциального дизайнера, которого мы с радостью готовы принять в наш коллектив. Мы обозначили все перспективы роста, развития и возможности полностью выразить себя для каждого специалиста, работающего в нашей компании.

Уже в конце выступления к нам подошли, в качестве претендентов, шесть специалистов с достойными портфолио. В результате этого общения, мы пригласили на работу одного дизайнера, наиболее “близкого нам по духу”.

Behance. Мы выбрали около 20 интересных страниц дизайнеров на портале Behance и начали диалог с ними о возможном сотрудничестве. Большинство претендентов было не готово работать в офисе, но были рады участвовать в любом проекте с нами на удаленной основе. В итоге, мы очень удачно «смотивировали» специалиста с одним из самых лучших портфолио, сделав акцент на гибкости графика и перспективах развития своих дизайн навыков в нашей компании.

В итоге специалист решил переехать в Москву и работать у нас в офисе. Уже в первую неделю было понятно, что мы не ошиблись с выбором. Наш новый дизайнер так же доволен своим новым рабочим местом и очень гармонично вписался в общее дело и коллектив.

Стартап инкубаторы. К сожалению, не принесли нам результата. Мы посетили их несколько: в Высшей школе экономики и Сколково. Основная часть аудитории, которую мы встретили, были специалистами, имеющими множество идей, но не готовыми их реализовывать на практике или обладающими своим, значительно отличающимся от нашего, видением совместного развития. Но поиск потенциальных дизайнеров на этих ресурсах принес нам, попутно, несколько хороших и достаточно крупных клиентов.

Новый подход компании к поиску необходимых специалистов позволил получить нам двух талантливых дизайнеров, которые с удовольствием смогли “влиться” в нашу культуру.

Испытав на собственном опыте насколько сложно найти «своего» сотрудника, тем более талантливого и компетентного дизайнера, мы решили поделиться своими идеями и пройденными путями в этом поиске.

|

Метки: author waytostart_ru управление персоналом управление медиа развитие стартапа карьера в it-индустрии дизайнер веб-дизайн дизайн студия дизайн дизайн сайтов веб-студия |

Совместная безопасность в облаке по версии RUVDS, HUAWEI и «Лаборатории Касперского» |

Мероприятие прошло в московском отеле ARARAT PARK HYATT 31 мая и, как и год назад, собрало около сотни вендоров, потребителей и прочих заинтересованных лиц. Особый интерес на мероприятии вызвала презентация технологического решения thinclient от компаний RUVDS и HUAWEI. Специализированное оборудование и программное обеспечение позволяет существенно снижать затраты на приобретении персональных компьютеров в пользу комбинированного облачного решения. Но обо всем по порядку.

Одним из самых ярких докладов форума- было выступление гостей из Швейцарии: CEO дата-центра Deltalis Франк Харцхайм и руководитель продаж Лидия Шрейдер-Стрюб, рассказали о своем дата-центре в кантоне Ури в Швейцарии, который считается одним из самых защищенных и безопасных дата-центров в мире. А с января этого года, данный дата-центр оказался также и в распоряжении клиентов RUVDS.

На фото: Франк Харцхайм (CEO, Deltalis), Лидия Шрейдер-Стрюб (руководитель продаж, Deltalis)

В личной беседе с корреспондентом RUVDS г-н Харцхайм сказал, что «Несмотря на все техническое совершенство и оснащение ЦОДа, который выдержит (в их случае) и электромагнитную бомбу, главным аспектом безопасности является доверие. И Швейцария, является именно тем местом, где этому уделяют особое внимание». После доклада был представлен короткий видеоролик о дата-центре, который был встречен бурными аплодисментами:

Следом выступили спикеры пленарной сессии Совместная безопасность облачных решений для бизнеса, в ходе которой спикеры обсудили самые различные методы обеспечения безопасности в облаке, их плюсы и минусы и то, насколько эти решения подходят конечным потребителям.

На фото слева направо: Станислав Погоржельский (HOSTKEY), Александр Мисюрев (директор по развитию, AIG), Александр Миляр (HUAWEI), Франк Харцхайм (CEO, Deltalis), Лидия Шрейдер-Стрюб (руководитель продаж, Deltalis)

Дискуссия получилась насыщенной и очень интересной. Спикеры сошлись во мнении на том, что абсолютную защиту обеспечить невозможно ни на физическом сервере, ни на виртуальном- и тут, как раз кстати пришлось недавнее решение от AIG и RUVDS по страхованию рисков потери данных и утечки конфиденциальной информации. RUVDS стал первым провайдером в России, кто застраховал своих клиентов и ответственность перед ними.

На фото: Александр Мисюрев (деректор по развитию, AIG), Александр Миляр (HUAWEI)

Директор отдела развития бизнеса AIG в России Александр Мисюрев заверил, что данный вид страхования не новый для AIG и до текущего момента основными страхователями выступали как крупные корпоративные клиенты, финансовые учреждения, беспокоящиеся о различных угрозах для своих данных и сервисов, так и предприятия малого и среднего бизнеса в сети Интернет. С кейсом RUVDS подтянутся и другие участники рынка уверен он. Ведь помимо всего прочего, это является и более зрелой альтернативой распространенным на рынке SLA-соглашениям. Но в отличии от последних страховой полис позволит получить компенсацию соразмерную с потенциальными потерями, а не со стоимостью услуг провайдера.

На фото слева направо: Владимир Островерхов (эксперт поддержки корпоративных продаж, «Лаборатория Касперского»), Михаил Сергеев (директор по корпоративным коммуникациям, ГАРС телеком), Никита Цаплин (управляющий партнер, RUVDS)

Сегмент СМБ (среднего и малого бизнеса) вообще стал ключевой темой сессии. Спикеры обсуждали запросы от данной аудитории, насколько этот сегмент важен для вендоров. И оказалось, что в этом сегменте спрос активно растет, согласились с Александром Мисюревым (AIG) и вендоры решений безопасности из «Лаборатория Касперского», и проекта Varity- Владимир Островерхов и Данила Чежин. Что касается провайдеров, то как представители RUVDS, так и провайдера HOSTKEY (Никита Цаплин и Станислав Погоржельский) не смогли подтвердить рост клиентов из числа предприятия СМБ, полагая, что многие регистрируют аккаунты на физических лиц. Тем не менее, нельзя не согласиться с Владимиром Островерховым в том, что сегмент СМБ стал более компетентным в технологиях как виртуализации, так и безопасности.

На фото слева направо: Никита Цаплин (управляющий партнер, RUVDS), Данила Чежин (директор по продажам, Variti)