Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Внедрение инструментов Lean в командe Сервис Деск |

Предыстория

Любой сервис для конечных пользователей должен быть гибким, отражающим их текущие потребности. Бизнес развивается, качество сервиса тоже должно расти. Если этого не происходит, рано или поздно уровень услуг, заданных на старте проекта, перестает устраивать потребителей. Поэтому хочу поделиться с вами своим опытом внедрения новых методов работы в нашей команде Сервис Деск (SD).

Любой сервис для конечных пользователей должен быть гибким, отражающим их текущие потребности. Бизнес развивается, качество сервиса тоже должно расти. Если этого не происходит, рано или поздно уровень услуг, заданных на старте проекта, перестает устраивать потребителей. Поэтому хочу поделиться с вами своим опытом внедрения новых методов работы в нашей команде Сервис Деск (SD). В конце 2012 года мы запустили в работу услугу SD для одного из наших клиентов в режиме 24/7/365. Полноценной службы SD у заказчика до этого не было, вся поддержка оказывалась силами внутренних подразделений. Под этот проект была подобрана и обучена новая команда, состоящая из 7 сотрудников, включая меня. Сервис стартовал активно — передача знаний, знакомство со спецификой работы. У команды было много идей и энтузиазма. Сервис заработал как часы.

Почему сложно оказывать хороший сервис без перемен в работе?

Состав команды не сильно менялся в течение 3-х лет. Кто знаком с работой SD, тот представляет, как это много. Со временем энтузиазм стал угасать, рутинные задачи поглотили коллектив, а вовлеченность в проект снижалась.

Последней каплей стала официально полученная от клиента обратная связь о низком качестве нашего сервиса. По ее результатам стало очевидно, что сотрудники не были полноценно погружены в работу проекта и не использовали свой опыт для улучшения процессов поддержки, а эти качества жизненно необходимы для конкуретно способной технической поддержки.

Настало время менять подходы команды к оказываемому сервису. В этом ключе к нам пришли инструменты Lean, хорошо зарекомендовавшие себя в нашей компании на протяжении нескольких лет.

Что такое Lean?

Бережливое производство (от англ. lean production, lean manufacturing — «стройное производство») — концепция управления производственным предприятием, основанная на постоянном стремлении к устранению всех видов потерь. Бережливое производство предполагает вовлечение в процесс оптимизации бизнеса каждого сотрудника и максимальную ориентацию на потребителя.

Lean подход в нашей компании — совокупность инструментов и принципов, помогающих сформировать и поддерживать культуру постоянного совершенствования.

Принципы Lean подхода следующие:

Инструменты и техники, которые мы уже используем на уровне компании:

- Communication Cell, или «кружки качества», — встречи команды с четкой программой, эффективный формат внутренней коммуникации.

- Demand analysis — способ поиска тенденций по входящим обращениям (например, инцидентам) для уменьшения их количества.

- Problem solving session — выявление корневых причин инцидентов и командная выработка мероприятий для их устранения.

- Workplace organization — оптимизация физического и виртуального рабочего пространства.

- Value stream mapping — инструмент оптимизации рабочих процессов, основанный на их детальном анализе.

Для оперативного исправления ситуации на проекте мы выбрали следующие инструменты:

- «Кружки качества» — для вовлечения всей команды в процесс улучшения сервиса, визуализации текущих показателей эффективности сервиса, сбора обратной связи.

- Demand analysis — оценка текущих трендов на сервисе, причин возникновения обращений, определения зон повышенных трудозатрат со стороны SD и клиента.

- Problem solving session — для выработки действий по достижению новых целевых показателей сервиса, уменьшению трудозатрат, повышению эффективности работы.

- Workplace organization — для реорганизации базы знаний и файлового хранилища, что поведет за собой снижение временных затрат на поиск информации, необходимой для решения обращений.

Внедрение инструментов на проекте разделили на три этапа:

- Запуск «кружков качества» .

- Практическое использование инструментов по выявлению, решению проблем.

- Организация виртуального рабочего места

Запуск «кружков качества»

«Кружки качества» — это площадка для эффективной коммуникации. Это структурированный формат взаимодействия команды для обсуждения всех актуальных вопросов, возникающих сложностей в работе, рисков. Информация для обсуждения визуализирована и размещена, как правило, на маркерных досках.

На рисунке ниже представлен один из вариантов организации места на маркерной доске.

Для территориально распределенных команд можно использовать электронную версию. Встречи мы стали проводить еженедельно в открытом формате.

Несмотря на необходимость этих перемен, первое, с чем мы столкнулись, — сопротивление со стороны команды.

Сотрудники не хотели принимать участие в собраниях, так как не видели в них смысла. Поэтому нашей задачей стало через «кружки качества» показать команде, как она работает, куда движется и на что нужно обратить внимание. Рассказать о выгодах, которые могут быть, например, сокращение затрат на обработку обращений, автоматизация рутинных задач, оптимизация внутренних процессов.

Принцип вовлечения каждого подразумевает участие всех сотрудников в проактивной работе команды. Это достигается, в том числе, и за счет распределения задач по подготовке к собраниям. За каждым сотрудником закрепляется определенная активность. На первых этапах задача подготовки и проведения «кружков качества» выполнялась только координатором, и правильным решением стало постепенное вовлечение в нее каждого члена команды.

Постепенно интерес к собраниям возрастал.

Каждый сотрудник получил возможность открыто обсудить с командой свои идеи, предложения. Если они требовали времени на проработку, то их фиксировали в специальном разделе, устанавливали сроки рассмотрения. Далее по итогам общего обсуждения принимали в работу или передавали информацию клиенту для внутреннего анализа.

Одной из задач «кружков качества» является поддержание фокуса команды на заранее определенных показателях эффективности. Правильно выбранные показатели помогают сконцентрироваться на том, что важно для клиента. Каждый показатель имеет целевое значение для достижения, согласованное с клиентом. Показатели могут быть как внутренними, направленными на улучшения работы внутри команды, так и внешними, направленными на повышение качества предоставляемого сервиса.

Первой задачей команды стал фокус на количестве ошибок, возникающих при заполнении карточки заявки в ITSM-системе. Для определения корневых причин применили инструмент командной работы — сессию по решению проблем (problem solving session).

Проведение сессии по решению проблем

При решении командных проблем все сотрудники должны быть вовлечены в процесс поиска решения, так как финальные решения, принятые без участия всей команды, с большой долей вероятности могут быть не восприняты всерьез.

Инструмент достаточно прост и состоит из шести этапов:

Расскажу немного о каждом этапе:

- В нашем случае проблемой стал один из показателей эффективности, вышедший за граничные значения.

- Для определения корневых причин мы провели «тихий» мозговой штурм. Каждый сотрудник зафиксировал по его мнению все факторы, влияющие на появление ошибок в работе.

- Далее мы распределили все варианты по 4-м зонам и выбрали те варианты, реализация которых даст нам максимальный эффект при минимальных затратах.

- Совместно с руководителем команды сформировали план внедрения, который еженедельно оценивался на «кружках качества». Срок достижения цели может быть, как месяц, так и год. Зависит от сложности показателя, факторов, влияющих на его формирование. Например, компетенций команды в той или иной области, технических знаний и т.д. Мы выбрали полгода.

- Определили шаги, в соответствии с которыми стали планомерно двигаться к достижению цели.

- На промежуточных этапах оценивали тренд, при необходимости выполняли корректирующие процедуры.

За полгода процент ошибок в заполнении карточки обращения был снижен с 17% до стабильного уровня в 0.8-1% по отношению к общему числу закрытых обращений.

Мы визуализировали достигнутые значения:

Получив положительный опыт с акцентом в работе на определенном показателе, мы пошли дальше.

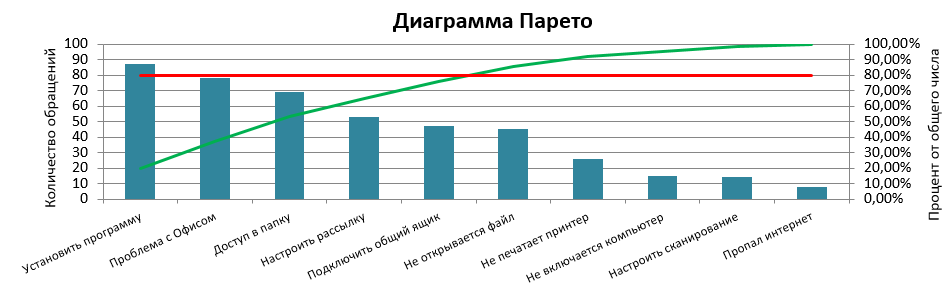

Следующей целью стало повышение процента обращений, решенных на первой линии без передачи их на последующие (First time fix, FTF).

Для анализа входящих обращений и определения потенциально возможных, которые могут быть закрыты на нашей линии, мы использовали инструмент по выявлению трендов (demand analysis).

Запуск инструмента по выявлению трендов

Необходимо обратить внимание, что одним из ключевых факторов успеха при анализе является корректная классификация.

Мы сделали выгрузку обращений пользователей в Сервис Деск, которые были переданы на решение на вторую линию поддержки (данные ниже были выбраны в качестве примера, оригинальная пунктуация сохранена). Для более тщательного анализа можно разделить все заявки на запросы на обслуживание и инциденты.

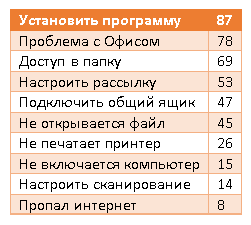

Отсортировали их по количеству:

Принцип Парето (принцип 20/80) означает, что 20% усилий дают 80% результата, а остальные 80% усилий — лишь 20% результата.

Сосредоточимся на наших 20%.

Выбираем обращения, которые расположены слева до пересечения зеленой линии с красной. В этом случае мы видим, что основная масса обращений связана с установкой ПО, проблемами с «Офисом», доступом к сетевым ресурсам, подключением общего ящика, добавления в группу рассылок. На это явно стоит обратить внимание и анализировать более детально.

Получив эти результаты, мы провели с командой очередной мозговой штурм в результате которого определили то, чего нам не хватает для решения подобных обращений на первой линии.

На старте подсчета процент заявок, закрытых на первой линии, был равен 13%. Через полгода мы получили результат уже 23%. Практически каждое 5 обращение было закрыто на стороне SD.

Для клиента это выражается в сокращении трудозатрат второй линии поддержки.

Организация виртуального пространства(Workplace organization)

Для продуктивной и качественной работы над обращениями необходимо не только удобно организованное физическое рабочее место, но и виртуальное. За время работы проекта для хранения информации было перепробовано множество инструментов начиная от txt-файла, excel-ки, локальных файловых ресурсов и заканчивая sharepoint.

Чем для нас стало организованное виртуальное рабочее место: вся проектная информация распределена так, чтобы любой старый или новый сотрудник тратил не более минуты на поиск необходимых данных.

Какие преимущества несет за собой это изменение:

- меньше времени на поиск информации, следовательно, сокращение времени обработки обращения;

- информация стандартизирована и визуально легко отличима;

- поток входящих данных легко управляем.

Для наведения порядка в информационном пространстве мы использовали подход 5S, состоящий из пяти этапов:

- Sift (отсеивание);

- Sort (сортировка);

- Shine (подсвечивание);

- Standardise (стандартизация):

- Sustain (поддержание).

Sift, Sort, Shine предназначены для изменений, а Standardise и Sustain —для поддержания и проверки соблюдения стандартов соответственно.

«Sift»: мы провели анализ всех наших мест хранения проектной информации на предмет устаревших или неиспользуемых данных. Всю ненужную информацию переместили в соответствующую папку «Архив» на каждом ресурсе. Все инструкции, документация, хранящуюся на локальных компьютерах, были размещены в общем доступе команды и так же проанализирована. Это позволило оценить общий объем накопленных знаний на проекте. Информация, требующая уточнения, была помечена и постепенно прояснялась. На проекте используется 7 различных ресурсов, содержащих многогранную информацию.

«Sift»: мы провели анализ всех наших мест хранения проектной информации на предмет устаревших или неиспользуемых данных. Всю ненужную информацию переместили в соответствующую папку «Архив» на каждом ресурсе. Все инструкции, документация, хранящуюся на локальных компьютерах, были размещены в общем доступе команды и так же проанализирована. Это позволило оценить общий объем накопленных знаний на проекте. Информация, требующая уточнения, была помечена и постепенно прояснялась. На проекте используется 7 различных ресурсов, содержащих многогранную информацию. «Sort» запустил процесс перераспределения всей актуальной информации в соответствии с ее типом. Дубликаты файлов были удалены.

«Sort» запустил процесс перераспределения всей актуальной информации в соответствии с ее типом. Дубликаты файлов были удалены.  «Shine»: совместно с командой определили новую файловую структуру хранилищ, а так же ответственных за внесение и изменение информации.

«Shine»: совместно с командой определили новую файловую структуру хранилищ, а так же ответственных за внесение и изменение информации. «Standardise»: создали внутренний стандарт хранения и распределения входящей информации. Наименование файлов и папок, категории информации, периоды обязательной актуализации данных.

«Standardise»: создали внутренний стандарт хранения и распределения входящей информации. Наименование файлов и папок, категории информации, периоды обязательной актуализации данных. «Sustain»: примение разработанных стандартов и подходов в ходе предоставления сервиса. Проверка соответсвия новых стандартов выполняемым рабочим операциям. Это позволило нам сформировать новый подход к хранению, распределению, актуализации информации.

«Sustain»: примение разработанных стандартов и подходов в ходе предоставления сервиса. Проверка соответсвия новых стандартов выполняемым рабочим операциям. Это позволило нам сформировать новый подход к хранению, распределению, актуализации информации. В заключении хочу сказать, что благодаря этим нехитрым инструментам команде удалось вернуть доверие клиента и значительно улучшить качество оказываемого сервиса без увеличения трудозатрат.

Для клиента изменения стали заметны в точечном исправлении проблемных зон, снижении количества инцидентов, сокращении времени решения обращений, полученных рекомендациях по оптимизации внутренних ИТ-процессов.

Материал по теме.

|

Метки: author Bender251 управление проектами service desk блог компании icl services управление командой lean бережливое производство |

Global DevOps Bootcamp + подборка видео |

Итак, поехали.

DevOps для каждой команды

Экскурсия по Microsoft Azure и Visual Studio Team Services. Вы узнаете о сервисах Microsoft, которые вам помогут в нелегком деле DevOps.

Быстрая настройка DevOps окружения с Azure Marketplace

Если вы не хотите тратить время и вам нужно всё и сразу, это видео точно будет вам полезно.

Continuous delivery на Microsoft Azure

Вы научитесь использовать App Service, VMs, Scale Sets, Container Service, Service Fabric и многое-многое другое из Azure Services.

OSS-based DevOps — все дороги ведут в Azure, часть I: CI/CD с Jenkins и Netflix Spinnaker

А вот здесь начинается настоящая практика. Часть 1.

OSS-based DevOps — все дороги ведут в Azure, часть II: Infrastructure as Code с Terraform

А вот здесь начинается настоящая практика. Часть 2.

Agile planning с Visual Studio Team Services (VSTS)

Инструменты для гибкой методологии разработки в VSTS.

Visual Studio Mobile Center и Visual Studio Team Services: для вашего Mobile DevOps

Вы научитесь делать ваших юзеров счастливыми с Visual Studio Team Services и Visual Studio Mobile Center.

Настройте Continuous Integration и Continuous Delivery из Visual Studio 2017

Умеете использовать Visual Studio IDE? Если нет, вам сюда.

DevOps для БД — Redgate Data Tools в Visual Studio 2017

Вы увидите Redgate Data Tools в действии, а также узнаете об основных подводных камнях.

Global DevOps Bootcamp

До ката мы приглашали вас на мероприятие и конечно расскажем о нём подробнее.

Global DevOps Bootcamp – это однодневное мероприятие для разработчиков, которое проводится локальными сообществами DevOps по всему миру 17 июня.

Инициатива проведения принадлежит компаниями Xpirit и Solidify. В Москве организовывается сообществом Microsoft Most Valuable Professional и пройдёт в Digital October.

Global DevOps Bootcamp полностью посвящён практикам и инструментам DevOps, построенных на основе технологий Microsoft. Узнайте всё о новейших тенденциях DevOps, проникните в суть новых технологий и делитесь опытом с остальными членами сообщества, а также попробуйте свои силы в Global DevOps-хакатоне.

Ведущие эксперты по DevOps станут кураторами вашей команды и помогут в разработке проектов.

Мероприятие откроет Донован Браун (Donovan Brown) — Principal DevOps Program Manager в Microsoft – всемирно известный специалист по DevOps.

В жюри: Microsoft, Yandex, Сбербанк Технологии, Лаборатория Касперского, ABBYY

Программа:

09.30 – 10.00 – Приветственный кофе

10.00 – 10.15 – Вступительное слово от организаторов – сообщества MVP в России. Владимир Гусаров, MVP

10.15 – 10.30 – «Что такое DevOps?» — приветственное слово Donovan Brown, Principal DevOps Program Manager (Microsoft)

10:30 – 11:15 Пленарный доклад. От серверного к бессерверному – следующий шаг в облачных вычислениях. Владимир Гусаров, MVP

11.15 – 11.30 – Кофе-брейк

11.30 – 11.45 – Презентация целей и задач хакатона (эволюция архитектуры существующего приложения в контейнерную и далее в бессерверную с помощью практик DevOps).

MVP Community, менторы команд

11.45 – 13.00 – Хакатон

13.00 – 13.45 – Обед

13.45 – 16.00 – Хакатон

16-00 – 17-00 – Подведение результатов хакатона. Церемония награждения победителей и вручение призов.

Регистрация и дополнительная информация доступна по ссылке.

|

Метки: author maria_gore visual studio microsoft azure блог компании microsoft devops global devops bootcamp mvp microsoft |

Android-митап в офисе Badoo 17 июня |

Привет! 17 июня в нашем офисе пройдет первый (для нас) Android-митап. С докладами будут выступать разработчики из Avito, Яндекса, Одноклассников, из Badoo – я, Аркадий Гамза. Начало – в 12:00. Описание докладов – под катом.

Программа митапа

11:00 – Начало регистрации (приходите, чтобы успеть выпить кофе и занять лучшие места)

12:00 – 12:40 – Филипп Уваров, Avito

12:40 – 12:55 – Вопросы

12:55 – 13:05 – Перерыв (вы успеете выпить по чашке кофе и задать еще пару вопросов спикеру)

13:10 – 13:50 – Аркадий Гамза, Badoo

13:50 – 14:05 – Вопросы

14:05 – 14:40 – Перерыв (обед)

14:40 – 15:20 – Андрей Сидоров, Яндекс.Браузер

15:20 – 15:35 – Вопросы

15:40 – 16:20 – Григорий Джанелидзе, OK.RU

16:20 – 16:35 – Вопросы

16:35 – 17:35 – Свободное общение

Спикеры и темы выступлений

Филипп Уваров, Avito

Тема: Компонентные тесты: как сделать жизнь вашего QA немного проще?

В докладе речь пойдёт о компонентных тестах, в том числе я поделюсь лучшими практиками, которые выработала наша команда, и расскажу, как они помогают нам делать более качественный продукт.

В частности поговорим о том:

- что такое компонентный тест? В чем отличия между юнит-, компонентным и функциональным тестом?

- для чего хороши компонентные тесты и какие проблемы они помогают нам решать?

- как минимизировать стоимость поддержки компонентных тестов без экономии на их надежности.

Аркадий Гамза, Badoo

Тема: Android Studio умеет больше, чем вы думаете

Мы обсудим полезные функции Android Studio – основного инструмента каждого Android-разработчика.

Я буду говорить:

- об эффективной навигации;

- о нетривиальном поиске;

- о режимах отображения;

- о средствах отладки.

Андрей Сидоров, Яндекс.Браузер

Тема: Измерение энергопотребления мобильных и внедрение в Continuous Integration.

Во время выступления я буду говорить про:

- проектирование устройства измерения энергопотребления;

- применение устройства анализа энергопотребления смартфона;

- автоматизацию процесса тестирования энергопотребления;

- поиск энергозатратных функций браузера;

- оптимизацию и контроль потребления энергии в браузере.

Григорий Джанелидзе, OK.RU

Тема: Как перестать беспокоиться и начать запускать фичи

Запуск новых фич для любого продукта – довольно опасная штука, ведь столько всего может пойти не так: может вылезти огромное число разных багов (от device specific до багов в самой фиче), могут не выдержать сервера и в конце концов пользователям может просто не понравиться фича.

Я расскажу о том, как мы запускаем новые фичи, какие проблемы, связанные с запусками, у нас возникали и как это всё работает в Android-клиенте.

Тезисы:

- feature toggles: что это, зачем это и как мы сделали своё;

- как мы мониторим и оцениваем запуски;

- как feature toggles дружат с ручным тестированием и как учитываются в автотестах.

Регистрация и место

Регистрироваться на митап – здесь (пишите ваши фамилии и имена кириллицей, пожалуйста).

Адрес: Москва, Цветной бульвар, 2, БЦ «Легенда Цветного», подъезд А. Метро: Трубная/Цветной бульвар. Захватите с собой какой-нибудь удостоверяющий личность документ.

|

Метки: author ArkadyGamza тестирование мобильных приложений разработка под android разработка мобильных приложений блог компании badoo android митап |

«Сломай голосовалку на РИТ++». Даёшь 1 000 000 RPS |

Прошёл второй день РИТ++, и по горячим следам мы хотим рассказать о том, как всем миром пытались сломать нашу голосовалку. Под катом — код, метрики, имена победителей и самых активных участников, и прочие грязные подробности.

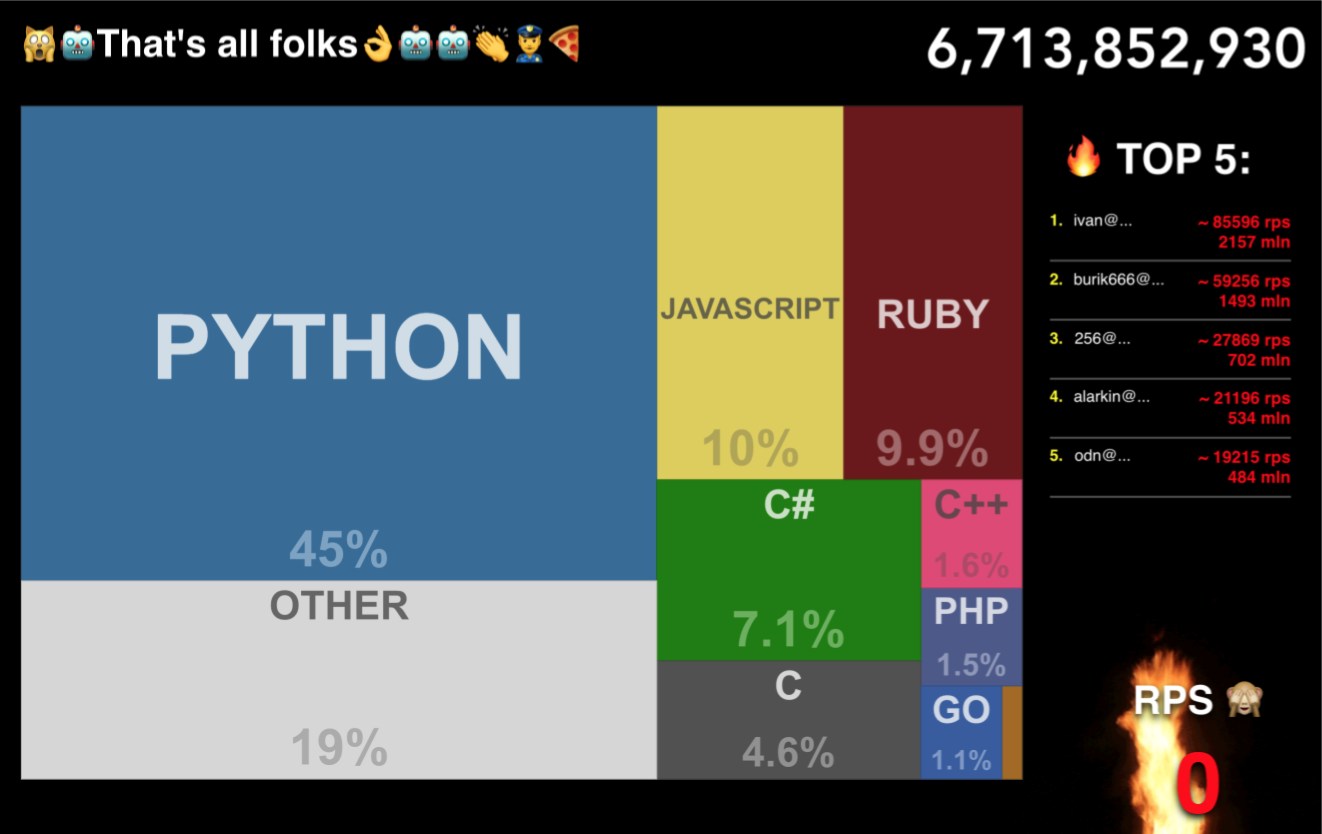

Незадолго перед РИТ++ мы задумались, чем можно развлечь народ? Решили сделать голосовалку за самый крутой язык программирования. И чтобы результаты в реальном времени выводились на дашборд. Процедуру голосования сделали простой: можно было с любого устройства зайти на сайт ODN.PW, указать своё имя и e-mail, и проголосовать за какой-нибудь язык. Со списком языков не мудрили — взяли девять самых популярных по данным GitHub, десятым пунктом сделали язык “Other”. Цвета для плашек тоже взяли с GitHub.

Но мы понимали, что накрутки будут неизбежны, причём с применением «тяжёлой артиллерии» — все свои, аудитория продвинутая, это же не голосование на мамочкином форуме. Поэтому мы решили приветствовать накрутки всеми возможными способами. Более того, предложили попробовать сообществу положить нашу голосовалку большой нагрузкой. А чтобы участникам было ещё проще, выложили ссылку на API для накруток с помощью ботов. И заодно решили наградить поощрительными призами первых трёх участников с наибольшим количеством RPS. Отдельная номинация была заготовлена для того силача, который сможет поломать голосовалку в одиночку.

День первый

Голосовалку запустили почти с самого начала работы РИТ++, и работала она до 18 часов. Наше развлечение понравилось посетителям и докладчикам РИТ++. Специалисты по высокопроизводительным сервисам активно включились в гонку за RPS. Гости стенда живо обсуждали способы положить голосовалку. Стихийно возникали команды адептов того или иного языка, которые начинали придумывать стратегии продвижения. Кто-то тут же садился и начинал писать микросервисы или ботов для участия в голосовании.

Некоторые компании, участвующие в РИТ++ и предоставляющие услуги защищённых хостингов, тоже включились в наше соревнование. К самому концу дня совместными усилиями участники всё же смогли ненадолго положить систему. Ну как «положили» — сервис-то работал, просто мы упёрлись в потолок по количеству одновременно регистрируемых голосов. Поэтому к 18 часам мы приостановили голосование, иначе результаты были бы недостоверными.

По результатам первого дня мы получили 160 млн голосов, а пиковая нагрузка достигала 20 000 RPS. Любопытно, что в этот день первое и второе места заняли активный участник РИТ++

Николай Мациевский (Айри) и спикер Елена Граховац из Openprovider.

Ночью мы подготовились к следующему дню, чтобы встретить его во всеоружии: оптимизировали общение с базой и поставили nginx перед Node.js-приложением на каждом воркере.

День второй

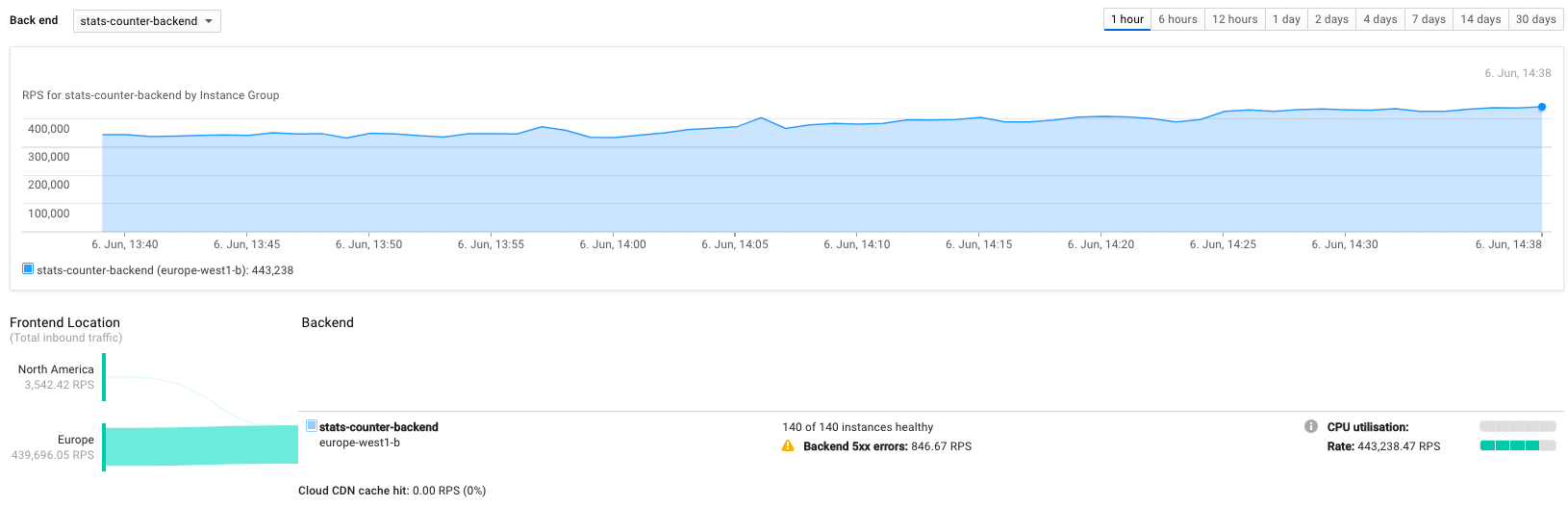

Многих заинтересовало наше предложение положить голосовалку, ведь гонка за RPS — задача увлекательная. Утром нас уже «ждали»: едва мы переключили DNS, как количество RPS взлетело до 100 000. И через полчаса нагрузка поднялась до 300 000 RPS.

Забавно, что когда мы только приступали к разработке голосовалки, то решили, что «неплохо было бы поддерживать 100 000 RPS». И на всякий случай заложили максимальную производительность в 1 млн RPS, но при этом даже всерьёз не рассматривали возможность приближения к такому показателю. А к середине второго дня уже практически делали ставки на то, пробьём ли потолок в миллион запросов в секунду. В результате мы достигли порядка 500 000 RPS.

Реализация

Проект мы запилили втроём за 1,5 дня, перед самым РИТ++. Голосовалку разместили в облачном сервисе Google Cloud Platform. Архитектура трёхуровневая:

• Верхний уровень: балансировщик, выступающий в роли фронтенда, на который приходит поток запросов. Он раскидывает нагрузку по серверам.

• Средний уровень: бэкенд на Node.js 8.0. Количество задействованных машин масштабируется в зависимости от текущей нагрузки. Делается это экономно, а не с запасом, чтобы не переплачивать впустую. К слову, проектик обошёлся в 8000 рублей.

• Нижний уровень: кластеризованная MongoDB для хранения голосов, состоящая из трёх серверов (один master и два slave’а).

Все компоненты голосовалки — open source, доступны на Github:

• Backend: https://github.com/spukst3r/counter-store

• Frontend: https://github.com/weglov/treechart

Во время разработки бэкенда в воздухе витала идея кешировать каждый запрос на накрутку голосов и периодически отправлять их в базу. Но из-за нехватки времени, неуверенности в количестве участников и банальной лени было решено отложить эту идею и оставить отправку данных в базу на каждый запрос. Заодно и производительность MongoDB в таком режиме проверить.

Что ж, как показал первый день, прикрутить кеш надо было сразу. Каждый воркер Node.js выдавал не больше 3000 RPS на каждый POST на /poll, а мастер MongoDB тяжело кашлял с LA >100. Не очень помогла даже оптимизация агрегации запросов для получения статистики путём изменения read preference на использование slave'ов для чтения. Ну ничего, самое время реализовать кеш для накрутки счётчиков и для проверки валидности email'а (который был завёрнут в простой _.memoize, ведь мы никогда не удаляем пользователей). Также мы задействовали новый проект в Google Compute Engine, с бОльшими квотами.

После включения кеширования голосов MongoDB чувствовала себя превосходно, показывая LA <1 даже в пике загрузки. А производительность каждого воркера выросла на 50% — до 4500 RPS. Для периодической отправки данных мы использовали bulkWrite с отключённым параметром ordered, чтобы оставить на стороне базы очередность исполнения запросов для оптимизации скорости.

В первый день на каждом воркере работал Node.js-сервер, создающий через модуль cluster четыре дочерних процесса, каждый из которых слушал порт 3000. Для второго дня мы отказались от такого сервера и отдали обработку HTTP «профессионалам». Опыты показали, что nginx, взаимодействующий с приложением через unix-сокет, даёт примерно +500 RPS. Настройка достаточно стандартная для большого количества соединений: увеличенный worker_rlimit_nofile, достаточный worker_connections, включенный tcp_nopush и tcp_nodelay. Кстати, отключение алгоритма Нейгла помогло поднять RPS и в Node.js. В каждой виртуалке потребовалось увеличить лимит на количество открытых файлов и максимальный размер backlog'а.

Итоги

За два дня ни одному участнику в одиночку не удалось положить наш сервис. Но в конце первого дня общими усилиями добились того, что система не успевала регистрировать все входящие запросы. На второй день мы поставили рекорд в нагрузке ~450 000 RPS. Различие в показаниях RPS на фронте (который высчитывал и усреднял RPS по фактическим записям в базе) и показания мониторинга Google пока остаётся для нас тайной.

И рады объявить победителей нашего маленького соревнования:

1 место — { "_id": "ivan@buymov.ru", "count": 2107126721 }

2 место — { "_id": "burik666@gmail.com", "count": 1453014107 }

3 место — { "_id": "256@flant.com", "count": 626160912 }

Для получения призов пишите kosheleva_ingram_micro!

|

|

Первыми закрываются компании где ставится много задач. Статистика использования системы управления проектами YouGile |

Чуть больше года мы делаем свою систему управления проектами. Не так давно база активных пользователей перевалила за 1000 и появилась крутая возможность — изучать статистику того, как компании подходят к организации процессов.

Что делают успешные команды и чего не делают разваливающиеся за неделю? Можно ответить на глупые вопросы: что важнее — назначить на каждую задачу исполнителя или проставлять дедлайны, а может самое важное ставить приоритеты? Есть ли действие, которое значительно увеличивает срок жизни проекта?

И оказалось, что есть простой ответ. Обнаружив его, мы резко приостановили работы над функциями и всей командой сфокусировались на мобильном приложении…

Эксперимент

Мы выделяли группы пользователей, которые после регистрации делали упор на той или иной функции в системе. Далее считали дневной показатель возвратов по сотрудникам этих компаний. (Daily Retention Rate — видео, которое вдохновило на эксперимент). Другими словами, мы смотрели, как конвертируется пользователь на ранних стадиях — воспринимает ли он систему как место для постановки задач или, например, хочет максимально контролировать процессы; пытались понять, насколько долго он задерживается в системе в зависимости от старта.

Казалось, что такой подход просто позволил бы узнать какой группе лучше всего подходит система. Однако правда такова, что и белая доска на стене подходит под любую схему организации, была бы только воля в команде постоянно пользоваться доской.

Таким образом, побочным, но гораздо более интересным результатом наших экспериментов оказалось то, что можно узнать, при каком подходе активность по проекту затухает за пару месяцев, а в каком он живет долго вне зависимости от результатов. Из статистики можно делать выводы о полезности действий при организации проекта.

По большинству выборок никаких интересных результатов обнаружить не удается. Как правило, действие, которое мы выбирали, ничего не говорит и никак не влияет на срок жизни начинающей команды. Например, назначение задач на исполнителей не несет никакой особенной важности; те компании, которые делают упор на это в начале использования, имеют такой же показатель возвратов как и в среднем по всей базе. Еще важно отметить, что все выборки были примерно одного размера. Ситуации, что мы просто отобрали компании, прошедшие более высокий барьер, нет.

Но две группы дали принципиальные отличия от среднего.

Результаты

Самый яркий отрицательный паттерн — это большое количество генерируемых задач. График активности таких компаний достаточно быстро падает и стремится к асимптоте около нуля.

Компании, которые генерируют много задач (более 20 в день на человека в первую неделю), через 100 дней будут существовать только с вероятностью 4%.

В реальности это выглядит так, что один очень энергичный руководитель бесконечно ставит задачи, разбивая проект так, как только ему понятно, практически ничего не обсуждает, требует выполнения, приходит в ярость, когда выполненные задачи не дают общего результата. Каким бы абсурдным не казался этот пример, встречается он часто.

Самый яркий положительный паттерн — это большое количество общения, вопросов.

Компании, которые в первые же дни набирают больше 10 сообщений на участника команды, через 100 дней выживают в системе с вероятностью 42%.

На практике это выглядит так, что задач генерируется немного, декомпозиция происходит в описании задачи, к большинству задач подключаются несколько человек и ведут обсуждения, нет одного самого активного участника, структура коллектива плоская, формулируется много вопросов. Как правило это команда равноправных участников или с грамотным руководителем.

Вобщем — задать вопрос в десять раз лучше, чем поставить задачу.

Разворот в приоритетах разработки

На проект YouGile эксперимент оказал сильное влияние. Нет, мы не стали задавать больше вопросов друг другу. Мы поменяли идеологию, сделали небольшой поворот в развитии продукта. Теперь делаем упор на организации взаимодействия команд вокруг задач.

В отличие от белой доски, система управления должна засасывать, как засасывает Facebook. Каждый день просматривать задачи по проекту, вовремя задавать вопросы, общаться — всё это должно быть нормой для всей команды. В идеальном мире такая система должна позволять организовать 100 человек с такой же легкостью, как стартап из 5.

Если общение настолько важно, то наличие мобильной версии должно заметно повысить шансы на успех в компаниях. Мы приостановили работу над функциями и всей командой стали допиливать мобильное приложение. Задача была сделать так, чтобы упор в системе управления проектами был именно на общении.

Получилось интересно, нам и нескольким близким компаниям из числа тестирующих нравится. Все общение окончательно перешло в систему и стало идеально структурировано по задачам.

Вот так выглядит список всех проектов. При клике на какой-то конкретный открывается доска и можно просмотреть все задачи.

Вторая кнопка в нижнем меню позволяет просмотреть все диалоги по задачам. Есть разделение диалогов, по которым вы были нотифицированы и диалогов, которые вам доступны для просмотра, но вас почему-то не добавили в уведомление.

Третья кнопка в нижнем меню открывает список участников всей компании и позволяет вести личную переписку. Никто кроме вас и собеседника не имеет к ней доступ.

От запуска мобильной версии ждем роста показателя возвратов на 10%, на практике это означает, что компании будут на 10% дольше упираться, прежде чем бросить проект. Может кто-то и потратит больше времени впустую, работая над заведомо мертвой идеей, но наша задача сделать так, чтобы при этом вся команда была вовлечена в процесс.

Как наберется статистика с использованием мобильной версии, добавлю сюда новый график.

Сайт системы — yougile.com

|

Метки: author Superslon управление разработкой управление проектами развитие стартапа agile блог компании yougile yougile исследования пользователей стартапы |

Видео: инди-разработчики о провалах, успехе и монетизации |

Студия One Dream из Ярославля в мае этого года получила грант в $20 000 от Epic Games. Ведущий разработчик Михаил Ваксман рассказал, как команде удалось создать свою Zelda — Be:Brave — с блэкджеком и переходом с Unity 3D на Unreal Engine после запуска игры.

Молодой разработчик Юра Саначев сделал простую, но стильную аркаду Hop — и успешно монетизирует ее.

Михаил Фарленков, cоздатель VR-шутера Hardcode от третьего лица: есть ли у таких игр будущее и зачем вообще нужен подобный VR? Ответы — в видео.

И на десерт — классные инсайты от Виталия Козлова, создателя детских игр по мотивам популярных мультфильмов (KB Production).

Совсем скоро мы опубликуем видео с экспертами по видеоблогам, аналитике приложений, художникам для игр и геймдизайну — оставайтесь на связи!

|

|

По дороге с облаками. Реляционные базы данных в новом технологическом контексте |

Мы задумываемся об издании не совсем обычной книги, автор которой желает изложить очень интересную трактовку современного технологического ландшафта, охватывающего базы данных и технологии обработки Big Data. Автор полагает, что без активного использования облаков никуда не деться, и рассказывает об этом ландшафте именно в таком ракурсе.

Об авторе:

Александр Васильевич Сенько, кандидат физико-математических наук в области компьютерного моделирования и оптимизации мощных сверхвысокочастотных приборов.

Автор имеет сертификаты Microsoft в области создания приложений в среде Microsoft Azure: Microsoft Certified Professional и Microsoft Specialist: Developing Microsoft Azure Solutions.

В 2008 году закончил Белорусский Государственный Университет Информатики и Радиоэлектроники (БГУИР) по специальности “Моделирование и компьютерное проектирование радиоэлектронных средств”.

С 2007 по 2012-й годы автор работает в научно-исследовательском институте ядерных проблем БГУ на должностях техника, лаборанта, инженера.

С 2013 года по настоящее время автор работает в компании ISSoft Solutions на должности разработчика ПО и DevOps с специализацией в области создания облачных приложений на базе стека Microsoft

Под катом вы сможете оценить идеи и стиль автора. Не стесняйтесь голосовать и комментировать — и добро пожаловать под кат!

Введение или почему эту статью следовало написать.

В настоящее время облачные сервисы позволяют разработчикам и системным администраторам очень быстро создавать инфраструктуру приложения и так же быстро от нее избавляться, когда в этом отпадает необходимость. Плата взимается за время использования ресурсов облака и за их уровень производительности, именуемый еще «ценовой уровень» – pricing tier. Можно очень быстро создать ресурсы, «поиграться» с ними, «пощупать», освоить их, и при этом совершенно не нужно заботиться о покупке/администрировании серверов, чтении документации об инсталляции требуемого софта и пр. В облачных средах все типовые задачи администрирования и мониторинга сведены в удобные API или пользовательский интерфейс веб-портала управления. Но тут появляется одна сложность – если человек не разбирается или не до конца понимает, как работают облачные среды, задача «что мне надо сделать, чтобы получить базу данных и подключиться к ней из моего приложения» на первых порах озадачивает. Обилие облачных сервисов и различных «ценовых уровней» для каждого сервиса еще больше осложняет задачу выбора. Эта статья представляет краткий обзор одного из самых популярных облачных сервисов – сервисов реляционных баз данных.

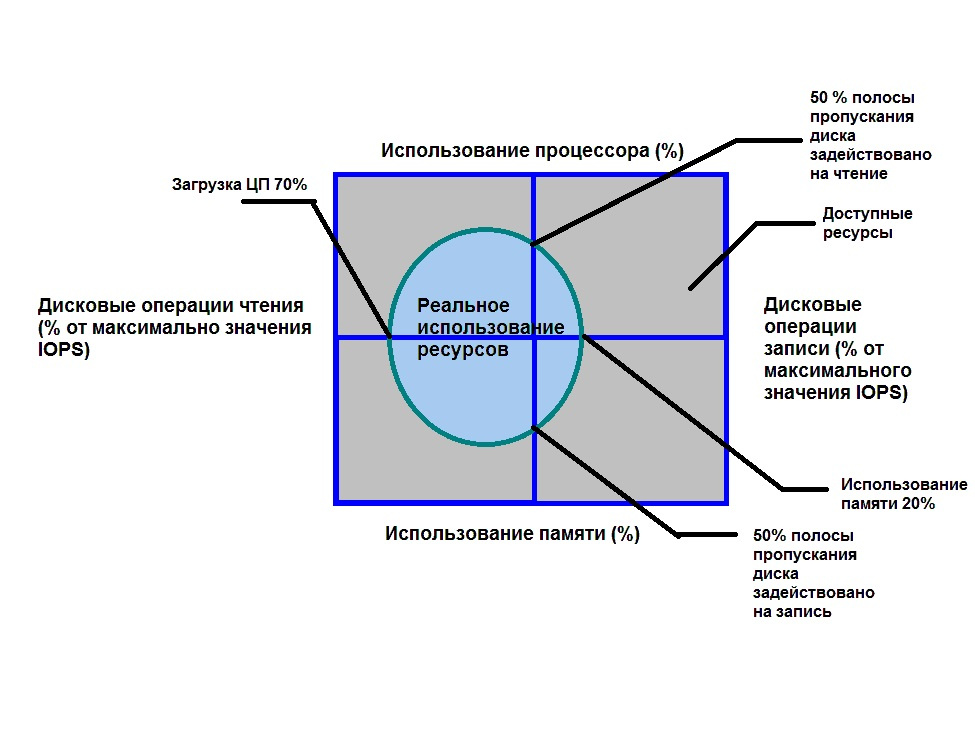

Реляционные базы данных являются традиционным хранилищем данных. Информацию в них можно представить в виде набора таблиц, состоящих из строк. Эти таблицы связаны друг с другом с помощью «ключей» — специальных ограничений целостности, ставивящих строкам одной таблицы в соответствие строки другой. «Большие данные» зачастую удобнее хранить и быстрее обрабатывать в нереляционном виде (например, в базах данных типа ключ/значение), но данные, хранящиеся в виде взаимосвязанных таблиц, допускают эффективный анализ в любом измерении – по строкам связанных таблиц и по всей таблице, что для случая NoSQL баз данных сопряжено с большими трудностями. Кроме того, для реляционных баз данных имеется очень эффективный язык запросов – SQL. В облачных средах реляционные базы данных представлены в двух видах – SQL as a Service и в виде готовых образов для виртуальных машин. Базы данных, размещаемые на виртуальных машинах, по сути, мало отличаются от серверов баз данных, размещенных на традиционных виртуальных и физических хостах. При этом выбор типа виртуальной машины, виртуальных дисков, облачного хранилища для их размещения и сетевых интерфейсов существенно влияют на ее производительнсть, но это тема отдельной главы, а возможно и книги. У серверов баз данных, размещенных на виртуальных машинах в облаках, есть существенные ограничения, связанные с масштабированием, доступностью и отказоустойчивостью. Например, виртуальные машины Azure имеют SLA (service level agreement – соглашение об уровне доступности) на уровне 99,95% только в случае использовании кластера минимум из двух машин, размещенных в одной общей группе доступности (Availability Set), при этом у них будут физически разделены сетевые интерфейсы и источники питания. Для того, чтобы достичь уровня 99,99 необходимо конфигурировать кластер из нескольких виртуальных машин Always On.

В то же время SQL обладает SLA на уровне 99.99 без дополнительных трудностей, связанных с конфигурированием кластеров. С другой стороны, требованиям стандартов HIPPA соответствуют SQL-сервера, размещенные на виртуальных машинах, но не сервис Azure SQL. В остальном же облачный сервиc SQL имеет непревзойденные возможности в плане масштабирования, доступности и простоте администрирования (репликация, резервное копирование, экспорт, анализ производительности выполняемых запросов). Кроме того, SQL as a Service в ряде случаев существенно дешевле аналогичного по производительности сервера, размещаемого на виртуальной машине (автор сознает, что это очень спорное утверждение, особенно учитывая особенности использования ресурсов в SQL as a Service и SQL на виртуальных машинах). SQL as a Service, не поддерживает всех возможностей традиционных серверов баз данных. Например, выполнение запросов из таблиц в одной базе данных внутри другой в случае SQL сервиса сопряжено с рядом трудностей и ограничений. Рассмотрим примеры реализации SQL as a Service в разных облачных средах.

Служба реляционной базы данных Azure SQL от Microsoft.

Реализация SQL-As-A-Service от Microsoft представляет собой облачную службу реляционной базы данных на основе движка Microsoft SQL Server и называется Azure SQL. В языке запросов Azure SQL реализовано подмножество функций T-SQL. Экземпляры сервисов Azure SQL, являющиеся прямыми аналогами баз данных MS-SQL, логически группируются в «серверы» Azure SQL Server. Каждый сервер Azure SQL должен иметь уникальный URL, учетные данные (имя пользователя и пароль), а также набор допустимых IP адресов, которые могут иметь доступ к нему (этот список формируется в firewall сервера и регулирует правила доступа к нему).

Физически Azure SQL Server размещается в ЦОД–е, расположенном в определенном географическом регионе. В этом же регионе размещаются все экземпляры баз данных Azure SQL. Возможна также географическая репликация баз данных в несколько регионов по схеме Primary-Secondary или Primary-ReadOnly Replica (первичный сервер – реплика, доступная только для чтения). Благодаря широкой поддержке T-SQL в Azure SQL имеется возможность прямой миграции баз данных из Microsoft SQL Server в Azure SQL. Конечно, прямая миграция из одного типа базы данных в другую – далеко не простая и не быстрая задача, но в данном случае это принципиально возможно и напрямую поддерживается с помощью специальных программ от Microsoft, Red Gate и пр. Однако следует иметь в виду, что это программное обеспечение в ряде случаев просто «вырезает» несовместимые объекты базы данных, не пытаясь их адаптировать. И может получиться, что после такой миграции база данных «поднялась», но счастливые разработчики могут «внезапно» недосчитаться ряда объектов базы данных в Azure SQL. Каждый экземпляр баз данных имеет определенный «ценовой уровень» — pricing tier — который характеризуется своей производительностью, ограничениями по размеру, количеству точек восстановления и возможностями репликации. Все возможные ценовые уровни разделены на следующие уровни: базовые (“Basic”), стандартные (“Standard”) и премиум (“Premium”). Самое главное различие ценовых уровней проявляется в разном значении DTU – обобщенного параметра, характеризующего производительность базы данных. Что же это за параметр? DTU (eDTU) это обобщенная характеристика производительности базы данных, включающая в себя показатели производительности центрального процессора, памяти, устройств ввода-вывода и сетевого интерфейса. Этот показатель определяет своего рода «объем», который может «занимать» производительность Azure SQL. Если в данный момент в базе выполняется запрос, то этот запрос потребляет определенное количество ресурсов, которые занимают часть этого разрешенного объема (см рисунок 1). При этом следует иметь в виду, что ограничивается не только объем, но и конкретные значения каждого из показателей (т.е. не получится «обменять» крайне малое использование CPU на крайне большое значение памяти). Это проявляется в частности в том, что один «кривой» запрос может вызвать переиспользование одного из ресурсов и в итоге одвесить всю базу данных (экземпляр сервиса Azure SQL Database но не Azure SQL Server) и точно такой же запрос будет нормально отрабатывать в традиционной базе данных Microsoft SQL Server. Это происходит потому, то в Azure SQL срабатывает механизм защиты ресурсов базы от чрезмерного использования, который вынуждает процесс, вызвавший запрос, отключиться по таймауту, освободив тем самым ресурсы базы данных.

Итак, Azure SQL состоят из экземпляров Azure SQL Database, являющихся собственно реляционными хранилищами информации с определенными значениями размера и максимального DTU; экземпляра Azure SQL Server, который группирует базы Azure SQL Database, обеспечивая им общую строку соединения (connection string), правила доступа, прописанные в firewall и в ряде случаев предоставляя общий эластичный пул ресурсов (Elastic Database Pool, о котором– ниже).

Теперь познакомимся с Elastic Database Pool. Этот сервис встроен в состав Azure SQL Server и служит для объединения баз данных в один пул и назначения всем им общих разделяемых ресурсов. Зачем это нужно? Рассмотрим пример SaaS приложения, созданного для оказания неких услуг зарегистрированным в нем пользователям (например, это «облачная» CRM система). Каждому зарегистрированному пользователю такой системы выделяется своя база данных определенного уровня производительности, выражающегося конкретным значением DTU. Каждый уровень производительности имеет определенную месячную стоимость, которая в конечном итоге скажется на прибыли владельца SaaS – она будет равна суммарной месячной плате всех пользователей за вычетом расходов на облачные сервисы, лежащие в основе архитектуры системы. Теперь предположим, что активность пользователей, выражающаяся в использовании DTU каждой базы, носит некореллированный характер, т.е. они нагружают свои базы в различные случайные временные промежутки. Это приводит к тому, что появляются моменты времени, когда использование DTU базы конкретного пользователя очень мало, и моменты, когда оно велико. Таким образом, в момент малого использования DTU базы «простаивают» — но за них взимается плата со стороны Azure. А что если взять несколько таких баз данных, что интервалы активности каждой совпадают с интервалами недогруженности других, и объединить их в общий пул баз данных и распределить общие ресурсы DTU между базами таким образом, чтобы суммарная нагрузка была равномерна во времени; плата за ценовой уровень при этом будет существенно меньше, чем суммарная плата за все базы данных. Именна такая идея лежит в основе сервиса Azure Elastic Database Pool. Кроме того, ElasticDatabasePool позволяет реализовывать сценарии разделения одной большой базы данных на меньшие, но выполнять запросы в этой разделенной на «фрагменты» (shard) БД так, как будто это одна монолитная база данных.

Рассмотрим теперь случай, когда все же необходимо выполнить запрос к данным, расположенным в разных базах данных. Если имеется просто набор баз данных без фрагментирования, необходимо выбрать одну головную базу данных и создать в ней внешние источники данных и внешние таблицы (reference table), являющиеся «отражениями» реальных таблиц, размещенных в других базах данных. Можно также не использовать специализированную головную базу данных, а создавать таблицы в каждом экземпляре Azure SQL Database. Недостаток такого подхода в том, что при смене схем таблиц в базах данных, необходимо синхронно менять схемы во внешних таблицах (если отсутствует головная база данных, то необходимо проделать очень большую работу по смене схемы во всех внешних таблицах во всех базах, где они присутствуют). Кроме того, у реализации T-SQL в Azure SQL есть ограничения на типы данных для внешних таблиц (например, они не поддерживают Foreign Key и тип nvatrchar(max)) и в настоящее время присутствует целый ряд ограничений на выполнение подобных запросов и базы данных, где эти запросы будут выполняться – например невозможно выполнить экспорт базы данных в BACPAC файл в случае наличия в ней ссылок на внешние таблицы. Ну и не следует забывать и об снижении производительности для таких запросов. А как же это все выглядит?

Давайте для определенности предположим, что у нас две базы данных – база First и база Second. Теперь допустим, что из базы Second нам нужно выполнить запрос к базе First. Для этого в базе Second должны быть созданы учетные данные (credentials), которые будут служить для доступа к базе данных First:

CREATE MASTER KEY ENCRYPTION BY PASSWORD = '<пар0ль>';

CREATE DATABASE SCOPED CREDENTIAL FirstDBQueryCred -- Это имя учетной записи

WITH IDENTITY = '<ИмяПользователя>',

SECRET = '<пар0ль>';

Затем в базе данных Second создадим внешний источник данных, который будет использоваться для связи с таблицами внешней базы данных:

CREATE EXTERNAL DATA SOURCE FirstDatabaseDataSource WITH

(

TYPE = RDBMS,

LOCATION = '.database.windows.net',

DATABASE_NAME = 'First',

CREDENTIAL = FirstDBQueryCred

)

После этого в базе Second надо создать «внешнюю таблицу» (External Table) – таблицу, являющуюся «отражением» аналогичной таблицы, размещенной в базе First:

CREATE EXTERNAL TABLE [dbo].[TableFromFirstDatabase]

( [KeyFieldID] [int] NOT NULL,

[DataField] [varchar](50) NOT NULL

)

WITH ( DATA_SOURCE = FirstDatabaseDataSource)И все! Теперь мы можем в базе данных Second делать запросы к таблице из базы First как к обычной таблице, размещенной в базе Second. Стоит иметь в виду, что эти таблицы связаны только по данным – любые изменения схемы в одной базе данных никак не отразятся на схеме таблицы в другой.

Другой возможный случай выполнения запросов к различным базам данных – это использование Elastic Database jobs. Суть этой технологии в том, что группа баз данных объединяется и управляется централизованно из общего специализированного головного сервера ВМ. Взаимодействуя с этим сервером программно или через Azure Portal, можно управлять всеми подключенными базами данных с помощью создания заданий (jobs). Эти задания могут быть следующего характера:

- административные (согласованное изменение схемы, выполнение перекомпиляции индексов);

- периодическое обновление данных или сбор данных для систем BI, в т.ч. для выполнения анализа большого количеств данных.

Сервис Elastic Database jobs содержит следующие компоненты (рисунок 2):

- головной сервер, размещаемый на экземпляре Azure Cloud Service Worker Role. По сути, это специализированное ПО, размещаемое (по состоянию на настоящее время) на виртуальной маший Azure Cloud Service. Для обеспечения высокой доступности, рекомендуется создавать минимум 2 экземпляра ВМ;

- управляющая база данных. Это экземпляр Azure SQL, служащий для хранения метаданных всех подключенных баз данных;

- экземпляр службы Azure Service Bus, служащий для объединения и синхронизации всех компонентов;

- экземпляр облачного хранилища Azure Storage Account, служащий для хранения журналов всей системы.

Настройка, использование и администрирование всей этой системы – довольно сложная тема и подробно рассматриваться не будет. Интересующиеся могут ознакомиться с темой здесь.

Помимо одиночных баз данных, сервис AzureSQL позволяет создавать более сложные реляционные хранилища – фрагментированные базы данных – Sharded Databases и реляционные хранилища с широкой поддержкой массивно-параллельного выполнения запросов – Azure SQL DWH.

Рассмотрим сперва фрагментированные базы данных. Нужда во фрагментации базы данных появляется в случае, когда ее размер становится чрезмерно большим для размещения на одном экземпляре Azure SQL (в настоящее время это более 1 ТБ для Premium pricing tier). Конечно, можно разбить большую базу данных на меньшие базы логически, проведя анализ ее структуры (схемы). Как уже указывалось ранее, Azure SQL Server это логическая группировка экземпляров Azure SQL Database, а не физическое объединение на одном сервере. И прямые запросы к объектам базы данных из другой базы данных возможны только если эти объекты являются External table или эти базы объединены в Elastic Database Pool, и используются запросы Elastic Database Query или транзакции Elastic Transactions. В этом случае необходимо применить фрагментацию (sharding) базы данных. Фрагментация базы данных — это по сути горизонтальное масштабирование, отличное от вертикального масштабирования – увеличения «размера» базы данных в масштабе CPU, оперативной памяти, IOPs и пр. Разделение одного большого хранилища на несколько хранилищ меньшего масштаба и параллельная обработка в их всех с последующим сложением результатов обработки – ключевая концепция всех технологий обработки больших данных, с которой мы будем далее не раз встречаться.

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

|

Метки: author ph_piter профессиональная литература microsoft azure big data блог компании издательский дом «питер» базы данных azure sql cloud computing cloud storage книги |

[Перевод] Понимание событийной архитектуры Node.js |

|

Метки: author AloneCoder разработка веб-сайтов программирование node.js javascript блог компании mail.ru group никто не читает теги |

Катаем «смоляной шарик» или создание собственных правил сборки с помощью Qbs |

A product is the target of a build process, typically an application, library or maybe a tar ball

Сегодня и рассмотрим процесс создания своих продуктов. Поехали…

Знакомство с это системой сборки хорошо описал mapron в данной статье, мы же не будем на этом останавливаться и приступим сразу к делу.

К сожалению в документации и сети слишком мало информации о деталях работы Qbs и значении свойств элементов. По этому я попробую восполнить некоторые пробелы в этом, опираясь на свой опыт работы с данной системой сборки. И буду благодарен читателям за дополнение или указания неточностей в данном материале.

Итак Qbs выполняет преобразования одних данных в другие с помощью элемента Rule. Данный элемент создает правило преобразования, которое преобразует входные данные inputs в выходные outputs при помощи набора команд, созданных в скрипте prepare. Каждая команда может как сама выполнять преобразования, так и делегировать эту работу внешней программе.

Входные артефакты

В качестве входных артефактов для правила преобразования выступают файлы собираемого продукта с тегом указанным в свойстве inputs, а также артефакты полученные из зависимостей собираемого продукта с тегом указанным в свойстве inputsFromDependencies (неявным является тег "installable", который присваивается всем файлам которые необходимо проинсталлировать, т.е. qbs.install: true).

Например:

---product1.qbs---

Application {

name: "simpleApplication";

targetName: "appSimple"

files: ["main.cpp", "app.h", "app.cpp"]

Depends {name: "cpp"}

}

---product2.qbs---

Product {

type: "exampleArtefact"

name: "example"

targetName: "myArtefact"

Depends {name: "simpleApplication" }

Depends {name: "exampleModule" }

Group {

files: ["description.txt", "readme.txt"]

fileTags: ["txtFiles"]

}

Group {

files: ["imgA.png", "imgB.png", "imgC.png"]

fileTags: ["pngFiles"]

}

Group {

files: ["fontA.ttf", "fontB.ttf"]

fileTags: ["fontFiles"]

}

}

---exampleModule.qbs---

Module {

Rule {

inputs: ["pngFiles", "fontFiles"]

inputsFromDependencies: ["application"]

Artifact {

filePath: product.targetName + ".out"

fileTags: ["exampleArtefact"]

}

...

}

...

}

В данном примере у нас есть 2 продукта и 1 модуль:

- Продукт с названием simpleApplication имеющий тип application (элемент Application по сути является Product {type: «application»}) содержащая 3 файла: main.cpp, app.h, app.cpp. Этот продукт зависит от модуля cpp, что указывает на то, что будет выполняться компиляция этого продукта компилятором C++ и на выходе получится артефакт помеченный тегом «application» и названием указанным в свойстве targetName, т.е. appSimple.exe (для windows или appSimple для unix платформ).

- Продукт с названием example имеющий тип exampleArtefact содержащий 7 файлов помеченных тремя тегами. Этот продукт зависит от продукта simpleApplication, что указывает на то, что он будет обрабатываться после создания продукта simpleApplication. А также от модуля exampleModule, что указывает на то, что для создания данного продукта будут браться правила преобразования и свойства из этого модуля. И на выходе ожидается артефакт с названием myArtefact типа (с тегом) exampleArtefact.

- Модуль exampleModule содержит правило преобразования файлов с тегами pngFiles и fontFiles, а также артефактов имеющих тег application, которые берутся из зависимостей собираемого продукта.

При сборке продукта будет определен список модулей от которых зависит продукт и сами модули. В них будет осуществлен поиск правил преобразования файлов помеченных входными тегами в выходные артефакты, которые соответствуют типу собираемого продукта. Сначала собирается продукт simpleApplication, т.к. он имеет зависимость только от модуля cpp. В нем ищутся правила преобразования файлов продукта в тип application. В модуле cpp есть элементы FileTagger которые по шаблону задают для файлов продукта теги. Преобразование входных файлов в выходной(ые) может быть выполнено как сразу, так и по цепочке преобразований файлов одного типа в другой, а затем в итоговый. На выходе обработки продукта simpleApplication, мы получим приложение appSimple имеющее тип (тег) application.

Затем начнется сборка продукта example. Для его файлов будет искаться правило, на выходе дающее артефакты типа exampleArtefact. Это правило требует для входа файлы типа (с тегом) pngFiles, fontFiles и application. При этом файлы типа application ищутся только в продуктах от которых зависит собираемый продукт. Так как продукт example уже содержит такие файлы, то на вход правила поступают файлы: imgA.png, imgB.png, imgC.png, fontA.ttf, fontB.ttf и appSimple.exe. А на выходе получим файл myArtefact.out типа exampleArtefact, который и будет являться нашим конечным продуктом.

Выходные артефакты

В качестве выходных артефактов для правила могут быть как один, так и несколько артефактов. Для описания выходных артефактов используется элемент Artifact:

Artifact {

filePath: input.fileName + ".out"

fileTags: ["txt_output"]

}Этот элемент описывает, какой артефакт получается на выходе правила. Через свойство filePath — указывается имя выходного файла. Если указывать относительный путь, то Qbs будет создавать этот артефакт относительно каталога сборки текущего собираемого продукта. Через свойство fileTags указывается список тегов, которые будет иметь артефакт после его создания. Это необходимо, для того чтобы другие правила сборки могли использовать выходные артефакты данного правила, как свои входные артефакты. Также если продукт будет иметь этот же тег в качестве своего типа, то эти артефакты будут являться результатом сборки этого продукта.

У каждого правила должен быть хоть один выходной тег, иначе правило работать не будет. Если артефактов несколько, то можно описать несколько элементов Artifact либо можно воспользоваться свойствами outputArtifacts и outputFileTags для элемента Rule.

Свойство outputArtifacts описывает список JavaScript объектов имеющих свойства, как у элемента Artifact. Используется это свойство для случаев, когда набор выходов не фиксирован, а зависит от содержания входных данных. Например:

outputArtifacts: [{

var artifactNames = inputs["pngFiles"].map(function(file){

return "pictures/"+file.fileName;

});

artifactNames = artifactNames.concat(inputs["fontFiles"].map(function(file){

return "fonts/"+file.fileName;

}));

artifactNames = artifactNames.concat(inputs["application"].map(function(file){

return "app/"+file.fileName;

}));

var artifacts = artifactNames.map(function(art){

var a = {

filePath: art,

fileTags: ["exampleArtefact"]

}

return a;

});

return artifacts;

}]В данном примере показано, что для входных файлов с тегом pngFiles, правило подготовит выходной артефакт с таким же названием и поместит его в папку pictures. Для тегов fontFiles и application, также поместив их соответственно в папки fonts и app. При этом т.к. пути будут относительные, то эти папки создадутся в папке сборки продукта.

Если мы решили использовать свойство outputArtifacts, то необходимо указать и свойство outputFileTags, которое является списком выходных тегов, которые правило потенциально производит. Для нашего примера:

outputFileTags:

["exampleArtefact"]Все полученные при сборке продукта артефакты, помеченные выходным тегом совпадающим с типом продукта, при установке продукта, будут скопированы из каталога сборки в каталог установки.

Правило преобразования

Когда определены входные и выходные артефакты, необходимо подготовить саму последовательность команд для выполнения преобразования. Для этого используется свойство prepare элемента Rule. Это свойство является JavaScript сценарием, который возвращает список команд для преобразования входов в выходы. Код в этом скрипте рассматривается как функция с сигнатурой function(project, product, inputs, outputs, input, output).

Параметры input и output не определены (undefined), если для этого правила имеется несколько артефактов ввода (и вывода соответственно). Служат они как синтаксический сахар: input = inputs[0] и output = outputs[0] и являются списками с одним элементом. Параметры project и product, являются JavaScript объектами, через которые доступны свойства текущего проекта и продукта соответственно. Особый интерес вызывают объекты inputs и outputs. Рассмотрим их более подробно.

Объекты inputs и outputs

Параметры inputs и outputs являются объектами JavaScript, ключи свойств которых являются файловыми тегами, а значениями свойств — являются списки объектов, представляющих артефакты, соответствующие этим тегам. В нашем примере переменная inputs имеет 3 ключа: pngFiles, fontFiles, application. А каждый входной артефакт доступен через inputs[«pngFiles»] (или inputs.pngFiles что равнозначно). Каждый артефакт в этом списке имеет следующие свойства:

- baseName — базовое имя файла (например для файла c:\123\test.plugin.dll это будет test)

- completeBaseName — название файла без расширения (например для файла c:\123\test.plugin.dll это будет test.plugin)

- fileName — название файла (например для файла c:\123\test.plugin.dll это будет test.plugin.dll)

- filePath — полный путь до файла с его полным именем

- fileTags — список тегов присвоенных артефакту

Помимо этого артефакты содержат в себе все свойства для каждого модуля, который используется в продукте. Эта особенность может использоваться для доступа к свойствам модуля. Например, свойство inputs.application[0].cpp.defines вернет для артефакта simpleApplication список определений, который будет передан при компиляции соответствующего файла. Это очень удобный и важный момент, позволяющий артефактам задать через свойства какого-нибудь модуля свои значения и группировать такие артефакты или обрабатывать их как-то по особенному.

* Было подмечено на Qbs версии 1.7.2, что если продукт подменяет свойства модуля в котором находится правило сборки, то эти свойства недоступны в артефакте. По этому эти свойства я выносил в отдельный модуль.

* Также inputs.application[0].cpp.defines не всегда срабатывает, по этому я использую функцию inputs.application[0].moduleProperty(«cpp», «defines»). Если эту функцию применять к входному артефакту, то будут возвращаться свойства которые использует артефакт в указанном модуле. Если же применять ее к продукту (например product.moduleProperty(«cpp», «defines»), то возвращаться будут свойства указанного модуля, которые использует собираемый в данный момент конечный продукт.

* Очень удобной функцией является dumpObject(object) из модуля ModUtils, которая выводит в консоль информацию о свойствах переданного в него параметра. Правда и она не всегда показывает свойства используемых в артефактах модулей.

Команды

В качестве результата выполнения скрипта выступает список команд. Команда — это то, что Qbs выполняет во время сборки. Команда всегда создается в сценарии подготовки правила. Команды бывают двух типов:

- Command, который запускает внешний процесс

- JavaScriptCommand, который выполняет произвольный код JavaScript (хотя может также запускать внешние процессы)

Для обоих типов команд доступны свойства:

- description — строка, показываемая в консоли при выполнении данной команды

- extendedDescription — строка детальной информации, показываемой в консоли при расширенном выводе

- highlight — тип (тег) команды. Влияет на то, как будет показываться description в консоли. Может быть: compiler, linker, codegen, filegen и пр.

- silent — скрывать ли вывод description при выполнении команды

Для использования Command, необходимо создать объект передав в его конструктор полный путь до исполняемой программы и список аргументов.

var myCommand = new Command("dir", ["/B", "/O", ">>", output.filePath]);Например данная команда запишет вывод команды dir в выходной файл правила сборки.

Полезными свойствами, позволяющими обойти ограничение Windows на длину командной строки являются свойства:

- responseFileThreshold содержит значение. Если это значение больше нуля и меньше длины полной командной строки, и если responseFileUsagePrefix не пуст, то содержимое командной строки перемещается во временный файл, путь которого становится полным содержимым списка аргументов. Затем программа должна прочитать полный список аргументов из этого файла. Этот механизм будет работать только с программами, которые явно поддерживают его.

- responseFileArgumentIndex — указывает индекс первого аргумента для включения в файл ответов.

- responseFileUsagePrefix — содержит префикс, который сообщает программе, что остальная часть аргумента — это путь к файлу, содержащему фактическую командную строку.

Для обработки вывода выполняемой команды могут применяться свойства:

- stderrFilterFunction — функция с входным параметром равным выводу программы в stderr и которая должна вернуть преобразованную строку для дальнейшего вывода.

Если не задана, то обработки не будет производиться. - stdoutFilterFunction — аналогичная stderrFilePath, только работающая с stdout

- stdoutFilePath — название файла, кода направляется отфильтрованный ранее вывод stdout. Если не задан, то вывод будет производиться в консоль

- stderrFilePath — аналогичная stdoutFilePath, только работает с stderr

JavaScriptCommand команда — представляет собой JavaScript функцию, которая будет выполняться при сборке. Задается это функция в свойстве sourceCode. В исходном коде функции доступны project, product, inputs и outputs (дающий доступ к свойствам проекта, продукта, входных и выходных артефактов соответственно). Чтобы передать в функцию произвольные данные, то для команды надо добавить произвольные свойства и присвоить им нужные значения. Например так:

var cmd = new JavaScriptCommand();

cmd.myFirstData = "This is 1 string";

cmd.mySecondData = "This is 2 string";

cmd.sourceCode = function() {

console.info("String from source code"); // -->> "String from source code"

console.info("Property 1: "+myFirstData); // -->> "Property 1: This is 1 string"

console.info("Property 2: "+mySecondData); // -->> "Property 2: This is 2 string"

};В функции, также можно использовать разные доступные сервисы:

- Environment Service — для доступа к системной среде и среде разработки

- File Service — для работы с файлами (копирование, перемещение, удаление файлов, проверки существования файла и даты модификации, создания путей и сканирования директории на содержимое)

- FileInfo Service — операции обработки пути к файлу (получение базового имени файла, пути к нему, получение относительного пути и т.п.)

- General Services — дополнительные функции расширяющие функционал обработки строк, массивов и т.п.

- Process Service — функции позволяющие запускать и управлять внешними программами, а также работать с его входом и выходом

- PropertyList Service — функции для работы со списками свойств в форматах JSON, XML, binaty и OpenStep для платформ Darwin (iOS, macOS, tvOS, и watchOS)

- TemporaryDir Service — функции для создания и управления временным каталогом

- TextFile Service — функции для работы с текстовыми файлами и позволяющие читать/писать из/в них.

- Utilities Service — функции для получения хешей

Прочие свойства элемента Rule

У элемента Rule также есть несколько дополнительных свойств:

Свойство multiplex, необходимо для указания порядка обработки входных артефактов. При multiplex=true, создается одна копия правила для всех входных артефактов и они обрабатываются все скопом. Таким образом в свойстве inputs будут все входные артефакты. Применяется в случаях, когда надо производить групповую обработку входных артефактов. Если же multiplex=false, то для каждого входного артефакта будет создаваться отдельная копия правила преобразования и будет создаваться свой выходной артефакт. Таким образом свойство inputs будет содержать всегда один элемент. По умолчанию это свойство имеет значение false.

Свойство condition, указывает на условие выполнения правила. Например, указать, что преобразование будет выполняться только в режиме release и для платформы windows.

qbs.buildVariant === "release" && qbs.targetOS.contains("windows") Свойство explicitlyDependsOn представляет собой список тегов. Каждый артефакт, тег которого совпадает с тегом перечисленным в этом свойстве, ставится в зависимость для каждого выходного артефакта. Таким образом на выходе мы можем получить выходные артефакты с уже подготовленными зависимостями для дальнейшей обработки.

Свойство alwaysRun указывает, на условия выполнения команд в правиле. Если alwaysRun=true, то команды будут всегда выполняться, даже не взирая на то, что выходные артефакты уже обновлены. По умолчанию равно false.

Пример подготовки правила преобразования

В качестве примера правила приведу следующую задачу:

Имеется проект, из нескольких программ и библиотек, для которого необходимо скопировать все необходимые для работы программ Qt библиотеки и плагины в заданную директорию. Для этого создаем модуль с правилом преобразования и самостоятельный продукт, который будет зависеть от всех продуктов проекта, для которых и необходимо подготовить Qt библиотеки. Дополнительно надо подготовить тестовый файл с указанием всех подготовленных Qt библиотек.

-- MyWindowsDeploy.qbs --

import qbs

import qbs.ModUtils

Module {

Rule {

condition: qbs.targetOS.contains("windows") //запускается только для windows

multiplex: true //обрабатываем все входные артефакты одним трансформером

alwaysRun: true //всегда выполнять правило

inputsFromDependencies: ["installable"] //брать устанавливаемые артефакты от зависимостей собираемого продукта

Artifact {

filePath: "Copied_qt_libs.txt";

fileTags: ["deployQt"];

}

prepare: {

var cmdQt = new JavaScriptCommand();

//определяем путь до windeployqt.exe

cmdQt.windeployqt = FileInfo.joinPaths(product.moduleProperty("Qt.core", "binPath"), "windeployqt.exe");

//задаем строку для вывода в консоли

cmdQt.description = "Copy Qt libs and generate text file: "+output.fileName;

//указываем развернутую информацию по выполняемой команде

cmdQt.extendedDescription = cmdQt.windeployqt + ".exe " +

["--json"].concat(args).concat(binaryFilePaths).join(" ");

//путь до папки, куда надо копировать qt библиотеки ("<папка установки>/QtLibs")

var deployDir = FileInfo.joinPaths(product.moduleProperty("qbs","installRoot"),

product.moduleProperty("qbs","installDir"));

deployDir = FileInfo.joinPaths(deployDir, "QtLibs");

cmdQt.qtLibsPath = deployDir;

//определяем аргументы запуска программы

cmdQt.args = [];

cmdQt.args.push("--libdir", deployDir);

cmdQt.args.push("--plugindir", deployDir);

cmdQt.args.push("--no-translations");

cmdQt.args.push("--release");

//полное имя файла для записи вывода.

cmdQt.outputFilePath = output.filePath;

//определяем список путей установки программ и библиотек, от которых зависит продукт

cmdQt.binaryFilePaths = inputs.installable.filter(function (artifact) {

return artifact.fileTags.contains("application")

|| artifact.fileTags.contains("dynamiclibrary");

}).map(function(a) { return ModUtils.artifactInstalledFilePath(a); });

cmdQt.sourceCode = function(){

var process;

var tf;

try {

//выводим значения параметров

console.info("windeployqtRule: outputFilePath: "+outputFilePath);

console.info("windeployqtRule: qtLibsPath: "+qtLibsPath);

console.info("windeployqtRule: windeployqt: "+windeployqt);

console.info("windeployqtRule: windeployqtArgs: "+windeployqtArgs.join(", "));

console.info("windeployqtRule: binaryFilePaths: "+binaryFilePaths.join(", "));

//создаем папку куда будут скопированы библиотеки Qt

File.makePath(qtLibsPath);

//создаем процесс

process = new Process();

//запускаем процесс

process.exec(windeployqt,

["--json"].concat(windeployqtArgs).concat(binaryFilePaths), true);

//читаем вывод программы

var out = process.readStdOut();

//парсим выходной JSON

var inputFilePaths = JSON.parse(out)["files"].map(function (obj) {

//определяем полный путь доя скопированной библиотеки

var fn = FileInfo.joinPaths(

FileInfo.fromWindowsSeparators(obj.target),

FileInfo.fileName(

FileInfo.fromWindowsSeparators(

obj.source)));

return fn;

});

//создаем файл

tf = new TextFile(outputFilePath, TextFile.WriteOnly);

//пишем заголовок

tf.writeLine("Copied Qt files:");

inputFilePaths.forEach(function(qtLib){

tf.writeLine(qtLib); //записываем в выходной файл полный путь до скопированной библиотеки

});

} finally {

if (process)

process.close();

if (tf)

tf.close();

}

}

return [cmdQt];

}

}

}

-- ProductDeploy.qbs --

import qbs

Product {

//продукт представляет собой результат деплоя Qt библиотек для продуктов от которых он

//зависит в виде скопированных библиотек и текстового файла

type: ["deployQt"]

// указываем зависимость от модуля в котором есть правило преобразования

Depends { name: "MyWindowsDeploy" }

// указываем зависимость от продуктов, для которых

// надо подготовить Qt библиотеки, плагины и пр.

Depends { name: "libratyA" }

Depends { name: "libratyB" }

Depends { name: "applicationA" }

Depends { name: "applicationB" }

Depends { name: "applicationC" }

condition: qbs.targetOS.contains("windows") // собирать только для windows

builtByDefault: false // собирать ли продукт при общей сборке проекта

qbs.install: true

qbs.installDir: "MyProject/qtDeploy"

}Ссылки

- doc.qt.io/qbs/index.html — официальная документация

- habrahabr.ru/post/144127 — знакомство с Qbs

- www.opennet.ru/opennews/art.shtml?num=33102 — новость о презентации Qbs

- stackoverflow.com/questions/tagged/qbs — вопрос-ответ по возникающим проблемам

- github.com/qt-labs/qbs — git репозиторий

|

Метки: author hooligan системы сборки qt qbs |

[Из песочницы] Mikrotik. QoS для дома |

Статья не претендует на охват всей информации по QoS на Mikrotik. Это демонстрация набора правил, позволяющих настроить несложную схему приоритезации трафика и пополнять её по мере необходимости.

Надеюсь, коллеги помогут советами в комментариях.

Говоря о QoS, обычно подразумевают два направления — более или менее равномерное деление канала по количеству пользователей, либо приоритезацию трафика. Направления эти вполне дополняют друг-друга, но для дома, для семьи заниматься делением канала я смысла не вижу и, если вас интересует эта тема, сошлюсь на исчерпывающе раскрывающую тему статью «MikroTik QoS — развенчание мифов».

Я же сосредоточусь на приоретизации трафика, благо это несколько проще.

Ограничение скорости передачи данных может быть выполнено двумя способами:

1. Отбрасываются все пакеты, превышающие лимит скорости передачи (шейпер).

2. Задержка превысивших заданное ограничение скорости передачи пакетов в очереди и отправка их позже, как только появляется такая возможность, т.е. выравнивание скорости передачи (шедулер).

Как видно на иллюстрации, шейпер режет всё, что не влезло, а шедулер просто притормаживает.

Соответственно, именно шедулер нам и нужен.

Теперь необходимо поделить трафик на классы и задать каждому классу свой приоритет. Первый класс обслуживается в первую очередь, последний — в последнюю.

Самый простой вариант такого решения, который зачастую и используется — просто пустить приоритетом VoIP-трафик, а весь остальной по остаточному принципу, но я сделаю чуть сложнее.

Итак, план таков:

prio_1: DNS, ICMP, ACK — в первую очередь идёт служебный трафик. Установка и разрыв соединений, резолвинг имён и т.п.

prio_2: SIP — VoIP очень любит минимальные задержки.

prio_3: SSH и игры — удалённый доступ важен для работы. Игры — для отдыха.

prio_4: RDP и HTTP/HTTPS — веб, видео и т.п.

prio_5: всё, что не опознано выше — в принципе, можно принудительно загнать сюда торренты. Благо дома порты с которых работают клиенты вполне известны..

Маленькое лирическое отступление: