Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Машинное обучение и анализ данных: решаем практические задачи с победителями индустриального хакатона ЛК |

Как вычислить замыслы киберпреступников, атакующих промышленный объект и распознать слабые сигналы SOS, которые периодически подает индустриальная АСУ ТП на фоне “нормального” поведения, – об этом и многом другом поговорим уже в ближайшую среду, 7 июня, на встрече CoLaboratory: Deep Learning в центральном офисе “Лаборатории Касперского”. Всех неравнодушных к теме промышленной безопасности ждет захватывающее погружение в мир машинного обучения и анализа данных под руководством победителей весеннего индустриального хакатона ЛК и экспертов нашей компании.

Герои вечера расскажут о том, как сразиться с огромным 44 Гб дата-сетом технологических сигналов индустриальной системы и выйти победителем, обнаружив атаки, которые почти невозможно идентифицировать. Причем, на суд публике будут представлены два решения этой задачи – от участников хакатона и от его составителей.

Так, победители хакатона расскажут о том, как:

- превратить нахождение аномального поведения в логах заводских приборов в задачу обычной классификации;

- как за короткое время сгенерировать легкие, но полезные фичи, характеризующие временной ряд целиком;

- как разделить работу внутри команды;

- как «на коленке» смешивать разные модели на одном наборе признаков;

- как поднять AUC с помощью kNN – вишенки на торте Competitive Data Science.

Небольшой спойлер: подход наших героев базируется на «трех китах»:

- ключевом решении на основе подсчета статистик временных рядов в качестве признаков;

- кодировании подряд идущих разреженных состояний системы вектором признаков;

- выявлении аномалий с помощью LSTM, идеям по их модификациям.

Ну а эксперты со стороны «Лаборатории Касперского» поделятся своим видением проблемы анализа данных ACУ ТП: какими критериями они руководствовались при составлении заданий и дата-сета для участников, чего ожидали от команд и что вышло в итоге.

Словом, 7 июня в 19.00 ждем всех желающих попрактиковаться в Deep Machine Learning в штаб-квартире ЛК. Зарегистрироваться на мероприятие можно тут.

|

Метки: author Kaspersky_Lab промышленное программирование информационная безопасность блог компании «лаборатория касперского» machine learning митапы асутп scada colaboratory |

Доигрались: как компании используют геймификацию в рекрутменте |

Так что в этот раз разберемся, как же геймификация может положительно или отрицательно сказываться на поиске и отборе, ну и соберем разные кейсы и стартапы (без ИИ не обошлось!).

Западные источники утверждают, что первые попытки именно с точки зрения технологий геймифицировать процесс шли от американской армии в 1999 году. Да, почти 20 лет назад это произошло. Игру-симулятор использовали для тренировки и обучения солдат. Вот слова полковника Касея Уардински, профессора Военной академии Соединенных Штатов о том, зачем была создана America’s Army: «нужно использовать компьютерные игровые технологии для предоставления виртуального солдатского опыта, который помог бы вовлечь, проинформировать и развлечь аудиторию». Никто не ожидал, что игра разрастется до таких масштабов — в неё рубятся до сих пор и даже придумали отдельный термин – militainment. Последняя версия вышла в 2013 году.

С того момента тема с геймификацией в рекрутменте внезапно бомбанула.

Но до сих пор остаются вопросы: на какой стадии введение игры может принести максимум пользы? как сделать так, чтобы это стоило не *арды? как учесть географический фактор и не облажаться? Попробуем посмотреть кейсы разных компаний и обратиться с исследованиям.

// Почему геймификация — это хорошо?

Наиграл

Среднестатистический западный миллениал (окей, подросток) к 21 году уже наиграет на 10,000 часов. Глупо не использовать это, чтобы обучить молодых специалистов чему-нибудь или продвигать среди них бренд работодателя.

Пирамида Маслоу уже не та

Есть исследование Cisco System (аж 2011 года), в котором отмечается, что для поколения Y интернет приравнивается к наличию кислорода, воды, еды и крыши над головой.

Кинь в меня вызов вызов

Геймификация хороша, когда как-то резонирует с интересами вашей аудитории. Но при этом и позволяет вам заинтересовать потенциальных кандидатов в той сфере, которая кажется им совершенно непривлекательной.

Отличный пример умения привлечь свою ЦА — попробуйте последить за активностью General Electric в последнее время — они используют разные вирусные видео, запускают подкасты и вовлекают через разные каналы аудиторию, меняя представление о работодателе и его миссии.

Цена вопроса

Геймификация — это не обязательно очень дорого и пафосно. Подобные технологии (с меньшим размахом, чем у US Army) могут стоить не очень дорого, к тому же можно воспользоваться услугами разных платформ. Также вполне можно попробовать внедрять геймификацию постепенно без затрат: делиться с аудиторией кейсами компании и поощрять тех, кто успешно справляется.

// А почему это может не работать в ряде случаев?

Сложность в том, что нужно сделать так, чтобы пользователь был вовлечен.

Геймификация — это всё же история не про игры. Это история про интерес и креативный подход, который помогает вам тестировать навыки кандидатов, а также влиять на восприятие бренда работодателя. Так что первым крупным косяком мы бы смело назвали — неумение ставить цели и понимать задачи геймификации. А также желание назвать геймификацией любого рода тестик. Нет, это всё не то!

1. Геймификация может быть нужна для тестирования профессиональных навыков кандидата. Это сложные задания, замороченные ассессмент-тесты.

2. Геймификация может быть нужна для вовлечения в процесс отбора и укрепления бренда работодателя.

И если первое уже сейчас плотно связывают с разными технологиями вроде искусственного интеллекта (вот исследование, посвящённое такого рода инструментам) и большими тратами, а также необходимостью подходить к вопросу научно, то креативный подход к отбору доступен всем компаниям и не требует огромных средств.

Ещё один пункт не в пользу геймификации: сложно измерить ROI. Вообще с играми и аналитикой есть отдельные вопросы. Распределение средств и усилий на создание такого рода этапа в отборе должно быть осмыслено, разложено по полочкам и вы вместе с командой должны очень точно понимать: ЗАЧЕМ ВАМ ЭТО НННАДА.

// Окей, какие кейсы вы приведете как примеры?

Мы приведем вам примеры, которые в большей степени связаны с креативным подходом к использованию игр в рекрутменте. Это проще и доступнее сейчас с точки зрения технологий в России и мы нашли конкретные кейсы. О внедрении сложных инструментов на базе ИИ пока говорить сложно, но об этом чуть дальше поговорим.

Linkedin как самый простой пример

Сейчас (может быть) мы вас удивим — вы тоже участвуете в геймификации. Если зарегистрированы на Linkedin. И если вы думаете, что элемент игры — это попытка обойти блокировку, то нет! На Linkedin вы, набирая контакты, условно перемещаетесь по уровням. То есть чем больше ваш “нетворк”, тем круче вы в системе.

Работает ли?

Да, потому что сейчас модно и круто иметь кучу друзей на FB и в Linkedin. Это как новый способ измерять влиятельность человека. Впрочем, довольно странный.

Goodby Silverstein & Partners в поисках секретаря

Один из самых интересных кейсов на нашей памяти — work4rich от компании Goodby Silverstein & Partners. В общем, искала компания своему боссу ассистента.

И создали они целый лендинг с абсолютно дурацкими странными заданиями и играми на расшифровку, например, звонка человека, который очень быстро говорит. А ещё надо было правильно расставить встречи с разными персонажами. Никакого смысла и логики почти.

15,000 человек прошли тест (!), потом они показали резюме кандидатов психиатру — да, всё в этой рекрутинговой кампании было странновато — а та отобрала самую крепкую, стрессоустойчивую и очень красивую девушку Грейс, которая до сих пор работает ассистентом руководителя. И если вам кажется, что это бестолковая история, то задумайтесь о том, что компания Goodby Silverstein & Partners вдруг прошла шумной волной по всему свету. Честь их бренду работодателя и хвала!

Сработало ли?

Конечно! Очевидно, были потрачены силы и средства на разработку лендинга, а также на разбор резюме, зато как много людей узнали о компании и о том, какие сумасшедшие ребята там работают. Второму отклику на вакансию от Goodby Silverstein & Partners быть без сомнений.

Убер как Большой брат

Ещё, конечно, стоит сказать о том, как продукты учатся внутри своего же функционала внедрять геймификацию.

И тут слово предоставляется Uber. В 2016 году они запустили сервис тестинга потенциальных кандидатов в рамках приложения. Вы садитесь в такси, и тут ваш же смартфон предлагает за три минуты решить три задачи. Если всё получается, то сразу появляется ссылка на вакансию. Задания появляются только в городах, где много it-компаний. Uber использует данные о маршрутах и предлагает сыграть только тем, кто часто бывает у офисов, сотрудники которой в основном занимаются разработкой. Игра была доступна только в Сиэттле, Денвере, Остине, Бостоне, Портланде — это действительно города в США, где концентрация it-специалистов высока.

Сработало ли?

Не сказать, что игра была воспринята с энтузиазмом. Во-первых, не очень круто ощущать, что твои поездки с такой регулярностью и тщательностью анализируют. Большой брат и всё такое. Во-вторых, как сказал один из участников этого эксперимента: “Я не уверен, что проходить шестидесяти секундные тесты Uber при водителе, который всё время пытается с тобой о чём-то поговорить, это хорошая идея”. И он прав.

Питчингуй пока молодой

Ещё один кейс, о котором обязательно нужно упомянуть — Saatchi&Saatchi и их игра для мобильных устройств. В компании разработали приложение, с помощью которого можно было отправить свою идею: записать или сфотографировать. И получить фидбек. Так они искали нового креативного директора, который предложит что-то совершенно уникальное потенциальным коллегам.

Сработало ли?

Да, о кампании написали крупнейшие издания. Шум — уже успех для HR-бренда. Ну и позицию они успешно закрыли.

Шпион на шпионе

“Окей,” — думаете вы, — “всё это крупные компании с кучей денег!”

Но это не так. Вот GCHQ (Government Communications Headquarters) в Великобритании, что тоже самое что АНБ в США или ФСБ у нас, запустили целую кампанию для поиска юных талантов, способных защитить Англию от кибератак. Сложный пазл для любителей поломать голову, систему и код — только 1% кандидатов решили поставленную перед ними задачу. А кандидатов было 400,000 человек. С тех пор GCHQ ищут только тех, чьи таланты открываются на деле. Только секретном.

Сработало ли?

Хорошо отразилось на лояльности. Тут, конечно, говорить о бренде работодателя так смело мы бы не стали, но действительно практика использования подобных способов привлечения специалистов даже в рамках государственных структур — это прекрасно.

Для любителей пазлов. Алгоритмических.

Google Code Jam — хороший пример. Тем, кто хочет попробовать свои силы, а ещё получить место в Google, предлагают пройти несколько раундов, решая алгоритмические пазлы. Звучит сложно, а на деле ещё сложнее. Огромное количество участников, разные технологии и языки, соревнование по количеству набранных баллов, в общем, настоящая геймификация и ЦА идеальна. У IBM и Miscrosoft тоже похожие состязания есть.

Работает ли?

Да. Но, конечно, это особенная ниша — крупные и классные компании могут позволить себе вовлекать потенциальных кандидатов в решение подобных задач, а также в работу над разными кейсами. Сейчас это модно, как и хакатоны.

Гордона Рамзи на вас нет

Есть у нас и ещё один кейс — My Marriot Game. Это игра, в которую можно было играть прямо на Facebook от Marriot. Сейчас она уже закрыта, так что можем только скриншотом поделиться:

Нужно было управлять работой кухни, следить за настроением сотрудников, расставлять предметы на кухне. В общем, почувствовать себя в шкуре настоящего работника. Игра выглядит просто, никаких наворотов и никакого особенно красивого интерфейса. Но её уже больше 5 лет приводят как пример крутой геймификации в рекрутменте. Особенно с точки зрения бренда.

Работает ли?

Работает и выполняет свою функцию. Наверняка Marriot ещё очень грамотно собирали данные об игроках. Не нашли точных цифр о том, сколько людей устроились благодаря игре, но раз до сих пор о ней столько говорят, Marriot'у ставим пять :)

Поделись задачею своей

Ещё есть платформы кейсов наподобие Hackertrail — ресурс, на котором работодатели и кандидаты находят друг друга. Кандидат откликается на позицию, решает какой-нибудь кейс, например, взламывая сайт (бугага!). И вот он уже сидит на собеседовании в компании своей мечты и он молодец. Платформа простейшая. И даже как таковая не нужна — вы же можете выкладывать имеющиеся у вас задачи для потенциальных кандидатов где угодно. На своей карьерной странице или даже в социальных сетях. Нужно только придумать кейс.

Работает ли?

Да. И вообще не требует особых затрат. Существуют разные ресурсы, на которых вы можете выложить какую-то задачу для своих потенциальных кандидатов. Минимальный элемент геймификации, а уже повышаете вовлеченность аудитории. Бинго.

// Понятно, что все такие молодцы! А теперь расскажите про стартапы в сфере геймификации рекрутмента.

Knack — приложение, в котором вы (если вы кандидат) сначала отвечаете на простейшие вопросы, а потом вам предлагают установить какие-нибудь игру. Затем все ваши показатели активности, ловкости и так далее анализируются.

Работодателям предлагают использовать эту площадку вообще в любых целях: карьерное консультирование, рекрутмент, вовлечение персонала, работа в команде. Компании нужно только зарегистрироваться и выбрать (или создать игры), соответствующую её потребностям.

Подобная платформа — Arctic Shores. Game-Based Assessments — снова несколько игр, в которые можно поиграть, чтобы потом ваши навыки оценили и куда-нибудь может позвали.

Ещё мы уже как-то рассказывали про Pymetrics и Pomello — сервисы, которые точно знают, какая позиция подойдёт кандидату и в какой компании. Если вы кандидат, то получить доступ к сервису можно бесплатно и начать играть – с помощью простых головоломок и задач сервис оценивает мотивацию, способность удерживать внимание и подсказывает, какая должность подходит кандидату больше всего.

Pomello — компании на этой платформе предлагают кандидатам пройти тесты и принять участие в играх (на 5-10 минут), которые позволяют понять, насколько он и компания-работодатель совместимы. Все «упражнения», как и в Pymetrics, сформированы на основе исследований, проведённых конкретно в каждой компании, на основе изучения особенностей работы команды.

И это работает?

Здесь нужно много раз и прям жирным шрифтом написать AI / ИИ / Искусственный интеллект. И трижды подчеркнуть. Как это сделано на лендингах всех этих стартапов.

Но пока все инструменты, которые мы пытались покликать и оценить, не очень похожи на настоящие платформы для тестирования на базе AI. К тому же, невозможно оценить, работают ли они и приносят ли толковый результат (есть слухи, что пока это только маркетинг и ничего прям ВАУ там нет).

Тем более в России, где на рынке HR-технологий пока только отстаивают свою позицию ATS, говорить о такого рода инструментах рано. Сложные и реально дорогие платформы геймификации только начинают внедрять модные западные компании, которые готовы к экспериментам и к встряске бюджета.

Уже сейчас на западе постепенно появляются также simulation-based assessments. И здесь уже речь идет о виртуальной реальности, носимых технологиях, технологиях анализирующих движения и язык тела — вот это всё и много больше.

// К какому выводу мы пришли?

Компании, которые придумывают креативные способы привлечения и отбора кандидатов, получают не просто хороших специалистов, они укрепляют бренд работодателя, повышают лояльность, да просто приносят удовольствие кандидатам.

И в этом процессе вот вообще далеко не всегда нужен искусственный интеллект (хотя мы ждем прорывных инструментов, что уж тут!). Начать можно с нетривиального технологического подхода к отбору. Как это сделали компании, о которых мы рассказали выше.

|

|

Unity: система сохранения для любого проекта |

1) Написал один раз и используй в любом проекте для любых сущностей. Ну, насколько возможно.

2) Создал сущность — и она сохраняется сама собою, с минимумом дополнительных усилий.

Решение пришло из стана синглтонов. Не надоело ли вам писать один и тот же синглтон-код? А меж тем есть generic singleton. Вот как он выглядит для MonoBehaviour

using System.Collections;

using System.Collections.Generic;

using UnityEngine;

public class GenericSingleton : MonoBehaviour {

static GenericSingleton instance;

public static GenericSingleton Instance { get { return instance; } }

void Awake () {

if (instance && instance != this)

{

Destroy(this);

return;

}

instance = this;

}

}

public class TestSingletoneA : GenericSingleton {

// Use this for initialization

void Start () {

Debug.Log("A");

}

}

Т.е. можно сделать Generic класс, статические поля которого будут уникальны для каждого входного типа.

И это как раз наш случай. Потому что поведение сохраняемого объекта полностью идентично, различаются только сохраняемые модели. И тип модели как раз и выступает в качестве входного.

Вот код интерфейса модели. Он примечателен тем, что метод SetValues примет в качестве аргумента только модель такого же (или производного) типа. Не чудо ли?

///

/// Voloshin Game Framework: basic scripts supposed to be reusable

///

namespace VGF

{

//[System.Serializable]

public interface AbstractModel where T : AbstractModel, new()

{

///

/// Copy fields from target

///

/// Source model

void SetValues(T model);

}

public static class AbstratModelMethods

{

///

/// Initialize model with source, even if model is null

///

/// (this T model, T source) where T: AbstractModel, new ()

{

//model = new T();

if (source == null)

return;

model.SetValues(source);

}

}

}

Для модели также нужен обобщенный контроллер, но с ним связан нижеследующий нюанс, поэтому пока что опустим.

От этих классов — абстрактной модели и обобщенного контроллера можно наследовать всё, что сохраняется и загружается. Написал модель, унаследовал контроллер — и забыл, всё работает. Отлично!

А что делать с сохранением и загрузкой? Ведь нужно сохранять и загружать сразу всё. А писать для каждой новой сущности код для сохранения и загрузки в каком-нибудь SaveLoadManager — утомительно и легкозабываемо.

И тут на помощь приходят статики.

1) Абстрактный класс с protected функциями сохранения и загрузки

2) У него — статичная коллекция All, куда каждый экземпляр класса-потомка добавляется при инициализации

3) И статичные публичные функции сохранения и загрузки, внутри которых перебираются все экземпляры из All и вызываются конкретные методы сохранения и загрузки.

И вот какой код получается в результате.

using System.Collections.Generic;

using UnityEngine;

namespace VGF

{

/* Why abstract class instead of interface?

* 1) Incapsulate all save, load, init, loadinit functions inside class, make them protected, mnot public

* 2) Create static ALL collection and static ALL methods

* */

//TODO: create a similar abstract class for non-mono classes. For example, PlayerController needs not to be a MonoBehaviour

///

/// Abstract class for all MonoBehaiour classes that support save and load

///

public abstract class SaveLoadBehaviour : CachedBehaviour

{

///

/// Collection that stores all SaveLoad classes in purpose of providing auto registration and collective save and load

///

static List AllSaveLoadObjects = new List();

protected override void Awake()

{

base.Awake();

Add(this);

}

static void Add(SaveLoadBehaviour item)

{

if (AllSaveLoadObjects.Contains(item))

{

Debug.LogError(item + " element is already in All list");

}

else

AllSaveLoadObjects.Add(item);

}

public static void LoadAll()

{

foreach (var item in AllSaveLoadObjects)

{

if (item == null)

{

Debug.LogError("empty element in All list");

continue;

}

else

item.Load();

}

}

public static void SaveAll()

{

Debug.Log(AllSaveLoadObjects.Count);

foreach (var item in AllSaveLoadObjects)

{

if (item == null)

{

Debug.LogError("empty element in All list");

continue;

}

else

item.Save();

}

}

public static void LoadInitAll()

{

foreach (var item in AllSaveLoadObjects)

{

if (item == null)

{

Debug.LogError("empty element in All list");

continue;

}

else

item.LoadInit();

}

}

protected abstract void Save();

protected abstract void Load();

protected abstract void Init();

protected abstract void LoadInit();

}

} using UnityEngine;

namespace VGF

{

///

/// Controller for abstract models, providing save, load, reset model

///

/// AbstractModel child type

public class GenericModelBehaviour : SaveLoadBehaviour where T: AbstractModel, new()

{

[SerializeField]

protected T InitModel;

//[SerializeField]

protected T CurrentModel, SavedModel;

protected override void Awake()

{

base.Awake();

//Init();

}

void Start()

{

Init();

}

protected override void Init()

{

//Debug.Log(InitModel);

if (InitModel == null)

return;

//Debug.Log(gameObject.name + " : Init current model");

if (CurrentModel == null)

CurrentModel = new T();

CurrentModel.InitializeWith(InitModel);

//Debug.Log(CurrentModel);

//Debug.Log("Init saved model");

SavedModel = new T();

SavedModel.InitializeWith(InitModel);

}

protected override void Load()

{

//Debug.Log(gameObject.name + " saved");

LoadFrom(SavedModel);

}

protected override void LoadInit()

{

LoadFrom(InitModel);

}

void LoadFrom(T source)

{

if (source == null)

return;

CurrentModel.SetValues(source);

}

protected override void Save()

{

//Debug.Log(gameObject.name + " saved");

if (CurrentModel == null)

return;

if (SavedModel == null)

SavedModel.InitializeWith(CurrentModel);

else

SavedModel.SetValues(CurrentModel);

}

}

} Примеры унаследованных конкретных классов:

public abstract class AbstractAliveController : GenericModelBehaviour, IAlive

{

//TODO: create separate unity implementation where put all the [SerializeField] attributes

[SerializeField]

bool Immortal;

static Dictionary All = new Dictionary();

public static bool GetAliveControllerForTransform(Transform tr, out AbstractAliveController aliveController)

{

return All.TryGetValue(tr, out aliveController);

}

DamageableController[] BodyParts;

public bool IsAlive { get { return Immortal || CurrentModel.HealthCurrent > 0; } }

public bool IsAvailable { get { return IsAlive && myGO.activeSelf; } }

public virtual Vector3 Position { get { return myTransform.position; } }

public static event Action OnDead;

///

/// Sends the current health of this alive controller

///

public event Action OnDamaged;

//TODO: create 2 inits

protected override void Awake()

{

base.Awake();

All.Add(myTransform, this);

}

protected override void Init()

{

InitModel.Position = myTransform.position;

InitModel.Rotation = myTransform.rotation;

base.Init();

BodyParts = GetComponentsInChildren();

foreach (var bp in BodyParts)

bp.OnDamageTaken += TakeDamage;

}

protected override void Save()

{

CurrentModel.Position = myTransform.position;

CurrentModel.Rotation = myTransform.rotation;

base.Save();

}

protected override void Load()

{

base.Load();

LoadTransform();

}

protected override void LoadInit()

{

base.LoadInit();

LoadTransform();

}

void LoadTransform()

{

myTransform.position = CurrentModel.Position;

myTransform.rotation = CurrentModel.Rotation;

myGO.SetActive(true);

}

public void Respawn()

{

LoadInit();

}

public void TakeDamage(int damage)

{

if (Immortal)

return;

CurrentModel.HealthCurrent -= damage;

OnDamaged.CallEventIfNotNull(CurrentModel.HealthCurrent);

if (CurrentModel.HealthCurrent <= 0)

{

OnDead.CallEventIfNotNull(this);

Die();

}

}

public int CurrentHealth

{

get { return CurrentModel == null? InitModel.HealthCurrent: CurrentModel.HealthCurrent; }

}

protected abstract void Die();

}

namespace VGF.Action3d

{

[System.Serializable]

public class AliveModelTransform : AliveModelBasic, AbstractModel

{

[HideInInspector]

public Vector3 Position;

[HideInInspector]

public Quaternion Rotation;

public void SetValues(AliveModelTransform model)

{

Position = model.Position;

Rotation = model.Rotation;

base.SetValues(model);

}

}

} Недостатки решения и способы их исправления.

1) Сохраняется (перезаписывается) всё. Даже то, что не было изменено.

Возможное решение: проверять перед сохранением равенство полей у исходной и текущей моделей и сохранять только при необходимости.

2) Загрузка из файла. Из json, например. Вот есть список моделей. Как загрузчику узнать, какой класс надо создать для этого json-текста?

Возможное решение: сделать словарь где регистрировать типы хардкодом. При загрузке из json берется строковой идентификатор типа и инстанцируется объект нужного класса. При сохранении объект проверяет, есть ли в словаре ключ его типа, и выдает сообщение/ошибку/исключение. Это позволит стороннему программисту не забыть добавить новый тип в словарь.

Посмотреть мой код с этим и другими хорошими решениями можно здесь (проекты в начальной стадии):

FPSProject

Невероятные космические похождения изворотливых котосминогов

Замечания, улучшения, советы — приветствуются.

Предложения помощи и совместного творчества приветствуются.

Предложения о работе крайне приветствуются.

|

Метки: author Neongrey разработка игр unity3d c# .net сохранение загрузка unity юнити котосминоги |

Анонс RamblerElixir #3 |

Приглашаем разработчиков, тимлидов и всех, кто так или иначе связан с разработкой на Elixir, принять участие в RamblerElixir Meetup, который состоится 14 июня 19:00, в среду, на уютной мансарде Rambler&Co.

В программе встречи три доклада:

1. Лингвистическая относительность – Станислав Герман (Rambler&Co)

У каждого языка есть принципы, на которых он основан. Для Erlang — «Let it crash and let someone else deal with it», для Ruby — «less astonishing» и «programmer happiness», в Python такие принципы как «Explicit is better than implicit», сформулированы в «Zen of Python». В то время, как одни взгляды нам близки, а другие мы не принимаем, они формируют не только дизайн языка и архитектуру библиотек и систем, которые разрабатываются на этом языке, но и сообщество разработчиков вокруг этого языка. В своем докладе я рассмотрю какие принципы заложены в Elixir, чем знание этих принципов полезно разработчику, и как они влияют на код, который мы пишем и используем в своей работе.

2. Трюки с ETS – Алексей Никитин (Bookmate)

У меня сложилось впечатление, что в Elixir-сообществе незаслуженно подзабыли про такую штуку как ETS. Про этот мощный инструмент, который предоставляет платформа. Я расскажу несколько хитростей, которые сделают работу с ETS более удобной и как решить некоторые проблемы, которые возникают при работе с ним. Доклад будет интересен в основном новичкам. Но, возможно, и опытные разработчики смогут узнать что-то новое.

3. Фреймворк для работы с нейронными сетями на Elixir – Алексей Овчинников (Sirin)

Нейронные сети набирают всё большую популярность в ИТ-индустрии, во многом благодаря применению графических сопроцессоров. Существует множество библиотек для реализации нейронных сетей, большинство из которых написано на Python или C. Вместе с тем платформа Erlang OTP позволяет без лишних усилий реализовать отказоустойчивое приложение с высокой степенью распараллеливания вычислений, и, на наш взгляд, идеально подходит для реализации высоко интегрированного решения для обработки потокового видео с помощью нейронных сетей. Также в библиотеке реализован медиа-сервер для приёма потокового видео. Таким образом пользователь может сосредоточиться на конфигурации нейронной сети, не отвлекаясь на технические детали обработки видео.

Регистрация здесь — rambler-co-e-org.timepad.ru/event/505943

Сбор гостей в 18:30.

Начало первого доклада в 19:00.

Место проведения – Мансарда Rambler&Co, которая расположена по адресу ул. Варшавское шоссе д.9 стр.1

Приходите, будет интересно!

|

Метки: author SanDark7 ruby on rails ruby erlang/otp elixir/phoenix блог компании rambler co elixir |

Анонс RamblerElixir #3 |

Приглашаем разработчиков, тимлидов и всех, кто так или иначе связан с разработкой на Elixir, принять участие в RamblerElixir Meetup, который состоится 14 июня 19:00, в среду, на уютной мансарде Rambler&Co.

В программе встречи три доклада:

1. Лингвистическая относительность – Станислав Герман (Rambler&Co)

У каждого языка есть принципы, на которых он основан. Для Erlang — «Let it crash and let someone else deal with it», для Ruby — «less astonishing» и «programmer happiness», в Python такие принципы как «Explicit is better than implicit», сформулированы в «Zen of Python». В то время, как одни взгляды нам близки, а другие мы не принимаем, они формируют не только дизайн языка и архитектуру библиотек и систем, которые разрабатываются на этом языке, но и сообщество разработчиков вокруг этого языка. В своем докладе я рассмотрю какие принципы заложены в Elixir, чем знание этих принципов полезно разработчику, и как они влияют на код, который мы пишем и используем в своей работе.

2. Трюки с ETS – Алексей Никитин (Bookmate)

У меня сложилось впечатление, что в Elixir-сообществе незаслуженно подзабыли про такую штуку как ETS. Про этот мощный инструмент, который предоставляет платформа. Я расскажу несколько хитростей, которые сделают работу с ETS более удобной и как решить некоторые проблемы, которые возникают при работе с ним. Доклад будет интересен в основном новичкам. Но, возможно, и опытные разработчики смогут узнать что-то новое.

3. Фреймворк для работы с нейронными сетями на Elixir – Алексей Овчинников (Sirin)

Нейронные сети набирают всё большую популярность в ИТ-индустрии, во многом благодаря применению графических сопроцессоров. Существует множество библиотек для реализации нейронных сетей, большинство из которых написано на Python или C. Вместе с тем платформа Erlang OTP позволяет без лишних усилий реализовать отказоустойчивое приложение с высокой степенью распараллеливания вычислений, и, на наш взгляд, идеально подходит для реализации высоко интегрированного решения для обработки потокового видео с помощью нейронных сетей. Также в библиотеке реализован медиа-сервер для приёма потокового видео. Таким образом пользователь может сосредоточиться на конфигурации нейронной сети, не отвлекаясь на технические детали обработки видео.

Регистрация здесь — rambler-co-e-org.timepad.ru/event/505943

Сбор гостей в 18:30.

Начало первого доклада в 19:00.

Место проведения – Мансарда Rambler&Co, которая расположена по адресу ул. Варшавское шоссе д.9 стр.1

Приходите, будет интересно!

|

Метки: author SanDark7 ruby on rails ruby erlang/otp elixir/phoenix блог компании rambler co elixir erlang phoenix |

Анонс RamblerElixir #3 |

Приглашаем разработчиков, тимлидов и всех, кто так или иначе связан с разработкой на Elixir, принять участие в RamblerElixir Meetup, который состоится 14 июня 19:00, в среду, на уютной мансарде Rambler&Co.

В программе встречи три доклада:

1. Лингвистическая относительность – Станислав Герман (Rambler&Co)

У каждого языка есть принципы, на которых он основан. Для Erlang — «Let it crash and let someone else deal with it», для Ruby — «less astonishing» и «programmer happiness», в Python такие принципы как «Explicit is better than implicit», сформулированы в «Zen of Python». В то время, как одни взгляды нам близки, а другие мы не принимаем, они формируют не только дизайн языка и архитектуру библиотек и систем, которые разрабатываются на этом языке, но и сообщество разработчиков вокруг этого языка. В своем докладе я рассмотрю какие принципы заложены в Elixir, чем знание этих принципов полезно разработчику, и как они влияют на код, который мы пишем и используем в своей работе.

2. Трюки с ETS – Алексей Никитин (Bookmate)

У меня сложилось впечатление, что в Elixir-сообществе незаслуженно подзабыли про такую штуку как ETS. Про этот мощный инструмент, который предоставляет платформа. Я расскажу несколько хитростей, которые сделают работу с ETS более удобной и как решить некоторые проблемы, которые возникают при работе с ним. Доклад будет интересен в основном новичкам. Но, возможно, и опытные разработчики смогут узнать что-то новое.

3. Фреймворк для работы с нейронными сетями на Elixir – Алексей Овчинников (Sirin)

Нейронные сети набирают всё большую популярность в ИТ-индустрии, во многом благодаря применению графических сопроцессоров. Существует множество библиотек для реализации нейронных сетей, большинство из которых написано на Python или C. Вместе с тем платформа Erlang OTP позволяет без лишних усилий реализовать отказоустойчивое приложение с высокой степенью распараллеливания вычислений, и, на наш взгляд, идеально подходит для реализации высоко интегрированного решения для обработки потокового видео с помощью нейронных сетей. Также в библиотеке реализован медиа-сервер для приёма потокового видео. Таким образом пользователь может сосредоточиться на конфигурации нейронной сети, не отвлекаясь на технические детали обработки видео.

Регистрация здесь — rambler-co-e-org.timepad.ru/event/505943

Сбор гостей в 18:30.

Начало первого доклада в 19:00.

Место проведения – Мансарда Rambler&Co, которая расположена по адресу ул. Варшавское шоссе д.9 стр.1

Приходите, будет интересно!

|

Метки: author SanDark7 ruby on rails ruby erlang/otp elixir/phoenix блог компании rambler co elixir erlang phoenix |

Анонс RamblerElixir #3 |

Приглашаем разработчиков, тимлидов и всех, кто так или иначе связан с разработкой на Elixir, принять участие в RamblerElixir Meetup, который состоится 14 июня 19:00, в среду, на уютной мансарде Rambler&Co.

В программе встречи три доклада:

1. Лингвистическая относительность – Станислав Герман (Rambler&Co)

У каждого языка есть принципы, на которых он основан. Для Erlang — «Let it crash and let someone else deal with it», для Ruby — «less astonishing» и «programmer happiness», в Python такие принципы как «Explicit is better than implicit», сформулированы в «Zen of Python». В то время, как одни взгляды нам близки, а другие мы не принимаем, они формируют не только дизайн языка и архитектуру библиотек и систем, которые разрабатываются на этом языке, но и сообщество разработчиков вокруг этого языка. В своем докладе я рассмотрю какие принципы заложены в Elixir, чем знание этих принципов полезно разработчику, и как они влияют на код, который мы пишем и используем в своей работе.

2. Трюки с ETS – Алексей Никитин (Bookmate)

У меня сложилось впечатление, что в Elixir-сообществе незаслуженно подзабыли про такую штуку как ETS. Про этот мощный инструмент, который предоставляет платформа. Я расскажу несколько хитростей, которые сделают работу с ETS более удобной и как решить некоторые проблемы, которые возникают при работе с ним. Доклад будет интересен в основном новичкам. Но, возможно, и опытные разработчики смогут узнать что-то новое.

3. Фреймворк для работы с нейронными сетями на Elixir – Алексей Овчинников (Sirin)

Нейронные сети набирают всё большую популярность в ИТ-индустрии, во многом благодаря применению графических сопроцессоров. Существует множество библиотек для реализации нейронных сетей, большинство из которых написано на Python или C. Вместе с тем платформа Erlang OTP позволяет без лишних усилий реализовать отказоустойчивое приложение с высокой степенью распараллеливания вычислений, и, на наш взгляд, идеально подходит для реализации высоко интегрированного решения для обработки потокового видео с помощью нейронных сетей. Также в библиотеке реализован медиа-сервер для приёма потокового видео. Таким образом пользователь может сосредоточиться на конфигурации нейронной сети, не отвлекаясь на технические детали обработки видео.

Регистрация здесь — rambler-co-e-org.timepad.ru/event/505943

Сбор гостей в 18:30.

Начало первого доклада в 19:00.

Место проведения – Мансарда Rambler&Co, которая расположена по адресу ул. Варшавское шоссе д.9 стр.1

Приходите, будет интересно!

|

Метки: author SanDark7 ruby on rails ruby erlang/otp elixir/phoenix блог компании rambler co elixir erlang phoenix |

IBM Watson и кибербезопасность: служба быстрого реагирования, которая работает круглосуточно |

В нашу интернет-эпоху информационная безопасность ставится во главу угла. Этому можно не удивляться, поскольку данных в сети чрезвычайно много, а пользователей — миллиарды. Если злоумышленники получат доступ хотя бы к малой толике всей этой информации, можно ждать беды (что, собственно, случается с завидной регулярностью). Конечно, эксперты по безопасности работают, различные компании выпускают инструменты, позволяющие, теоретически, уберечься от вмешательства злоумышленников в нормальный рабочий процесс.

Но, несмотря на принимаемые меры, проблемы зачастую возникают даже у самых, казалось бы, защищенных компаний и организаций. Недавно стало известно, например, что из-за массового распространения в сети вируса WCry в некоторых областях России даже пришлось отменить выдачу водительских прав. Этот вирус скомпрометировал многие компьютеры, которые без разблокировки практически невозможно использовать. Что будет, если сети достаточно крупной коммерческой компании заблокирует вирус? Такая компания потерпит многомиллионные, а то и миллиардные убытки. Так оно и есть, сейчас остановить эпидемию WannaCry удалось только чудом, а убытки еще никто не подсчитывал.

Стандартные инструменты защиты не всегда справляются с угрозой, но когнитивная система может значительно все упростить, управляя кибербезопасностью предприятия. У корпорации IBM есть такой продукт, это сервис Watson for Cyber Security. Подробнее об этом — ниже.

На данный момент специалисты по информационной безопасности зафиксировали десятки тысяч уязвимостей в различном программном обеспечении. Каждый день появляется новое ПО, обнаруживаются новые «дыры» в существующем программном обеспечении, злоумышленники выпускают вирусы, создают эксплоиты, занимаются взломом обычных и корпоративных сетей. Понятно, что специалисты по кибербезопасности не дремлют. Каждая выявленная уязвимость тщательно документируется, зачастую, такая информация выкладывается в открытом доступе. Но это не всегда помогает, поскольку каждый месяц авторы публикуют минимум 60 000 статей, имеющих отношение к этой сфере. Понятно, что уследить за таким потоком данных неспособен никто. Вернее, никто, кроме Watson — когнитивная платформа способна усваивать тысячи и тысячи документов в единицу времени. Практически все эти данные бесструктурные, многие материалы никак друг с другом не связаны, хотя и могут содержать схожие темы.

В информационной безопасности, как нигде, требуется использование машинного обучения и обработка естественного языка. Эти технологии, как и другие с ними связанные, становятся все более совершенными с течением времени. Компьютерные системы обучаются на примере каждой найденной уязвимости или проблемы, становясь все совершеннее в работе с внешними и внутренними информационными угрозами.

На основе сервиса Watson for Cyber Security работает один из продуктов платформы IBM QRadar — IBM Qradar Advisor with Watson.

Когнитивная система IBM Watson помогает аналитикам, которые занимаются обнаружением угроз, справляться со своей работой более эффективно и качественно. Никто не может получить всю необходимую информацию о проблеме, особенно о сложной, за несколько секунд. А вот компьютерная система Watson может, и делает это. Она определяет потенциальную угрозу, ищет информацию по ней, анализирует происходящее и действует по необходимости.

Все данные сохраняются, так что их может изучить как человек, так и сама когнитивная система впоследствии. IBM Watson может, например, обнаружив некую аномалию в корпоративной сети, добраться до сути проблемы, причем очень быстро. В результате эта проблема не успевает стать актуальной, угроза уничтожается еще «на подходе». Данные предоставляются группе технической поддержки, которая действует дальше, основываясь на данных, предоставленных Watson. Все это происходит быстро, система работает с высокой степенью точности.

Работа IBM Qradar Advisor with Watson ведется в режиме 24/7/365. Она состоит из четырех ключевых элементов:

1. Обнаружение инцидента и выявление его причины. При этом когнитивная система активно работает с данными мониторинга работы сети, накопленных Qradar;

2. Далее идет поиск по базе данных самой когнитивной системы, для обнаружения информации, которая относится к обнаруженной аномалии или происшествию;

3. Далее Qradar Advisor отправляет информацию о проблеме в Watson for Cyber Security, для фиксирования этих данных и изучения проблемы;

4. Идет идентификация угрозы и поиск подходящей стратегии борьбы с ней.

Кстати, в 2015 году институт Понемона проводил изучение особенностей работы различных компаний с QRadar. В рамках этого исследования был проведен опрос. Представителей компаний, которые согласились принять участие в опросе, спросили, работали ли они с дополнительными сервисами по сетевой безопасности после внедрения Qradar. 70% опрошенных ответили, что нет, причем 62% заявили, что если бы хотели, без проблем сменили бы продукт, но такого желания не возникало. 43% опрошенных заявили, что почувствовали эффект от работы с сервисом уже через несколько дней, для 27% этот эффект проявился в течение недели.

В целом, достоинства QRadar, включая и когнитивный сервис, можно выделить в следующие пункты:

• Единая архитектура для анализа журналов, сетевых потоков, пакетов, уязвимостей, данных о пользователях и ресурсах

• Анализ корреляции в реальном времени с использованием Sense Analytics для выявления наиболее серьезных угроз, атак и уязвимостей

• Расстановка приоритетов и выделение важнейших инцидентов среди миллиардов единиц данных, получаемых ежедневно

• Прогнозный анализ имеющихся рисков, вызванных некорректной настройкой устройств и известными уязвимостями

• Автоматическое реагирование на инциденты

• Автоматическое выполнение нормативных требований за счет возможностей сбора данных, определения их корреляции и составления отчетности

По оценке института Понемона, обычная компания тратит более 20 000 в год на работу с сетевыми угрозами, как внешними, так и внутренними. Это огромное количество времени, и его можно сэкономить, если автоматизировать все процессы мониторинга.

Watson for Cyber Security оперирует в своей работы данными из 100 000 задокументированных уязвимостей ПО, содержащихся в базе данных IBM X-Force Exchange. Также в распоряжении когнитивной системы более 10 000 различных документов и 700 000 записей в блогах специалистов по информационной безопасности, публикуемых каждый год. В случае необходимости все эти данные можно быстро структурировать и получить необходимую информацию по определенной тематике. Структурированные данные, сформированные Watson for CyberSecurity, поступают в сервис IBM QRadar, о чем уже говорилось выше. Если говорить об эффективности работы такой системы, то она может анализировать тысячи инцидентов в день, сортируя ложные срабатывания и актуальные проблемы с безопасностью.

Вскоре Watson for Cyber Security станет частью новой платформы Cognitive Security Operations Centre (SOC), которая окончательно объединит когнитивные технологии и операции в сфере сетевой безопасности. Ключевым элементом платформы является IBM BigFix Detect. Это решение, позволяющее отследить атаку, использует своеобразную «машину времени» для обнаружения начальной точки, где все началось. Для конечного пользователя это означает возможность быстро, очень быстро отвечать на возникающие угрозы, включая локальные сети и «облака». Другиекомпоненты SOC — это IBM Security, X-Force Exchange и i2. Доступ к этой унифицированной платформе IBM планирует предоставлять в качестве сервиса, который так и будет называться SOC-as-a-Service.

|

Метки: author ibm сетевые технологии облачные вычисления антивирусная защита блог компании ibm ibm watson кибербезопасность облачные сервисы будущее когнитивные вычисления |

В качестве приветствия |

С сегодняшнего дня Райффайзенбанк начинает свое вещание на Хабрахабр. За последние 2-3 года мы многое сделали с точки зрения внутренних преобразований, запуска и реализации ИТ-проектов. И нам есть, о чем рассказать.

Для начала пара слов об истории.

Райффайзенбанк работает на российском рынке уже более 20 лет, на сегодняшний день мы крупнейшая иностранная банковская группа в России. В 2016 году банк начал активно поддерживать стартапы в области финтеха. Мы работаем, в том числе с фондами Сколково и РВК. Райффайзенбанк стал партнером федерального стартап-акселератора GenerationS (проводится РВК) и учредил специальную номинацию Raiffeisen Award для участников, разрабатывающих продукты и решения для финансовой отрасли. В этом году мы провели первый хакатон GetApp. Как это было, вы можете посмотреть в фотоальбоме и отчетном видео.

Для увеличения надежности и доступности банковских сервисов, а также для развития банковских систем, продуктов и сервисов мы используем широкий спектр технологий. Например, разработчики работают на платформах: Tomcat/RHEL7, Scala stack, IBM WAS/AIX, IIS/Win2012, RPG(for AS400), IBM BPM/WPS, IBM ESB и пишут на Python, Kotlin, Swift, Java, C/C++ и С#. Мы используем несколько платформ для хранения и обработки данных большого объема и различной структуры: DB2, Oracle, SQL-server, PosgreSQL. Для задач, связанных с Big Data, используем Hadoop. Также работаем на крупных промышленных платформах, таких как Oracle Siebel, Mysis, BankFusion, MIDAS SAS, TSYS Prime. Ну, и в этом году внедряем у себя Jira/Confluence/Bamboo/Bitbucket/SonarCube.

Мы верим в культуру и философию Agile, активно применяем практики SCRUM, Kanban, TDD, для развития наших команд ежемесячно проводим внутренние митапы по Java и .Net, а для расширения кругозора ИТ и банка в целом – регулярно информируем о развитии рынка, новых технологиях и подходах к внедрению решений

Подробнее обо всем этом обязательно расскажем в следующих постах.

Читайте наш блог!

|

Метки: author Raiffeisenbank хакатоны финансы в it блог компании райффайзенбанк java hadoop agile oracle bigdata scrum ibm jira confluence |

Взнос за публикацию игры через Steam Direct установлен в размере $100 |

Компания Valve приняла решение о размере взноса для разработчиков, которые планируют публиковать свои игры в каталоге Steam. Эти взносы будут взиматься после того, как текущая система Greenlight будет заменена на Steam Direct. Взнос будет возвращаемым и в принципе, для разработчиков почти ничего не меняется, поскольку в текущей системе размер возвращаемой оплаты за публикацию игры такой же.

По словам представителей Valve, решение было не таким уж и простым, члены команды предлагали изменить размер взносов, причем рассматривались суммы от $100 до $5000 (нет, ноль здесь не лишний). После обсуждения было решено остановиться на $500, но мнение самого сообщества было решающим — в Valve прислушались к нему и решили не изменять размер взноса, чтобы позволить разработчикам без проблем публиковать свои игры.

«Наше внутреннее обсуждение привело к мысли о поднятии суммы взноса до $500, но разговоры в сообществе привели к тому, что мы решили сделать взнос минимально возможным», — говорится в обращении.

Систему Steam Greenlight было решено заменить еще в феврале, для того, чтобы у разработчиков был более прямой и простой путь публиковать свои игры. Собственно, намерения Valve отражены в самом названии нового сервиса — Steam Direct. Для работы нужно зарегистрироваться, после чего внести деньги, о чем и говорилось выше. «Мы попросим новых разработчиков поработать с документами, пройдя процедуру верификации и добавив налоговую информацию, все это похоже на открытие счета в банке», — объясняли в Valve в феврале.

После того, как пройдены все формальности и внесена оплата за игру (при публикации нового тайтла взнос снова придется заплатить) разработчик может начинать процедуру добавления. Правда, пока что нет информации о том, каким образом разработчик может получить свой возвращаемый взнос обратно, хотя представители Valve сообщили одному из интернет-СМИ о том, что деньги разработчик получит по достижению уровня продаж в $1000. В блоге компании пока этой информации нет.

Стоит отметить, что меняется не только алгоритм публикации игры, но и система кураторов Steam. Сотрудники Valve говорят о том, что они уже не вполне уверены в том, что могут «представлять интересы всего разнообразия пользователей».

Теперь пользователи могут принимать участие в выделении игр в Steam, а игроки — искать среди них тех, кто будет представлять их интересы. В Valve также решили ограничить полномочия кураторов: «Мы решили оставить деятельность кураторов функцией строго по выбору: комментарии кураторов могут повлиять на работу алгоритма только тех игроков, которые открыто заявили о желании подписаться на этих кураторов».

При этом расширяется вид контента, к которому могут приложить руку кураторы. Им разрешено предоставлять дополнительную информацию игрокам, которые думают о покупке игры. Также в Valve модифицировали инструменты, позволяющие кураторам легче управлять своими рекомендациями. Кураторам облегчили задачу и при показе контента для других платформ, включая YouTube.

Они получили и возможность создавать личный список игр. По мнению Valve, это позволит кураторам предоставлять конкретные советы относительно приобретения игр на текущей распродаже. Также они смогут составлять списки игр, которые открывают возможность отследить эволюцию игрового дизайна, игр определенного разработчика или другие интересные нюансы.

Valve обещает, что уже сейчас идет работа по созданию системы, которая позволяет облегчить процесс поиска создателями игр кураторов. В прошлом (да и сейчас) это такая уж и простая задача, но в скором будущем, после появления новой системы, в Steam появится больше обзоров, которые написаны кураторами, которым по душе новинки и их изучение. В качестве вспомогательного инструмента предлагается предоставить кураторам большую видимость на страницах магазина. Например, если пользователь системы подписался на куратора, то можно будет видеть его комментарии на новых полях страницы.

В дальнейшем Valve обещает постепенно дорабатывать и улучшать Steam Direct. Новая система упрощает задачу поиска игр, показывая те из них, которые должны понравиться конкретному игроку. Больше значения придается индивидуальным интересам. Создатели Steam Direct просят сразу сообщать о проблемах, как только они появляются, чтобы была возможность их исправить.

|

Метки: author marks разработка игр valve steam direct взнос публикация игр |

[Перевод] Обзор исследований в области глубокого обучения: обработка естественных языков |

Это третья статья из серии “Обзор исследований в области глубокого обучения” (Deep Learning Research Review) студента Калифорнийского университета в Лос-Анджелесе Адита Дешпанда (Adit Deshpande). Каждые две недели Адит публикует обзор и толкование исследований в определенной области глубинного обучения. В этот раз он сосредоточил свое внимание на применении глубокого обучения для обработки текстов на естественном языке.

Введение в обработку естественных языков

Введение

Под обработкой естественных языков (Natural Language Processing, NLP) понимается создание систем, обрабатывающих или “понимающих” язык с целью выполнения определенных задач. Эти задачи могут включать:

- Формирование ответов на вопросы (Question Answering) (то, что делают Siri, Alexa и Cortana)

- Анализ эмоциональной окраски высказываний (Sentiment Analysis) (определение, имеет ли высказывание положительную или отрицательную коннотацию)

- Нахождение текста, соответствующего изображению (Image to Text Mappings) (генерация подписи к входному изображению)

- Машинный перевод (Machine Translation) (перевод абзаца текста с одного языка на другой)

- Распознавание речи (Speech Recognition)

- Морфологическая разметка (Part of Speech Tagging) (определение частей речи в предложении и их аннотирование)

- Извлечение сущностей (Name Entity Recognition)

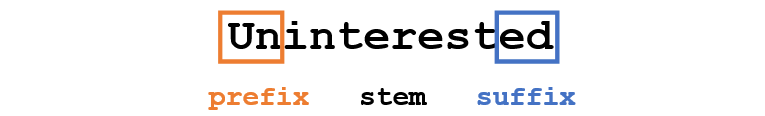

Традиционный подход к NLP предполагал глубокое знание предметной области – лингвистики. Понимание таких терминов, как фонемы и морфемы, было обязательным, так как существуют целые дисциплины лингвистики, посвященные их изучению. Посмотрим, как традиционное NLP распознало бы следующее слово:

Допустим, наша цель – собрать некоторую информацию об этом слове (определить его эмоциональную окраску, найти его значение и т.д.). Используя наши знания о языке, мы можем разбить это слово на три части.

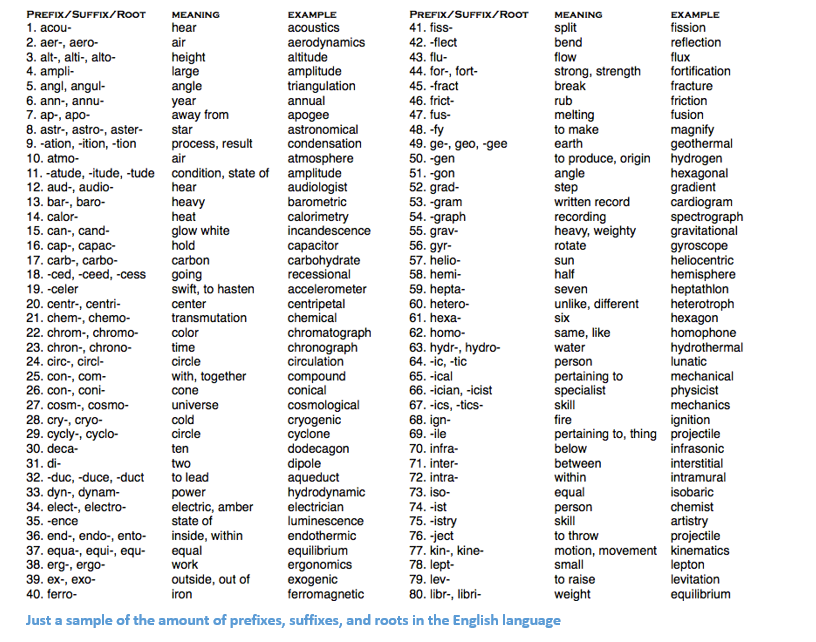

Мы понимаем, что приставка (prefix) un- означает отрицание, и знаем, что -ed может означать время, к которому относится данное слово (в данном случае – прошедшее время). Распознав значение однокоренного слова interest, мы легко можем сделать вывод о значении и эмоциональной окраске всего слова. Вроде бы просто. Тем не менее, если принять во внимание все многообразие приставок и суффиксов английского языка, понадобится очень умелый лингвист, чтобы понять все возможные комбинации и их значения.

Пример, показывающий количество приставок суффиксов и корней в английском языке

Как использовать глубокое обучение

В основе глубокого обучения лежит обучение представлениям. Например, сверточные нейронные сети (Convolutional Neural Network, CNN) включают в себя объединение различных фильтров, предназначенных для классификации объектов по категориям. Здесь мы попытаемся применить похожий подход, создавая представления слов в больших наборах данных.

Структура статьи

Эта статья организована таким образом, чтобы мы могли пройти по основным элементам, из которых можно строить глубокие сети для NLP, а затем перейти к обсуждению некоторых приложений, которых касаются недавние научные работы. Ничего страшного, если вы не будете точно знать, почему, например, мы используем RNN, или чем полезен LSTM, но, надеюсь, изучив эти работы, вы поймете, почему глубокое обучение так важно для NLP.

Векторы слов

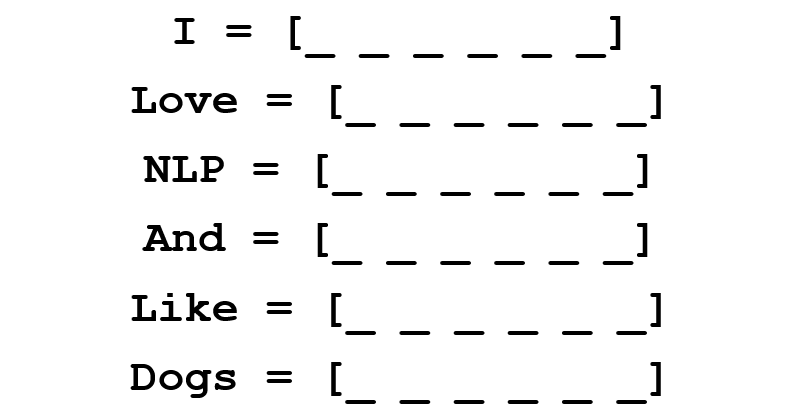

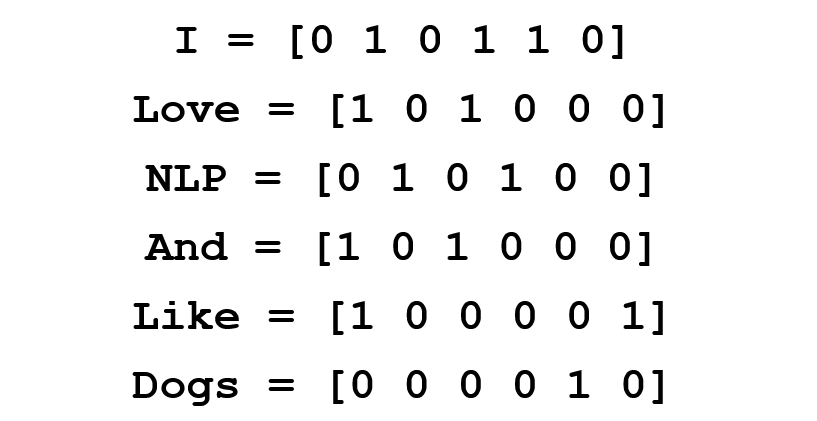

Так как глубокое обучение не может жить без математики, представим каждое слово в виде d-мерного вектора. Возьмем d=6.

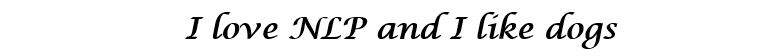

Теперь подумаем, как заполнить значения. Мы хотим, чтобы вектор был заполнен таким образом, чтобы он каким-то образом представлял слово и его контекст, значение или семантику. Один из способов – построить матрицу совместной встречаемости (cooccurrence matrix). Рассмотрим следующее предложение:

Мы хотим получить векторное представление для каждого слова.

Матрица совместной встречаемости содержит количество раз, которое каждое слово встретилось в корпусе (обучающем наборе) после каждого другого слова этого корпуса.

Строки этой матрицы могут служить в качестве векторных представлений наших слов.

Обратите внимание, что даже из этой простой матрицы мы можем почерпнуть довольно важные сведения. Например, заметим, что векторы слов “love” и “like” содержат единицы в ячейках, отвечающих за их соседство с существительными (“NLP” и “dogs”). У них также стоит “1” там, где они соседствуют с “I”, показывая, что это слово, скорее всего, глагол. Можете себе представить, насколько проще выявлять подобные схожие черты, когда набор данных больше, чем одно предложение: в этом случае векторы таких глаголов, как “love”, “like” и других синонимов, будут похожи, так как эти слова будут использоваться в схожих контекстах.

Хорошо для начала, но здесь мы обращаем внимание, что размерность вектора каждого слова будет линейно возрастать в зависимости от размера корпуса. В случае миллиона слов (что немного для стандартных задач NLP), мы получили бы матрицу размерности миллион на миллион, которая, к тому же, была бы очень разреженной (с большим количеством нулей). Это определенно не лучший вариант с точки зрения эффективности хранения данных. В вопросе нахождения оптимального векторного представления слов было сделано несколько серьезных подвижек. Самая известная из них – Word2Vec.

Word2Vec

Главная цель всех методов инициализации вектора слова – хранить в этом векторе как можно больше информации, сохраняя разумную размерность (в идеале, от 25 до 1000). В основе Word2Vec лежит идея научиться прогнозировать окружающие слова для каждого слова. Рассмотрим предложение из предыдущего примера: “I love NLP and I like dogs”. Сейчас нас интересуют только три первые слова. Пусть размер нашего окна и будет равен трем.

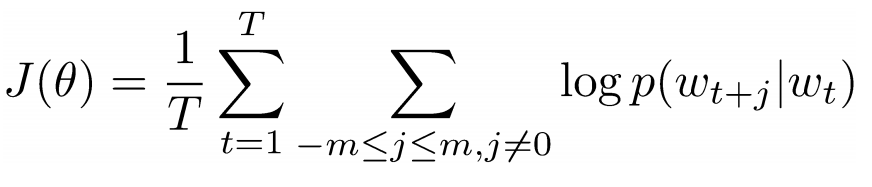

Теперь мы хотим взять центральное слово “love” и предсказать слова, идущие до и после него. Как же мы это осуществим? Конечно же, с помощью максимизации и оптимизации функции! Формально наша функция пытается максимизировать логарифмическую вероятность каждого слова-контекста для текущего центрального слова.

Изучим вышеприведенную формулу подробнее. Из нее следует, что мы будем складывать логарифмическую вероятность совместной встречаемости как “I” и “love”, так и “NLP” и “love” (в обоих случаях “love” – центральное слово). Переменная T означает количество обучающих (training) предложений. Рассмотрим логарифмическую вероятность поближе.

– векторное представление центрального слова. У каждого слова есть два векторных представления: и , одно для случая, когда слово занимает центральную позицию, другое для случая, когда это слово – “внешнее”. Векторы обучаются методом стохастического градиентного спуска. Это определенно одно из самых трудных для понимания уравнений, так что если вам все еще трудно представить себе, что происходит, можно найти дополнительную информацию здесь и здесь.

Подытожим одним предложением: Word2Vec ищет векторные представления различных слов, максимизируя логарифмическую вероятность встречаемости слов контекста для данного центрального слова и преобразуя векторы методом стохастического градиентного спуска.

(Дополнительно: дальше авторы работы подробно рассказывают о том, как с помощью негативного семплирования (negative sampling) и взятия подвыборок (subsampling) можно получить более точные векторы слов).

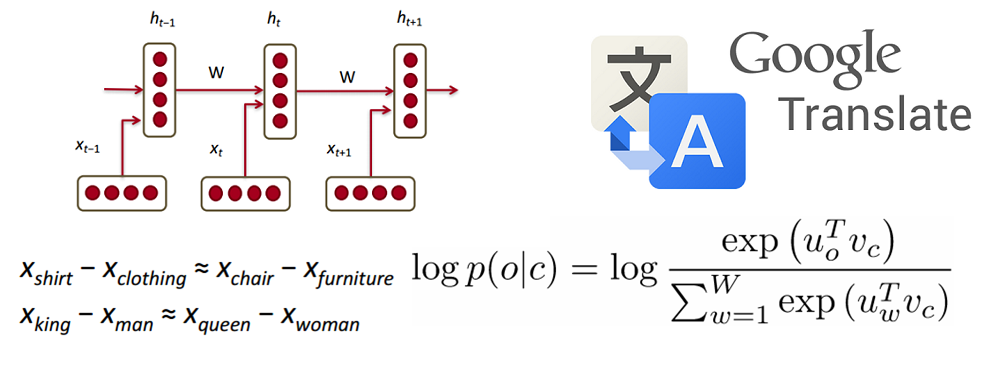

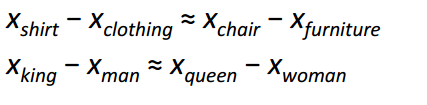

Пожалуй, самым интересным вкладом Word2Vec в развитие NLP стало появление линейных отношений между разными векторами слов. После обучения векторы отражают различные грамматические и семантические концепции.

Удивительно, как такая простая целевая функция и несложная техника оптимизация смогли выявить эти линейные отношения.

Бонус: еще один классный метод инициализации векторов слов – GloVe (Global Vector for Word Representation) (сочетает идеи матрицы совместной встречаемости с Word2Vec).

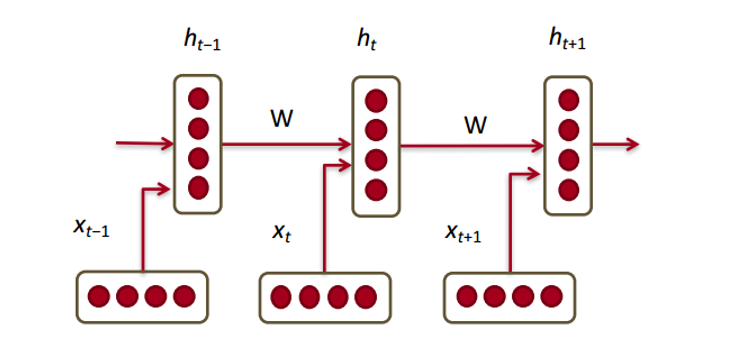

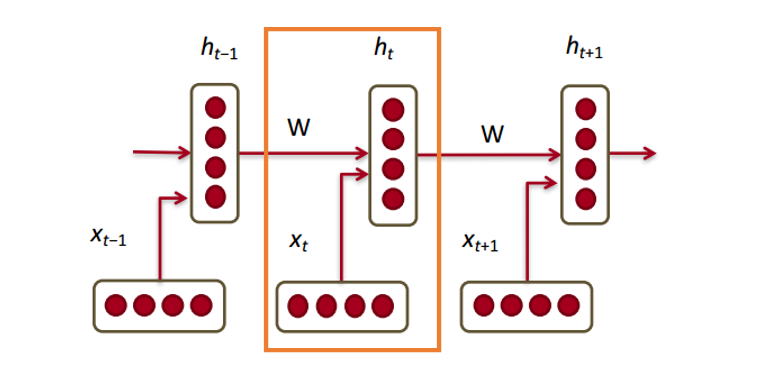

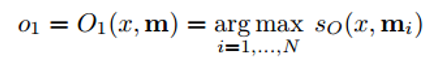

Рекуррентные нейронные сети (Recurrent Neural Networks, RNN)

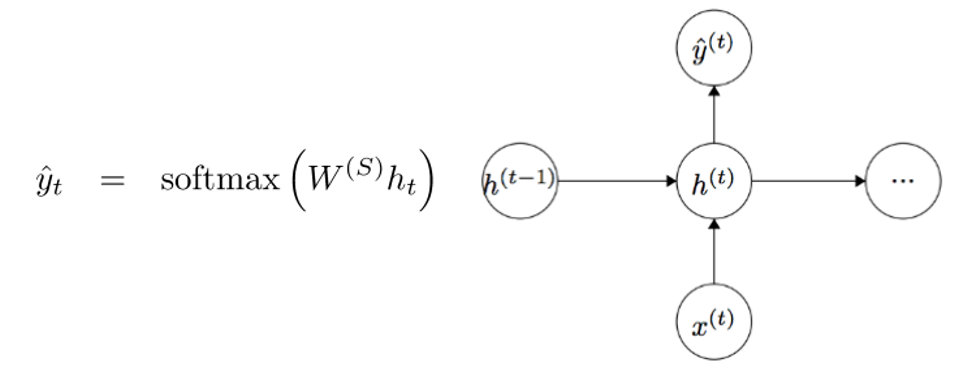

Теперь посмотрим, как с нашими векторами будет работать рекуррентная нейронная сеть. RNN – палочка-выручалочка для большинства современных задач обработки естественного языка. Главное преимущество RNN в том, что они могут эффективно использовать данные с предыдущих шагов. Вот так выглядит маленький кусочек RNN:

Внизу изображены векторы слов (). У каждого вектора на каждом шаге есть скрытый вектор состояния (hidden state vector) (). Будем называть эту пару модулем (module).

Скрытое состояние в каждом модуле RNN – это функция от вектора слова и вектора скрытого состояния с прошлого шага.

Если мы приглядимся к верхним индексам, то увидим, что здесь есть матрица весов , которую мы умножаем на входное значение, и есть рекуррентная матрица весов , которая умножается на вектор скрытого состояния с предыдущего шага. Имейте в виду, что эти рекуррентные матрицы весов на каждом шаге одинаковы. Это ключевой момент RNN. Если тщательно обдумать, то этот подход значительно отличается от, скажем, традиционных двухслойных нейронных сетей. В этом случае у нас обычно выбирается отдельная матрица W для каждого слоя: и . Здесь же рекуррентная матрица весов одна и та же для всей сети.

Для получения выходных значений каждого модуля (Yhat) служит еще одна матрица весов – , умноженная на h.

Теперь давайте посмотрим со стороны и поймем, в чем состоят преимущества RNN. Наиболее явное отличие RNN от традиционной нейронной сети в том, что RNN принимает на вход последовательность входных данных (в нашем случае слов). Этим они отличаются, например, от типичных CNN, на вход которым подается целое изображение. Для RNN же входными данными может служить как короткое предложение, так и сочинение из пяти абзацев. Кроме того, порядок, в котором подаются данные, может влиять на то, как в процессе обучения меняются матрицы весов и векторы скрытых состояний. К концу обучения в векторах скрытых состояний должна накопиться информация из прошлых шагов.

Управляемые рекуррентные нейроны (Gated recurrent units, GRU)

Теперь давайте познакомимся с понятием управляемого рекуррентного нейрона, с помощью которых производится вычисление векторов скрытых состояний в RNN. Такой подход позволяет сохранять информацию о более отдаленных зависимостях. Давайте порассуждаем о том, почему отдаленные зависимости для обычных RNN могут стать проблемой. В время работы метода обратного распространения ошибки (backpropagation) ошибка будет двигаться по RNN от последнего шага к самому раннему. При достаточно малом начальном градиенте (скажем, менее 0.25) к третьему или четвертому модулю градиент почти исчезнет (так как по правилу производной сложной функции градиенты будут перемножаться), и тогда скрытые состояния самых первых шагов не обновятся.

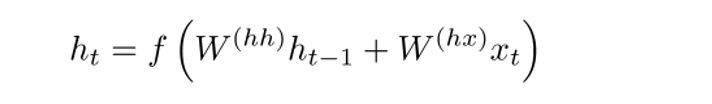

В обычных RNN вектор скрытых состояний вычисляется по следующей формуле:

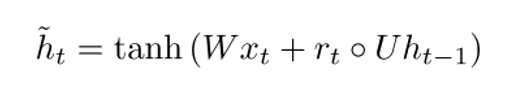

Метод GRU позволяет вычислять h(t) иначе. Вычисления разбиваются на три блока: фильтр обновления (update gate), фильтр сброса состояния (reset gate) и новый контейнер памяти (memory container). Обы фильтра – функции от входного векторного представления слова и скрытого состояния на предыдущем шаге.

Главное отличие состоит в том, что для каждого фильтра используются свои веса. Это обозначено разными верхними индексами. Фильтр обновления использует и , а фильтр сброса состояния – и .

Теперь рассчитаем контейнер памяти:

(пустой кружок здесь обозначает произведение Адамара).

Теперь, если присмотреться к формуле, то можно заметить, что если множитель фильтра сброса состояния близок к нулю, то и все произведение также приблизится к нулю, и таким образом, информация из предыдущего шага не будет учтена. В этом случай нейрон – всего лишь функция от нового вектора слова .

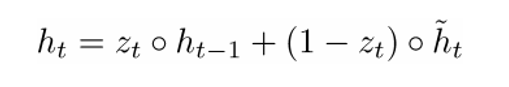

Окончательную формулу h(t) можно записать как

– функция от всех трех компонентов: фильтра обновления, фильтра сброса состояния и контейнера памяти. Можно лучше понять это, визуализируя, что происходит с формулой, когда близится к 1 и когда близко к 0. В первом случай вектор скрытого состояния в большей степени зависит от предыдущего скрытого состояния, а текущий контейнер памяти не принимается во внимание, так как (1 – ) стремится к 0. Когда же близится к 1, новый вектор скрытого состояния , наоборот, зависит в основном от контейнера памяти, а предыдущее скрытое состояние не учитывается. Итак, наши три компонента можно интуитивно описать следующим образом:

- Фильтр обновления

- Если ~ 1, то не принимает во внимание текущий вектор слова и просто копирует предыдущее скрытое состояние.

- Если ~ 0, то не учитывает предыдущее скрытое состояние и зависит только от контейнера памяти.

- Этот фильтр позволяет модели контролировать, как много информации от предыдущего скрытого состояния должно влиять на текущее скрытое состояние.

- Фильтр сброса состояния

- Если ~ 1, то контейнер памяти сохраняет информацию с предыдущего скрытого состояния.

- Если ~ 0, то контейнер памяти не учитывает предыдущее скрытое состояние.

- Этот фильтр позволяет отбросить часть информации, если в будущем она не будет нас интересовать.

- Контейнер памяти: зависит от фильтра сброса состояния.

Приведем пример, иллюстрирующий работу GRU. Допустим, у нас есть следующие несколько предложений:

и вопрос: “Чему равна сумма двух чисел?” Так как предложение посередине никак не влияет на ответ, фильтры сброса и обновления позволят модели “забыть” это предложение и понять, что изменять скрытое состояние может только определенная информация (в данном случае, числа).

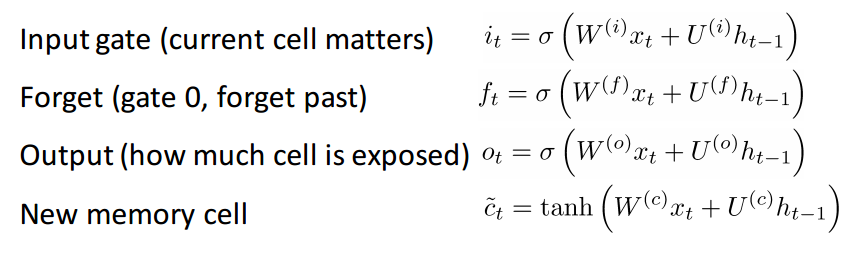

Нейроны с длительной кратковременной памятью (Long short-term memory, LSTM)

Если вы разобрались с GRU, то LSTM не составит для вас трудности. LSTM также состоит из последовательности фильтров.

LSTM определенно принимает на вход больше информации. Так как ее можно считать расширением GRU, я не буду разбирать ее подробно, а чтобы получить детальное описание каждого фильтра и каждого шага вычислений, вы можете обратиться к прекрасно написанному блог-посту Криса Олаха (Chris Olah). На текущий момент это самый популярный тьюториал по LSTM, и точно поможет тем из вас, кто ищет понятное и интуитивное объяснение работы этого метода.

Сравнение LSTM и GRU

Сначала рассмотрим общие черты. Оба эти метода разработаны для того, чтобы сохранять отдаленные зависимости в последовательностях слов. Под отдаленными зависимостями имеются в виду такие ситуации, когда два слова или фразы могут встретиться на разных временных шагах, но отношения между ними важны для достижения конечной цели. LSTM и GRU отслеживают эти отношения с помощью фильтров, которые могут сохранять или сбрасывать информацию из обрабатываемой последовательности.

Различие между двумя методами состоит в количестве фильтров (GRU – 2, LSTM – 3). Это влияет на количество нелинейностей, которое приходит от входных данных и в конечном итоге влияет на процесс вычислений. Кроме того, в GRU отсутствует ячейка памяти , как в LSTM.

Перед тем, как углубиться в статьи

Хотел бы сделать небольшое замечание. Если и другие модели глубокого обучения, полезные в NLP. На практике иногда используются рекурсивные и сверточные нейронные сети, хотя они не так распространены, как RNN, которые лежат в основе большинства NLP-систем глубокого обучения.

Теперь, когда мы начали хорошо разбираться в рекуррентных нейронных сетях применительно к NLP, давайте ознакомимся с некоторыми работами в этой области. Так как NLP включает в себя несколько различных областей задач (от машинного перевода до формирования ответов на вопросы), мы могли бы рассмотреть довольно много работ, но я выбрал те три, которые нашел особенно информативными. В 2016 году случился ряд серьезных продвижений в области NLP, но начнем с одной работы 2015 года.

Нейронные сети с памятью (Memory Networks)

Введение

Первая работа, которую мы обсудим, оказала большое влияние на развитие области формирования ответов на вопросы. В этой публикации авторства Джейсона Вестона (Jason Weston), Сумита Чопры (Sumit Chopra) и Антуана Бордеса (Antoine Bordes) был впервые описан класс моделей под названием ”сети с памятью”.

Интуитивно-понятная идея состоит в следующем: для того, чтобы точно ответить на вопрос, относящийся к фрагменту текста, необходимо каким-то образом хранить предоставленную нам исходную информацию. Если бы я спросил вас: “Что означает аббревиатура RNN?”, вы смогли бы ответить мне, потому что информация, которую вы усвоили, читая первую часть статьи, сохранилась где-то в вашей памяти. Вам понадобилось бы лишь несколько секунд, чтобы найти эту информацию и озвучить ее. Я понятия не имею, как это получается у мозга, но мысль о том, что необходимо пространство для хранения этой информации, остается неизменной.

Сеть с памятью, описанная в данной работе, уникальна, так как у нее есть ассоциативная память, в которую она может писать и из которой она может читать. Интересно заметить, что подобную память не используют ни CNN, ни Q-Network (для обучения с подкреплением (reinforcement learning), ни традиционные нейронные сети. Это отчасти связано с тем, что задача формирования ответов на вопросы в большой степени полагается на способность моделировать или прослеживать отдаленные зависимости, например, следить за героями истории или запоминать последовательность событий. В CNN или Q-Networks память как бы встроена в веса системы, так как она обучается различным фильтрам или картам соответствий состояний и действий. На первый взгляд, можно было бы использовать RNN или LSTM, но обычно они не способны запоминать входные данные из прошлого (что является критичным для задач формирования ответов на вопросы).

Архитектура сети

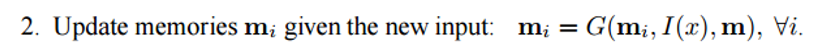

Теперь посмотрим, как такая сеть обрабатывает исходный текст. Как и большинство алгоритмов машинного обучения, первый шаг – преобразовать входные данные в представление в пространстве признаков. Под этим может подразумеваться использование векторных представлений слов, морфологическая разметка, синтаксический разбор и т.д., на усмотрение программиста.

Следующий шаг – взять представление в пространстве признаков I(x) и считать в память новую порцию входных данных x.

Память m можно рассматривать как подобие массива, составленного из отдельных блоков памяти . Каждый такой блок может быть функцией от всей памяти m, представления в пространстве признаков I(x) и/или самого себя. Функция G может просто хранить все представление I(x) в блоке памяти mi. Функцию G можно изменить так, чтобы она обновляла память о прошлом на основе новых входных данных. Третий и четвертый шаги включают в себя чтение из памяти с учетом вопроса, чтобы найти представление признаков o, и его декодирование, чтобы получить окончательный ответ r.

В качестве функции R может служить RNN, преобразующая представления признаков в человекочитаемые и точные ответы на вопросы.

Теперь давайте присмотримся к шагу 3. Мы хотим, чтобы функция O возвращала представление в пространстве признаков, наилучшим образом соответствующее возможному ответу на заданный вопрос x. Мы сравним этот вопрос с каждым отдельным блоком памяти и оценим, насколько каждый блок подходит под ответ на вопрос.

Мы находим аргумент максимизации (argmax) оценочной функции, чтобы найти представление, наиболее соответствующее вопросу (можно также выбрать несколько блоков с самыми высокими оценками, не обязательно ровно один). Оценочная функция вычисляет матричное произведение между различными векторными представлениями вопроса и выбранным блоком (или блоками) памяти (подробности вы найдете в самой работе). Можете представить этот процесс как перемножение двух векторов из двух слов, чтобы определить, равны ли они. Выходное представление о затем передается RNN, LSTM или другой оценочной функции, которая вернет человекочитаемый ответ.

Обучение сети проходит методом обучения с учителем, когда обучающие данные включают в себя исходный текст, вопрос, подтверждающие предложения и правильный ответ. Вот, как выглядит целевая функция:

Для тех, кто заинтересовался, привожу еще несколько работ, основанных на подходе сетей с памятью:

- End to End Memory Networks

- Dynamic Memory Networks

- Dynamic Coattention Networks (реализованы в ноябре 2016 и получили лучший за все времена результат на наборе данных Stanford’s Question Answering)

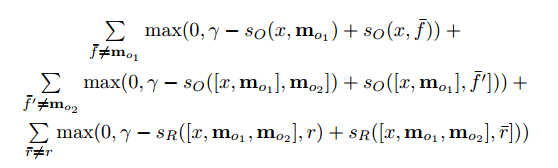

Tree-LSTM для анализа эмоциональной окраски высказываний

Введение

Следующая работа рассказывает о прогрессе в области анализа эмоциональной окраски – задачи определения, имеет высказывание положительную или отрицательную коннотацию (значение). Формально эмоциональную окраску можно определить как “взгляд на ситуацию или событие или отношение к ним”. На тот момент наиболее распространенным инструментом для задач распознавания эмоциональной окраски были LSTM. Работа авторства Кай Шенг Тай (Kai Sheng Tai), Ричарда Сочера (Richard Socher) и Кристофера Маннинга (Christopher Manning) вводит принципиально новый способ объединения нескольких LSTM-нейронов в нелинейную структуру.

Идея нелинейного расположения компонентов основана на мнении, что естественные языки демонстрируют свойство превращать последовательности слов в фразы. Эти фразы, в зависимости от порядка слов, могут иметь значение, отличное от исходного значения входящих в них компонентов. Чтобы отразить это свойство, сеть из нескольких LSTM-нейронов следует представить в виде дерева, где на каждый нейрон влияют его дочерние узлы.

Архитектура сети

Одно из отличий Tree-LSTM от обычного LSTM состоит в том, что во последнем скрытое состояние – функция от текущих входных данных и и скрытого состояния на предыдущем шаге. В Tree-LSTM скрытое состояние – функция от текущих входных данных и скрытых состояний его дочерних нейронов.

Вместе с новой структурой – деревом – вводятся также некоторые изменения в математике сети, например, у дочерних нейронов теперь есть фильтры забывания. С подробностями можно познакомится в самой работе. А я хотел бы уделить внимание объяснению, почему такие сети работают лучше линейных LSTM.

В Tree-LSTM каждый нейрон может вмещать в себя скрытые состояния всех его дочерних узлов. Это интересный момент, так как нейрон может оценивать каждый свой дочерний узел по-разному. Во время обучения сеть может осознать, что определенное слово (например, слово “не” или “очень”) чрезвычайно важно для определения эмоциональной окраски всего предложения. Возможность выше оценить соответствующий узел обеспечивает большую гибкость сети и может улучшить ее производительность.

Нейронный машинный перевод (Neural Machine Translation, NMT)

Введение

Последняя работа, которую мы сегодня рассмотрим, описывает подход к решению задачи машинного перевода. Авторы этой работы – специалисты Google по машинному обучению Джефф Дин (Jeff Dean), Грег Коррадо (Greg Corrado), Ориал Виньялс (Orial Vinyals) и другие – представляют систему машинного обучения, которая лежит в основе широко известного сервиса Google Translate. С введением этой системы количество ошибок перевода сократилось в среднем на 60% по сравнению с прежней системой, используемой Google.

Традиционные подходы к автоматическому переводу включают в себя нахождение пофразовых соответствий. Этот подход требовал хорошего знания лингвистики и в конце концов оказался недостаточно стабильным и неспособным к генерализации. Одна из проблем традиционного подхода состояла в том, что исходное предложение переводилось по кусочкам. Оказалось, что переводить все предложение за раз (как это делает NMT) более эффективно, так как в этом случае вовлекается более широкий контекст и порядок слов становится более естественным.

Архитектура сети

Авторы этой статьи описывают глубокую сеть LSTM, которая может быть от обучена с помощью восьми слоем энкодеров и декодеров. Мы можем разделить систему на три компонента: энкодер RNN, декодер RNN и модуль “внимания” (attention module). Энкодер работает над задачей преобразования входного предложения в векторное представление, декодер возвращает выходное представление, затем модуль внимания сообщает декодеру, на чем следует заострить внимание во время операции декодирования (здесь вступает идея использования всего контекста предложения).

Далее статья уделяет внимание проблемам, связанным с развертыванием и масштабированием данного сервиса. В ней обсуждаются такие темы, как вычислительные ресурсы, время задержки и массовое развертывание сервиса.

Заключение

На этом мы завершим пост о том, какой вклад глубокое обучение вносит в решение задач обработки естественного языка. Думаю, что дальнейшими целями в развитии данной области могли бы быть улучшение чатботов для обслуживания клиентов, идеальный машинный перевод и, возможно, обучение систем ответов на вопросы глубоко разбираться в неструктурированных или длинных текстах (например, страницы Википедии).

О, а приходите к нам работать? :)wunderfund.io — молодой фонд, который занимается высокочастотной алготорговлей. Высокочастотная торговля — это непрерывное соревнование лучших программистов и математиков всего мира. Присоединившись к нам, вы станете частью этой увлекательной схватки.

Мы предлагаем интересные и сложные задачи по анализу данных и low latency разработке для увлеченных исследователей и программистов. Гибкий график и никакой бюрократии, решения быстро принимаются и воплощаются в жизнь.

Присоединяйтесь к нашей команде: wunderfund.io

|

|

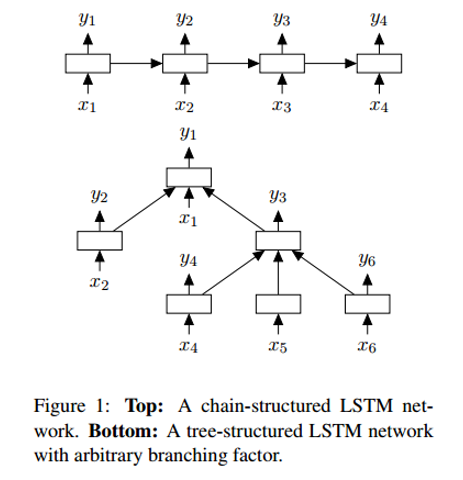

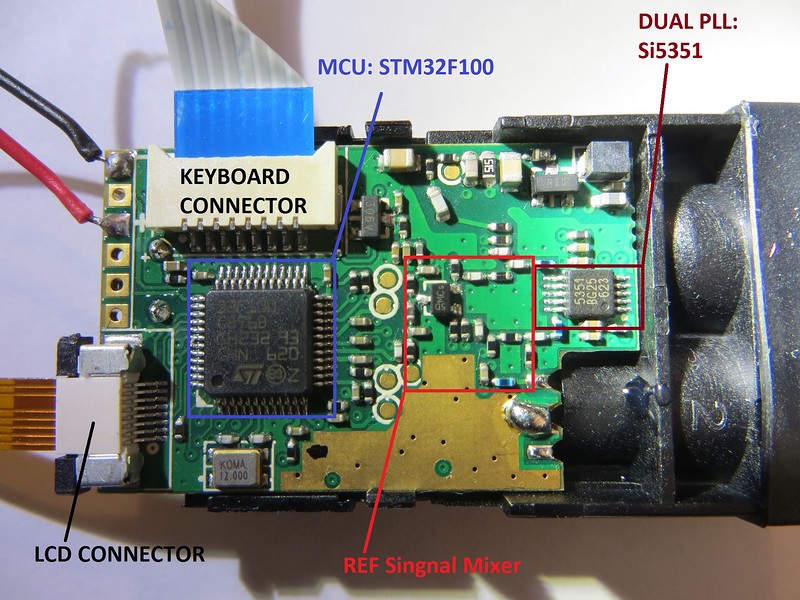

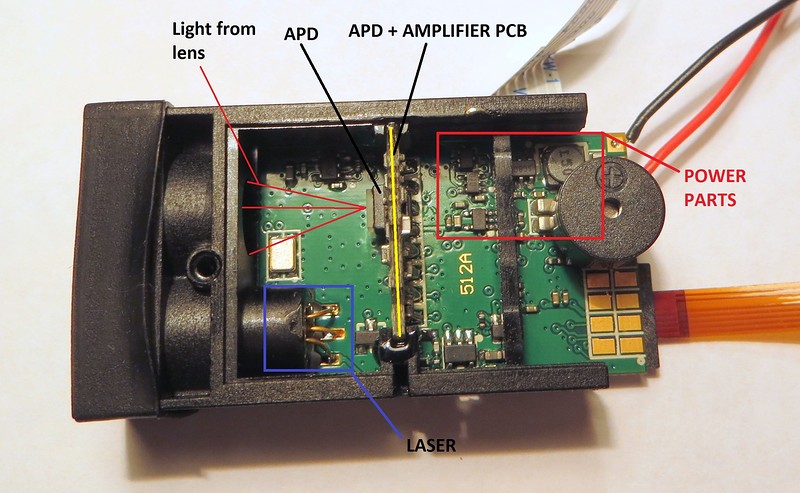

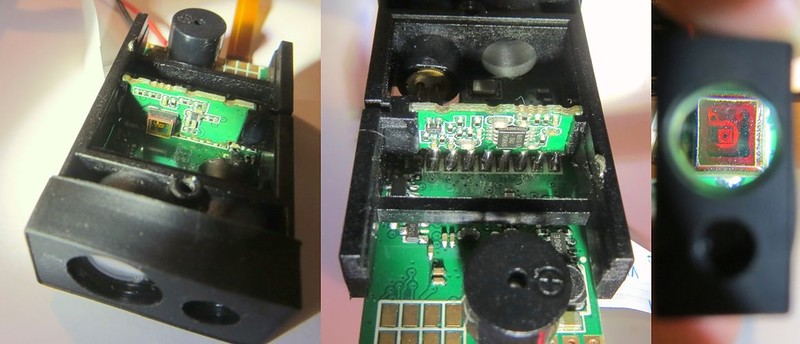

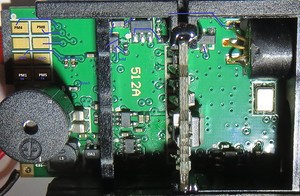

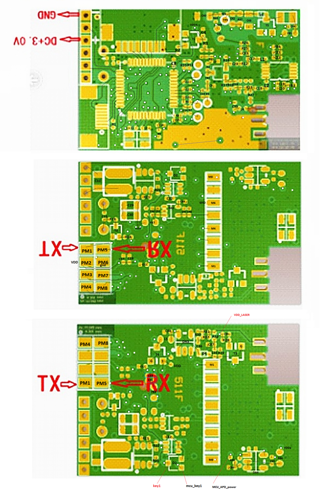

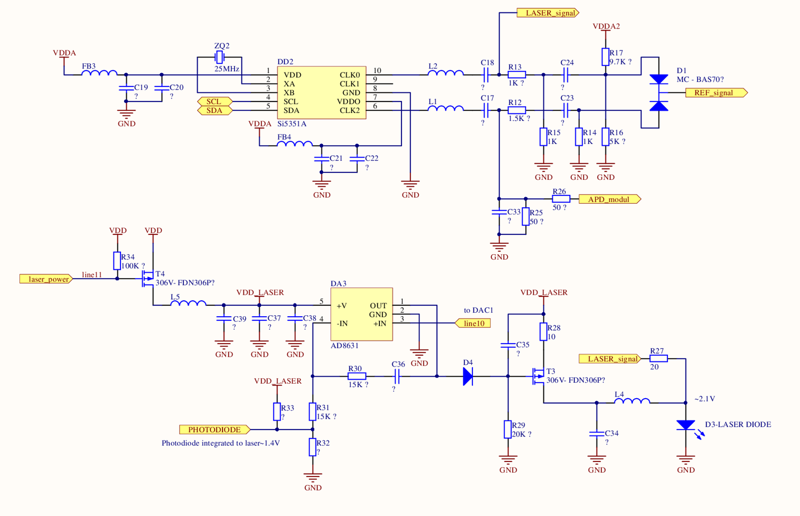

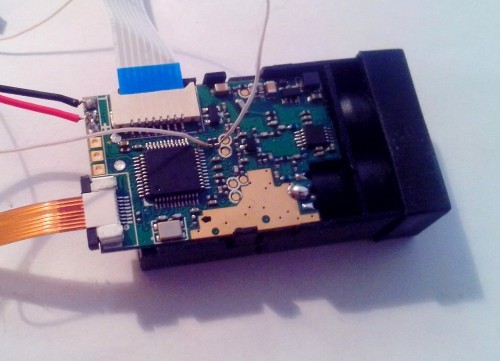

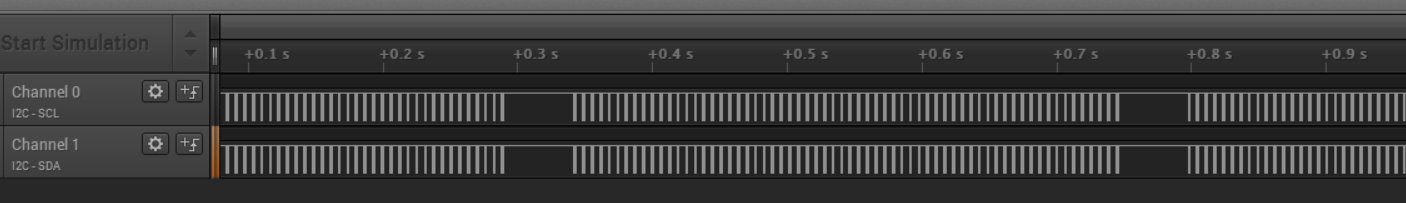

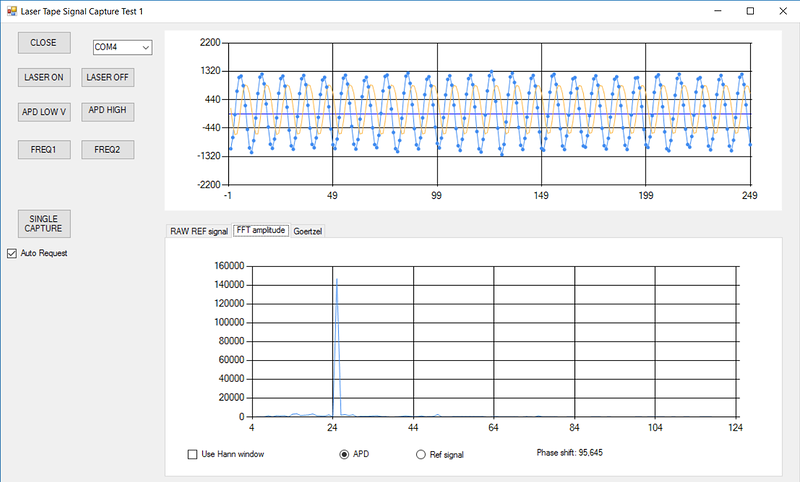

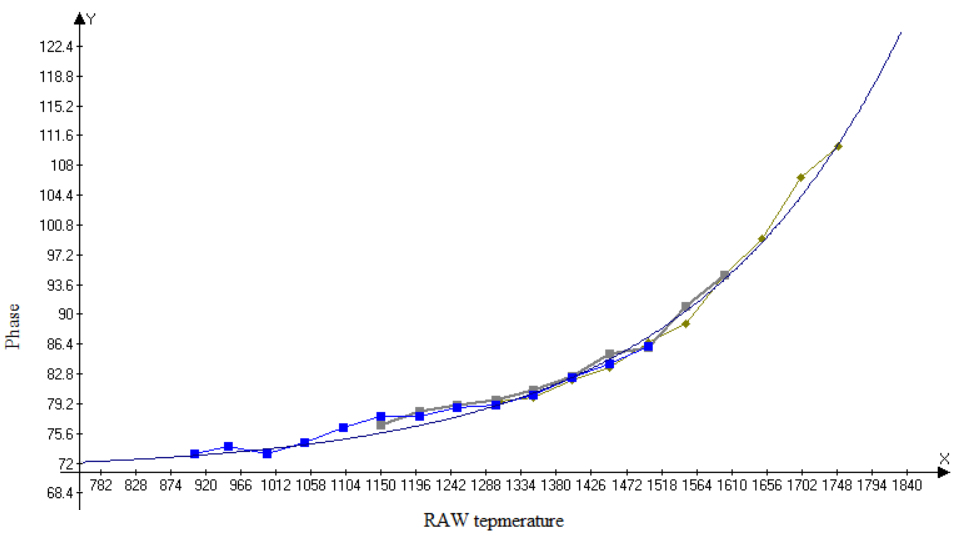

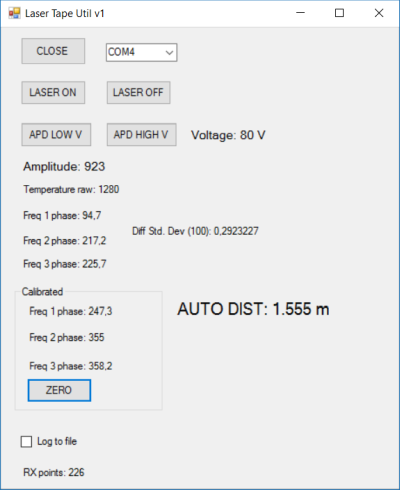

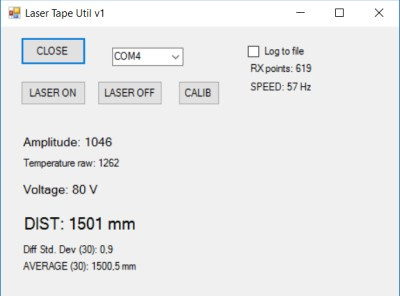

Как работает лазерная рулетка: реверс-инжиниринг |

Ранее в своей статье я рассказывал о том, как устроены фазовые лазерные дальномеры. Теперь пришло время разобраться с тем, как работают бытовые лазерные рулетки. Разобраться — это не просто заглянуть, что же там внутри, а полностью восстановить всю схему и написать собственную программу для микроконтроллера.

Принцип работы лазерных рулеток

Большинство лазерных рулеток используют фазовый, а не импульсный (времяпролетный, TOF) метод измерения расстояния.

Для целостности этой статьи процитирую часть теории из своей предыдущей статьи: