Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

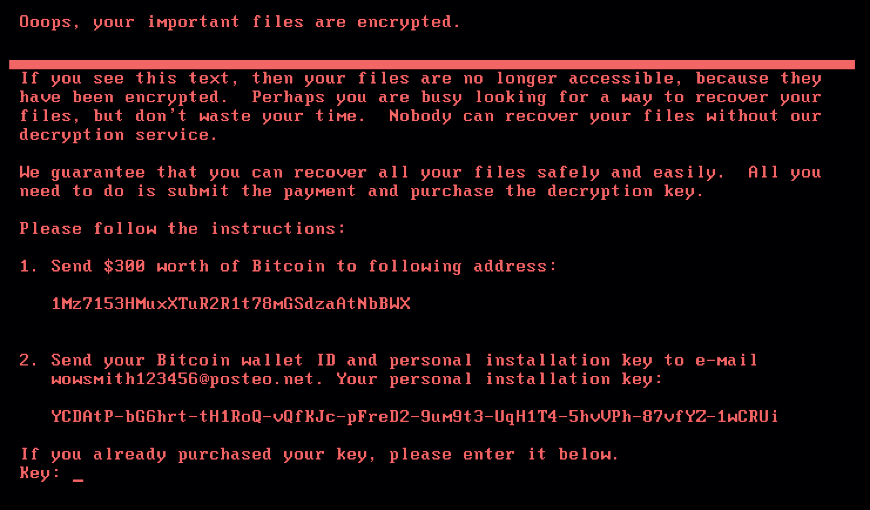

Боремся с вирусами и инфраструктурой, или отключение SMB v1 |

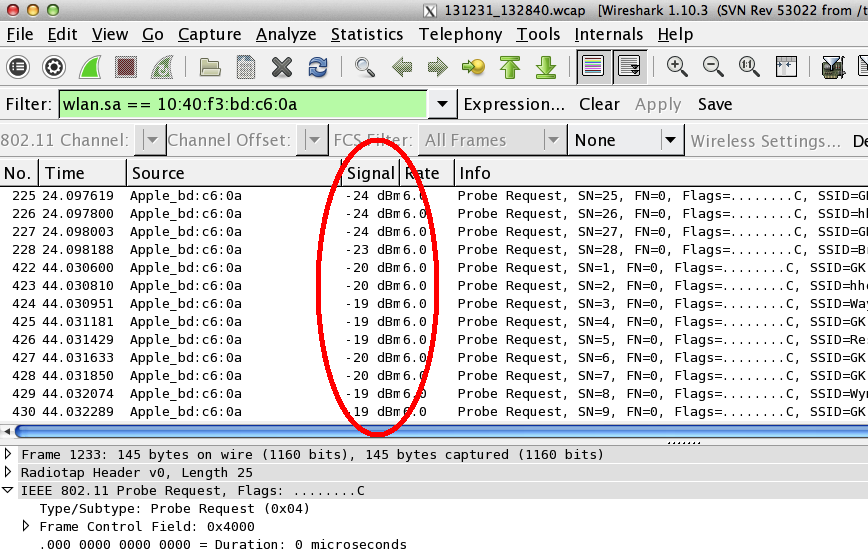

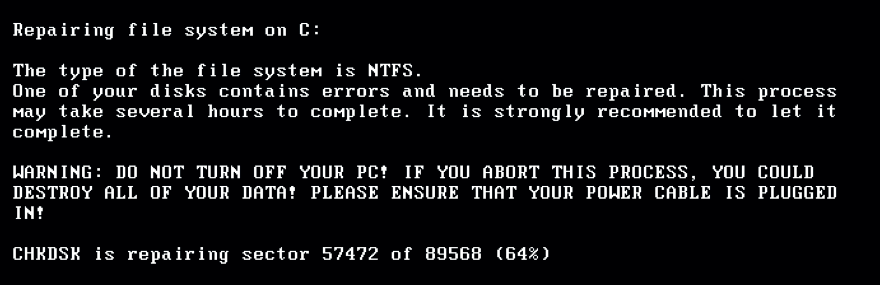

В связи с недавной эпидемией шифровальщика WannaCry, эксплуатирующим уязвимость SMB v1, в сети снова появились советы по отключению этого протокола. Более того, Microsoft настоятельно рекомендовала отключить первую версию SMB еще в сентябре 2016 года. Но такое отключение может привести к неожиданным последствиям, вплоть до курьезов: лично сталкивался с компанией, где после борьбы с SMB перестали играть беспроводные колонки Sonos.

Специально для минимизации вероятности «выстрела в ногу» я хочу напомнить об особенностях SMB и подробно рассмотреть, чем грозит непродуманное отключение его старых версий.

SMB (Server Message Block) – сетевой протокол для удаленного доступа к файлам и принтерам. Именно он используется при подключении ресурсов через \servername\sharename. Протокол изначально работал поверх NetBIOS, используя порты UDP 137, 138 и TCP 137, 139. С выходом Windows 2000 стал работать напрямую, используя порт TCP 445. SMB используется также для входа в домен Active Directory и работы в нем.

Помимо удаленного доступа к ресурсам протокол используется еще и для межпроцессорного взаимодействия через «именованные потоки» – named pipes. Обращение к процессу производится по пути \.\pipe\name.

Первая версия протокола, также известная как CIFS (Common Internet File System), была создана еще в 1980-х годах, а вот вторая версия появилась только с Windows Vista, в 2006. Третья версия протокола вышла с Windows 8. Параллельно с Microsoft протокол создавался и обновлялся в его открытой имплементации Samba.

В каждой новой версии протокола добавлялись разного рода улучшения, направленные на увеличение быстродействия, безопасности и поддержки новых функций. Но при этом оставалась поддержка старых протоколов для совместимости. Разумеется, в старых версиях было и есть достаточно уязвимостей, одной из которых и пользуется WannaCry.

| Версия | Операционная система | Добавлено, по сравнению с предыдущей версией |

| SMB 2.0 | Windows Vista/2008 | Изменилось количество команд протокола со 100+ до 19 |

| Возможность «конвейерной» работы – отправки дополнительных запросов до получения ответа на предыдущий | ||

| Поддержка символьных ссылок | ||

| Подпись сообщений HMAC SHA256 вместо MD5 | ||

| Увеличение кэша и блоков записи\чтения | ||

| SMB 2.1 | Windows 7/2008R2 | Улучшение производительности |

| Поддержка большего значения MTU | ||

| Поддержка службы BranchCache – механизм, кэширующий запросы в глобальную сеть в локальной сети | ||

| SMB 3.0 | Windows 8/2012 | Возможность построения прозрачного отказоустойчивого кластера с распределением нагрузки |

| Поддержка прямого доступа к памяти (RDMA) | ||

| Управление посредством командлетов Powershell | ||

| Поддержка VSS | ||

| Подпись AES–CMAC | ||

| Шифрование AES–CCM | ||

| Возможность использовать сетевые папки для хранения виртуальных машин HyperV | ||

| Возможность использовать сетевые папки для хранения баз Microsoft SQL | ||

| SMB 3.02 | Windows 8.1/2012R2 | Улучшения безопасности и быстродействия |

| Автоматическая балансировка в кластере | ||

| SMB 3.1.1 | Windows 10/2016 | Поддержка шифрования AES–GCM |

| Проверка целостности до аутентификации с использованием хеша SHA512 | ||

| Обязательные безопасные «переговоры» при работе с клиентами SMB 2.x и выше |

Считаем условно пострадавших

Посмотреть используемую в текущий момент версию протокола довольно просто, используем для этого командлет Get–SmbConnection:

Вывод командлета при открытых сетевых ресурсах на серверах с разной версией Windows.

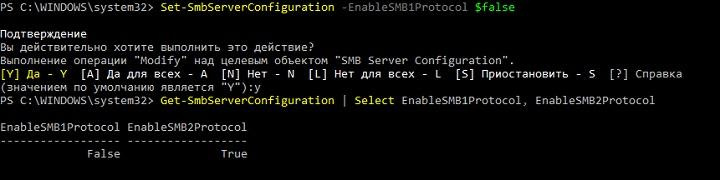

Из вывода видно, что клиент, поддерживающий все версии протокола, использует для подключения максимально возможную версию из поддерживаемых сервером. Разумеется, если клиент поддерживает только старую версию протокола, а на сервере она будет отключена – соединение установлено не будет. Включить или выключить поддержку старых версий в современных системах Windows можно при помощи командлета Set–SmbServerConfiguration, а посмотреть состояние так:

Get–SmbServerConfiguration | Select EnableSMB1Protocol, EnableSMB2Protocol

Выключаем SMBv1 на сервере с Windows 2012 R2.

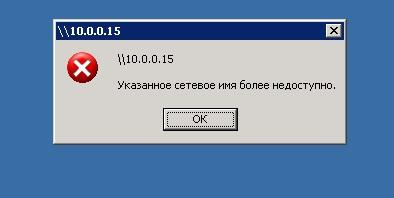

Результат при подключении с Windows 2003.

Таким образом, при отключении старого, уязвимого протокола можно лишиться работоспособности сети со старыми клиентами. При этом помимо Windows XP и 2003 SMB v1 используется и в ряде программных и аппаратных решений (например NAS на GNU\Linux, использующий старую версию samba).

| Производитель | Продукт | Комментарий |

| Barracuda | SSL VPN | |

| Web Security Gateway backups | ||

| Canon | Сканирование на сетевой ресурс | |

| Cisco | WSA/WSAv | |

| WAAS | Версии 5.0 и старше | |

| F5 | RDP client gateway | |

| Microsoft Exchange Proxy | ||

| Forcepoint (Raytheon) | «Некоторые продукты» | |

| HPE | ArcSight Legacy Unified Connector | Старые версии |

| IBM | NetServer | Версия V7R2 и старше |

| QRadar Vulnerability Manager | Версии 7.2.x и старше | |

| Lexmark | МФУ, сканирование на сетевой ресурс | Прошивки Firmware eSF 2.x и eSF 3.x |

| Linux Kernel | Клиент CIFS | С 2.5.42 до 3.5.x |

| McAfee | Web Gateway | |

| Microsoft | Windows | XP/2003 и старше |

| MYOB | Accountants | |

| NetApp | ONTAP | Версии до 9.1 |

| NetGear | ReadyNAS | |

| Oracle | Solaris | 11.3 и старше |

| Pulse Secure | PCS | 8.1R9/8.2R4 и старше |

| PPS | 5.1R9/5.3R4 и старше | |

| QNAP | Все устройства хранения | Прошивка старше 4.1 |

| RedHat | RHEL | Версии до 7.2 |

| Ricoh | МФУ, сканирование на сетевой ресурс | Кроме ряда моделей |

| RSA | Authentication Manager Server | |

| Samba | Samba | Старше 3.5 |

| Sonos | Беспроводные колонки | |

| Sophos | Sophos UTM | |

| Sophos XG firewall | ||

| Sophos Web Appliance | ||

| SUSE | SLES | 11 и старше |

| Synology | Diskstation Manager | Только управление |

| Thomson Reuters | CS Professional Suite | |

| Tintri | Tintri OS, Tintri Global Center | |

| VMware | Vcenter | |

| ESXi | Старше 6.0 | |

| Worldox | GX3 DMS | |

| Xerox | МФУ, сканирование на сетевой ресурс | Прошивки без ConnectKey Firmware |

Список взят с сайта Microsoft, где он регулярно пополняется.

Перечень продуктов, использующих старую версию протокола, достаточно велик – перед отключением SMB v1 обязательно нужно подумать о последствиях.

Все-таки отключаем

Если программ и устройств, использующих SMB v1 в сети нет, то, конечно, старый протокол лучше отключить. При этом если выключение на SMB сервере Windows 8/2012 производится при помощи командлета Powershell, то для Windows 7/2008 понадобится правка реестра. Это можно сделать тоже при помощи Powershell:

Set–ItemProperty –Path "HKLM:\SYSTEM\CurrentControlSet\Services\LanmanServer\Parameters" SMB1 –Type DWORD –Value 0 –Force

Или любым другим удобным способом. При этом для применения изменений понадобится перезагрузка.

Для отключения поддержки SMB v1 на клиенте достаточно остановить отвечающую за его работу службу и поправить зависимости службы lanmanworkstation. Это можно сделать следующими командами:

sc.exe config lanmanworkstation depend=bowser/mrxsmb20/nsi

sc.exe config mrxsmb10 start=disabled

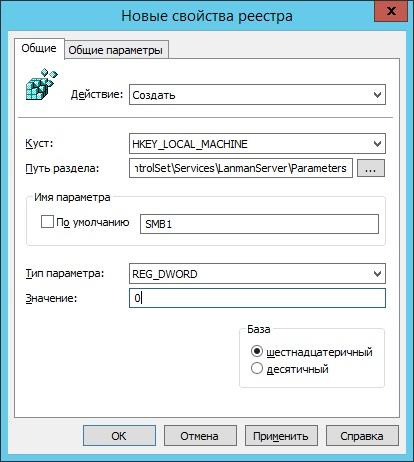

Для удобства отключения протокола по всей сети удобно использовать групповые политики, в частности Group Policy Preferences. С помощью них можно удобно работать с реестром.

Создание элемента реестра через групповые политики.

Чтобы отключить протокол на сервере, достаточно создать следующий параметр:

путь: HKLM:\SYSTEM\CurrentControlSet\Services\LanmanServer\Parameters;

новый параметр: REG_DWORD c именем SMB1;

- значение: 0.

Создание параметра реестра для отключения SMB v1 на сервере через групповые политики.

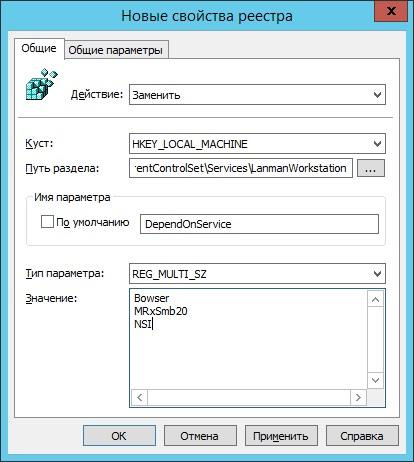

Для отключения поддержки SMB v1 на клиентах понадобится изменить значение двух параметров.

Сначала отключим службу протокола SMB v1:

путь: HKLM:\SYSTEM\CurrentControlSet\services\mrxsmb10;

параметр: REG_DWORD c именем Start;

- значение: 4.

Обновляем один из параметров.

Потом поправим зависимость службы LanmanWorkstation, чтоб она не зависела от SMB v1:

путь: HKLM:\SYSTEM\CurrentControlSet\Services\LanmanWorkstation;

параметр: REG_MULTI_SZ с именем DependOnService;

- значение: три строки – Bowser, MRxSmb20 и NSI.

И заменяем другой.

После применения групповой политики необходимо перезагрузить компьютеры организации. После перезагрузки SMB v1 перестанет использоваться.

Работает – не трогай

Как ни странно, эта старая заповедь не всегда полезна – в редко обновляемой инфраструктуре могут завестись шифровальщики и трояны. Тем не менее, неаккуратное отключение и обновление служб могут парализовать работу организации не хуже вирусов.

Расскажите, а вы уже отключили у себя SMB первой версии? Много было жертв?

|

Метки: author Tri-Edge системное администрирование серверное администрирование антивирусная защита it- инфраструктура блог компании сервер молл smb windows сетевые папки |

Размеры растровых изображений: пиксели, DPI, PPI, сантиметры — вы ничего не путаете? |

Пишу эту небольшую заметку как важный ликбез для всех, кто работает с растровыми картинками. Обычно, вопрос в чём измерять изображения встаёт у новичков, но путают термины и опытные специалисты.

Начнём с главного: растровые изображения состоят из пикселей. На этом можно было закончить данную статью, но не всем этого достаточно, поэтому поговорим о заблуждениях и мифах, которые я встречал на практике.

DPI, PPI и изменение размеров

Самое частое заблуждение — использование единиц DPI (dots per inch — точек на дюйм) и PPI (pixels per inch — пикселей на дюйм). На самом деле эти единицы относятся к принтерам и сканерам соответственно. Также их можно применять в характеристиках экранов. По сути это коэффициенты для перевода между физическими размерами в аналоге (в сантиметрах или дюймах) и размерами в пикселях для цифрового изображения.

Например, изображение в 100 пикселей, распечатанное с разрешением 100 DPI будет иметь размер 1 дюйм. Всё просто и понятно.

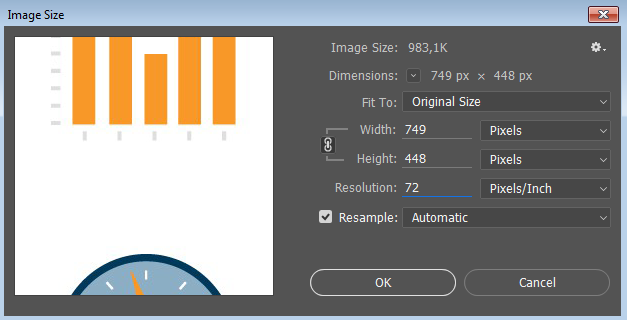

Однако, при изменении размеров в графических редакторах нам предлагают указать размеры в удобных нам измерениях, в том числе в DPI. Здесь и начинается путаница.

На самом деле физические размеры изображения (в сантиметрах, дюймах и т.д.) и значение DPI это всего лишь мета-информация в свойствах файла. Но редактор может использовать эти значения как средство указания требуемых размеров в пикселях.

Допустим, у нас изображение размером 3000 пикселей (квадратное), у которого стоит значение 300 DPI. Получаем: 3000 пикселей / 300 DPI = 10 дюймов. А теперь заходим в редактор (Photoshop) и изменяем значение DPI на 600. Что мы получим? А это зависит от галки «Resample». Если она стоит, мы получим upsampling (увеличение) изображения до 6000 пикселей. Если не стоит, то размер в дюймах станет 5 вместо 10.

Таким образом, для веб-разработки все значения физических размеров (DPI, сантиметры, дюймы и т.д.) можно смело игнорировать и смотреть исключительно на размеры в пикселях.

DPI/PPI экранов

Здесь мы подошли к вопросу разрешения и плотности пикселей экранов. Корректно эта плотность обозначается как PPI (pixels per inch) и показывает, сколько пикселей может быть отображено на одном дюйме экрана.

Здесь часто возникают мифические 72 и 96 PPI, которые должны показывать «стандартную» плотность пикселей для экранов. Для задач отображения графики в вебе они бесполезны. При этом реальная плотность пикселей экрана может быть совсем другой: типично что-то около 120 PPI (можете измерить и посчитать для своего экрана).

Но мы помним, что растровые картинки измеряются только в пикселях и никак иначе. Зачем мы вообще говорим о PPI экранов? Потому что есть «Retina» или «HiDPI» экраны.

Retina и HiDPI экраны

Такие дисплеи широко распространены в мобильных устройствах и дорогих ноутбуках. По сути это количественное увеличение пикселей при сохранении физических размеров экрана (например, 5 дюймов по диагонали и 330 PPI).

Для нас, как веб-разработчиков это значит появление разных пикселей в браузере: CSS-пикселей (которые мы обычно указываем в размерах элементов) и физических пикселей (реальных пикселей на экране). Формула такая: Физические пиксели = CSS-пиксели * DPR.

DPR это device pixel ratio — коэффициент перевода CSS-пикселей в физические.

При размещении картинки мы можем написать тег img с размерами 20px, а картинка будет 40 пикселей. При этом на экране с DPR=2,0 мы увидим все пиксели картинки. Но в этой ситуации нас абсолютно не волнуют реальные значения PPI экрана.

При этом мы можем использовать картинки с высокой плотностью пикселей и для обычных экранов, браузер сам отмасштабирует изображение. И опять, DPI и PPI здесь ни при чем, а картинки измеряются в пикселях. Как их показать будет решать браузер, у которого уже есть два вида пикселей.

Вот и вся история, хотя я конечно ничего не говорил об адаптивных картинках, способах оптимизации их отдачи и client hints. Но это другая история.

|

Метки: author Nickmob обработка изображений клиентская оптимизация css пиксели изображения оптимизация |

Усатый стрелок с полигональным пузом. Часть вторая |

Рассказ про разработку проекта похож на паутину: повсюду тянутся ниточки ассоциаций, истории про интересные идеи. А иногда нити повествования обвиваются коконом вокруг необычного бага. Вот и сейчас, материала накопилось столько, что приходится начинать работать над второй частью статьи до того, как первая опубликована.

А теперь, когда опубликована вторая часть, материала достаточно и для третьей части! :)

Сегодня в программе: смесь визуала и архитектуры проекта. Но сначала, ещё парочка деталей про тени.

Итак, поехали!

Статьи

- Первая часть. Усатый стрелок из двадцати трёх полигонов.

- Вторая часть. Усатый стрелок с полигональным пузом.

Оглавление

- Менеджер теней

- Рефакторинг архитектуры

- Рефакторинг игровых объектов

- Эффект гибели

- Эффект пятен

- Рендеринг тайлов

- Заключение второй части

Level 3.4. Менеджер теней.

Level 3.4. Менеджер теней.

Как вы помните, тени уже генерируются на CPU с кучей оптимизаций. А вот их отрисовку нужно доработать. Пока я разбирался с генерацией, мне нужен был самый простой способ рендеринга, поэтому всё работает так:

- У каждого объекта, отбрасывающего тень, два потомка, которые рендерят тени с разными шейдерами (один только back — грани, другой — front);

- На сцене лежит огромный спрайт, который отрисовывается самым последним, и подкрашивается в нужный цвет, если в стенсиле ненулевое значение.

- Самое простое — дублирование объектов (по два одинаковых потомка у каждого элемента). Избавиться от них, сделав двухпроходный шейдер — не вариант, т.к. объекты с многопроходными шейдерами не умеют батчиться;

- Далее, возможность сделать только один источник света с тенями;

- Очень скупые возможности по работе со светом (т.к. по сути, света и нет, только тень). Так что сделать цветную тень можно, а цветное освещение — нет;

- Стенсил буфер занят целиком и его не получится использовать для других эффектов.

Идея простая: вынести рендеринг теней в отдельный проход, добавив возможность отбрасывать тени любому количеству источников света (да-да, fps будет проседать).

Всего потребовалось несколько классов:

- LightSource, фонарик с бесконечной дальностью, настройкой цветов тени и освещения;

- IShadowSource, интерфейс с функцией пересчёта тени void RebuildShadow(Vector3 lightPosition);

- ShadowRenderer, который регистрирует все источники света и теней и умеет рендерить тени.

Код написан, шейдеры проверены, можно двигаться дальше. И тут начались проблемы.

Забагованные тени.

На изображении выше целых две проблемы.

Во-первых, тени слишком длинные и иногда неправильно перекрывают объекты. Такое может быть, если тени рендерятся поверх пустого z-buffer'а (другие объекты могут перекрывать тень, но сами тени в z-buffer ничего не пишут).

Во-вторых, тени в каком-то странном шуме. Такое бывает, если работать с неочищенным буфером.

Итак, проблема в том, что z-buffer, с которым я работаю, судя по всему, не использовался камерой. Рендеринг кадра сейчас работает так:

- Рендеринг сцены в RenderTexture;

- Рендеринг тени, depth-buffer берётся из п.1, а color-buffer свой (об этом ниже);

- Композинг теней и отрендереной сцены;

- Постэффекты.

Когда работаешь с постэффектами зачастую нужно с помощью какого-то шейдера преобразовать текстуру. В Unity3D для этого есть метод Graphics.Blit. Мы передаём в него исходную текстуру, указываем target — куда отрисовывать, материал и даже проход шейдера.

По сути, мы работаем минимум с тремя различными буферами:

- Исходный color buffer, откуда мы читаем цвета пикселей;

- Целевой color buffer, куда мы пишем цвета;

- Depth+stencil buffer, в который мы пишем (и из которого читаем глубину и данные стенсила).

И в методе Graphics.Blit целевой color buffer и depth buffer неразделимы. Т.е., если нам нужно, например, читать глубину геометрии сцены из исходной текстуры, а записывать пиксели в целевую — облом.

Или если мы сделали рендеринг сцены в текстуру, при этом часть шейдеров записала данные в стенсил, а теперь хотим получить новую текстуру, воспользовавшись этими данными (и сохранив исходную текстуру!) — тоже облом.

Выход есть и в документации Unity3D об этом прямо сказано:

Note that if you want to use depth or stencil buffer that is part of the source (Render)texture, you'll have to do equivalent of Blit functionality manually — i.e. Graphics.SetRenderTarget with destination color buffer and source depth buffer, setup orthographic projection (GL.LoadOrtho), setup material pass (Material.SetPass) and draw a quad (GL.Begin).

В общем, модифицированная версия Blit, позволяющая разделить передачу буферов:

static void Blit(RenderBuffer colorBuffer, RenderBuffer depthBuffer, Material material) {

Graphics.SetRenderTarget(colorBuffer, depthBuffer);

GL.PushMatrix();

GL.LoadOrtho();

for (int i = 0, passCount = material.passCount; i < passCount; ++i) {

material.SetPass(i);

GL.Begin(GL.QUADS);

GL.TexCoord(new Vector3(0, 0, 0));

GL.Vertex3(0, 0, 0);

GL.TexCoord(new Vector3(0, 1, 0));

GL.Vertex3(0, 1, 0);

GL.TexCoord(new Vector3(1, 1, 0));

GL.Vertex3(1, 1, 0);

GL.TexCoord(new Vector3(1, 0, 0));

GL.Vertex3(1, 0, 0);

GL.End();

}

GL.PopMatrix();

Graphics.SetRenderTarget(null);

}Использование в коде:

void RenderShadowEffect(RenderTexture source, RenderTexture target, LightSource light) {

shadowEffect.SetColor("_ShadowColor", light.ShadowColor);

shadowEffect.SetColor("_LightColor", light.LightColor);

shadowEffect.SetTexture("_WorldTexture", source);

shadowEffect.SetTexture("_ShadowedTexture", target);

Blit(target.colorBuffer, source.depthBuffer, shadowEffect);

}Итак, в чем же дело? Почему моя RenderTexture, в которую я рендерю камеру на выходе совершенно пуста (и даже не очищена от мусора)?

Выключаю тени и смотрю, что показывает frame debug:

Странные рендер-текстуры.

Любопытно. Судя по всему, постэффект антиалиасинга принудительно переводит камеру на рендеринг в свою текстуру. При этом доступа до этой текстуры у меня нет: при дебаге в Camera.аctiveTexture пустая.

Ах, так, антиалиасинг! Лезешь в мою последовательность отрисовки? Тогда я залезу в твой код!

Постэффекты работают через метод MonoBehaviour.OnRenderImage, а я через MonoBehaviour.OnRenderImage и

MonoBehaviour.OnPostRender. Делаю грязный хак: переименовываю OnRenderImage в Apply и вызываю его руками, после рендеринга теней, с моими renderTexture. Теперь антиалиасинг не мешает теням.

Новые тени позволяют делать смешные, но не очень нужные штуки вроде хроматической aберрации или гладких теней.

Сотня обычных бледных теней с небольшим смещением.

Три цветных тени.

Пока тени притормаживают на мобилках (съедают примерно 10 — 15 лишних fps). Если все будет грустно, переведу под конец все в однопроходную отрисовку, а пока не буду налегать на источники света.

Хинт: импровизируйте в отладке графики! Отлаживать вертексные шейдеры бывает больно, поэтому визуализируйте все данные, которые сможете: вытягивайте вертексы вдоль нормалей, добавляйте цвет и прозрачность и т.д.

Дебажная визуализация через шейдеры и гизмо.

Оказалось, что добавлять новые классы стало тяжелее из-за некоторых неудачных проектных решений.

Todo: почистить архитектуру и код проекта.

Level 4.1. Рефакторинг архитектуры.

Level 4.1. Рефакторинг архитектуры.

Как вы помните, я развиваю проект с прототипа. Но тянуть все прототипную архитектуру (знаете, какая архитектура в прототипах, написанных за 2 часа?) не хочется, значит, нужен рефакторинг.

Итак:

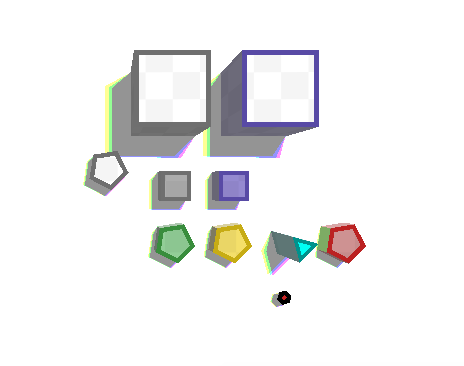

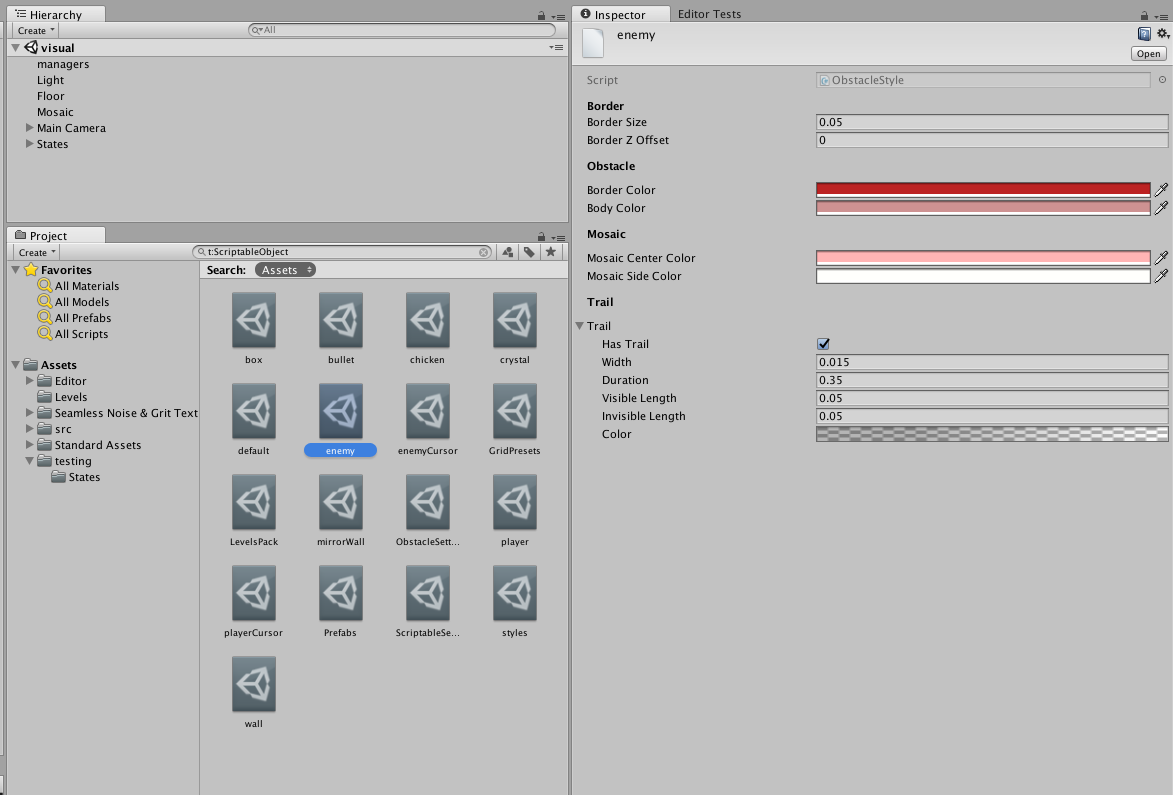

Для начала выношу как можно больше данных из MonoBehaviour в ScriptableObject. Это всяческие стили, настройки, библиотека префабов;

Настройки проекта.

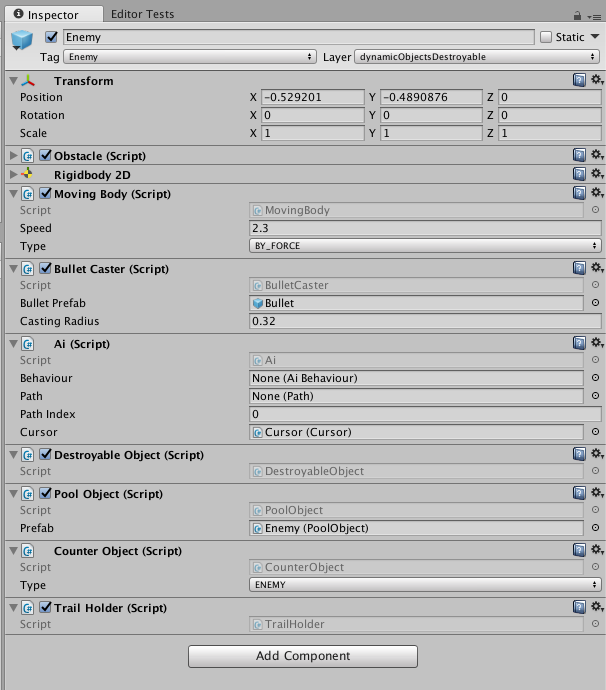

Разбиваю всю логику на маленькие классы, например, BulletCaster или MovableObject. Каждый из них содержит в себе нужные настройки и преследует только одну цель.

public class BulletCaster : MonoBehaviour {

public void CastBullet(Vector2 direction);

}

public class MovingBody : MonoBehaviour {

public Vector2 Direction {get; set;}

public bool IsStopped {get; set;}

}

Из микроклассов можно собрать сложную логику.

Убираю прямые зависимости от синглтонов (Clock, ShadowManager и т.д.) и реализую паттерн service locator (несколько спорная вещь, но куда аккуратнее, чем россыпь синглтонов).

Реализую обработку столкновений через слои, оптимизирую их, явно убирая невозможные столкновения (например, статика <-> статика).

Оптимизирую создание объектов, написав глобальный pool. Думаю, это очередной велосипед, но мне хотелось написать его своими руками. Пул умеет создавать объекты по ключу-префабу, инициализировать их после создания, уведомлять объекты о создании/удалении.

У моих пуль есть ограничение по времени жизни (примерно 10 секунд "незамороженного" времени). Как то раз появился странный баг: часть пуль исчезала прямо в воздухе, словно кулдаун наступал раньше срока и пуля исчезала по таймеру.

Отловить было сложно: не все пули исчезали, а дебажить каждую, надеясь, что хоть одна исчезнет — очень утомительно.

Впрочем, удалось выяснить два странных факта:

- Пули начинали исчезать только после перезапуска уровня;

- Код, ответственный за удаление пуль вообще не вызывался.

Самое важное правило в очередной раз не подвело:

Чем страннее кажется баг, тем глупее его причины.

Итак, наслаждайтесь:

- Уровни пересоздаются на одной сцене, без перезагрузки;

- При создании уровня я забыл удалять старые стены (т.к. уровень одинаковый, это не было заметно нигде, кроме иерархии;

- Когда пуля касалась такой двойной стены, обработчик коллизии вызывался дважды;

- В обработчике коллизии пуля удаляется (добавляется в пул). Таким образом, в данных пула оказывалось две ссылки на одну и ту же пулю;

- Через какое-то время игрок стрелял этой пулей;

- При попытке выстрелить ещё раз из пула забиралась ссылка на уже активную, летящую пулю. Она переинициализировалась, меняла свои координаты и "предыдущая" пуля исчезала прямо в воздухе.

Конечно, такая ошибка могла быть и без старых стен, при сложных коллизиях. Поэтому я добавил проверки на активность объекта при столкновениях и, конечно, начал удалять старые стены.

Вспоминаю про проблему с неудобным тачем и реализую TouchManager. Он запоминает последнее прикосновение и трекает только его. Он сохраняет N последних движений, игнорируя слишком короткие (дрожание пальца). В момент, когда палец или мышь перестали касаться экрана, менеджер рассчитывает направление и длину жеста. Если жест слишком короткий — менеджер игнорирует его: игрок передумал, не выбрав чёткого направления.

Теперь код стал более читаемым, добавлять новые классы стало проще, а ощущение, что архитектура проекта развалится при добавлении самой последней фичи перед релизом, исчезло.

Можно вернуться к арту и игровой логике. По правде говоря, и в логике игры не мешало бы провести чистку.

Todo: подумать над геймплейными элементами, понятностью и простотой геймплея для игрока.

Level 4.2. Рефакторинг игровых объектов.

Level 4.2. Рефакторинг игровых объектов.

Когда я обдумывал геймплейные фичи, я был заворожён огромным количеством возможностей. Судите сами, все объекты могут обладать четырьмя ортогональными характеристиками:

- Отражает ли пули или поглощает их?

- Уничтожим ли объект пулей?

- Подвижен ли или статичен?

- Каков тип объекта (игрок/враг/гражданский)?

Все эти характеристики можно скомбинировать и даже менять на лету. Но как показать это игроку? Сначала мой список объектов выглядел так:

- Обычные стены. Поглощают пули;

- Зеркальные стены. Отражают пули;

- Многоэтажные стены. Каждый этаж — обычный или зеркальный. При попадании пули нижний этаж уничтожается, верхние падают вниз. Так можно делать счётчики и т.д.;

- Ящики. Динамические, но неуничтожимые, поглощают пули;

- Зеркальные ящики. Динамические, но неуничтожимые, отражают пули.;

- Цыплята. Динамические, уничтожимые, игрок теряет очки при их гибели;

- Враги. Динамические, уничтожимые, нужно победить всех для прохождения уровня;

- Зеркальные враги. Обычные враги, но пуля, уничтожая врага, отражается;

- Кристаллы. Динамические, уничтожаются пулей, если игрок коснётся их, он получает бонус;

- Игрок.

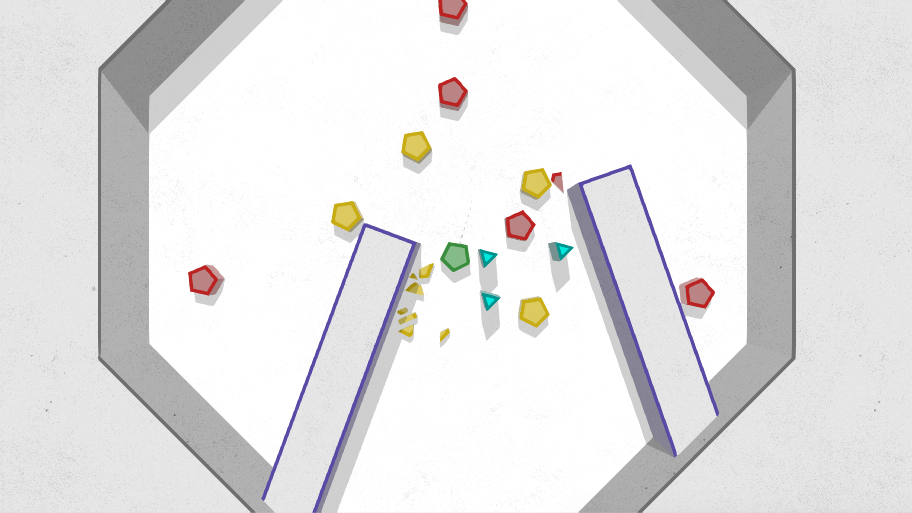

Все доступные объекты.

У меня явно будут проблемы с понятной визуализацией всей этой красоты. Когда я начинал работать над low-poly версией, я планировал использовать простое цветовое кодирование:

- Цвет кромки определяет тип объекта;

- Белый цвет потолка обозначает статический объект (стену), тонированный в цвет кромки потолок — динамический.

Например, серая кромка означает, что объект поглотит пулю, фиолетовая — отразит. Но получается, что цвет кромки должен кодировать очень много свойств. Слишком сложно. Нахожу типы объектов с очевидными проблемами:

- Многоэтажные стены. Когда остаётся только один этаж — он не будет отличаться от обычной стены. Но он будет уничтожим. Или нет? Очень нелогичная фича;

- Зеркальные ящики. Пуля всегда движется с одной скоростью. Переотражаясь от ящиков, она будет их бесконечно и непредсказуемо ускорять;

- Зеркальные враги. Придётся использовать другой цвет, не похожий ни на "вражеский", ни на "зеркальный". Эта сущность только путает все карты.

Итого, остаётся:

- Два типа стен, обычные и зеркальные;

- Игрок;

- Цыплята;

- Враги;

- Кристаллы;

- Ящики.

Объекты, оставшиеся после чистки.

Всё хорошо кодируется цветом, объектов стало мало, но есть простор для левелдизайна.

Теперь, когда я определился с игровыми сущностями и почистил код от мусора, можно довести графику до финального состояния. Это и эффекты и физика, и всякие интерфейсные элементы. Короче говоря, работы много.

Todo: начать разработку релизных эффектов.

Level 5.1. Эффект гибели.

Level 5.1. Эффект гибели.

Точный, выверенный жест и ход сделан. Пуля летит, отражается от стены, проходит в считанных пикселях от игрока, задевает кромку другого отражателя и вновь меняет направление. Теперь она нацелена в последнего противника на карте. Ход закончен. Новый ход, в ожидании победы. Направление уже не важно: прошлая пуля сделает своё дело. Итак, законы геометрии неумолимы и снаряд находит свою цель. Пуля касается врага… И враг просто исчезает. Вот облом.

Да, хочется какого-то фана при попадании пули. Чтобы игра визуально говорила:

- "Да, чел, ты это сделал! Ты расфигачил его в чёртовой бабушке!"

Или наоборот: - "Аккуратнее, аккуратнее… Нееееет! Ты был так близко, а теперь придётся проходить все снова!"

Но сейчас при попадании пули элементы просто исчезают. Пробую сделать плавное погружение объектов сквозь пол. Выглядит медленно и неестественно, а ещё, непонятно, что объект уже уничтожен и с ним нельзя взаимодействовать.

Ладно, что требуется от эффекта гибели?

- Он должен быть ярким, ощутимым и значимым;

- Последствия гибели должны быть видны в течении всего уровня, помогая планировать перепрохождение, но не отвлекая.

Осколки! Пусть пуля разбивает противников на кусочки! Хм, а это не сложно? Неа, все объекты выпуклые, а резать выпуклые многоугольники — одно удовольствие.

На самом деле, просто разрезать противника пополам я не могу. Он состоит из нескольких мешей:

- Внутренняя часть, выпуклый многоугольник, тут все просто;

- Цветное кольцо. Оно мало того, что не выпуклое, да ещё и с дыркой. Но состоит из N (где N — количество сторон) выпуклых четырёхугольников. Так что просто сохраню их в массиве и разрежу каждый из них;

- Внешняя сторона. По сути, это внешняя сторона четырёхугольников из предыдущего пункта. Но я буду работать с ней как с большим выпуклым многоугольником — для рендеринга боковых граней и физики через PolygonCollider2D.

Части объекта, которые нужно разрезать отдельно.

В результате алгоритм получается такой:

- Преобразую объект (игрока, врага и т.д.) во внутреннюю часть, массив кусков кольца, внешнюю часть. В дальнейшем буду именовать эту структуру "Piece";

- Нахожу геометрический центр для Piece;

- Выбираю случайное направление и "провожу" прямую в этом направлении через геометрический центр;

- Разрезаю Piece этой прямой. Для этого беру каждый многоугольник из Piece (кольцо, внутренняя и внешняя части или их кусочки):

4.1. Создаю левый и правый массив точек;

4.2. Указываю текущий массив — левый;

4.3. Добавляю первую точку многоугольника в текущий массив;

4.4. Прохожу по всем оставшимся точкам;

4.5. Если текущая и предыдущая точки находятся с одной стороны прямой, добавляю текущую точку в текущий массив;

4.5. Если текущая и предыдущая точки находятся с разных сторон прямой, нахожу точку пересечения, добавляю её и в левый и в правый массивы. Переключаю текущий массив на противоположный. Добавляю в новый текущий массив текущую точку. - Добавляю все левые осколки в новый левый Piece, а правые — в правый;

- Снов разрезаю получившиеся осколки рекурсивно, до указанной глубины.

При каждом разрезании я делю объекты на две части, поэтому при трёх разрезаниях получается 8 осколков. Можно было бы немного "играть" с глубиной, но и так красиво.

Модифицирую код создания меша, коллайдера и тени многоугольника, чтобы он мог создавать ещё и осколки по заданным точкам.

Получаю примерно такие осколки.

Сначала я планировал сделать кешированные разбиения и использовать только их, но оказалось, что разбиение в реалтайме не вызывает тормозов, а выглядит эффектнее.

Осколки выявили неприятный баг с тенями: я неправильно искал силуэтные точки на многоугольниках. Именно из-за этого на предыдущем видео часть осколков отбрасывают тени лишь частично. Исправления уже доступны в предыдущей статье.

Итак, теперь при попадании пули в объект я подменяю последний на осколки. Объект убирается в пул, а осколки загружаются из пула и обновляют свои меши/коллайдеры согласно своей новой форме. Скорости для rigidBody рассчитываются исходя из скорости разрушенного элемента и направления пули. У осколков выключен флаг isBullet, они взаимодействуют только со стенами и друг с другом. У каждого осколка есть специальный класс FloorHider, он опускает объект по координате z сквозь пол, а после его полного исчезновения — удаляет (перемещает в пул.)

Небольшая ретроспектива:

- Осколки — очень "физически" понятный образ. Поэтому он помогает понять концепцию остановки времени. Осколки начинают разлетаться, тут время останавливается и всё замирает. Игра перестала выглядеть детерминированно пошаговой;

- Все осколки батчатся друг с другом и не тормозят;

- Кристалл сейчас удаляется при прикосновении без эффектов. Может, тоже разбивать на кусочки?

- Не хватает какого-то следа после уничтожений, хочется, чтобы на уровне оставались последствия атак;

- Фаново смотрится, хочется стрелять!

Осколки!

Разлетающиеся на куски враги — весьма эффектный штрих, но он подпорчен тем, что осколки исчезают без всяких следов. Есть и ещё несколько причин, кроме эффектности, почему мне бы эти следы добавить.

Todo: реализовать эффект следов от осколков.

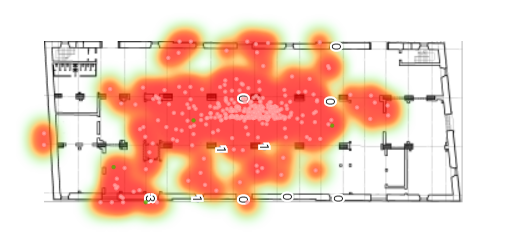

Level 5.2.1. Эффект пятен.

Level 5.2.1. Эффект пятен.

Когда я думал над визуалом, у меня в голове крутилась идея "пятен крови", которые бы появлялись при гибели игрока или npc. На длинных уровнях такие пятна станут удобными метками для навигации. А в случае проигрыша помогут оценить начальное положение врагов и обдумать тактику повторного прохождения.

Итак, пятна. Вариант с декалями и отрисованными текстурами отбрасываю: мне кажется, так я выбьюсь из стиля. Пробую отобразить след от осколков или места их исчезновения. Смотрится плохо:

Разные варианты пятен.

Думаю над полноценной заливкой, среди вариантов прототипирую такой:

Просто создание кучи треугольников.

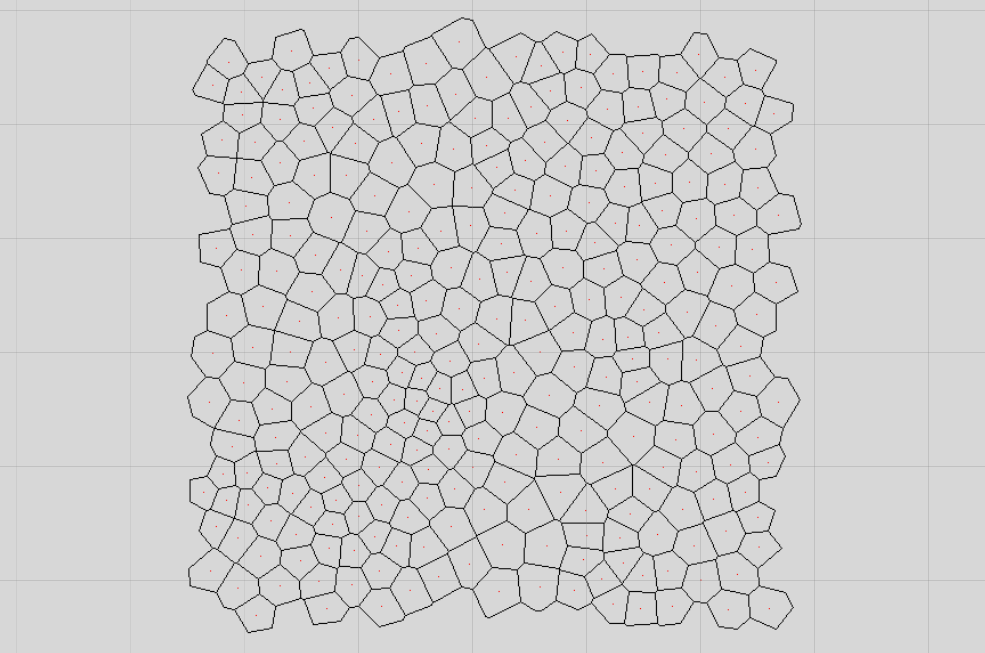

Да, этот вариант мне понравился больше. Но создавать множество треугольников с диким overdraw'ом — плохая идея. Впрочем, результат похож на мозаику, так что думаю в сторону диаграммы Вороного.

Вот только генерировать её на лету, особенно с последующей релаксацией Ллойда (релаксация делает ячейки схожими по размеру) на мобильных устройствах будет слишком больно. Нужен предрассчет. И отсюда очередная проблема: пятна могут быть на любом расстоянии друг от друга, и я, очевидно, не могу предрассчитать бесконечно большую диаграмму. Знаете, что такое тайлинг? :)

Для начала, нахожу подходящую библиотеку для генерации диаграммы Вороного.

Теперь разбираюсь с тайлингом. Построить диаграмму прямо на торе было бы идеальным решением, но лезть в дебри библиотеки или даже писать свою очень не хочется. Поэтому придумываю следующий алгоритм:

- Создаю N точек в квадрате с координатами {-0.5, -0.5, 0.5, 0.5};

- Для каждого Y в интервале [-tiles, tiles] и X в интервале [-tiles, tiles], кроме X = 0, Y = 0:

2.1. Копирую точки со смещением X, Y (при tiles = 1 получается 9 тайлов с моим начальным в центре); - Строю по всем точкам (включая смещённые клоны) диаграмму Вороного;

- Применяю при необходимости релаксацию Ллойда;

- Прохожу по всем получившимся полигонам и оставляю только те, у которых центр находится в исходном квадрате {-0.5, -0.5, 0.5, 0.5}.

В результате получается тайл с полигонами, у которого левая сторона идеально подходит к правой, верхняя — к нижней (с диагоналями — аналогично). На самом деле, не всё так гладко.

Идея в том, что диаграмма Вороного — очень локальная штука, поэтому можно эмулировать тор, сделав несколько копий исходных точек во все стороны. Но вот релаксация Ллойда уж точно локальной не является, и чем больше количество итераций, тем больше нужно делать копий (увеличивать значение tiles).

Да и координаты центров не всегда получается корректно проверить, все-таки, плавающая запятая. Поэтому иногда, очень редко, на краешке мозаики не хватает какого-нибудь элемента.

Найдёте повторения?

Итак, получается примерно такой кусочек мозаики:

Мозаика отрендерена на текстуре средствами библиотеки.

Делаю небольшой ScriptableObject, хранящий массив рассчитанных тайлов и редактор с большой кнопкой "recalculate tiles".

Проблемы с редкими дырами из-за float'а в проверках на попадание полигона в тайл я решил перегенерированием некорректных тайлов. Т.к. я делаю предрассчет один раз, руками в редакторе, могу себе такое позволить. :)

Теперь бы выводить эти тайлы на экран!

Todo: генерировать треугольники тайлов мозаики.

Level 5.2.2. Рендеринг тайлов.

Level 5.2.2. Рендеринг тайлов.

Допустим, что пятно будет идеально круглое и мне известны его координаты и радиус. Нужно как-то получить все полигоны, которые находятся внутри этого пятна. Кроме того, пятно может появится в любых координатах, так что мозаику нужно "виртуально" тайлить.

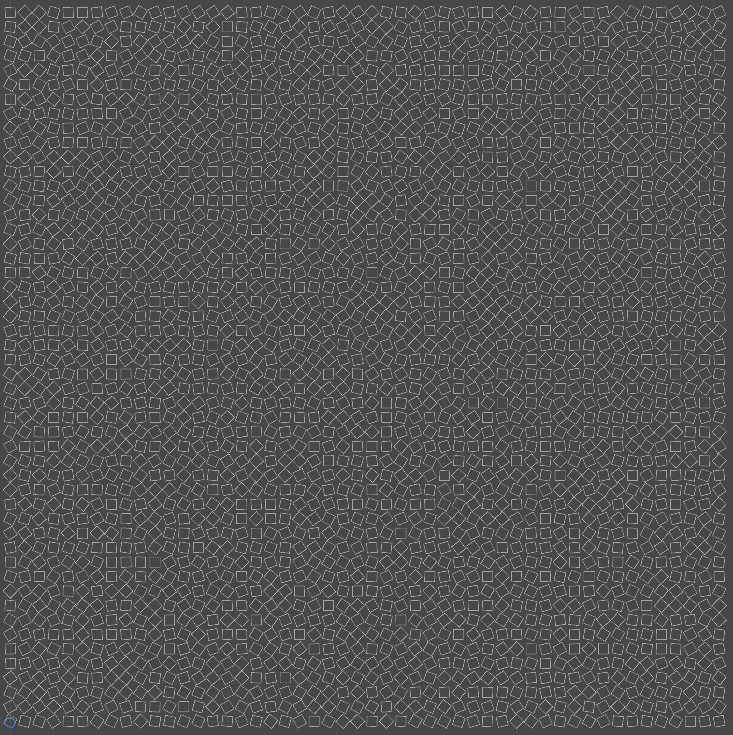

Для проверки алгоритма создал вот такую "мозаику", с ней проще будет найти проблемы:

Поддельная мозаика

Допустим, у меня мозаика генерируется из 512 точек. Значит, на выходе получится 512 полигонов и проверять каждый на пересечение с окружностью — слишком дорого. Поэтому храню мозаику в виде небольших прямоугольных блоков:

Визуализация разделения на блоки.

Зная площадь мозаики и количество полигонов, можно получить оптимальное количество блоков, при котором скорость поиска будет максимальна.

Итак, логика поиска такая:

Дана окружность с координатами center и радиусом radius. Нужно найти все полигоны, попадающие в окружность.

- Считаем из AABB окружности координаты первого и последнего блоков, попадающих в AABB (Значения координат могут быть меньше 0 или больше rows — 1 из-за тайлинга).

var rectSize = size / (float)rows; int minX = Mathf.FloorToInt((center.x - radius) / rectSize); int minY = Mathf.FloorToInt((center.y - radius) / rectSize); int maxX = Mathf.CeilToInt((center.x + radius) / rectSize); int maxY = Mathf.CeilToInt((center.y + radius) / rectSize); - Проходим по каждому блоку от min до max;

- Отбрасываем блоки, не пересекающиеся с окружностью;

- Получаем реальные координаты блока внутри тайла:

int innerX = ((x + rows) % rows + rows) % rows; int innerY = ((y + rows) % rows + rows) % rows; - Проходим по всем полигонам в блоке;

- Добавляем в список те полигоны, центры которых принадлежат окружности (с учётом смещения).

Итак, теперь можно одним запросом получить данные обо всех полигонах, попадающих в заданную окружность:

Запрос полигонов. Тестовая мозаика изменена на более наглядную

Все полигоны диаграммы Вороного выпуклы по определению, поэтому триангулировать их и добавить в меш — проще простого. Делаю первый тест рендеринга:

Выглядит, мягко говоря, скучно. Более того, если два пятна создаются с примерно на расстоянии одного тайла, например, {0, 0} и {1, 1}, бывают заметны повторения.

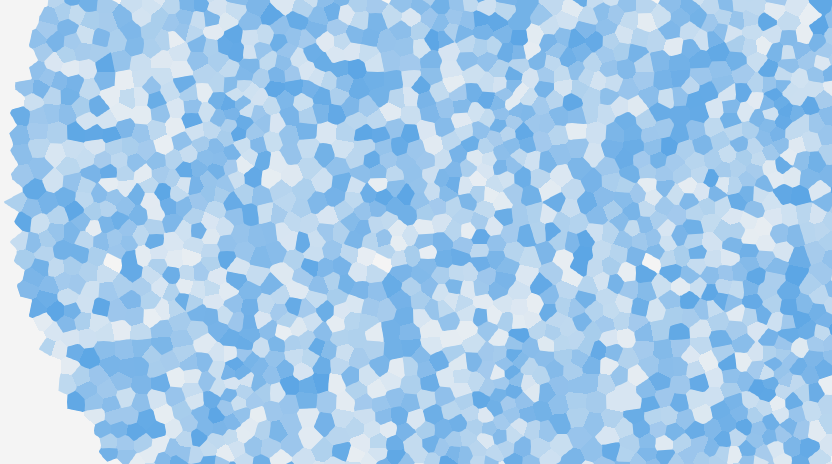

Спасибо любимой, она предложила хорошую модификацию этого алгоритма:

- Убрать релаксацию Ллойда, сделав полигоны более резкими;

- Заменить многоугольники на треугольники;

- Добавить больше случайности в расположение треугольников.

А теперь в картинках:

Пусть у нас есть вот такая мозаика:

Points = 500, Relax = 5

В ней бывают видны повторы, а ещё она очень однообразна.

Убираем релаксацию Ллойда:

Points = 500, Relax = 0

А теперь смешиваем все карты: считаем полигоном не многоугольник, сгенерированные в диаграмме Вороного, а треугольники, получаемые триангуляцией для рендеринга:

Triangles, Points = 500, Relax = 0

Теперь избавляемся от видимых паттернов. Полигоны, полученные из диаграммы Вороного, фактически, однонаправленны: нулевая вершина сверху, следующие вершины идут по часовой стрелке. Из-за этого чётко прослеживается "направление", как будто бумагу скомкали по диагонали и получилась мятая поверхность со складками, вытянутыми в одну сторону:

Выделены нулевые треугольники в каждом полигоне диаграммы.

Всё, что требуется — создавать треугольники начиная со случайной вершины полигона. Дополнительным плюсом становится то, что после триангуляции исчезают все повторы: в каждом тайле полигон триангулируется по-разному:

Паттерны перестали быть заметны.

Резюмирую: теперь у меня есть бесконечная мозаика, в которой не видно повторов. Я могу делать запрос на получение треугольников этой мозаики в определённом радиусе. Судя по всему, основа для пятен "крови" готова.

Todo: придумать конкретную геометрию пятен и замостить её мозаикой.

Заключение.

Проект развивается, и обрастает эффектами. Я отрезаю лишнее на уровне прототипа и пытаюсь упрощать всё донельзя — как геймплей, так и визуальную часть. Тем не менее, остается еще несколько эффектов (и их полировка), без которых игра смотрится незаконченной.

Итак, ещё несколько выводов:

- Процедурные эффекты рулят. Иногда классические алгоритмы (вроде диаграммы Вороного) не очень подходят, но после напильника и лобзика приобретают нужные качества;

- Закон Хофштадтера: Любое дело всегда длится дольше, чем ожидается, даже если учесть закон Хофштадтера. В общем, разработка проекта затягивается. :)

- Unity3D очень полезна, но иногда ставит палки в колёса. Если ваши кастомные постэффекты перестали работать — посмотрите во frame debug, может, после обновления Unity3D решила дополнить отрисовку своими эффектами (и включила на камере msaa).

В следующей статье я планирую закончить рассказ про рендеринг пятен, описать эффект следов, особенности редактора карт и загрузки уровней.

Спасибо за внимание, жду ваших комментариев и feedback'a!

|

|

[Перевод] Как создаются визуальные эффекты для игр |

|

Метки: author PatientZero разработка игр unreal engine unreal engine 4 визуальные эффекты частицы освещение |

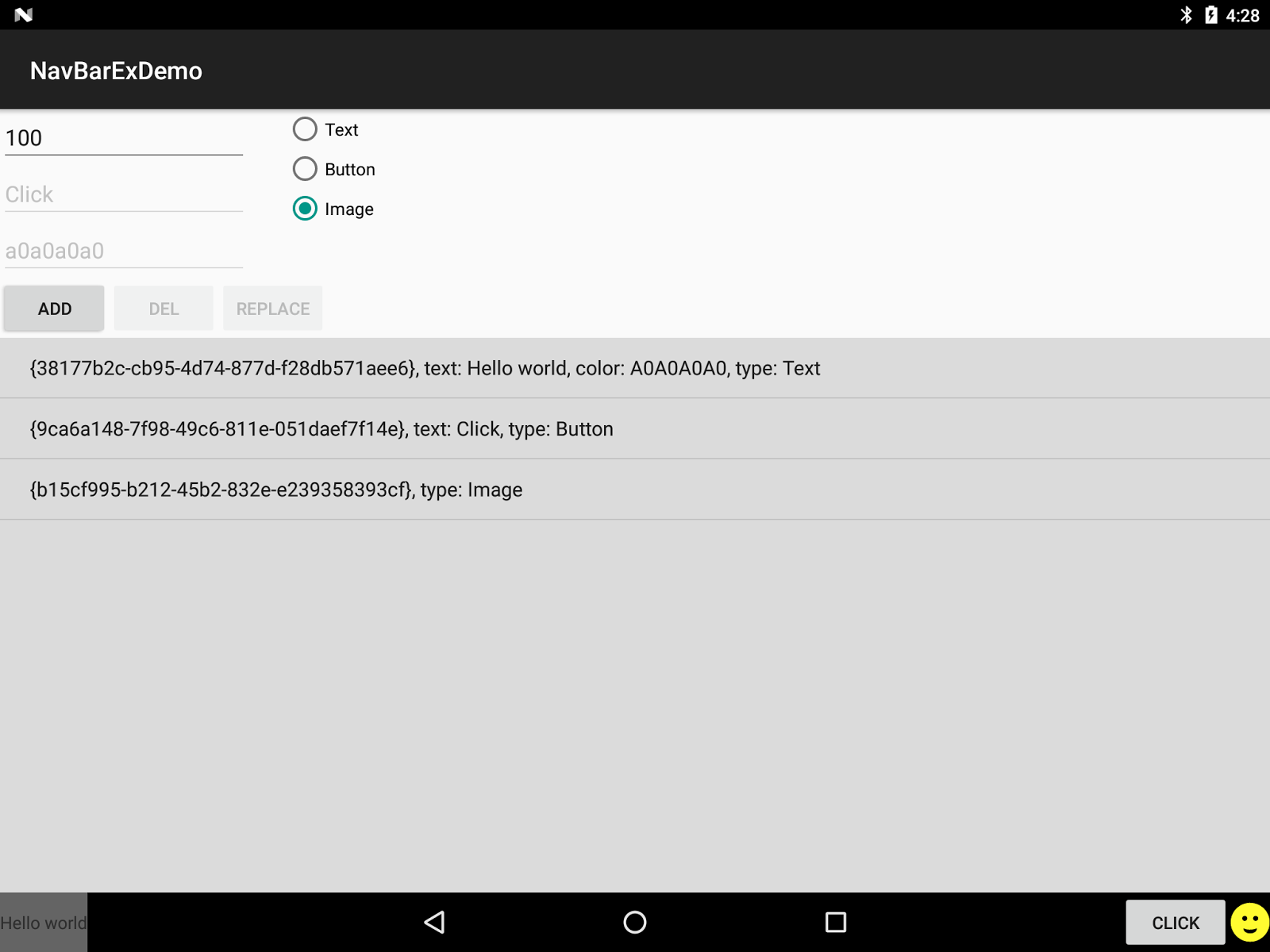

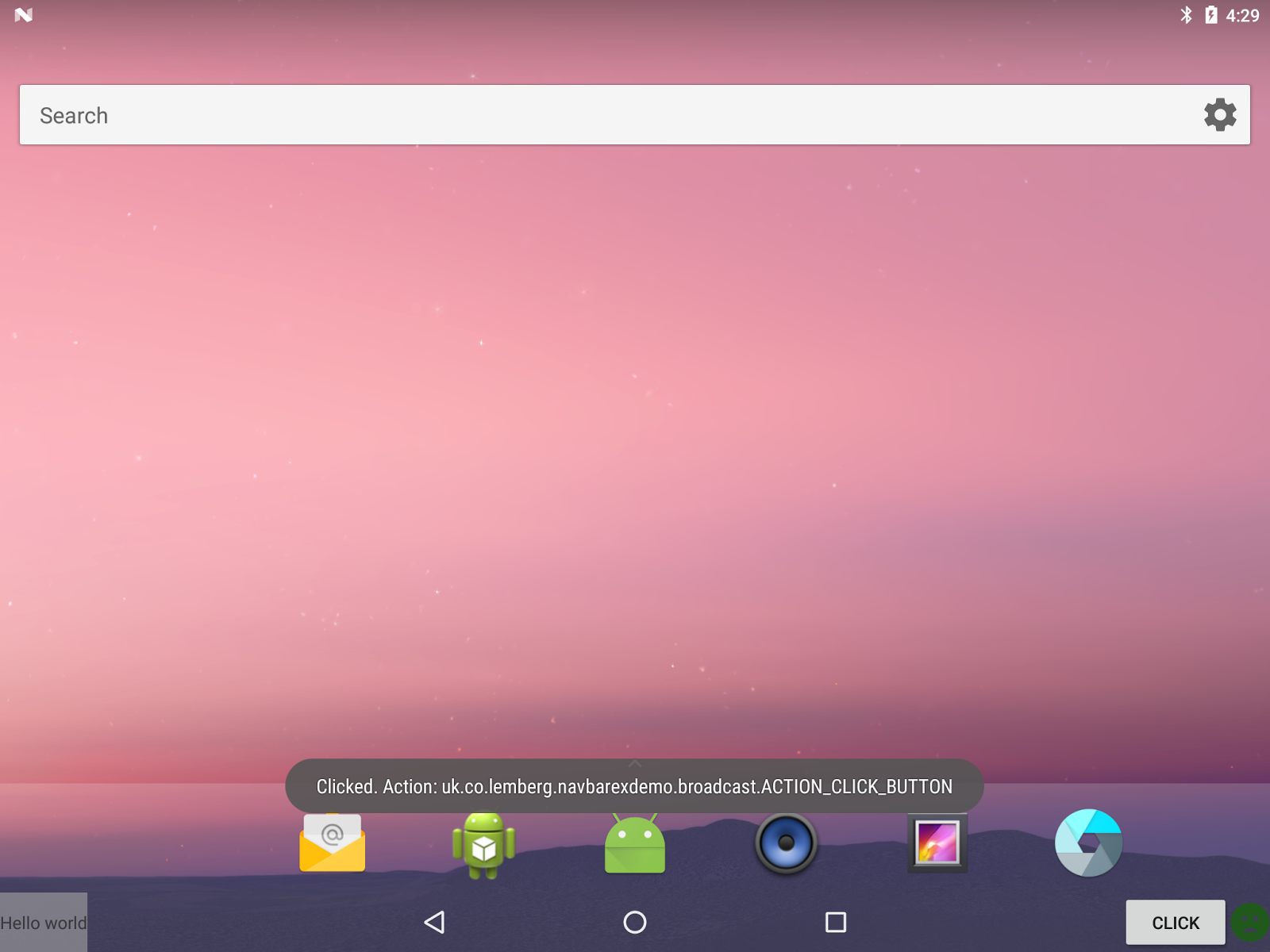

[Перевод] Разработка нового сервиса в Android 7 | Кастомизация строки навигации |

Представим себе следующую ситуацию: мы разрабатываем продукт, который требует очень специфические свойства которые или не существуют или недоступны в инвентаре Андроид. Например требуется кард-ридер.

Да, я знаю о внешних ридерах, но мы ведь серьезные разработчики и решили сделать его внутренним чтобы финальное устройство выглядело более целостным. Например как это:

Такие устройства скорее всего должны предоставлять специальные службы обработки платежей для сторонних разработчиков.

В этой статье я хочу описать процесс расширения Android API на примере создания нового сервиса для кастомизации строки навигации.

Формулировка задачи

Мы собираемся разработать API что даст возможность пользовательской настройки (кастомизации) строки навигации путем добавления туда новых элементов. Стандартная строка навигации выглядит по разному на разных устройствах, и даже может отсутствовать на устройствах с аппаратными кнопками навигации.

Давайте возьмем Nexus 9:

Строка навигации — это черный прямоугольник внизу с кнопками навигации. Он показывается пользователю все время (кроме случая когда какое-либо приложение работает в полно-экранном режиме) так что было бы неплохо предоставить возможность разработчикам помещать там свои собственные элементы.

Для того чтоб сделать API максимально гибким, возьмем Android Remote View как основный параметр нашего API. Это позволит пользователю (т.е. другому разработчику) использовать многие стандартные компоненты для кастомизации. Также это предоставит механизм обратной связи от элементов в приложение.

Как точку расширения, возьмем непосредственно Android SDK: мы внесем изменения в AOSP (Android Open Source Project) и соберем собственное Android SDK. Такое SDK подойдет только для устройств работающих под управлением нашей модифицированной прошивки, но нам такое ограничение подходит априори. Как результат наши службы будет очень просто использовать и они будут доступны сразу из Android SDK.

Релизация

Скачайте и настройте среду разработки AOSP

Вся необходимая информация для настройки среды разработки AOSP предоставлена здесь. Выберите соответствующую ветвь AOSP (это влияет на версию Android) совместимую с выбранным устройством. В моем случае это Nexus 9 и ветвь android-7.1.1_r33.

Разработайте новую службу

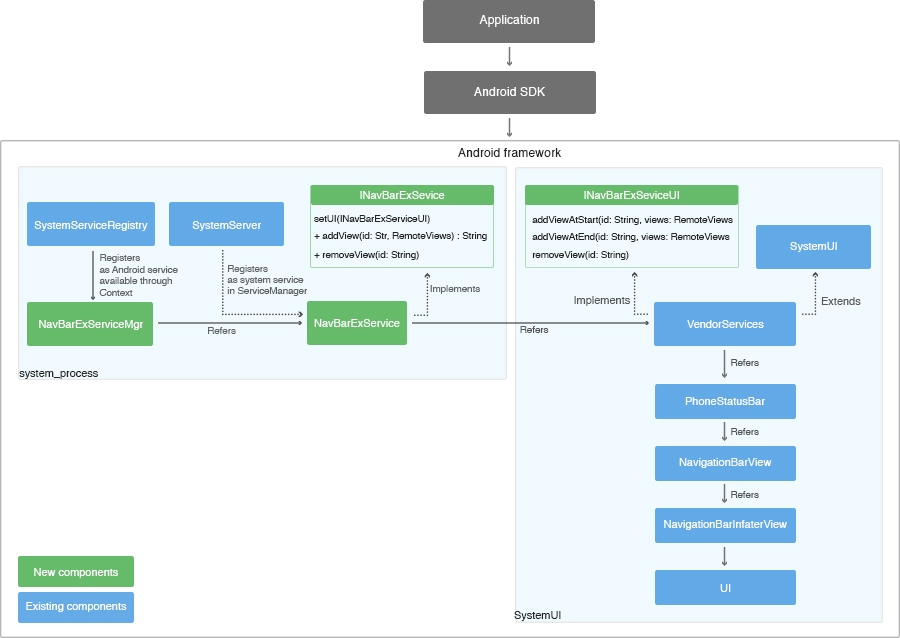

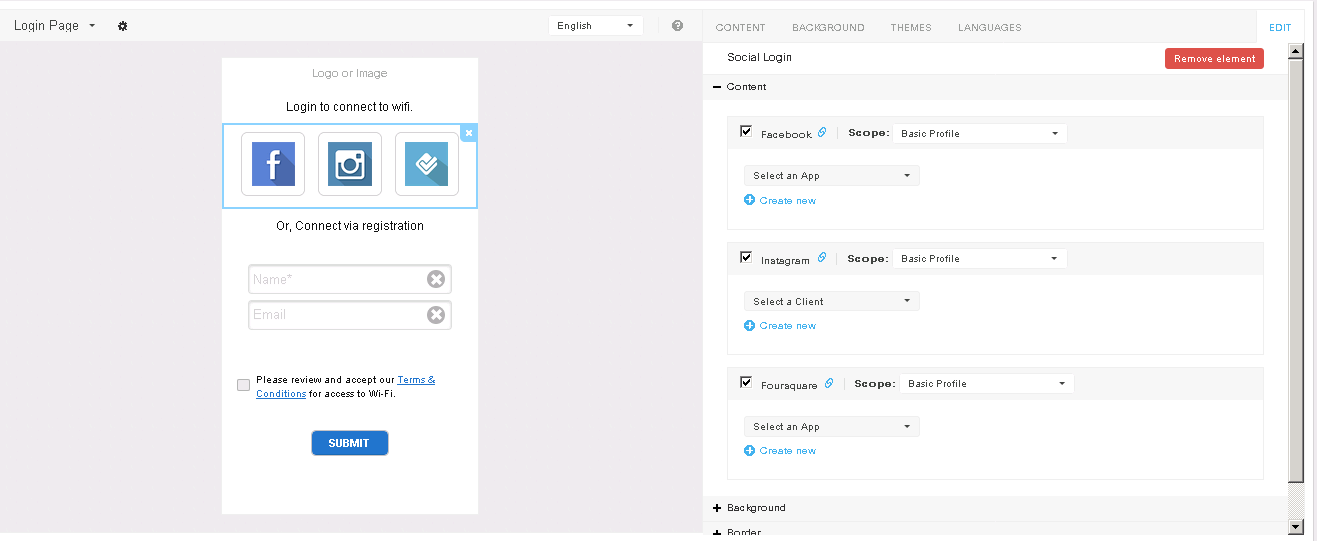

Забегая вперед следующая схема показывает все задействованные в реализации компоненты:

Идея состоит в том, чтоб предоставить расширенные функции по управлению строкой навигации клиентским приложениям через службу Android. Строка навигации определена в файлах NavigationBarInflaterView.java и {aosp}/frameworks/base/packages/SystemUI/res/layout/navigation_bar.xml. Но мы не можем получить доступ к ним напрямую из клиентского приложения, так как они находятся в системном приложении SystemUI в то время, как основные службы Android располагаются в процессе system_process.

Таким образом наша цель сводится к связи этих компонентов с system_process, где они будут доступны для клиентского кода.

1. Создать прокси сервиса (менеджер) который будет видим из клиентского приложения. Это стандартный Java класс, который делегирует все функции сервису:

package android.os;

/**

* /framework/base/core/java/android/os/NavBarExServiceMgr.java

* It will be available in framework through import android.os.NavBarExServiceMgr;

*/

import android.content.Context;

import android.widget.RemoteViews;

public class NavBarExServiceMgr

{

private static final String TAG = "NavBarExServiceMgr";

private final Context context;

private final INavBarExService navBarExService;

public static NavBarExServiceMgr getInstance(Context context)

{

return (NavBarExServiceMgr) context.getSystemService(Context.NAVBAREX_SERVICE);

}

/**

* Creates a new instance.

*

* @param context The current context in which to operate.

* @param service The backing system service.

* @hide

*/

public NavBarExServiceMgr(Context context, INavBarExService service)

{

this.context = context;

if (service == null) throw new IllegalArgumentException("service is null");

this.navBarExService = service;

}

/**

* Sets the UI component

*

* @param ui - ui component

* @throws RemoteException

* @hide

*/

public void setUI(INavBarExServiceUI ui) throws RemoteException

{

navBarExService.setUI(ui);

}

public String addView(int priority, RemoteViews remoteViews)

{

try { return navBarExService.addView(priority, remoteViews); }

catch (RemoteException ignored) {}

return null;

}

public boolean removeView(String id)

{

try { return navBarExService.removeView(id); }

catch (RemoteException ignored) {}

return false;

}

public boolean replaceView(String id, RemoteViews remoteViews)

{

try { return navBarExService.replaceView(id, remoteViews); }

catch (RemoteException e) {}

return false;

}

public boolean viewExist(String id)

{

try { return navBarExService.viewExist(id); }

catch (RemoteException e) {}

return false;

}

}

Этот класс должен быть зарегистрирован в статической секции класса SystemServiceRegistry:

registerService(Context.NAVBAREX_SERVICE, NavBarExServiceMgr.class,

new CachedServiceFetcher() {

@Override

public NavBarExServiceMgr createService(ContextImpl ctx) {

IBinder b = ServiceManager.getService(Context.NAVBAREX_SERVICE);

INavBarExService service = INavBarExService.Stub.asInterface(b);

if (service == null) {

Log.wtf(TAG, "Failed to get INavBarExService service.");

return null;

}

return new NavBarExServiceMgr(ctx, service);

}});

С клиентской стороны служба может быть доступна следующим образом:

NavBarExServiceMgr navBarExServiceMgr = (NavBarExServiceMgr) getSystemService(Context.NAVBAREX_SERVICE);

// TODO

2. Определить AIDL интерфейс службы:

/*

* aidl file :

* frameworks/base/core/java/android/os/INavBarExService.aidl

* This file contains definitions of functions which are

* exposed by service.

*/

package android.os;

import android.os.INavBarExServiceUI;

import android.widget.RemoteViews;

/** */

interface INavBarExService

{

/**

* @hide

*/

void setUI(INavBarExServiceUI ui);

String addView(in int priority, in RemoteViews remoteViews);

boolean removeView(in String id);

boolean replaceView(in String id, in RemoteViews remoteViews);

boolean viewExist(in String id);

}

И реализовать его:

public class NavBarExService extends INavBarExService.Stub

…

Как видно большинство методов прямолинейны, только setUI выглядит странно. Это внутренний метод используемый классом, который реализует интерфейс INavBarExServiceUI для регистрации себя в NavBarExService. Все сущности помеченные комментарием “@hide” будут вырезаны из финального Android SDK и таким образом не будут видимы из клиентского кода.

Несколько комментариев относительно семантики API:

- Каждый элемент идентифицируется строковым идентификатором. Он генерируется службой при добавлении нового элемента. Таким образом каждое приложение, что добавляет новые элементы через нашу службу должны сохранять возвращаемый идентификатор для того, чтоб иметь возможность работы с элементом в дальнейшем;

- Другие методы принимает идентификатор как параметр который идентифицирует элемент;

- Каждый элемент также имеет параметр «приоритет» который указывает в каком месте разместить элемент. Чем выше значение приоритета, тем левее будет размещение.

Реализация метода setUI:

@Override

public void setUI(INavBarExServiceUI ui)

{

Log.d(TAG, "setUI");

this.ui = ui;

if (ui != null)

{

try

{

for (Pair entry : remoteViewsList.getList())

{

ui.navBarExAddViewAtEnd(entry.first, entry.second);

}

}

catch (Exception e)

{

Log.e(TAG, "Failed to configure UI", e);

}

}

}

Реализация метода addView:

@Override

public String addView(int priority, RemoteViews remoteViews) throws RemoteException

{

String id = UUID.randomUUID().toString();

int pos = remoteViewsList.add(priority, id, remoteViews);

if (ui != null)

{

if (pos == 0)

ui.navBarExAddViewAtStart(id, remoteViews);

else if (pos == remoteViewsList.size() - 1)

ui.navBarExAddViewAtEnd(id, remoteViews);

else

{

// find previous element ID

Pair prevElPair = remoteViewsList.getAt(pos - 1);

ui.navBarExAddViewAfter(prevElPair.first, id, remoteViews);

}

}

return id;

}

remoteViewsList используется чтоб удерживать созданные элементы пока UI не будет подключен (не будет вызван метод setUI). Если он уже подключен (поле ui не равно null) новый элемент добавляется прямо в UI.

3. SystemServer должен зарегистрировать нашу службу в системе:

try {

traceBeginAndSlog("StartNavBarExService");

ServiceManager.addService(Context.NAVBAREX_SERVICE, new NavBarExService(context));

Slog.i(TAG, "NavBarExService Started");

} catch (Throwable e) {

reportWtf("Failure starting NavBarExService Service", e);

}

Trace.traceEnd(Trace.TRACE_TAG_SYSTEM_SERVER);

Добавление новой службы требует правки политик Android SEPolicy.

Добавьте новую запись в файл {aosp}/system/selinux/service.te:

type navbarex_service, app_api_service, system_server_service, service_manager_type;Добавьте новую запись в файл {aosp}/system/selinux/service_contexts:

navbarex u:object_r:navbarex_service:s0

Имейте ввиду что формат файлов SELinux для Android 7.0 отличается от прежних версий Android.

4. Добавьте константы имени службы в класс Context чтоб клиенты могли его использовать вместо строкового значения:

/**

* Use with {@link #getSystemService} to retrieve a

* {@link android.os.NavBarExServiceMgr} for using NavBarExService

*

* @see #getSystemService

*/

public static final String NAVBAREX_SERVICE = "navbarex";

5. Определите интерфейс INavBarExServiceUI:

/*

* aidl file :

* frameworks/base/core/java/android/os/INavBarExServiceUI.aidl

* This file contains definitions of functions which are provided by UI.

*/

package android.os;

import android.widget.RemoteViews;

/** @hide */

oneway interface INavBarExServiceUI

{

void navBarExAddViewAtStart(in String id, in RemoteViews remoteViews);

void navBarExAddViewAtEnd(in String id, in RemoteViews remoteViews);

void navBarExAddViewBefore(in String targetId, in String id, in RemoteViews remoteViews);

void navBarExAddViewAfter(in String targetId, in String id, in RemoteViews remoteViews);

void navBarExRemoveView(in String id);

void navBarExReplaceView(in String id, in RemoteViews remoteViews);

}

Обратите внимание, что он помечен атрибутом “hide”, что делает его невидимым для клиентов. Также обратите внимание на ключевое слово oneway. Оно делает межпроцессное взаимодействие от system_process к SystemUI быстрее, так как все вызовы будут неблокирующими (это также требует пустого возвращаемого значения в методах).

6. VendorServices это стандартный SystemUI компонент (он наследуется от класса SystemUI), который реализует интерфейс INavBarExServiceUI:

public class VendorServices extends SystemUI

{

private final Handler handler = new Handler();

private NavBarExServiceMgr navBarExServiceMgr;

private volatile PhoneStatusBar statusBar;

private INavBarExServiceUI.Stub navBarExServiceUI = new INavBarExServiceUI.Stub()

{

@Override

public void navBarExAddViewAtStart(final String id, final RemoteViews remoteViews)

{

if (!initStatusBar()) return;

handler.post(new Runnable()

{

@Override

public void run()

{

statusBar.navBarExAddViewAtStart(id, remoteViews);

}

});

}

//…

}

@Override

protected void onBootCompleted()

{

super.onBootCompleted();

navBarExServiceMgr = (NavBarExServiceMgr) mContext.getSystemService(Context.NAVBAREX_SERVICE);

if (navBarExServiceMgr == null)

{

Log.e(TAG, "navBarExServiceMgr=null");

return;

}

try

{

navBarExServiceMgr.setUI(navBarExServiceUI);

}

catch (Exception e)

{

Log.e(TAG, "setUI exception: " + e);

}

}

}

Интересен метод onBootCompleted. Он производит само-регистрацию (вызывает метод setUI) в NavBarExService через NavBarExServiceMgr. Также обратите внимание что процесс SystemUI может быть перезапущен (например из-за падения) в результате чего будут сделаны несколько вызовов setUI. Само собой только последний должен учитываться.

7. Класс PhoneStatusBar это ключевой элемент который связывает NavBarExService и NavigationBarInflaterView. Он содержит ссылку на NavigationBarView, который в свою очередь содержит ссылку на NavigationBarInflaterView. С другой стороны VendorServices получает ссылку на PhoneStatusBar через метод SystemUI.getComponent:

private boolean initStatusBar()

{

if (statusBar == null)

{

synchronized (initLock)

{

if (statusBar == null)

{

statusBar = getComponent(PhoneStatusBar.class);

if (statusBar == null)

{

Log.e(TAG, "statusBar = null");

return false;

}

Log.d(TAG, "statusBar initialized");

}

}

}

return true;

}

Вы заметили странную конструкцию “if (statusBar == null)”? Она называется “Double Checking Locking Pattern” и преследует следующую цель: произвести потоко-безопасную инициализацию объекта, но избежать вхождение в секцию синхронизации когда объект уже проинициализирован. Изменения в PhoneStatusBar и NavigationBarView достаточно простые: они просто делегируют все вызовы в класс NavigationBarInflaterView.

8. Класс NavigationBarInflaterView — это конечный класс который производит непосредственно изменения в UI. Вот его метод navBarExAddViewAtStart:

public void navBarExAddViewAtStart(String id, RemoteViews remoteViews) {

if ((mRot0 == null) || (mRot90 == null)) return;

ViewGroup ends0 = (ViewGroup) mRot0.findViewById(R.id.ends_group);

ViewGroup ends90 = (ViewGroup) mRot90.findViewById(R.id.ends_group);

if ((ends0 == null) || (ends90 == null)) return;

navBarExAddView(0, id, remoteViews, ends0);

navBarExAddView(0, id, remoteViews, ends90);

}

private void navBarExAddView(int index, String id, RemoteViews remoteViews, ViewGroup parent) {

View view = remoteViews.apply(mContext, parent);

view.setTag(navBarExFormatTag(id));

TransitionManager.beginDelayedTransition(parent);

parent.addView(view, index);

}

Этот код полагается на существующую реализацию и использует поля mRot0, mRot90 а также R.id.ends_group как ViewGroup для кастомных элементов. mRot0 и mRot90 представляют разметку для портретного и ландшафтного режимов, так что добавляем наши элементы к обоим из них. Также мы задействовали TransitionManager для проигрывания некоторой анимации.

9. Один нюанс насчет файла Android.mk. Он должен содержать ссылки на наши AIDL файлы. Два файла в секции LOCAL_SRC_FILES:

LOCAL_SRC_FILES += \

core/java/android/os/INavBarExService.aidl \

core/java/android/os/INavBarExServiceUI.aidl \

...

и INavBarExService.aidl в секции “aidl_files”:

aidl_files := \

frameworks/base/core/java/android/os/INavBarExService.aidl \

...

Все вместе

Исходные коды доступны на GitHub. В каталоге “patches” есть два файла: frameworks_base.patch и system_sepolicy.patch. Первый патч должен быть применен к каталогу “{aosp}/frameworks/base”, второй — к “{aosp}/system/sepolicy”.

Каталог NavBarExDemo содержит демонстрационное приложение для системы сборки gradle.

Чтобы проверить реализацию на реальном устройстве нам нужно:

- Скачать стоковые исходные коды Android и настроить среду разработки;

- Применить патчи;

- Собрать кастомный Android SDK;

- Собрать кастомную прошивку и прошить устройство;

- Запустить демонстрационное приложение.

Для сборки Android SDK выполните следующие команды:

. build/envsetup.sh

lunch sdk_x86-eng

make sdk -j16

Результирующий ZIP файл расположен в каталоге {aosp}/out/host/linux-x86/sdk/sdk_x86 (если запущен в Linux). Имейте ввиду что имя файла будет содержать ваше имя пользователя Linux. Для того чтоб изменить это поведение, определите переменную окружения “BUILD_NUMBER” и ее значение будет использовано вместо имени пользователя. Параметр J указывает сколько задач запускать одновременно. Используйте количество процессорных ядер умноженное на 2.

Прошивка может быть создана используя следующие команды (для устройства Nexus 9):

. build/envsetup.sh

lunch aosp_flounder-userdebug

make otapackage -j16

Прошивка может быть прошита используя комманду:

fastboot -w flashall

Устройство должно иметь разблокированный загрузчик.

Чтоб проверить результаты было создано специальное демонстрационное приложение. Оно позволяет управлять элементами строки навигации.

Нажатие на кастомный элемент покажет тост даже если демо приложение не запущено (на самом деле система сама запустит процесс если нужно).

Недочеты

После перезагрузки устройство утратит всю кастомизацию. Так что было бы хорошо сохранить ее где нибудь. Также было бы хорошо добавить параметр «gravity» в API для более точного контроля расположения элементов.

Резюме

Мы расширили Android SDK и внедрили новую службу предназначенную для кастомизации строки навигации Android. Также мы создали кастомную прошивку для планшета Nexus 9 содержащую нашу службу.

В прежней статье мы реализовали стабилизацию экрана для Nexus 7. Здесь эта-же реализация но для Nexus 9:

P.S. На самом деле я также являюсь и автором оригинальной англоязычной версии статьи, которая была опубликована на blog.lemberg.co.uk, так что могу ответить на технические вопросы.

|

Метки: author r_ii разработка под android open source android android development aosp customization |

У нас не только путь в сеньоры, но и путь развития для тех, кто уже таковыми стал |

Хочу передать пламенный привет эйчарам, из-за которых конференции для разработчиков часто напоминают больше ярмарку вакансий, нежели место, где можно пожать шеи авторов фреймворка. Я хочу немного понегодовать по этому поводу и рассказать, как мы тщательно выгоняли со своих конференций в специальные резервации всех тех, кто не знает, на какие 10 типов делятся люди по знанию двоичного исчисления.

В общем, ниже про то, как выжать максимум из посещения профильной конференции для разработчиков, чего можно и чего нельзя добиться, и где самый жир.

1. Практическое применение знаний

Практически никогда на конференциях вы не получите решения текущих проблем и задач. Почему? Очень просто: если вам нужно что-то здесь и сейчас, то вы смотрите на форумы и спрашиваете в сообществе у коллег. Либо ищете знакомых, кто знает и может всё разложить на пальцах. Глупо было бы ждать несколько недель или месяцев конференции, чтобы выяснить всё это на ней.

Скорее, речь о кругозоре. Раньше не знали, как решать, и гуглили бы 5 часов. Сейчас знаете, представляете чужой опыт, можете принять решение почти сразу. Вот разработчик из Яндекса делится:

«Был интересный доклад про дженерики. Там, типа, пазлеры с дженериками. Я после этого тоже, ну, не прямо по итогам доклада, но, типа, заинтересовался тоже темой этой более-менее и кое-что переписал в своем проекте».

С другой стороны, доклады профессиональных спикеров готовят к будущим задачам. То есть когда что-то сложное всплывёт, вы можете вспомнить, какой подход и почему обсуждался на конференции. И будет существенно проще. Плюс появляется кругозор, который позволяет понимать во многих аналогичных случаях, в какую сторону примерно копать.

Вот что про этот фактор говорит участник Сергей Б. (участие в JPoint и Joker с 2013 года):

«Сложно вспомнить, но совершенно точно Joker сильно расширяет кругозор. И даже если из тех докладов, которые прослушали, никаких практических выводов не делаем прямо в момент прослушивания, в любом случае это откладывается в голове. Когда мы встречаемся с какой-то проблемой, то вспоминаем, что да, что-то такое мы слышали. И во-вторых, мы расширяем кругозор в том смысле, что видим происходящее в индустрии и куда всё движется — это даже видно по темам докладов. У нас компания небольшая, нет специального отдела, следящего за тенденциями. Поэтому мы ездим сами. Вообще, мы занимаемся разработкой софта на заказ на Java уже 8 лет. Мы стараемся присутствовать и на JPoint, и на Joker — конечно, всю команду привезти не можем, но я как директор каждый раз езжу.

… Поскольку у нас много проектов на Enterprise Edition, то в каждом проекте встречаются, безусловно, задачи пакетной обработки. Мы раньше всегда их решали вручную. Сейчас это стало частью стандарта, но мы не обратили на это внимание, а после доклада стало понятно, что будем эту технологию использовать. Эффективность этой технологии в том, что она содержит в себе все вещи, которые обычно в ходе реализации пакетной обработки появляются потихоньку. То есть вам надо файл в 100 000 строк переместить — вы пишете одну строчку. Потом вы понимаете, что вам нужны чекпоинты, что нужно делать что-то с дефектными данными, нужна транзакционность, мониторинг. Всё это пишется вручную. Сейчас появился стандартизированный способ, есть поддержка контейнера для таких задач, и мы это будем использовать. Хотя это, конечно, немного не в стиле Joker, но этот доклад будет применен — не прямо завтра, но через несколько недель точно».

Гриша Б.:

«Как Шипилёв говорил в кейноуте, “нужно с умом подходить к этому делу”. Не просто так, мол, “а увидел крутую вещь — буду запиливать”. Всё пригодится на практике, просто не сразу».

2. Мировоззрение и обучение

Конференции не сделают вас сильнее-выше-быстрее просто потому, что вы там присутствуете. Точнее, для объективно хорошего стабильного эффекта пришлось бы посетить штук 40–50 конференций (почти как половина университетского семестра). Их столько просто нет. Учиться на конференциях бесполезно, учиться нужно самостоятельно.

Учиться — это в другом месте. На конференциях нет целенаправленного обучения. Просто каждый рассказывает про свои задачи и про то, как он их решал. Но и это может оказаться полезным — например, есть много вещей, которые вы пока не трогаете, потому что не знаете, что можно лучше. После конференций захочется их расковырять — вот как, например, рассказывает участник прошлого JPoint:

«Был доклад парня из Дойче-банка, я не помню, как его звали. Он рассказывал про мониторинг производительности. Мы этим воспользовались… Ну, там он снимал дампы и проводил статистический анализ этих треддампов. И на основе их смотрел, что у него тормозит. Мы этим потом воспользовались, когда решали проблему производительности наших приложений. Также в 2015 году был доклад Андрея Паньгина. Тоже там он рассказывал про java agent, мы этим периодически пользуемся, особенно если у нас application… Ну, проблема не в нашем коде, а в application server'е. Чего-нибудь залезть там, подхачить. В прошлом году мы, например, заказали онлайн-трансляцию. И сделали у нас на corporate, и сделали типа JPoint’а, но у нас, локальный, в офисе. Это для джуниоров хорошо, такой был этот. В этом году решили сами приехать, ещё раз посмотреть. Не стали заказывать. И уже пожалели, что ребят не подтянули».

Можно не наступать на чужие грабли (отзыв разработчика UnitedTraders):

«Начали внимательно следить за версиями драйвера Postgres’а, потому что товарищ рассказывал, как он там достаточно стрёмные вещи чинил в этом самом драйвере, локи довольно жёсткие. И посмотрели на Кассандру, ну, чуть более пристально, она не пошла. Но посмотрели».

Ещё от спикеров можно услышать, чему и как учиться. Самое главное — видно, кто и как решает разные сложные задачи. Путь Senior-developer — это много импровизации, море практики и умение видеть модели за практическими задачами. Часто одна только возможность «поднять голову» над рутиной помогает научиться мыслить чуть иначе.

Почти никогда нельзя стать Senior, просто изучая язык (или несколько). Нужно ещё думать как профессиональный разработчик — моделями задач и классами инструментов, а не конкретными реализациями. То есть, упрощая, конференции могут научить вас видеть архитектуру кода чуть иначе.

Вот рассказ команды с хорошим опытом:

«Мы уже давно ходим на конференции. У части докладов всегда был прикладной интерес. Сейчас я успел побывать на трёх (докладах), и все так или иначе для меня релевантные, даже Шипилёвский кейноут. Каждый раз открываешь для себя что-то либо изучаешь более подробно. Не знаю, что конкретно выделить. Каждый раз получаешь то, что ожидаешь получить. И нельзя рассматривать это напрямую, мол, вот я научился чему-то и сейчас пойду это запиливать. Это, скорее, толчок для дальнейшего подробного изучения и просмотра. Потому что мы уже матёрые ребята, нас сложно чем-то удивить. Конференция — это место пообщаться и некоторый способ нарушить изоляцию своего коллектива. Посмотреть, что в тренде, что народ делает. Посмотреть, насколько твоя команда актуальна сейчас. Ещё момент с точки зрения практической пользы — общение с докладчиками. В прошлый раз я с ними болтал просто так. Был спикер Venkat Subramaniam — я его книжки читаю, часто на YouTube смотрю. Было интересно с ним поговорить вживую, задать конкретные вопросы. А что касается дискуссионных зон… Вот видишь Шипилёва и думаешь, что бы у него такого спросить, и ничего в голову не приходит».

А вот так рождается желание ковырять что-то новое (Николай):

«И эти хардкорные вещи… Их обычно просто так не ищешь ради развлечения вечером. И потом, когда узнаешь о них, задумываешься: а может, так попробовать, а может, сяк? Второе — это разнообразие. Ты сидишь на работе, каждый день плюс-минус одно и то же. А конференция — это такая возможность заново окунуться в новый мир. Это сильно мотивирует. Смотришь, что народ делает, и думаешь: “А я вроде тоже не хуже! Вечером приду и тоже что-нибудь посмотрю”. И конференция действует как перезарядка. Вот, долго работаешь, всё бесит, а потом приходишь, узнаёшь кучу всего, общаешься, и уже как новый глоток воздуха».

Вот разработчик из КРОКа делится:

«Виктор Лаврентьев, брейнсторменное clean pragmatic architecture, это был очень практический доклад, который опять-таки очень помогает при создании фреймворков. Я бы отметил еще Калеолу, первый самый доклад. Просто открывает глаза на то, когда, в какие моменты жизни проекта какие оптимизации стоит применять, а когда надо опустить. Просто такой подход к ведению всего проекта».

3. Фан и драйв

С одной стороны, конференции — не развлечение и не отдых, а с другой — это он и есть. Мы это поняли, когда по просьбам участников все Joker/JPoint и DotNext с 2013 года стали проходить по будням, потому что на выходных у мидлов и сеньоров семьи (сейчас мы делаем сочетание пятница-суббота, чтобы не отжирать два рабочих дня и не забирать все выходные).

У профессионалов на самом деле обучение лежит не очень далеко от развлечения. Узнавать что-то новое и общаться с коллегами — это возможность почувствовать свежий ветер на лице. Поэтому, кстати, многие ходят на доклады, которые бы так им в жизни не понадобились, и (редко) внезапно выясняют, что всё же это оказалось полезнее, чем планировалось. Обучение по плану, без развлечения и доли случайности — это рутина. На конференциях же можно выдохнуть, узнать что-то новое и вернуться потом к обычной работе с пониманием перспективы.

Ну и, конечно, одна из важных вещей — знакомые. Не тусовка, а именно возможность увидеть тех, кто чего-то добился профессионально, узнать, чем и как они живут. Вот обратите внимание, как люди об этом говорят.

Виктор А.:

«В прошлом Джокере был Барух, который рассказывал про Мавен и Грейдл. Интересный был доклад. После него потянуло поковыряться в Грейдле, посмотреть, как с ним можно взаимодействовать. Сегодня тоже доклад про Мавен и Грейдл, который послушал, — буду разбираться дальше. Доклады про Stream API и Java 8 тоже слушаю, тоже применимы в работе. Плюс на конференции до фига знакомых».

Иван Е.:

«Потому что понравились в прошлом году — как доклады, так обстановка. Мне удалось случайно встретиться со многими людьми, которых не видел десяток лет, и это очень круто. Из полезного — в том году был доклад, который получилось принять на практике, про мутационное тестирование (спикер — Николас Франкель).

Сегодня меня интересуют две темы: микробенчмарки и проблемы микросервисов и распределённого логирования. Общаюсь с людьми, узнаю, как можно это сделать, получаю для себя полезную инфу и решения».

Евгений:

«На первом Joker было много полезного. Практическое применение — я знаю, куда рыть, чтобы интересные вещи для себя изучить более подробно. Сложно назвать что-то конкретное, потому что это по крупицам собирается из разных мест и потом применяется в работе. Ну, и плюс общение со знакомыми старыми. Так ни с кем не знакомлюсь».

4. Уровень требований и зарплат

Не секрет, что компании стараются на таких конференциях познакомиться с потенциальными жертвами хедхантинга, а разработчики иногда ездят, чтобы таковыми стать. «Прямых сделок» и передачи оферов почти не происходит, но все с радостью пользуются возможностью прощупать почву у коллег. Ключевые моменты — узнать, кто и сколько получает (и за что именно), у кого какие подводные камни в работе чисто в процессе. А ещё многие наши гости отмечают, что конференции — это социализация (насколько это возможно в сообществе разработчиков), то есть знакомства и связи между компаниями. Плюс разработчик может посмотреть возможности работы у компаний-спонсоров, которые чаще всего — международные холдинги со спектром хороших и интересных проектов.

Не секрет, что компании стараются на таких конференциях познакомиться с потенциальными жертвами хедхантинга, а разработчики иногда ездят, чтобы таковыми стать. «Прямых сделок» и передачи оферов почти не происходит, но все с радостью пользуются возможностью прощупать почву у коллег. Ключевые моменты — узнать, кто и сколько получает (и за что именно), у кого какие подводные камни в работе чисто в процессе. А ещё многие наши гости отмечают, что конференции — это социализация (насколько это возможно в сообществе разработчиков), то есть знакомства и связи между компаниями. Плюс разработчик может посмотреть возможности работы у компаний-спонсоров, которые чаще всего — международные холдинги со спектром хороших и интересных проектов.То есть поездка на конференцию — это рост в деньгах не только за счёт получения какой-то нетривиальной информации, но и за счёт вашей большей информированности. А часто такую информированность можно получить только лично и только от знакомых. Только не говорите это своему эйчару, если билеты оплачивает компания.

Кстати, для самих эйчаров это тоже важно (хоть мы их и не пускаем) — они получают галочки за то, что отправили вас учиться, вы прошли некоторое повышение квалификации и т. п. Ну, а у кого в компании с рабочим климатом всё в порядке — у них ещё и повышение лояльности. Потому что слушать жалобы других разработчиков на работу, а не на язык или фреймворк — музыка на сердце.

Как получить максимум?

Правильный сценарий, на мой взгляд, такой:

- Заранее составить план захвата конференции, то есть прочитать про каждый доклад и посмотреть, насколько интересен спикер. Скорее всего, у вас есть 2–3 доклада, на которые вы пойдёте точно, и надо ещё обозначить те, которые вы будете посещать «в промежутках». Лучший способ понять, надо оно вам или нет — посмотреть 3–4 минуты видео этого докладчика с предыдущей конференции, если он был. Если не был — просто почитать его публикации.

- После докладов спикеры идут «на поговорить» в специальную зону, где можно обсуждать с ними животрепещущие вопросы. Тут лучше заложить время на это обсуждение (полчаса после доклада, например) и ещё собрать сами вопросы. Часть ваша, часть наверняка захотят задать ваши коллеги, которые не идут (спросите их, есть ли что-то важное, что надо уточнить).

- Если вы пришли на доклад, а он вас не вставляет — к чёрту вежливость, вставайте и уходите, даже если вы сидите в середине ряда. В соседних залах ещё доклады.

- Стоит заранее узнать, кто из ваших знакомых приедет. Особенно важно это для тех, кто на конференцию едет из другого города. Запланируйте с ними обеды-ужины-посиделки среди дня.

- В «резервации», то есть за пределами зоны докладов, стоят специальные будки. Чаще всего в них либо стоит эйчар и ПМ, либо разработчик инструмента. Правильные вопросы разработчикам: «Мы пользуемся вашей шнягой, есть что ещё интересное?», «А вот мы пользуемся вашим конкурентом, чем вы лучше?» и «Ты кто такой?» Можно узнать много нового и получить либо скидки на продукты (они пригодятся компании), либо ключи на триальные версии с ограничениями — это чтобы потестить в своей команде, и если пригодится — купить.

- С любым вопросом до конференции (вообще любым!) не стесняйтесь писать оргам. Все контакты у вас в билете, как правило. Ещё конкретно в нашем случае полезно отметиться, какие доклады вам наиболее интересны. По этому голосованию мы выбираем размер зала. Самые популярные идут в главный зал, а остальные — в залы меньше. Иногда бывает так, что в маленьком зале становится тесно: если не хотите тесниться — стоит голосовать.

- Кейтеринг дорогой, поэтому билеты без еды часто сильно дешевле. Да, можно взять бутерброды из дома (кофе и чай и так будут бесплатно), но если вам оплачивает компания, то надо пользоваться обедом на все сто. Для начала не используйте «писсуарную» рассадку, то есть старайтесь занимать не наиболее далёкое свободное место, а подсаживаться к кому-нибудь, кто не похож на эйчара. И дальше просто спрашивайте, кто и над чем работает, за столом. Получится хорошая дискуссия, которая рано или поздно дойдёт или до мордобоя, или обсуждения нюансов и всяких лайфхаков разработки, или рассказа о багах инструментов.

В общем, вот примерно так, шаг за шагом выстраивая хардкор (чтобы было больше нетривиальных знаний и экспертов) и убирая всё малополезное (рекламные доклады и банальные будки на выставке), мы дошли в какой-то момент до того, что задачи с Джокера и .NET стали использовать на технических собеседованиях, а в некоторых вакансиях посещение Joker/JPoint стало «плюшкой» для продвинутых инженеров. Ну и к нам возвращаются участники JUG, поэтому с каждым годом конференция всё больше и больше.

Ну и напоследок — рассказ от одного из наших постоянных гостей конференций:

«Ну, такой наиболее яркий пример — это, например, доклад Романа Елизарова «Ожидай своего счастья без блокировок». То есть после его доклада я начал экспериментировать с его информацией, которую он дал. Через полгода у меня было решение, которое внезапно пригодилось на работе. То есть очень сильно продакшн удалось разгрузить. Много чего у Алексея Шипилёва: всякие нюансы, которые помогают более тонко осознавать, что я вижу при профайлинге. На всяких метриках с продакшна. Вот сегодня я уже три полезняшки успел снять, которые я, как приеду, буду смотреть, как это применяется… Инструмент для поиска deadlock'ов превентивный. Это профайлер от Куксенко, который тоже не есть код, который обычно профайлер не берёт, и я не мог понять, чего с этим делать. Теперь я хотя бы знаю, куда я смогу копать… Я просто фотографирую, записываю по ходу дела. Ну, и плюс «Разбор Полетов» узнал оттуда же. В результате я сейчас постоянно вишу в их чате, и там опять-таки со специалистами можно обсудить, с тем же Алексеем (не далее как во вторник он мне подсказал вещь, которую мне срочно надо было, чтобы понять, что у меня на продакшне творится). И в принципе просто кругозор расширяется. То есть сначала я сам съездил, потом стал каждый раз кого-то из сотрудников притаскивать. В этот раз уже организация поняла, что польза есть, польза большая. Выделили большую квоту, и даже этой квоты не хватило, и кое-кто из наших приехал уже даже за свой счёт. То есть у нас тут сейчас целая шайка. И это, наверно, самый ценный источник информации, которую больше достать негде».

В общем, вот как-то так. Joker 2017 уже в продаже, кстати.

|

Метки: author ARG89 программирование java блог компании jug.ru group конференция карьера обучение |

Знакомство с методологией ITIL в ITSM |

/ фото rawpixel CC

/ фото rawpixel CCЧто было раньше: ITSM или ITIL?