Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Как ритейл-компании оценивают эффективность внедрения систем лояльности в России и за рубежом |

Изображение: sekihan, CC BY 2.0

Программы лояльности стали очень популярным инструментом привлечения клиентов в сфере ритейла. Это неудивительно, ведь по результатам исследований до 87% покупателей хотят пользоваться такими программами, а для 83% наличие программы лояльности является серьёзным мотивирующим фактором для продолжения взаимодействия с компанией.

Таким образом, программа лояльности может не только привлекать новых клиентов, но и удерживать уже имеющихся покупателей. Однако для того, чтобы всё действительно заработало именно так, компании необходимо периодически анализировать то, насколько разработанная программа нравится аудитории. Сегодня мы поговорим о том, как эту задачу решает бизнес за рубежом и на российском рынке.

Как это работает за рубежом

Разработчики систем лояльности компании FiveStars опубликовали в своём блоге список из четырёх способов оценки качества их работы.

Интернет-опросы

Один из наиболее простых способов оценки удовлетворенности пользователей программы лояльности — проведение онлайн-опроса, организованного с помощью различных цифровых каналов. К примеру, опросы можно проводить на собственном сайте или в соцсетях. Вот несколько инструментов для проведения опросов в социальных сервисах:

- Facebook poll (или встроенная функциональность «ВКонтакте»)

- Twitter poll

- Twtpoll

Кроме того, опросы могут проводить с помощью текстовых сообщений на мобильный телефон или электронную почту. Некоторые компании собирают телефонные номера пользователей программ лояльности, другие хранят email-адреса. Вот какие инструменты могут применяться для создания таких опросов:

- Опросы через текстовые сообщения: TXTImpact

- Email-опросы: SurveyMonkey

- Google forms

Установка «пункта сбора мнений» в магазине

Идея проста — сотрудники магазина в любом случае обсуждают с клиентами программу лояльности, задавая им вопросы о том, есть ли у них нужные карточки. Тем покупателям, которые отвечают на такой вопрос утвердительно, компании могут предлагать небольшой подарок за то, что они ответят на несколько вопросов об отношении к программе лояльности. Подарком может быть что угодно, например купон на десятипроцентную скидку или удвоенные баллы программы лояльности за покупки в этот день.

Получить подарок за пару минут потраченного времени — для многих это окажется достаточно заманчивой перспективой. В магазинах, где не такой большой поток покупателей, сбором обратной связи может заниматься сам кассир, но если клиентов очень много, их чаще направляют к специальным пунктам сбора мнений, где вопросы задают выделенные сотрудники.

Сбор обратной связи на клиентских мероприятиях

На Западе довольно распространена практика организации мероприятий для покупателей конкретной компании — это может быть барбекю в городском парке или концерт, организованный при поддержке бизнеса. В таких случаях представители компании могут подходить к посетителям мероприятия и просить ответить на несколько вопросов о плюсах и минусах программы лояльности.

Старая школа: фокус-группы

Несмотря на идущие много лет споры о том, говорят ли люди правду во время участия в фокус-группах, этот инструмент выяснения общественного мнения все ещё очень популярен как у зарубежного, так и у российского бизнеса. Набор участников экспериментов может проводиться через социальные сети, почтовые или SMS-рассылки. За участие в опросе предлагают небольшой подарок — обычно это купоны на скидку при покупках в магазинах определённой компании.

Опросы — наше все, или что работает в России

Российские ритейлеры, также как и их зарубежные коллеги, уделяют немало внимания вопросу оценки эффективности программ лояльности. Инструментарий для решения этой задачи широк, но опыт отечественных компаний показывает, что наибольшую эффективность приносят прямые опросы покупателей. Например, один из клиентов «Пилота», использующих кассовое ПО «Профи-Т», у которого есть собственная программа лояльности — сеть магазинов детских товаров — эффективность программы лояльности оценивает посредством ежеквартального анкетирования и измерения индекса потребительской лояльности NPS.

Есть ритейлеры, которые используют интернет для выяснения мнения клиентов. Так, сеть продуктовых магазинов разочаровалась в обычных опросах и решила проводить интернет-опросы. Для этой цели она планирует сделать в магазинах доступным для покупателей бесплатный Wi-Fi: заходя в него, им потребуется ответить на пару вопросов о работе программы лояльности. К слову, самых активных респондентов сеть намерена мотивировать купонам на дополнительные скидки.

Один из наших заказчиков — региональная сеть продуктовых магазинов для оценки эффективности программы лояльности использует целый спектр инструментов. Самый архаичный из них — «Книга жалоб и предложений»: как это ни странно, но и в ней сотрудники сети находят отзывы, при помощи которых можно сделать выводы о том, эффективна программа лояльности или нет. Хотя, конечно, таких посланий в «Книге» не так уж и много. Помимо этого устаревшего канала, сеть использует горячую линию, мобильное приложение, группы в социальных сетях, покупатели могут высказаться о программе лояльности по телефону, электронной почте. Вся поступающая обратная связь обрабатывается сотрудниками отдела маркетинга, которые на ее основе готовят рекомендации для операционной и коммерческий служб по корректировке работы программы лояльности.

Как еще оценивают программы лояльности

Для оценки эффективности программ лояльности используют не только сбор обратной связи, но и специализированные метрики. Среди них:

- Показатель возвращаемости покупателей — он позволяет понять, насколько долго клиенты остаются с компанией. Чем больше участников программы лояльности, тем средний показатель должен быть выше. По данным автора книги «Эффект лояльности» (Loyalty Effect) Фреда Рехельда (Fred Reichheld), прирост показателя возвращаемости на 5% выливается в 25-100% рост прибыли компании.

- Отрицательный отток — это метрика, которая описывает клиентов, которые наоборот купили дополнительные товары и услуги или перешли на более дорогой тарифный план. Эти цифры помогают понять реальное положение вещей и компенсировать показатели естественного оттока, которого нельзя избежать в любом бизнесе. Эта метрика важна для оценки эффективности многоуровневых программ лояльности.

- Индекс потребительской лояльности NPS — он показывает уровень удовлетворенности пользователей по шкале от 1 до 10 — это степень вероятности того, что человек порекомендует компанию кому-то еще. Индекс высчитывается путем вычитания процента критиков бренда (detractors — тех, кто не стал бы рекомендовать компанию) из процента сторонников (promoters — люди, которые готовы ее рекомендовать).

- Оценка усилий клиента (CES, Customer Effort Score) — позволяет понять, насколько трудно им было решить свою задачу с помощью компании.

Подробнее о технической стороне организации систем лояльности мы рассказывали в этом материале: «Почему не взлетает «облако»: как работают системы лояльности в магазинах».

|

Метки: author pilot-retail повышение конверсии монетизация it-систем блог компании пилот системы лояльности ритейл |

[Перевод] Одинарная или двойная точность? |

|

Метки: author m1rko программирование математика float double плавающая запятая плавающая точка одинарная точность двойная точность |

«Проект Ironman». Как подготовиться к «Железному человеку» за 500 часов, используя скиллы PM’а |

Начало

Начну немного издалека. Несколько лет назад я решил начать вести здоровый образ жизни. Не с понедельника и не с 1 января. Однажды я обувался, чтобы пойти на работу, и распрямился с багровым лицом и ужасающей одышкой. Я представил, какой жалкий вид имеет эта сцена со стороны. Вечером того же дня я купил кроссовки и на следующее утро отправился в свой первый короткий забег. Первые полгода ЗОЖа были сплошным преодолением: я привыкал к нагрузкам, собрал целую коллекцию травм, но еще через шесть месяцев финишировал в своем первом марафоне. Я почувствовал взрыв эмоций, решил продолжать забеги ради улучшения результатов, чтобы посмотреть мир и познакомиться с интересными людьми – марафоны проводятся в разных странах и на разных континентах, а среди бегунов много действительно выдающихся личностей. Но с каждым новым финишем эмоции притуплялись. Мне нужен был новый вызов. На YouTube на глаза попался красочный мотивирующий ролик про Ironman. Я пересмотрел его несколько раз и понял, что “Железный человек” вполне годится в качестве следующей личной цели.

На следующее утро, когда я «переспал» с мыслью об Ironman, воодушевления существенно поубавилось. Я понял, какая масштабная цель стоит передо мной и насколько скуден набор средств для ее достижения. За 10 с лишним лет карьеры в Softline столь же высокую цель, средства для достижения которой были не вполне ясны, передо мной ставили только однажды: в рамках одного большого проекта пришлось заняться управлением разработкой программного обеспечения. Дело было 10 лет назад, я тогда был молод, не придал значения специфике проекта и согласился его реализовать. А чего бы и не взяться, ведь инструментарий проектного менеджера, как я на тот момент думал, «прокатит» и для той области, где у тебя нет даже базовых знаний. В итоге проект по моей вине почти потерпел фиаско. Спасибо коллегам, которые вовремя оказались на подхвате и занялись этой темой с гораздо большим успехом.

К чему это я? Да к тому, что затея с Ironman вполне могла бы стать способом реабилитации за давний факап. Я смахнул пыль с увесистого тома PM Body of Knowledge, освежил в памяти ряд очень важных рекомендаций из этой книги и решил идти на “проект Ironman” с намерением на этот раз сделать все правильно и вдобавок к спортивным целям закрыть гештальт 10-летней давности.

Про устав «проекта Ironman»

За один вечер я набросал устав проекта, причем постарался это сделать максимально близко к тому, как написано в «библии всех PM’ов». Устав стал основным моим документом для реализации «проекта Ironman».

- Обоснование «проекта Ironman»:

- Обрести новый смысл моей спортивной жизни.

- Доказать себе, что урок из фиаско 10-летней давности извлечен.

- Обрести новый смысл моей спортивной жизни.

- Измеримые цели проекта и соответствующие критерии успеха:

- Пройти всю дистанцию не более, чем за 17 часов.

- Уложить всю подготовку в девять месяцев – именно столько оставалось до соревнований, участие в которых я наметил.

- Завершить состязание во вменяемом состоянии (не под капельницей в карете скорой помощи).

- Пройти всю дистанцию не более, чем за 17 часов.

- Высокоуровневые тербования:

- Организовать непосредственное участие моей семьи в процессе тренировок и восстановления.

- Совместить работу с занятиями спортом без ущерба для выполнения рабочих задач.

- Организовать непосредственное участие моей семьи в процессе тренировок и восстановления.

- Допущения проекта:

- Скорее всего, на трассе первого Ironman будет существенно теплее, чем в Москве во время основной фазы подготовки к соревнованиям.

- Удаленная работа с тренером может быть неэффективной, и мне нужно где-то искать реального (не удаленного) наставника, поиски которого могут растянуться.

- Скорее всего, на трассе первого Ironman будет существенно теплее, чем в Москве во время основной фазы подготовки к соревнованиям.

- Ограничения проекта:

- Мне предстоит на время перестроить свою жизнь так, чтобы подчинить ее ритм целям проекта.

- Время на подготовку – девять месяцев с 500 часами чистого тренировочного времени.

- Среднее количество тренировочного времени в день – 2 часа.

- Бюджет на подготовку — 500 тыс. рублей, включая все накладные расходы, связанные непосредственно с соревнованием.

- Привязка к конкретной дате: старт отодвинуть нельзя.

- Мне предстоит на время перестроить свою жизнь так, чтобы подчинить ее ритм целям проекта.

- Высокоуровневые риски:

- Риск травмы, которая не позволит продолжать подготовку.

- Обстоятельства непреодолимой силы, которые могут возникнуть в день проведения соревнований. Например, сильный ветер и большие волны на открытой воде, из-за чего дистанция может быть сокращена, сильный ветер на велоэтапе, стихийное бедствие и т.д…

- Риск травмы, которая не позволит продолжать подготовку.

- Требования к одобрению проекта:

- Дистанция пройдена менее чем за 17 часов.

- После финиша мне не требуется медицинская помощь.

- Подготовка к финишу в Ironman заняла 9 месяцев.

- Дистанция пройдена менее чем за 17 часов.

Согласование импровизированного устава прошло гладко — грех было не договориться с самим собой.

Про внешнего консультанта

Поскольку перед стартом «проекта Ironman» я дал себе обещание не повторять ошибок, для следующего этапа – составления плана работ – я решил нанять внешнего подрядчика. Им стал опытный «железный человек» — сам действующий триатлет, финишировавший в полном Ironman более 60 раз. То ли у моего инструктора также был бэкграунд в области управления проектами (среди триатлетов много действующих и бывших «топов» разных компаний), то ли в триатлоне по-другому хороших результатов не достичь, но мой консультант начал диалог с правильных вопросов. Первое, о чем спросил меня тренер, — для чего мне вообще финиш в «Железном человеке»? Ответ его устроил, и мы перешли к более конкретным вещам.

Затем внешний консультант приступил в обзору имеющихся ресурсов. Он обрадовался, когда узнал, что мой первый Ironman состоится через девять месяцев, и что я готов уделять достаточно времени тренировкам. У триатлетов есть эмпирическое правило: чтобы вписаться в установленные регламентом Ironman 17 часов на все три этапа соревнования, на подготовку к состязаниям следует потратить 500 часов чистого тренировочного времени. Поскольку в нашем распоряжении чуть меньше 300 дней, эти 500 часов можно достаточно комфортно распределить по всему периоду; в сутки получится около двух часов на спорт. Тренер похвалил мой беговой опыт, а в недостатки записал две других дисциплины триатлона – велоспорт и плавание. На шоссейном велосипеде я не катался ни разу, а плавал к своим 33 годам так себе — мог с трудом переплыть 25-метровый бассейн. Поставить технику педалирования и научиться плыть в открытой воде мне предстояло с привлечением «субподрядчиков».

Далее тренер предложил план коммуникаций. Мы определились с периодичностью контактов и с каналами взаимодействия: по высокоуровневым вопросам было предложено использовать электронную почту, для оперативной связи – различные из доступных мессенджеров. Скажем, в мессенджеры я могу отправлять ему отчеты о тренировках на основе данных с устройств Garmin, которыми я пользуюсь несколько лет. Инструктор анализирует собранную информацию, следит, чтобы я прогрессировал согласно графику, и дает рекомендации, как поступить, если что-то идет не так.

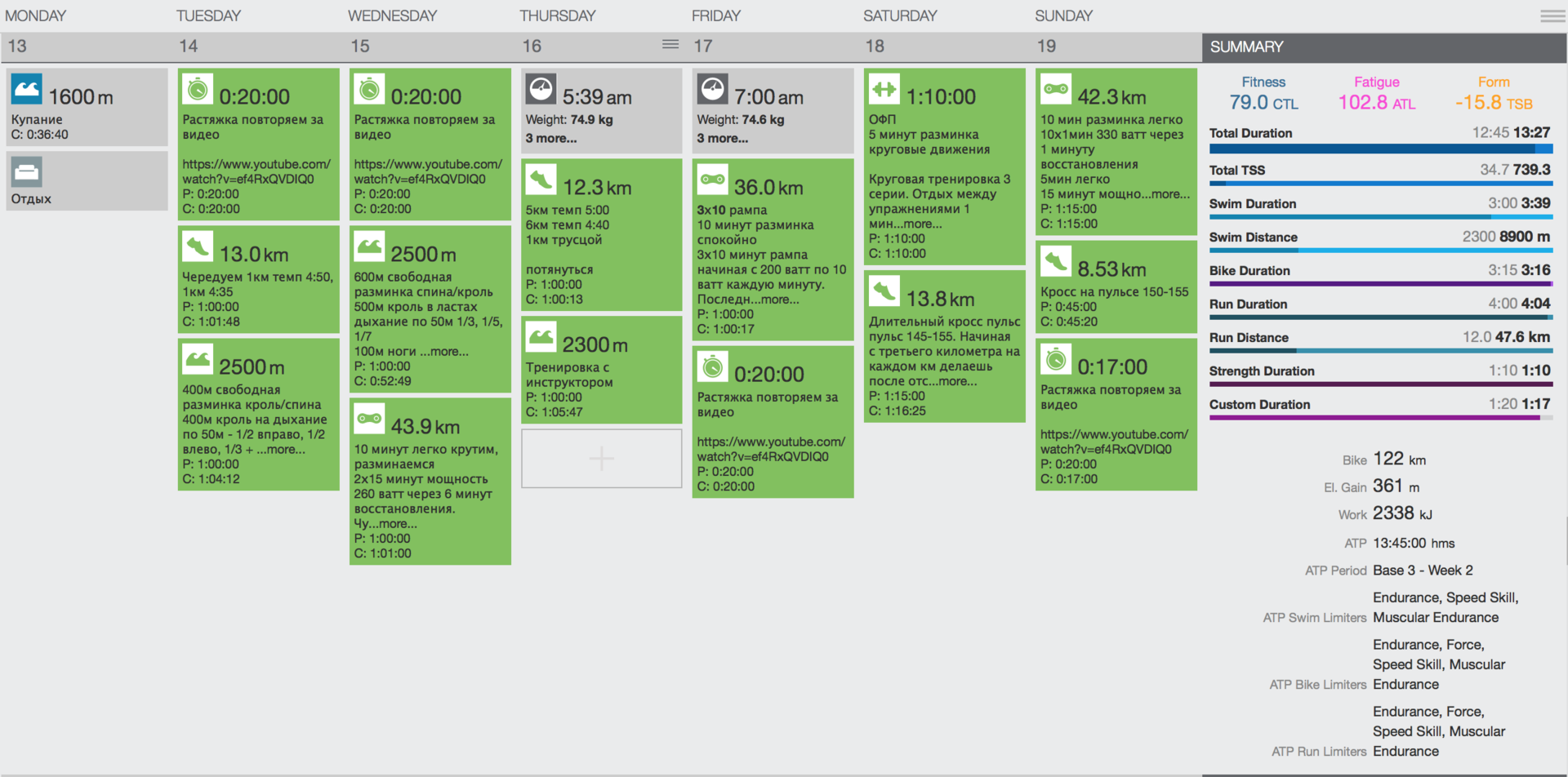

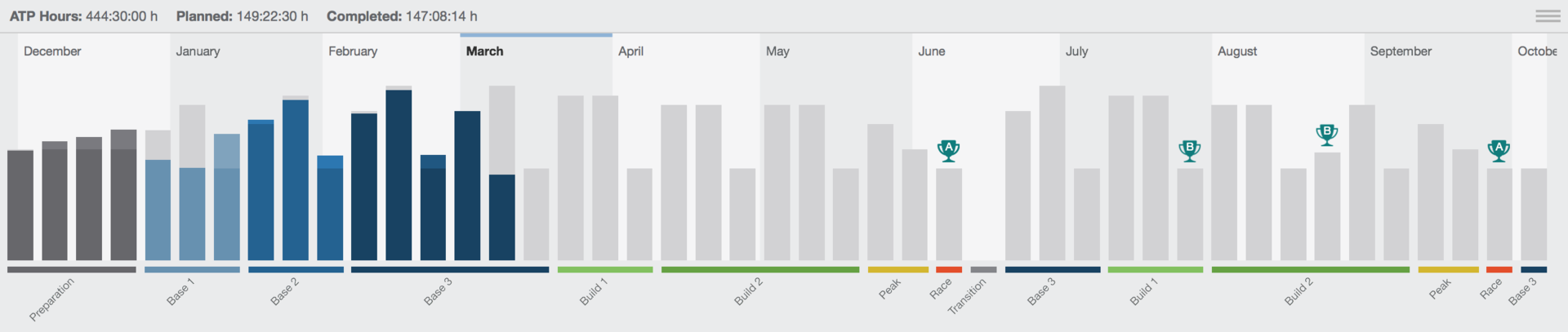

Самый главный для меня как для исполнителя документ – карту тренировок – тренер составил сам. Для этого он использовал сервис TrainingPeaks. Сначала план формировался достаточно крупными мазками. После того, как тренер впервые прислал мне план, я увидел только четыре больших этапа подготовки — базовый период, период строительства, выход на пиковую форму и предсоревновательный период. С началом занятий, когда тренер примерно понял, чего от меня можно ожидать, план стал обрастать деталями, но мой консультант все равно не заглядывал слишком далеко. Планирование конкретного набора занятий на неделю осуществляется с горизонтом 7-10 дней, и это нормально. Такой подход помогает практически без ошибок распределять главный в моих условиях ресурс – время — на конкретные виды активностей.

Тренировочный план триатлета – очень гибкая и «живая» штука. В план мой консультант вносил изменения практически ежедневно, объяснял, чем они обусловлены, и согласовывал их со мной. Мой рабочий график, а также планы провести время с семьёй, тоже вносили корректировки в тренировочный процесс. Контрольные точки в плане привязывались к так называемым пробным стартам или тестам, даты которых могли сдвигаться по таймлайну вперед или назад, и позволяли с высокой точностью определять, откуда и каким образом можно скинуть «лишние» минуты и секунды прохождения дистанции. Скажем, я с запасом укладываюсь в контрольное время в беге и в велосипеде, но сильно отстаю в том, что касается плавания. После анализа ситуации в моем расписании на неделю появляется одно-два «лишних» занятия в бассейне или на открытой воде.

Когда достигнут пик формы, наступает время заключительного тестирования. Оно с точностью в 90% показывает, на какой результат можно будет рассчитывать, если на дистанции не будет разного рода происшествий и неожиданностей.

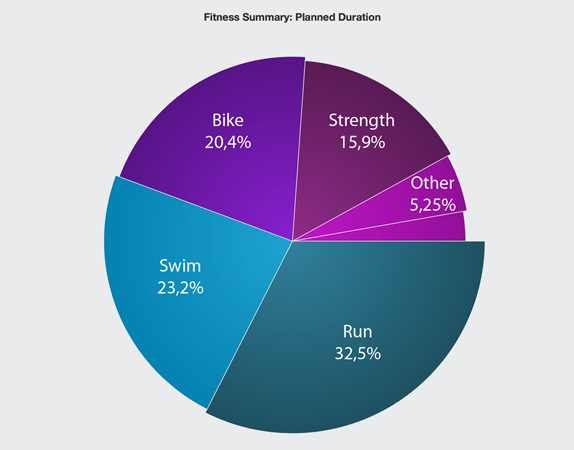

В моем случае распределение тренировочной активности (без учета занятий с железом и ОФП в зале) имело следующий вид:

40% — плавание

30% — велосипед

30% — бег

А вот так мы с тренером распланировали все активности в рамках подготовки к Ironman в целом.

Видя мой прогресс, тренер контролирует фазы проекта. Я, в свою очередь, на основе этих же параметров контролирую работу тренера, который выступает в роли менеджера проекта.

Еще «на берегу», до начала коммерческих взаимоотношений, тренер поднял вопрос о возможной несовместимости его как внешнего консультанта и меня как заказчика проекта. Это меня несколько насторожило. Но потом инструктор пояснил: если тренер плох, если прогресс в занятиях под его руководством надолго останавливается, даже если есть субъективное неприятие выбранной методики спортсменом, от услуг такого тренера нужно немедленно отказываться. Консультант, который не устраивает триатлета как заказчика, может стать причиной провала всего проекта.

Про тренировочное время

Как и в ИТ-проектах, время в «проекте Ironman» я бы назвал одним из главных ресурсов. Еще на этапе формирования устава проекта я прекрасно понимал, что время на тренировки само собой не образуется, и что его нужно будет где-то брать. Мне предстояло почти на год существенно перекроить распорядок собственной жизни и вместо work/life balance изобрести work/life/sport balance.

Сразу скажу, что под натиском work/life/sport balance первыми пали посиделки с приятелями за кружкой пива, долгие и ненужные поездки по пробкам и лежание на диване перед телевизором. Для меня триатлон – увлечение с очень высоким приоритетом, поэтому о том, что в моей жизни больше нет такого вида досуга, я не жалею.

Поскольку два часа подряд в будни выкроить малореально, я решил разделить тренировочное время на два фрагмента. Для первой тренировки я встаю в пять утра, провожу ее, завтракаю, проверяю рабочую почту, еду в офис или на встречи с заказчиками или вендорами. Вечером возвращаюсь домой, провожу вторую тренировку, общаюсь с семьей и ложусь спать. На сон я закладываю 7-8 часов – это необходимый минимум, чтобы успеть восстановиться. На выходные планирую длительные тренировки продолжительностью по 3-4 часа.

Глупо отрицать, что такой образ жизни совсем не конфликтует с рабочим расписанием. Накладки случаются во время длительных – от двух дней — командировок, но я со временем научился видеть в этом особенную прелесть: для меня проложить маршрут для часовой беговой тренировки в незнакомом городе — это дополнительный вызов. Стараюсь, впрочем, подходить к вопросу с позиции здравого смысла. Скажем, есть города, где я с энтузиазмом планирую маршрут и потом с удовольствием пробегаю часовую утреннюю тренировку. А вот для командировки в бразильский Сан-Паулу или в столицу Колумбии Боготу (в Латинской Америке у Softline мощный бизнес) я лучше поинтересуюсь, можно ли поселиться в отеле, где есть бассейн или спортзал: безопасность – превыше всего.

Основатель Softline Игорь Боровиков требовательный босс. Он привык, чтобы его поручения принимались в работу немедленно. Крайне важно было договориться о новых условиях коммуникации – в частности, о том, что в определенное время каждый день я могу не поднимать трубку немедленно и реагировать на письма не в течение 15 минут, а, скажем, через час-полтора. К счастью, сам Боровиков прекрасно знает, что такое спорт и подготовка к соревнованиям. За все время, которое я увлекаюсь триатлоном, не было ни единого эпизода, когда спорт каким-то образом помешал решению рабочих вопросов.

Про семью

У меня замечательная жена и четверо прекрасных сыновей. Я очень люблю свою семью, и мне было важно, чтобы мои домашние спокойно относились к моим тренировкам, без скандалов отпускали меня на сборы (хотя, к счастью, на сегодняшний день ситуация складывается успешно, и на сборы мы ездим всей семьёй), поддерживали, когда ничего не получается (а такое, поверьте, случается весьма часто), и болели за меня на дистанции. Их необходимо вовлекать. Мы все вместе ездим на соревнования, следим за моим прогрессом, я организую участие сыновей в IronKids – коротких забегах, где за участие и финиш им выдают символические подарки. Да, все эти перелеты, гостиницы, мероприятия стоят денег, но для меня эти деньги – инвестиция в мою крепкую семью.

В начале подготовки к триатлону тренер спросил, поддерживает ли меня моя семья в этом начинании. Я не придал этому вопросу значения, но со временем от него же узнал: у почти половины триатлетов, которые готовятся и участвуют в Ironman, распадаются семьи. Эти люди выбрали спорт и не подумали о вовлечении в процесс тем или иным способом своих домашних. Если вы намерены покорить Ironman, не повторяйте их ошибку.

Про деньги

Пожалуй, бюджет – это та часть проекта, которую я с треском провалил просто потому, что не смог спрогнозировать реальные расходы. И в результате сильно превысил сумму, закрепленную в уставе проекта. Сильнее всего по карману ударила покупка экипировки и оборудования. Один только велосипед для триатлона, который от обычного шоссейника отличается массой важных нюансов, и велостанок к нему для зимних тренировок в помещении, стоили космических денег. Остальные траты – несколько пар беговых кроссовок, гидрокостюм для плавания в открытой воде, комплект велоформы, шлем и другие вещи – на этом фоне выглядели достаточно скромно. Есть триатлеты, для которых финиш в Ironman – это вершина их спортивной карьеры. После успешного финиша в соревнованиях они продают снаряжение и отбивают часть затрат, но возместить инвестиции на 100% все равно не получается.

Вторая статья расходов – это оплата услуг тренера. Услуги титулованного консультанта, который полностью руководил «проектом Ironman», стоили мне в общей сложности $1 тыс. Еще примерно $500 я потратил на дополнительные занятия с тренерами по плаванию и велоспорту в Москве.

Теперь о выездах на сами соревнования. Я всегда стараюсь делать так, чтобы на состязания со мной летала вся семья – это оправданная инвестиция и хорошая возможность провести вместе несколько дней. Когда всем лететь не получается, со мной летит супруга. Про стоимость билетов и отелей говорить не будем – тут каждый решает для себя, так ли ему нужно лететь бизнес-классом и жить в пятизвездочной гостинице. А вот на чем сэкономить точно не выйдет, так это на организационных сборах. На соревнования Ironman они немаленькие и составляют $500-600. Сюда же необходимо приплюсовать такую неочевидную трату, как спецпитание во время гонки, одна порция которого стоит 150 руб. Порций на всю трассу надо 10-15.

От финансовой катастрофы меня спасло только то, что деньги на разностороннюю подготовку к соревнованиям я вытаскивал из бюджета постепенно. Зато я на собственном опыте убедился, что Ironman — крайне дорогое мероприятие.

Про итоги проекта

Почти годовая работа над «проектом Ironman» принесла результаты – трасса покорилась мне с первого раза. В принципе, «генеральный прогон» дистанции, который случился за пару недель до официального старта, уже показал, что целей проекта я достиг. Этот факт настроил меня на боевой лад. Я не только финишировал за 11 часов 45 минут — у меня остались силы потусоваться с другими участниками после завершения дистанции, спокойно вернуться в отель и поужинать с семьей. Следующий день я посвятил пассивному отдыху, в ходе которого мне удалось поразмыслить над итогами проекта.

Что безоговорочно расстроило, так это превышение бюджета. В классическом проектном менеджменте деньги – это одна из вершин «проектного треугольника». Если бы я вел обычный проект и превысил расходы чуть ли не в два раза, по всем правилам PM проект следовало бы признать провальным. Вместе с тем, я не считаю таковым «проект Ironman». Дело в том, что финиш на гонке Ironman – это круто в принципе. Всё-таки основная составляющая этого проекта – спортивная – оказалась выполнена в полном объёме.

Тренер также в общем и целом остался доволен достигнутым результатом. Вместе с тем, он проанализировал мой трек дистанции в Garmin и сказал, что в следующий раз я смогу пройти трассу быстрее. Так что и с его точки зрения «проект Ironman» нельзя считать для меня закрытым. Всё только начинается – и это несмотря на то, что к текущему моменту я уже трижды финишировал на этой престижной гонке и ещё три раза планирую сделать в этом году.

Я уже говорил, что заинтересованной стороной была моя семья. Безусловно, Ironman — хороший пример достижения целей для моих детей, а супруга тоже присоединилась и сама немного стала бегать. В самом начале подготовки никто из семьи не представлял, как вообще можно подготовиться и финишировать в одном из самых сложных однодневных соревнований на планете. Тем не менее, супруга и дети видели весь мой тренировочный процесс и были в него вовлечены. Например, они с самого начала прекрасно знали, что плаваю я неважно, а на велосипеде катался разве что по дорожкам парка. Поэтому мой возможный финиш в Ironman через год поначалу воспринимался ими как чудо. Но постепенно они увидели, из чего состоит это «чудо» — из разложенной по задачам «суперцели», неукоснительного соблюдения тренировочного графика, педантичного анализа каждого занятия и поиска, откуда и каким образом можно убрать «лишние» минуты и секунды.

Ironman, который в самом начале испугал меня масштабом задачи, помог существенно перестроить образ мышления. Теперь я знаю, что с правильной методологией и при грамотной реализации реален даже самый сложный проект – хоть личный, хоть профессиональный. Главное – чтобы такой проект содержал в себе разумный градус риска. Каждый раз, когда мне как начальнику департамента «заряжают» амбициозный план по продажам на очередной финансовый период, я мысленно возвращаюсь на несколько лет назад — к моменту, когда загорелся идеей пройти Ironman. И начинаю думать, какие есть возможности для реализации плана – что я могу сделать сам и как я могу помочь своей команде, чтобы этот план был выполнен. На мой взгляд, такая профессиональная деформация, которая произошла под влиянием личной цели, определенно стоит каждой капли пота, которым обильно полита моя дистанция Ironman.

|

Метки: author Softliner управление проектами управление персоналом блог компании softline pm проектный менеджмент ironman project management |

[Перевод] Как превратить увлечение программированием в работу |

Несколько лет назад я метался между двумя работами: в будни — озелененителем, на выходных — официантом. За плечами у меня был только что брошенный колледж, и я не знал, на что потратить свою жизнь.

Мыслей было много, но не было направления, в котором хотелось бы двигаться. И как раз в это время я начал самостоятельно изучать программирование. Сначала это было просто увлечение: мне казалось, что уметь создавать что-то из строчек кода, используя только мозг — это круто.

Потом я задумался о своей жизни, и мне показалось, что я вполне могу зарабатывать программированием.

Переведено в Alconost

Но я сразу же выбросил эту мысль из головы: у меня не было возможности получить настоящее образование. Однажды я уже бросил колледж из-за недостатка денег, и если б я пошел на программиста, пришлось бы начинать все сначала.

В этом случае через 6 лет я закончил бы обучение, имея долг в много более чем 50 000 долларов. Так что этот путь мне не подходил.

Затем я подумал, что вполне могу самостоятельно изучить веб-разработку достаточно хорошо, чтобы пойти на стажировку.

Первоначальный план состоял в том, чтобы рассказать о себе нескольким компаниям в городе и спросить, не хотят ли они встретиться со мной: я хотел обсудить возможность работы у них во время обучения — так я смог бы платить за обучение и одновременно получать кое-какой опыт.

Поэтому я всерьез занялся веб-разработкой.

Не мешкая, я начал собирать реальное портфолио и описывать свои навыки.

Меня уже можно было заметить на таких площадках, как Stack Overflow.

Я создал несколько решающих практические задачи приложений и выложил их на GitHub. Они не особо примечательны: их задача — показать, что я умею программировать.

И вот одна из компаний вместо того, чтобы предложить неполный рабочий день или обратиться к ним после получения диплома, решила взять меня на шестимесячный испытательный срок на полный рабочий день в качестве младшего разработчика.

Я был в восторге. Оказывается, после того как я стал относиться к разработке серьезно и начал кодить с определенной целью, я кое-чему успел научиться.

Поэтому я смог ответить на вопросы, которые мне задали на собеседовании, смог рассказать о тех скромных приложениях, которые к тому времени успел разработать, и даже сумел объяснить, как мои проекты работают.

Я остался в этой компании на два с половиной года, а затем устроился веб-разработчиком в городе, где живу.

Жизнь как постоянное обучение

Важной частью моего становления как профессионального разработчика стало время, проведенное на стажировке в предыдущей компании: я научился всему, чему смог.

Практические знания, полученные при работе в компании, невозможно переоценить: очень важно знать, как работать с клиентами, коллегами, а также в рамках заданных ограничений. И этому можно научиться только в реальной работе.

Сегодня я могу знать больше, чем тогда, когда только начинал заниматься веб-разработкой, но я никогда не перестану считать себя учеником. Чтобы быть отличным разработчиком, необходимо, кроме прочего, желание постоянно учиться. В то мгновение, когда мы начинаем считать, что освоили какой-либо навык полностью, мы перестаем расти.

Хемингуэй сказал об этом лучше меня:

«Мы все ученики в ремесле, в котором никто никогда не становится мастером».

Он говорил о писателях, но это относится и к разработке.

Самообучение в сочетании с работой в компании позволило мне очень многому научиться (я даже пишу книгу). Я понимаю практическую сторону веб-разработки и знаю, как из любителя стать профессионалом. Этот путь может пройти каждый, независимо от наличия времени и способностей.

Чтобы вы лучше понимали, о чем я говорю: я работал на двух работах, и на одной из них мне приходилось вставать в четыре утра и водить автопогрузчик.

Изучение программирования, когда у вас уже есть «взрослая» работа, требует решительности, мотивированности и настойчивости.

Из любителя — в профессионалы

Я опишу основные этапы, которых можно придерживаться. Конкретная траектория движения у каждого будет своя, однако есть определенные действия, которые помогут стать на правильный путь.

1. Осознайте, что это осуществимо.

Каждый может самостоятельно научиться программировать. Иногда можно услышать, что для самообучения нужно быть человеком определенного склада ума. В каком-то смысле это правда: вы не получите немедленной оплаты собственных стараний, поэтому должен быть какой-то другой стимул. И все-таки самообучение доступно каждому.

В нашем обществе есть представление о том, что кто-то рождается с определенными задатками, а кто-то — нет. Это мешает профессиональному росту, и это одна из причин, по которой многие ощущают неудовлетворенность жизнью.

Если всегда считать, что вам что-то либо дано, либо нет, то очень легко разочароваться и опустить руки.

Мне хотелось бы сразу же разрушить этот миф. Каждый может научиться мотивировать себя и самостоятельно изучить программирование. Или начать успешный бизнес. Или достичь долгосрочной цели.

Не обязательно рождаться с определенными задатками или уповать на счастливый случай — но здесь нужно упорство.

Если сможете погрузиться в работу, пережить трудное время и упорно трудиться — вы добьетесь своего.

Последнее — особенно важно, но, прежде чем двигаться дальше, хотелось бы кое о чем предупредить.

Мы слишком много значения придаем успехам — своим и чужим. Это называется ошибкой выжившего.

Во всем есть элемент удачи: иногда просто все складывается. Например, я связался с агентством по веб-разработке — и мне посчастливилось: они как раз искали работника, и я подошел под их требования.

Но что такое удача?

Конечно, получить эту работу — удача, но этой удачи не было бы, не решись я изучать программирование и подать резюме в эту компанию.

Удача и правда играет свою роль, но неверно будет говорить, что вообще все зависит от нее. Можно увеличить свои шансы на удачный случай — просто нужно быть готовым выложиться.

Но удача никогда не повернется лицом, если не стремиться достичь высокого мастерства в чем-либо.

2. Стремитесь в своем ремесле к совершенству

У меня есть слабые стороны, и одна из них — мне становится скучно и я начинаю отвлекаться. Появляется желание взяться за следующий проект. Такие склонности не позволят добиться успеха.

Иметь возможность бросить любой проект и перейти к другому, который сегодня больше нравится — это с какой-то стороны похоже на свободу, но…

Это ловушка! Если из этой статьи вы сможете вынести только одну мысль, пусть она будет такой:

Самый главный ключ к тому, чтобы стать профессиональным разработчиком — это кодить. Кодить и не останавливаться, пока не получишь желаемое.

И это относится вообще ко всему.

Люди напрягаются насчет того, какой фреймворк использовать. Но важно другое: выбрать какой-нибудь и работать с ним. Потом можно будет перейти на другой и изучить новые языки.

Важно то, какие навыки решения проблем вы приобретете при разработке. Важна способность думать, как разработчик.

Я учился программировать на фреймворке Laravel, но компания, в которую я устроился, использовала CakePHP — и это было неважно, ведь они знали, что я могу получить технические навыки, необходимые для перехода на другой фреймворк.

Поэтому выберите направление и держитесь его, что бы там ни было. И избавитесь от искушения отвлекаться на что-либо другое.

Мало что может сравниться с неумолимым стремлением овладеть ремеслом.

Это непросто. Но научившись игнорировать отвлекающие факторы, вы заметите, что начинаете получать большее удовольствие от работы.

Майк Роу (Mike Rowe) любит говорить, что не нужно начинать с поиска своего призвания.

Люди вокруг такие несчастные, потому что стремятся к безупречной карьере: они ищут свое призвание — что-то, чем они будут страстно увлечены.

Но увлеченность — это результат непреодолимого желания совершенствоваться в своем ремесле. И если научиться думать таким образом, ваши способности как разработчика обретут новое дыхание.

3. Начинайте сразу же писать код

Честолюбивые разработчики могут попасть в ловушку: они будут слишком много читать, ничего не делая.

Руководства и книги отлично помогают изучить основы, но загвоздка в том, что они дают ложное чувство уверенности.

У вас бывало так, что вы дочитали книгу по программированию и отправились сделать что-то самостоятельно — а в итоге поняли, что понятия не имеете, как это сделать? Тогда вы знаете, о чем я.

Решение здесь — простое, но совсем не легкое…

Начните писать код.

Сделайте что-нибудь. Напишите приложение, которое решает задачу из вашей собственной жизни или из жизни того, кто рядом.

Сделайте что-нибудь забавы ради.

Сделайте что-нибудь — и опубликуйте. Откройте исходные коды и выложите на GitHub. Вы делаете это не для кого-то еще — вы делаете это для себя, поэтому не беспокойтесь о том, что подумают другие.

Сначала ваш код будет уродлив. Иногда я просматриваю код, который написал всего несколько месяцев назад, и меня начинает тошнить. Но ведь нельзя стать разработчиком, ничего не разрабатывая. Книги — это прекрасно: я могу безостановочно проглатывать книгу за книгой. Но следующий за ними шаг — применять полученное знание.

Придется столкнуться со сложными задачами и приложить усилия. И это хорошо: такое обучение — самое эффективное.

Начните с приложений, которые решают конкретные задачи, — подробнее об этом я расскажу далее, на шаге 6.

4. Обозначьте себя в Интернете

Начав программировать, вы захотите обозначить свое присутствие в Интернете. Учетная запись GitHub — отличное начало.

Здесь можно выложить проекты, над которыми вы работаете, и поделиться ими с остальными.

Но вам захочется большего — и здесь я советую поднять собственный сайт для портфолио.

Такой сайт будет выполнять несколько задач:

- Он станет для работодателей доступным источником сведений о вас.

- На нем можно будет представить свои работы (чтобы не только GitHub знал о них).

- Он будет платформой для самовыражения и профессиональной деятельности.

И последнее — очень важно: запустив собственные, пусть небольшие, проекты, нужно сразу же начать писать о них. Заведите простой блог, где будете рассказывать о том, над чем работаете, и учить других всему, что знаете сами.

Это один из лучших способов дать потенциальным работодателям понять, кто вы и что вы умеете. Благодаря этому можно заработать себе репутацию и начать строить собственную платформу.

Так вы сможете расширить перспективы трудоустройства и получить возможность подзаработать — писательством или фрилансом.

Сайт должен служить очень конкретной цели.

Большинство создает онлайн-резюме, но вам придется пойти дальше: ответьте себе на вопрос, в чем конкретно состоит ваша цель, а затем разрабатывайте и оформляйте сайт с учетом этой цели.

Если вы ищете работу, связанную с определенным проектом или с определенным фреймворком — это должно быть на сайте.

Предлагаю разбить сайт на 4 основных раздела:

1.Главная страница

Главная страница — точка входа на сайт. На ней следует сжато изложить, кто вы и чем занимаетесь. Также она должна направлять посетителей к интересующей их информации.

Например, у вас будут две главные кнопки: одна будет направлять в раздел с вашими статьями о веб-разработке, а вторая — на страницу для потенциальных работодателей (если кто-то захочет вас нанять).

2. Статьи

Здесь будет обитать ваш блог и написанные вами руководства. Пишите так много, как только можете — и не бойтесь раздавать ссылки на свои статьи.

3. Информация о вас

Простой раздел «о себе», в котором подробнее описывается, кто вы и чем занимаетесь. Здесь должно быть не жизнеописание, а информация, связанная с тем, что вы хотите делать.

Не нужно описывать подробности личной жизни — расскажите о том, что привело вас к веб-разработке, как вы достигли того, что имеете, и куда хотите двигаться. Упомяните пару своих любимых проектов и оставьте ссылки на них.

4. Работодателям

Важная часть сайта — раздел для тех посетителей, которые заинтересованы нанять вас как разработчика.

Постарайтесь найти правильный баланс между честностью и желанием представить себя работодателю в лучшем свете. Сведения на этой странице и на странице о себе, вероятно, кое-где будут совпадать. Информация для работодателей должна конкретнее описывать навыки и то, чего нанимателю от вас можно ожидать.

Не забудьте также форму для связи — чтобы вам могли написать.

Начинайте писать не только для собственного сайта — предлагайте статьи крупным площадкам. Потом можно будет поставить на такие статьи ссылки в разделе «о себе».

5. Учите других всему, что знаете сами

Натан Барри (Nathan Barry) — большой поклонник подхода «учите всему, что знаете». Вот что он рассказывает о сайте CSS Tricks, основанном Крисом Койером (Chris Coyier).

Этот сайт появился на свет, когда Крис начал писал о том, что он изучает, — чтобы другие могли учиться вместе с ним. Теперь же это один из крупнейших сайтов о веб-разработке.

Отсюда можно почерпнуть урок: необязательно быть величайшим специалистом в мире, чтобы начать о чем-то писать и учить других.

В мире онлайн-бизнеса есть такой понятие, как «относительный специалист». Идея состоит в том, что каждый в чем-то является специалистом относительно кого-то другого.

К этой идее у меня есть вопросы — особенно когда ее используют, чтобы оправдать продажу чего-то, что продавать не следовало бы. Но все-таки это — полезное сравнение.

Меня беспокоит использование слова «специалист». Я не считаю, что обучать тому, что знаешь, — и даже продавать эту информацию — неправильно: если для кого-то эта информация представляет ценность, то почему бы и нет?

Но называть себя специалистом — это, пожалуй, немного слишком. Поэтому когда о чем-то пишете, старайтесь быть честными.

Я предпочитаю использовать термин «публичное обучение».

Многие с этого и начинали — учились публично: они изучали ремесло и описывали ход своего обучения.

Это отличный подход к обучению других всему тому, что вы умеете. Вы узнаёте все больше и больше, пишете статьи и при этом совершенствуетесь как автор. Со временем остальные работающие в вашей сфере начнут видеть в вас авторитетного специалиста.

И это окажется особенно ценным, когда дело дойдет до поиска работы — и даже если вы захотите начать собственное дело.

6. Решайте конкретные задачи

Один из самых важных аспектов на пути к тому, чтобы стать профессиональным разработчиком — работать над конкретными целями.

Одно дело — писать случайные приложения развлечения ради, и совсем другое — создавать приложения и сайты, которые решают конкретные задачи.

Студии веб-разработки на самом деле занимаются не программированием — они занимаются решением задач, а программирование — всего лишь выбранный ими для этого инструмент.

Возьмите любую книгу по маркетингу или написанию рекламных текстов — в ней обязательно будет говориться, что нужно продавать преимущества, а не функции продукта.

Веб-разработчикам, чтобы показать, насколько эффективно они решают задачи клиента, нужно продавать свои приложения, а затем — подтверждать свои заявления конкретными показателями. Клиенты, как правило, в этом случае более отзывчивы, чем если бы разработчик говорил об использованных технологиях.

Если вы сможете продемонстрировать свои навыки программирования, а также умение реализовывать решение конкретных задач и создавать полноценные приложения, вы станете очень привлекательным сотрудником для многих компаний.

Общаясь с потенциальными работодателями (или клиентами), наполняя свой сайт материалами, думайте не о функциях, а о преимуществах.

Безусловно, следует упомянуть и о профессиональных навыках в программировании, но большинство тратит на это все свое время. Поэтому упомяните их кратко, чтобы потенциальные работодатели знали, чем вы занимаетесь. Если у вас есть портфолио эффективных приложений, ваши навыки программирования будут говорить сами за себя.

7. Не прекращайте учиться

В тот день, когда вы решите, что освоили что-либо, вы перестанете учиться.

Научитесь жить, постоянно учась: всегда есть что изучать и всегда есть куда совершенствоваться.

Особенно это важно на ранних этапах карьеры. Если вы устроились на неполный рабочий день, или на стажировку, или вас взяли младшим разработчиком, вам просто необходимо сразу же включить образ мышления, который позволит как можно больше учиться и расти профессионально.

И это нужно сделать сразу же, не дожидаясь, пока у вас появится настоящий «наставник».

Джефф Гоинс в книге «Искусство работать» рассказывает об отношениях ученика и мастера в XXI веке.

В средневековье такие отношения были очень формальными. Мастер брал себе ученика на многие годы, и тот начинал постепенно осваивать ремесло, пока сам не добивался звания мастера, который может брать других себе в ученики.

Эти отношения изменились, но считать себя учеником — это по-прежнему очень важно. Главное отличие в том, что теперь нужно искать потенциальных наставников и возможность учиться, и на протяжении всей карьеры будет много и того, и другого.

В мире веб-разработки мы постоянно каким-либо образом находимся в Интернете, поэтому такие отношения могут принимать разные формы.

Книги, руководства, курсы, форумы и другие способы обучения — все они ценны. Мне, однако, кажется, что эффективнее всего учиться у того, кто сейчас находится там, где хотели бы оказаться вы.

Вот почему так важно усердие и желание учиться. Впервые устроиться на должность разработчика — это не завершение пути, а лишь его начало.

Именно отсюда начинается настоящее обучение, именно с этого момента ваши знания начинают расти.

8. Научитесь сотрудничать

Одно из главных отличий любительского программирования от профессиональной разработки — это необходимость сотрудничать с другими.

На протяжении всей карьеры придется взаимодействовать и работать с другими разработчиками, с начальниками, коллегами, клиентами, компаниями-партнерами — и вообще с самыми разными людьми.

Поэтому важно научиться эффективно сотрудничать.

В области веб-разработки общение — это главное. Когда к вам приходит заказчик и говорит, что ему нужно, а вы не совсем понимаете, как это должно выглядеть, то впоследствии это может вызвать множество проблем и головную боль.

Точно так же, если вы не можете общаться с людьми, вместе с которыми работаете, это отразится на вашей работе — вы попросту не сможете ее делать.

Пока вы только изучаете программирование, есть несколько отличных способов попрактиковаться в сотрудничестве.

Частично вы научитесь этому, когда начнете обучать других всему, что знаете: люди будут общаться с вами, причем иногда это будет неприятное общение, — но так вы узнаете, как вести себя в таких случаях.

Также я настоятельно советую участвовать в проектах с открытым исходным кодом. Они дают представление о том, каково это — совместно работать над проектом, где у каждого участника могут быть собственные идеи о том, как лучше добиться результата.

Поначалу участвовать в проектах с открытым исходным кодом может быть страшновато, но в итоге они принесут неоценимую пользу вашей карьере разработчика.

Начать можно с этого сайта.

Вперед — зарабатывайте на жизнь

Веб-разработка — это сложно. Это постоянное обучение и приспосабливание к новым технологиям. Идя по этому пути, нужно не только знать технологии, но также понимать деловые процессы и уметь общаться.

К счастью, ваши усилия воздадутся сторицей: вы будете писать код, который решает задачи других людей и облегчает им жизнь, и при этом будете отлично зарабатывать.

Сегодня есть множество ресурсов, которые учат программировать — и многие из них полностью бесплатны, — однако нам, похоже, не хватает ресурсов, которые помогали бы переходить из категории программистов-любителей в категорию профессиональных разработчиков.

Надеюсь, это небольшое руководство послужит вам хорошим планом действий на пути к тому, чтобы стать профессиональным разработчиком.

Помните: пока вы бездействуете, ничего не происходит. Заведите себе простой сайт с портфолио, напишите потенциальным работодателям, выложите пару статей на Medium — просто начните делать хоть что-то.

Чем больше вы прикладываете усилий, чем больше что-то делаете, тем скорее вы превратитесь из любителя в профессионала.

О переводчике

Перевод статьи выполнен в Alconost.

Alconost занимается локализацией приложений, игр и сайтов на 68 языков. Переводчики-носители языка, лингвистическое тестирование, облачная платформа с API, непрерывная локализация, менеджеры проектов 24/7, любые форматы строковых ресурсов, перевод технических текстов.

Мы также делаем рекламные и обучающие видеоролики — для сайтов, продающие, имиджевые, рекламные, обучающие, тизеры, эксплейнеры, трейлеры для Google Play и App Store.

Подробнее: https://alconost.com

|

|

[Перевод] Осознанные ошибки: как добавить глупость в код ИИ |

|

Метки: author PatientZero разработка игр искусственный интеллект геймдизайн |

Обзор основных секций конференции PG Day'17 Russia |

Неделю назад было опубликовано полное расписание конференции. Мероприятие ожидается очень насыщенным: учебный день, включающий себя 11 мастер-классов; Greenplum Day — бесплатное мероприятие, посвященное одноименной аналитической платформе, от наших партнеров Dell/EMC и Pivotal; два дня докладов — свыше 60 выступлений в шести секциях.

В преддверии конференции совместно с hydrobiont мы составили для вас подборку самых ярких и запоминающихся выступлений.

Интересных докладов хватит на всех. Разработчикам придутся по вкусу выступления экспертов из Data Egret. Макс Богук — специалист уникального уровня, ему не требуется база данных, чтобы прикинуть, как будет работать оптимизатор. Своими сверхспособностями Макс поделится в докладе "Неклассические техники оптимизации запросов в PostgreSQL, или как научить слона танцевать рок-н-ролл". Чтобы понять, что именно ждет вас на докладе Макса, приглашаю посмотреть презентацию 2014 года, с которой Макс выступил на одном из наших митапов под названием PG Master.

Алексей Ермаков, напарник Макса по Data Egret, обладает не менее пугающим объемом знаний по внутренному устройству механизмов PostgreSQL. Глубоко технические доклады Леши пользовались огромным спросом на прошлых PG Day. В этом году Алексей привезет интересный технический доклад про внутреннее устройство планировщика запросов PostgreSQL. Чтобы оценить глубину погружения Алексеем в технические детали, приглашаю ознакомиться с транскрипцией его доклада на одном из прошлых PG Day.

Специально, чтобы порадовать всех админов и девопс, к нам приезжает звездный десант из Zalando: Александр Кукушкин, Алексей Клюкин и Мурат Кабилов. В рамках двух докладов коллеги поделятся успешным опытом эксплуатации PostgreSQL в качестве облачной платформы. Каждый день перед Zalando стоит уникальное испытание: как объединить десятки разрозненных команд, работающих над разработкой многочисленных компонентов огромного бизнеса, без необходимости требовать от каждой из них один и тот же стек технологий. Ответ: единая платформа для хранения данных. Не секрет, что разработчики любят облака за отсутствие необходимости осущесвлять ручное управление базой данных. Специалисты из Zalando решили не плыть против течения, приняли потребность в наличии эффективной облачной платформы и написали несколько своих инструментов, способствующие эффективной экплуатации Посгреса в Amazon AWS. Своим опытом ребята поделятся в рамках двух докладов: "PostgreSQL “в кубе”: Kubernetes для высокодоступных баз данных в Zalando" и "PostgreSQL on AWS: Tips & Tricks (and horror stories)".

Компания Ispirer Systems представит очень любопытный доклад, который будет интересен всем. Коллеги из Ispirer Systems утверждают, что эффективная автоматизация миграции SQL и кода приложений возможна! На PG Day специалисты компании представят решение, которое позволяет автоматически конвертировать бизнес-логику, как SQL объекты, так и код приложений. Приходите послушать и подискутировать :-)

Пик тренда на импортозамещение пришел и ушел. Утихли продолжительные споры, а все заинтересованные компании, вынужденно или по собственному желанию, тихо двигаются в новом для них направлении. Приходилось ли вам задумываться, каково нынче Посгресу живется в кровавом энтерпрайзе? Ровно об этом поведает Антон Бушмелев в одноименном докладе "Кровавый энтерпрайз, или как мы приручили слона". Компания РТ Лабс, подразделение Ростелекома, уже второй год успешно применяет PostgreSQL в новых проектах. Опытом внедрения посгреса Антон поделится на PG Day.

Экстремальные нагрузки на СУБД — штатная ситуация в жизни разработчиков и администраторов из команды Avito. Опытом эксплуатации приедет поделиться Виктор Ягофаров, DBA компании. В докладе вас ждет рассказ про внутреннее устройство и секреты pgBouncer, тюнинг под высокие нагрузки, обеспечение отказоустойчивости и многие другие секреты одного из самых популярных connection pooler'ов в мире PostgreSQL.

В этом году мы расширили тематику конференции и пригласили на мероприятие профессионалов, работающих с популярными коммерческими и открытыми СУБД. Немного расскажем вам про самые интересные выступления, посвященные Oracle и MS SQL Server, которые стоит посетить как посгресистам, так и коллегам из мира Enterprise.

Самый важный доклад в этой секции представит Виктор Егоров, DBA из компании Data Egret. Опираясь на свой стаж работы как с PostgreSQL, так и с Oracle, Виктор проведет сравнительный обзор архитектуры обеих баз. Доклад будет поделен на несколько секций, посвященных конкретным архитектурным решениям: работе с памятью, процессам, версионности и хранению данных. Доклад будет интересен многим. Пользователи PostgreSQL смогут взглянуть на другую СУБД, её особенности и возможности, некоторые из которых можно реализовать и в PostgreSQL. У разработчиков PostgreSQL могут появиться идеи о дальнейшем направлении развития Посгреса. С другой стороны, все пользователи Oracle смогут оценить возможности открытой СУБД. Особенно актуально это для представителей организаций, размышляющих о миграции.

Всех любителей «хардкора» нам тоже есть чем порадовать. Эксперты из технологического центра Deutsche Bank готовят целых три крутых технических доклада. Дмитрий Ремизов преподаст урок по анатомии курсора, Николай Кудинов расскажет о трассировке пользовательских процессов и минимизации ожиданий, а Александр Халухин проведет практический мастер-класс по диагностике производительности Oracle Database.

Не оставили мы без внимания и специалистов по MS SQL Server. Независимый консультант Илья Вербицкий на примере системы безопасности SQL Server 2016 расскажет о наболевшем: как ограничивать доступ к данным и создавать безопасное окружение для функционирования вашего бизнеса. Для всех специалистов, желающих повысить свой уровень владения MS SQL Server, Константин Таранов, специалист одного из подразделений Газпром, проведет интенсивный crash-курс "SQL Server за один день", призванный помочь вам научиться эффективно эксплуатировать этот продукт.

В ходе мастер-класса будут рассмотрены следующие вопросы:

- сравнение функциональных возможностей SQL Server с Oracle и PostgreSQL;

- выбор версии и выпуска SQL Server с учетом решаемых вами задач;

- конфигурация и настройка SQL Server;

- TSQL — проверенные практики при написании хорошего кода;

- средства разработки и администрирования для SQL Server — бесплатные и платные инструменты.

В этом году на конференции PG Day Russia также впервые пройдет секция открытых баз данных, отличных от PostgreSQL. Отбор докладов в эту секцию в Программном комитете конференции курировал генеральный директор “Перконы” Пётр Зайцев. Что интересного ждет вас на этой секции?

Прежде всего, это три серьезных технических доклада от «Перконы» про внутреннее устройство MySQL и MongoDB:

- обработка транзакций в MySQL-derived базах от Николая Ихалайнена;

- хранилище на LSM-дереве в качестве движка базы данных. Опыт MongoRocks от Дениса Противенского;

- эффективная отладка репликации MySQL в исполнении Светы Смирновой.

Удивительный use-case привезли коллеги их ИТ-департамента МТС. Оказывается, решение для централизованной системы управления балансами, счётчиками, акумуляторами абонентов в режиме реального времени, построенное на базе MySQL Cluster, уже около года находится в эксплуатации компании МТС и продолжает развиваться. Любопытно? И нам тоже, приходите послушать вместе :-)

На PG Day, вы сможете из первых рук узнать нюансы устройства ElasticSearch и MongoDB. К нам в гости приедут Philipp Krenn и Henrik Ingo, эксперты компаний Elastic и MongoDB. Во время конференции коллеги проведут мастер-классы, доклады и семинары, посвященные разработкам своих компаний. Доклад и семинар Philipp'а будут посвящены внутренней организации и примерам организации полнотекстового поиска с помощью Elasticsearch. Henrik поведает про архитектуру нового механизма репликации и преподаст несколько уроков эффективной организации приложений с помощью MongoDB.

Не обошли мы стороной и отечественные разработки. Вас ждут подробные рассказы про Clickhouse от Алексея Миловидова и Tarantool от Василия Сошникова. Хотим отметить, что выступление Василия будет отдельным мастер-классом, в рамках которого вы научитесь строить эффективную микросервисную архитектуру, рассчитанную на высокие нагрузки, подобно тому, что уже существует и функционирует в «продакшене» крупных компаний: Beeline, Avito, Mail.ru и др.

Ну и напоследок, у вас появится прекрасная возможность сравнить NoSQL-фичи в PostgreSQL и MySQL, о которых расскажут Олег Бартунов и Пётр Зайцев соответственно!

Открывает секцию впечатляющий доклад о разработке новой системы хранения аттачей из писем почты Mail.Ru. Как правильно принимать, хранить и не терять 80 000 файлов в минуту, расскажет Андрей Сумин, технический директор сервиса.

Николай Сивко, экс-руководитель эксплуатации в HeadHunter и сооснователь отечественного мониторинга OKMeter, расскажет, как диагностировать различные «бытовые» проблемы эксплуатации постгреса в «продакшене». Практический взгляд на тему мониторинга предлагает Антон Шалимов, разработчик компании Aviasales. Антон прилетает из солнечного Таиланда специально чтобы поделиться с вами опытом построения платформы для сбора, хранения и мониторинга на базе СУБД InfluxDB.

Для всех участников PG Day'17 Russia команда конференции совместно с компаниями Pivotal и Dell/EMC организует бесплатный Greenplum Day, посвященный Greenplum — платформе с открытым исходным кодом для аналитики и Data Warehousing на базе PostgreSQL. Крупные компании, такие как Ростелеком и Тинькофф Банк, поделятся своим опытом эксплуатации.

Вас ждет несколько подробных технических докладов, посвященных устройству, функционированию и приемам использования Greenplum. Heikki Linnakangas, один из ведущих разработчиков платформы и самого PostgreSQL, даст подробный обзор архитектуры платформы. Представителей бизнеса заинтересует возможность пообщаться с коллегами из флагманских компаний, внедряющих Greenplum, из первых рук узнать, как применение платформы способствовало росту качества решений, принимаемых на базе собираемой аналитической информации.

Мероприятие пройдет 5-го июля, с 10:00 до 19:00, в день мастер-классов. Для регистрации на Greenplum Day достаточно записаться, воспользовавшись формой на странице https://pgday.ru/ru/greenplumday. Вход для всех зарегистрировашихся участников бесплатный.

Мы приглашаем всех принять участие! Регистрация будет открыта до старта мероприятия.

|

Метки: author rdruzyagin блог компании pg day'17 russia postgresql oracle ms sql server mysql innodb java conference конференция greenplum elasticsearch mongodb |

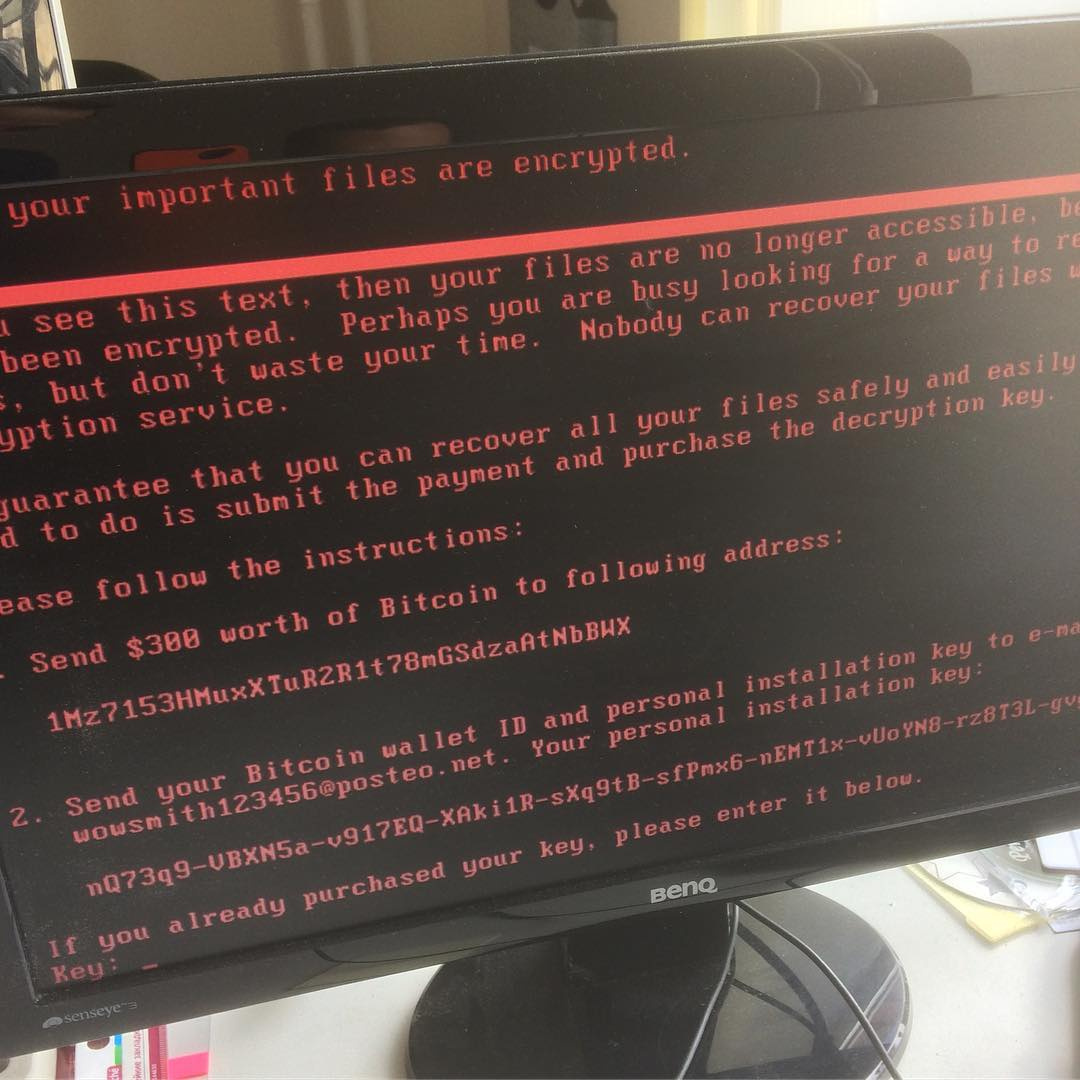

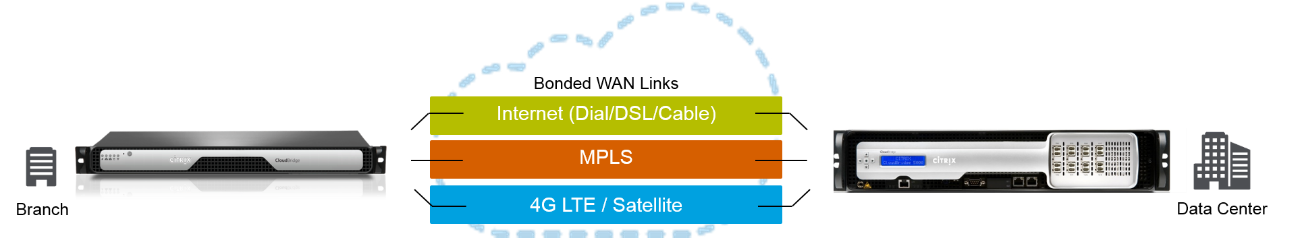

Как защитить корпоративный NAS от вирусов RansomWare |

Системы хранения NetApp FAS/ONTAP

Имеют не только множество интеграций с множеством софта для резервного копирования, антивирусными системами и другими инфраструктурными системами, но также обеспечивает высокую доступность для NAS (NFS, CIFS/SMB) и SAN (iSCSI, FC, FCoE). Унифицированное хранилище позволяет обеспечивать прозрачную миграцию данных между нодами кластера, который может состоять из 24 узлов, а также позволяет задействовать одновременно все ноды кластера для обслуживания NAS и SAN для повышения производительности. Таким образом можно полностью отказаться от подверженных уязвимостям Windows Server и не покупать лицензии и не строить кластеров для высокой доступности, ведь весь функционал уже есть в NetApp ONTAP.

Резервное копирование

Как в самых больших, так и в маленьких организациях рабочие файлы располагают на общедоступном файловом хранилище, чтобы все могли ими пользоваться. Централизация хранения даёт удобство для совместной работы нескольким людям над одними и теми же файлами, но это налаживает и ответственность по защите такой информации. Естественно для борьбы с вирусами-шифровальщиками необходимо регулярно выполнять резервное копирование по схеме 3-2-1. Резервные копии важно хранить отдельно от основной системы.

Системы хранения NetApp FAS/ONTAP имеет в своём арсенале снэпшоты не влияющие на производительность и репликацию на базе этих снэпшотов, которые позволяют интегрироваться с широким списком систем резервного копирования использующие технологии системы хранения данных NetApp:

- Veeam Backup & Replication

- CommVault Simpana

- NetApp SnapManager/SnapCenter.

- NetApp SnapCreator (бесплатный фреймворк)

- Veritas NetBackup

- Veritas BackupExec

- SyncSort

- Acronis

- IBM Tivoli

- EMC Networker

- HP Data Protector

- И другие

Давайте рассмотрим одну из таких систем резервного копирования, Veeam Backup & Replication, которая завоевала доверие и уважение благодаря лёгкости и простоте интерфейса управления. Но это далеко не все преимущества этого продукта, который не только умеет управлять снэпшотами и репликами между системами NetApp FAS, ONTAP Select, ONTAP Cloud и AltaVault, но также позволяет ещё средствами СХД клонировать данные на одной из площадок для тестирования работоспособности и восстанавливаемости из таких бэкапов. Клонирование как и снэпшоты на система NetApp FAS/ONTAP, это очень удобная технология, которая также не влияет на производительность и в начальный момент снятия снэпшота практически не занимает пространство на хранилище создаваясь меньше чем за секунду, в не зависимости от величины клонируемых данных.

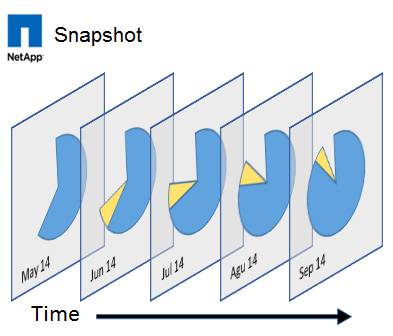

Снэпшоты для спасения

Но полное восстановление, во-первых, может быть достаточно длительным, а во-вторых резервное копирование может выполняться не каждые 15 минут, таким образом увеличивая RPO. И вот здесь становится понятно, насколько важной частью резервного копирования являются снэпшоты, которые можно выполнять на много чаще нежели резервные копии с NAS хранилища и соответственно восстанавливать такие данные намного быстрее из снэпшотов, таким образом существенно уменьшив значение RPO. И вот здесь становится понятно насколько важно, чтобы такие снэпшоты функционировали как часы, не тормозили работу всего хранилища, не имели архитектурных проблем по удалению и консолидации снэпшотов. При этом снэпшоты это не замена резервному копированию, а отличное дополнение для полноценной стратегии резервного копирования. Так снэпшоты можно выполнять достаточно часто, чтобы захватывать самые последние изменения вашей информации.

Снэпшоты это не полная копия данных, только разница новых данных на блочном уровне, своего рода обратный инкрементальный бэкап, который более рационально использует пространство хранилища, нежели полный бэкап. Но всё равно это пространство используется, чем больше изменений, тем больше попадает информации в снэпшот. Настроенное расписание авто-удаления старых снэпшотов позволит более рационально использовать ресурсы хранилища и не съесть всё доступное пространство на дорогостоящем NAS хранилище. А резервное, будет хранить намного дольше по времени копии более старых версий информации.

Есть отдельный документ как бороться с вирусами-шифровальшиками используя системы NetApp.

Как снэпшоты не должны работать

Многие уже сталкивались с различными реализациями снэпшотов и уже на практике знают, как снэпшоты не должны работать:

- они не должны увеличивать нагрузку на дисковую подсистему просто от наличия снэпшота

- они не должны увеличивать нагрузку просто от большего числа снэпшотов

- они должны быстро создаваться и удалиться и этот процесс не должен влиять на производительность дисковой подсистемы

- они должны удаляться так чтобы не повредить основные данные

- им не должно быть разницы сколько данных, всё должно работать быстро, моментально и без малейшей возможности повредить информацию из-за удаления или консолидации снэпшота.

Снэпшоты в операционной системе ONTAP для хранилищ NetApp так не работают. Они были впервые реализованы в операционной системе ONTAP, как часть файловой системы WAFL в 1993 году, эти технологии апробированы временим и сотнями тысяч компаний по всему миру. Кстати само слово «снэпшот» (Snapshot ™) является зарегистрированной торговой маркой компании NetApp, а эта технология снэпшотирования запатентована. Чтобы удостовериться в том, как работают снэпшоты WAFL можно бесплатно скачать на тестовый период виртуальную машину с образом хранилища ONTAP.

mysupport.netapp.com/NOW/cgi-bin/software/?product=ONTAP+Select&platform=Deploy+Install

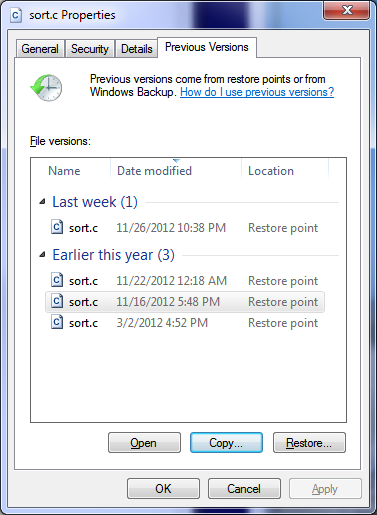

Автоматизация восстановления

Интеграция снэпшотов хранилища с операционными системами позволит снять рутину с администратора хранилища по восстановлению отдельных файлов. Чтобы пользователи сами могли восстанавливать свои файлы из снэпшотов прямо из своего компьютера стандартными срадствами ОС.

Репликация снэпшотов

Просто удаление старых снэпшотов, которые уже есть на хранилище и настроены в хорошо налаженной стратегии резервного копирования — это ужасная трата ресурсов. Ведь снэпшоты можно использовать для их репликации на вторую систему хранения. Во-первых снэпшоты уже есть, почему-бы их не использовать, во-вторых намного выгоднее передавать дельту нежели весь набор данных каждый раз, в третьих снэпшоты работают на подобии обратных инкрементальных бэкапов, то есть не требуют времени на «склеивание в полный бэкап», в четвертых снэпшоты ONTAP подобны обратным инкрементальным бэкапам, но они не требуют склеивания или консолидации ни во время репликации ни во время восстановления, как это происходит с традиционными инкрементальным бэкапом или обратным инкрементальным бэкапом. Но магии не бывает, снэпшоты при репликации данных всё равно вычитываются из целевой системы, чтобы быть отправленными на удалённую систему, это порождает дополнительные операции чтения во время реплики, но это намного лучше в сравнении с фулл-бэкапом, который каждый раз вычитывает заново все данные целиком.

WORM

Технология Wright Once Read Many или WORM, таже известна и под другими коммерческими названиями, к примеру NetApp SnapLock построенная на базе снэпшотирования, позволяет залочить данные на длительный срок от изменений, в том числе и пользователей системы хранения с повышенными привилегиями. Так можно хранить прошивки, конфиги от разнообразных устройств, к примеру свичей, роутеров и прочее. Подобного рода файлы редко если вообще меняются в течении жизни устройства, а харнилища с поддержкой WORM надежное место для расположения важных файлов-настроек для инфраструктуры, которые нельзя менять, но можно читать. Это свойство можно использовать для того, чтобы загружать конфигурации и прошивки для ключевых компонент вашей инфраструктуры.

Антивирусная защита NAS

Ну и конечно же возможность проверки файлов на стороне хранилища тоже будет не лишней. Системы NetApp FAS/ONTAP интегрируются с широким списком антивирусных систем которые будут выполнять проверку корпоративных данных на NAS хранилище. Поддерживаются самые известные системы резервного копирования:

- Symantec

- Trend Micro

- Computer Associates

- McAfee

- Sophos

- Kaspersky

Снэпшоты как индикатор заражения RansomWare

Как было сказано ранее снэпшоты хранят в себе блочную дельту, — разницу между предыдущим своим состоянием и между текущим, то есть актуальным. И чем больше изменений внесено в актуальные данные, тем больше занимает снэпшот. Кроме снэпшотов стоит ещё упомянуть про технологии компрессии и дедупликации данных, которые позволяют сжимать оригинальные данные, экономя пространство на хранилище. Так вот некоторые данные не компрессируются и не жмутся. К примеру фото, видео или аудио данные, а какие данные ещё не жмутся? Правильно зашифрованные данные. И вот представьте вы настроили расписание снэпшотов, у вас работает дедупликация и компрессия. Снэпшоты снимаются, а более старые удаляются, данные жмутся, потребление пространства достаточно размеренное и стабильное. И вдруг снэпшоты начинают занимать намного, намного больше нежели раньше, а дедуп и компрессия перестали показывать свою эффективность. Это и есть индикаторы молчаливой и вредоносной работы вируса-шифровальщика: ваши данные, во-первых, сильно изменяются (растут снэпшоты в объёме, по сравнениию с тем, как это было раньше), во-вторых дедуп и компрессия перестали давать результат (значит записывается несжимаемая информация, к примеру оригиналы файлов подменяются на зашифрованные версии). Эти два косвенных показателя приводят к более не рациональному потреблению пространства на хранилище, и вы можете заметить это на графике потребления пространства, который внезапно начал геометрически расти вверх.

Файл-Скрининг Fpolicy

Fpolicy и ONTAP directory-security API это механизмы которые позволяют анализировать файл, и в зависимости от натсроенных политик разрешать или не разрешать, записывать его или работать с ним. Анализ файла можно проводить на основе расширения файла (встроенный функционал Fpolicy в ONTAP) или по содержимому, тогда нужно специализированное ПО.

Free Cleondis SnapGuard Light Edition

Бесплатный продукт Cleondis SnapGuard Light Edition (SGLE) не только для детекции, но и для восстановления после вирусов-шифровальщиков при помощи снэпшотов на платформе NetApp ONTAP. SGLE способен распознавать паттерны вредоносной работы вирусов шифровальщиков, которые начинают шифровать ваши файлы и остановить клиенты которые зарежены от дальшейшего нанесения вреда и полностью совместим с существующими антивирусными системами.

Free Prolion DataAnalyzer-light

Бесплатный продукт Prolion DataAnalyzer-light предоставляет возможности детекции вирусов-шифровальщиков на платформе NetApp ONTAP.

SMB1 и WannaCry

Вирус WannaCry использует уязвимость в протоколе SMB1 на Windows машинах, этой уязвимости нет в системах NetApp ONTAP. Но попав на Windows он может зашифровать файлы расположенные на NAS хранилище. Компания NetApp рекомендует отключить SMB1 и перейти на более новые версии протоколов SMB v2 или v3 на клиентских Windows Workstation, чтобы избежать заражения.

Более новые версии вируса способны выключать теневое копирование VSS на Windows хостах, но так как расписание снэпшотов на NAS хранилище NetApp настраиваются, включаются и выключаются на самом СХД, то выключенный VSS никак не повлияет на работу снэпшотов.

PS

Также обратите внимание на документ описывающий настройки безопасности ONTAP для усиления защиты (Security Hardening Guide for NetApp ONTAP 9).

Вывод

Снэпшоты это не замена, а важная часть стратегии резервного копирования, которая позволяют более быстро, более часто резервировать данные и быстрее их восстанавливать. Снэпшоты WAFL являются базисом для репликации данных на резервную СХД, не тормозят систему, не требуют консолидации и склеивания, являются эффективным средством резервного копирования данных.

Сообщения по ошибкам в тексте прошу направлять в ЛС. Замечания, дополнения и вопросы по статье напротив, прошу в комментарии.

|

|

«Теперь он и тебя сосчитал» или Наука о данных с нуля (Data Science from Scratch) |

Не знаю на сколько уместно на Хабре описывать возможность обучения по печатному самоучителю, но в конце концов этот хаб же про учебный процесс в IT и поэтому если вам интересно, чему может научить эта книга полного новичка в области Data Science и стоит ли тратить на этот этап время и деньги, то милости прошу под кат.

Часть 1. «Я — это раз» — немного о навыках

Надо сказать, что до прочтения данной книги, мое представление о пользе Data Science не далеко ушло от заглавной картинки, позаимствованной из любимого мультфильма.

Для того, чтобы заглянувший сюда читатель мог спроецировать мой опыт на себя, придется мне немного поведать о своих стартовых навыках. Итак, как и в прошлый раз, досье осталось практически без изменений:

- В связах с мат. анализом и статистикой замечен не был;

- Навыками программирования на Python не владеет;

- Владеет знанием о существовании Data Science, практических навыков не имеет.

- Характер стойкий нордический, не женат.

Собственно, почему я решил изучить эту книгу, и поделится впечатлениями о ней?

Просто после курсов Cognitive Class, я решил заглянуть на Kaggle и понял, что даже в туториале по решению задачи про Титаник, я сути почти всех приемов и определений не понимаю.

Данная книга не требовала никаких стартовых навыков и обещала приятное погружение в мир науки о данных. Есть ли у меня теперь уверенность, что после прочтения книги я смогу решить эту задачу с Титаником? Ответ в конце статьи.

Часть 2. «Два — это Телёнок» — общие сведения о книге

Книга «Data Science. Наука о данных с нуля» — на отечественном рынке похоже появилась совсем недавно, о чем как минимум свидетельствует, то что её электронную версию мне не удалось ни скачать, ни купить. Сам же оригинал был выпущен в 2015 г. Само собой за 2 года в мире IT много чего меняется, например, выходят новые версии библиотек для анализа данных в Python. И тут надо отдать должное автору (Джоэл Грас) и локализатору книги. Изначально, книга писалась с расчетом на Python 2, но автор не оставил свое детище и адаптировал исходные тексты программ, для Python 3 (и кстати выложил это на GitHub), ну а переводчик слава богу разместил в книге уже адаптированные тексты программ (похоже, что с небольшими корректировками).

Также спасибо переводчикам, за краткую инструкцию по установке Anaconda и/или настройки среды для случая если вы не хотите ставить Анаконду.

И так начнём повествование о книге. На обороте обложки размещена цитата, действительно четко описывающая размещенный в ней материал: «Джоэл проведет для вас экскурсию по науке о данных. В результате вы перейдете от простого любопытства к глубокому пониманию насущных алгоритмов, которые должен знать любой аналитик данных.» — Роит Шивапрасад. Ну по крайней мере первая часть этой цитаты на 100% верна, книга действительно напоминает экскурсию, когда вам надо за 2 часа осмотреть Эрмитаж и все, что вы успеваете это бежать за экскурсоводом, ловя краткую справку о каждом шедевре. Как ни странно, не могу сказать, что это плохо, по крайней мере книгу успеваешь прочесть раньше, чем она надоест.

Надо отметить, что кого-то, как и меня может ввести в заблуждение название книги.

Важно отметить, что в данном случае «с нуля» подразумевает не с нуля знаний до какого-то практического уровня, а то, что все примеры функций для анализа и визуализации будут написаны в процессе изложения материала. Это напоминает аналогию с книгой «Linux from scratch», которая направлена не на то, чтобы вы прям вот сразу начали пользоваться каким-нибудь дистрибутивом Linux «с интересными обоями», а планомерно, собрали, свою систему с нуля (даже если вы ей потом не будете пользоваться).

У такого подхода есть свои плюсы и есть свои минусы. С одной стороны вы вряд ли в дальнейшем будете пользоваться теми функциями, которые позаимствуете из книги, с другой стороны, возможно к вам придет понимание общих принципов (ко мне с первого раза много где не пришло)

Итак, как пишут в рапортах представители силовых структур: «по существу вопроса, докладываю следующее:»

Часть 3. «Три — это Python» — содержание и общий подход.

Надо сказать, что с форматом «экскурсии» книга действительно справляется. В ней кратко изложены, наверное, почти все базовые концепции, которые можно встретить в иных курсах по Data Science (например, на той же Coursera). У краткости есть достоинства и недостатки, с одной стороны прочитать книгу при желании можно за 2-3 дня и она не успевает надоесть, с другой стороны материала реально мало и читая «по диагонали» можно, что-то пропустить, в таком случае чтобы что-то понять придется возвращаться и перечитывать главу еще раз.

Автор проявил фантазию и привязал изучаемый материал, к вашей работе в условной соцсети для ученых по данным — “DataSciencester”. Надо сказать, что это приятный подход, задачи выглядят из далека похожими на житейские. И сложность решаемых вами «рабочих» задач постепенно возрастает от главы к главе.

В первой главе обучение стартует с места в карьер, автор покажет, вам как с помощью Питона решить несколько условных задач, на малом объеме данных, например, построить граф отражающей количество друзей в нашей «условной» соцсети или выявить и графически отобразить связь между стажем работы и уровнем зарплаты, для ученого по данным.

Дальше будет изложен интенсив по Python, избыточным его точно не назовешь, но надо отдать автору должное, за рамки того, что дано в главе 2, он далее по тексту сильно не выходит, поэтому если вникнуть один раз в базовые типы данных и другие понятия, то по идее представленный в книге код проблем вызывать не должен (хотя у меня вызывал).

После вводной части и азов Python, остальные направления книги можно поделить на 3 части:

- Очень краткие основы мат. анализа и статистики;

- Сбор, обработка, хранение данных;

- Машинное обучение (математические модели и алгоритмы для обработки данных и предсказания);

Фрагмент книги и оглавление можно посмотреть на Ozon (не реклама), там как раз содержание и первая глава.

От текстовой части перейдем к практической, выше по тексту была ссылка на страничку автора на GitHub, где размещен код представленный в книге и необходимые данные.

В локализованной версии книги есть ссылка на архив с адаптированной (русифицированной) версией кода, чтобы не нарушать ни чьи права, воздержусь от ее размещения.

Весь код представлен в виде исходников на Python 2 и 3, а также в виде блокнотов для Jupyter notebook. Надо сказать, большое спасибо этой книге, потому что благодаря ей я открыл для себя Anaconda (удобная вещь). На мой взгляд удобней всего экспериментировать с кодом, представленным в книге именно в версии блокнотов Jupyter (который по умолчанию установлен в Анакодне). Хотя с другой стороны по сути в записной книжке весь код вбит в одну ячейку без разбивки и без отдельных текстовых вставок, так что это скорее вопрос вкуса, чем явного преимущества. Кстати если вдруг вас не устроит корневая директорию откуда Jupyter «видит» файлы, то вот действительно рабочий совет (есть варианты и для Windows и для Linux)