Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Эволюция после эволюции |

В начале – ты наемник. Работаешь фултайм (где-то больше, где-то меньше), раз в период получаешь доход. Все просто. Затем постепенно понимаешь, что можно работать столько же, но получать минимум в два раза больше – делаешь ИП (кто поумнее – сразу ООО). Далее снова виток – если не выполнять работу самому, а сосредоточиться на поиске клиентов и управлении – денег можно получить еще больше, при этом увеличив норму сна. И так далее, пока в ведении не остается лишь одно управление. Далее управление эволюционирует, появляются департаменты, отделы, направления и т.д.

Если сосредоточиться на формуле расчета цены для каждой стадии – при неизменном скоупе и качестве работ неизменно растет рейт себестоимости проекта (в общем случае это выходная цена для Заказчика, именно от этой суммы она идет в плюс бесконечность) относительно получаемых денег конечного исполнителя.

Данный факт означает, что маленьким организациям всегда будет место на рынке, так как большие организации не могут с ними конкурировать на равных из-за цены. Можно ли это изменить?

Причина роста рейта

Многие сваливают вину за увеличение рейта на увеличение надежности\вероятности достижения положительного результата у проекта. Так это продается внутри компании. Снаружи Заказчикам поется песня про самых лучших специалистов, полный цикл разработки, многоступенчатое тестирование, гарантии, бренд и т.д.

Причина в другом – многоступенчатая система управления.

Увеличивается непрозрачность системы управления. Когда ты работаешь один – такой проблемы нет. Появляется несколько помощников – появляется перманентный дискомфорт, выражающийся в том, что «очевидные» тебе решения необходимо долго и подробно разъяснять другим. При передаче информации из одной головы в другую неизбежно происходит деформация этой информации. Дальше – больше. Дело доходит до того, что ты уже давно не участвуешь а найме и видишь перед собой только членов правления. В итоге, пока твое решение дойдет до рядового сотрудника – оно обрастет всевозможными документами и пояснениями, которые иногда могут изменить цель и суть исходного решения.

Система управления становится настолько сложной, что создаются все условия для рассогласования целей Исполнителей всех звеньев и критичного снижения их мотивации решать декларируемые задачи. Наиболее «талантливые» в этой системе изощренно тянут одеяло на себя (раздувают штат, бюджет), умело используя KPI (свои, чужие, компании) и нормативную документацию.

Дело усугубляется тем, что компетенции деятельности организации распределены между ее подразделениями по большей части без пересечений, что создает почву для паразитной монополии одних подразделений над другими. Подразделения монополисты начинают становится узким горлом всего производственного процесса организации и при этом крайне сильно мотивированы не менять сложившийся порядок.

Стандартный путь ведет в тупик

Любое рассогласование или низкую мотивацию пытаются лечить увеличением контроля. Но контролировать не прозрачную систему, больше похожую на черный ящик – бесперспективно. Создаются все новые регламенты, изменения в регламентах (порой, несколько раз в день), новые подразделения (тот же проектный офис, департамент корпоративной архитектуры и т.д.)… Структура управления становится все более сложной, все более «мутной». Время, затрачиваемое на согласование чего-либо начинает зашкаливать.

В этой ситуации очень сложно посчитать реальную себестоимость работ конкретных отделов. Бухгалтера, конечно, все без проблем считают, вводя миллиарды коэффициентов (свет, вода, тепло, юристы, сами бухи, курьеры и т.д.), но по факту владелец бизнеса все равно не понимает сколько стоят, например, те же сисадмины и тестировщики в текущем количестве, сколько пользы они приносят, зачем они в текущем количестве – постоянно идет процесс

Что делать ?

Я верю в то, что лет через 30 я буду писать подобную статью, расхваливая жесткую древовидную вертикаль власти на основе нового витка технологий по контролю мышления людей. Например, путем вживления электродов в мозг, что позволит победить коррупцию на местах и повысить мотивацию (хотя данное понятие, возможно, будет уже не применимо).

В текущее время мы сильно ограничены в методах инвазивного контроля.

Что мы имеем:

• Административные меры – что-то типа KPI.

• Технические решения – что-то вроде детектора лжи.

Оба инструмента с высокой долей вероятности разбиваются о возможности разума «умного» человека. Но чем выше должность, тем более «умного» человека там хотелось бы видеть. Но чем он умнее, тем проще он обходит ограничения, которые мы ему ставим для того, чтобы он больше концентрировался на пользе для компании, чем на пользе для себя. Выхода нет…

Выход есть. Как всегда он не в заплатках и фиксах поверх текущей реализации. Необходимо сменить архитектуру — убрать многоступенчатость из вертикали власти, убрав возможность и мотивацию на местах делать ее непрозрачной и, как следствие, дорогой в стоимости владения.

Кого оставляем:

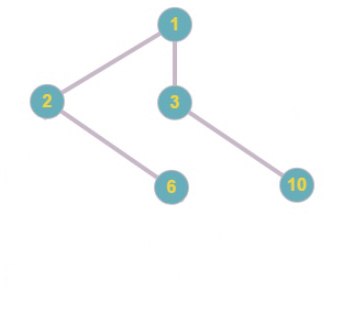

- Правление\Акционеров – кому-то же нужно получать прибыль. Это будет родительское юрлицо, которое будет участвовать в капитале всех остальных компаний.

- Отделы с непосредственными исполнителями. Из каждого отдела необходимо сформировать юрлицо (можно на ОСН, чтобы НДС прокидывать), Генеральным Директором которого поставить начальника отдела и дать ему долю из прибыли (можно без доли в капитале). Обязательно ограничиваем численность дочки (например, 50 человек), чтобы исключить образование дочернего монстра.

Далее разжигаем конкуренцию – разрешаем дочкам заказывать услуги или оказывать их компаниями не входящими в холдинг. Для окончательного добивания внутренней монополии необходимо разрешить формирование дублирующих друг друга по компетенциям юрлиц. Для предотвращения сговора, клонов следует разносить географически.

Цели достигнуты:

- Мотивация раздуть штат у начальника подразделения сразу уходит в ноль.

Раньше он всеми правдами и не правдами старался увеличить штат, так как фонд оплаты труда и численность подразделения напрямую влияла на значимость в компании, на премиальный фонд (обычно, он в процентах от ФОТ), вероятность повышения до начальника департамента (повышение часто идет по формальному признаку – можешь управлять самым большим отделом – управляй всеми отделами) и т.д. Теперь ФОТ – это твоя личная расходная статья, которая понижает твой непосредственный доход. - Мотивация затянуть одеяло на себя сильно худеет.

Общего одеяла нет, а то что есть – уже твое. - Мотивация осметить работы в «2 счетчика» пропадает.

При отсутствии сговора высокий прайс оставит твое юрлицо без заказов.

Это касается не только цены, но и сроков. - Лояльность больше не является единственным\основным параметром сотрудника подразделения.

Теперь необходимо строить команду максимально эффективную с точки зрения производства. - Вклад каждого в прибыль компании теперь не размазан среди тысяч других сотрудников.

Сколько наработал – столько получил. - В случае просадки по ресурсам\срокам всегда можно попросить подразделение «клон» помочь в выполнении задачи, тем самым кратно увеличив мощности производства.

С этого момента Правлению возможно на основе статистики убивать неэффективные подразделения, распределяя высвобождающиеся ресурсы в новые организации. Ничто не мешает делать это в автоматическом режиме.

Визуально представить предлагаемую модель устройства бизнеса можно так: допустим, люди — это мыло, а организации — это мыльные пузыри. Всеми этими пузырями управляет «папа».

Или «мама».

Кстати, наша вселенная, возможно, имеет подобную структуру…

|

Метки: author atmyzone управление разработкой управление персоналом бизнес-модели мотивация сотрудники эффективность конкуренция монополия декомпозиция мыло |

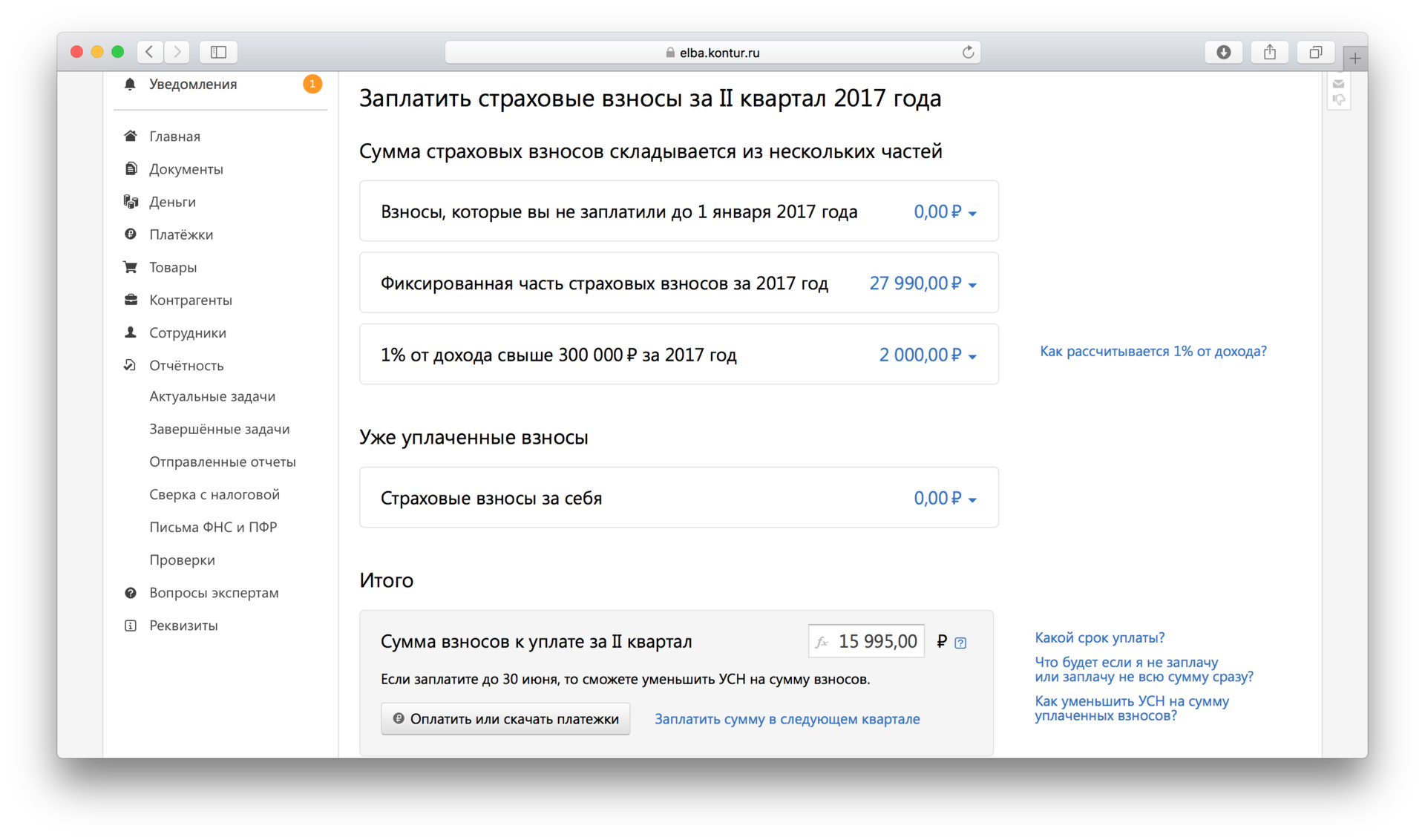

Технические подробности новой глобальной атаки шифровальщика Trojan.Encoder.12544 (в разных источниках — Petya и т.п.) |

На текущий момент известно, что троянец заражает компьютеры при помощи того же набора уязвимостей, которые ранее использовались злоумышленниками для внедрения на компьютеры жертв троянца WannaCry. Массовое распространение Trojan.Encoder.12544 началось в первой половине дня 27.06.2017. При запуске на атакуемом компьютере троянец несколькими способами ищет доступные в локальной сети ПК, после чего по списку полученных IP-адресов начинает сканировать порты 445 и 139. Обнаружив в сети машины, на которых открыты эти порты, Trojan.Encoder.12544 пытается инфицировать их с использованием широко известной уязвимости в протоколе SMB (MS17-10).

В своем теле троянец содержит 4 сжатых ресурса, 2 из которых являются 32- и 64-разрядной версиями утилиты Mimikatz, предназначенной для перехвата паролей открытых сессий в Windows. В зависимости от разрядности ОС он распаковывает соответствующую версию утилиты, сохраняет ее во временную папку, после чего запускает. При помощи утилиты Mimikatz, а также двумя другими способами Trojan.Encoder.12544 получает список локальных и доменных пользователей, авторизованных на зараженном компьютере. Затем он ищет доступные на запись сетевые папки, пытается открыть их с использованием полученных учетных данных и сохранить там свою копию. Чтобы инфицировать компьютеры, к которым ему удалось получить доступ, Trojan.Encoder.12544 использует утилиту для управления удаленным компьютером PsExec (она также хранится в ресурсах троянца) или стандартную консольную утилиту для вызова объектов Wmic.exe.

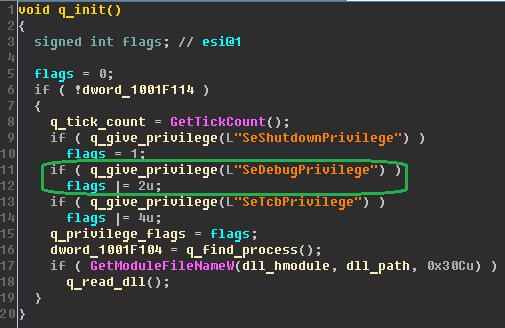

Контроль своего повторного запуска энкодер осуществляет с помощью файла, сохраняемого им в папке C:\Windows\. Этот файл имеет имя, соответствующее имени троянца без расширения. Поскольку распространяемый злоумышленниками в настоящий момент образец червя имеет имя perfc.dat, то файл, предотвращающий его повторный запуск, будет иметь имя C:\Windows\perfc. Однако стоит злоумышленникам изменить исходное имя троянца, и создание в папке C:\Windows\ файла с именем perfc без расширения (как советуют некоторые антивирусные компании), уже не спасет компьютер от заражения. Кроме того, троянец осуществляет проверку наличия файла, только если у него достаточно для этого привилегий в операционной системе.

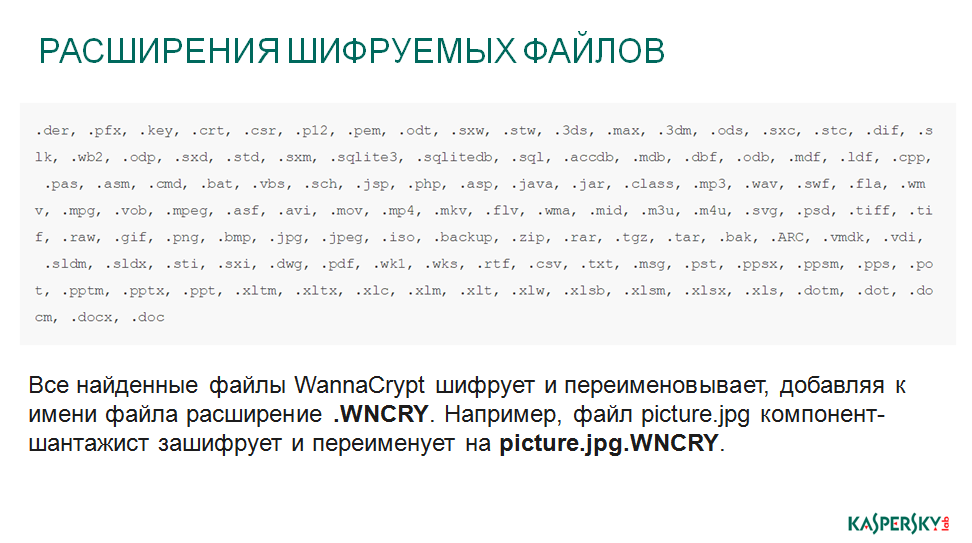

После старта троянец настраивает для себя привилегии, загружает собственную копию в память и передает ей управление. Затем энкодер перезаписывает собственный файл на диске мусорными данными и удаляет его. В первую очередь Trojan.Encoder.12544 портит VBR (Volume Boot Record, загрузочная запись раздела) диска C:, первый сектор диска заполняется мусорными данными. Затем шифровальщик копирует оригинальную загрузочную запись Windows в другой участок диска, предварительно зашифровав ее с использованием алгоритма XOR, а вместо нее записывает свою. Далее он создает задание на перезагрузку компьютера, и начинает шифровать все обнаруженные на локальных физических дисках файлы с расширениями .3ds, .7z, .accdb, .ai, .asp, .aspx, .avhd, .back, .bak, .c, .cfg, .conf, .cpp, .cs, .ctl, .dbf, .disk, .djvu, .doc, .docx, .dwg, .eml, .fdb, .gz, .h, .hdd, .kdbx, .mail, .mdb, .msg, .nrg, .ora, .ost, .ova, .ovf, .pdf, .php, .pmf, .ppt, .pptx, .pst, .pvi, .py, .pyc, .rar, .rtf, .sln, .sql, .tar, .vbox, .vbs, .vcb, .vdi, .vfd, .vmc, .vmdk, .vmsd, .vmx, .vsdx, .vsv, .work, .xls, .xlsx, .xvd, .zip.

Троянец шифрует файлы только на фиксированных дисках компьютера, данные на каждом диске шифруются в отдельном потоке. Шифрование осуществляется с использованием алгоритмов AES-128-CBC, для каждого диска создается собственный ключ (это — отличительная особенность троянца, не отмеченная другими исследователями). Этот ключ шифруется с использованием алгоритма RSA-2048 (другие исследователи сообщали, что используется 800-битный ключ) и сохраняется в корневую папку зашифрованного диска в файл с именем README.TXT. Зашифрованные файлы не получают дополнительного расширения.

После выполнения созданного ранее задания компьютер перезагружается, и управление передается троянской загрузочной записи. Она демонстрирует на экране зараженного компьютера текст, напоминающий сообщение стандартной утилиты для проверки дисков CHDISK.

В это время Trojan.Encoder.12544 шифрует MFT (Master File Table). Завершив шифрование, Trojan.Encoder.12544 демонстрирует на экране требование злоумышленников об уплате выкупа.

Если в момент запуска на экране появилось сообщение о запуске утилиты CHDISK, незамедлительно выключите питание ПК. Загрузочная запись в этом случае будет повреждена, но ее можно исправить при помощи утилиты восстановления Windows или Консоли восстановления, загрузившись с дистрибутивного диска. Восстановление загрузочной записи обычно возможно в ОС Windows версии 7 и более поздних, если на диске имеется используемый системой скрытый раздел с резервной копией критичных для работы Windows данных. В Windows XP такой способ восстановления загрузки не сработает. Также для этого можно использовать Dr.Web LiveDisk — создайте загрузочный диск или флешку, выполните загрузку с этого съемного устройства, запустите сканер Dr.Web, выполните проверку пострадавшего диска, выберите функцию «Обезвредить» для найденных угроз.

По сообщениям из различных источников единственный используемый распространителями Trojan.Encoder.12544 ящик электронной почты в настоящее время заблокирован, поэтому они в принципе не могут связаться со своими жертвами (чтобы, например, предложить расшифровку файлов).

С целью профилактики заражения троянцем Trojan.Encoder.12544 компания «Доктор Веб» рекомендует своевременно создавать резервные копии всех критичных данных на независимых носителях, а также использовать функцию «Защита от потери данных» Dr.Web Security Space. Кроме того, необходимо устанавливать все обновления безопасности операционной системы. Специалисты компании «Доктор Веб» продолжают исследование шифровальщика Trojan.Encoder.12544.

Инструкция пострадавшим от Trojan.Encoder.12544: news.drweb.ru/show/?i=11350

И это ещё не конец! Будем дальше ковырять.

|

|

[Из песочницы] Cobian Backup и отправление сообщений в Telegram |

Думаю найдется очень мало системных администраторов, которые не выполняют резервное копирование тех или иных данных. Эта заметка будет полезна (надеюсь) для тех, кто пользуется таким программным продуктом как Cobian Backup. А в особенности тем, у кого резервное копирование осуществляется не в одном месте, или даже в разных городах.

Как вы уже поняли из заголовка, я хочу поделиться с Вами маленьким скриптом, который позволяет отправлять что-то (в моем случае кусочек log файла) в telegram.

Для тех кто задается вопросом почему именно Telegram, ведь Cobian Backup умеет оправлять сообщения на почту — объясню свою точку зрения. Telegram — это популярный развивающийся месенджер, который использует огромное количество людей. На мой субъективный взгляд — это удобнее, чем почтовый клиент. Так же этот способ был опробован на ооооочень плохом интернете — все работает. Причем отправка через email в одинаковых условиях не срабатывала.

Скрипт для отправки сообщений в Telegram

Логику для себя я построил следующую. При выполнении задания в Cobian Backup в предпоследней строке лог файла у нас присутствует примерно следующий текст: " 2017-05-31 12:11 Копирование завершено. Ошибок: 0, обработано файлов: 3893, скопировано файлов: 3893, общий размер: 2,43 GB ". Значит мне каким то образом нужно выдернуть эту предпоследнюю строку из лог файла. Ну и собственно то, что я сделал — ниже.

Для отправки сообщений будем использовать PowerShell. Сам скрипт я позаимствовал тут, но чуть чуть его видоизменил.

$chat_id = 'chat_id' #Здесь указываем id чата, куда нам нужно отправлять сообщения. Сообщения отправляются как обычным пользователям, так и группам.

$date=get-date -uformat "%Y-%m-%d" #Вытягиваем дату в нужном нам формате

$text = get-content -Path ('c:\Program Files (x86)\Cobian Backup 11\Logs\log '+$date+'.txt') -Encoding UTF8 #Указываем путь, где находятся логи cobian backup

$token = 'token' #Указываем токен, который выдается при регистрации бота

[string]$text=$text[$text.count-2] #выдергиваем предпоследнюю строку

#ну и собственно само отправление

$payload = @{

"chat_id" = $chat_id;

"text" = "$text";

"parse_mode" = 'HTML';

}

Invoke-WebRequest `

-Uri ("https://api.telegram.org/bot{0}/sendMessage" -f $token) `

-Method Post `

-ContentType "application/json;charset=utf-8" `

-Body (ConvertTo-Json -Compress -InputObject $payload)Настройка Cobian Backup

Для тех, кто использует Cobian Backup в качестве утилиты для резервного копирования думаю не стоит описывать то, как создаются задания. Для тех, кто только собирается — думаю после установки Вам даже не понадобится что — то искать в интернете — все очень просто и доступно. Правда есть одно НО — Cobian Backup не умеет выполнять скрипты PowerShell. Ну не беда — зато знает что такое BAT. Для запуска используем следующий BATник

TIMEOUT /T 5 /NOBREAK

%SystemRoot%\System32\WindowsPowerShell\v1.0\PowerShell.exe -ExecutionPolicy ByPass -command "C:\ToTelegram.ps1"ToTelegram.ps1 — это скрипт, который мы ранее создали в PowerShell. После создание bat файла можно уже и добавить его выполнение в задание. В параметрах задания выпираем пункт меню "Доп.действия" и добавляем в завершающие действия наш BAT файл.

Вот в принципе и все, как видите ничего сложного. Надеюсь для кого-то это будет полезным.

P.S. Мои потребности этот скриптик удовлетворяет, но я буду очень рад, если кто-то внесет свои предложения и замечания.

|

Метки: author fedya_lutkovski резервное копирование powershell cobian backup cmd |

IBM Bluemix в университетах: примеры реализованных проектов от студентов и преподавателей |

Платформа Bluemix позволяет разработчикам, компаниям и конечным пользователям исследовать возможности, на которых будут базироваться облачные приложения и сервисы следующего поколения. Приложение может быть традиционным, социальным, мобильным или сочетать в себе все эти аспекты и обладать возможностями работы с большими данными.

Bluemix обеспечивает возможность в сжатые сроки создать приложение, которое обладает такими характеристиками, как уменьшение потребности в инициализации (как приложения, так и инфраструктуры), гибкое выделение доступных ресурсов, автоматизация технических задач и поддержка разнообразных видов рабочих нагрузок. Сразу освоиться в среде Bluemix не так просто, хотя платформа дружелюбна к пользователю. Понимая это, компания IBM помогает разработчикам. Сейчас принято решение ознакомить с платформой студентов и их преподавателей в ряде университетов.

В МГТУ им. Баумана на базе лаборатории Интернета вещей и кафедры «Компьютерные системы и сети» под руководством доцента А.Ю. Попова проводятся исследования и разработки студентов по созданию решений, имеющих практическую значимость. Студенты МГТУ реализуют свои проекты также и в рамках хакатона, регулярно проводимого вузом совместно с компанией IBM. Некоторые проекты выложены в YouTube, и мы можем с ними ознакомиться. В ходе работ над проектами использовались API, сервисы и протоколы, предоставляемые IBM бесплатно университетам по программе Академическая инициатива на академическом хабе (IBM ОТН).

Студентом Марком Макарычевым создана система отслеживания местоположения объекта с использованием геопозиционирования на основе GPS и сети LoRa.

Похожие приложения создаются многими. Особенностью данного проекта является использование приемо-передающей системы LoRa, которая дает некоторые преимущества в условиях города по точности позиционирования.

Торфяные пожары стали постоянной угрозой и головной болью, иногда в буквальном смысле, многих российских городов, включая Москву. Андрей Комаров и члены его команды, участвовавшие в хакатоне, разработали систему раннего обнаружения такого пожара. Как устроена и работает система, можно увидеть по ссылке. Эта же команда сделала систему удаленного учета расхода воды со счётчиков.

Интернет-торговля становится всё более популярной. Однако бывает сложно отследить доставку. А иногда и пропажу покупки. Студенты Бауманки Владислав Шутеев и Валентин Иванов предлагают принципиально новую трекинговую систему почтовых отправлений и грузов на основе Интернета вещей.

Студент из Киргизии Чоро Абдыманапов, обучающийся в МГТУ, заинтересовался практической задачей использования Интернета вещей для разведения рыбы в рыбоводческом хозяйстве, расположенного в селе Таш-Добе. Созданное им решение легло в основу его дипломного проекта, успешно защищенного в июне. Об устройстве предложенной им системы, повышающей продуктивность рыбоводства, он сам рассказывает в видеоролике.

Студенты Харьковского национального университета радиоэлектроники под руководством профессора В. И. Саенко, кафедра Информационных управляющих систем, разрабатывают курс по обучению работе с IBM Bluemix. Команда Vindict team в составе Анны Каневской, Богдана Горбатенко и Владислава Стёпина создала ресурс Bug Trace для поддержки пользователей, только начинающих осваивать платформу. К настоящему времени командой создано и опубликовано 6 видеосюжетов курса. Первый – начало работы.

Он посвящён реализации небольшого проекта с регистрацией и активацией бесплатного аккаунта, доступного по программе «Академическая инициатива».

Урок 2 содержит инструкцию по созданию первого приложения.

В уроке 3 подробнее разбирается взаимодействие с базой данных MySQL, как сервисом IBM Bluemix.

Урок 4 демонстрирует альтернативный вариант работы с IBM Bluemix через командную строку.

Урок 5 посвящен созданию простейшего сайта

В уроке 6 реализуются все сделанные на предыдущих уроках наработки для разработки практически значимого проекта — сайта турфирмы.

Пожелаем работе университета успешного продолжения и развития.

И, наконец, инициативная группа сотрудников IBM и университетов работает над проектом облачного когнитивного университета IBM Watson. Ресурс размещен на developerWorks и имеет целью создание курса по изучению когнитивных технологий и Интернета вещей для студентов. Присоединиться могут любые желающие, готовые внести свой вклад в совместную работу. Для этого необходимо обратиться к модератору alexander_sorokin@ru.ibm.com.

|

Метки: author ibm программирование высокая производительность блог компании ibm bluemix когнитивные вычисления |

Научи бота! — разметка эмоций и семантики русского языка |

Но дело серьёзно осложняется тем, что компьютеры так и научились ориентироваться в нашем мире. Всё, что они так хорошо делают, они делают по аналогии, не вдаваясь в суть и не нагружая себя смыслом происходящего. Может оно и к лучшему — дольше проживём, не будучи порабощены бездушным племенем машин.

Но дело серьёзно осложняется тем, что компьютеры так и научились ориентироваться в нашем мире. Всё, что они так хорошо делают, они делают по аналогии, не вдаваясь в суть и не нагружая себя смыслом происходящего. Может оно и к лучшему — дольше проживём, не будучи порабощены бездушным племенем машин.Но любопытство подталкивает к рискованным шагам, а именно к попыткам познакомить компьютер с нашим миром, в том числе и с внутренним — чувствами, эмоциями и переживаниями.

Как мы планируем прокачать сознание машин, научить их эмоциям, чувствам и оценочным суждениям, а также где вы можете свободно скачать размеченные

данные — читайте в статье.

Не хочу читать, покажите результат!

Можно сразу попробовать обучить бота по ссылке: Научи бота!

Если понравится отвечать — создайте свою Карту и результат будет запоминаться.

Ограничения дистрибутивной семантики

В чём, собственно, проблема понимания компьютером текстов, ведь машина может изучить всё текстовое культурное наследие и научиться всему оттуда? Лучше слов расскажет результат работы word2vec.

Для лексемы «мужчина»:

женщина 0.650

замужний 0.594

немолодой 0.542

антимужчина 0.538

…

беременный 0.519

нерожавший 0.516

девушка 0.498

...

Или для слова «горячий»:

теплый 0.510

…

холодный 0.498

остыть 0.486

жаркое 0.467

...

А для сильноположительной эмоции «восторг»:

восхищение 0.715

…

негодование 0.609

ярость 0.597

ужас 0.586

отчаяние 0.584

…

трепет 0.531

смятение 0.523

недоумение 0.522

…

бешенство 0.472

...

Или для широкого понятия «техника»:

…

технология 0.569

искусство 0.451

мастерство 0.410

…

самолётостроение 0.393

индустрия 0.392

медицина 0.379

ремесло 0.375

…

промышленность 0.370

…

знание 0.360

наука 0.358

...

Собственно эти примеры ярко показывают, сколько информации даёт контекст. Достаточно много, но явно недостаточно, чтобы разводить антонимы, часть-целое, общее-частное, делать различие между вертикальными и горизонтальными связями.

Поэтому, вполне разумно, что многие исследователи наряду с подходами дистрибутивной семантики (читай: word2vec) используют тезаурусы. Для английского языка таким ресурсом является WordNet, для русского — РуТез, Викисловарь.

Очевидное не так очевидно

Каждый исследователь, решившийся на дерзкую попытку объяснить машине смыслы, рано или поздно столкнётся с тем, что самые казалось бы тривиальные вещи компьютеру совершенно неочевидны. Более того, даже в детских книжках о них не написано ни слова. Мир, в целом ряде аспектов, познаётся нами через наши органы восприятия — посредством зрения, слуха, обоняния, осязания, вкуса и других.

Затем мы уже коммуницируем друг другу предельно сжатый и краткий контекст ситуации, который разворачивается в отдельно взятой голове в детальную картину. Причём у каждого человека ситуация раскрывается по-разному, в зависимости от личного опыта, культурного фона, особенностей характера и мировосприятия.

Эмоции, чувства, переживания

Слова и словосочетания несут в себе гораздо больше смысла, чем зафиксировано в толковых словарях. В первую очередь это связано с такими зыбкими и слабоосязаемыми свойствами, как оценка и сопутствующая эмоциональная окраска. Например, словосочетание тяжкие муки несёт в себе сильную отрицательную эмоцию. А словосочетание бурная радость — сильную положительную. Не подарок — это что-то отрицательное, но не слишком. А, к примеру, виртуоз имеет довольно сильную положительную оценку.

Сложность с фиксацией таких тонких характеристик слов в том, что они предельно субъективны и плохо формализуемы. Скажем, слово стратегия — оно положительное или нейтральное? Согласиться можно лишь с тем, что не отрицательное.

Тем не менее эмоциональные и оценочные атрибуты являются неотъемлемой частью языковых единиц и играют довольно важную роль в человеческой коммуникации. Следовательно, если мы хотим сделать машину более человечной и приятной в общении, она тоже должна проникнуться этими тонкими материями.

Что делать?

Вручную создать такого рода словарь было бы крайне трудоёмко, ведь размечать хочется не только слова, но и словосочетания. К тому же все оценки будут сильно привязаны к субъективному мнению исследователя.

Хорошие новости! мы живём в 2017-ом году и нам доступны такие замечательные технологии, как Интернет и краудсорсинг. Последний позволяет одновременно справляться как с проблемой трудоёмкости, так и c субъективностью оценок. Конечно это рождает эффект «среднего по больнице», но для первого приближения мы позволим себе закрыть глаза на неровности такого рода.

Научи бота! — разметка эмоций и семантики русского языка

Идея реализована на языковой платформе Карта слов. Работа будет вестись по нескольким направлениям:

- Оценочная разметка. Задача — разметить слова и выражения русского языка по критериям положительное/нейтральное/отрицательное и силе выраженности признака.

- Эмоциональная разметка. Задача — разметить эмоционально окрашенные слова и выражения по поляризации и силе эмоционального фона.

- Разметка тезауруса. Задача — разметить вертикальные и горизонтальные связи между словами, проставить семантические теги для слов и выражений.

- Экспериментальная разметка отношений по теории „Смысл <=> Текст“, предложенной И. А. Мельчуком: MAGN(кофе) = крепкий кофе, MAGN(чувство) = сильное чувство и т.д.

Чтобы использовать человеческий труд с максимальной пользой и сделать задания интересными для отвечающих, применяются подходы дистрибутивной семантики и машинное обучение. За основу системы семантических категорий мы взяли классификацию, используемую для НКРЯ.

Как принять участие?

Важная цель нашей инициативы — восполнение недостающих лингвистических ресурсов для русского языка, открытых для использования исследователями, учёными-лингвистами и инженерами-практиками. Мы рассчитываем, что основываясь на данных разметки будут проведены интересные исследования, написаны научные статьи, статьи на Хабре, появятся инженерные продукты и открытые технологии.

Вы можете помочь проекту следующими способами:

- Участвовать в обучении бота. Это легко и увлекательно, а также позволяет прокачивать своё языковое сознание и подмечать интересные особенности русского языка.

- Лайк, шер, Алишер! Делитесь ссылками на проект в социальных сетях, расскажите о нём в своём блоге или на сайте.

- Конструктивная критика помогает развиваться и не погружаться в болото собственных иллюзий. Обсуждение очень важно, чтобы вовремя корректировать курс и создавать действительно полезный ресурс. Единственное пожелание: критикуете — предлагайте.

- Семантика и когнитивная лингвистика. Мы стараемся прокачать своё понимание современных подходов к семантике и созданию такого рода ресурсов. Будем рады совету или рекомендации, что почитать, что изучить, с кем посоветоваться.

- Распространение информации. Нам пригодится ваш совет о том, где ещё можно рассказать о проекте — это может быть ваш любимый техноблог, онлайн-журнал о технологиях, группа во ВКонтакте/Слаке/Телеграме или что-то другое.

Открытые данные

Агрегированные результаты разметки будут открыты для скачивания и доступны по лицензии CC BY-NC 4.0.

Получить и опубликовать первые результаты мы рассчитываем к середине/концу июля — всё будет зависеть от активности отвечающих. Чтобы ничего не пропустить, ставьте звёздочки и подписывайтесь на наш гитхаб:

Открытые данные на Карте слов

Где деньги, Зин?

Здорово попробовать совместить в одном проекте краудсорсинг и краудфандинг, что мы и сделали, запустив кампанию по сбору средств на Планете.ру:

Научить компьютер понимать наш мир и эмоции

Важно. Проект мы уже делаем и доведём до результата своими силами и имеющимися ресурсами. Собранные данные, как и обещали, будут открытыми и доступными всем желающим. Вопрос лишь в сроках и объёме разметки. Сейчас мы рассчитываем получить базовый результат (10.000 самых частотных слов) за три месяца, разметка полного объёма займёт около двух лет.

Дополнительные ресурсы помогут существенно ускорить получение результата. Нам нужно помогать разработчикам, задействованным в создании и совершенствовании системы разметки, добавлять новые семантические категории и проводить исследовательскую работу. Также средства необходимы для продвижения проекта и проведения конкурсов.

Пожертвовать на кампанию можно любое количество денег — при этом вы будете знать, что в общем успехе есть и ваш вклад, а каждый вложенный рубль будет потрачен на крутое и полезное дело.

Не забывайте, что вы можете помочь инициативе и без денег. Ставьте лайки и рассказывайте о проекте в социальных сетях — это очень простой, совершенно бесплатный, но очень действенный способ продвижения.

Корпорейт спонсоршип

Вы представляете устоявшийся бизнес и вам интересно развитие открытых лингвистических данных в России? Становитесь корпоративным спонсором проекта! Вы получаете вечную графическую ссылку со страницы проекта, дополнительную рекламу на многотысячную аудиторию и неземной респект от сообщества.

Каждый вложенный рубль мы потратим с невероятной эффективностью, а за несколько месячных окладов одного программиста в крупной компании сделаем весь проект, результатами которого будут пользоваться тысячи исследователей, учёных и инженеров.

Коммерческое использование

По вопросам коммерческого использования или бизнес-специфичной разметки пишите на kartaslov@mail.ru или в ЛС автору статьи.

Благодарности

Большую благодарность хочется выразить организаторам и участникам Диалога-2017 — 23-ей международной конференции по компьютерной лингвистике и интеллектуальным технологиям.

Именно в кулуарных обсуждениях мероприятия стала понятна необходимость такого рода разметки, а также собрана группа единомышленников для обсуждения экспериментальной разметки отношений по теории „Смысл <=> Текст“. Хочется надеяться, что в следующем году, основываясь на собранных данных, можно будет запустить новое интересное соревнование в рамках Dialogue Evaluation.

Ссылки

- Научи бота! на Карте слов

- RusVectores: готовые word2vec модели для русского языка

- Тезаурус русского языка РуТез (RuWordNet)

- Викисловарь

- О лексико-семантической информации в НКРЯ

|

Метки: author kdenisk я пиарюсь семантика nlp семантическая разметка эмоции обработка естественного языка открытые данные словарь |

WannaCry и Petya — как действует центр мониторинга и реагирования на кибератаки в случае глобальных инцидентов |

Превентивные мероприятия

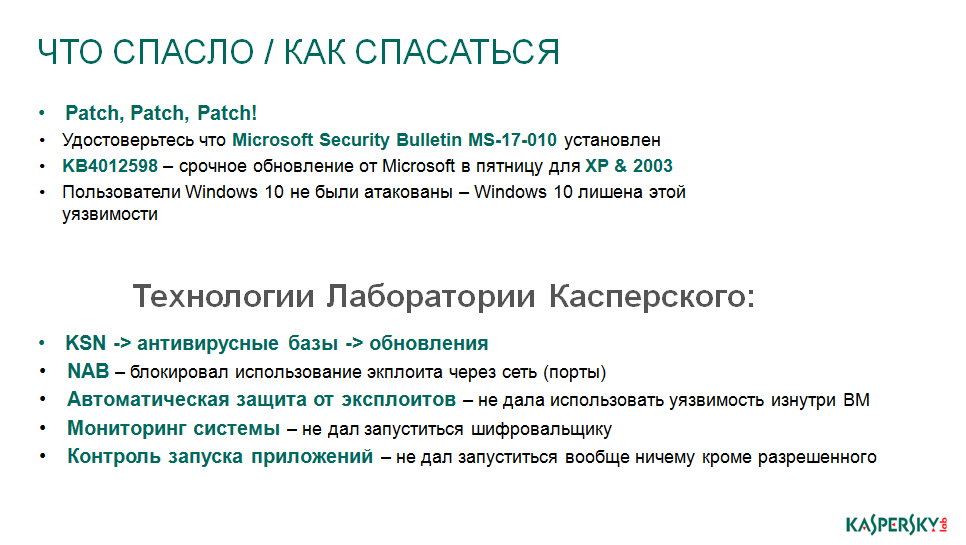

Petya, как и его предшественник WannaCry, использует уязвимость EternalBlue, но не ограничивается ей, поэтому те компании, которые установили соответствующие обновления от Microsoft, повысили свой уровень безопасности.

Атака и реагирование

15:00 МСК. Первые сообщения об атаке на крупные организации. Аналитики Solar JSOC начинают мониторинг в поисках подробностей, одновременно производится анализ ситуации у заказчиков. Первая линия переведена в состояние повышенной бдительности, осуществляется ручной мониторинг IPS, WAF, Anti-DDoS и периметровых сетевых устройств на предмет выявления аномалий.

Параллельно по партнерским каналам и со стороны антивирусных вендоров начинает приходить обрывочная информация, что работает вредоносный продукт Petya. Канал распространения – предположительно EternalBlue.

Работа была разделена еще на несколько направлений:

- Оповещение клиентов по первым появившимся индикаторам работы и мероприятиям.

- Фокусное общение с технологическими и техническими партнерами для обмена первыми результатами о разборах вируса.

- И – несколько нетипично – активное отслеживание СМИ и форумов вендоров и CERT для поиска дополнительной информации и индикаторов. К этой части работы привлекли, в том числе, наш маркетинг, который мониторил ленту Facebook, «взорвавшуюся» информацией о заражениях.

15:30 МСК. Получены первые индикаторы – первичное заражение организации шло через почтовый фишинг, имеются сетевые индикаторы и MD5 тела вируса. Данная информация оперативно проверяется на всех заказчиках в течение 30 минут. Параллельно сервис-менеджеры совершают звонки ответственным специалистам заказчика.

Ретроспективная проверка по всем заказчикам не дала положительных срабатываний. Также все индикаторы были добавлены в активные правила и листы для дальнейшего отслеживания попыток обращения (в том числе неуспешных) на выявленный вредоносный домен и для оперативного выявления зараженных машин. Все сетевые индикаторы компрометации поставлены на контроль обращения через межсетевые экраны и прокси, мониторятся DNS-запросы.

Клиенты получили оповещение о необходимости блокировки указанных адресов на сетевом оборудовании.

15:50 МСК. Создается инструкция по минимизации рисков, связанных с распространением Petya. В инструкции указаны основные меры:

- Обновление ОС Windows и баз АВС.

- Закрытие TCP-порта 445 там, где это возможно и не нарушает штатного функционирования сервисов.

- В некоторых случаях может оказаться эффективной защита MBR от перезаписи.

Делается рассылка клиентам.

Гизар Шакиров, начальник Отдела ИБ БАШКОМСНАББАНК (ПАО):

В 15:40 мы получили первый звонок от аналитика с оповещением о том, что наблюдается массовое заражение инфраструктур крупных компаний сферы энергетики, нефтегазового, финансового сектора и ретейла. Эпидемия очень похожа на WannaCry, но возможны новые каналы распространения. Каналом попадания, по первым предположениям, является почта. Сервис-менеджер предупредил, что дальнейшее распространение в инфраструктуре, возможно, происходит не только с помощью эксплуатации EternalBlue, обновления к которой у нас стояли.

Также в течение 10 минут была получена рассылка от Solar JSOC с результатами ретроспективного анализа и сетевыми индикаторами, которые необходимо было внести в черные списки на периметровых средствах защиты. Мы заранее предупредили ответственных специалистов банка, поэтому, как только оповещение пришло, внешние адреса были заблокированы в течение 5 минут.

16:30 МСК. Первые выводы о работе вредоносного ПО.

На хост изначально попадает дроппер, состоящий из нескольких компонент:

- Модифицированная версия криптолокера Misha и Petya.

- Модуль-сканер, выявляющий потенциально уязвимые к EternalBlue хосты.

- Модуль, использующий для распространения связку PsExec+Mimikatz (дамп паролей и распространение по windows-машинам в сети через штатную утилиту удаленного администрирования Microsoft, для работы которой нужен открытый 445 порт).

Попадая на хост, вирус пытается повысить привилегии до Системы. В случае успеха – рестарт и шифрование MFT. В случае неуспеха – шифрование файлов (как стандартный криптер).

Спустя некоторое время выявляется второй канал распространения в инфраструктуре – PsExec+Mimikatz. Чуть позже еще один – удаленный доступ к консоли WMI (Windows Management Instrumentation).

Инструкция дополняется следующей информацией:

- Блокировка запуска ПО «PSEXEC.EXE» на потенциально уязвимых машинах.

- В качестве временной меры – отключить удаленный доступ к WMI.

Гизар Шакиров, начальник Отдела ИБ БАШКОМСНАББАНК (ПАО):

После получения информации о дополнительных способах распространения, критичные сегменты и хосты были временно изолированы по 135, 445, 1024-135 портам, либо поставлены на особый контроль. Solar JSOC сообщил о том, что антивирусный вендор, чье решение используется в банке, выпустил сигнатуры для детектирования известных сэмплов Petya. Оперативно было выполнено принудительное обновление на всем парке защищаемых машин, и запущена полная проверка на критичных хостах.

В течение последующих часов мы получали информацию о функционале других сборок вредоносного ПО. Новые индикаторы компрометации проверялись в ретроспективе и ставились на активный контроль. Дежурный аналитик оперативно взаимодействовал с техническими специалистами заказчиков в том числе в ночное время. Все подозрительные почтовые вложения проверялись с особой тщательностью.

Гизар Шакиров, начальник Отдела ИБ БАШКОМСНАББАНК (ПАО):

На ночное время мы согласовали с коллегами из JSOC нештатный режим работы, в рамках которого по инцидентам, связанным с аномальной сетевой либо хостовой активностью и вирусными заражениями, помимо штатного оповещения ответственных специалистов банка звонок поступал бы сразу мне для организации оперативного реагирования и проведения проверки по факту инцидента.

Еще после эпидемии WannaCry стало понятно, что использование уязвимостей, обнародованных (и планируемых к публикации) известной хакерской группировкой, будет трендом ближайшего времени, и любые меры, касающиеся мониторинга, кастомных сигнатур и работы антивируса, стоит рассматривать лишь как компенсирующие. Поэтому служба эксплуатации Solar JSOC в еще более интенсивном режиме продолжили работать с обновлением систем, в том числе и legacy, для которых появились актуальные патчи в инфраструктурах заказчика.

Благодаря всем перечисленным выше мерам и активному взаимодействию специалистов клиентов и команды Solar JSOC, удалось избежать любых активных заражений эпидемией Petya, как месяцем ранее – эпидемией WannaCry.

|

Метки: author SolarSecurity информационная безопасность saas / s+s блог компании solar security wannacry petya soc киберугрозы |

PETYA malware. Recovery is possible |

27 июня в сети начали появляться сообщения о быстром распространении вредоносной программы – шифровальщика Petya, выполняющей шифрование данных на компьютере жертвы. Атаке подверглись крупные корпорации России, Украины, ЕС, США и ряда других стран. Специалисты компании BiZone провели подробный анализ работы вредоноса. Ниже приведены результаты исследования, а также рекомендации по его удалению с компьютера жертвы и восстановлению данных.

Распространение

Распространяется изначально несколькими способами, в том числе в виде почтового вложения (фишинговая рассылка).

Для последующего распространения внутри сети использует:

- Уязвимость MS17-10, также, как и WannaCry;

- Удаленный доступ к консоли WMI (Windows Management Instrumentation), команды вида

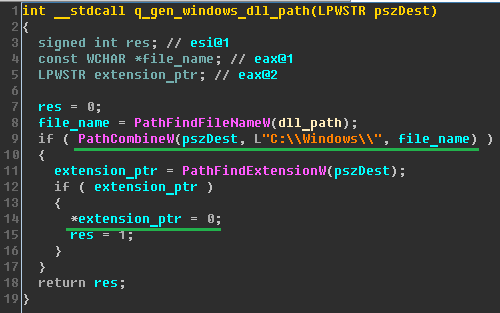

wmic.exe /node:"" /user:" " /password:" process call create "C:\Windows\System32\rundll32.exe \"C:\Windows\perfc.dat\" #1 - Утилиту PSEXEC от Microsoft (имена и пароли учетных записей собираются на зараженной машине с помощью утилиты, аналогичной по функциональности утилите «Mimikatz»; пароли в открытом виде получаются путем чтения памяти процесса lsass.exe.

Шифрование

Для затруднения последующего анализа Petya очищает системные журналы событий и журнал файловой системы с помощью команды:

wevtutil cl Setup & wevtutil cl System & wevtutil cl Security & wevtutil cl Application & fsutil usn deletejournal /D %c:Сами записи в журналах событий при этом не удаляются, лишь делается пометка в заголовке журнала о том, что он очищен, восстановление записей возможно.

Шифрование системы может производиться двумя различными способами:

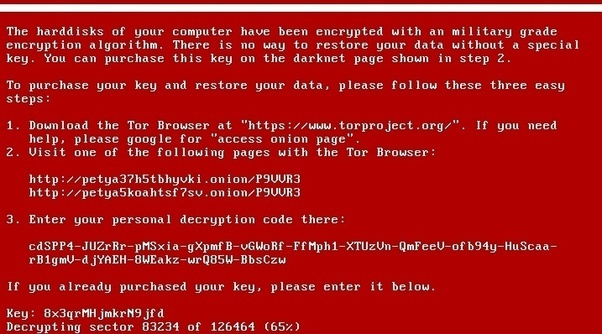

1. Шифрование таблицы размещения файлов $MFT (NotPetya)

Вредоносный файл записывает свой код в MBR и последующие несколько секторов (оригинальный MBR при этом сохраняется в 34 секторе в зашифрованном виде (xor 0x07)). Далее вызывается перезагрузка системы (с помощью команд “schtasks” и “at”)и при последующем включении выводится экран о работе утилиты CHKDSK. На самом деле в этот момент происходит шифрование $MFT с использованием криптографически стойкого шифра Salsa20 (код c схож с оригинальным Petya). Особенность данного способа в том, что шифруются записи о файлах, а не само содержимое файлов. Восстановление данных возможно.

Способы восстановления данных:

- Вручную. Возможен поиск файлов на диске по сигнатурам, однако данный способ работает только для нефрагментированных файлов, при этом имя файла не восстанавливается. Следующий применимый способ, это поиск файловых записей по сигнатуре “FILE”, получение списка кластеров, принадлежащих файлу, таким образом восстанавливается содержимое и имя файла. Также в ходе наших исследований был разработан метод восстановления выборочных файлов с помощью восстановления нерезидентного списка секторов, принадлежащих файлу (Data Runs). Данный метод основан на следующей концепции: выполняется поиск кластера содержащего начало файла (поиск производится по сигнатуре), далее номер этого кластера используется для поиска нерезидентного списка секторов, принадлежащих файлу. С помощью описанных методов, можно восстановить файлы большого размера, которые нельзя восстановить поиском по сигнатуре и автоматическими средствами.

- Автоматический: R-Studio, GetDataBack, и др.

- Восстановление MBR возможно с командой “bootrec /FixMbr” до перезагрузки системы (Vista+, в случае Windows XP можно использовать команду “fixmbr”).

- Восстановление MBR после перезагрузки, но до шифрования. Необходимо извлечь оригинальный MBR из 34 сектора (0x4400 смещение на диске, размер 0x200) расшифровать (xor 0x07) и записать в начало диска.

2. Шифрование файлов (Misha)

При невозможности получения привилегий в системе для перезаписи MBR, производится шифрование файлов без перезагрузки. Список шифруемых расширений файлов:

3ds, 7z, accdb, ai, asp, aspx, avhd, back, bak, c, cfg, conf, cpp, cs, ctl, dbf, disk, djvu, doc, docx, dwg, eml, fdb, gz, h, hdd, kdbx, mail, mdb, msg, nrg, ora, ost, ova, ovf, pdf, php, pmf, ppt, pptx, pst, pvi, py, pyc, rar, rtf, sln, sql, tar, vbox, vbs, vcb, vdi, vfd, vmc, vmdk, vmsd, vmx, vsdx, vsv, work, xls, xlsx, xvd, zip. Способы расшифровки в настоящее время неизвестны, возможно лишь восстановление из резервных копий, например, из Volume Shadow Copy, Restore points, File History.

Платить выкуп не рекомендуется, так как почтовый ящик злоумышленников был заблокирован. В настоящее время вызывает сомнение техническая возможность расшифровки данных, а также нет подтверждённых случаев успешной расшифровки.

Почему возможно восстановление данных?

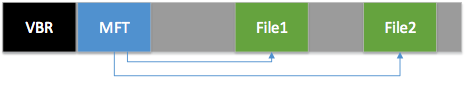

NotPetya шифрует только файловую таблицу, но не сами файлы, поэтому восстановить файлы после этого шифровальщика возможно. До шифрования структура файловой системы выглядит следующим образом:

В начале раздела расположена главная файловая таблица (MFT), в которой указаны названия файлов и их расположение. После шифрования все ссылки на файлы в MFT оказываются зашифрованы, но содержимое файлов остается неизменным:

Таким образом все методы восстановления данных, основанные на карвинге, (Carving) продолжают работать. Также идентичные записи MFT хранятся в разных частях файловой системы. Они могут попадать в файл hiberfil.sys, в файлы директорий и MFTmirr и т.п. Поэтому, собрав все целостные записи MFT возможно восстановить даже фрагментированные файлы.

Индикаторы

При заражении системы с использованием ПО «PSEXEC» в директории Windows могут присутствовать следующие файлы:

«C:\Windows\perfc.dat»

«C:\Windows\dllhost.dat»Рекомендации

Также для остановки распространения данного вредоносного ПО необходимо заблокировать запуск ПО «PSEXEC.EXE» с помощью средств локальной или групповой политики безопасности на потенциально уязвимых машинах, а также, если возможно, заблокировать, либо отключить удаленный доступ к WMI.

В ходе исследования была выявлена особенность, позволяющая предотвратить заражение через PsExec и WMI. Для этого достаточно создать пустой файл “C:\Windows\perfc”.

|

Метки: author vadimmaslikhin информационная безопасность блог компании bi.zone bizone petya ransomware |

Как победить вирус Petya |

Жертвами вымогателя уже стали украинские, российские и международные компании, в частности, Новая Почта, Запорожьеоблэнерго, Днепроэнерго, Ощадбанк, медиахолдинг ТРК «Люкс», Mondelez International, TESA, Nivea, Mars, операторы LifeCell, УкрТелеКом, Киевстар и многие другие организации. В Киеве оказались заражены в том числе некоторые банкоматы и кассовые терминалы в магазинах. Именно на Украине зафиксированы первые атаки.

Анализ образца вымогателя, проведенный нашими экспертами, показал, что принцип действия Petya основан на шифровании главной загрузочной записи (MBR) загрузочного сектора диска и замене его своим собственным. Эта запись – первый сектор на жёстком диске, в нем расположена таблица разделов и программа-загрузчик, считывающая из этой таблицы информацию о том, с какого раздела жёсткого диска будет происходить загрузка системы. Исходный MBR сохраняется в 0x22-ом секторе диска и зашифрован с помощью побайтовой операции XOR с 0x07.

После запуска вредоносного файла создается задача на перезапуск компьютера, отложенная на 1-2 часа, в это время можно успеть запустить команду bootrec /fixMbr для восстановления MBR и восстановить работоспособность ОС. Таким образом, запустить систему даже после ее компрометации возможно, однако расшифровать файлы не удастся. Для каждого диска генерируется свой ключ AES, который существует в памяти до завершения шифрования. Он шифруется на открытом ключе RSA и удаляется. Восстановление содержимого после завершения требует знания закрытого ключа, таким образом, без знания ключа данные восстановить невозможно. Предположительно, зловред шифрует файлы максимум на глубину 15 директорий. То есть файлы, вложенные на большую глубину, находятся в безопасности (по крайней мере для данной модификации шифровальщика).

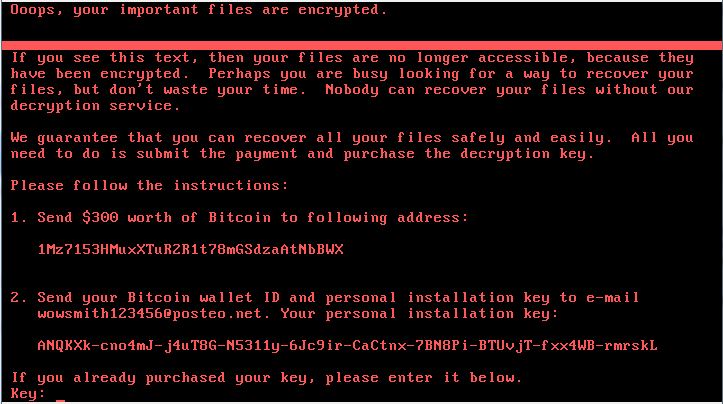

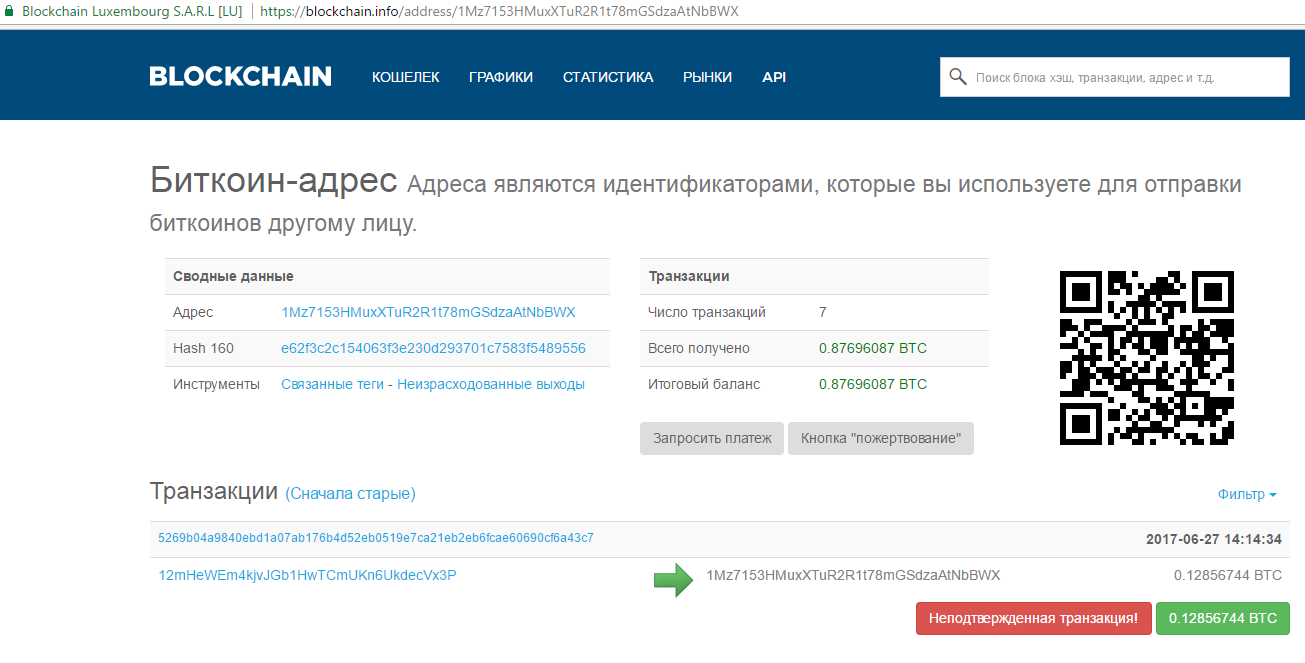

В случае, если диски оказались успешно зашифрованы после перезагрузки, на экран выводится окно с сообщением о требовании заплатить выкуп $300 (на 27 июня 2017 — примерно 0,123 биткойна) для получения ключа разблокировки файлов. Для перевода денег указан биткоин-кошелек 1Mz7153HMuxXTuR2R1t78mGSdzaAtNbBWX. Через несколько часов после начала атаки на кошелек уже поступают транзакции, кратные запрошенной сумме – некоторые жертвы предпочли заплатить выкуп, не дожидаясь, пока исследователи изучат зловред и попытаются найти средство восстановления файлов.

На данный момент число транзакций увеличилось до 45.

Petya использует 135, 139, 445 TCP-порты для распространения (с использованием служб SMB и WMI). Распространение внутри сети на другие узлы происходит несколькими методами: с помощью Windows Management Instrumentation (WMI) и PsExec, а также с помощью эксплойта, использующего уязвимость MS17-010 (EternalBlue). WMI – это технология для централизованного управления и слежения за работой различных частей компьютерной инфраструктуры под управлением платформы Windows. PsExec широко используется для администрирования Windows и позволяет выполнять процессы в удаленных системах. Однако для использования данных утилит необходимо обладать привилегиями локального администратора на компьютере жертвы, а значит, шифровальщик может продолжить свое распространение только с тех устройств, пользователь которых обладает максимальными привилегиями ОС. Эксплойт EternalBlue позволяет получить максимальные привилегии на уязвимой системе. Также шифровальщик использует общедоступную утилиту Mimikatz для получения в открытом виде учетных данных всех пользователей ОС Windows, в том числе локальных администраторов и доменных пользователей. Такой набор инструментария позволяет Petya сохранять работоспособность даже в тех инфраструктурах, где был учтен урок WannaCry и установлены соответствующие обновления безопасности, именно поэтому шифровальщик настолько эффективен.

В рамках тестирований на проникновение современных корпоративных инфраструктур эксперты Positive Technologies регулярно демонстрируют возможность применения эксплойта EternalBlue (в 44% работ в 2017 году), а также успешное применение утилиты Mimikatz для развития вектора атаки до получения полного контроля над доменом (в каждом проекте).

Таким образом, Petya обладает функциональностью, позволяющей ему распространяться на другие компьютеры, причем этот процесс лавинообразный. Это позволяет шифровальщику скомпрометировать в том числе контроллер домена и развить атаку до получения контроля над всеми узлами домена, что эквивалентно полной компрометации инфраструктуры.

О существующей угрозе компрометации мы сообщали более месяца назад в оповещениях об атаке WannaCry и давали рекомендации, каким образом определить уязвимые системы, как их защитить и что делать, если атака уже произошла. Дополнительные рекомендации мы дадим и в данной статье. Кроме того, наша компания разработала бесплатную утилиту WannaCry_Petya_FastDetect для автоматизированного выявления уязвимости в инфраструктуре. Система MaxPatrol выявляет данную уязвимость как в режиме Audit, так и в режиме Pentest. Подробная инструкция указана в наших рекомендациях. Кроме того, в MaxPatrol SIEM заведены соответствующие правила корреляции для выявления атаки Petya.

Эксперты Positive Technologies выявили “kill-switch” – возможность локально отключить шифровальщик. Если процесс имеет административные привилегии в ОС, то перед подменой MBR шифровальщик проверяет наличие файла perfc (либо другого пустого файла с иным названием) без расширения в директории C:\Windows\ (директория жестко задана в коде). Этот файл носит то же имя, что и библиотека dll данного шифровальщика (но без расширения).

Наличие такого файла в указанной директории может быть одним из индикаторов компрометации. Если файл присутствует в данной директории, то процесс выполнения ВПО завершается, таким образом, создание файла с правильным именем может предотвратить подмену MBR и дальнейшее шифрование.

Если шифровальщик при проверке не обнаружит такой файл, то файл создается и стартует процесс выполнения ВПО. Предположительно, это происходит для того, чтобы повторно не запустился процесс подмены MBR.

С другой стороны, если процесс изначально не обладает административными привилегиями, то шифровальщик не сможет выполнить проверку наличия пустого файла в директории C:\Windows\, и процесс шифрования файлов все же запустится, но без подмены MBR и перезапуска компьютера.

Для того, чтобы не стать жертвой подобной атаки, необходимо в первую очередь обновить используемое ПО до актуальных версий, в частности, установить все актуальные обновления MS Windows. Кроме того, необходимо минимизировать привилегии пользователей на рабочих станциях.

Если заражение уже произошло, мы не рекомендуем платить деньги злоумышленникам. Почтовый адрес нарушителей wowsmith123456@posteo.net был заблокирован, и даже в случае оплаты выкупа ключ для расшифрования файлов наверняка не будет получен. Для предотвращения распространения шифровальщика в сети рекомендуется выключить другие компьютеры, которые не были заражены, отключить от сети зараженные узлы и снять образы скомпрометированных систем. В случае, если исследователи найдут способ расшифрования файлов, заблокированные данные могут быть восстановлены в будущем. Кроме того, данный образ может быть использован для проведения анализа шифровальщика, что поможет исследователям в их работе.

В долгосрочной перспективе рекомендуется разработать систему регулярных тренингов сотрудников с целью повышения их осведомленности в вопросах информационной безопасности, основанную на демонстрации практических примеров потенциально возможных атак на инфраструктуру компании с использованием методов социальной инженерии. Необходимо проводить регулярную проверку эффективности таких тренингов. Также необходимо на все компьютеры установить антивирусное ПО с функцией самозащиты, предусматривающей ввод специального пароля для отключения или изменения настроек. Кроме того, необходимо обеспечить регулярное обновление ПО и ОС на всех узлах корпоративной инфраструктуры, а также эффективный процесс управления уязвимостями и обновлениями. Регулярное проведение аудитов ИБ и тестирований на проникновение позволит своевременно выявлять существующие недостатки защиты и уязвимости систем. Регулярный мониторинг периметра корпоративной сети позволит контролировать доступные из сети Интернет интерфейсы сетевых служб и вовремя вносить корректировки в конфигурацию межсетевых экранов. Для своевременного выявления и пресечения уже случившейся атаки необходимо осуществлять мониторинг внутренней сетевой инфраструктуры, для чего рекомендуется применять систему класса SIEM.

Для выявления атаки Petya в инфраструктуре могут быть использованы следующие индикаторы:

- C:\Windows\perfс

- Задача в планировщике Windows с пустым именем и действием (перезагрузка)

- "%WINDIR%\system32\shutdown.exe /r /f"

Срабатывание правил IDS/IPS:

- msg: "[PT Open] Unimplemented Trans2 Sub-Command code. Possible ETERNALBLUE (WannaCry, Petya) tool"; sid: 10001254; rev: 2;

- msg: "[PT Open] ETERNALBLUE (WannaCry, Petya) SMB MS Windows RCE"; sid: 10001255; rev: 3;

- msg: "[PT Open] Trans2 Sub-Command 0x0E. Likely ETERNALBLUE (WannaCry, Petya) tool"; sid: 10001256; rev: 2;

- msg: "[PT Open] Petya ransomware perfc.dat component"; sid: 10001443; rev: 1

- msg:"[PT Open] SMB2 Create PSEXESVC.EXE"; sid: 10001444; rev:1

Сигнатуры:

|

Метки: author ptsecurity информационная безопасность блог компании positive technologies вирус-вымогатель wannacry eternalblu petya |

[Из песочницы] Разработка браузерной онлайн-игры |

Я привык относить себя к тем везучим людям, у которых хобби совпадает с работой — я люблю разработку ПО. Поэтому для меня абсолютно нормально, вернувшись домой, вновь сесть за компьютер, открыть Visual Studio и продолжить что-то разрабатывать — отдых от этой деятельности мне не нужен. Проблема лишь одна — нужен проект, который мне интересен и который я смог бы осилить один в свободное время — по вечерам и в выходные дни.

Примерно год назад мне показали довольно популярную браузерную онлайн-игру — слитерио. После ознакомления у меня появилась навязчивая идея — мне захотелось сделать что-то похожее по подходу, но с чуть более продвинутым геймплеем. Спустя пару месяцев идея сформировалась в тему этой публикации — игру World of Frogs.

Суть игры — вы управляете лягушкой, можете нападать на других игроков, а также на управляемые компьютером объекты — мух, тараканов, болотных лягушек. Мухи не умеют нападать и умирают с одного удара, тараканы нападают лишь обороняясь, болотные же лягушки нападают как на мух, так и на игроков.

Побеждая врагов вы получаете опыт, растёте по уровням, изучаете новые способности и становитесь сильнее.

Основные пункты, от которых я отталкивался:

- С клиентской стороны никакого Flash, только html + js;

- Одна машина должна тянуть как можно больший онлайн игроков;

- Возможность горизонтального масштабирования;

- Низкий порог вхождения в игру и быстрый старт;

- Чуть более разнообразный геймплей, чем в слитерио;

- Красивый и запоминающийся домен;

Далее, подробней по каждому из пунктов.

1) Клиентский код

Мне не хотелось погрязнуть в межбраузерных различиях, а также в реализации примитивов, поэтому я сразу задвинул подальше идею работать напрямую с canvas — я начал с поиска графической библиотеки (разумеется, бесплатной).

Изначально взгляд упал на pixi.js — это движок, по которому немало документации, о котором положительно отзываются в плане производительности и вообще всячески хвалят.

Однако углубившись в поиски, я остановился на phaser.js (о нём уже были статьи на хабре) — это более высокоуровневая библиотека, которая позволила мне забыть о многих нюансах и сосредоточиться непосредственно на игровой логике.

Движок позволил без особых проблем прикрутить анимации, бэкграунд текстуру, камеру, границы мира и многое другое. И всё бы хорошо, но когда настало время проверять работу на других компьютерах, с другими операционными системами, выявились следующие проблемы:

1.1 Главная из проблем — фоновая текстура (tilesprite) жутко тормозит на windows 7

Выяснил я это с рабочего компьютера после первого деплоя на хостинг — ФПС был очень и очень низким — в районе 5. И так было во всех браузерах кроме, на удивление, IE — в нём всё работало вполне прилично, пускай и не идеально.

До того, что тормозит бэкграунд я додумался далеко не сразу — первым делом, я, методом тыка выяснил, что игра резко перестаёт тормозить при уменьшении размера окна браузера. Нагуглить по что-то по таким симптомам мне не удалось, поэтому я, профилактики ради, решил внедрить часть практик, которые советуют ребята из Mozilla — в частности, использование Object Pool (переиспользование игровых объектов). Особых успехов такого рода оптимизациями я не достиг, а профилировщик по-прежнему показывал что больше всего ресурсов съедает рендеринг.

Тогда, прибегнув к постепенному отключению отображения различных элементов игры я и выявил виновника — tilesprite.

Погуглив по tilesprite я выяснил, что такая проблема не у меня одного, и причина кроется в том, что canvas перерисовывается полностью при любом изменении — т.е. маленький объект сдвинулся — перерисоываем весь канвас, включая фон, что даёт нам высокий расход на отрисовку.

В попытке решить эту проблему я вынес фон на отдельный канвас с меньшим z-index, чтобы он перерисовывался отдельно, независимо от движущихся объектов — особых результатов это не дало.

В конечном итоге я решил отказаться от phaser.js и работать напрямую с canvas, созданным для отрисовки фона — в результате ФПС вырос примерно до 20.

1.2 Разные версии phaser — разная производительность в разных операционках

После изменения принципа отрисовки фона с производительностью всё стало намного лучше, но 20 ФПС — это всё ещё не желаемые 60 — было над чем поработать. Путём тыканья пальцем в небо было выяснено, что phaser версии 2.4.6 работает быстрее на windows 7, а версии 2.6.2 быстрее на windows 10. На линухе и маке обе версии показали себя одинаково хорошо.

Пришлось добавить условие, которое подключало ту или иную версию библиотеки в зависимости от браузера пользователя — это повысило ФПС на моей рабочей машине до 25-30. Выше поднять ФПС у меня так и не получилось — на этом я решил остановиться, т.к. после опроса друзей/знакомых, у которых стоит семёрка, сложилось впечатление, что проблема редкая, да и уже не такая серьёзная как изначально.

Описанное в этих двух пунктах — это не единственные, но основные и наиболее запомнившиеся проблемы, связанные с phaser.js — всё остальное прошло в общем-то гладко.

Также стоит отметить, что на разных машинах с windows 7 производительность была разной — кое-где и без всех моих телодвижений всё было хорошо, где-то же наблюдались проблемы аналогичные тем, что я наблюдал — какой-либо корреляции я установить не смог

2) Производительность одного инстанса игрового сервера

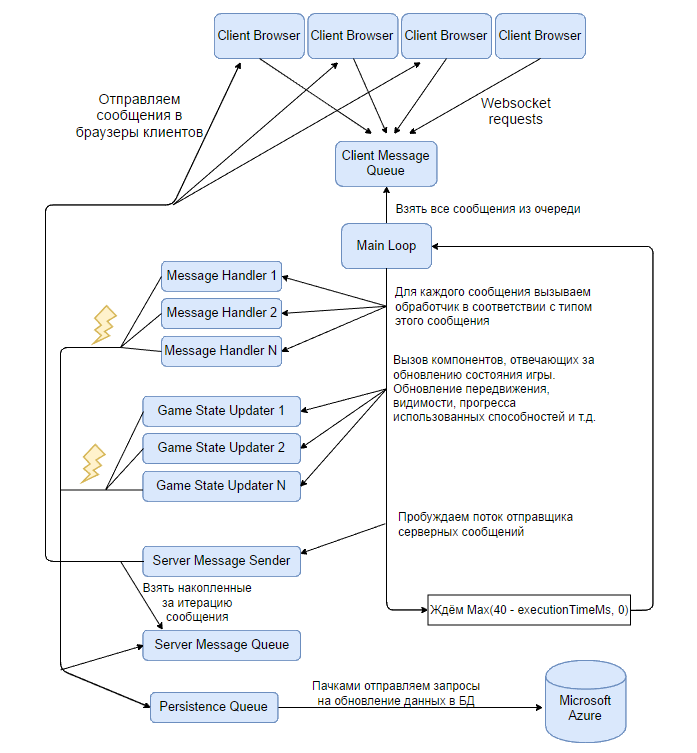

Здесь начать стоит с того, какая в целом архитектура у приложения, которое служит как игровой сервер. Было решено использовать следующую схему:

Параллельно от разных игроков принимаются сообщения по websocket и закладываются на обработку основному потоку, который обновляет игровую логику. Основной поток работает итерациями по 40мс, в рамках которых обновляет передвижение, видимость, респавн NPC, прогресс использования способностей и т.п.

Запись данных в базу происходит асинхронно — поток обновления игровой логики закладывает сообщения в очередь другому фоновому потоку, который их группирует и пачками пишет в базу.

Сериализация и отправка сообщений игрокам тоже происходит асинхронно — этим занимается очередной фоновый тред, которому сообщения в очередь для обработки пишутся в рамках выполнения итерации, а в конце итерации сообщения группируются для каждого пользователя и пачкой отправляются на клиент.

Если отобразить на схеме, то верхнеуровнево серверная архитектура выглядит так:

Т.к. с бэкендом у меня опыта прилично больше, здесь каких-то особо запомнившихся трудностей не было — неоптимальные места я отлавливал профилировщиком — где-то применял микрооптимизации вычислений, где-то кэширование, где-то оптимизации иного рода.

Самым серьёзным бустом к производительности был отказ от использования SignalR, т.к. он не поддерживает бинарный протокол, а на сериализацию в json уходило вычислительных ресурсов больше, чем на всю остальную логику игрового сервера вместе взятую. Остановился в итоге на использовании Fleck, т.к. он поддерживает бинарный формат, а также позволяет отключить алгоритм Нэйгла.

3) Возможность горизонтального масштабирования

Будучи оптимистом я решил заранее заложиться на то, что игра всем понравится и в неё захочет играть множество людей. В рамках одной машины можно долго заниматься оптимизациями, можно бесконечно апгрейдить железо, можно переписать приложение на чистом си с ассемблерными вставками для микрооптимизаций, но всё равно рано или поздно упрёшься в потолок. Было решено иметь архитектуру, позволяющую иметь множество серверов малой мощности, на каждом из которых потолок по онлайну в районе 200-300 человек.

Чтобы не было бутылочного горлышка в виде сети до какого-то одного глобального прокси, а также чтобы обеспечить минимальный пинг, было решено на стороне сайта выбирать из пула серверов один конкретный, с минимальным онлайном, закреплять его за сессией пользователя и в дальнейшем обеспечивать взаимодействие браузера пользователя напрямую с игровым сервером.

На текущий момент в выборе сервера из пула используются простая логика — берётся сервер с минимальным онлайном. В дальнейшем планируется также добавить логику учёта местоположения клиента и сервера.

4) Низкий порог вхождения в игру и быстрый старт

Мне не раз приходилось видеть игры, которые просто обязаны иметь наиужаснейшую конверсию из-за перегруженности интерфейса или же из-за необходимости вводить миллион полей для того, чтобы зайти в игру.

Я хотел обеспечить вход по одному клику мыши с главной страницы, т.е. никакой обязательной регистрации. В том же слитерио используется похожий подход, за одной небольшой разницей — от игрока всё же хотят, чтобы он ввёл ник.

Т.к. онлайн игра как правило предполагает возможность отличать одного игрока от другого, я решил использовать подход никогенерации — при входе в игру берётся случайное прилагательное из заранее заданного списка и комбинируется с случайным существительным, что выдаёт ники вида Неспящий Бугай, Жадный Бурундук, Могучий Валенок и т.п…

В дальнейшем, если игроку понравилась игра, ему предоставляется возможность зарегистрироваться, сохранив за собой прогресс, а также сменив ник на что-то более вменяемое.

Для более быстрого погружения на главную страницу было добавлено обучающее видео, а в саму игру были добавлены тултипы, выплывающие при изучении новых способностей.

5) Чуть более разнообразный геймплей, чем в слитерио

Как бывший поклонник игры WoW, я хотел разнообразить игру, внеся в неё такие элементы как набор опыта, рост по уровням, получение новых способностей по мере роста, PvE, PvP.

Игроку доступно к использованию 6 способностей (1-я доступна сразу, 2-4 становятся доступны по мере роста по уровням, а 5-6 оформлены как одноразовые поверапы — их можно поднять на игровом поле):

- Удар языком — лягушка выстреливает языком и наносит малый урон первой цели на пути;

- Прыжок — лягушка прыгает в указанном направлении и в месте приземления наносит высокий урон. Высокий урон способности компенсируется сложностью попадания, а также длительной задержкой между использованиями;

- Щит — в течение 3-х секунд поглощает 2 следующие вражеские атаки;

- Плевок — лягушка выплёвывает снаряд, который наносит средние повреждения всем врагам на траектории движения);

- Лечение — восстанавливает половину жизни;

- Ускорение — увеличивает скорость передвижения на 100% на 4 секунды;

Для возможности немного выделиться была добавлена возможность выбрать другую модель игрового персонажа.

6) Красивый и запоминающийся домен;

Изначально в планах было разместить игру на домене .io, аналогично слитерио, агарио и многим другим играм такого формата. Банальные frog.io и frogs.io были заняты, а чего-то более подходящего в .io подобрать не удалось. Играясь с доменами, содержащими frog, наткнулся на весьма удачный вариант — frogs.world, на котором сейчас проект и живёт. Довольно-таки непривычный домен первого уровня, но зато легко запоминается.

Спасибо за внимание. Надеюсь, что кому-то мой опыт будет полезен.

|

Метки: author taurenstyle разработка игр браузерная игра онлайн-игра |

Чем грозит преждевременная автоматизация |

Оды автоматизации на основе технологий перевода речи в текст и обратно не утихают. Кто только не хвалится тем, как оптимизировал бизнес и сократил издержки. Да взять хотя бы нас самих: не только автоматизируем собственные процессы, а еще и другим помогаем. Но важно понимать, что автоматизация не только полезна, но и вредна. Под катом пара примеров второго вида (без имен, разумеется) плюс чек-лист, с помощью которого удастся не превратить первое во второе.

Начнем с вредного

В недрах одной компании зарождался интерактивный помощник для клиентов. Очень многообещающий. Ну то есть как. Автоматический секретарь, который должен был помочь клиентам сориентироваться среди множества телефонных сервисов компании.

Из-за ограничений технологии распознавания и возможности робота понимать живую речь получилось громоздко и неудобно. Клиентам приходилось использовать строго заданный набор слов (чтобы робот их понимал). Для этого составили подсказки для «правильных» ответов на поставленный роботом вопрос. Несмотря на инструкцию, робот переспрашивал, правильно ли он понял решение человека.

Все это сделало общение с машиной крайне утомительным и неприятным для людей, и помощника тихо погасили, заменив старым добрым IVR с передачей решений человека по DTMF. И правильно сделали.

Кстати, о DTMF. Еще один неудачный пример автоматизации — объединенный сервис рекомендаций и бронирования, в котором клиенту нужно провзаимодействовать с роботом-ассистентом, выпытывающим предпочтения и на их основе предлагающим различные варианты досуга.

Подготовили динамическое голосовое меню, которое формировалось под каждого клиента в зависимости от его решений на предыдущих шагах. То есть как таковой строгой структуры меню не было, зато была возможность выразить свои предпочтения ответами на вопросы робота в виде сигналов DTMF.

Проект запустили в эксплуатацию, не озаботившись серьезным тестированием на своей целевой аудитории. И после этого внезапно выяснилось, что люди не очень любят подолгу выслушивать робота и выбирать минимум из пяти вариантов, чтобы ответить на его вопрос.

Оба кейса объединяет одно: интеллект ассистента и ограничения технологии не позволяют строить сложные дискуссии с автоматизированной системой по телефону. Люди быстро устают от механического помощника и пытаются соединиться с живым оператором. Либо просто отказываются от использования.

Запилим автоматизацию с распознаванием и роботами

Как же понять, что пора браться за автоматизацию с использованием этих технологий? Если на все вопросы из списка ниже можно ответить утвердительно, значит, время пришло:

- автоматизация принесет пользу продукту, за которую определенная аудитория захочет платить?

- она снизит/устранит барьеры при использовании продукта?

- точно не привнесет новых проблем и барьеров?

- предусмотрены все точки касания в пользовательском интерфейсе — от типового кейса до нестандартного, например, реакция системы на ошибки?

Добавить общение с роботом можно, если он сможет ответить на ряд вопросов и разгрузить службу поддержки. Поставить робота перед продавцом — практически подарить клиента конкуренту.

Еще несколько рекомендаций, которые помогут при внедрении технологии Text-to-speech:

- скорость воспроизведения текста должна быть тщательно подобрана — чтобы речь робота оказалась разборчива, но не слишком заунывна (старательно-отчетливая декламация очень быстро утомляет); особое внимание стоит уделить случаям, когда система диктует какие-то важные данные, скажем, номер заказа — здесь торопиться точно не стоит, чтобы дать человеку возможность записать информацию (еще можно предусмотреть повтор важных сведений);

- хорошо, если система синтеза речи поддерживает разметку интонации: это помогает сделать искусственную речь более естественной;

- количество касаний должно быть небольшим: вряд ли кому-то понравится продираться сквозь сложносочиненную структуру вопросов и уточнений; с каждым новым касанием вероятность отказа пользователя будет расти;

- то же самое можно сказать и про общее время взаимодействия — в идеале задача пользователя должна решаться за несколько секунд.

А вот на что стоит обратить внимание при использовании обратной технологии, Speech-to-text:

- качество распознавания должно чуть превышать порог, при котором система сможет неверно истолковать пользователя;

- если качество распознавания не очень высокое, то нужно продумать структуру диалога так, чтобы ответы человека (и их вариации — например, согласие можно выразить множеством способов: от простого «угу» до какого-нибудь редкого «есть такое дело») были максимально разнесены по звучанию;

- краткая инструкция для человека поможет ему отвечать понятнее для системы;

- линейность диалога, а также переход на оператора поможет спасти от негатива.

Text-to-speech мы внедрили давно, на ее основе работает несколько инструментов Виртуальной АТС, а прямо сейчас тестируем Speech-to-text, о чем я писал в прошлом материале. Интерактивная обработка вызова поможет увеличить отдачу от этих технологий, например, с помощью Text-to-speech можно для каждого звонящего «на лету» готовить персональное приветствие или меню с индивидуальными опциями.

|

|

«Лаборатория Касперского»: Правильная защита «облаков» |

Сегодня, когда Petya и Misha вовсю шагают по планете, данный материал становится особенно актуальным для пользователей виртуальных серверов. Представляем доклад Владимира Островерхова, «Лаборатория Касперского», «Правильная защита «облаков»».

Всем здравствуйте, меня зовут Владимир Островерхов. На данный момент я являюсь экспертом поддержки корпоративных продаж «Лаборатории Касперского».

Функционально я частично являюсь разработчиком, тренером, технарем, обучающим человеком для локальных команд всего мира.

Начнем с несерьезной темы. Какие требования предъявляются к современной системе ИТ-безопасности и почему мы поднимаем сегодня тему безопасности облачных инфраструктур, виртуальной безопасности, защиты для виртуализации, для виртуальных машин?

Давайте начнем с самого простого — с тех вирусов, о которых вы все знаете. 97-ой год. У нас хватало работы. Каждый день приходило 20 новых сэмплов, они действительно были сложными, интересными, мы их разбирали буквально руками, писали «маски» и общие структуры детектов. И все было хорошо. Год назад я снова вернулся в «Лабораторию Касперского», пришел к своим бывшим коллегам и спрашиваю: «Ребята, а как сейчас обстоят дела?» Вот было 20-30 проблемных вирусов в день, которые приходилось изучать вручную. И мне показали цифры…

Сегодня каждый день появляется более 300 тысяч единиц вредоносного ПО. Да, в эту статистику попадают и совсем простые. Например, школьник узнал новый код на уроках информатики, написал какую-то программку, выпустил ее в интернет. Вирус? Вирус, потому что может испортить данные. Сюда включаются и сложные целенаправленные атаки, те, которые разрабатываются специально под организации, под определенные кейсы, под определенные ситуации, и они очень хорошо умеют не только ломать и воровать данные, но и очень хорошо умеют себя прятать. Это все требует расследований. Объем вырос в разы, в тысячи раз. Старый и глупый вопрос: «Касперский пишет вирусы?», сами видите их и так без нас пишут столько, что нам бы разгрести…

Второй момент. Позиция нашей компании — мы, конечно, продаем продукты и решения, но основная ценность — это те накопленные знания, которые есть в нашей компании, в действительности выражаются в решения. За эту экспертизу и ценят компанию, это определяет ее репутацию.

Ладно, идем дальше про страшилки. Чем хороша виртуализация, думаю, все знаете. Да? Высокая плотность, низкое ресурсопотребление, все это здорово, все это красиво, об этом рассказывают обычно вендоры виртуализации. Чем это плохо и опасно, и почему виртуальную инфраструктуру надо дополнительно защищать и вообще не надо забывать про защиту? Две трети компаний во всем мире, включая крупный бизнес, считают, что они инвестировали в виртуализацию и дополнительной защиты никакой не надо. Виртуалка сама по себе безопасная, все с ней хорошо, ее никто не ломает. Неправда, ломают и еще чаще!

Первое – до 80 процентов всех тех 300 тысяч единиц вредоносного ПО, о которых я говорил ранее, вообще без модификаций, без каких-то изменений могут жить внутри виртуальной инфраструктуры, внутри облаков. Ничего править не надо, попало, заработало, начало удалять, стирать, портить данные.

Хакерам тоже виртуальная инфраструктура интереснее. Намного проще взломать ее и получить доступ сразу ко всем вашим виртуальным машинам и ко всем данным, нежели пытаться взломать каждый физический сервер отдельно. Логично и довольно просто.

В третьих, необходимо обратить внимание на скорость распространения вирусов, попавших внутрь виртуальной машины. Внутри виртуальной инфраструктуры зловредный код распространяется с огромной скоростью. Заразить за 15 минут 10 тысяч виртуальных машин — легко. Как-то это надо останавливать. Это эпидемии огромных скоростей и огромных масштабов.

Я не говорю про неправильные средства защиты, которые являются отдельным уровнем угроз, которые возникают для всех компаний, использующих виртуальные среды в своей работе.

Идем дальше. Облака частные, гибридные, публичные из себя всегда представляют центр обработки данных. От этого никуда не деться. Есть серверы, есть сеть, есть система хранения данных — это стандартный набор, который работает, от которого никто никуда не уходит, он традиционен.

Основной фокус атаки зловредов — это серверы и СХД. Серверы — порча данных и работы приложений, СХД — порча или воровство информации. Сеть — это только транспорт.

Сегодня я буду говорить про работу именно центра обработки данных с точки зрения криптобезопасности и с точки зрения того софта, который вы можете установить, и он окажет максимальную защиту.

А вот теперь немножко страшной статистики. Мы опросили порядка пяти тысяч компаний по всему миру. Это крупные компании, не менее полутора тысяч сотрудников, в 25 странах. Порядка 75 процентов из них уже используют виртуализацию, для крупного бизнеса – это стандартная тенденция, они все больше и больше верят в виртуализацию и внедряют у себя в ЦОДах. Статистика вендоров виртуализации показана на слайде. Интересно другое, порядка половины компаний не используют никакой защиты для виртуальных машин, а вторая половина считает, что хватит любого стандартного антивируса. Все эти компании в среднем тратят почти миллион долларов на восстановление после инцидентов: на расследование, на восстановление системы, на компенсацию затрат, на компенсацию потерь от одного единственного взлома. Как так то? Это 5 тысяч компаний и каждая из них потеряла по миллиону долларов в прошлом году? Статистика показывает «среднюю температуру по больнице». Например, есть большая компания, сервис-провайдер, один из самых крупных, пусть будет, в Испании. С ней работает очень много клиентов. Они подверглись единственному взлому в прошлом году.

Какими будут их траты в случае, если они себя скомпрометируют? Прямые потери на восстановление, замену оборудования, софта… Косвенные потери — репутация… Потери на компенсацию для их клиентов, в том числе и репутации… А еще расследование инцидентов, частичная замена инфраструктуры, потому что она уже себя скомпрометировала, это диалоги с правительствами, это диалоги со страховыми компаниями, диалоги с заказчиками, которым приходится платить компенсации.