Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[recovery mode] Clonezilla жив |

В институте Стивен проявляет интерес к параллельным и распределенным вычислениям. На веб-сайте Clonezilla показан не один урок, на которых обсуждается Clonezilla. На Стивена они, по-видимому, производят сильное впечатление.

В марте 2010-ого Джесси Смит проводит с ним интервью. В интервью Стивен Шиау не избегает навязчивых расспросов Джесси об Clonezilla. Когда Джесси просит его объясниться, он знакомит ее с историей создания Clonezilla.

Утилита была разработана Стивеном Шиау в лаборатории свободного программного обеспечения в «Национальном центре высокопроизводительных вычислений» Тайваня.

На самом деле вначале это не представляло собой хобби, и Стивен со своими коллегами просто хотели решить имеющуюся проблему. Впрочем, да, сейчас можно сказать, что это представляет собой хобби, и их работу тоже.

Скриншоты

Интерфейс Clonezilla live мало в чем похож на бурные графические сцены лесбийского секса. Эта программа имеет расслабляющий и позитивный интерфейс. В современном Clonezilla Live есть возможность вызвать небольшое множество подпрограмм: тест ОЗУ Memtest, командный интерпретатор FreeDOS (для машин конца 1980-х) и загрузчик iPXE.

На мягкие, светлые цвета фона загрузочного меню Clonezilla Live можно смотреть с вниманием, или же игнорировать, в зависимости от выбора пользователя

В мире Linux для работы с жесткими дисками есть инструменты, имеющие интерфейс, похожий на интерфейс командной оболочки UNIX/Linux. На их фоне с Clonezilla Live не нужно столько терпения и внимания.

В нем присутствует четкое, прорывное исполнение

Если подруги обращают ваше внимание, что Clonezilla явно вызывает вашу симпатию, вероятно, dd-wrt вам тоже нравится. На следующем скриншоте встречайте веб-интерфейс этой прошивки.

Встретив веб-интерфейс dd-wrt, пользователь пребывает в растерянности

Четкий и жизненный план

Следующая часть статьи рассказывает о том, как сделать samba-сервер из роутера с dd-wrt и портом usb и с помощью загрузочной флешки Clonezilla live сохранить на нем образ раздела жесткого диска, а потом восстановить его из этого образа.

Обратите внимание: создать samba-сервер из роутера с портом usb позволяет и его официальная прошивка; хоть dd-wrt и добрая прошивка, переходить на нее в этой ситуации повода нет.

Как установить Clonezilla live на флеш-накопитель usb

Переходим к установке Clonezilla live. Один-два шага приводят к его установке на загрузочный носитель, которым может быть флеш-накопитель usb.

Следующий абзац основан на переводе части официального веб-сайта Clonezilla.

Способы сделать это очень разные. Например, так: загрузив zip-файл Clonezilla live, распаковав его содержимое на NTFS- или FAT- раздел флеш-накопителя, имеющий объем не менее 200 Мб, найдя на нем в каталоге utils/linux скрипт makeboot.sh, запустив этот скрипт с правами суперпользователя и после этого следуя выводимым на экран инструкциям.

Здравствуй, dd-wrt

Представить себе перепрошивку роутера не намного сложнее, чем гулять по набережной. В Хабре есть статья об этом. С успехом реализовав перепрошивку, переходим к настройке samba-сервера.

С головой уйдем в настройку dd-wrt

С этого момента — перевод из dd-wrt wiki.

Чтобы включить USB, идите в Services > USB и включите «Core USB Support»: это приведет к открытию новых параметров. После этого включите «USB Storage Support», «Automatic Drive Mount» и нажмите кнопку Save.

Подключите ваш флеш-накопитель. Ждите, пока он появится в пространстве Disk info. Обратите внимание на путь монтирования (скорее всего /tmp/mnt/sda1).

Чтобы открыть сетевой доступ в вашему флеш-накопителю из сети Windows, идите в Services > NAS, включите «Samba» и введите имя вашей рабочей группы Windows. Под «File Sharing > Shares» нажмите кнопку Add Share, выберите «Path» (скорее всего /mnt/sda1) и дайте вашему флеш-накопителю имя. Под «File Sharing > Users» нажмите кнопку Add User, введите «User Name», «Password» и выберите имя устройства, которое вы дали ему ранее. Нажмите кнопку Apply Settings.

Конец перевода из dd-wrt wiki.

Наконец, запустим Clonezilla live и сохраним образ на samba-сервере. Проходит несколько минут.

Чтобы отвлечься, перейду к PXE

PXE

Clonezilla live можно загрузить не только с помощью загрузочной флешки, но и с помощью загрузочного сервера по сети — об этом написано на Хабре в статье «Загрузочный сервер — как загрузочная флешка, только сервер и по сети».

Представьте, — написано в статье, — что вы выбрали в BIOS загрузку по сети и можете (идет перечисление того, что можно сделать) с помошью PXE Boot сервера — «ведь это куда удобнее, нежели бегать с флешкой от машины к машине». В комментарии к Trinity Rescue Kit CD упоминается о клонировании компьютера по сети на несколько компьютеров одновременно — по-видимому, с помощью clonezilla.

В статье сервер устанавливается и настраивается по пунктам. Вначале его загрузочное меню содержит один пункт Boot from first HDD. После того, как основа готова, добавляется возможность загружать различные дисковые утилиты и тест памяти, в том числе clonezilla live: идет новый конфиг главного меню сервера и «несколько слов» о них.

Если все сделано правильно, то при загрузке какой-либо BIOS-машины с этого DHCP/PXE/TFTP сервера мы увидим, — написано в статье ServerClub'а, — загрузочное меню. Однако мы не увидим его при загрузке какой-либо UEFI-машины. В статье об этом ничего нет.

Про загрузку UEFI-машин написано в комментариях к статье.

Заключение

Раздел, данные с которого были сохранены в образе на samba-сервере, успешно отформатирован… Окончательное осознание потери приходит и с этого момента начинаем восстанавливать данные. В итоге «самый теплый» роутер загружает с подключенного к нему флеш-накопителя usb образ на компьютер, а программа Clonezilla live восстанавливает с его помощью систему.

Несмотря на сильное влечение пользователя восстановить систему, проходит еще несколько минут… Смешных, непонятных, нелепых и неубедительных минут.

|

Метки: author mikhaylovns системное администрирование настройка linux восстановление данных clonezilla dd-wrt dlink cloning imaging rescue system |

Еще один breakpad сервер. Часть 1 |

В прошлом квартале делали MVP сервиса по обработке крешей. Аналог Socorro от Mozilla, но с учетом своих требований. Код сервиса будет выкладываться на GitHub по мере рефакторинга. Утилиты, о которых пойдет речь в этой статье, доступны тут.

У нас были следующие требования:

- получение отчета с Windows, Mac OS X, GNU/Linux;

- получение отчета о падения с веба(собираем через emscripten);

- сбор данных об оборудовании(CPU, GPU, Memory);

- группировка падений по версии, платформе, пользователю, причине;

- приложение ведет логи, нужно вместе с отчетом хранить и лог.

Содержание:

- Breakpad: файлы символов и отчеты о падениях;

- Emscripten: параметры компиляции, файлы символов, обработка ошибок;

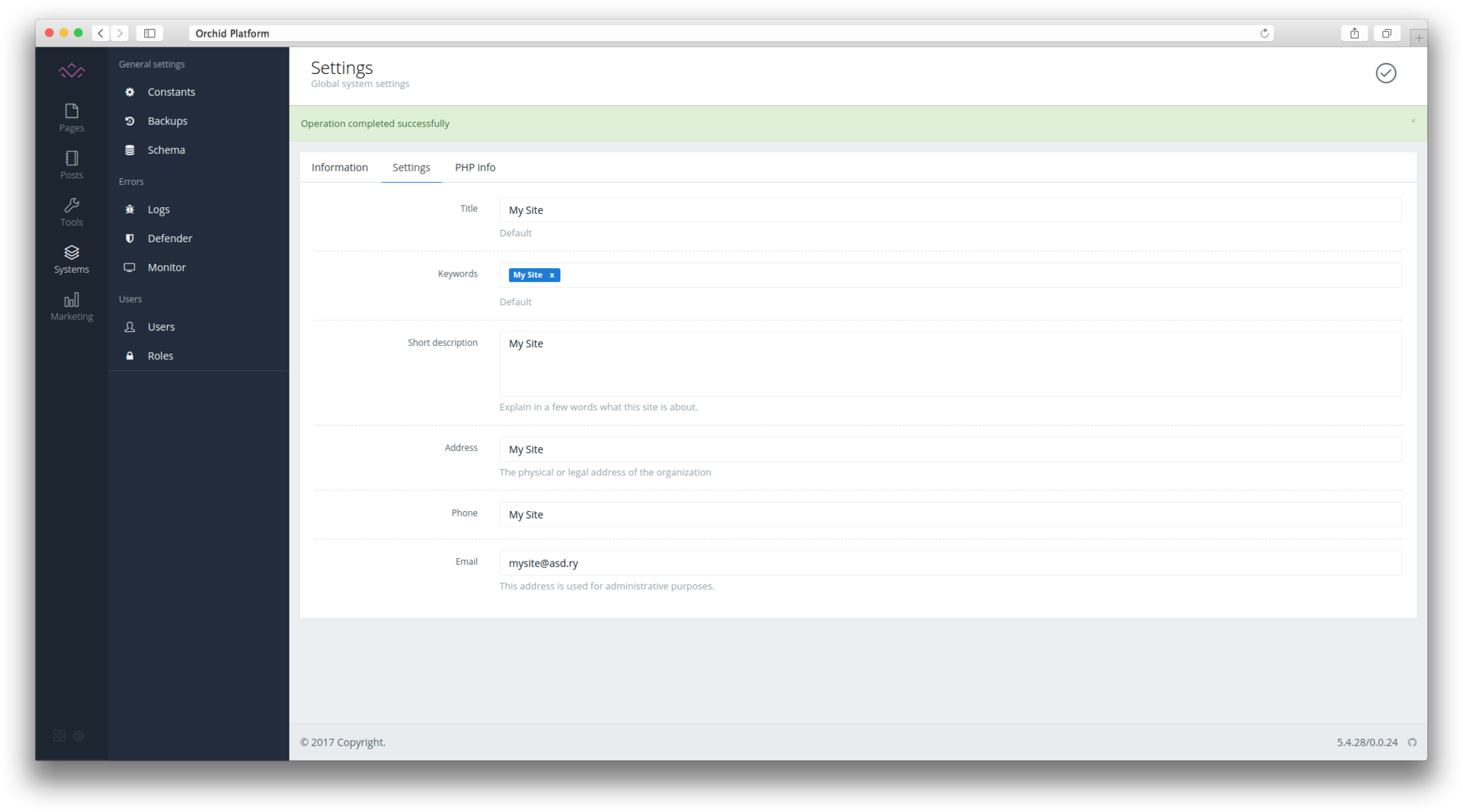

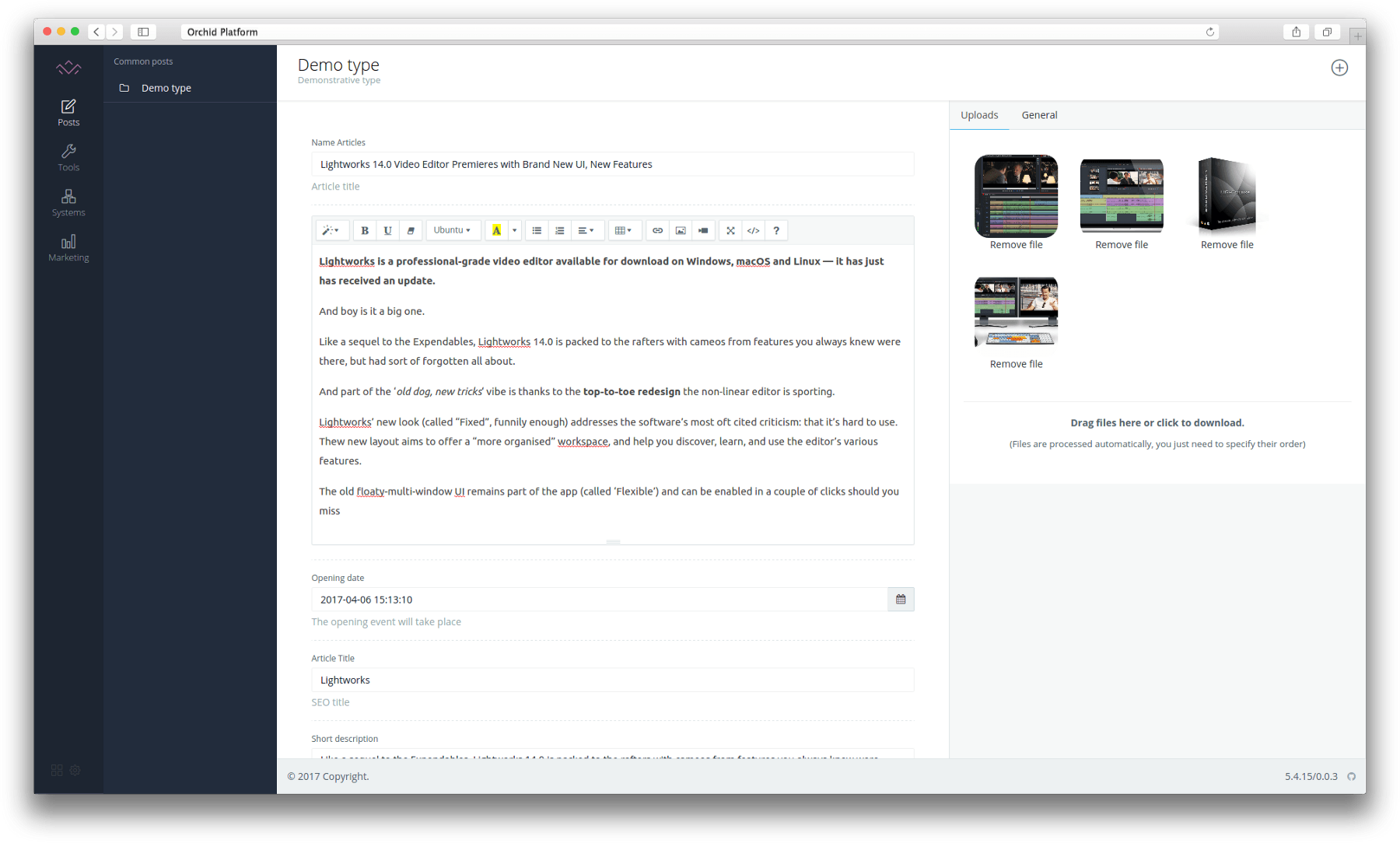

- UI.

Breakpad

В составе breakpad есть утилита извлекающая файлы символов из elf/pdb. Вот описание формата файла. Это текстовый файл, но нас интересует первая строка имеет формат MODULE operatingsystem architecture id name, у нас она выглядит так:

MODULE windows x86 9E8FC13F1B3F448B89FF7C940AC054A21 IQ Option.pdb

MODULE Linux x86_64 4FC3EB040E16C7C75481BC5AA03EC8F50 IQOption

MODULE mac x86_64 B25BF49C9270383E8DE34560730689030 IQOptionДалее эти файлы следует расположить в особом порядке: base_dir/name/id/name.sym, выглядит это так:

base_dir/IQ Option/9E8FC13F1B3F448B89FF7C940AC054A21/IQ Option.sym

base_dir/IQOption/4FC3EB040E16C7C75481BC5AA03EC8F50/IQOption.sym

base_dir/IQOption/B25BF49C9270383E8DE34560730689030/IQOption.symДля получения отчета о падения можно воспользоваться утилитой minidump_stackwalk из поставки breakpad:

$ minidump_stackwalk path_to_crash base_dirДанная утилита может выводить как в человеко читаемым виде так и в machine-readable формате.

Но это не очень удобно. В Mozilla Socorro входит утилита stackwalker которая выдает json(пример на crash-stats.mozilla.com)

Emscripten

Ловить падения можно через глобальный обработчик window.onerror. В зависимости от браузера, сообщения будут отличаться:

Uncaught abort() at Error

at jsStackTrace (http://localhost/traderoom/glengine.js?v=1485951440.84:1258:13)

at Object.abort (http://localhost/traderoom/glengine.js?v=1485951440.84:776417:44)

at _abort (http://localhost/traderoom/glengine.js?v=1485951440.84:9914:22)

at _free (http://localhost/traderoom/glengine.js?v=1485951440.84:232487:38)

at __ZN2F28ViewMain13setFullscreenEb (http://localhost/traderoom/glengine.js?v=1485951440.84:533436:2)

at Array.__ZNSt3__210__function6__funcIZN2F28ViewMainC1EvE4__13NS_9allocatorIS4_EEFbPNS2_9UIElementEEEclEOS8_ (http://localhost/traderoom/glengine.js?v=1485951440.84:658644:2)

at __ZNKSt3__28functionIFllEEclEl (http://localhost/traderoom/glengine.js?v=1485951440.84:673406:75)

at __ZNK2F26detail23multicast_function_baseIFbPNS_9UIElementEENS_24multicast_result_reducerIFbRKNSt3__26vectorIbNS6_9allocatorIbEEEEEXadL_ZNS_10atLeastOneESC_EEEEiLin1EEclERKS3_ (http://localhost/traderoom/glengine.js?v=1485951440.84:476310:12)

at __ZN2F29UIElement14processTouchUpERKNS_6vec2_tIfEE (http://localhost/traderoom/glengine.js?v=1485951440.84:471241:9)

If this abort() is unexpected, build with -s ASSERTIONS=1 which can give more information.uncaught exception: abort() at jsStackTrace@http://localhost/traderoom/glengine.js?v=1485951440.84:1258:13

stackTrace@http://localhost/traderoom/glengine.js?v=1485951440.84:1275:12

abort@http://localhost/traderoom/glengine.js?v=1485951440.84:776417:44

_abort@http://localhost/traderoom/glengine.js?v=1485951440.84:9914:7

_free@http://localhost/traderoom/glengine.js?v=1485951440.84:232487:38

__ZN2F28ViewMain13setFullscreenEb@http://localhost/traderoom/glengine.js?v=1485951440.84:533436:2

__ZNSt3__210__function6__funcIZN2F28ViewMainC1EvE4__13NS_9allocatorIS4_EEFbPNS2_9UIElementEEEclEOS8_@http://localhost/traderoom/glengine.js?v=1485951440.84:658644:2

__ZNKSt3__28functionIFllEEclEl@http://localhost/traderoom/glengine.js?v=1485951440.84:673406:9

__ZNK2F26detail23multicast_function_baseIFbPNS_9UIElementEENS_24multicast_result_reducerIFbRKNSt3__26vectorIbNS6_9allocatorIbEEEEEXadL_ZNS_10atLeastOneESC_EEEEiLin1EEclERKS3_@http://localhost/traderoom/glengine.js?v=1485951440.84:476310:12

__ZN2F29UIElement14processTouchUpERKNS_6vec2_tIfEE@http://localhost/traderoom/glengine.js?v=1485951440.84:471241:9

__ZN2F29UIElement17processTouchEventERNSt3__26vectorINS1_4pairIPS0_NS_6vec2_tIfEEEENS1_9allocatorIS7_EEEEjNS_15UI_TOUCH_ACTIONE@http://localhost/traderoom/glengine.js?v=1485951440.84:468018:35

__ZN2F29UIElement5touchEffNS_15UI_TOUCH_ACTIONEj@http://localhost/traderoom/glengine.js?v=1485951440.84:598797:8

__ZN2F213MVApplication5touchEffNS_15UI_TOUCH_ACTIONEj@http://localhost/traderoom/ at stackTrace (http://localhost/traderoom/glengine.js?v=1485951440.84:1275:12)

glengine.js?v=1485951440.84:360629:11

__ZN2F27UIInput7processEj@http://localhost/traderoom/glengine.js?v=1485951440.84:273450:6

__Z14on_mouse_eventiPK20EmscriptenMouseEventPv@http://localhost/traderoom/glengine.js?v=1485951440.84:446769:5

dynCall_iiii@http://localhost/traderoom/glengine.js?v=1485951440.84:767912:9

dynCall@http://localhost/traderoom/glengine.js?v=1485951440.84:501:14

handlerFunc@http://localhost/traderoom/glengine.js?v=1485951440.84:2526:30

jsEventHandler@http://localhost/traderoom/glengine.js?v=1485951440.84:2429:11

If this abort() is unexpected, build with -s ASSERTIONS=1 which can give more information.Такое сообщение создаются если при компиляции использовать ключ -g. На нашем проекте размер выходного asm.js кода раза в 3 больше. Поэтому у нас используется --emit-symbol-map.

На выходе получаем файл с символами в простом формате key:value:

$cc:__ZNSt3__210__function6__funcIZN2F28ViewMain17animateLeftPannelEbE4__36NS_9allocatorIS4_EEFvvEEclEv

f8d:__ZNKSt3__210__function6__funcIZN2F218MVMessageQueueImpl4sendINS2_26EventSocialProfileReceivedEJiEEEvDpRKT0_EUlvE_NS_9allocatorISA_EEFvvEE7__cloneEPNS0_6__baseISD_EE

Z1:__ZN2F211recognizers24UIPinchGestureRecognizer6updateEPNS_9UIElementERKNS_6vec2_tIfEEjа сообщения теперь имеют вид:

Uncaught abort() at Error

at jsStackTrace (http://10.10.1.247:8080/main.js:1:17947)

at stackTrace (http://10.10.1.247:8080/main.js:1:18118)

at Object.abort (http://10.10.1.247:8080/main.js:12:6480)

at _abort (http://10.10.1.247:8080/main.js:1:37453)

at Eb (http://10.10.1.247:8080/main.js:5:22979)

at Xc (http://10.10.1.247:8080/main.js:5:53767)

at rc (http://10.10.1.247:8080/main.js:5:47782)

at Array.$c (http://10.10.1.247:8080/main.js:5:54228)

at Pc (http://10.10.1.247:8080/main.js:5:52663)

at Array.Wb (http://10.10.1.247:8080/main.js:5:40899)

If this abort() is unexpected, build with -s ASSERTIONS=1 which can give more information.Для получения получения стека вызовов была написана вспомогательная утилита:

#include Утилита использует demangle, для преобразования:

_ZN2F211recognizers24UIPinchGestureRecognizer6updateEPNS_9UIElementERKNS_6vec2_tIfEEjв

F2::recognizers::UIPinchGestureRecognizer::update(F2::UIElement*, F2::vec2_t const&, unsigned int) UI

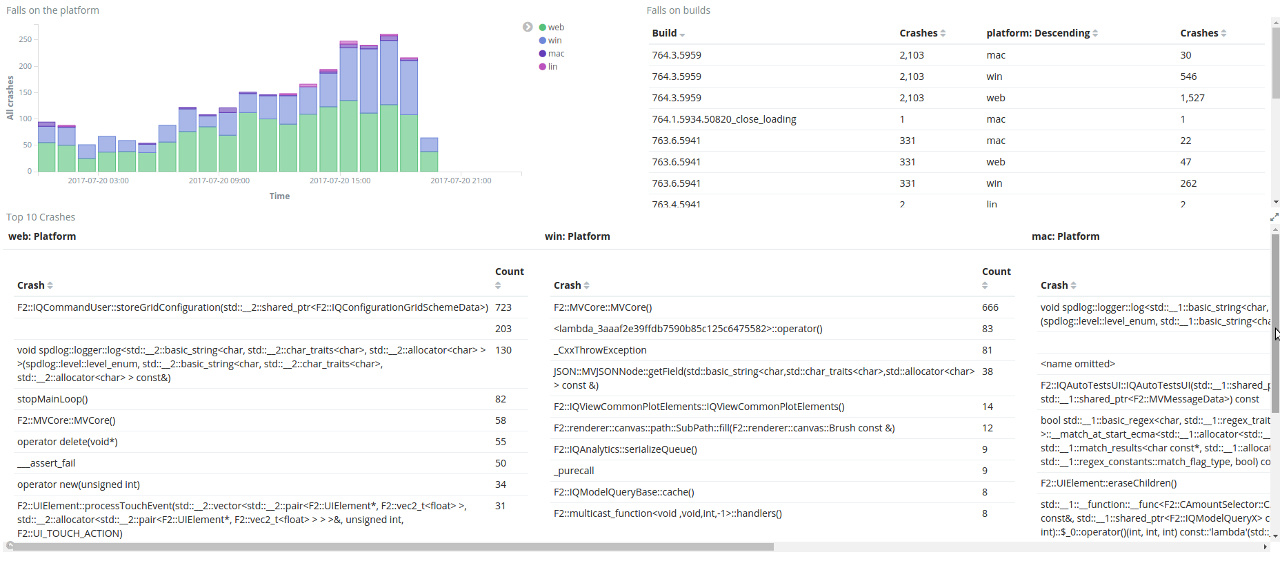

Отчеты о падении складываем в Elasticsearch, поэтому на первое время используем Kibana, как средство визуализации и анализа содержимого эластика.

При использовании кибаны получаем из коробки:

- дашборды с автоматическим обновлением;

- визуализации:

- грифики и диаграммы;

- таблицы.

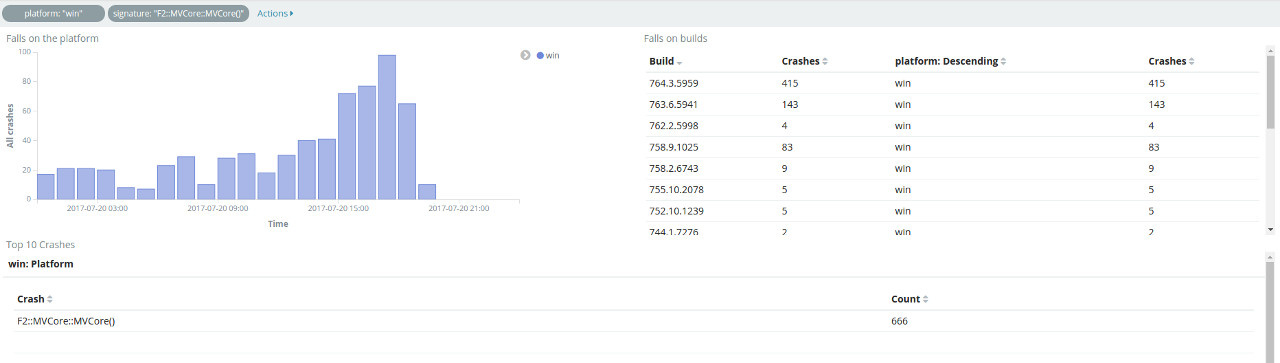

Дашборды группируют креши по платформе, билду, сигнатуре. Система фильтров позволяет узнать:

- в каких билдах встречается данный баг;

- на каких платформах воспроизводится.

Примененные фильтры можно перенести на вкладку discover, где можно посмотреть подробности падения. Как оказалось кибана имеет модульную структуру, что позволяет расширять её возможности. Был написан простой плагин, добавляющий рендер отчета, что намного удобней стандартного Table и JSon.

|

Метки: author RPG18 отладка c++ breakpad emscripten |

[Перевод] Куда уйти из IT: 3 сферы, которые нуждаются в технических специалистах |

Специалист по маркетингу из нью-йоркской рекрутинговой фирмы «The Hired Guns» Марк Нэйшн так прокомментировал проблему: «Существует много причин, по которым профессионал технического профиля может захотеть покинуть привычную среду обитания. Стартапы – это достаточно рискованно, однако в других отраслях вам могут предложить не только стабильную работу – возможно, именно там вы сможете реализоваться и – кто знает? – повлиять на будущее целого мира».

Рассмотрим 3 варианта возможного карьерного пути:

Сфера #1: Финансы

Если в финансах вы ну никак не разбираетесь, то самое время начать, — эта отрасль постоянно набирает обороты в своем развитии и становится лакомым кусочком для специалистов в сфере инновационных технологий. Например, финтех развивается семимильными шагами. Банки Северной Америки только за последний год потратили на финансовые технологии около 20 миллиардов долларов. Существует множество вариантов работы в данной отрасли, однако наиболее всего востребованы специалисты, занимающиеся мобильными приложениями, онлайн-платежами и безопасностью личных данных пользователей.

Java-разработчик

Финансовые учреждения должны быть доступны для всех клиентов, независимо от того, какую операционную систему или устройство они используют. Без специалистов в области Java это было бы просто невозможно. Без них трудно представить разработку программного обеспечения, поэтому профессия востребована. Будучи разработчиком Java, вы также сможете работать как с членами своей команды, так и с самими клиентами, что позволит получать обратную связь и определять личные бизнес-цели.

Что нужно для работы Java-разработчиком

- Специальность в области информатики или в аналогичной сфере

- Опыт работы с программами Hibernate или Spring

- Знание SQL, CSS или HTML5

- И бонусом будет опыт работы с клиентами и в команде.

Разработчик мобильных приложений

Если умеете создавать приложения для Android или iOS, то расслабьтесь — у вас всё будет хорошо :D Большинство крупных финансовых компаний работают над улучшением программного обеспечения в сфере мобильных технологий, а остальные стремятся наверстать упущенное и ухватить свой кусок пирога. Поэтому разработчики приложений в этой сфере пользуются большим спросом. Весомый плюс — тут не нужна научная степень в области компьютерных технологий – просто докажите, что вы в состоянии создать отличную программу для смартфона – и вуаля, цены вам нет.

Что нужно для работы IOS/Android-разработчиком

- Портфолио опубликованных приложений в магазине Google Play или магазине приложений Apple, который вы либо создали, либо дополнили

- Рабочие знания языков программирования на базе Android или iOS

- Бонусные баллы: опыт работы в рамках разработки Agile

Специалист по информационной безопасности

Самый страшный сон финансовых корпораций — нечаянно «выдать» личную информацию своих клиентов, поэтому неудивительно, что защита личных данных настолько важна для любой компании. Для обеспечения безопасности информации пользователей требуется определенный набор навыков, именно поэтому специалисты в данной сфере очень востребованны и никогда не останутся без работы.

Что нужно для работы специалистом по ИБ

- Опыт разработки и управления стратегиями в сфере кибербезопасности

- Знания в области информационной безопасности, особенно в финансовой сфере

- Умение работать со скриптами (Python, Ruby, Perl и т. д.)

- Опыт работы от 5 до 7 лет в области IT-безопасности

- Умение работать с методами выявления рисков и моделирования потенциальных киберугроз

- Бонусные баллы: навыки презентации и общения с клиентами

Сфера #2: Здравоохранение

Медицина давно использует информационные технологии: биоинформатика, ядерная медицина, компьютерная генетика. Теперь все специалисты в области медицины, начиная с местной поликлиники и заканчивая крупными больницами и госпиталями, полагаются на современные технологии, будь то роботизированная хирургия или систематизация медицинских данных.

Системный администратор

Как вам идея стать героем? Неплохо, верно? Значит, подумайте о том, чтобы подать резюме на должность системного администратора. Эти специалисты следят за производительностью и правильностью работы сложных компьютерных и телефонных систем, именно поэтому их должность пользуется спросом. Здесь не будет рутины, ведь никогда не придется заниматься одним и тем же на протяжении долгого. Возможно, в один прекрасный день вам придется восстанавливать базу данных, а в другой – установить новую операционную систему. Когда почтовый сервер больницы барахлит, а бухгалтер Маша что-то нажала и всё исчезло, системный администратор первый, к кому обратятся за помощью.

Что нужно для работы системным администратором

- Опыт установки и настройки ПО и прокси-серверов

- Опыт работы в смешанной операционной среде, например, в вариантах UNIX и Windows

- Знания в области сетевого администрирования

- Степень бакалавра в области информатики или информационных технологий

- Бонусные баллы: опыт работы и умение помогать технически неграмотным коллегам

Специалист по анализу данных

Если работа с данными относится к сфере ваших знаний, рассмотрите вариант работы аналитиком в сфере здравоохранении, где будете оценивать, компилировать и проверять большое количество медицинской информации. Вы будете систематизировать все, начиная с историй болезни пациентов и заканчивая общей информацией по работе всего учреждения, также вам придется готовить отчеты, которые помогут руководству больницы принимать обоснованные решения. Вы даже сможете использовать свои навыки, чтобы помочь начальнику более эффективно помогать своим пациентам.

Что нужно для работы специалистом по анализу данных

- Отличное понимание статистического анализа и опыт работы в этой сфере

- Опыт работы с приложениями машинного обучения

- Знание базы данных, работающей на платформах SQL или Hive

- Знание инструментов анализа данных, таких как SAS

- Отличные навыки работы с Excel

- Бонусные баллы: способность писать профессиональные отчеты и документы для сотрудников

Сфера #3: Образование

Если технологии в образовании наводят на мысль о допотопном компьютерном классе в стенах вашей родной школы, значит, пришло время пересмотреть свои взгляды на сферу образования. На самом деле, это многомиллиардный рынок, и развитие данной области с каждым годом только набирает обороты. Если сами любите учиться, подумайте, как вы можете использовать свои технические навыки, чтобы помочь молодым людям получать образование и развиваться.

UX–дизайнер

Чтобы быть эффективной, технология обучения должна быть интересной и насыщенной знаниями одновременно. Эксперт в области образования будет заниматься «информационной» частью, а вот заинтересовать потенциального ученика — это уже задача UX-дизайнера. Эти специалисты занимаются разработкой инструментов образования, которые должны быть легкими в использованиями и интересными. Они проводят разнообразные тестирования пользователей и используют эти данные для оптимизации приложений. В данной сфере есть много технических аспектов, таких как каркасное моделирование и разработка макетов, кроме того, вы можете столкнуться с элементами дизайна и психологической работы.

Что нужно для работы UX-дизайнером

1. Опыт проектирования и опыт в сфере взаимодействия с пользователями

2. Опыт работы с мобильным дизайном

3. Умение воплощать бизнес-цели в программном обеспечении

4. Навыки в сфере письменной и визуальной коммуникации

5. Бонусные очки: навык работы в сфере графического дизайна

Менеджер по продукции

Если вы в большей степени обладаете стратегическим, а не тактическим мышлением, рассмотрите вариант работы в сфере управления. Многие компании имеют несколько менеджеров по продукции, каждый из которых контролирует определенный сегмент программного продукта. Ваша основная задача – перевести бизнес-цели и потребности клиентов в готовое ПО. От вас требуется обозначить возможные стратегии развития и помочь команде разработчиков воплотить идею в жизнь.

Что нужно для работы менеджера по продукции

- Опыт работы менеджером по продукции или внутренним предпринимателем в компании

- Возможность выделять и анализировать потребности бизнес-структуры и клиентов, а затем переводить их в план-график проекта разработки программного обеспечения

- Навыки работы с Agile

- Бонусные баллы: умение находить общий язык с сотрудниками и клиентами и способность работать в нескольких командах

Мы перечислили всего лишь несколько отраслей, в рамках которых растет спрос на технических специалистов, поэтому не забудьте изучить все предложенные отрасли производства. В конце концов, там гораздо больше возможностей самореализации, чем на сайтах по поиску работы и в статьях про идеи для стартапов.

Перевод выполнен с любовью, оригинал смотрите тут: goo.gl/JxDMcY

|

Метки: author ksusha_icc исследования и прогнозы в it блог компании icanchoose.ru карьера выбор карьеры карьера в it начало карьеры |

«Познай самого себя»: social media mining-проекты в Университете ИТМО |

/ Фотография perzon seo CC-BY

/ Фотография perzon seo CC-BY«Что хочет покупатель»: профилирование в соцсетях

Этим проектом занималась группа магистрантов кафедры Компьютерных технологий Университета ИТМО во время стажировки в Национальном университете Сингапура. Задача проекта — создать систему, которая помогала бы компаниям лучше разбираться в потребностях их аудитории — с учетом того, что эта аудитория рассказывает о себе в социальных сетях.

Пример: компания хочет разобраться в том, что объединяет людей, довольных (или, наоборот, недовольных) ее продуктом. Разработка студентов Университета ИТМО позволяет сформировать портрет такого [довольного/недовольного] покупателя по данным из социальных сетей, и предложить подходящее решение: кого-то может заинтересовать скидка, а кому-то понадобится предложить другой продукт.

Как это работает: алгоритм, предложенный командой Университета ИТМО, анализирует открытые данные, которые оставляет пользователь социальных сетей: метки геолокации, общедоступные сообщения, фотографии и подписи к ним. Эти данные преобразуются в набор параметров (средний размер твита, наиболее частые объекты на фото, распределение чекинов и т.д.), который далее передается нейронной сети.

Результат ее работы зависит от поставленной задачи: в некоторых случаях необходимо оценить эмоциональную окраску сообщений, в других — составить более полную картину о выбранном типе пользователя и их вкусах по результатам анализа данных из нескольких социальных сетей. При этом речь идет не о работе с отдельными пользователями, а о формировании наборов атрибутов, которые будут характеризовать целые группы людей.

О чем говорит Twitter Дональда Трампа

Более ранняя разработка магистрантов Университета ИТМО, работавших над проектом профилирования потребителей, — система, угадывающая семейное положение человека по данным из Twitter, Instagram и Foursquare. По данным исследователей, комбинация из трех соцсетей обеспечивает точность предсказания до 86%, в то время как по информации только из одной соцести алгоритм угадывает семейное положение с точностью на 17% ниже.

Правда, многое в данном случае зависит и от того, кто и как заявляет о себе в соцсетях — например, Twitter Дональда Трампа «сообщает», что его владелец — холостяк. Исследователи предположили: полученный результат связан с тем, что основную работу по ведению Twitter-аккаунта выполняет не сам президент, а его PR-менеджер.

Кстати, по итогам данного исследования программисты Университета ИТМО выступили с докладом на конференции AAAI по искусственному интеллекту (AAAI Conference on Artificial Intelligence, AAAI-2017), которая объединяет ученых, занимающихся вопросами создания и обучения ИИ.

Эмоции и безопасность: как почувствовать настроение толпы

Еще один пример исследования, в основе которого лежат данные соцсетей, — система анализа эмоций, разработка сотрудников НИИ наукоемких компьютерных технологий (НИИ НКТ) Университета ИТМО.

Как это работает: выражения лиц на фотографиях сравниваются с восемью базовыми эмоциями — это злоба, пренебрежение, нейтральное состояние, печаль, удивление, счастье и грусть. В основе алгоритма распознавания эмоций также лежат сверточные нейронные сети. Для повышения точности работы алгоритма исследователи могут использовать результаты оценки части фотографий «вручную» — самими пользователями.

При этом алгоритм распознает не только «картинку», но и эмоциональный настрой текстовых сообщений: в первоначальном исследовании использовались данные из социальных сетей Facebook, Twitter и «Вконтакте», визуальная и текстовая составляющая постов оценивалась комплексно. Кроме того, исследователи могут задать «уточняющие условия» — например, оценивать материалы с привязкой к определенной локации.

Результат работы так же, как и в случае с профилированием аккаунтов, зависит от текущей исследовательской задачи: так, первый запуск системы в детском лагере «Сириус» позволил создать инновационный стенд — по материалам пользователей соцсетей он показывал, какие эмоции вызывает у людей тот или иной объект или место на карте в пределах Сочи, Красной поляны и Адлера.

Другой пример использования алгоритма — возможность распознать очаги напряженности на футбольных матчах (о том, какие еще разработки Университета ИТМО были использованы при подготовке к Кубку конфедераций и предстоящему ЧМ-2018, мы рассказывали здесь).

В этом случае исследователи ограничились соцсетью Instagram и анализировали фотографии, которые болельщики публиковали во время матчей. Выяснилось, что на фото с матчей, во время которых были зафиксированы драки, алгоритм в два раза чаще находит «злобных болельщиков» (по сравнению с матчами, в ходе которых драк не возникало).

За экстремальные ситуации, помимо драк, также считались использование пиротехники, бросание предметов на трибуны и поле стадиона, демонстрация оскорбительных баннеров, скандирование нетолерантных кричалок и другое. Мы рассматривали матчи [ФК «Зенит»] в период с 2013 по 2015 годы. Получилось около десяти игр, после чего мы брали и другие команды.

Всего матчей с драками было немного, но, когда мы стали работать с официальной статистикой Российского футбольного союза и смотрели не только драки, но и на иные события, которые могут угрожать здоровью и состоянию болельщиков, [выяснилось, что] за три сезона из 700 матчей с экстремальными событиями на трибунах прошло около половины игр.

– Василий Бойчук, инженер НИИ НКТ

Социальные сквозняки и распространение информации

Другая разработка НИИ НКТ, использующая данные соцсетей, — система поиска «социальных сквозняков» и оценки общественного мнения. Этот проект позволяет в соответствии с заданной стратегией проанализировать общедоступные материалы пользователей «Вконтакте», Twitter, Instagram, Live Journal, определить наиболее важные содержательные элементы, тему и эмоциональный настрой сообщения и разметить пост в соответствии с заданными характеристиками, включая количество лайков, репостов, цитирований, комментариев и т.д.

Этот подход позволяет в дальнейшем выстроить граф связей по выбранному критерию и спрогнозировать распространение информации по такому графу. Система умеет отличать реальных пользователей от ботов и может оценить «социальный вес» пользователя — в том числе понять, является ли он лидером мнений в той или иной социальной группе.

Панчи, скетчи, вайны

Социальные сети могут не только рассказать о точках напряженности в обществе и существующих проблемах. Не менее часто пользователи делятся со своими друзьями тем, что вызывает у них вдохновение, интерес или просто улыбку. Поэтому для посетителей фестивалей VK Fest и Geek Picnic Университет ИТМО часто готовит демонстрацию своих разработок в неклассическом — развлекательном формате.

Так, например, исследование по анализу эмоций было продемонстрировано на VK Fest в прошлом году — посетители, пришедшие тогда в Парк 300-летия, могли видеть «интерактивную картину» фестиваля: наиболее интересные места, самые популярные площадки для фото и т.д. Вся информация, естественно, менялась в соответствии с тем, что рассказывали о фестивале пользователи «Вконтакте» на своих страницах.

Ричард Докинз. Фотография Университета ИТМО

А для фестиваля Geek Picnic-2017 Университет ИТМО подготовил еще один пример анализа соцсетей — мемокуб с самыми узнаваемыми мемами: от «Wat» до всем известного кадра из «Великого Гэтсби». Рядом с ним состоялась автограф-сессия хедлайнера фестиваля, эволюционного биолога и популяризатора науки Ричарда Докинза.

Кстати, на фестиваль Geek Picnic Университет ИТМО привез не только мемокуб, но и многие свои разработки — от системы работы умного дома до функциональной еды. О том, чем еще запомнилась посетителям Geek Picnic интерактивная зона Университета — читайте здесь.

|

Метки: author itmo разработка под e-commerce блог компании университет итмо университет итмо social media mining анализ данных |

[Перевод] Полезные команды и советы при работе с Kubernetes через консольную утилиту kubectl |

Kubectl — инструмент, который знаком пользователям Kubernetes и обладает широкими функциональными возможностями. Овладение ими занимает время, но позволяет увидеть, что это более мощный инструмент, чем многие предполагали. Представляю набор советов, позволяющих улучшить ваши возможности при работе с

kubectl. Не забудьте также посмотреть на cheat sheet в секции официальной документации Kubernetes!Автоматическое дополнение в shell

В

kubectl есть отличное встроенное автодополнение для bash и zsh, что значительно упрощает работу с командами, флагами и объектами вроде пространств имён и названий подов. В документации есть готовые инструкции по его включению. А GIF-анимация ниже показывает, как автодополнение работает:

# Подключить код автодополнения для текущего сеанса в Bash

source <(kubectl completion bash)

# … или добавить код автодополнения в файл и подключить его к .bashrc

mkdir ~/.kube

kubectl completion bash > ~/.kube/completion.bash.inc

printf "\n# Kubectl shell completion\nsource '$HOME/.kube/completion.bash.inc'\n" >> $HOME/.bashrc

source $HOME/.bashrc

# Альтернатива — подключить код автодополнения для текущего сеанса в Zsh

source <(kubectl completion zsh)Слияние конфигов с контекстами через KUBECONFIG

Слияние конфигураций Kubernetes — популярный паттерн, если вы взаимодействуете со множеством кластеров Kubernetes. При работе с разными конфигами используется концепция контекста (

context), указывающего на параметры, которые kubectl будет использовать для поиска конкретного, целевого кластера. Но добиться нужного результата с контекстами бывает сложно. Чтобы упростить себе жизнь, воспользуйтесь переменной окружения KUBECONFIG — она позволяет указать на конфигурационные файлы, которые используются при слиянии. Подробнее о KUBECONFIG можно прочитать в официальной документации.Например, у вас есть два конфига Kubernetes для разных кластеров, и требуется провести их слияние.

Конфиг первого кластера:

$ kubectl config view --minify > cluster1-configapiVersion: v1

clusters:

- cluster:

certificate-authority: cluster1_ca.crt

server: https://cluster1

name: cluster1

contexts:

- context:

cluster: cluster1

user: cluster1

name: cluster1

current-context: cluster1

kind: Config

preferences: {}

users:

- name: cluster1

user:

client-certificate: cluster1_apiserver.crt

client-key: cluster1_apiserver.keyКонфиг второго кластера:

$ cat cluster2-configapiVersion: v1

clusters:

- cluster:

certificate-authority: cluster2_ca.crt

server: https://cluster2

name: cluster2

contexts:

- context:

cluster: cluster2

user: cluster2

name: cluster2

current-context: cluster2

kind: Config

preferences: {}

users:

- name: cluster2

user:

client-certificate: cluster2_apiserver.crt

client-key: cluster2_apiserver.keyИх слияние можно выполнить с помощью

KUBECONFIG. Преимуществом такого слияния станет возможность динамически переключаться между контекстами. Контекст — это «сопоставление» (map), включающее в себя описания кластера и пользователя, а также название, с помощью которого на конфигурацию можно ссылаться для аутентификации кластера и взаимодействия с ним. Флаг --kubeconfig позволяет посмотреть на контекст для каждого файла:$ kubectl --kubeconfig=cluster1-config config get-contexts

CURRENT NAME CLUSTER AUTHINFO NAMESPACE

* cluster1 cluster1 cluster1

$ kubectl --kubeconfig=cluster2-config config get-contexts

CURRENT NAME CLUSTER AUTHINFO NAMESPACE

* cluster2 cluster2 cluster2У каждого конфигурационного файла есть единственный контекст, так что они не конфликтуют между собой. Слияние двух файлов через

KUBECONFIG показывает оба контекста. Для сохранения текущего контекста создайте новый пустой файл с названием cluster-merge:$ export KUBECONFIG=cluster-merge:cluster-config:cluster2-config

dcooley@lynx ~

$ kubectl config get-contexts

CURRENT NAME CLUSTER AUTHINFO NAMESPACE

* cluster1 cluster1 cluster1

cluster2 cluster2 cluster2Список файлов, экспортируемых с

KUBECONFIG, загружается в строгом порядке. Поэтому контекст, который выбирается, соответствует указанному как current-context в первом конфиге. Изменение контекста на cluster2 смещает знак текущего (*) к этому контексту в списке, и команды kubectl начинают применяться к этому (второму) контексту:$ kubectl config get-contexts

CURRENT NAME CLUSTER AUTHINFO NAMESPACE

* cluster1 cluster1 cluster1

cluster2 cluster2 cluster2

$ kubectl config use-context cluster2

Switched to context "cluster2".

$ kubectl config get-contexts

CURRENT NAME CLUSTER AUTHINFO NAMESPACE

cluster1 cluster1 cluster1

* cluster2 cluster2 cluster2

$ cat cluster-mergeapiVersion: v1

clusters: []

contexts: []

current-context: cluster2

kind: Config

preferences: {}

users: []Остаётся только поддерживать правильное значение

current-context. Использовать контексты Kubernetes и осуществлять их слияние можно разными способами. Например, вы можете создать контекст (cluster1_kube-system), который будет определять пространство имён (kube-system) для всех исполняемых команд kubectl:$ kubectl config set-context cluster1_kube-system --cluster=cluster1 --namespace=kube-system --user=cluster1

Context "cluster1_kube-system" set.

$ cat cluster-mergeapiVersion: v1

clusters: []

contexts:

- context:

cluster: cluster1

namespace: kube-system

user: cluster1

name: cluster1_kube-system

current-context: cluster2

kind: Config

preferences: {}

users: []Новый контекст можно использовать так:

$ kubectl config use-context cluster1_kube-system

Switched to context "cluster1_kube-system".

$ kubectl get pods

NAME READY STATUS RESTARTS AGE

default-http-backend-fwx3g 1/1 Running 0 28m

kube-addon-manager-cluster 1/1 Running 0 28m

kube-dns-268032401-snq3h 3/3 Running 0 28m

kubernetes-dashboard-b0thj 1/1 Running 0 28m

nginx-ingress-controller-b15xz 1/1 Running 0 28mИзучение Kubernetes API

Чтобы узнать больше о возможностях, предоставляемых Kubernetes API, запросите файл

swagger.json:$ kubectl proxy

$ curl -O 127.0.0.1:8001/swagger.jsonМожно также зайти на

http://localhost:8001/api/ и посмотреть на имеющиеся в Kubernetes API пути.Поскольку

swagger.json — это документ в формате JSON, можно его просмотреть с помощью jq. Утилита jq — лёгкий обработчик JSON-файлов, позволяющий выполнять сравнения и другие операции. Подробнее читайте здесь.Просмотр

swagger.json поможет понять Kubernetes API. Это сложный API, функции в котором разбиты на группы, что затрудняет его восприятие:$ cat swagger.json | jq '.paths | keys[]'

"/api/"

"/api/v1/"

"/api/v1/configmaps"

"/api/v1/endpoints"

"/api/v1/events"

"/api/v1/namespaces"

"/api/v1/nodes"

"/api/v1/persistentvolumeclaims"

"/api/v1/persistentvolumes"

"/api/v1/pods"

"/api/v1/podtemplates"

"/api/v1/replicationcontrollers"

"/api/v1/resourcequotas"

"/api/v1/secrets"

"/api/v1/serviceaccounts"

"/api/v1/services"

"/apis/"

"/apis/apps/"

"/apis/apps/v1beta1/"

"/apis/apps/v1beta1/statefulsets"

"/apis/autoscaling/"

"/apis/batch/"

"/apis/certificates.k8s.io/"

"/apis/extensions/"

"/apis/extensions/v1beta1/"

"/apis/extensions/v1beta1/daemonsets"

"/apis/extensions/v1beta1/deployments"

"/apis/extensions/v1beta1/horizontalpodautoscalers"

"/apis/extensions/v1beta1/ingresses"

"/apis/extensions/v1beta1/jobs"

"/apis/extensions/v1beta1/networkpolicies"

"/apis/extensions/v1beta1/replicasets"

"/apis/extensions/v1beta1/thirdpartyresources"

"/apis/policy/"

"/apis/policy/v1beta1/poddisruptionbudgets"

"/apis/rbac.authorization.k8s.io/"

"/apis/storage.k8s.io/"

"/logs/"

"/version/"А вот следующая команда описывает API, доступные в кластере Kubernetes и к которым у вас есть доступ. Команда в примере ниже выполнена под пользователем-администратором. Если у вас включён контроль доступа по RBAC, вывод может отличаться:

$ kubectl api-versions

apps/v1beta1

authentication.k8s.io/v1beta1

authorization.k8s.io/v1beta1

autoscaling/v1

batch/v1

batch/v2alpha1

certificates.k8s.io/v1alpha1

coreos.com/v1

etcd.coreos.com/v1beta1

extensions/v1beta1

oidc.coreos.com/v1

policy/v1beta1

rbac.authorization.k8s.io/v1alpha1

storage.k8s.io/v1beta1

v1Команда

kubectl explain помогает лучше понять, что делают разные компоненты API:$ kubectl explain

You must specify the type of resource to explain. Valid resource types include:

* all

* certificatesigningrequests (aka 'csr')

* clusters (valid only for federation apiservers)

* clusterrolebindings

* clusterroles

* componentstatuses (aka 'cs')

* configmaps (aka 'cm')

* daemonsets (aka 'ds')

* deployments (aka 'deploy')

* endpoints (aka 'ep')

* events (aka 'ev')

* horizontalpodautoscalers (aka 'hpa')

* ingresses (aka 'ing')

* jobs

* limitranges (aka 'limits')

* namespaces (aka 'ns')

* networkpolicies

* nodes (aka 'no')

* persistentvolumeclaims (aka 'pvc')

* persistentvolumes (aka 'pv')

* pods (aka 'po')

* poddisruptionbudgets (aka 'pdb')

* podsecuritypolicies (aka 'psp')

* podtemplates

* replicasets (aka 'rs')

* replicationcontrollers (aka 'rc')

* resourcequotas (aka 'quota')

* rolebindings

* roles

* secrets

* serviceaccounts (aka 'sa')

* services (aka 'svc')

* statefulsets

* storageclasses

* thirdpartyresources

error: Required resource not specified.

See 'kubectl explain -h' for help and examples.Попробуйте выполнить

kubectl explain deploy. Команда explain работает с разными уровнями вложенности, что позволяет вам также ссылаться на зависимые объекты:$ kubectl explain deploy.spec.template.spec.containers.livenessProbe.exec

RESOURCE: exec

DESCRIPTION:

One and only one of the following should be specified. Exec specifies the

action to take.

ExecAction describes a "run in container" action.

FIELDS:

command <[]string>

Command is the command line to execute inside the container, the working

directory for the command is root ('/') in the container's filesystem. The

command is simply exec'd, it is not run inside a shell, so traditional shell

instructions ('|', etc) won't work. To use a shell, you need to explicitly

call out to that shell. Exit status of 0 is treated as live/healthy and

non-zero is unhealthy.Операции с подами через kubectl

Все последующие примеры используют Kubernetes API, чтобы узнать что-либо о подах. Одним из способов получения нужных данных — построить запрос и понять, какое его выражение потребуется в терминах

jsonpath. Например, можно выполнить kubectl get pods --all-namespaces -o json, чтобы увидеть весь вывод, из которого мы можем потом отфильтровать нужные данные для примера с сортировкой подов по времени (см. ниже).Если у вас нет запущенного приложения, для знакомства с примерами можно создать поды с лейблом run=shop и запустить их как сервис на порту 80:

$ kubectl run shop --replicas=2 --image quay.io/coreos/example-app:v1.0 --port 80 --exposeТеперь можно посмотреть, что мы будем делать с

jsonpath. Более подробную информацию по нему можно получить из официальной документации.Фильтрация подов Kubernetes по времени их создания

$ kubectl get pods --all-namespaces --sort-by='.metadata.creationTimestamp' -o jsonpath='{range .items[]}{.metadata.name}, {.metadata.creationTimestamp}{"\n"}{end}'Поиск пода Kubernetes по селектору лейбла и просмотр его логов

Укажите пространство имён (

your-namespace) и свой запрос на наличие лейбла, который поможет найти нужные поды, и получите логи этих подов. Если под не единственный, логи будут получены из всех подов параллельно:$ ns='' label='=' kubectl get pods -n $ns -l $label -o jsonpath='{range .items[]}{.metadata.name}{"\n"}{end}' | xargs -I {} kubectl -n $ns logs {} Поиск пода Kubernetes по селектору лейбла и подключение к нему

Укажите пространство имён (

your-namespace) и свой запрос на наличие лейбла, который поможет найти нужные поды, и подключитесь к нему по имени (к первому из найденных подов). Замените 8080 на нужный порт пода:$ ns='' label='=' kubectl -n $ns get pod -l $label -o jsonpath='{.items[1].metadata.name}' | xargs -I{} kubectl -n $ns port-forward {} 8080:80 Операции с узлами (нодами) через kubectl

Комбинация

jq и JSON-вывода kubectl позволяет делать сложные запросы, такие как фильтрация всех ресурсов по времени их создания.Подсчёт количества подов в узле Kubernetes

Зачастую высокоуровневая статистика помогает в отладке. Эта команда подсчитает количество всех подов на каждом из узлов:

$ kubectl get pods --all-namespaces -o json | jq '.items[] | .spec.nodeName' -r | sort | uniq -cФильтрация узлов по лейблу

Запросы с лейблами можно использовать и для узлов. Такой подход часто применяется при конфигурации deployments, нуждающихся в определённых ограничениях. Для получения подробной информации о селекторах смотрите вывод

kubectl explain deployment.spec.selector.$ kubectl get nodes -l 'master' or kubectl get nodes -l '!master'Вывести все лейблы можно с помощью аргумента

--show-labels для любого объекта Kubernetes:$ kubectl get nodes --all-namespaces --show-labelsСписок всех подов для каждого узла

Генерируется JSON-документ с названием узла Kubernetes и список всех названий подов, запущенных на этом узле. Очень полезная команда при отладке:

$ kubectl get pods --all-namespaces -o json | jq '.items | map({podName: .metadata.name, nodeName: .spec.nodeName}) | group_by(.nodeName) | map({nodeName: .[0].nodeName, pods: map(.podName)})'Получение внешних IP для узлов Kubernetes

$ kubectl get nodes -o jsonpath='{range .items[]}{.metadata.name} {.status.addresses[?(@.type=="ExternalIP")].address}{"\n"}{end}'Примечание: Читайте в нашем блоге перевод другой статьи от CoreOS про работу с Kubernetes из консоли: «Автоматизация SSH-доступа к нодам Kubernetes с помощью Fabric и интеграции от CoreOS», а также заметку «Полезные утилиты при работе с Kubernetes» (в ней представлены преимущественно консольные инструменты).

Источники

- «Kubernetes kubectl Tips and Tricks» (Duffie Cooley из CoreOS, 15 мая 2017 г.)

- «Kubectl Unix Pipes: Manage Multiple Clusters With Ease» (Duffie Cooley из CoreOS, 8 июня 2017 г.)

|

Метки: author shurup системное администрирование devops *nix блог компании флант kubernetes kubectl bash |

[recovery mode] Маршрутизация входящих вызовов в 3CX в зависимости от времени суток |

Введение

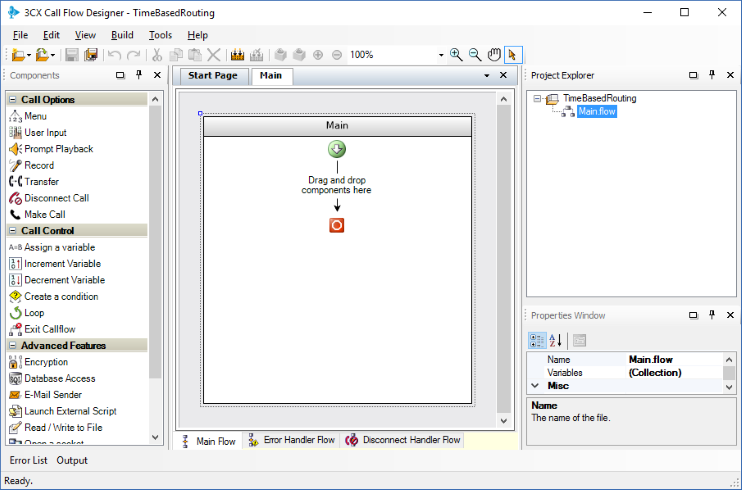

В этой статье мы покажем, как создавать голосовое приложение 3CX Call Flow Designer, которое маршрутизирует входящие вызовы с 3CX в зависимости от времени суток.

Такая функция весьма востребована, если нужно сообщать звонящим разные приветственные сообщения в зависимости от времени суток, либо направлять абонентов в Очереди обслуживания на разных языках, в зависимости от времени звонка.

Это простое приложение поможет вам освоиться в среде разработки и получить базовые навыки использования CFD.

Обратите внимание — утилита 3CX CFD бесплатно доступна для пользователей 3CX Phone System Pro.

Для вашего удобства, 3CX включила это приложение в набор демо-приложений CFD. Вы можете открыть и изучить его более детально. Готовый рабочий проект приложения размещается в папке Documents\3CX Call Flow Designer Demos при установке CFD.

Создание проекта

Создадим новый проект CFD. Откройте среду разработки, перейдите в File > New > Project, укажите папку, где будет сохранен проект, и укажите имя проекта, например, TimeBasedRouting.

Добавьте компонент Create a condition

Чтобы добавить компонент:

- Перетащите компонент Create a condition из Панели компонентов слева в рабочую область под зеленую стрелку, оборзачающую начало работы голосового приложения. Дайте компоненту понятное название, например, selectTimeRange. Для этого кликните по компоненту и измените название в правом нижнем окне Properties Window.

- Создайте 4 ветвления приложения и назовите их from0to9, from9to12, from12to18 и from18to0. Для этого кликните по компоненту правой кнопкой мыши и выберите Add branch.

- Теперь для каждого ветвления следует создать соответствующие условия. Условия — это логические выражения на C#, которые должны вернуть ИСТИНУ, чтобы сработал компонент, находящийся внутри ветвления (визуально — под условием). Условия проверяются слева направо, т.е. если первое условие вернуло ЛОЖЬ, проверяется второе условие и т.д. Определим условия:

- Для ветвления from0to9: DateTime.Now.Hour < 9

- Для ветвления from9to12: DateTime.Now.Hour >= 9 && DateTime.Now.Hour < 12

- Для ветвления from12to18: DateTime.Now.Hour >= 12 && DateTime.Now.Hour < 18

- Для ветвления from18to0: оставляем пустым. Это ветвление будет выполняться, если не “сработали” другие ветвления.

Добавьте компоненты Transfer

Создав условия для ветвлении, добавим в каждое ветвление компонент Transfer. Таким образом, при “срабатывании” условия, вызов будет переводиться на соответствующий добавочный номер.

Для этого перетащите компонент Transfer в каждое из ветвлений. Настройте каждый компонент для перевода вызова на разный добавочный номер. Для этого кликните на компоненте и установите свойство Destination на добавочные номера 101, 102, 103 и 104, соответственно.

Свойство Destination — это выражение, поэтому, если вы указываете здесь константу, она должна быть взята в скобки. Обратите внимание, что в Destination можно указывать и переменные, и вычисляемые выражения.

Компиляция и установка приложения на сервер 3CX

Голосовое приложение готово! Теперь его следует скомпилировать и загрузить на сервер 3CX. Для этого:

- Перейдите в меню Build > Build All,и CFD создаст файл TimeBasedRouting.tcxvoiceapp.

- Перейдите в интерфейс управления 3CX, в раздел Очереди вызовов. Создайте новую Очередь вызовов, укажите название и добавочный номер Очереди, а затем установите опцию Голосовые приложения и загрузите скомпилированный файл.

- Сохраните изменения в Очереди вызовов. Голосовое приложение готово к работе. Теперь, при поступлении вызова на эту Очередь, он будет переведен на соответствующий добавочный номер в зависимости от времени суток.

Вы можете проверить работу приложения, позвонив на добавочный номер Очереди, либо направив на эту Очередь вызовы с внешних транков.

Загрузки и документация

|

|

Квантовый протокол распределения ключей BB84 |

|

Метки: author vlsergey криптография квантовая криптография bb84 учебник |

Тестирование БД мобильного Delphi-приложения |

|

Метки: author SergeyPyankov тестирование мобильных приложений firebird/interbase delphi dunitx iblite firemonkey |

Дайджест свежих материалов из мира фронтенда за последнюю неделю №272 (17 — 23 июля 2017) |

| Веб-разработка |

| CSS |

| Javascript |

| Браузеры |

| Занимательное |

Веб-разработка

Веб-разработка

- CSSSR Garbage Collector #1: Еженедельная подборка ссылок из чатов CSSSR на интересные материалы.

Разбираемся с Shadow DOM

Разбираемся с Shadow DOM Измерение веб производительности; это довольно просто на самом деле

Измерение веб производительности; это довольно просто на самом деле  Размышления по поводу HTTP/2 и бандлинга

Размышления по поводу HTTP/2 и бандлинга О нюансах использования Inline SVG на продакшене. Продолжение популярной статьи двухлетней давности

О нюансах использования Inline SVG на продакшене. Продолжение популярной статьи двухлетней давности- Медиа:

HTML Шорты: Как прятать. display: none или visibility: hidden?

HTML Шорты: Как прятать. display: none или visibility: hidden? Подкаст «Frontend Weekend» FW #12: Ведущий «Пятиминутки React» про подкастинг и фреймворки

Подкаст «Frontend Weekend» FW #12: Ведущий «Пятиминутки React» про подкастинг и фреймворки Подкаст «Пятиминутка React» #26: Preact Rocks!

Подкаст «Пятиминутка React» #26: Preact Rocks! Подкаст «Фронтёрки» #8: Шебанов, зависимые типы, ВК

Подкаст «Фронтёрки» #8: Шебанов, зависимые типы, ВК Подкаст «Фронтенд Юность» #10: Как убивали JavaScript!

Подкаст «Фронтенд Юность» #10: Как убивали JavaScript!

- AMP/PWA:

Как сделать Progressive Web Apps: руководство новичка

Как сделать Progressive Web Apps: руководство новичка

Комьюнити выбрало официальный неофициальный логотип для Progressive Web Apps

Комьюнити выбрало официальный неофициальный логотип для Progressive Web Apps

Подробное руководство для новичков по PWA

Подробное руководство для новичков по PWA

Gulp и верстка простой AMP страницы, стрим Юрия Артюха ALL YOUR HTML #8

Gulp и верстка простой AMP страницы, стрим Юрия Артюха ALL YOUR HTML #8

Как использовать AMP в WordPress

Как использовать AMP в WordPress

Как Accelerated Mobile Pages (AMP) могут улучшить вам SEO

Как Accelerated Mobile Pages (AMP) могут улучшить вам SEO

- Инструменты:

WebStorm 2017.2 – что нового в поддержке JavaScript, TypeScript, Angular и Sass и работе с ESLint, Karma и Mocha

WebStorm 2017.2 – что нового в поддержке JavaScript, TypeScript, Angular и Sass и работе с ESLint, Karma и Mocha  npm link на стероидах

npm link на стероидах- Webpack: основы настройки проекта на JavaScript и Sass

Как использовать Polymer Webpack

Как использовать Polymer Webpack

bundle-buddy — инструмент, который поможет найти дубликаты в ваших бандлах

bundle-buddy — инструмент, который поможет найти дубликаты в ваших бандлах

- Практика:

Создание прогрессивного веб-приложения «Тренды Git»: Концепты и Service Workers, Кеширование и Оффлайн

Создание прогрессивного веб-приложения «Тренды Git»: Концепты и Service Workers, Кеширование и Оффлайн Создание графики на HTML Canvas: новый бесплатный курс на egghead.io

Создание графики на HTML Canvas: новый бесплатный курс на egghead.io Из грязи в князи, создание WebVR интерактива с помощью Babylon.js для всех платформ

Из грязи в князи, создание WebVR интерактива с помощью Babylon.js для всех платформ Создание вращающейся 3D карусели на CSS и JavaScript

Создание вращающейся 3D карусели на CSS и JavaScript GreenSock для новичков (часть 2): GSAP’s Timeline

GreenSock для новичков (часть 2): GSAP’s Timeline

- Эффектный веб:

Слайдер изображений на CSS с использованием шаблонов SVG

Слайдер изображений на CSS с использованием шаблонов SVG

Адаптивный анимированный дом на CSS

Адаптивный анимированный дом на CSS

LEGO Loader (SVG анимация)

LEGO Loader (SVG анимация)

CSS

CSS

CSS — это не чёрная магия

CSS — это не чёрная магия Как создать эффект матового стекла на чистом CSS?

Как создать эффект матового стекла на чистом CSS? Let's Get Critical: минимизация блокирующего рендер CSS с помощью Webpack

Let's Get Critical: минимизация блокирующего рендер CSS с помощью Webpack

Использование CSS для определения и подсчета простых чисел

Использование CSS для определения и подсчета простых чисел

Отключаем возможность зума в Google Maps iframe

Отключаем возможность зума в Google Maps iframe- Шрифты:

4 техники для задания отзывчивых размеров шрифта с помощью

4 техники для задания отзывчивых размеров шрифта с помощью RFS: миксин, автоматизирующий использование отзывчивой типографики

RFS: миксин, автоматизирующий использование отзывчивой типографики Что для веб-разработчиков означают вариабельные шрифты?

Что для веб-разработчиков означают вариабельные шрифты?

- CSS Grid Layout:

Коллекция интересных фактов о CSS Grid Layout

Коллекция интересных фактов о CSS Grid Layout Слайдшоу на CSS Grid Layout

Слайдшоу на CSS Grid Layout Rachel Andrew о причинах возникновения спецификации гридов и о проблемах, которые они решают

Rachel Andrew о причинах возникновения спецификации гридов и о проблемах, которые они решают display:contents — это не CSS Grid Layout subgrid

display:contents — это не CSS Grid Layout subgrid

JavaScript

JavaScript

Дели — сокращай, или как мы делали мобильный 2ГИС Онлайн

Дели — сокращай, или как мы делали мобильный 2ГИС Онлайн- Реактивные интерфейсы на нативном JavaScript — Часть 1: Чистый функциональный стиль

- Нейросети с нуля для JavaScript разработчиков (Часть 1: Перцептрон)

Состояние JavaScript в 2017. Ежегодный глобальный опрос

Состояние JavaScript в 2017. Ежегодный глобальный опрос Десять вещей, которые серьезный JavaScript разработчик должен изучить

Десять вещей, которые серьезный JavaScript разработчик должен изучить Скрытые сообщения в именах свойств в JavaScript

Скрытые сообщения в именах свойств в JavaScript Современный стек разработки фронтенда. Статья на linux.com о революции в JS разработке за последние несколько лет

Современный стек разработки фронтенда. Статья на linux.com о революции в JS разработке за последние несколько лет 6 нативных методов манипуляции DOM, вдохновленные jQuery

6 нативных методов манипуляции DOM, вдохновленные jQuery

Инструменты Javascript для end-to-end тестирования веб приложений

Инструменты Javascript для end-to-end тестирования веб приложений Состояние интернационализации в JavaScript

Состояние интернационализации в JavaScript Angular vs React vs Vue

Angular vs React vs Vue- ES2015+:

VueJS:

VueJS:

CSSSR Live: Мастер-класс по Vue.js. Приглашенный спикер Борис Окунский проводит двухчасовой мастер-класс для разработчиков CSSSR

CSSSR Live: Мастер-класс по Vue.js. Приглашенный спикер Борис Окунский проводит двухчасовой мастер-класс для разработчиков CSSSR CSSSR Pair Coding #1: Делаем учебный проект «Каталог фильмов» на Vue.js

CSSSR Pair Coding #1: Делаем учебный проект «Каталог фильмов» на Vue.js Начинаем работать с Vue.js

Начинаем работать с Vue.js Flue. Еще одна flux библиотека

Flue. Еще одна flux библиотека  Как (безопасно) использовать jQuery плагины с Vue.js

Как (безопасно) использовать jQuery плагины с Vue.js  История нашей прогрессивной миграции с Backbone на Vue.js

История нашей прогрессивной миграции с Backbone на Vue.js  Как работать с Computed Properties в VueJS?

Как работать с Computed Properties в VueJS? Как использовать вотчеры Vue.js для асинхронных обновлений?

Как использовать вотчеры Vue.js для асинхронных обновлений?

Vue.js API в терминале

Vue.js API в терминале Vue.js: прогрессивный Javascript фреймворк. Доклад Vito Huang на Bristol JS в июне 2017

Vue.js: прогрессивный Javascript фреймворк. Доклад Vito Huang на Bristol JS в июне 2017

React:

React:

В чём сила Redux?

В чём сила Redux?- Пользователи React подписали петицию к Facebook для релицензирования React.js. Петиция по релицензированию React была передана техническим директорам Facebook

Восемь вещей, которые необходимо изучить в React перед использованием Redux

Восемь вещей, которые необходимо изучить в React перед использованием Redux

React Starter Kit: быстрый стартовый шаблон, состоящий из React.js, Babel, PostCSS, Webpack

React Starter Kit: быстрый стартовый шаблон, состоящий из React.js, Babel, PostCSS, Webpack Введение в Hoodie и React

Введение в Hoodie и React Как создать клон Reddit с использованием React и Firebase

Как создать клон Reddit с использованием React и Firebase Как использовать React, ES6, Yarn и Webpack для создания WordPress плагина

Как использовать React, ES6, Yarn и Webpack для создания WordPress плагина Как изучать React: план из пяти шагов

Как изучать React: план из пяти шагов

Angular:

Angular:

Angular 4 — Third Party API’s

Angular 4 — Third Party API’s Lazy loading: разделение кода NgModules с Webpack

Lazy loading: разделение кода NgModules с Webpack Совмещаем формы Angular с @ngrx/store

Совмещаем формы Angular с @ngrx/store

- Libs & Plugins:

Popmotion — маленький кроссплатформенный JavaScript движок для работы с анимацией

Popmotion — маленький кроссплатформенный JavaScript движок для работы с анимацией RE:DOM — маленькая библиотека, добавляющая хелперы для создания DOM элементов и поддержки синхронизации с данными.

RE:DOM — маленькая библиотека, добавляющая хелперы для создания DOM элементов и поддержки синхронизации с данными.

mesh — визуализация данных и редактирование кода JavaScript в табличном интерфейсе

mesh — визуализация данных и редактирование кода JavaScript в табличном интерфейсе

wade — очень быстрая библиотека для поиска

wade — очень быстрая библиотека для поиска GPU.JS — JavaScript, ускоренный GPU

GPU.JS — JavaScript, ускоренный GPU

tiza — стилизация вывода данных в консоль

tiza — стилизация вывода данных в консоль

Браузеры

- Расширение Particle для Chrome сменило владельца и тут же стало вредоносным

Пересмотр рыночной доли Firefox. Почему создание лучшего браузера не приводит к росту популярности

Пересмотр рыночной доли Firefox. Почему создание лучшего браузера не приводит к росту популярности

Новый Firefox и огромное количество табов

Новый Firefox и огромное количество табов

Превью Storage API в Firefox Nightly

Превью Storage API в Firefox Nightly

Занимательное

Занимательное

- Рейтинг языков программирования 2017 года от издания IEEE Spectrum

- Что такое экономика токенов, или Почему блокчейн пожирает мир

- Mozilla развивает свою систему распознавания речи

- YouTube закрывает сервис редактирования видео. Его никто не использует

- Прибыль Microsoft превысила ожидания за счёт успехов в области облачных вычислений

- Google предлагает всем желающим виртуально прогуляться по МКС с помощью сервиса Street View

- Google добавила персонализированную ленту контента в своё мобильное приложение

- Как нам правильно купить шрифты, чтобы потом не было проблем с лицензиями?

- Инструменты сводят с ума

- Школы vs. искусственный интеллект. Почему Wolfram Alpha стоит отдать должное

- Google Glass возвращаются

- Представлен новый интерфейс GitLab

Просим прощения за возможные опечатки или неработающие/дублирующиеся ссылки. Если вы заметили проблему — напишите пожалуйста в личку, мы стараемся оперативно их исправлять.

Дайджест за прошлую неделю.

Материал подготовили dersmoll и alekskorovin.

|

|

[Из песочницы] Будь в курсе |

Вконтакте запустил Streaming API, инструмент для получения публичных данных из ВКонтакте по заданным ключевым словам.

ВК сам присылает новый подходящий контент по мере его появления. Таким образом можно получать интересующие записи без вступление в десятки групп, сразу после публикации.

Давайте напишем бота для телеграмма с оповещением о записях в ВК.

Получаем новости

Для начала нужно создать приложение в ВК и взять из настроек сервисный ключ

Для передачи данных используется протокол WebSocket. Испольхуем библиотеку «websocket».

import websocketПеред соединением используйте метод streaming.getServerUrl. В качестве результата метод возвращает URL для дальнейших запросов в поле endpoint (string) и ключ доступа в поле key (string).

Получаем урл и ключ

def get_streaming_server_key(token):

request_url = "https://api.vk.com/method/streaming.getServerUrl?access_token={}&v=5.64".format(token)

r = requests.get(request_url)

data = r.json()

return {"server":data["response"]["endpoint"],"key":data["response"]["key"]}

Слушаем сервер

def listen_stream():

websocket.enableTrace(True)

ws = websocket.WebSocketApp("wss://{}/stream?key={} ".format(stream["server"], stream["key"]),

on_message=on_message,

on_error=on_error,

on_close=on_close)

ws.on_open = on_open

ws.run_forever()

def on_message(ws, message):

print(">>>> receive message:", message)

def on_error(ws, error):

print(">>>> error thead:",error)

def on_close(ws):

print(">>>> close thead")

def on_open(ws):

print(">>>> open thead")

stream = get_streaming_server_key(my_servise_token)

listen_stream()

После запуска в консоли должно появиться примерно следующее

— request header — GET /stream?key=e6290ba04916a314c398c331f60224d012fabeb1 HTTP/1.1

Upgrade: websocket

Connection: Upgrade

Host: streaming.vk.com

Origin: streaming.vk.com

Sec-WebSocket-Key: vG40A5bwbPaVBS+DLBOyog==

Sec-WebSocket-Version: 13

— — response header — HTTP/1.1 101 Switching Protocols

Server: Apache

Date: Thu, 20 Jul 2017 22:06:55 GMT

Connection: upgrade

Upgrade: websocket

Sec-WebSocket-Accept: QRJNqD8K7vWNMcQesYKo64q8MfA=

— >>>> open thead

send: b"\x8a\x80d')\x90"

send: b'\x8a\x80\xfcmp\xe6'

send: b'\x8a\x80s\x9f6{'

send: b'\x8a\x80\xc9\xfa.\xd4'

send: b'\x8a\x80fU<\xed'

send: b'\x8a\x80\xc6Ji\x19'

send: b'\x8a\x80\xd2D\x08!'

Работа с правилами

Добавление

Метод HTTP POST

Content Type application/json

URL запроса https://{endpoint}/rules?key={key}

def set_my_rules(value):

rule_params = {"rule":{"value":value,"tag":'tag_'+str(random.randint(11111, 99999))}}

headers = {'content-type': 'application/json'}

r = requests.post("https://{}/rules?key={}".format(stream["server"], stream["key"]), data=json.dumps(rule_params), headers=headers)

data = r.json()

return data['code'] == 200Получение

Метод HTTP GET

URL запроса https://{endpoint}/rules?key={key}

def get_my_rules():

r = requests.get("https://{}/rules?key={}".format(stream["server"], stream["key"]))

data = r.json()

if data['code'] != 200:

return False

return data['rules']Удаление

Метод HTTP DELETE

Content Type application/json

URL запроса https://{endpoint}/rules?key={key}

def del_my_rules(tag):

headers = {'content-type': 'application/json'}

rule_params = {"tag":tag}

r = requests.delete("https://{}/rules?key={}".format(stream["server"], stream["key"]), data=json.dumps(rule_params), headers=headers)

data = r.json()

return data['code'] == 200Пробуем получить новости

stream = get_streaming_server_key(my_servise_token)

set_my_rules('кот')

listen_stream()В консоли должно появиться примерно следующее

send: b'\x8a\x80\xc9\xfa.\xd4'

send: b'\x8a\x80fU<\xed'

send: b'\x8a\x80\xc6Ji\x19'

send: b'\x8a\x80\xd2D\x08!'

{«code»:100,«event»:{«event_type»:«post»,«event_id»:{«post_owner_id»:-35708825,«post_id»:4560},«event_url»:«vk.com/wall-35708825_4560»,«text»:«vk.com/small.dolly

Пропал кот. В г.Электросталь на улице Загонова в районе 16 школы. Молодой мальчик, 2 года кастрирован. Обычного серого окраса с полосками. На подбородке и грудке белое пятно. Кот крупный около 7 кг. Пропал 27 июня. Если кто-то его видел пожалуйста сообщите 89250506596 или 89251527466. Мы его очень любим и хотим чтобы он вернулся домой»,«creation_time»:1498942995,«tags»:[«test_cats»],«author»:{«id»:-35708825}}} — наша новсть

Телеграм

Используем библиотеку «telebot».

import telebot

TELEGRAM_API_TOKEN = '3277332...' # токен выдаваемый при создании бота

bot = telebot.TeleBot(TELEGRAM_API_TOKEN)Старт бота

def _send(msg):

markup = types.ReplyKeyboardMarkup(row_width=1, resize_keyboard=True)

markup.add('Мои интересы', 'Очистить список интересов', 'Добавить')

msg = bot.send_message(chatID, msg, reply_markup=markup) # шлем текст с вариантами ответа

bot.register_next_step_handler(msg, process_step) # устанавливаем обработчик для наших ответов

# обработчик для 'help', 'start'

@bot.message_handler(commands=['help', 'start'])

def send_welcome(message):

global chatID

chatID = message.chat.id

hello_test = 'Привет, %s! Я бот использующий VK Streaming API!' % message.from_user.first_name

_send(hello_test)

# обработчик для наших ответов

def process_step(message):

if message.text == 'Мои интересы':

_send(get_rules_list())

if message.text == 'Очистить список интересов':

_send(clear_rules_list())

if message.text == 'Добавить':

msg = bot.send_message(chatID, "Что добавить?")

bot.register_next_step_handler(msg, add_rule_handler)Добавить

if message.text == 'Добавить':

msg = bot.send_message(chatID, "Что добавить?")

bot.register_next_step_handler(msg, add_rule_handler)

.....

def add_rule_handler(message):

new_rule = set_my_rules(message.text)

if new_rule:

_send("Successful")

else:

logging.debug("Error add rules")

_send("Error")Мои интересы

def get_rules_list():

rules = get_my_rules()

if rules:

return "\n".join([str(rule['value']) for rule in rules])

else:

logging.debug("Error get rules list")

return 'Error'Очистить список интересов

def clear_rules_list():

rules = get_my_rules()

if rules:

for rule in rules:

del_my_rules(rule['tag'])

return "Successful"

else:

logging.debug("Error clear rules list")

return 'Error'Отправка новостей

def on_message(ws, message):

print(">>>> receive message:", message)

message = json.loads(message)

if not message['code']:

return

if not message['event']['event_type'] or message['event']['event_type'] != 'post':

return # выходим, если запись не отдельный пост

post = message['event']['event_type'] +"\n"+message['event']['text'].replace("

", "\n") +"\n\n"+ message['event']['event_url']

_send_post(post)Запускаем все вместе

Для корректной работы сокеты нужно запустить в отдельном треде.

def listen_stream():

websocket.enableTrace(True)

ws = websocket.WebSocketApp("wss://{}/stream?key={} ".format(stream["server"], stream["key"]),

on_message=on_message,

on_error=on_error,

on_close=on_close)

ws.on_open = on_open

#ws.run_forever()

wst = threading.Thread(target=ws.run_forever)

wst.daemon = True

wst.start()Запускаем

if __name__ == '__main__':

try:

chatID = 0

stream = get_streaming_server_key(my_servise_token)

listen_stream()

bot.polling(none_stop=True)

except Exception as e:

logging.exception("error start")На этом все, спасибо.

полный код скрипта

Streaming API docs

Telegram API docs

Python websocket-client

Python TelegramBotAPI

|

Метки: author WSN3 программирование вконтакте api python telegram vk api |

[Перевод] Как объяснить дизайн четырехлетним? |

Недавно я пришел с предложением в местную начальную школу. Мне хотелось поговорить с детьми о моей работе, рассказать им какие-то основы дизайна, возможно, чему-то научить.

Я планировал пообщаться со старшими ребятами, рассказать то, что считал действительно крутым в своей работе, поделиться каким-то интересным опытом, но в итоге меня попросили провести урок с учениками подготовительной группы (примерно 4-5 лет). Несмотря на то что сначала я был скорее разочарован, это оказалось очень интересной задачей!

Главная особенность работы с детьми такого возраста в том, что ты не можешь ничего рассказать о брендах с которыми работал. Четырехлетние дети не будут восторженно реагировать на истории о работе на Channel 4, BBC и Disel. «Я получал награды BRIT, и даже разработал веб-сайт, на котором получил запись imdb!» — дети не поймут, о чем я вообще говорю. Поэтому нужно было в самых простых выражениях объяснить то, что я сделал, и почему это так важно. Я подумал: было бы здорово показать детям дизайн во всех его формах.

Что я сделал?

У меня уже давно сформировалось представление, что все формы дизайна эффективно связаны с коммуникацией — будь то дизайн пользовательского интерфейса, промышленный дизайн или дизайн одежды. Я пришел к мысли: дизайн — это, что-то простое в использовании и легкое для восприятия.

Затем я объяснил, что существуют разные дизайнеры: есть те, которые решают,

как увеличить количество комнат и где расположить двери и окна, бывают дизайнеры,

которые создают книги, которые вы читаете. Еще есть дизайнеры игр которые решают,

как сделать игру Angry Birds забавной, и где расположить кнопки чтобы нам было удобно играть. Дизайнеры мебели, они определяют, какого размера будут стулья,

и как сделать их удобными.

Я также отметил важность дизайна туалета — мы все пользуемся туалетами каждый день, и они должны быть правильного размера и удобны для сидения, к тому же, нам должно быть легко добраться до бумаги. В ответ я услышал много хихиканья и бормотания слова «туалет», хотите получить обратную связь и привлечь внимание 4-летних? Поговорите с ними о туалетах.

После этого, мы выполнили упражнение «да/нет». У меня был список разных вещей,

а дети должны были отвечать, делали ли эту вещь дизайнеры или нет? Мы начали:

— Лужа («неееет!»)

— Книга («даааа!»)

— Белка («неееет!»)

— Автомобиль («дааааа!»)

… и так далее.

Теперь, когда дети узнали о том, что такое дизайн, мне надо объяснить им, что такое графический дизайн.

Я задумался, как сделать свое объяснение легким для их восприятия? И через какое-то время пришел к простому выводу — надо использовать цвета, буквы и рисунки, чтобы помочь людям понять, что-то чего они не знают. Уф! После долгой карьеры, в которой приходилось отталкиваться от комментариев о «раскраске» и «создании вещей, которые выглядят хорошо» мне наконец удалось попасть в точку. Эта формулировка оказалась прекрасной в своей ясности,

я даже мог бы цитировать её на своих визитках.

Я начал с того, что спросил у класса: какой цвет помогает понять что перед нами кран с горячей водой?

После того как один ребенок успешно сказал «красный», я спросил их: почему мы думаем, что красный означает «горячий»? Почему «жарко» — это именно красный цвет? Среди ответов малышей мелькали очень хорошие для их возраста: «Огонь», «Солнце», «Лава». Мы выяснили что люди используют красный цвет для обозначения «горячего», потому что он ассоциируется с горячими вещами. Тоже самое происходит с синим цветом:

— «Дети, что бывает голубым и холодным?»

— «Лед!»

— «Да, иногда лед может выглядеть голубым и холодным, вот почему платье Эльзы из мультфильма морозно-голубого цвета.»

Пришло время поговорить о главном! Я сам отец двоих детей, поэтому знаю, что дети в таком возрасте не будут сидеть долго. Мой напарник (учитель начальной школы), сделал несколько небольших книг с образцами цветов, чтобы раздавать их детям, и попросил класс выбрать цвета на основе вопросов.

— Выберите цвет, который напоминает вам о ночи.

— Выберите цвет, который заставляет вас думать о фруктах.

— Выберите цвет, который напоминает вам о Gruffalo!*

* Персонаж книги английской писательницы Джулии Дональдсон — мохнатый и клыкастый житель леса.

На последний вопрос дети отвечали по разному — большинство выбрало коричневый цвет, но некоторые дети останавливались на оранжевом (цвет глаз Груффало), черном (цвет его языка) или фиолетовом (цвет его колючек). Так дети начали понимать, что часто возникает много ответов на вопросы связанные с дизайном, и как цвет помогает чувствовать разные объекты и вещи.

Затем, мы провели еще одно упражнение, в ходе которого я дал детям список слов, которые нужно было раскрасить определенным цветом. Так они смогли продемонстрировать свои знания на практике. Результаты были великолепны!

Множество красного цвета — для слова «сердитый», яркие цвета — для «сладостей», зеленые — для «травы». Потом я спрашивал у детей, почему они выбрали именно эти цвета? И получал очень убедительные ответы! Конечно, иногда они выбирали цвет «потому что мне это нравится», но ведь это тоже актуально :)

Типографика

Когда мы закончили с цветом, я перешел к тому как выглядят сами слова. Я рассказывал детям о том, как знаки рассказывают о важных вещах и что слова должны быть легко читаемыми. В качестве примера я показал классу слово напечатанное на листе и спросил детей — что я могу сделать с этим словом, чтобы оно стало понятнее?

Дети ответили, что нужно сделать его крупнее. Я показал им это слово крупнее и мы согласились, что это делает слово более важным и его становится видно издалека.

Я рассказал ребятам о том, что можно делать с целыми текстами и отдельными словами, чтобы их легче было читать. Мы поговорили про их любимые книги и про то, что слова используются всегда и везде, чтобы рассказывать истории и передавать важную информацию. В качестве примера, я показал им простое предложение, которое мы все прочитали вместе:

А затем показал тоже предложение, но с выделенным словом «большая»:

Дети согласились что это делает предложение более захватывающим. Мы произносим выделенное слово уже иначе, чем в прошлый раз и начинаем задумываться, насколько же велика была эта собака, из этого предложения?

Кроме этого, я показал как можно сделать серию изменений в простом слове, чтобы снова почувствовать его смысл. Я демонстрировал все следующие итерации по очереди:

Каждый раз дети соглашались, что новое слово ощущалось быстрее, чем названное до этого.

К сожалению, к этому моменту у нас уже не хватало времени. Хотя в планах были еще упражнения, в том чтобы «проектировать» слово, используя интересные комбинации цветов и некоторые визуальные трюки: например, составить слово «праздник», используя вещи, которые помогают детям чувствовать себя празднично — колпачки, мороженное, сладкая вата и так далее.

Я был удивлен двум вещам: насколько легко большинство детей понимали, что такое дизайн, и что у них легко получалось самовыразиться с его помощью. Этот опыт также полезен для тех, кто специализируется на разъяснении чего-либо неподготовленной аудитории. Мне нужно было поговорить с детьми на их языке, объясняя ценность своей профессии в ясных выражениях и посмотреть на то чем я занимаюсь, со стороны.