Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Результаты первого тура CTFzone |

Первый тур длился 36 часов и проходил в формате Jeopardy. Каждая команда представляла собой избирательный штаб кандидата на пост президента CTFzone. Основными задачами штабов были повышение уровня популярности кандидата и получение голосов избирателей. Для этого участникам было предложено решить 20 заданий различных категорий: Web, Crypto, MISC, Forensic, Pwn и Reverse. Баллы за задания начислялись по динамической системе – изначально команды получали одинаковое количество баллов, однако по мере увеличения числа участников, успешно справившихся с заданием, полученные баллы за него пересчитывались.

Наибольшей популярностью пользовались задания категорий Web и Crypto. Самыми сложными категориями оказались Forensic и MISC – задания данных категорий оказались под силу немногим, а один таск так и остался нерешенным.

По итогам соревнований во второй тур прошли 10 российских и зарубежных команд – им будет предложено принять участие во втором туре выборов CTFzone и привести своего кандидата к окончательной победе.

Второй этап состоится 16-17 ноября и пройдет в формате Attack/Defence. Учитывая высокий уровень профессионализма прошедших команд, битва обещает быть напряженной. Поэтому, мы желаем победителям первого тура удачи и ждем всех на конференции ZERONIGHTS 2017 в ноябре.

До новых встреч!

|

Метки: author vadimmaslikhin информационная безопасность ctf блог компании bi.zone zeronights2017 ctfzone results bi.zone |

[Из песочницы] Обзор-рейтинг провайдеров виртуальных серверов Windows: 2017 |

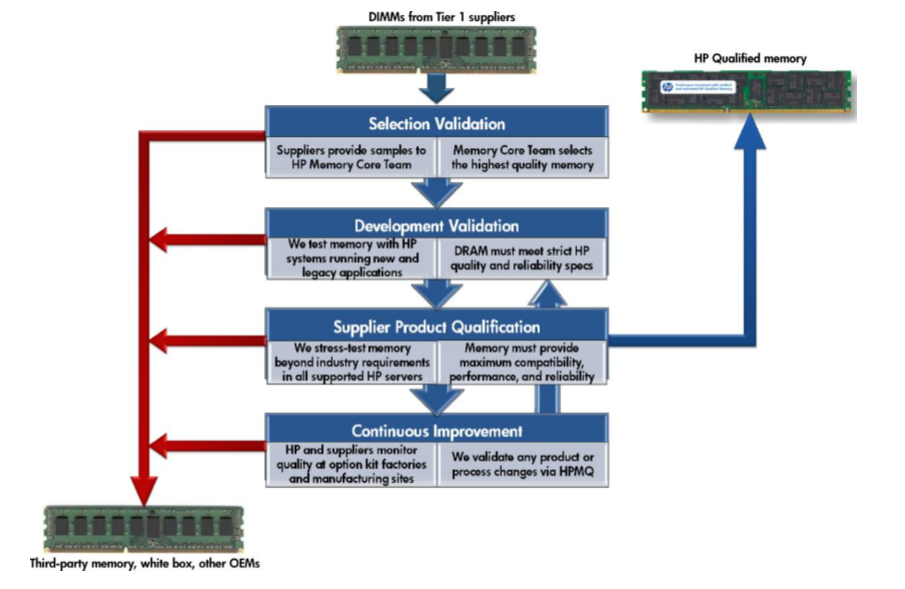

В марте 2017 года возникла необходимость в обновлении серверного оборудования под MS SQL Server и терминальный сервер, необходимых для работы приложения по учёту продаж. Стоимость нового сервера и системы хранения превышало 700 т.р., что не укладывалось в наши бюджеты, поэтому решили рассмотреть виртуальные серверы для размещения наших приложений.

Практически сразу отказались от выделенного сервера в связи с дороговизной реализации: оборудование, лицензии, услуги инженеров по настройке. Поэтому решили выбрать уже готовую платформу для реализации наших потребностей, это виртуальный сервер.

Можем выделить следующие преимущества:

- Реализация отказоустойчивости на уровне гипервизора;

- Преимущественно отказоустойчивое хранение данных;

- Низкая стоимость резервного копирования и простая реализация для нас;

- Расширение ресурсов в соответствии с нашими потребностями (Pay as you grow);

- Наличие SLA.

Программа и методика испытаний

Программа и методика испытаний, которая была заранее определена для тестирования провайдеров.

Объекты тестирования:

- Вычислительная подсистема;

- Дисковая подсистема;

- Подключение к сети Интернет.

Для тестирования подсистем использовалось следующее ПО:

- Вычислительная подсистема: Linpack

- Дисковая подсистема: CrystalDiskMark, HD Tune Pro

- Пропускная способность: beta.speedtest.net

Настройки ПО:

| Вычислительная подсистема: Linpack |

|

| Объём задачи |

10000 |

| Объём памяти |

772 МБ |

| Время испытания |

5 часов |

| Режим |

64-bit |

| Число потоков |

Равняется количеству ядер |

| Данные |

4 КБ |

| Дисковая подсистема: CrystalDiskMark |

|

| Размер файла |

1 ГБ |

| Количество проверок |

5 |

| Дисковая подсистема |

HD Tune Pro |

| Benchmark |

Чтение |

| File Benchmark |

Размер файла 500 МБ Шаблон: заполнение нулями |

| Пропускная способность доступа в сеть Интернет |

|

| Москва |

Билайн |

| Краснодар |

РТ (Ростелеком) |

| Екатеринбург |

РТ |

| Иркутск |

РТ |

| Владивосток |

РТ |

| Франкфурт |

Leaseweb |

Перечень городов обусловлен наличием в них наших филиалов. Для проведения испытаний использовалось подключение к сети Инернет в конкретном филиале. Измерение скорости проводилось с использованием beta.speedtest.net. Франкфурт взяли для понимания скорости загрузки в ownCloud, который размещается в Leaseweb.

Критерии оценивания

Использовали следующие критерии для оценивания провайдеров.

| Наименование |

Баллы |

Описание |

| Дата-центр |

0.6 |

|

| Информация о ДЦ |

0.2 |

Информация о том, где размещается оборудование |

| Информация об инженерных подсистемах |

0.2 |

Данные об уровне инженерных подсистемах ДЦ |

| Сертификация TIER |

0.2 |

Есть ли подтверждение о сертификации TIER по uptime institute / IBM и подобных организаций |

| Информация об оборудовании |

0.3 |

|

| Серверное оборудование |

0.1 |

Какое оборудование используется и какие вычислители задействованы в кластере |

| Система хранения данных |

0.1 |

Используются ли СХД или SDS решения |

| Сетевое оборудование |

0.1 |

Используемое сетевое оборудование |

| Информация о юр.лице |

0.3 |

|

| Контактные данные |

0.1 |

Контактные данные технической поддержки и наличие номера телефона для обращений в поддержку |

| Адрес юр.лица |

0.1 |

Контактные данные и адрес юридического лица, которое предоставляет хостинг услуги |

| Реквизиты компании |

0.1 |

Реквизиты юридического лица |

| Информация о платформе виртуализации |

0.1 |

|

| Договор оферты |

0.2 |

|

| Договор оферты |

0.1 |

Доступ к договору оферты без прохождения регистрации |

| SLA |

0.3 |

Доступ к SLA без прохождения регистрации |

| Тестирование сервиса |

||

| Вычислительная подсистема |

0.4 |

|

| Соответствие заявленной частоты и выделенной частоты процессора |

0.2 |

Соответствие выделенной частоты и процессора согласно описанию тарифа |

| Стабильность вычислительной подсистемы |

0.2 |

Стабильность вычислительной подсистемы без заметных провисов в производительности |

| Недокументированное ограничение вычислительной подсистемы |

-0.3 |

Наличие ограничений на использование CPU, которое не документировано в договоре. Параметр добавлен после выставления ограничений на ресурсы одним из провайдеров |

| Дисковая подсистема |

0.8 |

|

| Стабильность дисковой подсистемы |

0.2 |

Стабильность дисковой подсистемы с низкой задержкой и без заметных провисов в производительности |

| Высокоскоростная дисковая подсистема |

0.2 |

Высокая скорость дисковой подсистемы на уровне SSD (Seq.R 400 / Seq.W 300), HDD (Seq.R 100 / Seq.W 100) |

| Высокая доступность данных |

0.2 |

В случае падения сервера данные будут доступны |

| Отказоустойчивость дискового хранения |

0.2 |

|

| Сетевое соединение |

0.5 |

|

| Стабильность сетевого соединения |

0.2 |

Стабильное сетевое подключение без обрывов и зависаний |

| Низкие задержки по России |

0.1 |

Субъективный параметр основываясь на текущих наших средних показателях PRTG |

| Высокая скорость доступа по России (более 20 мбит/с) |

0.2 |

|

| Дополнительные услуги |

1 |

|

| Базовая техническая поддержка |

0.2 |

Наличие бесплатной базовой технической поддержки (не включая конфигурирование сервисов) |

| Расширенная техническая поддержка |

0.2 |

Наличие расширенной технической поддержки (включая конфигурирование сервисов) |

| Бесплатная лицензия Windows Server |

0.2 |

Бесплатное предоставление Windows Server по программе SPLA |

| Лицензия ПО | 0.1 | Возможен заказ дополнительных лицензий |

| Гибкое расширение ресурсов | 0.3 | Создание произвольной конфигурации виртуального сервера с возможностью расширения ресурсов |

Список провайдеров

Был определён список провайдеров, согласно следующим критериям:

- размещение в России;

- лицензия Windows Server включена в стоимость;

- бесплатное тестирование сервиса перед покупкой;

- возможность увеличения ресурсов виртуального сервера;

- гипервизор Hyper-V или VMware.

Согласно нашим критериям были определены следующие провайдеры:

- ultravds.com / ruvds.com / bigd.host

- incloud.ru

- cloudlite.ru

- parking.ru

- 1cloud.ru

- neoserver.ru

- adman.com

- infobox.ru

- eserver.ru

- mclouds.ru

- ihc.ru

- cloud-pro.ru

- rackstore.ru

- docker.ru

Провайдеры, которые были отклонены из-за отсутствия бесплатного тестирования:

- ultravds.com / ruvds.com / bigd.host

- adman.com

- parking.ru

- docker.ru

- cloud-pro.ru — ответа не получили

Особые условия тестирования:

- eserver.ru — активация после предоставления скана документа, подтверждающего личность

- neoserver.ru — активация через менеджера и по будням

- rackstore.ru — активация через менеджера

Для экономии вашего времени можете воспользоваться следующими ссылками:

Перейти к сводной таблице с критериями оценки.

Перейти к сводной таблице с результатами тестирования.

Тестирование провайдеров

incloud.ru

Хостинг провайдер incloud.ru предоставляет виртуальные машины на платформе виртуализации VMware vSphere.

Провайдер: incloud.ru

Дата-центр: Россия, г. Москва, ДЦ MSTN

Платформа виртуализации: VMware

Триальный период: предоставляется по запросу на 3 дня

Время активации сервера: после создания запроса данные для доступа предоставили через 15 минут

Заявленное оборудование:

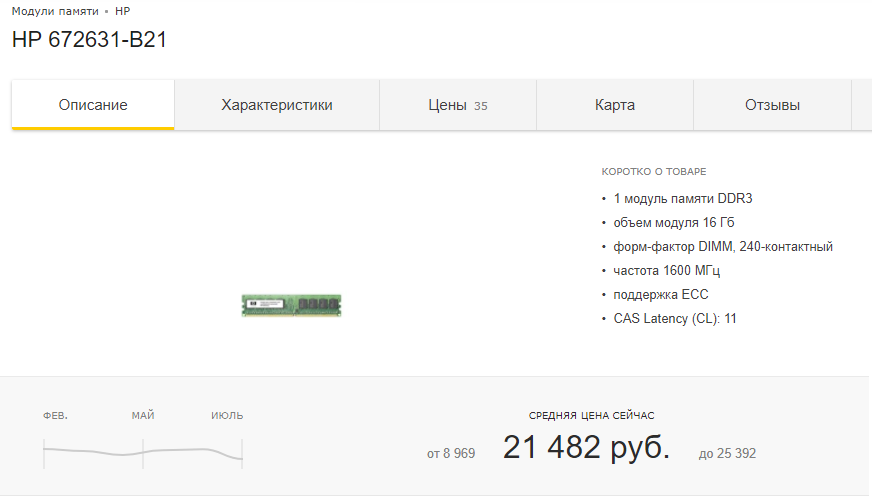

Серверное оборудование — HP, Dell, Supermicro

Сетевое оборудование — Cisco, Juniper

Система хранения данных — Dell

Характеристики тестируемого сервера:

vCPU: 2 x 2.4 (Intel Xeon E5645)

RAM: 2GB

Хранение: 50GB SSD

Результаты тестирования incloud.ru

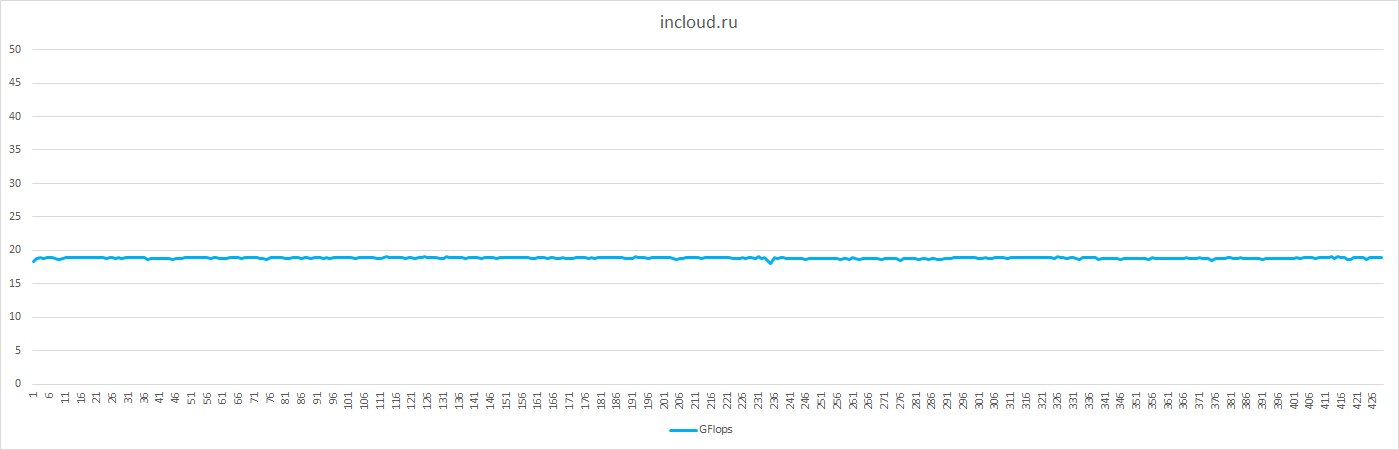

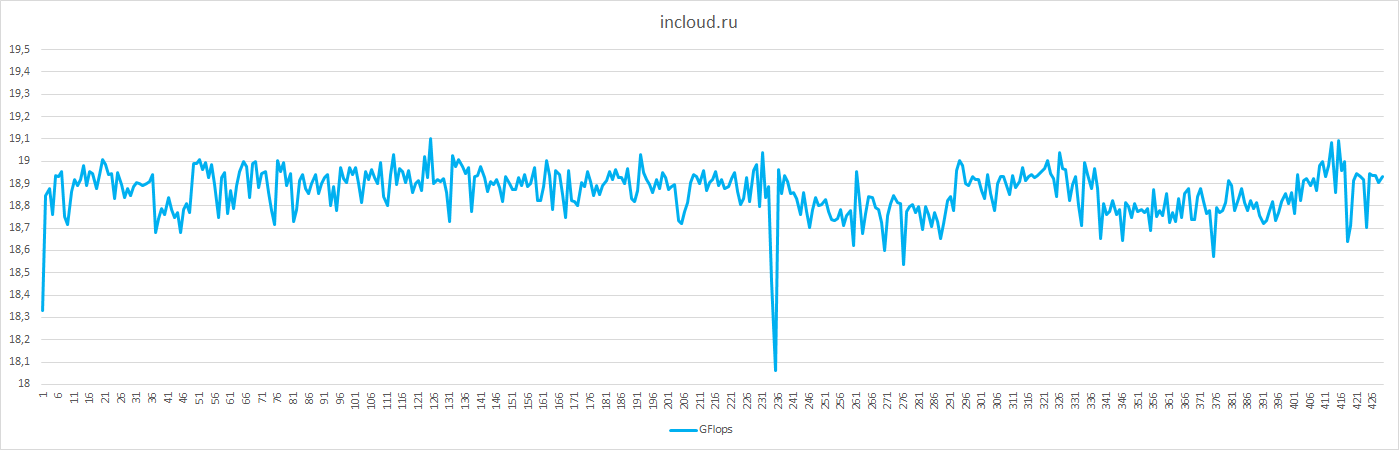

CPU

Согласно показателям LINPACK частота в сторону виртуальных машин ограничивается, информация о частоте при оформлении не указывается.

Частота CPU: 1.597 GHz

Количество CPU: 2

Количество ядер: 2

Число потоков: 2

Среднее значение производительности 18.86 GFlops.

Отклонение от среднего значения: до 6%

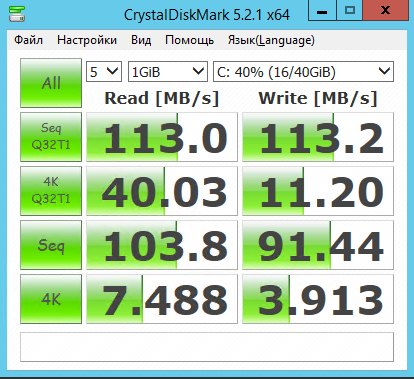

Дисковая подсистема

В качестве системы хранения используются СХД Dell, тестирование производилось на SSD.

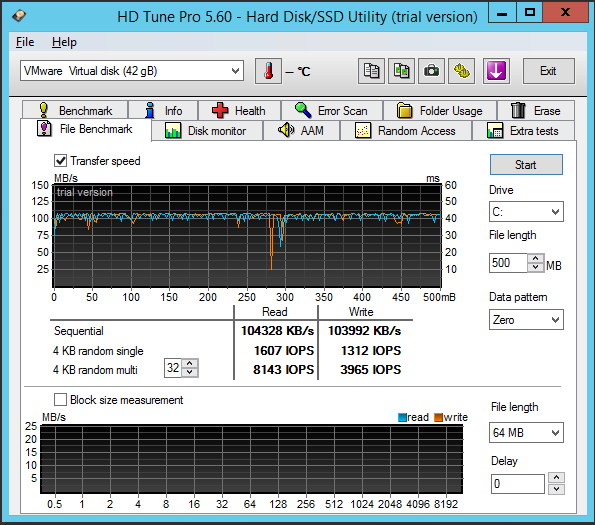

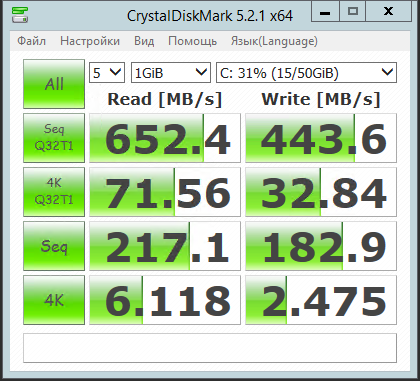

Тестирование с помощью CrystalDiskMark

Кеш виден издалека.

Работа с данными проходит гладко, сразу видно промышленную СХД, но утилизация ресурсов ограничена на чтение и запись на уровне 100 MB/s. Однако, этого вполне достаточно для комфортной работы.

Пропускная способность доступа в сеть Интернет

| Местоположение |

Download (Mbps) |

Upload (Mbps) |

Ping (ms) |

| Москва (Beeline) |

96.46 |

90.55 |

19 |

| Краснодар (Rostelecom) |

96.25 |

78.56 |

29 |

| Екатеринбург (Rostelecom) |

96.36 |

69.19 |

47 |

| Иркутск (Rostelecom) |

95.55 |

48.08 |

82 |

| Владивосток (Rostelecom) |

88.31 |

26.26 |

133 |

| Франкфурт (Leaseweb) |

96.23 |

75.11 |

42 |

Дополнительные возможности:

- Резервное копирование

- Лицензии ПО (Microsoft)

- Защита от DDoS-атак

Доступные образы: Windows Server 2008 R2, 2012 R2 и Linux-based. Доступна установка из своего образа

Стоимость: 1620 рублей в месяц за конфигурацию: 2 vCPU / 2 GB RAM / 40 GB SSD / Windows Server 2012 R2

Стоимость дополнительных ресурсов:

- 1 vCPU — 200 рублей

- 1 GB RAM — 200 рублей

- 10 GB SATA — 50 рублей

- 10 GB SAS — 100 рублей

- 10 GB SSD — 150 рублей

Ограничения согласно правилам:

Исполнитель оставляет за собой право ограничить скорость канала до 10-30 Мбит/с или заблокировать сервер в случае генерации большого объёма сетевого трафика на протяжении длительного периода времени, который будет создавать нагрузку на сетевое оборудование более 90%.

Плюсы:

- стабильная вычислительная и дисковая подсистема;

- произвольная конфигурация.

Минусы:

- ограниченные ресурсы вычислительной, дисковой подсистемы и доступа в сеть Интернет;

- отсутствие онлайн чата для уточнения состава услуг;

- на сайте представлено мало информации о компании.

ihc.ru

Хостинг-провайдер ihc.ru предоставляет широкий спектр услуг хостинга, начиная от размещения сайтов на shared хостинге до размещения виртуальных машин и аренды выделенных серверов в нескольких московских центрах обработки данных.

Провайдер: ihc.ru

Дата-центр: Россия, г. Москва, ДЦ DataPro и ДЦ IXcellerate

Платформа виртуализации: Microsoft Hyper-V

Триальный период: предоставляется на 3 дня при условии пополнения баланса на сумму от 100 р. (средства остаются на балансе и могут быть использованы в дальнейшем при оплате услуг)

Время активации сервера: 5 минут

Заявленное оборудование:

Серверное оборудование — нет информации

Сетевое оборудование — нет информации

Система хранения данных — локальный RAID5

Характеристики тестируемого сервера:

vCPU: 2 x 2.0 (E5645)

RAM: 4GB

Хранение: 50GB SAS HDD

Результаты тестирования ihc.ru

CPU

Согласно показателям LINPACK частота ЦП в сторону виртуальных машин ограничивается, информация о частоте при оформлении указана на уровне 2 GHz.

Частота CPU: 1.286 GHz

Количество CPU: 1

Количество ядер: 2

Число потоков: 2

Среднее значение производительности 4.79 GFlops.

Отклонение от среднего значения: до 2%

Низкая производительность вычислительной подсистемы.

Стабильное, но не «быстрое» вычисление без заметных провалов.

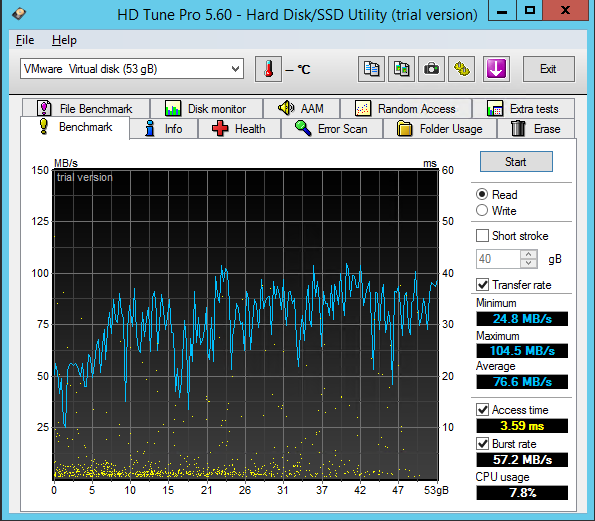

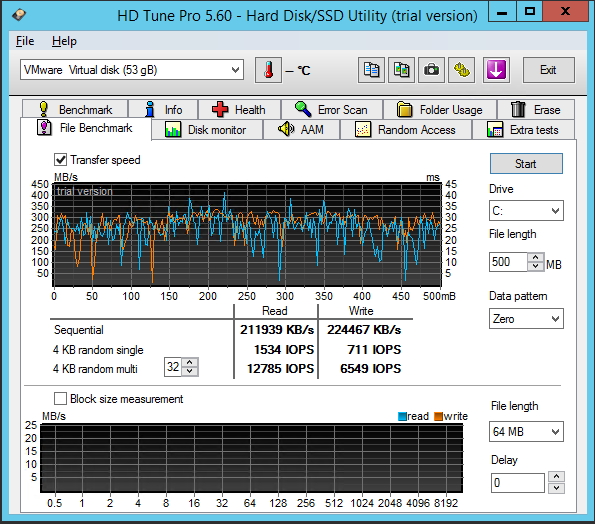

Дисковая подсистема

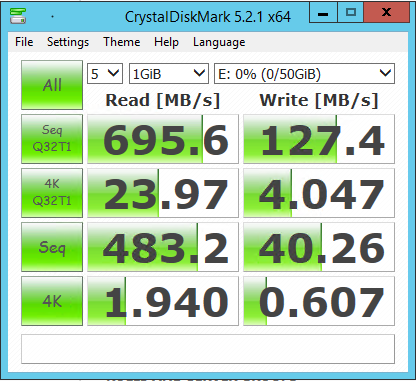

Интересное выделение дискового пространства для виртуальной машины — под ОС выделяется 30GB и дополнительно 50GB согласно тарифному плану.

Как указано в описании тарифа RAID5 SAS HDD.

Пропускная способность доступа в сеть Интернет

| Местоположение |

Download (Mbps) |

Upload (Mbps) |

Ping (ms) |

| Москва (Beeline) |

204.83 |

269.13 |

2 |

| Краснодар (Rostelecom) |

191.81 |

232.82 |

107 |

| Екатеринбург (Rostelecom) |

122.68 |

177.04 |

181 |

| Иркутск (Rostelecom) |

120.90 |

106.89 |

74 |

| Владивосток (Rostelecom) |

104.41 |

34.33 |

161 |

| Франкфурт (Leaseweb) |

143.03 |

181.90 |

65 |

Дополнительные возможности:

- Резервное копирование

- Возможность приобретения дополнительных IP-адресов

- Лицензии на ПО (ISPmanager, Microsoft, 1С-Битрикс)

Доступные образы: Windows Server 2008 R2, 2012 R2

Стоимость: 3000 рублей в месяц за конфигурацию: 2 x 2 GHz (2 GHz гарантировано) / 4 GB RAM / 50 GB RAID5 SAS HDD / Windows Server 2012 R2

Ограничения согласно правилам: При достижении объёма трафика 3 000 ГБ скорость ограничивается до 10 Мбит/с до конца расчётного месяца. Скорость может быть восстановлена за 250 р (1000 ГБ)

Плюсы:

- высокоскоростной доступ в сеть Интернет;

- стабильная производительность вычислительной системы без скачков и провалов.

Минусы:

- реальная частота CPU оказалась ниже заявленной;

- низкая скорость R/W 4K секторов;

- высокие задержки на маршрутах по России;

- отсутствие информации об используемых серверах и системе хранения данных.

infobox.ru

infobox.ru — один из старожилов на рынке хостинг услуг. Компания предоставляет хостинг-услуги: регистрация доменных имён, электронная почта, хостинг (размещение сайтов и серверов), а также хостинг бизнес-решений для корпоративных клиентов.

Провайдер: infobox.ru

Дата-центр: Россия г. Санкт-Петербург. Нидерланды, ДЦ EvoSwitch

Платформа виртуализации: Virtuozzo

Триальный период: 5 дней

Время активации сервера: 10 минут

Заявленное оборудование:

Серверное оборудование — Supermicro

Сетевое оборудование — Juniper

Система хранения данных — нет информации

Характеристики тестируемого сервера:

vCPU: 2 x 2.3 (E5-2650v3)

RAM: 2GB

Хранение: 50GB SSD

Результаты тестирования infobox.ru

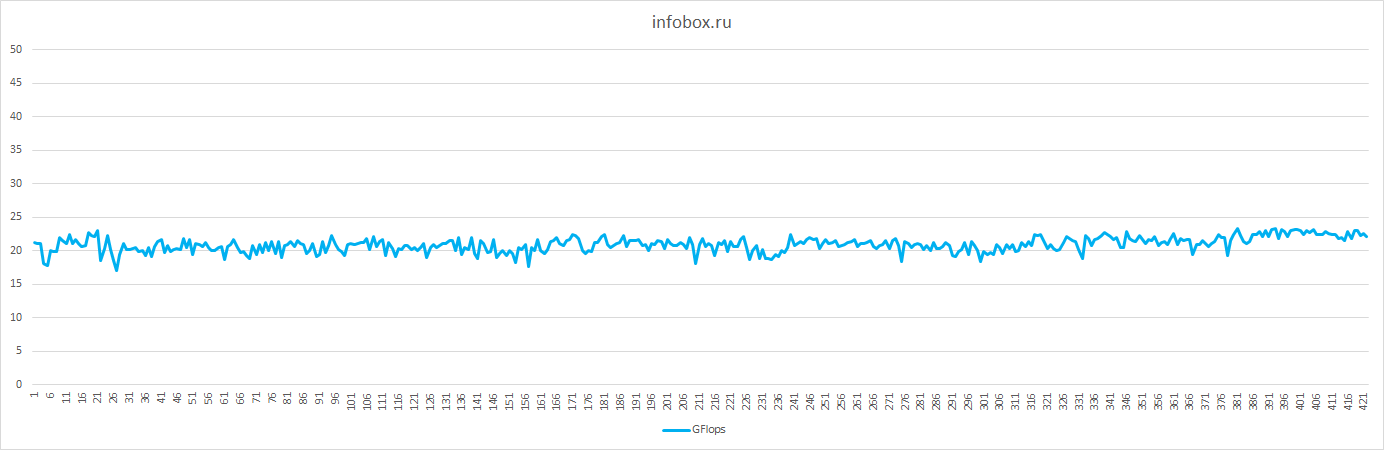

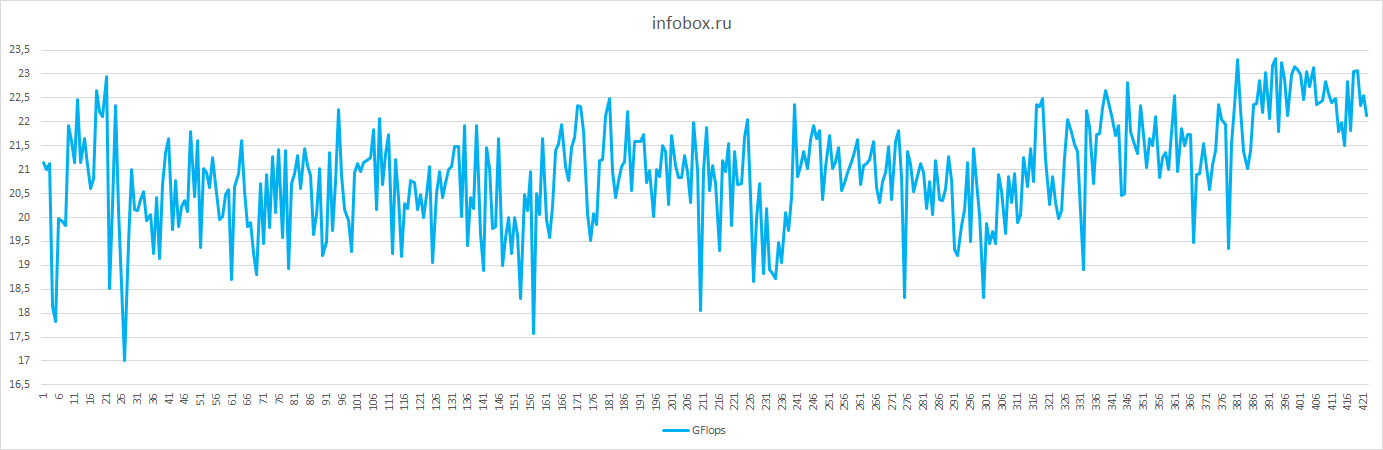

CPU

Согласно показателям LINPACK частота ЦП виртуальных машин не ограничивается, информация о частоте при оформлении указана на уровне 2.3 GHz.

Частота CPU: 2.414 GHz

Количество CPU: 1

Количество ядер: 2

Число потоков: 2

Среднее значение производительности 20.91 GFlops.

Отклонение от среднего значения: до 19%

Хорошее среднее значения производительности в GFlops, но имеются провалы в производительности до 19%.

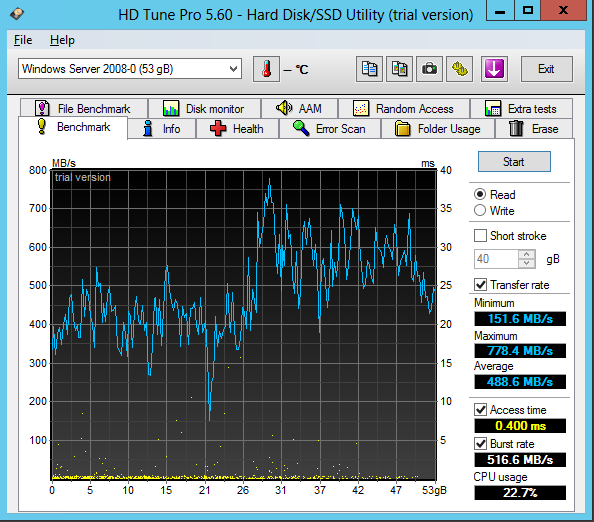

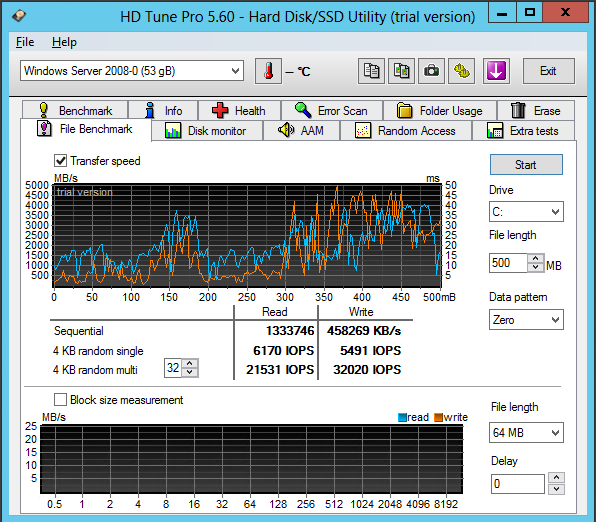

Дисковая подсистема

Исходя из графиков можно предположить, что пользователи активны в работе с дисковой подсистемой. Возможно, используется SDS-решение (программно-определяемое хранилище) или СХД.

Пропускная способность доступа в сеть Интернет

| Местоположение |

Download (Mbps) |

Upload (Mbps) |

Ping (ms) |

| Москва (Beeline) |

126.43 |

17.66 |

45 |

| Краснодар (Rostelecom) |

103.5 |

20.34 |

93 |

| Екатеринбург (Rostelecom) |

114.95 |

18.26 |

127 |

| Иркутск (Rostelecom) |

53.78 |

19.96 |

110 |

| Владивосток (Rostelecom) |

48.68 |

17.33 |

190 |

| Франкфурт (Leaseweb) |

193.87 |

20.31 |

15 |

Дополнительные возможности:

- Резервное копирование

- Администрирование серверов

- Лицензии ПО (Microsoft, Parallels)

Доступные образы: Windows Server 2008, 2008 R2, 2012, 2012 R2 и Linux-based

Стоимость: 1500 рублей в месяц за конфигурацию: 2 x 2 GHz / 2 GB RAM / 50 GB SSD / Windows Server 2012 R2

Стоимость дополнительных ресурсов: 10 GB SSD — 200 рублей

Ограничения согласно правилам: Пропускная способность сети 20 Мбит/с.

Плюсы:

- высокоскоростная дисковая подсистема;

- производительная вычислительная подсистема.

Минусы:

- высокие задержки по России;

- нет возможности изменить конфигурацию виртуальной машины.

1cloud.ru

1cloud.ru — облачный сервис провайдер предоставляющий виртуальные серверы на платформе виртуализации VMware vSphere с облачным функционалом — высокая доступность вычислительных ресурсов и ресурсов хранения.

Провайдер: 1cloud.ru

Дата-центр: Россия г.Москва ДЦ Dataspace. г. Санкт-Петербург ДЦ SDN. Казахстан ДЦ Ahost

Платформа виртуализации: VMware

Триальный период: 3 дня

Время активации сервера: 15 минут

Заявленное оборудование:

Серверное оборудование — Cisco, Dell

Сетевое оборудование — Cisco

Система хранения данных — Dell, NetApp

Характеристики тестируемого сервера:

vCPU: 2 x 2.0 (E7-4850)

RAM: 2GB

Хранение: 40GB SSD

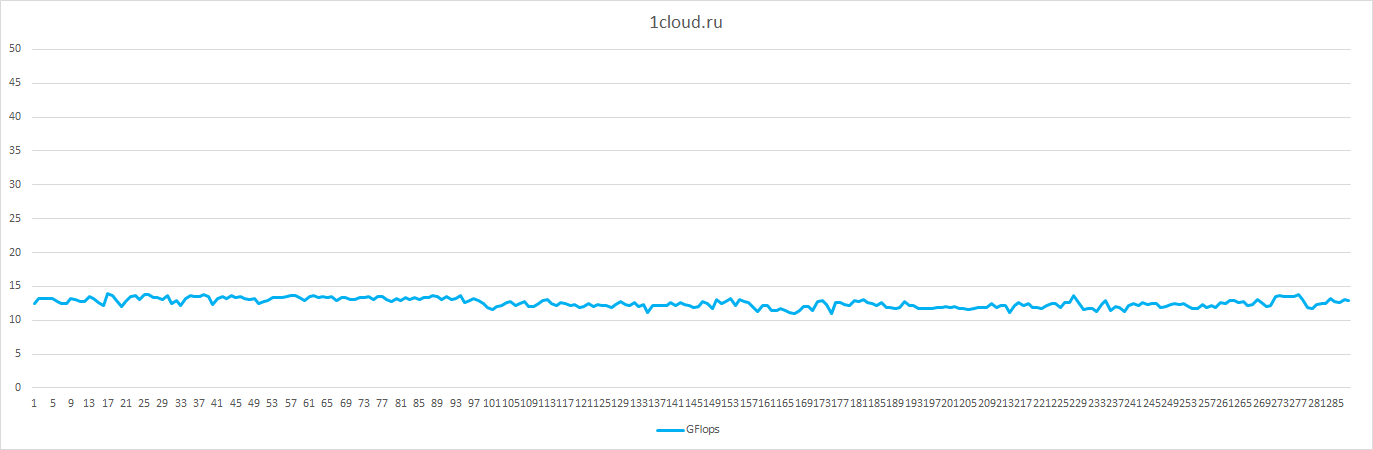

Результаты тестирования 1cloud.ru

CPU

Согласно показателям LINPACK частота ЦП виртуальных машин не ограничивается, информация о частоте при оформлении указана на уровне 2 GHz.

Частота CPU: 2.082 GHz

Количество CPU: 2

Количество ядер: 2

Число потоков: 2

Среднее значение производительности 12.57 GFlops.

Отклонение от среднего значения: до 16%

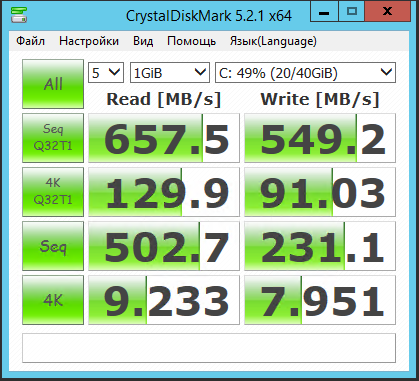

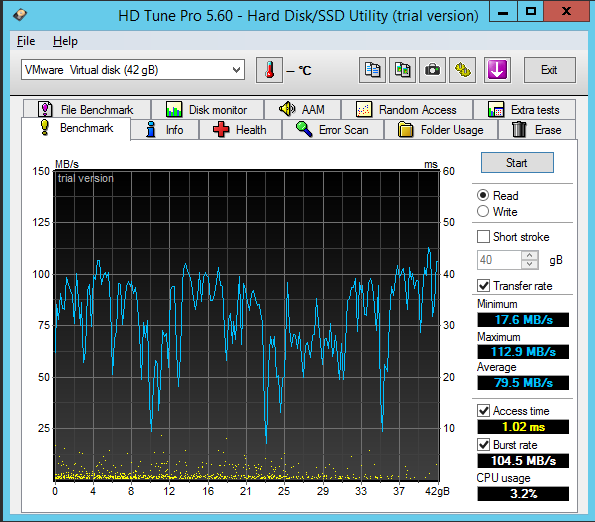

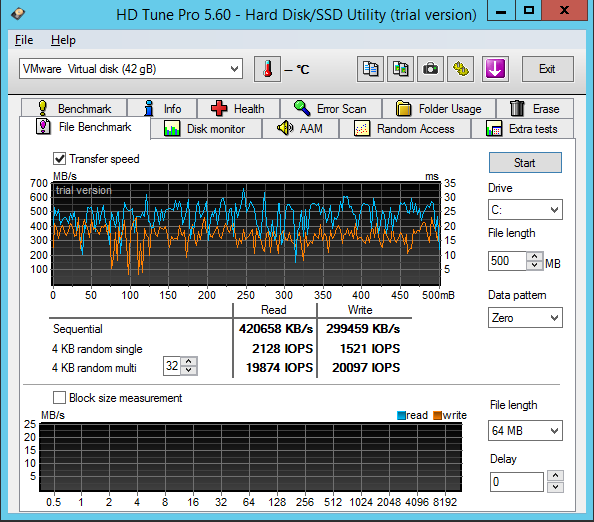

Дисковая подсистема

Стабильный доступ к дисковой подсистеме обеспечивается системами хранения данных корпоративного класса.

Пропускная способность доступа в сеть Интернет

| Местоположение |

Download (Mbps) |

Upload (Mbps) |

Ping (ms) |

| Москва (Beeline) |

19.72 |

19.78 |

13 |

| Краснодар (Rostelecom) |

19.71 |

19.64 |

78 |

| Екатеринбург (Rostelecom) |

19.64 |

16.55 |

41 |

| Иркутск (Rostelecom) |

19.76 |

16.16 |

72 |

| Владивосток (Rostelecom) |

19.6 |

12.65 |

135 |

| Франкфурт (Leaseweb) |

19.75 |

15.62 |

48 |

Дополнительные возможности:

- Резервное копирование

- Лицензии ПО (Microsoft)

Доступные образы: Windows Server 2008 R2, 2012 R2, Linux-based

Стоимость: 1650 рублей в месяц за конфигурацию: 2 x 2GHz / 2 GB RAM / 40 GB SSD / Windows Server 2012 R2

Стоимость дополнительных ресурсов:

- 1 vCPU — 110 рублей

- 1 GB RAM — 315 рублей

- 1 GB SATA — 3 рублей

- 1 GB SAS — 5 рублей

- 1 GB SSD — 20 рублей

Ограничения согласно правилам: 10 Мбит/с гарантированный канал, 100 Мбит/с максимально возможный.

Плюсы:

- удобная панель управления

- используется надежное оборудование известных производителей

Минусы:

- низкая пропускная способность канала и высокие задержки

- есть недокументированные лимиты на использование ресурсов CPU

cloudlite.ru

Проект компании DataLine по предоставлению вычислительных ресурсов на базе сертифицированных дата-центров по программе TIER III.

Провайдер: cloudlite.ru

Дата-центр: Россия г.Москва ДЦ DataLine NORD / OST.

Платформа виртуализации: VMware

Триальный период: виртуальный сервер не предоставляется

Время активации сервера: 3 минуты

Заявленное оборудование:

Серверное оборудование — Huawei

Сетевое оборудование — Cisco, Juniper

Система хранения данных — SDS

Характеристики тестируемого сервера:

vCPU: 2 x 2.2 (E7-4830 v2)

RAM: 2GB

Storage: 50 GB NL SAS HDD

Результаты тестирования cloudlite.ru

CPU

Согласно показателям LINPACK частота ЦП виртуальных машин не ограничивается, информация о частоте при оформлении указана на уровне 2.2 GHz.

Частота CPU: 2.147 GHz

Количество CPU: 2

Количество ядер: 2

Число потоков: 2

Среднее значение производительности 27.70 GFlops.

Отклонение от среднего значения: до 5%

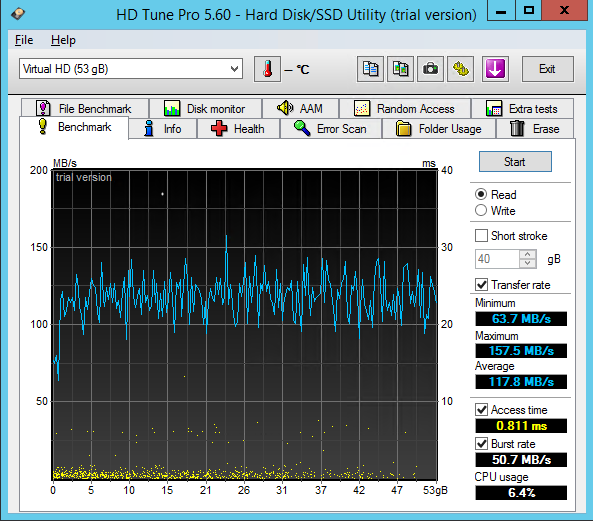

Дисковая подсистема

За высокую доступность и отказоустойчивость отвечает VMware VSAN.

Пропускная способность доступа в сеть Интернет

| Местоположение |

Download (Mbps) |

Upload (Mbps) |

Ping (ms) |

| Москва (Beeline) |

9.6 |

9.47 |

2 |

| Краснодар (Rostelecom) |

9.58 |

9.6 |

23 |

| Екатеринбург (Rostelecom) |

9.58 |

9.46 |

29 |

| Иркутск (Rostelecom) |

9.61 |

9.28 |

64 |

| Владивосток (Rostelecom) |

9.61 |

8.45 |

115 |

| Франкфурт (Leaseweb) |

9.58 |

9.44 |

49 |

Дополнительные возможности:

- Резервное копирование

- Лицензии ПО

Доступные образы: Windows Server 2008 R2, 2012 R2, Linux-based

Стоимость: 1857.6 рублей в месяц за конфигурацию: 2 x 2.2GHz / 2 GB RAM / 50 GB NL SAS HDD / Windows Server 2012 R2

Ограничения согласно правилам: Каждый виртуальный выделенный сервер (VPS/VDS) подключен на гарантированной скорости 10 Мбит/сек

Плюсы:

- высокая производительность CPU;

- низкие задержки по России.

Минусы:

- с лицензией Windows стоимость сильно увеличивается по сравнению с тарифами на Linux;

- невысокая скорость доступа в сеть Интернет.

mclouds.ru

mclouds.ru хостинг-провайдер, предоставляющий свой сервис на платформе виртуализации от VMware, позиционируется как облачный хостинг провайдер.

Провайдер: mclouds.ru

Дата-центр: г.Москва ДЦ Dataline NORD4

Платформа виртуализации: VMware

Триальный период: 1 день

Время активации сервера: 5 минут

Заявленное оборудование:

Серверное оборудование — HP, Supermicro

Сетевое оборудование — Cisco, Huawei

Система хранения данных — нет информации

Характеристики тестируемого сервера:

vCPU: 2 x 2.6 (E5-2670)

RAM: 2GB

Storage: 40 GB SSD

Результаты тестирования mclouds.ru

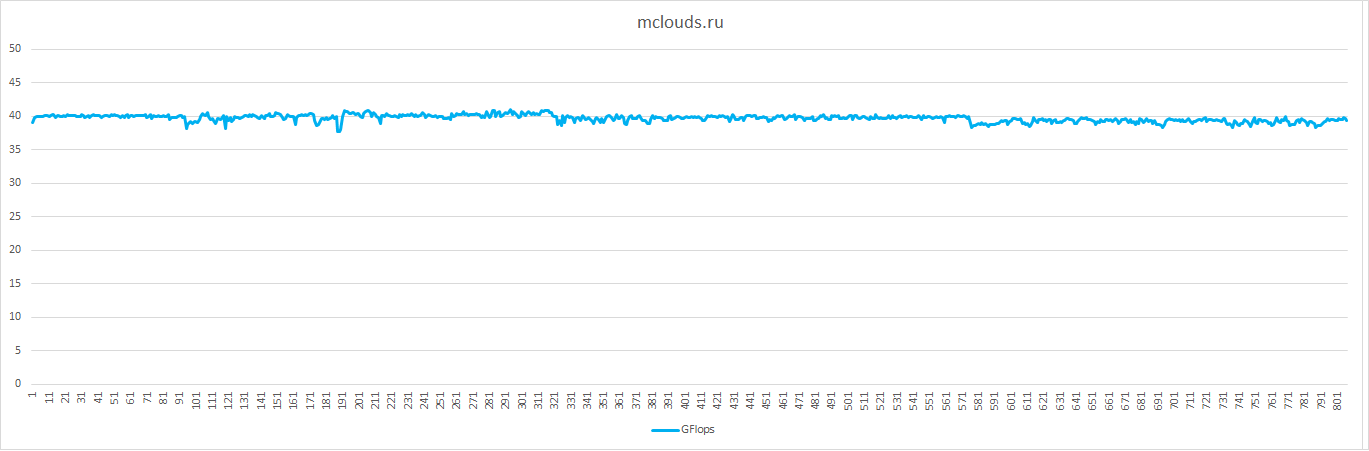

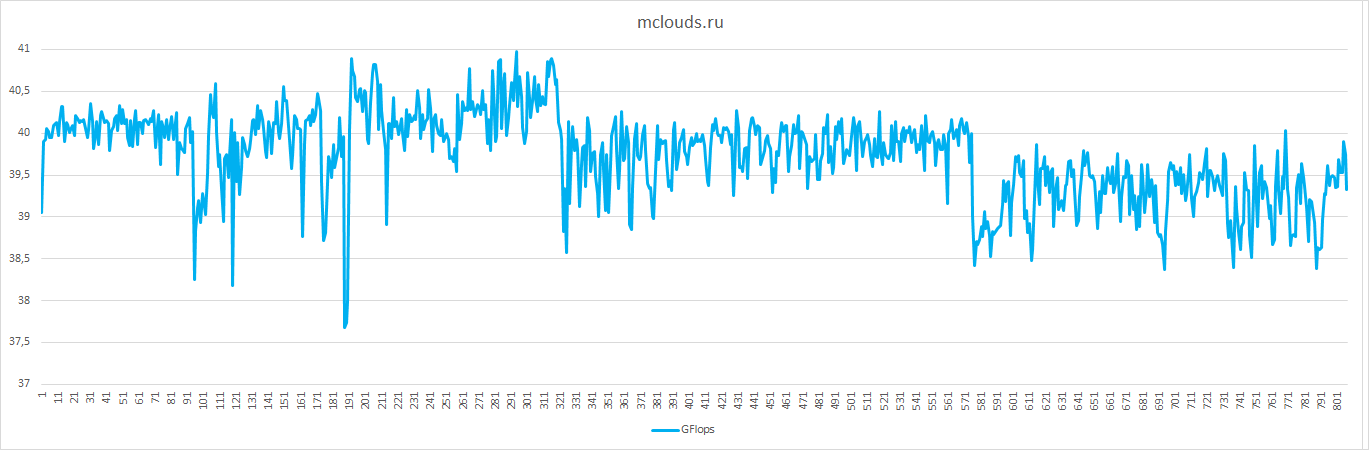

CPU

Согласно показателям LINPACK частота ЦП виртуальных машин не ограничивается, информация о частоте при оформлении указана на уровне 2.6 GHz.

Частота CPU: 2.592 GHz

Количество CPU: 2

Количество ядер: 2

Число потоков: 2

Среднее значение производительности 39.74 GFlops.

Отклонение от среднего значения: до 9%

На графике видна высокая производительность двух вычислительных ядер на уровне 40 GFlops.

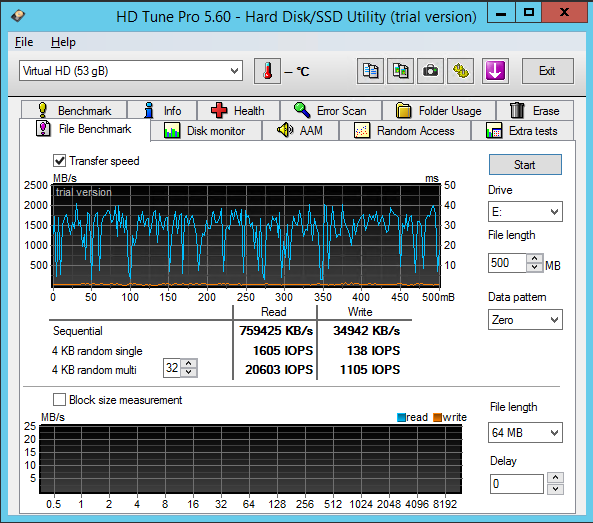

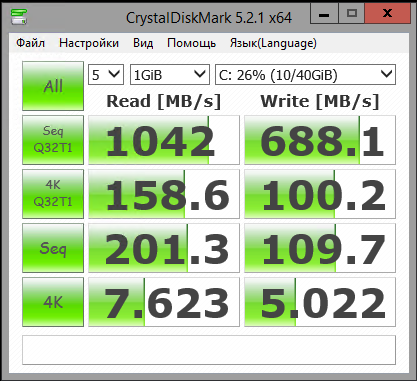

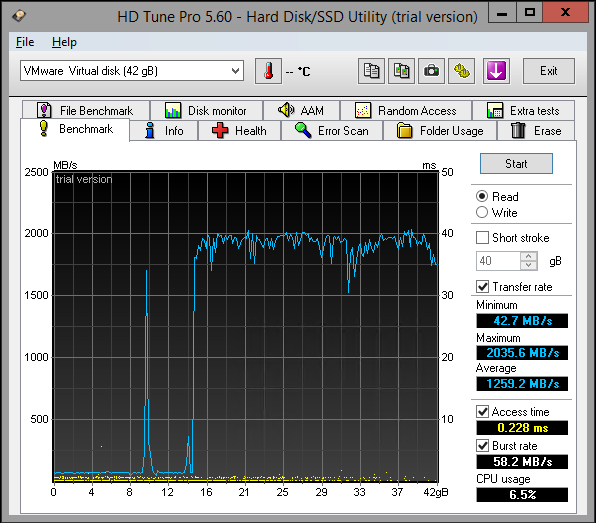

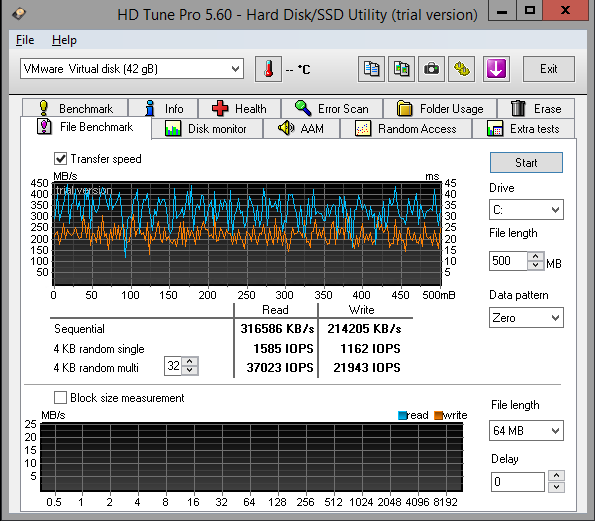

Дисковая подсистема

Пропускная способность доступа в сеть Интернет

| Местоположение |

Download (Mbps) |

Upload (Mbps) |

Ping (ms) |

| Москва (Beeline) |

87.9 |

83.6 |

3 |

| Краснодар (Rostelecom) |

89.4 |

31.3 |

17 |

| Екатеринбург (Rostelecom) |

97.4 |

89.1 |

29 |

| Иркутск (Rostelecom) |

76.1 |

59.7 |

64 |

| Владивосток (Rostelecom) |

91.3 |

45.1 |

107 |

| Франкфурт (Leaseweb) |

98 |

91.7 |

43 |

Дополнительные возможности:

- Резервное копирование

- Лицензии ПО

Доступные образы: Windows Server 2008 R2, 2012 R2, 2016 и Linux-based. Доступна установка из своего образа

Стоимость: 699 рублей в месяц за конфигурацию: 2 x 2.6GHz / 2 GB RAM / 40 GB SSD / Windows Server 2012 R2

Стоимость дополнительных ресурсов:

- 1 vCPU — 99 рублей

- 1 GB RAM — 190 рублей

- 1 GB SSD — 20 рублей

Ограничения согласно правилам: средняя нагрузка за день на аппаратный ресурс Исполнителя, создаваемая Заказчиком не должна превышать следующих установленных

Исполнителем параметров:

a. vCPU: не более 2500 MIPS на vCPU.

b. SSD IOPS: не более 75 IOPS на 1 GB SSD.

c. Средняя пропускная способность: не более 25 Мбит/c на протяжении 8 часов

Плюсы:

- стабильная и производительная вычислительная и дисковая подсистема;

- низкие задержки по России.

Минусы:

- ограниченные ресурсы вычислительной, дисковой подсистемы и доступа в сеть Интернет;

- нет информации об используемой СХД.

| Наименование |

Баллы |

incloud.ru |

ihc.ru |

infobox.ru |

1cloud.ru |

cloudlite.ru |

mclouds.ru |

| Дата-центр |

0.6 |

0.1 |

0.5 |

0.3 |

0.6 |

0.1 |

0.6 |

| Информация о ДЦ |

0.2 |

0 |

0.2 |

0.1 |

0.2 |

0.1 |

0.2 |

| Информация об инженерных подсистемах |

0.2 |

0.1 |

0.1 |

0.2 |

0.2 |

0.2 |

0.2 |

| Сертификация TIER |

0.2 |

0 |

0.2 |

0 |

0.2 |

0.2 |

0.2 |

| Информация об оборудовании |

0.3 |

0.3 |

0 |

0 |

0.3 |

0.3 |

0.2 |

| Серверное оборудование |

0.1 |

0.1 |

0 |

0 |

0.1 |

0.1 |

0.1 |

| Система хранения данных |

0.1 |

0.1 |

0 |

0 |

0.1 |

0.1 |

0.0 |

| Сетевое оборудование |

0.1 |

0.1 |

0 |

0 |

0.1 |

0.1 |

0.1 |

| Информация о юр.лице |

0.3 |

0 |

0.3 |

0.3 |

0.3 |

0.2 |

0.2 |

| Контактные данные |

0.1 |

0 |

0.1 |

0.1 |

0.1 |

0.1 |

0.1 |

| Адрес юр.лица |

0.1 |

0 |

0.1 |

0.1 |

0.1 |

0.1 |

0.1 |

| Реквизиты компании |

0.1 |

0 |

0.1 |

0.1 |

0.1 |

0 |

0 |

| Информация о платформе виртуализации |

0.1 |

0.1 |

0.1 |

0.1 |

0.1 |

0.1 |

0.1 |

| Договор оферты |

0.4 |

0.1 |

0.1 |

0.1 |

0.4 |

0.4 |

0.4 |

| Договор оферты |

0.1 |

0.1 |

0.1 |

0.1 |

0.1 |

0.1 |

0.1 |

| SLA |

0.3 |

0 |

0 |

0 |

0.3 |

0.3 |

0.3 |

| Тестирование сервиса |

|||||||

| Вычислительная подсистема |

0.4 |

0.2 |

0.2 |

0.2 |

-0.1 |

0.4 |

0.4 |

| Соответствие заявленной частоты и выделенной частоты процессора |

0.2 |

0 |

0 |

0.2 |

0.2 |

0.2 |

0.2 |

| Стабильность вычислительной подсистемы |

0.2 |

0.2 |

0.2 |

0 |

0 |

0.2 |

0.2 |

| Недокументированное ограничение вычислительной подсистемы * во время тестирования ограничения не были выявлены |

-0.3 |

0* |

0* |

0* |

-0.3 |

0* |

0* |

| Дисковая подсистема |

0.8 |

0.6 |

0.5 |

0.3 |

0.8 |

0.6 |

0.6 |

| Стабильность дисковой подсистемы |

0.2 |

0.2 |

0.2 |

0.1 |

0.2 |

0.2 |

0.2 |

| Высокоскоростная дисковая подсистема |

0.2 |

0 |

0.2 |

0.2 |

0.2 |

0.2 |

0.2 |

| Высокая доступность данных |

0.2 |

0.2 |

0 |

0 |

0.2 |

0.2 |

0.1 |

| Отказоустойчивость дискового хранения |

0.2 |

0.2 |

0.1 |

0.1 |

0.2 |

0.2 |

0.1 |

| Сетевое соединение |

0.5 |

0.5 |

0.4 |

0.4 |

0.3 |

0.3 |

0.5 |

| Стабильность сетевого соединения |

0.2 |

0.2 |

0.2 |

0.2 |

0.2 |

0.2 |

0.2 |

| Низкие задержки по России |

0.1 |

0.1 |

0 |

0 |

0 |

0.1 |

0.1 |

| Высокая скорость доступа по России (более 20 мбит/с) |

0.2 |

0.2 |

0.2 |

0.2 |

0.1 |

0 |

0.2 |

| Дополнительные услуги |

1 |

0.8 |

0.5 |

0.5 |

0.6 |

0.8 |

0.7 |

| Базовая техническая поддержка |

0.2 |

0.2 |

0.2 |

0 |

0 |

0.2 |

0.2 |

| Расширенная техническая поддержка |

0.2 |

0 |

0 |

0.2 |

0 |

0 |

0 |

| Бесплатная лицензия Windows Server |

0.2 |

0.2 |

0.2 |

0.2 |

0.2 |

0.2 |

0.2 |

| Лицензия ПО |

0.1 |

0.1 |

0.1 |

0.1 |

0.1 |

0.1 |

0 |

| Гибкое расширение ресурсов |

0.3 |

0.3 |

0 |

0 |

0.3 |

0.3 |

0.3 |

| Итого |

3,4 |

1,9 |

2,1 |

1,7 |

2,7 |

2,8 |

3 |

| |

incloud.ru |

ihc.ru |

infobox.ru |

1cloud.ru |

cloudlite.ru |

mclouds.ru |

| CPU GHz заявленная |

— | 2 |

— | 2 |

2.2 |

2.6 |

| CPU GHz выделенная |

1.597 |

1.286 |

2.414 |

2.082 |

2.147 |

2.592 |

| Ср.знач. GFlops |

18.86 |

4.79 |

20.91 |

12.57 |

27.7 |

39.74 |

| Отклонение от ср.знач. в % |

6 |

2 |

19 |

16 |

5 |

9 |

| Seq.R Q32T1 (MB/s) |

113 (SSD) |

695.6 (HDD) |

1402 (SSD) |

657.5 (SSD) |

652.4 (HDD) |

1042 (SSD) |

| Seq.W Q32T1 (MB/S) |

113.2 (SSD) |

127.4 (HDD) |

1300 (SSD) |

549.2 (SSD) |

443.6 (HDD) |

688.1 (SSD) |

| 4 KB Random Read (IOPS) |

8143 |

20603 |

21531 |

19874 |

12785 |

37023 |

| 4 KB Random Write (IOPS) |

3965 |

1105 |

32020 |

20097 |

6549 |

21943 |

| Access time (ms) |

0.287 |

0.811 |

0.400 |

1.02 |

3.59 |

0.228 |

Примечание: сравнение провайдеров производилось с марта по май месяц, некоторые данные были актуализированы в ходе тестирования. Для уточнения условий по тарифам и ресурсам рекомендую обратиться к провайдерам, они сами за себя отвечают.

Подводим итоги

Как видно по результатам тестов, уровень качества предоставляемых услуг в плане производительности работы ВМ у всех хостинг провайдеров различный. Приведенные результаты не претендуют на истину в последней инстанции, но я постарался сделать эту информацию максимально объективной. Надеюсь, это поможет сэкономить время тем, кому нужны вычислительные ресурсы, но нет необходимого бюджета на новое оборудование. Выход есть. Рынок облачных хостинг провайдеров в России широк и конкуренция здесь достаточно высока. Считаю, что доверять работу своих бизнес-приложений «облакам» можно и нужно, но следует внимательно относиться к выбору провайдера.

|

Метки: author igored хостинг серверное администрирование it- инфраструктура windows vps vps vds виртуальный сервер хостинг-провайдеры |

Британские спутниковые снимки 2: Как все было на самом деле |

Сразу оговорюсь, что данный пост не несет большой технической нагрузки и должен восприниматься исключительно в режиме «пятничной истории». Кроме того, текст насыщен английскими словами, какие-то из них я не знаю как перевести, а какие-то просто не хочется переводить.

Краткое содержание первой части:

1. DSTL (научно-техническая лаборатория при министерстве обороны Великобритании) провела соревнование на Kaggle.

2. Соревнование закончилось 7 марта, результаты объявлены 14 марта.

3. Пять из десяти лучших команд — русскоговорящие, причем все они являются членами сообщества Open Data Science.

4. Призовой фонд в $100,000 разделили брутальный малазиец Kyle, команда Романа Соловьева и Артура Кузина, а также я и Сергей Мушинский.

5. По итогам были написаны блог-посты (мой пост, пост Артура, наш с Серегой пост на Kaggle), проведены выступления на митапах (мое выступление в Adroll, мое выстпление в H20.ai, выступление Артура в Yandex, выступление Евгения Некрасова в Mail.Ru Group), написан tech report на arxiv.

Организаторам понравилось качество предложенных решений, но не понравилось, сколько они за это соревнование отстегнули. В Каggle ушло $500k, в то время как призовые всего $100k.

Был сделан логичный вывод — создать свой британский Kaggle с преферансом и гимназистками. Знаний и умений у двигателей науки при министерстве обороны UK и MI6, на серьезный AI Research не хватит, поэтому вместо того, чтобы сделать закрытый междусобойчик для своих, они устроили открытое соревнование, но с мутными правилами, а именно: участвовать могут все, а вот на призовые претендовать только те, кто является гражданами и проживает в странах, которые выше некой отсечки в очередном коррупционном рейтинге 2014 года. Почему 2014, а не чего-то более свежего? Это до сих пор непонятно. Существует конспирологическое мнение, что 2014 год был выбран именно для того, чтобы оставить за бортом китайцев и не оставить индусов. А вот в 2016 году Индия и Китай имеют одинаковый рейтинг, так что фокус бы не прошел.

Написать сайт, имитирующий Kaggle, у двигателей науки навыка тоже не хватило, поэтому они наняли подрядчика, а именно, британского коррупционера BAE Systems.

Для получения денег за то соревнование, про которое рассказано в первой части, было необходимо провести skype-конференцию с представителями DSTL и в двух словах описать решение. Мы презентовали, описали. Они откровенно плыли и, собственно, отчасти на этом основывается мое самоуверенное предположение о том, что специалистов высокого полета у них нет. Но сами по себе эти британские ученые достаточно адекватные, и в конце нашей речи их главный, в качестве рекламы, упомянул, что они тоже не пальцем деланы, и что у них есть своя площадка для проведения соревнований, и что вот только что стартовали две задачи, одна — под Computer Vision, другая — под Natural Language Processing и у каждой призовой фонд 40 тысяч фунтов (20k, 12k, 8k). Мы ответили, что в курсе и, в свою очередь, вежливо поинтересовались: «А почему у вас правила дискриминационные”? Мужик ответил, что это все ерунда, что это не они, а подрядчик, который проводит соревнование так начудил, и что DSTL тоже против дискриминации, что всё поменяют и вообще, счастья всем и каждому.

Позже мы уточнили по email, насколько серьезно они намереваются придерживаться правильной линии партии и получили в ответ:

— There is likely to be a change to the terms and conditions relating to the datasciencechallenge.org. The original conditions were set by the company who are running the challenge for us (based on legal grounds) but following feedback they have/will be changed. Please don't let it put you off participating.

Но на самом деле, это все было не важно. Идея в том, что с одной стороны я сильно проседал на знаниях в Object Detection и под это дело лихо пролетал на интервью. Например, в Nvidia на self driving car, я влетел на том, что Image Classification я умею, Image Segmentation умею, а вот Object Detection, который очень важен для многих бизнесовых задач, которые используют компьютерное зрение — нет. А как известно, учиться лучше в бою, так что это надо либо свой проект в свободное время пилить, либо поработать над каким-нибудь соревнованием.

Стоит добавить, что задача про классификацию рыбок, в которой нужен был object detection прошла для меня по нулям как раз из-за нехватки знаний, ну и другие задачи, которые к тому моменту уже начались, но не закончились, то есть про рак шейки матки, про подсчет морских котиков, да и ImageNet 2017, тоже угнетали, заставляя комплексовать на тему собственной беспомощности.

Суммируя:

1. О том, что денежный приз гражданам России не светит, было известно заранее. Когда позже вся эта история прошла по новостям этот кусок опускался, так как работать в режиме „наших бьют“ гораздо выгоднее для рейтинга. Да, была надежда, что правила поменяют, но „обещать — не значит жениться“, так что сильно на это никто не рассчитывал.

2. Соревнования — это 10-100x по специфичным знаниям в единицу времени в машинном обучении, по сравнению с академической средой или работой. Очень было нужно разобраться в Object Detection, плюс, хотелось, чтобы появился pipeline под этот тип задач, так как pipeline'ы имеют привычку кочевать из задачи в задачу, трансформируя многие задачи из „что-то как-то понятно, но не очень — влечу на пару месяцев“ в „задача сложная, значит на написание pipeline уйдет не один вечер, а целых два“.

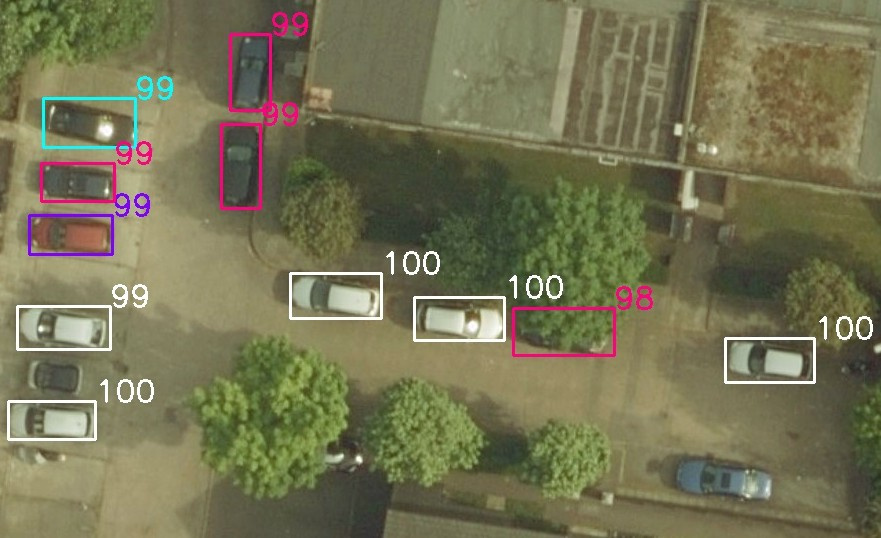

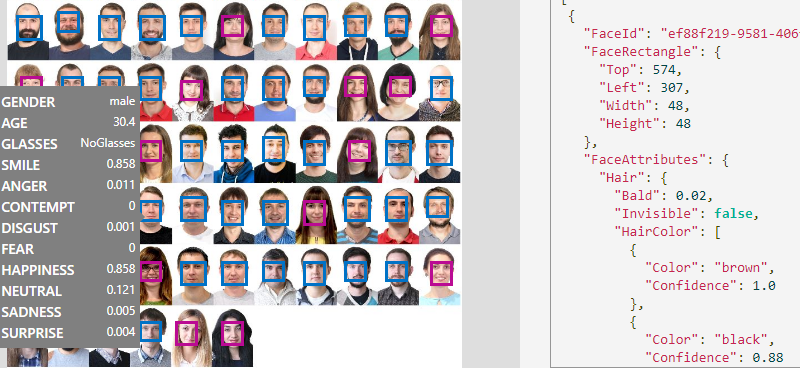

Постановка задачи

Что, собственно, требуется? Надо создать алгоритм, который будет брать спутниковые снимки, неизвестного города в Великобритании и на них находить мотоциклы, машины и автобусы определенного вида. По тени от колеса обозрения было сделано предположение, что этот неизвестный город — Лондон.

В задаче, про спутники, про которую рассказывалось в первой части, с данными все было сложно:

1. Снимки представлены в куче различных спектральных диапазонов, разрешениях, каналы сдвинуты как во времени, так и в пространстве.

2. Данных мало. Train, public test и private test соответствуют различным распределениям.

3. Классы сильно разбалансированы. Например, в train set одному пикселю класса машинок соответствовало 60000 пикселей класса ферм. Собственно, в нашем с Серегой решении мы полностью положили болт на машинки и не заморачивались c их нахождением в Нигерийских джунглях в которых все действо и происходило как раз из-за проблем с данными этого класса.

Там было увлекательно и очень интересно, но все умаялись. Задача была с исподвыподвертом и больше времени проводилось не над научными изысканиями, а над борьбой с инженерной мутью, часть из которой была обусловлена спецификой данных, а часть нездоровым креативом со стороны организаторов.

В этой же задаче все было наоборот:

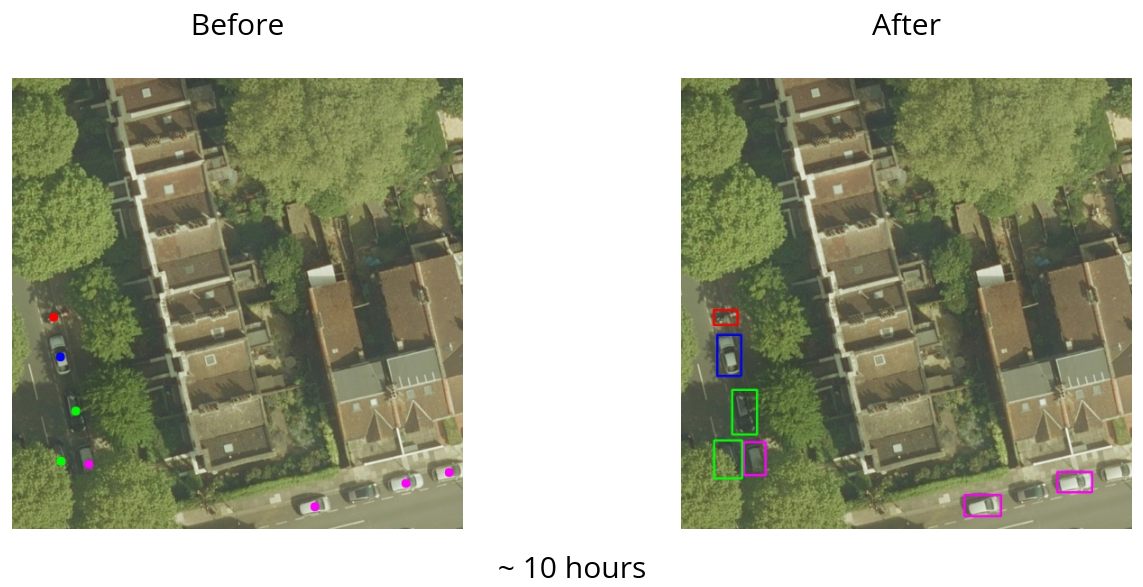

1. Данные представлены в обычном RGB, сделаны с одной высоты, и чуть не в одно время.

2. Train и test представлены 1200 картинками (600 и 600), каждая размером 2000x2000, в разрешении 5 см / pixel. То есть достаточно для решения задачи, но при этом не требует кластера из GPU и нескольких недель обучения.

В стандартных benchmark-датасетах, отмаркированных под Object Detection, на которых ученые мужи занимаютcя выяснением, чей алгоритм лучше, объекты отмечены через bounding boxes (боксы), то есть каждому объекту из train соответствуют координаты прямоугольника и метка класса, а модель, в свою очередь, предсказывает координаты прямоугольников, метку класса и то, насколько модель уверена в предсказании.

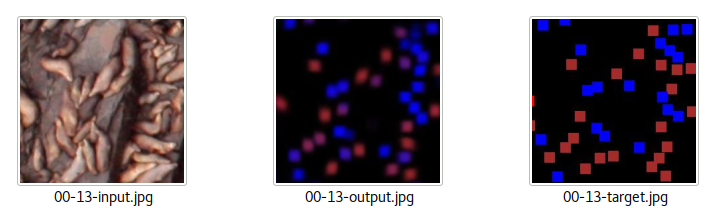

Проблема в подготовке таких датасетов в том, что эти прямоугольники достаточно долго обводить, а датасеты нужны большие, так что даже если нанять маркировщиков задешево, получится долго и дорого. Альтернативный вариант — это так называемое weak labeling, где вместо бокса ставится точка в центр объекта.

Британцы пошли именно по альтернативному пути, и маркировали точками, причем, в отличие от стандартного подхода, в котором есть объект — есть метка, они добавили воображения и проводили маркировку в режиме — вот этот объект алгоритмы участников, наверно, найдут — мы его отметим, а вот тут машина наполовину скрыта кроной дерева, так что мы ее отмечать не будем. Так делать не надо, сильно затрудняет тренировку моделей. Но спишем эти перекосы на их неопытность.

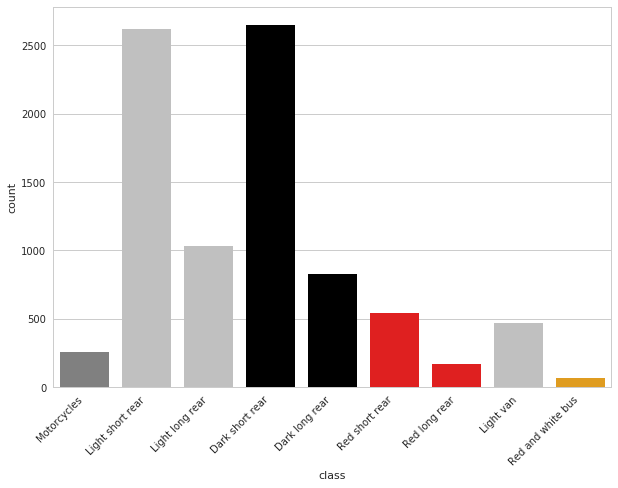

Классов было 9, а именно:

- A — любые мотоциклы и скутеры

- B — короткие светлые машины

- C — длинные светлые машины

- D — короткие темные машины

- E — длинные темные машины

- F — короткие красные машины

- G — длинные красные машины

- H — белые фургоны

- I — красно-белые автобусы

То есть мало найти машинку, надо еще правильно классифицировать, плюс, искать надо не всё. Синие, зеленые, желтые транспортные средства и прочее британцев не интересовали.

Классы несбалансированы, но наименее представленные классы, то есть мотоциклы, автобусы и красные машинки обладали ярко выраженными признаками, так что сеть это не сильно напрягало.

(Картинку предоставил Владислав Кассым)

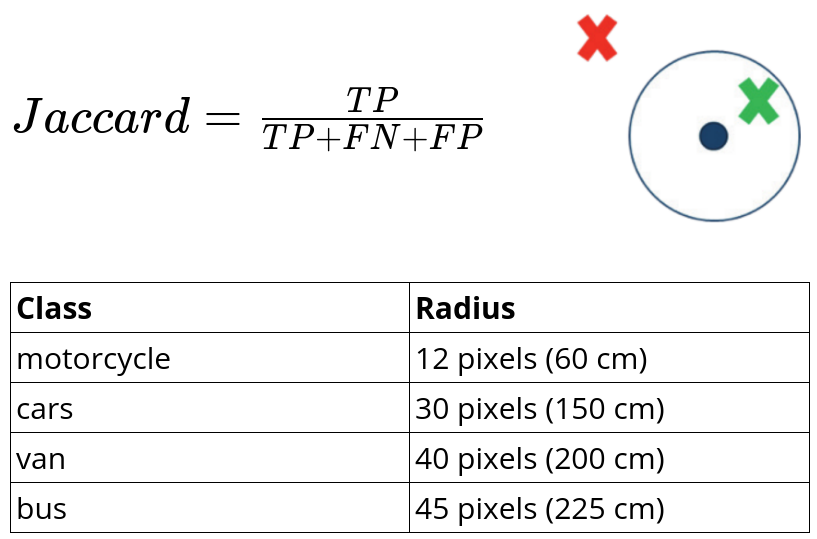

Метрика

В качестве оценки точности модели использовался jaccard similarity, где True Positive засчитывался, если предсказанная точка рядом с британской меткой, а так как размеры объектов различались, то и расстояние зависело от класса.

Что мы имеем? Задача, которая с одной стороны — стандартная, а с другой — черт его знает, как к ней подступиться. Как вариант, можно попытаться выехать на плечах коллектива, все-таки ребята, которые подобрались в слаке Open Data Science, обладают зашкаливающе высокой квалификаций в машинном обучении. Но факт, что организаторы считают граждан России, Украины и Беларуси людьми второго сорта и что параллельно идет море других задач, где и дискриминации в правилах нет, и денежные призы посимпатичнее, не добавляло мотивации начать работать над задачей. Кроме того, интенсивная рубка, которая шла в задаче про спутники, привела к тому, что многие выгорели, взяли перерыв от соревнований и занялись тем, что важнее, то есть спортом и личной жизнью.

Коллективом решать задачи интереснее и эффективнее, поэтому стояла задача разобраться самому и подбить остальных на участие. Времени оставалось мало, что-то в районе месяца.

Окунувшись в литературу по Object Detection стало понятно, что статей про детекцию через боксы много, а через точки в центрах масс — мало. Ну и реализаций кода, которые выкладывают авторы для случая с боксами под каждый фреймворк тоже хватает, а под точки при беглом просмотре я ничего не нашел.

Как следствие, первый шаг, который был сделан — сведение неизвестной задачи к стандартной, а именно, я угробил пару дней на работе и обвел все боксы в train. Использовал я для этого sloth, хотя позже, уже после того, как все разметил, догадался спросить, и коллектив подсказал, что существуют альтернативные инструменты, и для других задач, которые были после, я использовал labelimg.

На разметку ушло порядка десяти часов, что, в принципе, немало, но эта инвестиция в дальнейшем помогла легко уйти в топ, да и вообще, занять призовое место. Дополнительной маркировкой решились сразу две задачи, во-первых, стало понятно на чем именно сфокусироваться в литературе и какой чужой код перебивать под эту задачу, а во-вторых, что не менее важно, сразу добавило мотивации ребятам в чатике, чтобы присоединиться к работе над задачей. Много народу не подключилось, потому что, как я упомянул выше, параллельно шли не менее интересные задачи про рак шейки матки и про подсчет морских котиков. Например, Константин Лопухин сразу сказал, что на задачу про британские машинки времени мало, а вот на котиков самое оно и не прогадал, финишировав на той задаче вторым (выступление в Yandex с его решением). Желание набить руку на задаче детектирования британских машинок изъявили Сергей Мушинский и Владислав Кассым. Собственно, все трое и закончили в топ-10.

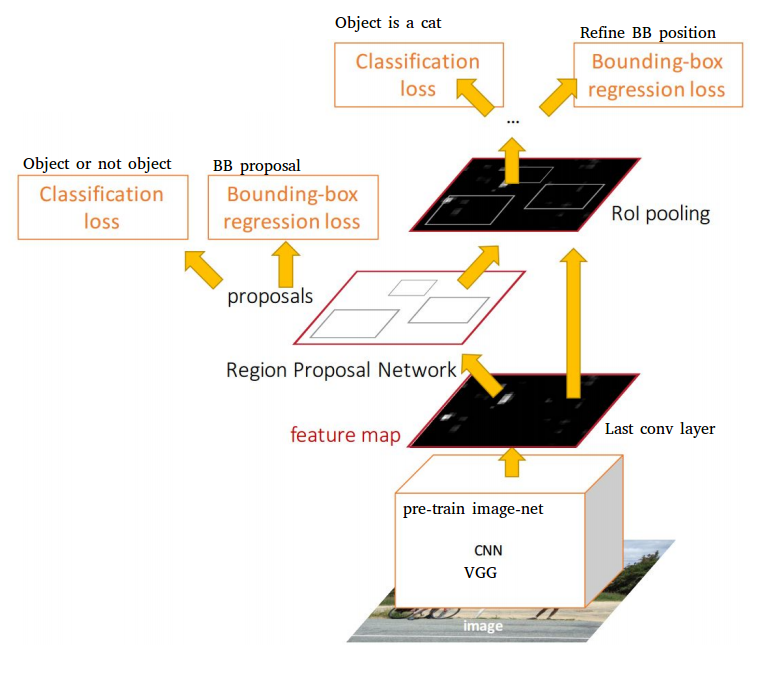

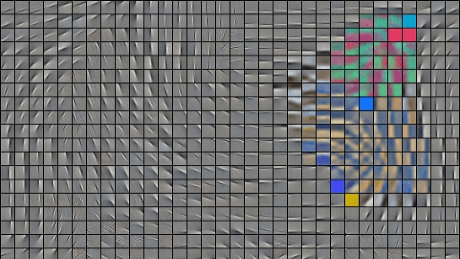

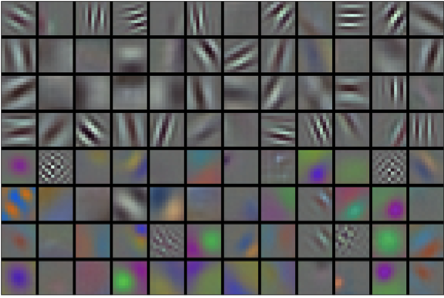

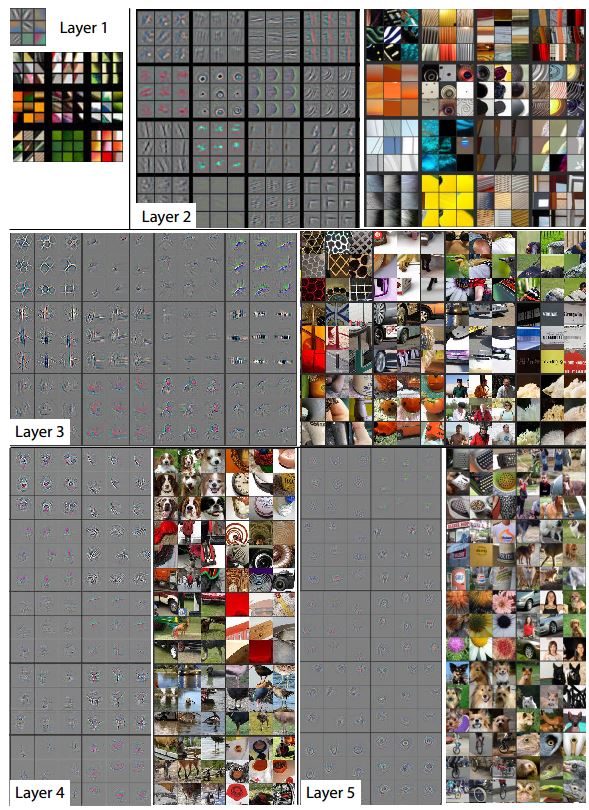

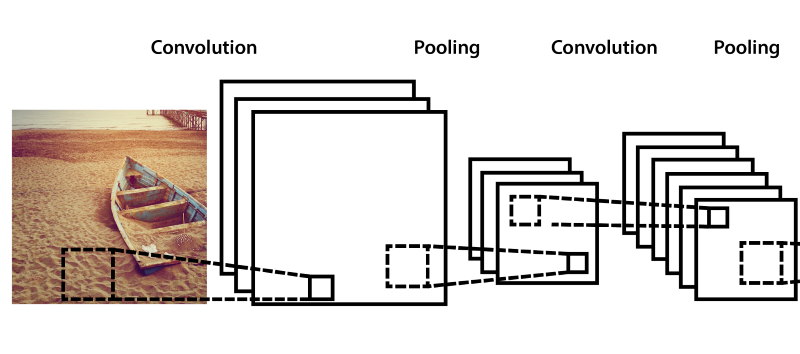

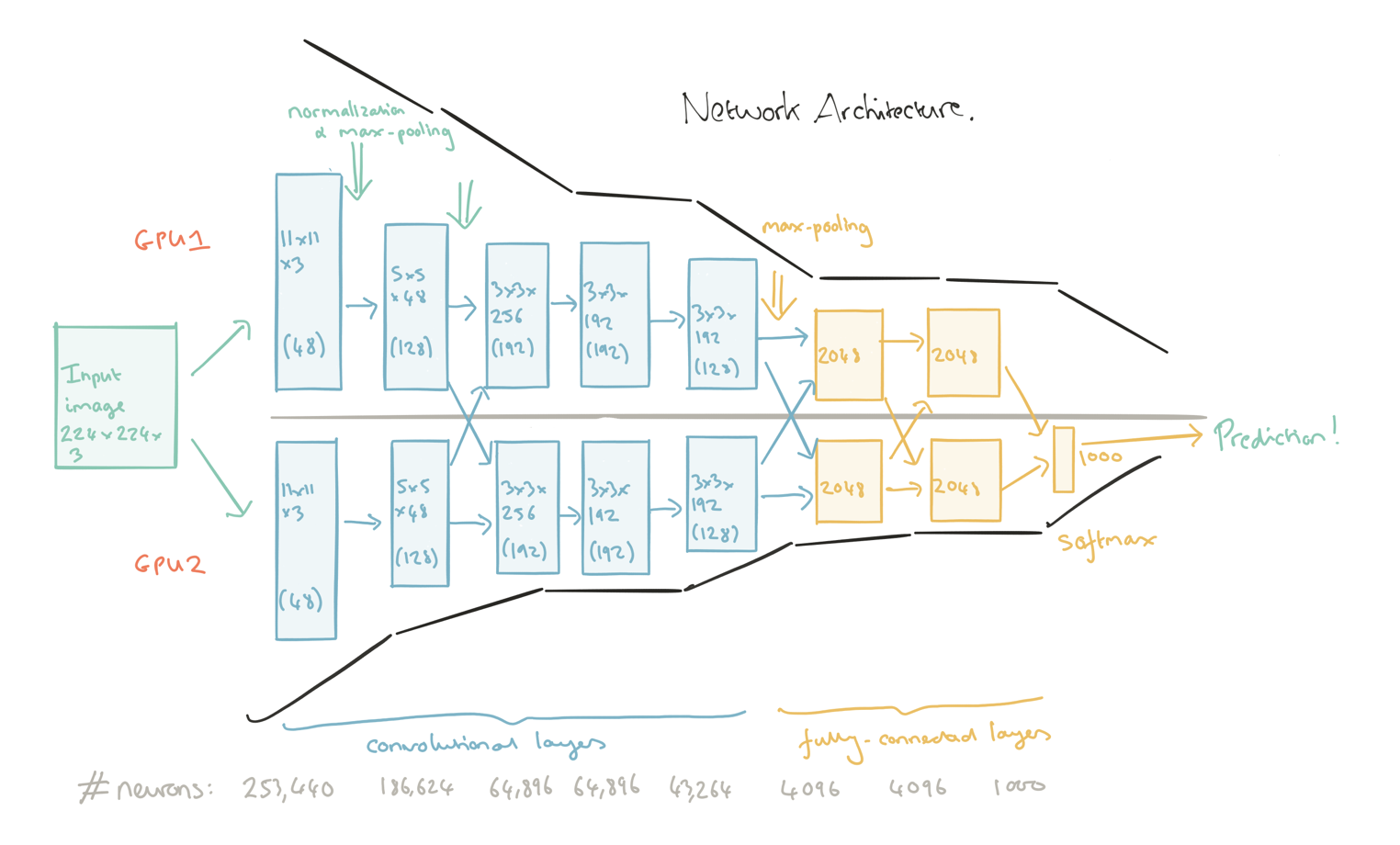

Итак, месяц до конца, обведены боксы, с этим надо что-то делать. Существуют две основные вариации на архитектуры сети для задачи детекции:

1. Семейство RCNN: Fast RCNN, Faster RNN — то есть сети, у которых pipeline можно разделить на две части: первая — найти области на картинке, которые соответствуют объектам, а вторая — провести классификацию для каждой области, чтобы определить какой именно объект там содержится.

2. Семество YOLO: YOLO, YOLO9000, SSD — в этих архитектурах поиск областей и классификация происходит в один заход.

Встает резонный вопрос, что лучше и когда. В каждой статье авторы утверждают, что вот именно они рвут конкурентов на британский флаг. Такой подход понятен, не будешь заниматься агрессивным академическим cherry picking, оверфитить на стандартные бенчмарки и трындеть про State Of The Art — не получишь грант, твои аспиранты не выпустятся и все прочие радости, которые мы сейчас имеем в академической среде. (На эту тему недавно была очень приятная статья в которой приводилась историческая справка о том, как мы дошли до такой жизни: Is the staggeringly profitable business of scientific publishing bad for science?).

Но это проблемы академической среды и их локальные заморочки. Тут у нас есть четко поставленная задача, есть метрика, есть leaderboard, на котором участники показывают серьезные результаты, а у меня, кроме обведенных боксов, нет ни черта. При наличии большого количества времени и вычислительных ресурсов, можно было бы прогнать все архитектуры через наши данные и посмотреть на то, что получилось, но ни времени, ни желания этого делать конечно не было. Но! Вопрос о том, когда и какие сети хороши, терзал не меня одного. Пару лет назад Object Detection занимались исключительно ученые, но к бизнесу, несмотря на мощь подхода, это не имело отношения. Все упиралось в то, что в отличие от задач классификации и сегментации, задачи детекции работали со скоростью эстонской черепахи, то есть ни о каком real time detection речи не было. Но это все было пару лет назад, то есть по меркам Deep Learning достаточно давно. С тех пор сделано много улучшений и сейчас компании активно применяют Object Detection для зарабатывания своих триллиардов.

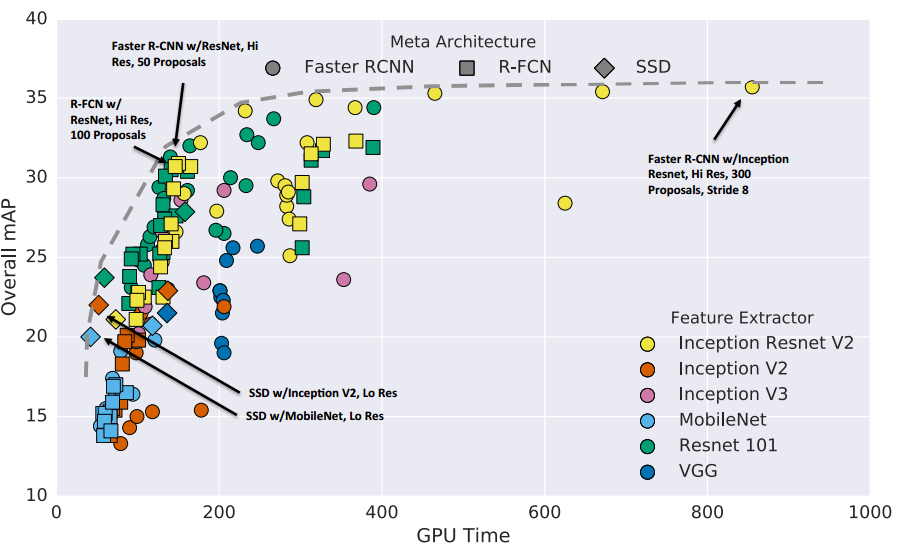

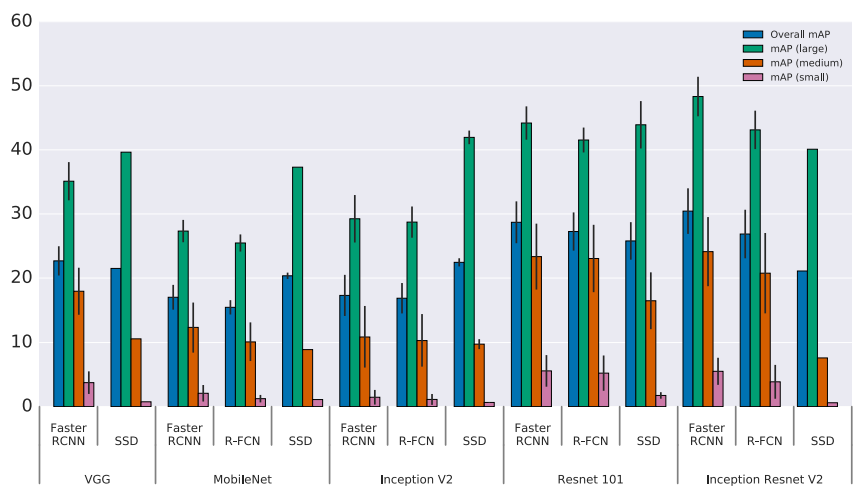

Так вот, в свое время ученые мужи, которые работают в Google воспользовались тем, что с вычислительными ресурсами у них все нормально и написали обзорную статью в 11 авторов в которой с одной стороны ни одной новой идеи, а с другой она обладает огромной ценностью, во всяком случае среди меня. В этой статье авторы прогнали Faster RCNN и SSD с различными base feature extractions и провели анализ результатов по скорости и точности.

В статье говорится о том, что Faster RCNN поточнее, особенно на небольших объектах, а SSD предсказывает пошустрее. Причем разница по скорости предсказаний между ними, на мой взгляд, проходит как раз между „нельзя пихать в production“ и „можно пихать в production“. С дивана я не очень представляю под какие задачи можно пихать Faster RCNN в прод, но с удовольствием послушаю про success story в комментариях.

Этой статье я поверил на слово, не потому что я люблю верить на слово и не потому что Google при написании статей больше печется о своем имени и, как следствие, больше говорит по делу, а просто потому что выбора большого не было. Времени до конца соревнования оставалось совсем немного.

По указанной выше причине, а именно — большая точность при детекции мелких объектов, мотоциклы на картинках были крайне небольшого размера, выбор пал на Faster RCNN.

Круто. Я обчитался литературы, что-то начало проясняться, но чтения было мало. От того, что в голове стали прорисовываться какие-то контуры и мозаика начала постепенно складываться в большую картину, на лидерборде ты не появишься. Надо писать код. Нет кода — нет разговора.

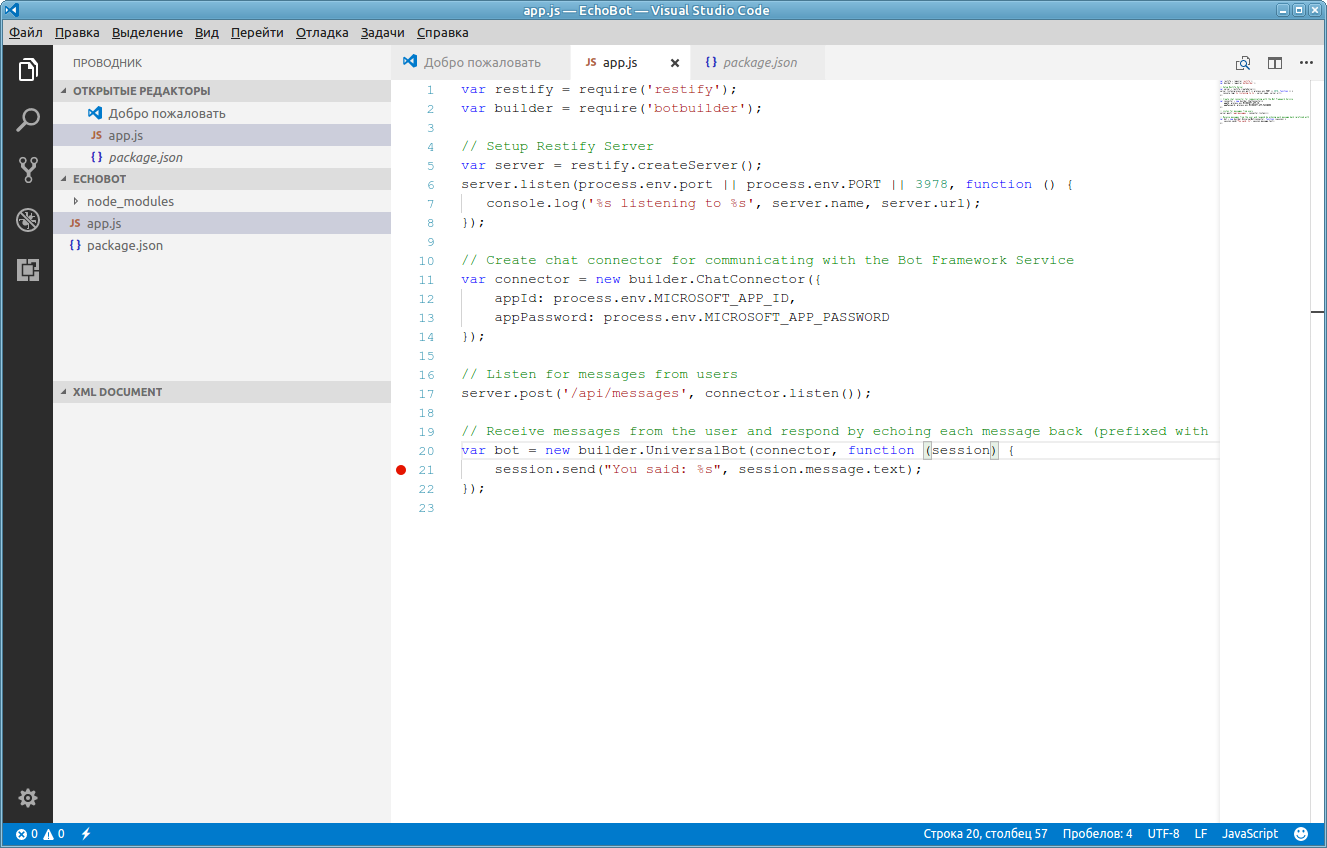

Детекция — это не классификация, с нуля писать тяжело, куча нюансов, море мистических параметров, которые авторы подбирали месяцами, так что обычно берется чужой код и адаптируется под свои данные. Существует много различных фреймворков для работы с нейронными сетями, у каждого свои плюсы и минусы. В начале работы над этой задачей наиболее комфортно я себя чувствовал с Keras, на котором мы с Серегой и затащили предыдущее соревнование. Сказано — сделано, берется реализация Faster RCNN на Keras и перебивается под наши данные. Запускается тренировка, что-то сходится, но это таааааак медленно. Как-то привыкаешь, что в других задачах через сеть летят десятки картинок в секунду, но тут все совсем не так. Сказывается и то, что Faster RCNN медленный и то, что Tensorflow не зашкаливает по производительности, плюс overhead, который идет от Keras, как от wrapper'a.

Что-то куда-то потренировалось, сошлось, предсказание, лидерборд и я десятый c результатом 0.49. То, что я в десятке — это хорошо, а вот то, что у ребят в первой тройке 0.8+, то есть разрыв достаточно большой — это не очень.

Keras — это хорошо и приятно, чистый код, понятная кодовая база, но он медленный и data parallelization осуществляется с большей болью, чем хочется. Всю зиму я работал над прошлой задачей, используя один GPU, а уже ближе к концу докупил второй. Два GPU — это очень удобно, как минимум, это позволяет проверять две идеи одновременно, да и если идей нет, не обязательно железу простаивать — на этих GPU всегда можно майнить криптовалюты, чем, скорее всего, и занимаются многие, кто решает задачки на Deep Learning, в свободное от тренировки моделей время.

В данном же случае идея одна — натренировать Faster RCNN. Тренируется сеть медленно, у меня два GPU, реализация на Keras небыстрая и мудреная, параллелить можно, но с болезненно. Сейчас ведется много работы над тем, чтобы можно было делать Data Parallelization на несколько GPU мизинцем левой ноги. Как я понимаю, на данный момент с этой задачей успешно справились разработчики mxnet и pytorch.

В этой задаче карты легли так, что выбор пал на mxnet. Он действительно быстрый сам по себе, он действительно легко параллелится мизинцем левой ноги. Это были плюсы, из минусов — такое ощущение, что его писали инопланетяне. Наверно, сказывается то, что и сам mxnet и реализация Faster RCNN для меня были в диковинку, но тем не менее, проблемы с тем, что делаешь шаг в сторону — сразу темный лес, документации не хватает, не покидали с начала и до конца. Спасло то, что Сергей и Владислав занимались ровно тем же самым и через дебри mxnet я продирался в составе группы, а не один.

На этом техническую часть можно было бы и закончить. По сути, применение реализации Faster RCNN на mxnet моментально вывело в регион 0.8+. Тренировка производилась на crops размером 1000x1000, которые аугментировались поворотами на углы кратные 90 градусам + отражения (преобразования из D4 group). При предсказании, исходные картинки 2000x2000 резались на пересекающиеся куски размером 1000x1000. После этого применялся Non Maximum Supression для борьбы с эффектом, когда один и тот же бокс предсказан в различных тайлах. После этого у каждого бокса находился центр масс и это и шло в итоговое предсказание.

В определенный момент, несмотря на то, что везде в литературе утверждается, что Resnet 152 как feature extractor работает лучше, чем VGG 16, выяснилось, что общепринятая точка зрения на этой задаче на работает. Кто-то, на дурака, попробовал использовать VGG 16 и это заметно улучшило результат. Позже, в другом разговоре, bobutis, который в составле команды выиграл задачи по классификации рыбок и рака шейки матки, используя Faster RCNN, подтвердил, что на практике, VGG как feature extractor работает лучше.

В этой задаче были такие чистые данные и их количество было подобрано так хорошо, что сеть работала за гранью моих ожиданий. Особенно радовали случаи, когда из-под дерева или из-под моста торчали одни фары.

Где у сети были проблемы? Как и ожидалось, плотно упакованные объекты предсказывались плохо. На эту тему тоже много литературы, но в целом, детекция плотно упакованных объектов — это другая задача.

На задаче про подсчет морских котиков подход через детекцию не зашел, как раз именно из-за плотной упаковки и народ решал через сегментацию, сопоставляя каждому котику гауссиану и сегментируя получившийся heatmap.

Иногда, но крайне редко, сеть пыталась выдать всякий хлам за интересующие нас объекты.

При этом, точность моей модели jaccard = 0.85, у ironabar, который на первом месте 0.87, но никак не 0.98-0.99. Навскидку, мы ошиблись примерно с 1200 машинками — а это очень много, особенно учитывая, что у меня сложилось стойкое впечатление, что на этой задаче и на этих данных сеть работает точнее, чем ручная разметка (первый раз с таким сталкиваюсь на практике).

Я думаю, что получилось вот что:

1. Многие классы тяжело отличать визуально, серая машина в тени может выглядеть как темная, а на солнце — как светлая. Синие и синеватые машинки тоже, совершенно запросто, могли упасть не в тот класс. И это сказывалось и при тренировке, и при предсказании.

2. Организаторы определили классы в достаточно странной манере — не, скажем, белый седан или хэтчбек, а белая длинная или короткая машина. При визуальной оценке, даже если отложить вопрос цвета в сторону, много пограничных случаев, которые не очевидно, к какому классу относить. Даже белые фургоны не всегда можно отличить от коротких белых машин.

3. Кабриолеты, несмотря на то, что сверху выглядят темными относятся к тому классу, которому соответствует основная расцветка, то есть, что бы сказал прохожий, если бы его спросили цвет машины. Это не проблема если бы таких кабриолетов в train было много, но число кабриолетов в Лондоне, скажем прямо, не зашкаливает.

5. Организаторы проявили креатив и решили упростить задачу для участников, то есть разбили случаи на простые и сложные, и ввели для этого какие-то свои внутренние правила, то есть если машина на краю и часть багажника выходит за край картинки они ее не учитывали ни в train, ни в test, что-то похожее можно сказать и про машины, которые наполовину скрыты деревьями. Как следствие, это добавило шума разметке, то есть сеть при тренировке щелкало за False Positive не по делу, уменьшая ее предсказательную силу и какие-то предсказанные машинки классифицировались как False Positive при вычислении jaccard на сайте соревнования.

Середина мая. Соревнование закончилось, на Public LB я третий, на Private — второй, организаторы пишут письмо в котором просят предоставить:

Please send the following information to general@datasciencechallenge.org:

Full name

Nationality

Telephone contact details

Whether you would be happy to provide an interview for the winner announcements

Passport details (scan/photo of details page with photo)

Proof of address (eg. scan/photo of a utility bill)

Bank account details (IBAN, Account Number and Sort Code)

В правилах написано, что если ты гражданин России — то денег дадут. Но уточнить с меня не убудет, я написал письмо, в котором английским по белому написал, что я гражданин России, живу в Сан Франциско, США, банк у меня американский и задаю логичный вопрос: „Призовые платить будем“? В ответ получаю email, который сводится к ожидаемому: „Нет, призовых не будет, ибо, несмотря на результат, по правилам, цветом паспорта ты не вышел“.

…

I'm sorry to say that due to your Russian citizenship you do not meet Clause 2.3b because Russia has a score below 37. As a result the company running the challenges is unable to award you any prize money as you do not meet the criteria that they need to follow due to their legal obligations in the UK.

…

Ответ был ожидаемым, так что обидно не было. Но! Сам факт наличия всех этих ограничений по месту жительства и по гражданству выбешивал с самого начала. Понятно, что в этом соревновании так уж получилось, но раз уж они позиционируют себя как очередную копию Kaggle, то очень бы хотелось щелкнуть по носу, чтобы увеличить шансы на то, что в будущем они будут думать, прежде чем запускать соревнования с нездоровыми правилами. Как щелкнуть — непонятно. Я написал что-то у них на форуме, добавил пару строчек к блог-посту на Kaggle про спутниковые снимки, хоть этот блог никто и не читает, но так, для очистки совести. Написал свой первый и единственный пост в twitter и гневный пост на facebook. Каюсь. Еще когда писал, я осознавал, что те, кто не в курсе деталей будут воспринимать текст как: „Подлые британцы в последний момент поменяли правила и кинули меня на деньги“.

Также я скинул ссылку на пост на facebook и twitter в слак ODS. На этом долг перед мировым научным сообществом был закончен, ибо непонятно, что еще сделать, чтобы уж точно по носу щелкнуть, и с этими мыслями я пошел спать. Скажем честно, cилу ODS я недооценил, кто-то репостнул, кто-то лайкнул, слово за слово, на следующий день эта история появилась где-то в телеграмме, на каких то мелких новостных сайтах, а потом все это окончательно вышло из под контроля.

Я уже не помню хронологию событий, помню лишь, как в определенный момент я сижу на работе, и, вместо тренировки очередной модели, читаю канал #_random_flood и это воспринимается как фронтовые сводки.

Народ мониторил различные средства массовой информации и скидывал, что и где в новостях пролетело.

Со мной пытались связаться:

1. Russia Today — я отказался давать интервью на камеру, но ответил на пару вопросов по email. И этого им хватило на заметку.

2. Первый канал — атаковали всех моих русскоговорящих знакомых на Facebook и VK с просьбой помочь связаться со мной.

3. Пятый канал — пытались связаться со мной, не получилось; пытались связаться с моими родителями, не получилось; поехали в школу и взяли интервью у учителей. Я сильно надеюсь, что учителя не прощелкали клювами и выбили под это доп. финансирование.

4. Рен ТВ — хотели что-то из серии их стандартных програм про инопланетян и прочую экзотику, а именно, чтобы я стал центральным персонажем выпуска передачи „Осторожно: русские!“.

5. Комсомольская правда — выпустили не только электронную, но и бумажную версию.

6. Я попал на главную lenta.ru. Ненадолго, но тем не менее.

7. Какие-то совсем неизвестные мне каналы вроде „Царьград ТВ“ тоже попытались общаться, но они все пропадали в лавине всех, кто пытался со мной связаться.

8. Я сам не смотрел, но народ рассказывал, что тот факт, что я отказался работать на камеру не остановил телевизионщиков. Они все равно выпустили сюжеты, добавив мое фото в фон. Ну и, как водится, пригласили каких-то непонятных персонажей высказать их экспертную оценку на происходящее.

Общаться со всеми этими людьми большого желания не было. Цель моего поста на Facebook щелкнуть британцев, чтобы у них мозги пошустрее зашевелились и чтобы в будущем они создавали меньше дискриминационных соревнований, а не стать центральным персонажем новостных сюжетов вида: „Скандалы. Интриги. Расследования“. Я никогда не работал на камеру, плюс, у меня есть грешок — говорить то, что думаю, а на камеру так делать, наверное, не стоит. Да и то, что я скажу и то, что может получиться после монтажа — это две большие разницы, так что несмотря на свойственный мне природный авантюризм, вписываться в это я не стал.

На фоне всего этого, я не побоюсь слова, стада, очень приятно выделился Mail.Ru Group. Они мне прямым текстом написали: „Мы готовы выплатить деньги вместо британцев. Как с вами связаться?“. Как я уже писал, я не рассчитывал получить денег с этого соревнования, но сам подход мне понравился. Понятно, что для них это PR, причем достаточно дешевый, но при этом, на мой взгляд, это красивый ход. Этим подходом они высказали свое уважение, что очень хорошо смотрелось на контрасте со всеми остальными, для которых „дать нам интервью — большая честь“. Мы пообщались. Текст press release у них был готов и в течение 30 секунд после того, как я дал добро, он был опубликован. Аккуратно, без истерик, без „наших бьют“, все по делу, как и положено серьезной компании.

Разведка донесла, что в самом Mail.Ru Group это решение было встречено неоднозначно, что, в общем, логично. По факту мы имеем:

1. Какой то левый парень, который в Mail.Ru Group не работает.

2. В России не живет.

3. Участвовал в соревновании, которое проводила британская разведка.

4. По правилам денег получить не должен.

5. Вместо того, чтобы потратить эти деньги и послать работников, которые пашут как негры на плантациях с утра до вечера, на какую-нибудь конференцию, этому левому перцу выделяются несколько месячных зарплат типичного Data Scientist'a.

Логика безусловно есть. И перед ребятами, которых все это огорчило я извиняюсь. В свое оправдание хочу сказать, что за выделение денег на конференции и на PR, отвечают различные департаменты и, что все-таки для здорового PR, деньги небольшие, так что и на конференции должно остаться.

Деньги выделили, это приятно. Но брать их нельзя, они токсичные. Хотя опять же, скажем честно, если бы речь шла не о 12 тысячах фунтов, а о 120, я бы, наверное, взял. Или нет? Черт его знает. Но 1,200,000 точно бы взял.

С деньгами надо было что-то делать. Кто-то в канале #_random_flood предложил их пожертвовать. Эта идея мне понравилась. Очень сильно напрягает отсутствие финансирования в фундаментальной науке. С одной стороны, это логично, ведь по большому счету людям платят за сам факт своего существования, надеясь, что в один прекрасный момент будет какой-то прорыв, что-то большое. И примеров таких прорывов в истории более, чем достаточно, но финансирование, что в России, что за рубежом фундаментальной науки, прямо скажем, не фонтан. Так и созрела идея пожертвовать эти деньги на российскую науку. Куда жертвовать? Черт его знает. Я, когда в России учился, на гранты не подавал, да и давно это было, все десять раз поменялось. Кто больше поддерживает? Кто меньше пилит? Не знаю. Погуглил какие-то фонды, выбрал на дурака РФФИ. Попытки с ними связаться не увенчались успехом. Может у них и правда с деньгами все нормально и пожертвований они не принимают. А вот Российский Научный Фонд согласился деньги взять, правда уточнил, кто был организатором соревнований. Как ни странно, ответ “британская разведка” их вполне устроил.

Как только по новостям прошло, что я жертвую призовые двенадцать тысяч фунтов на науку, народ одобрил, но не все. Например, сестра, которая тоже физик, правда экспериментатор и у которой финансирование зависит от грантов, написала мне гневное письмо о том, что я все сделал не так и что все распилят и вообще, что она в гневе.

Вообще вся эта история прошла на грани фола. Меня прокатили по новостям как обиженного русского гения, а могли точно так же прокатить как предателя родины. Живет за границей, разрабатывал алгоритмы на данных британской разведки — этого уже за глаза. При желании много можно было бы на эту тему накрутить и то, что это было открытое международное соревнование никого бы уже не волновало.

Перевели ли деньги? Насколько я знаю да. Это заняло больше месяца, но недавно мне пришло подтверждение, что деньги уже в фонде. Опять же, хочется надеяться, что хоть что-то из них дойдет до самих двигателей науки.

Приходили сообщения от тех, кто негативно отнесся к тому, что я живу и работаю за рубежём. Я эти сообщения игнорировал, но пусть будет, отвечу им тут и отвечу я вот так: после дембеля, когда я пришел в военкомат, военком выдал мне удостоверение ветерана боевых действий, медаль за воинскую доблесть, пожал руку и сказал, что Родина мной гордится. Даже если это и не так, с того момента я считаю, что все долги за два года срочной службы я отдал. И на этом вопрос с тем, кто, кому и что должен, считаю закрытым. Другой вопрос, почему двигать науку за границей зачастую проще, чем в России, но это отдельная проблема и детальный анализ, наверное, надо делать в другом посте и будем надеяться, до этого руки у меня дойдут.

Из забавного. Достаточно много девушек захотели добавиться в друзья на facebook или VK. Многие — очень симпатичные. Но при этом просто приходило извещение, о том, что кто-то захотел добавиться, без сообщения. Так скучно. А вот если бы какая-нибудь девушка написала вариацию на тему: „Владимир, вам, наверное, сейчас тяжело, такой стресс, приходите в гости на бокал вина, я и подружку приглашу“ — это было бы любопытнее, и, как минимум, я бы это интерпретировл, что девушка уверена в себе, умеет добиваться чего хочет, в общем не такая как все в хорошем смысле этого слова. Но максимум, что было: „Вы выглядите “cлегка» нетипично для программиста". Как-то даже без огонька.

На этой ноте данный пост можно и закончить, но есть еще пара событий, которые хочется добавить. Один парень, который живет в Лондоне и который сам испытал британский национализм на своей шкуре, связал меня с журналистом, который работает в каком-то небольшом британском новостном издании и пообщавшись со мной, этот журналист выпустил про эти события заметку у себя на сайте.

Организаторы соревнований, несмотря на то, что приз платить не собирались попросили за свой счет поднять на амазоне EC2 instance, воспроизвести решение, написать документацию и сделать презентацию, и за это они обещали у себя на сайте упомянуть мое имя. Я вежливо отказался. Но во время обмена email'ами на эту тему, выяснилось, что журналисты, что наши, что британец, пытались с DSTL связаться и задавали вопросы, на которые у тех не было красивых ответов. Я не знаю, удался ли антидискриминационный щелчок по носу или нет, но хочется надеяться, что да.

Ближе к середине июня они написали email и сказали, что несмотря ни на что, мое второе место у меня никто не отнимает, и попросили мое фото.

Меня очень сильно подмывало отправить фото с медвежонком со словами: «А в свободное от машинного обучения время, я выращиваю медведя, будете еще раз дискриминировать — он вас съест».

Фото с мишкой я им отправил, правда формулировку смягчил и убрал из нее эмоции. В итоговом press release они меня упоминули, но косолапого показывать почему-то не стали.

Параллельно со всей этой историей на Kaggle стартовало соревнование с призом в $1,200,000 где по каким то соображениям обрезали китайцев, коллектив не одобрил, правила поменяли, и все вроде нормально.

Примерно месяц назад стартовало еще одно соревнование на Kaggle и тоже дискриминационное. Приз $1,500,000, но претендовать на него могут только граждане США и обладатели Green Card, то есть на этот раз за бортом остались не только Китай и Россия, а Евросоюз, Великобритания, Канада, Австралия, Израиль и все остальные, кого за бортом США обычно не оставляет. Серега на эту тему написал гневный текст на форуме, и судя по числу upvotes, коллектив с ним в большинстве своем солидарен. Я тоже отметился и тут же со мной связался какой-то американский журналист и даже опубликовал текст на эту тему.

Когда я связался с администратором этого нового соревнования и вежливо уточнил: «Как так получилось? Вы же всегда были за меритократию”. Он что-то витиевато финтил, но по сути ответ свелся к двум словам: „Мы продались“.

В этом соревновании я планирую участвовать. Заканчивается оно через несколько месяцев, поглядим как оно пойдет. Задача достаточно злая, но если что-то склеится, не исключено, что будет вторая часть Марлезонского балета. В конце концов, когда ты топишь против дискриминации, из призовых мест тебя слышат лучше, чем когда у тебя ни черта на задаче не получилось.

А что по знаниям? Знаний в Deep Learning в различных областях у меня сейчас много, как минимум их хватило вот на такую историю:

В начале мая, через Kaggle со мной связался рекрутер Tesla, который искал специалистов на позицию AI Researcher. Я согласился проинтервьюироваться на эту вакансию. Лихо прошел take home test, оба tech screen, onsite interview, хорошо пообщался с своим потенциальным непосредственным начальником Andrej Karpathy, оставалось пройти background check и чтобы Элон Маск одобрил мою заявку. И вот как раз на стадии background check я и срезался. Рекрутер сказал мне, что я нарушил Non Disclosure Agreement, и что где-то разболтал о процессе интервью, и что офера не будет. Это было неожиданно, но в более развернутом виде эту байку, я, наверное, расскажу, когда буду писать третью часть эпопеи про офисный планктон.

Отдельное спасибо Сергею Мушинскому и Владиславу Кассыму за помощь в работе над этой задачей, Сергею Белоусову, за то, что отвечал на мои глупые вопросы по Object Detection, без его помощи вряд ли я бы успел за месяц так хорошо разобраться в этой теме, а также Юлию Семенову за помощь в подготовке этого текста.

|

|

Инструменты для прототипирования на Mac: сопоставительная характеристика |

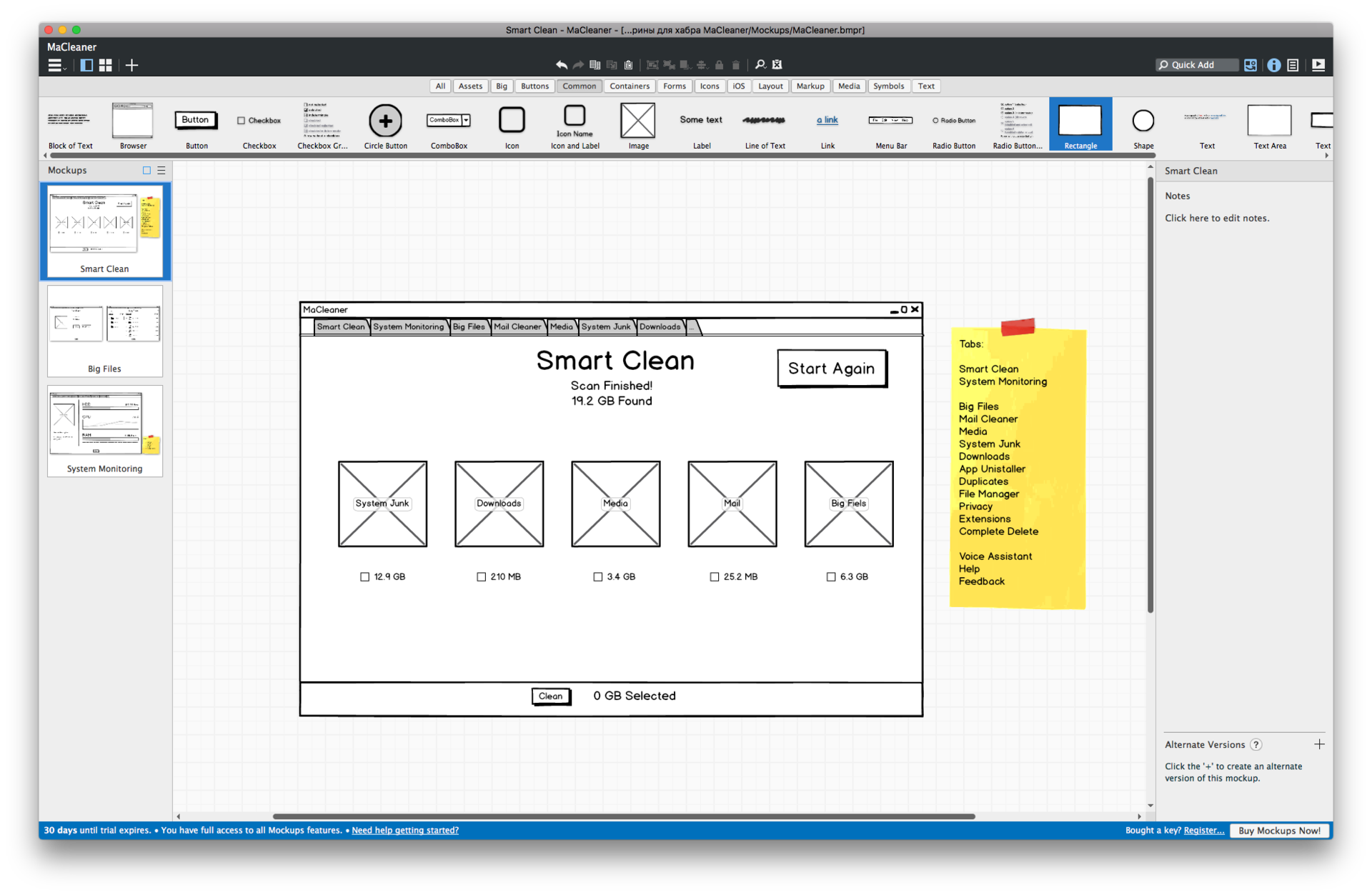

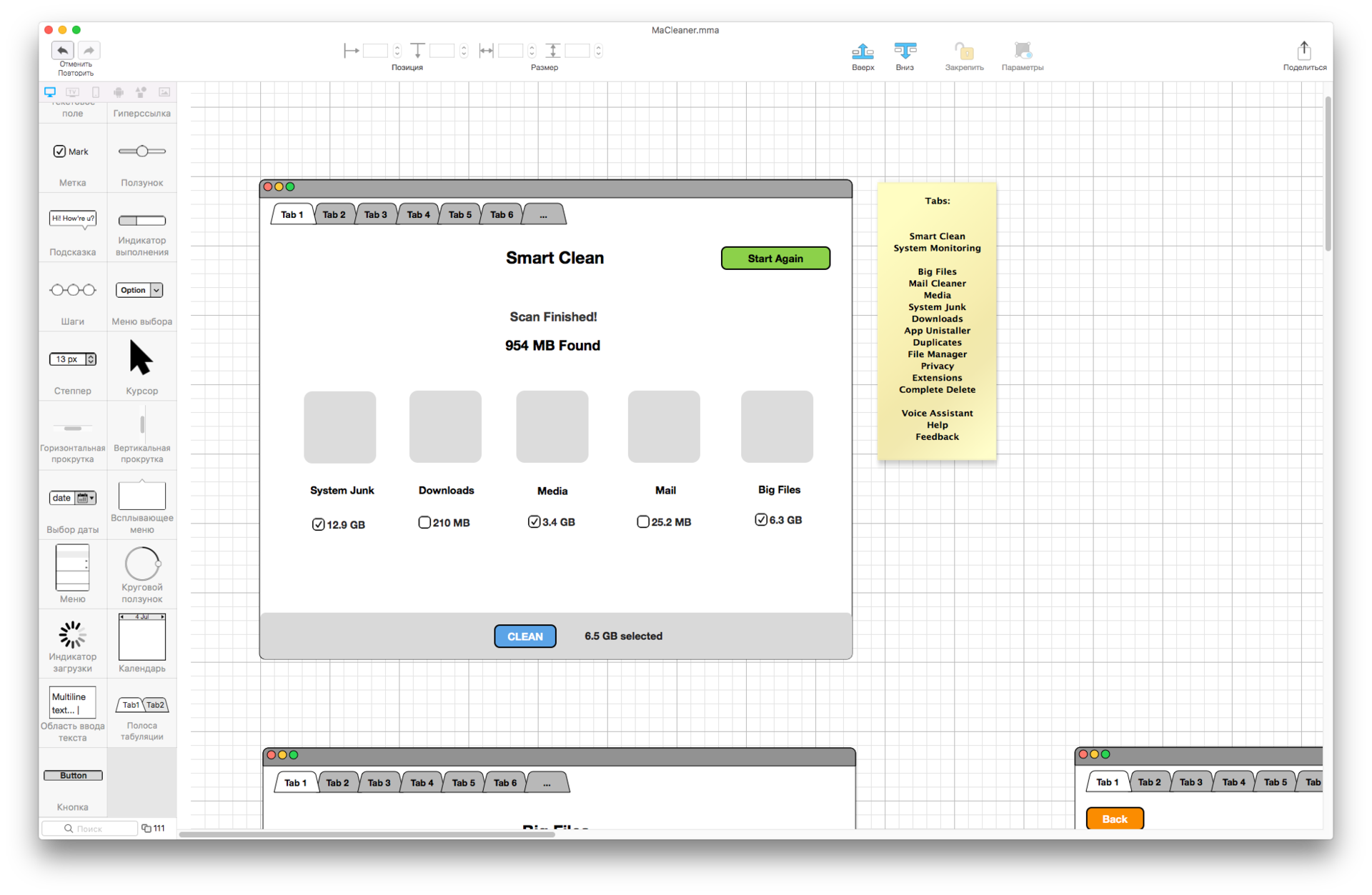

Всего мы отобрали пять претендентов из разных ценовых категорий — WireframSketcher, Flair Builder, Balsamiq Mockups, Make My App и Pencil Project. Из-за специфических требований рабочего процесса нас интересовали только варианты с возможностью работы оффлайн и доступной версией для Mac. Предпочтение отдавалось старым и зарекомендовавшим себя программам, однако в виде исключения взят был также молодой проект Make My App, с которым нам уже приходилось работать. Чтобы в полной мере оценить и сравнить возможности, мы выбрали 4 разных экрана из нашего оптимизатора для Mac MaCleaner 5 и попробовали воссоздать их средствами каждой из программ.

Ниже приводим результаты и короткую выжимку тех впечатлений и наблюдений, которые мы составили в процессе работы.

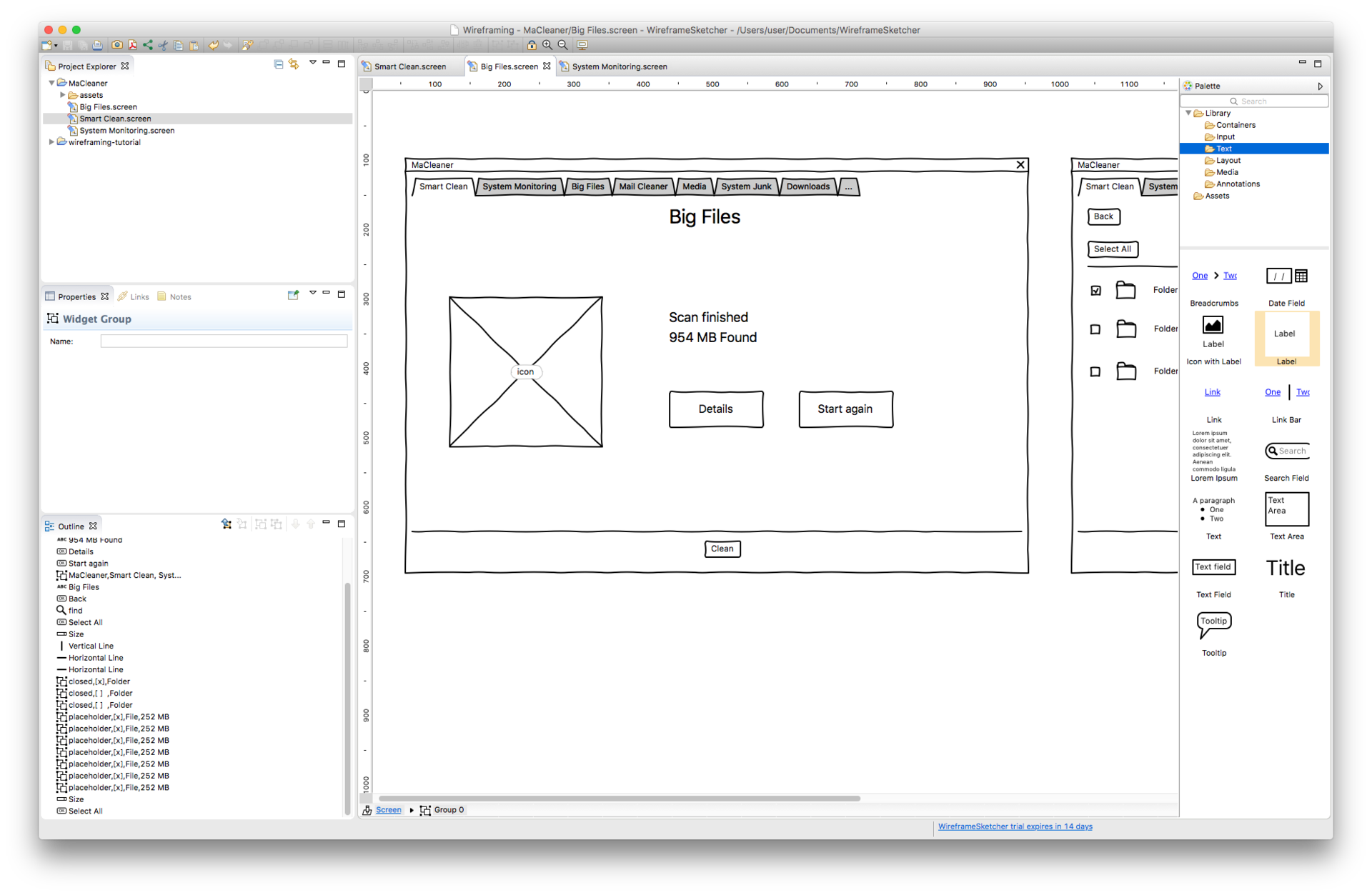

Wireframing Sketcher

Цена: 99 $ (5849 руб.) за годовую подписку, триал 14 дней

Распространение: через официальный сайт

Экспорт: PDF, HTML (онлайн), PNG

Платформы: Mac, Windows, Ubuntu

WireframeSketcher за свою немалую сравнительно с прочими вариантами цену предлагает весьма широкий ассортимент элементов, а в списке доступных шаблонов-макетов — бонусные веб-фреймворки и Windows Phone. Элементы разбиты на две группы: универсальные, которые, в свою очередь, подразделяются на тематические группы, и набор специфических для выбранной вами платформы. Из-за всего этого изобилия интерфейс и сама схема работы могут поначалу показаться несколько запутанными, но, когда вникнешь, программа оставляет приятное впечатление своей продуманностью в мелочах. Настройки элементов, к примеру, дают больше свободы и гибкости, чем в аналогах — можно не только выбирать цвета, шрифт и иконку, но также корректировать форму компонента и задавать нужное состояние элемента. Последнее, на наш взгляд, особенно ценно на фоне распространенной практики выносить в качестве отдельных элементов, что ограничивает возможности и перегружает библиотеку лишними вариантами. При растягивании или сжатии объекта на рабочей поверхности выдается окошечко с размерами. Ну и разумеется, очень полезна функция конвертирования в компонент, которая позволяет экономить время за счет создания мини-шаблонов для многократного использования. Макет на выходе получается стилизованный, утрированно «набросочный» — на любителя, но восприятию не препятствует.

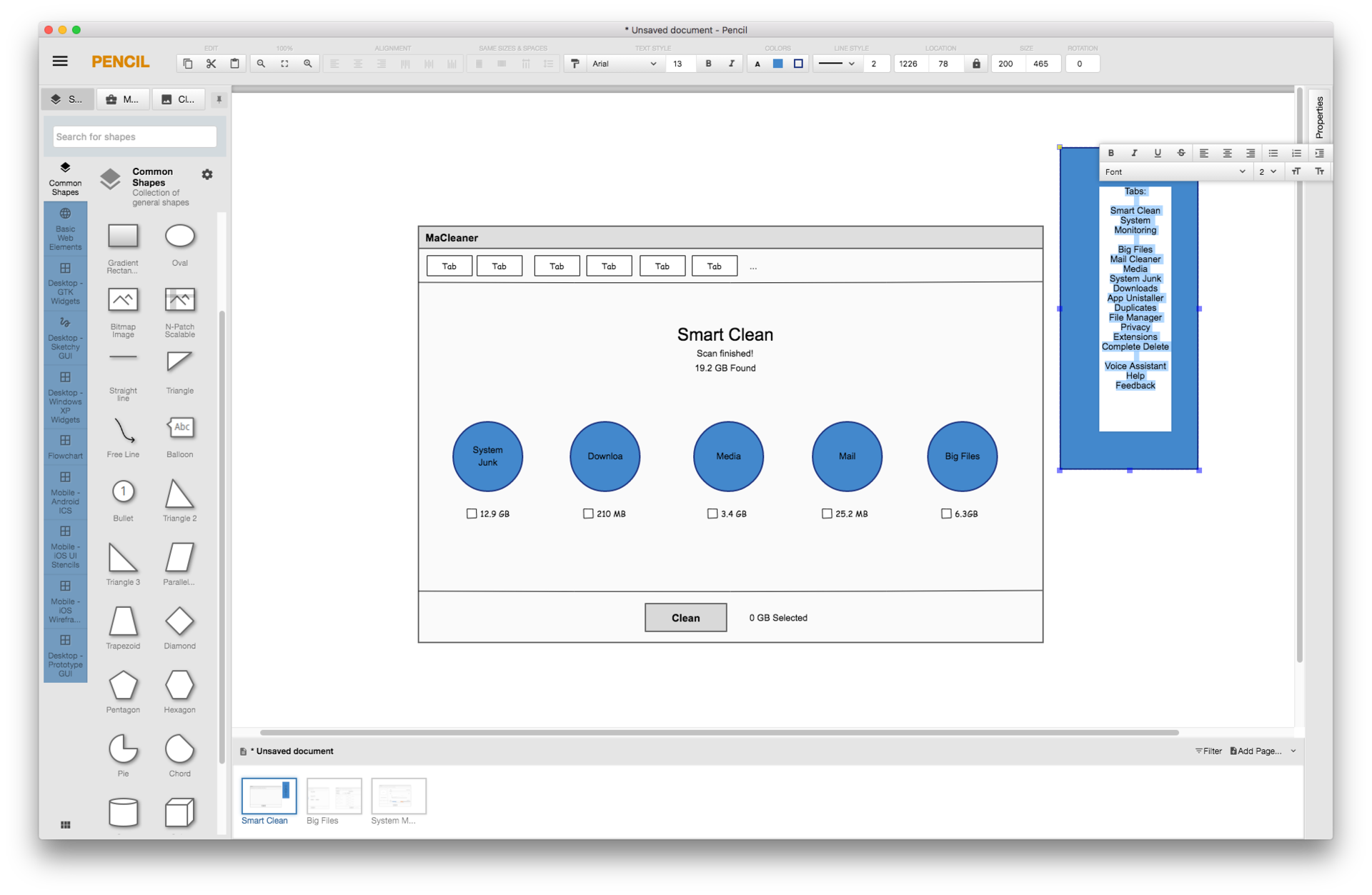

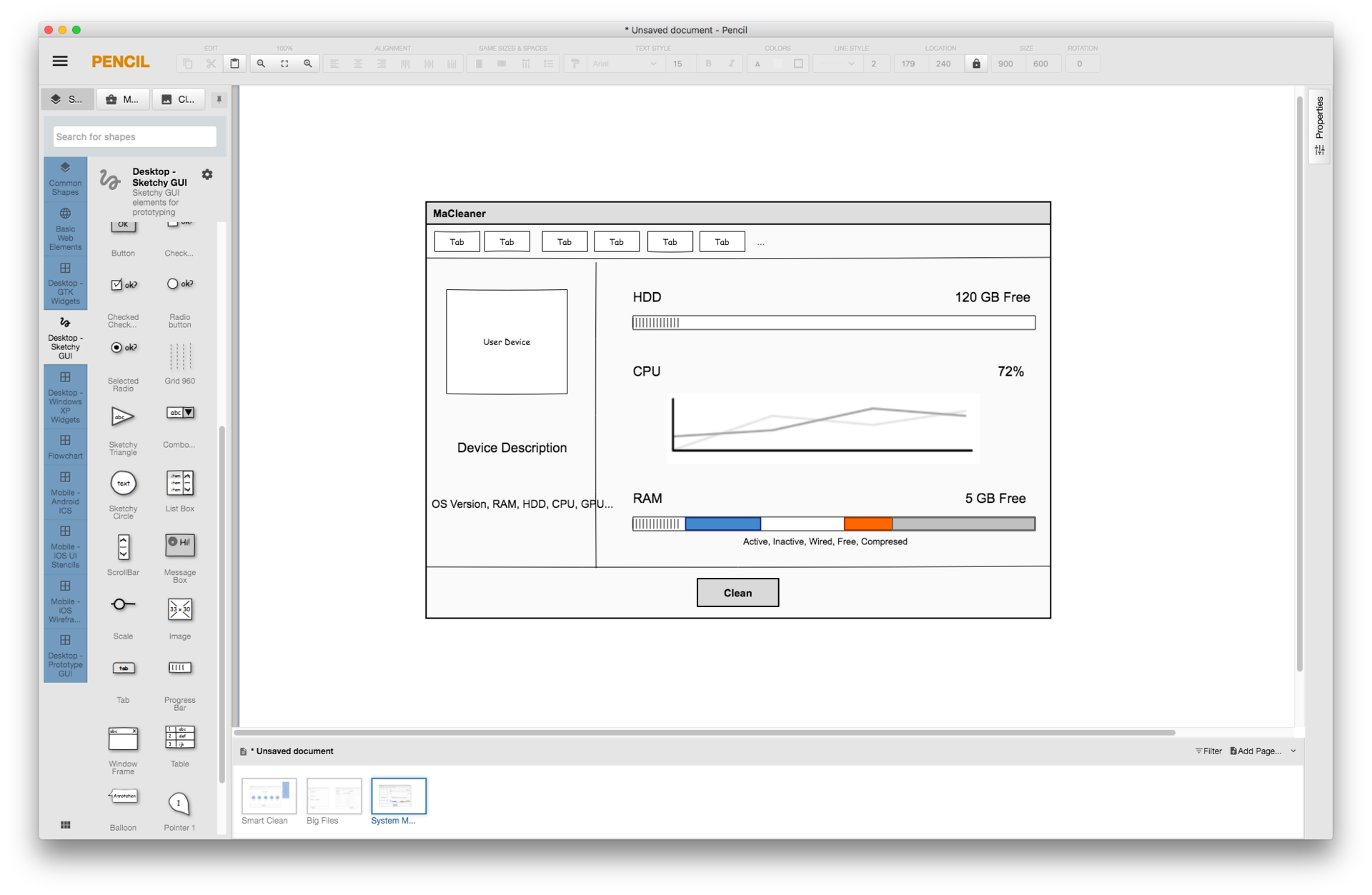

Pencil

Цена: бесплатно

Распространение: через официальный сайт

Экспорт: PNG, PSD, SVG, ODT, HTML

Платформы: Mac, Windows, Ubuntu

Pencil, единственное без оговорок бесплатное решение в подборке, смотрится на удивление достойно: воображения он не потрясает, но с поставленной задачей справляется без особых проблем. Здесь также в наличии три стандартных набора — iOS, Android, Web — с базовыми элементами (но без дифференциации по моделям). Возможности кастомизации значительно урезаны, однако положение спасает то, что многие элементы представлены в нескольких вариациях. В упрек Pencil можно поставить не слишком удобную навигацию — группировка объектов внутри библиотеки производится то по типу элементов, то по платформе, да и расположение групп не назовешь логичным. Смущает и полное отсутствие разметки на рабочем пространстве. Зато в плане форматов экспорта Pencil однозначный победитель: помимо обычных PNG и PDF, пользователю предложат обратить свой макет и веб-страницу, и в SVG файл, и даже в текстовый документ.

FlairBuilder

Цена: 99 $ (5849 руб.), триал 15 дней

Распространение: через официальный сайт

Экспорт: PNG, HTML

Платформы: Mobile, Tablet, Web

В интерфейсе FlairBuilder явно сбился баланс между минимализмом и интуитивностью: о существовании многих возможностей приходится буквально догадываться, так что на первый взгляд программа может показаться бедноватой в плане функций. «Стартовый» список элементов весьма ограничен, дополнительные, из коллекций Bootstrap 3 и Material Design, открываются в отдельном окне, что несколько затрудняет навигацию и управление. Форматы для экспорта также представлены скромно: нет даже классического, всеми востребованного PDF. Зато пользователю предлагается беспрецедентно широкий выбор канвасов для разных моделей девайсов (правда, без соответствующих пакетов кастомизированных объектов). Интересной особенностью программы является то, что тип и модель девайса не задаются фиксированно в пределах проекта — их можно поменять в любой момент, чтобы посмотреть, как ваш дизайн будет выглядеть на экране другого размера. Другой весомый плюс — то, насколько удобно и прозрачно выполнено все, что касается внутренней перелинковки страниц: сделать объект интерактивным и настроить параметры переходов немногим сложнее, чем выбрать цвет и шрифт.

Balsamiq Mockups

Цена: 89 $ (5277 р), триал 30 дней

Способ распространения: через официальный сайт

Экспорт: PDF, PNG, JSON

Поддержка платформ: браузерная версия, Mac, Windows клиент

Это, пожалуй, единственная программа, интерфейс которой не вызвал у нас никаких нареканий в процессе работы — все ясно, логично и удобно. Единственное: немного тесновато на рабочем поле, но его можно подогнать под свои нужды. Количество элементов в библиотеке и разнообразие настраиваемых параметров в целом сопоставимо с тем, что предлагает WireframeSketcher; интерактивность так же присутствует, хотя несколько уступает по уровню реализации функционалу FlairBuilder. Дифференциация по платформам минимальна: представлены базовые типы экранов (смартфон, iPhone, iPad, web-экран), особая категория элементов выделяется только для iOS-устройств, да и та насчитывает меньше десятка объектов. Упоминания заслуживают и пара встроенных хитростей, которые защищают разработчика от самого себя: возможность восстановления удаленных проектов и автоматическое сохранение всех изменений в мокапе. Наконец, список форматов экспорта включает все необходимое и JSON вдобавок. В целом, то, что Balsamiq Mockups пользуется большой популярностью в дев-сообществе, совершенно не удивляет — это приемлемая альтернатива WireframeSketcher по более доступной цене и с доработанным интерфейсом.

Make My App

Цена: 29, 99 $ (2290 р ) + есть бесплатная версия

Распространение: через Mac App Store

Платформа: Mac

Экспорт: PNG

Make My App напоминает Pencil, не только своей бюджетностью, но и общим впечатлением простоты и прозрачности. Работать с ним удобно: все функции, за редким исключением, на виду, рабочее поле очень просторно и позволяет работать с несколькими экранами одновременно, интерфейс не перегружен. Большое преимущество Make My App — наличие в библиотеке шаблонов для разных типов девайсов: помимо джентльменского набора iPhone-iPad-десктоп-Android здесь представлены также экраны и элементы для Apple TV и Apple Watch, кроме того, экраны Android и iPhone представлены в нескольких вариантах, соответствующих разным моделям телефона. Сами наборы элементов среднего объема — особых изысков не найдешь, но все самое распространенное имеется; доступные для редактирования параметры также ограничены самым базовым набором. Бросилось в глаза и то, что выгрузка проекта возможна только в изображение. Наконец, как последний штрих верности Apple, Make My App — единственное в нашем списке решение, которое распространяется через официальный магазин и, соответственно, доступно только для Mac. Это стоит иметь в виду и тем, для кого важны соображения безопасности, и тем, кто ценит кроссплатфомернность и синхронизацию.

Добавим, что на маркете уже появилась обновленная версия продукта — Make My App 2. Мы ознакомились и с ней, но для сравнения выбрали первую часть. Обновленное решение дешевле и имеет некоторые весомые преимущества — более удобное управление, возможность группировки элементов, — однако на данный момент уступает исходнику в количестве и разнообразии элементов. Возможно, через несколько апдейтов ситуация изменится, но пока мы рекомендовали бы старую версию.

Обобщая все сказанное, мы должны сказать, что однозначный вывод «кто лучше» сделать сложно: слишком многое зависит от исходных целей и приоритетов разработчика. Для тех, кто использует в работе очень широкий круг элементов, вероятно, имеет смысл вложиться в покупку WireframerSketcher или Balsamiq Mockups. Тех, кто специализируется на макетах попроще, хватит и библиотек, которые предлагают Pencil или Make My App. На FlairBuilder и WireframerSketcher стоит обратить внимание тем, для кого важна интерактивность, а Make My App может стать хорошей находкой для команд, которые делают софт для широкого круга устройств. Не последнюю роль играет и интерфейс — мы не пожалели о своем решении попробовать каждый из вариантов «в деле»: это позволило, как минимум, оценить разницу во временных затратах на создание макета, в которую выливаются абстрактные «неудачные UX-решения» и «хорошая юзабилити». Надеемся, что несмотря на отсутствие универсального вердикта, наши наблюдения помогут в выборе и другим командам. Если у вас есть опыт работы с какой-нибудь из рассмотренных программ или другими решениями для прототипирования на Mac, с интересом послушаем в комментариях.

|

Метки: author EverydayTools прототипирование блог компании everyday tools прототипы прототипирование интерфейсов макеты мокапы |

Безопасность в эпоху интернета вещей: истории взломов видеонянь, кардиостимуляторов и суперкаров |