Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Из песочницы] Runtime перекраска приложения |

Недавно мне выпала интересная задача перекрасить приложение по JSON объекту, стянутому с сервера. Google диктует идею, что все цвета/темы прописаны в xml. Из-за чего легким движением руки не выйдет везде заменить какой-нибудь R.color.primary_button с синего на зеленый.

Если вам интересен небольшой пересказ недельного приключения по Resources, то добро пожаловать под кат.

Небольшая предыстория

Наше приложение имеет несколько вариаций, каждая из которых прописана с использованием productFlavors. Любое изменение какой-либо мелочи (например, цвета текста) требует вмешательства разработчика, поэтому был принят ряд мер по разделению приложения и его ресурсов. В рамках этой задачи так же обратили внимание, что любое изменение цветовой схемы влечёт за собой обновление приложения в PlayMarket/AppStore. Потому один из разработчиков выдвинул идею: «А давайте стягивать цветовую схему с сервера и перекрашивать приложение в runtime».

Итак, что представляет собой поле действий:

- 47 различных экранов;

- ~50 shapes и selectors;

- ~70 разных цветов (одни элементы могут иметь градиент и рамку, другие – специфичны для конкретного экрана).

По существующему опыту были выделены следующие решения:

- В каждой Activity написать код, который будет перекрашивать UI (решение в лоб, всем Views назначаются id и в каждой Activity программно задаются цвета).

- Наследование от всех используемых UI элементов (развитие первого решения, исключающее внесение изменений в Activity, за место этого переписываются xml).

- Обертка над Resources или над чем-нибудь еще, что позволило бы реализовать требуемую задачу во время создания View или Shape.

Далее пойду изыскания по третьему решению.

Эксперимент номер один. Попытка завернуть Resources

В Android есть монополист на все ресурсы – это Resources. Любое создание View или Shape получает экземпляр этого класса из переданного в конструкторе контекста. И единственный способ вмешаться в работу конструктора – подменить Context.

Google не имеет ничего против такого и даёт нам доступ к ContextWrapper, который представляет собой полноценную обертку. Подмена контекста происходит с помощью перегрузки attachBaseContext. Тут ничего сложного.

Теперь о класс Resources

При изучении этого класса обнаружилось, что многие методы, которые хотелось бы перегрузить – пакетные. Никто не мешает перегрузить, например, getColor, но он не используется ни при построении View, ни в TypedArray (нужен для извлечения набора значений ресурсов соответствующего переданному набору атрибутов). А то, что используется – скрыто. Таким образом, провалилась первая, наивная, идея.

Но при этом было отмечено обильное использование TypedValue и TypedArray. В целом, Resources и работа с ним построены на активной работе через эти два класса.

С первым нет никаких проблем, в Resources существует метод getValue. Перегрузив этот метод, сразу получаешь правильно работающий getColor (в случае цвета) и getDrawable (в случае ColoredDraawble).

А с TypedArray всё куда хуже. Этот класс не обернуть, потому что его конструкторы private. Его поля закрыты и он не обладает методами для их изменения. Вмешаться в его заполнение тоже не получится, потому что это происходит через final класс AssetManager. Единственное, что у меня вышло с ним сделать, это получить доступ к нужному полю через рефлексию.

В итоге этот способ работоспособен. По крайней мере, первые экраны перекрасились полностью. Вмешавшись в работу TypedValue и TypedArray можно изменить в плане ресурсов почти всё, что хочешь. Но я не стал доводить его до конца, так как рефлексию считаю рискованной и прибегаю к ней в крайних случаях.

Уже во время второго эксперимента встретил еще одну проблему с оберткой Resources. Оказалось, что в Android уже существует android.support.v7.widget.ResourcesWrapper. Его реализации могут для какого-нибудь компонента обернуть твой класс и выдать совсем другой результат. Кстати, ResourcesWrapper – пакетный и скрыт для простых смертных.

Эксперимент номер два

По причине неспособности сделать всё централизованно, задача была разбита на две части:

- Замена ресурсов в View.

- Замена ресурсов в Shape и Selector.

O View. Подмена LayoutInflater

Наверное, многие знакомы с github.com/chrisjenx/Calligraphy. Для второго эксперимента была выбрана идея, используемая в этой библиотеке, а именно подмена LayoutInflater. Подмена LayoutInflater происходит так же через ContextWrapper. Внутри LayoutInflater переопределяются фабрики, обрабатывающие View (одна из них, к сожалению, через рефлексию). А внутри фабрики реализован код, который в зависимости от View и атрибутов занимается подменой нужных ресурсов.

О Shape

Тут сложнее. Фабрики для них нет. Cоздание происходит внутри Resources через статический метод createFromXml, который парсит переданный xml файл, а далее используется TypedArray. Аналогично происходит и с ColorStateList.

Вмешаться в работу создания не выйдет (за исключением способа, описанного в первом эксперименте). А созданный объект не хранит в себе Id ресурса, из-за чего перекрасить его после создания так же не получится. Но можно пойти в обход. В Resources существует метод getXml. Он позволяет получить любой xml и распарсить его самостоятельно. Таким образом, имея Id и Resources можно получить любой Drawable и внести в него требуемые изменения.

ColorStateList (В отличии от любой реализации Drawble) не дает изменять свой контент. Тут либо использовать рефлексию, либо создавать новый экземпляр и реализовывать кеширование на своей стороне.

Еще немного о кэше ресурсов

Первоначально была надежда использовать кэш Resources просто изменив в нем нужные Drawable и ColorStateList. Но от этого пришлось отказаться по двум причинам.

Первая описана выше и затрагивает ColorStateList. Без рефлексии свойства его экземпляров изменить нельзя, а значит закешированные в Resources экземпляры использовать не выйдет.

Вторая связана с кэшированием ColorDrawable и единичных ColorStateList (это когда запрашивается ColorStateList для цвета, а не selector). Их кэширование оптимизировано и происходит не по id ресурса, а по цвету, на который ссылается ресурс.

Результат

В итоге в приложении есть:

- Свой собственный LayoutInflater, который вносит изменения в View.

- Великий Singletone с набором методов вида getDrawable(int resId, Resources baseResource), который занимается хранением цветовой схемы, Drawables и ColorStateLists.

- Базовая активность, содержащая перекраску статус бара и оборачивание контекста.

Задача решилась с незначительным изменением существующего кода (например, где программно меняется цвет текста в зависимости от результата вычислений). И на дальнейшую разработку повлиять особо не должна.

Плата за это: как минимум увеличенная нагрузка при создании View, в случае Shapes и Selectors – двойная. А так же возможные проблемы при переходе на следующую версию API (сейчас мы используем 24) и device specific баги.

Я верю, что среди вас есть те, кто сталкивался с подобными проблемами. И было бы интересно увидеть ваши мысли на тему runtime перекраски в комментариях.

Спасибо за внимание!

|

Метки: author DeFract разработка под android android development |

«Необходимость возникает с обеих сторон»: программный комитет DevOops о конференции и о DevOps |

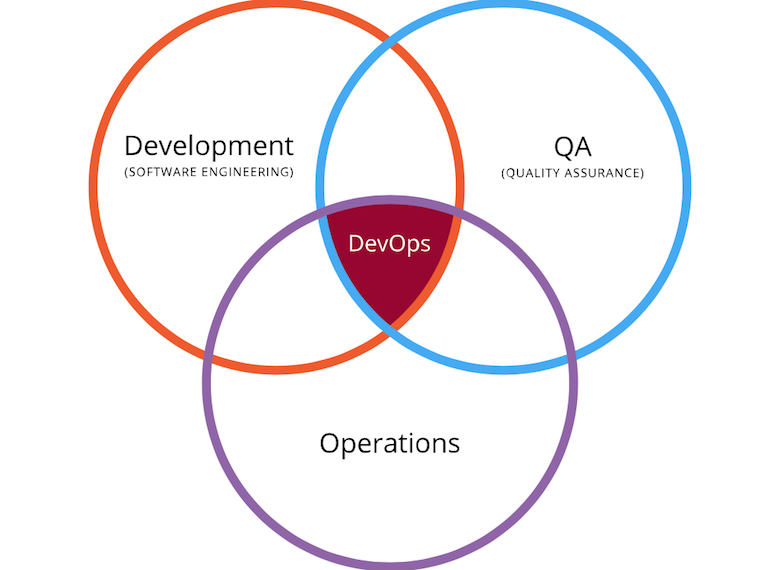

Хотя понятие DevOps на слуху уже далеко не первый день, о нём до сих пор не прекращаются споры, начиная с вопроса «что это вообще такое». Словосочетание «DevOps-конференция» тоже порождает вопросы: например, если тут сходятся «dev» и «ops», то мероприятие рассчитано на зрителей с бэкграундом в разработке или в администрировании?

Есть круг людей, знающих обо всём этом не понаслышке: программный комитет нашей конференции DevOops, которая впервые пройдёт этой осенью в Петербурге. От них зависит, какими окажутся доклады на мероприятии, поэтому мы решили расспросить их и о DevOps, и о самой конференции — чтобы всем стало яснее, чего от неё ждать. В беседе поучаствовали:

- Барух Садогурский (JFrog)

- Олег Анастасьев (Одноклассники)

- Алексей Акопян (Dell EMC)

- Кирилл Толкачёв (Альфа-Лаборатория)

- Александр Тарасов (Одноклассники)

А в ходе обсуждения спонтанно возник вопрос к вам всем — так что при чтении этого текста вы можете ещё и лично повлиять на программу конференции!

JUG.ru: В связи с понятием «DevOps» можно увидеть споры. А у вас по таким вопросам солидарность, или есть внутренние дискуссии?

Барух Садогурский: По-моему, что такое DevOps, все уже давно определились.

Барух Садогурский: По-моему, что такое DevOps, все уже давно определились.  Александр Тарасов: А по-моему, немного по-разному воспринимают до сих пор. У нас всех разный бэкграунд, и все мы видим разное. Как и с любым словом, которое является довольно большим обобщением. Безусловно, у людей есть общее понимание, но в деталях оно порой очень сильно разнится, а уж способов имплементации этой идеи на реальном ландшафте вообще зоопарк.

Александр Тарасов: А по-моему, немного по-разному воспринимают до сих пор. У нас всех разный бэкграунд, и все мы видим разное. Как и с любым словом, которое является довольно большим обобщением. Безусловно, у людей есть общее понимание, но в деталях оно порой очень сильно разнится, а уж способов имплементации этой идеи на реальном ландшафте вообще зоопарк. Барух: Я с тобой соглашусь в том, что если начинать говорить «окей, а как мы это делаем», то всё по-разному. Но как мне кажется, есть понимание общей идеи, таких вещей, как «you build it, you own it». А как именно это имплементировать, уже не так важно.

Александр: Часто DevOps понимают в узком смысле, когда developers — это именно разработчики, а operations — именно системные администраторы (а не сопровождение в целом, которое может быть разным). Но для меня это более широкое понятие: чтобы Continuous Delivery и прочие подобные вещи взлетали, как правило, требуется участие всей команды. Есть аналитики, тестировщики, есть сам процесс деплоймента, а после этого сопровождение в виде мониторингов и прочих штук. Хотя в самом слове «DevOps» нет ничего про QA, даже если просто открыть Википедию, сразу видишь на диаграмме три круга, одним из которых является QA.

JUG.ru: В девопсе сходятся разные стороны — а с какой приходит основная активность? От людей из разработки или из администрирования?

Барух: Большинство девопсников приходят со стороны администрирования. Грубо говоря, в чём наша задача в девопсе? Мы хотим, чтобы разработчики вместо перекидывания написанного на сисадминов могли всё это протаскивать прямо в продакшен, и если там это упало, то это их проблемы.

Это значит, что они должны научиться этой второй половине: грубо говоря, должны стать новыми сисадминами. Там совсем другой skill set, совсем другой набор инструментов, и так далее. Кто их может научить, кто может написать все приложения, которые им нужны, кто может построить автоматизацию внутри их конторы? Те самые бывшие администраторы, которых нынче порой называют devops engineers. То есть люди, которые приходят со стороны администрирования, становятся devops enablers, они настраивают все и инструменты и процессы, переучивают культуру, ходят и рассказывают, почему вам нужно теперь делать вот так — это все как раз бывшие админы. А бывшие программисты будут пользоваться вот этим всем, грубо говоря, для того, чтобы этот девопс выполнять.

Олег Анастасьев: А я вот в корне не соглашусь с Барухом, должна же быть интрига! Я скажу, что скорее наоборот: это движение идёт от программистов. Потому что админы до возникновения этого термина традиционно выполняли какие-то ручные процедуры, у них были свои процессы, свои инструкции, они их вручную или полускриптами решали. А программистам надоедает выполнять команды на машинах через админа, получается такой испорченный телефон: когда админ доходит до границы своей компетенции по поводу какого-то продукта, начинает программиста спрашивать. Программист сам не знает, что делать, и начинает командовать: ну посмотри, что в этой директории, а даты какие, а вот то что показывает, а это…

Олег Анастасьев: А я вот в корне не соглашусь с Барухом, должна же быть интрига! Я скажу, что скорее наоборот: это движение идёт от программистов. Потому что админы до возникновения этого термина традиционно выполняли какие-то ручные процедуры, у них были свои процессы, свои инструкции, они их вручную или полускриптами решали. А программистам надоедает выполнять команды на машинах через админа, получается такой испорченный телефон: когда админ доходит до границы своей компетенции по поводу какого-то продукта, начинает программиста спрашивать. Программист сам не знает, что делать, и начинает командовать: ну посмотри, что в этой директории, а даты какие, а вот то что показывает, а это… Раз на тридцатый такое выполнение команд через консоль скайпа задалбывает, и естественно, что программист хочет, с одной стороны, иметь больше контроля над продакшен-системой, а с другой — чтобы это не отнимало у него слишком много времени. А мы как программисты очень хорошо умеем писать всякие программки, и понаписали часть таких программок, которые нам облегчают жизнь, потом ещё понаписали, как-то это отмоделировали, архитектурку построили, ещё накрутили, здесь подкрутили — опа, и девопс получился. А потом научили админов, как им это всё завести, поставить и настроить, чтобы они тоже начинали получать бенефиты от этих программок.

Барух: Ну, Олег, я так подозреваю, что тут мы оба правы и необходимость возникает с обеих сторон, но популярные инструменты, про которые мы говорим (кроме CI-серверов, просто потому что они были созданы до девопса), всякие Infrastructure-as-a-Service, Chef, Ansible, тот же самый Docker и так далее — они созданы людьми из администрирования, а не разработки. То есть это их инструменты.

Олег: Ну, не знаю, у нас в Одноклассниках как-то наоборот. По перечисленным инструментам мне нечем аргументировать по поводу персоналий, я их просто не так хорошо знаю, но всё-таки мой пойнт в том, что если бы это было нужно только админам, то никто бы ничего и не делал. Здесь важно, что синергия получается тогда, когда у обоих лагерей есть свои бенефиты.

Барух: Я тут так скажу: это нужно бизнесу.

Алексей Акопян: Мне хочется добавить вот что. По-моему, важно, что в последнее время стало много сервисов, идущих на смену продуктам. Традиционно большую часть софтверного бизнеса составляли коробочные продукты, которые команда писала, затем отдавала в энном количестве заказчикам, они должны были где-то у себя разворачивать. Соответственно, нужны были инструкции, потому что админы сидели в первую очередь на стороне заказчика. А сейчас индустрия довольно сильно эволюционирует в сторону публичных сервисов (да и внутренних тоже). Соответственно, мы чаще сталкиваемся с тем, что есть сервис, с которым пользователи взаимодействуют зачастую через единственный размазанный в каком-нибудь облаке деплоймент, который надо поддерживать. И это, на мой взгляд, дало очень большой толчок всей идеологии девопса: совместное владение не кодом, а именно работающим сервисом.

Алексей Акопян: Мне хочется добавить вот что. По-моему, важно, что в последнее время стало много сервисов, идущих на смену продуктам. Традиционно большую часть софтверного бизнеса составляли коробочные продукты, которые команда писала, затем отдавала в энном количестве заказчикам, они должны были где-то у себя разворачивать. Соответственно, нужны были инструкции, потому что админы сидели в первую очередь на стороне заказчика. А сейчас индустрия довольно сильно эволюционирует в сторону публичных сервисов (да и внутренних тоже). Соответственно, мы чаще сталкиваемся с тем, что есть сервис, с которым пользователи взаимодействуют зачастую через единственный размазанный в каком-нибудь облаке деплоймент, который надо поддерживать. И это, на мой взгляд, дало очень большой толчок всей идеологии девопса: совместное владение не кодом, а именно работающим сервисом.JUG.ru: А что всё это означает применительно к конференциям? На кого в первую очередь рассчитана DevOops: людей с бэкграундом в разработке или администрировании?

Барух: Традиционно практически все западные девопс-конференции (вроде DevOps Days, DevOps Enterprise Summit и так далее) очень ориентированы на DevOps из администрирования. Они там обсуждают кишки своих инструментов и, грубо говоря, «как выдрессировать программистов, чтобы они делали правильный девопс».

И мне кажется, в нашей конференции интересно как раз то, что у нас будут и программисты. Основная аудитория всех конференций JUG.ru Group вообще программистская. Подход «даже если вы не админы, приходите на конференцию по девопсу» — он вообще всегда правильный, но для нас особенно правилен и интересен: во-первых, потому что это для нас естественная аудитория, а во-вторых, потому что это достаточно необычно для традиционных конференций по девопсу.

Александр: Я бы даже не стал ограничиваться «разработчиками и администраторами». Мне кажется, должно быть интересно большому кругу людей, которые в принципе интересуются вопросами автоматизации, улучшением организации процесса разработки и внедрения для ускорения доставки ценности клиенту, какие средства для этого можно сейчас использовать, и как они будут решать его проблему. Одним будет интересно послушать про хардкорную часть, «как сделать супермониторинг, который будет мониторить десять тысяч сервисов». Другим более интересны решения организационных проблем. Хотя у нас преобладают технические доклады, чаще всего проблемы в этой области — как технические, так и организационные, потому что в процессе участвует много сторон, каждая как с общими, так и со своими интересами.

JUG.ru: Уже по списку ключевых тем очевидно, что доклады действительно будут сурово техническими: везде сразу указаны конкретные инструменты. Не просто «Continuous Delivery», а с перечислением «Jenkins, TeamCity, Bamboo». А более общие выступления, не привязанные к конкретному продукту, предполагаются?

Барух: Мне кажется, тут есть две составляющих. Во-первых, разговоры про какой-то общий Continuous Delivery — они абстрактны, ни о чём. Это будет или что-то очень поверхностное, или что-то совершенно без конкретного приложения. А два наших основополагающих фактора при выборе докладов, как обычно с конференциями JUG.ru Group — во-первых, полезность, во-вторых, хардкорность. И какие-то общие доклады будут не особо полезны, не особо технологичны, не особо хардкорны.

Во-вторых, есть вопрос, который мы, на мой взгляд, пока что не решили. Из-за бэкграунда JUG.ru у нас заточенность под конкретные технологии и инструменты: кишочки, хардкор и технологии, а не soft skills и аджайл.

Но в приложении конкретно к девопсу это оказывается проблемой, потому что любой человек, реально имеющий к нему отношение, скажет вам, что инструменты и технологии в девопсе — не первое дело. Да, мы любим об этом говорить, и нам удобно об этом говорить: мы все технологи, программисты, нас немедленно туда тянет, давайте-ка посмотрим на конфиги.

Однако проблемы — они в поведении людей. Как изменить его так, чтобы из двух лагерей — программистов и админов — получился один процесс? И это у нас пока никто не затрагивает: во-первых, в принципе не очень понятно, как это затрагивать, а во-вторых, такой доклад по меркам JUG.ru будет заклеймён лайтовым и софт скиллзом.

Я надеюсь, что открывающий кейноут будет именно такой. По крайней мере, мой с Леонидом Игольником закрывающий кейноут будет не на 100% о технологиях. Но вопрос тут остаётся.

Кирилл Толкачёв: Ещё на других конференциях бывают доклады, которые можно назвать BizOps. Условно, я как начальник большой компании рассказываю про плюсы внедрения девопса в своей компании с цифрами, объясняющими формулу успеха. Слушайте, а мы вот такое хотим?

Кирилл Толкачёв: Ещё на других конференциях бывают доклады, которые можно назвать BizOps. Условно, я как начальник большой компании рассказываю про плюсы внедрения девопса в своей компании с цифрами, объясняющими формулу успеха. Слушайте, а мы вот такое хотим?Барух: Очень зависит от доклада. Как раз к моему стону по поводу того, что у нас из треугольника «people-process-tools» сплошные tools: вот такой доклад бы очень здорово привнёс people и process, если бы это была не просто болтовня «я сказал моим подчинённым, и они сначала были против...», а именно с выкладками, числами, с процессами, что изменилось, кого уволили, а кого наняли. Вот это всё, мне кажется, было бы не просто хороший доклад, а прекрасный кейноут.

Александр: Это интересный взгляд со стороны, с upper-level. Очень часто люди, которые работают на рядовых позициях, просто не понимают, какие там проблемы могут быть и почему в крупных компаниях принимаются те или иные решения, которые с первого взгляда кажутся нелогичными. Если об этом красиво и хорошо рассказать, то может получиться очень интересно.

Барух: А может быть, сделать какой-то парный доклад? Грубо говоря, кто-то достаточно высокого уровня со стороны бизнеса, кто-то со стороны разработки. И показать вот эту дискуссию: с одной стороны, как разработчикам уговорить начальство, а с другой стороны, как начальству тяжело с разработчиками? Или даже собрать нескольких людей C-level и устроить панельную дискуссию?

Алексей: А можем сделать опрос на тему того, будет нашей аудитории интересна такая дискуссия?

JUG.ru: Да не вопрос. Читатели, у которых есть мнение по этому поводу — пожалуйста, пройдите по ссылке и ткните в один из вариантов, вы поможете нам сделать конференцию лучше.

Возвращаясь к «доклады привязаны к инструменту»: а докладчиками будут преимущественно те, кто эти инструменты активно использует, или и те, кто их создаёт?

Барух: Есть разные случаи. У нас есть докладчики из компании HashiCorp, производящей очень большое количество очень хороших продуктов для девопса, которые мы все любим. У нас, надеюсь, будет один из разработчиков Google Cloud Platform — их, естественно, тоже очень любят. Будет даже человек, который имел отношение к разработке JFrog Artifactory, поверите вы или нет!

JUG.ru: В связи с тем, что ты сам работаешь в JFrog, и с тем, что некоторые другие спикеры будут представлять собственные проекты, небось найдутся желающие сказать «да будет сплошной ужасный маркетинг, никакой пользы». Хочется на это что-то ответить?

Барух: Ну, само собой разумеется, что мы стремимся делать доклады максимально глубокими и интересными, а ни в коем случае не каким-то рекламным product pitch. Доклады выбираются по своей технической составляющией, мы делаем прогоны и репетиции, чтобы быть уверенными, что они не будут product pitch. Те, кто был на других конференциях JUG.ru Group, в этом уже могли убедиться.

Но определённые люди считают, что если ты представляешь фирму и упоминаешь название её продукта в докладе, то совершенно не важно, что ты о нём говоришь, ты представитель зла и тебя надо закидывать помидорами. Извините, наболело!

Скажу так: если ты какой-либо проект использовал или планируешь использовать, то доклад об этом проекте на DevOops тебе будет интересен и полезен. Если не используешь и использовать не думаешь, то ты на этот доклад просто не идёшь. У нас будет несколько треков, всегда можно выбрать. Но я не сомневаюсь, что если человек использует Terraform или Packer, то он с огромным удовольствием пойдёт на доклад человека, который работает в HashiCorp.

И ещё благодаря тому, что конференция в России, мы более-менее защищены от натиска желающих порекламироваться. В России пока что недостаточно развита разработка продуктов для девопса. У нас практически нет кого-то, кто подаётся сам «вот я вам хочу рассказать про свой продукт». Большинство продуктов, которые будут обсуждаться на этой конференции — и CI-сервера, и средства развёртки, и виртуализация — разработаны за рубежом. И поэтому докладчик из этой компании может к нам попасть, только если мы сами его приглашаем. А когда мы его приглашаем, естественно, принимаем все необходимые меры, чтобы гарантировать, что это не будет product pitch.

Александр: Бывают ещё случаи, когда человек вроде и не особенно топит за технологию, но доклад оставляет сахарно-ватное ощущение, что всё так замечательно, прям бери и будет сразу работать, никаких подводных камней… Как правило, такие доклады относятся к категории «101», это обзорные доклады, или доклады начального уровня. Они полезны людям, которые ничего не знают про данную технологию или знают очень мало.

А тем, кто уже сам что-то изучает, использует в продакшене, более интересны внутренние детали реализации и особенно подводные камни. Поэтому очень здорово, если докладчик не только хорошо знает свой продукт, библиотеку, технологию и рассказывает позитивные стороны, но и знает проблемы пользователей и может рассказать про различного рода трейд-оффы, которые есть в любом инженерном решении.

JUG.ru: На других конференциях JUG.ru, например, Joker, уже были «околодевопсные» доклады. Что происходит теперь, когда появилась отдельная конференция — они все переезжают туда, или на Joker такие по-прежнему можно будет увидеть?

Барух: Это очень хороший вопрос, который я, будучи в программном комитете обеих конференций, вижу с обеих сторон.

С одной стороны, да, существует большое желание все девопсные доклады в DevOops. Но, с другой стороны, когда тема интересная, не хочется человека, который придёт только на Joker и не собирался идти на DevOops, оставить без этих тем вообще. Поэтому мы стараемся те доклады, которые имеют отношение и к девопсу, и к Java, оставить на Joker, а на DevOops принести те, которые к Java не имеют отношения.

Олег: Добавлю, что даже если темы на двух конференциях окажутся одинаковыми, то на DevOops они будут в большей степени про процессы и какие-то менеджмент-операционные части, а на Joker будут больше в хардкор и программирование. Тема та же, но рассматриваться будет с разных сторон.

JUG.ru: Спасибо за ответы. Хочется ли ещё что-то добавить?

Алексей: Что после DevOops сбор фидбэка поможет нам ответить на все те же вопросы к следующей конференции. Поймём на практике, чего тем людям, которые реально пришли, хватило на DevOops, а чего не хватило.

JUG.ru: То есть от людей, которые придут на первую конференцию, очень зависит, какой станет вторая? Хороший стимул идти.

DevOops впервые состоится 20 октября в Санкт-Петербурге, билеты уже в продаже (и дорожают со временем!). Ключевые темы:

— Контейнеры, Оркестрация (Docker, Kubernetes, Clusters, etc).

— Виртуализация, Облачные технологии (AWS, Azure, Heroku и другие).

— Мониторинг и аудит приложений (Prometeus, OkMeter, DataDog, BPF, Dynatrace, XRebel, Glimpse, Zipkin, OpenTrace и другие).

— Continuous Delivery (Jenkins, TeamCity, Bamboo).

— Configuration Management (puppet, chef, ansible).

— Security (Vault, etc.)

— Разбор полетов на примерах крупных проектов, внедряющих DevOps: успешных и провальных.

|

Метки: author phillennium системное администрирование облачные вычисления it- инфраструктура devops блог компании jug.ru group devoops |

Печать на произвольном размере бумаги в Linux |

|

Метки: author LinuxComp разработка под linux pdf open source printing libreoffice печать размер бумага cups ppd postscript kde bug |

ФИАС умер, да здравствует… да здравствует… да не понятно что пока |

Основная проблема называется так: «А черт его знает в какой стране мы живем». С одной стороны у нас незаметно в декабре 2014 года, после принятия Постановления Правительства прошло фундаментальное изменение связанное с тем, что теперь официально почтовым (не позволяет язык назвать это адресом) объектом является Муниципальный адрес. Его кортеж безумен как в своей тавтологии, так и запутанности, стирающий границы понимания деревень и сел. Причина проста: в ФНС решили, что ввиду отсутствия закона о почтовом адресе и Административном делении, давайте использовать муниципальный принцип. Их, конечно, до этого момента понять было можно. Ну какая им разница — ну нет у них задачи географического, административного, почтового и тд деления. Чисто внутренний запрос. И все было бы так, пока они не ввели это в ранг почтового адреса постановлением.

Это с одной стороны. С другой, так уже сложилась деловая практика, опять же объективно понятно почему, что в качестве эталонного справочника использовался КЛАДР, а у Почты РФ не было своего эталонного справочника. В общем, все подсели под исключительно ведомственный справочник — КЛАДР. И пока это соответствовало положению вещей в понимании обычного человека, который живет в Московской области, г. Троицк. И бог с ним, что ФНС не успевала отследить миграцию почтовых отделений. Погрешность в 5 процентов — вполне извинительно для того полезного дела, которое доброврольно взвалила на себя ФНС. Ну добавила она новый формат ФИАС, продолжая вести параллельно КЛАДР. Почта РФ в это время готовила свой ЦХДПА и народонаселение ожидало, что Почта его все же рано или поздно опубликует. Ну была еще надежда на то, что Росреестр разродится. Но там тоже нет дела до нужд трудящихся. Ибо нечего использовать сторонних экспертов, самим денег не хватает. В общем, базу так свести и не могут до сих пор. Ждали, что опять пронесет.

На все попытки с нашей стороны объединить усилия независимых логистических компаний и создать независимый справочник, например под эгидой НАДТ, не увенчалась успехом. Денег было всем жаль, ибо свои, а адресная база была бы общая.

Но… все пошло не по «авось» и ситуация изменилась кардинально. ФНС передала ведение КЛАДР/ФИАС в дочернюю организацию «Налог-сервис». Там же все довели до полного абсурда. Убили позиционность, заменив на иерархичность. Отказались от административного деления, в результате чего ленинский проспект в Москве из единого объекта превратился в кучу отрезков, в которых невозможно понять в Москве он или уже город спутник, да и вообще соединяется ли он между собой. Полностью потеряли историю изменений и многое другое.

И тут стали возникать разного рода идеи типа words3word, использования геокоординат напрямую и т.д. Казалось бы 21 век на дворе. В чем проблема? Но она есть. И их много:

1. Как переучить всех людей писать слова-координаты, просто координаты? адреса-то не все запоминают?

2. Что считать эталоном? Можно ли использовать недостоверные данные собранные проектами типа OSM или Яндексом? Который, кстати, недавно непроизвольно изменил адресный ландшафт. Видно какому-то программисту в Яндексе показалось не круто использовать дроби и он на карты вместо дома 21/2 нанес 21_2. А доблестные муниципальные власти объявили тендер на печать табличек на дома. Откуда доблестные подрядчики взяли данные? Конечно же не из Росреестра, а с карт Яндекса. Внесение же регламентации возвращает этот проект из свободного в государев — те все в исходную точку.

3. Как быть с юридически и финансово значимой корреспонденцией? Как гарантировать ее доставку по сомнительным эталонам или координатам?

4. До какой точности довести координаты и как понять что точка достигнута? До какого числа после запятой указывать координаты? Как долго почтальон должен ходить с GPS навигатором заходя на цель как истребитель?

5. Любой тех. процесс на Почте РФ или у любой логистической компании должен строиться на возможности отсутствия компьютера-интернета на каком-либо участке. Поэтому адрес должен быть интуитивно понятен. Это, кстати, одна из претензий к ФИАС.

6. Что делать с новостройками, которые в половине случаев граничат с самостроем типа многоэтажек на дачных участках, пронумерованных как участок 1 подъезд 2 этаж 3. Хотя на самом деле это 2 многоэтажных корпуса на участке в 30 соток? Ну не говоря о реальном самострое в южных пределах нашей родины?

Выходов, в целом, не очень много. Ждать возврата сознания у ФНС не приходится. Хотя бы потому, что это внутренняя ведомственная разработка, хоть и выведенная Постановлением правительства в общую головную боль. Анализ этого постановления — это отдельная тема статьи. Например, многим ли известно что в нем допускается адресация на национальных языках, введены абсурдные типы такие как «сооружение», разрешены литеры на латинице (как отличить П и Р?) и т.д.

Второе, с надеждой ждать, когда Почта опубликует ЦХДПА. Вот только вопрос: а оно ей надо? Заем ей поддерживать конкурентов? В данном случае — я бы подумал на месте Почты РФ. Остается только кто-то типа Яндека, кто получит «ярлык» от государства и станет чем-то типа «уполномоченного агента» с федеральным бюджетом. Но опять же регламенты никто не отменял, а кто их делать будет....? И не появятся ли опять дома с подчеркиванием? И кроме, того надо понимать, что адреса это не только место на карте, имеющие координаты, этажи, квартиры, но элементы социальной коммуникации, обмена вербальной! информацией, части делового и торгового оборота. Это культурный слой в конце-концов…

А пока скачиваем очередную версию ФИАС и… не ставим ее. Пишем парсеры на почтовый сайт в надежде выкачать оттуда хоть какие-то обновления почтовых индексов. И, да, коптеры наше все — доставка по координатам, в надежде что не влетит в соседнее окно с детской или кружка юных техников на первом этаже посылка с виски или еще с чем-то поинтересней. А дети, дети знают как его изловить и вскрыть…

|

Метки: author MaximKovalev читальный зал фиас кладр e-commerce логистика |

Процитировано 1 раз

[Из песочницы] Как рекламная сеть Vungle пытается усложнить жизнь своим клиентам |

Интерфейс Vungle в 2014 году

Общий доход, суммарный и по месяцам, можно было посмотреть на странице аккаунта. Ключевое слово — «было».

Через 2 года ситуация изменилась — Unity представила свою рекламную сеть, куда ушло множество разработчиков и рекламодателей, а Vungle решил сделать редизайн.

Изначально показалось, что все нормально, но ровно до того момента, как я решил посмотреть баланс на аккаунте. Облазив все страницы, найти его так не получилось, кроме вкладки с отчетами о доходах, которые загружаются в виде .csv файла. Выглядят они примерно так:

Благодаря формулам в Excel кое-как удалось вычленить данные о доходах и сложить, но это, мягко говоря, было не очень удобно. Тогда же было принято решение в новых приложениях использовать Unity Ads. Спустя время решил зайти и посмотреть доход у старых приложений за прошедший год, но тут ждал сюрприз.

Сначала очень удивился, подумал, что баг, но потом заметил плашку сверху.

Перейдя по ссылке, нахожу единственный способ посмотреть доход. Вот он. К сожалению, только для конкретного приложения, а не для всего аккаунта.

Ладно. Подумал, что API вернет мне немного текста, где я увижу общий доход. Получил ключ аккаунта, составил ссылку и перешел. API вернуло мне ЭТО. Как и раньше, доход высвечивался только для одного дня, без каких-либо итогов, но теперь еще и с разбивкой по странам. Большое спасибо.

Разозлившись, решил дойти до конца. Написал приложение на Unity, которое загружает по ссылкам json, обрабатывает и складывает общий доход.

#pragma strict

import System;

class MainMainVungle{

var mvungle: MainVungle;

}

class MainVungle {

var vungle: Vungle[];

}

class Vungle {

var date: String;

var impressions: int;

var views: int;

var completes: int;

var clicks: int;

var revenue: float;

var eCPM: float;

var geo_eCPMs: VunlgeCounty[];

}

class VunlgeCounty {

var country: String;

var views: int;

var clicks: int;

var revenue: float;

var eCPM: float;

}

var apps: String[];

private var url: String = "https://ssl.vungle.com/api/applications/{0}?key=[ВАШ КЛЮЧ API]&start={1}&end={2}&geo=all";

private var templateJson: String = '{"vungle":';

var startDate = "2016-09-27";

var mmvungle: MainMainVungle[];

var revenue: float;

function Start () {

var cTime: Date = System.DateTime.Now;

var i: int;

for (i = 0; i< apps.Length; i++){

var cUrl = String.Format(url, apps[i], startDate, cTime.Year+"-"+StringTime(cTime.Month)+"-"+StringTime(cTime.Day));

var www : WWW = new WWW(cUrl);

yield www;

var json: String = templateJson+ www.text+"}";

mmvungle[i].mvungle = JsonUtility.FromJson(json, MainVungle);

Debug.Log("Loading "+apps[i]);

}

for (i = 0; i< mmvungle.Length; i++){

for (var v: int = 0; v< mmvungle[i].mvungle.vungle.Length; v++){

revenue+=mmvungle[i].mvungle.vungle

}

}

Debug.Log("Revenue: "+revenue);

}

function StringTime(v: int){

if (v < 10){return "0"+v;}

else {return ""+v;}

}В итоге, все же удалось получить данные о доходе.

Интересно, зачем Vungle так старательно пытается усложнить жизнь своим пользователям?

|

Метки: author varlamov5264 монетизация игр реклама в приложениях vungle видеореклама монетизация приложений |

[Перевод] Сети Docker изнутри: связь между контейнерами в Docker Swarm и Overlay-сети |

В предыдущей статье я рассказал, как Docker использует виртуальные интерфейсы Linux и bridge-интерфейсы, чтобы установить связь между контейнерами по bridge-сетям. В этот раз я расскажу, как Docker использует технологию vxlan, чтобы создавать overlay-сети, которые используются в swarm-кластерах, а также где можно посмотреть и проинспектировать эту конфигурацию. Также я расскажу, как различные типы сетей решают разные задачи связи для контейнеров, которые запущены в swarm-кластерах.

Я предполагаю, что читатели уже знают, как разворачивать swarm-кластеры и запускать сервисы в Docker Swarm. Также в конце статьи я приведу несколько ссылок на полезные ресурсы, с помощью которых можно будет изучить предмет в деталях и вникнуть в контекст обсуждаемых здесь тем. Опять же, буду ждать ваших мнений в комментариях.

Оглавление

Docker Swarm и Overlay-сети

Overlay-сети используются в контексте кластеров (Docker Swarm), где виртуальная сеть, которую используют контейнеры, связывает несколько физических хостов, на которых запущен Docker. Когда вы запускаете контейнер на swarm-кластере (как часть сервиса), множество сетей присоединяется по умолчанию, и каждая из них соответствует разным требованиям связи.

Например, у меня есть 3 ноды docker swarm кластера:

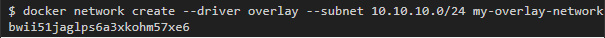

Для начала я создам overlay-сеть под названием my-overlay-network:

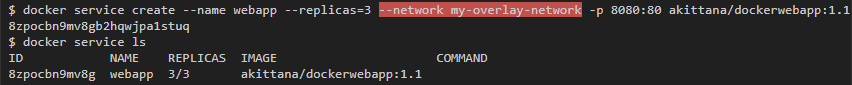

Затем запущу сервис с контейнером, на котором запущен простой веб-сервер, который смотрит портом 8080 во внешний мир. Этот сервис будет иметь 3 реплики, и я отмечу, что он связан только с одной сетью (my-overlay-network):

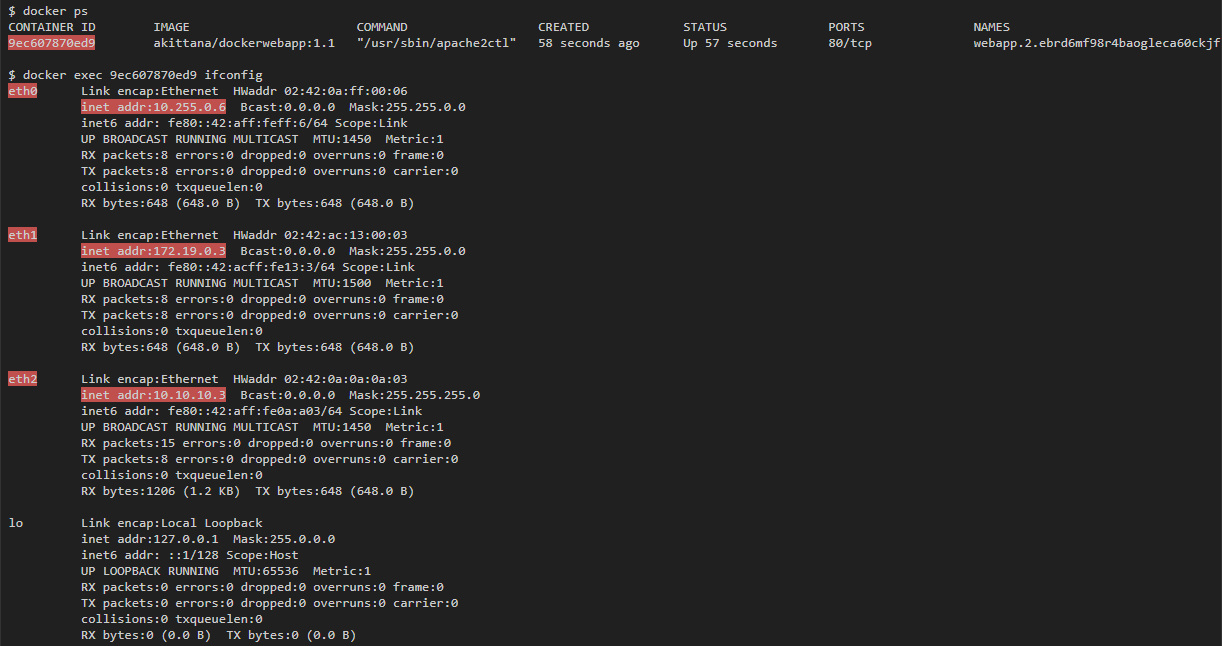

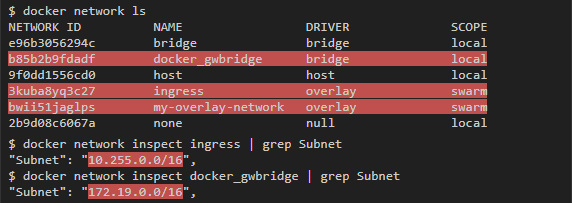

Если затем вывести список всех интерфейсов, доступных любому запущенному контейнеру, то их будет 3. В то же время, если запустить контейнер на одном хосте, то можно ожидать только 1 интерфейс:

Контейнер связан с my-overlay-network через eth2, что можно понять по IP-адресу. eth0 и eth1 связаны с другими сетями. Если запустить docker network ls, то можно увидеть 2 дополнительные сети, которые добавились: docker_gwbridge и ingress, а по адресам подсетей можно понять, что они привязаны к eth0 и eth1:

Overlay

Overlay-сеть создает подсеть, которую могут использовать контейнеры в разных хостах swarm-кластера. Контейнеры на разных физических хостах могут обмениваться данными по overlay-сети (если все они прикреплены к одной сети).

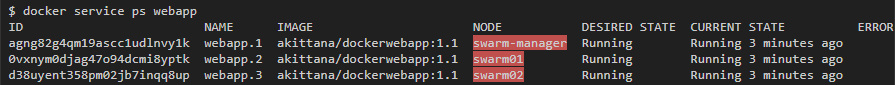

Например, для веб-приложения, которое мы запустили, можно увидеть по одному контейнеру на каждом хосте в swarm-кластере:

Я могу получить overlay IP-адрес для каждого контейнера при помощи команды ifconfig eth2 (eth2 — это интерфейс, присоединенный к overlay-сети).

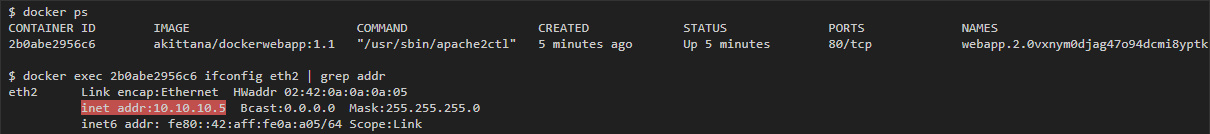

На swarm01:

Потом с контейнера на swarm02 у меня должна быть возможность пингануть 10.10.10.5 (IP контейнера на swarm01):

vxlan

Overlay-сеть использует технологию vxlan, которая инкапсулирует layer 2 фреймы в layer 4 пакеты (UDP/IP). При помощи этого действия Docker создает виртуальные сети поверх существующих связей между хостами, которые могут оказаться внутри одной подсети. Любые точки, которые являются частью этой виртуальной сети, выглядят друг для друга так, будто они связаны поверх свича и не заботятся об устройстве основной физической сети.

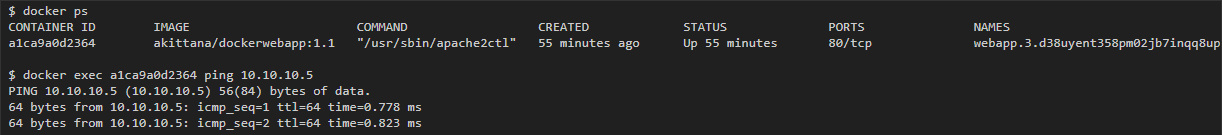

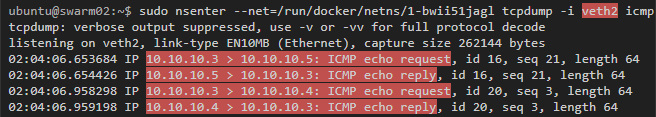

Чтобы увидеть этот процесс в действии, можно сделать захват трафика на хостах, которые являются частью overlay-сети. В последнем примере захват трафика на swarm01 или swarm02 выявит icmp-трафик между контейнерами, которые на них запущены (vxlan использует udp port 4789):

В этом примере в пакетах можно видеть два слоя. Первый — это туннельный трафик udp vxlan между хостами по порту 4789, а внутри можно увидеть второй — icmp трафик с IP-адресами контейнера.

Шифрование

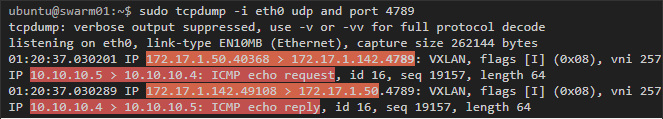

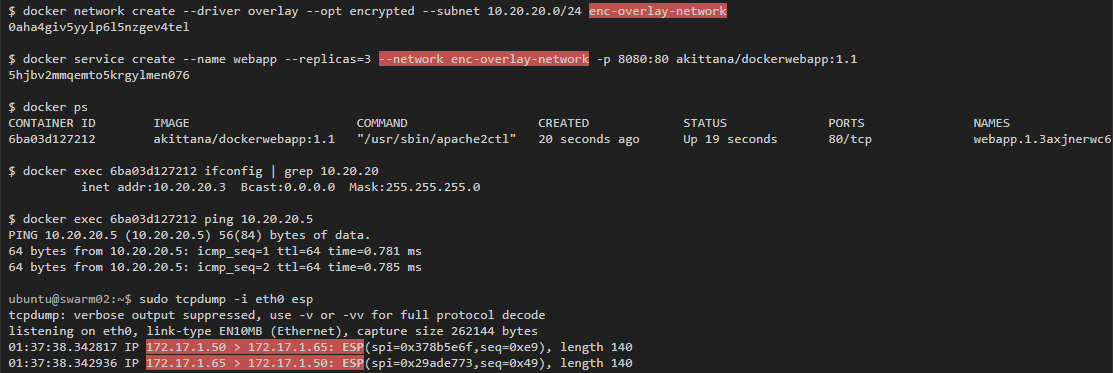

Захват трафика в этом примере показал, что если ты видишь трафик между хостами, то увидишь и трафик внутри контейнеров, проходящий по overlay-сети. Именно поэтому в Docker есть опция шифроования. Можно запустить автоматическое IPSec-шифрование vxlan-туннелей, просто добавив --opt encrypted при создании сети.

Если запустить такой же тест, но с использованием зашифрованной overlay-сети, то можно увидеть только зашифрованные пакеты между хостами:

Инспектирование интерфейсов vxlan-туннелей

Как и bridge-сети, Docker создает bridge-интерфейс для каждой overlay-сети, который соединяет виртуальные туннельные интерфейсы, выполняющие vxlan туннельную связь между хостами. Впрочем, эти туннельные интерфейсы (bridge и vxlan) создаются не напрямую на туннельном хосте. Они находятся в разных контейнерах, которые Docker запускает для каждой создаваемой overlay-сети.

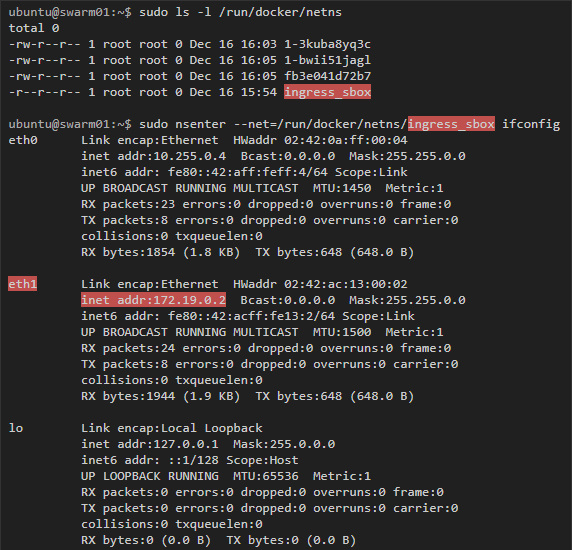

Чтобы действительно проинспектировать эти интерфейсы, надо использовать nsenter для запуска команд внутри сети контейнера, который управляет туннелями и виртуальными интерфейсами. Эту команду надо запустить на хостах с контейнерами, которые участвуют в overlay-сети.

Также надо отредактировать /etc/systemd/system/multi-user.target.wants/docker.service на хосте и закомментировать MountFlags=slave по инструкции из этого обсуждения.

Наконец, если запустить захват трафика на veth-интерфейсе, то мы увидим трафик, который покидает контейнер, но до того, как он будет направлен в vxlan туннель (упомянутый выше пинг все еще работает):

ingress

Вторая сеть, к которой были присоединены контейнеры, — это сеть ingress. Это overlay-сеть, но она устанавливается по умолчанию сразу после запуска swarm-кластера. Эта сеть отвечает за связи, которые устанавливаются с контейнерами со стороны внешнего мира. Также именно в ней происходит балансировка нагрузки, которую предоставляет swarm-кластер.

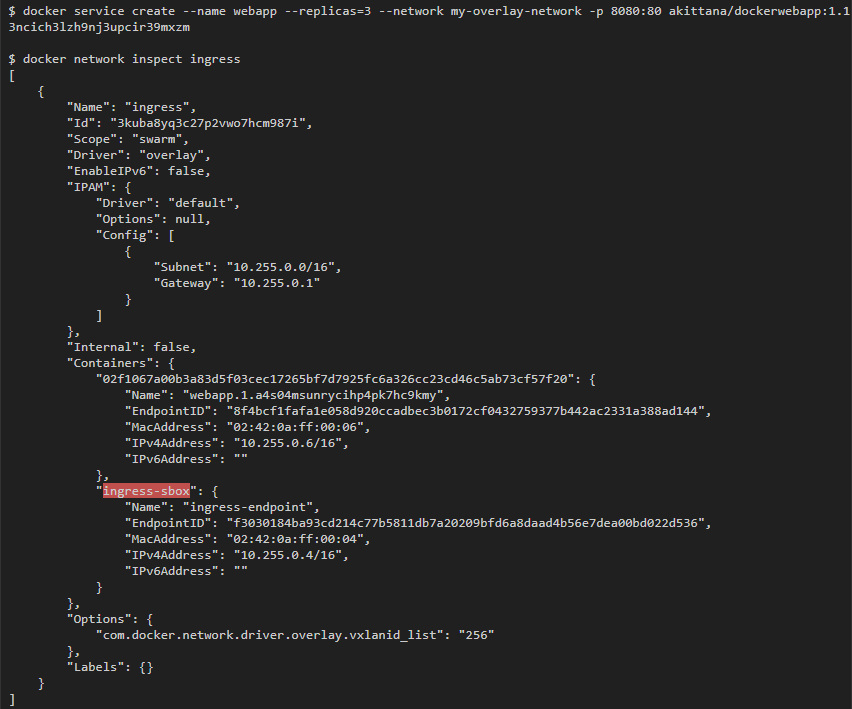

Балансировку нагрузки выполняет IPVS в контейнере, который Docker swarm запускает по умолчанию. Можно увидеть, что этот контейнер прикреплен к ingress-сети (я использовал тот же веб-сервис, что и раньше: он раскрывает порт 8080, который прикрепляется к порту 80 в контейнерах):

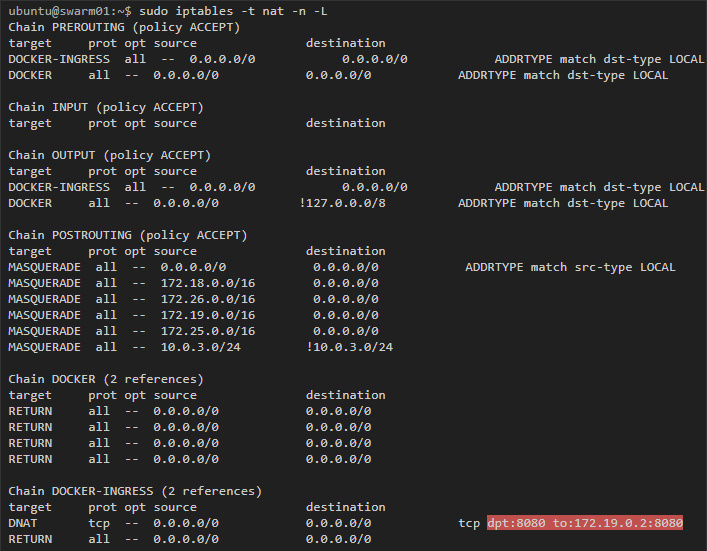

Для начала, взглянем на хост — на любой хост, который участвует в swarm-кластере:

Здесь мы видим правило, по которому трафик, предназначенный для порта 8080, перенаправляется по адресу 172.19.0.2. Этот адрес принадлежит контейнеру ingress-sbox, если проинспектировать его интерфейсы, то мы получим слещующее:

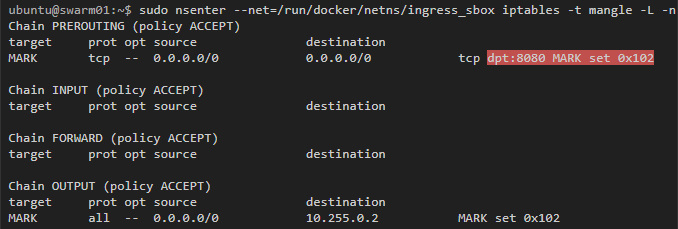

Docker использует mangle-правила iptables, чтобы назначить определенный номер пакетам для порта 8080. IPVS будет использовать этот номер, чтобы балансировать нагрузку в подходящие контейнеры:

Как Docker swarm использует iptables и IPVS для балансировки нагрузки контейнеров, можно более детально изучить по видеоролику Deep Dive into Docker 1.12 Networking.

Docker_gwbridge

Наконец, поговорим о сети docker_gwbridge. Это bridge-сеть с соответствующим интерфейсом под названием docker_gwbridge, который создается на каждом хосте swarm-кластера. Сеть docker_gwbridge соединяет трафик из контейнеров swarm-кластера с внешним миром. Например, такой трафик получится, если мы направим запрос в Google.

Не буду вдаваться в подробности, поскольку bridge-сети я уже в деталях рассмотрел в предыдущей статье.

Заключение

Контейнер, запущенный на swarm-кластере, по умолчанию может быть соединён с тремя и более сетями. Первая сеть, docker_gwbridge, позволяет контейнерам поддерживать связь с внешним миром. Сеть ingress нужна только для того, чтобы устанавливать входящие соединения из внешнего мира. И, наконец, сети overlay: их создает сам пользователь и их можно прикрепить к контейнерам. Эти сети служат общей подсетью для контейнеров единой сети, в которой они могут обмениваться данными напрямую (даже если они запущены на разных физических хостах).

Также существуют пространства разных сетей, которые создаются по умолчанию на swarm-кластере. Эти пространства помогают управлять vxlan-туннелями для overlay-сетей и правилами балансировки нагрузки для входящих связей.

Ссылки/ресурсы

- Deep dive into Docker Networking (видео)

- Overlay networking and swarm mode

- Docker Swarm overlay security

|

Метки: author r-moiseev системное администрирование сетевые технологии devops docker docker swarm overlay iptables |

TamTam: как мы делали новый мессенджер |

|

Метки: author Digal системы обмена сообщениями разработка мобильных приложений анализ и проектирование систем блог компании mail.ru group mail.ru tamtam мессенджер |

[Из песочницы] Вынос локального сервера в сеть с помощью другого внешнего сервера |

«Ну и что тут сложного? Практически любой провайдер предоставляет статический белый IP за небольшую плату!», – скажите Вы и будете абсолютно правы. Но это платно, да и вообще хотелось попробовать чего-нибудь более оригинального. Основная проблема доступа к моему серверу – NAT. Если вдруг кто не знает, что это, ниже оставил пояснение из Википедии.

Преобразование адреса методом NAT может производиться почти любым маршрутизирующим устройством — маршрутизатором, сервером доступа, межсетевым экраном. Наиболее популярным является SNAT, суть механизма которого состоит в замене адреса источника (англ. source) при прохождении пакета в одну сторону и обратной замене адреса назначения (англ. destination) в ответном пакете. Наряду с адресами источник/назначение могут также заменяться номера портов источника и назначения.

Принимая пакет от локального компьютера, роутер смотрит на IP-адрес назначения. Если это локальный адрес, то пакет пересылается другому локальному компьютеру. Если нет, то пакет надо переслать наружу в интернет. Но ведь обратным адресом в пакете указан локальный адрес компьютера, который из интернета будет недоступен. Поэтому роутер «на лету» транслирует (подменяет) обратный IP-адрес пакета на свой внешний (видимый из интернета) IP-адрес и меняет номер порта (чтобы различать ответные пакеты, адресованные разным локальным компьютерам). Комбинацию, нужную для обратной подстановки, роутер сохраняет у себя во временной таблице. Через некоторое время после того, как клиент и сервер закончат обмениваться пакетами, роутер сотрет у себя в таблице запись о n-ом порте за сроком давности.

Если своими словами, это внешний маршрутизатор, позволяющий Вам отправлять запросы в интернет, но не позволяющий Вам их получать. Ответ-то из Интернета Вы получаете, а значит уже не все потеряно. Мне вспомнилась старая программа LogMeIn Hamach, она же позволяла нам обмениваться пакетами данных при том, что ВСЕ клиенты были в закрытой NAT'ом сети. А что, если реализовать что-нибудь подобное:

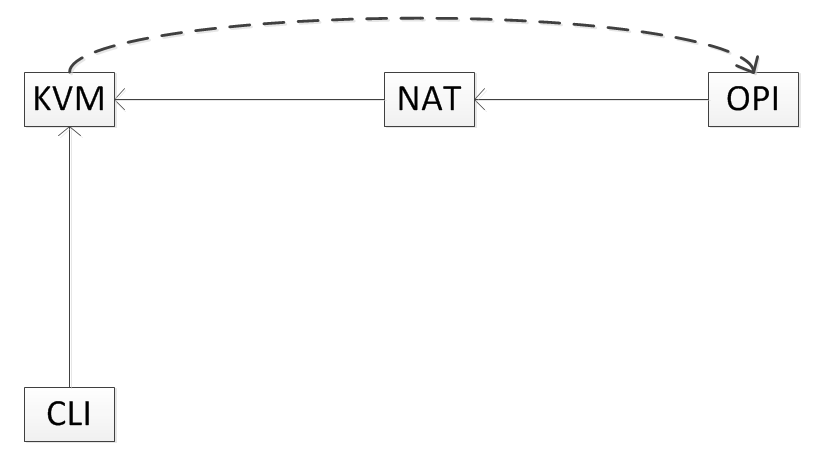

Что здесь нарисовано? OPI – это моя Orange Pi PC, которая выполняет роль сервера, NAT – это, как несложно догадаться, маршрутизатор моего оператора (он может быть не один, но сути это не меняет), KVM – внешний сервер товарища, CLI – клиент. Возможно, у вас возник вопрос: «По какой причине ты не мог просто выкинуть все свои сервисы на сервер товарища?». Ответ прост: не хочу. В конце концов и дисковое пространство пришлось бы использовать чужое, а меня это не устраивает. Не говоря уже об усложнении администрирования и обслуживания сервера…

OPI подключается к KVM и между ними устанавливается VPN канал. А далее клиент подключается к KVM, и эта машина в свою очередь отправляет запрос через VPN к OPI.

Почему KVM? Сервер товарища – обычный VDS(Virtual Dedicated Server). Обычно это либо KVM (Kernel-based Virtual Machine), либо OVZ (OpenVZ). OVZ в нашем случае не подходит, так как iptables там работают как-то не так, да и вообще штука очень странная.

Настройка сервера

В теории это звучит все здорово, но теперь надо реализовывать на практике. Нужно выбрать протокол для VPN. Изначально, я был склонен к OpenVPN, но после череды проб, ошибок, неудач, пришел к выводу, что это не лучший протокол для таких действий. В конце концов он использует сложные алгоритмы шифрования, которые еще и будут неслабо грузить процессор OPI и внешнего сервера, поэтому мой выбор пал на протокол PPTP.

Первым делом надо установить сам PPTP демон на сервере:

apt install pptpdСледующим шагом его надо настроить. Откроем его конфиг файл /etc/pptpd.conf и укажем IP адрес сервера и диапазон IP адресов клиентов:

localip 10.0.0.1

remoteip 10.0.0.100-200Теперь нужно создать учетные записи VPN клиентов. Их список находится в файле /etc/ppp/chap-secrets

# client server secret IP addresses

orange pptpd pass123 10.0.0.100

Мы создали клиента orange с паролем pass123 и IP адресом 10.0.0.100. Если вместо IP адреса указать *, то клиент получит любой свободный IP адрес из диапазона, указанного в remoteip. Нам рандома явно не надо. Теперь еще пару штрихов с настройками PPTPD. Добавим DNS сервера в файле /etc/ppp/pptpd-options

ms-dns 8.8.8.8

ms-dns 8.8.4.4И перезагрузим PPTPD:

service pptpd restartОчень важный шаг – включение IP форвардинга. Это позволит Вам пересылать пакеты между публичным IP и приватными IP, которые Вы настроили при помощи PPTP. Редактируем файл /etc/sysctl.conf и раскомментируем строку:

net.ipv4.ip_forward = 1Отлично, теперь можно начинать колдовать с ipatables.

Для начала узнаем название нашего сетевого интерфейса:

~$ ifconfig

ens3 Link encap:Ethernet HWaddr 52:54:00:f8:0c:4a

inet addr:31.148.99.234 Bcast:31.148.99.255 Mask:255.255.255.0

inet6 addr: fe80::5054:ff:fef8:c4a/64 Scope:Link

UP BROADCAST RUNNING MULTICAST MTU:1500 Metric:1

RX packets:8808733 errors:0 dropped:0 overruns:0 frame:0

TX packets:3300625 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:1000

RX bytes:3511383831 (3.5 GB) TX bytes:3245380453 (3.2 GB)

lo Link encap:Local Loopback

inet addr:127.0.0.1 Mask:255.0.0.0

inet6 addr: ::1/128 Scope:Host

UP LOOPBACK RUNNING MTU:65536 Metric:1

RX packets:216 errors:0 dropped:0 overruns:0 frame:0

TX packets:216 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:1

RX bytes:16618 (16.6 KB) TX bytes:16618 (16.6 KB)

У меня он называется ens3. Однако, чаще всего он называется eth0.

Создаем правило iptables:

iptables -t nat -A POSTROUTING -o ens3 -j MASQUERADE && iptables-saveНе забудьте заменить интерфейс на свой. Если вы планируете в будущем использовать VPN для своих нужд, можете прописать правила, чтобы клиенты VPN сети могли взаимодействовать:

iptables --table nat --append POSTROUTING --out-interface ppp0 -j MASQUERADE

iptables -I INPUT -s 10.0.0.0/8 -i ppp0 -j ACCEPT

iptables --append FORWARD --in-interface ens3 -j ACCEPT

ppp0 – виртуальный интерфейс сети.

Настройка локального сервера

Далее нужно подключить нашего первого клиента – Orange PI. На этом моменте я засел надолго, так как все инструкции в интернете говорили одно и то же, и все они не работали.

Первым делом на Orange PI установим PPTP клиент:

apt install pptp-linuxСоздадим файл /etc/ppp/peers/pptpserver и впишем следующее:

pty "pptp 31.148.99.234 --nolaunchpppd"

name orange

password pass123

remotename PPTP

require-mppe-128

Не забудьте поменять IP адрес сервера и прочие данные на свои.

Далее закомментируем все строки в файле /etc/ppp/options вставкой символа #

Файл /etc/ppp/options.pptp нужно привести к следующему виду:

lock

noauth

nobsdcomp

nodeflate

defaultroute

replacedefaultroute

mtu 1400

persist

maxfail 0

lcp-echo-interval 20

lcp-echo-failure 3

И, наконец, пробуем подключиться:

pon pptpserverЕсли все получилось, попробуем посмотреть на наш виртуальный интерфейс:

~$ ifconfig ppp0

ppp0 Link encap:Point-to-Point Protocol

inet addr:10.0.0.100 P-t-P:10.0.0.1 Mask:255.255.255.255

UP POINTOPOINT RUNNING NOARP MULTICAST MTU:1496 Metric:1

RX packets:1075 errors:0 dropped:0 overruns:0 frame:0

TX packets:959 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:3

RX bytes:154176 (154.1 KB) TX bytes:194499 (194.4 KB)

Попробуем пропинговать Orange PI с внешнего сервера:

~$ ping 10.0.0.100

PING 10.0.0.100 (10.0.0.100) 56(84) bytes of data.

64 bytes from 10.0.0.100: icmp_seq=1 ttl=64 time=8.91 ms

64 bytes from 10.0.0.100: icmp_seq=2 ttl=64 time=8.80 ms

64 bytes from 10.0.0.100: icmp_seq=3 ttl=64 time=8.93 ms

64 bytes from 10.0.0.100: icmp_seq=4 ttl=64 time=9.00 ms

Работает!

Проброс портов

Теперь самая малость: перенаправление пакетов с сервера на Orange PI. Тут уже способы могут быть разными, но так как на этом сервере 80 и 443 порт не используются вообще, мы можем просто попросить сервер все пакеты для этих портов перенаправлять на OPI

iptables -t nat -A PREROUTING -p tcp -d 31.148.99.234 --dport 80 -j DNAT --to-destination 10.0.0.100:80

iptables -A FORWARD -i ppp0 -d 10.0.0.100 -p tcp --dport 80 -j ACCEPT

iptables -t nat -A PREROUTING -p tcp -d 31.148.99.234 --dport 443 -j DNAT --to-destination 10.0.0.100:443

iptables -A FORWARD -i ppp0 -d 10.0.0.100 -p tcp --dport 443 -j ACCEPTНа забудьте поменять IP адреса на свои. Проверим, что все работает:

Здорово! Цель достигнута!

Маленькие доработки

Но вдруг в здании, где располагается Orange PI выключается свет и… После перезагрузки никто опять не может получить доступ к нашему апельсину. Почему? Потому что сам по себе Orange PI к VPN не подключится. Напишем простой скрипт на bash, который будет вциклически выполняться, проверяя, установлено ли соединение:

#!/bin/sh

while [ 0 ]

do

if ifconfig ppp0>>/dev/null

then

sleep 7

else

pon pptpserver

if $?

then

echo $(date) Connected

else

echo $(date) Connection error

fi

fi

sleep 3

doneТеперь добавим его в автозагрузку. В файл /etc/rc.local впишем строку с расположением скрипта. В моем случае это:

/root/scripts/ppp.shНе забываем дать скрипту права на исполнение:

chmod +x /root/scripts/ppp.shВнимательный пользователь мог заметить, что в скрипте есть команды echo, но ведь им некуда делать вывод! Изначально, я планировал сделать в виде сервиса, чтобы вывод удобно капал туда, но в итоге банально поленился, работает же. Кстати, а работает ли? Перезагружаем наш апельсин и видим, что интерфейс ppp0 успешно поднялся, а наши сервисы доступны из интернета. Цель достигнута, господа!

Итог

Все это сделано исключительно в развлекательных и учебных целях. Практической пользы это почти не несет, так как нам все равно необходим внешний сервер, да и нагрузка не его сеть удваивается, ибо ему приходиться принимать пакеты и сразу же передавать их дальше. Однако, у этого метода есть преимущества, т.к. реальный IP нашего сервера будет скрыт, этот внешний сервер сможет лучше противостоять DDoS атакам, а также сможет выводить беспокойным пользователям страницу о технических работах, если Orange PI будет недоступен. Конечно же, для этого нужно будет еще серьезно постараться, но разве не в самом пути к цели все удовольствие, товарищи?

Ссылки на используемые ресурсы

1. Как настроить VPN с помощью PPTP

2. Проброс портов через NAT

|

Метки: author Trofen сетевые технологии серверное администрирование настройка linux orange pi nat iptables linux vpn pptp |

Разработка для Sailfish OS: Работа c календарем и списком контактов |

Управление контактами

Все распространенные мобильные операционные системы предоставляют API для управления контактами, хранящимися на устройстве. И Sailfish OS не является исключением. Sailfsh OS предоставляет возможность хранения и управления данными контактов, а также возможность переноса контактов между устройствами.

Мы, как разработчики, можем получить доступ к данным контактов с помощью плагина Nemo QML Plugin Contacts. Данный плагин позволяет получать данные о контактах и редактировать их. Стоит отметить, что плагин не имеет текстовой документации, поэтому разбираться с тем, как он работает, пришлось непосредственно на основании исходного кода.

Плагины Nemo предоставляют доступ к различным службам Sailfish OS. Мы уже рассказывали о таких плагинах как Nemo QML Plugin Notification и Nemo QML Plugin D-Bus в наших предыдущих статьях о работе с уведомлениями и системой D-Bus.

Nemo QML Plugin Contacts предоставляет четыре QML-компонента:

- PeopleModel;

- PeopleNameGroupModel;

- PeopleVCardModel;

- Person.

Первые три компонента из списка являются моделями, которые могут быть использованы для отображения списков контактов с помощью SilicaListView, например.

PeopleModel содержит информацию о каждом контакте: имя, фамилию, номер телефона, e-mail, дату рождения или еще какие-нибудь данные, указанные пользователем при добавлении контакта в записную книжку устройства. PeopleNameGroupModel содержит информацию лишь об именах контактов и о том, сколько контактов с данным именем содержится в записной книжке. А каждый объект в PeopleVCardModel является своего рода «визитной карточкой» формата vCard.

Компонент Person же просто содержит в себе информацию о контакте.

Давайте подробнее остановимся на том, какие данные можно извлечь с помощью PeopleModel и Person. Компоненты PeopleNameGroupModel и PeopleVCardModel не предоставляют так же много полезной информации, поэтому далее мы их рассматривать не будем. Но Вы всегда можете ознакомиться с ними самостоятельно.

Каждый объект модели PeopleModel предоставляет следующие данные о контакте:

- firstName — имя контакта;

- lastName — фамилия контакта;

- favorite — true, если контакт помечен как «избранный», false — в противном случае;

- avatar — путь до изображения с аватаром контакта на устройстве;

- contactId — идентификатор контакта в базе данных устройства;

- phoneNumbers — список номеров телефонов контакта;

- emailDetails — информация об электронных адресах;

- person — объект типа Person, содержащий больше информации о контакте.

Возможно, Вы заметили, что PeopleModel содержит не все поля, которые может содержать контакт в записной книжке устройства. Зачастую для контакта можно указать дату рождения, адрес проживания и другие данные. Полный набор таких полей содержит компонент Person:

- id — идентификатор записи в базе данных;

- firstName — имя контакта;

- lastName — фамилия контакта;

- middleName — отчество контакта;

- companyName — название компании, где работает контакт;

- role — должность контакта в компании;

- department — отдел компании, где работает контакт;

- favorite — true, если контакт помечен как «избранный», false — в противном случае;

- avatar — путь до изображения с аватаром контакта на устройстве;

- phoneNumbers — список номеров телефонов контакта;

- emailDetails — информация об электронных адресах;

- addressDetails — информация об адресе проживания;

- birthday — дата рождения контакта.

Рассмотрим теперь подробнее как использовать плагин Nemo QML Plugin Contacts непосредственно в проекте.

Первое, что необходимо сделать – это добавить плагин в зависимости проекта. Для этого необходимо в yaml-файл в раздел Requires добавить плагин nemo-qml-plugin-contacts-qt5 следующим образом:

...

# Runtime dependencies which are not automatically detected

Requires:

- sailfishsilica-qt5 >= 0.10.9

- nemo-qml-plugin-contacts-qt5

...

Напомним, что yaml-файл располагается в директории rpm/ в корне проекта.

Для использования плагина внутри QML-кода необходимо импортировать модуль org.nemomobile.contacts.

import org.nemomobile.contacts 1.0

И теперь мы можем объявлять и использовать компоненты, описанные выше.

PeopleModel {

id: peopleModel

filterType: PeopleModel.FilterAll

requiredProperty: PeopleModel.PhoneNumberRequired

}

SilicaListView {

anchors.fill: parent

header: PageHeader {title: qsTr("Contacts")}

model: peopleModel

delegate: ListItem {

width: parent.width

Column {

width: parent.width

Label {text: firstName + " " + lastName}

Label {text: qsTr("Phone numbers: ") + phoneNumbers.join(", ")}

}

}

}

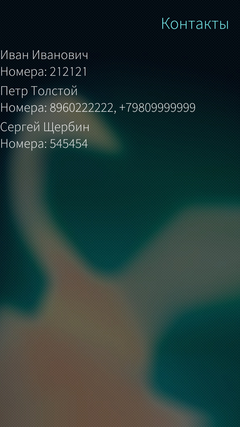

Данный пример демонстрирует создание компонента PeopleModel и использование его в качестве модели для списка SilicaListView. Для PeopleModel мы настраиваем свойство requiredProperty где указываем, что необходимо получить информацию о телефонных номерах. Также requiredProperty может принимать значение EmailAddressRequired для получения информации об электронных адресах контакта. С помощью значения FilterAll, переданного в свойство filterType, мы извлекаем список всех контактов. Свойство filterType также может принимать FilterFavorites и FilterOnline для извлечения только «избранных» контактов или только тех, которые сейчас онлайн.

Внутри делегата списка мы показанным выше образом можем использовать поля модели, такие как firstName, lastName и phoneNumbers. Поле phoneNumbers является списком строк, поэтому здесь используется метод join(), для объединения всех номеров телефонов в одну строку.

Для редактирования контакта необходимо внести изменения в поле person типа Person элемента модели PeopleModel. Затем, вызвать на объекте модели метод savePerson(Person person), куда в качестве аргумента необходимо передать измененный контакт person. В итоге, изменения данных контакта будут внесены в базу данных устройства. Новый контакт при этом создан не будет. Для добавления нового контакта в записную книжку устройства нужно создать новый объект типа Person и сохранить его данные аналогичным образом.

Управление событиями календаря

Помимо работы с контактами, Sailfish OS предоставляет разработчикам возможность создавать и просматривать события календаря, делиться ими с друзьями, устанавливать напоминания для событий.

Для работы с событиями календаря используется плагин Nemo QML Plugin Calendar. Он позволяет получать данные о событиях календаря и редактировать их внутри своих приложений. Данный плагин, так же как и Nemo QML Plugin Contacts, не имеет никакой текстовой документации, и разбираться с тем как он работает, тоже придется на основании исходного кода.

Плагин Nemo QML Plugin Calendar предоставляет несколько компонентов. В данной статье мы поговорим об основных из них, тех, что позволяют получить доступ к событиям календаря, а также редактировать их:

- AgendaModel;

- CalendarEvent;

- CalendarEventModification;

- Calendar.

AgendaModel — компонент для представления данных событий календаря. Обычно он используется в качестве модели для списка SilicaListView. AgendaModel имеет всего два свойства: startDate и endDate. Они служат для выбора событий из определенного временного диапазона, т.е. при установке данных свойств модель будет содержать данные именно за указанный период.

AgendaModel {

id: agendaModel

startDate: new Date()

endDate: new Date(2018, 0)

}

Модель, созданная в примере выше, будет содержать информацию о событиях календаря, начиная с текущего дня и заканчивая 1-м января 2018-ого года.

Элементами модели AgendaModel являются объекты CalendarEvent, каждый из которых содержит информацию об одном отдельно взятом событии. CalendarEvent содержит следующие свойства:

- displayLabel — название события;

- description — описание события;

- startTime — время начала события;

- endTime — время окончания события;

- allDay — true, если событие помечено как событие на «весь день»;

- location — место проведения мероприятия;

- color — цвет, которым помечается событие в календаре;

- uniqueId — уникальный идентификатор события в базе данных.

Все перечисленные свойства являются свойствами только для чтения. Для изменения же события используется компонент CalendarEventModification. Он содержит ровно те же свойства, что и CalendarEvent, но здесь все свойства могут быть отредактированы. Также CalendarEventModification обладает методом save(), который сохраняет изменения в базе данных.

Calendar — компонент-синглтон, позволяющий создавать, редактировать и удалять события календаря. Calendar имеет три функции:

- CalendarEventModification createNewEvent();

- CalendarEventModification createModification(CalendarEvent event);

- void remove(string uniqueId).

Функция createNewEvent() создает новый объект типа CalendarEventModification, позволяющий заполнять данные о событии календаря. После вызова метода save() на созданном объекте будет добавлена новая запись в базу данных устройства. Таким образом может быть добавлено новое событие календаря.

Функция createModification() позволяет создать объект CalendarEventModification на основе уже существующего события календаря — объекта CalendarEvent. Как мы писали выше, объект типа CalendarEvent не может быть отредактирован, т.к. все его свойства исключительно для чтения. Именно поэтому к нему и применяется функция createModification(), чтобы получить возможность отредактировать событие. После вызова метода save() изменения события будут сохранены в базе данных устройства. Новое событие создано не будет, но будет изменено то, из которого сделали модификацию.

Функция remove() позволяет удалить существующее событие календаря из базы данных, используя его уникальный id.

Так как Calendar является синглтоном, то и создавать объект нет необходимости. Вызывать методы можно напрямую, используя лишь имя компонента.

Calendar.createNewEvent();

Calendar.createModification(event);

Calendar.remove(event.uniqueId);

Для добавления плагина Nemo QML Plugin Calendar в зависимости проекта необходимо прописать его в yaml-файле, так же как и плагин для работы с контактами.

...

# Runtime dependencies which are not automatically detected

Requires:

- sailfishsilica-qt5 >= 0.10.9

- nemo-qml-plugin-calendar-qt5

...

Для использования плагина внутри QML-кода необходимо импортировать модуль org.nemomobile.calendar.

import org.nemomobile.calendar 1.0

Рассмотрим теперь пример реализации отображения списка событий календаря.

AgendaModel {

id: agendaModel

startDate: new Date()

endDate: new Date(2018, 0)

}

SilicaListView {

anchors.fill: parent

header: PageHeader { title: qsTr("Calendar events") }

model: agendaModel

delegate: ListItem {

width: parent.width

contentHeight: column.height

Column {

id: column;

width: parent.width

Label { text: eventDateTimeToString(event) }

Label { text: event.displayLabel }

Label { text: qsTr("Location: ") + event.location }

}

}

}

function eventDateTimeToString(event) {

return Qt.formatTime(event.startTime, "HH:mm") + " – "

+ Qt.formatTime(event.endTime, "HH:mm") + "\t"

+ Qt.formatDate(event.startTime, Qt.SystemLocaleShortDate);

}

Данный пример похож на описанный выше с отображением списка контактов. Здесь так же создается объект-модель, и описывается список SilicaListView. Каждый элемент списка отображает время и дату события календаря, его название и местоположение проведения мероприятия. Для форматирования и корректного отображения даты и времени здесь создана JavaScript-функция eventDateTimeToString(), которая принимает на вход объект события CalendarEvent, и с помощью функций formatTime() и formatDate() формирует строку для отображения.

Отображать список событий календаря мы научились. Но помимо этого необходимо иметь возможность добавлять новые события и редактировать существующие. Для этого создадим диалог для добавления и редактирования событий.

Dialog {

property var eventModification

SilicaFlickable {

// Компоненты ValueButton для установки даты, времени начала и времени конца события.

TextField {

id: eventLabelTextField

label: qsTr("Event")

text: eventModification.displayLabel

}

// Компонент TextField с id=locationTextField для установки места проведения мероприятия.

}

onAccepted: {

eventModification.displayLabel = eventLabelTextField.text;

eventModification.location = locationTextField.text;

eventModification.save();

}

}

Свойство eventModification представляет собой объект типа CalendarEventModification. Это будет абсолютно пустой объект, если мы создаем новое событие, либо это будет объект с данными уже существующего события. Для изменения свойств данного объекта будет использоваться диалог. Далее мы описываем компоненты для редактирования информации о событии. Здесь мы используем три компонента ValueButton для редактирования значений даты, времени начала и времени окончания события, а также два компонента TextField для редактирования названия события и местоположения его проведения. В обработчике сигнала onAccepted вызываем метод save(), сохраняющий все изменения события в базу данных устройства. Таким образом мы создали диалоговое окно, позволяющее редактировать события и создавать новые.

Теперь необходимо добавить возможность открывать наш диалог. Открывать диалог для создания нового события мы будем при помощи компонента PullDownMenu, а для редактирования при помощи контекстного меню.

Компонент PullDownMenu представляет собой вытягиваемое сверху меню и подробнее о нем говорилось в одной из наших предыдущих статей. Меню будет, конечно же, помещено на экран со списком событий и будет содержать лишь один пункт «Add new event», по нажатию на который откроется наш диалог.

PullDownMenu {

MenuItem {

text: "Add new event"

onClicked: pageStack.push(Qt.resolvedUrl("EditEventDialog.qml"),

{eventModification: Calendar.createNewEvent()})

}

}

При нажатии на элемент меню вызывается обработчик сигнала onClicked, где описан вызов, открывающий диалог для редактирования события, куда в качестве свойства eventModification передается новый объект созданный с помощью Calendar.createNewEvent(). В итоге будет создано новое событие и передано в диалог, где оно и будет редактироваться.

Для редактирования событий воспользуемся контекстным меню элементов списка SilicaListView. Создадим компонент ContextMenu и добавим к нему пункт «Edit».

SilicaListView {

// ...

model: agendaModel

delegate: ListItem {

// ...

menu: ContextMenu {

MenuItem {

text: "Edit"

onClicked: pageStack.push(Qt.resolvedUrl("EditEventDialog.qml"),

{eventMod: Calendar.createModification(event)})

}

}

}

}

По нажатию на пункт «Edit» будет открываться диалог для редактирования события. В качестве свойства eventModification передается объект CalendarEventModifiation, созданный с помощью метода createModification() объекта Calendar. В качестве параметра функции createModification() здесь используется объект event, полученный из модели AgendaModel и все его данные будут содержаться в новом объекте для редактирования, который передается в диалог.

Также добавим возможность удаления события календаря. Для этого необходимо создать еще один пункт меню.

MenuItem {

text: qsTr("Delete")

onClicked: Calendar.remove(event.uniqueId)

}

По нажатию на пункт меню «Delete» мы удаляем запись события из базы данных с помощью вызова Calendar.remove(), куда в качестве параметра передается уникальный идентификатор события, содержащийся в поле uniqueId. Таким образом мы реализовали возможность создания, редактирования и удаления событий календаря.

Заключение

На этом все. Данная статья демонстрирует пример работы с контактами и событиями календаря в Sailfish OS. Несмотря на то, что для описанных выше плагинов и компонентов нет никакой текстовой документации, разобраться с тем как их использовать не составит большого труда. В ходе написания статьи были созданы два готовых примера доступных на GitHub: пример управления контактами и пример управления событиями календаря.

Технические вопросы можно также обсудить на канале русскоязычного сообщества Sailfish OS в Telegram или группе ВКонтакте.

Автор: Иван Щитов

|

Метки: author FRUCT разработка мобильных приложений qt sailfish os qml контакты календарь события |

Команда веб-энтузиастов представила P2P-браузер Beaker |

Он разработан в партнерстве с командой, которая занимается поддержкой проекта Dat. Он, как и новый браузер, основан на P2P-протоколе Dat.

/ Flickr / hackNY.org / CC

/ Flickr / hackNY.org / CCЦель проекта — предоставить возможность создавать и размещать веб-сайты «прямо в браузере». Для этого достаточно сделать в прямом смысле слова «пару кликов»: создать локальную папку и поделиться соответствующей URL (демонстрационное видео).

При отправке содержимого используется протокол Dat (Distributed Dataset Synchronization and Versioning), специально разработанный для передачи данных в рамках распределенной сети.

Beaker позволяет посетителям вашего сайта копировать его содержимое и размещать у себя по аналогии с «re-seeding’ом» торрентов. Для локальной копии можно делать fork’и и внедрять любые изменения.

Параллельно с запуском P2P-браузера команда решила «связать» этот проект с реальным миром с помощью собственного облачного сервиса Hashbase. Он позволяет поддерживать постоянный доступ к Dat-сайтам, чьи локальные копии находятся оффлайн. При этом Hashbase-копии сайта не будет присвоен более высокий приоритет по сравнению с теми, что находятся на других узлах.

Beaker не предоставляет так назваемую «browsing privacy» — все обладатели URL для того или иного сайта «видят» устройства, которые его «хостят» или пытаются получить доступ. При этом одна из ключевых возможностей браудера — защищенный обмен файлами с помощью протокола Dat. Подробнее об этом можно почитать здесь. Документация по Dat-протоколу расположена тут.

Немного о разработке нашего IaaS-провайдера:

- Как создать провайдера виртуальной инфраструктуры

- Что нужно знать об IaaS-провайдере до начала работы

- Как выбрать направление для развития ИТ-проекта

- Мифы об облачных технологиях. Часть 1

- Как обезопасить Linux-систему: 10 советов

|

Метки: author 1cloud разработка веб-сайтов блог компании 1cloud.ru 1cloud p2p beaker dat |

[Перевод - recovery mode ] Почему мы выбрали TypeScript: история разработчиков из Reddit |

Примерно полгода назад CEO Reddit Стив сообщил о том, что мы перепроектируем сайт. Главный вопрос тут — как именно мы этим занимаемся. В наше время фронтенд-разработка очень сильно отличается от того, что было во времена, когда Reddit появился на свет. Сейчас имеется огромный выбор вариантов для каждой подсистемы веб-приложения. Как рендерить страницы? Как стилизовать контент? Как хранить и обслуживать картинки и видеофайлы? Как писать код? В современных условиях ни на один из этих вопросов нет готового ответа.

Примерно полгода назад CEO Reddit Стив сообщил о том, что мы перепроектируем сайт. Главный вопрос тут — как именно мы этим занимаемся. В наше время фронтенд-разработка очень сильно отличается от того, что было во времена, когда Reddit появился на свет. Сейчас имеется огромный выбор вариантов для каждой подсистемы веб-приложения. Как рендерить страницы? Как стилизовать контент? Как хранить и обслуживать картинки и видеофайлы? Как писать код? В современных условиях ни на один из этих вопросов нет готового ответа. Одним из первых подобных вопросов, на который нам необходимо было найти ответ, звучал так: «Какой язык выбрать?».

О богатстве выбора и требованиях к языку

Как ни странно, нашим языком для фронтенда не обязательно должен был стать JavaScript. В конечном счёте, какой бы язык для этой цели ни был бы выбран, код, написанный на нём, всё равно компилируется в JavaScript. Однако, во что именно компилируется код, возможно, менее важно, чем то, что именно пишет разработчик. Выбор языка оказался делом непростым. Вот что нам пришлось рассмотреть:

- BuckleScript

- ClojureScript

- CoffeeScript

- Elm

- ElixirScript

- JavaScript 2016 и будущие версии языка

- JavaScript + аннотации

- Nim

- PureScript

- Reason

- TypeScript

И это, кстати, далеко не полный список. У каждого языка есть свои плюсы и минусы, поэтому для того, чтобы помочь самим себе выбрать один из них, мы сформулировали следующие требования:

- Это должен быть язык со строгой типизацией. Типы, на микроуровне, играют роль документации. Они помогают, до определённой степени, обеспечивать правильность кода, и, что важнее, упрощают рефакторинг. Ещё одним соображением, в силу которого мы искали язык со строгой типизацией, была скорость разработки. Мы стремились найти строго типизированный язык, так как хотели ускорить работу. Такая идея идёт вразрез с тем видением типизации, которое сложилось у многих программистов. А именно, принято считать, что это — дополнительная нагрузка на разработчика, которая снижает скорость работы. Однако повышение скорости разработки означает ещё и увеличение вероятности появления ошибок. Нам нужна была типизация для того, чтобы код содержал как можно меньше ошибок, даже если пишут его быстро. Строгая типизация, кроме того, полезна в быстрорастущих проектах. Наша команда инженеров постоянно увеличивается в размерах, и число тех, кто работает над кодом, стабильно растёт.