Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

InnoDB cluster — оно работает, и вроде бы именно так, как обещали |

Я занимаюсь АТСками. И как-то так сложилась, что с самого первого заказа от меня хотели отказоустойчивости. Одним из ключевых компонентов современной АТС (как и любой информационной системы, наверное) является БД, где хранятся как данные о текущем состоянии системы, так и всякие конфигурационные параметры. Естественно, падение БД приводит к поломке всей системы. Начиналось все с MASTER-MASTER репликации в MySQL (исключительно для оперативности переключения), потом были эксперименты с MySQL over DRBD. Все это жило в pacemaker/corosync инфраструктуре. Там ездили IP-адреса, шлюзы и прочая лабудень. Со временем оно даже стало работать как-то более-менее устойчиво. Но тут мне попалась пара серверов, на которых DRBD сделать было нельзя, в MASTER-MASTER я разочаровался довольно давно (постоянно она у меня ломается, такая репликация), а без отказоустойчивой БД терялся весь смысл решения. На глаза мне попалось название InnoDB cluster и я решил: "была-не-была". Что из этого получилось — смотрите под катом.

Я все делаю на Debian Jessie. В других системах отличия будут, но не очень существенные.

Нам понадобятся:

- MySQL APT репозиторий

- MySQL Shell — для Debain пользователй в самом низу есть ссылка, по которой можно скачать скомпилированные бинарники, по какой причине они не попали в пакет именно для Debain для меня осталось загадкой

- терпение

- терпение

- и еще раз терпение

Скачиваем (это можно сделать только вручную, пройдя регистрацию на сайте Оракла) и устанавливаем файл репозитория, обновляем наш кэш, устанавливаем MySQL Router (интересный зверь, познакомимся ниже) и MySQL Client:

dpkg -i mysql-apt-config_0.8.6-1_all.deb

apt-get update

apt-get install mysql-router

apt-get install mysql-clientРаспаковываем и раскладываем по местам MySQL Shell из архива. Двигаемся дальше, ставим сервер:

apt-get install mysql-serverТут устанавливаем ВСЕ предложенные компоненты (обратите внимание, третий компонент в списке по-умолчанию не выбран, а он понадобится). И останавливаем запущенный сразу ретивым установщиком сервер:

systemctl stop mysqlДалее, идем в

/etc/mysql/mysql.conf.d/mysqld.cnf и пишем туда что-то типа:

[mysqld]

pid-file = /var/run/mysqld/mysqld.pid

socket = /var/run/mysqld/mysqld.sock

datadir = /var/lib/mysql

log-error = /var/log/mysql/error.log

bind-address = 0.0.0.0

port = 3300

symbolic-links=0

# Replication part

server_id=3

gtid_mode=ON

enforce_gtid_consistency=ON

master_info_repository=TABLE

relay_log_info_repository=TABLE

binlog_checksum=NONE

log_slave_updates=ON

log_bin=binlog

binlog_format=ROW

# Group replication part

transaction_write_set_extraction=XXHASH64

loose-group_replication_group_name="aaaaaaaa-aaaa-aaaa-aaaa-aaaaaaaaaaaa"

loose-group_replication_start_on_boot=off

loose-group_replication_local_address= "1.1.1.1:33061"

loose-group_replication_group_seeds= "1.1.1.1:33061,1.1.1.2:33061,1.1.1.3:33061"

loose-group_replication_bootstrap_group= off

Здесь уже надо остановиться подробнее.

Первая опция, заслуживающая нашего внимания — port Рекомендую её значение устанавливать отличным от 3306. Почему — станет понятно ниже (на 3306 мы повесим кое-что другое)

Следующая: server_id. Для каждого сервера mysql в кластере это значение должно быть уникальным.

Опция, которая съела пару часов моего времени — безобидная (казалось бы) group_replication_local_address. Эта опция говорит о том, на каком адресе/порту слушать обращения за репликами с локальной БД. Алгоритм, по которому MySQL определяет, является ли указанный в этом поле IP-адрес локальным, мне угадать не удалось. На машине с 2-мя активными интерфейсами и тремя IP-адресами, подвешенными на эти интерфейсы только один адрес устроил MySQL.

И последняя: group_replication_group_seeds — в ней перечисляются сокеты, на которые необходимо обращаться (в указанном порядке) с попытками заказать реплики актуальных данных при подключении.

За подробностями можно обратиться на страничку с официальной документацией по GROUP REPLICATION

Итак, развернув на машине MySQL и настроив его таким образом двигаемся дальше. Удаляем все содержимое /var/lib/mysql Я серьезно. Взяли себя в руки, пошли и удалили. Если там лежит что-то, что дорого Вам как память — сделайте предварительно бэкап. Можно. Запускаем mysql:

systemctl start mysqlВ общем-то, все подготовительные манипуляции завершены. Описанную процедуру надо будет повторить на всех серверах, которые планируется объединять в кластер.

Теперь особенности для первого сервера. Для начала объявляем root:

mysql

> create user 'root'@'%' identified by 'ochen-strashniy-parol';

> grant all to 'root'@'%' on *.* with grant option;

> flush privileges;

> \qЯ знаю, знаю, знаю… Несекьюрно. Но, поверьте, указанному в документации набору привилегий верить нельзя (проверял: не работает), и подключиться с локалхоста тоже не выйдет. Более точный вариант с выделением отдельного пользователя в следующий раз, как будет "час та натхнення".

Потом подгружаем модуль X. Честно-честно, именно так его и зовут:

mysqlsh --classic --dba enableXProtocolИ в этот момент модные брюки превращаются… превращаются… превращаются в элегантные шорты. То бишь, MySQL уже не совсем SQL, а вовсе даже Document Store

Но нас это никак не расстраивает, поэтому двигаемся дальше:

mysqlshТеперь мы можем общаться с MySQL на JavaScript. Для начала подключимся к нашему серверу:

\c root@1.1.1.1:3300Введем пароль и проверим, все ли в порядке с нашим сервером, подходит ли его конфигурация для кластеризации:

dba.checkInstanceConfiguration('root@1.1.1.1:3300')Если все сделано по инструкции, то вопросов быть не должно. Если вопросы есть — исправляем, дока вам в помощь. В принципе, там даже есть возможность сгенерировать конфигурацию самостоятельно:

dba.configureLocalInstance('localhost:3300', {password:'somePwd', mycnfPath:'some path'})Однако, у меня этот вариант сходу не заработал, потребовались допиливания напильником конфига до состояния, указанного в начале заметки. Естественно, что после каждого перепиливания конфига, сервер надо перезапускать. Например, при помощи systemctl restart mysq. Ну или как вам больше нравится…

Создаем кластер (предполагаю, что вы все еще в mysqlsh и сессия не обрывалась):

var cl = dba.createCluster('moyCluster')Ну и добавляем в него только что настроенный сервер:

cl.addInstance('root@1.1.1.1:3300')Начиная с этого момента рекомендую на какой-нибудь отдельной консоли держать

tail -f /var/log/mysql/error.logи при появлении любых ошибок туда поглядывать. Вывод у mysqlsh не очень информативный, а в логе есть все необходимое. В доке говорят, что можно увеличить уровень дебага вывода, но я не пробовал.

Если ошибок до данного момента не наблюдалось, то у нас есть кластер из одной машины.

Последняя манипуляция на данном сервере:

mysqldump --all-databases --triggers --routines --events > dump.sqlТеперь займемся остальными. Для этого на всех машинах повторяем манипуляции, описанные от начал статьи и до

systemctl start mysqlНе забываем поправить значения server_id и group_replication_local_address. После этого:

mysql

> reset master;

mysql < dump.sqlДа-да, заливаем в машину дамп с работающего в кластере сервера. Теперь с локальной машины (той, на которой крутится инстанс mysql-server`а, который мы будем подключать к кластеру) делаем:

mysql

> set GLOBAL group_replication_allow_local_disjoint_gtids_join=ON;

mysqlsh

> dba.checkInstanceConfiguration('root@1.1.1.2:3300')

> \c root@1.1.1.1:3300

> var cl = getCluster('moyCluster')

> cl.addInstance('root@1.1.1.2:3300',{ipWhitelist: '1.1.1.0/24, 127.0.0.1/8'})Если мы ничего не перепутали, то в этот момент у нас в кластере уже две машины. Аналогично добавляем третью.

В данный момент у нас есть кластер, который сам за собой присматривает, выбирает мастера и реплицируется на слэйвы. К каждому серверу можно обратиться на его порт 3300 и, если вы обратитесь к мастеру, то вы сможете читать и писать, а если к слейву — то только читать. Выяснить, мастером является сервер или слейвом можно из вывода cluster.status(). Но это еще не очень удобно. Хотелось бы обращаться всегда в одно и то же место, на один и тот же ip/port и не зависеть от внутреннего состояния кластера. Для этого используем MySQL Router Прямо в доке есть пример его начального конфигурирования, который делает почти все, что нам нужно. Изменим его немного:

mysqlrouter --bootstrap 1.1.1.1:3300 --user mysqlrouterТеперь идем в /etc/mysqlrouter/mysqlrouter.conf и исправляем там порты как-нибудь так:

[routing:moyCluster_default_rw]

...

bind_port=3306

...

[routing:moyCluster_default_ro]

...

bind_port=3307

...После этого можно делать

systemctl start mysqlrouterИ теперь у вас на порту 3306 отвечает обычный mysql с поддержкой чтения/записи вне зависимости от того, какая из машин кластера сейчас мастером, а какая слейвом. На 3307 — всегда read-only. Количество экземпляров mysqlrouter никак не ограничено, вы можете на каждой клиентской машине запустить свой экземпляр и повесить его на внутренний интерфейс 127.0.0.1:3306. mysqlrouter сам отслеживает изменения в кластере (как добавления, так и пропадания нод в нем) и актуализирует маршрутизацию. Происходит это раз в пять минут (если верить логам). Если в этом промежутке возникает обращение которое не может быть обработано (нода выпала или была целенаправленно выведена из кластера), то роутер дает отказ в исполнении транзакции и перечитывает состояние кластера во внеочередном порядке.

Кстати, если по какой-то причине нода отвалилась от кластера, её можно вернуть в семью командой

mysqlsh

> \c root@

> var cl = dba.getCluster('moyCluster')

> cl.rejoinInstance('root@ip:port-отвалившейся_ноды')Спасибо, что дочитали. Надеюсь, что это будет полезно. Если заметите в тексте неточности — пишите в комментарии, писал на горячую, но по памяти, так что мог напутать.

|

Метки: author Borikinternet хранилища данных администрирование баз данных mysql clusterization базы данных innodb |

Константин Кривопустов и Алексей Стукалов о CUBA Platform на jug.msk.ru |

Компания Haulmont является разработчиком CUBA Platform и созданных на её основе нескольких продуктов, наиболее крупными из которых являются Sherlock и ТЕЗИС. Год назад код ядра CUBA Platform стал доступным на GitHub.

Компания была серебряным спонсором конференций JUG.ru: JPoint 2014, JPoint 2017 и Joker 2016. Также её работники участвовали в конференциях JavaOne 2015 (с докладом и являясь серебряным спонсором) и JavaOne 2016 (с мастер-классами).

О докладчиках

Константин является техническим директором и соучредителем компании Haulmont. Традиционно принимает активное участие в представлении компании как на конференциях, так и на страницах Хабра.

Доклады Константина:

- «Выбор фреймворков реализации ORM и пользовательского интерфейса для корпоративного приложения» (JEEConf 2013: презентация, видео)

- «Выбор технологий для корпоративного приложения» (JPoint 2014: презентация, видео)

Прочие ссылки: Хабрахабр, GitHub, SlideShare.

Алексей ранее принимал непосредственное участие в разработке, в настоящий момент занимает позицию developer advocate.

Доклады Алексея:

- «Interviewing Aleksey Stukalov about Cuba platform» (JavaOne 2016: видео)

Прочие ссылки: Хабрахабр, GitHub, SlideShare.

О докладах

Андрей Когунь перед началом встречи с Алексеем и Константином.

Всего было два доклада. В первой части, до перерыва, Константин подробно остановился на архитектуре CUBA Platform, её составных частях, используемом технологическом стеке (более наглядно технологии перечислены здесь), конфигурировании. Приведены доводы, почему используется именно EclipseLink в качестве ORM. Показался интересным рассказ про Polymer UI и упоминание про CUBA Studio.

Во второй части Алексей представил используемые компанией подходы по кастомизации при реализации продуктовых решений для конкретных заказчиков. На основе реальных продуктов привёл доводы по преимуществам используемого подхода над прочими возможными вариантами (ветки, плагины, использование многочисленных конфигурационных параметров).

Желающие могли задать вопросы и пообщаться в неформальной обстановке. Было интересно посмотреть на реальных клиентов компании, которые присутствовали на встрече и задавали конкретные вопросы.

Доступны файлы презентаций Константина и Алексея. Фотографии со встречи уже появились здесь. Видео скоро ожидается на YouTube (с анонсом в VK и G+).

Подписаться на рассылку анонсов следующих встреч jug.msk.ru.

|

Метки: author dbelob java блог компании jug.ru group jug jug.msk.ru cuba haulmont |

Proxmox 5 и частичная запись в блочных устройствах эффективного хранения Ceph |

Et voil`a!

Методы хранения данных и блочные устройства

Ceph предлагает два вида пулов хранения:

- с репликациями

- с удаляющим кодированием

При стандарте допустимости двух отказавших устройств хранения, первый метод предполагает необходимость утроения сырого объема хранилища, в то время как второй допускает впечатляющее повышение эффективности использования пространства, например, до 90% при наличии возможности использовании 20 osd для расщепления данных (18 частей исходных данных + 2 части с избыточным кодом).

Поверх обоих видов пулов хранения можно строить объекты хранения, допускающие блочные операции (например, моментальные снимки). Разница начинает проявляться при операциях записи в такого рода объекты, поскольку одна операция записи в блочное устройство с применением удаляющего кодирования подразумевает в своём составе некоторую неделимую последовательность считывания хранимых данных, их частичного изменения и окончательной записи полученного результата. Атомарно. То есть, если какая- либо часть последовательности остаётся незавершённой, отвергается вся операция. Данная атомарность также именуется транзакцией.

До сих пор предлагалось два способа решения проблемы применимости пулов с удаляющим кодированием под блочные объекты:

- использование объекта для записи только целиком

- применение многоуровневости с пулом удаляющего кодирования в основе и пула репликаций поверх него

Оба метода имеют ограничения вариантов использования.

BlueStore как новое решение основы хранения

В основе хранения объектов Ceph в конечном итоге лежит некая файловая система на физическом диске (или разделе диска), которым управляет некий демон. Для решения множества возникающих по ходу дела проблем может применяться журнал в который и записываются данные, прежде чем клиент получит подтверждение о совершении своей операции. Помимо этого демон выполняет необходимые действия в одноранговой сети пула хранения по поддержанию необходимого числа копий данных (стандартно — трёх), причём с подразделением ролей хозяин — подчинённый. Всё это, собственно, и составляет osd (object storage device). Но в конечном итоге сами данные объекта хранятся в «обычном» файле на диске. Несколько осложняет задачу тот факт, что теоретически, сам объект может сопровождаться практически неограниченным числом метаданных. Как то: имя объекта, дата его создания, дата последнего изменения, контрольная сумма, сила вашей привязанности к этим данным и всё что вы можете придумать в добавление к тем метаданным, которыми снабжает этот объект ваш инструмент хранения — файловая система, система управления блочными устройствами или объектами и т.п. Причём изменение метаданных и самого объекта хранения тоже атомарно (всё или ничего).

Долгое время сообщество Ceph пребывало в уверенности, что решить проблемы с транзакциями его объектов на нижнем уровне позволит решить btrfs, которая должна была заменить xfs и ext4, применявшиеся в основной массе случаев для оконечного хранения на физических дисках.

Время шло, проблема оставалась.

Ceph Kraken предлагает вам поэкспериментировать с BlueStore, а Ceph Luminious ставит его по умолчанию. На мой личный вкус это второе существенное новшество помимо ставшей основной в Kraken асинхронной системы обмена сообщениями, которая делает возможной, например, Распределённые вычисления поверх Ceph RADOS и AsyncMessenger и применение RDMA.

Что и как подробнее...

Материалы:

- Полное руководство работы с сетями на Python Эрик Чоу, июнь 2017, Packt Publishing

- Полное руководство Ceph Ник Фиск, май 2017, Packt Publishing

- Книга рецептов Ceph Каран Сингх, февраль 2016, Packt Publishing

- Изучаем Ceph Каран Сингх, январь 2015, Packt Publishing

- Proxmox. Полное руководство. 2е изд Васим Ахмед, август 2015, Packt Publishing

- Книга рецептов Proxmox Васим Ахмед, май 2016, Packt Publishing

- Zabbix. Полное руководство. 2е изд. Андреа Далле Ваккье, сентябрь 2015, Packt Publishing

- Пример системы виртуализации Юрий Шкандыбин, 14-10-2016

- Обзор рекомендуемых аппаратных средств, sddc.mdl.ru, 01-04-2017

|

|

Как запутать аналитика. Часть третья. Глаголы и числителные |

- Мы моделируем объекты учета

- При помощи существительных и прилагательных мы моделируем их классификацию.

- Классификация всегда субъективна и потому надо указывать субъекта, который произвел эту классификацию

Я проводил мысленные эксперименты по объединению хранилищ с целью проверки созданной структуры хранилища на предмет его вместительности: изучал, что может быть включено в него, а что уже не поместится без переделки структуры.

Мы разобрались с существительными и прилагательными. Хотелось бы так же легко разобраться с глаголами. Однако, с глаголами так просто не получается.

Сначала уточним наши представления. До сего момента мы считали наш мир статичным. Если это автомобиль, то навсегда, если он желтый, то навсегда. В реальности, конечно, все не так. Один и тот же объект учета в разное время одним и тем же субъектом может быть классифицирован по-разному. В этом заключается учет жизненного цикла объекта. Поэтому, объектами учета, которые мы моделируем в ИС, являются не объекты в целом, а их темпоральные части. Например, мы моделируем не весь автомобиль, который существовал с 1990-го по 2010-й год, а только его темпоральную часть — состояние автомобиля, когда он был желтым: с 1995-го по 1999-ый. Темпоральные части объекта учета – тоже объекты учета, Это значит, что любой объект учета может быть разделен на части, которые также являются объектами учета.

Что стоит за глаголами?

Высказывание: «Мартынов продал станок» кажется очевидным и естественным. Кто? Мартынов. Что сделал? Продал. Что продал Мартынов? Станок. Прямо, как в 6-ом классе школы. И всем кажется, что тут ничего странного в этом нет. Кажется, что субъект выполнил действие, и это нормально. Но вот вопрос: может ли субъект совершать действия? И это вопрос не философский, на который ответил Декарт. Это вопрос из области моделирования. Могу ли я строить модели, исходя из гипотезы о том, что объекты и субъекты совершают действия, например, могу ли я предполагать, что машина едет?

Похожий вопрос я задавал в прошлой статье: могу ли я строить модели, исходя из гипотезы о том, что объекты обладают атрибутами? Ответом было – нет. Это объясняется просто: если объект обладает свойством, то можно подумать, будто объект обладает свойством по своей природе. Однако, свойствами его наделяет субъект. При этом разные субъекты наделят один объект учета разными свойствами.

Для того, чтобы понять, можно ли наделять объекты свойствами, я проводил мысленный эксперимент по объединению двух информационных хранилищ. Проверка объединением показала, что объединить два хранилища можно тогда, когда атрибуты отделены от типов, а их значения от объектов.

Если говорить о глаголах, то аналогия та же: только субъект может сказать, кто был исполнителем того или иного действия, при этом разные субъекты могут дать разные ответы на этот вопрос. Поэтому есть гипотеза, что исполнитель ничего не может делать точно так же, как объект не может обладать свойством.

Продолжим мысленный эксперимент.

Пусть есть два хранилища моделей, в одном из которых записано: Мартынов продал станок. Во втором хранилище сказано: Гаврилов купил станок. Как объединить хранилища, чтобы было ясно, что это была одна операция?

В ООП действия моделируются методами. Создается класс, объекты которого способны что-то делать. Например, класс людей. Объекты этого класса способны продавать и покупать. И есть две записи о том, что Мартынов выполнил метод по продаже, а Гаврилов выполнил метод по покупке. Чтобы объединить эти две записи в одну, должна быть одна запись, которая выглядит с точки зрения Мартынова как исполнение метода продать, а с точки зрения Гаврилова как исполнение метода купить. Чтобы это сделать, мы можем создать метод, участниками которого сделаем Мартынова, Гаврилова и станок, классифицируем этот метод для Мартынова как продажу, а для Гаврилова – как покупку. Таким образом, мы уравняем степень участия участников операции, отказав участникам в праве что-то выполнять, заодно изобрели функциональное программирование.

Очень важно: если мы хотим строить расширяемые хранилища моделей, нам придется принять как данность, что нет исполнителей операций, но есть участники операций. Исполнитель — не более, чем одна из множества интерпретаций участия одного из участников операции.

Однажды лектор опоздал на лекцию. Было это в Японии, где опоздание – серьезное нарушение этикета. Мне было интересно, как он выкрутится, но он лишь сказал: «Я сделал все, что мог. Обстоятельства были выше меня». Так и в любой операции — мы можем мыслить кого угодно исполнителем, но на деле оказывается, что природа сильнее.

Чуть более внимательно исследуем понятие операции. Операция – это объект учета. Только в отличие от «статичных» объектов учета таких как станок, операция динамична и быстротечна. С другой стороны, в операции могут участвовать «статичные» объекты, например, Мартынов и станок. Иначе говоря, есть объект учета, частями которого являются Мартынов и станок, который трактуется автором модели как операция по продаже. Но частями операции Мартынов и станок были не полностью, а лишь частично. Операция длилась всего один час, а все участники живут гораздо дольше, поэтому в операции участвуют не Мартынов и станок, а их темпоральные части. Поэтому модель операции выглядит так: есть объект учета, трактуемый автором как операция по продаже. Этот объект учета включает в себя темпоральные части объектов учета, которые трактуются как Мартынов и станок. Темпоральная часть Мартынова, являющаяся частью объекта учета, трактуемого как операция, трактуется как исполнитель операции. Все трактовки субъективны. Такая модель операции расширяема. Если появятся ее новые трактовки, например, как покупка, или новые участники, например, Гаврилов, не составит никакого труда добавить их в модель.

Мы получили следующее: для моделирования глаголов необходимо создать модель, которая учитывает отношения между объектами учета типа «часть-целое».

Числовые атрибуты

Часто думают, что длины, временные интервалы, веса и прочие свойства, выраженные в числовых значениях, — это естественные свойства объектов. Но на самом деле нет никаких свойств вне нашего сознания. Все эти атрибуты, единицы измерения и способы шкалирования существует в нашем сознании и зависят от решаемых нами задач.

Например, если вы художник, то цвет будет удобно моделировать при помощи названий. Если вы физик, то, в зависимости от области физики, вы будете моделировать цвет при помощи сравнения с эталоном:

- Длины (длин волн, если вы занимаетесь волновой оптикой)

- Частоты (частот волн, если вы радиофизик)

- Энергии (энергий квантов, если вы занимаетесь квантовой оптикой)

Если мы говорим о шкалах и числах, то помимо эталона надо выбрать метод сравнения с этим эталоном. Например, вы можете задать вопрос: во сколько раз вон то дерево выше эталонного метра? Кажется, что в десять раз. Но это кажущаяся очевидность. На самом деле вы могли бы воспользоваться другим методом для сравнения. Например, воспользоваться логарифмической шкалой. Тогда дерево было бы выше метра в два раза.

Выбор метода сравнения с эталоном зависит от решаемой задачи. При этом операции над значениями атрибутов будут моделировать операции, проводимые нами над объектами реального мира. Например, сложение масс двух тел имеет смысл, когда необходимо узнать массу тела, сложенного из двух тел. Однако, сложение длин волн двух квантов света – операция, лишенная смысла. Зато можно сложить энергию этих квантов, чтобы получить количество излученной энергии.

Без ответа на вопрос об эталоне, способе сравнения с ним и без описания того, какие операции над объектами моделируются какими операциями над численными значениями атрибутов, само по себе значение атрибута бессмысленно. Правильно говорить так: численное значение атрибута получено путем сравнения с эталоном (единицей измерения), выполненным указанным способом в рамках решения определенных задач.

И тогда вы узнаете, например, что высота здания измеряется от нулевой отметки, которая совпадает с уровнем перекрытия первого этажа. Возможно, вы узнаете, что для описания свойства электрона под названием спин, численных значений уже недостаточно, и приходится обращаться к матрицам. И, возможно, вы узнаете, что помимо одномерных шкал существуют многомерные и даже бесконечномерные шкалы.

|

Метки: author maxstroy семантика проектирование и рефакторинг анализ и проектирование систем it- стандарты моделирование предметной области аналитика |

Книга «Машинное обучение» |

Привет, Хаброжители к нам из типография наконец-то пришла новинка от Хенрика Бринка, Джозефа Ричардса и Марка Февероволофа.

Привет, Хаброжители к нам из типография наконец-то пришла новинка от Хенрика Бринка, Джозефа Ричардса и Марка Февероволофа.Эта книга позволит программистам, аналитикам данных, статистикам, специалистам по обработке данных и всем остальным применить машинное обучение к решению реальных задач или хотя бы просто понять, что оно собой представляет. Читатели, не прибегая к глубокому теоретическому изучению конкретных алгоритмов, получат практический опыт обработки реальных данных, моделирования, оптимизации и развертки систем машинного обучения. Для тех, кому интересна теория, мы обсуждаем математическую основу машинного обучения, объясняем некоторые алгоритмы и даем ссылки на материалы для дополнительного чтения. Основной акцент делается на практических результатах при решении поставленных задач.

Книга предназначена для тех, кто хочет применять машинное обучение к решению различных задач. В ней описываются и объясняются процессы, алгоритмы и инструменты, относящиеся к основным принципам машинного обучения. Внимание акцентируется не на способах написания популярных алгоритмов, а на их практическом применении. Каждый этап построения и использования моделей машинного обучения иллюстрируется примерами, сложность которых варьируется от простого до среднего уровня.

Структура книги

Часть I «Последовательность действий при машинном обучении» знакомит с пятью этапами основной последовательности машинного обучения:

• В главе 1 «Что такое машинное обучение?» рассказывается, что представляет собой машинное обучение и для чего оно нужно.

• В главе 2 «Реальные данные» подробно рассматриваются характерные стадии подготовки данных для моделей с машинным обучением.

• Глава 3 «Моделирование и прогнозирование» обучает с помощью распространенных алгоритмов и библиотек созданию простых ML-моделей и генерированию прогнозов.

• В главе 4 «Оценка и оптимизация модели» ML-модели подробно рассматриваются с целью оценки и оптимизации их производительности.

• В главе 5 «Основы проектирования признаков» рассказывается о том, как увеличить количество необработанных данных, используя информацию из поставленной перед нами задачи.

В части II «Практическое применение» вводятся техники масштабирования моделей, а также техники извлечения признаков из текста, изображений и временных рядов, увеличивающие эффективность решения многих современных задач с машинным обучением. Эта часть содержит три главы с практическими примерами.

• Глава 6 «Пример: чаевые для таксистов» — первая, полностью посвященная рассмотрению примера. Мы попытаемся предсказать шансы таксиста на получение чаевых.

• Глава 7 «Усовершенствованное проектирование признаков» знакомит с более сложными техниками проектирования признаков, предназначенными для извлечения значений из текстов, изображений и временных рядов.

• В главе 8 «Пример обработки естественного языка» усовершенствованные техники проектирования признаков используются для предсказания тональности рецензий на фильмы.

• Глава 9 «Масштабирование процесса машинного обучения» знакомит с техниками, дающими ML-системам возможность работать с большими объемами данных, обеспечивающими более высокую скорость прогнозирования и уменьшающими время их ожидания.

• В главе 10 «Пример с цифровой рекламой» на большом объеме данных строится модель, предсказывающая вероятность перехода по рекламному баннеру.

Как читать эту книгу

Тех, кто пока не имеет опыта в области машинного обучения, главы с 1-й по 5-ю познакомят с процессами подготовки и исследования данных, проектированием признаков, моделированием и оценкой моделей. В примерах кода на языке Python используются такие популярные библиотеки, как pandas и scikit-learn. Главы с 6-й по 10-ю включают в себя три практических примера машинного обучения наряду с такими продвинутыми темами, как проектирование признаков и оптимизация. Так как основная вычислительная сложность инкапсулирована в библиотеках, приведенные фрагменты кода легко адаптировать к вашим собственным ML-приложениям.

Об авторах

Хенрик Бринк — специалист по обработке и анализу данных и разработчик программного обеспечения, имеющий огромный практический опыт машинного обучения как в области производства, так и в сфере научной деятельности.

Джозеф Ричардс — старший научный сотрудник в области прикладной статистики и предсказательной аналитики. Хенрик и Джозеф совместно основали компанию Wise.io, которая занимается разработкой решений с машинным обучением для промышленности.

Марк Феверолф — основатель и президент компании Numinary Data Science, специализирующейся в области управления данными и предсказательной аналитики. Он работал статистиком и разработчиком аналитических баз данных в области социальных наук, химической инженерии, производительности информационных систем, планирования объема производства, кабельного телевидения и приложений для рекламы в Интернете.

» Более подробно с книгой можно ознакомиться на сайте издательства

» Оглавление

» Отрывок

Для Хаброжителей скидка 25% по купону — Машинное обучение

|

Метки: author ph_piter профессиональная литература машинное обучение блог компании издательский дом «питер» книги |

Кто владеет данными, генерируемыми устройствами из интернета вещей? |

Сегодня многие организации начинают передавать свои IoT-данные сторонним компаниям. Зачастую это делается ради монетизации, иногда — для соблюдения требований регуляторов. И все эти инициативы выдвигают на передний план проблемы владения данными и их лицензирования.

Любопытно, что не существует установленной схемы определения, как присваивается право собственности, и ещё хуже обстоят дела с правильным лицензированием IoT-данных. Давайте рассмотрим ситуацию чуть подробнее.

Владение данными в западном мире

По сути, владелец машинно-генерируемых данных (МГД), к которым относятся практически всё, что генерируется в IoT, это субъект, владеющий устройством, которое записало эти данные. Иными словами, субъект, владеющий IoT-устройством, также владеет и данными, которые устройство генерирует.

Однако не всегда ясно, «принадлежат» ли данные тому, кто обладает устройством и/или генерируемыми данными. Ведь когда речь заходит об аренде, то всё становится сложным и даже малопонятным.

С одной стороны, данные принадлежат собственнику устройства. То есть право собственности на данные сродни документу на владение землёй. МГД также могут содержать метаданные, что можно сравнить с владением полезными ископаемыми и водой на территории этой земли.

С другой стороны, одна сторона может владеть данными, а другая — контролировать их. Обладание данными не всегда эквивалентно праву на них. Обладание — это контроль. Право — это собственность. Проводя аналогию с правами на использование, каждый раз, когда данные копируются и передаются куда-то, то контроль над ними тоже передаётся. И наоборот — передача права собственности требует наличия легального механизма его оформления.

Я не юрист, но продолжим

Получается, что сами по себе данные не защищены законодательством в сфере интеллектуальной собственности. Однако права на владение данными аналогичны правам, предоставляемым авторским правом.

Права на владение данными включают в себя права на использование, поэтому владелец может копировать, распространять и создавать производные произведения. Данные, хранящиеся в базе данных, это как слова и изображения, из которых складывается защищённая авторским правом книга. Права на использование и на владение книгой различаются. Автор повести сохраняет права на слова и изображения, входящие в повесть.

Также автор владеет правом поручать издателю публиковать книги и распространять их. Однако он/она не контролирует права использования каждого читателя, как только тот начинает ими пользоваться.

Аналогично, субъект, обладающий правом собственности на данные или базу данных, обладает и сопутствующими правами. Если данные скопированы или куда-то переданы, то автор уступает права на использование.

Стороны контракта на передачу данных

В этом пространстве есть две основные категории сторон. Первая включает корпорации, брокеров данных и маркетплейсы, которые обмениваются данными между собой. Обычно это не подвергается жёсткому государственному регулированию.

Вторая категория состоит из потребителей, которые передают данные вендору в обмен на продукт или услугу. Соглашения в потребительском пространстве могут подлежать государственному надзору. В результате некоторые индустрии, такие как здравоохранение, должны соблюдать целый ассортимент уставов и агентских правил.

На другом конце шкалы мы имеем взаимообмен. Например, вендор может собирать всесторонние данные ради улучшения пользовательского опыта (UX). В данном случае контракт позволяет обменять все данные на стимулы, вроде курируемого сервиса или скидки. При таком подходе уступаются все права на использование данных и на их владение, как только пользователь соглашается с условиями.

Как права на данные используются в сельском хозяйстве

Сельскохозяйственная отрасль использует всевозможные датчики и МГД для максимизации производства, в результате чего усложнился учёт интересов владельцев данных.

Суть в том, что фермер владеет данными, которые генерирует его/её устройства. Тем не менее, производители сельхозоборудования разработали прозрачную систему соглашений, которая позволяет свободно циркулировать сельскохозяйственным МГД.

Сложный мир данных, генерируемых транспортом

Автомобили всё больше оснащаются информационными технологиями и датчиками, что привело к беспрецедентному взрывному росту объёма генерируемых данных. Разные заинтересованные стороны, от страховщиков до телекомов, хайтек-производителей и так далее, готовы интегрировать эти новые потоки данных в свои бизнес-модели.

Уникальная особенность рынка автоданных заключается в важности потребительского доверия и настроения. Потребители считают своими все данные, генерируемые их автомобилями. И безусловно ожидают, что в обмен на них должны что-то получать.

В ответ на это автопроизводители разрабатывают положения, которые используют подход взаимообмена. Как и в случае с агробизнесом, существует базовая презумпция, согласно которой МГД, полученные после продажи автомобиля, принадлежат субъекту, купившему автомобиль.

Регуляторы и промышленные группы согласны с тем, что владелец машины владеет и МГД. Как и страховой полис, права собственности на МГД привязаны к автомобилю. Это означает, что неперсональные МГД обрабатываются не так, как персональные данные, относящиеся к пассажирам автомобиля.

Энергетика и IoT

Растёт использование умных энергетических устройств. Но существует культурный барьер, мешающий завершению интеграции обмена данными. Дело в том, что умные энергоустройства подключаются к частным домам, а пользователи могут быть недовольны тем, что эти устройства собирают данные об их манере энергопотребления, а следовательно — об образе жизни. Не случайно компании внедряют практики сбора данных, подразумевающие получение отдельно права на использование потребительских МГД и права на владение ими.

По мере распространения IoT схемы и политики, регулирующие права собственности на данные и их передачу могут быть как-то стандартизированы.

Нет универсального ответа

Как показано выше, вопрос принадлежности прав на IoT-данные сложен. Как правило, владелец оборудования владеет и данными. В разных сферах и компаниях применяются разные подходы к регулированию передачи контроля и прав на данные. Общим знаменателем является хорошо продуманный контракт, защищающий интересы потребителей и питающий растущую экосистему данных.

|

|

Big Data в Райффайзенбанке |

В этой статье мы расскажем про Big Data в Райффайзенбанке.

Но прежде чем перейти к сути, хотелось бы внести ясность по поводу самого определения Big Data. Действительно, в последние несколько лет этот термин употреблялся во множестве контекстов, что привело к размытию границ самого термина и потере содержательной части. Мы в Райффайзенбанке выделили три направления, которые мы относим к Big Data:

(Отметим, что несмотря на то, что данная схема выглядит достаточно просто, есть очень много «пограничных» случаев. Если они возникают, то мы прибегаем к экспертной оценке, чтобы оценить, нужны ли технологии Big Data для решения поступающих задач или можно обойтись решениями на базе «классических» технологий RDBMS).

В рамках этой статьи речь пойдет прежде всего об используемых технологиях и разрабатываемых с их помощью решений.

Для начала пару слов о предпосылках интереса к технологиям. К моменту начала работ по Big Data в банке имелось несколько решений по работе с данными:

- Data Warehouse (DWH, Корпоративное хранилище данных)

- Operational Data Store (ODS, Хранилище операционных данных)

Что заставило нас смотреть в сторону Big Data?

От нас в ИТ ждали универсального решения, которое позволило бы максимально эффективно анализировать все доступные для банка данные с целью создания цифровых продуктов и для улучшения клиентского опыта.

На тот момент у DWH и ODS имелись некоторые ограничения, которые не позволяли развивать эти решения в качестве универсальных инструментов для анализа всех данных:

- Жесткие требования к качеству данных, предъявляемые к DWH, сильно влияют на актуальность данных в хранилище (данные доступны для анализа на следующий день).

- Отсутствие исторических данных в ODS (по определению).

- Использование реляционных СУБД в ODS и DWH позволяет работать только со структурированными данными. Необходимость определять модель данных еще при записи в DWH/ODS (Schema on write) влечет дополнительные расходы на разработку.

- Отсутствие возможности горизонтального масштабирования решения, ограниченность вертикального масштабирования.

Когда мы осознали эти ограничения, то решили смотреть в сторону технологий Big Data. В тот момент было понятно, что компетенции в этой области в перспективе дают конкурентное преимущество, поэтому необходимо наращивать внутреннюю экспертизу. Так как практическая компетенция в Банке на тот момент отсутствовала, у нас фактически было два варианта:

— или сформировать команду с рынка (извне);

— или найти энтузиастов за счет внутренних переходов, без фактического расширения.

Мы выбрали второй вариант, т.к. он нам показался более консервативным.

Далее мы пришли к пониманию, что Big Data это всего лишь инструмент, а вариантов решения конкретной задачи с помощью этого инструмента может быть множество.

Решаемая задача предъявляла следующие требования:

- Нужно иметь возможность вместе анализировать данные во всем многообразии их форм и форматов.

- Нужно иметь возможность решать широкий спектр аналитических задач – от плоских детерминированных отчетов до экзотических видов визуализации и предиктивной аналитики.

- Нужно найти компромисс между большими объемами данных и необходимостью анализировать их онлайн.

- Нужно иметь (в идеале) неограниченно масштабируемое решение, которое будет готово выполнять запросы от большого количества сотрудников.

Изучив литературу, почитав форумы и ознакомившись с доступной информацией, мы обнаружили, что решение, удовлетворяющее этим требованиям, уже существует в виде устоявшегося архитектурного шаблона и называется «Data Lake». Приняв решение о внедрении Data Lake, мы таким образом нацелились получить самодостаточную экосистему «DWH + ODS + Data Lake», способную решать любые задачи, связанные с данными, будь то управленческая отчетность, операционная интеграция или предиктивная аналитика.

Наш вариант Data Lake реализует типичную лямбда-архитектуру, в которой входные данные разделяются на два слоя:

— «быстрый» (speed) слой, в котором обрабатываются, в основном, потоковые данные, объемы данных небольшие, трансформации минимальные, но зато достигается минимальное время задержки (latency) между возникновением события и его отображением в аналитической системе. Для обработки данных мы используем Spark Streaming, а для хранения результата – Hbase.

— «пакетный» (batch) слой, в котором данные обрабатываются пакетами (батчами), которые могут включать несколько миллионов записей сразу (например, балансы по всем счетам по результатам закрытия операционного дня), это может занимать некоторое время, но зато мы можем обработать достаточно большие объемы данных (throughput). Данные в слое batch мы храним в HDFS, а для доступа к ним используем Hive или Spark, в зависимости от задачи.

Отдельно хочется отметить Spark. Мы широко его используем для обработки данных и для нас самые значимые преимущества – следующие:

- Можно использовать в качестве ETL средства.

- Более быстрый, чем стандартные джобы на MapReduce.

- Выше скорость написания кода по сравнению с Hive/ MapReduce, т.к. код получается менее многословный, в том числе за счет DataFrame’ов и библиотеки SparkSQL.

- Более гибкий, поддерживает более сложные пайплайны обработки, чем парадигма MapReduce.

- Поддерживается Python и JVM-языки.

- Встроенная библиотека машинного обучения.

Мы стараемся хранить данные в Data Lake в исходном, «сыром» виде, реализуя подход «schema on read». Для управления процессами в качестве планировщика задач мы используем Oozie.

Структурированные входные данные храним в формате AVRO. Это дает нам преимущества:

- Схема данных может меняться в ходе жизненного цикла, но это не будет нарушать работоспособность читающих эти файлы приложений.

- Схема данных хранится вместе с данными, не надо описывать отдельно.

- Встроенная поддержка многими фреймворками.

Для витрин данных, с которыми будут работать пользователи через BI-средства, планируем использовать форматы Parquet или ORC, т.к. это в большинстве случаев позволит ускорить выборку данных за счет колоночного хранения.

В качестве сборки Hadoop рассматривали Cloudera и Hortonworks. выбрали Hortonworks, потому что его дистрибутив не содерджит проприетарных компонентов. К тому же, у Hortonworks из коробки доступна 2-я версия Spark, а у Cloudera – только 1.6.

Среди аналитических приложений, которые используют данные Data Lake, отметим два.

Первое – Jupyter Hub с Python и установленным библиотеками машинного обучения, которое наши Data Scientist’ы используют для предиктивной аналитики и построения моделей.

На роль второго мы сейчас рассматриваем приложение класса Self-Service BI, с помощью которого пользователи самостоятельно смогут подготовить большинство стандартных ретроспективных отчетов – таблицы, графики, круговые диаграммы, гистограммы и т.д. При этом подразумевается, что роль ИТ будет заключаться в том, чтобы добавить данные в Data Lake, предоставить для приложения и пользователей доступ к данным, и … все. Остальное пользователи смогут делать сами, за счет чего, в частности, мы ожидаем уменьшения конечного времени поиска ответов на интересующие вопросы.

В заключение хотелось бы рассказать, чего мы достигли на данный момент:

- Вывели в Прод ветку Batch Layer, грузим данные, которые используются как для ретроспективного анализа (т.е. аналитики с помощью данных пытаются ответить на вопрос «как мы пришлю сюда»), так и предиктивного анализа: ежедневный прогноз на базе машинного обучения спроса на снятие наличных в банкоматах и оптимизация работы службы инкассации.

- Подняли Jupyter Hub, дали пользователям возможность анализировать данные самыми современными инструментами: scikit learn, XGBoost, Vowpal Wabbit.

- Активно разрабатываем и готовимся вывести в Прод ветку «Speed Layer», реализуя на Data Lake систему класса Real Time Decision Making.

- Составили продуктовый бэк-лог, реализация которого позволит наибыстрейшим темпом повысить зрелость решения. В числе запланированного:

- Катастрофоустойчивость. Сейчас решение развернуто в одном дата центре, и по сути мы не гарантируем непрерывность сервиса, а также можем необратимо потерять накопленные данные, случись что с дата-центром (такая вероятность мала, но все же существует). Мы столкнулись с проблемой: встроенными средствами HDFS нельзя добиться гарантированного хранения данных в разных дата-центрах. Есть доработка на этот счет (https://issues.apache.org/jira/browse/HDFS-5442), ее судьба пока непонятна, планируем реализовывать собственное решение.

- Обогащение метаданных (Atlas), Data Management / Governance на основе метаданных, ролевой доступ на основе метаданных.

- Исследовать альтернативы выбранным архитектурным компонентам. Первые кандидаты: Airflow как альтернатива Oozie, более продвинутые CDC как альтернатива Scoop для выгрузки данных из реляционных СУБД.

- Внедрение конвейера CI/CD. При всем разнообразии используемых технологий и инструментов мы хотим добиться, чтобы любое изменение кода можно было в автоматическом режиме максимально быстро выкатывать в продуктивную среду, и при этом гарантировать качество поставки.

Планов на использование Big Data в Райффайзенбанке еще очень много и мы обязательно расскажем об этом.

Спасибо за внимание!

|

Метки: author msetkin big data блог компании райффайзенбанк hadoop hortonworks spark data lake |

Бэкап скриптами в облако Google Cloud Platform (GCP) за пять минут |

Резервное копирование в облако — тема уже давно не новая. Каждый выбирает своего облачного провайдера, свои инструменты для копирования и пр. Вендоров много, здесь мы рассмотрим именно Google Cloud Platform. Мой выбор обусловлен стоимостью хранилища и простотой подключения. Мы все реализуем самыми простыми скриптами, без покупки софта, покупки дисковых хранилищ и прочего.

Что мы имеем

В тонкости инфраструктуры заказчика вдаваться не станем, каждому свое. В итоге имеется сервер резервного копирования, на который сливаются копии файлового хранилища и данных с машин, пакуются в архивы и падают на два дисковых массива. Один массив планируется использовать под другие цели, потому в любом случае нужно где-то хранить еще одну «копию копий». На ленты никто бюджет не выделит, но есть небольшой запас средств. Об этом и поговорим дальше.

Выбор облака

Кто-то посоветовал заказчику OneDrive или Google Drive. Этот вариант отпал сразу, ибо это бред, хранить около 10Тб бэкапов на облачном диске. Смотрели в сторону Azure — странное ценообразование и предоплата. AWS или Google Cloud… доверились более известному в массах :) Была еще пара облачных провайдеров, один даже выигрывал немного в цене, но последним аргументом стала оплата без банковской карты.

Два вида копирования

Да, нам нужно было применить две схемы резервирования различных данных:

- Репликация существующего набора копий на сервере

- Хранение копий длительное время только в облаке

Подготовка облака

Создаем триал на 300 долларов в Google Cloud Platform (Кому мало — стучите, обсудим).

После подключения триала, нам будет доступна консоль. В меню переходим в раздел Storage. Нам будет предложено создать проект, создаем, называем как нам заблагорассудится. После создания проекта, в разделе Storage создадим Сегмент, это и будет наше хранилище для копий. Называем как удобно, для статьи я назвал backwin для репликации и отдельно создал backupwin для копирования и хранения по дням.

Подготовка машины

С сервером все просто. Идем в раздел документации Google Cloud, открываем раздел Cloud SDK и действуем по инструкциям. В моем случае была машина с Windows Server, потому скачиваем, ставим. Достаточно стандартных параметров при установке, потому далее-далее-готово.

Открываем командную строку, пишем

gcloud initРепликация хранилища

В двух словах, зачем она нам была нужна. Есть машина на которой имеется набор резервных копий в определенном каталоге (c:\bak\). Это зашифрованные архивы и их нужно хранить где-то снаружи. Без проблем. Открываем командную строку, пишем

gsutil -m rsync -r -d -e -C file://c:\bak gs://bakwin- c:\bak — каталог с копиями для репликации в облако

- bakwin — "Сегмент" в облачном хранилище Google Cloud Storage, который мы создали ранее

Тут стоит оговориться, что я экспериментирую с машиной Windows, но точно так-же это работает и на Linux, только путь к каталогу поправить нужно.

Команда выполнена, все улетело в облако. Сохраняем как скрипт, включаем в планировщик. Все! Реально пять минут.

Резервное копирование каталога

В этом случае нам потребовалось хранить данные за каждый день в отдельном каталоге в Google Cloud Storage. Тоже оказалось все просто, берем бутерброд и наливаем кофе.

Для любителей PowerShell, я делал именно на нем т.к. машина на Windows Server. Модули у нас установились в системе вместе с Cloud SDK. Потому для начала, кроме

Import-Module GoogleCloudПоказываем где у нас каталог для копирования и в какой сегмент его помещать:

$folder = "C:\Bak"

$bucket = "gs:\backupwin"Тут можно дописать создание каталога по текущей дате копирования:

$date = Get-date -format dd.MM.yyyy

$bucket = $bucket + "\" + $date

mkdir $bucketСобственно сам скрипт для копирования:

cd $folder

$files = Get-ChildItem -Recurse -Attributes !Directory

$data = @()

foreach ($file in $files) {

$objectPath = $file | Resolve-Path -Relative

$data += @{file = $file; objectPath = $objectPath} #

}

cd $bucket

foreach($element in $data) {

Write-Host $element.objectPath

New-Item -ItemType File -Path $element.objectPath

}Проверяем, работает. Составляем в скрипт, ставим в планировщик. Вот и вся любовь.

По стоимости хранения 10 Тб данных (в облачном хранилище) оплата будет от 70 долларов в месяц. В целом все работает. Тюнинг скриптов под конкретные условия не применялся.

Вообще резервное копирование в Google Cloud Storage можно использовать и вместе с таким ПО как Cloudberry, Veritas и др. и использовать облачное хранилище как дополнительное пространство для копий. В случае с железом, большинство вендоров уже на уровне хранилищ поддерживают их резервирование в Google Cloud.

Вывод: дешево, быстро, надежно, а перевод из пробной версии в коммерческую происходит без каких-либо перенастроек и банковских карт.

|

|

Опыт создания реалтайм видео-секвенсора на iOS |

Привет, меня зовут Антон и я iOS-разработчик в Rosberry. Не так давно мне довелось работать над проектом Hype Type и решить несколько интересных задач по работе с видео, текстом и анимациями. В этой статье я расскажу о подводных камнях и возможных путях их обхода при написании реалтайм видео-секвенсора на iOS.

Немного о самом приложении…

Hype Type позволяет пользователю записать несколько коротких отрывков видео и/или фотографий общей длительностью до 15 секунд, добавить к полученному ролику текст и применить к нему одну из анимаций на выбор.

Основная особенность работы с видео в данном случае состоит в том, что у юзера должна быть возможность управлять отрывками видео независимо друг от друга: изменять скорость воспроизведения, делать реверс, флип и (возможно в будущих версиях) на лету менять отрывки местами.

Готовые решения?

“Почему бы не использовать AVMutableComposition?” — можете спросить вы, и, в большинстве

случаев, будете правы — это действительно достаточно удобный системный видео-секвенсор, но, увы, у него есть ограничения, которые не позволили нам его использовать. В первую очередь, это невозможность изменения и добавления треков на лету — чтобы получить измененный видеопоток потребуется пересоздавать AVPlayerItem и переинициализировать AVPlayer. Также в AVMutableComposition далеко не идеальна работа с изображениями — для того, чтобы добавить в таймлайн статичное изображение, придется использовать AVVideoCompositionCoreAnimationTool, который добавит изрядное количество оверхеда и значительно замедлит рендер.

Недолгий поиск по просторам интернета не выявил никаких других более-менее подходящих под задачу решений, поэтому было решено написать свой секвенсор.

Итак…

Для начала — немного о структуре render pipeline в проекте. Сразу скажу, я не буду слишком вдаваться в детали и буду считать что вы уже более-менее знакомы с этой темой, иначе этот материал разрастется до невероятных масштабов. Если же вы новичок — советую обратить внимание на достаточно известный фреймворк GPUImage (Obj-C, Swift) — это отличная стартовая точка для того, чтобы на наглядном примере разобраться в OpenGLES.

View, которая занимается отрисовкой полученного видео на экране по таймеру (CADisplayLink), запрашивает кадры у секвенсора. Так как приложение работает преимущественно с видео, то логичнее всего использовать YCbCr colorspace и передавать каждый кадр как CVPixelBufferRef. После получения кадра создаются luminance и chrominance текстуры, которые передаются в shader program. На выходе получается RGB изображения, которое и видит пользователь. Refresh loop в данном случае будет выглядеть примерно так:

- (void)onDisplayRefresh:(CADisplayLink *)sender {

// advance position of sequencer

[self.source advanceBy:sender.duration];

// check for new pixel buffer

if ([self.source hasNewPixelBuffer]) {

// get one

PixelBuffer *pixelBuffer = [self.source nextPixelBuffer];

// dispatch to gl processing queue

[self.context performAsync:^{

// prepare textures

self.luminanceTexture = [self.context.textureCache textureWithPixelBuffer:pixelBuffer planeIndex:0 glFormat:GL_LUMINANCE];

self.chrominanceTexture = [self.context.textureCache textureWithPixelBuffer:pixelBuffer planeIndex:1 glFormat:GL_LUMINANCE_ALPHA];

// prepare shader program, uniforms, etc

self.program.orientation = pixelBuffer.orientation;

// ...

// signal to draw

[self setNeedsRedraw];

}];

}

if ([self.source isFinished]) {

// rewind if needed

[self.source rewind];

}

}

// ...

- (void)draw {

[self.context performSync:^{

// bind textures

[self.luminanceTexture bind];

[self.chrominanceTexture bind];

// use shader program

[self.program use];

// unbind textures

[self.luminanceTexture unbind];

[self.chrominanceTexture unbind];

}];

}Практически все здесь построено на обертках (для CVPixelBufferRef, CVOpenGLESTexture и т.д.), что позволяет вынести основную low-level логику в отдельный слой и значительно упростить базовые моменты работы с OpenGL. Конечно, у этого есть свои минусы (в основном — небольшая потеря производительности и меньшая гибкость), однако они не столь критичны. Что стоит пояcнить: self.context — достаточно простая обертка над EAGLContext, облегчающая работу с CVOpenGLESTextureCache и многопоточными обращениями к OpenGL. self.source — секвенсор, который решает, какой кадр из какого трека отдать во view.

Теперь о том, как организовано получение кадров для рендеринга. Так как секвенсор должен работать как с видео, так и картинками, логичнее всего закрыть все общим протоколом. Таким образом, задача секвенсора сведется к тому, чтобы следить за playhead и, в зависимости от ее позиции, отдавать новый кадр из соответствующего трека.

@protocol MovieSourceProtocol

// start & stop reading methods

- (void)startReading;

- (void)cancelReading;

// methods for getting frame rate & current offset

- (float)frameRate;

- (float)offset;

// method to check if we already read everything...

- (BOOL)isFinished;

// ...and to rewind source if we did

- (void)rewind;

// method for scrubbing

- (void)seekToOffset:(CGFloat)offset;

// method for reading frames

- (PixelBuffer *)nextPixelBuffer;

@end Логика того, как получать кадры, ложится на объекты, реализующие MovieSourceProtocol. Такая схема позволяет сделать систему универсальной и расширяемой, так как единственным отличием в обработке изображений и видео будет только способ получения кадров.

Таким образом, VideoSequencer становится совсем простым, и главной сложностью остается определение текущего трека и приведение всех треков к единому frame rate.

- (PixelBuffer *)nextPixelBuffer {

// get current track

VideoSequencerTrack *track = [self trackForPosition:self.position];

// get track source

id source = track.source; // Here's our source

// get pixel buffer

return [source nextPixelBuffer];

} VideoSequencerTrack здесь — обертка над объектом, реализующим MovieSourceProtocol, содержащая различную метадату.

@interface FCCGLVideoSequencerTrack : NSObject

- (id) initWithSource:(id)source;

@property (nonatomic, assign) BOOL editable;

// ... and other metadata

@end Работаем со статикой

Теперь перейдем непосредственно к получению кадров. Рассмотрим простейший случай — отображение одной картинки. Получить ее возможно либо с камеры, и тогда мы сразу можем получить CVPixelBufferRef в формате YCbCr, который достаточно просто скопировать (почему это важно, я объясню чуть позже) и отдавать по запросу; либо из медиа-библиотеки — в этом случае придется немного извернуться и вручную конвертировать изображение в нужный формат. Операцию конвертирования из RGB в YCbCr можно было вынести на GPU, однако на современных девайсах и CPU справляется с этой задачей достаточно быстро, особенно учитывая тот факт, что приложение дополнительно кропает и сжимает изображение перед тем, как его использовать. В остальном же все достаточно просто, все что нужно делать — отдавать один и тот же кадр в течение отведенного промежутка времени.

@implementation ImageSource

// init with pixel buffer from camera

- (id)initWithPixelBuffer:(PixelBuffer *)pixelBuffer orientation:(AVCaptureVideoOrientation)orientation duration:(NSTimeInterval)duration {

if (self = [super init]) {

self.orientation = orientation;

self.pixelBuffer = [pixelBuffer copy];

self.duration = duration;

}

return self;

}

// init with UIImage

- (id)initWithImage:(UIImage *)image duration:(NSTimeInterval)duration {

if (self = [super init]) {

self.duration = duration;

self.orientation = AVCaptureVideoOrientationPortrait;

// prepare empty pixel buffer

self.pixelBuffer = [[PixelBuffer alloc] initWithSize:image.size pixelFormat:kCVPixelFormatType_420YpCbCr8BiPlanarFullRange];

// get base addresses of image planes

uint8_t *yBaseAddress = self.pixelBuffer.yPlane.baseAddress;

size_t yPitch = self.pixelBuffer.yPlane.bytesPerRow;

uint8_t *uvBaseAddress = self.pixelBuffer.uvPlane.baseAddress;

size_t uvPitch = self.pixelBuffer.uvPlane.bytesPerRow;

// get image data

CFDataRef pixelData = CGDataProviderCopyData(CGImageGetDataProvider(image.CGImage));

uint8_t *data = (uint8_t *)CFDataGetBytePtr(pixelData);

uint32_t imageWidth = image.size.width;

uint32_t imageHeight = image.size.height;

// do the magic (convert from RGB to YCbCr)

for (int y = 0; y < imageHeight; ++y) {

uint8_t *rgbBufferLine = &data[y * imageWidth * 4];

uint8_t *yBufferLine = &yBaseAddress[y * yPitch];

uint8_t *cbCrBufferLine = &uvBaseAddress[(y >> 1) * uvPitch];

for (int x = 0; x < imageWidth; ++x) {

uint8_t *rgbOutput = &rgbBufferLine[x * 4];

int16_t red = rgbOutput[0];

int16_t green = rgbOutput[1];

int16_t blue = rgbOutput[2];

int16_t y = 0.299 * red + 0.587 * green + 0.114 * blue;

int16_t u = -0.147 * red - 0.289 * green + 0.436 * blue;

int16_t v = 0.615 * red - 0.515 * green - 0.1 * blue;

yBufferLine[x] = CLAMP(y, 0, 255);

cbCrBufferLine[x & ~1] = CLAMP(u + 128, 0, 255);

cbCrBufferLine[x | 1] = CLAMP(v + 128, 0, 255);

}

}

CFRelease(pixelData);

}

return self;

}

// ...

- (BOOL)isFinished {

return (self.offset > self.duration);

}

- (void)rewind {

self.offset = 0.0;

}

- (PixelBuffer *)nextPixelBuffer {

if ([self isFinished]) {

return nil;

}

return self.pixelBuffer;

}

// ...Работаем с видео

А теперь добавим видео. Для этого было решено использовать AVPlayer — в основном из-за того, что он имеет достаточно удобное API для получения кадров и полностью берет на себя работу со звуком. В общем, звучит достаточно просто, но есть и некоторые моменты, на которые стоит обратить внимание.

Начнем с очевидного:

- (void)setURL:(NSURL *)url withCompletion:(void(^)(BOOL success))completion {

self.setupCompletion = completion;

// prepare asset

self.asset = [[AVURLAsset alloc] initWithURL:url options:@{

AVURLAssetPreferPreciseDurationAndTimingKey : @(YES),

}];

// load asset tracks

__weak VideoSource *weakSelf = self;

[self.asset loadValuesAsynchronouslyForKeys:@[@"tracks"] completionHandler:^{

// prepare player item

weakSelf.playerItem = [AVPlayerItem playerItemWithAsset:weakSelf.asset];

[weakSelf.playerItem addObserver:weakSelf forKeyPath:@"status" options:NSKeyValueObservingOptionNew context:nil];

}];

}

- (void)observeValueForKeyPath:(NSString *)keyPath ofObject:(id)object change:(NSDictionary *)change context:(void *)context {

if(self.playerItem.status == AVPlayerItemStatusReadyToPlay) {

// ready to play, prepare output

NSDictionary *outputSettings = @{

(id)kCVPixelBufferPixelFormatTypeKey: @(kCVPixelFormatType_420YpCbCr8BiPlanarFullRange),

(id)kCVPixelBufferOpenGLESCompatibilityKey: @(YES),

(id)kCVPixelBufferOpenGLCompatibilityKey: @(YES),

(id)kCVPixelBufferIOSurfacePropertiesKey: @{

@"IOSurfaceOpenGLESFBOCompatibility": @(YES),

@"IOSurfaceOpenGLESTextureCompatibility": @(YES),

},

};

self.videoOutput = [[AVPlayerItemVideoOutput alloc] initWithPixelBufferAttributes:outputSettings];

[self.playerItem addOutput:self.videoOutput];

if (self.setupCompletion) {

self.setupCompletion();

}

};

}

// ...

- (void) rewind {

[self seekToOffset:0.0];

}

- (void)seekToOffset:(CGFloat)offset {

[self.playerItem seekToTime:[self timeForOffset:offset] toleranceBefore:kCMTimeZero toleranceAfter:kCMTimeZero];

}

- (PixelBuffer *)nextPixelBuffer {

// check for new pixel buffer...

CMTime time = self.playerItem.currentTime;

if(![self.videoOutput hasNewPixelBufferForItemTime:time]) {

return nil;

}

// ... and grab it if there is one

CVPixelBufferRef bufferRef = [self.videoOutput copyPixelBufferForItemTime:time itemTimeForDisplay:nil];

if (!bufferRef) {

return nil;

}

PixelBuffer *pixelBuffer = [[FCCGLPixelBuffer alloc] initWithPixelBuffer:bufferRef];

CVBufferRelease(bufferRef);

return pixelBuffer;

}Создаем AVURLAsset, подгружаем информацию о треках, создаем AVPlayerItem, дожидаемся нотификации о том, что он готов к воспроизведению и создаем AVPlayerItemVideoOutput с подходящими для рендера параметрами — все по-прежнему достаточно просто.

Однако тут же кроется и первая проблема — seekToTime работает недостаточно быстро, и при loop’е есть заметные задержки. Если же не изменять параметры toleranceBefore и toleranceAfter, то это мало что меняет, за исключением того, что, кроме задержки, добавляется еще и неточность позиционирования. Это ограничение системы и полностью его не решить, но можно обойти, для чего достаточно готовить 2 AVPlayerItem’a и использовать их по очереди — как только один из них заканчивает воспроизведение, тут же начинает играть другой, в то время как первый перематывается на начало. И так по кругу.

Еще одна неприятная, но решаемая проблема — AVFoundation как следует (seamless & smooth) поддерживает изменение скорости воспроизведения и reverse далеко не для всех типов файлов, и, если в случае с записи с камеры выходной формат мы контролируем, то в случае, если пользователь загружает видео из медиа-библиотеки, такой роскоши у нас нет. Заставлять пользователей ждать, пока видео сконвертируется — выход плохой, тем более далеко не факт, что они будут использовать эти настройки, поэтому было решено делать это в бэкграунде и незаметно подменять оригинальное видео на сконвертированное.

- (void)processAndReplace:(NSURL *)inputURL outputURL:(NSURL *)outputURL {

[[NSFileManager defaultManager] removeItemAtURL:outputURL error:nil];

// prepare reader

MovieReader *reader = [[MovieReader alloc] initWithInputURL:inputURL];

reader.timeRange = self.timeRange;

// prepare writer

MovieWriter *writer = [[FCCGLMovieWriter alloc] initWithOutputURL:outputURL];

writer.videoSettings = @{

AVVideoCodecKey: AVVideoCodecH264,

AVVideoWidthKey: @(1280.0),

AVVideoHeightKey: @(720.0),

};

writer.audioSettings = @{

AVFormatIDKey: @(kAudioFormatMPEG4AAC),

AVNumberOfChannelsKey: @(1),

AVSampleRateKey: @(44100),

AVEncoderBitRateStrategyKey: AVAudioBitRateStrategy_Variable,

AVEncoderAudioQualityForVBRKey: @(90),

};

// fire up reencoding

MovieProcessor *processor = [[MovieProcessor alloc] initWithReader:reader writer:writer];

processor.processingSize = (CGSize){

.width = 1280.0,

.height = 720.0

};

__weak FCCGLMovieStreamer *weakSelf = self;

[processor processWithProgressBlock:nil andCompletion:^(NSError *error) {

if(!error) {

weakSelf.replacementURL = outputURL;

}

}];

}MovieProcessor здесь — сервис, который получает кадры и аудио сэмплы от reader’а и отдает их writer’у. (На самом деле он также умеет и обрабатывать полученные от reader’а кадры на GPU, но это используется только при рендере всего проекта, для того, чтобы наложить на готовое видео кадры анимации)

А теперь посложнее

А что, если юзер захочет добавить в проект сразу 10-15 видеоклипов? Так как приложение не должно ограничивать пользователя в количестве клипов, которые он может использовать в приложении, нужно предусмотреть этот сценарий.

Если готовить каждый отрывок к воспроизведению по мере надобности, возникнут слишком заметные задержки. Подготавливать к воспроизведению все клипы сразу тоже не получится — из-за ограничения iOS на количество h264 декодеров, работающих одновременно. Выход из этой ситуации, разумеется, есть и он достаточно прост — готовить заранее пару треков, которые будут проигрываться следующими, “очищая” те, которые использовать в ближайшее время не планируется.

- (void) cleanupTrackSourcesIfNeeded {

const NSUInteger cleanupDelta = 1;

NSUInteger trackCount = [self.tracks count];

NSUInteger currentIndex = [self.tracks indexOfObject:self.currentTrack];

if (currentIndex == NSNotFound) {

currentIndex = 0;

}

NSUInteger index = 0;

for (FCCGLVideoSequencerTrack *track in self.tracks) {

NSUInteger currentDelta = MAX(currentIndex, index) - MIN(currentIndex, index);

currentDelta = MIN(currentDelta, index + (trackCount - currentIndex - 1));

if (currentDelta > cleanupDelta) {

track.playheadPosition = 0.0;

[track.source cancelReading];

[track.source cleanup];

}

else {

[track.source startReading];

}

++index;

}

}Таким нехитрым способом удалось добиться непрерывного воспроизведения и loop’а. Да, при scrubbing’е неизбежно будет небольшой лаг, но это не столь критично.

Подводные камни

Напоследок расскажу немного о подводных камнях, которые могут встретиться при решении подобных задач.

Первое — если вы работаете с pixel buffers, полученными с камеры девайса — либо сразу освобождайте их, либо копируйте, если хотите использовать их позже. В противном случае видеопоток зафризится — я не нашел упоминаний об этом ограничении в документации, но, по-видимому, система трекает pixel buffers, которые отдает и просто не будет отдавать вам новые, пока старые висят в памяти.

Второе — многопоточность при работе с OpenGL. Сам по себе OpenGL с ней не очень и дружит, однако это можно обойти, используя разные EAGLContext, находящиеся в одной EAGLSharegroup, что позволит быстро и просто разделить логику отрисовки того, что пользователь увидит на экране, и различные фоновые процессы (обработку видео, рендер и т.п.).

|

Метки: author Narayan разработка под ios разработка мобильных приложений objective c obj-c ios видео секвенсор |

PHDays HackBattle: ломаем один на один |

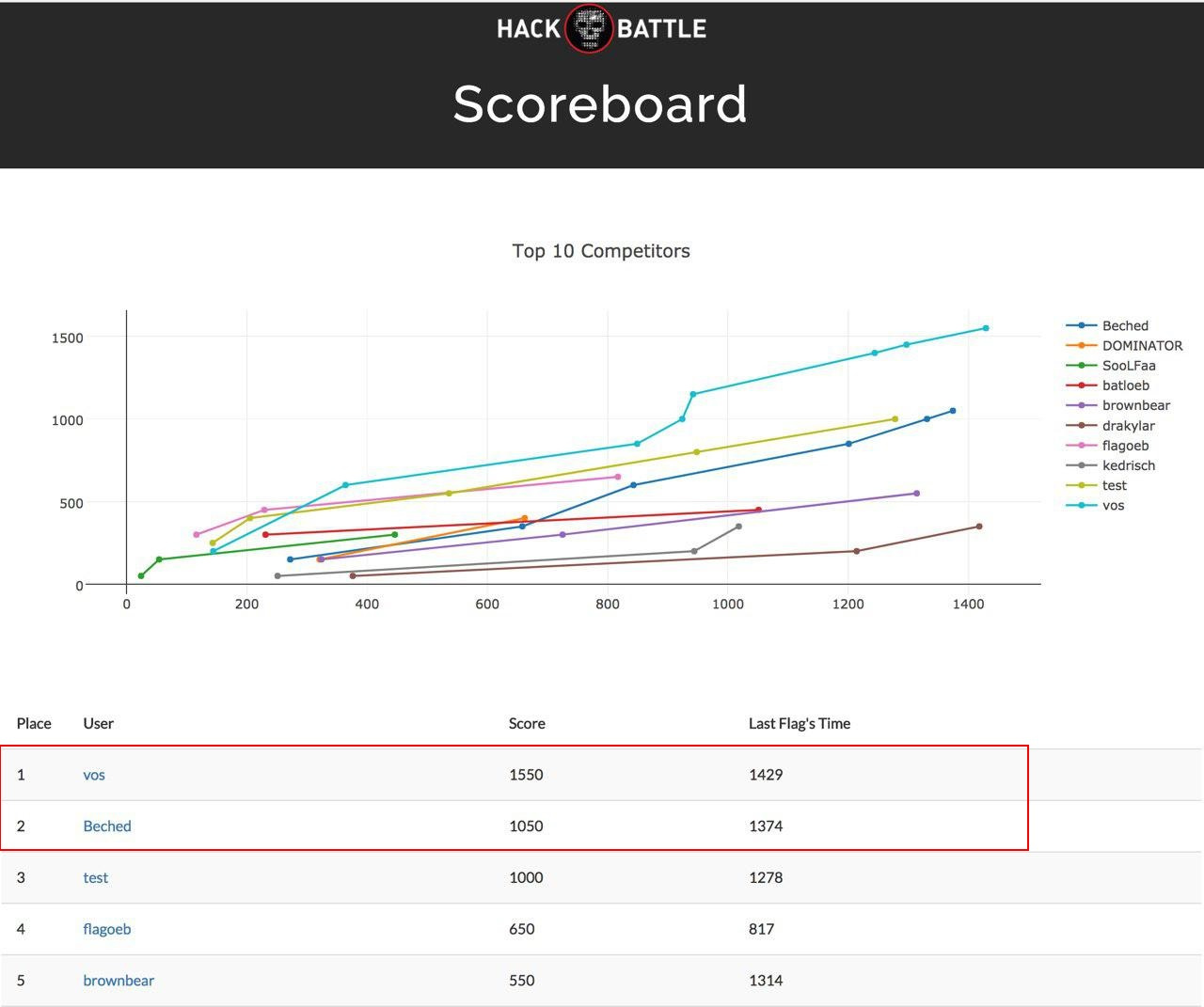

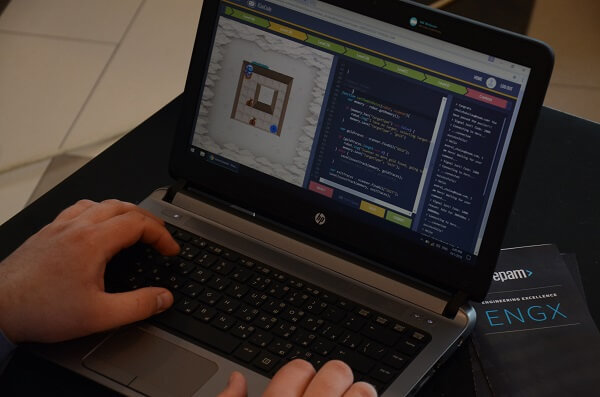

В мае на конференции по практической информационной безопасности Positive Hack Days VII впервые состоялся конкурс HackBattle. В первый день PHDays посетители могли принять участие в отборочных соревнованиях, а двое участников, выполнивших наибольшее количество заданий за наименьшее время, вышли в финал HackBattle, который состоялся на второй день конференции на главной сцене. В этой статье мы расскажем, как проходило соревнование, а также предложим всем желающим попробовать свои силы в тех задачах, которые использовались на конкурсе.

Отбор

Поскольку финал конкурса должен был проходить на главной сцене в условиях ограниченного времени, а также под пристальным наблюдением профессиональной публики, нам были нужны люди, которые не спасуют перед тем, что на них устремлены тысячи глаз, и смогут за адекватное время решить поставленную задачу.

Чтобы найти таких хакеров, мы решили использовать формат отборочных соревнований на основе задач типа CTF, но с ограничением по времени в 25 минут. Для отбора было подготовлено 9 задач, ранжированных по уровню сложности. При этом мы постарались подобрать такие задачи, сценарии которых встречаются в ходе настоящих пентестов.

Каждый гость конференции имел возможность один раз поучаствовать в отборочных соревнованиях, предварительно зарегистрировавшись. Участвовать можно было только с рабочих станций, предоставляемых организаторами. Первый посетитель, пожелавший принять участие в конкурсе, появился буквально в первые минуты работы форума, а общее число хакеров, принявших участие в отборе HackBattle, составило 97 человек!

Финал

Положение дел в отборочной таблице менялось на протяжении всего первого дня конференции, и лишь к вечеру там закрепились двое участников, которые и вышли в финал. Ими стали Влад “vos” Росков и Омар “Beched” Ганиев.

Финал состоялся на второй день, на главной сцене PHDays. Все происходящее на мониторах двух хакеров-финалистов транслировалось на большой экран, с профессиональными комментариями специалистов по информационной безопасности:

Финалистам было предложено атаковать одну и ту же инфраструктуру. По легенде это был департамент безопасности вымышленного города:

Задание состояло из трех этапов: на первых двух нужно было атаковать веб-приложение, чтобы сначала попасть в панель администратора приложения, а потом получить возможность выполнения команд с правами веб-сервера. На третьем этапе предстояло повысить привилегии до root и запустить bash-скрипт. По легенде игры он активировал сирену в здании департамента. Отдельно стоит отметить, что прохождение задания не было линейным, каждый этап можно было преодолеть несколькими способами, что наши финалисты и показали.

Битва была жаркой, до последнего момента было неясно, кто именно придет к финишу первым! Полную версию финала можно посмотреть на www.phdays.com/broadcast/, 24 мая, part 2 mix stream с 2:00:00. Если вы не хотите раньше времени знать победителя, то не читайте дальше, пока не посмотрите запись.

Победителем оказался Влад “vos” Росков! После конкурса мы взяли у финалистов небольшое интервью, чтобы они поделились впечатлениями от HackBattle.

Влад “vos” Росков:

«Обожаю хак-батлы один на один, ребята придумали крутой формат для шоу с финальной битвой на сцене. Уважуха за разноплановые таски. Бечеду тоже уважуха, достойный соперник :)

В этот раз была всего одна дуэль, на которую отбирались топ-2 по количеству решенного за первый день — было б круто в следующий раз построить турнирную сетку и все битвы сделать один на один».

Омар “Beched” Ганиев:

«Мне уже доводилось состязаться в подобном формате в более скромной обстановке — в рамках конференции RuCTF. В целом это наиболее захватывающий формат для зрителей и весьма интересный формат для участников. Сложность для организаторов — провести соревнование без огрехов в инфраструктуре, а главное — сделать задачи такими, чтобы они действительно решались за короткое время (10–30 минут). В итоге получается динамичное соревнование на скорость, которое демонстрирует зрителям подходы участников к решению задач».

Авторам HackBattle как раз таки удалось соблюсти такой баланс и сделать задачи, которые решаются разными способами и позволяют участникам выбрать свой путь.

Еще один плюс для участников — соревнование занимает совсем немного времени, так что можно размяться и отвлечься на конференции. С удовольствием поучаствую еще раз и рекомендую продумать масштабирование баттлов в формат турнира — чтобы не только два человека могли сражаться в финале. Схожее соревнование Rapid Fire проводила компания ForAllSecure.

Задания для конкурса: попробуйте сами

Задания для отбора и финала вы можете скачать в формате OVA:

http://static.ptsecurity.com/phdays/2017/hackbattle/creds.txt — доступы к виртуальным машинам

static.ptsecurity.com/phdays/2017/hackbattle/1.ova

static.ptsecurity.com/phdays/2017/hackbattle/2.ova

static.ptsecurity.com/phdays/2017/hackbattle/3.ova

static.ptsecurity.com/phdays/2017/hackbattle/4.ova

static.ptsecurity.com/phdays/2017/hackbattle/5.ova

static.ptsecurity.com/phdays/2017/hackbattle/6.ova

static.ptsecurity.com/phdays/2017/hackbattle/7.ova

static.ptsecurity.com/phdays/2017/hackbattle/8.ova

static.ptsecurity.com/phdays/2017/hackbattle/9.ova

static.ptsecurity.com/phdays/2017/hackbattle/FINAL.ova

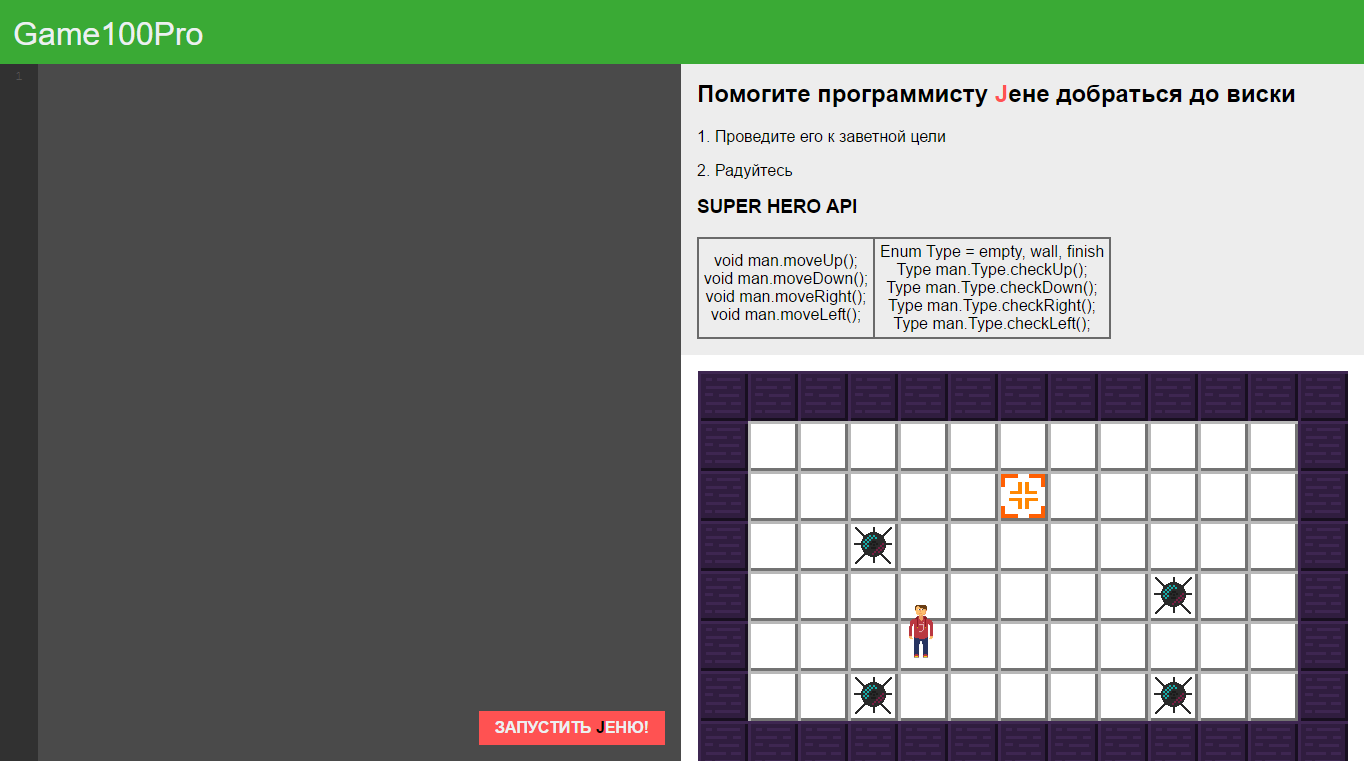

Задачи сильно различаются по сложности. Разбор одной из них (№ 3 по ссылке), за решение которой полагались скромные 100 баллов, можно найти ниже. Конечно, этот спойлер не стоит читать тому, кто хочет попробовать самостоятельно решить эту задачу.

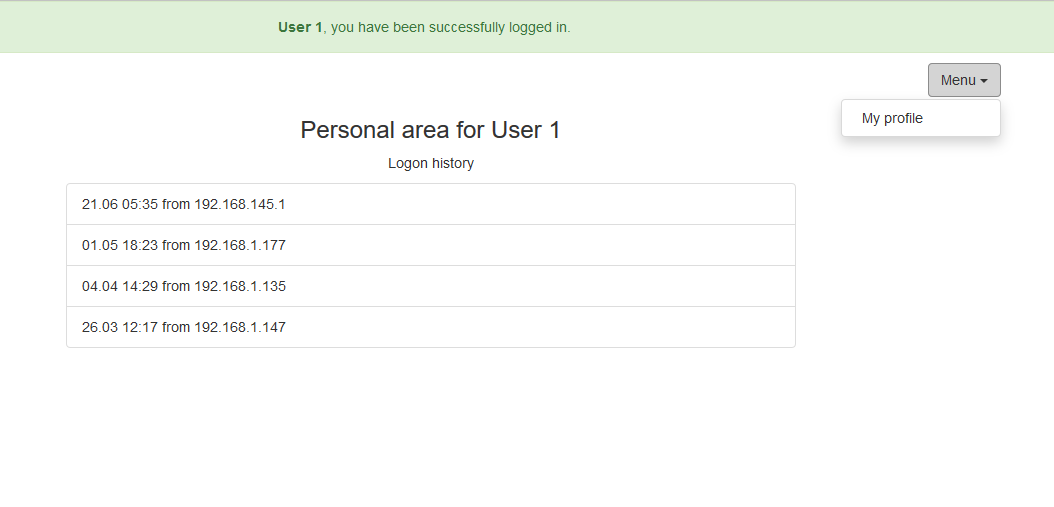

Разбор задания № 3

При переходе по ссылке участник видел веб-приложение с приветственной надписью «User 1, you have been successfully logged in.»:

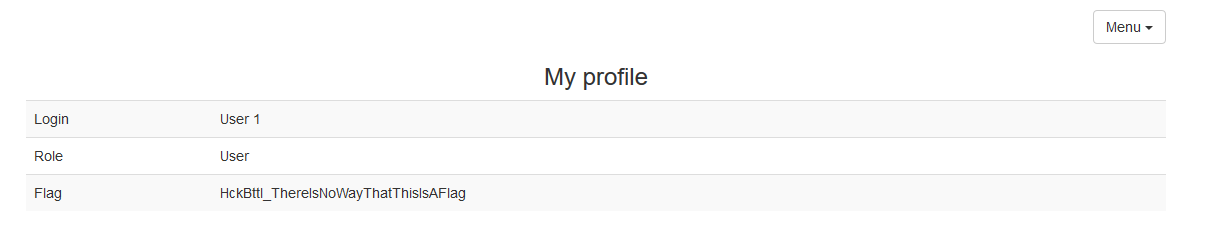

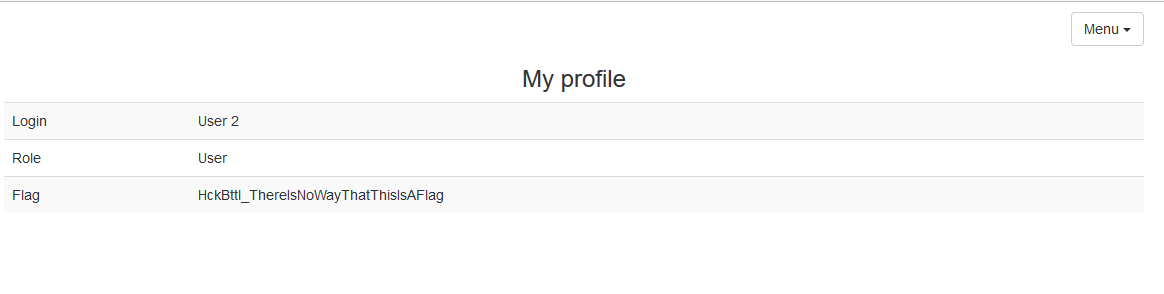

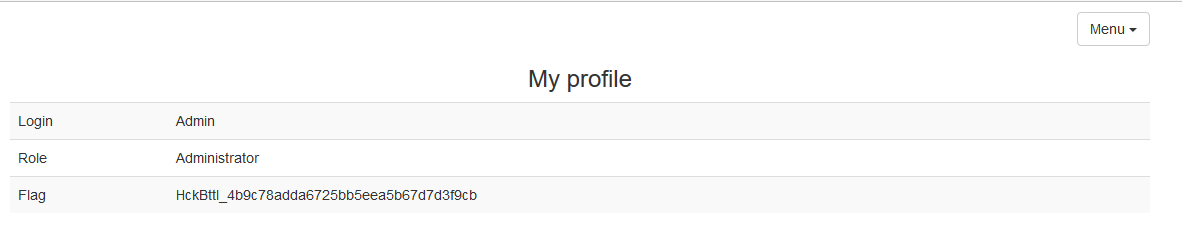

При клике по ссылке «My profile» открывалась страница профиля User 1:

Сообщение в строке Flag однозначно говорило, что флага тут нет.

Ссылка профиля имела вид «/profile/1», если попробовать перейти по ссылке «/profile/2», то отображался профиль User 2:

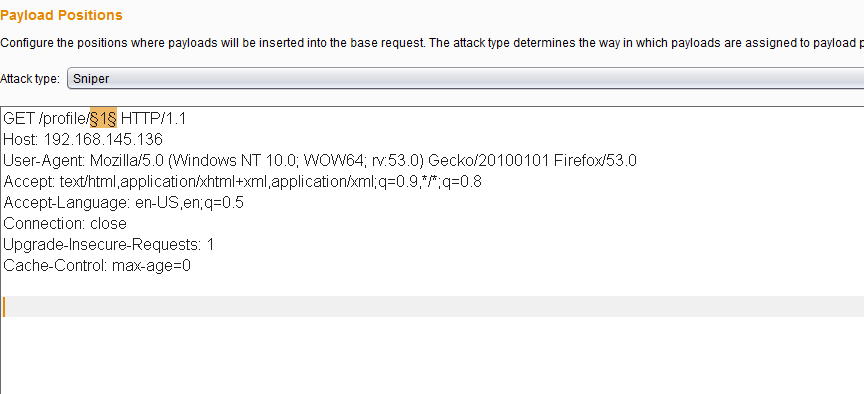

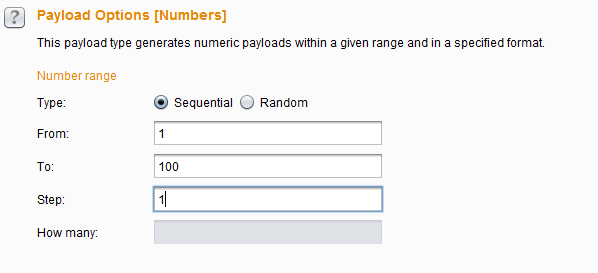

К большому сожалению, флага тут также не было, зато очевидно, что присутствует IDOR-уязвимость. Переберем первые 100 id с помощью Burp Intruder:

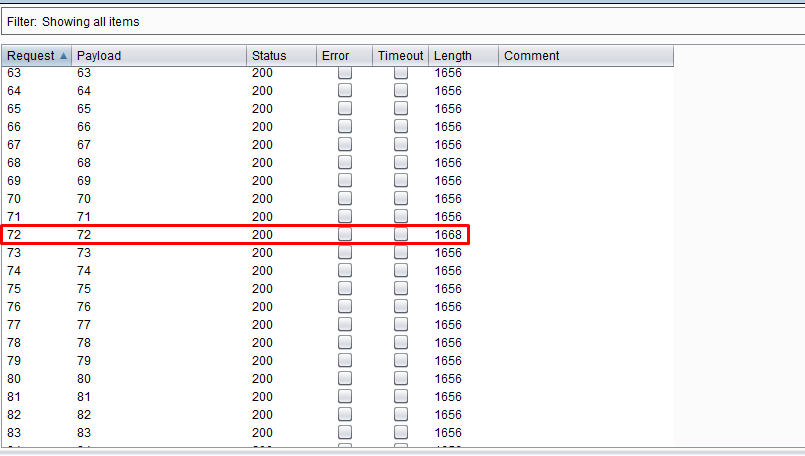

На id 72 видим аномалию в столбце Length, заходим:

Это то что надо! И флаг теперь выглядит вполне реалистично.

Авторы: Александр Морозов, Анатолий Иванов, Анна Вехтева, Positive Technologies

|

Метки: author ptsecurity информационная безопасность блог компании positive technologies phdays конкурс hackbattle |

Датацентр ВКонтакте |

Как построить датацентр?

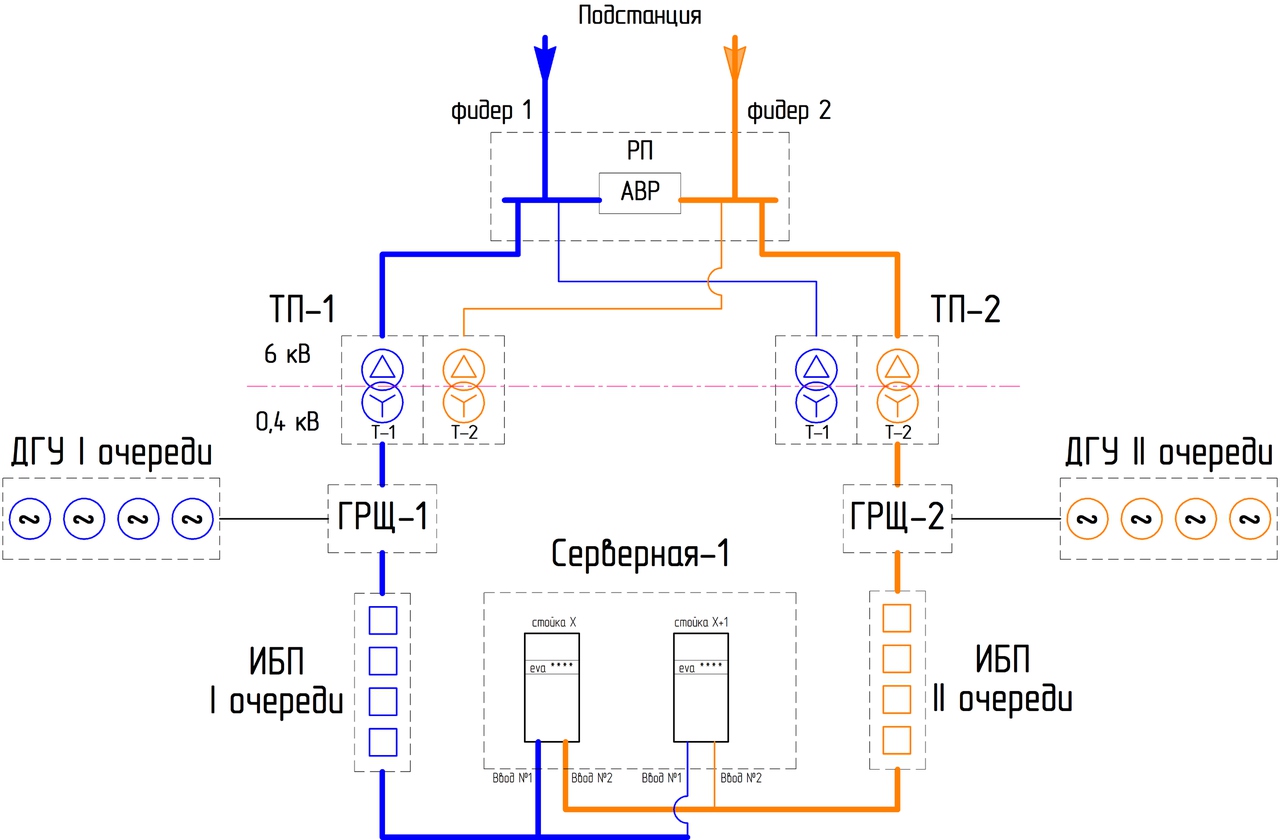

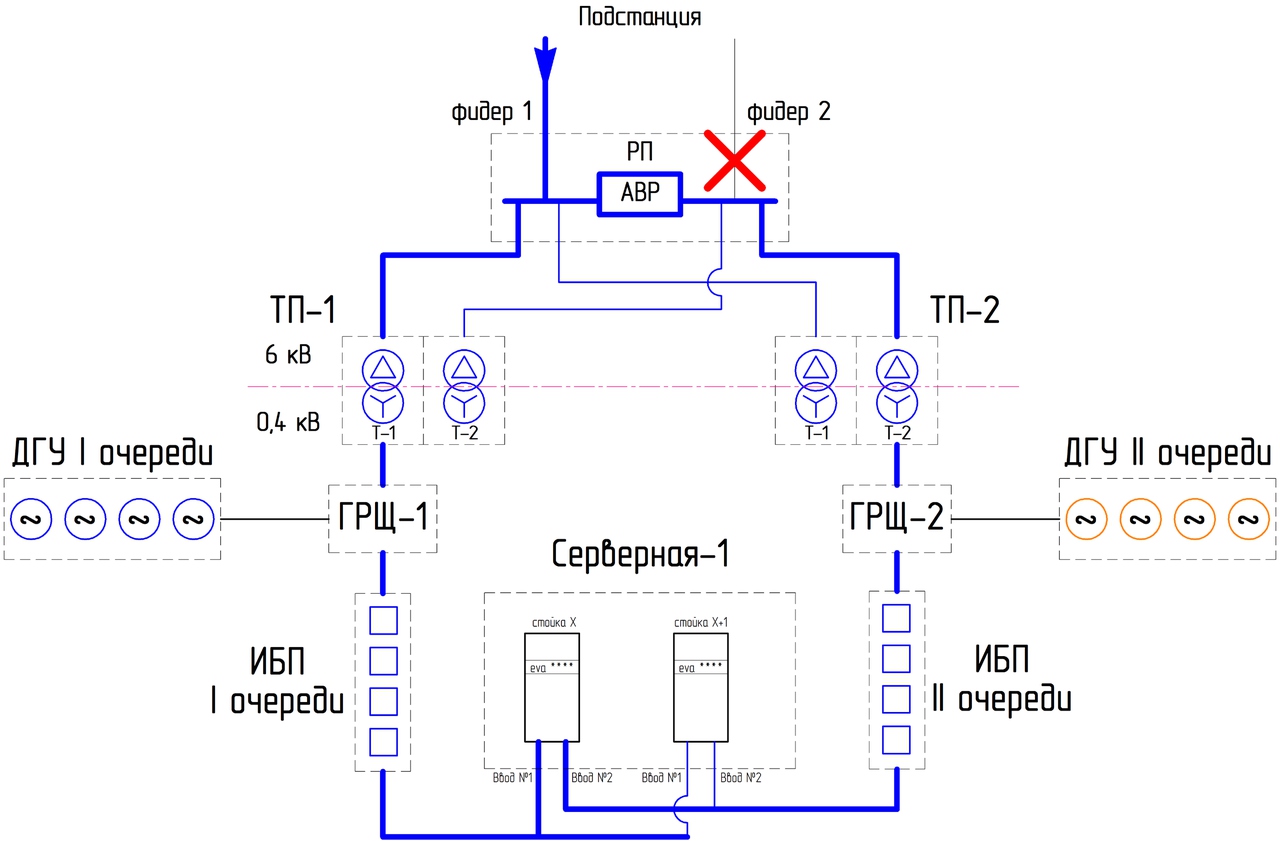

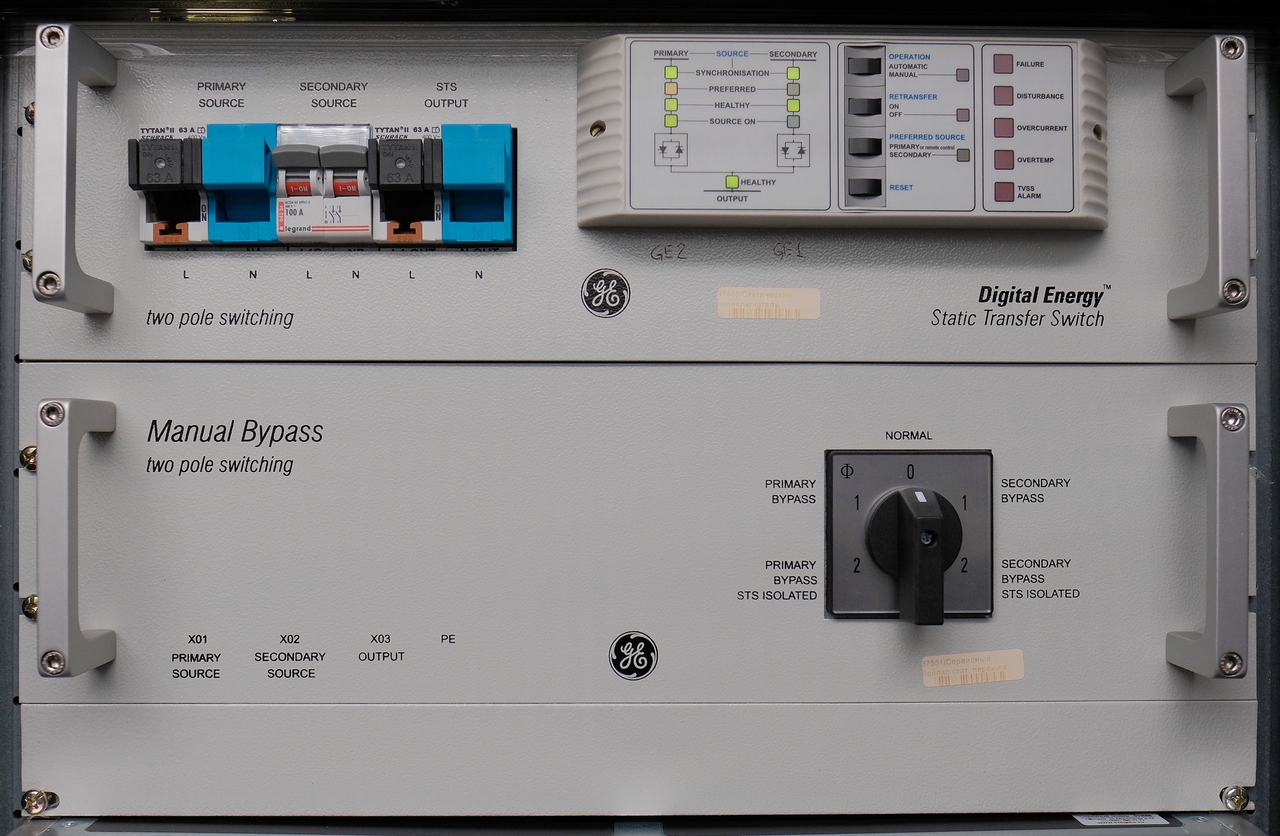

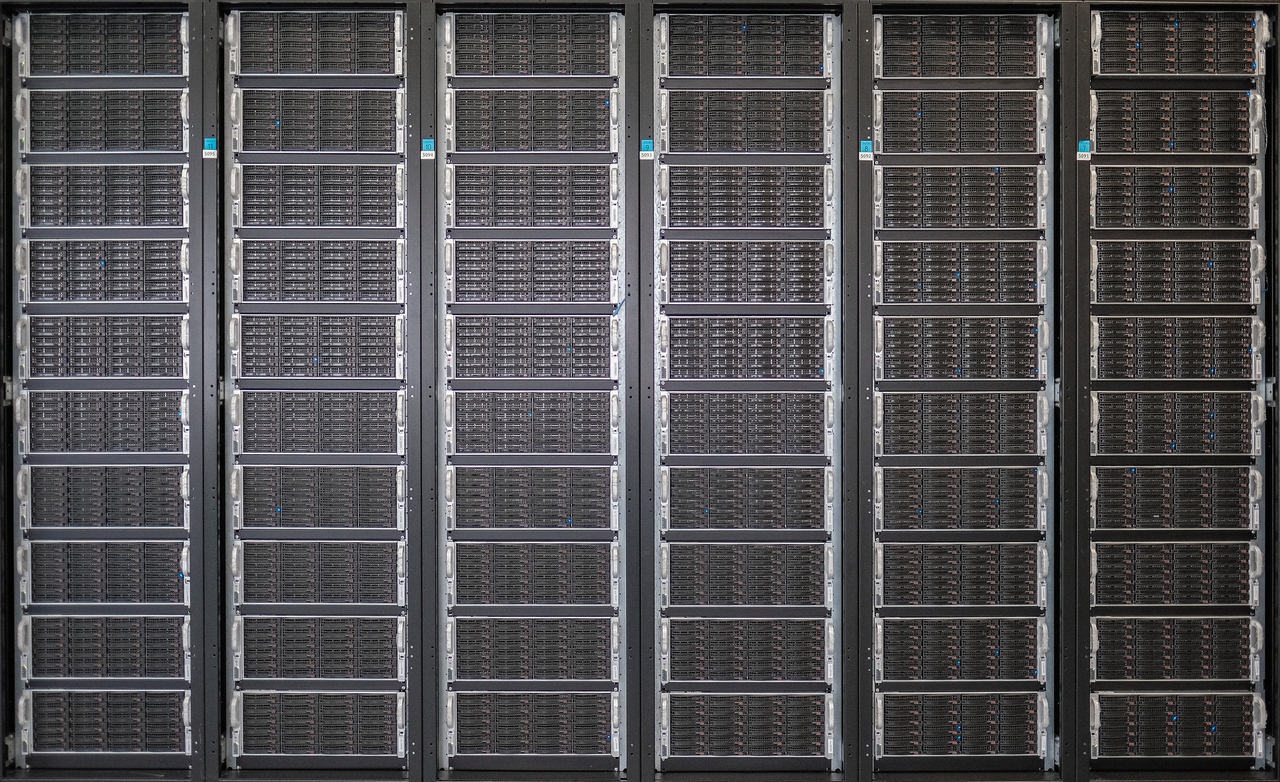

ЦОД (центр хранения и обработки данных, он же датацентр) — это совокупность нескольких инфраструктурных систем, которые обеспечивают надёжность и отказоустойчивость работы серверного и сетевого оборудования.

Нельзя просто поставить кучу серверов и коммутаторов. Нужно создать и поддерживать оптимальные условия для их работы. Если Вы хотите построить свой ЦОД, Вам потребуются:

- Система электроснабжения. Тут всё ясно — серверы работают на электричестве, и их много. Стало быть, обычной розетки на 220В, скорее всего, будет маловато.

- Система охлаждения. Даже игровая видеокарта в Вашем домашнем компьютере требует мощного кулера. Что уж говорить о сотнях и тысячах высокопроизводительных устройств.

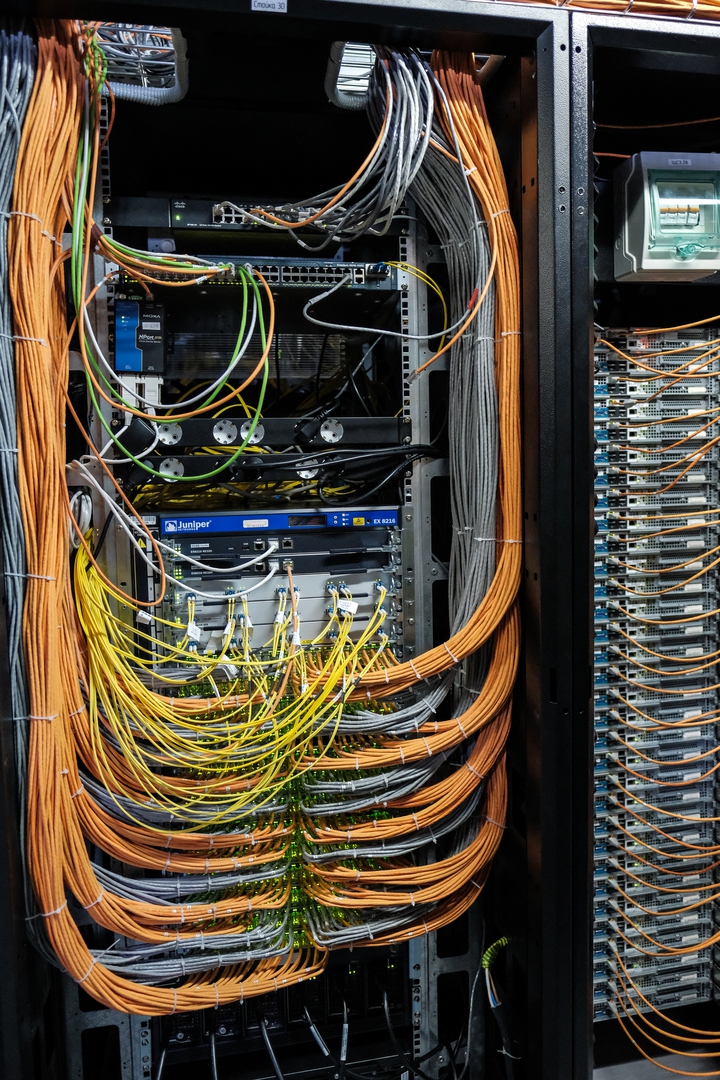

- Структурированная кабельная система (СКС). Что-то должно соединять все элементы в единое целое. Вам потребуется очень много кабелей и пылкая любовь к процессу их педантичной укладки.

Это основные системы «жизнеобеспечения», самый минимум, который нужен, чтобы просто запустить оборудование. Но для настоящего полноценного датацентра нужно кое-что ещё. А именно:

- Система пожаротушения. Важно позаботиться о том, чтобы случайная искра не превратила Ваш новенький ЦОД в руины.

- Система контроля и управления доступом (СКУД). Не стоит оставлять двери открытыми для всех желающих.

- Система мониторинга. Вы должны вовремя узнать, если что-то пошло не так.

- Охранная сигнализация. На случай, если вместо пропуска кто-то решит использовать лом.

- Система видеонаблюдения.

Мы верим, что у Вас получится отличный датацентр. А пока посмотрим, как выглядит наш.

Добро пожаловать в ИЦВА