Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Как технологии Яндекс.Такси приближают будущее личного и общественного транспорта |

На первый взгляд, не самое знаменательное событие, но я хочу рассказать, почему на деле это очень знаковый шаг к будущему — жить в котором нам предстоит уже очень скоро. Речь идет о будущем личного и общественного транспорта в городе. В статье я объясню, почему это важно и почему разработка сложнее, чем кажется, а способны на такое очень немногие компании в мире, обладающие нужными технологиями.

Начну издалека

Такси еще совсем недавно воспринималось как удобный транспорт, если у вас есть лишние деньги и время. Даже при отсутствии пробок было гораздо эффективнее воспользоваться метро или тем же трамваем.

Таксопарков с хорошими машинами всегда было немало, но водитель крайне редко мог приехать раньше, чем через полчаса. Чтобы успеть подать автомобиль хотя бы в это время, такси распределялись по разным частям города. Диспетчеры связывались со всеми сотрудниками разом, узнавали, кто где находится, не занят ли автомобиль, когда освободится, и дожидались, пока водители по радиосвязи договорятся, кто поедет на заказ. Кстати, очень часто пассажиру всю дорогу приходилось слушать беседы диспетчеров и таксистов.

Если машина требовалась раньше, чем через полчаса, люди порой выходили на дорогу и «голосовали». Вероятность, что машина найдется быстро, повышалась. Но при этом ценообразование становилось совершенно непрозрачным — вы не могли точно предсказать, сколько будет стоить поездка. Выйдя в середине ночи из московского клуба с выступления любимой группы, можно было уехать домой и за трехзначную, и за четырехзначную сумму. Кроме того, «бомбилы» зачастую не имели навигаторов и плохо знали город, что делало время в пути непредсказуемым.

На самом деле и при вызове такси из специальной службы с понятной ценой, и при ловле машины пассажир всегда оплачивал не только время поездки, но и время простоя автомобиля. Когда в аэропорту вас предлагали довезти за астрономические суммы, в них входила не только поездка, но и высокая стоимость парковки и время, которое шофер провел, отлавливая желающих у выхода. Возможность взять новый заказ сразу же после завершения текущего, да еще и недалеко от него, появилась только с развитием специальных онлайн-сервисов.

Эффективность. Технологии в очередной раз меняют мир

Для многих Яндекс.Такси — просто приложение, но за ним стоит практически вся история технологий Яндекса: от машинного обучения и построения графов до создания собственных карт. Когда Яндекс.Такси только запустилось, время подачи сразу же сократилось с получаса после заказа по телефону до 7 минут после открытия приложения. Прошло несколько лет, и автомобиль приезжает к вам уже за две минуты. Онлайн-сервисы стали резко поднимать конкуренцию между водителями и сокращать время простоя автомобиля, за счет чего падает стоимость поездки.

Таким образом, весь таксомоторный рынок меняется. Такси из редко используемой услуги превращается в массовую, постепенно становится базовым сервисом для перемещения в городе — почти как метро. Более того, такси теперь способно заменить не только метро, но и личный транспорт. Люди вызывают такси, чтобы доехать из супермаркета до дома с продуктами, успеть на рабочую встречу или к врачу, без опоздания добраться до незнакомого места.

Но, как я уже говорил выше, всё это возможно только в случае, когда водитель не простаивает без заказов. Потому что в итоге за время простоя всегда платят пассажиры.

Если посмотреть на классический рынок такси в России, то доля времени, когда водитель везет пассажира, составляет 10% и меньше. Даже в Европе, где распространены стоянки городского такси, время активности машин в среднем занимает от 7% до 15%. У современных сервисов-приложений этот показатель достигает 50% и больше. Разрыв очевиден.

И именно в такой системе быстро освободиться и быть готовым к новому заказу выгоднее, чем долго везти пассажира по нужному адресу и терять других клиентов — которые важны для общего уменьшения «пустого» времени. При этом цель Яндекс.Такси — сделать сервис таким же недорогим, как общественный транспорт, и таким же доступным, как собственный автомобиль. Последнее означает, что машина обязательно должна в нужный момент стоять у подъезда — подобно тому, как там всегда стоит личное авто. Оказывается, что для достижения указанной цели главное — эффективность. Для нас ценна любая минута, сэкономленная водителем.

Как появилась идея

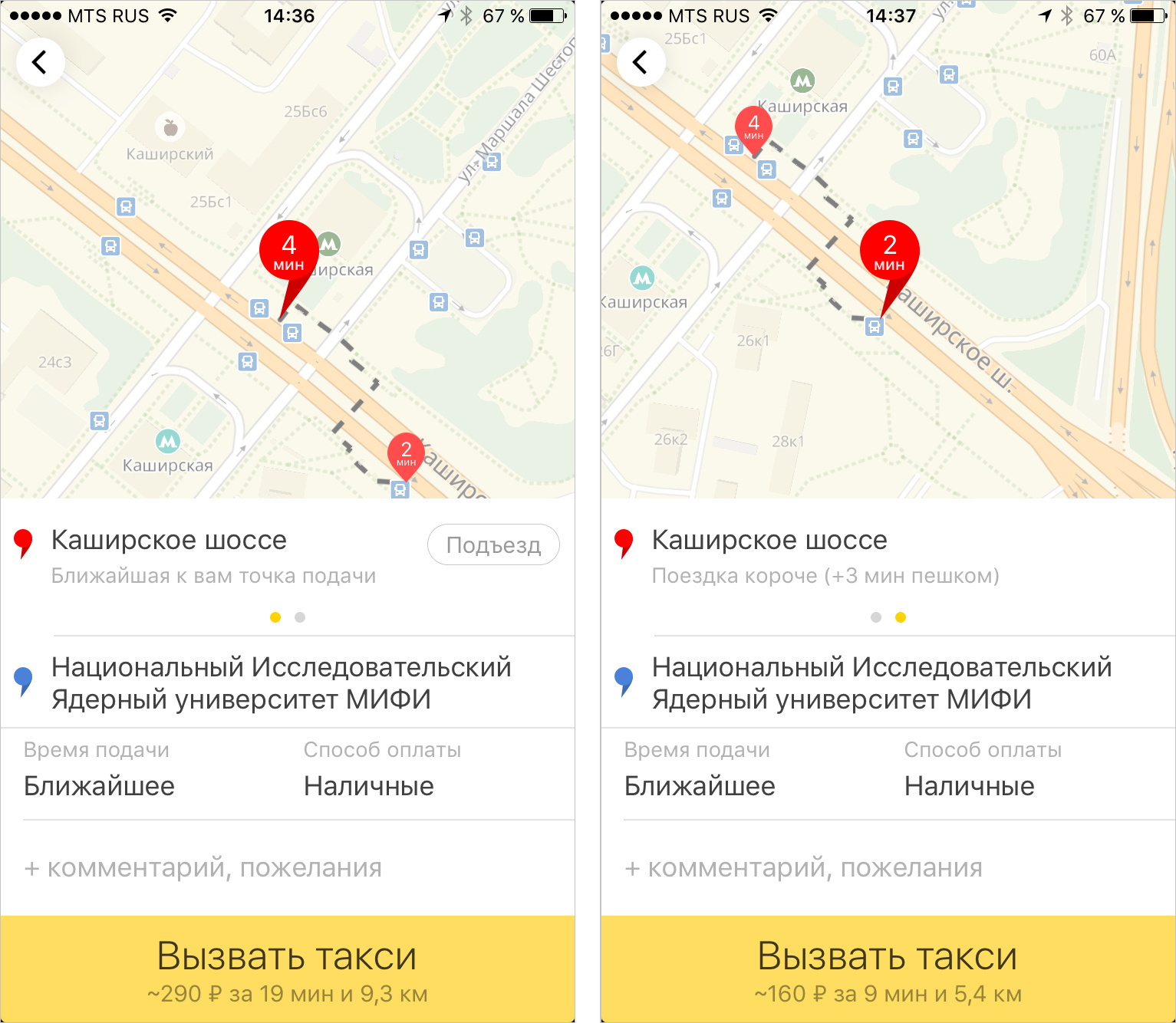

Как часто бывает в Яндексе, продуктовое решение выросло из идеи одного из сотрудников. Он даже не работает в Такси. Коллеге нужно было доехать от ближайшего к МИФИ метро до самого института. На карте это расстояние не превышает 1 км — вот как раз та ситуация, когда такси может заменить автобус или маршрутку. Но на деле ехать пришлось 11 км, так как необходимо было развернуться на Каширском шоссе. А ведь стоило перейти дорогу и пройти 100 метров, как время в пути сократилось бы в восемь раз! И, соответственно, стоимость поездки была бы ниже. На самом деле в команде Такси тоже уже обсуждали подобную фичу, но пост коллеги помог убедиться в правильном направлении мысли.

Почему это не так просто сделать?

Звучит просто, но реализовать такую задачу могут считанное количество компаний в мире. Дело в том, что требуется сочетание сразу нескольких факторов. Компания должна:

- Проводить маршрутизацию на автомобильных дорогах.

- Иметь граф пешеходных дорог и понимать, сколько человек потратит времени на то, чтобы дойти от одной точки до другой.

- Производить такие расчеты очень быстро: в момент, когда человек хочет вызвать такси, ему нужно мгновенно показать альтернативные точки. Через минуту они уже никому будут не нужны. Да и при задержке в 10 секунд продукт бы испортился.

- Принимать во внимание, что точек для обработки — десятки, а то и сотни. До каждой из них нужно уметь построить два маршрута — для клиента и для такси.

- Понимать, куда человеку удобно подойти, а машине — подъехать, и куда им добраться неудобно. Никто не будет садиться на сложной развязке, идти неудобными дорогами и т. п. «Обычные» пешеходные, да и автомобильные маршрутизаторы не всегда хорошо подходят для этой задачи.

- Уметь рассчитывать цену поездки — а это не только роутинг, но и учет пробок: текущих и будущих.

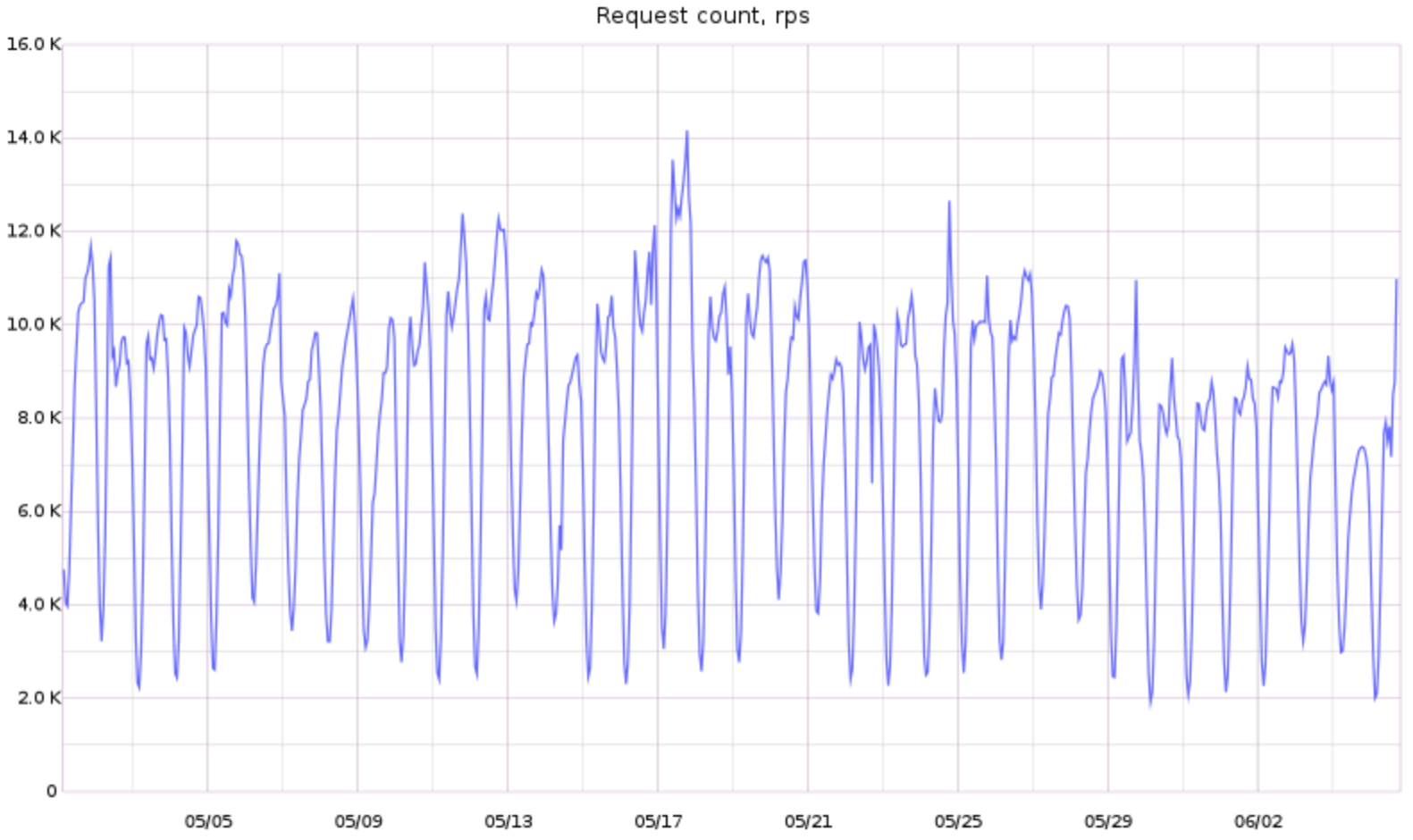

Как много запросов нужно уметь обрабатывать рутеру, чтобы строить альтерантивные точки посадки

Как эта штука работает, и почему так

Сейчас альтернативные точки посадки появляются, если:

- суммарная выгода от времени подачи и поездки пассажира составляет четыре минуты

- заказ сделан на ближайшее время

- известна точка назначения (без нее мы можем навредить, поскольку не знаем, каким путём поедет водитель)

- машина вызвана не в аэропорт (т. е. клиент, скорее всего, без чемоданов)

Тогда Яндекс.Такси считает время прибытия машины не только к точке, где находится человек, но и ко всем пересечениям с автомобильными дорогами в пешеходном радиусе трех минут от текущего положения человека. То есть получается некоторое множество точек: сейчас это пешеходные переходы, выходы из метро, остановки, шлагбаумы, мелкие дороги, которые можно перейти где угодно, проезды во дворах, точки, к которым люди сами часто вызывают машины, и т. п.

Что дальше?

Конечно, мы не планируем останавливаться на достигнутом. Уже сейчас понятно, что похожих решений может быть много.

Например, совсем скоро Такси научится предлагать для посадки по умолчанию именно те точки, где клиенты часто садятся в машины. Такие места обычно образуются естественным образом — у выходов из торговых центров, в удобных местах на улицах. Они подходят и пассажирам, и водителям, ведь лучше не заставлять людей каждый раз заново находить подобные места.

Далее: кажется, что в городах с большим количеством пробок возникают ситуации, когда часть маршрута удобнее проехать на общественном транспорте или даже пройти пешком, а затем снова пересесть в такси. Тут, конечно, надо знать расписание общественного транспорта, но у Яндекса есть приложение и для этого.

Бывает и так, что в конце поездки удобно не доезжать до цели 100 метров. Что если на машине их не удастся преодолеть быстро, что если гораздо быстрее дойти пешком? Было бы здорово автоматом предлагать переставить конечную точку на 100 метров, а не заставлять пассажира думать об этом самостоятельно (тем более, что клиент может не знать город или ситуацию на дорогах).

Я перечислил только часть вариантов развития. Кстати, ваши идеи мы с удовольствием выслушаем в комментариях и реализуем, если они окажутся хорошими.

* * *

Принято считать (и многие на Хабре наверняка в курсе), что идея современного общественного транспорта принадлежит математику — Блезу Паскалю. Именно он еще в середине XVII века предложил создать многоместные экипажи, запрягаемые лошадьми. Они должны были двигаться по строго определенным маршрутам — это помогало не ездить впустую (как бывало, например, с извозчиками) и увеличивать маржинальность поездки.

Подобные общественные экипажи получили развитие в XIX веке, когда становилось все больше крупных производств, до которых нужно было добираться множеству рабочих. Для них организовывались специальные омнибусы. В целом, с тех пор изменилось немногое. Основная нагрузка на общественный транспорт по-прежнему приходится на начало и конец стандартного рабочего дня.

Преимуществом маршрутного транспорта с момента его появления была постоянная загруженность. Она позволяла снижать стоимость поездки и делала транспорт массовым. Такси появилось как комфортная, но дорогая и менее эффективная альтернатива. Технологический прогресс позволил создавать все более эффективный общественный транспорт, а водители такси по-прежнему, как и извозчики несколько веков назад, могли долгое время ездить в поисках клиентов. И только благодаря технологиям, которые появились на наших глазах, такси начинает развиваться как личный общественный транспорт. Машины не ездят без пассажиров, водителям помогает навигатор, они получают очередные заказы максимально близко к местам завершения предыдущих. Можно даже принять новый заказ перед тем, как высадить пассажира в точке назначения: если сервис знает, где эта точка, он заранее начинает искать клиентов неподалеку. С учетом того, каковы издержки от владения собственным автомобилем, такси становится гораздо более дешевым и не менее комфортным способом передвижения. А в основе этой революции — как и при появлении первого общественного транспорта — лежит математическое мышление и, буквально, прикладная математика.

|

|

[Перевод] Dropout — метод решения проблемы переобучения в нейронных сетях |

|

Метки: author wunder_editor машинное обучение алгоритмы big data блог компании wunder fund dropout deep learning overfitting neural networks wunderfund wunder fund |

Топ 15 бесплатных Unity ассетов для начинающего 2D разработчика |

Введение

Unity3D – безумно удобная среда, которая многое делает за нас. Именно поэтому она сейчас так востребована: разработка игр при правильном подходе становится не сложнее сборки конструктора.

Сама платформа Unity предоставляет широкий набор инструментов, но иногда не хватает и их. Тогда в дело вступает Asset Store с миллионами ассетов, моделей и примеров проектов.

Если у вас еще мало опыта в разработке приложений, имейте в виду: Asset Store – это огромный склад велосипедов, которые уже изобрели до вас. При этом там можно найти очень много бесплатного контента, или же контента по цене одной чашки кофе (сэкономьте на латте!).

Почему мы посвятили статью именно 2D играм? Посмотрите на рынок: 2D игры сейчас переживают ренессанс. Чтобы в этом убедиться, достаточно взглянуть на инди-сектор в Steam, Ketchapp и Zeptolab в мобильной разработке. 2D игры давно превратились из отжившего свое сектора в отдельную процветающую нишу рынка. Поэтому если вы решили делать 2D игру на Unity, сначала убедитесь, что у вас в арсенале есть все нужные инструменты, чтобы обеспечить должное качество продукта.

Немного про Asset Store

Если вы читаете эту статью, то скорее всего что-то слышали про Asset Store. Там хранятся несколько тысяч моделей, плагинов, систем частиц, скриптов и многое другое. Часть этого добра распространяется за деньги, а часть совершенно бесплатно! И мы настоятельно рекомендуем пользоваться этим обстоятельством. Прежде чем реализовывать A* для ваших юнитов, подумайте: может быть, кто-то уже сделал это до вас и выложил в общий доступ в удобной форме.

Ассеты с точки зрения 2D разработки

Так как мы рассматриваем 2D направление, модели, скрипты для камеры, скайбоксы и подобное отсекается сразу. Естественно, найдется разработчик, который сможет применить эти вещи в 2D игре, но статья предназначена в первую очередь для начинающих, которым в таких проектах лишние сложности не нужны.

Что же нам может понадобиться? Вот список:

- Готовые шаблоны проектов, с помощью которых можно быстро научиться базовым механикам создания игры. Это могут быть как платформеры, так и что-то более специфическое, например, roguelike.

- Так называемые Sprite packs, то есть паки текстур для вашей 2D игры. Они очень полезны на том этапе, когда у вас еще нет арта, но уже появились идеи для механики. Спрайт паки можно использовать, просто чтобы было с чем работать. Естественно, в релизной версии их лучше заменить на оригинальную графику.

- Готовые 2D объекты. Это могут быть как классические триггеры (зоны смерти, точки респауна, телепорты), так и что-то более интересное, скажем, физически верно рассчитанный меховой шарик.

- Скрипты и расширения редактора. Это отдельный, огромный класс компонентов, которые могут выполнять широкий спектр разных задач. Можно поставить скрипт, который добавит несколько приятных визуализаций в редактор, а можно превратить Unity в инструмент визуального кодинга, вроде Unreal Blueprints.

- Эффекты. Сюда можно отнести огромные паки частиц, эффекты на камеру, шейдеры для спрайтов и т.п. В этом сегменте попадается особенно много бесплатных ресурсов.

- Анимации. Сюда можно отнести библиотеку простых анимаций (твинов), а также примеры покадровой или скелетной анимации.

Непосредственно ТОП

1. Standard Assets

Пак стандартных ассетов от самой Unity. Это самые необходимые и проверенные в деле ассеты. Все они относятся к следующим категориям: 2D, Cameras, Characters, CrossPlatformInput, Effects, Environment, ParticleSystems, Prototyping, Utility, Vehicles. Эти ассеты можно подключить при установке Unity.

2. LeanTween

Великолепная библиотека твинов. Содержит все необходимые виды твинов (move, scale, rotate, alpha, color). Ее отличает очень удобный вызов методов, поддержка easing type и многое другое. Комбинируя простые твины, можно создавать очень интересные эффекты.

3. Simple Sprite Packer

Очень простой для начинающего разработчика паковщик спрайтов. Необходим для создания атласов, которые экономят вам место и улучшают производительность.

4. Advanced Polygon Collider

Очень мощный инструмент для работы с полигон-коллайдерами. Позволяет более тонко настраивать количество вершин, работать с ними в рантайме.

5. 2D Platformer

Более сложный пример 2D платформера от самой Unity. В отличии от 2D Platformer Controller здесь добавлена анимация, стрельба и еще множество функций и объектов.

6. 2D Platformer Controller

Ассет, который содержит в себе все необходимое для создания платформера. Здесь есть скрипты, управление персонажем, работа с камерой, вся необходимая физика и механика различных платформ. Очень рекомендуем посмотреть на этот ассет, прежде чем приступать к своему проекту.

7. Collider2D Optimization

Небольшое улучшение для ваших полигон-коллайдеров. С этим ассетом они становятся более плавными и… более тяжелыми с точки зрения производительности. Но если вам нужны точные формы коллайдеров, то этот ассет для вас.

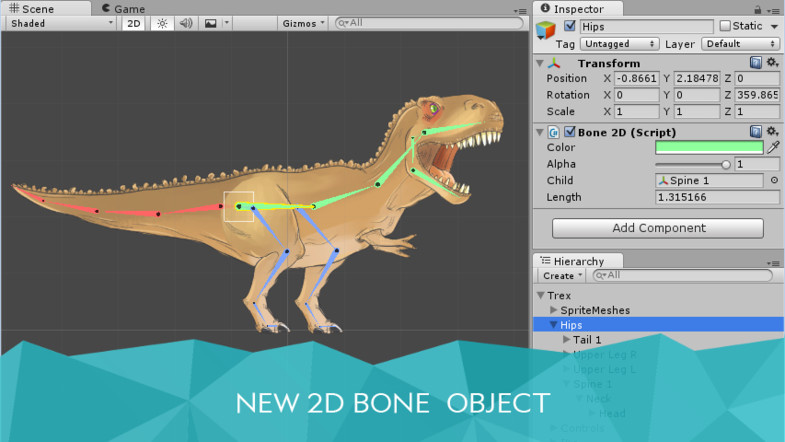

8. Unity Anima2D

Большой ассет для работы с скелетной 2d анимацией, включая инверсную кинематику и автоматическую генерацию весов. Раньше он стоил 60 $, но недавно Unity сделала его бесплатным. Очень мощный инструмент.

9. 2D Tilezone Lite

Удобный ассет-редактор для создания тайловых уровней; может разбивать атласы по сетке, рисовать уровни в редакторе Unity, добавлять коллайдеры на блоки и настраивать слои отрисовки.

10. Localization

Достаточно удобная и простая система локализации. Не подойдет для больших игр, но в маленьких проектах отлично справляется с заменой текста на разных языках.

11. AutoSave

AutoSave – ассет, который не ценишь, пока он не сработает. Суть в том, что при обычном положении вещей если Unity зависает или вылетает, а вы не сохранили сцену, то все внесенные изменения пропадут. То есть вы можете час делать уровнь, забыть сохраниться и потерять его из-за критической ошибке в скрипте (например, бесконечного цикла). AutoSave сохраняет сцену при каждом нажатии на кнопку Play. Это очень удобно.

12. Particle pack

Хороший бесплатный пак частиц с готовыми префабами. Содержит взрывы, вспышки, эффекты огня и так далее. Для начального проекта самое то, особенно если вы будете менять шейдеры у частиц и получать свои, новые эффекты.

13. 2D Roguelike

Мощный шаблон «рогалика». Содержит в себе управление героем, врагов, этажи уровней, звуки и эффекты.

14. TexturePacker Importer

Расширенный и усиленный вариант Simple Sprite Packer. Огромное количество функционала для работы с атласами.

15. Light2D — GPU Lighting System

Интересный ассет для создания красивой 2D системы освещения с контрастными тенями. Хорошо подойдет если вы делаете тактическую игру, стэлс платформер или какой-нибудь хоррор. Подобный ассет добавит в вашу игру атмосферы.

Заключение

Разумеется, у каждого ассета из этого списка есть свои альтернативы, и, возможно, вы где-то не согласитесь с нашим выбором. Это нормально, если учесть, что в Asset Store несколько тысяч ассетов. Поэтому обязательно делитесь своими предложениями в комментариях.

|

Метки: author TimTim разработка игр unity3d блог компании everyday tools unity unity asste store asset store ассеты |

[Из песочницы] Создание быстрых и более оптимизированных сайтов на WordPress |

Я собрал список плохих web-решений, а также рекомендаций о том, чего делать на вашем сайте не стоит. Список основывается на тысячах часов общения с клиентами, а также поддержки и устранения неполадок, с которыми я сталкиваюсь ежедневно. Что-то из предложенного будет достаточно примитивным, а какие-то вопросы будут более продвинутого уровня. Многое из описанного может отделять успешный сайт на WordPress от провального. Ведь, несмотря на то, что выбор правильного web-хостинга очень важен, вы должны уделять достаточно времени оптимизации сайта на WordPress, чтобы он был успешным.

Я часто замечаю, что опытные разработчики сосредотачиваются на том, что они хороши в создании тех или иных web-решений, что заставляет их пренебрегать или просто-напросто забывать про изучение и применение актуальных методов оптимизации. Вне зависимости от того, новичок вы в WordPress, или же опытный разработчик, следующие советы помогут вам создавать гораздо более быстрые и оптимизированные сайты на WordPress.

1. Смена хостинга — не всегда решение проблемы

2. Работающие сайты не предназначены для разработки

3. Не разработчик? - Не лезь в код

4. Не экономьте на темах и плагинах

5. Контролируйте AJAX-запросы

6. Будьте аккуратны при работе с рекламными сетями и внешними сервисами

7. Чрезмерная оптимизация может нанести вред производительности

8. Популярные проблемы с производительностью легко диагностировать

9. Изменение ядра WordPress, это плохо

10. Обеспечьте совместимость с PHP 7 и HHVM до переноса сайта

11. Крупные сайты должны заниматься оптимизацией баз данных

12. Действительно ли вам необходима универсальная тема?

13. Лог ошибок - ваш друг

14. Google здесь не просто так

15. 123456 больше не допускается

16. Скрипты не всегда должны загружаться по всему сайту

1. Смена хостинга — не всегда решение проблемы

Одна из самых важных вещей, которые люди должны осознавать, заключается в том, что смена web-хостинга не решит никаких проблем сама собой. Если ваш сайт на WordPress имеет проблемы с кодом или конфликтующие плагины, ваш сайт не исправится, где бы вы его не размещали.

Администрируемый хостинг предоставит вам столько поддержки и помощи, сколько сможет, но не будет заниматься отладкой кода или плагинов. Написание хорошего кода на PHP, создание и редактирование функционала плагинов и тем, правка интеграции, а также наполнение сайта содержимым - не зона ответственности web-хостинга. Этим может заняться опытный разработчик, который вникнет в работу сайта, изучит проблему и решит её.

2. Работающие сайты не предназначены для разработки

Я могу повторить это тысячу раз. Никогда не используйте работающие сайты для разработки! Сейчас почти все основные администрируемые хостинги WordPress имеют среды разработки и обкатки, и, безусловно, не без оснований. Использование этих решений спасает нас от аварийного падения рабочего сайта из-за неудачных попыток что-то протестировать.

Если вы не хотите использовать такие решения, вы можете воспользоваться локальной разработкой и тестированием, используя то, что некоторые называют LAMP или LEMP -стеком. Они предназначены для работы с Linux, Apache/Nginx, MySQL и PHP. А такие инструменты, как WAMP и MAMP упростят и ускорят сборку сервера для локальной разработки.

Все эти инструменты улучшались и развивались с течением времени, однако, в локальной разработке есть свои проблемы, например, среда, которая не очень точно имитирует ваш опубликованный сайт. Прежде всего, вам придется выяснить, как перенаправить ваши наработки с локальной машины на рабочий сайт так, чтобы не пришлось перезаписывать существующие данные, а сайт не упал. В зависимости от ваших настроек, этот процесс может стать отдельной проблемой. Отдельные сложности могут возникнуть с конфликтующими портами или ошибками из-за различий в версиях MySQL.

Чтобы избежать таких проблем, я рекомендую воспользоваться такими инструментами, как DesktopServer и Local, которые созданы исключительно для ускорения вашего рабочего процесса при локальной работе с WordPress. Они включают в себя упрощенные способы передачи данных рабочему сайту, а также имеют дополнительные функции, такие как работа с WP-CLI и встроенная поддержка режима мультисайтов. Поддержка мультисайтов сама по себе может быть бесценной, поскольку работа с большими локальными копиями WordPress иногда может быть довольно сложной.

Среды обкатки и локального тестирования могут помочь вам справиться с проблемами до того, как они сломают вам сайт.

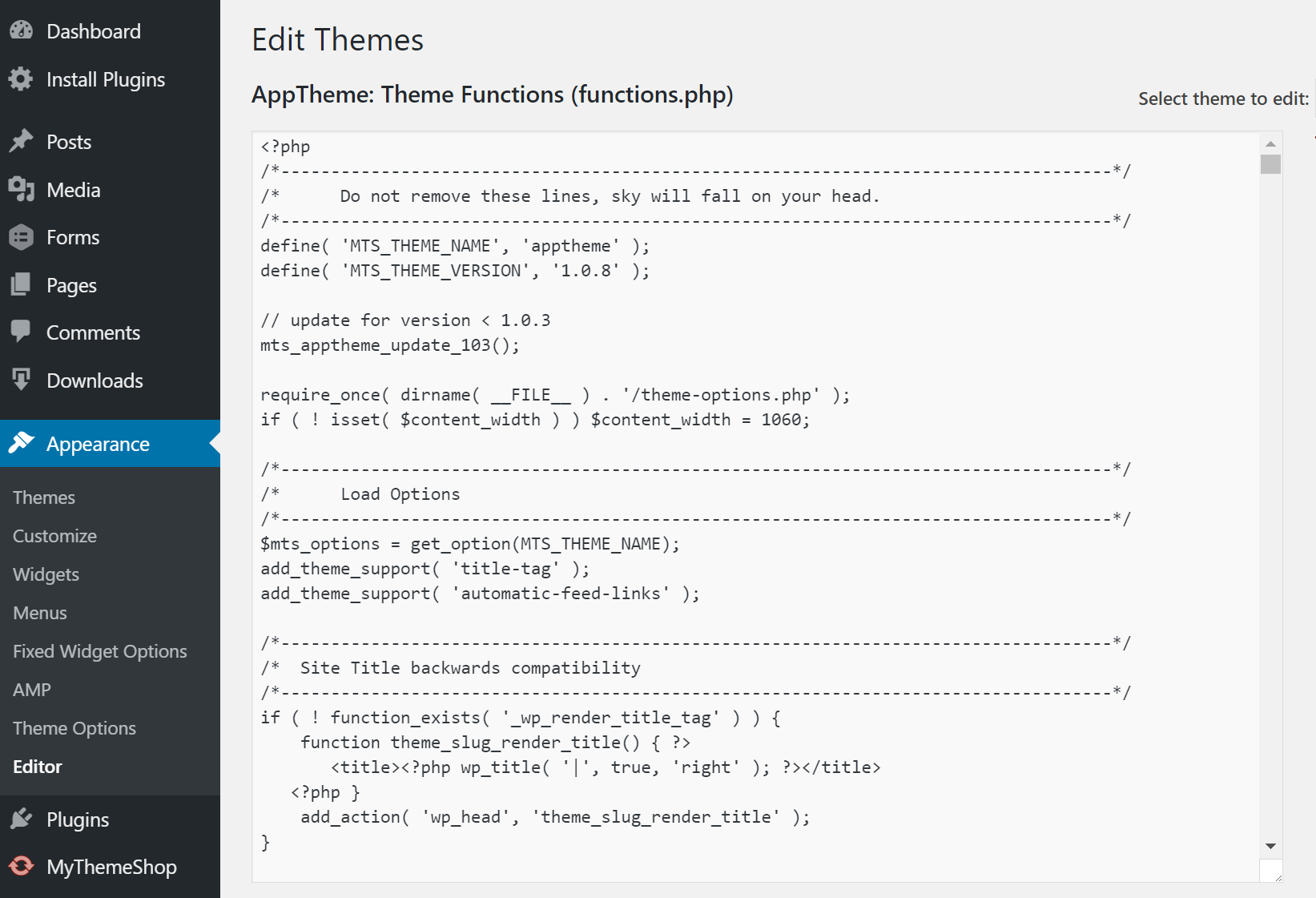

3. Не разработчик? - Не лезь в код

Люди, которые либо не знакомы с WordPress, либо не знают основ программирования, не должны редактировать файлы. Одна из самых распространенных причин, по которой сайты на WordPress падают, это то, что кто-то занимается редактированием PHP-файла прямо из редактора внешнего вида в панели управления. Кроме того, вы не должны редактировать работающий сайт, как уже было сказано ранее.

Рекомендация для администраторов: поместите следующий код в файл wp-config.php с заменой edit_themes, edit_plugins, и edit_files привелегий для всех пользователей. Это помешает пользователям уронить сайт посредством редактирования кода.

define('DISALLOW_FILE_EDIT', true);Также, отключите возможность редактирования файлов темы или установки плагинов для пользователей. Для этого поместите следующий код в файл wp-config.php.

define('DISALLOW_FILE_MODS', true);Учтите, вышеприведенные команды также отключат редактор файлов для тем и плагинов. Больше информации в WordPress Codex.

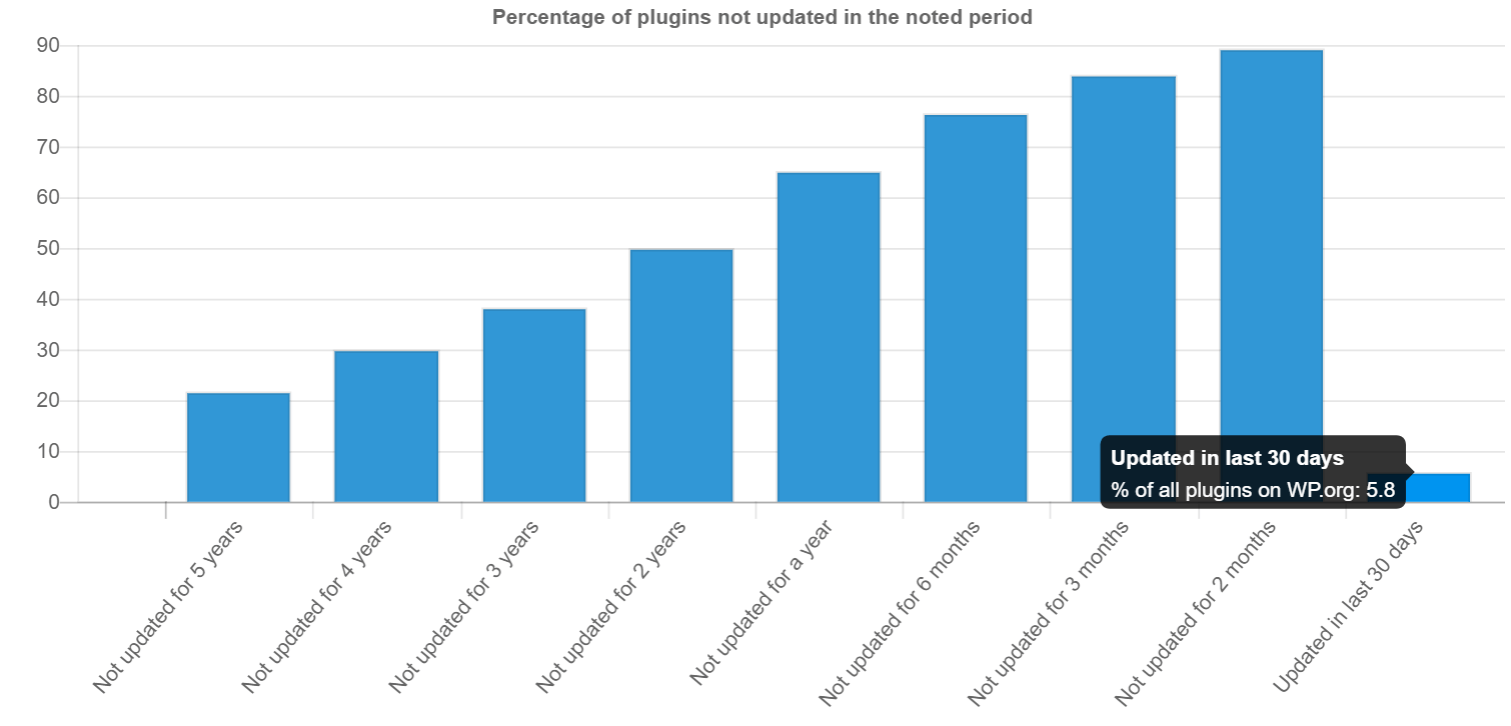

4. Не экономьте на темах и плагинах

Понятно, что вы хотели бы сэкономить пару долларов, но не стоит делать это за счет тем и плагинов. WordPress должен быть основой вашего сайта, а темы и плагины - это клей, держащий функционал проекта вместе. Старайтесь придерживаться авторитетных разработчиков при выборе плагинов. Заранее изучите историю поддержки продукта разработчиком, просмотрите рейтинги и прочитайте отзывы. Такое исследование может стать сложнейшей задачей, с учетом более чем 50.000 плагинов в каталоге WordPress.

Очень часто устаревшие или некачественные темы и плагины подвержены внедрению вредоносов или занимаются установкой вредоносного контента и ссылок на ваш сайт. Согласно исследованиям WP Loop, почти половина из всех опубликованных плагинов, не обновлялась уже более двух лет. Это одновременно шокирует и пугает.

Еще один источник плагинов и тем, который стоит изучить - это сторонние каталоги, предлагающие премиальные решения по низкой цене. При выборе этого источника, вы не поддержите разработчика. Кроме того, вы полагаетесь на ненадежный источник обновлений, что тоже не очень хорошо.

Ожидание обновлений установленных плагинов - это огромная проблема для пользователей WordPress, которые покупают решения в сторонних каталогах, вроде ThemeForest. Многие разработчики тем встраивают в них дополнительные плагины, такие как Revolution Slider или Visual Composer. Дело тут в том, что при обнаружении уязвимостей во встроенном плагине, пользователю приходится ждать обновления от разработчика темы, хотя сам плагин мог быть исправлен буквально сразу же. Это делает многие сайты очень уязвимыми для хакеров.

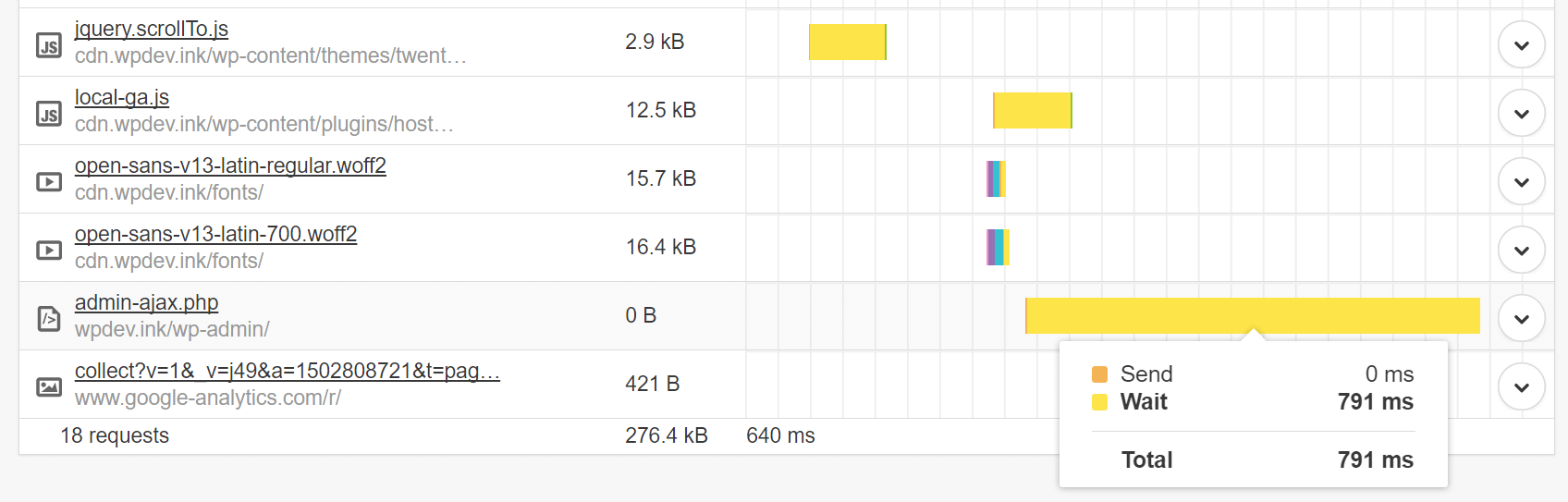

5. Контролируйте AJAX-запросы

Следите за тем, как используются AJAX-запросы на сайте, а также за плагинами, использующими AJAX. Например, API WordPress Heartbeat использует /wp-admin/admin-ajax.php для обращения к AJAX через браузер. Многие из этих обращений лишние. Особенно частое использование этого файла происходит при всплесках трафика и загрузке процессора. Это может существенно замедлить ваш сайт. Это чем-то похоже на запуск DDoS-атаки против себя самого.

Если есть сторонние плагины, использующие admin-ajax.php, убедитесь в том, что они взаимодействуют с ним правильно. Вы без труда можете отслеживать HTTP POST-запросы и, на основе имени, определять, каким плагином они вызваны. Например, тот, что обнаружил я, get_shares_count, оказался популярным плагином для взаимодействия с социальными сетями, который перегружал admin-ajax.php. На сайте с высоким трафиком, перегрузка выросла бы многократно.

Однако AJAX загружается только после загрузки самой страницы, так что, если вы видите соответствующие предупреждения в тесте скорости, не всегда проблема в AJAX.

6. Будьте аккуратны при работе с рекламными сетями и внешними сервисами

Большинство сайтов с высоким трафиком зарабатывают на рекламе, и отказ от сторонних поставщиков рекламных объявлений не представляется возможным. Тем не менее, важно, чтобы количество сторонних сервисов было минимальным - вы должны понимать, насколько сильно они нагружают ваш сайт.

Вот краткое сравнение того, как рекламные сети могут повлиять на ваш сайт на WordPress.

Параметры тестирования: на тестовый ресурс я добавил три объявления из Google AdSense, размером 300x250. На сайте установлена тема по умолчанию - Twenty Sixteen. Я замерил скорость загрузки до установке AdSense, и после.

До AdSense (результаты тестирования)

- Первая загрузка: 1,372 с.

- Повторная загрузка: 1,013 с.

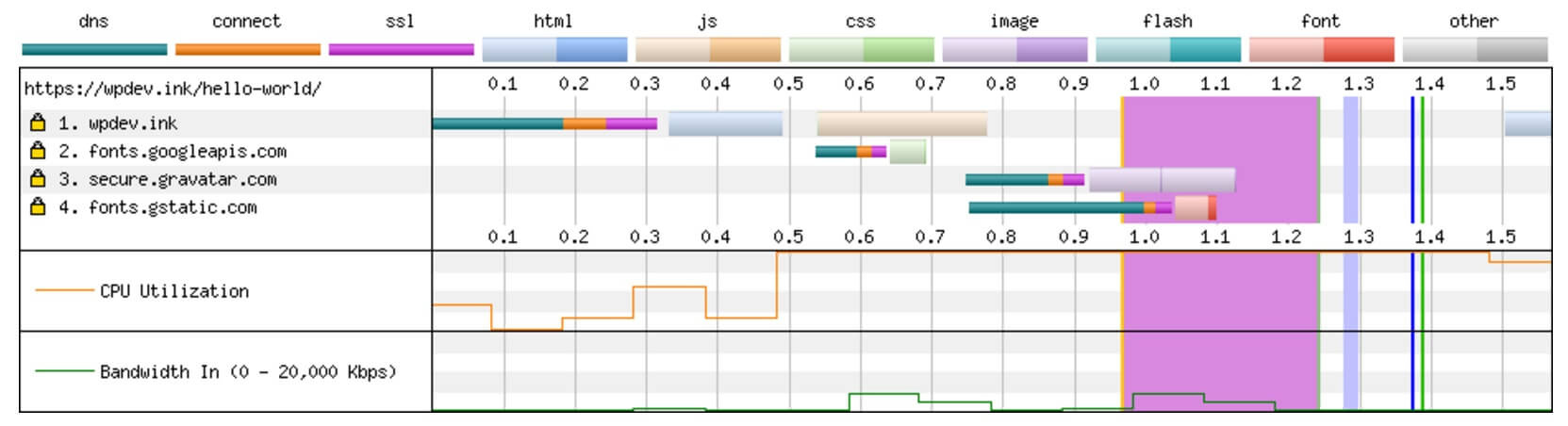

Разбивка содержимого по соединениям:

После AdSense (результаты тестирования)

- Первая загрузка: 4,103 с.

- Повторная загрузка: 3,712 с.

Разбивка содержимого по соединениям:

Просто установив 3 объявления Google AdSense, мы добавили 6 дополнительных подключений. Сайт на WordPress c рекламными объявлениями в 2,7 раза медленнее, чем без них. В основном это связано с дополнительным временем поиска DNS и использованием JavaScript на странице. Все это должно создать у вас картину происходящего на крупных сайтах, вставляющих 10 объявлений на одну страницу. Независимо от того, насколько быстрый хостинг вы используете, он не будет исправлять задержки от сторонних рекламных подключений.

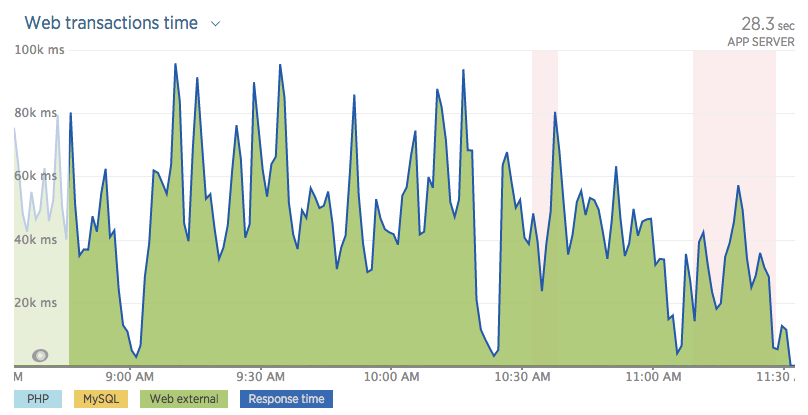

Ниже приведен еще один пример сайта с большим количеством внешних рекламных HTTP-запросов, что вызвало большую нагрузку на WordPress.

Было так много запросов, что сервер приложений вообще не загружался. Сайт был просто недоступен, пытаясь выполнить все внешние запросы.

Другим хорошим примером является сайт Huffington Post. Если вы проведете тест скорости загрузки, вы увидите огромное число HTTP-запросов к рекламным сетям. Быстрый тест показал скорость загрузки свыше 13 секунд!

- Первая загрузка: 15,908 с. | 221 HTTP-запрос

- Повторная загрузка: 13,957 с. | 66 HTTP-запросов

Но простое удаление рекламы маловероятно станет хорошим решением, ведь многие сайты большую часть дохода получают именно с нее. Придется заняться оптимизацией загрузки своих скриптов. Вы можете воспользоваться асинхронной загрузкой скриптов или отложить их загрузку, чтобы они не прерывали рендеринг ваших страниц. Когда дело доходит до производительности, всегда приходится балансировать между воспринимаемой и фактической производительностью.

Пример асинхронного JavaScript:

src="example.js" asyncПример отложенного JavaScript:

src="example.js" deferУ Патрика Секстона есть другой метод отсрочки JavaScript. WordPress версии 4.1 и выше, имеет фильтр, с помощью которого вы можете легко добавить атрибуты async или defer к своим скриптам.

Как правило, используя внешние службы, вы хотите кэшировать ответы. Зачем? Потому, что, если вы этого не сделаете, может возникнуть «проблема белого экрана смерти». Каждая внешняя служба, которую вы добавляете, должна быть из надежного и проверенного источника. В конце концов, если они упадут, это повлияет на весь ваш сайт или на ваши бизнес-операции.

7. Чрезмерная оптимизация может нанести вред производительности

В Интернете есть тысячи статей, дающих “советы” о том, как ускорить и оптимизировать сайт на WordPress. Но нет ничего хуже, чем когда пользователи чрезмерно оптимизируют свои сайты. Да, это происходит гораздо чаще, чем вы думаете. Владельцам сайтов WordPress часто кажется, что добавив чего-то, он удвоит скорость загрузки.

Ниже я перечислил несколько проблем, с которыми встречаюсь регулярно:

Попытка закэшировать кэш

В отличии от типичных VPS или обычных серверов, многие хостинги WordPress имеют собственное кеширование, которое выполняется на уровне сервера (например, Redis или Memcache). Многие провайдеры запрещают использование кэширующих плагинов, потому что их использование может вызвать все типы проблем, но чаще всего, 502 Bad Gateway. Попытка “закэшировать кэш”, как я это называю, никогда не является хорошей идеей.

Плагины, такие, как WP Rocket и Cache Enabler, великолепны, но они разрабатывались для серверов, которым необходима дополнительная помощь в ускорении вашего сайта. Рекомендую почитать подробнее о том, что касается кэширования объектов - популярной серверной формой кэширования, часто используемой сегодня.

2x CDN = 2x скорость загрузки, верно?

CDN действительно могут значительно уменьшить время загрузки контента в разных географических регионах, но только при грамотной настройке. Один из самых популярных сервисов - Cloudflare, технически является прокси-сервером, и немного отличается от обычного поставщика CDN, поскольку вы направляете к нему весь свой DNS, а не только содержимое сайта.

Обычно я вижу, как пользователи подключают Cloudflare, затем добавляют KeyCDN или MaxCDN вдобавок. Это часто происходит из-за того, что они читают чьи-то сообщения в блогах, где видят рекомендации попробовать новые сервисы. Они устанавливают новые сервисы, забывая про уже подключенные, и, хотя эта комбинация может работать при определенных сценариях, чаще всего, все заканчивается беспорядком. В большинстве случаев, стоит использовать либо Cloudflare, либо стороннего поставщика CDN, каждый из которых имеет свои преимущества и недостатки.

Огромное количество SEO-плагинов не обеспечивает более высокую позицию в поисковой выдаче

Вы хотите доминировать в поисковой выдаче, это понятно. Но ведь добавление 3 плагинов для SEO не поможет вам достичь этой цели. На самом деле, есть много проблем с совместимостью, возникающих при использовании All In One SEO, Yoast и других плагинов для SEO одновременно, например, вывод дублирующих метатегов. Установка дополнительных плагинов не гарантирует улучшение вашей поисковой оптимизации.

8. Популярные проблемы с производительностью легко диагностировать

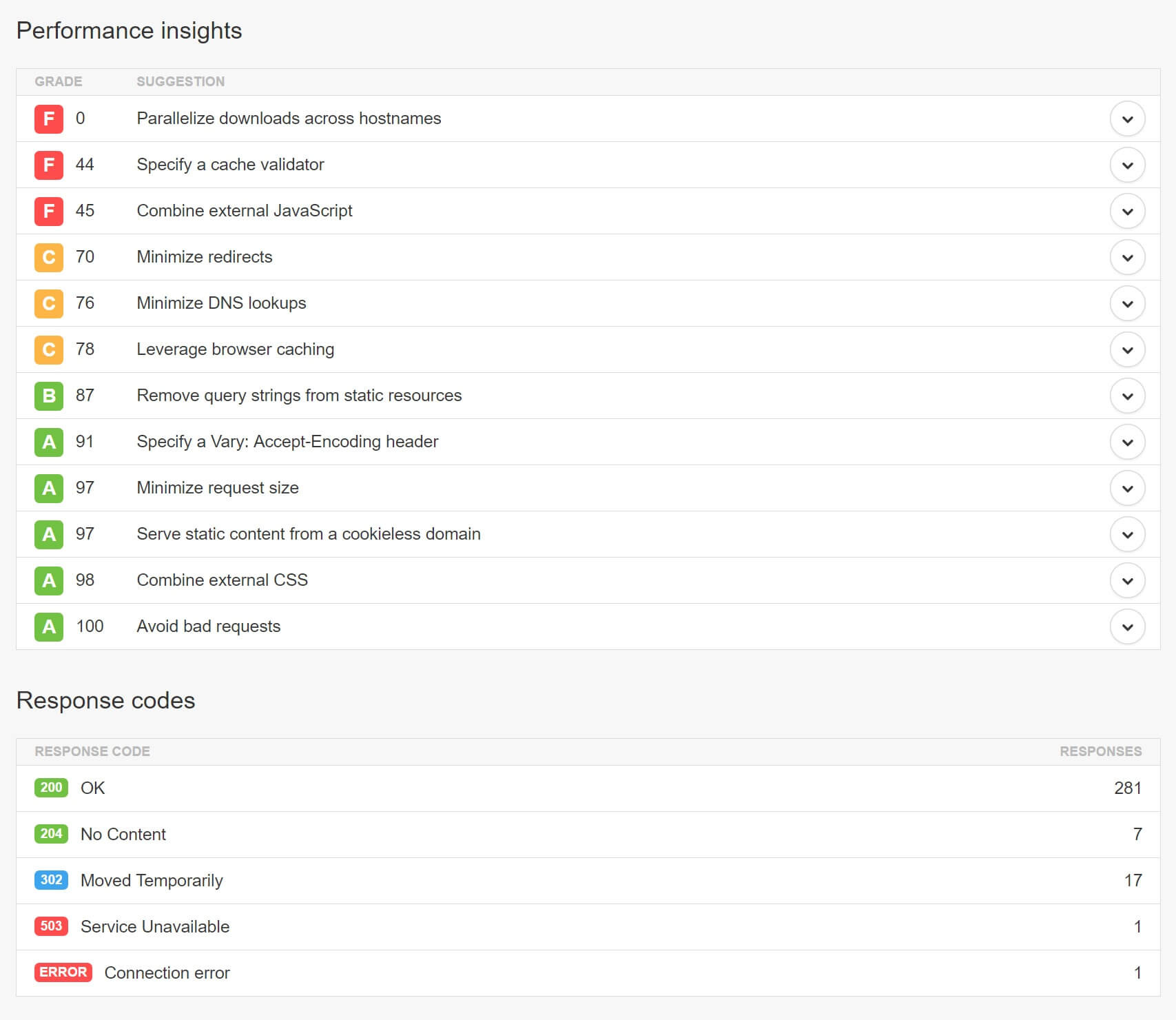

Даже если вы не являетесь продвинутым пользователем WordPress, общие проблемы с производительностью достаточно легко обнаруживать. Продвинутым пользователям я рекомендую пользоваться WebPageTest, поскольку он поддерживает последние протоколы HTTP/2. Для остальных подойдет Pingdom. Простой каскадный анализ покажет вам, есть ли у вас ненужные переадресации, отсутствующие файлы, избыток DNS-запросов или перегрузка сайта через сторонние скрипты или рекламные сети.

Взгляните на оценки производительности и коды ответов, и вы узнаете, с чего начать решение ошибок на вашем сайте.

9. Изменение ядра WordPress, это плохо

Возьмите за правило: внесение изменений в ядро WordPress, чтобы ваш код начал работать - это плохая идея. Особенно на работающем сайте. Такие манипуляции могут создать уязвимости на вашем сайте. А если вы не предусмотрели обновление изменений для новых версий ядра, ваши правки будут теряться с каждым новым обновлением WordPress. Лучше всего, если вы будете пользоваться встроенными инструментами и функциями WordPress, плагинами, дочерними темами и хуками.

10. Обеспечьте совместимость с PHP 7 и HHVM до переноса сайта

Известно, что PHP 7 и HHVM очень способствуют повышению производительности сайтов на WordPress. И конечно, всегда приятно использовать новейшее и самое лучшее. Но сначала стоит убедиться, что ваш сайт совместим с этими технологиями. Например, если вы обновляетесь с PHP 5.6 до PHP 7, вы должны протестировать все функции вашего сайта на WordPress в обкаточной среде или локально, чтобы убедиться, что проблем с совместимостью нет. Один устаревший, но очень важный для вас плагин, может не работать с PHP 7, что означает, что вам придется подождать его обновления, прежде чем переходить на более свежие технологические решения.

11. Крупные сайты должны заниматься оптимизацией баз данных

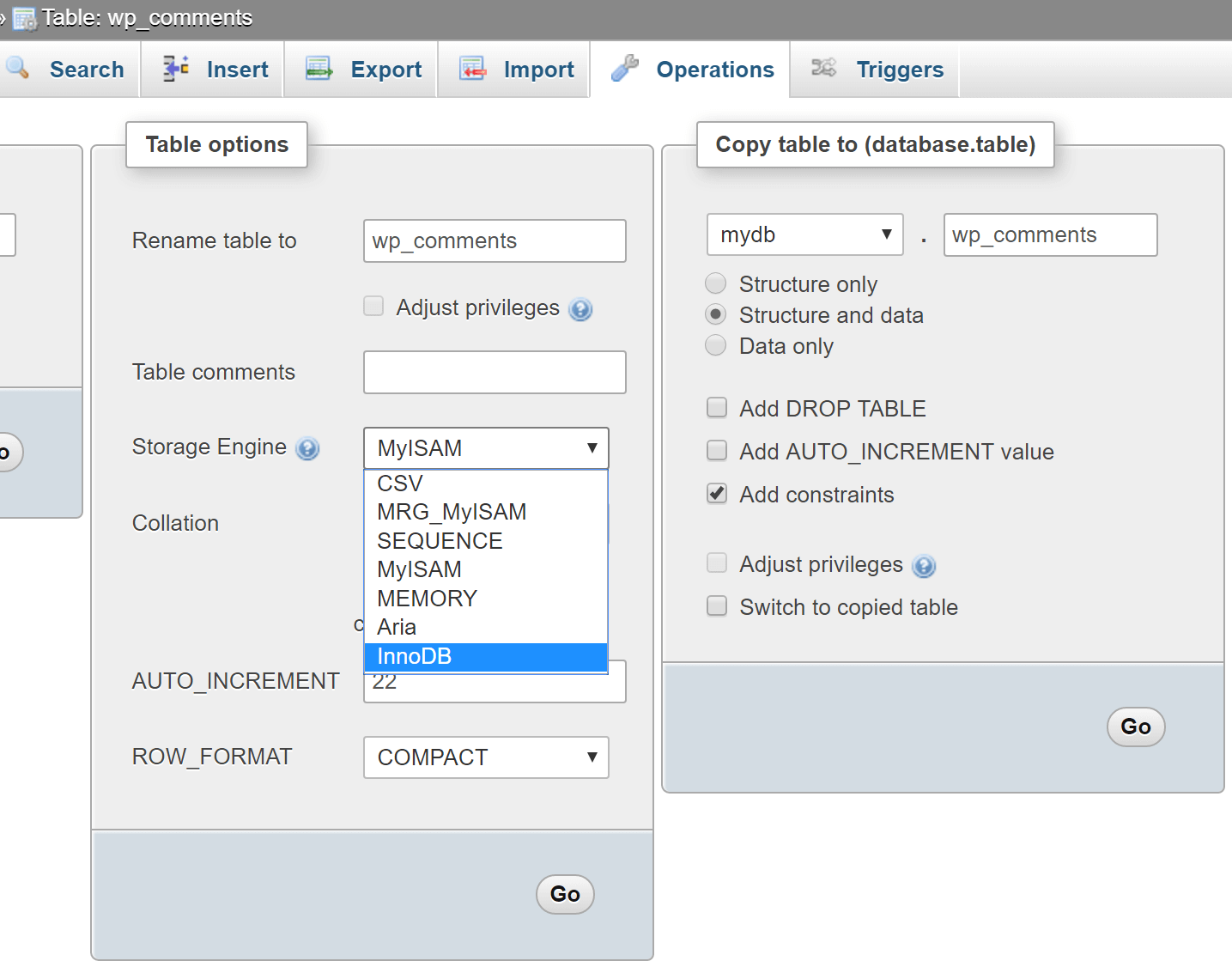

Один из самых простых способов замедлить работу большого сайта на WordPress - это не заниматься оптимизацией базы данных. Простые задачи, такие, как очистка следов старых версий WordPress или удаление неиспользуемых таблиц, могут защитить ваш сайт от замедления. Также, я заметил, что многие старые сайты все еще используют MyISAM в работе баз данных. InnoDB, на данный момент, является куда более быстрым и надежным решением.

Вы можете конвертировать свои таблицы всего в несколько простых действий. Для начала, убедитесь, что вы используете MySQL 5.6.4 или более новую, а также, что вы сделали резервную копию, в качестве меры предосторожности. В этом примере используется таблица wp_comments. Просто запустите команду ALTER, чтобы преобразовать для работы с InnoDB.

ALTER TABLE wp_comments ENGINE=InnoDB;Если же вы работаете с актуальной версией phpMyAdmin, вы можете открыть нужную таблицу, перейти во вкладку “Операции” и изменить механизм хранения там.

Еще один простой способ оптимизации - это отключение или ограничение количества хранимых исправлений в базе данных. Вы можете добавить в свой wp-config.php следующее, чтобы полностью их отключить.

define('WP_POST_REVISIONS', false );Или просто измените их количество, хранимое для каждого поста или страницы:

define('WP_POST_REVISIONS', 3);Мне попадалось множество сайтов с более чем 200 версий постов. Если у вашего хостинга нет внутренней оптимизации, настройки WordPress придется задавать вручную, ведь по умолчанию, он будет хранить неограниченное число исправлений.

Если на вашем сайте сохранено множество изменений, вы можете запустить этот сценарий в phpMyAdmin, чтобы их удалить:

DELETE FROM wp_posts WHERE post_type = "revision";Вы также можете воспользоваться плагином WP-Optimize для этих целей.

12. Действительно ли вам необходима универсальная тема?

Существует огромная проблема, которую я наблюдаю в сообществе WordPress. Люди покупают универсальные темы, а используют лишь 1% её функционала или и того меньше. Они смотрят на демо-страницы и видят красивые слайдеры и кастомизированные блоки, которые убеждают их в необходимости приобретения, однако, на самом деле, эти возможности могут никогда им не пригодиться. Можно купить более простую и менее функциональную тему, и тем самым, сэкономить и деньги и время, которое, в итоге, будет затрачено на ее оптимизацию, ведь простая тема будет быстрее прямо “из коробки”.

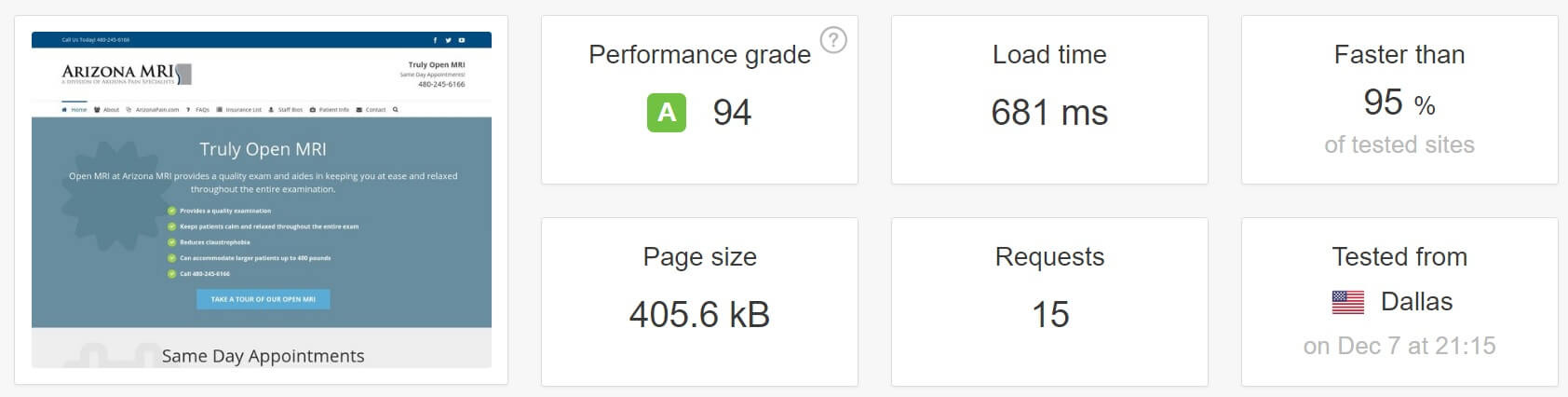

Я не хочу сказать, что все универсальные темы плохие. На самом деле, при грамотной настройке, они могут работать очень быстро - вот пример с темой Avada, которая загружается за 700 мс.

Однако для оптимизации существующей темы потребуется много знаний и времени. Для большинства пользователей WordPress, если они не используют и половину функционала темы, использование более простых тем - это выход. Не позволяйте красивым баннерам и причудливым слайдерам дурачить вас. Чаще всего, весь этот набор опций будет лишь замедлять ваш сайт.

13. Лог ошибок - ваш друг

Если вы знаете, как вести себя с файлами WordPress и файлом wp-config.php, журнал ошибок может сослужить вам хорошую службу. Регулярно проверяя его, вы спасете себя от всевозможных головных болей, а также глубже изучите работу WordPress. Мало кто из пользователей заглядывает в лог перед обращением за помощью к техподдержке хостинга. С помощью нескольких простых настроек в wp-config.php, вы сможете включить ведение журнала ошибок, который по умолчанию сохраняется в /wp-content/debug.log.

Включение логирования:

define( 'WP_DEBUG_LOG', true );Вывод логов на странице:

define( 'WP_DEBUG_DISPLAY', true );Подробнее в WP_DEBUG codex.

14. Google здесь не просто так

Не бойтесь искать ответы в Google. Интернет полон подсказок и решений. В течение пары минут, вы можете исправить большинство ваших проблем. Ответы на типичные вопросы, вроде “как изменить DNS в GoDaddy” или “как пользоваться sFTP”, легко могут быть найдены в Google.

В Интернете есть крупные ресурсы, посвященные работе с WordPress, такие, как StackExchange и WordPress Codex, не говоря уже о сотнях блогов с обучающими статьями.

Кроме того, у хорошего хостинга WordPress, вероятнее всего, есть собственная удобная база знаний, которая поможет пользователям находить ответы на вопросы, а хостингу - сократить время на поддержку пользователей в типовых случаях.

15. 123456 больше не допускается

SpashData собирает список наиболее часто используемых слитых паролей (более 2 млн.) каждый год. Неудивительно, что в 2015 году самым популярным паролем был “123456” - тот же, что и в 2014 году. Это довольно неприятно для хостингов, так как использование таких паролей держит сайты буквально в шаге от взлома. Одним из лучших решений является использование KeePass или его аналогов. Зашифрованный пароль в облаке всегда намного безопаснее, чем “123456”.

16. Скрипты не всегда должны загружаться по всему сайту

К сожалению, в отличии от статического веб-сайта, который контролируется вручную, сайт на WordPress находится во власти разработчиков тем и плагинов. И далеко не все разработчики заботятся о производительности своих решений. Существует огромное количество плагинов, которые загружают свои скрипты на все страницы сайта, хотя сам плагин применяется только на одной из них. Если учесть, что плагинов может быть несколько десятков, проблема множится, а сайт замедляется.

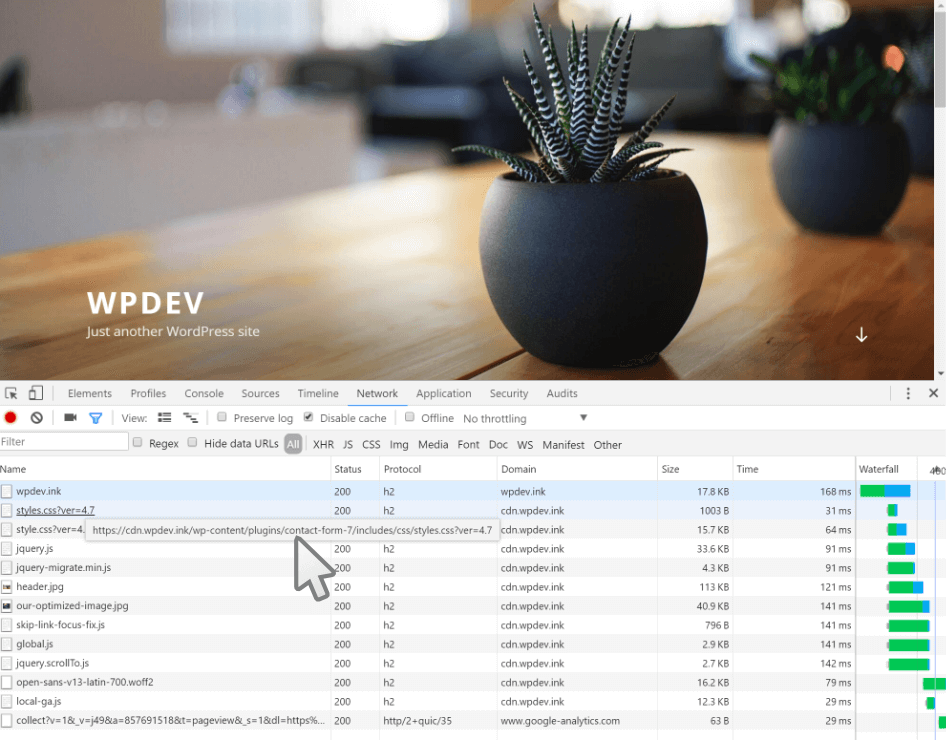

Один из таких примеров - популярный плагин Contact Form 7. Как показано ниже, он загружает файлы CSS и JavaScript на домашнюю страницу сайта, хотя там не используется ни одной контактной формы.

Есть несколько способов это исправить. Первый - использовать функцию wp_dequeue_script(), введенную в WordPress 3.1. Она позволяет удалять скрипты из очереди загрузки на вашем сайте. Вот пример использования этой функции с Contact Form 7. Разработчик Contact Form 7 также имеет документацию о том, как использовать JavaScript и CSS только там, где это необходимо.

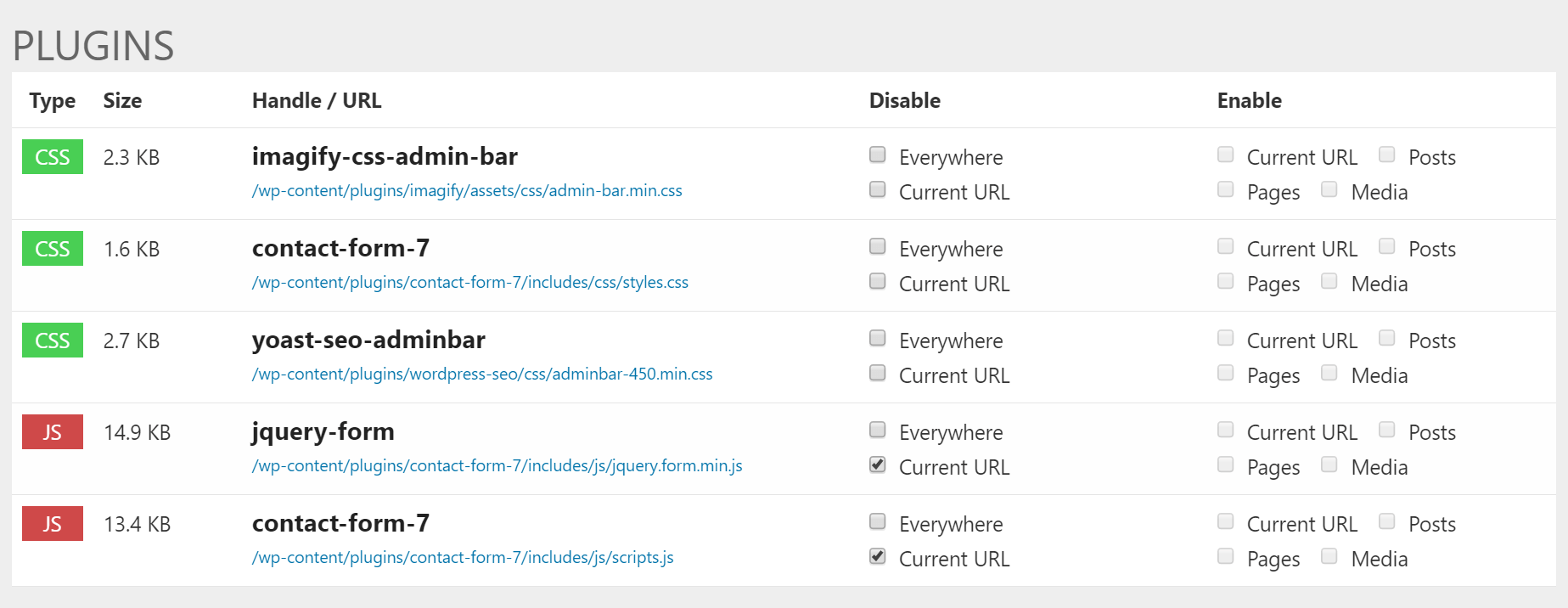

Второй способ - использовать специальные плагины для WordPress, например, Gonzalez или Plugin Organizer. Ниже приведен пример использования Gonzalez на нашем сайте. Удобное окно настроек позволяет за пару щелчков мыши убрать JavaScript и CSS файлы плагина Contact Form 7 со всех страниц, кроме страницы контактов, тем самым, увеличив скорость загрузки остального сайта.

Заключение

Существуют причины, по которым WordPress используется на более чем 28% всех веб-сайтов. Это очень надежная, удобная и многофункциональная CMS. Каждый, от авторов домашних блогов до нескольких сотен компаний, полагается на него каждый день. Так же, как и большинство платформ, если использовать WordPress неправильно или не заниматься его оптимизацией, работа с ним может быстро превратиться в головную боль.

Это перевод статьи «Creating Better, Faster And More Optimized WordPress Websites» за авторством Brian Jackson.

|

Метки: author ScarletFlash высокая производительность wordpress перевод оптимизация mysql css javascript хостинг |

gdb-дуэль — списки, деревья и хэш таблицы против командной строки |

Первый раз я увидел команду

duel в gdb на каком-то древнем IRIX-е, лет пятнадцать назад. Это была невероятно крутая штука для просмотра разных связанных списков, массивов структур, и прочих подобных конструкций. Помечтал, мол, если б в Линуксе такая была, и забыл. Лет десять назад вспомнил, погуглил — оказалось, что DUEL, это вообще-то патч 93-го года для gdb 4.6, а вовсе не что-то уникальное в IRIX. Только автор по идейным соображениям выпустил его как public domain, а gdb-шники были тоже идейные и хотели GPL, так что попасть в upstream этому патчу не грозило. Я портировал его на тогдашний gdb 6.6.2, отдал в gentoo и до выхода 7-го gdb наслаждался жизнью. Потом duel из gentoo выкинули, портировать на новый gdb было сложно, никто не взялся. А недавно я его попробовал оживить. Только вместо патча (надо собирать вместе с gdb из исходников, использует всякие внутренние gdb-шные функции) я его написал с нуля на питоне. Теперь Duel.py (так называется новая реализация Duel-а) грузится в gdb на лету, и, надеюсь, Python API не будет меняться от версии к версии так, как недокументированные gdb-шные потроха. Итак, встречайте: DUEL — высокоуровневый язык анализа данных для gdb.Примеры

Сразу, чтоб показать, на что он способен:

(gdb) dl table_list-->next_local->table_name

tables->table_name = 0x7fffc40126b8 "t2"

tables->next_local->table_name = 0x7fffc4012d18 "t1"

tables-->next_local[[2]]->table_name = 0x7fffc4013388 "t1"

Это из отладки MariaDB. Команда проходит односвязный список структур

TABLE_LIST и для каждого элемента списка выводит TABLE_LIST::table_name.(gdb) dl longopts[0..].name @0

longopts[0].name = "help"

longopts[1].name = "allow-suspicious-udfs"

longopts[2].name = "ansi"

<... cut ...>

longopts[403].name = "session_track_schema"

longopts[404].name = "session_track_transaction_info"

longopts[405].name = "session_track_state_change"

Оттуда же (я вырезал адреса, чтоб не захламлять текст). Есть массив структур, задающий опции командной строки. Команда выводит только имена опций, проходя весь массив до

name == 0. А можно просто посчитать, сколько их:(gdb) dl #/longopts[0..].name @0

#/longopts[0..].name@0 = 406

Основная идея

Duel построен на том, что выражение может возвращать много значений. Например,

(gdb) dl 1..4

1 = 1

2 = 2

3 = 3

4 = 4

или вот

(gdb) dl my_long_options[1..4].(name,def_value)

my_long_options[1].(name) = "allow-suspicious-udfs"

my_long_options[1].(def_value) = 0

my_long_options[2].(name) = "ansi"

my_long_options[2].(def_value) = 0

my_long_options[3].(name) = "autocommit"

my_long_options[3].(def_value) = 1

my_long_options[4].(name) = "bind-address"

my_long_options[4].(def_value) = 0

При этом такие выражения-генераторы допускается использовать везде, где ожидается одно значение. Это можно рассматривать как автоматический цикл по всем возможным значениям. А во втором примере даже два цикла, по индексам массива и по полям структуры. Такая штука работает очень хорошо, когда надо пройтись по массиву, или списку, или, например, дереву. Специальные операторы позволяют удобно записывать условия остановки генератора.

Операторы

Синтаксис похож на С, и C-шные операторы работают, как обычно. Гораздо интереснее, новые, специфичные для DUEL, операторы. Рассмотрим самые полезные из них:

Диапазон и перечисление, .. и ,

Выше я приводил пример обоих операторов. Это знакомые конструкции, они есть и в других языках. При этом в диапазоне можно опустить один из концов. Если указать только конец диапазона, например,

..20, то диапазон начнется с нуля и в нем будет 20 значений, так же, как если бы было написано 0..19. Если же указать только начало, то получится открытый диапазон! Чтобы duel не продолжал генерировать числа до тепловой смерти вселенной (или до переполнения счетчика, смотря что случится раньше), вместе с открытым диапазоном обычно используют оператор остановки по условию, @.Остановка по условию, @

В выражении

x@y, выражение x будет генерировать значения до тех пор, пока y ложно. Например,(gdb) dl arr[0..]@(count > 10)

И duel будет выводить элементы массива

arr[] до тех пор, пока arr[i].count будет не больше десяти.Как удобное сокращение, можно в качестве второго операнда использовать константу. Тогда генерация остановится, когда выводимое значение сравняется с этой константой. То есть,

(gdb) dl str[0..]@0

вернет все символы строки, вплоть до

'\0'. Более практичный пример — вывести все опции командной строки из argv:(gdb) dl argv[0..]@0

argv[0] = "./mysqld"

argv[1] = "--log-output=file"

argv[2] = "--gdb"

argv[3] = "--core-file"

Хотя тот же эффект достигается и

(gdb) dl argv[..argc]

argv[0] = "./mysqld"

argv[1] = "--log-output=file"

argv[2] = "--gdb"

argv[3] = "--core-file"

Перейти по указателю, -->

Генератор

a-->b порождает множество значений a, a->b, a->b->b, и так далее, пока не уткнется в NULL. Я уже приводил пример, как таким образом можно пройтись по односвязному списку. Но это точно так же работает и для деревьев, например:(gdb) dl tree-->(left,right)->info

Вычисляющие скобки {}

Фигурные скобки работают как обычные круглые, но они дополнительно заменяют выражение его значением при выводе. Проще показать на примере:

(gdb) dl i:=5

i = 5

(gdb) dl i+6

i+6 = 11

(gdb) dl {i}+6

5+6 = 11

(gdb) dl {i+6}

11 = 11

Это, в основном, нужно для массивов:

(gdb) dl if (my_long_options[i:=1..20].name[0] == 'd') my_long_options[i].name

if(my_long_options[i].name[0] == 'd') my_long_options[i].name = "debug-abort-slave-event-count"

if(my_long_options[i].name[0] == 'd') my_long_options[i].name = "debug-assert-on-error"

if(my_long_options[i].name[0] == 'd') my_long_options[i].name = "debug-assert-if-crashed-table"

if(my_long_options[i].name[0] == 'd') my_long_options[i].name = "debug-disconnect-slave-event-count"

if(my_long_options[i].name[0] == 'd') my_long_options[i].name = "debug-exit-info"

(gdb) dl if (my_long_options[i:=1..20].name[0] == 'd') my_long_options[{i}].name

if(my_long_options[i].name[0] == 'd') my_long_options[16].name = "debug-abort-slave-event-count"

if(my_long_options[i].name[0] == 'd') my_long_options[17].name = "debug-assert-on-error"

if(my_long_options[i].name[0] == 'd') my_long_options[18].name = "debug-assert-if-crashed-table"

if(my_long_options[i].name[0] == 'd') my_long_options[19].name = "debug-disconnect-slave-event-count"

if(my_long_options[i].name[0] == 'd') my_long_options[20].name = "debug-exit-info"

Тут фигурные скобки сразу показывают, какие элементы массива удовлетворяют условию.

Фильтры

|

Метки: author petropavel отладка c++ gdb |

Бизнес на данных: стероиды для компании |

Данные о клиентах — это актив наравне с вашими основными и оборотными средствами. Если вы их правильно собираете, храните, обрабатываете и интерпретируете, то у вас есть все шансы получить пул лояльных покупателей и увеличить свою прибыль.

На самом деле, бизнес не всегда собирает информацию о клиентах — точнее, ту информацию, которой будет достаточно для выстраивания именно отношений, а не попыток выцепить пару дополнительных продаж email или SMS-рассылкой. Даже по нашей предыдущей статье и комментариям к ней можно судить о том, какая информация чаще всего собирается: ФИО, контакты, что и когда купил. Этого мало. Поверьте опыту CRM-щиков: какую систему бы вы ни взяли, в карточке клиента предусмотрено множество полей, заполнение которых делает клиентскую базу более качественной.

В процессе разработки RegionSoft CRM мы также сделали карточку главной сущностью системы. В ней предусмотрено много вкладок, которые включают всю коммерческую информацию: от банальных контактов до аспектов финансовой безопасности. Все действия, документы, сделки, логи звонков и т.д. также доступны из карточки клиента. Таким образом, пользователи CRM-системы получают максимум данных, доступ к которым обеспечивается буквально в пару кликов.

Сбор данных помогает подходить к каждому клиенту индивидуально, исходя из его потребностей и профиля. Подобная персонификация делает покупку более ценной для клиента и прибыльной для вас — всё потому, что покупатель получает то, что хочет именно он.

Всем очевидно, но мы напомним, что отдавая свою личную и финансовую информацию вам, клиенты рассчитывают, что она останется в безопасности (все знают про ужесточение 152-ФЗ с 1 июля?) и вы не будете злоупотреблять доверием, как то продавать данные третьим лицам, спамить пару раз в день, небрежно хранить данные и т.д. Кстати, есть такая распространённая ситуация, как уход менеджера с клиентской базой. Это одна из проблем, частичное решение которой лежит на CRM-системе. Так вот, если ваш менеджер «уводит» или продаёт данные, это двойная проблема: во-первых, потеря части клиентской базы, а во-вторых, передача информации третьим лицам, которые потенциально будут извлекать коммерческую выгоду. То есть фактически компания не справилась с защитой переданных ей данных.

Какие данные собирать и зачем?

Персональные данные

Вообще собирать нужно любые данные — хорошая аналитика не знает мелочей и не терпит пренебрежительного отношения к фактам. Прежде всего, бизнесу нужны контактные данные клиента, его демографические и географические данные, а также информация, соответствующая целям компании (например, сколько лет машине для автосалона или какой марки телефон для салона связи). Эти данные собираются в процессе первых взаимодействий и с помощью персонального анкетирования (привет, 152-ФЗ, анкеты с определёнными данными надо также хранить особым образом).

Кстати, если вы думаете, что персональные параметры типа марки машины есть только в секторе В2С, то вы ошибаетесь: в В2В-секторе тоже есть предпочтения, которые потенциально могут сказаться на ваших взаимоотношениях. Это, например, наличие или отсутствие корпоративного транспорта, особенности корпоративной культуры, предпочтительное программное обеспечение, марки и модели рабочих ПК и т.д.

Транзакционные данные

После того, как собраны персональные и анкетные данные, важно тщательно собирать данные транзакционные: все точки взаимодействия с клиентом должны записываться. Из транзакционной информации также становится ясно, насколько ценен клиент, как часто и много он тратит, насколько быстро оплачивает счета и не формирует ли дебиторку, каковы его предпочтения. В транзакциях не существует мелочей, менеджерам стоит фиксировать всё: от протоколов личных встреч до фактов неответа на звонок. Транзакционная информация даст вам понять, насколько клиент контактен, разговорчив, что и когда он покупает, с какой периодичностью обращается в техническую поддержку, можно ли ему доверять. И такая информация — не просто источник допродаж, но и способ решить конфликтные ситуации.

Сравнительно недавно с нами произошла история, когда наша CRM-система нас же самих и выручила — всё потому, что менеджеры записывают в неё каждую мелочь, а в карточке хранятся документы, история переписки и записи переговоров. Дело было так: пользователь на публичном ресурсе обвинил нас в том, что наш продукт сырой и часть функциональности работала не так, как это ожидалось. Выпад с его точки зрения был красивым. Однако мы подняли информацию и нашли в его карточке клиента много опровержений его словам, а также гарантийное письмо, в котором он отказывался от претензий к продукту, который настоятельно купил в бета-версии. Нападение было отбито. Вообще, когда все данные и транзакции записаны, компанию максимально сложно опорочить лживыми сведениями — на вашей стороне будут факты.

Коммуникационные данные

Ещё один важный блок информации — коммуникационный. Прежде всего, нужно замерять время ответа клиента на письма, звонок, иные сообщения, считать количество входящих и исходящих коммуникаций. Обязательно отслеживать и анализировать, на какие воздействия клиент лучше реагирует: так, интроверт выберет электронную почту и с удовольствием будет общаться в чате, а занятый человек предпочтёт быстрые телефонные переговоры или редкие письма. Это позволит компании сделать общение комфортным и деловым, а не превратить его в надоедливый спам.

Откуда брать данные о клиентах?

Источников много, и у каждой компании есть свои секреты добычи ценной для бизнеса информации. Единственное важное условие — все методы должны быть законными, а данные — «чистыми». Иначе можно нарваться на штраф и в условиях вездесущего интернета поплатиться репутацией.

- Информация при регистрации на сайте. Создавайте формы на сайте, которые помогут вам собрать данные от клиентов. Правила: не требуйте данные за незначительные бонусы (типа скачивания рекламного буклета), собирайте данные поэтапно (часть — при регистрации, часть — во время совершения заказа), не забудьте прописать политику обработки данных (вы же всё ещё помните про 152-ФЗ?).

- Информация с онлайн-презентации. Постарайтесь собрать данные при оформлении заявки, а также во время общения с клиентом. Правила: задавайте наводящие вопросы, подготовьтесь к работе с клиентом заранее, сформируйте стандартную анкету (например, в RegionSoft CRM анкетирование — встроенная функция).

- Информация из чата. Спросите имя и электронную почту в чате. Многие приложения имеют встроенную возможность запроса информации о клиенте. Правила: не используйте назойливые всплывающие кнопки «перезвонить», в случае нежелания оставить свои данные клиент должен иметь возможность продолжить чат на сайте.

- Информация из телефонных переговоров. Уточняйте необходимые данные во время общения по телефону с клиентом. Правила: записывайте звонки и сохраняйте их, это даст возможности для обучения менеджеров и избавит вас от сотен конфликтных ситуаций (мы предусмотрели такую штуку — в RegionSoft CRM все разговоры записываются и сохраняются).

- Информация из заказов на сайте или в интернет-магазине. При оформлении заказа можно собрать много разнообразной информации, от наличия детей до предпочтительных способов оплаты. Неплохой результат дают анкеты по результатам покупки или сервиса. Правила: не перегружайте поля лишними вопросами, клиент может отказаться от покупки. Предоставьте формальный бонус за полную регистрацию или же предложите подключиться к бонусной системе после заполнения подробной анкеты.

- Информация в обмен на информацию. Предлагайте полезную информацию в обмен на данные клиента. Это могут быть интересные рассылки, статьи, видео уроки и т.д. Правила: не скатывайтесь в инфобизнес и не гоните дешёвый контент, работайте над содержанием.

- Личное общение в продажах. Во время разговора с клиентом менеджеры могут выяснить потребности клиента, задачи на будущее и многое другое. Кстати, наводить справки о клиенте в Интернете тоже никто не запрещает. Правила: не будьте слишком навязчивы, не настаивайте на своих вопросах, если клиент их намеренно и жёстко обходит.

- Интернет вещей (IoT). Отлично работает для ритейла, B2C. Поставьте NFC-метки, счётчики потока клиентов, интерактивные экраны — так ваши покупатели расскажут о себе сами. Правила: всё должно быть в рамках закона.

- Системы аналитики. Самый щедрый и безопасный способ сбора данных. Используйте привычные Яндекс.Метрику и Google Analytics, расширяйте свой арсенал систем BI, используйте трекеры, парсеры и т.д. Правила: информация на вас буквально польётся, но это не значит, что вы сможете её правильно обработать и интерпретировать. Выбирайте и используйте ценные данные, сравнивайте, ищите новые закономерности.

- Социальные сети. По нашему мнению, способ на любителя и практически всегда только для В2С. Однако, если вы сможете собрать данные из социальных сетей и правильно их использовать то это нужно делать, поскольку лишний источник не помешает. Правила: помните о приватной части жизни ваших клиентов.

- Заказные исследования — как целевых групп, так и потенциальных пользователей в целом. Отличный метод, в результате работы которого вы получите наглядный информативный документ с выводами и даже рекомендациями. Дорого. Очень дорого. Правила: используйте этот способ только, если он целесообразен. Перед заказом исследования проведите анализ, установите цели, которые вам нужно достичь, и гипотезы, которые нужно проверить в ходе исследования.

— Там, куда ты копаешь, откуда ты возьмёшь новую одежду, Как ты рассчитываешь преодолеть забор?

— Да кто ты?!

— Я бизнес-аналитик.

Как хранить информацию?

Как мы уже успели выяснить, адептов Excel у нас в стране достаточно — собственно, это и есть один из распространённых способов хранения клиентской базы среди тех предприятий, которые еще не внедрили CRM-системы. В какой-то мере он даже удобный и привычный широкому классу работников, но, конечно, один из самых небезопасных. Также у офисных работников есть привычка хранить все контакты и взаимодействия в почтовых клиентах. Это также чревато проблемами с безопасностью (особенно, если речь идёт о бесплатных почтовых приложениях), потерей данных, «уходом» базы вместе с менеджером.

Для хранения и анализа информации наиболее эффективно, безопасно и целесообразно использовать CRM-системы. Они, кстати, уже эволюционировали и объединяют в себе несколько решений: управление проектами и задачами, персональное и групповое планирование, телефонию и т.д.

Стоит помнить про два важных правила работы с клиентскими данными. Первое: не собирайте всю информацию сразу — взаимодействуйте дозированно и извлекайте ценные данные из каждого взаимодействия. Второе: не экстраполируйте информацию об одном клиенте или узкой группе на всю клиентскую базу или даже широкий сегмент. Вероятнее всего, вы ошибётесь с выводами и предположениями, что сделает продажи на данных неэффективными. И да, не забудьте оставить возможность отказаться от рассылок и взаимодействия с вами.

Методы сбора и обработки информации

Конечно, информация, способы её обработки и аналитические инструменты сильно отличаются от компании к компании. В любом случае, собранные данные должны быть обработаны и использованы, простое их наличие — не рецепт успеха, в «сыром» виде они бесполезны.

- Документы, справки, заявления и прочие бумаги -такой способ хорош для получения официальных данных. Плюс — точная и всеобъемлющая информация, минус — сбор требует времени, много законодательных ограничений (чаще всего нет согласия на обработку персональных данных и нужно исхитриться его получить).

- Анкетирование, опросы — отличный метод, когда нужно собрать специфическую информацию в сжатые сроки. Плюс анкет в их добровольности и иногда — анонимности, минус — в необходимости найти способ получить ответы от респондентов, в ошибках при заполнении и ложной информации.

- Телефонное или личное интервью — хороший способ «приблизиться» к клиенту, «снять» психологический портрет и получить нужные данные. Плюс — в общении с клиентом и охвате данных, минус — требует время и трудозатраты, интервьюеры должны быть обучены.

- Наблюдение — прекрасный способ для бизнеса, который знает, что он хочет. Информация о пользователях собирается со стороны и выглядит как умозаключение. Плюс — никаких законодательных ограничений, минус — трудности в персонализации, интерпретации и классификации данных.

- Исследования — собственные и заказные. Очень хороший источник информации, даёт полную корректную картину, позволяет выявить сложные и неочевидные тренды и закономерности. Плюсы — мощное средство сбора информации. Минусы — либо у профессионалов и дорого, либо самостоятельно и долго, с подготовкой и внимательной проработкой каждого вопроса панели, а также связок между вопросами. Об ошибках любительских исследований мы писали на своём примере.

- Фокус-группы — умерли. Шутка с долей шутки. Достаточно дорогое и глубокое исследование целевых групп с возможностью опроса, обсуждения и т.д. Плюсы — быстрый способ получить много информации, одновременное продвижение продукта в группе. Минусы — очень дорого, требует профессионального анкетирования, сложно собрать группу. А вымирают, потому что продвинутый бизнес ищет более дешевые цифровые способы и старается избегать грубых обобщений.

Бизнес инвестирует в аналитику (как минимум, платит за софт и зарплату маркетологам, аналитикам и сопровождающим программистам), а значит, должен получать отдачу от инвестиций. То есть информацию мало получить — её важно уметь проанализировать. Мы уже писали о принципах аналитики в бизнесе, но повторим несколько базовых способов применения этого актива.

- Оперативная аналитика: разведка и работа с данными при продвижении продукта, оперативная отчетность.

- Описательная аналитика: сегментация потребителей, создание портрета клиента, разработка программы лояльности.

- Предиктивная аналитика: прогнозы, предсказания, поведенческие паттерны.

Что считать и как не облажаться?

Есть целая группа информации, которую собирать строго обязательно любому бизнесу, поскольку она отражает его «здоровье» и адекватность требованиям клиентов.

- Считайте конверсию и пользуйтесь воронкой продаж. Данные о том, сколько входящих обращений превратились в покупки, сразу скажут вам, насколько корректно работает коммерческая служба и насколько правильно выстроена логика реализации.

- Постоянно пересматривайте ассортимент, используйте товарные матрицы и ABC-анализ. Это касается не только магазинов или интернет-магазинов, но и компаний с узким продуктовым ассортиментом (например, компании-разработчики софта). В случае низкого спроса на продукт, вы сможете его переработать или прекратить работу над ним, перебросив усилия на более перспективные направления.

- Измеряйте каналы продаж. Трудно найти компанию, которая продавала бы свой продукт через один канал. Проверяйте, все ли каналы рентабельны, чтобы избежать утечки денег на те, которые имеют самую высокую цену продажи. Но не попадите в типичную ловушку: канал может иметь высокую цену продажи, но эффективно поддерживать, продвигать, приводить лиды. Обязательно учитывайте это.

Пример из жизни. Компания продавала свои сервисы и свои продукты через монобрендовые салоны, дилеров, агентов, почтовые киоски и отделения, интернет-магазин. после исследования выяснилось, что цена продажи в монобренде в 10 раз выше средней цены по каналам. Закрыли два монобренда — выручка от подписок в полугодовом периоде ощутимо снизилась. Оказалось, что монобренды приносили самых высокодоходных и лояльных клиентов, которые приходили в салон с «серьёзными намерениями», а не брали продукт «на погонять недельку».

- Финансовые и денежные потоки. Обязательно отслеживайте, откуда точно приходят деньги и куда они уходят. Любая агрегация и укрупнение показателей в таких делах — худшее, что может случиться.

- Информация по технической поддержке клиентов. Анализируйте количество обращений, качество обслуживания, длительность общения клиента с сотрудником, собирайте отзывы и предложения — среди них иногда находятся потрясающие инсайты. И да, в наше ультра конкурентное время выигрывает тот, у кого лучше сервис.

- Информацию по персоналу. Обязательно анализируйте внутренние процессы — и это точно не опоздания и не интернет-логи. если человек работает продуктивно и дает вам запланированный результат, зачем его контролировать и провоцировать на нелояльность. Анализируйте KPI, скорость выполнения задач, пробуйте оценить, какие задачи кому удаются лучше и исходя из этого выстраивайте команду.

- Информационный шум вокруг вашей компании. Собирайте максимум внешней информации о вашей компании: отзывы, упоминания, цитирования и т.д. Чем больше вы заметны на рынке, тем больше шума. Но даже небольшие компании обязаны мониторить абсолютно всё во избежание репутационных потерь или во имя использования удачного момента. Тут вам на помощь придут специальные запросы в поисковиках, google alerts и т.д.

- Информацию о конкурентах. Вы должны знать о них всё — но не только для того, чтобы скопировать лучшее, а для того, чтобы отстроиться и занять свою нишу. Тщательно изучайте своих соперников по рынку, не оставляйте без внимания новые продукты, изменение цен, освоение технологий и рынков.

Оперативность информации — её важное свойство. Вы можете на минуту отвлечься от чтения статьи и задуматься, насколько быстро вы узнаете об изменении динамики важнейших для вас показателей. Можно биться о заклад, что сисадмин об изменении количества работающих нод или о критическом падении скорости соединения с сервером узнает практически сразу, а вот менеджер по продажам и его руководитель о резком падении объёма продаж узнают в лучшем случае спустя сутки — и то, если они ежедневно мониторят ситуацию. А так самый распространённый интервал — месяц, а затем уже неделя.

Между тем, чем раньше компания узнает о проблеме, тем дешевле и эффективнее окажется её решение. Так почему об информации не знают?

- Неверно выбран отчётный период. Можно пропустить кризисный момент или сравнить с неправильно выбранным базовым периодом. Во избежание такой проблемы используйте различные отрезки мониторинга для разных показателей: оперативные в режиме реального времени, почасовые, ежедневные, еженедельные, ежемесячные и т.д.

- Компания не уделяет внимание аналитике. Да, таких компаний, к сожалению, много. У них могут быть биллинг, CRM, BI и что угодно, но они даже счётчик метрики на сайт они не поставят, предпочитая работать по наитию. Ничем хорошим такая позиция не заканчивается, компания просто потеряет себя в конкурентной среде, потому что не сможет оценить и спрогнозировать своё состояние.

- Компании, анализируя данные, не берут во внимание фактор сезонности и в итоге получают ошибки и делают неверные выводы. Например, могут сравниваться показатели пика деловой активности и периода спада. Эта же ошибка происходит при планировании — план на любые периоды ставится без учёта сезона. В то время как у каждой компании есть свои интервалы спада и роста внутри года, соответственно, нужно их учитывать как при анализе информации, так и при планировании и прогнозировании.

- Данные аккумулируются в нескольких корпоративных информационных системах, между которыми взаимодействие настроено слабо или не настроено вообще. Это у нас здесь под номером три, а в сердцах CRM-щиков и других вендоров решений автоматизации бизнеса это номер один и гран-при среди причин аналитических фейлов бизнеса. Есть прекрасное исследование, которое показывает, что компании в среднем используют в работе 14 рабочих приложений. Среди них нередко есть и пересекающиеся в аналитике, а также те, которые должны друг друга дополнять (например, CRM и биллинг, CRM и 1С). Так вот, отстутствие интеграций делает данные лоскутными и снижает их информативность и полезность для бизнеса.

Чем хороша для сбора и хранения информации CRM-система?

Говоря про аналитику, нелишним будет ещё раз остановиться на роли руководителя. Некоторые топ-менеджеры свято верят в эффективность своей команды и полностью доверяют ей управление ключевыми ситуациями. Ну они говорят, что уверены, на самом деле им просто лень или неинтересно вникать в оперативную работу. Такая ситуация чревата — без активного контроля бизнес может зайти совсем не туда, куда бы хотелось его основателям и руководителям. Мы сейчас говорим не о микро-менеджменте, который по большей части кроме суеты, ничего не даёт, — мы говорим о периодическом контроле за показателями и активностями, а также об анализе управленческой деятельности. У руководителя должен быть доступ ко всем базовым показателям с возможностью их детализации (например, до менеджера или до региона).

Итак, имейте в виду, что эти числа точно так же точны, как и фиктивные данные, смехотворные предположения и принятие желаемого за действительное, на которых они основаны!

Кстати, такой контроль проще всего осуществлять в CRM-системе с помощью инструментов планирования, план-фактного анализа, воронки продаж и т.д. Начальник получает доступ к важным для бизнеса показателям в режиме реального времени, может иметь удалённый доступ к рабочему месту. Повторимся в сотый раз, CRM — инструмент контроля оперативной работы и выполнения задач, а не инструмент тотального контроля и слежки за сотрудниками. Система не умеет шпионить (мы о своей, конечно), да и вообще «фу» таким быть.

Экономия времени на отчётности. Можно сколько угодно хвалить Excel, но ваши сотрудники гарантированно тратят на него слишком много времени. Чтобы сделать отчёт в электронных таблицах, в 90% случаев необходимо приложить усилия — это касается численных данных. Хуже обстоит дело с задачами — например, если работник должен по окончании дня или недели отчитаться сколько времени на какую задачу у него ушло. Вы не просто получите материал, на создание которого убито около полутора часов, — вы получите поток вдохновенного вранья. В то время как в CRM у вас отобразятся сделанные, просроченные и отложенные задачи по каждому из подчинённых.

Улучшение производительности труда и результатов работы компании. Боб Парсон, основатель компании GoDaddy, заметил: «Всё, что измеряется и наблюдается, улучшается». Соответственно, если и руководитель, и сотрудники могут постоянно наблюдать за своим результатом на дашбордах, графиках, прогресс-барах, с помощью напоминаний, они будут даже чисто психологически стремиться улучшить показатели, исправить ситуацию с отставанием. Кстати, это уменьшает уровень нервозности и стресса в компании. В отечественной деловой практике живо наследие «догнать и перегнать» и «пятилетку в четыре года», поэтому управлению стрессом внимание почти не уделяется. Между тем, спокойный коллектив, способный контролировать свою работу и своё время, работает гораздо продуктивнее.

No Big Data или почему мы не «прикрутили» машинное обучение к RegionSoft CRM

В Facebook нас спросили, есть ли в нашей CRM-системе машинное обучение. Не будем делать интриги из этого вопроса — нет. Просто потому что пока нашей системе такая функциональность не нужна. И вот почему.

Для начала дадим простое объяснение того, что же такое машинное обучение и искусственный интеллект относительно корпоративной информационной системы (CRM, ERP и т.д.). Это программно-аппаратный комплекс или просто программа, которая собирает, хранит и анализирует информацию в автоматическом режиме. Искусственный интеллект заключается в том, что программа на основе больших данных «учится» находить в данных закономерности и связи, а потом при попадании на вход похожих данных, моделировать ситуацию (опять же, всё основано на теории вероятности — это работающая на больших данных теорема Байеса, согласно которой можно определить вероятность события при условии, что произошло другое статистически взаимозависимое с ним событие). Данных для обучения системы должно быть много, колоссально много. И именно в этом и заключается проблема медленного внедрения таких технологий в CRM-системы: малый и средний бизнес практически не в состоянии нагенерировать такое количество релевантной информации, а для обработки их данных на предмет закономерностей вполне достаточно базовых инструментов CRM-ки и умной человеческой головы, способной к дедукции и индукции.

— Ну и как там твой проект с большими данными, Хоскинс?

Машинное обучение актуально в банках (вот это реально огромные массивы данных), в телефонии и других видах связи федерального уровня, в безопасности граждан и дорожного движения, в крупных транспортных компаниях, в промышленности. В основном, машины внутри информационных систем компаний этих сфер учатся распознавать критические ситуации, мошенничество, фрод и т.д.

Внедрение машинного обучения в CRM для малого и среднего бизнеса возможно (то есть мы, разработчики в RegionSoft, можем взять и запилить самообучающуюся нейронную сеть), но это дорогая и довольно длительная разработка, которая сильно удорожает цену лицензии и сделает софт перегруженным и недоступным для части клиентов. Хотя не спорим, маркетинг красивый. Нам же хочется, чтобы для начала все освоились с базовой автоматизацией. А в этом процессе, увы, даже свет в конце туннеля не всегда виден.

Если вы владеете информацией, вы обладаете конкурентным преимуществом. Вы удивитесь, но пока по миру шагают машинное обучение, big data и data mining, большая часть конкурентов компаний малого и среднего бизнеса даже не удосуживается взглянуть на текущие показатели и проанализировать профиль продаж. В общем, деньги считать умеют все, а вот грамотно обеспечивать их прирост — лишь некоторые. А значит, можно смело обгонять своих конкурентов за счёт грамотной аналитики и умного управления бизнесом.

У нас есть работа

Программист Delphi — работа в отделе разработки программных решений, участие в разработке типовых решений и проектов, интеграционные решения.

Web-разработчик — работа по созданию и поддержке web-сервисов, SAAS-технологий, web-сайтов, интеграционных проектов.

Рассмотрим всех, в том числе молодых разработчиков, желающих развиваться в самых что ни на есть боевых условиях и практиковаться под руководством очень опытного инженера. Вы освоите не просто разработку, но и научитесь сопоставлять её с бизнес-задачами — в общем, энтерпрайз-хардкор.

Пишите письмо, шлите резюме и портфолио на contact@regionsoft.ru

Кстати, есть и такое:

Программист 1С — работа в отделе внедрения проектов на базе 1С: Предприятие 8, интеграционные решения.

По России:

Мы ищем надёжных и сообразительных продажников на удалёнке в Санкт-Петербурге, Новосибирске, Екатеринбурге, Москве и других городах. Обучим, разъясним и поддержим. Фактически у вас будет интересная и стабильная работа прямо из дома. Если есть технический опыт — оторвём с руками.

Пишите на contact@regionsoft.ru

|

Метки: author Axelus управление проектами управление продажами erp- системы crm- блог компании regionsoft developer studio crm аналитика анализ данных regionsoft |

Своя CRM система за 3 часа в Гугл-таблицах |

Я сразу отказался от всех полуготовых решений, типа amoCRM(удобная, но нам рановато пока), ShugarCRM(кривая и медленная, вызывает невроз) и др., потому что я люблю, чтобы софт подстраивался под мой бизнес, а не бизнес-процессы подстраивались под софт. (да и на первых порах нужно что-то по проще с низкой стоимостью внедрения)

Так что — только гугл-док, только хардкор!

На создание этой системы ушло часа 3 — не больше.

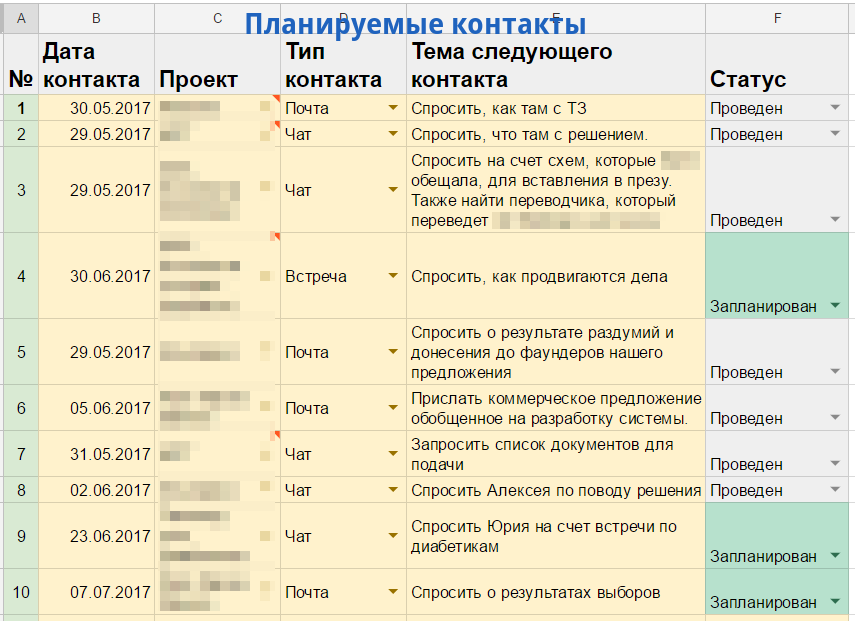

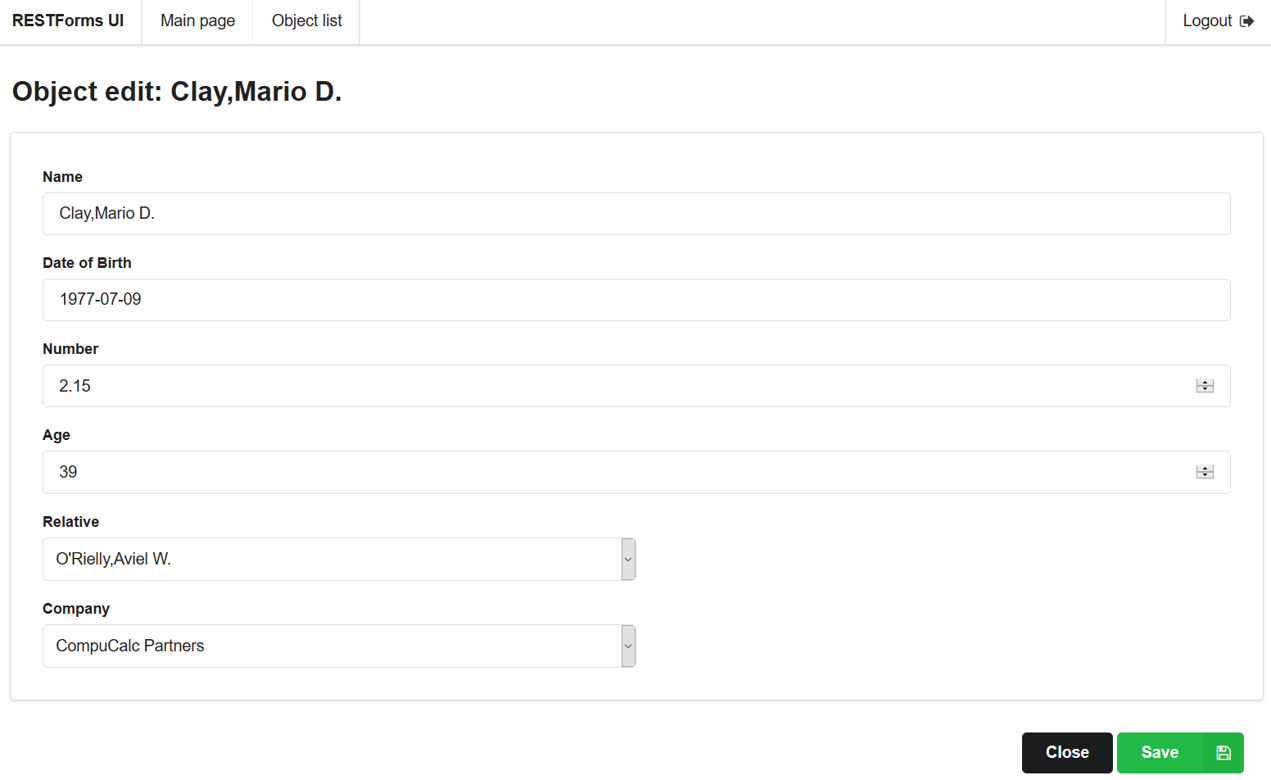

Давайте расскажу, как работает:

1. На листе «Активности» у нас исходные данные — мы указываем, все контакты по какому проекту, когда, что обсуждали и как изменился статус проекта. (Проекты, разумеется, выбираются из выпадающего списка — можно сделать кликнув по ячейке правой кнопкой -> проверка данных, и в графе «Правила» указать столбец со списком проектов, который у нас на странице «Лиды»)

2. Лиды — Это сводный лист со всеми проектами и статусами по ним. Взглянув на него сразу понятно, в каком состоянии продажи компании (даты последних контактов подсвечиваются в зависимости от свежести. Чем дольше не пинговал контакт, тем он белее) Это делается «Условным форматированием» во вкладке «Градиент»). Самое удобное, это то, что к каждому проекту подтягивается информация о последнем контакте и всегда видно, чем завершился последний контакт и чего ждать дальше.

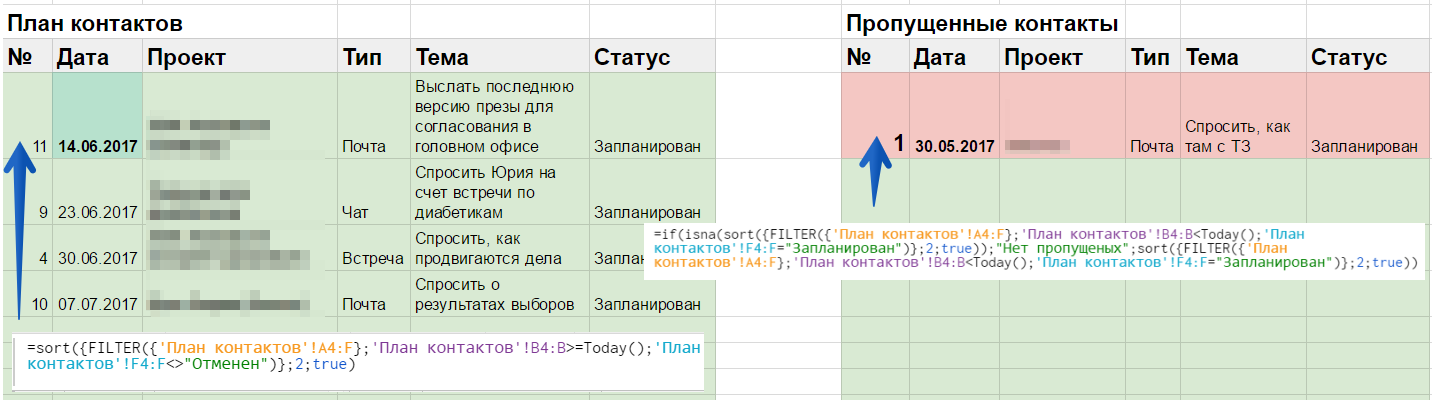

3. Ну и, конечно, планирование: лист «План контактов». Тут все просто — пишем проект, дату будущего контакта и тему. Статус указывает, произошел контакт или еще нет, либо плановый контакт отменен.

На листе «Звонки на сегодня» уже поинтереснее в плане формул — выбирается с одной стороны все будущие контакты (а те, что на сегодня подсвечиваем цветом: в условном форматировании ставим, что условие равно =today() ) а во втором столбце подсвечиваем красным те, что просрочены. По формуле видно, что как только статус на странице с плановыми контактами изменится на «Проведен» или «Отменен», из списка пропущенных они уйдут.

Таким образом, чтобы всегда быть в курсе происходящего и видеть картинку по всем проектам, мне достаточно просто записывать результаты всех своих контактов, заполнять план контактов и отмечать, когда они произошли.

Скажу вам, что после начала учета видение бизнеса меняется кардинальным образом, как и подход к продажам. Контакты с лидами становятся периодическими и системными (а не только во время панических атак на тему «Мы скоро разоримся!111!!!!»)

Сам шаблон файла можете скачать тут

Всем успешного ведения внутренних продаж!

|

Метки: author pkondaurov crm- системы #crm # гуглдок #самсебеинтегратор |

Что угрожает информационной безопасности или обзор форума PHDays VII 2017 в Москве |

Лазейки в прошивке ядра LTE-модема (Андрей Ловянников)

Андрей Ловянников выступил с докладом по анализу прошивки ядра LTE-модема Huaiwei E3372. В результате анализа было получено устройство с полностью отключенным шифрованием трафика. Анализ происходил по следующей схеме: выявление технической документации об устройстве; выявление архитектуры микропроцессора; определение работающих операционных систем; выявление основных API системы, связанных с GSM; выявление функций, отвечающих за шифрование.