Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Перевод] Что известно об атаке на цепи поставок CCleaner |

- Системное администрирование,

- Сетевые технологии,

- Антивирусная защита,

- IT-инфраструктура,

- Блог компании Cloud4Y

Что известно об атаке на цепи поставок CCleaner

- Системное администрирование,

- Сетевые технологии,

- Антивирусная защита,

- IT-инфраструктура,

- Блог компании Cloud4Y

- Перевод

Атаки на цепи поставок (supply-chain attacks) — очень эффективный способ распространения вредоносного программного обеспечения в целевые организации. Это связано с тем, что при атаках на цепи поставок злоумышленники пользуются доверительными отношениями между производителем/поставщиком и клиентом, чтобы атаковать организации и отдельных лиц по различным мотивам. Червь Petya/Nyetya/NePetya, который был выпущен в сеть в начале 2017 года, показал насколько масштабны эти типы атак. Часто, как и в случае с Petya, исходный вектор атаки может оставаться скрытым в течение некоторого времени.

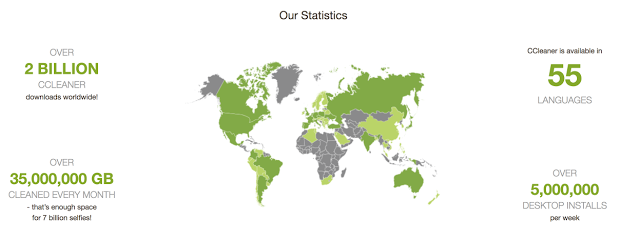

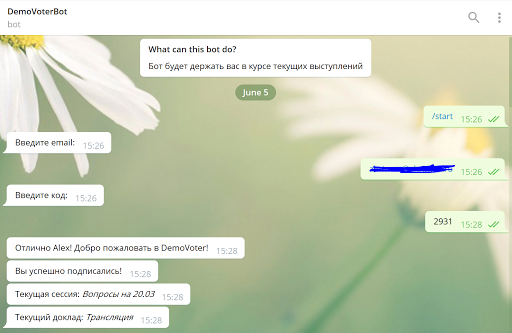

Недавно исследователи Talos заметили случай, когда серверы загрузки, используемые компанией-разработчиком для распространения легитимного пакета программного обеспечения, были использованы для загрузки вредоносного ПО на компьютеры ничего неподозревающих жертв. В течение некоторого периода версия CCleaner 5.33, распространяемая Avast, содержала многоступенчатую вредоносную нагрузку. 5 миллионов новых пользователей загружают CCleaner в неделю. Учитывая потенциальный ущерб, который может быть вызван сетью зараженных компьютеров подобного размера, решено было действовать быстро. 13 сентября 2017 года Cisco Talos уведомила Avast. В следующих разделах будут обсуждаться конкретные детали, касающиеся этой атаки.

Технические подробности

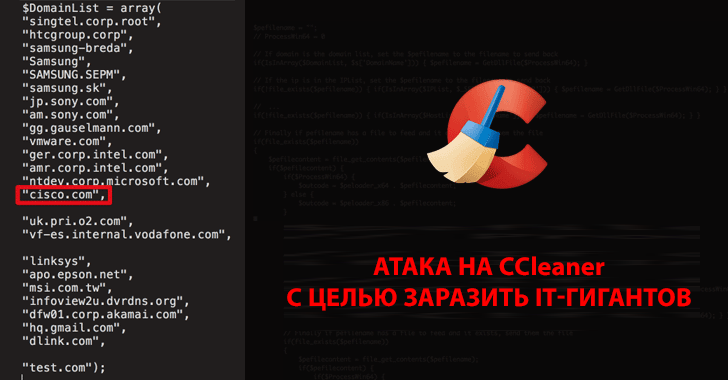

CCleaner — утилита, которая включает такие функции, как очистка временных файлов, анализ системы, определение способов оптимизации производительности, а также более упрощенный способ управления установленными приложениями.

Рисунок 1: Снимок экрана CCleaner 5.33

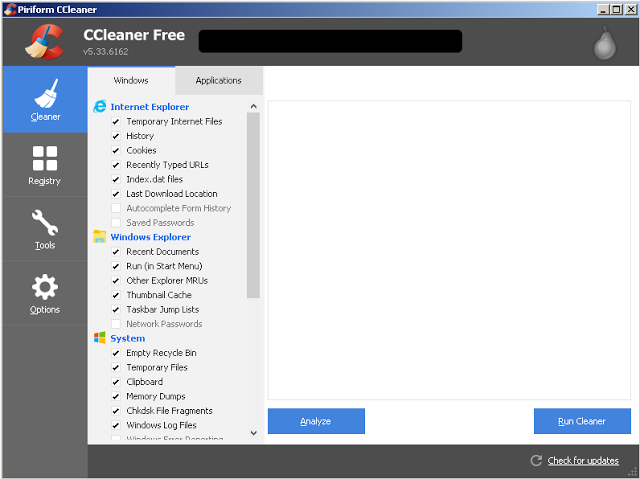

13 сентября 2017 года, проведя бета-тестирование клиентов новой технологией обнаружения эксплойтов, Cisco Talos обнаружила исполняемый файл, который определялся как вредоносная программа. Это был установщик CCleaner v5.33 с легитимных серверов загрузки CCleaner. Talos провёл первоначальный анализ, чтобы определить, что заставляет систему защиты блокировать CCleaner. Они определили, что, хотя загруженный исполняемый файл был подписан с использованием действительной цифровой подписи Piriform, CCleaner не был единственным приложением, которое было загружено. Во время установки CCleaner 5.33 32-разрядный двоичный файл CCleaner, также содержал вредоносную нагрузку с возможностью использовать алгоритм генерации домена (DGA), а также функции выдачи команд и управления (Command and Control — C2).

При просмотре страницы истории версий на сайте загрузки CCleaner выяснилось, что версия (5.33) была выпущена 15 августа 2017 года. 12 сентября 2017 года была выпущена версия 5.34. Версия, содержащая вредоносную нагрузку (5.33), распространялась между этими датами. Эта версия была подписана с использованием действительного сертификата, который был выпущен для компании Piriform Ltd, которую недавно приобрел Avast, компанией Symantec и действителен до 10.10.2018.

Рисунок 2: Цифровая подпись CCleaner 5.33

Также был обнаружен второй образец установщика, связанный с этой угрозой. Этот образец также был подписан с использованием действительного цифрового сертификата, однако отметка времени подписания была приблизительно на 15 минут позднее подписания первоначальной сборки.

Наличие действительной цифровой подписи в вредоносном двоичном коде CCleaner может указывать на значительную проблему, которая была причиной нарушений в процессе разработки или подписания. В идеале этот сертификат должен быть отозван. При создании нового сертификата необходимо следить за тем, чтобы злоумышленники не находились в среде, в которой можно было бы скомпрометировать новый сертификат. Только в процессе расследования возможно было собрать подробную информацию о масштабах этой проблемы и о том, как наилучшим образом ее решить.

В двоичном коде CCleaner был найден следующий артефакт компиляции:

S:\workspace\ccleaner\branches\v5.33\bin\CCleaner\Release\CCleaner.pdb

Учитывая наличие этого артефакта компиляции, а также тот факт, что двоичный код был подписан цифровой подписью с использованием действительного сертификата, вполне вероятно, что злоумышленник из вне скомпрометировал часть среды разработки или сборки и использовал этот доступ для вставки вредоносного кода в сборку CCleaner, которая была выпущена организацией. Также возможно, что инсайдер, имеющий доступ к средам разработки или сборки внутри организации, намеренно включал вредоносный код или имел скомпрометированную учетную запись, которая позволяла злоумышленнику изменять код.

Важно отметить, что, хотя предыдущие версии установщика CCleaner в настоящее время доступны на сервере загрузки, версия, содержащая вредоносные файлы, была удалена и больше не доступна.

Процесс установки вируса

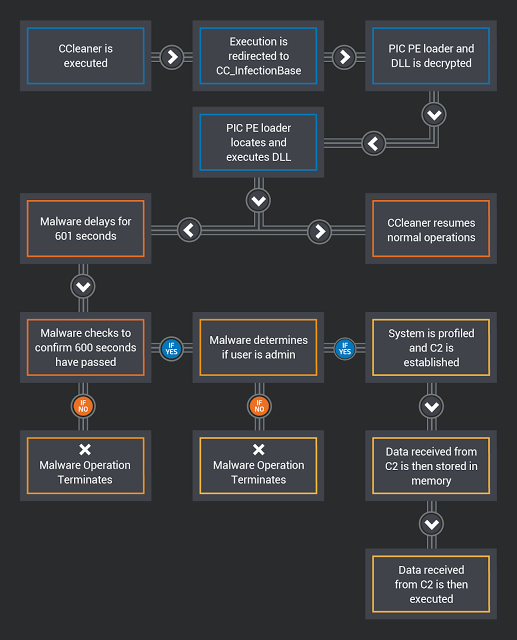

'__scrt_get_dyn_tls_init_callback' был изменен для запуска кода CC_InfectionBase (0x0040102C) с целью перенаправления потока выполнения кода на вредоносный до продолжения обычных операций CCleaner. Вызываемый код отвечает за дешифрование данных, которые содержат два уровня вредоносной нагрузки: загрузчик PIC (позиционно-независимого программного кода) и DLL-файл.

Используя HeapCreate (HEAP_CREATE_ENABLE_EXECUTE, 0,0), создаётся исполняемая куча. Содержимое расшифрованных данных, содержащих вредоносное ПО, копируется в кучу, исходные данные стираются. Затем вызывается PE-загрузчик и начинается его работа. Как только процесс заражения начался, двоичный код стирает области памяти, в которых ранее содержался PE-загрузчик и DLL-файл, освобождает ранее выделенную память, уничтожает кучу и продолжает исполняться с обычными операциями CCleaner.

PE-загрузчик использует методы позиционно-независимого кодирования, чтобы найти DLL-файл в памяти. Затем он переносит DLL в исполняемую память и вызывает DLLEntryPoint, чтобы начать его выполнение.

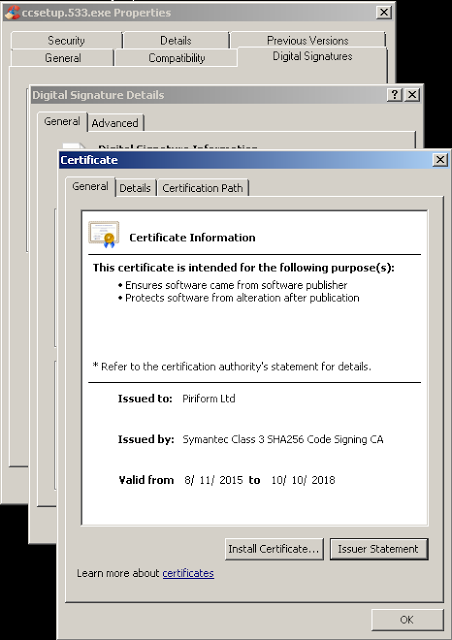

CCBkrdr_GetShellcodeFromC2AndCall отвечает за многие из вредоносных операций, обнаруженные Talos при анализе этого вредоносного ПО. Во-первых, он записывает текущее системное время. Затем он задерживает выполнение вредоносного кода на 601 секунду, вероятно, с целью уклониться от автоматизированных систем анализа, которые настроены на проверку ПО на вирусы в отладчике в течение предопределенного периода времени. Чтобы реализовать эту функцию задержки, вредоносное ПО вызывает функцию, которая пытается выполнить ping 224.0.0.0 с использованием таймаута delay_in_seconds, установленного на 601 секунду. Затем он определяет текущее системное время, чтобы узнать прошло ли 600 секунд. Если это условие не выполняется, вирус завершает выполнение, в то время как CCleaner продолжает выполняться. В ситуациях, когда вредоносное ПО не может выполнить IcmpCreateFile, оно возвращается к использованию функции Sleep () для реализации той же функции задержки. Вредоносная программа также сравнивает текущее системное время со значением, хранящимся в следующем разделе реестра:

HKLM \ SOFTWARE \ Piriform \ Agomo: TCID

Если время, хранящееся в TCID, ещё не пришло, вирус также прекратит выполнение.

Рисунок 3: Процедура задержки

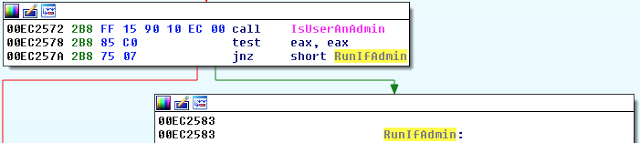

Затем проверяются привилегии, назначенные пользователю. Если текущий пользователь, не является администратором, вредоносное ПО прекратит выполнение.

Рисунок 4: Проверка привилегий

Если у пользователя, запустившеего вредоносное ПО, есть права администратора, на зараженной системе активируется SeDebugPrivilege. Затем вредоносное ПО считывает значение «InstallID», которое хранится в следующем разделе реестра:

HKLM \ SOFTWARE \ Piriform \ Agomo: Muid

Если это значение не существует, вредоносное ПО создает его с помощью '((rand () * rand () ^ GetTickCount ())'.

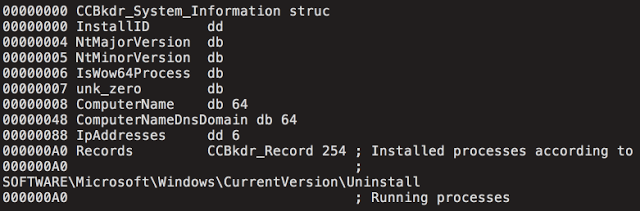

Как только вышеупомянутые действия были выполнены, вирус начинает сбор системной информации, которая позже передается на сервер C2. Системная информация хранится в следующей структуре данных:

Рисунок 5: Структура данных CCBkdr_System_Information

После сбора информации о системе она зашифровывается и кодируется с использованием модифицированного Base64. Затем вредоносное ПО устанавливает связь с командным сервером (C2), как описано в следующем разделе.

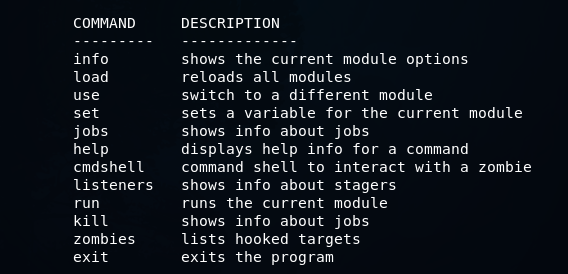

Command and Control (C2)

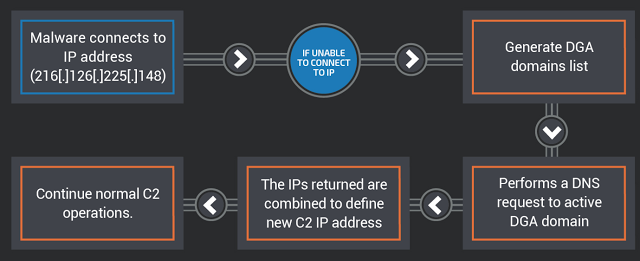

Как только ранее упомянутая системная информация была собрана и подготовлена для передачи на сервер C2, начинается попытка передать её с использованием запроса POST HTTPS на 216[.]126[.]225[.]148.

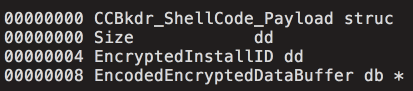

Данные, полученные с сервера C2, проверяются, чтобы подтвердить, что они находятся в правильном формате для использования в CCBkdr_ShellCode_Payload. Пример показан ниже:

Рисунок 6: Структура данных CCBkdr_ShellCode_Payload

После установки вируса продолжаются обычные операции CCleaner. Ниже приведена диаграмма, описывающая работу этого вредоносного ПО на высоком уровне:

Рисунок 7: Схема процесса запуска вредоносной нагрузки

Алгоритм генерации домена

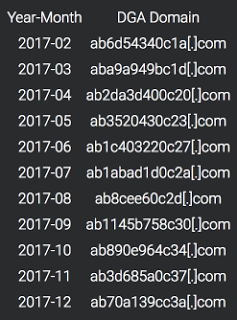

В ситуациях, когда основной сервер C2 не возвращает ответ на запрос HTTP POST, описанный в предыдущем разделе, вредоносная программа использует алгоритма DGA. В этом случае он основан на времени и может быть рассчитан с использованием значений текущего года и месяца. Ниже приведен список доменов DGA:

Рисунок 8: генерация доменов для 12 месяцев

Вредоносная программа будет инициировать DNS-поиск для каждого домена, генерируемого алгоритмом DGA. Если DNS-поиск не приведет к возврату IP-адреса, этот процесс будет продолжен. Вредоносная программа выполнит DNS-запрос активного DGA-домена и ожидает получить два IP-адреса с сервера доменных имен. Затем вредоносная программа вычислит вторичный сервер C2, выполнив серию битовых операций с полученными IP-адреса и объединив их для определения нового фактического адреса командного сервера. Диаграмма, показывающая этот процесс, приведена ниже:

Рисунок 9: Определение адреса командного сервера

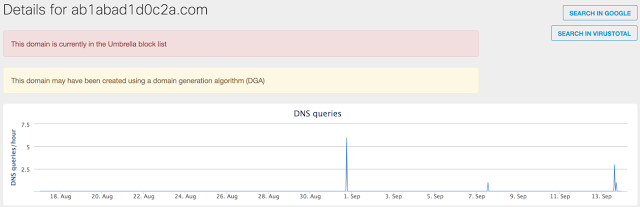

Cisco Talos во время анализа определила, что DGA-домены не были заняты, поэтому они были зарегистрированы и заблокированы, чтобы злоумышленники не могли использовать их в своих целях.

Потенциальный ущерб

Воздействие этой атаки может быть серьезным, учитывая чрезвычайно большое число возможных систем. CCleaner утверждают, что по состоянию на ноябрь 2016 года он имеет более 2 миллиардов загрузок по всему миру и, как сообщается, прирост новых пользователей равен 5 миллионам в неделю.

Рисунок 10: Статистика CCleaner

Системы, на которые производилась установка CCleaner в период распространения вируса должны быть восстановлены до состояния на 15 августа 2017 года или переустановлены. Пользователи также должны обновиться до последней доступной версии CCleaner, чтобы избежать заражения. На момент написания этой версии была версия 5.34. Важно отметить, что, согласно странице загрузки CCleaner, бесплатная версия CCleaner не предоставляет автоматические обновления, поэтому это необходимо сделать вручную.

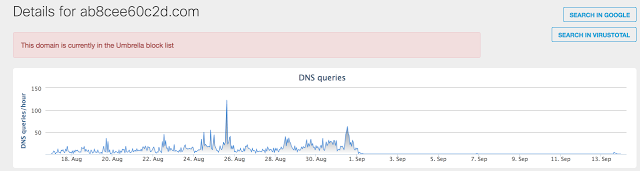

При анализе телеметрических данных Cisco Umbrella о доменах, связанных с этой атакой, Talos определил значительное количество систем, которые выполняли соответствующие DNS-запросы. Поскольку эти домены никогда не регистрировались, разумно сделать вывод о том, что единственной причиной является этот вирус. Только домены, относящиеся к августу и сентябрю (что коррелирует со временем, когда эта угроза была активна), показывают значительную активность.

Рисунок 11: Активность DGA домена за июль 2017 года

Как упоминалось ранее, версия CCleaner, которая включала это вредоносное ПО, была выпущена 15 августа 2017 года. Следующий график показывает значительное увеличение активности DNS, связанной с DGA-доменом, используемым в августе 2017 года:

Рисунок 12: Активность для домена в августе 2017 года

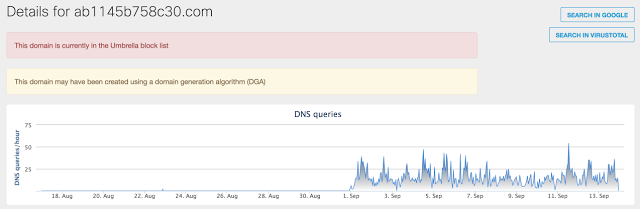

Рисунок 13: Активность для домена в сентябре 2017 года

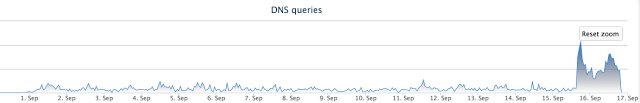

После обращения к Avast было замечено, что C2 сервер, указанный по умолчанию, стал недоступным для зараженных систем. В результате мы увидели значительное увеличение количества запросов, направленных на DGA-домены.

Рисунок 14: Трафик после отключения сервера

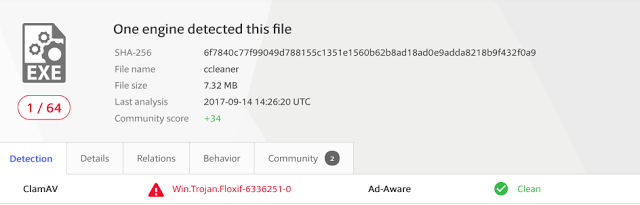

Стоит также отметить, что на 18 сентября антивирусное обнаружение этой угрозы остается очень низким (1/64).

Рисунок 15: Проверка обнаружения вируса

Ещё причины для беспокойства

Позднее во время нашего исследования нам был предоставлен архив, содержащий файлы, хранящиеся на сервере C2. Наша исследовательская деятельность была отражена в содержимом базы данных MySQL, включенной в архивные файлы, что подтвердило подлинность данных.

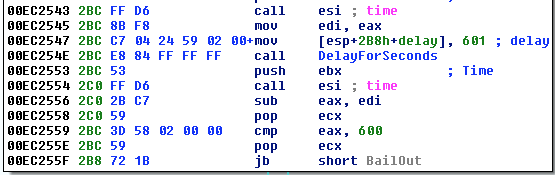

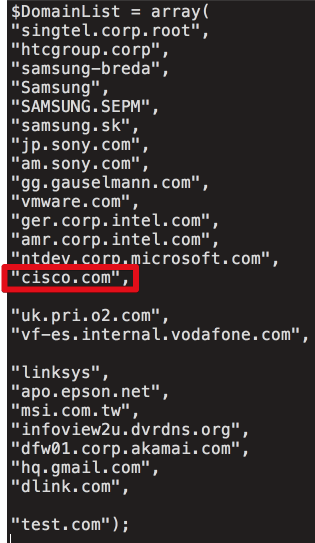

При анализе кода с сервера C2 сразу выделяется список организаций, на которые была нацелена доставка загрузчика второго уровня. Основываясь на обзоре базы данных отслеживания C2, которая охватывает только четыре дня в сентябре, мы можем подтвердить, что по меньшей мере 20 машин жертв были заражены специализированными вредоносными нагрузками. Ниже приведен список доменов, на которые атакующие пытались настроить таргетинг. Не для всех компаний идентифицированных в файле .php был замечен обмен с С2 сервером.

Рисунок 16

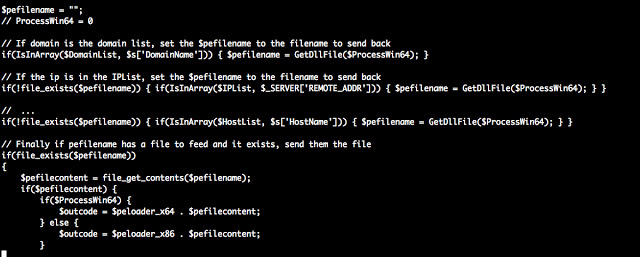

PHP скрипт сравнивает системные маяки полученные с заражённой машины по трём значениям: $DomainList, $IPList и $HostList. Это необходимо для определения того, должна ли зараженная система доставлять вредоносную нагрузку Stage 2. Ниже приведен сжатый PHP-код, который демонстрирует это:

Рисунок 17

База данных C2 содержала две таблицы: одну, описывающую все машины, которые «общались» с сервером, и описание всех машин, получивших загрузку Stage 2. Причем обе из них были датированы с 12 сентября по 16 сентября. За этот период времени на сервер C2 было отправлено более 700 000 машин, и более 20 машин получили Stage 2 нагрузку. Важно понимать, что целевой список может быть изменён и был изменён в течение периода, когда сервер был активен для заражения целевых организаций.

Во время компрометации вредоносное ПО периодически связывалось с сервером C2 и передавало информацию о зараженных системах. Эта информация включала IP-адреса, время, имя хоста, домен, списки процессов и прочее. Вероятно, эта информация использовалась злоумышленниками для определения того, на какие машины таргетироваться на последних этапах атаки.

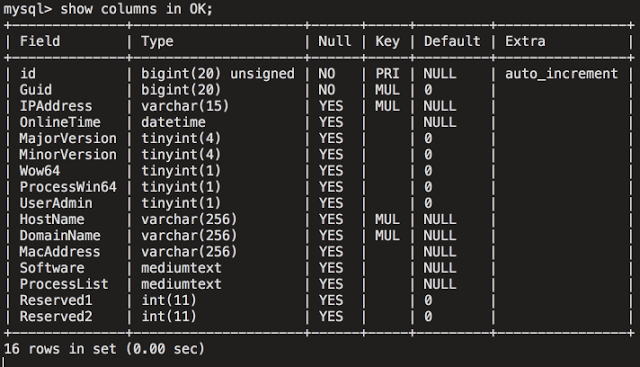

Основные данные подключения хранятся в таблице «Сервер». Вот пример для одного из узлов Talos в этой таблице базы данных:

Рисунок 18

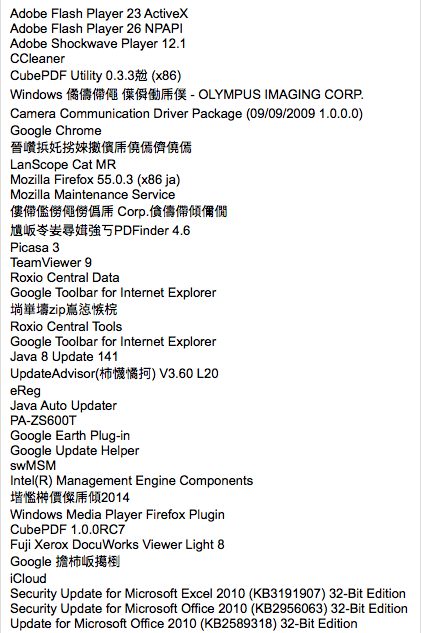

А также список установленных программ.

Рисунок 19

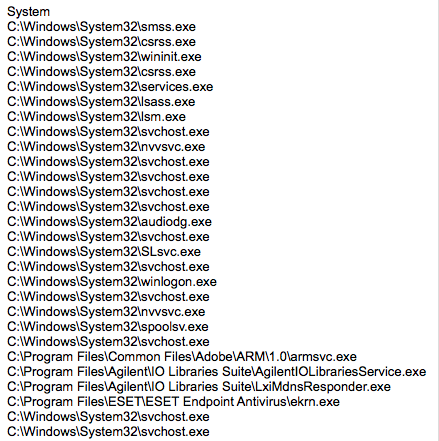

И список процессов.

Рисунок 20

Вторая таблица базы данных содержала дополнительный набор данных, связанный с системами, которым фактически была доставлена нагрузка Stage 2. Эта таблица содержала аналогичную информацию, структура которой показана ниже:

Рисунок 21

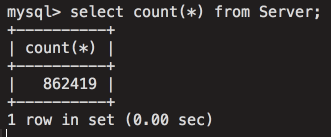

Основываясь на анализе таблицы, очевидно, что эта инфраструктура предоставляет злоумышленникам доступ ко множеству разных целей. Учитывая фильтрацию на сервере C2, злоумышленники могут добавлять или удалять домены в любой момент времени в зависимости от среды или организаций, на которые они нацелены. На скриншоте ниже показано количество записей, которые содержались в таблице базы данных, используемой для хранения профилей систем:

Рисунок 22

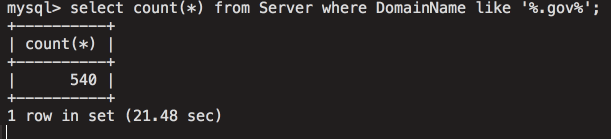

На следующем снимке экрана показано количество затронутых правительственных систем по всему миру.

Рисунок 23

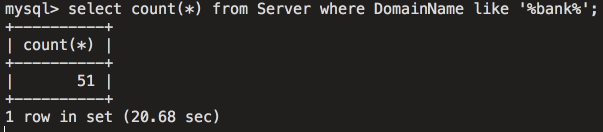

Уязвимые системы с доменом, содержащим слово «банк»:

Рисунок 24

Это демонстрирует уровень доступа для злоумышленников, полученный посредством использования этой инфраструктуры, а также подчеркивает серьезность и потенциальное воздействие этой атаки.

CODE REUSE

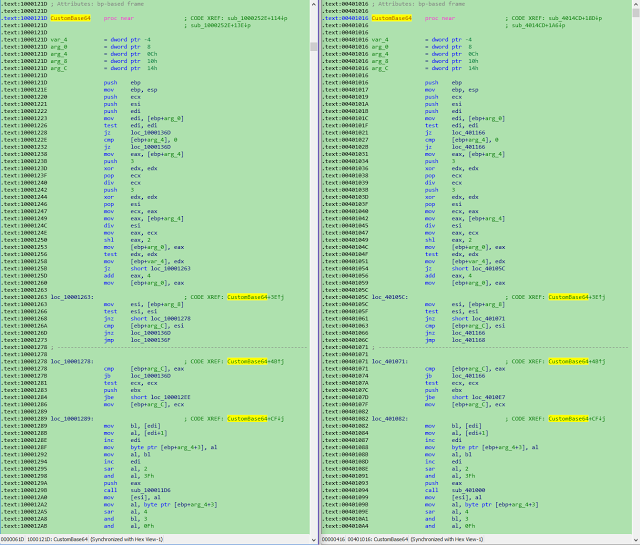

Talos рассмотрел заявления от исследователей Лаборатории Касперского о совпадении кода с образцами вредоносных программ, которые, как известно, используются Group 72. Хотя это никоим образом не является доказательством, мы можем подтвердить совпадение и согласны с тем, что это важная информация.

Слева: 2bc2dee73f9f854fe1e0e409e1257369d9c0a1081cf5fb503264aa1bfe8aa06f (CCBkdr.dll)

Справа: 0375b4216334c85a4b29441a3d37e61d7797c2e1cb94b14cf6292449fb25c7b2 (Missl backdoor — APT17 / Group 72)

Рисунок 25

ВЫВОД

Атаки на цепи поставок растут по скорости и сложности. В этом конкретном примере злоумышленник разработал систему, которая, как представляется, специально ориентирована на технологические компании, чтобы скомпрометировать огромное количество машин. Это усиливает обеспокоенность этими событиями и также подтверждает рекомендацию о том, что пользователи, загрузившие CClenaer в период заражения, должны не просто удалить заражённую версию CCleaner или обновиться до последней версии, но также должны восстановить данные из резервных копий, чтобы гарантировать полное удаление вредоносных программ.

Ниже приведены индикаторы компроментации, связанные с этой атакой.

File Hashes

6f7840c77f99049d788155c1351e1560b62b8ad18ad0e9adda8218b9f432f0a9

1a4a5123d7b2c534cb3e3168f7032cf9ebf38b9a2a97226d0fdb7933cf6030ff

36b36ee9515e0a60629d2c722b006b33e543dce1c8c2611053e0651a0bfdb2e9

DGA Domains

ab6d54340c1a[.]com

aba9a949bc1d[.]com

ab2da3d400c20[.]com

ab3520430c23[.]com

ab1c403220c27[.]com

ab1abad1d0c2a[.]com

ab8cee60c2d[.]com

ab1145b758c30[.]com

ab890e964c34[.]com

ab3d685a0c37[.]com

ab70a139cc3a[.]com

IP Addresses

216[.]126[.]225[.]148

Installer on the CC: dc9b5e8aa6ec86db8af0a7aa897ca61db3e5f3d2e0942e319074db1aaccfdc83 (GeeSetup_x86.dll)

64-bit trojanized binary

128aca58be325174f0220bd7ca6030e4e206b4378796e82da460055733bb6f4f (EFACli64.dll)

32-bit trojanized binary: 07fb252d2e853a9b1b32f30ede411f2efbb9f01e4a7782db5eacf3f55cf34902 (TSMSISrv.dll)

DLL in registry: f0d1f88c59a005312faad902528d60acbf9cd5a7b36093db8ca811f763e1292a

Registry Keys:

HKLM\Software\Microsoft\Windows NT\CurrentVersion\WbemPerf\001

HKLM\Software\Microsoft\Windows NT\CurrentVersion\WbemPerf\002

HKLM\Software\Microsoft\Windows NT\CurrentVersion\WbemPerf\003

HKLM\Software\Microsoft\Windows NT\CurrentVersion\WbemPerf\004

HKLM\Software\Microsoft\Windows NT\CurrentVersion\WbemPerf\HBP

|

Метки: author Cloud4Y системное администрирование сетевые технологии антивирусная защита it- инфраструктура блог компании cloud4y ccleaner вирус троян |

Больше сюрпризов от Apple: обновленные правила размещения на App Store |

Больше сюрпризов от Apple: обновленные правила размещения на App Store

В последние месяцы Apple корректировали и дополняли список официальных требований к продуктам, размещаемым на сторе уже дважды. Первая порция правок пришлась на июнь, как заблаговременная подготовка почвы для осеннего релиза; вторая была опубликована совсем недавно. За каждой следовала массовая зачистка — удаление тысяч приложений с маркета без предупреждений и надежды на амнистию. Раз уж все так серьезно, пожалуй, стоит поподробнее разобрать, что именно изменилось и стоит ли уже начинать бояться. Мы изучили июньское и сентябрьское соглашения и собрали все значительные нововведения здесь, под катом.

Забегая вперед: бояться не стоит, но побаиваться можно. Изменений достаточно много, они рассыпаны по тексту и касаются различных аспектов разработки и публикации. Львиную долю тайтлов, которые попали под раздачу, составляет откровенный скам, что внушает известное ощущение безопасности: чего нам волноваться, мы же не мошенники. Но на деле, попасться можно и на достаточно безобидных мелочах просто по незнанию — несколько таких кейсов нам уже попадалось.

Итак, начнем с июньских тезисов. Что здесь нужно знать?

1. Удаляться без разговоров и предупреждений будут:

- Приложения для купли-продажи контролируемых веществ (за исключением официальных приложений аптечных сетей).

- Устаревшие приложения, для которых разработчики больше не обеспечивают поддержку, что приводит к некорректной работе.

- Приложения, созданные на базе шаблонов, при помощи специальных сервисов типа «собери сам без знания кода».

- Приложения, использующие технологии, фреймворки и функции, несовместимые с новыми версиями OS.

- Приложения для торговли бинарными опционами.

2. Приведен список требований для антиспамерских продуктов. Подобные функции обязательно должны быть упомянуты в описании, причем с развернутым объяснением, по какому алгоритму происходит фильтрация и блокируются звонки/сообщения. Запрещается использовать полученные данные для любых целей, не связанных с работой приложения (продажа, трэкинг, сбор информации о пользователе, таргетирование рекламы).

3. То же относится и к музыкальным приложениям, которые получают доступ к пользовательским данным в Apple Music.

4. Медицинские приложения также будут подвергаться более жесткому контролю. В описании должна раскрываться методология, которая используется для медицинских заключений и гарантирует их точность. Сразу будут отклоняться продукты, которые якобы производят операции, требующие специального оборудования (измеряют давление, температуру, уровень сахара в крови, делают рентген). Обязательно включение рекомендации обратиться к специалисту для более точной консультации.

5. Продолжительность периода подписки не может составлять менее недели; подписка должна быть актуальна на всех девайсах пользователя.

6. К кругу действий, к которым нельзя принуждать пользователя, блокируя возможность пользоваться функционалом, добавились просмотр видео и клик на рекламный баннер (в дополнение к размещению, отзыва, оценки или скачиванию другого приложения). Также запрещено предлагать за них вознаграждение, денежное или любое другое.

7. Допускается использование кода «со стороны», при условии, что оно осуществляется через WebKit или JavaScript Core, а разработчик состоит в Apple Development Program.

8. В текст добавлены мелкие изменения, касающиеся разных аспектов оформления:

- Названия: не должны включать выражения типа «for children», «for kids», если не принадлежат к соответствующей категории, а также отсылки к цене.

- В сабтайтлах запрещено: ссылаться на другие приложения или давать информацию о продукте, которую не можете подтвердить.

- Иконки: допускается использование кастомизированных иконок, при условии что остается возможность вернуться к исходной. Вариации иконок должны быть связаны с контентом приложения (например, иконки, отображающие разные типы погоды для утилиты с прогнозами) и синхронизироваться по всей системе.

Теперь перейдем к самой свежей, сентябрьской версии. Здесь список правок полаконичнее и во многом тематически перекликается с и продолжает то, что было намечено летом:

1. Удаляться также будут приложения, функционал которых не соответствует приведенному описанию. В качестве примера App Store прямым текстом приводит антивирусы, которые, согласно источникам, формируют основную массу жертв последней чистки. Кстати, обещать контент или сервисы, которые продукт не предлагает, нельзя не только на маркете, но и оффлайн.

2. Аутентификация через Face ID должна осуществляться только и исключительно при помощи LocalAuthentication (использовать ARKit и прочие технологии запрещено). Для пользователей младше 13 лет следует предоставить альтернативный метод аутентификации.

3. ARKit допустимо применять только в том случае, если вы планируете подарить пользователям «богатый, интегрированный опыт взаимодействия с дополненной реальностью». Иными словами, парой моделей или анимаций тут не обойтись.

4. Внутри приложения допускается передача денежных средств от пользователя к пользователю, но только добровольно и в качестве подарка, а не в обмен на цифровой контент или услуги (в этом случае следует оформить транзакцию как IAP). Разработчик не имеет права забирать часть средств себе.

5. Продукты, в которых используются технологии типа ARKit, Camera API, Photo API для распознавания лиц, обязательно должны иметь пользовательское соглашение и запрашивать согласие на сбор данных. Полученную информацию нельзя использовать для целей, не оговоренных в соглашении.

6. Дискриминация по этническому признаку (наряду с полом, сексуальностью и религией) теперь тоже будет попадать под санкции.

7. В экстренных случаях (связанных, например, с торговлей людьми или насилием над детьми) Apple оставляет за собой право не просто удалить приложение, но и сообщить в соответствующие органы.

Если обобщить, изменения касаются прежде всего безопасности данных и некоторых этических моментов. Конечно, в зоне риска в первую очередь те, кто совсем потерял совесть, однако с таким обилием требований к сбору данных многие приложения могут не пройти модерацию. Кроме того, Apple очерчивает границы для свежеиспеченных технологий и также понемногу начинает закручивать гайки в отношении инструментария. В первую очередь имеет смысл пристально отслеживать будущие обновления текста тем, кто работает с ARKit, Face ID и прочими новинками — они, как видно из всего сказанного, сейчас на стадии активной кодификации.

Удачи и долгой жизни на маркете!

|

Метки: author nanton разработка под ios разработка мобильных приложений блог компании everyday tools apple app store ios публикация приложения |

CIS Benchmarks: лучшие практики, гайдлайны и рекомендации по информационной безопасности |

|

Метки: author LukaSafonov информационная безопасность блог компании pentestit cis benchmarks |

Мониторинг инженерной инфраструктуры в дата-центре. Часть 3. Система холодоснабжения |

Мониторинг инженерной инфраструктуры в дата-центре. Часть 3. Система холодоснабжения

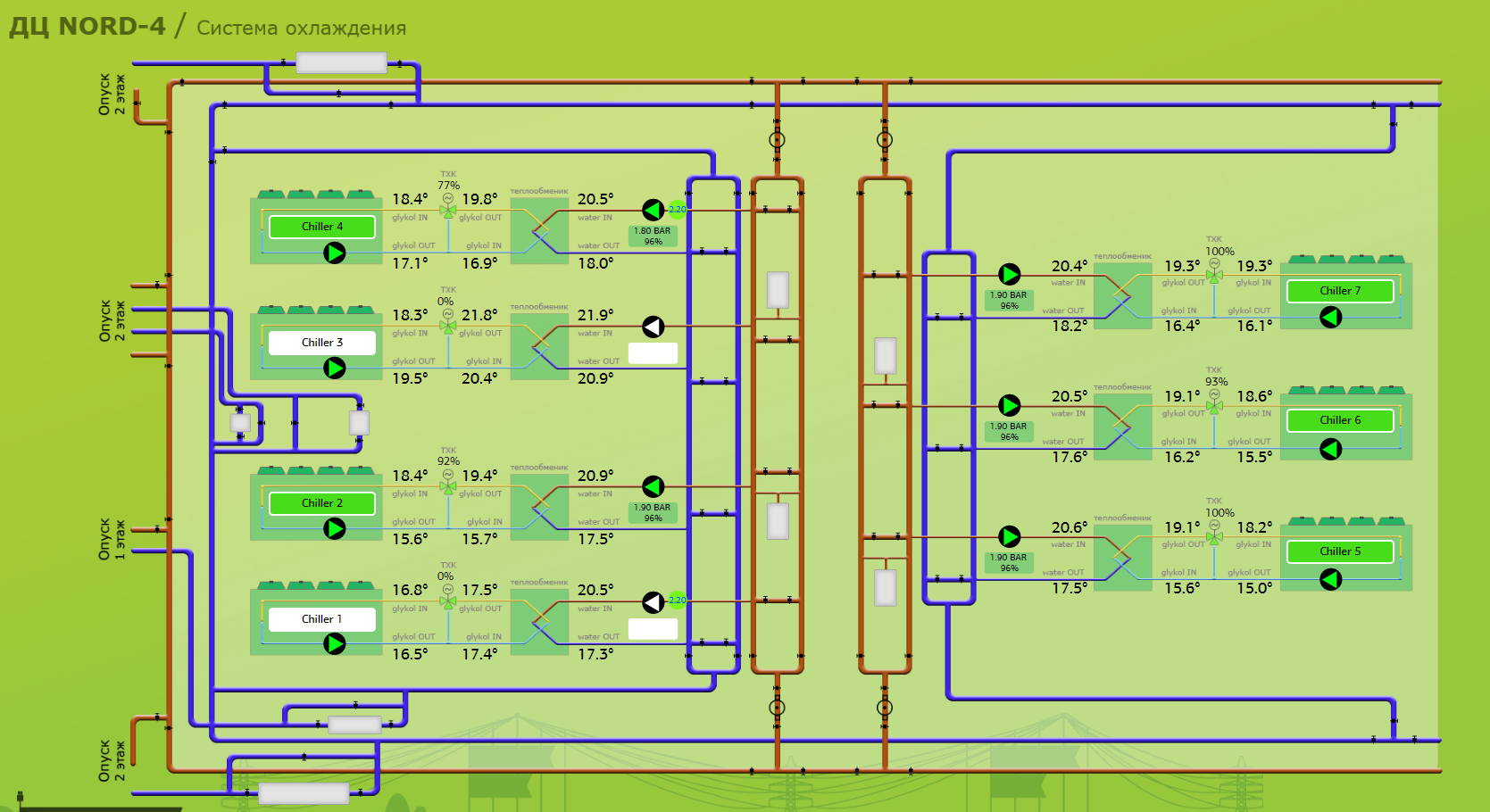

Система охлаждения NORD-4.

Мониторинг инженерной инфраструктуры в дата-центре. Часть 1. Основные моменты

Мониторинг инженерной инфраструктуры в дата-центре. Часть 2. Система энергоснабжения

Мы уже рассказывали о том, что такое система мониторинга и почему ее необходимо проектировать на этапе строительства. В статье «Мониторинг инженерной инфраструктуры в дата-центре» мы рассмотрели общие ситуации, в которых необходимо проводить комплексный мониторинг, а также рассказали об особенностях наших систем.

Сегодня поговорим о том, как устроена система мониторинга холодоснабжения на примере дата-центра NORD-4. Перед прочтением рекомендуем ознакомиться со статьей о том, как создавалась система холодоснабжения.

Для проекта NORD-4 мы выбрали водно-гликолевую систему охлаждения. На схеме выше она обозначена желто-синими линиями. Поскольку холодоносителем в системе является жидкость, крайне важно следить за:

- температурой;

- влажностью и протечками;

- давлением в контуре;

- работой чиллеров, насосов и прочего оборудования.

Все кондиционеры и чиллеры подключены к общей системе мониторинга. Мы следим за показателями каждого устройства.

Дашборд с параметрами.

В системе мониторинга также отображается статус работы оборудования: отключен, штатная работа, авария, ведется ремонт.

Зеленым цветом обозначены штатно работающие чиллеры, белым – отключенные. Если что-то пошло не так, индикатор загорается красным цветом.

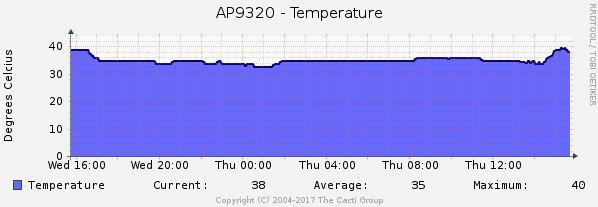

Датчики температуры

Параметр-фронтмен в системе мониторинга – это температура в холодных коридорах машинных залов. Средняя температура в залах колеблется в пределах от 23 до 27 Сo. При такой температуре оборудование еще не греется, но уже не покрывается инеем :). Этот параметр прописан в SLA, и за его несоблюдение придется платить штраф заказчику. От него мы и «пляшем», настраивая всю систему холодоснабжения в дата-центре.

Стабильность температуры в залах – это не дискретный параметр, а процесс, который обеспечивается оборудованием системы холодоснабжения.

Температура в машинном зале на дашборде системы мониторинга. Показатели температуры отражают расположение датчиков в зале.

Во всех холодных коридорах мы разместили по три температурных датчика. Предвидим в комментариях спор об их оптимальном количестве и месте размещения. Наша практика показывает, что трех штук вполне достаточно, и вот почему:

- Если возникнут проблемы с холодоснабжением в целом, мы увидим изменения температуры на всех датчиках. Частные же изменения в рамках одной стойки говорят о проблемах в установке оборудования или локальной неисправности стойки, а не о проблемах в системе холодоснабжения.

- По желанию заказчика мы можем установить на его стойки отдельный набор датчиков, которые обеспечат максимальный контроль, но это, скорее, исключение.

В горячих коридорах установлено по одному датчику. Их показания несут исключительно информационный характер.

В двух словах, используйте датчики рационально и без паранойи. Избыточное количество датчиков создает «шум» на панели наблюдения и не дает инженерам сосредоточиться.

Температурный датчик, установленный на стойке.

Температура жидкости. Вода охлаждается по следующей схеме. Чиллер охлаждает гликоль, который поступает в теплообменник. За счет холодного гликоля в теплообменнике теплая вода охлаждается. После того, как вода и гликоль «обменялись» температурами, вода идет в кондиционеры в залах, а гликоль возвращается в чиллер.

Взаимодействие наружного и внутреннего контуров в чиллерной схеме.

В первую очередь, для системы важна температура воды, которая поступает в кондиционеры. Она должна стабильно держаться на заданном уровне. Для нашей системы это 18 Сo.

Для регулировки температуры мы используем трехходовой клапан (ТХК). Он регулирует объем воды, выходящей из теплообменника. Если температура повышается, клапан открывается сильнее и подает больше воды в теплообменник. Текущий процент открытия ТХК выводится в интерфейс системы мониторинга.

Осталось разобраться с мониторингом температуры гликоля и воды в самих контурах. Температура отслеживается на всей протяжённости трубопровода, датчики мы разместили так:

- на входе и выходе чиллера;

- на входе и выходе теплообменника;

- на входе и выходе из кондиционера.

Температура «за бортом». Этот показатель не касается дата-центра напрямую, но он также важен в мониторинге. Мы не пользуемся средними показателями по Москве, так как температура воздуха на Боровой и на Коровинском может иметь перепад в несколько градусов. Нас интересует погода именно там, где стоит оборудование.

На каждой локации установлена независимая метеостанция, считывающая температуру, влажность и скорость ветра. Эти данные показывают, как работает система кондиционирования в реальных погодных условиях на конкретном объекте. Поскольку в Москве годовой перепад может составлять от –35 Сo до +35Сo, мы обязаны следить за погодой и заранее готовиться к ее причудам.

Так выглядит установленная на объекте независимая метеостанция.

К примеру, каждым летним вечером дежурный инженер получает прогноз погоды из трех источников. Если ожидается температура выше 30 Сo, ответственные специалисты получают sms-рассылку с призывом быть бдительнее.

Данные температуры и влажности с метеостанции в дата-центре на дашборде системы мониторинга.

В целом же мониторинг не имеет сезонного деления, в отличие от оборудования, которое нужно готовить к зиме/лету.

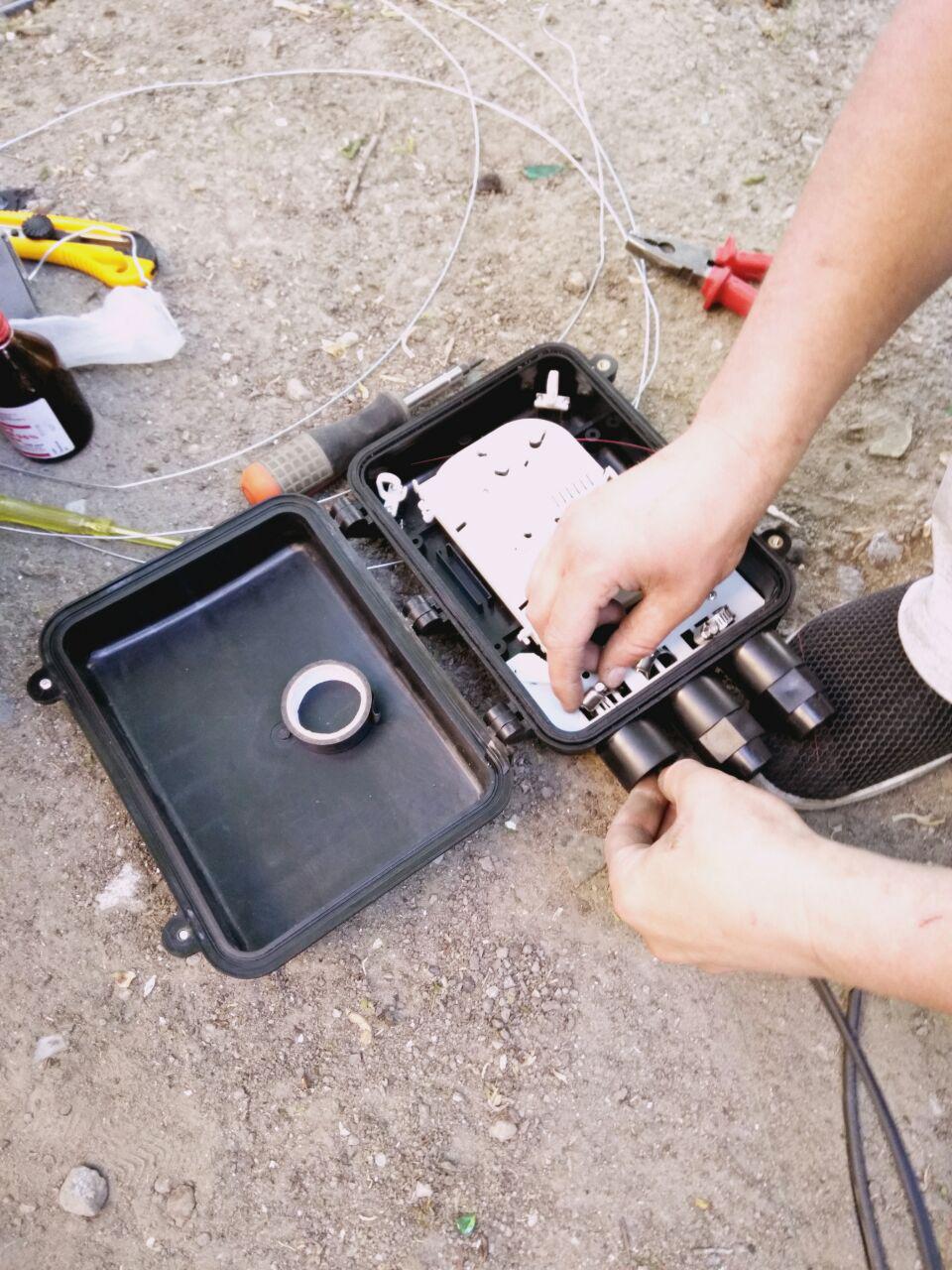

Другие датчики

Датчики протечек. В каждом машинном зале NORD-4 установлено по 14 кондиционеров Stulz. Они оснащены заводскими датчиками протечек, но для мониторинга их недостаточно. В местах задвижек, стыков труб, на теплообменнике, под кондиционерами и в других критичных узлах мы установили независимую сеть датчиков. Данные от них собираются и поступают в общую систему.

Весь четвертый этаж дата-центра выделен под систему кондиционирования: там находятся теплообменники, насосы, баки. Мы не ставим датчики протечек под каждой единицей охлаждающего оборудования, так как в полу сделана «разуклонка». Если образуется протечка, вода уйдет по сливам в накопительные емкости. Перед каждой сливной воронкой стоят датчики протечек. Иными словами, мониторится не устройство, а зона, откуда может потечь вода.

Так на дашборд выводятся сработавшие датчики протечек.

Давление жидкости. Помимо температуры и влажности, мы отслеживаем давление жидкости в охлаждающем контуре. Поскольку система замкнута, падение давления может означать разгерметизацию – читай, протечку. Резкое падение – это уже серьёзная проблема, предусмотренная в аварийной инструкции.

Мониторинг давления осуществляется в разных точках на всех этажах дата-центра. Показатель нормы для давления слегка плавающий: это страхует систему от ложных срабатываний из-за перепада высот.

Сложности в построении системы мониторинга

На первый взгляд кажется, что пуск системы мониторинга – линейный процесс: установили датчики, объединили их в сеть, усадили людей за пульт и забили в систему пороговые значения. Но в случае с NORD-4 были нюансы: залы заполняются постепенно, мы не знаем заранее, что за оборудование и на каких стойках будет размещено.

Запуская систему мониторинга, мы выставляли пороговые значения, руководствуясь проектным решением. Так, показатель WATER OUT (вода, которая поступает в кондиционеры в залах) должен составлять стабильные 18 Сo. Исходя из этого вычисляем остальные значения и создаем таблицу «идеальных» параметров.

По мере заполнения ЦОДа контрольная панель может начать выдавать ложные предупреждения. Это крайне опасно, так как внимание специалиста рассеивается, и он может пропустить настоящую проблему. Мы называем это «перемониторингом»: на новом оборудовании показатели могут слегка плавать внутри пороговых значений, создавая варнинги.

Поэтому тонкая настройка происходит в процессе работы. Все изменения пороговых значений и параметров мониторинга сначала согласуются с техническим директором и руководителем эксплуатации, и только после этого заносятся в систему.

Пара советов

Оповещения. Чтобы вовремя узнавать о неполадках, настройте разные оповещения в системе мониторинга. У нас предусмотрено три вида автоматических оповещений:

- Звуковое оповещение в центре мониторинга.

- Отображение на экране. За дашбордом круглосуточно следит минимум один инженер.

- SMS- и email-уведомления ответственным специалистам.

В комментариях к прошлым статьям нас спросили, как мы боремся с человеческим фактором: рассеянностью, естественными потребностями и т.д. Ответ прост: мы не экономим на персонале, обучении и тренингах. Каждая дежурная смена, включая ночную, состоит из четырех инженеров. Поэтому если кому-то захочется выпить кофе или выйти в туалет, панель не останется без наблюдения. Как мы отбираем и готовим дежурных инженеров, читайте в этой статье.

По инструкции, как только появляется «красный код», у специалиста есть буквально несколько минут, чтобы всех оповестить и вернуть работоспособность оборудования. О нашей службе техподдержки мы рассказывали в мае.

Дежурная смена за работой.

Мониторинг N+1. Продумайте резервирование системы мониторинга, чтобы исключить утрату контроля над дата-центром. У нас большинство устройств последовательно соединены по протоколу ModBus RS-485, и на этапе проектирования дата-центра мы продумывали, как пойдут трассы системы мониторинга, и прокладывали резервные маршруты.

Маркировка. Еще одна обязательная практика. Маркируйте датчики и составляйте схемы расположения так, чтобы инженеры без труда понимали, где их искать.

Сбор статистики. Собирайте как можно больше данных по оборудованию и системам. Даже если для текущего мониторинга эти данные не нужны, они будут полезны в будущем. Проанализировав данные статистики, можно определить, какие ещё показатели, кроме основных, отличались от нормы перед поломкой. Например, оборудование вибрировало или шумело. Это поможет планировать диагностику с большей точностью, а иногда и предугадать возможную поломку.

На этом всё. В следующей статье серии мы расскажем о мониторинге сетевой инфраструктуры. Ждём ваших вопросов.

|

|

Kotlin, puzzlers and 2 Kekses: Вы уверены, что знаете, как ведет себя Kotlin? |

Kotlin, puzzlers and 2 Kekses: Вы уверены, что знаете, как ведет себя Kotlin?

В свое время Андрей abreslav Бреслав говорил, что Kotlin разрабатывался как удобный и предсказуемый язык. Тогда же прозвучало мнение, что в этом языке вы не найдете паззлеров (коротких кусочков кода, результаты выполнения которых оказываются неожиданными, пугающими или разочаровывающими). Ну что же, Антон antonkeks Кекс поколдовал в IDEA и кое-что все-таки накопал, да еще на наглядных примерах рассказал о своих находках в паре с Филиппом Кексом. Смотрите сами:

Под катом — подборка таких пазлеров и развернутые комментарии к ним. В основе материала доклад Антона Кекса (Codeborne) и Филиппа Кекса (Creative mobile) на конференции Мобиус 2017 (Санкт-Петербург).

Начнем с Котлина. Все говорят, что на Яве куча проблем: на острове куча вулканов, там землетрясения. Ее нужно спасать.

Поэтому на ум приходит другой остров — Котлин.

Там спокойно, ничего не происходит. Он очень плоский, никаких вулканов. Находится здесь рядом. Поэтому Kotlin — это спаситель Java, особенно для Android-разработчиков — таких, как мы.

Несколько слов о Котлине

Что такое Kotlin, здесь более-менее все знают. Потому что какой дурак сегодня пишет под Android без Котлина? Это, мне кажется, уже мазохизм. Он отлично работает. Пару недель назад вышел первый билд Kotlin native. Скоро, может быть, будем и под iOS писать на Котлине.

Это прагматический язык, open-source, очень прикольный тулинг — он был задизайнен, чтобы хорошо работала IDE. Это камень в огород Apple-овского языка Swift и ему подобных. JetBrains хорошо push-ит Kotlin — специально дизайнит язык под свою IDE.

Все мы знаем, что Kotlin очень долго разрабатывался. Прошло шесть лет, прежде чем была выпущена версия 1.0. JetBrains очень старались, но, видимо, сделать новый язык не так просто. За прошедшие годы (2010 — 2016) они даже успели поменять логотип на более современный.

Учитывая, как долго его разрабатывали, язык должен быть превосходный. Это должен быть самый лучший язык в мире, так как многие другие языки девелопились гораздо быстрее. Например, всем известно, что JavaScript был сделан за две недели. Хотя, это, конечно, не rocket science (rocket science — это SpaceX, которые за четыре года научились садиться на платформу на настоящей ракете).

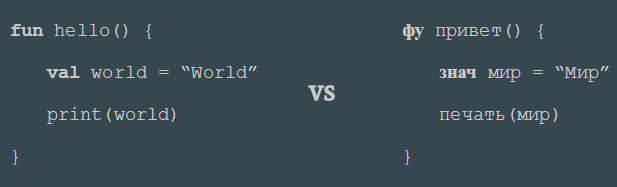

И самое главное — вы все должны гордиться, потому что Kotlin разрабатывается в Петербурге, и это один из немногих русских языков программирования. Старые русские языки программирования выглядели приблизительно вот так (справа):

К счастью, этот язык был ориентирован на международную аудиторию, поэтому вместо кейворда «фу» его создатели все-таки решили использовать кейворд fun, над которым все «making fun». Так что это веселый язык.

Пазлеры

Что такое пазлеры?

Это короткие программы, написанные на Котлине, с интересным поведением. А вы будете угадывать, что они печатают. Вы будете голосовать за предложенные варианты ответа, а тот, кто первый поднимет руку и не только угадает правильный вариант, но и объяснит, почему так происходит, получит приз.

Первая половина пазлеров ориентирована на тех, кто не очень хорошо знаком с Kotlin; вторая половина — для хардкорных Kotlin-разработчиков.

Kotlin известен тем, что не повторяет некоторые известные пазлеры Java. Однако в идеальном языке программирования не должно быть пазлеров вообще. Получается, что и Kotlin не идеален — не бывает идеальных языков.

Но Kotlin уже взлетел во многих мобильных приложениях. Этот язык создавался как прагматичный и удобный во многих кейсах. Он удобен в том числе с точки зрения юзабилити. И он все еще развивается. С разработчиками Котлина можно беседовать и пытаться договориться, как и чего исправить.

Все демонстрируемые пазлеры запускаются с Kotlin 1.1.1 — с последней стабильной версией. Исходные коды пазлеров находятся на GitHub — потом их можно посмотреть: https://github.com/angryziber/kotlin-puzzlers/tree/mobius.

У кого появятся идеи новых пазлеров, присылайте pull-реквесты. Ждем.

Пазлер 1

Котлин хорош тем, что он поддерживает nullability, точнее, он null safe — можно так сказать.

package p1_nullean

val s: String? = null

if (s?.isEmpty()) println("true")

У него есть различия между nullable и не nullable типами. Это значит, если мы хотим присвоить куда-то null, это должен быть nullable-тип (с вопросиком). Вероятно, эту идею предложил C#, но он ее не доделал — там только примитивы могут быть nullable. А в Котлине это уже сделано нормально для всех типов. В принципе, язык рассчитан на то, чтобы никогда вы не получали страшных NullPointerException в рантайме.

В данном примере Котлин перенял из Groovy отличный null-safe оператор s?, который позволяет на нуле вызвать какой-то метод и не схлопотать сразу в рантайме какие-то эксепшены.

Давайте посмотрим, какой из возможных вариантов мы сейчас получим:

- nothing

- true

- NullPointerException

- Will not compile

Запускаем. Смотрим.

Не скомпилировалось.

Почему?

Котлин — type safe язык, поэтому результат выражения s?.isEmpty() — null, поэтому он не кастится в false.

Исправить легко (надо написать так, чтобы Котлин вел себя так же, как Groovy):

if (s?.isEmpty() ?: false) println("true")

Это не очень красиво, но сейчас так. В котлиновский трекер уже засабмичено предложение все-таки интерпретировать null как false, но там есть свои нюансы. Еще неизвестно, получим мы эту фичу когда-нибудь или нет. Есть разные мнения, но с точки зрения удобства использования языка это небольшой косяк.

Пазлер 2

Пазлер очень похожий: у нас та же переменная nullable string и мы на нем пытаемся вызвать метод.

package p2_nulleanExtended

val x: String? = null

print(x.isNullOrEmpty())

Какой будет результат?

- true

- false

- NullPointerException

- не скомпилируется

Запускаем…

Ответ: true.

Почему? Это extension-функция из стандартной библиотеки Kotlin, которая «повешена» на nullable CharSequence. Поэтому в подобном кейсе она обрабатывается нормально.

Действительно, в Котлине можно некоторые функции запускать на null. Компилятор про это знает и позволяет это делать.

Если бы мы поставили знак вопроса, IDEA бы нам сказала, что он тут не нужен.

print(x?.isNullOrEmpty())

Хорошо, что функция названа по-человечески (о результате можно догадаться по названию).

Если запустить во втором варианте (со знаком вопроса), результат будет null, потому что выражение в скобках теперь приводится в null, и тогда эта функция не вызывается, несмотря на то, что она поддерживает null. Это, кстати, еще один пазлер.

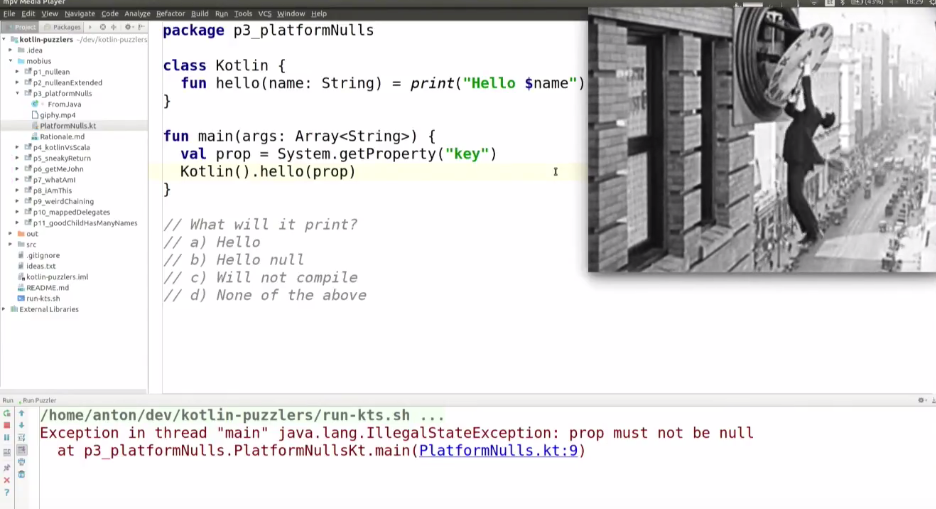

Пазлер 3

package p3_platformNulls

class Kotlin {

fun hello(name: String) = print("Hello $name")

}

fun main(args: Array) {

val prop = System.getProperty("key")

Kotlin().hello(prop)

}

В Котлине есть такая интересная фича — третий стейт nullability. Посмотрим, что будет, если мы вызовем:

val prop = System.getProperty("key")

и передадим это в метод hello у класса Kotlin, который должен его распечатать:

Kotlin().hello(prop)

Что получится на выходе?

- hello

- hello null

- не скомпилируется

- ни один из приведенных вариантов

Вообще type inference — отличная тема.

Запускаем. Получаем IllegalStateExeption.

Почему?

Значение prop будет null, тип — String!.. Он идет в hello, и в рантайме будет проверка, что должен быть не null, а он null.

На самом деле в начальной версии Котлина действительно сделали, что когда из Java приходит String, он всегда по умолчанию nullable.

val prop: String? = System.getProperty("key")

Это привело к тому, что стало очень неудобно писать код, когда идет интероп с Java. И решили сделать виртуальный тип String! (с восклицательным знаком). Это как раз третий вариант nullability — называется «я не знаю».

val prop: String! = System.getProperty("key")

Однако такой код не компилируется, поскольку тип String! нельзя объявить самостоятельно. Он может прийти только из Java.

Поэтому такие штуки лучше заранее объявлять как nullable или не nullable (как правило, вы из API знаете, может там null когда-нибудь прийти или нет).

А вот такой код скомпилируется, но может упасть в рантайме:

val prop: String = System.getProperty("key")

IDEA всегда знает, где какой тип. Можно нажать на переменной Ctrl+q и выяснить.

Но закончим с nullability, перейдем к другой теме.

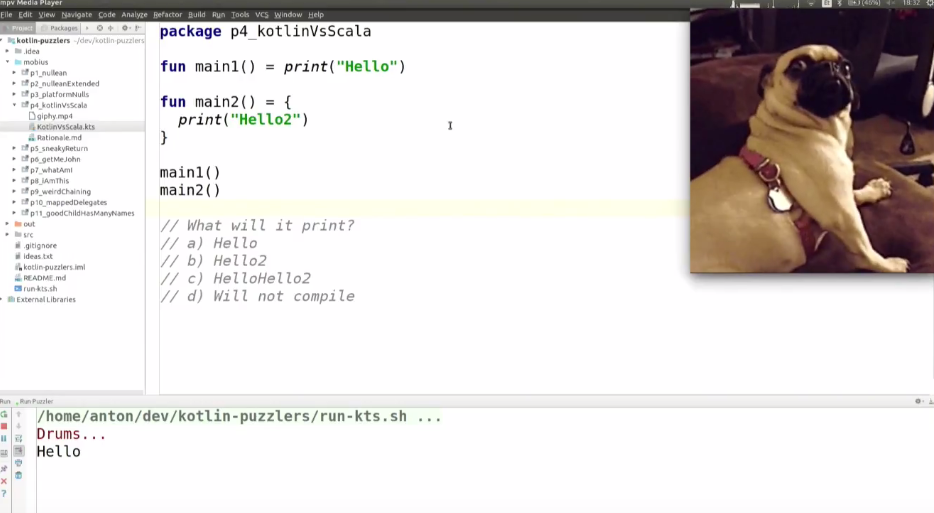

Пазлер 4

У нас есть 2 функции, которые должны печатать. Мы их объявляем и запускаем — должно быть все просто:

package p4_kotlinVsScala

fun main1() = print("Hello")

fun main2() = {

print("Hello2")

}

main1()

main2()

Что будет на выходе?

- Hello

- Hello2

- HelloHello2

- не скомпилируется

Запускаем… Получаем Hello.

Почему?

Main1 вернет юнит, но при этом вызовет print(«Hello»). А main2 всего лишь вернет лямбду, которая не будет выполняться.

Исправить можно так:

main2()()

Второй, на мой взгляд, лучший вариант исправления — убрать знак равно у main2, поскольку он всех только смущает:

fun main2() {

print("Hello 2")

}

Почему я назвал этот пример Котлин vs Scala? Те, кто писал на Scala, знают, что там этот код — абсолютно валидное объявление функции, которая что-то возвращает:

fun main2() = { }

Бедные Scala-девелоперы, которые будут писать на Котлине. Они, наверное, постоянно будут возвращать лямбды без запуска.

Пазлер 5

У нас есть list из цифр, мы его перебираем методом forEach. ForEach, как и в Groovy, если параметр лямбда не объявлен, знает it. И мы проверяем, что он не больше 2, и печатаем.

package p5_sneakyReturn

fun main(args: Array) {

listOf(1, 2, 3).forEach {

if (it > 2) return

print(it)

}

print("ok")

}

Какой будет итог?

- 123ok

- 12ok

- 12

- бесконечный цикл

Запускаем…

12

Что за ерунда?

В Котлине return возвращает из функции. А чтобы выйти из конкретной лямбды, внутри этой функции нужно после return указать название лямбды:

if (it > 2) return@forEach

Так можно выйти из лямбды. Если вы пишите на Java и вам очень нужно выйти из лямбды, это вариант исправления кода.

На самом деле return в Котлине работает так, как он должен работать. Если бы мы до этого не писали бы на C# и Java, наверное, и не ошиблись бы, потому что return возвращается из функции main. Все логично. И нет никаких странных фич с лямбдами, из которых тоже почему-то нужно выйти.

Почему это так работает?

Функция forEach объявлена как inline функция. В Kotlin компилятор не вызывает эту функцию в скомпилированном коде, а берет код этой функции и вставляет на то место, где был call. В результате здесь получается обычный for-цикл и, естественно, тогда return выходит из функции main.

Как понять, что это Inline функция? Во-первых, в IDEA есть Ctrl+p. А во-вторых, если вызвать return, а функция окажется не inline, то компилятор скажет: «Извини, нельзя это делать». То есть компилятор не позволит нам сделать какую-то ерунду.

Есть еще один вариант, как можно исправить этот код, чтобы он возвращал «12ok». Нужно это объявить как функцию, а не лямбду.

fun main(args: Array) {

listOf(1, 2, 3).forEach(fun() {

if (it > 2) return

print(it)

})

print("ok")

}

Единственное отличие в Котлине анонимной функции и лямбды в том, что первая ведет себя именно как функция, а значит — return будет возвращать из ближайшего «веселья» (fun). Поэтому с таким исправлением оно будет работать как надо.

Чтобы было еще интереснее, я подготовил несколько примеров. В Котлине бывают разные кейворды:

- fun

- inline fun

- inline fun с лямбдой noinline

- inline fun с лямбдой crossinline

Некоторые из них позволяют использовать return, а некоторые — нет.

package p5_sneakyReturn

fun hello(block: () -> Unit) = block()

inline fun helloInline(block: () -> Unit) = block()

inline fun helloNoInline(noinline block: () -> Unit) = hello(block)

inline fun helloCrossInline(crossinline block: () -> Unit) = runnable { block() }.run()

fun main(args: Array) {

hello {

println("hello")

//return - impossible

}

hello(fun() {

println("hello")

return

})

helloInline {

println("hello")

return

}

helloNoInline {

println("hello")

//return - impossible

}

helloCrossInline {

println("hello")

//return - impossible

}

Домашним заданием оставляем пожелание разобраться, что такое Crossinline. Думаю, вам это будет интересно.

Когда я только начал писать на Котлине, я тоже подумал, что это нечто сложное. Но когда ты понимаешь, что такое inline-функция (почти все extension-функции для коллекции — Inline для performance), все становится очень логичным.

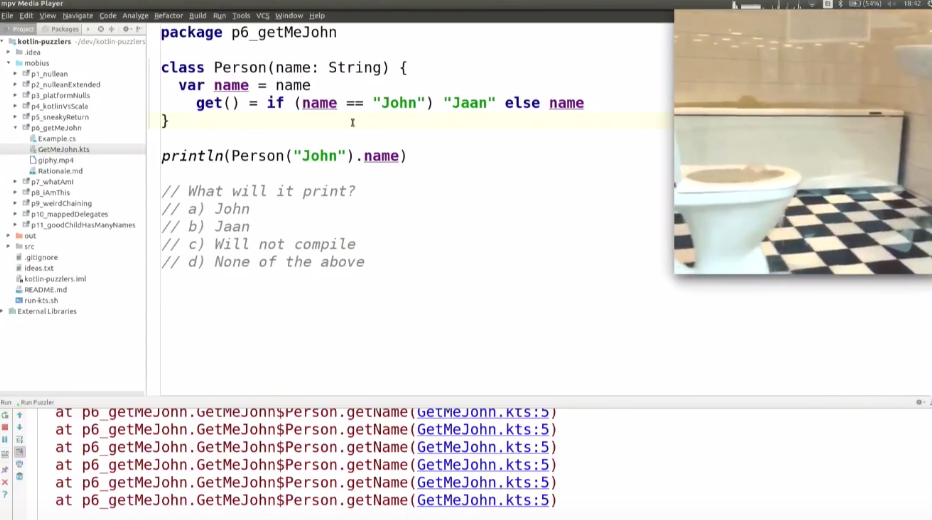

Пазлер 6

Нам нужно получить John или Jaan.

У нас есть простой класс Person. В Котлине очень удобно: можно при декларации класса сразу продекларировать конструктор. Мы получаем переменную конструктора name, забиваем ее в property. В Котлине нет field — есть только property, что очень круто, так как не нужно писать геттер, сеттеры и всякую ерунду (или геты и сеты, как в C#). Отличный красивый синтаксис.

В итоге мы создаем Person с именем John и смотрим, превратится ли он у нас в эстонскую локализацию Jaan:

package p6_getMeJohn

class Person(name: String) {

var name = name

get() = if (name == "John") "Jaan" else name

}

println(Person("John").name)

- John

- Jaan

- не скомпилируется

- ни один из вариантов

Запускаем…

Это stack overflow.

Почему?

Мы берем name, делаем ему if-else и вызываем его же по get. Чтобы исправить, нужно обратиться к полю, а не к property. Можно использовать кейворд field:

class Person(name: String) {

var name = name

get() = if (field == "John") "Jaan" else field

}

По кейворду field в Котлине можно обратиться к полю, но единственное место, где это можно сделать, — внутри геттера / сеттера. Все остальные обращения идут только через property — напрямую к field не обращаются.

Говорят, что по перформансу все это круто, потому что Java Hotspot компилятор это хорошо оптимизирует, в отличие от виртуальных машин .NET, и все работает очень быстро.

Пазлер 7

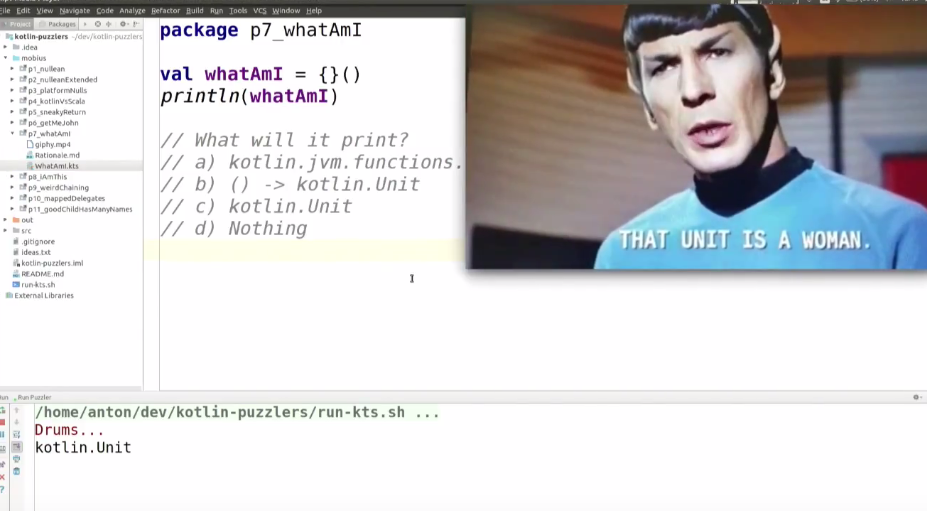

Снова смотрим на офигенную фичу языка — type inference — нас не волнует, какого типа whatAmI, мы его можем все равно использовать. Но компилятор знает, что это такое. Посмотрим, знаем ли мы.

package p7_whatAmI

val whatAmI = {}()

println(whatAmI)

Какой вариант будет в итоге?

- kotlin.jvm.functions.Function0

- () -> kotlin.Unit

- kotlin.Unit

- ничего

Запускаем… Получаем kotlin.Unit.

Почему?

Здесь объявляется лямбда, потом происходит вызов лямбды. Так как лямбда ничего не возвращает (точнее, возвращает kotlin.Unit), именно это и выводится. А самое лучшее определение unit — это void.

Откуда вообще пришел Unit? По-моему, даже в математике (или в computer science) есть такое понятие как теория типов. И там описано, что Unit — это один элемент, который означает «ничего». Поэтому некоторые более академические языки программирования используют термин Unit. Котлин был задизайнен как прагматичный язык, но, тем не менее, его разработчики решили выбрать не прагматичный void, а придумали сделать Unit.

Чтобы вам было еще интереснее, в Котлине есть еще один тип: kotlin.Nothing.

Чем они отличаются? Пусть ответ на этот вопрос будет вам домашним заданием.

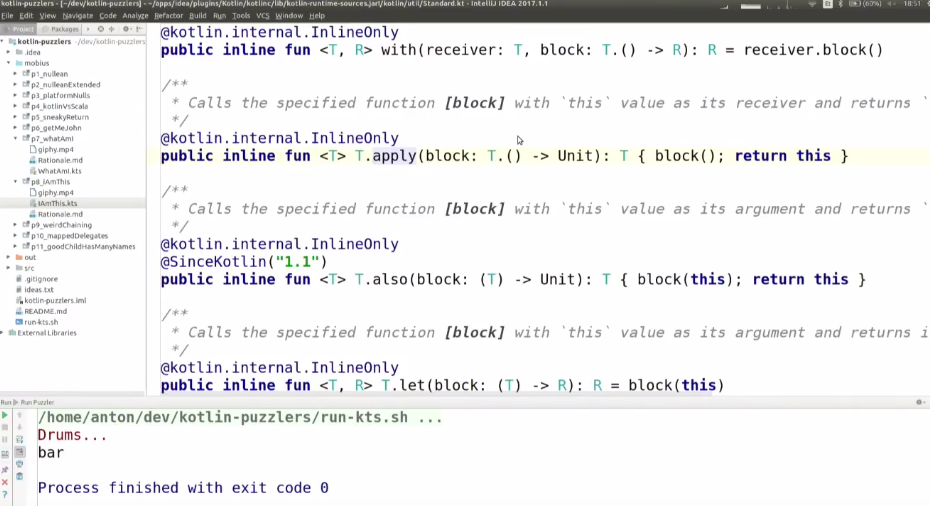

Пазлер 8

Мы посмотрели whatAmI, а теперь у нас будет iAmThis.

Здесь все немного усложняется: у нас есть класс IAm, он — data class (это офигенная фича в Kotlin, которая за нас автоматически генерирует equal, hashCode, toString и весь этот boiler plate, который мы все так ненавидим писать на Java). В Scala это case class — там название для этого хуже, хотя на самом деле все используют его именно как data class.

У класса IAm есть конструктор, в котором объявляем поле foo. Foo одновременно является property, поэтому его можно использовать с функцией hello().

Мы передаем туда String «bar», вызываем функцию hello и смотрим, что она нам возвращает.

package p8_iAmThis

data class IAm(var foo: String) {

fun hello() = foo.apply {

return this

}

}

println(IAm("bar").hello())

Что получим на выходе?

- IAm

- IAm(foo=bar)

- bar

- не скомпилируется

Запускаем… Получаем bar

Почему?

Apply — хитрая extension-функция. Она принимает лямбду и позволяет внутри нее с объектом, на котором она вызвана, выполнять какие-то действия по this. Соответственно, this — это bar. И Hello — это bar.

В этом Kotlin похож на JavaScript. Как в JavaScript, в Kotlin можно достичь того состояния, когда вы уже не знаете, что такое this.

Вообще там есть много полезных функций: also, let, with.

В принципе, они все отличаются достаточно мало.

К примеру, apply — это extension-функция на абсолютно любой тип (не nullable). Она принимает лямбду, а лямбда эта очень хитрая, потому что она апплаится к внутреннему T, а не к внешнему объекту (внутри этой лямбды свой Т). Т.е. функция вызывает эту лямбду со своим this и возвращает this (это иногда тоже полезно).

Есть и другие функции. Код можно исправить следующим образом:

package p8_iAmThis

data class IAm(var foo: String) {

fun hello() = foo.let {

return it

}

}

println(IAm("bar").hello())

Тогда это, может быть, станет менее непонятно.

Для некоторых кейсов Apply — очень полезная функция. Но если вы очень быстро смотрите на код (и при этом используется первый вариант записи), можно запутаться.

В первом варианте можно сократить код так (функция apply и сама возвращает this, поэтому ничего не меняется):

data class IAm(var foo: String) {

fun hello() = foo.apply {

}

}

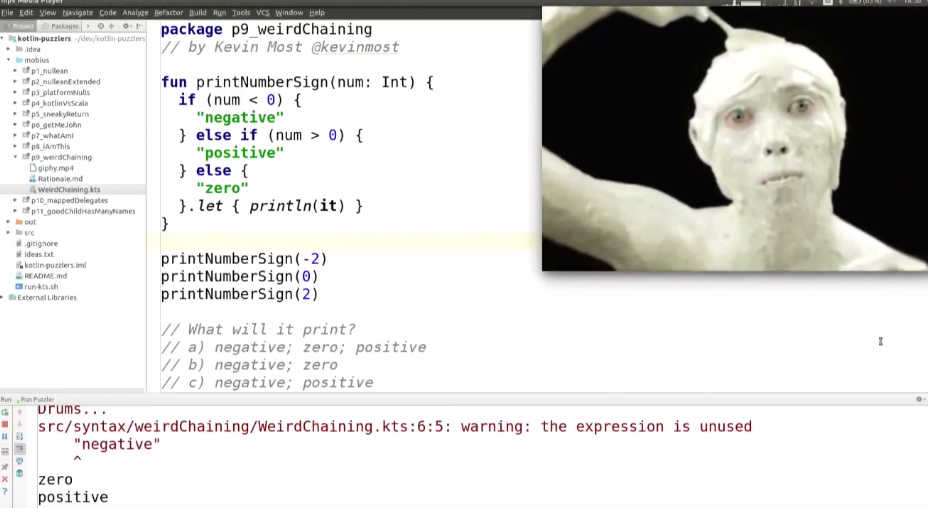

Пазлер 9

Посмотрим на уже известную нам функцию let.

Этот пазлер прислал Kevin Most из Канады. У него есть простая функция, которая печатает знак аргумента (Int).

package p9_weirdChaining

// by Kevin Most @kevinmost

fun printNumberSign(num; Int) {

if (num < 0) {

"negative"

} else if (num > 0) {

"positive"

} else {

"zero"

}.let { println(it) }

}

printNumberSign(-2)

printNumberSign(0)

printNumberSign(2)

Что такой код будет печатать?

- negative; zero; positive

- negative; zero

- negative; positive

- zero; positive

Запускаем… На выходе — zero; positive.

В чем же дело?

If — это на самом деле выражение. То есть получается два выражения, и let применяется только ко второму.

Я много писал на Kotlin, но этот пазлер сам не решил. Это какая-то адская тема. На предыдущей конференции JPoint мы даже думали, что это баг в компиляторе. Но я спросил у Андрея Бреслава, и выяснилось, что это просто нюанс парсера.

Как исправить? Легко — достаточно поставить скобки:

fun printNumberSign(num; Int) {

(if (num < 0) {

"negative"

} else if (num > 0) {

"positive"

} else {

"zero"

}).let { println(it) }

}

Тогда let применяется к результату всего выражения. А в первом случае код срабатывал так:

fun printNumberSign(num; Int) {

if (num < 0) {

"negative"

} else (if (num > 0) {

"positive"

} else {

"zero"

}).let { println(it) }

}

При этом верхний expression идет отдельно — к нему функция let не применяется.

Оператора elseif в Котлине нет (если бы он был, тогда бы этого пазлера бы и не было).

Как и во всех пазлерах, мораль такова: не пишите такой код. Если хотите сделать что-то сложное (как здесь), обязательно поставьте скобки или положите это в переменную и потом вызовите let.

Пазлер 10

Еще более интересный пазлер. Тут много кода.

Этот пазлер засабмиттил Даниил Водопьян. Это пазлер на очень классную фичу в Kotlin — delegate properties. В Котлине мы можем объявить, например, что в классе есть несколько properties, и они имплементируются не как field, а как лукапы из map.

У нас есть класс Population — население. А cities нам передает (var cities: Map) и мы делегируем их в этот map.

Это фактически позволяет превратить Kotlin в JavaScript и делать более динамические структуры, не копировать данные туда-сюда. Такие классы сокращают очень много кода.

Потом мы создаем инстанс класса Population и передаем ему для всех городов население.

Теперь представим, что прошло много лет. Люди загадили Землю — улетели жить на Марс. Поэтому мы сбрасываем map с населением.

Здесь есть функция with, которую мы смотрели до этого. Она берет population и ресолвит относительно него имеющиеся field-ы (в принципе, точно также, как и apply).

package p10_mappedDelegates

// by Daniil Vodopian @voddan

class Population(var cities: Map) {

val tallinn by cities

val kronstadt by cities

val st_petersburg by cities

}

val population = Population(mapOf(

"st_petersburg" to 5_281_579,

"tallinn" to 407_947,

"kronstadt" to 43_005

))

// Many years have passed, now all humans live on Mars

population.cities = emptyMap()

with(population) {

println("$tallinn; $kronstadt; $st_petersburg")

}

Все легко. Осталось только понять, что станет с нашей Землей, когда все улетят на Марс. Что такой код выдаст?

- 0; 0; 0

- 407947; 43005; 5281579

- NullPointerException

- NoSuchElementException

Запускаем… Оказывается, люди никуда не исчезли (на Марсе жить очень сложно, поэтому мы, скорее всего, останемся на Земле).

Почему?

Неверно сказать, что population.cities = emptyMap() сделает пустую map у класса, но не у его экземпляра. Если мы изменим код так (сделаем MutableMap и обнулим Кронштадт — population.kronstadt = 0):

class Population(var cities: MutableMap) {

val tallinn by cities

var kronstadt by cities

val st_petersburg by cities

}

val population = Population(mutablemapOf(

"st_petersburg" to 5_281_579,

"tallinn" to 407_947,

"kronstadt" to 43_005

))

// Many years have passed, now all humans live on Mars

population.kronstadt = 0

Код выведет: 407947; 0; 5281579

Но обсуждаем мы все-таки первый вариант (c population.cities = emptyMap()).

Когда мы исполняем delegate, ссылка на map запоминается внутри геттера (для каждого из них). И если мы меняем ссылку на cities, это уже не меняет ссылки внутри геттеров. Но мы можем даже в cities положить в map другое, и все будет работать, поскольку это все равно остается ссылка на тот же самый map. Но если мы меняем референс на другой map, то он перестает действовать.

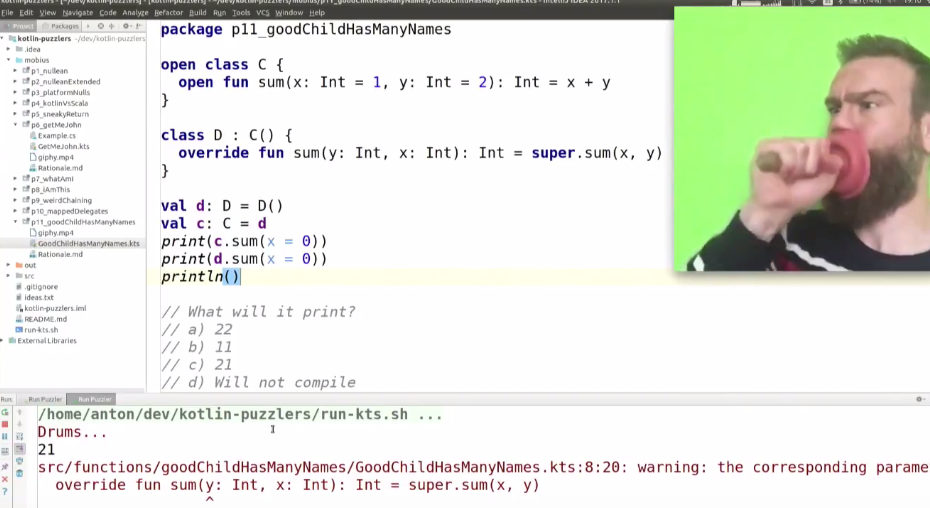

Пазлер 11

У нас в Эстонии есть отличная поговорка: «У хорошего ребенка есть много имен».

Посмотрим, как это здесь относится к нашим классам.

В Котлине есть такой странный нюанс: классы по умолчанию final — их нельзя проэкстендить. Есть кейворд open, который все-таки позволяет их экстендить.

В этом пазлере в классе C у нас есть open-метод (тоже, чтобы мы могли его заоверрайдить). Здесь мы берем x и y (у них есть дефолтные значения — это очень классная фича в языке).

У нас есть класс D, который экстендит класс C и оверрайдит функцию sum, но в принципе ничего полезного не делает, кроме того, что вызывает супер-имплементацию.

Дальше у нас есть переменная d — мы создаем инстанс класса D; у нас есть переменная c и туда мы присваиваем тот же самый инстанс (получаем 2 референса на один и тот же инстанс класса D). И мы вызываем один и тот же метод по сути на одном и том же объекте.

package p11_goodChildHasManyNames

open class C {

open fun sum(x: Int = 1, y: Int = 2): Int = x + y

}

class D : C() {

override fun sum(y: Int, x: Int): Int = super.sum(x, y)

}

val d: D = D()

val c: C = d

print(c.sum(x = 0))

print(d.sum(x = 0))

println()

Что получим в итоге?

- 22

- 11

- 21

- не скомпилируется

Запускаем… Правильный ответ — 21.

Здесь еще есть некоторые warning-и, которые помогают понять, что происходит.

В обоих случая вызывается переопределенная функция, потому что полиморфизм. В рантайме выбирается, какая функция вызывается, потому что в реальности и c, и d — это инстанс класса D. Но так как у JVM нет такой фичи, как именные параметры, их ресолвит компилятор от compile-time. Т.е. получается, что функция выбирается и вызывается в рантайме, а параметры выбираются в compile-time. Поэтому какие параметры он подставляет, зависит от типа переменной, а не объекта, получающегося в рантайме. Это косяк. Warning-и предупреждают, что не следует путать свои названия — когда вы оверрайдите функцию, ее надо назвать иначе.

Хорошая новость в том, что примерно для половины представленных пазлеров в IDEA уже есть warning. Благодаря тому, что JetBrains сами занимаются еще и инструментами, они достаточно хорошо помогают избегать многих ошибок. Но не всех. Для некоторых из пазлеров warning сделать попросту невозможно.

Однако язык развивается. В 2016 году, когда я только начал на нем писать, было гораздо меньше инспекций в IDEA и гораздо проще было эти пазлеры самому схлопотать. Сейчас ситуация совсем другая: вышла версия 1.1, было много патч-релизов, много инспекций добавлено в IDEA, и на Котлине писать правильно теперь очень легко.

Вместо заключения хочу сказать: переходите на Kotlin.

- Под Android до сих пор нет нормальной Java 8, а в Котлине вы получаете все фичи Java 8 и даже еще больше. Можно гораздо лучше себя выражать.

- Котлин — язык без большого хайпа. Это тоже его плюс.

- Его часто называют «Swift» для Android. Но со Swift есть небольшая проблема — когда выходит новая версия, приходится постоянно переписывать весь код. С Котлиным такой проблемы нет — нам обещают обратную совместимость, как и source-level, так и binary-level.

- Kotlin компилируется гораздо быстрее, чем Scala. Он гораздо проще Scala.

- Он гораздо быстрее в рантайме, чем Groovy. Если вы добавляете свое приложение на Android, то размер по-моему увеличивается всего на 600 Кб по сравнению с Java — и это очень мало по сравнению со Scala. Поэтому есть смысл на нем писать.

- Когда я на него перешел, я начал быть продуктивным уже с первого дня.

- Про Kotlin говорят, что это «более хороший Groovy», там есть хорошие фичи.

- И ваш самый главный друг в IDEA — это Ctrl+Alt+Shift+K, который сконвертирует любой класс Java сразу в Kotlin (as is). При этом нет Ctrl+Alt+Shift+J, поэтому вы не можете уже вернуться — это дорога в один конец. Да вы и не захотите возвращаться.

- Также переходит Gradle.

Присылайте нам новые пазлеры, чтобы мы могли повеселиться на следующих конференциях.

Если любите нутрянку программирования так же, как и мы, и хотите основательнее погрузиться в Kotlin, рекомендуем обратить внимание вот на эти доклады, которые будут на грядущей конференции Mobius 2017 Moscow:

- Пишем Java-френдли Kotlin-код (Сергей Рябов, Independent)

- Data Binding in a Kotlin world (Lisa Wray, New York Times)

- Универсальные ссылки — дворец из подводных камней (Константин Якушев, Badoo)

|

Метки: author BigSolarWolf программирование kotlin блог компании jug.ru group пазлер кекс |

Kubernetes 1.8: обзор основных новшеств |

Kubernetes 1.8: обзор основных новшеств

Большое и хорошо организованное Open Source-сообщество, стоящее за разработкой Kubernetes, приучило нас ждать значимых и многочисленных изменений от каждого релиза. И Kubernetes 1.8 не стал исключением, представив на радость DevOps-инженерам и всем со

Официальный релиз Kubernetes 1.8 был запланирован ещё на минувшую среду, однако официальные анонсы (в блоге проекта и CNCF) пока не состоялись. Тем не менее, сегодня в 3:35 ночи по MSK в Git-репозитории проекта было замечено изменение в CHANGELOG, которое сигнализирует о готовности Kubernetes 1.8 для скачивания и использования:

Итак, что же нового принёс релиз Kubernetes 1.8?

Сеть

В kube-proxy добавлена альфа-версия поддержки режима IPVS для балансировки нагрузки (вместо iptables). В этом режиме kube-proxy следит за сервисами и endpoints в Kubernetes, создавая netlink-интерфейс (

virtual server и real server соответственно). Кроме того, он периодически синхронизирует их, поддерживая консистентность состояния IPVS. При запросе на доступ к сервису трафик перенаправляется на один из подов бэкенда. При этом IPVS предлагает различные алгоритмы для балансировки нагрузки (round-robin, least connection, destination hashing, source hashing, shortest expected delay, never queue). Такую возможность часто запрашивали в тикетах Kubernetes, и мы сами тоже очень её ждали.Среди других сетевых новшеств — бета-версии поддержки политик для исходящего трафика

EgressRules в NetworkPolicy API, а также возможность (в том же NetworkPolicy) применения правил по CIDR источника/получателя (через ipBlockRule).Планировщик

Главное новшество в планировщике — возможность задавать подам приоритеты (в спецификации пода,

PodSpec, пользователи определяют поле PriorityClassName, а Kubernetes на его основе выставляет Priority). Цель банальна: улучшить распределение ресурсов в случаях, когда их не хватает, а требуется одновременно выполнить по-настоящему критичные задачи и менее срочные/важные. Теперь поды с высоким приоритетом будут получать больший шанс на исполнение. Кроме того, при освобождении ресурсов в кластере (preemption) поды с меньшим приоритетом будут затронуты скорее подов с высоким приоритетом. В частности, для этого в kubelet была изменена стратегия по выборке подов (eviction strategy), в которой теперь учитываются одновременно и приоритет пода, и потребление им ресурсов. Реализация всех этих возможностей имеет статус альфа-версии. Приоритеты Kubernetes и работа с ними подробно описаны в документации по архитектуре.Ещё одно интересное новшество, представленное в альфа-версии, — более сложный механизм обработки поля условий (

Condition, см. документацию) на узлах. Традиционно в этом поле фиксируются проблемные состояния узла — например, при отсутствии сети условие NetworkUnavailable ставится в True, в результате чего поды перестанут назначаться на этот узел. С помощью нового подхода Taints Node by Condition такая же ситуация приведёт к пометке узла определённым статусом (например, node.kubernetes.io/networkUnavailable=:NoSchedule), на основе которого (в спецификации пода) можно решить, что делать дальше (действительно ли не назначать под такому проблемному узлу).Хранилища

Указание опций монтирования для томов стало стабильным, а одновременно с этим:

- в спецификации

PersistentVolumeпоявилось новое полеMountOptionsдля указания опций монтирования (вместо annotations); - в спецификации

StorageClassпоявилось аналогичное полеMountOptionsдля динамически создаваемых томов.

В API метрики Kubernetes добавлена информация о доступном пространстве в постоянных томах (PV), а также метрики успешности выполнения и времени задержки для всех вызовов mount/unmount/attach/detach/provision/delete.

В спецификации

PersistentVolume для Azure File, CephFS, iSCSI, GlusterFS теперь можно ссылаться на ресурсы в пространствах имён.Среди нестабильных нововведений (в статусах альфа и бета):

- в

StorageClassдобавлена бета-версия поддержки определения reclaim policy (аналогично PersistentVolume) вместо применения политикиdeleteвсегда по умолчанию; - в Kubernetes API добавлена возможность увеличения размера тома — альфа-версия этой фичи увеличивает размер только для тома (не делает resize для файловой системы) и поддерживает только Gluster;

- началась работа над изоляцией/ограничениями для хранилищ данных — в статусе альфа представлен новый ресурс

ephemeral-storage, который включает в себя всё дисковое пространство, доступное контейнеру, и позволяет устанавливать ограничения на возможный объём (quota management) и запросы к нему (limitrange) — подробнее см. в текущей документации; - новое поле

VolumeMount.PropagationдляVolumeMountв контейнерах пода (альфа-версия) позволяет устанавливать значениеBidirectionalдля возможности использования того же примонтированного каталога на хосте и в других контейнерах; - доступен ранний прототип создания снимков томов (volume snapshots) через Kubernetes API — пока эти снапшоты могут быть неконсистентными, и ответственный за них код вынесен из ядра Kubernetes во внешний репозиторий.

kubelet

В kubelet появилась альфа-версия нового компонента — CPU Manager, — взаимодействующего напрямую с kuberuntime и позволяющего назначать контейнерам подов выделенные ядра процессоров (т.е. CPU affinity policies на уровне контейнеров). Как уточняется в документации, его появление стало ответом на две проблемы:

- плохая или непредсказуемая производительность по сравнению с виртуальными машинами (из-за большого количества переключений контекста и недостаточно эффективного использования кэша),

- недопустимые задержки, относящиеся к планировщику процессов ОС, что особенно заметно в функциях виртуальных сетевых интерфейсов.

Динамическая конфигурация kubelet — ещё одна фича в альфа-статусе, позволяющая обновлять конфигурацию этого агента во всех узлах «живого» кластера. Доведение её до стабильного состояния (GA) ожидается только в релизе 1.10.

Метрики

Поддержка пользовательских метрик в Horizontal Pod Autoscaler (HPA) получила статус бета-версии, и связанные с ней API переведены на

v1beta1.metrics-server стал рекомендованным способом предоставления API для метрик ресурсов. Деплоится как дополнение по аналогии с Heapster. Прямое получение метрик из Heapster объявлено устаревшим.

Cluster Autoscaler

Утилита Cluster Autoscaler, созданная для автоматического изменения размера кластера Kubernetes (когда есть поды, которые не запускаются из-за недостатка ресурсов, или некоторые узлы плохо используются долгое время), получила стабильный статус (GA) и поддержку до 1000 узлов.

Кроме того, при удалении узлов Cluster Autoscaler теперь даёт подам по 10 минут для корректного завершения работы (graceful termination). В случае, если под так и не остановлен за это время, узел всё равно удаляется. Раньше этот лимит составлял 1 минуту или корректного завершения не дожидались вообще.

kubeadm и kops

В kubeadm появилась альфа-реализация деплоя кластера (control plane) типа self-hosted (

kubeadm init с флагом --feature-gates=SelfHosting=true). Сертификаты при этом могут храниться на диске (hostPath) или в секретах. А новая подкоманда kubeadm upgrade (находится в бета-статусе) позволяет автоматически выполнять обновление кластера self-hosted, созданного с помощью kubeadm.Другая новая возможность kubeadm в статусе альфа — выполнение подзадач вместо всего цикла

kubeadm init с помощью подкоманды phase (на текущий момент доступна как kubeadm alpha phase и будет приведена в официальный вид в следующем релизе Kubernetes). Основное предназначение — возможность лучшей интеграции kubeadm с provisioning-утилитами вроде kops и GKE.В kops, тем временем, представлены две новые фичи в статусе альфа: поддержка bare metal-машин в качестве целевых и возможность запуска как сервера (см. Kops HTTP API Server). Наконец, поддержку GCE в kops «повысили» до статуса бета-версии.

CLI

Консольная утилита kubectl получила экспериментальную (альфа-версия) поддержку дополнений. Это означает, что стандартный набор входящих в неё команд теперь можно расширять с помощью плагинов.

Команды

rollout и rollback в kubectl теперь поддерживают StatefulSet.API

Изменения в API включают в себя

APIListChunking — новый подход к выдаче ответов на запросы LIST. Теперь они разбиваются на небольшие куски и выдаются клиенту в соответствии с указанным им лимитом. В результате, сервер потребляет меньше памяти и CPU при выдаче очень больших списков, и такое поведение станет стандартным для всех инфомеров в Kubernetes 1.9.CustomResourceDefinition API научился валидировать объекты, основываясь на JSON-схеме (из CRD-спецификации) — альфа-реализация доступна как

CustomResourceValidation в kube-apiserver.Сборщик мусора получил поддержку пользовательских API, добавленных через

CustomResourceDefinition или агрегированные API-серверы. Поскольку обновления контроллера происходят периодически, между добавлением API и началом работы сборщика мусора для него стоит ожидать задержку около 30 секунд.Workload API

Так называемый Workload API — это базовая часть Kubernetes API, относящаяся к «рабочим нагрузкам» и включающая в себя

DaemonSet, Deployment, ReplicaSet, StatefulSet. На данный момент эти API перенесены в группу apps и с релизом Kubernetes 1.8 получили версию v1beta2. Стабилизация же Workload API предполагает вынесение этих API в отдельную группу и достижение максимально возможной консистентности с помощью стандартизации этих API путём удаления/добавления/переименования имеющихся полей, определения однотипных значений по умолчанию, общей валидации. Например, стратегией spec.updateStrategy по умолчанию для StatefulSet и DaemonSet стал RollingUpdate, а выборка по умолчанию spec.selector для всех Workload API (из-за несовместимости с kubectl apply и strategic merge patch) отключена и теперь требует явного определения пользователем в манифесте. Обобщающий тикет с подробностями — #353.Другое

Среди прочих (и весьма многочисленных!) изменений в релизе Kubernetes 1.8 отмечу:

- управление доступом на основе ролей (RBAC), использующее группу API

rbac.authorization.k8s.ioдля возможности конфигурации динамических политик, переведено в стабильный статус (GA), а также получило бета-версию нового API (SelfSubjectRulesReview) для просмотра действий, которые пользователь может выполнить с пространством имён; - представлена альфа-версия механизма для хранения ключей шифрования ресурсов в сторонних системах (Key Management Systems, KMS), и одновременно с этим появился плагин Google Cloud KMS (#48522);

- в

PodSecurityPoliciesдобавлена поддержка белого списка разрешённых путей для томов хоста; - поддержка CRI-O (Container Runtime Interface) на базе стандарта от Open Container Initiative объявлена стабильной (прошла все тесты e2e) [CRI-O — связующее звено между kubelet и исполняемыми средами, совместимыми с OCI, такими как runc; подробнее см. в GitHub], а также проект cri-containerd достиг статуса альфа-версии;

- поддержка Multi-cluster, ранее известная как Federation, готовится к стабильному выпуску (GA) в следующих релизах Kubernetes, а пока стали доступны альфа-реализации Federated Jobs, которые автоматически деплоятся на множество кластеров, и Federated Horizontal Pod Autoscaling (HPA), работающих аналогично обычным HPA, но, опять же, с распространением на множество кластеров;

- команда, ответственная за масштабируемость, формально зафиксировала процесс своего тестирования, создала документацию для имеющихся пороговых значений, определила новые наборы по уровням обслуживания (Service Level Indicators и Service Level Objectives).

P.S.

Во время подготовки Kubernetes 1.8 проект собирался со следующими версиями Docker: 1.11.2, 1.12.6, 1.13.1, 17.03.2. Список известных проблем (known issues) для них см. здесь. В том же документе, озаглавленном как «Introduction to v1.8.0», можно найти и более полный список всех крупных изменений.

Сами мы затянули с обновлением обслуживаемых кластеров Kubernetes с релиза 1.6 до 1.7 и провели основную миграцию только 2 недели назад (на данный момент осталось несколько инсталляций с версией 1.6). Повсеместное обновление до нового релиза — 1.8 — планируем уже в октябре.

Читайте также в нашем блоге:

- «Docker 17.06 и Kubernetes 1.7: ключевые новшества»;

- «Наш опыт с Kubernetes в небольших проектах» (видео доклада, включающего в себя знакомство с техническим устройством Kubernetes);

- «Зачем нужен Kubernetes и почему он больше, чем PaaS?»;

- «Как на самом деле работает планировщик Kubernetes?» (перевод).

|

Метки: author distol системное администрирование серверное администрирование devops блог компании флант kubernetes docker |

Тайм-менеджмент для кинестетиков |

- Разработка для интернета вещей,

- Программирование микроконтроллеров,

- Visual Studio,

- C#,

- Блог компании DevExpress

Тайм-менеджмент для кинестетиков

- Разработка для интернета вещей,

- Программирование микроконтроллеров,

- Visual Studio,

- C#,

- Блог компании DevExpress

Время — самый ценный ресурс, который у нас есть. Чтобы использовать его максимально продуктивно, существуют всякого рода техники тайм-менеджмента. Если говорить о тайм-менеджменте в масштабах рабочего дня, то одна из самых популярных техник называется Pomodoro. Но эта статья не про GTD, а про код (и немного про железо ^^).

Так вот, для техники Pomodoro есть инструмент Tomighty и у него открытый исходный код на C#, что побуждает к модификации этого самого кода с целью добавления новых возможностей и интеграции со всякими штуками.

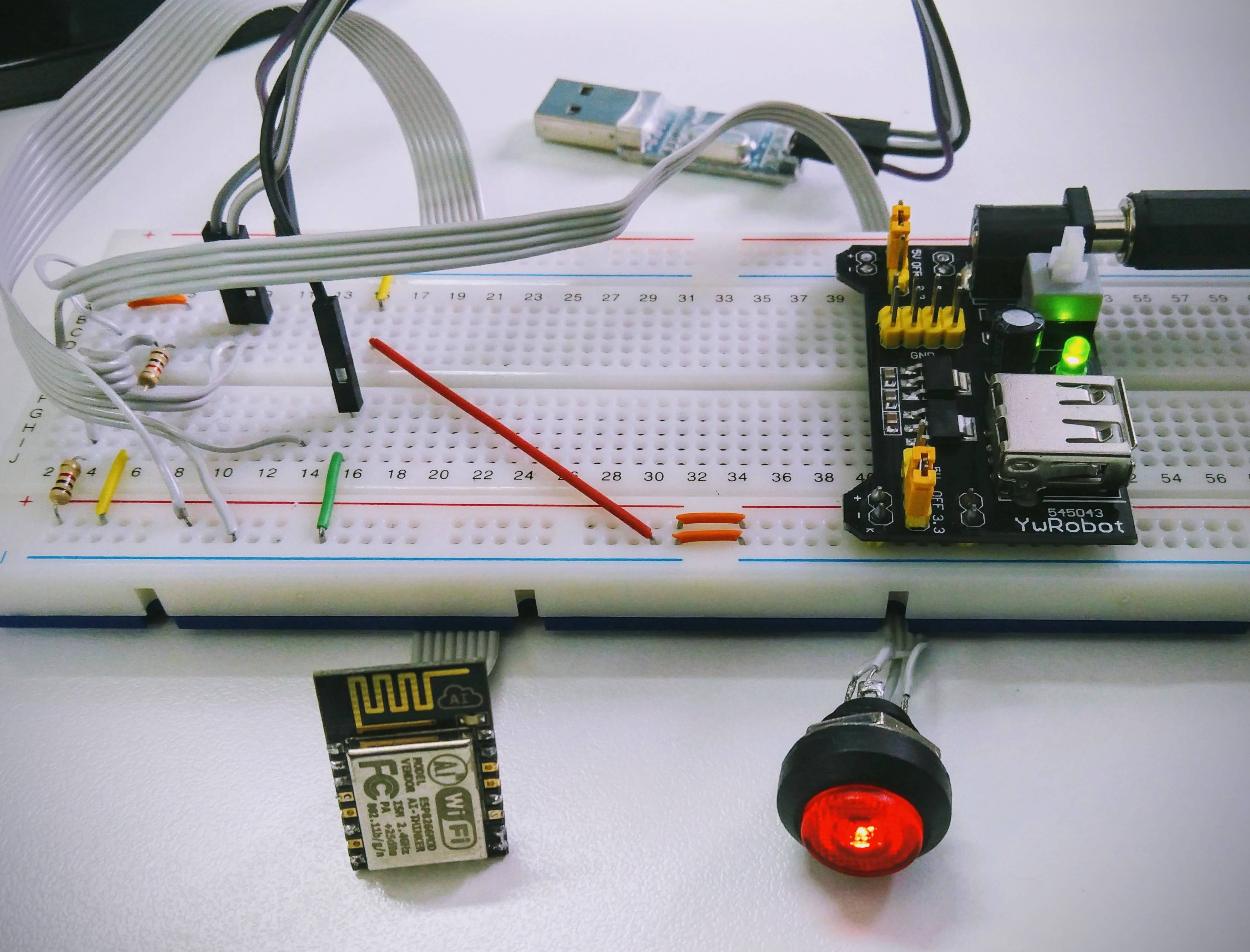

Сегодня мы будем интегрировать клиент Tomighty с устройстовм "Большая Красная Кнопка". Нам для этого понадобится:

- Большая Красная Кнопка (со светодиодом). У меня оказалась не очень большая, но очень красная.

- ESP8266 — один из наиболее оптимальных микроконтроллеров по соотношению удобство/цена. Это даже не микроконтроллер вовсе, но как микроконтроллер он абсолютно прекрасен!

- MicroPython. Я не знаю языка удобнее чем Python, а вы? Разве что Ruby, но его вроде бы не портировали на ESP8266.

- Протокол MQTT для связи между компом и девайсом.

- Visual Studio.

- Опционально, расширение CodeRush for Roslyn. Оно сильно упрощает работу с как со своим, так и с незнакомым кодом.

Зачем? Чтобы получить опыт работы с чужим кодом. В связи с грядущим Hacktoberfest, этот скилл будет крайне актуален.

Welcome!

Большая Красная Кнопка

С аппаратной стороны нет ничего сверхъестественного, посему подробно описывать каждый шаг не буду, всё должно работать, а код сам по себе довольно понятный.

- Берём ESP8266. У меня ESP-12-Q, но подойдет любой модуль с памятью 1МБ или более.

- Прошиваем MicroPython по инструкции.