Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Подборка интересных мероприятий на неделю в Москве |

Подборка интересных мероприятий на неделю в Москве

UX-Research Meetup

2 октября (понедельник) 19:00

Офис Mail.ru, Ленинградский пр-т, д. 39, стр.79

бесплатно

corp.mail.ru/ru/press/events/393

Бизнес-ужин ОК

3 октября (вторник) 18:30

ресторан Shakti Terrace, Болотная набережная 11 стр 1

бесплатно

corp.mail.ru/ru/press/events/394

Performance Marketing Moscow

4 октября (среда) 9:00

Кинотеатр «Октябрь», Новый Арбат 24

от 12 000

pm-moscow.com

Data Science завтрак

4 октября (среда) 9:30

Кафе-пекарня «Райский Пирожок”, Проспект мира, 26с1

бесплатно

Russian Affiliate Congress & Expo

4 октября (среда) — 5 октября (четверг) с 10:00

КВЦ «Сокольники», павильон № 7а, 5-й лучевой просек, 7с1

от 500 р, по коду RACE_partners скидка 66% на 2 дня конференции

goo.gl/BeNHib

Перспективы легального ICO в России

5 октября (четверг) 16:00

офис QIWI, мкр. Чертаново Северное, д.1А, корп.1

бесплатно

qviq.timepad.ru/event/581905

Travel Tech Conference Russia

5 октября (четверг) 9:00

Конгресс-центр „Технополис”, Волгоградский просп., 42к5

15 000 р.

traveltechcon.ru

Бизнес-форум «АТЛАНТЫ»

5 (четверг) — 6 (пятница) октября

Crocus City Hall, 65-66 км МКАД

от 6 900 р.

atlanty.ru

AIC Analytics Day: Fail Compilation

6 октября (пятница) 11:00

ФРИИ, Мясницкая, дом 13, стр 18

бесплатно

www.facebook.com/events/1894122860839825

Лекция Стива Возняка в Москве

7 октября (суббота) 12:00

МГУ, Ленинские Горы, 1

бесплатно

www.facebook.com/events/1938266743080680

Хакатон HSE VR AR Hack

7 октября (суббота) — 8 октября (воскресенье)

ул. Таллинская, д.34

бесплатно

studlife.hse.ru/announcements/209450025.html

mABBYYlity Hackaton

7 октября (суббота) — 8 октября (воскресенье)

Физтехпарк, Долгопрудненское шоссе, 3

бесплатно

mobility.abbyy.com/hack

|

Метки: author rvnikita хакатоны учебный процесс в it мероприятие мероприятия конференции митап митапы конференция хакатон маркетинг аналитика it |

[Перевод] Как эффективно работать с рекламным форматом Playable ads: пять типичных ошибок |

- Монетизация мобильных приложений,

- Монетизация игр,

- Аналитика мобильных приложений,

- Блог компании Appodeal

Как эффективно работать с рекламным форматом Playable ads: пять типичных ошибок

- Монетизация мобильных приложений,

- Монетизация игр,

- Аналитика мобильных приложений,

- Блог компании Appodeal

- Перевод

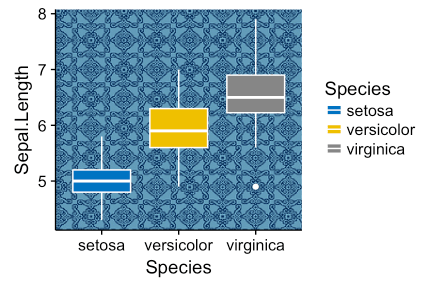

Playable ads — это интерактивная демо-версия игры, встроенная в рекламу, иными словами — реклама, в которую можно играть. Несмотря на то, что playable ads — стремительно растущее явление, многие до сих пор ошибаются при работе с этим форматом — до, во время и после запуска. Мы составили список из пяти наиболее распространенных ошибок на пользу рекламодателям, паблишерам и разработчикам.

Ошибка #1: Вы слишком сфокусированы на развлекательной части и теряете из виду общую картину

Зачастую бренды и разработчики крайне взбудоражены самой идеей playable ads. Каждая сессия мозговых штурмов посвящена только развлекательной части рекламы. Все пытаются создать игровой опыт с нуля, забывая, что на самом деле все, что нужно пользователю — это лишь немного веселья.

Как только дело доходит до реальных целей рекламы, далеко не все спешат детально изучить вопрос. Многие впадают в ступор, когда разговор заходит обо всех этих скучных цифрах вроде установок, СPI, CTR, доходности, воронки продаж и так далее. Помните: если вы запускаете кампанию с playable ads в формате HTML5, это чистой воды маркетинг. Следовательно, метрики имеют значение.

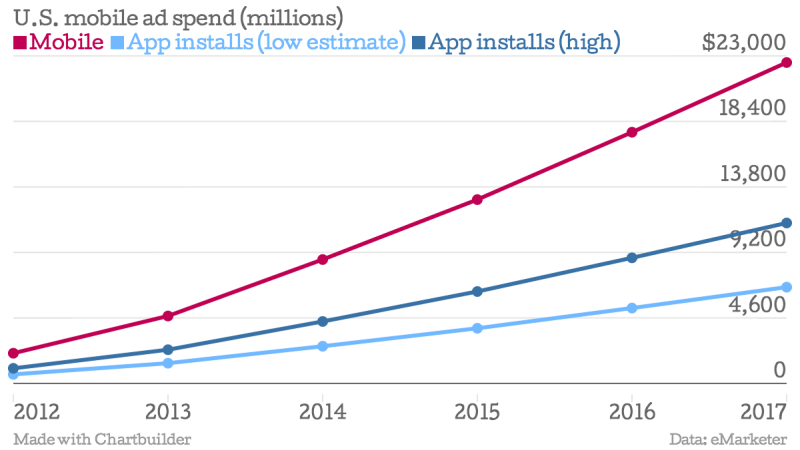

Цель каждой playable ad — получить как можно более дешевые установки приложения. Если бренды ежемесячно тратят миллионы долларов на закупку рекламы, формат playable должен оправдывать такие траты и обеспечивать адекватное количество загрузок.

Установки важнее, чем реклама сама по себе. Сместите фокус и сделайте выводы, какие типы рекламных креативов в формате playable срабатывают лучше остальных.

Ошибка #2: Вы не тестируете финальное сообщение для пользователя

Последнее сообщение — очень важное. Неправильный посыл может лишить вас потенциальной установки. Один скучный экран — и ваш CTR упадет.

Не жалейте времени на A/B тестирование креатива финального сообщения. Протестируйте каждый элемент, включая текст, картинки, кнопки и анимацию. Добавьте сюда локализацию — и вы увидите, как много вариантов добавится к стандартному месседжу.

На каждый A/B тест расходуется совсем небольшой рекламный бюджет, однако тесты помогают заранее определить, какой креатив лучше сработает. Как только лучший креатив найден — жгите! Запускайте кампанию и постоянно мониторьте ROI каждой установки.

Ошибка #3: Вы не оптимизируете первый пользовательский опыт (FTUE)

The First Time User Experience (FTUE) или первый пользовательский опыт — первое действие, которое совершает пользователь с момента запуска playable ad.

Существует множество примеров неоптимизированного FTUE — от медленного времени загрузки до непонятных инструкций для игроков.

Успешные playable ads грузятся очень быстро. Каждый килобайт креатива имеет значение. Избавьтесь от анимированных экранов загрузки, ненужных функций и переходите сразу к делу. Таким образом вы незамедлительно направите пользователя на действие — он начнет играть, потому что его об этом попросили.

Представим мобильного пользователя, который играет в паззл на телефоне. Он/она видит внутриигровую всплывающую рекламу со встроенной игрой (возможно, из-за награды, которую он/она пытается получить). Когда реклама уже активирована, пальцы пользователя по инерции ищут, на что бы нажать. Прикольная анимация — последнее, что хочет увидеть пользователь. Поверьте, все уже видели огромное количество rewarded video с классными анимациями. Пользователь хочет действия — и хочет остаться в своем игровом мире, в который вы вторглись с рекламой.

Как только вы разобрались с FTUE, следующий шаг — его оптимизация. Здесь стоит подумать о таких пользовательских действия, как нажатие, захват/сброс объекта, смахивание и так далее. Как правило, выигрышный FTUE вертится вокруг простейших действий — нажатие или захват/сброс объекта.

Ошибка #4: Вам не хватает бюджета

Эта часть больше относится к брендам, однако и разработчиками полезно знать о финансовых подводных камнях.

Чтобы преуспеть в playable ads, брендам приходится тратить на этот формат внушительную часть маркетингового бюджета. Минуло время, когда 1000 долларов в день было достаточно. Сегодня порой недостаточно и 100 тысяч долларов в месяц, особенно, если бренд работает в сфере с высокой конкуренцией.

Причина A: Конкуренты с бОльшими бюджетами предлагают куда более высокие расценки за привлечение внимания пользователей. Таким образом, их реклама в формате playable будет показываться вместо вашей.

Причина B: Чем больше рекламный бюджет, тем больше данных вы сможете собрать. Следовательно, вы сможете понять, сработал ли формат playable ads в масштабе или нет.

Мы рекомендуем как следует исследовать нишу, прежде чем разрабатывать playable ads. В случае с playable ads избегайте конкуренции на равных с приложениями из топа 10 по прибыли — как для iOS, так и для Android. Вместо этого попробуйте по-другому распределить бюджет в плане демографии, цельтесь в разные приложения, и так далее.

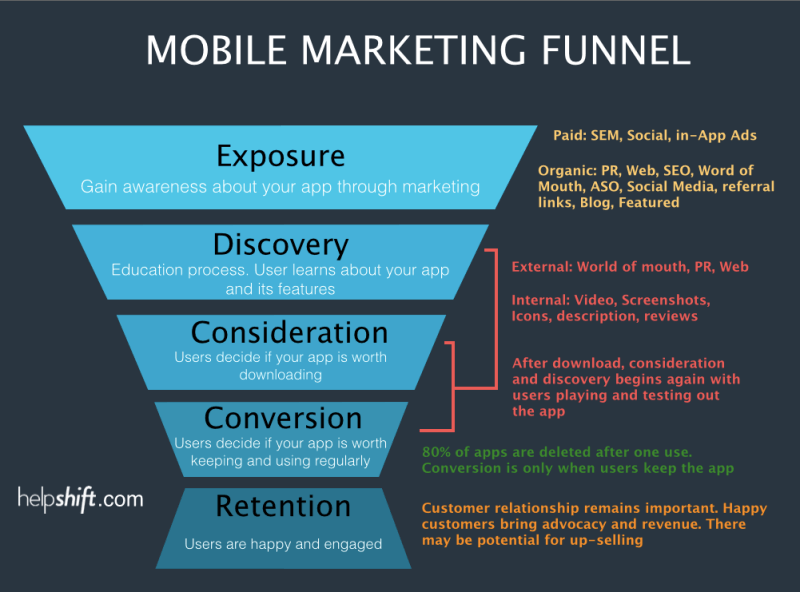

Ошибка #5: Вы не думаете о маркетинговой воронке в целом

Pеклама playable — это не просто реклама. Нельзя просто так отдать playable ads на контракт агентству и умыть руки — вас будет ждать мрачная статистика.

Успешные кампании для playable ads учитывают все: от разработки до A/B тестирования и запуска, дальнейших итераций и измерения показателей на каждой стадии маркетинговой воронки. Профессионалы регистрируют куда более сложные события уже после установки приложения — это помогает им определить, например, какую выручку будущая установка может дать на самом деле. Нередко можно предсказать, что 1 доллар затрат на рекламу может генерировать выручку в 4 доллара, что эквивалентно 300% ROI.

Вывод: не воспринимайте playable ads как мини-игру и просто забавный формат, с помощью которого можно разнообразить пользовательский опыт. Используйте метрики, проводите тесты, не жалейте бюджетов — и playable ads сработают на полную мощность и станут одним из самых эффективных рекламных форматов для ваших приложений.

Источник заглавной картинки — TechCrunch

|

|

VMware vCloud Director. Что нового в версии 9.0? |

- Системное администрирование,

- Облачные вычисления,

- Виртуализация,

- IT-инфраструктура,

- Блог компании Cloud4Y

VMware vCloud Director. Что нового в версии 9.0?

- Системное администрирование,

- Облачные вычисления,

- Виртуализация,

- IT-инфраструктура,

- Блог компании Cloud4Y

VMware vCloud Director (vCD) — проверенное решение, которое помогает провайдерам облачных услуг предоставлять услуги множественной аренды IT-инфраструктуры (Multi-Tenant Infrastructure-as-a-service, IaaS). vCloud Director предлагает решение для гибридных облаков «под ключ» в инфраструктуре vSphere. Какими новыми возможностями расширен функционал портала «самообслуживания» (Tenant portal) vCloud Director версии 9.0, который вышел на днях?

Улучшенный пользовательский интерфейс

Полностью обновлённый пользовательский интерфейс на HTML5 ориентирован на упрощение использования облака арендаторами. Веб-консоль, работающая на технологии Adobe Flex, по-прежнему доступна. Чтобы получить доступ к новому пользовательскому интерфейсу арендатора, пользователям необходимо войти в систему с URL-адресом:

https://{vCD _URP_IP}/Tenant/{organization_name}

Ключевые процессы клиентов, такие как создание экземпляров vApp, развертывание новых виртуальных машин, изменение сетевой топологии и прочие, были переработаны с целью повышения простоты и эффективности. К примеру, новую виртуальную машину теперь можно создать на одном экране интерфейса с несколькими опциями, ранее для этого требовалось семь шагов.

Демонстрация возможностей vCloud Director 9.0 HTML 5 Tenant Portal

Некоторые из улучшений, которые увидят арендаторы в новом интерфейсе:

- Виртуальные машины теперь можно просматривать как карты. В каждой карте есть возможность выбора действий или опции, таких как Power, Properties, создание снэпшота.

- Теперь Org vDC (Virtual Datacenter) Networks можно просматривать на вкладке «Сеть», что позволяет создавать и редактировать сети vDC.

- Автономные виртуальные машины могут быть созданы и просматриваться вместе с виртуальными машинами, которые являются частью контейнера vApp. Также присутствует возможность фильтрации. vCD 9.0 избавляет от необходимости создания vApp для создания отдельной виртуальной машины. vCD автоматически создает виртуальный контейнер vApp для виртуальных машин.

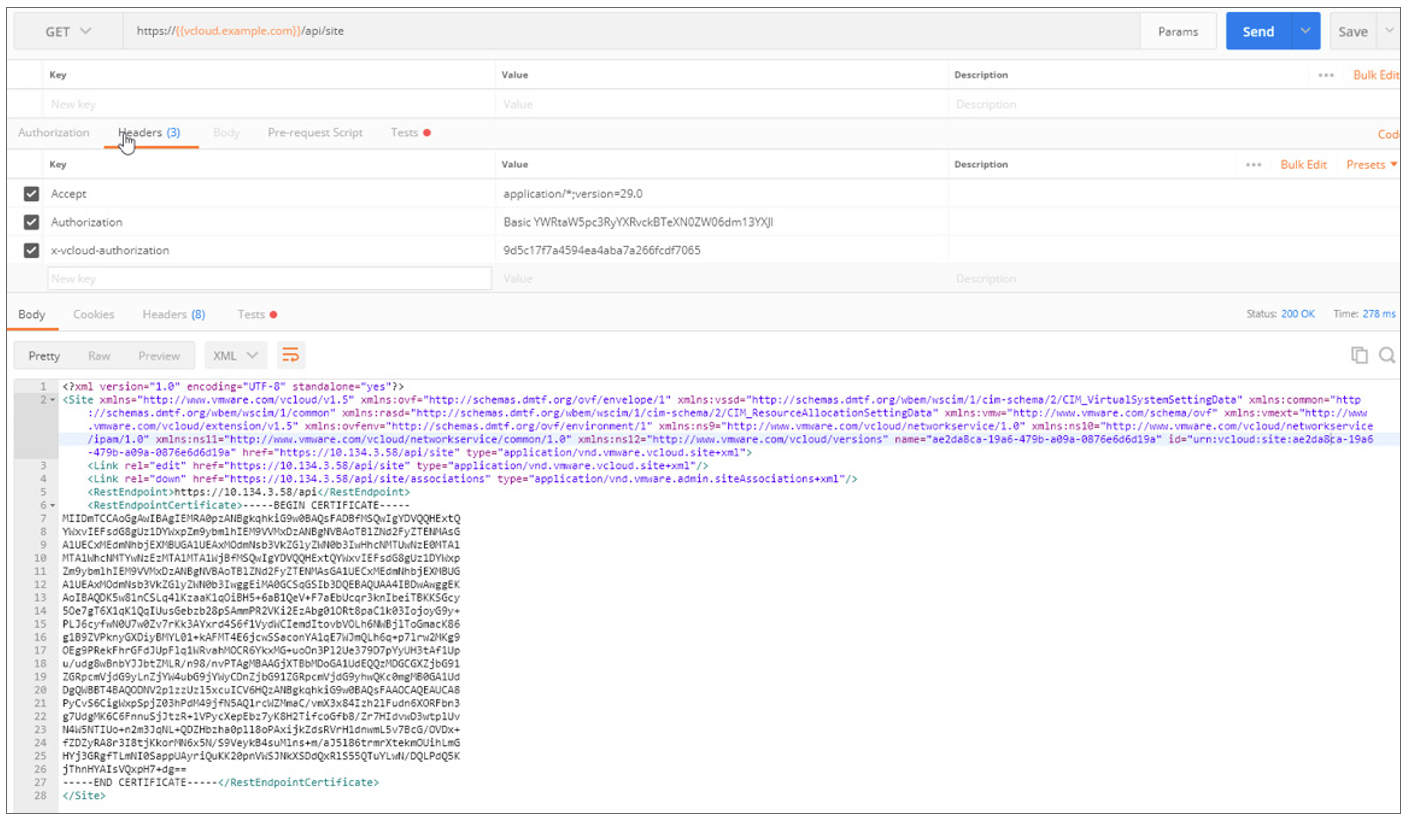

Multisite Management

Функция Multisite позволяет предоставить единый вход арендатору, имеющему несколько виртуальных центров обработки данных (Org vDC) под управлением разных vCD. Арендатор за один сеанс получает доступ к нескольким Org vDC, которыми управляют разные экземпляры vCloud Director, используя одни и те же учетные данные. Поставщики услуг, управляющие двумя или более экземплярами vCD, должны будут связать / замапить один сайт с другим, устанавливая ассоциацию типа site-to-site. Сайт может иметь несколько ассоциаций, но связь между сайтами может состоять только из двух объектов.

После того, как два сайта, управляемые отдельными экземплярами vCD, связаны Системным Администратором, Администраторы Организаций (Organization Admins) могут установить доверие между ними. Каждая Организация должна создать пару Public/Private Key, чтобы установить доверие между собой. При этом локальные и LDAP-пользователи на разных сайтах должны иметь одинаковые имена пользователей, роли и SAML-идентификацию.

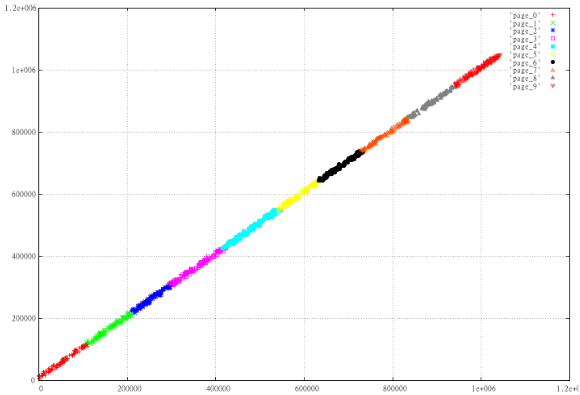

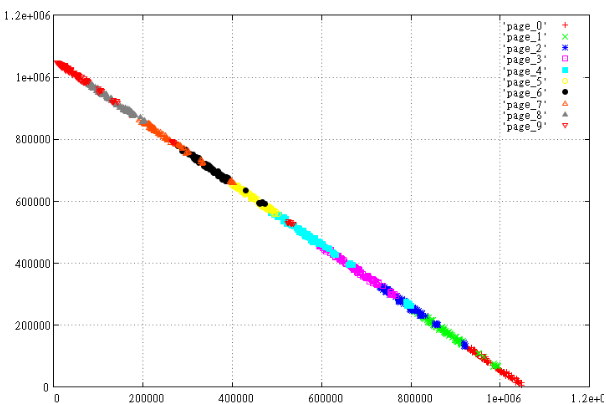

Приведенный ниже API предоставит атрибуты сайта, как показано на рисунке 1.

GET: https://{{vcloud.example.com}}/api/site

Рисунок 1. REST API для получения данных сайта

API ниже будет генерировать данные локального сайта, которые используются для связи с удаленным сайтом, как показано на рисунке 2.

GET: https://{{vcloud.example.com}}/api/site/association/localAssociationData

Рисунок 2. Данные для настройки ассоциации

Администратор системы должен будет отправить эти данные ассоциации в API сайта B и наоборот.

После того, как сайты будут связаны, организации на этих сайтах могут быть аналогичным образом связаны с получением ссылки ассоциации организации на сайте А и отправкой ее в API ассоциации организации на сайте B.

GET: https://{{vcloud.example.com}}/api/admin/org/SiteA-OrgA/ассоциации/localAssociationData

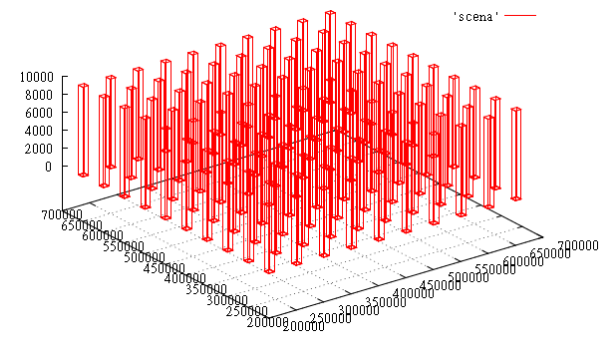

Distributed Logical Router

vCD 9.0 дает возможность использовать распределенный логический маршрутизатор для управления потребностями маршрутизации между двумя или более сетями Org vDC. Распределенный логический маршрутизатор (DLR) обеспечивает более быстрый способ построения таблиц маршрутизации между сетями org vDC. Это устраняет необходимость маршрутизации трафика через пограничный шлюз (Edge Gateway). До vCD 9.0 у арендатора могло быть несколько сетей org vDC, маршрутизация между этими сетями всегда выполнялась с помощью Edge Gateway, который находился между этими и внешней сетью. vCD развертывает DLR через NSX. Функциональность DLR находится в модулях ядра на хостах ESXi, которые являются частью кластера Provider vDC. DLR логически находится между сетью Org vCD network и шлюзом Edge Gateway. vCD автоматически создаст восходящий канал для DLR, который будет подключаться к сетевому интерфейсу Edge Gateway.

Сети арендатора с DLR смогут использовать функции DHCP и DNS пограничного шлюза через узел, который будет управляться с помощью vCD.

По умолчанию, когда создается пограничный шлюз, арендатор может включить DLR, как показано на рисунке 3. Это позволит подключить DLR к Edge Gateway в бэкэнд для потока трафика North South (внешний трафик ЦОД) из сети org.

После обновления до vCD 9.0 существующие пограничные шлюзы будут иметь возможность включения DLR кликом правой кнопкой мыши по Edge Gateway.

Рисунок 3. Опция Distributed Logical Router при создании Edge Gateway

Поддержка транкинга для внешних сетей и Routed Org Networks

У облачного провайдера могут быть клиенты, которые хотят подключить свои vLAN к сетям Org vDC. vCloud Director имел функционал создания внешних сетей с поддержкой сетей vLAN, но не Trunked vLAN. В vCD 9.0 теперь добавляется поддержка транкинга для внешних и маршрутизируемых сетей.

Чтобы включить поддержку транкинга, создайте внешнюю сеть в vCD, которая была сконфигурирована с поддержкой транкинговых vLANS. Для Routed Org Network установите флажок «Guest vLAN Allowed» при создании сети, как показано ниже.

Гибкость размещения пограничных шлюзов в отдельном пуле

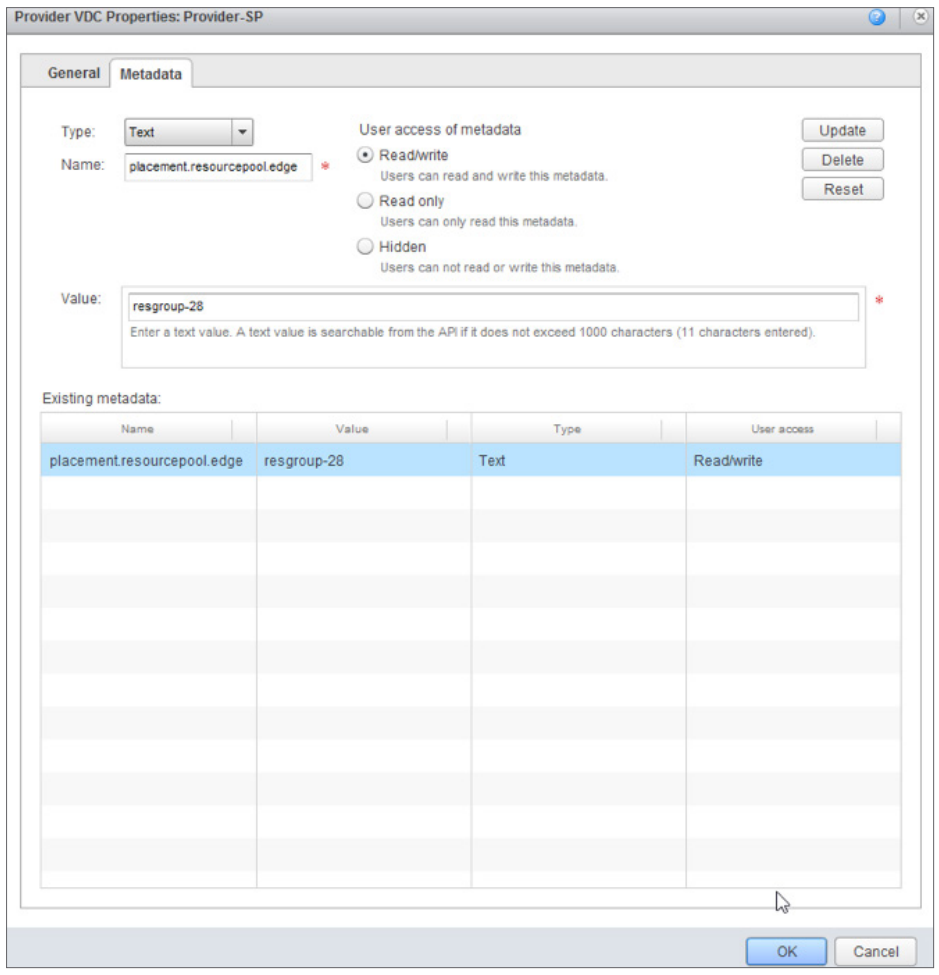

С помощью vCD 9.0 провайдер может определить пул/кластер ресурсов, который можно использовать для размещения виртуальных машин NSX Edge Gateway. Это делается путем определения атрибута в метаданных Provider vDC. Атрибут метаданных, называемый placement.resourcepool.edge = resourcepool moref, может быть определен в Provider vDC. Resourcepool moref — это идентификатор moRef пула ресурсов/Edge кластера. Пулы ресурсов и их moRef можно получить, запросив через API vCD (см. Рисунок 2).

Щелкните правой кнопкой мыши Provider vDC -> Properties -> Вкладка Meta-Data

Рисунок 4. Метаданные, созданные для размещения пограничных шлюзов в кластере moRef 'resgroup-28'

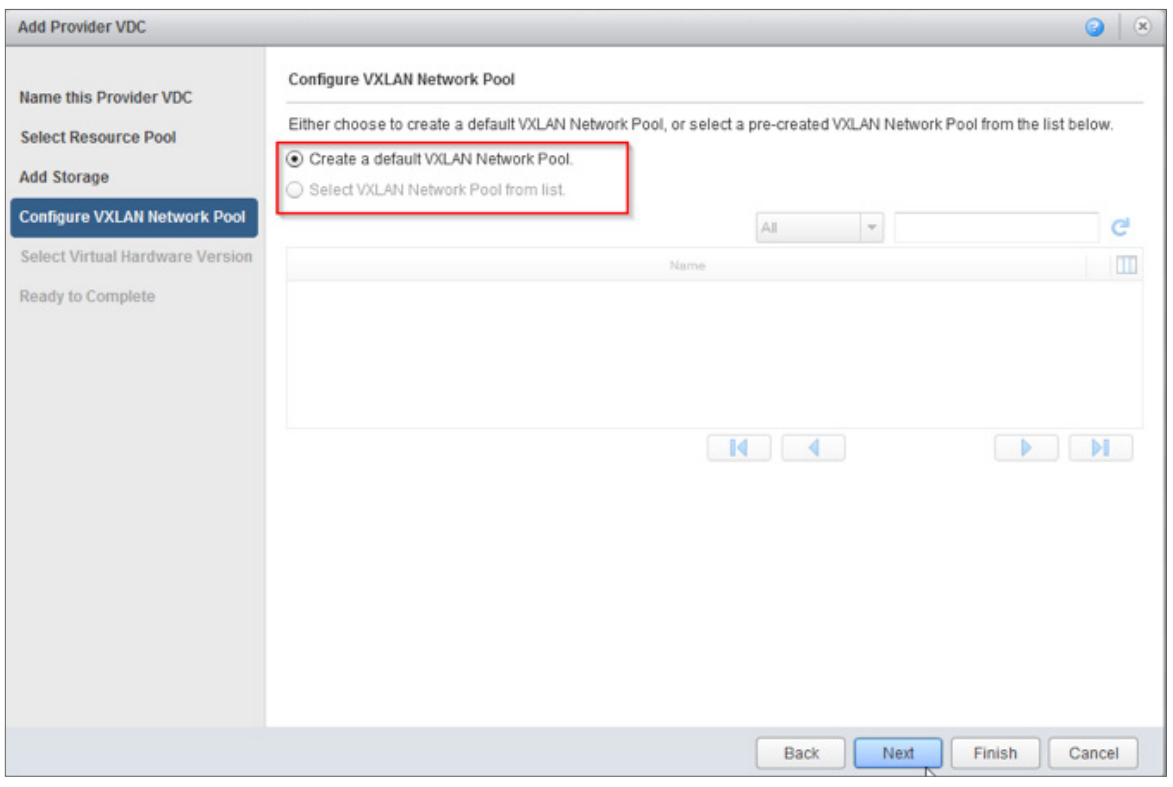

Примечание. Создание пула по умолчанию при создании Provider vDC теперь является опцией. Пользователь может выбрать вариант «создать сетевой пул по умолчанию» или выбрать из существующего настраиваемого сетевого пула VxLAN, как показано ниже.

Мониторинг и метрики VM

vCloud Director может собирать и хранить различные показатели по производительности ВМ. Эти метрики включают данные по использованию CPU/памяти/хранилища виртуальной машины, средней латентности операций с дисками и прочее. Предыдущие выпуски vCloud Director использовали Kairos DB, управляемую Apache Cassandra. С vCD 9.0 необходимости в Kairos DB для хранения и сбора метрических данных нет. Данные показателей могут храниться в базе данных Cassandra напрямую.

vCloud Director 9.0 Metrics Dashboard Demo

vRealize Operations Manager Tenant App for vCloud Director

Расширяемость

vCD UI extensibility framework позволяет расширить интерфейс пользователя Tenant Portal, добавив дополнительные разделы. С помощью framework можно добавить новый раздел, который может ссылаться на сторонний портал или может быть встроенным iFrame.

Изменения архитектуры

Поддержка PostgreSQL

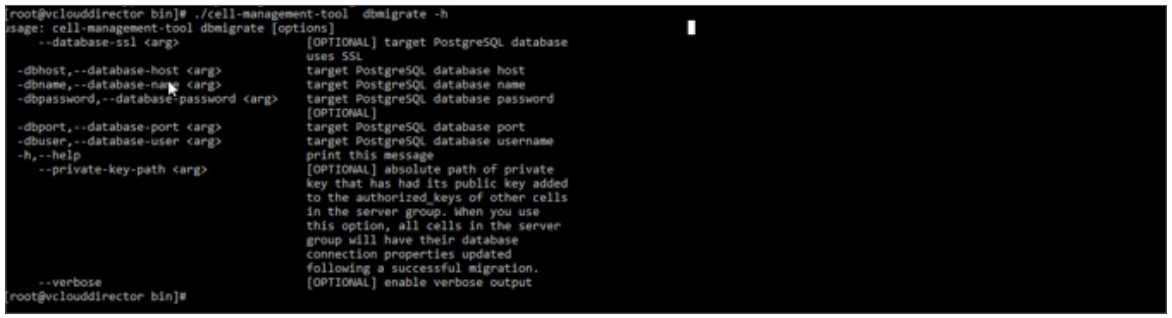

vCloud Director 9.0, помимо Microsoft SQL и Oracle, поддерживает базу данных PostgreSQL в качестве внешней базы данных. Этот релиз поддерживает PostgreSQL версии 9.5, кластерные конфигурации, а также SSL-соединение.

Для клиентов, имеющих базы данных MS SQL или Oracle, Cell Management Tool (CMT) поможет перенести их в предварительно установленный экземпляр базы данных PostgreSQL. Опция 'dbmigrate' в CMT поможет перенести существующую базу данных в новый экземпляр PostgreSQL.

[bash]# cell-management-tool dbmigrate

После миграции базы данных используйте параметр ‘reconfigure-database’ в CMT, чтобы vCD начал использовать новую базу данных PostgreSQL.

Рисунок 5. Инструмент CMT для миграции базы данных

vCenter Guest OS и согласованность аппаратной версии

Когда администратор провайдера услуг начинает создавать vDC, аппаратная версия, определённая vCD, будет самой высокой, которую может поддерживать вычислительный кластер. Это позволяет vCD расширять список гостевых ОС, которые он может поддерживать. vCD будет поддерживать все гостевые ОС, которые поддерживает среда vSphere.

vCD-vCenter Latency

vCloud Director теперь может поддерживать латентность до 100 миллисекунд между собой и сервером vCenter. Это помогает провайдерам услуг использовать один экземпляр vCD для управления серверами vCenter, которые могут быть расположены удаленно.

Сетевые улучшения

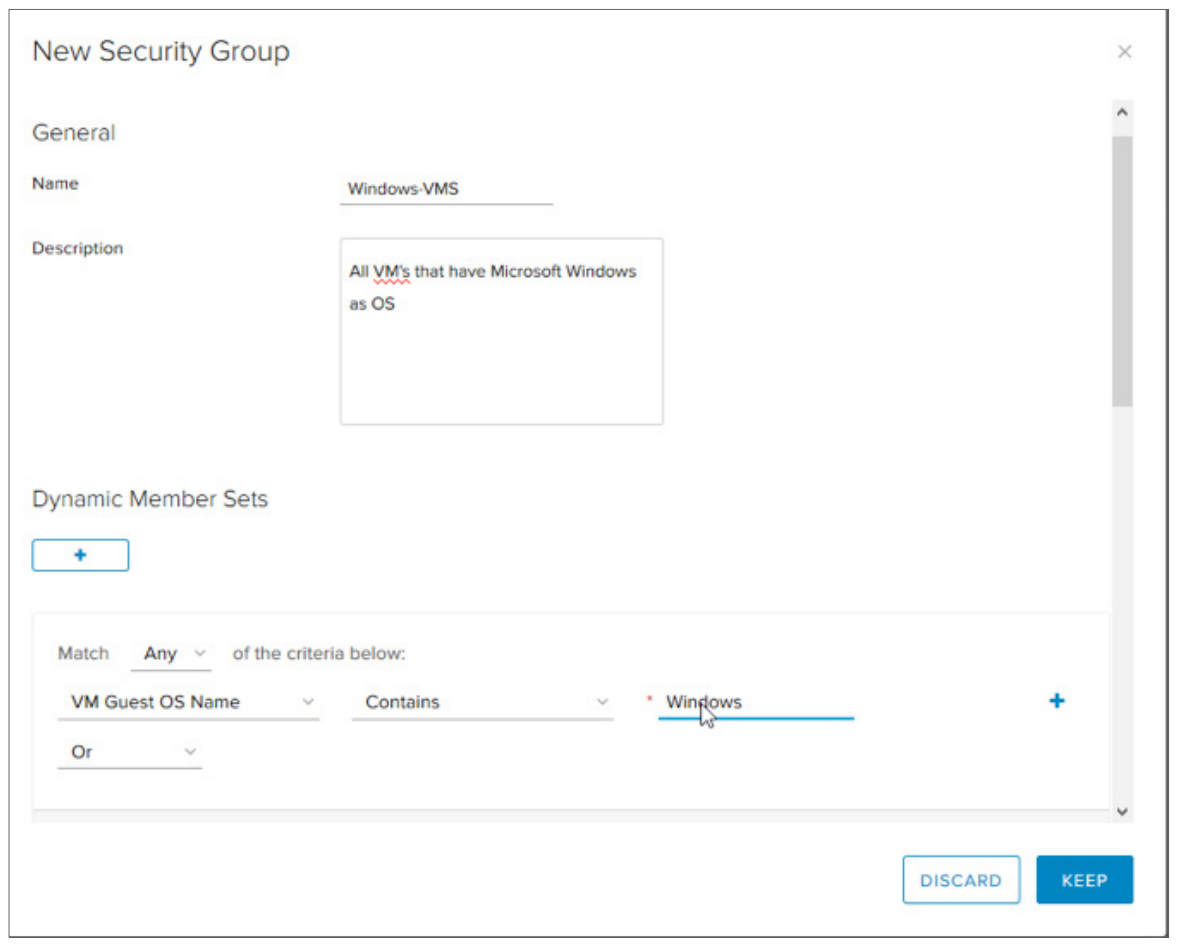

Группы безопасности

vCloud Director 8.20 представил возможности распределенного брандмауэра (Distributed Firewall — DFW) NSX арендаторам для самообслуживания. Они могут определять политики DFW, создавая индивидуальные правила для виртуальных машин или vApp. В то же время, они могут также применять эти политики в общем виде к набору IP-адресов, MAC-адресов или объектов, таких как виртуальные машины, сети Org vDC и т. д. Для использования этих возможностей необходимо точно знать эти наборы IP-адресов, MAC-адресов или объектов.

Ознакомиться с полным набором возможностей панели управления vCloud Director 8.20 вы можете, воспользовавшись бесплатным тестовым доступом к облаку Cloud4Y для юридических лиц.

vCloud Director 9.0 появляются группы безопасности (Security Groups), которые помогают динамически определять и применять политики безопасности. Администратор арендатора может определить критерий соответствия отдельных виртуальных машин через группы безопасности, а политики DFW могут применяться к этим группам безопасности.

Чтобы создать группы безопасности, щелкните правой кнопкой мыши Edge Gateway->Edge Gateway Services->Grouping Objects->Security Groups

Рисунок 6. Создание группы безопасности

Усовершенствования в хранении данных

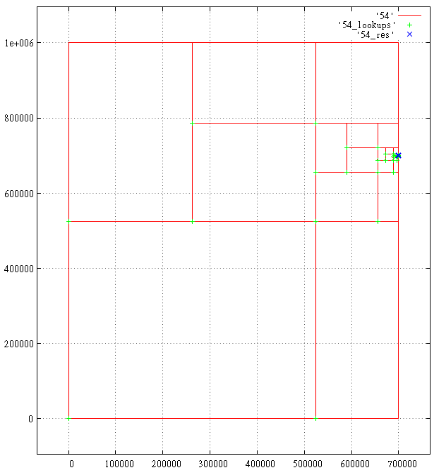

Горячая миграция данных клиентов между хранилищами данных

С помощью vCloud Director 9.0 Service Providers смогут выполнить горячую миграцию данных отдельных арендаторов из одного хранилища данных в другое. Все объекты, которые относятся к Организации, включая виртуальные машины, каталоги, изображения и прочее, будут перенесены в другое хранилище данных. Эта операция может выполняться только администратором облачного провайдера или пользователем, имеющим доступ.

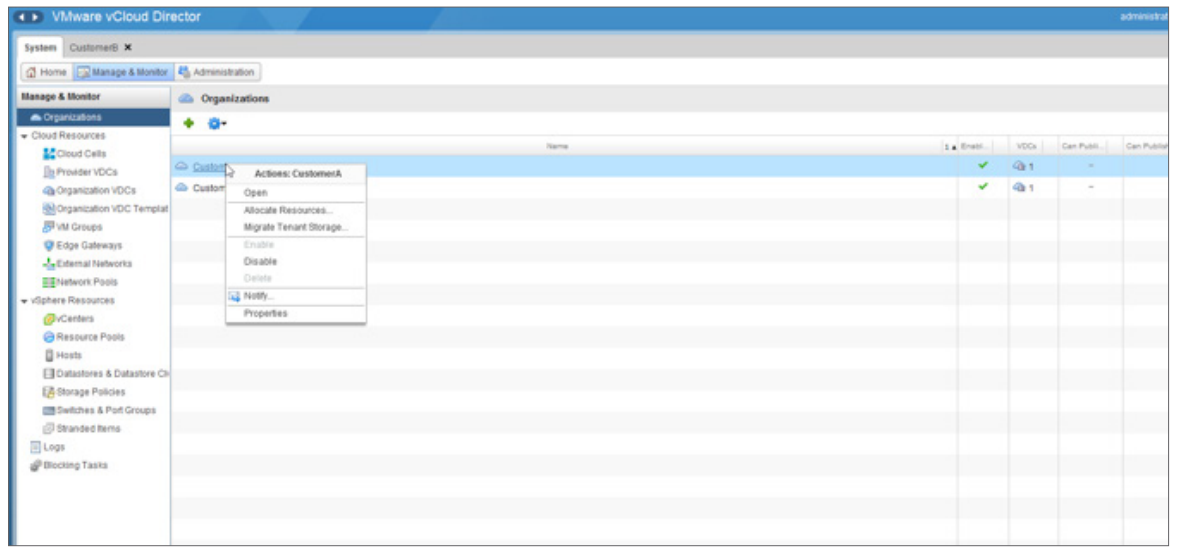

Рисунок 7. Миграция хранилища клиентов

Чтобы перенастроить хранилище арендаторов, войдите в vCD

Mange & Monitor->Organizations->Right click Organization->Migrate Tenant Data

Это запустит мастер, который поможет выбрать исходные и целевые хранилища для переноса данных арендатора. Одновременно можно перенести данные более чем одного арендатора.

Следует иметь в виду, что назначенные хранилища данных должны быть видимыми для всех хостов, которые являются частью кластера/пула ресурсов. Кроме того, Storage Profiles должны соответствовать в исходных и назначенных хранилищах.

Рисунок 8. Выбор источников данных и целевых хранилищ для миграции данных арендатора

Поддержка виртуальных томов (vVols)

vCloud Director 9.0 добавляет поддержку хранилищ данных, созданных в vCenter с использованием виртуальных томов. При создании Provider vDC vCD позволяет добавить хранилища данных с поддержкой vVols.

Вывод

vCloud Director 9.0 полностью обновляет процесс выполнения повседневных операций с виртуальной инфраструктурой как поставщиками услуг, так и арендаторами. В этом релизе основное внимание уделяется упрощению операций провайдеров путем добавления поддержки multisite management и PostgreSQL. Клиентов облака порадует новый пользовательский интерфейс на HTML5, который стал значительно удобнее и эффективнее. Мы, конечно, планируем переезд на 9-ку. Нам потребуется некоторое время для проведения валидации инфраструктуры и тестирования. О переходе на новую версию мы сообщим позже.

Статья составлена на основе "vCloud Director 9.0. What's New".

|

|

[Перевод] [Перевод] Переосмысление drag&drop |

[Перевод] Переосмысление drag&drop

- Перевод

Берем что-то всем давно известное и делаем это удобным и красивым

Представляем вашему вниманию

react-beautiful-dndФункция перетаскивания (drag&drop) — это интуитивный способ перемещения и переупорядочивания элементов. В Atlassian недавно выпустили

react-beautiful-dnd, которая делает перетаскивание (drag&drop) внутри списков в вебе красивыми, естественными и доступными. Тактильное чувство

Основный принцип дизайна

react-beautiful-dnd заключается в осязании (physicality): хочется, чтобы у пользователей было ощущение будто они передвигают физические объекты. Это лучше всего продемонстрировать контрастными примерами — поэтому давайте рассмотрим некоторые стандартные принципы использования этой техники, и посмотрим как можно их улучшить.

Cортировка элементов по группам.

Этот пример иллюстрирует замечательный метод сортировки группируемых элементов. Этот механизм функции перетаскивания самый стандартный, и он послужит нам отличной отправной точкой.

Движение

Традиционно принятое постоянное движение.

При перетаскивании элементов другие элементы исчезают и появляются по мере необходимости. Кроме того, при удалении элемента он немедленно появляется в своей новой исходной позиции.

Более естественное движение.

Для более естественного перетаскивания мы анимируем движение элементов, потому что им нужно двигаться в процессе, чтобы мы могли более четко показать сам эффект перетаскивания. Мы также анимируем падение элемента таким образом, чтобы он затем оказывался на своей новой позиции. Ни в коем случае элемент не перемещается мгновенно в какое-либо другое место вне зависимости от того перетаскивают его куда-либо или нет.

Знать, когда перемещать

Вполне естественно для действий функции перемещения базироваться на позиции, с которой начали перетаскивать объект.

Действие, основанное на позиции выбранного варианта.

В этом примере пользователь захватывает правый верхний угол первого элемента. Пользователь должен перетащить выбранный вариант на нужную позицию до того, как второй элемент переместится на свою новую позицию. Это происходит, потому что вычисления основаны на исходной позиции выбора пользователя.

Действие, основанное на центре притяжения.

В

react-beautiful-dnd действия перетаскиваемых элементов основаны на центре притяжения — независимо от того, откуда пользователь берет элемент. К действиям перетаскиваемых объектов применимы те же правила, что и к набору гирь. Ниже приведены некоторые правила, которые используются даже с подвижными элементами при естественном перетаскивании:- Список перетаскивается, когда центральное положение перетаскиваемого элемента переходит через одну из границ списка

- Элемент, который находится в покое, должен уйти с пути перетаскиваемого элемента, когда положение центра перетаскиваемого элемента уходит за край элемента, находящегося в покое. Другими словами: как только положение центра элемента (А) выходит за край другого элемента (Б), Б сдвигается в сторону.

Доступность

Традиционно функция перетаскивания приводилась в действие исключительно мышью или с помощью сенсора.

react-beautiful-dnd поддерживает возможность осуществлять функцию перетаскивания с помощью одной лишь клавиатуры. Это позволяет пользователям получить опыт использования этой функции еще и с клавиатуры и открывает возможность узнать об этой функции тем, кто был с ней ранее не знаком.Уважение к браузеру

В дополнение к поддержке клавиатуры, проверяем, как сочетания клавиш взаимодействуют со стандартными взаимодействиями клавиатуры браузера. Когда пользователь не осуществляет перетаскивание какого-либо элемента, он может пользоваться клавиатурой как обычно. Во время процесса перетаскивания мы переопределяем и отключаем определенные горячие клавиши браузера (например, табуляцию), чтобы обеспечить комфортную работу пользователю.

Тщательно продуманная анимация

Так как многие вещи двигаются, пользователь может легко отвлечься на анимации, а анимации могут легко возникнуть на пути пользователя. Различные анимации настроены так, чтобы обеспечить правильный баланс указаний, производительности и интерактивности.

Увеличить интерактивность

React-beautiful-dnd усердно работает, чтобы избежать периодов отсутствия интерактивности настолько, насколько это возможно. Пользователь должен иметь ощущение, что он контролирует интерфейс, а не ждет пока закончится анимация, прежде чем он сможет продолжить взаимодействие с интерфейсом. Выпадение

Когда вы отпускаете перетаскиваемый элемент, его движение основано на физике(спасибо

react-motion). Это приводит к тому, что когда элемент падает он кажется более весомым и ощутимым.Уходим с дороги

Предметы, которые уходят с пути перетаскиваемого элемента, делают это с помощью CSS-перехода, а не физики. Это позволяет увеличить производительность за счет того, что GPU обрабатывает движения. CSS animation curve была разработана, чтобы сделать этот процесс возможным.

Из чего она состоит:

- Период подготовки, чтобы имитировать естественное время отклика

- Небольшая фаза на то, чтобы элемент успел переместиться

- Длинная заключительная часть, чтобы люди могли читать любой текст, который проигрывается во второй половине анимации

Animation curve, используемая в момент перемещения.

Хорошая совместимость

Неаккуратные клики и блокировка нажатия клавиш.

Когда пользователь нажимает кнопку мыши на элементе, мы не можем определить, кликнул пользователь на него или перетаскивал его. Кроме того, иногда, когда пользователь нажимает на элемент, он может слегка переместить курсор — случайный клик. Таким образом, мы начинаем перетаскивание только после того, как пользователь отвел мышь вниз на определенное расстояние — большее, чем если бы он осуществил случайное нажатие. Если порог перетаскивания не превышен, то действие пользователя отреагирует так же, как обычный щелчок. Если порог перетаскивания превышен, то действие будет классифицировано как перетаскивание, и стандартное действие нажатия не произойдет.

Это позволяет потребителям работать с такими интерактивными элементами как теги привязки, чтобы они могли быть как стандартными тегами привязки, так и узнаваемыми элементами.

Управление фокусом

React-beautiful-dnd упорно трудится, чтобы убедиться, что он не влияет на обычные вкладки потока документов. Например, если вы добавляете теги привязки, то пользователь по-прежнему сможет перейти непосредственно к привязке, а не к элементу, к которому осуществляли привязку. Мы добавляем tab-index к определяемым элементам, чтобы убедиться, что даже если вы не добавляете что-либо к тому, что обычно является интерактивным элементом, (например, div), то пользователь все равно сможет получить доступ к нему с помощью своей клавиатуры, чтобы перетащить его куда-либо.Не для всех

Есть множество библиотек, которые позволяют осуществлять действия функции перетаскивания внутри React. Наиболее примечательной из них является замечательная

react-dnd. Она проделывает невероятную работу по обеспечению огромным набором примитивов функции перетаскивания, которые особенно хорошо работают с HTML5, несмотря на то что HTML5 мало с чем совместим. React-beautiful-dnd это абстракция высокого уровня, построенная специально для вертикальных и горизонтальных списков. С таким подмножеством функциональности react-beautiful-dnd предлагает действенный, красивый и естественный опыт использования функции перетаскивания. Однако, react-beautiful-dnd не обеспечивает широтой возможностей, предоставляемых react-dnd. Таким образом, эта библиотека может быть не для вас, все зависит от того в каких целях вы собираетесь её использовать.Проектирование

Чистый, мощный API

До выхода этой библиотеки было уделено много времени разработке декларативного, чистого и мощного API. Должно быть очень легко начать с него и тем самым обеспечить правильный уровень контроля над опытом пользования функцией перетаскивания. Он основан как на изучении других многочисленных библиотек, так и на коллективном опыте использования продуктов с функцией перетаскивания. Я не буду пускаться в описание деталей API — но вы можете найти полное руководство при желании.

Производительность

React-beautiful-dnd спроектирована быть чрезвычайно производительной — это часть её ДНК. Она основана на предыдущих исследованиях производительности реакции, которые можно прочитать здесь и здесь. React-beautiful-dnd предназначена для выполнения минимального количества исполнений, необходимых для каждой задачи. Ключевые аспекты

- Используйте связанные компоненты с хранением промежуточных значений в памяти, чтобы убедиться, что единственные компоненты, которые исполняются это те компоненты, что должны исполняться - благодаря

react-redux,reselectиmemoize-one. - Все задержки движения прерываются

requestAnimationFrame- благодаряraf-schd - Хранение промежуточных значений в памяти используется повсеместно — благодаря

memoize-one - Условно отключаются указатели на все элементы при перетаскивании, чтобы защитить браузер от избыточной работы — вы можете прочитать больше об этой технике здесь

- Неосновная анимация выполняется на GPU

Минимальное количество обновлений реакций.

Минимальное количество браузерных изображений.

Проверено

React-beautiful-dnd использует несколько различных стратегий тестирования, в том числе модульное тестирование, тестирование производительности и интеграционное тестирование. Проверка различных аспектов системы способствует повышению ее качества и стабильности.В то время как покрытие кода это не гарантия качества, это хороший показатель. Эта кодовая база в данный момент содержит 95% покрытия кода.

Типизированно

Эта кодовая база типизирована с

flowtype для повышения внутренней согласованности и устойчивости кода. Она также предоставляет историю документации разработчика о том, как работает API.Заключение

Мы думаем, что интернет станет гораздо более красивым и доступным местом, благодаря

react-beautiful-dnd. Для получения дополнительной информации и примеров перейдите в архив.Огромное спасибо всем в Atlassian, кто сделал это возможным.

Обновление#1

Поддержка

react-beautiful-dnd была невероятной! Большое спасибо. Мы уже добавили некоторые новые функции, такие как перемещение по-горизонтали.

Горизонтальное перетаскивание.

Горизонтальное перемещение в контексте доски объявлений.

Было много запросов на поддержку сенсора (это позволило бы

react-beautiful-dnd работать на мобильных и планшетных устройствах). Это всегда было в планах и мы уже очень скоро начнем над этим работать! Библиотека еще совсем новая.Обновление#2

Мы выпустили поддержку для перемещаемых элементов между списками

react-beautiful-dnd. Я написал блог. “Естественное движение клавиатуры между списками", в котором говорится о том, как мы пришли к тому, чтобы создать это обновление таким образом, чтобы оно ощущалось естественным.

Перетаскивание между списками.

EDISON Software профессионально занимается разработкой софта для крупных заказчиков (например, система управления городским освещением или электронная система медицинского осмотра) и мы стараемся, чтоб внешний вид у продуктов был максимально удобен для пользователя, а «технический долг» у UX-дизайнеров сокращался. Вот подборка полезных статей по Usability:

|

Метки: author MagisterLudi интерфейсы веб-дизайн usability блог компании edison дизайн react ui frontend development javascript ux edisonsoftware |

Разбираем WeChat — второй по популярности мессенджер в мире |

Разбираем WeChat — второй по популярности мессенджер в мире

* Небольшой экскурс в WeChat;

* О платформе, версии приложения, используемых утилитах и расшифровке исполняемого файла;

* О двух протоколах (старом и новым);

* О сериализации объектов;

* Используемая криптография и обмен ключами;

* О заголовках и хэш-функциях;

* О найденных уявзимостях.

Мессенджер WeChat от китайской компании Tencent

WeChat — второй по популярности мессенджер в мире. Официальных данных о количестве пользователей найти очень затруднительно, но сделать приблизительную оценку можно.

Речь идет примерно о 800 миллионах пользователей по всему миру, 90% которых приходится на Китай.

В Китае практически каждый владелец смартфона использует WeChat (китайское самоназвание -Weixin), так как это не только мессенджер в классическом понимании, а целая система, включающая мобильный кошелек, встроенный браузер, интернет-магазин и пр. В нем представлены все государственные учреждения Китая. Оплатить квитанцию или записаться на прием к врачу можно через мессенджер.

Актуальной задачей являлась интеграция CRM систем заказчиков, активно работающих в Китае, с WeChat. Этому способствовала широкая распространенность WeChat в Китае, а также отсутствие официального API. СМС-информирование в Китае стоит дорого и, что самое главное, работает нестабильно, к тому же здесь отсутствует статус «прочитано». Заказчик, используя API, сможет через свою через CRM систему уведомлять пользователей WeChat (подписанных на получение информации от номера заказчика, об этом расскажем ниже) о доставке товаров, новых заказах и прочей сервисной информации.

Исследование протокола

Было принято решение изучить мессенджер «изнутри», разобраться в коде 32-битной версии мессенджера для iOS. Имеется у нас старенький, видавший виды, iPhone 4S с версией iOS 7.2.1.

В качестве MITM использовуем Burp Suite Free Edition.

Скачиваем приложение и при помощи замечательной утилиты dumpdecrypted расшифровываем исполняемый файл.

На момент начала реверс-инжиниринга WeChat была актуальна версия 6.3.13.

Теперь осталось скопировать файл с устройства, дисассемблировать в IDA, и можно начинать.

Рассмотрим алгоритм обмена ключами на примере регистрации.

Запускаем приложение и видим предложение ввести номер телефона для регистрации.

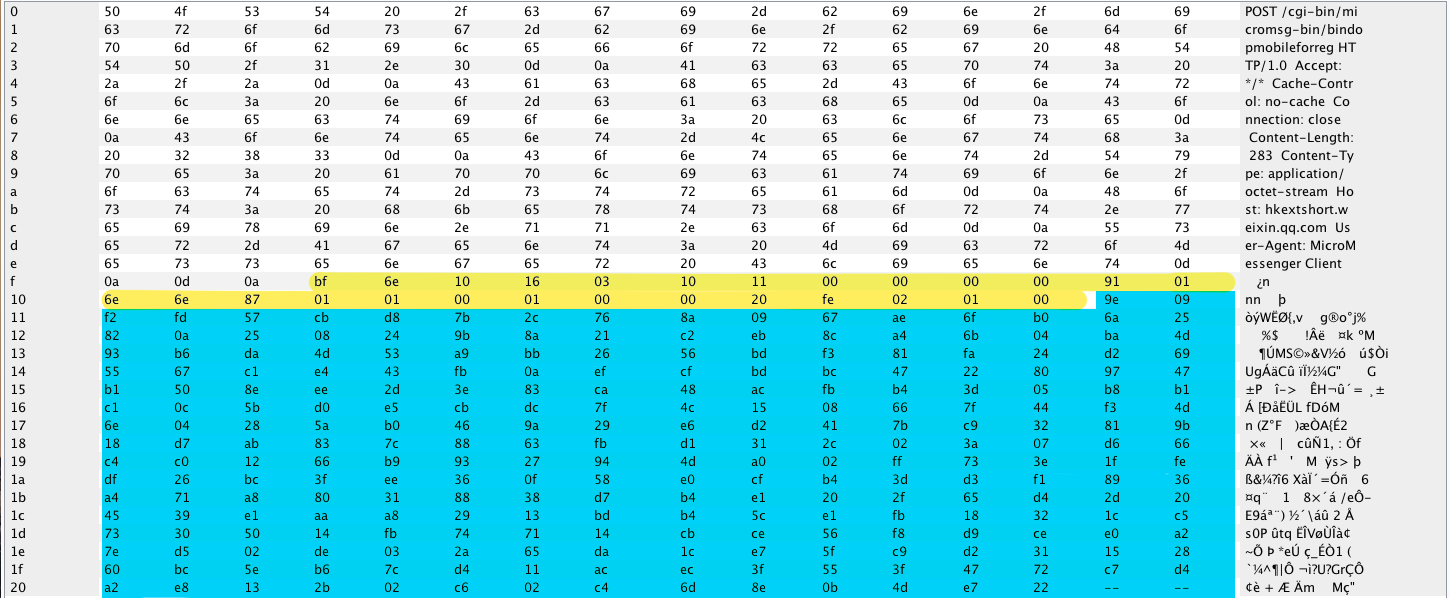

Вводим номер телефона и видим в MITM HTTP-запрос на адрес

http:// hkshort.weixin.qq.com/bindopmobileforreg.

Тело запроса состоит из:

• Заголовка (желтый цвет);

• Шифрованных данных (синий цвет).

После весьма продолжительного статического анализа кода удалось выяснить, что клиент общается с сервером посредством сериализованных объектов. Объекты сериализуются при помощи библиотеки Protocol Buffers.

Первым сообщением передаются следующие данные:

• Номер телефона;

• Язык системы телефона;

• ID устройства;

• Версия клиента;

• Ключ для расшифровывания ответа (случайные 16 байт);

• Прочие данные (не очень интересующие нас).

Сообщение сериализуется и шифруется публичным ключом сервера при помощи алгоритма RSA. Ответ сервера расшифровывается AES-ключом, переданным в запросе. В ответе сообщается, что либо все в порядке, либо указывается ошибка.

Получаем СМС и вводим код. Формируется тот же запрос, только уже с кодом из СМС, а в ответе получаем так называемый ticket. Теперь, имея ticket, можно отправлять запрос на регистрацию. Вводим имя и нажимаем Ок.

Обмен ключами происходит по алгоритму Диффи-Хеллмана с использованием эллиптической кривой над конечным полем «secp224r1». Генерируются закрытый и открытый ключ, и отправляется запрос на адрес hkshort.weixin.qq.com/newreg. Сервер генерирует свои ключи, а также выдает нам так называемые CryptUin и ServerID, о которых расскажем позже. В ответ сервер присылает нам свой публичный ключ и сессионный ключ.

Теперь у нас есть публичный ключ сервера, и мы вычисляем общий ключ, с помощью которого расшифровываем сессионный ключ. С этого момента общение клиент-сервер осуществляется с помощью симметричного алгоритма AES с длиной ключа 128 бит.

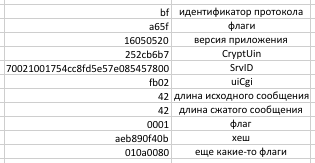

Вообще, в алгоритме установки соединения и обмена ключами нет ничего сверхъестественного. Правильно зашифровать данные и обменяться ключам — это половина задачи, необходимо также для каждого сообщения правильно составить заголовок. Даже если правильно сериализовать данные и зашифровать, то при неправильном заголовке сервер пришлет ответ с ошибкой. Заголовок выглядит так:

bfa65f16050520252cb6b770021001754cc8fd5e57e085457800fb0242420001aeb890f40b010a0080.

Теперь расскажем подробнее о каждом поле:

1. Идентификатор протокола. Каждый пакет начинается с этого байта.

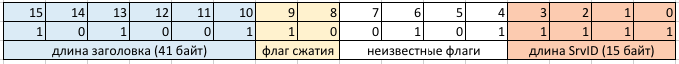

2. Флаги. Хранит информацию о длине SrvID, длине самого заголовка и сжатии исходного сообщения.

Флаг сжатия выставляется равным 0b10, если сообщение не сжималось, в противном случае ставится равным 0b01.

3. Версия приложения. Без комментариев.

4. CryptUin. После прохождения регистрации каждому аккаунту присваивается уникальный идентификатор из четырех байт.

5. SrvID. ID текущей сессии. Меняется при каждом новом подключении.

6. uiCgi. Код команды. У каждой команды есть свой uiCgi и url. Например для команды bindopmobileforreg, uiCgi равен 0x91, а для newreg – 0x7e. Большинство чисел упаковываются, используя следующий алгоритм:

private static void Write7BitEncodedInt(BinaryWriter store, int value)

{

Debug.Assert(store != null);

// Write out an int 7 bits at a time. The high bit of the byte,

// when on, tells reader to continue reading more bytes.

uint v = (uint)value; // support negative numbers

while (v >= 0x80)

{

store.Write((byte)(v | 0x80));

v >>= 7;

}

store.Write((byte)v);

}В данном примере uiCgi равен 0x17b, а в упакованном виде – fb02.

7. Длина исходного сообщения. Длина сериализованных данных. Число так же упаковывается, но поскольку оно меньше 0x80, осталось без изменений.

8. Длина сжатого сообщения. Сжатия не производилось, поэтому не отличается от предыдущего.

9. Флаг.

10. Хеш.

Вычисляется следующим образом:

hash1 = md5(cryptUin.shareKey);

hash2 = md5( strlen(data).shareKey.hash1.data)

resultHash = adler32(hash2)

sharedKey –это общий ключ, полученный при хендшейке.

Хеш также упаковывается.

11.Флаги. Значение этих флагов осталось загадкой, но они статичны, поэтому отдельно их изучать не было смысла.

Сейчас уже используется другой протокол, о котором напишем в последующих публикациях. По сути он является оберткой над вышеописанным. Старый протокол до сих пор поддерживается — для этого в отладчике необходимо сбросить флаг MmtlsCtrlFlag.

Защита от спама.

Чтобы защититься от спама, пользователь может включить опцию «подтверждение дружбы». В этом случае написать ему сообщение можно только после того как он подтвердит, что вы друзья. Запрос на подтверждение дружбы может содержать приветственное сообщение.

Отправить много приветственных сообщений не получится. После отправки пятнадцати запросов все остальные перестают отправляться и встают в очередь. Шестнадцатый запрос отправится только тогда, когда кто-то из предыдущих пятнадцати добавит вас в друзья. Но пользователь этого не знает, и интерфейс приложения тоже никак об этом не сообщает. Выяснить это удалось при помощи анализа траффика и экспериментов.

В процессе работы была так же обнаружена интересная уязвимость. В приложении есть возможность найти пользователя по номеру телефона. Сервер либо отвечает что такого пользователя нет, либо возвращает информацию о нем(имя, пол, город, фото итд). Но если отправлять эти запросы слишком часто, то сервер отвечает сообщением «Too many attempts. Try again later ». Этим можно воспользоваться, так как, если пользователя не существует, сервер всегда сообщит об этом, а если приходит ответ «Too many attempts. Try again later „- это значит, что пользователь существует. Используя это, можно собирать базу пользователей. Кстати обнаружились очень “интересные» пользователи, которые используют WeChat, но обычным способом их не обнаружить, и даже невозможно отправить им приглашение, скорее всего это «особенные» люди Китая. Даже если запросить регистрацию на «интересный» номер, то сервер сообщит, что данный пользователь уже зарегистрирован и предлагает восстановить аккаунт, но уже не по СМС.

Используя 20 000 потоков возможно с одного аккаунта за сутки собрать всю базу WeChat по Китаю, блокировки аккаунта не происходит.

Также отдельно хотелось бы сообщить, что End-to-End шифрования между пользователями не происходит. Сообщения шифруются только симметричным ключом, сервер их расшифровывает и заново зашифровывает симметричным ключом получателя и отправляет их получателю.

Данная статья является вводной, при наличии интереса со стороны сообщества Хабра возможно появление следующих публикаций по WeChat, так как любое событие в WeChat (например, сериализация объектов) достойны отдельных статей.

|

Метки: author Sqwony блог компании бринго reverse engineering криптография информационная безопасность мессенджеры messengers |

[Перевод] Три карьерных пути в IT: основатель, руководитель или наёмный работник |

Три карьерных пути в IT: основатель, руководитель или наёмный работник

- Перевод

Ниже я обрисую преимущества/недостатки и полезные стратегии для каждой роли.

Я написал эту статью, потому что на удивление часто приходится сталкиваться с людьми, которые при обсуждении карьеры думают только об одном пути, игнорируя другие варианты. Когда другие дают им советы, то часто рекомендуют следовать дальше по этому выбранному пути (как партнёр Y Combinator и бывший основатель я тоже очень виноват в этом).

Я не даю никаких оценочных суждений каждому из этих путей. За десять лет в Кремниевой долине я видел друзей, которые ведут успешную и полноценную жизнь, будучи в любой из трёх ролей.

Основатель

Преимущества

- Занятие любимым делом, к которому действительно лежит душа

- Создание чего-то нового в этом мире

- Высокий уровень ответственности часто вдохновляет на экстремальную продуктивность

- Выбор людей, с кем хочется работать

- Освоение новых навыков с исключительной быстротой

Недостатки

- Невероятно высокий уровень стресса. Даже успех будет болезненным

- Вероятно, не обеспечит вам максимальный уровень дохода

- Значительные барьеры для начала (финансы/навыки/местоположение)

- Масштабный успех часто требует десятилетия или больше работы с самоотдачей

- Уровень самоотдачи значительно мешает личной жизни

Стратегии для тех, кто хочет быть основателем

Ваша первоначальная цель — собрать все необходимые компоненты, чтобы стать основателем.

- Определить потенциальных коллег, с которыми вы можете работать и у которых есть необходимые технические навыки, чтобы помочь вам в создании минимально жизнеспособного продукта (MVP).

- Обрисовать финансовый план. Например, достаточно ли у вас личных накоплений, есть ли друзья/родственники, которые могут обеспечить посевные инвестиции, хватит ли денег для запуска, можете ли вы сократить расходы и сэкономить, чтобы обеспечить 6-12 месяцев работы над своей идеей?

- Определить проблему, которую вы и потенциальные коллеги страстно хотите решить.

- Наименее важная (но всё-таки необходимая) часть — это план, как именно решить проблему.

Многие люди, которые хотят стать основателями, упускают из внимания один или несколько из перечисленных компонентов. распространённая ошибка — пытаться с наскоку найти недостающий компонент вместо решения глубинной проблемы. Если у вашей команды не хватает технических навыков для создания MVP, не нужно делать заказ у сторонних студий и разработчиков. Заведите друзей среди тех, у кого есть необходимые навыки. Убедите их присоединиться к вам.

Часто есть серьёзные препятствия, которые мешают человеку начать бизнес. В этих случаях мой лучший совет — переехать поближе к IT-хабу (желательно рядом с Кремниевой долиной) и работать на IT-компанию, пока не заработаете достаточно денег. Подружиться с подходящими потенциальными коллегами и найти проблему, которую вам действительно сильно хочется решить. Обычно создание крупной и влиятельной компании занимает десять лет. Так что вполне нормально немного оттянуть момент запуска, чтобы увеличить шансы на успех.

Обратите внимание, что среди необходимых компонентов отсутствует опыт. Дело в том, что опыт переоценивают. Он имеет какое-то значение, но его очень сильно переоценивают те, кто думают о создании компании. Почти во всех случаях неважно, какие знания у вас есть. После запуска компании вы узнаете почти всё, что нужно, о проблеме, своих пользователях и наилучшем варианте решения проблемы.

Руководитель (топ-менеджер в крупной компании)

Преимущества

- Стабильный доход/бенефиты/проч.

- Высокий престиж (только самые успешные основатели пользуются б'oльшим уважением)

- Более высокая вероятность влияния на отрасль (поскольку большинство стартапов проваливаются)

- Не требуется создание команды и накопление денег для начала

Недостатки

- Хорошая работа и результат не гарантируют продвижение по корпоративной лестнице. Внутренняя политика может быть такой же важной или даже важнее.

- Успеху могут помешать другие сотрудники компании

- Нужно иметь талант к выбору компаний, которые будут успешно расти в течение долгого времени

- Требуется длительное время, чтобы добиться значительного уровня ответственности

Стратегии для тех, кто хочет быть руководителем

В реальности я вижу две стратегии на этом пути.

Первая стратегия — выбрать быстрорастущую компанию. Если вы умудритесь выбрать такую компанию на раннем этапе её развития, то получите больше ответственности по мере её роста — я предполагаю как само собой разумеющееся, что вы дружелюбный и продуктивный командный игрок. Например, если бы вы оказались одним из ста первых сотрудников Facebook и остались там в течение десяти лет, то сейчас имели бы много возможностей стать руководителем. Здесь проблема в том, что исключительно трудно определить компанию, которая будет быстро расти на протяжении долгого времени (во многих смыслах эта задача похожа на задачу венчурного инвестора).

Другой вариант — пойти на работу в признанную компанию. Я видел людей, которые успешно идут этим путём — и они не зацикливаются на работе в одной-единственной компании, а часто думают о диагональном перемещении по позициям между широко признанными брендами, пока в итоге не займут руководящий пост. Например, после колледжа вы начинаете в Google, принимаете приглашение Dropbox на позицию тимлида, переходите в Yahoo на позицию руководителя, возвращаетесь обратно в Google — и так далее.

Люди на пути к руководящей должности должны или думать как венчурные инвесторы и выбирать компанию, которая будет успешной в течение ближайших десяти лет, или непрерывно смотреть по сторонам в поиске всё лучших и лучших возможностей внутри и за пределами своей текущей компании.

Наёмный сотрудник (отдельный участник / менеджер среднего звена)

Преимущества

- Стабильный доход/бенефиты/проч.

- Больше работы и меньше совещаний

- Большее влияние напрямую на пользователей через свою работу

- Благодаря востребованным навыкам появляется гибкость, где и сколько вы будете работать

- Часто больше времени на общение с друзьями и семьёй

Недостатки

- Продуктивности может препятствовать плохой менеджмент

- Часто отсутствует возможность выбирать, над чем работать

- Часто отсутствует возможность повлиять на важные решения — даже если вы «знаете, как лучше»

- Трудно разбогатеть

- Может быть скучно

- Если у вас нет редких навыков или продуктивность падает, вас проще уволить

Стратегии для тех, кто хочет быть наёмным сотрудником

Стратегия по выбору места работы похожа на стратегию того, кто идёт по пути руководителя. Вам нужно или вычислить и присоединиться к быстрорастущей фирме, или найти способ устроиться в известную успешную компанию. Гораздо легче менять места работы среди известных компаний, если вы изначально начали с такой. Также, по моему опыту, особенно удобно оптимизировать такой вариант карьеры именно программистам.

Хотелось бы ещё сказать напоследок, что для достижения мастерства в каждой из трёх ролей требуется время. Среди ребят в колледже распространена мысль, что с 20 до 30 лет нужно искать себя и работу, которая доставляет больше всего удовольствия. Проблема в том, что если нужно 5-10 лет для достижения мастерства, а вы потратили 10 лет на поиск себя… то пройдёт очень много времени, прежде чем вы достигните успеха хоть в чём-нибудь (и получите соответствующее вознаграждение за это). Это не значит, что не нужно исследовать разные варианты, но нужно понимать цену этих исследований и планировать их соответствующим образом.

|

Метки: author m1rko развитие стартапа карьера в it-индустрии стартап основатель руководитель наемный сотрудник карьера |

Аналитика Solar JSOC: как атакуют российские компании |

Аналитика Solar JSOC: как атакуют российские компании

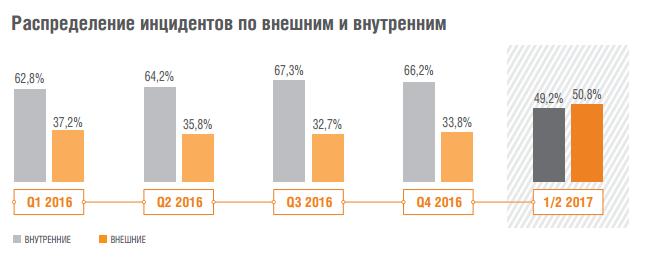

В первой половине 2017 года средний поток событий ИБ составлял 6,156 миллиардов в сутки, из них около 950 в сутки – события с подозрением на инцидент (172 477 за полгода). Это примерно на 28% больше, чем в первом полугодии 2016 года. Доля критичных инцидентов составила 17,2%. Таким образом, если в 2016 году критичным был каждый 9-й инцидент, то теперь – уже каждый 6-й. Предполагается, что такая динамика связана с общим повышением интенсивности массовых и целенаправленных атак на организации.

Когда атакуют?

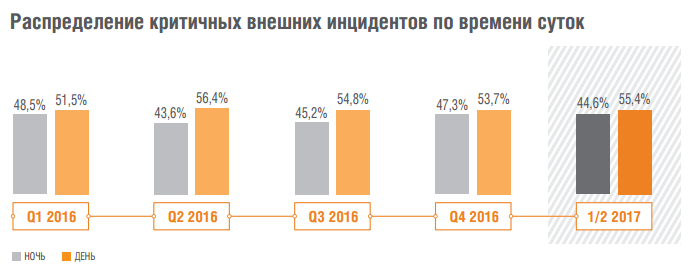

Если рассматривать общее количество инцидентов, то лишь в 12,5% случаев они происходили в ночное время.

Однако если из общей массы инцидентов выделить критичные, этот показатель возрастает до 29,4%, то есть почти трети всех случаев.

Если же критичные инциденты были вызваны действиями внешнего злоумышленника, то уже в половине случаев (44,6%) они приходились на ночное время.

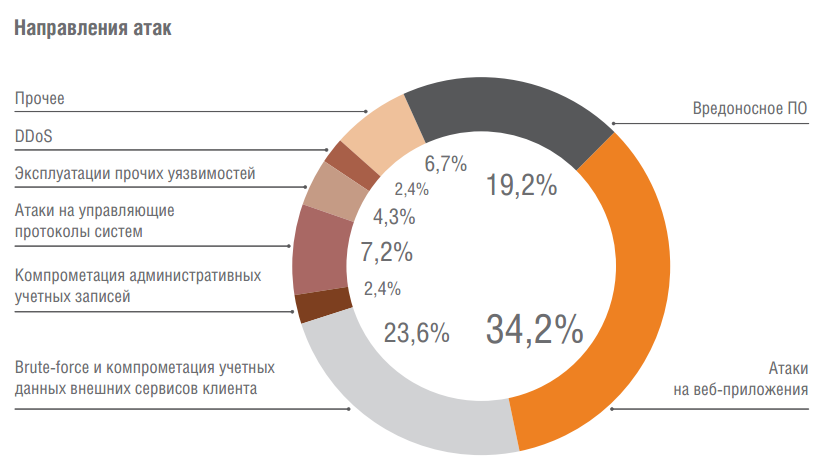

Как атакуют извне?

Основными инструментами киберпреступников оставались атаки на веб-приложения (34,2%), компрометация учетных данных внешних сервисов клиента (23,6%) и вредоносное ПО (19,2%).

Отдельно в отчете отмечается возрастающее число инцидентов, являющихся частью Kill Chain – цепи последовательных действий киберпреступника, направленных на взлом инфраструктуры и компрометацию ключевых ресурсов компании.

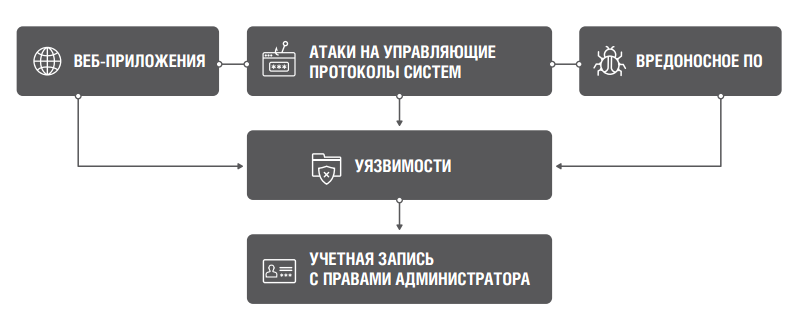

В первом полугодии 2017 года аналитики Solar JSOC чаще всего (в 87% случаев) сталкивались со следующей моделью атаки: после фазы первого проникновения в сеть компании (статистика описана ниже, см. стр. 7) злоумышленники пытаются выявить наиболее уязвимый сервер инфраструктуры (зачастую используя сканирование сети как промежуточный инструмент). В качестве такого уязвимого узла могут выступать серверы с необновленными версиями операционной системы. Злоумышленники стараются захватить контроль над сервером, чтобы в кратчайшие сроки получить доступ к привилегированным учетным записям сети (технологическим учетным записям, записям ИТ-администраторов), из-под которых они смогут скрытно получать доступ к большому количеству объектов инфраструктуры.

В 13% случаев первым шагом проникновения в компанию служила атака на веб-приложение (например, онлайн-банк), в 25% – на управляющие протоколы систем (в том числе использование уязвимости Shellshock, известной с сентября 2014 года), в 62% – внедрение в организацию вредоносного программного обеспечения через email-вложения или фишинговые ссылки.

Однако зачастую те или иные этапы развития атаки оказываются еще проще в реализации: например, пароли от привилегированных учетных записей обнаруживаются на файловых серверах или в конфигурации скриптов управления системным ПО в открытом виде. Нередки случаи, когда пароли от технологических учетных записей прописываются на уровне контроллера домена в комментариях (пометках) к самой УЗ и доступны для чтения всей организации, что, безусловно, упрощает злоумышленникам задачу по получению доступа к ним.

Интересные наблюдения:

- В среднем в течение месяца в общем доступе в сети Интернет публикуется от 2 до 5 сервисов заказчиков с критичными уязвимостями, не устранявшимися около года. Такие публичные сервисы позволяют злоумышленникам без особой подготовки и сложных инструментов проникнуть в корпоративную сеть компании и развивать атаку на критичные системы. Из них 2/3 публикуются администраторами ненамеренно, без ведома служб информационной безопасности, тем самым создавая существенный риск компрометации инфраструктуры.

- Тренд к росту числа вирусов-шифровальщиков не сдает позиций. Однако если раньше аналитики чаще имели дело с вредоносным ПО, чьей единственной функцией является шифрование данных на зараженной рабочей станции, то теперь шифрование, как правило, является лишь одной из функций. Все чаще ей сопутствуют keylogger и возможность удаленного управления зараженной рабочей станцией. Таким образом, инструментарий злоумышленников становится более многозадачным.

- Отдельно хотелось бы подчеркнуть, что, несмотря на массовые атаки Wannacry и Petya, цифры по внешним инцидентам демонстрируют высокий, но не драматический рост. Причина состоит в том, что массовые атаки на российские компании происходят регулярно, но, как правило, остаются вне поля зрения СМИ.

- Снизилось количество случаев компрометации учетных данных удаленного доступа. Ранее первым шагом атаки на компанию часто был взлом учетных записей ее сотрудников в публичных почтовых сервисах (Mail.ru, Yandex.ru, Gmail.com), поскольку пользователи часто устанавливают один и тот же пароль для различных учетных записей. Постепенное внедрение механизмов двухфакторной аутентификации и усложнение алгоритмов доступа в российских компаниях позволило снизить эффективность этого метода атаки.

Как атакуют изнутри?

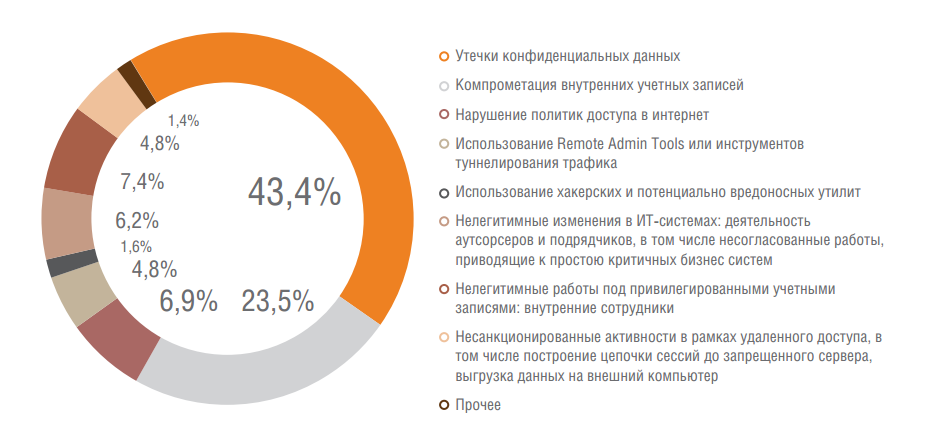

Инциденты, связанные с действиями внутренних злоумышленников, не претерпели существенных изменений. В 43,4% случаев это утечки информации, еще в 23,5% – компрометация внутренних учетных записей, и менее 10% приходится на использование хакерских утилит, средств удаленного администрирования и т.п.

Интересные наблюдения:

- Несмотря на то, что учетные записи удаленного доступа достаточно редко подвергаются компрометации, количество инцидентов, связанных с удаленной работой подрядчиков, растет. По нашим наблюдениям это связано с продолжением развития сервисов ИТ-аутсорсинга и невысоким ростом информационной безопасности в ИТ-аутсорсерах.

- Информационная образованность пользователей растет, но не в том ключе, который хотели бы видеть офицеры безопасности: в среднем раз в два месяца у заказчиков Solar JSOC фиксируются попытки использования рядовыми сотрудниками вредоносных или хакерских утилит. Например, утилит, позволяющих получить информацию о паролях пользователей (procdump, mimikatz), систем сканирования сети и поиска уязвимостей и т.д. Помимо желания нанести прямой вред компании, сотрудниками зачастую двигает обыкновенное любопытство.

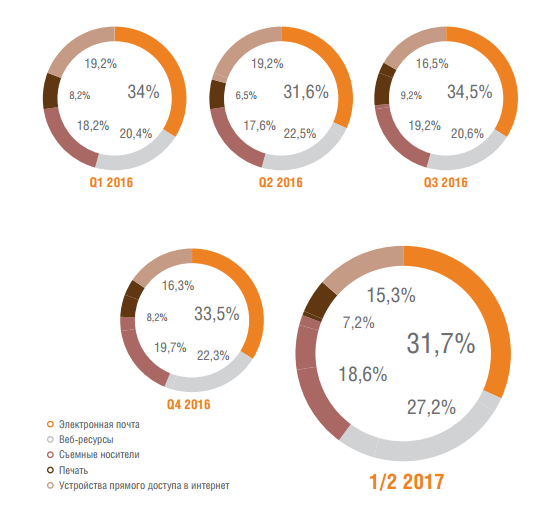

Анализ наиболее «популярных» каналов утечек показывает, что чаще всего сотрудники компаний используют в этих целях электронную почту (31,7%), веб-ресурсы (27,2%) и съемные носители (18,6%).

Как защищаться?

Технические средства

Около 67% исследованных событий было зафиксировано при помощи основных сервисов ИТ-инфраструктуры и средств обеспечения базовой безопасности: межсетевые экраны и сетевое оборудование, VPN-шлюзы, контроллеры доменов, почтовые серверы, базовые средства защиты (антивирусы, прокси-серверы, системы обнаружения вторжений). Это говорит о том, что полноценная эксплуатация и качественная настройка даже базовых средств защиты способны серьезно повысить уровень информационной безопасности организации.

При этом стоит отметить, что оставшиеся инциденты (33,1%), выявляемые при помощи сложных интеллектуальных средств защиты или анализа событий бизнес-систем, несут гораздо больший объем информации, критичной для информационной и экономической безопасности компании. Они позволяют глубже и полнее видеть картину защищенности компании и своевременно предотвращать критичные таргетированные атаки.

Threat Intelligence

Источники Threat Intelligence, используемые в Solar JSOC, можно условно разделить на следующие категории:

- Opensource – открытые базы индикаторов вредоносного ПО, серверов управления и фишинговых ссылок. Как правило, в разрезе детектирования с помощью SIEM-платформ актуальность имеют только сетевые индикаторы.

- Reputation feeds – платные подписки на репутационные списки вредоносного ПО, серверов управления и фишинговых ссылок. Как правило, в разрезе детектирования с помощью SIEM-платформ актуальность имеют только сетевые индикаторы.

- APT/IOC reporting – платные подписки на подробные описания 0day вредоносных тел, включающие, в том числе, и описание используемых уязвимостей, и хостовые индикаторы вредоносного ПО.

- Information Exchange – информация, полученная в рамках информационных обменов с государственными, ведомственными и иностранными центрами реагирования на инциденты (CERT).

- Internal Solar JSOC database – индикаторы, полученные в результате собственных исследований Solar JSOC или расследований инцидентов.

- User experience – информация, полученная напрямую от пользователей клиентов (успешное противодействие социальной инженерии, детектирование фишинговых рассылок и т.п.).

Как можно видеть, правильное использование бесплатных источников информации о TI может повысить защищенность компании и устойчивость от массовых атак. Но не менее половины инцидентов выявляется только при помощи платных коммерческих подписок.

|

|

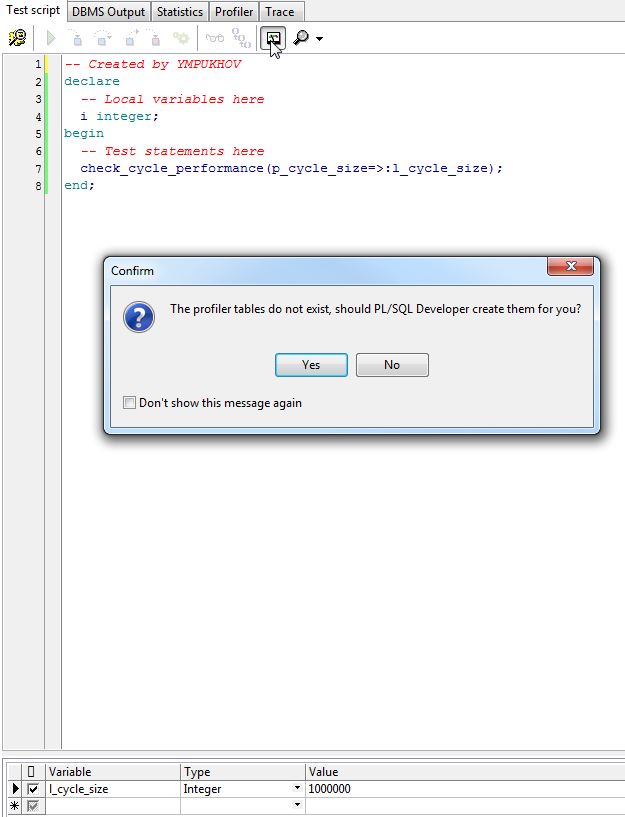

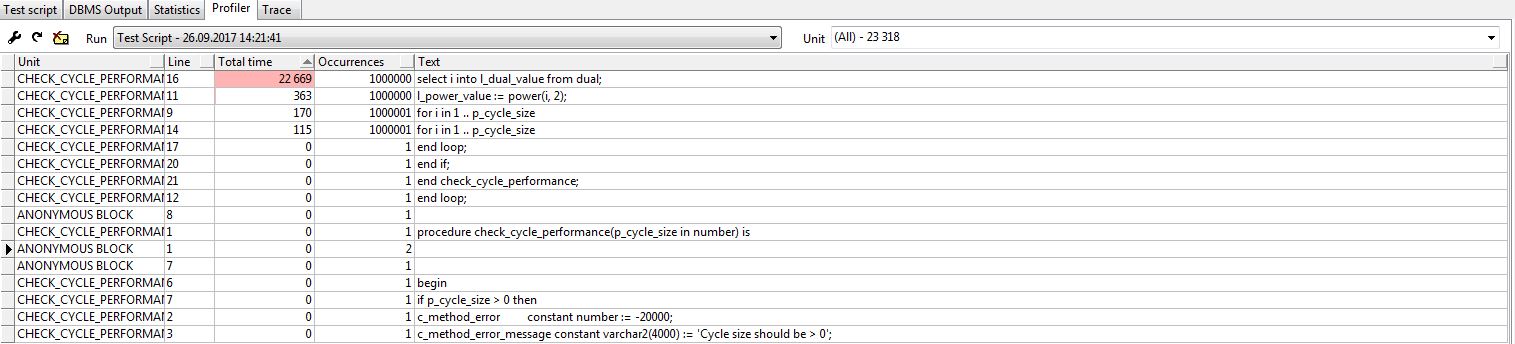

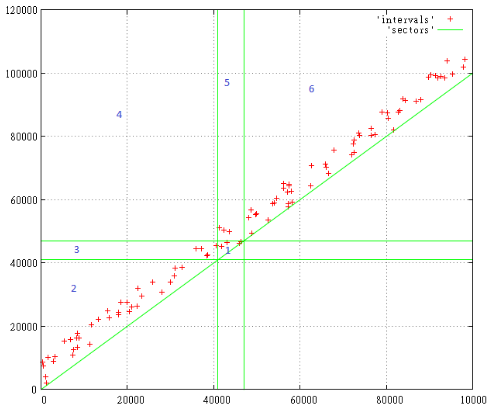

Отладка PL/SQL кода для внешней сессии БД |

Отладка PL/SQL кода для внешней сессии БД

Проблематика и назначение:

Периодически Oracle разработчики сталкиваются с проблемой отладки PL/SQL кода, когда код вызывается из веба или среднего слоя(т.е. когда сессия разработчика не совпадает с сессией в которой возникает проблема).

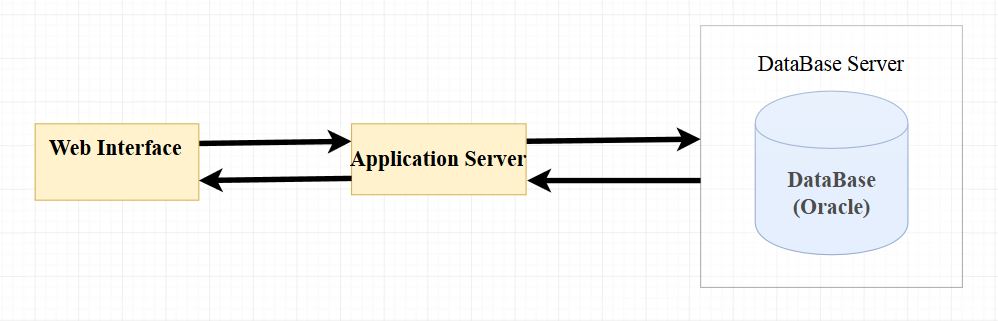

Особенно актуально, если какие-либо проблемы возникают на стороне Web при двухзвенных и трехзвенная схемах взаимодействия БД и Web(ниже пример трехзвенной архитектуры взаимодействия):

Рисунок 1 — Трехзвенная архитектура взаимодействия БД и Web.

Метод решения проблем:

В решение проблем с отладкой PL/SQL кода нам помогут пакеты:

- DBMS_PIPE — Пакет который позволяет отпавлять сообщения(пайпы) между 2мя сессиями БД Oracle.

- DBMS_ALERT — Пакет, который обеспечивает поддержку асинхронных оповещений для различных событий БД Oracle.

Ниже код метода, который мы будем отлаживать при помощи DBMS_PIPE и DBMS_ALERT одновременно:

create or replace procedure checkout_with_pipe_and_alert(p_cycle_size in number) is

c_method_error constant number := -20000;

c_method_error_message constant varchar2(4000) := 'Cycle size should be > 0';

l_power_value number;

l_i_value number := 1;

l_pipe pls_integer;

begin

if p_cycle_size > 0 then

for i in 1 .. p_cycle_size

loop

l_power_value := power(i, 2);

l_i_value := l_i_value * i;

--Send pipe info

l_pipe := dbms_pipe.create_pipe(pipename => 'pipe');

dbms_pipe.pack_message(i || '.l_power_value:=' || l_power_value || ' l_i_value=' || l_i_value);

l_pipe := dbms_pipe.send_message(pipename => 'pipe');

--Send alert info

dbms_alert.register('alert');

dbms_alert.signal(name => 'alert',

message => i || '.l_power_value:=' || l_power_value || ' l_i_value=' || l_i_value);

dbms_alert.remove(name => 'alert');

end loop;

else

raise_application_error(c_method_error, c_method_error_message);

end if;

end checkout_with_pipe_and_alert;При отсутствие грантов на DBMS_PIPE и DBMS_ALERT раздадим их:

Рисунок 2 — Раздача грантов c Oracle сервера схемы SYS на рабочую схему

Отловим сообщения для DBMS_PIPE и DBMS_ALERT при помощи PL/SQL Developer:

Отлавливание сообщений при помощи кода не рассматриваю, т.к. информации достаточно в Oracle DOC и на просторах интернета.

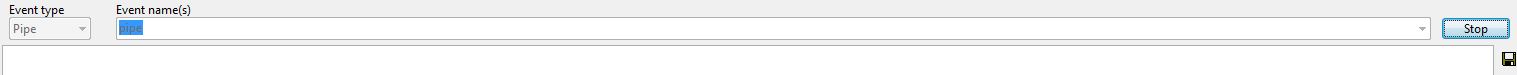

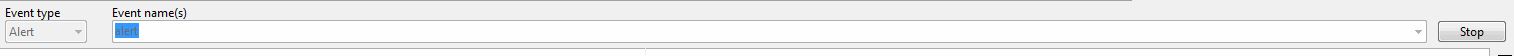

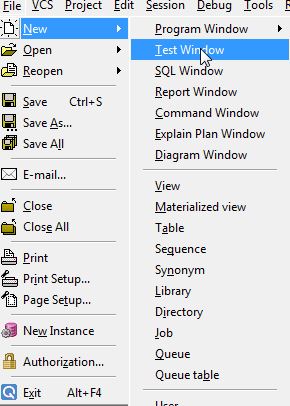

Заходим в Tools->Event Monitor..., в одном окне выбираем тип события "Pipe", а в другом "Alert" в Event name указываем название пайпы и алерта, которые задали в коде и нажимаем Start:

Рисунок 3 — Настройка окна с Pipe

Рисунок 4 — Настройка окна с Alert

После запуска метода checkout_with_pipe_and_alert из веба/среднего слоя(в нашем случае из другой сессии):

begin

checkout_with_pipe_and_alert(5);

end;В окнах Pipe и Alert получим следующие результаты:

Рисунок 5 — Результат получения информации от Pipe

Рисунок 6 — Результат получения информации от Alert

Выводы:

- dbms_pipe отличный метод, для отладки pl/sql в разных сессиях, только pipe периодически забивается и приходится использовать метод: dbms_pipe.purge

- dbms_alert я бы не советовал использовать, т.к. периодически теряются сообщения при отладке(как видно из рисунка 6), быть может не правильно его использую. Если кто-то с таким сталкивался, напишите в комментариях и я поправлю статью.

|

Метки: author ympukhov отладка oracle pl/sql developer oracle pl/sql |

[Перевод] Что последует за вебом? |

Что последует за вебом?

- Перевод

В первой части я утверждал, что пришло время подумать, как заменить современную веб-платформу для приложений. Причина — её низкая производительность и в принципе нерешаемые проблемы безопасности.

В первой части я утверждал, что пришло время подумать, как заменить современную веб-платформу для приложений. Причина — её низкая производительность и в принципе нерешаемые проблемы безопасности.Кое-кто решил, что я пишу слишком в негативном ключе и не обращаю внимания на положительные стороны веба. Так и есть: первая часть была в стиле «Обсудим факт, что мы попали в глубокую яму», а вторая часть — «Как разработать кое-что получше?» Это огромная тема, так что она на самом деле двумя частями не ограничится.

Назовём нашего конкурента вебу NewWeb (э, брендингом можно заняться потом). Для начала нужно понять, почему веб изначально стал успешным. Веб обошёл другие технологии создания приложений с лучшими инструментами для разработки GUI, так что у него явно есть какие-то качества, которые перевешивают недостатки. Если мы не будем соответствовать этим качествам, мы обречены.

Нужно также сконцентрироваться на дешевизне. У веба многочисленные группы разработчиков. Б'oльшая часть их работы дублируется или выбрасывается, кое-что можно использовать повторно. Возможна и новая разработка в небольшом объёме… но по большому счёту любую технологию NewWeb придётся собирать из кусочков существующего программного обеспечения. Беднякам не приходится выбирать.

Вот мой личный список пяти главных свойств веба:

- Развёртывание и изоляция в песочнице

- Простота в освоении пользователями и разработчиками

- Устранение дихотомии документ/приложение

- Продвинутое оформление и брендинг

- Открытый код и бесплатное использование

Это не совсем то, что принято считать главными принципами архитектуры: если опросить разработчиков, то большинство из них, вероятно, назовут сутью архитектуры веба URL, просмотр исходников, кроссплатформенность, HTTP и так далее. Но это всё просто детали реализации. Веб взял верх над Delphi и Visual Basic не потому что JavaScript настолько крут. Есть более глубокие причины.

Перечисленные выше вещи, в принципе, довольно понятны. Я более подробно проанализирую их по ходу статьи. Для победы над вебом недостаточно просто повторить его сильные стороны, мы должны идти дальше и предложить уникальные улучшения, которые веб не способен легко интегрировать. Иначе нет смысла: вместо своего проекта мы будем просто работать над улучшением веба.

В этой статье я предлагаю две вещи: определённые принципы архитектуры, которым, по-моему, должен следовать любой серьёзный конкурент веба, и конкретный пример, собранный из различных open source проектов. Многим читателям не понравится конкретный пример, потому что им по душе другие проекты или языки программирования, в этом нет ничего страшного. Мне не важно. Это просто иллюстрация — по-настоящему важны принципы. Я называю конкретные кодовые базы только для иллюстрации, что эти мечты не совсем нереалистичны.

Принципы архитектуры

У веба отсутствует вразумительная философия архитектуры, по крайней мере, в отношении приложений. Вот каких необходимых вещей ему не хватает, на мой взгляд:

- Ясное понятие идентификаторов приложений.

- Единое представление данных от бэкенда к фронтенду.

- Бинарные протоколы и API.

- Аутентификация пользователей на уровне платформы.

- Ориентированная на IDE разработка.

- Компоненты, модули и отличная система вёрстки UI — точно как в обычной разработке для настольных компьютеров или мобильных устройств.

- Также понадобятся вещи, с которыми хорошо справляется веб: мгновенный запуск стриминговых приложений без инсталляции или необходимости ручного обновления, изоляция этих приложений в песочнице, сложная стилизация UI, сочетание и и приведение в соответствие «документального» и «программного» материала (вроде возможности связать определённые виды приложений), возможность постепенного обучения и архитектура, которая не затрудняет разработчикам создание слишком сложных UI.

Первые четыре пункта, выделенные жирным, связаны с безопасностью, поскольку именно проблемы с безопасностью вынудили меня занять столь радикальную позицию. Возможно, низкую производительность веба можно исправить новым фреймворком JavaScript — может быть. Но я не думаю, что можно устранить проблемы с безопасностью. В последующих статьях я рассмотрю пункты, которые не выделены жирным.

Идентификаторы приложений и ссылки

Чтобы получить преимущества веба по развёртыванию и изоляции в песочнице, требуется некий браузер для приложений. Неплохо было бы получить возможность ссылаться на отдельные части приложения как на части гипертекстового документа. Это ключевой элемент успеха веба: страница с поисковыми результатами Amazon похожа на некое приложение, но мы можем ссылаться на него, так что это одновременно и документ.

Но наш браузер приложений не должен физически напоминать веб-браузер. Посмотрите свежим взглядом: UI веб-браузера не идеален.

URL — основная часть дизайна любого браузера, но иногда он вносит путаницу!

Первая проблема в том, что URL'ы проникают повсюду в UI. Адресная строка постоянно содержит случайные биты из памяти браузера, закодированные в таком виде, который сложно понять и людям, и машинам, что ведёт к параду эксплоитов. Если бы десктопное приложение выгружало случайные внутренние переменные в строку заголовка, мы бы посчитали это серьёзным багом, угрожающим репутации фирмы, так почему здесь мы должны это терпеть?

Вторая проблема в том, что машинам тоже сложно воспринимать URL'ы (здесь возможно создание сумасшедших эксплоитов). Даже не учитывая хитрых трюков кодирования вроде этого, в вебе есть различные способы установить идентичность приложения. Браузеру требуется некое понятие идентичности приложения для отделения друг от друга хранилищ кукисов и для отслеживания выданных разрешений. Это «источник» (origin). Со временем концепция источника в вебе эволюционировала, и теперь её в сущности невозможно сформулировать. RFC 6454 пытается сделать это, но в самом документе написано:

Со временем многие технологии сошлись на концепции источника как на удобной единице изоляции. Однако многие из ныне используемых технологий, такие как куки [RFC6265], созданы раньше, чем современная концепция источника в вебе. У этих технологий часто другие единицы изоляции, что ведёт к уязвимостям.

Например, подумайте, что мешает вашему серверу установить куки для домена .com. А что насчёт kamagaya.chiba.jp? (это не веб-сайт, а просто раздел иерархии, как и .com!)

Возможность неожиданно поставить ссылку на часть приложения, которая не получает от этого никакой выгоды и не ожидает этого — один из источников проблемы «опасных ссылок». Сильно URL-ориентированный дизайн подвергает всё ваше приложение опасности инъекции данных со стороны посторонних злоумышленников. Это ограничение дизайна, которое известно тем, что с ним практически невозможно бороться, но оно беспечно поощряется самой архитектурой веба.

Тем не менее, возможность поставить ссылку на середину приложения из документов и наоборот была бы очень приятной, если всё работает как задумано разработчиками. Итак, сформулируем пару требований:

Требование: идентичность приложения (изоляция) должна быть простой и предсказуемой.

Требование: мы должны иметь возможность поставить глубокую ссылку на приложение, но не всегда.

К их чести, архитекторы Android понимали эти требования и предложили решения. Отсюда мы можем начать:

- Идентичность приложения определяет публичный ключ. Все документы, подписанные одним ключом, изолированы в одном домене. Для определения изоляции не используется разбор строк.

- Приложения могут подписаться на получение строго типизированных пакетов данных, которые просят их открыться в какое-то состояние. Android называет эту концепцию «намерениями» (intents). Намерения на самом деле не очень строго типизированы в Android, но могли быть такими. Их можно использовать также для внутренней навигации, но чтобы разрешить ссылки из какого-то другого приложения, намерение должно быть опубликовано в манифесте приложения. По умолчанию приложения не реагируют на ссылки.

- Где найти приложение для скачивания? Доменное имя — достаточно хорошая позиция для начала. Хотя мы можем поддерживать и скачивания по HTTP[S], но мы находим сервер NewWeb по хорошо известному порту и забираем код оттуда. Так что доменное имя становится начальной точкой для получения приложения, но в остальных отношениях не такой важной.

Чтобы различать URL'ы и чужие намерения от наших собственных, назовём чужие линк-пакетами.

Отключение приёма внешних ссылок по умолчанию понизит ссылочную связность NewWeb, но улучшит безопасность. Может быть, это плохой компромисс и он станет фатальным. Но многие ссылки, которые люди могут теоретически создавать в современном вебе, по сути бесполезны или из-за требований аутентификации, или потому что не содержат никакого осмысленного начального состояния (многие SPA). Поэтому приложения минимизируют область атаки. Вредоносная ссылка, которая является стартовой точкой такого большого количества эксплоитов, немедленно становится менее опасной. Это кажется ценным достижением.

Но есть и другие преимущества — важность доменного имени для веб-приложений делает соблазнительным для провайдеров конфисковать домены, которые не нравятся их руководству. Хотя простые сайты можно перенести на другой домен без особых проблем, более сложные сайты могут дорожить сложившейся репутацией почтовых адресов, токенов OAuth и так далее, для них это более болезненная процедура. Секретные ключи могут быть потеряны или украдены, но то же самое с доменными именами. Если вы потеряли секретный ключ — по крайней мере, это только ваша вина.

Что касается остальных частей браузерного UI, от них, вероятно, можно избавиться. Вкладки могут пригодиться, но кнопка перезагрузки страницы никогда не должна использоваться, а кнопку возврата в предыдущее состояние можно встроить в само приложение, если в ней есть смысл, а-ля iOS.

Как создать браузер приложений? Хотя NewWeb довольно сильно отличается от веба, базовый UI полноэкраннных приложений вполне стандартен, а пользователи захотят переключаться туда и назад. Так почему бы не форкнуть Chromium и не добавить вкладку в новом режиме?

(Правка: некоторые поняли вышесказанное как «использовать Chrome для всего, что здесь перечислено» — это не то, что я имел в виду. Я имел в виду использование его реализации UI со вкладками, чтобы у вас были открыты рядом приложения NewWeb и OldWeb. Но UI с вкладками несложно сделать, и необязательно использовать Chromium, браузер приложений тоже может быть созданным с нуля приложением).

Единое представление данных

Может быть концепция линк-пакетов звучит немного туманно. Что это такое? Для более чёткого определения нам нужны структуры данных.

В вебе существует масса способов сделать это, но все они на основе текста. Напомню тезис из моей прошлой статьи: у текстовых протоколов (не только у JSON) есть фундаментальная уязвимость: это «внутриполосная» сигнализация буфера, то есть чтобы выяснить, где заканчиваются данные, нужно прочитать их все в поиске конкретной последовательности символов. Эти последовательности могут быть законной частью данных, то есть вам нужен механизм экранирования. А потом, поскольку эти протоколы предполагаются как человекочитаемые или хотя бы нердочитаемые, часто возникают странные пограничные случаи с обработкой пробелов или канонизированным Юникодом, что приводит к эксплоитам, вроде атак с разделением заголовка HTTP.

В прежние времена текстовые протоколы помогали веб-разработчикам. Просмотр исходника определённо помог мне столько раз, что я не могу сосчитать. Но теперь средний размер веб-страницы превышает 2 мегабайта, не говоря уже о веб-приложениях. Даже скучные веб-странички со статичным текстом часто содержат массу минифицированных скриптов, в которых без машинной помощи вы не сможете даже начать разбираться. Преимущества текстовых протоколов кажутся меньше, чем в прошлые времена.

Примитивный декомпилятор

Если честно, в последние годы веб медленно отказывается от текстовых протоколов. HTTP/2 бинарный. И разрекламированный “WebAssembly” — это бинарный способ выражения кода, хотя он на самом деле не решает проблем, о которых мы говорили. Но тем не менее.

Требование: сериализация данных должна быть автоматической типизированной, бинарной и неизменной от хранилища данных до фронтеда.

Код для сериализации не только утомительно писать, но это ещё и серьёзный вектор атаки. Хорошая платформа должна взять задачу на себя. Давайте определим в самом примитивном виде синтаксис для выражения структур данных:

enum SortBy {

Featured,

Relevance,

PriceLowToHigh,

PriceHighToLow,

Reviews

}

@PermazenType

class AmazonSearch(

val query: String,

val sortBy: SortBy?

) : LinkPacketВ вебе эквивалентом этого будет URL на сайте amazon.com. Он определяет структуру данных неизменного типа для обозначения запроса на открытие приложения в некоем состоянии.

Эта структура данных помечена как

@PermazenType. Что это значит?Если мы серьёзно относимся к коду с префиксированной длиной, строгой типизацией защитой от инъекций по всему стеку, то придётся что-то сделать с SQL. Язык структурированных запросов — приятный и хорошо понятный способ выразить сложные запросы к разнообразным исключительно мощным движкам БД, поэтому его жалко. Но SQL — это текстовый API. Хотя SQL-инъекции — один из самых простых типов эксплоитов, которые легко понять и исправить, но это также один из самых распространённых багов на веб-сайтах. Ничего удивительного: если использовать SQL на веб-сервере самым очевидным образом, то он будет нормально работать, но незаметно сделает сервер уязвимым для взлома. Параметризованные запросы помогают, но это сбоку привинченное решение, которое не в каждой ситуации можно использовать. Технологический стек создаёт для всех нас хорошо замаскированный медвежий капкан, и наша цель — минимизировать соотношение рисков и функциональности.

У SQL имеются и некоторые другие проблемы. Вы быстро столкнётесь с проблемой объектно-реляционного отображения. Результаты выполнения SQL-запроса нельзя нативно отправить по соединению HTTP или встроить в веб-страницу, так что всегда потребуется некая трансформация в другой формат. SQL скрывает от вас производительность нижележащих запросов. Бэкенд сложно масштабировать. Изменения схемы зачастую требуют заморозки таблицы, так что их невозможно развернуть без неприемлемого даунтайма.

Движки NoSQL ненамного лучше: они обычно исправляют одну или две из этих проблем, но за счёт отбрасывания решений SQL для всего остального. В итоге вы часто застреваете с решением, которое иное, но не обязательно лучшее. В результате крупнейшие компании вроде Google и Bloomberg тратят много времени, пытаясь найти способ масштабировать базы данных SQL (F1, ComDB2).

Permazen — это новый подход к хранению данных, который восхищает меня в данный момент. Цитата с их сайта:

Permazen — совершенно новый подход к стойкому программированию. Вместо того, чтобы начинать разработку со стороны технологии хранения, он начинает со стороны языка программирования, задавая простой вопрос: «Какие проблемы присущи стойкому программированию, независимо от языка программирования или технологии СУБД, и как их можно решить на уровне языка наиболее простым, самым корректным и самым естественным с точки зрения языка способом?»