Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Курсы Computer Science клуба, весна 2017, часть вторая |

Продолжаем выкладывать видеозаписи курсов Computer Science клуба при ПОМИ РАН. Первая часть здесь. В этом подборке четыре курса: «Коммуникационная сложность», «Экспандеры и их применения», «Машинный перевод» и «Избранные главы теории потоков».

Коммуникационная сложность

Лектор:

Николай Константинович Верещагин, профессор МГУ, член Европейской Академии.

Аннотация

Простейшая модель в теории коммуникационной сложности такова. Имеются два участника (компьютера или человека), которые совместно хотят решить некоторую задачу. Ни один из них самостоятельно решить задачу не может (например, у каждого из них недостаточно данных или ресурсов). Поэтому им необходимо общаться. Коммуникационная сложность измеряет минимально возможное количество битов, которым необходимо обменяться участникам, чтобы решить задачу. Время, необходимое для проведения локальных вычислений каждым из участников, не принимается во внимание — в этом принципиальное отличие от теории сложности вычислений. Результаты из коммуникационной сложности имеют очень широкое применение в других областях теоретической информатики.

Материалы и видео курса.

Экспандеры и их применения

Лектор:

Андрей Евгеньевич Ромащенко, научный сотрудник Института проблем передачи информации РАН в Москве и Лаборатории информатики, робототехники и микроэлектроники (LIRMM) в Монпелье.

Аннотация

Экспандеры (расширяющие графы) являются мощным и весьма изощрённым инструментом теоретической информатики и дискретной математики. По-видимому, эффективность экспандеров отчасти объясняется тем, что они (по самому своему определению) позволяют естественно сочетать комбинаторно-геометрические, алгебраические и вероятностные рассуждения. Экспандеры были определены в 1970-х годах. За прошедшие 30 лет они нашли множество красивых применений. Экспандеры используются в различных конструкциях дерандомизации. С помощью экспандеров строятся коды, исправляющие ошибки, и надёжные вычислительные схемы. Техника экспандеров применяется в различных доказательствах теории сложности вычислений (например, в доказательстве знаменитой PCP-теоремы). В данном курсе мы будем интересоваться экспандерами с точки зрения теории алгоритмов. Мы изучим связь комбинаторных и спектральных свойств экспандеров, рассмотрим эффективные алгоритмические методы построения таких графов, а также обсудим различные применения экспандеров. Мы также поговорим о связи экспандеров с другими замечательными классами графов: экстракторами, дисперсерами, компрессорами.

Материалы и видео курса.

Машинный перевод

Лектор:

Дэвид Талбот, ведущий научный сотрудник Google в Великобритании, преподаватель Школы анализа данных.

Аннотация

Первый день курса знакомит слушателей с проблемой машинного обучения с параллельных данных для автоматического перевода. Слушателям будет предложено реализовать простые алгоритмы для выравнивания слов. Второй день курса будет посвящён основам нейронного машинного перевода. Слушатели смогут получить практический опыт работы с простой моделью кодер-декодер. Будут полезны начальные навыки Python и умение компилировать и запускать код с github. Курс читается на английском языке.

Материалы и видео курса.

Избранные главы теории потоков

Лектор:

Максим Александрович Бабенко, доцент Высшей школы экономики, преподаватель Школы анализа данных, сотрудник Яндекс.

Аннотация

Теория потоков, без сомнения, представляет собой один из наиболее хорошо изученных разделов комбинаторной оптимизации, имеющий разнообразные приложения, как теоретические, так и практические. Курс начнется с краткого введения в предмет, в котором мы разберем базовые алгоритмы для задачи о максимальном потоке, а затем быстро перейдем к более современным темам: проталкиванию предпотока и параметрическим потоковым задачам. В заключительной части курса коснемся обобщений понятия потока: изучим простейшие виды мультипотоковых задач, а также поговорим о потоках в кососиметрических и двунаправленных графах. От слушателей предполагается знакомство с базовыми понятиями алгоритмической теории графов.

Материалы и видео курса.

|

Метки: author avsmal машинное обучение математика алгоритмы блог компании спбау экспандеры теория графов машинный перевод коммуникационная сложность потоки теория сложности |

Вебинар Linux on Azure и подборка материалов Open Source & Microsoft |

Привет! Завтра мы проводим вебинар «Linux на Microsoft Azure».. Конечно же, я, как докладчик на этом вебинаре, расскажу больше, чем обзор Open Source предложений в облаке. Будет про то, зачем, сколько и как мы тратим на поддержку Open Source как компания, про локальные и гибридные решения, поделив вебинар на две части – для разработчиков и не-разработчиков. Расскажу о внутреннем глобальном сообществе Open Source, успешно действующем в Microsoft, лидером коего являюсь. А ниже, под катом, мы совместными усилиями сделали подборку материалов Open Source + Microsoft. Регистрируйтесь и приходите, в общем, постараемся сделать интересно. :)

Работа с Linux в облаке Azure

Курс Microsoft Virtual Academy на русском языке, который поможет сделать первые шаги в Linux + Azure. Он включает в себя большое число демонстраций и практических рекомендаций.

Он состоит из следующих разделов:

1. Linux в Azure – обзорВ этом модуле рассмотрены основы облачной платформы Azure. Основное внимание сосредоточено на сервисе виртуальных машин, а именно — на запуске Linux виртуальных машин в облаке Azure.

2. Сетевое взаимодействие виртуальных машин Linux в AzureВ этом модуле рассмотрены основные моменты сетевого взаимодействия в Azure, а именно — создание нескольких виртуальных машин для обслуживания веб сайта, горизонтальное масштабирование и так далее.

3. Управление Linux VM в облаке Azure ч.1: Azure Management PortalВ этом модуле рассмотрены основные принципы работы с порталом Azure. Портал Azure — это веб приложение, следовательно, работать с ним можно практически с любого устройства.

4. Управление Linux VM в облаке Azure ч.2: Azure PowershellВ этом модуле рассмотрены команды PowerShell для работы с Azure. В модуле показано как можно установить себе команды PowerShell для работы с Azure и как подключить их к своей Azure подписке.

5. Управление Linux VM в облаке Azure ч.3: Azure Command Line interfaceВ этом модуле рассмотрены основные принципы работы с утилитами командной строки для Azure. В модуле показано как можно установить себе утилиты командной строки и как подключить их к Azure.

6. Управление Linux VM в облаке Azure ч.4: Инструменты Cerebrata ToolsВ этом модуле рассмотрены такие утилиты компании Cerebrata, как Azure Explorer, Azure PowerShell и Azure Management Studio. Все эти инструменты позволяют нам намного комфортнее работать с Azure.

7. Хранение данных в Azure - диски и распределенные файловые системыВ этом модуле рассмотрены все доступные возможности хранения данных Linux виртуальных машин в облаке Azure (Blob хранилище, Azure диски, распределенная файловая система GlusterFS в Azure и так далее).

Построение Linux кластеров в Azure

Русскоязычный курс Microsoft Virtual Academy, посвящённый погружению в работу со множеством виртуальных машин под Linux, размещённых в облаке Azure, и сконфигурированные для совместного решения одной задачи.

Он состоит из следующих разделов:

1. Типы кластеров, кластер балансировки нагрузкиВ начале рассматриваются различные типы Linux-кластеров, подходы к их построению и задачи, которые они решают. Обзорно рассматривается архитектура Linux-кластера балансировки нагрузки.

2. Отказоустойчивый и вычислительный кластерыТеория, вторая часть: отказоустойчивый и вычислительный кластеры. Подробнее об устройстве кластера отказоустойчивости и вычислительного кластера.

3. Настройка кластера отказоустойчивости в облакеПример создания кластера отказоустойчивости в IaaS-облаке Azure. Отказоустойчивое хранилище DRBD. Прикладное программное обеспечение: MySQL-сервер.

4. Настройка доступа к кластеру снаружи облака, настройка STONITHВ этой части подробно показано, как выполнить проверку работоспособности кластера в различных режимах; настройку множественного endpoint; настройку STONITH и проверку правильности его работы.

Полезные материалы

Общие сведения об Azure и Linux: базовые сведения об облаке Azure (размеры виртуальных машин, квоты, регионы и так далее) и его взаимодействии с Linux.

Создание виртуальной машины Linux с помощью Azure CLI: в этом руководстве описывается, как с помощью Azure CLI развернуть виртуальную машину под управлением сервера Ubuntu. После развертывания сервера создается подключение по протоколу SSH и устанавливается веб-сервер NGINX.

Сэмплы Azure CLI для виртуальных машин Linux.

Создание виртуальной машины Linux с помощью портала Azure: в этом кратком руководстве содержатся пошаговые инструкции по созданию виртуальной машины и установке веб-сервера на этой виртуальной машине.

Создание виртуальной машины Linux с помощью PowerShell: в этом руководстве описывается, как с помощью модуля Azure PowerShell развернуть виртуальную машину под управлением сервера Ubuntu. После развертывания сервера создается подключение по протоколу SSH и устанавливается веб-сервер NGINX.

Сэмплы PowerShell для виртуальной машины Azure.

Подробный пошаговый туториал по созданию виртуальных машин Linux и управлению ими с помощью Azure CLI.

Справочные материалы

|

Метки: author ahriman microsoft azure блог компании microsoft azure open source and microsoft linux |

Как учится и отвечает на вопросы когнитивная система IBM Watson. Часть 1 |

За последний десяток лет технологии шагнули далеко вперед. Интернет вещей, облачные системы, формы искусственного интеллекта, нейросети и когнитивные технологии. Все это появилось относительно недавно, но все это активно меняет нашу жизнь. IBM прикладывает значительные усилия, чтобы изменения были положительными. Делается все это не удовольствия ради, а с вполне практической целью. Дело в том, что потребности современной науки и бизнеса чрезвычайно велики. И для того, чтобы эти потребности удовлетворять, необходимы новые инструменты. Один из них — IBM Watson, когнитивная платформа, которая способная учиться, выявлять связи между отдельными элементами крупнейшего массива данных, а также взаимодействовать со своим окружением, включая пользователей.

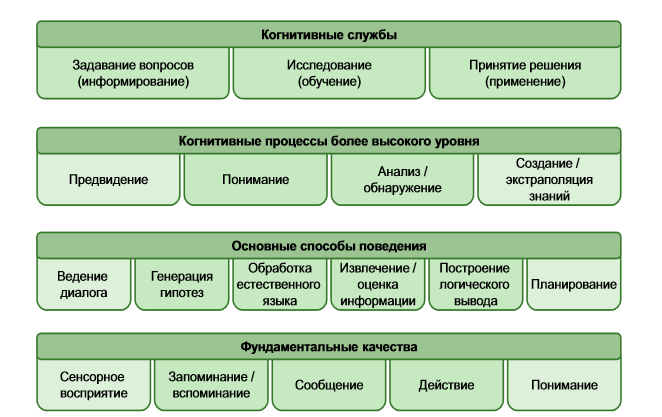

На Habrahabr и Geektimes наша компания не раз рассказывала о том, какую пользу может принести IBM Watson. Но как работает система? В целом, ее возможности основаны на анализе окружающей среды и различных факторов. Благодаря этому платформа способна принимать определенные решения и давать ответы на задаваемые вопросы. Ниже – относительно краткое изложение принципов работы нескольких составляющих работы когнитивной системы. Это обучение, обработка языка и ответы на вопросы.

Как Watson обучается

Ключевые элементы работы когнитивной системы –эмулирование некоторых особенностей мышления человека, которые задействуются во время принятия решения и ответов на вопросы.

Обучение Watson ведется в несколько этапов. Самый первый — это загрузка информации. Разработчики системы пытаются сделать ее пригодной для использования в любых областях науки, техники… да чего угодно.

Все начинается с загрузки релевантной информации по определенной тематике в базу данных Watson. Здесь можно вспомнить Шерлока Холмса и его объяснение эффективности дедуктивного метода и важности релевантных знаний. Холмс, изучая определенный вопрос, «загружал» в память лишь информацию, которая непосредственно касалась этого вопроса. То же и с Watson — когда разработчики принимают решение обучить систему новому предмету, то загружают в память исключительно релевантную информацию, имеющую отношение к тематике обучения. Устаревшие и не слишком релевантные данные выверяются и отсеиваются. Это постоянный процесс.

Затем наступает очередь IBM Watson — начинается предварительная обработка данных с построением индексов и других метаданных, позволяющих более эффективно работать в дальнейшем. Создается «граф знаний» для представления ключевой концепции осваиваемого материала.

По завершению предварительной обработки данных снова начинают работать люди, которые помогают Watson интерпретировать полученные данные. Это делается при помощи машинного обучения, когда эксперт начинает работать с системой в форме вопрос-ответ. Такой метод помогает создавать лингвистические паттерны, относящиеся к изучаемой теме.

Еще один способ обработки и усвоения данных – постоянное взаимодействие Watson с пользователями. Эксперты регулярно оценивают эту активность и помогают Watson совершенствовать свои возможности, отвечать на все более сложные вопросы, обновлять ранее полученную информацию.Цель разработчиков — научить когнитивную систему Watson отвечать на вопросы примерно так, как это делает человек. То есть эмулировать принятие решений человеком. Это нужно как науке, медицине, так и бизнесу.

Речь, фактически, идет о «динамическом обучении», когда Watson становится умнее, получая обратную связь от пользователей и разработчиков, обучаясь на собственных ошибках.

Как Watson работает с естественным языком?

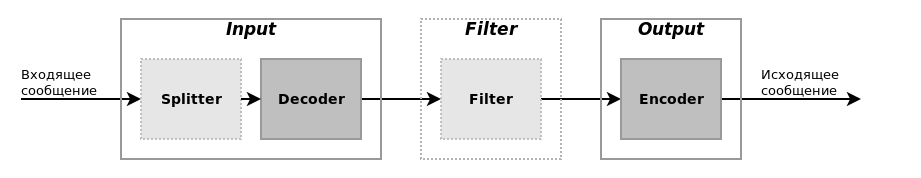

Вне зависимости от того, задается вопрос устно или письменно, системе необходимо уметь анализировать сложные смысловые конструкции, понимая не только смысловую, но и эмоциональную нагрузку текста. Для того, чтобы Watson мог правильно определять смысл текста, разработчики интегрировали в систему вопросно-ответную систему контентной аналитики (Deep Question*Answering, DeepQA). Это основа основ, на этой системе строится работа когнитивной платформы.

Благодаря ей Watson может понимать, что ему говорят, и давать адекватный и релевантный ответ. А ведь для машины понять язык человека чрезвычайно сложно. Многие определения слов и термины нелогичны. Взять то же выражение «сгореть со стыда» — человек прекрасно его понимает (если, конечно, слышал ранее). Для машины это выражение — нонсенс, если эта машина не Watson. Разработчики системы постепенно обучают Watson понимать идиомы, устанавливая лексические связи и строя паттерны, о чем уже говорилось выше.

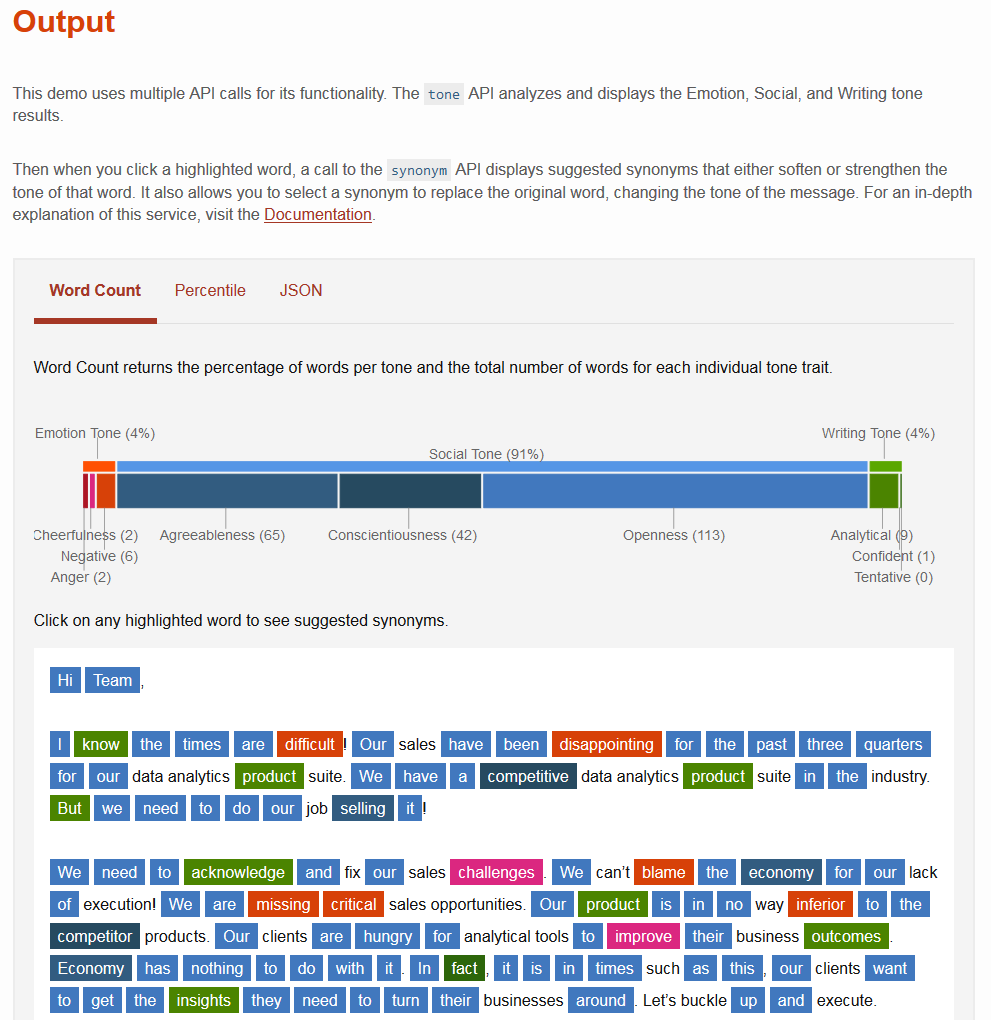

Кроме всего прочего, система умеет распознавать и эмоциональное наполнение текста. Для этого в 2016 году были добавлены сразу три API: ToneAnalyzer, EmotionAnalysis и VisualRecognition. Обновлен сервис TexttoSpeech (TTS) с получением новых возможностей по эмоциям, а также открыт доступ к API речевого модуля Expressive TTS (работа над ним велась в течение 12 лет). В целом, модули и сервисы, которые помогают системе работать с естественным языком, разрабатываются и добавляются постоянно. Это – одна из составляющих динамического обучения, о чем говорилось выше. Постоянный прогресс, развитие – одна из задач проекта, которая вполне успешно выполняется.

Один из примеров анализа смыслового и эмоционального наполнения письма системой IBM Watson

Watson теперь умеет определять стиль изложения в тексте, идентифицировать эмоции, включая позитивные и негативные, а также распознавать и классифицировать изображения.

Как Watson отвечает на вопросы?

Если упрощенно, то все выглядит следующим образом.

1. Для того, чтобы система могла отвечать на какой-либо вопрос, в ее памяти должны быть релевантные данные. Об этом уже говорилось выше. Эксперты загружают различную информацию в систему, где эти данные индексируются для того, чтобы при необходимости ими можно было воспользоваться.

2. Далее вопросы отсылаются системе в текстовой или голосовой форме.

3. Вопросы анализируются системой, Watson выделяет поисковый запрос и начинает искать необходимую релевантную информацию в своей базе данных. Это можно сравнить с тем, как работает Google.

4. Генерируется ряд гипотез путем анализа фраз, которые с определенной долей вероятности могут содержать нужный ответ. Выполняется глубокое сравнение языка вопроса и языка каждого из возможных вариантов ответов. Формируется база результатов поискового запроса.

5. Каждый результат оценивается определенным образом, получая балл. При этом анализируется, в какой степени ответ релевантен области вопроса.

6. Чем выше балл одного из ответов, тем выше он ранжируется.

7. Если Watson после финального анализа считает своей ответ релевантным и актуальным, он предоставляется пользователю.

Реальный процесс поиска ответа на вопрос гораздо сложнее, поскольку каждая фраза прорабатывается при помощи нескольких алгоритмов, работающих, зачастую, в параллельном режиме. Для Watson разработаны сотни алгоритмов логического вывода. Некоторые из них выполняют поиск совпадающих терминов и синонимов, другие — рассматривают временные и пространственные особенности, а третьи — ищут и анализируют необходимые источники контекстуальной информации.

Для того, чтобы получить правильный ответ, система обращается и к дополнительным источникам данных. Например, новостям в интернете, технической литературе, справочникам. Все подряд материалы не копируются, а выверяются на актуальность с отсеиванием нерелевантной информации. Этот процесс занимает считанные секунды благодаря огромной производительности когнитивной платформы.

Завершая этот материал, стоит отметить, что статья раскрывает далеко не все интересующие наших читателей вопросы. Пожалуйста, задавайте вопросы в комментариях, а мы будем собирать ответы наших специалистов и публиковать сборные материалы «по мотивам» комментариев. Это, наверное, один из лучших вариантов ответить на действительно интересующие вас вопросы.

|

Метки: author ibm машинное обучение высокая производительность блог компании ibm watson облачные сервисы ibm когнитивные системы глубокое обучение |

[Перевод] 11 вещей которые я узнал, читая спецификацию flexbox |

Я всегда считал, что с flexbox довольно легко работать — глоток свежего воздуха после стольких лет float'ов и clearfix'ов.

Правда недавно я обнаружил что борюсь с ним; что-то растягивалось, когда я не думал, что оно должно тянуться. Я поправил здесь, другой элемент сжался. Я починил это, что-то другое ушло за экран. Что во имя Джорджа Буша происходит?

В конце концов, все заработало, но солнце село, а мой процесс был привычной игрой с CSS. Или… как называется та игра, где надо ударить крота, а затем другой крот выпрыгивает и надо ударить и его тоже?

Как бы там ни было, я решил что пора вести себя как взрослый разработчик и выучить flexbox должным образом. Но вместо того, чтобы прочитать 10 очередных блог-постов, я решил отправиться прямиком к исходнику и прочитать The CSS Flexible Box Layout Module Level 1 Spec

Вот хорошие отрывки.

1. Margin обладает особыми силами

Я думал, что если, например, ты хочешь заголовок с логотипом и названием сайта слева, а кнопкой логина справа...

… тебе следует дать названию flex: 1, чтобы прижать остальные элементы к другому концу строки.

Вот почему flexbox — Очень Хорошая Вещь. Простые вещи такие простые.

Но возможно, по какой-то причине, ты не хочешь тянуть элемент только для того чтобы прижать другой элемент вправо. Может, потому что у элемента есть подчеркивание, изображение или какая-либо третья причина, которую я не могу придумать.

Отличные новости! Вместо этого, ты можешь сказать прямо: «прижми этот элемент вправо», определив margin-left: auto на нужном элементе. Думай об этом как о float: right.

Например, если элемент слева является изображением:

Мне не нужно применять flex к изображению, мне не нужно применять space-between к flex-контейнеру, я просто установлю margin-left: auto на кнопке «Войти» («Sign in»):

.header {

display: flex;

}

.header .logo {

/* nothing needed! */

}

.header .sign-in {

margin-left: auto;

}Тебе может показаться это некоторым хаком, но нет, это прямо там в обзоре спецификации как способ прижать flex-элемент в конец flexbox'а. У способа даже есть своя глава: "Выравнивание с авто margin'ами".

О, мне также следует здесь упомянуть, что я предполагаю flex-direction: row везде в этом блог-посте, но все применимо также и к row-reverse или column или column-reverse.

2. min-width имеет значение

Возможно, ты думаешь, что несложно заставить все flex-элементы внутри flex-контейнера сжиматься, для того чтобы уместить контент. Наверняка, если ты укажешь flex-shrink: 1 на элементах, они так и будут себя вести, правда?

Может, пример.

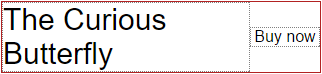

Скажем, у тебя есть часть DOM, которая отображает книгу на продажу и кнопку чтобы ее купить.

Ты разместил все с помощью flexbox и все хорошо.

.book {

display: flex;

}

.book .description {

font-size: 30px;

}

.book .buy {

margin-left: auto;

width: 80px;

text-align: center;

align-self: center;

}(Поскольку ты хочешь кнопку «Купить» справа — даже для очень коротких названий — ты, будучи умным, указал margin-left: auto)

Название книги довольно длинное, поэтому оно использует столько пространства сколько может и затем переходит на следующую строку. Ты счастлив, жизнь прекрасна. Ты блаженно отправляешь свой код в продакшн, с уверенностью, что он выдержит все.

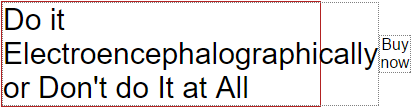

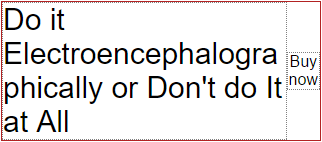

И потом получаешь неприятный сюрприз. Совсем не хорошего рода.

Некий маппет, много о себе возомнивший, написал книгу с длинным словом в названии.

Все сломано!

Если красная граница обозначает ширину смартфона, и ты скрываешь переполнение (overflow: hidden), ты только что потерял свою кнопку «Купить». Твой коэффициент конверсии — как и эго бедного автора — будет страдать.

(Примечание: к счастью, там где я работаю, есть хорошая QA команда, которая наполнила нашу базу данных разнородным текстом, наподобие такого. В частности, именно эта проблема побудила меня прочитать спецификацию.)

Оказывается, такое поведение происходит из-за того, что min-width элемента описания изначально установлена в auto, что в данном случае равняется ширине слова Electroencephalographically (электроэнцелографически). Flex-элементу буквально не разрешается быть уже чем это слово.

Решение? Переопределить эту проблемную минимальную ширину min-width: auto установив min-width: 0, указывая flexbox'у, что этот элемент может быть уже, чем содержимое внутри него.

Теперь за управление текстом внутри элемента отвечаешь ты. Я предлагаю перенести слово. Таким образом, твой CSS будет выглядеть так:

.book {

display: flex;

}

.book .description {

font-size: 30px;

min-width: 0;

word-wrap: break-word;

}

.book .buy {

margin-left: auto;

width: 80px;

text-align: center;

align-self: center;

}Результат будет таким:

Опять же, min-width: 0 не какой-то хак для обхода нелепости, это предлагаемое поведение прямо в спецификации.

В следующей секции, я вернусь к тому, что кнопка «Купить» совсем не 80 пикселей по ширине, как я довольно ясно ей сказал.

3. Авторы flexbox обладают хрустальным шаром

Как вы возможно знаете, свойство flex является краткой записью flex-grow, flex-shrink и flex-basis.

Должен признать, я потратил энное количество минут, гадая-проверяя различные значения для этой тройки, когда пытался заставить элементы тянуться так, как надо мне.

Что я не знал до сей поры, это то, что, в общем случае, я хочу одну из трех комбинаций:

- Если я хочу, чтобы элемент немного сжимался, когда места недостаточно, но не тянулся шире чем ему надо: flex: 0 1 auto

- Если мой flex-элемент должен тянуться для заполнения всего доступного пространства, и немного сжиматься если места не хватает: flex: 1 1 auto

- Если мой элемент не должен менять размеры совсем: flex: 0 0 auto

Надеюсь, что ты пока не на максимальном изумлении — сейчас станет еще поразительнее.

Видишь ли, Бригада Flexbox'а (мне нравится думать, что команда flexbox'а носит кожаные куртки с этой надписью сзади — доступны мужские и женские размеры). Где там было это предложение? Ах да, Бригада Flexbox'а знала, что я хочу эти три комбинации свойств в большинстве случаев. Поэтому они дали им ключевые слова специально для меня.

Первый случай — это значение initial так что ключевое слово не нужно. Для второго случая используется flex: auto, и flex: none замечательно простое решение чтобы элемент не тянулся совсем.

Кто бы мог подуть! (Who woulda thunk it — игра слов, прим. переводчика)

Это как если бы было box-shadow: garish, что по умолчанию равнялось 2px 2px 4px hotpink потому что считалось «полезным значением по умолчанию».

Вернемся к невероятно уродливому книжному примеру. Чтобы сделать ту кнопку «Купить» постоянно толстой для нажатия пальцем...

… мне всего лишь надо задать на ней flex: none:

.book {

display: flex;

}

.book .description {

font-size: 30px;

min-width: 0;

word-wrap: break-word;

}

.book .buy {

margin-left: auto;

flex: none;

width: 80px;

text-align: center;

align-self: center;

}(Да, я мог бы указать flex: 0 0 80px; и сэкономить строку CSS. Но есть что-то особенное в том, как ясно flex: none демонстрирует намерение кода. Это хорошо для Будущего Дэвида который забудет как это все работает.)

4. Есть такая вещь inline-flex

По правде говоря, я узнал, что есть такая вещь как display: inline-flex несколько месяцев назад. И то, что она создаст инлайновый flex-контейнер, вместо блочного.

Но по моей оценке, 28% людей еще не знали этого, так что… теперь знайте, нижние 28%.

5. vertical-align не влияет на flex-элемент

Возможно это то, что я знал наполовину, но я уверен, что в какой-то момент, когда пытался задать правильное выравнивание, я мог испробовать vertical-align: middle и пожать плечами, когда это не сработало.

Теперь я знаю наверняка, прямо из спецификации, что "вертикальное выравнивание не влияет на flex-элемент" (так же как и float, замечу).

6. Не используй margin или padding в %

Это не просто уровня «лучшая практика», это уровня «совет-от-бабушки», так что просто делай что говорят и не задавай вопросов.

«Авторам следует полностью избегать использования процентов в padding'ах или margin'ах на flex-элементах» — с любовью, спецификация flexbox.

За этим следует моя самая любимая цитата из всех, когда-либо существовавших, спецификаций:

Заметка: это разночтение отстой, но оно в точности отражает текущее состояние мира (нет консенсуса среди реализаций, и нет консенсуса внутри CSSWG)...

Осторожно! Бомбардировка честностью продолжается.

7. Margin'ы соседних элементов не схлопываются

Возможно, ты уже знаешь, что margin'ы иногда объединяются вместе. Ты также можешь знать, что margin'ы не объединяются вместе в некоторых других случаях.

И теперь мы все знаем, что margin'ы соседних flex-элементов никогда не объединяются.

8. z-index работает даже если position: static

Я не уверен, что мне есть дело до этого. Но я чувствую, что в один день, может быть, это пригодится. Это в точности та же причина, по которой я держу бутылку лимонного сока в холодильнике.

Однажды в моем доме будет другой человек, который скажет типа «эй, у тебя есть лимонный сок?», а я типа «конечно, в холодильнике», а он «спасибо, приятель. Эй, а надо ли мне указывать position если я хочу задать z-index на flex-элементе?», и тут я такой «не братан, не для flex-элементов».

9. Flex-basis тонкое и важное свойство

Когда твои требования перерастут ключевые слова initial, auto и none, все станет немного сложнее, и теперь, когда я понял flex-basis, забавно, знаешь, я не могу придумать как закончить это предложение. Оставь комментарий, если у тебя есть идеи.

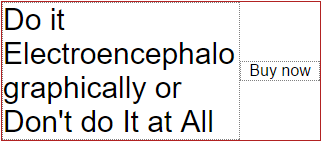

Если у тебя есть три flex-элемента с flex-значениями 3, 3, 4, тогда они гарантированно займут 30%, 30% и 40% доступного пространства, независимо от их содержимого, если их flex-basis равен 0. И только если он равен нулю.

Тем не менее, если ты хочешь чтобы flex вел себя в более дружественной, предсказуемой манере, используй flex-basis: auto. В этом случае flexbox примет твои flex-значения во внимание, но также учтет и другие факторы, подумает немного, и подберет ширины, подходящие по его мнению тебе.

Взгляни на эту четкую диаграмму из спецификации:

Я уверен, что это упомянуто по меньшей мере в одном из блог-постов про flex, которые я читал, но по какой-то причине, не проникся пока не увидел эту картинку в спецификации (schmick pick in the spec)(тройная рифма если ты из Новой Зеландии).

10. align-items: baseline

Когда я хотел выравнять flex-элементы по вертикали, я всегда использовал align-items: center. Но также как с vertical-align, у тебя есть возможность установить значение в baseline, что может быть более подходящим если у твоих элементов различный размер шрифта, а ты хочешь выравнять их базу.

Возможно очевидно, align-self: baseline тоже работает.

11. Я довольно глуп

Сколько бы раз я не читал следующий параграф, я остался неспособным его понять...

Размер содержимого — это минимальный размер содержимого на основной оси, зажатый, если он имеет соотношение сторон, с помощью любых определенных минимальных и максимальных свойств кросс-размера, преобразованных через соотношение сторон, а затем дополнительно зажатых с помощью свойства максимального основного размера, если это определено.

The content size is the min-content size in the main axis, clamped, if it has an aspect ratio, by any definite min and max cross size properties converted through the aspect ratio, and then further clamped by the max main size property if that is definite.

Слова проходят через мои отверстия, преобразуются в электрические импульсы, путешествующие по моему оптическому нерву, и прибывают как раз вовремя, чтобы увидеть как мой мозг выбегает через черный ход в клубе дыма.

Как будто Минни Маус и Мэд Макс завели ребенка семь лет назад, и теперь он, будучи пьяным с мятного шнапса, оскорбляет всех в пределах слышимости словами, которые он узнал когда Мамочка и Папочка ругались.

Леди и Джентльмены, мы начали наш спуск в чепуху, что значит пришло время подвести итоги (или перестань читать, если ты здесь для изучения нового).

Самое интересное из того, что я узнал, читая спецификацию, это то, насколько неполным было мое понимание, несмотря на полдюжины блог-постов которые я прочитал, и на то, насколько относительно простым является flexbox. Оказывается, что «опыт» — это не просто занятие одним и тем же из года в год.

С удовольствием могу отметить, что время, потраченное мной на чтение, уже окупилось. Я прошелся по старому коду, выставил авто margin'ы, flex-значения в краткой записи auto или none, и задал минимальную ширину в ноль там, где это было нужно.

Я лучше отношусь к этому коду теперь, зная что я делаю это должным образом.

Еще я узнал, что несмотря на то, что спецификация — местами — перенасыщена и предназначена для вендоров как я и думал, все же содержит много дружественных слов и примеров. В ней даже выделены части которые скромные веб-разработчики могут пропустить.

Однако это спорный вопрос, потому что я рассказал тебе про все хорошие отрывки, так что тебе не нужно утруждать себя ее чтением.

Теперь, если позволите, мне надо идти и прочитать все остальные CSS спецификации.

P.S. Я крайне рекомендую прочитать следующий список всех flexbox багов по браузерам:

github.com/philipwalton/flexbugs

От переводчика: это мой первый опыт перевода зарубежных публикаций, если есть замечания/предложения/ремарки по качеству перевода или по содержимому, пишите в комментариях.

Оригинальный пост здесь: hackernoon.com/11-things-i-learned-reading-the-flexbox-spec-5f0c799c776b

|

Метки: author Checkmatez разработка веб-сайтов браузеры html css flexbox layout specification |

Инвентаризация SCCM |

Передаю слово автору.

Здравствуйте коллеги. Каждый администратор, работающий с Microsoft System Center Configuration Manager (далее ConfigMgr), повседневно использует функционал инвентаризации (Inventory). Это базовый функционал, который собирает данные об управляемой среде и в дальнейшем это используется для построения коллекций, запросов, отчетов. При кажущейся легкости настройки и использования функционала инвентаризации, администраторы ConfigMgr сталкиваются с постоянными проблемами с достоверностью получаемых результатов. Задача статьи — дать полное понимание, как работает инвентаризация, как выявлять и как решать проблемы. По сути постараюсь максимально подробно рассмотреть «что есть под капотом».

Disclaimer

Прежде чем уйдём вглубь, необходимо обговорить маленький disclaimer. ConfigMgr работает как с Windows операционными системами, так и с Linux/Unix (используя nanoWbem), c мобильными системами. ConfigMgr изначально развивался как продукт по управлению Windows ОС, поэтому для полноценного технического охвата в статье будем рассматривать только клиентов, под управлением ОС Windows. Если есть интерес к пониманию, как работает инвентаризация для Linux/Unix — пишите в комментариях, подумаю над написанием статьи. Теперь перейдём к самому интересному.

Перейдём к инвентаризации

ConfigMgr имеет два разных типа инвентаризации — hardware inventory (в русскоязычной документации — инвентаризация оборудования) и software inventory (соответственно инвентаризация программного обеспечения). В статье я буду использовать англоязычные названия. Ключевой момент здесь то, что по сути «название не соответствует содержимому». И это причина одной из главных ошибок администраторов. По сути, hardware inventory — это WMI инвентаризация, а software inventory — файловая инвентаризация (сбор свойств файлов по заданной маске). Именно поэтому список установленного ПО ConfigMgr собирает через hardware inventory — эта информация находится в WMI классах (частично в дефолтовых, частично в ConfigMgr client WMI классах).

На практике более используемая и более критичная для успешного выполнения повседневных задач — hardware inventory. Поэтому в данной статье пристально рассматриваем именно её.

Для использования данного функционала необходимо, чтобы в настройках клиентов (client settings --> Hardware inventory) на стороне Primary site было значение «enable», настроено расписание, выбраны WMI классы, информацию из которых необходимо собрать (часть классов включены по умолчанию). Полное описание WMI классов есть на MSDN.

ConfigMgr использует файл Configuration.mof, расположенный в \inboxes\clifiles.src\hinv, в котором указывает используемые WMI provider, WMI классы. Когда клиент по расписанию обращается на сервер (к точке управления — management point), он скачивает политику, к которой прикреплен данный файл и компилит его локально. После этого, исходя из расписания, ConfigMgr client запускает процесс hardware inventory (далее по тексту hinv).

Здесь необходимо сделать маленькое отступление. ConfigMgr client состоит из движка (engine) и агентов, каждый из которых отвечает за определенный функционал. При этом, СonfigMgr клиент использует trigger codes (cписок можно посмотреть здесь) для запуска каких-либо действий со своими агентами. Для запуска hinv агента используется trigger code {00000000-0000-0000-0000-000000000001}.

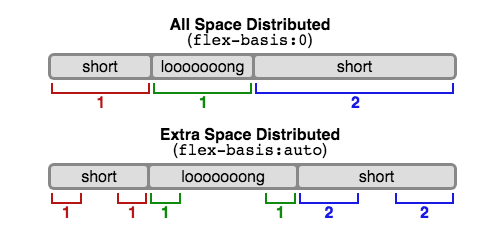

На клиенте будет происходит следующая последовательность действий:

1. Запуск hinv по расписанию. В inventoryagent.log будет следующая запись:

Inventory: Opening store for action {00000000-0000-0000-0000-000000000001}…

Inventory: Action=Hardware, ReportType=Delta, MajorVersion=1, MinorVersion=5

ReportType — тип отсылаемого на Primary site отчета (Delta или FULL). FULL — в отчёте будет вся информация, которая собрана (по умолчанию отправляется при первой инвентаризации). Delta — отчёт, который содержит лишь изменения со времени предыдущей hinv. Использование Delta report позволяет уменьшить размер пересылаемой по сети информации.

2. Сбор данных из WMI:

……

|

Метки: author Schvepsss it- инфраструктура блог компании microsoft microsoft инвентаризация configmgr system center configuration manager |

[recovery mode] Оценка качества алгоритмов распознавания лиц |

Мы, в компании NtechLab, занимаемся исследованиями и разработкой продуктов в области распознавания лиц. В процессе внедрения наших решений мы часто сталкиваемся с тем, что заказчики не очень ясно представляют себе требования к точности алгоритма, поэтому и тестирование того или иного решения для их задачи даётся с трудом. Чтобы исправить ситуацию, мы разработали краткое пособие, описывающее основные метрики и подходы к тестированию, которыми хотелось бы поделиться с сообществом Хабра.

В последнее время распознавание лиц вызывает все больше интереса со стороны коммерческого сектора и государства. Однако корректное измерение точности работы таких систем – задача непростая и содержит массу нюансов. К нам постоянно обращаются с запросами на тестирование нашей технологии и пилотными проектами на ее основе, и мы заметили, что часто возникают вопросы с терминологией и методами тестирования алгоритмов применительно к бизнес-задачам. В результате для решения задачи могут быть выбраны неподходящие инструменты, что приводит к финансовым потерям или недополученной прибыли. Мы решили опубликовать эту заметку, чтобы помочь людям освоиться в среде специализированных терминов и сырых данных, окружающих технологии распознавания лиц. Нам хотелось рассказать об основных понятиях в этой области простым и понятным языком. Надеемся, это позволит людям технического и предпринимательского склада говорить на одном языке, лучше понимать сценарии использования распознавания лиц в реальном мире и принимать решения, подтвержденные данными.

Задачи распознавания лиц

Распознаванием лиц часто называют набор различных задач, например, детектирование лица на фотографии или в видеопотоке, определение пола и возраста, поиск нужного человека среди множества изображений или проверка того, что на двух изображениях один и тот же человек. В этой статье мы остановимся на последних двух задачах и будем их называть, соответственно, идентификация и верификация. Для решения этих задач из изображений извлекаются специальные дескрипторы, или векторы признаков. В этом случае задача идентификации сводится к поиску ближайшего вектора признаков, а верификацию можно реализовать с помощью простого порога расстояний между векторами. Комбинируя эти два действия, можно идентифицировать человека среди набора изображений или принимать решение о том, что его нет среди этих изображений. Такая процедура называется open-set identification (идентификацией на открытом множестве), см. Рис.1.

Рис.1 Open-set identification

Для количественной оценки схожести лиц можно использовать расстояние в пространстве векторов признаков. Часто выбирают евклидово или косинусное расстояние, но существуют и другие, более сложные, подходы. Конкретная функция расстояния часто поставляется в составе продукта по распознаванию лиц. Идентификация и верификация возвращают разные результаты и, соответственно, разные метрики применяются для оценки их качества. Мы подробно рассмотрим метрики качества в последующих разделах. Помимо выбора адекватной метрики, для оценки точности алгоритма понадобится размеченный набор изображений (датасет).

Оценка точности

Датасеты

Почти всё современное ПО для распознавания лиц построено на машинном обучении. Алгоритмы обучаются на больших датасетах (наборах данных) с размеченными изображениями. И качество, и природа этих датасетов оказывают существенное влияние на точность. Чем лучше исходные данные, тем лучше алгоритм будет справляться с поставленной задачей.

Естественный способ проверить, что точность алгоритма распознавания лиц соответствует ожиданиям, это измерить точность на отдельном тестовом датасете. Очень важно правильно выбрать этот датасет. В идеальном случае организации стоит обзавестись собственным набором данных, максимально похожим на те изображения, с которыми система будет работать при эксплуатации. Обратите внимание на камеру, условия съемки, возраст, пол и национальность людей, которые попадут в тестовый датасет. Чем более похож тестовый датасет на реальные данные, тем более достоверными будут результаты тестирования. Поэтому часто имеет смысл потратить время и средства для сбора и разметки своего набора данных. Если же это, по какой-то причине, не представляется возможным, можно воспользоваться публичными датасетами, например, LFW и MegaFace. LFW содержит только 6000 пар изображений лиц и не подходит для многих реальных сценариев: в частности, на этом датасете невозможно измерить достаточно низкие уровни ошибок, как мы покажем далее. Датасет MegaFace содержит намного больше изображений и подходит для тестирования алгоритмов распознавания лиц на больших масштабах. Однако и обучающее, и тестовое множество изображений MegaFace’a есть в открытом доступе, поэтому использовать его для тестирования следует с осторожностью.

Альтернативный вариант заключается в использовании результатов тестирования третьим лицом. Такие тестирования проводятся квалифицированными специалистами на больших закрытых датасетах, и их результатам можно доверять. Одним из примеров может служить NIST Face Recognition Vendor Test Ongoing. Это тест, проводимый Национальным Институтом Стандартов и Технологий (NIST) при Министерстве торговли США. “Минус” данного подхода заключается в том, что датасет организации, проводящей тестирование, может существенно отличаться от интересующего сценария использования.

Переобучение

Как мы говорили, машинное обучение лежит в основе современного ПО для распознавания лиц. Одним из распространенных феноменов машинного обучения является т.н. переобучение. Проявляется он в том, что алгоритм показывает хорошие результаты на данных, которые использовались при обучении, но результаты на новых данных получаются значительно хуже.

Рассмотрим конкретный пример: представим себе клиента, который хочет установить пропускную систему с распознаванием лиц. Для этих целей он собирает набор фотографий людей, которым будет разрешен доступ, и обучает алгоритм отличать их от других людей. На испытаниях система показывает хорошие результаты и внедряется в эксплуатацию. Через некоторое время список людей с допуском решают расширить и обнаруживается, что система отказывает новым людям в доступе. Алгоритм тестировался на тех же данных, что и обучался, и никто не проводил измерения точности на новых фотографиях. Это, конечно, утрированный пример, но он позволяет понять проблему.

В некоторых случаях переобучение проявляется не так явно. Допустим, алгоритм обучался на изображениях людей, где превалировала определенная этническая группа. При применении такого алгоритма к лицам другой национальности его точность наверняка упадет. Излишне оптимистичная оценка точности работы алгоритма из-за неправильно проведенного тестирования – очень распространенная ошибка. Всегда следует тестировать алгоритм на новых данных, которые ему предстоит обрабатывать в реальном применении, а не на тех данных, на которых проводилось обучение.

Резюмируя вышесказанное, составим список рекомендаций: не используйте данные, на которых обучался алгоритм при тестировании, используйте специальный закрытый датасет для тестирования. Если это невозможно и вы собираетесь воспользоваться публичным датасетом, убедитесь, что вендор не использовал его в процессе обучения и/или настройки алгоритма. Изучите датасет перед тестированием, подумайте, насколько он близок к тем данным, которые будут поступать при эксплуатации системы.

Метрики

После выбора датасета, следует определиться с метрикой, которая будет использоваться для оценки результатов. В общем случае метрика – это функция, которая принимает на вход результаты работы алгоритма (идентификации или верификации), а на выходе возвращает число, которое соответствует качеству работы алгоритма на конкретном датасете. Использование одного числа для количественного сравнения разных алгоритмов или вендоров позволяет сжато представлять результаты тестирования и облегчает процесс принятия решений. В этом разделе мы рассмотрим метрики, наиболее часто применяемые в распознавании лиц, и обсудим их значение с точки зрения бизнеса.

Верификация

Верификацию лиц можно рассматривать как процесс принятия бинарного решения: “да” (два изображения принадлежат одному человеку), “нет” (на паре фотографий изображены разные люди). Прежде чем разбираться с метриками верификации, полезно понять, как мы можем классифицировать ошибки в подобных задачах. Учитывая, что есть 2 возможных ответа алгоритма и 2 варианта истинного положения вещей, всего возможно 4 исхода:

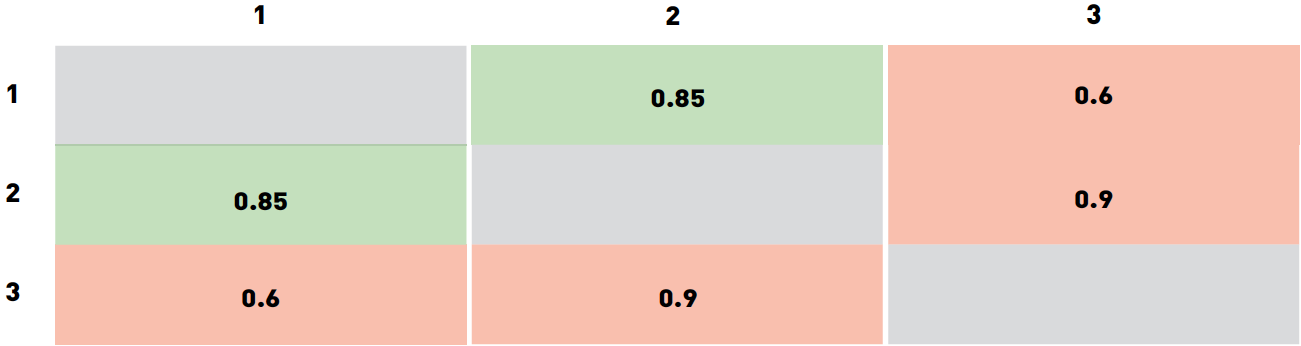

Рис. 2 Типы ошибок. Цвет фона кодирует истинное отношение между картинками (синий означает “принять”, желтый – “отвергнуть”), цвет рамки соответствует предсказанию алгоритма (синий – “принять”, желтый – “отвергнуть”

В таблице выше столбцы соответствуют решению алгоритма (синий – принять, желтый – отвергнуть), строки соответствуют истинным значениям (кодируются теми же цветами). Правильные ответы алгоритма отмечены зеленым фоном, ошибочные – красным.

Из этих исходов два соответствуют правильным ответам алгоритма, а два – ошибкам первого и второго рода соответственно. Ошибки первого рода называют «false accept», «false positive» или «false match» (неверно принято), а ошибки второго рода – «false reject», «false negative» или «false non-match» (неверно отвергнуто).

Просуммировав количество ошибок разного рода среди пар изображений в датасете и поделив их на количество пар, мы получим false accept rate (FAR) и false reject rate (FRR). В случае с системой контроля доступа «false positive» соответствует предоставлению доступа человеку, для которого этот доступ не предусмотрен, в то время как «false negative» означает, что система ошибочно отказала в доступе авторизованной персоне. Эти ошибки имеют разную стоимость с точки зрения бизнеса и поэтому рассматриваются отдельно. В примере с контролем доступа «false negative» приводит к тому, что сотруднику службы безопасности надо перепроверить пропуск сотрудника. Предоставление неавторизованного доступа потенциальному нарушителю (false positive) может привести к гораздо худшим последствиям.

Учитывая, что ошибки разного рода связаны с различными рисками, производители ПО для распознавания лиц зачастую дают возможность настроить алгоритм так, чтобы минимизировать один из типов ошибок. Для этого алгоритм возвращает не бинарное значение, а вещественное число, отражающее уверенность алгоритма в своем решении. В таком случае пользователь может самостоятельно выбрать порог и зафиксировать уровень ошибок на определенных значениях.

Для примера рассмотрим «игрушечный» датасет из трех изображений. Пусть изображения 1 и 2 принадлежат одному и тому же человеку, а изображение 3 кому-то еще. Допустим, что программа оценила свою уверенность для каждой из трех пар следующим образом:

Мы специально выбрали значения таким образом, чтобы ни один порог не классифицировал все три пары правильно. В частности, любой порог ниже 0.6 приведет к двум false accept (для пар 2-3 и 1-3). Разумеется, такой результат можно улучшить.

Выбор порога из диапазона от 0.6 до 0.85 приведет к тому, что пара 1-3 будет отвергнута, пара 1-2 по-прежнему будет приниматься, а 2-3 будет ложно приниматься. Если увеличить порог до 0.85-0.9, то пара 1-2 станет ложно отвергаться. Значения порога выше 0.9 приведут к двум true reject (пары 1-3 и 2-3) и одному false reject (1-2). Таким образом, лучшими вариантами выглядят пороги из диапазона 0.6-0.85 (один false accept 2-3) и порог выше 0.9 (приводит к false reject 1-2). Какое значение выбрать в качестве финального, зависит от стоимости ошибок разных типов. В этом примере порог варьируется в широких диапазонах, это связано, в первую очередь, с очень маленьких размеров датасетом и с тем, как мы выбрали значения уверенности алгоритма. Для больших, применяемых для реальных задач датасетов, получились бы существенно более точные значения порога. Зачастую вендоры ПО для распознавания лиц поставляют значения порога по умолчанию для разных FAR, которые вычисляются похожим образом на собственных датасетах вендора.

Также нетрудно заметить, что по мере того как интересующий FAR снижается, требуется все больше и больше положительных пар изображений, чтобы точно вычислить значение порога. Так, для FAR=0.001 нужно по меньшей мере 1000 пар, а для FAR= потребуется уже 1 миллион пар. Собрать и разметить такой датасет непросто, поэтому клиентам, заинтересованным в низких значениях FAR, имеет смысл обратить внимание на публичные бенчмарки, такие как NIST Face Recognition Vendor Test или MegaFace. К последнему следует относиться с осторожностью, так как и обучающая, и тестовая выборки доступны всем желающим, что может привести к излишне оптимистичной оценке точности (см. раздел «Переобучение»).

Типы ошибок различаются по связанной с ними стоимости, и у клиента есть способ смещать баланс в сторону тех или иных ошибок. Для этого надо рассмотреть широкий диапазон значений порога. Удобный способ визуализации точности алгоритма при разных значениях FAR заключается в построении ROC-кривых (англ. receiver operating characteristic, рабочая характеристика приёмника).

Давайте разберемся, как строятся и анализируются ROC-кривые. Уверенность алгоритма (а следовательно, и порог) принимают значения из фиксированного интервала. Другими словами, эти величины ограничены сверху и снизу. Предположим, что это интервал от 0 до 1. Теперь мы можем измерить количество ошибок, варьируя значение порога от 0 до 1 с небольшим шагом. Так, для каждого значения порога мы получим значения FAR и TAR (true accept rate). Далее мы будет рисовать каждую точку так, чтобы FAR соответствовал оси абсцисс, а TAR – оси ординат.

Рис.3 Пример ROC-кривой

Легко заметить, что первая точка будет иметь координаты 1,1. При пороге равном 0 мы принимаем все пары и не отвергаем ни одной. Аналогично, последняя точка будет 0,0: при пороге 1 мы не принимаем ни одной пары и отвергаем все пары. В остальных точках кривая обычно выпуклая. Также можно заметить, что наихудшая кривая лежит примерно на диагонали графика и соответствует случайному угадыванию исхода. С другой стороны, наилучшая возможная кривая образует треугольник с вершинами (0,0) (0,1) и (1,1). Но на датасетах разумного размера такое трудно встретить.

Рис.4 ROC-кривые NIST FRVT

Можно построить подобие RОС-кривых с различными метриками/ошибками на оси. Рассмотрим, например, рисунок 4. На нем видно, что организаторы NIST FRVT по оси Y нарисовали FRR (на рисунке – False non-match rate), а по оси X – FAR (на рисунке – False match rate). В данном конкретном случае лучшие результаты достигнуты кривыми, которые расположены ниже и смещены влево, что соответствует низким показателям FRR и FAR. Поэтому стоит обращать внимание на то, какие величины отложены по осям.

Такой график позволяет легко судить о точности алгоритма при заданном FAR: достаточно найти точку на кривой с координатой Х равной нужному FAR и соответствующее значение TAR. «Качество» ROC-кривой также можно оценить одним числом, для этого надо посчитать площадь под ней. При этом лучшее возможное значение будет 1, а значение 0.5 соответствует случайному угадыванию. Такое число называют ROC AUC (Area Under Curve). Однако следует заметить, что ROC AUC неявно предполагает, что ошибки первого и второго рода однозначны, что не всегда так. В случае если цена ошибок различается, следует обратить внимание на форму кривой и те области, где FAR соответствует бизнес-требованиям.

Идентификация

Второй популярной задачей распознавания лиц является идентификация, или поиск человека среди набора изображений. Результаты поиска сортируются по уверенности алгоритма, и наиболее вероятные совпадения попадают в начало списка. В зависимости от того, присутствует или нет искомый человек в поисковой базе, идентификацию разделяют на две подкатегории: closed-set идентификация (известно, что искомый человек есть в базе) и open-set идентификация (искомого человека может не быть в базе).

Точность (accuracy) является надежной и понятной метрикой для closed-set идентификации. По сути, точность измеряет количество раз, когда нужная персона была среди результатов поиска.

Как это работает на практике? Давайте разбираться. Начнем с формулировки бизнес-требований. Допустим, у нас есть веб-страница, которая может разместить десять результатов поиска. Нам нужно измерить количество раз, которое искомый человек попадает в первые десять ответов алгоритма. Такое число называется Top-N точностью (в данном конкретном случае N равно 10).

Для каждого испытания мы определяем изображение человека, которого будем искать, и галерею, в которой будем искать, так, чтобы галерея содержала хотя бы еще одно изображение этого человека. Мы просматриваем первые десять результатов работы алгоритма поиска и проверяем, есть ли среди них искомый человек. Чтобы получить точность, следует просуммировать все испытания, в которых искомый человек был в результатах поиска, и поделить на общее число испытаний.

Рис 5. Пример идентификации. В этом примере искомый человек появляется в позиции 2, поэтому точность Top-1 равна 0, а Top-2 и далее равна 1.

Open-set идентификация состоит из поиска людей, наиболее похожих на искомое изображение, и определения, является ли кто-то из них искомым человеком на основании уверенности алгоритма. Open-set идентификацию можно рассматривать как комбинацию closed-set идентификации и верификации, поэтому на этой задаче можно применять все те же метрики, что и в задаче верификации. Также нетрудно заметить, что open-set идентификацию можно свести к попарным сравнениям искомого изображения со всеми изображениями из галереи. На практике это не используется из соображений скорости вычислений. ПО для распознавания лиц часто поставляется с быстрыми алгоритмами поиска, которые могут находить среди миллионов лиц похожие за миллисекунды. Попарные сравнения заняли бы намного больше времени.

Практические примеры

В качестве иллюстрации давайте рассмотрим несколько распространенных ситуаций и подходов к тестированию алгоритмов распознавания лиц.

Розничный магазин

Допустим, что средний по размеру розничный магазин хочет улучшить свою программу лояльности или уменьшить количество краж. Забавно, но с точки зрения распознавания лиц это примерно одно и то же. Главная задача этого проекта заключается в том, чтобы как можно раньше идентифицировать постоянного покупателя или злоумышленника по изображению с камеры и передать эту информацию продавцу или сотруднику службы безопасности.

Пусть программа лояльности охватывает 100 клиентов. Данную задачу можно рассматривать как пример open-set идентификации. Оценив расходы, отдел маркетинга пришел в выводу, что приемлемый уровень ошибки – принимать одного посетителя за постоянного покупателя за день. Если в день магазин посещает 1000 посетителей, каждый из которых должен быть сверен со списком 100 постоянных клиентов, то необходимый FAR составит .

Определившись с допустимым уровнем ошибки, следует выбрать подходящий датасет для тестирования. Хорошим вариантом было бы разместить камеру в подходящем месте (вендоры могут помочь с конкретным устройством и расположением). Сопоставив транзакции держателей карт постоянного покупателя с изображениями с камеры и проведя ручную фильтрацию, сотрудники магазина могут собрать набор позитивных пар. Также имеет смысл собрать набор изображений случайных посетителей (по одному изображению на человека). Общее количество изображений должно примерно соответствовать количеству посетителей магазина в день. Объединив оба набора, можно получить датасет как «позитивных», так и «негативных» пар.

Для проверки желаемой точности должно хватить около тысячи «позитивных» пар. Комбинируя различных постоянных клиентов и случайных посетителей, можно собрать около 100 000 «негативных» пар.

Следующим шагом будет запустить (или попросить вендора запустить) ПО и получить уверенность алгоритма для каждой пары из датасета. Когда это будет сделано, можно построить ROC-кривую и удостовериться, что количество правильно идентифицированных постоянных клиентов при FAR=соответствует бизнес-требованиям.

E-Gate в аэропорту

Современные аэропорты обслуживают десятки миллионов пассажиров в год, а процедуру паспортного контроля ежедневно проходит около 300 000 человек. Автоматизация этого процесса позволит существенно сократить расходы. С другой стороны, пропустить нарушителя крайне нежелательно, и администрация аэропорта хочет минимизировать риск такого события. FAR= соответствует десяти нарушителям в год и кажется разумным в этой ситуации. Если при данном FAR, FRR составляет 0.1 (что соответствует результатам NtechLab на бенчмарке NIST visa images), то затраты на ручную проверку документов можно будет сократить в десять раз. Однако для того чтобы оценить точность при данном уровне FAR, понадобятся десятки миллионов изображений. Сбор такого большого датасета требует значительных средств и может потребовать дополнительного согласования обработки личных данных. В результате инвестиции в подобную систему могут окупаться чересчур долго. В таком случае имеет смысл обратиться к отчету о тестировании NIST Face Recognition Vendor Test, который содержит датасет с фотографиями с виз. Администрации аэропорта стоит выбирать вендора на основе тестирования на этом датасете, приняв во внимание пассажиропоток.

Таргетированная почтовая рассылка

До сих пор мы рассматривали примеры, в которых заказчик был заинтересован в низких FAR, однако это не всегда так. Представим себе оборудованный камерой рекламный стенд в крупном торговом центре. Торговый центр имеет собственную программу лояльности и хотел бы идентифицировать ее участников, остановившихся у стенда. Далее этим покупателям можно было бы рассылать таргетированные письма со скидками и интересными предложениями на основании того, что их заинтересовало на стенде.

Допустим, что эксплуатация такой системы обходится в 10 $, при этом около 1000 посетителей в день останавливаются у стенда. Отдел маркетинга оценил прибыль от каждого таргетированного email в 0.0105 $. Нам хотелось бы идентифицировать как можно больше постоянных покупателей и не слишком беспокоить остальных. Чтобы такая рассылка окупилась, точность должна быть равна затратам на стенд, поделенным на количество посетителей и ожидаемый доход от каждого письма. Для нашего примера точность равна . Администрация торгового центра могла бы собрать датасет способом, описанным в разделе «Розничный магазин», и измерить точность, как описано в разделе «Идентификация». На основании результатов тестирования можно принимать решение, получится ли извлечь ожидаемую выгоду с помощью системы распознавания лиц.

Поддержка видео

В этой заметке мы обсуждали преимущественно работу с изображениями и почти не касались потокового видео. Видео можно рассматривать как последовательность статичных изображений, поэтому метрики и подходы к тестированию точности на изображениях применимы и к видео. Стоит отметить, что обработка потокового видео гораздо более затратна с точки зрения производимых вычислений и накладывает дополнительные ограничения на все этапы распознавания лиц. При работе с видео следует проводить отдельное тестирование производительности, поэтому детали этого процесса не затрагиваются в настоящем тексте.

Частые ошибки

В этом разделе мы хотели бы перечислить распространенные проблемы и ошибки, которые встречаются при тестировании ПО для распознавания лиц, и дать рекомендации, как их избежать.

Тестирование на датасете недостаточного размера

Всегда следует быть аккуратным при выборе датасета для тестирования алгоритмов распознавания лиц. Одним из важнейших свойств датасета является его размер. Размер датасета нужно выбирать, исходя из требований бизнеса и значений FAR/TAR. «Игрушечные» датасеты из нескольких изображений людей из вашего офиса дадут возможность «поиграть» с алгоритмом, измерить его производительность или протестировать нестандартные ситуации, но на их основании нельзя делать выводы о точности алгоритма. Для тестирования точности следует использовать датасеты разумных размеров.

Тестирование при единственном значении порога

Иногда люди тестируют алгоритм распознавания лиц при одном фиксированном пороге (часто выбранном производителем «по умолчанию») и принимают во внимание лишь один тип ошибок. Это неправильно, так как значения порога «по умолчанию» у разных вендоров различаются или выбираются на основе различных значений FAR или TAR. При тестировании следует обращать внимание на оба типа ошибок.

Сравнение результатов на разных датасетах

Датасеты различаются по размерам, качеству и сложности, поэтому результаты работы алгоритмов на разных датасетах невозможно сравнивать. Можно запросто отказаться от лучшего решения только потому, что оно тестировалось на более сложном, чем у конкурента, датасете.

Делать выводы на основе тестирования на единственном датасете

Следует стараться проводить тестирование на нескольких наборах данных. При выборе единственного публичного датасета нельзя быть уверенным, что он не использовался при обучении или настройке алгоритма. В этом случае точность алгоритма будет переоценена. К счастью, вероятность этого события можно снизить, сравнив результаты на разных датасетах.

Выводы

В этой заметке мы описали основные составные части тестирования алгоритмов распознавания лиц: наборы данных, задачи, соответствующие метрики и распространенные сценарии.

Конечно, это далеко не всё, что хотелось бы рассказать о тестировании, и наилучший порядок действий может отличаться при многочисленных исключительных сценариях (команда NtechLab с радостью поможет с ними разобраться). Но мы очень надеемся, что этот текст поможет правильно спланировать тестирование алгоритма, оценить его сильные и слабые стороны и интерпретировать метрики качества с точки зрения бизнес-задач.

|

Метки: author dadalotta обработка изображений машинное обучение алгоритмы big data блог компании ntechlab распознавание лиц тестирование алгоритмов |

Git: много хуков полезных и разных |

Когда перед нами ставится задача при изменении кодбейса, например, в Github-репозитории выполнить пересборку/перезапуск какого-нибудь приложения на каком-то нашем окружении, то первое, что приходит на ум в качестве возможного триггера такой пересборки, это предоставляемый тем же гитхабом механизм веб-хуков: при наступлении какого-либо события с нашим удаленным репозиторием (т.к. появление нового коммита в какой-нибудь его отслеживаемой ветке) гитхаб задействует соответствующий веб-хук и «дернет» указанный в его настройках сервис, который и запустит процесс пересборки/перезапуска нашего приложения. Это стандартный широкоиспользуемый и простой механизм для таких случаев, все так делают, и все такое…

Но что, если наше приложение живет на хосте, доступ к которому по каким-то причинам гитхабу не положен? Например, хост находится в закрытой сети или за NAT'ом и недоступен из интернета?

В этом случае можно воспользоваться механизмом локальных хуков самого Git, о котором (механизме), как выясняется, мало кто знает даже из тех, кто использует Git уже довольно продолжительное время.

Когда мы создаем локальный репозиторий (инициализируем пустой, клонируем удаленный, ...), то в папке .git, что в его корне, или в самом корне, если это bare-репозиторий, присутствует папка hooks. После инициализации репозитория в этой папке сохраняются шаблоны хуков для различных событий, таких как, например: post-merge, post-receive, post-update и др.

Полное описание поддерживаемых событий для хуков можно найти, например, тут: git-scm.com/book/ru/v1/%D0%9D%D0%B0%D1%81%D1%82%D1%80%D0%BE%D0%B9%D0%BA%D0%B0-Git-%D0%9F%D0%B5%D1%80%D0%B5%D1%85%D0%B2%D0%B0%D1%82%D1%87%D0%B8%D0%BA%D0%B8-%D0%B2-Git

Мы воспользуемся этим механизмом и реализуем простенькую push-to-deploy схему для нашего горемычного приложения.

Нам понадобится два локальных репозитория. Создадим их, например, по указанным путям:

1. /opt/repo-dev/example-repo/

2. /opt/repo-remote.git/

Первый репозиторий — это клон нашего удаленного репозитория example-repo на гитхабе.

Второй — это bare репозиторий, копия первого, который будет служить нам исключительно для обработки события post-update при появлении обновлений в удаленном репозитории. Итак, как же мы это реализуем?

Схема очень проста (предположим, мы отслеживаем ветку test, а приложение наше это node.js, управляемый менеджером pm2):

1. Периодически обновляем первый локальный репозиторий до состояния, полностью соотвествующего состоянию удаленного репозитория.

2. Из первого локального репозитория обновляем второй.

3. Как только HEAD у нас переместился — появился новый коммит — во втором репозитории будет задействован хук post-update, который выполняется при появлении любых изменений в репозитории, и который и выполнит необходимые действия по ребилду и рестарту приложения.

Для этого мы делаем следующее:

1. В первом локальном репозитории добавляем remote — второй локальный репозиторий:

cd /opt/repo-dev/example-repo/ && git remote add prod /opt/repo-remote.gitТеперь мы можем выполнять git push из первого локального репозитория во второй.

2. В папке /opt/repo-remote.git/hooks/ создаем файл post-update и делаем его исполняемым:

touch /opt/repo-remote.git/hooks/post-update && chmod +x /opt/repo-remote.git/hooks/post-updateЭто обычный шел-скрипт, но согласно внутренней конвенции Git без расширения .sh!

Давайте добавим в него несколько команд:

#!/bin/bash

cd /opt/repo-remote.git

/usr/bin/git --work-tree=/opt/repo/example-repo/ checkout -f origin/test

cd /opt/repo/example-repo/

/usr/bin/npm install

/usr/local/bin/pm2 restart all

Что делает скрипт? Сначала просто выгружает working tree нашего bare репозитория в папку с нашим работающим приложением, а затем пересобирает зависимости и рестартует сервисы pm2. Как видите, никакой магии.

3. Настраиваем cron, который каждые n минут будет обновлять первый репозиторий из удаленного:

git fetch origin && git reset --hard -f origin/testТ.о. теперь наш хост будет являться регулярным инициатором проверки удаленного репозитория — а не появились ли там обновления?

Прошу заметить, что обновляем локальный репозиторий мы не путем git pull, а путем git reset --hard. Делается это для того, чтобы исключить необходимость мерджей при определенном содержимом очередного коммита — мы делаем локальный репозиторий полной копией удаленного.

4. Сразу после синхронизации первого локального репозитория с удаленным мы делаем пуш всех изменений в наш псевдо-удаленный второй локальный репозиторий:

git push prod testВот и все. Как только наш псевдо-удаленный локальный репозиторий получает ненулевые изменения, Git дергает свой хук post-update, который выполняет соответствующий скрипт. И мы получаем простенькую рабочую схему push-to-deploy, которую при желании можно и дальше усовершенствовать в соответствии с нашими потребностями.

«Зачем городить такую неудобоваримую монструозную схему?!» — спросите вы. Я сначала задавался этим же вопросом, но оказалось, что с существующим перечнем хуков Git'а только так мы сможем вызвать необходимую обработку при любом обновлении нашей ветки в удаленном репозитории. Нужный нам хук post-update предназначен для выполнения на remote репозитории (а часть хуков предназначена для выполнения на локальном репозитории). И мы таким вот не очень изящным способом это псевдо-удаленный репозиторий и сэмулировали. Возможно в скором времени появится еще какой-нибудь более удобный хук, выполняющийся локально, и схему можно будет упростить. Но пока так.

В заключение хочу дать несколько советов тем, кто решит это реализовать у себя и, столкнувшись с проблемами неработающего хука или каких-то его частей, будет яростно проклинать меня, Git, автора оригинальной статьи и всех остальных по списку:

1. Помните про специфику работы cron — программы в нем по умолчанию запускаются совсем не в том окружении, которое вы, вероятно, ожидаете.

2. Проверяйте версии ваших утилит (npm, node etc) при вызове их из скриптов и по cron — они могут быть не такими, как при ручном запуске из-за различия путей к исполняемым файлам в переменных окружения, например. А запуск других их версий может приводить к непрогнозируемым результатам.

3. Потратьте 20 минут на просмотр очередной серии Simpsons и возвращайтесь к экспериментам с новыми силами и хорошим настроением

Буду рад любым замечаниям и уточнениям по существу.

Хорошего всем дня!

|

Метки: author akrymets devops git continuous deployment continuous integration hooks |

Перспективы трудоустройства для Java-программистов |

Почему Java?

Портал TIOBE, ежемесячно составляющий рейтинг языков, основанный на запросах в популярных поисковиках, уже целый год не меняет лидера. И да, это Java. Информацию по нему разыскивают в среднем в 2 раза чаще, чем по C, в 4 раза чаще, чем по Python и в 6,5 раз чаще, чем по Swift. И дело не в том, что Java — сложный язык или по нему мало хорошей документации. За 22 года своего существования этот язык создал вокруг себя целую экосистему, которая развивается год от года, что усложняет поиск правильных образовательных источников и инструментов. Впрочем, это больше не проблема.

Java — невероятно развитый и востребованный язык программирования, что подтверждается практически безграничной областью применения. Можно загибать пальцы:

1. Мобильная разработка — самая популярная в мире ОС Android работает именно на Java. Не стоит забывать и о J2ME-приложениях для бюджетного сегмента;

2. Веб-приложения — сложно даже представить, какое количество мобильных версий веб-сайтов написано именно на Java;

3. Десктопное ПО — широчайший диапазон применения от игр (Minecraft) до офисных программ (Open Office). Для встраиваемых систем Java также подходит безупречно;

4. Финансовая область — такие гиганты, как Barclays, Citigroup, Goldman Sachs активно используют Java для внутренних электронных систем и в качестве инструмента для создания пользовательских приложений;

5. Большие данные — очень актуальное на сегодняшний день направление, связанное с обработкой, прогнозированием и моделированием информации.

Что говорят цифры?

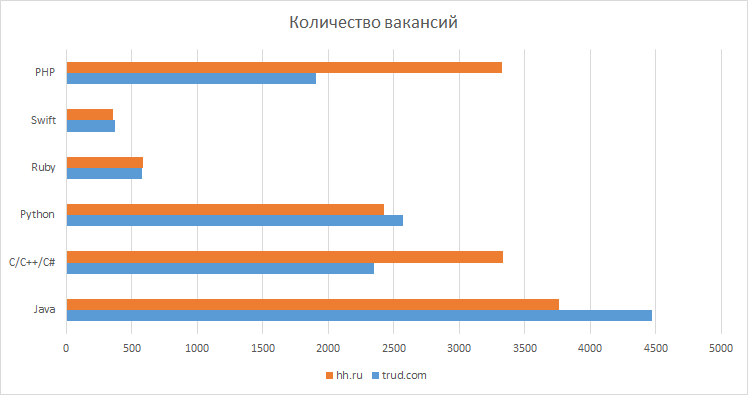

По информации портала trud.com в России Java-разработчиков требуется больше, чем C/C++/C# — разработчиков или, например, PHP-специалистов, не говоря уже о Python, Ruby или Swift. Аналогичную статистику можно найти на других HR-порталах, например, hh.ru.

Овладев языком Java и прилагающимся инструментарием, можно успешно начать карьеру и за пределами России, ведь потребность в профессиональных кадрах там не меньше, чем у нас в стране. Так, по информации портала Codingdojo, в 2017 году Java расположился на втором месте в списке самых востребованных языков, уступив лидерство лишь SQL. Как пишет издание, на сегодняшний день около 90% компаний из списка Fortune 500 (500 крупнейших компаний планеты) использует Java для разработки бэкенда в своих системах.

Справедливости ради, стоит всё же отметить, что потребность в JavaScript-программистах чуть выше, чем в Java-разработчиках. Однако и уровень зарплат там ниже, и спектр решаемых задач там куда уже.

Кстати о зарплатах. Угадайте, программисты со знаниями какого языка программирования имеют наибольшую среднюю заработную плату? И снова это Java. Вот цифры: Java-разработчик, окончивший ВУЗ по специальности или просто имеющий за плечами один год опыта, вполне может рассчитывать на 50-70 тысяч рублей зарплаты. Накопив опыт и знания, он уже претендует на оклад 70-100 тысяч рублей. Далее только по нарастающей: от 3 лет опыта — до 150 тысяч, от 5 лет — 200 тысяч, а тимлиды и сеньоры могут найти себе официальную зарплату от 200 до 300 тысяч рублей.

Если взглянуть на статистику по всей России, то ситуация изменится не сильно. По информации trud.com средняя заработная плата Java-разработчика составила 90 тысяч рублей. При этом важно учесть, что в данную статистику не входят тимлиды и руководители отделов.

Мировые тенденции в этом плане повторяют российские: так, по информации ресурса TechWorm, в 2016 году список самых “дорогих” и востребованных языков возглавил именно Java. Ведущий разработчик по данной специальности в США зарабатывает в среднем 115 тысяч долларов в год. Похожие цифры можно найти в Швейцарии, чуть ниже в Германии или Канаде. Сути это не меняет — программисты Java в любой стране живут хорошо.

Что насчёт конкуренции?

Она существует везде, где обитают большие деньги. Качественных Java-специалистов сейчас на рынке дефицит. Это косвенно подтверждает исследование CMS Magazine и «Рейтинга Рунета», в ходе которого 62% компаний, связанных с веб-разработкой, пожаловались на нехватку людей для выполнения поставленных задач. Как мы все понимаем, речь идёт не о верстальщиках и веб-дизайнерах.

Здесь мы подходим к главному вопросу: “Где получить качественное образование?”. Наша команда из otus.ru приложила максимум усилий, чтобы программа курса «Разработчик Java»

была полезна нашим студентам не просто с точки зрения новых знаний, но и с точки зрения соответствия требованиям компаний — работодателей на вакансии уровня middle и начала senior. Лучшим выпускникам мы гарантируем собеседование на вакантные позиции у наших партнеров — топовых IT компаний. Приходите к нам учиться и открывайте для себя новые карьерные перспективы, получая бесценные знания.

Кстати, новая группа Java начинает свое обучение уже в эту субботу!

|

Метки: author Dmitry21 программирование java блог компании отус otus otus.ru |

[Перевод] SQL101: Почему восстановление из резервной копии медленнее, чем ее создание |

Один из вопросов, который мне постоянно задают, это почему восстановление базы данных из полной резервной копии занимает больше времени, чем создание полной резервной копии. Ответ заключается в том, что почти всегда процесс восстановления требует выполнения большей работы.

Создание полной резервной копии включает в себя следующие главные стадии:

- Создание контрольной точки.

- Чтение всех используемых данных из файлов данных (технически, чтение всех размещенных экстентов, независимо от того, какое количество из 8 страниц в экстенте на самом деле используется).

- Чтение журнала транзакций с начала самой старой незафиксированной транзакции с начальной контрольной точки до момента, когда была завершена вторая стадия. Это необходимо, чтобы база данных могла быть восстановлена в согласованное состояние на момент времени, принадлежащий периоду создания резервной копии (посмотрите эту статью (английский) для подробного объяснения).

- (Опционально тестирование контрольных сумм всех страниц, опционально выполнение сжатия резервной копии и опционально шифрование резервной копии).

Восстановление из полной резервной копии включает в себя следующие главные стадии:

- Создание файлов данных (и заполнение их нулями, если не разрешена мгновенная инициализация файлов (английский, хорошая альтернатива на русском).

- Копирование данных из резервной копии в файлы данных.

- Создание файла журнала транзакций и заполнение его нулями. Файл журнала транзакций должен быть всегда заполнен нулями при создании (посмотрите эту статью (английский) для подробного объяснения).

- Копирование журнала транзакций из резервной копии в файл журнала.

- Запуск восстановления после сбоя на базе данных.

- (Опционально тестирование контрольных сумм всех страниц во время второй фазы, выполнение распаковки, если резервная копия была сжата, выполнение расшифровки, если резервная копия была зашифрована.)

Стадия 3 часто бывает самой долгой стадией при восстановлении, и она пропорциональна размеру журнала транзакций. Этот процесс выполняется в отдельной стадии, вместо того, чтобы выполняться параллельно с 1-2 стадией, и для глубокого изучения смотрите недавнюю запись в блоге Боба Варда.

Стадия 5 может быть самой долгой стадией в процессе восстановления, если в процессе создания резервной копии существовали долгие незафиксированные транзакции. И еще более долгой она может быть, если в журнале транзакций находится большое количество виртуальных файлов журнала (тысячи), поскольку они очень сильно замедляют механизм отката незафиксированных транзакций.

Здесь перечень вещей, которые вы можете сделать, чтобы сделать восстановление из полной резервной копии быстрее:

- Убедитесь, что мгновенная инициализация файлов включена для экземпляра SQL Server, который выполняет операцию восстановления, чтобы избежать траты времени на заполнение нулями любых файлов данных, которые должны быть созданы. Это может спасти часы времени простоя для очень больших файлов данных.

- Если возможно — восстанавливайте поверх существующей базы данных — не удаляйте существующие файлы. Это позволит избежать необходимости создания и потенциального заполнения нулями полного объема файлов, особенно файлов журнала транзакций. Будьте очень осторожны, используя этот пункт, поскольку существующая база данных будет безнадежно уничтожена, как только процесс восстановления начнет перезаписывать ее.

- Рассмотрите возможность использования сжатия резервных копий, это может ускорить операции и создания и восстановления из резервных копий, и сохранить дисковое пространство и затраты на место хранения.

- Рассмотрите возможность использования нескольких файлов резервных копий, каждый из них — на отдельном томе. SQL Server распознает такую ситуацию и будет использовать параллельную запись (по одному потоку на том) для записей файлов при создании резервной копии и при чтении в процессе восстановления — ускоряя все процессы. Если у вас есть несколько файлов базы данных, произойдет похожее распараллеливание процессов ввода/вывода — обеспечивая еще большее ускорение.

- Пытайтесь избегать долгих транзакций, так как они потребуют долгого времени в процессе отката.

- Управляйте вашим журналом транзакций так, чтобы избежать наличия избыточного количества виртуальных файлов журнала, чтобы при наличии транзакций, требующих отката, откат производился настолько быстро, насколько это возможно. Смотрите эту запись в блоге (английский) для подробного объяснения.

Надеюсь, это было полезно!

|

Метки: author minamoto microsoft sql server sql server администрирование баз данных резервные копии восстановление backup restore |

IT — проект со школьниками: несколько рекомендаций |