Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

День из жизни технической поддержки |

Итак, техническая поддержка – это специфическая работа, связанная с постоянным общением с клиентами. Как бы мы ни старались сделать программный код лучше, проблем всегда хватает. Они могут быть связаны и с очередным релизом, и с нетипичным сценарием использования софта, и с непредвиденными ситуациями в личной серверной клиента. В нашем случае все эти неприятности приходится решать команде саппортеров, в которой работает 10 человек – и их количество планируется увеличивать.

Ведущие специалисты техподдержки Virtuozzo Мария Антонова и Анна Винокурова

— Я уже давно работаю в технической поддержке, и мне очень нравится эта работа с точки зрения языкового самосовершенствования. Английский – язык международного общения, для многих наших клиентов он не является родным, и это не может не накладывать свой отпечаток на манеру их речи и восприятие того, что вы говорите в ответ. Для тех, кто любит общение и лингвистику в целом, но при этом видит себя в техническом профиле, мне кажется, работа в подобной среде – очень полезна для прокачки языкового скила и карьерного роста, — говорит Анна Винокурова.

Практика работы службы техподдержки Virtuozzo вывела для себя несколько правил, которых нужно придерживаться при общении с клиентами из различных регионов. В этом случае работать оказывается проще, а результаты достигаются быстрее. Вот некоторые из них:

• Клиентам из азиатского региона не стоит писать слишком длинные и подробные письма, из всего письма вероятнее всего будут прочитаны только первые пара абзацев.

• При устном общении с американскими клиентами необходимо несколько раз давать подтверждение того, что вас поняли правильно.

• Немцам и австрийцам можно выдавать достаточно комплексные инструкции, состоящие из множества пунктов, и они будут применять их в точности так, как было написано

Вообще специфика работы саппортеров – очень высокая степень спонтанности. Никогда не угадаешь, в какой момент что-то пойдёт не так и инженеры должны быть, как uоворится, «всегда наготове». Клиентам бывает нужна срочная помощь по разным причинам, но в основном любая срочность связана с обязательствами перед конечными пользователями – ведь большая часть клиентов Virtuozzo это хостеры, а неработающие виртуальные машины или контейнеры – это чьи-то недоступные сайты или базы данных.

Однако есть и предсказуемые волны нагрузки, они как правило связаны с релизами новых продуктов, выпуском мажорных апдейтов или же с обнаружением очередной уязвимости Linux.

— Когда в интернете публикуется очередной бюллетень безопасности (security advisory), в саппорт начинают приходить взволнованные клиенты, которые хотят узнать какие версии затронуты уязвимостью, и как скоро мы выпустим апдейт, — отмечает Анна Винокурова.

— Мне очень нравится работать в технической поддержке, потому что эта работа сочетает в себе задачи эксперта в сфере программного обеспечения, программиста и детектива. Иногда проблема оказывается настолько замаскирована, что ее решение — совершенно неочевидно. И каждый раз, когда удается разгадать загадку, «почему ничего не работает», приходит чувство глубокого удовлетворения и даже торжества! – говорит Мария Антонова.

Чем же занимается саппорт Virtuozzo?

Для тех, кто раздумывает, не пойти ли работать в саппортеры, мы расскажем несколько историй из реальной практики нашей техподдержки.

1. Память не добавляется – ошибка CPU

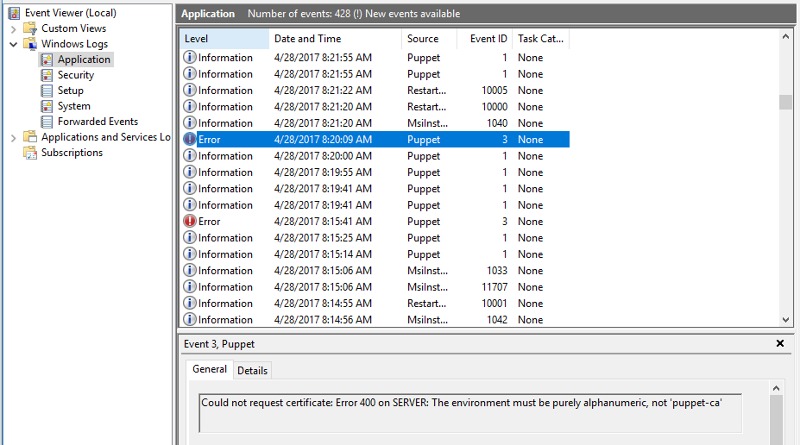

Однажды ночью клиент сообщает в поддержку об ошибке на попытке увеличить RAM для одной из виртуальных машин. Однако ошибка почему-то «ругается» на CPU, а не RAM.

Сначала такая ситуация всех очень удивила, но через некоторое время мы разобрались в том, что возвращаемая ошибка не имела прямого отношения к выполняемому действию – она лишь обнажала сбой, крывшийся намного глубже внутри системы.

Причина оказалась весьма серьезной: на физическом сервере «выбило» сокет CPU, и он перестал определяться, а вместе с ним все виртуальные ядра в пределах сокета ушли в offline. Естественно, при изменении лимитов памяти для виртуальной машины валидация будущей конфигурации не проходила просто в целом, ведь количество ядер стало превышать количество доступных ядер на узле сервера.

Дело в том, что в процессе валидации конфигурационного файла происходит обработка массивов NUMA, и CPU, которые им принадлежат. На физически «здоровом» сервере ни одна NUMA не должна быть пустой, и ситуация возникла потому, что раньше никто не предполагал, что поврежденный таким образом сервер вообще сможет работать продолжительное время.

Решение

На клиентском сервере было внесено исправление в python-составляющую продукта, которое позволило продолжать корректную работу, несмотря на существование узлов NUMA, состоящих целиком из offline-ядер. После этого мы смогли выставить количество CPU в пределах реальных “выживших” ядер для виртуальной машины, а значит – стали возможными дальнейшие изменения конфигурации.

Впрочем, последовали и более глобальные улучшения: в коде продукта на постоянной основе было улучшено определение статусов CPU: пустой массив с виртуальными CPU, принадлежащими одной группе NUMA больше не вызывает ошибок в коде и считается легальной ситуацией.

«На самом деле клиенту очень повезло, что его сервер оставался доступен достаточно длительное время, несмотря на такой серьезный аппаратный сбой. Это позволило мигрировать виртуальные машины на другие хосты, пока они всё ещё были доступны», — отметила Мария Антонова.

2. Пропадание сетевого подключения в виртуальных машинах

Клиент заметил периодическое пропадание доступа к сети в виртуальных машинах. Однако если такую виртуальную машину мигрировать на другой физический сервер или перезапустить на текущем, сеть снова работает.

Для исследования проблемы необходимо было получить виртуальную машину в момент воспроизведения проблемы, но сервисы внутри виртуальных машин должны были работать без перебоев, и наши исследования в режиме «онлайн» вызвали бы проблемы для большого количества конечных пользователей. Поэтому клиент предоставил нам копию виртуальной машины, на которой мы смогли воспроизвести проблему и исследовать её в нашей среде без неудобств для пользователей. Баг нашелся в механизме выделения памяти для сокет-буфера виртуального устройства virtio-net – часть модуля ядра.

Решение

Увы, быстрого решения проблемы, без изменения модулей ядра просто не было, оказалось, что клиент просто не обновился до последней версии Virtuozzo Linux. На момент обращения уже было выпущено обновление, причем в формате ReadyKernel. Это позволило применить обновление и решить проблему за несколько минут, даже не перезагружая сервисы.

3. Пользователь удалил все контейнеры

Один клиент решил напрямую сменить путь до приватной области контейнеров, но из-за ошибки в подготовленном им shell-скрипте, путь у всех контейнеров стал указывать в одно и то же место – общее хранилище всех контейнеров. Далее, как и следовало ожидать, один из конечных пользователей решил удалить свой собственный контейнер. Удаление привело к исчезновению всех контейнеров в хранилище – ведь обновленная конфигурация указывала на этот путь.

Решение

Чтобы предотвратить дальнейшую потерю данных, для конечных пользователей временно была отключена клиентская панель управления, чтобы они не могли остановить контейнеры, так как это привело бы к дальнейшей потере данных. С полностью удаленными контейнерами было ничего не сделать, поэтому задача сводилась к восстановлению метаданных для тех контейнеров, которые оставались запущенными.

Поскольку пострадавших контейнеров было около 400 штук, задача была достаточно творческой – нужно было написать скрипт, который делал бы схожие, но не однотипные манипуляции для всех пострадавших. Как показала более глубокая инспекция, для 200 контейнеров данные были потеряны полностью, так как контейнеры в этот момент находились в остановленном состоянии. Но для запущенных контейнеров удаление не прошло полностью, так как их виртуальные диски были заблокированы. В таких контейнерах были потеряны все данные, кроме самих виртуальных дисков – метаданные, конфигурационные файлы и другие сервисные файлы.

Физически файлы виртуальных дисков были перенесены во временную директорию для удаления файлов, и остановка такого контейнера привела бы к конечному удалению данных.

Так как метаданные варьируются от контейнера к контейнеру, их необходимо создавать с нуля индивидуально. Конфигурационные файлы восстанавливались на основании биллинговой информации и тарифных планов конечных пользователей — это клиент делал сам, так как у нашей службы поддержки нет доступа к биллинговой информации клиента. Но мы, в свою очередь, предоставили что-то вроде «скелета» конфигурации, в который нужно было внести IP, имя хоста, лимиты ресурсов. Для восстановления метаданных диска, саппортеры Virtuozzo создали скрипт, который генерировал корректные метаданные на основе информации о смонтированных контейнерах из ядра, а также вычислял виртуальные параметры дисков, такие как количество цилиндров, головок и секторов.

Кстати, после этого обращения в механизм удаления контейнера была включена проверка, является ли удаляемая директория контейнером – это позволит избежать подобных проблем в будущем, даже если пользователь запустит скрипт с ошибкой.

И детектив, и лингвист, и программист

Таким образом, мы можем уверенно сказать, что наша служба поддержки – это очень интересный коллектив, готовый решать многоплановые проблемы и даже заниматься доработкой продукта. И если вы хотите попробовать себя в такой работе, можете работать по ночам и не боитесь азиатского английского, у нас как раз могут открыться новые вакансии!

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

|

Метки: author Gummio_7 help desk software блог компании virtuozzo suport helpdesk работа техподдержка |

[recovery mode] Нерекурсивный алгоритм генерации всех разбиений целого числа |

Спасибо администрации Хабра за отзывчивость и молниеносную оперативность при восстановлении аккаунта!

Итак, плоды усилий долгих...

Нерекурсивный алгоритм генерации всех разбиений целого числа в лексикографическом

порядке, когда все элементы выстроены в порядке убывания, является альтернативным; в

Интернете представлено несколько способов порождения данных комбинаторных

объектов, однако, как это справедливо и относительно других комбинаторных алгоритмов,

реализации сводятся к двум типам — нерекурсивному и рекурсивному. Чаще можно встретить

реализации, которые не учитывают порядок вывода объектов или осуществляют

вывод по принципу дробления числа.

Приведенная ниже реализация работает по обратному

принципу: исходное число изначально разбито на единицы, алгоритм работает до тех пор,

пока число в нулевом индексе массива не станет равным сумме исходного числа.

Особенностью данного алгоритма является то, что он крайне прост для понимания, однако

это не лишает его некоторый специфики:

1) первый объект просто выводится на экран в

самом начале, таким образом, он вынесен за пределы циклов, фактически является

инициализирующим;

2) существует несколько способов реализации переноса единицы,

которые могут, как упростить код, так и сделать его более запутанным;

3) данная нерекурсивная реализация может служить наглядным примером для объяснения генерации комбинаторных объектов на нескольких процессорах, после незначительной модификации. Код на языке PHP приведен только для демонстрации корректности алгоритма и может содержать лишние языковые средства, которые добавляют реализации

избыточности.

Описание алгоритма

Дано: исходный массив в виде единиц — А (1,1,1,1).

Шаги

1) Двигаясь по массиву слева направо, искать в массиве А минимальный элемент — x,

последний элемент не учитывается.

2) Перенести единицу из конца (последнего элемента) в найденный минимальный элемент x

(равносильно увеличению x на единицу и уменьшению на единицу последнего элемента).

3) Если в массиве А есть ноль — 0, то удалить последний элемент.

4) Разложить сумму всех элементов после измененного элемента — x – на единицы.

Пример

А=(1,1,1,1,1)

2,1,1,1

2,2,1

3,1,1

Выводы

Хотел бы в конце поделиться одним наблюдением, я очень долго пытался понять, почему одни алгоритмы понятны сразу и легки для кодирования, а другие заставляют мучиться… и мучиться порой долго. Должен отметить, что этот алгоритм у меня получилось закодировать почти сразу, но только после того, как я получил однозначно понятное описание каждого шага. И тут есть важный момент, понять алгоритм и описать — задачи одна другой не легче. Однако, в алгоритмизации и составлении описания, особенно важным оказывается то, какими глаголами описываются действия в алгоритме — это (субъективно) в конечном счете может влиять и на конечную реализацию.

Литература

[1] Donald E. Knuth. The Art of Programming. Vol. 4. 2008.

[2] Dennis Ritchie and Brian Kernighan. The C Programming Language. 1978.

[3] Aleksandr Shen. Algorithms and Programming: Problems and Solutions.

[4] ru.wikipedia.org/wiki/Разбиение_числа

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

|

Метки: author dcc0 алгоритмы генерация разбиений числа |

Странности Generic типов Java |

Я множество раз слышал о том, что дизайн Generic типов в Java является неудачным. По большей части претензии сводятся к отсутствию поддержки примитивных типов (которую планируют добавить) и к стиранию типов, а конкретнее — невозможности получить фактический тип параметра в рантайме. Лично я не считаю стирание типов проблемой, как и дизайн Generic-ов плохим. Но есть моменты, которые меня порядком раздражают, но при этом не так часто упоминаются.

1

Например, мы знаем, что метод Class#getAnnotation параметризован и имеет следующую сигнатуру: public A getAnnotation(Class annotationClass). Значит, можно писать вот такой код:

Deprecated d = Object.class.getAnnotation(Deprecated.class);Тут я решаю вынести Object.class в отдельную переменную и код перестаёт компилироваться:

Class clazz = Object.class;

// incompatible types:

// java.lang.annotation.Annotation cannot be converted to java.lang.Deprecated

Deprecated d = clazz.getAnnotation(Deprecated.class);Где я ошибся?

Ошибся я в том, что не параметризовал тип переменной clazz.

Получается, что стирание у типа Class так же стирает типы во всех его методах! Зачем так было делать — понятия не имею. Вносим минимальное исправление в код и всё работает как надо.

Class clazz = Object.class;

Deprecated d = clazz.getAnnotation(Deprecated.class);2

Второй пример немного надуманный, но показательный. Представьте, есть у вас такой простой класс:

class Ref {

private T value = null;

public T getValue() {

return value;

}

public void setValue(T value) {

this.value = value;

}

} Имея переменную ref я решу написать такой код. Что с ним может произойти плохого?

ref.setValue(ref.getValue());Разумно было бы считать, что он всегда скомпилируется, но это не так! Вам всего лишь стоит объявить переменную ref с типом Ref h = new HasArrayList<>(new ArrayList<>());

ArrayList list = h.getList();

Параметр T класса HasArrayList имеет верхнюю границу равную ArrayList, а значит при стирании типов код всё ещё должен компилироваться.

HasArrayList h = new HasArrayList<>(new ArrayList<>());

// incompatible types: java.util.List cannot be converted to java.util.ArrayList

ArrayList list = h.getList();Ну вот, опять не работает. Сейчас то что не так?

Не так то, что в сигнатуре метода getList возвращаемым типом является List, а компилятору просто лень расставлять явные приведения типов. Исправляется всё очень просто — надо переопределить данный метод в подклассе.

class HasArrayList extends HasList {

public HasArrayList(T list) {

super(list);

}

@Override

public T getList() {

return super.getList();

}

} При этом компилятор сгенерирует синтетический bridge метод, возвращающий ArrayList, и именно он и будет вызван. Очевидно же...

Вообще, если у класса есть тип-параметр, то лучше в коде его не игнорировать, в крайнем случае можно указать

|

Метки: author ibessonov программирование java generic |

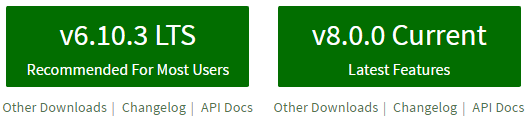

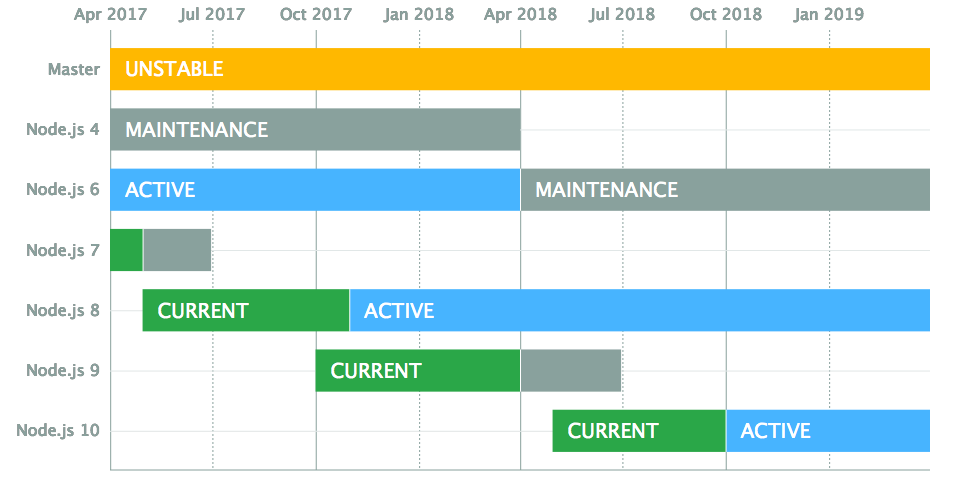

Обзор изменений в новом мажорном релизе Node 8 |

30 мая 2017 года в 23:00 по московскому времени вышел новый долгожданный мажорный релиз Node.js 8.0.0. Именно эта линейка версий за номером 8 в октябре 2017 перейдет в Long Term Support — цикл длительной поддержки. Предлагаю вашему вниманию небольшой обзор того огромного количества изменений и дополнений, вошедших в этот релиз.

- npm 5 (lock-файл!)

- V8 5.8

- Node.js API (N-API)

- async_hooks

- WHATWG URL парсер

- повышение безопасности буфера

- упрощенная промисификация

- статичные коды ошибок

- и многое другое!

Новая мажорная версия ознаменует собой начало новой ветки с циклом длительной поддержки. Уточню, что произойдет это в октябре 2017, вместе с присвоением кодового названия Carbon, и эта ветка будет поддерживаться до 31 декабря 2019 года. Также Node.js 6 перейдет в режим поддержки в апреле 2018 и окончит свою жизнь в апреле 2019 года.

npm 5.0.0

Новая версия Node поставляется в комплекте с новой версией менеджера пакетов npm. Очевидно, что значительное влияние на разработчиков npm оказал неожиданный конкурент: Yarn от Facebook'а.

Команда npm проделала большую работу по оптимизации, рефакторингу внутренних механизмов и исправлению ряда старых ошибок, связанных с архитектурой.

Вот неполный список изменений:

- ускоренная загрузка пакетов;

- стандартизированный lock-файл (package-lock.json), который в будущем может позволить разработчикам в одной команде использовать разные менеджеры пакетов, но при этом получать идентичные деревья зависимостей (подробнее про отличия с yarn-lock>);

- --save больше не требуется! Слышали в различных туториалах «введите в командной строке дэш-дэш-сейв»? Забудьте. При загрузке пакета он автоматически пропишется как зависимость в package.json, при этом опции --save-dev и --save-optional остались;

- обнаружение и поддержка имеющихся отступов в package.json, package-lock.json и npm-shrinkwrap.json;

- переписан внутренний механизм кеширования, повышена скорость и надежность.

V8 5.8

Новая версия JavaScript рантайм движка V8 содержит значительные улучшения в производительности и доступном API. Разработчики гарантируют, что эта версия будет содержать ABI (application binary interface) совместимый с грядущими версиями V8 — 5.9 и 6.0.

В 5.8 5.9 впервые включат по умолчанию оптимизирующий компилятор TurboFan и интерпретатор Ignition, которые правда были доступны и в предыдущем релизе. Это обещает нам меньшее потребление памяти, и значительную оптимизацию try/catch объявлений, генераторов и async функций. Эти же изменения попадут в следующий релиз Chrome 59.

Эти изменения оказались настолько значительными, что технический комитет Node.js (Core Technical Committee) принял решение перенести релиз 8.0.0, изначально планировавшийся в апреле, на май.

N-API

N-API — это API для разработки нативных аддонов, независимо от нижележащего JavaScript рантайма. Используемый ABI (application binary interface) будет оставаться стабильным на протяжении нескольких версий Node. Таким образом, модули скомпилированные для одной версии, будут выполняться и на более поздних версиях Node без перекомпиляции.

async_hooks

Этот экспериментальный модуль (ранее известный как async_wrap) предоставляет разработчикам возможность отслеживать исполнение событийного цикла Node.js. API позволяет зарегистрировать коллбэки, которые уведомляют потребителя о жизненном цикле асинхронных ресурсов внутри приложения, взаимодействующих с нижележащим C++ кодом. Такие асинхронные ресурсы отвечают, например, за TCP-сокеты, чтение из файла и т.д.

WHATWG URL парсер

Экспериментальный URL парсер, соответствующий стандарту WHATWG, был добавлен в 7 версии Node.js, а в 8-ой приставку «экспериментальный» официально отменили. Теперь реализация парсера в Node совпадает с таковой в современных браузерах, что позволяет код, связанный с URL, использовать как в серверном так и клиентском окружении.

Повышение безопасности буфера

До 8 версии Node.js буфер созданный с помощью конструктора Buffer(Number) не инициализировал выделяемую память нулями. В результате, инстансы буфера могли содержать чувствительную информацию. Эту уязвимость в новой версии устранили, при создании, буфер будет заполняться нулями. Поскольку это оказывает негативное влияние на производительность, для случаев где допустимо, разработчики предлагают использовать другой API — Buffer.allocUnsafe(), позволяющий создавать неинициализированный буфер.

Упрощенная промисификация

Промисификация — это обертка над асинхронным кодом, использующим коллбэки, возвращающая промис. Функция, выполняющая промисификацию, есть, например, у популярной библиотеки bluebird. Теперь в Node.js появился ее аналог для нативных промисов: util.promisify(). Вот пример ее использования:

const fs = require('fs');

const util = require('util');

const readfile = util.promisify(fs.readFile);

readfile('/some/file')

.then((data) => { /** ... **/ })

.catch((err) => { /** ... **/ });Статичные коды ошибок

Разработчики начали процесс присвоения статичных кодов всем ошибкам, генерируемых Node.js. Пока еще не все ошибки получили свой код. Преимущество кодов в том, что они гарантировано не изменяются даже если у ошибки поменяется тип или сообщение. Получить код ошибки можно двумя способами:

- используя новое свойство code у инстансов объекта Error

- при выводе трассировки стека ошибки, код будет в квадратных скобках, например: [ERR_ASSERTION]

Из мелких, но приятных бонусов: за флагом --harmony теперь можно использовать свойство rest у объектов:

let { x, y, ...z } = { x: 1, y: 2, a: 3, b: 4 }

console.log(x) // 1

console.log(y) // 2

console.log(z) // { a: 3, b: 4 }А также нативные методы (без --harmony) string.padStart() и string.padEnd(), ведь мы все помним и скорбим...

P.S. Ах да, и самое важное нововведение — при упоминании версий Node.js разработчики отказались от префикса «v»: v0.10, v0.12, v4, v6. Чтобы не было путаницы с движком V8, теперь официально звучит так: Node.js 8.

При подготовке статьи были использованы следующие ресурсы:

- nodejs.org/en/blog/release/v8.0.0

- blog.risingstack.com/important-features-fixes-node-js-version-8

- medium.com/@nodejs/node-js-8-big-improvements-for-the-debugging-and-native-module-ecosystem-58454861f2fc

|

Метки: author Checkmatez разработка веб-сайтов программирование высокая производительность node.js javascript v8 npm server-side release packet manager |

ТОП 100 англоязычных сайтов об IT |

Привет, Хабр!

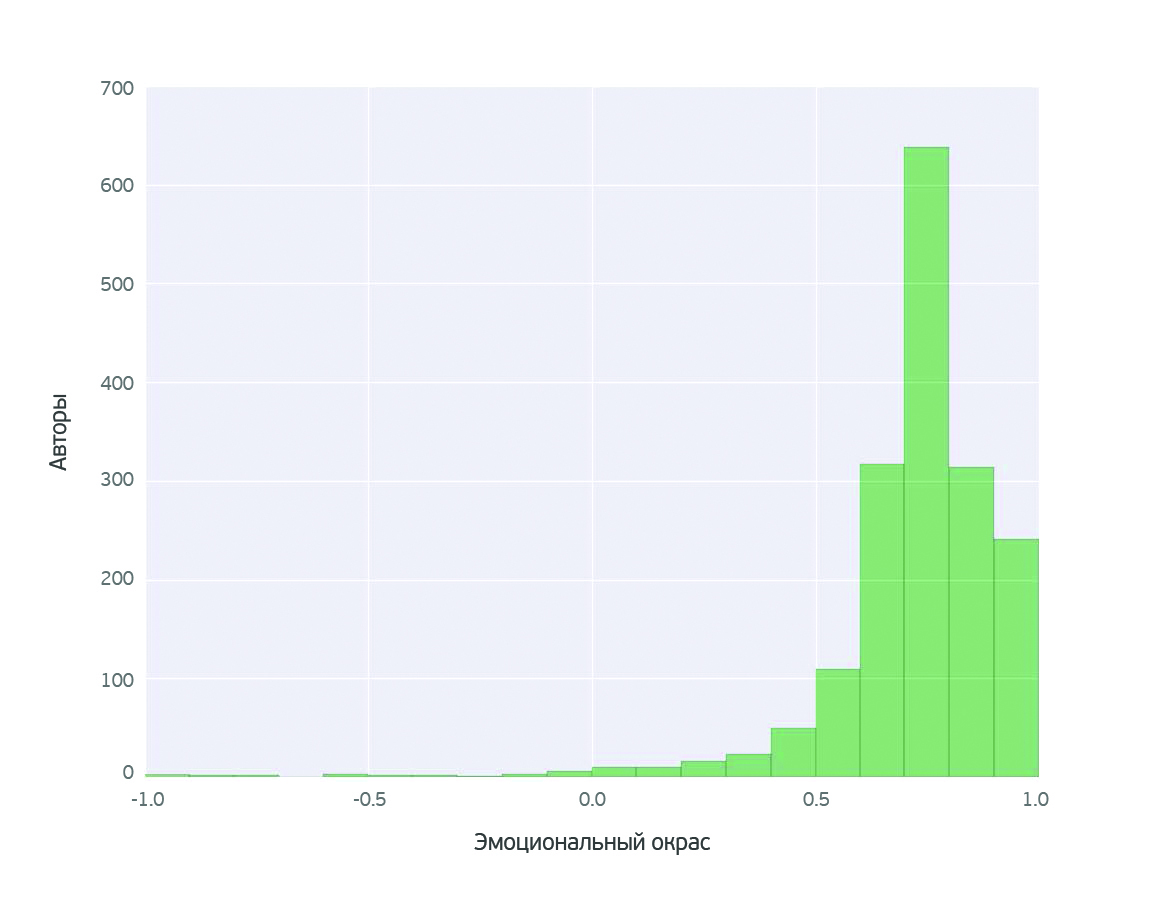

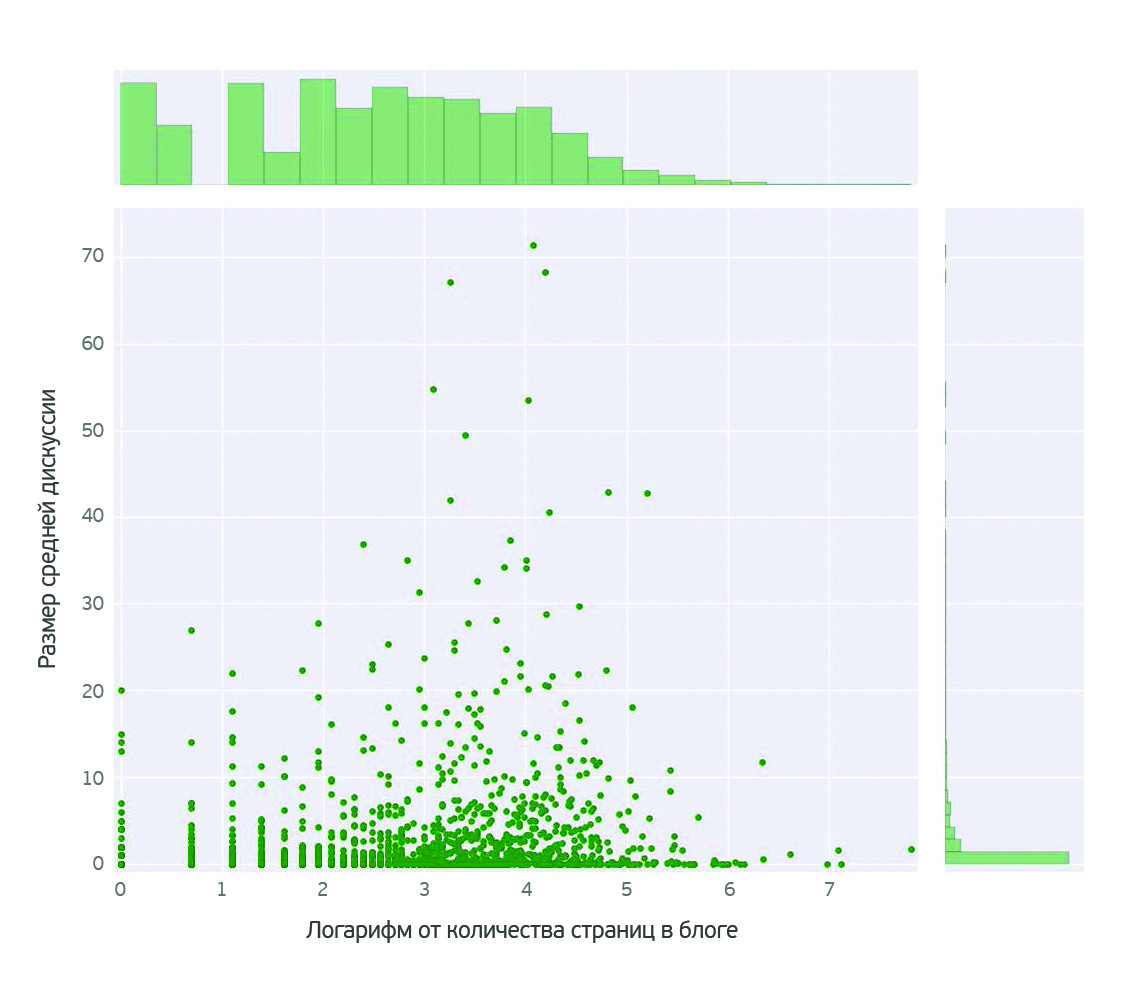

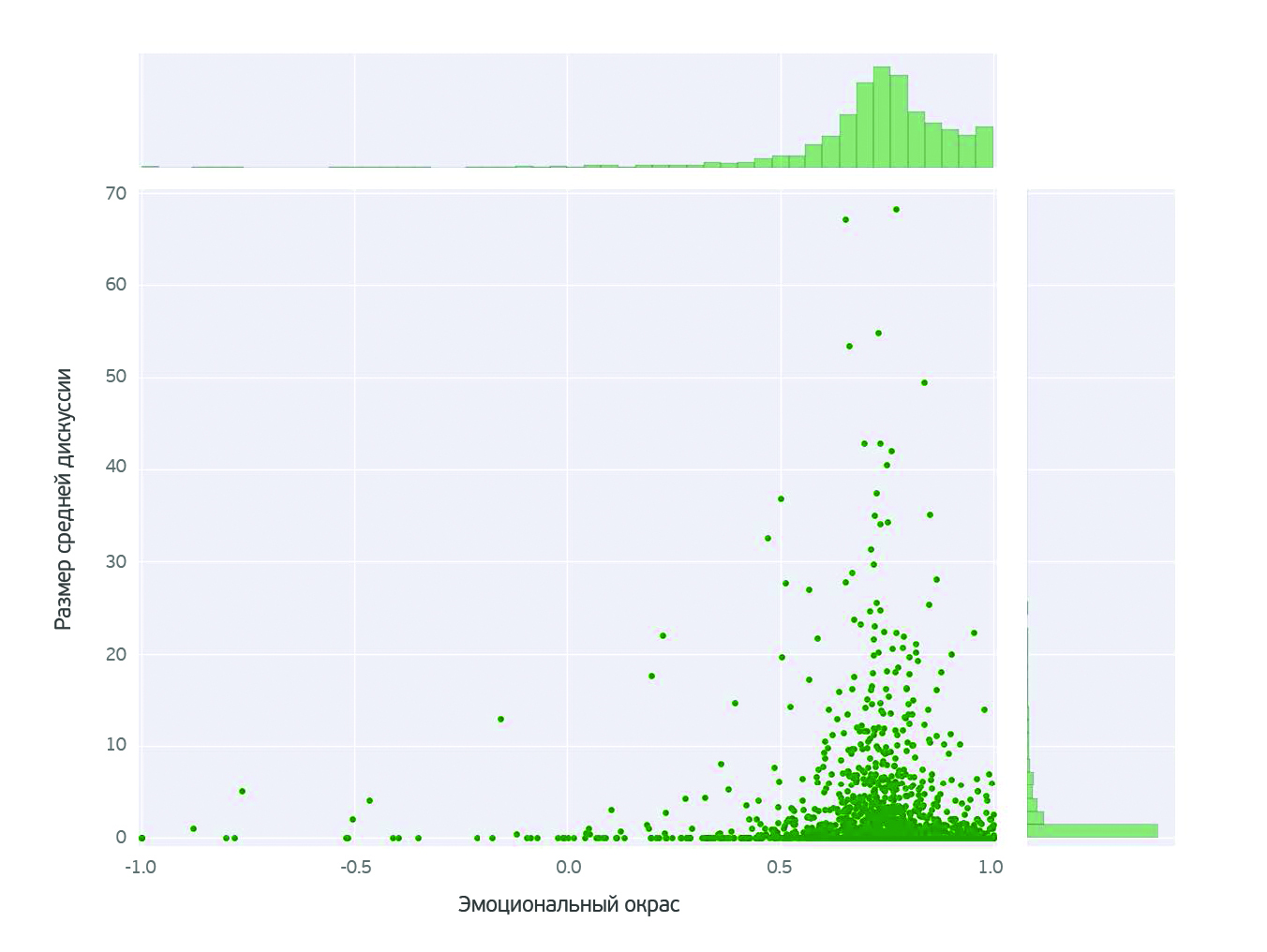

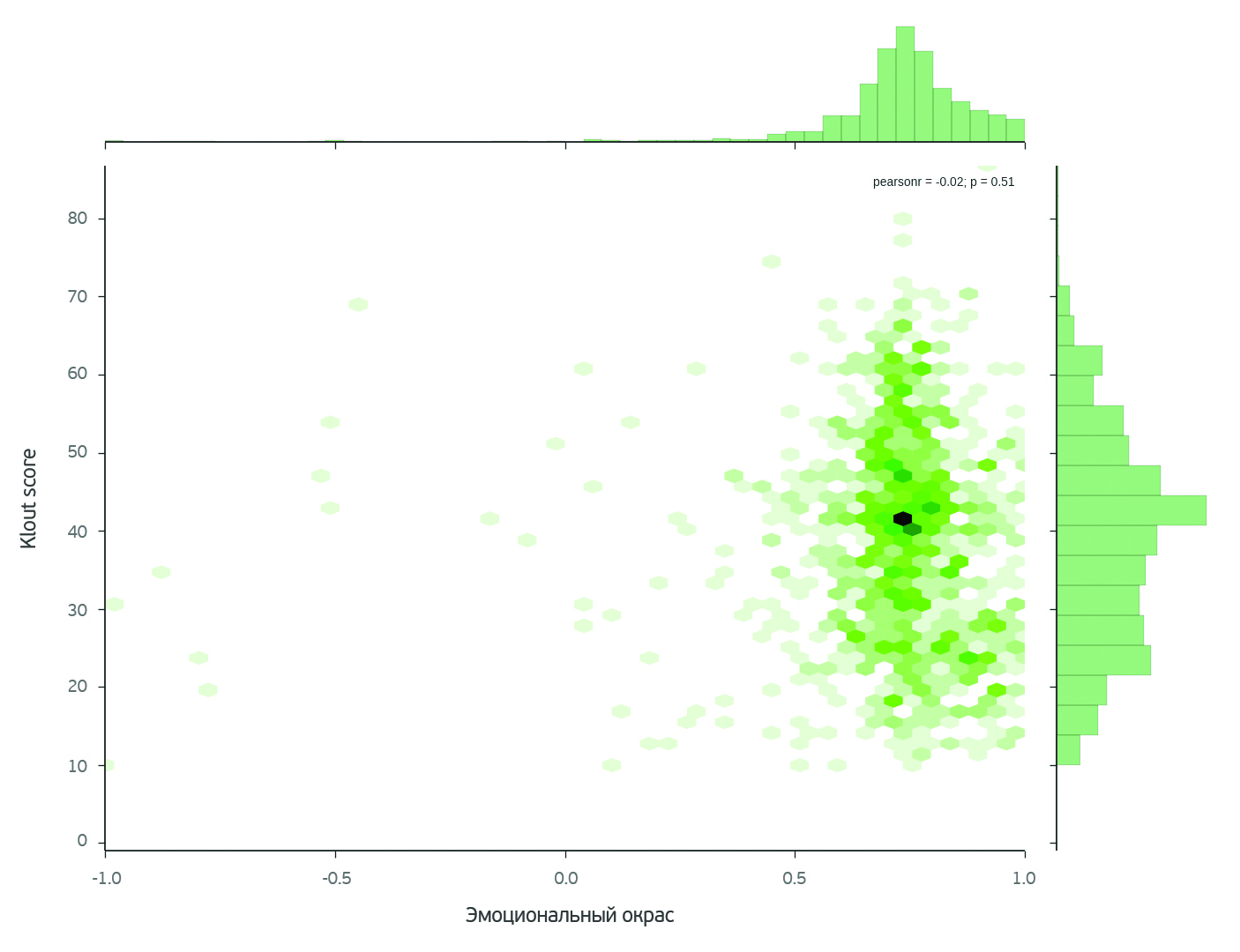

Чтение на английском может быть полезно как в изучении иностранного языка, так и в пополнении профессиональных знаний. Мы задались вопросом, какие новостные порталы, блоги и прочие Интернет-ресурсы на английском языке имеют четкую IT-направленность и наиболее интересны разработчикам, админам, тестировщикам, веб-дизайнерам и людям других технических специальностей в России?

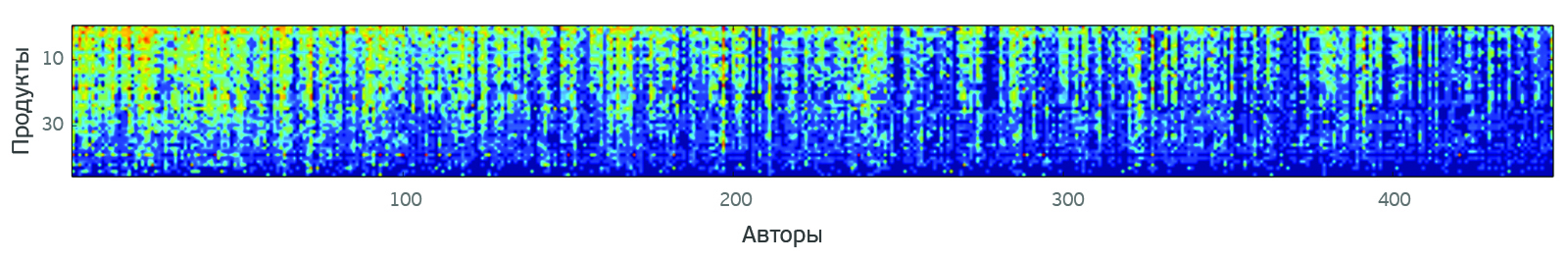

Чтобы создать ТОП полезных англоязычных IT-ресурсов, мы решили воспользоваться статистикой Хабрахабра. Наряду с авторскими публикациями, здесь публикуются и переводы интересных материалов. Такие посты отмечены тегом «Перевод» и содержат ссылку на оригинал.

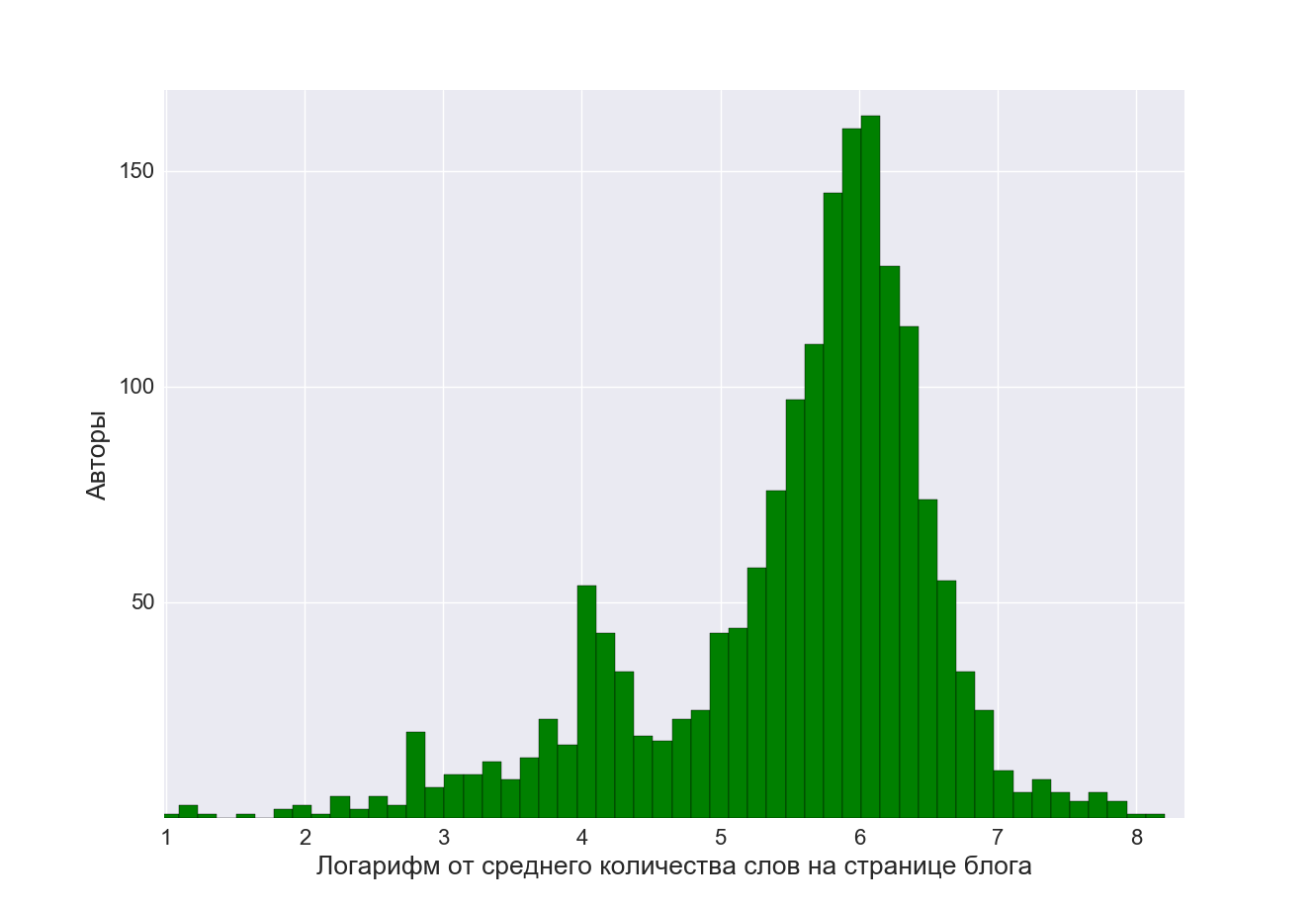

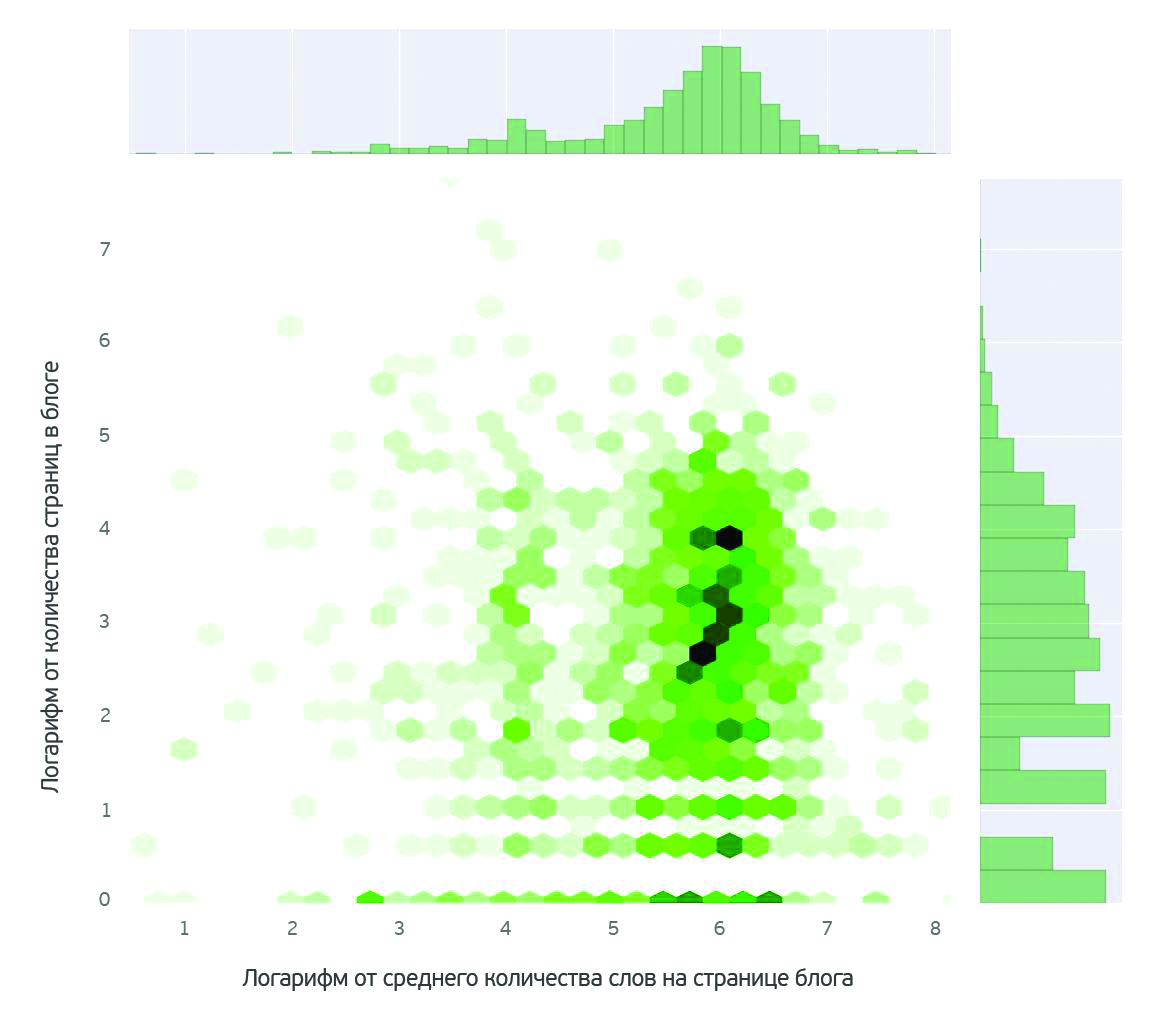

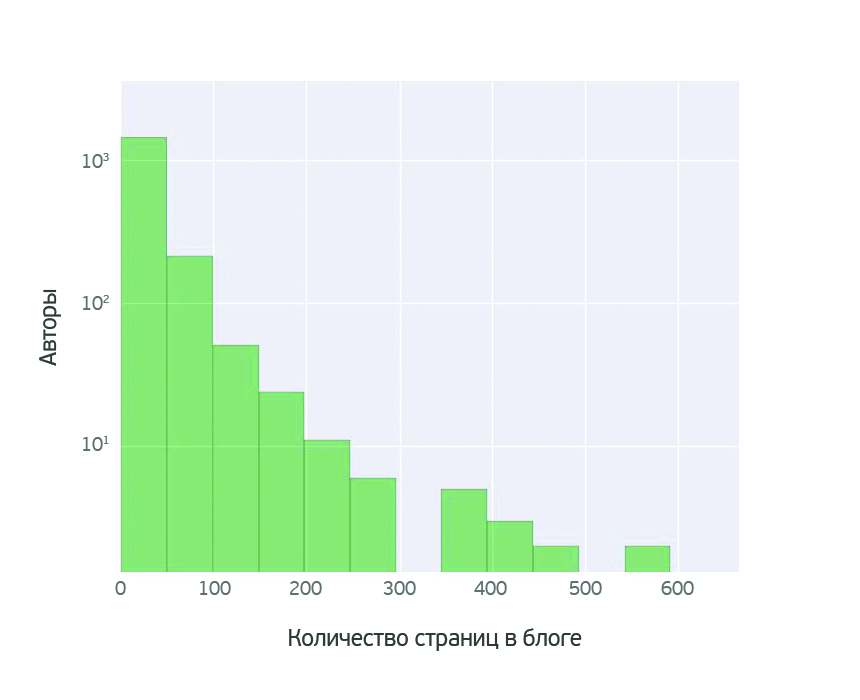

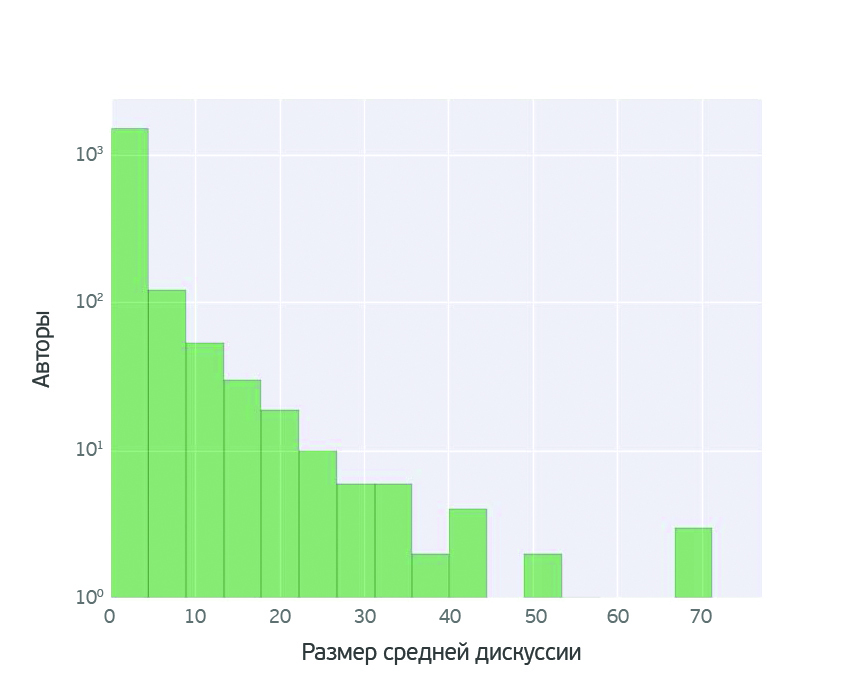

Всего за последние полгода на Хабре было около 1000 переводных статей. Мы посчитали для каждого источника переводов средний рейтинг публикации, среднее число просмотров и количество добавлений в Избранное. Затем были удалены сайты со средним рейтингом публикаций менее 16 и числом просмотров менее 4000. Полученные сайты мы отсортировали по числу переводов на Хабре из этого источника, так как, возможно, это характеризует ресурс как часто обновляемый и «объёмный».

Собрав и проанализировав таким образом данные о публикациях, мы получили наш ТОП100 компьютерных сайтов на английском, который мы надеемся будет полезен и вам.

Средние показатели для каждого IT-ресурса были помечены зеленым цветом, в случае если показатель выше среднего значения для любых переводов за полгода. Красным — если ниже среднего.

Qnty — количество переводов из источника

Rating — средний рейтинг перевода

Views — среднее число просмотров

Fav — среднее число добавлений в Избранное

Чтобы читателю было удобнее понять интересен ли для него ресурс, мы «спарсили» Title

medium.com

Qnty 83 | Rating 26 | Views 15700 | Fav 110

Title: Medium – Read, write and share stories that matter

www.gamasutra.com

Qnty 83 | Rating 25 | Views 11000 | Fav 70

Title: Gamasutra — The Art & Business of Making Games

medium.freecodecamp.com

Qnty 39 | Rating 24 | Views 23700 | Fav 180

Title: freeCodeCamp

hackernoon.com

Qnty 23 | Rating 51 | Views 33800 | Fav 220

Title: Hacker Noon — how hackers start their afternoons

www.youtube.com

Qnty 17 | Rating 28 | Views 15400 | Fav 80

Title: Donald Knuth (Scientist) on YouTube

geekflare.com

Qnty 15 | Rating 16 | Views 12000 | Fav 180

Title: Geek Flare — Web Infrastructure, Web Security & Web Tools.

github.com

Qnty 14 | Rating 32 | Views 25300 | Fav 290

Title: The world's leading software development platform

likegeeks.com

Qnty 12 | Rating 27 | Views 16300 | Fav 360

Title: Linux, Tutorials, Pentesting, Python and IOS — Like Geeks

blogs.msdn.microsoft.com

Qnty 10 | Rating 33 | Views 16100 | Fav 90

Title: MSDN Blogs — Get the latest information, insights, announcements, and news from Microsoft experts and developers in the MSDN blogs.

about.gitlab.com

Qnty 10 | Rating 23 | Views 10000 | Fav 70

Title: Code, test, and deploy together with GitLab open source git repo management software | GitLab

fabiensanglard.net

Qnty 7 | Rating 74 | Views 21100 | Fav 130

Title: Fabien Sanglard's website: Deep magic explained. Fabien Sanglard's chronicles of software wizardry. Fabien Sanglard's non-blog.

www.pymnts.com

Qnty 7 | Rating 16 | Views 6000 | Fav 20

Title: Payments News & Mobile Payments Trends, Consumer Payments News, Financial Technology News | PYMNTS.com

uxdesign.cc

Qnty 6 | Rating 44 | Views 19500 | Fav 160

Title: User Experience, Usability, Product Design. Follow the UX Bear.

www.smashingmagazine.com

Qnty 6 | Rating 32 | Views 19600 | Fav 230

Title: Smashing Magazine — For Professional Web Designers and Developers

docs.microsoft.com

Qnty 6 | Rating 23 | Views 7800 | Fav 80

Title: docs.microsoft.com | Microsoft Docs

blog.wolfram.com

Qnty 6 | Rating 21 | Views 10900 | Fav 70

Title: Wolfram Blog: News and Ideas from Wolfram Research

facebook.github.io

Qnty 5 | Rating 22 | Views 10600 | Fav 110

Title: Facebook code

blog.cleancoder.com

Qnty 4 | Rating 34 | Views 17800 | Fav 100

Title: Clean Coder Blog

learnopengl.com

Qnty 4 | Rating 28 | Views 17900 | Fav 160

Title: Learn OpenGL, extensive tutorial resource for learning Modern OpenGL

preshing.com

Qnty 4 | Rating 26 | Views 12500 | Fav 120

Title: Preshing on Programming — Jeff Preshing, Canadian computer programmer.

www.linux.com

Qnty 4 | Rating 26 | Views 32400 | Fav 200

Title: Linux.com | News for the open source professional

gamedevelopment.tutsplus.com

Qnty 4 | Rating 17 | Views 11600 | Fav 60

Title: How To Make and Design Computer Games by Envato Tuts+

bitsofco.de

Qnty 4 | Rating 17 | Views 11200 | Fav 100

Title: bitsofcode — Articles on Frontend Development. All articles are written by Ire Aderinokun, Frontend Developer and User Interface Designer.

eli.thegreenplace.net

Qnty 3 | Rating 54 | Views 7100 | Fav 80

Title: Eli Bendersky's website

dev.to

Qnty 3 | Rating 53 | Views 18900 | Fav 130

Title: dev.to() => The DEV Community

eng.uber.com

Qnty 3 | Rating 48 | Views 28200 | Fav 200

Title: Uber Engineering Blog

www.redblobgames.com

Qnty 3 | Rating 47 | Views 10100 | Fav 210

Title: Red Blob Games

gamedevelopment.tutsplus.com

Qnty 3 | Rating 43 | Views 12800 | Fav 200

Title: How To Make and Design Computer Games by Envato Tuts+

drawings.jvns.ca

Qnty 3 | Rating 42 | Views 20100 | Fav 270

Title: julia's drawings

m.signalvnoise.com

Qnty 3 | Rating 32 | Views 25600 | Fav 70

Title: Signal v. Noise — Strong opinions and shared thoughts on design, business, and tech. By the makers (and friends) of Basecamp. Since 1999.

martinfowler.com

Qnty 3 | Rating 24 | Views 10800 | Fav 80

Title: Martin Fowler — software delivery and consulting company

blog.revolutionanalytics.com

Qnty 3 | Rating 23 | Views 11200 | Fav 120

Title: Revolutions — Daily news about using open source R for big data analysis, predictive modeling, data science, and visualization since 2008

slack.engineering

Qnty 3 | Rating 22 | Views 8000 | Fav 90

Title: Several People Are Coding — The Slack Engineering Blog

www.percona.com

Qnty 3 | Rating 16 | Views 6100 | Fav 70

Title: Percona – The Database Performance Experts

blog.intercom.com

Qnty 3 | Rating 16 | Views 8800 | Fav 50

Title: Inside Intercom — Design, Customer Success, & Startup Blog

peteris.rocks

Qnty 2 | Rating 100 | Views 43600 | Fav 590

Title: Peteris Nikiforovs | peteris.rocks — Software Developer

www.yegor256.com

Qnty 2 | Rating 96 | Views 51900 | Fav 230

Title: Blog About Computers

jpauli.github.io

Qnty 2 | Rating 92 | Views 31100 | Fav 340

Title: Welcome to Julien Pauli's page

dzone.com

Qnty 2 | Rating 59 | Views 40200 | Fav 710

Title: Programming, Web Development, and DevOps news, tutorials and tools for beginners to experts. Hundreds of free publications, over 1M members, totally free.

80.lv

Qnty 2 | Rating 52 | Views 17700 | Fav 90

Title: 80 level is the best source of valuable information about the gaming industry and its recent trends.

blog.rust-lang.org

Qnty 2 | Rating 45 | Views 6300 | Fav 20

Title: The Rust Programming Language Blog

www.toptal.com

Qnty 2 | Rating 44 | Views 21500 | Fav 190

Title: Toptal — Hire Freelance Talent from the Top 3%

www.asimovinstitute.org

Qnty 2 | Rating 43 | Views 24900 | Fav 540

Title: The Asimov Institute — artificial intelligence research company that uses deep learning to develop tools for the creative industry – architects, graphic designers, fashion couturiers, marketeers and music producers.

blog.discordapp.com

Qnty 2 | Rating 42 | Views 18000 | Fav 120

Title: Discord Blog

gist.github.com

Qnty 2 | Rating 40 | Views 19400 | Fav 130

Title: Create a new Gist · GitHub

blog.acolyer.org

Qnty 2 | Rating 32 | Views 6700 | Fav 70

Title: an interesting/influential/important paper from the world of CS every weekday morning, as selected by Adrian Colyer

blog.codinghorror.com

Qnty 2 | Rating 32 | Views 43100 | Fav 160

Title: Coding Horror

blog.kovalevskyi.com

Qnty 2 | Rating 30 | Views 23000 | Fav 220

Title: TensorFlow in a nutshell

www.math.cornell.edu

Qnty 2 | Rating 26 | Views 7100 | Fav 60

Title: www.math.cornell.edu | Department of Mathematics

vsavkin.com

Qnty 2 | Rating 25 | Views 16200 | Fav 80

Title: Victor Savkin on Angular — In-depth articles about Angular by a core contributor and a co-founder of Nrwl.io.

www.johnzaccone.io

Qnty 2 | Rating 25 | Views 12800 | Fav 110

Title: Docker and other things

news.realm.io

Qnty 2 | Rating 24 | Views 7500 | Fav 110

Title: Realm: Create reactive mobile apps in a fraction of the time

foonathan.net

Qnty 2 | Rating 23 | Views 11000 | Fav 100

Title: foonathan::blog() — Thoughts from a C++ library developer

www.top500.org

Qnty 2 | Rating 21 | Views 10700 | Fav 30

Title: Home | TOP500 Supercomputer Sites

hintjens.com

Qnty 2 | Rating 20 | Views 6100 | Fav 80

Title: Large software systems and on-line communities, which he describes as "«Living Systems»"

www.bfilipek.com

Qnty 2 | Rating 20 | Views 7700 | Fav 70

Title: Bartek's coding blog

hpbn.co

Qnty 2 | Rating 18 | Views 8600 | Fav 200

Title: High Performance Browser Networking (O'Reilly)

kevinkuang.net

Qnty 2 | Rating 18 | Views 5100 | Fav 50

Title: Bioinformatics Playground

microsoft.github.io

Qnty 2 | Rating 17 | Views 4300 | Fav 10

Title: Microsoft on GitHub

androidworks-kea.blogspot.com

Qnty 2 | Rating 17 | Views 6300 | Fav 50

Title: Axiomworks — We create 3D live wallpapers for Android

paulgraham.com

Qnty 2 | Rating 16 | Views 7400 | Fav 40

Title: Paul Graham

seriot.ch

Qnty 1 | Rating 158 | Views 40700 | Fav 360

Title: seriot.ch — open-source software, such as an Objective-C Runtime Browser or the STTwitter library/

www.adriancourreges.com

Qnty 1 | Rating 144 | Views 25600 | Fav 170

Title: Projects — Adrian Courr`eges — French software engineer currently living and working in Tokyo.

mywiki.wooledge.org

Qnty 1 | Rating 139 | Views 44500 | Fav 710

Title: Greg's Wiki (also known as GreyCat's)

www.gwan.com

Qnty 1 | Rating 133 | Views 58000 | Fav 150

Title: G-WAN web server

fuzzyreflection.com

Qnty 1 | Rating 125 | Views 33000 | Fav 400

Title: Personal Space for Self-Reflection

corgibytes.com

Qnty 1 | Rating 124 | Views 69700 | Fav 310

Title: Corgibytes — Software Remodeling — Old Code. New Tricks | Corgibytes

jumpespjump.blogspot.ru

Qnty 1 | Rating 118 | Views 67000 | Fav 230

Title: Jump ESP, jump!

probablydance.com

Qnty 1 | Rating 116 | Views 27500 | Fav 270

Title: I can program and like games

donw.io

Qnty 1 | Rating 110 | Views 21500 | Fav 180

Title: Gazoo.vrv Don Williamson, Consultant Game Technology Programmer/Director of Celtoys

jazcash.com

Qnty 1 | Rating 101 | Views 26300 | Fav 250

Title: Jasper Cashmore — I write about web stuff

www-cs-students.stanford.edu

Qnty 1 | Rating 98 | Views 17200 | Fav 310

Title: Student Information

www.extentofthejam.com

Qnty 1 | Rating 90 | Views 21100 | Fav 210

Title: Extent of the Jam

3dgamedevblog.com

Qnty 1 | Rating 90 | Views 32500 | Fav 140

Title: 3dgamedevblog

labs.ig.com

Qnty 1 | Rating 89 | Views 26100 | Fav 80

Title: IG Labs | Trading APIs

codewords.recurse.com

Qnty 1 | Rating 88 | Views 86600 | Fav 820

Title: Code Words — A publication about programming from the Recurse Center

redditblog.com

Qnty 1 | Rating 83 | Views 16700 | Fav 90

Title: Upvoted — The official Reddit blog

www.brendangregg.com

Qnty 1 | Rating 81 | Views 26500 | Fav 220

Title: Brendan Gregg's Homepage — work on large scale cloud computing performance at Netflix

nothings.org

Qnty 1 | Rating 79 | Views 28300 | Fav 120

Title: the Nothing itself nothings

www.phpclasses.org

Qnty 1 | Rating 74 | Views 22300 | Fav 90

Title: PHP Class Scripts, Tutorials, Jobs, Professionals, Book reviews, User groups, Forums — PHP Classes

writing.kemitchell.com

Qnty 1 | Rating 73 | Views 33000 | Fav 370

Title: /dev/lawyer

www.joyent.com

Qnty 1 | Rating 73 | Views 34000 | Fav 300

Title: Joyent | Triton — THE NEXT GENERATION OF CLOUD

blog.daftcode.pl

Qnty 1 | Rating 73 | Views 26400 | Fav 120

Title: DaftCode Blog

jonibologna.com

Qnty 1 | Rating 72 | Views 28000 | Fav 490

Title: Joni Bologna’s Blog

devs.cloudimmunity.com

Qnty 1 | Rating 72 | Views 34800 | Fav 410

Title: Devs Security

vtorosyan.github.io

Qnty 1 | Rating 72 | Views 58500 | Fav 110

Title: Vardan Torosyan's Blog

mgba.io

Qnty 1 | Rating 72 | Views 10200 | Fav 50

Title: mGBA is a new generation of Game Boy Advance emulator.

herbertograca.com

Qnty 1 | Rating 71 | Views 46400 | Fav 440

Title: @herbertograca

sitr.us

Qnty 1 | Rating 69 | Views 18300 | Fav 90

Title: posts by Jesse Hallett

blog.elpassion.com

Qnty 1 | Rating 69 | Views 32000 | Fav 60

Title: EL Passion Blog

lukasa.co.uk

Qnty 1 | Rating 68 | Views 22100 | Fav 150

Title: LUKASA'S ECHOCHAMBER

blog.lemberg.co.uk

Qnty 1 | Rating 67 | Views 18700 | Fav 130

Title: Lemberg Solutions Blog | Mobile, Drupal, and All Tech …

www.aaronbell.com

Qnty 1 | Rating 67 | Views 12200 | Fav 60

Title: Funny and interesting words about humans and technology

engineering.instagram.com

Qnty 1 | Rating 66 | Views 25700 | Fav 130

Title: Instagram Engineering

charlesleifer.com

Qnty 1 | Rating 66 | Views 25000 | Fav 70

Title: blogging about Python and programming in general

basho.com

Qnty 1 | Rating 65 | Views 44200 | Fav 180

Title: Enterprise NoSQL Database | Scalable Database Solutions | Basho

sidbala.com

Qnty 1 | Rating 64 | Views 22100 | Fav 170

Title: Technology Polymath

blog.sourced.tech

Qnty 1 | Rating 63 | Views 14700 | Fav 180

Title: source{d} blog — Building the first AI that understands code

fvsch.com

Qnty 1 | Rating 62 | Views 26300 | Fav 290

Title: Florens Verschelde’s handcrafted website

artem.krylysov.com

Qnty 1 | Rating 62 | Views 10000 | Fav 170

Title: Welcome — Artem Krylysov — software engineer based in Philadelphia, PA, USA

У вас есть любимый IT-ресурс на английском? Расскажите о нём в комментариях.

|

|

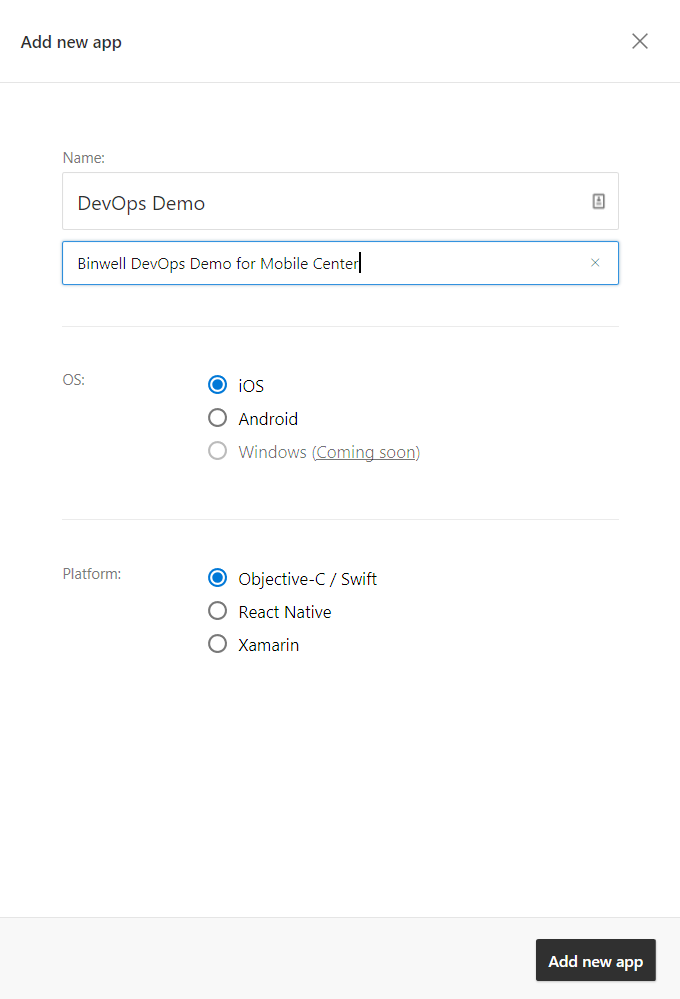

Деплоим мобильный софт с помощью devops-конвейера Microsoft |

В прошлой статье мы рассмотрели автоматизацию сборки мобильных приложений с помощью Bitrise, разобрались со сборкой Android- (и iOS-) приложения, подключили Xamarin Test Cloud, провели автоматическое UI-тестирование и внедрили HockeyApp для получения обратной связи. Сегодня мы продолжим погружение в мир инструментов Mobile DevOps, которые не просто ускоряют, но еще и заметно упрощают разработку мобильных приложений. На этот раз мы рассмотрим интегрированное решение Visual Studio Mobile Center.

Примечание: мы продолжаем серию публикаций полных версий статей из журнала Хакер. Орфография и пунктуация автора сохранены.

Начнем мы немного издалека и посмотрим на Mobile DevOps в историческом разрезе. Сами по себе смартфоны и планшеты вошли в нашу жизнь заметно быстрее, чем их шумные предки-пылесборники, и для многих людей на нашей планете уже давно стали основным способом подключения к цифровой реальности. Капитан Очевидность утверждает, что Mobile плотно войдет не только в жизнь обычных юзеров, но и в бизнес-процессы современных компаний по всему миру. Поэтому разработчику крутых приложений обязательно стоит присмотреться к практикам DevOps, чтобы не отстать от поезда.

Обзор Mobile Center

Корпорация Microsoft в недалеком прошлом упустила рынок мобильных экосистем, поэтому теперь всеми силами (и долларами) старается наверстать упущенное, предлагая разработчикам целую кучу различных SDK, сервисов и инструментов. Покупка Xamarin и HockeyApp позволила корпорации предложить рынку интегрированные инструменты для профессиональной разработки мобильных приложений вне зависимости от целевой платформы. Сам конвейер Visual Studio Mobile Center (далее VSMC) основан на уже знакомых нам сервисе аналитики и дистрибуции HockeyApp и облачной ферме устройств Xamarin Test Cloud.

Если рассматривать рынок инструментов разработки, то все идет к тому, что миром Mobile будут править Android + Java (или что там обещают вместо Java в будущем? Kotlin?), iOS + Swift, Xamarin и React Native. Все четыре стека уже поддерживаются из коробки в новом VSMC. А в будущем обещают добавить еще и Windows.

Mobile Center пока находится в стадии раннего Preview, поэтому возможности еще достаточно ограниченны и сам сервис не рекомендуется к использованию в production-окружении. Однако в VSMC уже доступны все основные элементы конвейера Mobile DevOps: сборка, тестирование, дистрибуция и аналитика (различные события и краши).

Приятное дополнение к VSMC — модули Tables и Identity, которые могут быть полезны, если ты планируешь использовать Azure в своих мобильных приложениях. Tables — это облачный MBaaS (mobile backend as a service), который позволит развернуть базу данных в облаке и в несколько строк кода получить к ней доступ из приложения. В Azure развернутся SQL Database и REST-сервер (на базе Azure App Services), настроенные для совместной работы и готовые к масштабированию и безотказному доступу. В реальных и больших проектах эта штука часто может быть излишней, однако для твоего стартапа или быстрого прототипа подойдет идеально. С помощью Identity можно будет легко авторизовать пользователей через Facebook, Google или Twitter. Авторизованные таким образом юзеры смогут получать доступ к данным из Tables, помеченным как требующие авторизации. И Tables, и Identity предоставляют базовую функциональность, которой может быть достаточно для небольших или простых проектов. Пара строк кода — и все работает.

Но сам по себе Mobile Center — это в первую очередь конвейер DevOps, поэтому перейдем к рассмотрению ключевой функциональности.

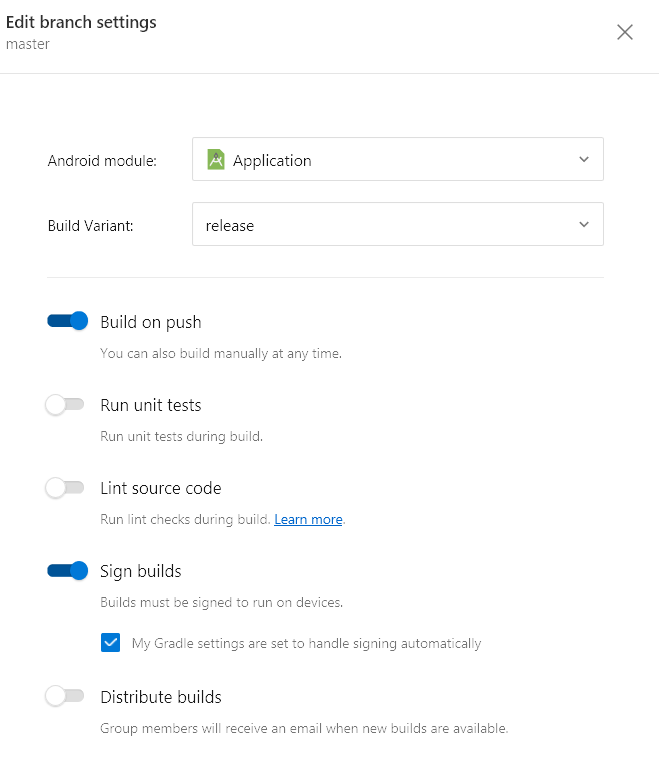

Билдим

Итак, у нас есть исходные коды проекта Navigation Drawer из набора стандартных примеров Android на Java. Заливаем их на GitHub (поддержка других сервисов будет добавлена в VSMC позже), создаем бесплатную учетку на mobile.azure.com и добавляем новое приложение.

Переходим в раздел Build, подключаем репозиторий GitHub и выбираем основной branch. После сборки мы можем скачать полученные APK и подробные логи. Все как у людей и без излишеств.

Из дополнительных опций сборки можно отметить возможность запуска Unit-тестов и автоматического уведомления бета-тестировщиков о готовности установочного пакета.

В будущем также обещают добавить поддержку репозиториев Bitbucket и Visual Studio Team Services. Для автоматических UI-тестов, правда, пока придется заливать сборку руками из консоли, о чем мы и поговорим далее.

Альтернатива VSMC на данном этапе

Если тебя интересует отдельная система для сборки проектов, то настоятельно рекомендуем познакомиться с Bitrise.io, о котором мы рассказывали.

Гоняем тесты

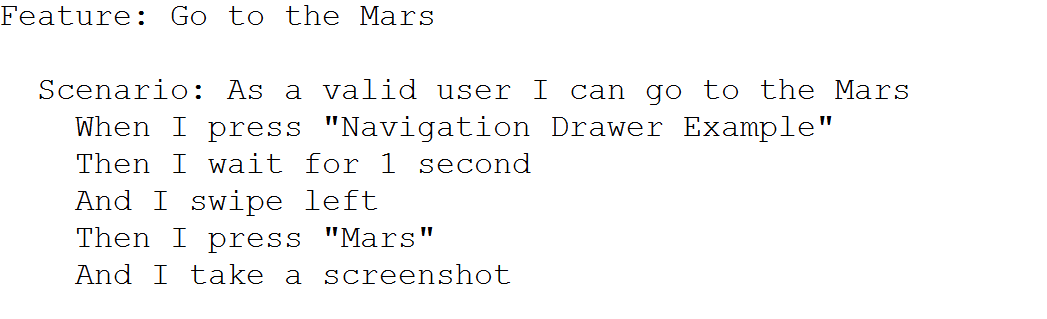

Как мы уже знаем, в VSMC интегрирован сервис Xamarin Test Cloud. Для нашего примера мы будем использовать написанный раньше скрипт на Calabash.

Для начала нам необходимо установить Node.js и Ruby плюс ряд дополнительных gems. Выдумывать ничего не придется, просто следуй инструкциям в Mobile Center. Перед тем как отправить приложение на тестирование, его нужно собрать командой calabash-android build [путь до apk].apk в консоли. Результатом работы этой команды должна быть папка test_servers, содержащая корректно подписанный APK-файл. После сборки потребуется выполнить команду mobile-center test run. Через несколько минут мы увидим результаты тестирования и получим email-уведомление о завершении тестов.

Кстати, свои фермы для автоматизированного UI-тестирования приложений также представили Amazon и Google.

Отличий от оригинального Xamarin Test Cloud здесь немного: есть пошаговые скриншоты и мониторинг потребления ресурсов. Устройств много, но в VSMC Preview пока есть ограничение на количество одновременных запусков (одно устройство за один раз) и выделенного времени (до одного часа в день).

Альтернативы VSMC на данном этапе

Если ты ищешь отдельную облачную ферму устройств для автоматизированного UI-тестирования, то могу посоветовать посмотреть в сторону AWS Device Farm, Xamarin Test Cloud, Google Firebase Test Lab.

Анализируем и распространяем

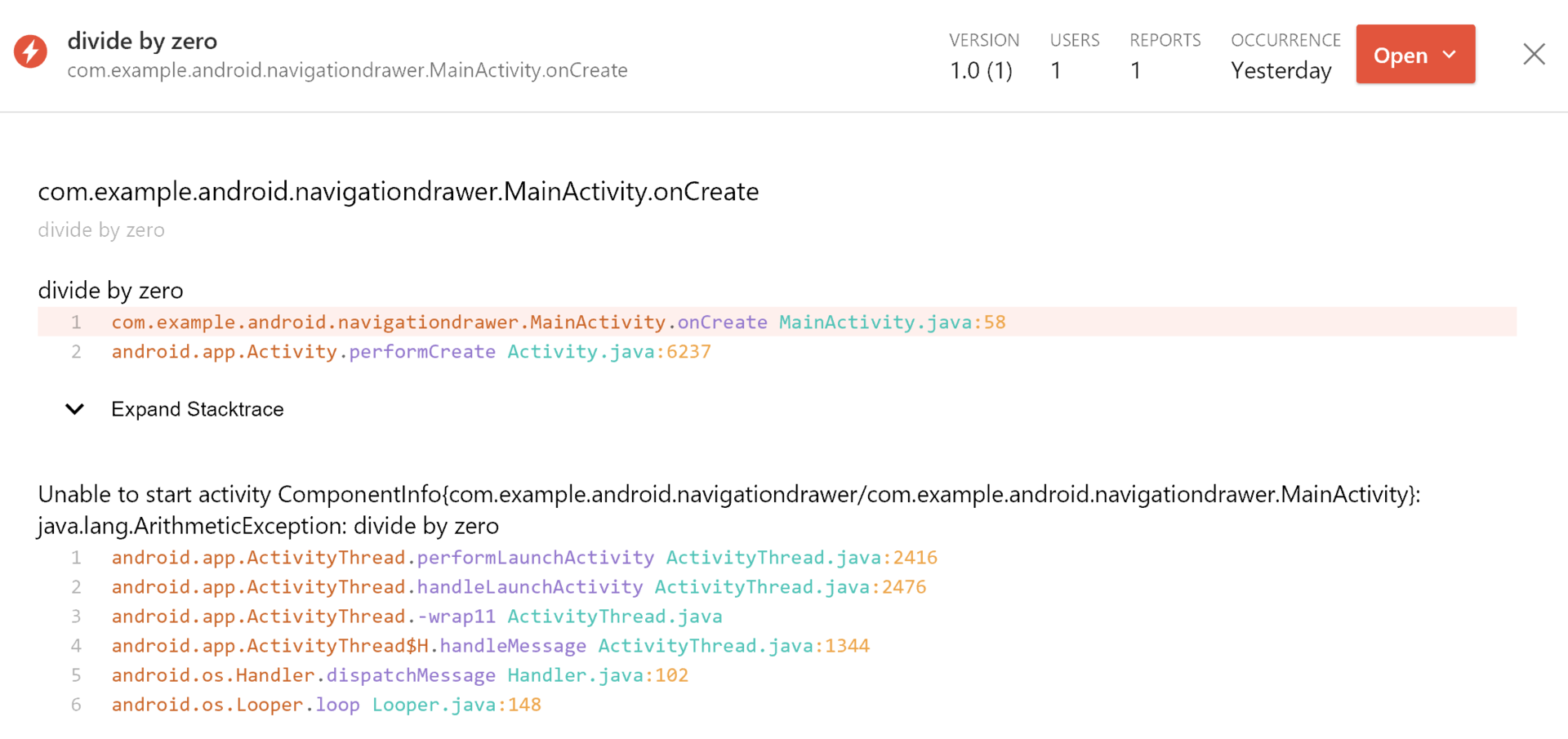

В качестве подсистемы для сборки крашей и событий внутри VSMC используется сервис HockeyApp. Для интеграции SDK достаточно добавить новые зависимости к проекту и зарегистрировать обработчик крашей.

Сами краши можно смотреть в stack trace, а события — в статистике.

Альтернативы VSMC на данном этапе

Для более детального анализа поведения пользователей все-таки лучше использовать «Яндекс.Метрику», Google Analytics или Flurry, так как маркетологи предпочитают для своей работы эти сервисы.

Выводы

Итак, сегодня мы познакомились с универсальным и интегрированным конвейером Visual Studio Mobile Center. Если сравнивать с тем же Bitrise.io, интегрированные решения, с одной стороны, могут сильно упростить жизнь разработчикам мобильных приложений и ускорить внедрение инструментов DevOps в повседневную практику, но с другой — они не настолько гибки и функциональны, как DIY-конвейеры. В ближайшее время стоит ожидать появления большего числа интегрированных систем от других игроков. Если же программистский зуд или задачи проекта требуют своего конвейера, то выбор инструментария уже сейчас достаточно широк, включая различные open source проекты, поэтому выбирать надо исходя из требований и планов развития продукта.

Успешной тебе автоматизации! Будут вопросы — пиши в комментариях!

Об авторе

Вячеслав Черников — руководитель отдела разработки компании Binwell. В прошлом — один из Nokia Champion и Qt Certified Specialist, в настоящее время — специалист по платформам Xamarin и Azure. В сферу mobile пришел в 2005 году, с 2008 года занимается разработкой мобильных приложений: начинал с Symbian, Maemo, Meego, Windows Mobile, потом перешел на iOS, Android и Windows Phone.

Статьи Вячеслава вы также можете прочитать в блоге на Medium.

Другие статьи автора:

- DevOps на службе человека

- Автоматизируем неавтоматизируемое, или про Xamarin в реальных проектах

- Удобный REST для Xamarin-приложений

- Быстрое создание MVP (minimum viable product) на базе Microsoft Azure и Xamarin.Forms

- Готовим Xamarin.Forms: настройка окружения и первые шаги

- Повышаем эффективность работы в Xamarin.Forms

- Работаем с состояниями экранов в Xamarin.Forms

- Подключаем Facebook SDK для Xamarin.Forms

- Подключаем ВКонтакте SDK для Xamarin.Forms

Напоминаем, что это полная версия статьи из журнала Хакер.

|

|

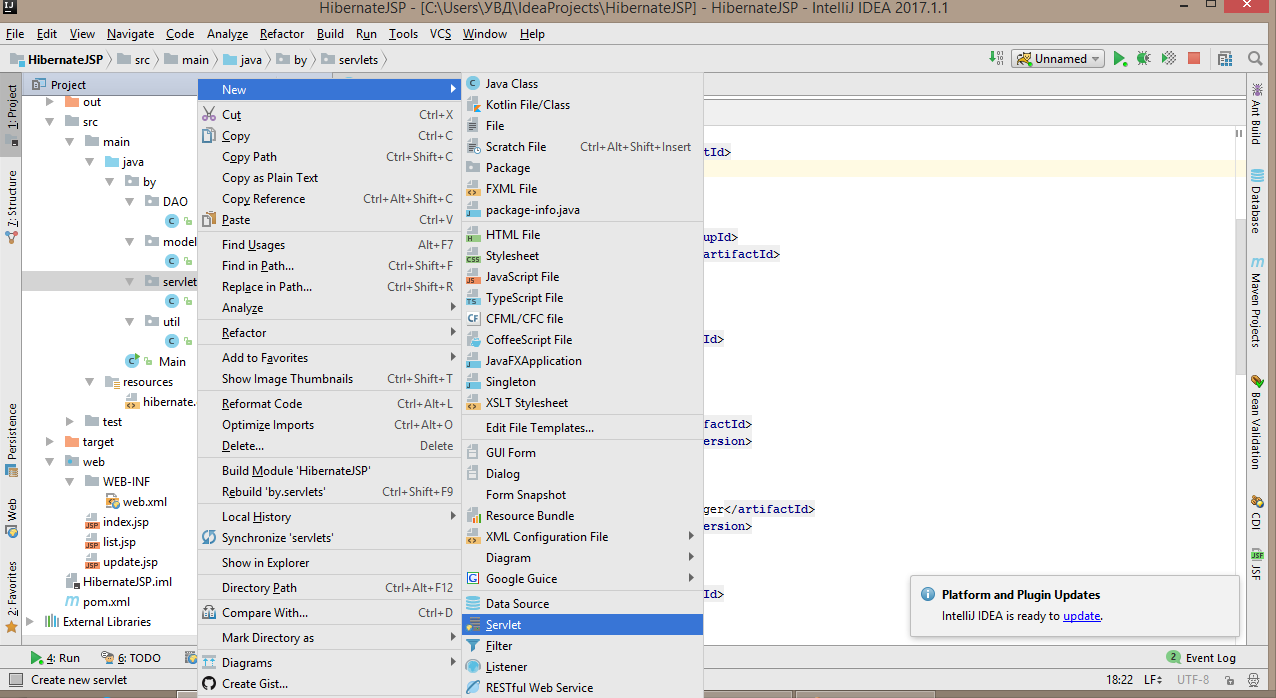

[recovery mode] Hibernate+jsp при поддержке сервлетов |

В этой статье я расскажу о том, как связать JSP с Hibernate при помощи сервлета. Я надеюсь, что вы умеете работать с Hibernate, если же нет, то настоятельно рекомендую прочитать эту статью. Также я надеюсь, что вы знакомы с сервлетами и хоть раз их успешно запускали.

Для того, чтобы у вас была такая же база данных в MySQL, вставьте туда следующий код:

CREATE SCHEMA `hero`;

CREATE TABLE `hero`.`heroes`

(

`idhero` INT NOT NULL AUTO_INCREMENT,

`name` VARCHAR(45) NOT NULL,

PRIMARY KEY (`idhero`));

Создаём maven проект и вставляем следующие зависимости и не только:

war

4.3.5.Final

javax.servlet

servlet-api

3.0-alpha-1

provided

commons-fileupload

commons-fileupload

1.2.2

commons-io

commons-io

2.4

org.hibernate

hibernate-core

${hibernate.version}

org.hibernate

hibernate-entitymanager

${hibernate.version}

javaee

javaee-api

5

mysql

mysql-connector-java

5.1.38

javax

javaee-web-api

6.0

provided

org.apache.commons

commons-lang3

3.4

jstl

jstl

1.2

Подключаемся к базе данных. Опять же: если вы не знаете, как это делается, то статья об этом и не только выше.

Затем подключаем web модуль.

Заходим в File,Project Structure вкладка modules. Передварительно удалите всё, что есть во вкладке modules(если оно там есть) нажав на -(красненький).Нажимаете на +(зелёный)

и добавьте web модуль

Дальше во вкладке Artifacts тоже удаляете все артефакты и добавляете новый +,Web Application:Exploded,From modules,OK

Дальше развертываем Hibernate и для того, чтобы было удобно, засуньте эту модель в папку model, которая находится в by, указав в этот путь при развертке Hibernate.

В папке by создайте папку util, а в ней класс HibernateUtil:

package by.util;

import org.hibernate.SessionFactory;

import org.hibernate.cfg.Configuration;

public class HibernateUtil {

private static SessionFactory sessionFactory=buildSessionFactory();

private static SessionFactory buildSessionFactory() {

try{

return new Configuration().configure().buildSessionFactory();

}catch (Exception e){

throw new ExceptionInInitializerError(e);

}

}

public static SessionFactory getSessionFactory() {

return sessionFactory;

}

}

Благодаря HibernateUtil мы можем создать специальный SessionFactory под наш проект.

В папке by создаём папку DAO, в ней класс DAOImple (мы не создаём интерфейс DAO, так как пример небольшой):

package by.DAO;

import by.model.HeroesEntity;

import by.util.HibernateUtil;

import org.hibernate.Query;

import org.hibernate.Session;

import java.util.List;

public class DAOImple {

public void saveHero(HeroesEntity heroesEntity){

Session session= HibernateUtil.getSessionFactory().openSession();

session.beginTransaction();

session.save(heroesEntity);

session.getTransaction().commit();

session.close();

}

public List getAll(){

Session session=HibernateUtil.getSessionFactory().openSession();

session.beginTransaction();

List list=session.createQuery("from HeroesEntity").list();

session.getTransaction().commit();

session.close();

return list;

}

public void update(HeroesEntity heroesEntity){

Session session=HibernateUtil.getSessionFactory().openSession();

session.beginTransaction();

session.update(heroesEntity);

session.getTransaction().commit();

session.close();

}

public HeroesEntity getHeroById(int id){

Session session=HibernateUtil.getSessionFactory().openSession();

session.beginTransaction();

Query query= session.createQuery("from HeroesEntity where idhero=:id");

query.setInteger("id",id);

HeroesEntity heroesEntity= (HeroesEntity) query.uniqueResult();

session.getTransaction().commit();

session.close();

return heroesEntity;

}

public void deleteHeroes(int id){

Session session=HibernateUtil.getSessionFactory().openSession();

session.beginTransaction();

Query query=session.createQuery("from HeroesEntity where idhero=:id");

query.setInteger("id",id);

HeroesEntity heroesEntity= (HeroesEntity) query.uniqueResult();

session.delete(heroesEntity);

session.getTransaction().commit();

session.close();

}

}

Класс DAOImple нам нужен для того, чтобы работать с той информацией, что есть в базе данных.

В папке by создаём папку servlets, а в ней создаём сервлет(не класс!) SaveServlet (комментарии в коде):

package by.servlets;

import by.DAO.DAOImple;

import by.model.HeroesEntity;

import javax.servlet.RequestDispatcher;

import javax.servlet.ServletException;

import javax.servlet.annotation.WebServlet;

import javax.servlet.http.HttpServlet;

import javax.servlet.http.HttpServletRequest;

import javax.servlet.http.HttpServletResponse;

import java.io.IOException;

public class SaveServlet extends HttpServlet {

protected void doGet(HttpServletRequest request, HttpServletResponse response) throws ServletException, IOException {

DAOImple daoImple=new DAOImple();

////////////////////////////////////////

//INDEX.JSP

////////////////////////////////////////

if(request.getParameter("add")!=null){//при нажатии на кнопку add

HeroesEntity heroesEntity=new HeroesEntity();//создаём экземпляр класса модели базы данных

heroesEntity.setIdhero(Integer.parseInt(request.getParameter("id")));//задаём ему id взятый из поля c именем id

heroesEntity.setName(request.getParameter("name"));//аналогично с прошлой строкой

daoImple.saveHero(heroesEntity);//сохраняем в базу данных полученный объект

request.setAttribute("list",daoImple.getAll());//создаём аттрибут который взял в себя всё что есть в базе данных

RequestDispatcher requestDispatcher=request.getRequestDispatcher("list.jsp");//перебрасываемся на list.jsp

requestDispatcher.forward(request,response);

}

if(request.getParameter("showAll")!=null){//при нажатии на кнопку showALL

request.setAttribute("list",daoImple.getAll());//создаём аттрибут который взял в себя всё что есть в базе данных

RequestDispatcher requestDispatcher=request.getRequestDispatcher("list.jsp");//перебрасываемся на list.jsp

requestDispatcher.forward(request,response);

}

///////////////////////////////////////////////////

//LIST.JSP

///////////////////////////////////////////////////

String action=request.getParameter("action");//создаём action который будет реагировать на те или иные действия

if(action.equalsIgnoreCase("update")){//если action отреагировал на update

request.setAttribute("hero",daoImple.getHeroById(Integer.parseInt(request.getParameter("idhero"))));//создаём атрибут который по id возвращает определённого HeroesEntity

RequestDispatcher requestDispatcher=request.getRequestDispatcher("update.jsp");////перебрасываемся на update.jsp

requestDispatcher.forward(request,response);

}

if(action.equalsIgnoreCase("delete")){//если action отреагировал на update

daoImple.deleteHeroes(Integer.parseInt(request.getParameter("idhero")));//удаляем по id

request.setAttribute("list",daoImple.getAll());//создаём аттрибут который взял в себя всё что есть в базе данных

RequestDispatcher requestDispatcher=request.getRequestDispatcher("list.jsp");//перебрасываемся на list.jsp

requestDispatcher.forward(request,response);

}

}

protected void doPost(HttpServletRequest request, HttpServletResponse response) throws ServletException, IOException {

DAOImple daoImple = new DAOImple();

//////////////////////////////////

// UPDATE.JSP

//////////////////////////////////

if (request.getParameter("update") != null) {//при нажатии на кнопку update

HeroesEntity heroesEntity = new HeroesEntity();//создаём экземпляр класса

heroesEntity.setIdhero(Integer.parseInt(request.getParameter("idhero")));//задаём id из поля idhero

heroesEntity.setName(request.getParameter("name"));//задаём name из поля name

daoImple.update(heroesEntity);//апдейтим

request.setAttribute("list", daoImple.getAll());//создаём аттрибут который взял в себя всё что есть в базе данных

RequestDispatcher requestDispatcher = request.getRequestDispatcher("list.jsp");//перебрасываемся на list.jsp

requestDispatcher.forward(request, response);

}

}

}

Регестрируем сервлет в web.xml:

SaveServlet

by.servlets.SaveServlet

SaveServlet

/save

В папке web создаём index.jsp стартовую страницу:

а так же list.jsp:

id

name

${list.idhero}

${list.name}

">update

delete

и update.jsp:

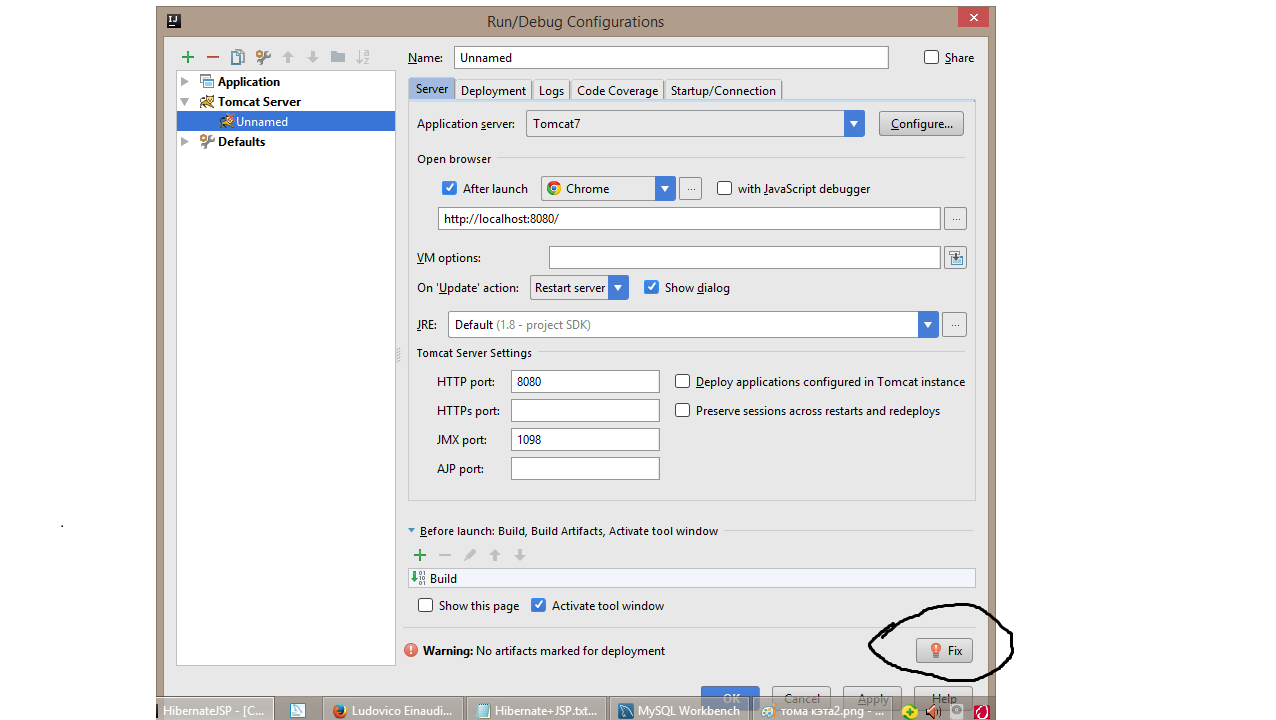

Дальше настраиваем TomCat:

Даём ему артефакт(можно просто нажать внизу на кнопку с красной лампочкой и названием Fix):

Я надеюсь что вам удалось запустить этот пример если же нет можете обратится ко мне в vk:ссылка

Этот пример на github:здесь

Удачи!

|

Метки: author RomeoLord java hibernate servlet tomcat jsp |

[Из песочницы] Многоступенчатая организация хранения резервных копий для самых маленьких |

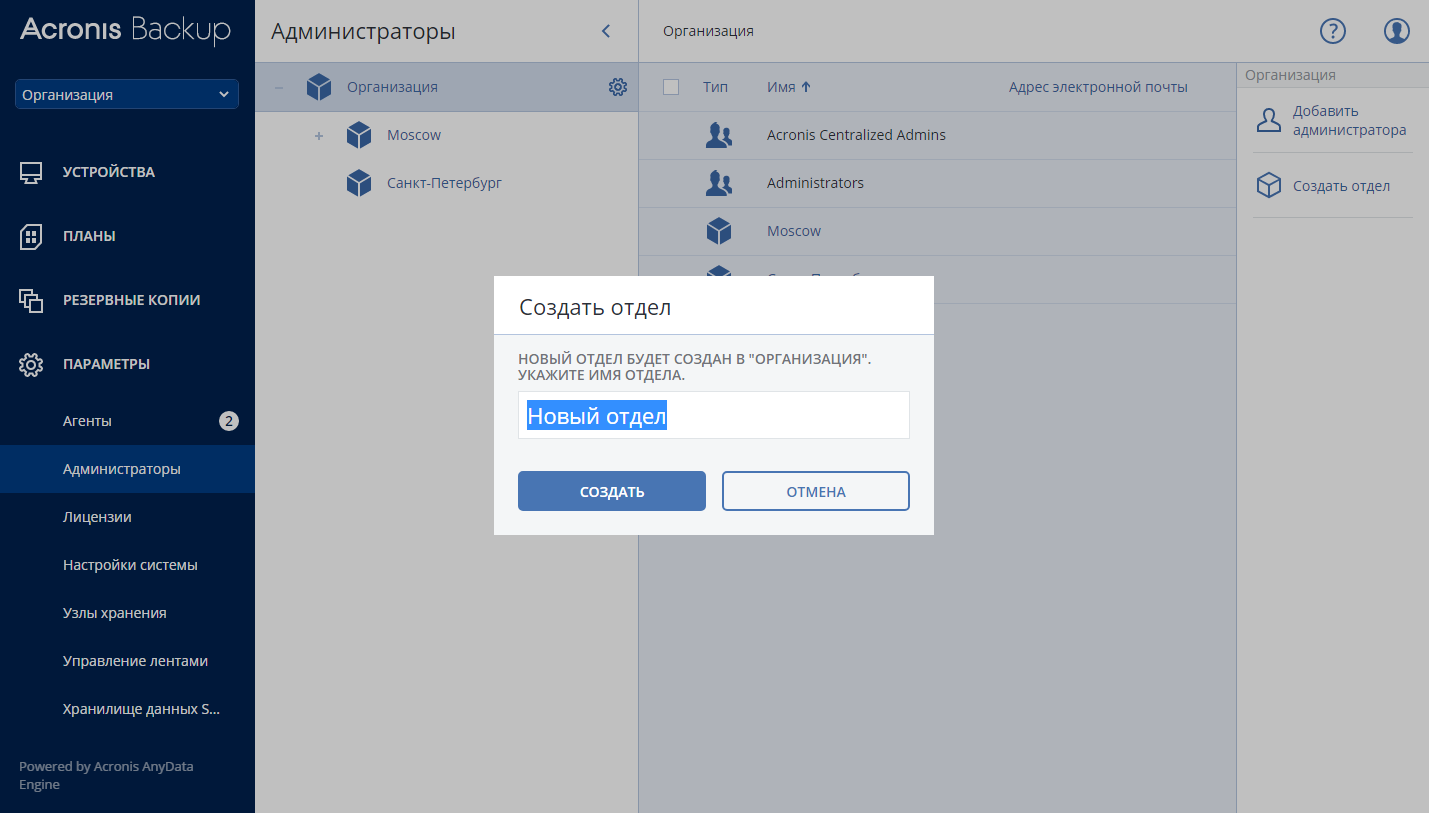

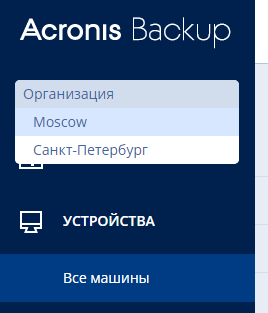

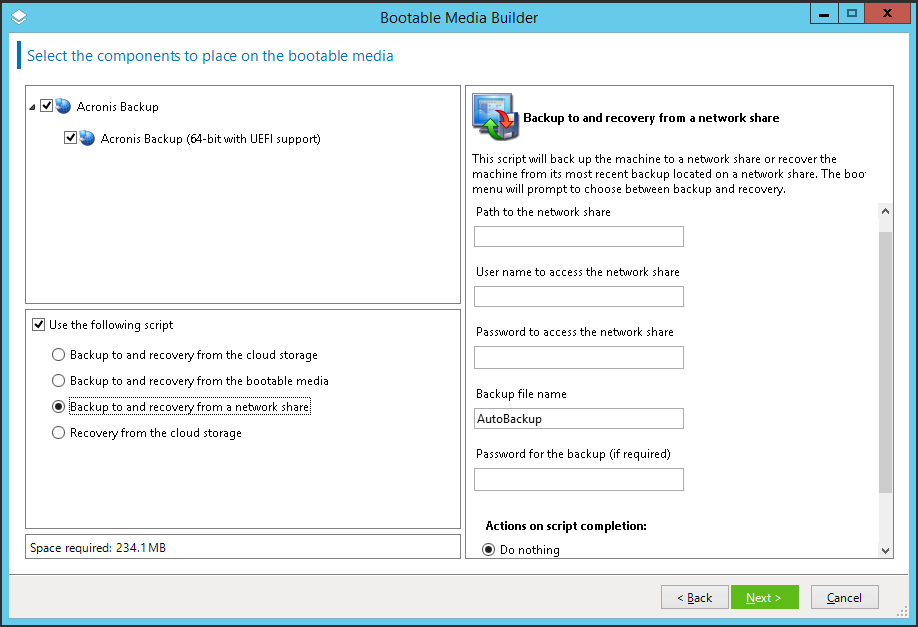

И тут то все четко начинают понимать, что нужны резервные копии (много, разных, в разных местах). Т.е. правило 3-2-1, придуманное и описанное Peter-ом Krogh-ом, весьма желательно выполнять. Данная статья – пример, который помогает сделать реальным выполнение данного правила на «коленке» — без покупки дорогостоящего оборудования (в условиях жесткой экономии).

Итак – условия решаемой задачи:

• Есть небольшая среда виртуализации от Vmware (пара-тройка ESXi-серверов, vCenter, самый дешевый пакет лицензий – начальный Kit – в целом это не важно для данной статьи. Аналогично статья подойдет и для Hyper-V);

• Есть с десяток виртуальных машин, содержимое которых не хочется потерять в случае отработки автоматизированным Ransomware скриптом;

• Есть система резервного копирования от Veeam (бесплатная редакция, бекапы делаются с помощью PowerShell и Task Schedule).

Задачи:

• Делать резервные копии серверов 1 раз в день по ночам;

• Размножать копии (копировать на NAS-сервер с FreeBSD + ZFS). К слову, на ZFS тоже делаются снапшоты, которые автоматически удаляются по заданному расписанию (zfSnap + Cron);

• Иметь оффлайновую копию «бекапов» на съемном носителе.

Реализация:

Так как основной сервер, который делает резервные копии из работающих виртуальных машин, управляется операционной системой Windows Server (ввиду того, что Veeam Backup работает пока что только на базе этой ОС), было решено для реализации задач использовать PowerShell.

Решение задачи синхронизации бекапов между основным сервером (Windows) и NAS-сервером (FreeBSD):

Для решения задачи требовался скрипт, который бы запускался через Task Scheduler и синхронизировал каталог A с сетевым ресурсом B, доступным через протокол SMB. Вначале я попробовал использовать robocopy – но тесты показали весьма низкую скорость работы полученного скрипта. И я решил реализовать данный скрипт на другом инструменте.

Пятиминутный поиск и 10 минут тестов показали наличие весьма жизнеспособного и готового решения: powershell-synchronizing-a-folder

Скрипт оказался шикарным:

• Работает как с локальными дисками, так и с сетевыми ресурсами;

• Позволяет исключать определенные файлы из задачи;

• Позволяет синхронизировать файлы по заданному шаблону

• Работает на максимальной скорости (т.е. сколько железо и сеть могут выдать – с такой скоростью синхронизация и проходит, в отличие от robocopy).

В итоге на основном сервере появилась пачка заданий в Task Schedule вида:

powershell.exe "C:\Scripts\syncfolder.ps1 -SourceFolder:G:\Backups\WEBAPPS -TargetFolder:\\192.168.0.232\backups$\WEBAPPS"И задача синхронизации резервных копий после выполнения заданий Veeam Backup была решена (2 копия с дельтой по времени).

Решение задачи создания оффлайновых резервных копий:

Сама идея проста:

• Подключаем к серверу с Veeam Backup внешний USB 3.0 жесткий диск на 2 Тб

• Большую часть времени держим его Offline (и этим мы защищаемся от автоматизированных Ransomware);

• Когда скрипт отрабатывает, он переводит диск в Online, делает каталог с текущей датой, копирует в него текущие резервные копии, и по окончании выполнения снова переводит диск в Offline.

Реализация:

Отправной точкой служит команда: Get-Disk – нам нужно понять, какие диски у нас есть в системе и виден ли нам внешний USB-диск:

PS C:\Windows\system32> Get-Disk

Number Friendly Name OperationalStatus Total Size Partition Style

------ ------------- ----------------- ---------- ---------------

1 WDC WD30PURX-64P6ZY0 Online 2.73 TB GPT

0 WDC WD10EZEX-60M2NA0 Online 931.51 GB GPT

2 WD Elements 25A3 USB Device Offline 1.82 TB GPT

Теперь нам нужно поместить ссылку на USB-диск в переменную. Для его идентификации предлагается использовать атрибут «Friendly Name». Если Вы предпочитаете использовать другие атрибуты – выведите полный список (get-disk | select *). Либо посмотрите список доступных свойств и методов (get-disk | get-member).

Итого первая часть скрипта:

# Find USB disk by FriendlyName

$mybackupdisk = get-disk | where {$_.FriendlyName -like 'WD Elements 25A3 USB Device'}

Далее – нужно перевести диск из Offline в Online, а также убедиться, что диск в режиме Read-Write (иногда, по невыясненной причине, диск после перехода в Online становился Read-Only. Для выяснения номера диска используем свойство Number ($mybackupdisk.Number).

Получаем кусок:

# Make disk Online

Set-Disk -Number $mybackupdisk.Number -IsOffline $False

Start-Sleep -s 5

# Make disk Writeable (some times it ReadOnly after online - shit happens...)

Set-Disk –Number $mybackupdisk.Number -IsReadonly $False

Start-Sleep -s 5

Для идентификации буквы диска сделаем следующий финт – на USB диск повесим метку (имя): VMUSBBACKUPS (либо через Disk Manager, либо с помощью команды Set-Volume).

Далее – с помощью команды Get-Volume определяем букву подключенного USB-диска (после перевода его в Online):

# Find Disk Volume

$usbvolumename = Get-Volume | where {$_.FileSystemLabel -like 'VMUSBBACKUPS'}

И собственно само копирование нужных данных на диск:

Создаем каталог с текущей датой в имени:

$date = Get-Date

$newbackupfolder = $date.ToString("yyyy-MM-dd")

# Full Backup Fath

$createdirfullpath = $usbvolumename.DriveLetter + ":\" + $newbackupfolder

# Create Backup Directory

New-Item -ItemType directory -Path $createdirfullpath -Force -Confirm:$false

Start-Sleep -s 2

Копируем резервные копии:

# Source Backup Dir (with backups)

$sourcebackup = "F:\Backups\VCENTER\"

# Copy to USB from Disk

Copy-Item $sourcebackup -Destination $createdirfullpath -Recurse

Start-Sleep -s 5

Другой вариант – когда нам нужно не создавать каждый раз новые каталоги и копии – а переписывать файлы новыми версиями – тогда используем уже ранее найденный скрипт для синхронизации каталога А с Б:

# Sync from HDD to USB:

C:\Scripts\syncfolder.ps1 -SourceFolder:F:\Backups\ -TargetFolder:$usbvolumename.DriveLetter:\VMs\

Start-Sleep -s 5

В любом случае – когда Вы закончите копировать либо синхронизировать, весьма желательно сбросить кэш операций (из ОЗУ на HDD/USB) командой:

# Write USB Disk Cache before offline

Write-VolumeCache $usbvolumename.DriveLetter

Start-Sleep -s 5

И не забыть снова перевести диск из Online в Offline:

# Place USB to Offline

Set-Disk -Number $mybackupdisk.Number -IsOffline $True

Результаты:

• Получили резервные копии в трех местах (Windows-сервер, FreeBSD-сервер, USB-диск);

• Два вида хранения (в шарах и на диске);

• Один носитель другого типа – отсуждаемый. Можно вообще иметь пару дисков – и просто 1 или 2 раза в месяц менять их местами (один в сейф). Так как USB-диск в режиме Offline 95% времени – его всегда можно безболезненно выдернуть из сервера.

Моя статистика:

• данная схема работает уже 6 месяцев без сбоев;

• объем синхронизируемых данных (сжатые и дедуплицированные бекапы – от 500 до 700 Гб);

• Время синхронизации на USB-диск – 1 час 20 минут в среднем (1 раз в неделю в выходные).

Полные скрипты можно скачать с Google Disk: BackupExamples

|

Метки: author Dorlas резервное копирование powershell backup |

Анализ изменений в игре |

Еще до сборки нового продакшен-билда мы должны понимать, на какие показатели повлияет нововведение. Ведь в новых версиях игры может быть множество изменений баланса. Без предварительного планирования неизбежно возникнет один из таких вопросов: «Что же повысило ARPU в Канаде — локальные мероприятия в честь национального праздника или общее повышение сложности группы каких-то уровней; а может, просто звезды так совпали?». Безусловно, и после выхода апдейта выполняется всесторонний анализ результатов, но понимать характер изменений нужно заранее.

Разработка изменений

Перед внедрением новых фич в игру мы стараемся ответить на ряд вопросов:

- Куда будем смотреть? — на какие метрики (как общепринятые KPI, так и внутренние критерии качества) изменение предположительно повлияет, какой эффект мы будем считать успешным для проекта.

- На кого будем смотреть? — для кого предназначено изменение (для китов, для новых игроков, для игроков из Китая, для игроков, застрявших на какой-то конкретной группе уровней, и т.д.).

- Зачем будем смотреть? — какие есть сопутствующие риски (сложнее уровни -> больше монетизация и больше отвалы (churn); легче уровни -> меньше монетизация и меньше отвалы).

- А есть что смотреть? — вся ли необходимая информация трекается в игре.

Когда мы ответили на самые важные вопросы, остается еще парочка. Например, а как мы будем добавлять изменения в игру? Здесь есть два варианта:

- AB-тест. Мы проводим AB-тесты для новых фич или сильных изменений текущего баланса и геймплея. Когда это возможно, предварительный AB-тест для нас предпочтителен.

- Сразу в игру. Добавление нового контента в игру без AB-теста возможно, когда мы или технически не можем провести AB-тест, или не считаем контент принципиально новым (новый набор уровней, новые декорации и т.д.).

Про AB-тесты написано много хорошего и разного, но мы напишем еще чуть-чуть.

Планирование AB-теста

Если решили проверить изменения с помощью AB-теста, главное — выделить ключевые моменты, иначе тест окажется бесполезным либо ввиду своей непоказательности, либо ввиду неправильной интерпретации. В любом случае бесполезный тест нам не нужен. Поэтому вот на что мы смотрим, когда планируем AB-тест:

- Выбор величин для оценки.

Пример: предполагается, что изменения должны «закрутить гайки» и стимулировать игроков платить для прохождения уровня. Что нам надо оценить: конверсия, ARPU, ретеншен, отвалы, сложность уровня, использование бустов. Нам нужно быть уверенными, что увеличение дохода за счет повышения конверсии стоит потенциальной потери пользователей. Тем более что часть отвалившихся пользователей могла бы в будущем начать смотреть рекламу и приносить доход. Нужно также быть уверенным, что уровень сделан хорошо, что он не слишком рандомный, что нет «серебряной пули» в виде одного буста, гарантирующего прохождение. Хватит ли этих контролируемых метрик или стоит добавить еще?

- Расчет необходимой требуемой выборки для получения значимого результата.

Пример: модель предсказывает гарантированное отсутствие конверсии у порядка 2000 человек в группе с левел-апом на выбранный уровень в выбранный день. Сколько дней запускать предсказания, чтобы по итогам теста получились значимые результаты при увеличении показа рекламных роликов для данной группы?

- Формализация условий запуска теста.

Пример: для запуска крупномасштабного теста нужно найти страну с хорошим уровнем конверсии. При этом, набирать только опытных игроков, которые не говорят на английском. Как это формализовать для динамического распределения игроков в тест?

- Понимание, какие механизмы предусмотрены для сбора данных и анализа результатов.

Пример: можем ли мы, параллельно проводить несколько тестов на разные группы уровней и удобным инструментом разделить влияние одних и других на игроков, участвующих сразу в двух тестах?

- Формализация критериев для принятия решений о завершении теста.

Пример: стоит ли останавливать тест раньше времени, если резко снизились метрики. Или это временный эффект, характерный для когорты, — и стоит подождать?

- Формализация критериев для принятия решения о внедрении изменения в игру. Поговорим об этом в следующем разделе статьи!

Принятие правильных решений по результатам теста

Даже если распределять игроков в группы в равных пропорциях, внутри они могут попасть в разные условия. Например те, кто пришли в игру и вошли в тест в начале месяца, могут иметь больший ARPU, чем пришедшие в конце теста. Выбор методологии — это может быть когортный подход или расчет ARPU Daily (ARPDAU) — зависит от определенных целей на стадии планирования и от игроков, распределяемых в тест на регулярной основе.

При когортной оценке результата нужно учитывать, что игроки, распределенные ближе к окончанию теста, могли еще не дойти до «точек конверсии». Нужно или отсечь часть «последних» когорт при анализе, или выждать нужное время после остановки распределения игроков в тест.

Также по-разному можно подходить к анализу итоговых данных групп. Мы используем два основных подхода:

- Частотный подход — классический подход в оценке результатов. Формулируем нулевую гипотезу об отсутствии достоверной разницы между группами и альтернативную гипотезу, отрицающую нулевую. Итогом исследования станет решение о справедливости какой-либо из двух гипотез для всей генеральной совокупности. Выбираем уровень альфа (1 — альфа = уровень значимости) и проводим тест с использованием статистического критерия (z-критерий, t-критерий). Далее строим доверительные интервалы для контрольной и тестовой групп. Если эти интервалы не пересекаются, то результат достоверный с вероятностью 1 — альфа. По сути, выбранное значение альфа — это вероятность ошибки первого рода, т.е. вероятность, что по результатам эксперимента будет принята альтернативная гипотеза, хотя для генеральной совокупности верна нулевая гипотеза.

Плюсы: гарантированный результат определения значимого различия при достаточно большой выборке.

Минусы: размеры выборки — чем выше выбранный уровень достоверности, тем больше набирается участников групп. А чем критичнее тестируемое изменение, тем выше уровень значимости, который мы устанавливаем пороговым значением.

- Байесовский подход — менее распространенный метод, который базируется на принципе расчета условной вероятности. Он позволяет считать вероятность того или иного события при условии, что генеральная совокупность распределена определенным образом. С точки зрения практики использование байесовского подхода позволяет снизить для ряда метрик требования на количество элементов выборки (участников AB-теста). Это работает, потому что в определенный момент при оптимизации параметров распределения построенная плотность уже не приближается к фактическим результатам в тесте.

Подход базируется на принципе расчета условной вероятности. Если на момент анализа результатов мы знаем, какой вид распределения имеет генеральная совокупность, мы можем восстановить плотность вероятности за счет оптимизации параметров этого распределения.

Если случайная величина не соответствует одному виду типовых распределений, то искомое распределение можно получить с помощью комбинирования нескольких типовых распределений, используя принцип совместной вероятности событий. Например, для ARPPU мы комбинируем распределение дохода от пользователя с распределением платящих пользователей (оптимизируя параметры произведения). Мы описываем модель итогового распределения для случайной величины и в рамках построенной модели сравниваем две выборки. Далее с помощью статистического критерия проверяем, что обе выборки соответствуют описанному в модели распределению и имеют разные параметры.

Плюсы: в случае удачного выбора модели и удачной оптимизации параметров можно улучшить точность и достоверность оценок и в некоторых случаях можно принимать решения, набирая для теста небольшие группы пользователей.

Минусы: удачной модели может не быть, либо она может быть достаточно сложна для прикладного использования.

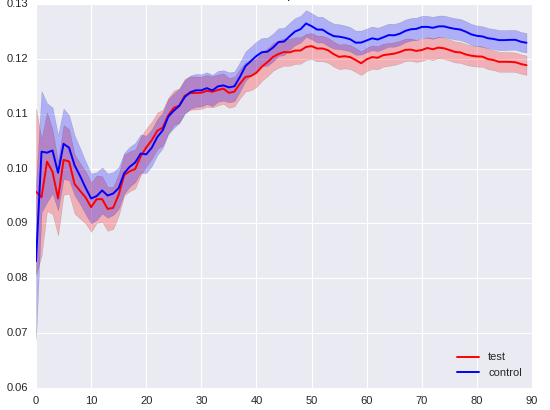

Приведем в качестве примера несколько тестов на проекте Township. Там использование байесовского подхода вместо частотного позволило улучшить точность.

В первом тесте мы изменили количество платной валюты, т.н. кеша, которое игрок может получить из одного конкретного источника. Мы планировали, что это может привести к небольшому улучшению монетизации. В итоге мы установили разницу:

- DPU (Daily Paying Users) — тестовая группа больше контрольной на 1% с вероятностью 87% при использовании байесовского подхода, тогда как это же расхождение групп при использовании частотного подхода справедливо с вероятностью 50%.

- ARPU Daily (ARPDAU) — тестовая больше контрольной на 2,55%, байесовский подход — 94%, частотный — 74%.

- ARPPU Daily — тестовая больше на 1,8%, байесовский — 89%, частотный — 61%.

Таким образом, мы смогли поднять точность до приемлемой без изменения размера групп участников.

В другом тесте мы изменяли настройки показа рекламы для определенной группы игроков в регионе с плохой монетизацией. На тот момент мы уже выяснили, что для некоторых хорошо подобранных групп игроков реклама может не только не портить, но и даже улучшить конверсию или ARPU, и хотели проверить этот подход на более широкой группе.

- Конверсия в контрольной группе была выше, чем в тестовой, при байесовском подходе с вероятностью 97% это было ясно по 50 000 игроков, при частном — с 95% вероятностью по 75 000 игроков.

- Разницу в ARPU в пользу контрольной группы байесовским подходом мы оценили по итогу с 97% вероятностью за месяц, в то время как при частотном подходе доверительные интервалы у нас так и не разошлись.

Независимо от итогового выбора подхода к оценке результатов мы получаем информацию о разнице между контрольной и тестовой группами. Если результат мы считаем положительным для проекта, то включаем изменение для всех пользователей. Еще до полного внедрения изменений в игру у нас есть представление о том, как они могут сказаться на наших игроках.

Мониторинг метрик

Конечно, в ряде случаев для нового контента мы можем не проводить AB-тест, если эффект от изменений предсказуем. Например, при добавлении новых матч-3 уровней в игру. Для этих изменений мы используем апостериорный контроль ключевых метрик. Как и в случае с AB-тестом, данные для этого собираются и обрабатываются из событий, которые пришли от пользователей, в автоматическом режиме.

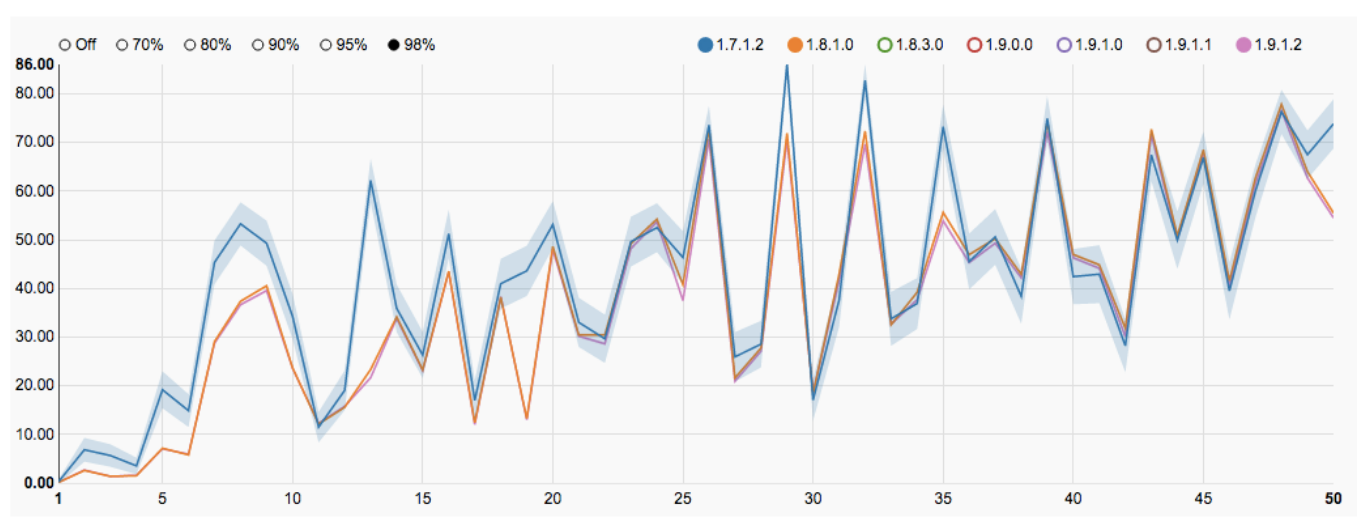

У нас есть свой дашборд, внутренняя разработка на базе opensource-решения Cubes. Им пользуются не только аналитики, но и гейм-дизайнеры, менеджеры, продюсеры и другие участники нашей дружной команды разработки. С помощью этого дашборда (точнее, набора дашбордов) по каждому проекту отслеживаются как ключевые показатели, так и свои внутренние метрики, такие как, например, сложность матч-3 уровней. Данные для дашбордов готовятся в формате olap-кубов, которые, в свою очередь, содержат агрегированные данные из базы данных raw-событий. Благодаря выбору аддитивных моделей для каждого графика есть возможность выполнения drilldown (разложения на составляющие) по необходимым категориям. При желании можно группировать или разгруппировать пользователей для применения фильтров при визуализации метрик. Например, можно сделать drilldown по версии приложения, версии настройки уровней, региону и платежеспособности, оставив только платящих игроков из Австралии с версией игры 1.8 и версией настройки уровней 4.

Конечно, самой интересной связкой по умолчанию является последняя версия игры и последняя версия уровней, которые сравниваются с предыдущим вариантом. Это дает возможность левел-дизайнерам вести непрерывный контроль за текущим состоянием кривой сложности проекта, абстрагированный от глобального анализа апдейта, и оперативно реагировать на отклонения показателей от планового курса.

|

Метки: author 9e9names тестирование игр разработка игр анализ и проектирование систем блог компании playrix playrix игры тестирование |

[Перевод - recovery mode ] Безопасность в веб-разработке: чек-лист |

Разработка безопасных и надежных облачных веб-приложений — очень, очень сложное дело. Если вы думаете иначе, вы либо не от мира сего, либо жизнь вас еще не проучила.

Если вы уже заразились идеей «минимально жизнеспособного продукта» (англ. MVP — minimum viable product, прим. перев.) и считаете, что за месяц можно создать одновременно полезный и безопасный продукт — подумайте дважды, прежде чем выпускать его. Просмотрев чек-лист, вы поймете, что оставляете немало уязвимостей.

Самое меньшее, что можно делать в такой ситуации — это честно предупреждать пользователей, что продукт еще на стадии рабочего прототипа и полная безопасность пока не гарантируется.

Чек-лист весьма прост и пока еще не до конца полон. Я занимаюсь разработкой безопасных веб-приложений уже более 14 лет и включил в список самые важные вопросы, с которыми столкнулся за это время. Надеюсь, что создавая свой продукт, вы отнесетесь к ним серьезно.

Базы данных

- Храните данные идентификации пользователей и конфиденциальные данные (токены, адреса электронной почты, платежные реквизиты) в зашифрованном виде.

- Если база данных поддерживает шифрование хранящихся данных (например, AWS Aurora), подключите его для защиты данных на диске. Убедитесь, что все резервные копии также хранятся в зашифрованном виде.

- Используйте наименьший уровень привилегий для доступа к учетным записям пользователей в базе данных. Не используйте корневую учетную запись базы данных.

- Храните и распространяйте секретные данные с помощью keystore, предназначенного для этих целей. Не используйте хардкод в приложениях.

- Предотвращайте SQL-инъекции, используя исключительно подготовленные SQL-запросы. Например: если вы используете NPM, не используйте npm-mysql, используйте npm-mysql2, который поддерживает подготовленные выражения.

Разработка

- Убедитесь, что все компоненты приложения проверены на наличие уязвимостей для каждой версии, переданной в продакшн. Сюда входят O/S, библиотеки и пакеты. Проверка должна быть автоматизирована в процессе CI-CD (CI — continuous integration — непрерывная интеграция, CD — continuous delivery — постоянная поставка, прим. перев.).

- С одинаковой бдительностью относитесь как к безопасности среды разработки, так и к безопасности продакшен-сервера. Создавайте программное обеспечение в защищенной изолированной среде разработки.

Идентификация

- Убедитесь, что все пароли хэшируются с использованием соответствующей криптографической функции, например, bcrypt. Никогда не пишите собственную функцию хеширования и корректно инициализируйте используемую криптографическую библиотеку случайными данными.