Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Перевод] Самый большой репозиторий Git на свете |

За это время много чего произошло, и я хочу поделиться с вами новостями. Три месяца назад GVFS был только мечтой. Не в том смысле, что его не существовало — у нас была готовая реализация — но в том, что он еще не показал себя в деле. Мы опробовали его на больших репозиториях, но не успели внедрить в рабочий процесс для сколько-нибудь значимого количества разработчиков. Поэтому у нас было только умозрительное убеждение, что все будет работать. Теперь же у нас есть подтверждение этому.

Сегодня я хотел быть представить результаты. Кроме того, мы озвучим для пользователей следующие шаги, которые планируем предпринять в целях развития GVFS: в частности, добавление возможности вносить свой вклад в открытый код и улучшение функционала в соответствии с потребностями нашей компании, партнеров и клиентов.

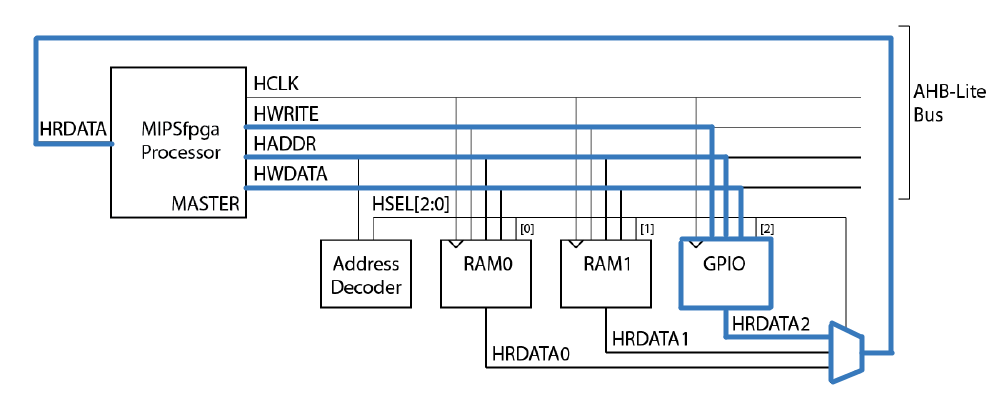

Windows на Git: прямая трансляция

За эти три месяца мы практически завершили процесс внедрения Git/GVFS для команды, работающей с Windows в Microsoft.

Если в двух словах: кодовая база Windows весит около 3.5 мегабайт; когда заливаешь ее на Git, получается репозиторий размером где-то в 300 гигабайт. Более того, в компании работает около 4000 инженеров; инженерная система ежедневно производит 1,760 сборок по 440 веткам, вдобавок к pull-запросам на валидацию билдов. Все эти три обстоятельства (количество файлов, размер репозитория, темп работы) сильно усложняют дело даже по отдельности, а взятые вместе делают обеспечение позитивного опыта невероятно сложной задачей. До перехода на Git мы пользовались Source Depot и код был распределен по 40 с лишним репозиториям, у нас даже был специальный инструмент, чтобы управлять операциями.

На момент выхода моей первой статьи три месяца назад весь наш код хранился в одном Git репозитории, которым пользовались несколько сотен программистов для обработки очень скромного процента билдов (менее 10%). С тех пор мы в несколько этапов выкатили проект для всего инженерного состава.

Первый, и самый массовый, скачок произошел 22 марта, когда мы перевели на новую систему всю команду Windows OneCore целиком — а это около 2000 человек. Эти 2000 инженеров еще в пятницу работали с Source Depot, а вернувшись в офис после выходных, обнаружили, что их ждет радикально новый опыт с Git. Все выходные моя команда просидела скрестив пальцы и молясь, чтобы в понедельник нас не разорвала разъяренная толпа инженеров, у которых застопорилась вся работа. На самом деле, команда Windows очень хорошо продумала запасные планы на случай, если что-то пойдет не так; к счастью, нам не пришлось к ним прибегнуть.

Но все прошло неожиданно гладко и разработчики с первого же дня сумели приспособиться к новым условиям без ущерба продуктивности — честно говоря, я даже удивился. Несомненно, возникали и сложности. К примеру, команде Windows из-за ее огромных размеров и специфики работы, часто приходилось производить слияние ОЧЕНЬ крупных ветвей (речь идет о десятках тысяч изменений и тысячах конфликтов). Уже в первую неделю стало ясно, что наш интерфейс для pull-запросов и разрешения конфликтов слияния просто не приспособлен для таких масштабных изменений. Пришлось в срочном порядке вирутализировать списки и получать данные командой fetch поэтапно, чтобы интерфейс не подвисал. Через пару дней мы с этим справились и, в целом, неделя прошла на более позитивной ноте, чем мы рассчитывали.

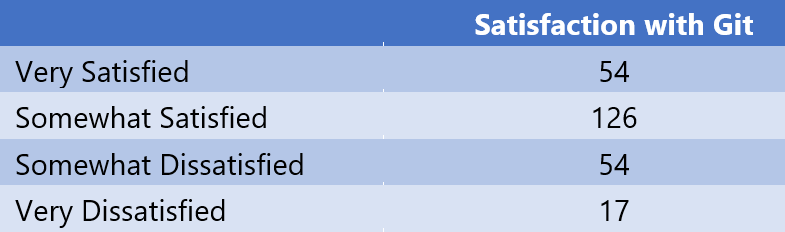

Один из способов, которые мы использовали, чтобы оценить успешность всего мероприятия — это опрос инженеров. Главный вопрос, который мы им задали — это «Довольны ли вы?», хотя, конечно, не забыли расспросить и о подробностях. Первый опрос состоялся через недели после запуска проекта и показал следующие результаты:

(Полностью довольны: 54;

Скорее довольны: 126;

Скорее недовольны: 54;

Крайне недовольны: 17)

Показатели не такие, чтобы запрыгать от радости, но учитывая, что у команды только что, можно сказать, мир перевернулся, им пришлось учиться работать по новой схеме и они все еще находились в процессе перехода — результаты показались мне вполне приличными. Да, из 2000 сотрудников откликнулись только 251, но добро пожаловать в мир тех, кто пытается заставить людей участвовать в опросах.

Другой способ, который мы применяли для оценки успешности, — отслеживание деятельность инженеров, чтобы проверить, выполняется ли необходимый объем работы. Например, мы фиксировали количество залитых фрагментов кода для всех официальных подразделений. Разумеется, половина компании все еще оставалась на Source Depot, в то время как вторая половина уже перешла на Git, поэтому наши замеры отражали некую смесь из их результатов. На графике, приведенном ниже, вы можете заметить ощутимый спад в числе залитых файлов на Source Depot и ощутимый подъем в pull-запросах на Git, но суммарное количество остается примерно одинаковым на всем отрезке. Мы решили, что на основании этих данных можно сделать вывод: система работает и существенных препятствий к использованию не содержит.

22 апреля мы выкатили продукт еще для 1000 инженеров; чуть позже, 12 мая — для следующих 300-400. Адаптация каждой следующей волны происходила по тем же паттернам, что и у предыдущих, и в данный момент 3500 из 4000 инженеров Windows перешли на Git. Оставшиеся команды в данный момент доводят свои проекты до завершения и пытаются определиться с оптимальным временем для перехода, но, думаю, к концу месяца будут охвачены все сотрудники.

Количество данных, с которыми работает система, потрясает воображение. Давайте посмотрим на конкретные цифры:

- В общей сложности за 4 месяца существования репозитория было совершено более 250,000 Git коммитов;

- 8,421 пушей в среднем за день;

- 2,500 pull-запросов и 6,600 инспекторов кода в среднем за рабочий день;

- 4,352 активных ответвлений;

- 1,760 официальных сборок в день.

Как вы сами видите, это огромное количество операций на очень обширной кодовой базе.

Производительность GVFS при работе на масштабных проектах

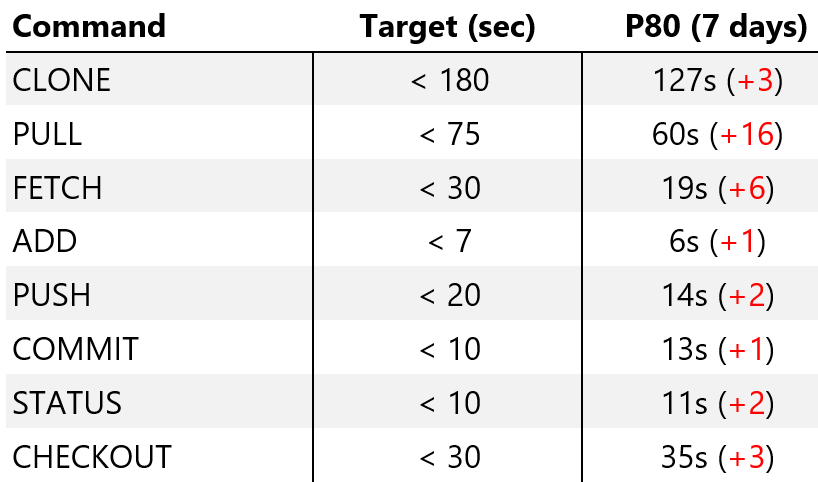

По результатам опроса видно, что существующим положением вещей довольны не все. Мы собрали много данных на этот счет, и причины самые разные — от того факта, что не все инструменты поддерживают Git, до досады, что приходится осваивать что-то новое. Но основная проблема — производительность, и ее-то я и хочу разобрать досконально. Выкатывая Git, мы знали, что с точки зрения производительности он еще недоработан, да и в процессе внедрения многому научились. Мы отслеживаем производительность для ряда ключевых операций. Вот данные, которые собрали телеметрические системы, по работе 3500 инженеров, использующих GVFS.

Здесь вы видите «цель» (мы рассчитывали ее как худшее из допустимых значений — не то, к чему мы стремимся, а порог, ниже которого нельзя опускаться, чтобы система вообще работала). Также приведены результаты по 80му перцентилю за последние семь дней и разница с результатами предыдущей недели. (Как можете заметить, все замедляется — мы поговорим об этом подробнее чуть позже).

Чтобы вам было с чем сравнивать, скажу так: если бы мы попытались проделать что-то подобное на «классическом Git», прежде чем начали работу над ним, многие из команд выполнялись бы от тридцати минут до нескольких часов, а некоторые вообще никогда бы не дошли до завершения. То, что большинство сейчас обрабатывается за 20 секунд и меньше — это огромный шаг вперед, хотя в постоянных 10-15 секундных интервалах ожидания тоже, конечно, ничего хорошего.

Когда мы только-только выкатили проект, результаты были куда лучше. Это стало для нас одним из главных открытий. Если вы прочитаете вводный пост, где я даю общее представление о GFVS, там говорится о том, как мы работали над Git и GVFS, чтобы сделать ряд операций пропорциональными не общему числу файлов в репозитории, но числу «прочитанных» файлов. Как выясняется, со временем инженеры расползаются по кодовой базе и прикасаются к все большему числу файлов, что приводит к проблеме, которую мы называем «over hydration» (перенасыщение). В итоге мы имеем кучу файлов, которых кто-то когда-то касался, но после этого не использовал и определенно не вносил никаких изменений. Как следствие, производительность падает. Люди могут «подчищать» свои списки заходов, но это лишняя морока и никто этого не делает, а работа системы все замедляется и замедляется.

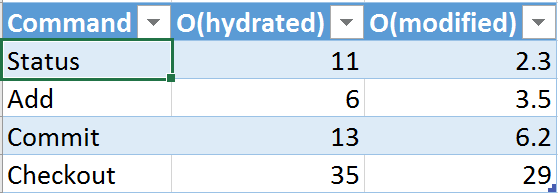

Это вынудило нас запустить очередную серию модификаций для улучшения производительности под названием «O(modified)», которые меняют многие ключевые команды, делая их пропорциональными количеству измененных файлов (в смысле, что имеются изменения, для которых коммит еще не был сделан). Мы добавим эти изменения в основную версию на той неделе, так что у меня еще нет статических данных, но тестирование пилотной версии показало неплохие результаты.

У меня пока что нет всех значений, но я отобрал для примера несколько полей из таблицы выше и вставил соответствующие цифры в колонку O(hydrated). В добавленной колонке O(modified) я привел результаты, которые мы получили по тем же командам с применением оптимизированной версии, которую собираемся выкатить на следующей неделе. Единица измерения там и там — секунды. Как видите, в целом и общем наблюдается заметный прогресс: где-то скорость возросла незначительно, где-то — в два раза, а где-то — в пять. Мы возлагаем большие надежды на эти улучшения и рассчитываем, что они качественно изменят пользовательский опыт. Я не совсем доволен (не успокоюсь, пока Status не станет занимать меньше секунды), но все-таки мы здорово продвинулись.

Другая немаловажная область производительности, которой я не коснулся в предыдущем посте — это географическое распределение команд. Инженеры Windows разбросаны по всему земному шару — США, Европа, Средняя Азия, Индия, Китай и так далее. Pulling большие объемы данных на больших расстояниях, зачастую с далекой от идеала пропускной способностью — серьезная проблема. Чтобы с ней справиться, мы создали прокси-решение на Git для GVFS, которое позволяет кэшировать данные с Git на выходе. Также мы использовали прокси, чтобы разгружать очень большие объемы траффика (скажем, серверы билдов) из главного сервиса Visual Studio Team Services, чтобы пользовательский опыт не страдал даже в часы, когда нагрузка максимальная. В общей сложности у нас 20 прокси для Git (которые, кстати, мы просто инкорпорировали в уже существующий Team Foundation Server Proxy) по всему свету.

Чтобы вы лучше представляли, какой это дало эффект, позвольте привести пример. Аккаунт Windows Team Services находится в дата-центре Azure, на западном побережье США. Выше я указывал, что для инженера Windows операция клонирования по 80му перцентилю занимает 127 секунд. Так как большая часть инженеров работает из Редмонда, это значение актуально в первую очередь для них. Мы провели тест в отделении в Северной Каролине, которое и более удалено от центра, и располагает меньшей пропускной способностью. Без применения прокси на ту же операцию потребовалось около 25 минут. С настроенным и обновленным прокси время сократилось до 70 секунд (то есть быстрее, чем в отделении Редмонда — там команда не пользуется прокси и от Azure их отделяют сотни миль интернет-кабелей). 70 секунд против 25 минут — это улучшение почти на 95%.

В целом, Git с GVFS абсолютно готов к употреблению и может применяться к проектам невероятного масштаба. Результаты показывают, что продуктивность наших инженеров при этом не страдает. Однако нам предстоит еще много работы, прежде чем система будет усовершенствована настолько, чтобы сотрудники были ей довольны. Работа, проделанная в O(modified), которую мы выкатим на следующей неделе, станет большим шагом в этом направлении, но потребуется несколько месяцев дополнительных доработок, чтобы с чистой совестью сказать, что все, что нужно, сделано.

Если хотите подробнее узнать о тех технических сложностях, с которыми мы столкнулись в процессе масштабирования Git и обеспечения хорошего уровня производительности, рекомендую цикл статей о масштабировании Git и GVFS от Saeed Noursalehi. Очень увлекательное чтение.

Попробуйте GVFS сами

GVFS — это проект с открытым кодом, и мы приглашаем всех желающих попробовать с ним поработать. Все, что от вас требуется — скачать и установить его, завести аккаунт в Visual Studio Team Services с репозиторием Git, и можно приступать. С первой публикации GVFS мы основательно продвинулись. Среди самых существенных изменений можно назвать:

1. Мы стали регулярно обновлять кодовую базу, постепенно переходя на «открытую» модель разработки. На данный момент все последние изменения (включая все, что было сделано для O(modified)) опубликованы, и мы планируем периодически загружать обновления и в дальнейшем.

2. На момент первой публикации мы были не готовы принимать вклад от сторонних разработчиков. Сегодня мы дошли до того этапа, когда можем официально заявить, что открыты для этой практики. Нам представляется, что базовая инфраструктура уже в достаточной степени заложена, чтобы дать людям возможность брать и развивать ее вместе с нами. Если кто-то хочет подключиться и помочь — мы будем только рады.

3. GVFS опирается на файловую систему Windows, которую мы называем GVFlt. До сих пор драйвер, доступ к которому мы обеспечили, был неподписанным (так как над ним еще активно велась работа). Очевидно, это значительно усложняло жизнь тем, кто хотел его опробовать. Теперь же мы выпустили подписанную версию GVFlt, в которой устранены все шероховатости (так, вам больше не придется отключать BitLocker для установки). Но хотя у нас появился подписанный GVFlt драйвер, это только временное решение. Мы планируем внедрить соответствующие функции в будущую версию Windows и в данный момент прорабатываем детали.

4. После выступления на конференции Git Merge мы стали активнее обсуждать нюансы масштабирования Git и, в частности, GVFS с широким кругом специалистов, заинтересованных в этой теме. Мы очень продуктивно пообщались с другими крупными компаниями (Google, Facebook), которые сталкиваются с такими же сложностями, и стали делиться своим опытом и подходом. Также мы провели работу с несколькими популярными Git-клиентами, чтобы убедиться, что они совместимы с GVFS. В их число вошли:

- Atlassian SourceTree — SourceTree стал первым инструментом, который прошел валидацию на совместимость с GVFS; уже вышло обновление, в котором были введены некоторые изменения для более гладкого рабочего процесса.

- Tower — команда Tower рада сообщить, что они работают над добавлением поддержки GVFS в версию приложения для Windows. В ближайшем будущем соответствующий функицонал будет доступен в бесплатном обновлении.

- Visual Studio — само собой, неплохо бы и нашему собственному Visual Studio Git нормально работать с GVFS. Мы внедрим поддержку GVFS в версию 2017.3, первое превью которой (со всем необходимым для поддержки) выйдет в начале июня.

- Git на Windows — в рамках своей инициативы по масштабированию Git мы внесли ряд изменений под Git в Windows (к примеру, командная строка Git), включая поддержку GVFS. Сейчас у нас на Git создано особое ответвление для Windows, но со временем мы хотим все перенести в основную версию кода.

Обобщая сказанное

Мы будем и дальше упорно работать над масштабированием Git, чтобы приспособить его для крупных команд и массивных кодовых баз в Microsoft. С тех пор, как мы впервые заговорили об этом проекте три месяца назад, много чего произошло. В частности, мы:

- успешно внедрили проект для 3500 инженеров;

- подключили прокси и доработали продуктивность;

- обновили открытый код и дали другим пользователям возможность вносить правки/вклады;

- обеспечили signed GVFlt драйвер, чтобы проще было воспользоваться сервисом;

- стали сотрудничать с другими командами, чтобы внедрить поддержку в популярные инструменты — SourceTree, Tower, Visual Studio и так далее;

- опубликовали несколько статей, где с технической точки зрения подробно рассматривается наш подход к масштабированию Git и GVFS.

Это был захватывающий опыт для Microsoft и серьезный вызов для моей команды и команды Windows. Я в восторге от того, чего мы уже добились, но не склонен недооценивать объем работы, который еще остается. Если вы тоже часто оказываетесь в ситуациях, когда приходится работать с кодовыми базами очень больших размеров, но при этом всей душой хотите перейти на Git, призываю вас попробовать GVFS. В данный момент Visual Studio — это единственное бэкенд-решение, которое поддерживает GVFS протокол со всеми нововведениями. В дальнейшем, если проект окажется востребован, мы добавим поддержку GVFS также в Team Foundation Server; также мы провели переговоры с другими сервизами Git, создатели которых рассматривают возможность обеспечить совместимость в будущем.

|

Метки: author nanton github git блог компании everyday tools microsoft gvfs |

[Из песочницы] Реактивная обработка стрима логов с RxJava — Часть 1 |

Reactive log stream processing with RxJava — Part l

В предыдущем посте автор рассматривал случаи использования ELK стека и сбора логов.

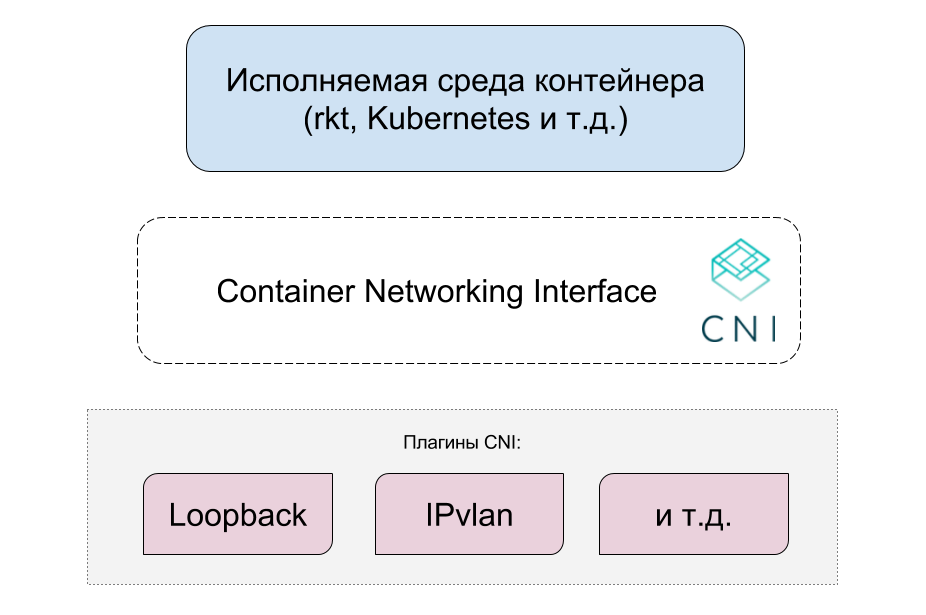

С учетом движения в сторону микросервисов и контейнеризации приложений, централизованная обработка логов и их хранение становится де-факто стандартом.

Может быть, нам стоит попробовать сделать следующий шаг и более активно использовать полученную информацию для того, чтобы находить причины ряда проблем задолго до их появления.*

Сноска — стримы и потоки данных в данном переводе являются взаимозаменяемыми словами. Также слово лог может означать журнал, хотя в большинстве случаев в тексте мы используем иное значение

Если бы мы рассматривали лог событий как поток данных того, что происходит в реальном времени в вашей системе, было бы очень интересно анализировать в реальном времени данные и все возможные варианты их использования, к примеру, обнаружить мошенническое поведение, с помощью агрегирования различных потоков информации непосредственно во время "атаки", и сразу же заблокировать атакующего вместо того, чтобы "традиционно" собирать лог данных и заниматься расследованием уже после возникновения инцидента.

Или другой пример, мы можем отфильтровать (filter) только те события, которые соответствуют определенному типу событий, сгруппировать (group by) их по общему ключу как userID и вычислить общее количество во временном окне, получив количество событий данного типа, которые пользователь совершает в определенный период времени.

failedLogStream()

.window(5,TimeUnit.SECONDS)

.flatMap(window ->

window

.groupBy(propertyStringValue("remoteIP"))

.flatMap(grouped -> grouped

.count()

.map( failedLoginsCount -> {

final String remoteIp = grouped.getKey();

return new Pair<>(remoteIp, failedLoginsCount);

}))

)

.filter(pair -> pair.get > 10)

.forEach(System.out::println); Мы можем инициировать запросы и в других системах и работать с их ответами как с потоками данных, на которые мы можем подписаться и применить несколько привычных операторов для работы со стримами (потоками данных), которые представлены во фреймворках reactive streams (реактивных стримов).

Учим новую парадигму разработки

Хорошо бы разобрать, что такое реактивное программирование стримов, для этого нам нет необходимости разворачивать что-то большое, такое как Kafka Streams Spark or Flink.

Реактивное программирование — это неблокирующие приложения, управляемые событиями, которые масштабируются даже при небольшом числе потоков с противодействием нагрузке (механизм обратной связи, при котором количество данных от производителей не превышает число данных принимаемых потребителями).

Самой большой темой, которую принесет Spring5, будет поддержка Реактивного программирования. Новый модуль spring-web-reactive — фреймворк, похожий на spring-web-mvc, который позволит отдавать асинхронные (неблокирующие) ответы для REST сервисов и реактивный веб-клиент, из чего следует возможность применения данного решение для микросервисной архитектуры. Концепция реактивных стримов не специфична для Spring, поскольку существует общая спецификация reactive-streams-jvm, согласованная большинством реактивных фреймворков (пока для нее, может быть, и не существует идентичного наименования, но концепция должна быть достаточно простой, чтобы стать заменой фреймворкам).

Исторически модель реактивные потоки была представлена Rx.NET, а затем при помощи Netflix портирована на java, получив название RxJava. В то же время концепция был также успешно реализована и в других языках, под названием Реактивные расширения (Reactive EXtensions). С тех пор компании движутся в том же направлении, что и спецификация реактивных стримов. Сейчас RxJava, поскольку он был первопроходцем, нуждается в значительном рефакторинге(переписании кода) — соответственно, версия 2.х лучше соответствует спецификации, и, пока Spring reactor еще новичок, компании не составит труда переписать реализацию согласно спецификации. Рекомендуем прочитать больше о том как они взаимосвязаны.

Doug Lea сообщил, что хочет включить реактивные потоки в состав объекта java.util.concurrent.Flow, а это значит, что реактивные стримы будут поставляться в составе Java 9.

Преимущества с точки зрения производительности

Также другим модным словом сейчас является микросервисная архитектура с обязательной возможностью делать запросы на множество разных сервисов. В идеале, лучше всего выполнять неблокирующие запросы, не ожидая для выполнения следующего запроса получение ответа целиком. Подумайте, вместо того чтобы ждать момента, когда какой-нибудь сервис вернет вам большой список результатов, возможно, стоит в то же время при получении первого фрагмента отправлять новый запрос в другую систему.

Если рассматривать ответ от удаленного запрос как Stream (Стрим-поток данных), подписка на который запускает action (действие) при получении ответа, то вместо блокировки потока, ожидающего свой ответ, мы можем воспользоваться меньшим числом потоков в целом, что, в свою очередь, уменьшит затраты ресурсов (к примеру, процессорное время для переключения контекста между потоками и памяти для каждого стека потоков).

Таким образом, использование реактивного программирования позволит нам на стандартном железе обработать больше логов событий, чем обычно.

Пример: сервису, такому как Gmail, нужно отображать пользовательские почтовые сообщения (emails). Тем не менее, emails, в свою очередь, могут иметь множество людей в копии (CC). Было бы прикольно отобразить фотографию для тех пользователей, которые находятся в твоих контактах, что означает вызов REST — ContactService.

Получится вот так:

Future> emailsFuture = mailstoreService.getUnreadEmails();

List emails = emailsFuture.get(); //блокировка текущего потока

//возможно долгое ожидание, пока не будет получен полный список данных

//можно ли запустить следующий процесс, как только первый фрагмент будет получен?

Future> contacts = getContactsForEmails(emails);

for(Mail mail : emails) {

streamRenderEmails(mail, contacts); //push(отправить) emails клиенту

} Частично проблема была решена с приходом поддержки реактивного программирования в Java 8 с CompletableFuture (со своими thenCompose, thenCombine, thenAccept и еще 50 методами, хотя это не отменяет того факта, что нужно помнить все, что они делают, а это никак не помогает в прочтении кода).

CompletableFuture> emailsFuture = mailstoreService.getUnreadEmails();

CompletableFuture> emailsFuture

.thenCompose(emails -> getContactsForEmails(emails)) //нам все еще нужно ожидать List

.thenAccept(emailsContactsPair -> streamRenderEmails(emailsContactsPair.getKey(), emailsContactsPair.getValue())) Мы можем переключиться на Iterator вместо List-а, и в тоже время не существует методов, говорящих выполнить какое-либо действие при появлении новых значений. В SQL есть такая возможность, к примеру, ResultSet (в котором вы можете выполнить rs.next()) вместо загрузки всех данных в память.

public interface Iterator {

/**

* Возвращает {@code true}, если в итерации больше элементов.

*/

boolean hasNext();

/**

* Возвращает следующий элемент итерации.

*/

E next();

} Но нам все еще нужно постоянно спрашивать "а у тебя есть новое значение?"

Iterable emails = mailstoreService.getUnreadEmails();

Iterator emailsIt = emails.iterator();

while(emailsIt.hasNext()) {

Mail mail = emailsIt.next(); //неблокирующее действие все равно тратит много процессорного времени на получение новых значений

if(mail != null) {

....

}

} Что нам нужно, так это реактивный итератор, такой тип данных, который сможет подписаться и выполнить действие, как только получено новое значение. Именно здесь начинается reactive stream programming (реактивное программирование стримов).

Так что же такое Stream?

Stream по-простому это последовательность упорядоченных во времени событий (событиеX происходит после событияY, так что события не конкурируют между собой).

Stream смоделирован так, что выпускает 0..N событий и одну из двух терминальных операций:

- событие завершения, через которое подписчикам сообщается, что выпуск данных окончен

- событие об ошибке, информирующее об окончании стрима с ошибкой (исключением)

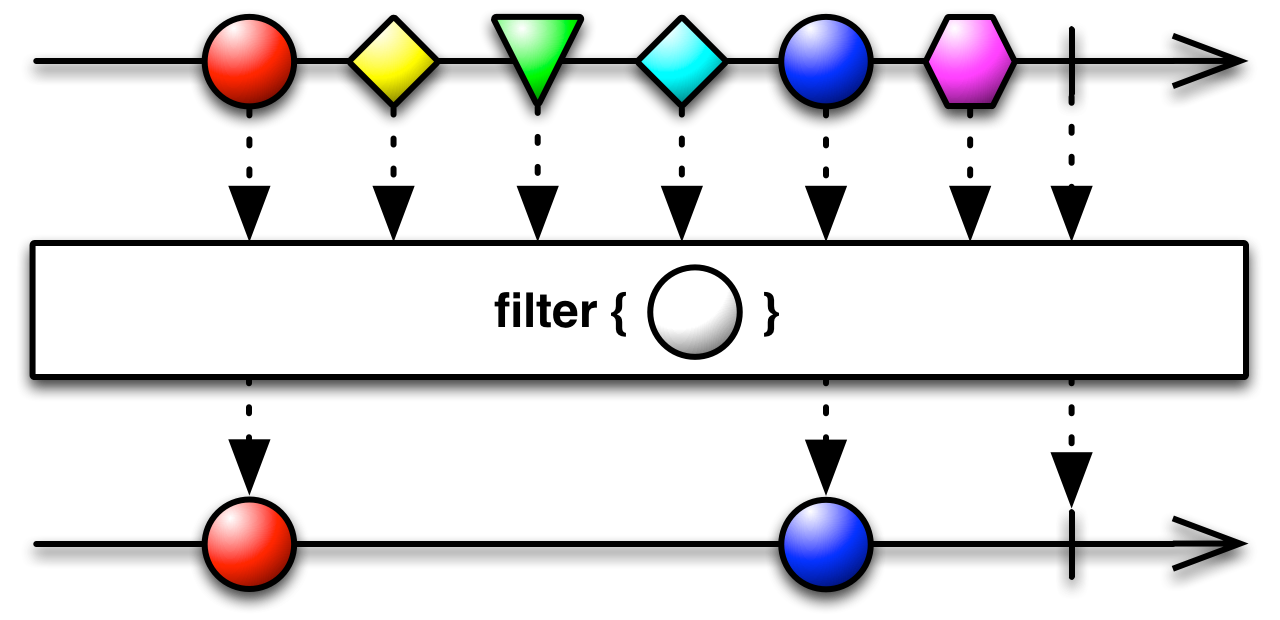

Мы можем описать это визуально с помощью 'marble diagrams'.

Таким образом мы можем представить, что Stream-ом является все, а не только лог событий. Даже единичное значение может быть выражено как Стрим, выпускающий значение, за которым следует событие о завершении.

Бесконечный стрим — стрим, который выпускает события, но без единого терминального события(завершения | ошибки).

RxJava определяет Observable (Наблюдаемый) тип данных для моделирования Stream-а событий типа . В Spring Reactor-е он равен типу Flux.

Observable представляет собой stream температур, взятых с различными интервалами.

Observable представляет собой stream продуктов, купленных в нашем веб магазине.

Observable представляет собой одного пользователя (User), вернувшегося по запросу к БД.

public Observable findByUserId(String userId) {...}

//пусть будет Single для большей наглядности

public Single findByUserId(String userId) {...} Но Observable это просто тип данных, поэтому, как и в случае с шаблоном проектирования Publish/Subscriber (Публикации/Подписчика), нам нужен Subscriber(Подписчик) чтобы обработать 3 типа событий

Observable cartItemsStream = ...;

Subscriber subscriber = new Subscriber() {

@Override

public void onNext(CartItem cartItem) {

System.out.println("Cart Item added " + cartItem);

}

@Override

public void onCompleted() {

}

@Override

public void onError(Throwable e) {

e.printStackTrace();

}

};

cartItemsStream.subscribe(subscriber); Реактивные операторы

Но это просто часть Stream-a, а до сих пор мы не применяли ничего необычного, только классический шаблон проектирования Observer (Наблюдатель).

Reactive (Реактивная) же часть означает, что мы можем определить некоторые Function (операторы — функции), которые будут выполнены, когда stream запустит событие.

Это значит, что будет создан другой stream (стримы immutable), на который мы можем подписать другой оператор и т.д.

Observable filteredCartStream = cartStream.filter(new Func1() {

@Override

public Boolean call(CartItem cartItem) {

return cartItem.isLaptop();

}

});

Observable laptopCartItemsPriceStream = filteredCartStream.map(new Func1() {

@Override

public Long call(CartItem cartItem) {

try {

return priceService.getPrice(cartItem.getId());

} catch(PriceServiceException e) {

thrown new RuntimeException(e);

}

}

}); Поскольку операторы (методы) класса Observable (filter, map, groupBy,...) возвращают Observable, это значит, что мы можем использовать цепочку из операторов, чтобы объединить их с лямбда синтаксисом и написать что-нибудь красивое.

Observable priceStream = cartStream

.filter((cartItem) -> cartItem.isLaptop()).

.map((laptop) -> {

try {

return priceService.getPrice(cartItem.getId());

} catch(PriceServiceException e) {

thrown new RuntimeException(e);

}

}); Обратите внимание, что выше, когда создается priceStream, ничего не происходит — priceService.getPrice() не вызывается, пока нет элемента, проходящего по цепочке операторов. Это означает, что мы создали через rx-оператор подобие плана, как управляемые данные будут спускаться вниз по цепочке(подписание регистрируется).

Когда просят объяснить реактивное программирование, обычно в шутку дают пример с Excel листами, где в колонках написаны формулы, вызываемые при обновлении ячейки, что, в свою очередь, обновляет другую ячейку, которая, в свою очередь, обновляет другую и так далее по цепочке.

Прямо как rx-operator, который ничего не делает, эти формулы просто управляют данными и каждая из них получает свой шанс сделать что-то до того момента, как данные спустились вниз по цепочке.

Чтобы лучше понимать, как события путешествуют вместе с цепочкой операторов, я нашел полезную аналогию, в примере с переездом из одного дома в другой, грузчики выступают в роли операторов, вместе с которым перемещаются вещи из вашего дома — так это изобразил Томас Нильд.

Его пример с кодом:

Observable- mover1 = Observable.create(s -> {

while (house.hasItems()) {

s.onNext(house.getItem());

}

s.onCompleted();

});

Observable

- mover2 = mover1.map(item -> putInBox(item));

Subscription mover3 = mover2.subscribe(box -> putInTruck(box),

() -> closeTruck()); //это сработает на событие OnCompleted()

"Грузчик 1 с одной стороны источник Observable. Он создает выбросы за счет того, что выносит вещи из дома. Он вызывает Грузчика 2 с методом onNext(), который выполняет map() операцию. Когда его метод onNext() вызван, он берет вещь и перекладывает в коробку. Затем он вызывает Грузчика 3, конечного Subscriber(подписчика), с методом onNext(), который грузит коробку в машину."

Магия RxJava — это большой набор доступных операторов, ваша же работа заключается в комбинировании их всех вместе для управления течением данных.

Множество Stream операторов помогают составить словарь терминов для обозначения действий, производимых со стримами, которые могут быть реализованы в популярных языках (RxJava, RxJS, Rx.NET, etc) из числа ReactiveX framework (Реактивных расширений).

Эти понятия надо знать даже при использовании различных фреймворков для работы с реактивными стримами, таких как Spring Reactor (в надежде на наличие неких операторов, общих для этих фреймворков).

Пока что мы видели только простые операторы, такие как фильтрация:

Которые только пропускают элементы, попадающие под условие фильтра (один грузчик перенесет только те вещи, которые стоят меньше 100$, вместо того, чтобы передать сразу все другому грузчику)

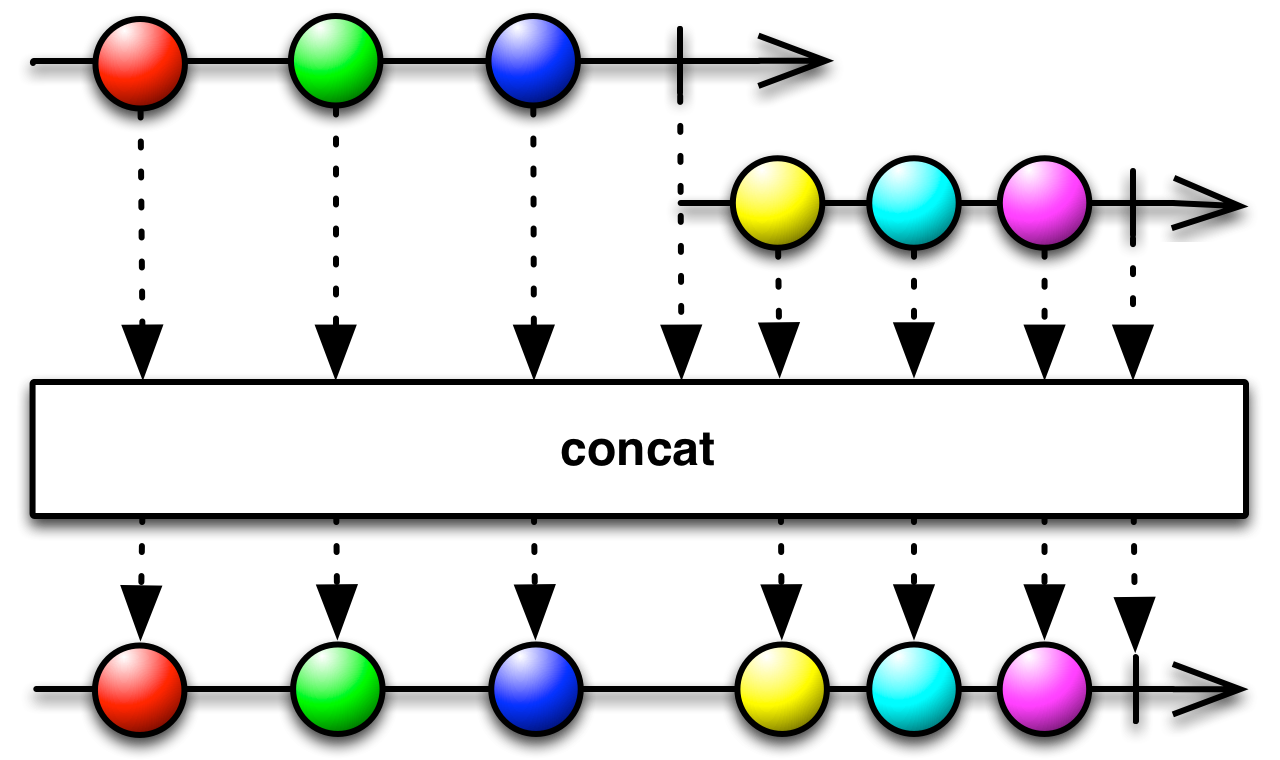

Однако есть операторы, которые могут разбить стрим на множество отдельных стримов — Observable>(Стрим стримов) — это такие операторы, как groupBy

Observable values = Observable.just(1,4,5,7,8,9,10);

Observable> oddEvenStream = values.groupBy((number) -> number % 2 == 0 ? "odd":"even");

Observable remergedStream = Observable.concat(oddEvenStream);

remergedStream.subscribe(number -> System.out.print(number +" ")); //Выводит

//1 5 7 9 4 8 10 и достаточно простой оператор concat, который снова из четных и нечетных стримов создает один-единственный стрим, и устанавливает на него подписку.

Мы видим, что оператор concat ожидает завершения стрима перед тем, как добавить еще один, снова создавая один стрим. Таким образом, нечетные числа отображаются первыми.

Также у нас есть возможность скомбинировать вместе множество stream-ов, как, например, это делает zip оператор

Zip назван так не потому, что он работает как архиватор, но скорее из-за то, что он, как молния (на куртке), комбинирует события из двух stream-ов.

Он берет одно событие из одного stream-а и соединяет с событием из другого (делая пару). Как только это выполнено, он применяет оператор склеивания, перед тем, как спуститься дальше по цепочке.

PS: это работает и для большего количества stream-ов.

Так что, даже если один stream выпускает события быстрее, то дальше слушатель увидит только скомбинированное событие, которое выпустится из более медленного stream-а.

Иметь возможность "ждать" ответа от множества удаленных вызовов, которые мы получаем от stream-ов, на самом деле очень полезно.

С другой стороны, оператор combineLatest не ожидает выпуска пары событий, но вместо этого, использует последние выпущенные события из более медленного stream-а, до применения функции склейки и передачи его дальше по цепочки.

Движемся к мышлению на основе Push подхода

Давайте рассмотрим несколько примеров, как на самом деле создают Observables. Наиболее длинный вариант создания:

log("Before create Observable");

Observable someIntStream = Observable

.create(new ObservableOnSubscribe() {

@Override

public void subscribe(ObservableEmitter emitter) throws Exception {

log("Create");

emitter.onNext(3);

emitter.onNext(4);

emitter.onNext(5);

emitter.onComplete();

log("Completed");

}

});

log("After create Observable");

log("Subscribing 1st");

someIntStream.subscribe((val) -> LOGGER.info("received " + val));

//мы можем опустить реализацию

//другие методы(for onError and onComplete) если мы ее хотим сделать, что-то особенное

log("Subscribing 2nd");

someIntStream.subscribe((val) -> LOGGER.info("received " + val)); События посылаются подписчику, как только тот подписался.

Не то, что мы пользуемся такой конструкцией, просто мы передали новый объект ObservableOnSubscribe, который демонстрирует, что делать, когда на него кто-нибудь подписывается.

Пока мы не подписались на Observable, выходных данных нет и ничего не происходит, данные не движутся.

Когда кто-то подписывается, вызывается метод call() и 3 сообщения проталкиваются вниз по цепочке, следом за ними идет сигнал, что stream завершился.

Выше мы дважды подписались, код внутри метода call(...) также будет вызван дважды. Так что он эффективно переотправляет те же значения, как только кто-нибудь еще подпишется и тогда получит следующие значения на вывод:

mainThread: Before create Observable

mainThread: After create Observable

mainThread: Subscribing 1st

mainThread: Create

mainThread: received 3

mainThread: received 4

mainThread: received 5

mainThread: Completed

mainThread: Subscribing 2nd

mainThread: Create

mainThread: received 3

mainThread: received 4

mainThread: received 5

mainThread: Completed Важно заметить, что rx операторы не обязательно означают многопоточность. RxJava не внедряет конкурентность по умолчанию между Observable и Subscriber. Поэтому все вызовы происходят на "главном" потоке.

Такой тип Observable, которые начинают распространение, когда кто-нибудь подписан называются cold observables(холодные наблюдатели). Другой вид — hot observables(горячие наблюдатели), они могут выпускать события, даже когда никто не подписан на них.

Cold Observablesначинают распространять события только когда кто-то подписывается. Каждый подписчик получает одни и те же события. Например, как CD на котором играют одни и те же песни для того, кто включил cd в плеер послушать.Hot Observablesсобытия распространяются даже когда на них еще никто не подписался. Как радиостанция которая проигрывает песни через радиовещание, даже когда никто его не включал. И так же, как при включении радиоприемника, ты пропускаешь предшествующие события. Hot observable моделирует события, распространением которых вы не можете управлять. Примерно как в случае записи событий в журнал (лог событий).

Subjects это такой специальный вид Observable, который также является Observer (как Subscriber — который решает, что он может протолкнуть данные (вызовом onNext()) до них) и сделает реализацию горячих Observables проще. Также существует множество реализаций, подобных ReplaySubject, которые сохраняют выделенные события в буфере и воспроизводят их по подписке (конечно, можно указать размер буфера, чтобы предотвратить ошибку OutOfMemory), пока PublishSubject только пропускает события, которые случились после подписания.

И конечно, существует множество статических методов для создания Observables и из других источников.

Observable.just("This", "is", "something")

Observable.from(Iterable collection)

Observable.from(Future future) - передает значение после того, как `future` выполнится Добавление в наш ELK-стек RabbitMQ эмиттера данных, отправляемых посредством push

По традиции, работая со стеком ELK, мы используем ElasticSearch чтобы запросить данные по логу событий, так что можно сказать, что они в опрашивающем стиле 'pull-based'.

Можем ли вместо этого иметь push-based, где мы собираемся информировать 'незамедлительно' при появлении события в журнале, чтобы дальше уменьшить время реагирования на событие, с того момента как оно произошло и до того как мы начнем его обрабатывать.

Одним из множества возможных решение может стать RabbitMq, как бывалое в сражениях решение с очень хорошей репутацией за его производительность, за его возможность обработки огромного числа сообщений. Несмотря на это Logstash уже поддерживает плагин для RabbitMQ (также есть еще один плагин для FluentD) так что мы можем с легкостью интегрировать его в наш существующий ELK стек и записывать логи в ElasticSearch и RabbitMQ.

Возможно вы помните, что Logstash может вести себя как контроллер, и выбирать как ему работать, и куда отправлять/сохранять логируемые событий. Это значит что мы можем отфильтровать те события, которые хотим обработать или указать куда их послать, например, в другие RabbitMQ очереди.

Существует даже возможность напрямую отправлять данные в RabbitMQ через Logback Appender, если вам захочется опустить использование Logstash.

К слову сказать: Пока так называемый AmqpAppender, является скорее специфичной реализацией RabbitMQ AMQP (с версией протокола AMQP 0-9-1, 0-9).

ActiveMQ для примера (пока тоже поддерживает AMQP connector) кажется реализует протокол версии AMQP 1.0, пока spring-amqp библиотека с протоколом версий 0-9-1, 0-9, которые совсем отличаются от 1.0), так что вы может столкнетесь с ошибками по типу 'org.apache.activemq.transport.amqp.AmqpProtocolException: Connection from client using unsupported AMQP attempted'

Однако наше решение было чтобы использовать logstash-logback-encoder и отправлять отформатированный JSON с журналом событий в Logstash. Мы перенаправим logstash вывод на точку обмена RabbitMQ (exchange).

Мы будем использовать docker-compose, чтобы запустить кластер logstash-rabbitmq

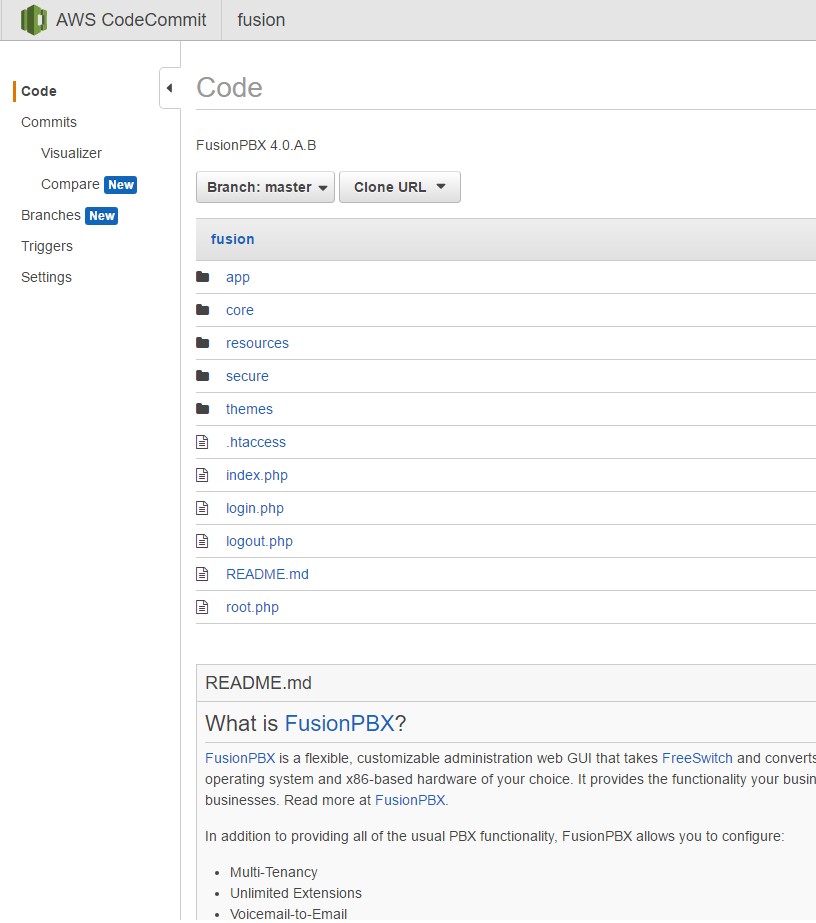

Вы можете склонировать репозиторий

docker-compose -f docker-compose-rabbitmq.yml up

и затем вы можете использовать

./event-generate.sh

чтобы сгенерировать некоторое число случайных событий которые будут отправлены на logstash.

Для того, чтобы определить, куда отправлять данные, используйте файл настроек logstash. Мы используем rabbitmq-output-plugin, как ссылку:

output {

rabbitmq {

exchange => logstash

exchange_type => direct

host => rabbitmq

key => my_app

}

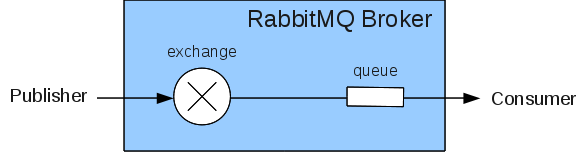

}RabbitMQ это не классический JMS сервер, вместо этого он использует AMQP протокол, который имеет весьма отличную от остальных концепцию для очередей.

Издатель отправляет сообщения на именованную точку обмена (exchange) и потребитель забирает сообщения из очереди.

У сообщения есть стандартный заголовок 'routing-key', который используется в процессе называемом ассоциативным привязкой, чтобы связать обмен сообщениями в очереди. Очереди могут фильтровать какие сообщения они получают через ключ привязки, и к тому же можно использовать подставленные знаки в привязке как эти 'logstash.'

Для более подробного объяснения AMQP вы можете прочитать здесь и тут. Так мы настроили Spring соединение c RabbitMq

@Bean

ConnectionFactory connectionFactory() {

return new CachingConnectionFactory(host, port);

}

@Bean

RabbitAdmin rabbitAdmin() {

RabbitAdmin rabbitAdmin = new RabbitAdmin(connectionFactory());

rabbitAdmin.declareQueue(queue());

rabbitAdmin.declareBinding(bindQueueFromExchange(queue(), exchange()));

return rabbitAdmin;

}

@Bean

SimpleMessageListenerContainer container(ConnectionFactory connectionFactory, MessageListenerAdapter listenerAdapter) {

SimpleMessageListenerContainer container = new SimpleMessageListenerContainer();

container.setConnectionFactory(connectionFactory);

container.setQueueNames(queueName);

container.setMessageListener(listenerAdapter);

return container;

}

@Bean

Queue queue() {

return new Queue(queueName, false);

}

DirectExchange exchange() {

return new DirectExchange("logstash");

}

private Binding bindQueueFromExchange(Queue queue, DirectExchange exchange) {

return BindingBuilder.bind(queue).to(exchange).with("my_app");

}

@Bean

MessageListenerAdapter listenerAdapter(Receiver receiver) {

MessageListenerAdapter messageListenerAdapter = new MessageListenerAdapter(receiver,

new MessageConverter() {

public Message toMessage(Object o, MessageProperties messageProperties)

throws MessageConversionException {

throw new RuntimeException("Unsupported");

}

public String fromMessage(Message message) throws MessageConversionException {

try {

return new String(message.getBody(), "UTF-8");

} catch (UnsupportedEncodingException e) {

throw new RuntimeException("UnsupportedEncodingException");

}

}

});

messageListenerAdapter.setDefaultListenerMethod("receive"); //the method in our Receiver class

return messageListenerAdapter;

}

@Bean

Receiver receiver() {

return new Receiver();

}Мы определили очередь и связываем с сервисом обмена 'logstash', чтобы принять сообщения с ключем маршрутизации 'my_app'. MessageListenerAdapter выше определяет, что метод 'receive' должен быть вызван на бине Receiver каждый раз, когда новое сообщение приходит из очереди.

Поскольку мы ожидаем непрерывный поток в лог событий, мы не имеем над ним контроль, мы можем подумать об использовании hot observable, которые распространяют события всем подписчикам после того, как они подписались, так что мы используем для работы PublishSubject.

public class Receiver {

private PublishSubject publishSubject = PublishSubject.create();

public Receiver() {

}

/**

* Method invoked by Spring whenever a new message arrives

* @param message amqp message

*/

public void receive(Object message) {

log.info("Received remote message {}", message);

JsonElement remoteJsonElement = gson.fromJson ((String) message, JsonElement.class);

JsonObject jsonObj = remoteJsonElement.getAsJsonObject();

publishSubject.onNext(jsonObj);

}

public PublishSubject getPublishSubject() {

return publishSubject;

}

} Мы должны знать, что событие SimpleMessageListenerContainer поддерживает наличие более одного потока, который потребляет из очереди (и пропускает события вниз по цепочки). Однако контракт Observable говорит, что мы не можем выделять события конкурентно (вызовы onNext,onComplete, onError должны быть сериализованы):

// ТАК ДЕЛАТЬ НЕ НАДО

Observable.create(s -> {

// Thread A

new Thread(() -> {

s.onNext("one");

s.onNext("two");

}).start();

// Thread B

new Thread(() -> {

s.onNext("three");

s.onNext("four");

}).start();

});

// ТАК ДЕЛАТЬ НЕ НАДО

//ДЕЛАЙТЕ ТАК

Observable obs1 = Observable.create(s -> {

// Thread A

new Thread(() -> {

s.onNext("one");

s.onNext("two");

}).start();

});

Observable obs2 = Observable.create(s -> {

// Thread B

new Thread(() -> {

s.onNext("three");

s.onNext("four");

}).start();

});

Observable c = Observable.merge(obs1, obs2); Мы можем обойти эту проблему вызывая Observable.serialize() или Subject.toSerialized(), но мы остаемся со значение по умолчанию 1 Thread в ListenerContainer, нет необходимости делать это. Еще вы должны быть в курсе того, что если вы планируете использовать Subjects как шину событий, распространяющихся на несколько потоков. Прочитайте подробное объяснение.

А сейчас вы можете взглянуть на код и репозиторий, как продолжение этого длинного поста Part II (Части 2) или перейдите на Rx Playground там вы найдете больше примеров.

|

Метки: author isatimur java elk rxjava |

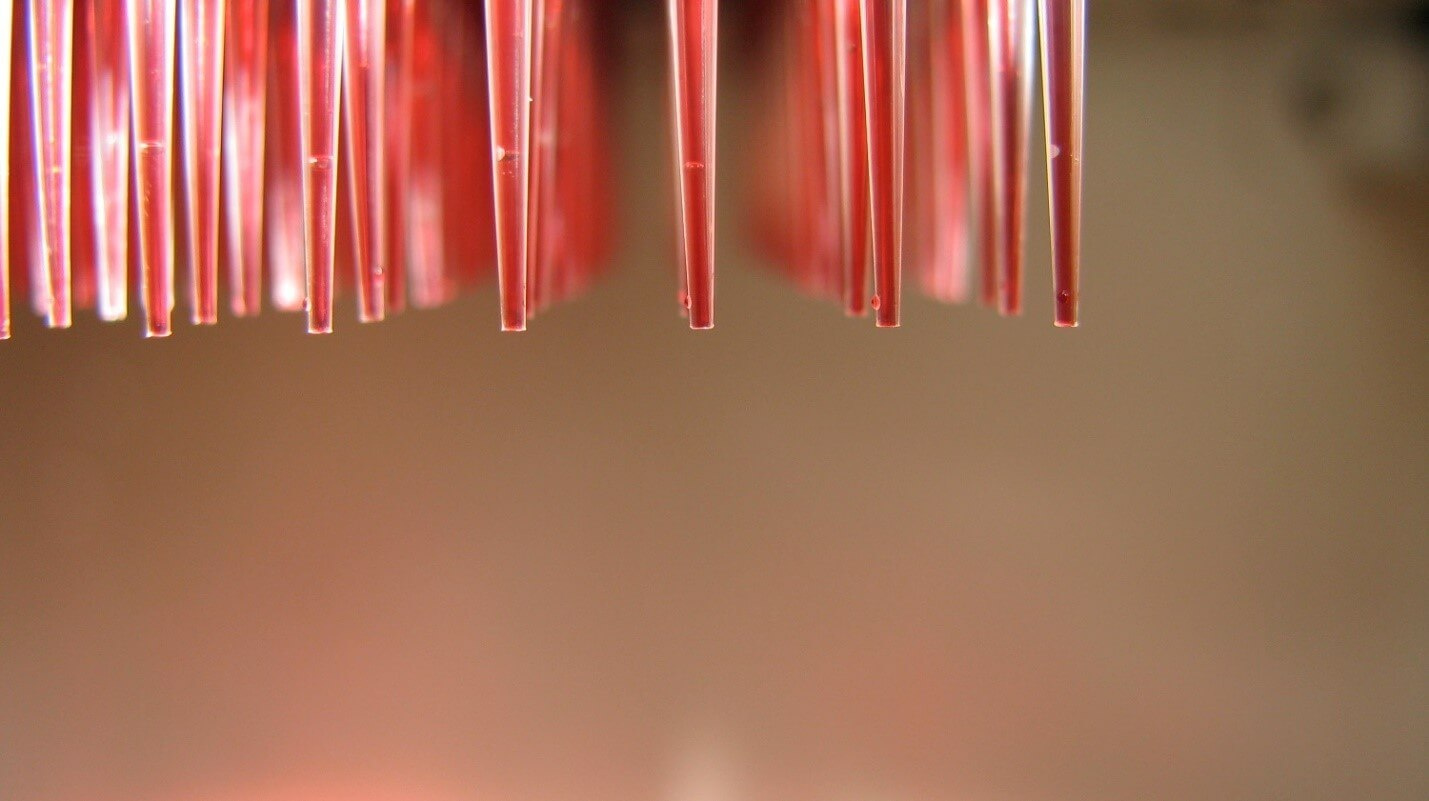

Microsoft внедрит ДНК-хранилище в одном из своих ЦОД |

/ фото igemhq CC

/ фото igemhq CCНад новым проектом работает исследовательское подразделение компании Microsoft Research, ученым из которого удалось записать на искусственные спирали ДНК 200 мегабайт данных. В молекулы дезоксирибонуклеиновой кислоты записали музыкальный клип в высоком разрешении, Всеобщую декларацию прав человека, переведенную на 100 языков и первые сто книг в списке проекта «Гутенберг».

Microsoft использует метод, предложенный специалистами из Гарварда, которые отказались от работы с живыми организмами — теперь синтетическая ДНК внедряется в молекулу, сгенерированную на специальном ДНК-чипе.

Сначала единицы и нули двоичного кода переводятся в комбинации нуклеотидов — аденин, гуанин, цитозин и тимин. Затем, выполняется синтез искусственной ДНК со всеми этими данными. Для определения конца и начала записываемых файлов в молекулу ДНК вводятся специальные маркеры. Из электронной версии сформированной последовательности компания-подрядчик Twist Bioscience синтезирует фрагменты ДНК длиной в 150 нуклеотидов каждый. Всего для записи понадобилось порядка 1,5 млрд азотистых оснований.

Даг Кармин говорит, что разрабатываемая ими система будет сопоставима по размерам с крупными копировальными аппаратами от Xerox 70-х годов прошлого века. Скорость записи данных пока что составляет всего 400 байт в секунду. Для считывания данных с ДНК используются секвенаторы.

Сейчас массовому внедрению систем хранения данных на основе ДНК препятствуют дороговизна технологии и низкие скорости чтения/записи информации. В Microsoft считают, что для успешного коммерческого внедрения решения необходимо удешевить его в 10 тыс. раз и увеличить скорость записи до 100 мегабайт в секунду.

Однако при этом в компании убеждены, что даже удвоения скорости чтения данных с ДНК будет достаточно, чтобы создать коммерческий продукт для определенных ситуаций, например архивирования важной медицинской информации. Также исследователи из Microsoft ставят перед собой более амбициозную цель — заменить ДНК-носителями магнитную ленту, до сих пор использующуюся сегодня для длительного хранения информации.

P.S. Другие материалы из Первого блога о корпоративном IaaS:

- Резервное копирование, клонирование и восстановление данных с помощью инструментов NetApp и VMware. Часть 1

- Резервное копирование, клонирование и восстановление данных с помощью инструментов NetApp и VMware. Часть 2

- Облачные технологии в киноиндустрии: как DreamWorks решила проблему обработки больших объемов данных

- Хостинг персональных данных в облаке— особенности услуги

- Репликация данных в облако NetApp сервис-провайдера

- Зарубежное или локальное размещение данных в облаке: подводные камни

|

Метки: author it_man хранение данных блог компании ит-град ит-град днк microsoft |

Пятое поколение СХД HPE MSA: удвоенная производительность за ту же цену |

HPE MSA: решения для хранения данных, масштабируемые по мере роста компании

Малый и средний бизнес, ограниченный бюджетными рамками и недостатком квалифицированного ИТ-персонала, требует правильной архитектуры СХД – такой, которая обеспечит простое управление при невысокой совокупной стоимости владения. Внедрение доступных по цене решений для хранения данных — первый шаг к эффективному управлению данными и ИТ-инфраструктурой.

Семейство продуктов HPE MSA включает в себя СХД начального уровня, которые обеспечивают оптимальную производительность, используя флеш-память для ускорения обработки рабочих нагрузок. Эти платформы обладают встроенной технологией динамического распределения данных по уровням (tiering), которая значительно повышает производительность бизнес-приложений. Системы MSA интегрируются с наиболее популярными гипервизорами для консолидации рабочих нагрузок и сокращения расходов на инфраструктуру ИТ. Расширенные функции программного обеспечения помогают повысить производительность среды хранения данных предприятия и обеспечивают бесперебойную работу бизнес-процессов.

Представляем пятое поколение систем MSA

Новая гибридная система MSA 2052 со встроенными накопителями флеш и базовая модель MSA 2050 (готовая к работе с флеш) предназначены для обеспечения высокой доступности данных приложений. Подключение к хосту осуществляется по протоколам FC, iSCSI и SAS. Кроме того, решения MSA 2050/2052 обладают средствами репликации данных и могут применяться для организации работы удаленных офисов и филиалов. Они просты в установке, управлении и обслуживании.

Расширенные опции HPE для управления данными (в том числе автоматическое распределение данных по уровням, динамическое выделение ресурсов, удаленная репликация и др.) помогают системным администраторам адресовать рост рабочих нагрузок и обеспечить высокую производительность всей инфраструктуры. Массив не требует глубокой настройки и специальных навыков администратора.

Конструкция и архитектура систем MSA пятого поколения

Системы MSA пятого поколения, включая модели MSA 2050 и 2052, специально предназначены для повышения скорости и надежности работы бизнес-приложений. Эти высокопроизводительные решения на основе флеш-накопителей обеспечивают усиленную защиту данных и большую емкость хранения. По сравнению с предыдущим поколением, системы MSA 2050 обеспечивают до двух раз больше производительности операций ввода-вывода по той же цене. Технология автоматического распределения данных по уровням (tiering) быстро адаптирует работу массива к изменяющейся нагрузке.

Новая система MSA подходит для организации сети хранения данных (SAN) начального уровня, обеспечивая высокую эффективность и возможности масштабирования. Стоимость новых систем MSA начинается от менее чем 10 000 долл. США, при этом они способны выполнять более 200 000 операций ввода-вывода в секунду.

Системы MSA 2050 и 2052 используют одинаковые контроллеры. Различия связаны с дополнительными опциями. MSA 2052 поставляется с двумя SSD объемом 800 ГБ, лицензией на Advanced Data Services и 512 мгновенных снимков. MSA 2050 поставляется без SSD, но с пакетом Advanced Data Services, за исключением автоматического распределения по уровням производительности (performance tiering). Лицензию на расширенное количество мгновенных снимков также можно докупить за номинальную стоимость.

Новые контроллеры поддерживают работу с существующими моделями дисков 12Gb. Благодаря этому возможно модернизировать системы MSA 2040/2042 путем простой замены контроллеров. Данные приложений при этом остаются доступными.

15 июня мы проведем вебинар, на котором подробно рассмотрим новинки и сможем ответить на ваши вопросы. Регистрация по ссылке.

А пока предлагаем посмотреть обзор ChalkTalk (внизу, на английском) о возможностях MSA нового поколения.

Материалы:

1. Driving Simplicity and Performance with a New Generation of HPE MSA Storage (блог Тима Питерса, вице-президента и главного руководителя по серверам HPE ProLiant и решениям для малого и среднего бизнеса)

2. HPE and Nimble Storage News Ahead of Discover (блог Кэлвина Зито, HPE Storage)

|

Метки: author beibaraban хранение данных it- инфраструктура блог компании hewlett packard enterprise msa storage схд hpe hewlett packard enterprise |

Сравнение Эльбрус-4С и Эльбрус-8С в нескольких задачах машинного зрения |

|

|

Реалистичный Realm. 1 год опыта |

Realm давно известен в среде мобильных (и не только) разработчиков. К сожалению, в рунете почти нет статей об этой базе данных. Давайте исправим эту ситуацию.

Ровно год назад в build.gradle нашего проекта появилась строчка:

classpath "io.realm:realm-gradle-plugin:0.89.1" За этот год код Realm вырос до версии 3.3, обзавелся множеством фич и починил кучу багов, реализовал новый функционал и получил облачный бекенд. Давайте поподробнее поговорим о Realm в реалиях Andoroid разработки и обсудим тонкие моменты, возникающие при его использовании.

- О нас

- Realm как стартап

- Realm как база данных

- Hello world

- Сравнение с другими базами данных

- Live Objects — Синхронное чтение

- Live Objects — Асинхронное чтение

- Основные особенности Realm объектов

- Транзакции

- Синхронные транзакции

- Асинхронные транзакции

- Open/close realm

- Notifications, RxJava

- Многопоточность и асинхронность

- Тестирование

- Один Realm хорошо, а три лучше

- Наследование и полиморфизм

- Kotlin

- Realm mobile platform

- Отладка

- Архитектура

- Полезные ссылки

- Заключение

О нас

Мы разрабатываем приложение для коммуникации внутри команды, что-то среднее между telegram и slack. Android приложение написано на Kotlin, с самого начала использовался подход offline-first, т.е. когда все данные, отображенные на экране, достаются из кэша. Попробовав несколько разных баз данных, мы остановились на Realm и в течении года активно использовали его. Данная статья выросла из внутреннего документа по использованию Realm. Статья не является переводом документации и не претендует на полноту описания, это скорее сборник рецептов и разбор тонких моментов. Для полного понимания строго рекомендуем прочитать официальную документацию. Мы же расскажем о своем опыте и какие шишки набили за этот год. Весь код для статьи написан на Kotlin, найти его вы можете на Github.

Realm как стартап

Если говорить о Realm как о компании, то это датский стартап основанный в 2011 году. Ранее проект назывался tight.db. За время существования привлечено 29M$ инвестиций. Зарабатывать компания планирует на основе Realm Mobile Platform, сама же база данных бесплатная и опенсорсная. Realm под Android появился в 2014 году и с тех пор постоянно развивается. Некоторые апдейты ломают обратную совместимость, однако фиксы можно сделать достаточно легко и быстро.

Realm как база данных

Realm — это база данных для нескольких платформ. О себе они пишут:

The Realm Mobile Platform is a next-generation data layer for applications. Realm is reactive, concurrent, and lightweight, allowing you to work with live, native objects.

Если кратко, то это нативная no-sql база данных для Android (Java, Kotlin), iOS (Objective-C, Swift), Xamarin (C#) и JavaScript (React Native, Node.js).

Так же есть backend, который позволяет синхронизировать данные из всех источников.

Из ключевых особенностей стоит отметить zero copy, MVCC и ACID. Встроенного механизма устаревания и очистки данных нет.

У Realm есть очень хорошая документация и множество примеров на github.

Сотрудники Realm периодически мониторят StackOverflow, также можно завести issue на github.

Hello world

Hello world под Android выглядит следующим образом:

Добавим в build.gradle

build.gradle (Project level)

classpath "io.realm:realm-gradle-plugin:3.3.0"

build.gradle (App level)

apply plugin: 'realm-android'В Application настроим Realm Configuration

Realm.init(this)

val config = RealmConfiguration.Builder()

.build()

Realm.setDefaultConfiguration(config)

И можно начинать работать с базой данных:

val realm = Realm.getDefaultInstance()

realm.executeTransaction { realm ->

val dataObject = realm.createObject(DataObject::class.java)

dataObject.name = "A"

dataObject.id = 1

}

val dataObject = realm.where(DataObject::class.java).equalTo("id", 1).findFirst()

dataObject.name // => A

realm.executeTransaction { realm ->

val dataObjectTransaction = realm.where(DataObject::class.java).equalTo("id", 1).findFirst()

dataObjectTransaction.name = "B"

}

dataObject.name // => B

Сравнение с другими базами данных

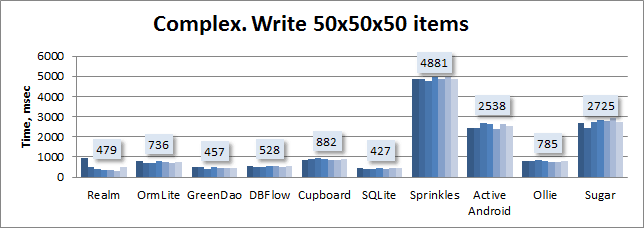

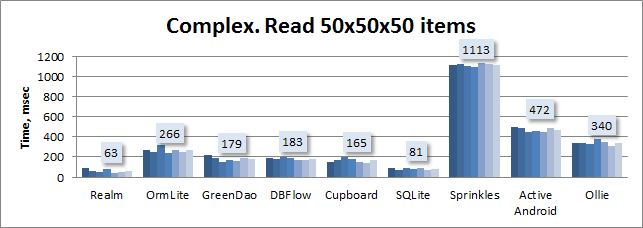

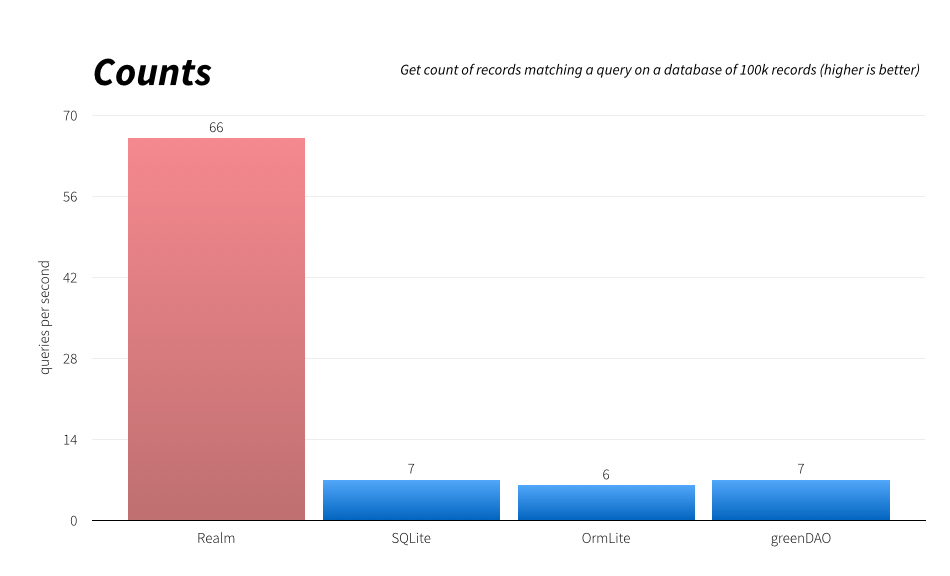

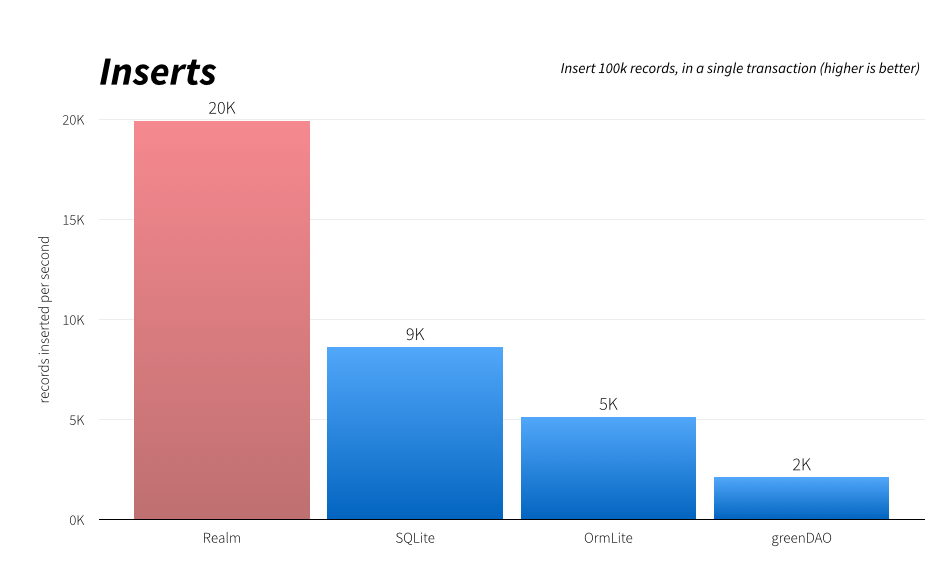

На хабре есть статья от 8 апреля 2016 года, где сравниваются 9 ORM под Android, в том числе Realm. Realm там в лидерах, вот графики:

На своем сайте Realm приводит следующую статистику:

Можно выделить три главные особенности, которые необходимо учитывать:

Live Objects — Все объекты, полученные из Realm, являются, по сути, прокси к базе данных. За счет этого достигается zero copy (объекты не копируются из базы)

Transactions — Все изменения привязанных объектов данных нужно проводить внутри транзакции

Open\Close — Необходимость открытия\закрытия instance базы данных

Live Objects

Все объекты из Realm можно получить синхронно или асинхронно.

Синхронное чтение

fun getFirstObject(realm: Realm, id: Long): DataObject? {

return realm.where(DataObject::class.java).equalTo("id", id).findFirst()

}Вызываем метод Realm и блокируем поток, пока не получим объект или null. Использовать объекты, полученные в других потоках, нельзя, поэтому для использования в главном потоке, нужно блокировать ui или использовать асинхронные запросы. К счастью, Realm предоставляет нам прокси, а не сам объект, поэтому все происходит достаточно быстро. С объектом можно работать сразу после получения.

Асинхронное чтение

Весьма неочевидный кейс. Как вы думаете, что произойдет в этом коде:

val firstObject = realm.where(DataObject::class.java).findFirstAsync()

log(firstObject.id)Правильный ответ: получим ошибку java.lang.IllegalStateException

При асинхронном чтении мы хоть и получаем объект сразу, но работать с ним не можем, пока он не загрузится. Проверять это нужно с помощью функции isLoaded() или вызвать блокирующую функцию load(). Выглядит достаточно неудобно, поэтому тут лучше использовать rx. Преобразуем в observable и получаем загруженный объект в OnNext. Асинхронные операции доступны только в потоках с Looper.

fun getObjectObservable(realm: Realm, id: Long): Observable {

return realm.where(DataObject::class.java).findFirstAsync().asObservable()

}

Основные особенности Realm объектов

- Получение объектов из базы очень быстрое, десериализации как таковой нет, чтение с диска происходит только при обращении к конкретному полю

- Именно для этого существует требование делать все поля приватными и обращаться через геттеры

- Метод copyFromRealm() — позволяет получать отвязанные, полностью собранные объекты, прямо как обычная ORM. Правда и все фишки Realm становятся недоступны. На вход принимается глубина десериализации, по умолчанию MAX_INT

- В дебагере все поля будут null. Для получения какого-либо значения нам нужно обращаться через геттер

- Все объекты Live, т.е живые. Изменения распространяются моментально в рамках одного потока. Более сложные кейсы смотрите ниже (многопоточность).

- Фильтрация объектов осуществляется по полям, причем названия полей вы указываете руками в виде строки. Например так: .equalTo(«id», 1). Это усложняет рефакторинг и приводит к ошибкам в наименовании полей для фильтрации. К сожалению Realm не генерирует переменные с названиями полей, поэтому все выборки лучше прятать внутри функции:

fun findFirstDataObject(id: Long, realm: Realm) : DataObject = realm.where(DataObject::class.java).equalTo("id", id).findFirst()

или использовать генератор имен полей от cmelchior

- Этот пункт изменился прямо во время написания статьи (яркий пример того, как развивается проект)

Было: Невозможно использовать DiffUtil при изменении объекта, невозможно понять какие поля у объекта изменились. Т.е. если вам пришла нотификация об изменении объекта, невозможно понять что у него изменилось. Связано это с тем, что оба объекта (старый и новый) являются live объектами и ссылаются на одни и те же данные, они всегда будут равны.

Стало: Можно использовать RealmObjectChangeListener для понимания что изменилось:

RealmObjectChangeListenerPerson p = realm.where(Person.class).findFirst(); p.addChangeListener(new RealmObjectChangeListener() { @Override public void onChange(Person person, ObjectChangeSet changeSet) { if (changeSet.isDeleted()) { hide(); // Object was deleted } else { // Use information about which fields changed to only update part of the UI if (changeSet.isFieldChanged("name")) { updateName(person.getName()); } } } });

- Любой объект доступен только пока открыт instance realm-a, из которого мы его получили. Проверять можно методами isValid. При обращении к невалидному объекту получим исключение

- Объекты доступны только в том потоке, в котором созданы. Обращаться из другого потока нельзя, получим исключение

Аналогично списки (RealmResult) объектов (результаты запроса) являются прокси к Realm, это приводит к следующему:

- Получение списков очень быстрое, по сути мы получаем только count. Все запросы lazy, получить большой список из сложных объектов мы можем очень быстро

- Списки доступны только для чтения, любые методы изменения приводят к исключению

- Т.к. мы можем быстро и дешево получать все элементы, можно забыть о проблеме пагинации. Мы всегда отдаем полный список элементов, при скролле обращаемся к объектам, и они быстро получаются из базы. Если нам нужно подгрузить данные, мы запускаем загрузку, получаем данные, сохраняем их в Realm, снова получаем полный список с загруженными элементами и отображаем его

- До недавнего времени (до версии 3.0) была проблема с перерисовкой всех элементов списка. Если мы используем список для адаптера, то при изменении одного элемента происходит полная перерисовка всего списка. Использовать DiffUtils и сравнивать какие объекты изменились, не получится, т.к. это live объекты. В Realm 3.0 появились OrderedCollectionChangeSet, который сообщает нам DeletionRanges, InsertionRange, ChangeRanges. Стало наконец возможно понять какие объекты и как изменились.

Пример CollectionChangeListenerprivate final OrderedRealmCollectionChangeListener> changeListener = new OrderedRealmCollectionChangeListener() { @Override public void onChange(RealmResultscollection, OrderedCollectionChangeSet changeSet) { // `null` means the async query returns the first time. if (changeSet == null) { notifyDataSetChanged(); return; } // For deletions, the adapter has to be notified in reverse order. OrderedCollectionChangeSet.Range[] deletions = changeSet.getDeletionRanges(); for (int i = deletions.length - 1; i >= 0; i--) { OrderedCollectionChangeSet.Range range = deletions[i]; notifyItemRangeRemoved(range.startIndex, range.length); } OrderedCollectionChangeSet.Range[] insertions = changeSet.getInsertionRanges(); for (OrderedCollectionChangeSet.Range range : insertions) { notifyItemRangeInserted(range.startIndex, range.length); } OrderedCollectionChangeSet.Range[] modifications = changeSet.getChangeRanges(); for (OrderedCollectionChangeSet.Range range : modifications) { notifyItemRangeChanged(range.startIndex, range.length); } } };

Транзакции

Изменять привязанные к Realm объекты можно только внутри транзакции, при изменении вне транзакции получим ошибку. С одной стороны, не очень удобно, с другой стороны — дисциплинирует и не дает изменять объекты в любой части кода, только в определенном слое (database). Также нужно помнить, что транзакции внутри другой транзакции запрещены.

Как нельзя делать:

val user = database.getUser(1)

button.setOnClickListener { user.name = "Test" }Как можно:

val user = database.getUser(1)

button.setOnClickListener { database.setUserName(user, "Test") }Транзакции можно производить синхронно и асинхронно. Давайте подробнее рассмотрим каждый из вариантов:

Синхронные транзакции:

fun syncTransaction() {

Realm.getDefaultInstance().use {

it.executeTransaction {

val dataObject = DataObject()

it.insertOrUpdate(dataObject)

}

}

}Также можно выполнять транзакции между beginTransaction и commitTransaction, однако рекомендуется использовать именно executeTransaction.

К сожалению, синхронные транзакции не поддерживают onError callback, так что обработка ошибок остается на вашей совести. Есть issue на добавление onError callback c июня 2016 года.

Асинхронные транзакции

Асинхронные транзакции запускаются методом asyncTransaction. На вход отдаем саму transaction и callback onSuccess и onError, на выходе получаем объект RealmAsyncTask, с помощью которого мы можем проверить статус или отменить транзакцию. Асинхронные транзакции запускаются только в тредах с Looper. Пример асинхронной транзакции:

Realm.getDefaultInstance().use {

it.executeTransactionAsync({

it.insertOrUpdate(DataObject(0))

}, {

log("OnSuccess")

}, {

log("onError")

it.printStackTrace()

})

}Пара важных нюансов:

Вы не сможете присвоить через сеттер объект, не привязанный к Realm. Необходимо сначала положить объект в базу, а потом прикрепить привязанную копию. Пример:

val realm = Realm.getDefaultInstance()

val parent = realm.where(Parent::class.java).findFirst()

val children = Children()

// parent.setChildren(children) <-- Error

val childrenRealm = realm.copyToRealmOrUpdate(children)

parent.setChildren(childrenRealm) /// OkМного транзакций лучше объединять в одну. В Realm есть внутренняя очередь на транзакции (размером 100) и если вы превысите ее, упадет исключение.

Все асинхронные транзакции работают на одном executor’e

// Thread pool for all async operations (Query & transaction)

static final RealmThreadPoolExecutor asyncTaskExecutor = RealmThreadPoolExecutor.newDefaultExecutor();Если у вас будет много асинхронных операций за короткое время, получите ошибку RejectedExecutionException. Выходом из данной ситуации будет использование отдельного потока и запуск в нем синхронных транзакций или объединение нескольких транзакций в одну.

Open/close realm

Все объекты из базы данных мы получаем, используя конкретный instance Realm-a, и можем работать с ними пока открыт этот instance. Как только мы вызовем realm.close(), любая попытка чтения объекта обернется для нас исключением. Если мы не будем вовремя закрывать Realm, то это приведет к утечкам памяти, т.к. сборщик мусора не умеет корректно работать с ресурсами, используемыми Realm.

В официальной документации рекомендуется открывать\закрывать Realm:

- для Activity: onCreate / onDestroy

- для Fragment: onCreateView/onDestroyView

Однако если вы хотите вынести логику работы с Realm из Activity\Fragments в презентеры, вам придется использовать (прокидывать) методы жизненного цикла.

В случае если вам нужно как-то изменить данные или добавить новые, проще всего получить новый instance, записать данные и затем закрыть его. В Kotlin для этого можно использовать .use()

Realm.getDefaultInstance().use { // it = realm instance}Для чтение объектов с помощью Rx можно использовать “изолированные” instance и закрывать их в doOnUnsubscribe (или использовать Observable.using)

// Use doOnUnsubscribe

val realm = Realm.getDefaultInstance()

realm.where(DataObject::class.java).findAllSorted("id").asObservable().doOnUnsubscribe { realm.close() }

// Use Observable.using

Observable.using(Realm.getDefaultInstance(), realm -> realm.where(DataObject::class.java).equalTo("id", id)

.findFirstAsync()

.asObservable()

.filter(realmObject -> realmObject.isLoaded())

.cast(DataObject::class.java), Realm::close);Также есть особенность, связанная с закрытием Realm в onDestroy\onDestroyView. Иногда после закрытия Realm происходит вызов FragmentManagerImpl.moveToState -> ViewGroup.removeView ->… -> RecyclerViewAdapter.getItemCount() и вызывается метод list.size() от невалидной коллекции. Так что тут нужно проверять isValid() или отвязывать adapter от recyclerView

Если вы используете Kotlin Android Extensions, то работать с view (из kotlinx.android.synthetic.*) из Fragment можно только начиная с метода onViewCreated(), лучше настраивать все listeners в этом методе, чтобы не получить NPE.

После разбора трех самых важных особенностей, пробежимся по менее важным:

Notifications, RxJava

Realm поддерживает уведомления об изменении данных, причем как самого объекта, так и вложенных объектов (всех залинкованных объектов). Реализовано это с помощью RealmChangeListener (нам приходит сам объект), RealmObjectChangeListener ( приходит измененный объект и ObjectChangeSet для него, можно понять какие поля изменились) или с помощью RxJava (в onNext получаем объект, в случае асинхронного запроса необходимо проверять isLoaded(), работает только в потоках с Looper).

RxJava2 пока не завезли, issue висит с сентября 2016 года, когда реализуют — неизвестно, используйте Interop.

Аналогично можно слушать изменения коллекций или всего instance Realm. Слушать изменения внутри транзакций запрещено.

Пример Rx:

fun getObjectObservable(realm: Realm, id: Long): Observable {

return realm.where(DataObject::class.java).equalTo("id", id).findFirstAsync()

.asObservable().filter({ it?.isLoaded }).filter { it?.isValid }

}Многопоточность и асинхронность

Realm это MVCC база данных. Википедия говорит про MVCC:

“Управление параллельным доступом с помощью многоверсионности (англ. MVCC — MultiVersion Concurrency Control) — один из механизмов обеспечения параллельного доступа к БД, заключающийся в предоставлении каждому пользователю так называемого «снимка» БД, обладающего тем свойством, что вносимые пользователем изменения в БД невидимы другим пользователям до момента фиксации транзакции. Этот способ управления позволяет добиться того, что пишущие транзакции не блокируют читающих, и читающие транзакции не блокируют пишущих.”

На практике это выглядит следующим образом: мы можем слушать изменения объекта или с помощью RxJava получать измененные объекты в onNext. В случае, если изменения происходят в потоке А, а мы работаем с объектом в потоке B, то поток B узнает об изменениях после закрытия Realm instance в потоке A. Изменения передаются посредством Looper. Если в потоке B Looper-a нет, то изменения не дойдут (можно проверить методом isAutoRefresh()). Выход из данной ситуации — использовать метод waitForChange().

Что касается асинхронных вызовов и транзакций, то их лучше не использовать вовсе. Удобнее переводить действия на отдельный поток и там выполнять синхронные операции. Причин несколько:

- Нельзя смешивать асинхронные транзакции и синхронные, если смешать, все транзакции станут синхронными

- Нельзя использовать асинхронные вызовы в потоках без Looper

- Для длительных транзакций нужно открыть отдельный instance realm, иначе realm может быть закрыт во время транзакции и вы получите исключение

- Все действия в асинхронной транзакции происходят на отдельном внутреннем executor-е, как следствие вы не можете пользоваться внешними realm объектами, возможно переполнение executor-а, изменения realm object не распространяются между потоками и прочие неудобства

Тестирование

Раньше Realm.java — был final и для тестирования нужен был powerMock или другие подобные инструменты. В данный момент Realm.java перестал быть final и можно спокойно использовать обычный mockito. Примеры тестов в демо проекте или на официальном репозитории

Один Realm хорошо, а три лучше

Работая с Realm мы всегда имеем ввиду стандартный realm, однако существуют еще In-Memory Realm и Dynamic Realm.

Стандартный Realm — можно получить методами Realm.getDefaultInstance() или с помощью конкретной конфигурации Realm.getInstance(config), конфигураций может быть неограниченное количество, это по сути отдельные базы данных.

In-Memory Realm — это Realm, который все записанные данные хранит в памяти, не записывая их на диск. Как только мы закроем этот instance, все данные пропадут. Подходит для кратковременного хранения данных.

Dynamic Realm — используется в основном при миграции, позволяет работать с realm — объектами без использования сгенерированных классов RealmObject, доступ осуществляется по именам полей.

Наследование и полиморфизм

Realm не поддерживает наследование. Любой realm-объект должен или наследоваться от RealmObject или реализовывать интерфейс маркер RealmModel и быть помеченным аннотацией @RealmClass. Наследоваться от существующих Realm объектов нельзя. Рекомендуется использовать композицию вместо наследования. Весьма серьезная проблема, issue висит с января 2015 года, но воз и ныне там.

Kotlin

Realm из коробки работает c Kotlin.

Не работают data class-ы, нужно использовать обычные open class.

Также стоит отметить Kotlin-Realm-Extensions, удобные расширения для работы с RealmObject.

Realm mobile platform

Первое время Realm был представлен только базами данных для разных платформ, сейчас они выкатили сервер для синхронизации между всеми устройствами. Теперь платформа состоит из:

- Realm Mobile Database – база для хранения данных

- Realm Object Server – сервер, отвечающий за автоматическую синхронизацию и обработку событий

- Realm Data Integration API – для подключения и синхронизации данных с существующими БД (Oracle, MongoDB, Hadoop, SAP HANA, Postgres и Redis)

Отладка

Для отладки у нас есть несколько инструментов:

- RealmLog — выводит лог, есть разные уровни логирования

- Realm браузер — нужен просмотра базы данных с компьютера. Работает только под Mac. Для просмотра базы на Windows можно использовать Stetho Realm

Также существуют несколько Android библиотек для удобного просмотра данных на девайсе.

- WriteCopyTo() — позволяет скопировать базу в файл и отправить ее на анализ.

- NDK Debugging — для анализа ошибок в нативном коде можно использовать Crashlytics NDK Crash Reporting

Архитектура

Realm отлично подходит для MV* архитектур, когда вся реализация прячется за интерфейсом базы данных. Все обращения и выборки происходят в модуле базы данных (repository), наверх отдаются Observable c автоматически закрываемым realm при unsubscribe. Или принимаем на вход instance realm и производим все действия с ним. При записи объектов мы открываем realm, записываем данные и закрываем его, на вход подается только объект для сохранения. Оба примера смотрите на github.

Увы, использование Realm (без copyFromRealm) накладывает серьезные ограничения на использование clean architecture. Использовать разные модели данных для разных слоев не получится, пропадает весь смысл live объектов и прокси списков. Также сложности возникнут при создании независимых слоев и открытии\закрытии Realm, тк эта операция привязана к жизненному циклу Activity\Fragment. Хорошим вариантом будет изолированный слой получения данных, преобразование объектов и сохранение их в базе данных.

Realm очень удобен при построении offline-first приложений, когда все данные для отображения мы получаем из базы данных.

Полезные ссылки

Для продолжения знакомства и разбора тонких моментов, рекомендуем следующие статьи:

Три статьи статьи от @Zhuinden:

Basics of Realm: A guide to using Realm 1.2.0

How to use Realm for Android like a champ, and how to tell if you’re doing it wrong

Realm 1.2.0 + Android Data Binding

Две статьи про интеграцию Realm от @Viraj.Tank

Safe-Integration of Realm in Android production code, Part-1 with MVP

Deep integration of Realm in Android production code, Part-2, with MVP

Многопоточность, подробный разбор:

Designing a Database: Realm Threading Deep Dive

Docs — Auto-Refresh

Docs — Threading

Недавняя статья на хабре от FairBear:

Как подружиться с Realm

Заключение

Realm сложнее, чем кажется на первый взгляд. Однако все недостатки с лихвой покрываются его мощностью и удобством. Live объекты, нотфикации и Rx, удобное API и множество других вещей упрощают создание приложений. Из конкурентов можно выделить requery, ObjectBox и GreenDao. Полностью же Realm раскрывает себя при построении offline-first приложений, когда все данные мы получаем из кэша и нам необходимы сложные выборки, а также постоянное обновление данных.

Весь приведенный код вы можете найти на Github

|

Метки: author andrey7mel разработка под android разработка мобильных приложений android android development android database realm |

Unit-тесты: что, как и когда тестировать? |

Как же писать unit-тесты правильно? Стоит ли гнаться за 100% покрытием? С какими сложностями приходится сталкиваться инженерам на практике? Своим опытом делятся Marc Philipp и Всеволод Брекелов.

Marc Philipp – один из основных разработчиков фреймворка JUnit 5 – инструмента для Java-тестировщиков. В данный момент работает в качестве инженера в немецкой компании LogMeIn над облачными SaaS-решениями.

Marc Philipp – один из основных разработчиков фреймворка JUnit 5 – инструмента для Java-тестировщиков. В данный момент работает в качестве инженера в немецкой компании LogMeIn над облачными SaaS-решениями. Всеволод Брекелов — Senior QA Engineer в компании Grid Dynamics, более 5 лет занимается тестированием, имеет опыт построения автоматизации тестирования с нуля.

Всеволод Брекелов — Senior QA Engineer в компании Grid Dynamics, более 5 лет занимается тестированием, имеет опыт построения автоматизации тестирования с нуля. — В статьях про unit-тестирование в качестве примеров обычно приводят тестирование методов и классов калькулятора. Такие примеры могут показать сложность реальных задач? С чем приходится сталкиваться тестировщику полнофункциональных программ?