Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Этапы развития проекта обучения Java: как это было, взгляд изнутри |

Этапы развития проекта обучения Java: как это было, взгляд изнутри

Здравствуйте! Меня зовут Григорий Кислин, автор и ведущий учебных проектов и стажировок Java. Хотел рассказать с технической точки зрения, как проект жил и развивался. На каждом этапе приходилось выбирть только самые необходимые для текущей работы решения, которые реализовывались по принципу KISS, или, по русски ДУП: Дешево, Удобно и Практично.

Начало: преподавание в учебном центре

Все началось с оффлайн преподавания в Санкт-Петербургском платном учебном центре в октября 2013 г. Там провел несколько очных выпусков разработанного мной курса «Практика Java. Разработка Web приложения». Преподавание шло на основе разработки одного большого веб проекта и приходилось решать достаточно тривиальные вещи, например, передача написаного мной кода всем участникам. Пробовались флешки:), скайп, передача файлов по сети. Искалось решение для обновления проекта участниками и отделения моего кода от кода домашних заданий. В конце пришли к очевидному решению — к системе контроля версий, обновлению проекта патчами и выполнению домашних заданий в ветках git. К обучению Java добавилось обучение Git и GitHub, без знания которых жизнь разработчика немыслима. Параллельно преподаванию я разрабатывал учебный проект Java Enterprise (Spring, JPA/Hibernate, REST, ..), основанный на вступительном задании в Toptal.

Уход в совбодное плавание

В преподавании хотелось некоторой автономии, например, приводить своих участников на курс с небольшой скидкой и получать за них комиссионные, что не было в планах владельцов центра. В результате переключился на онлайн формат и стал вести разработку проекта на вебинарах самостоятельно. Сделал простенький сайт на Bootstrap, выбрал недорогой хостинг host-food (там же можно недорого купить домен) и прикрутил к сайту php скрипт для рассылки писем: при регистрации на сайте он рассылал 2 письма — мне и участнику. Письма регистрации веб клиент Yandex сортировал в разные папки, откуда я их вставлял в Google Sheets. Письма рассылал несколькими группами (не более 25 адресатов в одном письме).

Для вебинаров взял платформу Adobe Connect (25 человек в комнате и месяц Trial), общались в группе Skype. Adobe хорошо работает с 2-мя экранами (один для показа, второй рабочий, с заранее подготовленным кодом проекта по занятию) и хорошо записывает у себя в облаке видео вебинара, которое доступно участникам сразу после занятия (надо только не забывать включать запись!). Параллельно скрёб по всем сусекам для набора на первый выпуск Java Enterprise. Запустил его в августе 2014, набралось целых 6 человек!

Рост вглубь

Скоро управление учетом и рассылкой стало занимать значительное время и я понял, что нужен собственный сервис рассылки. Пользоваться сторонним сервисом не хотел (автоматическое добавление туда новых пользователей было не намного проще развертывания своего), да и с Spring Boot хотел потренироваться.

Выбор пал на хостинг AWS с годом! бесплатного пользования. Будте аккуратнее их с бесплатным стеком, через пару недель мне начислили около доллара за то, что не был отключен ежедневный бэкап моего пустого PostgreSQL, и они превысили бесплатные 5 Gb на Amazon S3. А при нажатии кнопки примера деплоя в AWS Elastic Beanstalk он развернул сразу 3 инстанса, что обошлось мне в несколько центов:). В результате остановился на простой конфигурации: EC2 (Amazon Linux AMI), база H2 (понравилась возможность подключения к ней при работающем приложении через запуск TCP сервера) и запуск Spring Boot как JAR. Кстати, при моих нагрузках, бэкап H2 это обычное копирование файла без остановки сервера. Проекту делал

push на GitHub, и забирал его через pull на сервере (недавно процесс еще более упростился — делаю push со своего компа прямо на EC2 по ssh, а логи смотрю в Terminal окне IDEA). Шаблоны писем сделал в Thymeleaf с очисткой кэша каждые 3 секунды (полагаю, что это решение лучше, чем его полностью отключить). В результате шаблон на сервере обновляется сразу, передеплой не требуется.Почту отправлял через SMTP Yandex (ограничение ~ 500 писем в день, для массовой рассылки необходим заголовок List-Unsubscribe для возможности отписки). Форма регистрации на сайте дергала мой сервис, который сохранял человека в базу, отправлял письмо и показывал результат отправки.

Вместо админки сделал REST контроллер с базовой авторизацией и поставил Postman c набором заготовленных шаблонов для дерганья REST (рассылка, оплата, ручная регистрация).

Дальше-больше: ограничения

500 писем в день стало не хватать, и Yandex стал меня банить. Переключение на запасные email был не лучший вариант и, пошукав, я нашел отличное решение: Amazon Simple Email Service (SES). Единственно, что для нормальной работы с ним надо написать в техподдержку с просьбой снять ограничения, дать сылку на сайт и ответить 3 раза «Да» на вопросы про управление подпиской. В результате я целый год бесплатно рассылал письма и сейчас за них плачу центы (объемы небольшие, ~ 5-7 тыс. писем в месяц).

Группа Skype, где более 50 человек, становится неудобной для обучения. Мы перешли на Slak, где для каждого урока и каждой темы (например help, отзывы по работе, вакансии) сделали свой канал. Со временем появились каналы подписок RSS, изменений в проекте и пр. Приглашение в Slack также сделал автоматическим через их недокументированное API.

Следующим ограничением было максимальное количество людей для доступа к папке в Google Drive (отредактированные видео вебинаров храню там): 600 человек. Проблема решилось через предоставления доступа к Google группам и G-Suite Admin SDK для автоматического добавления участников в группу. Пришлось изрядно (дня 3-4) погуглить, чтобы с ним проинтегрироваться. Стоит удовольствие 4 € в месяц за участника (т.к. участник я один, а все остальные — гости, то выходит недорого:)

Развитие вширь: новые функции (фичи)

Сайт на host-food стал лишним, логично было его перенести вместе с приложением на AWS. При редизане сайта помогли простые рекомендации от Google, а при его настройке тестирование на скорость загрузки. Например, следуя рекомендации, простое включение Gzip в Ngix подняла оценку скорости загрузки с Good до Excelent.

Для выдачи партнерами информации я прикрутил к базе универсальный интерфейс (тема отдельной статьи): запросы храню в периодически перезагружаемом проперти-файле, а названия колонок читаю из метаданных запроса. В результате выставление нового запроса с рапортом ничем не отличается от обновления шаблона и также занимает секунды. Причем оживляю его с помощью простого js, которое возвращается как (ужас!) результаты SQL запроса. Например, партнерам по трудоустройству универсальный интерфейс отдает список участников стажировок с возможностью посмотреть информацию по каждому участнику и выгрузку данных в CSV.

Досточно долго я жил без авторизации вообще. Участник попадал в свой профиль на сайте по ссылке из письма с посоленным хэшем своего email. И только недавно c помощью выпускников (времени самому на все не хватает) добавил авторизацию по OAuth2 через Google и GitHub. Интерфейс задания пароля, его смены и напоминания не потребовался.

Авторизация позволила сделать профиль «умным»: по каждому проекту (пока их 3, готовлю 4-й), если он уже закончен, предлагается бесплатный повтор, если нет — получение бесплатного вступительного занятия. Также сделал автоматический расчет цены для каждого участника с учетом рефферальной программы и бонусов за участие. Наконец, недавно сделал следующий шаг в автоматизации — прием платежей с сайта (по современному интернет эквайринг). Интергировался с Тиньковым, т.к. счет открывал у них (были условия бесплатного оформления документов, открытия счета и первых 6 месяцев обслуживания для новых ИП). Уже в процессе подключения они добавили ложку дегтя — снизили бесплатный лимит на снятия наличных. Да и сам процесс подключения был непрямолинейным из-за нечеткой документации и задумчивой работы службы эквайринга. Компенсировали это внимательной и профессиональной работой менеджеров по работе с клиентами, так что общее впечатление осталось неплохое.

Приложение находится в постоянном изменении: пришлось изменить процесс выдачи бесплатных купонов на IDEA при переходе JetBrains на новую политику, настроил подписку с сайта на рассылки в группы VK (см. статью рассылки в ВК), интергируюсь с сервисом поиска разработчиков GetCoder. Кстати, если рассматриваете предложения о работе, заполните у себя в профиле GitHub локацию — это важная информация для HR. Около 2-х лет назад пришлось уйти с основной работы синьором и полностью отдать себя проекту.

Заранее отвечу на Ваши вероятные вопросы:

Текущий твой бизнес даёт доход хотя бы на уровне сениорной зарплаты? Не жалеешь о переходе?Нет, хотя сейчас получается примерно столько же. У синьора есть потолок: его возможности. А в бизнесе все от тебя зависит, только двигаться надо. Работать приходится много, но зато отдыхать тоже могу, когда хочу (вместе с компом правда:). И работа на себя приносит больше радости и удовлетворения. Особенно когда видишь ее результаты — трудоустроенных выпускников и хорошие отзывы.

Это не в рубрику «Я пиарюсь»?Надеюсь, что нет. Ссылок на себя не давал, писал про историческое развитие проекта и технические решения, которые, надеюсь, кому-то будут полезны.

Если статья была интересна или полезна, плюсаните. Если нет — напишите замечание. Спасибо за внимание.

|

Метки: author gkislin читальный зал учебный процесс в it java обучение программированию обучение онлайн история создания история стартапов образование в ит |

оБУЧЕНИНЕ РОБОТОВ ИЛИ ЛЮДЕЙ (страшный рассказ) |

оБУЧЕНИНЕ РОБОТОВ ИЛИ ЛЮДЕЙ (страшный рассказ)

Вообщем почитать хотел про обучение роботов ан нет компьютер уже не можеттекст грузить. Кроме сраных картинов к и видеол.ю

Акраз после после профессорам и 20 венчурным инветорам из пентагона.

Мой старый копьютерик затормозил.

И это мой копьютерки предо мной стоимостью в 40 долларов США с кпд в 299%

Эти люди мне пишут об облаках из пентагона и серетных баз Паловиджа?

Бред полный.

Учить робтов конечно легче но имхо им нужны просто задачи. Все эти муоттики и фильмы про роботов на скрипках играющих и рисующих картины

Во и все господа учите сових выродков дальше.

Понять вы ничего тут не сможете так как дебилы.

Эта программа для людей отсталых понимаешь из дурдомов, рожденных с дефектами и брачком. Но все аврно они должны учится и проходить тесты, славать экзамены и получать дипломы, чтобы вешать их на стеночки и опказывать своим выблядкам. :)

Ps вся статься не охраняется авторским правом можете брать и размещать.

|

Метки: author livandos исследования и прогнозы в it роботы |

Раскрутка на развлекательных сайтах, или “Извините, но похоже, что Вы единственный программист в России” |

Раскрутка на развлекательных сайтах, или “Извините, но похоже, что Вы единственный программист в России”

Все началось в 2012 году. В то время разработкой я только начинал интересоваться, но желание создать что-нибудь полезное (хайпануть) не давало мне покоя. Поиск идей привел меня на сайт www.ssa.gov, где каждый мог проверить наиболее популярное детское имя в США за определенный период. Данная тема меня заинтересовала, но, поскольку молодые семьи — это не самый большой рынок, я решил, что будет интереснее сравнивать популярность имен среди всего населения России. Так и родилась идея сайта names.pp.org (в поcледующем popname.ru), где каждый мог проверить, насколько популярно его имя по сравнению с другими мужскими / женскими именами в РФ.

Разработчиком в то время я был никудышным, поэтому пришлось как-то выкручиваться. Была скачана база данных самых популярных имен в России и сделан парсинг этих имен по базе данных Вконтакте, чтобы сравнить количество пользователей с тем или иным именем. Нужно заметить, что производные имена (Татьяна — Таня) игнорировались. Поэтому, а также по ряду других причин (средний возраст пользователя Вконтакте, особенно в то время, был явно ниже тридцати) рейтинг получился не совсем (или совсем не) актуальным. Но, как выяснилось позже, пользователей это мало волновало, поскольку они нашли немного другое применение сайту. В итоге на разработку сайта ушло примерно 2 дня. Финальным аккордом была идея добавить немного модифицированную страницу 404, которая сообщала, что “Извините, но похоже, что Вы единственный ХХХ в России. Гордитесь своей уникальностью!”.

Раскрутка

Не думаю, что стал первооткрывателем, когда решил раскручивать сайт через развлекательные порталы. Я создал два поста на самых популярных ресурсах в то время (Pikabu и Yaplakal), которые в сумме собрали чуть больше тысячи “лайков”. При этом ссылку на сайт я добавлять не стал и разместил ее только после того, как пользователи спросили адрес сайта в комментариях. Оба поста вышли в топ на каждом из ресурсов, и пошел огромный, по моим меркам, трафик. Скриншоты о том, насколько пользователи уникальны, стали разлетаться по Интернету, и возникло огромное желание монетизировать этот трафик. Adblock в то время еще не был популярен, и, поскольку у меня был опыт работы с Google Adsense, было решено добавить небольшой рекламный блок сразу под поисковой строкой. Главной “фишкой” сайта стали скриншоты, рассказывающие об уникальности их создателя, поэтому я решил не засорять их рекламой хотя бы первые сутки (на то, что рекламу вырежут при помощи консоли разработчика, я не надеялся). Но и ждать дольше я не мог, поскольку популярность сайта неизбежно должна была упасть. В итоге самым плодотворным днем стал третий, когда посещаемость сайта достигла 80 000 уникальных пользователей в день, что остается моим личным рекордом и по сей день. Далее трафик пошел на спад и сайт был продал третьим лицам.

Итог

После пяти лет забвения, когда посещаемость сайта вертелась на уровне 100 — 200 человек в день, я снова вспомнил о нем, когда мой товарищ прислал мне ссылку на какой-то твит со старым-добрым скриншотом. Я проверил сайт и увидел, что за последний день его посетили около 10 000 человек. После небольшого расследования было выяснена причина неожиданного трафика — статья на сайте Meduza, что стало приятной неожиданностью. Видимо, подросло новое поколение уникальных людей.

|

Метки: author Deka87 разработка веб-сайтов сайт вконтакте раскрутка сайта разработка сайтов |

Абстракция сетевого слоя с применением «стратегий» |

Абстракция сетевого слоя с применением «стратегий»

От всех моих предыдущих реализаций сетевого слоя осталось впечатление, что есть еще куда расти. Данная публикация ставит целью привести один из вариантов архитектурного решения по построению сетевого слоя приложения. Речь пойдет не об очередном способе использования очередного сетевого фреймворка.

Часть 1. Взгляд на существующие подходы

Для начала из публикации 21 Amazing Open Source iOS Apps Written in Swift взято приложение Artsy. В нем используется популярный фреймворк Moya, на базе которого и построен весь сетевой слой. Отмечу ряд основных недостатков, которые встретил в данном проекте и часто встречаю в других приложениях и публикациях.

Повторы цепочек преобразования ответа

let endpoint: ArtsyAPI = ArtsyAPI.activeAuctions

provider.request(endpoint)

.filterSuccessfulStatusCodes()

.mapJSON()

.mapTo(arrayOf: Sale.self)Разработчик этим кодом обозначил некую логическую цепочку, в которой ответ на запрос activeAuctions преобразуется в массив объектов Sale. При повторном использовании этого запроса в других ViewModel или ViewController разработчику придется копировать запрос вместе с цепочкой преобразования ответа. Чтобы избежать копирования повторяющейся логики преобразования, запрос и ответ можно связать неким контрактом, который будет описан ровно один раз.

Большое количество зависимостей

Часто для работы с сетью используются фреймворки Alamofire, Moya и др. В идеале приложение должно минимально зависеть от этих фреймворков. Если в поиске по репозитоию Artsy набрать import Moya, то можно увидеть десятки совпадений. Если вдруг проект решит отказаться от использования Moya — очень много кода придется рефакторить.

Не сложно оценить, на сколько каждый проект зависит от сетевого фреймворка, если убрать эту зависимость и попробовать доработать приложение до работоспособного состояния.

Общий класс менедежера запросов

Возможным выходом из ситуации с зависимостями будет создание специального класса, который будет один знать о фреймворках и обо всех возможных способах получить данные из сети. Эти способы будут описаны функциями со строго типизированными входящими и исходящими параметрами, что в свою очередь будет являться контрактом, упомянутом выше, и поможет справиться с проблемой повторов цепочек преобразования ответа. Такой подход тоже достаточно часто встречается. Его применение на практике можно также найти в приложениях из списка 21 Amazing Open Source iOS Apps Written in Swift. Например, в приложении DesignerNewsApp. Выглядит такой класс следующим образом:

struct DesignerNewsService {

static func storiesForSection(..., response: ([Story]) -> ()) {

// parameters

Alamofire.request(...).response { _ in

// parsing

}

}

static func loginWithEmail(..., response: (token: String?) -> ()) {

// parameters

Alamofire.request(...).response { _ in

// parsing

}

}

}У такого подхода также есть минусы. Количество обязанностей, возложенных на этот класс больше, чем того требует принцип единственной ответственности. Его придется менять при смене способа выполнения запросов (замена Alamofire), при смене фреймворка для парсинга, при изменении параметров запроса. Кроме того, такой класс может перерасти в god object или использоваться как singleton со всеми вытекающими последствиями.

Вам знакомо то чувство уныния, когда нужно интегрировать проект с очередным RESTful API? Это когда в очередной раз нужно создавать какой-нибудь APIManager и наполнять его Alamofire запросами… (ссылка)

Часть 2. Подход, основанный на стратегиях

Учитывая все недостатки, описанные в 1-й части публикации, я сформулировал для себя ряд требований к будущему слою работы с сетью:

- Снизить зависимость от внешних сетевых фреймворков

- Предусмотреть возможность быстро и легко заменять сетевые фреймворки между собой

- Использовать по максимому универсальные классы/структуры и протоколы со связанными типами

- Не допустить повтора цепочек преобразования и свести к минимуму повторяемость кода

Что получилось в итоге:

Базовые протоколы сетевого слоя

Протокол ApiTarget определяет все данные, которые необходимы для формирования запроса (параметры, путь, метод… и др.)

protocol ApiTarget {

var parameters: [String : String] { get }

}Обобщенный протокол ApiResponseConvertible определяет способ преобразования полученного объекта (в данном случае Data) в объект связанного типа.

protocol ApiResponseConvertible {

associatedtype ResultType

func map(data: Data) throws -> ResultType

}Протокол ApiService определяет способ отправки запросов. Обычно функция, объявленная в протоколе, принимает замыкание содержащее объект ответа и возможные ошибки. В текущей реализации функция возвращает Observable — объект реактивного фреймворка RxSwift.

protocol ApiService: class {

func request(with target: T) -> Observable where T: ApiResponseConvertible, T: ApiTarget

} Стратегии

Стратегией я называю упомянутый в начале публикации контракт, который связывает между собой несколько типов данных. Стратегия является протоколом и выглядит в самом простом случае таким образом:

protocol Strategy {

associatedtype ObjectType

associatedtype ResultType

}Для нужд сетевого слоя стратегия должна уметь создавать объект, который можно передать в экземпляр класса, соответствующего протоколу ApiService. Добавим функцию создания объекта в протокол ApiStrategy.

protocol ApiStrategy {

associatedtype ObjectType

associatedtype ResultType

static func target(with object: ObjectType) -> AnyTarget

} Введение новой универсальной структуры AnyTarget обусловленно тем, что мы не можем использовать обобщенный протокол ApiResponseConvertible в качестве типа возвращаемого функцией объекта, потому что у протокола есть связанный тип.

struct AnyTarget: ApiResponseConvertible, ApiTarget {

private let _map: (Data) throws -> T

let parameters: [String : String]

init(with target: U) where U: ApiResponseConvertible, U: ApiTarget, U.ResultType == T {

_map = target.map

parameters = target.parameters

}

func map(data: Data) throws -> T {

return try _map(data)

}

} Вот так выглядит самая примитивная реализация стратегии:

struct SimpleStrategy: ApiStrategy {

typealias ObjectType = Int

typealias ResultType = String

static func target(with object: Int) -> AnyTarget {

let target = Target(value: object)

return AnyTarget(with: target)

}

}

private struct Target {

let value: Int

}

extension Target: ApiTarget {

var parameters: [String : String] {

return [:]

}

}

extension Target: ApiResponseConvertible {

public func map(data: Data) throws -> String {

return "\(value)" // map value from data

}

} Стоит отметить, что структура Target является приватной, т.к. за пределами файла использоваться она не будет. Она нужна лишь для инициализации универсальной структуры AnyTarget.

Преобразование объекта тоже происходит в рамках файла, поэтому ApiService не будет ничего знать об инструментах, используемых при парсинге.

Использование стратегий и сервиса

let service: ApiService = ...

let target = SimpleStrategy.target(with: ...)

let request = service.request(with: target)Стратегия подскажет, какой объект нужен для осуществления запроса и какой объект будет на выходе. Все строго типизировано стратегией и не требуется указывать типы как в случае с универсальными функциями.

Реализация ApiService

Как можно было заметить, в данном подходе сетевой фреймворк остался за пределами основной логики построения сервиса. На первых порах его можно не использовать совсем. Например, если в реализации функции map протокола ApiResponseConvertible возвращать mock-объект, то сервис может быть совсем примитивным классом:

class MockService: ApiService {

func request(with target: T) -> Observable where T : ApiResponseConvertible, T : ApiTarget {

return Observable

.just(Data())

.map({ [map = target.map] (data) -> T.ResultType in

return try map(data)

})

}

} Тестовую реализацию и применение протокола ApiService на базе реального сетевого фреймворка Moya можно посмотреть спойлере:

public extension Api {

public class Service {

public enum Kind {

case failing(Api.Error)

case normal

case test

}

let kind: Api.Service.Kind

let logs: Bool

fileprivate lazy var provider: MoyaProvider = self.getProvider()

public init(kind: Api.Service.Kind, logs: Bool) {

self.kind = kind

self.logs = logs

}

fileprivate func getProvider() -> MoyaProvider {

return MoyaProvider(

stubClosure: stubClosure,

plugins: plugins

)

}

private var plugins: [PluginType] {

return logs ? [RequestPluginType()] : []

}

private func stubClosure(_ target: Target) -> Moya.StubBehavior {

switch kind {

case .failing, .normal:

return Moya.StubBehavior.never

case .test:

return Moya.StubBehavior.immediate

}

}

}

}

extension Api.Service: ApiService {

public func dispose() {

//

}

public func request(headers: [Api.Header: String], scheduler: ImmediateSchedulerType, target: T) -> Observable where T: ApiResponseConvertible, T: ApiTarget {

switch kind {

case .failing(let error):

return Observable.error(error)

default:

return Observable

.just((), scheduler: scheduler)

.map({ [weak self] _ -> MoyaProvider? in

return self?.provider

})

.filterNil()

.flatMap({ [headers, target] provider -> Observable in

let api = Target(headers: headers, target: target)

return provider.rx

.request(api)

.asObservable()

})

.map({ [map = target.map] (response: Moya.Response) -> T.ResultType in

switch response.statusCode {

case 200:

return try map(response.data)

case 401:

throw Api.Error.invalidToken

case 404:

do {

let json: JSON = try response.data.materialize()

let message: String = try json["ErrorMessage"].materialize()

throw Api.Error.failedWithMessage(message)

} catch let error {

if case .some(let error) = error as? Api.Error, case .failedWithMessage = error {

throw error

} else {

throw Api.Error.failedWithMessage(nil)

}

}

case 500:

throw Api.Error.serverInteralError

case 501:

throw Api.Error.appUpdateRequired

default:

throw Api.Error.unknown(nil)

}

})

.catchError({ (error) -> Observable in

switch error as? Api.Error {

case .some(let error):

return Observable.error(error)

default:

let error = Api.Error.unknown(error)

return Observable.error(error)

}

})

}

}

} func observableRequest(_ observableCancel: Observable, _ observableTextPrepared: Observable) -> Observable> {

let factoryApiService = base.factoryApiService

let factoryIndicator = base.factoryIndicator

let factorySchedulerConcurrent = base.factorySchedulerConcurrent

return observableTextPrepared

.observeOn(base.factorySchedulerConcurrent())

.flatMapLatest(observableCancel: observableCancel, observableFactory: { (text) -> Observable> in

return Observable

.using(factoryApiService) { (service: Api.Service) -> Observable> in

let object = Api.Request.Categories.Name(text: text)

let target = Api.Strategy.Categories.Auto.target(with: object)

let headers = [Api.Header.authorization: ""]

let request = service

.request(headers: headers, scheduler: factorySchedulerConcurrent(), target: target)

.map({ Objects(text: text, manual: true, objects: $0) })

.map({ Result(value: $0) })

.shareReplayLatestWhileConnected()

switch factoryIndicator() {

case .some(let activityIndicator):

return request.trackActivity(activityIndicator)

default:

return request

}

}

.catchError({ (error) -> Observable> in

switch error as? Api.Error {

case .some(let error):

return Observable.just(Result(error: error))

default:

return Observable.just(Result(error: Api.Error.unknown(nil)))

}

})

})

.observeOn(base.factorySchedulerConcurrent())

.shareReplayLatestWhileConnected()

} Вывод

Полученный сетевой слой сможет успешно существовать и без стратегий. Точно так же стратегии можно использовать для других целей и задач. Совместное же их использование сделало использование сетевого слоя удобным и понятным.

|

Метки: author iWheelBuy разработка под ios swift ios rxswift moya alamofire solid dry srp xcode |

learnopengl. Уроки 3.1(Assimp) + 3.2(класс Mesh) |

learnopengl. Уроки 3.1(Assimp) + 3.2(класс Mesh)

- Tutorial

Assimp

Во всех уроках, мы, в основном, использовали нашего маленького друга — контейнер, но через некоторое время, даже наши лучшие друзья становятся немного скучными. В большом графическом приложении, обычно присутствуют много моделей, на которые намного приятнее смотреть, чем на наш статичный контейнер. Хотя, в отличие от контейнера, нам будет очень сложно, вручную, определить все вершины, нормали и текстурные координаты таких сложных моделей, как например дом или человекоподобные персонажи. Вместо этого, мы будем имортировать модели в наше приложение; модели, которые были тщательно нарисованы, в 3D редакторах, таких как Blender, 3DS MAX или Maya.

Эти, так называемые инструменты 3D моделирования, позволяют художникам создавать сложные модели и применять текстуры к ним с помощью процесса, который называется текстурная развертка (uv-mapping). Инструменты автоматически генерируют все вершинные координаты, вершины нормалей и текстурные координаты, экспортируя их в файл модели. Таким образом, художники имеют обширный набор инструментов для создания высококачественных моделей, не заботясь о технических деталях. Все технические аспекты спрятаны в экспортируемом файле. Мы, как программисты графики, должны позаботится об этих технических деталях.

Таким образом, наша работа заключается в анализе этих экспортированных файлов модели и извлечении всей соответствующей информации, чтобы мы могли хранить их в формате, который понимает OpenGL. Однако, распространенная проблема заключается в том, что существуют десятки различных форматов файлов, каждый из которых экспортирует данные модели по-своему уникальному способу. Форматы модели, как .obj от Wavefront содержат только данные модели с незначительной информацией материала, такой как цвет модели или диффузные\бликовые карты, в то время как файлы моделей, на основе XML, чрезвычайно обширны и содержат модели, освещения, много информации о материалах, анимацию и многое другое. Формат obj считается легко анализированным. Рекомендуется ознакомиться со структурой файла, например, на странице в википедии. Это должно дать вам базовые сведения о том, как храниться модель в файле формата obj.

В общем, существует много разных форматов, где хранящаяся структура данных отличается. Поэтому, если мы хотим импортировать модель из этих файлов, нам нужно написать импортер самим, для каждого формата, который мы захотим импортировать. Удачно для нас, для этого есть библиотека.

Библиотека для загрузки моделей

Assimp — очень популярная библиотека, для импортирования моделей, которая расшифровывается как Open Asset Import Library. Эта библиотека может импортировать множество различных форматов, содержащие модели, сохраняя данные, которые импортируются, в виде простой иерархической структуры данных. Как только Assimp закончит загрузку моделей, мы сможем получить все нужные нам данные из этой структуры. Без разницы какой формат файлов мы импортируем, обращение к данным в структурах не изменяется, структура остается такой же для всех различных форматов файлов.

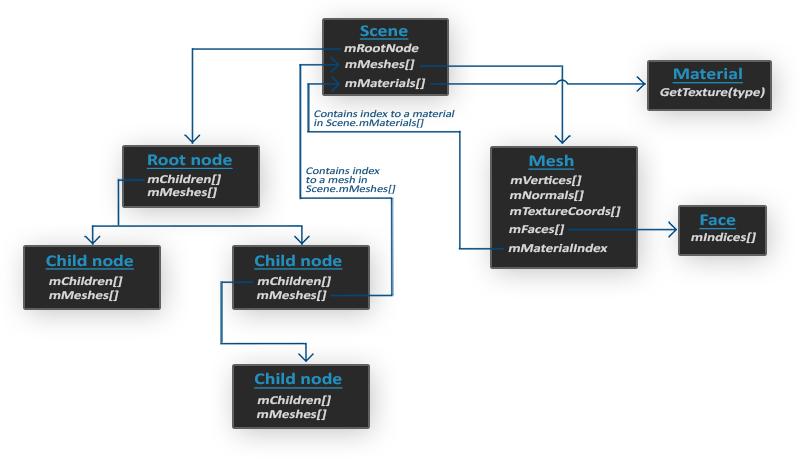

При импорте модели, с помощью Assimp, библиотека загружает всю модель в объект сцены (Scene), содержащий все данные импортированной модели. Затем Assimp создает коллекцию узлов, где каждый узел содержит индексы к данным, хранящимся в объекте сцены, каждый узел может иметь потомка. Простая модель структуры Assimp представлена ниже:

- Все данные модели содержатся в объекте Scene, как и данные о материалах и полигональной сетки. Scene также содержит ссылку на корневой узел (Root node) сцены.

- Корневой узел (Root node) может иметь потомков (Child node) (как и остальные узлы) и может иметь индексы, которые указывают на данные полигональной сетки, хранящиеся в массиве объекта сцены mMeshes. Массив mMeshes корневого узла содержит конкретные объекты полигональных сеток, а значения в массиве mMeshes у любого потомка являются лишь индексами для выборки из массива сеток корневого узла.

- Объект полигональной сетки (Mesh) содержит все соответствующие данные, необходимые для отрисовки: вершинные координаты, вектора нормалей, текстурных координаты, грани и информацию о материале объекта.

- Полигональная сетка (Mesh) содержит несколько граней. Грани (Faces) представляют собой примитивы объекта (треугольники, квадраты, точки). Они содержат индексы вершин, образующие примитивы. Так как у нас имеются вершины и их индексы, отрисовка происходит намного легче благодаря element buffer objects (Hello Triangle)

- Так же, полигональная сетка содержит индекс на материальный объект (Material), который имеет несколько функций для получения свойств материала.

И так, нам нужно сначала загрузить наш объект в объект сцены, рекурсивно извлекать соответствующие объекты полигональной сетки от каждого из узлов (рекурсивно пройдясь по потомкам каждого узла) и обработать каждый элемент полигональной сетки для извлечения вершин, индексов и свойств материала. Результатом является коллекция полигональных сеток, которые мы будем содержать в объекте Model.

Mesh — набор вершин и треугольников

Одна сетка (Mesh) — это минимальный набор данных, необходимый для вывода средствами OpenGL(данные вершин, индексов, материала). Модель же, обычно, состоит из нескольких сеток. При моделировании объектов в специальных программах(Blender, 3D max), художники не создают целую модель из одной формы. Обычно, каждая модель имеет несколько под-моделей\форм, из которых она состоит. Подумайте о человеке, как о модели: художник обычно моделирует голову, конечности, одежду, оружие, все как отдельные компоненты, затем объединив все под-модели, получает исходную.

В следующих уроках мы создадим наши собственные классы Model и Mesh, которые загружают и хранят импортированные модели, используя только что описанную структуру. Если мы хотим нарисовать модель, то мы выводим ее не целиком, а осуществляем вывод каждой из составляющих модель сеток по-отдельности. До того, как мы сможем имортировать модели, нам нужно сначала включить Assimp в наш проект.

Сборка Assimp

Вы можете скачать Assimp с этой страницы, выбрав соответствующую версию. Во время написания статьи, последняя версия Assimp была 3.1.1. Рекомендуется компилировать библиотеки самостоятельно, так как их, предварительно скомпилированые библиотеки, не работают на большинстве систем. Пересмотрите урок Создание окна, если вы забыли как компилировать библиотеку самим, используя CMake.

Несколько проблем появлялись во время сборки Assimp, так что я отмечу их здесь, с их решениями в случае, если кто-либо из вас получит те же ошибки:

- CMake выдает ошибки о отсутствующих библиотеках DiretX, такие как:

Could not locate DirectX

CMake Error at cmake-modules/FindPkgMacros.cmake:110 (message):

Required library DirectX not found! Install the library (including dev packages)

and try again. If the library is already installed, set the missing variables

manually in cmake.

Нужно установить DirectX SDK, в случае если он не был установлен. Вы можете скачать SDK здесь . - Во время установка DirectX SDK выскакивает код ошибки s1023.

В этом случае вам сначала нужно установить пакет С++, до того как устанавливать SDK,

как описано здесь.

- После завершения настройки можно создать файл проекта, открыть его и скомпилировать библиотеки.

- По умолчанию, Assimp предоставляется в виде динамической библиотеки, поэтому нам нужно включить в проект соответствующую dll с именем assimp.DLL. Можно просто файл библиотеку DLL в ту же папку, где находится исполняемый файл приложения.

- После компиляции, библиотека и её dll файл будут находится в папках code/Debug или code/Release.

- Далее просто свяжите файл библиотеки и dll файл с вашим проектом, и убедитесь, что вы не забыли также подключить заголовочные файлы Assimp.

Если вы хотите использовать многопоточность для увеличения производительности, вы можете собрать Assimp с Boost. Полная инструкция находится здесь.

На этом моменте, вы должны были скомпилировать Assimp и внедрить его в ваше приложение.

Класс Mesh

Используя Assimp мы можем загружать множество различных моделей в наше приложение, но после загрузки, данные все ещё хранятся в структуре Assimp. Нам нужно преобразовать эти данные в формат, который понимает OpenGL, чтобы мы смогли отрисовать модель. В предыдущем уроке мы узнали, что полигональная сетка представляет собой одну рисуемую сущность, поэтому давайте начнем с определения собственного класса Mesh.

Давайте подумаем, какой набор данных нам нужен для нашего класса. Полигональная сетка нуждается в наборе вершин, где каждая вершина содержит вектор позиции, вектор нормали и вектор текстурных координат. Полигональная сетка также должна содержать индексы,

для индексированной отрисовки, и данные для материалов.

Теперь, мы можем определить структуру вершины:

struct Vertex {

glm::vec3 Position;

glm::vec3 Normal;

glm::vec2 TexCoords;

};Каждая вершина хранится в структуре Vertex, которая может использоваться для индексации каждой вершины. Помимо структуры Vertex, нам также нужно создать структуру, которая хранит текстурные данные.

struct Texture {

unsigned int id;

string type;

}; Она хранит id и тип текстуры (диффузная или бликовая).

Написав структуры, можно начинать писать наш класс:

class Mesh {

public:

/* Mesh Data */

vector vertices;

vector indices;

vector textures;

/* Functions */

Mesh(vector vertices, vector indices, vector textures);

void Draw(Shader shader);

private:

/* Render data */

unsigned int VAO, VBO, EBO;

/* Functions */

void setupMesh();

}; Как вы можете видеть, класс не очень сложен. Конструктор принимает все нужные нам данные, в методе setupMesh мы инициализируем буферы, в методе Draw мы будем отрисовывать нашу полигональную сетку. Обратите внимание, что функция отрисовки (Draw), принимает объект шейдера, чтобы мы могли установить соответствующие uniform переменные, до отрисовки.

Код конструктора довольно прост, мы просто присваиваем аргументам класса, соответствующие аргуметы. Также мы вызываем функцию setupMesh:

Mesh(vector vertices, vector indices, vector textures)

{

this->vertices = vertices;

this->indices = indices;

this->textures = textures;

setupMesh();

} Как видите, ничего необычного здесь не происходит. Далее, переходим к функции setupMesh.

Инициализация

Благодаря конструктору, у нас имеется все нужные нам данные, которые мы можем использовать для отрисовки. Однако, нам сначала нужно настроить соответствующие буферы. К этому моменту у вас не должно быть проблем с этими понятиями, но, возможно, мы вас немного удивим как можно передавать данные в буфер, которые находятся в структуре:

void setupMesh()

{

glGenVertexArrays(1, &VAO);

glGenBuffers(1, &VBO);

glGenBuffers(1, &EBO);

glBindVertexArray(VAO);

glBindBuffer(GL_ARRAY_BUFFER, VBO);

glBufferData(GL_ARRAY_BUFFER, vertices.size() * sizeof(Vertex), &vertices[0], GL_STATIC_DRAW);

glBindBuffer(GL_ELEMENT_ARRAY_BUFFER, EBO);

glBufferData(GL_ELEMENT_ARRAY_BUFFER, indices.size() * sizeof(unsigned int),

&indices[0], GL_STATIC_DRAW);

// vertex positions

glEnableVertexAttribArray(0);

glVertexAttribPointer(0, 3, GL_FLOAT, GL_FALSE, sizeof(Vertex), (void*)0);

// vertex normals

glEnableVertexAttribArray(1);

glVertexAttribPointer(1, 3, GL_FLOAT, GL_FALSE, sizeof(Vertex), (void*)offsetof(Vertex, Normal));

// vertex texture coords

glEnableVertexAttribArray(2);

glVertexAttribPointer(2, 2, GL_FLOAT, GL_FALSE, sizeof(Vertex), (void*)offsetof(Vertex, TexCoords));

glBindVertexArray(0);

} Код не сильно отличается от того, что вы ожидали, но несколько маленьких трюков были использованы с помощью структуры Vertex.

В С++, у структур есть отличное свойство — их память является последовательной. То есть, если бы мы представили структуру как массив данных, то она содержала бы переменные в том порядке, в котором они определены в самой структуре. Например, если мы наполним структуру Vertex, какими нибудь значениями, то их размещение в памяти будет равной:

Vertex vertex;

vertex.Position = glm::vec3(0.2f, 0.4f, 0.6f);

vertex.Normal = glm::vec3(0.0f, 1.0f, 0.0f);

vertex.TexCoords = glm::vec2(1.0f, 0.0f);

// = [0.2f, 0.4f, 0.6f, 0.0f, 1.0f, 0.0f, 1.0f, 0.0f];Благодаря этому свойству, например, если мы применим функцию sizeof к нашей структуре, она вернет размер все аргументов, которые в ней определены. Она должна весить 32 байта

(8 * 4 — размер 1 float). Мы можем это использовать для функции glBufferData:

glBufferData(GL_ARRAY_BUFFER, vertices.size() * sizeof(Vertex), vertices[0], GL_STATIC_DRAW);Также мы используем макрокоманду offsetof, которая в качестве первого аргумента принимает структуру, а в качестве второго — имя переменной структуры. А возвращает она смещение в байтах указанной структуры, до переменной, переданной во втором аргументе. Это идеально подходит для определения последнего параметра функции glVertexAttribPointer:

glVertexAttribPointer(1, 3, GL_FLOAT, GL_FALSE, sizeof(Vertex), (void*)offsetof(Vertex, Normal));Смещение теперь определяется с помощью макроса offsetof, который, в данном случае, устанавливает смещение байта для вектора нормали. Обратите также, что мы указываем размер шага равным размеру структуры.

Использование такой структуры не только обеспечивает более читаемый код, но и позволит нам, в будущем, её расширять. Если мы захотим использовать какой нибудь другой вершинный артрибут, мы сможем легко добавить его в нашу структуру и из-за своей гибкости, код не поломается.

Отрисовка

Последняя функция, которую нам следует написать — это Draw. Но перед тем, как отрисовать наши полигоны, сначала нам нужно связать наши текстуры, до вызова функции glDrawElements. Однако, это немного тяжело, т.к. мы не знаем сколько у нас есть текстур (если они вообще есть) и какого они типа. И также, как установить текстурные блоки и текстурных объектов в шейдере?

Чтобы решить эту проблему, мы примем некоторые соглашения об именовании: каждая диффузная текстура называется texture_diffuseN, а каждая бликовая текстурная карта должна называться texture_specularN, где N-любое число, начиная с 1 до максимального количества разрешенных текстур. Допустим у нас есть 3 диффузные текстуры и 2 бликовые текстуры для конкретной полигональной сетки, мы должны определить их так:

uniform sampler2D texture_diffuse1;

uniform sampler2D texture_diffuse2;

uniform sampler2D texture_diffuse3;

uniform sampler2D texture_specular1;

uniform sampler2D texture_specular2;Благодаря этому соглашению, мы можем определить столько текстурных объектов, сколько захотим, и если полигональная сетка действительно содержит много текстур, мы знаем, какими будут их имена. Мы можем обрабатывать любое количество текстур на одной полигональной сетке и разработчик может свободно использовать столько текстур, сколько он хочет, просто определяя дополнительные текстурные объекты в шейдере.

Кроме этого решения, есть также много других, и если вам не нравится это, вы можете проявить свою творческую способность и придумать свое собственное решение.

Код метода Draw:

void Draw(Shader shader)

{

unsigned int diffuseNr = 1;

unsigned int specularNr = 1;

for(unsigned int i = 0; i < textures.size(); i++)

{

glActiveTexture(GL_TEXTURE0 + i); // активируем текстурный блок, до привязки

// получаем номер текстуры

stringstream ss;

string number;

string name = textures[i].type;

if(name == "texture_diffuse")

ss << diffuseNr++; // передаем unsigned int в stream

else if(name == "texture_specular")

ss << specularNr++; // передаем unsigned int в stream

number = ss.str();

shader.setFloat(("material." + name + number).c_str(), i);

glBindTexture(GL_TEXTURE_2D, textures[i].id);

}

glActiveTexture(GL_TEXTURE0);

// отрисовывем полигональную сетку

glBindVertexArray(VAO);

glDrawElements(GL_TRIANGLES, indices.size(), GL_UNSIGNED_INT, 0);

glBindVertexArray(0);

} Это не самый красивый код, но отчасти в этом виноват С++, так как, например, в нем нет такого преобразования типов, как int в строку. Мы пробегаемся по N-текстурам и определяем присваиваем их типы строковой переменной, что бы затем мы имели преставление, какой номер конкретного типа текстуры. Далее, мы узнаём номер нашего текстурного объекта, ну и наконец, устанавливаем этому текстурному объекту номер, соответствующий активному текстурному блоку и связываем текстуру. Обратите внимание, что мы собираемся хранить текстурные объекты в структуре Material, как обычно мы и делали.

Обратите внимание, что увеличив диффузные и бликовые счетчики, мы сразу передаем их в stringstream. Правый инкремент в C++ увеличивает значение на 1, но возвращает старое значение.

Вы можете найти полный код класса Mesh здесь.

В следующем уроке, мы создадим класс Model, который работает как контейнер, для объектов класса Mesh и фактически реализует интерфейс загрузки Assimp.

|

Метки: author dima19972525 разработка игр c++ перевод glsl opengl opengl 3 casters |

Беседы о Виртуальной реальности. Беседа №2. Практично о Виртуальности |

Беседы о Виртуальной реальности. Беседа №2. Практично о Виртуальности

- Tutorial

Иллюзии привлекают нас тем, что избавляют от боли, а в качестве замены приносят удовольствие.

За это мы должны без сетований принимать, когда, вступая в противоречие с частью реальности, иллюзии разбиваются вдребезги.

Зигмунд Фрейд

III Использование Виртуальной реальности

В первой части мы определили основные свойства и характеристики, действующих лиц и окружение явления Виртуальной реальности, трактуя этот феномен шире, чем Википедия и прочие современные источники. Мы предположили, что это искусственная реальность созданная, не только исключительно при помощи технических средств, а Иллюзия вообще. По крайней мере, это понятие так и трактовалось в докомпьютерную эпоху.

Теперь давайте соберем, и проанализируем информацию, для чего люди прибегают к ее “употреблению”, какие дозы безопасны, не вызывают привыкания и побочных эффектов.

1. Погружение в комфортную иллюзию, придуманную кем-то

А когда же мы впервые сталкиваемся с ощущениями несуществующего мира? Наверное это все-таки сказки, которые нам читали в детстве. С давних времен, испытывая потребность хотя бы на время убежать от жестокой реальности, в иную: счастливую, справедливую и комфортную, люди придумывали сказки. Хотя справедливости ради, надо заметить, что на некоторых больше действует обратный эффект. Окунаясь в ужасы и страдания, человек вырвавшись обратно в объективную реальность, понимает, что жизнь, по сравнению с прочувствованными ощущениями, не так уж ужасна, а вполне даже сносна, и он еще не плохо устроился, да чего там — повезло просто и все. И даже повзрослев, люди не перестают нуждаться в сказках. Так и тянет добавить сюда фразу «и некоторые козлы этим пользуются…».

Еще одна миссия сказок – это возможность получить жизненный опыт, а использование воображаемых (Виртуальных) образов помогает усилить впечатления и ускорить процесс обучения. И мы уже с детства точно знаем, как нужно правильно распорядиться желаниями, если случайно поймаем золотую рыбку, из чего надо строить домики, чтобы проходящий мимо волк не смог их разрушить. Вот сейчас подумал: странно, но почему-то мы с детства получаем широчайший опыт обращения именно с волками. Ну да ладно не суть. Шутки — шутками, а есть люди, которых сказки подтолкнули воплотить их счастливые сюжеты в жизнь, так или иначе, подправив свою реальность. При этом, иногда они даже и не догадывались, что это просто сказка, и не стоит даже пытаться ее воспроизвести.

Исходя из концепции представленной в первой беседе — модель сказки может выглядеть так

2. Воссоздание представления о потерянных со временем артефактах и событиях

Следующая полезность, лежит на поверхности, всем хорошо известна, и поэтому затронем ее лишь лапидарно. Связана она с тем, что все в жизни умирает: люди, традиции, здания, целые города и даже цивилизации. И помочь не растерять представление о них полностью и безвозвратно, позволяет пожалуй, только Виртуальная реальность. Ведь, при помощи искусственного воссоздания подобных иллюзий, можно смоделировать детали, знания о которых уже утрачены. Но тут важно не переборщить с домыслами и отсебятиной. А посему, можно утверждать, что одним из самых используемых назначений Виртуальной реальности, является воссоздание утраченных со временем артефактов и событий.

3. Построение иллюзии, своего идеального мира

Что еще? Скорее всего каждый из вас хоть раз в свой жизни встречал людей, о которых говорят: «живут в своем мире». Это может быть мир «волшебников и фей», «щенячьей любви ко всем», «веры во вселенскую справедливость» и т.п. В данном случае, мы говорим не о фобиях типа «всеобщего заговора против меня», диктуемых неким негативным жизненным опытом, а о стремлении человека вырваться из реальности своего бытия, которая его не устраивает и которую он не в силах изменить. Типичный пример существования в таком воображаемом мира, можно подчеркнуть из фильма «Влюблен по собственному желанию», когда героиня рассуждает:

«Посмотри: он скучающе едет и скучающе смотрит. Да понимает ли он, что он – избранник! избранник мироздания!»… «Я никогда не бываю одна. Вот например, сейчас я думаю о каком-то человеке. Ведь он сейчас, сию минуту, что-то делает, живет. А я подумала о нем и породнилась. Мы с ним побратимы одномоментности существования».

Этот фильм снимали еще в докомпьютерную эпоху. А в наш век всепоглощающих компьютерных игр и социальных сетей, так и тянет прикрыть проблемы таким воображаемым миром. При таковом даже не надо напрягать фантазию – опустил дряблые мышцы в кресло за компьютер, и вот ты уже супергерой, раскидывающий монстров за пределы монитора. Или красавчик, небрежно делящийся с другими, своими бесчисленными победами на любовном фронте. Весь такой в белом, на белом верблюде, за белым роялем… ну красавчик же, согласитесь. Отсюда можно сделать вывод: что востребованной ролью Виртуальной реальности в жизни человека, является возможность без особых физических усилий ощутить себя кем-то другим — идеальным, или в каком-то другом — идеальном окружении. Это явление также проявлялся с давних времен, что прекрасно подметил Оскар Уайльд в своей фразе: «Человек чувствует себя неуютно, когда говорит о себе. Дайте ему маску, и он расскажет вам всю правду».

Вот эдакой маской нас и наделили социальные сети, ставшие незаменимым «решалой» такого рода проблем. Цель использования подобного приема – скрыть свою физическую, а иногда и духовную идентичность. Претвориться другим человеком, для того чтобы обмануть другого, а чаще всего — обманываться самому.

Социальные сети реализуют еще один феномен, который успешно рассматривал в своих трудах американский психиатр Арнольд Людвиг (англ. Arnold M. Ludwig) – это социальная сплоченность, При помощи этого инструмента мир стал меняться гораздо быстрее. В последнее время, это все чаще стало обращаться в оружие, при борьбе кого-то с кем-то. Но эту тему как-то страшно даже поднимать. Когда я писал в свой статье об инструментах создания «Социального организма», меня обвинили в “состряпывании” инструкции по созданию секты. Но и умолчать об этом, я тоже не мог.

4. Имитация опасных ситуаций для приобретения опыта

Обратить внимание на проявление еще одного назначения Виртуальной реальности, мене помогла мысль великого философа Фридриха Вильгельма Ницше. Он писал: «Несбывшееся бывает куда важнее случившегося…». А несбывшегося, как мы понимаем, нет и никогда не было и единственная среда его существования – Виртуальная реальность. Именно она позволяет моделировать ситуации и заглядывать за грань обозримого, избегая негативных последствий в реальном мире. Человек приобретает опыт, учась на своих — «чужих» (виртуальных) ошибках. Это избавляет Вас от одной из самых страшных ошибок в жизни — постоянно боятся совершить ошибку. И вы можете как в фильме «День сурка», раз за разом пробовать изменить сюжетную линию и понаблюдать изнутри, к чему это приведет.

К тому же, если взять за основу предположение Алексея Толстого о том, что: «Счастье есть удовольствие без раскаяния.», то Виртуальный мир, как раз и способен делать нас счастливыми, исключив из схемы необходимость раскаиваться.

Это весьма полезное и труднозаменимое другими средствами, предназначение Виртуальной реальности.

5. Виртуализация деловых процессов

А еще в последнее время очень радует электронное правительство, разумеется виртуальное. Например, сайты «госуслуг». Какие же они быстрые, вежливые и услужливые — эти «госуслуги». Молча выслушают и ни разу не перебьют, пока ты им строчишь гневное письмо, брызгая слюной от переизбытка чувств, испытывая такую личную неприязнь, к тем другим — вполне реальным, безответственным бездельникам, портящим жизнь Вам. Да чего только Вам — всем окружающим вокруг. Подал жалобу или например, заявку на получение справки, документа, права что-либо делать, да мало ли чего еще. И ждешь… Нет, не в очереди в толкучке и гомоне, а дома на мягком диване, с чашечкой кофе, кому врач конечно дозволяет. И вот блымкнуло в компьютере, и ты знаешь — пришло сообщение, а там уже готовый ответ, разъяснение, разрешение, ну в крайнем случае отказ. Но тоже очень вежливый, с объяснениями конечно, извинениями, так мол и так вышло.

А почему все так здорово складывается? Да просто исключили человека из некоторых цепочек государева дела, заменив Виртуальной реальностью, которая не такая чувствительная, раздражительная и эмоциональная. Которая со временем, не возомнит себя незаменимой и не начнет хамить и требовать уважения к себе как к личности.

6. Виртуализация взаиморасчетов

Еще одно стремительно набирающее проявление Виртуальной реальности – это Виртуальные (или электронные) деньги. Они могут обмениваться как по правилам Центробанка, так и по правилам различных частных электронных платежных систем. Но тут стоит отметить, что один из главных признаков законности валюты – статус законного платежного денежного средства, коим на текущий момент не обладает ни одна из виртуальных валют.

Суть использования этой виртуальности состоит в том, что некая организация (эмитент) выпускает аналог денег, соответственно виртуальных, и продает их страждущим пользователям, за деньги реальные. Те могут совершить на них оговоренные покупки, у оговоренных продавцов, расплатившись с ним виртуальной наличностью. Продавец, в свою очередь, с полученными электронными денежками обращается обратно к эмитенту, выпустившему их и гасит оные, конвертируя в реальные деньги. Есть еще электронные чеки и прочие виртуальные взаиморасчеты.

У тех, кто никогда с этим не работал, может возникнуть вопрос: «Зачем же так сложно»? Тут выгода достигается в основном (но не только) за счет минимизации расходов на операции банковской системы. С ними взаимодействуют, грубо говоря, два раза в схеме. Первый раз купив электронные деньги, и второй — конвертируя их обратно в реальные. А между этими двумя событиями, можно совершить множество операций покупок не используя банковские транзакции. Получается так сказать беспошлинная зона — а-ля дьюти фри.

И тут уместно вспомнить пример из жизни, использования виртуальных (правда не электронных) денег в доинтернетовскую эпоху. Как-то в 90-ые денег на всех не хватало, и они, как-то очень быстро обесценивались и в связи с этим, их все больше не хватало. Что придумали светлые головы тогдашней современности? При поездке работников завода в заводской профилакторий, расположенный в другом регионе, им выдавались купоны на посещение бара с употреблением алкогольных напитков. Чем не виртуальные деньги? Такие не подведут. Ведь их: во-первых, можно использовать только по целевому назначению, жена на косметику не отберет, во-вторых, они не потеряют в покупательской способности при инфляции.

7. Резюме раздела

В итоге у нас получилось выделить следующие необходимости использовать Виртуальную реальность:

- Воссоздание представлений о потерянных со временем артефактах и событиях;

- Приобретение собственного опыта, основываясь на чужих представлениях, зачастую гипертрофированных, для усиления эффекта;

- Создания вокруг себя альтернативного, более комфортного мира, помогающего почувствовать себя счастливее, чем в реальной жизни;

- Возможность анонимного общения, позволяющая скрыть свою физическую идентичность, а иногда и духовную. Позволяет притвориться другим человеком, снизить уязвимость;

- Моделирование различных опасных ситуаций, которые могли бы происходить в реальной жизни, для предотвращения их негативных последствий в реальном мире и выбора наилучших вариантов решения проблем;

- Создание иллюзии, обмана, для того чтобы ввести людей в заблуждение, в каких-то корыстных целях;

- Подмена человека в деловых процессах, позволяющая исключить негативные проявления его слабостей и пороков;

- Исключение из взаиморасчетов официальных финансовых институтов, для минимизации затрат на их услуги.

2. Н.А., Носов. Виртуальная психология. Москва: «Аграф, 2000 г.

3. А.Ф., Иванов. Об онтологическом статусе виртуальной реальности.

|

Метки: author ARadzishevskiy читальный зал исследования и прогнозы в it социальные проекты виртуальная реальность виртландия реальность |

День открытых дверей «Лаборатории Касперского»: закрываем данные от взлома, открываем новые возможности |

|

Метки: author megapost карьера в it-индустрии информационная безопасность касперский день открытых дверей |

Достижения в глубоком обучении за последний год |

Достижения в глубоком обучении за последний год

Привет, Хабр. В своей статье я расскажу вам, что интересного произошло в мире машинного обучения за последний год (в основном в Deep Learning). А произошло очень многое, поэтому я остановился на самых, на мой взгляд, зрелищных и/или значимых достижениях. Технические аспекты улучшения архитектур сетей в статье не приводятся. Расширяем кругозор!

1. Текст

1.1. Google Neural Machine Translation

Почти год назад Google анонсировала запуск новой модели для Google Translate. Компания подробно описала архитектуру сети — Recurrent Neural Network (RNN) — в своей статье.

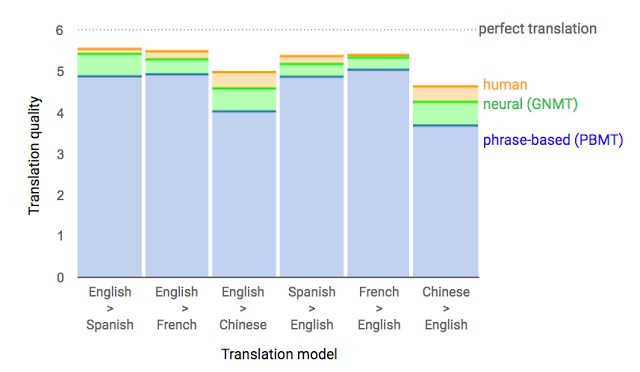

Основной результат: сокращение отставания от человека по точности перевода на 55—85 % (оценивали люди по 6-балльной шкале). Воспроизвести высокие результаты этой модели сложно без огромного датасета, который имеется у Google.

2.1. Переговоры. Будет сделка?

Вы могли слышать дурацкие новости о том, что Facebook выключила своего чат-бота, который вышел из-под контроля и выдумал свой язык. Этого чат-бота компания создала для переговоров. Его цель — вести текстовые переговоры с другим агентом и достичь сделки: как разделить на двоих предметы (книги, шляпы...). У каждого агента своя цель в переговорах, другой ее не знает. Просто уйти с переговоров без сделки нельзя.

Для обучения собрали датасет человеческих переговоров, обучили supervised рекуррентную сеть, далее уже обученного агента с помощью reinforcement learning (обучения с подкреплением) тренировали переговариваться с самим собой, поставив ограничение: похожесть языка на человеческий.

Бот научился одной из стратегий реальных переговоров — показывать поддельный интерес к некоторым аспектам сделки, чтобы потом по ним уступить, получив выгоду по своим настоящим целям. Это первая попытка создания подобного переговорного бота, и довольно удачная.

Подробности — в статье, код выложен в открытый доступ.

Разумеется, новость о том, что бот якобы придумал язык, раздули на пустом месте. При обучении (при переговорах с таким же агентом) отключили ограничение похожести текста на человеческий, и алгоритм модифицировал язык взаимодействия. Ничего необычного.

За последний год рекуррентные сети активно развивали и использовали во многих задачах и приложениях. Архитектуры рекуррентных сетей сильно усложнились, однако по некоторым направлениям похожих результатов достигают и простые feedforward-сети — DSSM. Например, Google для своей почтовой фичи Smart Reply достигла такого же качества, как и с LSTM до этого. А Яндекс запустил новый поисковый движок на основе таких сетей.

2. Речь

2.1. WaveNet: генерирующая модель для необработанного аудио

Сотрудники DeepMind (компания, известная своим ботом для игры в го, ныне принадлежащая Google) рассказали в своей статье про генерирование аудио.

Если коротко, то исследователи сделали авторегрессионную полносверточную модель WaveNet на основе предыдущих подходов к генерированию изображений (PixelRNN и PixelCNN).

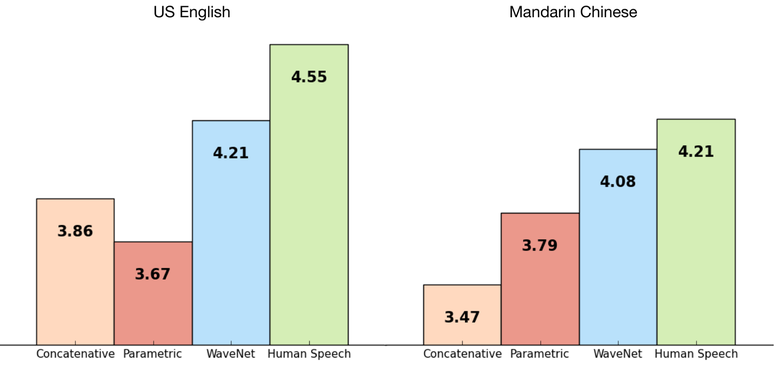

Сеть обучалась end-to-end: на вход текст, на выход аудио. Результат превосходный, разница с человеком сократилась на 50 %.

Основной недостаток сети — низкая производительность, потому что из-за авторегрессии звуки генерируются последовательно, на создание одной секунды аудио уходит около 1—2 минут.

Английский: пример

Если убрать зависимость сети от входного текста и оставить только зависимость от предыдущей сгенерированной фонемы, то сеть будет генерировать подобные человеческому языку фонемы, но бессмысленные.

Генерирование голоса: пример

Эту же модель можно применить не только к речи, но и, например, к созданию музыки. Пример аудио, сгенерированного моделью, которую обучили на датасете игры на пианино (опять же без всякой зависимости от входных данных).

Подробности — в статье.

2.2. Чтение по губам

Еще одна победа машинного обучения над человеком ;) На этот раз — в чтении по губам.

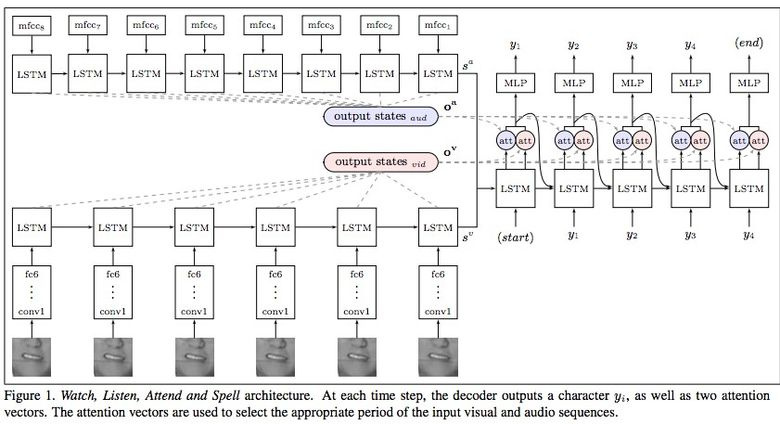

Google Deepmind в сотрудничестве с Оксфордским университетом рассказывают в статье «Lip Reading Sentences in the Wild», как их модель, обученная на телевизионном датасете, смогла превзойти профессионального lips reader’а c канала BBC.

В датасете 100 тыс. предложений с аудио и видео. Модель: LSTM на аудио, CNN + LSTM на видео, эти два state-вектора подаются в итоговую LSTM, которая генерирует результат (characters).

При обучении использовались разные варианты входных данных: аудио, видео, аудио + видео, то есть модель «омниканальна».

2.3. Синтезируя Обаму: синхронизация движения губ с аудио

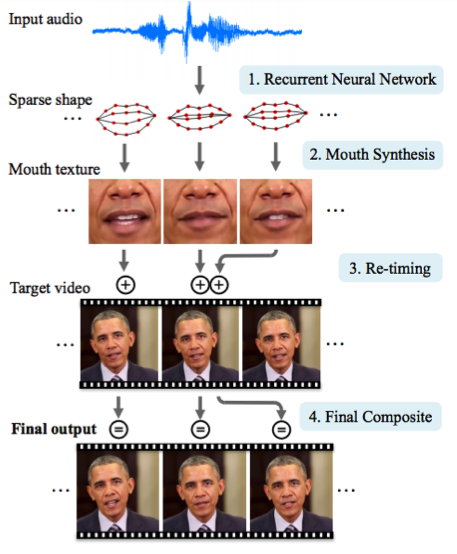

Университет Вашингтона проделал серьезную работу по генерированию движения губ бывшего президента США Обамы. Выбор пал на него в том числе из-за огромного количества записей его выступления в сети (17 часов HD-видео).

Одной сетью обойтись не удалось, получалось слишком много артефактов. Поэтому авторы статьи сделали несколько костылей (или трюков, если угодно) по улучшению текстуры и таймингам.

Результат впечатляет. Скоро нельзя будет верить даже видео с президентом ;)

3. Компьютерное зрение

3.1. OCR: Google Maps и Street View

В своих посте и статье команда Google Brain рассказывает, как внедрила в свои Карты новый движок OCR (Optical Character Recognition), с помощью которого распознаются указатели улиц и вывески магазинов.

В процессе разработки технологии компания составила новый FSNS (French Street Name Signs), который содержит множество сложных кейсов.

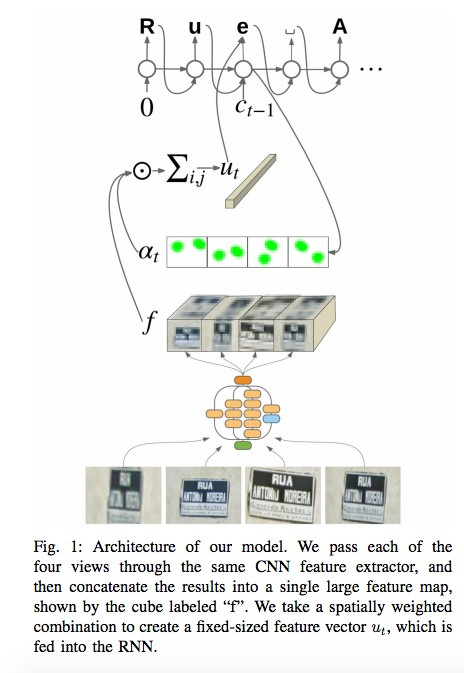

Сеть использует для распознавания каждого знака до четырех его фотографий. С помощью CNN извлекаются фичи, взвешиваются с помощью spatial attention (учитываются пиксельные координаты), а результат подается в LSTM.

Тот же самый подход авторы применяют к задаче распознавания названий магазинов на вывесках (там может быть много «шумовых» данных, и сеть сама должна «фокусироваться» в нужных местах). Алгоритм применили к 80 млрд фотографий.

3.2. Visual Reasoning

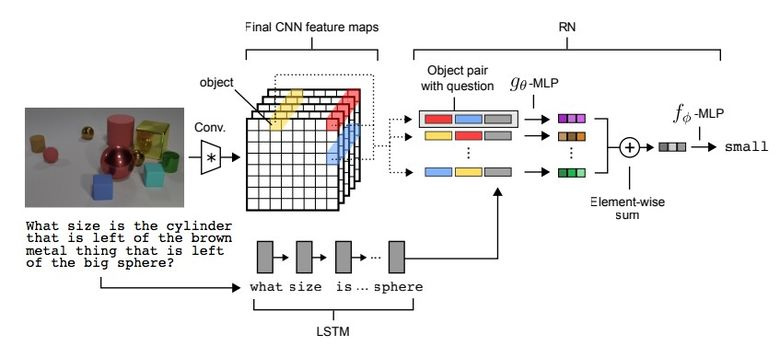

Существует такой тип задач, как Visual Reasoning, то есть нейросеть должна по фотографии ответить на какой-то вопрос. Например: «Есть ли на картинке резиновые вещи того же размера, что и желтый металлический цилиндр?» Вопрос и правда нетривиальный, и до недавнего времени задача решалась с точностью всего лишь 68,5 %.

И вновь прорыва добилась команда из Deepmind: на датасете CLEVR они достигли super-human точности в 95,5 %.

Архитектура сети весьма интересная:

- По текстовому вопросу с помощью pretrained LSTM получаем embedding (представление) вопроса.

- По картинке с помощью CNN (всего четыре слоя) получаем feature maps (фичи, характеризующие картинку).

- Далее формируем попарные комбинации покоординатных slice’ов feature maps (желтые, синие, красные на картинке ниже), добавляем к каждой координаты и текстовый embedding.

- Прогоняем все эти тройки через еще одну сеть, суммируем.

Полученное представление прогоняем через еще одну feedforward-сеть, которая уже на софтмаксе выдает ответ.

3.3. Pix2Code

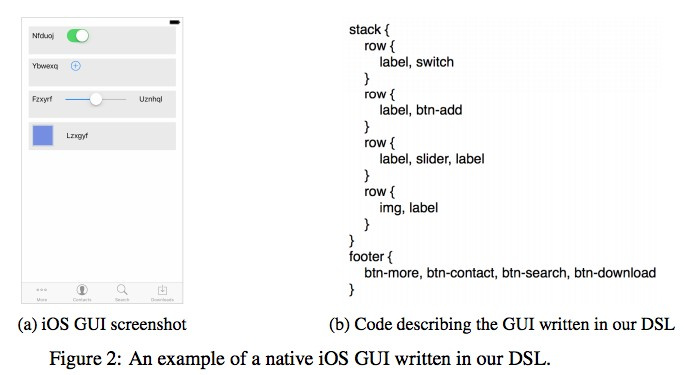

Интересное применение нейросетям придумала компания Uizard: по скриншоту от дизайнера интерфейсов генерировать код верстки.

Крайне полезное применение нейросетей, которое может облегчить жизнь при разработке софта. Авторы утверждают, что получили 77 % точности. Понятно, что это пока исследовательская работа и о боевом применении речи не идет.

Кода и датасета в open source пока нет, но обещают выложить.

3.4. SketchRNN: учим машину рисовать

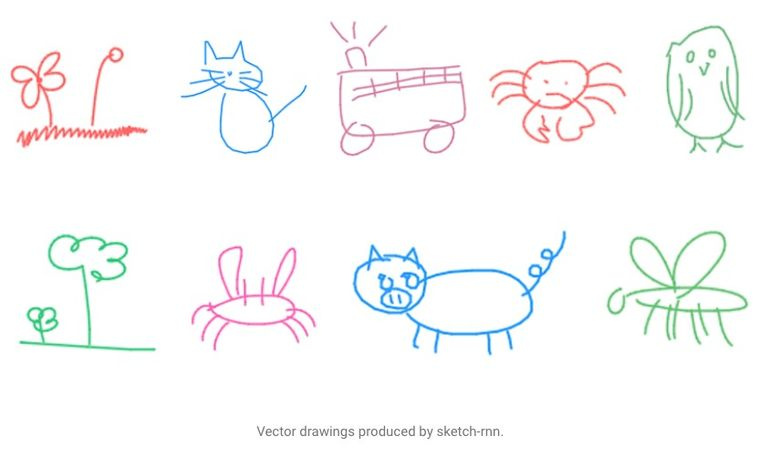

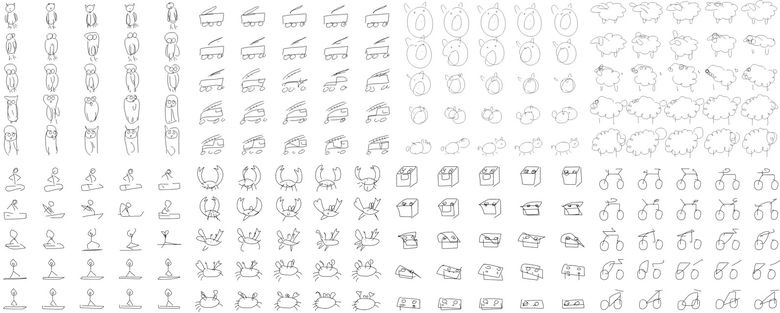

Возможно, вы видели страничку Quick, Draw! от Google с призывом нарисовать скетчи различных объектов за 20 секунд. Корпорация собирала этот датасет для того, чтобы обучить нейросеть рисовать, о чем Google рассказала в своем блоге и статье.

Собранный датасет состоит из 70 тыс. скетчей, он был в итоге выложен в открытый доступ. Скетчи представляют собой не картинки, а детализированные векторные представления рисунков (в какой точке пользователь нажал «карандаш», отпустил, куда провел линию и так далее).

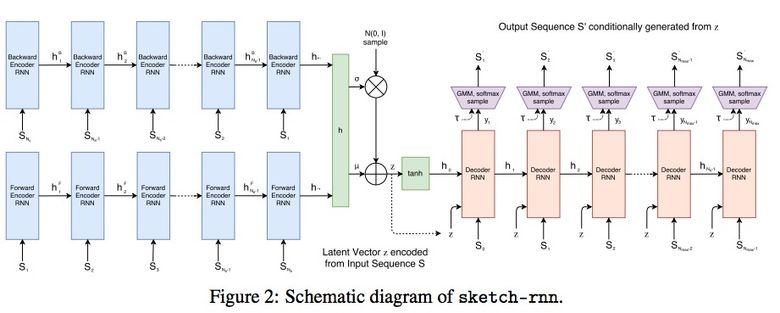

Исследователи обучили Sequence-to-Sequence Variational Autoencoder (VAE) c использованием RNN в качестве механизма кодирования/декодирования.

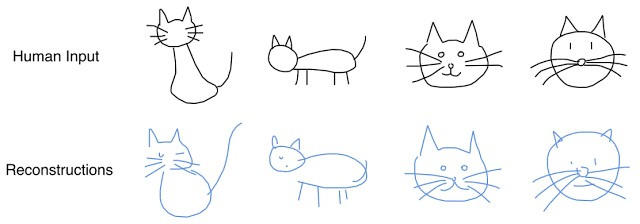

В итоге, как и положено автоенкодеру, модель получает латентный вектор, который характеризует исходную картинку.

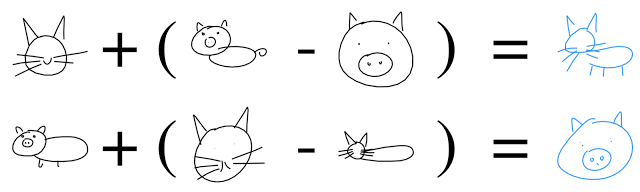

Поскольку декодер умеет извлекать из этого вектора рисунок, то можно его менять и получать новые скетчи.

И даже выполнять векторную арифметику, чтобы соорудить котосвина:

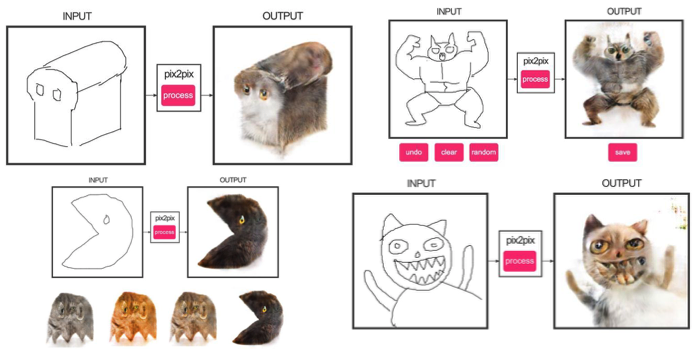

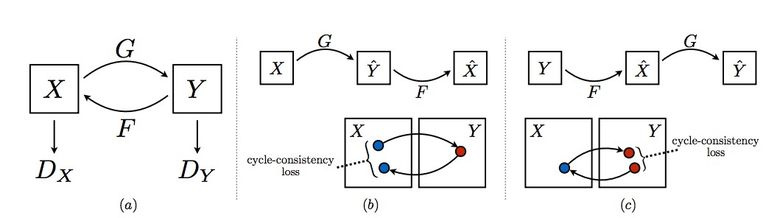

3.5. GAN

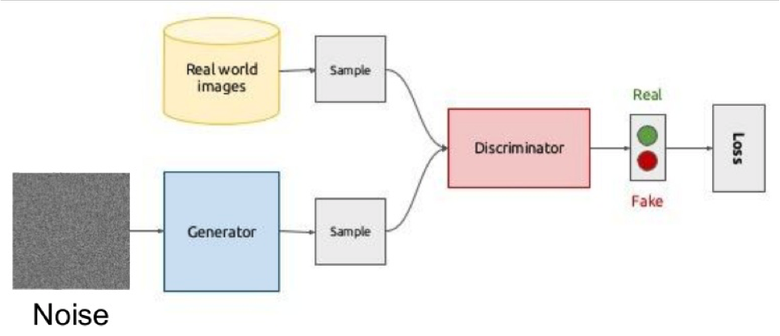

Одна из самых горячих тем в Deep Learning — Generative Adversarial Networks (GAN). Чаще всего эту идею используют для работы с изображениями, поэтому объясню концепцию именно на них.

Суть идеи состоит в соревновании двух сетей — Генератора и Дискриминатора. Первая сеть создает картинку, а вторая пытается понять, реальная это картинка или сгенерированная.

Схематично это выглядит так:

Во время обучения генератор из случайного вектора (шума) генерирует изображение и подает на вход дискриминатору, который говорит, фальшивка это или нет. Дискриминатору также подаются реальные изображения из датасета.

Обучать такую конструкцию часто тяжело из-за того, что трудно найти точку равновесия двух сетей, чаще всего дискриминатор побеждает и обучение стагнирует. Однако преимущество системы в том, что мы можем решать задачи, в которых нам тяжело задать loss-функцию (например, улучшение качества фотографии), мы это отдаем на откуп дискриминатору.

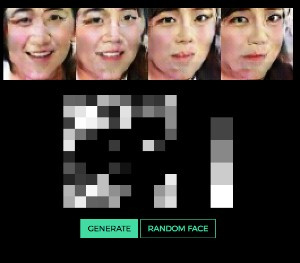

Классический пример результата обучения GAN — картинки спален или лиц.

Ранее мы рассматривали автокодировщики (Sketch-RNN), которые кодируют исходные данные в латентное представление. С генератором получается то же самое.

Очень наглядно идея генерирования изображения по вектору на примере лиц показана тут (можно изменять вектор и посмотреть, какие выходят лица).

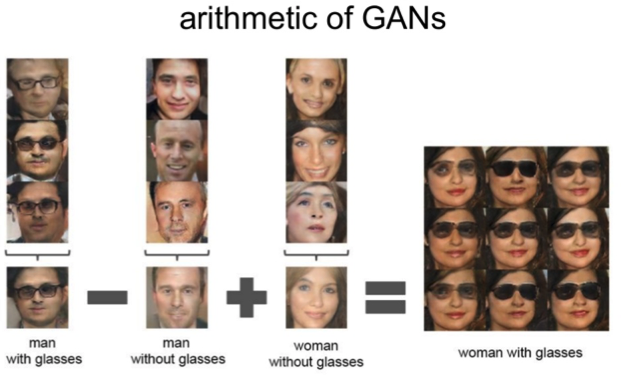

Работает все та же арифметика над латентным пространством: «мужчина в очках» минус «мужчина» плюс «женщина» равно «женщина в очках».

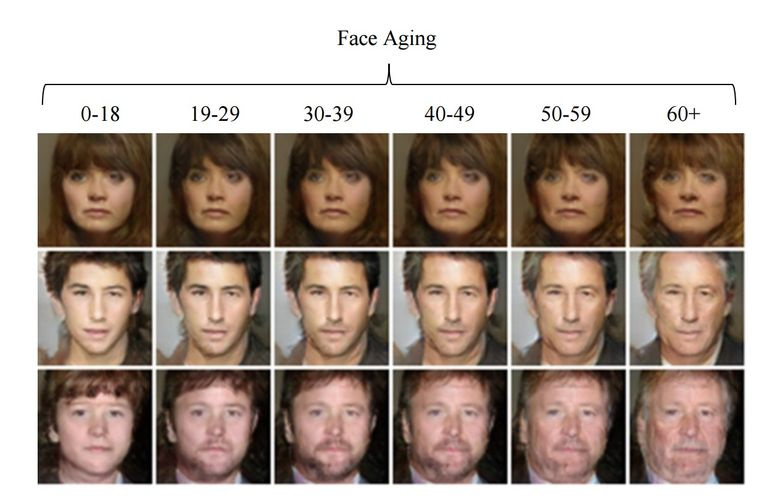

3.6. Изменение возраста лица с помощью GAN

Если при обучении подсунуть в латентный вектор контролируемый параметр, то при генерировании его можно менять и так управлять нужным образом на картинке. Этот подход именуется Conditional GAN.

Так поступили авторы статьи «Face Aging With Conditional Generative Adversarial Networks». Обучив машину на датасете IMDB с известным возрастом актеров, исследователи получили возможность менять возраст лица.

3.7. Фотографии профессионального уровня

В Google нашли еще одно интересное применение GAN — выбор и улучшение фотографий. GAN обучали на датасете профессиональных фотографий: генератор пытается улучшить плохие фотографии (профессионально снятые и ухудшенные с помощью специальных фильтров), а дискриминатор — различить «улучшенные» фотографии и реальные профессиональные.

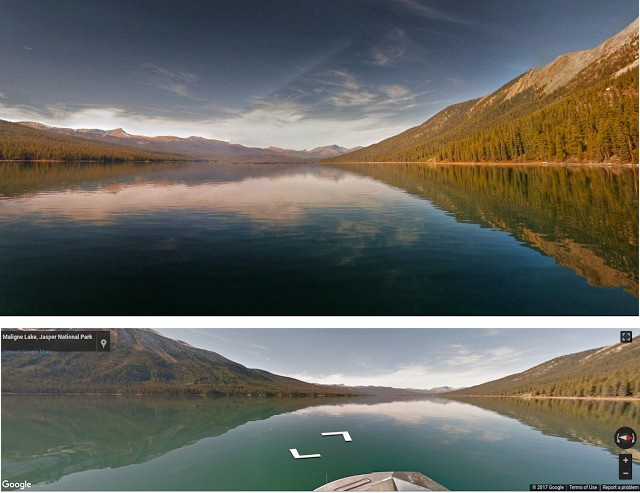

Обученный алгоритм прошелся по панорамам Google Street View в поиске лучших композиций и получил некоторые снимки профессионального и полупрофессионального качества (по оценкам фотографов).

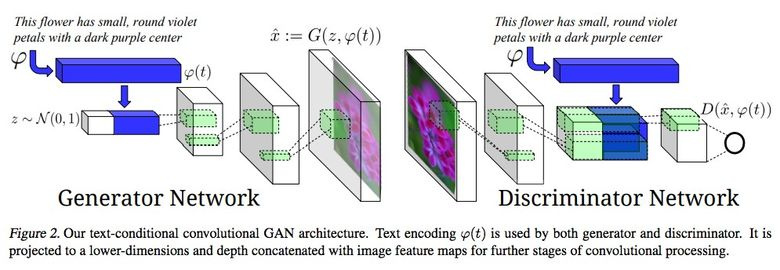

3.8. Синтезирование из текстового описания в изображение

Впечатляющий пример использования GAN — генерирование картинок по тексту.

Авторы статьи предлагают подавать embedding текста на вход не только генератору (conditional GAN), но и дискриминатору, чтобы он проверял соответствие текста картинке. Чтобы дискриминатор научился выполнять свою функцию, дополнительно в обучение добавляли пары с неверным текстом для реальных картинок.

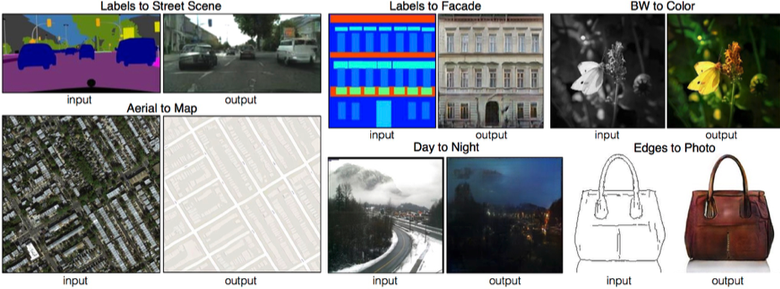

3.9. Pix2pix

Одна из ярких статей конца 2016 года — «Image-to-Image Translation with Conditional Adversarial Networks» Berkeley AI Research (BAIR). Исследователи решали проблему image-to-image генерирования, когда, например, требуется по снимку со спутника создать карту или по наброску предметов — их реалистичную текстуру.

Это еще один пример успешной работы conditional GAN, в данном случае condition идет на целую картинку. В качестве архитектуры генератора использовалась UNet, популярная в сегментации изображений, а для борьбы с размытыми изображениями в качестве дискриминатора взяли новый классификатор PatchGAN (картинка нарезается на N патчей, и предсказание fake/real идет по каждому из них в отдельности).

Авторы выпустили онлайн-демо своих сетей, что вызвало огромный интерес у пользователей.

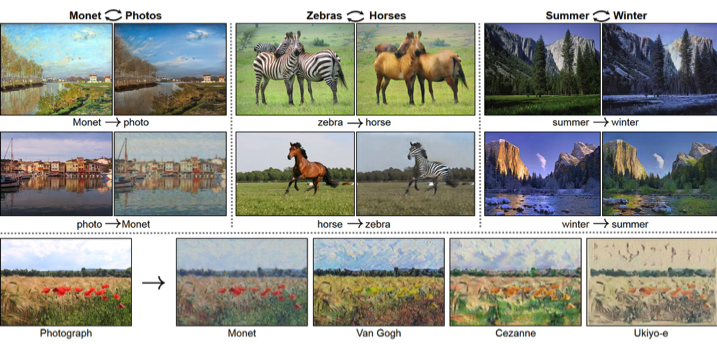

3.10. CycleGAN

Чтобы применить Pix2Pix, требуется датасет с соответствующими парами картинок из разных доменов. В случае, например, с картами собрать такой датасет не проблема. Но если хочется сделать что-то более сложное вроде «трансфигурирования» объектов или стилизации, то пар объектов не найти в принципе. Поэтому авторы Pix2Pix решили развить свою идею и придумали CycleGAN для трансфера между разными доменами изображений без конкретных пар — Unpaired Image-to-Image Translation.

Идея состоит в следующем: мы учим две пары генератор-дискриминатор из одного домена в другой и обратно, при этом мы требуем cycle consistency — после последовательного применения генераторов должно получиться изображение, похожее на исходное по L1 loss’у. Цикличный loss требуется для того, чтобы генератор не начал просто транслировать картинки одного домена в совершенно не связанные с исходным изображением.

Такой подход позволяет выучить маппинг лошади –> зебры.

Такие трансформации работают нестабильно и часто создают неудачные варианты:

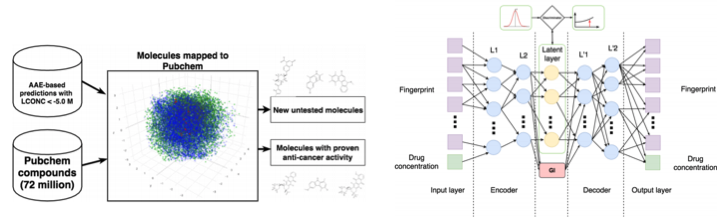

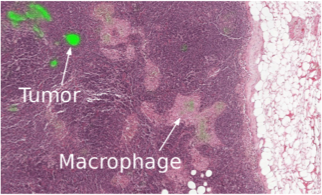

3.11. Разработка молекул в онкологии

Машинное обучение сейчас приходит и в медицину. Помимо распознавания УЗИ, МРТ и диагностики его можно использовать для поиска новых лекарств для борьбы с раком.

Мы уже подробно писали об этом исследовании тут, поэтому коротко: с помощью Adversarial Auto Encoder (AAE) можно выучить латентное представление молекул и дальше с его помощью искать новые. В результате нашли 69 молекул, половина из которых применяются для борьбы с раком, остальные имеют серьезный потенциал.

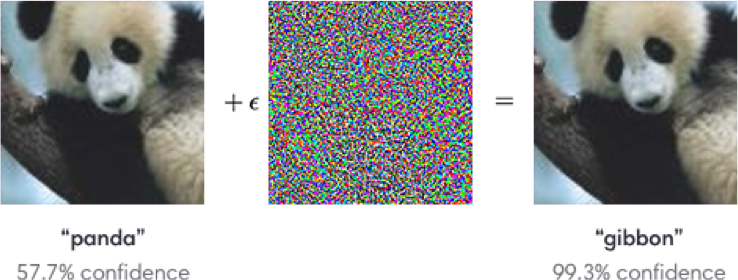

3.12. Adversarial-атаки

Сейчас активно исследуется тема с adversarial-атаками. Что это такое? Стандартные сети, обучаемые, например, на ImageNet, совершенно неустойчивы к добавлению специального шума к классифицируемой картинке. На примере ниже мы видим, что картинка с шумом для человеческого глаза практически не меняется, однако модель сходит с ума и предсказывает совершенно иной класс.

Устойчивость достигается с помощью, например, Fast Gradient Sign Method (FGSM): имея доступ к параметрам модели, можно сделать один или несколько градиентных шагов в сторону нужного класса и изменить исходную картинку.

Одна из задач на Kaggle к грядущему NIPS как раз связана с этим: участникам предлагается создать универсальные атаки/защиты, которые в итоге запускаются все против всех для определения лучших.

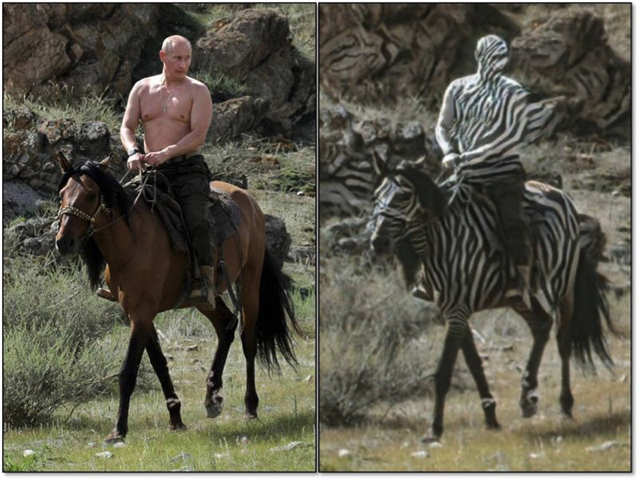

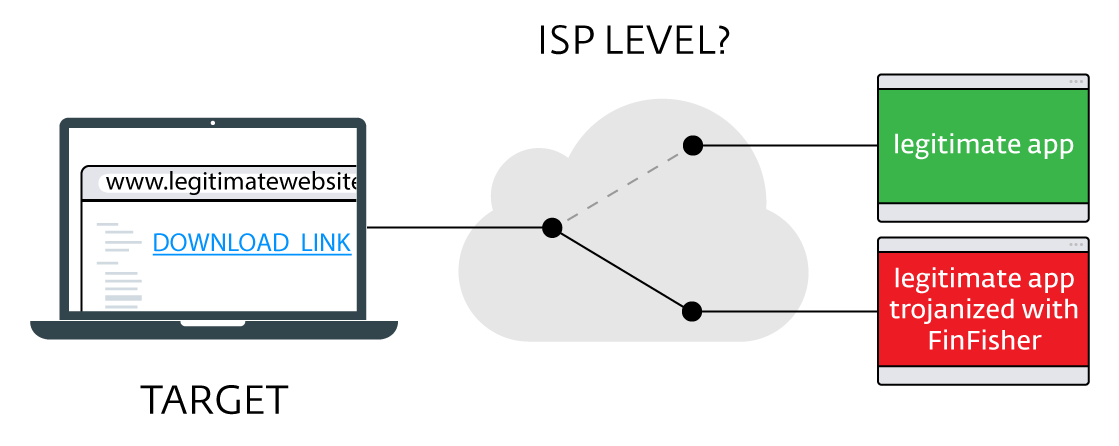

Зачем нам вообще исследовать эти атаки? Во-первых, если мы хотим защитить свои продукты, то можно добавлять к капче шум, чтобы мешать спамерам распознавать ее автоматом. Во-вторых, алгоритмы все больше и больше участвуют в нашей жизни — системы распознавания лиц, беспилотные автомобили. При этом злоумышленники могут использовать недостатки алгоритмов. Вот пример, когда специальные очки позволяют обмануть систему распознавания лиц и «представиться» другим человеком. Так что модели надо будет учить с учетом возможных атак.

Такие манипуляции со знаками тоже не позволяют правильно их распознать.

Набор статей от организаторов конкурса.

Уже написанные библиотеки для атак: cleverhans и foolbox.

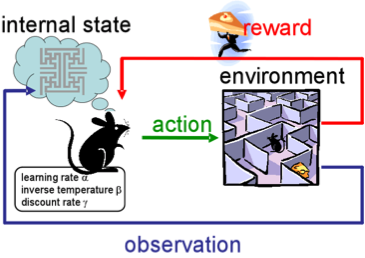

4. Обучение с подкреплением

Reinforcement learning (RL), или обучение с подкреплением, — также сейчас одна из интереснейших и активно развивающихся тем в машинном обучении.

Суть подхода заключается в выучивании успешного поведения агента в среде, которая при взаимодействии дает обратную связь (reward). В общем, через опыт — так же, как учатся люди в течение жизни.

RL активно применяют в играх, роботах, управлении системами (трафиком, например).

Разумеется, все слышали о победах AlphaGo от DeepMind в игре го над лучшими профессионалами. Статья авторов была опубликована в Nature «Mastering the game of Go». При обучении разработчики использовали RL: бот играл сам с собой для совершенствования своих стратегий.

4.1. Обучение с подкреплением с неконтролируемыми вспомогательными задачами

В предыдущие годы DeepMind научился с помощью DQN играть в аркадные игры лучше человека. Сейчас алгоритмы учат играть в более сложные игры типа Doom.

Много внимания уделено ускорению обучения, потому что наработка опыта агента во взаимодействии со средой требует многих часов обучения на современных GPU.

Deepmind в своем блоге рассказывает о том, что введение дополнительных loss’ов (auxiliary tasks, вспомогательных задач), таких как предсказание изменения кадра (pixel control), чтобы агент лучше понимал последствия действий, существенно ускоряет обучение.

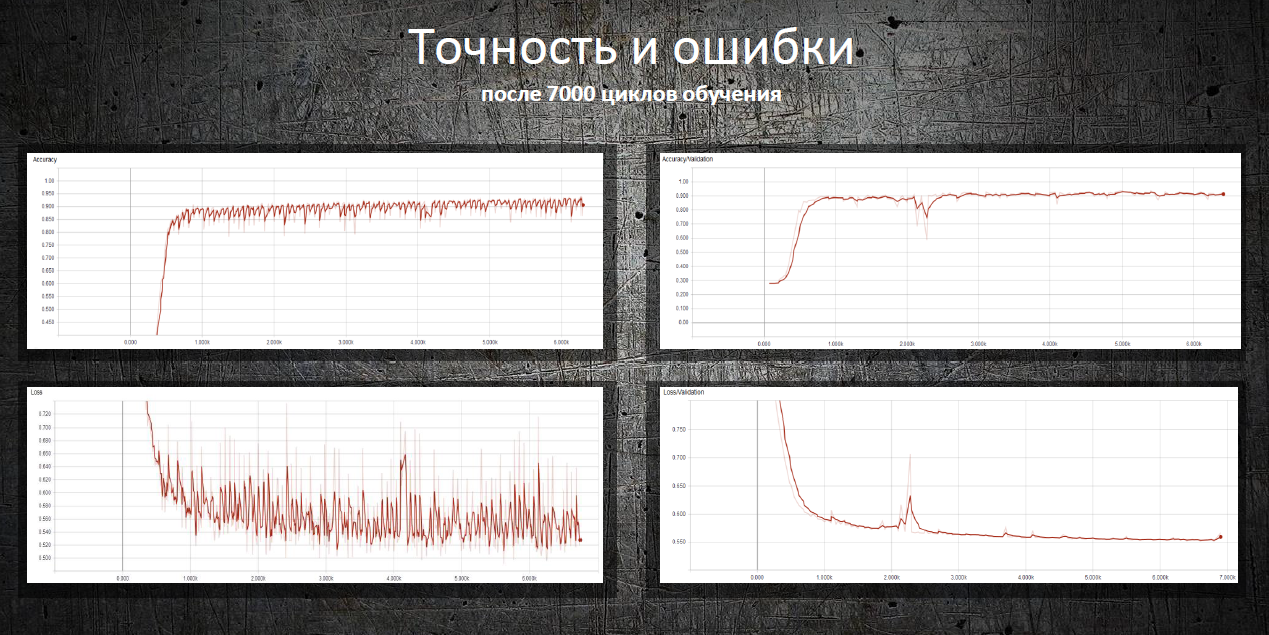

Результаты обучения:

4.2. Обучающиеся роботы

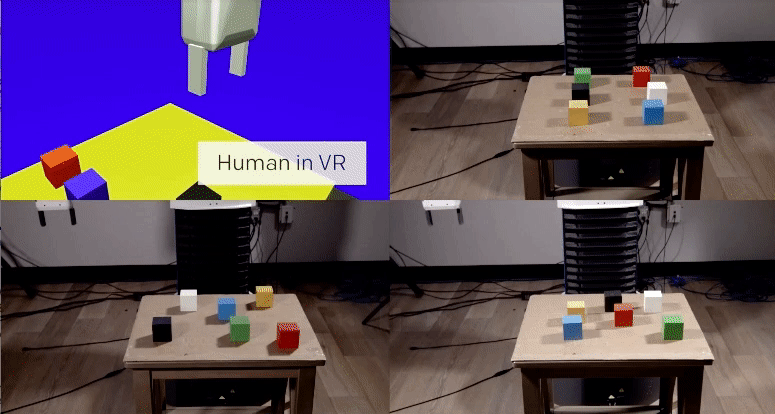

В OpenAI активно исследуют обучение человеком агента в виртуальной среде, что более безопасно для экспериментов, чем в реальной жизни ;)

В одном из исследований команда показала, что one-shot learning возможно: человек показывает в VR, как выполнить определенную задачу, и алгоритму достаточно одной демонстрации, чтобы выучить ее и далее воспроизвести в реальных условиях.

Эх, если бы с людьми было так просто ;)

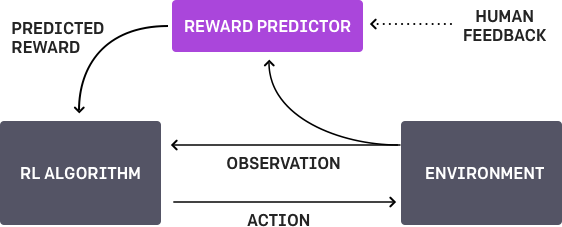

4.3. Обучение на человеческих предпочтениях

Работа OpenAI и DeepMind на ту же тему. Суть состоит в следующем: у агента есть некая задача, алгоритм предоставляет на суд человеку два возможных варианта решения, и человек указывает, какой лучше. Процесс повторяется итеративно, и алгоритм за 900 бит обратной связи (бинарной разметки) от человека выучился решать задачу.

Как всегда, человеку надо быть осторожным и думать, чему он учит машину. Например, оценщик решил, что алгоритм действительно хотел взять объект, но на самом деле тот лишь имитировал это действие.

4.4. Движение в сложных окружениях

Еще одно исследование от DeepMind. Чтобы научить робота сложному поведению (ходить/прыгать/...), да еще и похожему на человеческое, нужно сильно заморочиться с выбором функции потерь, которая будет поощрять нужное поведение. Но хотелось бы, чтобы алгоритм сам выучивал сложное поведение, опираясь на простые reward.

Исследователям удалось этого добиться: они научили агентов (эмуляторы тел) совершать сложные действия с помощью конструирования сложной среды с препятствиями и с простым reward за прогресс в передвижении.

Впечатляющее видео с результатами. Но оно гораздо забавнее с наложенным звуком ;)

Напоследок дам ссылку на опубликованные недавно алгоритмы обучения RL от OpenAI. Теперь можно использовать более современные решения, чем уже ставший стандартным DQN.

5. Прочее

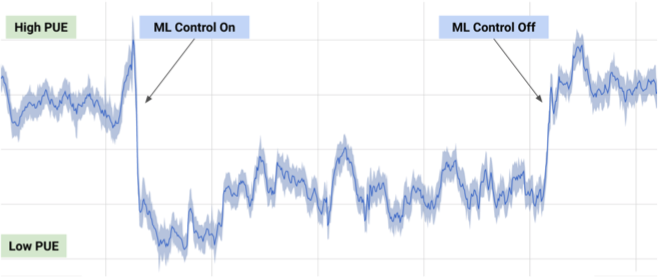

5.1. Охлаждение дата-центра

В июле 2017-го Google рассказала, что воспользовалась разработками DeepMind в машинном обучении, чтобы сократить энергозатраты своего дата-центра.

На основе информации с тысяч датчиков в дата-центре разработчики Google натренировали ансамбль нейросетей для предсказания PUE (Power Usage Effectiveness) и более эффективного управления дата-центром. Это впечатляющий и значимый пример практического применения ML.

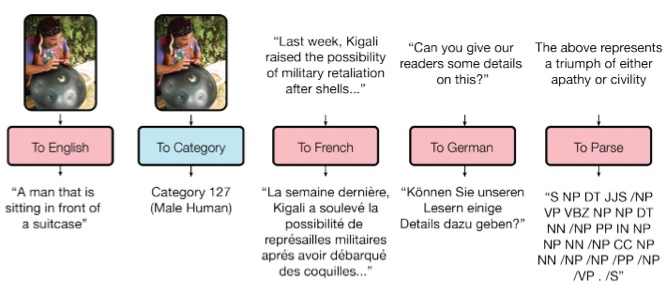

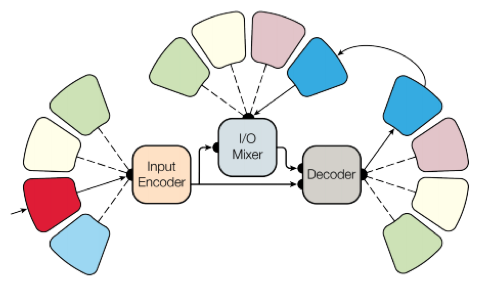

5.2. Одна модель на все задачи

Как вы знаете, обученные модели плохо переносятся от задачи к задаче, под каждую задачу приходится обучать/дообучать специфичную модель. Небольшой шаг в сторону универсальности моделей сделала Google Brain в своей статье «One Model To Learn Them All».

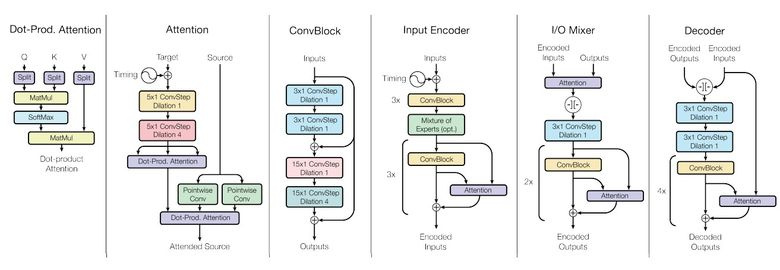

Исследователи обучили модель, которая выполняет восемь задач из разных доменов (текст, речь, изображения). Например, перевод с разных языков, парсинг текста, распознавание изображений и звука.

Для достижения этой цели сделали сложную архитектуру сети с различными блоками для обработки разных входных данных и генерирования результата. Блоки для encoder/decoder делятся на три типа: сверточные, attention, gated mixture of experts (MoE).

Основные итоги обучения:

- получились почти совершенные модели (авторы не делали тонкой настройки гиперпараметров);

- происходит передача знаний между разными доменами, то есть на задачах с большим количеством данных производительность будет почти такой же. А на маленьких задачах (например, на парсинге) — лучше;

- блоки, нужные для разных задач, не мешают друг другу и даже иногда помогают, например, MoE — для Imagenet-задачи.

Кстати, эта модель есть в tensor2tensor.

5.3. Обучение на Imagenet за один час

В своем посте сотрудники Facebook рассказали, как их инженеры смогли добиться обучения модели Resnet-50 на Imagenet всего за один час. Правда, для этого потребовался кластер из 256 GPU (Tesla P100).

Для распределенного обучения использовали Gloo и Caffe2. Чтобы процесс шел эффективно, пришлось адаптировать стратегию обучения при огромном батче (8192 элемента): усреднение градиентов, фаза прогрева, специальные learning rate и тому подобное. Подробнее в статье.

В итоге удалось добиться эффективности 90% при масштабировании от 8 к 256 GPU. Теперь исследователи из Facebook могут экспериментировать еще быстрее, в отличие от простых смертных без такого кластера ;)

6. Новости

6.1. Беспилотные автомобили