Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Tizen: подводим итоги |

Наша команда написала три заметки, связанные с анализом кода операционной системы Tizen. Операционная система содержит много кода и поэтому является благодатной почвой для написания различных статей. Думаю, что к Tizen мы ещё вернёмся в будущем, но сейчас нас ждут другие интересные проекты. Поэтому я подведу некоторые итоги проделанной работы и отвечу на ряд вопросов, возникших после опубликованных ранее статей.

Наша команда написала три заметки, связанные с анализом кода операционной системы Tizen. Операционная система содержит много кода и поэтому является благодатной почвой для написания различных статей. Думаю, что к Tizen мы ещё вернёмся в будущем, но сейчас нас ждут другие интересные проекты. Поэтому я подведу некоторые итоги проделанной работы и отвечу на ряд вопросов, возникших после опубликованных ранее статей.

Проделанная работа

Итак, наша команда написала 3 статьи:

- Андрей Карпов. 27000 ошибок в операционной системе Tizen. Фундаментальная статья, демонстрирующая всю важность использования статического анализа в больших проектах. Статический анализатор PVS-Studio отлично показал, как много различных паттернов ошибок он может обнаруживать в C/C++ коде.

- Андрей Карпов. Поговорим о микрооптимизациях на примере кода Tizen. На примере Tizen продемонстрировано, какие микрооптимизации кода предлагает анализатор PVS-Studio. Старый код править не стоит, но разрабатывать новый код с учетом этих рекомендаций следует однозначно.

- Сергей Хренов. Продолжаем изучать Tizen: C# компоненты оказались высокого качества. А вот здесь анализатор PVS-Studio не смог проявить себя. Неудача. Зато эта статья показывает, что мы честны в своих исследованиях. Удалось найти много интересных ошибок в C и C++ коде — мы написали про это. Не удалось найти ошибок в C# коде — про это мы тоже написали.

По итогам публикаций возникло два больших обсуждения: первое на Reddit, второе на Hacker News. Также появилось несколько новостных постов. Основные:

- Good news: Samsung's Tizen no longer worst code ever. Bad news: It's still pretty awful

- Researcher Claims Samsung's Tizen OS is Poorly Programmed; Contains 27,000 Bugs!

Всё это и натолкнуло меня на мысль обсудить несколько дополнительных тем и ответить на некоторые вопросы, которые поднимались в дискуссиях.

Надо всё переписать на Rust

В последнее время активизировались энтузиасты, агитирующие везде использовать Rust. Особенно бурный всплеск дискуссии на эту тему последовал после статьи "Rewrite the Linux kernel in Rust?".

Отметились эти энтузиасты и в комментариях к нашим статьям. Их предложение: чтобы не было таких ошибок, надо переписать всё на Rust.

На самом деле, мне всё равно, будет что-то переписываться или нет. В мире написано так много кода на C и C++, что еще лет 50 анализатору PVS-Studio будет что проверять. Уж если до сих пор используются статические анализаторы для Cobol, то для C и C++ они также будут требоваться ещё многие десятилетия.

И тем не менее, я не могу обойти эту тему стороной. Вы серьезно предлагаете переписывать такие проекты на Rust? Вот взять и переписать 72 MLOC кода на Rust? Да это же сумасшествие!

Это потребует невероятного количества времени и сил. Более того, потратив много лет на разработку, вы в результате получите ровно то же, что уже и так существовало! Намного лучше было бы вложить эти человеко-годы в создание чего-то нового в уже существующем проекте.

Кто-то возразит, что после такого переписывания код станет лучше и надёжнее. Вот вообще нет такой гарантии. В крупных проектах значение языка не так велико. Вдобавок, многие библиотеки на C или C++ давно отлажены, а при переписывании придётся изобретать велосипеды, которые долгие годы будут радовать пользователей разнообразнейшими ошибками.

Я считаю, тот, кто предлагает переписать 72 MLOC кода, просто некомпетентен. Это можно простить новичку, но если это говорит человек с опытом работы, то он, видимо, тролль.

3.3% — это очень маленькая выборка и ваша оценка количества ошибок неверна

Да, такой подход может дать неточный результат. Но переживать об этом есть смысл, если мы проверили 1000, 3000 или 10000 строк кода. Переживать стоит и в том случае, если проверялся только один проект, написанный одной командой. В другом проекте плотность ошибок может сильно отличаться.

Но я напомню, что мною (при помощи анализатора PVS-Studio) было проверено 2 400 000 строк кода на C/C++. Это много! Это размер некоторых проектов.

При этом проверялся код разных проектов. Я использовал метод выборки «пальцем в небо». Очень хороший, честный способ. Вот список изученных мною проектов:

alsa-lib-1.0.28, aspell-0.60.6.1, augeas-1.3.0, bind-9.11.0, efl-1.16.0, enlightenment-0.20.0, ise-engine-anthy-1.0.9, bluetooth-frwk-0.2.157, capi-appfw-application-0.5.5, capi-base-utils-3.0.0, capi-content-media-content-0.3.10, capi-maps-service-0.6.12, capi-media-audio-io-0.3.70, capi-media-codec-0.5.3, capi-media-image-util-0.1.15, capi-media-player-0.3.58, capi-media-screen-mirroring-0.1.78, capi-media-streamrecorder-0.0.10, capi-media-vision-0.3.24, capi-network-bluetooth-0.3.4, capi-network-http-0.0.23, cynara-0.14.10, e-mod-tizen-devicemgr-0.1.69, ise-engine-default-1.0.7, ise-engine-sunpinyin-1.0.10, ise-engine-tables-1.0.10, isf-3.0.186, org.tizen.app-selector-0.1.61, org.tizen.apps-0.3.1, org.tizen.bluetooth-0.1.2, org.tizen.browser-3.2.0, org.tizen.browser-profile_common-1.6.4, org.tizen.classic-watch-0.0.1, org.tizen.d2d-conv-setting-profile_mobile-1.0, org.tizen.d2d-conv-setting-profile_wearable-1.0, org.tizen.download-manager-0.3.21, org.tizen.download-manager-0.3.22, org.tizen.dpm-toolkit-0.1, org.tizen.elm-demo-tizen-common-0.1, org.tizen.indicator-0.2.53, org.tizen.inputdelegator-0.1.170518, org.tizen.menu-screen-1.2.5, org.tizen.myplace-1.0.1, org.tizen.privacy-setting-profile_mobile-1.0.0, org.tizen.privacy-setting-profile_wearable-1.0.0, org.tizen.quickpanel-0.8.0, org.tizen.screen-reader-0.0.8, org.tizen.service-plugin-sample-0.1.6, org.tizen.setting-1.0.1, org.tizen.settings-0.2, org.tizen.settings-adid-0.0.1, org.tizen.telephony-syspopup-0.1.6, org.tizen.voice-control-panel-0.1.1, org.tizen.voice-setting-0.0.1, org.tizen.volume-0.1.149, org.tizen.w-home-0.1.0, org.tizen.w-wifi-1.0.229, org.tizen.watch-setting-0.0.1, security-manager-1.2.17.

Вряд ли мне «повезло» взять столько проектов, относящихся к одной команде. Очевидно, что здесь трудились разные команды специалистов.

Поэтому можно считать, что полученное значение плотности обнаруживаемых ошибок является средним и для оставшейся части проекта.

Всё не так плохо, как вы утверждаете

После публикации моей статьи «27000 errors in the Tizen operating system» в интернете появилось несколько неграмотных новостей, где люди написали про большое количество уязвимостей, найденных в Tizen. Например, можно было встретить вот такие неграмотные заголовки «В коде операционной системы Tizen зафиксировано 27000 уязвимостей». Это, естественно, не соответствует действительности. Давайте я поясню почему.

Сразу скажу, что я писал не про уязвимости, а про ошибки. И ещё, в статье я нигде не говорил, что Tizen является некачественным кодом. Да, я говорю, что анализатор PVS-Studio выявляет много ошибок, однако в любом большом проекте ошибок будет много. Поэтому общее количество ошибок ещё не говорит о качестве кода.

Давайте теперь немного подробнее поговорим про уязвимости. Среди всех ошибок, которые встречаются в программах, выделяют security weaknesses. Их особенность в том, что возможно стечение обстоятельств, когда эта ошибка может использоваться злоумышленником. Эти типы ошибок описаны в CWE. CWE is a community-developed list of common software security weaknesses — https://cwe.mitre.org/.

В своей статье я классифицирую многие ошибки по классификации CWE. Однако это ещё ничего не значит. Дело в том, что такие ошибки удается очень редко использовать как уязвимости. Другими словами, очень редко удаётся превратить CWE в CVE. Подробнее с терминологией можно ознакомиться здесь: https://cwe.mitre.org/about/faq.html.

Ещё раз подчерку, что использовать ошибку как уязвимость можно очень-очень редко. В подавляющем большинстве случаев, ошибка — это просто ошибка, которая хоть и неприятна пользователям программы, но не доставляет проблем безопасности.

27000 ошибок говорит о хорошем или плохом качестве кода? Невозможно сказать. Однако это не является страшным числом, как может показаться на первый взгляд. Следует учитывать, что общий объём кода составляет 72 500 000 строк на языке C, C++ (без учёта комментариев). Получается, что анализатор PVS-Studio выявляет приблизительно 0,37 ошибки на 1000 строк кода. Или другими словами около 1 ошибки на 3000 строк кода.

Примечание. Не стоит путать это с общим количеством ошибок в коде Tizen. Это то, что мы можем выявить, а не то, сколько их всего там есть. Прошу обратить на это внимание, так как некоторые неправильно интерпретируют данные.

Итак, PVS-Studio выявляет приблизительно 0,37 ошибок на 1000 строк кода. Это много или мало? Скорее, средне. Бывает лучше и хуже. Вот некоторые примеры:

- Notepad++: мы находим около 2 errors per 1000 lines of code. https://www.viva64.com/ru/b/0511/

- Far Manager for Linux: мы находим около 0.46 errors per 1000 lines of code. https://www.viva64.com/ru/b/0478/

- Tor project: мы вообще ничего не находим. Плотность 0. https://www.viva64.com/ru/b/0507/

Подведём итоги. На самом деле никакой сенсации нет. Шокирует число в 27000 ошибок, но такая внушительная цифра связана с большим размером проекта Tizen. Если взять другой большой проект, там тоже будет много ошибок.

Целью моей статьи было показать, что инструмент PVS-Studio может быть полезен проекту Tizen. И кажется, мне это удалось. Однако я вовсе не ожидал той бурной реакции и обсуждения, которые возникли вокруг этой статьи. Мы регулярно пишем подобные заметки. С ними можно ознакомиться здесь: https://www.viva64.com/ru/inspections/

В статье не указан процент ложных срабатываний

Начну издалека. К сожалению, многие читатели знакомятся со статьями очень невнимательно. В результате они довольно часто неправильно воспринимают числа, которые в них указываются. Я уже хорошо знаком с этим эффектом и стараюсь учитывать это в статьях. Например, в статье про «27000 ошибок» я специально дважды написал, что я нашел 900 ошибок, изучив 3.3% кода. При этом подчеркивал, что речь идёт именно об ошибках, а не о количестве выданных анализатором предупреждений.

И хотя я подстраховался, всё равно появился вот этот комментарий:

900 варнингов в аналоге Lint'а не означает 900 багов. Я бы даже сказал, что эти показатели вообще не связаны никак. Наверняка, там обнаружены ошибки в форматировании кода, областях видимости переменных и т.д. В топку таких аналитегов.

Человек не читал статью, но увидел число 900 и спешит поделиться своим мнением с другими.

Вот именно по этой причине я не пишу о количестве ложных срабатываний. Люди увидят какое-то число, а потом многие годы везде будут писать в комментариях «это плохой анализатор, у которого процент ложных срабатываний составляет NN».

Всё дело в том, что анализатор требует настройки. Причем большинство ложных срабатываний относится к небольшому количеству макросов. Я уже не раз демонстрировал в некоторых своих статьях, как подавление предупреждений для нескольких макросов резко уменьшает количество ложных срабатываний.

Точно так же дело обстоит и с Tizen. Однако боюсь, на эти объяснения и примеры мало кто обратит внимание. Зато все запомнят число, означающее большой процент ложных срабатываний.

Возникает логичный вопрос: Тогда почему бы вам не настроить статический анализатор и не показать сразу хороший результат?

Отвечаю. Это займёт время, а меня ещё ждут такие интересные проекты, как iOS или Android. Однако это не главная причина, почему я не хочу этим заниматься. Дело в том, что непонятно где остановиться. Я знаю, что, приложив усилия, мы сможем свести количество ложных срабатываний до нуля, ну или почти до нуля. Например, мы сводили до нуля количество ложных срабатываний, когда работали над проектом Unreal Engine (см. статьи 1, 2).

Итак, если я с помощью настроек уменьшу количество ложных срабатываний до какого-то очень маленького процента, мне скажут, что это нечестно. Получается, что с одной стороны мне будет хотеться оставить как можно меньше ложных срабатываний, с другой стороны я должен не перестараться, показав слишком идеальный вариант. Что-то мне всё это не нравится. Я считаю, что лучше вообще тогда ничего не делать.

Так как же программисту понять, хорошо работает наш анализатор или плохо? Очень просто! Нужно его скачать и попробовать проверить рабочий проект. Cразу станет понятно, нравится он или нет. И будет сразу видно, как много ложных срабатываний и какого они типа. После чего, возможно, ваша компания с удовольствием пополнит список наших клиентов.

Только прошу не совершать ошибку и не пробовать анализатор на маленьких проектах или вообще тестовых примерах. Причины:

- Ощущения, которые подтвердились числами (в маленьких проектах, низкая плотность ошибок).

- Почему я не люблю синтетические тесты (тесты не отображают реальные типы ошибок).

Update. Вношу это примечание уже после написания статьи. Хорошо, читатели победили. Я сдаюсь и привожу число. Я провёл исследование EFL Core Libraries и вычислил, что статический анализатор PVS-Studio будет выдавать около 10-15% ложных срабатываний. Вот статья про это: пока не опубликована, чуть-чуть подождите.

Достаточно -Wall -Wextra -Werror

Как всегда, прозвучали комментарии о том, что современные компиляторы сами хорошо умеют выполнять статический анализ кода и дополнительные инструменты не нужны.

Дополнительные инструменты нужны. Статические анализаторы — это специализированные инструменты, которые всегда опережают компиляторы своими диагностическими возможностями. За это они и получают деньги от своих клиентов.

Впрочем, кроме слов у меня есть и доказательства. Каждый раз, когда мы проверяем какой-нибудь компилятор, мы находим там ошибки:

- Проверка LLVM (Clang) (август 2011), вторая проверка (август 2012), третья проверка (октябрь 2016)

- Проверка GCC (август 2016)

- В случае Visual C++ мы проверяли системные библиотеки. Раз мы находим там ошибки, значит Visual C++ их не видит. Проверка библиотек Visual C++ (сентябрь 2012), вторая проверка (октябрь 2014), третья проверка (май 2017).

При этом не стоит забывать, что статический анализ — это не только предупреждения, это ещё и инфраструктура. Вот некоторые возможности PVS-Studio:

- Удобная и простая интеграция с Visual Studio 2010-2017.

- Интеграция с SonarQube.

- Утилита BlameNotifier. Инструмент позволяет рассылать письма разработчикам об ошибках, которые PVS-Studio нашел во время ночного прогона.

- Mass Suppression — позволяет подавить все старые сообщения, чтобы анализатор выдавал 0 срабатываний. К подавленным сообщениям всегда можно вернуться позже. Возможность безболезненно внедрить PVS-Studio в существующий процесс разработки и сфокусироваться на ошибках только в новом коде.

- Сохранение и загрузка результатов анализа: можно ночью проверить код, сохранить результаты, а утром загрузить их и смотреть.

- Поддержка IncrediBuild.

- Mark as False Alarm — разметка в коде, чтобы не ругаться конкретной диагностикой в конкретном фрагменте файла.

- Интерактивная фильтрация результатов анализа (лога) в окне PVS-Studio: по коду диагностики, по имени файла, по включению слова в текст диагностики.

- Статистика ошибок в Excel — можно посмотреть темпы правки ошибок, количество ошибок во времени и т.п.

- Автоматическая проверка на наличие новых версий PVS-Studio (как при работе в IDE, так и при ночных сборках).

- Использование относительных путей в файлах отчета для возможности переноса отчета на другую машину.

- CLMonitoring — проверка проектов, у которых нет файлов Visual Studio (.sln/.vcxproj); если вдруг вам не хватит функциональности CLMonitoring, то вы можете интегрировать PVS-Studio в любую Makefile-based систему сборки вручную.

- pvs-studio-analyzer — утилита аналогичная CLMonitoring, но работающая под Linux.

- Возможность исключить из анализа файлы по имени, папке или маске.

Подробнее про всё это можно узнать в документации.

Нет цены

Да, на сайте у нас нет цены. Это стандартная практика компаний, продающих решения в сфере статического анализа кода.

Мы позиционируем PVS-Studio как B2B решение. При продаже компаниям необходимо обсудить множество моментов, которые влияют на цену лицензии. Вывешивать какую-то конкретную цену на сайт не имеет смысла и продуктивнее сразу приступить к обсуждению.

Почему мы не работаем с индивидуальными разработчиками? Мы пробовали, но у нас не получилось.

Впрочем, индивидуальные разработчики могут воспользоваться одним из вариантов бесплатной лицензии:

- Для этого они должны согласиться с условием модификации кода: как использовать PVS-Studio бесплатно.

- Также мы бесплатно предоставляем анализатор PVS-Studio экспертам безопасности.

- Бесплатную версию может получить любой Microsoft MVP.

Представителей компаний я приглашаю пообщаться по почте.

Не все участки, которые вы упоминаете в статье, являются настоящими ошибками

Да, возможно что-то окажется не ошибкой при более тщательном изучении кода. С другой стороны, при тщательном анализе может выясниться, что я, наоборот, пропускал некоторые ошибки. Например, я поленился изучать предупреждения V730 — Not all members of a class are initialized inside the constructor. Очень трудоёмко пытаться понять в чужом коде, является ли ошибкой, что какой-то член класса остался неинициализированным. Однако, если этим заняться, наверняка найдутся настоящие ошибки.

Давайте разберем один из таких случаев. Код относится к проекту org.tizen.browser-profile_common-1.6.4.

Для начала рассмотрим определение класса BookmarkItem.

class BookmarkItem

{

public:

BookmarkItem();

BookmarkItem(

const std::string& url,

const std::string& title,

const std::string& note,

unsigned int dir = 0,

unsigned int id = 0

);

virtual ~BookmarkItem();

void setAddress(const std::string & url) { m_url = url; };

std::string getAddress() const { return m_url; };

void setTitle(const std::string & title) { m_title = title; };

std::string getTitle() const { return m_title; };

void setNote(const std::string& note){m_note = note;};

std::string getNote() const { return m_note;};

void setId(int id) { m_saved_id = id; };

unsigned int getId() const { return m_saved_id; };

....

....

bool is_folder(void) const { return m_is_folder; }

bool is_editable(void) const { return m_is_editable; }

void set_folder_flag(bool flag) { m_is_folder = flag; }

void set_editable_flag(bool flag) { m_is_editable = flag; }

private:

unsigned int m_saved_id;

std::string m_url;

std::string m_title;

std::string m_note;

std::shared_ptr m_thumbnail;

std::shared_ptr m_favicon;

unsigned int m_directory;

std::vector m_tags;

bool m_is_folder;

bool m_is_editable;

}; Для нас интерес представляют члены m_is_folder и m_is_editable. Обратите внимание, что они находятся в конце описания класса. Я готов поставить $10 на то, что изначально их не было в первой версии класса и появились они уже позже, в процессе развития проекта. Так вот, когда добавляли эти члены, был модифицирован только один конструктор.

В результате мы имеем вот такие два конструктора:

BookmarkItem::BookmarkItem()

: m_saved_id(0)

, m_url()

, m_title()

, m_note()

, m_thumbnail(std::make_shared<.....>())

, m_favicon(std::make_shared<.....>())

, m_directory(0)

, m_is_folder(false)

, m_is_editable(true)

{

}

BookmarkItem::BookmarkItem(

const std::string& url,

const std::string& title,

const std::string& note,

unsigned int dir,

unsigned int id

)

: m_saved_id(id)

, m_url(url)

, m_title(title)

, m_note(note)

, m_directory(dir)

{

}Один конструктор инициализирует члены m_is_folder и m_is_editable, а другой — нет. У меня нет абсолютной уверенности, но скорее всего это ошибка.

Анализатор PVS-Studio выдаёт для второго конструктора следующее предупреждение: V730. Not all members of a class are initialized inside the constructor. Consider inspecting: m_is_folder, m_is_editable. BookmarkItem.cpp 268

Кстати, анализатор PVS-Studio умеет искать 64-битные ошибки. Tizen пока 32-битный, так что для него они пока не актуальны, но я хочу посвятить пару слов этой теме.

На самом деле, никаких «64-битных ошибок» не существует. Однако есть смысл выделять некоторые ошибки в такую категорию и рассматривать их отдельно. Дело в том, что такие ошибки никак не проявляют себя в 32-битной версии приложений. Причем совсем не проявляют и их невозможно обнаружить никаким тестированием.

Рассмотрим простой пример для пояснения. Нужно создать массив указателей и для этого написан вот такой ошибочный код:

int **PtrArray = (int **)malloc(Count * size_of(int));Память выделяется для массива int, а не для массива указателей. Правильный код должен был быть таким:

int **PtrArray = (int **)malloc(Count * size_of(int *));Ошибка в 32-битной программе не проявляет себя. Размер указателя и типа int совпадают, поэтому выделяется буфер правильного размера. Всё корректно работает и проблемы начнутся только когда мы начнем собирать 64-битную версию программы.

Примечание. Конечно, в некоторых 64-битных системах размер указателя также может совпадать с размером типа int. А может быть так, что размеры будут отличаться и в 32-битных системах. Это экзотика, про которую нет смысла говорить. Рассмотренный пример будет корректно работать во всех распространённых 32-битных системах и давать сбой в 64-битных.

На нашем сайте можно найти много интересных материалов, посвященных 64-битным ошибкам и способам борьбы с ними:

- Коллекция примеров 64-битных ошибок в реальных программах

- C++11 и 64-битные ошибки

- Undefined behavior ближе, чем вы думаете

- Уроки разработки 64-битных приложений на языке Си/Си++

Вернёмся к проекту Tizen и возьмём для примера проект capi-media-vision-0.3.24. Здесь можно наблюдать интересную разновидность 64-битных ошибок. Анализатор PVS-Studio выдаёт для него 11 предупреждений с кодом V204:

- V204 Explicit conversion from 32-bit integer type to pointer type. mv_testsuite_common.c 94

- V204 Explicit conversion from 32-bit integer type to pointer type. mv_video_helper.c 103

- V204 Explicit conversion from 32-bit integer type to pointer type. mv_video_helper.c 345

- V204 Explicit conversion from 32-bit integer type to pointer type. mv_mask_buffer.c 39

- V204 Explicit conversion from 32-bit integer type to pointer type. mv_surveillance.c 52

- V204 Explicit conversion from 32-bit integer type to pointer type. mv_surveillance.c 134

- V204 Explicit conversion from 32-bit integer type to pointer type. mv_surveillance.c 172

- V204 Explicit conversion from 32-bit integer type to pointer type. surveillance_test_suite.c 452

- V204 Explicit conversion from 32-bit integer type to pointer type: (unsigned char *) malloc(buf_size) surveillance_test_suite.c 668

- V204 Explicit conversion from 32-bit integer type to pointer type: (unsigned char *) malloc(buf_size) surveillance_test_suite.c 998

- V204 Explicit conversion from 32-bit integer type to pointer type: (unsigned char *) malloc(buf_size) surveillance_test_suite.c 1109

Эти предупреждения выдаются на первый взгляд на совершенно безобидный код вот такого вида:

*string = (char*)malloc(real_string_len * sizeof(char));В чем же причина? Дело в том, что нигде не подключен заголовочный файл, в котором объявлен тип функции malloc. В этом можно убедиться, выполнив препроцессирование C-файлов и посмотрев содержимое i-файлов. Использование функции malloc есть, а её объявления нет.

Так как эта программа на языке Си, то она компилируется, несмотря на отсутствие объявления. Раз функция не объявлена, то считается, что она принимает и возвращает аргументы типа int.

Т.е. компилятор считает, что функция объявлена так:

int malloc(int x);Благодаря этому 32-битная программа отлично компилируется и работает. Указатель помещается в тип int и всё хорошо.

Эта программа будет компилироваться и в 64-битном режиме. Она даже почти всегда работает. Важно вот это самое «почти всегда».

Всё будет хорошо, пока память выделяется в младших адресах адресного пространства. Однако в процессе работы память в младшей части адресного пространства может оказаться занятой или фрагментированной. Тогда менеджер памяти вернёт память, выделенную за пределами младших адресов. Произойдёт сбой из-за обрезания старших бит в указателе. Подробнее, как и что происходит, я описывал здесь: "Красивая 64-битная ошибка на языке Си".

В итоге мы видим 11 дефектов, которые могут приводить к трудновоспроизводимым сбоям программы. Очень неприятные ошибки.

К сожалению, диагностики PVS-Studio для выявления 64-битных ошибок генерируют много шума (ложных срабатываний) и с этим ничего нельзя сделать. Такова их природа. Анализатор часто не знает, каков диапазон тех или иных значений, и не может понять, что код будет работать правильно. Но если хочется сделать надёжное и быстрое 64-битное приложение, следует поработать со всеми этими предупреждениями. Кстати, мы можем взять на себя эту кропотливую работу и выполнить на заказ портирование приложения на 64-битную систему. У нас есть опыт по этому направлению (см. "Как перенести проект размером в 9 млн строк кода на 64-битную платформу").

Так что если разработчики Tizen захотят сделать систему 64-битной, то знайте, наша команда готова помочь в этом.

Заключение

Спасибо всем за внимание. Тем, кто заинтересовался анализатором PVS-Studio и хочет узнать больше о его возможностях, предлагаю посмотреть большую презентацию (47 минут): PVS-Studio static code analyzer for C, C++ and C#.

Приглашаю подписываться, чтобы быть в курсе новых публикаций:

- Twitter: @Code_Analysis

- RSS: viva64-blog-ru

- LinkedIn: PVS-Studio

- Facebook: StaticCodeAnalyzer

Если хотите поделиться этой статьей с англоязычной аудиторией, то прошу использовать ссылку на перевод: Andrey KarpovDate: 26.07.2017. Tizen: Summing Up

|

|

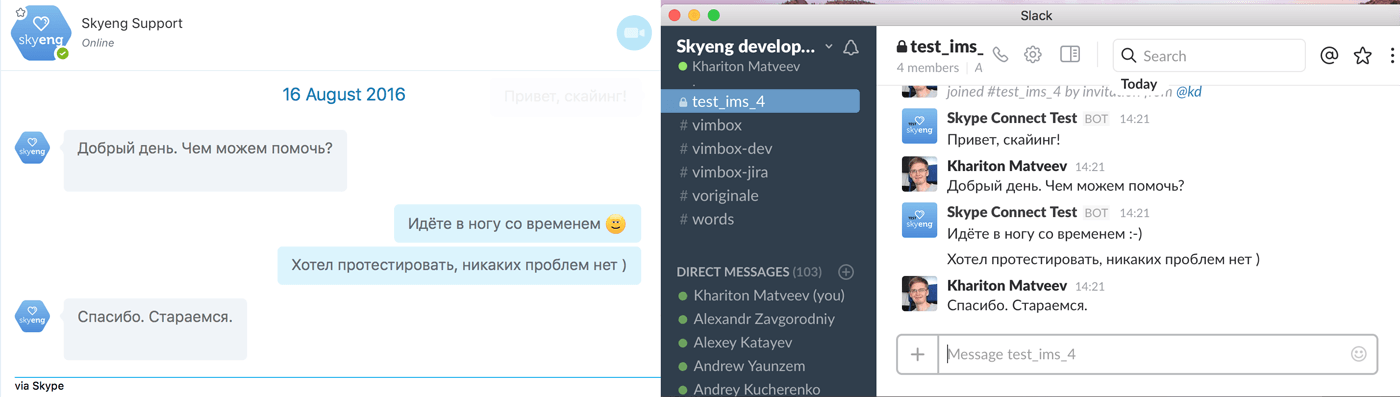

Skype-бот с человеческим лицом (на Microsoft Bot Framework V3 и Slack API) |

Skype – отличный канал для оперативной коммуникации с клиентами. Он есть у всех и обеспечивает быстрое живое общение без лишних телодвижений и затрат (например, на телефонную связь). Однако, когда количество клиентов исчисляется тысячами, преимущества Skype начинают превращаться в недостатки. В этой статье мы расскажем о нашем Skype-боте, по сути, выполняющем роль телефонистки начала 20-го века: он соединяет клиента со свободным менеджером и поддерживает эту связь до решения вопроса.

Перед школой Skyeng всегда стояла задача создания удобного канала связи между мессенджарами и операторами службы поддержки пользователей. Мессенджер, который сейчас принимает у нас наибольшее число заявок, – Skype. Когда количество контактов в Skype исчисляется тысячами, общение напрямую через клиент Skype становится проблематичным. Во-первых, производительность этого клиента при такой работе падает почти до нуля, контакт-лист подгружается непозволительно долго. Во-вторых, часто нескольким операторам нужно вести параллельную связь с пользователями; использование одного Skype-аккаунта на нескольких устройствах возможно, но входящие сообщения из всех диалогов видны всем операторам, что мешает работе. Кроме того, все коммуникации в Skype остаются в самом Skype, для их извлечения во внутренние CRM или HelpDesk системы приходится заниматься копи-пейстом.

Эти трудности привели нас к решению создать чат-бот, который будет служить точкой входа для сообщений в службу поддержки. Тема чат-ботов в последнее время весьма популярна, и Microsoft предоставила доступ к Skype REST API, к которому прилагается SDK с примерами для C# и Node.js.

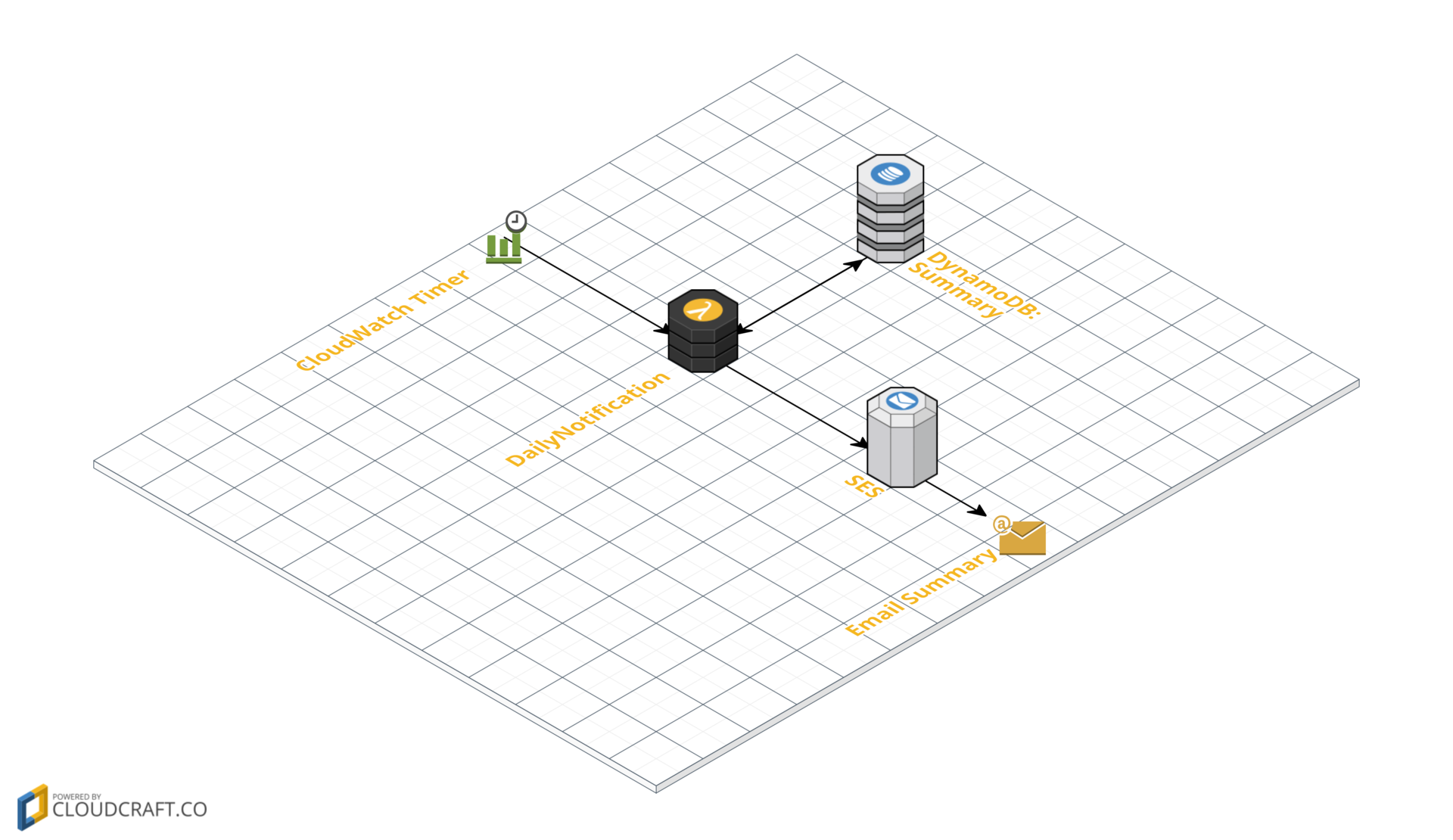

Для полноценной многоканальной связи недостаточно лишь приема сообщений, их надо еще доставить куда-то, где оператор сможет их прочитать. Поскольку наша школа активно использует Slack в своих внутренних коммуникациях, и этот мессенджер обладает хорошей поддержкой концепции каналов, было решено переправлять входящие сообщения туда.

В результате мы создали модель с точками входа и выхода, внутри которой мы имеем полный контроль над потоками данных.

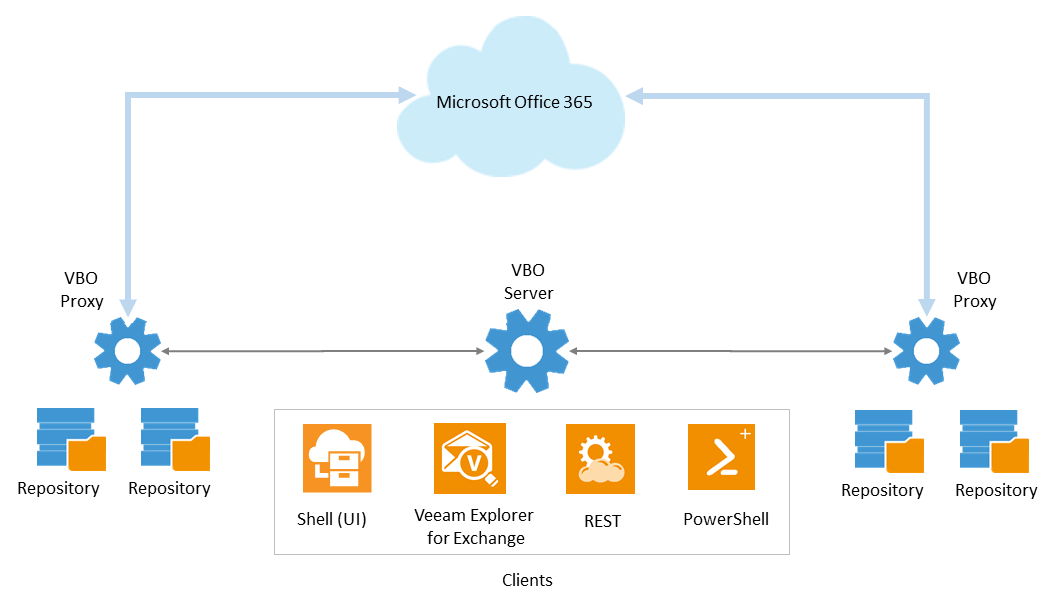

Архитектура

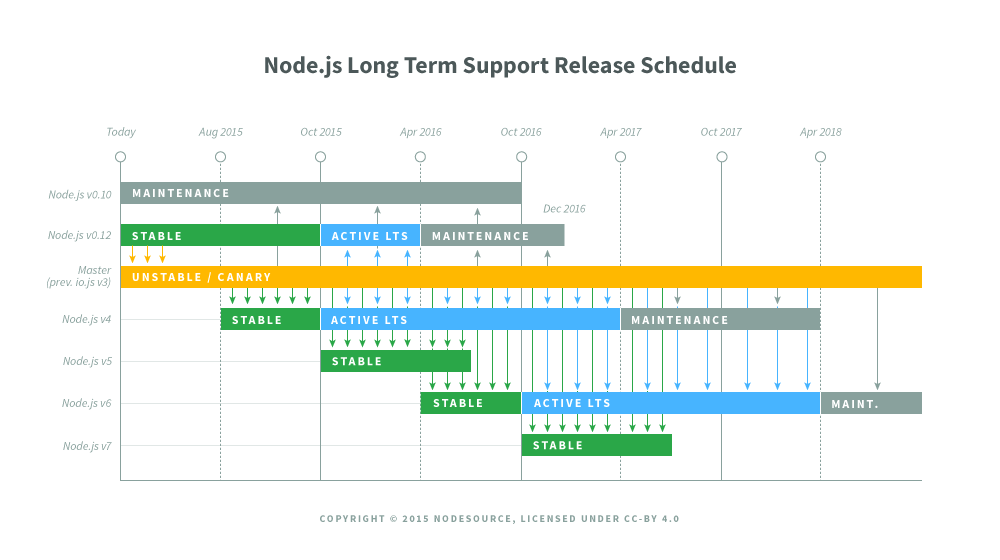

Система не подразумевает каких-то сложных вычислений на сервере; основные ее задачи – прием, хранение и роутинг данных. Поэтому в качестве основной платформы был выбран Node.js, хорошо подходящий для подобных задач. Взяли последнюю доступную LTS версию, на момент старта проекта – 6.3.0. Согласно node.green шестерка покрывает 95% ES 2015, что весьма приятно, а nodesource-блог обещает ее функционирование вплоть до апреля 2018, после чего начнется фаза maintenance. Годится.

К базе данных каких-то особых требований нет, поэтому взяли классическую надежную реляционку в виде PostgreSQL.

Чтобы обеспечить достаточно высокую отказоустойчивость, возможность масштабирования и в то же время низкую связанность компонентов, было принято решение включить в архитектуру очереди сообщений в виде RabbitMQ для обмена данными между модулями системы.

В результате получилась следующая схема работы:

Система состоит из трех основных сервисов (Skype service, Logic service, Slack service) и дополнительного микро-сервиса Slack messaging micro-service. Основная задача Slack service – обеспечение работы endpoint-а для Skype-бота и отправка сообщений в Skype. Logic service отвечает за роутинг сообщений, хранение сообщений, обработку команд и предоставление API для интеграции с внутренними сервисами школы. Slack service имеет подписку к Slack RTM и отвечает за endpoint по приемке команд от операторов поддержки в Slack.

Дополнительный Slack messaging micro-service понадобился для того, чтобы уверенно отправлять сообщения в Slack, не боясь превысить лимиты Slack API, поэтому сообщения отправляются путем long-polling считывания их по таймеру из RabbitMQ и передачи в Slack.

Можно ли доверять Preview? Миграция на Microsoft Bot Framework

Использование preview-версий инструментов всегда несет в себе определенный риск, поскольку к моменту релиза в них могут произойти серьезные изменения или, что еще хуже, этот релиз вообще не состоится. Именно такая участь постигла SDK для разработки Skype-ботов: он появился в виде preview и в этом же виде состарился (получил статус deprecated). После этого создание новых ботов исключительно для Skype стало невозможным, а затем и вовсе появились редирект на Microsoft Bot Framework и предупреждение о необходимости мигрировать в ближайшее время.

Microsoft Bot Framework – это попытка Microsoft охватить множество каналов связи в одном инструменте. На данный момент поддерживаются: Facebook Messenger, Kik, Slack, Telegram, Skype и даже такие каналы, как Email, Twilio (SMS) и Direct Line. Все это интересно, но на данном этапе нас интересовал только Skype (хотя задел, конечно, хороший, можно впоследствии добавить поддержку других мессенджеров с меньшими трудозатратами).

Мы не стали ждать и мигрировали сразу. Регистрация нового бота в Microsoft Bot Framework проста, достаточно иметь аккаунт Microsoft.

Алгоритм следующий:

- пройти по ссылке;

- заполнить все поля со звездочкой;

- нажать Create Microsoft App ID and Password;

- откроется новая страница, на которой нужно ввести название приложения например TestBotApp;

- далее кнопка Generate a password to continue;

- сгенерированный пароль нужно где-то себе сохранить, поскольку посмотреть повторно его уже нельзя, а он понадобится для работы с Framework и App ID;

- далее кнопка Finish and go back to Bot Framework;

- на странице регистрации нужно принять соглашение и нажать Register, после чего у нас есть готовый зарегистрированный бот для Microsoft Bot Framework

На странице регистрации есть поле Messaging endpoint, оно не обязательно для регистрации, но это точка входа для бота, без которой он не будет функционировать. Основное требование к endpoint'у – это должна быть рабочая HTTPS-ссылка.

В плане миграции кода больших изменений делать не пришлось, поскольку все, что должен уметь наш бот – это принимать и отправлять сообщения. Тем не менее, код для того же функционала стал побольше:

bot.send(

'8:skype.username',

'message from bot to user',

true, // escape

(error) => console.log(error)

);превратилось в

bot.send(

new builder.Message()

.address({

channelId: "skype",

user: {

id: "29:some-long-hash-here",

name: "User Display Name"

},

bot: {

id: "28:bot-uuid",

name: "Bot Name"

},

serviceUrl: "https://skype.botframework.com",

useAuth: true

})

.text('Message from bot to user'),

(err) => console.log(err)

);И небольшие изменения приема сообщений:

bot.on('personalMessage', (bot, data) => {

console.log('Got message from user');

});Поскольку в Bot Framework есть такое понятие, как диалоги, но нам нужно было просто получать сообщения, то мы сделали подписку на самый общий диалог, который представлен слэшем; он будет принимать все входящие сообщения:

bot.dialog("/", [

(session) => {

console.log("Got message from bot", session.message);

}

]);В приведенных фрагментах кода bot в случае Skype Bot SDK – экземпляр класса BotService, а на Bot Framework это уже UniversalBot.

Также стоит отметить, что если в Skype Bot SDK мы надеялись иметь возможность по id пользователя примерно понимать, с кем имеем дело, то в Microsoft Bot Framework все пользователи представлены в виде длинных хэшей, что делает собеседников анонимным. Задачу определения личности можно решить только в живом диалоге с пользователем.

Еще один любопытный момент – редактирование отправленных ботом сообщений. В Skype Bot SDK, как говорят некоторые пользователи github, такая возможность была, а вот в Microsoft Bot Framework именно для Skype ее нет (хотя для других платформ, в частности Telegram и Slack, это возможно).

Тем не менее, Microsoft Bot Framework – хороший шаг к унификации платформы разработки ботов для различных каналов коммуникаций. Остается надеяться, что Microsoft продолжит развитие этого продукта и добавит недостающие сейчас функции для Skype-ботов.

Встречаем сообщения в Slack

Для организации многоканальной приемки сообщений мы воспользовались таким инструментом Slack, как приватные каналы; в терминологии Slack API это groups.

Первоначально мы рассчитывали, что нам будет достаточно создания одного Custom Bot'а, который покроет весь функционал отправки сообщений в Slack: создаст там приватный канал, добавит туда оператора и дальше будет обеспечивать proxy-коммуникацию. Выяснилось, однако, что боты в Slack не имеют права создавать приватные каналы.

Поэтому кроме подключенного к Slack RTM Api Custom Bot’а мы создали еще и Slack-приложение, которое от лица обычного пользователя Slack создает приватные каналы и приглашает в них операторов.

Slack API достаточно стабилен, хорошо документирован и содержит даже онлайн-тестер, позволяющий проверить вызов методов, поэтому других сюрпризов, к счастью, не было. Для работы с ним мы взяли вот этот весьма простой npm пакет: он удобен, поскольку его методы в большинстве своем повторяют одноименные методы Slack API.

Не все так просто!

Для того, чтобы ваш бот заработал, он должен получить одобрение со стороны Microsoft. Казалось бы, простая формальность, но у нас на нее ушло немало времени и сил. Мы расскажем про грабли, на которые наступили сами, но это не значит, что вы не наступите на какие-нибудь еще; будьте к этому готовы.

Итак, через две недели после первого сабмита мы получили это:

с пояснением: Bot content is in Russian language. At this time, Skype Bots only support English Users. Please provide a translation or alternative option for users to read and use the bot in English («ваш бот на русском, а надо, чтобы он умел общаться с пользователями по-английски»). Как выяснилось, для решения этой проблемы достаточно иметь Terms of Service и Privacy Policy на английском; окей, написали, вывесили, отправили новую заявку.

На сей раз отлуп пришел быстрее:

Наш бот призван только связывать клиента с оператором. По мнению Microsoft, этого мало. Пришлось прикрутить минимальный функционал – пару команд, на которые бот сможет реагировать самостоятельно (help и lessons-count).

Пока мы выполняли эти требования, появилось новое: бот должен уметь по команде выдавать Terms of Service и Privacy Policy (просто наличия их на сайте недостаточно). Окей, сделали и это. Оказалось, что этого мало, условия должны присутствовать в каждом сообщении. Хорошо. Тем временем, в лондонском офисе Microsoft начались массовые перестановки, из-за чего одобрение опять раз за разом откладывалось…

Но в конце концов мы получили долгожданный апрув:

Все эти махинации отняли у нас огромное количество времени, будьте готовы к непредвиденным и иногда малообъяснимым задержкам.

Заключение

В результате мы получили Skype-бота, обеспечивающего быструю качественную реакцию на входящие сообщения и разговаривающего с клиентом «как живой» (что неудивительно, учитывая, что управляет им оператор). Ушли в прошлое ответы не в тот канал и пропущенные входящие контакты; «ваш вопрос очень важен для нас» – не пустые слова, сейчас ни одно сообщение не потеряется, а беседа не затухнет по нашей вине. При этом были решены проблемы обычного Skype, а коммуникации приобрели структурированную форму, которую мы интегрировали в наши внутренние сервисы поддержки пользователей. А вся «магия» – в незамысловатой архитектуре роутинга сообщений между разными платформами.

PS Напоминаем, что наши двери открыты для разных талантливых специалистов!

|

Метки: author Ontaelio системы обмена сообщениями node.js блог компании skyeng бот для скайпа microsoft bot framework slack api rabbitmq клиентский сервис |

Добавляем эффект нажатия в Xamarin.Forms |

Xamarin.Forms набирает обороты и к, сожалению, из коробки доступно совсем мало возможностей, все неоходимо добавлять через Dependency service или рендереры. На этой волне стало очень много различных библиотек, добавляющих зачастую базовый функционал.

Мое решение не исключение.

У меня стояла задача сделать небольшое расширение, позволяющее добавить эффект нажатия на почти любой элемент для iOS и Android.

Изначально у меня мысль создать контейнер с эффектом нажатия и в него уже добавлять необходимые элементы. От этой идеи пришлось отказаться в виду дополнительной вложенности и некорректности выделения. То есть, положив в этот контейнер не прямоугольный элемент по типу CircularImage или Frame я получил бы выделение за пределами закругленной области.

Переписывать и расширять все контролы было бы глупо, поэтому я решил добавить статическое расширение.

Как это должно выглядеть

Для Android 5+ очевидно, надо использовать Ripple effect. Но для iOS и Android <5 это решение будет выглядеть неуместно. Для этих платформ я решил реализовать цветное анимированное выделение, срабатываемое при касании.

Реализация

PCL

Для начала в PCL проекте был создан статический класс TouchEffect с двумя BindableProperty:

- bool On

- Color Color

Первое отвечает за активность расширения для элемента, соответсвенно второе за цвет эффекта.

Android

Необходимо определить переменную, которая идентифицирует нужно использовать Ripple effect или нет в зависимости от версии Android:

public bool EnableRipple => Build.VERSION.SdkInt >= BuildVersionCodes.Lollipop;Для реализация стандартных волн для андроида довольно проста:

private void AddRipple()

{

if (Element is Layout)

{

_rippleOverlay = new FrameLayout(Container.Context)

{

LayoutParameters = new ViewGroup.LayoutParams(-1, -1)

};

_rippleListener = new ContainerOnLayoutChangeListener(_rippleOverlay);

_view.AddOnLayoutChangeListener(_rippleListener);

((ViewGroup)_view).AddView(_rippleOverlay);

_rippleOverlay.BringToFront();

_rippleOverlay.Foreground = CreateRipple(Color.Accent.ToAndroid());

}

else

{

_orgDrawable = _view.Background;

_view.Background = CreateRipple(Color.Accent.ToAndroid());

}

_ripple.SetColor(GetPressedColorSelector(_color));

}

private void RemoveRipple()

{

if (Element is Layout)

{

var viewgrp = (ViewGroup)_view;

viewgrp?.RemoveOnLayoutChangeListener(_rippleListener);

viewgrp?.RemoveView(_rippleOverlay);

_rippleListener?.Dispose();

_rippleListener = null;

_rippleOverlay?.Dispose();

_rippleOverlay = null;

}

else

{

_view.Background = _orgDrawable;

_orgDrawable?.Dispose();

_orgDrawable = null;

}

_ripple?.Dispose();

_ripple = null;

}

private RippleDrawable CreateRipple(Android.Graphics.Color color)

{

if (Element is Layout)

{

var mask = new ColorDrawable(Android.Graphics.Color.White);

return _ripple = new RippleDrawable(GetPressedColorSelector(color), null, mask);

}

var back = _view.Background;

if (back == null)

{

var mask = new ColorDrawable(Android.Graphics.Color.White);

return _ripple = new RippleDrawable(GetPressedColorSelector(color), null, mask);

}

else if (back is RippleDrawable)

{

_ripple = (RippleDrawable) back.GetConstantState().NewDrawable();

_ripple.SetColor(GetPressedColorSelector(color));

return _ripple;

}

else

{

return _ripple = new RippleDrawable(GetPressedColorSelector(color), back, null);

}

}У контрола берется задний фон и на него добавляется эффект.

Для более старых версий андроида я решил добавлять FrameLayout поверх элемента с анимацией Alpha канала заднего фона.

К событию Touch элемента подписывается этот метод:

private void OnTouch(object sender, View.TouchEventArgs args)

{

switch (args.Event.Action)

{

case MotionEventActions.Down:

Container.RemoveView(_layer);

Container.AddView(_layer);

_layer.Top = 0;

_layer.Left = 0;

_layer.Right = _view.Width;

_layer.Bottom = _view.Height;

_layer.BringToFront();

TapAnimation(250, 0, 65, false);

break;

case MotionEventActions.Up:

case MotionEventActions.Cancel:

TapAnimation(250, 65, 0);

break;

}

}Который при нажатии добавляет в контейнер новый лэйаут с анимацией A-канала с 0 до 65, а при отпускании анимирует обратно от 65 до 0 и удаляет из контейнера.

Потом, в методе OnAttached определяем, что делать, создавать Ripple effect или подписываться на Touch:

if (EnableRipple)

AddRipple();

else

_view.Touch += OnTouch;iOS

Для iOS подход схож с предыдущим шагом, добавляется UIView поверх основного элемента при нажатии и так же анимируется A-канал. Для этого создаются UITapGestureRecognizer и UILongPressGestureRecognizer и добавляются к элементу:

_tapGesture = new UITapGestureRecognizer(async (obj) => {

await TapAnimation(0.3, _alpha, 0);

});

_longTapGesture = new UILongPressGestureRecognizer(async (obj) => {

switch (obj.State)

{

case UIGestureRecognizerState.Began:

await TapAnimation(0.5, 0, _alpha, false);

break;

case UIGestureRecognizerState.Ended:

case UIGestureRecognizerState.Cancelled:

case UIGestureRecognizerState.Failed:

await TapAnimation(0.5, _alpha);

break;

}

});

_view.AddGestureRecognizer(_longTapGesture);

_view.AddGestureRecognizer(_tapGesture);При долгом нажатии задается другое время анимации и, в отличие от простого нажатия, элемент удаляется только после отпускания пальца.

Собственно все.

Использование

XAML:

| iOS | Android API >=21 | Android API < 21 |

|---|---|---|

|

|

|

Итоги

Я привел основую идею реализации эффекта касания, весь код, а так же Nuget пакеты доступны на GitHub.

P.S. Опыт у меня в нативной разработке небольшой, буду рад советам, что можно улучшить/доработать.

P.P.S Habrastorage немного коряво преобразовал gif'ки.

|

Метки: author mrxten разработка мобильных приложений c# .net xamarin xamarin.forms effects |

Случайный лес vs нейросети: кто лучше справится с задачей распознавания аудио |

Мы попробовали составить гайд по решению задач, связанных с обработкой речи. Самой популярной и востребованной из них является, вероятно, распознавание того, что именно говорят, анализ на семантическом уровне, но мы обратимся к более простой задаче – определению пола говорящего. Впрочем, инструментарий в обоих случаях оказывается практически одинаков.

/ Фотография justin lincoln / CC-BY

/ Фотография justin lincoln / CC-BYЧто «услышит» наш алгоритм

Характеристики голоса, которые мы будем использовать

Первым делом нужно разобраться в физике процессов – понять, чем мужской голос отличается от женского. Про устройство речевого тракта у людей можно почитать в обзорах или специальной литературе, но и базовое объяснение «на пальцах» вполне прозрачно: голосовые связки, колебания которых производят звуковые волны до модуляции другими органами речи, у мужчин и женщин имеют различную толщину и натяжение, что ведет к разной частоте основного тона (она же pitch, высота звука). У мужчин она обычно находится в пределах 65-260 Гц, а у женщин – 100-525 Гц. Иными словами, мужской голос чаще всего звучит ниже женского.

Наивно предполагать, что одной лишь высоты звука может быть достаточно. Видно, что для обоих полов эти интервалы довольно сильно перекрываются. Более того, в процессе речи частоту основного тона – вариативный параметр, меняющийся, например, при передаче интонации, – невозможно определить для многих согласных звуков, а алгоритмы ее вычисления не безупречны.

В восприятии человека индивидуальность голоса содержится не только в частоте, но и в тембре – совокупности всех частот в голосе. В каком-то смысле его можно описать с помощью спектра, и тут на помощь приходит математика.

Звук – изменчивый сигнал, а значит его спектр с точки зрения среднего времени вряд ли даст нам что-то осмысленное, поэтому разумно рассмотреть спектрограмму — спектр в каждый момент времени, а также его статистику. Звуковой сигнал делят на перекрывающиеся 25-50 миллисекундные отрезки – фреймы, для каждого из которых при помощи быстрого преобразования Фурье вычисляют спектр, а для него уже после ищутся моменты. Чаще всего используют центроид, энтропию, дисперсию, коэффициенты асимметрии и эксцесса – много всего, к чему прибегают при подсчете случайных величин и временных рядов.

Также используют мел-частотные кепстральные коэффициенты (MFCC). Про них стоит почитать, например, тут. Проблем, которые они пытаются решить, две. Во-первых, восприятие звука человеком не линейно по частоте и по амплитуде сигнала, стало быть, требуется провести некоторое шкалирование (логарифмическое). Во-вторых, сам спектр речевого сигнала меняется по частоте довольно плавно, и его описание можно сократить до нескольких чисел без особенных потерь в точности. Как правило, используют 12 мел-кепстральных коэффициентов, каждый из которых представляет собой логарифм спектральной плотности внутри определенных частотных полос (ее ширина тем выше, чем больше частота).

Именно этот набор признаков (pitch, статистики спектрограммы, MFCC) мы и будем использовать для классификации.

/ Фотография Daniel Oines / CC-BY

Решаем задачу классификации

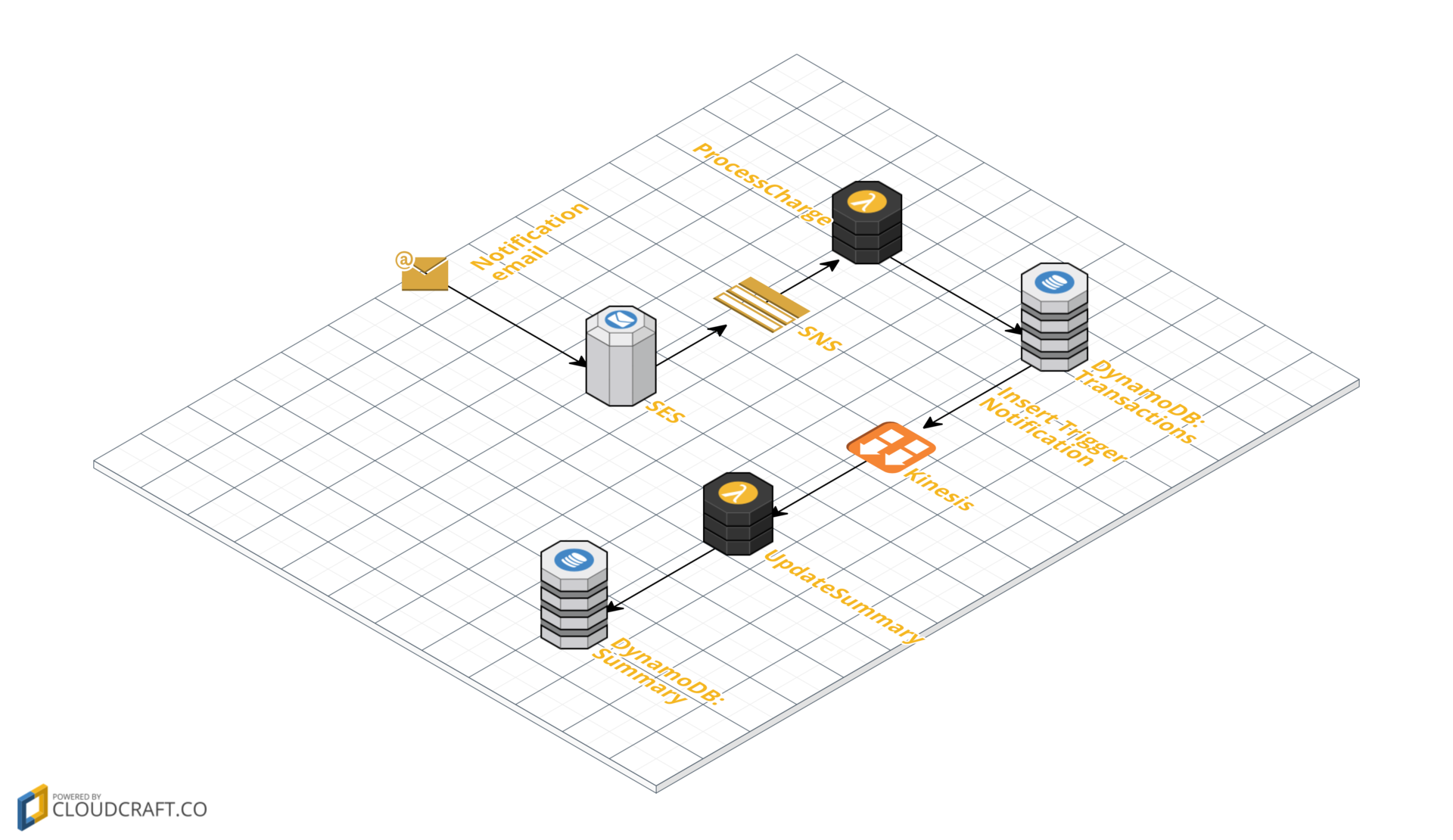

Машинное обучение начинается с данных. К сожалению, нет открытых и популярных баз для идентификации пола, таких как ImageNet для классификации изображений или же IMDB – для тональности текстов. Можно взять известную базу для распознавания речи TIMIT, но она платная (что накладывает некоторые ограничения на её публичное использование), поэтому воспользуемся VCTK – 7 Гб базой в свободном доступе. Она предназначена для задачи синтеза речи, но устраивает нас по всем параметрам: там есть звук и данные о 109 спикерах. Для каждого из них мы возьмем по 4 случайных высказывания длительностью 1-5 секунд и попытаемся определить пол их автора.

В компьютере звук выводится как последовательность чисел – отклонений мембраны микрофона от равновесного положения. Частота дискретизации чаще всего выбирается из диапазона от 8 до 96 кГц, и для одноканального звука одна его секунда будет представляться как минимум 8 тысячами чисел: любое из них кодирует отклонение мембраны от равновесного положения в каждый из восьми тысяч моментов времени в секунду. Для тех, кто слышал про Wavenet – нейросетевую архитектуру для синтеза звукового сигнала, – это не кажется проблемой, но в нашем случае подобный подход избыточен. Логичным действием на этапе предобработки данных является расчет признаков, которые позволяют существенно снизить количество параметров, описывающих звук. Здесь мы обратились к openSMILE – удобному пакету, способному рассчитать почти все, что имеет отношение к звуку.

Код написан на Python, а реализация – Random Forest, который лучше всего справился с классификацией, – взята из библиотеки sklearn. Также любопытно посмотреть, как с этой задачей справятся нейросети, но о них мы сделаем отдельный пост.

Решить задачу классификации – значит на обучающих данных построить функцию, которая по аналогичным параметрам возвращает метку класса, причем делает это довольно-таки точно. В нашем случае необходимо, чтобы по набору признаков для произвольного аудиофайла наш классификатор отвечал, чья речь в нем записана, мужчины или женщины.

Аудиофайл состоит из множества фреймов, обычно их число намного больше числа обучающих примеров. Если мы будем обучаться на совокупности фреймов, то едва ли получим что-то стоящее – число параметров разумно уменьшить. В принципе, можно классифицировать каждый фрейм по отдельности, но из-за выбросов конечный результат будет тоже не слишком воодушевляющим. Золотой серединой является подсчет статистик признаков по всем фреймам в аудиофайле.

Кроме того, нам необходим алгоритм валидации классификатора – следует убедиться, что он все делает правильно. В задачах обработки речи считается, что обобщающая способность модели низкая, если она хорошо работает не для всех спикеров, а только для тех, на которых обучалась. В противном случае говорят, что модель является т.н. speaker free, и это само по себе неплохо. Чтобы проверить этот факт, достаточно разбить спикеров на группы: на одних обучиться, а на остальных – проверить точность.

Так мы и поступим.

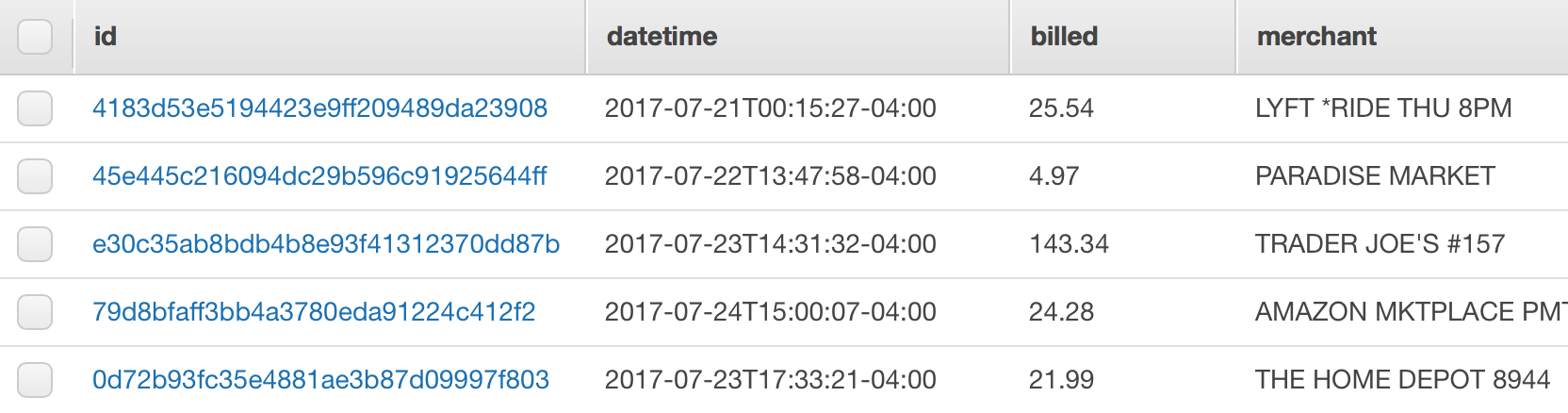

Таблица с данными хранится в файле data.csv, столбцы подписаны в первой строчке, при желании ее можно вывести на экран или посмотреть вручную.

Подключаем нужные библиотеки, читаем данные:

import csv, os

import numpy as np

from sklearn.ensemble import RandomForestClassifier as RFC

from sklearn.model_selection import GroupKFold

# read data

with open('data.csv', 'r')as c:

r = csv.reader(c, delimiter=',')

header = r.next()

data = []

for row in r:

data.append(row)

data = np.array(data)

# preprocess

genders = data[:, 0].astype(int)

speakers = data[:, 1].astype(int)

filenames = data[:, 2]

times = data[:, 3].astype(float)

pitch = data[:, 4:5].astype(float)

features = data[:, 4:].astype(float)Сейчас нужно организовать процедуру кросс-валидации по спикерам. Встроенный в sklearn итератор GroupKFold работает следующим образом: каждая точка в выборке относится к какой-либо группе, в нашем случае – к одному из спикеров. Множество всех спикеров разбивается на равные части и последовательно исключается каждая из них, на оставшихся обучается классификатор и запоминается точность на выкинутой. За точность классификатора берется средняя по всем частям точность.

def subject_cross_validation(clf, x, y, subj, folds):

gkf = GroupKFold(n_splits=folds)

scores = []

for train, test in gkf.split(x, y, groups=subj):

clf.fit(x[train], y[train])

scores.append(clf.score(x[test], y[test]))

return np.mean(scores)Когда все готово, можно ставить эксперименты. Сначала попробуем классифицировать фреймы. На вход классификатору подается вектор признаков, а выходная метка совпадает с меткой файла, из которого взят текущий фрейм. Сравним классификацию отдельно по частоте и по всем признакам (частота + спектральные + mfcc):

# classify frames separately

score_frames_pitch = subject_cross_validation(RFC(n_estimators=100), pitch, genders, speakers, 5)

print 'Frames classification on pitch, accuracy:', score_frames_pitch

score_frames_features = subject_cross_validation(RFC(n_estimators=100), features, genders, speakers, 5)

print 'Frames classification on all features, accuracy:', score_frames_featuresОжидаемо мы получили невысокую точность – 66 и 73% верно классифицированных фреймов. Не густо, ненамного лучше, чем случайный классификатор, который дал бы порядка 50%. В первую очередь такая низкая точность связана с наличием мусора в выборке – для 64% фреймов не удалось посчитать частоту основного тона. Причин может быть две: фреймы либо не содержали речь совсем (тишина, вздохи), либо были составными частями согласных звуков. И если первые можно отбраковать безнаказанно, то вторые – с оговорками: мы считаем, что по звуковым фреймам нам удастся корректно разделять мужскую и женскую речь.

На самом деле хочется классифицировать не фреймы, а аудиофайлы целиком. Можно вычислить разнообразные статистики от временных последовательностей признаков, а затем классифицировать уже их:

def make_sample(x, y, subj, names, statistics=[np.mean, np.std, np.median, np.min, np.max]):

avx = []

avy = []

avs = []

keys = np.unique(names)

for k in keys:

idx = names == k

v = []

for stat in statistics:

v += stat(x[idx], axis=0).tolist()

avx.append(v)

avy.append(y[idx][0])

avs.append(subj[idx][0])

return np.array(avx), np.array(avy).astype(int), np.array(avs).astype(int)

# average features for each frame

average_features, average_genders, average_speakers = make_sample(features, genders, speakers, filenames)

average_pitch, average_genders, average_speakers = make_sample(pitch, genders, speakers, filenames)Теперь каждый аудиофайл представляется вектором. Мы считаем среднее, дисперсию, медианное и экстремальные значения признаков и классифицируем их:

# train models on pitch and on all features

score_pitch = subject_cross_validation(RFC(n_estimators=100), average_pitch, average_genders, average_speakers, 5)

print 'Utterance classification on pitch, accuracy:', score_pitch

score_features = subject_cross_validation(RFC(n_estimators=100), average_features, average_genders, average_speakers, 5)

print 'Utterance classification on features, accuracy:', score_features97,2% — уже совсем другое дело, вроде бы всё здорово. Осталось отбросить мусорные фреймы, пересчитать статистики и радоваться результату:

# skip all frames without pitch

filter_idx = pitch[:, 0] > 1

filtered_average_features, filtered_average_genders, filtered_average_speakers = make_sample(features[filter_idx], genders[filter_idx], speakers[filter_idx], filenames[filter_idx])

score_filtered = subject_cross_validation(RFC(n_estimators=100), filtered_average_features, filtered_average_genders, filtered_average_speakers, 5)

print 'Utterance classification an averaged features over filtered frames, accuracy:', score_filteredУра, планка в 98.4% достигнута. Подбором параметров модели (и выбором самой модели), наверное, можно увеличить и это число, но качественно новых знаний мы не получим.

Заключение

Машинное обучение в обработке речи – объективно сложно. Решение «в лоб» в большинстве случаев оказывается в итоге далеким от желаемого, и часто приходится дополнительно «наскребать» по 1-2% точности, меняя что-то, казалось бы, малозначимое, но обоснованное физикой или математикой. Строго говоря, этот процесс можно продолжать бесконечно, но…

В следующей и последней части нашего вводного гайда мы детально рассмотрим, справятся ли нейронные сети с этой задачей лучше, изучим разные постановки эксперимента, архитектуры сетей и сопутствующие вопросы.

Над материалом работали:

- Григорий Стерлинг, математик, ведущий эксперт Neurodata Lab по машинному обучению и анализу данных

- Ева Казимирова, биолог, физиолог, эксперт Neurodata Lab в области акустики, анализа голоса и речевых сигналов

Оставайтесь с нами.

|

Метки: author IgorLevin работа со звуком блог компании neurodata lab neurodata lab распознавание аудио нейросети |

Плюсы автоматизации: как технологии исправляют ошибки сотрудников магазинов |

В нашем блоге мы много пишем о технологиях в сфере ритейла и автоматизации современных магазинов. Продвинутая инфраструктура позволяет не только повысить эффективность функционирования всех процессов в торговых точках, но и свести к минимуму влияния «человеческого фактора». Сегодня речь пойдет о том, как технологии помогают предотвращать ошибки сотрудников магазинов.

Игнорирование карт лояльности и возможности допродаж

Ошибки сотрудников могут приводить не только к проблемам с проверяющими органами, но и лишать магазин потенциальной прибыли. Не секрет, что многие ритейлеры активно работают над развитием программ лояльности, которые стимулируют клиентов покупать больше и чаще. Однако без участия сотрудника, стоящего за кассой, полноценная работа ни одной системы лояльности невозможна.

Американский ритейлер WalMart собирает данные о продажах для того, чтобы предсказывать возможные паттерны поведения покупателей. Иногда использование подобных технологий позволяет получать неожиданные результаты. К примеру, в пятницу вечером, мужчины с большей вероятностью купят подгузники для детей, а для себя — пиво. Таким образом, кассовый софт, в котором заложено знание этого факта, может советовать кассиру предлагать неожиданный на первый взгляд дополнительный товар при покупке пива. Сам кассир мог бы предложить что-то более подходящее к пиву на его взгляд — и прогадал бы. После обнаружения такой корреляции в Walmart секции подгузников передвинули ближе к холодильникам с пивом.

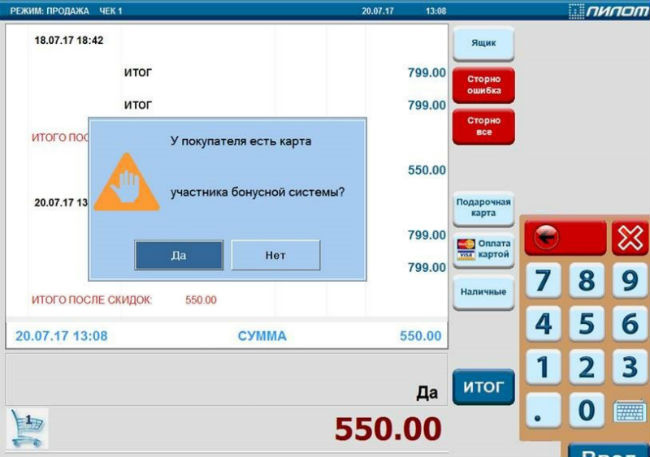

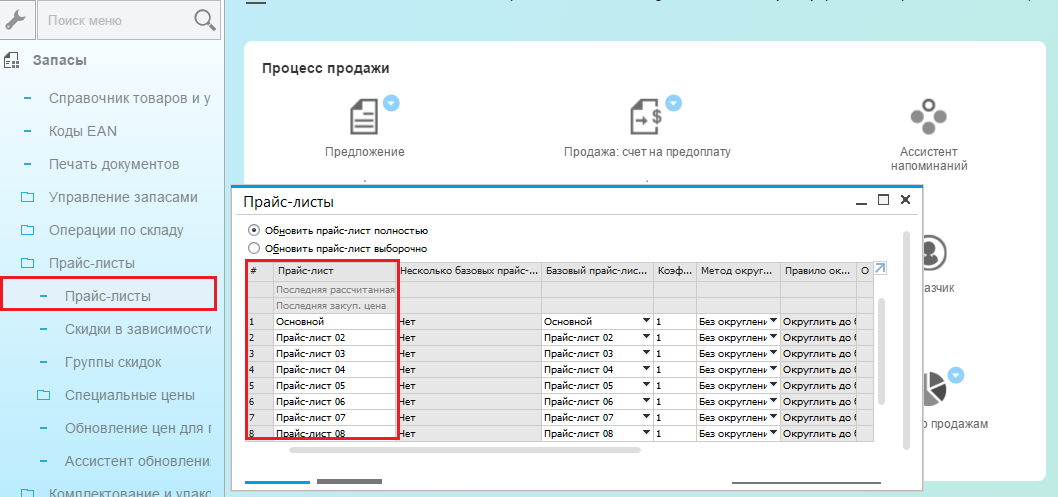

Часто сотрудники просто забывают спросить клиента о наличии у него специальной карты лояльности или предложить ему ее получить. Чтобы этого избежать, кассовый софт может показывать специальные напоминания — так делает система «Профи-Т». В результате вероятность того, что клиент оформит карту лояльности и начнет активно участвовать в программе, повышается.

Кроме того, от сотрудника во многом зависит и то, завершится ли в итоге продажа. В материале, посвященном автоматизации ритейла, журналист издания Pando рассказал историю о том, как один его знакомый венчурный инвестор пошел в магазин электроники. Покупатель уже был на кассе и собирался приобрести дорогой гаджет, когда продавец спросил его, видел ли он новую, более мощную модель устройства, которая скоро выйдет. В итоге тот решил отказаться от покупки и дождаться новую версию.

Еще чаще продажа не случается из-за бездействия продавца — сотрудник может не предложить клиенту совершить дополнительную покупку. Чтобы такого не происходило, кассовый софт также может генерировать рекомендации о том, какие дополнительные товары предложить клиенту вместе с его покупкой — это повышает шансы на увеличение итогового чека.

Ошибки при работе с товарами

Помимо проблем при коммуникациях с клиентом, могут возникать и чисто технические ошибки, которые, тем не менее, дорого обходятся магазинам. Одна из таких проблем — обновление ценников на товары и возникающие в ходе этого процесса ошибки, ведущие к негативу со стороны покупателей.

Распространенная ситуация — в кассовом софте у продукта установлена одна цена, но на ценнике по каким-то причинам оказалась другая (например, сотрудник ошибся или забыл ее сменить). Обычно все это выясняется уже на кассе, когда товар «пробился» по более высокой цене, чем ожидал покупатель — и это мало кому понравится.

Пока идет выяснение причин несоответствия у кассы собирается очередь, клиенты испытывают негатив. А любой осадок, оставшийся у покупателя, ведет к тому, что в другой раз он не придет в этот магазин, отдав предпочтение конкуренту. Кроме того, по закону магазин обязан продать клиенту товар по цене, указанной на ценнике. То есть ошибки в оформлении ценников приводят и к непосредственным финансовым потерям.

Чтобы избежать таких проблем некоторые ритейлеры используют технологию электронных ценников, информацию на которых можно обновлять централизованно через специальный сервер без необходимости ручного труда.

Однако внедрение системы электронных ценников (железо + софт) стоит достаточно дорого, и это пока влияет на проникновение технологии.

Существуют и более бюджетные способы снизить вероятность ошибок. Один из них — технология мобильной переоценки. Этот подход подразумевает использование в процессе переоценки товаров специальных программно-аппаратные комплексов. Они включают специализированный софт (например, у «Пилота» это собственная разработка — программный комплекс «ОмниЛинк»), терминалы сбора и обработки данных, а также мобильные термопринтеры.

Работает это так — когда происходит обновление цен или сотрудник видит, что стоимость товара в учетной программе изменилась и не совпадает с фактической на ценнике, он подходит к полкам с товаром и начинает процесс сканирования. Если система находит несоответствие в ценах, то автоматически отправляет команду на печать нового ценника. Мобильные принтеры размещаются на поясе сотрудника, так что ценник печатается прямо на месте. Это позволяет снизить вероятность ошибок и значительно упростить процесс переоценки.

Кроме того, использование технологий автоматизации позволяет работникам магазина и администрации торговой точки лучше понимать месторасположение конкретного товара. Это, помимо прочего, снижает вероятность потерь товара или его кражи.

Британский ритейл-консультант Ромео Ричардс в своем блоге приводит следующие расчеты по этому поводу — если у нас есть сеть с оборотом lb10 млн фунтов и показателем розничной усадки (то есть списаний потерянного, испорченного или украденного товара) в 2%, а на ошибки сотрудников приходится 18% этой «усадки», то в год это выльется в потерю lb36000. Если при этом уровень чистой прибыли магазина составляет 1%, то, чтобы покрыть эти убытки, нужно будет сгенерировать продаж на lb3,6 млн. Много ли магазинов могут так легко это сделать? Поэтому автоматизация очень важна.

Нарушение законодательных норм и правил

Одна из самых распространенных ошибок кассиров — продажа алкоголя и сигарет без просьбы предъявить паспорт. Если такие товары будут проданы несовершеннолетним, и это станет известно в ходе проверки или, например, контрольной закупки, магазину выпишут крупный штраф.

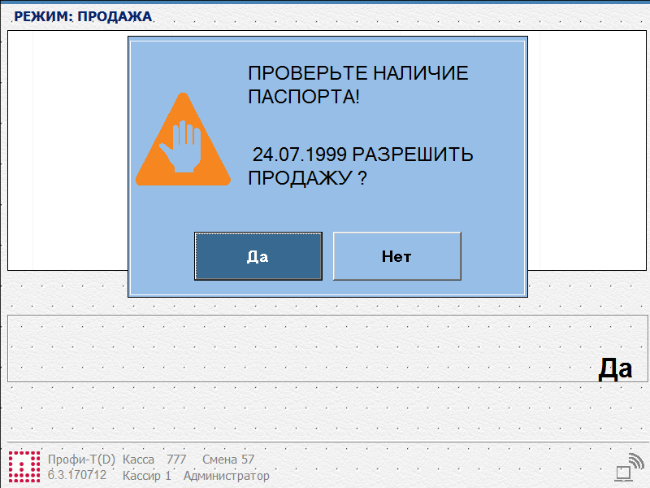

Чтобы избежать подобных проблем возможные ошибки сотрудников исправляют с помощью технологий — например, разработанная нами система «Профи-Т» выдает кассиру подсказки-указания по ходу обслуживания. Среди них есть и требование спросить паспорт при продаже алкоголя. При попытке «пробить» такой товар звучит сигнал и на экране кассы высвечивается соответствующее сообщение.

Будущее: угрожают ли технологии сотрудникам?

Согласно исследованиям, автоматизация может серьезно угрожать перспективам сотрудников магазинов — по некоторым данным, до половины всех позиций в ритейле могут быть автоматизированы в будущем. Некоторые должности не исключено, что в перспективе полностью исчезнут — как, например, позиция кассира.

Но ближайшие два-три года на рынке розничной торговли вряд ли что-то резко изменится: какими бы семимильными шагами не развивалась автоматизация ритейла, так быстро она «человеческие» профессии не уберёт. Однако, действительно, развитие техники для торговли помогает владельцам магазина сокращать персонал. Есть несколько заметных трендов, развивающихся и в России:

- процессы автоматизации товароучёта. Электронные ценники, мобильные принтеры позволяют ритейлерам сократить штат и траты на расходные материалы. В обоих случаях работникам магазинов не требуется вручную распечатывать ценники и расклеивать их по залу;

- внедрение в магазине систем самообслуживания позволяет сократить количество касс и, соответственно, кассиров, а также оптимизировать работу с наличностью;

- технология Digital Signage поможет ритейлеру сократить затраты на проведение промо-акций и, как следствие, и уменьшить число персонала, вовлеченных в них. Кроме того, этот инструмент позволяет продавать рекламное время своим партнерам и иметь дополнительный источник дохода;

- информационные киоски помогут сократить штат консультантов. Покупатели, просто отсканировав штрих-код интересующего товара, уточнят его цену и получат дополнительную информацию о нем. Ритейлеры могут демонстрировать на инфокиоске любой мультимедийный контент.

Кроме того, развитие технологий способствует и уменьшению площади торговых точек — для бизнеса в будущем может быть выгоднее содержать небольшой автоматизированный магазин с малым количеством персонала. Однако те работники, которые останутся в таких магазинах, должны будут стать более продуктивными и научиться управлять технологическими средствами.

Такой переход к более продвинутым навыкам, чем простая физическая работа, с другой стороны будет способствовать росту зарплат сотрудников. При этом сохраняется и вероятность того, что рост эффективности и прибыльности магазинов в конечном итоге приведет к росту их числа — как в свое время появление банкоматов позволило банкам открывать больше отделений, в которых сотрудники не только выдают деньги, а оказывают другие финансовые услуги, вроде оформления кредитов, и общаются с клиентами.

Другие материалы по теме:

- Как проходит автоматизация офлайн-магазинов: три реальных примера

- Не только касса: как устроена ИТ-инфраструктура современных магазинов

- Почему не взлетает «облако»: как работают системы лояльности в магазинах

- Технологии и «не-IT»: как и зачем S/4HANA применяется в оптовой торговле

|

Метки: author pilot-retail it- инфраструктура блог компании пилот ритейл технологии автоматизация |

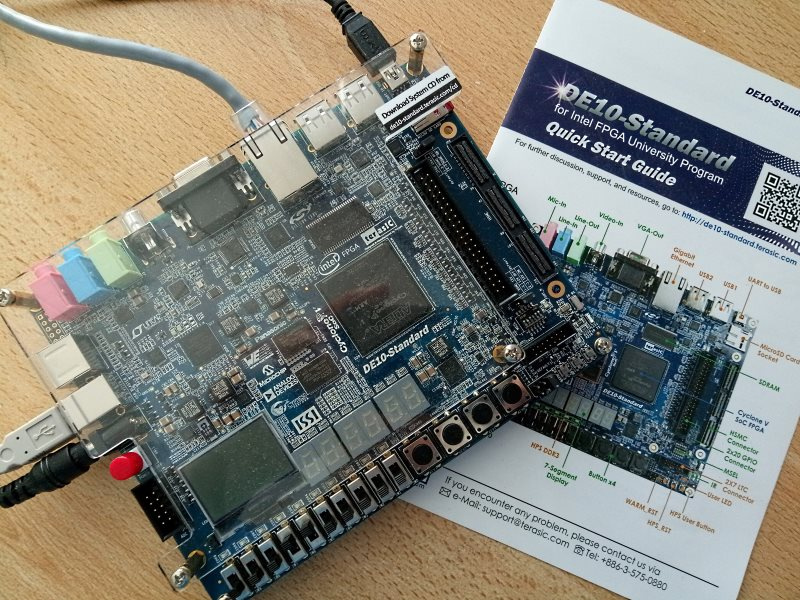

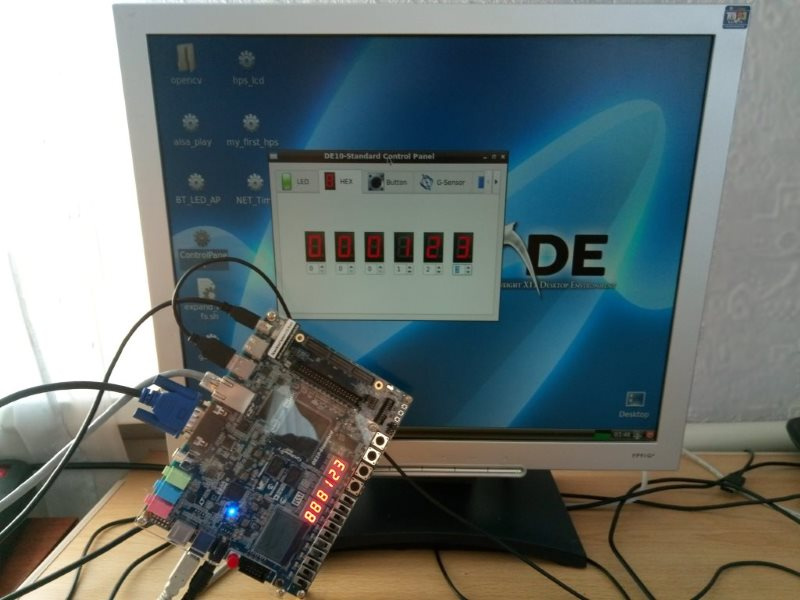

Опыт использования FPGA платы DE10-Standard и DMA PL330 |

Получил в свое распоряжение плату Terasic DE10-Standard. На ней много всего интересного: встроенный JTAG программатор, светодиоды, переключатели, кнопки, разъемы Audio / VGA / USB / Ethernet. Думаю, что нет особой необходимости перечислять все ее возможности, ведь каждый желающий может прочитать спецификацию платы на сайте производителя.

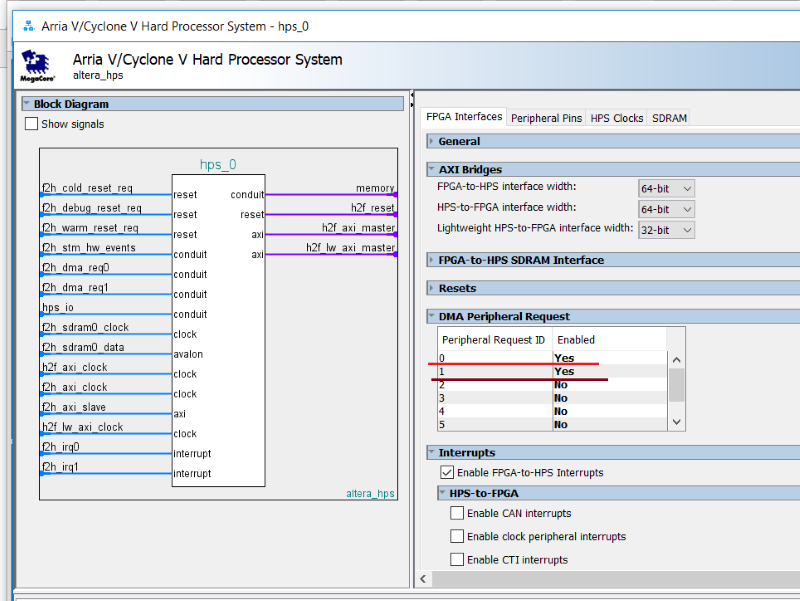

Для меня важно, что на плате стоит FPGA чип Cyclone V SX – 5CSXFC6D6F31C6N. Эта микросхема содержит два процессора ARM Cortex-A9 и 110K логических элементов FPGA. Это уже настоящая SoC HPS: System-On-Chip, Hard Processor System. С такими ресурсами можно пробовать делать довольно сложные проекты. Далее расскажу о своем опыте использования платы.

Очень просто скачать образ Linux с сайта терасика и подготовить загрузочную SD карту для платы DE10-Standard. ОС Linux загружается с SD, плата оживает и демонстрирует свои возможности.

Как только загрузился Linux, на рабочем столе можно отыскать иконку тестового приложения. Это тестовое GUI приложение позволяет включать и выключать отдельные светодиоды платы, смотреть состояние переключателей и кнопок, устанавливать значения на 7-сегментных индикаторах и так далее. Там много чего интересного. Когда поигрался с этой программой думаешь, что вот и сам сейчас быстро сможешь сделать свой проект и быстро его запустить.

Я не считаю себя новичком-разработчиком ПЛИС. Я делал проекты с софт процессорами и представляю себе, что такое Linux kernel. Я и сам участвую в разработке плат разработчиков с ПЛИС Altera/Intel. Однако, честно говоря, это мой первый опыт работы с SoC HPS-FPGA. Когда я начал делать свой собственный проект для этой платы, именно для этой ПЛИС, я понял, что на самом деле будет не просто.

Конечно, плата DE10-Standard сама по себе не виновата.

Есть некоторая иллюзия легкости разработки: вот есть образ SD карты от терасика, есть исходники примера проекта для ПЛИС и сишные исходники для тестовых программ. Казалось бы, бери адаптируй под свои нужды и будет все работать. Но, нет.

Нужно понять, что первое впечатление легкости разработки — оно обманчиво. Что видно с первого взгляда — это всего лишь вершина айсберга.

Пришлось очень много читать и изучать, например:

1. К плате прилагается диск DE10-Standard_v.1.2.0_SystemCD и он содержит 38 PDF файлов различной документации, схем и руководств.

2. Просто техническое описание от компании Интел “Cyclone V Hard Processor System Technical Reference Manual” www.altera.com/en_US/pdfs/literature/hb/cyclone-v/cv_5v4.pdf содержит 3536 страниц.

Конечно, не обязательно их все сразу читать, я думал вообще их читать не буду, обойдусь своими знаниями и опытом, но, все таки пришлось и читать и разбираться.

Есть еще хороший ресурс: https://rocketboards.org/, который содержит еще больше документации, исходников примеров и даже форум. Это делает жизнь с одной стороны легче, а с другой — еще сложнее, ведь придется читать и впитывать еще больше информации… К сожалению даже на форуме rocketboard, не всегда удается найти ответы на свои вопросы.

Таким образом, разработка проекта получается довольно сложной, потому, что сам предмет разработки SoC HPS является сложным.

Представьте себе часовой механизм с множеством шестеренок. Каждая шестеренка должна в точности подходить к следующей — иначе ничего не будет крутиться. То же самое и в случае с системой HPS-FPGA. Система состоит из очень многих программных и аппаратных компонентов: Preloader, U-BOOT, Linux kernel и драйвера, DTB файл генерируется из DTS файла, затем еще нужно создать RootFS и, конечно, разработать саму аппаратную систему в ПЛИС: FPGA SoC проект будет содержать несколько IP блоков, аппаратные регистры отображаемые в память, тактовые частоты и домены, сигналы ввода/вывода и прочее и прочее…

Я предполагаю, что знаю, как создать проект для FPGA для моей SoC, и я думаю, что должно работать ну где-то на 80% так как я не вижу очевидных ошибок в проекте. Так же я думаю, что примерно знаю, как написать DTS файл, который описывает мою аппаратную платформу. Предположим, я уверен, что я написал DTS файл правильно на 80%. Из DTS файла генерируется DTB файл. Потом, к своей аппаратуре ПЛИС я должен написать kernel driver. Это не просто, но я умею писать драйвера. Надеюсь я там не наделал много ошибок? Надеюсь мой драйвер корректен ну хотя бы на 80%. Но что там насчет Preloader? Preloader – это первая программа, которая будет считана и запущена с SD карты и она должна запрограммировать нужные аппаратные конфигурационные регистры системы на кристалле. Сделал ли я Preloader правильно? Ну допустим, я уверен на 80%. Теперь если подумать, то какова вероятность, что моя система заработает? Я думаю, что где-то вот так: 0.8*0.8*0.8*0.8=0.4096… Чем больше компонентов в системе, тем хуже. Если что-то не работает или не работает вообще ничего (например, kernel panic), то довольно трудно понять где проблема — она может быть везде.

Цель моей работы была сделать проект HPS-FPGA который использует DMA транзакции для переноса данных из системной памяти в ПЛИС и обратно из ПЛИС в системную память. Использование DMA должно разгрузить процессор. На хабре уже была статья про реализацию DMA в FPGA Cyclone V, однако, мне не хотелось идти путем создания собственного контроллера, как это сделал Des333… Я хотел использовать уже имеющийся в системе контроллер PL330.

Работая с платой DE10-Standard Board некоторое время я получил бесценный опыт. Если позволите, хочу дать несколько советов тем, кто решится заняться разработкой SoC HPS в ПЛИС.

Подготовьте плату к разработке.

Вероятно это совет из разряда очевидных. Существует образ SD карты, который содержит нужные файлы для старта системы: образ FPGA, файл DTB, U-BOOT и Linux kernel zImage. Дополнительные разделы содержат Preloader и RootFS. Если я разрабатываю SoC HPS проект для ПЛИС, я его компилирую в среде САПР Quartus Prime и результат (RBF, Raw Binary File) должен записать на SD карту. Потом я компилирую Linux kernel и мой драйвер в составе ядра. Мне так же нужно записать получившиеся файлы на SD Card.

Нет никакого смысла вытаскивать SD карту из платы, вставлять в кардридер компьютера или ноутбука, чтобы записать файлы на карту. Это может занимать слишком много времени. К тому же, частый plug/unplug может привести к поломке разъема SD карты в плате или ноутбуке. Я рекомендую сконфигурировать U-BOOT таким образом, чтобы нужные файлы скачивались из сети с TFTP сервера.

Плата имеет разъем UART-to-USB для ее подключения через USB кабель к компьютеру разработчика. Открываю программу терминала, например, PUTTY, и включаю плату. Сразу видно, как в терминале побежали сообщения из U-BOOT. Загрузку можно прервать, если сразу нажать любую клавишу в терминале.

Я добавил несколько переменных в окружение U-BOOT:

ethaddr=fe:cd:12:34:56:67

ipaddr=10.8.0.97

serverip=10.8.0.36

xfpga=tftpboot 100 socfpga.rbf; fpga load 0 100 $filesize; run bridge_enable_handoff; tftpboot 100 socfpga.dtb

xload=run xfpga; tftpboot 8000 zImage; bootz 8000 – 100На компьютере разработчика IP 10.8.0.36 я установил сервер TFTP. В папке /tftpboot я храню socfpga.rbf (Raw Binary File) – результат компиляции проекта SoC FPGA в среде Quartus Prime. Кроме того, там же в папке храню socfpga.dtb – соответствующий Device Tree Blob и Linux kernel zImage файл.

Теперь, когда я включаю питание на плате, я тут же прерываю обычную загрузку нажатием любой клавиши в терминале и ввожу команду:

>run xloadПо этой команде U-BOOT загружает нужные файлы из TFTP сервера, инициализирует FPGA последним скомпилированным образом проекта и загружает мой последний zImage. Быстро и просто. Когда делаю изменение в проекте ПЛИС, компилирую проект квартусом, результат копирую в папку /tftpboot. Точно так же, компилирую ядро Linux, результат компиляции копирую в папку /ftfpboot. Перезагружаю плату, делаю “run xload” и вот уже можно пробовать вести отладку новой системы.

2. Постарайтесь найти opensource пример проекта SoC-HPS максимально похожий на то, что вы собираетесь делать.

Капитан очевидность. Конечно, грамотный инженер может сделать все сам с нуля. Тем не менее, можно сэкономить немного времени, если найти исходники проекта, похожего на тот, что вы собираетесь делать.

Изначально DE10-Standard_v.1.2.0_SystemCD содержит два примера проектов для HPS-FPGA. Первый проект — это DE10_Standard_GHRD, представляет собой минимальные возможности, Linux console, простую отображаемую в память периферию вроде портов ввода вывода для светодиодов, кнопочек и переключателей. Второй пример, DE10_Standard_FB, — сложнее. Здесь уже в FPGA реализован framebuffer, видеоконтроллер, устройство захвата и декодирования видеосигнала и ряд других возможностей. Это позволяет запустить полноценный десктопный Linux. Если вас устраивают эти примеры — тогда все нормально, берите и пользуйтесь.

Лично мне хотелось найти пример с использованием DMA контроллера, так как я хотел разгрузить CPU во время передачи данных из системной памяти в FPGA и назад из FPGA в системную память. Я поискал такой пример и нашел его на сайте rocketboards: https://rocketboards.org/foswiki/view/Documentation/SampleDmaQuartusProjectForFpgaDmaCInTheKernel313

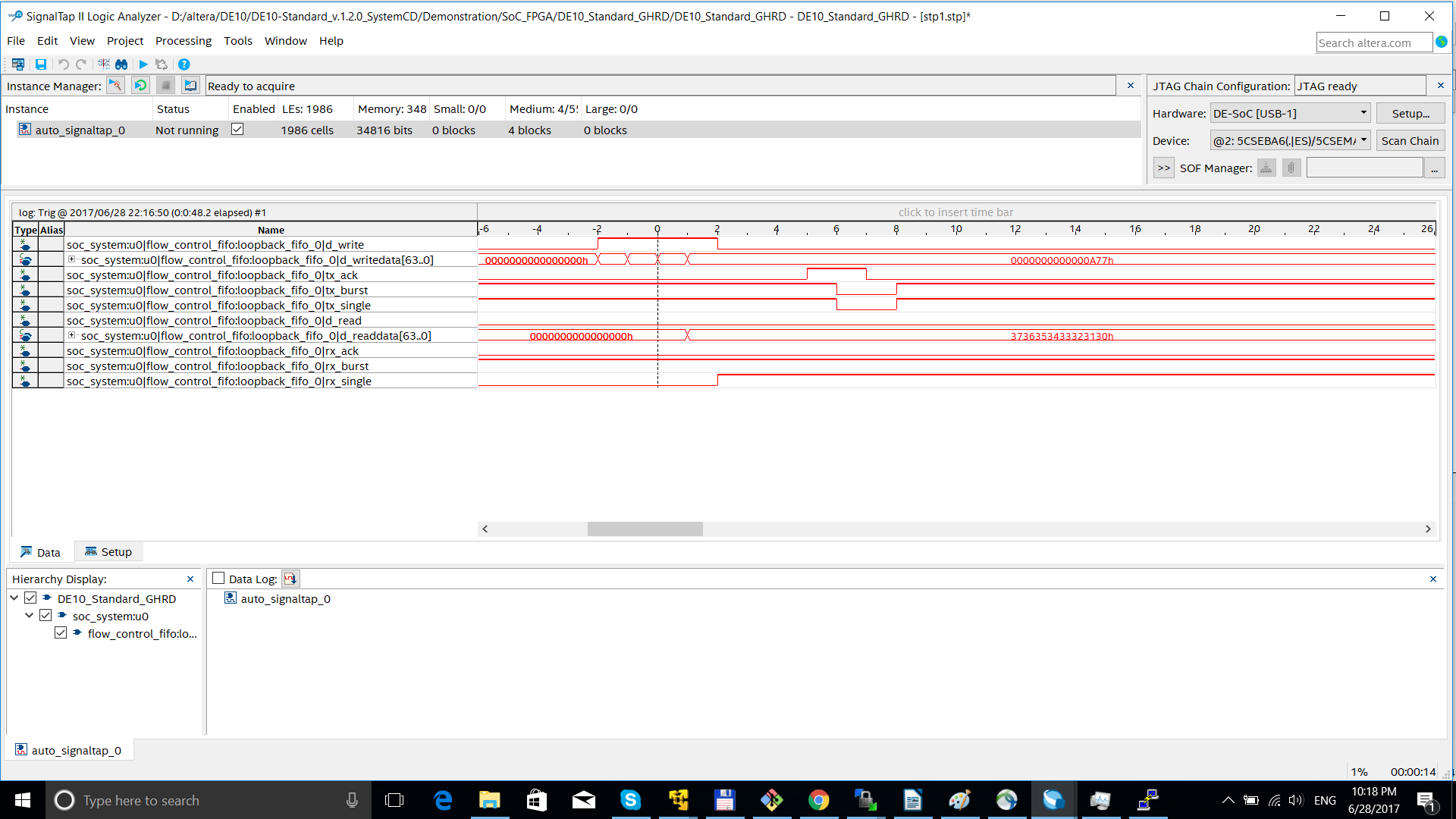

Пример вообще-то не очень, но хоть что-то, можно пробовать что-то сделать. Cyclone V HPS имеет встроенный DMA контроллер PL330 и я хотел бы попытаться использовать его. Я взял IP корку из проекта примера Loopback_FIFO и вставил его с помощью Quartus Prime QSYS в мой клон проекта DE10_Standard_GHRD. К сожалению, я потратил очень много времени на написание правильного DTS файла к моему проекту, DTS файла не было в архиве примера. Так же, я не сразу понял, что в Linux kernel уже есть пример DMA драйвера в arch/arm/mach-socfpga/fpga-dma.c. Я понял это слишком поздно, когда уже почти написал свой собственный драйвер.

Несмотря на эти трудности я все же советую начинать разработку с поиска существующих примеров, проектов и решений. Найдите несколько примеров, выберите наилучший для вас — с него и начинайте разработку.

3. Используйте исходники Linux kernel как документацию.

С FPGA Cyclone V HPS я разрабатываю новую аппаратную платформу. С большой вероятностью мне придется писать свой собственный драйвер к новой аппаратуре в ПЛИС. В интернете очень много статей как писать драйвера уровня ядра Linux. Но учтите, что очень многие из этих статей уже давным давно устарели, содержат не верные примеры, вызывают старый kernel API.

Если выбрать конкретную версию ядра Linux для проекта, то всю информацию о том, как писать драйвера можно почерпнуть конкретно из исходников этой версии ядра и это будет самая актуальная информация. Примеры драйверов в папке ./drivers, дествующая документация в папке ./Documentation, примеры написания *.DTS файлов в папке ./arch/arm/boot/dts

В моем случае для моего проекта с DMA контроллером документация о написании драйверов DMA получена из файлов ./Documentation/dmaengine/*.

Исходники ядра могут помочь в написании DTS файла — для меня DTS файл был очень большой проблемой. В файле DTS в текстовом виде описываются аппаратные ресурсы системы. Потом DTS компилируется в DTB файл, который потом используется ядром таким образом, что драйвера могут знать, какие ресурсы принадлежат устройствам.

Как я понял, теоретически разработка должна идти вот так:

- Разрабатываем аппаратную систему в среде САПР Quartus Prime QSYS, настраиваем параметры HPS, добавляем в систему компоненты и IP ядра, соединяем компоненты. Генерируем систему с помощью QSYS и получаем результат soc_system.qsys и soc_system.sopsinfo файлы.