Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Перевод] Данные: красивые и ужасные |

Данные повсюду. И это прекрасно. Они меняют нашу жизнь, заново изобретают сторителлинг и оказывают влияние практически на все отрасли — бизнес, искусство, развлечения, музыку, технологии.

Вот некоторые яркие примеры…

Информационная журналистика

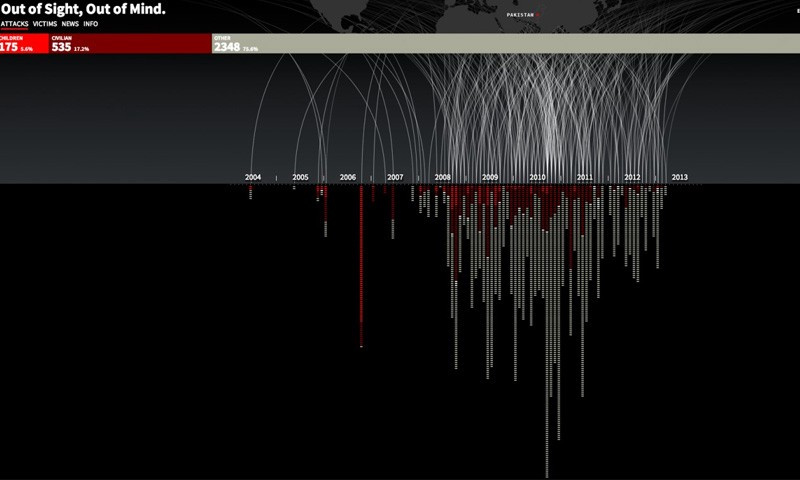

Яркая и совершенно ужасающая инфографика. Проект, который называется «С глаз долой, из сердца вон», — это хронология ударов беспилотных дронов в Пакистане с июля 2004 года по декабрь 2013 года.

С 2004 года США практиковали новый вид подпольной военной операции. Использование беспилотных летательных аппаратов для уничтожения вражеских целей казалось привлекательным, так как устраняло риск потери американских военных и политически было намного легче осуществимо. Показатель эффективности оказался крайне низок, а потери среди взрослого и детского гражданского населения очень высоки. Весь мир мог бы остаться в неведении о том, что на самом деле происходит, и, как говорится, с глаз долой, из сердца вон. Этот проект помогает осветить тему беспилотных летательных аппаратов, не говоря за или против. Изучив данные, вы можете самим решить, сможете ли вы поддерживать подобное использование беспилотных летательных аппаратов или нет.

Визуализация создается в HTML5 и JavaScript

drones.pitchinteractive.com

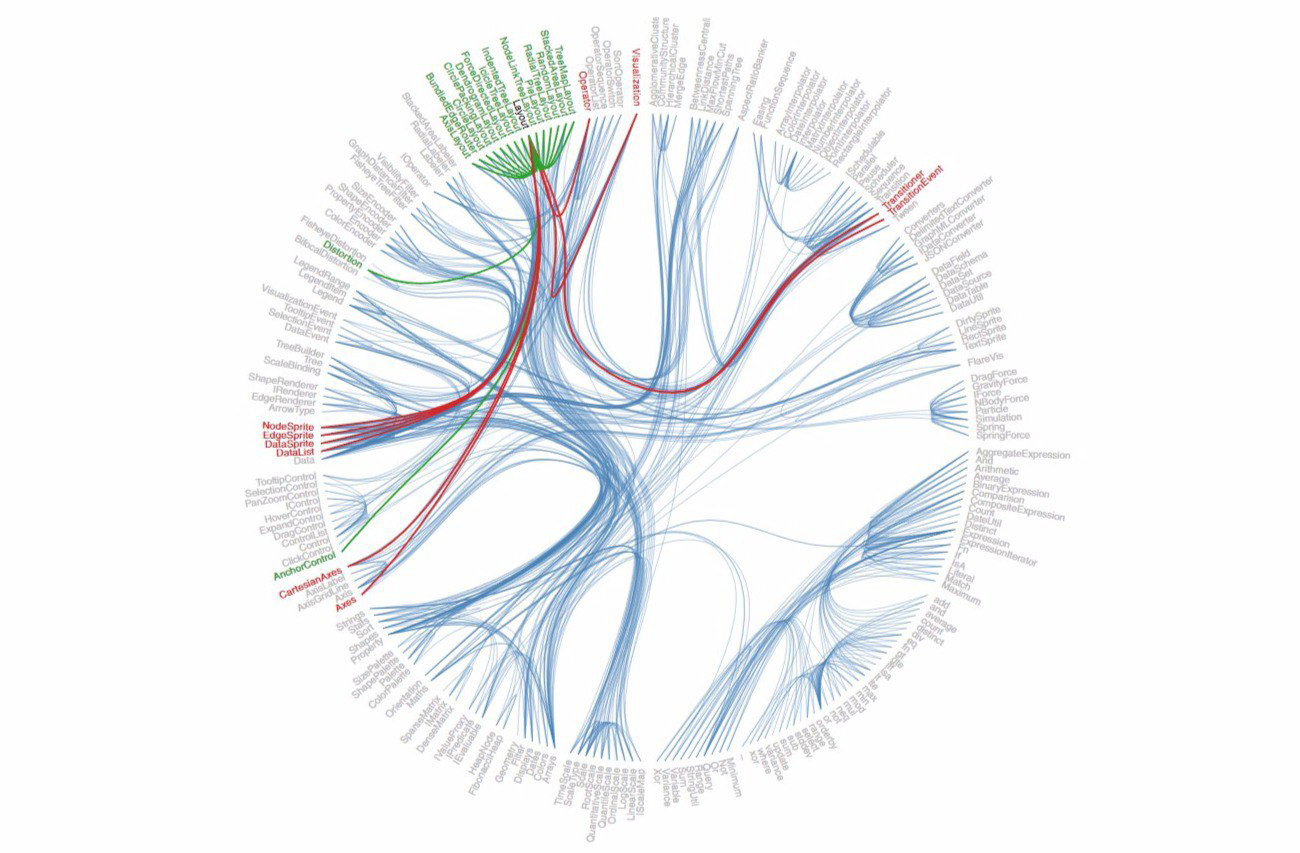

Разговор о визуализации данных в действительности не будет полным без упоминая d3.js — удивительной библиотеки javascript, которую создал Майк Босток, ранее ответственный за визуализацию данных New York Times (по ссылке коллекция его работ с кодом). Большинство проектов с визуализацией данных, которые вы видите в Интернете сегодня, построены с помощью d3.js.

Для новостных изданий создание интерактивных историй может быть сложным, но однажды увидев, читатели ожидают их всё больше и больше. Ссылки по теме:

Ханс Рослинг, который, к сожалению, скончался в начале этого года, в своей знаменитой лекции TED Talk представил данные, которые развенчали несколько мифов о мировом развитии. Это было нереально круто:

У него также было собственное шоу на BBC, The Joy of Stats:

Временная карта каждого ядерного взрыва с 1945 года. Страшно. Особенно много вопросов остаётся к советскому правительству, которое проводило испытания на разных полигонах сильно разбросанных по территории страны, в отличии, например, от США. Видео рекомендуем просматривать в ускоренном режиме воспроизведения.

Вот итоговая карта:

Больше интересных примеров с d3.js:

- Карта смертей от огнестрельного оружия в США: data.huffingtonpost.com/2013/03/gun-deaths

- Визуализация данных с финала NBA 2012: www.nytimes.com/interactive/2012/06/11/sports/basketball/nba-shot-analysis.html

- Сколько лет вам осталось жить: flowingdata.com/2015/09/23/years-you-have-left-to-live-probably

- Режимы дня известных творческих людей: podio.com/site/creative-routines

- Музыкальная хронология от Google: research.google.com/bigpicture/music

Количественное самоопределение

Николас Фелтрон, один из ведущих дизайнеров Facebook’s timeline, много лет собирал о себе множество данных, изначально тщательно описывая свою жизнь на бумаге, а затем создав приложение. Затем эти данные были превращены в годовые отчеты. Ознакомиться с ними можно здесь: feltron.com

Больше примеров:

- ericboam.com/Seven-Months-of-Sleep-1

- ericboam.com/2014-A-Year-In-New-Music

- jehiah.cz/one-four

- Federico Zannier продал данные о себе за 2 доллара в день. Используя Kickstarter, он сумел заработать $ 2733. Федерико предложил всем желающим архив, в котором собраны: информация gps-трекинга, все сайты, которые он посетил, информация о нажатиях клавиш, движениях мыши и даже скриншоты его лица каждые 30 секунд. www.kickstarter.com/projects/1461902402/a-bit-e-of-me/description

- Data coup помогает вам продавать ваши личные данные datacoup.com

- Калькулятор стоимости личных данных: www.ft.com/cms/s/2/927ca86e-d29b-11e2-88ed-00144feab7de.html#axzz2z2agBB6R

GPS и трекинг

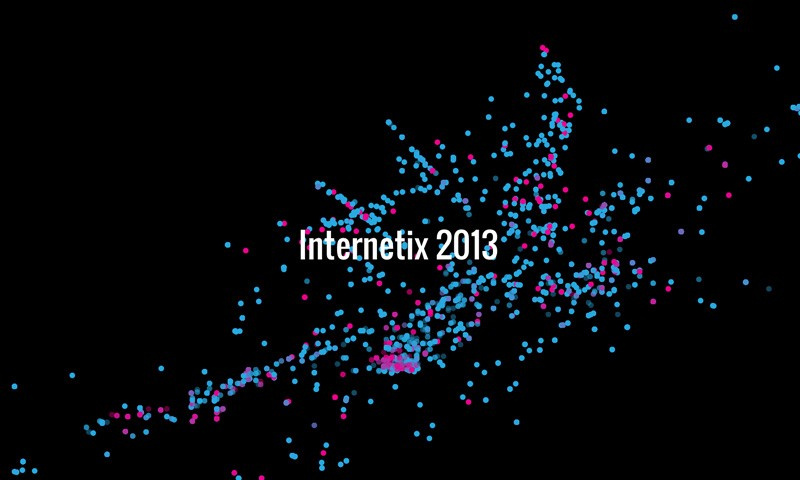

Just Landed — это визуализация твитов людей, передвигающихся по всему миру на самолете. Проект Джерома Торпа ищет твиты, содержащие фразы «только что приземлились ...» или «только что прибыл ...», а затем визуализирует путешествие в зависимости от местоположения в момент твита и места жительства человека.

datavisualization.ch/showcases/just-landed-a-twitter-visualization-in-processing

Больше работ Джерома Торпа

- www.fastcodesign.com/1669702/explore-the-galaxy-using-the-actual-minority-report-interface

- intotheokavango.org

Micro-геолокации:

Отслеживание делегатов конференции через Wi-Fi и визуализация их движения и связей — это проект, который Джордж Галли сделал несколько лет назад. Wi-Fi действительно может быть использован для точного определения местоположения людей.

radarboy.com/george/internetix.php

Больше GPS-визуализации:

- Один день из жизни такси: nyctaxi.herokuapp.com

- Визуализация Metropolitan Transportation Authority (Нью-Йорк):

Сторителлинг с визуализацией

Масштаб Вселенной: htwins.net

Простая, но эффективная визуализация о протяжённости времени: hereistoday.com

Визуализация данных о последствиях разделения Германии Берлинской стеной: zeit.de/feature/german-unification-a-nation-divided

Данные как искусство:

Диллон Марш создаёт композиции для визуализации данных о производстве на южноафриканских шахтах: www.dillonmarsh.com

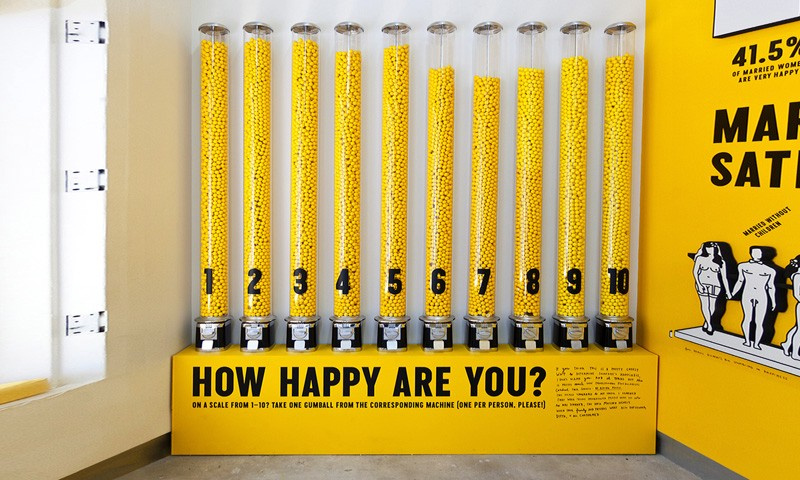

«Счастливое шоу» Стефана Сагмайстера — выставка, целью которой является измерить и контролировать уровень счастья: www.thisiscolossal.com/2013/08/the-happy-show-by-stefan-sagmeister

Надеемся, что вам понравилась эта подборка визуализаций. Знаете ещё не мало ярких примеров? поделитесь со всеми в комментариях.

|

Метки: author Cloud4Y открытые данные визуализация данных data mining big data блог компании cloud4y анализ данных красота |

Неожиданные результаты опросов Kotlin: маленькое расследование |

В итоге получилась история о статистике, твитах, конформности, внушении и скидках на одежду.

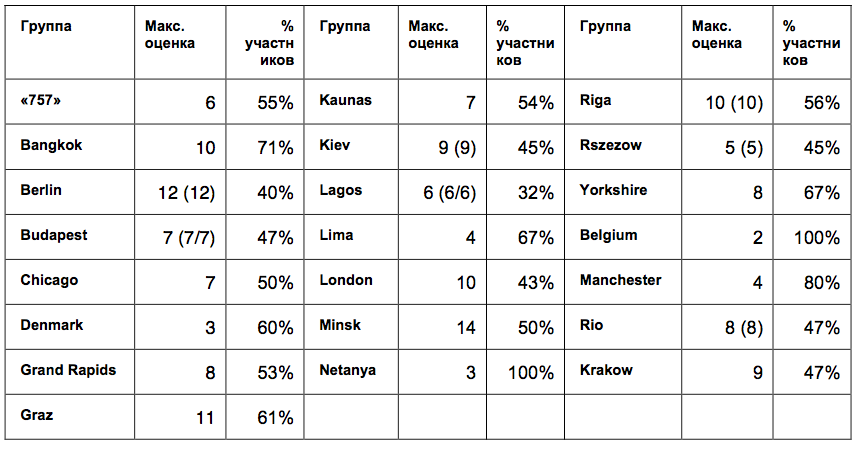

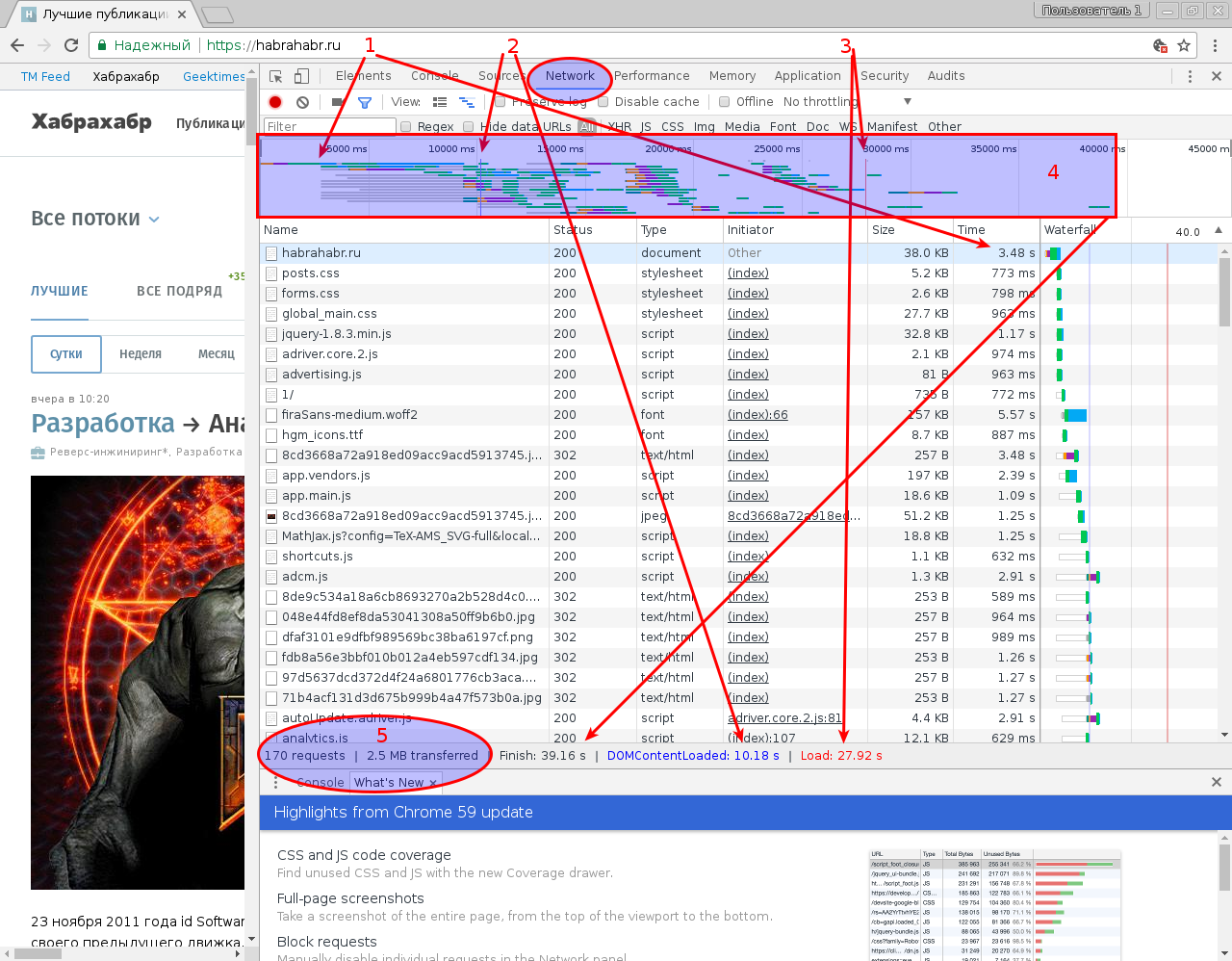

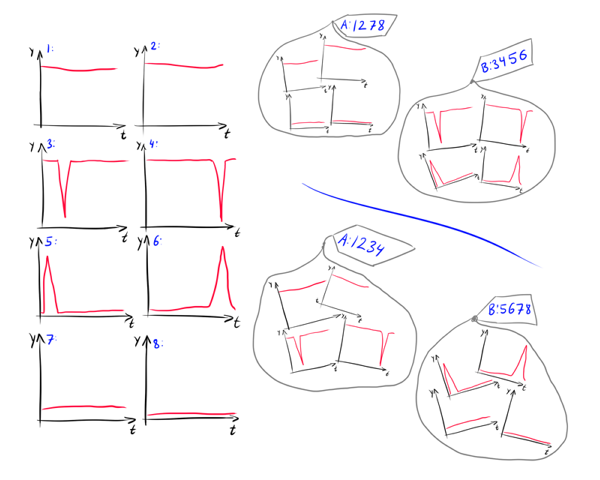

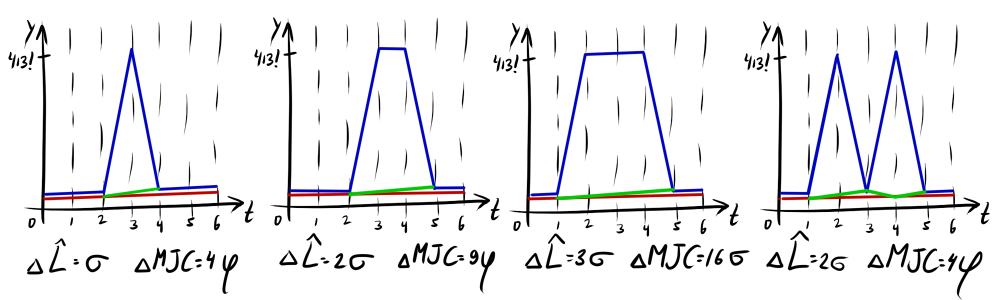

Рисунок 1. Фотографии с результатами опросов.

Статья может быть интересна тем, кто занимается опросами и исследованиями пользователей.

Итак, весной прошли международные опросы пользователей языка Kotlin о функциях, которые они хотели бы увидеть в следующем релизе. Позже в блоге Kotlin появился пост с результатами исследования и ссылкой на сырые данные.

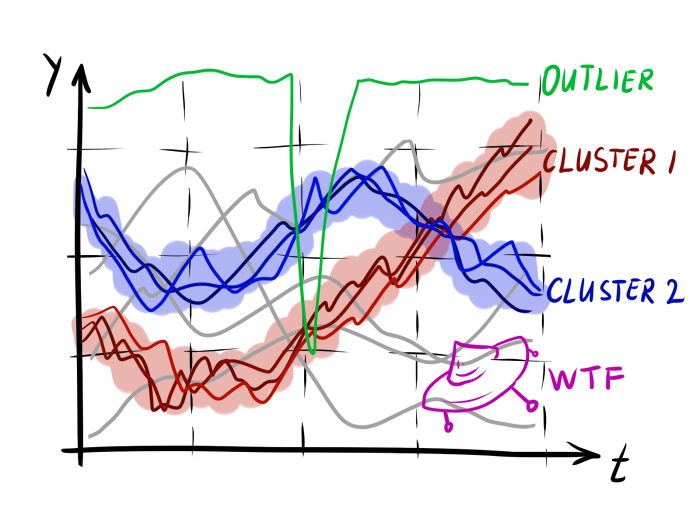

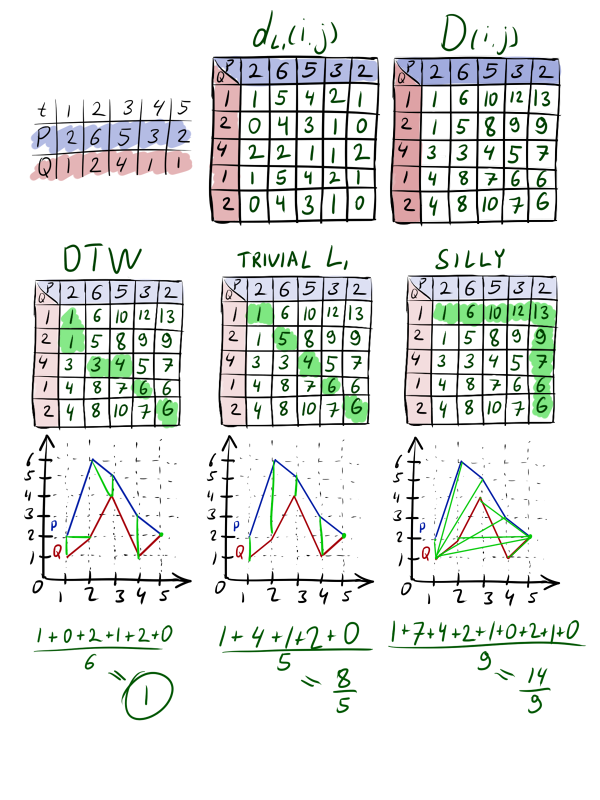

Исследование проводилось в 2 этапа. Часть пользователей языка голосовали на митапах, посвященных Kotlin 1.1, вторая часть заполняла on-line анкеты. В результате получилось 2 рейтинга с 3 явными фаворитами в каждом (рис. 2).

И фавориты не совпали.

Рисунок 2. Рейтинги ожидаемых новых функций в Kotlin 1.2: результаты off-line и on-line опросов.

Почему результаты двух опросов так отличаются друг друг от друга?

Организаторы предложили 2 объяснения:

1. Отличия групп. Участники митапов отличаются от остальных пользователей Kotlin.

2. Предвзятость. На off-line голосовании участники видели, за какую функцию голосуют другие, и это могло повлиять на их мнение.

Попробуем подробнее разобраться, почему результаты отличаются. Проведем маленькое расследование и ответим на вопросы:

1. Действительно ли между участниками митапов и остальными пользователями есть различия?

2. Действительно ли на голоса участников митапов повлияло мнение коллег?

3. Одинаково ли воспринимали условия голосования участники митапов и остальные пользователи?

4. Почему в рейтинге on-line голосования первая тройка набрала существенно больше голосов, чем остальные функции?

Для начала, восстановим, как проходило исследование.

Процедура исследования

Опрос состоял из 2 частей.

Off-line часть заполнялась участниками митапов. Большинство митапов прошло в одно время, 23 марта, в 21 стране мира (всего 30 митапов). Их участники смотрели прямую трансляцию демонстрации функций Kotlin 1.1, а после могли проголосовать за появление новых функций. Некоторые митапы голосовали до демонстрации (рис. 3). Для этого им раздали по 3 круглых оранжевых стикера, которые нужно было прикрепить к карточкам с описанием функций. Можно было использовать по 1 стикеру за функцию, или проголосовать двумя, или всеми тремя стикерами за одну функцию. Сейчас невозможно восстановить, сколько человек принимало участие в голосовании в каждом митапе, так как каждое сообщество назвало организаторам исследования только рейтинг: общее количество стикеров, оставленных за каждую функцию. Свои рейтинги передали 22 сообщества.

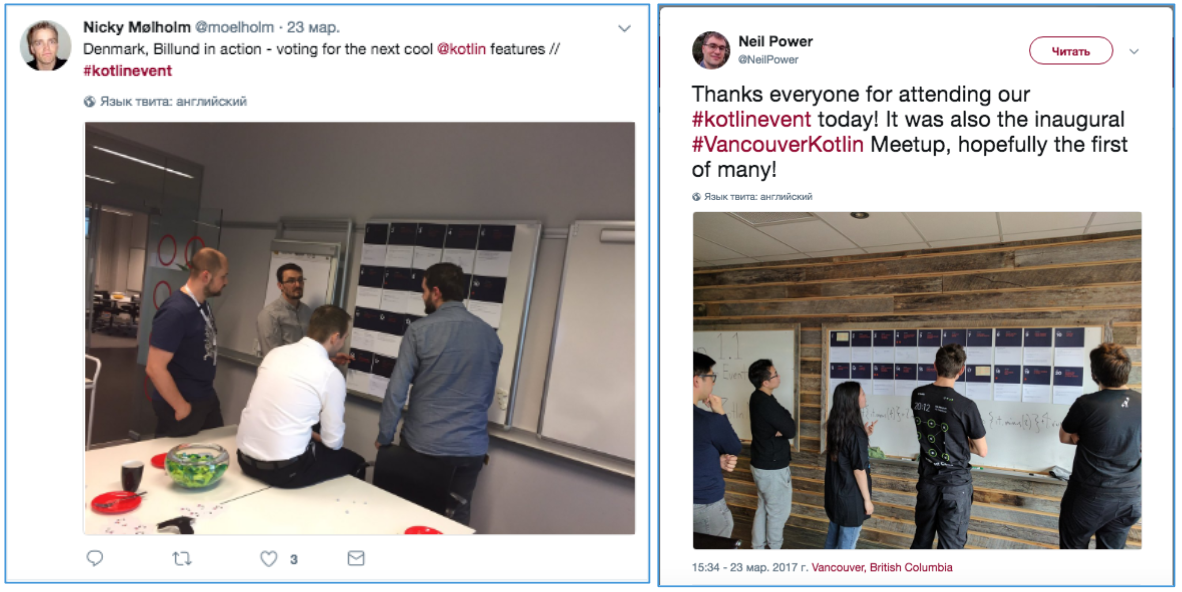

Рисунок 3: Фотографии из твитов сообществ Kotlin (на стенах видны карточки для голосования).

On-line часть опроса прошла после off-line части. В блоге Kotlin появилась статья с видео-записью трансляции и рассказом об опросе, проведенном в сообществах. В статье было написано, что опрос привлек много внимания, и теперь создатели предлагают пройти его on-line всем желающим и «высказать свое мнение о будущем Kotlin».

Участникам предлагалась on-line анкета с такими же, казалось бы, вопросами – об ожидаемых функциях языка. В конце анкеты были приложены такие же карточки с описанием каждой функции, которые были использованы после митапов. Дополнительно в анкету добавили вопрос о самой нежелательной функции. На on-line анкету был получен 851 ответ.

Результаты исследования

Данные обоих опросов обрабатывались простым суммированием. В результате получилось 2 списка – on-line и off-line рейтинги с 3 явными фаворитами в каждом (рис. 2), фавориты не совпали.

Только функция #18 «Truly immutable data» попала в первую тройку одновременно в обоих опросах. Более-менее совпала первая шестерка, с перемешанным порядком, за исключением двух функций: функция #4 «Private members accessible from tests» в on-line опросе оказалась всего лишь на 12 строчке и набрала максимум голосов против, а функция #9 «Inline classes/Value classes» в off-line опросе оказалась на 17 строчке.

Итак, лидерами в обоих опросах стали:

#18 Truly immutable data

#1: Multi-catch

#13: SAM conversions for Kotlin interfaces

#6: Collection literals

#8: Slices for lists and arrays

Обсуждение

1. А есть ли на самом деле различия?

На диаграммах различия явно видны. Но это первая ловушка, о которой предупреждают исследователей: вывод о различиях между группами не делается по простому подсчету средних, или частот. Здесь должна быть шутка про «среднее по больнице». На фото карточек off-line голосования видно, что на разных митапах лидерами мнений оказывались разные функции. А вдруг, мнения участников сильно различались, и получившиеся рейтинги – просто результат случайных колебаний?

Проверим гипотезу

Такие догадки проверяют статистикой. Но в нашем случае получилось 2 разных вида сырых данных: номинальные данные в on-line голосовании и количественные в off-line голосовании. Поэтому попробуем посмотреть просто на корреляции итоговых списков. Если получится, что корреляция между двумя списками сильнее, чем корреляции между списками митапов, это будет значить, что среди участников разных митапов согласия меньше, чем между всеми участниками митапов и участниками on-line голосования. А это будет значить, что нельзя делать вывод о том, что участники митапов и участники on-line голосования – это две существенно разные группы.

Коэффициент корреляции Спирмена между on-line и off-line голосованиями получился таким: r=0,680, p=0,001. В классификации Дж. Коэна для социальных исследований это довольно высокий показатель взаимосвязи (>0,5 – значительная корреляция).

Теперь посмотрим, как оценки митапов коррелируют между собой. Оказалось, что между списками митапов нет ни одной корреляции, превышающей значение 0,680. Самая сильная корреляция (0,618) проявилась между Бельгией и Берлином. Более того, были даже отрицательные корреляции (например, -0,454 между Лимой и Будапештом: интересно было бы узнать, есть ли объяснение этих отличий).

Другими словами, участники митапов в разных странах меньше согласны друг с другом, чем в общем согласны с on-line пользователями.

Насчет этого эффекта есть интересный пример из социальной психологии.

Несмотря на традиционные представления, научные исследования показывают, что различия между группами (между мужчинами и женщинами) часто оказываются менее существенными, чем различия внутри гендерных групп (например, только между женщинами).

Так, в разных странах проводились исследования математических способностей у мальчиков и девочек. В части стран лучше успевали мальчики, в других странах – девочки. Везде различия были статистически значимыми. И если бы мы знали только об одном таком исследовании, это бы могло сформировать наше представление о математических способностях мужчин и женщин. Но ученые провели мета-исследование и проверили разбросы внутри групп. В большинстве стран различия между мальчиками и девочками оказались меньше, чем различия внутри групп мальчиков и девочек (D. Baker, D. Jones, 1993).

Часто группы, которые нам кажутся очевидно разными, внутри имеют даже больший разброс. Особенно интересно узнавать про такие исследования внутри расовых групп (Zuckerman, 1990).

Вроде, о глобальных различиях между группами теперь можно не говорить. Но остается вопрос: почему результаты распределились именно так, почему в рейтингах есть явные фавориты, набравшие существенно больше голосов? Что еще могло повлиять на голоса участников?

2. Участники влияли друг на друга?

По мнению организаторов исследования, совместное голосование на митапах могло повлиять на ответы участников, изменить их мнение.

Если бы это было так, ответы внутри групп распределялись бы скученно, с маленьким разбросом (в группах все бы проголосовали примерно одинаково).

Проверим гипотезу

Попробуем восстановить, как проходили голосования. Поищем в твиттере. Здесь под хештегами #kotlin и #kotlinevent можно обнаружить много фотографий митапов и голосований (рис. 4). Действительно, на фото видно, что участники голосовали вместе и, возможно, обсуждали свои оценки.

Рисунок 4. Твиты участников митапов с фотографиями голосований.

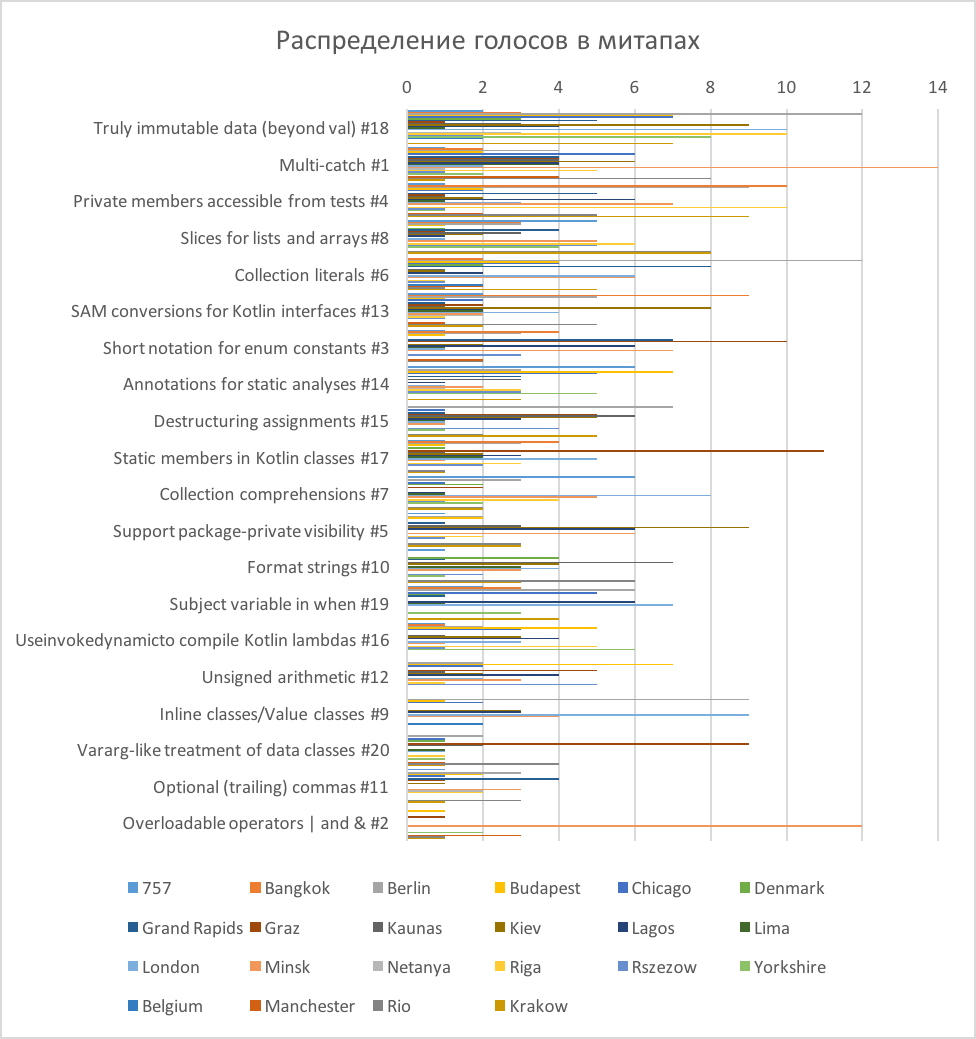

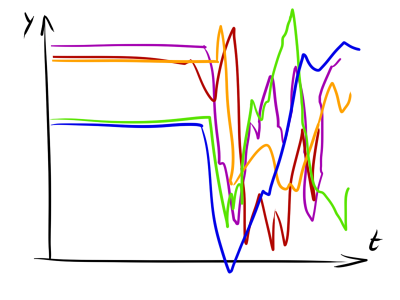

Отобразим на одной диаграмме голосования митапов (рис. 5). Визуально оценить, как проголосовал каждый митап, здесь сложно, зато хорошо видно, как по-разному рапределились оценки (это распределение еще раз подтверждает и нашу гипотезу о слабой взаимосвязи между группами).

Рисунок 5. Распределение голосов в митапах.

На диаграмме видно, что оценка «1» ставилась чаще остальных. То есть, во всех группах, за исключением Берлина и Бельгии, были функции, за которые проголосовал один человек одним стикером. В Бельгии участвовало всего 6 голосов (они распределились по 2 голоса за 3 функции), а в Берлине было просто много участников (90 голосов). Итак, почти во всех сообществах были участники, чье мнение не совпадало с большинством.

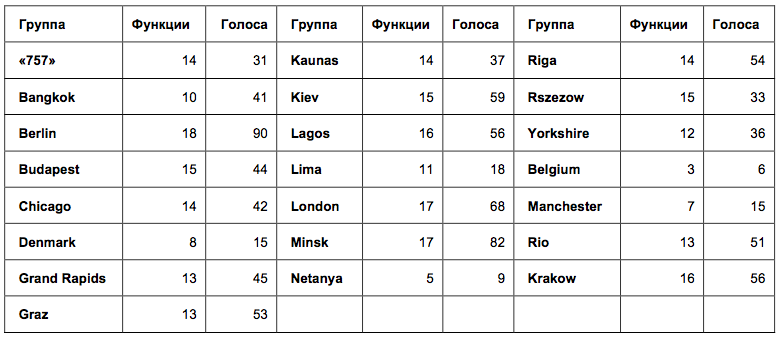

Чтобы проверить единогласие участников в каждом сообществе, оценим разброс оценок в группах. Из-за специфического типа данных, применить среднеквадратичное отклонение внутри групп не получится. Зато получится посмотреть, сколько оценок, отличных от 0, было поставлено в каждой группе. Так мы узнаем, в каких группах участники голосовали примерно за одни и те же функции, а в каких – за разные (Таблица 1).

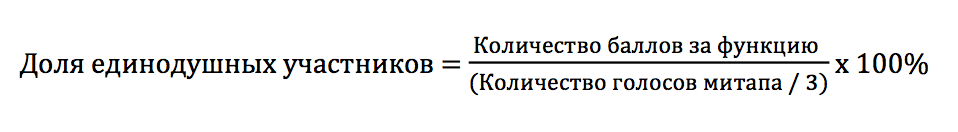

Таблица 1. Количество функций и общее число голосов в голосованиях митапов.

В таблице названий митапов цифры означают: количество функций, за которые были отданы голоса, и общее количество голосов от митапа. Чем больше первая цифра, тем меньше согласия было между участниками. Оказалось, что во всех группах, кроме 3 самых малочисленных, голоса отдавались за более, чем 10 разных функций. Такой разброс оценок наводит на мысль, что участники голосовали вполне независимо. Если бы они подражали друг другу, голоса отдавались бы, например, за 3 одинаковые функции.

Итак, по распределению голосов можно сделать вывод о независимом голосовании участников митапов. И вначале я с готовностью сделала такой вывод. Но затем, обсудив свой вывод с организаторами исследования, я получила закономерный вопрос: действительно ли выбор в группе 10 функций из 20 (то есть, всего половины из предложенных) свидетельствует о большом разбросе голосов? Достаточно ли этих данных для того, чтобы сделать вывод, что голосование участников не было согласованным?

Чтобы это проверить, посмотрим на данные по-другому. На диаграмме видно, что во многих митапах были выбросы: некоторые функции получали значительно больше баллов, чем остальные, за них голосовало большинство участников. Проверим нормальность распределения оценок в митапах с помощью критерия Колмогорова-Смирнова. При использовании критерия Колмогорова-Смирнова отклонение от нормального распределения считается существенным при значении р < 0,05.

Итак, близким к нормальному оказалось распределение оценок только в группах Лаоса, Лондона, Минска, Рио и Кракова (на границе, p=0,047). В остальных группах оценки существенно сместились. Чтобы лучше рассмотреть эти выбросы, я подсчитала, сколько участников митапа предположительно проголосовали за одну функцию.

Если допустить, что каждый участник голосовал одним стикером за одну функцию, то можно приблизительно посчитать процент участников, выбравших одну и ту же функцию:

Посмотрим теперь, какая доля участников проголосовала за самую популярную функцию в каждом митапе (Таблица 2).

Таблица 2. Максимальные оценки и доли проголосовавших за них участников митапов*.

* В скобках – повторяющиеся значения, если высшая оценка была поставлена нескольким функциям.

Выходит, почти во всех группах больше половины участников голосовали за одну и ту же функцию. В самых малочисленных группах доля единогласных участников достигала самых высоких значений: Бангкок – 71% из 14 участников; Манчестер – 80% из 5 участников, Нетания – 100% из 3 участников; Бельгия – 100% из 3 участников. А в крупных группах, наоборот, согласованность была более низкой: Берлин – 40% из 30 участников; Лондон – 43% из 23 участников; Лаос – 32% из 19 участников, но на их фоне Минск оказался довольно согласованным при большой группе – 50% из 28 участников.

Получается, что ответы более половины участников в каждом митапе были согласованными, но при этом отличались между митапами, что исключает возможность предпочтения какой-то одной функции всеми пользователями Kotlin. А это наводит на мысль, что внутри митапов пользователи все-таки ориентировались на какую-то общую точку зрения насчет функций. И чем меньше была группа, тем более похожими были ответы ее участников.

Поведение окружающих, действительно, оказывает влияние на взрослых здравомыслящих людей. Это описывают многие эксперименты конформности. Но бывают случаи, когда не только групповое давление, но и просто модель поведения других людей меняет действия человека.

В эксперименте С. Милгрэма на оживленной улице Нью-Йорка сообщники экспериментатора останавливались и начинали смотреть в одну точку, подняв головы. Оказалось, что число присоединившихся к ним прохожих росло по мере увеличения группы. Обычные люди тоже останавливались и начинали смотреть вверх, не зная, куда смотрят остальные. Эксперимент проводился с разным количеством сообщников. Чем больше их было (от 1 до 5), тем больше подражателей они привлекали. Но после того, как размер группы сообщников превышал 5 человек, рост подражателей останавливался. Группа становилась больше, но подражателей больше не становилось.

В других исследованиях – Герарда (1968) и Розенберга (1961) – также было показано, что увеличение группы сверх 5 человек приводит к снижению конформности.

Итак, есть основания считать, что участники сообществ выражали согласованное мнение. И согласованность ответов была тем выше, чем меньше был состав группы. Но эти вычисления приблизительны, так как мы допустили, что каждый участник голосовал один раз за каждую функцию. Участники видели, как голосуют другие. На что еще это могло повлиять? Вероятно, участники могли копировать не только ответы, но и манеру голосования.

Если, например, в некоторых сообществах первые отвечающие использовали 2, или 3 стикера за одну функцию, такую модель голосования могли повторить другие, что повлияло бы на распределение ответов. Обсудим это подробнее.

3. Одинаковые ли были условия исследования?

Это более интересный, с точки зрения методологии исследований, вопрос. У двух распределений есть 3 явных фаворита. Почему они выделились, если разброс оценок был большим? Насколько одинаковыми были условия у обоих групп? И было ли это одно исследование, или два совершенно разных исследования?

Представим, как проходило голосование.

Когда участникам митапов давали по 3 круглых оранжевых стикера, у них была возможность использовать их, как монетки: голосовать двумя, или тремя стикерами за одну функцию. А условия on-line исследования могли восприниматься по-другому. Хотя в инструкции было написано, что одну функцию можно выбрать дважды, или трижды, формулировки вопросов («The most expected feature 1», «The most expected feature 2», «The most expected feature 3»), похоже, чаще вызывали желание выбрать в каждом вопросе новую функцию (первую, вторую, третью).

Проверим гипотезу

В сырых данных on-line опроса видно, что дважды проголосовали за одну функцию всего только 10 человек, а трижды – 8 человек из 851. При этом, 11 участников не использовали все возможности голосования, ответив только на 2 вопроса из 3.

А что было в off-line голосованиях? Из сырых данных мы можем делать только косвенные выводы. Например, из 22 митапов у 10 итоговое количество голосов не кратно 3. То есть, в 10 митапах (как минимум) один, или несколько участников тоже использовали при голосовании не все стикеры.

Далее, в рейтингах митапов видно, что в 20 митапах из 22 есть функции с 1 голосом (за них проголосовал один участник одним стикером). Значит, на митапах тоже были люди, отдававшие не все свои голоса за одну функцию. Но сколько таких людей было по сравнению с on-line голосованием, из данных понять сложно.

Мы спросили у нескольких митапов, насколько часто участники голосовали за одну функцию двумя, или тремя стикерами, и получили ответы пока только из Киева и Минска. Организаторы сказали, что участники редко клеили несколько стикеров за функцию. Обычно голосовали одним стикером за одну функцию.

Так что, пока нельзя подтвердить, или опровергнуть гипотезу о том, что участники митапов и участники on-line опроса по-разному понимали инструкцию голосования. Пока аргументы указывают на то, что в обоих случаях участники чаще голосовали за три разных функции, независимо от способа голосования.

4. «Тройка – семерка – туз». А может, было внушение?

Меня не оставляет вопрос: почему в on-line голосовании выделились именно такие лидеры: #6 (с отрывом) – #13 – #18?

128 человек из 851 выбрали в качестве первой функции, 98 человек в качестве второй и 60 – третьей. Из них только двое выбрали функцию #6 дважды. 15 человек проголосовали за нее, как за нежелательную. То есть, за функцию #6 проголосовало положительно 284 участника, или каждый третий участник голосования.

При этом, в off-line голосовании в половине групп за нее никто, или почти никто не голосовал: в 10 группах функция #6 получила 0, или 1 голос. Однако, в 1 группе она получила больше всего голосов и в двух других группах разделила первое место с функцией #18. Общее количество голосов, отданных за #6 в off-line голосованиях, оказалось 60 из 941. Значит, максимум 19% участников в off-line голосованиях выбирали функцию #6. На самом деле, их было меньше, так как не все использовали по 3 голоса, а некоторые могли голосовать за функцию повторно.

Почему on-line голосовали именно за #6, если в off-line опросах она оказалась только на 6 месте в общем рейтинге? Может, еще что-то повлияло на ответы участников?

Проверим гипотезу

Для начала, проверим, действительно ли характер on-line рейтинга отличается от off-line? Визуально распределение оценок в off-line рейтинге кажется более плавным. Сравним распределения оценок с нормальным распределением с помощью статистического критерия Колмогорова-Смирнова.

Действительно, ошибка отклонения от нормального распределения в off-line рейтинге p=0,087, в то время как в on-line рейтинге ошибка значительно меньше, p=0,016. Значит, оценки в off-line опросе распределились нормально, а в on-line опросе 3 функции были оценены существенно выше. Визуальная оценка не подвела.

Итак, остается понять, почему именно эти функции: #6 – #13 – #18 победили в голосовании с таким отрывом.

Оценим еще раз условия on-line опроса.

В блоге Kotlin публикуется пост, в котором написано, что off-line опрос привлек много внимания. Затем читателей приглашают также принять участие в голосовании и размещают ссылку на on-line опрос.

Посмотрим еще раз, как был оформлен пост в блоге Kotlin. Но перед этим я попрошу вас припомнить, рассматривали ли вы первую картинку к статье, которую сейчас читаете? Обратили ли вы внимание, на каких карточках было больше всего оранжевых стикеров? Если вы знакомы с языком Kotlin и обеспокоены тем, какие функции будут добавлены в v.1.2, вероятно, эти карточки для вас что-то значат. Будь я разработчиком, я бы точно рассматривала их и пыталась бы понять, почему люди за них проголосовали.

Итак, я специально выбрала заглавной картинкой к статье тот же коллаж из фотографий, который был размещен в блоге Kotlin прямо над приглашением принять участие в опросе. Рассмотрим его подробнее (рис. 6). Оказывается, на самом первом (левом) и самом крупном снимке отчетливо видно, что больше всего голосов отдано за функции #6, #13 и #18. Карточки размещены именно в таком порядке, карточка #6 видна лучше других и считывается первой.

Рисунок 6. Фрагмент поста в блоге Kotlin, приглашающего к on-line тистированию.

Таким образом, фотография с результатами опроса могла оказать влияние на оценки участников (осознаваемое, или неосознаваемое) и изменить распределение голосов. Это похоже на действие «эффекта привязки», о влиянии которого на анкетные исследования я писала в одной из прошлых статей.

«Эффект привязки» был описан в одном из исследований Д. Канемана. Если одну группу испытуемых спросить: «Дожил ли Ганди до 114 лет? В каком возрасте он умер?», а другую: «Дожил ли Ганди до 35 лет? В каком возрасте он умер?», то первая группа оценит жизнь Ганди как гораздо более долгую, чем вторая.

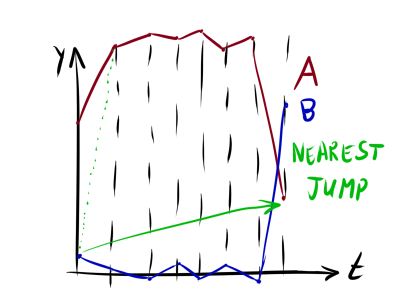

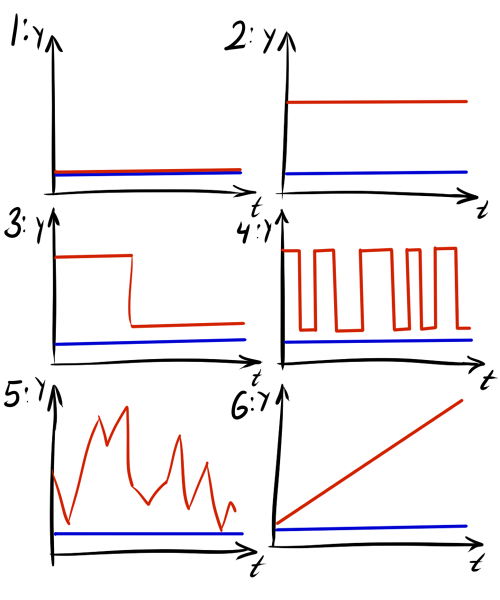

Чаще всего эффект привязки используется в торговле, когда пишется самая низкая цена в группе товаров без уточнения, что остальные товары стоят дороже (рис. 7). Или, наоборот, когда вначале выставляются самые дорогие товары, чтобы скидки на остальные товары воспринимались более существенными.

Рисунок 7. Эффект привязки часто используют в магазинах одежды, указывая над стойкой самую низкую цену, или самую большую скидку, соответствующую, однако, не всем вещам, висящим на стойке.

Интересно, в исследованиях было доказано, что эффект привязки продолжает действовать, даже если человек знает о нем.

Сложно поверить, что программисты, работающие с языком Kotlin, подражали ответам, которые увидели на случайной фотографии. С другой стороны, влияние «эффекта привязки» на ответы в анкетных опросах давно описано в науке и фотография не была такой уж случайной. Так что, можно допустить, что на некоторых участников фотография могла оказать влияние. Как бы то ни было, эта гипотеза останется непроверенной, так как для ее доказательства пришлось бы организовать дополнительное исследование.

Выводы

Ответим на вопросы, поставленные в начале статьи:

1. Действительно ли между участниками митапов и остальными пользователями есть различия? – Такой вывод сделать нельзя, так как в голосованиях участников митапов обнаружилось больше различий, чем между голосованиями всех участников митапов и остальных пользователей.

2. Действительно ли на голоса участников митапов повлияло мнение коллег? – При некоторых допущениях можно сделать вывод, что участники митапов голосовали согласованно. И согласованность ответов была тем выше, чем меньше был размер группы.

3. Одинаково ли воспринимали условия голосования участники митапов и остальные пользователи? – Разные условия исследования могли привести к разной манере голосования, из-за чего двойные и тройные голоса за дну функцию чаще отдавались в митапах, а не при on-line голосовании. Для того, чтобы это доказать, не достаточно данных. Напротив, косвенные аргументы свидетельствуют, что большинство участников предпочитали голосовать за 3 разные функции.

4. Почему в рейтинге on-line голосования первая тройка набрала существенно больше голосов, чем остальные? – Три функции в рейтинге on-line голосования (#6 – #13 – #18), действительно, существенно выше оценены участниками. Возможно, это связано с действием «эффекта привязки» из-за публикации в приглашении к on-line опросу фотографии, на которой карточки с такими номерами были оценены выше других.

Пока это все, что мне удалось обнаружить. Если у вас есть другие идеи, или рекомендации по выбору методов статистики, буду рада им в комментариях.

Если у вас есть случаи исследования пользователей, или сотрудников, вызывающие вопросы, присылайте: проведем расследование.

Я благодарна Алине Долгих за предоставленные материалы и критическое обсуждение статьи, а также участникам facebook-сообщества «Статистика и анализ данных» за готовность помочь в выборе методов статистики.

|

|

Enjoy! Сервер аутентификации Isolate в Open Source |

В работе команды системных администраторов наступает момент, когда поддерживаемых серверов становится слишком много. А может быть еще и людей много, ну и опять же безопасность: если что-то пошло не так, нужно отовсюду ключи удалять.

У нас 300 клиентов. Кому-то это «всего», а для нас — это почти 2000 серверов на обслуживании. Чтобы хранить, обновлять и управлять базой из 2000 паролей для 60 сотрудников, управлять доступом к ней и не объяснять каждый раз клиенту, что пароли к его серверам будут одновременно знать 60 человек, мы сделали сервер аутентификации и назвали его Isolate. Под катом описание функций и ссылка на Github — мы выложили его в Open Source.

У нас есть отдельные серверы авторизации, через которые сотрудники попадают на конкретный поддерживаемый сервер. Мы сами давно и успешно пользуемся этой разработкой, а теперь решили дать ей имя и поделиться с сообществом.

Итак, Isolate — набор утилит auth сервера и ansible-playbook для быстрого его разворачивания. Он позволяет нам авторизовываться по аппаратному ключу (безопасность превыше всего!) и удобно управлять огромным количеством проектов/серверов. При этом:

- сотрудники не знают root пароль (опять же безопасность);

- при нештатных ситуациях аппаратный ключ сотрудника деактивируется на auth сервере, и он теряет доступ к клиентским серверам (к счастью, у нас таких ситуаций не было);

- все SSH-сессии записываются — можно считать время, проведенное на серверах.

Принимая сервер на поддержку, мы создаем на нем sudo-пользователя и прописываем ключ auth серверов. Дальше сотрудник авторизуется на auth сервере с использованием аппаратного ключа (мы используем yubikey), командой s (search) находит нужный сервер (по имени проекта, сервера, сайта и т.п.) и командой g (go) подключается к нему по SSH.

Основные моменты Isolate:

- у пользователей нет доступа к приватному ключу;

- все исходящие SSH-сессии логируются;

- используются только системные средства управления доступом (поддержка SELinux в ближайшем будущем);

- вход на Isolate выполняется по одноразовому паролю (2FA, OTP); можно использовать либо аппаратные ключи, либо всеми любимый Google Authentificator;

- менеджер конфигураций SSH с возможностью соединения через SSH прокси-сервер, поддержка серверов в VPN через внешний гейт;

- устанавливается через Ansible, но требует вмешательства в системные файлы (в ручном режиме);

- поддерживаются CentOS 7, Ubuntu 16.04, Debian 9.

Как это выглядит

Пример списка серверов:

[~]$ s .

myproject

------

10001 | 11.22.22.22 | aws-main-prod

10002 | 11.33.33.33 | aws-dev

10003 | 11.44.44.44 | vs-ci

------

Total: 3

[~]$точка s. в данном случае — как универсальный патерн для поиска всех серверов.

Пример входа на сервер с кастомным портом и SSH-proxy:

[~]$ g myproject aws-dev

Warning: Permanently added 3.3.3.100 (RSA) to the list of known hosts.

Warning: Permanently added 10.10.10.12 (RSA) to the list of known hosts.

[root@dev ~]$Пример входа на произвольный сервер (без конфига в ISOLATE) c произвольными параметрами:

[isolate ~]$ g 45.32.44.87 --user support --port 2232 --nosudo

Warning: Permanently added 45.32.44.87 (RSA) to the list of known hosts.Принцип работы

Установка достаточно подробно описана в README на Github, тут же поговорим о принципах работы.

Сам доступ разграничивается системными пользователями ОС. Как прослойка для доступа используется sudo + ssh.py обертка, цель которой — не допустить попадания за sudo опасных конструкций; ssh.py верифицирует аргументы и запускает SSH-клиент, на этом его обязанности заканчиваются.

Например:

$ sudo -l

(auth) NOPASSWD: /opt/auth/wrappers/ssh.py

$ sudo /opt/auth/wrappers/ssh.py -h

usage: ssh-wrapper [-h] [--user USER] [--port PORT] [--nosudo]

[--config CONFIG] [--debug] [--proxy-host PROXY_HOST]

[--proxy-user PROXY_USER] [--proxy-port PROXY_PORT]

[--proxy-id PROXY_ID]

hostname

positional arguments:

hostname server address (allowed FQDN,[a-z-],ip6,ip4)

optional arguments:

-h, --help show this help message and exit

--user USER set target username

--port PORT set target port

--nosudo run connection without sudo terminating command

--debug

--proxy-host PROXY_HOST

--proxy-user PROXY_USER

--proxy-port PROXY_PORT

--proxy-id PROXY_ID just for pretty logs

------Этот скрипт также отвечает за логирование — он формирует имена лог файлов и их расположение, определяет имя пользователя, сделавшего sudo, создает каталоги для лог файлов. Рядом с каждым логом есть *.meta файл, содержащий объект текущего соединения в JSON.

Скрипт helper.py включает в себя все основные функции, изоляция с ssh.py позволит реализовать даже сложную логику без опасения ошибки с определением прав пользователя или какой либо еще небезопасной функцией.

В скрипт завернуты функции, используемые в shared/bootstrap.sh.

Например, поиск сервера:

s () {

if [[ $# -eq 0 ]] ; then

echo -e "\\n Usage: s \\n";

return

elif [[ $# -gt 0 ]] ; then

"${ISOLATE_HELPER}" search "${@}";

fi

} Работать с прокси можно без установки дополнительных пакетов. Достаточно SSH-сервера и установленного на нем nc/netcat. Также можно использовать функцию проброса порта в современных SSHD/SSH, но эта методика не рекомендуется, так как еще довольно много устаревших SSHD, которые не поддерживают эту функцию.

При попытке соединиться функцией/alias g, также, вызывается helper.py, который проверяет аргументы, классифицирует адрес/IP/FQDN/project и запускает ssh.py с нужными аргументами. При попытке входа по IP/FQDN без указания project/group будет использован default конфиг для SSH.

Все настройки для сервера доступны только при точном указании, например:

$ g rogairoga nyc-prod-1Или, если сервер находится за корпоративным прокси после имени проекта, можно указать любой адрес FQDN/IP.

$ g rogairoga 192.168.1.1все обычные для g дополнительные аргументы также доступны:

$ g rogairoga 192.168.22.22 --port 23 --user support --nosudoтакже есть возможность входа по ID сервера.

$ g 12345Вместо заключения

Исходный код Isolate выложен на Github. Надеемся, что наше решение поможет многим DevOps-командам структурировать и упростить работу с серверами. Ждем комментариев, пожеланий и, конечно же, пул реквестов! Предложить идеи или задать вопросы можно в Телеграм-чате.

Наши дальнейшие планы:

- разграничение прав доступа (пользователь-проект);

- хелпер для трансфера файлов через auth сервер с/на конкретную машину;

- интеграция с Zabbix (Tech Preview уже есть!).

|

Метки: author eapotapov системное администрирование серверное администрирование блог компании itsumma otp ssh logging security management |

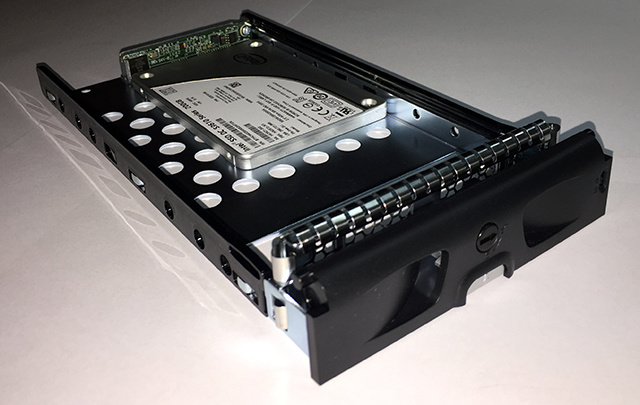

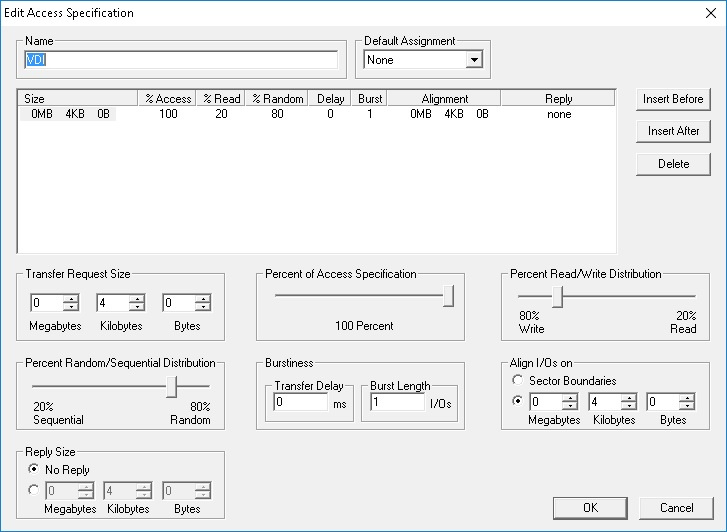

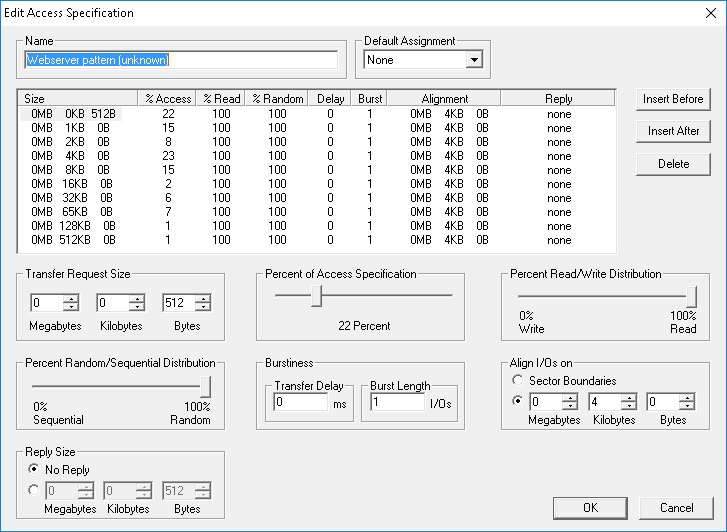

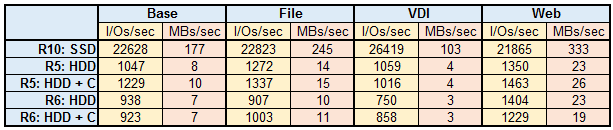

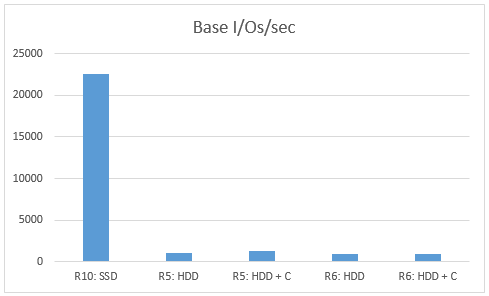

Сервер VESNIN: первые тесты дисковой подсистемы |

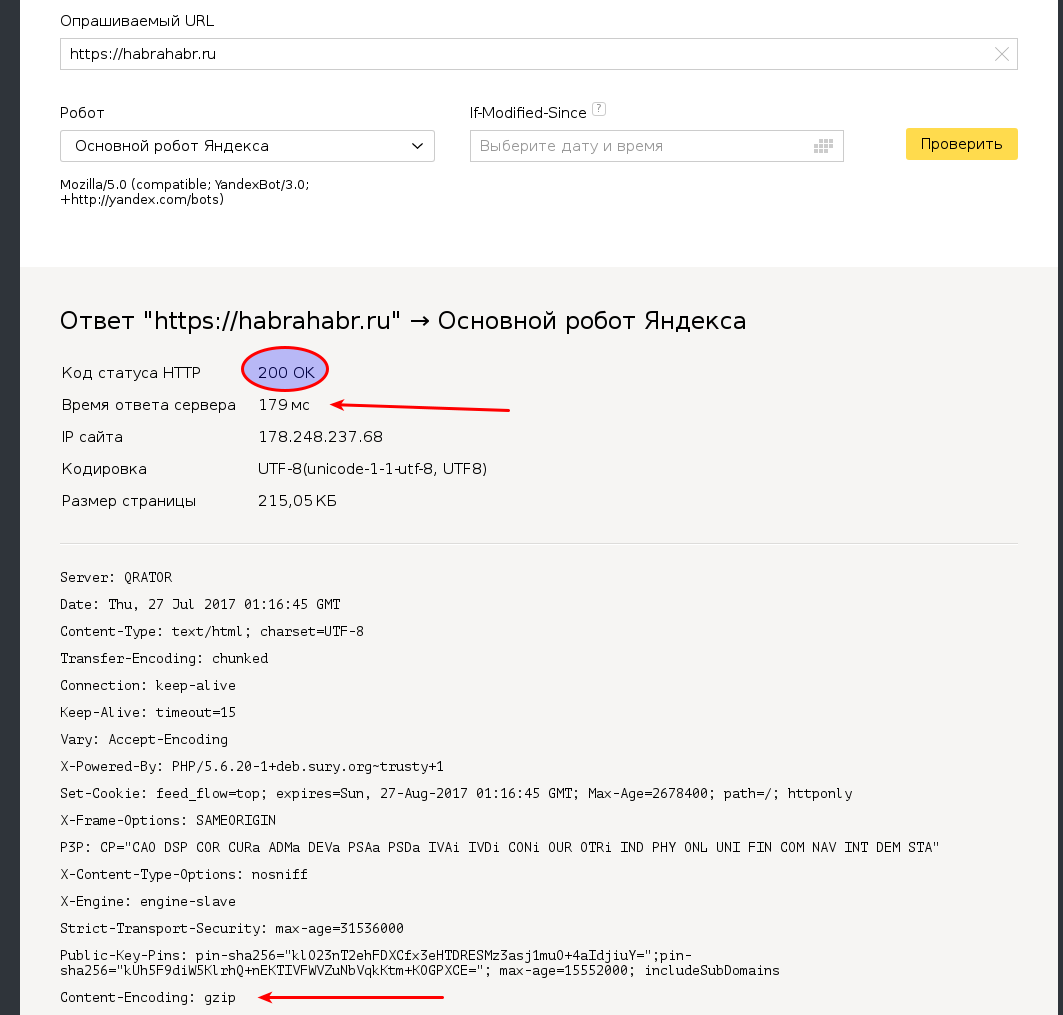

Методика теста и нагрузка

Начну издалека. В наш сервер можно поставить до 4 процессоров (соответственно до 48 ядер POWER8) и очень много памяти (до 8 ТБ). Это открывает много возможностей для приложений, но большой объем данных в оперативной памяти влечёт за собой необходимость где-то их хранить. Данные надо быстро достать с дисков и также быстро обратно запихнуть. В недалёком будущем нас ждёт прекрасный мир дезагрегированной энергонезависимой и разделяемой памяти. В этом прекрасном будущем, может быть, вообще не будет нужды в backing store. Процессор будет копировать байты напрямую из внутренних регистров в энергонезависимую память с временем доступа, как у DRAM (десятки нс) и иерархия памяти сократится на один этаж. Это всё потом, сейчас же все данные принято хранить на блочной дисковой подсистеме.

Определимся с начальными условиями для тестирования:

Сервер имеет относительно большое число вычислительных ядер. Это удобно использовать для параллельной обработки большого объёма данных. То есть один из приоритетов — это большая пропускная способность подсистемы ввода-вывода при большом числе параллельных процессов. Как следствие, логично использовать микробенчмарк и настроить достаточно много параллельных потоков.

Кроме того, подсистема ввода вывода построена на NVMe дисках, которые могут обрабатывать много запросов параллельно. Соответственно, мы можем ожидать прироста производительности от асинхронного ввода-вывода. Иначе говоря, интересна большая пропускная способность при параллельной обработке. Это больше соответствует назначению сервера. Производительность на однопоточных приложениях, и достижение минимального времени отклика, хоть и является одной из целей будущей настройки, но в данном тесте не рассматривается.

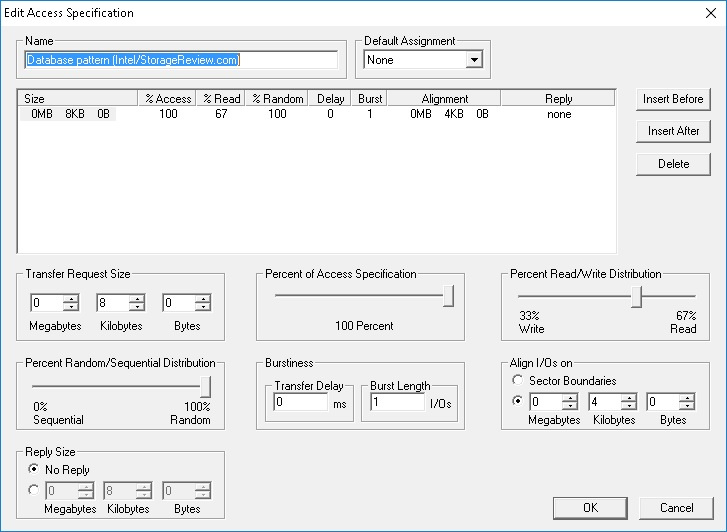

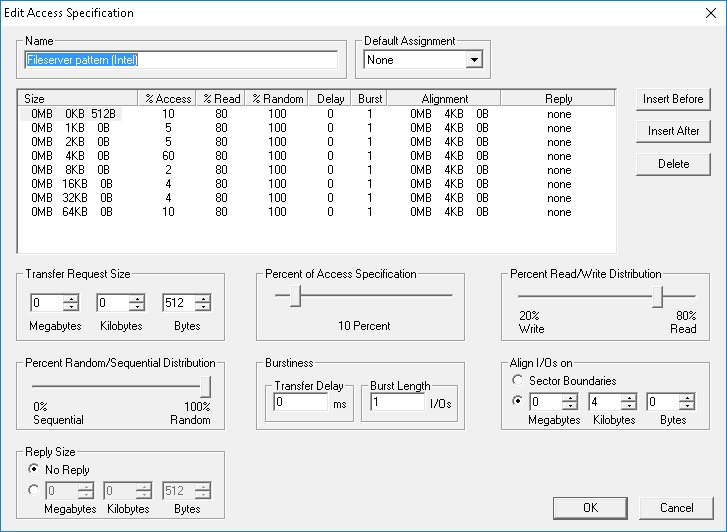

Бенчмарков отдельных NVMe дисков полно в сети, плодить лишние не стоит. В данной статье я рассматриваю дисковую подсистему как целое, поэтому диски нагружать будем в основном группами. В качестве нагрузки будем использовать 100% случайное чтение и запись с блоком разного размера.

Какие метрики смотреть?

На маленьком блоке 4КБ смотреть будем на IOPS (число операций в секунду) и во вторую очередь latency (время отклика). C одной стороны, фокус на IOPS — это наследие от жёстких дисков, где случайный доступ маленьким блоком приносил наибольшие задержки. В современном мире, all-flash системы способны выдавать миллионы IOPS, часто больше чем софт способен употребить. Сейчас «IOPS-интенсивные нагрузки» ценны тем, что показывают сбалансированность системы по вычислительным ресурсам и узкие места в программном стеке.

С другой стороны, для части задач важно не количество операций в секунду, а максимальная пропускная способность на большом блоке >=64КБ. Например, при сливе данных из памяти в диски (снэпшот базы данных) или загрузке базы в память для in-memory вычислений, прогреве кеша. Для сервера с 8 терабайтами памяти пропускная способность дисковой подсистемы имеет особенное значение. На большом блоке будем смотреть пропускную способность, то есть мегабайты в секунду.

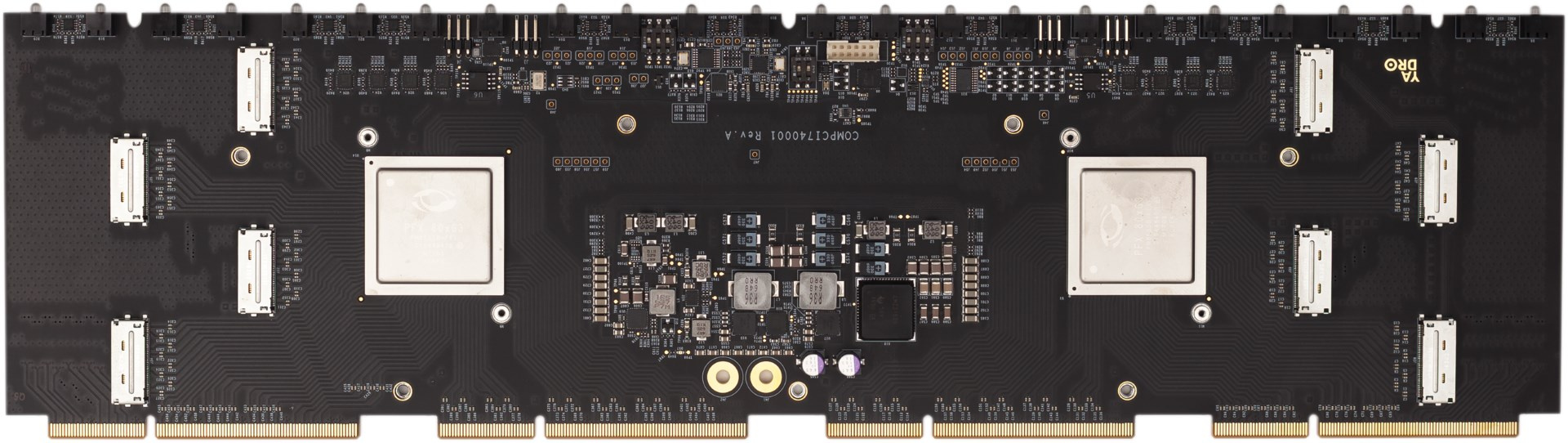

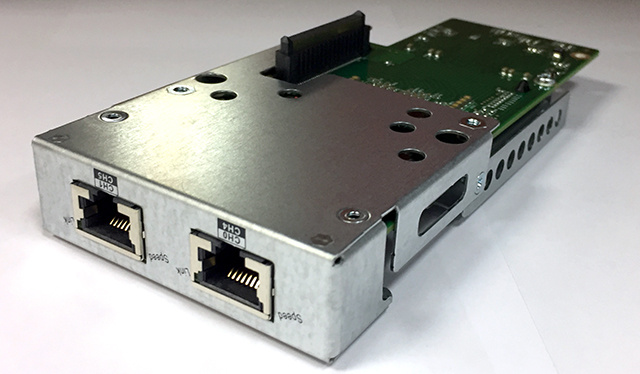

Встроенная дисковая подсистема

Дисковая подсистема сервера может включать до 24 дисков стандарта NVMe. Диски равномерно распределены по четырём процессорам с помощью двух PCI Express свитчей PMC 8535. Каждый свитч логически разделен на три виртуальных свитча: один x16 и два x8. Таким образом, на каждый процессор доступно PCIe x16, или до 16 ГБ/с. К каждому процессору подключено по 6 NVMe дисков. Суммарно, мы ожидаем пропускную способность до 60 ГБ/с со всех дисков.

Для тестов мне доступен экземпляр сервера с 4 процессорами (8 ядер на процессор, максимально бывает 12 ядер). Диски подключены к двум сокетам из четырёх. То есть это половина от максимальной конфигурации дисковой подсистемы. На объединительной плате с PCI Express свитчами первой ревизии оказались неисправны два разъёма Oculink, и поэтому доступна только половина дисков. Во второй ревизии это уже исправили, но тут я смог поставить только половину дисков, а именно получилась следующая конфигурация:

- 4 x Toshiba PX04PMB160

- 4 x Micron MTFDHAL2T4MCF-1AN1ZABYY

- 3 x INTEL SSDPE2MD800G4

- 1 x SAMSUNG MZQLW960HMJP-00003

Разнообразие дисков вызвано тем, что мы попутно тестируем и их для формирования номенклатуры стандартных компонентов (диски, память, и т.д.) от 2-3 производителей.

Нагрузка минимальной конфигурации

Для начала выполним простой тест в минимальной конфигурации — один диск (Micron MTFDHAL2T4MCF-1AN1ZABYY), один процессор POWER8 и один поток fio с очередью = 16.

[global]

ioengine=libaio

direct=1

group_reporting=1

bs=4k

iodepth=16

rw=randread

[ /dev/nvme1n1 P60713012839 MTFDHAL2T4MCF-1AN1ZABYY]

stonewall

numjobs=1

filename=/dev/nvme1n1

Получилось вот так:

# numactl --physcpubind=0 ../fio/fio workload.fio

/dev/nvme1n1 P60713012839 MTFDHAL2T4MCF-1AN1ZABYY: (g=0): rw=randread, bs=(R) 4096B-4096B, (W) 4096B-4096B, (T) 4096B-4096B, ioengine=libaio, iodepth=16

fio-2.21-89-gb034

time 3233 cycles_start=1115105806326

Starting 1 process

Jobs: 1 (f=1): [r(1)][13.7%][r=519MiB/s,w=0KiB/s][r=133k,w=0 IOPS][eta 08m:38s]

fio: terminating on signal 2

Jobs: 1 (f=0): [f(1)][100.0%][r=513MiB/s,w=0KiB/s][r=131k,w=0 IOPS][eta 00m:00s]

/dev/nvme1n1 P60713012839 MTFDHAL2T4MCF-1AN1ZABYY: (groupid=0, jobs=1): err= 0: pid=3235: Fri Jul 7 13:36:21 2017

read: IOPS=133k, BW=519MiB/s (544MB/s)(41.9GiB/82708msec)

slat (nsec): min=2070, max=124385, avg=2801.77, stdev=916.90

clat (usec): min=9, max=921, avg=116.28, stdev=15.85

lat (usec): min=13, max=924, avg=119.38, stdev=15.85

………...

cpu : usr=20.92%, sys=52.63%, ctx=2979188, majf=0, minf=14

Что мы тут видим? Получили 133K IOPS с временем отклика 119 мкс. Обратим внимание, что загрузка процессора составляет 73%. Это много. Чем занят процессор?

Мы используем асинхронный ввод-вывод, и это упрощает анализ результатов. fio отдельно считает slat (submission latency) и clat (completion latency). Первое включает в себя время выполнения системного вызова чтения до возвращения в user space. То есть все накладные расходы ядра до ухода запроса в железо показаны отдельно.

В нашем случае slat равен всего 2.8 мкс на один запрос, но с учетом повторения этого 133 000 раз в секунду получается много: 2.8 мкс * 133,000 =372 мс. То есть 37.2% времени процессор тратит только на IO submission. А есть еще код самого fio, прерывания, работа драйвера асинхронного ввода вывода.

Общая нагрузка процессора 73%. Похоже, еще одного fio ядро не потянет, но попробуем:

Starting 2 processes

Jobs: 2 (f=2): [r(2)][100.0%][r=733MiB/s,w=0KiB/s][r=188k,w=0 IOPS][eta 00m:00s]

/dev/nvme1n1 P60713012839 MTFDHAL2T4MCF-1AN1ZABYY: (g=0): rw=randread, bs=(R)

pid=3391: Sun Jul 9 13:14:02 2017

read: IOPS=188k, BW=733MiB/s (769MB/s)(430GiB/600001msec)

slat (usec): min=2, max=963, avg= 3.23, stdev= 1.82

clat (nsec): min=543, max=4446.1k, avg=165831.65, stdev=24645.35

lat (usec): min=13, max=4465, avg=169.37, stdev=24.65

…………

cpu : usr=13.71%, sys=36.23%, ctx=7072266, majf=0, minf=72

С двумя потоками скорость подросла со 133k до 180k, но ядро перегружено. По top утилизация процессора 100% и clat вырос. То есть 188k — это предел для одного ядра на этой нагрузке. При этом легко видим, что рост clat вызван именно процессором, а не диском. Посмотрим ‘biotop’ ():

PID COMM D MAJ MIN DISK I/O Kbytes AVGus

3553 fio R 259 1 nvme0n1 633385 2533540 109.25

3554 fio R 259 1 nvme0n1 630130 2520520 109.25

Из-за включенной трассировки скорость несколько просела, но время отклика от дисков ~109 мкс, такое же, как и в предыдущем тесте. Измерения другим способом (sar -d) показывают те же цифры.

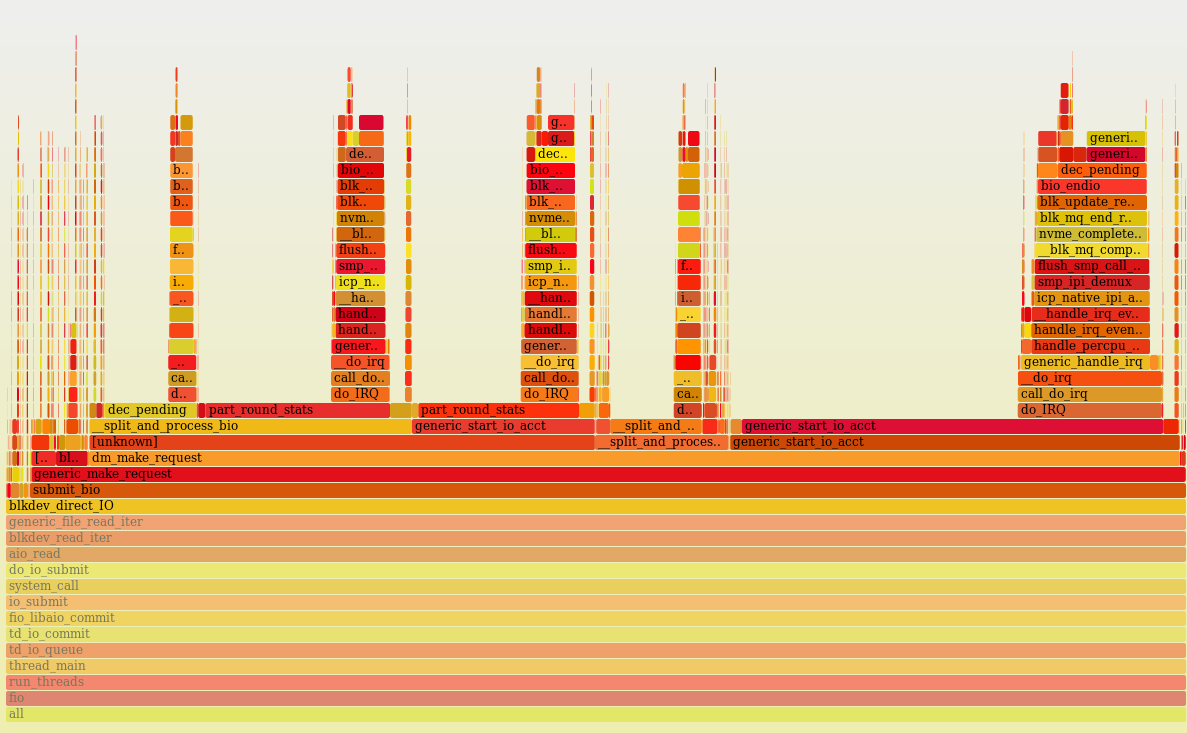

Ради любопытства, интересно посмотреть, чем занят процессор:

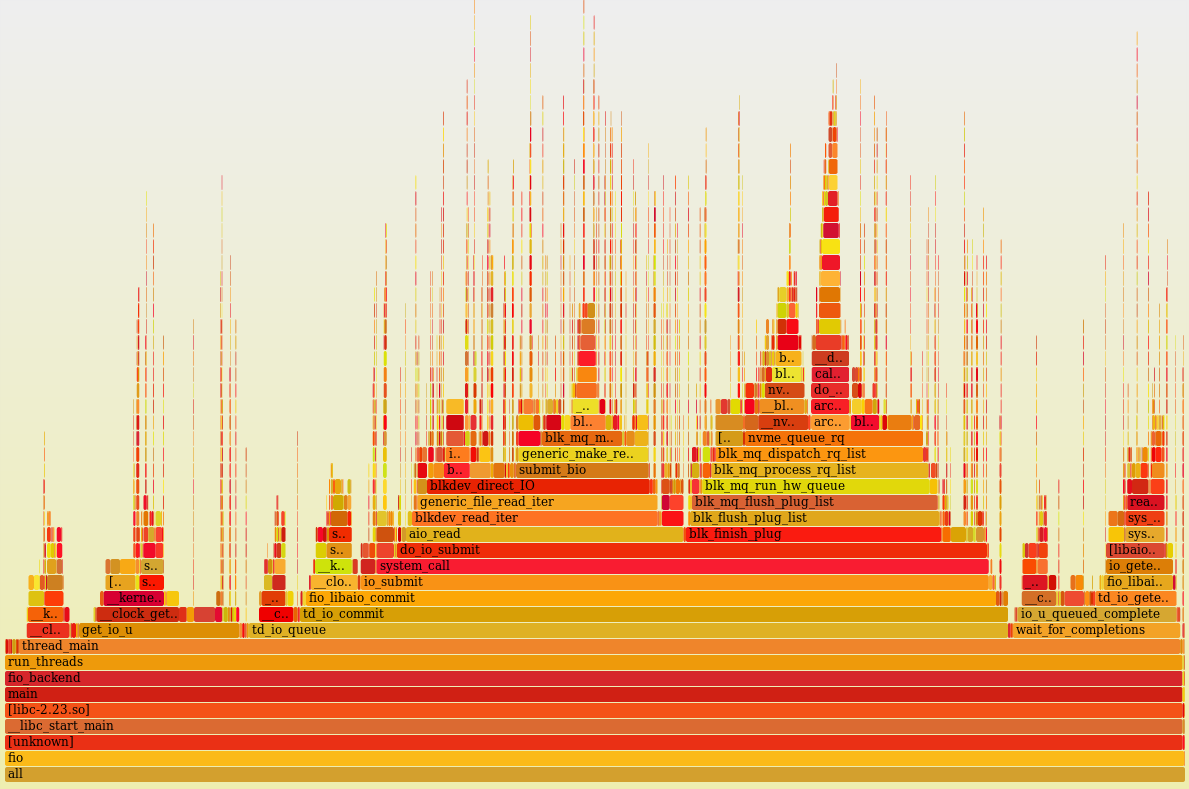

Профиль нагрузки одного ядра (perf + flame graph) с отключённой многопоточностью и работающими двумя процессами fio. Как видно, он 100% времени что-то делает (idle =0%).

Визуально, процессорное время более-менее равномерно распределено между большим количеством пользовательских (код самого fio) и ядерных функций (асинхронный ввод-вывод, блочный уровень, драйвер, много маленьких пиков – это прерывания). Не видно какой-то одной функции, где бы расходовалось аномально большое количество процессорного времени. Выглядит неплохо и, при просмотре стеков в голову не приходит идей, что тут можно было бы покрутить.

Влияние многопоточности POWER8 на скорость ввода-вывода

Итак, мы выяснили, что при активной нагрузке по IO, процессор легко перегрузить. Цифра утилизации процессора показывает, что он занят для операционной системы, но ничего не говорит о загрузке узлов процессора. В том числе, процессор может казаться загруженным во время ожидания внешних компонентов, например, памяти. Здесь у нас нет цели выяснять эффективность использования процессора, но чтобы понять потенциал тюнинга, интересно взглянуть на “CPU counters”, частично доступные через ‘perf’.

root@vesninl:~# perf stat -C 0

Performance counter stats for 'CPU(s) 0':

2393.117988 cpu-clock (msec) # 1.000 CPUs utilized

7,518 context-switches # 0.003 M/sec

0 cpu-migrations # 0.000 K/sec

0 page-faults # 0.000 K/sec

9,248,790,673 cycles # 3.865 GHz (66.57%)

401,873,580 stalled-cycles-frontend # 4.35% frontend cycles idle (49.90%)

4,639,391,312 stalled-cycles-backend # 50.16% backend cycles idle (50.07%)

6,741,772,234 instructions # 0.73 insn per cycle

# 0.69 stalled cycles per insn (66.78%)

1,242,533,904 branches # 519.211 M/sec (50.10%)

19,620,628 branch-misses # 1.58% of all branches (49.93%)

2.393230155 seconds time elapsed

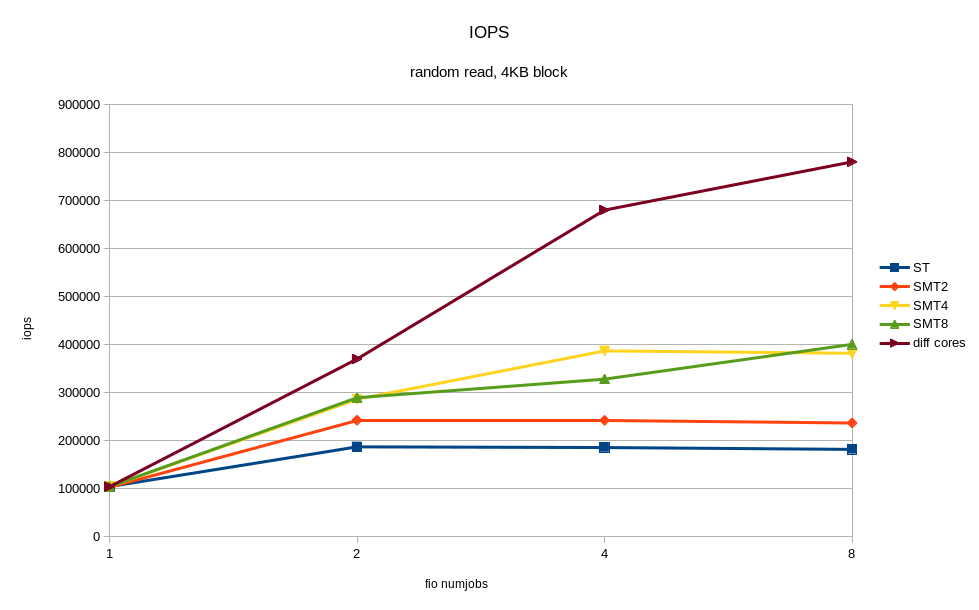

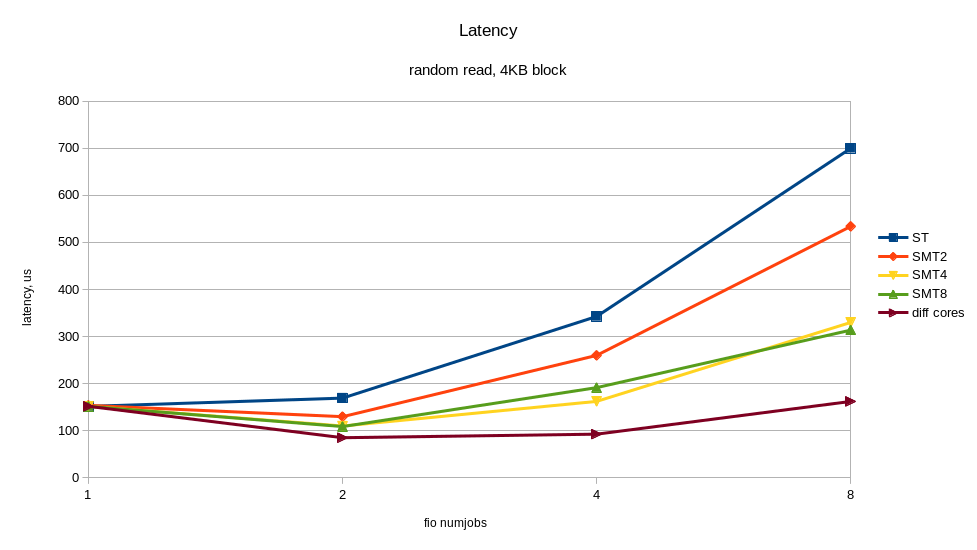

В выводе выше видно, IPC (insn per cycle) 0.73 – не так плохо, но теоретически на Power8 он может быть до 8. Кроме того, 50% “backend cycles idle” (метрика PM_CMPLU_STALL) может значить ожидание памяти. То есть процессор занят для планировщика Linux, но ресурсы самого процессора не особо загружены. Вполне можно ожидать прироста производительности от включения многопоточности (SMT), при увеличении числа потоков. Результат того, что случилось при включении SMT показан на графиках. Я получил ощутимый прирост скорости от дополнительных процессов fio, работающих на других потоках одного и того же процессора. Для сравнения приведён случай, когда все потоки работают на разных ядрах (diff cores).

По графикам видно, что включение SMT8 даёт почти двукратный рост скорости и снижение времени отклика. Вполне неплохо и с одного ядра мы снимаем > 400K IOPS! Попутно видим, что одного ядра, даже с включённым SMT8 мало, чтобы полностью нагрузить NVMe диск. Раскидав потоки fio по разным ядрам, мы получаем почти вдвое лучшую производительность диска – это то, что может современный NVMe.

Таким образом, если архитектура приложения позволяет регулировать количество пишущих/читающих процессов, то лучше подстраивать их число под количество физических/логических ядер, во избежание замедлений от перегруженных процессоров. Один NVMe диск может легко перегрузить процессорное ядро. Включение SMT4 и SMT8 даёт кратный прирост производительности и может быть полезно для нагрузок с интенсивным по вводом-выводом.

Влияние NUMA архитектуры

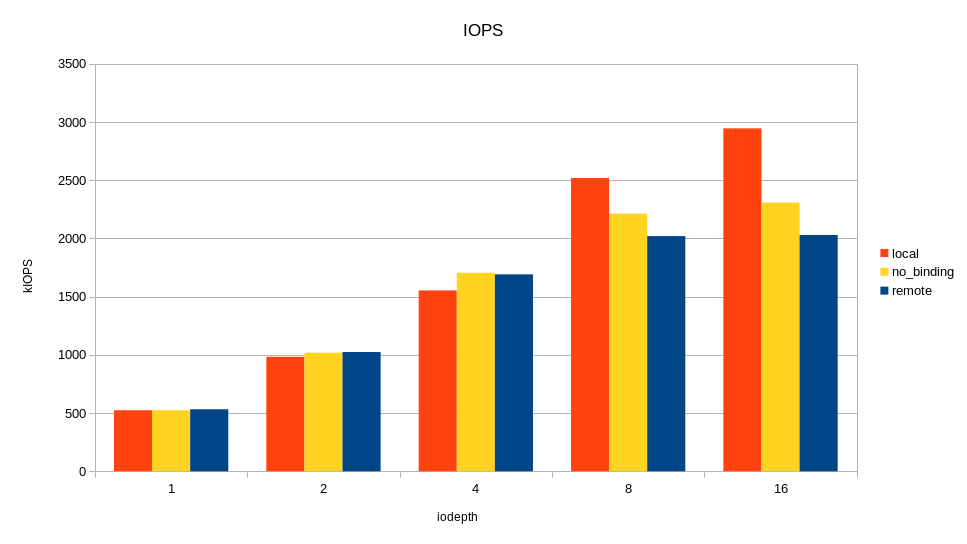

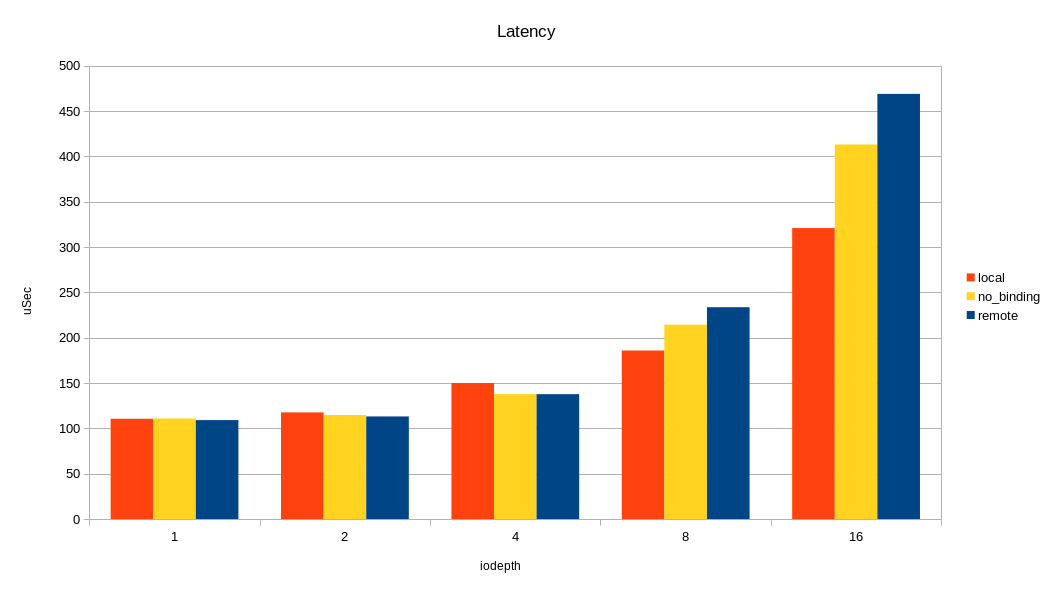

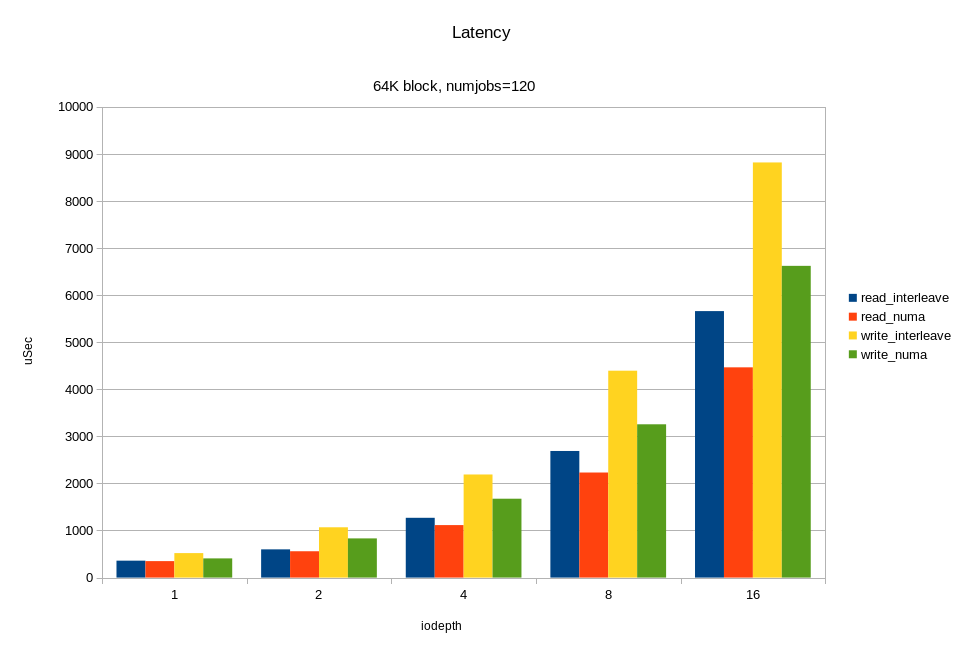

Для балансировки нагрузки 24 внутренних NVMe диска сервера равномерно подключены к четырём процессорным сокетам. Соответственно, для каждого диска есть «родной» сокет (NUMA локальность) и «удалённый». Если приложение обращается к дискам с «удалённого» сокета, то возможны накладные расходы от влияния межпроцессорной шины. Мы решили посмотреть, как доступ с удалённого сокета влияет на итоговую производительность дисков. Для теста снова запускаем fio и с помощью numactl привязываем процессы fio к одному сокету. Сначала к «родному» сокету, потом к «удалённому». Цель теста — понять, стоит ли тратить силы на настройку NUMA, и какого эффекта можно ожидать? На графике я привёл в сравнение только один удалённый сокет из трёх, из-за отсутствия между ними разницы.

Конфигурация fio:

- 60 процессов (numjobs). Число взято из аппаратной конфигурации. У нас в тестовом образце установлены процессоры с 8 ядрами и включен SMT8. C точки зрения операционной системы, могут выполняться 64 процесса на каждом сокете. То есть нагрузку я нагло подгонял под аппаратные возможности.

- размер блока — 4kb

- тип нагрузки — случайное чтение 100%

- объект нагрузки — 6 дисков, подключённых к сокету 0.

Изменяя очередь, я смотрел пропускную способность и время отклика, запуская нагрузку в локальном сокете, удалённом, и без привязки к сокету вообще.

Как видно на графиках, разница между локальным и удалённым сокетом есть и весьма ощутима на большой нагрузке. Накладные расходы проявляются при очереди 16 (iodepth =16) >2M IOPS с блоком 4КБ (> 8 ГБ/с, проще говоря). Можно было бы сделать вывод, что уделять внимание NUMA стоит только на задачах, где нужна большая пропускная способность по вводу-выводу. Но не все так однозначно, в реальном приложении кроме ввода-вывода будет траффик по межпроцессорной шине при доступе к памяти в удалённой NUMA локальности. Как следствие, замедление может наступать и при меньшем трафике по вводу-выводу.

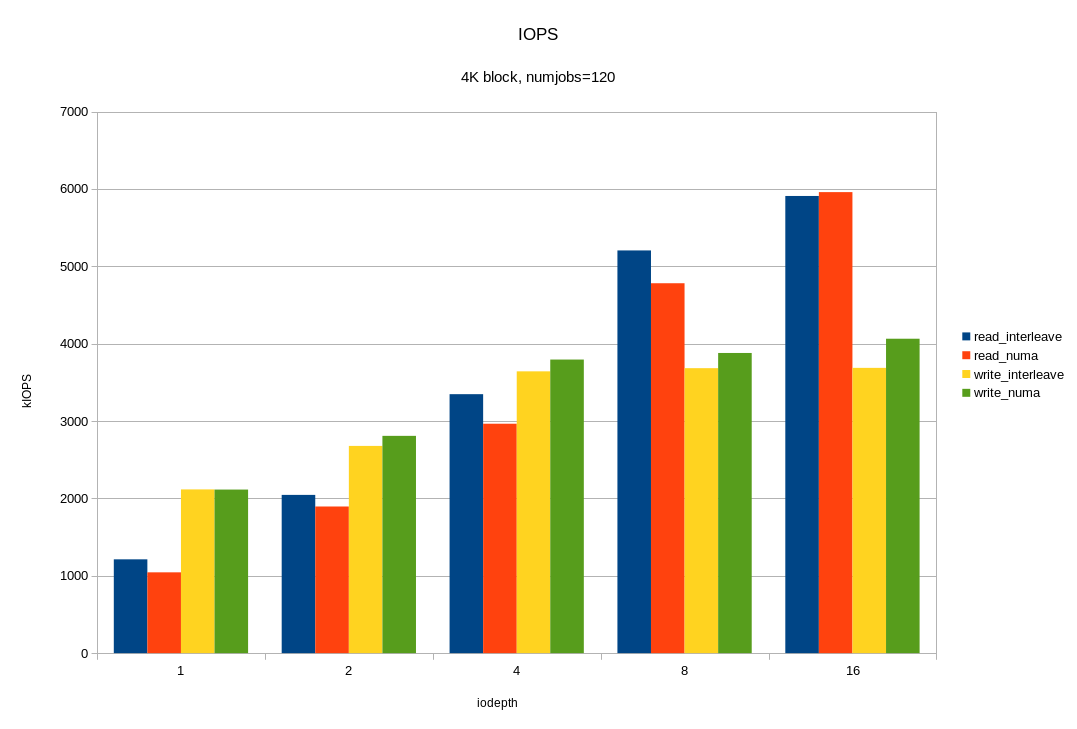

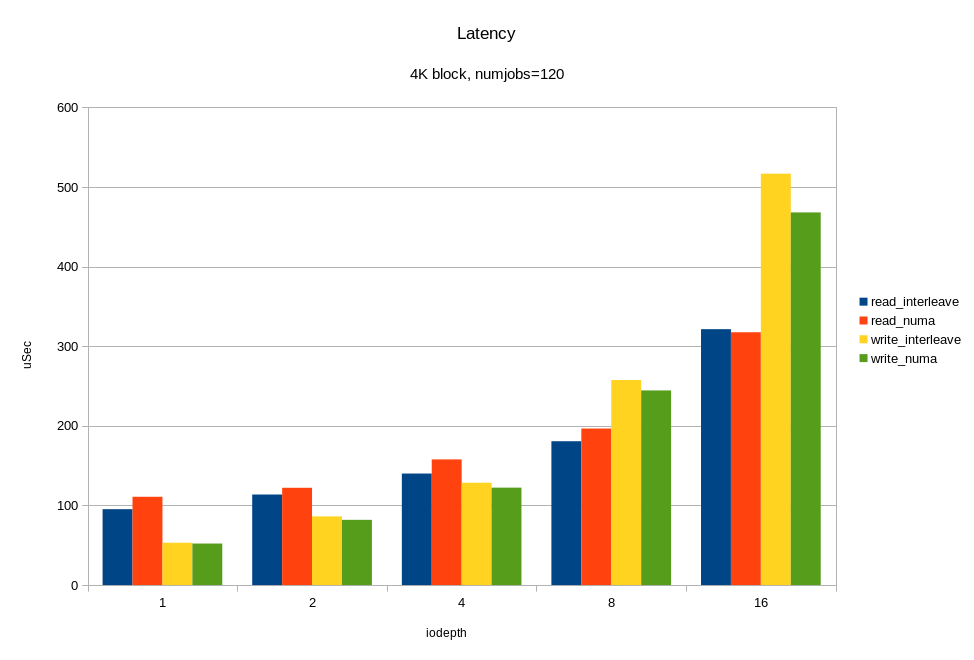

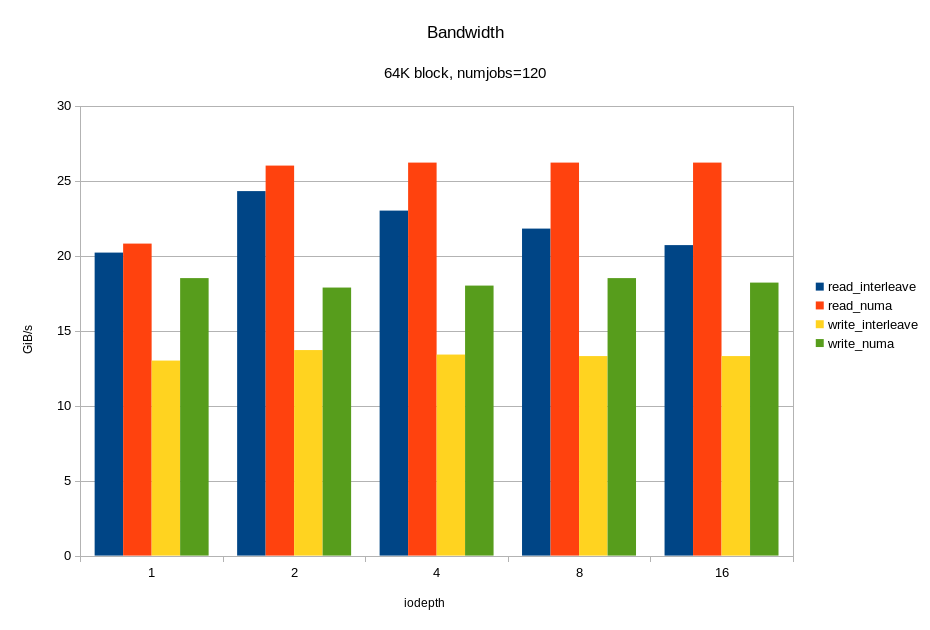

Производительность под максимальной нагрузкой

И теперь, самое интересное. Нагрузим все имеющиеся 12 дисков одновременно. Причём, с учётом предыдущих экспериментов, сделаем это двумя способами:

- ядро выбирает на каком сокете запускать fio без учёта физического подключения;

- fio работает только на том сокете, к которому подключены диски.

Смотрим, что получилось:

Для операций случайного чтения с блоком 4KB, мы получили ~6M IOPS при времени отклика < 330 мкс. Для блока 64KB мы получили 26.2 ГБ/с. Вероятно, мы упираемся в шину x16 между процессором и PCIe свитчем. Напомню, это половина аппаратной конфигурации! Опять же, видим, что на большой нагрузке привязка ввода-вывода к «домашней» локальности дает хороший эффект.

Накладные расходы LVM

Отдавать диски приложению целиком, как правило, неудобно. Приложению может оказаться либо слишком мало одного диска, либо слишком много. Часто хочется изолировать компоненты приложения друг от друга через разные файловые системы. С другой стороны, хочется равномерно сбалансировать нагрузку между каналами ввода-вывода. На помощь приходит LVM. Диски объединяют в дисковые группы и распределяют пространство между приложениями через логические тома. В случае с обычными шпинделями, или даже с дисковыми массивами, накладные расходы LVM относительно малы в сравнении с задержками от дисков. В случае с NVMe, время отклика от дисков и оверхед программного стека – цифры одного порядка. интересно посмотреть их отдельно.

Я создал LVM-группу с теми же дисками, что и в предыдущем тесте, и нагрузил LVM-том тем же числом читающих потоков. В результате, получил только 1M IOPS и 100% загрузку процессоров. С помощью perf, я сделал профилирование процессоров, и вот что получилось:

В Linux LVM использует Device Mapper, и очевидно система проводит очень много времени при подсчёте и обновлении статистики по дискам в функции generic_start_io_acct(). Как отключить сбор статистики в Device Mapper я не нашёл, (в dm_make_request() ). Вероятно, тут есть потенциал для оптимизации. В целом, на данный момент, применение Device Mapper может плохо влиять на производительность при большой нагрузке по IOPS.

Поллинг

Поллинг – новый механизм работы работы драйверов ввода вывода Linux для очень быстрых устройств. Это новая фича, и упомяну ее только для того, чтобы сказать почему в данном обзоре она не протестирована. Новизна фичи в том, что процесс не снимается с выполнения во время ожидания ответа от дисковой подсистемы. Переключение контекста обычно выполняется во время ожидания ввода-вывода и затратно само по себе. Накладные расходы на переключение контекста оцениваются в единицы микросекунд (ядру Linux надо снять с выполнения один процесс, вычислить самого достойного кандидата для выполнения и т.д. и т.п.) Прерывания при поллинге могут сохраняться (убирается только переключение контекста) или полностью исключаться. Этот метод оправдан для ряда условий:

- требуется большая производительность для однопоточной задачи;

- основной приоритет – минимальное время отклика;

- используется Direct IO (нет кеширования файловой системы);

- для приложения процессор не является бутылочным горлышком.

Обратная сторона поллинга — это повышение нагрузки на процессор.

В актуальном ядре Linux (для меня сейчас 4.10) поллинг по умолчанию включён для всех NVMe устройств, но работает только для случаев, когда приложение специально просит его использовать для отдельных «особо важных» запросов ввода-вывода. Приложение должно поставить флаг RWF_HIPRI в системных вызовах preadv2()/pwritev2().

/* flags for preadv2/pwritev2: */

#define RWF_HIPRI 0x00000001 /* high priority request, poll if possible */Так как однопоточные приложения не относятся к основной теме статьи, поллинг откладывается на следующий раз.

Заключение

Хотя у нас тестовый образец с половиной конфигурации дисковой подсистемы, результаты впечатляют: почти 6M IOPS блоком 4KB и > 26 ГБ/с для 64KB. Для встроенной дисковой подсистемы сервера это выглядит более чем убедительно. Система выглядит сбалансированной по числу ядер, количеству NVMe дисков на ядро и ширине шины PCIe. Даже с терабайтами памяти, весь объем можно прочитать с дисков за считанные минуты.

Стек NVMe в Linux легковесный, процессор оказывается перегружен только при большой нагрузке fio >400K IOPS, (4KB, read, SMT8).

NVMe диск быстрый сам по себе, и довести его до насыщения приложением достаточно сложно. Больше нет проблемы с медленными дисками, но возможна проблема с ограничениями шины PCIe и программного стека ввода-вывода, а иногда и ресурсами ядра. Во время теста мы именно в диски практически не упирались. Интенсивный ввод-вывод сильно нагружает все подсистемы сервера (память и процессор). Таким образом, для приложений, интенсивных по вводу-выводу, нужна настройка всех подсистем сервера: процессоров (SMT), памяти (интерливинга, к примеру), приложения (количество пишущих/читающих процессов, очередь, привязка к дискам).

Если планируемая нагрузка не требует больших вычислений, но интенсивна по вводу-выводу с маленьким блоком, все равно лучше брать процессоры POWER8 с наибольшим числом ядер из доступной линейки, то есть 12.

Включение в стек ввода-вывода на NVMe дополнительных программных слоев (типа Device Mapper) может ощутимо снижать пиковую производительность.

На большом блоке (>=64KB), привязка IO нагрузки к NUMA локальностям (процессорам), к которым подключены диски, дает снижение времени отклика от дисков и ускоряет ввод-вывод. Причина в том, что на такой нагрузке важна ширина шины от процессора до дисков.

На маленьком блоке (~4KB) все менее однозначно. При привязке нагрузки к локальности есть риск неравномерной загрузки процессоров. То есть можно просто перегрузить сокет, к которому подключены диски и привязана нагрузка.

В любом случае, при организации ввода—вывода, особенно асинхронного, лучше разносить нагрузку по разным ядрам с помощью NUMA-утилит в Linux.

Использование SMT8 сильно повышает производительность при большом числе пишущих/читающих процессов.

Заключительные размышления на тему.

Исторически, подсистема ввода-вывода медленная. С появлением флеша она стала быстрой, а с появлением NVMe совсем быстрой. В традиционных дисках есть механика. Она делает шпиндель самым медленным элементом вычислительного комплекса. Что из этого следует?

- Во-первых, у дисков скорость измеряется в милисекундах, и они многократно медленнее всех остальных элементов сервера. Как следствие, шанс упереться в скорость шины и дискового контроллера относительно невысок. Гораздо более вероятно, что проблема возникнет со шпинделями. Бывает, один диск нагружен больше остальных, время отклика от него чуть выше, и это тормозит всю систему. С NVMe пропускная способность дисков огромная, «бутылочное горлышко» смещается.

- Во вторых, чтобы минимизировать задержки от дисков, дисковый контроллер и операционная система используют алгоритмы оптимизации, в том числе кеширование, отложенную запись, опережающее чтение. Это потребляет вычислительные ресурсы и усложняет настройку. Когда диски сразу быстрые, необходимость в большом количестве оптимизации отпадает. Вернее, ее цели изменяются. Вместо сокращения ожиданий внутри диска, становится более важно сократить задержку до диска и как можно быстрее донести блок данных из памяти в диск. Стек NVMe в Linux не требует настройки и сразу работает быстро.

- И в третьих, забавное о работе консультантов по производительности. В прошлом, когда система тормозила, искать причину было легко и приятно. Ругайся на систему хранения и скорее всего, не ошибёшься. Консультанты по базам данных это дело любят и умеют. В системе, с традиционными дисками всегда можно найти какую-нибудь проблему с производительностью хранилища и озадачить вендора, даже если база данных тормозит из-за чего-то другого. С быстрыми дисками все чаще «бутылочные горлышки» будут смещаться на другие ресурсы, в том числе приложение. Жизнь будет интереснее.

|

Метки: author kachini анализ и проектирование систем блог компании yadro серверы проектирование openpower in-memory nvme storage latency bandwidth iops |

Planning Poker: как сделать процесс постановки задач максимально прозрачным и четким |

Как и зачем мы проводим планирования

Планирование — это регулярный процесс командного обсуждения каждой задачи. Мы проводим его раз в 2 дня, и в нем участвуют только члены инженерной команды и те, кто ставит им задачу.

Для проведения планирования мы собираем всех участников в конференцию лично или удаленно.

Заказчик (постановщик задачи – менеджер продукта, маркетолог или даже генеральный директор) обязательно должен присутствовать на планировании, чтобы объяснить суть задачи, рассказать, как он ее понимает, донести до команды почему задача важна и мотивировать исполнителей на ее выполнение. Цель инженерной команды — за счет дополнительных вопросов выяснить максимальное количество подробностей, вытянуть из заказчика скрытые требования, предложить свои идеи по реализации и выработать наилучший способ решения. Либо объяснить, почему выполнение задачи стоит отложить на некоторое время или не брать в работу вообще.

Постановка задачи

Заказчик зачитывает свою задачу (это всегда делает строго заказчик, чтобы избежать “сломанного телефона” при передаче данных и ускорения процесса выработки решения), объясняет, что именно нужно сделать и почему это важно.

Цель каждого участника команды исполнителей, задавая различные вопросы заказчику и членам команды, выяснить что именно нужно сделать и понять, как лучше всего решить задачу. Затем исполнитель объясняет, что конкретно он планирует сделать, и уточняет, устроит ли такой вариант заказчика и команду. Все участники высказываются по очереди, и после того, как все определились с наилучшим решением, наступает этап оценки сложности задачи.

Оценка сложности

Оценка сложности производится с помощью цифровых карт — это и есть так называемый Planning Poker: все участники команды исполнителей должны в закрытую оценить сложность задачи в днях трудозатрат, т.е. сколько рабочих дней (из расчета стандартных 8 часов) нужно конкретно ему (участнику) на выполнение задачи. После того как все исполнители положили карты рубашками вверх, все должны перевернуть свои карты так, чтобы числа были видны всем участникам процесса.

Исполнители с пограничными оценками (т.е. участники, которые дали самую низкую и самую высокую оценку по времени) должны объяснить свой выбор. С одной стороны, давление команды не позволит участникам дать неадекватно завышенную оценку сроков, с другой — команда получает возможность обсудить возможные проблемы по задаче. Тот, кто поставил наименьшую оценку по времени, делится с командой, как именно он планирует выполнить задачу так быстро. Участник, который дал самую большую оценку, должен рассказать о том, какие риски и сложности он предвидит при выполнении этой задачи. После повторного обсуждения с учетом всех подводных камней, команда принимает решение о том, какая оценка является более подходящей для задачи. Этот срок заносится в карточку с описанием задачи в таск-менеджере.

Главная цель оценки сложности не предсказать, когда задача будет готова, а убедиться, что все участники одинаково понимают задачу.

Если один участник оценивает задачу в 1/2 дня, а другой в 3 дня, они явно задумали выполнять задачу по-разному, и поэтому должны согласовать свои действия и объяснить, почему надо делать именно так, как они думают. Иногда расхождение в оценке может быть обусловлено разным опытом в решении схожих задач, в этом случае берется максимальная оценка, но если срок отличается более чем на 1 день, то задача выполняется в парном программировании, когда тот, кто оценил в меньшую сторону, руководит тем, кто оценил в большую.

Советы:

Нужно стремимся, чтобы сложность задачи не превышала 1 день.

Планирование лучше всего проводить так, чтобы у команды всегда был запас задач на 1-2 дня, но не больше. Так все участники будут хорошо помнить все детали обсуждения каждой конкретной задачи. Если задача провисела в очереди на исполнение более 4-х дней, ее нужно снова вынести на обсуждение, чтобы команда вспомнила, что и как нужно сделать по задаче.

Если задача выполняется на 2 дня дольше, чем планировалось, ее нужно вынести заново на планирование и обсудить с командой и заказчиком все сложности и проблемы с которыми столкнулись в ходе выполнения, чтобы в следующий раз при оценке учесть их.

Формат «Planning Poker» хорошо прижился в работу наших команд: разработчиков, аналитиков, админов, и позволяет лучше понимать задачи и пути их решения на этапе постановки.

А как вы обсуждаете задачи и оцениваете сложность и время их выполнения? Делитесь своим опытом в комментариях!

|

Метки: author RetailRocket управление разработкой управление продуктом блог компании retail rocket управление продуктами управление процессами в it планирование разработка |

[Перевод] XBRL: просто о сложном - Глава 5. Открывая новые измерения |

5. Открывая новые измерения

Предыдущие главы показали вам, что такое XBRL, и что с его помощью можно сделать. Как вы уже знаете, он является расширяемым стандартом. В этой главе мы рассмотрим один из расширяющих стандартную спецификацию модулей – XBRL Dimensions (Измерения).

Глава основывается на спецификации XBRL Dimensions версии 1.0 CR от 19.06.2006. На момент написания книги спецификация находится в статусе Candidate Recommendation, но ожидается, что окончательный вариант не принесет никаких значительных сюрпризов.

Что касается самой спецификации XBRL, данная глава подчеркивает некоторые ее важные моменты, необходимые для уверенного базового понимания XBRL Dimensions. Остальные нюансы приведены в полной спецификации.

5.1. Введение

Обычно, факты в отчетах некоторым образом классифицируются, например:

- Продажи в разных периодах;

- Продажи по продуктовым линиям;

- Продажи по регионам;

- Продажи по отделам;

- Количество сотрудников по возрасту;

- Количество сотрудников по полу;

- ...

Две из этих категорий явно определены спецификацией XBRL – период и составитель отчета (компания, департамент, отдел компании). Эти категории всегда присутствуют в контекстах, на которые ссылаются факты отчета.

Желание расширить эти возможности, чтобы позволить авторам таксономии указать свои собственные категории вроде продуктовой линии, пола и т.д., является вполне естественным. Это именно то, что позволяет сделать XBRL Dimensions. В этой спецификации такие категории называются измерениями (dimension).

Как определено в спецификации XBRL, входящие в контекст сценарий и сегмент могут иметь любое валидное XML-содержание. XBRL Dimensions определяет формализованный способ использования таких элементов для добавления новых измерений (категории) в контекст.

Пример, который мы ранее использовали, очень хорошо подходит для иллюстрации:

Нам лишь надо определить концепт nr_employees и пару измерений: gender (пол) со значениями {‘men’, ‘women’} и age group (возрастная группа) со значениями {‘...–20’, ‘21–40’, ‘41–…’}.

Отчет содержит набор контекстов для каждого сочетания периода и измерения, и каждому контексту соответствует свой факт:

Контекст Факт 01-01-2015 nr_employees = 35 01-01-2015 + ‘men’ nr_employees = 23 01-01-2015 + ‘women’ nr_employees = 12 01-01-2015 + ‘...–20’ nr_employees = 5 01-01-2015 + ‘21–40’ nr_employees = 23 01-01-2015 + ‘41–…’ nr_employees = 7 31-12-2015 nr_employees = 41 31-12-2015 + ‘men’ nr_employees = 27 31-12-2015 + ‘women’ nr_employees = 15 31-12-2015 + ‘...–20’ nr_employees = 9 31-12-2015 + ‘21–40’ nr_employees = 21 31-12-2015 + ‘41–…’ nr_employees = 11

5.1.1. Понятия измерений

Спецификация XBRL Dimensions использует ряд понятий, которые кратко представлены здесь и будут более подробно разобраны в следующем разделе.

- Измерение (dimension)

Измерение – это по сути категоризация фактов. Измерения определяются в Таксономии элементов домена (Domain Members Taxonomy, DMT), а ее элементы могут использоваться в контекстах отчета для категоризации передаваемых фактов. - Домен (domain) и Элементы домена (domain members)

Набор допустимых значений измерения называется его доменом. Элемент домена – это одно из этих значений. Есть два типа элементов: типизированные (typed) и явные (explicit). Типизированные элементы определяются синтаксическими ограничениями, напр. «целые числа от 0 до 100». Явные элементы домена являются item-концептами, которые явно указываются элементами домена измерения. Получается перечисление элементов, напр. ‘men’ и ‘women’ для измерения gender. - Гиперкуб (hypercube)

Измерения могут быть объединены, напр. «продажи по региону и продуктовой линии» или «количество сотрудников по полу и возрастной группе». Набор возможных значений такой комбинации измерений можно представить в виде элементов в n-мерном пространстве:

- при n = 1 элементы образуют отрезок на прямой;

- при n = 2 элементы образуют квадрат на плоскости;

- при n = 3 элементы образуют куб в пространстве;

- случаи n > 3 не так легко визуализировать, поскольку мы живем в трехмерном пространстве; математический термин для таких случаев – гиперкуб.

- Первичная таксономия (primary taxonomy)

Это обычная таксономия в соответствии со спецификацией XBRL. Она определяет концепты, по которым могут формироваться отчеты. Спецификация XBRL Dimensions берет на себя заботу о том, чтобы не требовалось никаких изменений в первичной таксономии. - Таксономия элементов домена (domain members taxonomy, DMT)

Измерения и элементы измерений определяются как концепты DMT. - Таксономия шаблонов (template taxonomy)

Объединяет первичную таксономию и таксономию элементов домена, определяя структуру гиперкубов и связывая их с первичными концептами.

Спецификация определяет три типа таксономий. Это разделение на три типа – лишь концепция. Можно использовать три отдельные таксономии, но спецификация не требует использования отдельных таксономий для каждого из типов. Комбинировать разные типы в одной таксономии – совершенно нормально. Допустимо даже использовать концепт в качестве первичного концепта в одной взаимосвязи, и в качестве элемента измерения в другой.

5.2. Таксономии измерений

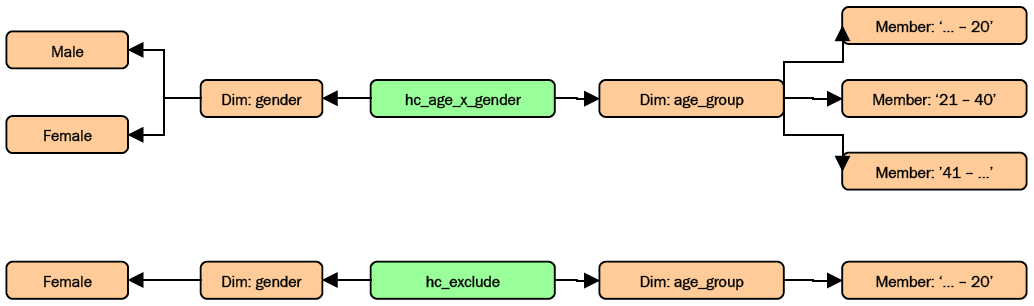

В этом разделе рассматривается способ расширения таксономий для применения спецификации XBRL Dimensions. Начну с архитектурной диаграммы, показывающей, как все компоненты связаны между собой.

Следующие подразделы описывают каждый компонент архитектуры более подробно.

5.2.1. Измерения

DMT определяет измерения как абстрактные item-концепты со значением xbrldt:dimensionItem атрибута substitution group.

Примечание: Атрибуты xbrli:balance, xbrli:periodType и nillable игнорируются.

Измерения могут быть типизированными или явными, как было сказано выше, в каждом из них используется свой способ определения элементов домена.

5.2.1.1. Типизированное измерение (typed dimension)

Определение типизированного домена должно иметь значение атрибута xbrldt:typedDomainRef, которое ссылается на объявление элемента, определяющего домен измерения.

Домен определяется с использованием типов XML Schema:

- Тип

SimpleTypeможет, к примеру, определить в качестве идентификатора клиента компании значения от 0 до 100 в виде целого числа или строки длиной 5 символов; - Тип

ComplexTypeможет быть использован для определения адреса, включающего в себя город, улицу, номер дома, индекс и т.д.

5.2.1.2. Явное измерение (explicit dimension)

Домен явного измерения идентифицируется связью dimension-domain от измерения к корню сети связей domain-member между элементами домена. В явном измерении не может содержаться атрибут xbrldt:typedDomainRef.

Элементами домена измерения являются все qname-элементы в сети связей domain-member. Каждый элемент – это определение item-концепта со значением xbrli:item атрибута substitution group (он не может принадлежать к группе xbrldt:hypercubeItem или xbrldt:dimensionItem).

Связи domain-member образуют иерархию элементов. Можно добавлять элементы в иерархию, например, чтобы создать корень вложенной иерархии, который не предназначен для использования в качестве элемента домена. Для этого в булевом атрибуте usable, имеющего по умолчанию значение true, указывается значение false.

У явного измерения может быть указан элемент по умолчанию, это делается с помощью связи dimension-default к элементу домена. Это значение по умолчанию используется в контексте, если не задано ни одного элемента измерения. Само значение по умолчанию в не может быть явно указано в контексте, оно всегда определяется автоматически.

Обратите внимание, что связь dimension-default сама по себе не добавляет элемент в домен и не является эквивалентом связи domain-member.

5.2.2. Связи domain-member и наследование (inheritance)

Первичные концепты могут наследовать гиперкубы других первичных концептов путем указания связи domain-member между первичными концептами.

Предположим, у нас есть два первичных концепта, один из которых (item) связан с гиперкубом hc_age, а другой (another item) – связьюdomain-memberс первым концептом:

Так как у первого концепта есть связь с измерением age_group через гиперкуб hc_age, а второй концепт имеет связьdomain-memberс первым концептом – второй концепт наследует измерение age_group.

5.2.3. Гиперкубы (hypercube)

Гиперкубы определяются в таксономии шаблонов (template taxonomy) путем объединения нуля (гиперкуб может быть пустым) и более измерений.

Объявляющий элемент является абстрактным концептом, который должен иметь значение xbrldt:hypercubeItem атрибута substitution group.

Измерения связываются с гиперкубом дугами с ролью hypercube-dimension. Эти отношения упорядочены значением атрибута order в каждой дуге. Дуги не могут образовывать циклических связей.

5.2.4. Связь первичных концептов с гиперкубами

При создании таксономии с измерениями вам захочется иметь возможность контролировать, с какими измерениями может быть связан каждый из концептов. Таксономия шаблонов обеспечивает такую возможность путем определения связей между гиперкубами и первичными концептами через связи has-hypercube между первичным концептом и концептом гиперкуба.

Есть два типа связей has-hypercube – all и notAll:

- связь типа

allиспользуется для определения измерений (и элементов измерений), которые разрешены для концепта; - связь типа

notAllиспользуется для определения измерений (и элементов измерений), которые не разрешены.

Сочетание этих типов связей позволяет точно контролировать состав измерений и элементов измерений для каждого концепта.

Предположим, у нас есть два гиперкуба:

Первичный концепт со связьюhas-hypercubeтипаallс кубом hc_age_x_gender может иметь все элементы измерений gender и age_group. Если мы добавим к этому концепту связь типаnotAllс гиперкубом hc_exclude, элемент ‘Female’ измерения gender и элемент ‘...–20’ измерения age_group станут ему недоступны.

Связь has-hypercube должна указывать, в какой части контекста должны быть определены измерения – segment или scenario, для этого предназначен атрибут contextElement:

- значение

segmentиспользуется для измерений, которые определяют часть организационной структуры формирующей отчет компании, напр. отдел, регион и т.д.; - значение

scenarioиспользуется для измерений, не связанных с организационной структурой компании, таких как возрастная группа, продукт и т.д.

Чтобы указать, что концепту доступны только элементы внутри измерений гиперкуба, в необязательном булевом атрибуте closed связи has-hypercube указывается значение true. Этот атрибут применяется только к сегменту сценария в соответствии со значением атрибута contextElement в связи. Значением по умолчанию является false, которое оставляет сегмент или сценарий открытым.

5.2.5. Наборы взаимосвязей измерений (dimensional relationship sets, DRS)

Определенные в XBRL Dimensions взаимосвязи включаются в базы ссылок определений (definition linkbase). В соответствии со спецификацией XBRL, взаимосвязи группируются в сети в соответствии с их ролями. Это называют базовым набором взаимосвязей.

Спецификация XBRL Dimensions расширяет понятие базового набора путем введения атрибута targetRole для таких типов связей как all, notAll, hypercube-dimension, dimension-domain и domain-member. Атрибут targetRole ссылается на другую роль и определяет переход от базы ссылок в одном базовом наборе к базе ссылок в базовом наборе с указанной в атрибуте ролью. Набор таких сгруппированных взаимосвязей называется Набором взаимосвязей измерений, DRS.

Создание DRS может быть полезным и даже необходимым, когда таксономия измерений становится все более сложной. Без DRS вы скорее всего включите элементы в измерения, которым они не принадлежат или добавите измерения не в те гиперкубы. Вы можете запросто получить набор взаимосвязей, которые не имеют никакого смысла или могут даже оказаться противоречивыми и невалидными.

Этот механизм перехода от одной базы ссылок (роли) к другой делает процесс валидации таксономии или отчета намного более сложным, так как взаимосвязи существуют вне границ базовых наборов, как это определено в спецификации XBRL.

Спецификация XBRL Dimensions использует понятие последовательных взаимосвязей (consecutive relationship). Оно означает, что, например, элементы гиперкуба определяются сначала по взаимосвязиhypercube-dimension, а затем для всех найденных измерений – последовательно по каждой из связейdomain-member.

Все последовательные взаимосвязи находятся в пределах одной роли баз ссылок, если не определено значение атрибутаtargetRole. Если же в дуге этот атрибут присутствует, то поиск взаимосвязей переходит в базу ссылок с указанной ролью. Последовательные взаимосвязи в исходной базе ссылок (роли) в этом случае отсутствуют.

Взаимосвязи, которые могут быть объединены как последовательные, ограничены тем, что вы бы логично ожидали – связиhas-hypercube(all,notAll) могут иметьhypercube_dimensionв качестве последовательных взаимосвязей, но неdimension_domainилиdomain_member, так как они пропускают связи.

5.3. Измерения в отчетах XBRL

Как говорилось во введении, измерения используются в сегменте или сценарии контекстов отчета. Выбор между ними производится с помощью атрибута contextElementType связи has-hypercube.

5.3.1. Типы элементов измерений

5.3.1.1. Типизированные элементы (typed member)

Для типизированных измерений значения указываются как дочерние элементы xbrldi:typedMember внутри сегмента или сценария. Атрибут dimension таких элементов должен ссылаться на определение типизированного измерения. Содержанием typedMember является элемент с типом как у измерения, указанного в атрибуте xbrldt:typedDomainRef. Значением для измерения является значение этого элемента.

Предположим, у нас есть измерение ageDim типа age с целочисленными значениями от 0 до (будем оптимистами) 150. Значение измерения 45 задается как дочерний элемент age внутри, к примеру, сегмента следующим образом:

45

5.3.1.2. Явные элементы (explicit member)

Для явных измерений значения указываются с помощью элементов xbrldi:explicitMember. Атрибут dimension таких элементов должен ссылаться на определение явного измерения. Значением для измерения является содержание этого элемента и оно должно быть qname-элементом одного из явно определенных значений измерения.

Предположим, у нас есть измерение ageGroupDim со следующими явно определенными элементами: ageLessThan20, ageFrom21To40 и age41OrMore. Значение измерения для возрастной группы 21–40 задается дочерним элементом внутри, к примеру, сегмента следующим образом:

d:ageFrom21To40

5.3.2. Валидация (validation)

Спецификация XBRL Dimensions дополняет набор правил валидации из спецификации XBRL.

5.3.2.1. Валидация первичных фактов

Факты по первичным концептам должны валидироваться на основании концепта и контекста. Факт автоматически считается валидным по измерениям, если для его концепта не определены связи has-hypercube.

Если в концепте определены связи has-hypercube, указанные ими гиперкубы должны быть валидными по измерениям. Контекст факта должен содержать валидную комбинацию элементов домена или значений для каждого из связанных с ним измерений гиперкуба в пределах как минимум одного базового набора. Если не задано ни одного значения измерения, используется значение измерения по умолчанию (при его наличии). Недопустимо указывать более одного значения измерения.

Обратите внимание, что при определении валидности указанного значения в пределах измерения учитываются такие атрибуты как usable в связях domain-member и closed в связях has-hypercube.