Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

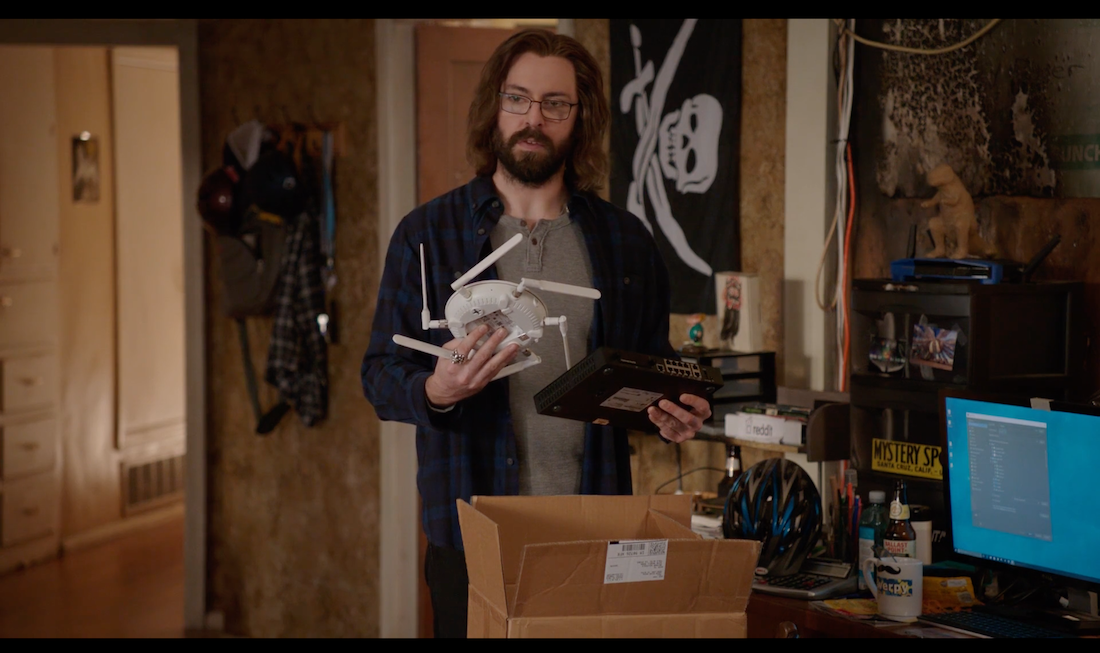

Идеальная домашняя сеть или «сам себе злобный перфекционист» |

Динеш, единственная польза от твоих жалких и вульгарных телодвижений в постели с кибертеррористкой, это то, что я наконец-то занялся нашей защитой.

Как говорит технический директор Qrator Labs Артём ximaera Гавриченков, DDoS-mitigation начинается там, где заканчиваются силы и время одного хорошего системного администратора.

В день системного администратора, который в Qrator Labs считают профессиональным праздником даже больше, чем день программиста, мы задумались — о чём таком можно было б рассказать на Хабре, с чем точно сталкивался каждый?..

Решение было найдено быстро, ведь есть такое место, где каждый человек может побыть системным администратором в любой удобный, а порой и неудачно-вынужденный, момент времени — дома.

Домашние сети — это объект гордости и особого, крайне тщательного, планирования. Если на работе мы часто хотим «побыстрее и подешевле», то дома не может быть никаких компромиссов — только самое лучшее и надежное.

Составив список из 10 вопросов, мы попросили всех коллег, потративших время хотя бы чуть большее, чем то, что требуется на распаковку роутера из коробки, отозваться и поделиться собственными историями. Насколько интересно получилось — судить вам. Мы также попросили ответить на вопросы системного администратора Хабрахабра Вадима Pas Рыбалко и сотрудника бара «Get Jerry» Александра Shoohurt Савицкого.

В комментариях мы предлагаем каждому желающему ответить на те же самые 10 вопросов — посмотрим, насколько тщательно вы относитесь к работе домашней сети, и есть ли что-то, отличающее её от сети соседа.

1. Сколько устройств в вашей домашней сети?

Алексей Старков, Qrator: Около 5.

Илья Урвачев, Qrator: Общее кол-во: 18. Из них: носимые устройства (6): 4 телефона, 2 планшета носимые ноутбуки: 2; стационарный ноутбук: 1; мультимедиа: 2 SmartTV + 1 видеорегистратор (домашнее видеонаблюдение); сетевые устройства: 2 mikroTik-a (wifi + switch); периферия: 1 сетевое МФУ + 1 телефон (a510 ip). Серверная группировка(2): border router (intel d510), multipurpose server (xeon E3-1230) — оба gentoo linux.

Александр Зубков, Qrator: Сейчас 3 сетевых девайса, 3 ноутбука и 4 телефона/планшета, 1 почти комп.

Андрей Лескин, Qrator: Где живу сейчас, в Чехии и куда еще не все свои железки перевез, около 10.

Дмитрий Шемонаев, Qrator: Пока их 8: межсетевой экран Juniper SRX100H, точка доступа TP-Link, сервер Fujitsu, сервер Supermicro, коммутатор D-Link DES-3200, проба RIPE Atlas, ноутбук, iPhone.

Антон Орлов, Qrator: Модем GPON, WiFi-рутер, 2 стационарных компьютера, медиаплеер, телевизор, плюс по WiFi более или менее постоянно 3 ноутбука, несколько планшетов, несколько телефонов.

Сергей Куценко, Qrator: ~8-10.

Алексей Березин, Qrator: Пять — роутер, десктоп (win10), MB Air, iPhone 5, китайский смартфон-андроид.

Вадим Рыбалко, Хабрахабр: В целом, плюс-минус постоянно два-три, иногда четыре ноутбука, где-то столько же смартфонов, несколько планшетов, AppleTV, потенциально сетевые медиаплееры либо игровая консоль. Это не считая «специализированных устройств». Плюс-минус обычная история.

Александр Савицкий, Get Jerry: В моей домашней сети около 25 устройств, из которых примерно 20 подключены постоянно.

2. Помимо полноценных десктопов и ноутбуков — какая периферия наличествует (NAS, «умные» устройства — именно подключаемая техника)?

Алексей Старков: В роутере есть USB для подключения накопителей, но я им не пользуюсь.

Александр Зубков: Нет. Хотя раньше был Raspberry с OpenELEC подключенный к телевизору, на котором кино смотрели, телевизор остался в Москве.

Андрей Лескин: Там, где я живу сейчас — 2. Весы с аплоадом в облако и Chromecast, PlayStation, PS Vita.

Там, где я жил раньше: Все то же самое, за исключением того, что добавляется домашняя файлопомойка, где кино\сериалы\музыка\сторадж для облачного файлохранения и чего только фантазия не пожелает, подключенная напрямую к телеку.

Наконец, на даче, где была возможность продумать всё и сразу: Меньше периферии, но есть Raspberry Pi, который выступает температурным демоном и если что, верещит в почту, если в доме стало сильно холодно.

Дмитрий Шемонаев: Такого пока нет, но если появится телевизор, то он обязательно будет с Ethernet.

Антон Орлов: Медиаплеер, телевизор.

Сергей Куценко: Телефоны + роутер выступает в роли NAS+torrent, chromeCast.

Алексей Березин: Никакой. Не ощущаю в ней какой-то необходимости. Интернеты в

телевизоре — это что-то странное.

Вадим Рыбалко: Один двухдисковый NAS, один мини-сервер на базе тонкого клиента (по сути, полноценный компьютер), беспроводной принтер. Потенциально, пара IP-камер. Устройства «умного дома» что-то пока внимание сильно не привлекают, в силу на сегодняшний день тотальной кривости и взаимной несовместимости.

Александр Савицкий: В этот пул, помимо ноутбуков и смартфонов, входят несколько телевизоров, NAS, пара игровых консолей, пара телеприставок Apple TV и МФУ — ничего специфического.

3. Что для вас важно в ключе создания домашней сети, каковы основные требования?

Алексей Старков: Удобство подключения из разных комнат, т.е. покрытие. Самих устройств малое количество, интенсивность низка, поэтому настройка не очень критична.

Илья Урвачев: Стабильный wifi, который не надо перезагружать и/или мучаться, а только настроить и забыть, возможность иметь минимальный latency в местах где может быть установлен ПК (игры, да), мультимедиа никогда не должно заикаться и фризиться, возможность подключения удаленных «офисов» (родительская квартира, дача), сделать самому и как для себя любимого (теперь нет /(d|tp)link/-ков).

Александр Зубков: Желательно, чтобы работало хорошо и быстро и без wifi сейчас никуда.

Андрей Лескин: Чтобы работало и не тупило, кино можно было посмотреть с любого устройства в любом месте (иногда проблемы с FullHD и воздухом), особенно при зашумленном эфире.

Дмитрий Шемонаев: Для меня важна возможность сегментировать сеть, поэтому дома есть 3 vlan: HOME, MANAGEMENT, LAB. В состав HOME входят домашний ноутбук, айфон и пробник атласа. В MANAGEMENT входят все интерфейсы управления (свитч, IPMI, интерфейсы управления виртуальными роутерами). В LAB всякое остальное.

Антон Орлов: Скорость на скачивание из интернета (при этом скорость на отдачу не

так важна), скорость внутри домашней сети, безопасность, доступность

интернета, удобство просмотра фильмов.

Сергей Куценко: 5ГГц диапазон wi-fi an/ac; WPA2; QOS; upnp.

Алексей Березин: Производительность, простота, стабильность работы. KISS же!

Вадим Рыбалко: Производительность беспроводного сегмента не так важна, как надёжность, ибо в многоквартирном доме много интерференций. Важно покрытие беспроводной сетью без «слепых зон», наличие более-менее стабильного доступа в интернет.

Александр Савицкий: Ввиду довольно большого количества устройств при создании домашней сети главным требованием для меня была способность роутера обслуживать весь этот зоопарк. Второе требование — возможность работы в сети беспроводных устройств на всей территории дома без потери качества сигнала. Третье — масштабируемость.

4. Каковы номинальные (тариф оператора) и реальные параметры подключения (скриншот измерителя скорости типа speedtest)?

Алексей Старков: Номинальный 100 Мбит/с, реально:

Илья Урвачев: 100Mbps FD — меня устраивает (если не ошибаюсь — этот тест на wifi запускался).

Александр Зубков: ADSL 20 download / 2 upload (более-менее так и есть).

Андрей Лескин: Там, где я сейчас: Боль и страдание. ADSL 20/2 с отключением в полночь) speedtest показывает это же.

Там, где я был до этого: 100/100 полноценный. Если цепляться проводом к роутеру то достигало нужных значений. По воздуху — не всегда.

На даче: У всех по-разному, интернет обеспечивается свистками от мобильных операторов, зависит от погоды\уровня сигнала\удаленности вышки.

Дмитрий Шемонаев: 50 мегабит от Билайна и статический IP адрес. Скорость скорее соответствует тарифу.

Антон Орлов: Тариф 20 Мбит/с, реально 50 Мбит/с (это так с 2012 года, с момента

подключения GPON) — вот такой добренький МГТС:

Сергей Куценко: Безлимитный тариф от 50Мбит.

Алексей Березин: Скриншотов не будет, тариф 100МБит анлим. Работает на 100МБит анлим. Все хорошо, такой скорости хватает, оператор (2КОМ) ломается нечасто, стоит недорого.

Вадим Рыбалко: Тариф ISP 50 Мбит/с в обе стороны плюс статический публичный адрес. Реальные измерения более-менее совпадают с заявленными.

Александр Савицкий: Мой тариф подразумевает 100-мегабитное подключение, и надо отметить, что провайдер чаще всего честно отдает мне ровно сотню. Конечно, иногда, во время пиковой нагрузки, скорость может падать до 70-75% от номинальной, но это не проблема.

5. Что в вашем окружении с забитостью частот и как вы решаете данную проблему на уровне организации Wi-Fi сети?

Алексей Старков: Прибавляю мощность. На самом деле в дальних от роутера комнатах довольно плохо, а так время от времени переключаю канал на посвободнее. Ловится около десятка разных сетей.

Илья Урвачев: Тут прям удивительный момент возникает — вокруг огромное количество сетей, но только в общем коридоре, внутри же — видно только своя и соседскую сеть. Думаю, основная причина заключается в том, что дом — монолитный и стены и перекрытия хорошо справляются с экранированием.

Александр Зубков: На 2.4 ГГц плохо всё, выбираю менее забитую из 1,6,11. Решается 5 ГГц диапазоном, но не все устройства ещё умеют.

Андрей Лескин: Эфир на 2 ГГц забит до отказа везде, поэтому двойная AP на 2,4 и 5 ГГц. 5 ГГц эфир свободный совсем. А на даче помимо меня интернет есть только у соседа.

Дмитрий Шемонаев: Все плохо, поэтому ноутбук подключен проводом.

Антон Орлов: Не ощущаю проблему. Вокруг меня относительно мало живых квартир.

Сергей Куценко: *опа. ~ 40 точек доступа в видимости wi-fi; После неудачных попыток смены каналов в диапазоне 2.4 перетаскиваю все девайсы в 5ГГц диапазон.

Алексей Березин: Как и в любом многоквартирном доме из картона (панельный дом) — с утилизацией частот все плохо. В основном благодаря сидорам из ростелика/мгтс, ставящих бабушкам на замену телевизора и телефона новомодную цифру в виде GPON, который внезапно оказывается с включенным вай-фаем и и свистит на 200 метров вокруг. По делу — не использую диапазон 2.4ГГц совсем. 5ГГц гораздо быстрее затухает с расстоянием от источника и хуже проникает через препятствия типа стен,

больше каналов в эфире — можно подобрать пустой достаточной ширины. В этом диапазоне все еще можно получить устойчивую связность на модном нынче 802.11ac. Дальше, подозреваю, и в 5ГГц будет набег дэбилов с выкрученной мощой передатчиков «шоб в моей ласточке во дворе был

инторнет».

Вадим Рыбалко: Диапазон 2.4 ГГц утилизирован достаточно сильно, особенно вечерами. Надеятся на него не стоит. Диапазон 5 ГГц практически пуст, этим и пользуемся.

Александр Савицкий: В моем окружении частоты забиты неравномерно и не очень сильно: вокруг меня примерно 6-7 соседских точек Wi-Fi и все они скучкованы вокруг частот, устанавливаемых роутерами по умолчанию. 5-гигагерцевый диапазон ожидаемо практически не используется.

6. Опишите «сетап домашний»: используемые устройства, особенности настройки LAN/WAN

Алексей Старков: Сетап из коробки. Роутер через pppoe связан с циской провайдера в коридоре, от него идет WiFi, конфигурация через DHCP.

Илья Урвачев: Провайдер -> d510 -> MTik switch — ядро сети, а дальше собираем в свич wifi-ap и всё остальное. Особенностей каких-то специфических пожалуй что и нету, всё есть в манах и на stackoverflow.

Тут можно было бы рассказать много боли про l2tp (и kernel support pathces), но слава богу beeline от него отказывается.

Тут можно было бы рассказать много боли про всякие dlink/tp-link (конкретно те экземпляры что достались мне) которые не могут жить без регулярных ребутов или «выходят» из сети если вдруг ктото решит что-то большое скачать по локальной wifi, но теперь есть MirkoTik который этим не страдает.

Тут можно было бы написать что писать правила для iptables с NAT'он — трудно, но трудно это делается по большому счету только первый раз.

Александр Зубков: ADSL-роутер, коммутатор Mikrotik, wifi-точка dual-band. В Москве был проводной интернет и в качестве роутера был PandaBoard, но оно сдохло похоже, ну и тут всё равно без этой ADSL-коробки не обойтись.

Андрей Лескин: Два ноутбука, два телефона, пара планшетов, +- железки на поизучать, chromecast, консоли. Стараюсь сделать максимально просто все: 192.168.X.0/24 с DHCP. В отдельных случаях делается static IP для конкретных железок.

Дмитрий Шемонаев: В МСЭ приходит провод от провайдера, к нему же подключен коммутатор, куда подключены все остальные устройства.

Антон Орлов: GPON-модем имеет wi-fi модуль, но он выключен, так как там есть известные неустранимые проблемы с безопасностью (МГТС в то время всем такие ставил и не парился на эту тему). От него по квартире разведён проводной интернет (к двум стационарным компьютерам, к медиаплееру и WiFi-рутеру). По проводам 100 Мбит/с.

Один из компьютеров служит, в частности, как файловое хранилище. Медиаплеер умеет брать с него фильмы по NFS.

Сергей Куценко: Провайдерский роутер: 2-х диапазонный wi-fi/ac по проводу к нему подключен другой роутер (используется как NAS+torrent), все остальные девайсы подключены по wifi предпочтительно к 5ГГц.

Включен upnp для проброса портов torrent; Настроен QOS приоретизируя http трафик; Иногда повышая приоритет для определенных mac-адресов; Иногда включаю фильтр по mac; к роутеру подключен стационарный телефон по проводу; По LAN подключена TV-приставка.

Алексей Березин: Про WAN — провайдер почти адекват. Лочит по MAC, но хоть чистый белый DHCP, без всякого PPP-жупела.

С LAN немного интереснее. До недавнего времени в качестве роутера был какой-то простецкий TP-Link — поэтому и LAN был прост. Плоская адресация на все устройства, проброс порта для RDP, применение DynDNS от no-ip.com.

Теперь, после замены роутера на Mikrotik hAP ac, появилась возможность сегментирования сети (деление по vlan для провода/беспровода, выделение виртуалочек, живущих на стационарном компе, в отдельный vlan — все со своей адресацией). Плюшки про DynDNS и и проброс портов остались. Это пока только начало, дальше буду делать всякие разные приколы с авторизациями (в основном — беспровод, EAP/TLS, не-openvpn точка входа в домашнюю сеть, возможно поддержка IPv6, баловство c VRF etc).

Вадим Рыбалко: Так как основная сфера работы — возня с Цисками и серверами, коробки а-ля «всё в одном» не совсем устраивали. В первую очередь из-за того, что нужно было роутер размещать в географическом центре квартиры. Пробовал несколько, ни одна не удовлетворила потребности и практически со всеми были нарекания к стабильности работы. В предыдущем сетапе был маршрутизатор Cisco 871 и несколько точек доступа 3COM, но они морально устарели по характеристикам производительности (но не по функционалу). В актуальном сетапе я обратил внимание на серию Unifi от Ubuquiti — это оказалось практически идеально для меня. Центром является управляемый 8-портовый (на самом деле портов 10) коммутатор Unifi. Он имеет PoE почти по всем портам. К нему подключены маршрутизатор USG, две точки доступа стандарта AC и всё остальное сетевое железо. К нему же подключён контроллер Unifi в виде небольшого устройства Unifi Cloud Key. Всё, что может питаться по PoE, питается по PoE. На балконе планируется установить уличную точку доступа с небольшой секторальной антенной для покрытия сетью части парка, где планируется проводить много времени. Но это больше fun. Открывать её для гостей не планируется в свете последних законодательных инициатив.

Александр Савицкий: Моя домашняя сеть устроена довольно просто: поскольку в дом заходит не витая пара, а оптический кабель, на входе установлен конвертер, за ним — маршрутизатор, к нему подключен неуправляемый свитч (для нескольких проводных устройств) и точка доступа Wi-Fi. К ней, помимо всех беспроводных устройств, прицеплен рипитер, к которому подключено одно проводное устройство.

Каких-то специфических настроен не делал: и маршрутизатор, и точка Wi-Fi работают на настройках, мало отличающихся от базовых.

7. Какое количество провайдеров обеспечивают доступность из вашей домашней сети, если более одного. Зачем?

Алексей Старков: Один.

Илья Урвачев: 2,5 провайдера: beeline (основной) + net-by-net (резерв, почти не используется и не оплачивается) + постоянно меня дергает МГТС со своим gpon — может быть додергают когда-нибудь.

Александр Зубков: Ну без инета плохо, тем более, что для работы может понадобиться круглосуточно. Но если не считать мобильный инет, то 2-го канала нет. Так-то было бы хорошо резерв иметь, но дорого и было бы из чего выбирать. В первом приближении проще найти надёжного поставщика, если с другими есть проблемы постоянные.

Андрей Лескин: Там, где я сейчас — один единственный. На даче: основные мобильные операторы с интернетом. 3 штуки, что ли. Меняются по мере необходимости. Yota режет VPN, нужно подключать другой. У Beeline лимит трафика, но хорошая полоса. Megafon полоса похуже, лимитов побольше. В зависимости от потребности выбирается инструмент. Последнее время используется только билайн.

Дмитрий Шемонаев: Пока один, есть резерв в виде раздачи интернета через телефон.

Антон Орлов: Если что, то раздаётся мобильный интернет с телефона. Реально за почти

5 лет было нужно только когда вырубался свет во всём доме, в остальное

время всё работало без перебоев.

Сергей Куценко: Один провайдер, в случае отключения использую Yota.

Алексей Березин: Базовый — один. Всегда есть emergency в виде интернета от ОпСоС'а.

Вадим Рыбалко: Один провайдер. Практически ни один домашний роутер не может организовать нормальный dual WAN (хотя многие имеют такую возможность). Редко когда отваливается «последняя миля», иногда просадки где-то на сети оператора или его стыках. Если не будет интернета некоторое время — не катастрофа, если чего, можно принудительно переключить трафик на LTE-маршрутизатор.

Александр Савицкий: Я пользуюсь услугами одного провайдера, хватает с лихвой.

8. Безопасность — каковы ваши основные подходы к защите устройств от компрометации или несанкционированного доступа?

Алексей Старков: Апдейты прошивки, доступ по ssh к роутеру закрыт со стороны интернета, WPA2 для WiFi, в общем то и все.

Илья Урвачев: Со стороны провайдеров и интернетов: border с нормальным linux + iptables. Со стороны wifi: wpa2 без wps, отдельная гостевая сеть с wpa2, отдельная гостевая-гостевая сеть для соседей. Для внутренних устройств: только ipv4 и только NAT сами внутренние устройства win: только пользовательские учетки, урезанные права и прочее угнетение сами внутренние устройства: в интернет ходить могут только те устройства, которым туда надо (например принтеру или видеорегистратору в интернете делать нечего).

Александр Зубков: Инфа на диске ноутбука и домашнего сервера зашифрована. На телефоне впрочем тоже.

Андрей Лескин: Шифрованный диск, потереть ключи через 2 часа неиспользования.

— Setup FileVault2;

— Disable Fast User Switching (REVERT IT);

— Setup Firmware Password;

— sudo pmset -a destroyfvkeyonstandby 1;

— sudo pmset -a standbydelay 3600;

+ encrypted backups.

Дмитрий Шемонаев: На МСЭ снаружи открыт только ssh на сам роутер. Внешние соединения на внешний IP сбрасываются.

Антон Орлов: Самое главное — регулярное обновление прошивок и софта на всех устройствах.

Сергей Куценко: WPA2 / шифрованные разделы на дисках для критичных данных.

Алексей Березин: Как у ГД. Закрыть и не пущать. Лучшая защита от компрометации — лишение возможности компрометации. Ну то есть как минимум надо обламывать все неинициированное изнутри. Ну и слава РКН и МНУ — не позволяют ходить на компрометированные URL.

Вадим Рыбалко: Снаружи всё прикрыто, кроме проброшенного порта SSH на сервер. Есть uPNP, открывающий порты приложениям, здесь удобство победило паранойю. Изнутри в интернет можно ходить без ограничений, на беспроводной сети WPA2-PSK с AES. На Unifi Cloud Key и NAS можно попасть из вне при помощи фирменных облачных сервисов.

Александр Савицкий: Я ограничивал доступ к админкам маршрутизатора и точки доступа не только сложным паролем, но и белым списком. Сама сеть Wi-Fi разделена на две: основную, доступ к которой есть только у белого списка, и гостевую с авторизацией по паролю.

9. Физическая инфраструктура: сверлили ли дырки, прятали ли провода под плинтуса и т.д. Насколько далеко вы готовы зайти в вопросе организации домашней сети: кинуть провод или затеять ремонт? Необходима аргументация.

Алексей Старков: Смешная история — ремонтники завели в квартиру 3 параллельных кабеля, по одному в каждую комнату, естественно три порта в циске никто не собирался мне давать. Розетки специальные есть везде, но работает только одна — в ней роутер. К ремонту не готов, думаю повесить роутер на улице. Аргументация — ремонт только закончили, а стабильная сеть нужна мне только на работе, остально время могу потерпеть.

Илья Урвачев: Коротко — уже. Длиннее:

0) Никаких полумер — только хардкор;

1) Варианты типа валяющейся витой пары или запихивание её под плинтус — неприемлемы от слова совсем;

2) Квартира недавно пережила второй за 3 года капитальный ремонт (отдельная тема для разговора — как без бюджета самостоятельно сделать капитальный ремонт) — при каждом из них для конечных стационарных устройств (ПК/ТВ/etc) провода укладывалить в гофре в стены, вводы провайдеров передвигались;

3) Ядро сети (сервера и роутеры) разполагаются специально для этого созданной антресоли — goo.gl/photos/WbdvqrnkYeaRtW2U8, к слову — вот так делалась электрика goo.gl/photos/Z9mTV1AZTrGUiGFT7 (на двушку);

4) Обеспечения устройств на балконе (smartTV и может быть еще что-то) — прокидывать на балкон витую пару.

Александр Зубков: Всякое было в разных местах. Розетки разводил, провода прятал. Но это жена их не любит и ругается. Есть даже устройства Ethernet over PowerLine — связь по ним лучше, чем через WiFi, но к сожалению иногда глючат.

Андрей Лескин: Там, где я живу сейчас съемная квартира, живем без этого. Там, где я жил раньше также была съемная квартира, приходилось для NAS откопать старый роутер, который работал в режиме «беспроводной сетевой карты». То есть от NAS к нему провод, далее по воздуху до основной точки входа. А на даче на этапе прокладки электричества при строительстве также развел в каждую комнату по сетевой розетке. В мыслях сделать роуминг-сеть.

Дмитрий Шемонаев: По этому поводу не заморачивался пока, но если инфраструктура будет расти, то скорее всего она переедет в какое-то маленькое отдельное помещение, чтобы не шумела.

Антон Орлов: Когда делал ремонт в квартире, заранее подумал, где будут нужны интернет-розетки и развёл провода в стенах. Не ошибся.

Сергей Куценко: Всё что не жрет полосу подключается по wifi, по проводу по возможности близко к роутеру. Исключение только TV приставка к которой по плинтусу протянута витая пара в другую комнату.

Алексей Березин: Живу на съемной квартире. Можно усверлиться, но лень и как-то незачем. Все в плинтусах, где можно. В своей ква (если появится когда-то) будет ремонт с учетом слаботочки — люблю порядок таки.

Вадим Рыбалко: В текущем сетапе сеть собрана в шкафу (временное жильё и делать много дырок не стоит). В новой квартире на стадии ремонта скрытно проложено много сетевого кабеля с запасом, для точек доступа подведён Ethernet к выводам потолочных люстр в двух помещениях. Узел связи располагается в коридоре под потолком на отдельной полке.

Александр Савицкий: Да, при организации домашней сети пришлось просверлить пару дырок и проложить кабели по коробам. Но поскольку большинство устройств в сети — беспроводные, проблема с проводами решилась малой кровью. Впрочем, если бы мне пришлось раскидывать кабели по всему жилищу, я бы сделал это при помощи оставленных еще на стадии строительства закладных в стенах и внешних коробов, так как все-таки хочется, чтобы провода не портили интерьер.

10. Чем отличается ваша домашней сеть от домашней сети соседа и почему она лучше?

Алексей Старков: У меня специальные розетки в стенах, ну. А так не сильно лучше, сделано по принципу «достал из коробки — работает — не трогай».

Илья Урвачев:

— Мало кто будет дома использовать роутер x86_64 (ну да atom) на linux и упарываться всякими l2tp и засовываением его в ядро (так как лопатить трафик userspace — накладно и безсмысленно) (отдельный привер beeline);

— Мало кто будет дома делать закрытую гостевую сеть + wifi-hotspot для соседей;

— Мало кто будет дружить torrent + dlna + smarttv и обмазывать это автоматизацией;

— Мало кто будет будет ставить на балкон отдельную точку доступа (витая пара есть);

— Мало кто будет заморачиваться дома с asterisk;

— Мало кто будет обмазывать motion (который motion-project.github.io) своим web-gui (и пожалуй никто не будет его делать на html+js+nginx+ssi и чуточку на bash);

— Мало кто будет делать самостоятельно multiroom-multimedia (правда и я тоже бросил не закончив);

— Мало кто будет запиливать zabbix;

— Мало кто будет локальный gentoo mirror;

— Мало кто будет объяснять samsung мфу что надо сканы в папочки по датам на smb шаре раскладывать;

— Мало кто будет брать под торренты/файлохранилища/etc только WD-Black, а я, попробовав — настоятельно рекомендую.

Александр Зубков: Не знаю что там у соседей.

Андрей Лескин: Там, где я сейчас все берут провайдерские железки, которые практически всегда Китай, который не очень хорошо работает. Выбираю адекватные железки под задачи. Очень полюбил микротики, но они не умеют в ADSL, поэтому пришлось взять Asus (в стоковой прошивке уныл, но есть прошивка энтузиастов, Tomato и прочее). Tomato даже когда-то патчил, когда к старому роутеру подключал терабайтный хард.

Там, где я жил раньше Mikrotik! Они сложнее в освоении, но, единожды настроив (понимая, что к чему), кладешь их на полку на года и забываешь. Он просто работает.

На даче я — Д'Артаньян.

Дмитрий Шемонаев: Я к соседям не заглядывал, поэтому не знаю.

Антон Орлов: У некоторых соседей модемы от МГТС так и стоят много лет с настройками

по умолчанию (включая пароли).

Сергей Куценко: Не думаю что есть какие-то особенные отличия.

Алексей Березин: Как только вломлюсь к соседу — узнаю. Это будет второй вопрос

после «Какого хрена куришь на горшке какое-то говно?!».

Вадим Рыбалко: Наличием 5 ГГц — к счастью, попсовые роутеры не вещают в этом диапазоне (хотя с приходом в массы AC всё может измениться). При этом с точки зрения масштабируемости топология сети больше походит на сеть небольшого предприятия, чем домашнюю. Лучше охват беспроводной сети за счёт нескольких точек прямо по центру помещений под потолком.

Александр Савицкий: Моя домашняя сеть отличается от соседских тем, что в моей обслуживается в разы больше устройств, причем это обеспечивается не одним беспроводным роутером, а связкой «маршрутизатор+свитч+точка WiFi». Трудно сказать, чем она лучше, но точно знаю, что уровень безопасности соседских сетей значительно ниже моей.

Всех причастных — с праздником! Если у вас есть непростая история создания и администрирования домашней сети, занимающая отдельное место в вашем сердце — поделитесь ею в комментариях.

|

Метки: author Shapelez сетевые технологии беспроводные технологии it- инфраструктура блог компании qrator labs системный администратор домашняя сеть перфекционизм паранойя |

20 правил самых коротких маркетинговых текстов |

Конечно, речь не о надоедливом спаме. Мало того, что это незаконно, так еще и малоэффективно. Суть смс-маркетинга в адресной доставке сообщения тому, кто добровольно готов его получать и ждет нужной информации. Все иные подходы вызывают только негатив.

Другое дело, когда коммуникация с аудиторией осуществляется с ее согласия. Но даже здесь, всегда есть некоторые приемы, положительно влияющие на конверсию, лояльность и другие важные маркетинговые метрики. Сотрудничая с крупнейшими телекоммуникационными и маркетинговыми компаниями, мы обнаружили несколько закономерностей, которые повышают шансы на то, что ваше SMS заинтересует адресата.

1.Обращайтесь к человеку лично

Если это существующий клиент, то, конечно, правильно будет обратиться к нему по имени. Но даже если имя вам неизвестно, помните, что сообщение, которое адресовано конкретному человеку, отличается от рекламного объявления на улице, а значит, не может быть обезличенным. Для красивого обращения подберите подходящее в данной ситуации слово.

При этом стоит избегать чрезмерной фамильярности или же формальности, если это не часть вашего корпоративного стиля. Часто, обращения «Уважаемый клиент!» бывает вполне достаточно.

2. Коротко и по сути

Современные технологии уже не ограничивают отправителя 160 символами при отправке SMS, но все же не стоит выходить за эти пределы. Отправляя сообщение, вы врываетесь в жизнь другого человека, и ему вряд ли захочется читать в SMS длинные рассказы. Всегда пишите максимально коротко, стараясь помещать в сообщение максимально полезной информации, избегая лишних деталей. Если суть сообщения понята без дополнительных кликов, чтобы его открыть и дочитать — вы мастер короткого текста (почти, как Чехов).

3. Правильно формулируйте — не запутывайте клиентов

Не нужно “придумывать велосипед”. В гонке за оригинальностью иногда страдает простота восприятия. Старайтесь сформулировать текст SMS таким образом, чтобы сообщение не несло двусмысленный характер (если только в этом не заключается вся суть вашей рекламы). Если ваше предложение сложно читается и воспринимается, большая вероятность, что его просто сразу же удалят.

4. Выделяйте только самое важное

Так как при составлении SMS текст невозможно выделить ярким цветом или другим шрифтом, часто для акцентирования определенного слова используют заглавные буквы. Но не стоит ими слишком увлекаться. Вы, вероятно, замечали, что сообщение написанное большими буквами (Caps Lock-ом), очень сложно воспринимается и почти не читабельно. Не повторяйте подобные ошибки, выделяя большими буквами лишь самое важное в вашем тексте.

5. Исключите сложные слова/ аббревиатуры

Всевозможные текстовые сокращения, сленг и малоизвестные слова также негативно влияют на эффективность SMS-рассылки. Неправильно подобранные слова могут пагубно повлиять и на имидж вашей компании, даже уменьшая лояльность к ней клиентов. Если невозможно избежать сокращений, используйте их крайне редко и только там, где слово будет логически понятны получателю после сокращения.

6. Пишите на понятном языке

Очень часто нам приходят SMS, слова которых читаются, как на кириллице, но пишутся английскими буквами. Мода на подобные сообщения пришла еще со времен, когда одна SMS могла вместить в себя больше латинских символов, чем слов написанных на кириллице. Мы не рекомендуем пользоваться подобным вариантом составления текстов, так как данный метод недостаточно читабельный и сложно воспринимается людьми. К тому же использование, например, таких букв, как «J»/ «Y» вводят в заблуждение получателей, потому что очень часто они имеют достаточно разные варианты трактовки: й, я, ж, ь и т.д.

7. Добавляйте призывы к действию

Безусловно, краткость сестра таланта. Но если вы просто напишите в сообщении скучную безэмоциональную информацию без намека на то, что же с ней человек должен сделать, вряд ли добьетесь нужного эффекта. Обязательно, прописывая текст рассылки, включайте в него призывы к действию. Четко пропишите человеку, что вы ожидаете от него. Например: “Приходи и получи подарок!”/ “Покупай со скидкой!” / “Запишись прямо сейчас!”.

8. Первое слово дороже второго

Не секрет, что если нас не заинтересовали первые строчки статьи, то вряд ли мы будем дочитывать ее до конца. Такой же принцип действует и в коротких текстах для SMS-рассылки. Чтобы получатель прочитал всю информацию целиком, вызовите интерес в нем с самого начала. Если текст содержит данные о скидках, разместите его вначале SMS, например: “СКИДКИ до -50%”.

9. Акцентируйте внимание на выгоде для клиента

Мы уже говорили о том, что очень важно правильно расставлять акценты в SMS. Но сейчас требуется понять, на чем именно необходимо акцентировать внимание. Все просто, конечно же на том, что же получит клиент, если согласится на ваше предложение. В случае, если в контексте сообщения подразумевается выгода в виде скидок или возможности покупки эксклюзивного товара — пишите об этом.

10. Побольше цифр

Минимизируйте временные затраты на прочтение вашей SMS. Не стоит писать буквами то, что можно сократить, написав цифрами. К тому же числовые данные дают определенную конкретику получателю сообщения. А также, как показывают исследования, цифры легче воспринимаются людьми в тексте, чем слова.

11. Долой хаос — выдерживайте структуру

Конечно, все зависит от особенностей компании, но мы рекомендуем вам всегда придерживаться единой структуры. Так получатель всегда будет заранее знать в каком месте прописана информация о скидках или адреса магазинов. Например, сначала пишите какая именно действует скидка, далее в каком магазине, адрес и контакты.

12. Подарите человеку чувство значимости

Старайтесь составлять текст сообщений так, чтобы человек чувствовал заботу о себе и то, что это предложение достаточно уникальное. Покажите, что вы заботитесь о клиенте и помните важные для него даты, такие как, например, День рождения. Если компания занимается свадебными услугами, отправьте клиенту SMS-поздравление с годовщиной свадьбы и информацией о скидке на услуги фотографа.

13. Не забывайте о бренде

Каким бы идеальным не был текст для SMS-рассылки, все же не стоит забывать, что продает себя именно бренд. А рассылка — это способ донести нужную информацию к потенциальным клиентам. Обязательно указывайте название бренда в тексте именно в таком виде, в котором он встречается, например, в торговых центрах, чтобы человек мог визуально определить к кому именно идти за скидкой.

14. Будьте на шаг впереди получателя

Вы — профессионал своего дела и точно знаете, какие вопросы могут возникнуть у человека, получившего от вас сообщение. Постарайтесь заранее предугадать, какая информация нужна потенциальному клиенту для того, чтобы он все таки совершил покупку. Не забывайте, например, уточнять в SMS сроки действия акции или время работы заведения.

15. Всегда будьте актуальны

Важно помнить, отправляя SMS, об актуальности предложения. Ведь в первую очередь оно должно быть интересно вашему клиенту. Даже если вы и продаете шубы в августе по супер-ценам, вряд ли человек, покупающий купальник, будет бежать к вам за шубой.

16. Играйте на контрасте — сравнивайте цены

Прописывая текст, достаточно эффективно указывать старую и новую цену на товар. Таким образом человек сразу видит выгоду от сотрудничества с вами/ покупки именно у вас.

17. Не используйте уловки

Скорее всего, этот совет будет лишним для большинства ответственных компаний, но все же уточним: ваше предложение должно в точности описывать то, что получит клиент. Никаких специальных или дополнительных условий, звездочек, сносок, никакого мелкого шрифта. Иначе вы потеряете лояльность, так и не получив ее.

18. Группируйте свою базу клиентов

Постарайтесь подойти к рассылке предложений более индивидуально, учитывая потребности потенциальных клиентов. Не стоит отправлять всей своей существующей базе SMS одинаковой формулировки и содержания. Если ваша компания может предложить товары и для мужчин, и для женщин, тогда разделите базу на 2 категории. Абсолютно необязательно включать в рассылку о скидках на рыболовные снасти женщин или же отправлять сообщение мужчинам о поступлении нового товара для плетения макраме.

19. Указывайте свои контакты

Самая распространенная ошибка при рассылке — отсутствие контактов. Многие долго стараются, придумывая акции и предложения, составляют красивые тексты, но весь труд, часто, остается недооцененным. А все потому, что отправитель не указывает, например, адрес, где проходит распродажа, телефон ресторана для брони столика или личные контакты специалиста, который и рекламирует свои услуги.

20. Тестирование — ключ к успеху

Не существует волшебного текста для SMS, который будет продавать ваши товары или услуги со 100%-й гарантией. Мы должны понимать, то, что эффективно для одних, может абсолютно не дать результата для других. Ведь есть множество факторов, влияющих на продажи, от качества товара и локации магазина до приветливости и дружелюбности персонала. В любом случае именно тестирование дает наилучший результат. Используя разные варианты рассылок и анализируя приток клиентов, а также их осведомленность о маркетинговых активностях компании, со временем вы легко сможете определить какой подход ваша целевая аудиторию любит больше всего.

О том, как правильно тестировать SMS-рассылки мы писали в одном из наших предыдущих материалов.

|

Метки: author serkon повышение конверсии контент-маркетинг интернет-маркетинг блог компании infobip смс sms a2p маркетинг копирайтинг текст инфобип infobip |

Ужасный рекрутер, ужасный кандидат |

Хочу написать о самых ужасных представителях российского рынка труда — ужасном рекрутере и ужасном кандидате, которых мы рассмотрим как два собирательных образа. Важно подчеркнуть, что я описываю далеко не типичные случаи, а самые крайние, клинические варианты. Пост написан на основании своего и чужого горького опыта, а также по мотивам постов и комментариев в социальных сетях и сайтах по трудоустройству.

Когда два таких вот товарища сталкиваются в сети или в реале, происходит нечто аналогичное аннигиляции — взаимное уничтожение и выброс энергии космических масштабов. Как мы увидим далее, это два брата близнеца, которые оказались по разные стороны баррикад.

Ужасный рекрутер

Разрешите представиться — Бог. Пребывает в уверенности, что вместе с должностью получил магические суперспособности, позволяющие видеть людей насквозь.

Цитата: «пока мы с кандидатом доходим до переговорной, я уже знаю, будет он у нас работать или нет». Со своим незаконченным заочным педагогическим образованием безапелляционно судит об уровне интеллекта системного архитектора. Пока руководитель борется с нехваткой ресурса, а команда перерабатывает, рекрутер экспериментирует над кандидатами, подсовывая им идиотские тесты «как в гугле» или составляет психологический профиль по ещё более идиотским методикам с сайтов «для психолухов». До элементарной вежливости снисходит редко, не перезванивает никогда. Это не лень и не отсутствие профессионализма — в силу эгоцентрической зацикленности на себе не задумывается об эмоциях и чувствах других людей. Пребывает в полной уверенности, что кандидаты обладают бесконечными запасами времени и терпения и готовы неделями выполнять его хотелки: первое собеседование с hr, 2-ое с руководителем, 3-е с директором, потом тест, а потом ещё тест, а потом финальное, а потом детектор лжи для бедолаг, прошедших все круги ада. Не владеет методиками проведения интервью, не учится, задаёт одни и те же, давно превратившиеся в мемы и обстёбанные на всех форумах вопросы из серии «кем вы себя видите через 5 лет?!!» Зато обладает потрясающими способностями делать далеко идущие выводы из скупых ответов кандидатов «ну… э… я не знаю…». Ставит безапелляционные и категоричные диагнозы. Резюме такого рекрутера — это череда небольших кадровых агентств с опытом работы по несколько месяцев в каждом. Либо не пыльное существование in-house под прикрытием могущественного родственника. Из всех остальных мест он изгоняется, потому что хронически не в состоянии выполнить план по набору персонала.

Ужасный кандидат

Данный товарищ в силу инфантильного и эгоцентричного склада характера рассматривает окружающий мир как некую абстрактную мамочку, которая ему по факту должна. Цитата: «рекрутеры — это сотрудники, в обязанности которых входит мое трудоустройство». Дружище, твоё трудоустройство — это твоя ответственность и больше ничья, а обязанность рекрутера — сделать так, чтобы в компании работали квалифицированные сотрудники. Ничтоже сумняшеся отправляет резюме с годом опыта работы на позицию ведущего разработчика, не думая о том, что придется конкурировать с людьми, обладающими большим опытом и реальными достижениями в этой области. Очень обижается на отказ и абсолютно не в состоянии понять его причины, ну и что что половину технологий не знаю, а вы обучите меня! Если ужасный рекрутер никогда не перезванивает по итогам интервью, то ужасный кандидат динамит собеседования и выходы на работу. Если hr-у удаётся ему дозвониться, отвечает что-то вроде «ачётакова? не пришёл — значит мне не интересно».

Определяется по часто употребляемому слову «должны». Его должны взять на работу, ему должны предоставить обучение, ему должны регулярно повышать заработную плату. Цитата: «через полгода вы должны будете прибавить мне зарплату. Почему? Потому что я разберусь в ваших процессах». Рекрутер у такого кандидата отвечает за всё: расположение офиса, цвет заработной платы, характер потенциального руководителя и погоду в день собеседования. За его пробелы в знаниях отвечают технические специалисты, присутствовавшие на собеседовании. Не то спросили, не так вопросы задавали, оскорбили предложением написать код, дали неправильное тестовое задание. Предложение повысить уровень знаний рождает лютый баттхёрт и шквал аргументов, почему это никак нельзя сделать: долго, дорого, некогда, он пока не определился, что хочет изучать и т.д. и т.п. Каждое не пройденное собеседование, каждый отказ воспринимает как подтверждение некоего существующего заговора работодателей против «всех хороших людей». Пишет разгромные посты в соцсетях, пишет на сайты антиджоба и жалуется, жалуется, жалуется. Или матерится, в зависимости от темперамента и склада характера.

В чем сходство этих двух типажей?

Неадекватно завышенная самооценка. Человек не тестирует реальность, не понимает, что его ожидания неоправданно завышены, его стоимость на рынке ниже, чем он хотел бы, его значимость низка, выбирает не только он, также выбирают его.

Иллюзии, мешающие адекватной самооценке. После факапа, у всех, как правило, возникают горькие мысли: если я такой крутой, как так получилось, что ничего не получилось? А дальше иллюзии услужливо начинают камуфлировать печальную действительность. «Собеседование провалено, я не ответил на большую часть вопросов» говорит голос разума. «Кому нужна эта теория, все есть в википедии» — отвечают иллюзии. «Кандидат ушёл к конкурентам, пока я тянул резину» — пытается достучаться разум до рекрутера, месяц динамившего кандидата с повторным собеседованием. «У меня огромная нагрузка, стресс и невыполнимый план, я просто не успел» — поют иллюзии.

Внешняя ответственность. Внимание человека сконцентрировано не на том, что может сделать он, а на том, что якобы должны предоставить ему другие. Успехи и неудачи приписываются преимущественно внешним факторам, виноват всегда кто-то.

Что делать, если ужасный рекрутер — это ты?

- Уважай своих кандидатов. Если мы говорим о рынке труда в отрасли ИТ, большая часть из них умнее, талантливее, профессиональнее, чем ты.

- Вот прямо сейчас! напиши всем, кто ждёт твой ответ по итогам встречи. Отказ в E-staff отправляется одной кнопкой.

- Учись. Прекрати спрашивать, кем себя человек видит через 5 лет, этот вопрос всех достал.

Что делать если ужасный кандидат — это ты?

- Сними розовые очки и посмотрись в зеркало без них. Попроси продвинутого коллегу честно охарактеризовать твой профессиональный уровень. Главное — не поссорьтесь. Адекватная оценка будет полезна всем.

- Выучи уже Exchange, или что тебе необходимо, чтобы найти работу. Открой Лутца, стряхни пыль с Бертрана Мейера, ведь ты же его зачем-то купил?

- Прекрати жаловаться в соцсетях. Даже если твой пост наберёт 1000 лайков, какой в этом толк, если у тебя по-прежнему нет работы.

- Прекрати считать, что все кругом виноваты: hr, тимлид и заговор работодателей. Хуже всего от этой позиции тебе самому.

Вывод. Что делать если повстречался такой ужасный представитель рынка труда?

- Отойти на безопасное состояние, не тратить свои нервы

- Не реагировать на его комментарии, не принимать близко к сердцу его «профессиональную» оценку. Она ничего не значит и никому не интересна.

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

|

|

Уменьшаем размер приложения: проверенные способы |

Введение

Одним из немаловажных аспектов разработки мобильных приложений является оптимизация размера. Мы все по личному опыту знаем, что чем меньше весит приложение, тем охотнее его скачивают, особенно если под рукой нет точки доступа Wi-Fi, а скорость и/или трафик мобильного интернета оставляют желать лучшего. К тому же, нельзя забывать и о том, что некоторые маркеты ставят ограничение на размер выпускаемого приложения. Например, в App Store продукты размером до 100 МБ доступны для скачивания по мобильному интернету, если же вес приложения превышает этот порог, то скачать его можно только через Wi-Fi. На Play Market же приложение, которое вытягивает больше 100 МБ, нельзя загрузить в принципе. В данной статье мы опишем, к каким методам и хитростям прибегали наши разработчики нативных приложений на iOS для того, чтобы уменьшить вес продукта, и добавим к этому несколько дельных советов, найденных в сети.

Основные способы уменьшения размера приложения

Графический контент

Сейчас дизайн играет ключевую роль в любом хорошем приложении. Если интерфейс минималистичен или продукт имеет небольшой набор функций, то этот этап можно пропустить. Если же проект отличается богатым функционалом или поддерживает некоторое количество цветовых схем, то здесь уже не обойтись без большого количества изображений со всеми вытекающими последствиями для веса. Кроме того, зачастую в проекты по умолчанию добавляются наборы изображений под различные форм-факторы мобильных устройств, как например @1x, @2x, @3x для iOS приложений. Ниже мы приведем методы, которые использовали в своих приложениях, чтобы разрешить проблему с обилием графического контента. Возможно, какие-то из них вы применяете и сами.

Один из простейших путей — использовать вместо трех масштабов только 3x изображение. Этот способ не назовешь оптимальным, так как на устройствах, ориентированных под 1x и 2x масштабы, такие изображения не всегда будут смотреться приемлемо. Однако за неимением лучшего этим приемом можно неплохо уменьшить размер проекта при огромном количестве графики.

Другой способ завязан на добавлениеи векторных изображений вместо растровых. На iOS мы экспортировали изображения в формат PDF. Зачастую такой файл действительно весит меньше, однако это работает не со всеми изображениями. Загвоздка здесь в том, что в векторная графика может некорректно отображать некоторые маски изображения, делая их абсолютно черными или искажая цвета.

Теперь рассмотрим пример с приложением, имеющим несколько цветовых схем (в простонародье «скин»). Чем больше цветовых схем в приложении, тем сильнее возрастает количество необходимых изображений. Если в изображении используется более одного цвета, то приходится хранить несколько вариантов на каждый скин. Однако, в случае когда изображение однотонное, его можно сделать шаблонным и уже в самом коде менять цвет оттенка (tint color). На iOS создать подобный шаблон можно двумя способами:

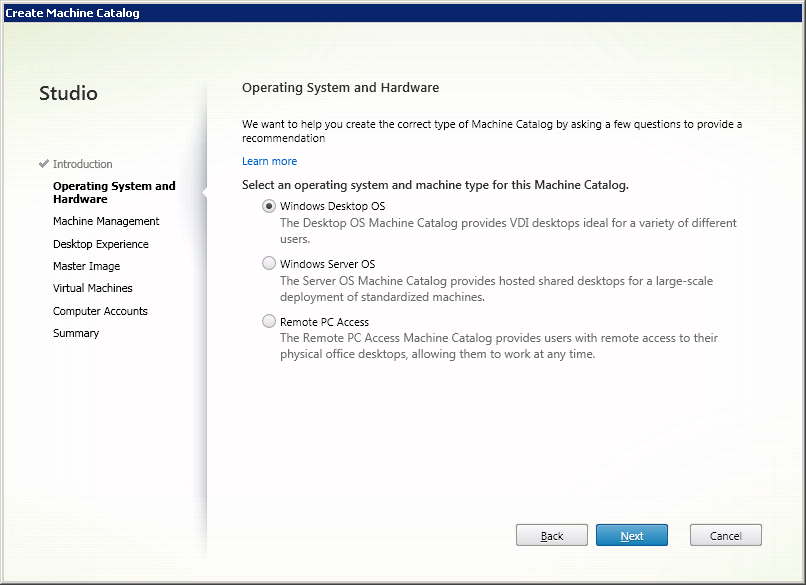

- выставить Template Image в самом XCode (см. Рис.1);

- задать шаблонный режим программно

Рис.1. Выставление шаблонного режима изображения в XCode.

UIImage *templateImage = [[UIImage imageNamed:@«Back Chevron»] imageWithRenderingMode:UIImageRenderingModeAlwaysTemplate]; - где UIImageRenderingModeAlwaysTemplate и является шаблонным режимом изображения.

После чего уже в коде выставлять цвет оттенка:

[backButton setTintColor:[UIColor blueColor]];Замена анимационных изображений

Добавление анимации — обычное дело в приложениях. Она привлекает внимание пользователя к нужным объектам интерфейса и делает его менее статичным, обеспечивая более приятный опыт взаимодействия. Некоторые простые анимации, наподобие перемещения объекта из одной части экрана в другую или появления снизу нового окна, можно сделать программно. Другие же, более сложные, требуют отрисовки каждого кадра анимации. Когда мы впервые столкнулись с добавлением анимационного изображения в ходе разработки, то использовали для его реализации один из распространенных способов, а именно анимирование через массив изображений. Выглядело это так:

NSArray *gif=@[@"frame1",@"frame2",@"frame3",@"frame4",@"frame5", @"frame6",@"frame7",@"frame8",@"frame9",@"frame10"];

NSMutableArray *images = [[NSMutableArray alloc] init];

for (int i = 0; i < gif.count; i++)

{

UIImage *image=[UIImage imageNamed:[gif objectAtIndex:i]];

[images addObject:image];

}

imageView.animationImages = images;

imageView.animationDuration = 0.3;

imageView.animationRepeatCount=1;

[imageView startAnimating]; Сначала создается массив с названиями изображений, затем — массив который поочередно пополняется изображениями из названий. Потом у переменной типа UIImageView задаются массив изображений для анимации, продолжительность анимации и количество повторений. После чего запускается сама анимация. Однако если кадров много и при этом на каждый из них приходится по три масштаба, то для размера приложения это не сулит ничего хорошего. Придя к такому печальному итогу, мы задались поиском способа добавления gif-файла вместо массива картинок. К счастью, на просторах интернета нам попалась категория UIImage+animatedGIF, которая все это уже умеет. Данная категория добавляет классу UIImage два метода:

+ (UIImage * _Nullable)animatedImageWithAnimatedGIFData:(NSData * _Nonnull)theData;

+ (UIImage * _Nullable)animatedImageWithAnimatedGIFURL:(NSURL * _Nonnull)theURL;Первый метод загружает gif, сохраненный в виде данных, а второй метод берет его прямо из ссылки на ресурс, например, из бандла приложения. Сам gif-файл можно сделать из тех же кадров на каком-нибудь сервисе для создания таких файлов, где задается количество кадров в секунду, сжатие и разрешение. Правильно выставленные параметры дадут на выходе гифку приемлемого веса. Теперь остается только добавить ее в бандл и использовать один из методов указанных выше.

Однако gif-файл тоже занимает пространство, поэтому мы старались выполнить все анимации программно. В Audio Editor Tool на стартовом экране у нас проигрывается анимация появления логотипа AUDIO EDITOR побуквенно. Раньше данная анимация была реализована с помощью гифки, но из-за большого разрешения изображения весила она многовато. Поэтому мы решили реализовать ее с помощью CABasicAnimation.

CAGradientLayer *gradient=[CAGradientLayer layer];

gradient.frame=animationLabel.bounds;

gradient.colors = @[(id)[UIColor colorWithWhite:1 alpha:1.0].CGColor,

(id)[UIColor clearColor].CGColor];

gradient.startPoint = CGPointMake(0.0, 0.5);

gradient.endPoint = CGPointMake(0.1, 0.5);

animationLabel.layer.mask=gradient;

dispatch_after(dispatch_time(DISPATCH_TIME_NOW, (int64_t)(0.99 * NSEC_PER_SEC)), dispatch_get_main_queue(), ^{

gradient.colors = @[(id)[UIColor colorWithWhite:1 alpha:1.0].CGColor,

(id)[UIColor colorWithWhite:1 alpha:1.0].CGColor];

});

CABasicAnimation *startPoint=[CABasicAnimation animationWithKeyPath:@"startPoint"];

startPoint.fromValue= [NSValue valueWithCGPoint:CGPointMake(0.0, 0.5)];

startPoint.toValue= [NSValue valueWithCGPoint:CGPointMake(1.0, 0.5)];

startPoint.duration = 0.9;

[startPoint setBeginTime:0.1];

startPoint.removedOnCompletion=NO;

CABasicAnimation *endPoint=[CABasicAnimation animationWithKeyPath:@"endPoint"];

endPoint.fromValue= [NSValue valueWithCGPoint:CGPointMake(0.1, 0.5)];

endPoint.toValue= [NSValue valueWithCGPoint:CGPointMake(1.0, 0.5)];

endPoint.duration = 1.0;

[endPoint setBeginTime:0.0];

endPoint.removedOnCompletion=NO;

CAAnimationGroup *group = [CAAnimationGroup animation];

[group setDuration:1.2];

[group setAnimations:[NSArray arrayWithObjects:startPoint, endPoint, nil]];

[ gradient addAnimation:group forKey:nil];Чтобы логотип у нас появлялся побуквенно, как на гифке, мы использовали градиентную маску, которая со временем смещала начальную позицию прозрачности. Для начала мы создали слой градиента, у которого прозрачный цвет идет практически с самого начала. Потом задали градиент как маску слоя текста логотипа, тем самым делая его прозрачным. Следующим шагом создали группу анимаций, в которую добавили две анимации. Первая из них смещала начальную позицию градиента, а вторая — конечную, тем самым делая его непрозрачным. Отметим один нюанс: важным шагом было указать в свойстве removeOnCompletion отрицательное значение, иначе анимация была бы удалена по завершению и слой вернулся бы к начальному значению.

Конвертирование аудио

В наших приложениях часто используются аудиофайлы формата WAV. В силу своей структуры этот формат занимает много места в проекте. По этой причине было решено сначала полностью заменить в бандле все файлы этого формата на более легковесный M4A, а потом, уже в самом приложении, конвертировать их в WAV. Почему бы просто не использовать M4A? Потому, что при цикличном воспроизведении файла этого формата происходит задержка при начале каждого цикла, будто там присутствует некая пустота. Завершающий шаг — сохранить уже конвертированный файл в директории приложения после первого запуска.

+(void)convertAudio:(NSURL *)url toUrl:(NSURL *)convertedUrl{

AVAudioFile *audioFile = [[AVAudioFile alloc] initForReading:url error:nil];

AVAudioPCMBuffer *buffer = [[AVAudioPCMBuffer alloc] initWithPCMFormat:audioFile.processingFormat frameCapacity:(uint32_t)audioFile.length];

[audioFile readIntoBuffer:buffer error:nil];

NSDictionary *recordSettings = @{

AVFormatIDKey : @(kAudioFormatLinearPCM),

AVSampleRateKey : @(audioFile.processingFormat.sampleRate),

AVNumberOfChannelsKey : @(audioFile.processingFormat.channelCount),

AVEncoderBitDepthHintKey : @16,

AVEncoderAudioQualityKey : @(AVAudioQualityMedium),

AVLinearPCMIsBigEndianKey: @0,

AVLinearPCMIsFloatKey: @0,

};

AVAudioFile *writeAudioFile = [[AVAudioFile alloc] initForWriting:convertedUrl settings:recordSettings error:nil];

[writeAudioFile writeFromBuffer:buffer error:nil];

}

В данном методе берется файл из бандла по url и сохраняется в директорию по convertedUrl. Считываемый файл загружается в буфер и уже оттуда записывается в новый с требуемыми настройками записи. Таким образом, мы используем более стабильный и тяжеловесный WAV после первого запуска, но при этом размер приложения существенно уменьшается на этапе загрузки и установки.

Подгрузка файлов с сервера

Подгрузка файлов с сервера — это то что нужно для приложений со значительным объемом контента. Большое количество пресетов музыки, наборы изображений и многое другое, что сильно увеличивает размер приложения, можно загрузить и позднее. Конечно, загрузка каждого отдельного файла потребовала бы много времени и трафика, поэтому с сервера подгружаются архивы со всем необходимым, а уже в самом приложении они распаковываются и сохраняются в директории приложения. Для разархивирования используется библиотека SSZipArchive (репозиторий библиотеки вы найдете по ссылке). Этот библиотека способна как упаковывать файлы в архив, так и распаковывать архивы. Но нас интересует только один метод из основного класса библиотеки:

+ (BOOL)unzipFileAtPath:(NSString *)path

toDestination:(NSString *)destination

progressHandler:(void (^)(NSString *entry, unz_file_info zipInfo, long entryNumber, long total))progressHandler

completionHandler:(void (^)(NSString *path, BOOL succeeded, NSError *error))completionHandler;Данный метод распаковывает файл из пути path в путь destination, а пока он распаковывается в progressHandler можно совершать какие-либо действия (например, отображение прогресса распаковки), после чего в completionHandler показать, что распаковка благополучно завершилась, либо вывести ошибку при неудаче.

Заключение

В конечном счете, если судить по приложению Mix Wave, которое до установки весит ~41 МБ, а после загрузки всех пресетов — 281 МБ, то описанные методы смогли уменьшить размер приложения примерно в семь раз. Результат неплохой, хотя, возможно, существуют и более актуальные способы. Если вы знаете о таких, предлагаем поделиться в комментариях.

|

|

[Из песочницы] Как крупная курьерская компания персональные данные своих клиентов раздавала |

Сразу хочу оговориться, что данная статья — не крик души, не бахвальство и, тем более, не попытка очернить чью-то там репутацию. Я просто призываю быть немного внимательнее пользователей услуг к сервисам компаний, которые их обслуживают, а сами компании — к сервисам, которые они предлагают своим клиентам. Иной раз такие сервисы ради удобства клиентов жертвуют их же, клиентов, конфиденциальностью. В каких пределах это происходило в моем случае — под катом.

В один прекрасный день на мой телефон в очередной раз позвонили из Москвы (сам я проживаю в регионе), попросили поучаствовать в опросе и спросили мою супругу. Я просто молча положил трубку. А через час мне пришло долгожданное SMS-сообщение из службы экспресс-доставки, услугами которой мы пользовались уже не первый год. Текст, аналогичный полученному, был выслан мне в Viber и на электронную почту. Данное SMS-сообщение содержало ссылку на официальный сайт компании вида www.XXXX.ru/dostavka/?hash=XXXXXXXXXXXX, пройдя по которой я мог отслеживать движение груза и управлять его доставкой (отказаться от груза, выбрать дату доставки и пр.).

Пройдя по ссылке, я увидел, что браузер автоматически залогинился с моим номером телефона и номером накладной (заполненная форма авторизации была на экране буквально секунды две), после чего я получил доступ к личному кабинету, в котором были представлены персональные данные (ФИО и домашний адрес) получателя, а также сведения о дате и времени доставки груза. И тут меня передернуло — доставку мы часто заказывали на имя супруги (ее ФИО и были указаны на сайте), поскольку она работает ближе к офису компании и забрать посылку ей обычно проще. А номер телефона был указан мой, поскольку заказываю товар у отправителя я. При этом я только сейчас обратил внимание, что совершение каких-либо действий для того, чтобы залогиниться (т.е. подтвердить свою личность), с моей стороны не требовалось вообще. Просто прошел по ссылке и вуаля! Удобно, казалось бы.

Данное обстоятельство позволило мне предположить, что любой человек, пройдя по моей ссылке, может увидеть информацию о моем отправлении (а заодно и персональные данные, а именно: номер телефона, ФИО и домашний адрес). Само по себе данное обстоятельство уже не особо приятное. В то же время, слово «hash» в адресе дало мне надежду на то, что следующая за ним последовательность — результат некой хэш-функции, и подобрать последовательность таким образом, чтобы попасть в чей-то личный кабинет, будет затруднительно. Чтобы проверить данное предположение, я изменил последний символ в последовательности (цифру) и попал в чужой личный кабинет, где мне были доступны чужие персональные данные, а при входе логином автоматически послужил чужой номер телефона. Поверхностно пробежавшись по «соседним» личным кабинетам, я понял, что последовательность символов, следующая за "?hash=" — это не результат хэш-функции, а некий код, выдающийся по порядку каждому клиенту по каждому отдельному отправлению. Замена иных символов в последовательности — шестнадцатеричных цифр на предыдущие или последующие позволила мне попасть без какой-либо авторизации в чужие личные кабинеты, что давало доступ к сведениям о номере телефона, фио получателя и его адресе (часто — домашнем).

Так я с ужасом понял, что компания хранит персональные данные своих клиентов (а заодно и наши с супругой) в открытом виде на страницах, доступных любому лицу, имеющему доступ к их официальному сайту. Для доступа к персональным данным клиентов компании по всей стране достаточно пропарсить страницы личных кабинетов, подставляя методом перебора значения последовательности, следующей за "/?hash=" в url. Причем абсолютно никакой защитой от скрапинга сайт не располагал. Спешно набросанный на коленке краулер безо всяких проксей в 20 потоков буквально за пару минут собрал несколько сотен живых записей, после чего я его выключил. Нет, IP не забанили. Это была бомба. Справедливости ради надо сказать, что так можно было собрать данные не всех клиентов, а только тех, кто находится, так сказать, в «активной фазе получения груза». До момента поступления груза в какой-то из ближайших сортировочных центров и почти сразу после его получения доступ в кабинет управления доставкой закрыт, но телефон и номер накладной все еще светились в форме авторизации (т.е. базу живых номеров собрать все-таки было можно).

Таким образом, избранный компанией способ хранения персональных данных клиентов обеспечивал неконтролируемое раскрытие этих данных третьим лицам, что являлось грубейшим нарушением требований статей 7 и 19 Федерального закона от 27.07.2006 №152-ФЗ «О персональных данных». С одной стороны, очень-очень сильно хотелось пожаловаться в Роспотребнадзор, с другой же стороны я понимал, что для компании создание сайта направление не профильное (а сайт, судя по копирайтам, они сделали сами), а службы ИБ в ее штате вообще могло и не быть. Поэтому (чтобы писать от себя) я выждал пару дней, пока придет груз уже на мое имя, убедился, что все по-прежнему работает, и изложил им обнаруженную мной проблему, честно указав, что намерен написать о ней сразу по закрытии уязвимости или через две недели с момента обращения (что наступит раньше). В ответ я получил дежурную благодарность и обещание передать информацию руководству и моему менеджеру.

Сколько эта брешь просуществовала на сайте можно только гадать, но я уверен, что она вовсю эксплуатировалась заинтересованными лицами. На сегодня (спустя почти три недели) брешь, вроде бы, закрыта. В прочем, со мной представитель компании не связывались.

|

Метки: author iSergios информационная безопасность персональные данные авторизация без паролей хранение информации |

Про Agile, Scrum и командную работу. Как устроены процессы развития продуктов в Альфа-Лаборатории |

Негибкий “Энтерпрайз” и гибкие методологии

Существует устоявшееся мнение, что IT-специалист в крупных компаниях — это маленький “винтик” в огромном механизме, призванный выполнять какую-то конкретную функцию. А механизм, в свою очередь, беспощадно эксплуатирует ресурс своих “винтиков”.

Однако мы (в Альфа-Банке в целом и в Альфа-Лаборатории в частности) придерживаемся иного подхода. Подхода, когда усилия всех участников процесса направлены на создание ценности для клиента, при этом путь, которым они этого достигают, может содержать очень много степеней свободы.

Я расскажу, как у нас в Лаборатории выстраиваются процессы работы. Мы опираемся на концепцию Agile. В качестве основного фреймворка мы выбрали Scrum, модель производства — командно-центричная.

Составы команд варьируются в зависимости от потребностей создаваемого продукта, но практически всегда это “полный стек”, необходимый для доработки или разработки продукта. Чаще всего это Product Owner (PO), скрам-мастер, дизайнер, системный аналитик, несколько разработчиков и тестировщик. Набирается 7 — 10 человек. Всего в Лабе таких команд порядка 30.

Наши принципы

В нашей работе мы стараемся придерживаться ряда принципов, которые помогают нам достигать большей эффективности. Расскажу о них подробнее.

Кросс-функциональность и взаимовыручка

Одна из самых важных вещей в командной работе — это внутрикомандное взаимодействие.

Мы в командах не ставим задачи вроде “разработчик — пишет код”, “аналитик — готовит документацию” и т.д.

Общая цель команды — чтобы клиент получал ценность. И если, например, у нас накопилась очередь в тестировании, то остальные ребята помогают своему тестировщику, чтобы команда выполнила цели спринта и по его итогам привнесла инкремент продукта.

В Scrum-гайде это называется “кросс-функциональная команда”.

Никаких заказчиков и исполнителей

Большинство команд сидят вместе, группами, в одной локации, и продуктологи являются частью команды.

PO проводит с ребятами каждый день — с утра до вечера, он знает, чем живет и дышит его команда, что она делает сегодня и чем займется завтра.

Соответственно, и в проработке бэклога задействована вся команда. У нас нет такого, что PO в качестве заказчика “загружает” в команду требования, а затем просто ожидает результата.

Продуктологи приходят к команде с клиентской проблемой (иногда бывает, что и сразу с решением). Далее все члены команды участвуют в проработке проблемы, формировании гипотез, поиске решений — они вместе делают “story map”, формируют пользовательские истории, обсуждают сценарии, решают, как будет выглядеть продукт.

При этом члены команды имеют полное право выносить на обсуждение свои идеи по улучшению продукта.

К примеру, я как руководитель аналитиков и скрам-мастеров никогда не даю им директивных указаний. Что делать, команда определяет сама совместно со своим PO.

Главная ценность всего этого в том, что все участники команды вовлечены в процесс создания продукта и чувствуют гораздо большую ответственность за то, что они сделали.

Итеративность

Как и положено, работа строится итерациями. Команды сами определяют длину своего спринта, но обычно это 1 или 2 недели, поскольку нам критически важно получать обратную связь от клиента как можно быстрее и чаще.

Прозрачность

Мы стремимся быть максимально прозрачными — внутри команд, для продуктолога, для стейкхолдеров.

В качестве “градусника” мы используем burndown-диаграмму спринтов команды. Burndown достаточно оперативно отражает возникающие в процессе работы проблемы (если график “плоский”), и мы можем своевременно реагировать на эти проблемы.

Кроме того, по совокупности графиков нескольких спринтов можно оценить общее положение дел в команде.

Очень удобно то, что все наши команды используют Jira в качестве таск-менеджера — воспользовавшись этим, мы настроили общий дашборд, на котором видны все 30 burndown-диаграмм. Можно сказать, что это наш Центр Управления Полётами :)

Не надо стесняться

В продолжение темы прозрачности поговорим о важном для нас мероприятии — демонстрации итогов.

В конце итерации (раз в одну или две недели) в каждой команде проводится Sprint Review — ребята показывают и рассказывают, что они сделали за спринт.

Состав приглашенных на “демо” определяется по усмотрению команды — они могут как пригласить реальных пользователей, так и ограничиться демонстрацией коллегам и своему PO.

Помимо регулярных командных sprint review раз в месяц проходит общий Демо-день, на котором все команды демонстрируют, какую ценность они донесли до клиентов за прошедший месяц.

На Демо-день мы также периодически приглашаем “живых” клиентов, стейкхолдеров из банка и вообще всех интересующихся и неравнодушных, чтобы получить их обратную связь.

Система поощрений

Помимо комфортного офиса, интересных задач, крутой команды и стандартных “белая зарплата + ДМС”, у нас существует система мотивации сотрудников.

Мотивация как финансовая — в виде премии для тех, кто показывает отличные результаты в работе, является лидером улучшений и помогает коллегам, так и нефинансовая.

Например, конкурс «Лучшие из лучших», который проводится раз в квартал.

Любой сотрудник Лаборатории может отметить успехи своего коллеги и номинировать на участие в “Лучших из лучших”.

Победителей конкурса мы награждаем на глазах у всей Лаборатории. При этом мы не вручаем деньги, а стараемся узнать об увлечениях победителей и подарить что-то по-настоящему ценное для них.

Кто на новенького

Немало внимания мы уделяем поиску и подбору людей.

Безусловно, кандидаты должны иметь техническое образование, но не менее важными критериями отбора для нас являются умение работать в команде, увлеченность тем, что делаешь, желание развиваться и улучшаться.

Человеческие качества кандидата, подходит ли он нам по духу — это те вещи, на которые мы обращаем внимание на собеседованиях.

Для того чтобы вновь присоединившиеся к нашей команде ребята освоились в новой обстановке, в новых условиях, мы организовали такую вещь как “институт наставничества”.

Суть его в том, что за новичком закрепляется наставник — это не руководитель, а коллега, у которого достаточно для этого опыта. Задача наставника — помочь максимально быстро адаптироваться в коллективе, понять устройство Лабы, наши правила и принципы, а также решить все технические и организационные моменты.

Также на плечи наставника ложится задача ввести человека в предметную область.

Первые 2-3 дня это происходит в режиме повествования от наставника, а затем начинается парная работа. Новичок присоединяется к одной из команд и продолжает своё обучение уже на практике, выполняя реальные бизнес-задачи.

В общем, мы делаем все, чтобы вновь прибывшие ребята как можно раньше начали приносить ценность команде, клиентам и банку.

В начале испытательного срока “новобранец” и его наставник формируют “План на 100 дней”, в котором они совместно определяют цели на ближайшие три месяца и договариваются о метриках успешности испытательного срока.

Хотя на самом деле, обычно уже через месяц становится понятно — подходит нам человек или нет, поскольку прогресс, готовность меняться, вовлеченность и тяга к улучшениям проявляются достаточно быстро.

Думаю, наше особое внимание к именно этим критериям помогло нам собрать такую крутую команду, работать в которой — всегда в радость и с удовольствием!

Если вы разделяете подобный подход к работе и хотели бы стать частью команды — обратите внимание на наши текущие вакансии — дизайнер интерфейсов, Scrum master, iOS-разработчик и многие другие.

|

|

Red Architecture — красная кнопка помощи для сложных и запутанных систем — часть 2 (пример с миллиардом ячеек) |

По следам свежих комментариев к первой части рассмотрим законченный пример, демонстрирующий применение Red Architecture для решения нетривиальной задачи.

У нас есть клиетское приложение — редактор таблиц, в нём отображается лист таблицы. Экран у пользователя настолько большой, что на нём помещается 1 000 000 000 (один миллиард) табличных ячеек. Всё усложняется тем, что наш табличный редактор подключен к облаку для возможности совместного редактирования таблицы, поэтому изменения в любой из одного миллиарда ячеек “где-то в облаке” должны быть сразу же отображены нашему пользователю.

Паттерн Red Architecture позволяет реализовать данную функцию просто и с высокой производительностью.

Прежде всего, нам нужно немного усовершенствовать класс v

Вариант, когда каждая из миллиарда ячеек проверяет каждое полученное событие на соответствие самой себе — не подходит. Миллиард вызовов функций-обработчиков + миллиард сравнений guid’ов при каждом изменении какой-то одной ячейки — это слишком даже для высокопроизводительных пользовательских устройств.

Рассмотрим решение этой проблемы

Теперь ключи (идентифицирующие логические цепочки) в классе v будут не элементами перечисления, а строками. Для краткости и лёгкого восприятия будем писать в псевдокоде:

class v {

// value got from this format string will look like OnCellUpdateForList_List1_Cell_D9

public const string KeyOnCellUpdate = “OnCellUpdateForList_%s_Cell_%s”;

}

Мы объявляем ключ, который по факту является форматной строкой, для чего? Дело в том, что ячейка в любом случае должна быть некоторым образом идентифицирована на табличном листе. Мы предполагаем, что информация об обновлении ячейки, пришедшая “из облака”, содержит данные идентифицирующие ячейку (иначе как мы её найдём в листе чтобы проапдейтить?), такие как имя листа (List1) и адрес ячейки (D9). Также мы предполагаем, что каждая ячейка, отображённая на экране пользователя, тоже “знает” путь к себе, а именно те же имя листа и свой адрес (иначе как она оповестит систему о том, что изменения произошли именно в ней, а не в какой-то другой ячейке?)

Далее, нам нужно добавить ещё один аргумент в метод h(). Теперь обработчики подписываются не на все ключи которые есть в системе, а на конкретный ключ, который передаётся первым аргументом:

class v {

// for instance, OnCellUpdateForList_List1_Cell_D9

public const string KeyOnCellUpdate = “OnCellUpdateForList_%s_Cell_%s”;

private var handlers = new HashMap >();

void h(string Key, HandlerMethod h) {

handlers[Key] += h;

}

void Add(string Key, data d) {

for_each(handler in handlers[Key]) {

handler(Key, d);

}

}

}

Для хранения обработчиков мы используем приватную коллекцию типа HashMap, содержащую пары “один ко многим” — один ключ, на который могут подписаться один и более обработчиков; а в методе Add(), “рассылающем” события по подписчикам, мы используем только функции-обработчики подписанные на данный ключ. Для контейнера с потенциальным миллиардом элементов стоит подыскать подходящую для такого объёма данных реализацию, поэтому мы используем HashMap — коллекцию, которая неявно конвертирует строковые ключи в числовые хеш значения. В случае с миллиардом элементов, HashMap позволит нам найти нужный элемент бинарным поиском за не более чем 30 операций сравнения чисел. Такая задача даже на низкопроизводительном оборудовании будет выполнена почти мгновенно.

Вот и всё! На этом изменения “инфраструктуры” Red Architecutre, а именно класса v, закончены. И теперь мы можем приступить к рассмотрению логики приёма и отображения апдейта ячейки.

Для начала нам нужно зарегистрировать ячейку для приёма апдейта. Код регистрации ячейки представлен в методе OnAppear():

class TableCellView {

// List and Address are components of identifier for this cell in system (i.e. GUID consisting of two strings)

private const string List;

private const string Address;

handler void OnEvent(string key, object data) {

string thisCellUpdateKey = string.Format( /* format string */ v.OnCellUpdate, /* arguments for format string */ this.List, this.Address);

if(key == thisCellUpdateKey)

// update content of this cell

this.CellContent = data.Content;

}

// constructor

TableCellView(string list, string address) {

this.List = list;

this.Address = address;

}

// cell appears on user’s screen - register it for receiving events

void OnAppear() {

string thisCellUpdateKey = string.Format( /* format string */ v.OnCellUpdate, /* arguments for format string */ this.List, this.Address);

v.Add(thisCellUpdateKey, OnEvent);

}

// don't forget to "switch off" the cell from receiving events when cell goes out of user's screen

void OnDisappear() {

string thisCellUpdateKey = string.Format( /* format string */ v.OnCellUpdate, /* arguments for format string */ this.List, this.Address);

v.m(thisCellUpdateKey, OnEvent);

}

}

При появлении ячейки на экране в методе OnAppear() мы “регистрируем” её для получения событий с уникальным ключом thisCellUpdateKey, который формируется в конструкторе объекта и является производным от форматной строки-ключа v.OnCellUpdate, и который позволяет позже передать данные именно этой ячейке, не вызывая функции обработчики у других ячеек.

А в методе обработчика OnEvent() мы проверяем ключ на соответствие текущей ячейке (на самом деле, в случае с OnCellUpdate эта проверка не обязательна, но поскольку в обработчике мы можем обрабатывать более одного ключа — всё же желательна) и в случае соответствия пришедшего ключа ключу текущей ячейки апдейтим отображаемые данные this.CellContent = data.Content;

Теперь рассмотрим логику получения и передачи данных ячейке

Допустим, информация об апдейте ячейки к нам приходит из “облака” через сокет. В этом случае логика приёма и передачи данных в ячейку может выглядеть следующим образом:

class SomeObjectWorkingWithSocket {

void socket.OnData(data) {

if(data.Action == SocketActions.UpdateCell) {

string cellKey = string.Format( /* format string */ v.OnCellUpdate, /* arguments for format string */ data.List, data.Address);

v.Add(cellKey, data);

// This call for objects which process updates for any of the cells, for instance, caching data objects

v.Add(v.OnCellUpdate, data);

}

}

}

Таким образом, мы всего одним вызовом (не считая логики внутри класса v, которая не относится к какой-либо конкретной логической цепочке) передали данные из места их получения — в место их использования — в одну конкретную ячейку из миллиарда. Во всей логической цепочке всего несколько строк кода, и один ключ OnCellUpdate, по которому находится весь код связанный с этой функцией.

Представим, что к нам в команду приходит новый разработчик, первая задача для него — некоторым образом анимировать апдейт ячейки, или, например, при апдейте ячейки выводить не только новые данные, но и дату/время изменения.

Чтобы понять насколько это будет тяжело для него, попробуем ответить на несколько вопросов:

- Сколько времени займёт поиск кода, который нужно «патчить» для решения этой задачи? — Весь связанный код найдётся моментально, главное сказать разработчику, чтобы он поискал по коду v.OnCellUpdate.

- Сколько времени такая задача займёт у нового человека в нашем случае? — Если удаётся обойтись уже существующим API для решения вопросов отображения и анимации, то 1-2 дня точно хватит.

- Сколько шансов у нового разработчика сделать что-то не так? — Мало: код простой, разобраться в нём несложно.

Схематично цепочка передачи данных по ключу v.OnCellUpdate выглядит следующим образом