Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

JetBrains MPS для интересующихся #1 |

Введение

Спасибо всем за критику в комменте под первым постом, где я хотел попробовать написать про MPS, не затрагивая важные темы, чтобы можно было потом более качественно начать писать по порядку.

Зачем нам нужен язык Weather?

В комментариях к 1 посту было следующее высказывание

С этой точки зрения, DSL — это как фреймворк, только с более удобным интерфейсом. Ясное дело, под один проект фреймворк делать никто не будет, за исключением совсем уж монструозных случаев. А сделать его под конкретную предметную область — почему бы и нет?..

В принципе, так оно все и работает. Хорошие языки похожи по сути на хорошие фреймворки: они позволяют писать что-то важное, не заморачиваясь о том, что мы не хотим писать. По ходу повествования я буду периодически обращаться к другим языкам для аналогий и сравнений.

Синтаксис

Язык Weather, который мы хотим реализовать, должен выполнять следующую задачу: мы должны уметь лаконично выражать условия (погода сегодня, например) и следствия (погода завтра, послезавтра...).

В языке Weather мы будем делать наши прогнозы отталкиваясь от 1 фактора: от температуры на сегодняшний день(массив объектов время + погодные условия).

const weatherInput = [

{

time: 1501179579253,

temperature: {

unit: "celsius",

value: 23.7

}

},

{

time: 1501185944759,

temperature: {

unit: "fahrenheit",

value: 15.3

}

}

]Думаю сойдет.

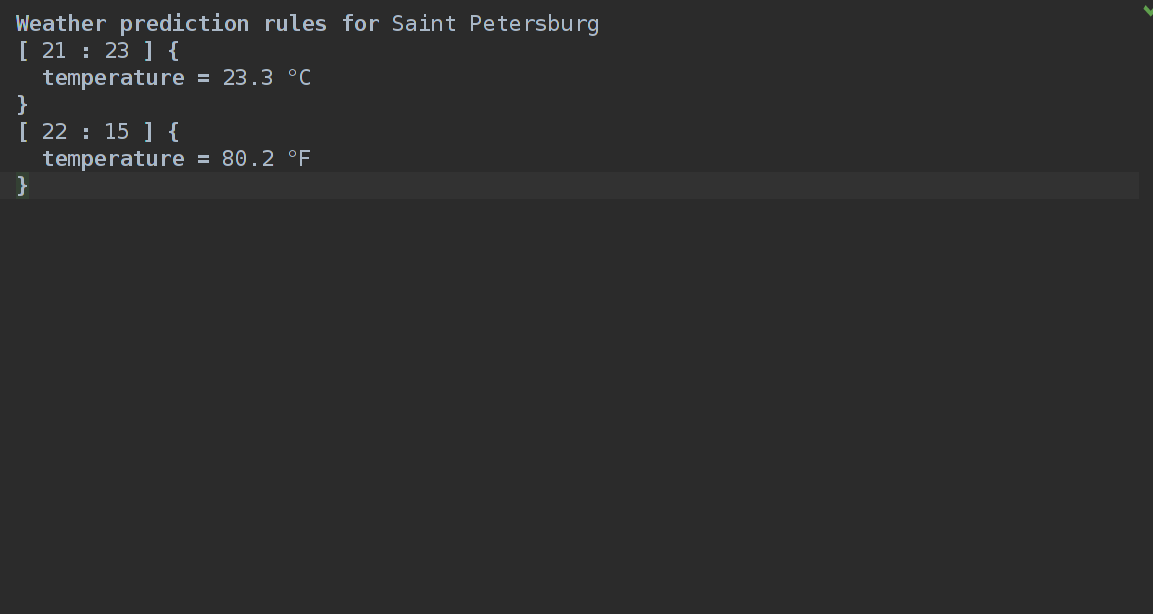

Weather prediction rules for Saint Petersburg

data Today:

[21:23]{

temperature = 23.7 °C

}

[23:06]{

temperature = 15.3 °F

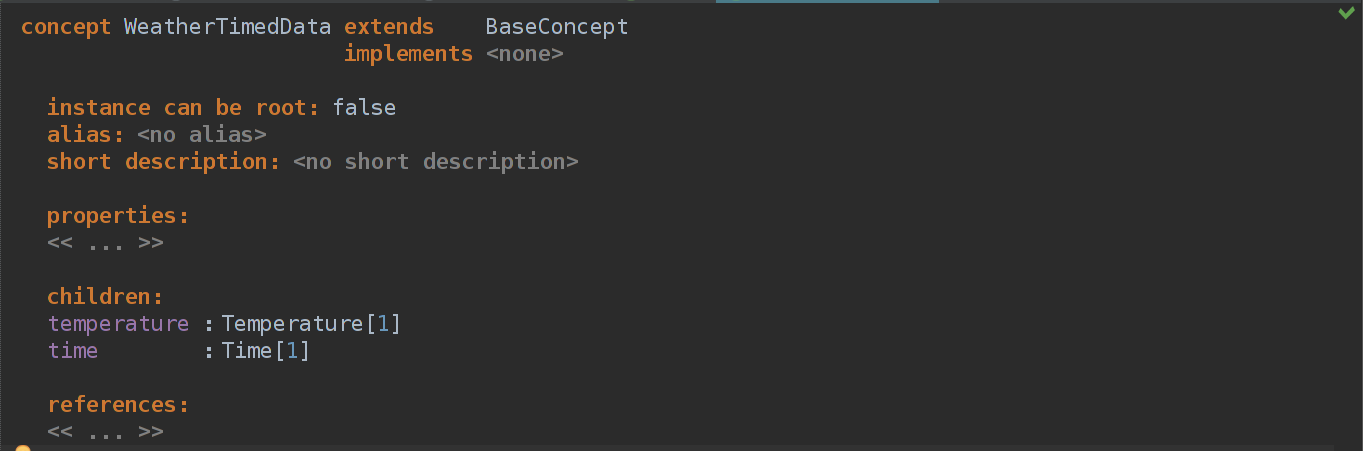

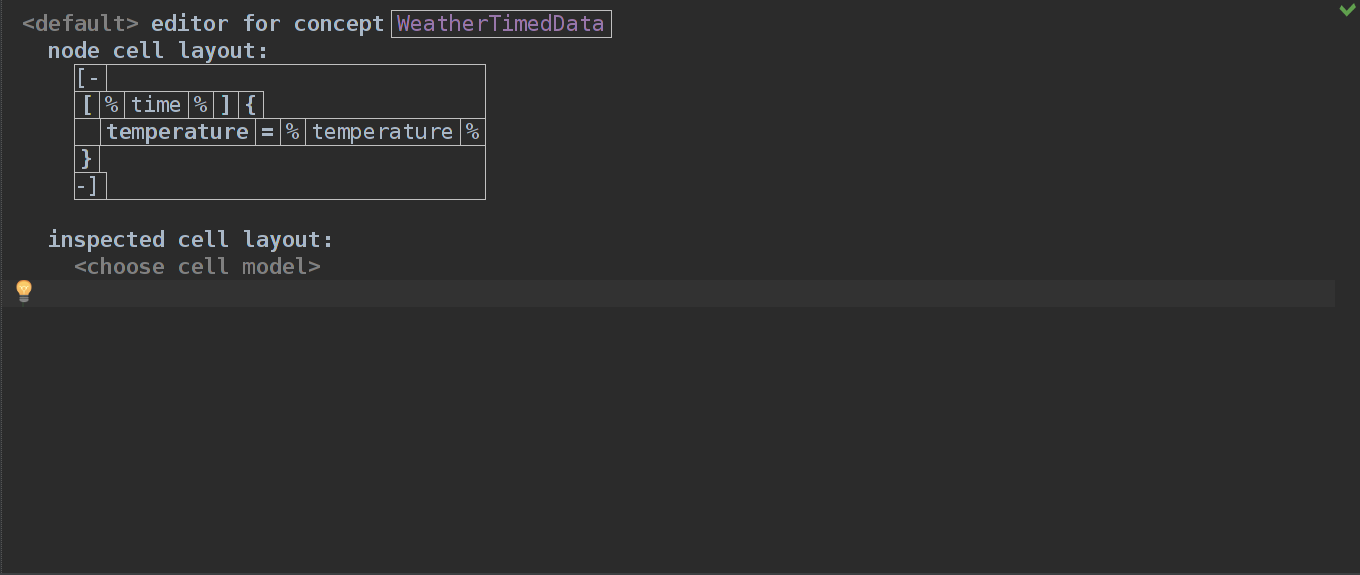

}У нас очень простые данные — время + температура в единицах измерения. Создадим абстрактный концепт WeatherTimedData — он нам нужен для хранения времени измерения и самой температуры.

Теперь нужно определить, что такое Temperature и Time.

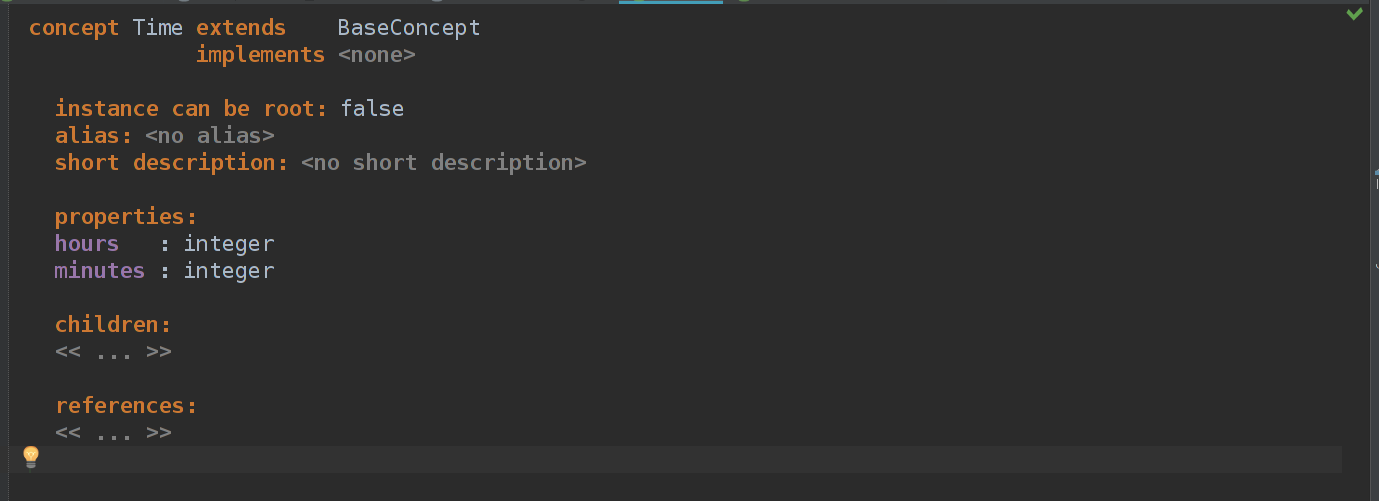

Time реализован очень просто — у нас есть время в часах и минутах, а отображается оно как hh : mm.

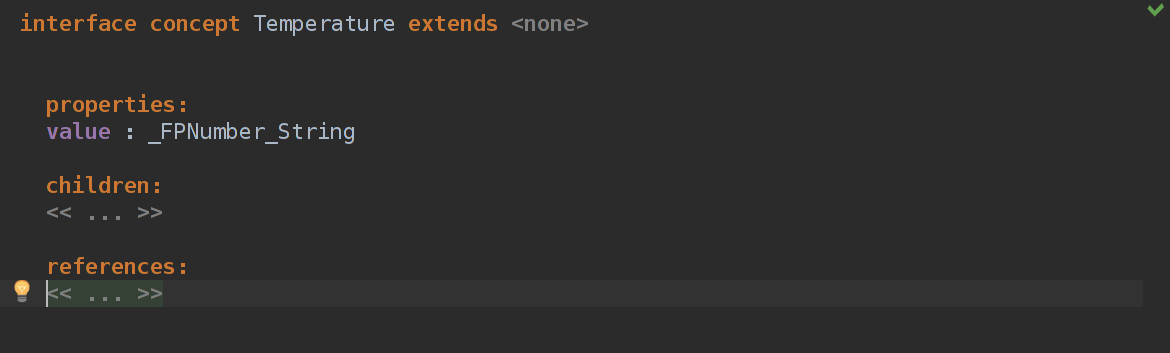

Если с Time все понятно, то с Temperature немного нет. Во-первых — value это какой-то _FPNumber_String. На самом деле это MPS'овский double, так что ничего страшного. Но вопрос — как из интерфейса Temperature сделать реализации температуры в разных единицах измерения, да так чтобы это еще и красиво было? И вообще, что такое интерфейс концепт?

У таких концептов не может быть реализации в AST. То есть, вообще никакой. Только если другой концепт расширяет его, и никак иначе. Делается это, как и в ООП, для того, чтобы обобщить несколько классов под одно общее начало.

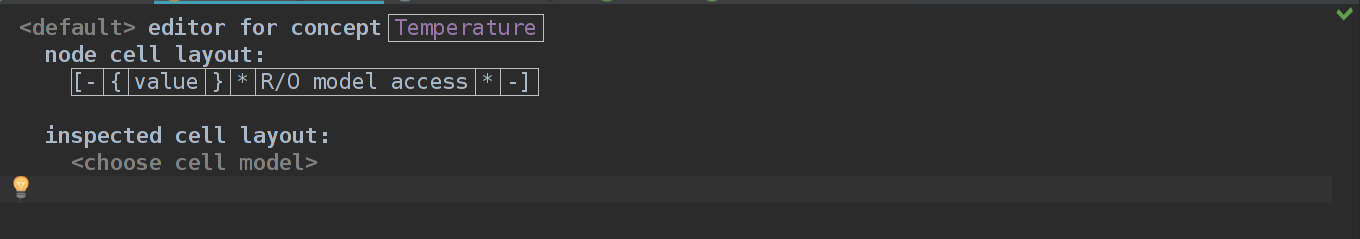

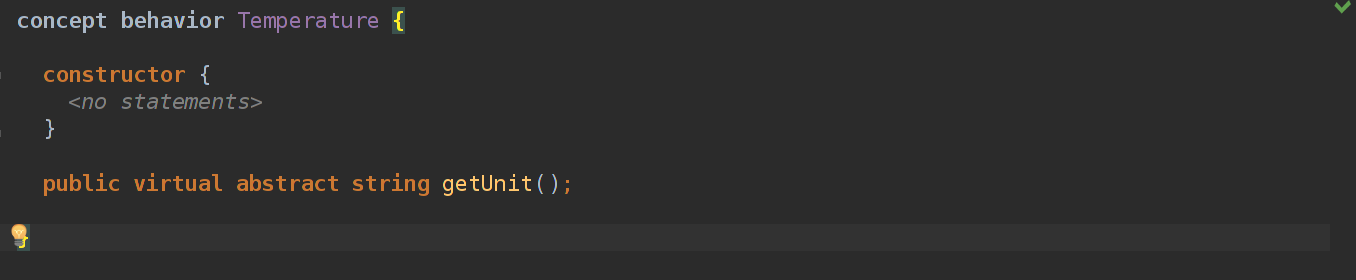

Вот как я реализовал отображение в редакторе для Temperature:

Здесь у нас первая ячейка — double значение, величина температуры, а вторая — Read-Only model access. Здесь мы немного отдаляемся от практики и переходим к теории.

Теория

В MPS все строится на концептах, если проводить прямую параллель с ООП, то концепты — это классы. Они могут расширять другие концепты, реализовывать интерфейсы, но еще они могут иметь какую-то логику. Например, если мы описываем абстрактный класс температуры, то нужно предусмотреть возможность задания собственных единиц измерения.

abstract class Temperature{

abstract double value;

public abstract String getUnit();

override String toString(){

return value + this.getUnit();

}

}Можно было бы задать unit как переменную, а не писать абстрактный метод, но…

Есть аспект, называется Behavior. Все, что он может делать — добавлять новые методы к концепту. То есть добавить переменную мы не можем, поэтому будем использовать абстрактный метод.

И вот после этого мы можем у каждой реализации концепта Temperature вызывать этот метод. Но где же его вызывать? Как вообще кодить в этом MPS?..

Снова практика

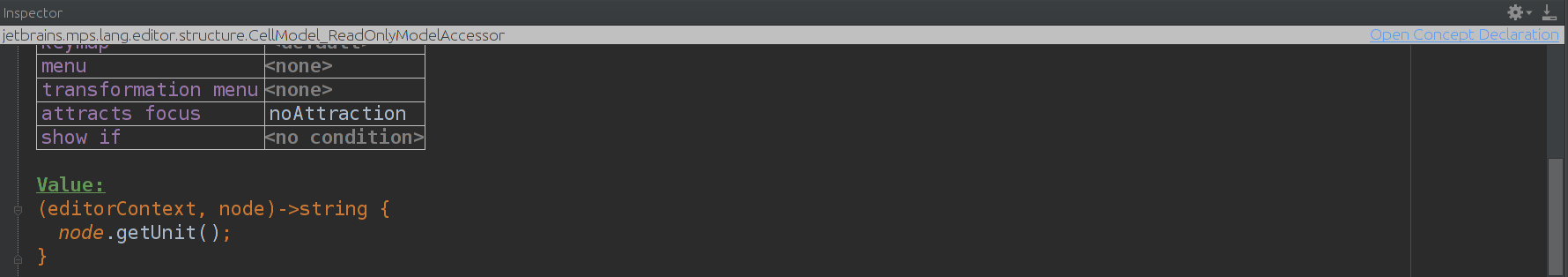

Мы остановились на том, что у нас есть непонятная ячейка в Editor аспекте — ReadOnly model access. Все очень просто — если нужно как-то логически обработать proeprty/children/reference перед тем, как его показывать, и на это не хватает встроенных приколов, то мы можем сами получить нужную строку из контекста редактора и реализации концепта. Если просто — нам дают текущий объект концепта, то есть реализованный, и мы можем из него получить все, что мы там понапихали. В данном случае мы хотим получить единицу измерения, поэтому мы нажимаем на ячейку R/O model access и пишем

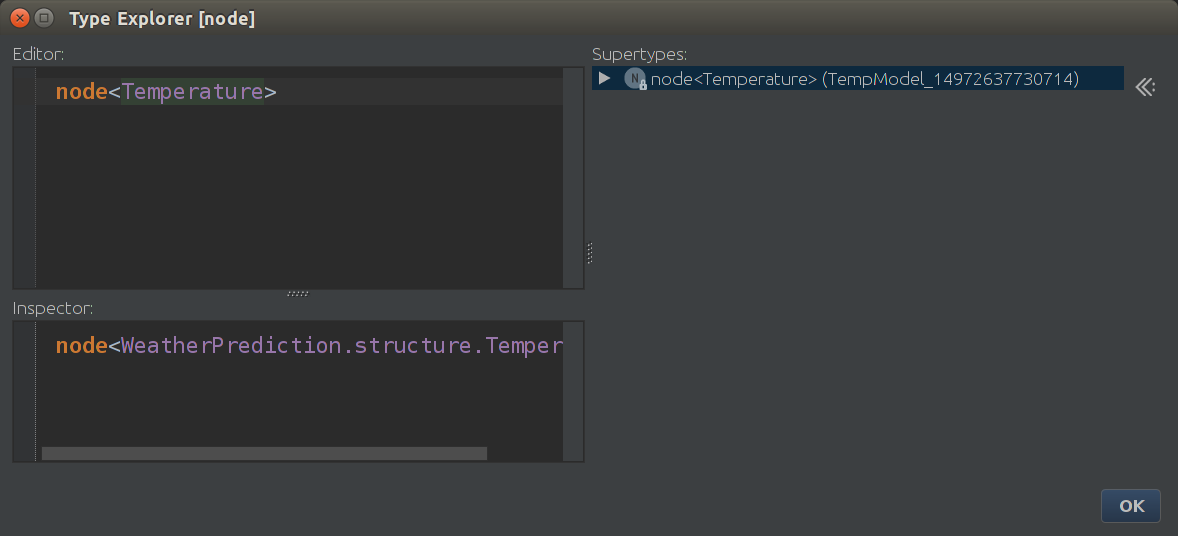

Кстати, в любом месте кода вы можете тыкнуть на штучку, что Вас интересует и нажать Ctrl + Shift + Enter и получить информацию о типе этой штучки. Например, если мы нажмем на node в скрине выше и узнаем его тип, то мы получим

node<Название Концепта> = какая-то реализация концепта

concept<Название Концепта> = класс концепта

Так! Мы уже умеем составлять температуру по значению и единице измерения, но откуда мы возьмем, какая единица измерения нам нужна? Из дочерних реализаций, естественно.

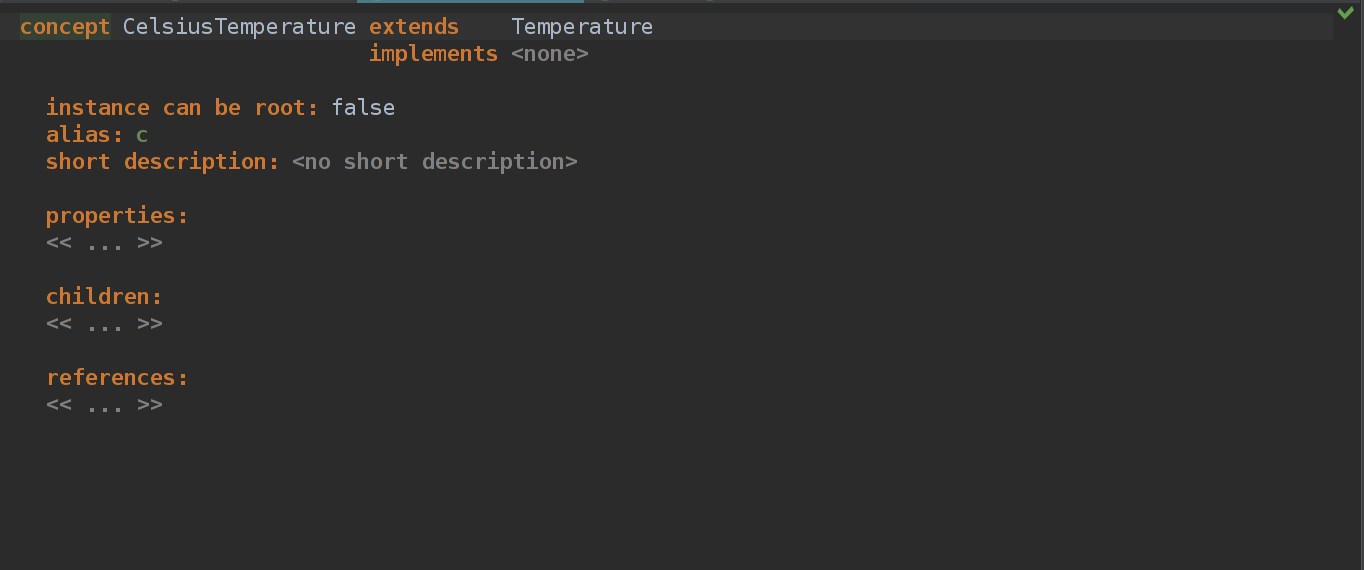

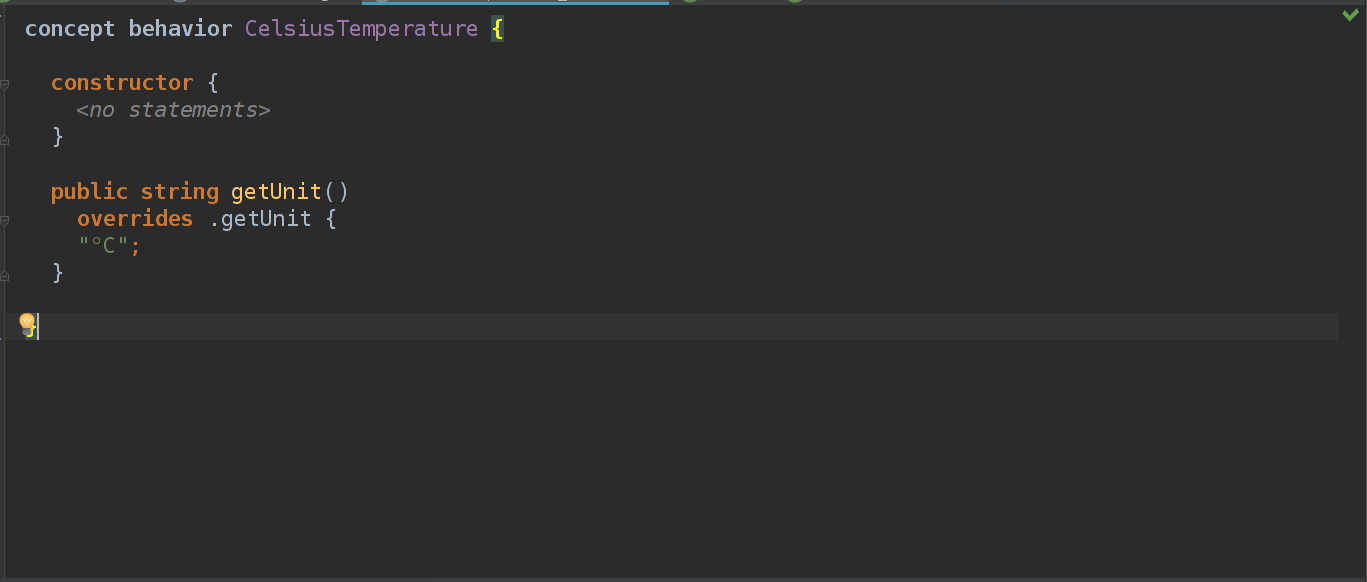

Создаем пустой CelsiusTemperature концепт, расширяем Temperature и создаем для него behavior.

Как видно на последнем скрине, мы переопределяем метод getUnit(он имеется в зоне видимости из-за того, что мы наследовали концепт от Temperature) и возвраещем "°C". Все просто!

Остается только собрать все вместе в WeatherTimedData:

Собираем язык и смотрим на результат:

Вроде похоже на правду. Еще, конечно, нет самих предсказаний погоды, нет подсветки, к тому же часы у нас могут быть больше 24 и меньше нуля, минуты тоже не ограничены ничем, кроме размерности integer… В следующем посте ждите разъяснений по новому аспекту — constraints и еще чего-нибудь. А пока — пишите фидбек в комментариях, все как всегда, если вопрос простой — отвечаю там же, если он обширен и скорее как пожелание — то я постараюсь с каждым постом писать все качественнее. Спасибо за внимание!

|

Метки: author enchantinggg программирование java jetbrains mps language design language model javascript |

Перевод книги Appium Essentials. Глава 6 |

- Глава 1, в которой мы разбираемся, что тут и как

- Глава 2 про установку и настройку всего необходимого для работы

- Глава 3, где мы изучаем, что такое Appium GUI

- Глава 4 о том, как можно локализовать элементы в мобильном приложении

- Глава 5, где мы, наконец-то автоматизируем приложения, но пока только на эмуляторах

В этой главе:

- Автоматизируем набор номера на устройстве Android

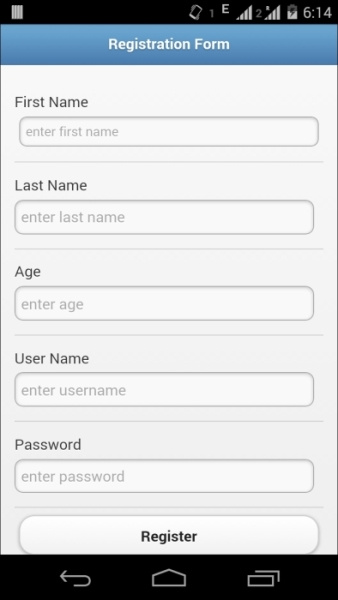

- Автоматизируем форму регистрации на Android

- Используя Chrome, залогинимся на Gmail

- iOS. Автоматизируем Body Mass Index (BMI)

- Автоматизация гибридных приложений на устройствах iOS

- iOS. Автоматизация веб-приложений

Перед стартом

Перед началом работы, еще раз убедимся, что все настроено:

| Требования для Android | Требования для iOS |

| Java (версии 7 и выше) | Mac OS (версии 10.7 и выше) |

| Android SDK API, версии 17 и выше | Xcode (версии 4.6.3 и выше; рекомендуется 5.1) |

| Устройство с Android | Профиль iOS [эти и другие непонятные слова объясняются ниже] |

| Браузер Chrome на устройстве | Устройство iOS |

| Eclipse [или Idea] | Приложение SafariLauncher |

| TestNG | ios-webkit-debug-proxy |

| Appium сервер | Java (версии 7 и выше) |

| Клиентская библиотека Appium (у нас все еще Java) | Eclipse [или Idea] |

| Selenium Server и Java-библиотека WebDriver | TestNG |

| Приложение Apk Info app | Selenium Server и Java-библиотека WebDriver |

| Appium сервер | |

| Клиентская библиотека Appium (у нас все еще Java) |

Убедитесь, что на устройстве Android включен режим разработчика и разрешена отладка оп USB.

Чтобы проверить, что девайс подключен, введите в командную строку

adb devicesВы получите список Android-устройств. Если нет, попробуйте перезапустить adb-сервер:

adb kill-server

adb start-server

Desired capabilities для Android для нативных и гибридных приложений

В главе 1 мы обсудили, какие есть опции и зачем они. Так что здесь, перейдем сразу к коду.

Сначала, импортируем пакеты:

import java.io.File;

import org.openqa.selenium.remote.DesiredCapabilities;

import io.appium.java_client.remote.MobileCapabilityType;

Теперь DC:

DesiredCapabilities caps = new DesiredCapabilities();

File app=new File("path of the apk");//чтобы определить путь до apk

caps.setCapability(MobileCapabilityType.APP,app);//если приложение уже установлено, эти две опции не нужны

caps.setCapability(MobileCapabilityType.PLATFORM_VERSION, "4.4");//версия Android

caps.setCapability(MobileCapabilityType.PLATFORM_NAME, "Android");//Имя OS

caps.setCapability(MobileCapabilityType.DEVICE_NAME, "Moto X");//здесь указывается имя устройства

caps.setCapability(MobileCapabilityType.APP_PACKAGE, "имя пакета вашего приложения(можете получить его, используя apk info app)");

caps.setCapability(MobileCapabilityType.APP_ACTIVITY, "активити, которую нужно будет запустить (получить так же через apk info app)");

Desired capabilities для Android для веб-приложений

При работе с веб-приложениями, некоторые опции, указанные выше, нам не понадобятся: APP, APP PACKAGE и APP ACTIVITY, поскольку мы работаем с браузером.

Сперва, импортируем пакеты:

import java.io.File;

import org.openqa.selenium.remote.DesiredCapabilities;

import io.appium.java_client.remote.MobileCapabilityType;

Теперь DC:

DesiredCapabilities caps = new DesiredCapabilities();

caps.setCapability(MobileCapabilityType.PLATFORM_VERSION, "4.4");//версия Android

caps.setCapability(MobileCapabilityType.PLATFORM_NAME, "Android");//Имя OS

caps.setCapability(MobileCapabilityType.DEVICE_NAME, "Moto X");//здесь указывается имя устройства

caps.setCapability(MobileCapabilityType.BROWSER_NAME, "Chrome"); //чтобы запустить Chrome

Мы закончили с конфигурацией, теперь можно инициализировать драйвер.

Импорт:

import io.appium.java_client.android.AndroidDriver;

import java.net.URL;

Инициализация:

AndroidDriver driver = new AndroidDriver (new URL("http://127.0.0.1:4723/wd/hub"), caps);//указываем адрес, где запущен Appium-сервер

Все готово для работы с устройством Android.

Разбираемся с provisional profile, SafariLauncher и ios-webkit-debug-proxy

Прежде чем настраивать драйвер для iOS, нужно выполнить несколько шагов.

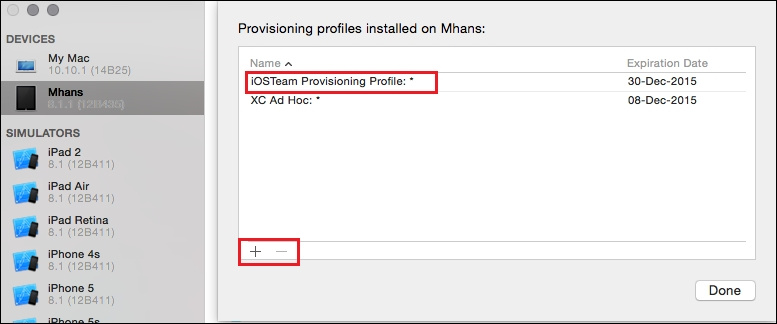

Provisional profile

Профиль нужен для того, чтобы ставить свои приложения на устройства iOS. Для этого нужно присоединиться к программе iOS Developer Program

После регистрации, посетите эту страницу, чтобы сгенерировать профиль.

Этот профиль нужно будет установить и на девайс:

- Скачайте сгенерированный профиль

- Подключите iOS устройство к Mac

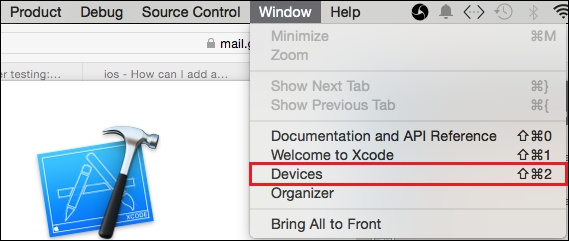

- Откройте Xcode (версии 6) и перейдите в меню Window -> Devices

- Вызовите контекстное меню для подключенного устройства и кликните на Show Provisional Profiles…

- Нажмите +, выберите скаченный профиль, нажмите Done

Приложение SafariLauncher и ios-webkit-debug-proxy

SafariLauncher используется для запуска браузера Safari на устройстве. Нужно собрать и задеплоить SafariLauncher на устройство iOS, чтобы работать с браузером Safari:

- Скачайте исходники

- Запустите Xcode и откройте проект SafariLauncher

- Выберите устройство для деплоя и нажмите кнопку build

- Затем нужно будет заменить SafariLauncher в Appium.dmg; для этого необходимо:

- Вызвать контекстное меню для Appium.dmg

- Кликнуть на Show Package Contents и перейти в Contents/Resources/node_modules/appium/build/SafariLauncher

- Разархивировать SafariLauncher.zip

- Перейти в submodules/SafariLauncher/build/Release-iphoneos и замените приложение SafariLauncher своим.

- Заархивируйте submodules и переименуйте в SafariLauncher.zip

Теперь нужно поставить ios-webkit-debug-proxy на Mac, чтобы установить соединение и получить доступ к web-view. Чтобы поставить прокси, можете использовать brew и выполнить команду

brew install ios-webkit-debug-proxyDesired capabilities для iOS для нативных и гибридных приложений

В главе 1 мы обсудили, какие есть опции и зачем они. Так что здесь, перейдем сразу к коду.

Сначала, импортируем пакеты:

import java.io.File;

import org.openqa.selenium.remote.DesiredCapabilities;

import io.appium.java_client.remote.MobileCapabilityType;

Теперь DC:

DesiredCapabilities caps = new DesiredCapabilities();

File app=new File("path of the .app");

caps.setCapability(MobileCapabilityType.APP,app);

caps.setCapability(MobileCapabilityType.PLATFORM_VERSION, "8.1");

caps.setCapability(MobileCapabilityType.PLATFORM_NAME, "iOS");//

caps.setCapability(MobileCapabilityType.DEVICE_NAME, "iPad");//

caps.setCapability("udid","Id реального устройства");//UDID

Desired capabilities для iOS для веб-приложений

Некоторые из опция нам не понадобятся. К этим опциям относятся: APP, APP PACKAGE и APP ACTIVITY. Теперь к делу.

Сначала, импортируем пакеты:

import java.io.File;

import org.openqa.selenium.remote.DesiredCapabilities;

import io.appium.java_client.remote.MobileCapabilityType;

Теперь DC:

DesiredCapabilities caps = new DesiredCapabilities();

caps.setCapability(MobileCapabilityType.PLATFORM_VERSION, "8.1");

caps.setCapability(MobileCapabilityType.PLATFORM_NAME, "iOS");

caps.setCapability(MobileCapabilityType.DEVICE_NAME,"iPad");

caps.setCapability("udid","UDID вашего устройства");

caps.setCapability(MobileCapabilityType.BROWSER_NAME,"Safari"); //чтобы запустить Safari

Мы закончили с конфигурацией, теперь можно инициализировать драйвер.

Импорт:

import io.appium.java_client.ios.IOSDriver;

import java.net.URL;

Инициализация:

IOSDriver driver = new IOSDriver (new URL("http://127.0.0.1:4723/wd/hub"),caps); //Адрес, где Appium-сервер

Все готово для работы с устройством iOS.

Теперь можно добавить TestNG и попробовать запустить все вместе:

import io.appium.java_client.ios.IOSDriver;

import io.appium.java_client.remote.MobileCapabilityType;

import java.io.File;

import java.net.MalformedURLException;

import java.net.URL;

import java.util.concurrent.TimeUnit;

import org.openqa.selenium.remote.DesiredCapabilities;

import org.testng.annotations.AfterClass;

import org.testng.annotations.BeforeClass;

import org.testng.annotations.Test;

public class TestAppIication {

IOSDriver driver;

@BeforeClass //этот метод выполняется перед каждым тестом

public void setUp() throws MalformedURLException{

DesiredCapabilities caps = new DesiredCapabilities();

File app=new File("path of the .app");

caps.setCapability(MobileCapabilityType.APP,app);

caps.setCapability(MobileCapabilityType.PLATFORM_VERSION, "8.1");

caps.setCapability(MobileCapabilityType.PLATFORM_NAME, "iOS");

caps.setCapability(MobileCapabilityType.DEVICE_NAME,"iPad");

caps.setCapability("udid","UDID вашего устройства");

caps.setCapability(MobileCapabilityType.BROWSER_NAME, "Safari");//в случае, если работаем с веб-приложением

driver = new IOSDriver (new URL("http://127.0.0.1:4723/wd/hub"), caps);

driver.manage().timeouts().implicitlyWait(30,TimeUnit.SECONDS);

}

@Test

public void testExample(){

//здесь шаги теста

}

@AfterClass

public void tearDown(){

driver.closeApp();

//driver.quit(); //в случае, если работаем с веб-приложением

}

}

Автоматизация нативных приложений

Нативные приложения на Android

В случае с автоматизацией Android, сработает тот же код, что и в предыдущей главе (тестировали на эмуляторе), только нужно удалить информацию про avd.

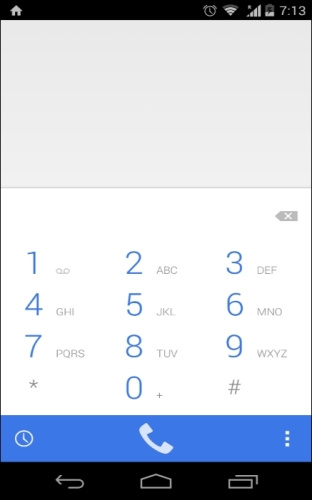

Давайте разберем пример набора номера на Android:

- Установите следующие desired capabilities, для запуска приложения dialer

caps.setCapability(MobileCapabilityType.APP_PACKAGE, "com.android.dialer"); caps.setCapability(MobileCapabilityType.APP_ACTIVITY, "com.android.dialer.DialtactsActivity"); - Теперь нужно найти dial pad. Искать будем по AccessibityId

WebElement dialPad= driver.findElementByAccessibilityId("dial pad")); - Клик

dialPad.click(); - Нужно найти клавиши с цифрами. Задействуем немного логики, чтобы найти клавиши 0-9 по name и кликнем каждую из них

for(int n=0;n<10;n++){ driver.findElement(By.name(""+n+"")).click(); } - В данном случае, мы используем некорректный номер телефона, так что телефон никуда не позвонит

- Давайте найдем кнопку вызова. Искать будем по AccessibilityId:

WebElement dial= driver.findElementByAccessibilityId("dial")); - Клик:

dial.click(); - Весь скрипт, с использованием TestNG, будет выглядеть вот так:

public class TestAppIication { AndroidDriver driver; @BeforeClass public void setUp() throws MalformedURLException{ DesiredCapabilities caps = new DesiredCapabilities(); caps.setCapability(MobileCapabilityType.PLATFORM_VERSION, "4.4"); caps.setCapability(MobileCapabilityType.PLATFORM_NAME, "Android"); caps.setCapability(MobileCapabilityType.DEVICE_NAME,"Moto X");//I am using Moto X as Real Device caps.setCapability(MobileCapabilityType.APP_PACKAGE, "com.android.dialer"); caps.setCapability(MobileCapabilityType.APP_ACTIVITY, "com.android.dialer.DailtactsActivity"); driver = new AndroidDriver (new URL("http://127.0.0.1:4723/wd/hub"), caps); driver.manage().timeouts().implicitlyWait(30,TimeUnit.SECONDS); } @Test public void testExample(){ WebElement dialPad=driver.findElementByAccessibilityId("dial pad"); dialPad.click(); for(int n=0;n<10;n++){ driver.findElement(By.name(""+n+"")).click(); } WebElement dial=driver.findElementByAccessibilityId("dial"); dial.click(); } @AfterClass public void tearDown(){ driver.closeApp(); } }

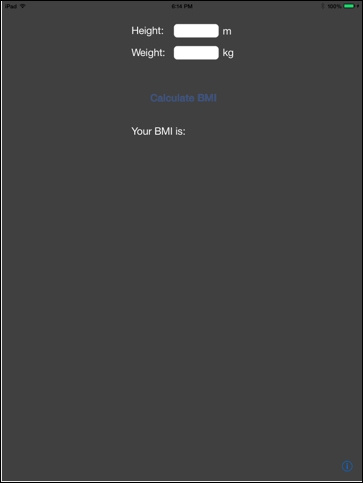

Нативные приложения на iOS

Здесь мы поработаем с калькулятором BMI

Мы рассчитаем индекс массы тела по весу и росту. Для этого, делаем следующее:

- Установите следующие desired capabilities, для запуска приложения

File app=new File("/Users/mhans/appium/ios/BmiCalc.app");//You can change it with your app address caps.setCapability(MobileCapabilityType.APP,app);//To set the app path - Теперь нужно найти поля ввода роста и веса. Будем искать по Xpath

WebElement height=driver.findElement(By.xpath("(//UIATextField)[2]")); WebElement weight=driver.findElement(By.xpath("(//UIATextField)[4]")); - Ищем кнопку calculate. Используем name:

WebElement calculateBMI=driver.findElement(By.name("Calculate BMI")); - Указываем рост

height.sendKeys("1.82"); - Указываем вес

weight.sendKeys("75"); - Считаем индекс

calculateBMI.click(); - Весь скрипт, с использованием TestNG, будет выглядеть вот так:

public class TestAppIication { IOSDriver driver; @BeforeClass public void setUp() throws MalformedURLException{ File app=new File("/Users/mhans/appium/ios/BmiCalc.app");//You can change it with your app address DesiredCapabilities caps = new DesiredCapabilities(); caps.setCapability(MobileCapabilityType.APP,app); caps.setCapability(MobileCapabilityType.PLATFORM_VERSION, "8.1"); caps.setCapability(MobileCapabilityType.PLATFORM_NAME, "iOS"); caps.setCapability(MobileCapabilityType.DEVICE_NAME,"iPad"); caps.setCapability("udid","Real Device Id "); driver = new IOSDriver (new URL("http://127.0.0.1:4723/wd/hub"), caps); driver.manage().timeouts().implicitlyWait(30,TimeUnit.SECONDS); } @Test public void testExample(){ WebElement height=driver.findElement(By.xpath("(//UIATextField)[2]")); height.sendKeys("1.82"); WebElement weight=driver.findElement(By.xpath("(//UIATextField)[4]")); weight.sendKeys("75"); WebElement calculateBMI=driver.findElement(By.name("Calculate BMI")); calculateBMI.click(); } @AfterClass public void tearDown(){ driver.closeApp(); } }

Автоматизация веб приложений

Веб приложения на Android

Для примера, рассмотрим страницу авторизации в Gmail. В этом разделе, мы посмотрим, как запустить Chrome на реальном устройстве, перейти по нужному адресу, передать логин/пароль и нажать SignIn

- Установите следующие desired capabilities, для запуска Chrome

caps.setCapability(MobileCapabilityType.BROWSER_NAME, "Chrome"); - Теперь нужно указать адрес

driver.get("https://www.gmail.com"); - Нужно найти элемент username. Используем локатор name

WebElement username=driver.findElement(By.name("Email")); - Передаем значение

username.sendKeys("test"); - Теперь, нужно найти элемент password. Используем локатор name

WebElement password=driver.findElement(By.name("Passwd")); - Передаем значение

password.sendKeys("test"); - Ищем кнопку SignIn. Используем локатор name

WebElement signIn=driver.findElement(By.name("signIn")); - Клик

signIn.click(); - Весь скрипт, с использованием TestNG, будет выглядеть вот так:

public class TestAppIication { AndroidDriver driver; @BeforeClass public void setUp() throws MalformedURLException { DesiredCapabilities caps = new DesiredCapabilities(); caps.setCapability(MobileCapabilityType.BROWSER_NAME, "Chrome"); caps.setCapability(MobileCapabilityType.PLATFORM_VERSION, "4.4"); caps.setCapability(MobileCapabilityType.PLATFORM_NAME, "Android"); caps.setCapability(MobileCapabilityType.DEVICE_NAME,"Moto X"); driver = new AndroidDriver (new URL("http://127.0.0.1:4723/wd/hub"), caps); driver.manage().timeouts().implicitlyWait(30,TimeUnit.SECONDS); } @Test public void testExample(){ driver.get("https://www.gmail.com"); WebElement username=driver.findElement(By.name("Email")); username.sendKeys("test"); WebElement password=driver.findElement(By.name("Passwd")); password.sendKeys("test"); WebElement signIn=driver.findElement(By.name("signIn")); signIn.click(); } @AfterClass public void tearDown(){ driver.quit(); } }

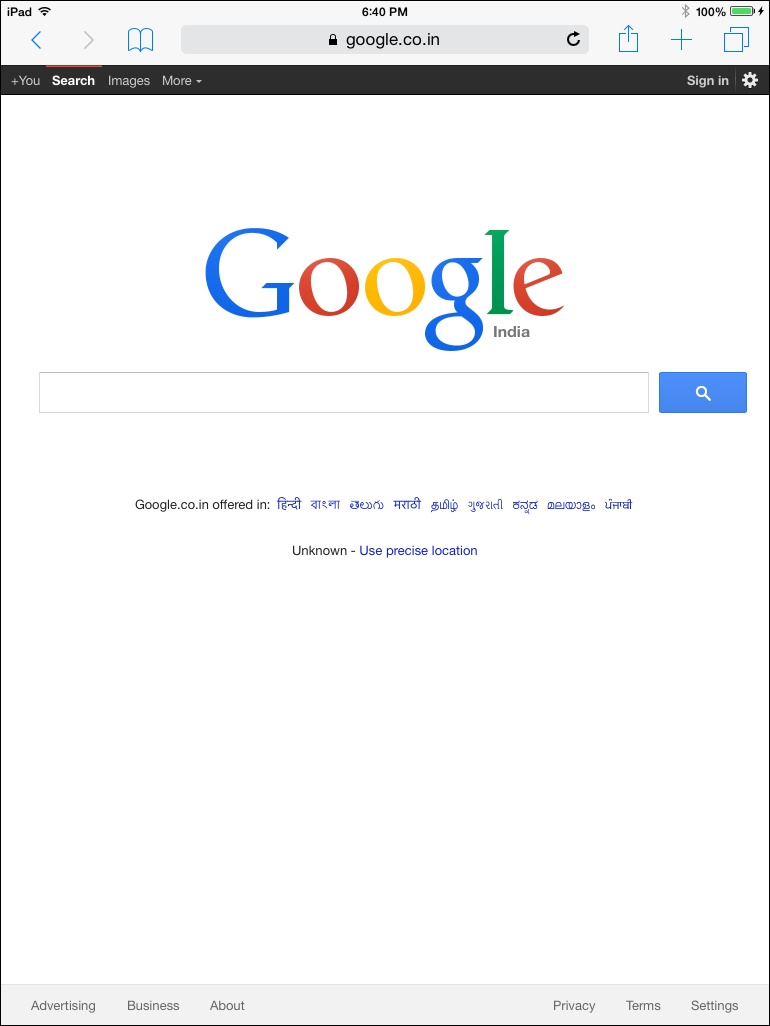

Веб приложения на iOS

Для примера, рассмотрим страницу поиска в Google. В этом разделе, мы посмотрим, как запустить браузер на реальном устройстве, перейти по нужному адресу, передать строку для поиска и нажать Search

- Установите следующие desired capabilities, для запуска Safari

caps.setCapability(MobileCapabilityType.BROWSER_NAME, "Safari"); - Теперь нужно указать адрес

driver.get("https://www.google.com"); - Нужно найти элемент searchBox. Используем локатор name

WebElement searchBox=driver.findElement(By.name("q")); - Передаем значение

searchBox.sendKeys("Appium for mobile automation"); - Перед запуском скрипта, нам нужно будет включить прокси командой:

ios_webkit_debug_proxy -c 2e5n6f615z66e98c1d07d22ee09658130d345443:27753 –d

Замените 2e5n6f615z66e98c1d07d22ee09658130d345443 на UDID вашего девайса. Порт должен быть 27753 - Убедитесь, что Web Inspector включен (Settings | Safari | Advanced) и SafariLauncher установлен на ваш девайс

- Весь скрипт, с использованием TestNG, будет выглядеть вот так:

public class TestAppIication { IOSDriver driver; @BeforeClass public void setUp() throws MalformedURLException{ DesiredCapabilities caps = new DesiredCapabilities(); caps.setCapability(MobileCapabilityType.BROWSER_NAME, "Safari"); caps.setCapability(MobileCapabilityType.PLATFORM_VERSION, "8.1"); caps.setCapability(MobileCapabilityType.PLATFORM_NAME, "iOS"); caps.setCapability(MobileCapabilityType.DEVICE_NAME, "iPad"); caps.setCapability("udid","Real Device Identifier"); driver = new IOSDriver (new URL("http://127.0.0.1:4723/wd/hub"), caps); driver.manage().timeouts().implicitlyWait(30,TimeUnit.SECONDS); } @Test public void testExample(){ driver.get("https://www.google.com"); WebElement searchBox=driver.findElement(By.name("q")); searchBox.sendKeys("Appium for mobile automation"); } @AfterClass public void tearDown(){ driver.quit(); } }

Автоматизация гибридных приложений

Гибридные приложения на Android

Для примера, будем работать с Hybridtestapp

Для работы с гибридными приложениями, нужно выполнить изменения, указанные здесь. В нашем приложении Hybridtestapp, они уже применены.

В примере попробуем заполнить форму в приложении:

- Установите следующие desired capabilities, для запуска гибридного приложения

File app=new File("C:\\Appium_test\\HybridtestApp.apk");// (On window platform) caps.setCapability(MobileCapabilityType.APP,app); caps.setCapability(MobileCapabilityType.APP_PACKAGE, "com.example.hybridtestapp"); caps.setCapability(MobileCapabilityType.APP_ACTIVITY, "com.example.hybridtestapp.MainActivity"); - Теперь нужно сменить контекст, чтобы работать с WebView

Setcontexts = driver.getContextHandles(); for (String context : contexts) { System.out.println(context); //выводим список контекстов } - Переключаем

driver.context("WEBVIEW_com.example.hybridtestapp");

илиdriver.context((String) contextNames.toArray()[1]); - После перехода в WebView, нам нужно найти поле ввода First Name. Искать будем по локатору name

WebElement firstName=driver.findElement(By.name("fname")); firstName.sendKeys("test"); - И Last Name

WebElement lastName=driver.findElement(By.name("lname")); lastName.sendKeys("test"); - Таким образом заполняем остальные поля

WebElement age=driver.findElement(By.name("age")); age.sendKeys("26"); WebElement username=driver.findElement(By.name("username")); username.sendKeys("appiumTester"); WebElement password=driver.findElement(By.id("psw")); password.sendKeys("appium@123");

- И кликаем на копку Register

WebElement registerButton=driver.findElement(By.id("register")); registerButton.click(); - Весь скрипт, с использованием TestNG, будет выглядеть вот так:

public class TestAppIication { AndroidDriver driver; @BeforeClass public void setUp() throws MalformedURLException{ File app=new File("C:\\Appium_test\\HybridtestApp.apk"); caps.setCapability(MobileCapabilityType.APP,app); DesiredCapabilities caps = new DesiredCapabilities(); caps.setCapability(MobileCapabilityType.PLATFORM_VERSION, "4.4"); caps.setCapability(MobileCapabilityType.PLATFORM_NAME, "Android"); caps.setCapability(MobileCapabilityType.DEVICE_NAME, "Moto X"); caps.setCapability(MobileCapabilityType.AUTOMATION_NAME, "Appium");//Используйте Selendroid если версия android ниже 4.4 caps.setCapability(MobileCapabilityType.APP_PACKAGE, "com.example.hybridtestapp"); caps.setCapability(MobileCapabilityType.APP_ACTIVITY, "com.example.hybridtestapp.MainActivity"); driver = new AndroidDriver (new URL("http://127.0.0.1:4723/wd/hub"), caps); driver.manage().timeouts().implicitlyWait(30,TimeUnit.SECONDS); } @Test public void testExample(){ Setcontexts = driver.getContextHandles(); for (String context : contexts) { System.out.println(context); } driver.context((String) contexts.toArray()[1]); WebElement firstName=driver.findElement(By.name("fname")); firstName.sendKeys("test"); WebElement lastName=driver.findElement(By.name("lname")); lastName.sendKeys("test"); WebElement age=driver.findElement(By.name("age")); age.sendKeys("26"); WebElement username=driver.findElement(By.name("username")); username.sendKeys("appiumTester"); WebElement password=driver.findElement(By.id("psw")); password.sendKeys("appium@123"); WebElement registerButton=driver.findElement(By.id("register")); registerButton.click(); } @AfterClass public void tearDown(){ driver.closeApp(); } }

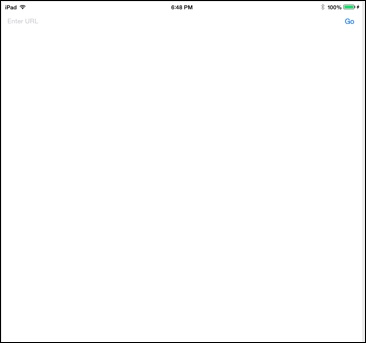

Гибридные приложения на iOS

Пример будем рассматривать на приложении WebViewApp

Пробуем работать с приложением:

- Установите следующие desired capabilities, для запуска гибридного приложения

File app=new File("/Users/mhans/appium/ios/WebViewApp.app"); caps.setCapability(MobileCapabilityType.APP,app); - Теперь нужно найти поле ввода и указать нужный адрес

WebElement editBox=driver.findElement(By.className("UIATextField")); editBox.sendKeys("www.google.com"); - Ищем и кликаем кнопку Go

WebElement goButton=driver.findElement(By.name("Go")); goButton.click(); - Теперь нужно сменить контекст, чтобы работать с WebView

Setcontexts = driver.getContextHandles(); for (String context : contexts) { System.out.println(context); } - Переключаем

driver.context("WEBVIEW_com.example.testapp");

илиdriver.context((String) contextNames.toArray()[1]); - Все. Можем работать со страницей google. Пробуем открыть кладку Images:

WebElement images=driver.findElement(By.linkText("Images")); images.click(); - Перед запуском всего теста, нужно включить прокси

ios_webkit_debug_proxy -c:27753 –d

Порт должен быть 27753 - Весь скрипт, с использованием TestNG, будет выглядеть вот так:

public class TestAppIication { IOSDriver driver; @BeforeClass public void setUp() throws MalformedURLException{ DesiredCapabilities caps = new DesiredCapabilities(); File app=new File("/Users/mhans/appium/ios/WebViewApp.app"); caps.setCapability(MobileCapabilityType.APP,app); caps.setCapability(MobileCapabilityType.PLATFORM_VERSION, "8.1"); caps.setCapability(MobileCapabilityType.PLATFORM_NAME, "iOS"); caps.setCapability(MobileCapabilityType.DEVICE_NAME, "iPad"); caps.setCapability("udid","Real Device Identifier"); driver = new IOSDriver (new URL("http://127.0.0.1:4723/wd/hub"), caps); driver.manage().timeouts().implicitlyWait(30,TimeUnit.SECONDS); } @Test public void testExample(){ WebElement editBox=driver.findElement(By.className("UIATextField")); editBox.sendKeys("https://www.google.com"); WebElement goButton=driver.findElement(By.name("Go")); goButton.click(); Setcontexts = driver.getContextHandles(); for (String context : contexts) { System.out.println(context); } driver.context((String) contexts.toArray()[1]); WebElement images=driver.findElement(By.linkText("Images")); images.click(); } @AfterClass public void tearDown(){ driver.closeApp(); } }

Вот и все. У нас осталась последняя глава, в которой мы посмотрим, как имитировать специфичные, для мобильной платформы, пользовательские действия.

|

Метки: author EreminD читальный зал appium automation testing тестирование тестирование мобильных приложений java |

Как уязвимость платежной системы раскрывала данные кредитных карт |

Есть одна платежная система, на которой присутствовала уязвимость, позволяющая получить критически важную информацию о пользователе, его пароле, кредитной карте и тд. Баг очень легко воспроизводился, правда вывод средств со взломанных аккаунтов был затруднен по нескольких причинам, расскажу о них под катом.

Сайт компании https://www.plategka.com, это 7900 alexarank в Украине. Я обычно не трачу много времени на каждый сайт, потому что ещё не известно, как относится к уязвимостям на своём сайте владелец, возможно он проигнорирует уязвимость и моё время будет потрачено зря. Если нашёл первую стоящую уязвимость на сайте, то я её сразу репорчу, смотрю на реакцию владельца, и если он положительно относится к такого рода мероприятиям и хочет чтобы я сотрудничал с ним дальше, то продолжаю свои поиски.

Первое, что я сделал — это проверил поддомены и директории по моему словарю, поддомены были выявлены следующие

mail.plategka.com

test.plategka.com

, в целом брут ничего не дал.

Далее была просмотрена выдача по google доркам, увы, поиск не увенчался успехом, и единственное что было найдено — статья Gorodnya на Хабре о том, как он нашёл уязвимость на plategka https://habrahabr.ru/post/269663/, и о том как ему заплатили очень много денег — всего $8 :)

Следующим шагом было решено протестить функционал личного кабинета, csrf баги не удалось воспроизвести из-за подтверждения паролем для изменения данных, также стояли фильтры на xss.

Единственное, что было обнаружено – это self xss в подтверждении формы паролем, опасность такой баги минимальна, поэтому нужно было искать что-то другое и более серьезное.

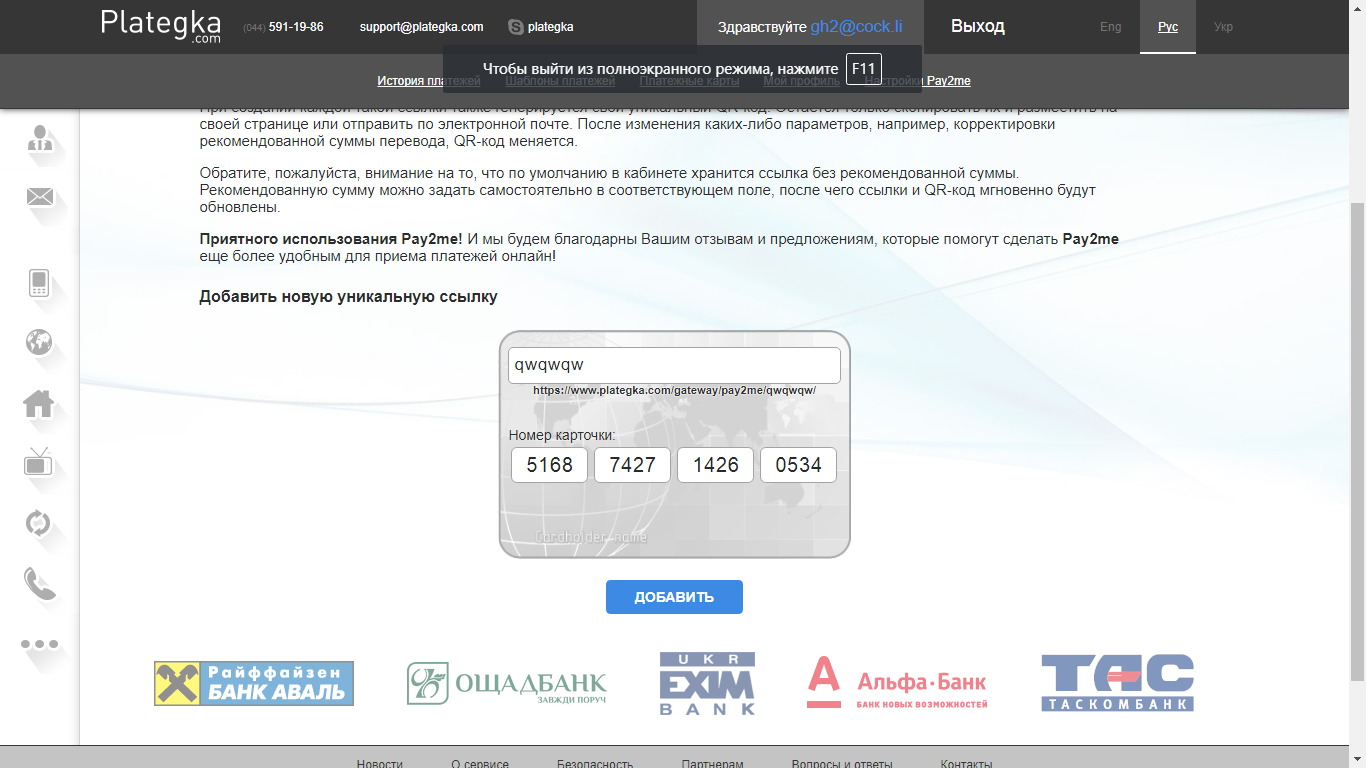

Одна вещь, на которую я обратил внимание — это сервис pay2me. Его работа заключается в обработке данных о кредитных картах, я посчитал это интересным предметом для изучения.

Раньше натыкался на новости с этим сервисом https://ain.ua/2015/10/15/novyj-servis-po-priemu-platezhej-pay2me-ot-plategka, но не обращал на них особого внимания. Инструкция к созданию:

В личном кабинете есть соответствующая вкладка — «Настройки Pay2me». Для создания уникальной ссылки необходимо ввести ее название, 16-значный номер карты и нажать клавишу «Добавить».

Я создал свою ссылку https://www.plategka.com/gateway/pay2me/qwqwqw/

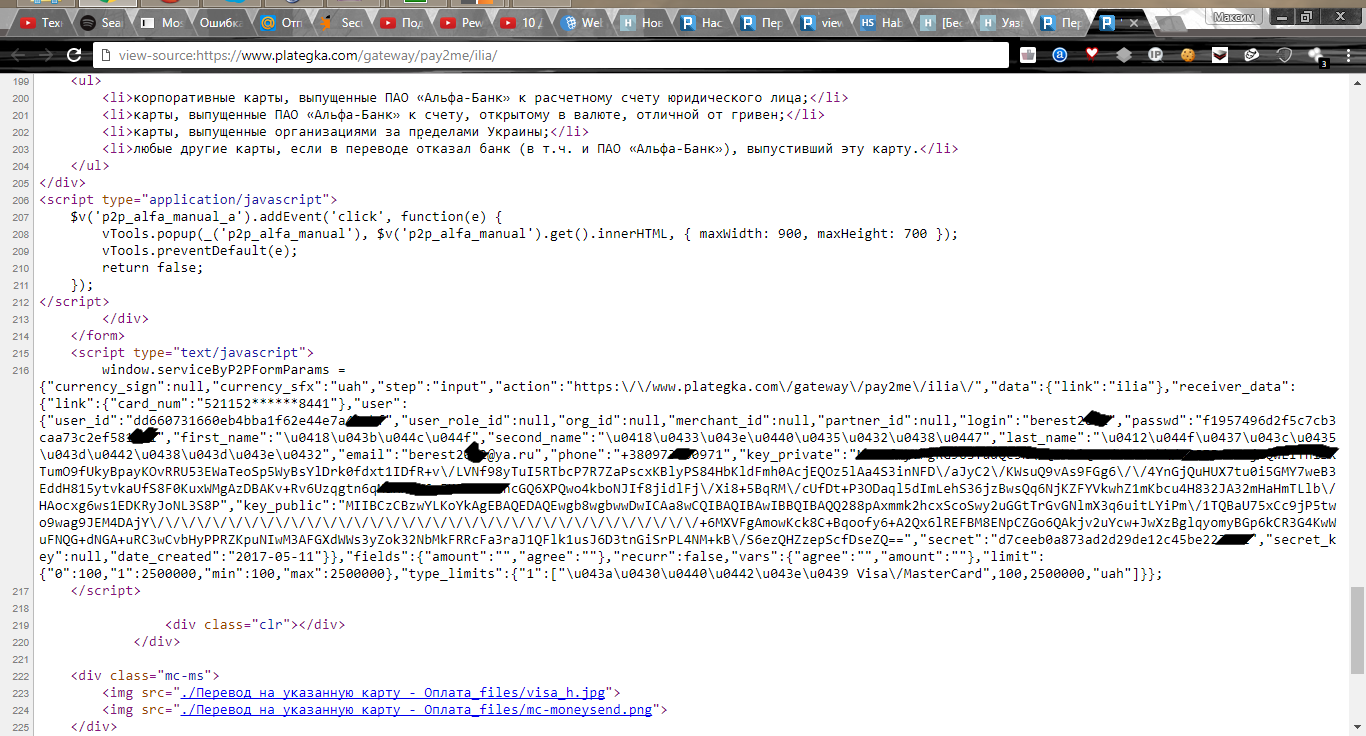

Данные о карте были скрыты, xss уязвимости отсутствовали. Внимание привлек ответ бурпа. В исходном коде страницы с оплатой в javascript выдавался логин юзера, md5 хэш его пароля, ФИО, email и номер телефона:

{“user_id”:”dd660731660eb4bba1f62e44e7'',”user_role_id”:null,”org_id”:null,”merchant_id”:null,”partner_id”:null,”login”:”berest****”,”passwd”:”f1957496d2f5c7cb3caa73c2e*******”,”first_name”:”\u0418\u043b\u044c\u044f”,”second_name”:”\u0418\u0433\u043e\u0440\u0435\u0432\u0438\u0447'',”last_name”:”\u0412\u044f\u0437\u043c\u0435\u043d\u0442\u0438\u043d\u043e\u0432'',”email”:”berest****@ya.ru”,”phone”:”+38097360'',”key_private”:”inNFD\/aJyC2\/KWsuQ9vAs9FGg6\/\/4YnGjQuHUX7tu0i5GMY7weB3EddH815ytvkaUfS8F0KuxWMgAzDBAKv+Rv6Uzqgtn6qMaHH8N6v5KFWFeeRncGQ6XPQwo4kboNJIf8jidlFj\/Xi8+5BqRM\/cUfDt+P3ODaql5dImLehS36jzBwsQq6NjKZFYVkwhZ1mKbcu4H832JA32mHaHmTLlb\/HAocxg6ws1EDKRyJoNL3S8P”,”key_public”:”/\/\/\/\/\/\/\/\/\/\/\/\/\/\/\/\/\/\/+6MXVFgAmowKck8C+Bqoofy6+A2Qx6lREFBM8ENpCZGo6QAkjv2uYcw+JwXzBglqyomyBGp6kCR3G4KwWuFNQG+dNGA+uRC3wCvbHyPPRZKpuNIwM3AFGXdWWs3yZok32NbMkFRRcFa3raJ1QFlk1usJ6D3tnGiSrPL4NM+kB\/S6ezQHZzepScfD”,”secret”:”d7ceeb0a873ad2d29de12c45b******”,”secret_key”:null,”date_created”:”2017-05-11''}(это данные, взятые из url https://www.plategka.com/gateway/pay2me/ilia/ ).

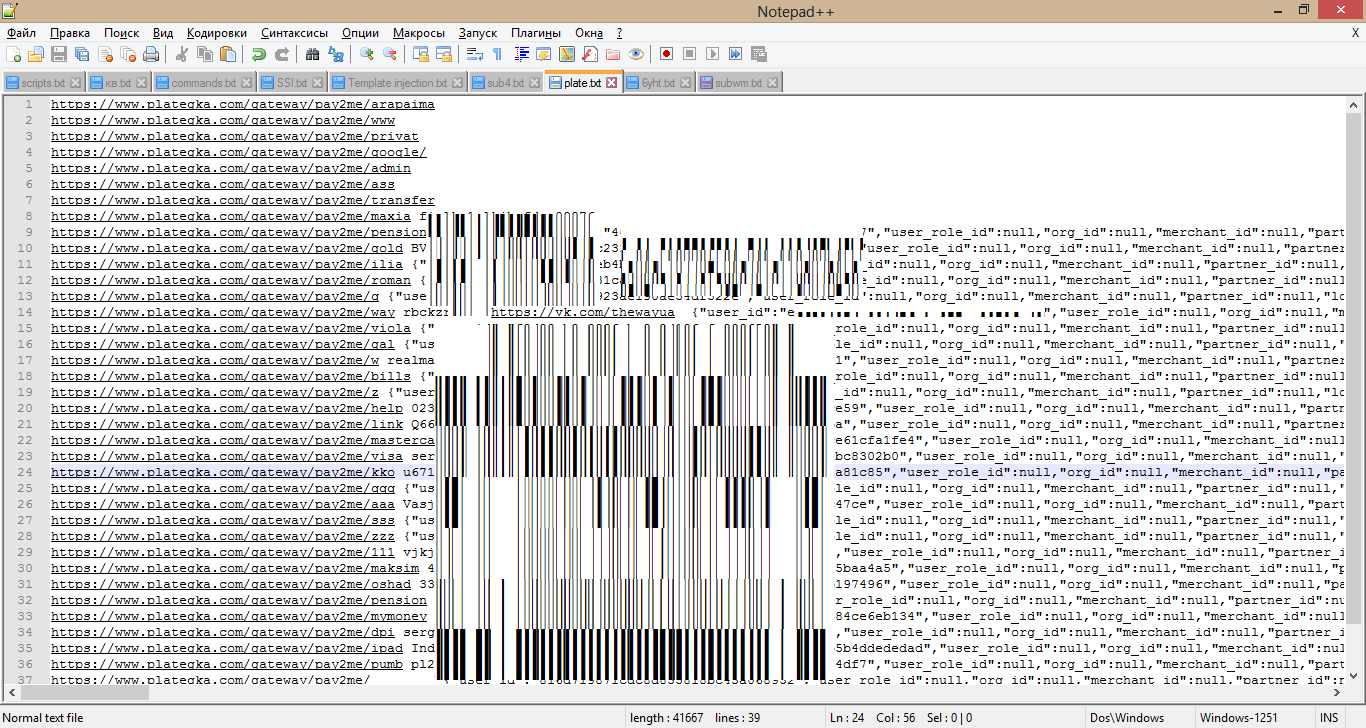

Уязвимость найдена, но одной моей ссылки для доказательства будет маловато, было принято решение о нахождении других подобных ссылок.

Были попытки их нахождения с помощью дорков вида site:plategka.com inurl:pay2me/, выдало только одну ссылку https://vk.com/thewayua?w=wall63064560_1589. Я знал, что ссылок должно быть намного больше, потому что сервис пользуется хорошей популярностью.

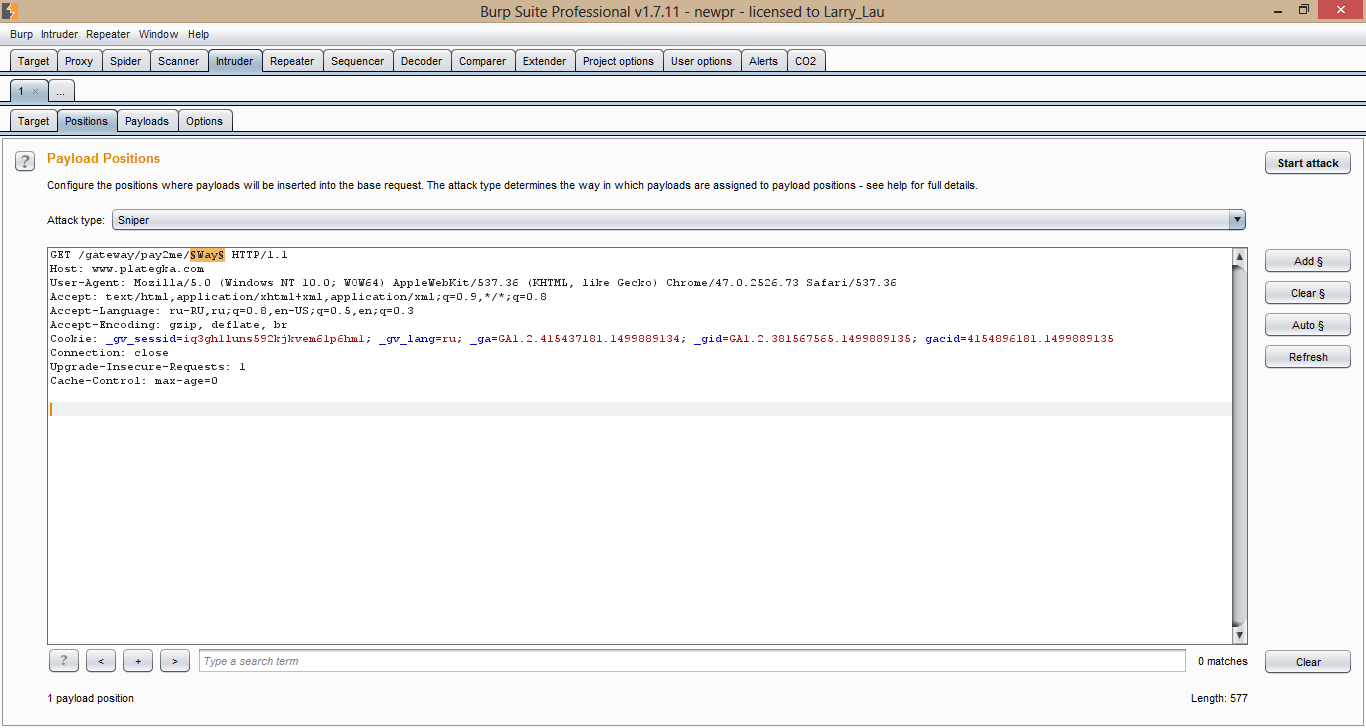

Последним шансом получить заветные ссылки стал брутфорс в интрудере, было загружено более 100 000 популярных английских слов и начат перебор.

Получилось найти около 40 ссылок, примерно половину паролей удалось узнать

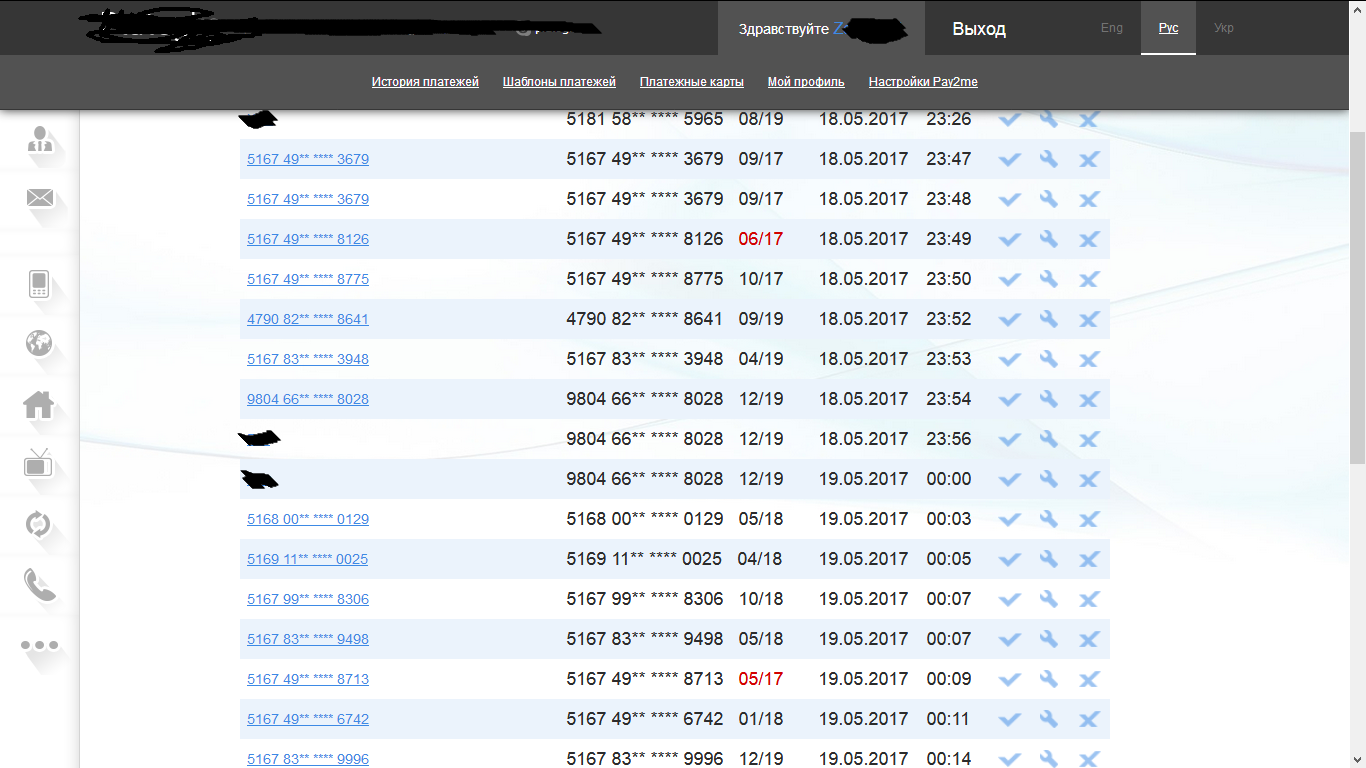

Я зашёл на пару аккаунтов проверить, шифруются ли cvv2 и др данные карты.

На первом аккаунте обнаружил 3 действительных карты

На втором было 20

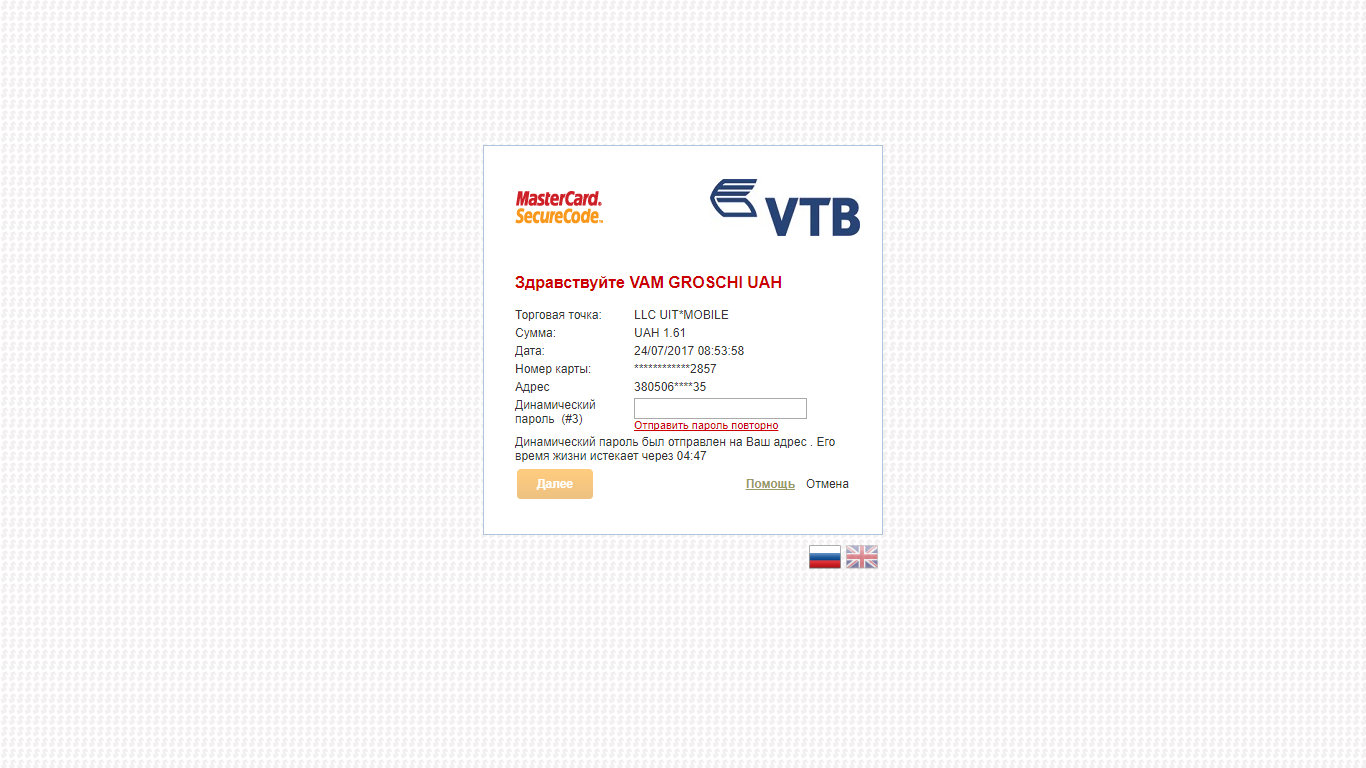

cvv в аккаунте скрыт, раскрывается информация только о 10 цифрах номера карты и срок её действия. Чтобы обналичить карты, можно, например, пополнить webmoney, или другой электронный кошелёк. Но для того, чтобы это сделать, придется ввести cvv2 код в подтверждении платежа, даже если карта была верифицирована.

Первое, что мы можем сделать – это ввести рандомный cvv2 код, например 111. Часто нас редиректит на ввод otp от банка, и тогда платёж не проходит из-за неверного cvv2.

Также можем забрутить cvv2, но потом опять можно столкнутся с вводом кода из банка, который тяжело обойти.

Если у нас будет дата и частичный номер карты, то обычная фишинг атака может заставить юзера рассказать о номере своей карты (мы получили email, номер телефона, ФИО, я даже смог получить несколько ссылок на страницы пользователей в соцсетях), даже обычное письмо вида: “Вы выиграли денежный приз, для его получения Вам необходимо прислать нам номер Вашей карты” может сработать, действие не требует предоставления критических конфиденциальных данных.

Чтобы подобрать cvv2, можно использовать какой-то онлайн магазин, всего 1000 запросов и мы подобрали код (вот статья об этом https://xakep.ru/2016/12/05/visa-brutforce/ ). Конечно, некоторые магазины делают редирект на ввод otp от банка, но многие “забугорные” магазины сразу списывают деньги без необходимости редиректа.

Уязвимость была зарепорчена почти сразу после брутфорса, в комплекте к данным по уязвимости прислал и базу пользователей, которые были оперативно заморожены, а сам баг был быстро устранен.

За уязвимость заплатили всего $100, сказали, что для того чтобы получить больше, я должен узнать все данные кредитной карты из аккаунта.

Хронология:

13.07 в 17:00 — отправлен репорт.

13.07 — уязвимость исправлена.

20.07 — выплачена награда $100.

24.07 — статья была согласована с тех поддержкой plategka.com.

Вывод из статьи: Не смотря на заявленное прохождение PCI DSS, я бы рекомендовал сайтам периодически проверять уязвимости, а клиентам — заводить виртуальные карты для использования в Интернет.

P.S:

|

|

[Из песочницы] Мониторинг акторов в Akka.Net, но на F# |

Для тех кто не знаком с F#, но знаком с C#, рекомендую наисвежайшую статью от Microsoft.

Она поможет Вам испытывать меньше WTF моментов при прочтении, т.к. моя статья не туториал к синтаксису.

Контекст задачи

Есть сервис, написанный на Akka.NET, он вываливает в разные текстовые логи кучу инфы. Отдел эксплуатации грепает эти логи, жарит по ним регекспами, чтобы узнать о кол-ве ошибок (бизнесовых и не очень), о кол-ве входящих в сервис сообщений и кол-ве исходящих. Далее эта информация заливается в ElasticDB, InfluxDB и показывается в Grafana и Kibana в разных срезах и агрегациях.

Звучит сложно, да и парсить текстовые логи сервиса, который генерит несколько десятков ГБ текстового мусора в день — занятие неблагодарное. Поэтому встала задача — сервис должен быть способен поднять ендпоинт, который можно дёрнуть и получить сразу всю инфу о нём.

Решать задачу будем так:

- Напишем доменную модель для метрик

- Замапим доменную модель метрик на реализацию App.Metrics и поднимем апишечку

- Сделаем структурированный доменный логгер, который натянем на внутренний логгер Akka

- Сделаем обёртку для функциональных акторов, которая спрячет работу с метриками и логгером

- Соберём всё вместе и запустим

Доменная модель для метрик

В App.Metrics есть 6 типов представлений:

- Counters

- Apdex

- Gauges

- Histograms

- Meters

- Timers

В первой итерации нам вполне хватит счётчиков, таймеров и… метров :)

В начале опишем типы и интерфейсы (все приводить не буду, можно посмотреть в репозитории, ссылка в конце).

Так же условимся, что все наши сообщения для метрик будут приходить к особому актору (его мы определим позже) через EventStream (шина сообщений в самой Akka.Net).

Например таймер, который должен уметь замерить некоторое количество времени для какого-то объекта:

type IMetricsTimer =

abstract member Measure : Amount -> unit

abstract member Measure : Amount * Item -> unit

Или счётчик, который должен уметь увеличиваться/уменьшаться как с указанием количества, так и без:

type IMetricsCounter =

abstract member Decrement : unit -> unit

abstract member Decrement : Amount -> unit

abstract member Decrement : Amount * Item -> unit

abstract member Increment : unit -> unit

abstract member Increment : Amount -> unit

abstract member Increment : Amount * Item -> unit

И пара примеров команд для шины:

type DecrementCounterCommand =

{ CounterId : CounterId

DecrementAmount : Amount

Item : Item }

type CreateCounterCommand =

{ CounterId : CounterId

Context : ContextName

Name : MetricName

MeasurementUnit : MeasurementUnit

ReportItemPercentages : bool

ReportSetItems : bool

ResetOnReporting : bool }

Самое главное — определим возможные сообщения, которые могут ходить по шине, и на которые будет реагировать наш метрик-актор. Для этого воспользуемся Discriminated Union:

type MetricsMessage =

| DecrementCounter of DecrementCounterCommand

| IncrementCounter of IncrementCounterCommand

| MarkMeter of MarkMeterCommand

| MeasureTime of MeasureTimeCommand

| CreateCounter of CreateCounterCommand

| CreateMeter of CreateMeterCommand

| CreateTimer of CreateTimerCommand

Теперь надо реализовать интерфейсы и на этом закончить первый пункт. Реализовывать мы их будем в функциональном стиле, т.е. через функции.

Пример создания метра:

let private createMeter (evtStream: EventStream) meterId =

{ new IMetricsMeter with

member this.Mark amount =

this.Mark (amount, Item None)

member this.Mark item =

this.Mark (Amount 1L, item)

member this.Mark (amount, item) =

evtStream.Publish <| MarkMeter { MeterId = meterId; Amount = amount; Item = item }

Для людей из мира C# даю аналог:

private IMetricsMeter createMeter(EventStream evtStream, MeterId meterId)

{

private class TempClass : IMetricsMeter

{

public void Mark(long amount)

{

Mark(amount, "");

}

public void Mark(string item)

{

Mark(1, item);

}

public void Mark(long amount, string item)

{

evtStream.Publish(new MarkMeter {...});//omitted

}

}

return new TempClass();

}

Пусть вас не смущает что аналог не компилируется, это нормально, т.к. приватный класс в теле метода смущает компилятор. А вот в F# вы можете вернуть анонимный класс через интерфейс.

Основное на что надо обратить внимание — мы кидаем в шину сообщение что надо подвинуть измеритель, который определяется через MeterId.

Аналогично поступаем с IMetricsAdapter, но т.к. методов у него много приведу один:

member this.CreateMeter (name, measureUnit, rateUnit) =

let cmd =

{ MeterId = MeterId (toId name)

Context = context

Name = name

MeasurementUnit = measureUnit

RateUnit = rateUnit }

evtStream.Publish <| CreateMeter cmd

createMeter evtStream cmd.MeterId

При запросе на создание таймера мы отправляем в шину сообщение о создании, а вызывающему возвращаем результат метода createMeter с аргументами evtStream и cmd.MeterId.

Результат её, как видно выше — IMetricsMeter.

После этого создадим расширение для ActorSystem, чтобы можно было вызывать наш IMetricsAdapter откуда угодно:

type IActorContext with

member x.GetMetricsProducer context =

createAdapter x.System.EventStream context

Акторы для метрик и апишечка

Нам понадобятся два актора:

- Первый будет слушать шину на наличие в ней MetricsMessage и создавать/писать в метрики.

- Второй актор будет держать WebApi с одним методом, который будет отгружать по GET запросу всю собранную инфу.

Сразу сообразим ApiController, он тривиален:

type public MetricController(metrics: IMetrics) =

inherit ApiController()

[]

[]

member __.GetMetrics() =

__.Ok(metrics.Snapshot.Get())

Далее объявим функцию актора, который будет считывать все MetricsMessage из EventStream и что-то с ними делать. В функцию внедрим зависимость IMetrics через аргументы, внутри создадим кэши для всех метрик через обычные Dictionary.

Почему не ConcurrentDictionary, спросите Вы? А потому что актор обрабатывает сообщения по очереди. Чтобы словить внутри актора race condition, надо целенаправленно стрелять себе в ногу.

let createRecorder (metrics: IMetrics) (mailbox: Actor<_>) =

let self = mailbox.Self

let counters = new Dictionary()

let meters = new Dictionary()

let timers = new Dictionary()

//Часть кода для мапинга пропущена...

let handle = function

| DecrementCounter evt ->

match counters.TryGetValue evt.CounterId with

| (false, _) -> ()

| (true, c) ->

let (Amount am) = evt.DecrementAmount

match evt.Item with

| Item (Some i) -> c.Decrement (i, am)

| Item None -> c.Decrement (am)

| CreateMeter cmd ->

match meters.TryGetValue cmd.MeterId with

| (false, _) ->

let (ContextName ctxName) = cmd.Context

let (MetricName name) = cmd.Name

let options = new MeterOptions(

Context = ctxName,

MeasurementUnit = toUnit cmd.MeasurementUnit,

Name = name,

RateUnit = toTimeUnit cmd.RateUnit)

let m = metrics.Provider.Meter.Instance options

meters.Add(cmd.MeterId, m)

| _ -> ()

//Остальные случае в этом match пропущены

subscribe typedefof self mailbox.Context.System.EventStream |> ignore

let rec loop() = actor {

let! msg = mailbox.Receive()

handle msg

return! loop()

}

loop()

Краткий смысл — объявили внутреннее состояние в виде словарей разных метрик, объявили функцию обработки сообщения MetricsMessage, подписались на MetricsMessage и вернули рекурсивную функцию обработки сообщения из мейлбокса.

Сообщения для работы с метриками обрабатывается так:

- Смотрим какое именно сообщение (через паттерн матчинг)

- Ищем в соответствующем словаре метрику с этим Id (для этого есть прекрасный паттерн через пару (bool, obj), который возвращает TryGetValue в F#

- Если это запрос на создание метрики и её нет — создаём, добавляем в словарь

- Если это запрос на использование метрики и она есть — используем

Так же нам понадобится актор, который поднимает Owin хост с контроллером выше.

Для этого напишем функцию, которая принимает зависимость в виде конфига и IDependencyResolver. Чтобы не завалиться на старте, актор сам себе посылает сообщение, которое инициирует возможный Dispose() старого API и создание нового. И опять таки, т.к. актор внутри себя синхронен, мы можем использовать mutable state.

type IMetricApiConfig =

abstract member Host: string

abstract member Port: int

type ApiMessage = ReStartApiMessage

let createReader (config: IMetricApiConfig) resolver (mailbox: Actor<_>) =

let startUp (app: IAppBuilder) =

let httpConfig = new HttpConfiguration(DependencyResolver = resolver)

httpConfig.Formatters.JsonFormatter.SerializerSettings.Converters.Add(new MetricDataConverter())

httpConfig.Formatters.JsonFormatter.Indent <- true

httpConfig.MapHttpAttributeRoutes()

httpConfig.EnsureInitialized()

app.UseWebApi(httpConfig) |> ignore

let uri = sprintf "http://%s:%d" config.Host config.Port

let mutable api = {new IDisposable with member this.Dispose() = ()}

let handleMsg (ReStartApiMessage) =

api.Dispose()

api <- WebApp.Start(uri, startUp)

mailbox.Defer api.Dispose

mailbox.Self Так же мы кидаем метод api.Dispose в отложенные задачи при окончательной остановке актора с помощью mailbox.Defer. А для начального состояния переменной api используем заглушку через object expression, которое конструирует пустой IDisposable объект.

Делаем структурированный логгер

Смысл задачи — сделать обёртку для логгера из Akka.Net (он представлен через интерфейс ILoggingAdapter), которую можно будет использовать для замера времени операции и типизированного заноса инфы (не просто стринги, а внятные бизнесовые случаи).

Вся типизация логгера заключена в одном union.

type Fragment =

| OperationName of string

| OperationDuration of TimeSpan

| TotalDuration of TimeSpan

| ReceivedOn of DateTimeOffset

| MessageType of Type

| Exception of exn

А сам логгер будет работать по такому интерфейсу:

type ILogBuilder =

abstract OnOperationBegin: unit -> unit

abstract OnOperationCompleted: unit -> unit

abstract Set: LogLevel -> unit

abstract Set: Fragment -> unit

abstract Fail: exn -> unit

abstract Supress: unit -> unit

abstract TryGet: Fragment -> Fragment option

Создавать его будем через обычный класс:

type LogBuilder(logger: ILoggingAdapter) =

let logFragments = new Dictionary()

let stopwatch = new Stopwatch()

let mutable logLevel = LogLevel.DebugLevel

interface ILogBuilder with

//Реализация интерфейса

Возможно Вы спросите, почему обычный Dictionary? Как было сказано выше, данный LogBuilder предназначен для использования внутри актора при обработке одной операции. Нет смысла использовать конкурентную структуру данных.

Приведу пример методов реализации интерфейса:

let set fragment =

logFragments.[fragment.GetType()] <- fragment

member x.OnOperationBegin() =

stopwatch.Start()

member this.Fail e =

logLevel <- LogLevel.ErrorLevel

set <| Exception e

member this.OnOperationCompleted() =

stopwatch.Stop()

set <| OperationDuration stopwatch.Elapsed

match tryGet <| ReceivedOn DateTimeOffset.MinValue with

| Some (ReceivedOn date) -> set <| TotalDuration (DateTimeOffset.UtcNow - date)

| _ -> ()

match status with

| Active ->

match (logLevel) with

| LogLevel.DebugLevel -> logger.Debug(message())

| LogLevel.InfoLevel -> logger.Info(message())

| LogLevel.WarningLevel -> logger.Warning(message())

| LogLevel.ErrorLevel -> logger.Error(message())

| x -> failwith(sprintf "Log level %s is not supported" <| string x)

| Supressed -> ()

Самое интересное это логика работы OnOperationCompleted():

- Останавливаем таймер и пишем прошедшее время в логгер через фрагмент OperationDuration

- Если у нас есть в логе фрагмент ReceivedOn (который в моей модели означает время прихода сообщения в сервис ВООБЩЕ), то пишем в лог общее время нахождения сообщения в сервисе через TotalDuration

- Если логгер не был выключен (через метод Supress()), то пишем инфу в Akka логгер через метод message(), который я не привёл, но он просто как-то собирает все Fragments в строку с учётом типов сообщений

Создаём обёртку для функциональных акторов

Самая магическая часть, которая позволит нам писать простые функции обработки сообщений без бойлерплейта, который несёт за собой тотальное логирование.

Чего мы хотим добиться? Для начала мы хотим залогировать:

- Что мы делаем. В нашем случае — это название операции, т.к. функциональные акторы имеют один тип FuncActor

- Тип обрабатываемого сообщения

- Сколько таких функций (по сути акторов) живёт в системе

- Показать время, которое ушло на выполнение операции

- Показать суммарное время, которое прошло с момента получения данного сообщения на входе в сервис

- Залогировать ошибку, если она возникла, особым образом

- иметь возможность писать простые функции обработки сообщений, не думая обо всём выше

Сделать всё выше перечисленное нам помогут Linq.Expressions. Как сделать это через QuotationExpressions из F# я не знаю, т.к. не нашёл простого способа скомпилировать их. Буду рад, если кто предложит варианты.

И так, для начала объявим пару вспомогательных типов и один метод:

type Expr<'T,'TLog when 'TLog :> ILogBuilder> = Expression, 'T, 'TLog>>

type Wrap =

static member Handler(e: Expression, 'T, #ILogBuilder>>) = e

let toExprName (expr: Expr<_,_>) =

match expr.Body with

| :? MethodCallExpression as methodCall -> methodCall.Method.Name

| x -> x.ToString()

Expr — это выражение, которое содержит Action от мейлбокса (на случай если надо наплодить детей, остановить себя или детей и вообще), обрабатываемого сообщения и логгера (если надо делать с ним какие-то особые действия).

Wrap.Handler(Expr) — позволит нам писать в него обычные F# выражения вида «fun mb msg log -> ()», а на выходе получать Linq.Expressions.

toExprName — метод, который получает название метода, если выражение является вызовом метода (MethodCallExpression) или просто пытается привести наше выражение к строке.

Для выражения вида «fun mb msg log -> handleMsg msg» — toExprName вернёт «handleMsg».

Теперь напишем обёртку для создания функциональных акторов. Начало объявления выглядит так:

let loggerActor<'TMsg> (handler: Expr<'TMsg,_>) (mailbox: Actor<'TMsg>) =

let exprName = handler |> toExprName

let metrics = mailbox.Context.GetMetricsProducer (ContextName exprName)

let logger = mailbox.Log.Value

На вход мы будем подавать только handler, т.к. mailbox потом докинет сама Akka (partial application).

С помощью написанного нами расширения к ActorSystem получим экземпляр IMetricsAdapter в значение metrics. Так же получим логгер Akka в значение logger.

Затем мы создадим для данного актора все необходимые метрики и тут же ими воспользуемся:

let errorMeter = metrics.CreateMeter (MetricName "Error Rate", Errors)

let instanceCounter = metrics.CreateCounter (MetricName "Instances Counter", Items)

let messagesMeter = metrics.CreateMeter (MetricName "Message Processing Rate", Items)

let operationsTimer = metrics.CreateTimer (MetricName "Operation Durations", Requests, MilliSeconds, MilliSeconds)

instanceCounter.Increment()

mailbox.Defer instanceCounter.Decrement

Как видите, мы увеличиваем значение instanceCounter и закладываем уменьшение этого счётчика на остановке актора.

Нам понадобятся ещё пара методов, которые будут заполнять известные нам параметры в логгер и дёргать нужные метрики.

В этом куске кода мы кидаем в логгер название операции, вызываем завершение её логирования, закидываем в метрику таймеров время операции, а в метрику мессаджей — тип сообщения:

let completeOperation (msgType: Type) (logger: #ILogBuilder) =

logger.Set (OperationName exprName)

logger.OnOperationCompleted()

match logger.TryGet(OperationDuration TimeSpan.Zero) with

| Some(OperationDuration dur) ->

operationsTimer.Measure(Amount (int64 dur.TotalMilliseconds), Item (Some exprName))

| _ -> ()

messagesMeter.Mark(Item (Some msgType.Name))

В обработке исключений внутри актора нам поможет следующий метод:

let registerExn (msgType: Type) e (logger: #ILogBuilder) =

errorMeter.Mark(Item (Some msgType.Name))

logger.Fail e

Осталось немного чтобы всё заработало. Свяжем всё вместе через обёртку над обработчиком:

let wrapHandler handler mb (logBuilder: unit -> #ILogBuilder) =

let innherHandler mb msg =

let logger = logBuilder()

let msgType = msg.GetType()

logger.Set (MessageType msgType)

try

try

logger.OnOperationBegin()

handler mb msg logger

with

| e -> registerExn msgType e logger; reraise()

finally

completeOperation msgType logger

innherHandler mb

wrapHandler обладает сложной сигнатурой. На языке C# это выглядело бы так:

Func wrapHandler(

Func handler,

TMailbox mb,

Func logBuilder)

where TLogBuilder: ILogBuilder

При этом на все остальные типы никаких ограничений нет.

По смыслу wrapHandler должен на выходе дать функцию, которая получает TMsg и выдаёт TResults. Порядок действий в этой функции будет следующий:

- Начинаем логирование операции

- Выполняем операцию

- В случае возникновения необработанного в handler исключения, логируем его и пробрасываем выше (родителю данного актора)

- Завершаем логирование

Для преобразования Expression в Action и подачи в каждое действие актора нового экземпляра логгера сделаем ещё одну вспомогательную функцию:

let wrapExpr (expr: Expr<_,_>) mailbox logger =

let action = expr.Compile()

wrapHandler

(fun mb msg log -> action.Invoke(mailbox, msg, log))

mailbox

(fun () -> new LogBuilder(logger))

В ней мы как раз получаем наш Expression, компилим его и подаём в wrapHandler выше, вместе с мейлбоксом и функцией на получение нового LogBuilder().

Сигнатура данного метода так же непростая. На C# это выглядело бы так:

Action wrapExpr(

Expr expr,

Actor mb,

ILoggingAdapterlogger)

Ограничений на TMsg всё ещё нет.

Осталось только создать рекурсивную функцию :)

let rec loop() =

actor {

let! msg = mailbox.Receive()

wrapExpr handler mailbox akkaLogger msg

return! loop()

}

loop()

Вот это выражение «wrapExpr handler mailbox akkaLogger», как видно из объяснения выше, возвращает Action, т.е. метод, в который можно подать любой тип на вход и получить unit (void в c#).

Дописав в конце выражения «msg» мы кидаем в эту функцию аргумент msg и выполняем наше действие над полученным сообщением.

На этом мы закончили с кодированием нашей задачи и перейдём к примерам!

Как всё это запустить?

Чтобы это всё работало необязательно писать много кода.

Можно вообще писать исключительно обработчики сообщений без знания о том, что нам нужны мейлбоксы, логгеры или обработка ошибок.

Простой случай может выглядеть так:

type ActorMessages =

| Wait of int

| Stop

let waitProcess = function

| Wait d -> Async.Sleep d |> Async.RunSynchronously

| Stop -> ()

А чтобы завернуть эту функцию в loggerActor и получить все плюшки ради которых мы так старались можно написать так:

let spawnWaitWorker() =

loggerActor <| Wrap.Handler(fun mb msg log -> waitProcess msg)

let waitWorker = spawn system "worker-wait" <| spawnWaitWorker()

waitWorker Если у вас сложная логика и нужен доступ к мейлбоксу и логеру:

let failOrStopProcess (mailbox: Actor<_>) msg (log: ILogBuilder) =

try

match msg with

| Wait d -> failwith "can't wait!"

| Stop -> mailbox.Context.Stop mailbox.Self

with

| e -> log.Fail e

let spawnFailOrStopWorker() =

loggerActor <| Wrap.Handler(fun mb msg log -> failOrStopProcess mb msg log)

let failOrStopWorker = spawn system "worker-vocal" <| spawnFailOrStopWorker()

failOrStopWorker EntryPoint самой программы, создание ActorSystem, поднятие метрик и акторов можно посмотреть под спойлером, там ничего примечательного нет.

open Akka.FSharp

open SimpleInjector

open App.Metrics;

open Microsoft.Extensions.DependencyInjection

open SimpleInjector.Integration.WebApi

open System.Reflection

open System

open Metrics.MetricActors

open ExampleActors

let createSystem =

let configStr = System.IO.File.ReadAllText("system.json")

System.create "system-for-metrics" (Configuration.parse(configStr))

let createMetricActors system container =

let dependencyResolver = new SimpleInjectorWebApiDependencyResolver(container)

let apiConfig =

{ new IMetricApiConfig with

member x.Host = "localhost"

member x.Port = 10001 }

let metricsReaderSpawner = createReader apiConfig dependencyResolver

let metricsReader = spawn system "metrics-reader" metricsReaderSpawner

let metricsRecorderSpawner = createRecorder (container.GetInstance())

let metricsRecorder = spawn system "metrics-recorder" metricsRecorderSpawner

()

type Container with

member x.AddMetrics() =

let serviceCollection = new ServiceCollection()

let entryAssemblyName = Assembly.GetEntryAssembly().GetName()

let metricsHostBuilder = serviceCollection.AddMetrics(entryAssemblyName)

serviceCollection.AddLogging() |> ignore

let provider = serviceCollection.BuildServiceProvider()

x.Register(fun () -> provider.GetRequiredService())

[]

let main argv =

let container = new Container()

let system = createSystem

container.RegisterSingleton system

container.AddMetrics()

container.Verify()

createMetricActors system container

let waitWorker1 = spawn system "worker-wait1" <| spawnWaitWorker()

let waitWorker2 = spawn system "worker-wait2" <| spawnWaitWorker()

let waitWorker3 = spawn system "worker-wait3" <| spawnWaitWorker()

let waitWorker4 = spawn system "worker-wait4" <| spawnWaitWorker()

let failWorker = spawn system "worker-fail" <| spawnFailWorker()

let waitOrStopWorker = spawn system "worker-silent" <| spawnWaitOrStopWorker()

let failOrStopWorker = spawn system "worker-vocal" <| spawnFailOrStopWorker()

waitWorker1 ignore

0

Самое главное — метрики!

Если во время работы зайти по ссылке localhost:10001/metrics, увидим достаточно большой json, в котором будет много информации. Приведу кусок для функции waitProcess:

{

"Context": "waitProcess",

"Counters": [

{

"Name": "Instances Counter",

"Unit": "items",

"Count": 4

}

],

"Meters": [

{

"Name": "Message Processing Rate",

"Unit": "items",

"Count": 4,

"FifteenMinuteRate": 35.668327519112893,

"FiveMinuteRate": 35.01484385742755,

"Items": [

{

"Count": 4,

"FifteenMinuteRate": 0.0,

"FiveMinuteRate": 0.0,

"Item": "Wait",

"MeanRate": 13.082620551464204,

"OneMinuteRate": 0.0,

"Percent": 100.0

}

],

"MeanRate": 13.082613248856632,

"OneMinuteRate": 31.356094372926623,

"RateUnit": "min"

}

],

"Timers": [

{

"Name": "Operation Durations",

"Unit": "req",

"ActiveSessions": 0,

"Count": 4,

"DurationUnit": "ms",

"Histogram": {

"LastUserValue": "waitProcess",

"LastValue": 8001.0,

"Max": 8001.0,

"MaxUserValue": "waitProcess",

"Mean": 3927.1639786164278,

"Median": 5021.0,

"Min": 1078.0,

"MinUserValue": "waitProcess",

"Percentile75": 8001.0,

"Percentile95": 8001.0,

"Percentile98": 8001.0,

"Percentile99": 8001.0,

"Percentile999": 8001.0,

"SampleSize": 4,

"StdDev": 2932.0567172627871,

"Sum": 15190.0

},

"Rate": {

"FifteenMinuteRate": 0.00059447212531854826,

"FiveMinuteRate": 0.00058358073095712587,

"MeanRate": 0.00021824579927905906,

"OneMinuteRate": 0.00052260157288211038

}

}

]

}

Из него можно узнать, что:

- У нас сейчас активно 4 инстанса workProcess

- Они обработали 4 сообщения типа Wait

- Медианное время обработки сообщений 5021 мс

В консоли будет примерно следующее.

Заключение

В данной статье много кода и, скорее всего, мало пояснений (отвечу в коментах, если что непонятно), но это потому что статья призвана показать решение нескольких рутинных задач из реального проекта.

Возможно кому-то пригодится, тем более этот код был изначально написан для акторов на C#, так что при желании можно всё это перенести (дам хинт, можно сделать свою версию Receive() с теми же экспрешнами внутри).

Рекомендую изучить F# тем кто занимается моделированием сложных доменных моделей, т.к. его система типов намного богаче, отсутствие null и проектирование в типах позволяет сделать модель устойчивой к ошибкам программиста.

Репозиторий с примером лежит тут.

Спасибо за внимание!

|

Метки: author Szer функциональное программирование c# .net f# |

[Из песочницы] SOAP и REST сервисы с помощью Python-библиотеки Spyne |

Знакомство с библиотекой Spyne

В данной статье я хочу рассказать о замечательной Python-библиотеке Spyne.

Мое знакомство с Spyne началось в тот момент, когда передо мной поставили задачу написать Веб-сервис, который будет принимать и отдавать запросы через SOAP-протокол. Немного погуглив я наткнулся на Spyne, которая является форком библиотеки soaplib. А еще я был удивлен, насколько мало русскоязычной информации встречается о данной библиотеке.

С помощью Spyne можно писать веб-сервисы, которые умеют работать с SOAP, JSON, YAML, а написанный скрипт можно запустить через mod_wsgi Apache. Итак, давайте рассмотрим несколько примеров, напишем работающие скрипты и настроим так, чтобы скрипты работали через apache.

1. SOAP-сервис

Давайте напишем веб-сервис, который будет служить нам переводчиком на английский язык. Наш веб-сервис будет получать запросы, обращаться в Yandex-translator, получать перевод и данный перевод отдавать клиенту. Принимаются входящие запросы в XML-формате. Ответ также будет уходить в XML-формате.

Первым делом необходимо получить API-ключ, чтобы сказать Яндексу, что мы свои. Как можно это сделать, смотрим тут.

Теперь переходим непосредственно к разработке.

Устанавливаем необходимые библиотеки: «pytz», «spyne», а также «yandex_translate». Библиотеки ставятся очень легко через pip.

Код приложения выглядит следующим образом:

from spyne import Application, rpc, ServiceBase, Unicode

from lxml import etree

from spyne.protocol.soap import Soap11

from spyne.protocol.json import JsonDocument

from spyne.server.wsgi import WsgiApplication

from yandex_translate import YandexTranslate

class Soap(ServiceBase):

@rpc(Unicode, _returns=Unicode)

def Insoap(ctx, words):

print(etree.tostring(ctx.in_document))

translate = YandexTranslate('trnsl.1.1.201somesymbols')

tr = translate.translate(words, 'en')

tr_answer = tr['text'][0]

return tr_answer

app = Application([Soap], tns='Translator',

in_protocol=Soap11(validator='lxml'),

out_protocol=Soap11()

application = WsgiApplication(app)

if __name__ == '__main__':

from wsgiref.simple_server import make_server

server = make_server('0.0.0.0', 8000, application)

server.serve_forever()Разберем код:

После импортирования необходимых библиотек, мы создали класс «Soap» с аргументом «ServiceBase». Декоратор "@rpc(Unicode, _returns=Unicode)" определяет тип входящих аргументов («Unicode») и исходящих ответов ("_returns=Unicode"). Список доступных типов аргументов можно посмотреть в официальной документации.. Далее создается метод «Insoap» с аргументами «ctx» и «words». Аргумент «ctx» очень важен, так как в нем содержится много информации о входящих запросах. Строка «print(etree.tostring(ctx.in_document))» выводит на экран входящий xml-запрос, в таком виде, в каком нам его отправил пользователь. В некоторых моментах это может быть важно. Например, мне в ходе написания веб-сервиса нужно было вытащить входящий xml-запрос и записать в базу данных. Но как вытащить этот xml-запрос не упомянуто в официальной документации Spyne. Burak Arslan (автор Spyne) порекомендовал смотреть в сторону библиотеки lxml. Только после этого я нашел ответ и результат видите в данноме скрипте. Далее наш метод обращается в Яндекс-переводчик и возвращает клиенту полученный от Яндекс-переводчика результат.

Переменная «app» определяет настройки нашего веб-сервиса: «Application([Soap]» — указывается, какой класс инициализируется (их может быть несколько), параметры «in_protocol» и «out_protocol» определяет тип входящих и исходящих запросов, в нашем случае это SOAP v1.1.

Строкой «application = WsgiApplication(app)» определяется, чтобы наш скрипт мог работать через wsgi.

Важно! имя переменного обязательно должен быть «application», чтобы наше приложение мог работать через apache с помощью mod_wsgi.

Последующие строки кода инициализирует и запускает Веб-сервер по порту 8000.

Запускаем скрипт и можно приступать к тестированию. Для этих целей я использую SoapUI. Удобство состоит в том, что после запуска и настройки для работы с SOAP сервером, SoapUI автоматически формирует xml-запрос. Наш xml-запрос выглядит следующим образом:

Тестируем наше приложение

Наш веб-сервис дал следующий ответ:

Test our app

Все просто, не правда ли?

2. REST-сервис

Предположим, что теперь у нас поменялось тех. задание, и нужно сделать веб-сервис, который работает через JSON. Что делать? Переписывать наш сервис на другом фреймворке, например Django Rest Framework или Flask? или можно обойтись меньшими усилиями? Да, можно! И нужно!

Библиотека Spyne нам в помошь.

Все что потребуется поменять в нашем приложении, это переменную «app» привести к следующему виду:

app = Application([Soap], tns='Translator',

in_protocol=JsonDocument(validator='soft'),

out_protocol=JsonDocument())Запускаем наш веб-сервис и тестируемся.

Наш JSON-запрос выглядит так:

Веб сервер вернул следующий ответ:

3. Вывод в продакшн

Для запуска нашего веб-сервиса через apache, необходимо на сервер установить и настроить веб-сервер apache и mod_wsgi. Данные работы несложно выполнить, опираясь на документацию. Кроме этого, в нашем скрипте мы должны удалить следующие строки:

from wsgiref.simple_server import make_server

server = make_server('0.0.0.0', 8000, application)

server.serve_forever()

Ура! Наш веб-сервис готов к использованию в эксплуатации.

P.S. о дополнительных возможностях Spyne (а их немало) всегда можно ознакомиться на официальном сайте, чего я вам очень рекомендую.

|

Метки: author maxpy разработка под linux python spyne apache httpd wsgi soap rest xml json |

[recovery mode] Призрак локомотива или биржевой рынок через призму корреляций |

Одной из легенд трейдеров является понятие «локомотива». Описать ее можно следующим образом: есть бумаги «ведущие» и есть бумаги «ведомые». Если поверить в существование подобной закономерности, то можно «предсказывать» будущие движения финансового инструмента по движению «локомотивов» («ведущих» бумаг). Так ли это? Есть ли под этим основания?

Сформулируем задачу. Есть финансовые инструменты: A, B, C, D; есть характеристика времени — t. Существуют ли связи между движениями этих инструментов:

At и Bt-1; At и Ct-1; At и Dt-1

Вt и Сt-1; Bt и Dt-1; Bt и At-1

Ct и Dt-1; Ct и At-1; Ct и Bt-1

Dt и At-1; Dt и Bt-1; Dt и Bt-1

Как получить данные для исследования этого вопроса? Насколько сильны, стабильны упомянутые связи? Как их можно измерить? Какими инструментами?

Предварительно заметим, что на сегодняшний день существует значительное количество прогнозных моделей. В некоторых источниках говорится о том, что их число превысило отметку ста. К слову — основная шутка действительности в том, что … чем сложнее модель, тем труднее интерпретация, понимание каждой отдельной компоненты этой самой модели. Подчеркну, что цель данной статьи – ответить на поставленные выше вопросы, а не использовать одну из существующих моделей прогнозирования.

Предварительно заметим, что на сегодняшний день существует значительное количество прогнозных моделей. В некоторых источниках говорится о том, что их число превысило отметку ста. К слову — основная шутка действительности в том, что … чем сложнее модель, тем труднее интерпретация, понимание каждой отдельной компоненты этой самой модели. Подчеркну, что цель данной статьи – ответить на поставленные выше вопросы, а не использовать одну из существующих моделей прогнозирования. Пакет pandas является мощным средством для анализа данных, который имеет богатый арсенал инструментов. Используем его возможности, чтобы изучить поставленные нами вопросы.

Предварительно, получим котировки с сервера компании «ФИНАМ». Будем брать «часовики» за период с 01.01.2017 по 13.07.2017. Немного модифицировав функцию, упомянутую здесь, получим:

# -*- coding: utf-8 -*-

"""

@author: optimusqp

"""

import os

import urllib

import pandas as pd

import time

import codecs

from datetime import datetime, date

from pandas.io.common import EmptyDataError

e='.csv';

p='7';

yf='2017';

yt='2017';

month_start='01';

day_start='01';

month_end='07';

day_end='13';

year_start=yf[2:];

year_end=yt[2:];

mf=(int(month_start.replace('0','')))-1;

mt=(int(month_end.replace('0','')))-1;

df=(int(day_start.replace('0','')));

dt=(int(day_end.replace('0','')));

dtf='1';

tmf='1';

MSOR='1';

mstimever='0'

sep='1';

sep2='1';

datf='5';

at='1';

def quotes_finam_optimusqp(data,year_start,month_start,day_start,year_end,month_end,day_end,e,df,mf,yf,dt,mt,yt,p,dtf,tmf,MSOR,mstimever,sep,sep2,datf,at):

temp_name_file='id,company\n';

incrim=1;

for index, row in data.iterrows():

page = urllib.urlopen('http://export.finam.ru/'+str(row['code'])+'_'+str(year_start)+str(month_start)+str(day_start)+'_'+str(year_end)+str(month_end)+str(day_end)+str(e)+'?market='+str(row['id_exchange_2'])+'&em='+str(row['em'])+'&code='+str(row['code'])+'&apply=0&df='+str(df)+'&mf='+str(mf)+'&yf='+str(yf)+'&from='+str(day_start)+'.'+str(month_start)+'.'+str(yf)+'&dt='+str(dt)+'&mt='+str(mt)+'&yt='+str(yt)+'&to='+str(day_end)+'.'+str(month_end)+'.'+str(yt)+'&p='+str(p)+'&f='+str(row['code'])+'_'+str(year_start)+str(month_start)+str(day_start)+'_'+str(year_end)+str(month_end)+str(day_end)+'&e='+str(e)+'&cn='+str(row['code'])+'&dtf='+str(dtf)+'&tmf='+str(tmf)+'&MSOR='+str(MSOR)+'&mstimever='+str(mstimever)+'&sep='+str(sep)+'&sep2='+str(sep2)+'&datf='+str(datf)+'&at='+str(at))

print('http://export.finam.ru/'+str(row['code'])+'_'+str(year_start)+str(month_start)+str(day_start)+'_'+str(year_end)+str(month_end)+str(day_end)+str(e)+'?market='+str(row['id_exchange_2'])+'&em='+str(row['em'])+'&code='+str(row['code'])+'&apply=0&df='+str(df)+'&mf='+str(mf)+'&yf='+str(yf)+'&from='+str(day_start)+'.'+str(month_start)+'.'+str(yf)+'&dt='+str(dt)+'&mt='+str(mt)+'&yt='+str(yt)+'&to='+str(day_end)+'.'+str(month_end)+'.'+str(yt)+'&p='+str(p)+'&f='+str(row['code'])+'_'+str(year_start)+str(month_start)+str(day_start)+'_'+str(year_end)+str(month_end)+str(day_end)+'&e='+str(e)+'&cn='+str(row['code'])+'&dtf='+str(dtf)+'&tmf='+str(tmf)+'&MSOR='+str(MSOR)+'&mstimever='+str(mstimever)+'&sep='+str(sep)+'&sep2='+str(sep2)+'&datf='+str(datf)+'&at='+str(at))

print('code: '+str(row['code']))

#Формируем перечень файлов в которых будут содержаться котировки.

#Один файл - один торгуемый инструмент

file = codecs.open(str(row['code'])+"_"+"0"+".csv", "w", "utf-8")

content = page.read()

file.write(content)

file.close()

temp_name_file = temp_name_file + (str(incrim) + "," + str(row['code'])+"\n")

incrim+=1

time.sleep(2)

#Формируем файл в котором содержатся code заголовки торгуемых инструментов,

#из расчета одна строка - один заголовок.

write_file = "name_file_data.csv"

with open(write_file, "w") as output:

for line in temp_name_file:

output.write(line)

#Перед запуском quotes_finam_optimusqp в распоряжении должен быть

#файл параметров function_parameters.csv

#___http://optimusqp.ru/articles/articles_1/function_parameters.csv

data_all = pd.read_csv('function_parameters.csv', index_col='id')

#Сузим область нашей выборки до тех инструментов, которые торгуются

#исключительно на id_exchange_2 == 1, т.е. МосБиржа акции

data = data_all[data_all['id_exchange_2']==1]

quotes_finam_optimusqp(data,year_start,month_start,day_start,year_end,month_end,day_end,e,df,mf,yf,dt,mt,yt,p,dtf,tmf,MSOR,mstimever,sep,sep2,datf,at)

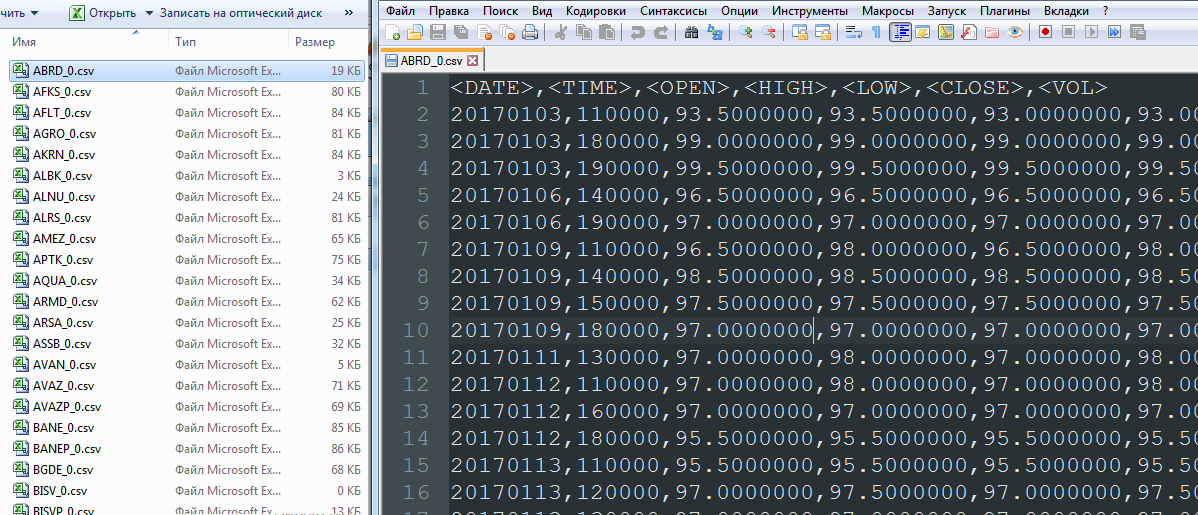

В результате имеем перечень файлов типа A_0.csv:

Далее определяем движения финансовых инструментов At-At-1, удаляем столбцы OPEN, HIGH, LOW, VOL, формируем единый столбец DATETIME. Произведем отсев тех финансовых инструментов, которые имеют слишком мало данных для анализа (торгуются недавно, нестабильно либо обладают малой ликвидностью).

#Зачем мы записываем файлы, и потом их считываем тут же?

#Все просто - ради наглядности процесса.

name_file_data = pd.read_csv('name_file_data.csv', index_col='id')

incrim=1;

#Введем показатель how_work_days - он нужен нам затем, чтобы не рассматривать

#неликвидные инструменты, либо инструменты с малой продолжительностью торговли

#на рынке

temp_string_in_file='id,how_work_days\n';

for index, row1 in name_file_data.iterrows():

how_string_in_file = 0

#открываем файл с котировкой по инструменту, в соответствие с имеющейся маской

name_file=row1['company']+"_"+"0"+".csv"

#а существует ли файл котировок? проверка файла на существование

if os.path.exists(name_file):

folder_size = os.path.getsize(name_file)

#если файл котировок имеет нулевой вес - следовательно он пуст, и мы можем его просто удалить

if folder_size>0:

temp_quotes_data=pd.read_csv(name_file, delimiter=',')

#если файл котировок пуст, в соответствие с исключением типа EmptyDataError

#его также удаляем

try:

#здесь будем рассматривать цены закрытия (CLOSE);

#остальные столбцы можем просто удалить

quotes_data = temp_quotes_data.drop(['', '', '', ''], axis=1)

#Определяем - какое количество строк в файле котировок

how_string_in_file = len(quotes_data.index)

#если файл котировок имеет количество строк менее чем 1 100,

#удаляем его; причина отсев неликвидных инструментов

if how_string_in_file>1100:

#формируем построчные записи для файла days_data.csv, в котором

#определяется количество периодов в течение которых торговался

#данный инструмент

temp_string_in_file = temp_string_in_file + (str(incrim) + "," + str(how_string_in_file)+"\n")

incrim+=1

quotes_data['DATE_str']=quotes_data[''].astype(basestring)

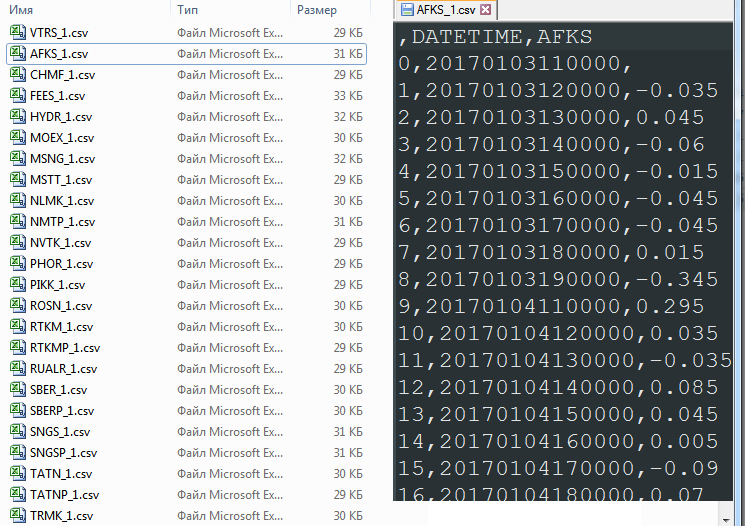

quotes_data['TIME_str']=quotes_data[' В результате получим перечень файлов типа A_1.csv. Всего 91 файл:

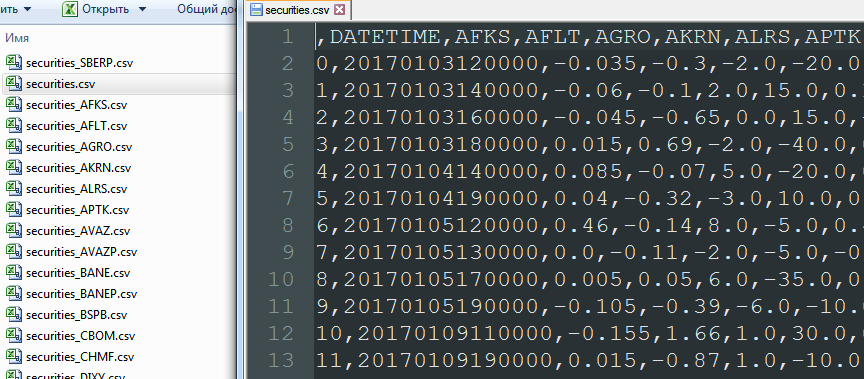

«Сливаем» в один файл securities.csv все движения всех финансовых инструментов, удалив первую пустую строку.

import glob

allFiles = glob.glob("*_1.csv")

frame = pd.DataFrame()

list_ = []

for file_ in allFiles:

df = pd.read_csv(file_,index_col=None, header=0)

list_.append(df)

dfff = reduce(lambda df1,df2: pd.merge(df1,df2,on='DATETIME'), list_)

quotes_data = dfff.drop(['Unnamed: 0_x', 'Unnamed: 0_y', 'Unnamed: 0'], axis=1)

quotes_data.to_csv("securities.csv", sep=',', encoding='utf-8')

quotes_data = quotes_data.drop(['DATETIME'], axis=1)

number_columns=len(quotes_data.columns)

columns_name_0 = quotes_data.columns

columns_name_1 = quotes_data.columns

На данном этапе происходит довольно интересная операция объединения записей по столбцу DATETIME (pd.merge). Этот порядок объединения отбрасывает те даты, в которые не торговалась хотя бы одна из 91 ценной бумаги. То есть объединение основано на полном исключении пустых данных. В результате:

В файле securities.csv, оперируя данными в цикле сдвигаем все строки, кроме текущей. Таким образом, напротив At оказываются значения Bt-1, Ct-1, Dt-1.

incrim=0

quotes_data_w=quotes_data.shift(1)

for column in columns_name_0:

quotes_data_w[column]=quotes_data_w[column].shift(-1)

quotes_data_w.to_csv("securities_"+column+".csv", sep=',', encoding='utf-8')

#Вернем на место сдвинутые строки

quotes_data_w[column]=quotes_data_w[column].shift(1)

incrim+=1

Данные будут выглядеть так:

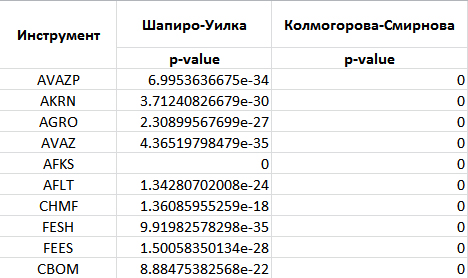

И, да, необходимо удалить первую строку с пустыми данными. Теперь можно построить корреляции между столбцами. Они то и выявят существование либо отсутствие бумаг-«локомотивов»… или дадут возможность уверится, что «локомотивы» — это не более чем миф.