Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Открытый протокол для децентрализованной коммуникации [matrix] ищет спонсоров для продолжения разработки |

|

Метки: author Murz децентрализованные сети matrix.org riot.im matrix мессенджеры мессенджеры для командной работы slack |

Нематериальная мотивация — что туда включено |

tl/dr: список всяких нематериальных бонусов, и что спросить на собеседовании.

Больше этого люблю только рассказы от HR на собеседованиях, вида — у нас, вы не поверите, белая !1одинодин зарплата .

Вот только часто список этим и исчерпывается, увы. Конечно, возможность получить 2-НДФЛ с большой суммой для ипотеки кому-то и сгодится как бонус, но я слышал о несознательных бухгалтериях (один мой друг, граф ДлФ даже работал в таковой), которые в 2-НДФЛ напишут сколько надо, даже если у тебя официально 30к (в Москве), а остальное премия, бонус, и иногда конвертик.

Для удобства опроса HR-ов на собеседованиях и был составлен список ниже. Список, конечно, местами очень нематериальный — но легко пересчитывается в рубли.

Начну с все же материального:

Зарплата: белая, серая или как. И в каком соотношении. Сколько оклад, сколько премия, есть ли она.

Премии. Связаны ли они с KPI и вообще есть ли он.

Обратное премии – штрафы. Есть ли, за что и откуда вычитаются.

Индексация ЗП по инфляции

Переработки, работа в выходные, их частота, оплата.

Работа вне плана – например, устранение аварий. Оплата, сроки оплаты.

Есть ли система переаттестации по и не итогам, «грейдов» и прочего, и как это все работает.

Пенсионные планы. Конечно, 401(к) в РФ нет, но можно и уточнить.

ВНЕЗАПНО актуально для РФ. Даже для некоторых крупных (действительно крупных) организаций – что у вас с задержками ЗП за последний год.

Также в некоторых финансовых учреждениях и нефтегазовых компаниях дают льготную ипотеку или программу улучшения жилищных условий

Правда, автор и критики/коллеги, за годы работы не встречали коллег, успешно участвующих в настоящей программе. При этом кредиты (порой невозвратные, или под 0%) для топ-менеджмента – явление более чем постоянное.

Не материальное, но влияющее на жизнь и судьбу.

Будет ли работа с гостайной

Будет ли и сколько займет проверка СБ.

Каковы условия и продолжительность испытательного срока

Теперь не материальное, но все еще не бонусы.

График работы – 8-17, 9-18, сменный, прочие варианты. Возможность сдвига графика на +- час.

Строгость контроля графика. Надо ли приходить строго за 2 минуты до, или как.

Сам график – обед, перерывы на покурить / чай / прочее. Строго 5 минут/час, или свободно.

Дресс-код. Есть ли, строгий/не строгий.

Отпуска, и особенно вызов из отпуска

Есть такая штука, как передача дел во время отпуска (замещение). Как это оформлено, устроено, практикуется ли и вообще.

Проезд в отпуск (актуально для около-РЖД, около-авиа и в некоторых регионах).

Уходы с половины дня – например, к зубному или по другим задачам.

Нематериальное: ДМС и прочий ЗОЖ

ДМС. Включена ли в ДМС стоматология и в каком объеме

Фитнесс (свой или бонусы / скидки)

1-2 дня болезни без оформления.

Доплата за время болезни по полной ставке, а не по стандарту ОМС.

Страховка (дмс) на детей.

Страхование жизни также кое-где присутствует и страховка для выезжающих за границу (мелочь но приятно, особенно когда нужно на визу такую страховку делать).

Врач в офисе, который может выписать какое лекарство или первичный осмотр провести.

Да хотя бы просто аптечка в офисе.

Примечание – автор с времен работы сборщиком компов из говнокорпусов привык держать на работе свою аптечку — бинт, пластырь, йод, перекись, и универсальную таблетку – от головы и вторая половинка. Поскольку автор еще и немного жирный и чуть-чуть дебиловат (не так как некоторые дизайнеры, конечно) – то в аптечке есть еще и жгут, и хлоргексидин, и термометр (электронный), и еще что-то. И, внезапно, ацикловир, после наблюдения коллег с распухшей физиономией.

ЗОЖ

Наличие велопарковки (открытой/закрытой) и, например, душа. Опять же, актуально при устранении серьезных аварий, когда иногда приходится сутки-двое проводить на работе.

Кухня.

Что с питанием, своей столовой или просто кухней, с кофемашиной (бесплатной – кофе свой или как) или кофейным автоматом и микроволновкой, и холодильником. Есть ли бонусы на питание в местной столовой. Ближайшие магазины. Можно ли пить кофе/чай/соки-воды на рабочем месте.

Транспорт

Стоянка (актуально для МСК). Есть ли, открытая/закрытая, что и как с оплатой.

Корпоративный транспорт, служебный проездной (в 1с вроде было).

Специфика транспорта в РФ.

Иногда могут предложить служебный автомобиль (или Рено Логан вместо автомобиля) или предложить компенсацию использования собственного автомобиля (Но готовы ли вы использовать собственный автомобиль за 1000 (одну) тысячу рублей в месяц – видел такое объявление).

Но в целом для работы в около-ИТ (например, обслуживание кассовой и сопутствующей техники в магазинах) служебная машина – это часто встречающееся явление. Могут быть фокусы с оплатой бензина (лимиты, по чекам, итд).

Доступность.

Сотовый телефон (служебный, актуально для тех кто всегда на связи, даже в отпуске).

Состояние «на телефоне» — и в выходные, и в отпуске тоже или как? Оплата пребывания «на телефоне в зоне 3 часовой физической доступности / с доступом к интернету и доступности в любой точке мира даже в отпуске».

Работа из дома. Можно ли, как часто.

Оплата интернета (бывает кое-где).

Учеба.

Учеба по специальности. Есть ли, каковы условия. Есть ли отработка и прочие условия. Сколько лет срок рабства при оплате за тебя конторой. В том числе поездки скажем на VMworld.

Отпустят ли в учебный отпуск (если учеба в институте)

Как будет проходить отсутствие на рабочем месте, если учебу сам оплатил – как отпуск за свой счет, как вычитание из отпуска или как учебный отпуск? Или просто закроют глаза по какой-то договоренности?

Примечание: Вообще говоря, стоит избегать неявных договоренностей с рядом руководителей. Гораздо проще, чтобы это все проводилось через отдел кадров, и потом не возникало недоговорок «кто что подумал».

Скидки или какие-то учебные курсы в офисе (иностранный язык) или по партнерским программам

Наличие у организации подписок на всякие MSDN

Наличие партнерских курсов за бонусы (у интеграторов и крупных продавцов)

Наличие связей у организации для отправки на всякие вроде бесплатные курсы на 1-3 дня, иногда даже и в рабочее время.

Командировки и работа в филиалах / офисах.

Командировки ДЛЯ проведения учебы кому-то, например чтение лекций и докладов.

Перспективы и задачи на ближайшие полгода-год.

Рабочее место.

Просто показать рабочее место.

Что хотя бы просто с ПК – потому что для ИТ порой удобно держать два монитора. Иногда три, на третий выводится мониторинг.

Что с освещением, вентиляцией, оборудованием. Тепло/холодно, особенно в случае холодных балок и закрытых наглухо окнах(принципиально не открываемых). Шумность, удобство. Степень опен-спейсности. Возможность поставить свой увлажнитель.

Наличие контроля CO/CO2. Видел в одном офисе (одной кампании с хабра, хочу заметить) такое вживую.

Всякие офисные бонусные зоны – мини-переговорки, настольный теннис итд.

Корпоративы и тимбилдинги.

Есть ли, что там как, насколько маразматичны. Потому что корпоратив уровня «вот вам 100$ на отдел, дальше сами» отличается от корпоратива с конкурсами по бегу в мешках и кукурузе-царице полей.

Пополнение приветствуется.

|

Метки: author Scif_yar читальный зал собеседование собеседования условия труда условия работы мотивация мотивация персонала мотивация сотрудников |

Универсальная рекламная кампания для всех видов бизнеса |

Конечно, это мысль утопическая, но все-таки можно выявить некоторые шаблоны поведения людей и создать такие паттерны для креативов, которые бы работали безотказно. В каком-то роде мне это даже удалось.

Персональное обращение

Самая эффективная реклама была тогда, когда у потенциального покупателя создавалось впечатление диалога. Когда бренд обращается к потребителю напрямую. Один на один. Без всяких заумных слоганов, без лишнего. А с простым вопросом в подтексте: «А тебе вообще это надо?». На что у потребителя возникал ответ да или нет.

Я продолжил свои поиски. Мне хотелось создать такую кампанию, которая бы сразу била в цель. Без особых усилий. Как донести до человека, что я обращаюсь к нему? Как сделать так, чтобы это работало на всех и в то же время было персональным обращением? И тут вспомнилась легендарная рекламная кампания Красной Армии.

Я перепробовал десятки разных картинок, в том числе и эту, а потом и с изображением дяди Сэма. И понял, что в них самое важное — указательный палец. Покажи на человека пальцем и спроси. Неужели вот он тот концепт, который я ищу? Я начал просто фокусироваться на пальце. Попробовал разные креативы с пальцем.

И в итоге найден тот самый

На фото вы видете только несколько ниш.

- Кредитные карты

- Услуги по настройке яндекс директа

- Написание песен для влюбленных

- Банкротство физических лиц

- Услуги по ремонту квариры

- Оригинальные хенд-мейд подарки

- Купоны на скидку

- Услуги риелтора

Через таргет я общался с разными сегментами целевой аудитории. В абсолютно разных нишах, ценовых сегментах, B2C и B2B секторах. И этот концепт работал эффективно снова и снова. Менялось лишь предложение. Менялся лишь вопрос. Тизер для привлечения внимания оставался одним и тем же. В некоторых нишах рекламные кампании работают и сейчас уже более двух лет. И этот палец все еще тащит им клиентов.

Из всех ниш, где я его пробовал, то в 60% случаев этот тизер был самым эффективным. И мне кажется, что где-то существует в природе универсальная рекламная кампания, которая работала бы максимально эффективно для большего процента бизнесов. Возможно, это просто другая картинка указательного пальца?

|

Метки: author Tenqz интернет-маркетинг таргетированная реклама таргетинг маркетинг реклама вконтакте таргетинговая реклама |

[Перевод] Почему я ненавижу Spring |

Но некоторые мои коллеги были склонны не согласиться. У них возникали проблемы, когда они пытались связать всё так, как им хочется; они не знали, где какие XML-файлы им нужны. Были проблемы с версиями Spring, с тем, как подружить их (я, к тому же, далеко зашел с модульностью: у нас было 5 или 6 разных модулей с разными номерами версий, и нельзя было просто так взять и понять, какой из них использовать, не спросив меня). Это были тревожные звоночки, но я их не замечал; я думал, что нужно больше документации или что те ребята просто тупые. Такая ситуация типична сама по себе: мольбы пользователей одного из самых нелюбимых и трудных в использовании фреймворков о помощи часто разбиваются о «да там один файл и немного параметров, это не так уж и тяжело», в то время как все остальные целыми днями пытаются найти магическую комбинацию файлов и параметров, чтобы хоть что-нибудь как-нибудь заработало.

Я всё ещё работаю в той же организации, но теперь я пользователь своего старого фреймворка. В результате этого питания кормом своей собаки я стал ненавидеть Сэма (автор имеет в виду себя — прим. пер.) 2009-2010 годов по нескольким причинам, но в основном — за Spring. Spring — это зло в хорошую погоду, но когда его включают в состав библиотеки или API, которым пользуются другие программисты, — это уже другой уровень зла: как плод любви Гитлера и дьявола. Не позволяйте Spring торчать из вашего API наружу.

Spring — отстой по ряду причин, и я почувствовал, что их нужно перечислить, т.к. в google нет четких контраргументов.

- Конфигурация в XML. Хотел бы я думать, что мы как профессия оставили XML в прошлом. Он невероятно многословен, но это ещё цветочки. Намного важнее то,

что я не хочу программировать на XML. Связывание всех классов воедино — чрезвычайно важная часть вашего приложения. Вы Java-разработчик, а не XML-разработчик. Одна из прелестей Java как языка — compile time safety. Я могу скомпилировать свои приложения, в которых нет Spring, и быть на 100% уверенным, что всё собрано, подключено и готово к работе. Но если в приложении есть Spring, ты запускаешь его, ждешь 30-60 секунд, пока оно инициализирует бины, прежде чем упасть. В современном мире это безумие, особенно если это еще и умножается на кучу интеграционных тестов, в которых вам нужно вертеть контейнер так и этак. Отдельного места в расстрельном списке заслуживает «это значит, что я могу менять реализацию без перекомпиляции!». Так никто не делает. Никогда. - Магия. Тут обычно следует реплика: «Теперь вы можете делать всё с помощью аннотаций! Больше никакого XML!». Здорово, когда не нужно программировать на XML, но аннотации — это всё ещё магия. Пока вы не запустите приложение, вы понятия не имеете, свяжется ли оно правильно. И даже потом вы не знаете, правильно ли оно связалось; вы всего лишь знаете, что оно связалось. Не люблю магию.

- Импортирование других Spring-файлов. В данный момент это бесит меня больше всего. Я обнаружил, что существует тенденция разбивать Spring-файлы на более мелкие и раскидывать их по модулям. Я только что убил 2 недели, продираясь сквозь JAR'ы и пытаясь найти правильную комбинацию/порядок/версию Spring-файлов, чтобы кое-что заработало. Spring-файлы в JAR'ах — это плохая, плохая идея. Ужасная. Каждый раз, когда вы размазываете зависимые Spring-файлы по JAR'ам, где-то умирает ребенок.

- Сложность. Когда на собеседовании спрашиваешь кандидата: «Какие подводные камни есть в Spring?» — чаще всего слышишь в ответ, что у него крутая кривая обучения. Правда это или нет — отдельная тема, но я хотел бы подчеркнуть тот факт, что Spring сейчас настолько сложен, что у него есть собственный фреймворк — Spring Boot. Фреймворк для фреймворка. Мы во «Framework Inception» — фильме о Леонардо Ди Каприо, который пытается найти свой давно потерянный Java-код, всё глубже и глубже погружаясь в слои XML и аннотаций, прежде чем в конце концов покончить с собой.

Штука в том, что я уверен: удачно использовать Spring в приложении теоретически возможно. Я еще никогда такого не видел, и это проблема. Как по мне, все «плюшки», которые он предлагает, вполне возможны и без него. Когда мы спрашиваем о Spring на собеседовании, кандидат обычно отвечает: «Со Spring у вас есть чистый код, разделение ответственности, к тому же он действительно хорош для тестирования». В общем, все те вещи, большим поклонником которых я являюсь (особенно тестирование), но на самом деле это результаты не использования Spring, а хорошего программирования. Возможно, для новичков Spring — это хороший костыль для освоения таких идей, как внедрение зависимостей, mocking и тестирование, но на самом деле они ортогональны Spring. Если вы применяете TDD, у вас в коде не будет геттеров и сеттеров — только внедрение зависимостей через конструкторы, которые вы можете «замокать» для тестирования, а затем, когда вы связываете своё приложение воедино, просто используете часто забываемый способ создания объектов — ключевое слово «new». Зачастую мы создаем класс «ApplicationContext», который отвечает за связывание всего воедино. Он чистый, всё тестируемо, у меня есть compile time safety, и мои тесты выполняются чертовски быстро.

|

Метки: author s-kozlov java spring framework spring sucks holywar |

Процесс создания синематика вживую. Стрим завтра, 27 июля в 15.00 |

Наблюдайте вживую за отрисовкой скетчей, митингами, созданием анимаций и процессом озвучки нового синематика для игры Vikings: War of Clans.

На следующем стриме 27 июля в 15.00 мы ответим на вопросы в комментариях, разберем сценарий ролика и нюансы раскадровки. После этого наш Concept Artist продолжит отрисовку скетчей в прямом эфире.

Для тех, кто не видел первый стрим, мы выбрали самое интересное и добавили комментарии к процессу.

|

|

Высокотехнологичный шопинг: инновации, меняющие облик ритейла и торговых центров |

Фото foodandnutrition.org

Покупателям не понадобятся деньги…

До коммунизма, при котором «все будет бесплатно», мы, похоже, не доживем. Зато шопинг в современном торговом центре без наличных денег и даже банковских карт – это уже наша действительность. Внедряющийся повсеместно процесс оплаты при помощи смартфона предельно прост. Клиент использует либо мобильное приложение своего банка, либо софт, поставляемый ритейлером. Удобно со всех сторон – даже с точки зрения хранения чеков и квитанций, которые приходят покупателю по электронной почте. Похоже, что в скором времени большей неприятностью при поездке в торговый центр станет не забытый дома кошелек, а разрядившийся смартфон. Хотя МЕГА, например, уже решила эту проблему: гости торговых центров могут зарядить свои телефоны в защищенных замками ячейках.

Сегодня смартфон – важнейший союзник ритейла в деле сбора информации о потенциальных клиентах. Эти данные, именуемые Big Data, содержат сведения о «средних чеках», предпочтениях и интересах покупателей.

Большие данные – волшебный ключик к лояльности клиента, который позволяет максимально персонализировать взаимоотношения. Многие ритейлеры разрабатывают для этих целей собственное ПО. С одной стороны, такой софт помогает продавцу собрать еще больше данных. С другой – улучшает сервис для постоянных клиентов. В тех же торговых центрах МЕГА при помощи мобильного приложения покупатель может получить множество приятных привилегий. Например, быстро найти нужный магазин, синхронизировать данные с другими устройствами или поделиться списком покупок с другими членами семьи. Приложение МЕГА также помогает найти самый удобный способ добраться до торгового центра (в зависимости от местоположения пользователя, времени суток и загруженности дорог) и оперативно получать информацию о новых интересных акциях во всех (или определенных) магазинах. Хит программы лояльности МЕГА — дебетовая или кредитная карта MEGACARD, которая работает как полноценная банковская карта и при этом позволяет накапливать баллы за МЕГА-шоппинг и практически полностью оплачивать ими товары в магазинах торгового центра.

… а магазинам – продавцы

Представьте себе: выбрав в торговом зале нужные товары, вы преспокойно выходите с ними из магазина, не задерживаясь ни на секунду. А деньги автоматически списываются с вашего счета. Такие «магазины без продавцов» в Японии начинают внедрять на правительственном уровне. До 2025 года на эту систему должны перейти порядка 50 тысяч торговых точек страны.

Для учета и контроля все товары будут оснащаться чипами, содержащими информацию о цене и производителе, сроке годности продукта и другие полезные данные. Помимо прочего, такие чипы упростят процесс учета товаров для самих ритейлеров. А также для производителей – информацию можно будет просматривать удаленно.

Внешне эта система напоминает тестовый проект Amazon Go. Впрочем, этот знаменитый оффлайновый супермаркет, открывшийся в Сиэтле в конце прошлого года, не использует чипы. Контроль ведут системы искусственного интеллекта, однако им пока далеко до совершенства. К примеру, если в магазине находится больше 20 человек – система дает сбои. Проблемы возникают и в случае, когда товар меняет свое положение на полке. Например, клиент посмотрел на продукт, покрутил его в руках – и положил на другую полку. А система его уже «потеряла». Так что массовый запуск сети «роботизированных магазинов», планировавшийся изначально на весну 2017 года, не состоялся.

Amazon Go – магазин, в котором не нужны продавцы. Фото engadget.com

В любом случае роботы выполняют в Amazon все больше задач. И довольно эффективно: например, робо-кладовщики Kiva позволили компании снизить складские расходы аж на 20%.

И все же совсем без «человеческого» персонала не обойтись. А вот помочь продавцам в их работе искусственному интеллекту вполне по силам. В этом плане любопытна инновация российских разработчиков из Дубны – алгоритм слежения за эмоциями, распознающий потенциальных покупателей по лицам. Ноу-хау пока что тестируется в единственном магазине спорттоваров в Дубне. Интеллектуальная камера по мимике и другим характерным признакам определяет, когда человек готов совершить покупку. После чего система отправляет сообщение с фотографией клиента ближайшему консультанту.

Тем временем французский ритейлер Auchan успешно протестировал в одном из своих супермаркетов в Португалии робота-носильщика. WiiGO узнает клиента в лицо и следует за ним по торговому залу на расстоянии около полутора метров. В планах компании – использовать такого рода ассистентов для оказания помощи пожилым людям, лицам с ограниченными возможностями, а также женщинам с детьми и беременным. К примеру, WiiGO можно доверить коляску с ребенком или тележку с покупками.

Тележки с планшетами и планшеты без тележек

Кстати о тележках. Оригинальную противоугонную систему CartControl запатентовала канадская компания Gatekeeper Systems. «Умные» колеса автоматически блокируются при попытке пересечь заданный периметр. Администрация может установить необходимые границы – например, в пределах парковки. Теперь и супермаркет не несет потери от «угонщиков», и клиенту не нужно оставлять залог за тележку в виде жетонов или монет.

Такое антиугонное устройство не помешало бы smart-тележке, созданной белорусскими стартаперами. Суть инновации – планшет в антивандальном корпусе, который вмонтирован в тележку. Гаджет Shop Carts помогает выбирать товары и даже оплачивать покупки, избавляя клиентов от необходимости терять время в очередях. Удобная навигация включает голосовой поиск. Поднесите к планшету штрих-код – на тачскрине отобразится цена продукта и другая информация. Гаджет подсчитывает стоимость всех товаров в корзине и без проблем принимает оплату при помощи мобильных телефонов и банковских карт. Shop Carts может хранить информацию о каждом клиенте: в следующий раз «умная» тележка быстро сориентирует вас по сохраненному в «Личном кабинете» списку покупок.

Интерфейс «умной» тележки: исчерпывающая информация о товарах плюс возможность прорекламировать акции магазина.

Фото tech.onliner.by

Стоит отметить, что в китайских супермаркетах тележки с планшетами используются уже давно. Правда, в Китае этот гаджет выполняет сугубо развлекательные и рекламные функции. Не самая плохая идея: клиенты могут просматривать почту или новости, стоя в очереди, или гуглить информацию о товаре в интернете. Однако концепт, предложенный белорусами, открывает перед ритейлом гораздо больше перспектив. Чего стоит только персонализация подхода к каждому клиенту, возможность разработок программ лояльности или сбора пресловутой Big Data! Дальше все зависит от софта. Например, в предложенной разработчиками демоверсии, есть виртуальная помощница, которая эмоционально призывает гостей к шопинговым подвигам.

«Умное» зеркало и непогода в примерочной

После smart-тележки наделенное искусственным интеллектом зеркало впечатляет уже не так сильно. Такие зеркала появились в примерочных магазинах компании Ralph Lauren. Устройство считывает информацию о предметах одежды, которые покупатель принес в кабину. После этого на поверхности зеркала отображаются не только выбранные товары и информация о них, но и похожие модели. Сочетания с другими предметами гардероба, различные цвета и размеры, данные о материалах – все это кликабельно и интерактивно. Нужен другой размер или фасон? Кликните по изображению на зеркале, и консультант тут же принесет заказ. Стоит ли пояснять, что зеркало является одновременно тачскрином? Немаловажно, что система способна запомнить покупателя – с тем, чтобы улучшить его обслуживание в ходе следующего визита.

Зеркала в примерочных Ralph Lauren дают дельные советы по обновлению гардероба.

Фото starfl.com

Впрочем, далеко не все примерочные кабины предназначены для создания комфортных условий – бывает и наоборот. Компания Globetrotter выпускает одежду для экстремальных видов спорта. И примерить ее предлагается в не менее экстремальных условиях. Так, в специально разработанных кабинах для клиентов устраивают настоящий шторм, обливая их водой и обдувая холодным воздухом. А можно понизить температуру до минус 30 градусов, чтобы сымитировать суровую зиму. Опять же, по желанию клиента – с порывистым ледяным ветром. Отличная возможность протестировать товар в приближенных к реальным условиям!

Бывает и так, что примерять одежду по каким-либо причинам не хочется. Здесь как раз пригодится разработка Texel. Компания — разработчик программного обеспечения и производитель профессиональных 3D-сканеров для получения 3D-моделей людей и крупногабаритных объектов, победитель российского этапа конкурса для стартапов Seedstars World 2015 и финалист прошлогоднего МЕГА Accelerator (подробно о продукте и о том, что ему дал акселератор, мы рассказывали в прошлой публикации).

По словам разработчиков, созданная ими 3D-кабина способна сканировать по 40 объектов в час, при этом полученные с ее помощью модели могут легко использоваться пользователями для 3D-печати, поскольку точность передачи текстуры составляет 1 миллиметр. В ходе пилотного проекта в МЕГА Белая Дача были отсканированы более 20 тыс. человек.

Покупки, которые добираются «своим ходом»

Современный ритейл упрощает не только процесс приобретения товара, но и его доставку. Не исключено, что вскоре торговые центры последуют примеру онлайн-ритейлеров, успешно наладивших оперативную транспортировку посылок беспилотниками. Например, китайский интернет-магазин JD.com к концу года намерен наладить доставку заказов дронами по ста регулярным маршрутам. Кстати, по «дронизации» ритейла Китай уже обогнал Соединенные Штаты. Хотя родоначальник такого типа доставки, упомянутый выше Amazon, продолжает внедрять инновации в «воздушное направление». Компания намерена запускать «складские дирижабли» над районами, в которых наблюдается повышенный спрос. Время доставки таким образом можно будет свести к минимуму.

Беспилотники могут быстро доставить заказ покупателю. Фото gagadget.com

В идеале клиента вообще не должно заботить то, как покупки попадут к нему домой – пусть об этом подумает соответствующая служба магазина. Более того, заботливый ритейлер и покупателю поможет с транспортом. В МЕГЕ этой цели служит интерактивный киоск, через который можно быстро заказать такси. И не только: эти интерактивные дисплеи стараются стать настоящими виртуальными помощниками для наших гостей.

Мы пробежались лишь по некоторым, наиболее заметным инновациям в сфере ритейла. И хотя многие проекты пока находятся в стадии тестирования, можно не сомневаться: в недалеком будущем они найдут свое место в магазинах и торговых центрах. Надеемся, что они вдохновят вас на участие в нашем МЕГА Accelerator 2. Приходите к нам со своими высокотехнологичными идеями о том, как сделать посещение торгового центра интереснее, комфортнее и полезнее для его гостей, получите большую экспертизу, 350 тыс. на создание прототипа и шанс выиграть 2 миллиона рублей.

Подробную информацию можно получить на нашем сайте. Последний день приема заявок — 27 июля.

|

Метки: author MEGA_Accelerator управление проектами управление e-commerce развитие стартапа бизнес-модели блог компании мега accelerator мега акселератор ритейл инновации |

Что нового в nginx? |

Максим Дунин (Nginx, Inc.)

Ведущий: Я представляю вашему вниманию следующего докладчика. Встречайте – Максим Дунин. И он расскажет о том, что же нового появилось в технологии под названием nginx.

Дисклеймер: речь пойдёт о нововведениях в 2016 году. Можно подумать, что это давно, но информация об изменениях в changelog от автора этих самых изменений полезна всегда!

Максим Дунин: Добрый день! Я Максим Дунин. Как вы, наверное, знаете, я разработчик nginx. Сегодня буду вам читать changelog вслух и с выражением. Для начала давайте определимся, с какого именно места мы будем читать changelog. Посмотрим на статистику.

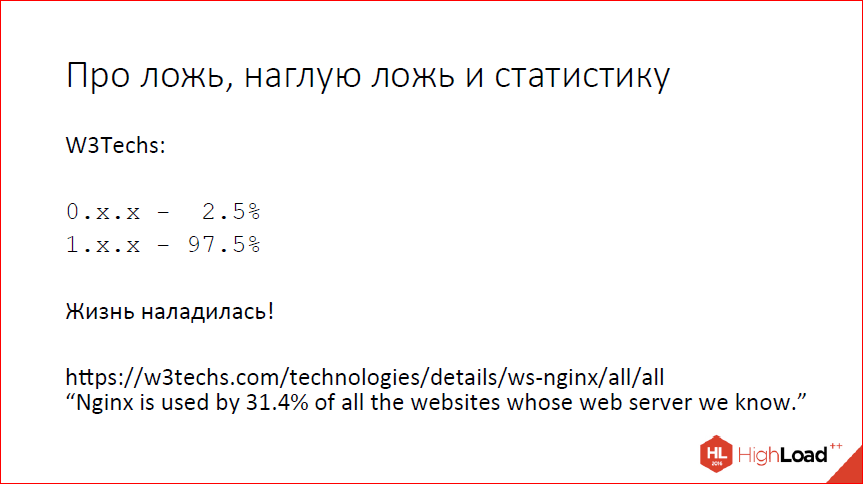

Если верить W3Techs, нулевой версии nginx практически не осталось. Есть еще отдельные товарищи, которые держатся за Debian 6, но их мало, на них мы ориентироваться не будем. Если вы все еще используете нулевые версии nginx, вам стоит обновиться.

Первая версия – сейчас уже практически 97%. Я искренне считаю, что это хорошо, потому что когда 3 года назад я делал аналогичный доклад, все было очень печально, народ как-то очень усиленно сидел на старых версиях, мы предприняли массу усилий, чтобы как-то эту ситуацию изменить.

Смотрим подробнее на то, что происходит в первой версии. И видим, что фактически 50% пользователей уже на текущем стейбле 1.10, еще 5% достаточно смелые, чтобы использовать то, что мы используем и разрабатываем mainline 1.11. Остальные, так или иначе, выучили, что четные версии у нас стабильные, и как-то не спешат обновляться, наверное, просто потому что используют то, что предоставляют собственные дистрибутивы операционных систем и nginx не особо пользуются или не знают, чего нового появилось и зачем им нужно обновляться.

Сегодня я расскажу, зачем нужно обновляться, и что вы получили, если уже обновились до 1.10 или до 1.11.

Для начала – то, что появилось в ветке 1.9 и доступно в версии 1.10.

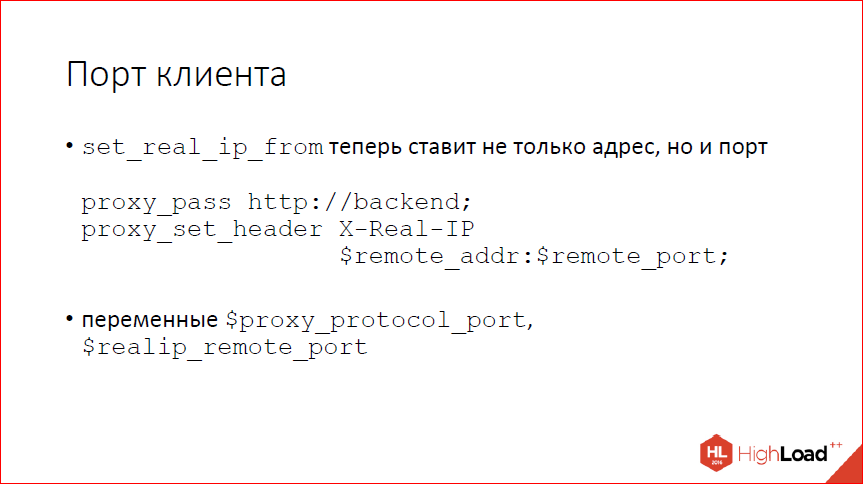

Мы научились, наконец-то, использовать порт клиента в различных местах, отошли от моделей, что IP’шников хватит всем, и, если вы много работаете с клиентами за NAT’ом (что сейчас, наверное, у всех), то Real_IP-модуль в том числе поддерживает порт, и можно вытаскивать его из proxy-протокола, можно передавать на бэкенд руками через X-Real-IP.

Следующий вопрос – идемпотентность. Кто знает, что такое идемпотентность? 3 человека в зале. Круто… Приблизительно это мне и говорил Игорь, когда я произносил слово «идемпотентность».

Идемпотентность – это такое свойство объекта или операции при повторе давать тот же самый результат. С точки зрения http, GET-запрос идемпотентен, потому что каждый раз вам возвращают один и тот же ресурс, если вы сделаете запрос не один раз, а два раза, то ничего не изменится. Если вы сознательно не пытались нарушить протокол http и не повесили на GET-запрос какую-нибудь операцию, как большинство счетчиков делают. Например, любая статистика у вас в результате не идемпотентна, потому что повторенный дважды GET-запрос засчитывает два хита. Но с точки зрения стандарта GET идемпотентен. Практически все методы http идемпотентны, кроме POST из основного стандарта и двух дополнительных методов LOCK И PATCH.

Почему это важно? Важно это потому что, когда nginx куда-то что-то проксирует, он имеет привычку запросы повторять. Для неидемпотентных запросов это может плохо кончиться, если ваше приложение ожидает полного соответствия стандарту. Вы можете от этого защититься, напрограммировав некую защиту для POST-запросов, чтобы детектировать дубли. Наверное, даже не можете, а должны защищаться, потому что, так или иначе, у вас, скорее всего, дубли из браузера будут прилетать. Но, поскольку мы стремимся быть стандартными, мы сделали так, что теперь nginx запросы неидемпотентные по умолчанию не повторяет и ведет себя так, как предполагает стандарт и т.к. некоторые люди программируют.

Если nignx начал уже отправлять запрос на бэкенд, случилась ошибка, повторно он этот запрос не отправляет для POST-запросов. GET-запросы замечательно отправляет, потому что имеет право. POST-запросы не отправляет. Если вам хочется вернуть прежнее поведение, это можно сделать легко с помощью конфигурации. Пишете: «proxy_next_upstream» и добавляете параметр «non_idempotent».

Следующий вопрос – запись в кэш. Мы в nginx записью особо долгие годы не занимались, потому что с записью все обычно просто. Вы сказали ОС: «Запиши мне в файлик данные», ОС сказала: «OK, я записала», а на самом деле сохранила в буфера и когда-то потом запишет.

Это не всегда так. Если у вас очень много записи, вы можете наступить на то, что буфера ОС закончились, и ваша запись заблокируется. Чтобы этого не происходило, теперь nginx умеет писать через thread’ы, если у вас очень много записи в кэш, вы можете с помощью директивы aio_write включить запись через thread’ы. Пока работает только через thread’ы. Вероятно, когда-нибудь в будущем сделаем и через posix aio.

Опять же, кэш теперь научился за собой следить и превентивно очищать зону разделяемой памяти от лишних записей, если у него памяти не хватает.

Теперь вы ошибок аллокации видеть не должны, если вдруг у вас зона маленькая, просто nginx будет хранить столько, сколько в зоне помещается. Он и раньше это пытался делать, но пытался он это делать по факту, т.е. когда он не мог аллоцировать очередную запись в разделяемой памяти, он говорил: «А давайте мы попробуем удалить самую старую запись», удалял ее и пытался аллоцировать снова. Обычно это получалось. Если у вас высокая нагрузка, много рабочих процессов, это могло не получиться просто потому, что какой-то другой рабочий процесс успевал освобожденную память занять. Плюс к тому, это требует некоторого времени, потому что предполагает удаление файла, соответственно, syscall, уход в диск. Не хочется этого делать в рамках обработки запроса, не хочется, чтобы пользователь ждал, теперь этим умеет заниматься cache manager.

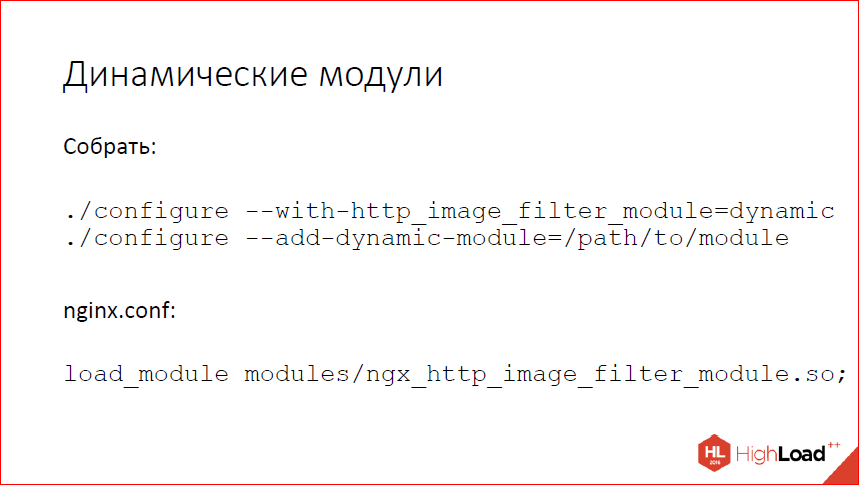

Напрограммировали динамические модули, наконец-то.

Основные цели, которые мы ставили – это упростить сборку пакетов в первую очередь. потому что внешние зависимости у отдельных модулей сильно усложняют сборку и установку пакетов. Либо вы делаете некоего монстра, который зависит от всего в системе, либо вы не включаете какие-то модули, которые имеют плохие внешние зависимости, либо вы собираете много разных пакетов с такими модулями, с другими модулями. С точки зрения пакетирования, статическая сборка nginx – это боль.

Кстати, мы выложили в открытый доступ видеозаписи последних пяти лет конференции разработчиков высоконагруженных систем HighLoad++. Смотрите, изучайте, делитесь и подписывайтесь на канал YouTube.

Вторая цель, которая ставилась – это упростить отладку, потому что писать хорошие модули для nginx мало кто умеет и зачастую, когда к нам приходят с проблемами, проблема оказывается в сторонних модулях. Поэтому уже долгие годы первое, что мы просим, когда к нам приходят со словами: «А у меня nginx падает, все разваливается!», мы говорим: «Покажите нам “nginx –V”» и рекомендуем пересобраться без сторонних модулей и посмотреть, воспроизведется ли проблема. Скорее всего, она не воспроизведется.

Напрограммировали, теперь можно достаточно легко собрать динамический модуль. Для стандартных модулей это включается с помощью суффикса dynamic. Если вы собираете какой-то свой или сторонний модуль, вместо add-module вы используете add-dynamic-module. И потом в конфиге загружаете.

Переделать свой модуль, чтобы он умел загружаться динамически, достаточно тривиально. Мы предприняли массу усилий, чтобы максимально упростить это все для авторов модулей, и чтобы все это требовало минимальных переделок. Фактически вам нужно поменять config-файл, если он у вас в старом виде написан, чтобы использовался скрипт auto-модуля.

Если у вас сложный модуль, вам еще нужно проделать пару изменений во внутренней логике. Ничего сложного – вместо подсчета модулей с помощью собственного цикла нужно вызывать nginx-функцию, вместо глобальной переменной со списком модулей нужно использовать тот список, который теперь появился в цикле.

Конфиг переделывается как-то так.

Была прямая установка переменных со списками модулей, и стал вызов скрипта auto-модуля с поставленными параметрами для скрипта. Сам этот скрипт потом уже разберется – динамический ваш модуль собирают, статический собирают – и сделает все нужное.

Следующий вопрос – CPU affinity.

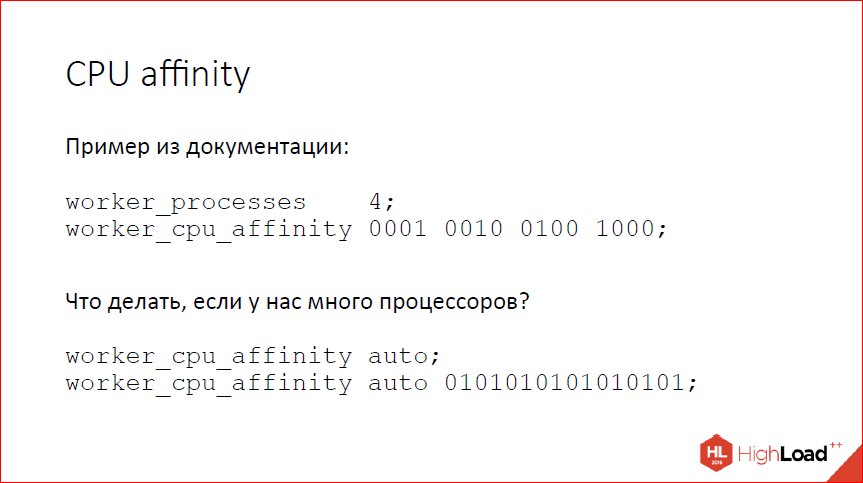

Nginx давно умеет CPU affinity, биндить рабочие процессы конкретным процессорам. Это конфигурилось как-то так. Т.е. бинарную маску задаете для каждого рабочего процесса, соответствующий рабочий процесс начинает работать на тех процессорах, которые ему разрешены. Это хорошо работало, когда были 2х-процессорные машины, 4х-процессорные машины. Сейчас, когда машины бывают 64х-процессорные, это уже немного неудобно конфигурить, потому что если вы хотите занять всю машину, у вас там 64 рабочих процесса по 64 бита в каждой маске, руками это уже писать невозможно. Я видел людей, которые пишут PERL-скрипты для того, чтобы делать это. Мы приняли их боль, сделали простую ручку auto, которая раскладывает рабочие процессы по процессорам один за одним. Если полной автоматики мало, можно указать маску, из которой nginx будет выбирать процессоры. Это позволяет ограничить эту раскладку каким-то сапсетом процессоров. Если в маске меньше бит, чем имеется рабочих процессов nginx, он просто пойдет по кругу.

Еще одна проблема, с которой периодически люди сталкиваются – это кэширование больших файлов. Совсем больших файлов, когда у вас 4 ГБ имидж или 40 ГБ имидж, или много-гигабайтное видео. Nginx, конечно, умеет такие файлы кэшировать, но делает это не очень эффективно, особенно, когда речь идет про range-запросы. Если вам присылают range-запрос на что-то из файлика 2 Гб, nginx пойдет скачивать файл целиком, чтобы положить его в кэш, положит его целиком в кэш и, когда до второго Гб докачает, начнет возвращать ответ клиенту. Latency для клиента получается совершенно запредельной. Как-то с этим хочется бороться, но опять же зачастую нужно только начало файла. Наоборот, если у вас какой-нибудь видеостриминг с длинным и скучным фильмом, большинство клиентов открывают, скачивают первые несколько Мб этого потока и после чего соединение закрывают. А вы пошли и скачали все несколько Гб, к себе в кэш положили и думаете, что они нужные.

Как с этим бороться? Одно из возможных решений которое предполагает, что у вас файлы на бэкенде не меняются – это качать по кускам и кэшировать тоже по кускам. У нас появился модуль slice, который умеет качать и кэшировать по кускам.

Он создает последовательно подзапросы на диапазоны заданного размера. И мы можем эти диапазоны, отдельные кусочки небольшого размера, закэшировать с помощью стандартного кэша. При отдаче клиенту эти кусочки склеиваются. Все работает и кэширует очень эффективно, но, опять же повторюсь, это все можно использовать только в неких специфических условиях, когда у вас файлы на бэкенде не меняются. Если у вас файлы меняются, то вполне возможна ситуация, когда клиенту отдалась половина файла, потом файл поменялся и что делать дальше? Второй половины у нас просто нет. Сейчас nginx пытается отслеживать подобные ситуации и закрывать соединения, ругаясь громко, но, вообще, если у вас такое, то этот модуль вам не нужен. Это стоит использовать, когда у вас просто статика на бэкенде, и вы ее пытаетесь раздавать и кэшировать.

Пока суд да дело, SPDY умер, вместо него появился HTTP/2. Отличия есть, но небольшие. С точки зрения общей логики идея все та же – мы в рамках одного соединения мультиплексируем много запросов, за счет этого пытаемся экономить на установлении соединений и экономить latency. Как-то это работает, что-то это дает. Не могу сказать, что это работает хорошо с той точки зрения, что очень много всяких нюансов в реализациях, протокол новый, много кто делает неправильно, в том числе сам google делает в chrome неправильно. Мы им периодически пишем тикеты про то, что они эту часть протокола обрабатывают не так, ту часть протокола обрабатывают не так, встраиваем в nginx workaround для всего этого. Как-то оно работает, я лично не большой фанат этого протокола, в основном, потому что протокол бинарный, и это боль с точки зрения отладки и разработки.

Теперь его мы тоже нормально умеем, даже убрали некоторые ограничения, которые были раньше в SPDY, с точки зрения реализации в nginx. Если хотите, можете пробовать пользоваться. Наверное, многие уже пробовали и пользовались. Тема популярная, говорят про него много.

Научились несколько sub_filter’ов делать за раз, заодно sub_filter разогнали. Раньше не умели, это было плохо, а теперь умеем и это хорошо, с одной стороны. С другой стороны, если вы используете sub_filter, наверное, у вас опять же что-то не так в архитектуре. Для highload это плохое решение.

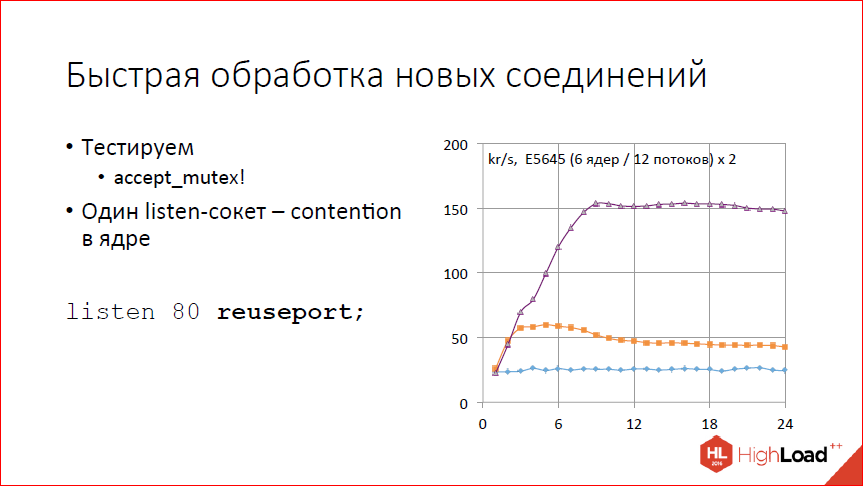

Разогнали слегка обработку новых соединений. Точнее говоря, сделали ручку, которая их позволяет обрабатывать быстрее. Смотрим на график. На графике тест количества обрабатываемых запросов в секунду в тысячах запросов от количества рабочих процессов. Видим, что совсем не скалируется. Почему так? Потому что у нас по умолчанию включен accept_mutex, и фактически у нас всегда работает один рабочий процесс. 25 тыс. соединений в секунду он как-то обрабатывает, а дальше не может, потому что все сериализованно.

Выключаем accept_mutex. Смотрим – где-то до 2-х рабочих процессов, может быть, до 3-х скалируется, 60 тыс. запросов в секунду выдает, дальше все становится только хуже с увеличением количества рабочих процессов. Почему так? Процессор у нас не кончился, но зато система начала лочиться на listen-сокете. У нас один listen-сокет, получаем contention просто на этом listen-сокете.

Как решать? Добавлять listen-сокетов. Простое решение. Можно добавить руками, разнести по IP-адресам, и все у вас будет хорошо. Если руками неудобно или невозможно, IP-адрес, например, один, теперь это можно сделать с помощью специальной ручки reuseport. Эта ручка позволяет nginx создавать для каждого рабочего процесса собственный listen-сокет, с помощью опции so_ reuseport.

Работает на Linux’е не очень хорошо, работает на DragonFly BSD хорошо, но, к сожалению, малопопулярная ОС. Если вы пытаетесь сделать это на Linux’е, стоит иметь в виду, что при изменении количества рабочих процессов у вас будут теряться соединения. Если вы уменьшили количество рабочих процессов, nginx один из listen-сокетов закроет. Если какие-то соединения в этом listen-сокете лежат, они закроются. Linux пока не умеет перераспределять эти соединения между другими сокетами.

С точки зрения производительности что получаем? Получаем вполне неплохое скалирование где-то до 8-ми рабочих процессов. Дальше опять полка. Почему полка? Потому что клиент на той же машине и ест вдвое больше, чем nginx. И когда у нас 8 процессоров заняты nginx, а остальные 16 заняты клиентом, больше машина не может – все, у нее процессор кончился. Если хочется больше, надо клиента на какие-нибудь другие машины выносить.

Еще одна большая вещь, которую добавили – это модуль Stream. Он позволяет балансировать произвольные соединения, не привязываясь к HTTP. В общем и целом, умеет почти то же, что и HTTP, но чуть попроще, чуть поменьше. Сейчас мы говорим про версии 1.9 и 1.10. Умеет балансировку произвольных соединений с теми же методами балансировки, что и у HTTP, Round-robin умеет, IP hash умеет. Умеет принимать SSL от клиентов, умеет устанавливать SSL к бэкендам. Умеет ограничивать количество соединений, умеет ограничивать скорость в этих соединениях, на бэкенд умеет через proxy-протокол отправлять адрес клиента. Даже умеет немного UDP, но так, чуть-чуть. Можно принять UDP-пакетик от клиента и отправить его на бэкенд, а потом обратно принять один или несколько пакетиков от бэкенда и отправить его обратно к клиенту. Если вам нужно, скажем, балансировать DNS, то, в принципе, можно сделать это с помощью модуля Stream. Если у вас что-то сложное на UDP, то, наверное, сейчас вам счастья не будет. Но зато произвольные TCP-соединения умеем в хвост и в гриву, как хотите.

И всякого разного по мелочи. Научили Resolver пользоваться не только UDP, но и TCP. Это позволяет работать нормально, если у вас больше 30 А-записей, и DNS-ответ не влезает в 512 байт UDP-пакета. Теперь Resolver может в этом случае увидеть, что там стоит битик truncate и пойти по TCP получить полный список. Если вы балансируете с использованием переменных имен и т.д. и используете Resolver, чтобы узнавать списки бэкендов, то вам это немного поможет. Блоки upstream теперь могут быть в разделяемой памяти. Это позволяет держать общий state между рабочими процессами. Т.о. если один рабочий процесс увидит, что ваш бэкенд умер, то все остальные об этом тоже узнают. Если у вас лист кон балансировка, и вы хотите минимизировать количество соединений к бэкендам, то, опять же, оно теперь не в рамках одного рабочего процесса работает и знает соединения только в конкретном рабочем процессе, но и знает все соединения по всему nginx.

Разделяемая память теперь работает на версиях Windows ASLR, т.е. Vista и новее. Если вы вдруг пытаетесь использовать nginx под Windows, вам это немного поможет. Но хочу заметить, что не надо использовать nginx под Windows в продакшне, пожалуйста. Это может быть очень больно. Он серьезно для этого никогда не точился.

SSLv3 мы по умолчанию выключили. Если очень надо можно включить, но, наверное, не надо.

Добавили переменную $upstream_connect_time, которая – сюрприз – показывает время, потраченное на установление соединения с бэкендом.

Умеем печатать полный конфиг по ключику «-T». Это, как показала практика нашего собственного support, очень важная и нужная фича, когда у вас траблшутинг, и вы пытаетесь разобраться, что у клиента не работает. Полный конфиг люди зачастую прислать просто не могут. Не понимают, где его брать. Мы этот процесс автоматизировали.

И научились выводить версию OpenSSL в выводе «-V». Причем, даже научились ее выводить не просто так, а смотреть, с какой версией OpenSSL nginx был собран и с какой будет сейчас работать. Если вдруг у вас nginx был собран с одной версией OpenSSL, а вы сейчас работаете с другой версией OpenSSL, он вам это покажет.

Собственно, более или менее все про ветку 1.9. Все это доступно в стабильной версии 1.10.2.

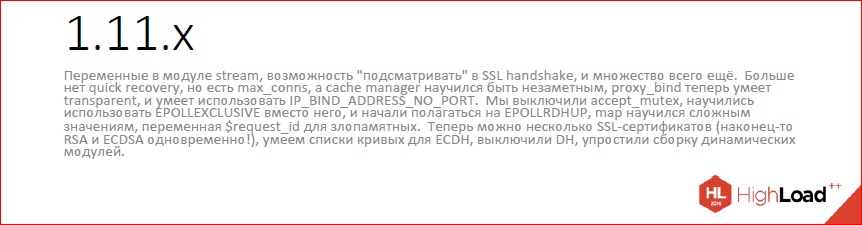

Что у нас появилось нового в 1.11. Это mainline-ветка, которую мы сейчас разрабатываем. Последняя версия 1.11.5. Что появилось?

В Stream появились переменные. Вообще, Stream усиленно развивается. Появились модули, которые умеют работать с переменными – map, geo, geoip, split_clients, real ip, access log, появилась возможность вернуть некий простой ответ из переменных или просто статическую строку return. Можно теперь делать всякие странные конструкции с помощью map’ов, limit_conn, чтобы применять ограничения избирательно. В общем, практически то же самое, что мы умеем делать в HTTP.

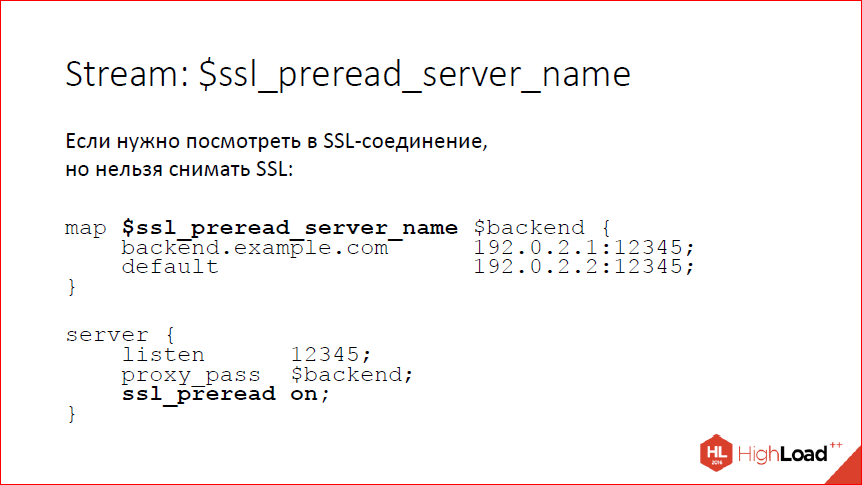

Опять же, в Stream мы научились заглядывать внутрь SSL-соединения, при этом, не снимая SSL. Зачем это может быть нужно? Вам может быть нужно посмотреть на server_name, который прислал клиент, и отправить клиента либо на один бэкенд, либо на другой бэкенд. Сейчас умеем вытаскивать из client_hello server_name. Есть для этого переменная, можно по этой переменной отбалансировать на один или другой бэкенд – на слайде пример, как это сделать. Это нужно включать явно, потому что по умолчанию мы, конечно, ничего не ждем. Если мы хотим дождаться client_hello, то включаем директиву ssl_preread, nginx дождется и, соответственно, будет переменная ssl_preread_server_name.

Научились ограничивать количество соединений с конкретными бэкендами, т.е. для каждого сервера вы теперь можете прописать max_conns, и nginx не будет открывать больше заданного числа соединений к данному бэкенду. Исходно это было сделано для NGINX Plus. Сейчас мы помержили open source просто для того, чтобы сделать людям приятно, с одной стороны, и таскать кастомного кода – с другой.

Научились работать в режиме transparent proxy. Обычно, если вам нужно передать адрес клиента на бэкенд, вы либо в HTTP используете заголовки с адресом клиента, либо, если речь идет про произвольные соединения, вначале соединения передаете заголовок proxy-протокола с адресом, портом. Это, к сожалению, не всегда возможно использовать, есть люди, у которых ничего из этого не работает. Есть люди, которые пытаются использовать nginx не со своими бэкендами, а просто внешний мир как-то проксировать.

Теперь можно в директиве proxy_bind сказать параметр «transparent», и она попытается сделать bind с нужной опцией для того адреса, который ей передали. Соответственно, если вы передадите туда remote_addr, т.е. адрес клиента, она сделает bind на адрес клиента. Соответственно, если вы построили сеть так, чтобы это все работало, то transparent proxy будет работать. Но для этого нужен root, для этого нужна специально построенная сеть. Вообще, если вы со своими бэкендами работаете, скорее всего вам лучше этого не пытаться делать. Может быть, это полезно со всяким legaсy-софтом, который обучить понимать X-Forwarded-For или X-Real-IP нереально.

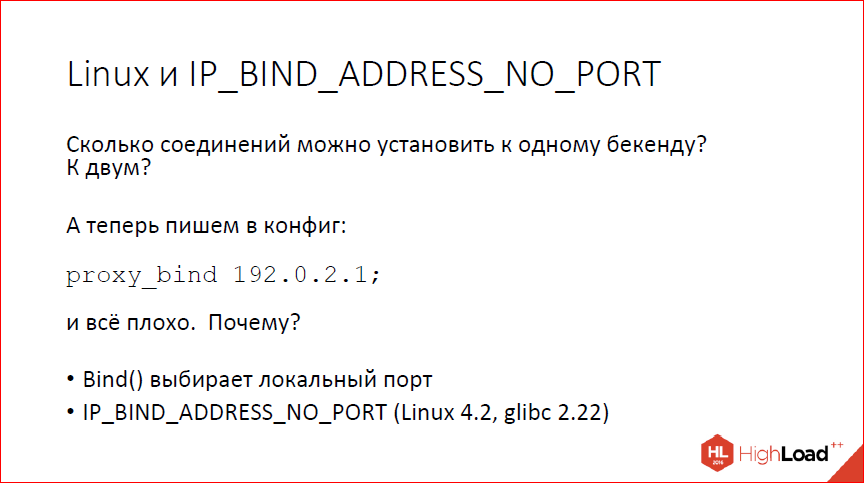

Еще одна вещь, которой научились… Кто скажет, сколько соединений можно установить к одному бэкенду, если у нас есть один IP-адрес? Есть фронтенд с одним IP-адресом. Сколько соединений можно установить?

65 535 по количеству портов. Потому что destination-порт у нас один, а локальных портов, ну, максимум 65 535. Если у нас, соответственно, два бэкенда – 128 тысяч. Если у нас 10 бэкендов, то больше полумиллиона соединений можно установить, это не проблема.

А теперь пишем в конфиг «proxy_bind» и указываем IP-адрес. Наши полмиллиона портов при десяти бэкендах превращаются обратно в 65 тысяч. Почему так происходит? Происходит это потому что системный вызов bind делается до коннекта, то есть он не знает, куда именно мы будем коннектиться и он должен выбрать локальный порт. Поскольку куда именно мы будем коннектиться, он не знает, он должен выбрать локальный порт так, чтобы можно было потом законнектиться куда угодно, а всего локальных портов у нас 65 тыс. Соответственно, в 65 тысяч мы начинаем упираться, просто написав в конфиге «proxy_bind».

Как с этим бороться? Бороться с этим можно. На свежих версиях Linux есть специальная опция IP_BIND_ADDRESS_NO_PORT, которая говорит bind’у, что не надо ему выбирать локальный порт, мы его использовать не будем, клянемся, что не будем и, соответственно, операционная система не будет его выбирать, а сделает это как обычно в системном вызове connect, когда уже будет знать, куда именно мы хотим приконнектиться. Это опять возвращает нам наши многие тысячи соединений, даже если мы используем bind.

Следующий вопрос – accept mutex. Что, вообще, такое accept mutex? Это такая ручка для борьбы с проблемой thundering herd. Если у вас есть listen-сокет и много процессов, все процессы ждут событий на этом listen-сокете, т.е. ждут, пока придет клиент. Вот, клиент приходит, все процессы ждут, ядро все процессы разбудило. Клиент один, какой-то один процесс его забрал, а все остальные проснулись просто так, просто потратили процессор, погрели окружающий воздух, ничего полезного не сделали. Традиционный метод борьбы – это сказать только одному процессу, чтобы он слушал и ждал новых соединений, а все остальные пусть обрабатывают старые и о новых соединениях не беспокоятся.

Есть проблема с таким подходом. Ну, во-первых, у нас процессов не так много, чтобы это было как-то актуально, а, во-вторых, есть проблемы. Одну из проблем я показывал чуть раньше. Если мы забываем выключить accept mutex, то в наших тестах на количество соединений в секунду мы получаем полочку, которая никак не зависит от количества рабочих процессов, очень удивляемся. Ну, то есть, мы-то не удивляемся, потому что мы знаем, что это такое, а пользователи nginx зачастую удивляются, пишут нам письма с вопросами, иногда возмущенные, иногда публикуют бенчмарки про то, какой nginx плохой. Ну, в общем, нас это утомило – очень долго объяснять и бессмысленно, главное, потому что процессов так мало, вполне можно обойтись без всего этого.

Кроме того, accept mutex нельзя использовать на Windows, потому что на Windows у нас недопрограммирована нормальная работа с сокетами. Если вдруг вы запустили несколько рабочих процессов и включили accept mutex, то на Windows у вас все просто встанет колом. Точнее, сейчас не встанет, потому что accept mutex на Windows принудительно выключен и игнорируется. Даже если вы попытаетесь его включить, он все равно не включится.

При использовании listen reuseport accept mutex не нужен, потому что у каждого рабочего процесса свой listen-сокет. И, наконец, на свежих версиях Linux в ядре появился флаг EPOLLEXCLUSIVE, который позволяет сказать ядру, чтобы оно будило не все процессы, а только один. Это не для всех программ допустимо, потому что у вас может случиться какая-то другая активность, т.е. процесс разбудят, а он пойдет чем-то другим заниматься. В nginx это вполне работает. Так что мы accept mutex по умолчанию выключили, EPOLLEXCLUSIVE теперь поддерживаем.

Так что если у вас совсем свежий Linux, вы ничего не потеряли, у вас сплошные плюсы, если у вас не Linux или что-то чуть более старое, то вы, в общем, тоже ничего не потеряли, у вас сплошные плюсы, потому что если вы будете запускать какие-нибудь бенчмарки, вы увидите реальное поведение системы, а не поведение accept mutex.

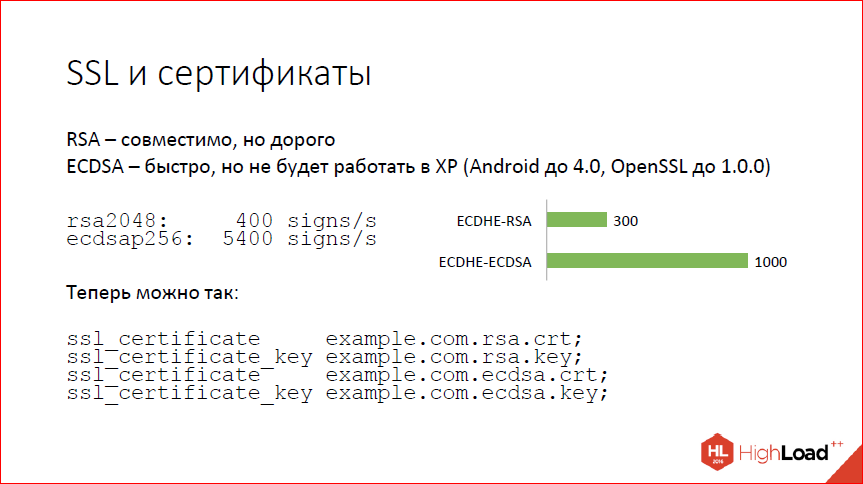

Следующий вопрос – SSL и сертификаты. SSL – это такая штука, где большая часть времени тратится на handshake. И handshake сводится к тому, чтобы проверить подлинность сертификата. Сертификаты бывают современные – RSA и ECDSA, т.е. на эллиптических кривых. RSA – это хорошо, но дорого, а эллиптические кривые – это быстро и, в общем, тоже хорошо, но не везде работает. В частности, не работает на Windows XP. Как показывают всякие сервисы статистики, Windows XP сейчас все еще от 5 до 10%. Так что, если переключитесь на ECDSA-сертификаты, вам будет несчастье, вы 5% клиентов потеряете. Наверное, если вы большая компания, вы себе не можете этого позволить.

Что делать? Вот циферки (на слайде). Запускаем по SSL speed, видим, что двухкилобитный RSA дает 400 подписей на ядре, мы можем сделать, а ECDSA – 5000 с лишним, и это не предел на самом деле. Это циферки от достаточно старой версии ОpenSSL. Конечно, когда вы поставите перед этим еще forward secrecy, все немножко ухудшится. На реальных handshake’ах с nginx циферки немного не такие впечатляющие, но все равно 300 handshake’ов в секунду в случае RSA, 1000 handshake’ов в секунду на ядре – в случае ECDSA. Рост в три раза.

То, что хочется получить, теперь мы умеем делать так. Вы можете сказать nginx’у: «Вот тебе два сертификата, работай с ними», и nginx их по мере необходимости будет предъявлять клиенту. Если клиент новый и умеет ECDSA, будет использоваться ECDSA, все будет быстро. Если клиент старый, то для него будем использовать RSA.

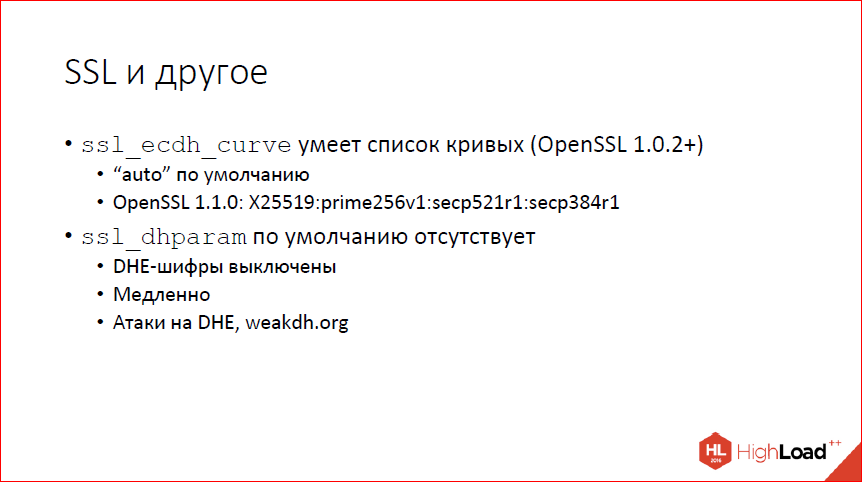

Кроме того, в SSL теперь можно задавать несколько кривых одновременно, если у вас достаточно свежая OpenSSL. По умолчанию, если раньше был prime256v1, теперь загадочное слово «auto». «Auto» зависит от того, какая именно версия OpenSSL у вас используется. В совсем свежем сначала будет кривая бернштейновская 25519, потом тот же самый prime256v1, который был раньше по умолчанию. Настоятельно рекомендую не трогать, просто имеет смысл знать, что такая ручка есть. Но трогать не надо.

dhparam – параметры для Диффи-Хеллмана обычного классического. По умолчанию мы теперь не предоставляем. Если раньше внутри nginx были защиты килобитные параметры, то теперь их нет, и по умолчанию у вас DHE-шифры, т.е. forward secrecy с использованием Диффи-Хеллмана выключены. Это на самом деле хорошо, потому что они медленные по сравнению с эллиптическими кривыми и есть все основания полагать, что существуют атаки даже на достаточно большую битность, потому что они поддаются предпросчету.

В динамических модулях существуют проблемы. В той реализации, которая в стабильной версии сейчас, проблема связана с тем, что структуры в nginx зависят от опции сборки. Nginx, если ему чего-то там не нужно, он это что-то из структуры убирает, позволяет сделать структуру поменьше, а nginx побыстрее. Это приводит к тому, что если вы собираете модуль, то собирать его нужно с теми же самыми опциями сборки, что и основной nginx, куда вы этот модуль собрались грузить.

В ситуации сборки пакетов это работает нормально. Когда вы собираете основной nginx и к нему множество пакетиков с разными модулями, вы можете контролировать опции сборки и собрать все одинаково. Это не всегда удобно, когда вы хотите свой модуль для каких-то произвольных пакетов подсобрать. Можно, но не всегда удобно. И, опять же, под каждую сборку nginx вам приходится делать свою сборку модуля. Теперь у нас есть специальная опция configure --with-compat, которая включает режим совместимости при динамической загрузке модулей, и все соответствующие поля, вне зависимости от опций сборки, в структурах nginx присутствуют. Соответственно, модули и nginx становятся бинарно совместимыми, даже если вы какие-то опции сборки поменяли, главное, чтобы среди опций был with-compat, тогда вы можете собрать свой модуль и загрузить в любой другой nginx, собранный тоже с опцией with-compat.

Кроме того, теперь можно так собирать модули и грузить их в наш коммерческий продукт NGINX Plus. Если раньше из-за той же самой проблемы собрать модули для NGINX Plus вы сами не могли, потому что там структуры другие внутри были, то теперь можете собрать сами свои модули и загрузить в наш коммерческий NGINX Plus.

И всякое разное по мелочи:

- EPOLLRDHUP на Linux. Теперь мы умеем на него полагаться, если видим, что ядро свежее, это экономит syscall’ы при детектировании, а не закрыл ли клиент соединение.

- HTTP/2 улучшаем, дополняем.

- Map научился работать с произвольными комбинациями переменных и строк.

- Для злопамятных людей появилась переменная $request_id, которая может использоваться для идентификации конкретного запроса.

Все это есть в 1.11.5. И разработка продолжается.

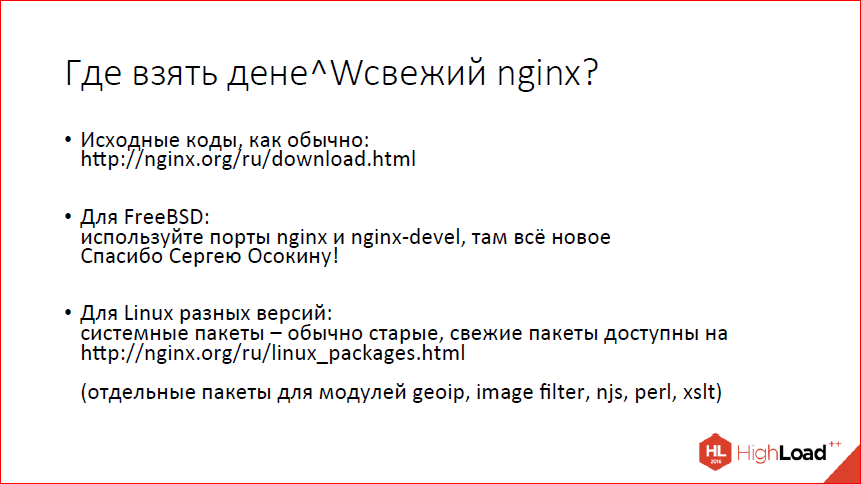

Свежий nignx можно скачать у нас на сайте. Если вы используете FreeBSD, можно поставить из портов, если вы используете Linux, то системные пакеты, скорее всего, у вас старые, хотя последнее время ситуация слегка улучшается. Мы предоставляем собственную сборку. Можно взять у нас на сайте. Для модулей, которые имеют внешние зависимости, у нас теперь отдельные пакеты с внешними зависимостями.

Спасибо за внимание!

Контакты

» mdounin@mdounin.ru

» Блог компании Nginx

Этот доклад — расшифровка одного из лучших выступлений на профессиональной конференции разработчиков высоконагруженных систем HighLoad++.

Сейчас мы уже вовсю готовим конференцию 2017-года — самый большой HighLoad++

в истории. Если вам интересно и важна стоимость билетов — покупайте сейчас, пока цена ещё не высока!

|

Метки: author olegbunin блог компании конференции олега бунина (онтико) максим дунин highload++ nginx |

«Data mining сейчас — это преимущество на рынке»: о конференции SmartData и больших данных |

Конференции, посвящённые одной и той же теме, могут выглядеть совершенно по-разному. И когда планируется совсем новое мероприятие, заранее не вполне понятно, чего ожидать. Если конференция посвящена «большим и умным данным», то не окажется ли она рассчитана на гигантские компании, где сотрудникам маленьких делать нечего? И не будет ли там такого уклона в data science, что людям без учёной степени лучше не заходить?

В ожидании конференции SmartData, которая впервые состоится в Санкт-Петербурге 21 октября, мы решили внести ясность и расспросили двух членов её программного комитета: Виталия Худобахшова (Одноклассники) и Романа p0b0rchy Поборчего. Они развеяли многие опасения, а разговор получился не только о конференции, но и о состоянии индустрии: что сейчас происходит вокруг machine learning, зачем маленьким компаниям лезть в data mining и почему менеджеры тоже покупают билеты на техническую конференцию обо всём этом.

JUG.ru: В списке тем на сайте есть machine learning, а это направление сейчас выглядит бурно развивающимся. Не окажется ли так, что доклады конференции устареют ещё в ходе подготовки?

Виталий: На самом деле, технологически всё меняется не так быстро. Важнее то, что сейчас большинство компаний — это такие «догоняющие».

Виталий: На самом деле, технологически всё меняется не так быстро. Важнее то, что сейчас большинство компаний — это такие «догоняющие». Есть «передний край», вроде DeepMind, который никому ничего уже не рассказывает, а что-то делает. Но даже они зачастую делают не то чтобы очень сложные вещи, просто ввиду большого бюджета они не очень парятся и могут позволить себе получать профит, долго-долго ударяясь головой об одну и ту же стену.

И, конечно, не все могут себе позволить так вкладываться. Но при этом, во-первых, теперь есть много опенсорса, хорошего наработанного кода, который уже можно использовать, во-вторых, есть много доступной информации. Поэтому большинство людей сейчас только начинают это использовать. Если посмотреть, например, на стоимость акций компании NVIDIA в последние три года, то будет понятно, что настоящий deep learning начинается только сейчас. Просто по спросу на видеокарты: понятно, что на нём сказались криптовалюты, но сейчас продажи видеокарт для deep learning уже переплюнули продажи видеокарт для того, чтобы поиграть. И это хороший маркер, показывающий, что deep learning, несмотря на свою «баззвордность» — реально рабочая вещь.

Мы в Одноклассниках полтора года назад впервые пробовали использовать deep learning, а теперь, когда к нам приходят студенты, они говорят: «Ой, а у вас видяшечки есть, чтобы мы сеточку сделали» — и мы достаём из кармашка Tesla P40. И если несколько лет назад статья о том, что сеточку научили играть в классические игры Atari 2600, оказалась опубликована в очень серьёзном журнале Nature, то сейчас студент какого-нибудь МФТИ в состоянии написать модель, которая будет играть в те же игры лучше. Ничего такого уж сложного, по сути, в этом нет, один кто-то сделал — теперь повторить может любой. И даже сделать лучше могут уже многие.

То есть объективная ситуация такова, что громадных технологических изменений не происходит, главное уже известно и доступно, и теперь вопрос в том, насколько аудитория в состоянии всё это обработать и принять на вооружение. И как раз конференция — то, что помогает в этом.

Роман: Мне хочется сказать не конкретно про нейросети, а про «большие и умные данные» в целом: вообще велико расслоение по тому, насколько уже принята на вооружение та или иная технология. Какие-то вещи в одних местах с 2008 года используются, допустим, а где-то их только сейчас узнают, как ни странно. Несмотря на то, что вроде как все следят за статьями, но вижу, что реальное расслоение в индустрии очень большое.

Роман: Мне хочется сказать не конкретно про нейросети, а про «большие и умные данные» в целом: вообще велико расслоение по тому, насколько уже принята на вооружение та или иная технология. Какие-то вещи в одних местах с 2008 года используются, допустим, а где-то их только сейчас узнают, как ни странно. Несмотря на то, что вроде как все следят за статьями, но вижу, что реальное расслоение в индустрии очень большое.JUG.ru: Ну, наверняка не все следят за статьями. Есть множество небольших компаний, которые не претендуют на мировое господство и революционные инновации, а занимаются довольно стандартными вещами и не особо следят за «передним краем». Вот такие на SmartData обнаружат для себя пользу или нет?

Виталий: Они-то и обнаружат, на самом деле.

Строго говоря, конференция показывает, что вы можете решить вот такой вот спектр задач вот таким образом. Мы, наверное, всё же не теорией струн занимаемся. И, может быть, даже не очень продвинутые компании что-то из этого могут взять на вооружение. И получить за счёт этого какое-то преимущество на рынке.

Потому что сейчас data mining — это не что иное, как преимущество на рынке. Он позволяет вам быть лучше. А для маленькой компании быть лучше задёшево — очень ценно. Посмотрим так: можно нанять какого-нибудь умного человека, который будет принимать решения, кому что продавать. А можно скачать и обучить модель на random forest, которая будет делать лучше.

Есть замечательный сюжет, очень старый: как в Amazon появилась вся эта идея с рекомендациями. Когда-то у Amazon был штат специалистов, которые делали рекомендации вручную. Но потом просто пришёл студент, написал алгоритм коллаборативной фильтрации, и всех уволили, потому что он просто был лучше.

И у меня есть целая серия докладов, где я для студентов и начинающих специалистов по датамайнингу (да и не только начинающих) показывал, как на MapReduce сделать item-to-item коллаборативную фильтрацию, в один слайд. Я показываю, что это может сделать любой. И это то, что мы хотим донести: не обязательно быть Яндексом, Mail.Ru Group или Google. Это, конечно, очень круто, когда вы Google. Но очень классно, что мы можем взять опенсорс каких-то больших крупных компаний и воспользоваться этим. Использовать этот алгоритм в повседневной жизни и показать, что можно получить преимущество на рынке, даже если в вашей компании пять человек. Это вполне наша аудитория.

JUG.ru: Поскольку в темах заявлен data science, хочется уточнить: сколько на конференции будет «академического», а сколько «индустриального»?

Виталий: Тут есть два разных сюжета. Один — это большие данные и умные данные in production. Это то, к чему привыкли люди, которые ходят на конференцию Joker, например. И из data science, когда работаешь с продакшеном каждый день, применяется не так уж много вещей: линейная регрессия, логистическая регрессия, deep learning.

А другой сюжет — то, что делается в теории, а также в точечных задачах: сделать аналитику, получить результат, отнести эту аналитику боссу, он посмотрит и примет решение.

Между тем, что нужно делать каждый день автоматически, и тем, что можно сделать однократно, существует гигантский разрыв. Нужно понимать, что это две абсолютно разных ситуации, две разные публики, и то, что сейчас постоянно делается в продакшене — это то, что было нарисёрчено 30, 40 или 50 лет назад, а может быть, и 100-200 лет назад. Но при этом то, что будет в продакшене завтра — это то, что рисёрчится сейчас.

Мы, программный комитет, исходим из практической пользы для слушателей конференции. И задаём вопрос докладчикам: «а то, что вы рассказываете и хотите нам показать — это что-то, что уже есть в продакшене, или это вы только где-то нарисёрчили?»

Но при этом я лично считаю, что оба этих сюжета важны. И не стоит забивать гвозди в какой-то научный хардкор просто потому, что люди, которые сейчас пишут на Java, о нём никогда не слышали. Реальное value завтра — это то, что хардкор сейчас.

По этому вопросу внутри программного комитета есть разные мнения. Тут вопрос в репрезентативности: насколько возможно сделать хардкор доступным для публики, чтобы было понятно не только узкой группе людей, которые придут специально за этим, но и людям, которые, условно говоря, просто хотят писать свой MapReduce на Hadoop. Хочется, чтобы формул, возможно, было не так много, как могло бы быть, но было понятно возможное value, а кому интересно подробнее — тот открывает статью и читает.

JUG.ru: А какой вы видите аудиторию конференции?

Виталий: Мы её видим как реальных профессионалов, которые приходят от практики, от программирования, хотят впитать в себя культуру data science, data mining, и может быть, внедрить это у себя в компании.

Кроме того, во многих крупных компаниях есть R&D department — те люди, которые обладают куда большим объёмом знаний, чем простые разработчики, и делают что-то, что в продакшен не попадает или попадает не сразу. Например, я в Одноклассниках, по сути, в R&D department. Ко мне обычно приходят с каким-то вопросом, на который никто не знает ответ. И вот такие люди — это, безусловно, тоже наши клиенты, пусть они и окажутся в меньшинстве. Таким, может, про продакшен и не очень интересно, зато хочется послушать доклад Алексея Потапова или других известных людей в области науки, которые смотрят вперёд в анализе данных, в искусственном интеллекте.

А помимо этого, наша аудитория — это ещё и менеджеры, которые хотят проникнуться и научиться ставить задачи. Потому что всё-таки обычно задачи приходят сверху. И чтобы сделать какой-то data mining, менеджер должен понимать, какие задачи вообще решаются методом анализа данных, а какие не решаются. И с этим уже прийти к инженерам, к дата майнеру, и поговорить с ним об этом. Например, банкинг — это ультраконсервативный бизнес, где data mining может быть полезен, но у них такой менеджмент, который сейчас про data mining мало что знает. У них есть алгоритмический трейдинг, это несколько другая история, но в целом они очень консервативные.

Некоторые менеджеры уже купили билеты, они мне сами об этом говорили. Может быть, не всякому менеджеру будет это интересно, потому что многие просто не понимают, что это важно. Но многие понимают.

JUG.ru: Слова о менеджерах для многих могут быть неожиданными, потому что обычно конференции от JUG.ru Group с ними не ассоциируются. Сами доклады при этом в первую очередь рассчитаны на технарей? Не приходится их видоизменять, чтобы менеджерам понятнее было?

Виталий: В первую очередь на технарей, безусловно. Но нужно понимать, что это всё-таки не Joker. Тут нет Шипилёва с его «щас мы наденем перчатки, залезем в кишки JVM и посмотрим, что там есть». Мы говорим о реальных кейсах использования реальных данных. У таких задач, условно говоря, есть инженерная составляющая и предметная составляющая, и мы как раз всё делаем так, чтобы доклады были более предметными.

Роман: Хочется добавить вот что: слой людей, которые так или иначе работают с машинным обучением или сталкиваются с проблемой по-настоящему больших объёмов данных, сейчас ещё гораздо тоньше, чем слой Java-программистов. Поэтому в случае с Java, даже если выбрать из слоя Java-программистов какое-то подмножество и сделать конференцию в расчёте на этот узкий сегмент, можно всё равно собрать большую аудиторию. А в нашем случае пока представляется, что логичнее включать более разные вещи для разных людей. Кроме того, мы пока что исследуем аудиторию, у нас всё-таки первый раз. Когда проведём, то посмотрим, как оно, с применением методов работы с данными, которые как раз знаем.

JUG.ru: Роман, вас многие знают как тренера спикеров, вы на Хабре уже подробно разбирали доклады, объясняя вещи вроде «лазерные указки — зло». Раз вы участвуете в ПК SmartData и отсматриваете доклады, то, помимо содержания, следите везде и за тем, чтобы никаких лазерных указок не было?

Роман: Да, их я искореняю везде, где встречаю, ну правда же, без них лучше? Но ладно лазерные указки, есть и другие вещи. Вот я вижу, что распространился чудесный slide deck Codeware о том, как код на слайдах оформлять. Конечно же, мы постараемся, чтобы код во всех презентациях был оформлен в соответствии с этим. Ну и будем стараться, чтобы люди не забыли рассказать, какую проблему они решают, какие рекомендации они по итогам своего рассказа хотят дать зрителям, чтобы всё, что выносят на слайды, было более-менее по делу и можно было разглядеть. Вот эти вещи — да, конечно, будем стараться делать.

JUG.ru: Что будет на конференции, стало понятнее. Напоследок такой вопрос: а чего на SmartData не будет и быть не может?

Роман: Мы очень стараемся отсеивать булшиттинг. При желании про большие данные можно сказать много эффектных слов, при этом ничего не сказав по сути. Мы — за конкретику.

Виталий: Есть два типа неподходящих докладов. Один — это булшит, а второй — когда в борьбе за пятый знак после запятой забывают о практической пользе, когда начинаются стекинг и блендинг ради самих стекинга и блендинга, а не ради достижения конкретных целей.

И то, и другое плохо из-за того, что оторвано от реальности. А мы хотим сделать конференцию такой, чтобы она была связана с реальностью.

SmartData состоится 21 октября, билеты на конференцию уже в продаже на сайте конференции (и они дорожают со временем). Её главные темы:

- Данные и их обработка (Spark, Kafka, Storm, Flink)

- Storages (Базы данных, NoSQL, IMDG, Hadoop, облачные хранилища)

- Data Science (Machine learning, нейросети, анализ данных)

|

Метки: author phillennium открытые данные big data блог компании jug.ru group smart data data science smartdataconf конференция виталий худобахшов роман поборчий |

[Перевод] Пиратство и четыре валюты |

|

Метки: author PatientZero разработка игр пиратство drm защита от копирования торренты |

Откуда появился День Сисадмина и почему важно его отмечать |

Традиционно День сисадмина празднуется в последнюю пятницу июля. Эта традиция популярна во всем мире, а в последние годы набирает обороты и в России.

Немного истории. «Отцом» данного праздника является американский системный администратор с 20-летним стажем Тед Кекатос, увидевший журнальную рекламу Hewlett-Packard, в которой установившего новые принтеры системного администратора благодарные пользователи одаривают цветами и корзинками фруктов. Кекатос, недавно установивший несколько принтеров той же модели, решил создать специальный день, посвященный профессии системного администратора. Первый такой день, устроенный Кекатосом, пришелся на пятницу 28 июля 2000 года. Это был просто пикник на природе на окраине Чикаго, в котором приняли участие члены небольшой софтверной компании. С тех пор праздник принято отмечать в последнюю пятницу июля.

2006 года начал отмечаться «Всемирный день информационного общества» (с 2007 года Всемирный день электросвязи и информационного общества), который закреплён за 17 мая. Провозглашённый Генеральной Ассамблеей ООН, этот памятный день имеет официальный статус, и, видимо, может заменить собой день системного администратора.

Тем не менее, последняя пятница июля не собирается сдавать позиции. Например, с 2006 года под Калугой ежегодно проходит Всероссийский слёт системных администраторов, с каждым годом собирающий все больше и больше участников. Так, если первый Слет посетило около 350 человек, то в 2009 году на него приехало более 4000 человек из 174 городов России, Украины, Белоруссии и Казахстана. Также проходит сбор системных администраторов в Новосибирске, который проходит на берегу Обского моря.

Каждый год все больше людей принимает участие в этом празднике, и мы считаем, что это очень круто! Ведь должен же быть у скромных тружеников «невидимого фронта» свой день и свой праздник, чтобы они помнили о том, как важна и ценна их работа. В конце концов, именно от них напрямую зависит успешная и стабильная деятельность компаний.

В этом году праздник выпал на пятницу 28 июля. Еще в прошлом году мы решили, что раз наша программа напрямую связана с работой системных администраторов, то этот день мы должны отпраздновать вместе с ними. Для такого случая в прошлом году мы сняли целый зал в одном из лучших московских пабов. В итоге, мы все отлично провели время, познакомились, поделились опытом и историями трудовых будней и, конечно, выпили много пива). Мы решили придерживаться этой традиции и в этом году и уже во второй раз приглашаем всех крутых сисадминов Москвы (и других городов тоже, если доберутся) провести последнюю пятницу июля вместе с нами. Мероприятие пройдет в формате неформального диалога. Всех гостей будут угощать отличным ужином с бургерами, закусками и, конечно, изобилием пива и приятного общения с коллегами по цеху.

Ну, и по случаю вот содержимое нашего «репозитория»:

• 0,1 л — demo;

• 0,25 л — trial version;

• 0,5 л — personal edition;

• 0,7 л — professional edition;

• 1 л — network edition;

• 1,75 л — enterprise;

• 3 л — for small business;

• 5 л — corporate edition;

• Бутыль самогона — home edition;

• На посошок — service pack;

• Рассол с утра — recovery tool;

• Закуска — plugins;

• Пиво — patch;

• Coca-cola, Fanta, 7-UP — trojan viruses.

Записаться на празднование можно заполнив анкету на TimePad (DriverPack угощает!) alt=«image»/>https://driverpack.timepad.ru/event/539899/

|

Метки: author ArtX системное администрирование серверное администрирование dps driverpack solution drp сисадмин день сисадмина |

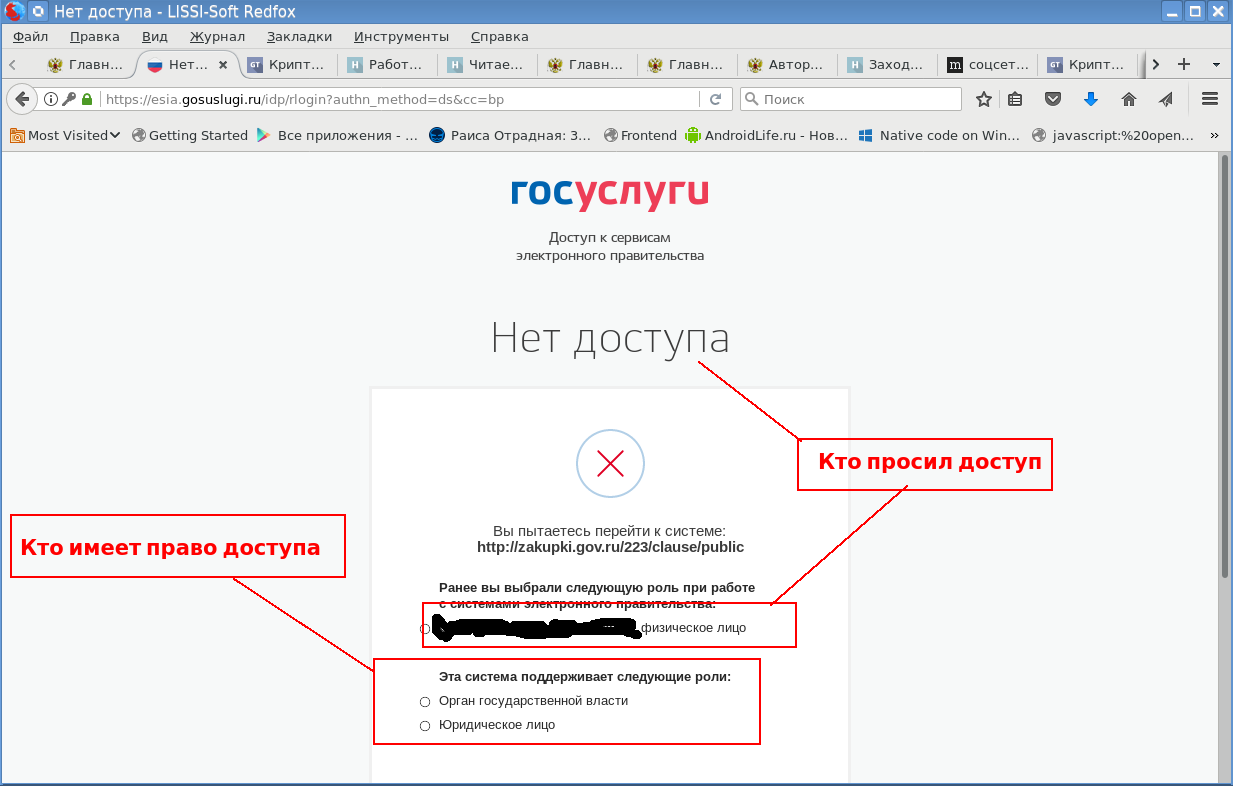

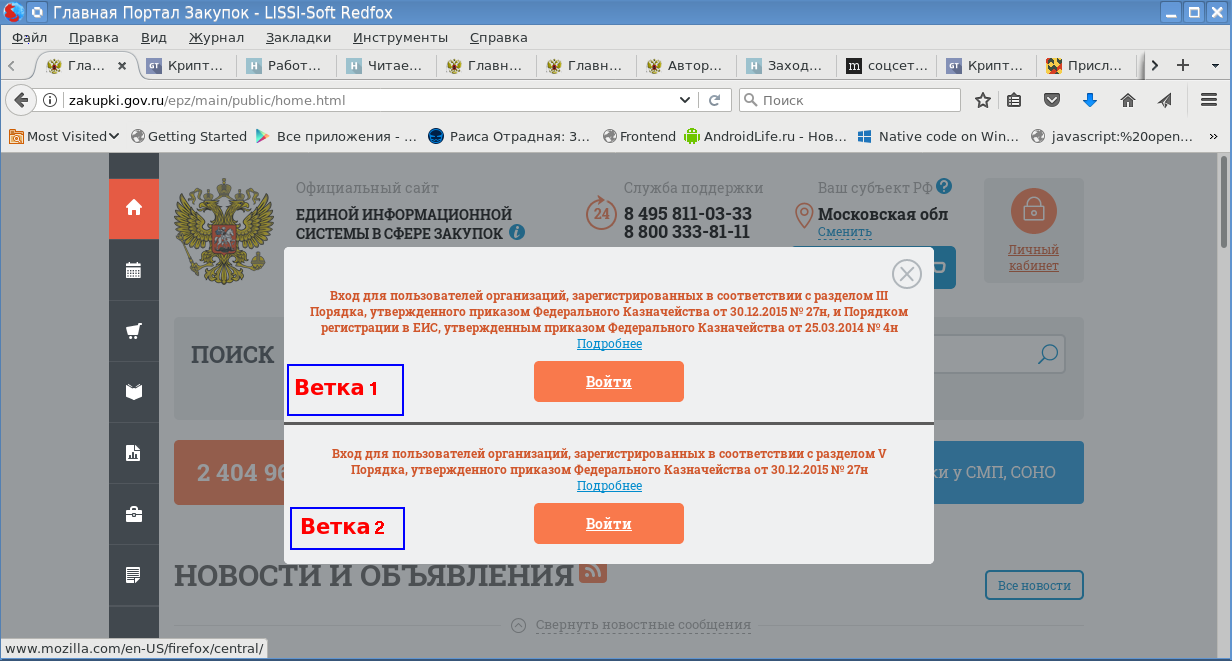

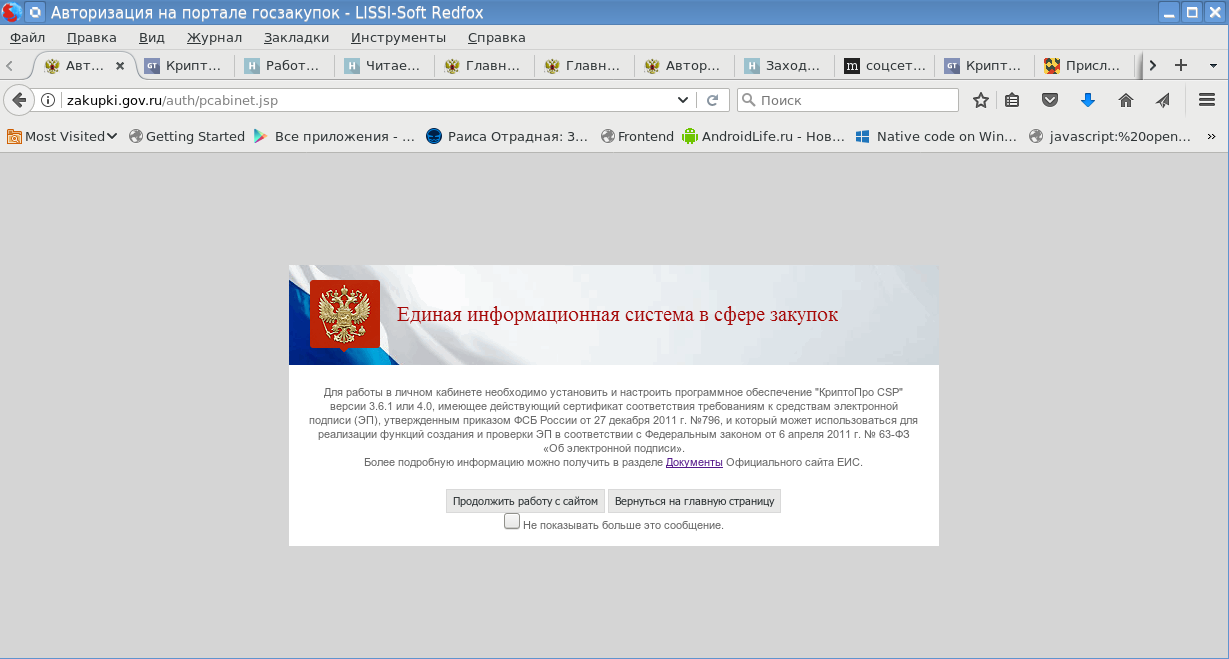

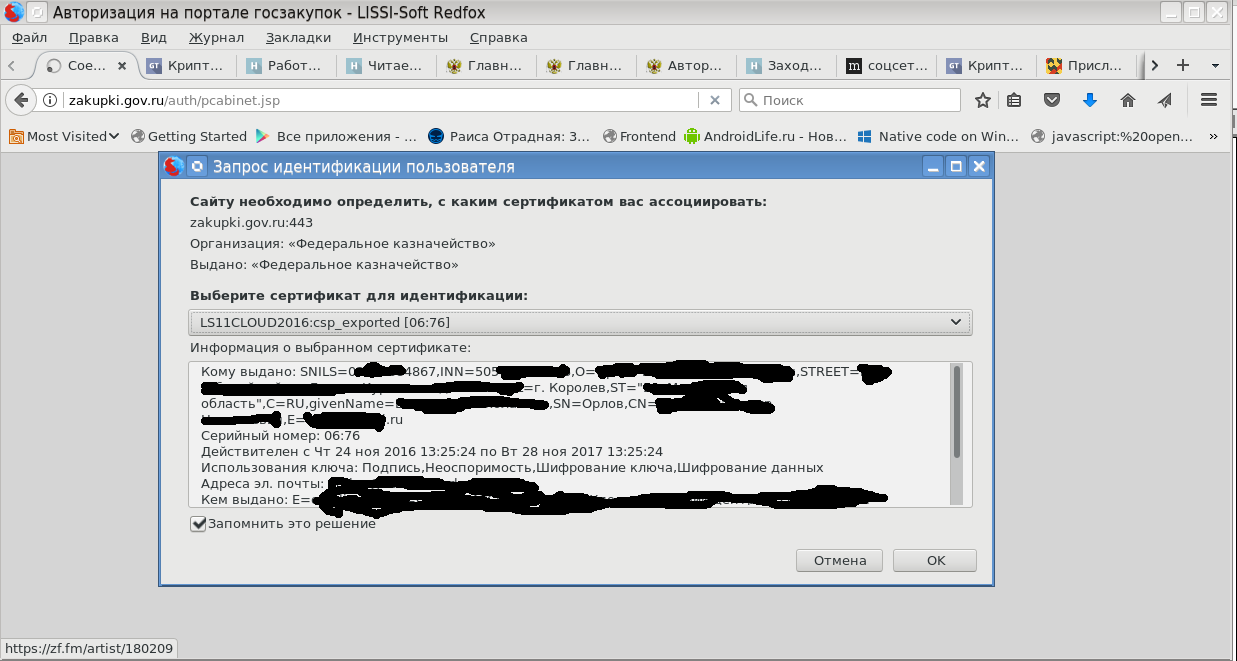

Есть ли альтернатива MS Windows, IE и CSP при доступе в личные кабинеты порталов Госзакупок, ФНС России и Госуслуг |

И сразу дадим ответ – да, можно и нужно, только не отказаться, а дать гражданам и организациям возможность использовать и другие операционные системы, браузеры и средства криптографической защиты информации (СКЗИ). Ответим на вопрос и как – соблюдать стандарты и технологии. Почему бы для доступа в личные кабинеты не использовать авторизованный доступ по протоколу https? И тогда нет необходимости в использования только CSP а ля Микрософт с поддержкой российской криптографии. Тогда автоматом станут востребованы и токены PKCS#11 и как международный стандарт, так и стандарт, поддерживаемый ТК-26, стандарты PKCS#12 (тем же ТК-26), может что-то другое, но стандартное. В этом случае речь уже будет идти не об MS Windows, Interner Explorer и CSP, а о браузерах или других программ с поддержкой https с российскими шифрсьютами. Это может быть и Internet Explorer, и модификации того же Mozilla Firefox, наконец Google Chrome или прокси типа stunnel.

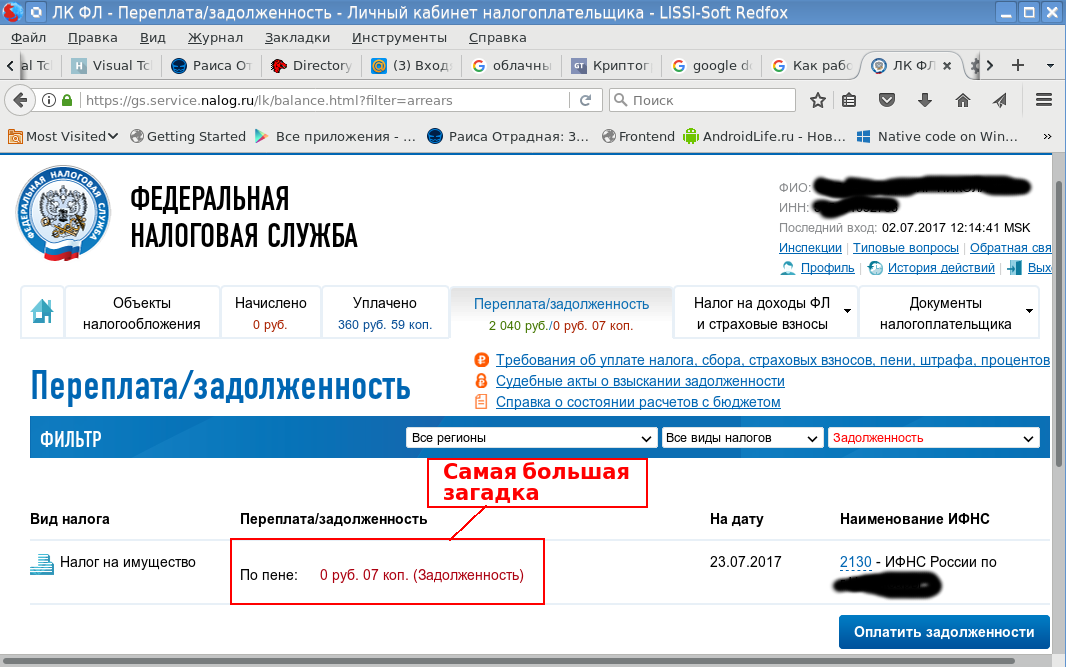

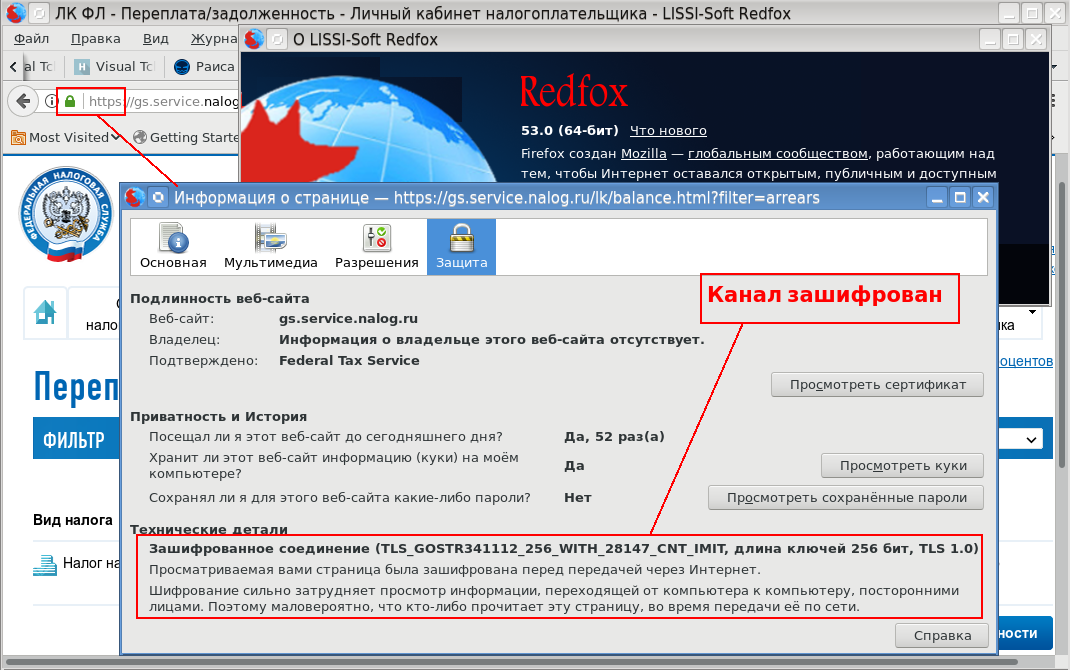

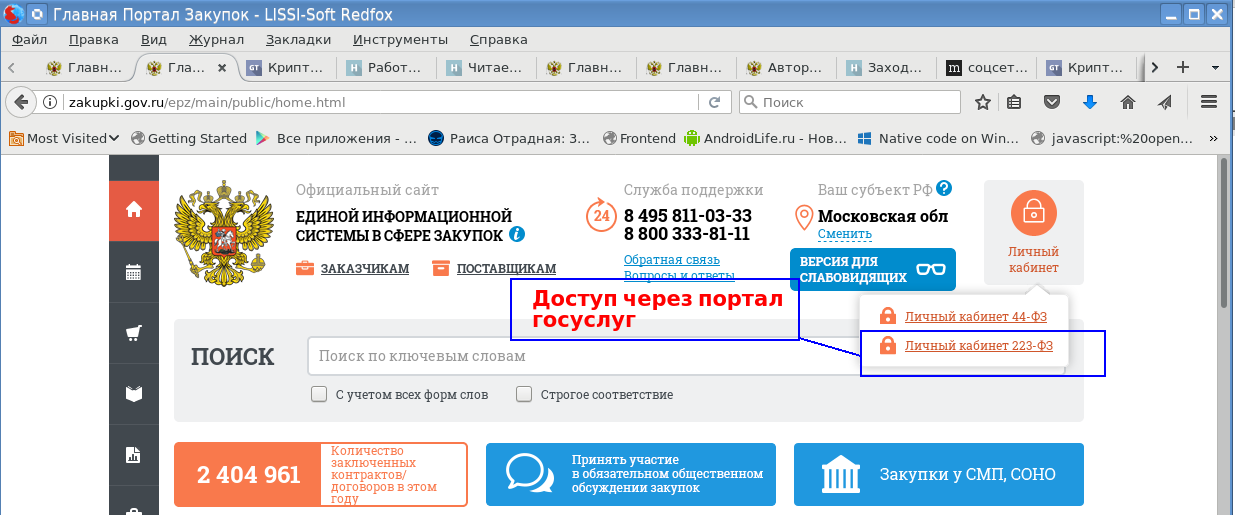

А как обстоят дела сегодня? В принципе, задел есть. Уже сегодня мы можем попасть в личный кабинет по авторизованному https с российскими шифрсьютами и на портале ФНС России и на портале Госзакупок. И для этого нам не потребуется ни MS Windows, ни Interner Explorer и даже CSP не потребуется, как это пишется в документации на этих сайтах.

Токен PKCS#11

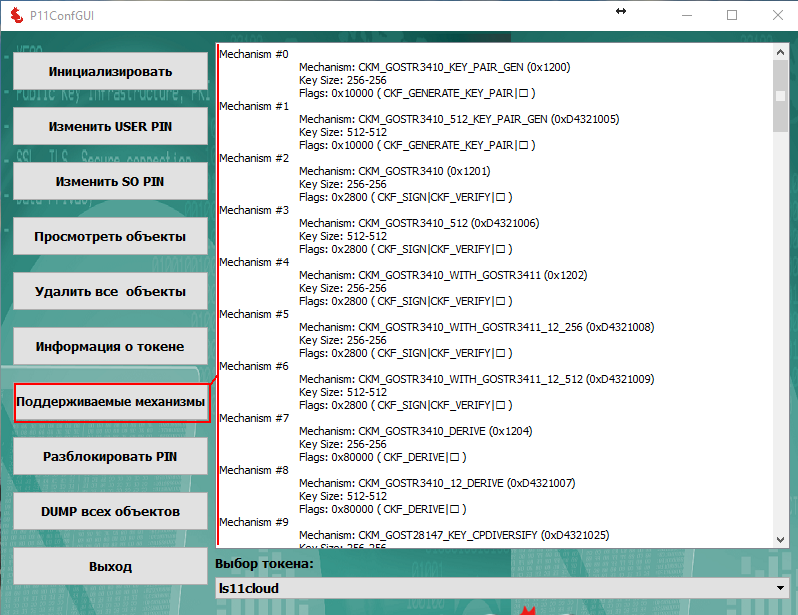

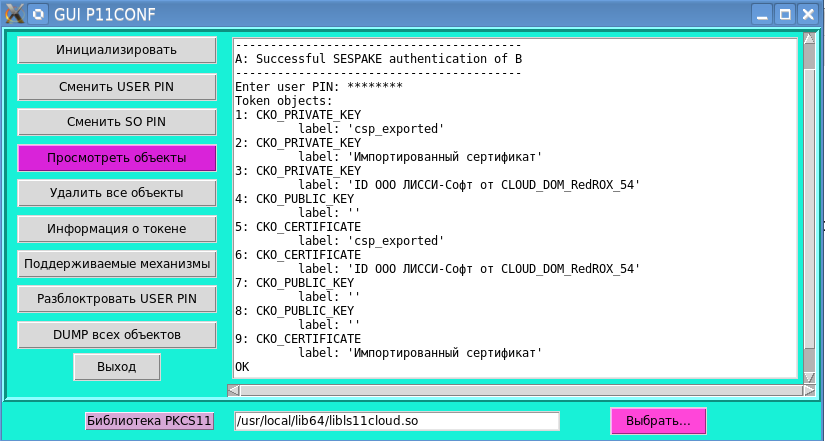

Для демонстрации в качестве СКЗИ мы будем использовать облачный токен PKCS#11. В принципе можно использовать любой токен с поддержкой российской криптографии соответствующий стандарту PKCS#11 v.2.30, если речь идет об электронной подписи ГОСТ Р 34.10-2001 г. (напомним, что этот стандарт действует только до 31 декабря 2018 и фактически уже с 1 января 2018 года надо получать сертификаты с ключом электронной подписи по ГОСТ Р 34.10-2012, если мы хотим сэкономить свои деньги). Если используются сертификаты ключа проверки электронной подписи по ГОСТ Р 34.10-2012, то токен должен соответствовать стандарту PKCS#11 v.2.40.

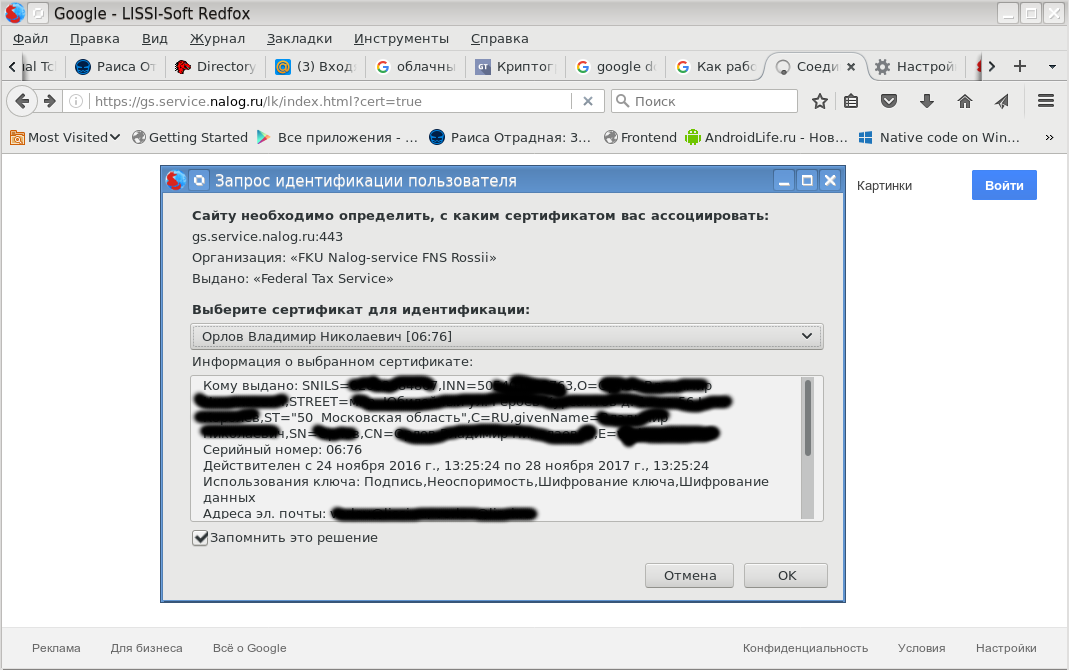

Итак, наша задача показать альтернативу MS Windows. Это может быть и OS X и Linux и Android и т.д. Остановимся на Linux. В качестве браузера рассмотрим браузер Redfox, который представляет собой доработанный с учетом поддержки российской криптографии браузер Mozilla Firefox.