Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Canvas — почти как SVG |

Ссылка на канвас ниндзю в конце.

Конкретно речь пойдёт об элементе Path и как его реализовать на canvas.

Как мы помним path в svg умеет рисовать кривые безье, сплайны из этих кривых, а так же окружности. У канваса в этом плане возможностей куда меньше, так что будем работать с ним. Для начала научимся рисовать кривые. В svg как и в canvas кривые ограничены лишь 3-мя степенями, это сделано ради оптимизации, мы же будем использовать каноничное уравнение для их вычисления, так что кривые у нас будут любого порядка.

Ничего сложного в расчёте кривых нет. Ниже код функции, которая возвращает массив вида [x,y] — это точка на кривой. Входные параметры для функции: массив контрольных точек и коэффициент смещения относительно начала кривой. Смещение — это значение в процентах от 0% до 100% (0 — начало кривой, 100 — конец), надеюсь этот момент понятен.

// так же понадобится найти факториал

function factorial (number) {

var result = 1;

while(number){

result *= number--;

}

return result;

}

function getPointOnCurve (shift, points) {

var result = [0,0];

var powerOfCurve = points.length - 1;

shift = shift/100;

for(var i = 0;points[i];i++){

var polynom = (factorial(powerOfCurve)/(factorial(i)*factorial(powerOfCurve - i))) *

Math.pow(shift,i) *

Math.pow(1-shift,powerOfCurve - i);

result[0] += points[i][0] * polynom;

result[1] += points[i][1] * polynom;

}

return result;

}

getPointOnCurve(60, [[0,0],[100,0],[100,100]]); // -> [84, 36]

Весь фокус здесь состоит в полиноме, который играет роль коэффициента для вычисления точки. Я уже писал когда-то о кривых, только высчитывал их через рекурсию (вот здесь).

Следующая остановка — сплайны.

Вообще с помощью предыдущей функции можно отрисовать произвольный участок кривой, но со сплайнами всё сложнее, чтобы нарисовать только часть сплайна нужно знать его длину, а соответственно и длины его кривых. Этого не потребуется, если мы будем выводить сплайн целиком, но кто же ищет лёгких путей?

Теперь массив контрольных точек будет иметь такой вид:

[[0,0],[100,0],[100,100,true],[200,100],[200,0]]Точки с флагом true — опорные.

function getCenterToPointDistance (coordinates){

return Math.sqrt(Math.pow(coordinates[0],2) + Math.pow(coordinates[1],2));

}

function getLengthOfCurve (points, step) {

step = step || 1;

var result = 0;

var lastPoint = points[0];

for(var sift = 0;sift <= 100;sift += step){

var coord = getPointOnCurve(sift,points);

result += getCenterToPointDistance([

coord[0] - lastPoint[0],

coord[1] - lastPoint[1]

]);

lastPoint = coord;

}

return result;

};

function getMapOfSpline (points, step) {

var map = [[]];

var index = 0;

for(var i = 0;points[i];i++){

var curvePointsCount = map[index].length;

map[index][+curvePointsCount] = points[i];

if(points[i][2] && i != points.length - 1){

map[index] = getLengthOfCurve(map[index],step);

index++;

map[index] = [points[i]];

}

}

map[index] = getLengthOfCurve(map[index],step);

return map;

};

function getPointOnSpline (shift, points, services) {

var shiftLength = services.length / 100 * shift;

if(shift >= 100){

shiftLength = services.length;

}

var counter = 0;

var lastControlPoint = 0;

var controlPointsCounter = 0;

var checkedCurve = [];

for(;

services.map[lastControlPoint] &&

counter + services.map[lastControlPoint] < shiftLength;

lastControlPoint++

){

counter += services.map[lastControlPoint];

}

for(

var pointIndex = 0;

points[pointIndex] && controlPointsCounter <= lastControlPoint;

pointIndex++

){

if(points[pointIndex][2] === true){

controlPointsCounter++;

}

if(controlPointsCounter >= lastControlPoint){

checkedCurve.push(points[pointIndex]);

}

}

return getPointOnCurve(

(shiftLength - counter) / (services.map[lastControlPoint] / 100),

checkedCurve

);

};

var points = [[0,0],[100,0],[100,100,true],[200,100],[200,0]];

var services = {};

services.map = getMapOfSpline(points);

services.length= 0;

for(var key in services.map){

services.length += services.map[key];

}

getPointOnSpline(60, points, services); // -> [136, 95.(9)]

Ну что ж осталось дело за малым, научиться включать в наши сплайны дуги эллипсов. Тут стоит рассказать о родном алгоритме SVG и чем мы будем от него отличаться.

Для дуги в path SVG предусматривает 7 параметров, что на мой взгляд излишне, вот эти параметры:

A rx ry x-axis-rotation large-arc-flag sweep-flag x yРасшифровка:

- первые два параметра вполне очевидны — это полуоси ординаты и абсциссы

- третий — это наклон эллипса, заданный в градусах

- четвёртым и пятым задаётся направление отрисовки дуги

- шестой и седьмой — координаты конечной точки

Полностью контролировать дугу можно и меньшим числом параметров, к тому же на практике не всегда известны координаты конечной точки. К тому же неправильно указанная конечная координата деформирует эллипс и при слишком большом её значении, параметры полуосей уже не соответствуют заданным.

Для дуги нам нужно знать:

- полуоси эллипса

- углы начала и конца дуги

- наклон эллипса

Всего 5 параметров.

Итак логика будет такая, следим за руками. Началом нашей дуги эллипса (не путать с его центром) будет предыдущая точка в массиве или начало координат, если предыдущей точки нет. Конец дуги — опорная точка для дальнейшего построения пути. С помощью параметров, дуга принимает любую форму и направляется куда угодно, всё чинно. Опять же нужно посчитать длину всех отрезков для построения лишь части пути.

Вот как будет выглядеть набор точек с включённым в него эллипсом:

[

[x1,y1],

[x2,y2],

[x3,y3],

[radiusX,radiusY,startRadian,endRadian,tilt], // tilt - optional

[x5,y5],

...

[xN,yN]

]

function getPointOnEllipse (radiusX,radiusY,shift,tilt,centerX,centerY){

tilt = tilt || 0;

tilt *= -1;

centerX = centerX || 0;

centerY = centerY || 0;

var x1 = radiusX*Math.cos(+shift),

y1 = radiusY*Math.sin(+shift),

x2 = x1 * Math.cos(tilt) + y1 * Math.sin(tilt),

y2 = -x1 * Math.sin(tilt) + y1 * Math.cos(tilt);

return [x2 + centerX,y2 + centerY];

}

function getLengthOfEllipticArc (radiusX, radiusY, startRadian, endRadian, step) {

step = step || 1;

var length = 0;

var lastPoint = getPointOnEllipse(radiusX,radiusY,startRadian);

var radianPercent = (endRadian - startRadian) / 100;

for(var i = 0;i<=100;i+=step){

var radian = startRadian + radianPercent * i;

var point = getPointOnEllipse(radiusX,radiusY,radian);

length += getCenterToPointDistance([point[0]-lastPoint[0],point[1]-lastPoint[1]]);

lastPoint = point;

}

return length;

};

function getMapOfPath (points, step) {

var map = [[]];

var index = 0;

var lastPoint = [];

for(var i = 0;points[i];i++){

var point = points[i];

if(point.length > 3){

map[index] = getLengthOfEllipticArc(point[0], point[1], point[2], point[3], step);

if(!points[i+1]){continue}

var centerOfArc = getPointOnEllipse(point[0], point[1], point[2] + Math.PI, point[4], lastPoint[0], lastPoint[1]);

var endOfArc = getPointOnEllipse(point[0], point[1], point[3], point[4], centerOfArc[0], centerOfArc[1]);

index++;

map[index] = [endOfArc];

lastPoint = endOfArc;

continue;

}

map[index].push(point);

if(point[2] === true || (points[i+1] && points[i+1].length > 3)){

map[index] = getLengthOfCurve(map[index],step);

index++;

map[index] = [point];

}

lastPoint = point;

}

if(typeof map[index] !== 'number'){map[index] = getLengthOfCurve(map[index],step);}

return map;

};

function getPointOnPath (shift, points, services) {

var shiftLength = services.length / 100 * shift;

if(shift >= 100){

shiftLength = services.length;

}

var counter = 0;

var lastControlPoint = 0;

var controlPointsCounter = 0;

var checkedCurve = [];

for(; services.map[lastControlPoint] && counter + services.map[lastControlPoint] < shiftLength; lastControlPoint++){

counter += services.map[lastControlPoint];

}

var lastPoint = [];

for(var pointIndex = 0; points[pointIndex] && controlPointsCounter <= lastControlPoint; pointIndex++){

var point = points[pointIndex];

if(point.length > 3){

var centerOfArc = getPointOnEllipse(point[0], point[1], point[2] + Math.PI, point[4], lastPoint[0], lastPoint[1]);

if(controlPointsCounter === lastControlPoint){

var percent = (shiftLength - counter) / (services.map[lastControlPoint] / 100);

var resultRadian = point[2] + ((point[3] - point[2])/100*percent);

return getPointOnEllipse(point[0], point[1], resultRadian, point[4], centerOfArc[0], centerOfArc[1]);

}

lastPoint = getPointOnEllipse(point[0], point[1], point[3], point[4], centerOfArc[0], centerOfArc[1]);

controlPointsCounter++;

if(controlPointsCounter === lastControlPoint){

checkedCurve.push(lastPoint);

}

continue

}

if(point[2] === true || (points[pointIndex+1] && points[pointIndex+1].length > 3)){

controlPointsCounter++;

}

if(controlPointsCounter >= lastControlPoint){

checkedCurve.push(point);

}

lastPoint = point;

}

return getPointOnCurve(

(shiftLength - counter) / (services.map[lastControlPoint] / 100),

checkedCurve

);

};

var points = [[0,0],[100,0],[100,100],[20,20,0,Math.PI],[200,100],[200,0]];

var services = {};

services.map = getMapOfPath(points);

services.length= 0;

for(var key in services.map){

services.length += services.map[key];

}

getPointOnPath(60, points, services); // -> [96.495, 98.036]

Ну вот теперь мы крутые чуваки, много чего умеем.

Ссылка на примеры вот.

|

Метки: author takovoy javascript canvas |

Сказ о том, как Android-разработчика спамеры задолбали, и что и из этого вышло |

Сам процесс установки выглядит так: вызываете мастера из сертифицированной конторы, он устанавливает счетчик, опечатывает его, расписывается и ставит печать в бумагах, с которыми идёте в единый расчетный центр, и ваш счетчик ставится на учет.

Далее через сайт, либо по телефону вы передаете показания. Но как обычно, ко всякому благому делу присасываются кровопийцы и мошенники разных мастей. Чтобы облегчить себе жизнь, и усложнить её спамерам и мошенникам я написал приложение «Журнал счетчиков».

Под катом я расскажу вам о размышлениях, творческих метаниях, и процессе разработки, в шести частях, с антрактом, лирическими отступлениями и техническими подробностями.

Часть первая — Воинственная

Вот поставили вы себе счётчики, опломбировали и подали информацию в службу Единого Окна. Живёте себе спокойно, передаёте данные по показаниям, и в ус не дуете. И тут через год или два раздаётся звонок, от Единого Расчетного Центра/Управы/Городского Центра Метрологии/Самой Управляющей Компанией (нужное подчеркнуть). В трубке воинственная барышня/юноша сообщают, что срок службы счётчика вашего истёк — и быстрее ставьте новый – и когда наш мастер приедет?

Мошенники ведут себя агрессивно, вываливают поток слов, угрожают переводом на повышенный тариф без счетчиков, штрафами и санкциями. Так как звонят в середине рабочего дня, когда все на работе, и дома в основном пенсионеры, то в основном рассчитано на них, как наиболее доверчивых людей.

Общая рекомендация – не стесняйтесь, и посылайте этих нехороших людишек в далёкие страны. А информацию о сроках поверки, вы можете посмотреть в паспорте на свой счетчик.

Но порой найти вы в упор не помните, когда и что меняли и устанавливали, и куда паспорт от прибора запихали.

(С) – (и даже не поздоровался, хамло) РосКосмосВодоНаноКанал имени Святой Метрологии. Вы должны поменять счетчики на воду! У вас заканчивается срок службы!

(Я) – (в голосе паника) Ой! Что же делать!

(С) – (довольный, рыбка-то попалась) Мы пришлем вам мастера. Когда сможете принять?

(Я) – А что мастер сделает?

(С) – Он поменяет вам счетчики на новые!

(Я) – А зачем менять то?

(С) – (сердится) Потому, что так положено! Говорите адрес!

(Я) – Погодите. У меня сосед, он профессиональный строитель. Он мне сказал, что детальку меняют, и не надо счетчик снимать!

(С) – (уже с душой) Ваш сосед ничего не понимает! Это же метрология!

(Я) — (праведный гнев) Вы обманываете меня! Мой сосед ПРОФЕССИОНАЛЬНЫЙ строитель!!! Он лучше всех знает!!!

(С) – (раздражение и злость, смешалось в этом голоске) Ах так!!! Ну тогда вам пришлют письменное извещение!!! И платить вы будете по повышенному тарифу!!! (гудки....)

Часть вторая – Размышления.

Итак, чтобы не искать информацию по счетчикам, необходимо иметь её под рукою. Может записать её в тетрадочку и положить на стол? А заодно в эту тетрадочку буду записывать и ежемесячные показания счётчиков.

Решение простое, и эффективное. Осложняется тем, что у меня трое весёлых малышей, для которых любая бумага в пределах доступности (включая документы и обои) – потенциальный альбом, который нужно изрисовать или порвать на мелкие кусочки. По той же причине дома порой не найдёшь нормально пишущей ручки или карандаша. И приходится писать показания на огрызках салфеток (манжетах/глиняных табличках).

Хорошо, заведу-ка я таблицу в Excel, табличку и буду записывать всё там. Но опять же, не потащу я компьютер в ванную и туалет, чтобы записать показания. Иначе мы опять возвращаемся к бумажке и ручке.

ОК. Буду использовать планшет. Но всё что мог на тот момент предоставить Маркет – либо платное, либо не отвечающее моему представлению о прекрасном. Да и в конце-то концов я Android – разработчик, или где?

(Я) – Простите, представьтесь пожалуйста.

(С) – Ээээ… Мария. Так вот…

(Я) – (торжественно) Мария! Я хочу поговорить с вами о Боге!

(С) — …

(Я) – Вы хотите поговорить со мной о Боге? Мария, я не слышу вас!

(С) — … Мы вообще-то…

(делает попытку вернуть все в русло первоначальной беседы)

(С) – Послушайте, мы хотим предложить вам выгодные условия…

(Я) – (добавив, щепотку праведного гнева) Мария! О чем вы?!!! Что может быть важнее разговора о Боге?!!!

(С) – Как понимаю, в не хотите разговаривать. (гудки...)

Часть третья – Подготовительная

Итак, составим план, в котором перечислив всё, что нам нужно.

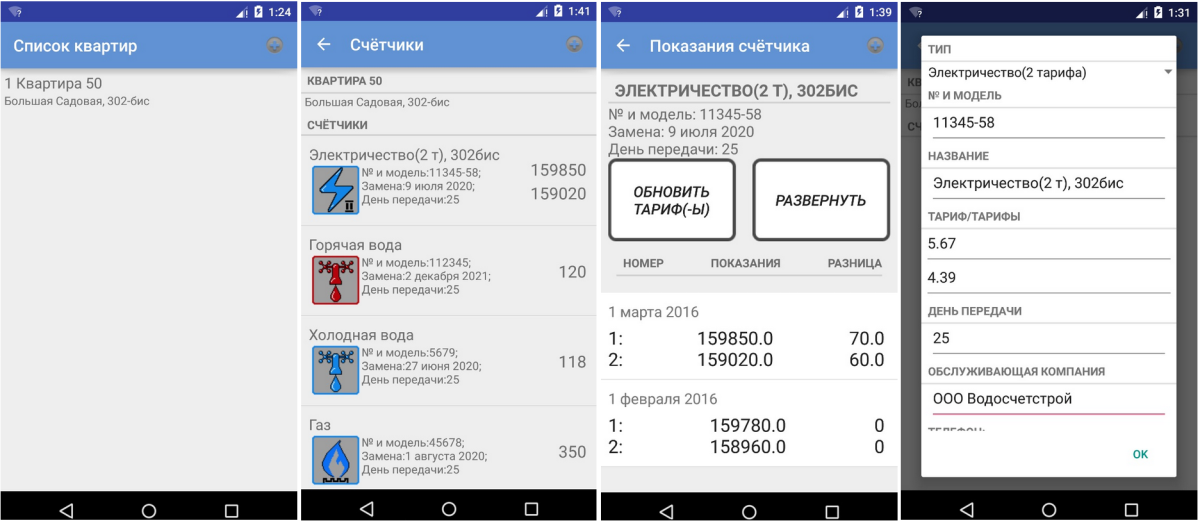

Первое – иметь под рукой все данные по счётчикам. А именно: номер, модель, дата замены, лицевой счёт, контакты обслуживающей компании и мастер-установщик.

Второе – удобный инструмент для занесения ежемесячных показаний, а также какой-то простейший инструмент анализа.

Третье – иметь возможность завести несколько квартир, например чтобы вести статистику по квартире родителей.

Четвёртое – если понравится в использовании, не быть жадиной и поделиться с миром.

(Я) – Виталька!!! Это ты?!!! Сколько лет!!! Сколько зим!!!

(С) – (слегка обалдев) Я…

(Я) – Блин!!! Я ж твоего звонка ждал!!! Как сам?!!! Как жена?! Как дети?!!!

(С) – (охреневая глубже) Я вообще-то не женат…

(Я) – Ну что ж ты балбес. Мужик без жены, как гусеница без дерева!

(С) – Ну, я как понимаю вас достали со звонками. До свидания…

Часть четвёртая – Эксперименты.

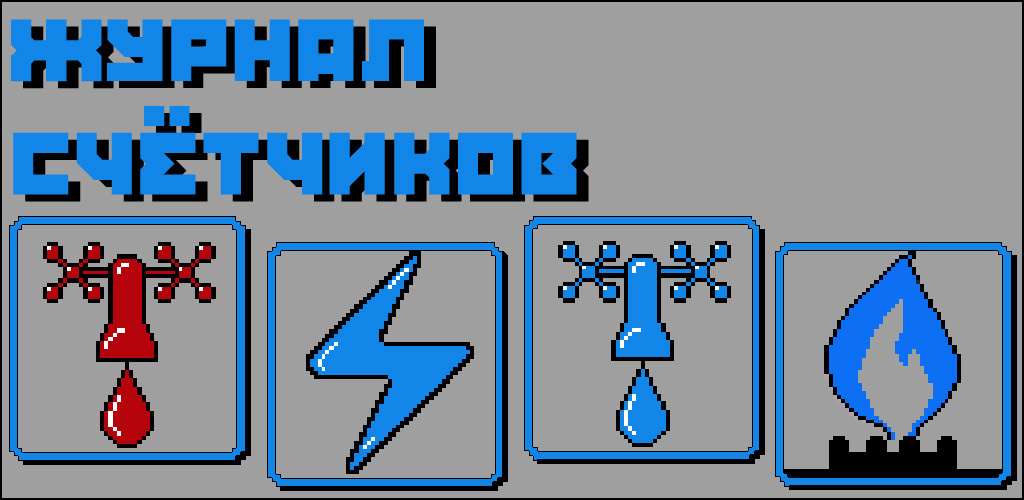

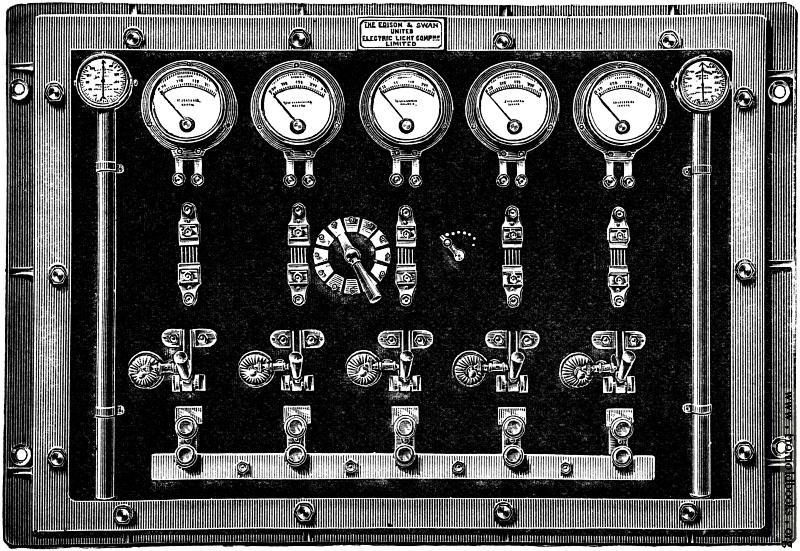

Первый вариант был прост и бесхитростен. Всё построено на ListView. Настроек нет. Зато ввиду моего тогдашнего увлечения пиксель-артом, значки нарисовал сам.

Старый дизайн

Главное, что приложение работало. Велась статистика (кстати пригодилось, когда пришлось пободаться с Мосэнерго).

Ввиду того, что меня приложение устраивало – создал аккаунт разработчика в Маркете, и выложил на суд общественности. Параллельно написал пост на Пикабу.

Основная критика касалась непритязательного внешнего вида, полного отсутствия Материал Дизайна, и значков которые «словно вернули в 90-е». Но в целом отзывы были положительными.

Тем временем я написал еще одно приложение, о чем рассказал на Хабре. Совершенно неожиданно для меня, количество скачиваний именно «Журнала счётчиков» резко скакануло вверх.

Чувствуя ответственность перед более 5000 пользователей, я решил переписать приложение.

Для начала сел с блокнотом (чудом спасённым от моих индейцев), проанализировал комментарии, и выписал наиболее интересные предложения. Причём некоторые был весьма неожиданными, но реально добавляющие удобства пользователю. Например, добавить возможность включить фонарик, при занесении показаний счетчика.

Переписывать пришлось очень много. А с учетом работы и семьи, работать приходилось ночами, и переделка заняла чуть ли не больше времени, чем написание первой версии.

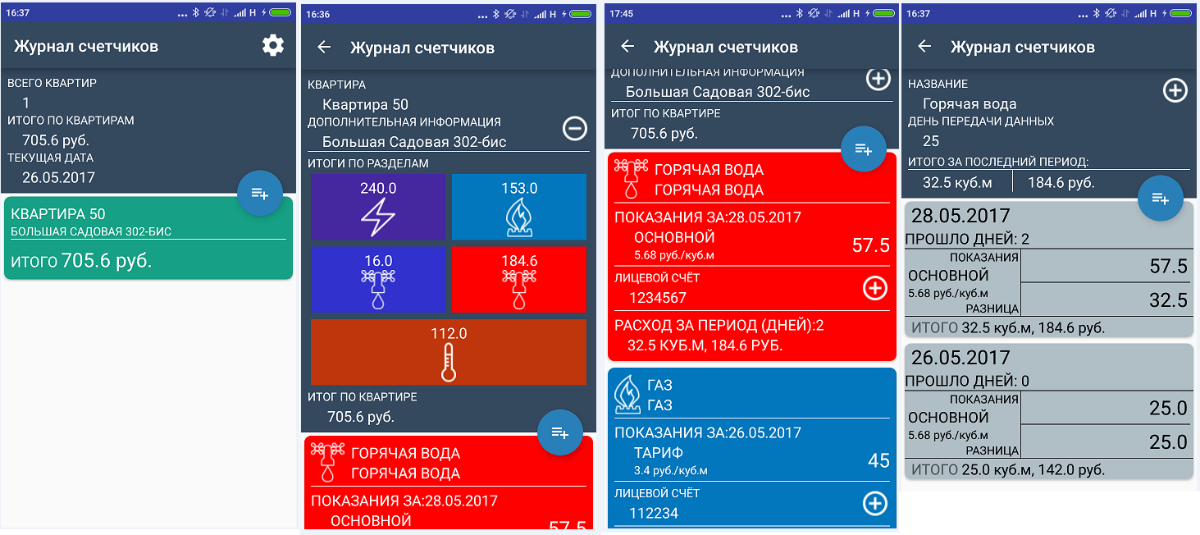

Поменял полностью дизайн:

Новый дизайн

Добавил настройки, и возможность сохранить/загрузить данные в/из файла:

Перерисовал иконки в векторе, исправил кучу глюков и ошибок, добавил счётчик тепла, и написал инструкцию. В общем, почти с нуля переделал.

(Я) – Нет

(С) – Можно узнать почему?

(Я) – Боги запретили мне делать это.

(С) – (пауза....) Простите, что?

(Я) – Боги запретили мне брать кредиты.

(С) – А может всё-таки…

(Я) – (возмущённо) Вы хотите поспорить с Богами?!!!

(С) – Ээээ… нет… До свидания…

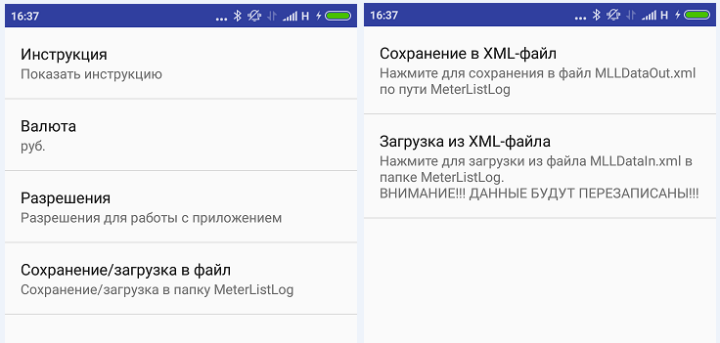

Часть 5. Трюки разработчика

При разработке приложения столкнулся с кучей интересных моментов. Например, если вы хотите создать ListView, внутри которого будут не просто данные, а еще и управляющие элементы (чекбоксы, редактируемые поля) вы можете столкнуться с тем, что информация неверно отображается, или передаётся в родительскую активность.

Например, в моём случае это был ListView и его адаптер, заполняемый при внесении показаний.

Диалог для ввода данных

Всё было нормально для обычных, однотарифных счётчиков, но для многотарифных началась ерунда. Вот так я победил это. Заводим адаптер (amountList)

ListView lvAmounts = (ListView)mView.findViewById(R.id.lv_newAmount_Amount); insertAmountAdapter insertAmountAdapter = new insertAmountAdapter(getActivity(), amountList);

lvAmounts.setAdapter(insertAmountAdapter);

Класс адаптера (также есть класс следящий за введёнными показаниями AmountTextWatcher):

public class insertAmountAdapter extends BaseAdapter {

Context mContext;

ArrayList amountList;

LayoutInflater mLayoutInflater;

EditText etAmount, etTariff;

TextView tvTariffTitle;

public insertAmountAdapter(Context mContext, ArrayList amountList) {

this.mContext = mContext;

this.amountList = amountList;

mLayoutInflater = (LayoutInflater)mContext.getSystemService(Context.LAYOUT_INFLATER_SERVICE);

}

@Override

public int getCount() {

return amountList.size();

}

@Override

public Object getItem(int position) {

return amountList.get(position);

}

@Override

public long getItemId(int position) {

return position;

}

@Override

public View getView(int position, View convertView, ViewGroup parent) {

View view = convertView;

if(view == null){

view = mLayoutInflater.inflate(R.layout.item_insertamount, parent, false);

etTariff = (EditText)view.findViewById(R.id.et_amount_tariffInfo);

etTariff.addTextChangedListener(new AmountTextWatcher(view, etTariff, amountList));

etAmount = (EditText)view.findViewById(R.id.et_amount_Amount);

etAmount.addTextChangedListener(new AmountTextWatcher(view, etAmount, amountList));

}

etAmount.setTag(position);

etAmount.setText(String.valueOf(amountList.get(position).getAmount()));

etAmount.setFilters(new InputFilter[]{new DigitalFilter(3)});

tvTariffTitle = (TextView)view.findViewById(R.id.tv_amount_tariffTitle);

tvTariffTitle.setText(amountList.get(position).getTariffTitle()+", "+amountList.get(position).getUnit());

etTariff.setTag(position);

etTariff.setText(amountList.get(position).getTariffValue());

etTariff.setFilters(new InputFilter[]{new DigitalFilter(2)});

return view;

}

}

class AmountTextWatcher implements TextWatcher {

private View view;

private EditText editText;

private ArrayList amountList;

public AmountTextWatcher(View view, EditText editText, ArrayList amountList) {

this.view = view;

this.editText = editText;

this.amountList = amountList;

}

@Override

public void beforeTextChanged(CharSequence s, int start, int count, int after) {

}

@Override

public void onTextChanged(CharSequence s, int start, int before, int count) {

}

@Override

public void afterTextChanged(Editable s) {

if(editText.equals(view.findViewById(R.id.et_amount_Amount))){

amountList.get(Integer.parseInt(editText.getTag().toString())).setAmount(Double.valueOf(s.toString().isEmpty()?"0":s.toString()));

} else if(editText.equals(view.findViewById(R.id.et_amount_tariffInfo))){

amountList.get(Integer.parseInt(editText.getTag().toString())).setTariffValue(s.toString().isEmpty()?"0":s.toString());

}

return;

}

}

Как видите, отслеживание рабочей строки идёт, через setTag и getTag.

Также, я захотел сделать инструкцию не просто с текстом, а с иллюстрациями. Для этого я решил использовать html-разметку. Но при работе с ней, есть некоторые нюансы.

Создаём инструкцию в strings.xml:

Добавляем картинки, под такими же именами, которые прописаны в инструкции, в папку drawables (у меня это: add_btn_instruction.png и open_btn_instruction.png).

В требуемом месте создаём строку, TextView и ImageGetter:

String instructionHTML = getString(R.string.instructionText);

TextView tvInstruction = (TextView)findViewById(R.id.tv_instruction);

tvInstruction.setText(Html.fromHtml(instructionHTML, htmlImageGetter, null));

Html.ImageGetter htmlImageGetter = new Html.ImageGetter() {

public Drawable getDrawable(String source) {

int resId = getResources().getIdentifier(source, "drawable", getPackageName());

Drawable ret = InstructionActivity.this.getResources().getDrawable(resId);

ret.setBounds(0, 0, ret.getIntrinsicWidth(), ret.getIntrinsicHeight());

return ret;

}

};

(Я) – В чем вопрос?

(С) – Мы проводим социологический опрос…

(Я) – Женщина, вы вообще на часы смотрите? Время уже десять вечера!

(С) – (праведное возмущение) Ну если вы спать хотите, то выключать телефон надо! (гудки...)

Часть 6. Реклама и все-все-все.

Как уже упоминал, изначально приложение писал для себя. И никаких вложений в рекламу не делал. Единственное – это статьи на пикабу, и косвенная на Хабре. Перевёл на английский, так на всякий случай.

Монетизации, нет никакой. Приложение бесплатно, и без рекламы. Как говорил уже раньше, в другой статье «Никакой материальной выгоды, кроме морального удовлетворения (и немного, для удовлетворения мании величия), и желания поделиться полезным инструментом с сообществом, автор не получает.»

В планах на следующую версию добавить напоминалку, расширить список счётчиков (счетчики с тарификацией, водоотведение), перевести еще на несколько языков (немецкий, белорусский, украинский, быть может казахский).

Вот собственно и вся история написания моего самого первого приложения.

(Я) – Зови меня, Добрый Человек, Добрый Человек.

(гудки....)

Засим позвольте откланяться. Надеюсь кому-то это окажется полезным. Если у кого-то есть замечания или подсказки, с большим удовольствием их выслушаю.

|

Метки: author Snakecatcher разработка под android android счетчики жэк спамеры |

Три дня как все кассы в стране должны стать онлайн (на самом деле нет) |

Теперь так делать нельзя

Старая логика такая: внутри кассы есть некая постоянная write-only память, в которую касса пишет каждый пробитый чек. Это реализовано в виде ЭКЛЗ — электронной контрольной защищённой ленты, которая уже давно не лента, а плата. Это устройство требует много геморроя — там целый квест с заменой, заведением новой кассы и так далее.

В цифровом мире такие проблемы очень давно решаются сертификатами. Именно эту плюшку даёт нам ФЗ-54, который описывает онлайн-отправку чеков. Он же запрещает с 1 февраля 2017 заводить новые кассы старого типа, а с 1 июля 2017 (то есть уже) — вообще использовать такие кассы. То есть если в феврале планировалось открытие нового магазина, то в нём уже должна быть онлайн-касса. С 1 июля 2017 все кассы должны быть онлайн.

Мелкие бизнесы (ИП, ЕНВД и патентное налогообложение) могли перетоптаться до 1 июля вообще без кассы, но потом даже для торговых автоматов они стали обязательными. На самом деле это нереально круто для страны, но…

… реализация породила целую гору проблем. Первая и главная — фактическая спекуляция новым оборудованием, потому что потребность в нём была больше, чем производители успевали выставлять на полки.

Как теперь выстроен процесс передачи данных о чеке

Теперь, когда вы что-то покупаете, данные о выбитом чеке подписываются и кладутся в буфер отправки. По логике, этот буфер сразу же опустошается в реальном времени по мере отправки данных оператору фискальных данных. На деле — в России интернет лагает, есть выездные ярмарки и прочие вещи, где хрен вам, а не связь. Поэтому буфер хранится столько, сколько нужно — до месяца, вроде, ничего страшного произойти не должно.

Оператор фискальных данных, получив чек, должен сообщить кассе, что всё в порядке, чек получен. Дальше он хранит этот чек «и по необходимости передает Федеральной налоговой службе». Как я понимаю текущую логику реализации (это моё личное мнение) — просто сразу выгружает в налоговую.

На каждом бумажном носителе чека есть QR-код, который можно отсканировать и получить себе этот чек в личный кабинет Госуслуг или в приложение налоговой службы.

Вместо сканирования можно вбить параметры с чека руками:

И получить вот такой результат:

Если в течение 30 дней касса пробивает, но не передаёт чеки в онлайн, она автоматически блокируется (и потом налагается штраф). Блокировка в наших модулях реализована на уровне прошивки устройства.

То есть теперь Икея сможет проводить свою акцию «гарантия 25 лет при сохранении чека» без страха — он не выцветет через год до белого состояния, а будет храниться вечно в электронном виде.

Апгрейд

Чтобы всё это заработало, нужно:

- Обновить кассы аппаратно

- Получить ЭЦП для налоговой, чтобы регистрировать кассу

- Выбрать оператора фискальных данных.

- Снять кассу с учёта и поставить её на учёт.

Пункт (4) теперь делается легко через личный кабинет налоговой: раньше нужно было ехать лично, ставить на учёт, ждать, через неделю привозить ещё документы.

Аппаратная база почти не поменялась — это те же старые добрые страшные кассы, но теперь с модулем подключения к сети. И есть ещё кассы-планшеты, как в будущем.

Модуль связи — касса отдаёт данные через Ethernet. Есть похожие выходные интерфейсы с 3G-модемом.

У нас «Штрихи». Соответственно, было два варианта — либо подключить к уже имеющейся кассе модуль доработки с блоком ФН и комплектом активации ККТ ШТРИХ-М-02Ф (17 тысяч рублей), либо купить новую модель кассы — от 27 тысяч рублей. На новые модели мы заменили только старые кассы. К «Штриху» вопроса нет, они крутые и очень грамотно сработали.

С другой стороны, компании-продавцы сразу смекнули, что можно в нагрузку продавать свои услуги регистрации-интеграции. В нашем случае модули не продавались без услуги за 2000 рублей, которая нафиг нам не нужна, и поддержки за 2400 рублей. Это как аудиосистема и прочие прибамбасы к машине — вроде, брать ты их не хочешь, и они необязательны, но если не возьмёшь — машины может и не быть. По факту модули модернизации почти не продавались без вот этой «прилепки». Только настойчивость и знание прав меняло ситуацию.

Немного прошлого

Объяснять новый ФЗ начали в сентябре, наши спецы 1С ездили на конференцию. На тот момент на стендах конференции присутствовали новые кассы, но был только предзаказ, модули не продавались. Сроки рассказали приблизительно. Чёткой рабочей инструкции и тестового экземпляра Штрих не давал — но не потому что они злые гады, а потому что, по всей видимости, не пускали железо в серию до появления окончательных уточнений по реализации закона.

Ближе к ноябрю-декабрю появились комплекты модернизации для новых касс. Было видно, что сделано всё в режиме ранней беты. Наша тестовая игрушка пришла без нормальной инструкции, поэтому всё делалось пальцами наугад. В первый же день касса накрылась и отказывалась отправлять чеки в сеть — мы её тупо брикнули своими опытами. Пришлось перепрошивать у сертифицированного партнёра. Потом спустя неделю появилась инструкция с чётко описанными багами, которые приводят к падению кассы.

Мы решили сделать всё заранее к февралю, потому что февраль и март — это много выездных ярмарок, мы не хотели заморачиваться с новыми ЭКЛЗ на короткий срок до замены, плюс надо было иметь кассы для открытия точек в феврале. Опять же, не было уверенности, что 1С обновит всё как надо, и мы сможем за две недели взять и перепрыгнуть сразу.

ИТ-команда ещё в январские праздники поставила кассу в офиса, и начала торговать играми сама себе. Было много доработок — например, чтобы чек нормально отправлялся в ОФД, чтобы 1С сам проверял соединение и предупреждал продавцов, если чеки не грузятся онлайн.

Нужно было обновить чеки, в т.ч. добавить печать QR-кода и имя кассира. Оно теперь обязательно. И вот за такое как на картинке сверху (снято в Волгограде) теперь будут бить ногами, если, конечно, в паспорте не так же.

По разработке и тестам — 3 месяца мы медленно изобретали велосипеды, потому что внятных best practice не было. Нормально кассы начали продавать только с этого года.

Наше время

В апреле-мае мы не могли в нужном количестве закупиться устройствами модернизации, потому что их тупо нет, все ушли в продуктовые сети. Например, у Пятёрочки и Перекрёстка тоже «Штрихи-М». Полтора месяца назад примерно на семинаре «ONLINE РЕВОЛЮЦИЯ: все чеки в облаках» сказали, что зарегистрированных кассовых аппаратов в стране более миллиона, а перешло на новую схему только 250 тысяч (это ещё без учёта тех парней, которые раньше не били чеки, а теперь должны будут торговать с кассой).

В итоге контролирующим органам стало понятно, что не все успевают — вернее, производитель не успевает удовлетворить спрос. Вышло вот такое письмо. Самая интересная часть:

«В целях установления факта принятия исчерпывающих мер по соблюдению указанных выше требований законодательства Российской Федерации может быть исследован заключенный пользователем договор поставки фискального накопителя на предмет разумного срока до окончания действия блока ЭКЛЗ или до определенного законодательством Российской Федерации о применении контрольно-кассовой техники предельного срока возможности его использования.»

То есть если есть предзаказ (договор поставки и совершённая оплата) на новые кассы, но их ещё не привезли, а в старых не кончилась ЭКЛЗ — можно печатать старые чеки, пока не приедут кассы.

Штрафы

- Старая касса, но чек выбит — 10 тысяч рублей.

- Чек не отправлен покупателю — 10 тысяч рублей.

- Нет кассы, а она должна быть — 30 тысяч рублей.

И вот очень хороший сайт с FAQ с кучей деталей.

Резюме

Это всё очень круто, потому что мы в стране наконец-то отказались от устаревшего носителя, плюс получили возможность проверять всё онлайн. Да, проблемы при внедрении есть, но в целом — оно того стоит.

|

Метки: author Milfgard управление проектами управление продажами управление e-commerce блог компании мосигра кассы будущее чек продажи |

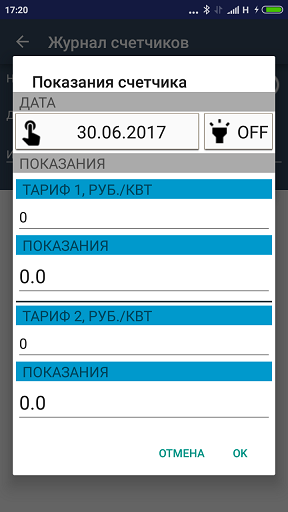

4 популярные ошибки в дизайне визиток |

Проблемы с версткой

Задача верстки — правильно расставить акценты на визитке. В случае с плохой версткой, получатель не поймет, куда смотреть и что читать в первую очередь.

Кроме того, без «сетки» блоки текста нередко оказываются слишком близко друг к другу или к краям, из-за чего тексту не хватает «воздуха» и он попросту «слипается», и прочесть его становится трудно.

Плохое обращение со шрифтами

Вот краткий список принципов, которыми можно руководствоваться при работе со шрифтами:

- Важно правильно подобрать сочетающиеся друг с другом шрифты, поэтому лучше не использовать больше двух шрифтов на одной визитке — меньше шанс промахнуться;

- Эффекты к шрифтам неприменимы (за очень редким исключением);

- Деформировать (растягивать) шрифт нельзя — буквы должны выглядеть так, как они задуманы.

Проблемы с читаемостью

В погоне за количеством «ДИЗАЙНА» на квадратный сантиметр на визитке не следует применять как можно больше доступных в фотошопе эффектов.

Тени, имитация 3D и различных текстур мешают донести информацию максимально просто и ясно. Не стоит забывать, что визитка по сути своей — тонкий лист бумаги, и имитировать объемное изображение или текстуру на нём с помощью эффектов не стоит — наилучшим решение будет вложиться в материал подороже.

Неправильное оформление визитки

Под финальным пунктом объединены часто встречающиеся ошибки на этапе наполнения визитки:

1. Оформление ссылок. В первую очередь, избавьтесь от «https://». Эта часть не обязательна для ввода и выглядит как мусор на пути к полезной информации. Также постарайтесь, чтобы «id» ваших сообществ и страниц выглядели как «/logomachine», а не «/id32754081»;

2. Оформление номера телефона. Мобильные имеют формат «8 911 123 44 55», а городские — «111 22 33». В скобках пишутся только необязательные для набора цифры (код города, например);

3. Оформление почты. Почта на @rambler.ru, а также «zaychik777» в качестве логина — плохая идея (или “под запретом”). Лучше всего — использовать почту на домене своей компании;

4. Использование собственного фото на визитке считается дурным тоном, если вы известный человек (предприниматель, глава фирмы и т.д.). Исключением могут быть менеджеры, фотография на визитке которых поможет отличить их от других менеджеров компании;

5. Визитка на двух языках с двух сторон говорит о желании сэкономить на партии визиток для иностранных клиентов.

Как итог:

Конечно, есть и исключения из правил, но следуя этим простым советам вы научитесь не совершать самых распространенных ошибок при создании визитной карточки.

|

Метки: author Logomachine типографика графический дизайн логомашина дизайн студия дизайн бизне визитка |

Как обеспечить безопасность в эпоху AI и облачных платформ. Интервью с профессором Малковым |

|

Метки: author megapost microsoft azure информационная безопасность |

Как быстро удалить множество строк из большой базы в MySQL |

Подобно им, администраторы БД также делятся на две категории, те, кто уже запускал процедуру удаления на большой БД с типом таблиц InnoDB, и те, кому это ещё предстоит.

Разумеется, в теории все знают, что из-за особенностей InnoDB, удаление может быть долгим, но это знание сродни тому, что «надо делать бэкапы». Многие осознают эти нехитрые истины, только наступив на грабли.

Для понимания, удаление 350М записей в таблице на 500М записей может занять более двух суток. Вторые грабли, на которые многие наступают, это попытка прибить запрос. Как мы все помним, InnoDB движок транзакционный, поэтому если вы попытаетесь прибить запрос, он попытается откатить изменения, а это может занять больше времени, чем выполнялся запрос.

Как сделать так, чтобы не было мучительно больно? Добро пожаловать под кат!

1. Если вы УЖЕ запустили удаление и теперь хотите приблизительно оценить, сколько уже сделано и сколько ещё осталось, используйте SHOW ENGINE INNODB STATUS;

Получите длинный вывод. Ищите в нём вашу команду и смотрите undo log entries, это и будет количество уже обработанных записей.

---TRANSACTION 1 4141054098, ACTIVE 191816 sec, OS thread id 36004918272 updating or deleting, thread declared inside InnoDB 84

mysql tables in use 1, locked 1

686063 lock struct(s), heap size 88520688, undo log entries 229144332

MySQL thread id 56087872, query id 2202164550 1.1.1.2 database updating

DELETE

FROM table

WHERE UNIX_TIMESTAMP(moment) < 1498712335 - 365 * 86400

AND UNIX_TIMESTAMP(moment) > 0Далее, в зависимости от того, сколько уже сделано, решаете, ждать до победного конца или прерывать запрос.

2. Если вы только планируете начать удаление, используйте LIMIT.

Количество записей подбирается эмпирически, скажем на не особо мощном сервере я использовал LIMIT 5000, на более мощном LIMIT 50000.

Начните с небольших значений и увеличивайте их по необходимости.

Минусы решения:

а) надо руками запустить запрос необходимое количество раз (ну, или сделать текстовый файл с необходимым количеством строк с запросом и запускать из него.

б) каждый последующий запрос выполняется дольше, чем предыдущий

3. Используйте pt-archiver из комплекта percona-tools.

Я бы рекомендовал именно этот способ по ряду причин:

а) он быстрый;

б) его можно прервать в любой момент;

в) в нём можно наблюдать за прогрессом операции.

Пример:

pt-archiver --source h=127.0.0.1,D=build4,t=b_iblock_element \

--optimize s --purge --where 'TAGS LIKE "%САПР%"' \

--limit 1000 --commit-each --progress 500 --charset "CP1251"В принципе, ключи довольно очевидны, тем не менее, пройдусь по ним:--source — описывает подключение. Хост, база и таблица. При необходимости можно дописать логин и пароль (в примере я использую креды из ~/.my.cnf);

--optimize — оптимизирует исходную таблицу, либо ту, в которую переносятся данные. Поскольку в данном случае я не переношу, а удаляю данные, оптимизирую именно исходную (s) таблицу. В принципе, делать это необязательно;

--purge — изначально утилита предназначена для переноса данных в другую таблицу (или в файл). Но можно и просто удалять строки;

--where — обычное SQL-условие, по которому будут отбираться строки для удаления;

--limit 1000 — обрабатывать за раз 1000 строк (можно больше, зависит от производительности вашего сервера);

--commit-each — делать коммит после количества строк, указанного в --limit;

--progress 500 — выводить прогресс каждые 500 строк (опять же, имеет смысл подобрать этот параметр индивидуально);

--charset — кодировка. Если будет использоваться только ASCII-кодировка, проще указать --no-check-charset. Отдельно упомяну, что необходимо чтобы локаль консоли совпадала с указанным charset'ом, иначе ошибка не выведется, но и строки обработаны не будут.

Надеюсь, эта небольшая заметка показалась вам полезной (или хотя бы интересной).

Если вам есть, что добавить, поправить или просто высказаться — пишите!

Отдельной строкой хочу принести благодарность жж-пользователю merkwurdig, поднявшему обсуждение этой проблемы и заставившему меня вспомнить, как я бегал по таким же граблям, жж-пользовательнице svetasmirnova, которая всегда приходит на помощь при затруднениях с MySQL и сообществу ru_root, благодаря которому и появилась эта небольшая статья.

|

Метки: author StraNNicK системное администрирование администрирование баз данных mysql innodb |

Как искать людей в числе Пи и причем тут Python |

emails = pandas.read_csv("emails.csv")

emails.sample(NUM_WINNERS, random_state=SEED)

И это хорошо, это работает. Да и бритва Оккама говорит, что не стоит сущности плодить без необходимости. Но есть проблема — это не весело. Плюс, так мы уже выбирали победителей на курсе по Java. Там, конечно, за две строчки это не сделаешь, нужна фабрика фабрик абстрактных классов и вот это все. Все равно повторяться не хочется.

Хотелось бы сделать робота, который сам выбирает реальные шары из корзины, распознает номера и отправляет в чатик по API (это весело!), но это не очень быстро. Решение должно быть бессмысленным, беспощадным и не особо времязатратным. Так в голову пришло число Пи. Вообще у нас с коллегами есть inside joke про идеальный Пи-архиватор. Суть проста: чтобы сжать любые данные нужно лишь найти то место в числе Пи, где они начинаются и запомнить позицию (+длину, конечно). Непревзойденное сжатие! Получается, что также можно искать устаников, в частности их emai’ы в числе Пи, и считать победителем тех, кто найдется первым. Если хотите сразу к сути, то можно тут же перейти в notebook.

Непродолжительный поиск в интернетах выдал множество решений по генерации цифр числа Пи, в том числе на Python (также в процессе находится этот прекрасный ресурс: www.angio.net/pi, — не могу не поделиться). Я, честно говоря, не знал, что человечество до такой степени обеспокоено этой проблемой. Самые популярные решения: Gauss–Legendre algorithm, Chudnovsky algorithm, BBP formula.

Я же выбрал тот вариант, который позволяет генерировать цифры числа бесконечно, а не выдает заранее определенное количество цифр

def pi_digits():

"""generator for digits of pi"""

q, r, t, k, n, l = 1, 0, 1, 1, 3, 3

while True:

if 4 * q + r - t < n * t:

yield n

q, r, t, k, n, l = (10*q, 10*(r-n*t), t, k, (10*(3*q+r))/t-10*n, l)

else:

q, r, t, k, n, l = (q*k, (2*q+r)*l, t*l, k+1, (q*(7*k+2)+r*l)/(t*l), l+2)

Это Spigot algorithm товарища Гиббонcа, который вычисляет цифры числа Пи в потоковом режиме. Все подробности есть в research paper, которая особенно понравится любителям Haskell.

Остается только связать email’ы участников с какими-то числами. Сначала я хотел брать md5 от почты и потом делить по модулю, чтобы получить число не больше заданной длины. Но это как-то не очень случайно, тем более что можно подобрать и зарегистрировать почту, которая окажется достаточно близко к началу числа Пи. Поэтому расчехляем старый добрый ПГСЧ:

np.random.seed(SEED)

emails["num"] = np.random.randint(10 ** (NUM_DIGITS - 1), 10 ** NUM_DIGITS - 1, size=len(emails))

Длина чисел задается заранее, чем длиннее число, тем, соответственно, сложнее найти его в Пи. Осталось только написать функцию поиска.

class _Num(object):

def __init__(self, n):

self.n = n

self.s = str(n)

self.p = 0 # pointer in number string representation

self.l = len(self.s)

def move_p(self, d):

if d == self.s[self.p]:

self.p += 1

else:

self.p = 0

def find_nums_in_pi(nums, first_n=None):

MAX_POS = 10 ** 6

pi_gen = pi_digits()

first_n = first_n if first_n is not None else len(nums)

_nums = [_Num(n) for n in nums]

nums_pos = {}

for pos in itertools.count():

if pos % 1000 == 0:

print "Current Pi position: %s. Nums found: %s" % (pos, len(nums_pos))

if pos == MAX_POS:

raise RuntimeError("Circuit breaker!")

d = str(pi_gen.next())

for cur_num in _nums:

cur_num.move_p(d)

# whole number found

if cur_num.p == cur_num.l:

nums_pos[cur_num.n] = pos - cur_num.l + 1

# found enough numbers

if len(nums_pos) == first_n:

return nums_pos

# create new search array without found number

_nums = [num for num in _nums if num.n != cur_num.n]

break

Тут я решил пойти простым путем. Кастую числа в строки, устанавливаю указатили в их начала, генерирую цифры Пи, если данная цифра есть в данном числе, то сдвигаю указатель вперед, если нет, то возвращаю назад. Когда число найдено, запоминаю его и позицию, удаляю из массива поиска. На всякий случай добавляю ограничитель, чтобы не ходить дальше миллионной цифры и делаю какое-то логирование прогресса.

Найти двух победителей, email’ам которых сопоставлены шестизначные числа, заняло около минуты на моей машине. Профит!

Как водится, “в бою” все пошло не совсем так гладко. Розыгрыш запускался в live режиме, с компа одновременно транслировалось видео, он немного поднапрягся и поиск занял уже 5 минут, вместо одной. Но чтобы еще более накалить обстановку я ненароком (честно!) перезапустил в notebook’е выполнение cell’а с поиском чисел после его успешного выполнения в первый раз. А notebook ошибок не прощает, старые значения не запоминает, выполняет ячейки синхронно. Нервы натянулись, как канаты. К счастью, все закончилось хорошо, победители были выявлены, награждены, справедливость восторжествовала. Слава роботам, слава числу Пи!

Кстати, впереди еще один розыгрыш мест на курсе 5 июля в 20-00. Хотите прикоснуться к прекрасному? Проходите тест и регистрируйтесь на День открытых дверей, время есть!

|

Метки: author Rumpelstiltskin программирование python блог компании отус online education online- курс lottery |

Как компьютерные профи раскалывают хакеров |

В последнее время, на фоне всевозможных вирусов Wanna Cry и Petya, тема кибербезопасности не сходит с первых полос СМИ. В этой связи показалась примечательной заметка найденная на одном из заморских сайтов. Под катом рассказ Роджера Краймса о том, как одни профессионалы доставляют неприятности другим и наоборот. Суть статьи сводится к тому, что если хотите познакомиться с действительно толковым хакером, поговорите со специалистом по защите от кибератак. Эти талантливые люди каждый день работают над тем, чтобы совершать киберпреступления становилось труднее и наименее прибыльно. Кстати, с удивлением узнал, что любимое развлечение специалистов по информационной безопасности, «ломать» компы соседей на профессиональных конференциях.

Долгая неловкая пауза, это всегда первый признак того, что когда-то самоуверенный хакер вдруг осознал, что неожиданно стал сам жертвой. И так происходит каждый раз.

Один вредный хакер стрелял из своей «ионной пушки» по моему сетевому адресу, пытаясь подавить мой домашний компьютер и интернет-соединение. Я послал ему накануне электронку, дав понять, что знаю, кто он, чем зарабатывает на жизнь (он был начинающим свадебным фотографом), его имя (Рик), и что он только что женился на красивой девушке. Обычно этого достаточно, чтобы напугать большую часть хакеров, но иногда некоторые, такие как Рик, продолжают упорствовать.

По своему собственному, защищенному Tor’ом чат-каналу, Рик рассказывал своим дружкам о том, что готовится запустить против меня еще более мощную DDoS-атаку. Вроде как до этого он использовал «детские» хакерские штучки, а теперь подумывает о том, чтобы оплатить профессиональный хакерский сервис для атаки на меня.

DDoS-атаки, в которых задействованы сотни тысяч совершенно непричастных к ней компьютеров и устройств, бывает катастрофически трудно остановить, не только мне, но и любому специалисту, и даже целой компании. Мощный поток вредоносного сетевого трафика может парализовать работу любых сервисов, кроме самых больших и богатых (например, Google). Как только начинаются атаки, жертва (в данном случае, я) может быть отрезана от интернета на несколько дней.

Я влез в его чат-канал и посоветовал завязывать с этим. Задержка с ответом убедила меня, что я застал его врасплох. Он ответил мне, обозвав нецензурными словами и заподозрил, что я член его форума. Когда я ответил, что таковым не являюсь, он опять наговорил гадостей и добавил, что я пожалею о том, что вломился на его частный форум. Я вежливо попросил отказаться от самой идеи атаковать меня, так как мне надо было заниматься настоящей работой.

Вечером следующего дня, примерно в то же время, судя по медлительности моего интернета, я понял, что угроза о DDoS-атаке перешла в реальное действие. Если бы ничего я не предпринял, то мог бы лишиться связи на не знаю сколько дней. Поэтому, только из чистого опасения, что не смогу выполнить работу в срок, я взломал его компьютер.

Мне пришлось идентифицировать компьютер и софт, которым он пользовался (в хакерском лексиконе это называется «алгоритм отпечатков»), узнал, что он пользуется устаревшим файерволом. Один из моих любимых приемов — взламывать компьютеры и компании, используя софт и устройства, которые, как они уверены, смогут их защитить. Поэтому, используя слабые места в защите, я взломал его компьютер, изменил настройки и оставил новый командный файл. Затем я связался с ним по его чат-каналу и предложил проверить мою работу.

Командный файл должен был переформатировать его жесткий диск и уничтожить на нем всё, если бы Рик перезагрузил компьютер. Я предварительно «закоментил» губительные строки своего сценария, с тем, чтобы программа была пока-что безвредной. Но удали я буквально три знака (то есть rem), и этот пока еще безвредный сценарий превратился бы в погибельный, по крайней мере, для его компьютера.

DDoS-атака тут же прекратилась. Присмиревший хакер вернулся в чат-канал и недоверчиво спросил: «Старик, а как ты это сделал?» Наконец-то он начал разговаривать человеческим языком, когда с него сошла вся эта фальшивая развязность. Я ответил: «Рик, есть много хакеров лучше тебя. Бросай свое вредное занятие и направь свои таланты на что-то хорошее. Проводи больше времени со своей красавицей женой. Когда-нибудь ты замутишь не с тем парнем или не с тем агентством. Это тебе был предупредительный звоночек».

С этими словами я закрыл чат и вернулся к работе. Это уже не первый раз, когда мне пришлось заняться подобным наступательным хакерством для того, чтобы другой хакер оставил меня в покое. И я, конечно, не единственный, кто умеет это делать. На самом деле, самые лучшие и умные хакеры, которых я знаю — хорошие ребята и девчонки, а вовсе не зловредные отморозки, насылающие эпидемию на нашу цифровую жизнь. Я ветеран компьютерной безопасности с 30-летним стажем, постоянно ведущий борьбу вместе с десятками тысяч таких же, как я. Наши соперники, в среднем, не так хитроумны, как мы.

Это не к тому, что все вредные хакеры — недалекие люди. Не в этом дело. Просто подавляющее большинство не очень-то умны, они — средненькие. В свое время, я, может, и увижу одного или парочку умных хакеров, которые могут делать нечто, что никто прежде не делал. Но большинство хакеров-злоумышленников, с которыми я столкнулся, не гениальны и не изобретательны. Они просто пользуются инструментами, приемами и сервисами, которые были изобретены другими более умными хакерами. Они в большинстве своём лишь заурядные «лохи», неспособные создать даже эмоджи, а совсем не те легендарные хакеры, изображаемые Голливудом.

Если захотите познакомиться с действительно толковым хакером, поговорите со специалистом по защите от кибератак. Эти люди — эксперты в различных технологиях, должны уметь распознавать и останавливать все угрозы. Они — невидимые Генри Форды и Эйнштейны цифрового мира. Вопреки устоявшемуся в кино образу умного и находчивого хакера, защитники борются за сеть и помогают остановить и арестовать больше хакеров, чем, кажется.

Прямо сейчас заниматься хакерством можно почти с нулевым риском

Хакерство сегодня очень процветает, почти как вооруженные ограбления банков в ранних 1900-ых. Богатство и разнообразие нашего цифрового мира формируется быстрее, чем необходимая для него защита. А шансы быть пойманным или арестованным за киберпреступление равны почти нулю. Хакер может украсть миллионы долларов почти безо всякого риска.

Попробуй ограбить настоящий банк, и есть шанс, что возьмешь меньше 8000 долларов и, возможно, будешь пойман (по последней статистике ФБР 55% банковских грабителей было опознано и арестовано за 2014 год) и сядешь в тюрьму на годы. Негативный фактор риска/награды является причиной того, что в США происходит менее 4000 ограблений банков в год.

Сравните это с киберпреступлениями. Каждый месяц в ФБР поступает более 22 000 заявлений о киберпреступлениях, и, скорее всего, будет совершаться еще большее число преступлений. Средний заявленный ущерб составляет почти 6500 долларов, а из 269 000 заявлений только 1500 были переданы в правоохранительные органы. Хотя большинство последних ежегодных отчетов ФБР не включали в себя сведений об обвинительных приговорах, отчет 2010 года с похожим количеством жалоб и случаев указывает только на шесть судебных приговоров. Это значит, что на каждые 50 635 жертв приходится только один осужденный киберпреступник. И это только случаи, заявленные в ФБР.

Укради миллион долларов онлайн, и можешь наслаждаться своим новообретенным богатством почти без всяких волнений. Трудность со сбором улик, юридические вопросы (Россия и Китай игнорируют американские ордеры на обыск и арест) и возможности передачи киберпреступления в правовые органы, превращают это занятие в авантюру с минимальным риском. И, как я уже сказал, не надо быть особо умным, чтобы стать успешным хакером. Любой чувак или преступный синдикат может это сделать. Всё, что надо знать, это несколько трюков ремесла.

Секрет хакерства

Секрет хакерства в том, что здесь нет секрета. Хакерство — это как обычная профессия, сантехник или электрик, где надо научиться владеть какими-то инструментами или методами, а остальное — лишь практика и упорство. Большинство хакеров находят недостающие программные патчи, ошибки в конфигурации, уязвимости или применяют социальную инженерию. Если это сработает хоть раз, оно будет эффектным тысячи раз. Это настолько легко и срабатывает настолько регулярно, что многие профессиональные пентестеры (им платят за разрешенное хакерство) бросают эту работу через несколько лет, потому что она больше не вызывает у них интереса.

За 30 лет профессионального тестирования на возможность несанкционированного доступа, я взломал каждую компанию, куда меня нанимали, за три и менее часа. Это и банковский, и больничный бизнес, и правительственные учреждения. Я с трудом закончил среднюю школу и был исключен из простого колледжа за низкую успеваемость. Скажем так, я — не золотой медалист с красным дипломом.

По шкале от одного до десяти, я нахожусь где-то на уровне шести или семи, но при этом могу взломать почти всё. Я работаю с хакерами, которые, по моему мнению, набирают десятку по этой шкале, а они почти все считают себя средними. При этом они сами могут перечислить людей, которых они считают «на десятку». И так далее. Это говорит о том, что многие могут взломать что им хочется. Количество хакеров в мире неизвестно, но счёт наверняка приближается к сотне тысяч. К счастью, большинство из них на хорошей стороне.

Люди, взламывающие хакеров

Люди, выполняющие работу по защите компьютеров и борющиеся с хакерами и их вредоносными кодами, количественно превосходят хакеров. Сюда входят пентестеры, специалисты по закрытию уязвимостей, авторы политик, преподаватели, разработчики продуктов, аналитики систем безопасности, технические писатели, криптографы, защитники приватности и просто защитники, моделировщики угроз и другие специалисты во всевозможных областях. Вот лишь некоторые из них.

Брайан Кребс

Кребс — журналист, давно занимающийся расследованиями, знаменит тем, что разоблачил самые отъявленные сетевые криминальные группировки. Он систематически называет прежде анонимных вредоносных хакеров по имени, что часто приводит к их аресту. Кребс выучился говорить и читать по-русски, поэтому он может выслеживать и заявлять о русских киберпреступных компаниях и синдикатах. Он настолько в этом преуспел, что хакеры постоянно добиваются его ареста, подкладывая ему наркотики, фальшивые деньги или приписывая ему захват заложников. Его бестселлер «Нация спама» стала настоящей разгромной книгой русской индустрии спама, разоблачающей тот факт, что порой западные правоохранительные органы поддерживают международную киберпреступность, потому что она оказывается финансово выгодна для них. Всё, что написано Брайаном Кребсом, стоит почитать.

Брюс Шнайер

За создание многочисленных криптоалгоритмов, заслуживших доверие, Шнайер признан «отцом» современной компьютерной криптографии. Он является корифеем в области компьютерной защиты, постоянно выступает перед американским Конгрессом и крупными СМИ. Сегодня Шнайер в основном рассматривает человеческий фактор в сбоях компьютерной защиты. Я считаю, что изучение статей Шнайера должно стать обязательным условием при изучении киберзащиты.

Доктор Дороти Деннинг

Заслуженный профессор Деннинг из Школы повышения квалификации офицеров ВМС была пионером компьютерной защиты, создала фундаментальный труд по компьютерному шифрованию, определению нападения, кибервойнах и ограничению доступа. Она изобрела модель безопасности на основе решёток, которая сегодня используется во многих других моделях. Она предупреждала (и писала) о возможности кибервойн еще до их появления.

Кевин Митник

Известный международный хакер Митник, получивший однажды запрет на использование даже телефона, давно вышел из тюрьмы и стал законопослушным гражданином. Сегодня он генеральный директор собственной компании по компьютерной защите и регулярно пишет об угрозах социальной инженерии и нарушениях приватности. Многим вредоносным хакерам верить нельзя, но Митник — исключение.

Майкл Ховард

Ховард с друзьями создали метод безопасного написания программного обеспечения известный, как Цикл разработки безопасного программного обеспечения (SDL, Security Development Lifecycle), которым повсеместно пользуются тысячи компаний, чтобы сократить количество багов и уязвимостей в продуктах. Недавние критики этого метода теперь пользуются им, увидев, насколько хорошо он работает в течение многих лет.

Джоанна Рутковская

Польский эксперт по компьютерной защите Джоанна Рутковская приобрела известность после обнародования деталей своей «атаки голубой таблетки». Она продемонстрировала настолько гениальный хакерский метод, трудный для обнаружения и предотвращения, что защитники радуются тому, что никто из хакеров им еще не воспользовался. Она решила не доверять безопасности ни одной общедоступной ОС и создала свою собственную «достаточно безопасную» систему под названием QubesOS. Самые талантливые шпионы и защитники приватности пользуются этой ОС.

Ланс Спитцнер

Спитцнера считают отцом ловушки для хакеров. Ловушка для хакеров — это фальшивое устройство (то есть компьютерное, роутер, принтер и так далее), которое существует с единственной целью — определить вредоносную хакерскую деятельность. Ловушки для хакеров считаются самыми лучшими защитами, которые любая компания может взять себе на вооружение для раннего обнаружения угрозы. В настоящий момент Спитцнер работает в SANS, самой респектабельной международной организации по компьютерной защите, и обучает компании тому, как можно результативно и быстро реагировать на взломы.

Кормак Херли

Херли — исследователь компьютерной безопасности. Используя настоящие данные, он опровергает устоявшуюся догму безопасности об эффективности длинных и сложных паролей. Херли доказал, что использование длинных, сложных и часто меняемых паролей не только не спасает ситуацию, но создает ещё больше проблем. Его исследования и заключения настолько революционны, что, скорее всего, пройдут десятилетия, прежде чем мы увидим внедрение большинства из них.

Майкл Дубинский

Постоянно атакуемое государство Израиль известно во всем мире своим очень хорошим ПО для киберзащиты. Израильтянин Дубинский — главный разработчик продукта, известного тем, что он обнаруживает ранее не обнаруживаемое. Его продукт замечает коварных и скрытых хакеров, охотящихся за главным богатством компании… и срабатывает быстрее атакующих.

Все эти специалисты — часть огромной армии «белых» хакеров, создающих с каждым годом всё больше и больше трудностей для хакерства. Критическая масса растёт, и в течение следующего десятилетия онлайн-киберпреступления станут таким же редким явлением, как ограбление банка. Они будут совершаться, но их будет всё меньше, за них будет гораздо легче наказать. Кстати, а кого из русских «белых» хакеров знаете вы?

|

Метки: author SmirkinDA разработка под windows программирование криптография информационная безопасность блог компании parallels parallels иб wanna cry petya |

Конкурс по программированию: JSDash |

- Первое место: 3000 USD.

- Второе место: 2000 USD.

- Третье место: 1000 USD.

- Если Вы отправите кому-то ссылку на этот конкурс, поставив наш адрес в CC, и этот человек займёт призовое место, Вы получите половину суммы приза (разумеется, не в ущерб награде победителя). За одного победителя такую награду может получить только один человек — тот, кто отправил ссылку первым.

Авторы интересных решений будут приглашены на собеседования.

Правила

Условия конкурса на английском языке размещены на GitHub. Ниже — перевод на русский язык.

- Отправляйте решения с помощью этой формы. По электронной почте решения не принимаются.

- Решения принимаются до 31 июля 2017, 23:59:59 UTC.

- Предварительные результаты будут опубликованы 7 августа 2017, а окончательное объявление победителей — 15 августа 2017.

- Можно отправлять решения многократно, но от каждого участника будет рассмотрено только самое последнее решение, отправленное до окончания срока приёма работ.

- Для тестирования мы будем использовать Node.js v8.1.3 (текущая версия на момент публикации). Можно использовать любые возможности языка, поддерживаемые интерпретатором в стандартной конфигурации.

- Весь код решения должен находиться в единственном файла на JS.

- Решение должно быть на JS. Если Вы предпочитаете CoffeeScript или подобные языки, необходимо оттранслировать решение в JS перед отправкой.

- Если Ваш JS-файл — продукт генерации, минификации и/или компиляции с других языков вроде CoffeeScript, пожалуйста, приложите архив с исходниками, а также, желательно, описанием подхода. Содержимое этого архива будет опубликовано, но мы не будем его тестировать.

- Нельзя загружать никаких модулей, даже тех, что входят в стандартный комплект Node.js.

- Нам нужно знать Ваше полное имя, но если Вы хотите, мы опубликуем вместо него псевдоним. Мы сохраним Ваш адрес электронной почты в тайне.

- Задавайте вопросы по условию задачи в комментариях к этой публикации или по электронной почте.

JSDash

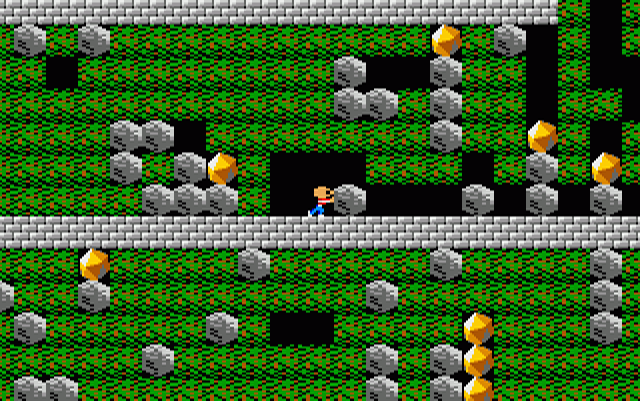

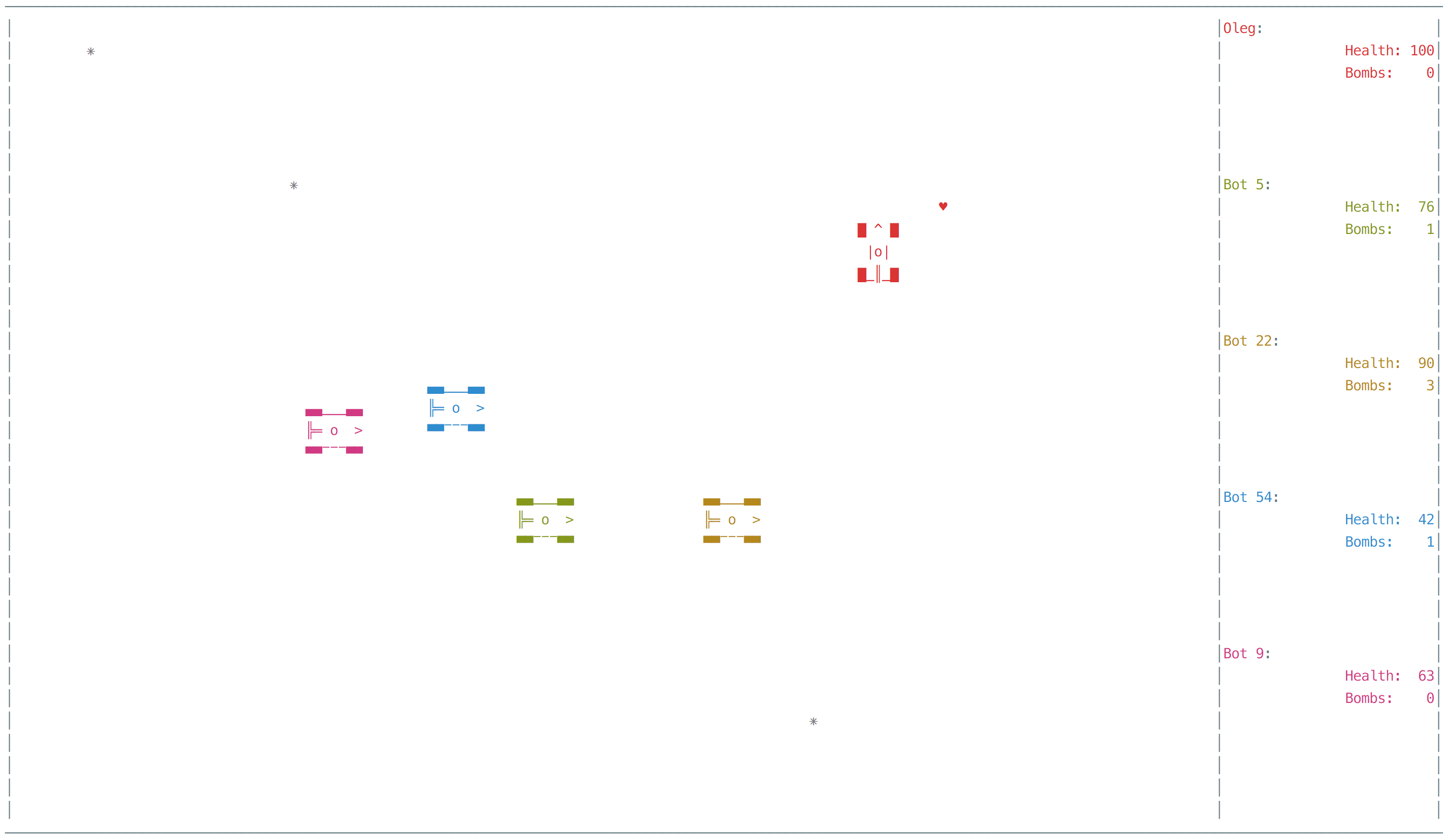

Поиграем в текстовую игру! Несомненно, вы распознаете в ней клон классической видеоигры, впервые изданной в 1984 году.

Ваша цель — написать искусственный интеллект, который играет в эту игру, принимая решения вместо человека. Игра будет проходить в реальном времени, и у вашего скрипта будет столько же времени на принятие решений, сколько у человека.

Мы рекомендуем запустить скрипт game/jsdash.js и сыграть в игру несколько раз перед тем, как читать дальше. (Примечание: мы разрабатывали и тестировали игру под xterm в Linux. В других системах может работать, а может и не работать.)

Игра

Клавишами-стрелочками можно перемещаться в четырёх направлениях. Зелёная буква

A — это вы. Можно перемещаться через пустое пространство или землю (:), толкать камни (O) по горизонтали в пустое пространство и собирать алмазы (*). Через кирпичи (+) и сталь (#) пройти невозможно. Камни и алмазы падают, когда остаются без опоры, а также скатываются вбок друг с друга и с кирпичей. Падающие предметы убивают игрока. Бабочки (анимация /|\-) взрываются при соприкосновении с игроком, от удара падающим предметом, а также будучи запертыми без возможности передвижения. Взрыв бабочки поглощает любые материалы, кроме стали, и может убить игрока. После взрыва образуются алмазы, которые можно собрать.За каждый взятый алмаз начисляется 1 очко. Если собрать 3 алмаза с промежутками не более 2 секунд, в дополнение к очкам за каждый из них, начисляется 3 призовых очка. Если продолжать быстро собирать алмазы, не делая промежутков длиннее 2 секунд, то начисляется 5 очков после пятого алмаза, 7 очков после седьмого (в дополнение ко всем предыдущим премиям), и так далее для каждого простого числа. За убитую бабочку начисляется 10 очков при условии, что игрока не убило взрывом.

Ограничение времени игры — 2 минуты. Можно прервать игру раньше, нажав Q, Esc или Ctrl-C; набранные очки при этом не теряются. Клавиша P позволяет приостановить игру.

Остаток времени, очки и сообщения о призовых цепочках (hot streak) отображаются в строке состояния под игровым полем.

Механика нашей игры в целом соответствует образцу 1984 года (она известна благодаря подробному описанию на фан-сайте Boulder Dash), однако для простоты мы решили использовать не все типы объектов. Самое большие отличия — описанная выше система начисления очков и то, что на уровне нет выхода. Цель игры — набрать как можно больше очков, прежде чем игра закончится смертью персонажа или по истечению времени. Если вас интересуют подробности игровой механики, читайте исходный код модуля game.js.

Решения

Решение представляет собой модуль Node.js без зависимостей. Модуль должен экспортировать одну функцию:

play(screen)

Игра загрузит модуль и вызовет функцию

play один раз, передав начальное состояние игры в качестве параметра screen. Оно представляет собой массив строк, по одной на каждую строку экрана с верхней до нижней, включая строку состояния. Строки будут содержать в точности то, что вы видите на экране, только без раскраски в ANSI-цвета (игру можно увидеть в таком режиме на консоли, если запустить её с параметром --no-color). Функция play должна быть генератором. Чтобы сделать ход, она должна сгенерировать (yield) значение 'u', 'd', 'r' или 'l' для шага вверх, вниз, вправо или влево соответственно. Ещё можно сгенерировать 'q' или просто завершить работу генератора (return), чтобы окончить игру досрочно (набранные очки при этом не теряются). Если сгенерировать любое другое значение, это означает ход «остаться на месте». Пытаться идти в направлении, в котором двигаться невозможно (например, в стену) не запрещено: персонаж просто останется на месте. После каждого yield содержимое массива screen обновляется, и ваш код может снова его проанализировать для принятия дальнейших решений.Если ваша функция возбудит исключение, то игра закончится с результатом 0 очков. Это не помешает вашей программе играть и набирать очки на других уровнях.

Ваш скрипт будет запускаться в отдельном процессе. Даже если он зависнет, это не замедлит ход игры (при этом персонаж будет стоять на месте).

Состояние игры обновляется раз в 100 мс. Если функция

play будет генерировать команды быстрее, то персонаж будет двигаться 10 раз в секунду. После каждой команды генератор будет блокироваться на инструкции yield до конца рануда длиной в 100 мс. Если функция «думает» над ходом дольше, чем 100 мс, она начинает пропускать ходы, и тогда персонаж будет оставаться на месте в те раунды, когда функция не успела сделать ход. В этом случае генератор также не увидит некоторых промежуточных состояний экрана. Например, если скрипт «задумается» на 250 мс между двумя инструкциями yield, то не увидит двух состояний экрана, а персонаж останется неподвижным на два раунда; таким образом, будут упущены две возможности сделать ход, которые были бы, если бы программа работала быстрее. После этого генератор будет заблокирован на 50 мс до конца раунда, и сгенерированная им команда будет выполнена.Очень простой пример работающего скрипта искусственного интеллекта приведён в файле game/example.js. Каждый раунд он находит все возможные ходы (направления, в которых по соседству с позицией игрока находятся пустое пространство, земля, камень, который можно сдвинуть, или алмаз) и выбирает один из них случайным образом. Обычно этот скрипт убивается вскоре после начала игры.

Тестирование

Скрипт jsdash.js, который мы предоставляем на GitHub, — это не только интерактивная игра, но и мощный инструмент для тестирования. Запустите его с параметром

--help, чтобы узнать обо всех его возможностях.Каждое присланное нам решение будет запущено по меньшей мере на 20 автоматически сгенерированных уровнях. Участник, чьё решение наберёт наибольшую сумму очков на всех уровнях, будет признан победителем. Мы оставляем за собой право увеличить число уровней (для всех участников), если это потребуется для того, чтобы исключить «ничью» между лидерами; если и это не поможет, победит тот, кто прислал своё решение раньше.

При тестировании каждого решения будет использоваться один и тот же набор затравочных значений (seeds) для генератора псевдослучайных чисел, чтобы программы всех участников получали одни и те же уровни. При запуске ваших решений мы будем использовать настройки по умолчанию:

jsdash.js --ai=submission.js --log=log.json

Тем не менее, мы рекомендуем обратить внимание на весь набор доступных параметров командной строки, которые могут помочь вам в отладке.

По окончанию конкурса будут опубликованы записи игр каждого решения на каждом из тестовых уровней. Эти записи можно воспроизвести такой командой:

jsdash.js --replay=log.json

Отправка решений

Для отправки решений пользуйтесь формой на нашем сайте. По электронной почте решения не принимаются!

Поскольку код решений часто бывает сгенерированным, минимизированным или оттранслированным с другого языка, форма содержит также поле для отправки архива с исходными тестами. Если код сгенерирован, включите туда генератор; если он минимизирован, включите исходную версию; если код переведён с CoffeeScript или другого языка, включите код на том языке, на котором он написан. Желательно также включить в архив файл README с кратким описанием подхода к решению (по-английски). Архив должен быть в формате tar.gz, tar.bz2 или zip. Содержимое архива будет опубликовано, но не будет протестировано (мы тестируем только JS-файл, который вы отправляете вне архива).

Максимальный размер JS-файла установлен в 64 МиБ. Это произвольно выбранная цифра, которая существует в основном для того, чтобы чьё-нибудь «решение» одномоментно не заполнило нам диск. Если ваше решение правда больше 64 МиБ, напишите нам, и мы увеличим ограничение.

Если у вас есть вопросы по условию задачи или проблемы с отправкой решения, напишите, пожалуйста, комментарий или письмо.

Желаем удачи всем участникам!

|

|

[Из песочницы] Обновление document.title в фоновой вкладке |

Согласно документации, rAF (requestAnimationFrame) обычно вызывается 60 раз в секунду. Для экранов, у которых частота обновления выше, это значение будет также выше (хотя вы можете и не замечать это глазом).

Далее написано, что, если вкладка фоновая и не активная, то частота может уменьшиться, что и происходит, как мы увидим ниже.

Проведём эксперимент. В коде под спойлером по requestAnimationFrame простейшим образом обновляется тайтл:

tab

Результат в хроме выглядит следующим образом:

Да, так и должно быть. Давайте посмотрим, что делают другие браузеры:

* Edge работает аналогично

Результат — только Firefox выполняет rAF в фоновой вкладке. Казалось бы удивительно, что даже IE11 не выполняет rAF в фоне, однако, Per the documentation, Chrome does not call requestAnimationFrame() when a page is in the background. This behavior has been in place since 2011. С 2011, Карл!, что означает, что таким поведением никого не удивить. Не удивить, даже если в бэкграунде играет музыка (через

Поэтому, отвечая на изначальный вопрос «Как показать цену в тайтле», ответ достаточно прост — показывать её не в момент отображения компонента, а в момент получения данных из API. Вторым решением был бы вынос из функции, которая используется для анимации страницы при возврате данных с API (большой лоадер на весь экран красиво убираем просто)), функции-инициализатора. К сожалению, так сложилось, что таких функций почему-то больше чем одна, поэтому этот вариант влечёт за собой большие перестановки и от него решено было отказаться. К слову, setTimeout/setInterval, выполняются корректно, через них возможен третий вариант решения проблемы.

На этом стори можно доделывать и закрывать, а теперь перейдём к тому, что происходит на самом деле, используя исходный код requestAnimationFrame из WebKit:

int Document::requestAnimationFrame(Ref&& callback)

{

if (!m_scriptedAnimationController) {

#if USE(REQUEST_ANIMATION_FRAME_DISPLAY_MONITOR)

m_scriptedAnimationController = ScriptedAnimationController::create(*this, page() ? page()->chrome().displayID() : 0);

#else

m_scriptedAnimationController = ScriptedAnimationController::create(*this, 0);

#endif

// It's possible that the Page may have suspended scripted animations before

// we were created. We need to make sure that we don't start up the animation

// controller on a background tab, for example.

if (!page() || page()->scriptedAnimationsSuspended())

m_scriptedAnimationController->suspend();

if (page() && page()->isLowPowerModeEnabled())

m_scriptedAnimationController->addThrottlingReason(ScriptedAnimationController::ThrottlingReason::LowPowerMode);

if (!topOrigin().canAccess(securityOrigin()) && !hasHadUserInteraction())

m_scriptedAnimationController->addThrottlingReason(ScriptedAnimationController::ThrottlingReason::NonInteractedCrossOriginFrame);

}

return m_scriptedAnimationController->registerCallback(WTFMove(callback));

}

Первый if довольно понятен, подробнее по suspendScriptedAnimations и setIsVisibleInternal.

Во втором if, значение функции isLowPowerModeEnabled, у каждой ОС будет браться из разных источников; в iOS, вероятно, оно берётся из _didReceiveLowPowerModeChange.

Третий if наиболее интересен; topOrigin это просто SecurityOrigin документа верхнего уровня; сам метод находится здесь, в комментариях в этом методе достаточно подробно расписано, что в нём происходит. Этот метод возвращает true, если два скрипта с разных origin могут общаться между собой (на чтение или на запись). В то же время, у пользователя остаётся место для манёвра при помощи NonInteractedCrossOriginFrame.

Таким образом, webkit-браузеры будут получать блокировку rAF каждый раз, когда они заходят в один из трёх if.

Вернёмся к Firefox. Преобразуем исходную функцию, меняющую заголовок страницы, на следующую:

requestAnimationFrame(function handler() {

document.title += 'R'

requestAnimationFrame(handler);

});

Как можно заметить, в Firefox/Gecko всё происходит немного иначе, чем в webkit. Если найти реализацию request_animation_frame, то можно заметить, что:

- // TODO: Should tick animation only when document is visible — что означает, что когда-нибудь поведение будет соответствовать поведению остальных браузеров, поэтому на том, что происходит сейчас, можно особо не зацикливаться.

- Существует is_faking_animation_frames где оказывается, что ребята из Gecko, в случае, если у вас много фейковых анимаций, выбрасывают вас на FakeRequestAnimationFrameCallback.

Даже не знаю, кто круче.

Хорошие ссылки:

- Background tabs & offscreen frames — Chrome team future plans

- requestAnimationFrame Scheduling For Nerds

- VSync if Firefox

- How to dramatically improve Chrome's requestAnimationFrame VSYNC accuracy in Windows

|

Метки: author samsdemon javascript requestanimationframe |

Многопользовательская игра на Go через telnet |

Заниматься веб-анимацией или писать приложение под мобильную платформу мне не хотелось, поэтому я решил в качестве клиента использовать любимый инструмент сисадминов — telnet.

Вот что получилось:

Выбор технологий

Telnet

Про приложения, использующие telnet, я слышал уже давно. Например, небольшой отрывок из «Звёздных войн»:

telnet towel.blinkenlights.nl

Но, почему telnet, спросите Вы? Ведь netcat намного круче и современнее добавят другие. Не все знают, но telnet — это не только утилита для установления TCP-соединения. Это целый протокол, который позволяет, например, отправлять на сервер введённые данные без нажатия Enter (line feed ANSII).

Поскольку мы хотим использовать стрелочки для управления машинкой и мы не хотим каждый раз нажимать Enter, чтобы отправить последовательность символов на сервер — telnet прекрасно подходит для решения подобной задачи.

Как вариант можно было использовать

stty -icanon && nc

но это, прямо скажем, костыль.

Go

Почему Go? Помимо того, что я хотел подтянуть свои навыки, в Go есть Goroutines, которые идеальны для написания «многопоточных» приложений. А поскольку мы хотим чтобы много людей играло параллельно — причин не использовать Go не было.

Так же я не так давно прочитал вот эту статью и мне было интересно попробовать визуализировать Goroutines в приложении.

Game design

Игровой процесс

Игра представляет собой мультиплеер до 5 человек в раунде. Если количество игроков будет меньше — оставшиеся слоты будут представлены ботами.

Вам нужно, играя машинкой, выжить и уничтожить соперников. Игрок может собирать бонусы или разбрасывать бомбы, которые накапливаются с течением времени.

Система повреждений

Один из интересных и спорных моментов — система повреждений. Мы решили учитывать разницу в скорости и часть машины, на которую пришелся удар.

Скорость может варьироваться. При ударе она сбрасывается до 1. При безаварийной езде через некоторое время она увеличивается до 5.

Теперь рассмотрим ситуацию, когда один игрок догоняет другого и врезается в заднюю часть автомобиля. Формулы подсчета урона для игроков будут следующие:

if player.Car.Borders.intersects(&opponent.Car.Borders) {

switch player.Car.Borders.nextTo(&opponent.Car.Borders, 0) {

case LEFT:

// Игрок слева

switch player.Car.Direction {

...

case RIGHT:

// Удар сзади

player.Health -= DAMAGE_BACK * (maxSpeed - player.Car.Speed)

...

case RIGHT:

// Игрок справа

switch player.Car.Direction {

case RIGHT:

// Удар спереди

player.Health -= DAMAGE_FRONT * player.Car.Speed

...

...

}

То есть если игрок А двигался со скоростью 4 и его догнал игрок Б со скоростью 5, игрок А потеряет 2*(5-4) = 2. Однако, атакующий игрок потеряет 4*5 = 20.

Самым же сильным повреждением окажется удар сбоку DAMAGE_SIDE = 6 и может доходить до 24.

Разработка

Хочу ещё раз напомнить, что игра создавалась в качестве учебного упражнения. Если есть у Вас есть предложения по улучшению — с радостью их приму во внимание.

Исходный код находится на github, но давайте пробежимся по основным моментам:

Telnet