Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

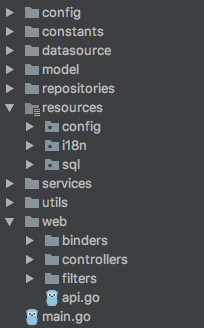

[Из песочницы] Автоматическое развертывание приложения с Maven и Wildfly |

Wildfly – Это ребрендинг и развитие JBoss AS7/EAP6 в области как администрирования, так и API для разработчика. Wildfly построен с использованием Java SE 7. Отлично интегрируется с основными Java IDE. Краткая цитата из статьи

Немного официальной информации о 10 версии

- Реализация сертифицирована на соответствие Full- и Web-профилям Java EE 7. Код WildFly распространяется под лицензией LGPL;

- В отличие от коммерческого продукта JBoss Enterprise Application Platform, позиционируемого как полностью протестированная и сертифицированная платформа Java EE, WildFly ориентирован, прежде всего, на продвижение технологий. WildFly выступает в роли upstream-проекта для коммерческого продукта JBoss Enterprise. В качестве основной области использования WildFly рассматривается разработка и быстрое внедрение прототипов.

Основные особенности релиза

- Прекращена поддержка Java 7, что позволило обеспечить более глубокую интеграцию с Java 8 Runtime. Добавлена поддержка текущих снапшотов Java 9;

- Поставка ActiveMQ Artemis в качестве брокера рассылки сообщений (Java Message Service Broker), совместимого на уровне протокола и заменившего собой HornetQ;

- Поддержка запуска хост-контроллера при помощи CLI. Новая команда embed-host-controller позволяет редактировать содержимое файлов domain.xml и host.xml без запуска дополнительных процессов или открытия сетевых сокетов;

- Поддержка JavaScript в http-сервере Undertow.io, позволяющая создавать на языке JavaScript серверные скрипты, которые могут обращаться к CDI Beans и JPA Entity Beans. Указанную возможность удобно использовать для создания внешних обвязок или REST-обработчиков. Отредактированный код JavaScript становится доступен сразу и не требует перезапуска приложения;

- Поддержка одиночного отказоустойчивого развёртывания приложения («singleton deployment»), при котором в случае использования группы кластеризованных серверов развёртывание будет произведено только на одном узле, но в случае выхода этого узла из строя, приложение будет автоматически перенесено на другой узел;

- Поддержка одиночного отказоустойчивого брокера рассылки сообщений (Singleton MDB), запускающего доставку только на одном узле, но в случае сбоя использующего для обработки сообщений другой узел;

- Автоматический выбор размера пула SLSB и MDB, в зависимости от имеющихся системных ресурсов;

- Средства для миграции устаревших подсистем, таких как jbossweb (AS 7.1), jacorb (WildFly 8) и hornetq (WildFly 9), которые автоматизируют преобразование старых конфигураций в эквиваленты, работающие в WildFly 10;

- В реализации Hibernate 5 значительно улучшено качество байткода, внесены оптимизации производительности и добавлены улучшения в API.

Хочу рассказать об автоматическом деплое в Wildfly с помощью Maven, а так же рассказать кратко о запускe UI в том же самом контейнере.

Необходимо использовать Maven версии не ниже 3.3.9( использую maven 3.5.0 ), иначе Wildfly Plugin не будет работать.

Версия Wildfly, который на данный момент использую — 10.1.0-Final, версия плагина — 1.2.0.Alpha4

В Pom.XML собираемого приложения необходимо прописать данные для подключения к серверу Wildfly

Пример:

org.wildfly.plugins

wildfly-maven-plugin

${wildfly-hostname}

${wildfly-port}

${wildfly-username}

${wildfly-password}

${wildfly-name}

Так же хорошей практикой может быть вынос настроек в settings.xml либо в pom.xml уровнем выше. Это позволит так же использовать профили при деплое – локальный деплой, деплой на прод.

Область профилей в settings.xml.

localhost

localhost

9990

admin

admin

core.war

dev

Prod_Server

9990

admin

admin

core-prod_vers.war

После всех настроек, с помощью maven, из командной строки, из IDE, из, например, Jenkins (maven plugin), можно будет деплоить war c помощью mvn wildfly:deploy, так же можно использовать mvn wildfly:undeploy и mvn wildfly:redeploy для удаления и передеплоя соответственно. Выбор профиля -Plocalhost позволит запускать с настройками из профиля с id localhost, -Pdev соответственно запускает для прода( все данные в настройках дефолтны или вымышлены).

При верной настройке в WildFly консоле в разделе deployments у Вас появится необходимый war.

Кроме этого, WildFly позволяет запускать UI.

Настройка WildFly для запуска UI:

Проект помещать в корень WildFLy в директорию, которую Вы сами выберете для Вашего UI.

В данном примере я использовал директорию UI.

В файле /PathToWildfly/standalone/configuration/standalone.xml необходимо добавить строки(строки с учетом соседних строк, для облегчения поиска):

После этого WildFLy автоматически подхватывает изменения и по адресу localhost:8080/UI будет доступно ваше приложение.

На данный момент запуск был осуществлен с помощью команды ./standalone.sh -b=0.0.0.0 -bmanagement=0.0.0.0, приложение работает на Linux Oracle в screen.

За время использования были выявлены 2 проблемы:

- Иногда перезапуск WildFLy затягивается и долго подтягивается localhost:9990 — консоль.

- При запуске из Jenkins на Maven 3.3.9 с тэгом redeploy происходит утекание памяти и приложение удаляет обе версии war и ругается на дубликат. (Воспроизводится не всегда)

Данная связка около 2 месяцев, кроме вышеописанных, проблем не встречал. Всем рулит Jenkins в данном случае, он стартует и mvn wildfly:undeploy mvn wildfly:deploy ( использую такую стратегию, т.к. redeploy не отрабатывает) и доставляет собранный UI в директорию UI, обновление происходит по ночам, полёт нормальный.

Так же тестировал запуск на win хосте, отличий не заметил в работе, все так же стабильно.

|

Метки: author SicYar системное администрирование it- инфраструктура devops wildfly maven администрирование |

Автоэнкодеры в Keras, Часть 6: VAE + GAN |

Содержание

- Часть 1: Введение

- Часть 2: Manifold learning и скрытые (latent) переменные

- Часть 3: Вариационные автоэнкодеры (VAE)

- Часть 4: Conditional VAE

- Часть 5: GAN (Generative Adversarial Networks) и tensorflow

- Часть 6: VAE + GAN

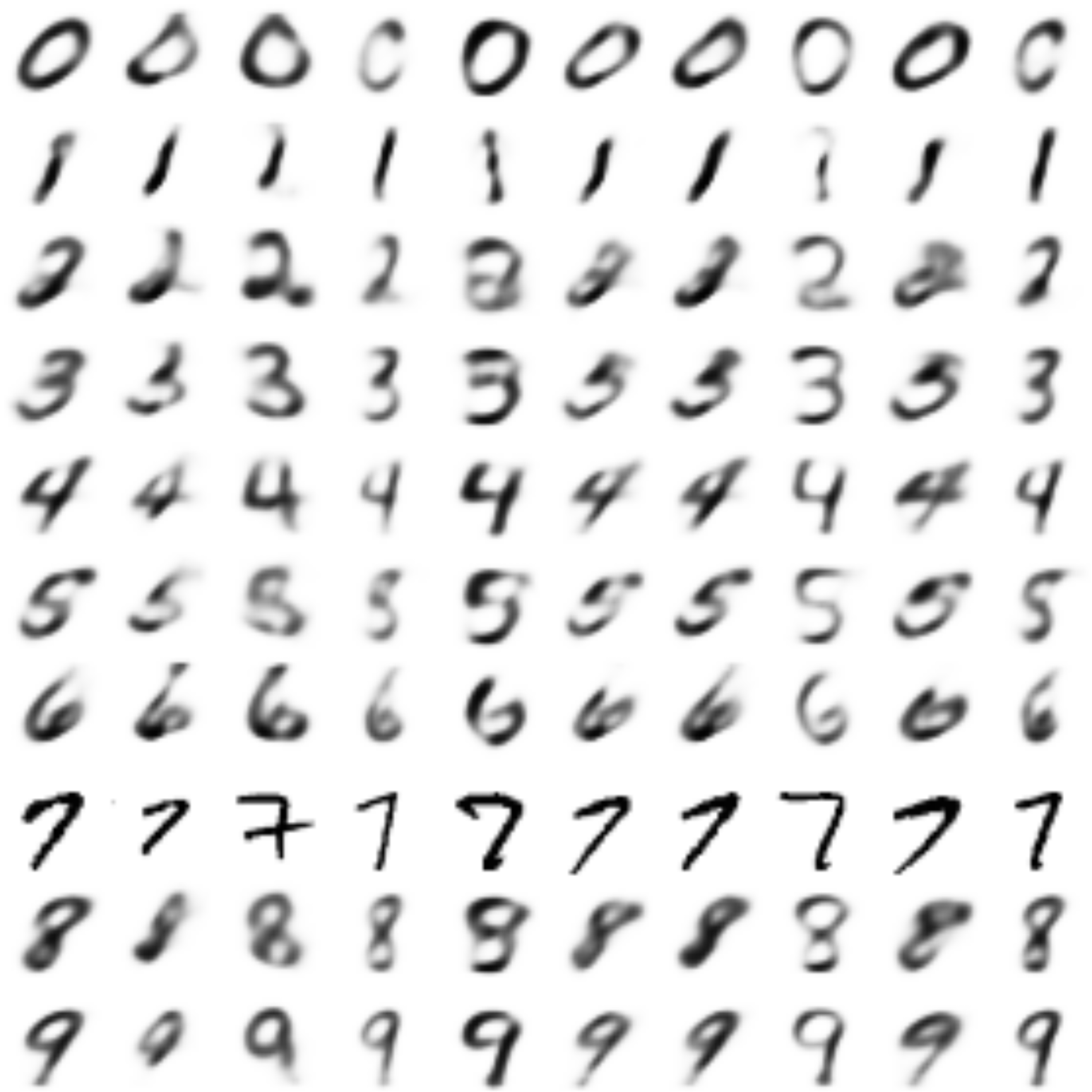

В позапрошлой части мы создали CVAE автоэнкодер, декодер которого умеет генерировать цифру заданного лейбла, мы также попробовали создавать картинки цифр других лейблов в стиле заданной картинки. Получилось довольно хорошо, однако цифры генерировались смазанными.

В прошлой части мы изучили, как работают GAN’ы, получив довольно четкие изображения цифр, однако пропала возможность кодирования и переноса стиля.

В этой части попробуем взять лучшее от обоих подходов путем совмещения вариационных автоэнкодеров (VAE) и генеративных состязающихся сетей (GAN).

Подход, который будет описан далее, основан на статье [Autoencoding beyond pixels using a learned similarity metric, Larsen et al, 2016].

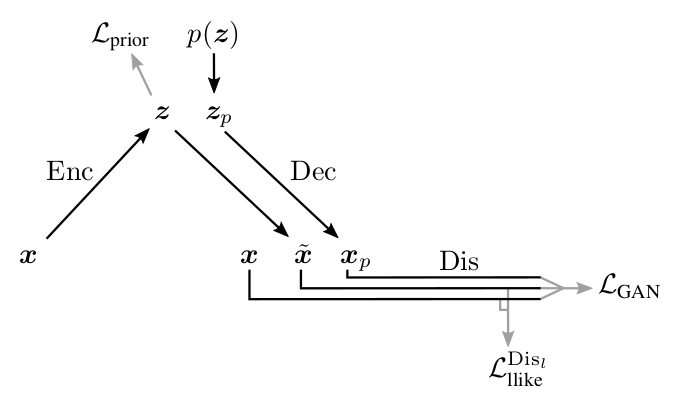

Иллюстрация из [1]

Разберемся более подробно, почему восстановленные изображения получаются смазанные.

В части про VAE рассматривался процесс генерации изображений

Так как размерность скрытых переменных

где

Когда мы обучаем автоэнкодеры, мы сравниваем вход из выборки

где

Задавая

Минимизируя

Если шум

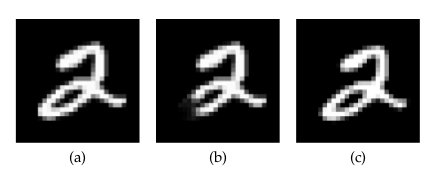

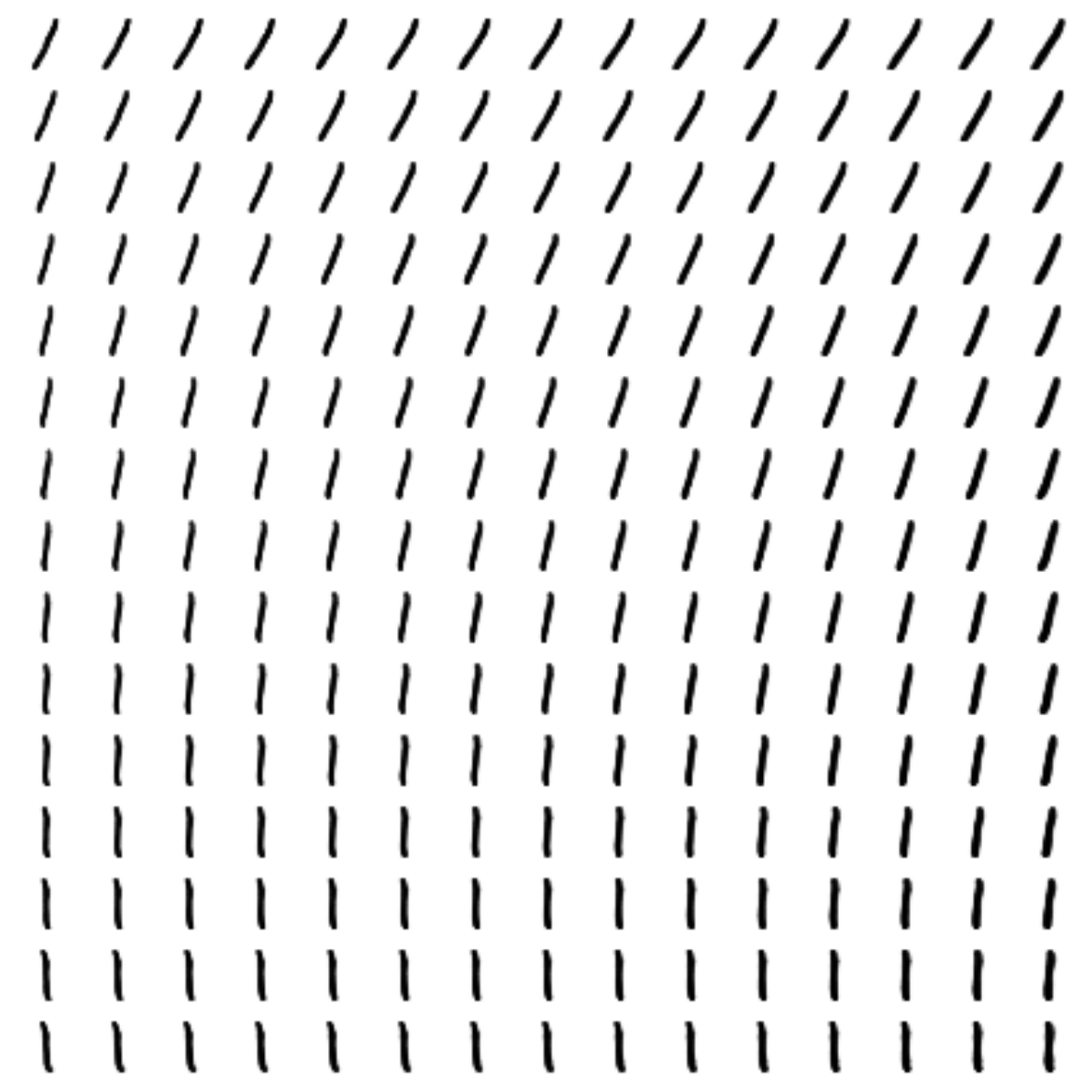

Возвращаясь к картинкам: посмотрим, как связана попиксельная метрика, которой определен лосс в предыдущих частях, и метрика, используемая человеком. Пример и иллюстрация из [2]:

На картинке выше:

(а) — оригинальное изображение цифры,

(b) — получена из (а) отрезанием куска,

(с) — цифра (а), сдвинутая на полпикселя вправо.

С точки зрения попиксельной метрики (а) намного ближе к (b), чем к (с); хотя с точки зрения человеческого восприятия (b) — даже не цифра, а вот разница между (а) и (b) практически незаметна.

Автоэнкодеры с попиксельной метрикой, таким образом, размазывали изображение, отражая тот факт, что

в рамках близких

- положение цифр слегка гуляет по картинке,

- нарисованы цифры слегка по-разному (хотя попиксельно может быть значительно далеко).

По метрике же человеческого восприятия тот факт, что цифра размылась, уже заставляет ее быть сильно непохожей на оригинал. Таким образом, если мы будем знать метрику человека или близкую к ней и оптимизировать в ней, то цифры не будут размываться, а важность того, чтобы цифра была полноценной, не как с картинки (b), резко возрастет.

Можно пытаться вручную придумывать метрику, которая будет ближе к человеческой. Но используя подход GAN, можно обучить нейронную сеть самой искать хорошую метрику.

Про GAN’ы написано в прошлой части.

Соединяя VAE и GAN

Генератор GAN выполняет функцию, аналогичную декодеру в VAE: оба сэмплят из априорного распределения

Идея: добавить в VAE третью сеть — дискриминатор и подавать ей на вход и восстановленный объект и оригинал, а дискриминатор обучать определять, какой из них какой.

Иллюстрация из [1]

Разумеется, использовать ту же самую метрику сравнения из VAE мы уже не можем, потому что, обучаясь в ней, декодер генерирует изображения, легко отличимые от оригинала. Не использовать метрику вообще — тоже, так как нам бы хотелось, чтобы воссозданный

Задумаемся, однако, вот о чем: дискриминатор, учась отличать реальный объект от сгенерированного, будет вычленять какие-то характерные черты одних и других. Эти черты объекта будут закодированы в слоях дискриминатора, и на основе их комбинации он уже будет выдавать вероятность объекта быть реальным. Например, если изображение размыто, то какой-то нейрон в дискриминаторе будет активироваться сильнее, чем если оно четкое. При этом чем глубже слой, тем более абстрактные характеристики входного объекта в нем закодированы.

Так как каждый слой дискриминатора является кодом-описанием объекта и при этом кодирует черты, позволяющие дискриминатору отличать сгенерированные объекты от реальных, то можно заменить какую-то простую метрику (например, попиксельную) на метрику над активациями нейронов в каком-то из слоев:

где

При этом можно надеяться, что новая метрика

Ниже приведена схема работы получившейся VAE+GAN сети, предлагаемая авторами [1].

Иллюстрация из [1]

Здесь:

— входной объект из

,

— сэмплированный

из

,

— объект сгенерированный декодером из

,

— объект восстановленный из

,

— лосс, заставляющий энкодер переводить

в нужное нам

(точно как в части 3 про VAE),

— метрика между активациями

-ого слоя дискриминатора

на реальном

и восстановленным

,

— кросс-энтропия между реальным распределением лейблов настоящих/сгенерированных объектов, и распределением вероятности предсказываемым дискриминатором.

Как и в случае с GAN, мы не можем обучать все 3 части сети одновременно. Дискриминатор надо обучать отдельно, в частности, не нужно, чтобы дискриминатор пытался уменьшать

Схема, предлагаемая авторами:

Выше видно, на каких лоссах какие сети учатся. Особое внимание разве что стоит уделить декодеру: он, с одной стороны, пытается уменьшить расстояние между входом и выходом в метрике l-го слоя дискриминатора (

Код

Код во многом повторяет то, что было в прошлых частях про чистые VAE и GAN.

Опять же сразу будем писать conditional модель.

from IPython.display import clear_output

import numpy as np

import matplotlib.pyplot as plt

%matplotlib inline

import seaborn as sns

from keras.layers import Dropout, BatchNormalization, Reshape, Flatten, RepeatVector

from keras.layers import Lambda, Dense, Input, Conv2D, MaxPool2D, UpSampling2D, concatenate

from keras.layers.advanced_activations import LeakyReLU

from keras.layers import Activation

from keras.models import Model, load_model

# Регистрация сессии в keras

from keras import backend as K

import tensorflow as tf

sess = tf.Session()

K.set_session(sess)

# Импорт датасета

from keras.datasets import mnist

from keras.utils import to_categorical

(x_train, y_train), (x_test, y_test) = mnist.load_data()

x_train = x_train.astype('float32') / 255.

x_test = x_test .astype('float32') / 255.

x_train = np.reshape(x_train, (len(x_train), 28, 28, 1))

x_test = np.reshape(x_test, (len(x_test), 28, 28, 1))

y_train_cat = to_categorical(y_train).astype(np.float32)

y_test_cat = to_categorical(y_test).astype(np.float32)

# Глобальные константы

batch_size = 64

batch_shape = (batch_size, 28, 28, 1)

latent_dim = 8

num_classes = 10

dropout_rate = 0.3

gamma = 1 # Коэффициент гамма

# Итераторы тренировочных и тестовых батчей

def gen_batch(x, y):

n_batches = x.shape[0] // batch_size

while(True):

idxs = np.random.permutation(y.shape[0])

x = x[idxs]

y = y[idxs]

for i in range(n_batches):

yield x[batch_size*i: batch_size*(i+1)], y[batch_size*i: batch_size*(i+1)]

train_batches_it = gen_batch(x_train, y_train_cat)

test_batches_it = gen_batch(x_test, y_test_cat)

# Входные плейсхолдеры

x_ = tf.placeholder(tf.float32, shape=(None, 28, 28, 1), name='image')

y_ = tf.placeholder(tf.float32, shape=(None, 10), name='labels')

z_ = tf.placeholder(tf.float32, shape=(None, latent_dim), name='z')

img = Input(tensor=x_)

lbl = Input(tensor=y_)

z = Input(tensor=z_)

Описание моделей от GAN отличается почти только добавленным энкодером.

def add_units_to_conv2d(conv2, units):

dim1 = int(conv2.shape[1])

dim2 = int(conv2.shape[2])

dimc = int(units.shape[1])

repeat_n = dim1*dim2

units_repeat = RepeatVector(repeat_n)(lbl)

units_repeat = Reshape((dim1, dim2, dimc))(units_repeat)

return concatenate([conv2, units_repeat])

# у меня получалось, что батч-нормализация очень сильно тормозит обучение на начальных этапах (подозреваю, что из-за того, что P и P_g почти не ра)

def apply_bn_relu_and_dropout(x, bn=False, relu=True, dropout=True):

if bn:

x = BatchNormalization(momentum=0.99, scale=False)(x)

if relu:

x = LeakyReLU()(x)

if dropout:

x = Dropout(dropout_rate)(x)

return x

with tf.variable_scope('encoder'):

x = Conv2D(32, kernel_size=(3, 3), strides=(2, 2), padding='same')(img)

x = apply_bn_relu_and_dropout(x)

x = MaxPool2D((2, 2), padding='same')(x)

x = Conv2D(64, kernel_size=(3, 3), padding='same')(x)

x = apply_bn_relu_and_dropout(x)

x = Flatten()(x)

x = concatenate([x, lbl])

h = Dense(64)(x)

h = apply_bn_relu_and_dropout(h)

z_mean = Dense(latent_dim)(h)

z_log_var = Dense(latent_dim)(h)

def sampling(args):

z_mean, z_log_var = args

epsilon = K.random_normal(shape=(batch_size, latent_dim), mean=0., stddev=1.0)

return z_mean + K.exp(K.clip(z_log_var/2, -2, 2)) * epsilon

l = Lambda(sampling, output_shape=(latent_dim,))([z_mean, z_log_var])

encoder = Model([img, lbl], [z_mean, z_log_var, l], name='Encoder')

with tf.variable_scope('decoder'):

x = concatenate([z, lbl])

x = Dense(7*7*128)(x)

x = apply_bn_relu_and_dropout(x)

x = Reshape((7, 7, 128))(x)

x = UpSampling2D(size=(2, 2))(x)

x = Conv2D(64, kernel_size=(5, 5), padding='same')(x)

x = apply_bn_relu_and_dropout(x)

x = Conv2D(32, kernel_size=(3, 3), padding='same')(x)

x = UpSampling2D(size=(2, 2))(x)

x = apply_bn_relu_and_dropout(x)

decoded = Conv2D(1, kernel_size=(5, 5), activation='sigmoid', padding='same')(x)

decoder = Model([z, lbl], decoded, name='Decoder')

with tf.variable_scope('discrim'):

x = Conv2D(128, kernel_size=(7, 7), strides=(2, 2), padding='same')(img)

x = MaxPool2D((2, 2), padding='same')(x)

x = apply_bn_relu_and_dropout(x)

x = add_units_to_conv2d(x, lbl)

x = Conv2D(64, kernel_size=(3, 3), padding='same')(x)

x = MaxPool2D((2, 2), padding='same')(x)

x = apply_bn_relu_and_dropout(x)

# l-слой на котором будем сравнивать активации

l = Conv2D(16, kernel_size=(3, 3), padding='same')(x)

x = apply_bn_relu_and_dropout(x)

h = Flatten()(x)

d = Dense(1, activation='sigmoid')(h)

discrim = Model([img, lbl], [d, l], name='Discriminator')

Построение графа вычислений на основе моделей:

z_mean, z_log_var, encoded_img = encoder([img, lbl])

decoded_img = decoder([encoded_img, lbl])

decoded_z = decoder([z, lbl])

discr_img, discr_l_img = discrim([img, lbl])

discr_dec_img, discr_l_dec_img = discrim([decoded_img, lbl])

discr_dec_z, discr_l_dec_z = discrim([decoded_z, lbl])

cvae_model = Model([img, lbl], decoder([encoded_img, lbl]), name='cvae')

cvae = cvae_model([img, lbl])

Определение лоссов:

Интересно, что получался слегка лучше результат, если в качестве метрики на активациях слоев брать не MSE, а кросс-энтропию.

# Базовые лоссы

L_prior = -0.5*tf.reduce_sum(1. + tf.clip_by_value(z_log_var, -2, 2) - tf.square(z_mean) - tf.exp(tf.clip_by_value(z_log_var, -2, 2)))/28/28

log_dis_img = tf.log(discr_img + 1e-10)

log_dis_dec_z = tf.log(1. - discr_dec_z + 1e-10)

log_dis_dec_img = tf.log(1. - discr_dec_img + 1e-10)

L_GAN = -1/4*tf.reduce_sum(log_dis_img + 2*log_dis_dec_z + log_dis_dec_img)/28/28

# L_dis_llike = tf.reduce_sum(tf.square(discr_l_img - discr_l_dec_img))/28/28

L_dis_llike = tf.reduce_sum(tf.nn.sigmoid_cross_entropy_with_logits(labels=tf.sigmoid(discr_l_img),

logits=discr_l_dec_img))/28/28

# Лоссы энкодера, декодера, дискриминатора

L_enc = L_dis_llike + L_prior

L_dec = gamma * L_dis_llike - L_GAN

L_dis = L_GAN

# Определение шагов оптимизатора

optimizer_enc = tf.train.RMSPropOptimizer(0.001)

optimizer_dec = tf.train.RMSPropOptimizer(0.0003)

optimizer_dis = tf.train.RMSPropOptimizer(0.001)

encoder_vars = tf.get_collection(tf.GraphKeys.TRAINABLE_VARIABLES, "encoder")

decoder_vars = tf.get_collection(tf.GraphKeys.TRAINABLE_VARIABLES, "decoder")

discrim_vars = tf.get_collection(tf.GraphKeys.TRAINABLE_VARIABLES, "discrim")

step_enc = optimizer_enc.minimize(L_enc, var_list=encoder_vars)

step_dec = optimizer_dec.minimize(L_dec, var_list=decoder_vars)

step_dis = optimizer_dis.minimize(L_dis, var_list=discrim_vars)

def step(image, label, zp):

l_prior, dec_image, l_dis_llike, l_gan, _, _ = sess.run([L_prior, decoded_z, L_dis_llike, L_GAN, step_enc, step_dec],

feed_dict={z:zp, img:image, lbl:label, K.learning_phase():1})

return l_prior, dec_image, l_dis_llike, l_gan

def step_d(image, label, zp):

l_gan, _ = sess.run([L_GAN, step_dis], feed_dict={z:zp, img:image, lbl:label, K.learning_phase():1})

return l_gan

Функции рисования картинок после и в процессе тренировки:

digit_size = 28

def plot_digits(*args, invert_colors=False):

args = [x.squeeze() for x in args]

n = min([x.shape[0] for x in args])

figure = np.zeros((digit_size * len(args), digit_size * n))

for i in range(n):

for j in range(len(args)):

figure[j * digit_size: (j + 1) * digit_size,

i * digit_size: (i + 1) * digit_size] = args[j][i].squeeze()

if invert_colors:

figure = 1-figure

plt.figure(figsize=(2*n, 2*len(args)))

plt.imshow(figure, cmap='Greys_r')

plt.grid(False)

ax = plt.gca()

ax.get_xaxis().set_visible(False)

ax.get_yaxis().set_visible(False)

plt.show()

# Массивы, в которые будем сохранять результаты, для последующей визуализации

figs = [[] for x in range(num_classes)]

periods = []

save_periods = list(range(100)) + list(range(100, 1000, 10))

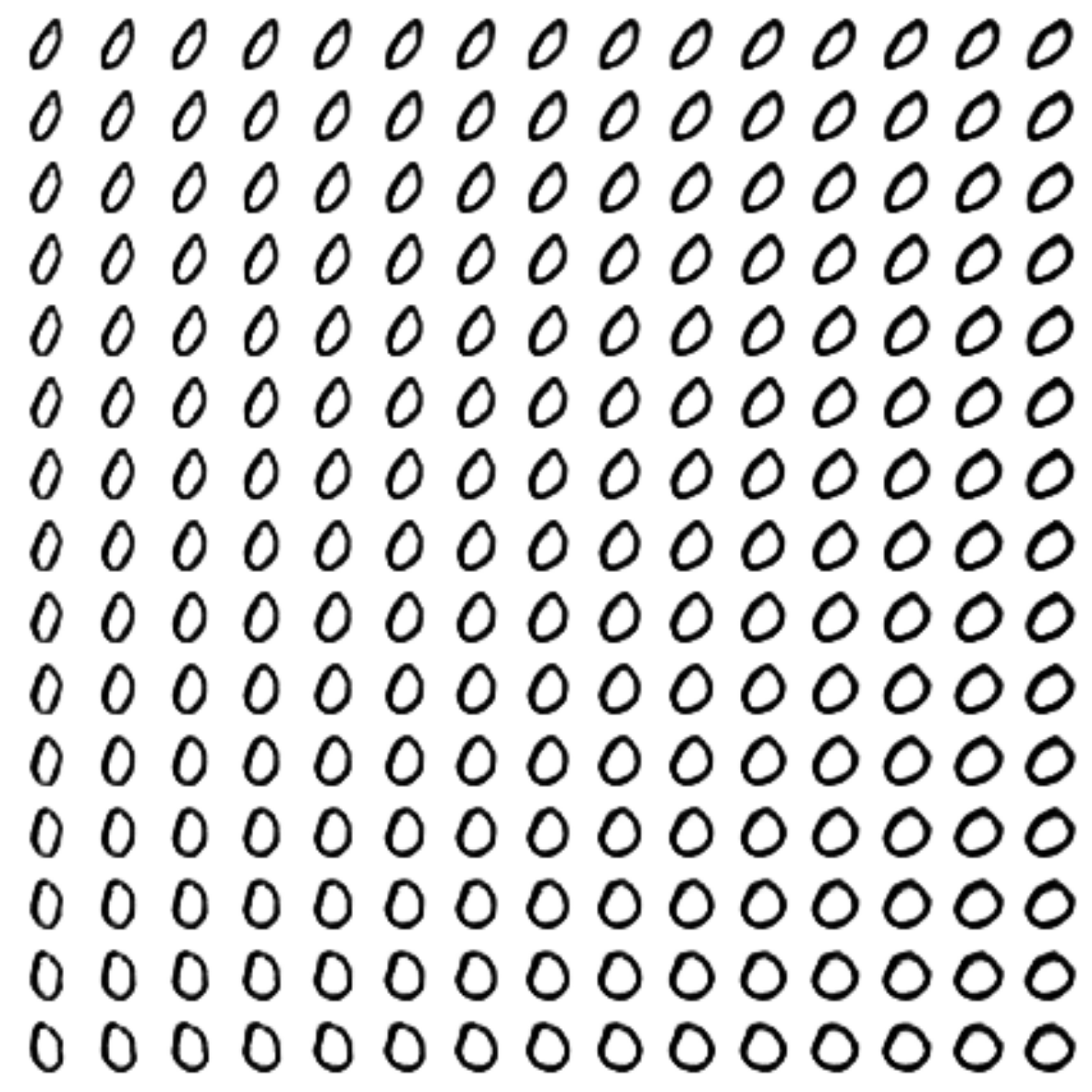

n = 15 # Картинка с 15x15 цифр

from scipy.stats import norm

# Так как сэмплируем из N(0, I), то сетку узлов, в которых генерируем цифры берем из обратной функции распределения

grid_x = norm.ppf(np.linspace(0.05, 0.95, n))

grid_y = norm.ppf(np.linspace(0.05, 0.95, n))

grid_y = norm.ppf(np.linspace(0.05, 0.95, n))

def draw_manifold(label, show=True):

# Рисование цифр из многообразия

figure = np.zeros((digit_size * n, digit_size * n))

input_lbl = np.zeros((1, 10))

input_lbl[0, label] = 1

for i, yi in enumerate(grid_x):

for j, xi in enumerate(grid_y):

z_sample = np.zeros((1, latent_dim))

z_sample[:, :2] = np.array([[xi, yi]])

x_decoded = sess.run(decoded_z, feed_dict={z:z_sample, lbl:input_lbl, K.learning_phase():0})

digit = x_decoded[0].squeeze()

figure[i * digit_size: (i + 1) * digit_size,

j * digit_size: (j + 1) * digit_size] = digit

if show:

# Визуализация

plt.figure(figsize=(15, 15))

plt.imshow(figure, cmap='Greys')

plt.grid(False)

ax = plt.gca()

ax.get_xaxis().set_visible(False)

ax.get_yaxis().set_visible(False)

plt.show()

return figure

# Рисование распределения z

def draw_z_distr(z_predicted):

im = plt.scatter(z_predicted[:, 0], z_predicted[:, 1])

im.axes.set_xlim(-5, 5)

im.axes.set_ylim(-5, 5)

plt.show()

def on_n_period(period):

n_compare = 10

clear_output() # Не захламляем output

# Сравнение реальных и декодированных цифр

b = next(test_batches_it)

decoded = sess.run(cvae, feed_dict={img:b[0], lbl:b[1], K.learning_phase():0})

plot_digits(b[0][:n_compare], decoded[:n_compare])

# Рисование многообразия для рандомного y

draw_lbl = np.random.randint(0, num_classes)

print(draw_lbl)

for label in range(num_classes):

figs[label].append(draw_manifold(label, show=label==draw_lbl))

xs = x_test[y_test == draw_lbl]

ys = y_test_cat[y_test == draw_lbl]

z_predicted = sess.run(z_mean, feed_dict={img:xs, lbl:ys, K.learning_phase():0})

draw_z_distr(z_predicted)

periods.append(period)

Процесс обучения:

sess.run(tf.global_variables_initializer())

nb_step = 3 # Количество шагов во внутреннем цикле

batches_per_period = 3

for i in range(48000):

print('.', end='')

# Шаги обучения дискриминатора

for j in range(nb_step):

b0, b1 = next(train_batches_it)

zp = np.random.randn(batch_size, latent_dim)

l_g = step_d(b0, b1, zp)

if l_g < 1.0:

break

# Шаг обучения декодера и энкодера

for j in range(nb_step):

l_p, zx, l_d, l_g = step(b0, b1, zp)

if l_g > 0.4:

break

b0, b1 = next(train_batches_it)

zp = np.random.randn(batch_size, latent_dim)

# Периодическая визуализация результата

if not i % batches_per_period:

period = i // batches_per_period

if period in save_periods:

on_n_period(period)

print(i, l_p, l_d, l_g)

Функция рисования гифок:

from matplotlib.animation import FuncAnimation

from matplotlib import cm

import matplotlib

def make_2d_figs_gif(figs, periods, c, fname, fig, batches_per_period):

norm = matplotlib.colors.Normalize(vmin=0, vmax=1, clip=False)

im = plt.imshow(np.zeros((28,28)), cmap='Greys', norm=norm)

plt.grid(None)

plt.title("Label: {}\nBatch: {}".format(c, 0))

def update(i):

im.set_array(figs[i])

im.axes.set_title("Label: {}\nBatch: {}".format(c, periods[i]*batches_per_period))

im.axes.get_xaxis().set_visible(False)

im.axes.get_yaxis().set_visible(False)

return im

anim = FuncAnimation(fig, update, frames=range(len(figs)), interval=100)

anim.save(fname, dpi=80, writer='ffmpeg')

for label in range(num_classes):

make_2d_figs_gif(figs[label], periods, label, "./figs6/manifold_{}.mp4".format(label), plt.figure(figsize=(10,10)), batches_per_period)

Так как у нас снова модель на основе автоэнкодера, мы можем применять перенос стиля:

# Трансфер стиля

def style_transfer(X, lbl_in, lbl_out):

rows = X.shape[0]

if isinstance(lbl_in, int):

label = lbl_in

lbl_in = np.zeros((rows, 10))

lbl_in[:, label] = 1

if isinstance(lbl_out, int):

label = lbl_out

lbl_out = np.zeros((rows, 10))

lbl_out[:, label] = 1

# Кодирем стиль входящего изображения

zp = sess.run(z_mean, feed_dict={img:X, lbl:lbl_in, K.learning_phase():0})

# Восстанавливаем из этого стиля, заменяя лейбл

created = sess.run(decoded_z, feed_dict={z:zp, lbl:lbl_out, K.learning_phase():0})

return created

# Картинка трансфера стиля

def draw_random_style_transfer(label):

n = 10

generated = []

idxs = np.random.permutation(y_test.shape[0])

x_test_permut = x_test[idxs]

y_test_permut = y_test[idxs]

prot = x_test_permut[y_test_permut == label][:batch_size]

for i in range(num_classes):

generated.append(style_transfer(prot, label, i)[:n])

generated[label] = prot

plot_digits(*generated, invert_colors=True)

draw_random_style_transfer(7)

Результаты

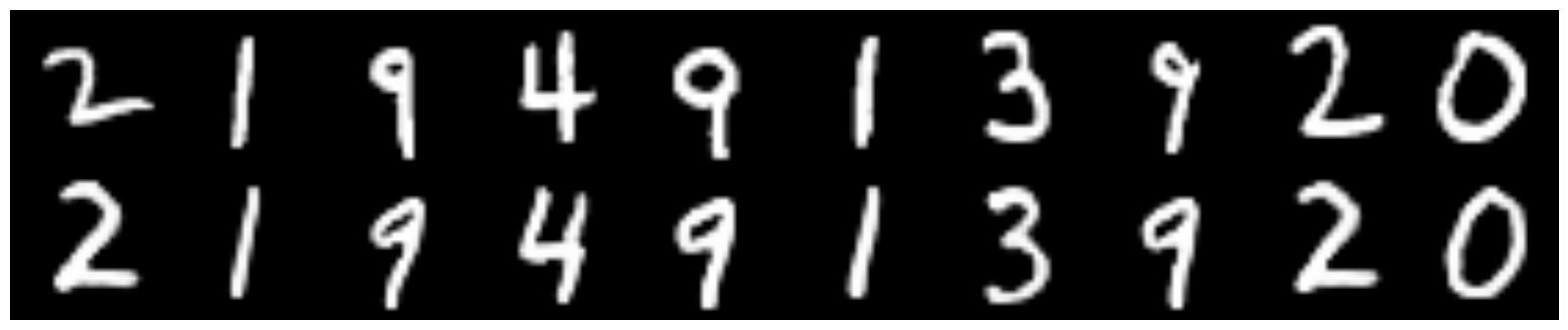

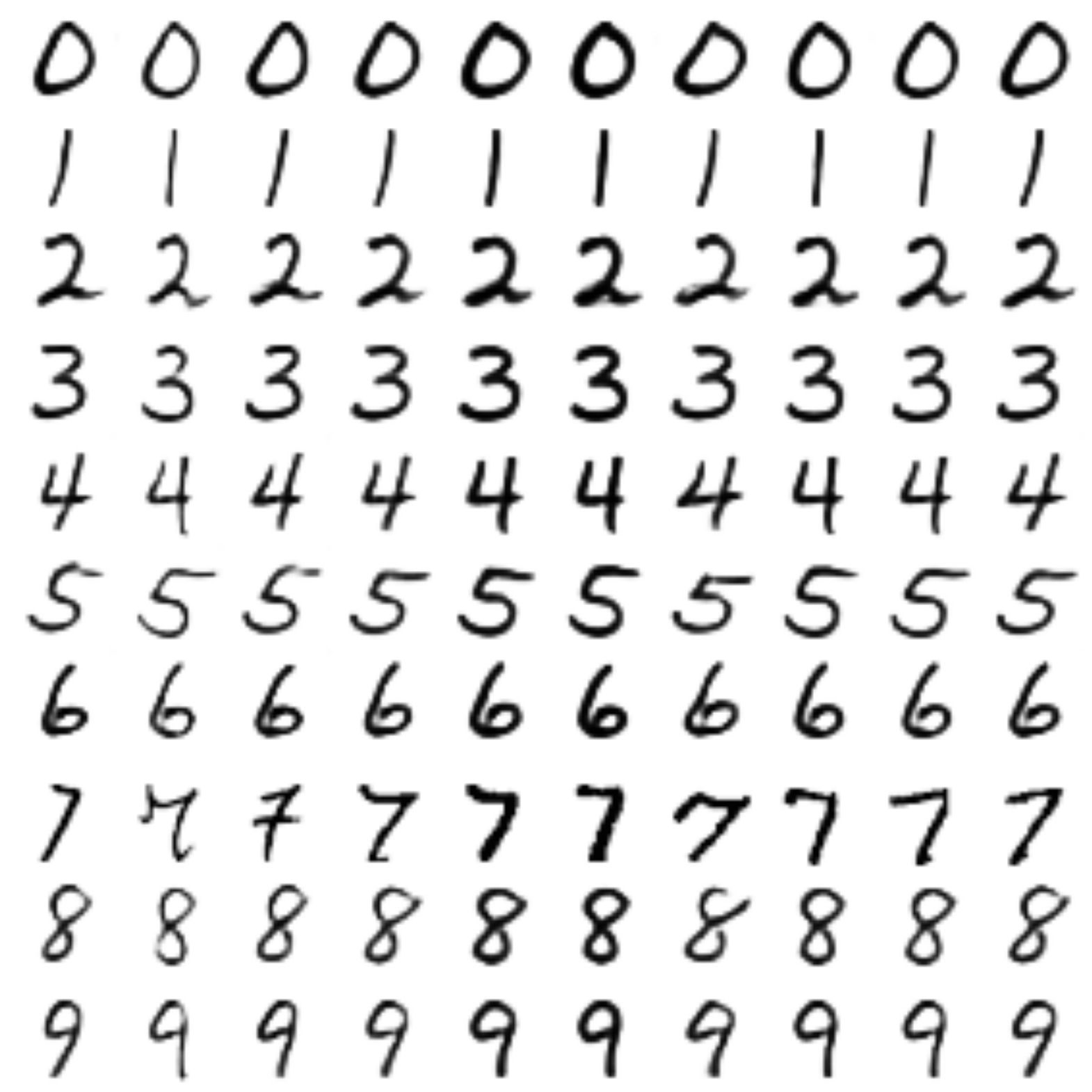

Сравнение с простым CVAE

Сверху оригиналы цифр, снизу восстановленные.

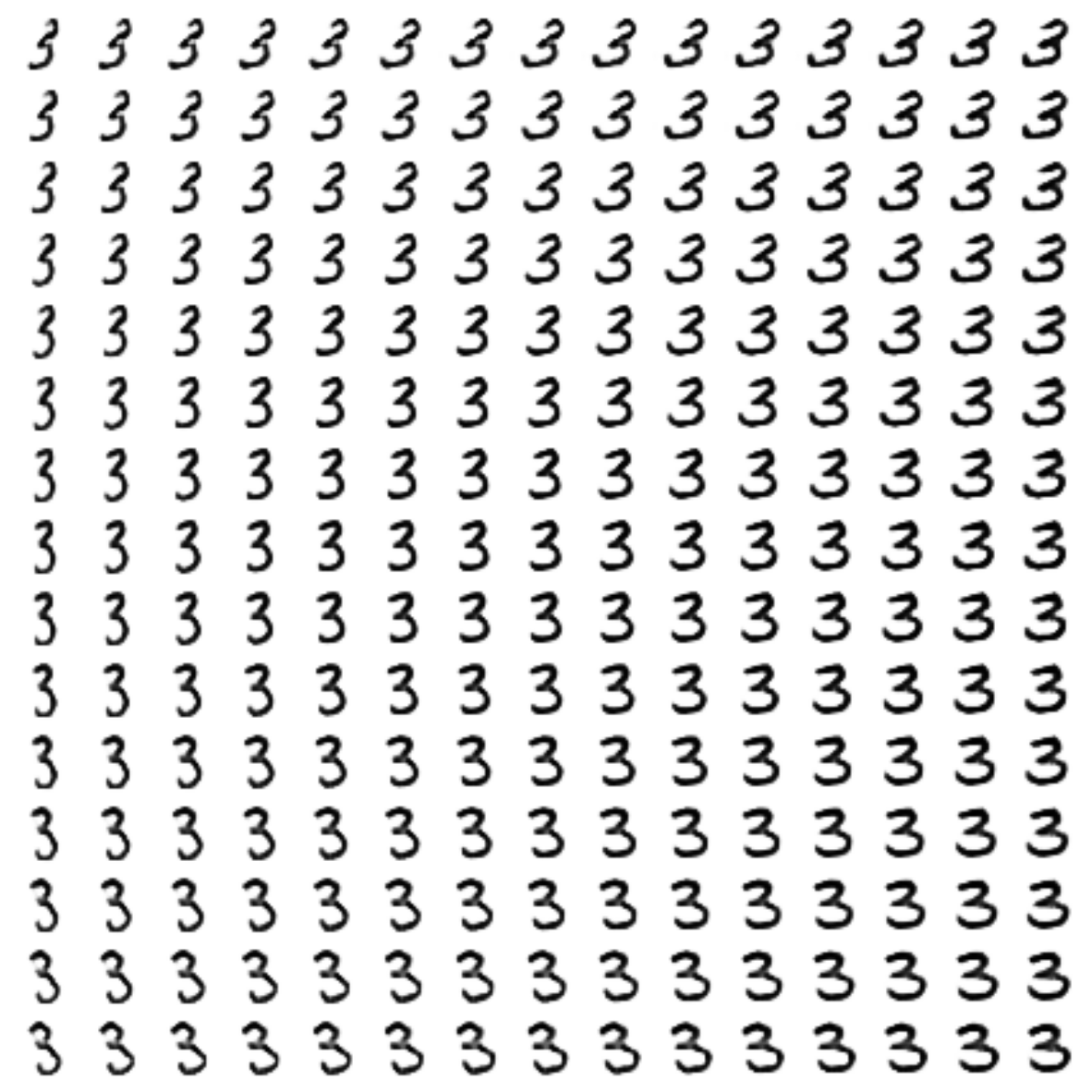

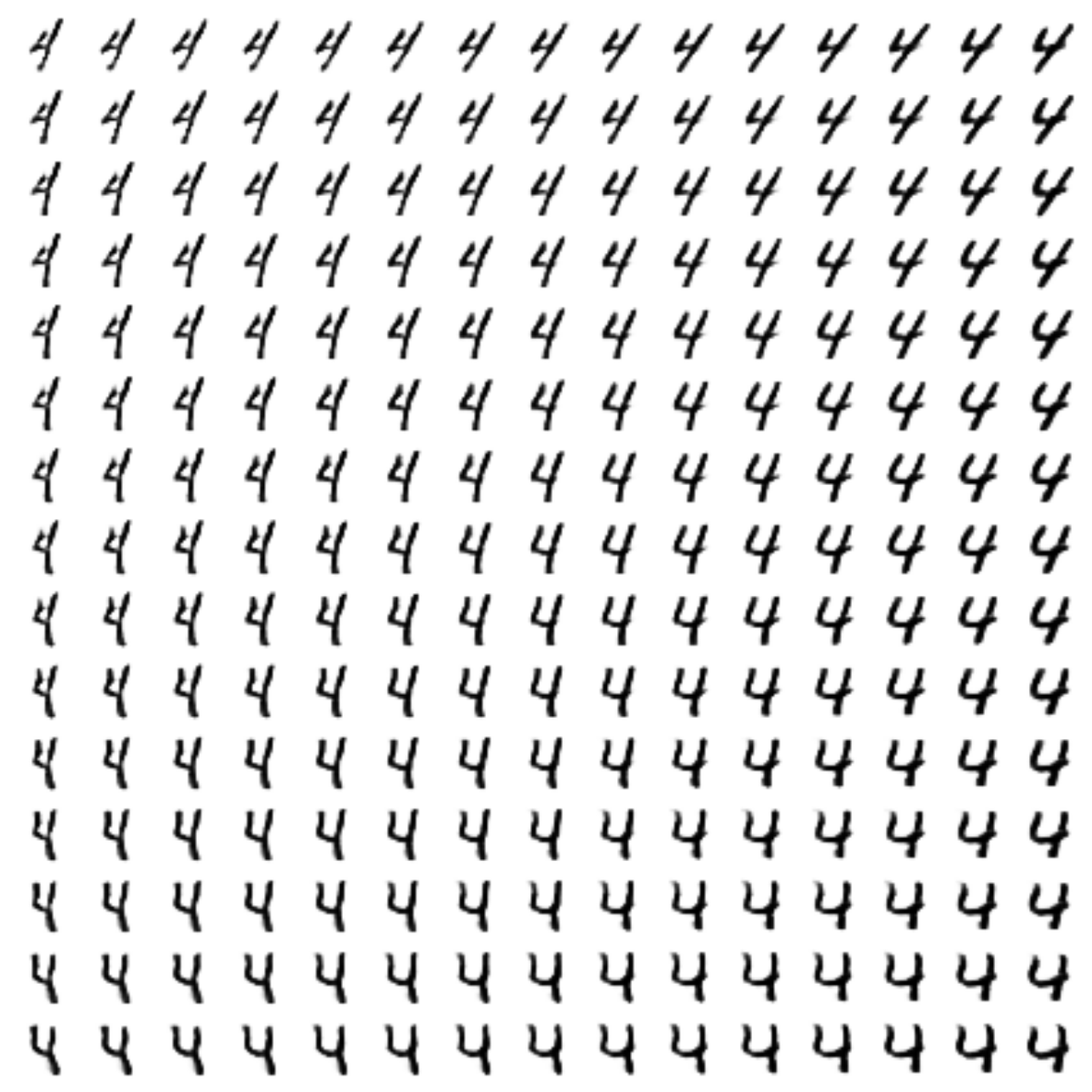

CVAE, скрытая размерность — 2

CVAE+GAN, скрытая размерность — 2

CVAE+GAN, скрытая размерность — 8

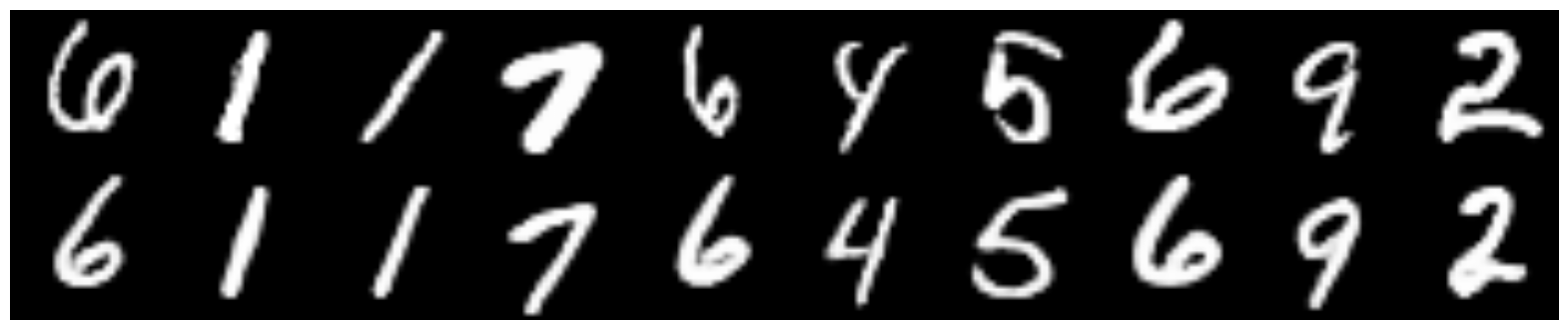

Сгенерированные цифры каждого лейбла сэмплированные из

Процесс обучения

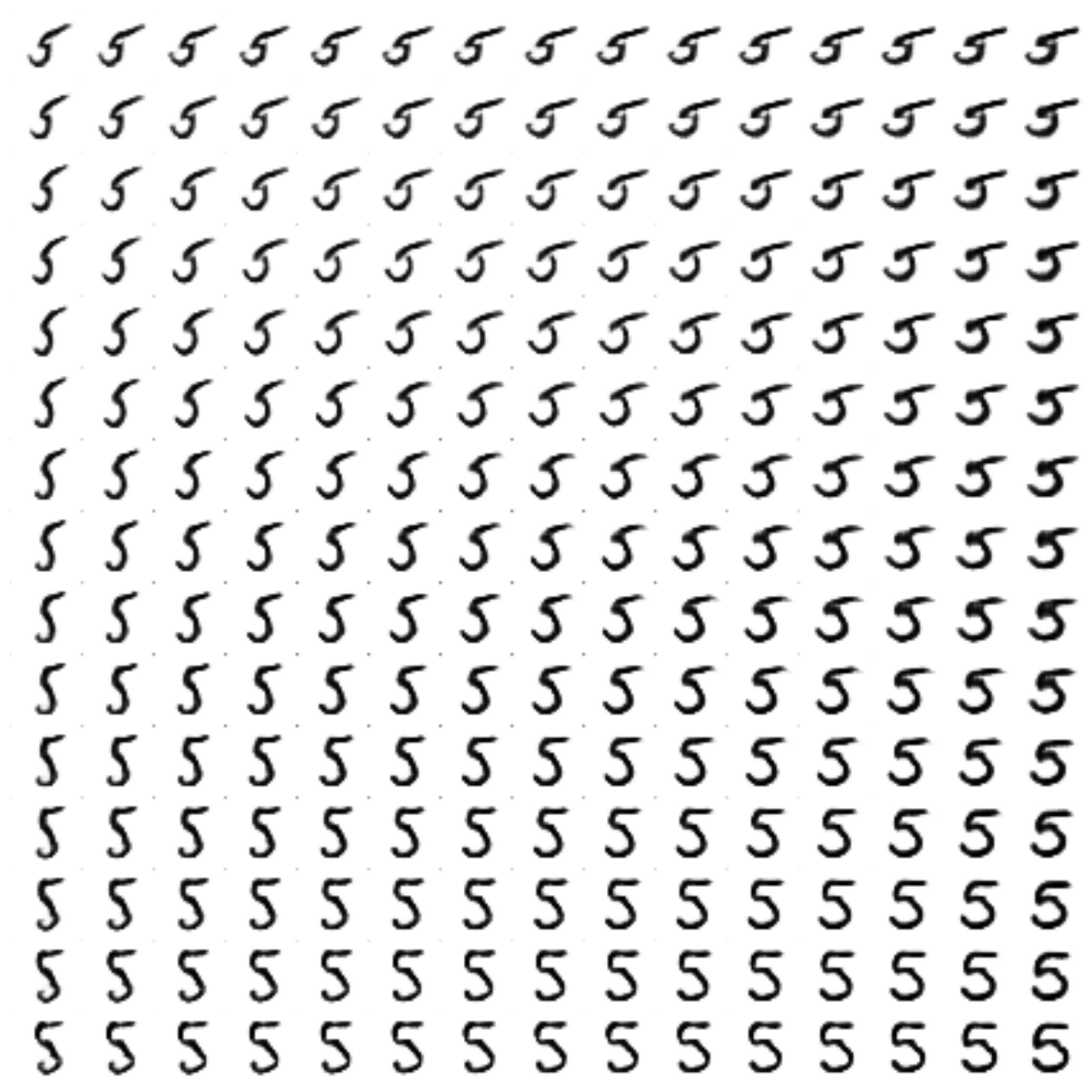

Трансфер стиля

За основу брались «7», из стиля которых создавались уже остальные цифры (здесь

Вот так было с простым CVAE:

А вот так стало:

Заключение

На мой взгляд, получилось очень неплохо. Пройдя путь от простейших автоэнкодеров, мы дошли до генеративных моделей, а именно до VAE, GAN, поняли, что такое conditional модели, и почему важна метрика.

Мы также научились пользоваться keras’ом и совмещать его с голым tensorflow.

Всем спасибо за внимание, надеюсь было интересно!

Репозиторий со всеми ноутбуками

Полезные ссылки и литература

Оригинальная статья:

[1] Autoencoding beyond pixels using a learned similarity metric, Larsen et al, 2016, https://arxiv.org/abs/1512.09300

Туториал по VAE:

[2] Tutorial on Variational Autoencoders, Carl Doersch, 2016, https://arxiv.org/abs/1606.05908

Туториал по использованию keras вместе с tensorflow:

[3] https://blog.keras.io/keras-as-a-simplified-interface-to-tensorflow-tutorial.html

|

Метки: author iphysic обработка изображений машинное обучение математика алгоритмы python gan keras mnist deep learning machine learning autoencoder |

[Из песочницы] Работа с гетерогенными контейнерами с C++17 |

В данной публикации разработаем небольшую библиотеку (3 функции (apply, filter, reduce) и одна как «домашнее задание» (map) :)) по удобной работе с гетерогенными контейнерами в рантайме (гетерогенность за счёт std::variant из 17 стандарта).

Из нового, помимо новых библиотечных типов, попробуем на вкус fold expressions и совсем немного structured binding

Введение

Для начала небольшое введение в тему гетерогенных контейнеров. Как известно, настоящих гетерогенных контейнеров, работающих в рантайме на c++ нет. В нашем распоряжении есть std::tuple, следы которого практически полностью исчезают в рантайме (not pay for what you don't use) и… впрочем всё. Всё остальное — лишь строительные блоки для построения собственных

Стоительных блока, которые позволяют нам сделать гетерогенный контейнер два — std::any и std::variant. Первый не помнит тип, поэтому его использование сильно ограничено. std::variant помнит тип и умеет матчить функторы на текущий тип с помощью std::visit (реализовано с помощью генерации таблицы методов и последующих переходов по ней). Реализация поистине магическая, а магия — единственное, что поможет сделать то, что сделать на первый взгляд невозможно :) (конечно возможно, ведь на c++

Дисклеймер

Заранее предупреждаю о максимальной компактности кода. Не стоит бездумно его копировать, он был максимально облёгчён для быстрого понимания. Нет пространств имён, форвардинга ссылок и ещё много чего.

Так же не претендую на уникальность, наверняка есть подобные хорошие библиотеки :)

Начало

Для более лёгкого понимания и тестирования функций возьмём простой пример. Для этого проэмулируем обычную полиморфную структуру:

struct Circle

{

void Print() { cout << "Circle. " << "Radius: " << radius << endl; }

double Area() { return 3.14 * radius * radius; }

double radius;

};

struct Square

{

void Print() { cout << "Square. Side: " << side << endl; }

double Area() { return side * side * side * side; }

double side;

};

struct EquilateralTriangle

{

void Print() { cout << "EquilateralTriangle. Side: " << side << endl; }

double Area() { return (sqrt(3) / 4) * (side * side); }

double side;

};

using Shape = variant;

Так же для сравнения будем держать в уме её простой полиморфный аналог:

struct Shape

{

virtual void Print() = 0;

virtual double Area() = 0;

virtual ~Shape() {};

};

struct Circle : Shape

{

Circle(double val) : radius(val) {}

void Print() override { cout << "Circle. " << "Radius: " << radius << endl; }

double Area() override { return 3.14 * radius * radius; }

double radius;

};

struct Square : Shape

{

Square(double val) : side(val) {}

void Print() override { cout << "Square. Side: " << side << endl; }

double Area() override { return side * side * side * side; }

double side;

};

struct EquilateralTriangle : Shape

{

EquilateralTriangle(double val) : side(val) {}

void Print() override { cout << "EquilateralTriangle. Side: " << side << endl; }

double Area() override { return (sqrt(3) / 4) * (side * side); }

double side;

};

Создадим вектор и попытаемся стандартными средствами добиться полиморфного поведения. Проитерируемся по вектору и вызовем функцию Print.

Для начала возьмём динамический аналог (на виртуальных функциях). Как можно думать, никаких проблем с динамическим полиморфизмом у нас нет:

vector shapes;

shapes.emplace_back(new Square(8.2));

shapes.emplace_back(new Circle(3.1));

shapes.emplace_back(new Square(1.8));

shapes.emplace_back(new EquilateralTriangle(10.4));

shapes.emplace_back(new Circle(5.7));

shapes.emplace_back(new Square(2.9));

Однако выглядит не очень современно. Голые вызовы new не внушают доверия. Перепишем:

vector> shapes;

shapes.emplace_back(make_shared(8.2));

shapes.emplace_back(make_shared(3.1));

shapes.emplace_back(make_shared(1.8));

shapes.emplace_back(make_shared(10.4));

shapes.emplace_back(make_shared(5.7));

shapes.emplace_back(make_shared(2.9));

Теперь выглядит лучше. Однако для новичка понятности в коде явно не прибавилось. Но не будем разводить холивар, выполним нашу задачу:

for (shared_ptr shape: shapes)

{

shape->Print();

}

// Вывод:

// Square. Side: 8.2

// Circle. Radius: 3.1

// Square. Side: 1.8

// EquilateralTriangle. Side: 10.4

// Circle. Radius: 5.7

// Square. Side: 2.9

Так же попробуем реализовать схожее поведение для гетерогенного контейнера:

vector operations;

operations.emplace_back(EquilateralTriangle { 5.6 });

operations.emplace_back(Square { 8.2 });

operations.emplace_back(Circle { 3.1 });

operations.emplace_back(Square { 1.8 });

operations.emplace_back(EquilateralTriangle { 10.4 });

operations.emplace_back(Circle { 5.7 });

operations.emplace_back(Square { 2.9 });

Здесь уже никаких указателей. Без проблем можно работать с объектами на стеке. Так же вместо коструктора можно использовать aggregate initialization для в «меру простых» типов.

Однако просто проитерироваться и вызвать функцию уже не удастся. Попробуем сделать это средствами, которые предоставляет std::variant. Для этого имеем функцию std::visit, так же нужно создать класс функторов.

Всё будет выглядеть подобным образом:

struct Visitor

{

void operator()(Circle& c) { c.Print(); }

void operator()(Square& c) { c.Print(); }

void operator()(EquilateralTriangle& c) { c.Print(); }

};

...

...

...

for (Shape& shape: shapes)

{

visit(Visitor{}, shape);

}

Вывод аналогичный. Так же такое же поведение можно проэмулировать с помощью constexpr if. Здесь уже кому что больше нравится.

Познакомившись с функционалом, который предоставляет нам стандартная библиотека, попробуем немного упростить работу с гетерогенными последовательностями.

Реализуем самые частые и всеобъемлющие функции: apply, filter, reduce.

Шаг 1

Для начала упростим себе задачу. Первый шаг достаточно притивен — описывался уже не раз.

Возьмём variadic templates, механизм наследования и знание о том, что лямбда-функции разворачиваются в обычные стуктуры — функторы. Унаследуемся от набора лябмд и создадим функцию, которая поможет нам вывести шаблонные типы:

template < typename... Func >

class Visitor : Func... { using Func::operator()...; }

template < class... Func > make_visitor(Func...) -> Visitor < Func... >;

Теперь вместо создания классов с функторами мы можем пользоваться набором лямбд, которые будут матчится по своим сигнатурам:

for (Shape& shape: shapes)

{

visit(make_visitor(

[]](Circle& c) { c.Print(); },

[]](Square& c) { c.Print(); },

[]](EquilateralTriangle& c) { c.Print(); }

), shape);

}

Также можем воспользоваться выводом типов с generic параметром:

for (Shape& shape: shapes)

{

visit(make_visitor([]](auto& c) { c.Print(); }), shape);

}

Получилось достаточно симпатично и в меру коротко.

Apply

Осталось собрать всё вместе и получить функцию apply для гетерогенных последовательностей:

template <

typename InputIter,

typename InputSentinelIter,

typename... Callable

>

void apply(InputIter beg,

InputSentinelIter end,

Callable... funcs)

{

for (auto _it = beg; _it != end; ++_it)

visit(make_visitor(funcs...), *_it);

};

Готово. Показанная техника на новизну не претендует, любой разработчик, так или иначе работавший с boost::variant давно реализовал для себя нечто подобное http://en.cppreference.com/w/cpp/utility/variant/visit, https://habrahabr.ru/post/270689/).

Теперь мы можем использовать функцию подобным образом:

apply(shapes.begin(), shapes.end(), [](auto& shape) { shape.Print(); });

или

apply(shapes.begin(), shapes.end(),

[] (Circle& shape) { shape.Print(); },

[] (Square& shape) { shape.Print(); },

[] (EquilateralTriangle& shape) { shape.Print(); });

Как видите, получилось довольно непохо. Однако, если мы передадим функторы не для всех типов, которые есть в std::variant, получится ошибка компиляции. Чтобы избежать этого, по подобию SFINAE сделаем функтор с elipsis, который будет вызываться при отсутствии любой другой альтернативы, причём в порядке вызова он будет самым последним вариантом.

template <

typename InputIter,

typename InputSentinelIter,

typename... Callable

>

void apply(InputIter beg,

InputSentinelIter end,

Callable... funcs)

{

for (auto _it = beg; _it != end; ++_it)

visit(make_visitor(funcs..., [](...){}), *_it);

};

Теперь можем передавать функторы не для всех типов, для отсутствующих будет произведён вызов пустой лямбды:

// Выводит информацию только для типов Circle

apply(shapes.begin(), shapes.end(), [] (Circle& shape) { shape.Print(); });

Для наглядного примера просто покажу, как сделать подобное с помощью динамического полиморфизма:

// Выводит информацию только для типов Circle

for_each(shapes.begin(), shapes.end(),

[] (shared_ptr shape) {

if (dynamic_pointer_cast(shape))

shape->Print();

});

Далеко не самый приятный вид.

Filter

По аналогии сделаем функцию filter. Смысловая нагрузка практически не отличается кроме того, что лямбда, имеющая elipsis в сигнатуре должна возвращать значение типа bool. Будем считать, что если мы не передали функтор, обрабатывающих какой то конкретный тип, то мы не хотим его видеть его экземпляры отфильтрованном контейнере.

template <

typename InputIter,

typename InputSentinelIter,

typename OutputIter,

typename... Callable

>

void filter(InputIter beg,

InputSentinelIter end,

OutputIter out,

Callable... funcs)

{

for (auto _it = beg; _it != end; ++_it)

{

if (visit(make_visitor(funcs..., [] (...) { return false; }),

*_it))

*out++ = *_it;

}

};

Пользоваться реализованной функцией можно следующим образом:

vector filtered;

filter(shapes.begin(), shapes.end(),

back_inserter(filtered),

[] (Circle& c) { return c.radius > 4.; },

[] (Square& s) { return s.side < 5.; });

apply(filtered.begin(), filtered.end(), [](auto& shape) { shape.Print(); });

// Вывод:

// Square. Side: 1.8

// Circle. Radius: 5.7

// Square. Side: 2.9

Аналог, реализованный с помощью динамического полиморфизма:

vector> filtered;

copy_if(shapes.begin(), shapes.end(),

back_inserter(filtered),

[] (shared_ptr shape)

{

if (auto circle = dynamic_pointer_cast(shape))

{

return circle->radius > 4.;

}

else if (auto square = dynamic_pointer_cast(shape))

{

return square->side < 5.;

}

else return false;

});

for_each(filtered.begin(), filtered.end(), [](shared_ptr shape) { shape->Print(); });

// Вывод:

// Square. Side: 1.8

// Circle. Radius: 5.7

// Square. Side: 2.9

Reduce

Осталось реализовать reduce (аналог std::accumulate) и map (аналог std::transform). Реализация этих функций несколько сложнее, чем это было с apply и filter. Для reduce мы используем функторы с двумя параметрами (значение аккумулятора и сам объект). Для того, чтобы реализовать схожее поведение, можно частично применить лямбда функции таким образом, чтобы для std::variant остались функции одного аргумента. Красивого решения для c++ по частичному применению нет, быстрый способ — захват необходимого контекста с помощью другой лямбды. Учитывая, что мы работаем не с одной лямбдой, а с variadic pack, код раздувается и начинает быть плохо читаемым. Спасает нас обработка вариадиков с помощью fold expressions. Ветераны знают, какими костылями приходилось раньше сворачивать списки типов.

template <

typename InputIter,

typename InputSentinelIter,

typename AccType,

typename... Callable

>

struct reduce < InputIter, InputSentinelIter, AccType, false, Callable... >

{

constexpr auto operator()(InputIter beg, InputSentinelIter end,

AccType initial_acc, Callable... funcs)

{

for (auto _it = beg; _it != end; ++_it)

{

initial_acc = visit(utility::make_overloaded_from_tup(

tup_funcs(initial_acc, funcs...),

make_index_sequence{},

[&initial_acc] (...) { return initial_acc; } ),

*_it);

}

return initial_acc;

}

};

Для того, чтобы сделать что то подобное, было решено воспользоваться старым добрым кортежем (std::tuple). Обработка его элементов не слишком сложная, в любой момент можно написать свою. И так, я создаю кортеж из лямбд, который трасформируется в новый кортеж путём оборачивания каждой лямбды в другую с захватом значения аккумулятора. Благо трансформация кортежа, используя новый стандарт, пишется относительно легко:

template < typename... Types, typename Func, size_t... I >

constexpr auto tuple_transform_impl(tuple t, Func func, index_sequence)

{

return make_tuple(func(get(t)...));

}

template < typename... Types, typename Func >

constexpr auto tuple_transform(tuple t, Func f)

{

return tuple_transform_impl(t, f make_index_sequence{});

}

Для того, чтобы создать объемлющую лябду, мне нужно знать тип второго аргумента приходящей лямбды. С помощью helper'ов, найденных на просторах интернета, можно скастовать лямбду к структуре, имеющей оператор вызова и путём матчинга получить желаемый тип.

Выглядит это всё примерно так:

template < typename Func, typename Ret, typename _, typename A, typename... Rest >

A _sec_arg_hlpr(Ret (Func::*)(_, A, Rest...));

template < typename Func >

using second_argument = decltype(_sec_arg_hlpr(&Func::operator()));

template < typename AccType, typename... Callable >

constexpr auto tup_funcs(AccType initial_acc, Callable... funcs)

{

return tuple_transform(tuple{ funcs... },

[&initial_acc](auto func) {

return [&initial_acc, &func] (second_argument arg) {

return func(initial_acc, arg); };

});

}

Всё бы хорошо, но эти чудеса не работают с generic функциями, типы входных аргументов которых мы не можем получить по определению. Поэтому, используя tag dispatching и создав простенький трейт для проверки функции мы создаём для этого случая свою реализацию.

Резюмируя, получаем для reduce следующие возможности для использования:

using ShapeCountT = tuple;

auto result = reduce(shapes.begin(), shapes.end(),

ShapeCountT{},

[] (ShapeCountT acc, Circle& item)

{

auto [cir, sq, tr] = acc;

return make_tuple(++cir, sq, tr);

},

[] (ShapeCountT acc, Square& item)

{

auto [cir, sq, tr] = acc;

return make_tuple(cir, ++sq, tr);

},

[] (ShapeCountT acc, EquilateralTriangle& item)

{

auto [cir, sq, tr] = acc;

return make_tuple(cir, sq, ++tr);

});

auto [cir, sq, tr] = result;

cout << "Circle count: " << cir

<< "\tSquare count: " << sq

<< "\tTriangle count: " << tr << endl;

// Вывод:

// Circle count: 2 Square count: 3 Triangle count: 2

Функция map реализуется на базе похожих идей, описание её реализации и саму реализацию опущу. Для тренировки своих meta скиллов предлагаю реализовать её самим :)

Что дальше?

Немного об ошибках. Сделаем шаг в сторону и увидим подобное сообщение:

Текст этой ошибки не удастся разобрать, даже если вы используете очень простой код (ошибка заключается в неправильном использовании generic параметра функтора). Представьте что будет, если вы будете использовать классы намного сложнее представленных.

Есть несколько подходов, как можно элегантно или не очень сказать об истинной природе ошибки.

В следующей раз разбавим написанное с Concepts TS из gcc-7.1.

Резюмируя, можно сказать, что подобный подход может сильно пригодиться для работы с библиотеками, которым приходилось использовать TypeErasure технику, для шаблонных классов с разной специализацией, для примитивной эмуляции полиморфизма,…

А как бы дополнили / использовали этот функционал вы? Пишите в комментариях, будет интересно почитать

Вышеприведённый код доступен тут.

|

Метки: author JegernOUTT ненормальное программирование c++ c++17 map apply reduce filter modern c++ |

[Из песочницы] Интеграция 1С с DLL с помощью Python |

Начнем с того, что сам алгоритм представлен в виде dll библиотеки, у которой одна точка входа, принимающая JSON строку как параметр, и отдающая 2 колбэка. Первый для отображения статуса выполнения, другой для получения результата. С web-сервисом все довольно просто, у питона есть замечательный пакет ctypes, достаточно подгрузить нужную библиотеку и указать точку входа.

Выглядит это примерно так:

import ctypes

def callback_recv(*args):

print(args)

lib = ctypes.cdll.LoadLibrary('test.dll')

Callback = ctypes.CFUNCTYPE(None, ctypes.c_int, ctypes.c_char_p)

my_func = getattr(lib, '_ZN7GtTools4testEPKcPFviS1_E')

cb_func = Callback(callback_recv)

my_func(ctypes.c_char_p('some data'), cb_func)

Как можно заметить, точка входа не совсем читабельная. Чтобы найти данную строчку в скомпилировнанных данных, нужно открыть соответствующий файл с расширением .lib и применить утилиту objdump с параметром -D, в выводе легко можно найти нужный метод по названию.

Данное коверканье метода происходит из-за того, что компилятор манглит («mangle» — калечить) название всех точек входа, причем разные компиляторы «калечат» по разному. В примере указан метод полученный MinGW

В 1С все оказалось гораздо менее тривиально. Для подключения dll нужно, чтобы у нее был специальный интерфейс Native API, позволяющий зарегестрировать Внешнюю Компоненту. Все написал по примеру, но ничего не взлетало. Я подумал, что это из-за gcc. Все мои попытки поставить Visual Studio были провальны, то ничего не устанавливалось, то не хватало стандартных библиотек.

Уже засыпая мне в голову пришла гениальная гипотеза. Наверное данную проблему не могли не оставить питонисты, ведь на Питон разработно все, что вообще возможно. А-ля правило интернета 34, только по отношению к чудесному Python. И ведь я оказался прав!

Для python существует пакет win32com который позволяет регестрировать Python объекты, как COM объекты. Для меня это было какой то магией, ведь я даже не очень понимаю что такое COM объект, но знаю что он умеет в 1С.

Пакет pypiwin32 не нужно ставить с помощью pip, а скачать его установщик, т.к. почему-то объекты не регестрировались после установки pip'ом.

Разобравшись с небольшим примером, я взялся за разработку. Для начала нужно создать Объект с интерфейсом идентифицирующим COM-Объект в системе

class GtAlgoWrapper():

# com spec

_public_methods_ = ['solve','resultCallback', 'progressCallback',] # методы объекта

_public_attrs_ = ['version',] # атрибуты объекта

_readonly_attr_ = []

_reg_clsid_ = '{2234314F-F3F1-2341-5BA9-5FD1E58F1526}' # uuid объекта

_reg_progid_= 'GtAlgoWrapper' # id объекта

_reg_desc_ = 'COM Wrapper For GTAlgo' # описание объекта

def __init__(self):

self.version = '0.0.1'

self.progressOuterCb = None

# ...

def solve(self, data):

# ...

return ''

def resultCallback(self, obj):

# ...

return obj

def progressCallback(self, obj):

# в колбэк необходимо передавать 1С объект, в котором идет подключение

# например ЭтотОбъект или ЭтаФорма

if str(type(obj)) == "":

com_obj = win32com.client.Dispatch(obj)

try:

# сохраним функцию из 1С (progressCallback) в отдельную переменную

self.progressOuterCb = com_obj.progressCallback1C;

except AttributeError:

raise Exception('"progressCallback" не найден в переданном объекте')

return obj

и конечно опишем его регистрацию

def main():

import win32com.server.register

win32com.server.register.UseCommandLine(GtAlgoWrapper)

print('registred')

if __name__ == '__main__':

main()

Теперь при запуске данного скрипта в системе появится объект GtAlgoWrapper. Его вызов из 1С будет выглядеть вот так:

Функция progressCallback1C(знач, тип) Экспорт

Сообщить("значение = " + знач);

Сообщить("тип = " + тип);

КонецФункции

//...

Процедура Кнопка1Нажатие(Элемент)

//Создадим объект

ГТАлго = Новый COMОбъект("GtAlgoWrapper");

//Установим колбэки

ГТАлго.progressCalback(ЭтотОбъект);

//...

Данные = ...; // JSON строка

ГТАлго.solve(Данные);

КонецПроцедуры

Таким образом, все попадающие в колбэки даные можно будет обработать. Единственное, что может еще остаться непонятным — как передать данные из dll в 1C:

_dependencies = ['libwinpthread-1.dll',

'libgcc_s_dw2-1.dll',

# ...,

'GtRouting0-0-1.dll']

def solve(self, data):

prefix_path = 'C:/release'

# должны быть подключены все зависимые библиотеки

try:

for dep in self._dependencies:

ctypes.cdll.LoadLibrary(os.path.join(prefix_path, dep))

# запоминаем библиотеку с нужной нам точкой входа

lib = ctypes.cdll.LoadLibrary(os.path.join(prefix_path, 'GtAlgo0-0-1.dll'))

except WindowsError:

raise Exception('cant load' + dep)

solve_func = getattr(lib, '_ZN6GtAlgo5solveEPKcPFviS1_ES3_')

# создаем колбэки

StatusCallback = ctypes.CFUNCTYPE(None, ctypes.c_int, ctypes.c_char_p)

ResultCallback = ctypes.CFUNCTYPE(None, ctypes.c_int, ctypes.c_char_p)

scb_func = StatusCallback(self.progressOuterCb)

rcb_func = ResultCallback(self.resultOuterCb)

# колбэки 1C превратились в функции которые мы передадим в DLL. Magic!

if self.resultOuterCb is None:

raise Exception('resultCallback function is not Set')

if self.progressOuterCb is None:

raise Exception('progressCallback function is not Set')

# запустим алгоритм

solve_func(ctypes.c_char_p(data), scb_func, rcb_func)

Для успешной работы, в первую очередь требуется вызов python-скрипта, чтобы зарегистрировать класс GtAlgoWrapper, а затем уже можно смело запускать конфигурацию 1С.

Вот так просто можно связать dll библиотеку и 1C с помощью питона, не уползая в сильные дебри.

Всем Магии!

citforum.ru/book/cook/dll0.shtml — Динамические библиотеки для чайников

habrahabr.ru/post/191014 — NativeAPI

infostart.ru/public/115486 — COM объект на C++

infostart.ru/public/190166 — COM объект на Python

pastebin.com/EFLnnrfp — Полный код скрипта на Python из статьи

|

Метки: author atnes python c++ com dll |

«Ты, гроза, грозись, а мы друг за друга держись!» — сказ о том, как я ADSL-модем спасал |

Провайдер плачет.

Но он не смог поступить иначе.

Гремит гроза...»

Гроза! Стихия! Караул! Иной раз тяжело предугадать, какой ущерб она может учинить домашней электронике… Благо, её можно предупредить, тем самым исключив возможность выхода из строя, скажем, хотя бы домашних маршрутизаторов и модемов — обычно они в первую очередь и подвергаются воздействию буйных действ природы.

За прошедшие лета я похоронил ровно два модема — причиной их гибели послужили резкие перепады в сети электропитания. В этом же году я наконец набрался смелости порвать сей порочный круг и попытаться спасти бедный D-Link от преждевременной погибели!

Наиболее рациональным решением было бы просто изредка поглядывать в оконце и в случае приближения грозы заблаговременно отключать модем от сети электропитания; но как быть, если иной раз приходится оставить дом на продолжительное время, а родные не ведают, что делать, куда нажимать и что переключать в случае наступления грозы?

То-то и оно! Потому мне и подумалось, что будет неплохо соорудить некое подобие EAS (Emergency Alert System) для дома, с пищанием, оповещением по TV и прочими финтифлюшками.

Для начала я набросал две простеньких схемки, по которым можно было бы воплотить в жизнь задуманное. Первая из них – как д'oлжно получать текущий код погоды EAS-клиенту; вторая же – что должно быть отображено на экране телевизора.

Но, как говорится в одной небезызвестной поговорке, «скоро сказка сказывается, да не скоро дело делается». Думу долгую думал я, как же выводить буду на телевизор оповещение; то и дело откладывал на потом реализацию проекта, но вот «потом» и пришло нежданно-негаданно – в голове спонтанно возникла донельзя простая идея того, как же всё-таки разделаться с этой проблемой.

Решением оказалось превращение Raspberry Pi B+ в EAS-клиент путём запуска браузера epiphany в kiosk-режиме. Браузер цепляется за локальный веб-сервер, который, в свою очередь, возвращает следующий код:

...

...

...

Таким образом, благодаря простецкому js-скрипту и тегу iframe, мы

Но не будем забегать так далеко вперёд, давайте же разберёмся, как устроен EAS-клиент изнутри; если быть более точным, как происходит загрузка:

- Старт ОС (raspbian)

- Обращение к /etc/rc.local

- Инициализация иксов через xinit

- Запуск браузера

- Подключение к серверу

- Получение данных

Файл /etc/rc.local отличается от оригинального одной-единственной строкой:

sudo xinit ./home/eas/eas.boot & ## Инициируем загрузку иксовА файл /home/eas/eas.boot ответственен за запуск браузера:

#!/bin/sh

xset -dpms

xset s off

xset s noblank

matchbox-window-manager -use_titlebar no & ## Запускаем оконный менеджер

unclutter -idle 0.01 -root & ## Скрываем курсор мыши

WEBKIT_DISABLE_TBS=1 epiphany-browser -a http://podivilov.local/ --profile /home/eas/.config ## Запускаем браузер в kiosk-режиме на весь экранНаш браузер обращается к домашнему серверу, обозначенному как podivilov.local; тот же, в свою очередь, запрашивает у внешнего сервера данные о погоде, default и extra коды (default — целое число, нуль или единица; нуль — EAS не активирована, единица — активирована; extra — код погоды, полученный с сайта прогноза погоды, требуемый для отладки).

Происходит это следующим образом:

$code_default = file_get_contents('https://***.podivilov.ru/api/method/weather.getCode/?token=********************');

$code_extra = file_get_contents('https://***.podivilov.ru/api/method/weather.getCode.extra/?token=********************');Данные о погоде внешний сервер получает с сайта openweathermap.org:

$json = file_get_contents('http://api.openweathermap.org/data/2.5/weather?lat=**.******&lon=**.******&APPID=********************************'); // lat & lon - широта и долгота, а APPID - api-код, который можно получить опосля регистрации на сайте

$data = json_decode($json,true);

$result = substr($data['weather'][0]['icon'], 0, -1);Полученный сервером extra-код обрабатывается, проходя несколько условий, а на выходе получается код, которым уже можно воспользоваться для предотвращения потенциального выгорания модема.

В зависимости от условий погоды и полученного кода наша система выводит на экран различные наборы цифр: например, если ожидается сильная гроза и следует выключить пробки №1 (маршрутизатор/модем) и №2 (прочая бытовая техника), EAS-система отображает код 12 (пробка №1 и №2).

Помимо этого, каждые полчаса на домашних компьютерах менеджер задач запускает следующий скрипт (оный опрашивает сервер, нет ожидается ли гроза; если ответ положителен, запускается программа, предупреждающая о возможном наступлении катаклизма):

dim xHttp: Set xHttp = createobject("MSXML2.ServerXMLHTTP")

xHttp.Open "GET", "https://***.podivilov.ru/api/method/weather.getCode/?token=********************", False

xHttp.setOption 2, 13056

xHttp.Send

If xHttp.responseText = "1" Then

Set objShell = CreateObject("WScript.Shell")

objShell.Run """C:\путь_к_программе\EAS.exe"""

Set objShell = Nothing

Else

WScript.Quit

End IfНо лучше один раз увидеть, чем тысячу раз услышать. Собственно, пред вами результат того, о чём я повествовал выше:

Вот и сказочке конец, а кто слушал – молодец… Берегите себя и свои роутеры!

Спасибо за внимание!

|

Метки: author Mihip облачные вычисления настройка linux беспроводные технологии nginx *nix безопасность adsl гроза raspberry pi |

Хакеры и биржи: как атакуют сферу финансов |

Пока финансовый сектор совершенствуется и внедряет новые технологии, киберпреступники не дремлют. Согласно данным компании FireEye за 2014 год, специализирующейся на информационной безопасности, финансовые учреждения — на втором месте по частоте хакерских атак, уступая первенство лишь правительственным ресурсам. Со временем атаки на этот сектор только усилились.

Сегодня мы рассмотрим несколько примеров реальных атак на банки и биржи и поговорим о последствиях этих киберинцидентов.

Популярная цель хакеров

Нападения хакеров на сферу финансов — дело столь же привычное, как и утренний кофе для большинства людей. На клиентов «Сбербанка» совершается около 5 тыс. атак в неделю. Не лучше ситуация и с целевыми взломами — в 2016 году хакеры попытались украсть у российских банков 2,87 млрд рублей, сообщает Центробанк.

Однозначно сказать, как меняется число кибератак на финансовый сектор, довольно сложно. Во-первых, статистики различных банков и финансовых компаний разнятся и могут даже противоречить друг другу. Во-вторых, сами банки и биржи могут как утаивать информацию о хакерских атаках, боясь потерять доверие клиентов, так и списывать на них свои внутренние ошибки.

Большая часть хакерских атак приходится на пользователей — клиентов банков. Но профессионалы предпочитают взламывать сами финансовые учреждения — это выгоднее для киберпреступников. При этом хакеры могут преследовать различные цели и использовать множество способов атаковать сферу финансов.

Кража денег из банков с помощью уязвимости в системе переводов

В прошлом году система международных денежных переводов SWIFT неоднократно подвергалась хакерским атакам. Воспользовавшись уязвимостями в этой системе, хакеры сумели вывести $81 млн из Центробанка Бангладеш. Ещё $9 млн преступники похитили у банка в Эквадоре. Летом 2016 года $10 млн было украдено у неназванного украинского банка. Во всех этих случаях хакеры действовал одинаково: внедрялись в банки, подключенные к SWIFT, а после получали данные операторов, имеющих право на создание и одобрение SWIFT-сообщений, и проводили поддельные транзакции.

Эксперты предполагают, что атаки на систему переводов — дело хакерской группировки Lazarus. Интересно, что представители SWIFT поначалу заявляли, что уязвимость не является причиной краж. Но после нескольких инцидентов компания взялась за усиление безопасности.

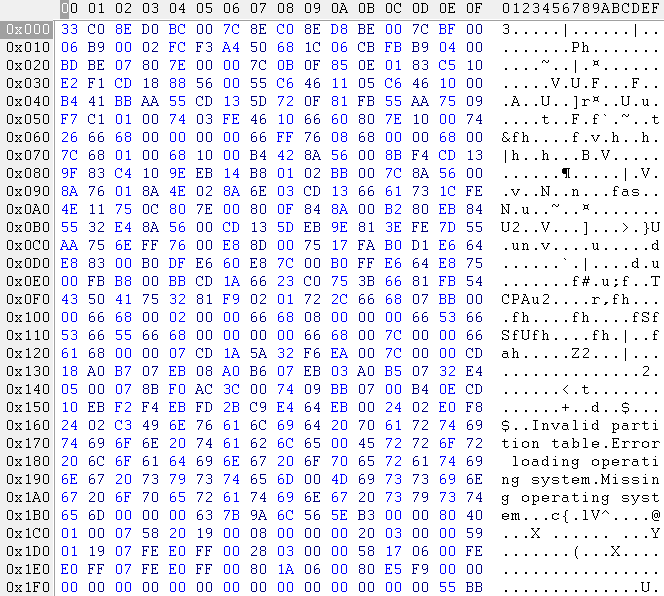

В феврале 2016 года со счета российского Металлинвестбанка исчезло 667 млн рублей. Атака пришлась на АРМ КБР (автоматизированное рабочее место клиента Банка России), с которого ведётся управление счетом в Центробанке. В какой-то момент представители банка заметили, что с устройства отправляются несанкционированные переводы на счета частных лиц в банках по всей стране. По словам специалистов, за инцидентом в Металлинвестбанке и ещё как минимум 13 взломами стоит группировка Buhtrap, члены которой были задержаны в июне 2016 года. Хакеры запускали троян в банковскую сеть, рассылая письма от имени Центробанка, собирали логины и пароли от доменных учетных записей, а после получали доступ к АРМ КБР и подменяли платежные документы.

Похищение торговых алгоритмов и сбои в биржевой торговле

В июле 2015 года торги на Нью-Йоркской фондовой бирже (NYSE) были приостановлены на несколько часов. Официально причиной сбоя назвали внутренние неполадки, но журналистов и некоторых экспертов такая версия не убедила. По их мнению, виной всему стали хакерские атаки. Вину за случившееся приписывали как группе Anonymous, так и китайским киберпреступникам. К слову, Anonymous пыталась атаковать биржу и в 2011 году, но тогда к серьёзным последствиям это не привело. О том, каким способом была взломана биржа в 2015 году (если атака действительно имела место), доподлинно неизвестно.

Изображение: Christine Puccio, CC BY-SA 2.0

На Московской бирже в том же 2015 году произошла не менее загадочная ситуация. В начале февраля во время торгов курс рубля снизился на 15%, поскольку один из трейдеров — казанский Энергобанк — продавал валюту по нерыночным ценам. За 15 минут такой торговли игрок потерял 244 млн рублей. В случившемся банк обвинил хакеров. За расследование инцидента взялись специалисты из Group-IB, которые установили, что банк и впрямь пострадал от злоумышленников. Механизм атаки оказался простым: хакеры заразили трояном Corcow трейдинговую систему банка, получив тем самым удаленный контроль над ней. Однако многие, в том числе и первый зампредседателя Центробанка Сергей Швецов, посчитали, что дело не в хакера, а в том, что банк сознательно манипулировал валютой.

Американская биржа Nasdaq подверглась крупной хакерской атаке. В 2010 году ФБР заметило попытку проникновения на центральные сервера биржи. В результате расследования, о ходе которого докладывали самому президенту США, было установлено, что в систему проникли, используя несколько ранее не обнаруженных в системе уязвимостей. Такой подход, по сообщению зарубежных журналистов, характерен для спецслужб. Однако в дальнейшем выяснилось, что в Nasdaq «наследили» несколько независимых друг от друга группировок. Существуют разные предположения о цели атаки от банальной кражи денег до попытки уничтожить биржу. Представители Nasdaq заявили, что преступники охотились за инсайдерской информацией сервиса Directors Desk, который содержит данные 300 компаний.

Еще одна неочевидная цель атак злоумышленников — торговые алгоритмы хедж-фондов. Специалисты компаний, занимающихся информационной безопасностью, заявляли, что алгоритмы похищают, чтобы шантажировать хедж-фонды. Для них подобные инциденты могут стать крайне серьезным репутационным ударом.

Кража инсайдерской информации

Похищения данных, способных повлиять на ход торгов, случаются на биржах куда чаще попыток помешать работе и украсть торговые алгоритмы. Такую информацию куда проще использовать или продать. Но в этом случае атакам подвергаются не только сами биржи, но и другие влиятельные в финансовом мире компании. Показательный случай — кража инсайдерской информации у Dow Jones&Co.

О взломе и хищении данных 3500 клиентов компания сообщила в 2015 году. Но оказалось, что этот инцидент с Dow Jones не самый интересный. На тот момент ФБР уже расследовало кражу неопубликованных статей и другой информации, дающей преимущество в ходе торгов. Одна из служб компании — Factiva — ещё до официальной публикации собирает важные финансовые данные из более чем 4000 источников, а потому ее взлом особенно интересен хакерам.

Аналогичная проблема возникла и у американских ресурсов для публикации пресс-релизов компаний PRNewswire, Marketwired и Businesswire. Они, сами того не замечая, целых пять лет делились с хакерами важной для рынка информацией до ее публикации. Доступ к данным киберпреступники получили с помощью фишинговых атак. Хакеры работали в связке с трейдерами. Последние использовали полученные данные для торгов на бирже, а вырученные средства переводили в офшоры. Ущерб от действий группы оценивается по разным данным в сумму до 30 до 100 млн долларов.

Заключение

Несмотря на пристальное внимание со стороны хакеров, финансовые компании постоянно укрепляют собственную безопасность. Например, разработчики системы финансовых переводов SWIFT после описанных ситуаций разработали многочисленные меры, призванные улучшить безопасность.

Финансовые компании разрабатывают различные средства защиты и самостоятельно — прием они могут быть направлены не только на борьбу с последствиями взломов, но и обычных ошибок ИТ-систем. К примеру, ошибки в работе биржевых систем могут приводить в том числе и к некорректному отображению торговых данных или неверному расчету гарантийного обеспечения для удержания позиции (ошибка может привести даже к преждевременному закрытию сделки)

Для того, чтобы минимизировать возможный ущерб брокерские компании разрабатывают различные системы защиты клиентов. О том, как реализована подобная защита в торговой системе ITinvest MatriX можно прочитать по ссылке.

|

Метки: author itinvest информационная безопасность блог компании itinvest биржи банки сфера финансов |

[Перевод] Используем IoC-контейнер Laravel на полную мощность |

Laravel имеет мощный IoC-контейнер, но, к сожалению, официальная документация Laravel не описывает все его возможности. Я решил изучить его и задокументировать для собственного использования.

Примеры в данной статье основаны на Laravel 5.4.26, другие версии могут отличаться.

Введение в Dependency Injection

Я не буду объяснять, что такое DI и IoC в этой статье — если вы не знакомы с этими принципами, вы можете прочитать статью "What is Dependency Injection?" от Fabien Potencier (создателя фреймворка Symfony).

Получение контейнера (Container)

В Laravel существует несколько способов получения сущности контейнера * и самый простой из них это вызов хелпера app():

$container = app();Я не буду описывать другие способы, вместо этого я сфокусирую свое внимание на самом контейнере.

* В Laravel есть класс Application, который наследуется от Container (именно поэтому хелпер называется app()), но в этой статье я буду описывать только методы класса Container.

Использование Illuminate\Container вне Laravel

Для использования контейнера Laravel вне фреймворка необходимо установить его с помощью Composer, после чего мы можем получить контейнер так:

use Illuminate\Container\Container;

$container = Container::getInstance();Пример использования

Самый простой способ использования контейнера — указать в конструкторе классы, которые необходимы вашему классу используя type hinting:

class MyClass

{

private $dependency;

public function __construct(AnotherClass $dependency)

{

$this->dependency = $dependency;

}

}Затем, вместо создание объекта с помощью new MyClass, нужно вызвать метод контейнера make():

$instance = $container->make(MyClass::class);Контейнер автоматически создаст и внедрит зависимости, что будет эквивалентно следующему коду:

$instance = new MyClass(new AnotherClass());(За исключением того случая, когда у AnotherClass есть свои зависимости. В таком случае контейнер автоматически создаст и внедрит его зависимости, зависимости его зависимостей и т.д.)

Реальный пример

Ниже показан более реальный пример, который взят из документации PHP-DI. В нем логика отправки сообщения отделена от логики регистрации пользователя:

class Mailer

{

public function mail($recipient, $content)

{

// Send an email to the recipient

// ...

}

}class UserManager

{

private $mailer;

public function __construct(Mailer $mailer)

{

$this->mailer = $mailer;

}

public function register($email, $password)

{

// Create the user account

// ...

// Send the user an email to say hello!

$this->mailer->mail($email, 'Hello and welcome!');

}

}use Illuminate\Container\Container;

$container = Container::getInstance();

$userManager = $container->make(UserManager::class);

$userManager->register('dave@davejamesmiller.com', 'MySuperSecurePassword!');Связывание интерфейса и реализации

Для начала определим интерфейсы:

interface MyInterface { /* ... */ }

interface AnotherInterface { /* ... */ }Затем создадим классы, реализующие эти интерфейсы. Они могут зависеть от других интерфейсов (или других классов, как это было ранее):

class MyClass implements MyInterface

{

private $dependency;

public function __construct(AnotherInterface $dependency)

{

$this->dependency = $dependency;

}

}Теперь свяжем интерфейсы с реализацией с помощью метода bind():

$container->bind(MyInterface::class, MyClass::class);

$container->bind(AnotherInterface::class, AnotherClass::class);И передадим название интерфейса вместо названия класса в метод make():

$instance = $container->make(MyInterface::class);Примечание: Если вы забудете привязать интерфейс к реализации, вы получите немного странную ошибку:

Fatal error: Uncaught ReflectionException: Class MyInterface does not existЭто происходит потому, что контейнер пытается создать экземпляр интерфейса (new MyInterface), который не является классом.

Реальный пример

Ниже представлен реальный пример связывания интерфейса с конкретной реализацией — изменяемый драйвер кеша:

interface Cache

{

public function get($key);

public function put($key, $value);

}class RedisCache implements Cache

{

public function get($key) { /* ... */ }

public function put($key, $value) { /* ... */ }

}class Worker

{

private $cache;

public function __construct(Cache $cache)

{

$this->cache = $cache;

}

public function result()

{

// Use the cache for something...

$result = $this->cache->get('worker');

if ($result === null) {

$result = do_something_slow();

$this->cache->put('worker', $result);

}

return $result;

}

}use Illuminate\Container\Container;

$container = Container::getInstance();

$container->bind(Cache::class, RedisCache::class);

$result = $container->make(Worker::class)->result();Связывание абстрактных и конкретных классов

Связывание может быть использовано и с абстрактным классом:

$container->bind(MyAbstract::class, MyConcreteClass::class);Или для замены класса его потомком (классом, который наследуется от него):

$container->bind(MySQLDatabase::class, CustomMySQLDatabase::class);Custom Bindings

Если объект при создании требует дополнительной настройки, вы можете передать замыкание вторым параметром в метод bind() вместо названия класса:

$container->bind(Database::class, function (Container $container) {

return new MySQLDatabase(MYSQL_HOST, MYSQL_PORT, MYSQL_USER, MYSQL_PASS);

});Каждый раз, когда будет запрашиваться класс Database, будет создан новый экземпляр MySQLDatabase с указанной конфигурацией (если нужно иметь только один экземпляр класса, используйте Singleton, о котором говорится ниже).

Замыкание получает в качестве первого параметра экземпляр класса Container, который может быть использован для создания других классов, если это необходимо:

$container->bind(Logger::class, function (Container $container) {

$filesystem = $container->make(Filesystem::class);

return new FileLogger($filesystem, 'logs/error.log');

});Замыкание также можно использовать для настройки класса после создания:

$container->bind(GitHub\Client::class, function (Container $container) {

$client = new GitHub\Client;

$client->setEnterpriseUrl(GITHUB_HOST);

return $client;

});Resolving Callbacks

Вместо того, чтобы полностью перезаписывать биндинг, мы может использовать метод resolving() для регистрации коллбеков, которые будут вызваны после создания требуемого объекта:

$container->resolving(GitHub\Client::class, function ($client, Container $container) {

$client->setEnterpriseUrl(GITHUB_HOST);

});Если было зарегистрировано несколько коллбеков, все они будут вызваны. Это также работает для интерфейсов и абстрактных классов:

$container->resolving(Logger::class, function (Logger $logger) {

$logger->setLevel('debug');

});

$container->resolving(FileLogger::class, function (FileLogger $logger) {

$logger->setFilename('logs/debug.log');

});

$container->bind(Logger::class, FileLogger::class);

$logger = $container->make(Logger::class);Также есть возможность регистрации коллбека, который будет вызываться при создании любого класса (это может быть полезно для логгирования или при отладке):

$container->resolving(function ($object, Container $container) {

// ...

});Расширение класса

Вы также можете использовать метод extend() для того, чтобы обернуть оригинальный класс и вернуть другой объект:

$container->extend(APIClient::class, function ($client, Container $container) {

return new APIClientDecorator($client);

});Класс возвращаемого объекта должен реализовывать тот же интерфейс, что и класс оборачиваемого объекта, иначе вы получите ошибку.

Singleton

Каждый раз, когда возникает необходимость в каком либо классе (если указано имя класса или биндинга, созданного с помощью метода bind()), создается новый экземпляр требуемого класса (или вызывается замыкание). Для того, чтобы иметь только один экземпляр класса необходимо вызвать метод singleton() вместо метода bind():

$container->singleton(Cache::class, RedisCache::class);Пример с замыканием:

$container->singleton(Database::class, function (Container $container) {

return new MySQLDatabase('localhost', 'testdb', 'user', 'pass');

});Для того, чтобы получить синглтон из класса, необходимо передать его, опустив второй параметр:

$container->singleton(MySQLDatabase::class);Экземпляр синглтона будет создан только один раз, в дальнейшем будет использоваться тот же самый объект.

Если у вас уже есть сущность, которую вы хотите переиспользовать, то используйте метод instance(). Например, Laravel использует это для того, чтобы у класса Container был только один экземпляр:

$container->instance(Container::class, $container);Произвольное название биндинга

При биндинге вы можете использовать произвольную строку вместо названия класса или интерфейса, однако вы уже не сможете использовать type hinting и должны будете использовать метод make():

$container->bind('database', MySQLDatabase::class);

$db = $container->make('database');Для того, чтобы одновременно иметь название класса и короткое имя, вы можете использовать метод alias():

$container->singleton(Cache::class, RedisCache::class);

$container->alias(Cache::class, 'cache');

$cache1 = $container->make(Cache::class);

$cache2 = $container->make('cache');

assert($cache1 === $cache2);Сохранение произвольного значения

Контейнер позволяет хранить и произвольные значения (например, данные конфигурации):

$container->instance('database.name', 'testdb');

$db_name = $container->make('database.name');Также поддерживается array-access синтаксис, который выглядит более привычно:

$container['database.name'] = 'testdb';

$db_name = $container['database.name'];Это может быть полезно при использовании его с биндингом-замыканием:

$container->singleton('database', function (Container $container) {

return new MySQLDatabase(

$container['database.host'],

$container['database.name'],

$container['database.user'],

$container['database.pass']

);

});(Сам Laravel не использует контейнер для хранения конфигурации, для этого существует отдельный класс — Config, а вот PHP-DI так делает).

Совет: array-access синтаксис можно использовать для создания объектов вместо метода make():

$db = $container['database'];Dependency Injection для функций и методов

До сих пор мы использовали DI только для конструкторов, но Laravel также поддерживает DI для произвольных функций:

function do_something(Cache $cache) { /* ... */ }

$result = $container->call('do_something');Дополнительные параметры могут быть переданы как простой или ассоциативный массив:

function show_product(Cache $cache, $id, $tab = 'details') { /* ... */ }

// show_product($cache, 1)

$container->call('show_product', [1]);

$container->call('show_product', ['id' => 1]);

// show_product($cache, 1, 'spec')

$container->call('show_product', [1, 'spec']);

$container->call('show_product', ['id' => 1, 'tab' => 'spec']);DI может использован для любых вызываемых методов:

Замыкания

$closure = function (Cache $cache) { /* ... */ };

$container->call($closure);Статичные методы

class SomeClass

{

public static function staticMethod(Cache $cache) { /* ... */ }

}$container->call(['SomeClass', 'staticMethod']);

// or:

$container->call('SomeClass::staticMethod');Методы объекта

class PostController

{

public function index(Cache $cache) { /* ... */ }

public function show(Cache $cache, $id) { /* ... */ }

}$controller = $container->make(PostController::class);

$container->call([$controller, 'index']);

$container->call([$controller, 'show'], ['id' => 1]);Сокращения для вызова методов объекта

Container позволяет использовать сокращение вида ClassName@methodName для создания объекта и вызова его метода. Пример:

$container->call('PostController@index');

$container->call('PostController@show', ['id' => 4]);Контейнер используется для создания экземпляра класса, т.е.:

- Зависимости передаются в конструктор класса, а также в вызываемый метод

- Вы можете объявить класс как синглтон, если хотите переиспользовать один и тот же объект

- Вы можете использовать интерфейс или произвольное имя вместо названия класса

Пример ниже будет работать:

class PostController

{

public function __construct(Request $request) { /* ... */ }

public function index(Cache $cache) { /* ... */ }

}$container->singleton('post', PostController::class);

$container->call('post@index');Наконец, вы можете передать название "метода по умолчанию" в качестве третьего параметра. Если первым параметром передано название класса и не указано название метода, будет вызвать метод по умолчанию. Laravel использует это в обработчиках событий:

$container->call(MyEventHandler::class, $parameters, 'handle');

// Equivalent to:

$container->call('MyEventHandler@handle', $parameters);Подмена методов объекта

Метод bindMethod() позволяет переопределить вызов метода, например, для передачи параметров:

$container->bindMethod('PostController@index', function ($controller, $container) {

$posts = get_posts(...);

return $controller->index($posts);

});Все примеры ниже будут работать, при этом будет вызвано замыкание вместо настоящего метода:

$container->call('PostController@index');

$container->call('PostController', [], 'index');

$container->call([new PostController, 'index']);Однако любы дополнительные параметры, переданные в метод call(), не будут переданы в замыкание и они не могут быть использованы:

$container->call('PostController@index', ['Not used :-(']);Примечания: метод wrap() не является частью интерфейса Container, он есть только в классе Container. См. [Pull Request(https://github.com/laravel/framework/pull/16800), в котором объясняется, почему параметры не передаются при переопределении.

Биндинг на основе контекста

Может случиться так, что вы захотите иметь разные реализации одного интерфейса в зависимости от места, где он необходим. Ниже показан немного измененный пример из документации Laravel:

$container

->when(PhotoController::class)

->needs(Filesystem::class)

->give(LocalFilesystem::class);

$container

->when(VideoController::class)

->needs(Filesystem::class)