Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

От b2b-приложений к массовому сервису по всему миру |

Привет, Хабр! Меня зовут Евгений Лисовский, я руковожу проектом MAPS.ME — это международный проект, интересный и очень амбициозный. Наша задача — конкурировать с Google, Apple и несколькими компаниями второго эшелона. Сегодня я кратко расскажу о своём трудовом пути, чтобы затем подробнее остановиться на самых интересных этапах.

До института я подрабатывал, собирал компьютеры на заказ. А свой компьютер у меня появился в 1995 году, в 13 лет — спасибо родителям, это было реально очень круто. В институте я начал сам изучать PHP, MySQL, соорудил собственный движок для интернет-магазина. Сделал три сайта, брал по 300 долларов за каждый. С 2004 года я работал в международной компании Radmin.com, которая создаёт b2b-продукт для удалённого управления компьютерами, там я провёл шесть лет. Потом ломанулся в стартапы: KupiBonus, детские товары BabyBoom. Там было интересно! Важны не только успешные проекты, но и фейлы: надо хорошо анализировать, почему они происходили. Потом был Litres. Очень интересный бизнес — продавать электронные книги при уровне пиратства 96 %. В 2015 году мы заработали 15 млн долларов, с 2011 года выручка выросла в 18 раз. Затем я вместе с партнерами запустил собственный проект MoikaMoika.ru. Не то чтобы основатели сразу стали миллионерами, но это интересный опыт. Проект жив и развивается. А дальше про всё это — более подробно.

Институт

Я писал на С++ программную часть дипломной работы, а мой партнёр делал аппаратную часть. По сути, печатную плату. Прибор был очень простой: снимал ЭКГ с трёх отведений — правой руки, левой руки, левой ноги — и формировал электрокардиограмму. Она снималась простым аналого-цифровым преобразователем, плюс частотный модулятор на звуковой частоте, и передавалась через звуковую плату компьютера. Поскольку звуковая карта есть во всех компьютерах, то это самый простой способ ввести данные в цифровом виде. Потом я программно снимал огибающую, которая и представляет собой ЭКГ. По высоте зубцов и расстоянию между ними можно определить разные типы заболеваний, отметить определённые паттерны, сравнить их с базой и сделать вывод о диагнозе.

Это было ещё в 2004 году. Тогда я понимал, что наш прибор может стать массовым продуктом, но был я слишком зелен и юн. Главная моя проблема в прошлом — неуверенность в своих силах. Мне казалось, что мир такой большой, вокруг такие взрослые дяди, они зарабатывают деньги, а я ещё такой глупый, маленький и ничего не умею. Это ключевая сложность. Крайне важно перебороть страх. Когда вы делаете что-то новое, вам всегда кажется, что задача неподъёмна. А потом проходит месяц-два, вы оборачиваетесь и понимаете: блин, чего я вообще боялся? Всё нормально, в этом нет ничего сложного. На протяжении всей своей карьеры я боролся со страхом. А ещё очень важно уметь признавать свои ошибки и исправлять их.

Первая компания

После института я начал искать работу веб-программистом, программистом на PHP, MySQL или сисадмином. Для последней должности навыков не хватало, я даже собеседовался в Лабораторию Касперского, но это оказалось очень сложно. Да и с PHP-программированием было не особо. Я пришёл, а мне говорят: вот блокнот, напиши нам плагинатор. И ты думаешь: зачем блокнот, когда есть DreamWeaver, в котором все теги подсвечиваются.

Потом меня пригласили в софтверную международную компанию Radmin интернет-маркетологом. У меня был свободный английский. Погоняли всякие IQ-тесты, позадавали вопросы, я на всё ответил, и мой будущий руководитель говорит: «Я вижу, что ты нормальный парень, но слишком молодой. Если сразу во всё быстро вникнешь и за шесть дней вольёшься в работу, то мы тебя берём. Ты маркетингом занимался?» Я думаю: сайты делал, SEO делал — ну конечно, маркетинг — это моё вообще, любимое. Он: «Google Adwords знаешь?» А я в контекстной рекламе — вообще ни в зуб ногой. Но мне деньги были очень нужны, у меня только сын родился. Говорю: «Ну конечно!»

Так я и устроился на работу. Мне повезло. Этот опыт дал мне, инженеру, огромный профит. Мне стало очень легко общаться с разработчиками. Знаете, есть классическое противостояние между разработчиками и маркетологами. Приходит маркетолог, говорит: сделай мне такую красивую красную кнопку, чтобы всё хорошо работало. А инженеры отвечают: да иди ты куда подальше… И всё, начинается обособление. А когда ты приходишь и говоришь: чувак, всё нормально, я тоже кодил на С++, то IT-директор сразу выдыхает с облегчением. И становится гораздо проще общаться. Ведь практически все современные IT-проекты — это симбиоз разработки и маркетинга продукта, они неотделимы друг от друга. И когда их искусственно разделяют, то получается не очень хорошая ситуация.

В этой компании я работал с контекстной рекламой ещё в 2004 году, когда в России было очень мало интернет-маркетологов. Очень интересный опыт. Я ездил по разным международным конференциям, где уже тогда обсуждалось тестирование лендинговых страниц. В США и Европе А/В-тестирование, оптимизация конверсий и прочие методики были отработаны на высшем уровне. До нас это докатывалось с задержкой примерно в пять лет.

Я не могу сказать, что сделал много за время работы в Radmin. Уйдя в стартап KupiBonus — купонный проект, — я за полгода сделал больше, чем за шесть лет в предыдущей компании. Возможно, динамика жизни в интернете была немного ниже или я боролся с собой: мне казалось, что пора уходить, но я оставался, потому что это хорошая надёжная компания. Я думал: приду на позицию интернет-маркетолога, дорасту до маркетинг-директора — и вот оно, счастье. На самом деле счастье — это достижение целей в создании каких-либо продуктов.

В кризисный 2009 год мне удалось перепозиционировать продукт. Я объездил всю Россию, все федеральные округи, провёл большую работу с продажниками, которые потом распространили нашу систему оптимизации бизнес-процессов по всей стране. И в итоге в кризисный год получилось поднять выручку в России на 30 %.

Какие выводы я сделал для себя, поработав в софтверной компании? Я хотел поменять команду. Я понял, что когда веб-мастер сидит и при мне в буквальном смысле спит, то это беда. Я пытался искать какие-то системы управления проектами, проанализировал кучу разных вариантов. Думал, что если внедрю нормальную систему, то всё сразу заиграет яркими красками. Но на самом деле проблема была в людях. Надо изначально нанимать правильных людей.

Первые стартапы

Мне захотелось создать свою команду с нуля. Уйдя в стартап, я пришёл в готовую команду. Это тоже оказалось проблемой, потому что людей нанимал не я. У нас не было взаимного доверия, приходилось налаживать отношения, а это достаточно сложно. В купонном бизнесе мой рабочий день начинался с шоколадки и чашки кофе в восемь утра, а заканчивался в одиннадцать вечера. Был даже период (конец 2010 года), когда мы работали по 15 часов в сутки. Это очень динамичный бизнес. Топ-менеджмент у нас была сильный, а ребята в моей команде — слабоваты. В итоге многое приходилось делать самому.

Мне говорили: Женя, ты хреновый менеджер, взял всё на себя, ты должен делегировать. И я понимал, что это так. Я не пытался обмануть себя, работал над собой, но всё равно продолжал делать сам, потому что не мог зафакапить проект.

Было очень приятно, когда президент компании, француз, бывший (до 1998 года) владелец OZON.ru подходил и говорил: Евгений, маркетинг — это ключевое. Это так. Я не мог заснуть ночью, пока не придумывал, как бы выполнить план. А план у нас был конский. Я пришёл из компании с бюджетом в 100 тыс. долларов в год в купонный бизнес с бюджетом 200 тыс. евро в месяц. И нам крайне не хватало лидов.

Затем был проект BabyBoom — классический ретейл. Мой совет: не работайте с неподходящими людьми, увольняйте слабых, нанимайте сильных. Например, в BabyBoom и Litres я собирал команды с нуля и зачастую делал выбор в пользу, может, не самого опытного человека, но готового быстро обучаться. В маркетинге нет ничего суперсложного, всё можно освоить за месяц, если нормально подойти к процессу. В итоге гораздо проще выучить людей, чем нанять очень опытных и дорогих. Также у меня был пунктик, чтобы это была именно моя команда.

Но тут есть одна проблема. Boss Cap — Friend Cap. Это то, чему я научился в BabyBoom, стартапе по продаже детских товаров. Сначала мы подняли 1 млн долларов инвестиций, начали увеличивать оборот, выросли в пять раз. Но логистика в детских товарах очень сложная: часто встречаются крупногабаритные товары. Хотя средний чек достаточно большой, маржинальность доходила до 30 %, однако крупногабаритные товары просто убивали бизнес-модель. Логистика сжирала всю маржу. Добавьте сюда далеко не полную информацию об остатках на складе. К сожалению, у нас не получилось закрыть второй раунд инвестиций из-за слишком большого количества рисков. В итоге проект развалился, и я пошёл в Litres.

Growth Hacking

На протяжении всей своей карьеры я пытался искать хаки, нестандартные решения, которые позволяют превзойти конкурентов. Результат — это команда, хороший продукт, хороший маркетинг, хороший менеджмент, но без предпринимательских навыков ничего не получится. Нужно работать на опережение.

Что может привести к успеху? Интеллект, эрудиция, социальная адаптация, помноженные на предпринимательские способности. Человек может быть интеллектуалом, но не особо эрудитом, но при этом иметь высокие способности в предпринимательстве и социальной адаптации. Социальная адаптация — это умение общаться, договариваться, строить взаимоотношения с людьми. Очень полезный навык. Постарайтесь развивать его в себе.

Команда — это основа успешности проекта. Ключевая компетенция руководителя — подбор сотрудников. Я сам искал людей, не прибегая к услугам кадровиков. Я тратил много времени, но оно того стоит. Как обычно я выбирал работников? Я смотрел в их добрые глаза и рассказывал о проекте. Представьте: 2011 год, электронные книги — кто их покупает? Это как продавать мороженое эскимосам. Я рассказывал, что в США электронные книги занимают уже 20 % всего книжного рынка, и сейчас мы будем круто расти. Если у собеседника расширяются глаза, он наливается румянцем — значит, правильный человек, ему это интересно.

Если ты будешь заниматься тем, что тебе нравится, то добьёшься большого результата, и это увидят все: руководство, акционеры. Работайте как собственник. Это очень интересная концепция. Я всегда действовал так, будто это мои деньги, и я их трачу. Я не останусь в проекте, который мне не нравится, но я всегда работаю так, будто это мой собственный проект. Это заметят, поверьте. Но не следуйте принципу «я наёмный работник и выше головы прыгать не буду, потому что больше мне не заплатят». Это неправильный подход, обязательно нужна самоотдача.

Представьте себе, например, строителя по найму. Он строит дома тяп-ляп и мечтает о собственном доме, когда будут деньги. И если он 20 лет работал по найму и строил как придётся, как вы думаете, сможет ли он собственный дом построить хорошо? Конечно же, нет. Невозможно стать предпринимателем, не работая по найму как предприниматель.

Будьте как Йода. Это прописные истины правильного руководителя в IT. Конечно, должны быть достижения. Если ты приходишь руководить командой, то очень тяжело завоевать авторитет. Нужна открытость. Если ребята понимают, что ты делал, знают о твоих достижениях, то у них не будет вопросов. Если есть достижения, тогда легко вольёшься. Также надо быть лидером и разбираться в IT. Тут мне очень хорошо помогает технический бэкграунд.

Во время работы приходится очень много анализировать. Если человек не умеет пользоваться Excel — скорее всего, у него несистемное мышление, а это значит, что мы не сработаемся. Я не требовал от людей технического образования, главное, чтобы кандидаты понимали базовые принципы. Один пример. В BabyBoom я нанял парня на партнёрские программы, заниматься женскими форумами. Я ему говорю: есть сотни сайтов, давай выберем самые крупные, отранжируем. Сделай мне табличку — и посмотрим, как будем дальше работать. Он пошёл думать, с утра приносит табличку. А в ячейках с рейтингом записаны не цифры 4/5, а «четыре из пяти баллов». Я говорю: а как ты автофильтр включишь? Это же просто символы, а не цифры. Но он меня даже не понял.

Моя ошибка: я недостаточно подробно его расспрашивал на собеседовании. После этого я всем кандидатам давал такое задание: «Представьте, что вы — менеджер партнерской программы в Litres. Существует 10 000 сайтов о книгах. Ваша задача — запартнёриться со всеми этими сайтами. Как вы будете действовать?» Мне важно оценить, как человек понимает бизнес-процессы. Мыслит ли он структурно: «Занесу в табличку, отсортирую по убыванию трафика, возьму топ-20, которые, скорее всего, будут генерировать 80 % трафика, и начну в первую очередь с ними работать». По сути, Excel и Google Docs Spreadsheets — это своеобразные CRM. У меня всё на них сделано и отработано на куче стартапов, никакая система управления проектами не нужна.

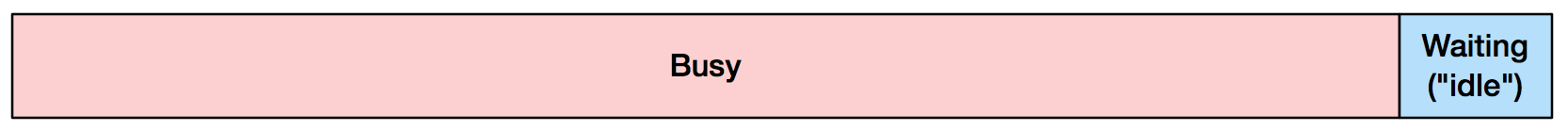

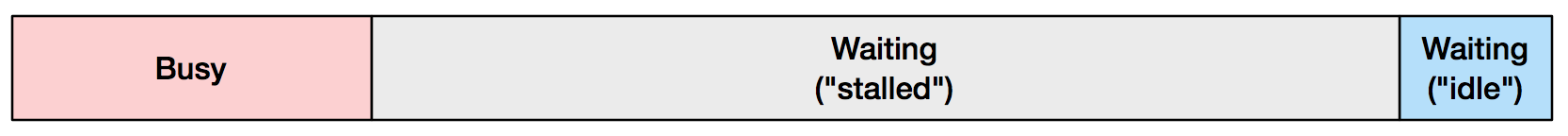

Создавая у себя в голове структуру команды и нанимая людей, я всегда давал им понять, где они могут оказаться. Например, кандидату, который пришёл на партнёрские программы, я сказал: «У меня есть план структуры компании на два года вперёд, и здесь есть позиция — руководитель партнёрских программ. Я ничего не гарантирую, но если ты будешь активно расти и развиваться, ты сможешь быть там». В итоге он действительно занял эту должность. И мне это очень приятно. Я люблю, когда сотрудники растут. Также я открыто объясняю, что карьера — это не безоблачный полёт, когда всё ровно и гладко, каждый может забуксовать. Но либо человек движется вперёд, либо мы расстаемся. Есть два состояния: падение и рост. Без вариантов.

О продукте

В 2011 году в Litres мы сделали мобильное приложение. Так себе, просто читалка. Ни закладок, ни заметок, ни синхронизации позиций — ничего, примитивная читалка с каталогом за деньги.

Понадобилось это как-то продвигать. У меня не было опыта в мобильном маркетинге, и я договорился о взаимном консалтинге с компанией Alawar Entertainment, с подразделением мобильных игр. Я консультировал их по классическому вебу, а они меня — по мобильному сегменту. Так я набрался знаний, и мы начали продвигать свою читалку. В 2012 году выручка выросла на 120 %. Тогда в России мало кто занимался мобильным маркетингом так же активно. Мы просто скупали кучу трафика. Как только в AdMob, впоследствии Facebook, появилась реклама, мы были одними из первых в России, кто начал её активно скупать.

Если бы мы в 2011 году решили сначала сделать суперклассный продукт с кучей возможностей и запустили бы его на год позже, то мы бы прозевали решающий 2012 год. Когда я пришёл в Litres, то один из моих знакомых вёл сделку с Dream Industries. Проект Bookmate. И в конце 2011 года эти ребята подняли 30 млн долларов. А у меня бюджет на маркетинг в 2012 году был 9 млн рублей. Как вы думаете, какие у меня появились мысли? А я проработал в Litres только месяц. Прибегаю к генеральному директору: «Серега, что делать?» — «Ну, работать».

Как мы работали? Как лошадям закрывают глаза шорами, чтобы они не видели, что происходит вокруг, так и мы просто понеслись вперёд. Прошёл год, оборачиваемся — а что-то и не видать никого сзади. Time to Market — вовремя сделанный продукт и хороший маркетинг решили судьбу проекта.

Само ничего не взлетит. Многие думают, что достаточно сделать превосходный продукт, выложить в App Store или Google Play, и оно попрёт как на дрожжах. Это уже давно не работает. Сейчас необходим системный отлаженный маркетинг, привлечение трафика с кучи разных каналов, анализ конверсий и когорт, внутренняя аналитика. Не надейтесь, что кнопочка «Рассказать друзьям» даст вам мощнейший виральный эффект.

Системный маркетинг

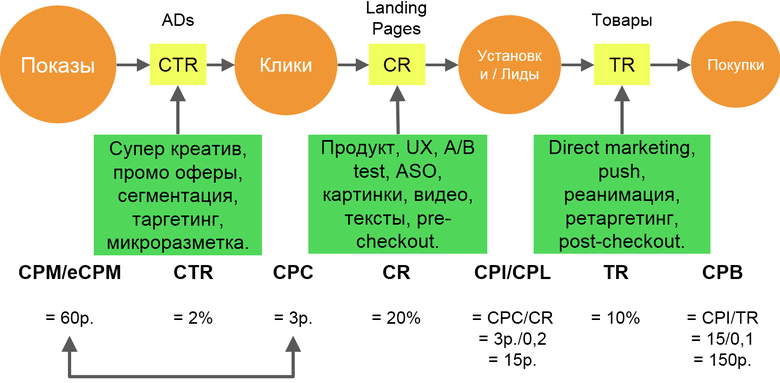

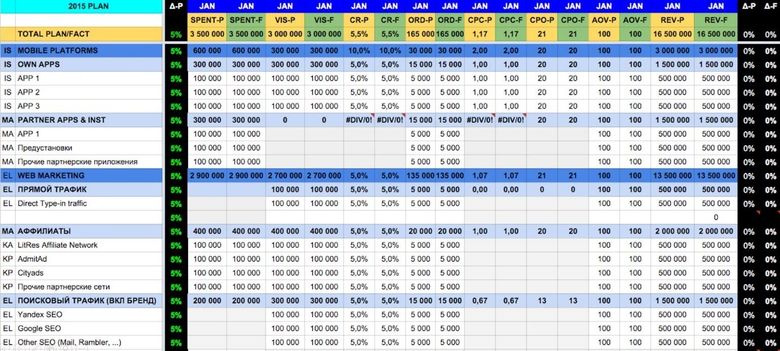

Здесь отображён базовый подход к маркетингу. Есть показы, клики, установки и т. д. Допустим, вы покупаете трафик на Facebook. Думаете, что если поставить CPI 50 центов, то Facebook принесёт вам кучу установок. Такого не будет, потому что Facebook берёт на себя все риски за плохой креатив, за плохой лендинг, за плохие описания, низкий рейтинг и т. д. Естественно, что при этом он будет завышать планку. Покажу на примере контекстной рекламы. Проводя собеседования на должности в маркетинге, я задавал простой вопрос: «Объясни, как работает контекстная реклама?» Кандидат говорит: «Вот, есть система ранжирования…» — «А зачем она нужна?» — «Чтобы рекламодатели нормально друг с другом, чтобы была честная сортировка…» Всё не так.

Представьте, что я — коммерческий директор Яндекс.Директа. Моя задача — увеличить выручку на тысячу показов с контекста. Каким KPI можно это выразить? И CPM, выручка на тысячу показов. Как его максимизировать? Алгоритм ранжирования в Яндекс.Директе — это формула, максимизирующая выручку на тысячу показов, и ничего более. Это не система, которая позволяет уравнять в правах рекламодателей. Это система, максимизирующая выручку. Там есть несколько факторов: CTR, CPC. Если у тебя высокий CTR, то на сторону рекламодателя идёт больше трафика, а значит, больше денег.

Есть ещё один — качество лендинговой страницы. Зачем он нужен? Здесь кандидаты вообще терялись и отвечали: «Чтобы людям было хорошо». На самом деле — для увеличения выручки lifetime value. Надо понимать, что тому, кто продаёт вам трафик, нужны деньги. И этот фактор позволяет контролировать уровень доверия к контекстной рекламе. Если пользователь по объявлению перейдёт на лендинг, где окажется совершенно другая информация, то он потеряет доверие к контекстной рекламе и в долгосрочной перспективе будет реже на неё кликать.

Напоследок приведу пример того, что мы делали в купонных системах. Это из разряда growth hacks, как можно хакнуть систему. Тогда на рынке была компания Darberry, потом её купил «Групон». У них было размещение на Mail.Ru Group за 300 тыс. рублей в день. Очень дорого, как мне тогда казалось. Такими бюджетами я управлял впервые. CTR был достаточно низкий, а стоимость за лид получалась 86 рублей, хотя по модели она была около 50. Дороговато, ещё и женская аудитория. Что делать? У меня был сотрудник, который отвечал за макеты баннеров. Он в шесть вечера часов заявляет, что ему пора бежать на учёбу. А мне до одиннадцати надо отправить макет. Я говорю: «У меня кампания стартует, а ты уходишь». — «Ну, сорян». Потом я его уволил, но в тот вечер пришлось сесть и подумать, как быть.

Я просто открыл Paint и нарисовал баннер, написал на белом фоне «–90 %», максимально растянув на весь экран, без окантовки. Не знаю, как тогда это пропустили. Позже, кстати, запретили делать баннеры без окантовки и сделали заливку градиентом. Но тогда это прокатило. Я отправил. Есть книга Стива Круга «Don’t make me think». Надо всё упрощать — чем проще, тем лучше. Благодаря этому примитивному баннеру CTR вырос более чем в восемь раз. Естественно, конверсия в регистрацию упала, но на выходе я всё равно получил стоимость за лид в 34 рубля.

Правда, потом к нам пришла юридическая служба Mail.Ru Group и сказала, что у вас тут написано «–90 %», а на сайте такой акции нет. Действительно, не было. Потом мы начали подбирать акции под такие большие размещения.

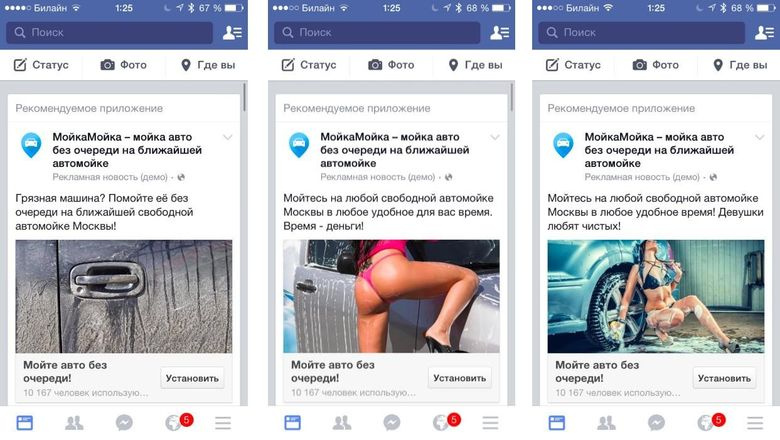

Свой стартап

В 2014 году мы с партнёрами решили запустить стартап MoikaMoika. Это запись на мойку без очереди. И звучит неплохо, и рынок приличный. Действительно, есть такая проблема — очереди на мойку. Здесь существует определённая сезонность, но мы рассчитали бизнес-модель, всё прикинули. В 2014 году начали разработку, в феврале 2015-го выпустили на iOS и Android и взялись за маркетинг. Я придумывал всевозможные креативы. Потом, кстати, их блокировали, но какое-то время они работали.

Вот пример того, что если поработать над креативом, над CTR, эффективностью, если сделать биндинг по CPI, то результат будет гораздо хуже.

Начальный капитал стартапа — примерно по 300 тыс. с каждого из основателей. Пример расчёта бизнес-модели MoikaMoika с когортами, конверсиями, примерным подходом:

MAPS.ME

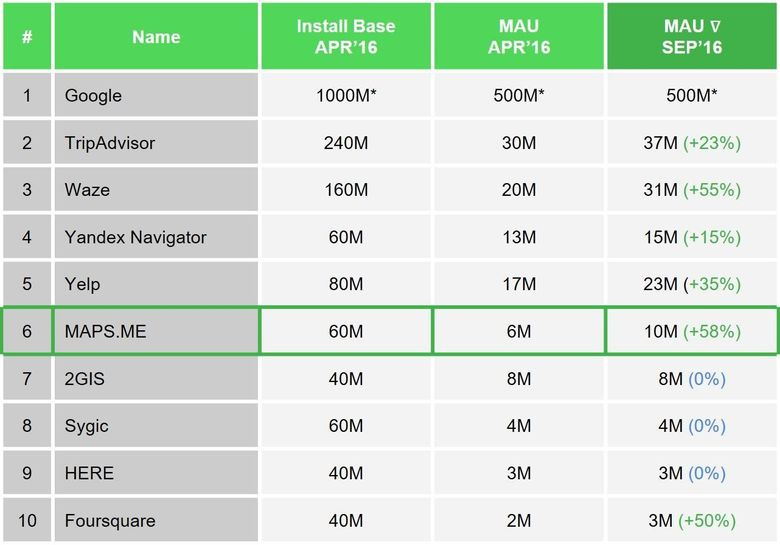

Что касается MAPS.ME, то сегодня проект где-то на шестом месте в мире по размеру аудитории, при этом мы не пытаемся быть Google Maps, у нас своя ниша и свои пользователи. Сейчас мы — карты для путешественников: лёгкие, быстрые и надёжные, созданные для работы без интернета. В этом сегменте мы лидеры, поскольку основная масса навигаторов «старой гвардии» вообще не рассчитана на пешеходную навигацию, а туристов, передвигающихся без автомобиля, — около 70 %. По оценкам Google, 40 % путешественников предпочитают использовать офлайн-карты.

Именно за этот сегмент рынка мы боремся. В год в мире порядка 1,3 млрд путешественников, нам их вполне достаточно :) Однако перед нами стоит задача бороться также за ежедневное использование MAPS.ME, для чего мы активно работаем над функционалом, который позволит лучше удерживать аудиторию. К примеру, в декабре 2016 года мы запустили пробки по 38 странам мира, что позволило поднять уровень дневной аудитории среди автомобилистов и конвертировать пользователей из туристического сценария использования в ежедневный. При этом мы внедряем в весь добавляемый функционал простоту и надёжность: пробки эффективно сжимаются и потребляют в четыре раза меньше мобильного трафика, чем приложения конкурентов, что позволяет использовать нашу навигацию с пробками даже в роуминге. Также весь функционал — поиск, авто-, вело- и пешая навигация, закладки, заметки — работает без интернета. Это не значит, что наши пользователи вообще обходятся без него: по нашей статистике, более 80 % подключаются к интернету в течение дня, что позволяет нам зарабатывать на партнёрских программах с туристическими гигантами вроде Booking.com, с которыми мы за полгода вошли в топ-10 партнёров по объёму бронирований. Интеграция Booking.com для нас — это не только возможность заработать, но и востребованный функционал поиска отелей на карте. Он весьма удобен, если вам важно видеть, где находится отель и как далеко он расположен от транспортных узлов и основных достопримечательностей.

У нас много планов по развитию, сформированных на базе опросов пользователей и бэклогов от нашей службы клиентской поддержки, но все задачи приоритезируются по простому принципу: по вкладу в удержание аудитории, в монетизацию, в привлечение аудитории и по сложности разработки. Это позволяет достигать быстрых побед и двигаться в развитии поступательно, однако немалое внимание мы уделяем и долгосрочному (на три года) стратегическому функционалу.

Если коротко говорить о нашей долгосрочной стратегии, то в рамках туристического сегмента стоит задача расширить применение MAPS.ME, превратить его из инструмента «добраться из точки А в точку В» в полноценный помощник путешественника. Поэтому мы планируем добавлять функционал, востребованный среди туристов: UGC (user-generated content) — рейтинги, отзывы, чтобы туристу было легче выбрать ресторан или любое другое заведение; поиск интересных мест; покупку билетов в музеи и на различные местные активности. Мы убеждены, что карта — это инструмент базовой регулярной потребности, вокруг которого можно надстраивать дополнительный комплементарный функционал, расширяющий сценарии туристического использования. При этом востребованность офлайн-карт будет только расти, особенно в развивающихся странах, где мобильный интернет стоит дорого и имеет плохое покрытие.

В плане монетизации мы также верим в гиперлокальную рекламу, которая в последнее время набирает обороты, ведь малый и средний бизнес значительно ограничен в рекламных инструментах.

У нас сильная команда разработчиков и маркетологов и отлаженная система планирования бизнес-процессов и управления ими. Наш девиз: хорошему продукту — хороший маркетинг. Это позволяет достигать максимальной синергии для проактивного развития проекта и добиваться высоких результатов.

Полезные материалы

Я выложил все свои наработки в открытый доступ бесплатно для любого использования (некоммерческого/коммерческого): www.lisovskiy.ru/edu. Там есть шаблоны примеров расчёта бизнес-моделей в табличках, презентации. Есть подробный обучающий курс: в 2016 году я постарался собрать воедино весь свой практический опыт. Надеюсь, кому-то это пригодится и поможет в запуске новых проектов и развитии существующих.

|

Метки: author eugene-lisovskiy управление продуктом развитие стартапа карьера в it-индустрии блог компании mail.ru group mail.ru maps.me стартапы |

[Перевод - recovery mode ] Сперва сторифреймы, потом вайрфреймы |

В какой-то момент я решил, что буду начинать процесс создания дизайна не с вайрфреймов (и траты времени на перетаскивание серых квадратиков и текстовых блоков по экрану) и даже не с набросков на бумаге с той степенью детализации, которую считаю приемлемой, а с того, что впоследствии назвал сторифреймами — документа, который представляет собой что-то среднее между сценарием/текстом и вайрфреймом.

Какие программы я для этого использую?

Текстовый редактор.

Google Doc. Или Microsoft Word. Или Apple TextEdit. Любой сойдет.

Эта техника работает особенно хорошо для лэндингов, домашних страниц или вебсайтов с длинной прокруткой, которые нацелены на то, чтобы рассказать связную, целостную историю. И если уж начистоту, именно такие страницы набирают популярность в последнее время.

Главный вопрос, который я задаю себе, прежде чем открыть текстовый редактор и «написать» страницу — это «Как бы я объяснил другу в письме или личной беседе, что представляет собой эта идея/тема/продукт/история, которую я пытаюсь донести?».

Интерфейс — это история

Вспомните лучшие продукты и сервисы на рынке и те истории, которые пытаются нам поведать их веб-сайты. Кто-то не пожалел времени на наполнение, проектирование и верстку этих страниц, чтобы вы, как посетитель, могли легко и бегло считать посыл, выраженный человеческим языком.

Практически любая веб-страница в Сети пытается рассказать нам какую-то историю.

- Домашняя страница Dropbox рассказывает, что это сервис, как он появился и какое место может занимать в вашей жизни.

- Домашняя страница NY Times рассказывает, что происходит в мире с точки зрения редакции.

- Домашняя страница AirBNB рассказывает о компании и приводит примеры услуг, которые она предлагает.

Для таких историй хорошо подходит текстовый формат. Избавившись от визуальной мишуры, вы сможете лучше сосредоточиться на сути того посыла, который хотите выразить. А текстовые редакторы — отличный инструмент для этой цели: простые, аккуратные и адаптированы под большую девайсов, которыми постоянно пользуются дизайнеры — от компьютеров и планшетов до мобильных телефонов.

Если делать скачок из брифа прямиком в дизайнерскую программу, которой вы отдаете предпочтение (Sketch, Photoshop, InDesign, Axure, Principle, неважно), скорее всего, вы в итоге потратите много усилий на то, чтобы отполировать форму при том, что история еще не готова.

Даже если вы набили руку в работе с этой программой и делаете малодостоверные вайрфреймы, все равно на определение формы уйдет какое-то количество интеллектуального трафика (и лишнего времени), который стоило бы потратить то, чтобы в общих чертах определить, что вы хотите сказать. Работая в графических редакторах или просто рисуя ручкой на бумаге, вы обдумываете решения, связанные с дизайном (две или три колонки?), хотя даже еще не знаете точно, нужна ли вообще эта часть истории на странице.

Каждый интерфейс — это история, а каждый дизайнер — рассказчик, что бы он ни проектировал: дизайн лэндинга, концепцию продукта, окно регистрации или диалог чатбота.

Разумеется, история не может заменить форму, но она определено на нее влияет и зачастую предшествует ей. Кто-то из дизайнеров, возможно, возразит, что работа над дизайном может помочь с выстраиванием истории и что эти два аспекта должны образовывать симбиоз, подпитывая друг друга. Так и есть. Но в этой статье речь идет о том, с чего лучше начинать, и предлагаемая техника, по моему опыту за последние годы, работает хорошо. Не сомневаюсь, что у других дизайнеров есть свои хитрости.

Пример сторифрейма

Сторифрейм выглядит как блок текста, в котором основное внимание уделяется иерархии и структуре страницы; это не макет и не финальная версия текстового наполнения. В качестве небольшого примера: вот как выглядит домашняя страница Dropbox в формате сторифрейма:

Вот несколько лучших практик, которые вы можете применить при создании истории для своей страницы:

1. Для начала запишите все.

Серьезно, первый шаг — выплеснуть все свои идеи и соображения на чистый лист текстового редактора. Рассматривайте каждый абзац как отдельный модуль, а каждое предложение — как элемент вашего будущего дизайна. Это упражнение — запись всего, что только можно сказать о продукте — поможет вам собраться с мыслями, прежде чем вы начнете определяться, каким пунктам отдать приоритет.

Я всегда возвращаюсь к исходному вопросу, который приводил выше: «Как бы я объяснил другу в письме или личной беседе, что представляет собой эта идея/тема/продукт/история, которую я пытаюсь донести?».

Обычно на этот упражнение уходит минут 15 и пол-кружки кофе.

2. Будьте лаконичны.

Теперь, когда вы все собрали в один текстовый документ, пришло время урезать длину вашей истории. Так как вы входите в команду, которая разрабатывала продукт, скорее всего вы слишком много знаете о том, как он работает, и не устоите перед соблазном углубиться в частности.

«Я написал бы короче, но у меня не было времени». — Марк Твен

Отвлекитесь немного, сделайте глубокий вдох и только после этого возвращайтесь к тексту, чтобы выделить именно то, что пользователям необходимо знать о продукте. Задумайтесь о контексте: как они попадают на вашу страницу? Что им уже известно о продукте на этом этапе и что еще нужно узнать, чтобы сделать следующий шаг?

3. Попробуйте разные истории.

Как только у вас будет готов первый черновик, сделайте несколько копий документа и начинайте играть со структурой: как можно переставить элементы, чтобы получить другие истории, какие из вариантов звучат более естественно и приятно для человеческого уха? В этом упражнении вы также можете переставлять местами абзацы или снова вводить те фрагменты текста, которые выбросили на предыдущем этапе.

4. Покажите другим.

Прелесть (и, в общем-то, весь смысл) прописывания истории прежде, чем начнется работа над вайрфреймами, в том, что это позволяет с легкостью показывать ее другим командам, получать от них фидбэк и собирать предложения. Только убедитесь, что они понимают: это не финальный текст, а синтезированная версия структуры страницы.

И только после этого можно переходить к вайрфреймам и визуальным мокапам.

В конечном итоге, в каком виде вы и ваша команда ни решили бы реализовать каждый из модулей, история сайта в целом остается неизменной — ведь вы задали расположение базовых информационных блоков с самого начала.

Сторифреймы: предельно низкая достоверность

Чем нравятся в сторифреймы (они же «структуры страниц» они же «сценарии сайтов») — они в конечном счете экономят мне массу времени. Можно принимать достаточно фундаментальные решения касательно стратегии, потоков задач, нарратива, не тратя время на лишние подробности.

Когда история намечена и вы в достаточной степени определили общую схему расположения, чтобы перейти на следующий этап, можно задаться более конкретными вопросами относительно дизайна страницы:

- В каком виде лучше отобразить эту информацию?

- Какие части текста можно объединить в один модуль?

- В каких частях истории текст можно заменить за изображение, видео или короткую анимацию?

- Для каких частей текст следует дополнить вышеперечисленными материалами?

- Какие конкретные факты вы приведете в качестве доказательства тех или иных утверждений?

- Каких действий вы ждете от посетителей, после того как они ознакомятся с историей, которую рассказывает ваш вебсайт?

|

Метки: author elder_cat прототипирование веб-дизайн блог компании everyday tools дизайн сайтов дизайн лендингов вайрфреймы мокапы |

11 вопросов к администраторам баз данных PostgreSQL |

В перерывах между докладами, в кулуарах конференции PG Day’16 мы буквально на пару минут отвоевали внимание опытных администраторов и задали вопросы о том, что они думают о своей профессии, какие досадные ошибки они допустили в работе и какие советы дали бы новичкам. Антон Бушмелев, Александр Чистяков, Дмитрий Васильев, Михаил Тюрин и Брюс Момжан вспомнили истории на старте своей карьеры и рассказали, сколь тернист оказался их путь.

Кто такой администратор баз данных, и чем он отличается от других «айтишников»?

Александр Чистяков: Администратор баз данных – это человек, который умеет читать план запросов. В основном, этим он и отличается от других айтишников. На самом деле, человек, который умеет читать план запроса, немного печален, потому что он хотел бы, чтобы другие айтишники тоже так могли, но они такого не могут. Он пытается их сподвигнуть на это, но они не хотят. Возникает некий конфликт. Человек, который не хочет быть тем, кем он является, но вынужден.

Александр Чистяков: Администратор баз данных – это человек, который умеет читать план запросов. В основном, этим он и отличается от других айтишников. На самом деле, человек, который умеет читать план запроса, немного печален, потому что он хотел бы, чтобы другие айтишники тоже так могли, но они такого не могут. Он пытается их сподвигнуть на это, но они не хотят. Возникает некий конфликт. Человек, который не хочет быть тем, кем он является, но вынужден. Антон Бушмелев: Администратор баз данных – эксперт в своем деле. Это должен быть человек с опытом. Желательно, с background в разработке, чтобы с ходу замечать косяки при “накате” релиза. Администратор должен быть самым квалифицированным человеком в команде. За ним большая ответственность, он один отвечает сразу за много баз. Чем отличается от остальных “айтишников”? Он должен быть фанатом своего дела, любить свою работу!

Антон Бушмелев: Администратор баз данных – эксперт в своем деле. Это должен быть человек с опытом. Желательно, с background в разработке, чтобы с ходу замечать косяки при “накате” релиза. Администратор должен быть самым квалифицированным человеком в команде. За ним большая ответственность, он один отвечает сразу за много баз. Чем отличается от остальных “айтишников”? Он должен быть фанатом своего дела, любить свою работу! Дмитрий Васильев: На инженере базы данных лежит максимальная ответственность не только за текущую работу приложений, но и за сохранность данных, в том числе исторических. Подчас, сердцем и кровеносной системой любого типового проекта является база данных. Нет ничего важнее сохранности данных, это очень большая нагрузка на человека.

Дмитрий Васильев: На инженере базы данных лежит максимальная ответственность не только за текущую работу приложений, но и за сохранность данных, в том числе исторических. Подчас, сердцем и кровеносной системой любого типового проекта является база данных. Нет ничего важнее сохранности данных, это очень большая нагрузка на человека.

Михаил Тюрин: Администратор баз данных отличается от других “айтишников” тем, что его сложно найти. Чрезвычайно редкий специалист. К нему повышенные требования. Большая редкость – найти человека, который одновременно понимает, что такое транзакция и bаsh-скрипт.

Брюс Момжан: Администратор работает с запросами, которые пишут разработчики приложений, и настраивает БД таким образом, чтобы производительность не падала, работа была надежной, вовремя происходили обновления. Он также устанавливает дополнительные пакеты, делает резервные копии и т.д. – есть множество задач на бэкенде, которые выполняет администратор баз данных, чтобы помочь разработчикам приложений. Этот человек отвечает за то, чтобы все таблицы были созданы, управляет правами пользователей, контролирует, как всё работает и следит за производительностью.

Брюс Момжан: Администратор работает с запросами, которые пишут разработчики приложений, и настраивает БД таким образом, чтобы производительность не падала, работа была надежной, вовремя происходили обновления. Он также устанавливает дополнительные пакеты, делает резервные копии и т.д. – есть множество задач на бэкенде, которые выполняет администратор баз данных, чтобы помочь разработчикам приложений. Этот человек отвечает за то, чтобы все таблицы были созданы, управляет правами пользователей, контролирует, как всё работает и следит за производительностью.Что главное в профессии?

Расскажите о самой своей досадной ошибке.

В 8 часов начались проблемы с блокировками, так как индексы по субпартициям все-таки оказались инвалидными, и банк стоял 2 часа. Минус 20% дали потом. После этого случая очень пристальное внимание уделяю мониторингу, чтобы все это отлавливалось. Ночью можно что-то забыть, а мониторинг работает постоянно.

Ошибкой также может быть недооценка масштаба катастрофы. То, что очевидно человеку с многолетним опытом работы с данными, может быть абсолютно неочевидно программисту, который переоценивает свои силы и навыки, с высоко поднятым флагом рвется что-то делать, если его вовремя не остановить.

Конкретные примеры ошибок – неинтересные вещи: забыл выключить логирование, забыл закрыть коннект, уехал в отпуск. Ты пятый день лежишь на пляже, и вдруг тебе звонят, что запрос перестал работать. Ты просишь показать stat_activity, а там висит транзакция, которую ты забыл закрыть перед тем, как уехал.

Что бы вы посоветовали тем, кто хочет заниматься базами данных и думает, не стать ли дба?

Нужно знать классические проблемы computer science. Мы их знаем, как минимум, три: инвалидация кеша, именование объектов и, третья проблема – это проблема потерянной единички. Вообще, основная проблема – все любят распределенную обработку, а в распределенных системах часто бывает так, что одно и тоже повторяется несколько раз.

Продолжение следует…

|

Метки: author rdruzyagin блог компании pg day'17 russia postgresql dba интервью interview |

Для ИТ-ишников. Если у вас устают глаза, покраснения, раздражение. Возможно эта статья для вас |

Я с 2004 года работаю в ИТ-сфере. Как и вы я провожу много времени за экраном монитора (даже двух). А если это релиз, дедлайн или срочный вопрос, то время работы за компьютером плавно перерастает в большую часть суток.

Недавно меня спросил один знакомый, как это все выдерживают мои глаза и зрение остается хорошим?! Я всегда отвечаю, что годы тренировок помогают. Думаете это сарказм? Только отчасти:) На самом деле это тренировки.

Далее я попрошу не читать тех, кто и так все знает и тех, кому не нравятся “не медицинские” термины :)

В далеком 2004 году, когда мы две недели работали без передышки перед презентацией проекта, на которую заказчик уже пригласил гостей, арендовал помещение ну и на над нами “сгустил краски”, у меня начали очень сильно пересыхать глаза. И в конце концов усилием постоянного растирания пальцами я получил сильнейшее раздражение. В итоге конъюнктивит и прочие неприятности. В общем финал проекта мне тогда дался с боем.

Не буду более досаждать вам историей, после я начал активно искать средства и правила, как правильно работать за компьютером. Правильная осанка, освещение, контрастность, яркость, температура цвета (теплая/холодная), … это все реально помогает. Но это не является секретным ингредиентом.

Настоящим решением проблемы стал видео ролик, который мне показал друг. К сожалению я не могу найти это видео сейчас. На видео мистер И.И., с суровой закалкой постсоветского ученого, рассказывал о строении глаза, о том как развивалась история медицины глаза и что мы имеем сейчас. И еще много всего интересного. А в конце он показал упражнения для глаз. Да И.И. утверждал, что глаза это мышца. И чтобы она всегда была в форме ее нужно “качать”.

Далее кому стало вовсе скучно прошу покинуть эту аудиторию :)

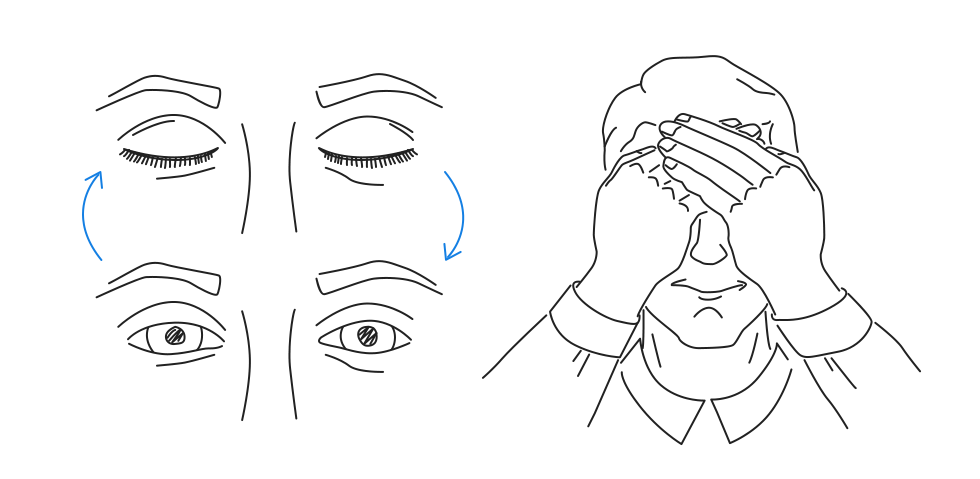

Это простые упражнения, которые занимают 3-5 мин. Вам понадобятся только чистые руки и спокойная обстановка.

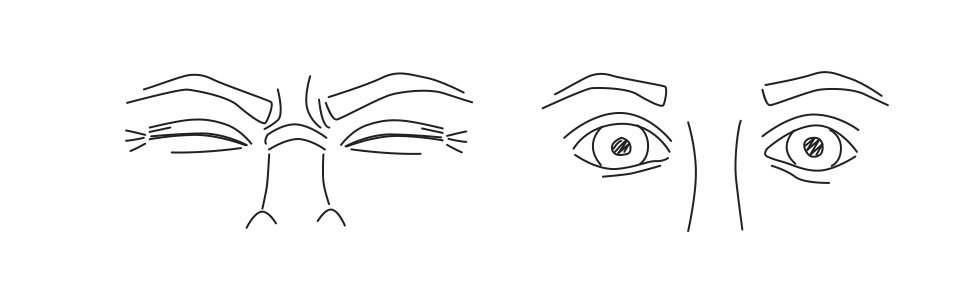

Подготовка

— Разотрите ваши ладошки до горяча.

— Затем накройте пальцы одной руки, пальцами второй, чтобы угол между “лодочками ладоней” был прямым.

— После, как “очки” наденьте на нос. Ладошки должны быть немного вогнутыми, чтобы при моргании вы не касались ресницами ладоней, но при этом так, чтобы свет не пробивался сквозь щели (можете делать в темноте).

— Все упражнения выполнять медленно и до приятной боли. Глаза держим открытыми.

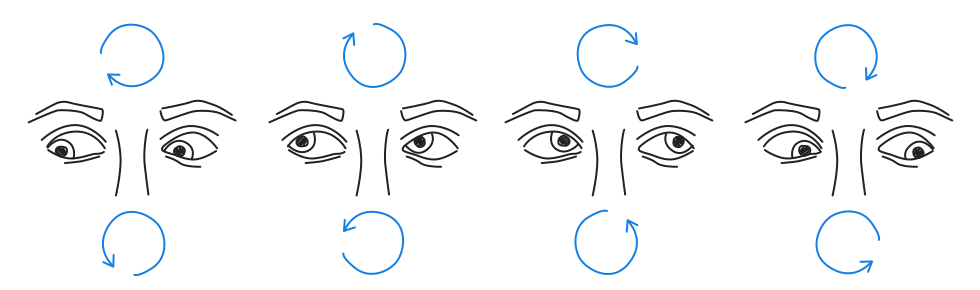

Упражнение 1

Далее смотрим до упора вправо, на вдохе возвращаем глаза к центру и на выдохе смотрим до упора влево. Посмотрим по 10 раз в каждую сторону

Упражнение 2

Далее смотрим до упора вверх, на вдохе возвращаем глаза к центру и на выдохе смотрим до упора вниз. Посмотрим по 10 раз в каждую сторону

Упражнение 3

Далее смотрим до упора в правый верхний угол по диагонали, на вдохе возвращаем глаза к центру и на выдохе смотрим до упора в нижний левый угол. Посмотрим по 10 раз в каждую сторону

Упражнение 4

Далее смотрим до упора в левый верхний угол по диагонали, на вдохе возвращаем глаза к центру и на выдохе смотрим до упора в нижний правый угол. Посмотрим по 10 раз в каждую сторону

Упражнение 5

Медленно очерчиваем глазами окружность, под максимально возможным углом. Так чтобы мы все время смотрели в крайнее положение. Повторяем по 5 раз в каждую сторону

Упражнение 6

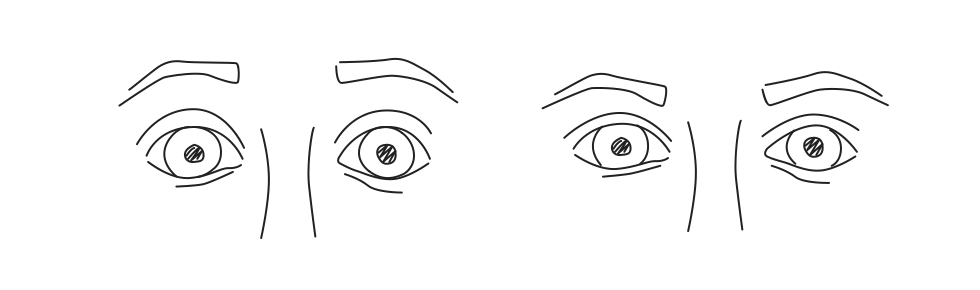

Аккуратно и на выдохе выпячиваем немного глаза. Повторяем 5 раз

Упражнение 7

Сильно сжимаем (как будто боимся чтобы туда ничего не попало) и разжимаем глаза. Повторяем 5 раз.

Упражнение 8

Быстро-быстро моргаем в течении 5-7 сек.

Завершение

Теперь немного поддержим руки на месте, глаза открытыми в течении 10-15 сек. Затем открываем глаза. Если все краски стали ярче, а света в помещении больше, то упражнение, вы сделали правильно. Пробуйте и пусть ваше зрение всегда будет отличным!

|

Метки: author abz_dn_ua читальный зал исследования и прогнозы в it зрение красные глаза для итшников как правильно сидеть как сохранить зрение |

Технологии платных скоростных дорог: настоящее и недалекое будущее |

«Классический» пункт взимания платы на обходе Воронежа — один из крупнейших в Европе

С момента публикации последней статьи на тему технологий платных дорог прошло более двух лет. За это время сеть платных дорог в РФ значительно увеличилась, появились и нашли применение новые технологии, наконец-то решились старые проблемы (и появились новые). А также был запущен мега-проект «Платон», о технологических нюансах которого можно выпустить целый цикл статей (про социальные нюансы скромно умолчим). Независимо от того, нравится нам идея платных дорог или нет, их автоматизация является очень интересной и специфической ИТ-задачей, находящейся на стыке различных дисциплин. Проектов в этой области будет становиться все больше, а людей с комплексным пониманием задачи, соответственно, все меньше. Поэтому, чтобы хоть немного исправить описанную плачевную ситуацию, давайте подведем итоги того, что уже наворочено в отрасли платных дорог в нашей стране, и посмотрим немного вперед, чтобы сориентироваться в технологиях, на которые делать ставку в ближайшие пару лет. Авось, пригодится.

Счастливого пути, или Шлагбаум в лобовуху

Промысел сбора денег за проезд по «классической» схеме с остановкой ТС у кабины (в зоне оплаты, как говорят специалисты) существует в нашей стране с 2007 года. На старте автоматизацией этого дела занимались сплошь иностранцы, но сегодня мы и сами кое-чему научились и даже «импортозаместили» некоторые компоненты. Базовые технологические моменты описаны в моей статье от 2012 года (ссылка) и с тех пор существенно не изменились.

На платных дорогах тариф зависит от класса ТС, определяемого по правилам ГК Автодор, которые в свое время были срисованы у французских консультантов. Правила выделяют 4 класса ТС: ТС высотой до 2 метров, ТС высотой от 2 до 2.6 метров, ТС выше 2.6 метров с двумя осями и ТС выше 2.6 метров с 3-мя и более осями. Как видите, в последних двух классах фигурируют оси, автоматический подсчет которых оказался непростой задачей в наших условиях. Дело в том, что в Европе для подсчета осей применяются оптические датчики, размещаемые у поверхности дороги. В совокупности с индуктивной петлей, которая чувствует наличие чего-то большого и железного наверху, эти датчики довольно эффективно считают оси. Но проблема заключается в том, что климат у нас такой, что одно межсезонье плавно переходит в другое, и все, что находится ниже 2-х метров, через пару часов может покрыться слоем воды и грязи (а на скоростных трассах грязь взлетает на все 10). Поэтому было принято решение считать оси с использованием видеокамер и софта машинного зрения, который сразу определял и габариты, и число осей. И тут возникли проблемы, свойственные уже системам машинного зрения: дождь, снег, зловещие тени, недостаточная освещенность, блики от фар — все это сбивает видеоклассификатор с толку. Сейчас уже никто не возьмется судить, что лучше — регулярно чистить оптические датчики или разгадывать ребусы шалящего в непогоду машинного зрения. Рассматривается и третий вариант с использованием альтернативных счетчиков осей на основе автономных магнитных датчиков в толще бетона или на основе недорогих лазерных сканеров (лидаров), подвешенных сбоку на высоте 2 метров. Для установки лидаров не нужно штробить бетон, они также отлично справляются с замерами габаритов, не боятся темноты и непогоды и могут стать полноценной заменой дорогостоящему оборудованию классификации.

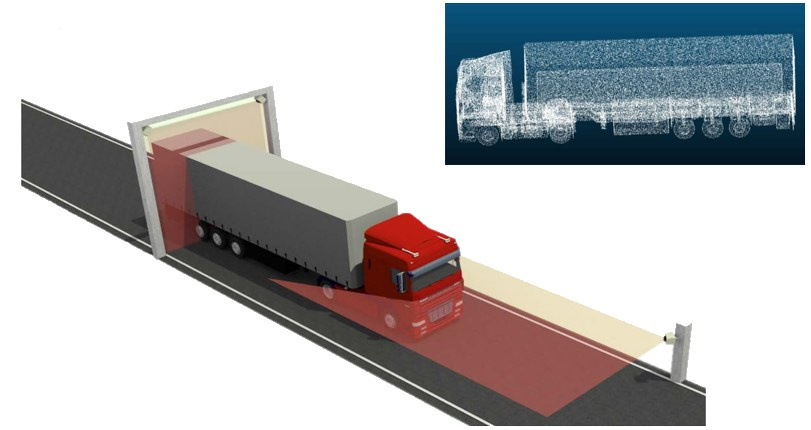

3D профайлер на основе лазерных сканеров и пример получаемого облака точек

Непрерывно совершенствуются как сами лидары (спасибо автономному транспорту за это), так и софт для них, который решает задачу анализа облака точек для выявления фич (колеса, прицепы, груз, количество и расположение стекол и т.п.). Сейчас уже начинают выводить на рынок недорогие лидары без вращающегося зеркала, умещающиеся в гнезде обычной противотуманки для применения в системах машинного зрения автономных автомобилей (что, в общем-то, тоже не для нас, так как вода непрозрачна для ИК-диапазона, и шмат грязного снега гарантированно ослепит самый изощренный ИИ).

Пользователям классической платной дороги хорошо знакомо понятие транспондер — электронный гаджет, с помощью которого можно проехать пункт оплаты без остановки. За техническими деталями снова прошу в мою статью (ссылка). Количество пользователей транспондеров постепенно растет, в летний сезон за ними вообще начинается давка. Но только недавно была, наконец, решена основная проблема и снято последнее серьезное препятствие на пути транспондерного счастья — теперь с одним единственным транспондером можно проехать по большинству платных дорог. Нет, понятно, что это очевидный пользовательский запрос. Но когда почитаете форумы европейских дальнобойщиков, вы поймете, что каждый из них вынужден возить целую коллекцию бортовых устройств (т.н. рояль) для оплаты проезда, топлива, экологических сборов и т.п. То есть, единого устройства у них нет и в скором времени не будет. Проблема это не техническая, а, скорее эволюционная. В 2012 году у нас еще был шанс сделать «как в Европе», но мы в кои-то веки сделали лучше. После нескольких лет разработки, отягощенной многосторонними согласованиями, еженедельными совещаниями на фоне непрерывной корректировки требований по мере дозревания сторон, у нас, наконец, заработала ИС межоператорского взаимодействия, выполненная в соответствии с европейскими стандартами ISO.

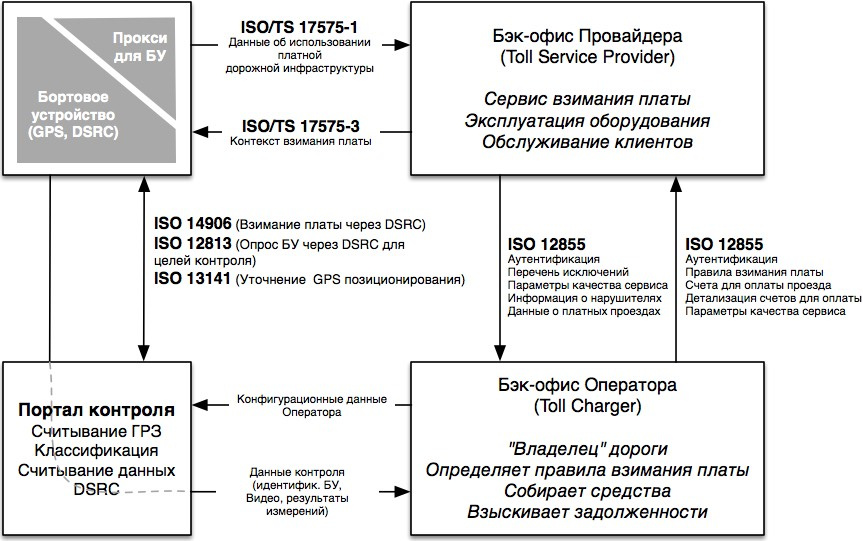

В рамках ИС были выделены следующие роли:

- Эмитент транспондеров, предоставляющий списки выпущенных транспондеров;

- Поставщик услуг, регистрирующий параметры транспорта, проезжающего по быстрым полосам ПВП

Архитектура ИС межоператорского взаимодействия основана на распределенном кластере первичных узлов, каждый из которых содержит копию всех данных, включающих списки транспондеров, ключей безопасности, записей о проездах с использованием транспондеров, различных корректировок, произведенных операторами и т.п. От оператора платной дороги, желающего подключиться к системе, теперь требуется только привести свои данные к стандартизованному виду, реализовать протокол обмена и залить «роуминговые» ключи на свои антенны DSRC для того, чтобы они могли корректно регистрировать проезды «чужих» пользователей. Так как базовое содержимое памяти транспондеров закреплено стандартом ISO 14906, который свято чтится всеми участниками, основные проблемы возникли в области корректировок данных и в общем недоверии операторов друг другу (что, собственно, и породило похожую на blockchain архитектуру репликации данных).

Очевидно, что будущее за технологиями электронного взимания платы (см. мою статью на эту тему). Только эти технологии позволяют взимать плату в режиме свободного потока, без шлагбаумов, капитальных сооружений и пробок в часы пик. А вот радужные ожидания от систем на базе технологий спутникового позиционирования наоборот, пришлось существенно скорректировать. Виной тому суровая реальность и практический опыт внедрения «Платона».

Гость из будущего

Мобильный и стационарный посты контроля системы «Платон»

Судьба проекта системы взимания дорожного сбора с 12-тонников (aka «Платон») драматична и наполнена болью, начиная от отмененного в 2014 году конкурса с участием мировых технологических грандов и крупнейших банков и заканчивая героическим вводом системы в эксплуатацию буквально годом позже силами структур Ростеха. Тем не менее, если закрыть глаза на ошибки и недочеты, чисто технологически «Платон» стоит на вершине горы систем взимания платы. Что одновременно и хорошо, и плохо, и дальше я объясню почему. Кстати, матчасть можно вспомнить тут: раз, два.

Технологическая новизна «Платона» и подобных систем заключается в идее полного отказа от использования наземной стационарной инфраструктуры для целей взимания платы. Вместо этого данные об использовании платных дорог формируются на основе привязки GPS треков к дорожному графу. Преимуществом подобного подхода является возможность покрытия режимом платности целой дорожной сети. Например, «Платон» покрывает все 50 000 км. федеральных дорог. При этом можно менять конфигурацию сети, добавлять или исключать сегменты, вводить разнообразные тарифы: за пробег, за участок, за часть участка и т.п. Можно даже объединять несколько сетей и нескольких операторов в рамках одной системы, например, федеральную сеть и региональные сети (структурированный подход к определению контекста взимания платы приведен в стандартах серии ISO 17575-*).

Стандартная архитектура гибридных систем взимания платы

А дальше начинаются минусы. Во-первых, от наземной инфраструктуры полностью отказаться не получилось. Подобному классу систем необходим дополнительный контроль исполнения правил взимания платы. Поэтому по всей сети федеральных дорог начали устанавливать стационарные порталы контроля (более 400 порталов), также по дорогам запустили автомобили контроля (числом более 100). Во-вторых, в ходе проекта стали возникать неприятные сюрпризы.

Дело в том, что аналогичные западные системы дорожных сборов с грузовиков используют бортовые GPS трекеры совмещенные с DSRC транспондерами (Германия, Словакия). При проезде порталов контроля от оснащенного таким трекером ТС в систему поступает следующая информация: класс (определяется лазерным сканером), фотография с распознанным номером, а также считанные данные DSRC, облегчающие идентификацию пользователя и включающие, к примеру, класс ТС и его номерной знак. Портал контроля может в автономном режиме сверить данные DSRC и данные непосредственных измерений и с большой долей уверенности принять решение о факте нарушения, а точнее о факте не нарушения.

В «Платоне» же, видимо, по причине экономии средств, было решено отказаться от добавления модулей DSRC в трекеры. Задача опознания нарушителя в заляпанном грязью грузовике, проносящемся посреди ночи под порталом контроля кардинально усложнилась — ведь теперь не стало двух независимых средств идентификации. В плохую погоду читаемость номерных знаков падает с обычных 96-97% до 60-70%, а в снегопад и после него зачастую читается только каждый третий номерной знак. Откуда взять вторичный источник достоверных идентификационных данных? Можно, например, взять частично прочитанный номерной знак и сверить его с базой данных зарегистрированных пользователей. Но каждый, кто занимался технологиями распознавания номерных пластин, только посмеется над этим, так как пластина обычно загрязняется или равномерно вся, или снизу вверх, поэтому результаты распознавания проседают сразу по всей пластине. По базе можно попытаться восстановить только номера любителей заклеивать отдельные цифры, но они погоды не делают.

Если системы контроля скоростных режимов могу позволить себе фиксировать ТС через одно (все равно будут бояться), то порталы контроля не должны пропускать ни одной машины, с номерным знаком или без, ведь все это деньги «владельца» платной дороги.

Вторая идея — восстанавливать данные о проездах под порталом по полученным трекам и пытаться сопоставить их с результатами наблюдений. Звучит в теории хорошо, но на практике получается ужасно, ведь после привязки трека к карте в системе остаются лишь идентификаторы дорожных сегментов, время проезда по которым несколько отличается от времени проезда под порталом. Можно также заставить прошивку трекера выдавать специальный пакет данных при проезде области, совпадающей с порталом (т.н. geo-fencing). Но это потребует хранить в памяти трекера и оперативно обновлять координаты всех порталов. Да и сама эта технология на мелких объектах работает с ошибками.

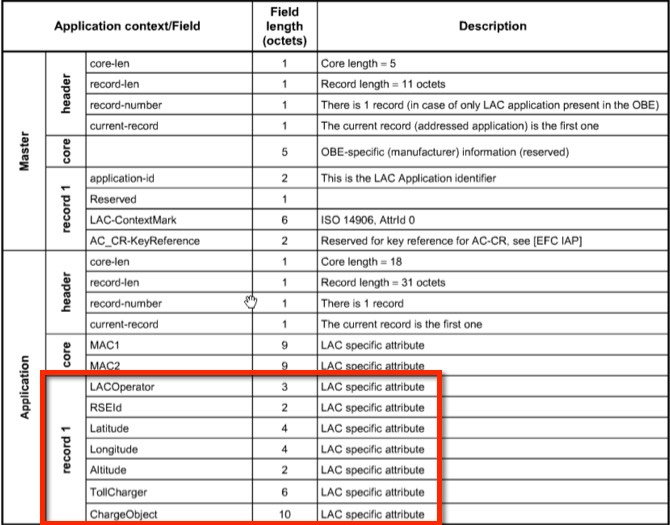

Вообще говоря, привязка трека к карте с целью расчета пробега — та еще задачка! Особенно если от точности привязки напрямую зависит качество выставляемого счета. В условиях плотной дорожной сети, где платные и бесплатные сегменты находятся близко друг от друга (например, бесплатный дублер параллельно платной дороге) скачки GPS трека могут приводить к ошибочному выставлению счета. В горной местности, в тоннелях, под эстакадами, на развязках, в лесу, рядом с высотными зданиями или вблизи Кремля данным GPS вообще нет никакого доверия, и разработчики софта изощряются как могут, пытаясь удержать ТС на маршруте по косвенным данным. В подобных условиях без дополнительных «маячков» на дороге нельзя ничего гарантировать. На помощь приходят все те же DSRC антенны, которые формируют аккуратное «пятно» на дороге. Стандарт ISO 13141 описывает сервис LAC (Localisation Augmentation Communication), позволяющий устанавливать недорогие автономные маячки DSRC, единственной функцией которых является запись фиксированного блока данных с координатами и таймстампами в память БУ, что является 100% свидетельством того, что ТС пересело пятно маяка. Логика БУ использует эти данные для уточнения GPS трека.

Пример данных DSRC по стандарту ISO 13141, дополняющих GPS трекинг

Ближайшее будущее технологий платных дорог

Все идет к тому, что шлагбаумы на платных дорогах должны скоро исчезнуть, а обирать автомобилистов станут электронным способом и на полной скорости. На пути к счастью у нас сейчас существуют три проблемы:

- Классификация по осям. Как уже говорилось в этой статье, углядеть оси на полной скорости довольно сложно. А если они подняты? В общем, неплохо бы отказаться от учета осей при расчете тарифа. Например, вместо количества осей можно использовать длину ТС.

- Слабая законодательная база для прижучивания нарушителей. Оператор платной дороги почти не имеет законных оснований штрафовать нарушителей, и если сейчас он имеет право не пустить ТС на свою дорогу без оплаты, то в режиме свободного потока у него отберут и эту возможность.

- Каша в голове у проектировщиков при выборе правильной технологии взимания платы в каждом конкретном случае.

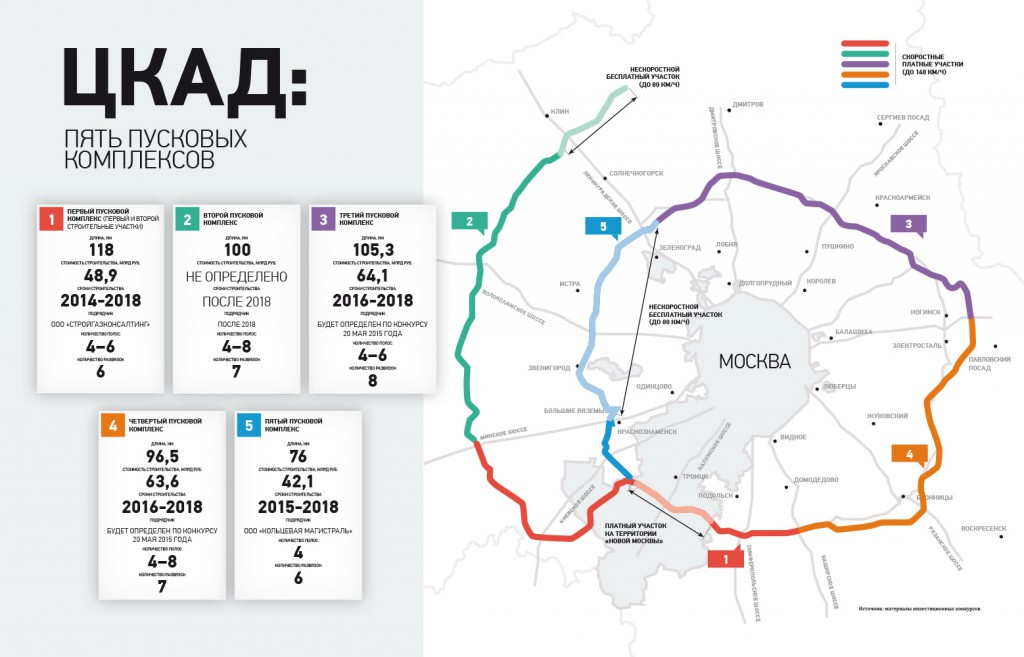

Среди перечисленных проблем только последняя относится к разряду технологических. Её мы и разберем на примере самого крупного инфраструктурного проекта ближайших двух лет — ЦКАД. В прессе недавно мелькнуло, что бесплатный участок под Звенигородом хотят запустить уже в этом году.

ЦКАД — первая платная дорога в РФ, которая, скорее всего, будет обходиться без шлагбаумов

В настоящее время существуют три основные технологии взимания платы в режиме свободного потока: GNSS — на базе привязки треков, DSRC — с использованием транспондеров, ANPR — с использованием распознавания номерных знаков. Вот сравнительная таблица параметров систем взимания платы на перечисленных технологиях (добавлены RFID и ручной сбор для полноты картины):

Сравнительные параметры технологий взимания платы (via).

Выбор технологии взимания платы неразрывно связан со стоимостью создания и эксплуатации платной дороги — ведь все будущие проекты носят инвестиционный характер, и чем дешевле будет объект, тем меньше (в теории) будет плата за проезд по нему.

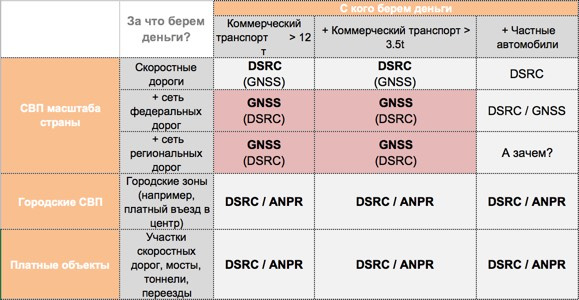

Вот как технологии распределяются в зависимости от типа проекта.

Карта выбора технологий. (via)

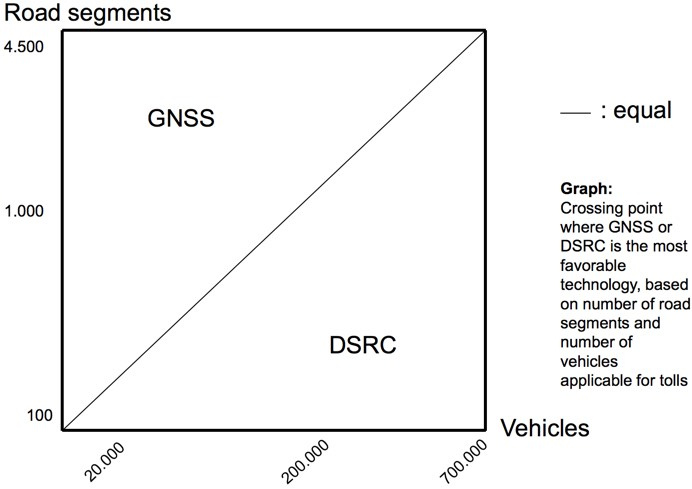

Как видно из картинки, заморачиваться с GPS трекерами имеет смысл только на крупных дорожных сетях и если наш клиент — коммерческий транспорт. Сложность дорожной сети определяется количеством сегментов, которые обычно определяются от съезда до съезда. Вот как определяется выбор базовой технологии в зависимости от количества сегментов:

Выбор технологии в зависимости от количества дорожных сегментов и количества пользователей платной дороги (via)

Как мы видим, на платных скоростных дорогах, где малое количество сегментов и большое количество пользователей, таких как ЦКАД (у которого, несмотря на длину, будет не более 30 сегментов), имеет смысл использовать порталы с DSRC антеннами для оплаты проезда и с видеокамерами для контроля нарушений. Это одновременно эффективно и технологически, и в плане стоимости создания и эксплуатации. Тем более, что по ЦКАДу поедут пользователи существующих платных дорог, которые к тому времени в подавляющем большинстве перейдут на единый DSRC транспондер. При этом крайне желательно обязать всех пользователей ЦКАД использовать транспондеры (их можно отдавать ниже себестоимости или вообще бесплатно вместе с абонементом, все равно окупятся десять раз). Для легковых ТС можно распространять «транспондеры в пакете» — готовое к использованию решение, позволяющее создать временную регистрацию пользователя с начальным балансом при первом проезде под порталом. Такие «заряженные» транспондеры можно продавать на заправках или даже через вендинговые автоматы.

В городской среде и на объектах платной дорожной инфраструктуры технологии DSRC должны быть дополнены технологиями оплаты по результатам распознавания номерного знака. В городе нельзя требовать от всех и каждого наличия транспондера, можно только аккуратно намекать и заманивать скидками. Камеры для распознавания номерных знаков могут при этом одновременно контролировать нарушителей. Подобным образом организован, к примеру, платный въезд в центральную часть Лондона. Да и в Москве система платной парковки в центре идентифицирует клиентов по номерным знакам.

А как же RFID, могут спросить меня коллеги, его же тоже используют для идентификации транспорта? Разумеется, RFID, также как и DSRC, является перспективным направлением и на нем тоже делают платные дороги (например, в США и в ЮВА). По плюсам и минусам могу сориентировать в комментариях, но, вкратце, если у нас уже создана и уже 10 лет работает инфраструктура для DSRC, введен в действие единый транспондер, технологическая поляна расписана в серии стандартов, сам девайс стоит не больше 10 евро (что сопоставимо по стоимости со скоростными автомобильными RFID метками) и имеет батарейку на 7 лет, то о чем еще можно думать? А еще — DSRC транспондер умеет пиликать и мигать лампочкой, сообщая о статусе операции! Мне кажется, поезд RFID в части отечественных платных дорог ушел. А вот идентификация транспорта в целях контроля (aka электронные номерные знаки) — задача как раз для RFID меток. Но это уже совсем другая история.

|

Метки: author drosselmayer анализ и проектирование систем итс dsrc свп автоматизация на транспорте умные дороги |

[Перевод - recovery mode ] Самое простое руководство по иконографике |

Сколько в среднем времени надо дизайнеру на создание одной пользовательской иконки? Пару минут? Десять? Час, два или три? А что если мы покажем, как сделать 10 крутых иконок менее чем за 10 минут?

Иконографика — особая форма коммуникации. Она дополняет визуальный язык бренда, поэтому пользовательский набор иконок гораздо выразительнее и привлекательнее стандартного. Многие дизайнеры даже не заморачиваются над изучением иконографики. Причина чаще всего в том, что для этого требуется еще один курс в очень долгом процессе обучения.

Поэтому я создал мегапростое руководство, с помощью которого можно изучить основы иконографики менее чем за 10 минут. И, да, я серьезно.

Умение создавать пользовательские иконки откроет перед вами огромный новый мир образов, которые вы сможете использовать в своих проектах — это выделит вас из толпы и даст конкурентное преимущество перед другими дизайнерами.

Изначально на создание руководства меня вдохновила гифка Моргана Аллана Нутсона, где показывалось, как за пару секунд создать иконку локационной службы. Прием показался мне не избитым, изящным и быстрым.

Я понял, насколько просто можно создавать пользовательские иконки. На самом деле иконка — это всего лишь определенная геометрическая фигура, результат соединения или искажения базовых фигур: прямоугольников, треугольников, окружностей.

Главное в дизайне логотипов или иконок — это ничего не усложнять.

С помощью этого руководства вы сможете создать 10 разных иконок за 10 секунд, использовав при этом простые геометрические фигуры.

Важно: я использовал Adobe Illustrator, но вы получите такой же результат в любом другом редакторе: Sketch или Figma. Точки на фигуре мы добавляли и удаляли инструментом «Перо» (Pen Tool), выбирали и двигали — «Частичным выделением» (Direct Selection Tool).

Глаз (Eye Icon)

Разместите в центре листа четыре круга на одной оси: от самого крупного до самого мелкого. Маленький круг поместите в чуть больший по размеру и так раз за разом от маленького к самому большому. Затем растяните его за крайние от центра правую и левую точки. Наконец сдвиньте самый маленький (внутренний) круг к краю предыдущего, и у вас получится эффект блика на радужке.

Совет: чтобы не использоваться белые круги, воспользуйтесь палитрой «Обработка контуров» (Pathfinder) и вычтите две окружности из нижнего круга.

Стрелка (Arrow Icon)

Чтобы получить стрелку, просто добавьте дополнительные точки по краям исходного квадрата.

Совет: как вариант, просто нарисуйте тонкую линию и придайте ей форму стрелы.

Батарейка (Battery Icon)

Нарисуйте один контурный квадрат и два с заливкой. Поместите один из залитых квадратов внутрь пустого и поиграйте с пропорциями. Второй оставьте снаружи, придав ему форму кончика батареи.

Совет: попробуйте разные значения толщины контура и отступов, чтобы добиться нужной визуальной гармонии.

Маркированный список (Bullet List Icon)

Начните с обычного квадрата; скопируйте его и разместите копию справа; придайте ему форму удлиненного прямоугольника. Выделите всё вместе и сделайте две копии, разместив их одну под другой с равными промежутками.

Совет: замените квадраты на круги — и вид иконки смягчится.

Облако (Cloud Icon)

Нарисуйте три окружности разных размеров — две одинаковые маленькие и одну большую. Маленькие круги расположите на одном уровне, а крупный — по центру между и над ними. Чтобы получился низ облака, растяните одну из меньших окружностей.

Совет: чтобы облако выглядело натуральнее, попробуйте разные диаметры кругов.

Перемотка вперед (Forward Play Icon)

Нарисуйте длинный прямоугольник. Поставьте точку по центру левого края, а затем удалите нижнюю и верхнюю точки. Получился треугольник — скопируйте его и поместите справа. Иконка готова.

Совет: чтобы справиться еще быстрее, сразу нарисуйте треугольник, а не квадрат.

Воронка (Funnel Icon)

Нарисуйте длинный прямоугольник. Добавьте точки по центру левого и правого ребер. Теперь растяните верхний край в ширину. Готово.

Совет: поставьте два прямоугольника друг на друга и просто растяните край верхнего.

Воспроизведение/Пауза (Play/Pause Icon)

Нарисуйте три длинных параллельных прямоугольника. Самый широкий из них трансформируйте в треугольник.

Совет: как вариант, сразу нарисуйте треугольник, а за ним два параллельных прямоугольника.

Навигационная стрелка (Position Arrow Icon)

Это видоизмененная иконка локационного сервиса из гифки Моргана. Просто нарисуйте квадрат, а затем потяните за нижний левый угол в направлении противоположного угла.

Совет: Если работаете в Illustrator, зажмите клавишу Shift, чтобы получить строго диагональное направление.

Метка геолокации (Position Pin Icon)

Внутри большего круга создайте маленький, используя палитру «Обработка контуров» (Pathfinder). Опустите нижнюю точку на нужное расстояние и заострите получившийся кончик: переключитесь на инструмент «Перо» (Pen Tool), затем щелкнете по точке, зажав клавишу Shift.

Совет: можете не заострять угол полностью — просто немного округлите его, выбрав точку и изменив значение «Радиус скругления» (corner radius) в палитре «Трансформирование» (Transform).

Иконка звука (Sound Icon)

Делается точно так же, как и иконка воронки, только с поворотом в 90 градусов.

Совет: просто скопируйте воронку и разверните её по часовой стрелке.

Волна (Wave Icon)

Нарисуйте прямую линию, затем по всей длине на равных промежутках расставьте точки. Потяните вниз изменяющиеся точки и максимально округлите все углы, пока линия не станет плавной.

Совет: чтобы линия стала еще мягче, округлите её концы.

Хорошая иконка стоит тысячи слов

Часто говорят, что иллюстрация стоит тысячи слов. Это особенно справедливо по отношению к иконкам. Замещая собой слова и целые предложения, они оптимизируют визуальное пространство, улучшают юзабилити и эстетическое восприятие.

Умение создавать наборы простых и полезных иконок всегда пригодится. В статье мы как раз показали, как легко и быстро сделать иконки из базовых фигур.

10 правил иконографики:

- Делайте иконки символическими и осмысленными.

- Рекомендация, которую вы, вероятно, слышали уже сотни раз: не усложняйте. Не жертвуйте считываемостью иконки в угоду внешнему виду.

- Работайте осознанно и вдумчиво. Прежде чем начать, хорошо всё обдумайте.

- Убедитесь, что иконка правильно выглядит в разных размерах.

- Выдерживайте единый стиль.

- В векторе, пожалуйста!

- Используйте разные цвета осторожно и только при необходимости.

- Знание основ геометрии очень помогает.

- Помните, что с первого взгляда должно быть понятно, для чего нужен тот или иной элемент дизайна — то есть помните про так называемый аффорданс.

- Язык иконографики должен быть универсальным.

- На самом деле английский алфавит — это всего лишь набор из 26 иконок, а русский — из 33.

Совершенствуйте свое мастерство и увидите, что вскоре 10 секунд для создания одной иконки вам покажется много — вы научитесь справляться намного быстрее.

Рекламный абзац от редакции

В этом посте мы принесли не только перевод (надеемся, он пригодится начинающим дизайнерам), но и новую программу.

Теперь кроме отдельных курсов по UX-дизайну и UX-аналитике, мобильному и веб-дизайну, скетчингу, моушену и инфографике, есть программа «Профессия продуктовый дизайнер». Это комплексное обучение веб + мобайл + UX. Курс длится 6 месяцев. За это время студенты учатся решать разноплановые интерфейсные задачи и создавать работающие цифровые продукты. Каждое занятие на курсе сопровождается домашним заданием, а в конце программы каждый студент разрабатывает дипломный проект под руководством личного наставника. Для обучения предварительной подготовки не требуется, однако знание основ графического дизайна будет плюсом.

Спасибо за внимание!

|

Метки: author blognetology интерфейсы дизайн мобильных приложений графический дизайн веб-дизайн блог компании нетология иконографика дизайн перевод нетология |

Data Science meetup в офисе Avito 24 июня |

24 июня мы собираем специалистов по Data Science в нашем офисе, чтобы обменяться опытом в создании рекомендательных сервисов. На встрече мы подведём итоги проходившего на площадке Dataring.ru конкурса Avito на построение рекомендательной системы для объявлений: наградим победителей и попросим их подробнее рассказать о своих решениях. Кроме того, в программе интересные доклады от представителей Яндекс.Дзена, OZON.ru и, конечно же, Avito. Подробности под катом!

Доклады

В начале встречи мы заслушаем докладчиков, которые поделятся своим опытом создания рекомендательных сервисов.

Машинное обучение в Дзене

Первыми выступят спикеры из Яндекса: Евгений Соколов и Дмитрий Ушанов. Евгений — руководитель группы качества рекомендаций и анализа контента Яндекс.Дзена. Дмитрий — старший разработчик сервиса Дзен, а до этого занимался разработкой лингвистических компонентов поиска: поисковых колдунщиков и объектных ответов.

Яндекс.Дзен — сервис персональных рекомендаций, который агрегирует новости и медийный контент с большого количества сайтов, а также позволяет авторам делать публикации напрямую в платформу. На всех этапах построения рекомендаций, от сбора контента и его фильтрации до ранжирования, используется машинное обучение. В рекомендательных алгоритмах используется два основных типа сигналов: обратная связь пользователей и семантическая близость контента. Спикеры разберут несколько необычных примеров учёта этих сигналов: как использовать модели со скрытыми переменными для текстов в матричных разложениях и как правильно формировать факторы на их основе; как учитывать клики пользователей с помощью систем спортивных рейтингов; как совмещать явный и неявный пользовательский фидбек.

Рекомендации в OZON.ru

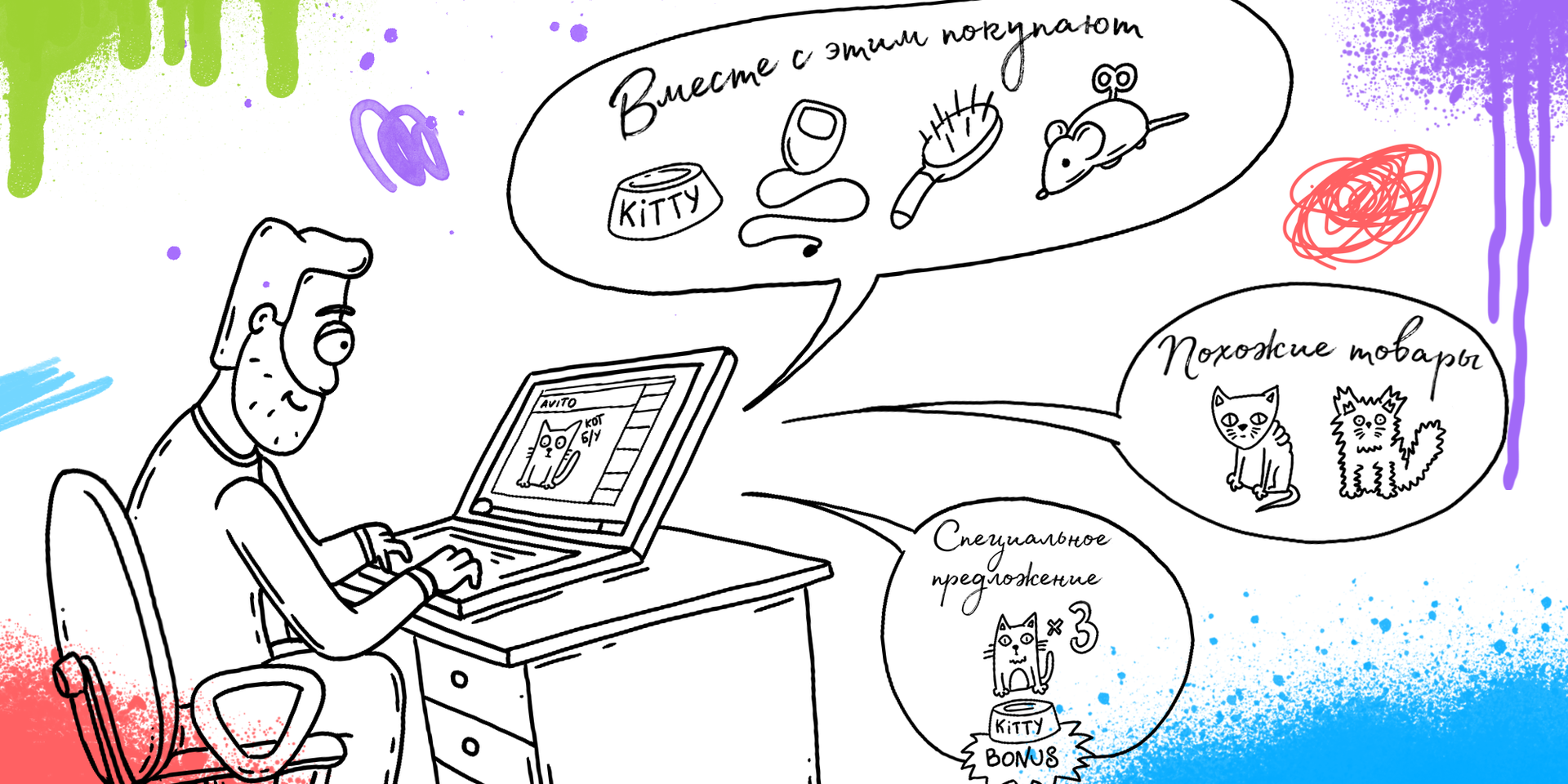

Ведущий аналитик OZON.ru Ксения Бокша, не вдаваясь сильно в математику, расскажет про различные виды рекомендаций, которые предоставляет маркетплейс своим пользователям: связанные товары, аксессуары, бандлы, персональные рекомендации, рекомендуемые категории товаров по запросам, рекомендуемые поисковые запросы, рекомендации в корзине. Кроме того, из доклада вы узнаете о стеке технологий, который использует команда, а также о ближайших планах.

Какие задачи решает команда рекомендаций в Avito

На одной из прошлых встреч руководитель юнита рекомендаций Василий Лексин уже рассказывал, что под капотом у рекомендаций в Avito. В этот раз вместе с аналитиком Михаилом Каменщиковым они расскажут о том, какие задачи решает юнит рекомендаций, зачем был организован конкурс на построение рекомендательной модели, какие результаты они ожидали получить по итогам соревнования, что из этого удалось, а что нет. Кроме того, они поделятся своим опытом участия в RecSys Challenge 2017.

Конкурс

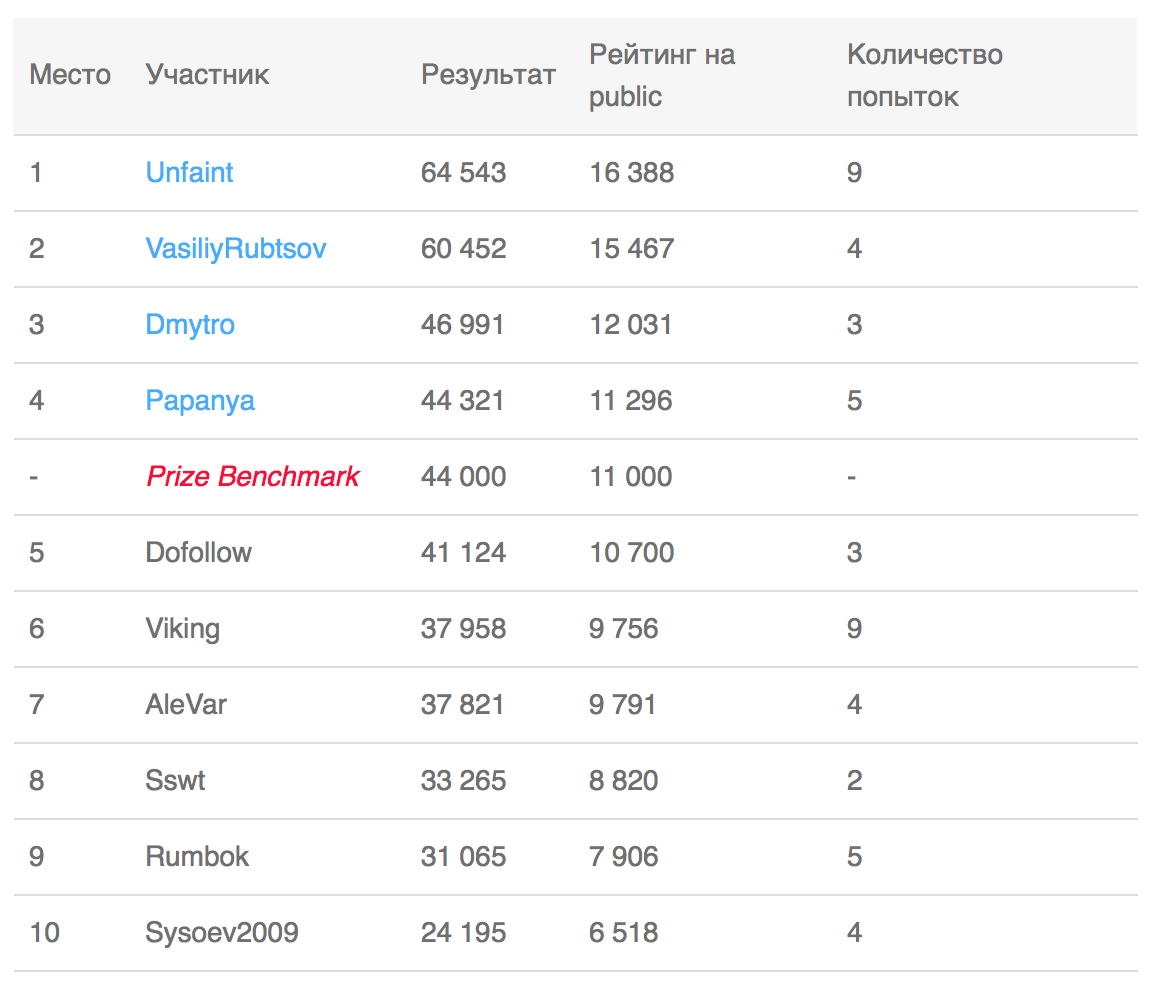

Далее мы перейдем к подведению итогов конкурса, наградим победителей и попросим их рассказать немного подробностей о своих подходах и решениях.

Пару слов о самом конкурсе. В этом датаринге участникам предлагалось построить свою рекомендательную систему для объявлений на основе истории активности около 600 000 пользователей в течение 6 дней. После получения обучающей выборки участникам предстояло предсказать события взаимодействия пользователя с объявлением, которые могли быть 4-х типов: клик по объявлению, отправка сообщения продавцу, добавление объявления в избранное и запрос контакта продавца. Правильные предсказания событий разных типов имели различный вес.

Финальные результаты конкурса уже опубликованы на портале DataRing.ru, а решения призеров проходят валидацию.

Регистрация

Для того, чтобы попасть на встречу, нужно зарегистрироваться и получить подтверждение. Пожалуйста, регистрируйтесь под своим настоящим именем и не забудьте в день мероприятия захватить с собой паспорт или водительское удостоверение.

Стартуем доклады в 12:30 и планируем завершить встречу к 16:00. В перерыве можно будет перекусить воком.

Адрес: Лесная, 7, 15 этаж (БЦ “Белые Сады”). Вход с Лесной улицы. Ближайшая станция метро — Белорусская кольцевая.

До встречи!

|

Метки: author Oldtuna машинное обучение data mining big data блог компании avito рекомендательные системы рекомендации рекомендательный сервис авито дзен ozon.ru |

[Из песочницы] Страх и ненависть в MiddleWare |

Внезапно, вокруг нас раздался ужасный бум… И весь WEB кишал этими статьями про LAMP…

Казалось, что они были написаны под любые нужды. Они разрастались и поглощали задачи для которых ранее пользовался perl, bash и даже С. Нет смысла говорить об этих статьях, подумал я. Все и так это знают.

У нас был пятый IE, немного Netscape, Opera и целое море разношёрстных cgi модулей на perl. Не то что бы это был необходимый стек технологий. Но если начал собирать дурь, становится трудно остановиться. Единственное что вызывало у меня опасение — это студент, употребляющий PHP. Нет ничего более беспомощного, безответственного и испорченного, чем это. Я знал, что рано или поздно мы перейдем и на эту дрянь.

В начале было не было

Когда-то JS между браузерами отличался как конь от пробки, а XMLHttpRequest возможен был исключительно через ActiveX. Выхода особо не было. Что на корню вырубало динамический веб. IE 6 казался революцией. Но если вы хотели кросплатформености — ваш путь пролегал через объемный MiddleWare. А большое количество статей по php, инструментов и сопутствующих новоиспеченных библиотек делали своё дело.

Проклятый php, начинаешь вести себя как деревенский пьяница из старинных ирландских романов, полная потеря основных двигательных функций, размытое зрение, деревянный язык, мозг в ужасе. Интересное состояние когда все видишь, но не в силах что-либо контролировать. Подходишь к задаче, чётко зная, где данные, где логика и где представление. Но на месте всё происходит не так. Тебя запутывает злобный лапшичный код, а ты думаешь: в чём дело, что происходит?...

Постепенно титанические плиты между браузерами начали сходится. Везде появился XMLHttpRequest и мечты о динамическом WEB с четким разделение по фронтам становились реальностью.

Конечно же, я пал жертвой повального увлечения. Обыкновенный уличный бездельник, который изучал все, что попадало под руку. В воздухе витали идеи о едином языке для Web разработки. Погоди, вот увидишь эти изменения в новом обличие, мужик.

— Давай Node.js посмотрим.

— Чего? Нет!

— Здесь нельзя останавливаться. Это толстый Middle.

— Садись.

Что за чушь они прут, не знаю сколько нужно писать на JavaScript чтобы найти сходство между Front, Middle и BackEnd? Это неподходящий вариант. Слишком толсто для выбранной цели.

Но, подобные мысли я оставил. Пришло понимания того, что забить гвоздь можно и отвёрткой, но если иногда дотягиваться до молотка, то процесс серьезно ускорится.

Я почувствовал чудовищный протест против всей ситуации.

Есть же СУБД, такие как PostgreSQL, позволяющие невообразимо оперировать данными через встраиваемые функции. Бизнес логика внутри базы! Настоящий BackEnd. Не нравиться бизнес логика в СУБД и ей там не место? А такие прямые потоки данных нравится?

Попробуем разобраться, с тернистым движением данных на «прямых» потоках курильщика.

Первое с чем мы сталкиваемся — это постоянная перегонка данных в середину, по любому поводу. К тому же, эти данные могут быть совсем не окончательными и требоваться только для расчёта последующих запросов. Для обработки данных используются циклы. Процедурные циклы — не оптимизированы на многопоточность.

Множественность запросов в одной сессии к СУБД ведёт к неизбежному апофеозу кончины скорости — многопроходности по таблицам базы.

Для исключения этих факторов, логику приходится переносить ближе к данным, т.е. в СУБД!

И это наиболее оптимальный способ вывести скорость на новые величины!

Становление идеи

Со временем, браузеры научились полной динамической генерации интерфейса. Открылась ачивка чёткого разделения по фронтам данных и представления. Появилась полноценная возможность гонять от сервера к клиенту преимущественно данные. Оставался только один вопрос: Что делать со средним слоем? Как его минимизировать исключительно до транспортной функции с элементами простого роутинга запросов по коллекциям на стороне сервера.

Эти наивные разработчики полагали, что можно обрести душевный мир и понимание, изучив один из оплотов старого Middle, а результат — поколение толстого слоя, так и не понявших главную, старую как мир ошибку IT индустрии. Упустив убеждение, что Кто-то или Что-то может обладать фатальным недостатком.

К тому времени начал работать nginx, и уже не оставалось вопросов с чем нужно готовить предполагаемую мысль. Это больше была не идея. Теперь это было состязание программиста с ленью. Сама мысль, попытаться как-то описать архитектуру традиционным образом, через apache, казалась абсурдной.

В 2010 на github подоспел модуль ngx_postgres. Задание запросов в конфигурационном файле и выдача в JSON/CSV/ЧТОТОЕЩЕ.

Для конфигурации достаточно было простого SQL кода. Сложный можно было обернуть в функцию, которая потом вызывалась из конфига.

Но этот модуль не умел загружать тело http запроса в СУБД. Что накладывало серьезные ограничения на данные, оправляемые к серверу. URL же явно подходил только для фильтрации запроса.

Cериализация выходных данных проводилась средствами самого модуля. Что, с высоты моего дивана, казалось бессмысленным переводом ОЗУ — сериализовать умел и PostgreSQL.

Возникла мысль поправить, переписать. Я стал копать в коде этого модуля.

После бессонной ночи поисков многим хватило бы ngx_postgres. Нам нужно было что-то посильнее.

Мадам, сэр, детка, или как вас… вариант есть, вот, держите ngx_pgcopy.

NGX_PGCOPY

После эксперимента экспериментов и анализа анализов, возникла мысль переписать всё практический с нуля. Для ускорения загрузки были выбраны запросы COPY, которые перегоняют данные в базу на порядок быстрее инсертов и содержат собственный парсер. К сожалению, ввиду скудности описания подобного типа запросов, сложно сказать как будет вести СУБД при особо массовых вызовах данного метода.

Мир безумен в любом направлении и в любое время, с ним сталкиваешься постоянно. Но было удивительное, вселенское ощущение правильности всего того, что мы делали.

Вместе с COPY-requests мы автоматом получили сериализацию в CSV по обоим направлениям, что избавило от необходимости заботы о преобразовании данных.

Начнём с примитива, отправка и получение всей таблицы в CSV по URL:

http://some.server/csv/some_tableCSV часть import.export.nginx.conf