Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Гумано-ориентированное программирование. Часть первая |

Всякая профессия начинается не с инструмента, но со взявших его рук. Так и программирование начинается не с Hello, world и даже не с того, как вы сели на стул. И даже не с того, как вы приобрели машину. Но с того, как вы сформулировали проблему, которую хотите решить. Если вы не хотите решать проблемы людей при помощи автоматизации, то программирования — не ваша работа.

Всякая профессия призвана по своей сути решать чужие проблемы, компенсируя чужую лень делать что-то. И особняком в ряду стоит программирование, потому что оно — суть автоматизация труда или чего-то другого, будь то общение или развлечения.

Врач оперирует. Программист — пишет алгоритм для робота, делающего операции. Архитектор чертит чертёж — программист пишет программу, которая по чертежу создаст модель здания и просчитает его поведение, включая поправки на ветер, коммуникации, распределение нагрузок на опоры и так далее.

Геолог ищет нефть. А что делает программист? Пишет программу, которая по геологическим данным будет прогнозировать расположение месторождений. Наконец, бухгалтер вводит финансовую операцию — и хорошая база данных 1С вместе с конфигурацией посчитают налоги по актуальному законодательству и сведут дебет с кредитом, а плохая конфигурация — сами понимаете. И так далее — практически во всём.

Откуда вывод: программирование — сложнейшая инженерная область. Потому, что задача программиста — автоматизация любого труда. Причём задача эта — сделать программу не только быстрой и эффективной, но и удобной. Неудобная программа требует больше времени на освоение и привыкание, чем удобная, но медленная — на работу.

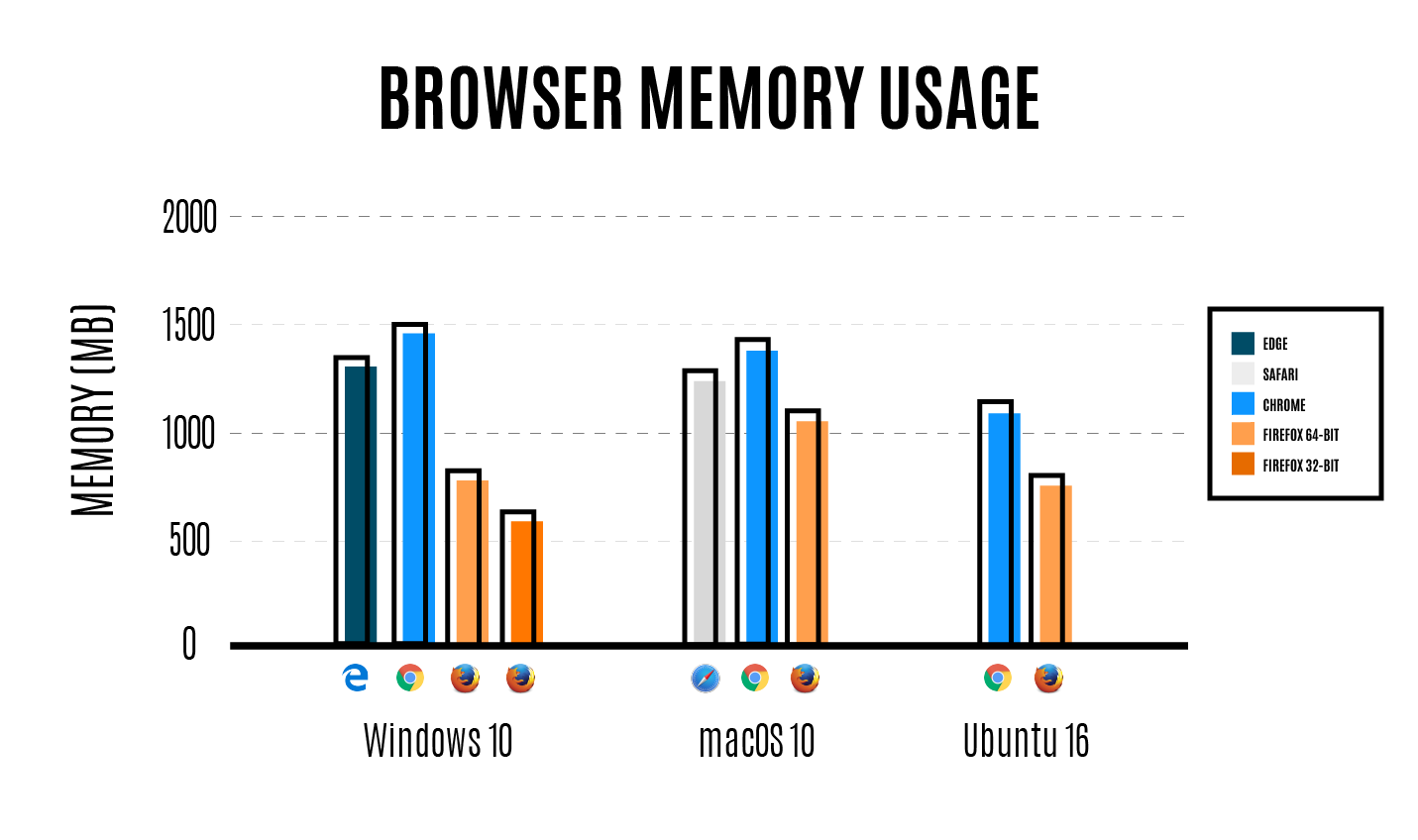

К примеру, браузер А грузит страницу медленнее, чем браузер Б, на полсекунды. Но у браузера А неудобная навигация и пользователь каждый раз, каждый раз тратит своё время и нервы (а это самое драгоценное для нас) на эти чёртовы неудобные кнопки! А психологический комфорт использования переоценить сложно. Это всё я говорю к тому, чтобы особенно подчеркнуть важность человека и его проблем в принципе. Я говорю совершенно очевидные вещи, чтобы вывести их на сознательный уровень.

И вот свежайший, буквально сегодняшний смешной пример «Из жизни эникея». Мой племянник играет в игру с использованием OpenAL. Он нечаянно вырвал наушники из гнезда, совсем на чуть-чуть, и, конечно, OpenAL на чистом английском пожаловалась, что не может создать устройство. «Какая жаль!» Всем бы жилось легче, если бы сообщения об ошибках были локализованы и человекопонятны, то есть — с учётом хотя бы простейшей наиболее распространённой проблемы пользователя, пользователя, чёрт возьми! Благо OpenAL — OpenSource и я могу вместо того, чтобы просто жаловаться, взять и предложить фикс. Например, так: «OpenAL не может создать устройство. Проверьте соединение с динамиками или наушниками, неполадки с аудиоустройствами». А ныне мне пришлось идти и смотреть на иконку отключенного устройства в Windows. А если бы это было учтено, то сказывалось бы на доверии к продукту наилучшим образом.

И именно это — ориентир на человека — то, чему нужно учить абсолютно любого джуниора в первую очередь, а вовсе не Hello, world. Программы пишутся для людей, а не для того, чтобы показать, какие мы умные и что мы «могём», а точнее — могем.

Кстати, принимаю рекомендации по удобочитаемоссти статьи, сокращения, обобщения и так далее. Пишу для людей.

Ещё пример, следующего дня. Windows-программа diskpart. Как известно, в виндоус принято вызывать хелп вот так: /?

DISKPART> create partition /?

Microsoft DiskPart, версия 10.0.14393.0

EFI - Создание системного раздела EFI.

EXTENDED - Создание расширенного раздела.

LOGICAL - Создать логический диск.

MSR - Создание резервного раздела Майкрософт.

PRIMARY - Создание основного раздела.

DISKPART> create partition logical /?

Для этой команды указаны недопустимые аргументы.

Чтобы получить дополнительные сведения о данной команде, введите HELP CREATE PARTITION LOGICALВам это не кажется странным? Мне тоже. Напоминает статью про PHP — фрактал плохого дизайна, где нет строгой конвенции именования функций.

Ещё веселее, когда запускаешь cmd и делаешь что-то вроде

cd c:\ && dir /b/s | findstr "\.docx$" > list.txt && list.txtИ, конечно, имена файлов на русском из-за дефолтной кодовой страницы 866 превращаются в чушь. И, конечно, я могу исхитриться и сделать удобно (и снова, конечно же, я знаю об Everything и она у меня стоит), но — так или иначе — это не отменяет проблему, а такие вещи снижают уровень доверия к системе, уровень её разумной предсказуемости. И это — моё время, моя жизнь и я как клиент заплатил деньги за то, чтобы мне было удобно и хорошо. Соответственно, совершенно другое отношение к OpenSource: нашёл ошибки или неудобство, сообщи как минимум, как максимум сделай исправление сам. И скажи спасибо, что тебе чужой труд достался вообще даром…

Кроме того, когда человек чувствует, что продукт сделан для него, это порождает синергию, новые идеи. Например, прекрасный в своей парадоксальности сервис будист, так лии иначе решает проблему пробуждения и да, проблему одиночества для одиноких. И фактически из-за человеческого отношения становится ещё и сетью знакомств, наверняка гораздо более эффективной в сравнении с типичными решениями, хотя, конечно, выверенных данных у меня нет, но это понятно интуитивно.

Так фейсбук, решающий в начале проблему общения сокурсников, стал одним из решений для взаимодействия в принципе, синергией порождено, например, такое понятие, как маркетинговый аккаунт. А почему? Потому, что людям удобно и хорошо! И захотелось ещё удобнее… И вообще, абсолютно любой успешный стартап решает проблему. Делая это быстро, приятно, с комфортом. И в этом смысле, когда я запускаю diskpart, я ожидаю от программы запрос: «Для режима мастера нажмите M, для режима строки нажмите ВВОД». При выборе режима мастера программа опрашивает меня и делает конкретную операцию. Быстро и удобно. Профит! И доверие к системе повышается, и зная, что она удобная, начинаешь рекомендовать её, и так далее…

Да, да, конечно же, существуют вещи сложнее, чем создать пару разделов на диске и при работе с зеркалами томов и массивами дисков целесообразно использовать сценарии diskpart. Но так или иначе всё сведётся к человеку, использующему программу. И если это простой пользователь, узнавший о преимуществе разбиения дисков, то разумно ему предложить мастер, а если это администратор парка машин с космическим количеством дисков, то для него разумно предложить IDE разработки сценария и их шаблоны.

И, кстати, во всём этом — одна из главных проблем освоения компьютера как такового. Люди старшего поколения «автоматически» доверяют всё знающим людям, понимая, что давно отстали от прогресса. Знаюшие люди — программисты. И вот человек садится за ту же Windows… и понимает, что перед ним — экран с какими-то картинками. Никаких пояснений. Хотя, чёрт возьми, «интуитивно понятный интерфейс»! А человек понятия не имеет, что со всем этим делать и чувствует себя «динозавром». Совсем другое дело, когда ОС загружается и при соответствующих настройках (предполагающих, например, что за компьютер сел пенсионер) показывает вводный ролик: мол, вот вам мышь, вот вам экран, вот так мышь управляется… Но ничего этого (по моему опыту, поправьте меня, если я не прав) зачастую нет, было в Vista и в школьных редакциях ALT Linux — тоже есть. И это очень радует.

Люди старшего поколения считают программистов компетентными. Да. А теперь представьте, что вот такой человек столкнулся с банально неудобной программой. Что тогда делает человек? Пугается! И это нормальная реакция… И тут надо сказать, что лет через 40 мы с вами будем «динозаврами» куда большими: прогресс ускоряется… Помните об этом. Особенно хорошо помните об этом, когда делаете интерфейс. Давайте будем заботиться о людях.

Во второй части я напишу о том, как программист может позаботиться о себе. Об организации рабочего места и да, напомню лишний раз о здоровье и подходу к его сбережению. Безопасная работа с инструментом — естественная часть культуры в профессии, уважения к ней. И как, например, шахтёры работают в касках, мы — по крайней мере в идеале — должны работать в очках, защищающих глаза от утомительной сине-фиолетовой части спектра и со специально подобранным фокусным расстоянием.

Организация работы в условиях автоматизации — вопрос, на мой взгляд, очень интересный, важный и заслуживает отдельного внимания. Очень важно здесь не быть сапожником без сапог, используя все возможные блага, предоставленные программистам программистам. И только после этого, если вы чувствуете кайф от предоставленных возможностей, имеет смысл писать Hello, world и всё прочее. Если же вам скучно в автоматическом мире, если вы не получаете удовольствия от того, что «Оно работает!», то скорее всего программирование не для вас.

И, наконец, когда мы приступим к алгоритмам, структурам данных, к математике и всему остальному — упор будет сделан на людей. На мышление людей, сущность идеи, на то, как человек приходил к тому или иному решению проблемы. И это объективно даст гораздо больше понимания, (а значит — владения), чем просто рассказ, что есть вот такая структура данных (такие-то способы добавления и удаления элементов в ней) и такой-то алгоритм, а есть ещё кучка остальных… Примерно как в анекдоте: «Третий раз объясняю… сам уже понял, а они всё никак». Да, когда человек задумывается, как научить других, то учиться сам.

Очень надеюсь, что такой, ориентированный на человека подход окажется интересным и найдёт сторонников. Наверняка очень и очень многие люди так или иначе понимают изложенное. Это вполне очевидные вещи. И задача таких постов — просто закрепить их в сознании, напомнить о них.

У меня всё.

|

Метки: author stranger777 учебный процесс в it человек |

Ищу команду для создания простой игры с целью изучения Unreal Engine 4 |

Возможно, этому посту не место на Хабре, но где ещё искать грамотных разработчиков для совместного самообучения программированию?

Меня зовут Алексей и я собираю команду для работы над хобби-проектом.

Это видео – с самых первых дней работы над игрой, когда я пытался реализовать управление сразу несколькими персонажами (сейчас это стало опциональной фичей, т.к. не уверен, что оно будет работать в условиях быстрого геймплея).

Немного о себе:

- программист

- 10+ лет занимаюсь веб-разработкой (в основном Javascript, фронт-енд и всё такое)

- ~0.5 лет изучения разработки игр, в особенности Unreal Engine 4

- пока что разработка игр для меня – хобби, обычно есть только пара часов в день на это дело (в лучшем случае)

О проекте

- Хобби-проект, для самообучения

- Движок: Unreal Engine 4, в основном C++

- Жанр: Shoot 'em up, нечто похожее на Crimsonland: вид сверху, скоротечный геймплей, кучи врагов со всех сторон, разные виды оружия, бонусы и т.д.

- Тематика: фентезийная, с магией и всё такое

- Несколько стилей геймплея, по выбору игрока: например – рыцарь с мечом, лучник, маг

- Элементы RPG: прокачка персонажа, изучение скиллов

- Однопользовательская игра, без мультиплеера

- [обсуждаемо] Вместо одного персонажа игрок может контролировать сразу нескольких, например одновременно DD (damage dealer), танк и хилер. По аналогии с мобильной игрой Battleheart.

- [опционально] Кросс-платформеный релиз: все PC – Windows, macOS, Linux; мобильные ОС: iOS, Android

Кого я ищу:

- Всех заинтересованых! (наиболее нужны сейчас программисты и 3D-моделлеры)

- Кто может работать самостоятельно (т.к. я ни разу не менеджер)

- Кто умеет аргументированно обсуждать идеи, но, в то же время, умеет соглашаться с мнением, отличным от своего

Ещё о проекте:

Есть краткий План Разработки в виде mind map

Репозиторий игры на GitLab (потому что у них бесплатный LFS), если вас интересует код и ход разработки (можно посмотреть историю коммитов).

Добро пожаловать!

p.s. Аналогичный пост создал на Reddit для англоязычной аудитории.

p.p.s. Также буду рад и просто пообщаться на тему этого проекта или геймдева в принципе.

|

Метки: author norlin разработка игр хобби unreal engine 4 ue4 c++ никто не читает теги обучение |

Повседневный C++: изолируем API в стиле C |

Мы все ценим C++ за лёгкую интеграцию с кодом на C. И всё же, это два разных языка.

Наследие C — одна из самых тяжких нош для современного C++. От такой ноши нельзя избавиться, но можно научиться с ней жить. Однако, многие программисты предпочитают не жить, а страдать. Об этом мы и поговорим.

Не смешивайте C и бизнес-логику на C++

Не так давно я случайно заметил в своём любимом компоненте новую вставку. Мой код стал жертвой Tester-Driven Development.

Согласно википедии, Tester-driven development — это антиметодология разработки, при которой требования определяются багрепортами или отзывами тестировщиков, а программисты лишь лечат симптомы, но не решают настоящие проблемы

Я сократил код и перевёл его на С++17. Внимательно посмотрите и подумайте, не осталось ли чего лишнего в рамках бизнес-логики:

bool DocumentLoader::MakeDocumentWorkdirCopy()

{

std::error_code errorCode;

if (!std::filesystem::exists(m_filepath, errorCode) || errorCode)

{

throw DocumentLoadError(DocumentLoadError::NotFound(), m_filepath, errorCode.message());

}

else

{

// Lock document

HANDLE fileLock = CreateFileW(m_filepath.c_str(),

GENERIC_READ,

0, // Exclusive access

nullptr, // security attributes

OPEN_EXISTING,

FILE_ATTRIBUTE_NORMAL,

nullptr //template file

);

if (!fileLock)

{

CloseHandle(fileLock);

throw DocumentLoadError(DocumentLoadError::IsLocked(), m_filepath, "cannot lock file");

}

CloseHandle(fileLock);

}

std::filesystem::copy_file(m_filepath, m_documentCopyPath);

}Давайте опишем словесно, что делает функция:

- если файл не существует, выбрасывается исключение с кодом NotFound и путём к файлу

- иначе открыть файл с заданным путём на чтение, с эксклюзивными правами доступа, без аттрибутов безопасности, по возможности открыть существующий, при создании нового файла поставить ему обычные атрибуты файла, не использовать файл-шаблон

- и если предыдущая операция не удалась, закрываем файл и бросаем исключение с кодом IsLocked

- иначе закрываем файл и копируем его

Вам не кажется, что кое-что тут выпадает из уровня абстракции функции?

Не смешивайте слои абстракции, код с разным уровнем детализации логики должен быть разделён границами функции, класса или библиотеки. Не смешивайте C и C++, это разные языки.

На мой взгляд, функция должна выглядеть так:

bool DocumentLoader::MakeDocumentWorkdirCopy()

{

boost::system::error_code errorCode;

if (!boost::filesystem::exists(m_filepath, errorCode) || errorCode)

{

throw DocumentLoadError(DocumentLoadError::NotFound(), m_filepath, errorCode.message());

}

else if (!utils::ipc::MakeFileLock(m_filepath))

{

throw DocumentLoadError(DocumentLoadError::IsLocked(), m_filepath, "cannot lock file");

}

fs::copy_file(m_filepath, m_documentCopyPath);

}Почему C и C++ разные?

Начнём с того, что они родились в разное время и у них разные ключевые идеи:

- лозунг C — "Доверяй программисту", хотя многим современным программистам уже нельзя доверять

- лозунг C++ — "Не плати за то, что не используешь", хотя вообще-то дорого заплатить можно и просто за неоптимальное использование

В C++ ошибки обрабатываются с помощью исключений. Как они обрабатываются в C? Кто вспомнил про коды возврата, тот неправ: стандартная для языка C функция fopen не возвращает информации об ошибке в кодах возврата. Далее, out-параметры в C передаются по указателю, а в C++ программиста за такое могут и отругать. Далее, в C++ есть идиома RAII для управления ресурсами.

Мы не будем перечислять остальные отличия. Просто примем как факт, что мы, C++ программисты, пишем на C++ и вынуждены использовать API в стиле C ради:

- OpenGL, Vulkan, cairo и других графических API

- CURL и других сетевых библиотек

- winapi, freetype и других библиотек системного уровня

Но использовать не значит "пихать во все места"!

Как открыть файл

Если вы используете ifstream, то с обработкой ошибок попытка открыть файл выглядит так:

int main()

{

try

{

std::ifstream in;

in.exceptions(std::ios::failbit);

in.open("C:/path-that-definitely-not-exist");

}

catch (const std::exception& ex)

{

std::cout << ex.what() << std::endl;

}

try

{

std::ifstream in;

in.exceptions(std::ios::failbit);

in.open("C:/");

}

catch (const std::exception& ex)

{

std::cout << ex.what() << std::endl;

}

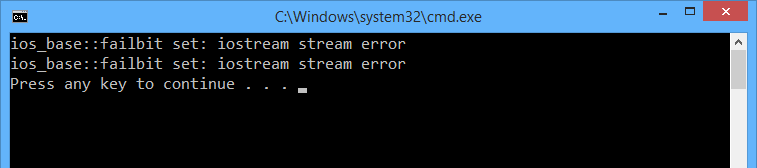

}Поскольку первый путь не существует, а второй является директорией, мы получим исключения. Вот только в тексте ошибки нет ни пути к файлу, ни точной причины. Если вы запишете такую ошибку в лог, чем это вам поможет?

Типичный код, использующий API в стиле C, ведёт себя хуже: он даже не даёт гарантии безопасности исключений. В примере ниже при выбросе исключения из вставки // .. остальной код файл никогда не будет закрыт.

// Держи это, если ты вендовоз

#if defined(_MSC_VER)

#define _CRT_SECURE_NO_WARNINGS

#endif

int main()

{

try

{

FILE *in = ::fopen("C:/path-that-definitely-not-exist", "r");

if (!in)

{

throw std::runtime_error("open failed");

}

// ..остальной код..

fclose(in);

}

catch (const std::exception& ex)

{

std::cout << ex.what() << std::endl;

}

}А теперь мы возьмём этот код и покажем, на что способен C++17, даже если перед нами — API в стиле C.

А почему бы не сделать как советует ООП?

Валяйте, попробуйте. У вас получится ещё один iostream, в котором нельзя просто взять и узнать, сколько байт вам удалось прочитать из файла, потому что сигнатура read выглядит примерно так:

basic_istream& read(char_type* s, std::streamsize count);А если вы всё же хотите воспользоваться iostream, будьте добры вызвать ещё и tellg:

// Функция читает не более чем count байт из файла, путь к которому задан в filepath

std::string GetFirstFileBytes(const std::filesystem::path& filepath, size_t count)

{

assert(count != 0);

// Бросаем исключение, если открыть файл нельзя

std::ifstream stream;

stream.exceptions(std::ifstream::failbit);

// Маленький фокус: C++17 позволяет конструировать ifstream

// не только из string, но и из wstring

stream.open(filepath.native(), std::ios::binary);

std::string result(count, '\0');

// читаем не более count байт из файла

stream.read(&result[0], count);

// обрезаем строку, если считано меньше, чем ожидалось.

result = result.substr(0, static_cast(stream.tellg()));

return result;

}Одна и та же задача в C++ решается двумя вызовами, а в C — одним вызовом fread! Среди множества библиотек, предлагающих C++ wrapper for X, большинство создаёт подобные ограничения или заставляет вас писать неоптимальный код. Я покажу иной подход: процедурный стиль в C++17.

Шаг первый: RAII

Джуниоры не всегда знают, как создавать свои RAII для управления ресурсами. Но мы-то знаем:

namespace detail

{

// Функтор, удаляющий ресурс файла

struct FileDeleter

{

void operator()(FILE* ptr)

{

fclose(ptr);

}

};

}

// Создаём FileUniquePtr - синоним специализации unique_ptr, вызывающей fclose

using FileUniquePtr = std::unique_ptr;Такая возможность позволяет завернуть функцию ::fopen в функцию fopen2:

// Держи это, если ты вендовоз

#if defined(_MSC_VER)

#define _CRT_SECURE_NO_WARNINGS

#endif

// Функция открывает файл, пути в Unicode открываются только в UNIX-системах.

FileUniquePtr fopen2(const char* filepath, const char* mode)

{

assert(filepath);

assert(mode);

FILE *file = ::fopen(filepath, mode);

if (!file)

{

throw std::runtime_error("file opening failed");

}

return FileUniquePtr(file);

}У такой функции ещё есть три недостатка:

- она принимает параметры по указателям

- исключение не содержит никаких подробностей

- не обрабатываются Unicode-пути на Windows

Если вызвать функцию для несуществующего пути и для пути к каталогу, получим следующие тексты исключений:

Шаг второй: собираем информацию об ошибке

Во-первых мы должны узнать у ОС причину ошибки, во-вторых мы должны указать, по какому пути она возникла, чтобы не потерять контекст ошибки в процессе полёта по стеку вызовов.

И тут надо признать: не только джуниоры, но и многие мидлы и синьоры не в курсе, как правильно работать с errno и насколько это потокобезопасно. Мы напишем так:

// Держи это, если ты вендовоз

#if defined(_MSC_VER)

#define _CRT_SECURE_NO_WARNINGS

#endif

// Функция открывает файл, пути в Unicode открываются только в UNIX-системах.

FileUniquePtr fopen3(const char* filepath, const char mode)

{

using namespace std::literals; // для литералов ""s.

assert(filepath);

assert(mode);

FILE *file = ::fopen(filepath, mode);

if (!file)

{

const char* reason = strerror(errno);

throw std::runtime_error("opening '"s + filepath + "' failed: "s + reason);

}

return FileUniquePtr(file);

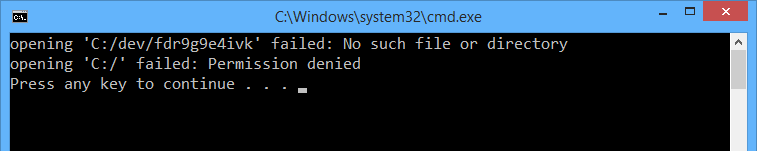

}Если вызвать функцию для несуществующего пути и для пути к каталогу, получим более точные тексты исключений:

Шаг третий: экспериментируем с filesystem

C++17 принёс множество маленьких улучшений, и одно из них — модуль std::filesystem. Он лучше, чем boost::filesystem:

- в нём решена проблема 2038 года, а в boost::filesystem не решена

- в нём есть однозначный способ получить UTF-8 путь, а ведь ряд библиотек (например, SDL2) требуют именно UTF-8 пути

- реализация

boost::filesystemсодержит опасные игры с разыменованием указателей, в ней много Undefined Behavior

Для нашего случая filesystem принёс универсальный, не чувствительный к кодировкам класс path. Это позволяет прозрачно обработать Unicode пути на Windows:

// В VS2017 модуль filesystem пока ещё в experimental

#include

#include

#include

#include

#include

namespace fs = std::experimental::filesystem;

FileUniquePtr fopen4(const fs::path& filepath, const char* mode)

{

using namespace std::literals;

assert(mode);

#if defined(_WIN32)

fs::path convertedMode = mode;

FILE *file = ::_wfopen(filepath.c_str(), convertedMode.c_str());

#else

FILE *file = ::fopen(filepath.c_str(), mode);

#endif

if (!file)

{

const char* reason = strerror(errno);

throw std::runtime_error("opening '"s + filepath.u8string() + "' failed: "s + reason);

}

return FileUniquePtr(file);

} Мне кажется очевидным, что такой код трудно написать и что писать его должен один раз кто-то из опытных инженеров в общей библиотеке. Джуниорам в такие дебри лезть не стоит.

Заглядывая в будущее: мир без препроцессора

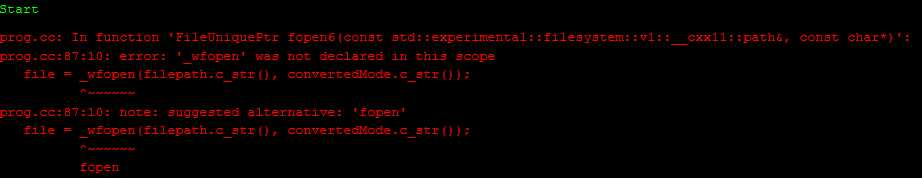

Сейчас я покажу вам код, который в июне 2017 года, скорее всего, не скомпилирует ни один компилятор. Во всяком случае, в VS2017 constexpr if ещё не реализован, а GCC 8 почему-то компилирует ветку if и выдаёт следующую ошибку:

Да-да, речь пойдёт о constexpr if из C++17, который предлагает новый способ условной компиляции исходников.

FileUniquePtr fopen5(const fs::path& filepath, const char* mode)

{

using namespace std::literals;

assert(mode);

FILE *file = nullptr;

// Если тип path::value_type - это тип wchar_t, используем wide-функции

// На Windows система хочет видеть пути в UTF-16, и условие истинно.

// примечание: wchar_t пригоден для UTF-16 только на Windows.

if constexpr (std::is_same_v)

{

fs::path convertedMode = mode;

file = _wfopen(filepath.c_str(), convertedMode.c_str());

}

// Иначе у нас система, где пути в UTF-8 или вообще нет Unicode

else

{

file = fopen(filepath.c_str(), mode);

}

if (!file)

{

const char* reason = strerror(errno);

throw std::runtime_error("opening '"s + filepath.u8string() + "' failed: "s + reason);

}

return FileUniquePtr(file);

}Это потрясающая возможность! Если в язык C++ добавят модули и ещё несколько возможностей, то мы сможем забыть препроцессор из языка C как страшный сон и писать новый код без него. Кроме того, с модулями компиляция (без компоновки) станет намного быстрее, а ведущие IDE будут с меньшей задержкой реагировать на автодополнение.

Плюсы процедурного стиля

Хотя в индустрии правит ООП, а в академическом коде — функциональный подход, фанатам процедурного стиля пока ещё есть чему радоваться.

- процедурный стиль легче понять, он проще для джуниоров и на нём написано большинство коротких примеров в сети

- вы можете завернуть функции C, практически не меняя семантику: наша функция

fopen4по-прежнему использует флаги, mode и другие фокусы в стиле C, но надёжно управляет ресурсами, собирает всю информацию об ошибке и аккуратно принимает параметры - документация функции fopen всё-ещё актуальна для нашей обёртки, это сильно облегчает поиск, понимание и переиспользование другими программистами

Я рекомендую все функции стандартной библиотеки C, WinAPI, CURL или OpenGL завернуть в подобном процедурном стиле.

Подведём итоги

На C++ Russia 2016 и C++ Russia 2017 замечательный докладчик Михаил Матросов показывал всем желающим, почему не нужно использовать циклы и как жить без них:

Насколько известно, вдохновением для Михаила служил доклад 2013 года "C++ Seasoning" за авторством Sean Parent. В докладе было выделено три правила:

- не пишите низкоуровневые циклы for и while

- используйте алгоритмы и другие средства из STL/Boost

- если готовые средства не подходят, заверните цикл в отдельную функцию

- не работайте с new/delete напрямую

- подробнее об этом — в докладе Михаила Матросова С++ without new and delete

- не используйте низкоуровневые примитивы синхронизации, такие как mutex и thread

Я бы добавил ещё одно, четвёртное правило повседневного C++ кода. Не пишите на языке Си-Си-Плюс-Плюс. Не смешивайте бизнес-логику и язык C.

- Заворачивайте язык C как минимум в один слой изоляции.

- Если речь об асинхронном коде, заворачивайте в два слоя: первый изолирует C, второй — прячем примитивы синхронизации и шедулинг задач на потоках

Причины прекрасно показаны в этой статье. Сформулируем их так:

Только настоящий герой может написать абсолютно надёжный код на C/C++. Если на работе вам каждый день нужен герой — у вас проблема.

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

|

Метки: author sergey_shambir c++ c++17 повседневный c++ |

Что может пойти не так на сайте метапоисковика и что с этим делать? Часть 2 |

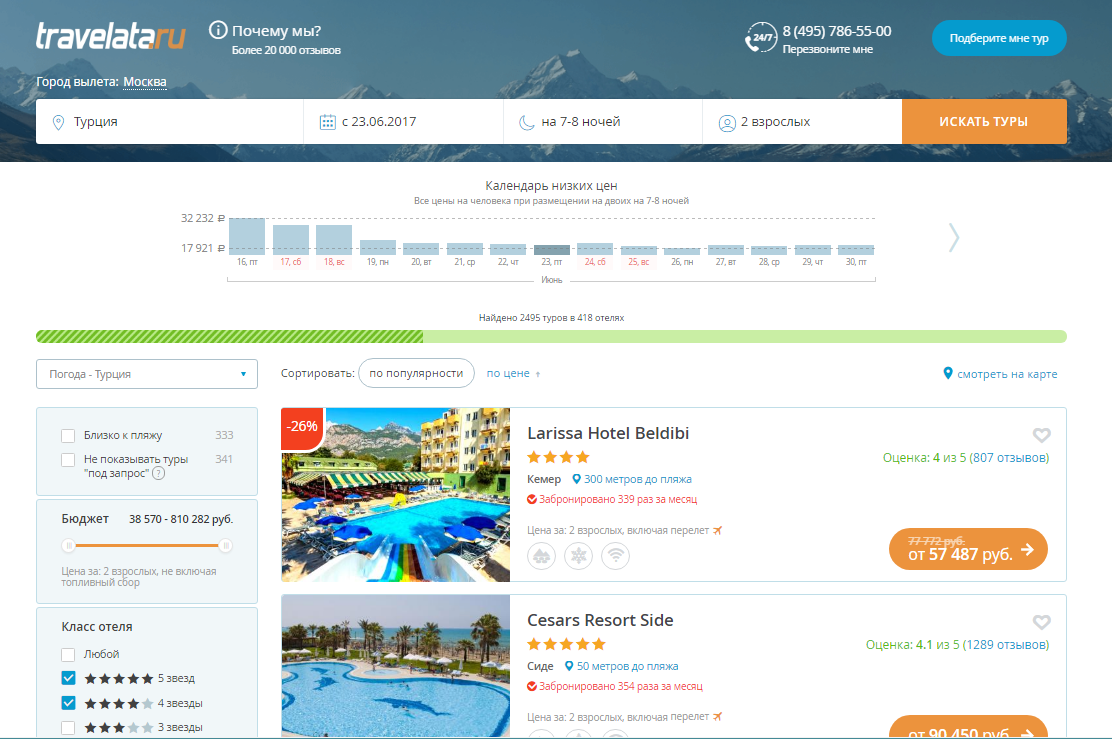

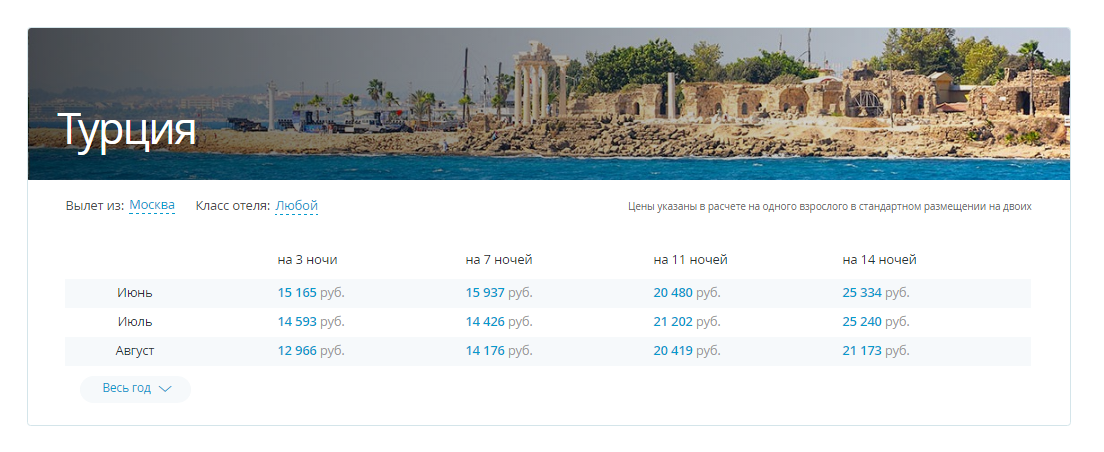

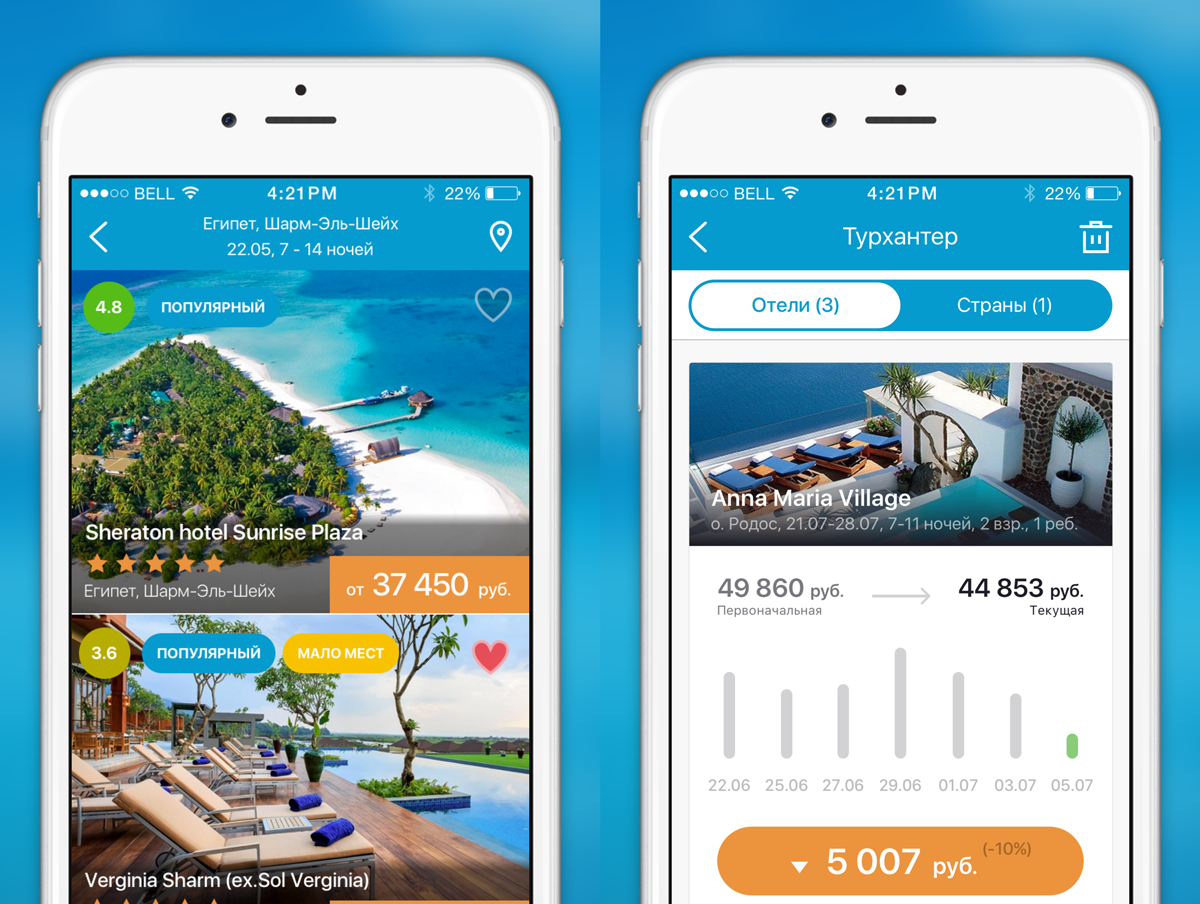

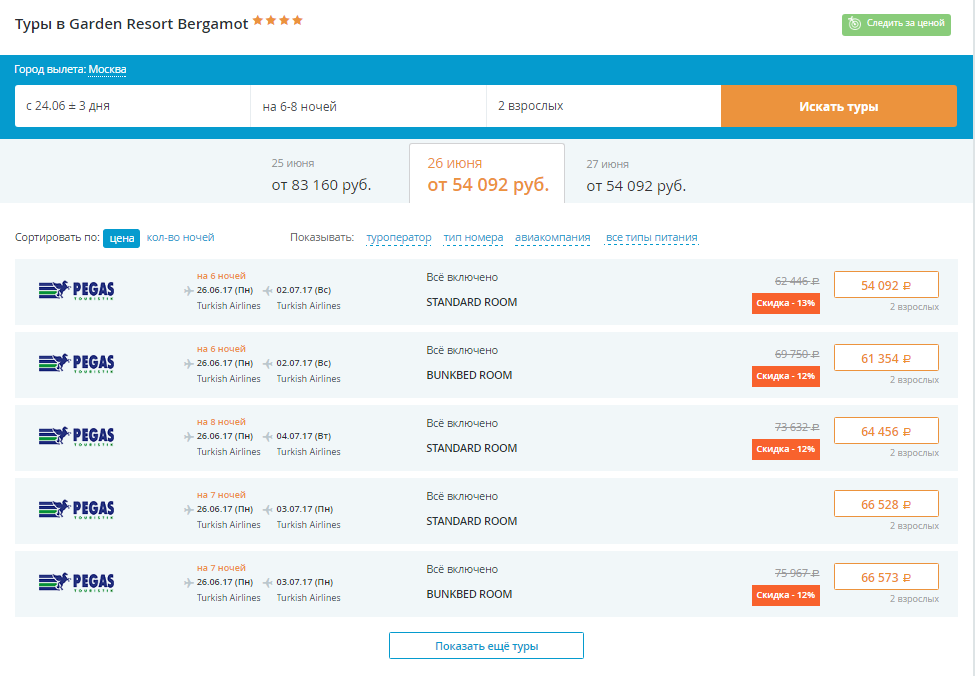

Об этих и других проблемах и багах сайта Travelata.ru я рассказал в первой части. Продолжаем публичную порку самих же себя.

Отельная страница

Когда открывается серп, направляется запрос в кеш, который хранится от 15 минут до нескольких часов. В момент открытия отельной страницы, если на отель из кеша пришло менее 3 туров, к ТО отправляется новый запрос на поиск по названию отеля. И могут приехать новые цены. Актуальные.

Почему вообще приходится так часто отправлять запросы к ТО?

По большей части причина в динамическом ценообразовании. Особенности современных турпакетов — цены меняются несколько раз в течение дня в зависимости от загрузки рейса и отеля и популярности тура. Пересчёт происходит автоматически в системе или делается вручную маркетологами туроператора. Где-то ежеминутно, а где-то несколько раз в неделю.

Вторая причина — туры просто быстро раскупают.

Самые большие скачки цен на динамический пакетах (не путать с динамическим ценообразованием из абзаца выше). Динамические пакеты — это туры “отель, билет и иногда трансфер”. Туроператор собирает их самостоятельно, подключаясь к GDS в момент стороннего запроса. Схема такова: мы стучимся к ТО, ТО обращается к GDS, забирая стоимость авиабилета (это всегда регулярный рейс) и одновременно к своей базе отелей и трансферов. И только потом складывается финальная цена. Такие туры могут оказаться выгоднее готовых чартерных пакетов, если у ТО есть договорённость с авиакомпанией или отелем и спецтарифы.

Всё это очень сложно донести до пользователя, отсюда много негатива. Клиенты думают, что мы сами специально накручиваем цены, но у нас нет маркапов. Все цены практически идентичны туроператорским, а зарабатываем мы на комиссии от ТО, как и обычное турагентство.

Какие тут могут возникать проблемы?

- Не приехал тур.

У того же Букинга есть прямые контакты с отельерами и база с ценами. А наша сборка выдачи больше напоминает метапоиск. Мы отправляем поставщикам цен асинхронные запросы и зависим от того, что отдаст каждый из них. Если ТО тормозят, то и инвентаря не будет. Поэтому клиентам выдача иногда кажется непредсказуемой — в 12 дня увидел одни предложения, через 3 часа приехали другие. Ну или просто желаемый тур уже купили :)

- Мало информации об отеле.

Также на странице отеля клиенты рассчитывают найти всю информацию об отеле. То есть вообще всю. Например, многим важно наличие бесплатного вайфая в номере. Но сегодня в отеле может быть бесплатный интернет, а завтра за него начнут брать плату — отслеживать такие вещи слишком энергозатратно. Для таких специфических вопросов мы подключили возможность написать менеджеру в мессенджерах. Это гораздо удобнее живых чатов на сайте. Вся переписка сохраняется в телефоне, и к ней можно вернуться в любой момент.

Мы не контентный проект. Но все равно стараемся наполнять карточки отелей по максимуму. Подключили отзывы с TopHotels — клиенты говорят, очень удобно.

Чекаут

Пользователь выбрал тур, происходит финальная актуализация цены. Мы отправляем запрос ТО на этот тур, проверяем места в отеле и на рейс и приносим всю дополнительную информацию по перелетам и доплатам.

Что может пойти не так?

1. Подгрузился топливный сбор, и цена выросла

Топливный сбор — это такое эфемерное понятие. Кто-то называет его уловкой туроператоров, но бОльшая часть туристов вообще не понимают, что это и для чего он нужен. Тем не менее, он есть и чаще всего на популярные направления. Составляет от $40 до $80 в зависимости от авиакомпании. Нет строгого правила в какую страну и по какому ТО есть топливо, а куда нет. По каждому туру расчёт индивидуален. Но вот у Библио-Глобуса топливного сбора нет ни на одном направлении. Возможно он уже зашит в цену и с ней и передаётся к нам.

2. Топливный сбор не подтянулся, но он есть

Чтобы получить данные по топливу, нужно прокинуть запрос в личный кабинет туроператора на конкретный тур. Иногда ТО может не отдать критерии, и цена не подъезжает. Бывают случаи, когда в ЛК что-то поменяли, и парсер отвалился. Подключаемся, фиксим.

Почему нельзя добавить топливный сбор сразу, в цены на серпе?

Теоретически это возможно. Но конкуренты тоже показывают цены на туры без учёта топлива. Есть риск, что люди увидят более высокие цены и уйдут от нас. И в целом будет складываться впечатление дорогих туров. Обязательно попробуем выводить топливо сразу, но в качестве эксперимента.

3. Не прошла актуализация по туру (неверная цена и информация о перелёте)

ТО может не ответить на запрос, и вся информация не актуализируется. То есть если вы не видите данных о перелётах (время вылета, аэропорт), то скорее всего цена тоже не обновилась. В таком случае вернитесь на страницу отеля и сузьте запрос. Например, если вас интересует тур на 7 ночей, а в поиске выставлен фильтр на 6-10 ночей, проставьте точно на 7 ночей и запустите поиск. Если не сработает, вернитесь к этому туру через несколько минут.

В среднем уровень успешных ответов на актуализацию составляет 92%. Когда падает до 90%, разбираемся с ТО и отключаем его, пока не пофиксят баги.

На регулярные рейсы запрос может быть более долгим. Если за 1 минуту ТО не ответил, то актуализации не происходит.

Что говорим клиенту?

При любой ошибке, если оплата от клиента прошла, менеджер связывается с ним и сообщает, что цена на тур изменилась по не зависящим от нас причинам. Менеджер предлагает переподбор, и если клиент отказывается, деньги на карте размораживаются. Если турист негативит, дарим скидку на следующий тур. В 70% случаев клиенты успокаиваются и соглашаются.

Оплата

Мы не можем бронировать туры без оплаты. Это гарантия, что клиент серьёзно настроен на покупку. К тому же после аннуляции брони по турам вступают штрафные санкции, и ТО перекладывают их на нас. При этом мы позволяем забронировать тур с минимальной информацией — обязательны только поля со звёздочками, остальное можно заполнить потом. Это удобно, если тур горящий, и может “уйти” в любой момент.

При этом мы не списываем деньги с карты клиента, а замораживаем их. Если произойдёт какая-либо ошибка, деньги моментально размораживаются и можно забронировать другой тур.

1. На этапе оплаты могут произойти проблемы с банком. На стороне банка, естественно.

Мы используем систему 3D Secure — это когда по SMS отправляется код подтверждения оплаты. Однако не все банки отправляют SMS для 3DS-аутентификации и не ко всем картам подключена 3DS. Отменить эту систему мы не можем, она позволяет избежать фрода.

Когда мы холдируем деньги, от большинства банков приходит SMS клиенту о том, что деньги списаны. Некоторые банки присылают SMS о том, что деньги заморожены. А бывают и такие случаи, когда приходит смс о заморозке и за ней — и списании. Это редкий случай, но клиенты пугаются, что с них 2 раза сняли деньги. Приходится успокаивать.

2. Иногда возникает ошибка в процессе оплаты. В таком случае мы просим пользователя оплатить тур другой картой, позвонить в банк или попробовать оплатить тур позднее.

После оплаты

1. Оплаченный тур может не подтвердить туроператор

Есть туры на моментальном бронировании — это значит, что за туроператором закреплена определённая квота по номерам и билетам на самолёт, причём уже проплаченная. Другие туры подтверждаются реже — обычно у ТО есть договорённость с этими отелями и авиакомпаниями, но сами места на проплачены. Но это не гарантирует наличия мест на определённые даты. Поэтому туроператору приходится обращаться к партнёрам за подтверждением.

Туры под запрос на Травелате помечены значком. Можно эти туры отфильтровать и не показывать в поисковой выдаче. Туры под запрос подтверждаются примерно в 60% случаев, не под запрос — в 90%.

Хуже всего подтверждаются не самые популярные направления у россиян. Если железобетонно нужно уехать по непопулярному направлению, например, на свадьбу к друзьям, и вы бронируете тур в последний момент, лучше перестраховаться и подобрать путешествие самостоятельно.

Если тур не подтверждают, а на переподбор клиент не согласился, мы размораживаем деньги. Обычно это процесс моментальный, но могут произойти проблемы на стороне банка. Тогда обращайтесь в банк.

2. Рейс перенесли

Здесь ничего не поделаешь. Это особенность чартерных рейсов, которая чётко прописана в договоре. У нас на чекауте есть услуга конкретизации рейса, которая фиксирует номер чартерного рейса. Без этой услуги туриста могут пересадить на любой рейс с вероятностью 20-30%. С конкретизацией рейс зафиксирован, он практически приравнивется к “регулярке”. Хотя и может задержаться, как и любой другой перелёт.

Как справиться с недоверием?

Новый клиент очень аккуратен, он боится платить, боится неправильно заполнить паспортные данные. Что уж говорить об оплате… В таких случаях опять же поможет чат в мессенджерах.

Поставщик и посредник — кто кого вытягивает?

Технические возможности ТО постепенно улучшаются. К примеру, 5 лет назад ни у кого не было API, приходилось парсить данные из личных кабинетов. Сейчас API есть почти у всех, даже не самых крупных ТО.

Сильно выросла онлайн нагрузка на сервера ТО. Раньше у них на сайтах сидели только турагенты и искали точечные запросы. Сейчас в онлайн с ними работают такие игроки как мы, от нас уходит несколько миллионов запросов в день.

Наши отношения с туроператорами — это взаимовыгодное сотрудничество. Для них IT — не основная специализация. Около 95% всех туров до сих пор продаются в офлайне.

Пускай ТО создают хороший продукт. А мы своим фидбеком поможем им развиваться в онлайне. Если у них возникли какие-то проблемы, мы просто отключим выдачу по одной из стран или полностью отключим на время. Часто мы находим баги у ТО быстрее, чем они. Поэтому все в выигрыше.

|

Метки: author zalexis управление разработкой управление продуктом управление e-commerce блог компании травелата api туризм интерфейсы ui базы данных |

Лучше один раз услышать чем семь раз прочитать |

текстовое описание, скажем, отличия септаккорда от трезвучия, есть, а звука, чтоб это отличие услышать — нет.

Хорошим обратным примером является интерактивный мини-учебник по теории музыки от Ableton

В статьях учебника кратко описываются основные аспекты композиции от ритма до гармонизации. Причём на каждой странице встроен интерактивный редактор где можно не только прослушать пример, но и попробовать что-то поменять и сразу проверить результат.

Данный учебник это целое веб-приложение над которым работала серьёзная команда программистов.

К сожалению, данный подход неприменим для большинства статей на тематических сайтах или постов в форумах.

Можно ли как-то попроще?

В идеале было бы достаточно иметь возможно вставить в текст ссылку по которой открывается интерактивный редактор с обсуждаемым куском мелодии. Ну и скришот редактора сделанный стандартными средствами т.к. картинки и ссылки можно вставлять в любых блогах, почтовых сообщения и т.п.

Многие веб-секвенсоры предоставляют такую возможность. Например Flat.io даже предоставляет API по встраиванию редактора в страницу с помощью iframe (хотя для большинства форумов это бесполезно т.к. тэг iframe запрещён в сообщениях)

К сожалению, распространённые сервисы предоставляют только нотный стан. Хотя большинство современной музыки пишется в пианоролл (см. Ableton Live, FL Studio, Pro Tools), а не в классической нотации.

Работающий пример с Piano Roll

Возможно использовать RiffShare. Сервис позволяет задать мелодию (или импортировать через .mid) и получить на неё обычную ссылку:

Результат можно вставить в любой блог, в том числе даже в пост или комментарий на Хабре. Вот как может выглядеть статья о гармонизации из учебника Ableton:

Аккорды

“Mary Had a Little Lamb”

Это известная детская песня с узнаваемой простой мелодией. Вот одноголосая мелодия в тональности Фа-мажор.

открыть http://tinyurl.com/y9k93o3r

Но если мы гармонизируем мелодию с помощью нескольких аккордов, у нас получится полноценное произведение.

Этот пример показывает простую прогрессию (последовательность) аккордов. В большинстве стилей музыки прогрессия аккордов используется для создания напряжения или завершённости и т.п. Для этого аккорды могут как совпадать с основной тональностью, так и противостоять ей.

http://tinyurl.com/y8r9xabu

Как используются аккорды?

Мы добавили трезвучия Фа-мажоре и в До-мажоре. Но почему мы добавили именно эти аккорды?

Обратите внимание на совпадение нот мелодии с нотами аккомпанирующих аккордов. Например, в первом такте ноты Фа и Ля мелодии входят в трезвучие Фа-мажор. Ноты Соль не входят в это трезвучие, но они используются в мелодии как «соединение» между Фа и Ля.

Попробуйте поэкспериментировать поменяв аккорды в композиции.

RiffShare это опенсорсная разработка которая использует WebAudioFont и работает в любом браузере на любой платформе. Позволяет обмениваться музыкальными фрагментами широкого формата (см. примеры на странице сервиса) от джаза до транса.

|

Метки: author musicriffstudio работа со звуком интерфейсы web audio api sound web |

Тестируем возможности ARKit. Создаем игру с дополненной реальностью |

На WWDC 2017 Apple анонсировала ARKit — SDK для работы с дополненной реальностью. Благодаря ему порог вхождения в эту технологию стал значительно ниже. Можно ожидать появления большого количества качественных игр и приложений.

Если вы смотрели Keynote, то, вероятно, вы уже в восторге от увиденного. Игровой мир, который инженеры Apple смогли развернуть на обычном столе при помощи ARKit, не может оставить равнодушными даже самых искушенных геймеров. Это был не просто прототип, а хорошо работающая технология, над которой действительно потрудились. В этом легко убедиться, запустив несколько демо или попробовав самим привнести что-либо виртуальное в наш мир.

Вынужден расстроить счастливых обладателей iPhone 6 и ниже. На данных девайсах все эти прелести жизни будут недоступны. Для использования всех ключевых функций ARKit необходим процессор А9 и выше. Apple, конечно, даст урезанный доступ к функциональности, но это уже совсем не то.

Дополненная реальность

Дополненная реальность (augmented reality, AR) — это виртуальная среда, которая накладывается на реальный мир для придания ему большей выразительности, информативности или просто ради развлечения. Термин, предположительно, был предложен исследователем компании Boeing Томасом Коделлом еще в 1990 году. Уже тогда начали появляться первые примеры устройств с применением данной технологии. Впервые дополненная реальность была реализована на электронных шлемах летчиков для вывода информации о полете и радаре.

Хочется спросить, чем же все занимались почти 20 лет и почему масштабное развитие эта технология получила лишь сейчас. Все предельно просто. Появление хороших камер в телефонах, сенсоров и развитие технологий компьютерного зрения сделали это возможным.

Что же можно сделать полезного и чего ждать в ближайшее время на полках AppStore? На самом деле все ограничивается лишь фантазией разработчиков. Можно с уверенностью назвать несколько отраслей, где AR произведет революцию с выходом нового фреймворка от Apple:

- Игровая индустрия;

- Архитектура;

- Киноиндустрия.

Возможности ARKit

ARKit — не волшебная палочка Гарри Поттера, а инструмент, который умеет грамотно обрабатывать большое количество данных, полученных от устройства. Благодаря камере и датчикам движения фреймворк отслеживает движение, находит поверхности и определяет освещенность. После анализа данных мы получаем конкретное представление об окружающем мире в виде точек пересечения, координат поверхностей и положении камеры в пространстве.

Основой задачей ARKit является слежение за окружающим миром (World Tracking) для создания виртуальной модели реального мира. Фреймворк распознает особенности видеокадров, отслеживает изменения их положения и сравнивает эту информацию с данными от датчиков движения. Результатом является виртуальная модель реального мира. Отдельная возможность — распознавание плоских горизонтальных поверхностей. ARKit находит плоскости и сообщает об их расположении и размерах.

Слежение за окружающим миром требует анализа картинки, получаемой от камеры. Для достижения наилучшего результата, необходимо хорошее освещение.

Основой ARKit являются ARSCNView и ARSKView. Они служат для отображения live видео и рендеринга 3D и 2D изображений. Как все уже догадались, это наследники от SCNView и SKView. Следовательно, ARKit не привносит каких-то невероятных особенностей в отображении данных. Это все те же движки для работы с 2D и 3D графикой, с которыми уже все знакомы. Поэтому порог вхождения в данную технологию будет достаточно низким. Apple знаменита любовью к своим технологиям и продуктам, но несмотря на это разработчики ARKit сделали поддержку Unity и Unreal Engine. Это положительно скажется на количестве качественных приложений, которые появятся в ближайшее время.

ARSCNView и ARSKView содержат в себе сердце ARKit — ARSession. Именно этот класс содержит в себе все необходимое для работы с дополненной реальностью. Для запуска ARSession необходимо передать конфигурацию работы сессии.

Тип конфигурации определяет стиль и качество работы AR, которое может быть достигнуто:

- На девайсах с процессором A9 и новее можно использовать

ARWorldTrackingSessionConfiguration. Именно эта конфигурация дает возможность воспользоваться всей мощью нового фреймворка. Для вас будет создана модель окружающего мира в виртуальной реальности и предоставлена информация о плоскостях в поле видимости камеры. Это поможет расположить виртуальные объекты с максимальной точностью. - На остальных девайсах, поддерживающих ARKit, будет доступна лишь

ARSessionConfiguration. Базовый класс предоставляет только информацию о движении устройства в пространстве, но не строит виртуальных моделей. Это не даст необходимого эффекта и не позволит насладиться всем качеством новой технологии. Вам будет недоступна возможность фиксации виртуальных объектов относительно объектов реального мира.

После выбора типа конфигурации необходимо создать ее экземпляр, произвести настройку и запустить сессию:

override func viewWillAppear(_ animated: Bool) {

super.viewWillAppear(animated)

// Create a session configuration

let configuration = ARWorldTrackingSessionConfiguration()

// Run the view's session

sceneView.session.run(configuration)

}Важно помнить, что ARKit потребляет довольно много энергии для расчетов. Если View с контентом не отображается в данный момент на экране, то имеет смысл приостановить сессию на это время, используя session.pause().

После запуска сессии можно начинать работать с виртуальным контентом. Если хотите, чтобы ARKit распознавал плоскости, не забудьте установить значение planeDetection у конфигурации в значение horizontal. Изначально распознавание горизонтальных поверхностей выключено. Будем надеяться, что в будущем появится возможность находить и вертикальные поверхности, но пока только горизонтальные.

Способ получения информации об окружающей среде зависит от того, какой вид отображения данных вы будете использовать ARSCNView, ARSKView или Metal. Единицей информации, которую предоставляет ARKit, является ARAnchor. Если у вас включено распознавание поверхностей, то вы столкнетесь с сабклассом ARPlaneAnchor. Он содержит в себе информацию о найденных плоскостях. Благодаря данным якорям есть возможность ориентироваться в пространстве. В случае использования Metal вам придется вручную заниматься рендерингом. Тогда можете подписаться на обновления, используя делегат ARSessionDelegate у класса ARSession, и получать якоря от сессии. Если используете один из Apple движков для рендеринга объектов, тогда есть возможность воспользоваться более удобными делегатами ARSCNViewDelegate или ARSKViewDelegate.

На первый взгляд все довольно просто. Почти всю сложную работу делает ARSession. Давайте попробуем сделать тестовое приложение.

Тестируем возможности ARKit

Дополненная реальность сейчас у всех ассоциируется с игрой Pok'emon GO, которая взорвала рынок игровой индустрии. Попробуем сделать нечто похожее.

Для создания тестового приложения мы воспользуемся ARSCNView для создания и рендеринга 3D моделей. Наша игра будет состоять из 2 этапов. Сначала мы будем расставлять мишени по комнате, а после пытаться как можно быстрее попасть по ним всем. Игра довольна примитивна, но продемонстрирует простоту создания игр с дополненной реальностью.

Начнем с того, что растянем на весь ViewController ARSCNView и создадим IBOutlet. Далее будем работать с ней, как с обычной SCNView. Произведем первоначальную настройку. Сделаем контроллер делегатом контактов физического мира и выведем статистику. Настроим запуск и паузу сессии при появлении и скрытии контроллера.

override func viewDidLoad() {

super.viewDidLoad()

sceneView.scene.physicsWorld.contactDelegate = self

// Show statistics such as fps and timing information

sceneView.showsStatistics = true

}

override func viewWillAppear(_ animated: Bool) {

super.viewWillAppear(animated)

// Create a session configuration

let configuration = ARSessionConfiguration.isSupported ?

ARWorldTrackingSessionConfiguration() : ARSessionConfiguration()

// Run the view's session

sceneView.session.run(configuration)

}

override func viewWillDisappear(_ animated: Bool) {

super.viewWillDisappear(animated)

// Pause the view's session

sceneView.session.pause()

}Выбор конфигурации сессии зависит от модели устройства, на котором запустили приложение. Крайне важно сделать эту проверку. Иначе, в случае неверной конфигурации, сессия пришлет ошибку и игра не запустится вообще.

ARKit настолько прост, что мы больше не будем использовать никакие его настройки. Единственное, что еще понадобится — это расположение камеры в пространстве виртуального мира. Остальное — дело техники и немного SceneKit.

Мы не будем здесь описывать обработку нажатий или подсчет очков. Это не так важно, и вы можете это увидеть сами в ДЕМО, представленном в конце статьи.

Наша игра содержит две модели объектов: шарик, которым мы будем стрелять, и летающие логотипы Touch Instinct. Для добавления этих моделей на экран, необходимо создать их, используя SCNNode.

Что понадобится, чтобы создать физический объект:

- задать фигуру определенного размера;

- создать фигуру с физическими свойствами для контролирования контактов с другими объектам;

- создать физическое тело для описания поведения объекта при соприкосновении;

- задать текстуры.

Пример реализации классов патрона в виде шара и логотипа в виде куба с нужными текстурами.

class ARBullet: SCNNode {

override init() {

super.init()

let arKitBox = SCNSphere(radius: 0.025)

self.geometry = arKitBox

let shape = SCNPhysicsShape(geometry: arKitBox, options: nil)

self.physicsBody = SCNPhysicsBody(type: .dynamic, shape: shape)

self.physicsBody?.isAffectedByGravity = false

self.physicsBody?.categoryBitMask = CollisionCategory.arBullets.rawValue

self.physicsBody?.contactTestBitMask = CollisionCategory.logos.rawValue

// add texture

let material = SCNMaterial()

material.diffuse.contents = UIImage(named: "art.scnassets/ARKit_logo.png")

self.geometry?.materials = [material]

}

required init?(coder aDecoder: NSCoder) {

fatalError("init(coder:) has not been implemented")

}

}class Logo: SCNNode {

override init() {

super.init()

let logo = SCNBox(width: 0.1, height: 0.1, length: 0.1, chamferRadius: 0)

self.geometry = logo

let shape = SCNPhysicsShape(geometry: logo, options: nil)

self.physicsBody = SCNPhysicsBody(type: .dynamic, shape: shape)

self.physicsBody?.isAffectedByGravity = false

self.physicsBody?.categoryBitMask = CollisionCategory.logos.rawValue

self.physicsBody?.contactTestBitMask = CollisionCategory.arBullets.rawValue

// add texture

let material = SCNMaterial()

material.diffuse.contents = UIImage(named: "art.scnassets/logo-mobile.png")

self.geometry?.materials = Array(repeating: material, count: 6)

}

required init?(coder aDecoder: NSCoder) {

fatalError("init(coder:) has not been implemented")

}

}Хочется обратить внимание на CollisionCategory. Это структура используется для определения типа объекта при контакте.

struct CollisionCategory: OptionSet {

let rawValue: Int

static let arBullets = CollisionCategory(rawValue: 1 << 0)

static let logos = CollisionCategory(rawValue: 1 << 1)

}Это стандартная тактика для определения контакта. Свойство categoryBitMask задает маску конкретного объекта, а contactTestBitMask настраивает все контакты, которые нам будут интересны и о которых мы хотим получать уведомления.

Раз мы заговорили про обработку контактов, давайте посмотрим, как это выглядит в контроллере. Во viewDidLoad мы уже подписались на события контактов физического мира. Осталось реализовать одну функцию.

extension ViewController: SCNPhysicsContactDelegate {

func physicsWorld(_ world: SCNPhysicsWorld, didBegin contact: SCNPhysicsContact) {

guard let nodeABitMask = contact.nodeA.physicsBody?.categoryBitMask,

let nodeBBitMask = contact.nodeB.physicsBody?.categoryBitMask,

nodeABitMask & nodeBBitMask == CollisionCategory.logos.rawValue & CollisionCategory.arBullets.rawValue else {

return

}

contact.nodeB.removeFromParentNode()

logoCount -= 1

if logoCount == 0 {

DispatchQueue.main.async {

self.stopGame()

}

}

DispatchQueue.main.asyncAfter(deadline: .now() + 0.5, execute: {

contact.nodeA.removeFromParentNode()

})

}

}Самое интересное — это первая проверка того, что произошло именно соударение патрона и мишени в виде куба. Она выполняется на основе битовой маски. Это очень удобно и избавляет от большого количества других проверок.

При соударении мы убавляем счетчик оставшихся логотипов и удаляем оба объекта. Второй объект удаляется с небольшой задержкой для визуализации столкновения.

Две основные игровые функции — это добавление мишени и выстрел. Добавление происходит на небольшом расстоянии от экрана в той стороне, куда направлена камера. Мы просто создаем уже сконфигурированный объект куба, добавляем его на сцену и настраиваем его расположение относительно камеры в пространстве.

private func addLogo() {

guard let currentFrame = sceneView.session.currentFrame else {

return

}

let logo = Logo()

sceneView.scene.rootNode.addChildNode(logo)

var translation = matrix_identity_float4x4

translation.columns.3.z = -1

logo.simdTransform = matrix_multiply(currentFrame.camera.transform, translation)

logoCount += 1

if logoCount == ViewController.logoMaxCount {

startGame()

}

}При выстреле мы также создаем объект шара. Добавляем его на сцену. Но теперь нам необходимо не просто его добавить, но и придать ему ускорение. Для этого мы определяем позицию посередине экрана и придаем ускорение, приложив силу в нужном направлении.

private func shoot() {

let arBullet = ARBullet()

let (direction, position) = cameraVector

arBullet.position = position

arBullet.physicsBody?.applyForce(direction, asImpulse: true)

sceneView.scene.rootNode.addChildNode(arBullet)

}Вот так всего за пару десятков строк мы создали простую игру.

Будущее наступит в сентябре

Как видите, Apple потрудились на славу. Благодаря новому фреймворку ARKit создание приложений с дополненной реальностью — так же просто, как сделать приложение с несколькими контроллерами. При этом вам не нужно беспокоиться о красивых декорациях. Эта технология точно изменит наше представление о мобильных приложениях.

Скачивайте новый Xcode 9, и создавайте приложения, которые добавят в наш мир виртуальной магии. Будущее уже здесь. Ну или будет здесь ближе к сентябрю, после очередной презентации Apple.

Демо проект

Скачивайте в репозитории Touch Instinct

|

Метки: author GrigoryUlanov разработка под ios разработка под ar и vr xcode swift блог компании touch instinct ios wwdc wwdc 2017 ar arkit |

[Перевод] Как добиться того, чтобы обучение в играх не раздражало |

Когда я пишу статьи об обучении в видеоиграх, вокруг них всегда начинаются яростные обсуждения. Люди неизбежно начинают перечисляют все неудачные фрагменты обучения, неуклюжие техники и провалившиеся эксперименты как примеры того, что «обучение — это плохо, лучше бы его вообще не было!».

Если поискать на сайте tvtropes.org (это база данных клише поп-культуры) слово «tutorial», то найдётся больше десяти разных тропов, связанных с тем, что люди ненавидят в процессе обучения видеоигр. Для сравнения: я нашёл всего два обсуждения того, как сильно пользователи ненавидят скачиваемый контент.

Самое печальное в этом то, что когда я пишу об обучении, я имею в виду не такое обучение.

Из-за этого заблуждения я не могу сообщить об обучении то, что хочу.

Когда я говорю об обучении в видеоиграх, то стремлюсь свести всё к очень простой идее, которая, как мне кажется, отлично реализована в лучших играх: если создать очень умный дизайн уровней, то можно обучать игроков просто… дав им играть.

Я надеюсь показать, что это не какой-то особенно новый или революционный взгляд на обучение. При правильной реализации дизайнер стремится к том, чтобы игрок даже не заметил, что обучение уже происходит. Именно поэтому такие примеры обычно не обсуждаются.

Однако при плохой реализации обучение может стать одним из самых плохих моментов игры.

RTFM?

Прежде чем продолжить, я должен упомянуть один из старейших способов обучения играм: руководство. Если вы молоды, то можете и не помнить эти небольшие бумажные брошюрки, поставлявшиеся в комплекте с видеоигрой. В этих брошюрах были картинки, предупреждения об опасности эпилептических приступов и (наверно, самое важное) объяснение того, как играть в игру.

Руководства — это довольно неплохой способ обучения пользователей игре, но у них есть очевидные недостатки:

- Они предполагают способность читать, что не подходит для игр разных типов и рассчитанных на разную аудиторию.

- Их легко потерять (или не забыть отдать при перепродаже), при этом игроки остаются вообще без обучения.

- Они могут стать жертвой тех же самых проблем, что и внутриигровое обучение. Немного позже я рассмотрю эти проблемы.

- Они значительно увеличивают интервал между временем покупки и временем начала игры. Это нежелательно, будь руководство в бумажном или в программном виде.

Из-за этих и других недостатков брошюр-руководств дизайнеры игр начали пробовать встроить обучение непосредственно в игру. Некоторым это удавалось лучше других.

Зачем играм вообще нужно обучение?

Общее для всех игр заключается в том, что все они имеют правила. Правила определяют границы игры, принципы набора очков, условия завершения, способы взаимодействия игроков с игрой и друг с другом. Если собрать компанию для игры в прятки, то нужно сначала объяснить, кто будет водить, где по правилам можно прятаться, до скольки считает водящий, и так далее.

Если двое игроков садятся за шахматную доску, игра не начнётся, пока оба игрока не узнают как двигаются фигуры и каковы условия победы. (И применимо ли правило «взятия на проходе».)

Всё сводится к следующему: дизайнер игры (ребёнок, объясняющий правила) должен каким-то образом донести правила до игроков (других детей).

Если первый ребёнок (дизайнер игры) не сможет объяснить правила, то игра не состоится. Первый ребёнок должен обучить остальных.

Если игрок не знает, как играть, то он не сможет играть.

Почему многие считают, что ненавидят обучение в видеоиграх?

Тропа, проложенная дизайнерами старых игр, усеяна телами провалившихся экспериментов с обучением. Зная, что игрокам совершенно необходимо знать правила игры, многие заходят слишком далеко и обучение начинает раздражать.

Вот некоторые из часто встречающихся (и абсолютно справедливых) причин ненависти к обучению:

«Обучение впустую тратит время игрока!»

Игроки обычно вспоминают невероятно долгие обучающие уровни (некоторые продолжались дольше шести часов), или обязательные этапы с тиром в начале каждого шутера от первого лица. Это очень раздражающая задумка, поэтому ненависть здесь вполне понятна, но под «обучением» я понимаю нечто другое.

«Обучение навязывают игроку!»

После этой жалобы обычно идёт длинный список непропускаемых и невероятно надоедающих «подсказок», которые нужно пройти, прежде чем вас допустят к игре. Такой подход неэлегантен и не очень дружественен к игроку. И это тоже не то «обучение», о котором я рассказываю.

«Туториалы — это скучища!»

За этим восклицанием следует перечень обязательных туториалов, которые «ведут за руку» игрока и не позволяют ему научиться чему-то самостоятельно, исследовать мир, очерченный правилами игры, да и просто учиться тому, как играть в игру! При втором прохождении это обычно ещё хуже — вы уже знаете всю эту чушь, и просто хотите добраться до игры! Но и это не то обучение, о котором я говорю.

«Обучение оскорбительно!»

Обычно это относится к ерунде про «хотите ли вы переключиться в лёгкий режим». Тон такого обучения слишком снисходящий, он как будто подразумевает, что игрок не является разумным человеческим существом, способным на мышление и исследование. Другим частым случаем бывает текст, котторый появляется уже после того, как вы несколько раз делали какое-то действие. Например, пятидесятое повторение «Нажмите A для прыжка!».

Но буду я говорить о чём-то другом.

О, стрелковый тир, где героями не рождаются, но становятся!

«Обучение неприемлемо эстетически!»

Иногда оно действительно неприемлемо, например, когда ваш персонаж — мощнейший супергерой, изрыгающий сотни пуль, а вас учат, как направлять оружие на цель и стрелять. Иногда это менее очевидно, и только замедляет игру, разрушая ощущение потока в той части игры, в которой темп должен ускоряться (т.е. на первом уровне).

Нет, и не об этом я собираюсь рассказать.

«Обучение почти никогда не работает!»

Эта жалоба относится обычно к типу туториалов «быстро покажем экран управления и вы больше никогда его не увидите». Ещё иногда игра обучает чему-то на первом уровне, но не использует это знание, а к моменту его применения игрок о нём уже забывает.

«Как там делается долгий прыжок?»

Как вы наверно уже догадались, я буду говорить и не об этом.

«Я люблю исследовать всё самостоятельно. Мне больше нравятся игры, которые дают мне самому заниматься чем угодно».

Это ощущение изучения и пространства для экспериментов — и есть конечный результат того, что я говорил об обучении. Если создавать уровни (или контент), не забывая об обучении, вы обучаете игроков, просто давая им играть в игру.

«Вы уверены, что у вас есть мозг? Нажмите X для потверждения». (Пародия на туториал из Far Cry 3: Blood Dragon.)

Самый известный пример

Я хочу рассказать об известнейшем примере обучения «внутри геймплея»: о первых двух экранах оригинальной Super Mario Bros. для NES.

В одном из эпизодов Iwata Asks технический директор Nintendo Сатору Ивата (Satoru Iwata) беседует с дизайнером Super Mario Bros. Сигэру Миямото (Shigeru Miyamoto) об этом первом экране и обо всём «скрытом» обучении, встроенном в этот обманчиво простой дизайн:

Про гумб (goomba):

Ивата: Если вы играете в первый раз, не имея никаких знаний об игре, то наткнётесь на первого гумбу и умрёте.

Миямото: Да, и поэтому нам нужно было естественным образом обучить игрока… чтобы он перепрыгивал и избегал их.

Ивата: Тогда при попытке избежать их иногда будет происходить так, что игрок ошибается и случайно падает на гумбу сверху. Таким образом, он в процессе игры узнаёт, что можно победить их, запрыгивая им на голову.

Про грибы-бонусы:

Миямото:… Когда вы играете, то прямо с самого начала видите гумбу, и он похож на гриб. Когда вы ударяете по ящику и из него вылетает что-то, похожее на гумбу…

Ивата: Вы убегаете.

Миямото: Правильно, убегаете. Это стало для нас серьёзной проблемой. Нам нужно было как-то дать понять игроку, что на самом деле это что-то хорошее.

Ивата: Если игрок избежит первого гумбу, а потом подпрыгнет и ударит ящик над головой, то из него выскочит гриб и игрок удивится. Но потом он увидит, что гриб уползает вправо и подумает, что находится в безопасности. «Появилось что-то странное, но со мной всё в порядке!» Но потом, конечно же, ударившись об трубу, гриб вернётся назад! (смеётся)

Миямото: Верно! (смеётся)

Ивата: В этот момент, даже если игрок запаникует и попытается отпрыгнуть с его пути, то ударится об ящик. И в ту секунду, когда он поймёт, что с ним покончено, Марио неожиданно затрясётся и увеличится в размерах! Может быть, игрок сначала и не поймёт, что произошло, но по крайней мере, он не потерял жизнь.

На этих двух экранах игрок, по словам Миямото «учится естественным образом» большинству важных навыков, необходимых для игры.

Например, Марио начинает игру с левой части экрана. Весь экран пуст, и игрок может безопасно поэкспериментировать с управлением. Когда игрок нажимает A, Марио подпрыгивает на месте. Нажимая на крестовину, игрок учится бежать вправо (Марио может бежать влево, но камера не скроллит экран в эту сторону).

Весь первый экран разработан таким образом, чтобы дать игрокам самостоятельно изучить управление. Весь второй экран посвящён знакомству с другими сложными в понимании игровыми механиками (например, тому, что бонус похож на врага) и позволяет с лёгкостью учиться, исследуя.

Существует вероятность, что игрок упустит всё это в первый раз, но поскольку после каждой смерти уровень начинается заново, его необходимо проходить снова и снова. Постепенно обучение сработает и игрок «откроет» эти почти скрытые правила.

Примеры из мобильных игр

Pudding Monsters

Один из моих любимых примеров мобильных игр, хорошо справляющихся с обучением — Pudding Monsters. Первый набор уровней посвящён обучению основам игры. Ниже я привёл изображение первых трёх уровней Pudding Monsters с описанием того, чему должен научиться игрок в каждой головоломке:

Уровень 1

На уровне 1 игрок учится сенсорному перемещению монстра к другому монстру. Если игрок отправит монстра в любом другом направлении, то он улетит с экрана и головоломка начнётся заново. Также игроки учатся тому, что при соединении монстров они превращаются в одного, более крупного нового монстра.

Уровень 2

На уровне 2 игроки обучаются тому, что есть другие, неподвижные части уровня, с которыми могут сталкиваться пудинговые монстры. Такая схема позволяет выполнять повороты. Уровень также учит, что иногда для решения головоломки монстра нужно передвинуть несколько раз. Кроме того, игрок может решить головоломку несколькими способами (двигая верхнего монстра или нижнего).

Уровень 3

Взяв то, чему игрок научился на предыдущих двух уровнях, игра учит его, что когда головоломку можно решить несколькими способами, дизайнеры располагают на земле тайлы со звёздами. Если игрок заканчивает головоломку, когда на всех звёздах стоят монстры, то он получает бонусные очки. Заметьте, что на этом уровне есть способы закрыть две или три звезды.

Cut the Rope

В Cut the Rope больше текста, чем в Pudding Monsters, но можно заметить, как увеличивается сложность дизайна уровней и игрока обучают базовым навыкам, по одному за раз (красные стрелки и текст добавлены мной).

Уровень 1

Уровень 1 учит игрока, как достичь победы — а именно, нужно накормить двумя конфетами монстров (по одной каждому), отрезая держащие их верёвки. Также в этом уровне вводится идея звёздочек за хорошее прохождение.

Уровень 2

За исключением падения конфет, первый уровень не показывает игроку никакой физики, поэтому он может и не знать, что конфеты способны раскачиваться на верёвках. Эта головоломка учит игрока физике раскачивания конфет и влиянию нескольких верёвок.

Игрокам также нужно узнать, что в головоломке можно проиграть (для этого нужно перезапустить головоломку заново). Это первая головоломка, в которой возможен проигрыш (если отрезать сначала верхнюю левую или нижнюю верёвку).

Уровень 3

На этом уровне добавляется множество возможностей проигрыша, но по-прежнему есть единственный способ выиграть. В первую очередь этот уровень учит тому, как конфеты могут сталкиваться друг с другом и отталкивать другие конфеты. В первых уровнях очень сложно не получить три звезды. Постепенно в игру вводятся усложнения, затрудняющие прохождение с получением всех звёзд. Кроме того, появляются различные варианты решений.

Один из моих любимых примеров

Один из моих любимых примеров из истории игр взят из игры для Super Nintendo The Legend of Zelda: A Link to the Past.

Первые две комнаты Восточного дворца (Eastern Palace), первого подземелья игры, стали моими любимыми частями обучения во всей игре.

Ко времени, когда игрок достигнет Восточного дворца, игра в обучении переходит от подталкивания игрока к стимулированию исследования. Поскольку игрок на этот момент знает все основные действия, таинственные изменения в управлении случаются гораздо реже, поэтому текстовые подсказки для них не нужны.

Когда дизайнеры вводят новые элементы головоломок в новом подземелье, игрок должен учиться тому, как взаимодействовать с этими элементами, чтобы решить более сложные и запутанные головоломки в будущем.

К этому времени игрок научился трём способам открывания дверей: нахождение ключа, убийство врагов или использование рычага. Во многих головоломках Восточного дворца используется два новых способа открывания дверей: спрятанные и видимые кнопки на полу.

Концепция головоломки проста — игроку нужно найти кнопку на полу и поставить на неё Линка, чтобы открыть дверь. Но если игроки не знают, как выглядит кнопка, то головоломка очень быстро запутывается и её решение становится случайным.

Простой (ленивый и неэлегантный) способ научить игрока — закрыть его в комнате с кнопкой на полу и выходом. Когда игрок выходит из комнаты, закрыть игрока в новой комнате с кнопкой, спрятанной под горшком, и другим выходом. Когда игрок пройдёт через эти две комнаты, дизайнер может считать, что игрок уже знает всё необходимое для прохождения.

В этом случае (первая комната подземелья) я понимаю, почему дизайнеры не захотели закрывать игрока. На случай, если игрок решит не ходить в подземелье, дизайнеры хотели оставить ему возможность выйти, побродить по миру и поискать улучшения, а потом вернуться назад, когда игрок будет готов к исследованию подземелья.

Кроме того, в игре есть множество скрытых областей, состоящих из одной комнаты, которые нельзя пройти, не имея определённого предмета. Подземелье с открытой дверью и без очевидных способов прохождения дальше может выглядеть очень похожим на одну из таких скрытых комнат. Поэтому игроки могут сдаться и пойти искать Восточный дворец где-нибудь в другом месте.

Кнопка на полу под центральным горшком открывает центральную дверь. Открытые коридоры с обеих сторон сообщают, что центральная дверь — это путь вперёд.

Найденное дизайнерами решение избавляет от всех этих потенциальных проблем. На картинке выше игрок входит в комнату снизу. Средняя дверь закрыта, её можно открыть кнопкой, спрятанной под коричневым горшком посередине. Двери слева и справа открыты и ведут на второй экран.

Если игрок проходит через одну из этих дверей, он видит, что единственный путь вперёд возможен только через платформу в центре. Если бы её не было, игрок мог войти в комнату, немного по ней побегать (думая, что он находится в вышеупомянутой одной комнате, требующей для прохождения какого-то предмета, и не видя никаких решений, позволяющих открыть дверь).

Возможность видеть путь вперёд подразумевает, что решение загадки должно находиться в первой комнате.

Во второй комнате игрок должен наступить на видимую кнопку на полу, чтобы открыть следующую дверь. Поскольку это не так интересно, как поиск спрятанной кнопки, игрок должен справиться ещё и с врагами в этой комнате.

Послесловие

Я не думаю, что кто-нибудь делает обучение плохим намеренно. Не думаю, что дизайнеры хотят, чтобы какая-то часть игры раздражала игрока, не говоря уже о части, наиболее важной для понимания и получения удовольствия от игрового процесса.

Однако иногда, когда игру уже надо выпускать, и сроки поджимают, нам приходится добавлять откровенно слабый туториал, очевидно надоедающую текстовую подсказку или что-нибудь столь же неэлегантное просто потому, что не хватает времени. Такое случается даже с лучшими из нас, и я не уверен, что в какой-то игре (за исключением, пожалуй, Super Metroid) с этим справились идеально. Я знаю, что ни в одной созданной мной игре этого не получалось, как бы мы не старались.

Иногда, несмотря на огромные усилия, созданный нами элегантный дизайн уровней как обучения не срабатывал, и нам приходилось в последнюю минуту добавлять нечто менее качественное.

Но если вам нравятся игры, которые оставляют вас в покое и позволяют изучать всё самостоятельно, то такой тип обучения восхитит вас и как игрока, и как разработчика игр. Многие игры справляются с этим, в той или иной степени, и когда это получается, то эффект бывает очень мощным.

Зная это и работая над этим, можно выработать гораздо более продуктивное отношение, чем простое «обучение — это отстой».

Вы учитесь (и учите других) играть так, как вас учил играть в прятки друг во дворе: в процессе игры, по одному правилу за раз.

Дополнительное чтение

- Если вы хотите изучить действительно подробный анализ того, как этот способ обучения игроков работал в одной из величайших игр, я рекомендую прочитать превосходную статью Уго Билле (Hugo Bille) The Invisible Hand of Super Metroid.

- Джош Байсер (Josh Bycer) написал пост о том, что он назвал «органическим дизайном», и я уверен, что он говорит о том же.

- Я написал ещё одну статью о темпе и архетипах, в которой объясняются некоторые полезные трюки для создания такого типа обучения (а именно мой трюк с ABC из статьи по ссылке). Вводя с нужной скоростью механики, вы естественным образом получаете преимущества, даваемые таким типом обучения.

|

Метки: author PatientZero разработка игр обучение в играх туториалы tutorials |

Security Week 24: 95 фиксов от Microsoft, роутер сливает данные светодиодами, для MacOS появился рансомвар-сервис |

Этот вторник патчей – просто праздник какой-то! Microsoft решила порадовать админов и выпустила 95 фиксов для Windows всех поддерживаемых версий, Office, Skype, Internet Explorer и Edge. 18 из них – для критических уязвимостей, включая три RCE. Кто не знает, это дыры, позволяющие удаленно запускать код без аутентификации, то есть самые опасные из всех. Первые две, согласно Microsoft, уже под атакой.

Этот вторник патчей – просто праздник какой-то! Microsoft решила порадовать админов и выпустила 95 фиксов для Windows всех поддерживаемых версий, Office, Skype, Internet Explorer и Edge. 18 из них – для критических уязвимостей, включая три RCE. Кто не знает, это дыры, позволяющие удаленно запускать код без аутентификации, то есть самые опасные из всех. Первые две, согласно Microsoft, уже под атакой.CVE-2017-8543 содержится в поисковом движке Windows Search Service (WSS). Сервис удобный, но, как оказалось, с дырой. Хакер, подключившись по SMB, может тотально поработить системы, например, изменять, удалять файлы, создавать новые учетные записи. Проблема имеется как в актуальных версиях Windows, так и в Windows XP и Server 2003. Для ее решения Microsoft снова выпустила отдельные патчи к неподдерживаемым системам. Похоже, это входит у компании в привычку. Вот все бы вендоры так делали!

CVE-2017-8464 – красивая, если так можно выразиться, дыра, позволяющая запускать код с помощью хитровывернутого ярлыка. Пользователю достаточно увидеть зловредный ярлык в Проводнике, чтобы его машина выполнила какой-нибудь нехороший код. Проблема имеется в операционных системах, начиная с Windows 7 SP1, точный список версий можно поглядеть тут. Кстати, уязвимость этого же типа использовал великий и ужасный Stuxnet.

CVE-2017-8527 сидит в библиотеке шрифтов, в том, как она обрабатывает встроенные шрифты. Снова тотальное порабощение, в этот раз через шрифт на вебсайте или в документе. То есть достаточно зайти на вебсайт с любым текстом, лишь бы он был написан специально сконструированным шрифтом, чтобы хакер мог сделать с вашей системой буквально что угодно. С вашим уровнем полномочий, естественно – хорошая причина сидеть под рядовым юзером, а не под админом. Список уязвимых продуктов длинен, и патчить надо не только Windows.

Исследователи заставили роутер передавать данные миганием светодиодов

Новость. Исследование. Когда исследователям нечего делать, они изобретают причудливые способы взлома всяких защищенных систем. Высший пилотаж у этих сумрачных гениев – ломануть компьютер, не подключенный к Интернету. Это вполне реализуемо, спасибо двуногим переносчикам инфекций, сующим флешки куда попало, но внедрить на систему троянца – это только половина дела. Еще надо как-то извлечь украденные данные, и вот тут безопасники свою фантазию не сдерживают.

Новость. Исследование. Когда исследователям нечего делать, они изобретают причудливые способы взлома всяких защищенных систем. Высший пилотаж у этих сумрачных гениев – ломануть компьютер, не подключенный к Интернету. Это вполне реализуемо, спасибо двуногим переносчикам инфекций, сующим флешки куда попало, но внедрить на систему троянца – это только половина дела. Еще надо как-то извлечь украденные данные, и вот тут безопасники свою фантазию не сдерживают.Группа товарищей из Университета имени Бен-Гуриона в Негеве придумала новое применение бытовым роутерам и свитчам. Если на девайс внедрить специальную малварь (для экспримента взяли роутер с прошивкой DD-WRT и загрузили на него самодельный скрипт), то она может задорно мигать индикаторами, передавая данные в двоичном представлении со скоростью до 1000 бит/c на один светодиод. Прием этих данных требует, естественно, прямой видимости до устройства, и камеры с высокой частотой кадров.

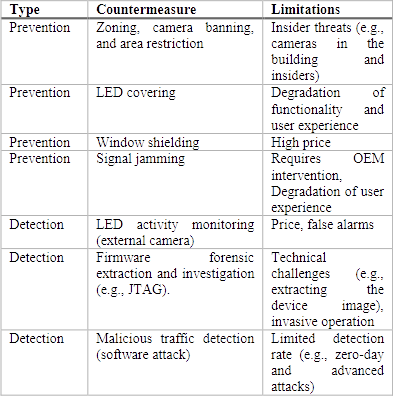

Отдельного упоминания заслуживает разработанный исследователями список методов защиты от такой вот утечки данных. Потенциальным жертвам предлагается заклеивать индикаторы, заставлять их рандомно мигать с помощью модифицированной прошивки, а еще можно держать окна занавешенными или заклеить их тонировочной пленкой. Звучит комично, но учреждениям, имеющим дело с информацией, интересной для зарубежных спецслужб, стоит задуматься.

Подобные методы извлечения данных годятся для жестко огороженных сетей, где периметр не получается преодолеть более вменяемыми способами. Роутеру домашнего класса в такой сети делать особо нечего, и скорее всего его не поставят в прямой видимости от окна – но вот, скажем, точка доступа WiFi вполне может стать каналом утечки данных.

В даркнете появился сервис троянцев-вымогателей для MacOS