Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Из песочницы] Сборка модуля ядра Linux без точных заголовочных файлов |

Представьте, что у вас имеется образ ядра Linux для телефона на базе Android, но вы не располагаете ни соответствующими исходниками, ни заголовочными файлами ядра. Представьте, что ядро имеет поддержку подгрузки модулей (к счастью), и вы хотите собрать модуль для данного ядра. Существует несколько хороших причин, почему нельзя просто собрать новое ядро из исходников и просто закончить на том (например, в собранном ядре отсутствует поддержка какого-нибудь важного устройства, вроде LCD или тачскрина). С постоянно меняющимся ABI ядра Linux и отсутствием исходников и заголовочных файлов, вы можете подумать, что окончательно зашли в тупик.

Как констатация факта, если вы соберете модуль ядра, используя другие заголовочные файлы (нежели те, что были использованы для сборки того образа ядра, которым вы располагаете, — прим. пер.), модуль не сможет загрузиться с ошибками, зависящими от того, насколько заголовочные файлы отличались от требуемых. Он может жаловаться о плохих сигнатурах, плохих версиях и о прочих вещах.

Но больше об этом далее.

Конфигурация ядра

Первый шаг — найти исходники ядра наиболее близкие к тому образу ядра, насколько это возможно. Наверное, получение правильной конфигурации — наиболее сложная составляющая всего процесса сборки модуля. Начните с того номера версии ядра, который может быть прочитан из

/proc/version. Если, как я, вы собираете модуль для устройства Android, попробуйте ядра Android от Code Aurora, Cyanogen или Android, те, что наиболее ближе к вашему устройству. В моем случае, это было ядро msm-3.0. Заметьте, вам не обязательно необходимо искать в точности ту же версию исходников, что и версия вашего образа ядра. Небольшие отличия версии, наиболее вероятно, не станут помехой. Я использовал исходники ядра 3.0.21, в то время как версия имеющегося образа ядра была 3.0.8. Не пытайтесь, однако, использовать исходники ядра 3.1, если у вас образ ядра 3.0.x. Если образ ядра, что у вас есть, достаточно любезен, чтобы предоставить файл

/proc/config.gz, вы можете начать с этого, в противном случае, вы можете попытаться начать с конфигурацией по умолчанию, но в этом случае нужно быть крайне аккуратным (хотя я и не буду углубляться в детали использования дефолтной конфигурации, поскольку мне посчастливилось не прибегать к этому, далее будут некоторые детали относительно того, почему правильная конфигурация настолько важна).Предполагая, что

arm-eabi-gcc у вас доступен по одному из путей в переменной окружения PATH, и что терминал открыт в папке с исходными файлами ядра, вы можете начать конфигурацию ядра и установку заголовочных файлов и скриптов:$ mkdir build

$ gunzip config.gz > build/.config # или что угодно, для того, чтобы приготовить .config

$ make silentoldconfig prepare headers_install scripts ARCH=arm CROSS_COMPILE=arm-eabi- O=build KERNELRELEASE=`adb shell uname -r`

Сборка

silentoldconfig, наиболее вероятно, спросит, хотите ли вы включить те или иные опции. Вы можете выбрать умолчания, но это вполне может и не сработать.Можно использовать что-нибудь другое в

KERNELRELEASE, однако это должно совпадать в точности с версией ядра, с которого вы планируете подгружать модуль.Написание простого модуля

Чтобы создать пустой модуль, необходимо создать два файла: исходник и

Makefile. Расположите следующий код в файле hello.c, в некоторой отдельной директории:#include Поместите следующий текст в файл

Makefile в той же директории:obj-m = hello.o

Сборка модуля достаточна проста, однако на данном этапе полученный модуль не сможет загрузиться.

Сборка модуля

При обычной сборки ядра система сборки ядра создает файл

hello.mod.c, содержимое которого может создать различные проблемы:MODULE_INFO(vermagic, VERMAGIC_STRING);

Значение

VERMAGIC_STRING определяется макросом UTS_RELEASE, который располагается в файле include/generated/utsrelease.h, генерируемом системой сборки ядра. По умолчанию, это значение определяется версией ядра и статуса git-репозитория. Это то, что устанавливает KERNELRELEASE при конфигурации ядра. Если VERMAGIC_STRING не совпадает с версией ядра, загрузка модуля приведет к сообщению подобного рода в dmesg:hello: version magic '3.0.21-perf-ge728813-00399-gd5fa0c9' should be '3.0.8-perf'

Далее, также имеем здесь определение структуры модуля:

struct module __this_module

__attribute__((section(".gnu.linkonce.this_module"))) = {

.name = KBUILD_MODNAME,

.init = init_module,

#ifdef CONFIG_MODULE_UNLOAD

.exit = cleanup_module,

#endif

.arch = MODULE_ARCH_INIT,

};

Само по себе, это определение выглядит безобидно, но структура

struct module, определенная в include/linux/module.h, несет в себе неприятный сюрприз:struct module

{

(...)

#ifdef CONFIG_UNUSED_SYMBOLS

(...)

#endif

(...)

/* Startup function. */

int (*init)(void);

(...)

#ifdef CONFIG_GENERIC_BUG

(...)

#endif

#ifdef CONFIG_KALLSYMS

(...)

#endif

(...)

(... plenty more ifdefs ...)

#ifdef CONFIG_MODULE_UNLOAD

(...)

/* Destruction function. */

void (*exit)(void);

(...)

#endif

(...)

}

Это означает, что для того, чтобы указатель

init оказался в правильном месте, CONFIG_UNUSED_SYMBOLS должен быть определен в соответствии с тем, что использует наш образ ядра. Что же насчет указателя exit, — это CONFIG_GENERIC_BUG, CONFIG_KALLSYMS, CONFIG_SMP, CONFIG_TRACEPOINTS, CONFIG_JUMP_LABEL, CONFIG_TRACING, CONFIG_EVENT_TRACING, CONFIG_FTRACE_MCOUNT_RECORD и CONFIG_MODULE_UNLOAD. Начинаете понимать, почему обычно предполагается использовать в точности те же заголовочные файлы, с которыми было собрано наше ядро?

Далее, определения версий символов:

static const struct modversion_info ____versions[]

__used

__attribute__((section("__versions"))) = {

{ 0xsomehex, "module_layout" },

{ 0xsomehex, "__aeabi_unwind_cpp_pr0" },

{ 0xsomehex, "printk" },

};

Эти определения берутся из файла

Module.symvers, который генеруется в соответствии с заголовочными файлами. Каждая такая запись представляет символ, требуемый модулю, и то, какую сигнатуру должен иметь символ. Первый символ,

module_layout, зависит от того, как выглядит struct module, то есть, зависит от того, какие опции конфигурации, упомянутые ранее, включены. Второй, __aeabi_unwind_cpp_pr0, — функция, специфичная ABI ARM, и последний — для наших вызовов функции printk.Сигнатура каждого символа может отличаться в зависимости от кода ядра для данной функции и компилятора, использованного для сборки ядра. Это означает, что если вы соберете ядро из исходников, а также модули для данного ядра, и затем повторно соберете ядро после модификации, например, функции

printk, даже совместимым путем, модули, собранные изначально, не загрузятся с новым ядром.Так, если мы соберем ядро с исходниками и конфигурацией, достаточно близкими к тем, при помощи которых был собран имеющийся у нас образ ядра, есть шанс того, что мы не получим те же самые сигнатуры, что и в нашем образе ядра, и оно ругнулось бы при загрузке модуля:

hello: disagrees about version of symbol symbol_name

Что значит, что нам нужен правильный, соответствующий образу ядра, файл

Module.symvers, которым мы не располагаем. Изучаем ядро

Поскольку ядро делает эти проверки при загрузке модулей, оно также содержит список символов, которые экспортирует и соответствующие сигнатуры. Когда ядро загружает модуль, оно проходит по всем символам, которые требуются модулю, для того, чтобы найти их в своей таблице символов (или прочих таблицах символов модулей, которые использует данный модуль) и проверить соответствующие сигнатуры.

Ядро использует следующую функцию для поиска в своей таблицы символов (в kernel/module.c):

bool each_symbol_section(bool (*fn)(const struct symsearch *arr,

struct module *owner,

void *data),

void *data)

{

struct module *mod;

static const struct symsearch arr[] = {

{ __start___ksymtab, __stop___ksymtab, __start___kcrctab,

NOT_GPL_ONLY, false },

{ __start___ksymtab_gpl, __stop___ksymtab_gpl,

__start___kcrctab_gpl,

GPL_ONLY, false },

{ __start___ksymtab_gpl_future, __stop___ksymtab_gpl_future,

__start___kcrctab_gpl_future,

WILL_BE_GPL_ONLY, false },

#ifdef CONFIG_UNUSED_SYMBOLS

{ __start___ksymtab_unused, __stop___ksymtab_unused,

__start___kcrctab_unused,

NOT_GPL_ONLY, true },

{ __start___ksymtab_unused_gpl, __stop___ksymtab_unused_gpl,

__start___kcrctab_unused_gpl,

GPL_ONLY, true },

#endif

};

if (each_symbol_in_section(arr, ARRAY_SIZE(arr), NULL, fn, data))

return true;

(...)

Структура, используемая в данной функции, определена в include/linux/module.h:

struct symsearch {

const struct kernel_symbol *start, *stop;

const unsigned long *crcs;

enum {

NOT_GPL_ONLY,

GPL_ONLY,

WILL_BE_GPL_ONLY,

} licence;

bool unused;

};

Примечание: данный код ядра не изменился значительно за последние четыре года (видимо, с момента рассматриваемого релиза ядра 3.0, — прим. пер.).

То, что мы имеем выше в функции

each_symbol_section — три (или пять, когда конфиг CONFIG_UNUSED_SYMBOLS включен) поля, каждое из которых содержит начало таблицы символов, ее конец и два флага.Данные эти статичны и постоянны, что означает, что они появятся в бинарнике ядра как есть. Сканируя ядро на предмет трех идущих друг за другом последовательностей состоящих из трех указателей в адресном пространстве ядра и следом идущих значений типа

integer из определений в each_symbol_section, мы можем определить расположение таблиц символов и сигнатур, и воссоздать файл Module.symvers из бинарника ядра.К несчастью, большинство ядер сегодня сжатые (

zImage), так что простой поиск по сжатому образу невозможен. Сжатое ядро на самом деле представляет небольшой бинарник, следом за которым идет сжатый поток. Можно просканировать файл zImage с тем, чтобы найти сжатый поток и получить из него распакованный образ.Я написал скрипт для декомпрессии и извлечения информации о символах ядра в автоматическом режиме. Это должно работать с любой свежей версией ядра, при условии, что ядро не перемещаемое (relocatable) и вы знаете базовый адрес в памяти, куда оно грузится. Скрипт принимает опции для количества и порядка следования битов (endianness) архитектуры, и по умолчанию использует значения, подходящие для ARM. Базовый адрес, однако, должен быть указан. Он может быть найден, на ядрах ARM, в

dmesg:$ adb shell dmesg | grep "\.init"

<5>[01-01 00:00:00.000] [0: swapper] .init : 0xc0008000 - 0xc0037000 ( 188 kB)

(прим. пер. — однако, не все ядра выводят эти данные в лог, мне довелось встретить один такой практически уникальный случай, когда, видимо, ввиду урезанных опций конфигурации эта информация не выводилась, в таком случае можно обратиться к конфигу PAGE_OFFSET в файле arch/arm/Kconfig и просто надеяться, что вендор использовал одно из дефолтных значений).

Базовый адрес в примере выше —

0xc0008000.Если как я, вы интересуетесь загрузкой модуля на девайсе Android, тогда бинарник ядра, что вы имеете — полный образ boot. Образ boot содержит другие вещи помимо ядра, так что вы не можете напрямую использовать его со скриптом выше. Исключение составляет только тот случай, если ядро в образе boot сжато, при этом часть скрипта, которая ожидает на входе сжатый образ, все равно найдет ядро.

Если ядро не сжато, вы можете использовать программу unbootimg как изложено в данном посте, для того, чтобы получить образ ядра из вашего образа boot. Как только у вас есть образ ядра, скрипт может быть запущен следующим образом:

$ python extract-symvers.py -B 0xc0008000 kernel-filename > Module.symvers

Сборка ядра

Теперь, когда мы имеем правильный файл

Module.symvers для ядра, из которого мы хотим загрузить модуль, мы наконец можем собрать модуль (опять, полагая, arm-eabi-gcc доступно из PATH, и что терминал открыт в директории с исходниками):$ cp /path/to/Module.symvers build/

$ make M=/path/to/module/source ARCH=arm CROSS_COMPILE=arm-eabi- O=build modules

Вот и собственно все. Вы можете скопировать файл hello.ko на девайс и загрузить модуль:

$ adb shell

# insmod hello.ko

# dmesg | grep insmod

<6>[mm-dd hh:mm:ss.xxx] [id: insmod]Hello world

# lsmod

hello 586 0 - Live 0xbf008000 (P)

# rmmod hello

# dmesg | grep rmmod

<6>[mm-dd hh:mm:ss.xxx] [id: rmmod]Goodbye world

Данная статья является переводом публикации в блоге Mike Hommey.

|

Метки: author RadicalDreamer разработка под linux разработка под android android module linux hack |

Немного о ServiceNow, ITSM и ServiceDesk в формате подборки полезных материалов |

Изображение Dennis Skley CC

Изображение Dennis Skley CC5 шагов для успешного внедрения ServiceNow

- Как получить одобрение команды? Здесь мы сформировали краткий чеклист, который поможет начать процесс внедрения ITSM и заинтересовать будущих пользователей.

Тактика лучшего внедрения Service Desk — 7 шагов

- Как не потерять работу, занимаясь внедрением новой системы? Мы собрали простые тактические решения, которые помогут все сделать правильно.

Внедрение ServiceNow. 7 ошибок, которые нельзя допустить

- Нельзя так просто взять и купить ПО. Наши вредные советы для тех, кто планировал обойтись минимальными телодвижениями для интеграции нового решения.

6 интересных фактов о компании ServiceNow

- Интересные «пасхалки» для тех, кто сомневался в чувстве юмора мирового лидера среди производителей облачных ITSM-платформ.

Что такое ServiceNow, или Как не сесть в тюрьму и заработать миллиард

- Краткая история компании, путь развития и другие мелочи, которые будут полезны тем, кто только знакомится с этой темой.

Лучшие бесплатные ресурсы для специалиста ServiceNow

- Быстро разобраться с принципами работы ServiceNow — не проблема. Тематический Slack-канал. сабреддиты, репозитории, официальные сообщества и лучшие практики.

Искусственный интеллект для классификации запросов в ServiceNow

- Что следует из новостей о покупке системы машинного обучения DxContinuum? Как ServiceNow решит применить технологии этой компании? Об этом в нашем материале.

GRC — управление ИТ, управление рисками и соответствие требованиям в ServiceNow

- Немного о том, как можно решать «взрослые задачи» по планированию развития и оценке рисков с помощью GRC-треноги (Governance, Risk, Compliance).

Что читать в 2017 году для успешного внедрения ServiceNow

- С чего начать. Что есть на русском. Самое свежее на английском.

В чем причина популярности ServiceNow

- PAAS, ITOM, ServiceNow Store и другие интересные особенности, которые позволяют платформе ServiceNow набирает обороты с каждым новым годом.

Инновационные способы использования ServiceNow

- Интеграция Skype, прием корреспонденции, обслуживание клиентов, управление магазином и… автоматизация автогонок!

Интервью с CTO ServiceNow об инновациях, приоритетах и развитии ИТ

- Как работает и распределяет свои ресурсы команда Аллана Лейнвана (Allan Leinwand) — насыщенное и краткое интервью в нашем блоге.

ServiceNow — релиз Istanbul

- Детальный обзор интересных нововведений.

Как не надо внедрять ITSM в компании

- Разбираемся с путаницей в терминологии, необходимостью планирования отдельного бюджета на внедрение и возможностью самостоятельного внедрения ITSM.

ITSM в облако. 9 преимуществ SaaS-платформы для ITSM

- Говорим о стоимости сервиса, затратах на обслуживание, доступности, процессе внедрения, надежности и общем удобстве использования для сотрудников компании.

6 различий между Helpdesk и ServiceDesk

- Кратко затрагиваем тему происхождения данных терминов, приводим обещанные 6 характерных особенностей и немного тематической статистики.

Тактика лучшего внедрения Service Desk — 7 шагов

- Определяем цели и задачи, варианты использования гибридного подхода к разработке и ускорения внедрения, возможности для обучения и тестирования.

В чем разница между инцидентом и проблемой

- Разбираем этот вопрос на примере поломки обыкновенного чайника. Тот самый случай, когда простой пример помогает легко запомнить разницу между двумя терминами.

Правильно внедряем «Управление финансами в ИТ» (ITFM)

- Смотрим на то, почему необходимо внедрение ITFM и разбираем несколько процессов модели ITIL. Помимо этого мы даем 5 рекомендаций для успешного внедрения проекта.

Что такое Управление портфелем проектов?

- Знакомимся с понятием рисков в бизнесе и разбираемся с разницей между управлением портфелем проектов (PPM) и управления проектами (PM).

5 причин внедрения управления HR

- Очевидные выгоды, которые может принести адекватная работа с персоналом. Для этого возможно использовать различные методы автоматизации и накопления знаний.

Как управлять эксплуатацией объекта недвижимости

- Разбираемся с такими возможностями приложения Facilities Service Management как: каталог услуг, интерактивные карты, управление объектами и отчетностью.

Управлять активами (ITAM) или вести амбарную книгу

- ИТ-активы составляют существенную часть капитальных затрат, и отсутствие управления ими влечет за собой неэффективное расходование средств. Постараемся разрешить этот вопрос.

10 фактов, которые вы должны знать об ITIL

- Немного о том, что подразумевает ITIL, кто его поддерживает и других нюансах, которые помогут погрузиться в эту тему даже новичку.

Как сделать ITIL более клиентоориентированной

- Ориентирована ли ITIL на клиента, как определить и выбрать клиентов, наладить обратную связь и оценить проделанную работу с точки зрения клиента.

|

Метки: author it-guild help desk software блог компании ит гильдия ит-гильдия servicenow itsm servicedesk дайджест |

[Перевод - recovery mode ] Страны Юго-Восточной Азии переходят на гибридную модель хранения данных |

Чтобы удовлетворить растущий спрос на облачное хранение данных, новые поставщики облачных решений организовали в регионе центры обработки данных. На рынке облачных технологий Юго-Восточной Азии уже действуют такие крупные игроки, как AWS, Microsoft, IBM, HP, Oracle, а также множество небольших центров обработки данных и провайдеров управляемых ИТ-услуг. Недавно в Сингапуре были созданы компании Alibaba Cloud и Google Cloud для привлечения клиентов из стран Юго-Восточной Азии.

«С выходом компаний Alibaba и Google на рынок облачного хранения данных руководители ИТ-компаний получат более широкий выбор услуг, и это выгодно для тех компаний, которые способны разработать облачную модель, будь то полное погружение компании в облако или внедрение гибридной облачной модели», — отметил Рик Скарфилд, президент компании NetApp APAC.

По словам Энди Кокса, технического директора в компании Dimension Data Asia Pacific, выход провайдеров облачных хранилищ данных на рынок данного региона больше всего повлияет на малые и средние предприятия. «Глядя на некоторых лидирующих поставщиков традиционных хранилищ данных на рынке, можно увидеть, что их рост ограничен рынком, а количество довольно небольшое, — отметил он. — Переход на услуги облачных, гипермасштабных поставщиков, таких как Amazon и Microsoft Azure, а также новых участников рынка, таких как Alibaba Cloud и Google Cloud, окажет значительное влияние на малые и средние предприятия».

Кокс предположил, что полный переход на облачные хранилища данных, как правило, считается слишком рискованным для промышленных предприятий из-за критически важных приложений или конфиденциальной информации, например, в финансовом секторе, здравоохранении или государственном секторе, а также из-за беспокойства о рисках нарушения безопасности и недостатке независимости данных, связанном с облачными платформами.

«В связи с этим на хранение данных в облаке в основном перейдут малые и средние предприятия, особенно после того, как в облаке появится больше новых приложений, — сказал он. — Например, начинающие компании пользуются услугами облачных провайдеров для запуска своих приложений без необходимости создания инфраструктуры».

Пол Серрано, главный специалист по пропаганде в компании Nutanix (Азия, страны Тихоокеанского региона и Япония), отметил: «Поскольку в 2017 году отделы информационных технологий предприятий будут оценивать облачные решения открытого доступа и на местах, вероятно, они придут к заключению, что облачные решения открытого доступа лучше подходят для гибкой рабочей нагрузки, то есть нагрузки без определенных требований». Но, по его словам, для многих компаний переход на облачное решение открытого доступа может быть преждевременным.

По мнению Прабхитхы Шитхал Дкруз, старшего рыночного аналитика, проводившего исследование в IDC, организации Азии/Тихоокеанского региона, Юго-Восточной Азии недостаточно быстро переходят на облачные технологии. «Организации в Юго-Восточной Азии довольно медленно принимают облачные технологии, — отметила она. — Рынок Юго-Восточной Азии менее развит, и свойственный ему консерватизм до сих пор ограничивал внедрение компаний AWS, Google и Azure, главным образом их отдельными рабочими операциями, а локальные провайдеры облачных решений должны еще увеличить свой потенциал до уровня, на котором они будут приняты крупными предприятиями».

Но по словам Дкруз, с выходом на рынок таких компаний, как Alibaba Cloud и Google Cloud, клиенты станут перемещать постоянную, второстепенную рабочую нагрузку в облачную инфраструктуру.

Компания Alibaba добилась успеха в Китае

В соответствии с полугодовым анализом IDC публичной облачной среды за первую половину 2016 года, компания Alibaba стала вторым лидирующим провайдером облачных услуг в Азиатско-Тихоокеанском регионе (за исключением Японии), обогнав Microsoft и Google. «Однако успех Alibaba ограничивается Китаем, и отсутствие обширной партнерской экосистемы за пределами Китая означает, что компания не окажет существенного влияния на рынок, за исключением влияния на китайские компании, осуществляющие операции за пределами Китая, и компаний Юго-Восточной Азии, осуществляющих деятельность в Китае, — отметила Дкруз. — Реалии корпоративного рынка отодвинут компанию Alibaba на второй план вместе с ее партнерами, занимающими лидирующее положение в совместной деятельности. Чтобы добиться доверия корпоративного рынка, компании Alibaba необходимо построить партнерскую экосистему для соответствия конкурентам».

Но Нишчал Кхорана, директор облачных технологий и центра обработки данных Азиатско-Тихоокеанского региона компании Frost & Sullivan, не видит таких ограниченных перспектив для компании Alibaba Cloud. «Исходя из долгосрочной перспективы, важно отметить, что рынок облачных хранилищ данных стран Юго-Восточной Азии является очень чувствительным к курсу ценных бумаг, давая возможность компании Alibaba Cloud выступать в качестве основного поставщика в регионе, учитывая ее агрессивную ценовую стратегию», — отметил он.

Однако по прогнозам Кхорана, пройдет некоторое время, прежде чем Alibaba Cloud достигнет успеха. «Индонезия, Малайзия и Филиппины являются быстрорастущими рынками облачной инфраструктуры в Юго-Восточной Азии с инфраструктурой как услугой на рынке, рост которого прогнозируется в размере от 40 до 50 % в год с 2015 по 2022 годы. В то время как Alibaba Cloud и Google находятся в выгодном положении для использования роста рынков облачных хранилищ данных, Amazon Web Services и Microsoft Azure в ближайшем будущем будут удерживать лидирующие позиции благодаря своему устойчивому присутствию».

Уменьшится ли объем рынка традиционных систем хранения данных?

По словам Кхорана, рост традиционных систем хранения данных будет снижаться по мере укрепления облачных моделей с увеличением концентрации внимания на безопасности предприятий, а предприятия постепенно будут переходить на индивидуальную, общедоступную облачную или гибридную ИТ-модель.

«В целом традиционный рынок хранения данных останется относительно стабильным, без существенного уменьшения в течение ближайших лет», — сказал Кокс, компания Dimension Data.

Джеймс Ву, директор по информационным технологиям Farrer Park, риэлтерской компании в сфере здравоохранения и гостиничного бизнеса, отметил: «Я сомневаюсь, что традиционный рынок хранения данных уменьшится, так как организациям понадобится время, чтобы реорганизовать свою инфраструктуру для работы с облачными хранилищами данных».

Переход к гибридной модели

По словам Дкруз из компании IDC, организации в странах Юго-Восточной Азии все еще находятся «на незапланированных стадиях развития структуры IDC, зависящих от ситуации». Она добавила, что неоднородное состояние азиатского региона означает то, что не все страны будут следовать одной схеме, некоторые страны могут быстрее других принять решения облачного хранения данных для более сложных вариантов использования.

«Текущая система принятия облачных технологий ограничена резервным копированием, защитой данных или восстановлением в аварийных ситуациях, — отметила она. — Имея большое количество функций и привлекательные цены, облачные технологии хранения данных могут стать заманчивым предложением для многих организаций, но различные законодательные, культурные и политические последствия делают облачные технологии невыгодными для правительств стран Юго-Восточной Азии, которые продвигают внутренние облачные решения».

|

Метки: author ICLServices хранилища данных облачные вычисления блог компании icl services облачные технологии схд облачные хранилища гибридная модель |

ZFS on Linux: вести с полей 2017 |

Да, она не является «серебряной пулей», но в своей области показывает прекрасные результаты.

Проект ZFS on Linux изначально был создан для портирования существующего кода из Solaris. После закрытия его исходного кода совместно с сообществом OpenZFS проект продолжил разработку ZFS для Linux. Код может быть собран как в составе ядра, так и в виде модуля.

Сейчас пользователь может создать пул с последней совместимой с Solaris версией 28, а также с приоритетной для OpenZFS версией 5000, после которого началось применение feature flags (функциональные флаги). Они позволяют создавать пулы, которые будут поддерживаться в FreeBSD, пост-Sun Solaris ОС, Linux и OSX вне зависимости от различий реализаций.

В 2016 году был преодолён последний рубеж, сдерживавший ZFS на Linux — многие дистрибутивы включили его в штатные репозитории, а проект Proxmox уже включает его в базовую поставку. Ура, товарищи!

Рассмотрим как наиболее важные отличия, так и подводные камни, которые есть в настоящее время в версии ZFS on Linux 0.6.5.10.

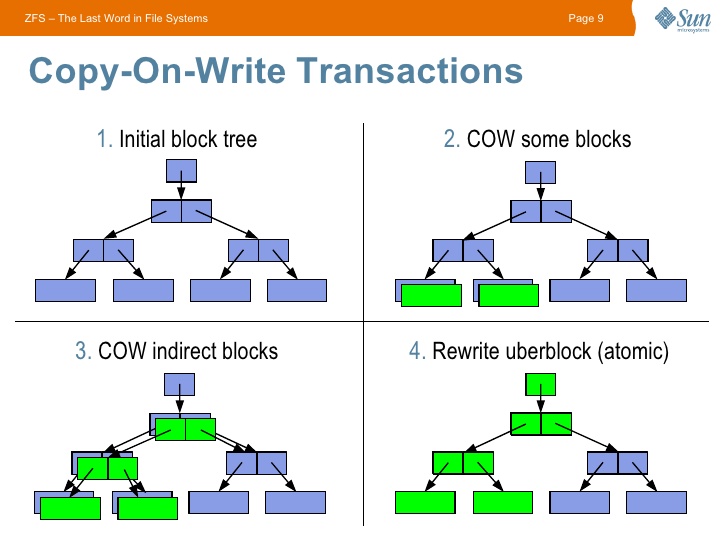

Начинать знакомство с ZFS стоит с изучения особенностей CopyOnWrite (CoW) файловых систем — при изменении блока данных старый блок не изменяется, а создается новый. Переводя на русский — происходит копирование при записи. Данный подход накладывает отпечаток на производительности, зато даёт возможность хранить всю историю изменения данных.

CoW подход в ZFS даёт огромные возможности: эта ФС не может иметь некорректного состояния, т.к. в случае проблем с последней транзакцией (например при отключении питания) будет использована последняя корректная.

Также сразу стоит отметить, что для всех данных считается контрольная сумма, что также оставляет свой отпечаток на производительности, но даёт гарантию целостности данных.

Кратко о главных преимуществах ZFS для вашей системы.

Защита данных:

- контрольные суммы — гарантия корректности данных;

- возможность резервирования как на уровне создания зеркал и аналогов RAID массивов, так и на уровне отдельного диска (параметр

copies); - в отличие от многих файловых систем с их fsck на уровне журнала, ZFS проверяет все данные по контрольным суммам и умеет проводить их автоматическое восстановление по команде scrub (если в пуле есть живая копия битых данных);

- первая ФС, разработчики которой честно признались во всех возможных рисках при хранении — везде при упоминании ZFS можно встретить требование оперативной памяти с поддержкой ECC (любая ФС имеет риск повреждения при отсутствии ECC памяти, просто все, кроме ZFS, предпочитают не задумываться об этом);

- ZFS создавалась с учетом ненадёжности дисков, просто помните это и перестаньте волноваться о вашем

WD GreenSeagateetc(только, если рядом трудится ещё один выживший диск).

Максимальная гибкость вашего хранилища:

- закончилось место? Замените диск на более объёмный, и ваш покорный ZFS сам займёт новоотведённое ему место (по параметру autoexpand);

- лучшая реализация снапшотов среди файловых систем для Linux. На это подсаживаешься. Инкрементально по сети, в архив,

/dev/null, да хоть раздвойте личность вашего дорогого Linux в реальном времени (clone); - нужно больше

золотаместа? 256 зебибайт хватит всем!

Структура.

В ZFS структура хранилища выглядит следующим образом:

- pool

-- vdev (virtual device) - объединяет носители (в mirror, stripe и др.)

--- block device - диск, массив, файлВ пуле может быть неограниченное количество vdev, что позволяет создать пул из двух и более mirror, RAID-Z или других сочетаний. Также доступны классические RAID10 и т.д.

Типы массивов:

Stripe — обычный RAID0.

Mirror — RAID1 на манер ZFS — реплицируются только занятые блоки, забудьте о синхронизации пустого места.

RAID-Z — создавался как замена RAID5-6, но имеет большие отличия:

— каждый блок данных — аналог отдельного массива (с динамической длинной);

— отсутствует проблема write hole;

— при ребилде создаются только данные (т.е. риск сбоя в этот момент уменьшается). Также в тестовой ветке уже находятся улучшения, которые дополнительно ускорят этот процесс.

Рекомендуется использовать RAID-Z2 (аналог RAID6).

При создании RAID-Z стоит обязательно изучить эту статью, основные нюансы:

— IOPS равен самому медленному диску (создавайте RAID-Z с наименьшим количеством дисков);

— эффективность утилизации места увеличивается при бОльшем количестве дисков в массиве (требуется задать корректный recordsize, см. ссылку выше);

— в существующий массив RAID-Z нельзя добавить ещё один диск (пока), но можно заменить диски на более ёмкие. Эта проблема решается созданием нескольких массивов в рамках одного vdev.

dRAID (в разработке) — базируется на наработках RAID-Z, но при сбое позволяет задействовать на чтение-запись все диски массива.

ARC — умное кеширование в ZFS.

CoW ухудшает производительность. Для сглаживания ситуации был создан adaptive replacement cache (ARC). Его основная особенность в проработанных эвристиках для исключения вымывания кеша, в то время как обычный page cache в Linux к этому очень чувствителен.

Бонусом к ARC существует возможность создать быстрый носитель со следующим уровнем кеша — L2ARC. При необходимости он подключается на быстрые SSD и позволяет заметно улучшить IOPS HDD дисков. L2ARC является аналогом bcache со своими особенностями.

L2ARC стоит использовать только после увеличения ОЗУ на максимально возможный объём.

Также существует возможность вынести запись журнала — ZIL, что позволит значительно ускорить операции записи.

Дополнительные возможности.

Компрессия — с появлением LZ4 позволяет увеличить скорость IO за счёт небольшой нагрузки на процессор. Нагрузка настолько мала, что включение данной опции уже является повсеместной рекомендацией. Также есть возможность воспользоваться другими алгоритмами (для бекапов прекрасно подходит gzip).

Дедупликация — особенности: процесс дедупликации производится синхронно при записи, не требует дополнительной нагрузки, основное требование — ~ 320 байт ОЗУ на каждый блок данных (Используйте команду

zdb -S название_пула для симуляции на существующем пуле) или ~ 5гб на каждый 1 тб. В ОЗУ хранится т.н. Dedup table (DDT), при недостатке ОЗУ каждая операция записи будет упираться в IO носителя (DDT будет читаться каждый раз с него).Рекомендуется использовать только на часто повторяющихся данных. В большинстве случаев накладные расходы не оправданы, лучше включить LZ4 шифрование.

Снапшоты — в силу архитектуры ZFS абсолютно не влияют на производительность, в рамках данной статьи на них останавливаться не будем. Отмечу только прекрасную утилиту zfs-auto-snapshot, которая создаёт их автоматически в заданные интервалы времени. На производительности не отражается.

Шифрование (в разработке) — будет встроенным, разрабатывается с учётом всех недостатков реализации от Oracle, а также позволит штатными send/receive и scrub отправлять и проверять данные на целостность без ключа.

Основные рекомендации (TL;DR):

— Заранее продумайте геометрию массива, в настоящий момент ZFS не умеет уменьшаться, а также расширять существующие массивы (можно добавлять новые или менять диски на более объёмные);

— используйте сжатие:

compression=lz4— храните расширенные атрибуты правильно, по умолчанию хранятся в виде скрытых файлов (только для Linux):

xattr=sa— отключайте atime:

atime=off— выставляйте нужный размер блока (recordsize), файлы меньше recordsize будут записываться в уменьшенный блок, файлы больше recordsize будут записывать конец файла в блок с размером recordsize (при

recordsize=1M файл размером 1.5мб будет записан как 2 блока по 1мб, в то время как файл 0.5мб будет записан в блок размером 0.5мб). Больше — лучше для компрессии:recordsize=128K— ограничьте максимальный размер ARC (для исключения проблем с количеством ОЗУ):

echo "options zfs zfs_arc_max=половина_ОЗУ_в_байтах" >> /etc/modprobe.d/zfs.conf

echo половина_ОЗУ_в_байтах >> /sys/module/zfs/parameters/zfs_arc_max— дедупликацию используйте только по явной необходимости;

— по возможности используйте ECC память;

— настройте zfs-auto-snapshot.

Важные моменты:

— многие свойства действуют только на новые данные, к примеру при включении сжатия оно не применится к уже существующим данным. В дальнейшем возможно создание программы, применяющей свойства автоматически. Обходится простым копированием.

— консольные команды ZFS не запрашивают подтверждение, при выполнении

destroy будьте бдительны!— делайте бекапы на любой ФС!

В настоящий момент ZFS on Linux уже является стабильным продуктом, но плотная интеграция в существующие дистрибутивы будет проходить ещё некоторое время.

ZFS — прекрасная система, от которой очень сложно отказаться после знакомства. Она не является универсальным средством, но в нише программных RAID массивов уже заняла своё место.

Я, gmelikov, состою в проекте ZFS on Linux и готов с радостью ответить на любые вопросы!

Отдельно хочу пригласить к участию, всегда рады issues и PR, а также готовы помочь вам в наших mailing lists.

Полезные ссылки:

ZFS on Linux github page

FAQ

ZFS Performance tuning

|

|

Борьба за время сборки iOS-приложений |

На просторах интернета было найдено много действенных и не очень способов ускорить время сборки проекта. Особенно нас интересовало время сборки debug-версии, потому что работать становилось всё сложнее. Ниже я расскажу о методах, которые мы опробовали в рамках решения задачи, и результатах, которых мы добились. Хочу отметить, что долгое время сборки может зависеть от разных факторов, поэтому и методы для каждого проекта используются разные.

1. Участки кода, сложные для компиляции.

Поскольку Swift еще молод, некоторые сладкие синтаксические конструкции могут вызывать непонимание у компилятора. Для оценки самых тяжелых для компиляции функций можно использовать встроенный в компилятор Swift-анализатор. Проще всего получить отчет, выполнив сборку проекта из консоли этой командой:

xcodebuild -workspace App.xcworkspace -scheme App clean build OTHER_SWIFT_FLAGS="-Xfrontend -debug-time-function-bodies" | grep .[0-9]ms | grep -v ^0.[0-9]ms | sort -nr > functions_build_analysis.txtгде «App.xcworkspace» — название файла workspace вашего проекта, «App» — название схемы, по которой нужно сделать билд.

Мы передаем флаги "-Xfrontend -debug-time-function-bodies" для отладки процесса компиляции и учета времени на компиляцию каждой функции. С помощью grep мы выбираем строки, содержащие время компиляции, затем выводим отсортированный результат в файл functions_build_analysis.txt.

С помощью такого отчета мы нашли несколько тяжелых для компиляции функций, одна из которых собиралась 17 секунд, а другая — 6. Основная причина такого плачевного результатам — использование «Nil Coalescing» в конструкторе объекта. В коде были такие конструкции:

let object = Object(param1: param1Value ?? defaultParam1Value,

param2: param2Value ?? defaultParam2Value)Мы вынесли вычисление значения параметра в отдельную строку выше, и проблема была решена — время компиляции функций сократилось до 300 миллисекунд.

Это далеко не единственный сюрприз, который может преподнести вам компилятор Swift. Основные проблемы долгой сборки отдельных функций связаны с определением типов переменных. Чаще всего это связано с использованием операторов «??», «?:» в конструкторах объектов, словарей, массивов, а также при конкатенации строк и массивов. Вы можете прочитать статью с интересными наблюдениями по поводу ускорения времени сборки через рефакторинг кода.

Общий выигрыш, который мы смогли получить от манипуляций с кодом, — 30 секунд, это было уже неплохим достижением.

2. Сборка только выбранной архитектуры для Debug-билдов.

В debug-сборке происходит компиляция проекта только для архитектуры устройства, выбранного для отладки. То есть, выбирая здесь Yes, мы теоретически ускоряем время сборки в два раза.

Поскольку в нашем проекте этот флаг уже был установлен в Yes, мы не добились выигрыша в этом пункте. Но ради эксперимента мы опробовали сборку с флагом, выставленным в No. Для этого пришлось повозиться с Pod’ами, потому что они тоже были готовы предоставить скомпилированный код только для активной архитектуры. Время сборки проекта в итоге составило 10 минут 21 секунду, что действительно почти в два раза больше, чем изначальное.

3. Whole Module Optimization.

У Swift-компилятора есть флаг под названием «-whole-module-optimization». Он отвечает за то, каким образом будут обрабатываться файлы во время компиляции: будут ли они компилироваться по одному или сразу собираться в модуль. В Xcode управлять этим флагом можно с помощью секции «Optimization Level», однако по умолчанию нам доступны только эти опции:

Использование Whole Module Optimization существенно уменьшает время компиляции debug-сборок. Но вместе с этим флагом нам добавляют флаг «-O», который включает SIL-оптимизатор, и возникает проблема — проект перестает поддаваться отладке. В консоли мы видим следующее:

App was compiled with optimization - stepping may behave oddly; variables may not be available.Чтобы сохранить возможность сборки сразу целого модуля и отключить оптимизацию, можно добавить флаг «-Onone» в секции «Other Swift Flags». В итоге для отладки мы получаем сборку, максимально быстро собирающуюся за счет отключения всякого рода оптимизаций. В нашем проекте это дало поразительные результаты — скорость сборки debug увеличилась почти в 3 раза.

4. Precompiled Bridging Headers.

Есть еще один флаг компилятора, который помогает сократить время компиляции. Но работает он только для сборок без флага «-whole-module-optimization» и, скорее, может быть полезен для Release-сборок. Это флаг «-enable-bridging-pch».

Помогает он не во всех случаях, а только в проектах с Bridging-хедерами от Objective-C. Эффект заключается в том, что каждый раз во время сборки компилятор не перестраивает таблицу бриджинга Objective-C методов в Swift.

Для нашего проекта с выключенным флагом «-whole-module-optimization» и включенным «-enable-bridging-pch» выигрыш во времени составил около 15%.

Итоги

По итогам исследования для ускорения компиляции вашей Debug-сборки можно выделить два основных способа: оптимизация самого кода для компилятора и использование флага «whole-module-optimization». Нам удалось снизить чистое время сборки проекта (clean build) с 6 минут до 1 минуты 20 секунд, половину из которых занимает сборка сторонних зависимостей. Если у вас есть свой опыт борьбы с компилятором Swift, поделитесь в комментариях.

P.S.: железо, на котором проводились тесты:

Mac mini (Late 2012)

2,3 GHz Intel Core i7

16 GB 1600 MHz DDR3

250 GB SSD

|

Метки: author ToyoApps разработка под ios xcode swift objective c блог компании tinkoff.ru ios development ios разработка objective-c compile-time время компиляции |

Частоты и емкость сети — все, о чем вы хотели спросить |

Чтобы не блуждать по специализированной литературе, мы подготовили небольшой ликбез о частотах мобильной сети, который поможет сориентироваться.

Из школьного курса физики мы помним, что беспроводная связь — это передача данных с помощью электромагнитных волн радиодиапазона.

Немного теории беспроводной передачи данных

Данные (аналоговые или цифровые) «закладываются» в волну при помощи модуляции — процесса, при котором определенные параметры сигнала высокой частоты (несущего) изменяются с низкой частотой. Именно модуляция дает возможность использовать для передачи различной информации весь радиодиапазон, не ограничиваясь лишь частотами, соответствующими нашему голосу.

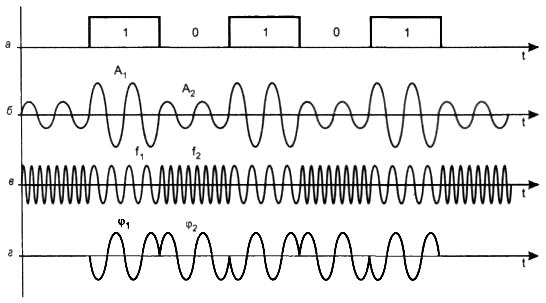

Модуляция аналогового сигнала

В процессе модуляции варьировать можно частоту, фазу или амплитуду колебаний, соответственно, для аналогового сигнала выделяют частотную, амплитудную и фазовую модуляцию. Они могут использоваться в чистом виде или в сочетании друг с другом для обеспечения большей помехозащищенности при передачи сигнала.

Рис. 1. Пример: амплитудная модуляция

При передаче аналогового сообщения передатчик использует модуляцию, чтобы «заложить» полезный сигнал в несущую частоту, и передает ее при помощи антенны приемнику. Последний проделывает обратную процедуру — демодуляцию — выделяя изначальный сигнал.

Модуляция меняет спектр передаваемого сигнала — с одной единственной частоты он расширяется, а степень и характер этих изменений зависят от типа модуляции. Таким образом, для передачи полезного сигнала без потерь необходима целая полоса частот, ширина которой в простейшем случае модуляции гармоническим сигналом грубо определяется двойной частотой модулирующего сигнала (см. рис. 2).

Рис. 2. Простейший пример: высокочастотная несущая модулируется низкочастотным гармоническим сигналом. В спектре суммарного сигнала появляются дополнительные частоты

Рис. 3. Спектр при частотной модуляции гармоническим сигналом

Существуют способы сжатия полосы спектра, необходимой для передачи информации, за счет более хитрых способов модуляции.

Модуляция цифрового сигнала

Для передачи цифрового сигнала — последовательности 0 и 1 — могут использоваться как указанные выше варианты модуляции в чистом виде, так и более сложные цифровые схемы.

Рис. 4. Амплитудная, частотная и фазовая модуляции дискретного сигнала

К ним можно отнести схемы, при которых дискретный сигнал проходит предварительную обработку перед модуляцией для сжатия итоговой спектральной полосы, требующейся для передачи сигнала с минимальными потерями. Хороший пример — используемая в стандарте GSM гаусcовская частотная модуляция с минимальным частотным сдвигом (Gaussian Minimum Shift Keying — GMSK) — разновидность частотной модуляции. Она сокращает спектральную полосу и допускает использование нелинейных усилителей, которые лучше подходят для маленького мобильного аппарата с ограниченной емкостью батареи. Помимо GSM, GMSK-модуляция используется в автоматической идентификационной системе на флоте, в Bluetooth, GPRS, EDGE, CDPD и других приложениях.

В сетях LTE используются иные варианты модуляции — OFDM и SC-FDMA, отличающиеся лучшей устойчивостью к помехам. Ранее эти схемы просто не могли быть реализованы из-за дороговизны требуемых вычислительных мощностей.

Радиодиапазон

До сих пор мы говорили о беспроводной передаче данных в отрыве от реальных частот. Теперь разберемся с радиодиапазоном. С точки зрения физики границы этого диапазона условны — к нему относятся электромагнитные волны с частотой от нескольких герц до десятков гигагерц.

Рис. 8. Положение радиодиапазона на шкале ЭМИ

В зависимости от частоты, электромагнитные волны по-разному рассеиваются и отражаются препятствиями. С учетом этого внутри упомянутого отрезка частот выделены диапазоны под различные нужды: радио, телевидение, военные и гражданские фиксированные службы, авиация, морское сообщение и т.п. К примеру, для связи с подводным флотом используются волны, способные проникать в глубь воды (длина волны — десятки километров, глубина проникновения — порядка десятков метров), а для космической связи выбран диапазон миллиметровых волн, проникающих через ионосферу Земли.

Упомянутые поддиапазоны сначала «резервировались» под определенные задачи инженерами, а затем их выделенный статус подтверждался международными соглашениями, учитывающими возможность распространения тех или иных сигналов за пределы географических границ (трансграничное согласование частотных присвоений — это тема отдельного долгого разговора). В ходе глобализации определилась и еще одна цель согласованного выделения частот — импорт и экспорт оборудования связи для своего сегмента.

Рис. 9. Радиодиапазон

С частью радиодиапазона рядовой пользователь не сталкивается ни разу в жизни, но есть определенные частоты, которыми он пользуется чуть ли не ежедневно, например:

- радиодиапазон, закрепленный за FM-станциями (FM — отсылка к частотной модуляции, принятой в диапазоне) — 87,5 — 108,0 МГц;

- «гражданский» или Си-Би (Citizen`s Band) диапазон 27 МГц (26,965—27,405 МГц) — известен радиолюбителям; диапазон активно использовался автомобилистами до повсеместного распространения мобильных телефонов;

- LPD — диапазон для маломощной пользовательской радиосвязи, в частности, пультов сигнализации, радионянь и прочих применений (тут выделено целых 3 диапазона: 403 — 410 МГц, 417 — 422 МГц и 433 — 447 МГц);

- эфирное телевидение (49,75 — 56,25 МГц для 1 частотного канала и т.п.);

- мобильная связь стандарта GSM, в частности, 890 — 915/935 — 960 МГц для GSM-900; 1710 — 1785/1805 — 1880 МГц для GSM-1800 (в других странах используются также GSM-450, GSM-850 и GSM-1900);

- 3G (UMTS: 1885 МГц — 2025 МГц для uplink и 2110 МГц — 2200 МГц для downlink);

- спутниковое телевидение (Ku-диапазон — 12-18 ГГц).

При выделении диапазона под определенные нужды оговаривается не только частота, но и другие параметры сигнала. Это необходимо, чтобы устройства, работающие в этом и соседних диапазонах, не мешали друг другу.

Законодательное регулирование

В России частотным регулированием (в части спектра, не переданной военным) занимается Государственная комиссия по радиочастотам (ГКРЧ) — процесс регламентирует федеральный закон «О связи».

Для выделения частоты оператор подает заявку и ждет очередного заседания ГКРЧ. ГКРЧ принимает решение о выделении диапазона, но, если оно положительное, это еще не обещает запуска услуги. С этим решением, а также деталями планируемого строительства (точками размещения базовых станций, мощностями передатчиков и т.п.) оператор идет в ФГУП «ГРЧЦ», где проверяется совместимость стандарта связи, который предполагается использовать на данной частоте, с существующим и планируемым к использованию оборудованием соседних диапазонов. На этом этапе оператор может получить отказ, например, от военных. Процедура, к слову, платная, вне зависимости от результата.

Лишь после этого Федеральная служба по надзору в сфере связи, информационных технологий и массовых коммуникаций выдает разрешение. Если на частоту претендует несколько операторов, ресурс распределяется на конкурсной, а в последнее время — на аукционной основе.

Существует такая процедура, как расчистка частот — когда по заказу оператора военными или другими заинтересованными организациями высвобождается определенный диапазон частот. Но этот процесс никак не регламентирован — все держится на взаимной договоренности компаний.

Частотный диапазон может выделяться на ограниченный срок (10 лет) на всей территории страны или в отдельном регионе (поэтому у федерального оператора может быть разный набор лицензий в разных частях страны). По истечении срока, указанного в разрешении, документы переоформляются, если, конечно, нет причин отказа, например, диапазон запланирован под другую технологию.

Получая частоту, оператор берет на себя определенные обязательства: начать предоставлять услуги, под которые выделяется частота, в течение заранее оговоренного срока. Речь в данном случае идет не только о мобильной связи, но о беспроводных услугах вообще — трансляция телевидения, интернет. Если это условие не выполняется, оператор может лишиться диапазона.

Политика оплаты использования частот за время существования мобильной связи менялась несколько раз. Сначала операторы платили за каждый объект связи (базовую станцию), затем — за использование частот в отдельном регионе (условия выделения частоты при этом могли содержать пункт о выплате денежной компенсации предыдущему владельцу диапазона, как это было при выделении частот LTE на конкурсе 2012 года). А т.к. разрешения на разные участки спектра в разных регионах оформлялись не единовременно, условия оказались неодинаковыми для отдельных участников рынка, что выливалось в склоки и борьбу компаний между собой за ценный ресурс. В последние годы был принят ряд мер, уравнивающих права компаний на частоты. В частности, с 2015 года начались аукционы (это совершенно не означает, что теперь все частоты выделяются в рамках аукционов, но до 2015 года подобной практики не было), а в 2016 вышло обобщенное решение о распределении частот, уравнивающее условия использования частот (зону покрытия, допустимые технологии для отдельных участков спектра и т.п.).

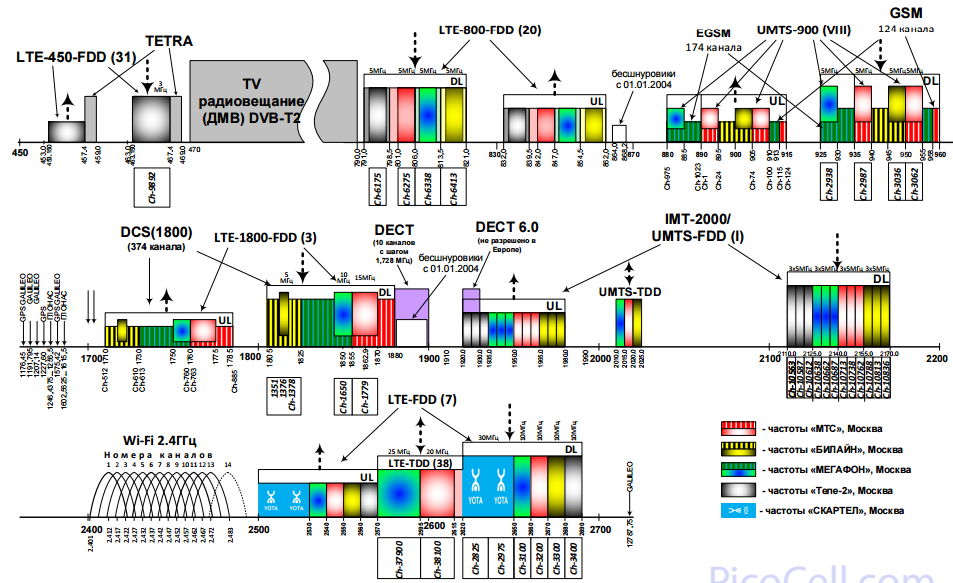

Текущая «картина» распределения частот в Москве (на ноябрь 2016) представлена на рисунке ниже.

Рис. 10. Распределение частот в Москве

Лидерами по количеству частот под цифровую мобильную связь в России на данный момент являются МТС и Мегафон.

Диапазоны мобильной связи

Как видно из схемы, под гражданскую мобильную связь выделено довольно много отрезков частотного спектра где-то между 300 и 3000 МГц, которые поделены между действующими на данной территории операторами.

На разных частотах действуют работают разные стандарты связи — эта ситуация складывалась исторически, по мере развития и внедрения операторами новых поколений, выделения частот в ходе аукционов или конкурсов, высвобождения участков спектра из под устаревших технологий.

О поколениях мобильной связи

Стандарты современной мобильной связи описаны в спецификации 3GPP (The 3rd Generation Partnership Project) — партнерства ведущих организаций в сфере стандартизации телекоммуникационных технологий. В названии партнерства речь идет о «третьем поколении» связи, но GSM обычно рассматривается в качестве 2 и 2.5 поколения (2G и 2.5G, соответственно). После завершения работы над спецификацией GSM, организация занялась разработкой 3G (UMTS), а затем pre-4G (LTE) и 4G (LTE-Advanced).

Рис. 11. Развитие мобильной связи

Повсеместно разработанные 3GPP стандарты не заменяют друг друга, а сосуществуют вместе, в рамках сетей одних операторов — новые технологии не одномоментно вытесняют старые.

Если рассматривать ситуацию в теории, то все указанные частотные отрезки могут использоваться под связь 4G: сети нового поколения разрабатывались так, чтобы максимально задействовать существующую инфраструктуру. С расчетом на это 3GPP классифицировали возможные диапазоны (bands), присвоив каждому порядковый номер и дав рекомендации по деталям организации передачи (в частности, по способу деления канала между абонентами). Общий список каналов можно найти здесь.

На практике некоторые участки спектра закреплены ГКРЧ за определенными технологиями, так что начать там предоставление услуг оператор не может (например, в диапазоне 2100 МГц должны предоставляться услуги 3G, хотя операторы с удовольствием отвели бы его под LTE). Для других же действует принцип технологической нейтральности, согласно которому оператор, владеющий частотой, может использовать ее не только для организации связи по стандарту GSM, но и для технологий следующих поколений (3G, 4G). В итоге у нас же на момент написания данной статьи для 4G используются лишь диапазоны 3 (1800 МГц), 7 (2600 МГц), 20 (800 МГц) и 38 (2600 МГц) в классификации 3GPP.

Учитывая разницу в характере распространения волн каждого из диапазонов в помещении и на открытом пространстве, а также различие в политике операторов относительно поддержки этих диапазонов, пользователям при выборе оборудования приходится превращаться в специалистов по частотному регулированию.

Наилучшим вариантом будет аппарат с поддержкой всех используемых у нас диапазонов. Но «минимально рекомендуемый» вариант — это поддержка диапазонов 3 и еще одного: 7 или 38 (в зависимости от оператора).

Если не учитывать диапазоны, можно остаться вообще без 4G, как это происходит с владельцами некоторых американских iPhone SE (а именно — модели A1662): в списке диапазонов LTE, поддерживаемых устройством, лишь 20-й как-то развивается в России, и то не во всех регионах (в моделях для международного рынка также присутствует диапазон 7, распространенный у нас, и 38 для TD-LTE).

Оптимизация использования частотного ресурса

Емкость — один из основных параметров операторской сети. Она характеризует техническую возможность по оказанию определенных услуг: чем выше емкость — тем большее число абонентов можно обслужить одновременно при прочих равных.

Общая емкость неизбежно зависит от ширины спектральной полосы (а также ее расположения в радиодиапазоне). Так что операторами востребованы технологии все более эффективного использования доступной спектральной полосы, реализуемые в каждом последующем поколении мобильной связи.

В 2G для повышения емкости (на фоне аналоговых стандартов и цифровой связи первого поколения) использовалось сочетание FDMA и TDMA. Во-первых, абонентские устройства были разделены по частотным каналам по принципу FDMA (Frequency Division Multiple Access — множественный доступ с частотным разделением каналов).

Рис. 13. TDMA и FDMA

Сети третьего поколения используют иной принцип разделения частотных каналов — кодовый или CDMA (Code Division Multiple Access), который позволяет повысить емкость сети при том же используемом частотном диапазоне, а заодно и обеспечить больший уровень безопасности.

В сетях LTE используется либо временное, либо частотное разделение каналов (TDD и FDD, соответственно), но реализованы они иначе, нежели в GSM (2G). TDD (TD-LTE) использует всю ширину спектральной полосы (от 1,4 до 20 МГц) для передачи данных в двух направлениях по очереди; при этом временные отрезки для передачи данных в каждом из направлений могут быть не равны. В FDD (FD-LTE) диапазон разделяется на 2 полосы в общем случае не равных полосы: для каждого из направлений передачи данных. Спецификация рекомендует применять либо FDD, либо TDD для каждого из предписанных для LTE диапазонов (http://en.wikipedia.org/wiki/LTE_frequency_bands#Frequency_bands_and_channel_bandwidths), поскольку метод TDD показал себя лучше на высоких частотах, а FDD, соответственно, на низких. Стоит отметить, что особенность стандарта LTE позволяет сравнительно недорого интегрировать поддержку обоих методов в одном устройстве, поэтому оборудование, поддерживающие и FDD, и TDD не редкость.

Дополнительно пропускная способность доступного спектра в LTE увеличивается за счет технологии многоантенной передачи MIMO (Multiple input-multiple output).

Глазами конечного абонента

Последний момент, о котором хотелось бы поговорить в этой статье — то, как выглядят услуги глазами конечных абонентов.

Скорость передачи данных для абонента неизбежно зависит от ширины спектральной полосы, отведенной для его потока информации. Если в поколениях 2G и 3G скорость была ограничена самим стандартом связи, то благодаря нововведениям 4G, скорость в большей степени определяется возможностями устройства.

В 4G (а точнее в LTE-Advanced, признанном Международным союзом электросвязи истинным стандартом 4G) появился механизм увеличения абонентской скорости — агрегация частот, в том числе из разных частотных диапазонов. В зависимости от характеристик устройство может задействовать до 4 полос по 20 МГц (в двух столицах на данный момент задействовать можно максимально 3 полосы у «Мегафона»). Для агрегации 4х несущих устройство должно относиться к категории 16 (CAT16). 4х4 MIMO совместно с агрегацией позволяет скачивать данные на таких устройствах со скоростью до 980 Мбит/с. 3 несущие агрегируют устройства категорий 9 и 12 (CAT9 со скростью до 450 Мбит/с и CAT12 с 600 Мбит/с, соответственно), а наиболее простые устройства CAT4 вовсе не агрегируют, достигая скорости не более 150 Мбит/с. Подробнее о непосредственно моделях, поддерживающих ту или иную скорость,здесь.

Работает ли заявленная теорией агрегация на практике в условиях реального радиоприема? В рамках тестов Мегафоном на оборудовании Huawei была продемонстрирована скорость в 1 Гбит/с. Для этого использовалась агрегация трех несущих.

|

Метки: author MegaFon стандарты связи беспроводные технологии блог компании «мегафон» частоты |

Индексы в PostgreSQL — 4 |

Мы уже рассмотрели механизм индексирования PostgreSQL и интерфейс методов доступа, а также один из методов доступа — хеш-индекс. Сейчас поговорим о самом традиционном и используемом индексе — B-дереве. Глава получилась большой, запасайтесь терпением.

Btree

Устройство

Индекс btree, он же B-дерево, пригоден для данных, которые можно отсортировать. Иными словами, для типа данных должны быть определены операторы «больше», «больше или равно», «меньше», «меньше или равно» и «равно». Заметьте, что одни и те же данные иногда можно сортировать разными способами, что возвращает нас к концепции семейства операторов.

Как всегда, индексные записи B-дерева упакованы в страницы. В листовых страницах эти записи содержат индексируемые данные (ключи) и ссылки на строки таблицы (TID-ы); во внутренних страницах каждая запись ссылается на дочернюю страницу индекса и содержит минимальное значение ключа в этой странице.

B-деревья обладают несколькими важными свойствами:

- Они сбалансированы, то есть любую листовую страницу отделяет от корня одно и то число внутренних страниц. Поэтому поиск любого значения занимает одинаковое время.

- Они сильно ветвисты, то есть каждая страница (как правило, 8 КБ) содержит сразу много (сотни) TID-ов. За счет этого глубина B-деревьев получается небольшой; на практике до 4–5 для очень больших таблиц.

- Данные в индексе упорядочены по неубыванию (как между страницами, так и внутри каждой страницы), а страницы одного уровня связаны между собой двунаправленным списком. Поэтому получить упорядоченный набор данных мы можем, просто проходя по списку в одну или в другую сторону, не возвращаясь каждый раз к корню.

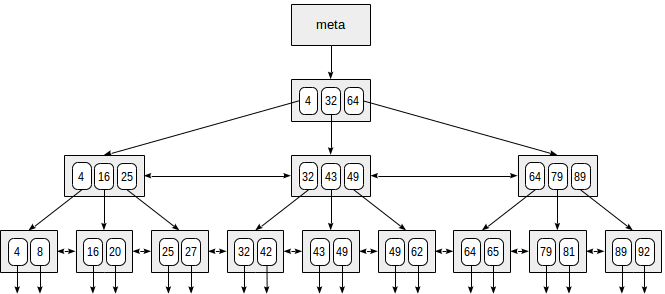

Вот схематичный пример индекса по одному полю с целочисленными ключами.

В самом начале файла находится метастраница, которая ссылается на корень индекса. Ниже корня расположены внутренние узлы; самый нижний ряд — листовые страницы. Стрелочки вниз символизируют ссылки из листовых узлов на строки таблицы (TID-ы).

Поиск по равенству

Рассмотрим поиск значения в дереве по условию «индексированное-поле = выражение». Допустим, нас интересует ключ 49.

Поиск начинается с корневого узла, и нам надо определить, в какой из дочерних узлов спускаться. Зная находящиеся в корневом узле ключи (4, 32, 64) мы тем самым понимаем диапазоны значений в дочерних узлах. Поскольку 32 <= 49 < 64, надо спускаться во второй дочерний узел. Дальше та же процедура повторяется рекурсивно до тех пор, пока не будет достигнут листовой узел, из которого уже можно получить необходимые TID-ы.

В реальности эта простая на вид процедура осложняется рядом обстоятельств. Например, индекс может содержать неуникальные ключи и одинаковых значений может оказаться достаточно много, чтобы они не поместились на одну страницу. Продолжая наш пример, кажется, что из внутреннего узла следовало бы спуститься по ссылке, которая ведет от значения 49. Но, как видно на картинке, так мы пропустим один из ключей 49 в предыдущей листовой странице. Поэтому, обнаружив на внутренней странице точное равенство ключа, нам приходится спускаться на одну позицию левее, а затем просматривать индексные записи нижележащего уровня слева направо в поисках интересующего ключа.

(Другая сложность вызвана тем, что во время поиска другие процессы могут изменять данные: дерево может перестраиваться, страницы могут разбиваться на две и т. п. Все алгоритмы построены таким образом, чтобы эти одновременные действия по возможности не мешали друг другу и не требовали лишних блокировок. Но в эти детали мы уже не будем вдаваться.)

Поиск по неравенству

При поиске по условию «индексированное-поле <= выражение» ( или «индексированное-поле >= выражение»), сначала находим в индексе значение по условию равенства «индексированное-поле = выражение» (если оно есть), а затем двигаемся по листовым страницам до конца в нужную сторону.

Рисунок иллюстрирует этот процесс для условия n <= 35:

Аналогично поддерживаются и операторы «больше» и «меньше», надо лишь исключить исходно найденное значение.

Поиск по диапазону

При поиске по диапазону «выражение1 <= индексированное-поле <= выражение2» находим значение по условию «индексированное-поле = выражение1», а затем двигаемся по листовым страницам, пока выполняется условие «индексированное-поле <= выражение2». Или наоборот: начинаем со второго выражения и двигаемся в другую сторону, пока не дойдем до первого.

На рисунке показан процесс для условия 23 <= n <= 64:

Пример

Посмотрим, как выглядят планы запросов на примере. Как обычно, используем демонстрационную базу данных, и на этот раз возьмем таблицу самолетов. В ней всего девять строк и по собственной воле планировщик не будет использовать индекс — ведь вся таблица целиком помещается в одну страницу. Но нам она интересна по причине наглядности.

demo=# select * from aircrafts;

aircraft_code | model | range

---------------+---------------------+-------

773 | Boeing 777-300 | 11100

763 | Boeing 767-300 | 7900

SU9 | Sukhoi SuperJet-100 | 3000

320 | Airbus A320-200 | 5700

321 | Airbus A321-200 | 5600

319 | Airbus A319-100 | 6700

733 | Boeing 737-300 | 4200

CN1 | Cessna 208 Caravan | 1200

CR2 | Bombardier CRJ-200 | 2700

(9 rows)

demo=# create index on aircrafts(range);

CREATE INDEX

demo=# set enable_seqscan = off;

SET

(Или явно create index on aircrafts using btree(range), но по умолчанию строится именно B-дерево.)

Поиск по равенству:

demo=# explain(costs off) select * from aircrafts where range = 3000;

QUERY PLAN

---------------------------------------------------

Index Scan using aircrafts_range_idx on aircrafts

Index Cond: (range = 3000)

(2 rows)

Поиск по неравенству:

demo=# explain(costs off) select * from aircrafts where range < 3000;

QUERY PLAN

---------------------------------------------------

Index Scan using aircrafts_range_idx on aircrafts

Index Cond: (range < 3000)

(2 rows)

И по диапазону:

demo=# explain(costs off) select * from aircrafts where range between 3000 and 5000;

QUERY PLAN

-----------------------------------------------------

Index Scan using aircrafts_range_idx on aircrafts

Index Cond: ((range >= 3000) AND (range <= 5000))

(2 rows)

Сортировка

Стоит еще раз подчеркнуть, что при любом способе сканирования (индексном, исключительно индексном, по битовой карте) метод доступа btree возвращает упорядоченные данные, что хорошо видно на приведенных выше рисунках.

Поэтому, если на таблице имеется индекс по условию сортировки, оптимизатор будет учитывать обе возможности: обращение к таблице по индексу и автоматическое получение отсортированных данных, либо последовательное чтение таблицы и последующая сортировка результата.

Порядок сортировки

При создании индекса можно явно указывать порядок сортировки. Например, индекс по дальности полета можно было создать и так:

demo=# create index on aircrafts(range desc);

При этом слева в дереве оказались бы большие значения, а справа — меньшие. Зачем это может понадобиться, если по индексированным значениям можно проходить как в одну сторону, так и в другую?

Причина в многоколоночных индексах. Давайте создадим представление, которое будет показывать модели самолетов и условное деление на ближне-, средне- и дальнемагистральные суда:

demo=# create view aircrafts_v as

select model,

case

when range < 4000 then 1

when range < 10000 then 2

else 3

end as class

from aircrafts;

CREATE VIEW

demo=# select * from aircrafts_v;

model | class

---------------------+-------

Boeing 777-300 | 3

Boeing 767-300 | 2

Sukhoi SuperJet-100 | 1

Airbus A320-200 | 2

Airbus A321-200 | 2

Airbus A319-100 | 2

Boeing 737-300 | 2

Cessna 208 Caravan | 1

Bombardier CRJ-200 | 1

(9 rows)

И создадим индекс (с использованием выражения):

demo=# create index on aircrafts(

(case when range < 4000 then 1 when range < 10000 then 2 else 3 end), model);

CREATE INDEX

Теперь мы можем использовать этот индекс, чтобы получить данные, отсортированные по обоим столбцам по возрастанию:

demo=# select class, model from aircrafts_v order by class, model;

class | model

-------+---------------------

1 | Bombardier CRJ-200

1 | Cessna 208 Caravan

1 | Sukhoi SuperJet-100

2 | Airbus A319-100

2 | Airbus A320-200

2 | Airbus A321-200

2 | Boeing 737-300

2 | Boeing 767-300

3 | Boeing 777-300

(9 rows)

demo=# explain(costs off) select class, model from aircrafts_v order by class, model;

QUERY PLAN

--------------------------------------------------------

Index Scan using aircrafts_case_model_idx on aircrafts

(1 row)

Точно так же можно выполнить запрос с сортировкой по убыванию:

demo=# select class, model from aircrafts_v order by class desc, model desc;

class | model

-------+---------------------

3 | Boeing 777-300

2 | Boeing 767-300

2 | Boeing 737-300

2 | Airbus A321-200

2 | Airbus A320-200

2 | Airbus A319-100

1 | Sukhoi SuperJet-100

1 | Cessna 208 Caravan

1 | Bombardier CRJ-200

(9 rows)

demo=# explain(costs off)

select class, model from aircrafts_v order by class desc, model desc;

QUERY PLAN

-----------------------------------------------------------------

Index Scan Backward using aircrafts_case_model_idx on aircrafts

(1 row)

Но из этого индекса невозможно получить данные, отсортированные по одному столбцу по убыванию, а по другому — по возрастанию. Для этого потребуется отдельно выполнить сортировку:

demo=# explain(costs off)

select class, model from aircrafts_v order by class asc, model desc;

QUERY PLAN

-------------------------------------------------

Sort

Sort Key: (CASE ... END), aircrafts.model DESC

-> Seq Scan on aircrafts

(3 rows)

(Заметьте, что с горя планировщик выбрал сканирование таблицы, даже несмотря на установку enable_seqscan = off, сделанную ранее. Это потому, что на самом деле она не запрещает сканирование таблицы, а только устанавливает ему запредельную стоимость — посмотрите план с «costs on».)

Чтобы такой запрос мог быть выполнен с использованием индекса, индекс надо построить с сортировкой в нужном порядке:

demo=# create index aircrafts_case_asc_model_desc_idx on aircrafts(

(case when range < 4000 then 1 when range < 10000 then 2 else 3 end) asc, model desc);

CREATE INDEX

demo=# explain(costs off)

select class, model from aircrafts_v order by class asc, model desc;

QUERY PLAN

-----------------------------------------------------------------

Index Scan using aircrafts_case_asc_model_desc_idx on aircrafts

(1 row)

Порядок столбцов

Другой вопрос, который встает при использовании многоколоночных индексов — порядок перечисления столбцов в индексе. В случае B-дерева этот порядок имеет огромное значение: данные внутри страниц будут отсортированы сначала по первому полю, затем по второму и так далее.

Индекс, который мы построили по интервалам дальностей и моделям, можно условно представить таким образом:

Конечно, на самом деле такой небольшой индекс поместится в одну корневую страницу; на рисунке он искусственно распределен на несколько страниц для наглядности.

Из этой схемы понятно, что поиск будет работать эффективно с такими, например, предикатами, как «class = 3» (поиск только по первому полю) или «class = 3 and model = 'Boeing 777-300'» (поиск по обоим полям).

А вот поиск по предикату «model = 'Boeing 777-300'» будет куда менее эффективным: начиная с корня, мы не можем определить, в какой из дочерних узлов спускаться, поэтому спускаться придется во все. Это не значит, что такой индекс не может использоваться в принципе — вопрос только в эффективности. Например, если бы у нас было три класса самолетов и очень много моделей в каждом классе, то нам пришлось бы просмотреть примерно треть индекса, и это могло бы оказаться эффективнее, чем полное сканирование таблицы. А могло бы и не оказаться.

Зато если создать индекс таким образом:

demo=# create index on aircrafts(

model, (case when range < 4000 then 1 when range < 10000 then 2 else 3 end));

CREATE INDEX

то порядок полей поменяется:

И с таким индексом поиск по предикату «model = 'Boeing 777-300'» будет выполняться эффективно, а по предикату «class = 3» — нет.

Неопределенные значения

Метод доступа btree индексирует неопределенные значения и поддерживает поиск по условиям is null и is not null.

Возьмем таблицу рейсов, в которой встречаются неопределенные значения:

demo=# create index on flights(actual_arrival);

CREATE INDEX

demo=# explain(costs off) select * from flights where actual_arrival is null;

QUERY PLAN

-------------------------------------------------------

Bitmap Heap Scan on flights

Recheck Cond: (actual_arrival IS NULL)

-> Bitmap Index Scan on flights_actual_arrival_idx

Index Cond: (actual_arrival IS NULL)

(4 rows)

Неопределенные значения располагаются с одного или другого края листовых узлов в зависимости от того, как был создан индекс (nulls first или nulls last). Это важно, если в запросе участвует сортировка: порядок расположения неопределенных значений в индексе и в порядке сортировки должны совпадать, чтобы индекс можно было использовать.

В этом примере порядки совпадают, поэтому индекс может использоваться:

demo=# explain(costs off) select * from flights order by actual_arrival nulls last;

QUERY PLAN

--------------------------------------------------------

Index Scan using flights_actual_arrival_idx on flights

(1 row)

А здесь порядки отличаются, и оптимизатор выбирает сканирование таблицы и сортировку:

demo=# explain(costs off) select * from flights order by actual_arrival nulls first;

QUERY PLAN

----------------------------------------

Sort

Sort Key: actual_arrival NULLS FIRST

-> Seq Scan on flights

(3 rows)

Чтобы индекс мог использоваться, надо создать его так, чтобы неопределенные значения шли в начале:

demo=# create index flights_nulls_first_idx on flights(actual_arrival nulls first);

CREATE INDEX

demo=# explain(costs off) select * from flights order by actual_arrival nulls first;

QUERY PLAN

-----------------------------------------------------

Index Scan using flights_nulls_first_idx on flights

(1 row)

Причина таких неувязок, конечно, в том, что неопределенные значения не являются сортируемыми: результат сравнения неопределенного значения с любым другим не определен:

demo=# \pset null NULL

Null display is "NULL".

demo=# select null < 42;

?column?

----------

NULL

(1 row)

Это идет вразрез с сущностью B-дерева и не укладывается в общую схему. Но неопределенные значения играют такую важную роль в базах данных, что для них все время приходится делать исключения.

Следствием того, что неопределенные значения индексируются, является возможность использовать индекс, даже если на таблицу не наложено вообще никаких условий (поскольку в индексе гарантированно содержится информация обо всех строках таблицы). Это может иметь смысл, если в запросе нужно упорядочить данные и индекс обеспечивает нужный порядок. Тогда планировщик может предпочесть индексный доступ, чтобы сэкономить на отдельной сортировке.

Свойства

Посмотрим свойства метода доступа btree (запросы приводились ранее).

amname | name | pg_indexam_has_property

--------+---------------+-------------------------

btree | can_order | t

btree | can_unique | t

btree | can_multi_col | t

btree | can_exclude | t

Как мы видели, B-дерево может упорядочивать данные и поддерживает уникальность — и это единственный метод доступа, который обеспечивает такие свойства. Индексы по нескольким столбцам также допустимы; но это умеют и другие методы (хотя и не все). Про поддержку ограничений exclude мы, не без причины, поговорим в следующий раз.

name | pg_index_has_property

---------------+-----------------------

clusterable | t

index_scan | t

bitmap_scan | t

backward_scan | t

Метод доступа b-tree поддерживает оба способа получения значений: и индексное сканирование, и сканирование битовой карты. И, как мы видели, умеет обходить дерево как «вперед», так и в обратном направлении.

name | pg_index_column_has_property

--------------------+------------------------------

asc | t

desc | f

nulls_first | f

nulls_last | t

orderable | t

distance_orderable | f

returnable | t

search_array | t

search_nulls | t

Первые четыре свойства этого уровня говорят о том, как именно упорядочены значения данного конкретного столбца. В этом примере значения отсортированы по возрастанию (asc), а неопределенные значения находятся к конце (nulls_last). Но, как мы видели, могут быть и другие комбинации.

Свойство search_array говорит о том, что индекс поддерживает такие конструкции:

demo=# explain(costs off)

select * from aircrafts where aircraft_code in ('733','763','773');

QUERY PLAN

-----------------------------------------------------------------

Index Scan using aircrafts_pkey on aircrafts

Index Cond: (aircraft_code = ANY ('{733,763,773}'::bpchar[]))

(2 rows)

Свойство returnable говорит о поддержке исключительно индексного сканирования — что логично, ведь в индексных записях хранятся сами проиндексированные значения (в отличие от хеш-индекса, например). Тут уместно сказать несколько слов об особенностях покрывающих индексов на основе B-дерева.

Уникальные индексы с дополнительными столбцами

Как мы говорили ранее, покрывающим называется индекс, который содержит все значения, необходимые в запросе; при этом обращение к самой таблице уже не требуется (почти). В том числе покрывающим может быть и уникальный индекс.

Но допустим, мы хотим добавить к уникальному индексу дополнительные столбцы, необходимые в запросе. Значения нового составного ключа уже могут быть и не уникальными, и тогда потребуется иметь два индекса практически по одним и тем же столбцам: один уникальный (для поддержки ограничения целостности) и еще один не уникальный (в качестве покрывающего). Это, конечно, неэффективно.

В нашей компании Анастасия Лубенникова lubennikovaav доработала метод btree так, чтобы в уникальный индекс можно было включать дополнительные — неуникальные — столбцы. Надеемся, что этот патч будет принят сообществом и войдет в PostgreSQL, но это случится уже не в версии 10. Пока патч доступен в Postgres Pro Standard 9.5+, и вот как это выглядит.

Возьмем таблицу бронирований:

demo=# \d bookings

Table "bookings.bookings"

Column | Type | Modifiers

--------------+--------------------------+-----------

book_ref | character(6) | not null

book_date | timestamp with time zone | not null

total_amount | numeric(10,2) | not null

Indexes:

"bookings_pkey" PRIMARY KEY, btree (book_ref)

Referenced by:

TABLE "tickets" CONSTRAINT "tickets_book_ref_fkey" FOREIGN KEY (book_ref) REFERENCES bookings(book_ref)

В ней первичный ключ (book_ref, код бронирования) поддержан обычным btree-индексом. Создадим новый уникальный индекс с дополнительным столбцом:

demo=# create unique index bookings_pkey2 on bookings(book_ref) include (book_date);

CREATE INDEX

Теперь заменим существующий индекс на новый (в транзакции, чтобы все изменения вступили в силу одновременно):

demo=# begin;

BEGIN

demo=# alter table bookings drop constraint bookings_pkey cascade;

NOTICE: drop cascades to constraint tickets_book_ref_fkey on table tickets

ALTER TABLE

demo=# alter table bookings add primary key using index bookings_pkey2;

ALTER TABLE

demo=# alter table tickets add foreign key (book_ref) references bookings (book_ref);

ALTER TABLE

demo=# commit;

COMMIT

Вот что получилось:

demo=# \d bookings

Table "bookings.bookings"

Column | Type | Modifiers

--------------+--------------------------+-----------

book_ref | character(6) | not null

book_date | timestamp with time zone | not null

total_amount | numeric(10,2) | not null

Indexes:

"bookings_pkey2" PRIMARY KEY, btree (book_ref) INCLUDE (book_date)

Referenced by: