Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Из песочницы] Послевкусие от Kotlin |

Сразу оговорюсь: я ничуть не жалею об использовании Kotlin и всем его рекомендую. Однако хочется предупредить о некоторых подводных камнях.

1. Annotation Processors

Проблема в том, что Kotlin компилируется в Java, а уже на основе Java генерятся классы, скажем, для JPA или, как в моём случае, QueryDsl. Поэтому результат работы annotation processor не удастся использовать в том же модуле (в тестах можно).

Варианты обхода проблемы:

- выделить классы, с которыми работает annotation processor в отдельный модуль.

- исползовать результат annotation processor только из Java класов (их можно будет легально вызывать из Kotlin). Придётся возиться с maven, чтобы он в точности соблюдал последовательность: компилируем Kotlin, наш annotation processor, компилируем Java.

- попробовать помучиться с kapt (у меня с QueryDsl не вышло)

2. Аннотации внутри конструктора

Наткулся на это при объявлении валидации модели. Вот класс, который правильно валидируется:

class UserWithField(param: String) {

@NotEmpty var field: String = param

}

А вот этот уже нет:

class UserWithConstructor(

@NotEmpty var paramAndField: String

)

Если аннотация может применяться к параметру (ElementType.PARAMETER), то по умолчанию она будет подвешена к параметру конструктора. Вот починеный вариант класа:

class UserWithFixedConstructor(

@field:NotEmpty var paramAndField: String

)

Сложно винить за это JetBrains, они честно задокументировали это поведение. И выбор дефолтного поведения понятен – параметры в конструкторе — не всегда поля. Но я чуть не попался.

Мораль: всегда ставьте @field: в аннотациях конструктора, даже если это не нужно (как в случае javax.persistence.Column), целее будете.

3. Переопределение setter

Вещь полезная. Так, к примеру, можно обрезать дату до месяца (где это ещё делать?). Но есть одно но:

class NotDefaultSetterTest {

@Test fun customSetter() {

val ivan = User("Ivan")

assertEquals("Ivan", ivan.name)

ivan.name = "Ivan"

assertEquals("IVAN", ivan.name)

}

class User(

nameParam: String

) {

var name: String = nameParam

set(value) {

field = value.toUpperCase()

}

}

}

С одной стороны, мы не можем переопределить setter, если объявили поле в конструкторе, с другой – если мы используем переданный в конструктор параметр, то он будет присвоен полю сразу, минуя переопределенный setter. Я придумал только один адекватный вариант лечения (если есть идеи по-лучше, пишите в коменты, буду благодарен):

class User(

nameParam: String

) {

var name: String = nameParam.toUpperCase()

set(value) {

field = value.toUpperCase()

}

}

4. Особенности работы с фреймворками

Изначально были большие проблемы работы со Spring и Hibernate, но в итоге появился плагин, который всё решил. Вкратце – плагин делает все поля not final и добавляет конструктор без параметров для классов с указанными анотациями.

Но интересные вещи начались при работе с JSF. Раньше я, как добросовестный Java-программист, везде вставлял getter-setter. Теперь, так как язык обязывает, я каждый раз задумываюсь, а изменяемо ли поле. Но нет, JSF это не интересно, setter нужен через раз. Так что всё, что у меня передавалось в JSF, стало полностью mutable. Это заставило меня везде использовать DTO. Не то чтобы это было плохо…

А ещё иногда JSF нужен конструктор без параметров. Я, если честно, даже не смог воспроизвести, пока писал статью. Проблема связана с особенностями жизненного цикла view.

Мораль: надо знать чего ожидает от вашего кода фреймворк. Особенно надо уделить внимание тому, как и когда сохраняются/восставнавливаются объекты.

Дальше идут соблазны, которые подпитываются возможностями языка.

5. Код, понятный только посвященным

Изначально всё остается понятным для неподготовленного читателя. Убрали get-set, null-safe, функциональщина, extensions… Но после погружения начинаешь использовать особенности языка.

Вот конкретный пример:

fun getBalance(group: ClassGroup, month: Date, payments: Map>): Balance {

val errors = mutableListOf()

fun tryGetBalanceItem(block: () -> Balance.Item) = try {

block()

} catch(e: LackOfInformation) {

errors += e.message!!

Balance.Item.empty

}

val credit = tryGetBalanceItem {

creditBalancePart(group, month, payments)

}

val salary = tryGetBalanceItem {

salaryBalancePart(group, month)

}

val rent = tryGetBalanceItem {

rentBalancePart(group, month)

}

return Balance(credit, salary, rent, errors)

}

Это расчет баланса для группы учеников. Заказчик попросил выводить прибыль, даже если не хватает данных по аренде (я его предупредил, что доход будет высчитан неверно).

val result: String

try {

//some code

result = "first"

//some other code

} catch (e: Exception) {

result = "second"

}

С точки зрения компилятора нет никакой гарантии, что result не будет проинециализирован дважды, а он у нас immutable.

Дальше: fun tryGetBalanceItem – локальная функция. Прямо как в JavaScript, только со строгой типизацией.

Кроме того, tryGetBalanceItem принимает в качестве аргумента другую функцию и выполняет её внутри try. Если переданная функция провалилась, ошибка добавляется в список и возвращается дефолтный объект.

6. Параметры по умолчанию

Вещь просто замечательная. Но лучше задуматься перед использованием, если количество параметров может со временем вырасти.

Например, мы решили, что у User есть обязательные поля, которые нам будут известны при регистрации. А есть поле, вроде даты создания, которое явно имеет только одно значение при создании объекта и будет указываться явно только при восстановлении объекта из DTO.

data class User (

val name: String,

val birthDate: Date,

val created: Date = Date()

)

fun usageVersion1() {

val newUser = User("Ivan", SEPTEMBER_1990)

val userFromDto = User(userDto.name, userDto.birthDate, userDto.created)

}

Через месяц мы добавляем поле disabled, которое, так же как и created, при создании User имеет только одно осмысленное значение:

data class User (

val name: String,

val birthDate: Date,

val created: Date = Date(),

val disabled: Boolean = false

)

fun usageVersion2() {

val newUser = User("Ivan", SEPTEMBER_1990)

val userFromDto = User(userDto.name, userDto.birthDate, userDto.created, userDto.disabled)

}

И вот тут возникает проблема: usageVersion1 продолжает компилироваться. А за месяц мы немало уже успели написать. При этом поиск использования конструктора выдаст все вызовы, и правильные, и неправильные. Да, я использовал параметры по умолчанию в неподходящем случае, но изначально это выглядело логично…

7. Лямбда, вложенная в лямбду

val months: List = ...

val hallsRents: Map> = months

.map { month ->

month to halls

.map { it.name to rent(month, it) }

.toMap()

}

.toMap()

Здесь получаем Map от Map. Полезно, если хочется отобразить таблицу. Я обязан в первой лямбде использовать не it, а что-нибудь другое, иначе во второй лямбде просто не получиться достучаться до месяца. Это не сразу становится очевидно, и легко запутаться.

Казалось бы, обычный стримоз мозга – возьми, да и замени на цикл. Но есть одно но: hallsRents станет MutableMap, что неправильно.

Долгое время код оставался в таком виде. Но сейчас подобные места заменяю на:

val months: List = ...

val hallsRents: Map> = months

.map { it to rentsByHallNames(it) }

.toMap()

И волки сыты, и овцы целы. Избегайте хоть чего-либо сложного в лямбдах, выносите это в отдельные методы, потом намного приятнее будет читать.

Свой проект я считаю репрезентативным: 8500 строк, при том что Kotlin лаконичен (в первый раз считаю строки). Могу сказать, что кроме описаных выше, проблем не возникало и это показательно. Проект функционирует в prod два месяца, при этом проблемы возникали только дважды: один NPE (это была очень глупая ошибка) и одна бага в ehcache (к моменту обнаружения уже вышла новая версия с исправлением).

PS. В следующей статье напишу о полезных вещах, которые дал мне переход на Kotlin.

|

Метки: author gnefedev kotlin |

Как программист машину покупал. Часть III |

В этой статье я более подробно остановлюсь на результатах и возможностях сервиса robasta.ru.

Для тех, кто не читал предыдущие статьи и не горит желанием этого делать:

Robasta.ru — сервис для поиска выгодных автомобилей (цена которых ниже рыночной) по данным со всех основных сайтов с объявлениями о продаже б/у автомобилей в РФ.

Перед покупкой автомобиля большинство людей хочет продать предыдущий и сделать это быстро и эффективно — для этого на нашем сервисе существует услуга оценки автомобиля, воспользовавшись которой, вы получите pdf-сертификат, где будет указана стоимость вашего авто в данный момент, стоимость в будущем (если достаточно статистических данных по вашей модели) и многое другое.

Для экономии вашего времени на сайте реализован telegram-информатор, позволяющий получать уведомления о новых объявлениях интересующих вас моделей автомобилей с необходимой вам частотой.

Читать дальше →

|

Метки: author nikitos18 я пиарюсь машинное обучение data mining predictive analytics покупка автомобиля продажа авто поиск выгодных автомобилей robasta.ru |

Время смелых. Как мигрировать в облака, не нарушая требований регуляторов? |

Сегмент финансовых услуг — один из самых технологичных. В то же время в России он один из самых зарегулированных. Банкиры вынуждены принимать в расчет «гору» требований, поэтому очень внимательно относятся ко всем новым инициативам госорганов, которые могут отразиться на их бизнесе.

Несмотря на то, что в мире банковский сектор стал одним из первых использовать облачные технологии, в РФ к ним, из-за принятия ряда новых законов (Закона «О персональных данных» и сопутствующих документов), финансовые учреждения относятся осторожно. И если рынка частных облаков законодательные акты не коснулись, то публичных компании опасаются. Ведь использование «внешних» сервисов всегда требовало повышенного внимания к вопросам информационной безопасности, все-таки банковская отрасль. Кроме того, за последние годы существенно увеличилось количество киберугроз и хакерских атак, и теперь на участников финансового рынка накладываются ужесточенные требования законодательства РФ в области защиты информации и акты регулирующих органов.

Итак, ниже разберем отношение регуляторов к использованию банками облаков под управлением сторонних провайдеров. А также нормативные требования по защите информации, которые эти провайдеры должны соблюдать.

Законодательные акты, дотянувшиеся до «облаков»

Начнем с главного – с требований законодательства и регулирующих органов.

- Требования законодательства РФ в области защиты информации – Федеральные законы 149-ФЗ («Об информации, информационных технологиях и о защите информации»), 152-ФЗ («О персональных данных»), 242-ФЗ («О внесении изменений в отдельные законодательные акты РФ по вопросам осуществления государственного контроля (надзора) и муниципального контроля»), 161-ФЗ («О национальной платежной системе») и др.;

- Требования ФСТЭК России и ФСБ России в области защиты информации – содержащие меры по защите персональных данных приказ ФСТЭК России №21 и Приказ ФСБ России №378, методические документы и разъяснения регуляторов;

- Требования Центрального Банка РФ (ЦБ) в области защиты информации – отраслевой стандарт по обеспечению информационной безопасности (СТО БР ИББС) и рекомендации в области стандартизации (РС БР ИББС), Положения ЦБ РФ №382-П и №552-П по защите информации при обеспечении переводов денежных средств, указания ЦБ РФ и другие документы;

- Требования ФСТЭК России и ФСБ России к лицензиатам по деятельности в области защиты информации;

- Требования международных платежных систем по защите информации данных держателей карт (PCI DSS);

- Инициативы ЦБ.

Разрушая мифы о невозможности публичных «облаков»

Список документов внушительный. Давайте разбираться. Если не рассматривать информацию, отнесенную к государственной тайне, то запрета по размещению в публичных облаках любых банковских информационных систем нет. В том числе нет запретов на использование информационных систем (ИС), обрабатывающих персональные данные (ПДн). Единственное законодательное ограничение содержится в Федеральном Законе №242-ФЗ и касается физического размещения средств обработки и хранения ПДн на территории РФ при сборе ПДн.

Документы ЦБ, ФСТЭК и ФСБ предъявляют требования по защите информации в рамках всего жизненного цикла информационных систем. Требования федерального законодательства и документов, указанных выше регуляторов, достаточно понятно как соблюдать при размещении банковских ИС на собственной площадке банка. Но, когда идет речь об информационных системах в облаке, появляются некоторые особенности реализации тех или иных технических и организационных мер защиты, а вместе с ними и множество вопросов по реализации конкретных мер. Большая часть вопросов относится к разграничению зон ответственности по обеспечению информационной безопасности между провайдером облачных услуг и банком. Это связано с тем, что при размещении системы в облаке управлением системы защиты занимаются как работники банка, так и представители провайдера облачных услуг.

В результате, ввиду необходимости использования нетривиальных решений по выполнению тех или иных требований законодательства и регуляторов, а также ввиду необходимости детальной проработки матрицы зон ответственности по обеспечению ИБ, наиболее часто встречаются аргументы против передачи банковских ИС в публичное облако, мол, невозможно их всех соблюсти. Но так ли это?

ФСТЭК не возражает, ФСБ не против

Реализовать комплекс мер и исполнять законодательные требования в облаке сложно, согласимся, но все же – возможно. Выходом для банков при переносе своей инфраструктуры на площадку стороннего провайдера в этих условиях является решение не только организационно-технических, но и правовых вопросов.

ФСТЭК со своей стороны не предъявляет дополнительных требований по защите информации при использовании публичных облаков. Есть требования по защите среды виртуализации, но конкретно по защите облаков – нет. Приказ ФСТЭК №21, непосредственно посвященный обеспечению безопасности ПДн, говорит о необходимости защиты ключевого элемента облачных вычислений — «среды виртуализации» (ч.2, п.8), не запрещая напрямую или косвенно использовать внешние сервисы. Также данный приказ содержит конкретные меры по защите среды виртуализации, которые должны быть реализованы в зависимости от уровня защищенности персональных данных и наличия актуальных угроз (ЗСВ.1 – ЗСВ.10).

Кстати, об угрозах. Если посмотреть банк данных угроз, пользоваться которым при моделировании угроз активно призывает ФСТЭК (а в случае с госсистемами — явно требует), то в данном банке можно обнаружить множество угроз, реализация которых возможна исключительно в системах, расположенных в облаках.

ФСБ пока молчит. В ее документах отсутствует упоминание облаков.

Исходя из вышесказанного, можно сделать вывод, что ФСТЭК и ФСБ допускают использование облачных технологий для обработки защищаемой информации.

Облачные намерения ЦБ

Свое видение по облачным технологиям, помимо вышеуказанных документов, есть и у регулятора финансовой отрасли – Центробанка (ЦБ). К тестированию облачных технологий финансовый регулятор приступил в 2011 году. Уже тогда ИТ-специалисты Банка России говорили, что в «облаке» должны быть защита от вредоносного кода, контроль и разграничение доступа на сетевом уровне, на уровне доступа к различным приложениям и виртуальным машинам. В 2014 году была создана рабочая группа, задачей которой стала разработка предложений по внесению необходимых изменений в законодательство, позволяющих более широко использовать электронный документооборот (ЭДО). По сути, тогда ЦБ стал готовиться к проведению финансовых операций в облачных сервисах. В мае 2016 года участники финрынка перешли на обязательный ЭДО с Банком России. Летом прошлого года на Международном финансовом конгрессе зампред ЦБ Ольга Скоробогатова объявила, что крупнейшие банки и ИТ-компании во главе с Банком России создают консорциум по внедрению новых технологий. Сообщество поставило целью изучить и затем внедрять технологии распределенных регистров (blockchain), облачных технологий, управления большими данными (big data) и развитие системы упрощенной идентификации.

В «Основных направлениях развития финансового рынка Российской Федерации на период 2016–2018 годов» говорится, что Банк России намерен «проработать подходы по предоставлению сервисов для малых поднадзорных финансовых организаций, позволяющих вести учет хоздеятельности без обязанности сдавать отчетность при предоставлении ЦБ права непосредственного использования данных бухгалтерского учета, в том числе с использованием облачных технологий». В рамках этого, согласно «Основным мероприятиям по развитию финансового рынка Российской Федерации на период 2016–2018 годов», в 2016 году был определен подход (план) работы ЦБ по созданию для малых поднадзорных организаций единой технологии по ведению учета хоздеятельности без обязанности сдавать отчетность. Иных мероприятий по «облачному» направлению в документе не значится.

Собственно, сам ЦБ уже использует облачные продукты в своей деятельности. К примеру, в марте этого года «Ведомости» со ссылкой на данные электронной торговой площадки сообщили, что Банк России намерен приобрести около 45 тыс. лицензии на облачный офисный продукт Office 365. ЦБ объяснял покупку продлением лицензий. В планах у финансового регулятора и создание с банками, входящими в ассоциацию «Финтех», платформы моментальных платежей (p2p). И понятно, что без облачных технологий здесь не обойтись.

Безобидный PCI DSS

Выполнение требований стандарта PCI DSS становятся актуальными для банка при размещении в публичном облаке систем, осуществляющих обработку данных держателей платежных карт. Требования и взаимоотношения организаций финансового сектора при использовании облачных технологий регулируются п. 12.8 PCI DSS, и уже давно распространена практика использования PCI DSS-хостинга у сторонних сервис-провайдеров.

Итак, каких-либо преград или запрета на использование публичных облаков банками, находящихся на территории РФ, в нормативных документах и требованиях для организаций финансовой отрасли нет. В случае использования банком инфраструктуры из публичного облака сторонний провайдер должен в своем облаке реализовать и выполнять нормативные требования (в рамках своей зоны ответственности) и требования банка по информационной безопасности. Зона ответственности облачного провайдера должна быть закреплена в соответствующем соглашении между сторонами.

Страх против технологий

Конечно же, опасения от использования публичных облаков банками никуда не деваются. Хотя, как известно, специализированные провайдеры облачных сервисов одними из первых изучают свежие нормативные акты и максимально оперативно приводят свои предложения в полное соответствие с требованиями отечественного законодательства.

Например, сейчас при размещении ИС банка в облаке Техносерв Cloud обе стороны обязательно составляют полный реестр требований по ИБ, предъявляемых к банку и банком и разграничивают зоны ответственности. Как правило, провайдер облачных услуг ответственен за защиту периметра от внешних угроз (межсетевое экранирование, защита от сетевых этак) и за защиту виртуальной инфраструктуры, а банк ответственен за обеспечение информационной безопасности внутри предоставленных ему провайдером виртуальных машин. При этом, провайдер безусловно обеспечивает защиту рабочих станций своих администраторов и предоставление им защищенного доступа к средствам администрирования инфраструктуры облачной платформы.

Далее начинается работа над подготовкой или актуализацией внутренних документов банка, необходимых для успешного прохождения аудитов по СТО БР ИББС, положению ЦБ РФ №382-П, стандарту PCI DSS v.3.2 и др. с учетом новой модели потребления инфраструктурных ресурсов. Параллельно идет перенос ИС банка в облачную платформу.

В целом, мировая практика показывает, что компании, специализирующиеся на облачных сервисах, чаще всего, создают более качественную инфраструктуру и сервисы, чем это могут позволить себе большинство не профильных организаций. К примеру, Техносерв Cloud развернута на площадке дата-центра категории Tier III. Платформа состоит из двух физически изолированных частей (VDC и VDC.152; для государственных и финансовых организаций):

Сегмент «Закрытый» реализован с использованием решений VMware. Инфраструктура соответствует требованиям приказов №17 и №21 ФСТЭК для обеспечения до 1-го класса защиты ГИС и 1-го уровня защищенности ПДн включительно. Собственно говоря, решение позволяет, в том числе, государственным органам размещать ИС с наивысшими требованиями к информационной безопасности, что подтверждается наличием аттестата соответствия требованиям защиты информации, установленным ФСТЭК России.

- Сегмент «Защищенный» подходит для финансовых учреждений, реализован с использованием решений VMware. Инфраструктура соответствует требованиям Положения ЦБ РФ №382-П, сертифицирована на соответствие требованиям стандарта PCI DSS.

В сухом остатке – не так страшно облако, «как его малюют». Что до регуляторов, то облачным провайдерам соблюсти их требования вполне реально.

|

Метки: author TS_Cloud облачные вычисления блог компании техносерв публичные облака банки регулятор фстэк pci dss техносерв cloud |

Материальная мотивация персонала в отделе интернет-маркетинга |

По вопросам мотивации персонала написано множество статей и сломана гора копий. Каждый руководитель стремится к тому, чтобы создать команду мечты, члены которой были бы лояльны к клиентам, профессионально совершенствовались, ценили рост заработной платы и выкладывались в рабочее время на 100%.

Но идеал чаще всего разбивается о банальные будничные трудности и менталитет конкретных людей. Я много лет работаю на рынке разработки сайтов и интернет-маркетинга и постоянно сталкиваюсь с проблемами роста и мотивации персонала.

В сфере IT-технологий успехов добиваются те, кто обладает высоким интеллектом, хорошим творческим мышлением и креативной составляющей. Некий симбиоз лириков и физиков в одном флаконе. Работать с такими коллегами очень интересно, но невероятно сложно. Процесс управления коллективом похож на работу с сотней блестящих ртутных шариков, которые, собравшись вместе, могут дать выдающийся результат, а могут рассыпаться, раскатиться и превратиться в ничто. На сегодняшний день в WebCanape уже более 90 сотрудников, 10 лет опыта работы и куча набитых шишек. В этой статье мне хочется поделиться «с коллегами по цеху» опытом того, как мы отстраивали схему материальной мотивации на примере отдела интернет-маркетинга.

Проблемы

В компаниях, аналогичных нашей, руководителю чаще всего приходится бороться с профессиональным выгоранием, несоответствием ожиданий и реальной стоимости сотрудника для агентства, нежеланием рационально организовать свои рабочие процессы и повышать профессиональные компетенции.

Как настроить и мотивировать команду, чтобы новые клиенты, приводимые отделом продаж, вызывали интерес и азарт, а не реакцию «опять привалило»? Чтобы менеджер боролся за удержание клиентской базы и видел прозрачную зависимость своего дохода от приложенных усилий? Чтобы сотрудники равнялись на лидеров производства и стремились к их результатам? Чтобы каждый старался нести клиенту реальную пользу и ориентировался не только на финансовый, но и на качественный результат своей работы?

Пытаясь ответить на эти вопросы, я понял, что систему мотивации персонала выстраивать необходимо, но делать это нужно очень аккуратно. Чтобы получить эффект повышения работоспособности и исключить обиды и внезапные увольнения.

Я рассматриваю принципы построения системы мотивации именно отдела интернет-маркетинга, не затрагивая остальные структурные подразделения компании. Мотивация отдела продаж, производственного отдела и вспомогательного персонала — это тема отдельной статьи.

Я также не буду касаться нематериальных сторон мотивации, таких как комфортные условия работы, плавающий график, активная событийная жизнь внутри компании, сплочение коллектива и т.д. Все это есть в культуре WebCanape, растет, поддерживается и успешно развивается. Речь пойдет больше о деньгах, знаниях и технологиях.

Общие принципы мотивации

Для начала я сформировал список целей и задач, которые должен буду решить при помощи схемы мотивации, а затем определил принципы, которым буду следовать при распределении премий.

Цели и задачи мотивации персонала:

- стимулировать сотрудников к достижению их личных целей;

- повышать профессиональный рост компании в целом и каждого из членов команды в отдельности;

- более эффективно планировать и распределять нагрузку на отделы;

- выполнять план доходов и расходов компании, утвержденный на текущий год;

- повышать качество предоставляемых агентством услуг.

Принципы мотивации, которые я заложила в основу модели стимулирования в отделе интернет-маркетинга:

- Размер премии зависит от общего дохода. Премиальный фонд сотрудников заложен в финансовый план агентства.

- Премия должна быть приятным бонусом, который сотрудник получает в случае достижения сверхрезультата. Основная составляющая его материального благополучия заложена в базовую зарплату.

- Специалист не может постоянно показывать сверхрезультат, эффективность работы сотрудника похожа на синусоиду. Задача руководителя — чтобы синусоиды эффективности его подчиненных работали в противофазе. В этом случае группа будет постоянно показывать стабильный положительный результат.

- Правила мотивации и распределения премий фиксируются в общедоступном корпоративном документе и корректируются не чаще 1 раза в 6 месяцев.

- Цели и задачи для каждого из сотрудников формируются 1 раз в месяц и являются объективно достижимыми.

- Цели и задачи распределяются исходя из квалификации специалистов. Все сотрудники знают персональные цели коллег.

- Сотрудники отделов и групп в режиме реального времени могут контролировать процент выполнения как общего плана, так и своего собственного.

- Размер премии каждого зависит от его личного вклада и общего вклада всех коллег из его группы.

- Размер премии имеет прогрессивную шкалу и может варьироваться от 60% до 120% от максимально возможного.

- Каждый может увеличить размер премии за счет продажи дополнительных услуг и разовых работ клиентам.

Немного о структуре отдела интернет-маркетинга

В нашей компании отдел интернет-маркетинг делится на 3 основные группы:

Составы каждой группы укомплектованы по единой схеме: руководитель группы, аккаунт-менеджеры, технические и финансовые специалисты. Последние не привязаны к какой-то конкретной группе, а обслуживают отдел в целом.

Схемы мотивации для разных категорий персонала

Находясь на разных позициях, сотрудники нацелены на выполнение своего круга задач, поэтому и схемы мотивации выстроены разные: для руководителей, аккаунт-менеджеров и специалистов.

Общий премиальный фонд отдела формируется как процент от суммы оплаченных в текущем месяце услуг и агентских вознаграждений за вычетом накладных расходов и делится на 2 части:

- премия для групп (руководители, менеджеры) — 80% от общего фонда;

- премия технических и финансовых специалистов — 20% от общего фонда.

Руководители групп принимают участие в формировании и утверждении финансового плана, который учитывает как интересы компании в целом, так и индексацию фонда оплаты труда и изменение численного состава сотрудников конкретной группы. Принятый и утвержденный финансовый план становится основным KPI для его руководителя.

Премии всех руководителей групп взаимосвязаны. Руководители получают 100% премию только в том случае, если выполнен суммарный план всего отдела интернет-маркетинга. Такая схема реализована для того, чтобы все три группы не конкурировали за клиентов и бюджеты по услугам, а помогали друг другу выполнить суммарный план.

Премия руководителя группы рассчитывается и выплачивается ежемесячно. Размер премии зависит не только от выполнения финансовых показателей, но и от того, насколько четко организован процесс работы и обучения персонала:

- актуальные регламенты работы;

- наличие сданных квалификационных экзаменов у подчиненных специалистов;

- количество положительных и отрицательных отзывов со стороны клиентов;

- составление и реализация планов по профессиональному росту сотрудников.

Размер премии руководителя группы рассчитывается по следующей схеме:

- Премиальный фонд группы, который рассчитывается пропорционально внесенному финансовому вкладу. Если SEO заработали 60% от оборота отдела, на долю его сотрудников придется 60% общего премиального фонда.

- Потенциальная премия руководителя составляет 25% от премиального фонда группы.

Свою премию руководитель получает по следующей схеме:

| Процент выполнения суммарного плана по итогам месяца | Размер премии в % от потенциальной |

| Менее 90% от поставленного плана | премия не выплачивается |

| 90,00–99,99% от поставленного плана | 60% |

| 100,00–109,99% от поставленного плана | 100% |

| 110,00% и более от поставленного плана | 120% |

Дополнительные бонусы руководителя:

- за успешную сдачу сотрудниками внутренних квалификационных экзаменов;

- за сданные сотрудниками с первого раза квалификационные экзамены Яндекс, Google и т.д.;

- за внедрение новых технологий и методов, позволяющих повысить эффективность работы.

Снижение премии руководителя возможно, если сотрудники сдают экзамены с низким баллом, есть пересдачи, снижение клиентской базы в течение 3 месяцев подряд, отрицательные отзывы, невыполнение персоналом регламентов работы, за отсутствие в группе работы по обучению и повышению квалификации.

Подобная схема мотивации стимулирует руководителя выполнять общий финансовый план, контролировать уровень профессиональных знаний своих сотрудников, отслеживать удовлетворенность клиентов качеством услуг, внедрять новые и совершенствовать текущие технологии, контролировать актуальность регламентов работы по услугам.

Анализируя работу схемы мотивации для руководителей групп в течение 10 месяцев, мы получили следующие цифры:

- Повышенную премию руководитель получает в среднем 1 раз в четыре месяца.

- Премию в размере 60% от РПП руководители получают каждый второй месяц.

- Без премии руководители остаются 1 из четырех месяцев.

- Премия в размере 100% от РПП составляет 60% от базового оклада руководителя, что для сотрудника является приятным и существенным бонусом.

- В целом для компании удалось наладить работу, при которой руководители хорошо замотивированы на эффективность, принятый финансовый план агентства выполняется, а клиентская база растет.

KPI для аккаунт-менеджеров формируется на основании 7 составляющих:

- личного ежемесячного финансового плана, который зависит от квалификации менеджера и объема клиентской базы, которую он ведет;

- наличия успешно сданных квалификационных экзаменов — внутренних по продуктам компании и экзаменов внешних сервисов;

- соблюдения регламентов работы по услугам;

- количества положительных и отрицательных отзывов;

- процента потери «отвалов» клиентской базы;

- личного вклада в инновационные технологии работы;

- к участию в премиях допускаются менеджеры, которые достигли определенной квалификации и курируют достаточный объем клиентской базы.

Премия аккаунт-менеджера рассчитывается по схеме:

Потенциальная премия менеджера = общая премия всех менеджеров группы * личная доля менеджера.

Финальный размер премии зависит от процента выполнения его личного плана:

| Процент выполнения суммарного плана по итогам месяца | Размер премии в % от потенциальной |

| Менее 90% от поставленного плана | премия не выплачивается |

| 90,00–99,99% от поставленного плана | 60% |

| 100,00–109,99% от поставленного плана | 100% |

| 110,00% и более от поставленного плана | 120% |

Дополнительные бонусы менеджера:

- за четкое выполнение регламентов ведения проектов;

- за наличие в течение отчетного месяца не менее 4 отзывов от клиентов со средним баллом 4 и выше;

- за внедрение новых технологий и методов работы, личный вклад;

- за ведение клиентов сотрудников, которые уходят в отпуск или на больничный.

Снижение премии менеджера возможно в случаях нарушения регламентов ведения проектов, отсутствия положительных или наличия отрицательных отзывов, оттока постоянных клиентов, личного требования руководителя, не вовремя сданных квалификационных экзаменов.

Такая схема мотивации стимулирует сотрудников к выполнению личного финансового плана, повышению уровня знаний, отслеживанию удовлетворенности клиентов качеством услуг. Кроме того, она помогает соблюдать стандарты и регламенты, способствует тому, что люди задумываются о совершенствовании технологий своей работы.

Анализ работы схемы мотивации менеджеров в течение 10 месяцев показал

Менеджеры проектов практически всегда получают финансовые бонусы и чувствуют отдачу от собственных вложенных усилий. Они охотнее берут на обслуживание новых клиентов, чтобы увеличить долю своего личного участия, а, следовательно, и размер премии. Они хорошо понимают: чем больше штат сотрудников, тем меньше будет доля их личного премиального фонда. В целом для компании такая схема стабилизирует клиентскую базу, позволяет выполнять поставленные финансовые планы, оптимизировать количество менеджеров и нагрузку на них.

KPI для технических и финансовых специалистов формируется на основании 6 составляющих:

- выполнения общего финансового плана отдела;

- наличия успешно сданных квалификационных экзаменов;

- соблюдения регламентов работы;

- процента потери «отвалов» клиентской базы;

- личного вклада в инновационные технологии работы;

- к участию в премиях допускаются специалисты, которые достигли определенной квалификации и сдали необходимый набор экзаменов.

Премия технического или финансового специалиста рассчитывается по схеме:

Потенциальная премия специалиста = общая премия специалистов * коэффициент личного участия.

Финальный размер премии специалиста зависит от процента выполнения общего финансового плана отдела:

| Процент выполнения суммарного плана по итогам месяца | Размер премии в % от потенциальной |

| Менее 90% от поставленного плана | премия не выплачивается |

| 90,00–99,99% от поставленного плана | 60% |

| 100,00–109,99% от поставленного плана | 100% |

| 110,00% и более от поставленного плана | 120% |

Дополнительные бонусы специалист может получить за четкое выполнение регламентов ведения работ, внедрение новых технологий и методов работы, повышенную нагрузку в периоды отпусков или больничных.

Снижение премии специалиста возможно, если есть нарушения в регламентах ведения работ или за персональные замечания от аккаунт-менеджеров и руководителей групп. Специалист может быть полностью лишен премии по обоснованному требованию руководителя группы, за не вовремя сданные квалификационные экзамены.

Подобная схема помогает специалистам эффективнее работать на общий финансовый план отдела, повышать уровень собственных профессиональных знаний, стремиться внедрять новые и совершенствовать текущие технологии, соблюдать регламент работы.

Анализ работы схемы мотивации специалистов в течение 10 месяцев показал

Специалисты, хотя и не работают напрямую с клиентами, но чувствуют ценность своего вклада в общий план, поэтому стараются максимально полно закрывать возложенные на них задачи, что в конечном итоге выгодно для компании.

ИТОГИ

Что дало внедрение схемы дополнительной мотивации отдела интернет-маркетинга по итогам 10 месяцев?

- Увеличился совокупный финансовый доход эффективных и квалифицированных сотрудников, что повысило их лояльность к компании.

- Удалось на 15% уменьшить текучку клиентской базы и ускорить темпы ее роста.

- Повысился общий уровень удовлетворенности клиентов качеством услуг.

- Стабилизировалась кривая выполнения финансового плана отдела.

- Получилось оптимизировать штат сотрудников, т.к. они четко понимают: увеличение персонала снижает нагрузку на каждого из них, но и уменьшает размер их личной премии.

- Удалось дать общий вектор достижения целей для всех групп, исключить конкуренцию между ними за клиентов и ресурсы.

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

|

Метки: author vasyay управление персоналом блог компании webcanape мотивация персонала работа в команде интернет-маркетинг управление командой управление людьми |

Скорочтение: работает или нет? Часть 1 |

/ Фото Craig Sunter / CC

/ Фото Craig Sunter / CCФантастические возможности «быстрого чтения»

Каждый из нас в среднем успевает прочесть 200-400 слов в минуту, тогда как «скорочтецы», по их признаниям, могут увеличить этот показатель в 3-4 раза (до 1 000 или даже 1 700 слов в минуту соответственно). Пожалуй, один из самых известных скорочтецов – президент США Джон Ф. Кеннеди. По собственным словам, он не только владел этим навыком и (по некоторым оценкам) читал со скоростью 1 200 слов в минуту, но и стремился к тому, чтобы члены его команды также учились скорочтению и посещали курсы Эвелин Вуд (Эвелин Вуд в конце 1950-х гг. разработала основы обучения скорочтению, которые стали базой для ее учебника и школы «динамического чтения»).

Однако успехи Кеннеди меркнут на фоне других «звезд скорочтения» – Ким Пик (Kim Peek), прототип героя Дастина Хоффмана из фильма «Человек дождя», мог читать со скоростью 10 000 слов в минуту (8-10 секунд на стандартный книжный разворот). При этом он мог «распараллеливать процессы» – читать две страницы книги одновременно. Такая удивительная способность, правда, была достигнута не только (и не столько) упражнениями: Пик родился с врожденным пороком, который характеризуется отсутствием в мозге мозолистого тела (это сплетение нервных волокон обеспечивает связь между полушариями мозга), и потому (по некоторым предположениям) его полушария могли обрабатывать информацию независимо друг от друга.

Тем не менее, и рекорд в 10 000 слов в минуту оказался побит. Материалы американского исследования 1963 года сообщали о скорочтеце, который умудрялся прочитать более 17 000 слов в минуту. Самым быстрым чтецом в мире, согласно Книге рекордов Гиннеса (издание за 1990 год), оказался Говард Берг (Howard Berg), который утверждал, что читает книги со скоростью 25 000 слов в минуту (в среднем это более 80 стандартных страниц текста за 60 секунд). Чтение книги в таком режиме выглядит просто как быстрое перелистывание страниц!

Результаты, которых добиваются скорочтецы, действительно поражают. Тем не менее, далеко не все из них стоит принимать за чистую монету – об этом мы расскажем чуть позже, а пока стоит разобраться, чем скорочтение отличается от «обычного чтения», и что по этому поводу думают исследователи.

Чтение и скорочтение: в чем разница

Несмотря на то, что чтение кажется нам непрерывным и плавным процессом, это не совсем так. При чтении наш взгляд фиксируется на слове или группе слов (это занимает примерно четверть секунды). Затем мы переводим взгляд к следующей группе. Такие скачкообразные движения взгляда по странице называется «саккадами» и сами по себе отнимают у нас примерно одну десятую секунды.

После нескольких скачков мы снова останавливаемся, чтобы «переварить» прочитанную фразу или предложение. На это обычно тратится еще 0,3–0,5 секунды. Поэтому Кит Рейнер (Keith Rayner), психолингвист из Массачусетского университета в Амхерсте признавал, что большинство людей, владеющих навыком чтения на уровне школьника старших классов или студента, и читающих «для удовольствия», делают это примерно с одинаковой скоростью – порядка 300 слов в минуту.

Как выглядит скорочтение

Разумеется, при скорочтении мы (чаще всего) точно так же движемся взглядом по странице, на некоторое время задерживаясь на группах слов или символов. Тем не менее, методики, которые обычно применяются в скорочтении, отличаются от того, как «обычно» читают текст. Одни из наиболее популярных методик скорочтения: поверхностное чтение, слежение за текстом, быстрое последовательное визуальное предъявление и некоторые другие.

Слежение за текстом – одна из наиболее старых техник, ускоряющих процесс чтения. В самом простом виде это – использование указателя (пальца, линейки), который необходимо водить по строчкам (чем-то напоминает то, как учатся читать дети). Более сложные вариации на тему слежения за текстом предполагают еще и поиск специфических ключевых слов, что (по словам адептов этой методики) помогает дополнительно ускорить процесс.

Быстрое последовательное визуальное предъявление (Rapid Serial Visual Presentation) – метод, который чаще других используется в современных программах по обучению скорочтению. Он состоит в том, что текст выводится на экран устройства пословно. По мере обучения растет и скорость смены слов на экране (один из наиболее известных примеров проектов, обучающих этой технике скорочтения, – Spritz) [о приложениях, проектах и методиках, помогающих читать если не быстрее, то качественнее, мы подробно расскажем во второй части материала].

Поверхностное чтение – это, по сути «просматривание» текста, помогающее найти наиболее важные его части (ключевые слова, тезисы) и отсеять лишнее, «достроить» весь текст по его части. Пожалуй, эта техника скорочтения вызывает больше всего дебатов.

Поверхностное чтение направлено в первую очередь на «просеивание» текста на предмет ненужной или неважной информации и не подразумевает прочитывание текста как таковое. Поэтому, по мнению некоторых авторов, к скорочтению оно не относится, поскольку не влияет на скорость чтения и не позволяет оценить всю представленную в тексте информацию (согласно исследованиям, наша способность воспринимать информацию при поверхностном чтении заметно ниже, чем при чтении в обычном режиме).

Другие авторы, наоборот, считают, что практически все методики скорочтения так или иначе связаны с поверхностным чтением и отсеиванием «лишнего»:

Просматривание – это не чтение. Если вы ранее не читали текст, который просматриваете, вы упустите массу информации. А курсы скорочтения учат именно просматриванию, а не чтению, хотя (в большинстве своем) и не признают этого

– Тимоти Ноа (Timothy Noah), писатель, редактор Politico, ведущий автор в Slate (2000–2011гг.)

Журналист Тимоти Ноа в своих предположениях оказывается не одинок – с ним соглашался в том числе и уже знакомый нам Кит Рейнер. Его исследования, а также работы некоторых других ученых можно свести к следующему заключению:

Скорочтение – это не чтение [что бы это ни значило]

Выводы Рейнера оказываются не беспочвенны: научную работу, в которой они опубликованы, автор назвал «Движения глаз при чтении и обработке информации: результаты 20 лет исследований» (Eye movements in reading and information processing: 20 years of research). В этой работе Рейнер подтвеждает, что доля людей, читающих «на уровне студента колледжа» (в данном случае имеется в виду, что испытуемый имеет базовое образование и умеет читать не «по слогам»), попадающих по скорости чтения в интервал от 200 до 400 слов в минуту, составляет 95% (средняя скорость чтения, повторимся, равна примерно 300 словам в минуту).

Читать быстрее без существенной потери понимания смысла прочитанного могут буквально единицы. А следовательно, методики скорочтения, обещающие научить практически любого человека читать в несколько раз быстрее, имеют один, но очень весомый минус – они не позволяют в полной мере понять смысл написанного:

Я окончил курсы скорочтения – нас заставляли водить пальцем вдоль страниц, – и прочел «Войну и мир» за двадцать минут. Там что-то про Россию

– Вуди Аллен

Рональд Карвер (Ronald Carver), автор книги «Причины высоких и низких достижений в чтении» («The Causes of High and Low Reading Achievement») (издана в 1990 году) и профессор в сфере педагогики и психологии Университета Миссури в Канзас-Сити, также активно занимался вопросами изучения скорости чтения. Он тщательно изучил различные техники «ускорения» чтения и провел ряд собственных исследований. В частности, для тестирования он отобрал группу из 16 «суперзвезд» скорочтения. В нее входили как победители конкурсов по скорочтению, так и профессионалы, в чьи рабочие обязанности входило чтение большого объема текстов (среди них – колумнист «Нью-Йоркера» Фред Шапиро и редактор медицинского журнала).

Карвер предложил участникам теста прочесть отрывки из изданий «Ридерз дайджест». Выяснилось, что ни один из испытуемых не смог читать материалы со скоростью выше, чем 600 слов с минуту, сохраняя достаточное (75% и выше) понимание содержания текста. Разумеется, это в два раза быстрее, чем стандартная скорость чтения, но до десятков тысяч слов в минуту скорочтецам оказалось далеко.

Но, может быть, Карвер собрал слишком маленькую группу добровольцев? Или они были недостаточно квалифицированы в скрочтении – в конце концов, не каждый скорочтец может поставить мировой рекорд. Такие возражения вполне обоснованны, однако это исследование дало повод усомниться в «сверх-достижениях» индустрии, которая к моменту проведения тестирования существовала уже несколько десятков лет.

Что стоит за впечатляющими результатами скорочтецов

К сожалению, выдающиеся результаты многих скорочтецов (за исключением Кима Пика) обусловлены их эго, а не реальными возможностями. Все тот же Карвер отмечает, что достижения Кеннеди в реальности могли быть более скромными – скорее всего, он мог читать со скоростью 500-600 слов в минуту, а бегло просматривать текст – со скоростью порядка 1000 слов в минуту (хотя это все равно в два раза быстрее «обычного» чтения).

Как же тогда появилась цифра в 1200 слов в минуту? Биограф Кеннеди Ричард Ривз (Richard Reeves) считает, что она фактически была «взята с потолка» – так предположил один из репортеров Time magazine, работавших в Белом доме. Репортер связывался со школой Эвелин Вуд, в которой обучался скорочтению Кеннеди, но не получил результатов его итогового тестирования – оно не проводилось, так как Кеннеди не завершил курс.

Что касается других выдающихся результатов, то исследование 1963 года (кейс скорочтеца, читающего по 17 040 слов в минуту) относится к разряду неподтвержденных данных. В то время для фиксации достижений не применялись специализированные тесты, и результаты были основаны на самооценке испытуемого – которая вряд ли была точной.

То же самое относится и к достижениям Говарда Берга. По словам Марка Пеннингтона (Mark Pennington), специалиста по вопросам чтения, «Представители Книги рекордов Гиннеса в то время не отличались любовью к перепроверке рекордов, которые они публиковали, и этот рекорд не был зафиксирован ими лично. Они поверили Бергу на слово, а он, вероятно, просто выдумал свой рекорд».

Кстати, в 1998 году Берга привлекла к ответственности Федеральная Торговая Комиссия США за «неверные» и «вводящие в заблуждение» маркетинговые приемы, связанные с продажей его продуктов по повышению скорости чтения. В итоге Бергу было запрещено рекламировать свой продукт как «систему, позволяющую любому – ребенку, взрослому, человеку с инвалидностью – научиться читать со скоростью в 800 слов в минуту и выше».

Итак, вкратце:

Мы читаем дискретно – переводим взгляд от одной группы слов к другой. Такие скачки, или саккады, а также необходимость осмыслить и проговорить про себя прочитанное, отнимают у нас ценное время.

Скорочтение – это совокупность различных механик, позволяющих сэкономить время на изучение текстового материала (за счет сокращения количества движений глазами по строке, умения составить мнемоническую схему материала и ряда других техник).

Скорочтение отличается от обычного чтения – не только по «механике работы», но и потому, что увеличение скорости чтения невозможно без потери понимания текста.

Супер-результаты скорочтецов – как правило, результат саморекламы. Если вы захотите обучиться какой-либо методике скорочтения, стоит рассчитывать на то, что вы сможете читать со скоростью 500-600 слов в минуту без существенной потери понимания текста. Результат в несколько тысяч (или десятков тысяч) слов в минуту едва ли достижим. Но даже 600 слов в минуту – это в два раза быстрее средней скорости чтения практически у всех, кто окончил школу или вуз.

Во второй части материала мы остановимся на том, какие методы скорочтения помогают сэкономить время, а какие не имеют ничего общего с физиологией и реальными возможностями человека. А также расскажем, какие еще методы и лайфхаки помогают узнавать из книг и статей больше за меньшее время.

|

Метки: author itmo gtd блог компании университет итмо университет итмо скорочтение |

[Перевод] HTTP/2 Server Push не так прост, как я думал |

Фото найдено на просторах Википедии

Привет! Меня зовут Макс Матюхин, я работаю PHP-программистом в Badoo. Мы постоянно изучаем различные возможности по ускорению работы нашего приложения и самыми интересными находками, конечно, делимся в нашем блоге на Хабре.

Вторая версия протокола HTTP обещает нам много улучшений, и одной из любопытных особенностей HTTP/2 является поддержка push. Теоретически эта возможность позволяет ускорить загрузку приложения. Недавно Jake Archibald написал большую статью, в которой проанализировал особенности реализации push в различных браузерах, и оказалось, что таких особенностей довольно много.

Мы уже публиковали пост, описывающий базовый функционал HTTP/2 Server Push, а этот будет хорошим дополнением, рассказывающим, как в реальности обстоят дела с поддержкой HTTP/2 Server Push в различных браузерах.

Я много раз слышал фразу «HTTP/2 Server Push справится с этим», когда дело касалось проблем с загрузкой страницы, но я мало что понимал в этой теме и потому решил разобраться подробнее.

HTTP/2 Server Push оказалась более сложной и низкоуровневой, чем я думал, но по-настоящему меня удивило то, насколько отличается её взаимодействие с различными браузерами – я-то всегда считал, что это полностью отработанная фича, готовая к использованию в production.

Я не хочу сказать, что HTTP/2 Server Push – это бесполезная ерунда; думаю, это действительно мощный инструмент, который со временем станет лучше. Но я уже не считаю его «серебряной пулей из золотого ружья».

Схема извлечения данных

Между вашей страницей и целевым сервером есть целая серия кешей и функций, которые могут перехватить запрос:

Указанная выше модель напоминает блок-схемы, которые используются для описания Git или её характерных признаков. Те, кто знаком с темой, убеждаются в правильности своих знаний, остальные – только пугаются. Прошу прощения, если это так, и надеюсь, следующие разделы помогут вам разобраться.

Как работает HTTP/2 Server Push

Страница: Привет, example.com, могу я получить твою домашнюю страницу? 10:24

Сервер: Конечно! О, пока она отправляется, вот ещё таблица стилей, изображения, JavaScript и JSON. 10:24

Страница: Вау, класс! 10:24

Страница: Я читаю HTML, и, похоже, мне понадобится таблица сти… О, ты уже отправил мне её, круто! 10:25

Отвечая на запрос, сервер может включить дополнительные ресурсы, такие как заголовки запросов, которые браузер сможет сопоставить позже. Они находятся в кеше до тех пор, пока браузер не запросит ресурс, соответствующий описанию.

Повышение производительности происходит благодаря тому, что ресурсы отправляются ещё до того, как браузер запросит их. Теоретически это означает, что страница должна загружаться быстрее.

Вот практически всё, что я знал об HTTP/2 Server Push. Звучало это довольно легко, но на деле всё оказалось совсем не так просто…

Что угодно может использовать push-кеш

HTTP/2 Server Push – это низкоуровневая сетевая фича: всё, что использует сетевой стек, может использовать и её.

Но любая фича полезна, если она непротиворечива и предсказуема. Я протестировал HTTP/2 Server Push по этим показателям, запушив ресурсы и попробовав их собрать с помощью:

fetch()XMLHttpRequest

|

Метки: author max_m разработка веб-сайтов программирование javascript html блог компании badoo http2 server push |

[Из песочницы] GraphicsJS – графическая JavaScript библиотека |

Перевод статьи. Англоязычный оригинал опубликован на SitePoint – "Introducing GraphicsJS, a Powerful Lightweight Graphics Library".

HTML5 – основа основ современного веба. И сегодня, когда встает задача создать интерактивную графику, выбор чаще всего падает на такие технологии, как SVG и Canvas. Flash позабыт, Silverlight – редкая птица, обитающая на задворках веба, и почти никто не помнит сторонние ActiveX и Java-плагины.

Плюсы и минусы SVG и Canvas хорошо известны – в целом все сводится к тому, что для создания интерактивных элементов и работы с ними больше подходит SVG. Это векторный формат, основанный на XML, и, когда изображение загружается на страницу с использованием тега

В данной статье я хочу рассказать о GraphicsJS. Это мощная графическая JavaScript-библиотека с открытым исходным кодом, основанная на технологии SVG (VML для старых версий IE). Начну с краткого введения в основы GraphicsJS, а затем проиллюстрирую возможности библиотеки двумя небольшими, но наглядными примерами. Первый из них посвящен изобразительному искусству. Второй покажет, как менее чем за 50 строк кода сделать простую арт-игру в жанре таймкиллера.

Почему GraphicsJS

Библиотек, облегчающих работу с SVG, довольно много: в число лучших входят Rapha"el, Snap.svg и BonsaiJS. У каждой есть сильные и слабые стороны, однако их детальное сравнение будет темой одной из следующих публикаций. Данная же статья – исключительно о GraphicsJS, и сейчас я попытаюсь объяснить, чем эта библиотека хороша и выделяется среди прочих.

Во-первых, GraphicsJS весит совсем немного и обладает очень гибким JavaScript API. Она предоставляет богатые возможности для форматирования текста, а также виртуальный DOM – независимый от специфики HTML DOM в разных браузерах.

Во-вторых, код этой библиотеки был открыт только прошлой осенью. Компания AnyChart, один из лидеров в разработке решений для интерактивной визуализации данных, использует GraphicsJS как графический движок в своих коммерческих продуктах уже порядка трех лет (с момента выхода AnyChart 7.0), так что эта библиотека проверена в боевых условиях. (Дисклеймер: я руководитель R&D в AnyChart и ведущий разработчик GraphicsJS.)

В-третьих, в отличие от других продуктов AnyChart – JavaScript-библиотек для построения графиков – GraphicsJS бесплатна для использования как в коммерческих, так и в некоммерческих целях. Библиотека доступна на GitHub под лицензией Apache.

В-четвертых, GraphicsJS обладает кросс-браузерной совместимостью, включая поддержку Internet Explorer 6.0+, Safari 3.0+, Firefox 3.0+, Opera 9.5+. В старых версиях IE библиотека использует VML, во всех остальных браузерах – SVG.

Наконец, GraphicsJS позволяет эффективно комбинировать графику и анимацию. Посмотрите главную галерею библиотеки: здесь есть такие примеры, как пылающий костер, вращающаяся галактика, дождь, процедурно генерируемые листья, головоломка «Пятнашки» и так далее. В развернутой документации и детальном описании API можно найти еще больше примеров использования GraphicsJS.

Основы GraphicsJS

Для начала работы с GraphicsJS нужно подключить саму библиотеку и создать блочный элемент HTML-кода для будущего рисунка:

Затем надо построить рабочую область и что-нибудь в ней нарисовать, например прямоугольник, круг или какую-то другую фигуру:

// создаем рабочую область

var stage = acgraph.create('stage-container');

// рисуем прямоугольник

var stage.rect(25, 50, 350, 300);Вот пример на CodePen, в котором мы идем чуть дальше и рисуем знак Даров Смерти.

Наш первый шедевр

Контур, заливка цветом и узором

Любую фигуру или линию можно раскрашивать, используя настройки заливки и контура. Контур (граница) есть у всего, но заливка доступна только для фигур и замкнутых линий.

GraphicsJS предлагает многочисленные настройки этих параметров, вплоть до линейного и радиального градиента, причем и в заливке, и в контуре. Линии могут быть пунктирными, а также поддерживается заливка изображением с несколькими режимами замощения. Однако такой набор функций можно найти практически в любой библиотеке. Что отличает GraphicsJS – так это опция заливки штриховкой и узором, которая позволяет не только выбирать из тридцати двух (!) готовых вариантов заполнения, но и легко создавать собственные паттерны из фигур или текста.

А теперь посмотрим, что конкретно можно сделать. Я нарисую небольшую картинку (человечек, стоящий возле дома) и затем доработаю ее с помощью заливки цветом и узорами. Пусть для простоты это будет изображение в стиле наивного искусства (постараюсь не докатиться до ар брют). Поехали:

// создаем рабочую область

var stage = acgraph.create('stage-container');

// рисуем рамку

var frame = stage.rect(25, 50, 350, 300);

// рисуем дом

var walls = stage.rect(50, 250, 200, 100);

var roof = stage.path()

.moveTo(50, 250)

.lineTo(150, 180)

.lineTo(250, 250)

.close();

// рисуем человечка

var head = stage.circle(330, 280, 10);

var neck = stage.path().moveTo(330, 290).lineTo(330, 300);

var kilt = stage.triangleUp(330, 320, 20);

var rightLeg = stage.path().moveTo(320, 330).lineTo(320, 340);

var leftLeg = stage.path().moveTo(340, 330).lineTo(340, 340);Результат можно посмотреть на CodePen.

Как видите, здесь мы используем переменные: все методы, которые что-либо рисуют в рабочей области, возвращают ссылку на созданный объект, которую можно использовать для его изменения или удаления.

Кроме того, в GraphicsJS можно активно применять цепные вызовы (например,

stage.path().moveTo(320, 330).lineTo(320, 340);), что позволяет сократить код. Использовать эту возможность нужно аккуратно, но при правильном подходе цепной вызов действительно делает код более компактным и легко читаемым.Теперь можно дать получившуюся у нас картинку какому-нибудь ребенку и попросить раскрасить ее – ведь даже ребенок способен освоить следующий прием:

// раскрашиваем картинку

// элегантная рамка

frame.stroke(["red", "green", "blue"], 2, "2 2 2");

// кирпичные стены

walls.fill(acgraph.hatchFill('horizontalbrick'));

// соломенная крыша

roof.fill("#e4d96f");

// клетчатый килт

kilt.fill(acgraph.hatchFill('plaid'));Теперь наш пример выглядит вот так.

Сейчас на картинке изображен горец в килте. Он стоит возле своего кирпичного замка с соломенной крышей. Можно даже рискнуть и действительно назвать нашу картинку произведением искусства, авторские права на которое мы хотим защитить. Что ж, проделаем это с помощью оригинальной заливки текстовым паттерном, которую мы сами и настроим:

// 169 - символьный код значка копирайта

var text = acgraph.text().text(String.fromCharCode(169)).opacity(0.2);

var pattern_font = stage.pattern(text.getBounds());

pattern_font.addChild(text);

// заполняем паттерном все изображение

frame.fill(pattern_font);Как видите, это очень просто: нужно создать экземпляр текстового объекта, затем построить паттерн в рабочей области и, наконец, вставить текст в паттерн.

Рисуем арт-игру (таймкиллер) менее чем за 50 строк кода

В следующей части статьи я покажу, как с помощью GraphicsJS нарисовать игру-кликер типа Cookie Clicker меньше чем за 50 строк кода.

Название этой игры – «Дворник на ветру». В ней пользователь выступает в роли дворника, который подметает улицу ветреным осенним днем. Здесь частично используется код примера с процедурно генерируемыми листьями из галереи GraphicsJS.

Финальный вариант игры можно посмотреть на CodePen (или в конце этой статьи).

Слои, zIndex, виртуальный DOM

Начнем с создания рабочей области (как в предыдущем примере). И затем объявим несколько исходных переменных:

// создаем рабочую область

var stage = acgraph.create("stage-container");

// цветовые палитры для листьев

var palette_fill = ['#5f8c3f', '#cb9226', '#515523', '#f2ad33', '#8b0f01'];

var palette_stroke = ['#43622c', '#8e661b', '#393b19', '#a97924', '#610b01'];

// счетчик

var leavesCounter = 0;Для создания игры нам пригодится возможность работы со слоем – объектом, отвечающим за группировку элементов в GraphicsJS. Элементы должны быть сгруппированы, чтобы к ним было удобно применять одинаковые изменения, например трансформации. Слои можно модифицировать в режиме приостановки (о нем расскажу чуть ниже): это улучшает производительность и впечатления от использования.

В данном примере функциональность слоя помогает сгруппировать листья и не дать им закрыть собой надпись, сообщающую, сколько листьев мы вымели. Для этого сначала создадим надпись, а затем с помощью метода

stage.layer создадим слой для всей рабочей области и назначим последнему более низкий zIndex, чем у надписи.// создаем надпись для отображения счетчика

var counterLabel = stage.text(10,10, "Swiped: 0", {fontSize: 20});

// слой для листьев

var gameLayer = stage.layer().zIndex(counterLabel.zIndex()-1);Теперь, сколько бы мы ни создавали листьев в этом слое, они никогда не окажутся поверх текста.

Трансформации

Далее добавим функцию для отрисовки листьев, воспользовавшись удобным API для трансформаций, который позволяет перемещать, масштабировать, поворачивать и обрезать как элементы, так и группы элементов. В связке с другими возможностями, которые предоставляет GraphicsJS, – слоями и виртуальным DOM – это очень мощный инструмент.

function drawLeaf(x, y) {

// выбираем произвольный цвет из палитры

var index = Math.floor(Math.random() * 5);

var fill = palette_fill[index];

var stroke = palette_stroke[index];

// генерируем произвольные масштабирующий коэффициент и угол поворота

var scale = Math.round(Math.random() * 30) / 10 + 1;

var angle = Math.round(Math.random() * 360 * 100) / 100;

// создаем новый путь (лист)

var path = acgraph.path();

// задаем раскраску и рисуем лист

path.fill(fill).stroke(stroke, 1, 'none', 'round', 'round');

var size = 18;

path.moveTo(x, y)

.curveTo(x + size / 2, y - size / 2, x + 3 * size / 4, y + size / 4, x + size, y)

.curveTo(x + 3 * size / 4, y + size / 3, x + size / 3, y + size / 3, x, y);

// применяем произвольные трансформации

path.scale(scale, scale, x, y).rotate(angle, x, y);

return path;

};Как видите, каждая линия создается одним и тем же образом, но затем трансформируется. В результате получается очень симпатичный случайный узор из листьев.

Работа с событиями

Все объекты, рабочие области и слои в GraphicsJS умеют обрабатывать события. Список всех доступных событий есть в EventType API. При этом рабочие области поддерживают четыре специальных события для контроля рендеринга.

В примере с игрой мы используем слушатели событий, привязанные к каждому объекту (листу), чтобы заставить листья исчезать по одному при наведении на них мыши. Чтобы добиться этого, добавим следующий код в конец функции

drawLeaf, перед оператором return:path.listen("mouseover", function(){

path.remove();

counterLabel.text("Swiped: " + leavesCounter++);

if (gameLayer.numChildren() < 200) shakeTree(300);

});Отсюда также ясно, что для подсчета листьев используется слой.

if (gameLayer.numChildren() < 200) shakeTree(300); Заметьте, на самом деле мы не храним здесь количество листьев. Листья – это линии, которые добавляются в тот или иной слой или удаляются оттуда, и потому можно отследить, сколько у нас дочерних объектов (а значит, и сколько листьев остается).

Библиотека GraphicsJS дает возможность использовать виртуальный DOM, абстракцию HTML DOM, легкую и независимую от специфики применения SVG/VML в разных браузерах. Эта технология пригодится для реализации целого ряда полезных функций, таких как контроль за всеми объектами и слоями, применение трансформаций к группам и оптимизация рендеринга с помощью методов, которые позволяют отслеживать и контролировать весь его процесс.

Оптимизация производительности

Благодаря виртуальному DOM, а также обработчикам событий пользователи GraphicsJS могут контролировать рендеринг. О том, как эти вещи связаны, можно прочитать в статье "Производительность" из документации библиотеки.

На время, когда в нашей игре генерируются листья, рендеринг нужно приостановить, а затем возобновить его, как только все изменения будут произведены:

function shakeTree(n){

stage.suspend(); // приостанавливаем рендеринг

for (var i = 0; i < n; i++) {

var x = Math.random() * stage.width()/2 + 50;

var y = Math.random() * stage.height()/2 + 50;

gameLayer.addChild(drawLeaf(x, y)); // добавляем лист

}

stage.resume(); // возобновляем рендеринг

}При таком способе добавления элементов новые листья появляются практически мгновенно.

// первый раз сбрасываем все листья

shakeTree(500);Ну и наконец, сбрасываем все листья, вызвав метод

shakeTree().Конечный результат

Заключение

Переход на HTML5 изменил Веб. Когда дело касается современных веб-приложений или даже простого сайта, мы часто сталкиваемся с задачами, которые требуют манипуляций с графикой. Хотя невозможно найти решение, которое идеально работает в абсолютно любой ситуации, я предложил бы вам обратить внимание на библиотеку GraphicsJS. У нее открытый код и open-source лицензия, она очень функциональна и производительна, а также оснащена отличной браузерной поддержкой и множеством фич. Все это делает GraphicsJS интересным, удобным и, конечно, эффективным решением.

Буду рад получить обратную связь по поводу GraphicsJS в комментариях. Уже используете эту библиотеку? Готовы ли рассмотреть возможность ее применения в новом проекте? Интересно было бы узнать, почему, равно как и почему нет. Кстати, сейчас я работаю над созданием списка лучших графических JavaScript-библиотек и статьей, где они будут сравниваться, – так что предлагаю написать в комментариях, какие библиотеки вы бы хотели там видеть.

Cсылки

- Общая информация

- Библиотеки

Автор оригинальной статьи на SitePoint: Роман Любушкин (Roman Lubushkin).

|

|

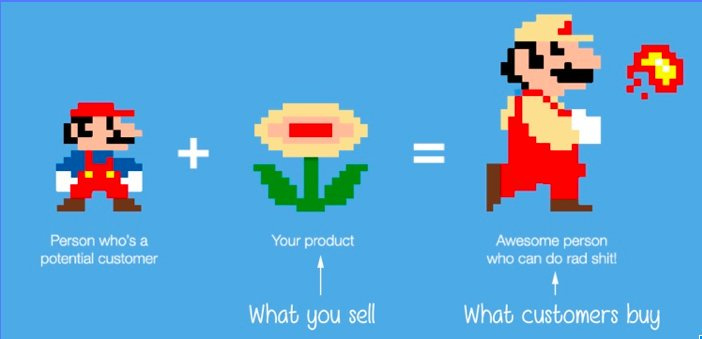

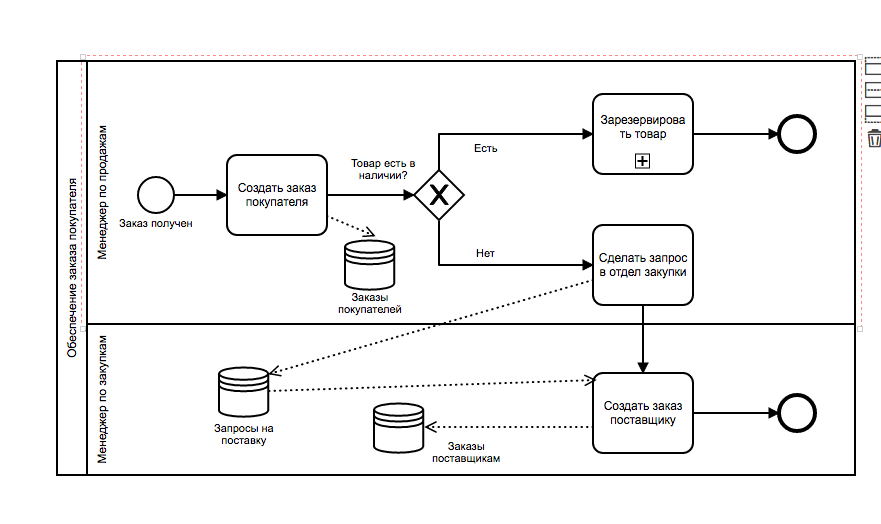

Фреймворк Jobs-To-Be-Done: наш опыт использования |

Outcome-driven innovation — это фреймворк, в основе которого приоритизация планов разработки компании на основе задач, для которых клиенты эти продукты покупают — Jobs to be done. Фреймворк дает хорошее методическое описание и обоснование идей и практик, которые каждый product owner, по идее, и так применяет или должен применять, но обычно — интуитивно и на менее системном уровне.

На Codefest 2017 Аркадий Рушкевич, product-manager Wrike, рассказал о собственном опыте использования Jobs to be done и ODI — как и зачем Wrike начал заниматься этим, какие плюсы и минусы мы увидели, чего добились.

Делимся видеозаписью и презентацией доклада. Надеемся, что интересно будет и продакт оунерам с опытом, и тем, кто только начинает думать, как расставлять приоритеты и находить новые точки роста продукта.

|

Метки: author Wriketeam управление разработкой управление проектами управление продуктом развитие стартапа блог компании wrike jtbd wrike wriketechclub odi jobstobedone |

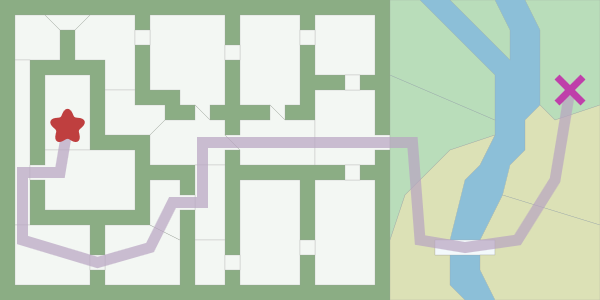

[Перевод] Введение в алгоритм A* |

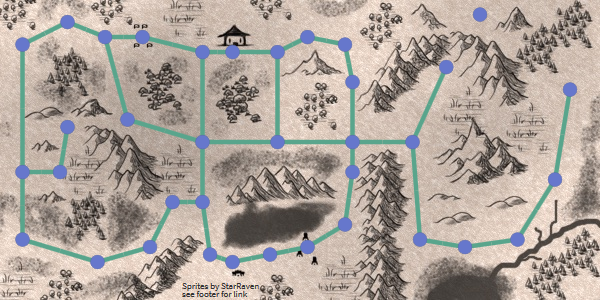

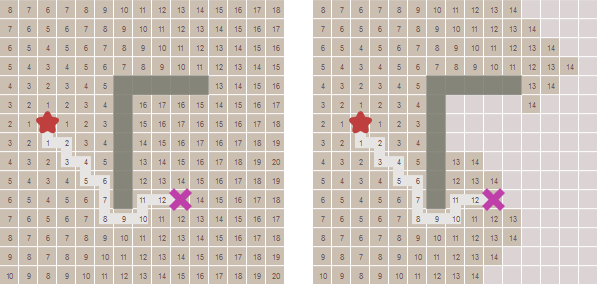

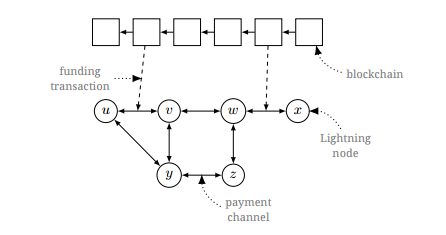

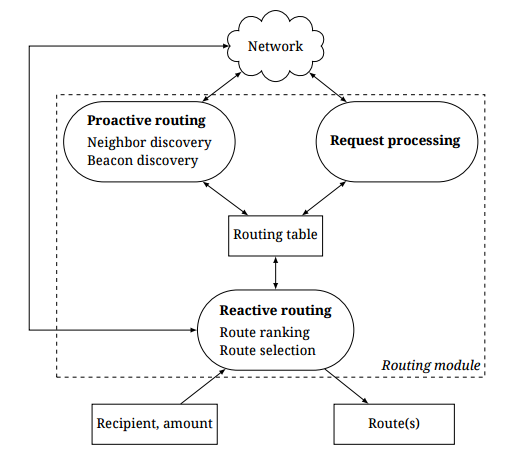

Для поиска этого пути можно использовать алгоритм поиска по графу, который применим, если карта представляет собой граф. A* часто используется в качестве алгоритма поиска по графу. Поиск в ширину — это простейший из алгоритмов поиска по графу, поэтому давайте начнём с него и постепенно перейдём к A*.

Представление карты

Первое, что нужно при изучении алгоритма — понять данные. Что подаётся на вход? Что мы получаем на выходе?

Вход: алгоритмы поиска по графу, в том числе и A*, получают в качестве входных данных граф. Граф — это набор точек («узлов») и соединений («рёбер») между ними. Вот граф, который я передал A*:

A* не видит ничего другого. Он видит только граф. Он не знает, находится ли что-то в помещении или за его пределами, дверь это или комната, насколько велика область. Он видит только граф! Он не понимает никакой разницы между картой сверху и вот этой:

Выход: определяемый A* путь состоит из узлов и рёбер. Рёбра — это абстрактное математическое понятие. A* сообщает нам, что нужно перемещаться из одной точки в другую, но не сообщает, как это нужно делать. Помните, что он ничего не знает о комнатах или дверях, он видит только граф. Вы сами должны решить, чем будет являться ребро графа, возвращённое A* — перемещением с тайла на тайл, движением по прямой линии, открытием двери, бегом по кривому пути.

Компромиссы: для каждой игрокой карты есть множество разных способов передачи графа поиска пути алгоритму A*. Карта на рисунке выше превращает двери в узлы.

А что, если мы превратим двери в рёбра?

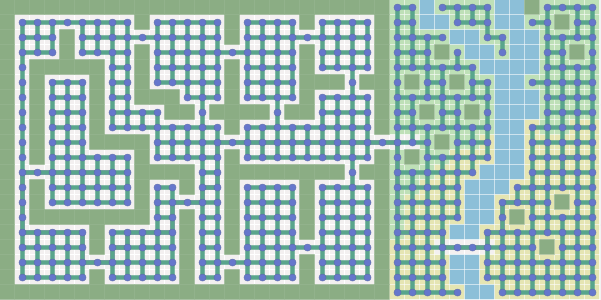

А если мы применим сетку для поиска пути?

Граф поиска пути не обязательно должен быть тем же, что используется в вашей игровой карте. В карте на основе сеток можно использовать граф поиска пути без сеток, и наоборот. A* выполняется быстрее с наименьшим количеством узлов графа. С сетками часто проще работать, но в них получается множество узлов. В этой статье рассматривается сам алгоритм A*, а не дизайн графов. Подробнее о графах можно прочитать на моей другой странице. Для объяснений я в дальнейшем буду использовать сетки, потому что так проще визуализировать концепции.

Алгоритмы

Существует множество алгоритмов, работающих с графами. Я рассмотрю следующие:

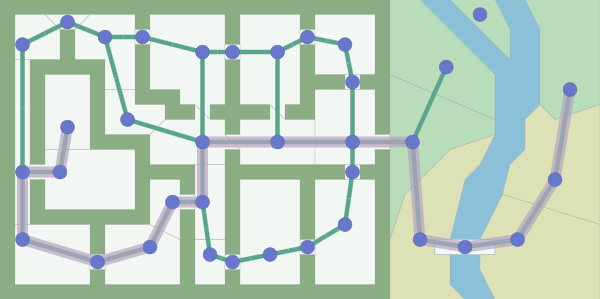

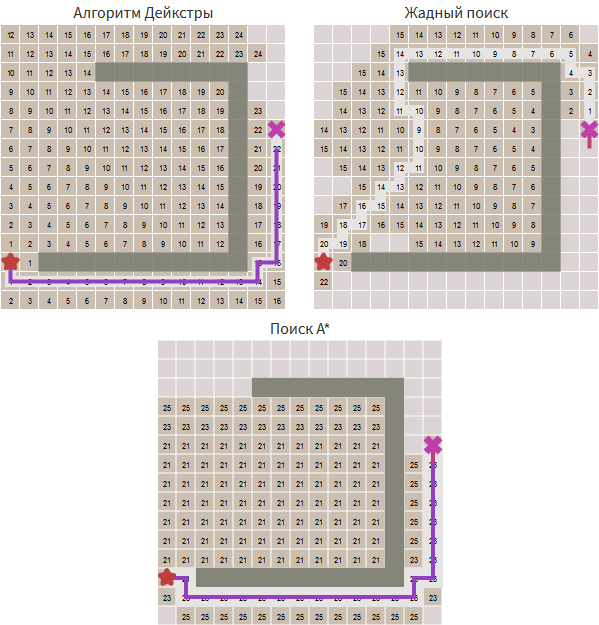

Поиск в ширину выполняет исследование равномерно во всех направлениях. Это невероятно полезный алгоритм, не только для обычного поиска пути, но и для процедурной генерации карт, поиска путей течения, карт расстояний и других типов анализа карт.

Алгоритм Дейкстры (также называемый поиском с равномерной стоимостью) позволяет нам задавать приоритеты исследования путей. Вместо равномерного исследования всех возможных путей он отдаёт предпочтение путям с низкой стоимостью. Мы можем задать уменьшенные затраты, чтобы алгоритм двигался по дорогам, повышенную стоимость, чтобы избегать лесов и врагов, и многое другое. Когда стоимость движения может быть разной, мы используем его вместо поиска в ширину.

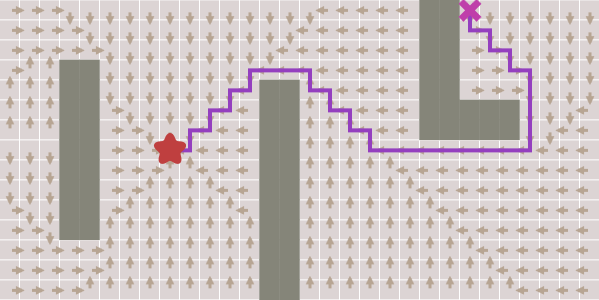

A* — это модификация алгоритма Дейкстры, оптимизированная для единственной конечной точки. Алгоритм Дейкстры может находить пути ко всем точкам, A* находит путь к одной точке. Он отдаёт приоритет путям, которые ведут ближе к цели.

Я начну с самого простого — поиска в ширину, и буду добавлять функции, постепенно превращая его в A*.

Поиск в ширину

Ключевая идея всех этих алгоритмов заключается в том, что мы отслеживаем состояние расширяющегося кольца, которое называется границей. В сетке этот процесс иногда называется заливкой (flood fill), но та же техника применима и для карт без сеток. Посмотрите анимацию расширения границы:

Как это реализовать? Повторяем эти шаги, пока граница не окажется пустой:

- Выбираем и удаляем точку из границы.

- Помечаем точку как посещённую, чтобы знать, что не нужно обрабатывать её повторно.

- Расширяем границу, глядя на её соседей. Всех соседей, которых мы ещё не видели, добавляем к границе.

Давайте рассмотрим это подробнее. Тайлы нумеруются в порядке их посещения:

Алгоритм описывается всего в десяти строках кода на Python:

frontier = Queue()

frontier.put(start )

visited = {}

visited[start] = True

while not frontier.empty():

current = frontier.get()

for next in graph.neighbors(current):

if next not in visited:

frontier.put(next)

visited[next] = TrueВ этом цикле заключается вся сущность алгоритмов поиска по графу этой статьи, в том числе и A*. Но как нам найти кратчайший путь? Цикл на самом деле не создаёт путей, он просто говорит нам, как посетить все точки на карте. Так получилось потому, что поиск в ширину можно использовать для гораздо большего, чем просто поиск путей. В этой статье я показываю, как он применяется в играх tower defense, но его также можно использовать в картах расстояний, в процедурной генерации карт и многом другом. Однако здесь мы хотим использовать его для поиска путей, поэтому давайте изменим цикл так, чтобы отслеживать, откуда мы пришли для каждой посещённой точки, и переименуем

visited в came_from:frontier = Queue()

frontier.put(start )

came_from = {}

came_from[start] = None

while not frontier.empty():

current = frontier.get()

for next in graph.neighbors(current):

if next not in came_from:

frontier.put(next)

came_from[next] = currentТеперь came_from для каждой точки указывает на место, из которого мы пришли. Это похоже на «хлебные крошки» из сказки. Нам этого достаточно для воссоздания целого пути. Посмотрите, как стрелки показывают обратный путь к начальной позиции.

Код воссоздания путей прост: следуем по стрелкам обратно от цели к началу. Путь — это последовательность рёбер, но иногда проще хранить только узлы:

current = goal

path = [current]

while current != start:

current = came_from[current]

path.append(current)

path.append(start) # optional

path.reverse() # optionalТаков простейший алгоритм поиска путей. Он работает не только в сетках, как показано выше, но и в любой структуре графов. В подземелье точки графа могут быть комнатами, а рёбра — дверями между ними. В платформере узлы графа могут быть локациями, а рёбра — возможными действиями: переместиться влево, вправо, подпрыгнуть, спрыгнуть вниз. В целом можно воспринимать граф как состояния и действия, изменяющие состояние. Подробнее о представлении карт я написал здесь. В оставшейся части статьи я продолжу использовать примеры с сетками, и расскажу о том, для чего можно применять разновидности поиска в ширину.

Ранний выход

Мы нашли пути из одной точки во все другие точки. Часто нам не нужны все пути, нам просто нужен путь между двумя точками. Мы можем прекратить расширять границу, как только найдём нашу цель. Посмотрите, как граница перестаёт расширятся после нахождения цели.

Код достаточно прямолинеен:

frontier = Queue()

frontier.put(start )

came_from = {}

came_from[start] = None

while not frontier.empty():

current = frontier.get()

if current == goal:

break

for next in graph.neighbors(current):

if next not in came_from:

frontier.put(next)

came_from[next] = currentСтоимость перемещения

Пока мы делали шаги с одинаковой стоимостью. В некоторых случаях поиска путей у разных типов движения есть разная стоимость. Например, в Civilization движение через равнины или пустыню может стоить 1 очко движения, а движение через лес — 5 очков движения. На карте в самом начале статьи прохождение через воду стоит в 10 раз дороже, чем движение по траве. Ещё одним примером является диагональное движение в сетке, которое стоит больше, чем движение по осям. Нам нужно, чтобы поиск пути учитывал эту стоимость. Давайте сравним количество шагов от начала с расстоянием от начала:

Для этого нам нужен алгоритм Дейкстры (также называемый поиском с равномерной стоимостью). Чем он отличается от поиска в ширину? Нам нужно отслеживать стоимость движения, поэтому добавим новую переменную

cost_so_far, чтобы следить за общей стоимостью движения с начальной точки. При оценке точек нам нужно учитывать стоимость передвижения. Давайте превратим нашу очередь в очередь с приоритетами. Менее очевидно то, что у нас может получиться так, что одна точка посещается несколько раз с разной стоимостью, поэтому нужно немного поменять логику. Вместо добавления точки к границе в случае, когда точку ни разу не посещали, мы добавляем её, если новый путь к точке лучше, чем наилучший предыдущий путь.frontier = PriorityQueue()

frontier.put(start, 0)

came_from = {}

cost_so_far = {}

came_from[start] = None

cost_so_far[start] = 0

while not frontier.empty():

current = frontier.get()

if current == goal:

break

for next in graph.neighbors(current):

new_cost = cost_so_far[current] + graph.cost(current, next)

if next not in cost_so_far or new_cost < cost_so_far[next]:

cost_so_far[next] = new_cost

priority = new_cost

frontier.put(next, priority)

came_from[next] = currentИспользование очереди с приоритетами вместо обычной очереди изменяет способ расширения границы. Контурные линии позволяют это увидеть. Посмотрите видео, чтобы понаблюдать, как граница расширяется медленнее через леса, и поиск кратчайшего пути выполняется вокруг центрального леса, а не сквозь него:

Стоимость движения, отличающаяся от 1, позволяет нам исследовать более интересные графы, а не только сетки. На карте в начале статьи стоимость движения основана на расстоянии между комнатами. Стоимость движения можно также использовать, чтобы избегать или предпочитать области на основании близости врагов или союзников. Интересная деталь реализации: обычная очередь с приоритетами поддерживает операции вставки и удаления, но в некоторых версиях алгоритма Дейкстры используется и третья операция, изменяющая приоритет элемента, уже находящегося в очереди с приоритетами. Я не использую эту операцию, и объясняю это на странице реализации алгоритма.

Эвристический поиск

В поиске в ширину и алгоритме Дейкстры граница расширяется во всех направлениях. Это логичный выбор, если вы ищете путь ко всем точкам или ко множеству точек. Однако обычно поиск выполняется только для одной точки. Давайте сделаем так, чтобы граница расширялась к цели больше, чем в других направлениях. Во-первых, определим эвристическую функцию, сообщающую нам, насколько мы близки к цели:

def heuristic(a, b):