Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Перевод] Офис открытого типа умер? |

Офис открытого типа умер?

- Перевод

Как мы к этому пришли

Два немецких брата изобрели оригинальную планировку офисов открытого типа в 1958 году. В таких офисах больше не было закрытых кабинетов менеджеров и рядов со столами мелких клерков. Вместо этого в новом дизайне все столы группировались в кластеры, в зависимости от принадлежности к тому или иному департаменту. Устранив физические барьеры, авторы идеи были уверены, что уж теперь точно нет помех для общения и обмена идеями.

Не прошло и десяти лет, как Роберт Пропст, исполнительный директор Herman Miller, изобрёл кубикл — и стены вернулись. Пропст критиковал офисы открытого типа как пустыню, которая «высасывает жизненную энергию, мешает талантам, делает тщетными любые достижения». Он представлял себе кубиклы как способ дать свободу работникам, обеспечив им приватность и персональное пространство. К сожалению, большинство компаний свело его просторные, гибкие планировки ко всем нам известным депрессивным, но менее дорогим, перенаселённым бежевым кубиклам. (В интервью от 1998 года сам Пропст обвинил компании, что они превратили его оригинальную идею в «адские дыры»).

Сегодня планировки офисов открытого типа вернулись, чтобы отомстить. В исследовании 2013 года, проведённом CoreNet Global, ассоциацией для корпоративных менеджеров по недвижимости, более 80% респондентов сказали, что их компании перешли на открытую планировку. И опять начали проявляться негативные последствия. В последние пять лет этот прогрессивный дизайн, который предполагался прогрессивным, атаковало множество статей с алармистскими заголовками вроде «Смерть офисам открытого типа!» и «Офисы открытого типа созданы дьяволом в самых глубоких пещерах ада».

Так что конкретно не так с современными планировками открытых офисов и как организовать пространство в соответствии с изначальными обещаниями более радостной и эффективной совместной работы?

В чём проблема

По определению, коллеги сближаются в открытой планировке. Как только у вас возникает вопрос, вы можете легко шагнуть к столу коллеги или просто подкатиться на кресле напротив него. К сожалению, такие добронамеренные вторжения ведут к реальным проблемам.

Первая из них — снижение производительности труда. Изучение убытков из-за прерванной работы показало, что типичный офисный работник прерывает свою работу каждые 11 минут. Хуже того, людям часто требуется до 25 минут, чтобы снова сконцентрироваться на задаче.

В безбарьерной среде шум тоже может стать проблемой. Громкие телефонные разговоры, шушукающие сотрудники и тот парень, чавкающий яблоком каждый полдень — всё это вместе стремится истощить вашу нервную систему. Исследователи обнаружили, что в открытых планировках потеря производительности из-за шума вдвое выше, чем в персональных офисах, у людей снижается способность запоминать события и им труднее выполнять даже простые арифметические задачи.

Как знает каждый, кому приходилось звонить врачу по телефону в офисе открытого типа, один из главных недостатков открытых планировок в том, что вы не можете контролировать, кого вы слышите — а кто слышит вас. В исследовании 2013 года о компромиссах приватности в офисах открытого типа, 60% работников в кубиклах и 50% работников в офисах без перегородок значительной проблемой назвали отсутствие конфиденциальности переговоров.

Кроме всех этих неприятностей, офисы открытого типа в прямом смысле лишают людей здоровья. Исследование взаимосвязи между количеством больничных и открытыми планировками показало, что сотрудники офисов открытого типа берут на 62% больше больничных, чем люди из закрытых кабинетов. И ещё, вы же помните обо всех тех помехах работе в офисах открытого типа? Исследование, опубликованное в «Международном журнале по управлению стрессом», показало, что частые помехи работе сотрудников повышают уровень нервного истощения на 9%.

Офис будущего уже здесь

Очевидно, офисы открытого типа не стали генераторами креативности, как рассчитывали их создатели. И с дефицитом офисного пространства невозможно выделить каждому личный кабинет, да это и не идеальный вариант. Приливы и отливы эффективного сотрудничества требуют существования нескольких типов офисов. Как изложили эксперты в данной области в Harvard Business Review, сотрудники склонны генерировать идеи и обрабатывать информацию в одиночку или в парах, потом собираться в большие группы для развития этих идей, а затем снова изолироваться для осуществления следующих шагов.

К счастью, решение здесь довольно простое — проектировать офисы с разнообразными вариантами планировки для разных типов работы, в том числе хабами для общения, залами для совместной работы и небольшими приватными пространствами, где можно задуматься и сконцентрироваться. Затем дать людям свободу выбора между всеми этими пространствами в течение рабочего дня.

С чего начать? Поговорите со своими сотрудниками. Если компания понимает, в каком окружении сотрудники будут работать лучше всего, она может спроектировать лучший офис, соответствующий этим требованиям. Инженерам с их часами мозговых штурмов в небольших группах не всегда нужны такие же отдельные места для сфокусированной концентрации, как литературным сотрудникам или финансовым аналитикам. Вот три более прогрессивных способа приспособить офис к вашим сотрудникам:

Уголки приватности. Пожалуй, самый мощный и популярный способ избавиться от офисов открытого типа — увеличить количество небольших приватных пространств. В их числе комнаты со звукоизолированными стеклянными стенами, что обеспечивает звукоизоляцию, сохраняя воздушное ощущение открытой офисной планировки как своеобразные «телефонные будки», а также небольшие пространства для сфокусированной уединённой работы и конфиденциальных разговоров между двумя людьми.

Зонирование. Вместе с созданием большего количество частных уголков, компании теперь заменяют обычные конференц-залы б'oльшим разнообразием мест для переговоров. Среди них небольшие ниши, где три-четыре коллеги могут быстро собраться для переговоров в процессе работы, и более большие места на 5-8 человек, которые можно бронировать заранее или зарезервировать для часто встречающихся групп. Компании также могут уменьшить количество нежелательных помех работе сотрудников, разделив пространство на районы, основываясь на ожидаемых уровнях шума и поместив более шумные отделы, такие как отдел продаж и оперативный отдел, как можно дальше от тихих отделов. Столы, стеллажи и большие растения создают более лабиринтные конфигурации, уменьшая слуховые и зрительные отвлекающие факторы.

Нет обязательного рабочего места. Современные средства мобильной связи позволяют работать в любом месте, открывая всё здание в качестве потенциального рабочего места. Вам может потребоваться та энергия, которую даёт шум кафе или атриума (центральное пространство общественного здания — прим. пер.). Или вы можете обнаружить, что перемещение на свежий воздух приносит свежие идеи. Более того, согласно архитектурной и дизайнерской фирме Gensler, «у работодателей, которые предлагают выбор, когда и где работать, работники на 12% больше удовлетворены своей работой и показывают более высокие показатели эффективности».

Такие типы планировок — где у человека есть выбор работать в той части офиса, которая наилучшим образом отвечает его задачам и настроению в каждый конкретный момент, — именно то, что нужно офисам. С их помощью компании могут, наконец-то, добиться той свободы и обмена идеями, которые обещали изобретатели офисов открытого типа в 1950-е годы. И это может дать то, что нужно всем: рабочие места, подходящие каждому сотруднику.

|

Метки: author m1rko управление проектами управление персоналом офис открытого типа открытая планировка зонирование |

Работа с API КОМПАС-3D -> Урок 4 -> Основная надпись |

Работа с API КОМПАС-3D -> Урок 4 -> Основная надпись

- Tutorial

Основная надпись в КОМПАС описывается интерфейсом ksStamp. Для получения указателя на него используются методы GetStamp() и GetStampEx() интерфейсов ksDocument2D, ksSpcDocument и ksDocumentTxt.

Единственным параметром метода GetStampEx является номер листа, для которого запрашивается интерфейс основной надписи. Нумерация листов начинается с единицы. Метод GetStamp не имеет параметров. Он возвращает интерфейс основной надписи для первого листа чертежа или спецификации.

Прежде чем перейти к рассмотрению интерфейса ksStamp, бегло рассмотрим интерфейс ksTextItemParam.

Компонента строки

Интерфейс ksTextItemParam задает компоненту строки текста. Под «компонентой» понимается строка или спецсимвол. Получить этот интерфейс можно с помощью метода GetParamStruct интерфейса KompasObject. Для этого в качестве единственного параметра данному методу нужно передать константу ko_TextItemParam.

Свойств у интерфейса ksTextItemParam всего три.

- iSNumb – код спецсимвола. Спецсимволы и их номера приведены в файле NumbSymb.frw, входящем в комплект поставки КОМПАС. Он расположен в подкаталоге SDK основного каталога программы КОМПАС.

- s – строка. Если интерфейс ksTextItemParam используется для описания спецсимвола, то данная строка выводится после спецсимвола.

- type – задает назначение интерфейса. Если значение этого свойства равно SPECIAL_SYMBOL, то интерфейс описывает спецсимвол и строку. При этом строка располагается сразу за спецсимволом. Если же значение этого свойства отлично от SPECIAL_SYMBOL, то значение свойства iSNumb игнорируется, а интерфейс описывает только строку s. Учтите, что в заголовочных файлах старых версий КОМПАС данное свойство называется type_ (со знаком подчеркивания), а константа SPECIAL_SYMBOL не определена. Она равна 17.

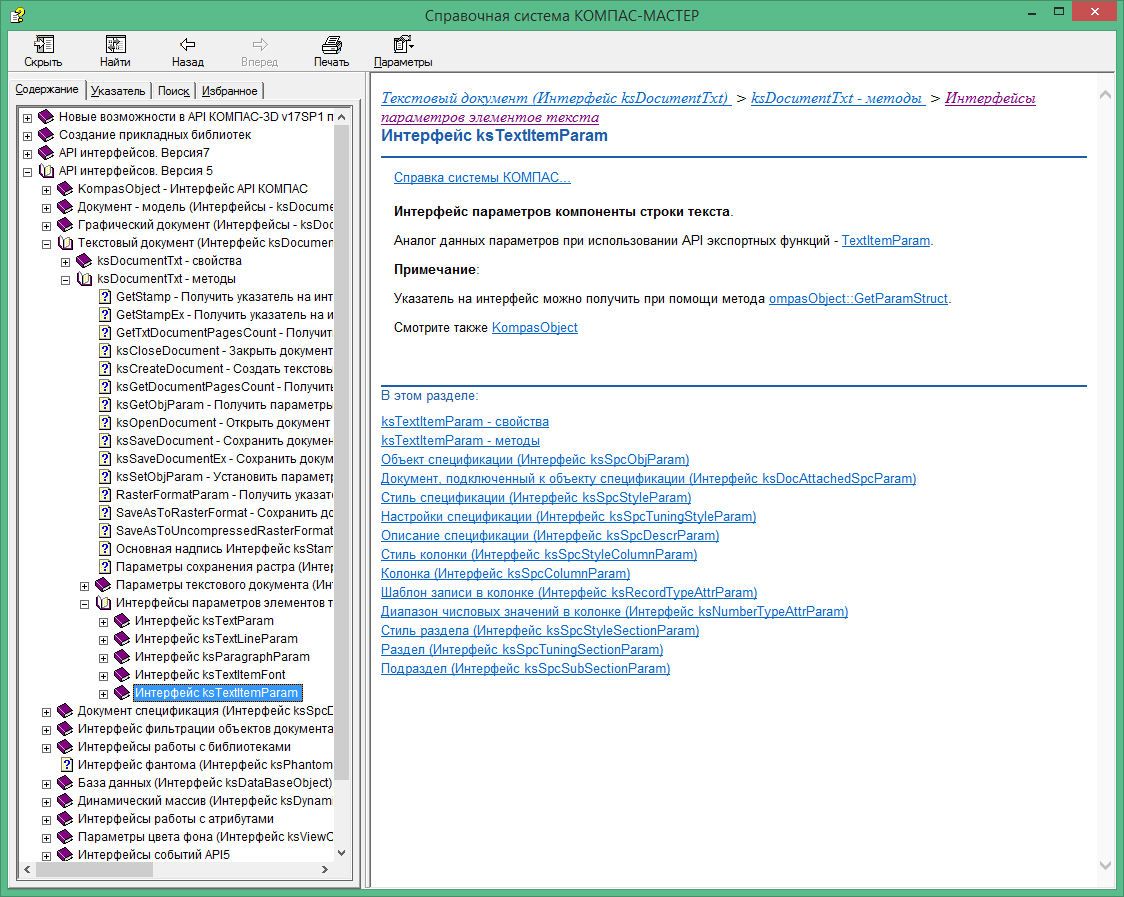

В документации КОМПАС-3D v17 интерфейс ksTextItemParam описан в рубрике «Текстовый документ (Интерфейс ksDocumentTxt) / ksDocumentTxt – методы / Интерфейсы параметров элементов текста /».

Описание интерфейсов параметров элементов текста в SDK

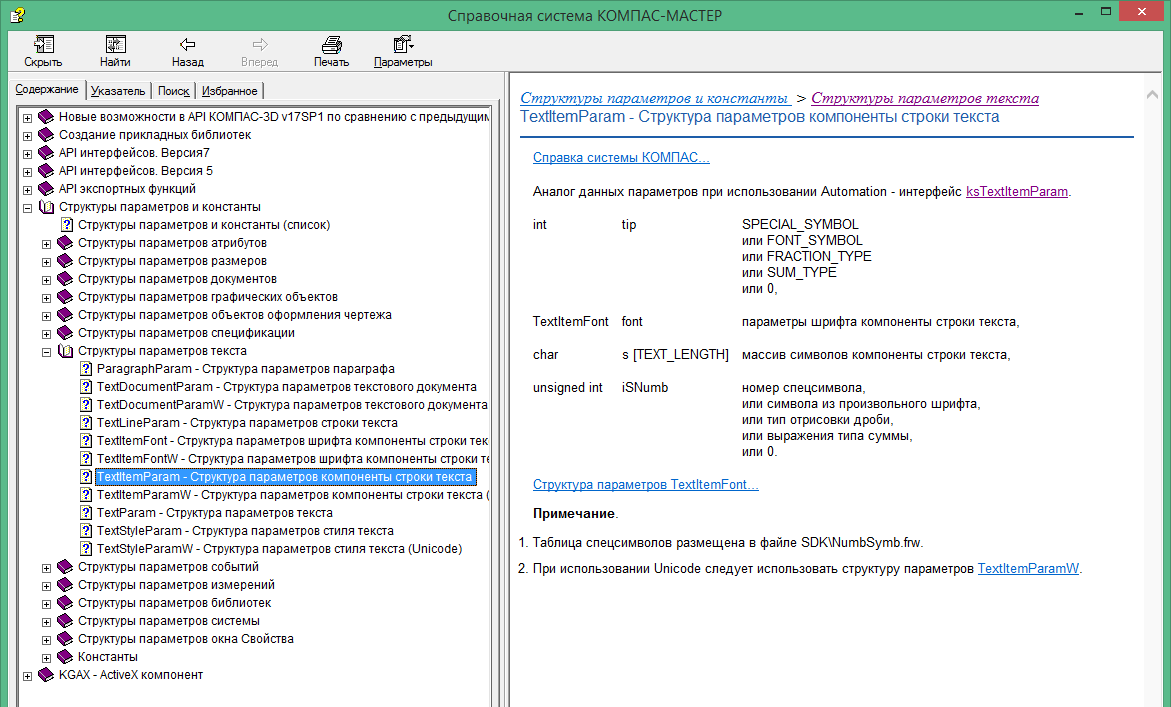

Но при описании свойства type константа SPECIAL_SYMBOL не упоминается. Она приводится (правда без числового значения) в разделе «Структуры параметров и константы / Структуры параметров текста / TextItemParam – структура параметров компоненты текста».

Описание структуры параметров компоненты строки текста в SDK

Там же приводятся еще три возможных значения свойства type (FONT_SYMBOL, FRACTION_TYPE, SUM_TYPE), но их назначение я так и не понял. Как показали эксперименты, поведение интерфейса ksTextItemParam при данных константах ничем не отличается от нулевого значения свойства type. Правда я тестировал в контексте основной надписи, возможно, что это накладывает какие-то свои ограничения.

Теперь рассмотрим методы интерфейса ksTextItemParam.

- GetItemFont() – возвращает интерфейс параметров шрифта ksTextItemFont.

- SetItemFont – устанавливает новый интерфейс параметров шрифта ksTextItemFont. Устанавливаемый интерфейс передается в качестве значения единственного параметра. В случае успеха метод возвращает значение true.

- Init() – инициализирует нулями свойства интерфейса. В случае успеха возвращает значение true.

Основная надпись

Как говорилось выше, основная надпись описывается интерфейсом ksStamp. У данного интерфейса нет интересных свойств, поэтому сразу переходим к рассмотрению его методов.

- ksClearStamp – очищает основную надпись или ее отдельную ячейку. Единственным параметром данного метода является номер очищаемой ячейки. Если его значение равно нулю, то очищается вся основная надпись. В случае успеха данный метод возвращает единицу, а в случае ошибки — нуль.

- ksCloseStamp() – закрыть основную надпись. Это означает выйти из режима редактирования основной надписи. В случае успеха возвращает единицу, а в случае ошибки – нуль.

- ksColumnNumber – делает текущей заданную ячейку. В качестве единственного параметра в данный метод передается номер ячейки, которая делается текущей. В случае успеха данный метод возвращает единицу, а в случае ошибки — нуль.

- ksOpenStamp() – открыть основную надпись. Это означает войти в режим редактирования основной надписи. Не имеет входных параметров, в случае успеха возвращает единицу, а в случае ошибки — нуль.

- ksTextLine – записать строку в текущую ячейку. Текущая ячейка должна быть установлена методом ksColumnNumber. Единственным параметром метода ksTextLine является указатель на интерфейс ksTextItemParam, о котором я говорил чуть выше. В случае успеха метод ksTextLine возвращает единицу, а в случае ошибки — нуль.

Это неполный перечень методов интерфейса ksStamp, но их вполне достаточно для работы с основной надписью. Тем не менее, нужно сделать ряд замечаний.

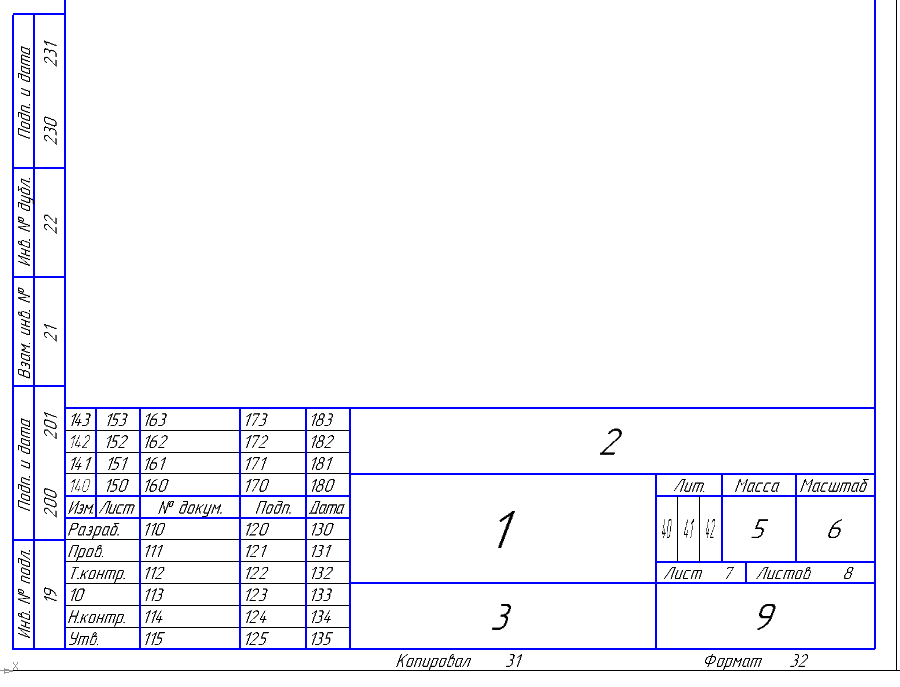

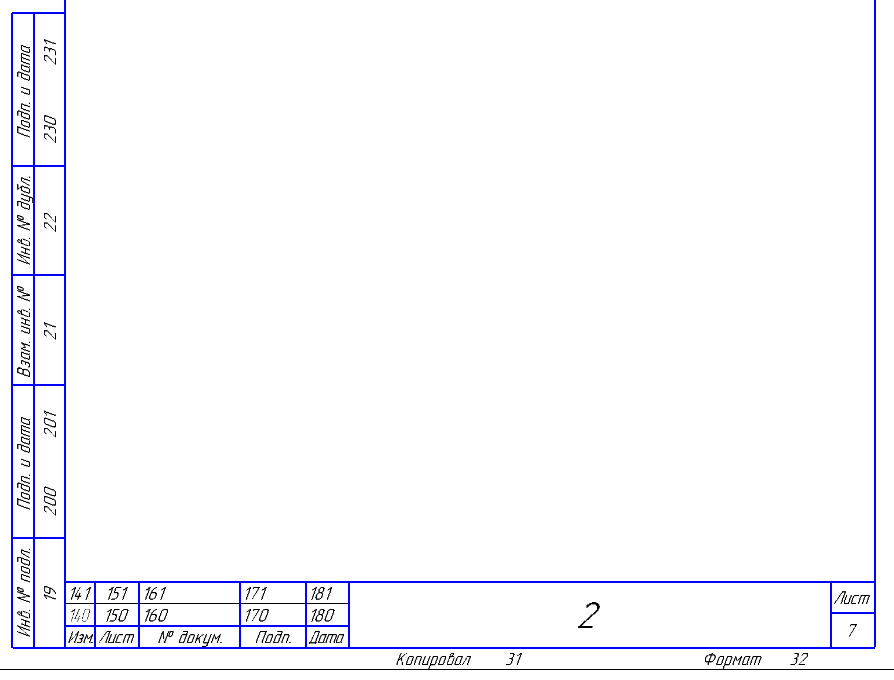

- Все ячейки основной надписи пронумерованы. В документации КОМПАС данных номеров нет, но есть отсылка к ГОСТам на основную надпись (ГОСТ 2.104-68 и ГОСТ 2.104-2006). Также нумерацию ячеек основной надписи можно посмотреть на странице. На рисунках ниже представлены номера ячеек основной надписи форм 2а и 2б, полученные экспериментальным путем.

Первый лист

Второй и последующие листы

- Метод ksTextLine — не единственный способ записи строк в основную надпись. Помимо него у интерфейса ksStamp есть метод ksSetStampColumnText, который делает то же самое. Единственное отличие состоит в том, что в нем устанавливаемая строка задается не в виде интерфейса ksTextItemParam, а в виде динамического массива ksDynamicArray. В данной статье мы не будем его рассматривать.

Редактирование основной надписи

Заполнение основной надписи состоит из нескольких последовательных этапов:

- Получить указатель на интерфейс ksTextItemParam. Для этого используется метод GetParamStruct интерфейса ksKompasObject. Интерфейс ksTextItemParam нужен для представления строк, записываемых в основную надпись.

- Получить указатель на интерфейс основной надписи ksStamp с помощью методов GetStamp или GetStampEx интерфейсов документа, спецификации.

- Вызвать метод ksOpenStamp() интерфейса ksStamp. Так мы входим в режим редактирования основной надписи.

- Подготовить строку, которая будет записана в ячейку основной надписи. Строка должна быть представлена в виде интерфейса ksTextItemParam.

- Выделить ячейку, в которую нужно записать строку. Для выделения ячейки используется метод ksColumnNumber интерфейса ksStamp.

- Вызвав метод ksTextLine интерфейса ksStamp, записать строку в выделенную ячейку.

- Повторить пункты 4-6 для всех строк, записываемых в основную надпись.

- Закрыть основную надпись методом ksCloseStamp интерфейса ksStamp.

Пример

Ниже приводится фрагмент программы, демонстрирующий работу с основной надписью.

//Получаем интерфейс представления строк

TextItemParamPtr TextItemParam;

TextItemParam = (TextItemParamPtr)kompas->GetParamStruct(ko_TextItemParam);

//Получаем интерфейс основной надписи

StampPtr Stamp;

Stamp = (StampPtr)Document2D->GetStamp();

//Открываем основную надпись

Stamp->ksOpenStamp();

Stamp->ksColumnNumber(1);

TextItemParam->s = SysAllocString(L"Деталь");

Stamp->ksTextLine(TextItemParam);

Stamp->ksColumnNumber(3);

TextItemParam->s = SysAllocString(L"");

TextItemParam->type = SPECIAL_SYMBOL;

TextItemParam->iSNumb = 51;

Stamp->ksTextLine(TextItemParam);

Stamp->ksColumnNumber(110);

TextItemParam->set_s(SysAllocString(L"Норсеев С.А."));

TextItemParam->type = 0;

Stamp->ksTextLine(TextItemParam);

//Закрываем основную надпись

Stamp->ksCloseStamp();

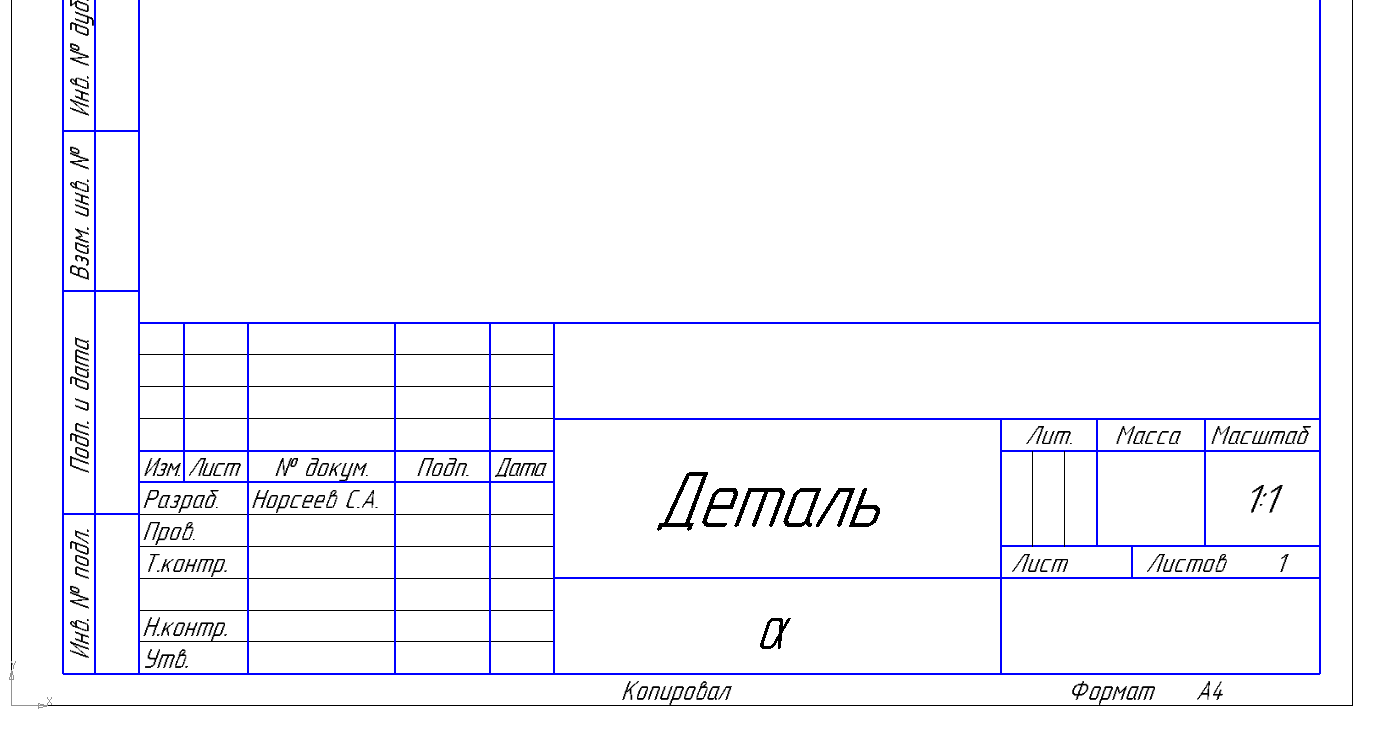

В результате работы этой программы вы увидите основную надпись, показанную на рисунке ниже.

Основная надпись, полученная программно.

Сделаю два замечания по поводу приведенного выше фрагмента программы.

- В данном примере не приводится код, ответственный за подключение к КОМПАС и создание чертежа. Я убрал его для облегчения понимания кода. О том, как подключаться к КОМПАС и настраивать чертеж (в том числе выбирать формат основной надписи в нем), говорилось в предыдущих статьях цикла.

- Если внимательно посмотреть на приведенный выше код, то можно увидеть, что в одном случае строка устанавливалась в интерфейсе ksTextItemParam путем присвоения значения свойству s, а в другом — путем вызова метода set_s, про который я ничего не говорил. Дело в том, что в технологии COM все свойства представляются в виде методов (как правило, установки и чтения). Наименование этих методов формируется следующим образом:

get_<имя свойства>

set_<имя свойства>

В своих программах вы можете использовать любой из этих подходов (присвоение значения свойству или же вызов соответствующего метода).

Заключение

В данной статье мы научились заполнять основную надпись и познакомились с одним из интерфейсов для представления строк и спецсимволов. В последующих статьях цикла мы познакомимся и с другими интерфейсами.

Продолжение следует, следите за новостями блога.

Сергей Норсеев, автор книги «Разработка приложений под КОМПАС в Delphi».

Сергей Норсеев, автор книги «Разработка приложений под КОМПАС в Delphi».|

Метки: author kompas_3d разработка под windows cad/cam c++ api блог компании аскон компас 3d компас компас-3d приложения библиотеки c++ builder |

Kак Microsoft пытается отправить мобильную почту к себе |

Kак Microsoft пытается отправить мобильную почту к себе

Хранит ли Outlook-iOS-Android копию почтового ящика на сервере микрософт?

В подвешенном состоянии очутились многие корпоративные пользователи, которые недавно обновились до iOS 11. Дело в том, что после обновления перестает работать стандартный клиент (Mail.app) с ресурсами на Exchange Server 2016, Office 365 или Outlook.com

Отправка сообщения заканчивается ошибкой «Cannot Send Mail. The message was rejected by the server.»

Проблема заключается в том, что Exchange 2016 использует HTTPS / 2 TLS-соединения для своих клиентов. Когда почтовое приложение iOS пытается подключиться к Exchange с помощью ActiveSync, оно неправильно согласовывает соединение.

Microsoft подтвердило проблему и в качестве решения предлагает установить клиента Outlook for iOS.

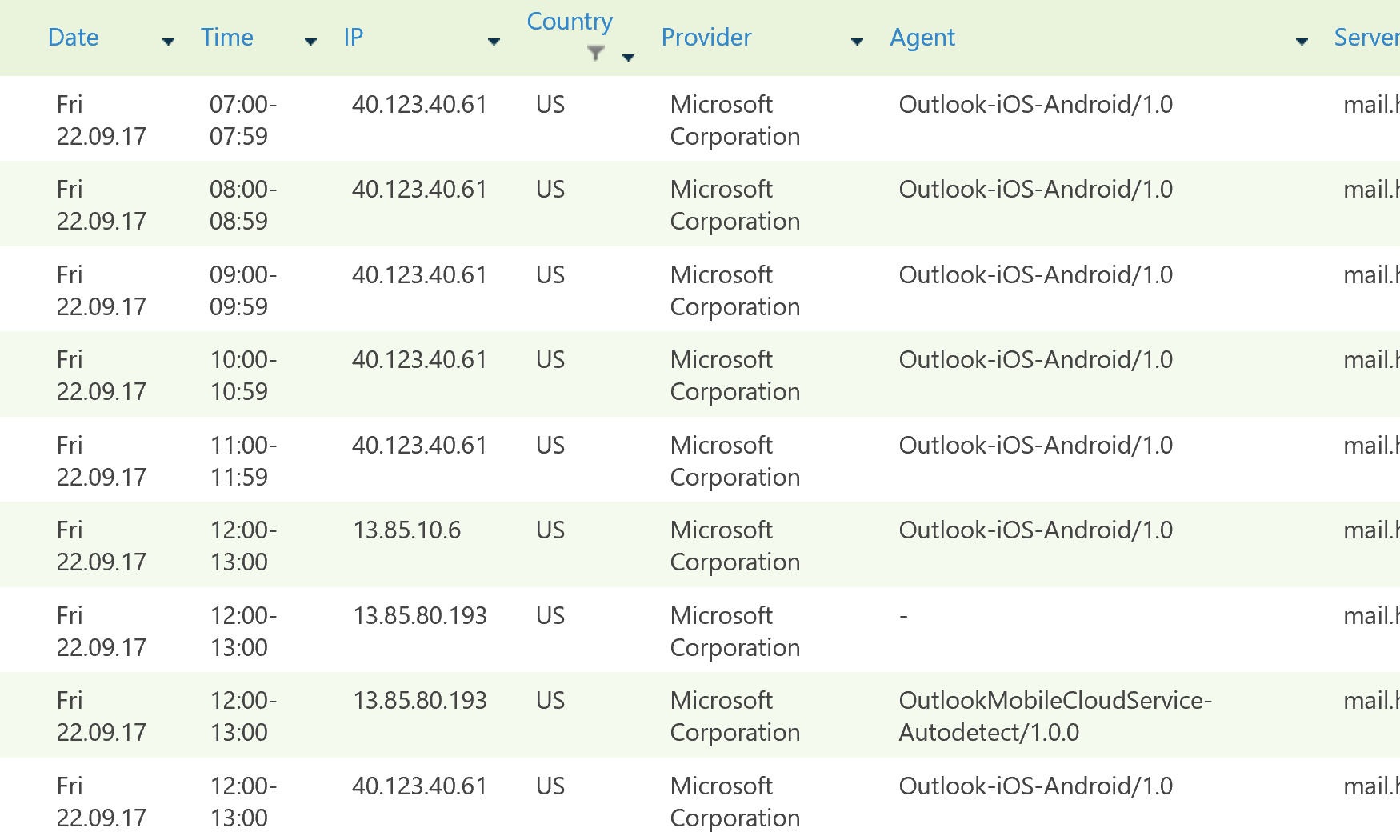

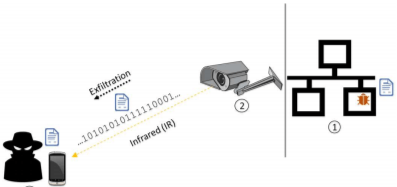

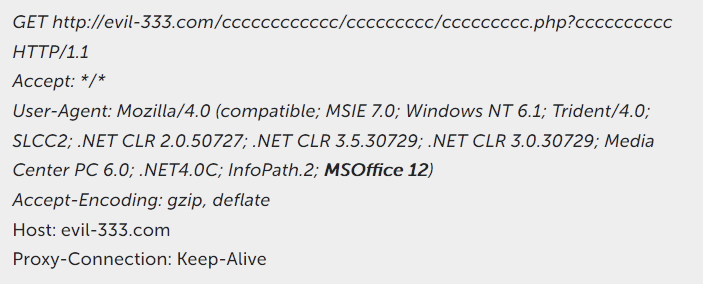

Данное решение весьма спорное, т.к. программа Outlook не подключается напрямую к почтовому серверу, а с введенными учетными записями сервер Microsoft, расположенный в США, подключается к вашему серверу и, скорее всего, загружает на него копию вашего почтового ящика.

Ниже приведен фрагмент анализа логов подключения из программы SkypeTime.

В российском сегменте этому вопросу не уделено достаточного внимания, поэтому приводим ссылки на зарубежные источники.

news.ok.ubc.ca/it/2015/02/03/outlook-app-for-ios-and-android-devices-blocked

blog.winkelmeyer.com/2015/01/warning-microsofts-outlook-app-for-ios-breaks-your-company-security

blog.winkelmeyer.com/2015/02/updates-on-the-latest-outlook-ios-app-issues

Насколько это юридически правильно и хорошо мы судить не будем, но для повышения уровня конфиденциальности можно заблокировать подключение с этих серверов на Exchange 2016.

New-ActiveSyncDeviceAccessRule -QueryString "Outlook for iOS and Android" -Characteristic DeviceModel -AccessLevel BlockНадеюсь данная информация будет кому то полезна.

|

Метки: author hardpoint информационная безопасность exchange outlook office 365 ios |

Трансляция с геймдев-конференции 4C в Санкт-Петербурге. День второй |

Трансляция с геймдев-конференции 4C в Санкт-Петербурге. День второй

Видео-стрим: www.facebook.com/4CSPb/videos/1849539205375515

|

Метки: author Wargaming разработка игр блог компании wargaming трансляция |

CGLayout — новая система автоматического layout'а в iOS |

CGLayout — новая система автоматического layout'а в iOS

Привет Хабр!

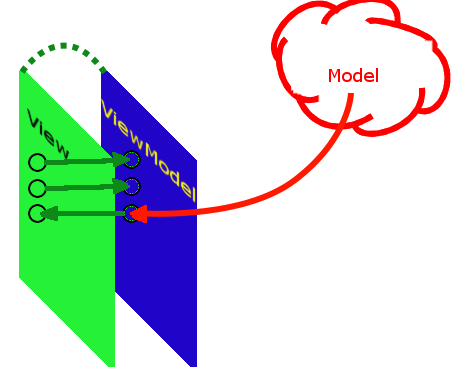

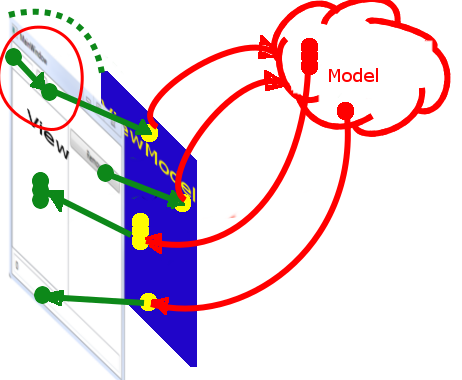

Хочу представить мою последнюю open-source разработку — CGLayout — вторая система разметки в iOS после Autolayout, основанная на ограничениях.

"Очередная система автолайаута… Зачем? Для чего?" — наверняка подумали вы.

Действительно iOS сообществом создано уже немало layout-библиотек, но ни одна так и не стала по-настоящему массовой альтернативой ручному layout`у, не говоря уже про Autolayout.

CGLayout работает с абстрактными сущностями, что позволяет одновременно использовать UIView, CALayer и not rendered объекты для построения разметки. Также имеет единое координатное пространство, что позволяет строить зависимости между элементами, находящимися на разных уровнях иерархии. Умеет работать в background потоке, легко кешируется, легко расширяется и многое-многое другое.

CGLayout функциональный продукт, у которого есть хорошие перспективы развиться в большой проект.

Но изначально цель была банальна, как и обычно, просто упростить себе жизнь.

Всем иногда приходится писать ручной layout, либо из-за плохой производительности Autolayout, либо из-за сложной логики. Поэтому постоянно писались какие-то расширения (а-ля setFrameThatFits и т.д.)

В процессе реализации таких расширений возникают идеи более сложного порядка, но из-за отсутствия времени, как обычно, это все остается в рамках записи в Trello и висит там вечность.

Но когда ты наконец добрался до реализации и не видно горизонта, тебя затягивает, и остановиться уже нереально. Все-таки я надеюсь время было потрачено не зря и мое решение облегчит кому-то жизнь, если не функциональностью фреймворка, то примером кода.

Помимо рассказа о своем решении, я попробую проанализировать и сравнить другие фреймворки, поэтому думаю скучно не будет.

Сравнение

Функциональность

| Требования | FlexLayout | ASDK (Texture) | LayoutKit | Autolayout | CGLayout |

|---|---|---|---|---|---|

| Производительность | + | + | + | - | + |

| Кешируемость | + | + | + | +- | + |

| Мультипоточность | - | + | + | - | + |

| Cross-hierarchy layout | - | - | - | + | + |

| Поддержка CALayer и 'not rendered' вью | - | + | - | - | + |

| Расширяемость | - | + | + | - | + |

| Тестируемость | + | + | + | + | + |

| Декларативный | + | + | + | + | + |

Какие-то показатели могут быть субъективны, т.к. я не использовал эти фреймворки в production. Если я ошибся, поправьте меня пожалуйста.

Производительность

Для тестирования использовался LayoutFrameworkBenchmark.

AsyncDisplayKit не добавлен в график в силу того, что он не был включен разработчиком бенчмарка, да и ASDK осуществляет layout в бэкграунде, что не совсем честно для измерений производительности. В качестве альтернативы можно посмотреть приложение Pinterest. Производительность там действительно впечатляющая.

Анализ

Про многие фреймворки уже есть много информации, я лишь поделюсь своим мнением. Я буду говорить в основном о негативных моментах, потому что они бросаются в глаза сразу, а плюсы описаны на страницах фреймворков.

LayoutKit

Github 25 issues

Не очень гибкий, требует написания большого количества кода, и достаточно большого включения программиста в реализацию. Не нашел информации об использовании LayoutKit'а в каких-то других приложениях, кроме самого LinkedIn.

И все-таки есть мнение, что LayoutKit не достиг своей цели, лента в приложении LinkedIn все равно тормозит.

Особенности:

- Под каждую нестандартную разметку необходимо создавать субкласс с реализацией этого layout'а.

- Ядро системы занимается созданием вью и их переиспользованием. Все вью крутятся в кеше, что может сломать ссылочную целостность при использовании внешней ссылки на вью. Да и в принципе вью недоступны через публичный интерфейс.

- Layout блоки (такие как LabelLayout) дублируют много информации о представлении. При их инициализации нужно задавать дефолтные значения (текста и т.д)

- Нет гибкости в создании относительных зависимостей между элементами.

FlexLayout (aka YogaKit)

Предоставляет возможность заниматься только layout'ом. Никаких других плюшек, фишек нет.

Особенности:

- Нет возможности закешировать layout. Можно получить только размер.

- Не нативная реализация. API больше подходящее для кроссплатформерных разработчиков, веб-разработчиков.

- Проблемы с изменением размера экрана — приходится вручную изменять размер layout-объекта и делать пересчет.

- Требует создания лишних вью при организации layout-блоков.

AsyncDisplayKit (Texture)

В Facebook пошли путем создания потокобезопасной абстракции более высокого уровня. Что вызвало необходимость реализовывать весь стек инструментов UIKit. Тяжелая библиотека, если вы решили ее использовать, отказаться потом от нее будет невозможно. Но все-таки это пока самое грамотное и развитое open-source решение.

Особенности:

- Не совместим с другими layout-фреймворками, кроме встроенного Yoga.

- Требует использования ASDisplayNode субклассы. По сути исключая работу с UIKit. Решив работать с ASDK можно забыть про другие средства, привыкайте писать вместо UI…, AS… .

- Собственная реализация большого количества UIKit механизмов, что может привести к устареванию кода и больших расхождений с реализацией от Apple, багам не связанным с релизами Apple.

- Дорогая поддержка.

- Мало информации связанных с решением проблем. Поиск на StackOverflow со строкой "AsyncDisplayKit" находит 181 совпадений (для сравнения “UIKit” — 66,550).

CGLayout

- Использование как на уровне UIView, так и на уровне CALayer. Можно комбинировать и ограничивать вью по положению layer'а и наоборот. Возможность использовать

not renderedобъекты. - Переиспользование layout-спецификации для разных объектов.

- Возможность создания cross-hierarchy зависимостей.

- Строгая типизация.

- Кеширование разметки через получение snapshot'ов.

- Создание кастомных ограничений независимых от окружения. Например ограничение по размеру строки для лейбла.

- Поддержка layout guides и легкое создание плейсхолдеров для вью.

- Поддерживает любой доступный layout (прямой, background, кэшированный).

- Простая интеграция с UIKit.

- Легко расширяемая.

Текущие ограничения:

- Программисту необходимо думать о последовательности при определении layout-схемы и применении ограничений.

- Расчет разметки UIView, используя

layerсвойство ведет к неопределенному поведению, так какframeу UIView изменяется неявно и побочные действия (такие как drawRect, layoutSubviews) не вызываются. При этомlayerUIView спокойно можно использовать как ограничение для другого layer'а. - В случае получения snapshot для фрейма, отличающегося от текущего значения

boundsв супервью и наличии ограничений, основанных на супервью, может приводить к неожидаемому результату. - Пока не очень приспособлен к сложному layout'у с вероятностными ограничениями.

- Расчет разметки с ограничениями между UIView и CALayer медленный из-за необходимости конвертировать координаты с моей реализацией.

Что пока не реализовано:

- Поддержка RTL.

- Поведение при удалении вью из иерархии.

- Поддержка macOS, tvOS.

- Поддержка trait-коллекций.

- Нет удобной конструкций для выполнения разметки переиспользуемых вью.

- Динамическое изменение текущей layout-конфигурации.

Реализация CGLayout

CGLayout построен на современных принципах языка Swift.

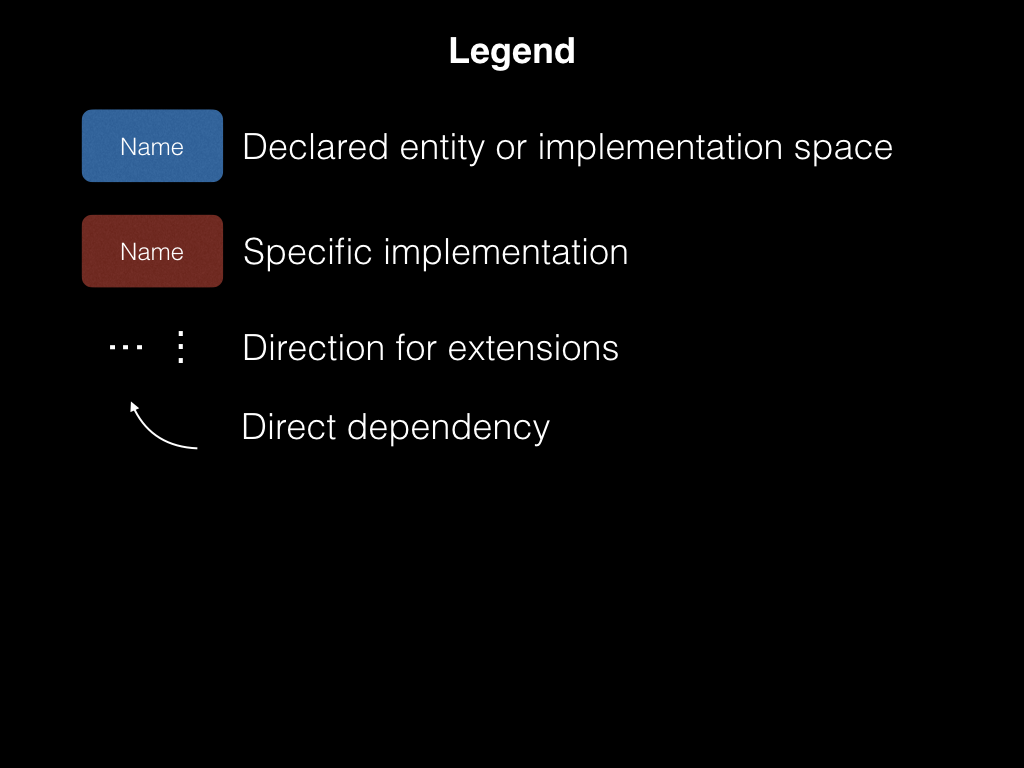

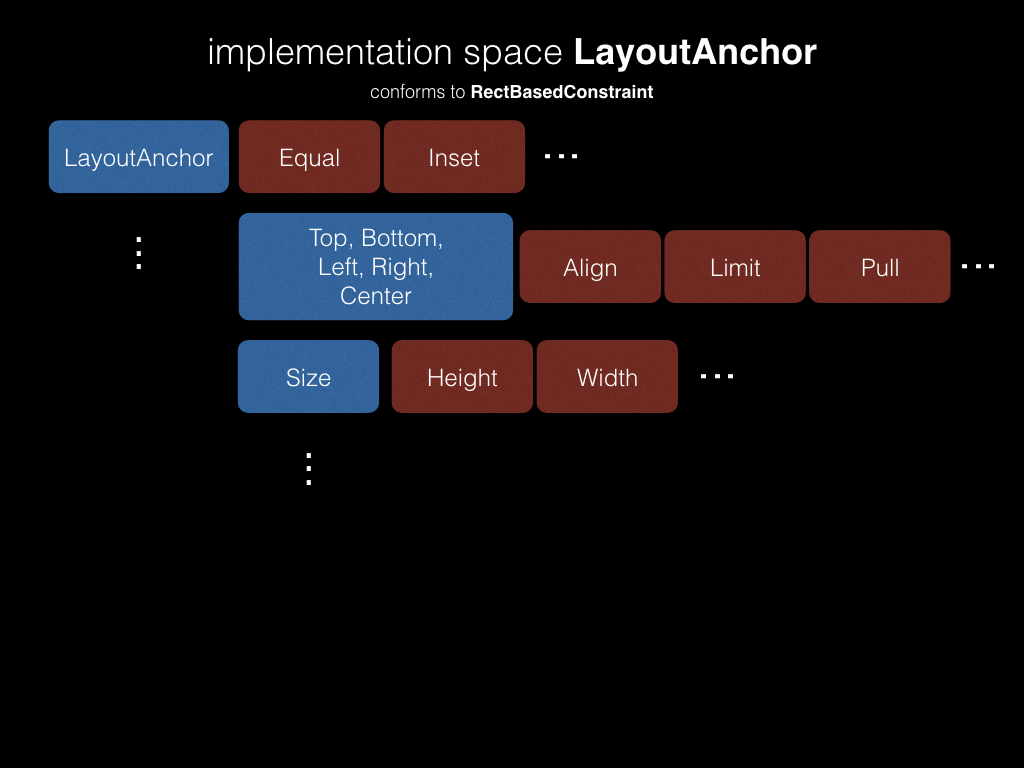

Реализация управления разметкой в CGLayout базируется на трех базовых протоколах: RectBasedLayout, RectBasedConstraint, LayoutItem.

Все сущности имплементирующие LayoutItem я буду называть layout-элементами, все остальные сущности просто layout-сущностями.

Основная разметка

public protocol RectBasedLayout {

func layout(rect: inout CGRect, in source: CGRect)

}RectBasedLayout — декларирует поведение для изменения разметки и определяет для этого один метод, с возможностью ориентирования относительно доступного пространства.

Структура Layout, имплементирующая протокол RectBasedLayout, определяет полную и достаточную разметку для layout-элемента, т.е. позиционирование и размеры.

Соответственно, Layout разделяется на два элемента выравнивание Layout.Alignment и заполнение Layout.Filling. Они в свою очередь состоят из горизонтального и вертикального лайаута. Все составные элементы реализуют RectBasedLayout. Что позволяет использовать элементы лайаута разного уровня сложности для реализации разметки. Все лайаут сущности легко могут быть расширены вашими имплементациями.

Ограничения

Все ограничения реализуют RectBasedConstraint. Если сущности RectBasedLayout определяют разметку в доступном пространстве, то сущности RectBasedConstraint это доступное пространство определяют.

public protocol RectBasedConstraint {

func constrain(sourceRect: inout CGRect, by rect: CGRect)

}LayoutAnchor содержит конкретные ограничители (сторона, размер и т.д.), имеющие абстрагированное от окружения поведение.

В данный момент реализованы основные ограничители.

Layout constraints

public protocol LayoutConstraintProtocol: RectBasedConstraint {

var isIndependent: Bool { get }

func layoutItem(is object: AnyObject) -> Bool

func constrainRect(for currentSpace: CGRect, in coordinateSpace: LayoutItem) -> CGRect

}Определяют зависимость от layout-элемента или контента (текст, картинка и т.д.). Являются самодостаточными ограничениями, которые содержат всю информацию об источнике ограничения и применяемых ограничителях.

LayoutConstraint — ограничение, связанное с layout-элементом с определенным набором ограничителей.

AdjustLayoutConstraint — ограничение, связанное с layout-элементом, содержит size-based ограничители. Доступен для layout-элементов, поддерживающих AdjustableLayoutItem протокол.

Layout-элементы

public protocol LayoutItem: class, LayoutCoordinateSpace {

var frame: CGRect { get set }

var bounds: CGRect { get set }

weak var superItem: LayoutItem? { get }

}Его реализуют такие классы как UIView, CALayer, а также not rendered классы. Также вы можете реализовать другие классы, например stack view.

Во фреймворке есть реализация LayoutGuide. Это аналог UILayoutGuide из UIKit, но с возможностью фабрики layout-элементов. Что позволяет использовать LayoutGuide в качестве плейсхолдера, что довольно актуально в свете последних дизайн решений. В частности для этих целей создан класс ViewPlaceholder. Он реализует такой же паттерн загрузки вью как и UIViewController. Поэтому работа с ним будет очень знакомой.

Для элементов, которые могут рассчитать свой размер задекларирован протокол:

public protocol AdjustableLayoutItem: LayoutItem {

func sizeThatFits(_ size: CGSize) -> CGSize

}По умолчанию его реализуют только UIView.

Layout coordinate space

public protocol LayoutCoordinateSpace {

func convert(point: CGPoint, to item: LayoutItem) -> CGPoint

func convert(point: CGPoint, from item: LayoutItem) -> CGPoint

func convert(rect: CGRect, to item: LayoutItem) -> CGRect

func convert(rect: CGRect, from item: LayoutItem) -> CGRect

var bounds: CGRect { get }

var frame: CGRect { get }

}Система лайаута имеет объединенную координатную систему представленную в виде протокола LayoutCoordinateSpace.

Она создаёт единый интерфейс для всех layout-элементов, при этом используя основные реализации каждого из типов (UIView, CALayer, UICoordinateSpace + собственная реализация для кросс-конвертации).

Layout-блоки

public protocol LayoutBlockProtocol {

var currentSnapshot: LayoutSnapshotProtocol { get }

func layout()

func snapshot(for sourceRect: CGRect) -> LayoutSnapshotProtocol

func apply(snapshot: LayoutSnapshotProtocol)

}Layout-блок является законченной и самостоятельной единицей макета. Он определяет методы для выполнения разметки, получения/применения snapshot`а.

LayoutBlock инкапсулирует layout-элемент, его основной лайаут и ограничения, реализующие LayoutConstraintProtocol.

Процесс актуализации разметки начинается с определения доступного пространства с помощью ограничений. Следует учитывать, что система пока никак решает проблем с конфликтными ограничениями и никак их не приоритезирует, поэтому следует внимательно подходить к применению ограничений. Так в общем случае, ограничения основанные на размере (AdjustLayoutConstraint) следует ставить после ограничений, основанных на позиционировании. В качестве исходного пространства берется пространство супервью (bounds). Каждое ограничение изменяет доступное пространство (обрезает, смещает, растягивает и т.д.). После того как ограничения отработали, полученное пространство передается в Layout, где и рассчитывается актуальная разметка для элемента.

LayoutScheme — блок, который объединяет другие лайаут блоки и определяет корректную последовательность для выполнения разметки.

Layout snapshot

public protocol LayoutSnapshotProtocol {

var snapshotFrame: CGRect { get }

var childSnapshots: [LayoutSnapshotProtocol] { get }

}LayoutSnapshot — снимок представленный в виде набора фреймов, сохраняя иерархию layout-элементов.

Extended

Все расширяемые элементы реализуют протокол Extended.

public protocol Extended {

associatedtype Conformed

static func build(_ base: Conformed) -> Self

}Таким образом, при расширении функционала вы можете использовать уже определенный в CGLayout тип, для построения строго типизированного интерфейса.

Пример использования

CGLayout почти не отличается от ручного лайаута в смысле построения последовательности актуализации фреймов. Реализуя разметку в CGLayout программист обязан помнить, о том, что все ограничения до начала работы должны оперировать актуальными фреймами, иначе результат будет неожидаемым.

let leftLimit = LayoutAnchor.Left.limit(on: .outer)

let topLimit = LayoutAnchor.Top.limit(on: .inner)

let heightEqual = LayoutAnchor.Size.height()

...

let layoutScheme = LayoutScheme(blocks: [

distanceLabel.layoutBlock(with: Layout(x: .center(), y: .bottom(50),

width: .fixed(70), height: .fixed(30))),

separator1Layer.layoutBlock(with: Layout(alignment: separator1Align, filling: separatorSize),

constraints: [distanceLabel.layoutConstraint(for: [leftLimit, topLimit, heightEqual])])

...

])

...

override public func viewDidLayoutSubviews() {

super.viewDidLayoutSubviews()

layoutScheme.layout()

}В этом примере сепаратор использует ограничения по distanceLabel, после того, как определено положение этого лейбла.

Итоги

Autolayout пока остаётся основным инструментом лайаута в силу своей стабильности, хорошего API и мощной поддержкой. Но сторонние решения могут помочь решить частные проблемы, в силу своей узкой направленности или гибкости.

CGLayout имеет не совсем привычную логику описания процесса layout'а, поэтому требует привыкания.

Тут еще много работы, но это вопрос времени, при этом уже сейчас видно, что он имеет ряд преимуществ, которые должны ему позволить занять свою нишу в области подобных систем. Работа фреймворка ещё не тестировалось в production, и у вас есть возможность попробовать это сделать. Фреймворк покрыт тестами, поэтому больших проблем возникнуть не должно.

Надеюсь на ваше активное участие в дальнейшей разработке фреймворка.

И в конце хотелось бы поинтересоваться у хабра-юзеров:

Какие требования предъявляете вы к layout-системам?

Что вам больше всего не нравится делать при построении верстки?

|

Метки: author K-o-D-e-N разработка под ios разработка мобильных приложений swift open source ios layout uikit uiview calayer cglayout autolayout |

MikroTik — несколько адресов и несколько разных MAC на одном интерфейсе |

MikroTik — несколько адресов и несколько разных MAC на одном интерфейсе

Нечасто, но с завидной периодичностью на профильных форумах возникал один и тот же вопрос: «как на одном интерфейсе роутера MikroTik получить два IP-адреса с разными MAC?». Обычно этот вопрос остается без ответа, либо вопрошающему отвечают «никак». И действительно, задача нетривиальная. В стандартной конфигурации соблюдается правило «1 интерфейс = 1 MAC». В этой статье я расскажу как обойти это ограничение используя расширенный функционал MikroTik.

Сначала вспомним матчасть RouterBoard. Помимо маршрутизации, устройства MikroTik могут выполнять и коммутацию. Для этого некоторые из них имеют отдельный свитч-чип, а также возможность объединять интерфейсы с помощью программного коммутатора — bridge. Bridge (в русской терминологии «мост») производит коммутацию пакетов за счёт ресурсов процессора устройства. С помощью моста также объединяют между собой разнородные ethernet-образные инетрфейсы — ethernet, wlan, vlan, eoip, vpls.

Мост в иерархии интерфейсов микротик является более высокой, объединяющей сущностью. При объединении интерфейсов с помощью моста, на него устанавливается MAC-адрес, который будет транслироваться во все подчиненные (slave) интерфейсы. MAC-адреса подчиненных интерфейсов перестают использоваться и заменяются в исходящих фреймах MAC-адресом моста. Соответственно, IP-адрес и все службы связанные с протоколом IP должны быть привязаны НЕ к зависимым интерфейсам, а к вышестоящему мосту.

За счёт того, что мост реализован ресурсами CPU, он имеет очень широкий функционал по управлению трафиком. Фильтрация входящих и транзитных пакетов, а также возможность трансляции MAC-адресов сразу привлекли моё внимание. Итак, инструментом решения задачи будет bridge, точнее bridge NAT.

Приступим. У нашего подопытного маршрутизатора есть внутренний мост «bridge-local», которому присвоен адрес 192.0.2.1/24 и который является шлюзом для компьютеров локальной сети. Для «bridge-local» администратором назначен MAC D4:CA:6D:C7:11:11 Физический интерфейс Ether2 является одним из подчиненных (slave) портов моста «bridge-local» и непосредственно соединяется с локальной сетью.

Задача: добавить на маршрутизатор адрес из той же IP-подсети, но с другим MAC-адресом. Для примера выбрано сочетание IP 192.0.2.111/24 и MAC: D4:CA:6D:C7:22:22

Поскольку в лоб правило «1 интерфейс = 1 MAC» преодолеть нельзя, мы пойдем в обход. Для начала создадим вспомогательный интерфейс «bridge111» куда навесим дополнительный IP-адрес и MAC:

/interface bridge add admin-mac=D4:CA:6D:C7:22:22 auto-mac=no name=bridge111 protocol-mode=none

Теперь разбираемся, что, откуда и куда нужно будет подменять используя мост. Для этого заглянем в описание протокола ARP: ru.wikipedia.org/wiki/ARP#.D0.9F.D1.80.D0.B8.D0.BD.D1.86.D0.B8.D0.BF_.D1.80.D0.B0.D0.B1.D0.BE.D1.82.D1.8B

Очевидно, что нам нужно перехватывать ARP-запросы узлов запрашивающих MAC устройства имеющего IP 192.0.2.111. Для этого в NAT существует отдельный action «arp-reply»:

/interface bridge nat add action=arp-reply arp-dst-address=192.0.2.111/32 chain=dstnat dst-mac-address=FF:FF:FF:FF:FF:FF/FF:FF:FF:FF:FF:FF in-bridge=bridge-local mac-protocol=arp to-arp-reply-mac-address=D4:CA:6D:C7:22:22

Попытка выполнить с компьютера команду «ping 192.0.2.111» явного результата не дала, однако при просмотре на компьютере локальной arp-таблицы стало видно сопоставление нового IP-адреса с новым MAC. Получается протокол ARP мы победили.

Переходим к следующему шагу — нам нужно добиться связности по IP. Для этого захватываем пакеты идущие на дополнительную пару MAC+IP:

/interface bridge add action=redirect chain=dstnat dst-address=192.0.2.111/32 in-bridge=bridge-local mac-protocol=ip

После этой команды появляется некое подобие связности. Локальная ARP-таблица компьютера содержит две записи — по одной для каждой пары MAC+IP. MAC-адреса в ней различаются, так как мы и хотели. Пинг до адреса 192.0.2.111 и ответы исправно прилетают.

Но давайте посмотрим на принятые пакеты через wireshark:

Мы видим, что echo-ответы идут с MAC-адреса D4:CA:6D:C7:11:11, связанного с первым IP-адресом 192.0.2.1. И хотя связность есть, решение является незаконченным. Нам необходимо также подменять MAC-адреса в исходящих от роутера пакетах, имеющих src-ip 192.0.2.111. Сделаем это:

/interface bridge nat add action=src-nat chain=srcnat mac-protocol=ip src-address=192.0.2.111/32 src-mac-address=D4:CA:6D:C7:11:11/FF:FF:FF:FF:FF:FF to-src-mac-address=D4:CA:6D:C7:22:22

Вот, теперь пакеты в сети выглядят правильно — имеют правильное сочетание src-IP и src-MAC:

В окошке winbox настроенные правила преобразования выглядят так:

Аналогичным способом на интерфейс можно добавить сколько угодно дополнительных IP, каждый со своим MAC прописывая соответствующие правила трансляции адресов. Маскарад вам в помощь.

Update: добавил результаты теста с включенным и с выключенным Bridge L2-NAT.

Для теста использовался RB951Ui-2HnD с процессором AR9344. Загрузка процессора изменяется незначительно, в пределах погрешности измерительных инструментов. В среднем рост составил 2% на 100M интерфейсе.

L2-NAT выключен:

L2-NAT включён:

|

Метки: author nkusnetsov системное администрирование сетевые технологии it- инфраструктура mikrotik routeros arp mac nat bridging |

Автоматизация по сбору данных о росте таблиц и файлов всех баз данных |

Автоматизация по сбору данных о росте таблиц и файлов всех баз данных

- Tutorial

Предисловие

Часто возникает потребность контролировать рост всех таблиц и файлов всех баз данных.

В данной статье будет рассмотрен пример того, как можно автоматизировать сбор данных о росте таблиц и файлов баз данных.

Решение

1) Создадим представление о размерах всех таблиц для каждой БД (базы данных):

USE [НАЗВАНИЕ_БАЗЫ_ДАННЫХ]

GO

SET ANSI_NULLS ON

GO

SET QUOTED_IDENTIFIER ON

GO

CREATE view [inf].[vTableSize] as

with pagesizeKB as (

SELECT low / 1024 as PageSizeKB

FROM master.dbo.spt_values

WHERE number = 1 AND type = 'E'

)

,f_size as (

select p.[object_id],

sum([total_pages]) as TotalPageSize,

sum([used_pages]) as UsedPageSize,

sum([data_pages]) as DataPageSize

from sys.partitions p join sys.allocation_units a on p.partition_id = a.container_id

left join sys.internal_tables it on p.object_id = it.object_id

WHERE OBJECTPROPERTY(p.[object_id], N'IsUserTable') = 1

group by p.[object_id]

)

,tbl as (

SELECT

t.[schema_id],

t.[object_id],

i1.rowcnt as CountRows,

(COALESCE(SUM(i1.reserved), 0) + COALESCE(SUM(i2.reserved), 0)) * (select top(1) PageSizeKB from pagesizeKB) as ReservedKB,

(COALESCE(SUM(i1.dpages), 0) + COALESCE(SUM(i2.used), 0)) * (select top(1) PageSizeKB from pagesizeKB) as DataKB,

((COALESCE(SUM(i1.used), 0) + COALESCE(SUM(i2.used), 0))

- (COALESCE(SUM(i1.dpages), 0) + COALESCE(SUM(i2.used), 0))) * (select top(1) PageSizeKB from pagesizeKB) as IndexSizeKB,

((COALESCE(SUM(i1.reserved), 0) + COALESCE(SUM(i2.reserved), 0))

- (COALESCE(SUM(i1.used), 0) + COALESCE(SUM(i2.used), 0))) * (select top(1) PageSizeKB from pagesizeKB) as UnusedKB

FROM sys.tables as t

LEFT OUTER JOIN sysindexes as i1 ON i1.id = t.[object_id] AND i1.indid < 2

LEFT OUTER JOIN sysindexes as i2 ON i2.id = t.[object_id] AND i2.indid = 255

WHERE OBJECTPROPERTY(t.[object_id], N'IsUserTable') = 1

OR (OBJECTPROPERTY(t.[object_id], N'IsView') = 1 AND OBJECTPROPERTY(t.[object_id], N'IsIndexed') = 1)

GROUP BY t.[schema_id], t.[object_id], i1.rowcnt

)

SELECT

@@Servername AS Server,

DB_NAME() AS DBName,

SCHEMA_NAME(t.[schema_id]) as SchemaName,

OBJECT_NAME(t.[object_id]) as TableName,

t.CountRows,

t.ReservedKB,

t.DataKB,

t.IndexSizeKB,

t.UnusedKB,

f.TotalPageSize*(select top(1) PageSizeKB from pagesizeKB) as TotalPageSizeKB,

f.UsedPageSize*(select top(1) PageSizeKB from pagesizeKB) as UsedPageSizeKB,

f.DataPageSize*(select top(1) PageSizeKB from pagesizeKB) as DataPageSizeKB

FROM f_size as f

inner join tbl as t on t.[object_id]=f.[object_id]

GO

2) Создадим специальную БД и в ней определим таблицу для хранения информации по росту всех таблиц всех БД:

USE [НАЗВАНИЕ_БАЗЫ_ДАННЫХ]

GO

SET ANSI_NULLS ON

GO

SET QUOTED_IDENTIFIER ON

GO

SET ANSI_PADDING ON

GO

CREATE TABLE [srv].[TableStatistics](

[Row_GUID] [uniqueidentifier] NOT NULL CONSTRAINT [DF_TableStatistics_Row_GUID] DEFAULT (newid()),

[ServerName] [nvarchar](255) NOT NULL,

[DBName] [nvarchar](255) NOT NULL,

[SchemaName] [nvarchar](255) NOT NULL,

[TableName] [nvarchar](255) NOT NULL,

[CountRows] [bigint] NOT NULL,

[DataKB] [int] NOT NULL,

[IndexSizeKB] [int] NOT NULL,

[UnusedKB] [int] NOT NULL,

[ReservedKB] [int] NOT NULL,

[InsertUTCDate] [datetime] NOT NULL CONSTRAINT [DF_TableStatistics_InsertUTCDate] DEFAULT (getutcdate()),

[Date] AS (CONVERT([date],[InsertUTCDate])) PERSISTED,

[CountRowsBack] [bigint] NULL,

[CountRowsNext] [bigint] NULL,

[DataKBBack] [int] NULL,

[DataKBNext] [int] NULL,

[IndexSizeKBBack] [int] NULL,

[IndexSizeKBNext] [int] NULL,

[UnusedKBBack] [int] NULL,

[UnusedKBNext] [int] NULL,

[ReservedKBBack] [int] NULL,

[ReservedKBNext] [int] NULL,

[AvgCountRows] AS ((([CountRowsBack]+[CountRows])+[CountRowsNext])/(3)) PERSISTED,

[AvgDataKB] AS ((([DataKBBack]+[DataKB])+[DataKBNext])/(3)) PERSISTED,

[AvgIndexSizeKB] AS ((([IndexSizeKBBack]+[IndexSizeKB])+[IndexSizeKBNext])/(3)) PERSISTED,

[AvgUnusedKB] AS ((([UnusedKBBack]+[UnusedKB])+[UnusedKBNext])/(3)) PERSISTED,

[AvgReservedKB] AS ((([ReservedKBBack]+[ReservedKB])+[ReservedKBNext])/(3)) PERSISTED,

[DiffCountRows] AS (([CountRowsNext]+[CountRowsBack])-(2)*[CountRows]) PERSISTED,

[DiffDataKB] AS (([DataKBNext]+[DataKBBack])-(2)*[DataKB]) PERSISTED,

[DiffIndexSizeKB] AS (([IndexSizeKBNext]+[IndexSizeKBBack])-(2)*[IndexSizeKB]) PERSISTED,

[DiffUnusedKB] AS (([UnusedKBNext]+[UnusedKBBack])-(2)*[UnusedKB]) PERSISTED,

[DiffReservedKB] AS (([ReservedKBNext]+[ReservedKBBack])-(2)*[ReservedKB]) PERSISTED,

[TotalPageSizeKB] [int] NULL,

[TotalPageSizeKBBack] [int] NULL,

[TotalPageSizeKBNext] [int] NULL,

[UsedPageSizeKB] [int] NULL,

[UsedPageSizeKBBack] [int] NULL,

[UsedPageSizeKBNext] [int] NULL,

[DataPageSizeKB] [int] NULL,

[DataPageSizeKBBack] [int] NULL,

[DataPageSizeKBNext] [int] NULL,

[AvgDataPageSizeKB] AS ((([DataPageSizeKBBack]+[DataPageSizeKB])+[DataPageSizeKBNext])/(3)) PERSISTED,

[AvgUsedPageSizeKB] AS ((([UsedPageSizeKBBack]+[UsedPageSizeKB])+[UsedPageSizeKBNext])/(3)) PERSISTED,

[AvgTotalPageSizeKB] AS ((([TotalPageSizeKBBack]+[TotalPageSizeKB])+[TotalPageSizeKBNext])/(3)) PERSISTED,

[DiffDataPageSizeKB] AS (([DataPageSizeKBNext]+[DataPageSizeKBBack])-(2)*[DataPageSizeKB]) PERSISTED,--показывает как изменяется само приращение

[DiffUsedPageSizeKB] AS (([UsedPageSizeKBNext]+[UsedPageSizeKBBack])-(2)*[UsedPageSizeKB]) PERSISTED,--показывает как изменяется само приращение

[DiffTotalPageSizeKB] AS (([TotalPageSizeKBNext]+[TotalPageSizeKBBack])-(2)*[TotalPageSizeKB]) PERSISTED,--показывает как изменяется само приращение

CONSTRAINT [PK_TableStatistics] PRIMARY KEY CLUSTERED

(

[Row_GUID] ASC

)WITH (PAD_INDEX = OFF, STATISTICS_NORECOMPUTE = OFF, IGNORE_DUP_KEY = OFF, ALLOW_ROW_LOCKS = ON, ALLOW_PAGE_LOCKS = ON) ON [PRIMARY]

) ON [PRIMARY]

GO

SET ANSI_PADDING ON

GO

За сам размер таблицы отвечает TotalPageSizeKB.

Сумма TotalPageSizeKB всех таблиц БД+размер системных таблиц=размеру данных БД.

3) Определим процедуру сбора информации:

USE [НАЗВАНИЕ_БАЗЫ_ДАННЫХ]

GO

SET ANSI_NULLS ON

GO

SET QUOTED_IDENTIFIER ON

GO

CREATE PROCEDURE [srv].[InsertTableStatistics]

AS

BEGIN

SET NOCOUNT ON;

SET TRANSACTION ISOLATION LEVEL READ UNCOMMITTED;

declare @dt date=CAST(GetUTCDate() as date);

declare @dbs nvarchar(255);

declare @sql nvarchar(max);

select [name]

into #dbs

from sys.databases;

while(exists(select top(1) 1 from #dbs))

begin

select top(1)

@dbs=[name]

from #dbs;

set @sql=

N'INSERT INTO [srv].[TableStatistics]

([ServerName]

,[DBName]

,[SchemaName]

,[TableName]

,[CountRows]

,[DataKB]

,[IndexSizeKB]

,[UnusedKB]

,[ReservedKB]

,[TotalPageSizeKB]

,[UsedPageSizeKB]

,[DataPageSizeKB])

SELECT [Server]

,[DBName]

,[SchemaName]

,[TableName]

,[CountRows]

,[DataKB]

,[IndexSizeKB]

,[UnusedKB]

,[ReservedKB]

,[TotalPageSizeKB]

,[UsedPageSizeKB]

,[DataPageSizeKB]

FROM ['+@dbs+'].[inf].[vTableSize];';

exec sp_executesql @sql;

delete from #dbs

where [name]=@dbs;

end

drop table #dbs;

declare @dt_back date=CAST(DateAdd(day,-1,@dt) as date);

;with tbl1 as (

select [Date],

[CountRows],

[DataKB],

[IndexSizeKB],

[UnusedKB],

[ReservedKB],

[ServerName],

[DBName],

[SchemaName],

[TableName],

[TotalPageSizeKB],

[UsedPageSizeKB],

[DataPageSizeKB]

from [srv].[TableStatistics]

where [Date]=@dt_back

)

, tbl2 as (

select [Date],

[CountRows],

[CountRowsBack],

[DataKBBack],

[IndexSizeKBBack],

[UnusedKBBack],

[ReservedKBBack],

[ServerName],

[DBName],

[SchemaName],

[TableName],

[TotalPageSizeKBBack],

[UsedPageSizeKBBack],

[DataPageSizeKBBack]

from [srv].[TableStatistics]

where [Date]=@dt

)

update t2

set t2.[CountRowsBack] =t1.[CountRows],

t2.[DataKBBack] =t1.[DataKB],

t2.[IndexSizeKBBack] =t1.[IndexSizeKB],

t2.[UnusedKBBack] =t1.[UnusedKB],

t2.[ReservedKBBack] =t1.[ReservedKB],

t2.[TotalPageSizeKBBack]=t1.[TotalPageSizeKB],

t2.[UsedPageSizeKBBack] =t1.[UsedPageSizeKB],

t2.[DataPageSizeKBBack] =t1.[DataPageSizeKB]

from tbl1 as t1

inner join tbl2 as t2 on t1.[Date]=DateAdd(day,-1,t2.[Date])

and t1.[ServerName]=t2.[ServerName]

and t1.[DBName]=t2.[DBName]

and t1.[SchemaName]=t2.[SchemaName]

and t1.[TableName]=t2.[TableName];

;with tbl1 as (

select [Date],

[CountRows],

[CountRowsNext],

[DataKBNext],

[IndexSizeKBNext],

[UnusedKBNext],

[ReservedKBNext],

[ServerName],

[DBName],

[SchemaName],

[TableName],

[TotalPageSizeKBNext],

[UsedPageSizeKBNext],

[DataPageSizeKBNext]

from [srv].[TableStatistics]

where [Date]=@dt_back

)

, tbl2 as (

select [Date],

[CountRows],

[DataKB],

[IndexSizeKB],

[UnusedKB],

[ReservedKB],

[ServerName],

[DBName],

[SchemaName],

[TableName],

[TotalPageSizeKB],

[UsedPageSizeKB],

[DataPageSizeKB]

from [srv].[TableStatistics]

where [Date]=@dt

)

update t1

set t1.[CountRowsNext] =t2.[CountRows],

t1.[DataKBNext] =t2.[DataKB],

t1.[IndexSizeKBNext] =t2.[IndexSizeKB],

t1.[UnusedKBNext] =t2.[UnusedKB],

t1.[ReservedKBNext] =t2.[ReservedKB],

t1.[TotalPageSizeKBNext]=t2.[TotalPageSizeKB],

t1.[UsedPageSizeKBNext] =t2.[UsedPageSizeKB],

t1.[DataPageSizeKBNext] =t2.[DataPageSizeKB]

from tbl1 as t1

inner join tbl2 as t2 on t1.[Date]=DateAdd(day,-1,t2.[Date])

and t1.[ServerName]=t2.[ServerName]

and t1.[DBName]=t2.[DBName]

and t1.[SchemaName]=t2.[SchemaName]

and t1.[TableName]=t2.[TableName];

END

GO

Данное решение можно модифицировать с целью собирать со всех нужных экземпляров MS SQL Server данные по размерам таблиц всех БД.

4) Определим представление по собранной информации:

USE [НАЗВАНИЕ_БАЗЫ_ДАННЫХ]

GO

SET ANSI_NULLS ON

GO

SET QUOTED_IDENTIFIER ON

GO

create view [srv].[vTableStatisticsShort] as

with d as (select DateAdd(day,-1,max([Date])) as [Date] from [srv].[TableStatistics])

SELECT t.[ServerName]

,t.[DBName]

,t.[SchemaName]

,t.[TableName]

,t.[CountRows]

,t.[DataKB]

,t.[IndexSizeKB]

,t.[UnusedKB]

,t.[ReservedKB]

,t.[InsertUTCDate]

,t.[Date]

,t.[CountRowsBack]

,t.[CountRowsNext]

,t.[DataKBBack]

,t.[DataKBNext]

,t.[IndexSizeKBBack]

,t.[IndexSizeKBNext]

,t.[UnusedKBBack]

,t.[UnusedKBNext]

,t.[ReservedKBBack]

,t.[ReservedKBNext]

,t.[AvgCountRows]

,t.[AvgDataKB]

,t.[AvgIndexSizeKB]

,t.[AvgUnusedKB]

,t.[AvgReservedKB]

,t.[DiffCountRows]

,t.[DiffDataKB]

,t.[DiffIndexSizeKB]

,t.[DiffUnusedKB]

,t.[DiffReservedKB]

,t.[TotalPageSizeKB]

,t.[TotalPageSizeKBBack]

,t.[TotalPageSizeKBNext]

,t.[UsedPageSizeKB]

,t.[UsedPageSizeKBBack]

,t.[UsedPageSizeKBNext]

,t.[DataPageSizeKB]

,t.[DataPageSizeKBBack]

,t.[DataPageSizeKBNext]

,t.[AvgDataPageSizeKB]

,t.[AvgUsedPageSizeKB]

,t.[AvgTotalPageSizeKB]

,t.[DiffDataPageSizeKB]

,t.[DiffUsedPageSizeKB]

,t.[DiffTotalPageSizeKB]

FROM d

inner join [SRV].[srv].[TableStatistics] as t on d.[Date]=t.[Date]

where t.[CountRowsBack] is not null

and t.[CountRowsNext] is not null

GO

Здесь стоит обратить внимание на Diff. Если он больше 0, то это означает, что таблица с каждым днем все быстрее растет.

Предполагается, что сбор будет производиться 1 раз в 24 часа.

Аналогичным образом можно автоматизировать и сбор роста файлов всех БД, используя следующее представление:

USE [НАЗВАНИЕ_БАЗЫ_ДАННЫХ]

GO

SET ANSI_NULLS ON

GO

SET QUOTED_IDENTIFIER ON

GO

select t2.[DB_Name] as [DBName]

,t1.FileId

,t1.NumberReads

,t1.BytesRead

,t1.IoStallReadMS

,t1.NumberWrites

,t1.BytesWritten

,t1.IoStallWriteMS

,t1.IoStallMS

,t1.BytesOnDisk

,t1.[TimeStamp]

,t1.FileHandle

,t2.[Type_desc]

,t2.[FileName]

,t2.[Drive]

,t2.[Physical_Name]

,t2.[Ext]

,t2.[CountPage]

,t2.[SizeMb]

,t2.[SizeGb]

,t2.[Growth]

,t2.[GrowthMb]

,t2.[GrowthGb]

,t2.[GrowthPercent]

,t2.[is_percent_growth]

,t2.[database_id]

,t2.[State]

,t2.[StateDesc]

,t2.[IsMediaReadOnly]

,t2.[IsReadOnly]

,t2.[IsSpace]

,t2.[IsNameReserved]

,t2.[CreateLsn]

,t2.[DropLsn]

,t2.[ReadOnlyLsn]

,t2.[ReadWriteLsn]

,t2.[DifferentialBaseLsn]

,t2.[DifferentialBaseGuid]

,t2.[DifferentialBaseTime]

,t2.[RedoStartLsn]

,t2.[RedoStartForkGuid]

,t2.[RedoTargetLsn]

,t2.[RedoTargetForkGuid]

,t2.[BackupLsn]

from fn_virtualfilestats(NULL, NULL) as t1

inner join [inf].[ServerDBFileInfo] as t2 on t1.[DbId]=t2.[database_id] and t1.[FileId]=t2.[File_Id]

GO

Результат

В данной статье был рассмотрен пример автоматизации сбора информации по размерам и росту всех таблиц и файлов всех баз данных. Это дает полный контроль над изменением размеров как самих файлов БД, так и ее таблиц, а также вовремя принимать меры по уменьшению таблицы или файла или для увеличения носителя информации (или разбинение информации на несколько носителей).

Источники:

» MSDN

|

Метки: author jobgemws администрирование баз данных ms sql server |

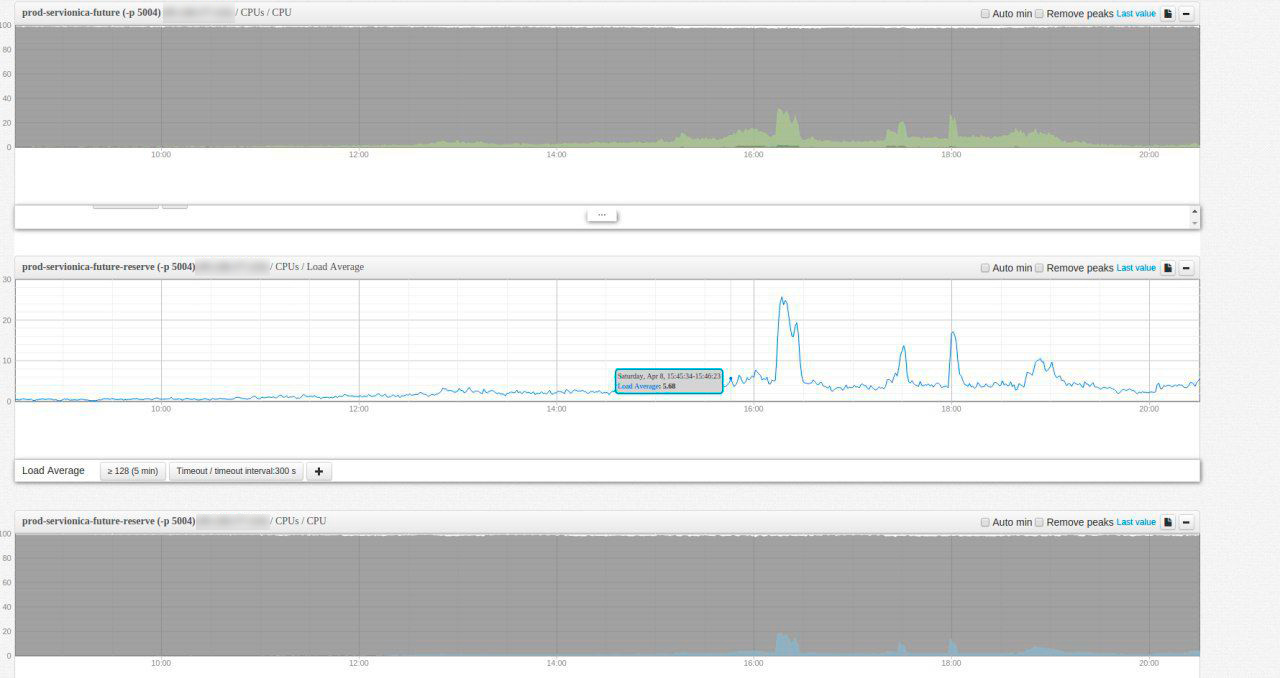

Использование Zabbix для слежения за базой данных |

Использование Zabbix для слежения за базой данных

- Tutorial

Предисловие

Часто возникает потребность в режиме реального времени сообщать администратору о проблемах, связанных с БД (базой данных).

В данной статье будет описано, что необходимо настроить в Zabbix для слежения за базой данных MS SQL Server.

Обращаю внимание на то, что подробно как настраивать приводиться не будет, однако формулы и общие рекомендации, а также подробное описание по добавлению пользовательских элементов данных через хранимые процедуры будут приведены в данной статье.

Также здесь будет рассмотрены только основные счетчики производительности.

Решение

Вначале опишу все те счетчики производительности (через элементы данных в Zabbix), которые нам нужны:

- Logical Disk

- Avg Disc sec/Read

Показывает выраженное в секундах среднее время чтения данных с диска. Среднее значение счетчика производительности Avg. Disk sec/Read не должно превышать 10 миллисекунд. Максимальное значение счетчика производительности Avg. Disk sec/Read не должно превышать 50 миллисекунд.

Zabbix: perf_counter[\LogicalDisk(_Total)\Avg. Disk sec/Read], а также важно проследить за нужным диском, например так: perf_counter[\LogicalDisk(C:)\Avg. Disk sec/Read]

Примеры триггеров:

{НАЗВАНИЕ_УЗЛА:perf_counter[\LogicalDisk(_Total)\Avg. Disk sec/Read].last()}>0.005, уровень-высокий

и

{НАЗВАНИЕ_УЗЛА:perf_counter[\LogicalDisk(_Total)\Avg. Disk sec/Read].last()}>0.0025, уровень-средний

- Avg Disc sec/Write

Показывает выраженное в секундах среднее время записи данных на диск. Среднее значение счетчика производительности Avg. Disk sec/Write не должно превышать 10 миллисекунд. Максимальное значение счетчика производительности Avg. Disk sec/Write не должно превышать 50 миллисекунд.

Zabbix: perf_counter[\LogicalDisk(_Total)\Avg. Disk sec/Write], а также важно проследить за нужным диском, например так: perf_counter[\LogicalDisk(C:)\Avg. Disk sec/Write]

Примеры триггеров:

{НАЗВАНИЕ_УЗЛА:perf_counter[\LogicalDisk(_Total)\Avg. Disk sec/Write].last()}>0.005, уровень-высокий

и

{НАЗВАНИЕ_УЗЛА:perf_counter[\LogicalDisk(_Total)\Avg. Disk sec/Write].last()}>0.0025, уровень-средний - Avg Disk Queue Length

Cредняя длина очереди запросов к диску. Отображает количество запросов к диску, ожидающих обработки в течении определенного интервала времени. Нормальным считается очередь не больше 2 для одиночного диска. Если в очереди больше двух запросов, то возможно диск перегружен и не успевает обрабатывать поступающие запросы. Уточнить, с какими именно операциями не справляется диск, можно с помощью счетчиков Avg. Disk Read Queue Length (очередь запросов на чтение) и Avg. Disk Wright Queue Length (очередь запросов на запись).

Значение Avg. Disk Queue Length не измеряется, а рассчитывается по закону Литтла из математической теории очередей. Согласно этому закону, количество запросов, ожидающих обработки, в среднем равняется частоте поступления запросов, умноженной на время обработки запроса. Т.е. в нашем случае Avg. Disk Queue Length = (Disk Transfers/sec) * (Avg. Disk sec/Transfer).

Avg. Disk Queue Length приводится как один из основных счетчиков для определения загруженности дисковой подсистемы, однако для его адекватной оценки необходимо точно представлять физическую структуру системы хранения. К примеру, для одиночного жесткого диска критическим считается значение больше 2, а если диск располагается на RAID-массиве из 4-х дисков, то волноваться стоит при значении больше 4*2=8.

Zabbix: perf_counter[\LogicalDisk(_Total)\Avg. Disk Queue Length], а также важно проследить за нужным диском, например так: perf_counter[\LogicalDisk(C:)\Avg. Disk Queue Length]

- Avg Disc sec/Read

- Memory

- Pages/sec

Показывает число страниц, которые SQL Server считал с диска или записал на диск для того, чтобы разрешить обращения к страницам памяти, которые не были загружены в оперативную память в момент обращения. Эта величина является суммой величин Pages Input/sec и Pages Output/sec, а также учитывает страничный обмен (подкачку/свопинг) системной кэш-памяти для доступа к файлам данных приложений. Кроме того, сюда включается подкачка не кэшированных файлов, непосредственно отображаемых в память. Это основной счетчик, за которым следует следить в том случае, если наблюдается большая нагрузка на использование памяти и связанный с этим избыточный страничный обмен. Этот счётчик характеризует величину свопинга и его нормальное (не пиковое) значение должно быть близко к нолю. Увеличение свопинга говорит о необходимости наращивания ОЗУ или уменьшения числа исполняемых на сервере прикладных программ.

Zabbix: perf_counter[\Memory\Pages/sec]

Пример триггера:

{НАЗВАНИЕ_УЗЛА:perf_counter[\Memory\Pages/sec].min(5m)}>1000, уровень-информация - Page Faults/sec

Это значение счетчика ошибок страницы. Ошибка страницы возникает, когда процесс ссылается на страницу виртуальной памяти, которая не находится в рабочем множестве оперативной памяти. Данный счетчик учитывает как те ошибки страницы, которые требуют обращения к диску, так и те, которые вызваны нахождением страницы вне рабочего множества в оперативной памяти. Большинство процессоров могут обрабатывать ошибки страницы второго типа без особых задержек. Однако, обработка ошибок страницы первого типа, требующая доступа к диску, может привести к значительным задержкам.

Zabbix: perf_counter[\Memory\Page Faults/sec]

Пример триггера:

{НАЗВАНИЕ_УЗЛА:perf_counter[\Memory\Page Faults/sec].min(5m)}>1000, уровень-информация - Available Bytes

Отслеживает количество доступной памяти в байтах для выполнения различных процессов. Низкие показатели означают нехватку памяти. Решение — увеличить память. Этот счётчик в большинстве случаев должен быть постоянно выше 5000 КВ.

Есть смысл выставлять порог для Available Mbytes вручную из соображений:

•50% свободной памяти доступно = Отлично

•25% доступно памяти = Требует внимания

•10% свободно = Возможны проблемы

•Меньше 5% доступно памяти= Критично для скорости, нужно вмешиваться.

Zabbix: perf_counter[\Memory\Available Bytes]

- Pages/sec

- Processor (Total): % Processor Time

Этот счетчик показывает процентное отношение времени, которое процессор был занят выполнением операций для не простаивающих потоков (non-Idle thread). Эту величину можно рассматривать как долю времени, приходящегося на выполнение полезной работы. Каждый процессор может быть назначен простаивающему потоку, который потребляет непродуктивные циклы процессора, не используемые другими потоками. Для этого счётчика характерны непродолжительные пики, которые могут достигать 100 процентов. Однако, если наблюдаются продолжительные периоды, когда утилизация процессора выше 80 процентов, то система будет более эффективной при использовании большего числа процессоров.

Zabbix: perf_counter[\Processor(_Total)\% Processor Time], здесь же может иметь место по ядрам выводить

Пример триггера:

{НАЗВАНИЕ_УЗЛА:perf_counter[\Processor(_Total)\% Processor Time].min(5m)}>80, уровень-информация

- Network Interface (*): % Bytes Total/sec

Общее количество переданных и полученных байт за секунду по всем интерфейсам. Это пропускная способность интерфейса (в байтах). Необходимо сравнить значение этого счётчика с максимальной пропускной способностью сетевой платы. Вообще, этот счётчик должен показать не более 50% утилизации пропускной способности сетевого адаптера.

Zabbix: perf_counter[\Network Interface(*)\Bytes Sent/sec]

- MS SQL Server: Access Methods

Объект Access Methods (Методы доступа) в SQL Server предоставляет счетчики, помогающие следить за доступом к логическим данным в рамках базы данных. Физический доступ к страницам базы данных на диске контролируется при помощи счетчиков диспетчера буферов. Наблюдение за методами доступа к данным в базе данных помогает определить, можно ли увеличить производительность запросов путем добавления или изменения индексов, добавления или перемещения секций, добавления файлов или групп файлов, дефрагментации индексов или изменения текста запросов. Кроме того, при помощи счетчиков объекта Access Methods можно следить за размером данных, индексов и свободного пространства в базе данных, контролируя объем и фрагментацию для каждого экземпляра сервера. Чрезмерная фрагментация индексов может значительно снизить производительность.

- Page Splits/sec

Количество разбиений страниц в секунду, выполненных в результате переполнения страниц индекса. Большое значение этого показателя означает, что при выполнении операций вставки и изменения данных SQL Server приходится выполнять большое количество ресурсоемких операций по разбиению страниц и переносу части существующей страницы на новое место. Таких операций по возможности следует избегать. Проблему можно попытаться решить двумя способами:

— создать кластерный индекс для столбцов с автоприращением. В этом случае новые записи не будут помещаться внутрь страниц, уже занятых данными, а будут последовательно занимать новые страницы;

— перестроить индексы, увеличив значение параметра Fillfactor. Этот параметр позволяет зарезервировать в страницах индексов свободное место, которое будет использоваться для размещения новых данных, без необходимости производить операции разбиения страниц.

Zabbix: perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:Access Methods\Page Splits/sec",30]

Пример триггера: {НАЗВАНИЕ_УЗЛА:perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:Access Methods\Page Splits/sec",30].last()}>{НАЗВАНИЕ_УЗЛА:perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:SQL Statistics\Batch Requests/sec",30].last()}/5, уровень-информация

- Full Scans/sec

Количество неограниченных операций полного сканирования в секунду. К таким операциям относятся сканирование основной таблицы и полное сканирование индекса. Стабильное повышение этого показателя может свидетельствовать о деградации системы (нехватка нужных индексов, их сильная фрагментация, неиспользование оптимизатором существующих индексов, наличие неиспользуемых индексов). Однако, стоит отметить, что полное сканирование в небольших таблицах невсегда плохо, т к если удается всю таблицу разместить в ОЗУ, то как раз быстрее будет произвести полное сканирование. Но в большинстве случаев стабильный рост показателя этого счетчика будет говорить о деградации системы. Все это применимо только для OLTP-систем. В OLAP-системах постоянные полные сканирования-это нормально.

Zabbix: perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:Access Methods\Full Scans/sec",30]

- Page Splits/sec

- MS SQL Server: Buffer Manager

Объект Buffer Manager (диспетчера буферов) предоставляет счетчики, позволяющие наблюдать за тем, как SQL Server использует следующие ресурсы:

— память для хранения страниц данных;

— счетчики, служащие для мониторинга физического ввода-вывода, когда SQL Server считывает и записывает страницы баз данных;

— расширение буферного пула для расширения буферного кэша с использованием быстрой энергонезависимой памяти, например твердотельных накопителей (SSD);

— мониторинг памяти и счетчиков, используемых SQL Server, помогает получить следующие сведения;

— существуют ли «узкие места», вызванные недостатком физической памяти. Если часто используемые данные не могут быть сохранены в кэше, SQL Server вынужден считывать их с диска;

— можно ли повысить эффективность выполнения запросов, увеличив объем памяти или выделив дополнительную память для кэширования данных или хранения внутренних структур SQL Server;

— насколько часто SQL Server считывает данные с диска. В сравнении с другими операциями, такими как доступ к памяти, физический ввод-вывод выполняется дольше. Уменьшение объема ввода-вывода может повысить производительность выполнения запросов.

- Buffer Cache hit radio

Показывает, насколько полно SQL Server может разместить данные в буфере кэша. Чем выше это значение, тем лучше, т.к. для эффективного обращения SQL сервера к страницам данных, они должны находиться в буфере кэша, и операции физического ввода-вывода (I/O) должны отсутствовать. Если наблюдается устойчивое снижение среднего значения этого счётчика, необходимо рассмотреть возможность добавления ОЗУ. Данный показатель всегда должен быть выше 90% для OLTP-систем и выше 50% для OLAP-систем.

Zabbix: perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:Buffer Manager\Buffer cache hit ratio",30]

Примеры триггеров: {НАЗВАНИЕ_УЗЛА:perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:Buffer Manager\Buffer cache hit ratio",30].last()}<70, уровень-высокий

и

{НАЗВАНИЕ_УЗЛА:perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:Buffer Manager\Buffer cache hit ratio",30].last()}<80, уровень-средний

- Page life expectancy

Показывает, как долго страница будет постоянно находиться в памяти в нынешнем состоянии. Если значение постоянно падает, то это означает, что система злоупотребляет буферным пулом. Таким образом, потенциально работа памяти может вызывать проблемы, приводящие к снижению производительности. Стоит отметить, что не существует универсального показателя, ниже которого можно однозначно судить о том, что система злоупотребляет буферным пулом (показатель в 300 секунд устарел с MS SQL Server 2012).

Zabbix: perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:Buffer Manager\Page life expectancy",30]

Пример триггера: {НАЗВАНИЕ_УЗЛА:perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:Buffer Manager\Page life expectancy",30].last()}<5, уровень-информация

- Buffer Cache hit radio

- MS SQL Server: General Statistics

Объект General Statistics (Общая статистика) в SQL Server предоставляет счетчики, позволяющие наблюдать общую активность сервера, например количество одновременных соединений и количество пользователей в секунду, подключающихся или отключающихся от компьютера, где запущен экземпляр SQL Server. Эти показатели полезно использовать в больших системах оперативной обработки транзакций (OLTP), где большое количество клиентов постоянно подключаются и отключаются от экземпляра SQL Server.

- Process blocked

Количество блокированных в данный момент процессов.

Zabbix: perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:General Statistics\Processes blocked",30]

Пример триггера: ({НАЗВАНИЕ_УЗЛА:perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:General Statistics\Processes blocked",30].min(2m,0)}>=0)

and ({НАЗВАНИЕ_УЗЛА:perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:General Statistics\Processes blocked",30].time(0)}>=50000)

and ({НАЗВАНИЕ_УЗЛА:perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:General Statistics\Processes blocked",30].time(0)}<=230000), уровень-информация (здесь идет ограничение по сигнализации с 05:00 до 23:00)

- User Connections

Количество пользователей, подключенных в данный момент к серверу SQL Server.

Zabbix: perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:General Statistics\User Connections",30]

- Process blocked

- MS SQL Server: Locks

Объект Locks (Блокировки) в Microsoft SQL Server предоставляет сведения о блокировках SQL Server, полученных для отдельных типов ресурсов. Блокировки выдаются на такие ресурсы SQL Server, как прочитанные или измененные транзакцией строки, для предотвращения одновременного использования ресурсов несколькими транзакциями. Например, если исключительная (X) блокировка получена транзакцией на строку в таблице, никакая другая транзакция не сможет изменить эту строку, пока блокировка не будет освобождена. Минимизация использования блокировок повышает параллелизм, что может улучшить общую производительность. Одновременно может отслеживаться несколько экземпляров объекта Locks, каждый из которых будет представлять собой блокировку отдельного вида ресурсов.

- Average Wait Time (ms)

Средняя длительность ожидания (в миллисекундах) для всех запросов блокировки, при которых потребовалось ожидание. Этот счетчик показывает, сколько в среднем процессам пользователей приходится проводить в очереди, чтобы наложить на ресурс блокировку. Максимально допустимое значение этого счетчика полностью зависит от вашей задачи, какое-то среднее значение для всех приложений здесь определить сложно. Слишком высокое значение этого счетчика может означать проблемы с блокировками в вашей базе данных.

Zabbix: perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:Locks(_Total)\Average Wait Time (ms)",30]

Пример триггера: {НАЗВАНИЕ_УЗЛА:perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:Locks(_Total)\Average Wait Time (ms)",30].last()}>=500, уровень-информация

- Lock Wait Time (ms)

Суммарное время ожидания блокировок (в миллисекундах) за последнюю секунду.

Zabbix: perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:Locks(_Total)\Lock Wait Time (ms)",30] - Lock Waits/sec

Количество случаев за последнюю секунду, когда потоку приходилось ожидать в связи с запросом блокировки.

Zabbix: perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:Locks(_Total)\Lock Wait Time (ms)",30] - Lock Timeouts/sec

Количество повторений, когда не удается получить блокировку путем циклического обращения. Значение параметра конфигурирования SQL Server spin counter определяет количество «оборотов» потока (spins), прежде чем истечет время тайм-аута и поток перейдет в неактивное состояние.

Zabbix: perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:Lock Timeouts/sec",30]

Пример триггера: {НАЗВАНИЕ_УЗЛА:perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:Locks(_Total)\Lock Timeouts/sec",30].last()}>1000, уровень-информация - Lock Requests/sec

Количество запросов в секунду указанного типа блокировки.

Zabbix: perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:Lock Requests/sec",30]

Пример триггера: {НАЗВАНИЕ_УЗЛА:perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:Locks(_Total)\Lock Requests/sec",30].last()}>500000, уровень-информация - Lock Number of Deadlocks/sec

Количество запросов блокировки в секунду, приводящих к взаимоблокировке. Наличие взаимоблокировок свидетельствует о неправильно построенных запросах, которые блокируют совместные ресурсы.

Zabbix: perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:Number of Deadlocks/sec",30]

Пример триггера: {НАЗВАНИЕ_УЗЛА:perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:Locks(_Total)\Number of Deadlocks/sec",30].last()}>1, уровень-высокий

- Average Wait Time (ms)

- MS SQL Server: Memory Manager

Объект Memory Manager (Диспетчер памяти) в Microsoft SQL Server обеспечивает счетчики для контроля использования памяти всего сервера. Контроль над использованием памяти всего сервера для оценки действий пользователя и использования ресурсов может помочь идентифицировать нехватку производительности. Контроль над памятью, используемый экземпляром SQL Server, может помочь определить:

— существуют ли нехватки в недостаточной физической памяти для хранения в кэше часто используемых данных. Если памяти недостаточно, SQL Server должен получить данные с диска;

— может ли производительность запроса улучшиться, если будет добавлена память или увеличится объем доступной памяти для кэширования данных или внутренних структур SQL Server.

- Memory Grants Outstending

Указывает общее число процессов, успешно получивших память рабочей области. При стабильном падении показателя, необходимо увеличить ОЗУ.

Zabbix: perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:Memory Manager\Memory Grants Outstanding",30]

- Memory Grants Pending

Указывает общее число процессов, ожидающих предоставления памяти рабочей памяти. При стабильном росте показателя, необходимо увеличить ОЗУ.

Zabbix: perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:Memory Manager\Memory Grants Pending",30]

- Memory Grants Outstending

- MS SQL Server: Statistics

Объект Statistics (Статистика) в Microsoft SQL Server обеспечивает работу счетчиков для наблюдения компиляции и типов запросов, отправляемых экземпляру SQL Server. Наблюдение за числом компиляций и повторных компиляций запросов и числа пакетов, полученных экземпляром SQL Server, дает представление о том, как быстро SQL Server выполняет запросы пользователей и насколько эффективно их обрабатывает оптимизатор запросов.

- Butch Requests/sec

Число пакетов команд Transact-SQL, полученных за секунду. На эту статистику влияют любые ограничения (ввод-вывод, число пользователей, размер кэша, сложность запросов и т. д.). Высокое число запросов пакетов свидетельствует о высокой пропускной способности.

Zabbix: perf_counter["\MSSQL$НАЗВАНИЕ_ЭКЗЕМПЛЯРА:SQL Statistics\Batch Requests/sec",30]

- Butch Requests/sec

Помимо всего выше перечисленного также можно настроить и другие элементы данных (а также и создать триггеры по ним с последующим оповещением).Например:

1) размер свободного места на диске

2) размеры БД-файлов данных и журнала лога

и т. д.

Однако, все эти показатели не показывают проблему именно запросов в реальном времени.

Для этого необходимо создавать свои специальные счетчики.

Из-за соображений конфиденциальности, не буду приводить примеры таких счетчиков. Тем более, что они настраиваются уникально для каждой системы. Но отмечу, что для таких систем как 1С, NAV и CRM специализированные счетчики создать можно совместно с соответствующими разработчиками.

Приведу пример создания обобщенного показателя, который показывает сколько запросов выполняется и сколько запросов ожидают выполнения (приостановлены или заблокированы) на каждый момент времени.

Для этого необходимо создать хранимую процедуру:

USE [ИМЯ_БАЗЫ_ДАННЫХ]

GO

SET ANSI_NULLS ON

GO

SET QUOTED_IDENTIFIER ON

GO

CREATE PROCEDURE [nav].[ZabbixGetCountRequestStatus]

@Status nvarchar(255)

AS

BEGIN

/*

возвращает кол-во запросов с заданным статусом

*/

SET NOCOUNT ON;

select count(*) as [Count]

from sys.dm_exec_requests ER with(readuncommitted)

where [status]=@Status

END

Далее необходимо зайти в папку, где находится Zabbix (zabbix\conf\userparams.d) и создать 2 файла с расширением ps1 (PowerShell) и написать в каждом из них следующие коды:

$SQLServer = "НАЗВАНИЕ_ЭКЗЕМПЛЯРА";

$uid = "ЛОГИН";

$pwd = "ПАРОЛЬ";

$Status="running";

$connectionString = "Server = $SQLServer; Database=НАЗВАНИЕ_БД; Integrated Security = False; User ID = $uid; Password = $pwd;";

$connection = New-Object System.Data.SqlClient.SqlConnection;

$connection.ConnectionString = $connectionString;

#Создаем запрос непосредственно к MSSQL / Create a request directly to MSSQL

$SqlCmd = New-Object System.Data.SqlClient.SqlCommand;

$SqlCmd.CommandType = [System.Data.CommandType]::StoredProcedure;

$SqlCmd.CommandText = "nav.ZabbixGetCountRequestStatus";

$SqlCmd.Connection = $Connection;

$paramStatus=$SqlCmd.Parameters.Add("@Status" , [System.Data.SqlDbType]::VarChar);

$paramStatus.Value = $Status;

$connection.Open();