Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Из песочницы] DI для полностью переиспользуемых JSX-компонентов |

DI для полностью переиспользуемых JSX-компонентов

Привет, меня зовут Сергей и мне интересна проблема переиспользования компонент в вебе. Глядя на то, как пытаются применить SOLID к реакту, я решил продолжить эту тему и показать, как можно достичь хорошей переиспользуемости, развивая идею внедрения зависимостей или DI.

DI как основа для построения фреймворка, применительно к вебу, довольно молодой подход. Что бы тут было понятней о чем идет речь, начну c привычных для react-разработчиков вещей.

От контекстов к DI

Уверен, что многие использовали контексты при работе с react. Если не напрямую, то наверняка через connect в redux или inject в mobx-react. Суть в том, что в одном компоненте (MessageList) мы объявляем нечто в контексте, а в другом (Button) — говорим, что хотим получить это нечто из контекста.

const PropTypes = require('prop-types');

const Button = ({children}, context) =>

;

Button.contextTypes = {color: PropTypes.string};

class MessageList extends React.Component {

getChildContext() {

return {color: "purple"};

}

render() {

return ;

}

}Т.е. один раз в родительском компоненте задается context.color, а далее он автоматически пробрасывается любым нижележащим компонентам, в которых через contextTypes объявлена зависимость от color. Таким образом Button можно кастомизировать без прокидывания свойств по иерархии. Причем на любом уровне иерархии можно через getChildContext() ... переопределить color для всех дочерних компонент.

Такой подход лучше изолирует компоненты друг от друга, упрощая их настройку и переиспользование. В примере выше, достаточно в родительском компоненте определить color и все кнопки поменяют цвет. Причем компонент Button может быть в другой библиотеке, которую при этом не надо рефакторить.

Однако, для реакта, в виду недостаточной продуманности, этот подход пока развит слабо. Напрямую его использовать разработчики не рекомендуют:

It is an experimental API and it is likely to break in future releases of React

написано в документации. Оно experimental в текущем виде уже достаточно давно и ощущение, что разработка зашла в тупик. Контексты в компонентах сцеплены с инфраструктурой (getChildContext), псевдотипизацией через PropTypes и больше похожи на service locator, который некоторые считают антипаттерном. Роль контекстов, на мой взгляд, недооценена и в реакте второстепенная: локализация и темизация, а также биндинги к библиотекам вроде redux и mobx.

В других фреймворках подобные инструменты развиты лучше. Например, в vue: provide/inject, а в angular, его angular di это уже полноценный навороченный DI с поддержкой типов typescript. По-сути, начиная с Angular второй версии, разработчики попытались переосмыслить опыт бэкенда (где DI уже давно существует) применительно к фронтенду. А что если попытаться развить аналогичную идею для реакта и его клонов, какие проблемы бы решились?

Прибивать или нет, вот в чем вопрос

В полноценном реакт/redux-приложении не всё делают через redux-экшены. Состояние какой-нибудь малозначительной галочки удобнее реализовать через setState. Получается — через redux громоздко, а через setState не универсально, но проще, т.к. он всегда под рукой. Статья You Might Not Need Redux известного автора, как бы говорит "если вам не нужно масштабирование — не используйте redux", подтверждая эту двойственность. Проблема в том, что это сейчас не нужно, а завтра может быть понадобится прикрутить логирование состояния галочки.

В другой статье того же автора, Presentational and Container Components, говорится примерно, что "Все компоненты равны (Presentational), но некоторые равнее (Container)" и при этом высечены в граните (прибиты к redux, mobx, relay, setState). Кастомизация Container компонента усложняется — не предполагается его переиспользовать, он уже прибит к реализации состояния и контексту.

Что бы как-то упростить создание Container-компонент, придумали HOC, но по-сути мало что поменялось. Просто чистый компонент стали комбинировать через connect/inject с чем-то вроде redux, mobx, relay. А полученный монолитный Container использовать в коде.

Иными словами, говорим Presentational и Container, а подразумеваем — переиспользуемый и непереиспользуемый. Первый удобно кастомизировать т.к. все точки расширения в свойствах, а второй — рефакторить, т.к свойств меньше, за счет его прибитости к стейту и некоторой логике. Это — некий компромисс по решению двух противоположных проблем, плата за который — разделение компонент на два типа и жертвование принципом открытости/закрытости.

Например, как в статье Заменяй и властвуй — подход SOLID, где предлагается делать большинство компонент максимально простыми, ухудшая их целостность. Но, сложные компоненты из простых все-равно надо будет где-то собирать и при этом остается вопрос как их кастомизировать. Т.е. проблема переносится на другой уровень.

> this.setState({ dialogOpen: false })} />

> this.setState({ dialogOpen: false })} />

Dialog header

Some content

Если все же условиться, что эти оконечные компоненты мы не кастомизируем, то в реальности получается большое кол-во шаблонного кода, когда ради замены одной Button, весь компонент строится заново. Полноценный SOLID при таком подходе невозможен. Всегда будут компоненты-биндинги к стейту, которые нельзя расширить без модификации и компоненты-шаблоны без логики внутри и этим сложные в использовании.

Прототип

Развивая идею внедрения зависимостей, можно решить некоторые из этих проблем. Разберем решение на основе вот такого примера:

// @flow

// @jsx lom_h

// setup...

class HelloService {

@mem name = ''

}

function HelloView(props: {greet: string}, service: HelloService) {

return

{props.greet}, {service.name}

> { service.name = e.target.value }} />

}

// HelloView.deps = [HelloService]

ReactDOM.render(Здесь есть одна универсальная форма компонента в виде функции, независимо от того, работает он с состоянием или нет. Контексты используют типы. Из них автоматически генерируются описания зависимостей с помощью babel-plugin-transform-metadata. Аналогично typescript, который это делает, правда, только для классов. Хотя можно описывать аргументы и вручную: HelloView.deps = [HelloService]

Lifecycle

А как же быть с жизненным циклом компонента? А так ли нужна низкоуровневая работа с ним в коде? Посредством HOC как раз пытаются убрать эти lifecycle methods из основного кода, например, как в relay/graphql.

Идея в том, что актуализация данных — это не ответственность компонента. Если у вас загрузка данных происходит по факту доступа к этим данным (например, используется lazyObservable из mobx-utils), то componentDidMount в этом случае не нужен. Если надо прикрутить jquery-плагин, то есть свойство refs в элементе и т.д.

Предположим, что универсальный компонент, свободный от vendor lock-in реакта, теперь есть. Пусть, мы даже выделили его в отдельную библиотеку. Осталось решить, как расширять и настраивать то, что приходит в контекст. Ведь HelloService — это некая реализация по-умолчанию.

Поди туда — не знаю куда, принеси то — не знаю что

Что если компоненты, в силу частых изменений требований, та часть приложения, где инкапсуляция начинает мешать. Не сама по себе конечно, а в том виде, как она сегодня реализована практически во всех фреймворках: в виде шаблона, композиции функций или JSX.

Представим на секунду, что в случае любого компонента нельзя заранее сказать, что у него будет кастомизироваться. И нужен способ менять любую внутреннюю часть компонента без рефакторинга (принцип открытости/закрытости), при этом не ухудшая его читабельности, не усложняя его исходную реализацию и не вкладываясь в переиспользуемость изначально (нельзя все предвидеть).

Например, без DI можно проектировать, подразумевая кастомизацию через наследование. Т.е. дробить содержимое на мелкие методы, теряя при этом в наглядности и иерархии. О минусах этого подхода пишет автор в статье Идеальный UI фреймворк:

class MyPanel extends React.Component {

header() { return {this.props.head} }

bodier() { return {this.props.body} }

childs() { return [ this.header() , this.bodier() ] }

render() { return {this.childs()}

}class MyPanelExt extends MyPanel {

footer() { return {this.props.foot} }

childs() { return [ this.header() , this.bodier() , this.footer() ] }

}Надо сказать, что этот автор (@vintage), придумал формат tree, который позволяет описать вышеприведенный пример с сохранением иерархии. Несмотря на то, что многие критикуют этот формат, у него есть преимущество как раз в виде переопределяемости даже самых мелких деталей без специального разбиения на части и рефакторинга. Иными словами, это бесплатная (почти, кроме постижения новой необычной концепции) буковка O в SOLID.

Полностью перенести этот принцип на JSX невозможно, однако частично реализовать его через DI можно попытаться. Смысл в том, что любой компонент в иерархии — это еще и точка расширения, слот, если рассуждать в терминах vue. И мы в родительском компоненте можем поменять его реализацию, зная его идентификатор (исходная реализация или интерфейс). Примерно так работают многие контейнеры зависимостей, позволяя ассоциировать реализации с интерфейсами.

В js/ts, в runtime, без усложнений или внедрения строковых ключей, ухудшающих безопасность кода, нельзя ссылаться на интерфейс. Поэтому следующий пример не заработает в flow или typescript (но аналогичный заработает в C# или Dart):

interface ISome {}

class MySome implements ISome {}

const map = new Map()

map.set(ISome, MySome)Однако, можно ссылаться на абстрактный класс или функцию.

class AbstractSome {}

class MySome extends AbstractSome {}

const map = new Map()

map.set(AbstractSome, MySome)Т.к. создание объектов и компонент происходит внутри DI-контейнера, а там внутри может быть подобный map, то любую реализацию можно переопределить. А т.к. компоненты, кроме самых примитивных — функции, то их можно подменять на функции с таким же интерфейсом, но с другой реализацией.

Например, TodoResetButtonView является частью TodoView. Требуется переопределить TodoResetButtonView на кастомную реализацию.

function TodoResetButtonView({onClick}) {

return

}

function TodoView({todo, desc, reset}) {

return

> todo.finished = !todo.finished}

/>{todo.title} #{todo.id} ({desc.title})

reset

}Предположим у нас нет возможности править TodoView (он в другой библиотеке и мы не хотим его трогать, нарушая open/close принцип и заново тестировать 11 других проектов, которые его использовали со старой кнопкой).

Поэтому создаем новую кнопку и клонируем существующий TodoView, заменяя ее в клоне. Это наследование, только наглядность не нарушается — остается иерархия и не нужно специально заранее проектировать TodoView так, что бы можно было заменить кнопку.

function ClonedTodoResetButtonView({onClick}) {

return

}

const ClonedTodoView = cloneComponent(TodoView, [

[TodoResetButtonView, ClonedTodoResetButtonView]

], 'ClonedTodoView')

const ClonedTodoListView = cloneComponent(TodoListView, [

[TodoView, ClonedTodoView]

], 'ClonedTodoListView')

ReactDOM.render(Переопределять иногда надо не только компоненты, но и их зависимости:

class AbstractHelloService {

name: string

}

function HelloView(props: {greet: string}, service: AbstractHelloService) {

return

{props.greet}, {service.name}

> { service.name = e.target.value }} />

}

class AppHelloService {

@mem name = 'Jonny'

}

function AppView() {

return HelloView получит экземпляр класса AppHelloService. Т.к. AppView.aliases для всех дочерних компонент переопределяет AbstractHelloService.

Есть конечно и минус подхода "все кастомизируется" через наследование. Т.к. фреймворк предоставляет больше точек расширения, то, больше ответственности по кастомизации перекладывается на того, кто использует компонент, а не проектирует его. Переопределяя части компонента "таблица", без осознания смысла, можно ненароком превратить его в "список", а это плохой признак, т.к. является искажением исходного смысла (нарушается LSP принцип).

Разделение состояния

По-умолчанию, состояние в зависимостях компонента будет выделено под каждый компонент. Однако действует общий принцип: все определяемое в компонентах выше — имеет приоритет над нижележащими зависимостями. Т.е. если зависимость впервые используется в родительском компоненте, то она будет жить вместе с ним и все нижележащие компоненты, ее запросившие, получат именно родительский экземпляр.

class HelloService {

@mem name = 'John'

}

function HelloView(props: {greet: string}, service: HelloService) {

return

{props.greet}, {service.name}

> { service.name = e.target.value }} />

}

class AppHelloService {

@mem name = 'Jonny'

}

function AppView(_, service: HelloService) {

return

В такой конфигурации, оба HelloView разделяют общий экземпляр HelloService. Однако, без HelloService в AppView, на каждый дочерний компонент будет свой экземпляр.

function AppView() {

return

Подобный принцип, когда можно управлять, какому компоненту принадлежит объект, используется в иерархическом DI ангулара.

Стили

Я не утверждаю, что подход css-in-js единственно правильный для использования в веб. Но и тут можно применить идею внедрения зависимостей. Проблема аналогична вышеописанной с redux/mobx и контекстами. Например, как и во многих подобных библиотеках, стили jss прибиваются к компоненту через обертку injectSheet и компонент связывается с конкретной реализацией стилей, с react-jss:

import React from 'react'

import injectSheet from 'react-jss'

const styles = {

button: {

background: props => props.color

},

label: {

fontWeight: 'bold'

}

}

const Button = ({classes, children}) => (

)

export default injectSheet(styles)(Button)Однако, эту прямую зависимость от jss и ему подобных можно убрать, перенеся эту ответственность на DI. В коде приложения достаточно определить функцию со стилями, как зависимость компонента и пометить ее соответственно.

// ... setup

import {action, props, mem} from 'lom_atom'

import type {NamesOf} from 'lom_atom'

class Store {

@mem red = 140

}

function HelloTheme(store: Store) {

return {

wrapper: {

background: `rgb(${store.red}, 0, 0)`

}

}

}

HelloTheme.theme = true

function HelloView(

_,

{store, theme}: {

store: Store,

theme: NameOf

}

) {

return

color via css {store.red}: > { store.red = Number(target.value) }}

/>

} Такой подход для стилей обладает всеми преимуществами DI, таким образом обеспечивается темизация и реактивность. В отличие от переменных в css, здесь работают типы в flow/ts. Из минусов — накладные расходы на генерацию и обновление css.

Итог

В попытке адаптировать идею внедрения зависимостей для компонентов, получилась библиотека reactive-di. Простые примеры в статье постронены на ее основе, но есть и более сложные, с загрузкой, обработкой статусов загрузки, ошибок и т.д. Есть todomvc бенчмарк для react, preact, inferno. В котором можно оценить оверхед от использования reactive-di. Правда, на 100 todos, погрешность измерений у меня была больше, чем этот оверхед.

Получился упрощенный Angular. Однако есть ряд особенностей, reactive-di

- Умеет интегрироваться с реактом и его клонами, оставаясь совместимым с legacy-компонентами на чистом реакте

- Позволяет писать на одних чистых компонентах, не оборачивая их в mobx/observe или подобное

- Хорошо работает с типами в flowtype не только для классов, но и для компонент-функций

- Ненавязчив: не требуется кучи декораторов в коде, компоненты абстрагируются от react, его можно поменять на свою реализацию, не затрагивая основной код

- Настраивается просто, не нужно региситрации зависимостей, provide/inject-подобных конструкций

- Позволяет доопределять содержимое компонента без его модификации, c сохранением иерархии его внутренностей

- Позволяет ненавязчиво, через интерфейсы, интегрировать css-in-js решения в компоненты

Почему до сих пор идею контекстов не развивали в этом ключе? Скорее всего непопулярность DI на фронтенде объясняется не повсеместным господством flow/ts и отсутствием стандартной поддержки интерфейсов на уровне метаданных. Попытками скопировать сложные реализации с других backend-ориентированных языков (как InversifyJS клон Ninject из C#) без глубокого переосмысления. А также пока недостаточным акцентом: например, некоторое подобие DI есть в react и vue, но там эти реализации являются неотделимой частью фреймворка и роль их второстепенная.

Хороший DI — это еще половина решения. В примерах выше часто мелькал декоратор @mem, который необходим для управления состоянием, построенном на идее ОРП. С помощью mem можно писать код в псевдосинхронном стиле, с простой, по-сравнению с mobx, обработкой ошибок и статусов загрузки. Про него я расскажу в следующей статье.

|

Метки: author redyuf программирование reactjs javascript react.js dependency injection |

[Перевод] Реактивные приложения с Model-View-Intent. Часть 2: View и Intent |

Реактивные приложения с Model-View-Intent. Часть 2: View и Intent

- Перевод

Прежде, чем начать, вкратце обсудим основную идею MVI.

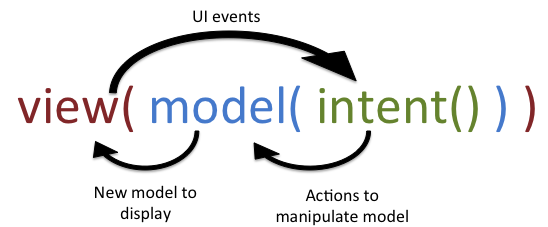

Model-View-Intent (MVI)

Этот паттерн был описан Андре Штальтцем (Andr'e Staltz) для JavaScript-фреймворка cycle.js. С теоретической и математической точки зрения MVI можно описать следующим образом:

- intent(): Функция, которая принимает входные данные от пользователя (например, события пользовательского интерфейса, такие как события click) и переводит в то, что будет передано как параметр функции model(). Это может быть простая строка для установки значения модели или более сложная структура данных, например, объект.

- model(): Функция, которая использует выходные данные из функции intent() в качестве входных данных для работы с моделью. Результат работы этой функции – новая модель (с измененным состоянием). При этом нужно, чтобы данные были неизменяемыми. В первой части я приводил пример с приложением-счетчиком: мы не меняем уже существующий экземпляр модели, а создаем новую модель согласно изменениям, описанным в интенте. Функция model() – лишь часть кода, ответственная за создание нового объекта модели. По сути, функция model() осуществляет вызов бизнес-логики приложения (будь-то Interactor, UseCase, Repository) и в результате возвращает новый объект модели.

- view(): Функция, которая получает на входе модель от model() и просто отображает ее. Обычно функция view() выглядит как view.render(model).

Вернемся к нашей задаче. Мы хотим создать реактивное приложение. Но реактивен ли MVI? Что же в действительности означает реактивность в этом контексте?

Под реактивностью мы понимаем приложение с UI, которое реагирует на изменение состояния. Поскольку состояние отражает модель, то необходимо, чтобы наша бизнес-логика реагировала на события (интенты), а на выходе создавала модель, которую можно было бы отобразить во View, вызвав метод render(model).

Соединяем точки с помощью RxJava

Нам нужно, чтобы поток данных был однонаправленным. Здесь в игру вступает RxJava. При создании реактивных приложений с однонаправленным потоком данных не обязательно использовать именно эту библиотеку. Однако RxJava хорошо подходит для событийного программирования. И поскольку UI основан на событиях, имеет смысл использовать именно ее.

В этой статье я опишу создание простого приложения для вымышленного интернет-магазина. В приложение можно будет искать продукты и добавлять их в корзину.

Готовое приложение будет выглядеть так:

Исходный код можно найти на GitHub.

Начнем с реализации экрана поиска. Первым делом я определяю модель, которая будет отображена с помощью View, как описано в первой части этого цикла статей. Все классы моделей я буду писать с суффиксом ViewState, поскольку модель отражает состояние.

public interface SearchViewState {

final class SearchNotStartedYet implements SearchViewState {}

final class Loading implements SearchViewState {}

final class EmptyResult implements SearchViewState {

private final String searchQueryText;

public EmptyResult(String searchQueryText) {

this.searchQueryText = searchQueryText;

}

public String getSearchQueryText() {

return searchQueryText;

}

}

final class SearchResult implements SearchViewState {

private final String searchQueryText;

private final List result;

public SearchResult(String searchQueryText, List result) {

this.searchQueryText = searchQueryText;

this.result = result;

}

public String getSearchQueryText() {

return searchQueryText;

}

public List getResult() {

return result;

}

}

final class Error implements SearchViewState {

private final String searchQueryText;

private final Throwable error;

public Error(String searchQueryText, Throwable error) {

this.searchQueryText = searchQueryText;

this.error = error;

}

public String getSearchQueryText() {

return searchQueryText;

}

public Throwable getError() {

return error;

}

}

Java – строго типизированный язык, поэтому я выбрал типобезопасный подход к созданию модели, разделив каждое подсостояние внутри класса. Бизнес-логика будет возвращать объект типа SearchViewState, который может быть экземпляром SearchViewState.Error и т.д. Это мое личное предпочтение, вы можете проектировать модель по-своему.

Сосредоточимся на бизнес–логике. Создадим SearchInteractor, который будет отвечать за поиск. Результатом выполнения будет объект SearchViewState.

public class SearchInteractor {

final SearchEngine searchEngine;

public Observable search(String searchString) {

if (searchString.isEmpty()) {

return Observable.just(new SearchViewState.SearchNotStartedYet());

}

return searchEngine.searchFor(searchString)

.map(products -> {

if (products.isEmpty()) {

return new SearchViewState.EmptyResult(searchString);

} else {

return new SearchViewState.SearchResult(searchString, products);

}

})

.startWith(new SearchViewState.Loading())

.onErrorReturn(error -> new SearchViewState.Error(searchString, error));

}

}

Посмотрим на сигнатуру метода SearchInteractor.search(): есть входной параметр searchString и выходной параметр Observable

Метод onErrorReturn() ловит любые исключения, которые могут возникнуть во время выполнения поиска, и эмитит SearchViewState.Error. Мы не можем просто использовать колбэк onError() при подписке на Observable. Это распространенное заблуждение в RxJava: колбэк onError() нужно использовать тогда, когда весь наблюдаемый поток наталкивается на неустранимые ошибки и весь поток завершается.

В нашем случае ошибка отсутствия подключения к интернету не попадает под определение неустранимых ошибок – это просто одно из состояний нашей модели. Кроме того, мы сможем переключиться на другое состояние – SearchViewState.Loading, – после того, как подключение к интернету снова будет доступно.

Таким образом мы создаем наблюдаемый поток из бизнес–логики во View, который эмитит новую модель каждый раз, когда изменяется состояние. Нам не нужно, чтобы наблюдаемый поток завершался при ошибке подключения к интернету, поэтому такие ошибки обрабатываются как состояние. Обычно в MVI наблюдаемый поток никогда не завершается (не вызываются методы onComplete или onError()).

Подводя итог: SearchInteractor предоставляет наблюдаемый поток Observable

Рассмотрим, как выглядит слой View, который должен отобразить модель. Ранее я предложил, чтобы View имела функцию render(model). Кроме того, View должна предоставлять возможность другим слоям реагировать на события UI. В MVI эти события называются интенты. В нашем случае есть только один интент: пользователь ищет продукт путем ввода поискового запроса в поле поиска. В MVP есть хорошая практика создавать интерфейс для слоя View, поступим также и для MVI.

public interface SearchView {

Observable searchIntent();

void render(SearchViewState viewState);

}

В нашем случае View предоставляет только один интент, но в зависимости от задачи их может быть несколько.

В первой части мы обсудили, почему использование единственного метода render() является хорошим решением. Перед созданием конкретной реализации слоя View посмотрим на то, как будет выглядеть окончательный вариант:

public class SearchFragment extends Fragment implements SearchView {

@BindView(R.id.searchView) android.widget.SearchView searchView;

@BindView(R.id.container) ViewGroup container;

@BindView(R.id.loadingView) View loadingView;

@BindView(R.id.errorView) TextView errorView;

@BindView(R.id.recyclerView) RecyclerView recyclerView;

@BindView(R.id.emptyView) View emptyView;

private SearchAdapter adapter;

@Override

public Observable searchIntent() {

return RxSearchView.queryTextChanges(searchView)

.filter(queryString -> queryString.length() > 3 || queryString.length() == 0)

.debounce(500, TimeUnit.MILLISECONDS);

}

@Override

public void render(SearchViewState viewState) {

if (viewState instanceof SearchViewState.SearchNotStartedYet) {

renderSearchNotStarted();

} else if (viewState instanceof SearchViewState.Loading) {

renderLoading();

} else if (viewState instanceof SearchViewState.SearchResult) {

renderResult(((SearchViewState.SearchResult) viewState).getResult());

} else if (viewState instanceof SearchViewState.EmptyResult) {

renderEmptyResult();

} else if (viewState instanceof SearchViewState.Error) {

renderError();

} else {

throw new IllegalArgumentException("Don't know how to render viewState " + viewState);

}

}

private void renderResult(List result) {

TransitionManager.beginDelayedTransition(container);

recyclerView.setVisibility(View.VISIBLE);

loadingView.setVisibility(View.GONE);

emptyView.setVisibility(View.GONE);

errorView.setVisibility(View.GONE);

adapter.setProducts(result);

adapter.notifyDataSetChanged();

}

private void renderSearchNotStarted() {

recyclerView.setVisibility(View.GONE);

loadingView.setVisibility(View.GONE);

errorView.setVisibility(View.GONE);

emptyView.setVisibility(View.GONE);

}

private void renderLoading() {

recyclerView.setVisibility(View.GONE);

loadingView.setVisibility(View.VISIBLE);

errorView.setVisibility(View.GONE);

emptyView.setVisibility(View.GONE);

}

private void renderError() {

recyclerView.setVisibility(View.GONE);

loadingView.setVisibility(View.GONE);

errorView.setVisibility(View.VISIBLE);

emptyView.setVisibility(View.GONE);

}

private void renderEmptyResult() {

recyclerView.setVisibility(View.GONE);

loadingView.setVisibility(View.GONE);

errorView.setVisibility(View.GONE);

emptyView.setVisibility(View.VISIBLE);

}

}

Метод render(SearchViewState) должен выглядеть лаконично. В searchIntent() я использую библиотеку RxBindings. RxSearchView.queryText() создает Observable, который эмитит строку каждый раз, когда пользователь что-то вводит в виджет EditText. Я использую filter(), чтобы поисковый запрос начинался после ввода трех символов и более. Нам не нужно, чтобы поисковый запрос отправлялся на сервер каждый раз, когда пользователь вводит новый символ, поэтому я добавил оператор debounce().

Мы знаем, что входной поток данных для данного экрана – метод searchIntent(), а выходной поток данных – метод render().

Следующее видео наглядно демонстрирует, как происходит взаимодействие между двумя этими потоками.

Остался вопрос, как связать интент и бизнес–логику? Если вы внимательно посмотрите видео, то увидите оператор flatMap() посередине. Это указывает на наличие дополнительного компонента, о котором я не говорил – Presenter, – отвечающего за соединения слоев.

public class SearchPresenter extends MviBasePresenter {

private final SearchInteractor searchInteractor;

@Override protected void bindIntents() {

Observable search =

intent(SearchView::searchIntent)

.switchMap(searchInteractor::search) // на видео я использовал flatMap(), но здесь имеет смысл использовать switchMap()

.observeOn(AndroidSchedulers.mainThread());

subscribeViewState(search, SearchView::render);

}

}

Что такое MviBasePresenter, методы intent() и subscribeViewState(). Этот класс – часть библиотеки Mosby. Стоит сказать несколько слов о Mosby и о том, как работает MviBasePresenter. Начнем с жизненного цикла: у MviBasePresenter его нет. Метод bindIntent() связывает интент из View с бизнес–логикой. Как правило для пересылки интента в бизнес-логику используется flatMap() или switchMap(). Этот метод вызывается единожды, когда View присоединяется к Presenter, но не вызывается после того, как View вновь присоединится к Presenter, например, после изменение ориентации экрана.

Может возникнуть вопрос, действительно ли MviBasePresenter может пережить изменение ориентации экрана, и если да, то каким образом Mosby гарантирует, что наблюдаемый поток не “утекает”? Для этого и предназначены методы intent() и subscribeViewState().

intent() создает PublishSubject внутри Presenter и использует его как “шлюз” для бизнес–логики. PublishSubject подписывается на интент View. Вызов интента (О1) на самом деле возвращает PublishSubject, который подписан на О1.

После изменения ориентации экрана Mosby отсоединяет View от Presenter, но только временно отписывает внутренний PublishSubject из View и повторно переподпиcывает PublishSubject на интент View, когда View вновь присоединяется к Presenter.

subscribeViewState() делает то же самое в обратную сторону. Он создает внутри Presenter BehaviorSubject в качестве “шлюза” от бизнес–логики ко View. Так как это BehaviorSubject, мы можем получить обновленную модель из бизнес–логики даже когда View отсоединена от Presenter. BehaviorSubject всегда хранит последнее значение, которое он получил, и повторяет его, когда View вновь присоеденится к Presenter.

Простое правило: используйте метод intent() чтобы обернуть любой интент. Используйте subscribeViewState() вместо Observable.subscribe(…).

Как насчет других событий жизненного цикла, например, onPause() или onResume()? Я по–прежнему считаю, что презентеру не нужны события жизненного цикла. Однако если вы действительно думаете, что они вам нужны, то можете создать их как интент. В вашем View появится pauseIntent(), запуск которого инициирует жизненный цикл Android, а не действие пользователя.

Заключение

В этой части мы поговорили об основах MVI и реализовали простой экран. Вероятно, этот пример слишком прост, чтобы понять все преимущества MVI. Нет ничего плохого в MVP или MVVM, и я не говорю, что MVI лучше, чем другие архитектурные шаблоны. Тем не менее, я считаю, что MVI помогает нам писать более элегантный код для сложных проблем, как мы увидим в следующей части, в которой поговорим о state reducer.

|

Метки: author valpostnov разработка под android разработка мобильных приложений блог компании tinkoff.ru android mvi mosby mvp mvvm |

Визуализация результатов выборов в Москве на карте в Jupyter Notebook |

- Геоинформационные сервисы,

- Визуализация данных,

- Python,

- Data Mining,

- Блог компании Open Data Science

Визуализация результатов выборов в Москве на карте в Jupyter Notebook

- Геоинформационные сервисы,

- Визуализация данных,

- Python,

- Data Mining,

- Блог компании Open Data Science

Всем привет!

Сегодня мы поговорим о визуализации геоданных. Имея на руках статистику, явно имеющую пространственную привязку, всегда хочется сделать красивую карту. Желательно, с навигацией да инфоокнами В тетрадках. И, конечно же, чтоб потом можно было показать всему интернету свои успехи в визуализации!

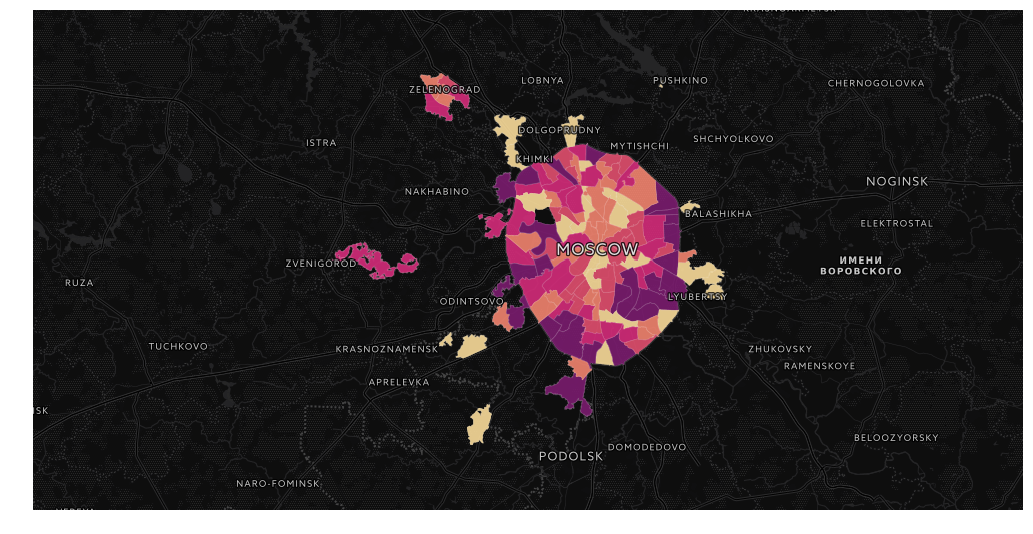

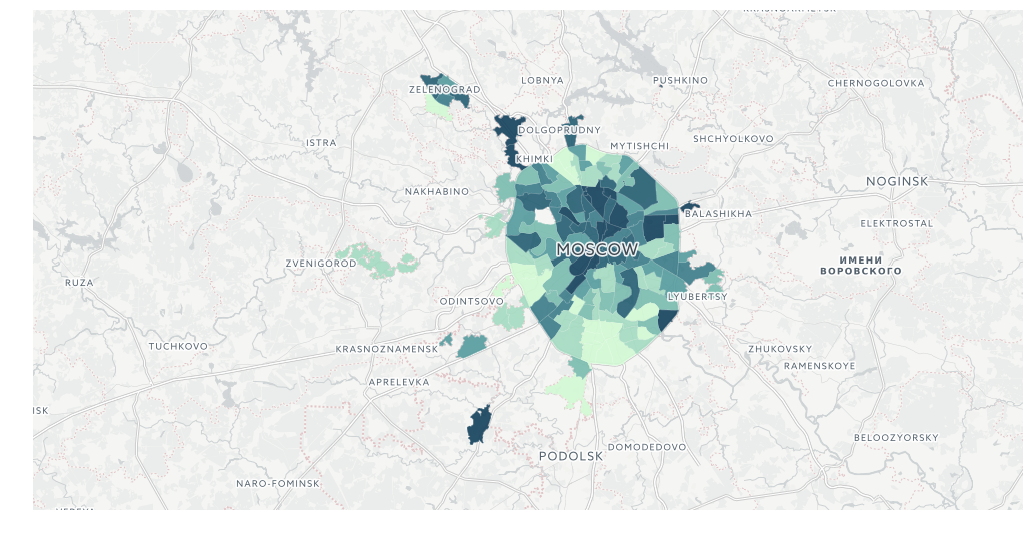

В качестве примера возьмем недавно отгремевшие муниципальные выборы в Москве. Сами данные можно взять с сайта мосгоризбиркома, в можно просто забрать датасеты с https://gudkov.ru/. Там даже есть какая-никакая визуализация, но мы пойдем глубже. Итак, что же у нас в итоге должно получиться?

Потратив некоторое время на написание парсера сайта Избиркома, я получил нужные мне данные. Итак, начнем с импортов.

import pandas as pd

import numpy as np

import os

import pickleЯ работаю в jupyter notebook на Linux-машине. Если вы захотите использовать мой код на Windows машине, то обращайте внимание на написание путей, а также на важные отступления в тексте.

Обычно я использую отдельную папку для проекта, поэтому для простоты задаю текущую директорию:

os.chdir('/data01/jupyter/notebooks/habr/ods_votes/')Дальше нам трубуется забрать данные с самого сайта Избиркома. Для разбора данных я написал отдельный парсер. Весь процесс занимает 10-15 минут. Забрать его можно из репозитория.

Я решил создать большой словарь с датафреймами внутри. Для превращения html-страниц в датафреймы я использовал read_html, эмпирически подбирал нужные датафрейс, а после этого делал небольшую обработку, выкидывая лишнее и добавляя недостающее. Предварительно я уже обработал данные по партиям. Изначально они были не особо читаемы. К тому же, встречается разное написание одних и тех же партий (забавно, но в некоторых случаях это не разное написание, а реально разные партии).

Разбор данных избиркома

Непосредственно сборка справочника. Что здесь происходит:

- собираются структура административных и муниципальных округов;

- собираются все ссылки на Территориальные Избирательные Комиссии (ТИК);

- для каждого ТИК собирается список кандидатов;

- внутри каждого ТИК собираются Окружные Избирательные Комиссии (ОИК);

- для каждого ОИК собирается статистика по ОИК и статистика по кандидатам;

- из полученного датасета собираем статистику по муниципальным округам.

В репозитории этой статьи лежат уже готовые данные. Их мы и будем использовать.

import glob

# забираем справочник сокращений для партий

with open('tmp/party_aliases.pkl', 'rb') as f:

party_aliases = pickle.load(f)

votes = {}

# забираем список округов и мунициальных образований

votes['atd'] = pd.read_csv('tmp/atd.csv', index_col=0, sep=';')

votes['data'] = {}

# идем по мунициальным образованиям и собираем статистику ТИК

for v in votes['atd']['municipal'].values:

votes['data']

# забираем статистику по кандидатам

candidates = glob.glob('tmp/data_{}_candidates.csv'.format(v))[0]

votes['data'][v]['candidates'] = pd.read_csv(candidates, index_col=0, sep=';')

votes['data'][v]['votes'] = {}

# теперь по каждому ОИК собираем его статистику

# статистика по УИК

okrug_stats_list = glob.glob('tmp/data_{}*_okrug_stats.csv'.format(v))

for okrug_stats in okrug_stats_list:

okrug = int(okrug_stats.split('_')[2])

try:

votes['data'][v]['votes'][okrug]

except:

votes['data'][v]['votes'][okrug] = {}

votes['data'][v]['votes'][okrug]['okrug_stats'] = pd.read_csv(okrug_stats, index_col=0, sep=';')

# статистика по кандидатам

candidates_stats_list = glob.glob('tmp/data_{}*_candidates_stats.csv'.format(v))

for candidates_stats in candidates_stats_list:

okrug = int(candidates_stats.split('_')[2])

votes['data'][v]['votes'][okrug]['candidates_stats'] = pd.read_csv(candidates_stats, index_col=0, sep=';')

# теперь собираем статистику в удобной нам форме

data = []

# пройдемся по муниципальным округам

for okrug in list(votes['data'].keys()):

#чистим данные

candidates = votes['data'][okrug]['candidates'].replace(to_replace={'party':party_aliases})

group_parties = candidates[['party','elected']].groupby('party').count()

# создаем общую статистику по избирателям

stats = np.zeros(shape=(12))

for oik in votes['data'][okrug]['votes'].keys():

stat = votes['data'][okrug]['votes'][oik]['okrug_stats'].iloc[:,1]

stats += stat

# создаем статистику по партиям

# количество мест

sum_parties = group_parties.sum().values[0]

# количество полученных мест

data_parties = candidates[['party','elected']].groupby('party').count().reset_index()

# процент полученных мест

data_parties['percent'] = data_parties['elected']/sum_parties*100

# собираем итоговую таблицу по округу

tops = data_parties.sort_values('elected', ascending=False)

c = pd.DataFrame({'okrug':okrug}, index=[0])

c['top1'], c['top1_elected'], c['top1_percent'] = tops.iloc[0,:3]

c['top2'], c['top2_elected'], c['top2_percent'] = tops.iloc[1,:3]

c['top3'], c['top3_elected'], c['top3_percent'] = tops.iloc[2,:3]

c['voters_oa'], c['state_rec'], c['state_given'], c['state_anticip'], c['state_out'], c['state_fired'], c['state_box'], c['state_move'], c['state_error'], c['state_right'], c['state_lost'] , c['state_unacc'] = stats

c['voters_percent'] = (c['state_rec'] - c['state_fired'])/c['voters_oa']*100

c['total'] = sum_parties

c['full'] = (c['top1_elected']== sum_parties)

# добавляем полученный датафрейм в список

data.append(c)

# создаем итоговый датафрейм

winners = pd.concat(data,axis=0)Мы получили датафрейм со статистикой явки, бюллютеней (от количества выданных до количества испорченных), распределением мест между партиями.

Можно приступать к визуализации!

Базовая работа с геоданными в geopandas

Для работы с геоданными мы будем использовать библиотеку geopandas. Что такое geopandas? Это расширение функциональности pandas географическими абстракциями (унаследованными из Shapely), которые позволяют нам проводит аналитические географические операции с геоданными: выборки, оверлей, аггрегация (как, например, в PostGIS для Postgresql).

Напомню, что существует три базовых типа геометрии — точка, линия (а точнее, полилиния, так как состоит из соединенных отрезков) и полигон. У всех у них бывает вариант мульти-(Multi), где геометрия представляет собой объединение отдельных географических образований в один. Например, выход метро может быть точкой, но несколько выходов, объединенных в сущность "станция", уже являются мультиточкой.

Следует обратить внимание, что geopandas неохотно ставится через pip в стандартной установке Python в среде Windows. Проблема, как обычно, в зависимостях. Geopandas опирается на абстракции библиотеки fiona, у которой нет официальных сборок под Windows. Идеально использовать среду Linux, например, в docker-контейнере. Кроме того, в Windows можно использовать менеджер conda, он все зависимости подтягивает из своих репозиториев.

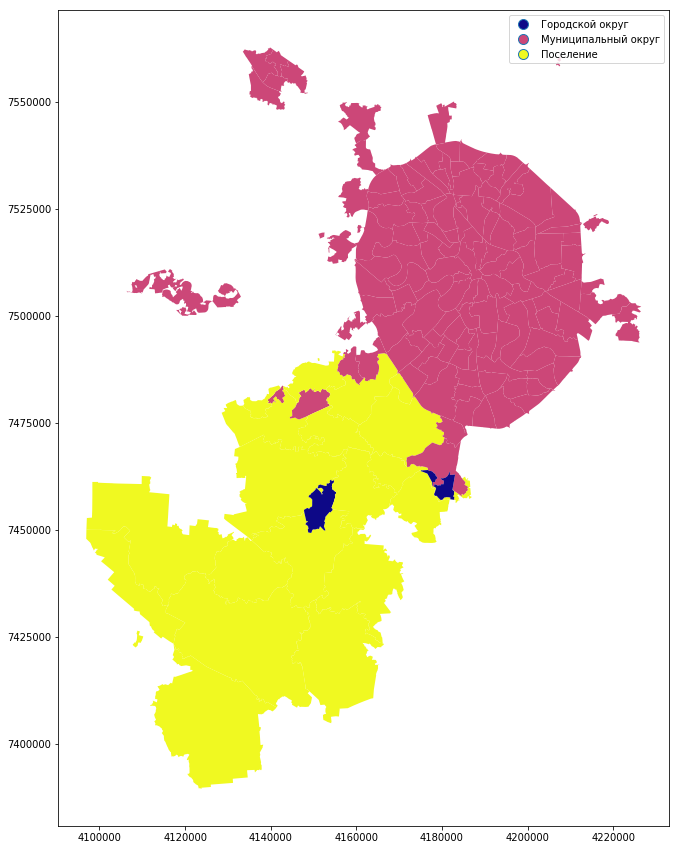

C геометрией муниципальных образований все достаточно просто. Их можно легко забрать из OpenStreetMap (подробнее тут) или, например, из выгрузок NextGIS. Я использую уже готовые шейпы.

Итак, начнем! Выполняем нужные импорты, активируем графики matplotlib...

import geopandas as gpd

%matplotlib inline

mo_gdf = gpd.read_file('atd/mo.shp')

mo_gdf.head()Как видите, это привычный DataFrame. Поле geometry — представление географических объектов (в данном случае — полигонов) в виде WKT, well known text (подробнее — https://en.wikipedia.org/wiki/Well-known_text). Можно довольно просто построить карту наших объектов.

mo_gdf.plot()

Угадывается Москва! Правда, не совсем привычно выглядит. Причина в проекции карты. На Хабре уже есть отличный ликбез по ним.

Итак, представим наши данные в более привычной проекции Web Mercator (исходную проекцию можно легко получить по параметру crs). Окрасим полигоны по названию Административного округа. Ширину линий выставим 0,5. Метод окраски cmap использует стандартные значения matplotlib (если вы, как и я, не помните их наизусть, то вот шпаргалка). Чтобы увидеть легенду карты, задаем параметр legend. Ну а figsize отвечает за размер нашей карты.

mo_gdf_wm = mo_gdf.to_crs({'init' :'epsg:3857'}) #непосредственно преобразование проекции

mo_gdf_wm.plot(column = 'ABBREV_AO', linewidth=0.5, cmap='plasma', legend=True, figsize=[15,15])

Можно построить карту и по типу муниципального образования:

mo_gdf_wm.plot(column = 'TYPE_MO', linewidth=0.5, cmap='plasma', legend=True, figsize=[15,15])

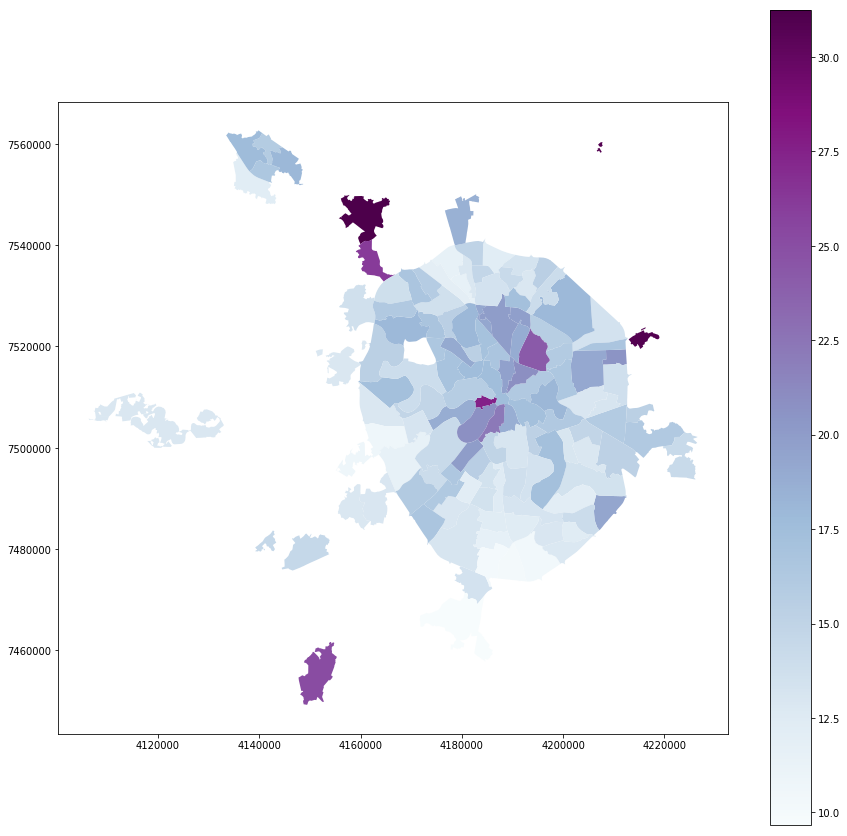

Итак, построим карту статистики по муниципальным округам. Ранее мы уже создали датафрейм winners.

Нам необходимо соединить наш датафрейм с геодатафреймом для создания карты. Немного причешем названия мунициальных округов, чтобы соединение произошло без сюрпризов.

winners['municipal_low'] = winners['okrug'].str.lower()

winners['municipal_low'] = winners['municipal_low'].str.replace('ё', 'е')

mo_gdf_wm['name_low'] = mo_gdf_wm['NAME'].str.lower()

mo_gdf_wm['name_low'] = mo_gdf_wm['name_low'].str.replace('ё', 'е')

full_gdf = winners.merge(mo_gdf_wm[['geometry', 'name_low']], left_on='municipal_low', right_on='name_low', how='left')

full_gdf = gpd.GeoDataFrame(full_gdf)Построим простую категориальная карту, где от зеленого к синему распределены партии-победители. В районе Щукино в этом году и правда не было выборов.

full_gdf.plot(column = 'top1', linewidth=0, cmap='GnBu', legend=True, figsize=[15,15])

Явка:

full_gdf.plot(column = 'voters_percent', linewidth=0, cmap='BuPu', legend=True, figsize=[15,15])

Жители:

full_gdf.plot(column = 'voters_oa', linewidth=0, cmap='YlOrRd', legend=True, figsize=[15,15])

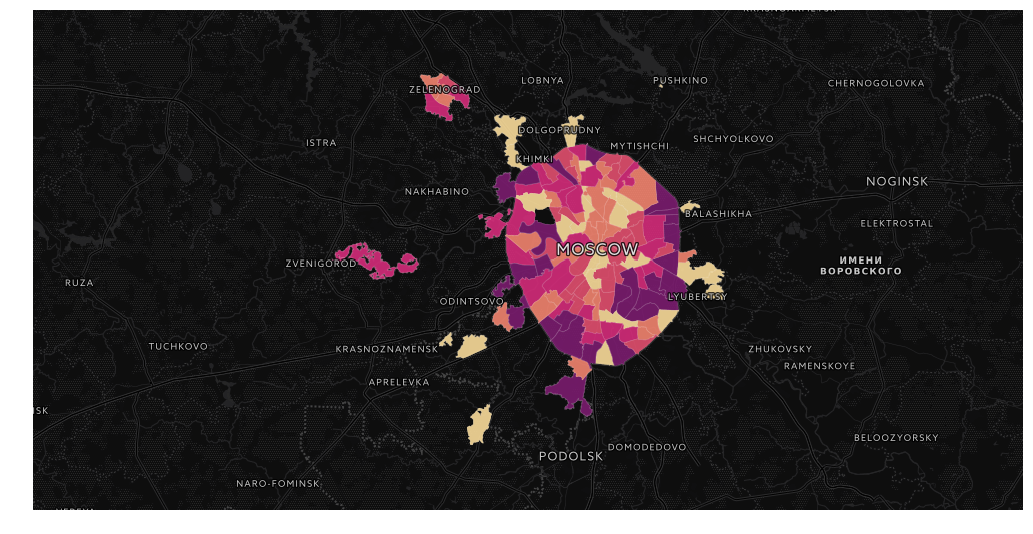

Отлично! У нас получилась симпатичная визуализация. Но хочется и базовую карту, и навигацию! На помощь нам придет библиотека cartoframes.

Визуализация геоданных с помощью cartoframes

Одним из самых удобных инструментов для визуализации геоданных является Carto. Для работы с этим сервисом существуюет библиотеке cartoframes, которая позволяет работать с функциями сервиса прямо из тетрадок Jupyter.

Библиотека cartoframes требует внимательного обращения под Windows в силу особенностей разработки (например, при заливке датасета библиотека пытается использовать стиль папок linux, что приводит к печальным последствиям). С кириллическими данными можно легко отстрелить себе ногу (кодировка cp1251 может быть превращена в кракозябры). Лучше ее использовать или в docker-контейнере, или на полноценном Linux. Ставится библиотека только через pip. В windows ее можно успешно установить, предварительно поставив geopandas через conda (или поставив все зависимости руками).

Cartoframes работает с проекцией WGS84. В нее и перепроецируем наш датасет. После соединения двух датафреймов может теряться информация о проекции. Зададим ее заново и перепроецируем.

full_gdf.crs = ({'init' :'epsg:3857'})

full_gdf = full_gdf.to_crs({'init' :'epsg:4326'})Делаем нужные импорты...

import cartoframes

import json

import warnings

warnings.filterwarnings("ignore")Добавляем данные от аккаунта Carto:

USERNAME = 'ваш пользователь Carto'

APIKEY = 'ваш ключ API'И, наконец, подключаемся к Carto и заливаем наш датасет:

cc = cartoframes.CartoContext(api_key=APIKEY, base_url='https://{}.carto.com/'.format(USERNAME))

cc.write(full_gdf, encode_geom=True, table_name='mo_votes', overwrite=True)Датасет можно выгрузить с Carto обратно. Но полноценный геодатафрейм пока только в проекте. Правда, можно с помощью gdal и shapely сконвертировать бинарное представление геометрии PostGIS снова в WKT.

Особенностью работы плагина является приведением типов. Увы, в текущей версии датафрейм заливается в таблицу с назначением типа str для каждого столбца. Об этом надо помнить при работе с картами.

Наконец, карта! Разукрасим данные, положим на базовую карту и включим навигацию. Подсмотреть схемы окрашивания можно здесь.

Для нормальной работы с разбиением классов напишем запрос с приведением типов. Синтаксис PostgreSQL

query_layer = 'select cartodb_id, the_geom, the_geom_webmercator, voters_oa::integer, voters_percent::float, state_out::float from mo_votes'Итак, явка:

from cartoframes import Layer, BaseMap, styling, QueryLayer

l = QueryLayer(query_layer, color={'column': 'voters_percent', 'scheme': styling.darkMint(bins=7)})

map = cc.map(layers=[BaseMap(source='light', labels='front'), l], size=(990, 500), interactive=False)

Количество жителей

l = QueryLayer(query_layer, color={'column': 'voters_oa', 'scheme': styling.burg(bins=7)})

map = cc.map(layers=[BaseMap(source='light', labels='front'), l], size=(990, 500), interactive=False)

И, например, надомное голосование

l = QueryLayer(query_layer, color={'column': 'state_out', 'scheme': styling.sunsetDark(bins=5)})

map = cc.map(layers=[BaseMap(source='light', labels='front'), l], size=(990, 500), interactive=False)

Следует заметить, что в данный момент cartoframes не позволяет встроить инфоокна прямо в окно тетрадки, показывать легенду, а также публиковать карты на Carto. Но эти опции в процессе имплементации.

А теперь попробуем более сложный, но весьма гибкий способ встраивания карт в Jupyter Notebook...

Визуализация геоданных с помощью folium

Итак, нам хотелось бы получить не только навигацию, но и инфоокна на карте. А еще получить возможность публикации визуализации на своем сервере или на github. Нам поможет folium.

Библиотека folium — довольно специфичная штука. Она представляет собой python-обертку вокруг JS-библиотеки Leaflet, которая как раз и отвечает за картографическую визуализацию. Следующие манипуляции выглядят не очень pythonic, но не пугайтесь, я все поясню.

import foliumПростая визуализация наподобие Carto делается достаточно просто.

Что происходит?

- мы создаем инстанс карты, m, с центром в выбранных координатах;

- добавляем инстанс картограммы (choropleth)

В инстансе картограммы мы задаем много атрибутов: - geo_data — геоданные, мы конвертируем данные нашего датафрейма в geojson;

- name — задаем имя слоя;

- data — непосредственно данные, их мы выбираем тоже из датафрейма;

- key_on — ключ для соединения (обратите внимание, в geojson все атрибуты сложены в отдельный элемент, properties);

- columns — ключ и атрибут для раскрашивания;

- fill_color, fill_opacity, line_weight, line_opacity — цветовая шкала заливки, прозрачность заливки, ширина и прозрачность линий;

- legend_name — заголовок легенды;

- highlight — добавление интерактива (подсветки при наведении и приближения при клике) у объектов.

Цветовая шкала основывается на библиотеке Color Brewer. Я крайне рекомендую при работе с картами пользоваться ей.

m = folium.Map(location=[55.764414, 37.647859])

m.choropleth(

geo_data=full_gdf[['okrug', 'geometry']].to_json(),

name='choropleth',

data=full_gdf[['okrug', 'voters_oa']],

key_on='feature.properties.okrug',

columns=['okrug', 'voters_oa'],

fill_color='YlGnBu',

line_weight=1,

fill_opacity=0.7,

line_opacity=0.2,

legend_name='type',

highlight = True

)

mИтак, у нас получилась интерактивная картограмма. Но хотелось бы и инфоокон...

Здесь нам придется немного хакнуть библиотеку. У нас есть партии-победители в каждом ТИК. Для каждой из них мы определим базовый цвет. Но не в каждом округе победа партии означает 100% голосов. К каждому базовому цвету мы определим 3 градации: абсолютная власть (100%), контрольный пакет (>50%) и кооперация (<50%). Напишем функцию определения цвета:

def party_color(feature):

party = feature['properties']['top1']

percent = feature['properties']['top1_percent']

if party == 'Единая Россия':

if percent == 100:

color = '#969696'

elif 50 < percent < 100:

color = '#bdbdbd'

else:

color = '#d9d9d9'

elif party == 'Яблоко':

if percent == 100:

color = '#78c679'

elif 50 < percent < 100:

color = '#addd8e'

else:

color = '#d9f0a3'

elif party == 'КПРФ':

if percent == 100:

color = '#ef3b2c'

elif 50 < percent < 100:

color = '#fb6a4a'

else:

color = '#fc9272'

elif party == 'Справедливая Россия':

if percent == 100:

color = '#2171b5'

elif 50 < percent < 100:

color = '#4292c6'

else:

color = '#6baed6'

elif party == 'Самовыдвижение':

if percent == 100:

color = '#ec7014'

elif 50 < percent < 100:

color = '#fe9929'

else:

color = '#fec44f'

return {"fillColor":color, "fillOpacity":0.8,"opacity":0}Теперь напишем функцию формирования html для инфоокна:

def popup_html(feature):

html = ' Распределение мест в ТИК {}

'.format(feature['properties']['okrug'])

for p in ['top1', 'top2', 'top3']:

if feature['properties'][p + '_elected'] > 0:

html += '

{}: {} мест'.format(feature['properties'][p], feature['properties'][p + '_elected'])

return htmlНаконец, мы конвертируем каждый объект датафрейма в geojson и добавляем его к карте, привязывая к каждому стиль, поведение при наведении и инфоокно

m = folium.Map(location=[55.764414, 37.647859], zoom_start=9)

for mo in json.loads(full_gdf.to_json())['features']:

gj = folium.GeoJson(data=mo, style_function = party_color, control=False, highlight_function=lambda x:{"fillOpacity":1, "opacity":1}, smooth_factor=0)

folium.Popup(popup_html(mo)).add_to(gj)

gj.add_to(m)

mНаконец, мы сохраняем нашу карту. Ее можно опубликовать, например, на Github:

m.save('tmp/map.html')Заключение

С помощью простых инструментов визуализации геоданных можно найти бесконечный простор для инсайтов. А немного поработав над данными и визуализацией, можно успешно опубликовать ваши инсайты на Carto или на github. Репозиторий этот статьи: https://github.com/fall-out-bug/izbirkom_viz.

Поздравляю, теперь вы политолог!

Вы научились анализировать результаты выборов. Поделитесь инсайтами в коментах!

|

Метки: author fall_out_bug геоинформационные сервисы визуализация данных python data mining блог компании open data science jupyter notebook картография картограмма visualization |

[Из песочницы] Как сделать карьеру в digital: первый год жизни интернет-маркетолога |

Как сделать карьеру в digital: первый год жизни интернет-маркетолога

Рассказываем, как пережить первый год в онлайн-маркетинге и не сломаться.

Путь интернет-маркетолога по мнению экспертов в интернете выглядит следующим образом:

1) Получите высшее образование по маркетингу, научитесь делать SWOT-анализ и работать с матрицей BCG

2) 5 лет оптимизируйте сайты, станьте гуру контекста, выучите PHP, HTML и JavaScript, научитесь писать не хуже Максима Ильяхова, получите сертификат на знание Яндекс.Метрики

3) Поздравляем! Вы — интернет-маркетолог!

План амбициозный, но увы, бестолковый. Он оставляет больше вопросов, чем ответов: с чего начать, как выбрать специализацию и где практиковать навыки?

Чтобы помочь новичкам выжить в безжалостном мире digital, мы с Елизаветой Целютиной, интернет-маркетологом бизнес-школы IHSBM, составили «маршрут развития». Начиная стажером, Лиза прошла диджитал-интенсив по ирландской программе DMI и «без отрыва от производства» тут же тестировала новые знания в своей компании. Надеемся, этот опыт поможет джуниорам за короткий срок пройти путь с нуля до перспективного специалиста по онлайн-маркетингу.

Шаг 1. Обучение

Не слушайте старообрядцев, которые рекомендуют начинать с классического маркетинга: в одно ухо влетит, в другое вылетит. В первый год никто вам не доверит составлять SWOT-анализ и выводить новый продукт на рынок. Вернитесь к этому чуть позже.

Если выбирать самый короткий путь в профессию, лучше все-таки разориться на хороший курс по digital-маркетингу (IHSBM, Нетология, Digital October). Лучшие инвестиции — инвестиции в себя, не жадничайте на знаниях, это ваш карьерный фундамент.

Специализация — дискуссионный вопрос. По нашим наблюдениям, быстрее растут те диджитальщики, которые выбрали путь «всего по чуть-чуть». Поэтому если у вас нет твердого убеждения всю жизнь посвятить только контекстной рекламе, лучше выбрать «обзорный курс», в котором изучаются все аспекты интернет-маркетинга. Кроме того, только попробовав каждый инструмент digital-маркетинга, сможете понять, к чему лежит душа — SMM, планирование кампаний или SEO-хардкор.

Что касается бесплатного контента, доступного в интернете. Он поможет, если у вас уже есть в голове база и система. Для комплексной самостоятельной подготовки с нуля бесплатные вебинары-семинары, блоги и книги не подходят, но могут еще больше запутать и разочаровать.

Зато во время обучения стоит подписаться на проверенные источники: специализированные СМИ (Cossa, vc.ru, Seonews), блоги известных агентств (Texterra, Ingate, i-Media, Adventum, IT-agency). Задача — нарастить вокабуляр. Вас должны перестать пугать бесконечные CPC, CTR, ARPU и LTV. Отдельное внимание уделяйте изучению кейсов. Чтобы проникнуться целями и задачами интернет-маркетинга, читайте и впитывайте, как компания N с помощью рассылок повысила продажи на 15%, а стартап X с помощью социальных сетей привлек 1000 лидов.

Шаг 2. Идем практиковаться!

Итак, у вас голова трещит от новых знаний, а на стенке висит сертификат. Пришло время практики. Составляем резюме на должность ассистента. Лайфхак: лучше делать не одно универсальное, а каждое затачивать под конкретную вакансию. Да, это дольше, чем бездумно жать на кнопку «Откликнуться», но и выхлоп больше.

Если нет цели попасть в консервативную компанию с сотрудниками в галстуках, можно составить резюме в неформальном виде. Добавив щепотку творчества и оригинальности, не забудьте про свой серьезный подход к делу. В этой сфере ценится креативность, особенно для SMM и email-маркетинга, которую вы таким способом и продемонстрируете. Никому не хочется пичкать потребителя сухими и монотонными постами. Возможно, так вы избавите себя от тестового задания.

Есть мнение, что лучше и быстрее можно стартовать в агентстве, однако мы не будем так категоричны. Самое главное и неожиданное — на собеседовании вы должны задать очень много вопросов! Не смотрите пока на соцпакеты, корпоративные плюшки и даже зарплату. Выиграв бесплатные завтраки и оклад на 10 тысяч больше сейчас, вы рискуете целый год проверять договоры с подрядчиками или делать бесконечные ресайзы баннеров. Интернет-маркетинг у каждого разный.

Так как нам нужен быстрый старт в digital-маркетинге, ищите компании с разноплановыми проектами. Выбрав должность ассистента по SEO или помощника по контекстной рекламе, вы будете долгое время выполнять механическую работу, решая однотипные задачи. Да, вы быстро вырастете в одной сфере. Однако потом вам будет трудно получить работу с более широким кругом обязанностей. Как минимум по зарплате вы не сможете сильно вырасти.

Итак, вот список вопросов, который можете смело брать на собеседование, чтобы приятно удивить рекрутера.

1) Отдел маркетинга или команда проекта

Узнайте, как можно больше об отделе интернет-маркетинга, уточните, какие задачи решаются штатными силами, какие — аутсорсом. Что получается сейчас хорошо, а где провалы или проблемы, попробуйте уточнить их причины. Может, до вас уже три человека сгорели на этих участках еще на испытательном сроке, и вы следующая жертва, просто потому что компания сама не знает, чего хочет?

2) Бизнес-процессы и ИТ-составляющая

Интересные маркетинговые задачи требуют системного подхода и грамотного управления проектами. У команды должны быть инструменты для обсуждения и планирования работы. Используют ли Trello, Меgaplan, Worksection, Basecamp? А как насчет Scrum и Agile? Современный маркетинг не работает без ИТ-решений: нагло выясняйте, какую CRM используют в компании, какой сервис для рассылок, настроена ли Яндекс.Метрика и на каком движке сделан сайт. Чем шире применяемый инструментарий, тем интереснее и продуктивнее будет работа.

3) Бюджет на маркетинг или средний бюджет проекта

Все просто: он должен быть. Да, на рынке есть мастера по партизанскому маркетингу, но начинать лучше в проектах, где есть маркетинговые бюджеты, иначе массу эффективных приемов привлечения аудитории вы так и не распробуете. Новичку надо «понюхать» проекты хотя бы с небольшими бюджетами, чтобы почувствовать возможности онлайн-маркетинга.

«С деньгами любой дурак сможет» — эта присказка скорее про PR, потому что в маркетинге работает другой подход: каждый вложенный рубль должен принести 10 рублей прибыли.

4) Как растут и обучаются сотрудники?

В компании внедрена система наставничества — сразу два жирных плюса в её пользу. Если нет, спросите у HR-менеджера, часто ли сотрудников отправляют на обучение, принято ли ездить на профильные конференции? В таких компаниях вы будете расти в два раза быстрее, да и веселее, пожалуй.

5) Какие планы на ближайшее будущее у компании в интернете?

Если она довольна своей контекстной рекламой и почтовыми рассылками, и ничего больше не планирует, значит, вы будете работать роботом. А как же ваша мечта сделать мир лучше? На рынке полно компаний, которые только сейчас открывают для себя новые соцсети, мессенджеры, чат-боты, блоги, видео-стриминг, с помощью которых делают свои продукты и обслуживание по-настоящему увлекательными и полезными. Вот, где нужно реализовываться!

Не сдавайтесь и не снижайте планку, если на первых собеседованиях вы встретили полнейшее недоумение.

Значит, у компании нет ресурсов на реализацию интересных и качественных проектов, хорошего опыта вы здесь не получите. Работа просто на стаж в digital — смертный приговор для карьеры.

Осторожнее относитесь к фармацевтической, алкогольной и табачной отрасли — здесь работают очень специализированные инструменты. Избегайте сложных b2b-компаний: тут тоже специфический маркетинг, традиционные онлайн-инструменты работают пока плохо. Не ставьте крест на этих сферах насовсем — нет, просто с наработанным опытом там будет проще.

Идеально: ИТ-компании и e-commerce, digital-агентства полного цикла, услуги (трэвел, ивенты, развлечения, недвижимость, фитнес).

Шаг 3. Практика и специализация

Итак, вы ассистент отдела маркетинга или junior digital specialist. Если вам выделили наставника — поздравляем, это счастливый билет. Но увы, в российских компаниях такая практика еще большая редкость.

В остальных случаях, старайтесь держать под контролем ваше развитие в компании. Это не так трудно, как кажется — рассказывайте, какими задачами вам интересно заниматься, проявляйте инициативу, задавайте вопросы коллегам.

Если есть возможность, сразу начинайте с социальных сетей. Изучите, как устроены аккаунты компании, какой контент там публикуется, какие вопросы задают подписчики. Проследите, в какой форме общались с подписчиками: было ли это «Хай, котики» или же «Здравствуйте, уважаемые подписчики»? Параллельно погружайтесь в бизнес, тщательно промониторьте конкурентов. При должной сноровке у вас на это уйдет 1-2 недели.

Далее подключайтесь или просите присоединиться к e-mail маркетингу. Изучив прежний опыт, предложите написать текст рассылки, освойте сервис, поверстайте в нем тестовые письма. Особое внимание уделите теме письма — текст рассылки может быть бесконечно хорош, но какой в этом толк, если тема не сработала, и Open Rate низкий. На это уйдет еще неделя.

Теперь подступайте к контексту. Посмотрите, как настроены текущие рекламные кампании. Изучите, какие установлены таргетинги по времени и географии, как выставляются ставки, какие используются минус-слова. Нашли ошибку? Не стесняйтесь предлагать свои рекомендации. Попросите потренироваться в составлении семантического ядра для новой услуги или акции. На изучение аккаунтов Директа и AdWords заложите неделю.

Пошла тяжелая артиллерия: теперь можно залезть в SEO. Посмотрите, что на вашем сайте из контента работает на благо выдачи, как устроена навигация, есть ли блог, по каким ключевым словам продвигается ваш сайт, какие пункты из внешней оптимизации выполнены. И опять не спускаем глаз с конкурентов. Недели должно хватить.

И вот только сейчас пришло время аналитики. Изучите, что и как настроено в личном кабинете, какие выставлены цели, какие цифры собираются. Проштудируйте отчеты, загляните в вебвизор. Аналитика — один из самых жизненно важных разделов онлайн-маркетинга. С ее помощью вы узнаете, какая часть рекламного бюджета тратится впустую, а что приносит максимальный эффект.

К концу испытательного срока у вас должно быть четкое представление об эффективности каналов, стоимости лидов, системе распределения бюджета. Кроме того, вы должны знать ваших конкурентов и ЦА почти в лицо!

За следующие полгода вам надо научиться оптимизировать маркетинговый бюджет, анализируя стоимость одного клика, лида или покупки по всем каналам. Так вы сможете на каждый вложенный рубль генерировать не 10 рублей прибыли, а 20 или даже 30. Такие успехи руководство не оставляет без внимания и поощряет премиями.

Вот еще 4 совета, чтобы хорошо себя зарекомендовать в компании

• На самой начальной стадии с особой осторожностью беритесь за задачи на креатив и планирование (идеи для рассылок, посты для социальных сетей, темы объявлений). Чтобы не изобретать велосипед, всегда выясняйте, что уже было сделано, и главное, что из этого получилось, а что — нет.

• На первых порах вам может показаться, что в компании все устроено не так идеально, как рассказывали на курсах. Не спешите критиковать или опрометчиво советовать, как надо делать. Первые два месяца работы — не время для радикальных предложений. Запишите свои наблюдения и вернитесь к ним спустя некоторое время. И помните, что любой спорный вопрос можно решить с помощью А/В-тестирования.

• Составляйте чек-листы и проверяйте свои действия — новички часто по невнимательности забывают поставить какую-нибудь галочку. А одна такая галочка, например, по геотаргетингу в контекстной рекламе, может очень серьёзно сказаться на качестве трафика.

• Научитесь грамотно и интересно писать! Вам необязательно выдавать креативные слоганы, достойные каннских львов, но писать хорошие тексты для блога, рассылок, социальных сетей вы должны! При этом не забывайте, что для каждой компании нужна своя стилистика.

• Учитесь, учитесь и еще раз учитесь! Digital — это развитие нон-стоп: новинки, лайфхаки и тренды. За этим нужно следить и успевать оперативно внедрять, пока вас не опередили конкуренты. Составьте план по обучению — вот теперь пришло время для блогов, книг, вебинаров.

Где-то через 9-12 месяцев упорного труда, начинайте думать о своих KPI. Зарплата хорошего маркетолога складывается из оклада и бонуса, который высчитывается по ключевым показателям. Чаще всего это новые лиды-заявки. Учитесь работать на результат — это здорово мотивирует, не даст вам заскучать и затормозить в развитии. Да и фраза: «Я получил большее за меньшую цену» для работодателя лучше любой вашей «корочки».

Если год в компании прошел, а вы до сих пор занимаетесь только мониторингом СМИ, ответами на комментарии клиентов в соцсетях, размещением новостей на сайте и бумажками — это повод серьезно задуматься. Кажется, что вы занимаетесь фигней? Меняйте компанию. Подумайте о специализации. Может, за время работы у вас появился фаворит — тогда стоит отдать ему предпочтение и посвятить год-два оттачиванию навыка в какой-то одной сфере, например, SMM или видео-блогинг. Подтяните теорию, подбейте резюме цифрами — и снова в бой!

|

Метки: author Mlle_booo интернет-маркетинг карьера junior |

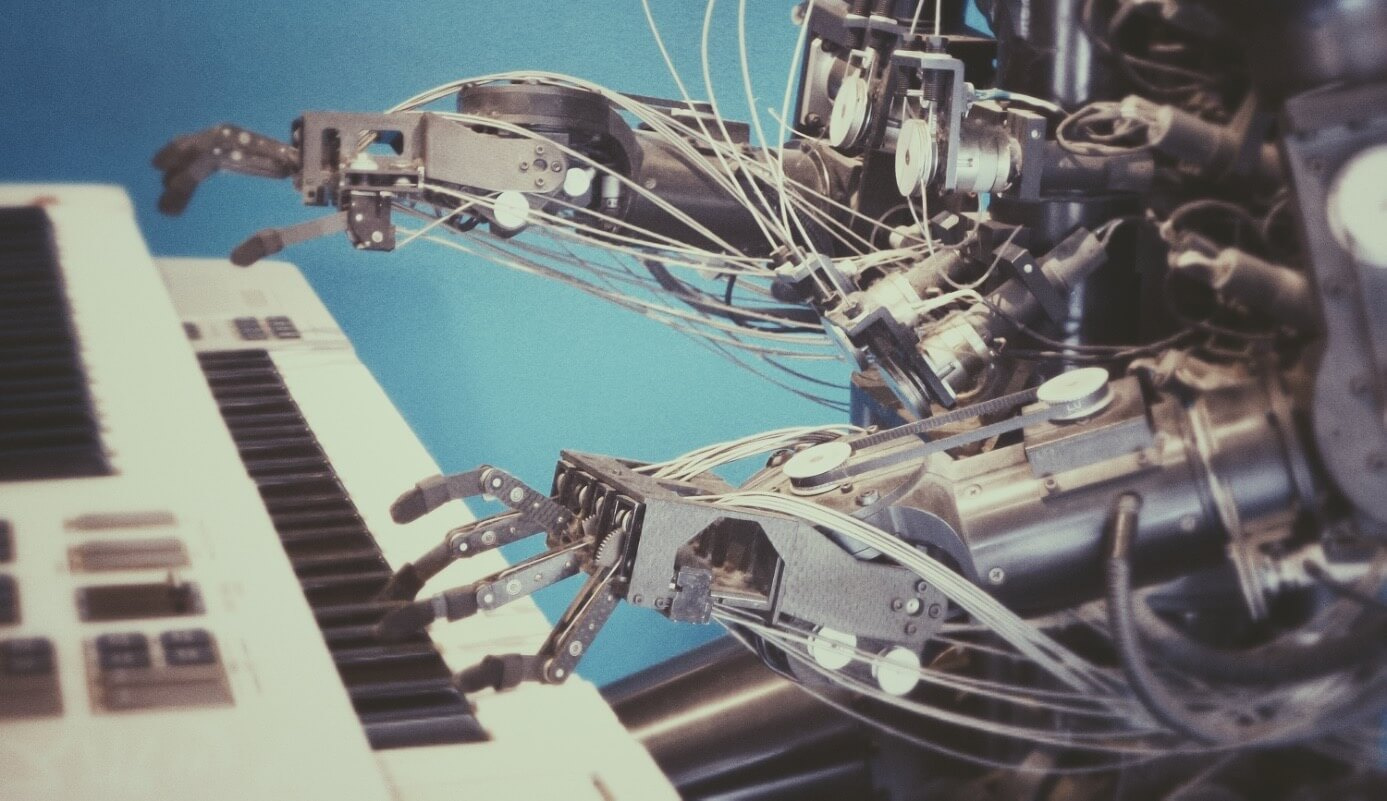

HR-робот обзванивает тысячи людей одновременно: рассказываем, как |

- Разработка мобильных приложений,

- Разработка веб-сайтов,

- Программирование,

- JavaScript,

- Блог компании Voximplant

HR-робот обзванивает тысячи людей одновременно: рассказываем, как

- Разработка мобильных приложений,

- Разработка веб-сайтов,

- Программирование,

- JavaScript,

- Блог компании Voximplant

Хабр, привет. Период отпусков закончился, так что вливаемся в работу. Мы работаем и пишем, вы — читаете и тоже работаете (надеемся, и с нашей помощью тоже). Сегодня хотим поделиться еще одним кейсом – расскажем о нашем сотрудничестве с Роботом Верой. Эта компания помогает подбирать персонал для тех, кому нужны новые кадры. Частичная (и эффективная) автоматизация процесса рекрутинга не отменяет того, что нужно много звонить. Здесь на помощь Вере приходим мы – на Voximplant компания автоматизирует телефонный дозвон кандидатам.

Хабр, привет. Период отпусков закончился, так что вливаемся в работу. Мы работаем и пишем, вы — читаете и тоже работаете (надеемся, и с нашей помощью тоже). Сегодня хотим поделиться еще одним кейсом – расскажем о нашем сотрудничестве с Роботом Верой. Эта компания помогает подбирать персонал для тех, кому нужны новые кадры. Частичная (и эффективная) автоматизация процесса рекрутинга не отменяет того, что нужно много звонить. Здесь на помощь Вере приходим мы – на Voximplant компания автоматизирует телефонный дозвон кандидатам.Что делает автоматика в HR?

Робот Вера – настоящая помощница hr-менеджера. Начинается все с задания клиента – найти специалиста в определенной сфере, соответствующего ряду критериев (тут ничего необычного – регион, образование, уровень английского, гибкость графика, опыт работы, возраст, пол). Для работы клиентам предоставляется уютный и минималистичный кабинет (понятно, виртуальный), где формируется задание. Как только заказ готов, отдается приказ роботу, и начинается процесс поиска.

Вера (голос женский, имя – тоже, поэтому по тексту ниже — «она») ищет резюме на крупнейших сайтах по работе. Затем она в автоматическом режиме обрабатывает данные по соискателям, чьи анкеты размещены на таких ресурсах.

Обработав базу резюме, Робот Вера приступает к обзвону. Если вызов по какой-то причине не прошел (отключен телефон, занято, сбой сети), то она пытается “достучаться” по другим каналам – например, email. На усмотрение работодателя, письмо может содержать, помимо описания вакансии, ссылку для отклика, ссылку для прохождения видеоинтервью и номер телефона.

Как рассказала нам команда Веры, 50% откликов на вакансии они получают по телефону. Оставшиеся 50 распределяются по остальным каналам привлечения кандидатов — лидогенерирующая страничка в интернете, email. Давайте рассмотрим, как устроен самый эффективный канал в рекрутинге.

Зима Сингулярность близко!

Итак, Вера звонит соискателю. Если на том конце снимают трубку, она представляется и спрашивает, желает ли кандидат на вакансию получить информацию о работе. Если ответ положительный, робот кратко рассказывает об условиях (зарплата, время работы, наличие печенек в буфете) и снова спрашивает, интересна ли эта вакансия собеседнику. Если ответ — снова “да”, то Вера сообщает, что соискателю перезвонит уже менеджер-человек для подробного обсуждения условий. И это лишь один вариант общения по телефону, самый простой. Большой плюс системы в том, что алгоритм “вопрос-ответ” можно изменять, усложнять или упрощать.

Спама, кстати, нет. Если кандидат говорит, что он не ищет работу, звонить не будут.

В процессе звонка задействованы технологии Voximplant. Вера анализирует звонок и предоставляет своим клиентам отчет.

Вся система телефонной связи у робота — это задача Voximplant. При этом компания может делать со звонками все, что захочет: облачные сценарии Voximplant пишутся на JavaScript и любой веб разработчик может сделать сложную телефонию за пару часов. В команде Веры экспериментируют и прикручивают “свой” синтез голоса. Модульность – это всегда хорошо, правда-правда. Добавить или убрать что-то к основной платформе Voximplant может любой программист.

Что касается распознавания голоса Верой, то здесь бывают проблемы, винить в которых нельзя ни нас, ни ее. Практически любая современная система, которая занимается распознаванием речи, не справляется с сильными сторонними шумами. Проезжающие машины, разговоры коллег во время звонка звуки — все это очень мешает. Так что из 100% звонков около 80% оказываются успешными, в 20% наблюдаются проблемы. В случае обнаружения проблемного звонка на помощь приходит email-рассылка.

Положительный момент — это то, что потенциальные кандидаты, которые по какой-то причине не были на связи во время телефонного звонка Веры или не увидели e-mail, могут связаться с ней позже, и работодатель увидит отклик.

И еще один момент (не менее положительный) — при помощи Voximplant наш партнер настроил обработку входящих звонков таким образом, что когда кандидат перезванивает, его номер распознается и Вера говорит ему именно то, что предназначено для этого человека, интересующегося конкретной вакансией.

Очень упрощенный пример кода, как это сделать:

Синтез речи у Веры — свой. При желании клиент может указать роботу общаться с потенциальными соискателями голосом с нейтральными интонациями, есть еще положительная интонация, добрая и радостная.

Кроме Веры сейчас с клиентами работает и робот Захар — то есть, добавлен и мужской голос. У Веры и Захара только голоса разные, суть – одна.

Почему Voximplant, а не Asterisk?

Мы любим, когда все работает, как часы — и без ложной скромности можем сказать, что с Voximplant так все и обстоит. Сотрудничество с Верой продолжается уже несколько месяцев, и за это время у компании не было проблем и сбоев.

Команда робота начала работать с нами уже после того, как интегрировала в свою платформу Asterisk. Почему? Работать он работал, но с платформой часто что-то случалось. Приходилось вызывать специалиста по Asterisk для решения мелких и крупных проблем, включая отсутствие звонков. Проблемы были частым явлением, а специалист мог отсутствовать, заболеть, он мог быть занят. Само собой, простой не нравился клиентам и ухудшал общую эффективность работы. С Voximplant у ребят ничего такого пока не случалось, и мы надеемся, что и не случится. Во всяком случае, мы делаем все для этого.

Вторая причина, которая побудила обратиться к нам — возможность работы с JavaScript. Если возникает проблема, нужно добавить, изменить или убрать что-то, то, не требуется вызывать специалиста откуда-то, все можно сделать своими силами.

Переход с Asterisk осуществлялся поэтапно, чтобы не было ничего вроде «в омут с головой». Сначала ребята добавили звонки из браузера — всего за один вечер был добавлен соответствующий функционал. После того, как эта функция хорошо себя показала, последовали и другие этапы интеграции.

Вера, вперед! Чемпионские результаты робота

Вера (и Захар, да) работают очень эффективно. О процессе их работы дольше писать, чем все происходит в реальности. Обзвон соискателей Верой по заданию конкретного клиента, то есть сформированной в кабинете заявки, выполняется всего за полтора часа. Средняя конверсия поиска кандидатов — 15%. То есть из 100 человек, которых нашел робот, остается 15, которые соответствуют всем критериям и сами заинтересованы в сотрудничестве.

Сейчас робот Вера делает за день в 10 раз больше звонков, чем профессиональный рекрутер. Это подтверждает не только собственный опыт, но и обратная связь от клиентов.

Единовременно Робот обзванивает десятки тысяч человек. В день число звонков достигает 30-50 тысяч. С начала работы Вера провела 2300 интервью с кандидатами на разные позиции, совершила 440000 звонков соискателям, обработала миллионы анкет на работных сайтах.

Об эффективности работы робота можно судить и по результатам, полученным компанией МТС после формирования заказа по поиску сотрудников. Компания получила 5000 откликов за месяц. Вера совершила более 40000 звонков, отправила 37000 сообщений электронной почты, более 100 кандидатов прошли видео-интервью.

В общем и целом, у нас с Верой получился отличный симбиоз технологий, куда входят распознавание голоса, звонки, синтез речи, работа с Big Data и многое другое. Определить, где заканчивается Voximplant и начинается робот, непосвященному человеку реально сложно. И главное — все это работает!

|

Метки: author glagoleva разработка мобильных приложений разработка веб-сайтов программирование javascript блог компании voximplant робозвонок |

«Человек» искусства: способен ли искусственный интеллект творить? |

«Человек» искусства: способен ли искусственный интеллект творить?

Но есть одна сфера, которая традиционно считалась принадлежащей исключительно человеку — творчество. Однако и это утверждение начинают ставить под сомнение. Ли Седоль, проигравший AlphaGo, признался: «Поражение заставило меня засомневаться в человеческой креативности. Когда я увидел, как играет AlphaGo, то усомнился в том, насколько хорошо играю сам». Поэтому в сегодняшнем посте давайте поговорим о том, способны ли роботы ступить на территорию искусства, в пространство креативности, а значит эмоций и восприятия.

/ Flickr / franck injapan / PD

/ Flickr / franck injapan / PDТворчество роботов

Самообучающиеся системы давно начали проверять на креативность. Например, в 1970 году ученые разработали алгоритм, который мог писать прозаические тексты — правда, довольно бессмысленные.

С тех пор нейросети научились рисовать картины, сочинять музыку и стихи, а также придумывать сценарии к фильмам. Яндекс учит нейросети записывать музыкальные альбомы, похожие на альбомы популярных групп, и писать стихи в стиле Егора Летова. Принцип действия всех алгоритмов похож: они анализируют огромный массив произведений искусства, а потом на основе полученных закономерностей «создают» свое творение: картину, музыкальную композицию, роман и т. д.

Творчество нейросетей постепенно институционализируется. Так, в 2016 году впервые прошел конкурс художественных произведений, созданных роботами. В этом году главный приз в 40 тыс. долларов выиграл алгоритм PIX18, придуманный Creative Machines Lab: его похвалили за хороший мазок и умение генерировать произведения на базе фотографий, находящихся в его распоряжении.

Так прокомментировали победу в комитете: «Композиция и работа с кистью напоминает Ван Гога. Интересная палитра». Это выглядит как настоящая критика картины начинающего художника.

Восприятие произведений

Картины, созданные алгоритмом DeepDream от Google, считаются практически искусством — в первую очередь именно потому, что их создал искусственный интеллект.

Однако есть другой важный вопрос — новизна. По этому критерию мы оцениваем и творения художников. Если алгоритмы не срисовывают или не обрабатывают фотографии, а, например, пишут абстрактные картины, могут ли они действительно создать что-то новое?

На этот вопрос попробовали ответить разработчики из Лаборатории искусственного интеллекта и искусства Ратгерского университета, создав генеративно-состязательную сеть (GAN). Ранее алгоритм учился на основе ответов одного дискриминатора: анализировал картины, рисовал свои и сверял результат. Он продуцировал изображения, похожие на те, что изучал до того.

Команда сделала следующий шаг в развитии сети и добавила второй дискриминатор, соревнующийся с первым. Теперь нейросеть анализирует примерно 81 тысячу картин и, опираясь на такую объемную выборку, формирует список условий, при которых созданная картина может быть отнесена к произведениям искусства. Параллельно второй дискриминатор составляет список стилей и проверяет картину на схожесть с ними – проводит операцию по верификации. Новая картина рождается тогда, когда изображение признается произведением искусства, не идентичным ни одному из существовавших ранее стилей.

Кроме того, нейросети уже способны создавать мульфильмы. Компьютерная программа The Painting Fool, разработанная Саймоном Колтоном (Simon Colton) из Имперского колледжа Лондона, смогла сплести нарисованные ею же изображения в видеоряд.

Система адаптирует специальные решения для автоматизированного создания коллажей, симулируя мазки кисти на холсте. ПО в состоянии имитировать техники рисования, для чего используются возможности многоядерных процессоров — каждый поток контролирует отдельную кисть. Это позволяет «смешивать» кисти в непредсказуемых комбинациях, что приводит к более правдоподобному эффекту.

Сам процесс рисования – например, портрета – начинается с разметки областей заинтересованности: глаз, рта, бровей и т. д. Для каждого «региона» программа сегментирует изображение методом neighbourhood-growing и обосновывает границы. Затем The Painting Fool занимается окраской каждого сегмента. Он может «рисовать» карандашами, пастелью, акварелью и мелками, учитывая освещенность, условия среды.

И The Painting Fool — лишь показательный пример, только один представитель «компьютеров искусства». Причем их количество постоянно увеличивается. Одному роботу удалось настолько очаровать аудиторию музыкальной композицией, что они решили, будто её написал человек. А короткий роман, написанный японским роботом, чуть не выиграл литературную премию.

Это подводит нас к важному вопросу — проблеме рецепции искусства смотрящим. Существует ли разница между нашим восприятием произведения, созданного человеком, и тем, что «сгенерировано» роботом? В интернете есть сайт Bot or Not, предлагающий угадать, кто написал то или иное стихотворение — бот или человек. Ответ не всегда очевиден. Это неоднозначная территория.

На сайте Bot or Not есть стихотворения, написанные роботами – при том, что люди отнесли их к авторству человека. Соответственно, можно считать, что эти алгоритмы прошли тест Тьюринга для поэзии. Компьютер должен убедить 30% людей в своей «человечности», чтобы пройти тест. Но писатель Оскар Шварц, создатель Bot or Not, отмечает что это игра не в одни ворота: мы не только можем перепутать написанное ботом с работой человека, но и наоборот — принимаем творчество людей за творчество роботов. Возникает смешение уровней, новое понимание текстов и смыслов, где стирается грань между иллюзией и аутентичностью в привычном нам виде.

Творчество — это эмоциональное воздействие